数据集-鉴黄

前方高能预警,非战斗人士请火速撤离……

数据集1:https://github.com/EBazarov/nsfw_data_source_urls/tree/master/raw_data

在 raw_data 文件夹里,可以找到不同的 .txt 格式的文档,每个文档都含有一组 URL,以下是关于该数据集的一些统计信息:

159个 不同的类别

158.9331 万个 URL

下载并清洗后大约有 500GB,或者说有 130 万张 NSFW 图像

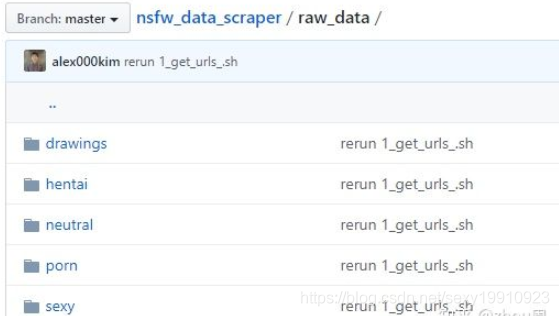

数据集2:https://github.com/alex000kim/nsfw_data_scraper

主要五大类

比较成熟的模型:

项目1:

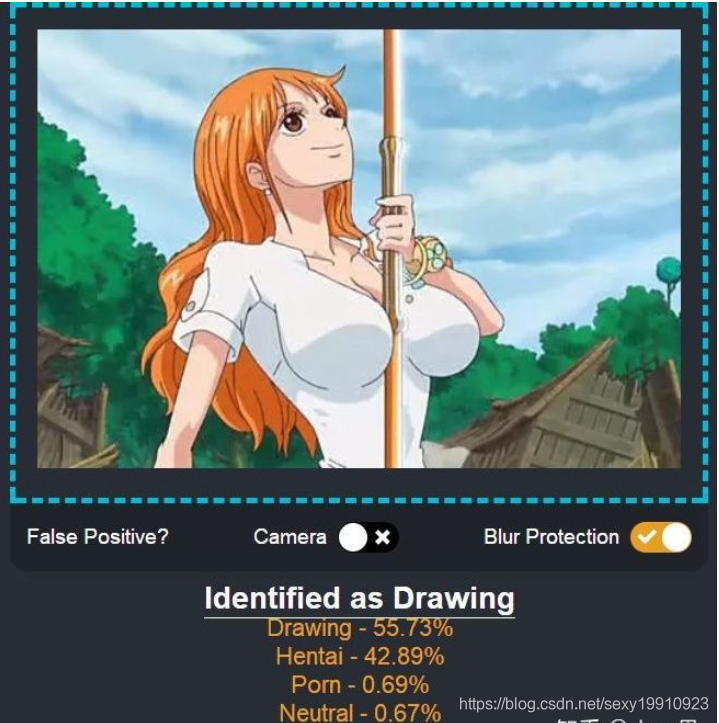

项目地址:https://github.com/infinitered/nsfwjs

网页测试地址:https://nsfwjs.com/

该模型主要包括五大标签:

绘画(Drawing):无害的艺术,或艺术绘画。

变态(Hentai):色情艺术,不适合大多数工作环境下观看。

中立(Neutral):一般,无害的内容。

色情(Porn):不雅的内容和行为,通常涉及生殖器。

性感(Sexy):不合时宜的挑衅内容。

项目2:

项目地址 :https://github.com/devzwy/open_nsfw_android

该项目支持色情图片离线识别(离线鉴黄),基于TensorFlow实现。识别只需200ms,可断网测试,成功率99%,调用只要一行代码,从雅虎的开源项目open_nsfw移植,tflite(6M)为训练好的模型(已量化),该模型文件可用于iOS、java、C++等平台,Python使用生成的tfLite文件检测图片的速度远远快于实用原模型。

项目3:

项目地址:https://github.com/yahoo/open_nsfw

项目更多介绍:https://yahooeng.tumblr.com/post/151148689421/open-sourcing-a-deep-learning-solution-for

该项目是由雅虎开源,自动识别图像(包括令人讨厌的图像和成人图像)不适合(SFW)/不适合工作(NSFW)。雅虎建议大家在使用时选择自己的阈值,因为应用场景和对 NSFW 标准的理解可能会有差异,所以开发人员最好根据自己应用对 NSFW 的定义来设定评估值。

关于更多视频/图片鉴黄有哪些算法和开源库参考:

1.视频/图片鉴黄开源库

2.图像鉴黄算法综述

本文来自博客园,作者:海_纳百川,转载请注明原文链接:https://www.cnblogs.com/chentiao/p/16381595.html,如有侵权联系删除

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律