手势识别

手势识别是计算机科学和语言技术中的一个主题,其目标是通过数学算法解释人类手势。手势可以源自任何身体运动或状态,但通常源自面部或手部。该领域的当前焦点包括来自面部的情绪识别和手势识别。用户可以使用简单的手势来控制设备或与设备交互,而无需实际触摸它们。已经使用相机和计算机视觉算法来解释手语的许多方法。然而,姿势,步态,代理和人类行为的识别和识别也是姿势识别技术的主题。[1] 手势识别可以被视为计算机开始理解人体语言的一种方式,从而在机器和人类之间建立一个比原始文本用户界面甚至GUI(图形用户界面)更丰富的桥梁,这仍然限制了大部分输入键盘和鼠标,无需任何机械设备即可自然交互。使用手势识别的概念,可以指向此处的手指将相应地移动。这可以使设备上的传统输入成为可能,甚至是冗余的。

内容

概述[ 编辑]

手势识别功能:

- 更准确的

- 稳定性高

- 解锁设备可节省时间

当前场景中手势识别的主要应用领域是:

手势识别技术被认为是非常成功的技术,因为它节省了解锁任何设备的时间。

该文献包括计算机视觉领域中正在进行的关于通过连接到计算机的相机捕获手势或更一般的人体姿势和运动的工作。[5] [6] [7] [8]

手势识别和笔计算: 笔式计算减少了系统的硬件影响,并且还增加了可用于控制的物理世界对象的范围,超越了传统的数字对象,如键盘和鼠标。这样的实现可以实现不需要监视器的新范围的硬件。这个想法可能会导致全息显示的创建。术语手势识别已被用于更狭义地指代非文本输入手写符号,例如在图形输入板上着墨,多点触摸手势和鼠标手势识别。这是通过使用指点设备光标绘制符号的计算机交互。[9] [10] [11](参见笔计算)

手势类型[ 编辑]

在计算机界面中,区分了两种类型的手势:[12]我们考虑在线手势,这也可以被视为直接操作,如缩放和旋转。相反,离线手势通常在交互完成后处理; 例如,绘制一个圆圈以激活上下文菜单。

- 脱机手势:用户与对象交互后处理的手势。一个例子是激活菜单的手势。

- 在线手势:直接操纵手势。它们用于缩放或旋转有形物体。

非接触式界面[ 编辑]

无接触用户界面是与手势控制相关的新兴技术。无接触用户界面(TUI)是通过身体动作和手势命令计算机而不触摸键盘,鼠标或屏幕的过程。[13]例如,微软的Kinect是一款非接触式游戏界面; 然而,诸如Wii之类的产品并不被认为是完全无触摸的,因为它们与控制器程序代写接单群733065427相连。除了手势控制之外,非接触式界面正变得广泛流行,因为它们提供了与设备交互而无需物理触摸它们的能力。

非接触式技术的类型[ 编辑]

有许多设备利用这种类型的接口,例如智能手机,笔记本电脑,游戏和电视。虽然非接触式技术主要出现在游戏软件中,但现在人们对其他领域,包括汽车和医疗保健行业感兴趣。即将到来,无声技术和手势控制将在语音识别之外的汽车中实施。参见BMW 7系列。

非接触式技术的未来[ 编辑]

世界上已有许多公司正在制作手势识别技术,例如:[14]

英特尔公司[ 编辑]

白皮书:探索英特尔的用户体验研究,该研究展示了无接触式多因素身份验证(MFA)如何帮助医疗机构降低安全风险,同时提高临床医生的效率,便利性和患者护理。这种非接触式MFA解决方案结合了面部识别和设备识别功能,可实现双因素用户身份验证。[15]

微软公司在美国[ 编辑]

该项目的目的是探索在外科手术设置中使用非接触式交互,通过使用基于摄像头的手势识别技术,无需接触即可查看,控制和操纵图像。特别是,该项目旨在了解这些环境对这些系统的设计和部署所面临的挑战,并阐明这些技术可能改变手术实践的方式。虽然我们的主要关注点是保持无菌状态,但使用这些无触摸手势技术可提供其他潜在用途。[16]

椭圆实验室[ 编辑]

Elliptic Labs软件套件通过重复使用以前仅用于音频的现有耳机和麦克风,提供手势和接近功能。从集成在智能手机和平板电脑中的扬声器通过空气发送的超声信号反弹到手/物体/头部,并由麦克风记录,麦克风也集成在这些设备中。通过这种方式,Elliptic Labs的技术可识别您的手势,并使用它们在屏幕上移动物体,类似于蝙蝠使用回声定位进行导航的方式。[17]

虽然这些公司在这个时代处于未来非接触式技术的最前沿,但目前还有许多其他公司和产品趋势,也可能为这一新领域增加价值。以下是一些例子:

Airwriting:允许在空中书写信息和文本的技术[18]

eyeSight:允许在不亲自触摸设备的情况下导航屏幕

Leap Motion:运动传感器设备

Myoelectric Armband:允许蓝牙设备通信[19]

输入设备[ 编辑]

通过各种工具可以实现跟踪人的动作并确定他们可能正在执行的手势的能力。动态用户界面(KUI)[20]是一种新兴的用户界面类型,允许用户通过对象和物体的运动与计算设备进行交互。KUI的示例包括有形用户界面和动作感知游戏,例如Wii和Microsoft的Kinect,以及其他交互式项目。[21]

尽管在基于图像/视频的手势识别方面进行了大量研究,但在实现之间使用的工具和环境中存在一些变化。

- 有线手套。这些可以使用磁性或惯性跟踪装置向计算机提供关于手的位置和旋转的输入。此外,一些手套可以高精度(5-10度)检测手指弯曲,或者甚至向用户提供触觉反馈,这是触觉的模拟。第一款商用手持式手套式设备是DataGlove,[22]一种手套式设备,可以检测手的位置,移动和手指弯曲。这使用沿着手背向下延伸的光纤电缆。产生光脉冲并且当手指弯曲时,光通过小裂缝泄漏并且记录损失,给出手姿势的近似值。

- 深度感知相机。使用结构光或飞行时间相机等专用相机,可以生成短距离通过相机看到的内容的深度图,并使用此数据近似显示所看到内容的3d表示。由于它们的短距离能力,这些可以有效地检测手势。[23]

- 立体相机。使用彼此关系已知的两个相机,可以通过相机的输出来近似3d表示。为了获得相机的关系,可以使用定位参考,例如lexian-stripe或红外发射器。[24]结合直接运动测量(6D-Vision)可以直接检测手势。

- 基于手势的控制器。这些控制器充当身体的延伸部分,以便在执行手势时,可以通过软件方便地捕获他们的一些动作。新兴的基于姿势的动作捕捉的一个示例是通过骨骼手跟踪,其正在为虚拟现实和增强现实应用而开发。跟踪公司uSens和Gestigon展示了这项技术的一个例子,它允许用户在没有控制器的情况下与周围环境进行交互。[25] [26]

另一个例子是鼠标手势跟踪,其中鼠标的运动与人手绘制的符号相关,如Wii Remote或Myo臂带或mForce Wizard腕带,它可以研究加速度随时间的变化表示手势。[27] [28] [29] LG电子魔术棒,Loop和Scoop等设备使用Hillcrest Labs的Freespace技术,该技术使用MEMS加速度计,陀螺仪和其他传感器将手势转换为光标移动。该软件还可以补偿人体震颤和无意中的移动。[30] [31] [32] AudioCubes是另一个例子。这些智能发光立方体的传感器可用于感测手和手指以及附近的其他物体,并且可用于处理数据。大多数应用都是音乐和声音合成,[33]但可以应用于其他领域。

- 单摄像头。标准2D相机可以用于手势识别,其中资源/环境对于其他形式的基于图像的识别不方便。早些时候人们认为单个相机可能不如立体声或深度感知相机那么有效,但一些公司正在挑战这一理论。基于软件的手势识别技术,使用可以检测稳健手势的标准2D相机。

- 雷达。请参阅2015年谷歌I / O上透露的Project Soli。从13:30开始,Google I / O 2015 - 一点点坏蛋。美丽。科技与人类。工作和爱。ATAP。- YouTube和简短介绍视频,欢迎使用Project Soli - YouTube

算法[ 编辑]

根据输入数据的类型,可以以不同方式完成解释手势的方法。然而,大多数技术依赖于3D坐标系中表示的关键指针。基于这些的相对运动,可以高精度地检测手势,这取决于输入的质量和算法的方法。

为了解释身体的运动,必须根据共同属性和运动可能表达的信息对它们进行分类。例如,在手语中,每个手势代表一个单词或短语。Quek在“走向基于视觉的手势界面”中提出了似乎非常适合人机交互的分类法。[34] 他提出了几个交互式手势系统,以捕捉手势的整个空间:

- 手法

- 信号灯

- 对话的

一些文献区分了手势识别中的两种不同方法:基于3D模型和基于外观。[35]所述的首要方法使得以获得几个重要参数,像手掌的位置或关节角度使用的身体部分的键元件的3D信息。另一方面,基于外观的系统使用图像或视频进行直接解释。

基于3D模型的算法[ 编辑]

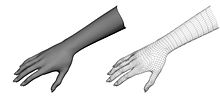

3D模型方法可以使用体积或骨架模型,甚至是两者的组合。容量方法已经大量用于计算机动画行业和计算机视觉目的。模型通常是从复杂的3D表面创建的,如NURBS或多边形网格。

该方法的缺点是计算量很大,并且还需要开发用于实时分析的系统。目前,一种更有趣的方法是将简单的原始物体映射到人体最重要的身体部位(例如手臂和颈部的圆柱体,头部的球体)并分析它们相互作用的方式。此外,一些抽象结构,如超级二次曲面和广义圆柱体可能更适合近似身体部位。这种方法的令人兴奋的事情是这些对象的参数非常简单。为了更好地建模这些关系,我们在对象之间使用约束和层次结构。

基于骨骼的算法[ 编辑]

可以使用关节角度参数的简化版本以及段长度,而不是使用3D模型的密集处理和处理大量参数。这被称为身体的骨架表示,其中计算人的虚拟骨架并且身体的部分被映射到某些片段。这里的分析是使用这些段的位置和方向以及它们中的每一个之间的关系(例如,关节之间的角度和相对位置或方向)来完成的。

使用骨架模型的优点:

- 算法更快,因为只分析关键参数。

- 可以对模板数据库进行模式匹配

- 使用关键点可使检测程序专注于身体的重要部位

基于外观的模型[ 编辑]

这些模型不再使用身体的空间表示,因为它们使用模板数据库直接从图像或视频中导出参数。一些是基于身体人体部位的可变形2D模板,特别是手。可变形模板是对象轮廓上的点集,用作对象轮廓近似的插值节点。最简单的插值函数之一是线性,它从点集,点可变性参数和外部变形器执行平均形状。这些基于模板的模型主要用于手部跟踪,但也可用于简单的手势分类。

使用基于外观的模型的手势检测中的第二种方法使用图像序列作为手势模板。此方法的参数是图像本身,或从这些图像派生的某些特征。大多数时候,仅使用一个(单视场)或两个(立体)视图。

挑战[ 编辑]

手势识别软件的准确性和实用性存在许多挑战。对于基于图像的手势识别,使用的设备和图像噪声存在限制。图像或视频可能不在一致的光照下,也可能在同一位置。背景中的项目或用户的不同特征可能使识别更加困难。

基于图像的手势识别的各种实现也可能导致技术对于一般使用的可行性的问题。例如,针对一个相机校准的算法可能不适用于不同的相机。背景噪声的量也会导致跟踪和识别困难,尤其是在发生遮挡(部分和全部)时。此外,与相机的距离以及相机的分辨率和质量也会导致识别准确度的变化。

为了通过视觉传感器捕获人类手势,还需要强大的计算机视觉方法,例如用于手部跟踪和手势识别[36] [37] [38] [39] [40] [41] [42] [43 ] ] [44]或用于捕捉头部,面部表情或凝视方向的运动。

社会可接受性[ 编辑]

在消费者移动设备(如智能手机和智能手表)上采用手势界面的一个重大挑战源于手势输入的社会可接受性含义。虽然手势可以促进许多新颖的外形计算机上的快速和准确的输入,但它们的采用和有用性通常受到社会因素而非技术因素的限制。为此,手势输入方法的设计者可以寻求平衡技术考虑因素和用户在不同社交环境中执行手势的意愿。[45]此外,不同的设备的硬件和感测机构支持不同类型识别手势。

移动设备[ 编辑]

移动和小型设备上的手势接口通常由运动传感器(例如惯性测量单元)的存在支持(惯性测量单元)。在这些设备上,手势感测依赖于用户执行能够被这些运动传感器识别的基于运动的手势。这可能潜在地使来自微妙或低运动姿势的捕获信号具有挑战性,因为它们可能变得难以与自然运动或噪声区分开。通过对手势可用性的调查和研究,研究人员发现,包含微妙运动的手势(看起来与现有技术类似)看起来或感觉与每个动作相似,并且令人愉快的手势更可能被用户接受,而手势则看起来奇怪,执行不舒服,干扰沟通,或涉及不常见的移动导致用户更有可能拒绝他们的使用。[45] 移动设备手势的社交可接受性在很大程度上依赖于手势和社交背景的自然性。

体上和可穿戴计算机[ 编辑]

可穿戴计算机通常与传统移动设备的不同之处在于它们的使用和交互位置发生在用户的身体上。在这些上下文中,手势界面可能变得优于传统输入方法,因为它们的小尺寸使得触摸屏或键盘不那么吸引人。然而,当涉及手势交互时,它们与移动设备有许多相同的社会可接受障碍。然而,可穿戴计算机隐藏在视线之外或集成在其他日常物品(例如衣服)中的可能性允许手势输入以模仿常见的服装交互,例如调整衬衫领或摩擦前面的裤子口袋。[46] [47]可穿戴计算机交互的主要考虑因素是设备放置和交互的位置。一项研究探讨了美国和韩国对可穿戴设备互动的第三方态度,发现男性和女性对可穿戴计算使用的看法存在差异,部分原因是身体的不同区域被认为是社会敏感的。[47]另一项调查身体投射界面的社会可接受性的研究发现了类似的结果,两项研究都标明腰部,腹股沟和上半身(女性)周围的区域是最不可接受的,而前臂和手腕周围的区域是最可接受的。[48]

公共设施[ 编辑]

公共安装(例如交互式公共显示)允许在公共场所(例如博物馆,画廊和剧院)中访问信息和显示交互式媒体。[49]虽然触摸屏是用于公共显示输入的常见形式中,手势接口提供额外的益处,例如改进的卫生,相互作用从远处,改进的发现性,并且可能有利于表演相互作用。[46]手势与公共展示互动的一个重要考虑因素是观众的高概率或期望。因此,手势设计不仅应考虑用户自己的体验,还应考虑观众的体验。[49]

“大猩猩手臂” [ 编辑]

“大猩猩手臂”是垂直定向触摸屏或光笔使用的副作用。在长期使用期间,使用者的手臂开始感到疲劳和/或不适。尽管在20世纪80年代初期普及,但这种效应导致了触摸屏输入的下降。[50] [51]