长文本摘要模型的位置编码

Longformer

Roberta使用绝对位置编码,最大512.为了能够适应更长的文本,Longformer添加到4096。为了利用Roberta的预训练后的权重,多次复制512位置编码。

做了实验,对比随机初始化位置编码和复制位置编码,显示出复制位置编码的重要性。

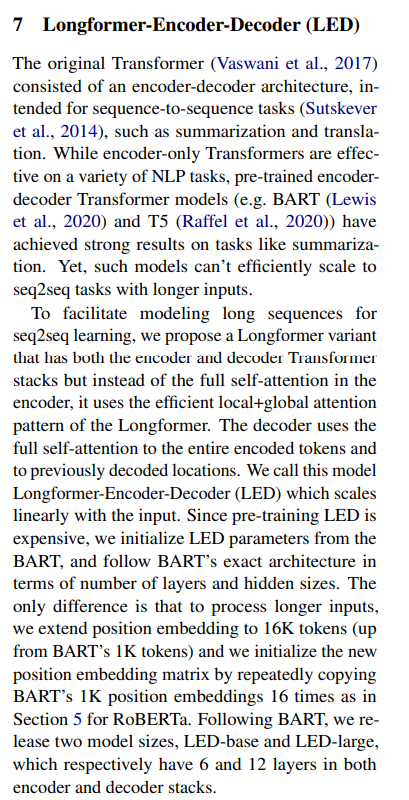

扩展BART的1K tokens到16K tokens。初始化位置编码矩阵通过复制BART的1K位置编码16次。

除此之外,还做了相对位置编码的实验

BART_LS

Roberta使用绝对位置编码,最大512.为了能够适应更长的文本,Longformer添加到4096。为了利用Roberta的预训练后的权重,多次复制512位置编码。

做了实验,对比随机初始化位置编码和复制位置编码,显示出复制位置编码的重要性。

扩展BART的1K tokens到16K tokens。初始化位置编码矩阵通过复制BART的1K位置编码16次。

除此之外,还做了相对位置编码的实验