反向传播过程中不可导情况处理

参考这篇文章:

https://blog.csdn.net/weixin_42720875/article/details/105936398

《神经网络反向求导不可导情况处理》

写的蛮好,主要写了Relu函数、平均池化、最大池化的处理方式。

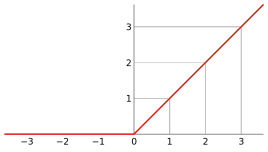

Relu函数

次梯度方法(subgradient method)是传统的梯度下降方法的拓展,用来处理不可导的凸函数。它的优势是比传统方法处理问题范围大,劣势是算法收敛速度慢。但是,由于它对不可导函数有很好的处理方法,所以学习它还是很有必要的。

对于relu函数,当x>0时,导数为1,当x<0时导数为0。因此relu函数在x=0的次梯度c ∈ [ 0 , 1 ] c\in[0,1]c∈[0,1],c可以取[0,1]之间的任意值。

池化不可导

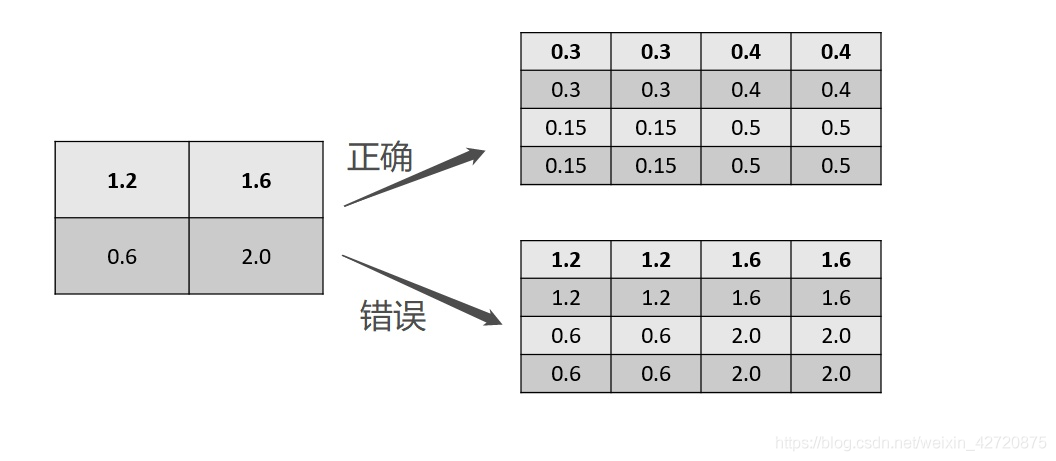

平均池

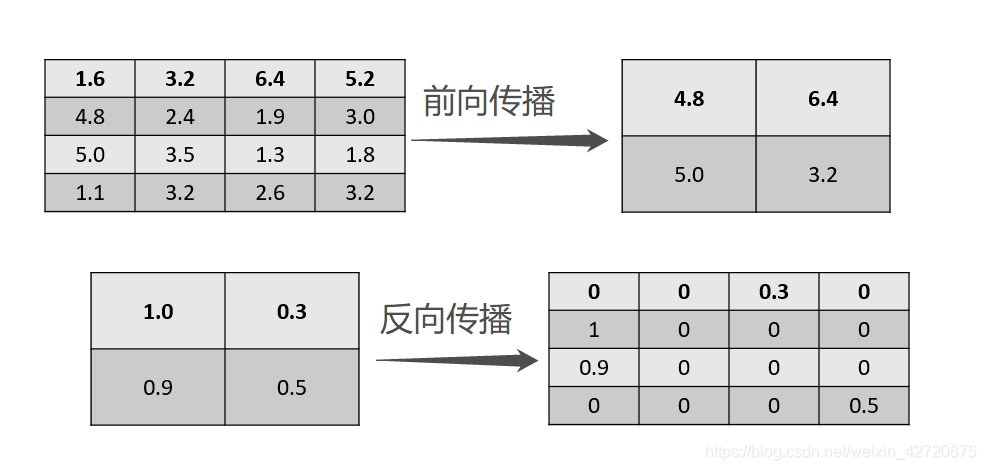

最大池化

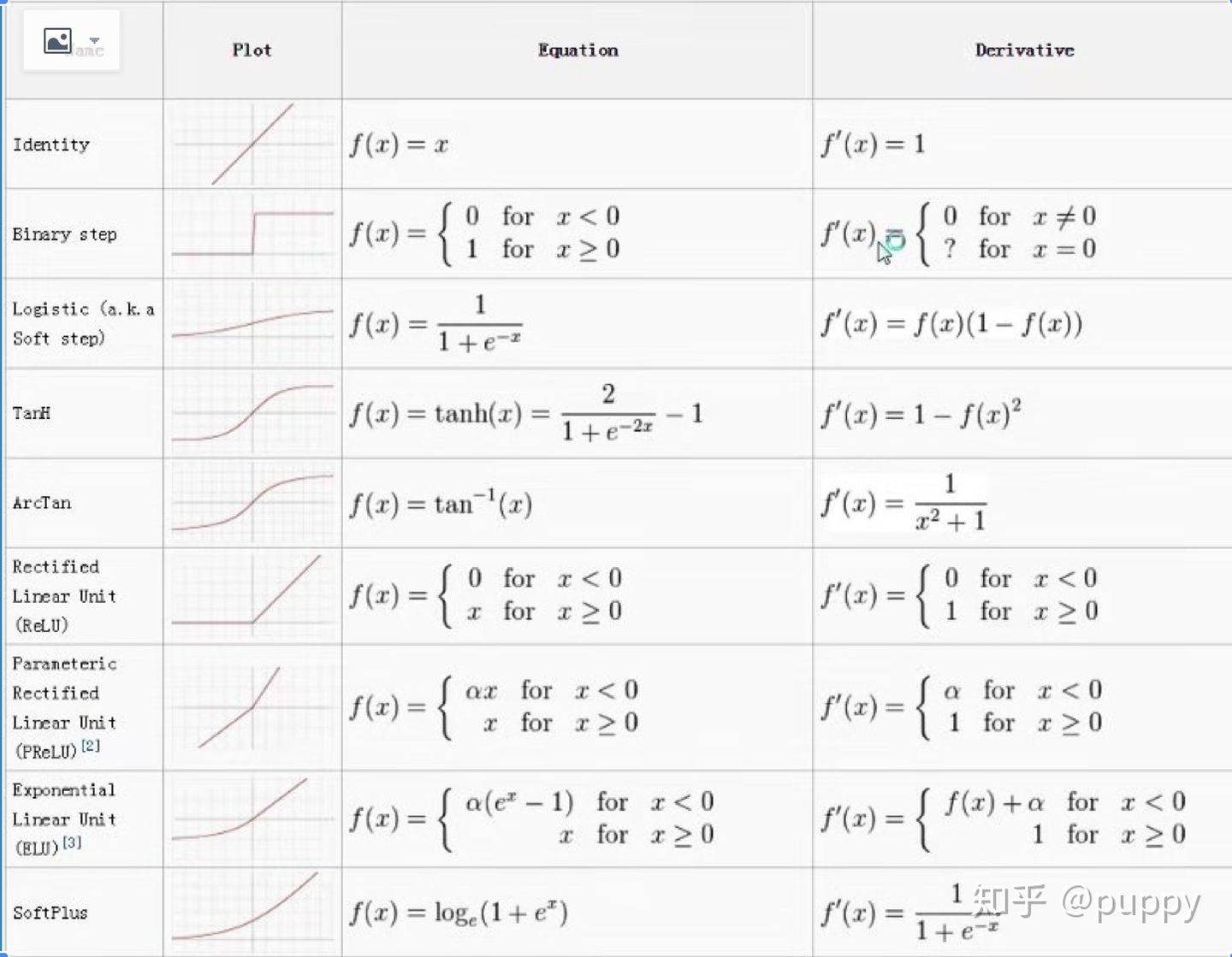

下面还有一张图是一些常见激活函数的导数结果,可以简单看看。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!

2019-02-22 识别疑问句的训练

2019-02-22 准备参考这个做个tf-serving

2018-02-22 推荐-离线评估指标-设计 - F-Score, AUC,NDCG,MAP等等 - 目标不可微很难优化 - NDCG连续MAP离散 - 弱泛化和强泛化 - 冷启动 - 训练测试集拆分的好办法

2018-02-22 矩阵相乘 与 行列变换

2018-02-22 SVM和SVC的学习

2018-02-22 标准化- 正则化 等数据处理 sklearn来支持

2018-02-22 从mofa上面学习sklearn - 通用流程,标准化,learning_curve,validation_curve