encoder-decoder读书摘要

文本生成相关文章,还不错,看一下

《文本生成系列之encoder-decoder》

https://mp.weixin.qq.com/s/ZSf5XUfq3LyjUtai2XVyAQ

文本生成是自然语言处理领域一种常见的任务,它实现了从源文本到目标文本之间的转换。

应用于包括机器翻译(Machine Translation),文本简化(Text Simplification),文本摘要(Document Summarization)等更具体的场景,在不同具体的场景可能有所差异,但是底层的技术基本共通。

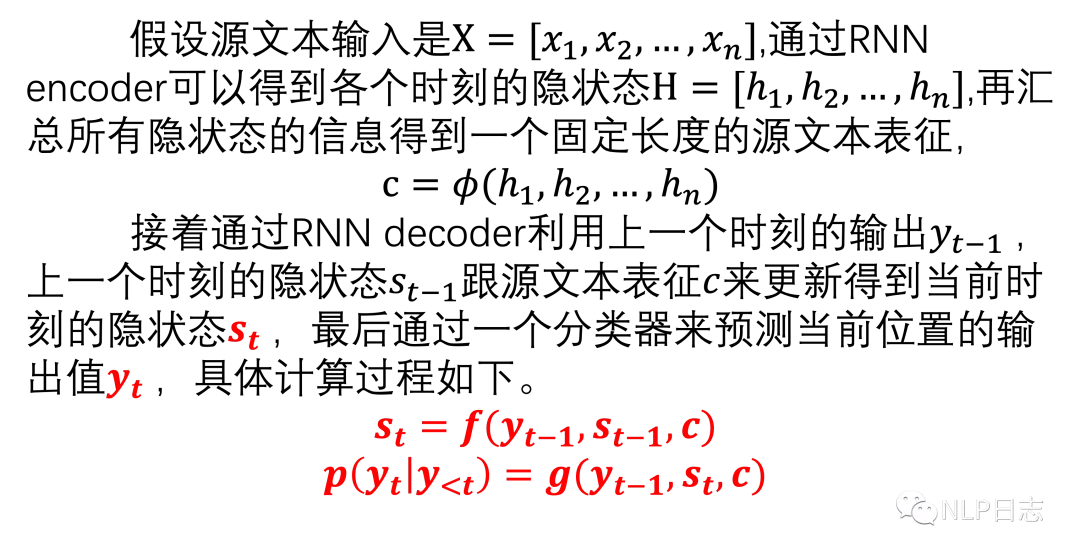

文本生成的模型结构有多种形式,本文主要介绍其中的encoder-decoder这种架构的,通过一个encoder对源文本进行编码,然后再通过一个decoder按顺序进行预测输出。

在实际应用中发现用LSTM或者GRU来替代RNN作为encoder或者decoder效果会更好,也可以使用attention机制来动态更新每个时刻的源文本表征。

T5

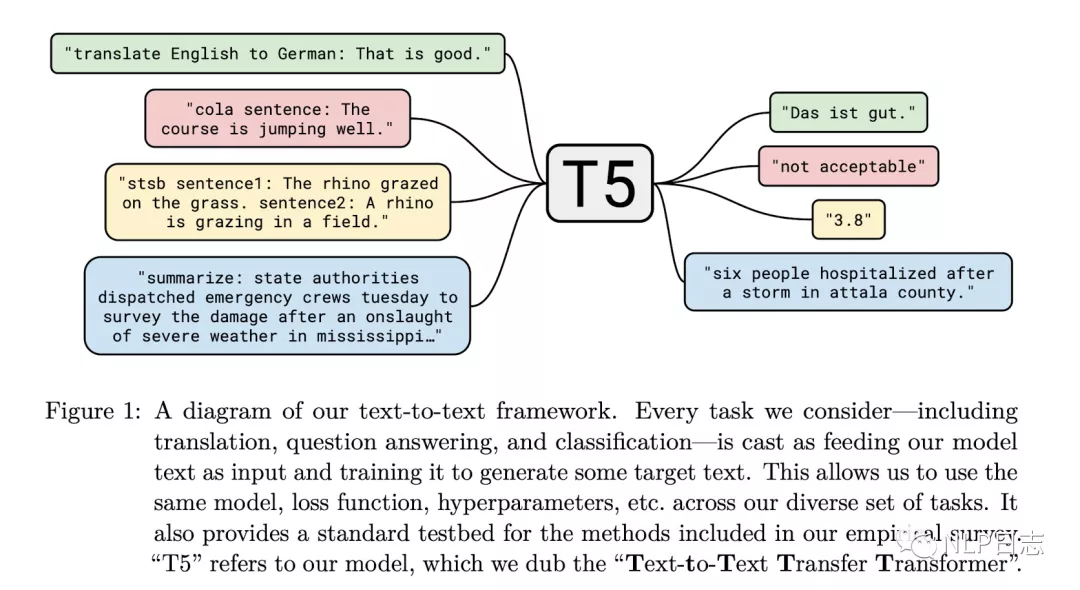

T5相信大家多多少少都曾听过它的名字,它在模型结构上并没有多少创新,更多是是给整个NLP预训练模型领域提供一个通用的框架,把所有NLP的任务都转化成文本到文本的格式中去。无论是分类模型,还是回归等等各种任务,统统转化为文本生成任务。

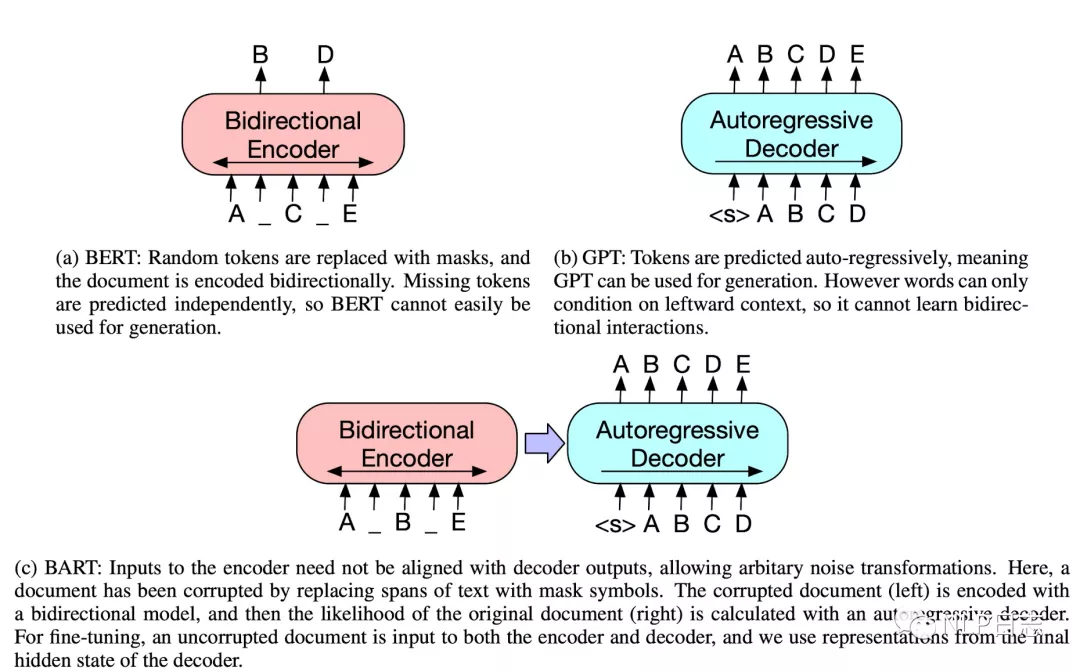

3.4 Bart

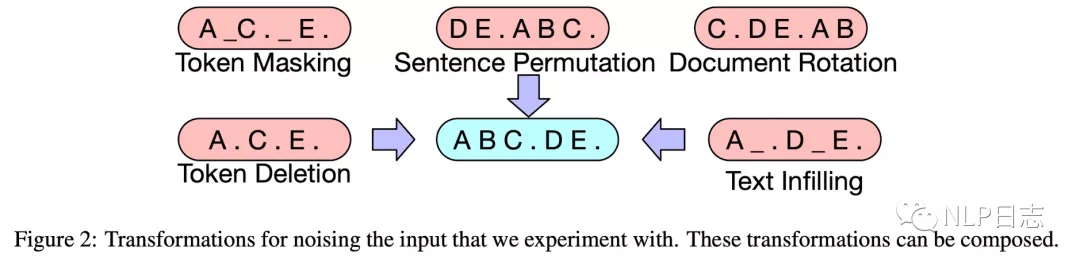

除了模型结构外,论文作者尝试了多种损坏文本的方式,包括Token Masking(随机选取token进行Mask), Token Deletion(随机删除token),Sentence Permutation(随机调整句子之间的顺序),Document Rotation(随机以某个token翻转顺序),Text Infilling(随机将一个片段替换为Mask),最后发现使用Sentence Permutation跟Text Infilling效果最好。

浙公网安备 33010602011771号

浙公网安备 33010602011771号