学习率和训练过程的关系

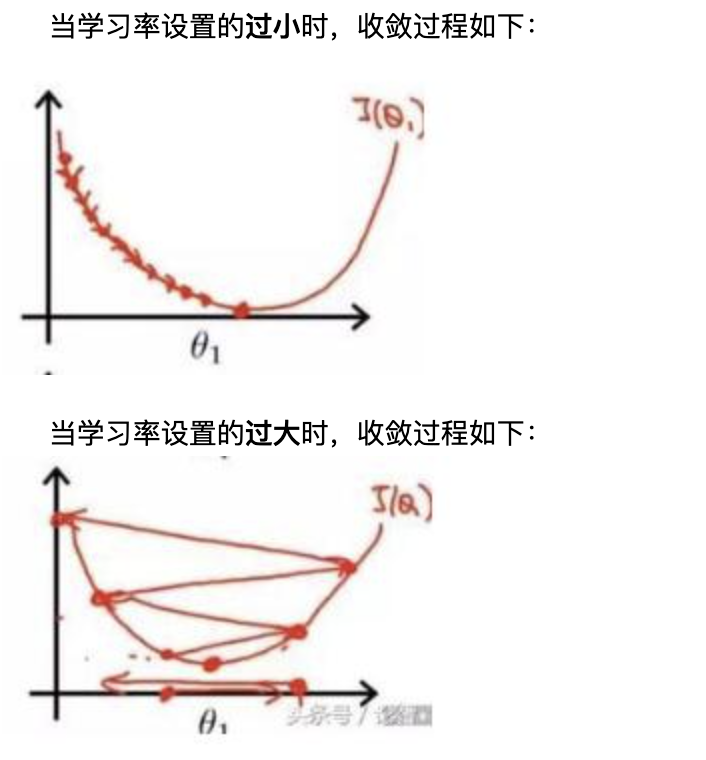

这张图比较直观

当学习率设置的过小时,收敛过程将变得十分缓慢。而当学习率设置的过大时,梯度可能会在最小值附近来回震荡,甚至可能无法收敛。

下面来了解一些学习率调整的方法。

2.1 离散下降(discrete staircase)

对于深度学习来说,每 𝑡t 轮学习,学习率减半。对于监督学习来说,初始设置一个较大的学习率,然后随着迭代次数的增加,减小学习率。

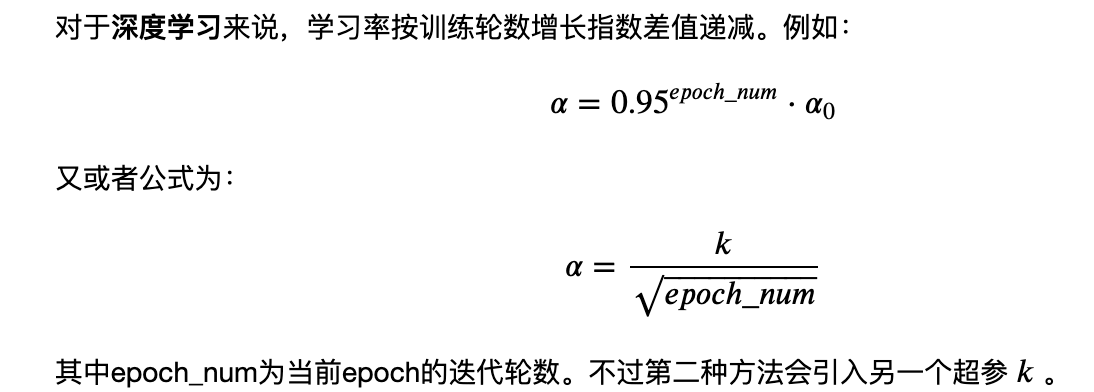

2.2 指数减缓(exponential decay)

2.3 分数减缓(1/t decay)

参考这篇文章:

https://www.cnblogs.com/lliuye/p/9471231.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2018-02-14 好题 - 剑指Offer - 把数组排成最小的数

2018-02-14 剑指Offer - 平衡二叉树

2017-02-14 我写的快排程序

2017-02-14 快速排序、查第k大

2017-02-14 手写一些题目

2017-02-14 非常好的数据挖掘面经

2017-02-14 数据库第一二三范式复习