环境规划:

系统:centos 7.6

重要的组件:

k8s 版本:1.14.3 https://dl.k8s.io/v1.14.3/kubernetes-server-linux-amd64.tar.gz

etcd:3.3.11 参考文档:https://www.cnblogs.com/centos-python/articles/11044019.html

flanneld: 0.11.0 参考文档:https://www.cnblogs.com/centos-python/articles/11044504.html (这个不是必须的,选择安装)

k8s-master1,etcd 10.211.55.11

k8s-master2,etcd 10.211.55.12

k8s-master3,etcd 10.211.55.13

高可用组件(都是系统自带的版本,当然可用通过源码安装最新的版本)

haproxy yum install haproxy -y

keepalived yum install keepalived -y

vip 10.211.55.8

还有docker安装等等优化操作这里也不介绍了,可以参考本人前面通过kubeadmin 安装k8s 的优化配置一遍

这里提示一下,

对以上软件不熟悉的同学,自行学习一下,这边不细节讲了

接下来进入正式的安装过程

官网提供的安装脚本,可以参考一下

https://github.com/kubernetes/kubernetes/tree/release-1.14/cluster/centos

还有证书这块,务必在安装之前参考一下我写的:https://www.cnblogs.com/centos-python/articles/11043570.html

按要求生成所需要的证书,分别拷贝到3台节点上面

我这边规划到/etc/ssl/kubernetes/下面去了

admin-key.pem

admin.pem

ca-key.pem

ca.pem

kube-proxy-key.pem

kube-proxy.pem

kubernetes-key.pem

kubernetes.pem

kube-controller-manager-key.pem

kube-controller-manager.pem

kube-scheduler-key.pem

kube-scheduler.pem

配置Kubernetes master集群

kubernetes master 节点包含的组件:

- kube-apiserver

- kube-scheduler

- kube-controller-manager

目前这三个组件需要部署在同一台机器上

kube-scheduler kube-controller-manager 和 kube-apiserver 三者的功能紧密相关;

同时只能有一个 kube-scheduler kube-controller-manager 进程处于工作状态,如果运行多个,则需要通过选举产生一个 leader

所以,我们这边只需要对kube-apiserver做高可用就可用了

部署kubectl命令工具

wget https://dl.k8s.io/v1.14.3/kubernetes-server-linux-amd64.tar.gz(到网上查下看有分享到云盘里面的包吗,默认访问不到这个地址,需要FQ)

解压以后包的结构

[root@k8s-master1 kubernetes]# tree

.

├── addons

├── kubernetes-src.tar.gz

├── LICENSES

└── server

└── bin

├── apiextensions-apiserver

├── cloud-controller-manager

├── cloud-controller-manager.docker_tag

├── cloud-controller-manager.tar

├── hyperkube

├── kubeadm

├── kube-apiserver

├── kube-apiserver.docker_tag

├── kube-apiserver.tar

├── kube-controller-manager

├── kube-controller-manager.docker_tag

├── kube-controller-manager.tar

├── kubectl

├── kubelet

├── kube-proxy

├── kube-proxy.docker_tag

├── kube-proxy.tar

├── kube-scheduler

├── kube-scheduler.docker_tag

├── kube-scheduler.tar

└── mounter

这里我们把需要用到的组件都拷贝到/usr/bin/ (当然可用创建自己定义的目录,做环境变量,我这里是为了方便)

cp kube-apiserver kube-scheduler kube-controller-manager kubectl /usr/bin/ #同理在scp 到其他节点/usr/bin/

因为我们是高可用集群的API-server所以,默认不监听非安全端口8080,所以需要客户端或者其他组件通过安全端口访问 通过安全端口访问 kube-apiserver,

则必须先通过 TLS 证书认证,再通过 RBAC 授权;kube-proxy kubelet 通过在使用的证书里指定相关的 User Group 来达到通过 RBAC 授权的的;

kubectl 默认从 ~/.kube/config 文件读取 kube-apiserver 地址、证书、用户名等信息,如果没有配置,执行 kubectl 命令时可能会出错。

~/.kube/config只需要部署一次,然后拷贝到其他的master。

创建~/.kube/config文件

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/ssl/kubernetes/ca.pem \

--embed-certs=true \

--server=https://10.211.55.8:8443 \

--kubeconfig=kubectl.kubeconfig

cd /etc/ssl/kubernetes/

# 设置客户端认证参数

kubectl config set-credentials admin \

--client-certificate=admin.pem \

--client-key=admin-key.pem \

--embed-certs=true \

--kubeconfig=kubectl.kubeconfig

# 设置上下文参数

kubectl config set-context kubernetes \

--cluster=kubernetes \

--user=admin \

--kubeconfig=kubectl.kubeconfig

# 设置默认上下文

kubectl config use-context kubernetes --kubeconfig=kubectl.kubeconfig

分发~/.kube/config文件

cp kubectl.kubeconfig ~/.kube/config #同理在scp 到另外两台节点,

部署api-server

1.创建kube-apiserver配置文件和system启动脚本文件

mkdir /etc/kubernetes/

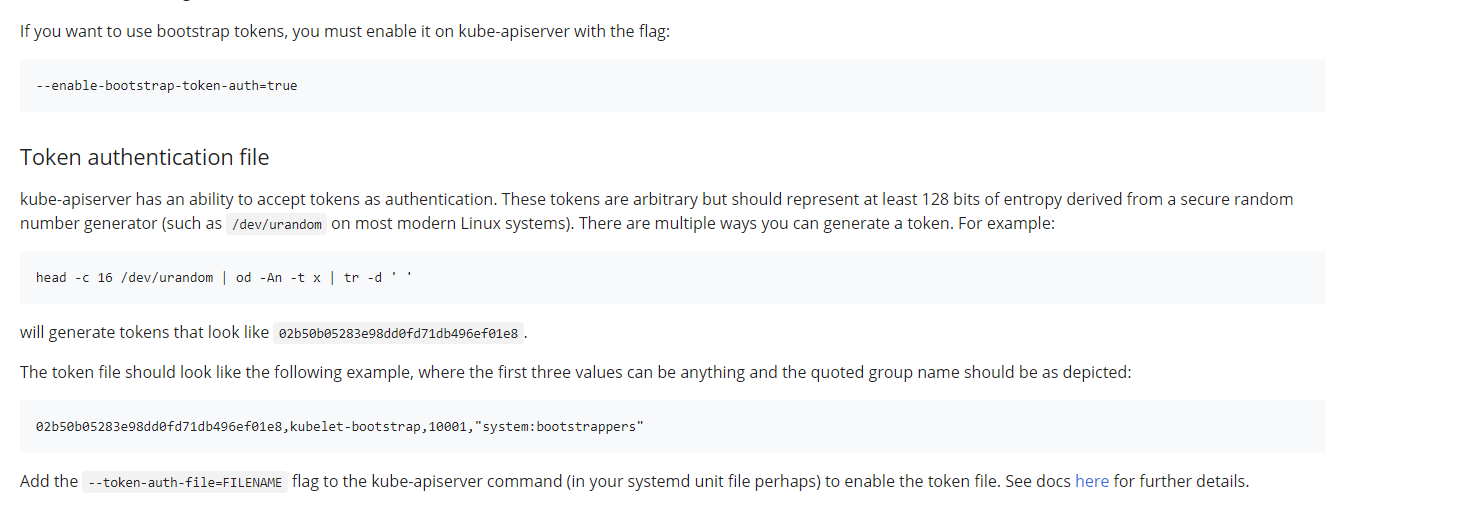

创建TLS bootstrapping 需要的token文件

参考文档:

https://kubernetes.io/docs/reference/command-line-tools-reference/kubelet-tls-bootstrapping/

https://mritd.me/2018/01/07/kubernetes-tls-bootstrapping-note/

2.生成token

head -c 16 /dev/urandom |od -An -t x |tr -d ' '

vim token.csv

651b461c1009e4da048bde8f8ce35b9f,kubelet-bootstrap,10001,"system:kubelet-bootstrap"

3.增加配置文件

vim kube-apiserver

KUBE_APISERVER_OPTS="--logtostderr=false \

--v=2 \

--log-dir=/var/log/ \

--etcd-servers=https://10.211.55.11:2379,https://10.211.55.12:2379,https://10.211.55.13:2379 \

--enable-admission-plugins=NamespaceLifecycle,LimitRanger,SecurityContextDeny,ServiceAccount,ResourceQuota,NodeRestriction \

--anonymous-auth=false \

--advertise-address=10.211.55.8 \

--insecure-port=0 \

--bind-address=10.211.55.11 \

--authorization-mode=Node,RBAC \

--service-cluster-ip-range=10.0.0.0/24 \

--service-node-port-range=3000-32700 \

--tls-cert-file=/etc/ssl/kubernetes/kubernetes.pem \

--tls-private-key-file=/etc/ssl/kubernetes/kubernetes-key.pem \

--client-ca-file=/etc/ssl/kubernetes/ca.pem \

--kubelet-client-certificate=/etc/ssl/kubernetes/kubernetes.pem \

--kubelet-client-key=/etc/ssl/kubernetes/kubernetes-key.pem \

--service-account-key-file=/etc/ssl/kubernetes/ca-key.pem \

--etcd-cafile=/etc/ssl/kubernetes/ca.pem \

--etcd-certfile=/etc/ssl/kubernetes/kubernetes.pem \

--etcd-keyfile=/etc/ssl/kubernetes/kubernetes-key.pem \

--enable-bootstrap-token-auth \

--token-auth-file=/etc/kubernetes/token.csv \

--allow-privileged=true \

--apiserver-count=3 \

--audit-log-maxage=30 \

--audit-log-maxbackup=3 \

--audit-log-maxsize=100 \

--audit-log-path=/var/log/kube-apiserver-audit.log \

--event-ttl=1h \

--alsologtostderr=true"

参考文档:

https://kubernetes.io/docs/reference/command-line-tools-reference/kube-apiserver/

https://www.kubernetes.org.cn/doc-30

https://www.jianshu.com/p/c201724a4ec6

重点参数说明:

--advertise-address : 推荐用高可用的IP ,一般是VIP

--authorization-mode=Node,RBAC:

#开启 Node 和 RBAC 授权模式,拒绝未授权的请求;认证授权,启用RBAC授权和节点自管理

--enable-admission-plugins:

#启用准入控制模块,Kubernetes中许多高级功能需要激活Admission Controller插件,以便更好的支持该功能(必须包含 ServiceAccount)

相关文档:http://docs.kubernetes.org.cn/144.html

--service-account-key-file:

#签名 ServiceAccount Token 的公钥文件,kube-controller-manager 的 --service-account-private-key-file 指定私钥文件,两者配对使用

--tls-*-file:

#指定 apiserver 使用的证书,私钥和 CA 文件。--client-ca-file 用于验证 client (kue-controller-manager、kube-scheduler、kubelet、kube-proxy 等)请求所带的证书;

--kubelet-client-certificate

--kubelet-client-key:

#如果指定则使用 https 访问 kubelet APIs;需要为证书对应的用户定义 RBAC 规则,否则访问 kubelet API 时提示未授权;

--bind-address:

#不能为 127.0.0.1,否则外界不能访问它的安全端口 6443;

--service-cluster-ip-range:

#指定 Service Cluster IP 地址段;

--service-node-port-range:

#指定 NodePort 的端口范围,kubernetes集群可映射的物理机端口范围

--runtime-config=api/all=true:

#启用所有版本的 APIs,如 autoscaling/v2alpha1;

--apiserver-count:

#集群中运行的apiserver的数量,必须为一个正数

--logtostderr

#启用日志

--v

#日志等级,参考文档:https://www.cnblogs.com/iiiiher/p/7879817.html

--etcd-servers

#etcd集群地址

--bind-address

#监听地址 #不能为127.0.0.1

--secure-port https

#安全端口

--advertise-address

#集群通告地址

--allow-privileged

#启用授权

--insecure-bind-address

#非安全端口的服务IP地址,默认是本地地址,可以不用证书验证。kube-scheduler kube-controller-manager 一般和 kube-apiserver 部署在同一台机器上它们可以使用非安全端口和kube-apiserver通信;

--insecure-port=0

#关闭非安全端口,只允许安全端口访问

--kubelet-https[=true]

#使用https建立kubelet连接

--enable-bootstrap-token-auth

#启用TLS bootstrap功能,后面会讲到

参考文档:

https://www.jianshu.com/p/bb973ab1029b

--token-auth-file

#指定生成token文件位置

--feature-gates=CustomPodDNS=true

#启用该特性后,用户可以将Pod的dnsPolicy字段设置为"None",并且可以在Pod。Spec中添加新的字段dnsConfig,

其中dnsConfig用来定义DNS参数,而dnsPolicy用来给Pod选取预设的DNS 参考http://www.jintiankansha.me/t/Js1R84GGAl

--enable-swagger-ui=true

#可以通过/swagger-ui访问Swagger UI

4.配置启动脚本:

vim /usr/lib/systemd/system/kube-apiserver.service

[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

EnvironmentFile=-/etc/kubernetes/kube-apiserver

ExecStart=/usr/bin/kube-apiserver $KUBE_APISERVER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

5.启动服务和加入开机启动

[root@k8s-master1 ssl]# systemctl daemon-reload

[root@k8s-master1 ssl]# systemctl enable kube-apiserver

[root@k8s-master1 ssl]# systemctl start kube-apiserver

[root@k8s-master1 kubernetes]# netstat -ptln | grep kube-apiserve

tcp 0 0 10.211.55.11:6443 0.0.0.0:* LISTEN 18638/kube-apiserve

分发配置文件和启动脚本到其他节点,修改本机IP启动

后续所有组件(如 kubeclt apiserver controller-manager scheduler kube-proxy 等)都通过 VIP 和 haproxy 监听的 8443 端口访问 kube-apiserver 服务。

所以需要我们做apiserver 高可用的配置

部署api-server高可用

keepalived 提供 kube-apiserver 对外服务的 VIP;

haproxy 监听 VIP,后端连接所有 kube-apiserver 实例,提供健康检查和负载均衡功能;

运行 keepalived 和 haproxy 的节点称为 LB 节点。由于 keepalived 是一主多备运行模式,故至少两个 LB 节点。

本文档复用 master 节点的三台机器,haproxy 监听的端口(8443) 需要与 kube-apiserver 的端口 6443 不同,避免冲突。

keepalived 在运行过程中周期检查本机的 haproxy 进程状态,如果检测到 haproxy 进程异常,则触发重新选主的过程,VIP 将飘移到新选出来的主节点,从而实现 VIP 的高可用。

在3节点机器上安装keepalived+haproxy ,推荐yum安装

vim /etc/haproxy/haproxy.cfg

global

log /dev/log local0

log /dev/log local1 notice

chroot /var/lib/haproxy

stats socket /var/run/haproxy-admin.sock mode 660 level admin

stats timeout 30s

user haproxy

group haproxy

daemon

nbproc 1

defaults

log global

timeout connect 5000

timeout client 10m

timeout server 10m

listen admin_stats

bind 0.0.0.0:10080

mode http

log 127.0.0.1 local0 err

stats refresh 30s

stats uri /status

stats realm welcome login\ Haproxy

stats auth admin:123456

stats hide-version

stats admin if TRUE

listen kube-master

bind 0.0.0.0:8443

mode tcp

option tcplog

balance roundrobin

server 10.211.55.11 10.211.55.11:6443 check inter 2000 fall 2 rise 2 weight 1

server 10.211.55.12 10.211.55.12:6443 check inter 2000 fall 2 rise 2 weight 1

server 10.211.55.13 10.211.55.13:6443 check inter 2000 fall 2 rise 2 weight 1

配置文件不一一说明了,自己查看相关说明

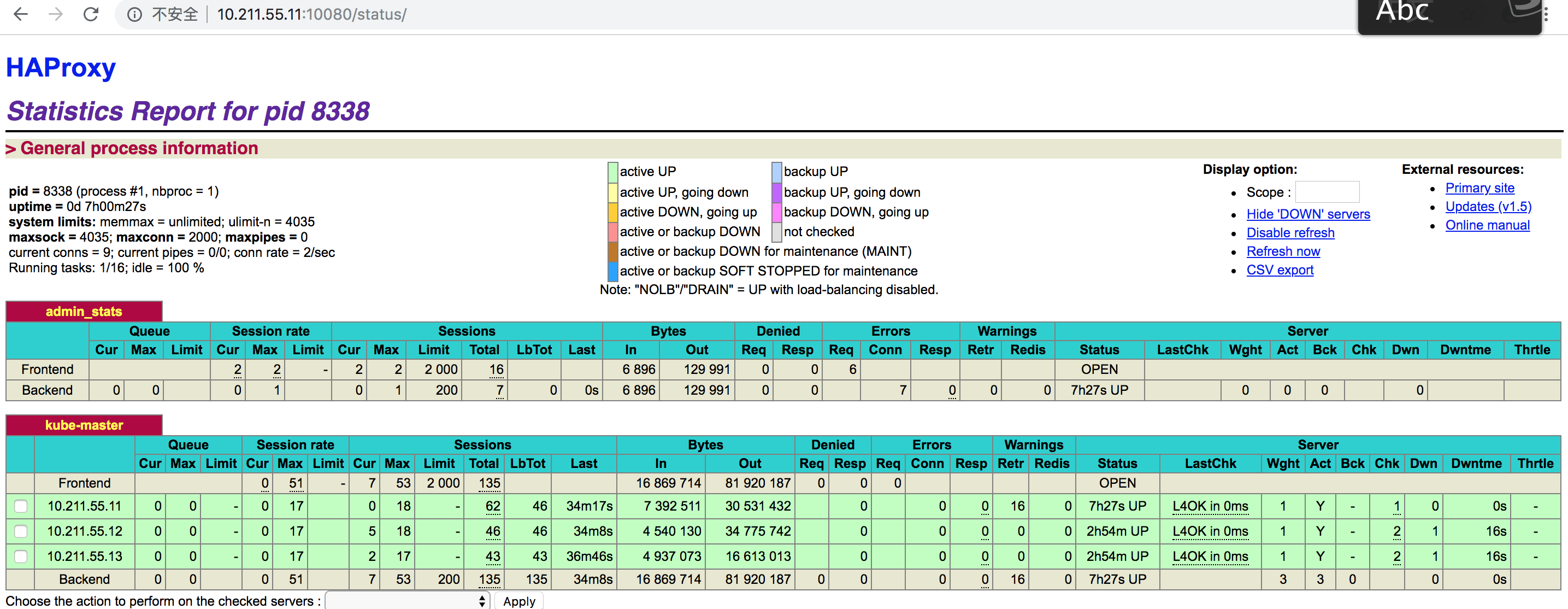

haproxy 在 10080 端口输出 status 信息;

haproxy 监听所有接口的 8443 端口,该端口与环境变量 ${KUBE_APISERVER} 指定的端口必须一致;

server 字段列出所有 kube-apiserver 监听的 IP 和端口;

systemctl enable haproxy

systemctl start haproxy

[root@k8s-master1 src]# netstat -nulpt |egrep haproxy

tcp 0 0 0.0.0.0:8443 0.0.0.0:* LISTEN 8338/haproxy

tcp 0 0 0.0.0.0:10080 0.0.0.0:* LISTEN 8338/haproxy

通过客户端测试一下

![]()

三个master配置keepalived服务

vim /etc/keepalived/keepalived.conf

global_defs {

router_id lb-master-8

script_user root

enable_script_security

}

vrrp_script check-haproxy {

script "killall -0 haproxy"

interval 3

}

vrrp_instance VI-kube-master {

state BACKUP

nopreempt

priority 120

dont_track_primary

interface eth0

virtual_router_id 8

advert_int 3

track_script {

check-haproxy

}

virtual_ipaddress {

10.211.55.8

}

}

说明一下

使用 killall -0 haproxy 命令检查所在节点的 haproxy 进程是否正常。

如果没有killall 命令,安装一下yum install psmisc -y

router_id、virtual_router_id 用于标识属于该 HA 的 keepalived 实例,如果有多套 keepalived HA,则必须各不相同;

其他2个backup把nopreempt去掉,及priority分别设置110和100即可,标红部分。

nopreempt设置不抢占,必须设置在backup上且priority最高的节点上

systemctl enable keepalived

systemctl start keepalived

查看日志和状态

service keepalived status

tail -f /var/log/message

[root@k8s-master1 src]# ip addr show |egrep eth0

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

inet 10.211.55.11/8 brd 10.255.255.255 scope global eth0

inet 10.211.55.8/32 scope global eth0

可以看到VIP 按预期在master1 上面,可以关闭haproxy 看VIP 是否转移到其他节点,这里就不测试了

这样就可以通过kubectl 查看集群状态了

[root@k8s-master3 .kube]# kubectl cluster-info

Kubernetes master is running at https://10.211.55.8:8443

CoreDNS is running at https://10.211.55.8:8443/api/v1/namespaces/kube-system/services/kube-dns:dns/proxy

这样就达到apiserver的高可用,同时可以通过HA 来负载各API服务

部署kube-controller-manager

该集群包含 3 个节点,启动后将通过竞争选举机制产生一个 leader 节点,其它节点为阻塞状态。

当 leader 节点不可用后,剩余节点将再次进行选举产生新的 leader 节点,从而保证服务的可用性。

为保证通信安全,通过证书和私钥来认证和授权。

kube-controller-manager 在如下两种情况下使用该证书:

1.与 kube-apiserver 的安全端口通信时;

2.在安全端口(https,10252) 输出 prometheus 格式的 metrics;

1.创建kubeconfig文件

kubectl config set-cluster kubernetes \

--certificate-authority=/etc/ssl/kubernetes/ca.pem \

--embed-certs=true \

--server=https://10.211.55.8:8443 \

--kubeconfig=kube-controller-manager.kubeconfig

cd /etc/ssl/kubernetes

kubectl config set-credentials system:kube-controller-manager \

--client-certificate=kube-controller-manager.pem \

--client-key=kube-controller-manager-key.pem \

--embed-certs=true \

--kubeconfig=kube-controller-manager.kubeconfig

kubectl config set-context system:kube-controller-manager \

--cluster=kubernetes \

--user=system:kube-controller-manager \

--kubeconfig=kube-controller-manager.kubeconfig

kubectl config use-context system:kube-controller-manager --kubeconfig=kube-controller-manager.kubeconfig

cp kube-controller-manager.kubeconfig /etc/kubernetes/#在scp复制到其他master节点

2.增加配置文件

vim /etc/kubernetes/kube-controller-manager

KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=true \

--v=2 \

--kubeconfig=/etc/kubernetes/kube-controller-manager.kubeconfig \

--authentication-kubeconfig=/etc/kubernetes/kube-controller-manager.kubeconfig \

--leader-elect=true \

--bind-address=127.0.0.1 \

--use-service-account-credentials=true \

--service-cluster-ip-range=10.0.0.0/24 \

--cluster-name=kubernetes \

--cluster-signing-cert-file=/etc/kubernetes/ssl/ca.pem \

--cluster-signing-key-file=/etc/kubernetes/ssl/ca-key.pem \

--feature-gates=RotateKubeletServerCertificate=true \

--experimental-cluster-signing-duration=87600h0m0s \

--root-ca-file=/etc/kubernetes/ssl/ca.pem \

--tls-cert-file=/etc/kubernetes/ssl/kube-controller.pem \

--tls-private-key-file=/etc/kubernetes/ssl/kube-controller-key.pem \

--service-account-private-key-file=/etc/kubernetes/ssl/ca-key.pem"

参考文档:https://www.jianshu.com/p/bdb153daba21

重要参数说明:

--port=0:关闭监听 http /metrics 的请求,同时 --address 参数无效让--bind-address 取代;

--secure-port=10252、--bind-address=0.0.0.0: 在所有网络接口监听 10252 端口的 https /metrics 请求;

--kubeconfig:指定 kubeconfig 文件路径,kube-controller-manager 使用它连接和验证 kube-apiserver;

--cluster-signing-*-file:签名 TLS Bootstrap 创建的证书;

--experimental-cluster-signing-duration:指定 TLS Bootstrap 证书的有效期;

--root-ca-file:放置到容器 ServiceAccount 中的 CA 证书,用来对 kube-apiserver 的证书进行校验;

--service-account-private-key-file:签名 ServiceAccount 中 Token 的私钥文件,必须和 kube-apiserver 的 --service-account-key-file 指定的公钥文件配对使用;

--service-cluster-ip-range :指定 Service Cluster IP 网段,必须和 kube-apiserver 中的同名参数一致;

--leader-elect=true:集群运行模式,启用选举功能;被选为 leader 的节点负责处理工作,其它节点为阻塞状态;

--feature-gates=RotateKubeletServerCertificate=true:开启 kublet server 证书的自动更新特性;

--controllers=*,bootstrapsigner,tokencleaner:启用的控制器列表,tokencleaner 用于自动清理过期的 Bootstrap token;

--horizontal-pod-autoscaler-*:custom metrics 相关参数,支持 autoscaling/v2alpha1;

--tls-cert-file、--tls-private-key-file:使用 https 输出 metrics 时使用的 Server 证书和秘钥;

--use-service-account-credentials=true:如果为true,为每个控制器使用单个service account

kube-controller-manager 不对请求 https metrics 的 Client 证书进行校验,故不需要指定 --tls-ca-file 参数,而且该参数已被淘汰。

3.配置服务启动脚本

vim /usr/lib/systemd/system/kube-controller-manager.service

[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes

After=network-online.target kube-apiserver.server

Wants=network-online.target

[Service]

EnvironmentFile=-/etc/kubernetes/kube-controller-manager

ExecStart=/usr/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

查看服务状态和日志是否有异常

[root@k8s-master1 .kube]# netstat -nulpt |egrep kube-con

tcp 0 0 127.0.0.1:10257 0.0.0.0:* LISTEN 15046/kube-controll

4.查看当前kube-controller-manager的leader

[root@k8s-master1 .kube]# kubectl get endpoints kube-controller-manager --namespace=kube-system -o yaml

apiVersion: v1

kind: Endpoints

metadata:

annotations:

control-plane.alpha.kubernetes.io/leader: '{"holderIdentity":"k8s-master1_a1aa4d9b-91ac-11e9-acb6-001c42baaf43","leaseDurationSeconds":15,"acquireTime":"2019-06-18T09:37:23Z","renewTime":"2019-06-18T12:37:01Z","leaderTransitions":29}'

creationTimestamp: "2019-06-14T13:13:09Z"

name: kube-controller-manager

namespace: kube-system

resourceVersion: "111657"

selfLink: /api/v1/namespaces/kube-system/endpoints/kube-controller-manager

uid: 278d06a6-8ea6-11e9-a7b0-001c42baaf43

可以看到当前的 leader 为 master1 节点。

部署kube-scheduler

该集群包含 3 个节点,启动后将通过竞争选举机制产生一个 leader 节点,其它节点为阻塞状态。

当 leader 节点不可用后,剩余节点将再次进行选举产生新的 leader 节点,从而保证服务的可用性。

kube-scheduler 在如下两种情况下使用该证书:

1.与 kube-apiserver 的安全端口通信;

2.在安全端口(https,10251) 输出 prometheus 格式的 metrics;

1.创建kube-scheduler.kubeconfig文件

cd /etc/ssl/kubernetes/

kubectl config set-cluster kubernetes \

--certificate-authority=ca.pem \

--embed-certs=true \

--server=https://10.211.55.8:8443 \

--kubeconfig=kube-scheduler.kubeconfig

kubectl config set-credentials system:kube-scheduler \

--client-certificate=kube-scheduler.pem \

--client-key=kube-scheduler-key.pem \

--embed-certs=true \

--kubeconfig=kube-scheduler.kubeconfig

kubectl config set-context system:kube-scheduler \

--cluster=kubernetes \

--user=system:kube-scheduler \

--kubeconfig=kube-scheduler.kubeconfig

kubectl config use-context system:kube-scheduler --kubeconfig=kube-scheduler.kubeconfig

2.增加配置文件

vim /etc/kubernetes/kube-scheduler

KUBE_SCHEDULER_OPTS="--logtostderr=true \

--v=2 \

--address=127.0.0.1 \

--kubeconfig=/etc/kubernetes/kube-scheduler.kubeconfig \

--leader-elect"

参考文档:

https://blog.csdn.net/zhonglinzhang/article/details/85839899

参数说明

--address:在 127.0.0.1:10251 端口接收 http /metrics 请求;kube-scheduler 目前还不支持接收 https 请求;

--kubeconfig:指定 kubeconfig 文件路径,kube-scheduler 使用它连接和验证 kube-apiserver;

--leader-elect=true:集群运行模式,启用选举功能;被选为 leader 的节点负责处理工作,其它节点为阻塞状态;

3.配置服务启动脚本

vim /usr/lib/systemd/system/kube-scheduler.service

[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes

[Service]

EnvironmentFile=-/etc/kubernetes/kube-scheduler

ExecStart=/usr/bin/kube-scheduler $KUBE_SCHEDULER_OPTS

Restart=on-failure

[Install]

WantedBy=multi-user.target

[root@k8s-master1 ssl]# systemctl daemon-reload

[root@k8s-master1 ssl]# systemctl enable kube-scheduler

[root@k8s-master1 ssl]# systemctl start kube-scheduler

查看服务状态和日志

[root@k8s-master1 kubernetes]# netstat -nulpt |egrep kube-sche

tcp 0 0 127.0.0.1:10251 0.0.0.0:* LISTEN 15047/kube-schedule

tcp6 0 0 :::10259 :::* LISTEN 15047/kube-schedule

4.查看当前kube-scheduler的leader

[root@k8s-master1 kubernetes]# kubectl get endpoints kube-scheduler --namespace=kube-system -o yaml

apiVersion: v1

kind: Endpoints

metadata:

annotations:

control-plane.alpha.kubernetes.io/leader: '{"holderIdentity":"k8s-master1_99d53f73-91ac-11e9-8e40-001c42baaf43","leaseDurationSeconds":15,"acquireTime":"2019-06-18T09:37:22Z","renewTime":"2019-06-18T12:58:54Z","leaderTransitions":32}'

creationTimestamp: "2019-06-14T13:13:09Z"

name: kube-scheduler

namespace: kube-system

resourceVersion: "113359"

selfLink: /api/v1/namespaces/kube-system/endpoints/kube-scheduler

uid: 2809cea3-8ea6-11e9-a7b0-001c42baaf43

当前的 leader 为 master1 节点

到这里master 相关的重要组件都安装完成

在各节点验证一下

[root@k8s-master1 kubernetes]# kubectl get cs

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-0 Healthy {"health":"true"}

etcd-1 Healthy {"health":"true"}

etcd-2 Healthy {"health":"true"}

kubectl 命令补全

yum install bash-completion -y

kubectl completion bash >/etc/bash_completion.d/kubectl

重新连接终端就可以了

这里提示一下:

如果使用云搭建的集群,在高可用这块可以直接用云服务商提供的SLB服务,如果haproxy+keepalive可能不支持,原因你懂的。(云底层封掉了)

浙公网安备 33010602011771号

浙公网安备 33010602011771号