第十二章-自我总结

在学习和推导了统计学习方法-李航(第2版)中的内容,收获蛮多,对此,既然轻轻地来了,那就得潇洒地给这个阶段学习的内容画上一个圆满的句号。

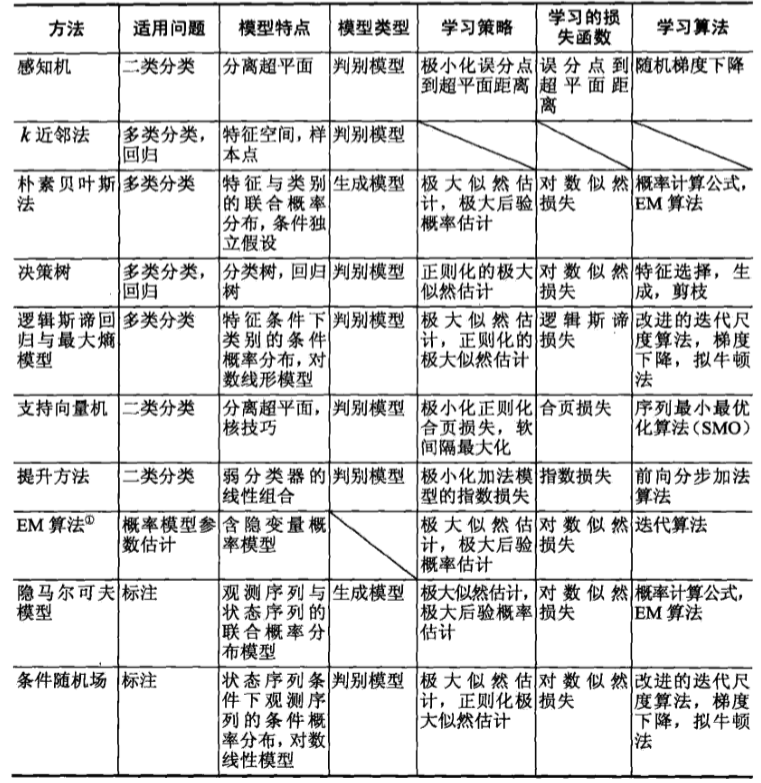

统计学习方法总结

以下是整本书中出现的10种统计学习方法的特点和概括总结,对于学习的一些方法,我们需要很清楚的知道这些统计学习方法的模型、策略、算法,还有适合应用的场景,这才对于我们以后在解决实际问题的过程中,才会清楚选择哪种比较适合当前需要解决的实际场景。另外个人觉得,对于现在飞速发展的深度学习技术,大多都是在传统的机器学习的基础上发展起来的,如果想要深入了解深度学习的内容,传统的机器学习的一些算法的巩固和学习时很有必要的。

在这里,EM算法只是一般的方法,不具备具体的模型。

个人总结

在学习这本书的过程中,身边有朋友问我,你知道什么是随机梯度下降法吗?我觉得用句简单的话来阐述,就是随机梯度下降法就是对当前的无约束条件的目标函数进行求偏导迭代寻优的过程。(PS:当然,如果有人指出这句话有问题,希望指正,这也是个人的见解。)对此,我对这些统计学习方法需要解决的问题做了一个小的总结——

-

解决无约束条件的目标函数的寻优问题。对此,可以采用最常用的梯度下降法、拟牛顿法等来求解最优解。其思路就是对目标函数进行求偏导迭代更新需要的参数寻找最优解。另外还会提及到,目标函数尽可能满足是凸函数的要求。

-

解决有约束条件的目标函数的寻优问题。在这种情况下,一般正常的思路求偏导就不可以适用了,此时需要做个转化,需要用到对偶问题的方法来将其转换再进行寻找最优解。其中感知机模型和SVM模型就是典型代表。

-

监督场景下求解模型的参数问题。对于一个模型,如果需要对该模型的参数进行参数估计,那么常用的方法就是极大似然估计和贝叶斯估计。在某种程度上,贝叶斯估计会和极大似然估计是对等的,但是如果样本数量更多的时候,贝叶斯估计相对来说,估计更精确些。那么为何使用极大似然估计或者贝叶斯估计就能得到模型的参数呢?个人觉得,极大似然估计或者贝叶斯估计能根据经验分布得到最优解,即概率最大的一组参数,得到的这组参数组成的模型就有可能是我们所想要的。

-

含隐变量的模型的参数估计。如果当前的模型参数中还存在一些隐藏未知的变量,即隐变量,那么此时需要采用EM算法来对此进行求解。

——最后,希望站在大佬的肩膀上,学之所用,思之所想!——