零拷贝

传统网络I/O

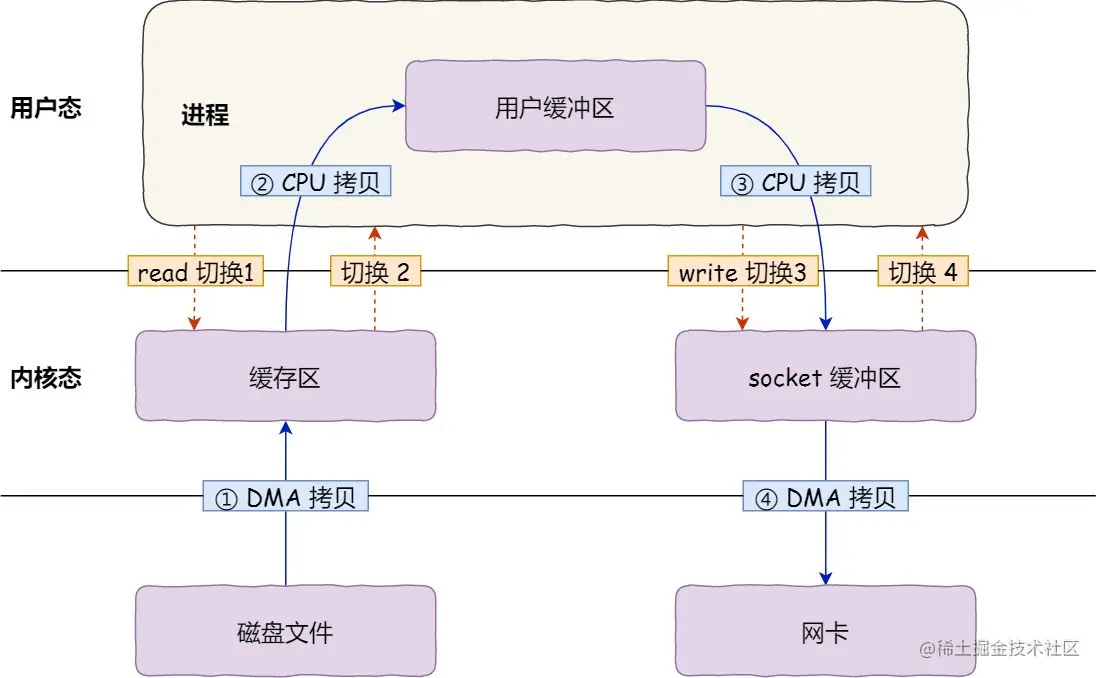

如果服务端要提供文件传输的功能,我们能想到的最简单的方式是:将磁盘上的文件读取出来,然后通过网络协议发送给客户端。

传统 I/O 的工作方式是,数据读取和写入是从用户空间到内核空间来回复制,而内核空间的数据是通过操作系统层面的 I/O 接口从磁盘读取或写入。

代码通常如下,一般会需要两个系统调用:

read(file, tmp_buf, len);

write(socket, tmp_buf, len);4次数据拷贝和4次上下文切换

4 次数据拷贝

-

把磁盘上的数据拷贝到操作系统内核的缓冲区里,这个拷贝的过程是通过 DMA 完成的

-

把内核缓冲区的数据拷贝到用户的缓冲区里,于是我们应用程序就可以使用这部分数据了,这个拷贝到过程是由 CPU 完成的。

-

把刚才拷贝到用户的缓冲区里的数据,再拷贝到内核的 socket 的缓冲区里,这个过程依然还是由 CPU 搬运的。

-

把内核的 socket 缓冲区里的数据,拷贝到网卡的缓冲区里,这个过程又是由 DMA 完成的。

4次上下文切换

涉及到2次系统调用

-

read 系统调用时:用户态切换到内核态

-

read 系统调用完毕:内核态切换回用户态

-

write 系统调用时:用户态切换到内核态

-

write 系统调用完毕:内核态切换回用户态

这种简单又传统的文件传输方式,存在冗余的上文切换和数据拷贝,在高并发系统里是非常糟糕的,多了很多不必要的开销,会严重影响系统性能。

所以,要想提高文件传输的性能,就需要减少「上下文切换」和「内存拷贝」的次数。

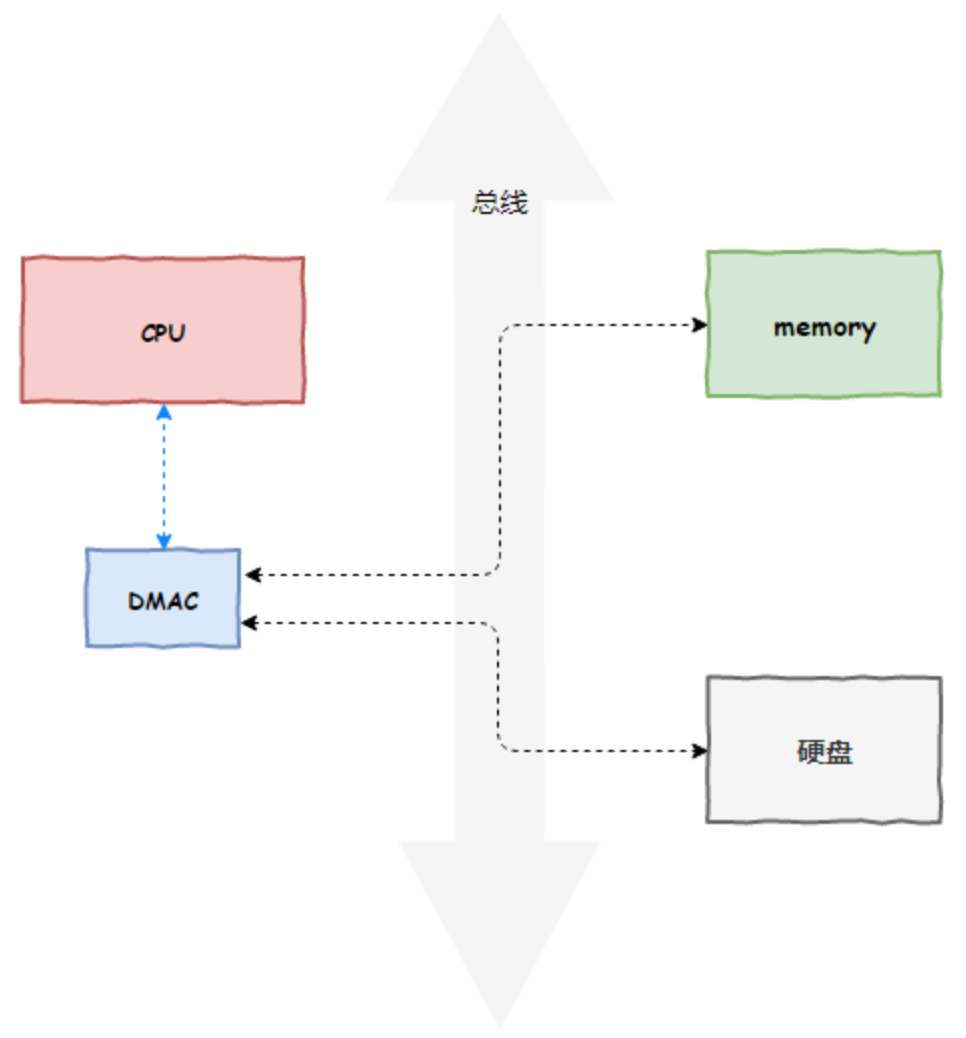

DMA

DMA 技术很容易理解,本质上,DMA 技术就是我们在主板上放一块独立的芯片。在进行内存和 I/O 设备的数据传输的时候,我们不再通过 CPU 来控制数据传输,而直接通过 DMA 控制器(DMA Controller,简称 DMAC)。这块芯片,我们可以认为它其实就是一个协处理器。

DMAC 的价值在如下情况中尤其明显:当我们要传输的数据特别大、速度特别快,或者传输的数据特别小、速度特别慢的时候。

比如说,我们用千兆网卡或者硬盘传输大量数据的时候,如果都用 CPU 来搬运的话,肯定忙不过来,所以可以选择 DMAC。而当数据传输很慢的时候,DMAC 可以等数据到齐了,再发送信号,给到 CPU 去处理,而不是让 CPU 在那里忙等待。

注意:这里面的“协”字。DMAC 是在“协助”CPU,完成对应的数据传输工作。在 DMAC 控制数据传输的过程中,DMAC 还是被 CPU 控制,只是数据的拷贝行为不再由 CPU 来完成。

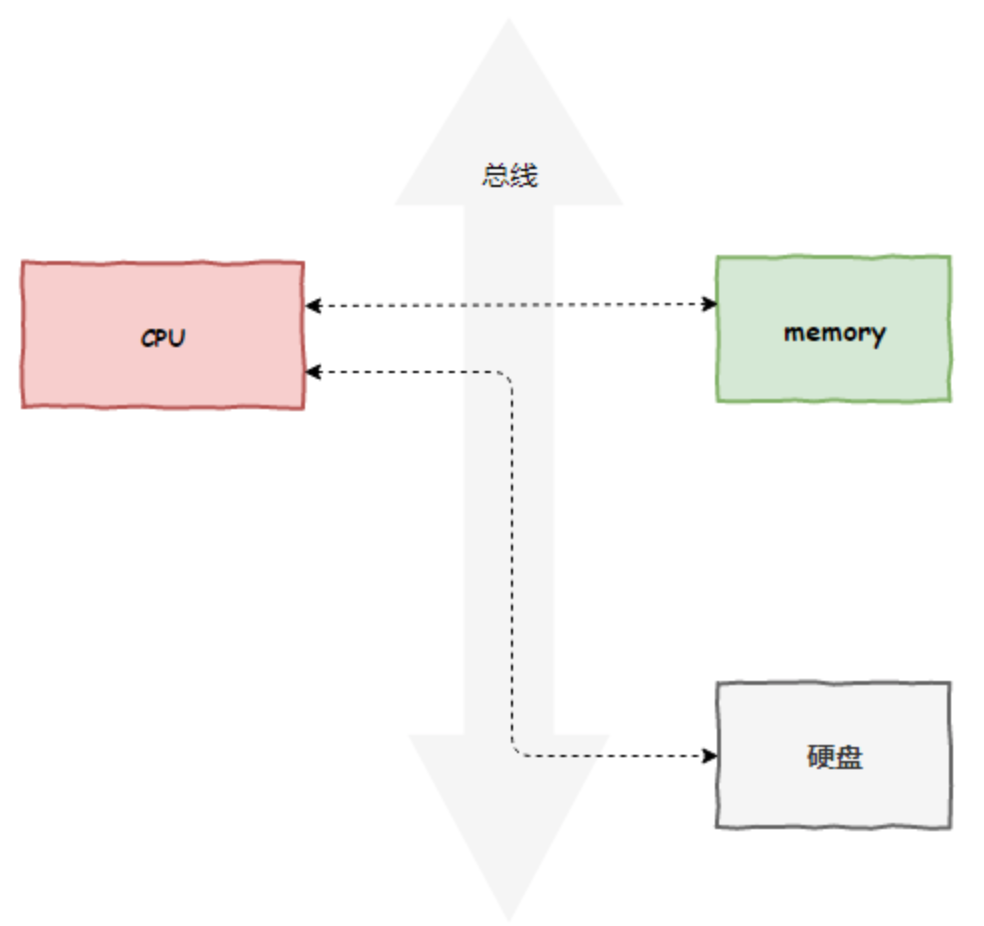

原本,计算机所有组件之间的数据拷贝(流动)必须经过 CPU。以磁盘读写为例,如下图所示:

现在,DMAC 代替了 CPU 负责内存与磁盘、内存与网卡之间的数据搬运,CPU 作为 DMAC 的控制者,如下图所示:

但是 DMAC 有其局限性,DMAC 仅仅能用于设备间交换数据时进行数据拷贝,但是设备内部的数据拷贝还需要 CPU 来亲力亲为。例如, CPU 需要负责内核空间与用户空间之间的数据拷贝(内存内部的拷贝),如下图所示:

零拷贝

零拷贝技术是一个思想,指的是指计算机执行操作时,不需要CPU拷贝。

可见,零拷贝的特点是 CPU 不全程负责内存中的数据写入其他组件,CPU 仅仅起到管理的作用。但注意,零拷贝不是不进行拷贝,而是 CPU 不再全程负责数据拷贝时的搬运工作。如果数据本身不在内存中,那么必须先通过某种方式拷贝到内存中(这个过程 CPU 可以仅仅负责管理,DMAC 来负责具体数据拷贝),因为数据只有在内存中,才能被转移,才能被 CPU 直接读取计算。

零拷贝技术的具体实现方式有很多,例如:

-

mmap

-

sendfile

-

splice

mmap+write

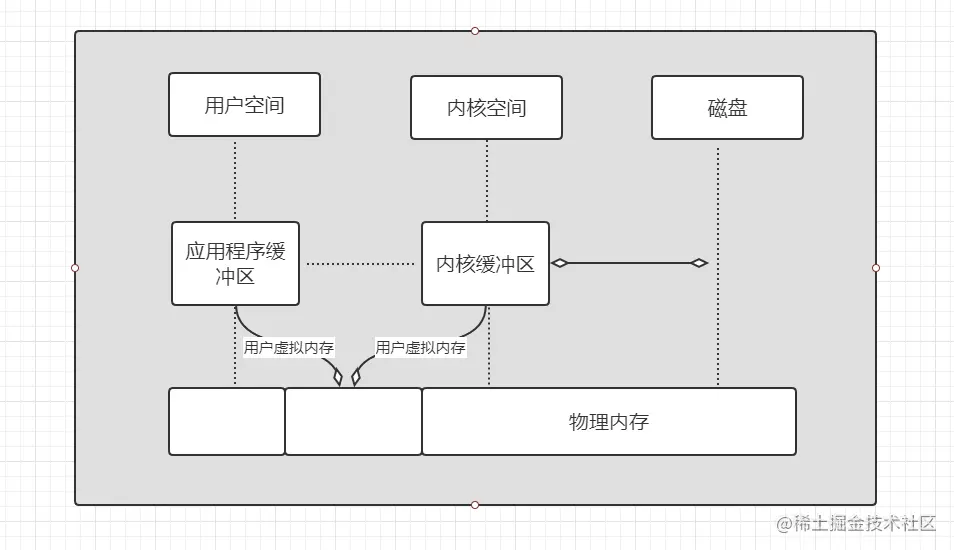

虚拟内存

现代操作系统都使用虚拟内存,使用虚拟地址取代物理地址,主要有以下几点好处:

-

多个虚拟内存可以指向同一个物理地址。

-

虚拟内存空间可以远远大于物理内存空间。

利用上述的第一条特性可以优化,可以把内核空间和用户空间的虚拟地址映射到同一个物理地址,这样在 I/O 操作时就不需要来回复制了。

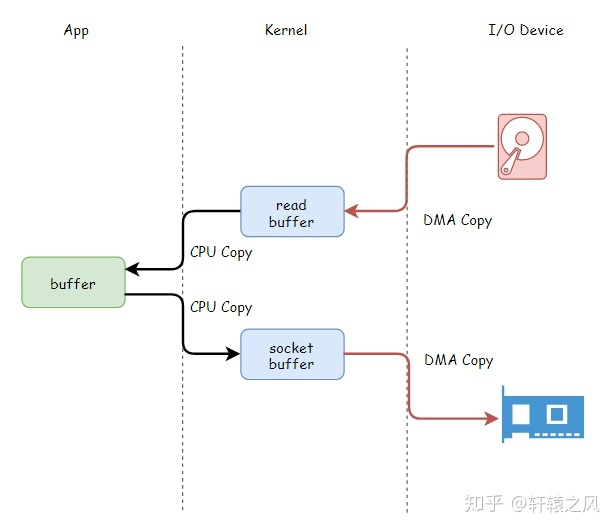

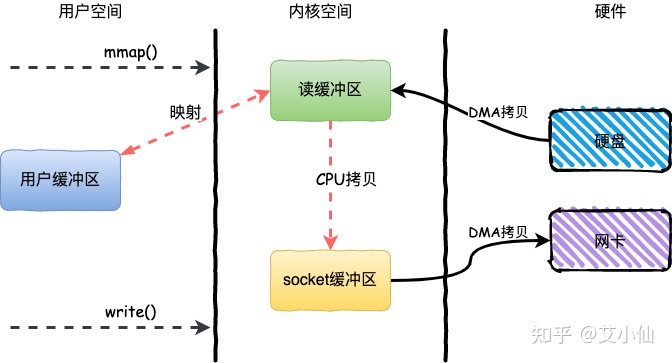

mmap+write简单来说就是使用mmap替换了read+write中的read操作,减少了一次CPU的拷贝。

mmap主要实现方式是将读缓冲区的地址和用户缓冲区的地址进行映射,内核缓冲区和应用缓冲区共享,从而减少了从读缓冲区到用户缓冲区的一次CPU拷贝。

整个过程发生了4次上下文切换和3次拷贝,具体流程如下:

-

用户进程通过

mmap()方法向操作系统发起调用,上下文从用户态转向内核态 -

DMA控制器把数据从硬盘中拷贝到读缓冲区

-

上下文从内核态转为用户态,mmap调用返回

-

用户进程通过

write()方法发起调用,上下文从用户态转为内核态 -

CPU将读缓冲区中数据拷贝到socket缓冲区

-

DMA控制器把数据从socket缓冲区拷贝到网卡,上下文从内核态切换回用户态,

write()返回

mmap的方式节省了一次CPU拷贝,同时由于用户进程中的内存是虚拟的,只是映射到内核的读缓冲区,所以可以节省一半的内存空间,比较适合大文件的传输。

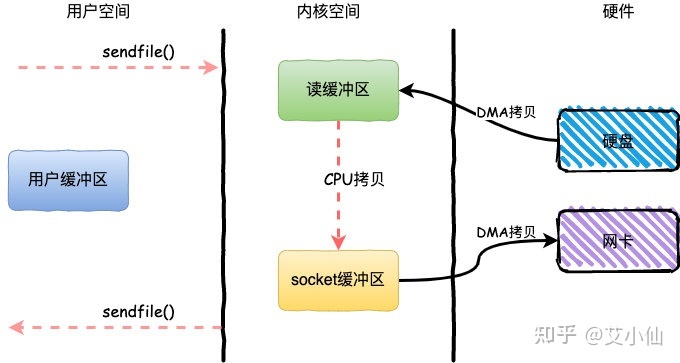

sendfile

sendfile是Linux2.1内核版本后引入的一个系统调用函数,通过使用sendfile数据可以直接在内核空间进行传输,因此避免了用户空间和内核空间的拷贝,同时由于使用sendfile替代了read+write从而节省了一次系统调用。

整个过程发生了2次上下文切换和3次拷贝,具体流程如下:

-

用户进程通过

sendfile()方法向操作系统发起调用,上下文从用户态转向内核态 -

DMA控制器把数据从硬盘中拷贝到读缓冲区

-

CPU将读缓冲区中数据拷贝到socket缓冲区

-

DMA控制器把数据从socket缓冲区拷贝到网卡,上下文从内核态切换回用户态,

sendfile调用返回

sendfile方法IO数据对用户空间完全不可见,所以只能适用于完全不需要用户空间处理的情况,比如静态文件服务器。

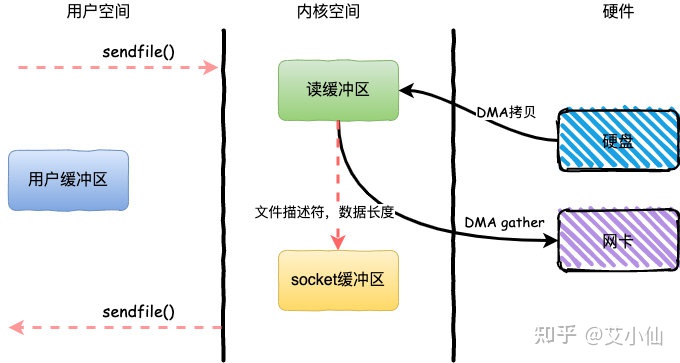

sendfile+DMA Scatter/Gather

Linux2.4内核版本之后对sendfile做了进一步优化,通过引入新的硬件支持,这个方式叫做DMA Scatter/Gather 分散/收集功能。

它将读缓冲区中的数据描述信息--内存地址和偏移量记录到socket缓冲区,由 DMA 根据这些将数据从读缓冲区拷贝到网卡,相比之前版本减少了一次CPU拷贝的过程

整个过程发生了2次用户态和内核态的上下文切换和2次拷贝,其中更重要的是完全没有CPU拷贝,具体流程如下:

-

用户进程通过

sendfile()方法向操作系统发起调用,上下文从用户态转向内核态 -

DMA控制器利用scatter把数据从硬盘中拷贝到读缓冲区离散存储

-

CPU把读缓冲区中的文件描述符和数据长度发送到socket缓冲区

-

DMA控制器根据文件描述符和数据长度,使用scatter/gather把数据从内核缓冲区拷贝到网卡

-

sendfile()调用返回,上下文从内核态切换回用户态

DMA gather和sendfile需要硬件支持

splice

splice 调用和sendfile 非常相似,用户应用程序必须拥有两个已经打开的文件描述符,一个表示输入设备,一个表示输出设备。与sendfile不同的是,splice允许任意两个文件互相连接,而并不只是文件与socket进行数据传输。对于从一个文件描述符发送数据到socket这种特例来说,一直都是使用sendfile系统调用,而splice一直以来就只是一种机制,它并不仅限于sendfile的功能。也就是说 sendfile 是 splice 的一个子集。

在 Linux 2.6.17 版本引入了 splice,而在 Linux 2.6.23 版本中, sendfile 机制的实现已经没有了,但是其 API 及相应的功能还在,只不过 API 及相应的功能是利用了 splice 机制来实现的。

和 sendfile 不同的是,splice 不需要硬件支持。

总结

由于CPU和IO速度的差异问题,产生了DMA技术,通过DMA搬运来减少CPU的等待时间。

传统的IOread+write方式会产生2次DMA拷贝+2次CPU拷贝,同时有4次上下文切换。

而通过mmap+write方式则产生2次DMA拷贝+1次CPU拷贝,4次上下文切换,通过内存映射减少了一次CPU拷贝,可以减少内存使用,适合大文件的传输。

sendfile方式是新增的一个系统调用函数,产生2次DMA拷贝+1次CPU拷贝,但是只有2次上下文切换。因为只有一次调用,减少了上下文的切换,但是用户空间对IO数据不可见,适用于静态文件服务器。

sendfile+DMA gather方式产生2次DMA拷贝,没有CPU拷贝,而且也只有2次上下文切换。虽然极大地提升了性能,但是需要依赖新的硬件设备支持。