机器学习-无监督机器学习-SVD奇异值分解-24

[POC]

1. 奇异值分解的本质

特征值分解只能够对于方阵提取重要特征,

Ax=λx λ为特征值 x为对应的特征向量

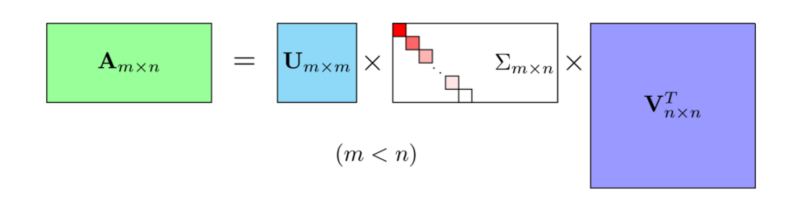

奇异值分解可以对于任意矩阵;

注意看中间的矩阵是一个对角矩阵,颜色越深越起作用-值越大 颜色越浅越接近0

U是左奇异矩阵,V是右奇异矩阵,均是正交矩阵,

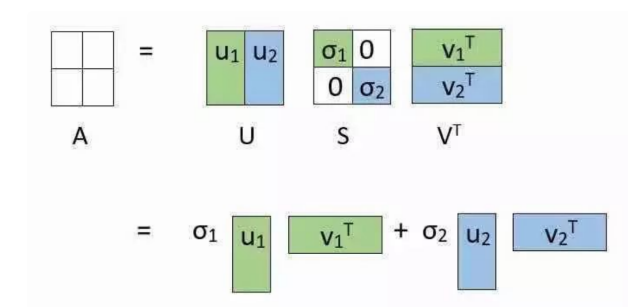

中间的Σ是对角阵,除对角线元素外都是0,对角线元素是奇异值。

在大多数情况下,前10%甚至前1%的奇异值的和便占据了全部奇异值之和的99%以上了,因此当利用奇异值分解对数据进行压缩时,我们可以用前 个大的奇异值来近似描述矩阵。

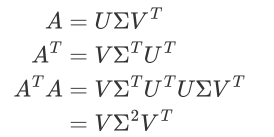

其他性质:

- 特征向量张成的矩阵就是SVD中的v矩阵

- 协方差矩阵的特征值矩阵等于奇异值矩阵的平方

用处呢?

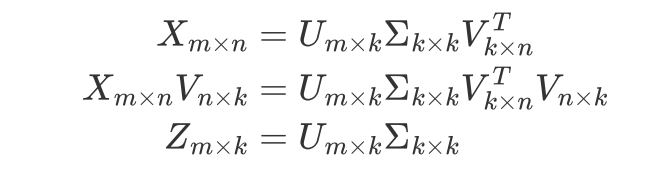

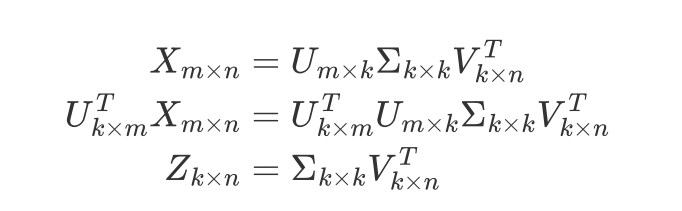

降维 n维降到k维:

数据压缩 m行降到k行:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 从HTTP原因短语缺失研究HTTP/2和HTTP/3的设计差异

· 三行代码完成国际化适配,妙~啊~