Week5:Neural Network BackPropagation疑难点记录

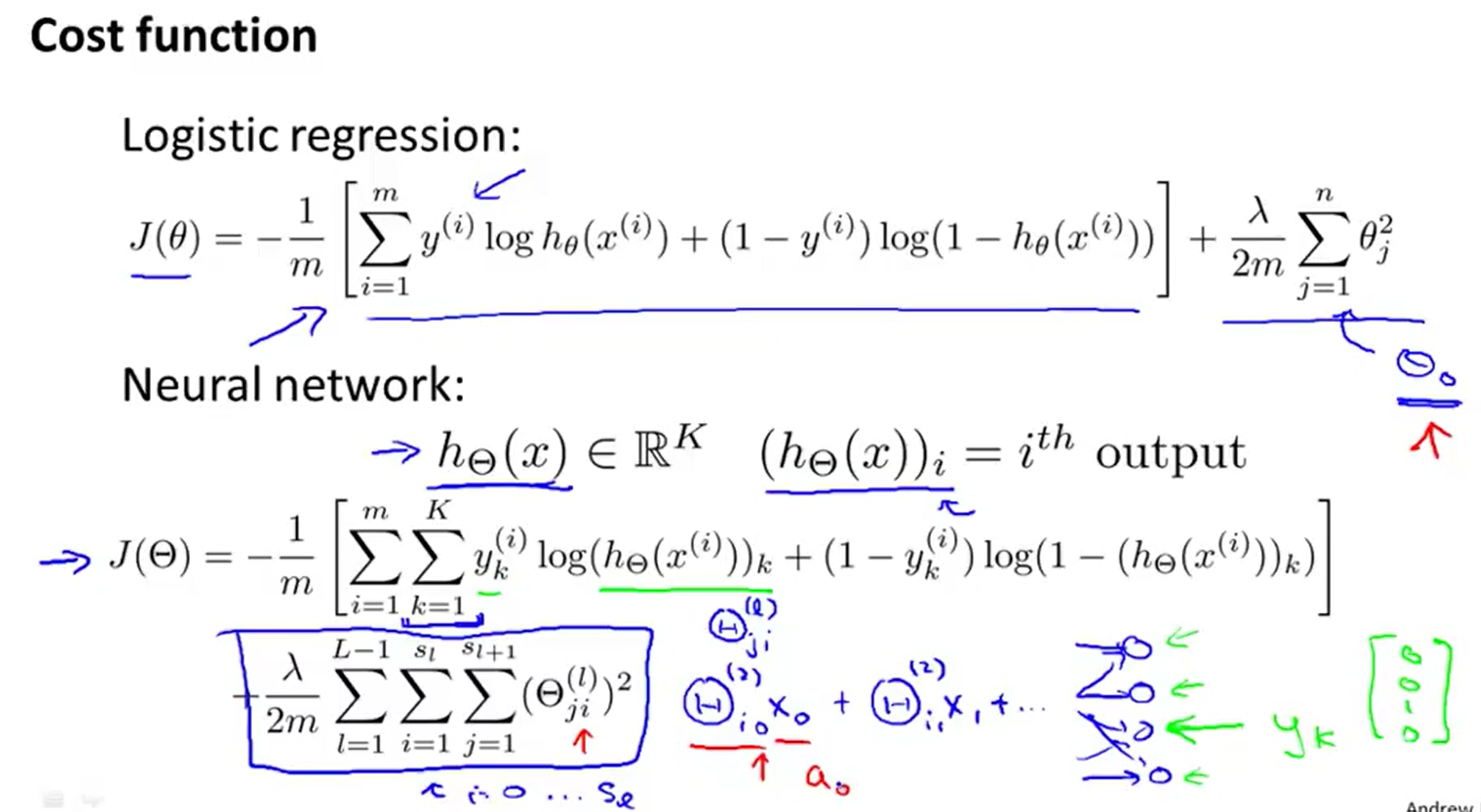

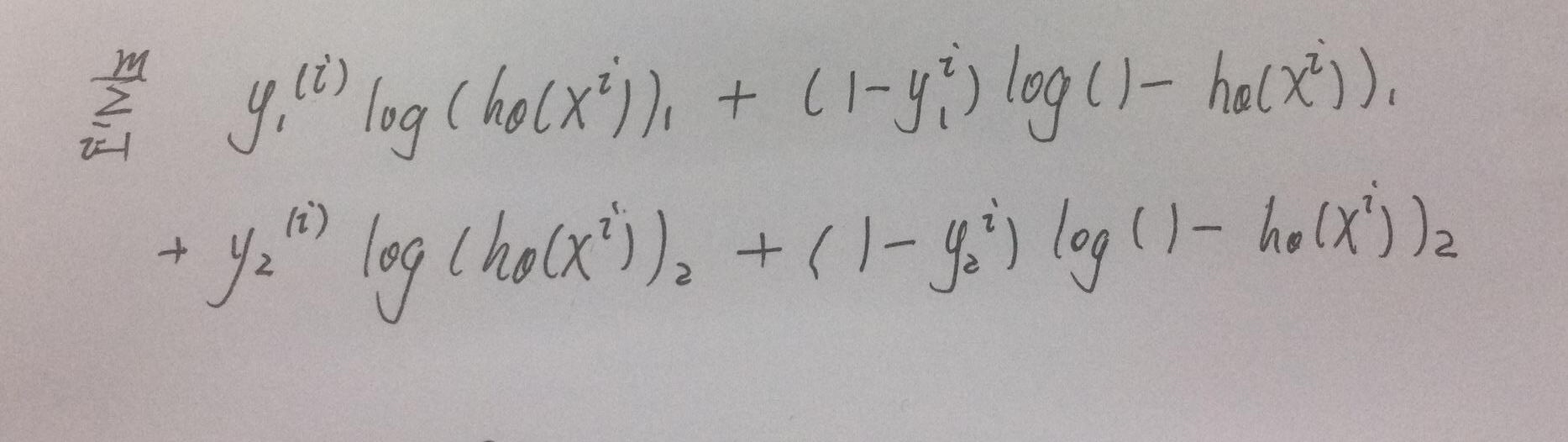

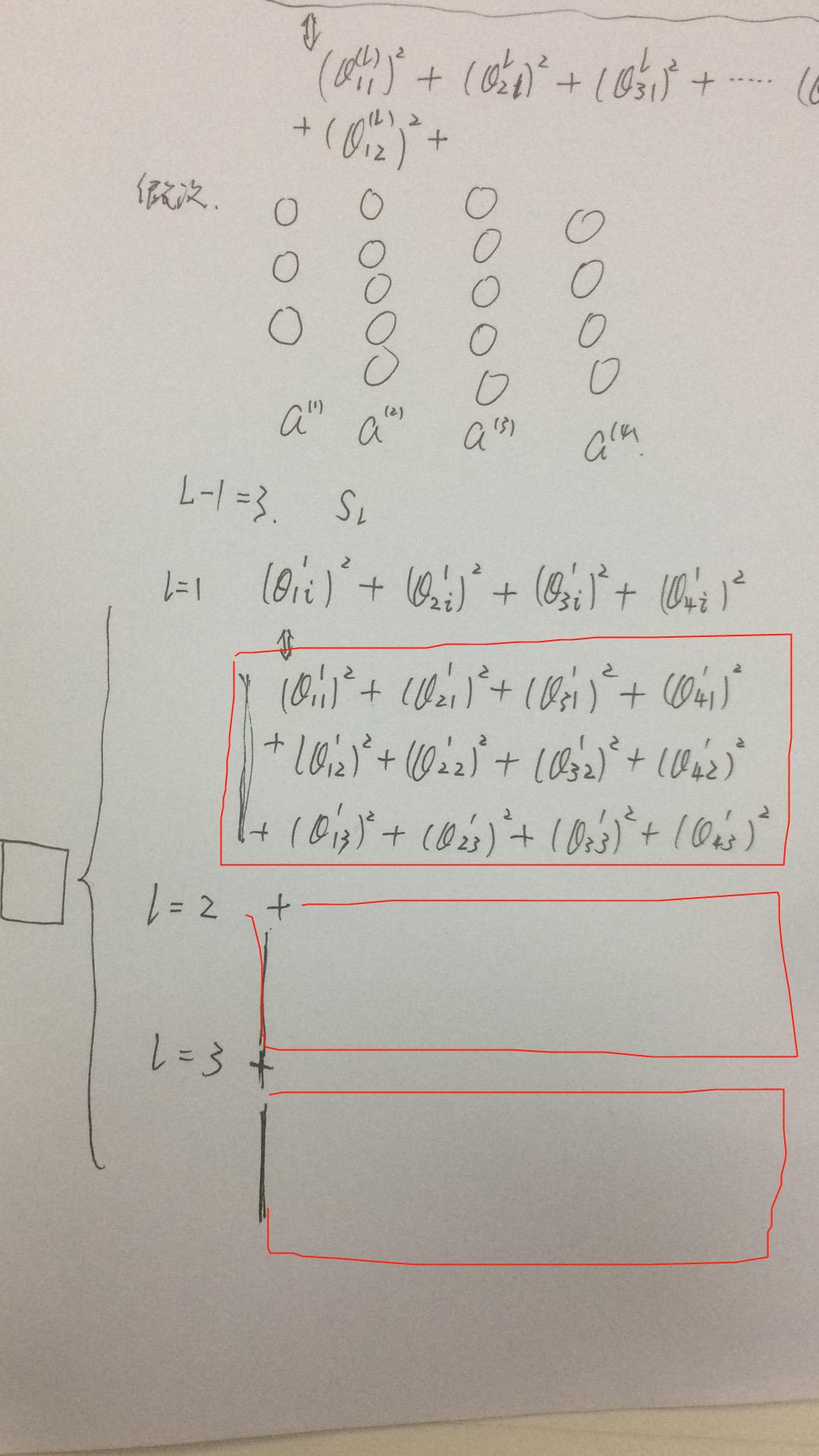

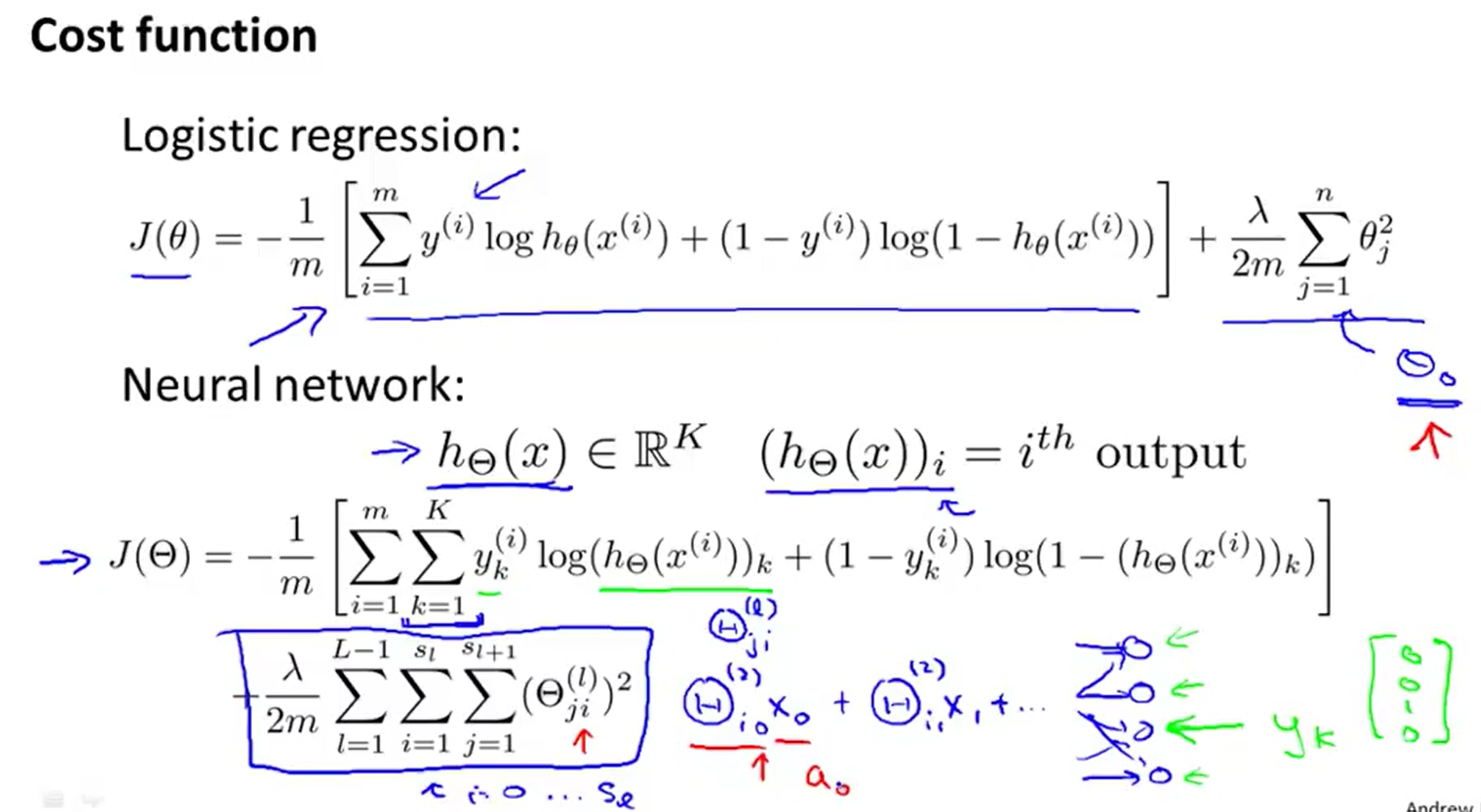

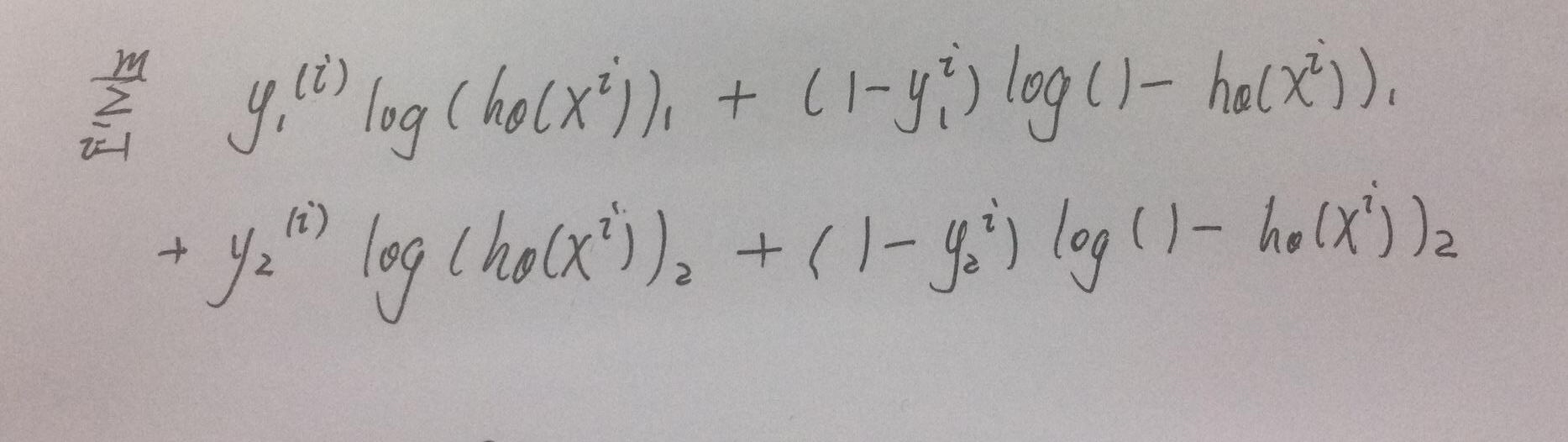

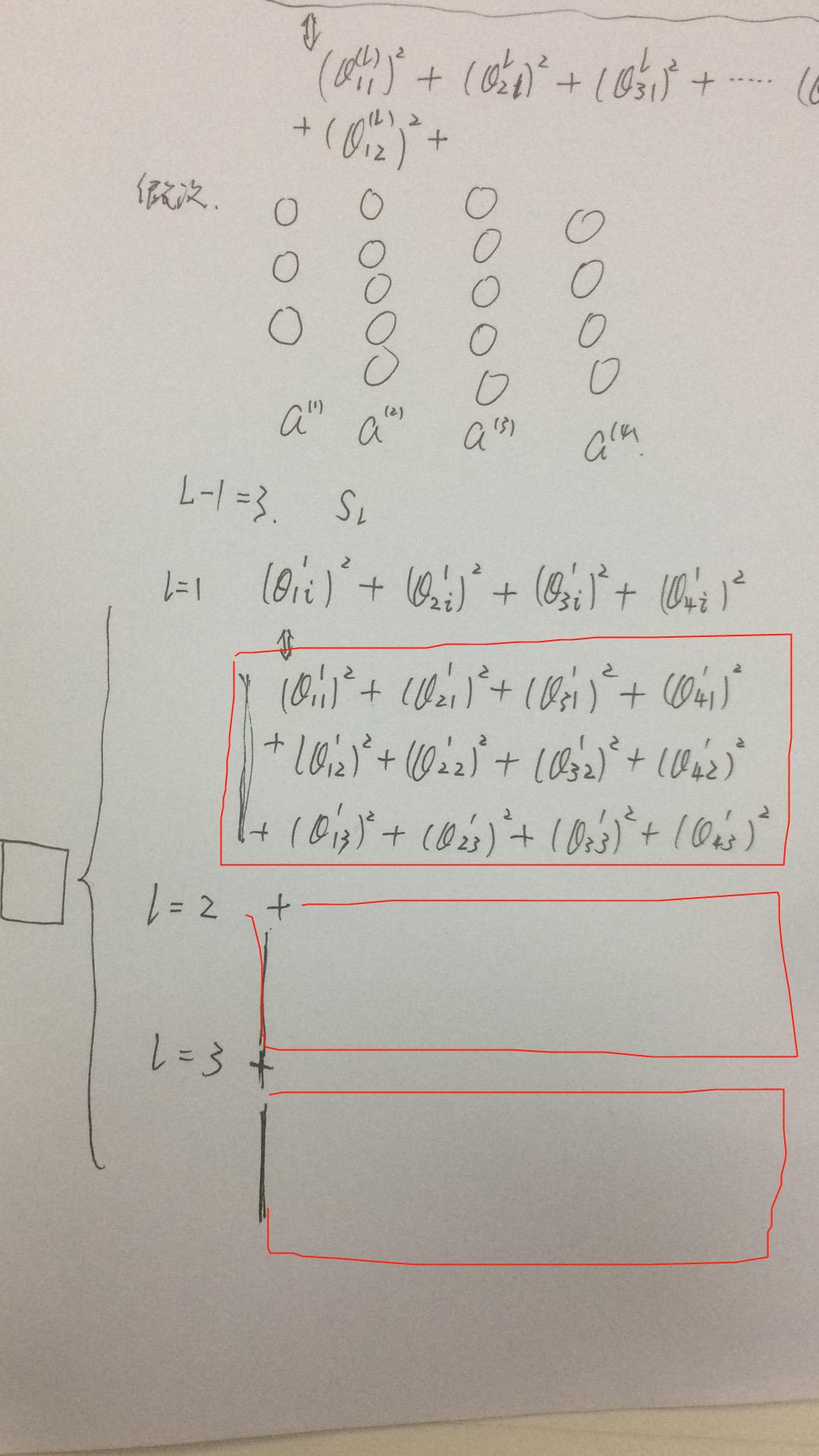

1.这个neural network 的costfunction 看起来很复杂,其实把连加化简,就是上面的普通代价函数在神经网络的应用,只不过把每一层都加起来了。

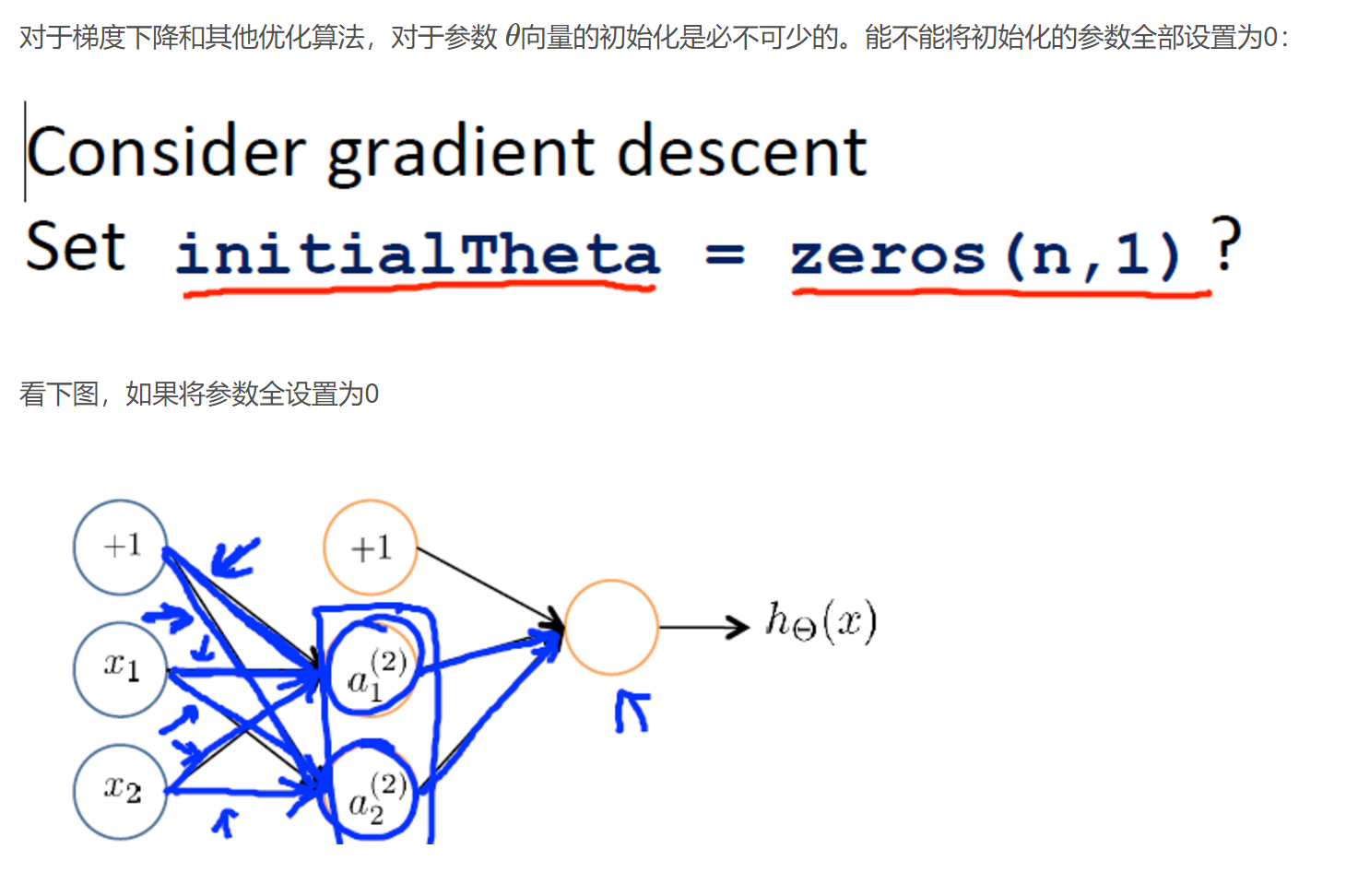

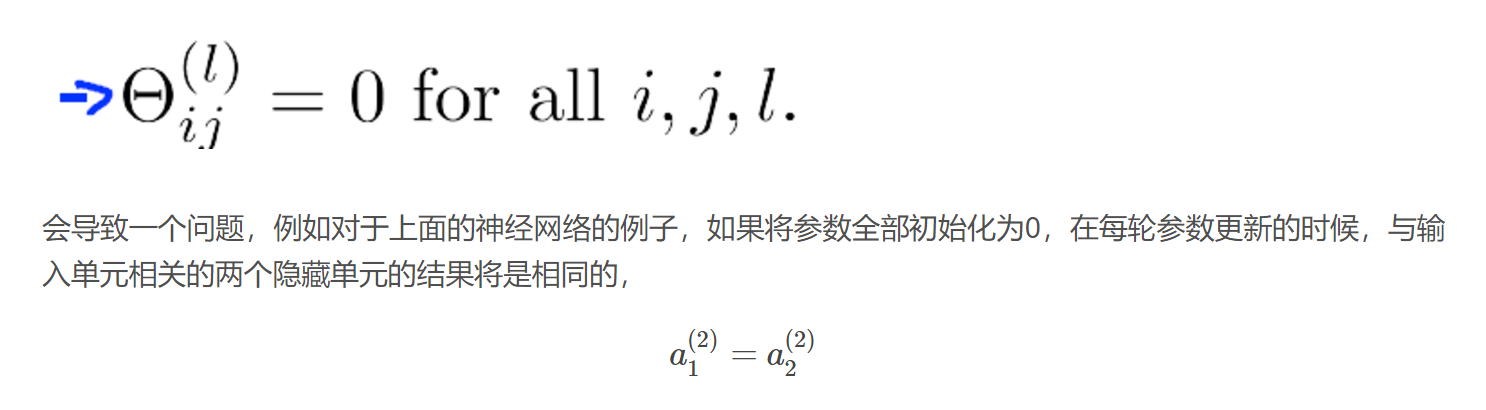

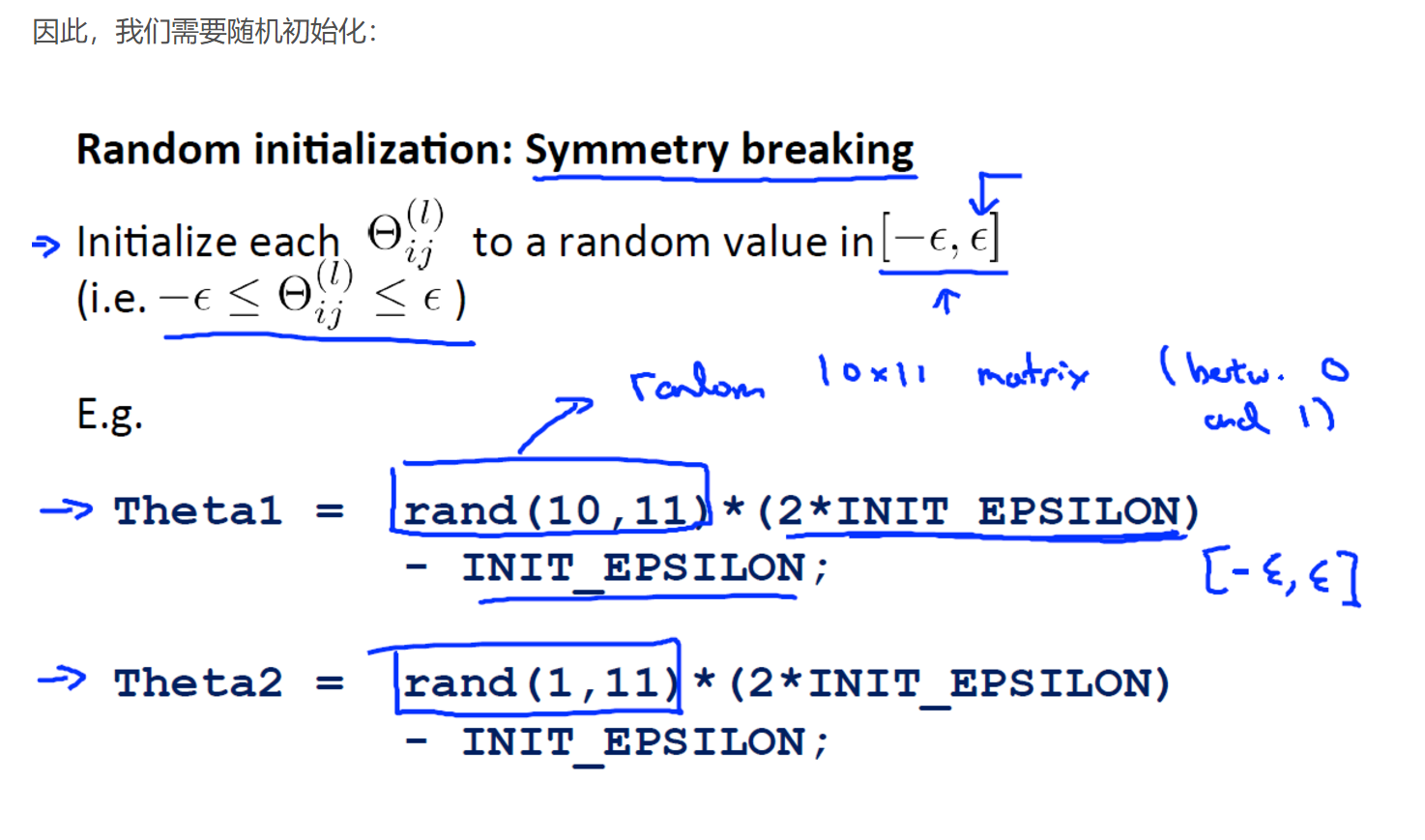

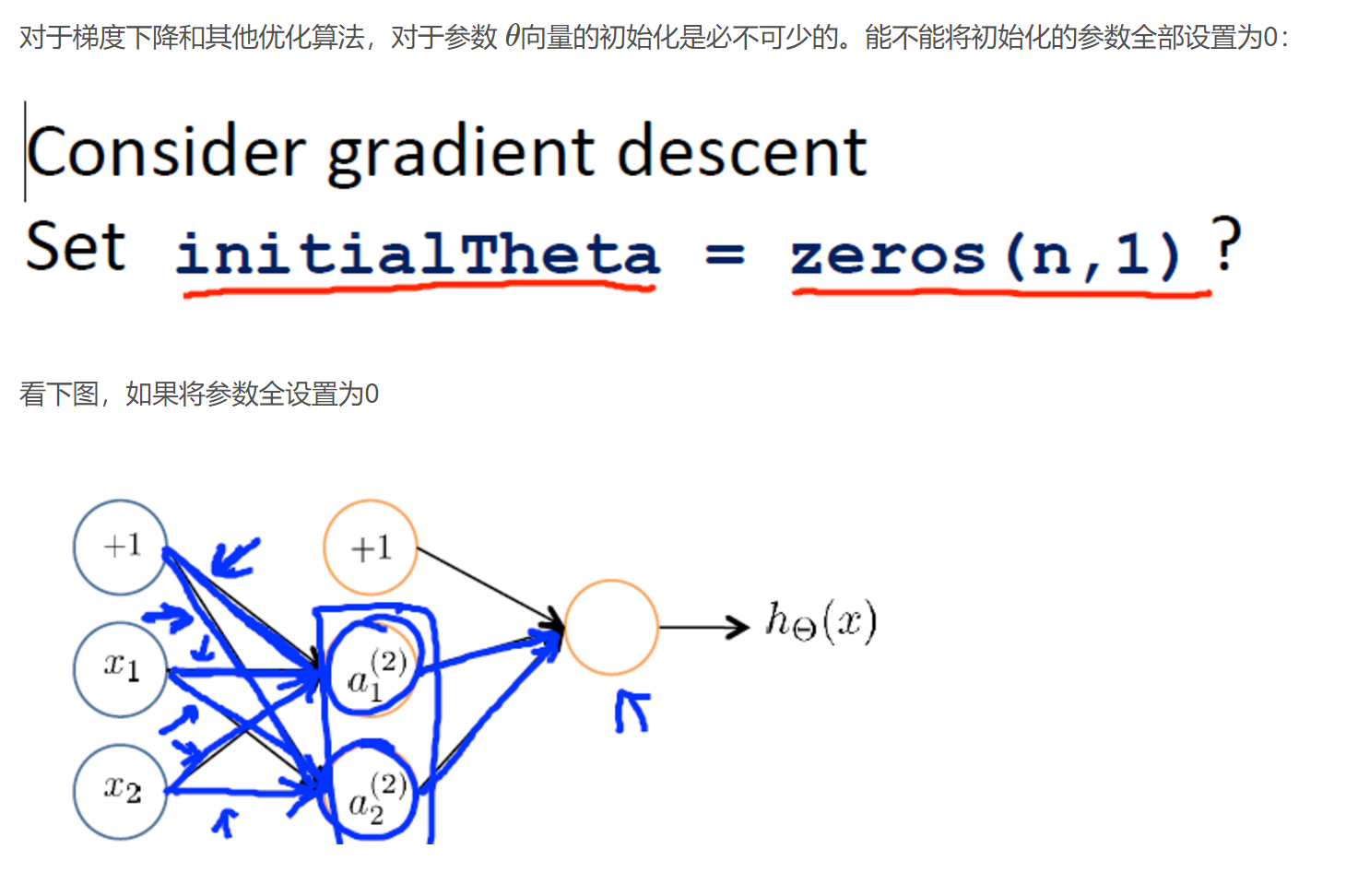

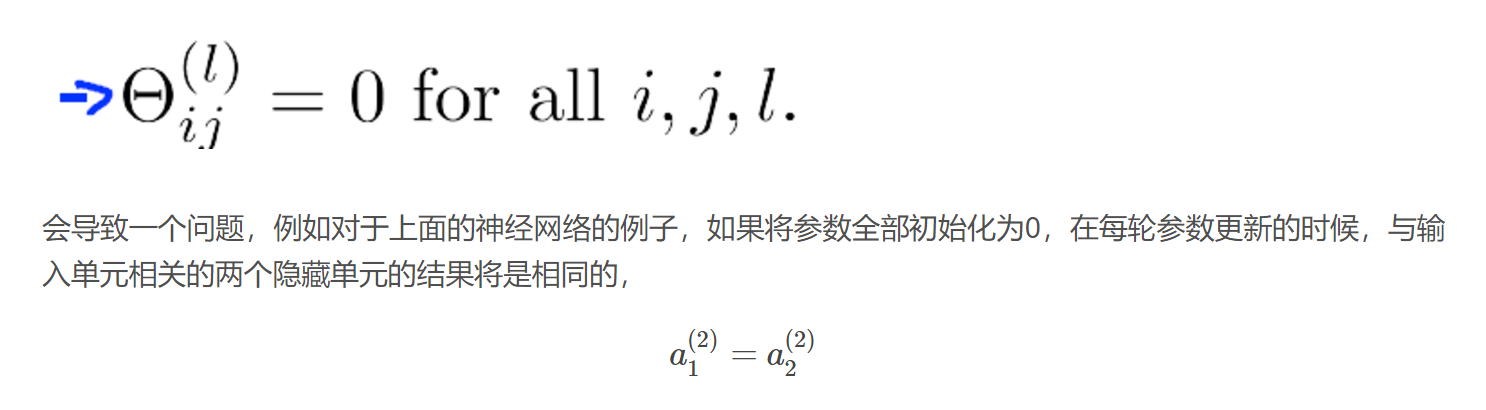

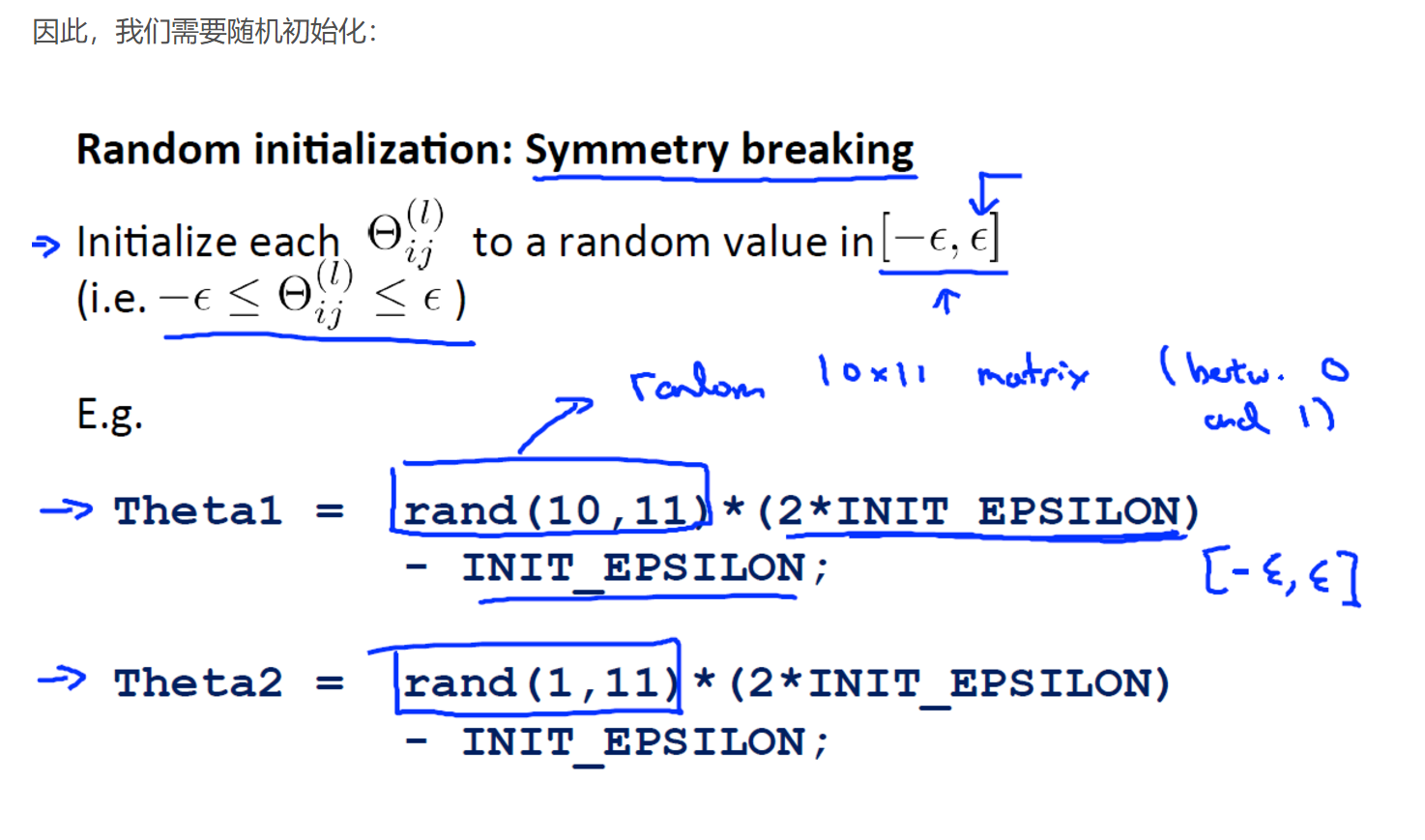

为什么要初始化θ值?

后向传播涉及的公式的推导,把这些公式独立推导?

编程过程中的完整矩阵变换怎么变换的?

1.这个neural network 的costfunction 看起来很复杂,其实把连加化简,就是上面的普通代价函数在神经网络的应用,只不过把每一层都加起来了。

为什么要初始化θ值?

后向传播涉及的公式的推导,把这些公式独立推导?

编程过程中的完整矩阵变换怎么变换的?