iOS开发直播需要的准备

这里我们要研究直播技术首先需要对AVFoundation熟悉掌握

- AVFoundation拍照和录制视频

AVFoundation中提供了很多现成的播放器和录音机,但是事实上它还有更加底层的内容可以供开发者使用。因为AVFoundation中抽了很多和底层输入、输出设备打交道的类,依靠这些类开发人员面对的不再是封装好的音频播放器AVAudioPlayer、录音机(AVAudioRecorder)、视频(包括音频)播放器AVPlayer,而是输入设备(例如麦克风、摄像头)、输出设备(图片、视频)等。首先了解一下使用AVFoundation做拍照和视频录制开发用到的相关类:

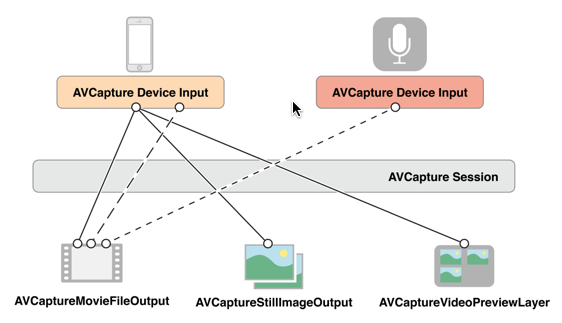

AVCaptureSession:媒体(音、视频)捕获会话,负责把捕获的音视频数据输出到输出设备中。一个AVCaptureSession可以有多个输入输出:

AVCaptureDevice:输入设备,包括麦克风、摄像头,通过该对象可以设置物理设备的一些属性(例如相机聚焦、白平衡等)。

AVCaptureDeviceInput:设备输入数据管理对象,可以根据AVCaptureDevice创建对应的AVCaptureDeviceInput对象,该对象将会被添加到AVCaptureSession中管理。

AVCaptureOutput:输出数据管理对象,用于接收各类输出数据,通常使用对应的子类AVCaptureAudioDataOutput、AVCaptureStillImageOutput、AVCaptureVideoDataOutput、AVCaptureFileOutput,该对象将会被添加到AVCaptureSession中管理。注意:前面几个对象的输出数据都是NSData类型,而AVCaptureFileOutput代表数据以文件形式输出,类似的,AVCcaptureFileOutput也不会直接创建使用,通常会使用其子类:AVCaptureAudioFileOutput、AVCaptureMovieFileOutput。当把一个输入或者输出添加到AVCaptureSession之后AVCaptureSession就会在所有相符的输入、输出设备之间建立连接(AVCaptionConnection):

AVCaptureVideoPreviewLayer:相机拍摄预览图层,是CALayer的子类,使用该对象可以实时查看拍照或视频录制效果,创建该对象需要指定对应的AVCaptureSession对象。

使用AVFoundation拍照和录制视频的一般步骤如下:

- 创建AVCaptureSession对象。

- 使用AVCaptureDevice的静态方法获得需要使用的设备,例如拍照和录像就需要获得摄像头设备,录音就要获得麦克风设备。

- 利用输入设备AVCaptureDevice初始化AVCaptureDeviceInput对象。

- 初始化输出数据管理对象,如果要拍照就初始化AVCaptureStillImageOutput对象;如果拍摄视频就初始化AVCaptureMovieFileOutput对象。

- 将数据输入对象AVCaptureDeviceInput、数据输出对象AVCaptureOutput添加到媒体会话管理对象AVCaptureSession中。

- 创建视频预览图层AVCaptureVideoPreviewLayer并指定媒体会话,添加图层到显示容器中,调用AVCaptureSession的startRuning方法开始捕获。

- 将捕获的音频或视频数据输出到指定文件。

#import "ViewController.h"

#define WIDTH [UIScreen mainScreen].bounds.size.width

#define HEIGHT [UIScreen mainScreen].bounds.size.height

@interface ViewController ()<AVCaptureVideoDataOutputSampleBufferDelegate>

@property (nonatomic,strong)AVCaptureSession *session;

@property (nonatomic,strong)AVCaptureVideoPreviewLayer *preViewLayer;

@end

@implementation ViewController{

AVCaptureConnection *_videoConnection;//输入输出建立连接

AVCaptureConnection *_audioConnection;

}

- (void)viewDidLoad {

[super viewDidLoad];

[self initView];

// Do any additional setup after loading the view, typically from a nib.

}

-(void)initView{

//初始化会话

NSError * error = nil;

self.session = [[AVCaptureSession alloc] init];

// ???

self.session.sessionPreset = AVCaptureSessionPresetMedium;

//设置摄像头

AVCaptureDevice * device = [self cameraWithPosition:AVCaptureDevicePositionFront];

//获取输入设备

AVCaptureDeviceInput * input = [AVCaptureDeviceInput deviceInputWithDevice:device error:&error];

if (error) {

NSLog(@"%@",error);

}

//添加输入设备

if ([_session canAddInput:input]) {

[self.session addInput:input];

}

//获取输出设备

AVCaptureVideoDataOutput * output = [[AVCaptureVideoDataOutput alloc] init];

dispatch_queue_t queue = dispatch_queue_create("myQueue", NULL);

[output setSampleBufferDelegate:self queue:queue];

output.videoSettings = [NSDictionary dictionaryWithObject:[NSNumber numberWithInt:kCVPixelFormatType_420YpCbCr8BiPlanarFullRange] forKey:(NSString *)kCVPixelBufferPixelFormatTypeKey];

output.alwaysDiscardsLateVideoFrames = YES;

[self startRuning];

//添加输出设备

if ([self.session canAddOutput:output]) {

[self.session addOutput:output];

}

//创建浏览层,用于展示

self.preViewLayer = [[AVCaptureVideoPreviewLayer alloc] initWithSession:self.session];

self.preViewLayer.frame = CGRectMake(0, 0, WIDTH, 500);

self.preViewLayer.videoGravity = AVLayerVideoGravityResizeAspectFill;//填充模式

[self.view.layer addSublayer:self.preViewLayer];

//

_videoConnection = [output connectionWithMediaType:AVMediaTypeVideo];

}

-(void)startRuning{

[self.session startRunning];

}

// 选择是前摄像头还是后摄像头

- (AVCaptureDevice *)cameraWithPosition:(AVCaptureDevicePosition) position {

NSArray *devices = [AVCaptureDevice devicesWithMediaType:AVMediaTypeVideo];

for (AVCaptureDevice *device in devices) {

if ([device position] == position) {

return device;

}

}

return nil;

}

// 关键方法,捕获摄像头每一帧的画面并编码

-(void) captureOutput:(AVCaptureOutput *)captureOutput didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection {

if (connection == _videoConnection) {

// [_manager264 encoderToH264:sampleBuffer];

}

if (connection == _audioConnection) {

NSLog(@"yy");

}

}

@end

浙公网安备 33010602011771号

浙公网安备 33010602011771号