大数据Hadoop第二周——配置新的节点DataNode及ip地址

大数据第二周:

- 安装CentOS7最小安装版

磁盘空间不小于30G,将虚拟磁盘存储为单个文件。

自定义硬件界面上,注意要勾选“虚拟化Intel VT-x或AMD-V/RVI(V)”。

在此界面上,“SOFTWARE SELECTION”保持默认,因为默认就是最小安装。

最小安装完成后,要配置网络,使其可以上网。

打开NameNode虚拟机,在GUI中右键打开一个终端窗口,输入命令:

cd /etc/sysconfig

进入系统设置文件夹。然后用命令cd network-scripts,进入网络设置目录。

用ls命令查看目录内容。找到对应网卡号的文件。

怎么知道的网卡号:用命令ip a。

修改NAT内网的网络地址。第一步关闭虚拟机;第二部,点击VMware的编辑菜单,选中虚拟网络编辑器,由于我们使用的是NAT模式,选中NAT模式进行修改。

在子网IP栏里输入任何你想用的IP,最后一位需要是0,应为子网掩码是255.255.255.0。

点击NAT设置,将网关如图对应设置,注意网关最后一位不可以是1。并记住网关地址,虚拟机设置时需要使用。

NameNode虚拟机中,对应网卡号的文件内容,当前时dhcp形式,自动分配IP地址:

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=dhcp

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=343c6011-73f9-457c-84e7-30c635136974

DEVICE=ens33

ONBOOT=no

修改网卡为静态IP地址,然后,再看配置文件内容:

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=343c6011-73f9-457c-84e7-30c635136974

DEVICE=ens33

ONBOOT=no

IPADDR=10.0.0.10

PREFIX=24

GATEWAY=10.0.0.2

DNS1=10.0.0.2

开机DataNode1,进入网卡配置文件,由于没有图形界面,只能用内置编辑器vi。Vi有三种模式,一般命令模式,底行命令模式,编辑模式。刚进入时是一般命令模式,按i或s进入编辑模式,按Esc进入一般命令模式;在一般命令模式下,按冒号“:”,进入底行命令模式。在相应目录下,执行sudo vi ifcfg-ens33命令,编辑文件。

点击i进入编辑模式,修改两句成为:

BOOTPROTO=none

ONBOOT=yes

添加4句;

IPADDR=10.0.0.11

NETMASK=255.255.255.0

GATEWAY=10.0.0.2

DNS1=10.0.0.2

然后按ESC进入一般命令模式,再按冒号进入底行命令模式,输入wq,回车后退出。

重启虚拟机命令:sudo reboot

检查能否上网,用命令,例如:ping www.zufe.edu.cn

如能ping通,说明网络配置完成。

- 确定Spark、Hadoop、 Java版本

2.1选择Spark版本

进入Spark官方网站,http://spark.apache.org/,查找有关spark的版本信息。在主页上没有版本信息说明,按照经验,进入download界面。界面上显示:

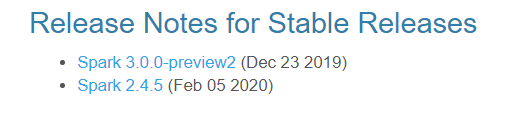

提示下载Spark3.0.0,但是我们作为学习,能否下载此版本?页面下端有如下图:

点击相应链接,认真阅读说明,选择稳定版。

http://spark.apache.org/news/spark-3.0.0-preview2.html

从以上说明,Spark3.0.0并不是一个稳定版。

在这个页面上http://spark.apache.org/releases/spark-release-2-4-5.html:

页面上说明Spark2.4.5是正在维护的一个稳定版,所以我们选择此版本。

回到下载页面:http://spark.apache.org/downloads.html

选择Spark2.4.5,页面显示如下:

需要Hadoop2.7版本。

结论:Spark2.4.5,Hadoop2.7

下载Spark2.4.5。

2.2选择java版本

进入Hadoop官方网站,按照经验,点击download进入下载页面,下载页面中没有Hadoop2.7版本下载,也没有java版本相关信息,但有一个镜像网站链接,点击链接,可以找到Hadoop2.7版本,将此版本下载下来。

在Hadoop官方网站主页,点击“Learn more”,跳转到https://hadoop.apache.org/docs/stable/,点击页面底端的“Cluster Setup”链接,跳转到:

https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/ClusterSetup.html,在页面“Prerequisites”标题下,有“Install Java. See the Hadoop Wiki for known good versions”提示,点击链接进入:https://cwiki.apache.org/confluence/display/HADOOP2/HadoopJavaVersions,页面里有java版本信息,从此信息判断,我们需要java7.

结论:安装java7。

linux查看网络设置命令:

cd /etc/sysconfig/network-scripts/ sudo vim ifcfg-ens33 service network restart

重启centos7:systemctl restart network