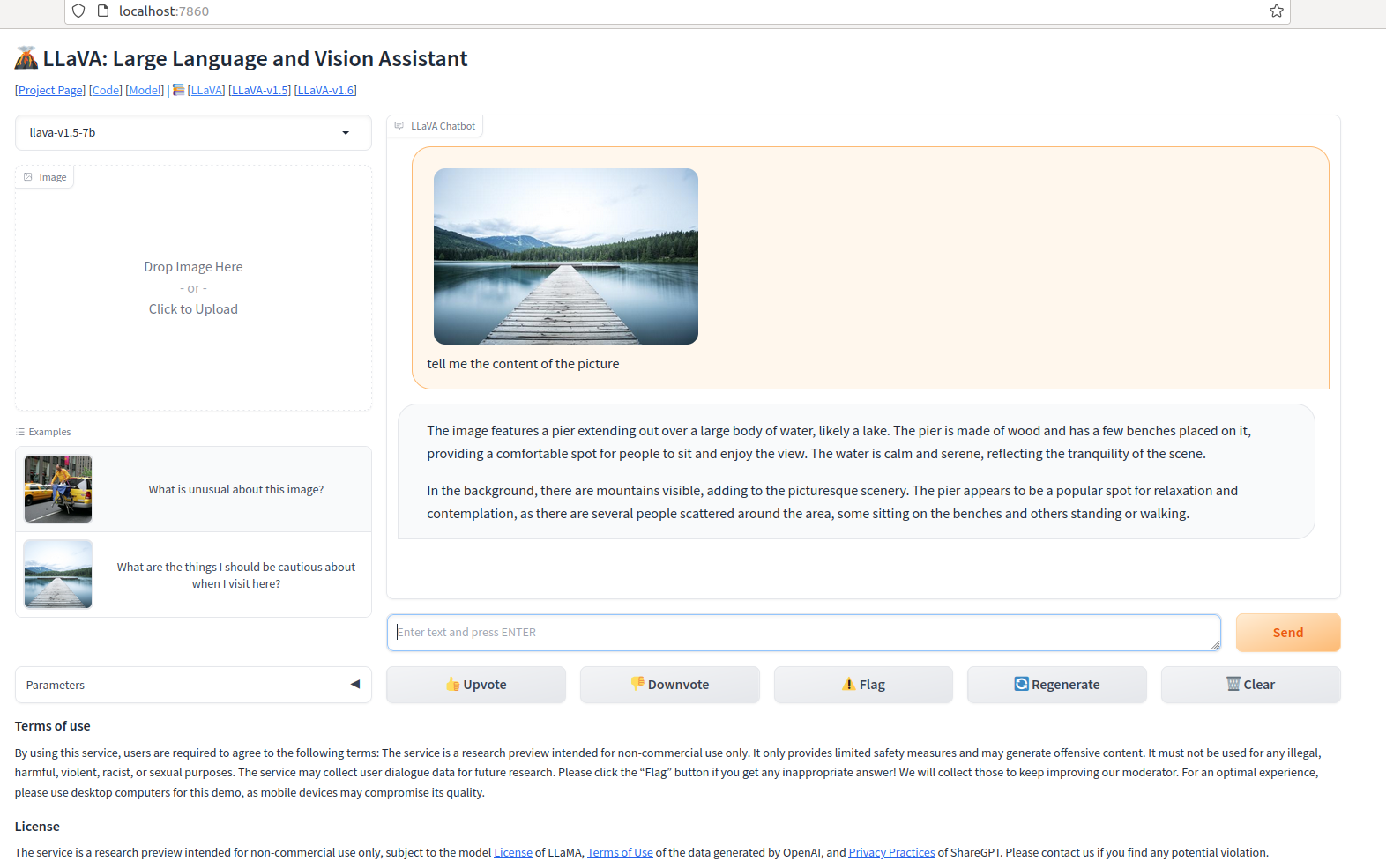

LLAVA部署

先简单记录版本,以后再详细;

haotian-liu/LLaVA at v1.2.1 (github.com)

当前调通版本:

cuda11.7; cudnn

LLava-1.2.1;

python3.10; torch2.0.1

flash-attn; flash_attn-2.0.7+cu117torch2.0cxx11abiTRUE-cp310-cp310-linux_x86_64.whl

3090Ti

llava-7b模型

具体工作:

1. 先测试cuda版本;--> 至少11.6以上;

--> 学习一个linux同时安装多个cuda; 多版本cuda切换;

--> 根据系统gpu 驱动,匹配对应可以安装的cuda; 我用的老的,导致我最高只能安装cuda11.7; 驱动是可以更高的;

2. LLava最新版本在pip install -e .的时候,会安装非常新的torch. 而这个torch又会非常麻烦的不匹配cuda和driver, 除非你的driver很新。所以我这里只能用旧的。测试了1.2.1版本。

3. flash-attn也是非常有问题的,按照官网指示的cuda和torch和python版本是没有用的,他们即使和你的一模一样也不行,就是匹配不上,能做的就是一代一代往前试,然后有一代就通过了。

4. 接下来最后一个工作是web-driver出来了,model上不去的问题,最后发现是指令不对,所以建议指令还是复制比较好。

详细工作,我会专门写一篇详细部署过程,也会出一期视频来讲解。链接会放在这个下面。如果还没放,说明还没写好。