【Hadoop学习之五】win7+Eclipse+hadoop3搭建本机开发环境

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk8

hadoop-3.1.1

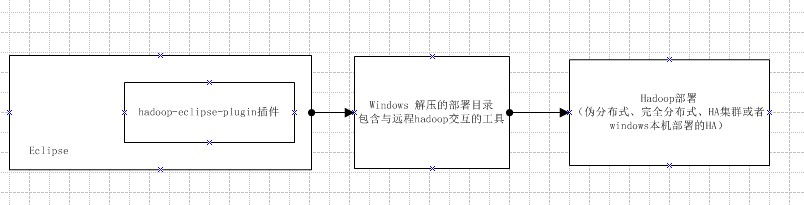

拓扑:

知识准备:

1、eclipse在win7本机电脑上,而部署的hadoop可以是在本机windows 也可以是远程Linux 伪分布式、完全分布式、HA集群

2、为了方便开发,引入hadoop的eclipse插件(插件并不是必需的),方便之处有两点:(1)对hadoop中的文件可视化(2)创建MapReduce Project时帮你引入依赖的jar

3、win7上有一个解压的hadoop-3.1.1目录,这不是部署用的,作用有两点:

(1)eclipse要使用hadoop-3.1.1\bin下的工具与远程部署的hadoop交互:创建目录、查看、上传、下载、删除文件等

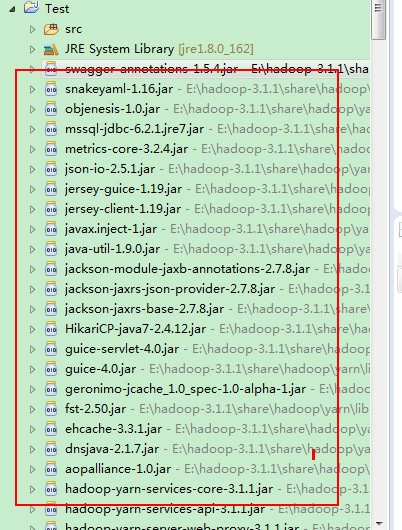

(2)提供hadoopjar:创建MapReduce Project自动引入的jar来源于hadoop-3.1.1\share\hadoop

一、软件准备

远程:

hadoop-3.1.1已部署启动(伪分布式)

本机:

1、安装jdk8,设置环境变量JAVA_HOME

2、hadoop-3.1.1

2.1解压hadoop-3.1.1.tar.gz到本地:我这里是E:\hadoop-3.1.1 设置环境变量:HADOOP_HOME和HADOOP_USER_NAME(默认访问hdfs集群的用户 否则会取当前windows名称访问)

2.2原版的Hadoop不支持Windows系统,我们需要修改一些配置方便在Windows上运行

下载 hadoop.rar

2.2.1 拷贝bin下所有到hadoop-3.1.1\bin下

2.2.2 拷贝bin下 hadoop底层依赖库:hadoop.dll 到C:\Windows\System32下

2.2.3 修改hadoop-env.cmd中java_home为最新的jdk(如果新版已经设置了取系统环境变量 这里就不用设置了)

3、将插件hadoop-eclipse-plugin-2.6.0.jar放到eclipse安装目录下面的plugins里面 重启eclipse

eclipse操作:

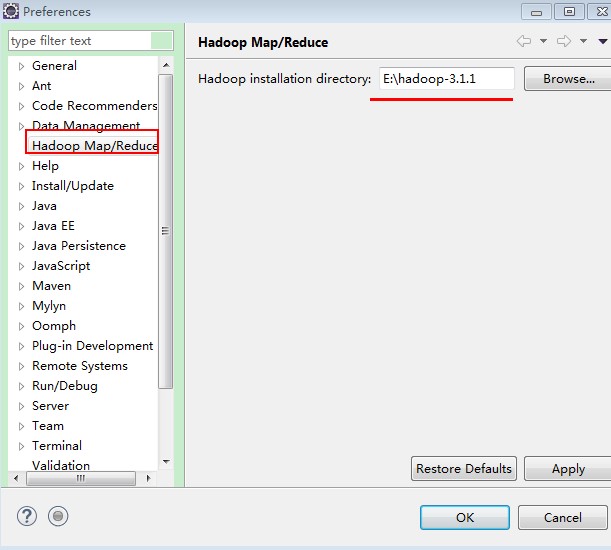

1、配置hadoop安装目录

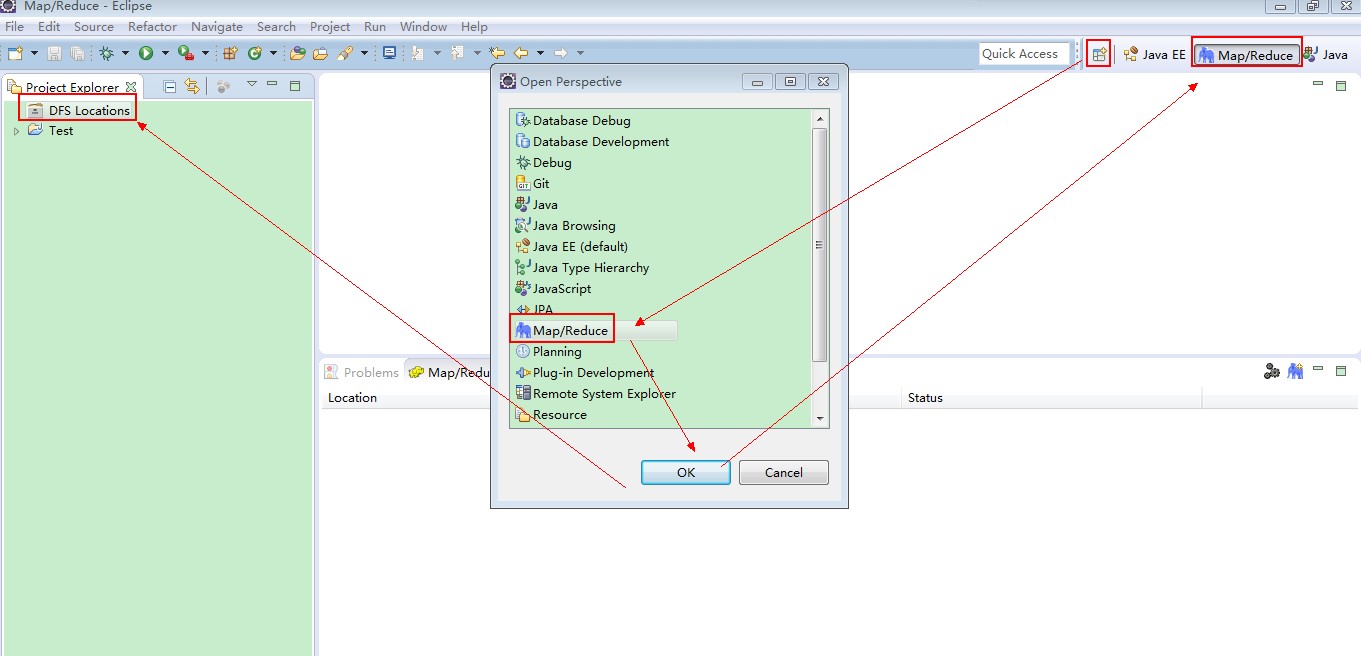

2、打开Map/Reduce Perspective

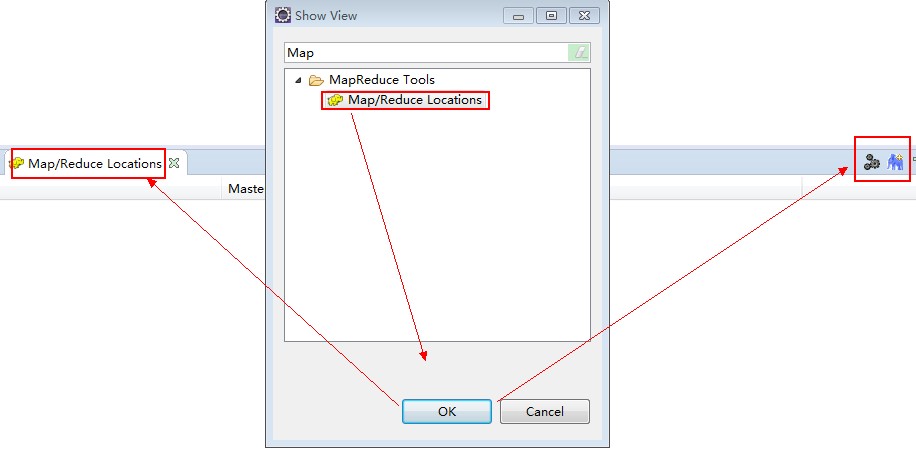

3、打开Map/Reduce Locations视图

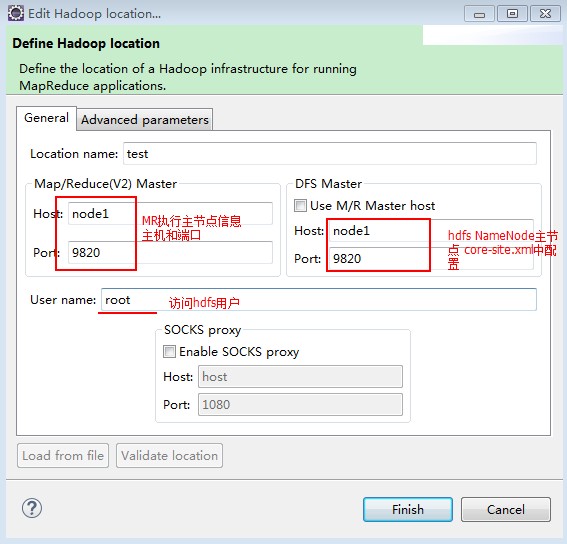

4、创建HDFS Location

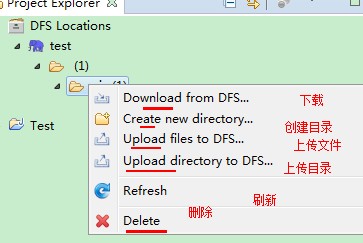

查看DFS Locations

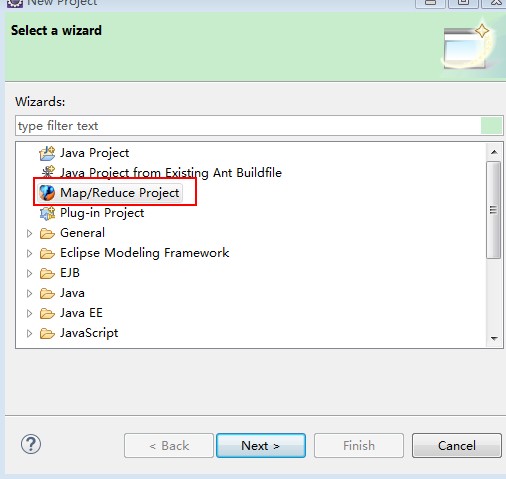

5、创建Map/Reduceproject

创建的工程就是java工程 只不过会自动把hadoop-3.1.1\share\hadoop下的jar导入工程

参考:

hadoop-eclipse-plugin插件原理

hadoop-eclipse-plugin插件使用

其他:

https://www.cnblogs.com/wenhaizhang/p/5345094.html

https://blog.csdn.net/crazytaliban/article/details/70190774

https://blog.csdn.net/yang1464657625/article/details/78453678

https://blog.csdn.net/csdn_fzs/article/details/78985586

https://www.cnblogs.com/dream-to-pku/p/7930241.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号