推理server 二 tensorflow serving使用示例

docker run --network=host -v /home/test/models/:/mnt/models tensorflow-serving:v1.14.0 --port=9045 --rest_api_port=8040 --model_name="flowers" --model_base_path="/mnt/models/flowers"

注意,kserve使用的就是tensorfow serving,未做更改。

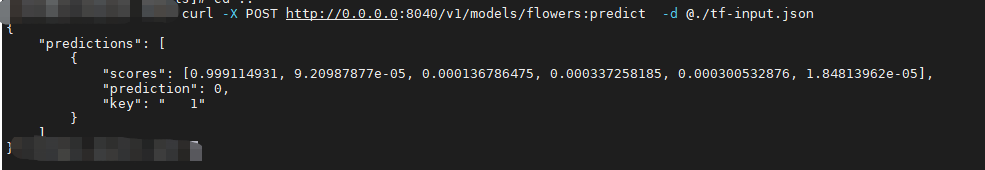

启动后进行测试:curl -X POST http://0.0.0.0:8040/v1/models/flowers:predict -d @./tf-input.json

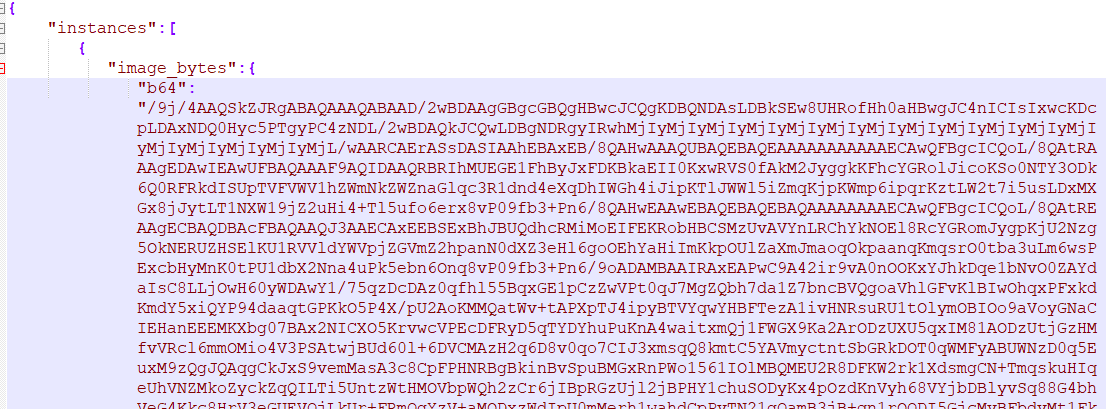

tf-input.json是一张图片:

posted on 2021-11-09 11:02 MissSimple 阅读(73) 评论(0) 编辑 收藏 举报