爬虫之浏览器指纹ja3_hash的更改

浏览器指纹

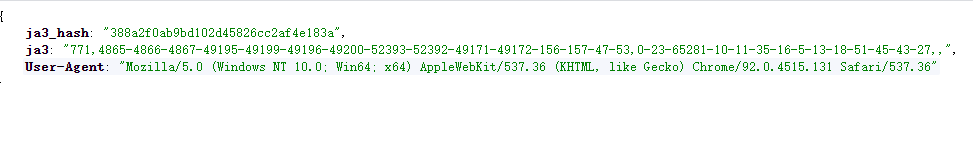

反爬中会遇到浏览器指纹,它是不会随着你更换 IP 或者 User-Agent 而改变的。并且他们的指纹每次请求也是固定的。只要网站发现某个拥有特定指纹的客户端持续高频率请求网站,它就可以把你封掉。例子如下:

https://ja3er.com/ # 可以看到ja3的指纹

https://ja3er.com/json # 请求这个直接返回本次请求的json

当在网页打开的时候是这样的

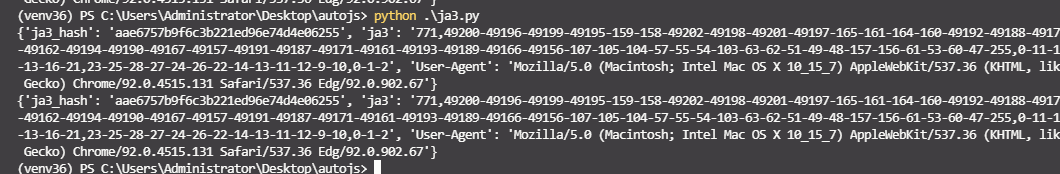

未修改requests加密的时候请求打开是这样的

因为通过python,或者浏览器,或者其他解释器 得到的结果都是不一样的, 但是每个解释器里面的请求是一样的,所以,我们要修改 ja3_hash 的值,因为代码修改是参考别人的,所以就直接粘出来好了,具体解释去网上看看

新建一个Py文件,然后复制代码

import random

from requests.adapters import HTTPAdapter

from requests.packages.urllib3.util.ssl_ import create_urllib3_context

ORIGIN_CIPHERS = ('ECDH+AESGCM:DH+AESGCM:ECDH+AES256:DH+AES256:ECDH+AES128:DH+AES:ECDH+HIGH:'

'DH+HIGH:ECDH+3DES:DH+3DES:RSA+AESGCM:RSA+AES:RSA+HIGH:RSA+3DES')

# 覆盖父类的适配器

class DESAdapter(HTTPAdapter):

def __init__(self, *args, **kwargs):

"""

A TransportAdapter that re-enables 3DES support in Requests.

"""

CIPHERS = ORIGIN_CIPHERS.split(':')

random.shuffle(CIPHERS)

CIPHERS = ':'.join(CIPHERS)

self.CIPHERS = CIPHERS + ':!aNULL:!eNULL:!MD5'

super().__init__(*args, **kwargs)

def init_poolmanager(self, *args, **kwargs):

context = create_urllib3_context(ciphers=self.CIPHERS)

kwargs['ssl_context'] = context

return super(DESAdapter, self).init_poolmanager(*args, **kwargs)

def proxy_manager_for(self, *args, **kwargs):

context = create_urllib3_context(ciphers=self.CIPHERS)

kwargs['ssl_context'] = context

return super(DESAdapter, self).proxy_manager_for(*args, **kwargs)

import requests

headers = {'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.131 Safari/537.36 Edg/92.0.902.67'}

# 有了适配器以后,我们使用 requests 时,初始化一个 Session,然后把这个适配器绑定到特定的网站上:

s = requests.Session()

s.headers.update(headers)

for _ in range(2):

s.mount('https://ja3er.com', DESAdapter()) # s.mount的第一个参数表示这个适配器只在https://ja3er.com开头的网址中生效

resp = s.get('https://ja3er.com/json').json()

print(resp)

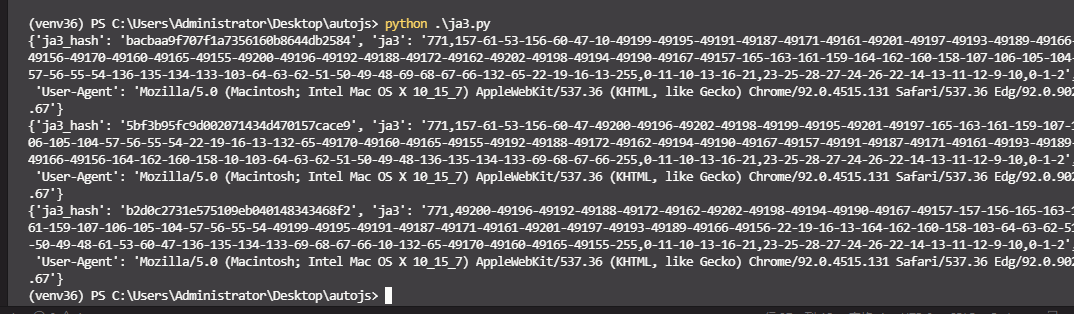

执行py代码,会看到ja3_hash已经被修改了

成功。这样就可以绕过 ja3_hash 指纹检测的网站了