python机器学习-chapter2_6

•logistic回归中有一个参数是penalty,penalty用来控制logistic回归的正则化,默认penalty = 'l2',也可等于l1

当使用penalty = 'l1'时就是使用了L1正则化,使用L1正则化的logistic回归是一个解释性更强的模型,只使用了少数几个特征。

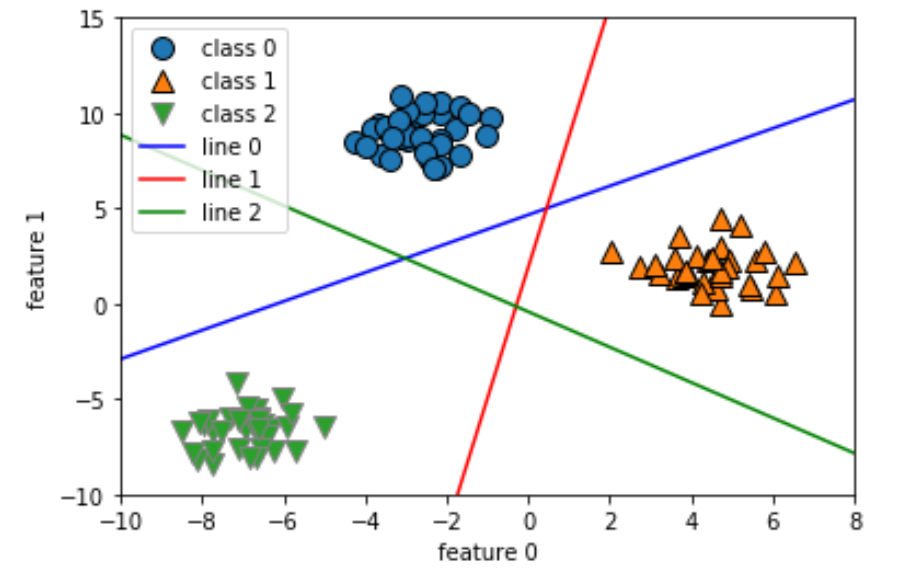

•one-vs.-rest “一对其余” 多分类线性模型

♠训练集中所有属于类别0的点都在 与类别0对应的直线 上方,说明这些点 位于 这个二类分类器 属于“类别0”的那一侧。

属于类别0的点 位于 类别1对应的直线的左侧,这说明类别0的点被 类别1对应的直线划为“其余”。

属于类别0的点 位于 类别2对应的直线的上方,这说明类别0的点被 类别2对应的直线划为“其余”。

因此,这一区域的所有点被 最终分类器 划为类别0(类别0对应的置信方程结果 >0,其余两个方程的结果 <0)

♠对于图像中央的三角区域,三个二类分类器都将其划为其余,三角区域内的点如何归属?

三角区域内的点被归属为分类方程结果最大的那个类别,即最靠近的那条线的类别。

•线性模型总结

♠线性模型中的主要参数是alpha和C:

在线性回归(OLS)、岭回归、lasso回归中为alpha,

在logistic回归、linear SVM中为C,

alpha越大或C越小,说明约束力越大,模型越简单,泛化能力越好。

♠特征数量大于样本数量时,线性模型的表现通常很好

♠回归:线性回归、岭回归、lasso回归

线性回归:不可控制模型的复杂度

岭回归:可控制模型的复杂度,L2正则化,

lasso回归:L1正则化(适用于特征很多但只有几个特征的情况 和 需要建立容易理解的模型的情况)

分类:logistic回归、linearSVM

logistic回归:LI正则化、L2正则化(有penalty参数控制),可用于二分类和多分类

linearSVM:L2正则化,用于二分类