tf.nn.relu()

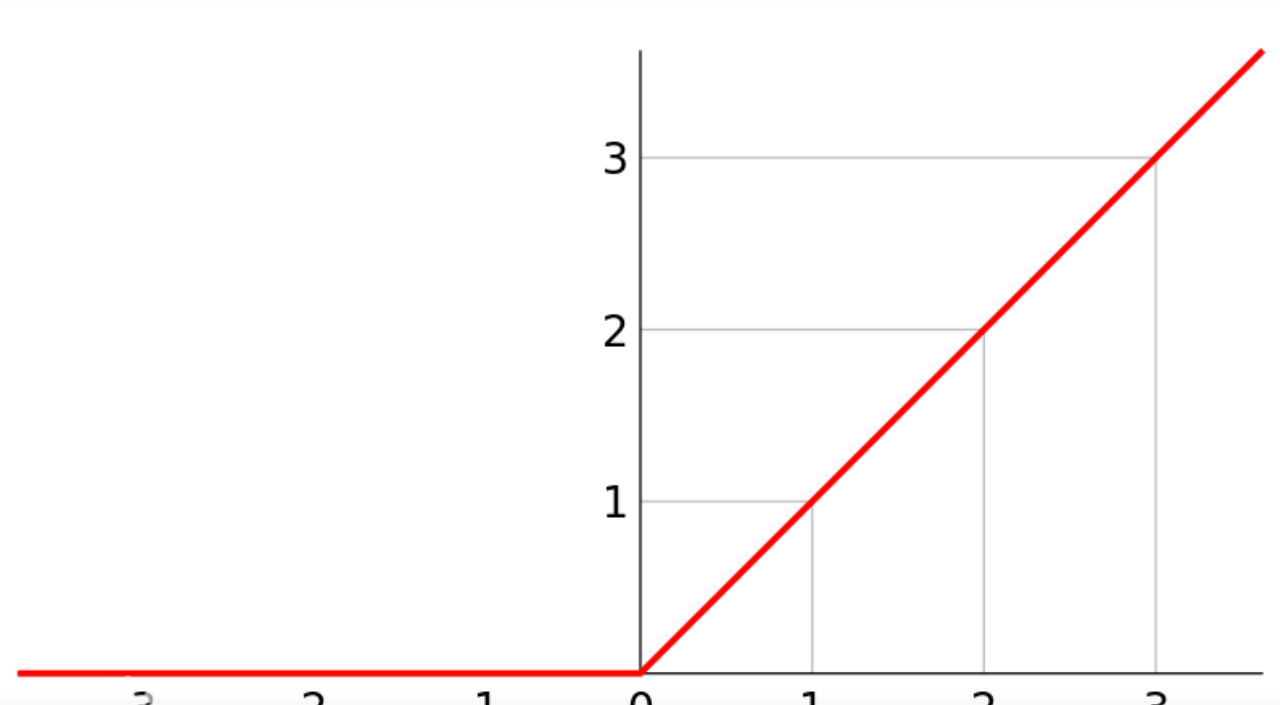

线性整流函数(Rectified Linear Unit, ReLU),又称修正线性单元。其定义如下图,在横坐标的右侧,ReLU函数为线性函数。在横坐标的右侧,ReLU函数为值为0。

因此,tf.nn.relu()函数的目的是,将输入小于0的值幅值为0,输入大于0的值不变。

import tensorflow as tf

a = tf.constant([-1.0, 2.0,-3.6])

with tf.Session() as sess:

b = tf.nn.relu(a)

print(sess.run(b))

测试结果为:

[0. 2. 0.]

其实我的理解tf.nn.relu()函数就是数据变为大于等于0的非负数。