python爬虫公众号所有信息,并批量下载公众号视频

之前写过一篇类似的文章:python爬取公众号,用最简单的方式爬虫

还有同学一直在问,可能中间有一些小细节不明确,这次彻底明确一下细节。

本篇添加一个批量下载公众号内视频的功能,可以实现完全复制一个公众号,危险动作,请不要操作!谢谢

主要功能

如何简单爬虫微信公众号

获取信息:标题、摘要、封面、文章地址

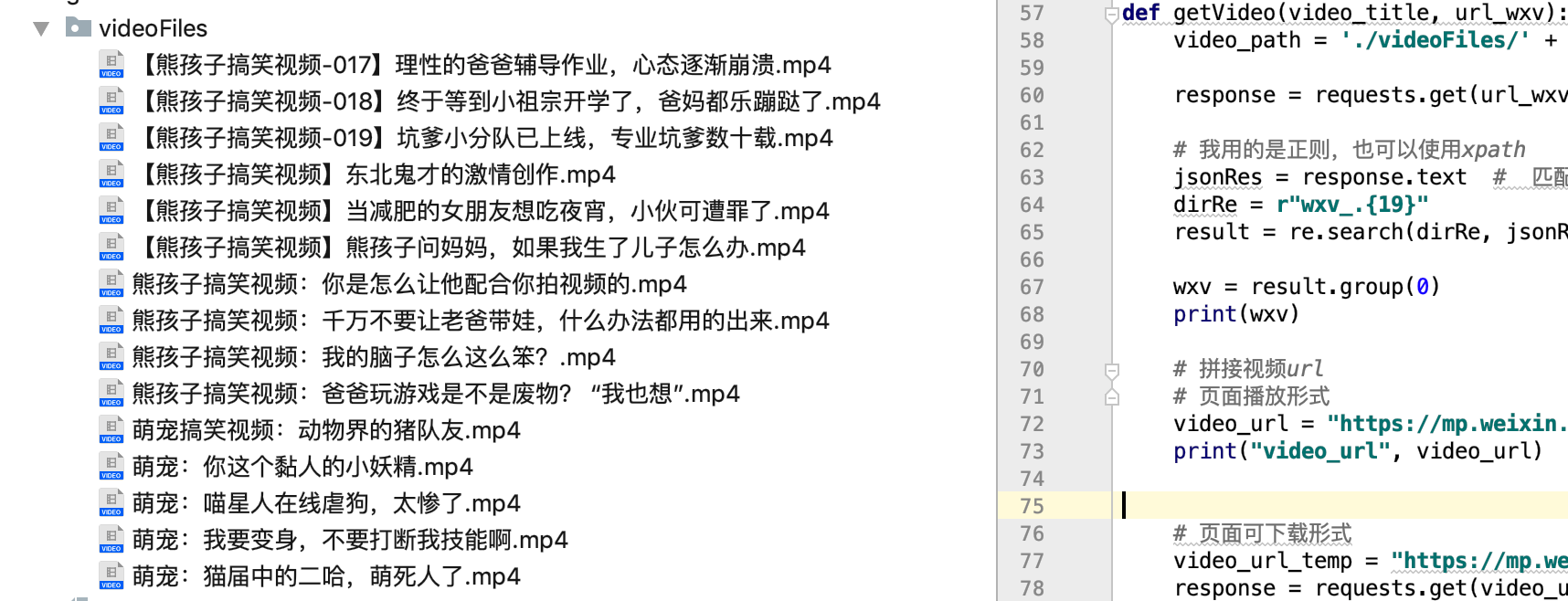

自动批量下载公众号内的视频

本次选取的公众号:熊孩子与萌宠

每天更新视频:熊孩子日常、萌宠日常、熊孩子和萌宠搞笑视频,笑声不断快乐常伴!

请允许我强制打一波广告:

因为每次爬虫公众号都是他家的,一年前是,现在亦是,只是更换了主题和名字。

一个喜欢小宠物,养不起猫的码农,工作之余看看还是很开心的。可以关注一下!

为了视频安全与避免造成损失,已友善提醒号主,视频添加水印。

获取公众号信息

标题、摘要、封面、文章URL

操作步骤:

1、先自己申请一个公众号

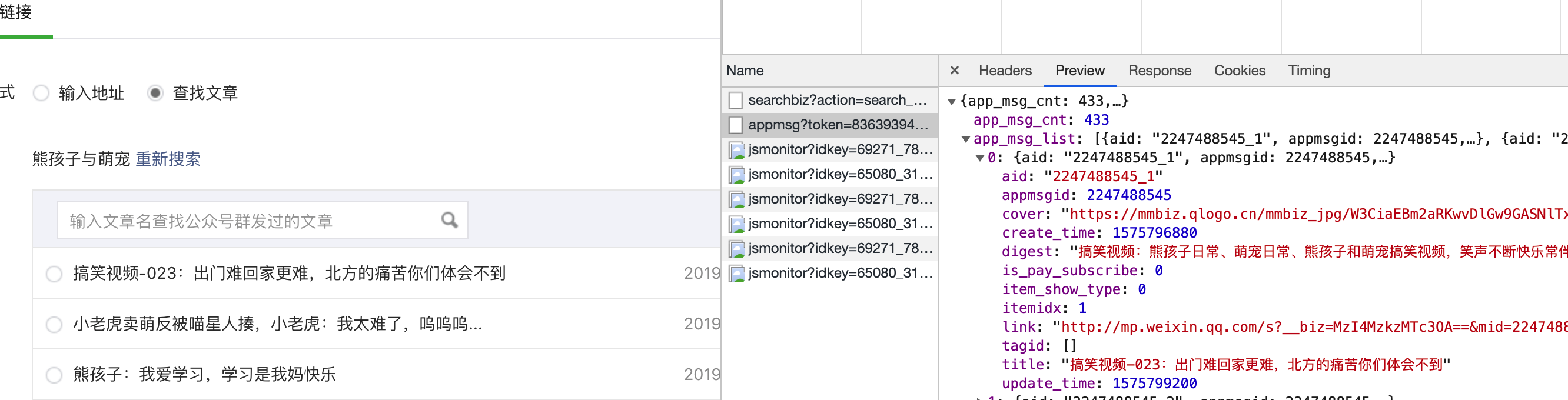

2、登录自己的账号,新建文章图文,点击超链接

3、弹出搜索框,搜索自己需要的公众号,查看历史文章

4、通过抓包获取信息,定位请求的url

通过查看信息,找到了我们需要关键的内容:标题、摘要、封面和文章URL,确定这就是我们需要的URL,通过点击下一页,多次获取url发现,只有random和bengin的参数发生变化

所以主信息URL确定。

那就开始吧:

事实发现我们需要修改的参数为:token、random、cookie

这两个值的来源,获取url时的就可以

# -*- coding: utf-8 -*-

import re

import requests

import jsonpath

import json

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36",

"Host": "mp.weixin.qq.com",

"Referer": "https://mp.weixin.qq.com/cgi-bin/appmsg?t=media/appmsg_edit&action=edit&type=10&isMul=1&isNew=1&lang=zh_CN&token=1862390040",

"Cookie": "自己获取信息时的cookie"

}

def getInfo():

for i in range(80):

# token random 需要要自己的 begin:参数传入

url = "https://mp.weixin.qq.com/cgi-bin/appmsg?token=1904193044&lang=zh_CN&f=json&ajax=1&random=0.9468236563826882&action=list_ex&begin={}&count=5&query=&fakeid=MzI4MzkzMTc3OA%3D%3D&type=9".format(str(i * 5))

response = requests.get(url, headers = headers)

jsonRes = response.json()

titleList = jsonpath.jsonpath(jsonRes, "$..title")

coverList = jsonpath.jsonpath(jsonRes, "$..cover")

urlList = jsonpath.jsonpath(jsonRes, "$..link")

# 遍历 构造可存储字符串

for index in range(len(titleList)):

title = titleList[index]

cover = coverList[index]

url = urlList[index]

scvStr = "%s,%s, %s,\n" % (title, cover, url)

with open("info.csv", "a+", encoding="gbk", newline='') as f:

f.write(scvStr)

获取结果(成功):

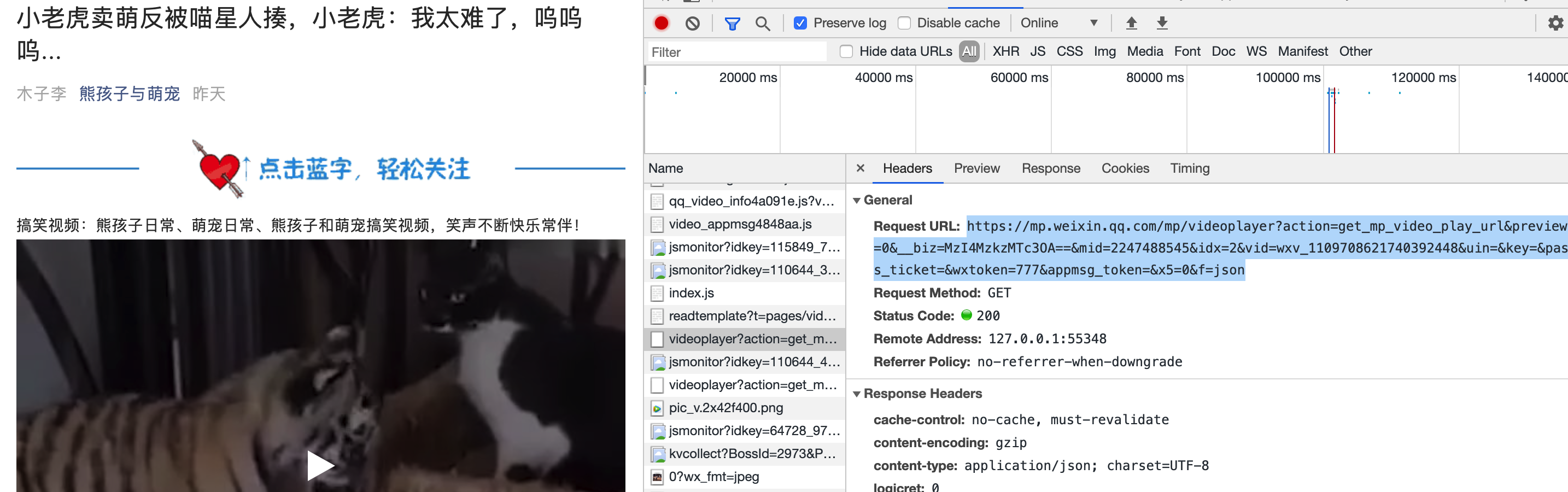

获取文章内视频:实现批量下载

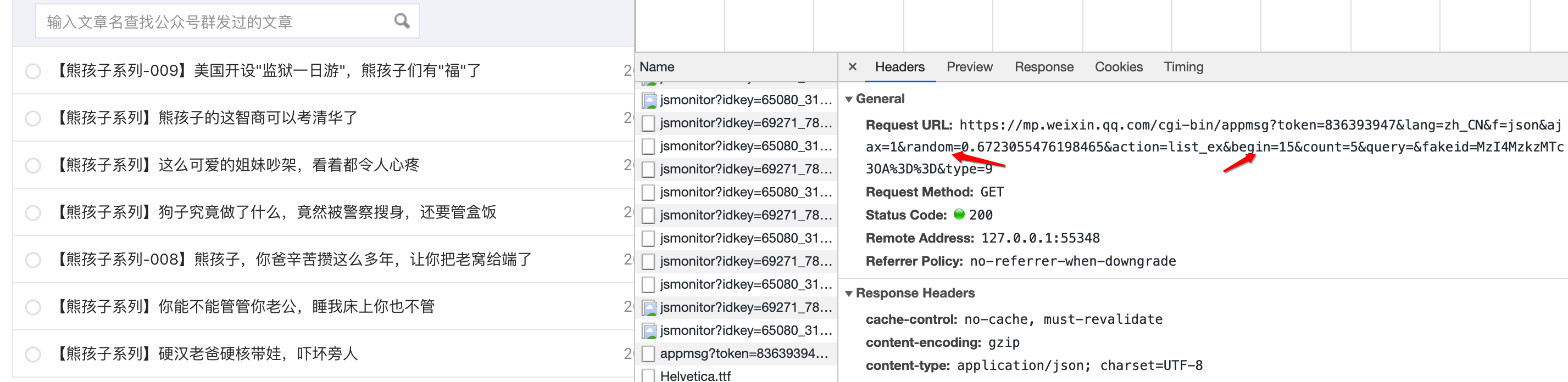

通过对单篇视频文章分析,我找到了这个链接:

通过网页打开发现,是视频的网页下载链接:

哎,好像有点意思了,找到了视频的网页纯下载链接,那就开始吧。

发现链接里的有一个关键参数vid 不知道哪来的?

和获取到的其他信息也没有关系,那就只能硬来了。

通过对单文章的url请求信息里发现了这个参数,然后进行获取。

response = requests.get(url_wxv, headers=headers)

# 我用的是正则,也可以使用xpath

jsonRes = response.text # 匹配:wxv_1105179750743556096

dirRe = r"wxv_.{19}"

result = re.search(dirRe, jsonRes)

wxv = result.group(0)

print(wxv)

视频下载:

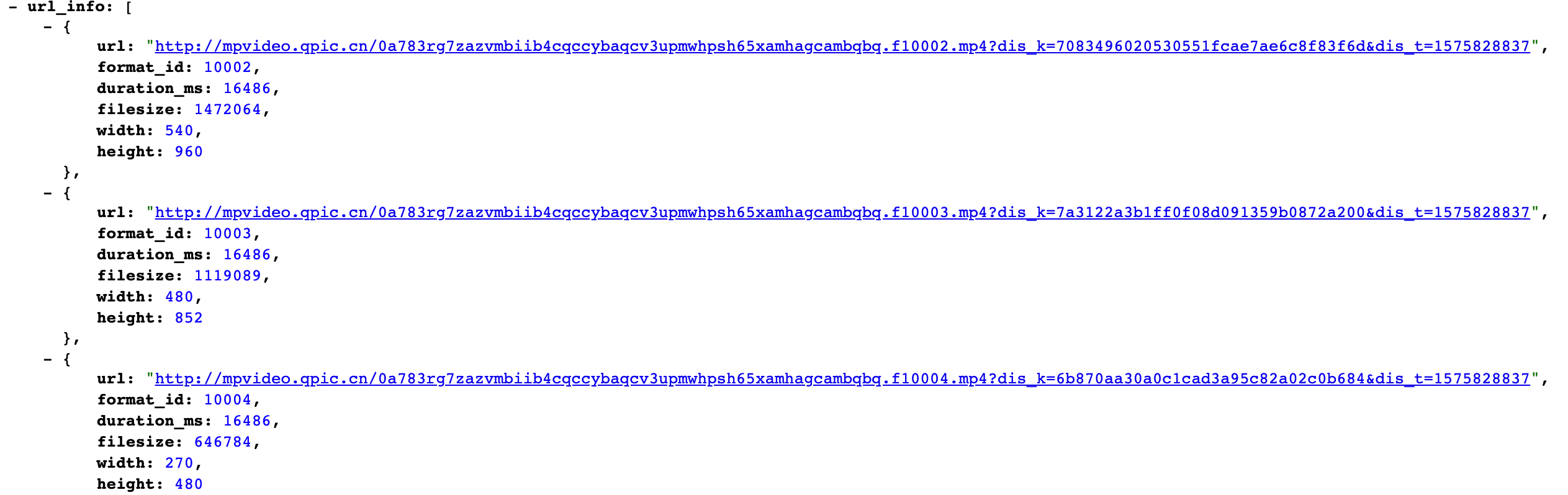

def getVideo(video_title, url_wxv):

video_path = './videoFiles/' + video_title + ".mp4"

# 页面可下载形式

video_url_temp = "https://mp.weixin.qq.com/mp/videoplayer?action=get_mp_video_play_url&preview=0&__biz=MzI4MzkzMTc3OA==&mid=2247488495&idx=4&vid=" + wxv

response = requests.get(video_url_temp, headers=headers)

content = response.content.decode()

content = json.loads(content)

url_info = content.get("url_info")

video_url2 = url_info[0].get("url")

print(video_url2)

# 请求要下载的url地址

html = requests.get(video_url2)

# content返回的是bytes型也就是二进制的数据。

html = html.content

with open(video_path, 'wb') as f:

f.write(html)

那么所有信息就都完成了,进行code组装。

a、获取公众号信息

b、筛选单篇文章信息

c、获取vid信息

d、拼接视频页面下载URL

e、下载视频,保存

代码实验结果:

获取公众号的:标题,摘要、封面、视频,

可以说拥有了一个视频公众号的所有信息,完全可以复制一个出来。

危险动作,请勿操作!切记 ! 切记!切记!

获取code请公众号回复:20191210 或 公众号code

浙公网安备 33010602011771号

浙公网安备 33010602011771号