Mac配置Scala和Spark最详细过程

Mac配置Scala和Spark最详细过程

原文链接: http://www.cnblogs.com/blog5277/p/8567337.html

原文作者: 博客园--曲高终和寡

一,准备工作

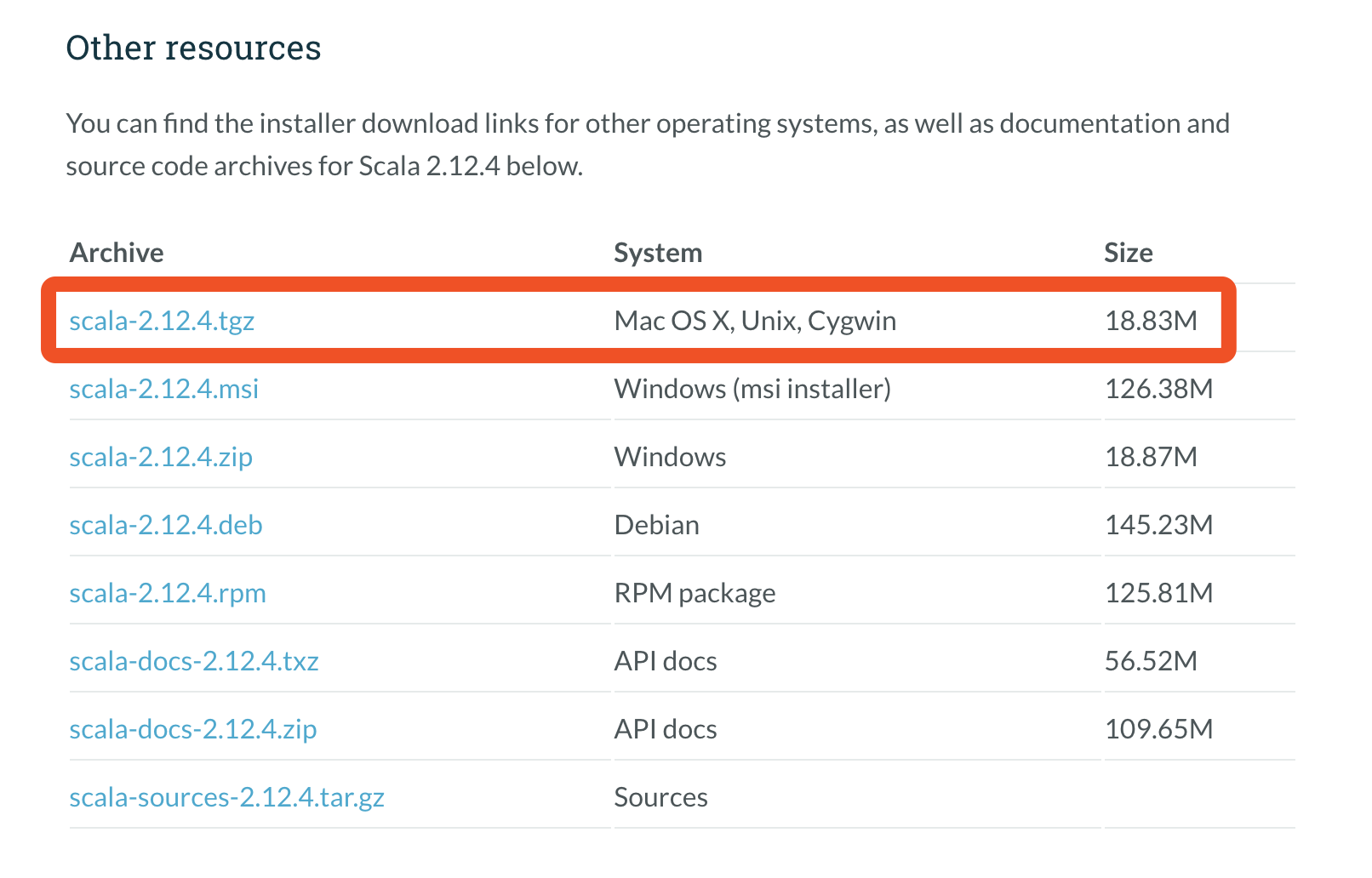

1.下载Scala http://www.scala-lang.org/download/ 拖到最下面,下载for mac的版本

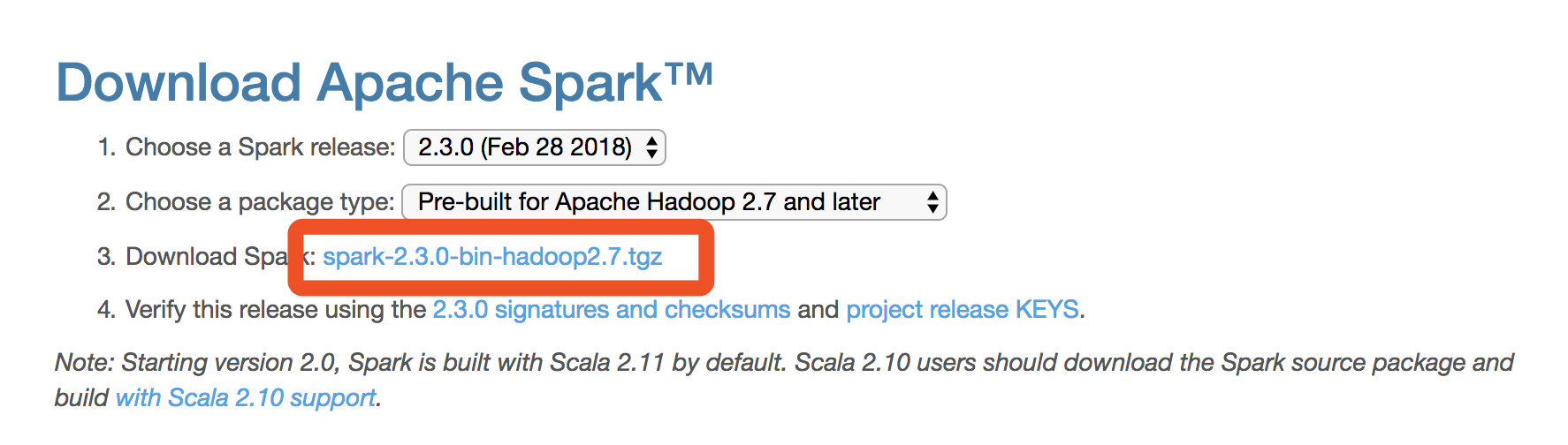

2.下载Spark http://spark.apache.org/downloads.html

记得选版本啊,如果你是按照我之前的

Mac配置Hadoop最详细过程

配置的话就是最新的2.7版本以后的,就直接点3下载就可以了

二.安装Scala

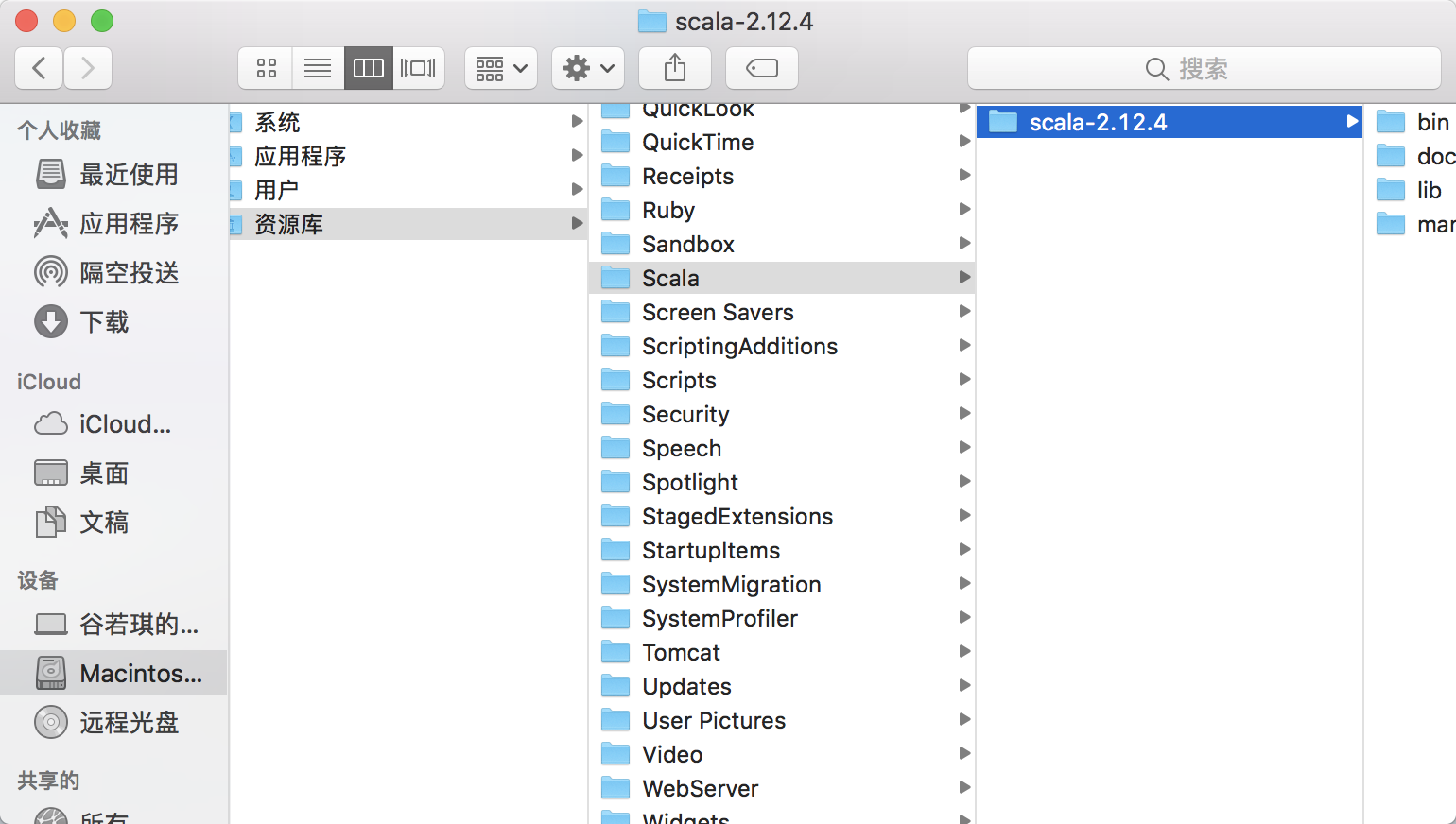

1.我个人喜欢把各个软件都放在/Library/目录下,所以这里我也在改目录下新建文件夹,提取后放进去,如下图所示:

2.配置Scala的环境变量,打开终端,输入以下代码(涉及系统环境变量修改,所以应该会让你输入Mac的密码):

sudo vim /etc/profile

在/Library/Scala/scala-2.12.4路径上,同时按下 option + command +c 复制你选中的文件的路径 , 粘贴出来如下:

/Library/Scala/scala-2.12.4

然后在刚刚你打开的终端里面,按 i 进入编辑模式 , 输入如下代码(如果路径/版本不一样,记得替换成你刚刚粘贴的那个)

export SCALA_HOME=/Library/Scala/scala-2.12.4

export PATH=$PATH:$SCALA_HOME/bin

按esc退出编辑模式,输入:wq!保存并退出,输入以下代码:

source /etc/profile

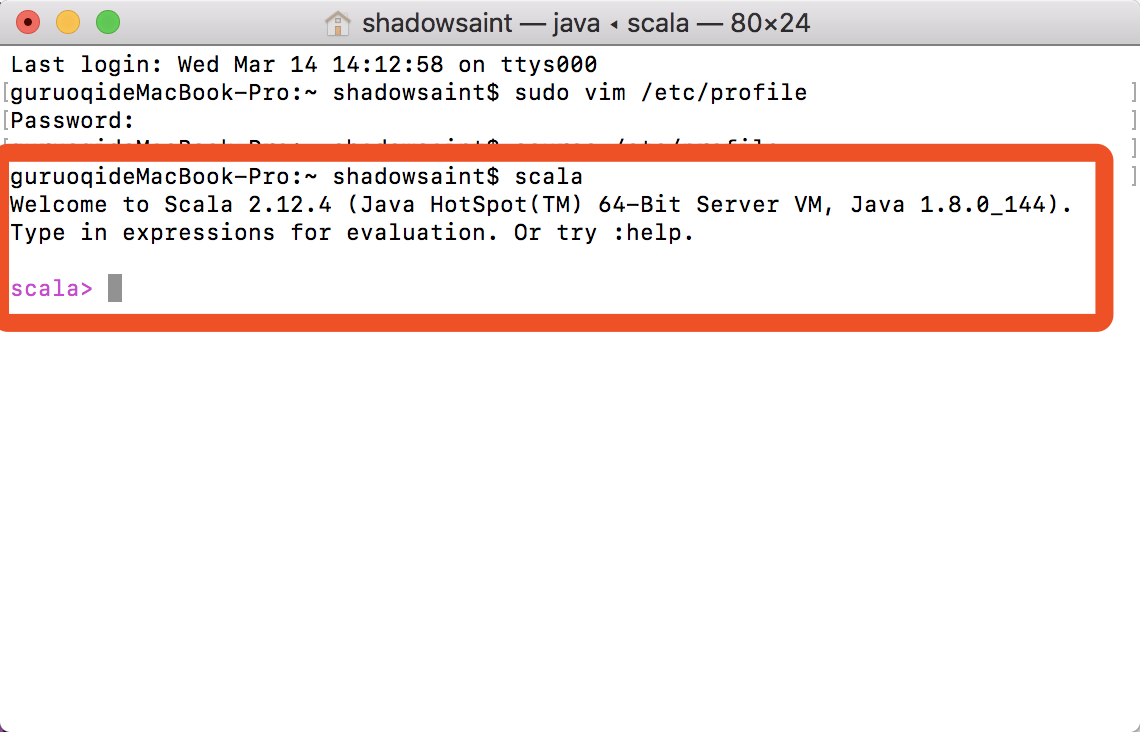

使得改动立刻生效,输入:

scala

即可看到你已经成功配置了Scala,如下图所示:

按下 control + c 或者输入 :quit 可以退出命令行Scala工具

三,安装Spark

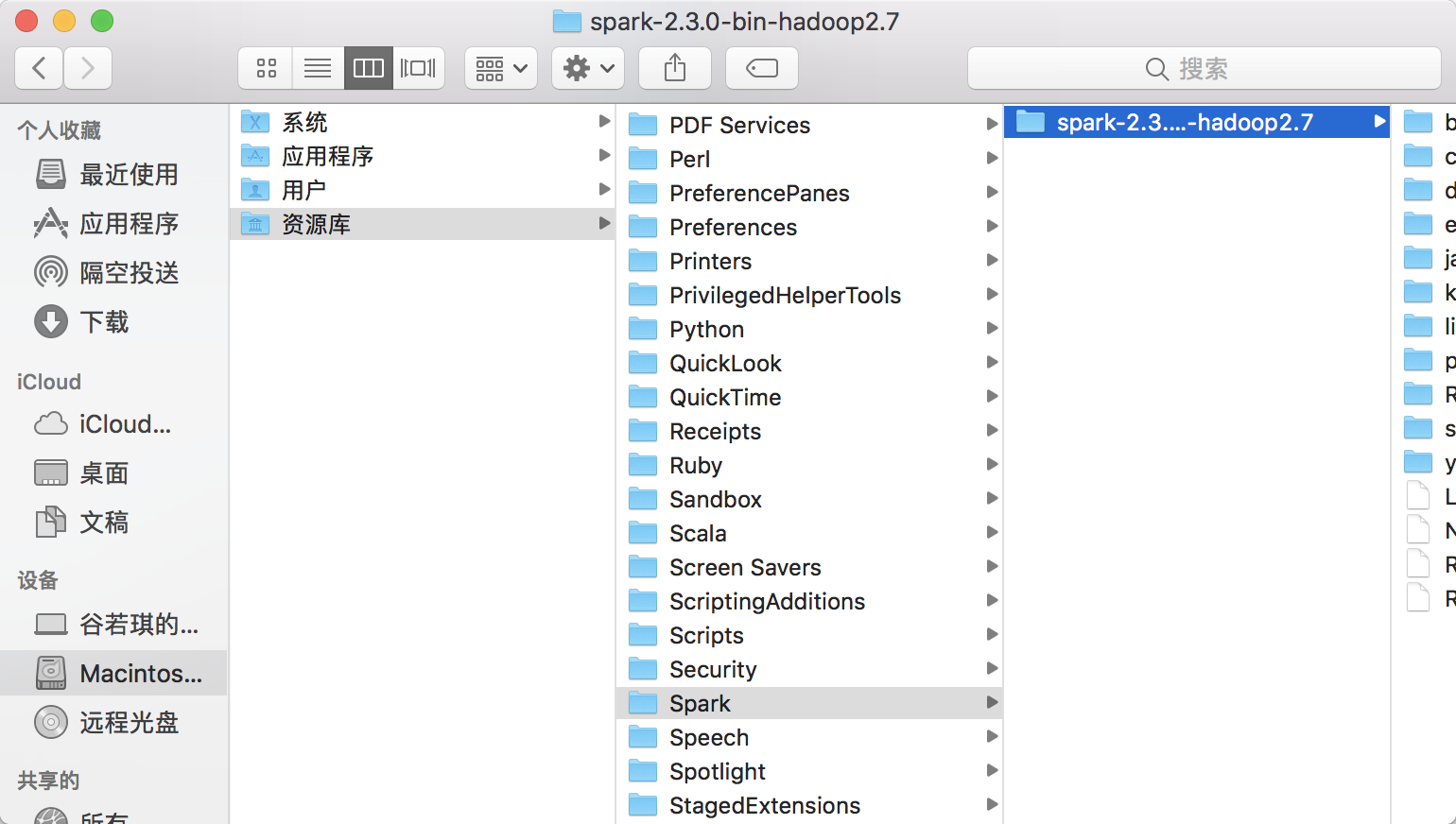

1.在/Library/下新建目录,把之前下载的东西提取并放进去,如下图所示:

2.配置Spark的环境变量,打开终端,输入以下代码(涉及系统环境变量修改,所以应该会让你输入Mac的密码):

sudo vim /etc/profile

在/Library/Spark/spark-2.3.0-bin-hadoop2.7路径上,同时按下 option + command +c 复制你选中的文件的路径 , 粘贴出来如下:

/Library/Spark/spark-2.3.0-bin-hadoop2.7

然后在刚刚你打开的终端里面,按 i 进入编辑模式 , 输入如下代码(如果路径/版本不一样,记得替换成你刚刚粘贴的那个)

export SPARK_HOME=/Library/Spark/spark-2.3.0-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/bin

按esc退出编辑模式,输入:wq!保存并退出,输入以下代码:

source /etc/profile

使得改动立刻生效

3.进入/Library/Spark/spark-2.3.0-bin-hadoop2.7/conf目录下,将 spark-env.sh.template 复制一份 , 把复制出来的 spark-env.sh的副本.template 重命名为 spark-env.sh 右键-->打开方式-->文本编辑.app

在末尾加入下面代码:

export SCALA_HOME=/Library/Spark/spark-2.3.0-bin-hadoop2.7

export SPARK_MASTER_IP=localhost

export SPARK_WORKER_MEMORY=4g

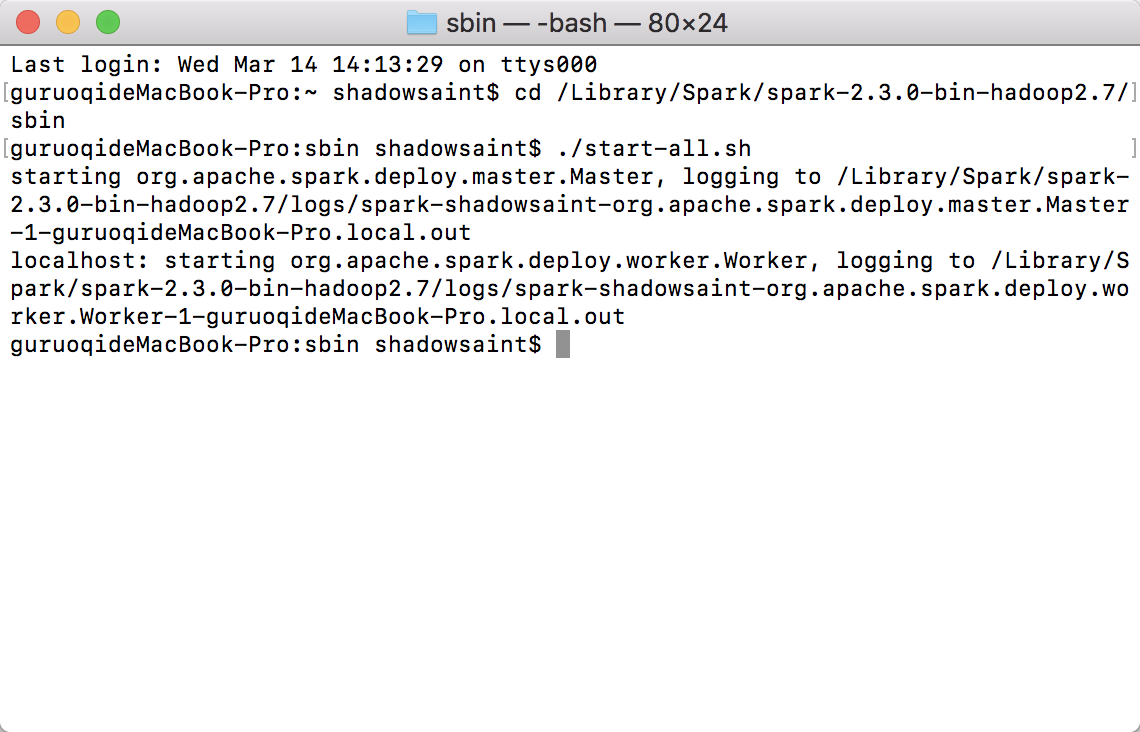

4.截止上面,Spark已经配置完成了,下面测试一下,在终端中跳转至 /Library/Spark/spark-2.3.0-bin-hadoop2.7/sbin

cd /Library/Spark/spark-2.3.0-bin-hadoop2.7/sbin

输入

./start-all.sh

如下图所示,即为启动成功:

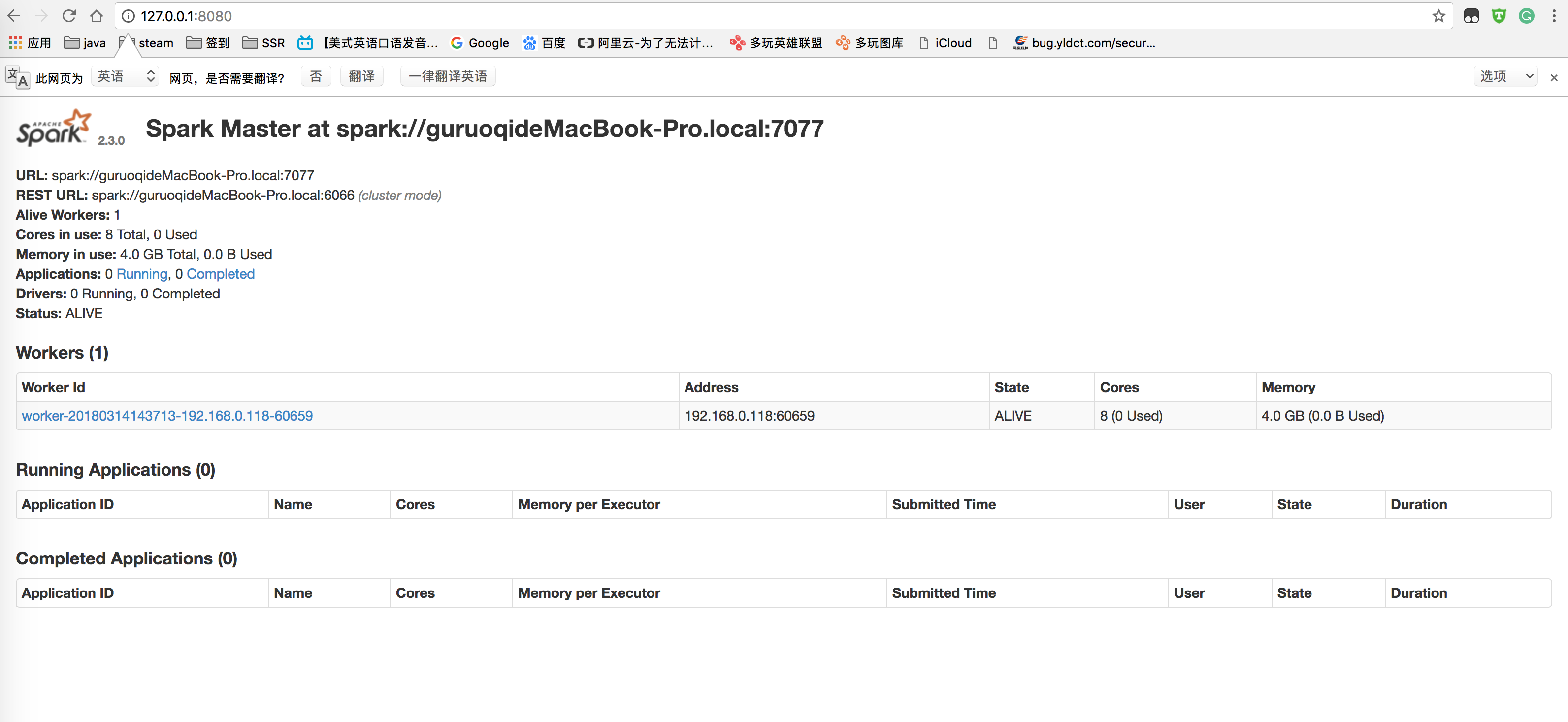

在浏览器输入以下网址即可看到打开的页面:

127.0.0.1:8080

关闭Spark的话还是在 /Library/Spark/spark-2.3.0-bin-hadoop2.7/sbin 目录下,输入

./stop-all.sh