(重点)如何解决消息队列的延时(消息堆积)及过期失效问题?

或者: 消息队列满了以后该怎么处理?

或者: 几百万消息持续积压几小时,怎么解决?

问题本质是消费端出问题了,不消费或者消费慢。

1、消费端出问题了,大量消息积压在kafka里几个小时,怎么办?

正常思路是:修复consumer的问题,让他恢复消费,然后傻等几个小时消费完毕(不可取,用户等不了)

实际解决方法:只能操作临时紧急扩容:

(1)修复consumer问题,确保其恢复消费速度,然后停掉现有consumer;

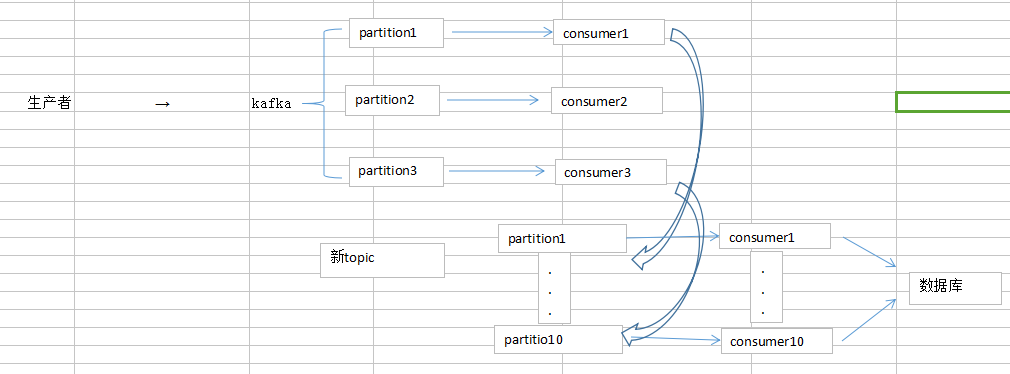

(2)新建topic并设置原来10倍或者20倍的partition,不管是改原来的消费者将消息写入新partition,还是直接处理积压的消息进partition,新建10倍或20倍的consumer,来处理消息并写库;

(3)等快速消费完积压数据后,恢复原先的部署架构,重新用原来的consumer机器来消费数据;

2、假设用的是rabbitMQ。rabbitMQ是可以设置过期时间的。如果消息在queue里积压一定时间就会被rabbitMQ清掉,造成的问题是因积压超时而丢数据了。

解决方法是: 重导入数据。手工查找丢的数据,重新灌入MQ里面去(一般不设rabbitMQ的过期时间)

3、消息积压在MQ里导致MQ快满了

解决方法:临时写程序接入消息来消费,消费一个丢一个(不写库了,快速把MQ里的消息处理掉)

然后到晚上再采用2的方法,补数据。(针对的是线上问题)

你接受吗

浙公网安备 33010602011771号

浙公网安备 33010602011771号