【吴恩达机器学习】第10章 神经网络参数的反向传播算法

代价函数

像大部分机器学习一样,从代价函数开始讲起。

重点讲解,神经网络在分类问题中的应用。

神经网络层数

用来表示神经网络结果的总层数。

每层单元数

用表示第层的单元数,但不包括偏置。

Binary classification

一个输出单元

Multi-class classification

k分类,含有k个输出单元

Cost function

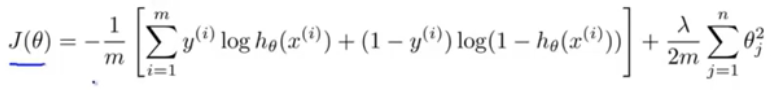

- Logistic regression:

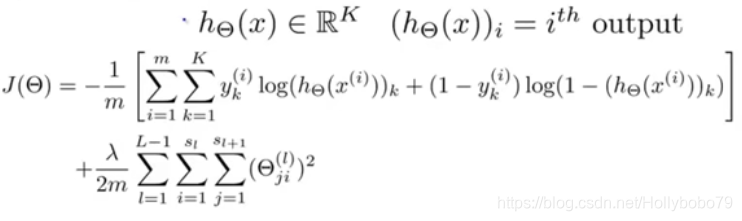

- Neural network

不再只有一个输出单元,而是K个。

表示第层T对应的参数,最后一层没有参数。

反向传播算法

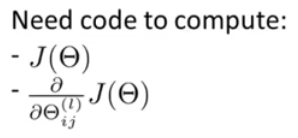

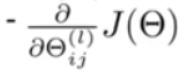

需要优化的参数

如何计算参数的偏导

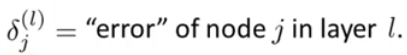

每个单元的激活误差

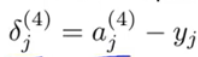

第4层的激活误差

其它层的激活误差

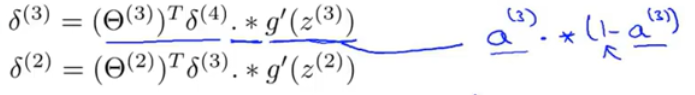

参数的偏导

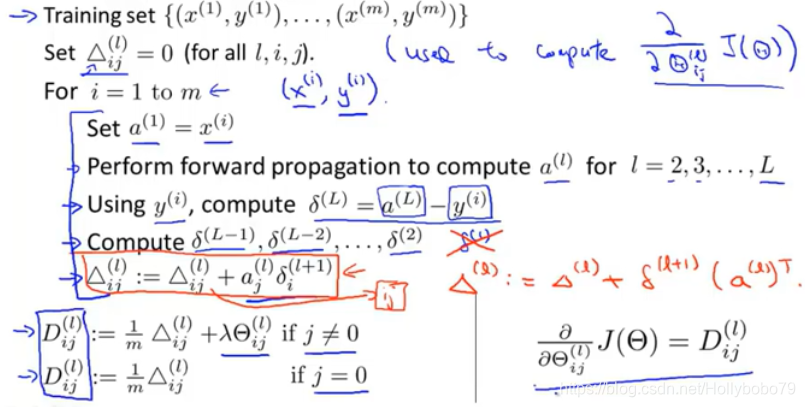

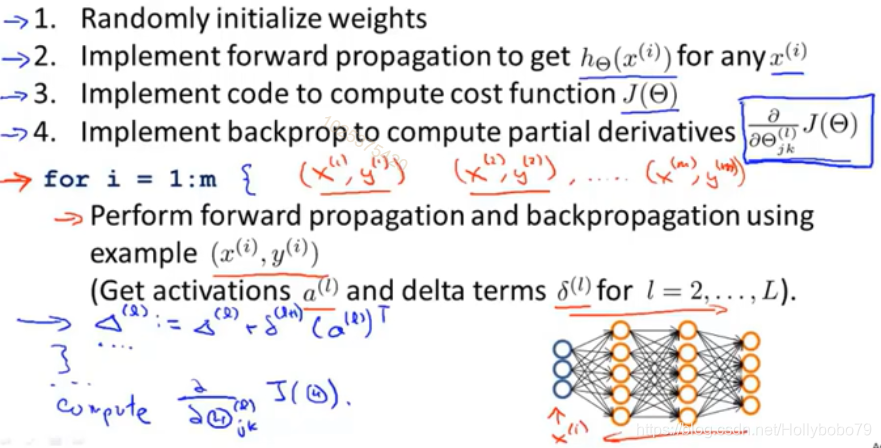

Backpropagation algorithm

理解反向传播

中间偏导

如果cost函数为:

则对求导后:

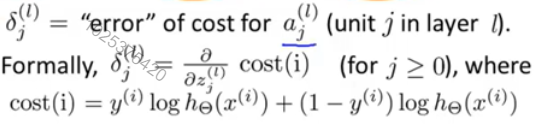

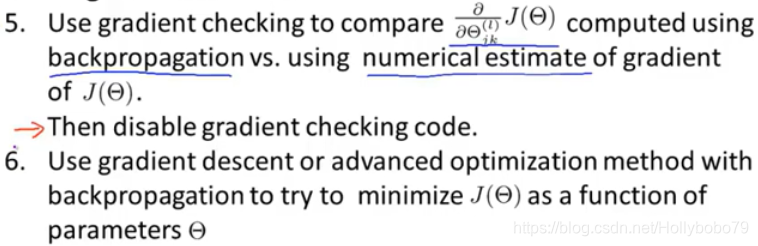

梯度检测

将计算的导师值与比较

随机初始化

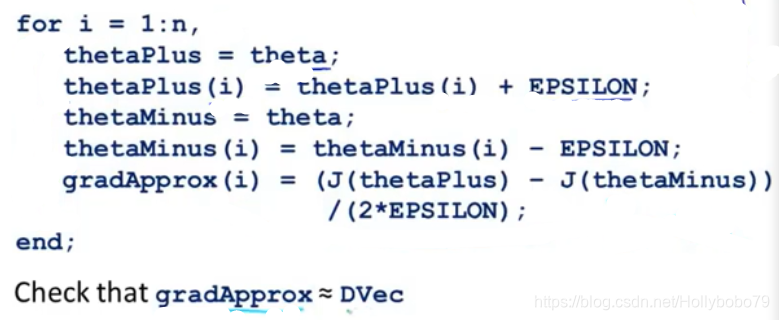

对称权重问题

当两个参数初始化为0时,之后用梯度下降法,它们的更新保持一致。

随机初始化思想

初始化时,对参数进行随机化。

组合到一起

输入特征的维数

输出特征的维数

隐藏层数量

默认一层

每一层的隐藏层单元相同,效果会更好。

一般单元数也与输出层单元数相同,或者大几倍。

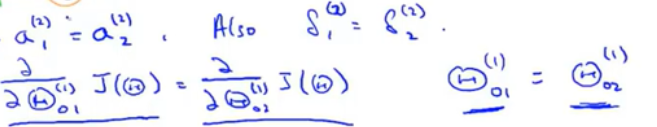

训练一个神经网络的过程

浙公网安备 33010602011771号

浙公网安备 33010602011771号