传统神经网络

一、神经网络起源:线性回归

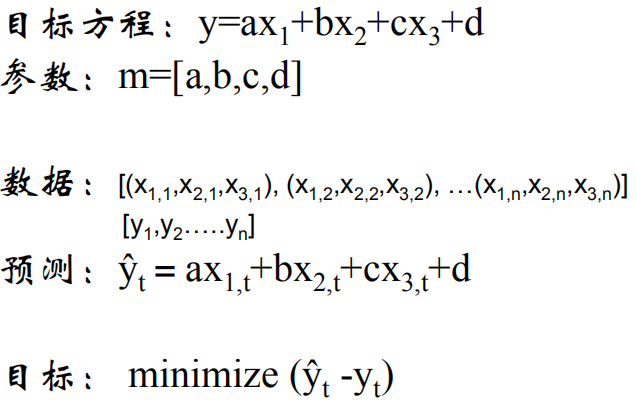

1.线性回归:

(1)概念:线性关系来藐视输入到输出的映射关系

(2)应用场景:网络分析,银行风向分析

(3)线性回归问题:

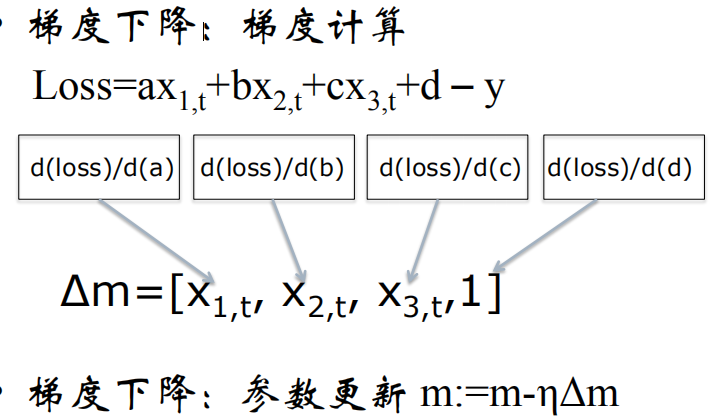

优化方法:梯度下降法SGD

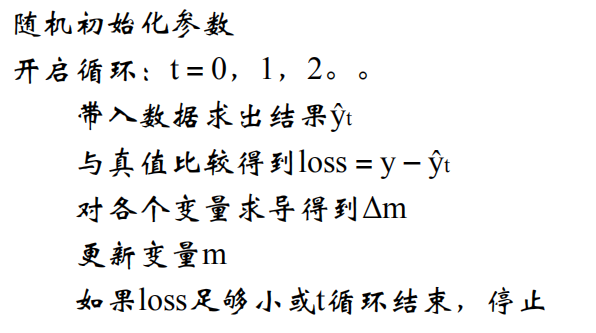

梯度下降总结:

2.线性回归多个y值的输出

(1)多目标学习的过程,通过合并多个任务loss,一般能够产生比单个模型更好的效果

(2)局限:线性回归能够清楚的描述分割线性分布的数据,对非线性分布的数据描述比较弱

二、从线性到非线性

1.非线性激励

2.评价非线性激励的标准:

(1)正向输入的调整

(2)反向梯度损失

3.常用的非线性激励函数

(1)Sigmoid

函数效果,导数

优点,缺点

将输入数据映射到[0,1]

梯度下降非常明显,至少减少75%

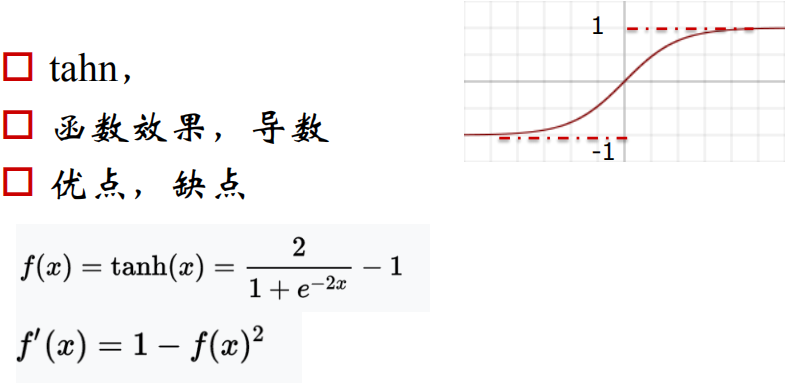

(2)tanh函数

函数效果,导数

优点、缺点

将数据映射到[-1,1],梯度损失明显

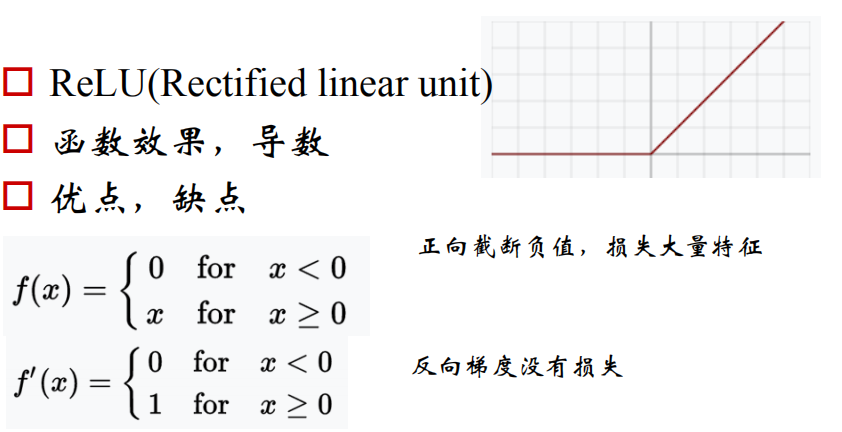

(3)relu函数,导数

优点,缺点

(4)Leaky ReLU

函数效果,导数

优点,缺点

三、神经网络的构建

四、神经网络的配件

1.损失函数-Loss

(1)影响深度学习行性能的最重要的因素之一,就是外部世界对神经网络模型的直接训练。

(2)合适的损失韩式能够确保深度学习模型收敛。

(3)设计合适的损失函数是研究工作的主要内容之一。

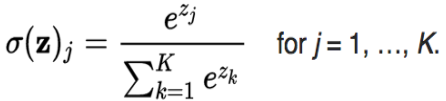

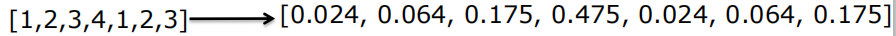

(4)softmax

loss影响

softmax的好处:分类问题的预测结果更为明显

2.学习率:learning rate

数值大:收敛速度快

数值小:精度高

如何选用合适的学习率?

1.fixed;2.step;3.Adagrad

3.动量

(1)正常:x+=-learning_rate*dx

(2)用动量和直接调大学习率有什么区别?

4.过拟合:

(1)

(2)应对:Dropout,Pooling

浙公网安备 33010602011771号

浙公网安备 33010602011771号