普罗米修斯官方文档

介绍

什么是普罗米修斯?

Prometheus是最初在SoundCloud上构建的开源系统监视和警报工具包 。自2012年成立以来,许多公司和组织都采用了Prometheus,该项目拥有非常活跃的开发人员和用户社区。现在,它是一个独立的开源项目,并且独立于任何公司进行维护。为了强调这一点并阐明项目的治理结构,Prometheus 在2016年加入了 Cloud Native Computing Foundation,这是继Kubernetes之后的第二个托管项目。

有关Prometheus的详细说明,请参见媒体部分中的资源链接 。

特征

普罗米修斯的主要特点是:

- 一个多维数据模型,其中包含通过度量标准名称和键/值对标识的时间序列数据

- PromQL,一种灵活的查询语言 ,可利用此维度

- 不依赖分布式存储;单服务器节点是自治的

- 时间序列收集通过HTTP上的拉模型进行

- 通过中间网关支持推送时间序列

- 通过服务发现或静态配置发现目标

- 多种图形和仪表板支持模式

组件

Prometheus生态系统包含多个组件,其中许多是可选的:

- Prometheus主服务器,它会刮取并存储时间序列数据

- 客户端库,用于检测应用程序代码

- 一个支持短暂工作的推送网关

- 诸如HAProxy,StatsD,Graphite等服务的专用出口商

- 一个alertmanager处理警报

- 各种支持工具

大多数Prometheus组件都是用Go编写的,因此易于构建和部署为静态二进制文件。

建筑

下图说明了Prometheus的体系结构及其某些生态系统组件:

Prometheus直接或通过中间推送网关从已检测作业中删除指标,以用于短期作业。它在本地存储所有刮取的样本,并对这些数据运行规则,以汇总和记录现有数据中的新时间序列,或生成警报。Grafana或其他API使用者可用于可视化收集的数据。

什么时候合适?

Prometheus非常适合记录任何纯数字时间序列。它既适合以机器为中心的监视,也适合于高度动态的面向服务的体系结构的监视。在微服务世界中,它对多维数据收集和查询的支持是一种特别的优势。

Prometheus的设计旨在提高可靠性,使其成为中断期间要使用的系统,以使您能够快速诊断问题。每个Prometheus服务器都是独立的,而不依赖于网络存储或其他远程服务。当基础结构的其他部分损坏时,您可以依靠它,并且无需设置广泛的基础结构即可使用它。

什么时候不合适?

普罗米修斯重视可靠性。即使在故障情况下,您始终可以查看有关系统的可用统计信息。如果您需要100%的准确性(例如按请求计费),则Prometheus并不是一个不错的选择,因为所收集的数据可能不会足够详细和完整。在这种情况下,最好使用其他系统来收集和分析数据以进行计费,并使用Prometheus进行其余的监视。

普罗米修斯!Prometheus是一个监视平台,它通过在这些目标上刮擦度量标准HTTP端点来从被监视的目标收集度量标准。本指南将向您展示如何使用Prometheus安装,配置和监视我们的第一个资源。您将下载,安装并运行Prometheus。您还将下载并安装导出器,这些工具可在主机和服务上显示时间序列数据。我们的第一个导出器将是Prometheus本身,它提供有关内存使用,垃圾回收等的各种主机级别指标。

下载Prometheus

下载适用于您的平台的最新版本的Prometheus,然后将其解压缩:

tar xvfz prometheus-*.tar.gz

cd prometheus-*Prometheus服务器是一个称为prometheus(或prometheus.exe在Microsoft Windows上)的二进制文件。我们可以运行二进制文件,并通过传递--help标志来查看有关其选项的帮助。

./prometheus --help

usage: prometheus [<flags>]

The Prometheus monitoring server

. . .在启动Prometheus之前,让我们对其进行配置。

配置Prometheus

Prometheus配置为YAML。Prometheus下载随附一个名为的文件中的示例配置,prometheus.yml这是一个入门的好地方。

我们删除了示例文件中的大多数注释,以使其更加简洁(注释以开头的行#)。

global:

scrape_interval: 15s

evaluation_interval: 15s

rule_files:

# - "first.rules"

# - "second.rules"

scrape_configs:

- job_name: prometheus

static_configs:

- targets: ['localhost:9090']有示例配置文件中配置的三个模块:global,rule_files,和scrape_configs。

该global块控制Prometheus服务器的全局配置。我们有两个选择。第一个scrape_interval控制,Prometheus多久刮一次目标。您可以为单个目标覆盖此目标。在这种情况下,全局设置是每15秒刮一次。该evaluation_interval选项控制Prometheus多久评估一次规则。Prometheus使用规则来创建新的时间序列并生成警报。

该rule_files块指定了我们希望Prometheus服务器加载的任何规则的位置。目前,我们还没有任何规则。

最后一块,scrape_configs控制Prometheus监视哪些资源。由于Prometheus还将有关自身的数据公开为HTTP端点,因此它可以抓取并监视其自身的运行状况。在默认配置中,有一个名为的作业,prometheus它会刮擦Prometheus服务器公开的时间序列数据。该作业包含一个静态配置的目标localhost端口9090。Prometheus希望指标可用于路径上的目标/metrics。因此,此默认作业是通过以下网址进行抓取:http:// localhost:9090 / metrics。

返回的时间序列数据将详细说明Prometheus服务器的状态和性能。

有关配置选项的完整说明,请参阅 配置文档。

开始普罗米修斯

要使用我们新创建的配置文件启动Prometheus,请切换到包含Prometheus二进制文件的目录并运行:

./prometheus --config.file=prometheus.yml普罗米修斯应该开始。您还应该能够在http:// localhost:9090上浏览到有关其自身的状态页。给它大约30秒的时间,以从其自己的HTTP指标终结点收集有关自身的数据。

您还可以通过导航到自己的指标终结点:http:// localhost:9090 / metrics来验证Prometheus是否正在提供有关其自身的指标。

使用表达式浏览器

让我们尝试查看Prometheus收集的有关自身的一些数据。要使用Prometheus的内置表达式浏览器,请导航至 http:// localhost:9090 / graph,然后在“图形”选项卡中选择“控制台”视图。

正如您可以从http:// localhost:9090 / metrics收集的那样,称为Prometheus导出的有关其自身的一个指标 promhttp_metric_handler_requests_total(/metricsPrometheus服务器已处理的请求总数)。继续并将其输入到表达式控制台中:

promhttp_metric_handler_requests_total

这将返回多个不同的时间序列(以及每个序列的最新值),所有时间序列均带有度量名称promhttp_metric_handler_requests_total,但带有不同的标签。这些标签指定不同的请求状态。

如果我们只对导致HTTP代码的请求感兴趣200,则可以使用此查询来检索该信息:

promhttp_metric_handler_requests_total{code="200"}

要计算返回的时间序列数,您可以编写:

count(promhttp_metric_handler_requests_total)

有关表达语言的更多信息,请参见 表达语言文档。

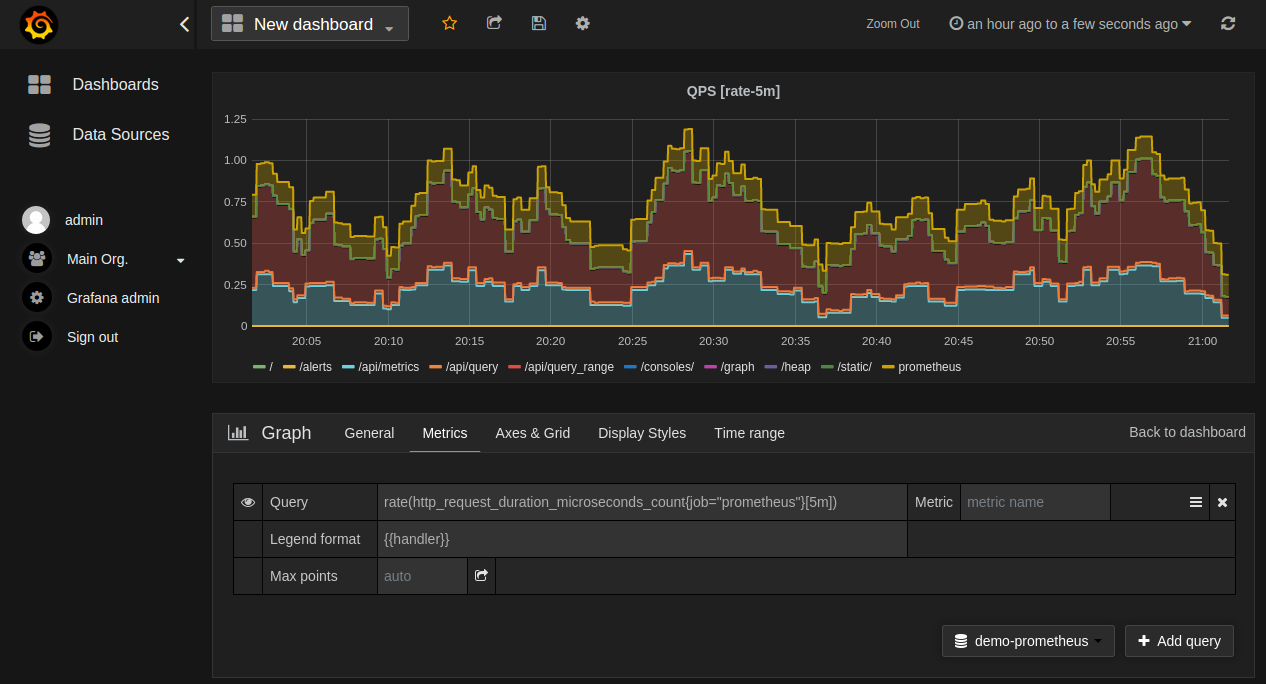

使用绘图界面

要绘制图形表达式,请导航至http:// localhost:9090 / graph并使用“图形”选项卡。

例如,输入以下表达式以图形化显示自抓取的Prometheus中发生的每秒HTTP请求速率返回状态代码200:

rate(promhttp_metric_handler_requests_total{code="200"}[1m])

您可以尝试使用图形范围参数和其他设置。

监控其他目标

仅从Prometheus收集指标并不能很好地说明Prometheus的功能。为了更好地了解Prometheus可以做什么,我们建议您浏览有关其他出口商的文档。在使用节点监控出口Linux或MacOS的主机指标指南是一个良好的开端。

摘要

在本指南中,您安装了Prometheus,配置了Prometheus实例以监视资源,并了解了在Prometheus表达式浏览器中使用时间序列数据的一些基础知识。要继续学习Prometheus,请查看“ 概述”以获取有关接下来要探索的内容的一些想法。

普罗米修斯与石墨

范围

Graphite专注于成为具有查询语言和图形功能的被动时间序列数据库。其他任何问题都可以通过外部组件解决。

Prometheus是一个完整的监视和趋势分析系统,其中包括基于时间序列数据的内置和主动抓取,存储,查询,制图和警报。它了解有关世界的外观(应该存在哪些端点,什么时间序列模式意味着麻烦等),并积极尝试查找错误。

资料模型

石墨存储命名时间序列的数值样本,就像Prometheus一样。但是,Prometheus的元数据模型更加丰富:尽管Graphite指标名称由点分隔的组件组成,这些组件隐式地对维进行编码,但是Prometheus明确将维编码为键值对(称为标签),并附加到指标名称。这允许通过查询语言通过这些标签轻松进行过滤,分组和匹配。

此外,尤其是当Graphite与StatsD结合使用 时,通常只在所有受监视实例上存储聚合数据,而不是将实例保留为一个维度并能够深入到单个有问题的实例。

例如,使用Graphite / StatsD通常使用如下代码存储对API服务器的HTTP请求数以及响应代码500和POST对/tracks端点的方法:

stats.api-server.tracks.post.500 -> 93

在Prometheus中,可以像这样对相同的数据进行编码(假设三个api服务器实例):

api_server_http_requests_total{method="POST",handler="/tracks",status="500",instance="<sample1>"} -> 34

api_server_http_requests_total{method="POST",handler="/tracks",status="500",instance="<sample2>"} -> 28

api_server_http_requests_total{method="POST",handler="/tracks",status="500",instance="<sample3>"} -> 31

存储

Graphite以Whisper格式将时间序列数据存储在本地磁盘上,这 是一种RRD样式的数据库,它希望样本以固定的时间间隔到达。每个时间序列都存储在一个单独的文件中,新样本在一定时间后会覆盖旧样本。

Prometheus还在每个时间序列上创建一个本地文件,但允许在出现刮擦或规则评估时以任意间隔存储样本。由于仅附加了新样本,因此旧数据可以任意保留。普罗米修斯(Prometheus)也适用于许多短暂的,经常变化的时间序列集。

摘要

Prometheus除了更易于运行和集成到您的环境之外,还提供了更丰富的数据模型和查询语言。如果您想要一个可以长期保存历史数据的群集解决方案,那么Graphite可能是一个更好的选择。

Prometheus与InfluxDB

InfluxDB是一个开放源代码的时间序列数据库,具有用于扩展和集群化的商业选项。Prometheus开发开始将近一年后,InfluxDB项目才发布,因此我们当时无法将其视为替代方案。尽管如此,Prometheus和InfluxDB之间仍然存在显着差异,并且两种系统都针对稍有不同的用例。

范围

为了进行公平的比较,我们还必须将Kapacitor与InfluxDB一起考虑 ,因为它们结合起来可以解决与Prometheus和Alertmanager相同的问题空间。

对于InfluxDB本身,与Graphite相同的范围差异 适用于此。此外,InfluxDB还提供连续查询,这些查询等同于Prometheus记录规则。

Kapacitor的范围是Prometheus记录规则,警报规则和Alertmanager的通知功能的组合。Prometheus提供了一种更强大的查询语言来进行图形显示和警报。Prometheus Alertmanager还提供了分组,重复数据删除和静音功能。

数据模型/存储

与Prometheus一样,InfluxDB数据模型也将键值对作为标签,称为标签。此外,InfluxDB还有第二级标签,称为字段,使用范围受到更多限制。InfluxDB支持最高达十亿分之一秒分辨率的时间戳,以及float64,int64,bool和字符串数据类型。相比之下,Prometheus支持float64数据类型,但对字符串和毫秒分辨率时间戳的支持有限。

InfluxDB使用日志结构合并树的变体进行存储,并带有按时间分片的预写日志。与Prometheus每个时间序列的仅附加文件相比,此方法更适合事件记录。

日志,指标和图形,我的天哪! 描述了事件记录和指标记录之间的区别。

建筑

Prometheus服务器彼此独立运行,并且仅依靠其本地存储来实现其核心功能:抓取,规则处理和警报。InfluxDB的开源版本与此类似。

根据设计,商业InfluxDB产品是一个分布式存储集群,其中存储和查询由多个节点一次处理。

这意味着商业InfluxDB将更易于水平扩展,但是这也意味着您必须从一开始就管理分布式存储系统的复杂性。Prometheus的运行更简单,但是在某些时候,您将需要沿着产品,服务,数据中心或类似方面的可伸缩性边界明确地分片服务器。独立服务器(可以并行冗余运行)也可以为您提供更好的可靠性和故障隔离。

Kapacitor的开源版本没有用于规则,警报或通知的内置分布式/冗余选项。Kapacitor的开源发行版可以通过用户手动分片来扩展,类似于Prometheus本身。Influx提供了Enterprise Kapacitor,它支持HA /冗余警报系统。

相比之下,Prometheus和Alertmanager通过运行Prometheus的冗余副本并使用Alertmanager的高可用性 模式提供了完全开源的冗余选项 。

摘要

系统之间有许多相似之处。两者都有标签(在InfluxDB中称为标签),可以有效地支持多维指标。两者都使用基本相同的数据压缩算法。两者都有广泛的集成,包括彼此之间的集成。两者都有钩子,可让您进一步扩展它们,例如使用统计工具分析数据或执行自动操作。

InfluxDB更好的地方:

- 如果您要进行事件记录。

- 商业选项为InfluxDB提供集群,这对于长期数据存储也更好。

- 最终在副本之间保持一致的数据视图。

普罗米修斯更好的地方:

- 如果您主要是在做指标。

- 更强大的查询语言,警报和通知功能。

- 图形和警报的可用性和正常运行时间更高。

InfluxDB由一家商业公司按照开放核模型进行维护,并提供高级功能,如封闭源群集,托管和支持。Prometheus是一个完全开源的独立项目,由许多公司和个人维护,其中一些还提供商业服务和支持。

Prometheus与OpenTSDB

OpenTSDB是基于Hadoop和HBase的分布式时间序列数据库 。

范围

这里适用的范围与石墨相同 。

资料模型

OpenTSDB的数据模型几乎与Prometheus的数据模型相同:时间序列由一组任意键值对标识(OpenTSDB标签是Prometheus标签)。指标的所有数据都 存储在一起,从而限制了指标的基数。尽管有一些细微的差别:Prometheus允许标签值中包含任意字符,而OpenTSDB的限制更严格。OpenTSDB还缺少完整的查询语言,仅允许通过其API进行简单的汇总和数学运算。

存储

OpenTSDB的存储在Hadoop和HBase之上实现 。这意味着可以轻松地水平扩展OpenTSDB,但是您必须从一开始就接受运行Hadoop / HBase集群的总体复杂性。

Prometheus最初运行起来会更简单,但是一旦超出单个节点的容量,就需要进行明确的分片。

摘要

Prometheus提供了更丰富的查询语言,可以处理更高的基数指标,并且构成了完整监视系统的一部分。如果您已经在运行Hadoop并重视长期存储的优势,那么OpenTSDB是一个不错的选择。

普罗米修斯与纳吉斯

Nagios是一个始于1990年代的NetSaint监视系统。

范围

Nagios主要是基于脚本的退出代码进行警报。这些称为“检查”。单个警报会静音,但是不会进行分组,路由或重复数据删除。

有各种各样的插件。例如,允许管道传输几千字节的perfData插件以返回到时间序列数据库(例如Graphite)或使用NRPE 在远程计算机上运行检查。

资料模型

Nagios是基于主机的。每个主机可以具有一个或多个服务,并且每个服务可以执行一项检查。

没有标签或查询语言的概念。

存储

除了当前的检查状态外,Nagios本身还没有存储空间。有一些插件可以存储诸如可视化的数据。

建筑

Nagios服务器是独立的。所有检查配置均通过文件进行。

摘要

Nagios适用于黑匣子探测已足够的小型和/或静态系统的基本监视。

如果您想进行白盒监控,或者具有动态或基于云的环境,那么Prometheus是一个不错的选择。

普罗米修斯vs.森苏

Sensu是可组合的监视管道,可以重用现有的Nagios检查。

范围

这里适用与Nagios相同的一般范围差异。

还有一个客户端套接字,允许将临时检查结果推送到Sensu中。

资料模型

Sensu与Nagios具有相同的粗略数据模型。

存储

Sensu使用Redis持久监视数据,包括Sensu客户端注册表,检查结果,检查执行历史记录和当前事件数据。

建筑

Sensu具有许多组件。它使用RabbitMQ作为传输方式,使用Redis作为当前状态,并使用单独的服务器进行处理和API访问。

Sensu部署的所有组件(RabbitMQ,Redis和Sensu Server / API)都可以集群化,以实现高可用性和冗余配置。

摘要

如果您现有的Nagios设置希望按原样缩放,或者想利用Sensu的自动注册功能,那么Sensu是一个不错的选择。

如果您想进行白盒监控,或者具有非常动态或基于云的环境,那么Prometheus是一个不错的选择。

一般

什么是普罗米修斯?

Prometheus是具有活跃生态系统的开源系统监视和警报工具包。请参阅概述。

Prometheus与其他监控系统相比如何?

请参阅比较页面。

普罗米修斯有什么依赖性?

Prometheus主服务器独立运行,没有外部依赖性。

可以使Prometheus高度可用吗?

是的,在两台或更多台单独的计算机上运行相同的Prometheus服务器。相同的警报将由Alertmanager进行重复数据删除。

为了提高Alertmanager的可用性,您可以在Mesh群集中运行多个实例,并将Prometheus服务器配置为向每个实例 发送通知。

有人告诉我普罗米修斯“没有规模”。

实际上,存在多种缩放和联合Prometheus的方法。阅读 “稳健感知”博客上的扩展和联合Prometheus,以开始使用。

普罗米修斯用什么语言书写?

大多数Prometheus组件都是用Go编写的。有些还用Java,Python和Ruby编写。

Prometheus功能,存储格式和API的稳定性如何?

Prometheus GitHub组织中所有已达到版本1.0.0的存储库都大致遵循 语义版本控制。重大更改以主要版本的增量表示。实验性组件可能会出现例外,声明中会明确标明例外情况。

通常,即使尚未达到1.0.0版的存储库也相当稳定。我们的目标是为每个存储库制定适当的发布流程并最终发布1.0.0。无论如何,[CHANGE]对于尚未正式发布的组件,重大更改都将在发布说明中(以标记)或明确传达。

为什么要拉而不是推?

提取HTTP有许多优点:

- 开发更改时,可以在笔记本电脑上运行监控。

- 您可以更轻松地判断目标是否已关闭。

- 您可以手动转到目标并使用Web浏览器检查其运行状况。

总体而言,我们认为拉动比推动略好,但在考虑使用监控系统时,不应将其视为重点。

对于必须推送的情况,我们提供Pushgateway。

如何将日志输入Prometheus?

简短的回答:不要!请改用ELK堆栈之类的东西。

更长的答案:Prometheus是一个收集和处理指标的系统,而不是事件记录系统。Raintank博客文章 Logs and Metrics and Graphs,Oh My! 提供有关日志和指标之间差异的更多详细信息。

如果您想从应用程序日志中提取Prometheus指标,则Google的 mtail可能会有所帮助。

谁写了普罗米修斯?

Prometheus最初由Matt T. Proud和 Julius Volz私人创立 。它的大部分初始开发是由SoundCloud赞助的。

现在,它已由众多公司和个人维护和扩展。

Prometheus使用什么许可证?

Prometheus是根据 Apache 2.0许可发布的。

普罗米修斯的复数是什么?

经过广泛研究,已经确定“ Prometheus”的正确复数是“ Prometheis”。

我可以重新载入Prometheus的配置吗?

是的,发送SIGHUP到Prometheus进程或到/-/reload端点的HTTP POST请求 将重新加载并应用配置文件。各种组件尝试妥善处理失败的更改。

我可以发送警报吗?

是的,使用Alertmanager。

当前,支持以下外部系统:

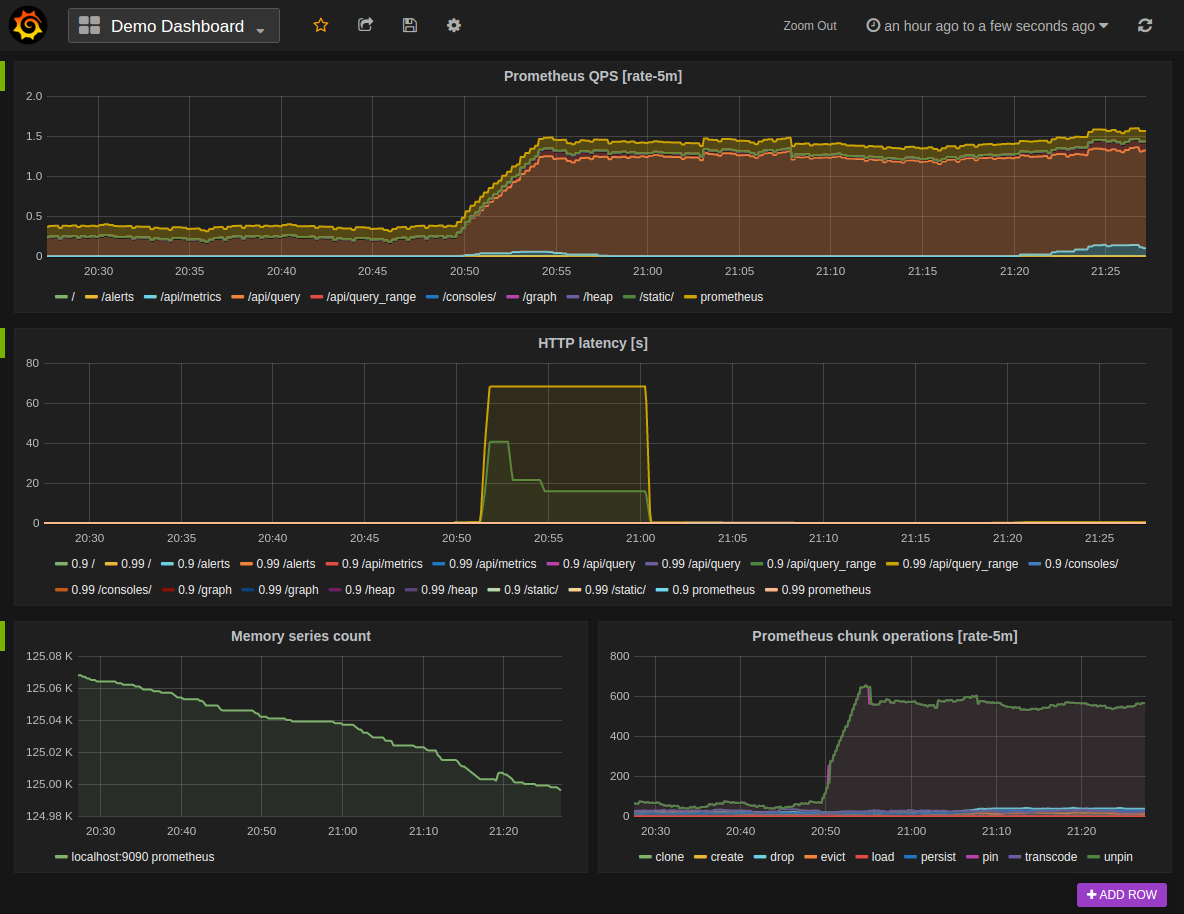

我可以创建仪表板吗?

是的,我们建议您使用Grafana进行生产。也有控制台模板。

我可以更改时区吗?为什么所有内容都采用UTC?

为避免任何时区混乱,特别是在涉及所谓的夏时制时,我们决定在Prometheus的所有组件中内部专门使用Unix time和UTC进行显示。可以将精心完成的时区选择引入UI。欢迎捐款。有关 此工作的当前状态,请参阅 问题500。

仪器仪表

哪些语言有乐器库?

有许多客户端库可使用Prometheus指标来检测您的服务。有关 详细信息,请参见客户端库文档。

如果您有兴趣为新语言的客户库提供帮助,请参阅博览会格式。

我可以监视机器吗?

是的,Node Exporter在Linux和其他Unix系统上公开了一组广泛的计算机级别指标,例如CPU使用率,内存,磁盘使用率,文件系统完整性和网络带宽。

我可以监视网络设备吗?

是的,SNMP导出器允许监视支持SNMP的设备。

我可以监视批处理作业吗?

是的,使用Pushgateway。另请参阅监视批处理作业的 最佳做法。

Prometheus可以直接监视哪些应用程序?

请参阅导出器和集成列表。

我可以通过JMX监视JVM应用程序吗?

是的,对于不能直接使用Java客户端进行检测的应用程序,可以将JMX Exporter 单独使用或作为Java代理使用。

仪器的性能影响是什么?

客户端库和语言之间的性能可能会有所不同。对于Java, 基准测试 表明,根据争用,使用Java客户端增加计数器/表将花费12-17ns。除了对延迟最关键的代码之外,所有其他代码都可以忽略不计。

故障排除

我的Prometheus 1.x服务器需要花费很长时间才能启动,并且会向日志发送有关崩溃恢复的大量信息。

您正在遭受不干净的关机。Prometheus必须在结束后彻底关闭SIGTERM,对于频繁使用的服务器可能需要一段时间。如果服务器崩溃或被严重杀死(例如,内核被OOM杀死,或者在等待Prometheus关闭时,您的运行级别系统不耐烦),则必须执行崩溃恢复,在正常情况下,恢复时间应少于一分钟,但是可以在某些情况下要花很长时间。有关详细信息,请参见 崩溃恢复。

我的Prometheus 1.x服务器内存不足。

请参阅有关 配置Prometheus的内存使用情况的部分以获取可用内存量。

我的Prometheus 1.x服务器报告处于“紧急模式”或“存储需要节流”。

您的存储设备负担重。阅读 有关配置本地存储的部分, 以了解如何调整设置以获得更好的性能。

实作

为什么所有样本值都是64位浮点数?我想要整数。

我们将自己限制在64位浮点数以简化设计。该 IEEE 754双精度二进制浮点格式 支持整数精度值高达2 53。如果需要整数精度高于2 53但低于2 63,则支持本机64位整数将(仅)有帮助。原则上,可以实现对不同样本值类型(包括某种大整数,甚至支持64位以上)的支持,但现在并不是优先考虑的事情。计数器即使每秒增加一百万次,也只会在超过285年后才会出现精度问题。

为什么Prometheus服务器组件不支持TLS或身份验证?我可以添加那些吗?

注意:Prometheus团队在2018年8月11日的开发峰会上改变了其立场,该项目的路线图上现已支持在服务端点中支持TLS和身份验证 。更改代码后,将更新此文档。

尽管TLS和身份验证是经常需要的功能,但我们故意没有在Prometheus的任何服务器端组件中实现它们。两者都有太多不同的选项和参数(仅TLS就有10多个选项),我们决定专注于构建最佳监视系统,而不是在每个服务器组件中都支持完全通用的TLS和身份验证解决方案。

如果您需要TLS或身份验证,我们建议在Prometheus前面放置一个反向代理。例如,请参见使用Nginx将基本身份验证添加到Prometheus。

这仅适用于入站连接。Prometheus确实支持 刮除启用TLS和auth的目标,并且其他创建出站连接的Prometheus组件也具有类似的支持。

概念

资料模型

Prometheus从根本上将所有数据存储为时间序列:带有时间戳的值流属于同一度量标准和同一组标注维。除了存储的时间序列外,Prometheus可能会生成临时的导出时间序列作为查询的结果。

指标名称和标签

每个时间序列都通过其指标名称和可选的键值对(称为标签)来唯一标识。

所述度量名称指定了测得的系统的一般特征(例如http_requests_total-请求接收到的HTTP的总数)。它可能包含ASCII字母和数字,以及下划线和冒号。它必须匹配正则表达式[a-zA-Z_:][a-zA-Z0-9_:]*。

注意:冒号是为用户定义的记录规则保留的。出口商或直接仪器都不应使用它们。

标签启用了Prometheus的维度数据模型:具有相同度量标准名称的标签的任何给定组合都可以标识该度量标准的特定维度实例(例如:所有POST向/api/tracks处理程序使用该方法的HTTP请求)。查询语言允许基于这些维度进行过滤和聚合。更改任何标签值,包括添加或删除标签,都会创建一个新的时间序列。

标签名称可能包含ASCII字母,数字和下划线。它们必须匹配正则表达式[a-zA-Z_][a-zA-Z0-9_]*。开头的标签名称__ 保留供内部使用。

标签值可以包含任何Unicode字符。

标签值为空的标签被认为等同于不存在的标签。

样本

样本构成实际的时间序列数据。每个样本包括:

- 一个float64值

- 毫秒精度的时间戳

符号

给定度量标准名称和一组标签,通常使用以下符号来标识时间序列:

<metric name>{<label name>=<label value>, ...}

例如,度量名称的时间序列api_http_requests_total和标签method="POST",并handler="/messages"可以这样写:

api_http_requests_total{method="POST", handler="/messages"}

这与OpenTSDB使用的符号相同。

METRIC TYPES

Prometheus客户端库提供了四种核心度量标准类型。这些仅在客户端库(以启用针对特定类型的使用量身定制的API)和有线协议中有所区别。Prometheus服务器尚未使用类型信息,而是将所有数据展平为未键入的时间序列。将来可能会改变。

计数器

一个计数器是代表一个累积指标单调递增计数器,其价值只能在重新启动增加或归零。例如,您可以使用计数器来表示已服务请求,已完成任务或错误的数量。

不要使用计数器来显示可以减小的值。例如,请勿对当前正在运行的进程数使用计数器;而是使用量规。

客户端的客户端库使用文档:

量规

甲轨距是表示单个数值,可以任意地上升和下降的度量。

量表通常用于测量值,例如温度或当前的内存使用量,还用于可能上升和下降的“计数”,例如并发请求数。

量规的客户端库使用文档:

直方图

甲直方图样本观测(通常之类的东西请求持续时间或响应大小)和计数它们配置的桶中。它还提供所有观察值的总和。

基本指标名称为的直方图<basename>在刮擦期间会暴露多个时间序列:

- 观察桶的累积计数器,以

<basename>_bucket{le="<upper inclusive bound>"} - 的总和的所有观察值的,公开为

<basename>_sum - 该计数已观察到的事件的,公开为

<basename>_count(等同于<basename>_bucket{le="+Inf"}上文)

使用该 histogram_quantile()功能 可以根据直方图甚至是直方图的聚合来计算分位数。直方图也适用于计算 Apdex得分。在铲斗上操作时,请记住直方图是 累积的。有关直方图用法的详细信息以及与摘要的差异,请参见 直方图和摘要。

客户端库使用情况的直方图文档:

摘要

类似于直方图,摘要会采样观察结果(通常是请求持续时间和响应大小之类的东西)。尽管它还提供了观测值的总数和所有观测值的总和,但它可以计算滑动时间窗口内的可配置分位数。

基本度量标准名称为“摘要”的摘要会<basename>在刮刮期间显示多个时间序列:

- 流φ-位数(0≤φ≤1)观察到的事件的,公开为

<basename>{quantile="<φ>"} - 的总和的所有观察值的,公开为

<basename>_sum - 该计数的事件已经被观察到,暴露

<basename>_count

有关φ分位数的详细说明,摘要用法以及与直方图的差异,请参见直方图和摘要。

客户端库使用情况文档摘要:

作业和实例

用Prometheus术语来说,您可以抓取的端点称为实例,通常对应于单个进程。具有相同目的的实例的集合(例如,出于可伸缩性或可靠性而复制的过程)称为job。

例如,具有四个复制实例的API服务器作业:

- 工作:

api-server- 实例1:

1.2.3.4:5670 - 实例2:

1.2.3.4:5671 - 实例3:

5.6.7.8:5670 - 实例4:

5.6.7.8:5671

- 实例1:

自动生成的标签和时间序列

当Prometheus抓取目标时,它会自动在抓取的时间序列上附加一些标签,以识别被抓取的目标:

job:目标所属的已配置作业名称。instance:<host>:<port>抓取的目标网址的一部分。

如果在抓取的数据中已经存在这些标签中的任何一个,则行为取决于honor_labels配置选项。有关 更多信息,请参见 抓取配置文档。

对于每个实例刮擦,Prometheus 按照以下时间序列存储样本:

up{job="<job-name>", instance="<instance-id>"}:1实例是否正常(即可达)或0刮取失败。scrape_duration_seconds{job="<job-name>", instance="<instance-id>"}:刮擦的持续时间。scrape_samples_post_metric_relabeling{job="<job-name>", instance="<instance-id>"}:应用公制重新标记后剩余的样本数。scrape_samples_scraped{job="<job-name>", instance="<instance-id>"}:目标暴露的样本数量。scrape_series_added{job="<job-name>", instance="<instance-id>"}:此刮板中新系列的大概数量。v2.10的新功能

该up时间序列对于实例可用性监视很有用。

普罗米修斯

入门

本指南是一种“ Hello World”风格的教程,该教程显示了如何在简单的示例设置中安装,配置和使用Prometheus。您将在本地下载并运行Prometheus,对其进行配置以抓取自身和示例应用程序,然后使用查询,规则和图形来利用收集的时间序列数据。

下载并运行Prometheus

为您的平台下载最新版本的Prometheus,然后解压缩并运行它:

tar xvfz prometheus-*.tar.gz cd prometheus-*

在启动Prometheus之前,让我们对其进行配置。

配置Prometheus进行自我监控

Prometheus通过在这些目标上刮擦度量标准HTTP端点来从受监视的目标收集度量标准。由于Prometheus还以相同的方式公开有关其自身的数据,因此它也可以抓取并监视其自身的运行状况。

虽然仅收集有关自身数据的Prometheus服务器在实践中不是很有用,但它是一个很好的入门示例。将以下基本Prometheus基本配置另存为名为的文件prometheus.yml:

global: scrape_interval: 15s # By default, scrape targets every 15 seconds. # Attach these labels to any time series or alerts when communicating with # external systems (federation, remote storage, Alertmanager). external_labels: monitor: 'codelab-monitor' # A scrape configuration containing exactly one endpoint to scrape: # Here it's Prometheus itself. scrape_configs: # The job name is added as a label `job=<job_name>` to any timeseries scraped from this config. - job_name: 'prometheus' # Override the global default and scrape targets from this job every 5 seconds. scrape_interval: 5s static_configs: - targets: ['localhost:9090']

有关配置选项的完整说明,请参阅 配置文档。

开始普罗米修斯

要使用新创建的配置文件启动Prometheus,请切换到包含Prometheus二进制文件的目录并运行:

# Start Prometheus. # By default, Prometheus stores its database in ./data (flag --storage.tsdb.path). ./prometheus --config.file=prometheus.yml

普罗米修斯应该开始。您还应该能够在localhost:9090浏览到有关其自身的状态页。花几秒钟的时间从其自己的HTTP指标终结点收集有关其自身的数据。

您还可以通过导航到其度量标准端点来验证Prometheus是否正在提供有关其自身的度量标准: localhost:9090 / metrics

使用表达式浏览器

让我们尝试查看Prometheus收集的有关自身的一些数据。要使用Prometheus的内置表达式浏览器,请导航至 http:// localhost:9090 / graph,然后在“图形”选项卡中选择“控制台”视图。

正如您可以从localhost:9090 / metrics收集的那样,称为Prometheus导出的有关其自身的一项指标 prometheus_target_interval_length_seconds(两次目标刮擦之间的实际时间间隔)。继续并将其输入到表达式控制台中:

prometheus_target_interval_length_seconds

这将返回多个不同的时间序列(以及每个序列的最新值),所有时间序列均带有度量名称 prometheus_target_interval_length_seconds,但带有不同的标签。这些标签指定不同的延迟百分比和目标组间隔。

如果我们只对第99个百分位延迟感兴趣,则可以使用以下查询来检索该信息:

prometheus_target_interval_length_seconds{quantile="0.99"}

要计算返回的时间序列数,您可以编写:

count(prometheus_target_interval_length_seconds)

有关表达语言的更多信息,请参见 表达语言文档。

使用绘图界面

要绘制图形表达式,请导航至http:// localhost:9090 / graph并使用“图形”选项卡。

例如,输入以下表达式以绘制在自抓取的Prometheus中创建的块的每秒速率:

rate(prometheus_tsdb_head_chunks_created_total[1m])

试用图形范围参数和其他设置。

启动一些样本目标

让我们变得更加有趣,并为Prometheus抓取一些示例目标。

Go客户端库包含一个示例,该示例导出具有不同延迟分布的三个服务的虚拟RPC延迟。

确保您已安装Go编译器,并设置了可正常运行的Go构建环境(带有正确的GOPATH)。

下载Prometheus的Go客户端库,并运行以下三个示例过程:

# Fetch the client library code and compile example. git clone https://github.com/prometheus/client_golang.git cd client_golang/examples/random go get -d go build # Start 3 example targets in separate terminals: ./random -listen-address=:8080 ./random -listen-address=:8081 ./random -listen-address=:8082

现在,您应该具有示例目标,可以监听http:// localhost:8080 / metrics, http:// localhost:8081 / metrics和http:// localhost:8082 / metrics。

配置Prometheus监视样本目标

现在,我们将配置Prometheus来抓取这些新目标。让我们将所有三个端点归为一个名为的工作example-random。但是,假设前两个端点是生产目标,而第三个端点代表金丝雀实例。为了在Prometheus中对此建模,我们可以将多个端点组添加到单个作业中,并为每个目标组添加额外的标签。在此示例中,我们将group="production"标签添加到第一组目标,同时添加group="canary"到第二组。

为此,请将以下作业定义添加到scrape_configs 您的部分,prometheus.yml然后重新启动Prometheus实例:

scrape_configs: - job_name: 'example-random' # Override the global default and scrape targets from this job every 5 seconds. scrape_interval: 5s static_configs: - targets: ['localhost:8080', 'localhost:8081'] labels: group: 'production' - targets: ['localhost:8082'] labels: group: 'canary'

转到表达式浏览器,并验证Prometheus现在是否具有有关这些示例端点公开的时间序列的信息,例如 rpc_durations_seconds度量。

配置规则以将抓取的数据汇总到新的时间序列中

尽管在我们的示例中不是问题,但是在临时计算时,汇总了数千个时间序列的查询可能会变慢。为了提高效率,Prometheus允许您通过配置的记录规则将表达式预记录到全新的持久时间序列中。假设我们感兴趣的是记录在5分钟的时间内在rpc_durations_seconds_count所有实例(但保留job和service尺寸)上平均的示例RPC()的每秒速率。我们可以这样写:

avg(rate(rpc_durations_seconds_count[5m])) by (job, service)

尝试绘制此表达式的图形。

要将由该表达式产生的时间序列记录到名为的新指标中job_service:rpc_durations_seconds_count:avg_rate5m,请使用以下记录规则创建一个文件,并将其另存为prometheus.rules.yml:

groups: - name: example rules: - record: job_service:rpc_durations_seconds_count:avg_rate5m expr: avg(rate(rpc_durations_seconds_count[5m])) by (job, service)

要使Prometheus接受这一新规则,请在中添加一条rule_files语句prometheus.yml。现在,配置应如下所示:

global: scrape_interval: 15s # By default, scrape targets every 15 seconds. evaluation_interval: 15s # Evaluate rules every 15 seconds. # Attach these extra labels to all timeseries collected by this Prometheus instance. external_labels: monitor: 'codelab-monitor' rule_files: - 'prometheus.rules.yml' scrape_configs: - job_name: 'prometheus' # Override the global default and scrape targets from this job every 5 seconds. scrape_interval: 5s static_configs: - targets: ['localhost:9090'] - job_name: 'example-random' # Override the global default and scrape targets from this job every 5 seconds. scrape_interval: 5s static_configs: - targets: ['localhost:8080', 'localhost:8081'] labels: group: 'production' - targets: ['localhost:8082'] labels: group: 'canary'

通过新配置重新启动Prometheus,并job_service:rpc_durations_seconds_count:avg_rate5m 通过表达式浏览器查询或绘制图表,以验证具有度量标准名称的新时间序列现在可用。

安装

使用预编译的二进制文件

我们为大多数官方Prometheus组件提供了预编译的二进制文件。请查看下载部分,以获取所有可用版本的列表。

从来源

要从源代码构建Prometheus组件,请参见Makefile相应存储库中的目标。

使用Docker

所有Prometheus服务都可以在Quay.io或 Docker Hub上作为Docker映像使用 。

在Docker上运行Prometheus就像docker run -p 9090:9090 prom/prometheus。这将以示例配置启动Prometheus,并将其公开在端口9090上。

Prometheus映像使用卷来存储实际指标。对于生产部署,强烈建议使用“ 数据卷容器” 模式来简化Prometheus升级中的数据管理。

要提供您自己的配置,有几个选项。这是两个例子。

体积和装订量

prometheus.yml通过运行以下命令从主机绑定挂载:

docker run \

-p 9090:9090 \

-v /tmp/prometheus.yml:/etc/prometheus/prometheus.yml \

prom/prometheus

或使用其他卷进行配置:

docker run \

-p 9090:9090 \

-v /path/to/config:/etc/prometheus \

prom/prometheus

自订图片

为了避免在主机上管理文件并将其绑定安装,可以将配置烘焙到映像中。如果配置本身是静态的,并且在所有环境中都相同,则此方法效果很好。

为此,使用Prometheus配置创建一个新目录, Dockerfile如下所示:

FROM prom/prometheus

ADD prometheus.yml /etc/prometheus/

现在构建并运行它:

docker build -t my-prometheus . docker run -p 9090:9090 my-prometheus

一个更高级的选项是在使用某些工具开始时动态呈现配置,甚至让守护程序定期更新它。

使用配置管理系统

如果您更喜欢使用配置管理系统,则可能对以下第三方贡献感兴趣:

Ansible

Chef

Puppet

SaltStack

配置

Prometheus通过命令行标志和配置文件进行配置。尽管命令行标志配置了不可变的系统参数(例如存储位置,要保留在磁盘和内存中的数据量等),但配置文件定义了与抓取作业及其实例有关的所有内容,以及哪些规则文件加载。

要查看所有可用的命令行标志,请运行./prometheus -h。

Prometheus可以在运行时重新加载其配置。如果新配置格式不正确,则更改将不会应用。通过向SIGHUPPrometheus进程发送a或向/-/reload端点发送HTTP POST请求(--web.enable-lifecycle启用该标志)来触发配置重载。这还将重新加载所有已配置的规则文件。

配置文件

要指定要加载的配置文件,请使用该--config.file标志。

该文件以YAML格式写入,由以下所述的方案定义。方括号表示参数是可选的。对于非列表参数,该值设置为指定的默认值。

通用占位符定义如下:

<boolean>:可以接受值的布尔值true或false<duration>:与正则表达式匹配的持续时间[0-9]+(ms|[smhdwy])<labelname>:与正则表达式匹配的字符串[a-zA-Z_][a-zA-Z0-9_]*<labelvalue>:一串unicode字符<filename>:当前工作目录中的有效路径<host>:由主机名或IP后跟可选端口号组成的有效字符串<path>:有效的网址路径<scheme>:可以采用值http或https<string>:常规字符串<secret>:是秘密的常规字符串,例如密码<tmpl_string>:使用前已模板扩展的字符串

其他占位符分别指定。

在这里可以找到有效的示例文件。

全局配置指定在所有其他配置上下文中有效的参数。它们还用作其他配置部分的默认设置。

global: # How frequently to scrape targets by default. [ scrape_interval: <duration> | default = 1m ] # How long until a scrape request times out. [ scrape_timeout: <duration> | default = 10s ] # How frequently to evaluate rules. [ evaluation_interval: <duration> | default = 1m ] # The labels to add to any time series or alerts when communicating with # external systems (federation, remote storage, Alertmanager). external_labels: [ <labelname>: <labelvalue> ... ] # File to which PromQL queries are logged. # Reloading the configuration will reopen the file. [ query_log_file: <string> ] # Rule files specifies a list of globs. Rules and alerts are read from # all matching files. rule_files: [ - <filepath_glob> ... ] # A list of scrape configurations. scrape_configs: [ - <scrape_config> ... ] # Alerting specifies settings related to the Alertmanager. alerting: alert_relabel_configs: [ - <relabel_config> ... ] alertmanagers: [ - <alertmanager_config> ... ] # Settings related to the remote write feature. remote_write: [ - <remote_write> ... ] # Settings related to the remote read feature. remote_read: [ - <remote_read> ... ]

<scrape_config>

一个scrape_config小节指定一组目标和参数,描述如何刮除它们。在一般情况下,一个刮擦配置指定一个作业。在高级配置中,这可能会改变。

可以通过static_configs参数静态配置目标,也可以使用受支持的服务发现机制之一动态发现目标。

此外,relabel_configs在刮擦之前,允许对任何目标及其标签进行高级修改。

# The job name assigned to scraped metrics by default. job_name: <job_name> # How frequently to scrape targets from this job. [ scrape_interval: <duration> | default = <global_config.scrape_interval> ] # Per-scrape timeout when scraping this job. [ scrape_timeout: <duration> | default = <global_config.scrape_timeout> ] # The HTTP resource path on which to fetch metrics from targets. [ metrics_path: <path> | default = /metrics ] # honor_labels controls how Prometheus handles conflicts between labels that are # already present in scraped data and labels that Prometheus would attach # server-side ("job" and "instance" labels, manually configured target # labels, and labels generated by service discovery implementations). # # If honor_labels is set to "true", label conflicts are resolved by keeping label # values from the scraped data and ignoring the conflicting server-side labels. # # If honor_labels is set to "false", label conflicts are resolved by renaming # conflicting labels in the scraped data to "exported_<original-label>" (for # example "exported_instance", "exported_job") and then attaching server-side # labels. # # Setting honor_labels to "true" is useful for use cases such as federation and # scraping the Pushgateway, where all labels specified in the target should be # preserved. # # Note that any globally configured "external_labels" are unaffected by this # setting. In communication with external systems, they are always applied only # when a time series does not have a given label yet and are ignored otherwise. [ honor_labels: <boolean> | default = false ] # honor_timestamps controls whether Prometheus respects the timestamps present # in scraped data. # # If honor_timestamps is set to "true", the timestamps of the metrics exposed # by the target will be used. # # If honor_timestamps is set to "false", the timestamps of the metrics exposed # by the target will be ignored. [ honor_timestamps: <boolean> | default = true ] # Configures the protocol scheme used for requests. [ scheme: <scheme> | default = http ] # Optional HTTP URL parameters. params: [ <string>: [<string>, ...] ] # Sets the `Authorization` header on every scrape request with the # configured username and password. # password and password_file are mutually exclusive. basic_auth: [ username: <string> ] [ password: <secret> ] [ password_file: <string> ] # Sets the `Authorization` header on every scrape request with # the configured bearer token. It is mutually exclusive with `bearer_token_file`. [ bearer_token: <secret> ] # Sets the `Authorization` header on every scrape request with the bearer token # read from the configured file. It is mutually exclusive with `bearer_token`. [ bearer_token_file: /path/to/bearer/token/file ] # Configures the scrape request's TLS settings. tls_config: [ <tls_config> ] # Optional proxy URL. [ proxy_url: <string> ] # List of Azure service discovery configurations. azure_sd_configs: [ - <azure_sd_config> ... ] # List of Consul service discovery configurations. consul_sd_configs: [ - <consul_sd_config> ... ] # List of DNS service discovery configurations. dns_sd_configs: [ - <dns_sd_config> ... ] # List of EC2 service discovery configurations. ec2_sd_configs: [ - <ec2_sd_config> ... ] # List of OpenStack service discovery configurations. openstack_sd_configs: [ - <openstack_sd_config> ... ] # List of file service discovery configurations. file_sd_configs: [ - <file_sd_config> ... ] # List of GCE service discovery configurations. gce_sd_configs: [ - <gce_sd_config> ... ] # List of Kubernetes service discovery configurations. kubernetes_sd_configs: [ - <kubernetes_sd_config> ... ] # List of Marathon service discovery configurations. marathon_sd_configs: [ - <marathon_sd_config> ... ] # List of AirBnB's Nerve service discovery configurations. nerve_sd_configs: [ - <nerve_sd_config> ... ] # List of Zookeeper Serverset service discovery configurations. serverset_sd_configs: [ - <serverset_sd_config> ... ] # List of Triton service discovery configurations. triton_sd_configs: [ - <triton_sd_config> ... ] # List of labeled statically configured targets for this job. static_configs: [ - <static_config> ... ] # List of target relabel configurations. relabel_configs: [ - <relabel_config> ... ] # List of metric relabel configurations. metric_relabel_configs: [ - <relabel_config> ... ] # Per-scrape limit on number of scraped samples that will be accepted. # If more than this number of samples are present after metric relabelling # the entire scrape will be treated as failed. 0 means no limit. [ sample_limit: <int> | default = 0 ]

在<job_name>所有刮板配置中,哪里必须是唯一的。

<tls_config>

A tls_config允许配置TLS连接。

# CA certificate to validate API server certificate with. [ ca_file: <filename> ] # Certificate and key files for client cert authentication to the server. [ cert_file: <filename> ] [ key_file: <filename> ] # ServerName extension to indicate the name of the server. # https://tools.ietf.org/html/rfc4366#section-3.1 [ server_name: <string> ] # Disable validation of the server certificate. [ insecure_skip_verify: <boolean> ]

<azure_sd_config>

Azure SD配置允许从Azure VM检索抓取目标。

重新标记期间,以下meta标签可用于目标:

__meta_azure_machine_id:机器ID__meta_azure_machine_location:机器运行的位置__meta_azure_machine_name:机器名称__meta_azure_machine_os_type:机器操作系统__meta_azure_machine_private_ip:机器的专用IP__meta_azure_machine_public_ip:机器的公用IP(如果存在)__meta_azure_machine_resource_group:机器的资源组__meta_azure_machine_tag_<tagname>:机器的每个标签值__meta_azure_machine_scale_set:vm所属的比例尺集的名称(仅当您使用比例尺集时才设置此值)__meta_azure_subscription_id:订阅ID__meta_azure_tenant_id:租户ID

请参阅以下有关Azure发现的配置选项:

# The information to access the Azure API. # The Azure environment. [ environment: <string> | default = AzurePublicCloud ] # The authentication method, either OAuth or ManagedIdentity. # See https://docs.microsoft.com/en-us/azure/active-directory/managed-identities-azure-resources/overview [ authentication_method: <string> | default = OAuth] # The subscription ID. Always required. subscription_id: <string> # Optional tenant ID. Only required with authentication_method OAuth. [ tenant_id: <string> ] # Optional client ID. Only required with authentication_method OAuth. [ client_id: <string> ] # Optional client secret. Only required with authentication_method OAuth. [ client_secret: <secret> ] # Refresh interval to re-read the instance list. [ refresh_interval: <duration> | default = 300s ] # The port to scrape metrics from. If using the public IP address, this must # instead be specified in the relabeling rule. [ port: <int> | default = 80 ]

<consul_sd_config>

Consul SD配置允许从Consul的 Catalog API 检索抓取目标。

__meta_consul_address:目标地址__meta_consul_dc:目标的数据中心名称__meta_consul_tagged_address_<key>:每个节点标记了目标的地址键值__meta_consul_metadata_<key>:目标的每个节点元数据键值__meta_consul_node:为目标定义的节点名称__meta_consul_service_address:目标的服务地址__meta_consul_service_id:目标的服务ID__meta_consul_service_metadata_<key>:目标的每个服务元数据键值__meta_consul_service_port:目标的服务端口__meta_consul_service:目标所属的服务名称__meta_consul_tags:由标签分隔符连接的目标的标签列表

# The information to access the Consul API. It is to be defined # as the Consul documentation requires. [ server: <host> | default = "localhost:8500" ] [ token: <secret> ] [ datacenter: <string> ] [ scheme: <string> | default = "http" ] [ username: <string> ] [ password: <secret> ] tls_config: [ <tls_config> ] # A list of services for which targets are retrieved. If omitted, all services # are scraped. services: [ - <string> ] # See https://www.consul.io/api/catalog.html#list-nodes-for-service to know more # about the possible filters that can be used. # An optional list of tags used to filter nodes for a given service. Services must contain all tags in the list. tags: [ - <string> ] # Node metadata used to filter nodes for a given service. [ node_meta: [ <name>: <value> ... ] ] # The string by which Consul tags are joined into the tag label. [ tag_separator: <string> | default = , ] # Allow stale Consul results (see https://www.consul.io/api/features/consistency.html). Will reduce load on Consul. [ allow_stale: <bool> ] # The time after which the provided names are refreshed. # On large setup it might be a good idea to increase this value because the catalog will change all the time. [ refresh_interval: <duration> | default = 30s ]

请注意,用于刮擦目标的IP地址和端口组装为 <__meta_consul_address>:<__meta_consul_service_port>。但是,在某些Consul设置中,相关地址在中__meta_consul_service_address。在这种情况下,您可以使用重新标签 功能来替换特殊__address__标签。

在重新标记阶段是过滤器的服务或节点优选和更有力的方式为基于任意标签的服务。对于拥有数千项服务的用户而言,直接使用Consul API更为有效,该API具有基本的过滤节点支持(当前通过节点元数据和单个标签)。

<dns_sd_config>

基于DNS的服务发现配置允许指定一组DNS域名,这些域名会定期查询以发现目标列表。从中读取要联系的DNS服务器/etc/resolv.conf。

此服务发现方法仅支持基本DNS A,AAAA和SRV记录查询,但不支持RFC6763中指定的高级DNS-SD方法 。

在重新标记阶段,元标记 __meta_dns_name在每个目标上可用,并设置为产生发现的目标的记录名称。

# A list of DNS domain names to be queried. names: [ - <domain_name> ] # The type of DNS query to perform. [ type: <query_type> | default = 'SRV' ] # The port number used if the query type is not SRV. [ port: <number>] # The time after which the provided names are refreshed. [ refresh_interval: <duration> | default = 30s ]

<domain_name>有效的DNS域名在哪里。凡<query_type>为SRV,A或AAAA。

<ec2_sd_config>

EC2 SD配置允许从AWS EC2实例检索抓取目标。默认情况下使用私有IP地址,但可以通过重新标记将其更改为公共IP地址。

__meta_ec2_availability_zone:实例在其中运行的可用性区域__meta_ec2_instance_id:EC2实例ID__meta_ec2_instance_state:EC2实例的状态__meta_ec2_instance_type:EC2实例的类型__meta_ec2_owner_id:拥有EC2实例的AWS账户的ID__meta_ec2_platform:操作系统平台,在Windows服务器上设置为“ Windows”,否则不存在__meta_ec2_primary_subnet_id:主网络接口的子网ID(如果有)__meta_ec2_private_dns_name:实例的私有DNS名称(如果有)__meta_ec2_private_ip:实例的私有IP地址(如果存在)__meta_ec2_public_dns_name:实例的公共DNS名称(如果有)__meta_ec2_public_ip:实例的公共IP地址(如果有)__meta_ec2_subnet_id:用逗号分隔的实例在其中运行的子网ID列表(如果有)__meta_ec2_tag_<tagkey>:实例的每个标签值__meta_ec2_vpc_id:运行实例的VPC的ID(如果有)

请参阅以下有关EC2发现的配置选项:

# The information to access the EC2 API. # The AWS region. If blank, the region from the instance metadata is used. [ region: <string> ] # Custom endpoint to be used. [ endpoint: <string> ] # The AWS API keys. If blank, the environment variables `AWS_ACCESS_KEY_ID` # and `AWS_SECRET_ACCESS_KEY` are used. [ access_key: <string> ] [ secret_key: <secret> ] # Named AWS profile used to connect to the API. [ profile: <string> ] # AWS Role ARN, an alternative to using AWS API keys. [ role_arn: <string> ] # Refresh interval to re-read the instance list. [ refresh_interval: <duration> | default = 60s ] # The port to scrape metrics from. If using the public IP address, this must # instead be specified in the relabeling rule. [ port: <int> | default = 80 ] # Filters can be used optionally to filter the instance list by other criteria. # Available filter criteria can be found here: # https://docs.aws.amazon.com/AWSEC2/latest/APIReference/API_DescribeInstances.html # Filter API documentation: https://docs.aws.amazon.com/AWSEC2/latest/APIReference/API_Filter.html filters: [ - name: <string> values: <string>, [...] ]

在重新标记阶段是基于任意标签过滤目标的优选和更强大的方式。对于具有数千个实例的用户,直接使用支持过滤实例的EC2 API可能会更有效。

<openstack_sd_config>

OpenStack SD配置允许从OpenStack Nova实例检索抓取目标。

<openstack_role>可以将以下类型之一配置为发现目标:

hypervisor

该hypervisor角色为每个Nova虚拟机管理程序节点发现一个目标。目标地址默认为host_ip虚拟机监控程序的属性。

The following meta labels are available on targets during relabeling:

__meta_openstack_hypervisor_host_ip: the hypervisor node's IP address.__meta_openstack_hypervisor_name: the hypervisor node's name.__meta_openstack_hypervisor_state: the hypervisor node's state.__meta_openstack_hypervisor_status: the hypervisor node's status.__meta_openstack_hypervisor_type: the hypervisor node's type.

instance

The instance role discovers one target per network interface of Nova instance. The target address defaults to the private IP address of the network interface.

The following meta labels are available on targets during relabeling:

__meta_openstack_address_pool: the pool of the private IP.__meta_openstack_instance_flavor: the flavor of the OpenStack instance.__meta_openstack_instance_id: the OpenStack instance ID.__meta_openstack_instance_name: the OpenStack instance name.__meta_openstack_instance_status: the status of the OpenStack instance.__meta_openstack_private_ip: the private IP of the OpenStack instance.__meta_openstack_project_id: the project (tenant) owning this instance.__meta_openstack_public_ip: the public IP of the OpenStack instance.__meta_openstack_tag_<tagkey>: each tag value of the instance.__meta_openstack_user_id: the user account owning the tenant.

请参阅以下有关OpenStack发现的配置选项:

# The information to access the OpenStack API. # The OpenStack role of entities that should be discovered. role: <openstack_role> # The OpenStack Region. region: <string> # identity_endpoint specifies the HTTP endpoint that is required to work with # the Identity API of the appropriate version. While it's ultimately needed by # all of the identity services, it will often be populated by a provider-level # function. [ identity_endpoint: <string> ] # username is required if using Identity V2 API. Consult with your provider's # control panel to discover your account's username. In Identity V3, either # userid or a combination of username and domain_id or domain_name are needed. [ username: <string> ] [ userid: <string> ] # password for the Identity V2 and V3 APIs. Consult with your provider's # control panel to discover your account's preferred method of authentication. [ password: <secret> ] # At most one of domain_id and domain_name must be provided if using username # with Identity V3. Otherwise, either are optional. [ domain_name: <string> ] [ domain_id: <string> ] # The project_id and project_name fields are optional for the Identity V2 API. # Some providers allow you to specify a project_name instead of the project_id. # Some require both. Your provider's authentication policies will determine # how these fields influence authentication. [ project_name: <string> ] [ project_id: <string> ] # The application_credential_id or application_credential_name fields are # required if using an application credential to authenticate. Some providers # allow you to create an application credential to authenticate rather than a # password. [ application_credential_name: <string> ] [ application_credential_id: <string> ] # The application_credential_secret field is required if using an application # credential to authenticate. [ application_credential_secret: <secret> ] # Whether the service discovery should list all instances for all projects. # It is only relevant for the 'instance' role and usually requires admin permissions. [ all_tenants: <boolean> | default: false ] # Refresh interval to re-read the instance list. [ refresh_interval: <duration> | default = 60s ] # The port to scrape metrics from. If using the public IP address, this must # instead be specified in the relabeling rule. [ port: <int> | default = 80 ] # TLS configuration. tls_config: [ <tls_config> ]

<file_sd_config>

基于文件的服务发现提供了一种配置静态目标的更通用的方法,并用作插入自定义服务发现机制的接口。

它读取一组包含零个或多个 <static_config>s的文件。对所有已定义文件的更改将通过磁盘监视来检测并立即应用。文件可以以YAML或JSON格式提供。仅应用导致形成良好目标组的更改。

JSON文件必须包含使用以下格式的静态配置列表:

[

{

"targets": [ "<host>", ... ],

"labels": {

"<labelname>": "<labelvalue>", ...

}

},

...

]

作为备用,文件内容也将以指定的刷新间隔定期重新读取。

__meta_filepath在 重新标记阶段,每个目标都有一个元标记。它的值设置为从中提取目标的文件路径。

There is a list of integrations with this discovery mechanism.

# Patterns for files from which target groups are extracted.

files:

[ - <filename_pattern> ... ]

# Refresh interval to re-read the files.

[ refresh_interval: <duration> | default = 5m ]

Where <filename_pattern> may be a path ending in .json, .yml or .yaml. The last path segment may contain a single * that matches any character sequence, e.g. my/path/tg_*.json.

<gce_sd_config>

GCE SD configurations allow retrieving scrape targets from GCP GCE instances. The private IP address is used by default, but may be changed to the public IP address with relabeling.

The following meta labels are available on targets during relabeling:

__meta_gce_instance_id: the numeric id of the instance__meta_gce_instance_name: the name of the instance__meta_gce_label_<name>: each GCE label of the instance__meta_gce_machine_type: full or partial URL of the machine type of the instance__meta_gce_metadata_<name>: each metadata item of the instance__meta_gce_network: the network URL of the instance__meta_gce_private_ip: the private IP address of the instance__meta_gce_project: the GCP project in which the instance is running__meta_gce_public_ip: the public IP address of the instance, if present__meta_gce_subnetwork: the subnetwork URL of the instance__meta_gce_tags: comma separated list of instance tags__meta_gce_zone: the GCE zone URL in which the instance is running

See below for the configuration options for GCE discovery:

# The information to access the GCE API. # The GCP Project project: <string> # The zone of the scrape targets. If you need multiple zones use multiple # gce_sd_configs. zone: <string> # Filter can be used optionally to filter the instance list by other criteria # Syntax of this filter string is described here in the filter query parameter section: # https://cloud.google.com/compute/docs/reference/latest/instances/list [ filter: <string> ] # Refresh interval to re-read the instance list [ refresh_interval: <duration> | default = 60s ] # The port to scrape metrics from. If using the public IP address, this must # instead be specified in the relabeling rule. [ port: <int> | default = 80 ] # The tag separator is used to separate the tags on concatenation [ tag_separator: <string> | default = , ]

Credentials are discovered by the Google Cloud SDK default client by looking in the following places, preferring the first location found:

- a JSON file specified by the

GOOGLE_APPLICATION_CREDENTIALSenvironment variable - a JSON file in the well-known path

$HOME/.config/gcloud/application_default_credentials.json - fetched from the GCE metadata server

If Prometheus is running within GCE, the service account associated with the instance it is running on should have at least read-only permissions to the compute resources. If running outside of GCE make sure to create an appropriate service account and place the credential file in one of the expected locations.

<kubernetes_sd_config>

Kubernetes SD configurations allow retrieving scrape targets from Kubernetes' REST API and always staying synchronized with the cluster state.

One of the following role types can be configured to discover targets:

node

The node role discovers one target per cluster node with the address defaulting to the Kubelet's HTTP port. The target address defaults to the first existing address of the Kubernetes node object in the address type order of NodeInternalIP, NodeExternalIP, NodeLegacyHostIP, and NodeHostName.

Available meta labels:

__meta_kubernetes_node_name: The name of the node object.__meta_kubernetes_node_label_<labelname>: Each label from the node object.__meta_kubernetes_node_labelpresent_<labelname>:truefor each label from the node object.__meta_kubernetes_node_annotation_<annotationname>: Each annotation from the node object.__meta_kubernetes_node_annotationpresent_<annotationname>:truefor each annotation from the node object.__meta_kubernetes_node_address_<address_type>: The first address for each node address type, if it exists.

In addition, the instance label for the node will be set to the node name as retrieved from the API server.

service

The service role discovers a target for each service port for each service. This is generally useful for blackbox monitoring of a service. The address will be set to the Kubernetes DNS name of the service and respective service port.

Available meta labels:

__meta_kubernetes_namespace: The namespace of the service object.__meta_kubernetes_service_annotation_<annotationname>: Each annotation from the service object.__meta_kubernetes_service_annotationpresent_<annotationname>: "true" for each annotation of the service object.__meta_kubernetes_service_cluster_ip: The cluster IP address of the service. (Does not apply to services of type ExternalName)__meta_kubernetes_service_external_name: The DNS name of the service. (Applies to services of type ExternalName)__meta_kubernetes_service_label_<labelname>: Each label from the service object.__meta_kubernetes_service_labelpresent_<labelname>:truefor each label of the service object.__meta_kubernetes_service_name: The name of the service object.__meta_kubernetes_service_port_name: Name of the service port for the target.__meta_kubernetes_service_port_protocol: Protocol of the service port for the target.

pod

The pod role discovers all pods and exposes their containers as targets. For each declared port of a container, a single target is generated. If a container has no specified ports, a port-free target per container is created for manually adding a port via relabeling.

Available meta labels:

__meta_kubernetes_namespace: The namespace of the pod object.__meta_kubernetes_pod_name: The name of the pod object.__meta_kubernetes_pod_ip: The pod IP of the pod object.__meta_kubernetes_pod_label_<labelname>: Each label from the pod object.__meta_kubernetes_pod_labelpresent_<labelname>:truefor each label from the pod object.__meta_kubernetes_pod_annotation_<annotationname>: Each annotation from the pod object.__meta_kubernetes_pod_annotationpresent_<annotationname>:truefor each annotation from the pod object.__meta_kubernetes_pod_container_init:trueif the container is an InitContainer__meta_kubernetes_pod_container_name: Name of the container the target address points to.__meta_kubernetes_pod_container_port_name: Name of the container port.__meta_kubernetes_pod_container_port_number: Number of the container port.__meta_kubernetes_pod_container_port_protocol: Protocol of the container port.__meta_kubernetes_pod_ready: Set totrueorfalsefor the pod's ready state.__meta_kubernetes_pod_phase: Set toPending,Running,Succeeded,FailedorUnknownin the lifecycle.__meta_kubernetes_pod_node_name: The name of the node the pod is scheduled onto.__meta_kubernetes_pod_host_ip: The current host IP of the pod object.__meta_kubernetes_pod_uid: The UID of the pod object.__meta_kubernetes_pod_controller_kind: Object kind of the pod controller.__meta_kubernetes_pod_controller_name: Name of the pod controller.

endpoints

The endpoints role discovers targets from listed endpoints of a service. For each endpoint address one target is discovered per port. If the endpoint is backed by a pod, all additional container ports of the pod, not bound to an endpoint port, are discovered as targets as well.

Available meta labels:

__meta_kubernetes_namespace: The namespace of the endpoints object.__meta_kubernetes_endpoints_name: The names of the endpoints object.- For all targets discovered directly from the endpoints list (those not additionally inferred from underlying pods), the following labels are attached:

__meta_kubernetes_endpoint_hostname: Hostname of the endpoint.__meta_kubernetes_endpoint_node_name: Name of the node hosting the endpoint.__meta_kubernetes_endpoint_ready: Set totrueorfalsefor the endpoint's ready state.__meta_kubernetes_endpoint_port_name: Name of the endpoint port.__meta_kubernetes_endpoint_port_protocol: Protocol of the endpoint port.__meta_kubernetes_endpoint_address_target_kind: Kind of the endpoint address target.__meta_kubernetes_endpoint_address_target_name: Name of the endpoint address target.

- If the endpoints belong to a service, all labels of the

role: servicediscovery are attached. - For all targets backed by a pod, all labels of the

role: poddiscovery are attached.

ingress

The ingress role discovers a target for each path of each ingress. This is generally useful for blackbox monitoring of an ingress. The address will be set to the host specified in the ingress spec.

可用的元标签:

__meta_kubernetes_namespace:入口对象的名称空间。__meta_kubernetes_ingress_name:入口对象的名称。__meta_kubernetes_ingress_label_<labelname>:来自入口对象的每个标签。__meta_kubernetes_ingress_labelpresent_<labelname>:true用于来自入口对象的每个标签。__meta_kubernetes_ingress_annotation_<annotationname>:来自入口对象的每个注释。__meta_kubernetes_ingress_annotationpresent_<annotationname>:true用于来自入口对象的每个注释。__meta_kubernetes_ingress_scheme:https如果设置了TLS配置,则为入口的协议方案。默认为http。__meta_kubernetes_ingress_path:来自入口规范的路径。默认为/。

请参阅以下有关Kubernetes发现的配置选项:

# The information to access the Kubernetes API. # The API server addresses. If left empty, Prometheus is assumed to run inside # of the cluster and will discover API servers automatically and use the pod's # CA certificate and bearer token file at /var/run/secrets/kubernetes.io/serviceaccount/. [ api_server: <host> ] # The Kubernetes role of entities that should be discovered. role: <role> # Optional authentication information used to authenticate to the API server. # Note that `basic_auth`, `bearer_token` and `bearer_token_file` options are # mutually exclusive. # password and password_file are mutually exclusive. # Optional HTTP basic authentication information. basic_auth: [ username: <string> ] [ password: <secret> ] [ password_file: <string> ] # Optional bearer token authentication information. [ bearer_token: <secret> ] # Optional bearer token file authentication information. [ bearer_token_file: <filename> ] # Optional proxy URL. [ proxy_url: <string> ] # TLS configuration. tls_config: [ <tls_config> ] # Optional namespace discovery. If omitted, all namespaces are used. namespaces: names: [ - <string> ]

凡<role>必须是endpoints,service,pod,node,或 ingress。

有关 为Kubernetes配置Prometheus的详细示例,请参见此示例Prometheus配置文件。

您可能希望查看第三方Prometheus Operator,它可以自动在Kubernetes上设置Prometheus。

<marathon_sd_config>

Marathon SD配置允许使用Marathon REST API 检索刮擦目标 。Prometheus将定期检查REST端点是否有当前正在运行的任务,并为每个至少具有一个正常任务的应用程序创建目标组。

__meta_marathon_app:应用程序的名称(斜杠由破折号代替)__meta_marathon_image:使用的Docker映像的名称(如果可用)__meta_marathon_task:Mesos任务的ID__meta_marathon_app_label_<labelname>:附加到应用程序的所有马拉松标签__meta_marathon_port_definition_label_<labelname>:端口定义标签__meta_marathon_port_mapping_label_<labelname>:端口映射标签__meta_marathon_port_index:端口索引号(例如1为PORT1)

请参阅以下有关Marathon发现的配置选项:

# List of URLs to be used to contact Marathon servers. # You need to provide at least one server URL. servers: - <string> # Polling interval [ refresh_interval: <duration> | default = 30s ] # Optional authentication information for token-based authentication # https://docs.mesosphere.com/1.11/security/ent/iam-api/#passing-an-authentication-token # It is mutually exclusive with `auth_token_file` and other authentication mechanisms. [ auth_token: <secret> ] # Optional authentication information for token-based authentication # https://docs.mesosphere.com/1.11/security/ent/iam-api/#passing-an-authentication-token # It is mutually exclusive with `auth_token` and other authentication mechanisms. [ auth_token_file: <filename> ] # Sets the `Authorization` header on every request with the # configured username and password. # This is mutually exclusive with other authentication mechanisms. # password and password_file are mutually exclusive. basic_auth: [ username: <string> ] [ password: <string> ] [ password_file: <string> ] # Sets the `Authorization` header on every request with # the configured bearer token. It is mutually exclusive with `bearer_token_file` and other authentication mechanisms. # NOTE: The current version of DC/OS marathon (v1.11.0) does not support standard Bearer token authentication. Use `auth_token` instead. [ bearer_token: <string> ] # Sets the `Authorization` header on every request with the bearer token # read from the configured file. It is mutually exclusive with `bearer_token` and other authentication mechanisms. # NOTE: The current version of DC/OS marathon (v1.11.0) does not support standard Bearer token authentication. Use `auth_token_file` instead. [ bearer_token_file: /path/to/bearer/token/file ] # TLS configuration for connecting to marathon servers tls_config: [ <tls_config> ] # Optional proxy URL. [ proxy_url: <string> ]

默认情况下,Prometheus将刮除Marathon中列出的每个应用。如果并非所有服务都提供Prometheus指标,则可以使用Marathon标签和Prometheus重新标签来控制实际上将被擦除的实例。有关 如何设置Marathon应用程序和Prometheus配置的实际示例,请参阅Prometheus marathon-sd配置文件。

默认情况下,所有应用程序都将在Prometheus(配置文件中指定的一项)中显示为单个作业,也可以使用重新标记进行更改。

<nerve_sd_config>

Nerve SD配置允许从AirBnB的Nerve中检索刮擦目标,这些目标存储在 Zookeeper中。

__meta_nerve_path:Zookeeper中端点节点的完整路径__meta_nerve_endpoint_host:端点的主机__meta_nerve_endpoint_port:端点的端口__meta_nerve_endpoint_name:端点名称

# The Zookeeper servers.

servers:

- <host>

# Paths can point to a single service, or the root of a tree of services.

paths:

- <string>

[ timeout: <duration> | default = 10s ]

<serverset_sd_config>

Serverset SD配置允许从存储在Zookeeper中的Serverset检索抓取目标。服务器集通常由Finagle和 Aurora使用。

重新标记期间,以下meta标签可用于目标:

__meta_serverset_path:Zookeeper中服务器集成员节点的完整路径__meta_serverset_endpoint_host:默认端点的主机__meta_serverset_endpoint_port:默认端点的端口__meta_serverset_endpoint_host_<endpoint>:给定端点的主机__meta_serverset_endpoint_port_<endpoint>:给定端点的端口__meta_serverset_shard:成员的分片号__meta_serverset_status:成员的状态

# The Zookeeper servers. servers: - <host> # Paths can point to a single serverset, or the root of a tree of serversets. paths: - <string> [ timeout: <duration> | default = 10s ]

Serverset数据必须为JSON格式,当前不支持Thrift格式。

<triton_sd_config>

Triton SD配置允许从Container Monitor 发现端点检索刮取目标。

重新标记期间,以下meta标签可用于目标:

__meta_triton_groups:属于目标的组列表,由逗号分隔__meta_triton_machine_alias:目标容器的别名__meta_triton_machine_brand:目标容器的品牌__meta_triton_machine_id:目标容器的UUID__meta_triton_machine_image:目标容器的图像类型__meta_triton_server_id:目标容器的服务器UUID

# The information to access the Triton discovery API. # The account to use for discovering new target containers. account: <string> # The DNS suffix which should be applied to target containers. dns_suffix: <string> # The Triton discovery endpoint (e.g. 'cmon.us-east-3b.triton.zone'). This is # often the same value as dns_suffix. endpoint: <string> # A list of groups for which targets are retrieved. If omitted, all containers # available to the requesting account are scraped. groups: [ - <string> ... ] # The port to use for discovery and metric scraping. [ port: <int> | default = 9163 ] # The interval which should be used for refreshing target containers. [ refresh_interval: <duration> | default = 60s ] # The Triton discovery API version. [ version: <int> | default = 1 ] # TLS configuration. tls_config: [ <tls_config> ]

<static_config>

A static_config允许指定目标列表和目标的通用标签集。这是在抓取配置中指定静态目标的规范方法。

# The targets specified by the static config. targets: [ - '<host>' ] # Labels assigned to all metrics scraped from the targets. labels: [ <labelname>: <labelvalue> ... ]

<relabel_config>

重新标记是一种强大的工具,可以在刮擦目标之前动态重写目标的标签集。每个刮擦配置可以配置多个重新标记步骤。它们按照在配置文件中出现的顺序应用于每个目标的标签集。

最初,除了配置的每个目标标签外,目标的job 标签还设置为job_name相应的scrape配置的值。该__address__标签被设定为<host>:<port>目标的地址。重新标记后,如果在重新标记过程中未设置标签,则默认将instance标签设置为值__address__。的__scheme__和__metrics_path__标签分别被设定为目标的方案和度量路径。该__param_<name> 标签设置称为国内首家通过URL参数的值<name>。

__meta_在重新贴标签阶段,可能会加上其他带有前缀的标签。它们由提供目标的服务发现机制设置,并且在机制之间有所不同。

标签开始__会从标签集中移除目标重新标记完成后。

如果重新标记步骤仅需要临时存储标签值(作为后续重新标记步骤的输入),请使用__tmp标签名称前缀。保证该前缀不会被Prometheus自己使用。

# The source labels select values from existing labels. Their content is concatenated # using the configured separator and matched against the configured regular expression # for the replace, keep, and drop actions. [ source_labels: '[' <labelname> [, ...] ']' ] # Separator placed between concatenated source label values. [ separator: <string> | default = ; ] # Label to which the resulting value is written in a replace action. # It is mandatory for replace actions. Regex capture groups are available. [ target_label: <labelname> ] # Regular expression against which the extracted value is matched. [ regex: <regex> | default = (.*) ] # Modulus to take of the hash of the source label values. [ modulus: <uint64> ] # Replacement value against which a regex replace is performed if the # regular expression matches. Regex capture groups are available. [ replacement: <string> | default = $1 ] # Action to perform based on regex matching. [ action: <relabel_action> | default = replace ]

<regex>是任何有效的 RE2正则表达式。这是必需的replace,keep,drop,labelmap,labeldrop和labelkeep行动。正则表达式固定在两端。要取消固定正则表达式,请使用.*<regex>.*。

<relabel_action> 确定要采取的重新标记操作:

replace:regex与串联的匹配source_labels。然后,设置target_label于replacement与匹配组的引用(${1},${2},...)中replacement可以通过值取代。如果regex不匹配,则不进行替换。keep:删除regex与串联不匹配的目标source_labels。drop:删除regex与串联的目标匹配的目标source_labels。hashmod:设置target_label为的modulus哈希值的source_labels。labelmap:regex与所有标签名称匹配。然后匹配标签的值复制到由给定的标签名称replacement与匹配组的参考(${1},${2},...)在replacement由他们的价值取代。labeldrop:regex与所有标签名称匹配。任何匹配的标签将从标签集中删除。labelkeep:regex与所有标签名称匹配。任何不匹配的标签都将从标签集中删除。

必须注意labeldrop并labelkeep确保一旦删除标签,度量标准仍会被唯一地标记。

<metric_relabel_configs>

进食前的最后一步是对样品进行公制重新标记。它具有与目标重新标记相同的配置格式和操作。指标重新标记不适用于自动生成的时间序列,例如up。

这样做的一种用途是将过于昂贵而无法摄取的时间序列列入黑名单。

<alert_relabel_configs>

警报重新标记将应用于警报,然后再将其发送到Alertmanager。它具有与目标重新标记相同的配置格式和操作。在外部标签之后应用警报重新标签。

一种用途是确保具有不同外部标签的HA对Prometheus服务器对发送相同的警报。

<alertmanager_config>

本alertmanager_config节指定Prometheus服务器向其发送警报的Alertmanager实例。它还提供了用于配置如何与这些Alertmanager通信的参数。

警报管理器可以通过static_configs参数静态配置,也可以使用受支持的服务发现机制之一动态发现。

另外,relabel_configs允许从发现的实体中选择Alertmanagers,并提供对使用的API路径的高级修改,该路径通过__alerts_path__标签公开。

# Per-target Alertmanager timeout when pushing alerts. [ timeout: <duration> | default = 10s ] # The api version of Alertmanager. [ api_version: <version> | default = v1 ] # Prefix for the HTTP path alerts are pushed to. [ path_prefix: <path> | default = / ] # Configures the protocol scheme used for requests. [ scheme: <scheme> | default = http ] # Sets the `Authorization` header on every request with the # configured username and password. # password and password_file are mutually exclusive. basic_auth: [ username: <string> ] [ password: <string> ] [ password_file: <string> ] # Sets the `Authorization` header on every request with # the configured bearer token. It is mutually exclusive with `bearer_token_file`. [ bearer_token: <string> ] # Sets the `Authorization` header on every request with the bearer token # read from the configured file. It is mutually exclusive with `bearer_token`. [ bearer_token_file: /path/to/bearer/token/file ] # Configures the scrape request's TLS settings. tls_config: [ <tls_config> ] # Optional proxy URL. [ proxy_url: <string> ] # List of Azure service discovery configurations. azure_sd_configs: [ - <azure_sd_config> ... ] # List of Consul service discovery configurations. consul_sd_configs: [ - <consul_sd_config> ... ] # List of DNS service discovery configurations. dns_sd_configs: [ - <dns_sd_config> ... ] # List of EC2 service discovery configurations. ec2_sd_configs: [ - <ec2_sd_config> ... ] # List of file service discovery configurations. file_sd_configs: [ - <file_sd_config> ... ] # List of GCE service discovery configurations. gce_sd_configs: [ - <gce_sd_config> ... ] # List of Kubernetes service discovery configurations. kubernetes_sd_configs: [ - <kubernetes_sd_config> ... ] # List of Marathon service discovery configurations. marathon_sd_configs: [ - <marathon_sd_config> ... ] # List of AirBnB's Nerve service discovery configurations. nerve_sd_configs: [ - <nerve_sd_config> ... ] # List of Zookeeper Serverset service discovery configurations. serverset_sd_configs: [ - <serverset_sd_config> ... ] # List of Triton service discovery configurations. triton_sd_configs: [ - <triton_sd_config> ... ] # List of labeled statically configured Alertmanagers. static_configs: [ - <static_config> ... ] # List of Alertmanager relabel configurations. relabel_configs: [ - <relabel_config> ... ]

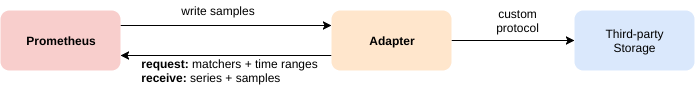

<remote_write>

write_relabel_configs将重新标签应用于样本,然后再将其发送到远程端点。在外部标签之后应用写重新标记。这可以用来限制发送哪些样本。

有一个小样演示如何使用此功能。

# The URL of the endpoint to send samples to. url: <string> # Timeout for requests to the remote write endpoint. [ remote_timeout: <duration> | default = 30s ] # List of remote write relabel configurations. write_relabel_configs: [ - <relabel_config> ... ] # Sets the `Authorization` header on every remote write request with the # configured username and password. # password and password_file are mutually exclusive. basic_auth: [ username: <string> ] [ password: <string> ] [ password_file: <string> ] # Sets the `Authorization` header on every remote write request with # the configured bearer token. It is mutually exclusive with `bearer_token_file`. [ bearer_token: <string> ] # Sets the `Authorization` header on every remote write request with the bearer token # read from the configured file. It is mutually exclusive with `bearer_token`. [ bearer_token_file: /path/to/bearer/token/file ] # Configures the remote write request's TLS settings. tls_config: [ <tls_config> ] # Optional proxy URL. [ proxy_url: <string> ] # Configures the queue used to write to remote storage. queue_config: # Number of samples to buffer per shard before we block reading of more # samples from the WAL. It is recommended to have enough capacity in each # shard to buffer several requests to keep throughput up while processing # occasional slow remote requests. [ capacity: <int> | default = 500 ] # Maximum number of shards, i.e. amount of concurrency. [ max_shards: <int> | default = 1000 ] # Minimum number of shards, i.e. amount of concurrency. [ min_shards: <int> | default = 1 ] # Maximum number of samples per send. [ max_samples_per_send: <int> | default = 100] # Maximum time a sample will wait in buffer. [ batch_send_deadline: <duration> | default = 5s ] # Initial retry delay. Gets doubled for every retry. [ min_backoff: <duration> | default = 30ms ] # Maximum retry delay. [ max_backoff: <duration> | default = 100ms ]

有 此功能的集成列表 。

<remote_read>

# The URL of the endpoint to query from. url: <string> # An optional list of equality matchers which have to be # present in a selector to query the remote read endpoint. required_matchers: [ <labelname>: <labelvalue> ... ] # Timeout for requests to the remote read endpoint. [ remote_timeout: <duration> | default = 1m ] # Whether reads should be made for queries for time ranges that # the local storage should have complete data for. [ read_recent: <boolean> | default = false ] # Sets the `Authorization` header on every remote read request with the # configured username and password. # password and password_file are mutually exclusive. basic_auth: [ username: <string> ] [ password: <string> ] [ password_file: <string> ] # Sets the `Authorization` header on every remote read request with # the configured bearer token. It is mutually exclusive with `bearer_token_file`. [ bearer_token: <string> ] # Sets the `Authorization` header on every remote read request with the bearer token # read from the configured file. It is mutually exclusive with `bearer_token`. [ bearer_token_file: /path/to/bearer/token/file ] # Configures the remote read request's TLS settings. tls_config: [ <tls_config> ] # Optional proxy URL. [ proxy_url: <string> ]

有 此功能的集成列表 。

定义记录规则

配置规则

Prometheus支持两种类型的规则,可以对其进行配置,然后定期进行评估:记录规则和警报规则。要在Prometheus中包括规则,请创建一个包含必要规则语句的文件,并让Prometheus通过Prometheus配置中的rule_files字段加载该文件。规则文件使用YAML。

可以通过发送SIGHUP到Prometheus进程在运行时重新加载规则文件。仅当所有规则文件的格式正确时,才应用更改。

语法检查规则

要在不启动Prometheus服务器的情况下快速检查规则文件在语法上是否正确,请安装并运行Prometheus的promtool命令行实用工具:

go get github.com/prometheus/prometheus/cmd/promtool

promtool check rules /path/to/example.rules.yml

当该文件在语法上有效时,检查器将已解析的规则的文本表示形式打印到标准输出,然后以0返回状态退出。

如果存在任何语法错误或无效的输入参数,则会将错误消息打印为标准错误,并以1返回状态退出。

记录规则

记录规则使您可以预先计算经常需要或计算量大的表达式,并将其结果保存为一组新的时间序列。因此,查询预计算结果通常比每次需要原始表达式都要快得多。这对于仪表板特别有用,仪表板每次刷新时都需要重复查询相同的表达式。

记录和警报规则存在于规则组中。组中的规则以规则的时间间隔顺序运行。

规则文件的语法为:

groups:

[ - <rule_group> ]

一个简单的示例规则文件将是:

groups:

- name: example

rules:

- record: job:http_inprogress_requests:sum

expr: sum(http_inprogress_requests) by (job)

<rule_group>

# The name of the group. Must be unique within a file.

name: <string>

# How often rules in the group are evaluated.

[ interval: <duration> | default = global.evaluation_interval ]

rules:

[ - <rule> ... ]

<rule>

记录规则的语法为:

# The name of the time series to output to. Must be a valid metric name.

record: <string>

# The PromQL expression to evaluate. Every evaluation cycle this is

# evaluated at the current time, and the result recorded as a new set of

# time series with the metric name as given by 'record'.

expr: <string>

# Labels to add or overwrite before storing the result.

labels:

[ <labelname>: <labelvalue> ]

警报规则的语法为:

# The name of the alert. Must be a valid metric name.

alert: <string>

# The PromQL expression to evaluate. Every evaluation cycle this is

# evaluated at the current time, and all resultant time series become

# pending/firing alerts.

expr: <string>

# Alerts are considered firing once they have been returned for this long.

# Alerts which have not yet fired for long enough are considered pending.

[ for: <duration> | default = 0s ]

# Labels to add or overwrite for each alert.

labels:

[ <labelname>: <tmpl_string> ]

# Annotations to add to each alert.

annotations:

[ <labelname>: <tmpl_string> ]警报规则

警报规则使您可以基于Prometheus表达式语言表达式定义警报条件,并将有关触发警报的通知发送到外部服务。只要警报表达式在给定的时间点生成一个或多个矢量元素,警报就被视为这些元素的标签集处于活动状态。

定义警报规则

警报规则在Prometheus中的配置方式与记录规则相同。

带有警报的示例规则文件为:

groups:

- name: example

rules:

- alert: HighRequestLatency

expr: job:request_latency_seconds:mean5m{job="myjob"} > 0.5

for: 10m

labels:

severity: page

annotations:

summary: High request latency

可选for子句使Prometheus在第一次遇到新的表达式输出矢量元素与将警报计为对此元素的触发进行计数之间等待一段时间。在这种情况下,Prometheus将在每次发出警报10分钟之前检查警报是否继续处于活动状态。处于活动状态但尚未触发的元素处于挂起状态。

该labels子句允许指定一组附加到警报的附加标签。任何现有的冲突标签都将被覆盖。标签值可以模板化。

该annotations子句指定了一组信息标签,可用于存储更长的附加信息,例如警报描述或运行手册链接。注释值可以模板化。

模板化

标签和注释值可以使用控制台模板进行模板化。该$labels 变量保存警报实例的标签键/值对。可以通过$externalLabels变量访问已组态的外部标签。该 $value变量保存警报实例的评估值。

# To insert a firing element's label values:

{{ $labels.<labelname> }}

# To insert the numeric expression value of the firing element:

{{ $value }}

例子:

groups:

- name: example

rules:

# Alert for any instance that is unreachable for >5 minutes.

- alert: InstanceDown

expr: up == 0

for: 5m

labels:

severity: page

annotations:

summary: "Instance {{ $labels.instance }} down"

description: "{{ $labels.instance }} of job {{ $labels.job }} has been down for more than 5 minutes."

# Alert for any instance that has a median request latency >1s.

- alert: APIHighRequestLatency

expr: api_http_request_latencies_second{quantile="0.5"} > 1

for: 10m

annotations:

summary: "High request latency on {{ $labels.instance }}"

description: "{{ $labels.instance }} has a median request latency above 1s (current value: {{ $value }}s)"

在运行时检查警报

要手动检查哪些警报处于活动状态(挂起或触发),请导航到Prometheus实例的“警报”选项卡。这将向您显示当前每个定义的警报均处于活动状态的确切标签集。

对于未决和触发警报,Prometheus还存储表格的合成时间序列ALERTS{alertname="<alert name>", alertstate="pending|firing", <additional alert labels>}。1只要警报处于指示的活动(挂起或触发)状态,样本值就设置为,如果不再如此,则将系列标记为陈旧。

发送警报通知

Prometheus的警报规则擅长于确定当前已发生的问题,但它们并不是完整的通知解决方案。在简单的警报定义之上,还需要另一层来添加摘要,通知速率限制,静默和警报依赖性。在Prometheus的生态系统中, Alertmanager担当了这个角色。因此,Prometheus可以配置为定期将有关警报状态的信息发送到Alertmanager实例,该实例随后负责调度正确的通知。

可以将Prometheus 配置为通过其服务发现集成自动发现可用的Alertmanager实例。

范本范例

Prometheus支持在警报的注释和标签以及服务的控制台页面中进行模板化。模板具有对本地数据库运行查询,遍历数据,使用条件语句,格式化数据等功能。Prometheus模板语言基于Go模板系统。

简单的警报字段模板

alert: InstanceDown

expr: up == 0

for: 5m

labels:

severity: page

annotations:

summary: "Instance {{$labels.instance}} down"

description: "{{$labels.instance}} of job {{$labels.job}} has been down for more than 5 minutes."

警报字段模板将在每次触发的每个规则迭代期间执行,因此请保持所有查询和模板的轻量级。如果您需要更复杂的警报模板,建议改为链接到控制台。

简单迭代

这将显示实例列表以及它们是否启动:

{{ range query "up" }}

{{ .Labels.instance }} {{ .Value }}

{{ end }}

特殊.变量包含每次循环迭代的当前样本值。

显示一个值

{{ with query "some_metric{instance='someinstance'}" }}

{{ . | first | value | humanize }}

{{ end }}

Go和Go的模板语言都是强类型的,因此必须检查返回的样本以避免执行错误。例如,如果刮刮或规则评估尚未运行,或者主机已关闭,则可能发生这种情况。

包含的prom_query_drilldown模板可以处理此问题,允许格式化结果并链接到表达式浏览器。

使用控制台URL参数

{{ with printf "node_memory_MemTotal{job='node',instance='%s'}" .Params.instance | query }}

{{ . | first | value | humanize1024 }}B

{{ end }}

如果按进行访问console.html?instance=hostname,.Params.instance将求值为hostname。

高级迭代

<table>

{{ range printf "node_network_receive_bytes{job='node',instance='%s',device!='lo'}" .Params.instance | query | sortByLabel "device"}}

<tr><th colspan=2>{{ .Labels.device }}</th></tr>

<tr>

<td>Received</td>

<td>{{ with printf "rate(node_network_receive_bytes{job='node',instance='%s',device='%s'}[5m])" .Labels.instance .Labels.device | query }}{{ . | first | value | humanize }}B/s{{end}}</td>

</tr>

<tr>

<td>Transmitted</td>

<td>{{ with printf "rate(node_network_transmit_bytes{job='node',instance='%s',device='%s'}[5m])" .Labels.instance .Labels.device | query }}{{ . | first | value | humanize }}B/s{{end}}</td>

</tr>{{ end }}

</table>

在这里,我们遍历所有网络设备并显示每个网络设备的网络流量。

由于该range操作未指定变量,.Params.instance因此在循环内部不可用,因为.现在循环变量不可用。

定义可重用模板

Prometheus支持定义可重复使用的模板。与控制台库支持结合使用时,此功能特别强大 ,允许在各个控制台之间共享模板。

{{/* Define the template */}}

{{define "myTemplate"}}

do something

{{end}}

{{/* Use the template */}}

{{template "myTemplate"}}

模板仅限于一个参数。该args函数可用于包装多个参数。

{{define "myMultiArgTemplate"}}

First argument: {{.arg0}}

Second argument: {{.arg1}}

{{end}}

{{template "myMultiArgTemplate" (args 1 2)}}模板参考

Prometheus支持在警报的注释和标签以及服务的控制台页面中进行模板化。模板具有对本地数据库运行查询,遍历数据,使用条件语句,格式化数据等功能。Prometheus模板语言基于Go模板系统。

数据结构

处理时间序列数据的主要数据结构是样本,定义为:

type sample struct {

Labels map[string]string

Value float64

}

样品的度量名称被编码在地图的特殊__name__标签中Labels。

[]sample 表示样本列表。

interface{} Go中的代码类似于C中的void指针。

功能

除了Go模板提供的默认功能外,Prometheus还提供了一些功能,可简化模板中查询结果的处理。

如果在管道中使用函数,则管道值将作为最后一个参数传递。

查询

| 名称 | 争论 | 退货 | 笔记 |

|---|---|---|---|

| 询问 | 请求参数 | []样品 | 查询数据库,不支持返回范围向量。 |

| 第一 | []样品 | 样品 | 相当于 index a 0 |

| 标签 | 标签,样品 | 串 | 相当于 index sample.Labels label |

| 值 | 样品 | float64 | 相当于 sample.Value |

| sortByLabel | 标签,[]样本 | []样品 | 按给定标签对样本进行排序。很稳定。 |

first,label以及value旨在使查询结果中的管道易于使用。

号码

| 名称 | 争论 | 退货 | 笔记 |

|---|---|---|---|

| 人性化 | 数 | 串 | 使用度量前缀将数字转换为更易读的格式。 |

| 人性化1024 | 数 | 串 | 类似于humanize,但是使用1024作为基础,而不是1000。 |

| 人性化持续时间 | 数 | 串 | 将持续时间(以秒为单位)转换为更具可读性的格式。 |

| 人性化百分比 | 数 | 串 | 将比率值转换为100的分数。 |

| 人性化时间戳 | 数 | 串 | 将以秒为单位的Unix时间戳转换为更具可读性的格式。 |

人性化功能旨在产生合理的输出以供人类使用,并且不能保证在Prometheus版本之间返回相同的结果。

弦乐

| 名称 | 争论 | 退货 | 笔记 |

|---|---|---|---|

| 标题 | 串 | 串 | strings.Title,大写每个单词的第一个字符。 |

| 上层 | 串 | 串 | strings.ToUpper,将所有字符转换为大写。 |

| 降低 | 串 | 串 | strings.ToLower,将所有字符转换为小写。 |

| 比赛 | 图案,文字 | 布尔值 | regexp.MatchString测试未锚定的 regexp匹配。 |

| reReplaceAll | 图案替换文字 | 串 | Regexp.ReplaceAllString Regexp替换,未锚定。 |

| graphLink | expr | 串 | 返回表达式浏览器中该表达式的图形视图的路径。 |

| tableLink | expr | 串 | 在表达式浏览器中返回表达式的表格视图(“控制台”)的路径。 |

其他

| 名称 | 争论 | 退货 | 笔记 |

|---|---|---|---|

| args | []接口{} | map [string] interface {} | 这会将对象列表转换为具有键arg0,arg1等的映射。这旨在允许将多个参数传递给模板。 |

| 汤普 | 字符串,[]界面{} | 没有 | 类似于内置template,但允许使用非文字作为模板名称。注意,假定结果是安全的,并且不会自动转义。仅在控制台中可用。 |

| 安全HTML | 串 | 串 | 将字符串标记为HTML,不需要自动转义。 |

模板类型差异

每种类型的模板都提供了可用于参数化模板的不同信息,并且还有一些其他区别。

警报字段模板

.Value,.Labels和分别ExternalLabels包含警报值,警报标签和全局配置的外部标签。为了方便起见$value,它们也显示为$labels,和$externalLabels变量。

控制台模板

控制台在上公开/consoles/,并从-web.console.templates标志所指向的目录中获取。

控制台模板使用html / template呈现 ,该模板提供自动转义。要绕过自动转义,请使用safe*功能。

URL参数可在中作为映射使用.Params。要访问具有相同名称的多个URL参数,.RawParams是每个参数的列表值的映射。URL路径可在中使用.Path,但/consoles/ 前缀除外。全局配置的外部标签为 .ExternalLabels。还有所有四个惯用变量: $rawParams,$params,$path,和$externalLabels。

控制台还可以访问标记所指向的目录{{define "templateName"}}...{{end}}中的*.lib文件中定义的所有模板-web.console.libraries。由于这是共享的名称空间,因此请注意避免与其他用户发生冲突。模板名称以prom,_prom和开头, __保留给Prometheus使用,上面列出的功能也是如此。

规则的单元测试

您可以promtool用来测试您的规则。

# For a single test file. ./promtool test rules test.yml # If you have multiple test files, say test1.yml,test2.yml,test2.yml ./promtool test rules test1.yml test2.yml test3.yml

测试文件格式

# This is a list of rule files to consider for testing. Globs are supported. rule_files: [ - <file_name> ] # optional, default = 1m evaluation_interval: <duration> # The order in which group names are listed below will be the order of evaluation of # rule groups (at a given evaluation time). The order is guaranteed only for the groups mentioned below. # All the groups need not be mentioned below. group_eval_order: [ - <group_name> ] # All the tests are listed here. tests: [ - <test_group> ]

<test_group>

# Series data interval: <duration> input_series: [ - <series> ] # Unit tests for the above data. # Unit tests for alerting rules. We consider the alerting rules from the input file. alert_rule_test: [ - <alert_test_case> ] # Unit tests for PromQL expressions. promql_expr_test: [ - <promql_test_case> ] # External labels accessible to the alert template. external_labels: [ <labelname>: <string> ... ]

<series>

# This follows the usual series notation '<metric name>{<label name>=<label value>, ...}' # Examples: # series_name{label1="value1", label2="value2"} # go_goroutines{job="prometheus", instance="localhost:9090"} series: <string> # This uses expanding notation. # Expanding notation: # 'a+bxc' becomes 'a a+b a+(2*b) a+(3*b) … a+(c*b)' # 'a-bxc' becomes 'a a-b a-(2*b) a-(3*b) … a-(c*b)' # Examples: # 1. '-2+4x3' becomes '-2 2 6 10' # 2. ' 1-2x4' becomes '1 -1 -3 -5 -7' values: <string>

<alert_test_case>

Prometheus允许您为不同的警报规则使用相同的警报名称。因此,在此单元测试中,您必须在单个警报名称下列出警报名称的所有触发警报的并集<alert_test_case>。

# The time elapsed from time=0s when the alerts have to be checked. eval_time: <duration> # Name of the alert to be tested. alertname: <string> # List of expected alerts which are firing under the given alertname at # given evaluation time. If you want to test if an alerting rule should # not be firing, then you can mention the above fields and leave 'exp_alerts' empty. exp_alerts: [ - <alert> ]

<alert>

# These are the expanded labels and annotations of the expected alert. # Note: labels also include the labels of the sample associated with the # alert (same as what you see in `/alerts`, without series `__name__` and `alertname`) exp_labels: [ <labelname>: <string> ] exp_annotations: [ <labelname>: <string> ]

<promql_test_case>

# Expression to evaluate expr: <string> # The time elapsed from time=0s when the expression has to be evaluated. eval_time: <duration> # Expected samples at the given evaluation time. exp_samples: [ - <sample> ]

<sample>

# Labels of the sample in usual series notation '<metric name>{<label name>=<label value>, ...}' # Examples: # series_name{label1="value1", label2="value2"} # go_goroutines{job="prometheus", instance="localhost:9090"} labels: <string> # The expected value of the PromQL expression. value: <number>

例

这是通过测试的单元测试的示例输入文件。test.yml是遵循上述语法并alerts.yml包含警报规则的测试文件。

随着alerts.yml在同一目录下,运行./promtool test rules test.yml。

test.yml

# This is the main input for unit testing. # Only this file is passed as command line argument. rule_files: - alerts.yml evaluation_interval: 1m tests: # Test 1. - interval: 1m # Series data. input_series: - series: 'up{job="prometheus", instance="localhost:9090"}' values: '0 0 0 0 0 0 0 0 0 0 0 0 0 0 0' - series: 'up{job="node_exporter", instance="localhost:9100"}' values: '1+0x6 0 0 0 0 0 0 0 0' # 1 1 1 1 1 1 1 0 0 0 0 0 0 0 0 - series: 'go_goroutines{job="prometheus", instance="localhost:9090"}' values: '10+10x2 30+20x5' # 10 20 30 30 50 70 90 110 130 - series: 'go_goroutines{job="node_exporter", instance="localhost:9100"}' values: '10+10x7 10+30x4' # 10 20 30 40 50 60 70 80 10 40 70 100 130 # Unit test for alerting rules. alert_rule_test: # Unit test 1. - eval_time: 10m alertname: InstanceDown exp_alerts: # Alert 1. - exp_labels: severity: page instance: localhost:9090 job: prometheus exp_annotations: summary: "Instance localhost:9090 down" description: "localhost:9090 of job prometheus has been down for more than 5 minutes." # Unit tests for promql expressions. promql_expr_test: # Unit test 1. - expr: go_goroutines > 5 eval_time: 4m exp_samples: # Sample 1. - labels: 'go_goroutines{job="prometheus",instance="localhost:9090"}' value: 50 # Sample 2. - labels: 'go_goroutines{job="node_exporter",instance="localhost:9100"}' value: 50

alerts.yml

# This is the rules file. groups: - name: example rules: - alert: InstanceDown expr: up == 0 for: 5m labels: severity: page annotations: summary: "Instance {{ $labels.instance }} down" description: "{{ $labels.instance }} of job {{ $labels.job }} has been down for more than 5 minutes." - alert: AnotherInstanceDown expr: up == 0 for: 10m labels: severity: page annotations: summary: "Instance {{ $labels.instance }} down" description: "{{ $labels.instance }} of job {{ $labels.job }} has been down for more than 5 minutes."

查询普罗米修斯

Prometheus提供了一种称为PromQL(Prometheus查询语言)的功能查询语言,使用户可以实时选择和汇总时间序列数据。表达式的结果可以显示为图形,可以在Prometheus的表达式浏览器中显示为表格数据,也可以由外部系统通过HTTP API使用。

例子

本文档仅供参考。为了学习,从几个示例开始可能会更容易。

表达语言数据类型

在Prometheus的表达语言中,一个表达式或子表达式可以计算为以下四种类型之一:

- 即时向量 -一组时间序列,每个时间序列包含一个样本,所有样本共享相同的时间戳

- 范围向量 -一组时间序列,其中包含每个时间序列随时间变化的一系列数据点

- 标量 -一个简单的数字浮点值

- String-一个简单的字符串值;目前未使用

根据用例(例如,在绘制图形或显示表达式的输出时),由于用户指定的表达式的结果,其中只有某些类型是合法的。例如,返回即时向量的表达式是唯一可以直接绘制图形的类型。

文字

字符串文字

可以在单引号,双引号或反引号中将字符串指定为文字。

PromQL遵循与Go相同的转义规则。在单引号或双引号反斜杠开头的转义序列,其可以随后a,b,f, n,r,t,v或\。可使用八进制(来提供特定的字符\nnn)或十六进制(\xnn,\unnnn和\Unnnnnnnn)。

反引号内不会处理任何转义。与Go不同,Prometheus不会在反引号内丢弃换行符。

例:

"this is a string"

'these are unescaped: \n \\ \t'

`these are not unescaped: \n ' " \t`

浮点文字

标量浮点值可以从字面上写为以下形式的数字 [-](digits)[.(digits)]。

-2.43

时间序列选择器

即时向量选择器

即时矢量选择器允许在给定的时间戳(即时)上选择一组时间序列和每个样本的单个采样值:以最简单的形式,仅指定度量名称。这将导致一个即时向量,其中包含具有该度量名称的所有时间序列的元素。

本示例选择所有具有http_requests_total度量标准名称的时间序列: