机器学习--K折交叉验证和非负矩阵分解

1、交叉验证

交叉验证(Cross validation),交叉验证用于防止模型过于复杂而引起的过拟合.有时亦称循环估计, 是一种统计学上将数据样本切割成较小子集的实用方法。

于是可以先在一个子集上做分析, 而其它子集则用来做后续对此分析的确认及验证。 一开始的子集被称为训练集。而其它的子集则被称为验证集或测试集。

交叉验证是一种评估统计分析、机器学习算法对独立于训练数据的数据集的泛化能力(generalize)。

交叉验证一般要尽量满足:

1)训练集的比例要足够多,一般大于一半

2)训练集和测试集要均匀抽样

将数据集A随机分为k个包,每次将其中一个包作为测试集,剩下k-1个包作为训练集进行训练。

在matlab中,可以利用:

indices=crossvalind('Kfold',x,k);

来实现随机分包的操作,其中x为一个N维列向量(N为数据集A的元素个数,与x具体内容无关,只需要能够表示数据集的规模),k为要分成的包的总个数,输出的结果indices是一个N维列向量,每个元素对应的值为该单元所属的包的编号(即该列向量中元素是1~k的整随机数),利用这个向量即可通过循环控制来对数据集进行划分。例:

[M,N]=size(data);//数据集为一个M*N的矩阵,其中每一行代表一个样本

indices=crossvalind('Kfold',data(1:M,N),10);//进行随机分包

for k=1:10//交叉验证k=10,10个包轮流作为测试集

test = (indices == k); //获得test集元素在数据集中对应的单元编号

train = ~test;//train集元素的编号为非test元素的编号

train_data=data(train,:);//从数据集中划分出train样本的数据

train_target=target(:,train);//获得样本集的测试目标,在本例中是实际分类情况

test_data=data(test,:);//test样本集

test_target=target(:,test);

[HammingLoss(1,k),RankingLoss(1,k),OneError(1,k),Coverage(1,k),Average_Precision(1,k),Outputs,Pre_Labels.MLKNN]=MLKNN_algorithm(train_data,train_target,test_data,test_target);//要验证的算法

end

//上述结果为输出算法MLKNN的几个验证指标及最后一轮验证的输出和结果矩阵,每个指标都是一个k元素的行向量

交叉验证的目的:假设分类器或模型有一个或多个未知的参数,并且设这个训练器(模型)与已有样本数据集(训练数据集)匹配。训练的过程是指优化模型的参数,以使得分类器或模型能够尽可能的与训练数据集匹配。我们在同一数据集总体中,取一个独立的测试数据集。

当用于模型训练的数据量越大时,训练出来的模型通常效果会越好。所以训练集和测试集的划分意味着我们无法充分利用我们手头已有的数据,所以得到的模型效果也会受到一定的影响。

K折交叉验证能充分利用现有的数据。

K倍交叉验证(K>=2)。将样本数据集随机划分为K个子集(一般是均分),将一个子集数据作为测试集,其余的K-1组子集作为训练集;

将K个子集轮流作为测试集,重复上述过程,这样得到了K个分类器或模型,并利用测试集得到了K个分类器或模型的分类准确率。

用K个分类准确率的平均值作为分类器或模型的性能指标。10-倍交叉证实是比较常用的。

优点:每一个样本数据都即被用作训练数据,也被用作测试数据。避免的过度学习和欠学习状态的发生,得到的结果比较具有说服力。

2、

非负矩阵分解(NMF,Non-negative matrix factorization)

NMF的基本思想

NMF的基本思想可以简单描述为:对于任意给定的一个非负矩阵A,NMF算法能够寻找到一个非负矩阵U和一个非负矩阵V,使得满足 ,从而将一个非负的矩阵分解为左右两个非负矩阵的乘积。

NMF问题描述

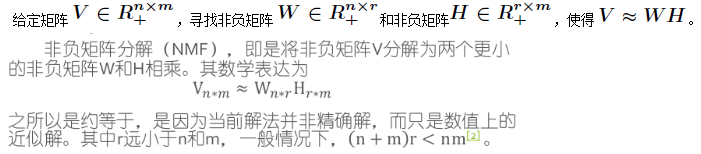

传统的NMF问题可以描述如下

论文作者实际的解释是:

- 非负性会引发稀疏

- 非负性会使计算过程进入部分分解

浙公网安备 33010602011771号

浙公网安备 33010602011771号