机器学习—特征选择

1、特征选择

特征选择是一种及其重要的数据预处理方法。假设你需要处理一个监督学习问题,样本的特征数非常大(甚至),但是可能仅仅有少部分特征会和对结果产生影响。甚至是简单的线性分类,如果样本特征数超过了n,但假设函数的VC维确仍然是O(n),那么,除非大大扩展训练集的数量,否则即会带来过拟合的问题。在这样的情况下,可以使用特征选择算法降低特征的数量。

假设样本有n个特征,那么,其有种可能的特征子集,如果特征选择需要去穷举所有种可能的特征子集,对于n比较大的情况,计算的代价太大,无法真正实现。

特征选择的定义 :对当前学习任务有价值的属性称为是“相关特征”,没有价值的属性称为是“无关特征”,从给定的特征集中选择出相关特征子集的过程,就称为是“特征选择”。 其中还有一种特征称为是“冗余特征”,这些特征指的是可以从其他特征中推演出来的特征。

特征选择是一个“数据预处理”过程,它的重要性体现在两个方面:

1)减轻维度灾难问题。

2)去除无关特征可以降低学习的难度。

2、包裹式选择

与过滤式选择不考虑后续学习器不同,包裹式选择直接把最终将要使用的学习器的性能作为特征子集的评价依据,也就是说,包裹式特征选择是为给定的学习器选择最有利的特征子集。

与过滤式选择相比,包裹式选择的效果一般会更好,但由于在特征选择过程中需要多长训练学习器,因此包裹式选择的计算开销要大很多。

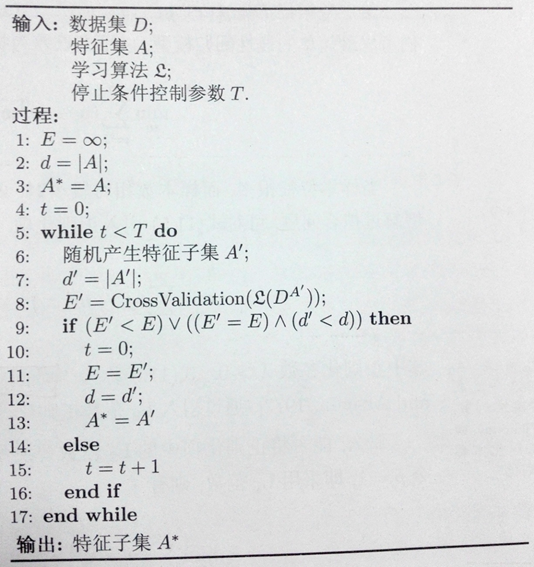

LVW(Las Vegas Wrapper)是一种典型的包裹式特征选择方法,它在拉斯维加斯方法框架下使用随机策略来进行子集搜索,并以最终分类器的误差为特征子集评价准则。

LVW 基于拉斯维加斯方法的框架,拉斯维加斯方法是一个典型的随机化方法,即概率算法中的一种。它具有概率算法的特点,允许算法在执行的过程中随机选择下一步,许多情况下,当算法在执行过程中面临一个选择时,随机性选择常比最优选择要省时,因此概率算法可在很大程度上降低算法的复杂度。

拉斯维加斯算法不会得到不正确的解,一旦用拉斯维加斯算法找到一个解,那么这个解一定就是正确的解,但有时用拉斯维加斯算法找不到解。

LVW 基于拉斯维加斯方法的框架,假设数据集为 D,特征集为 A,则 LVW 每次从特征集 A 中随机产生一个特征子集 A′,然后使用交叉验证的方法(伪代码的第 8 步)估计学习器在特征子集 A′上的误差,若该误差小于之前获得的最小误差,或者与之前的最小误差相当但 A′中包含的特征数更少,则将 A′保留下来。

由于 LVW 算法每次评价子集 A′ 时,都需要重新训练学习器,计算开销很大,因此设置了参数 T 来控制停止条件。但当特征数很多(即 |A| 很大)并且 T 设置得很大时,可能算法运行很长时间都不能停止。

3、其他的特征选择方法

其他的还有很多,如:

子集搜索与评价

过滤式选择

嵌入式选择

浙公网安备 33010602011771号

浙公网安备 33010602011771号