IDEAL基于maven创建spark程序

今天创建spark项目遇到一个奇葩问题,困扰了好久,特此记录一下。

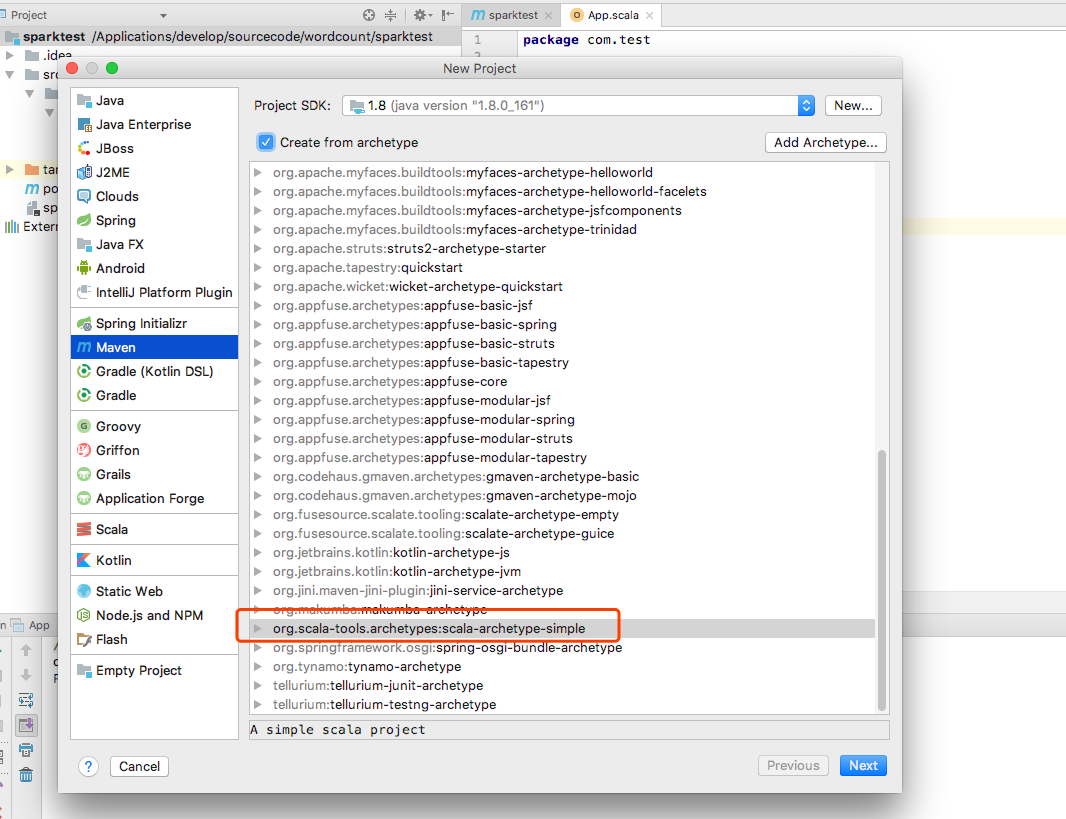

1.按照截图创建spark项目

2.项目创建好后,运行报错:

Error:scalac: error while loading JUnit4, class file '/Applications/develop/jarpackage/org/specs/specs/1.2.5/specs-1.2.5.jar(org/specs/runner/JUnit4.class)' is broken (class java.lang.RuntimeException/error reading Scala signature of JUnit4.class: Scala s

要想解决这个错误就把自动生成的Test文件整个删除,整个目录结构如下:

3.运行程序时又报如下错误:

xception in thread "main" java.lang.NoSuchMethodError: scala.Predef$.refArrayOps([Ljava/lang/Object;)Lscala/collection/mutable/ArrayOps;

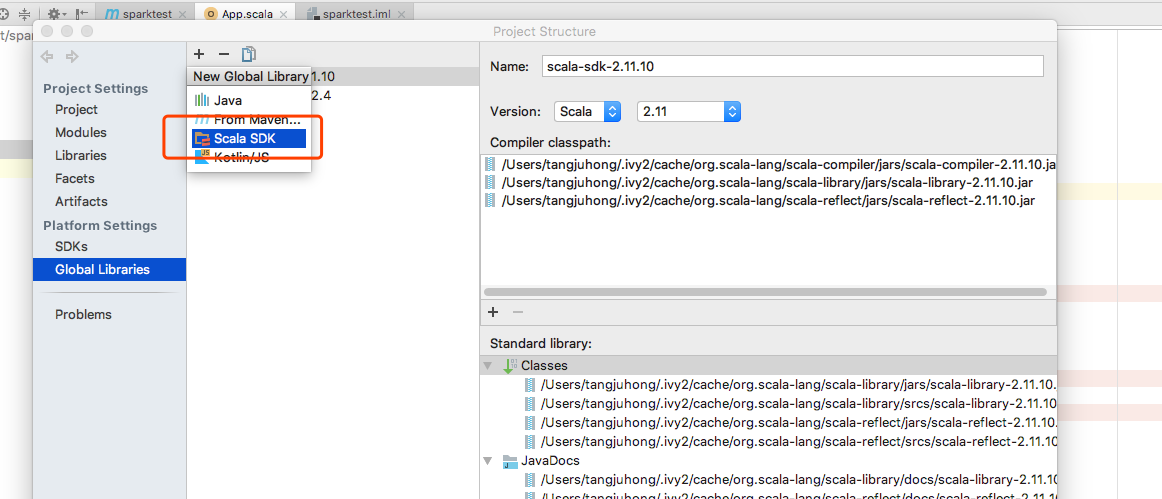

这是因为scala版本和spark版本没有对应起来,可以在如下截图进行配置。

浙公网安备 33010602011771号

浙公网安备 33010602011771号