1_Spark Streaming 概述

1. Spark Streaming 是什么 ?

Spark Streaming 是 Spark Core 的扩展API

用来支持 高吞吐、高容错的 处理 流式数据

数据源可以是 : Kafka、TCP sockets、Flume、Twitter等流式数据源

处理数据: 可以用 Spark Core的算子 map、reduce、join、window 来处理数据

数据输出: 可以将处理后的数据 输出到 文件系统(HDFS)、数据库、live dashboards(实时仪表盘)

Spark Streaming是Spark的上一代 流式引擎

Spark Streaming 不在更新,它是一个传统项目

Spark 现在又提供了一个 更新、更容易使用的流式引擎,Spark Structured Streaming

2. Spark Streaming 工作流程 ?

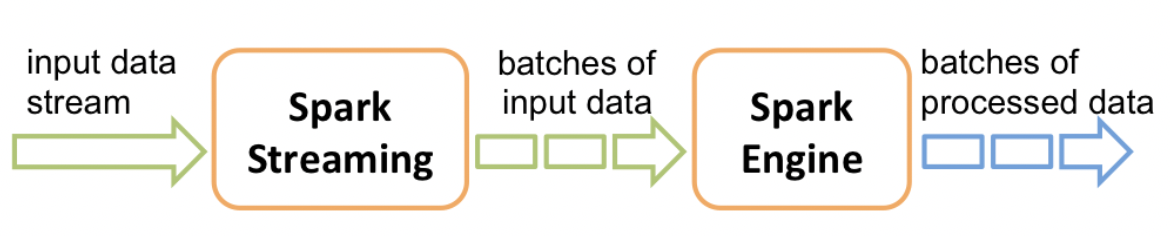

Spark Streaming接收实时的输入数据流

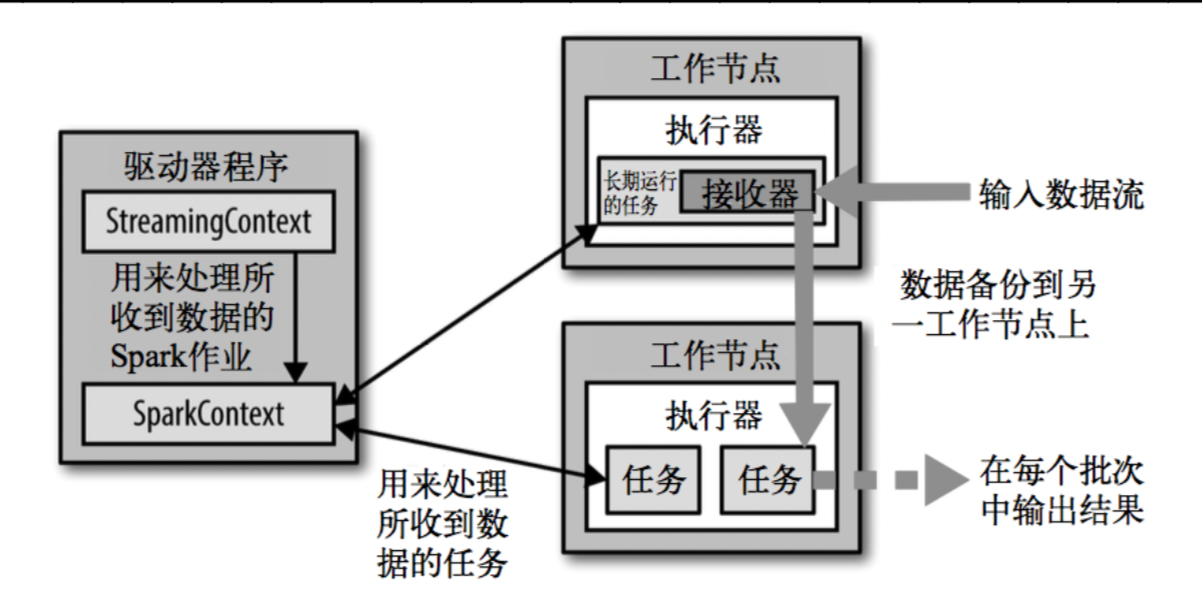

将数据进行批量处理,再由Spark引擎进行处理,最终批量生成结果流 (本质还是将数据 封装成RDD 进行处理)

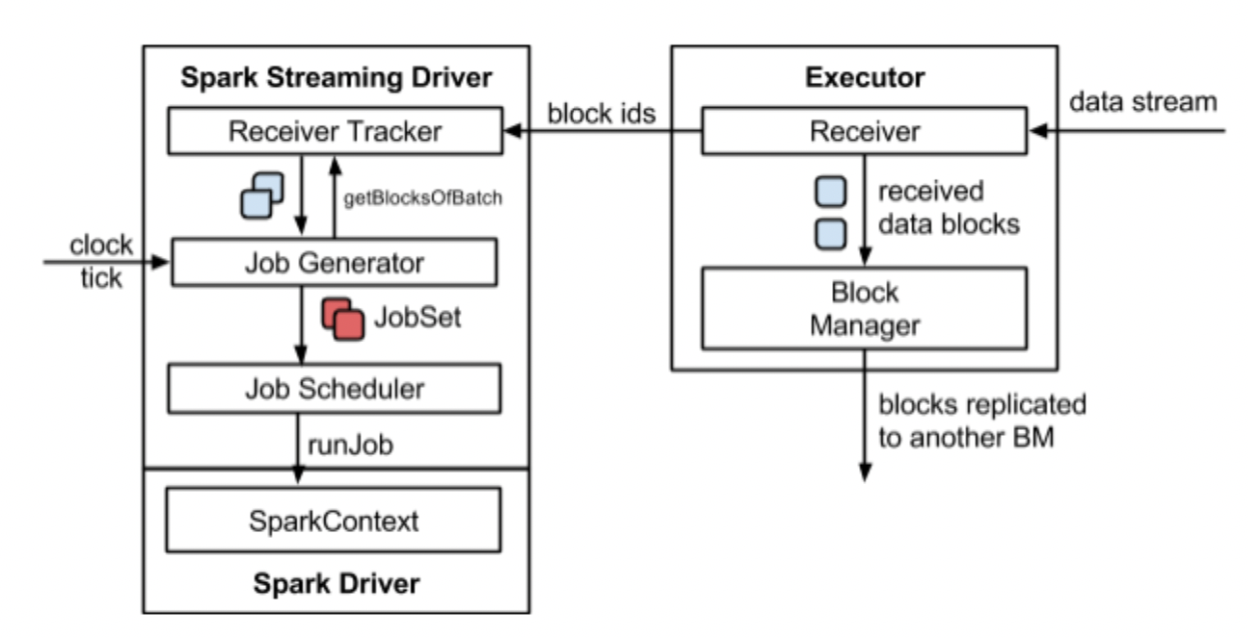

Receiver 接收数据流 -> 生成 DStream(一系列RDD) -> SparkConext 处理 RDD -> 输出处理结果

分类:

SparkStreaming

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

2021-08-08 29-将十进制数转成二进制数(二进制>> 和掩码实现)

2021-08-08 28.二进制的按位运算和移位运算(~、&、|、^、<<、>>)