第五章_Spark核心编程_Rdd执行原理

1. 思考 : 处理数据 需要哪些东西呢?

1. 计算资源(CPU&内存)

2. 计算模型(也就是计算逻辑)

2. 在Yarn 环境中,Rdd 执行流程

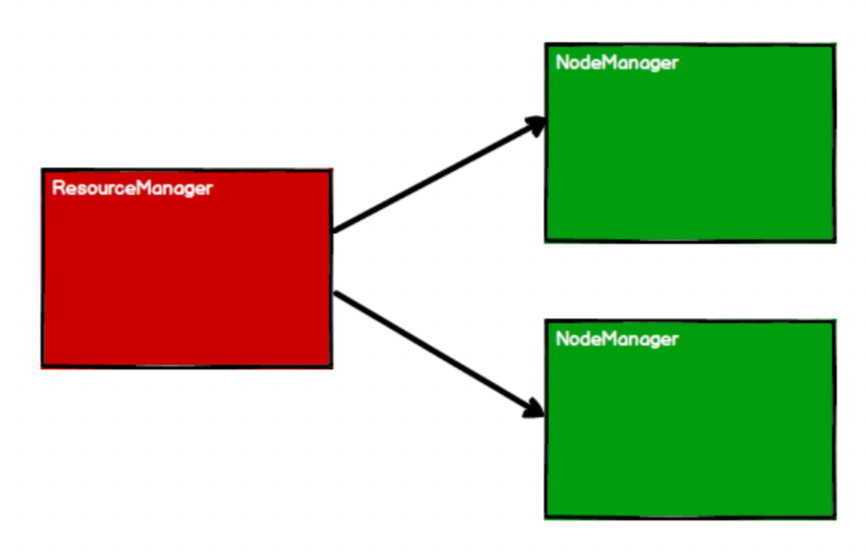

1. 启动 Yarn 集群环境

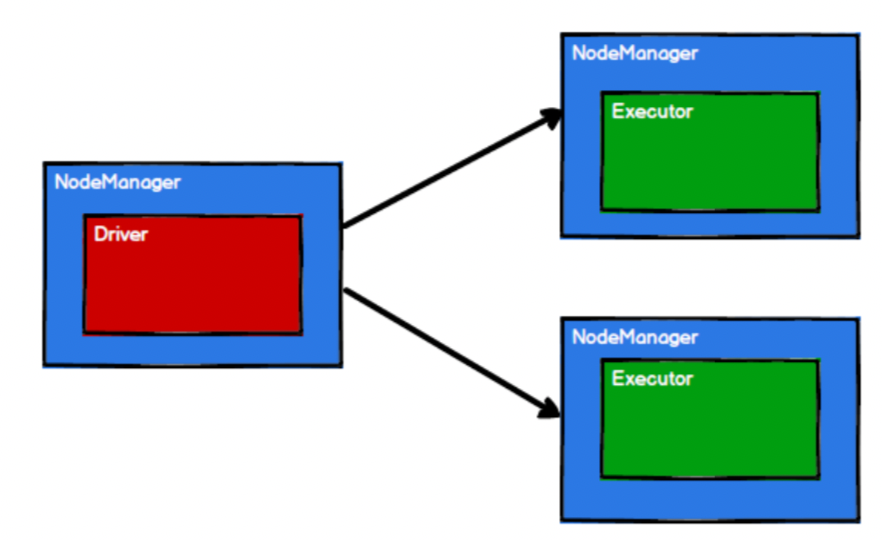

2. Spark 通过申请资源创建调度节点(ApplicationMaster)和计算节点(Executor)

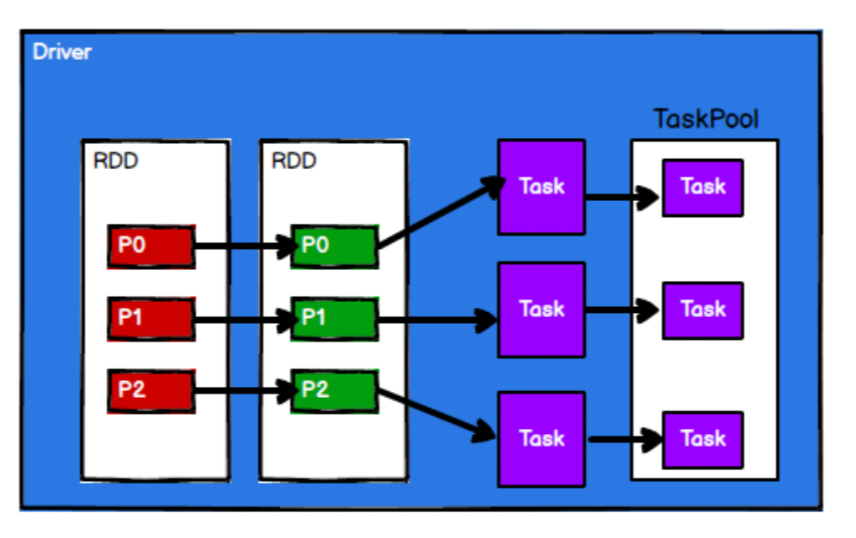

3. Spark 框架根据需求将计算逻辑根据分区划分成不同的任务

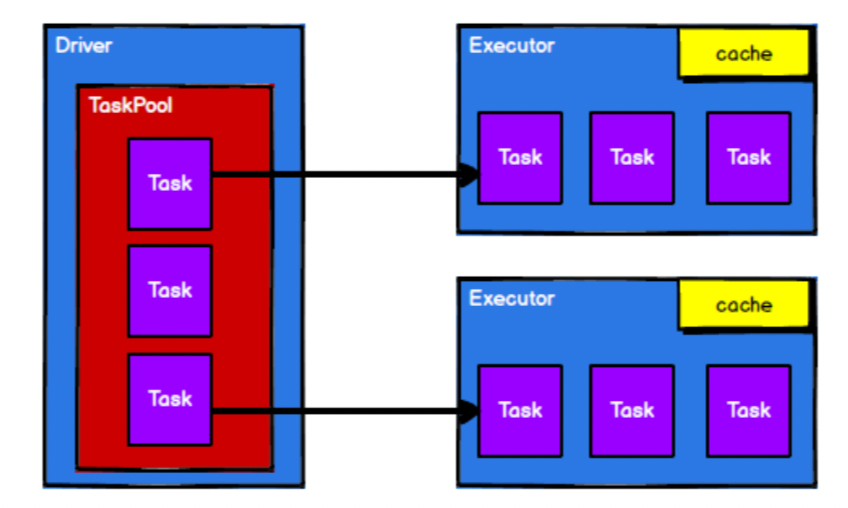

4. 调度节点将任务根据计算节点状态发送到对应的计算节点进行计算

3. 总结说明 :

1. 提交任务给Yarn 2. 申请资源 ApplicationMaster、NodeManager-container-executor 3. Driver 将任务进行拆分成不同的Task 4. 将拆分后的Task 分发到不同的Executor中

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· 字符编码:从基础到乱码解决

· SpringCloud带你走进微服务的世界