前情提要:

scrapy框架

- 框架:具有很多功能且具有很强通用性的一个项目模板。

- 环境换装:

Linux:

pip3 install scrapy

Windows:

a. pip3 install wheel

b. 下载twisted http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

c. 进入下载目录,执行 pip3 install Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl

d. pip3 install pywin32

e. pip3 install scrapy

- 创建一个工程:scrapy startproject proName

- cd proName

- 创建爬虫文件:scrapy genspider spiderName www.xxx.com

- 执行工程:scrapy crawl spiderName

- 持久化存储:

- 基于终端指令:只可以将parse方法的返回值存储到磁盘文件中

- 基于管道:

一:创建一个scrapy 工程

二: 创建一个爬虫文件

scrapy genspider spiderName www.xxx.com

三:解析数据

选取的网站是

https://www.qiushibaike.com/text/

代码:

# -*- coding: utf-8 -*- import scrapy class Myspiders1Spider(scrapy.Spider): name = 'myspiders1' # 允许反应的域名 ,正常来说注释掉,因为有的网站会 用域名加img拼接. # allowed_domains = ['images.so.com'] # 起始的url ,第一个url ,可以很多页,因为是个列表 start_urls = ['https://www.qiushibaike.com/text/'] # 解析数据 def parse(self, response): # print(response) # pass # div_list = response.xpath('//div[@id="content-left"]/div') div_list = response.xpath('//div[@id="content-left"]//div//a/h2/text()').extract() # print(div_list) names = [] for div in div_list: author = div.strip() dic = { 'name': author } # print(author) names.append(dic) # print(names)

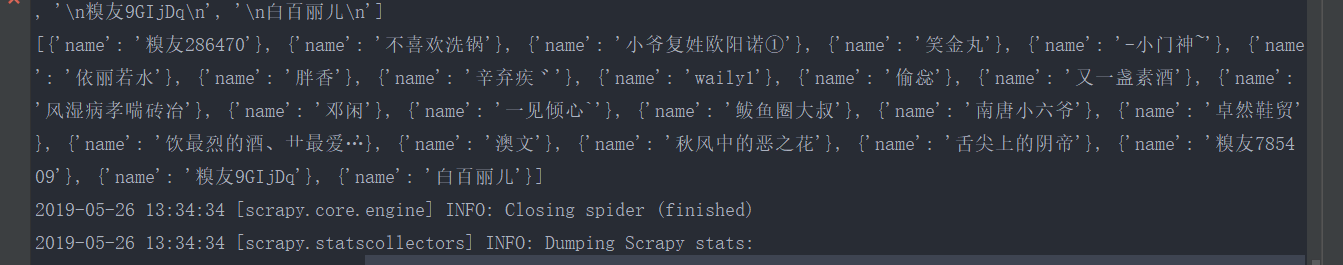

结果

四: 数据持久化

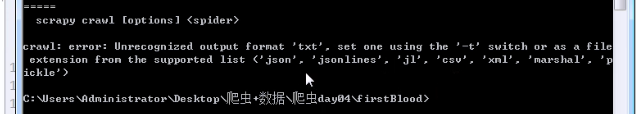

1 : 存储在磁盘文件中

F:\scrapydemo\demo101>scrapy crawl myspiders1 -o qiubai.csv

只能存储一些常用的文件格式

年与时驰,意与日去,遂成枯落,

多不接世,悲守穷庐,将复何及。