【模式识别与机器学习】学习笔记

1.1 什么是模式识别

模式识别概念

所谓模式识别的问题就是用计算的方法根据样本的特征将样本划分到一定的类别中去。模式识别就是通过计算机用数学技术方法来研究模式的自动处理和判读,把环境与客体统称为“模式”。随着计算机技术的发展,人类有可能研究复杂的信息处理过程,其过程的一个重要形式是生命体对环境及客体的识别。模式识别以图像处理与计算机视觉、语音语言信息处理、脑网络组、类脑智能等为主要研究方向,研究人类模式识别的机理以及有效的计算方法。

模式识别的应用实例

- 计算机视觉领域

- 手写体字符识别:OCR

- 交通标志识别:辅助/无人驾驶

- 动作识别

- 人机交互领域

- 语音识别

- 医学领域

- 心跳异位搏动识别

- 网络领域

- 应用程序识别:基于TCP/IP流量

- 金融领域

- 银行信贷识别

- 股票价格预测

- 机器人领域

- 机械手目标抓取点位姿

- 无人车领域

- 无人驾驶

模式识别的基本定义

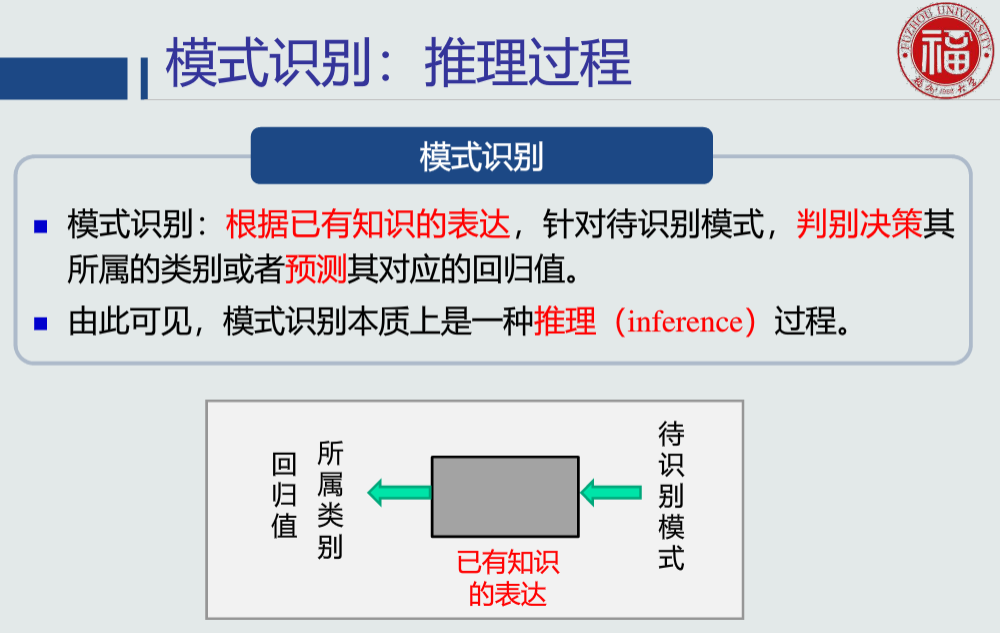

模式识别的推理过程

1.2 模式识别数学表达

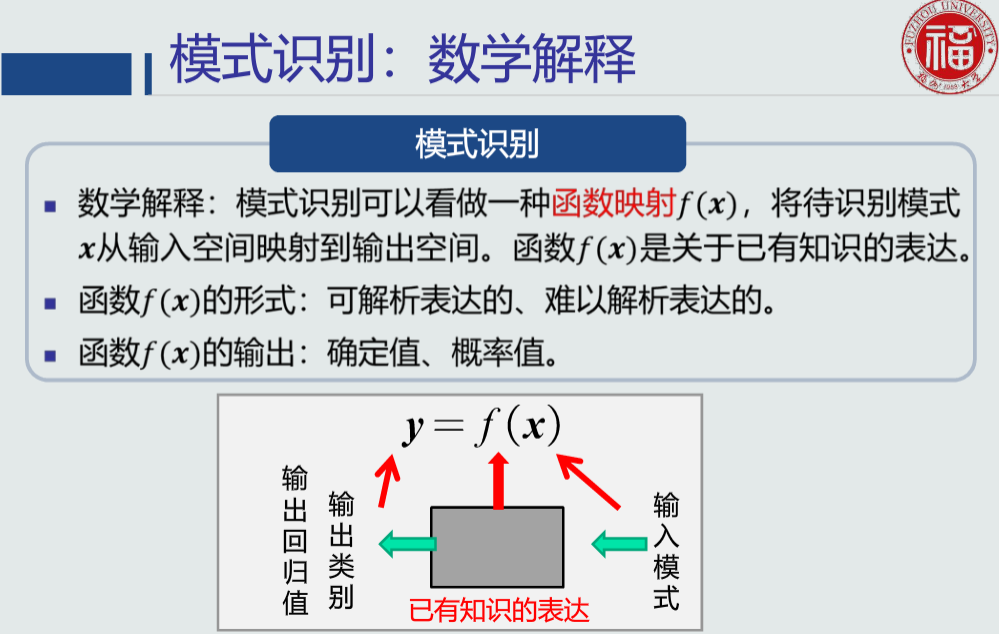

模式识别的数学解释

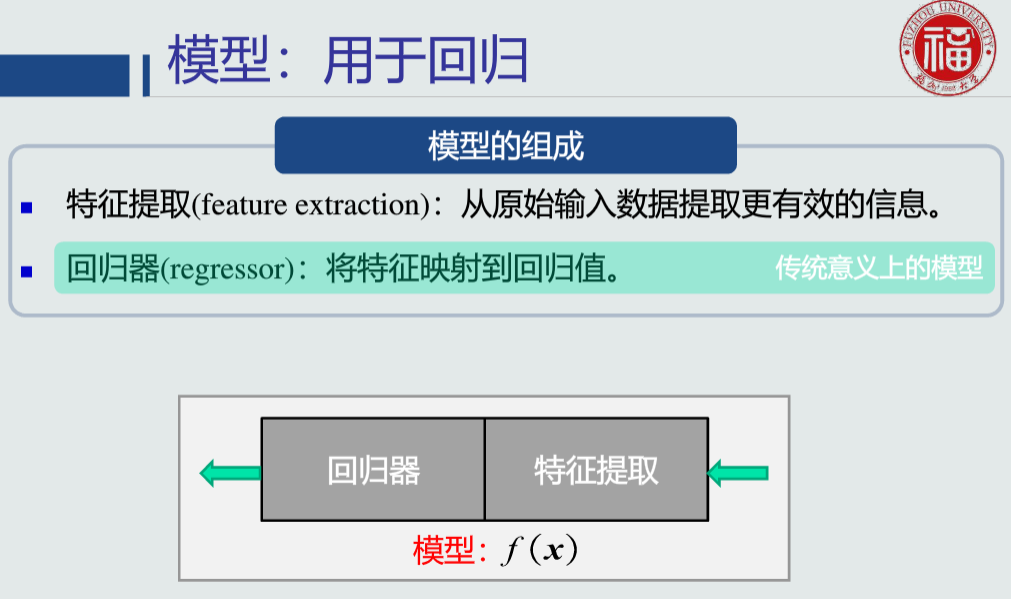

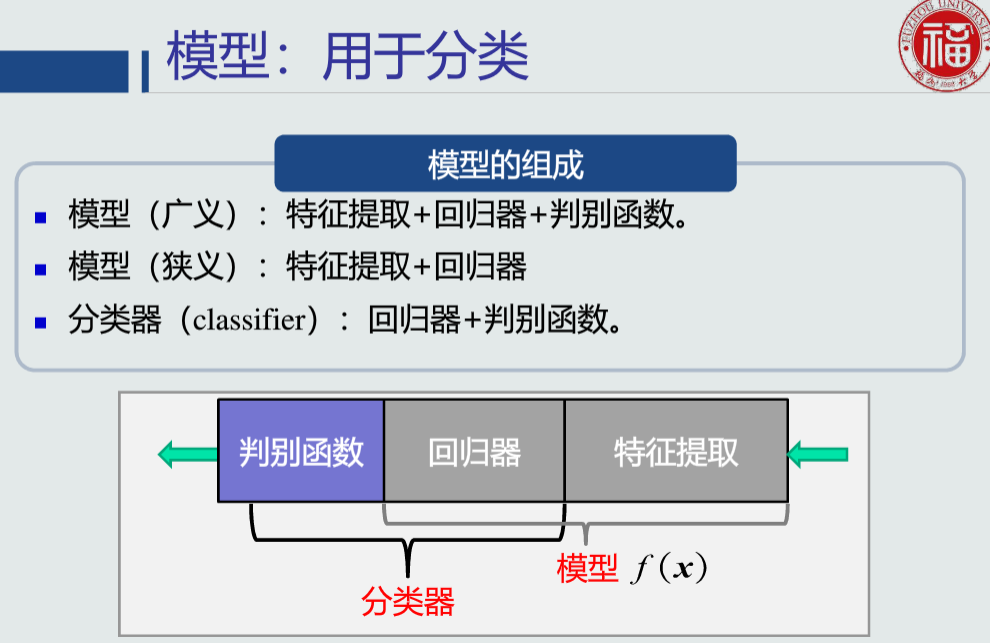

模型的定义及组成

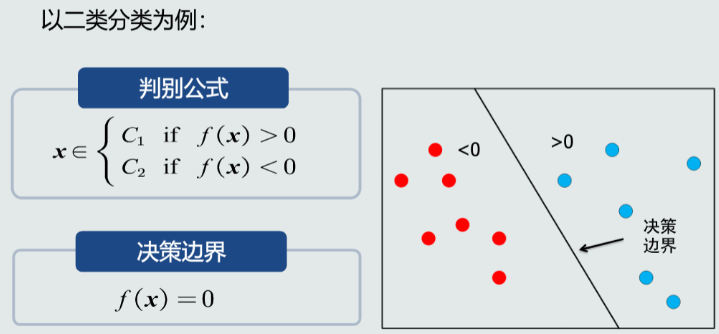

判别函数的概念

判别函数是指各个类别的判别区域确定后,可以用一些函数来表示和鉴别某个特征矢量属于哪个类别,这些函数就称为判别函数。这些函数不是集群在特征空间形状的数学描述,而是描述某一位置矢量属于某个类别的情况,如属于某个类别的条件概率,一般不同的类别都有各自不同的判别函数。

判别函数用于分类举例

特征

- 可以用于区分不同类别模式的、可测量的量。

- 输入数据也可以看作是一种原始特征表达。

特征的特性

- 具有辨别能力:提升不同类别之间的识别性能。

- 基于统计学规律,而非个例。

- 鲁棒性:针对不同的观测条件,仍能够有效表达类别之间的差异性。

特征向量

特征空间

1.3 特征向量的相关性

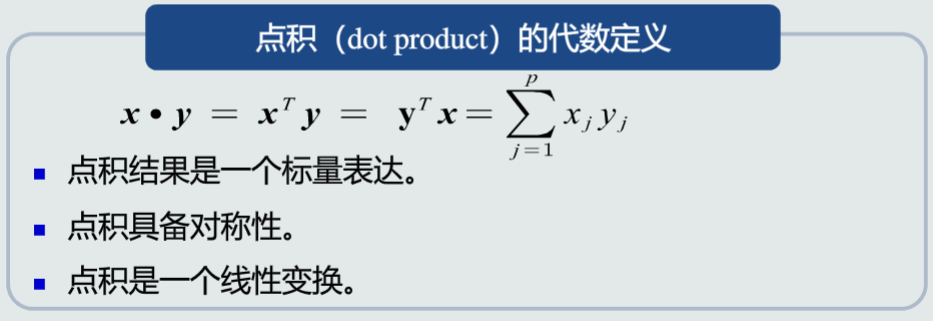

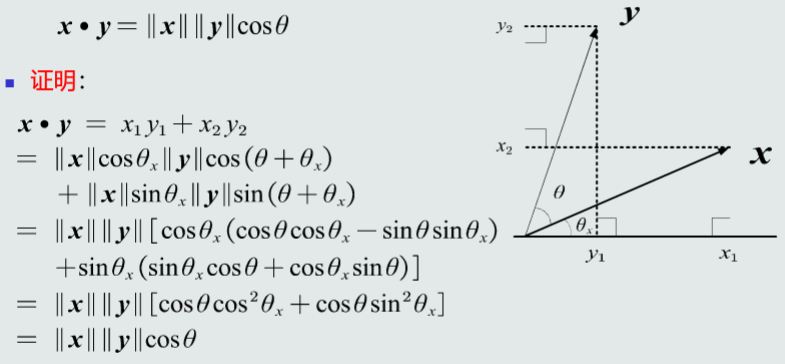

特征向量点积

- 点积可以表征两个特征向量的共线性,即方向上的相似程度。

- 点积为0,说明两个向量是正交的。

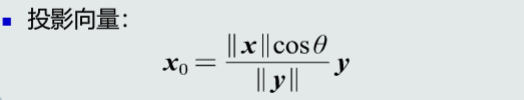

特征向量投影

残差向量

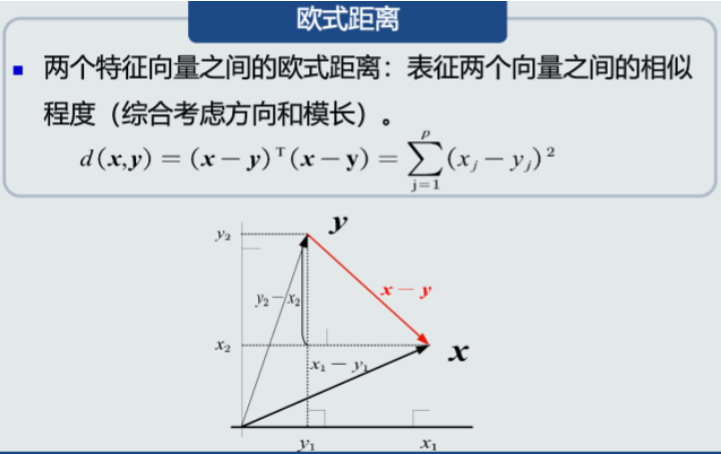

特征向量欧氏距离

1.4 机器学习基本概念

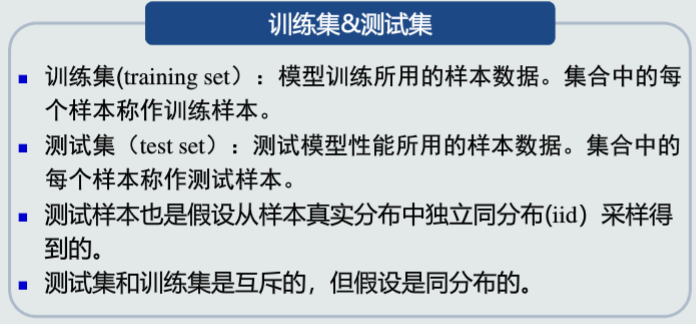

训练样本与测试样本

-

训练样本的目的是 数学模型的参数,经过训练之后,可以认为你的模型系统确立了下来。

-

建立的模型有多好,和真实事件的差距大不大,既可以认为是测试样本的目的。

-

一般训练样本和测试样本相互独立,使用不同的数据。

线性模型

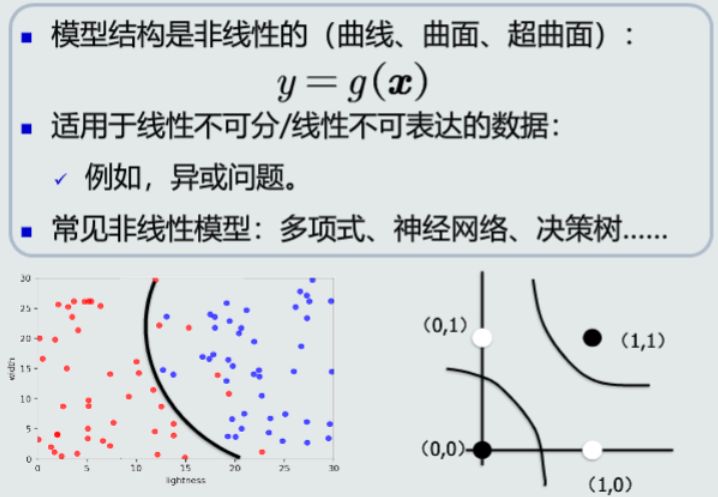

非线性模型

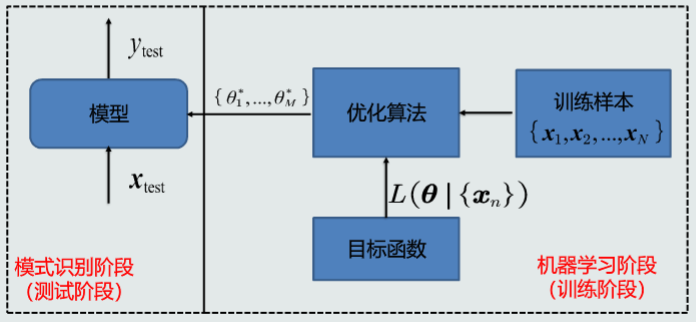

机器学习流程

机器学习的方式

- 输出真值

- 监督式学习:训练样本及其输出真值都给定情况下的机器学习算法。

- 无监督式学习:只给定训练样本、没有给输出真值情况下的机器学习算法。

- 半监督式学习:既有标注的训练样本、又有未标注的训练样本情况下的学习算法。

- 强化学习:需要先后累积多次决策动作。

1.5 模型的泛化能力

训练集&测试集

模型的泛化能力

1.6 评估方法与性能指标

评估方法

-

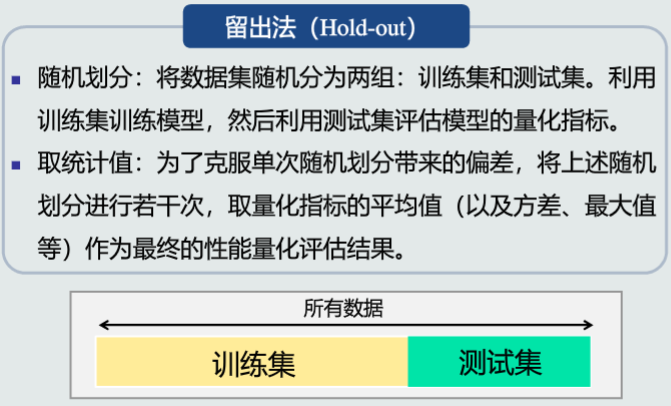

留出法

-

K折交叉验证

将数据集随机分为k份,每次不重复地取一份作为测试集,其余作为训练集,重复k次,最后取这k次地统计指标作为评估结果。

-

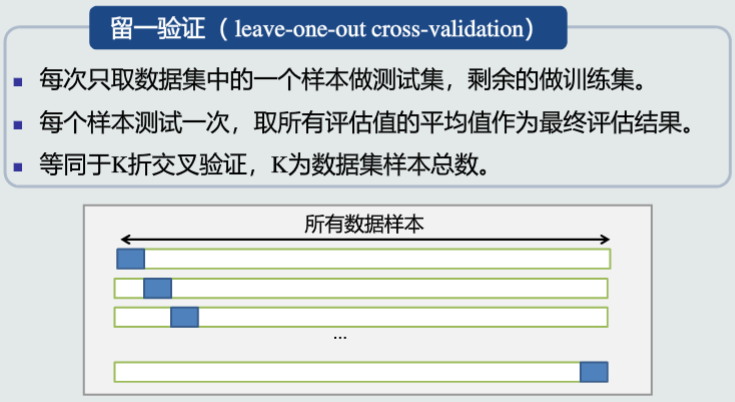

留一验证

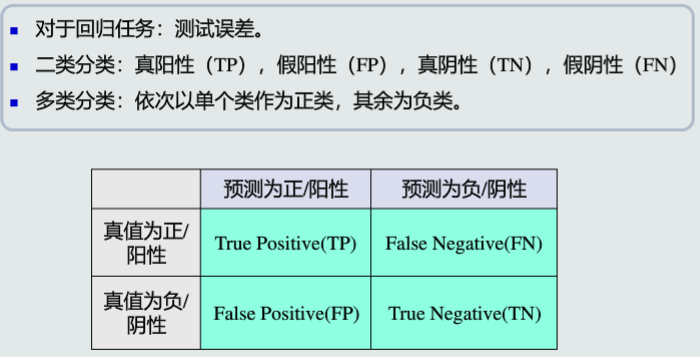

性能指标度量

-

基本概念

-

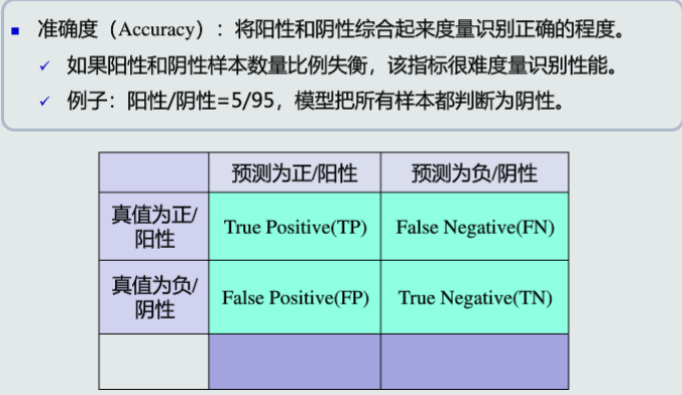

准确度

-

精度&召回率

-

F-Score

第一章 学习心得

物体识别实际上是通过模式识别来实现的,现实生活中的很多时候,区分两个物体的不同,并不是靠最本质的区别来判定的,因为会很复杂或者麻烦。所以要借助一些其他的特征来判定。因此实际上,模式识别并不是根据物体本身来判断的,而是根据被感知到的某些性质,容易感知到的某些物体特征来进行判别。也就引出了模式的定义——如物体的颜色、厚度、大小、重量等的易被感知到的物体特性,叫做模式。 为了识别物体,也就是进行分类,一般会用分类器这个工具。故而分类器实际上识别的不是物体,而是物体的模式。

2.1 MED分类器

MED分类器

MED分类器,即最小欧拉距离(Mininal Euclidean Distance)分类器,它选取类中样本均值作为类的原型,将待预测样本判断为与其欧拉距离最小的类

-

二分类决策边界:

在高维空间中,该决策边界是一个超平面,且该平面垂直且二分连接两个类原型的线。

-

由于只考虑到类原型的距离,不考虑类样本的分布,可能出现反直觉或错误的结果,如:

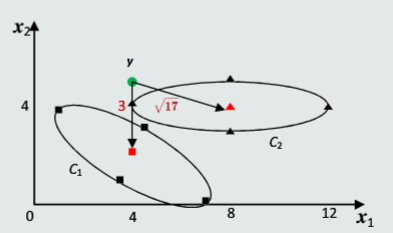

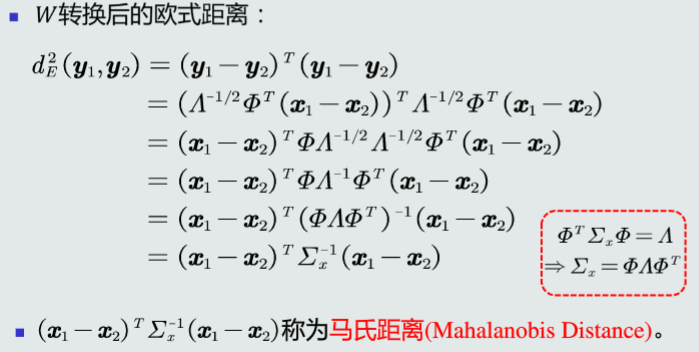

2.2 特征白化

白化的目的是去除输入数据的冗余信息。

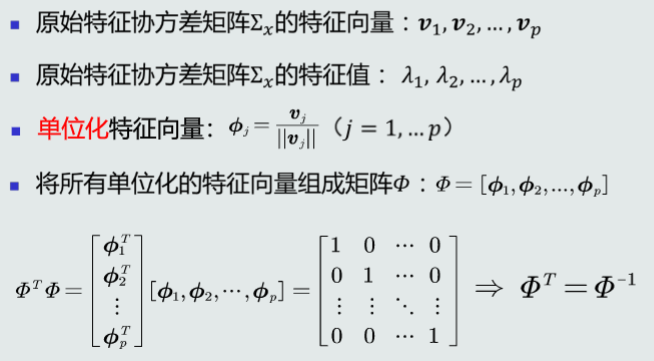

特征正交白化

- 将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性。

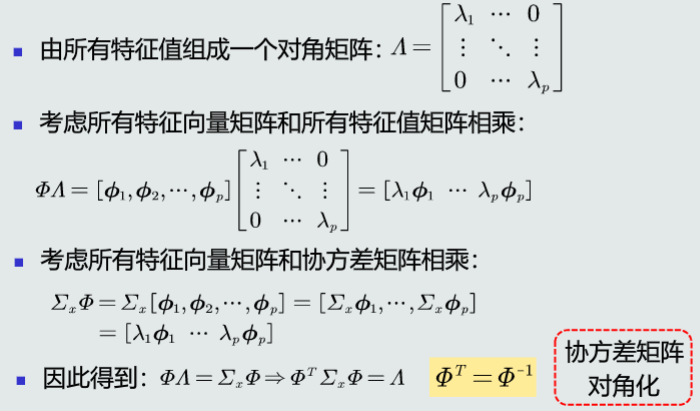

- 将特征转换分为两步:先去除特征之间的相关性(解耦,Decoupling),然后再对特征进行尺度变换(白化,Whitening),使每维特征的方差相等。

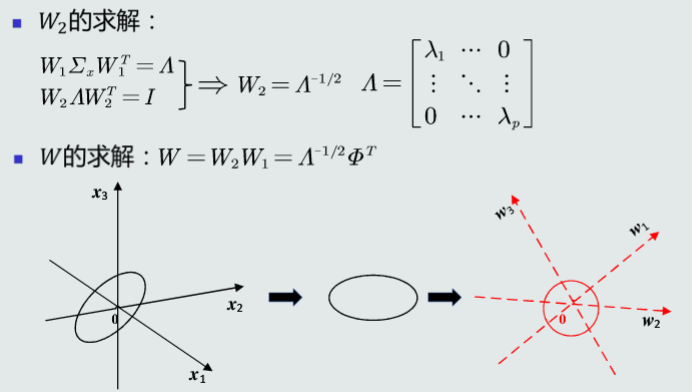

- 令$ W=W_2W_1$

- 解耦:通过\(W_1\)实现协方差矩阵对角化,去除特征之间的相关性。

- 白化:通过\(W_2\)对上一步变换后的特征再进行尺度变换,实现所有特征具有相同方差。

特征解耦

特征白化

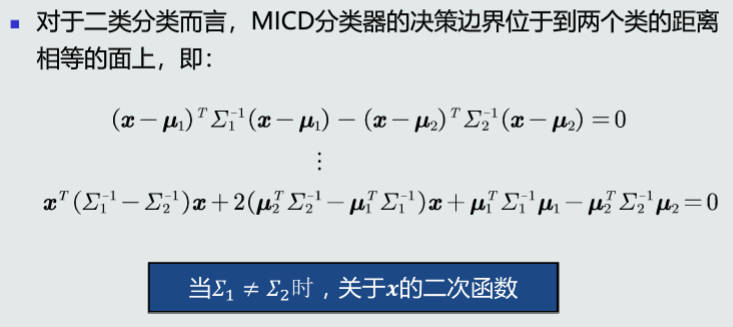

2.3 MICD分类器

MICD分类器

MICD分类器,即最小类内距离(Minimal Intra-Class Distance)分类器由MED分类器演化而来,同样采用均值作为类的原型,但采用马氏距离作为距离度量。将待预测样本判断为与其马氏距离最小的类。

-

二分类决策边界:

决策边界为超平面、超球面、超椭球面、超抛面或者超双曲面。

-

此分类器采用马氏距离,综合考虑了类的不同特征之间的相关性和尺度差异

-

但在均值相同时,趋向于选择方差较大的类,因为方差较大会使\(∑^{−1}\)较小

第二章 学习心得

学习了基于距离的分类器及特征白化的原理和思想,把测试样本到每个类之间的距离作为决策模型,将测试样本判定为其距离最近的类。距离衡量为欧式距离的是MED分类器,但是MED分类器没有排除距离之间的相关性和特征的方差的不同,会造成判别错误。 特征白化的目的是去除数据的冗余信息,可以通过特征白化来去除特征相关性,有两个步骤:解耦、白化。特征白化之后的欧式距离变成了马氏距离,用马氏距离作为距离衡量的是MICD分类器。但是MICD分类器的缺点是会选择方差较大的类。也还是会产生判别错误。

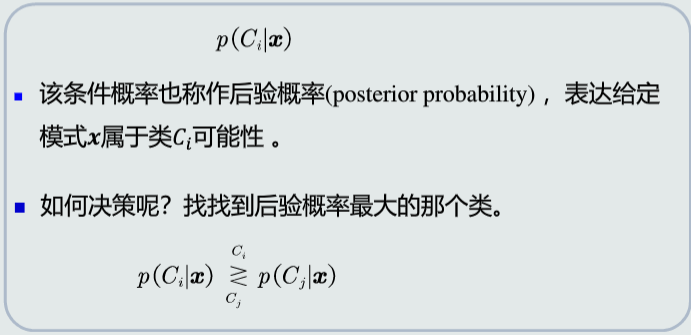

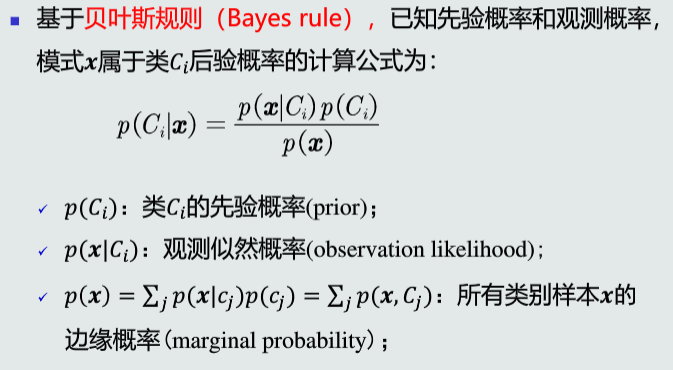

3.1/3.2 贝叶斯决策与MAP分类器及高斯观测概率

后验概率:用于分类决策

贝叶斯规则

MAP分类器

MAP分类器,即最大后验概率(Maximum posterior probability)分类器,基于贝叶斯规则,利用类的先验概率和观测似然概率,计算模式x属于类C的后验概率,进而进行分类判别。

其后验概率公式为:

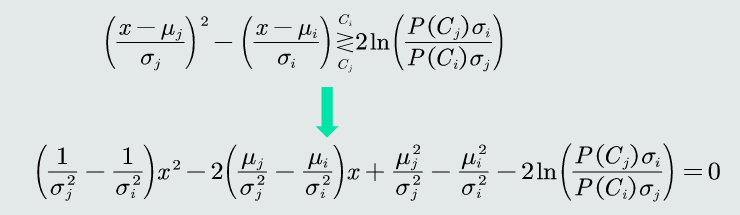

其二分类决策边界为:

在单维空间中通常有两条决策边界,高维空间则是复杂的非线性边界。

决策误差

-

概率误差为未选择的类的后验概率

-

平均概率误差:

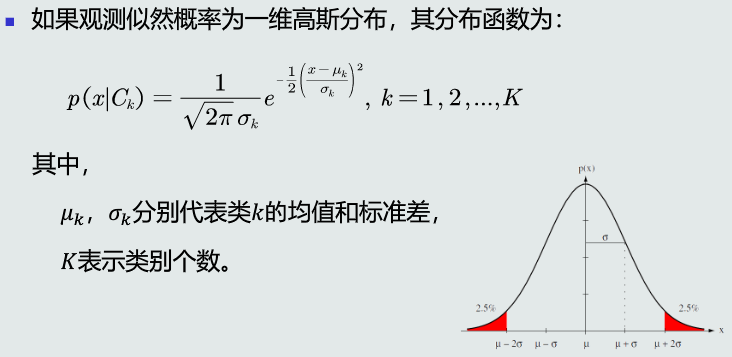

高斯观测概率

- 单维高斯分布:

- 决策边界:

- 方差相等时倾向于选择先验概率较高的类,先验概率相等时倾向于选择方差较小的类。

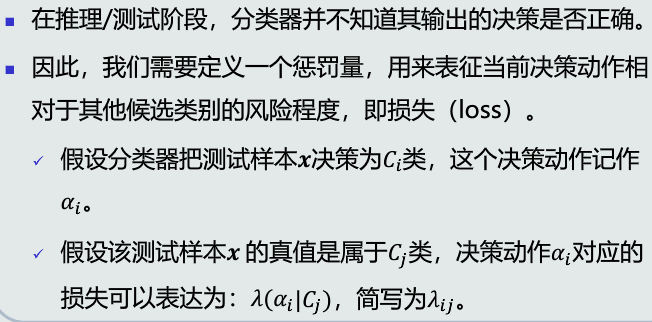

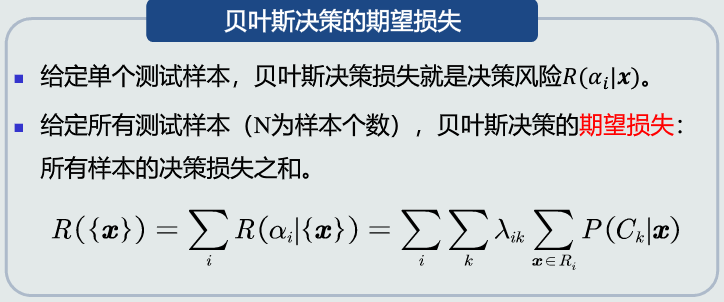

3.3 决策风险与贝叶斯分类器

决策风险的概念

损失的概念

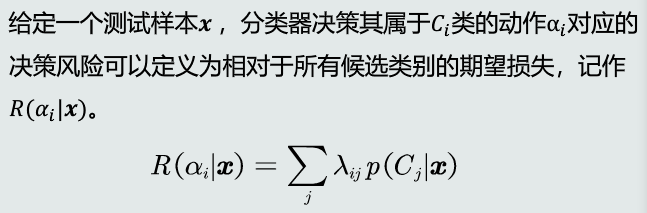

决策风险的评估

贝叶斯分类器

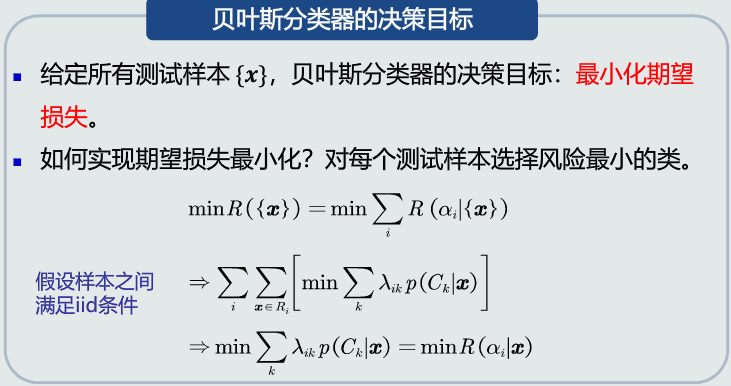

在MAP分类器基础上,加入决策风险因素,成为贝叶斯分类器

-

决策损失

-

决策目标

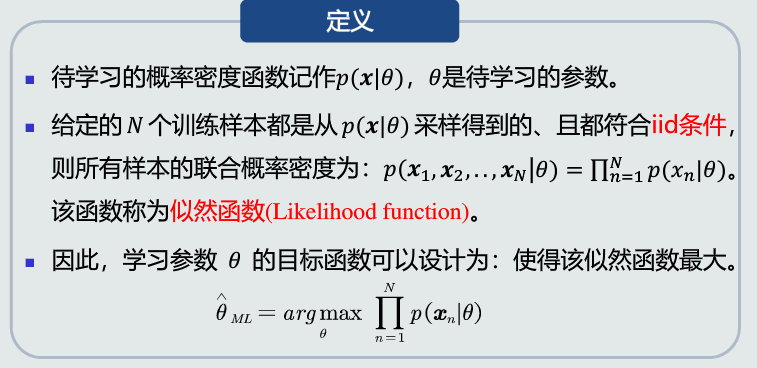

3.4/3.5 最大似然估计

监督式学习方法

- 如果给定标签的训练样本,采用监督式学习。

- 根据概率分布的表达形式,监督式学习方法有以下两种:

- 参数化方法:给定概率分布的解析表达,学习这些解析表达函数中的参数。该类方法也称为参数估计。

- 非参数化方法:概率密度函数形式为未知,基于概率密度估计技术,估计非参数化的概率密度表达。

常用的参数估计方法

- 最大似然估计

- 贝叶斯估计

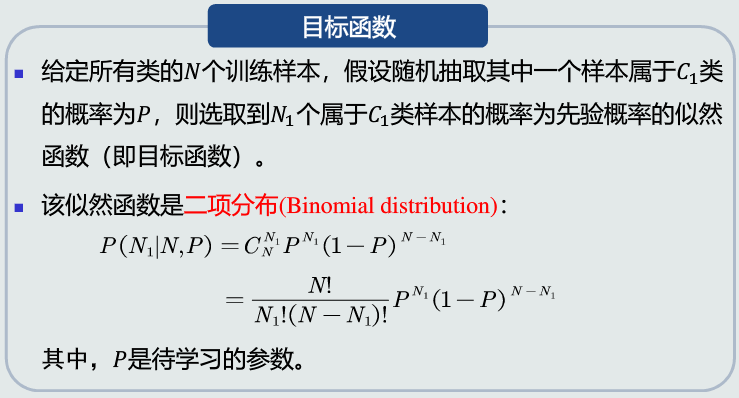

最大似然估计

-

先验概率估计

-

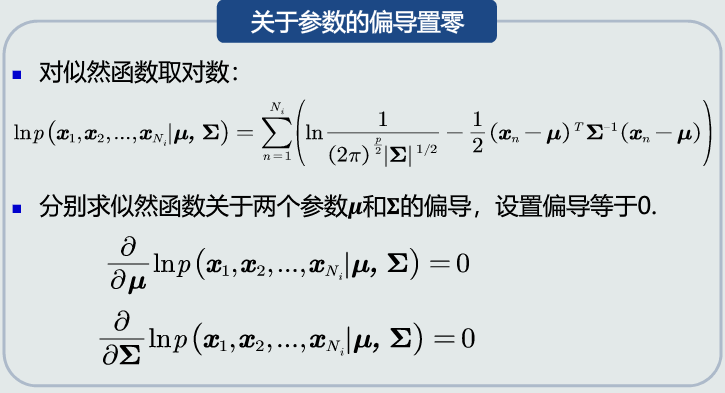

观测概率估计:高斯分布

-

均值估计

-

协方差估计

3.6/3.7 贝叶斯估计(1)

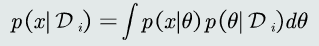

贝叶斯估计概念

不断学习能力

贝叶斯估计具备不断学习的能力

- 它允许最初的、基于少量训练样本的、不太准的估计。

- 随着训练样本的不断增加,可以串行的不断修正参数的估计值,从而达到该参数的期望真值。

贝叶斯估计流程步骤

-

目的:估计观测似然概率。

-

给定量:观测似然分布的形式、参数的先验概率、训练样本。

-

贝叶斯估计的步骤:

-

1.估计参数的后验概率:

-

2.估计观测似然关于\(\theta\)的边缘概率:

-

3.8 KNN估计

常用的无参技术主要有:

- K近邻法

- 直方图技术

- 核密度估计

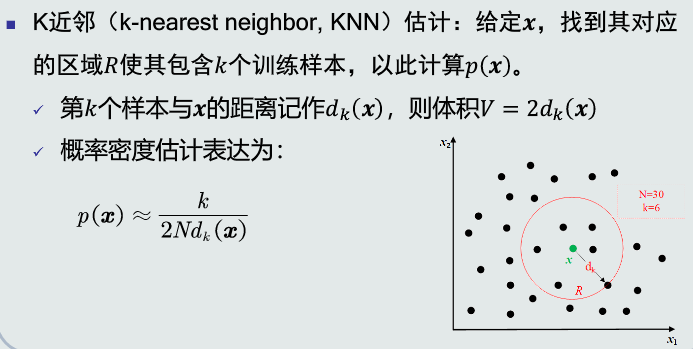

KNN估计

-

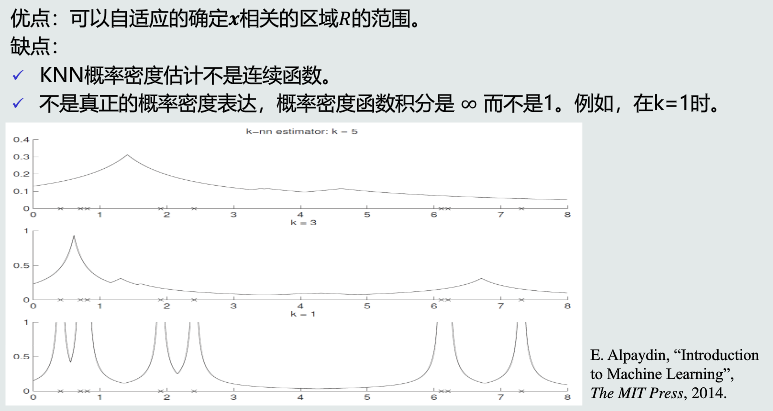

优缺点

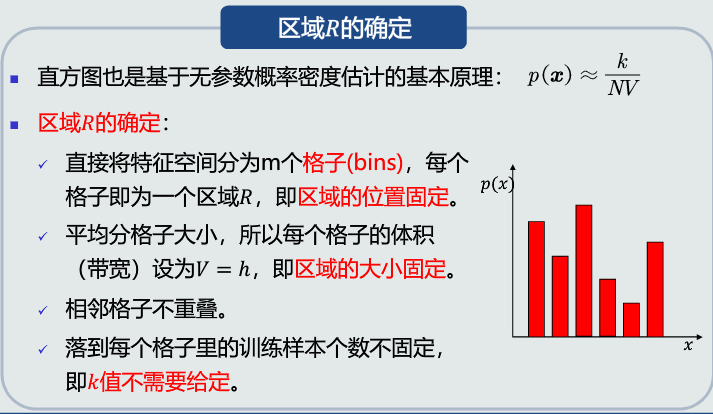

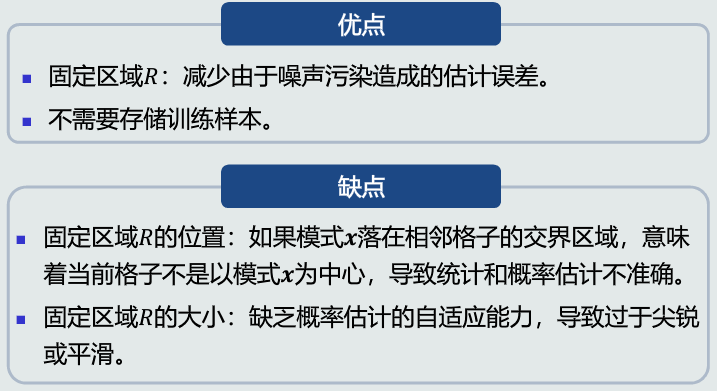

3.9 直方图与核密度估计

直方图估计

-

原理

-

优缺点

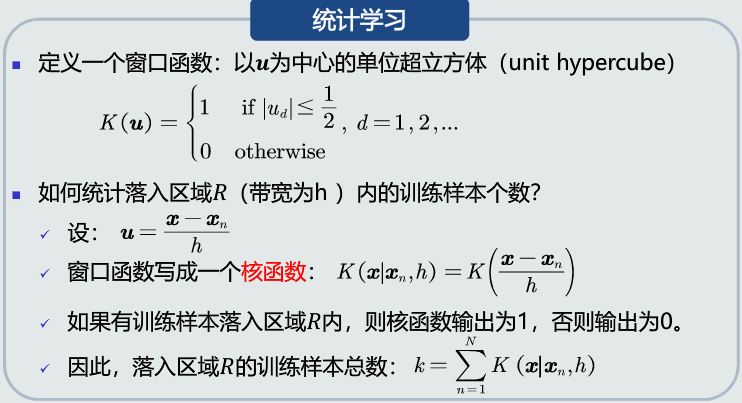

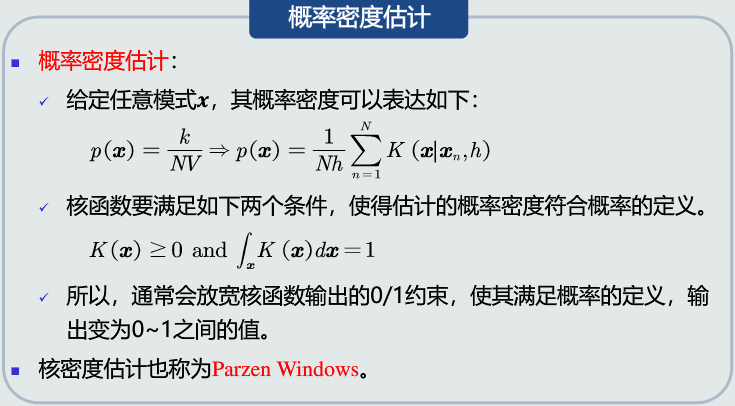

核密度估计

-

KNN估计:以待估计的任意一个模式为中心,搜寻第K个邻近点,以此来确定区域,易被噪声污染。

-

直方图估计:手动将特征空间划分为若干个区域,待估计模式只能分配到对应的固定区域,缺乏自适应能力。

-

原理

-

优缺点

第三章 学习心得

印象最深刻的应该就是贝叶斯估计方法的学习,在参数估计上经典学派运用的是矩法和极大似然估计,贝叶斯学派则用的是Bayes估计。贝叶斯除了运用经典学派的总体信息和样本信息外,海涌到了先验信息,其中的两个基本概念是先验分布和后验分布。完成贝叶斯估计后进一步学习了贝叶斯决策问题,即把损失函数加入到贝叶斯推断中形成,根据决策者的分析和偏好可以用不同形式的损失函数。损失函数也同样是贝叶斯估计中的一种重要信息。

贝叶斯估计还具备不断学习的能力,它允许最初的、基于少量训练样本的、不太准的估计。随着训练样本的不断增加,可以串行的不断修正参数的估计值,从而达到该参数的期望真值。

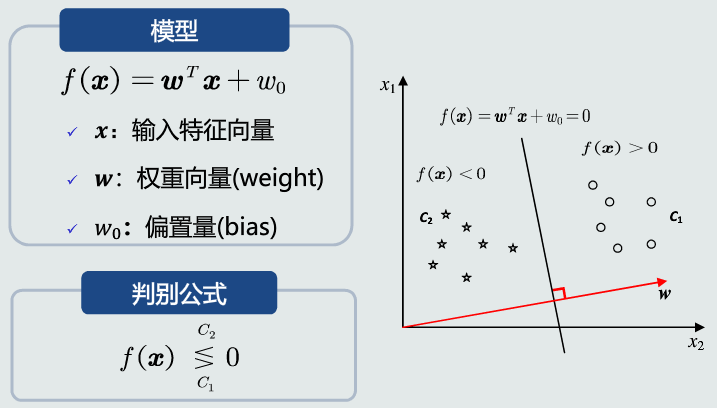

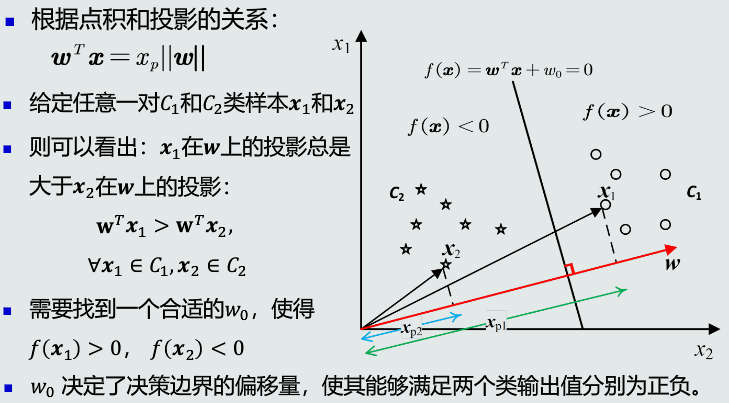

4.1/4.2 线性判据

-

定义

- 如果判别模型f(x)是线性函数,则f(x)为线性判据。

- 可以用于两类分类

- 也可以用于多类分类,相邻两类之间的决策边界也是线性的。

-

优势

- 计算量少:在学习和分类过程中,线性判据方法都比基于学习概率分布的方法计算量少。

- 适用于训练样本较少的情况。

-

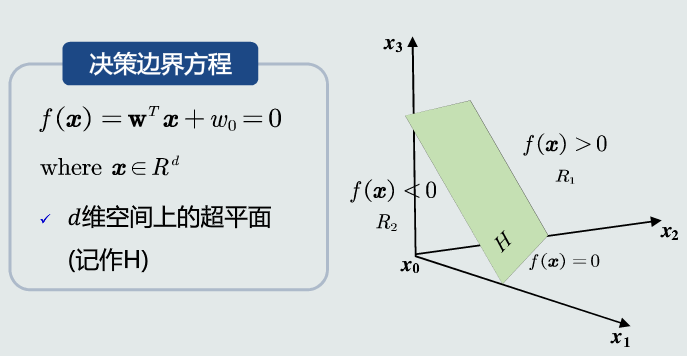

数学表达

-

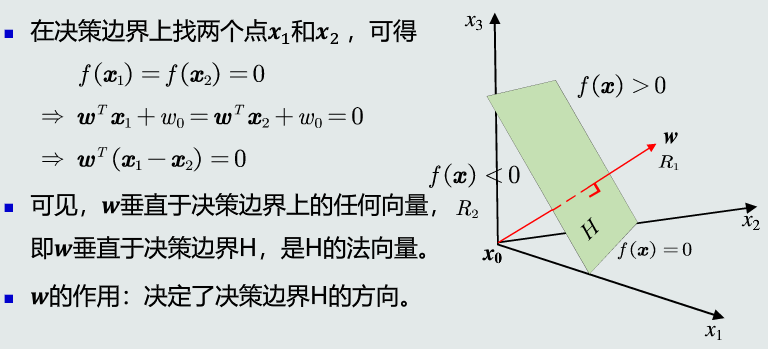

决策边界

-

w的方向

-

\(w_0\)的作用

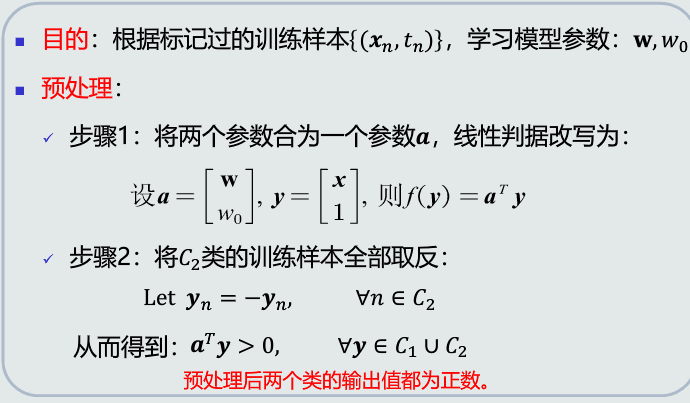

4.3/4.4 并行/串行感知机算法

感知机算法:预处理

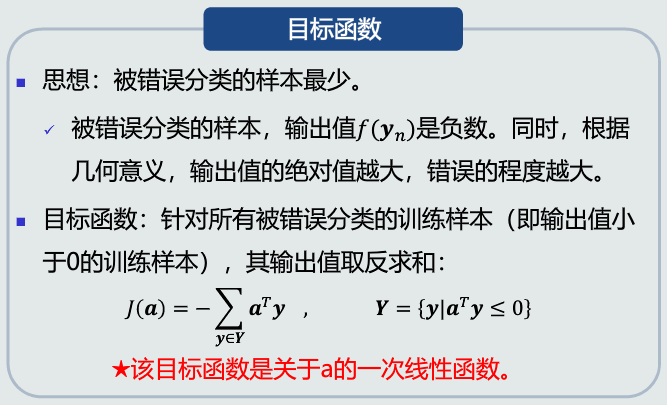

并行感知机:目标函数

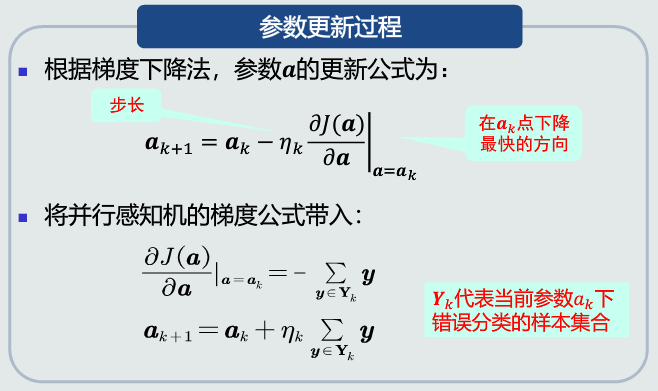

参数更新

并行感知机算法流程

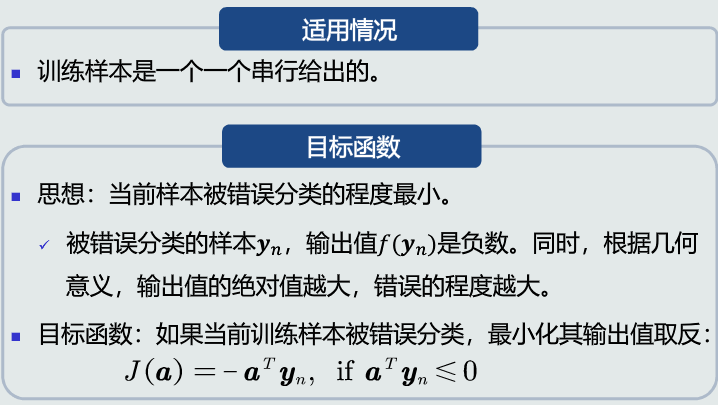

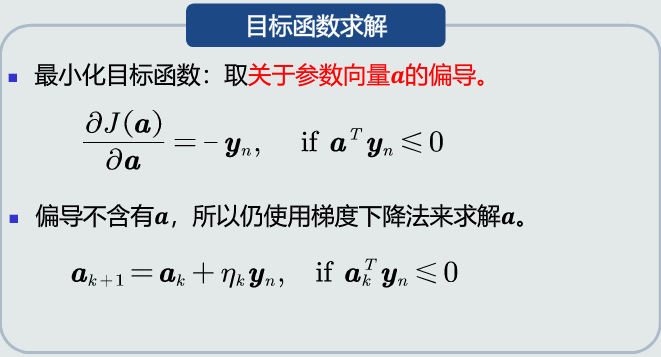

串行感知机

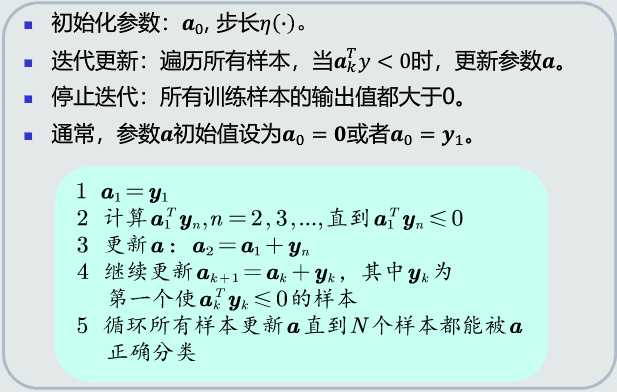

串行感知机算法流程

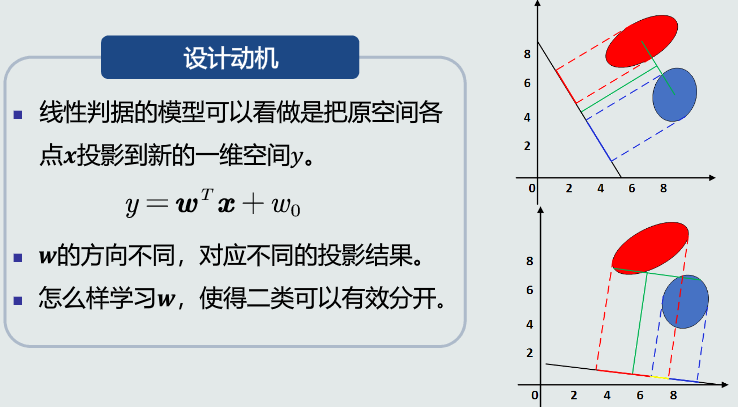

4.5 Fisher线性判据

原理及概念

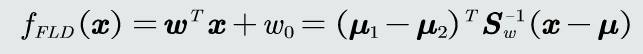

最优参数解

-

w最优解

-

\(w_0\)的解

-

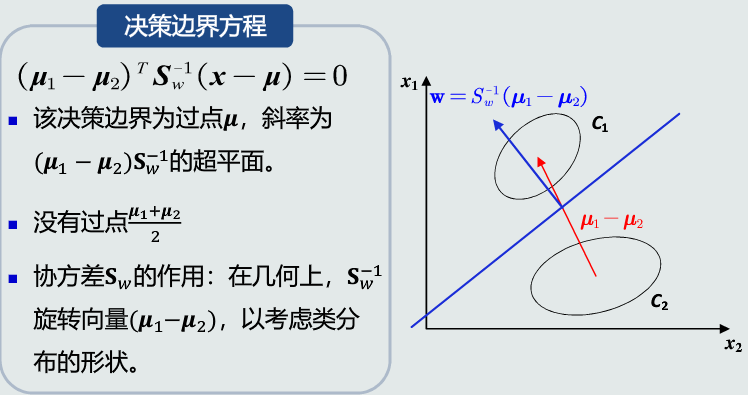

Fisher线性判据

决策边界

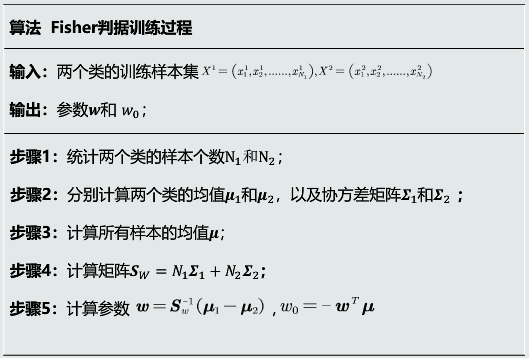

训练算法流程

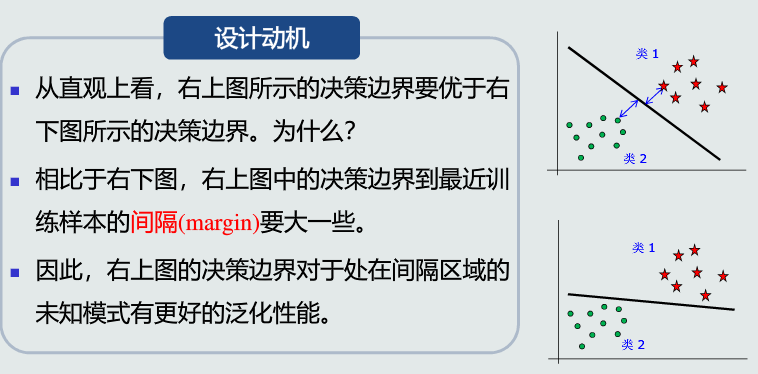

4.6 支持向量机基本概念

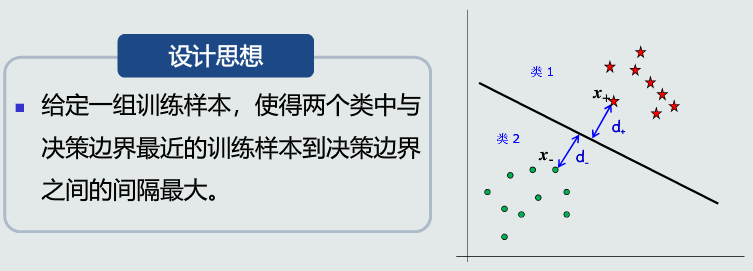

设计动机及思想

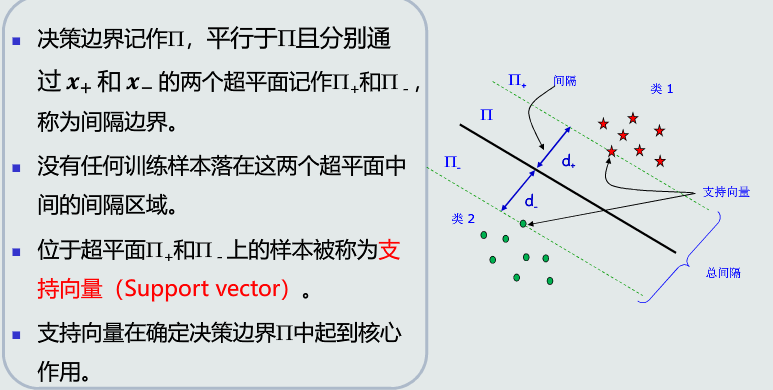

支持向量的概念

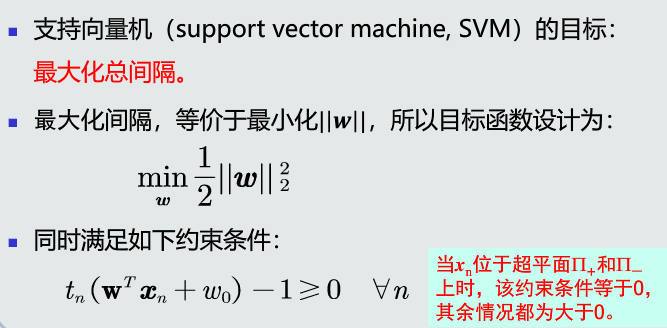

支持向量机目标函数

4.7 拉格朗日乘数法

拉格朗日乘数法(以数学家约瑟夫·路易斯·拉格朗日命名)是一种寻找变量受一个或多个条件所限制的多元函数的极值的方法。

这种方法将一个有n 个变量与k个约束条件的最优化问题转换为一个有n + k个变量的方程组的极值问题,其变量不受任何约束。

这种方法引入了一种新的标量未知数,即拉格朗日乘数:约束方程的梯度(gradient)的线性组合里每个向量的系数。此方法的证明牵涉到偏微分,全微分或链法,从而找到能让设出的隐函数的微分为零的未知数的值。

设给定二元函数z=ƒ(x,y)和附加条件φ(x,y)=0,为寻找z=ƒ(x,y)在附加条件下的极值点,先做拉格朗日函数 ,其中λ为参数。

令F(x,y,λ)对x和y和λ的一阶偏导数等于零,即

F'x=ƒ'x(x,y)+λφ'x(x,y)=0

F'y=ƒ'y(x,y)+λφ'y(x,y)=0

F'λ=φ(x,y)=0

由上述方程组解出x,y及λ,如此求得的(x,y),就是函数z=ƒ(x,y)在附加条件φ(x,y)=0下的可能极值点。

若这样的点只有一个,由实际问题可直接确定此即所求的点。

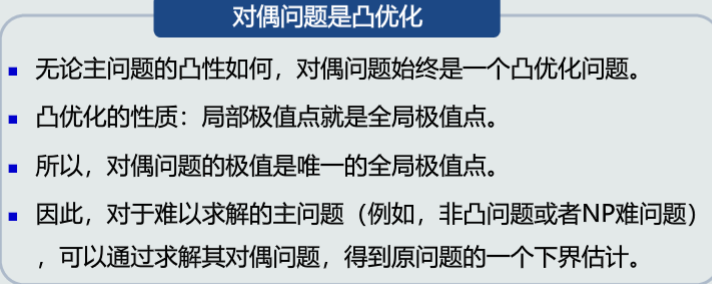

4.8 拉格朗日对偶问题

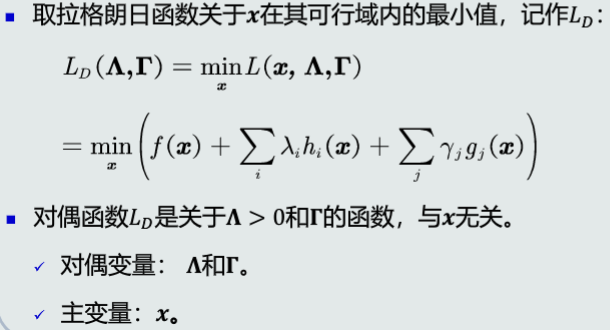

对偶函数

对偶法的优势

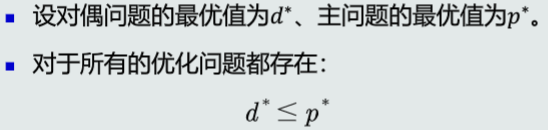

弱对偶性

强对偶性

第四章 学习心得

学习了线性判据方法的基本概念,并行及串行感知机算法,Fisher线性判据等,尤其对拉格朗日乘数法有了进一步的了解。

线性判据顾名思义,如果判别模型f(x)是线性函数,则称为线性判据,既可以用于两类分类,也可以用于多类分类,多类分类中要求相邻两类之间的决策边界也是线性的即可。而拉格朗日乘数法则是一种寻找变量受一个或多个条件所限制的多元函数的极值的方法。

这种方法将一个有n 个变量与k个约束条件的最优化问题转换为一个有n + k个变量的方程组的极值问题,其变量不受任何约束,对问题的求解有很大的帮助。

浙公网安备 33010602011771号

浙公网安备 33010602011771号