django & celery - 关于并发处理能力和内存使用的小结

背景

众所周知,celery 是python世界里处理分布式任务的好助手,它的出现结合赋予了我们强大的处理异步请求,分布式任务,周期任务等复杂场景的能力。

然鹅,今天我们所要讨论的则是如何更好的在使用celery, 主要讨论的点针是对内存的使用方面。

django & celery & django-celery

楼主的项目中使用的是 celery 和 django 的相结合的方式,版本分别为:

python == 2.7

celery==3.1.25

Django==1.11.7

django-celery==3.2.2

celery 处理并发

项目中使用celery beat 来触发定时任务;并且根据业务需求,分别使用了2个 celery worker 来处理异步请求。

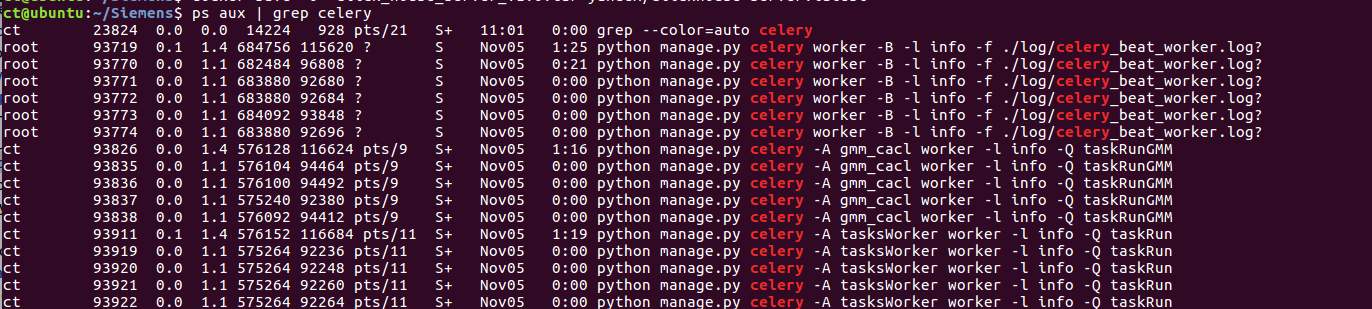

在开发环境下,操作系统有4个processors, 内存为8GB。在默认情况下,启动celerycelery beat 和 两个 worker 后,并发情况如下:

可以看到,默认情况下,celery 会根据processor的数量(4个)来启动相应数量的worker。

celery 允许我们通过配置 ‘CELERYD_CONCURRENCY ’ 来 控制 celery worker 并发数 。

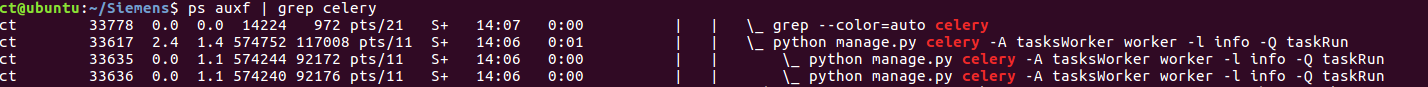

当修改celery worker 为 tasksWorker 的 worker 的配置为: CELERYD_CONCURRENCY = 2 后,worker数量如下图:

我们可以看到, 只有 2个 worker 被启动。

celery worker 关于内存

网上有不少帖子分析过 celery worker 对于内存的使用,发现worker在处理完任务后并没有释放内存。但是,celery提供了一个配置允许我们制定每个worker处理任务的最大数量 (CELERYD_MAX_TASKS_PER_CHILD),当一个worker处理任务的数量到达制定数量后,celery会销毁该worker并且重新启动一个新的。

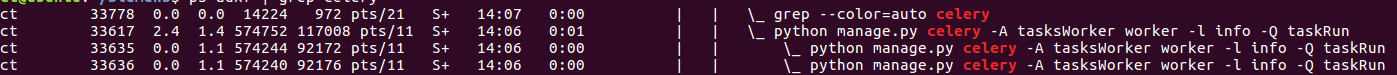

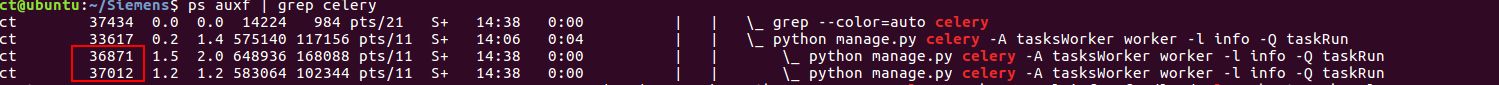

当 CELERYD_MAX_TASKS_PER_CHILD = 5 时,worker运行多次后,可以看到 旧的worker 被销毁,新的 worker 被启动。

旧的 worker :

新的 worker :

此外,当我们结合使用 django 和 celery是,需要关闭 Debug 配置,因为开启会引起celery beat 的 memory leak。 详细描述请看:https://stackoverflow.com/questions/45366680/celerybeat-process-consumes-all-os-memory

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:基于图像分类模型对图像进行分类

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 25岁的心里话

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

2017-11-06 log4donet 的 一篇简单使用实例