创新实训 (一) CodeGeeX 模型部署

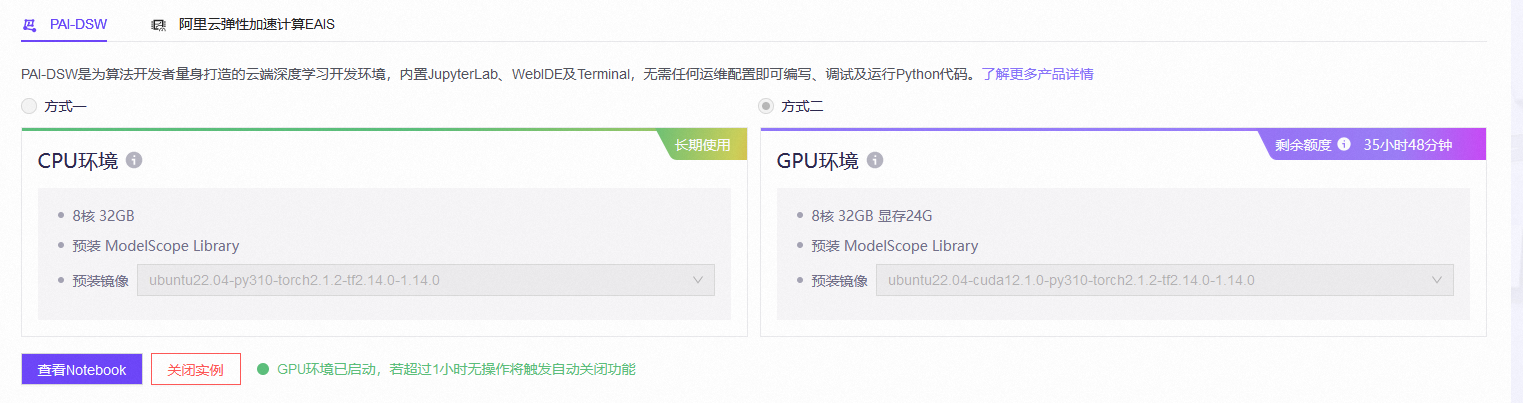

在对模型进行部署时,可以使用魔搭默认的环境,CPU免费,GPU有使用的时间限制,需要关联阿里云的账号,因为 CodeGeeX 要用 GPU,所以先选择限制使用时长的 GPU。

在相应的模型库中选择:CodeFuse-CodeGeeX2-6B

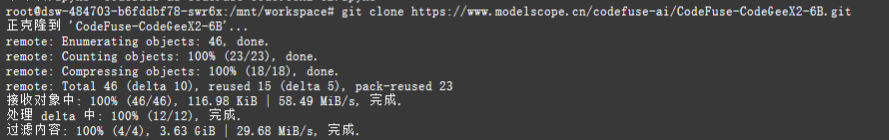

使用教程中对应的 git clone https://www.modelscope.cn/codefuse-ai/CodeFuse-CodeGeeX2-6B.git 命令,从对应的 Git 仓库克隆 CodeGeeX 的代码。

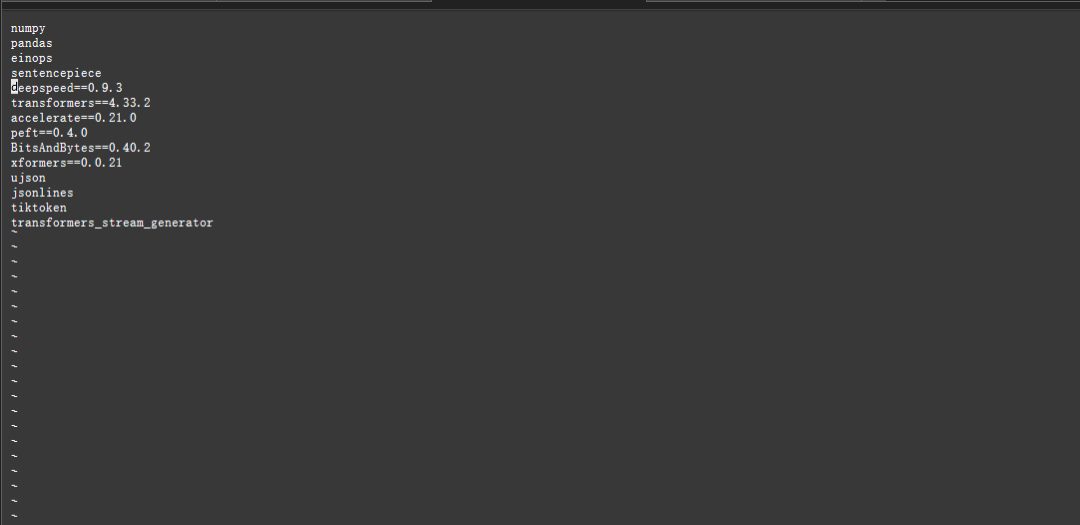

但是如果按照原来教程中的步骤,使用 pip install -r requirements.txt 安装项目所需的所有依赖包时会出现问题,查看 requirements.txt 后发现是版本不兼容导致的。

解决方案是删去 requirements.txt 中的 deepspeed 一行,DeepSpeed 是一个由微软开发的深度学习优化库,它旨在提高大型模型训练的效率,通过优化内存使用和分布式训练来实现。

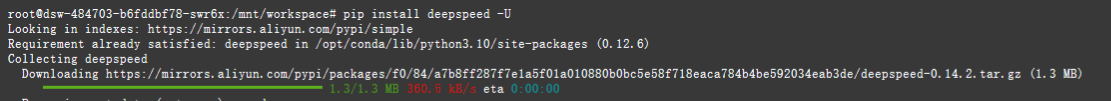

尝试了一下方法后,发现可以使用 pip install deepspeed -U 来安装依赖。

将所有依赖都安装的时间较长,需要进行一段时间的等待。且在安装的最后,仍然会出现一段报错信息,但是模型已经可以正常运行了。

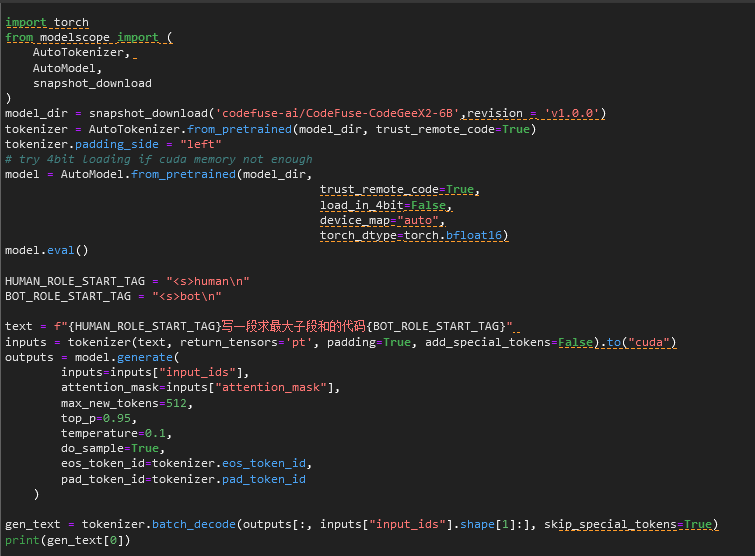

可以通过修改下面代码中的 text, 来实现代码的生成。如命令模型生成求最大子段和的代码:

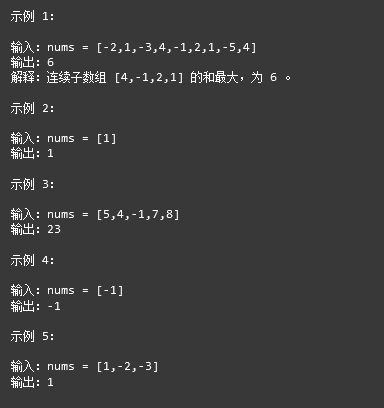

模型给出的结果包括代码和一些测试用例:

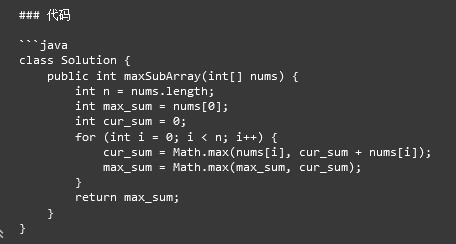

代码:

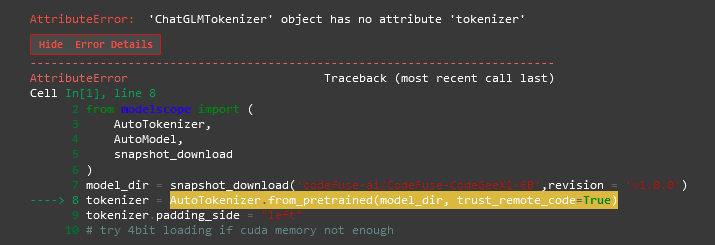

再一次打开模型,进行运行时,出现了一个错误:

经过查阅资料,可以通过调整transformers版本解决:pip install transformers==4.33.2。