KDNuggets-博客中文翻译-四-

KDNuggets 博客中文翻译(四)

原文:KDNuggets

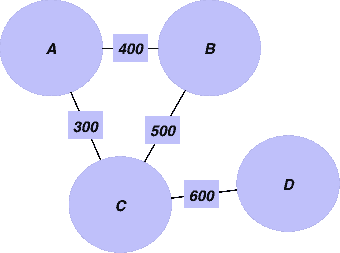

5 本免费数据科学书籍

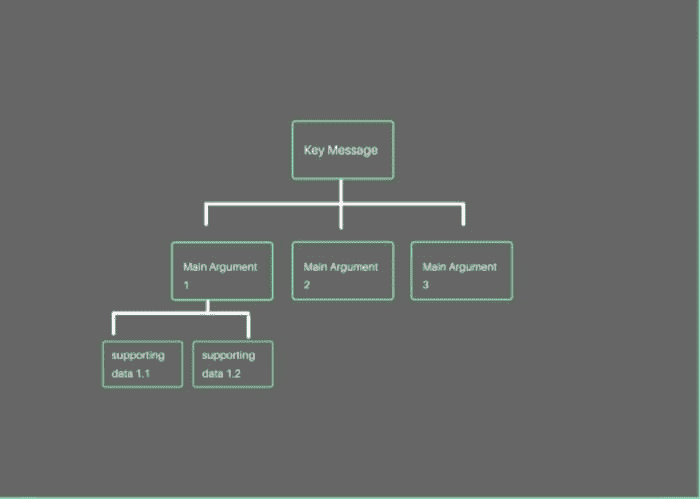

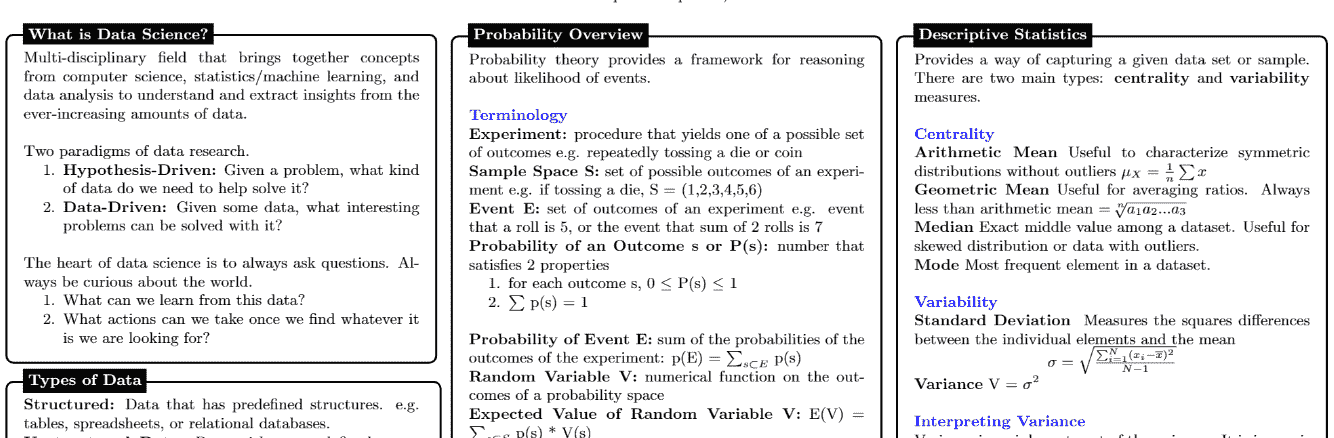

作者插图

当你进入数据科学领域时,你会发现各种资源触手可及,比如 Udemy 课程、YouTube 视频和文章。但是,你需要给自己一个明确的学习结构,以避免感到不知所措和失去动力。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

本文将探讨五本涵盖数据科学旅程中应学习的基本概念的书籍。这些书籍各自帮助学习:

-

Python

-

统计

-

线性代数

-

机器学习

-

深度学习

《Python 极速之旅》

书籍链接: Python 极速之旅

如果你有兴趣开始学习 Python 而不想花费太多时间,这本书可能非常适合你。它对 Python 的基本概念进行了非常简短的概述。除了这本 100 页的书之外,还有一个包含练习的 GitHub 代码库。

特别是,你可以快速学习 Python 的主要数据类型:整数、浮点数、字符串、布尔值、列表、元组、字典和集合。在书的最后,有一个对 Python 库的简要概述,包括 NumPy、Pandas、Matplotlib、Scipy。

它涵盖了以下内容:

-

基本语法

-

变量

-

运算符

-

主要数据类型

-

For Loop

-

While 循环

-

函数

-

If-elif-else

-

Python 库的快速概览

Think Stats: 为程序员准备的概率与统计

书籍链接: Think Stats: Probability and Statistics

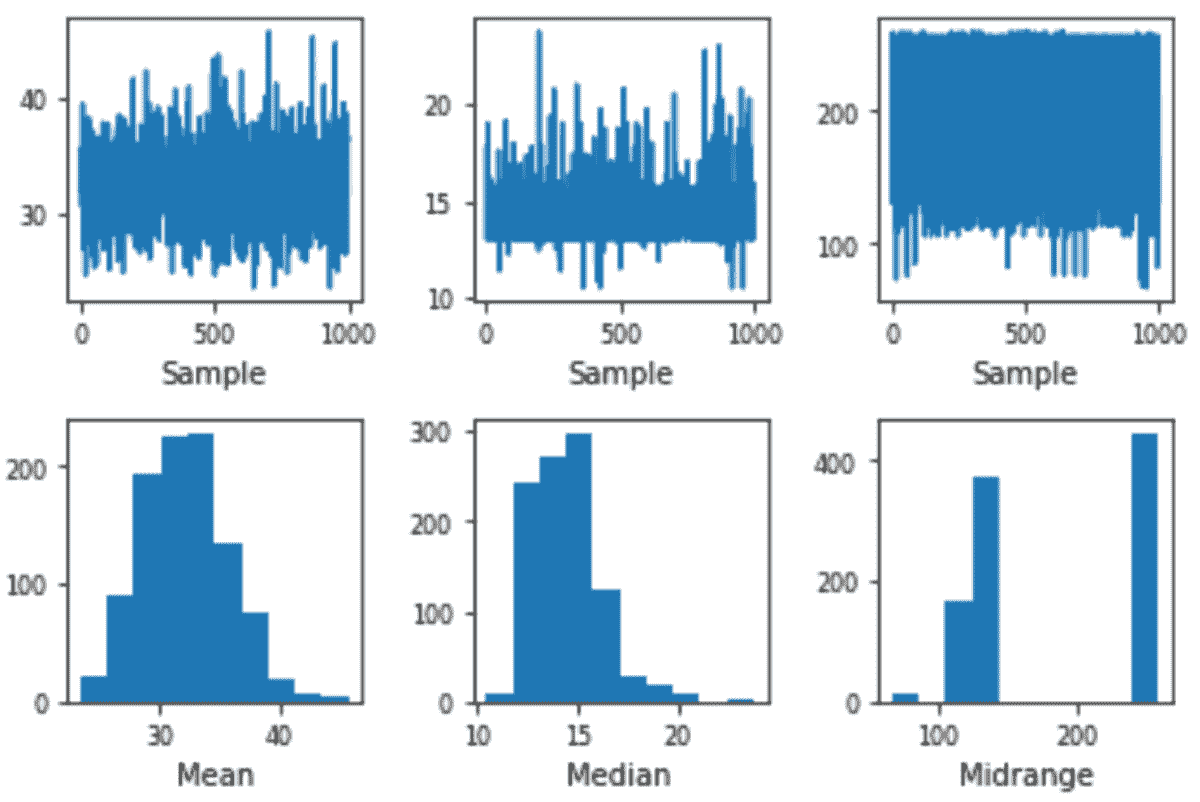

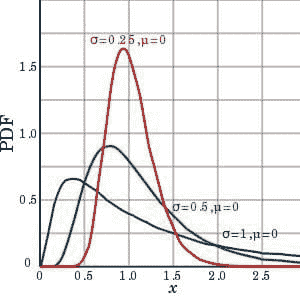

在没有将所学内容付诸实践的情况下,很难获得良好的概率和统计知识。这本书的美妙之处在于它专注于一些基本概念,不仅展示理论,还有用 Python 编写的实际练习。

这本书涵盖了:

-

概要统计

-

数据分布

-

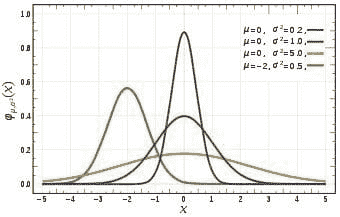

概率分布

-

贝叶斯定理

-

中心极限定理

-

假设检验

-

估计

适用于应用机器学习的线性代数入门

书籍链接: 应用机器学习的线性代数入门

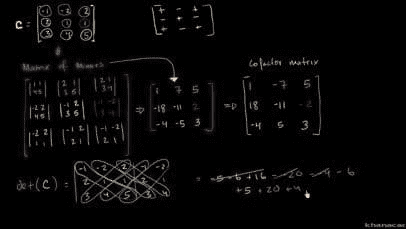

当你在大学学习线性代数时,大多数时候教授会讲解所有的理论而没有任何实际应用。因此,你最终参加考试,并在完成后忘记所有概念,因为在你的头脑中这些太抽象了。

幸运的是,我找到了一本出色的书,它为你介绍了线性代数的基础知识,这些知识在学习机器学习模型时会遇到。每个理论概念后面都有一个使用 NumPy 编写的实际例子,NumPy 是一个知名的科学计算 Python 库。

主要涵盖的主题包括:

-

向量

-

矩阵

-

投影

-

行列式

-

特征值和特征向量

-

奇异值分解

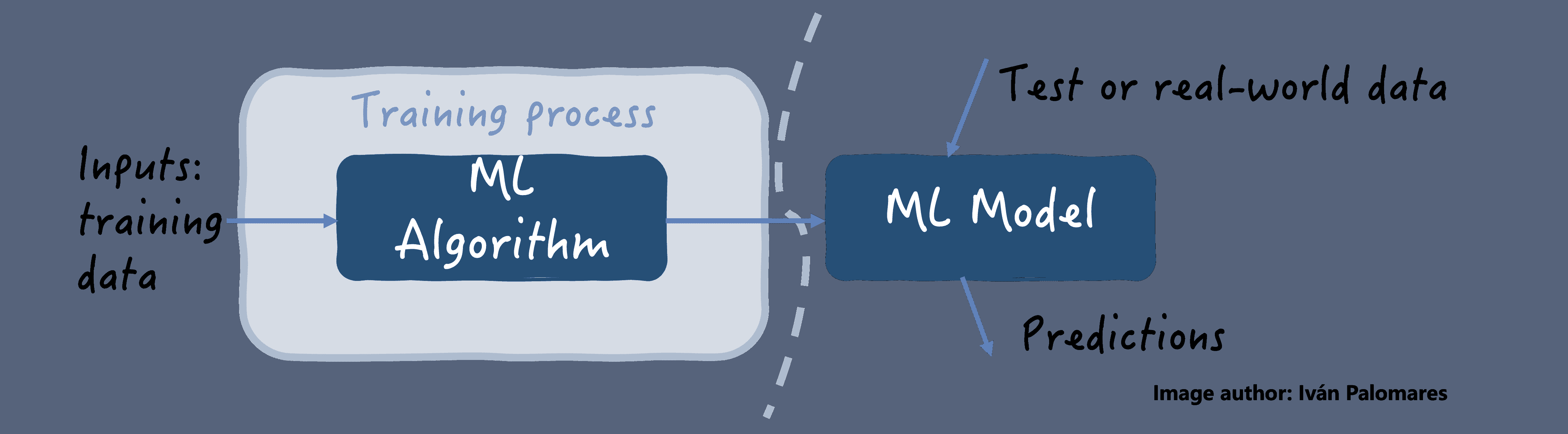

机器学习与 Python 简介

图书链接:Introduction to Machine Learning with Python

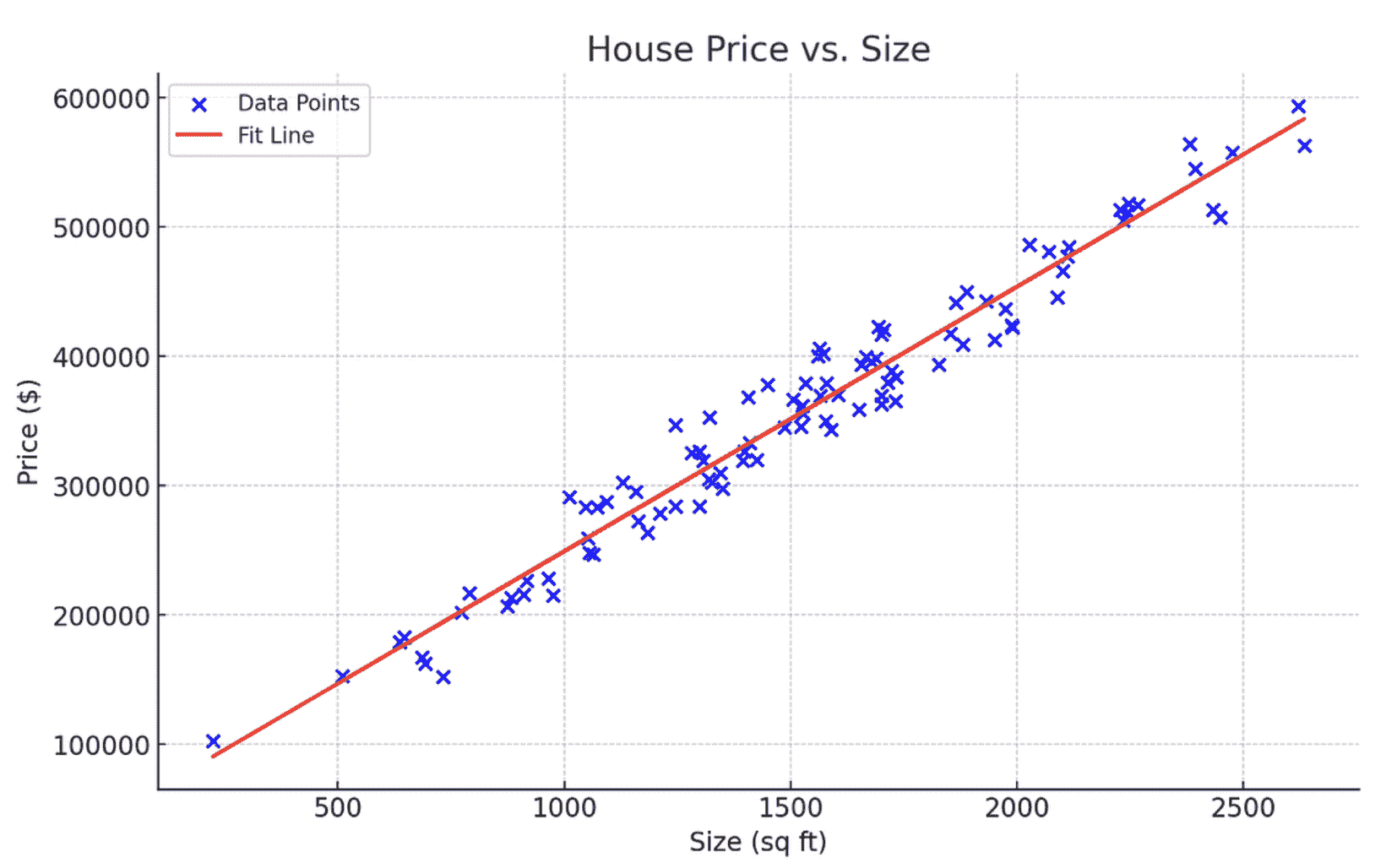

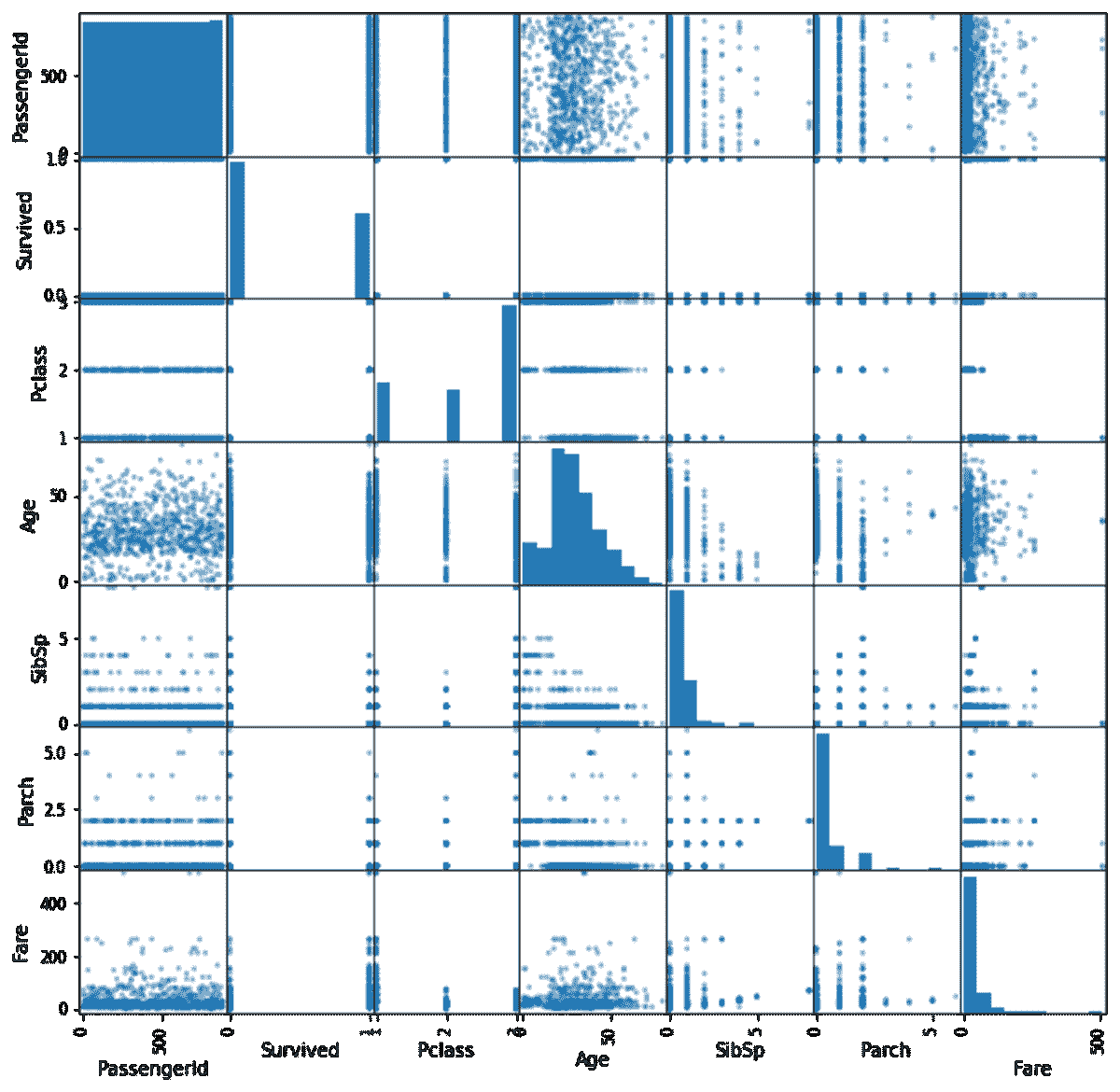

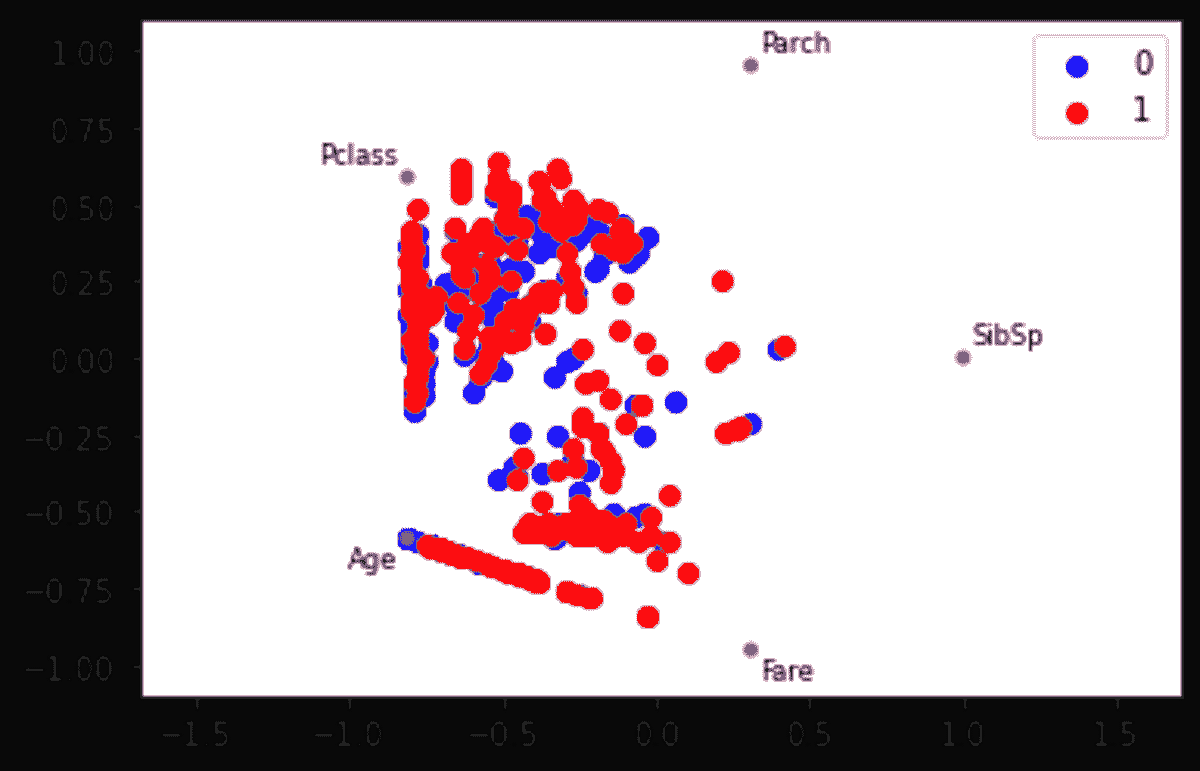

在学习 Python、统计学和线性代数后,是时候深入了解机器学习模型,以解决实际问题。这本书适合刚入门的人,并使用 scikit-learn 进行机器学习应用。

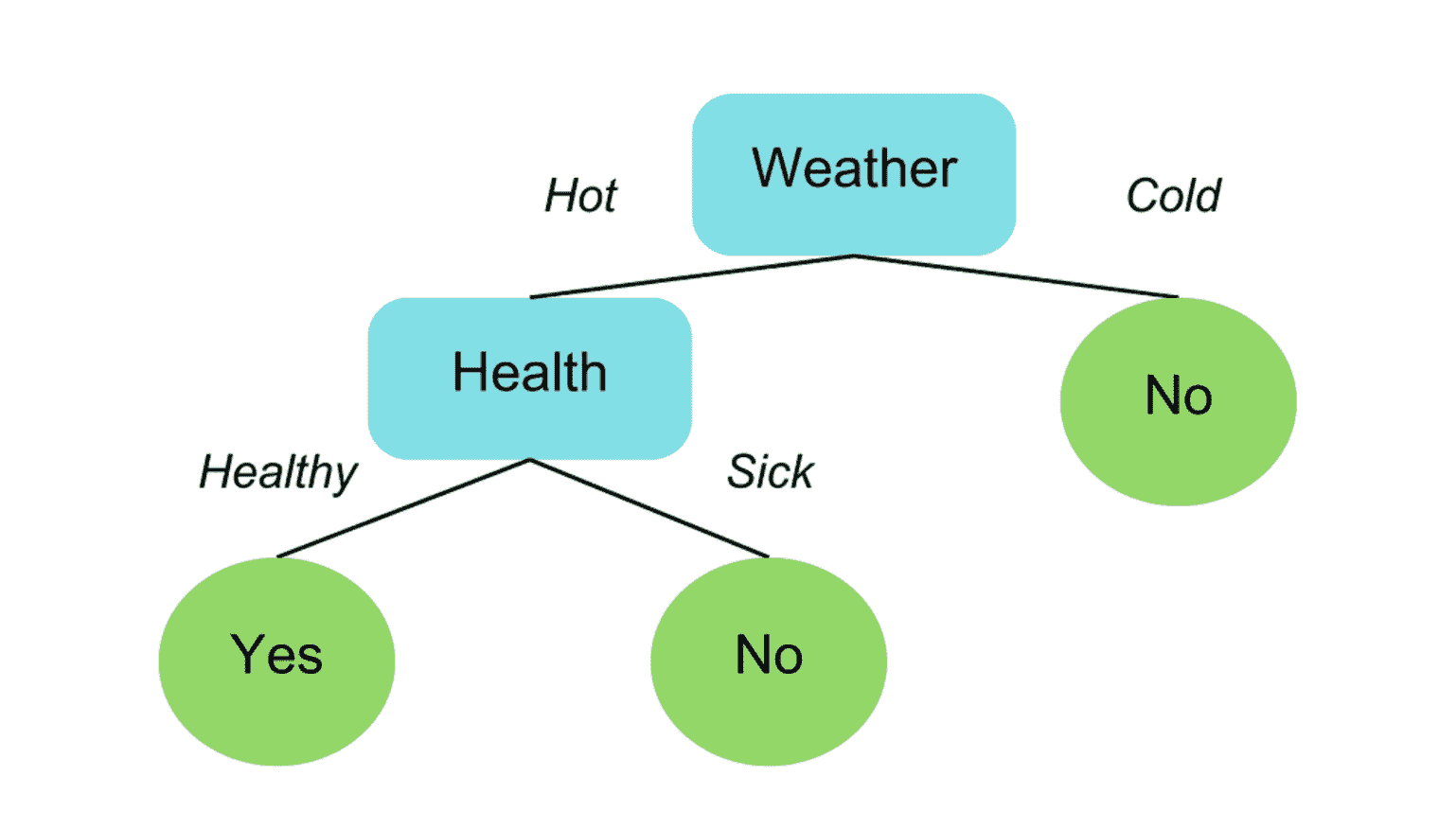

主要解释的机器学习模型包括:

-

线性回归

-

朴素贝叶斯

-

决策树

-

决策树集成

-

支持向量机

-

主成分分析

-

t-SNE

-

K 均值聚类

-

DBSCAN

深度学习与 Python

图书链接:Deep Learning with Python

这本第五本也是最后一本书是为那些已经具备 Python 编程知识的人设计的,不需要先前的机器学习经验。这本书的作者是Francois Chollet,他是谷歌的工程师和 AI 研究员,以创建 Keras 而闻名,Keras 是 2015 年发布的深度学习库。这些是最重要的概念:

-

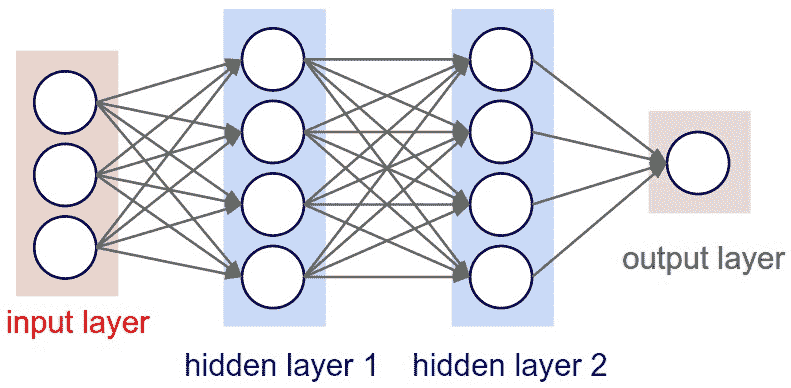

神经网络

-

卷积神经网络

-

循环神经网络

-

LSTM

-

生成对抗网络

最终思考

这些建议对于希望进入数据科学领域的初学者都很有帮助。此外,它们对那些意识到自己在某些概念上知识不足并需要加强理解的数据科学家和研究人员也很有用。希望你喜欢这份书单。你知道其他关于数据科学的有用书籍吗?如果有值得一提的建议,请在评论中分享。

Eugenia Anello目前是意大利帕多瓦大学信息工程系的研究员。她的研究项目专注于结合异常检测的持续学习。

更多相关主题

5 本免费书籍掌握机器学习

原文:

www.kdnuggets.com/5-free-books-to-master-machine-learning

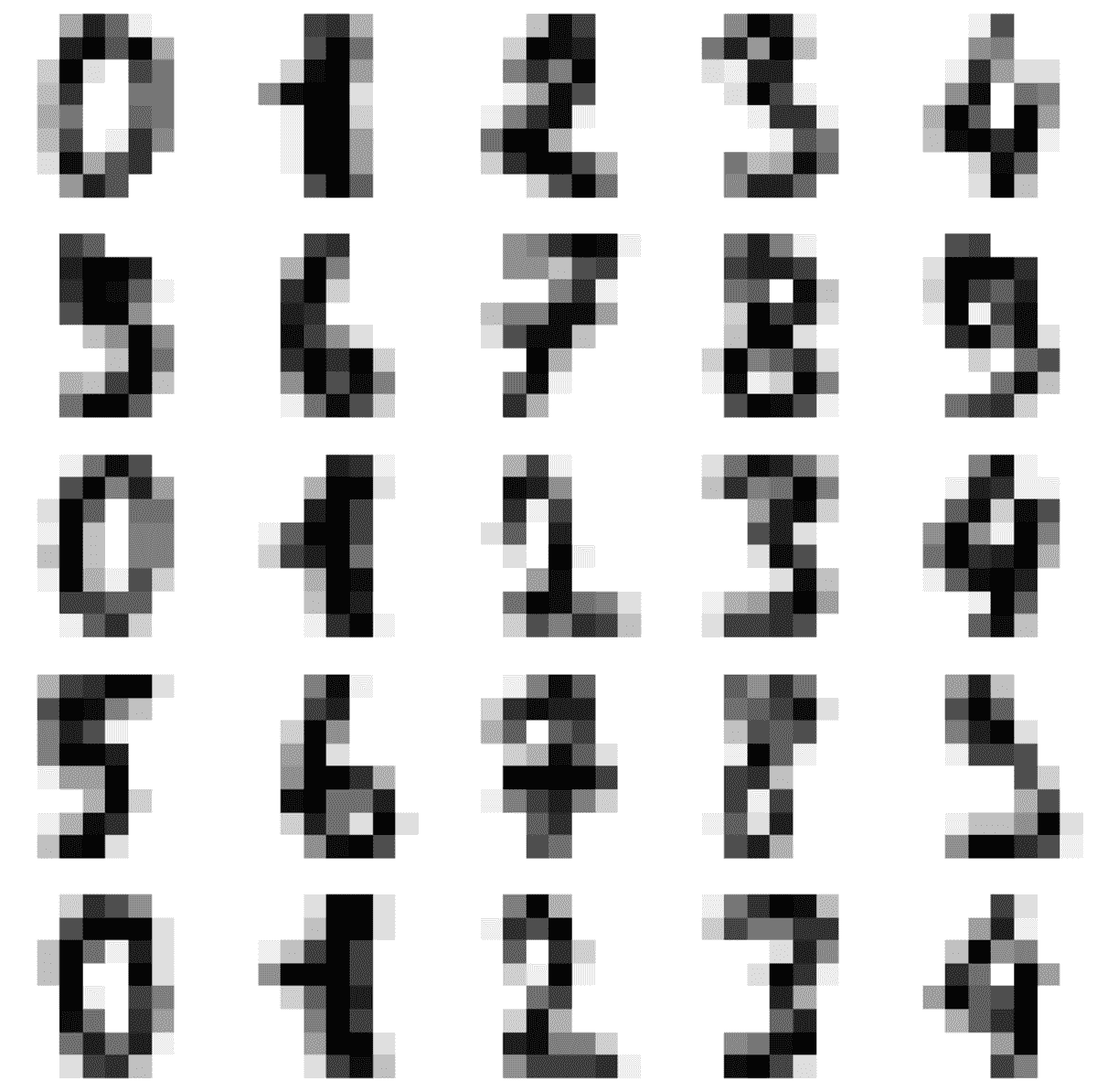

图片生成于 DALL-E 3

在今天的高科技世界中,机器学习非常重要。你可能已经参加了一些在线课程,但它们往往忽略了细节。如果你真的想深入探究并掌握机器学习,书籍是最佳选择。我知道面对如此多的选择可能会感到不知所措。但别担心,我们会为你提供帮助。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业

1. 谷歌网络安全证书 - 快速入门网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

我精心挑选了五本在我自己的机器学习旅程中产生重大影响的书籍。这些书籍将帮助你在 2023 年更好地理解机器学习。

所以,如果你准备好将你的知识提升到一个新的水平,深入探索这一迷人领域,继续阅读。

1. 绝对初学者的机器学习

作者: 奥利弗·西奥博德

链接: 绝对初学者的机器学习

书籍封面

你听说过机器学习这个词,想要深入了解这个激动人心的领域,但不知道从哪里开始。那么这本书是适合你的!

这本书非常适合那些对这个领域新手且没有任何编程经验的人。它以通俗易懂的语言编写,不需要任何先前的编程经验。书中提供了机器学习的高层次介绍、可下载的代码练习和视频演示。还有什么比这更好的呢?

涵盖的主题:

-

什么是机器学习?

-

机器学习类别

-

机器学习工具箱

-

数据清洗

-

设置你的数据

-

回归分析

-

聚类

-

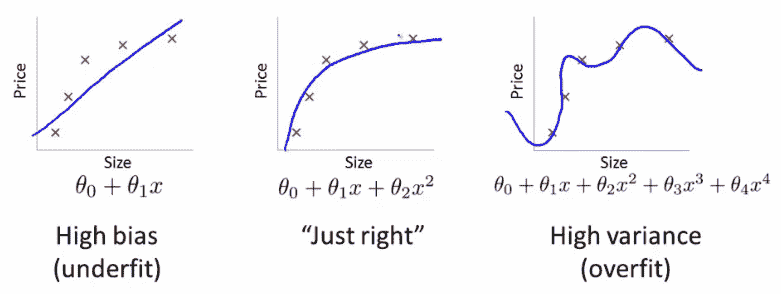

偏差与方差

-

人工神经网络

-

决策树

-

集成建模

-

在 Python 中构建模型

-

模型优化

2. 机器学习的数学

作者: 马克·彼得·德森罗斯

链接: 机器学习数学

书籍封面

既然你已经了解了一些基本概念,现在是时候为复杂的机器学习主题打下基础了。你现在应该做什么?机器学习的数学就是你所需要的!

这是一本自包含的教科书,介绍了理解机器学习所需的基本数学工具。该书以最少的先决条件呈现数学概念,并利用这些概念推导出四种核心机器学习方法:线性回归、主成分分析、高斯混合模型和支持向量机。

本书的作者 Marc Peter Deisenroth 是伦敦大学学院的 DeepMind 人工智能主席,并因其在机器学习领域的研究获得了多个奖项。

涉及主题:

-

线性代数

-

解析几何

-

矩阵分解

-

向量微积分

-

概率与分布

-

连续优化

-

当模型遇到数据

-

线性回归

-

主成分分析的维度缩减

-

使用高斯混合模型的密度估计

-

使用支持向量机的分类

3. 《黑客的机器学习》

作者: Drew Conway 和 John Myles White

链接: 黑客的机器学习

书籍封面

你至今一直在学习理论,现在你真的想开始深入的机器学习编码。那就不用担心了。如果你对编程和编码有天赋,这本书就是为你量身定制的。

本书结合了实际案例研究,展示了机器学习算法的现实相关性。这些示例,包括一个关于构建 Twitter 关注者推荐系统的示例,帮助将抽象概念与具体应用联系起来。这本书最适合喜欢实际案例研究的程序员。

涉及主题:

-

数据探索

-

分类: 垃圾邮件过滤

-

排序: 优先收件箱

-

回归: 预测页面浏览量

-

正则化: 文本回归

-

优化: 破解代码

-

PCA: 构建市场指数

-

MDS: 视觉探索美国参议员相似性

-

kNN: 推荐系统

-

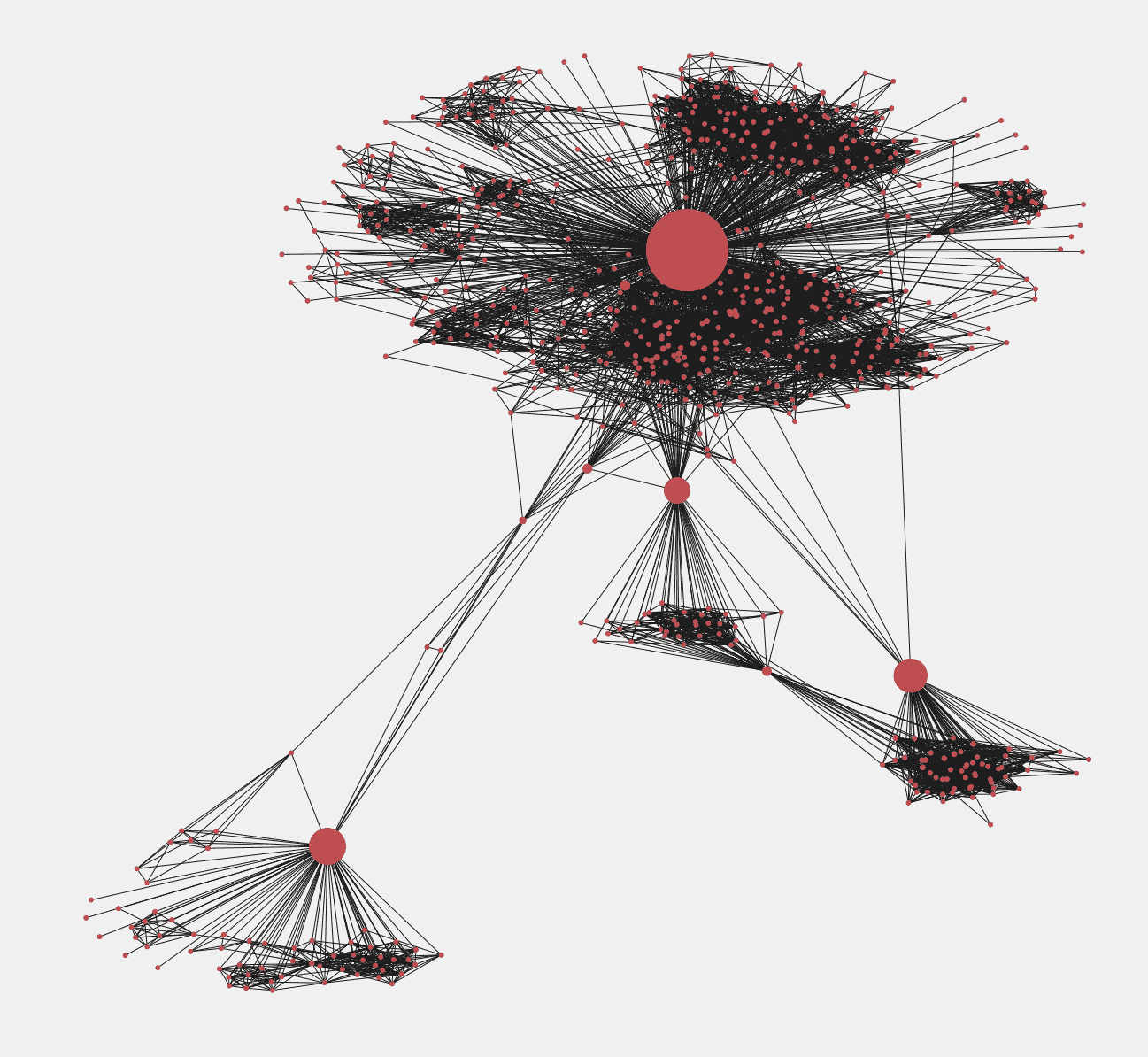

分析社交图谱

-

模型比较

4. 《使用 Scikit-Learn、Keras 和 TensorFlow 的动手机器学习》

作者: Geron Aurelien

链接: 使用 Scikit-Learn、Keras 和 TensorFlow 的动手机器学习

书籍封面

这本书是一本实用的机器学习指南,重点在于构建端到端的系统。书中涵盖了线性回归、决策树、集成方法、神经网络、深度学习等广泛主题。

本书的最新版本包含了来自前沿版本的机器学习和深度学习库(如 TensorFlow 和 Scikit-Learn)的代码。

涵盖的主题:

-

性能测量选择

-

测试集创建

-

使用梯度下降进行线性回归

-

岭回归、套索回归和弹性网回归

-

用于分类的 SVM

-

决策树与基尼不纯度

-

集成学习方法

-

主成分分析(PCA)

-

使用 K-Means 和 DBSCAN 进行聚类

-

使用 Keras 的人工神经网络

-

深度神经网络训练

-

使用 TensorFlow 的自定义模型

-

使用 TensorFlow 的数据加载和预处理

-

深度学习中的 CNN、RNN 和 GAN

5. 接近(几乎)任何机器学习问题

作者:Abhishek Thakur

书籍封面

想把你的机器学习技能提升到一个新水平吗?这本书是你通向应用机器学习精彩世界的通行证。虽然它没有让你陷入复杂的算法,但它全是关于如何和什么来解决现实世界中的问题。若你渴望弥合理论与实践之间的差距,这本书肯定会成为你的指南!

涵盖的主题:

-

监督学习与非监督学习

-

交叉验证技术

-

评估指标

-

结构化机器学习项目

-

处理分类变量

-

特征工程

-

特征选择

-

超参数优化

-

图像和文本分类、集成和可重复代码

结论

在这篇文章中,我们向你介绍了 2023 年学习机器学习的五本最佳书籍。这些书涵盖了从机器学习基础到更高级的深度学习主题,内容都写得很好,即使是初学者也容易跟随。

如果你认真对待机器学习,我建议你阅读这五本书。然而,如果你只能读一两本,我推荐 Oliver Theobald 的《绝对初学者的机器学习》 和 Aurélien Géron 的《动手机器学习:使用 Scikit-Learn、Keras 和 TensorFlow》。

我们很想知道哪些书在你的机器学习旅程中发挥了关键作用。欢迎在评论区分享你的推荐。

Kanwal Mehreen**** Kanwal 是一名机器学习工程师和技术作家,对数据科学和人工智能与医学的交叉领域充满了深厚的热情。她共同撰写了电子书《利用 ChatGPT 最大化生产力》。作为 2022 年 APAC 的 Google Generation Scholar,她倡导多样性和学术卓越。她还被认定为 Teradata 技术多样性学者、Mitacs Globalink 研究学者和哈佛 WeCode 学者。Kanwal 是变革的坚定倡导者,她创立了 FEMCodes 以支持 STEM 领域的女性。

更多相关主题

5 本免费 SQL 书籍

图片由Freepik提供

SQL,或结构化查询语言,是许多公司标准的数据库操作语言。目前,每个数据相关的职位都期望了解 SQL 语言,因为我们的工作涉及提取这些存储的数据以进行进一步分析。这就是为什么无论我们的专业水平如何,都应该提升我们的 SQL 知识。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

本文将讨论五本免费书籍,这些书籍可以提升你的 SQL 水平。我们将涵盖从初级到高级的各种需求。

这些书籍是什么?让我们深入了解一下。

SQL 专业笔记

GoalKicker.com提供的《SQL 专业笔记》是一本超过 150 页的免费 SQL 书籍,涵盖了 SQL 的主要使用场景。在每一章中,你将学习到语法的简要说明、示例用法以及使用语法时的技巧。

这本书可以成为你学习和刷新基础知识的首选,因为它适合任何专业水平。这本书主要涵盖以下概念:

-

SQL 基础知识

-

数据操作

-

数据库和表管理

-

函数和表达式

-

数据清理和维护

-

处理特殊数据类型

你可以在以下页面获取这本书:SQL 专业笔记。

学习 SQL

这是另一本适合任何初学者和高级用户的免费书籍,旨在提升你的 SQL 技能。该书由 Stack Overflow 的贡献者编写,旨在解答你大部分的 SQL 问题。

这本书提供了 64 章,超过 200 页。每章包含简单的解释和易于跟随的用法示例。总体而言,这本书的内容如下:

-

SQL 基础知识

-

数据库设计

-

高级查询技术

-

管理和错误处理

-

理解 SQL 的元数据

-

SQL 的信息检索

你可以在以下页面获取这本书:SQL 学习。

SQL 简介

Bobby Iliev 的入门书籍是一本开源书籍,旨在教会初学者使用 SQL。它为每一章提供了清晰的解释,并提供了跟随示例所需的教程和前提条件。这本书使用了 MySQL,所以如果你想进一步了解这种语言,它也是不错的选择。

书籍内容包括:

-

MySQL 基础

-

数据操作

-

使用 JOINS 和子查询的高级查询

-

使用 MySQL 特定功能

-

最佳实践和编写干净代码

你可以在以下页面获取该书:SQL 入门。

必备 SQL

必备 SQL 是 必备编程 书籍的一部分,是 2017 年停止更新的 Stack Overflow 文档的延续。电子书对每个主题提供了简单的解释,并提供了一个示例操作场地,你可以在其中进行调整。这是一本适合初学者和高级用户的优秀电子书。

电子书包含以下内容:

-

SQL 基础知识

-

数据检索和操作

-

优化和高级查询

-

数据库设计和管理

-

最佳实践和维护

你可以在这里访问电子书:必备 SQL。

SQL 索引和调优

SQL 索引和调优是由 Markus Winand 开发的电子书,专注于索引 SQL 活动。这本电子书更适合高级用户,但从长远来看将有助于我们的工作。

电子书内容包括:

-

索引基础

-

索引结构

-

索引性能问题

-

索引管理最佳实践

-

高级索引技术和考虑事项

结论

SQL 是数据专业人员必备的重要技能,因为它将成为我们日常工作的一个部分。为了提高你的 SQL 知识,我们可以利用一些免费的 SQL 书籍,这些书籍在本文中有讨论。这些书籍增强了你的 SQL 基础,并提供了实际案例中的示例。

Cornellius Yudha Wijaya**** 是一名数据科学助理经理和数据撰写员。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作分享 Python 和数据技巧。Cornellius 在各种 AI 和机器学习主题上都有所撰写。

更多相关内容

5 本免费书籍掌握数据科学中的统计学

原文:

www.kdnuggets.com/5-free-books-to-master-statistics-for-data-science

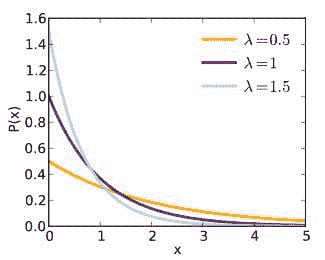

编辑图片

要学习数据科学,你还需要扎实的数学基础。统计学是数据科学中必不可少的数学技能之一。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织中的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织中的 IT

然而,学习统计学可能会让人感到畏惧,尤其是如果你来自非数学或计算机科学领域。为了帮助你入门,我们整理了一份免费书籍清单,使数据科学中的统计学变得易于获取。

大多数这些书籍采用了实践导向的方法来讲解统计学概念,这是作为数据科学家有效使用统计学所需的。让我们来详细了解这些统计书籍。

1. 入门统计学

入门统计学 这本书是一本易于理解的统计学入门书,涵盖了大学里通常教授的一个学期的入门统计学课程内容。

本书在 OpenStax 上可免费访问,由一组贡献专家作者撰写,采用了应用优先的统计学方法,而非理论优先,并且在每个主题的练习中包含了例子。

这本书将帮助你学习以下内容:

-

采样与数据

-

描述性统计

-

概率和随机变量主题

-

正态分布

-

中央极限定理

-

置信区间

-

假设检验

-

卡方分布

-

线性回归和相关性

-

F 分布和单因素方差分析

链接: 入门统计学 2e

2. 现代统计学导论

现代统计学导论 是 OpenIntro 项目的免费在线教科书,由 Mine Çetinkaya-Rundel 和 Johanna Hardin 撰写。

如果你想学习有效数据分析的统计学基础,那么这本书适合你。此书的内容如下:

-

数据介绍

-

探索性数据分析

-

回归建模

-

推断基础

-

统计推断

-

推断建模

链接: 现代统计学导论

3. 《思考统计学》

思考统计学 作者 Allen B. Downey 将帮助你使用 Python 学习和实践统计学概念。

这样你可以运用你的 Python 技能学习统计学和概率概念,以有效处理数据。通过阅读这本书,你将编写简短的 Python 程序并使用真实数据集来加深对统计学概念的理解。

涵盖的主题如下:

-

探索性数据分析

-

分布

-

概率质量函数

-

累积分布函数

-

建模分布

-

概率密度函数

-

变量之间的关系

-

估计

-

假设检验

-

线性最小二乘法

-

回归

-

生存分析

-

分析方法

链接: 思考统计学 2e

4. 计算与推断思维

计算与推断思维:数据科学基础 由 Ani Adhikari、John DeNero 和 David Wagner 合著,将帮助你学习数据科学的统计学基础。

本书作为 UC Berkeley 提供的 Data 8: 数据科学基础 课程的配套书籍开发。书中涵盖的主题包括:

-

数据科学导论

-

Python 编程

-

数据类型、序列和表格

-

可视化

-

函数和表格

-

随机性

-

抽样和经验分布

-

假设检验

-

估计

-

回归

-

分类

链接: 计算与推断思维:数据科学基础

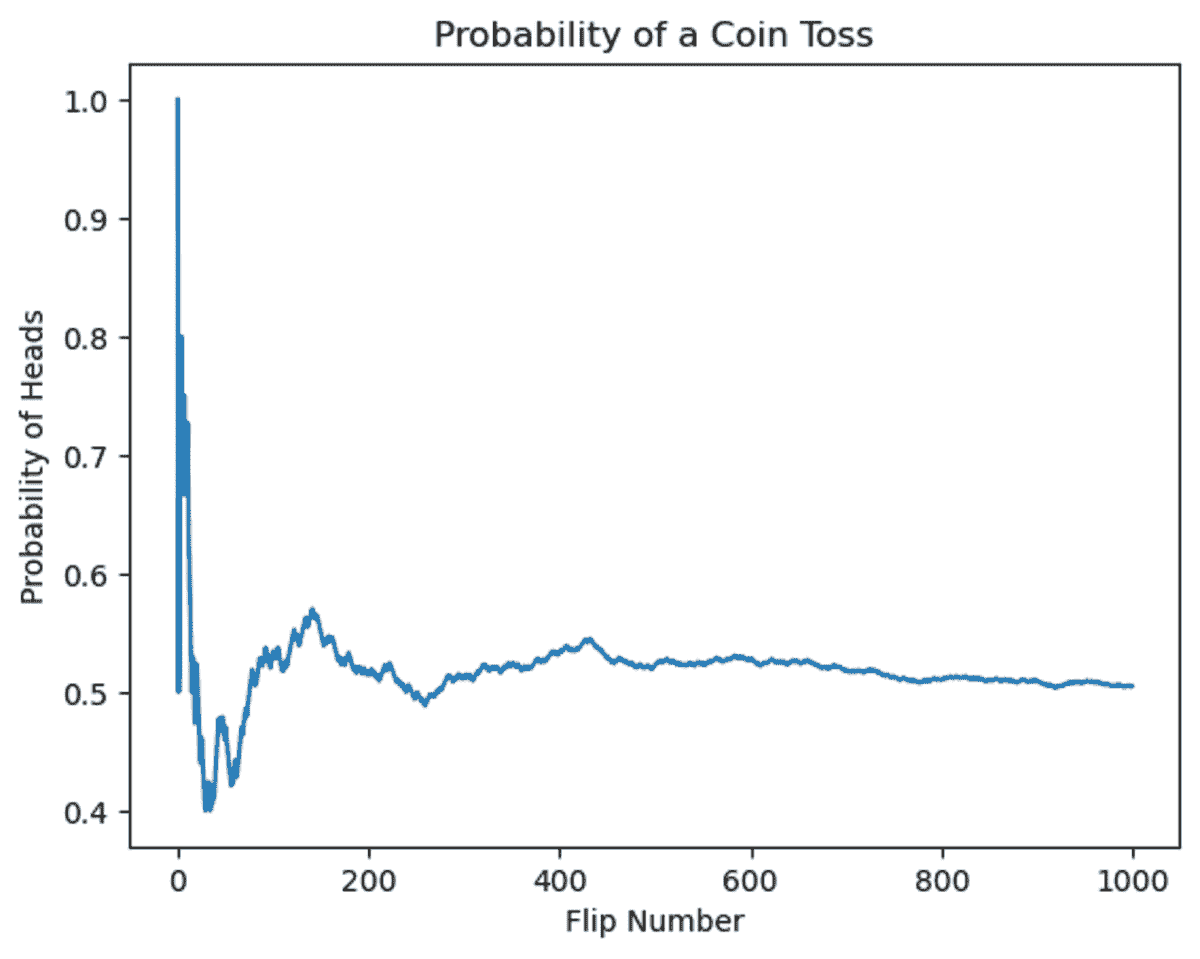

5. 概率编程与黑客的贝叶斯方法

概率编程与黑客的贝叶斯方法 或《黑客的贝叶斯方法》是一本关于贝叶斯统计方法的热门书籍。

“黑客的贝叶斯方法”:介绍贝叶斯方法 + 概率编程,以计算/理解优先、数学次之的视角。全用纯 Python 😉 - 来源

你将熟悉概率理论和贝叶斯推断,同时使用 PyMC 包。这本书的内容如下:

-

贝叶斯方法导论

-

PyMC 库

-

马尔可夫链蒙特卡洛

-

大数法则

-

损失函数

-

先验

链接: 概率编程与黑客的贝叶斯方法

总结

希望你觉得这些免费统计学书籍的汇总对你有帮助。理论和实践的结合应该能帮助你提升数据科学技能,并在处理大型真实数据集时做出更明智的决策。

如果你喜欢通过免费课程学习或希望通过课程来补充阅读,请查看 5 个免费课程掌握数据科学统计学。

Bala Priya C** 是来自印度的开发人员和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和喝咖啡!目前,她正在通过撰写教程、使用指南、观点文章等,学习并与开发者社区分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。**

更多相关内容

5 个免费证书助你获得首个开发者职位

原文:

www.kdnuggets.com/5-free-certifications-to-land-your-first-developer-job

作者提供的图片

技能比任何证书都更有价值。那么为什么获得认证仍然有帮助呢?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业

1. Google 网络安全证书 - 快速进入网络安全职业

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

如果你有计算机科学或相关领域的学位,那么在开始寻找软件开发角色时,可能不需要认证。但是现在,我们知道的许多人都在寻求转向软件角色——从非技术或技术相关角色。认证在这里可以发挥作用。

通过学习特定的轨道——一个认证或课程——可以帮助你确定自己的兴趣,并使学习针对目标角色的核心技能变得更容易。此外,还有一些高质量的认证,具有精心设计的课程,涵盖了数十小时的编码练习和项目。因此,如果你想成为开发人员,以下证书将帮助你学习你需要掌握的最相关和最基本的技能!

1. 响应式网页设计 – freeCodeCamp

如果你是软件开发的新手,响应式网页设计认证是一个很好的起点。完成这个认证将帮助你学习 HTML、CSS、CSS 网格和 Flexbox。

从基本的 HTML 标签到 CSS 动画和变换,整个认证的结构是一系列的小项目。因此,你将通过实际应用这些概念来构建项目,从而学习这些概念。

除了一系列的小项目外,还有五个项目必须完成才能获得证书。一旦你对 HTML 和 CSS 感到熟悉,你可以继续学习 JavaScript。

链接: 响应式网页设计认证

2. JavaScript 数据结构与算法 – freeCodeCamp

如果你想进入前端开发领域,学习 JavaScript 并熟练掌握前端库是至关重要的。既然你已经学会了 HTML 和 CSS,那么学习 JavaScript 编程是很好的选择。

-

freeCodeCamp 的JavaScript 算法和数据结构认证将帮助你通过 JavaScript 学习编程基础、正则表达式、数据结构和算法。

-

你还将学习面向对象编程(OOP)和函数式编程范式。像响应式网页设计认证一样,这也要求你完成若干 JavaScript 编码挑战和五个项目,以获得证书。

3. 前端开发库 – freeCodeCamp

-

当你熟悉 HTML、CSS 和 JavaScript 后,你应该学习如何使用流行的 JavaScript 前端库,如 React 和 Redux。freeCodeCamp 的前端开发库认证将帮助你学习所有必需的知识。

-

通过详细的课程安排,这个认证将帮助你学习以下内容:

-

Bootstrap

-

jQuery

-

SASS

-

React

-

Redux

- 在掌握了所有 HTML 和 CSS 基础、JavaScript 以及 JavaScript 库后,你应该能够为你的开发者作品集构建有趣的项目。

链接: 前端开发库认证

4. CS50 的计算机科学导论 – 哈佛

-

CS50 的计算机科学导论由哈佛大学的 David J. Malan 教授及其团队教授,是一门非常受欢迎的计算机科学入门课程。如果你是编程新手,这门课程将帮助你学习计算机科学和编程基础、计算思维、数据结构等。

-

在为期 11 周的课程中,这个课程将帮助你掌握计算机科学和编程基础。你将学习低级编程语言如 C,然后转向 Python。你还将学习 SQL 基础,以查询数据库。此外,你还将学习 HTML、CSS 和 JavaScript。

-

这个课程包含需要解决的问题集和一个最终项目,以应用你所学到的知识。课程中探讨的主题范围也应帮助你了解下一步想要追求的方向,比如专注于网页编程、数据分析等。

链接: CS50 的计算机科学导论

5. CS50 的 Python 和 JavaScript 网页编程

CS50 的 Python 和 JavaScript 网页编程专注于使用 Python、JavaScript 和 SQL 开发网页应用程序,同时使用 React 和 Django 等框架。你还将学习如何设计 API 和 UI、使用云服务等。

与所有 CS50 课程一样,你将在课程中完成多个项目。CS50 网络编程课程有九周的课程内容,包括以下内容:

-

HTML, CSS

-

Git

-

Python

-

SQL、模型和迁移

-

JavaScript

-

用户界面

-

测试,CI/CD

-

可扩展性和安全性

链接: CS50 的 Python 和 JavaScript 网络编程

总结

我希望你觉得这些免费认证有帮助。这些认证的最佳部分在于,它们强调通过编码挑战、问题集和项目主动应用所学内容,而不是被动地消耗内容。

运用这些课程学到的技能,你应该能够构建一个令人印象深刻的项目组合,并为技术面试做好充分准备。祝学习愉快,编程顺利!

Bala Priya C** 是来自印度的开发者和技术写作者。她喜欢在数学、编程、数据科学和内容创作的交叉点上工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正通过编写教程、操作指南、观点文章等,与开发者社区分享她的知识。Bala 还创建引人入胜的资源概述和编码教程。**

更多相关内容

5 个免费竞赛,适合有志的数据科学家

原文:

www.kdnuggets.com/5-free-competitions-for-aspiring-data-scientists

图片由编辑 | Midjourney & Canva

图片由编辑 | Midjourney & Canva

数据科学就像艺术,因为解决问题的方法有很多种。这就是为什么数据科学竞赛存在的原因,以获得破解数据科学问题的最佳方法。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

我见过一些有志的数据科学家因为数据科学竞赛而开启职业生涯。这些竞赛展示了参与者能够解决问题并且具有创造力。此外,竞赛还允许你进行网络交流并向同行学习。

数据科学竞赛是提高我们技能的有趣方式,同时使我们在其他有志之士中具有竞争优势。在本文中,我将解释你现在可以参加的五个免费数据科学竞赛。

你感兴趣吗?让我们开始吧。

Kaggle 竞赛

Kaggle 是一个专为数据科学家设计的在线平台和社区。它提供了许多功能,包括公开数据集共享用于分析和数据项目、免费的教程学习以及一个 竞赛平台。

竞赛平台是数据科学竞赛最受欢迎的地方之一,因为许多现实世界的公司在这里举办竞赛。此外,无论你的经验水平如何,这里都有许多竞赛供有志之士参加。

一些竞赛有时间限制,但许多竞赛总是可以参加。所有这些竞赛都是免费的,许多竞赛甚至还有奖金。然而,那里的竞争可能非常激烈,因为许多才华横溢的专业人士也会参加这些竞赛。不过,如果你想开始你的数据科学竞赛经历,这里是一个不错的地方。

DataHack 由 Analytic Vidhya 主办

你可以参加的下一个免费竞赛是 DataHack。这是由 Analytics Vidhya 主办的数据科学竞赛平台,Analytics Vidhya 是一个在线平台和数据科学社区。它提供了许多文章、教程、职位平台和竞赛。

DataHack 是一个数据科学竞赛平台,允许参与者解决现实世界中的问题并争夺奖品。你不需要有数据科学经验就可以参加竞赛,而且是免费的。此外,许多竞赛对公众开放,没有奖品,因为它们旨在用于学习。

总体而言,该平台非常适合那些希望体验与全球其他人竞争的感觉,同时仍能与社区互动的人。通过观察他人如何应对竞赛,你可以学到很多东西。

MachineHack 的 AI Hackathons

MachineHack 是一个为数据科学和机器学习爱好者提供的在线平台。它主要提供竞赛和黑客马拉松,以提高用户的技能和积累经验。排行榜是公开的,这使得它成为通过竞赛建立声誉的绝佳平台。

AI Hackathon 是 MachineHack 提供竞赛的地方。你可以加入各种竞赛,无需支付任何费用,同时争夺第一名。有些竞赛可能提供奖金,而许多则用于练习你的技能。

竞赛吸引了许多有才华的个人,因此你可以尝试与他们竞争,提高你的数据科学能力。同时,你可以建立一个项目组合,并与该领域的其他专业人士建立联系。

AI Crowd

AI Crowd 旨在作为一个研究平台,但它是通过提供数据科学竞赛来推动研究的。该平台的原则是开放科学和可重复的研究,这可能会带来现实问题的创造性解决方案。

与前一个平台类似,这个平台提供了许多有奖金的竞赛。然而,竞赛的种类并不多,因为许多竞赛是为了研究目的而设计的。尽管如此,该平台上的竞赛大多足够高级,可以作为竞赛者的学习经历。

DrivenData

DrivenData 与 AI Crowd 相似,它是一个基于现实世界问题的数据科学竞赛平台。它为用户提供了解决具有实际影响问题的机会。

竞赛的例子包括预测疾病传播或管理水资源,这使它们非常适合学习并带来实际改变。该平台是提升数据科学技能和积累现实经验的绝佳方式。你甚至可以在过程中赢得一些奖金。

结论

竞赛是提高数据科学技能并与同行建立联系的绝佳方式。如果你在竞赛中表现出色,可能会赢得一些奖品。在本文中,我们讨论了 5 个适合有志数据科学家的免费竞赛:

-

Kaggle 竞赛

-

Analytic Vidhya 的 DataHack

-

MachineHack 的 AI Hackathons

-

AI Crowd

-

DrivenData

希望这对你有所帮助。

Cornellius Yudha Wijaya 是一名数据科学助理经理和数据编写员。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。Cornellius 在各种人工智能和机器学习主题上撰写文章。

更多相关内容

5 个免费的 ChatGPT 课程

你可能听说过很多关于 ChatGPT 的事情,使用过它,也听说过人们用它做的各种疯狂的事情。你可能会想,这些人是如何学会使用 ChatGPT 的,我该从哪里学习?

不用再寻找了。本文将介绍 5 个免费课程,帮助你提升 ChatGPT 技能,并充分利用它!所以我们开始吧

1. ChatGPT 入门

链接: ChatGPT 入门

如果你在玩弄 ChatGPT,但不清楚它的全部潜力 - 这个 DataCamp 的 ChatGPT 入门课程可能适合你。无需任何先前知识,因此你可以开始了解 ChatGPT 的能力和局限性,以及如何在日常生活中利用它。

许多人在提示 ChatGPT 时遇到困难,本课程的前半部分将讲解提示 ChatGPT 以生成高质量相关内容的最佳实践。然后,你将学习如何通过了解文本摘要和代码解释等不同用例,将 ChatGPT 转化为业务价值。

2. ChatGPT 初学者指南:适用于每个人的终极用例

很多人想知道如何利用 ChatGPT 将业务提升到新的水平。ChatGPT 已经简化了许多员工的生活,但仍有些人不清楚这些功能是如何实现的。

该课程将介绍如何通过从商业和个人的角度审视 ChatGPT 的能力来大幅提升当前业务。你将了解到如何利用 ChatGPT 为你完成工作,从而赚取更多利润并最大化成本效益。

3. ChatGPT 的提示工程

链接: ChatGPT 的提示工程

由计算机科学副教授 Dr. Jules White 设计的课程,旨在向学生介绍如何为大规模语言模型(LLMs)编写有效提示的模式和方法。该课程对任何人开放,只需要基础的计算机知识,例如使用浏览器和访问 ChatGPT。

你将从理解基本提示开始,逐渐建立起编写更复杂提示的能力,帮助你解决各种任务。ChatGPT 具有许多用途,例如担任辅导员、制定餐计划、为软件应用编写代码等。能够理解如何提示 ChatGPT 将使你成为这些生成型 AI 工具的专家用户,拥有强大的提示工程技能,适用于任何用例。

4. ChatGPT 提示工程师课程

链接: ChatGPT 提示工程师课程

由 DeepLearning.AI 和 OpenAI 提供的 1 小时短期课程,适合所有人——初学者和高级人员。讲师是 Isa Fulford(OpenAI)和 Andrew Ng(DeepLearning.AI),课程仅限时间免费。

在这个短期课程中,你将学习如何使用大型语言模型(LLMs)构建新的高效应用程序,了解提示工程的最佳实践,并展示如何将 LLM API 用于各种任务。

例如,你将学习如何总结用户评价,确定情感,识别主题,改善语法等。在课程中,你将学习如何创建一个独特的聊天机器人,并编写强有力的提示。这些都有助于为开发人员提供如何最有效使用 LLMs 的知识。

无论你有什么样的编程经验,这门课程在 LLMs 如雨后春笋般涌现的世界中都至关重要。

5. 使用 ChatGPT API 构建系统

另一个由 DeepLearning.AI 和 OpenAI 提供的短期课程,你将深入了解 ChatGPT API 以及如何使用这些 API 通过链式调用 LLMs 来自动化复杂的工作流程。讲师是 Isa Fulford 和 Andrew Ng,课程仅限时间免费。

这是一个适合初学者的课程,你需要具备基础的 Python 知识来完成课程。该课程也适合中级或高级的机器学习工程师,他们希望了解关于 LLMs 的前沿提示工程技能。

你将学习如何构建与之前提示相关的提示链,创建与完成和新提示交互的系统,以及从课程中学到的知识制作一个客户服务聊天机器人。

总结

完成上述所有免费课程后,你将能够熟练理解 ChatGPT,学习如何在不同的应用场景中使用它,定制符合你需求的提示,并利用 ChatGPT API 创建聊天机器人等。

如果你知道其他免费的 ChatGPT 课程,请在下方评论中分享,以便其他人学习!

Nisha Arya 是一位数据科学家、自由技术作家以及 KDnuggets 的社区经理。她特别关注于提供数据科学职业建议或教程以及数据科学的理论知识。她还希望探索人工智能如何或将如何促进人类寿命的延续。她是一位热衷学习的者,寻求拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关主题

5 个免费课程帮助你入门人工智能

原文:

www.kdnuggets.com/2017/02/5-free-courses-getting-started-artificial-intelligence.html

对人工智能感兴趣?不知道从哪里或如何开始学习?

没有任何东西可以替代严格的正规教育,但由于各种原因,这并非对每个人都是一个选项。然而,深入了解人工智能及其众多交叉和相关领域与应用领域并不需要博士学位。刚开始可能会让人感到不安,但不要灰心;查看这个激励和启发的帖子,作者在一年内从对机器学习的初步了解,到积极有效地在工作中应用这些技术。

寻找来自网络上自由提供的材料的研究生级人工智能课程?随着越来越多的高等教育机构决定通过网络让课程材料对非学生开放,几乎任何地方的任何人都可以突然体验到伪大学课程。查看以下所有适合初学者的免费课程材料,其中一些也涵盖了特定应用概念和材料。

一些教授及其分享的材料在塑造世界顶尖 AI 研究人员和从业者的思想方面发挥了重要作用。你完全可以从这些相同的材料和教学中受益。

这可能被视为现存的首屈一指、开创性的、面向在线的开放访问大学级人工智能课程。

并非所有内容对非加州大学伯克利分校的学生开放(作业和自动评分),但绝大多数材料都是公开的。这些材料完整且组织良好,包括以下内容:

-

2014 年春季的课程样本时间表

-

讲义和视频的完整集

-

电子作业提交接口

-

课件

-

Pacman 项目规格

-

伯克利 CS188 课程的源文件和过去的考试 PDF

-

申请 edX 托管的自动评分器的表单(用于作业和项目等)

-

联系信息

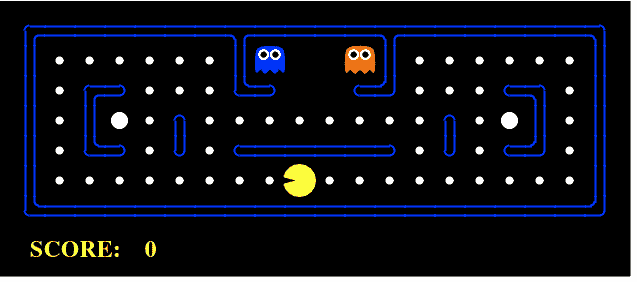

虽然提到作业不公开,但一系列逐步进行的 Pacman 项目是公开的,涵盖了搜索、强化学习、分类等方面。

由 Dan Klein 和 Pieter Abbeel 教授主讲,讲座、视频、考试及其他材料可追溯到 2014 年;然而,你在这门课程中学到的内容绝不会过时。我自己几年前就学习了这部分课程材料,你可以在这里获得对基础 AI 主题的充分概述,包括理论和实践。

斯坦福大学在其网站上对这门课程这样描述:

这门课程讲什么? 网络搜索、语音识别、人脸识别、机器翻译、自动驾驶和自动排程有什么共同之处?这些都是复杂的现实世界问题,而人工智能(AI)的目标是用严格的数学工具来解决这些问题。在这门课程中,你将学习驱动这些应用的基础原理,并练习实现一些这些系统。

从一些领域内最受推崇的文本(Russell & Norvig;Koller & Friedman;Hastie, Tibshirani & Friedman;Sutton & Barto)中汲取灵感,这些材料包括笔记、幻灯片、作业、考试和项目(包括解决方案)。你会发现与上述伯克利课程有重叠,但这里开放的作业种类可能更丰富,其中包括如下项目:

-

情感分类

-

二十一点

-

吃豆人

-

排程

-

汽车跟踪

-

语言与逻辑

很容易认为,这前两门课程材料的某种组合会提供一个实质性的人工智能入门教育。此外,考虑到斯坦福课程中至少有一些文本是(合法地)在线免费提供的,几乎可以实现沉浸式体验。

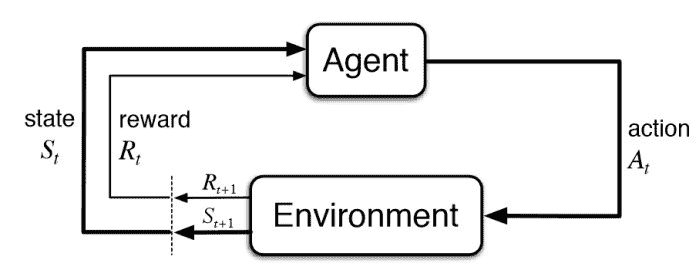

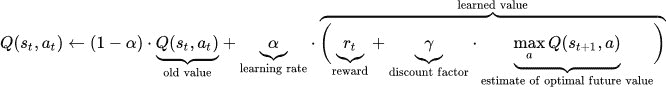

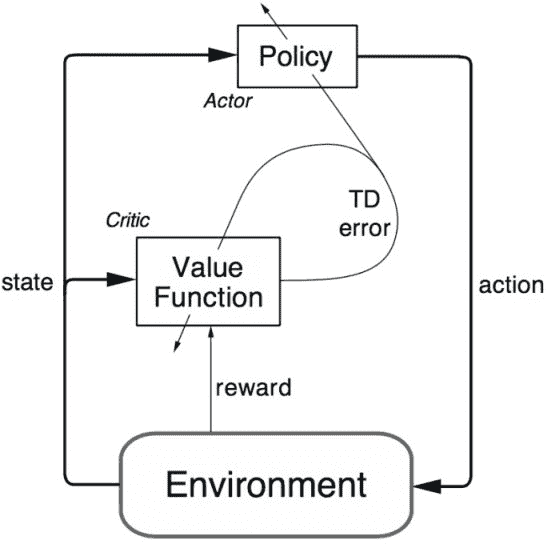

3. 强化学习

这是 David Silver 在伦敦大学学院的著名强化学习课程。材料简明扼要,包括讲座视频和对应的幻灯片,内容丰富。

这不是一门入门 AI 课程,与前两门课程不同,它专注于最令人兴奋和活跃研究的领域之一。由 Google DeepMind 的专家构建的这门课程非常值得花时间学习。

由 Sergey Levine、John Schulman 和 Chelsea Finn 教授的这门课程是对强化学习的另一种探讨。课程目前正在进行中,新的讲座会实时直播,并且课程结束后也可以观看。

课程材料包括前述的视频、幻灯片、教程和作业。计划安排了嘉宾讲座,其中包括 OpenAI 的 Igor Mordatch 和 Google Brain Team 的 Mohammad Norouzi(以及其他伯克利的明星教授)。作业使用了如 TensorFlow 和 OpenAI Gym 等标准框架。

再次提一下,这门课程仍在进行中,所以你需要跟随课程的进度,因为下周的讲座材料尚不可用 😃

这门课程自上线以来在网上引起了广泛关注,这是由 Lex Fridman 主讲的 MIT 自动驾驶汽车课程。与之前的课程一样,这门课程也在进行中。

随着深度学习从研究转向实际应用,看到这些专注于深度学习的应用课程在世界各地的知名大学中涌现出非常有趣。此外,随着Udacity 的自动驾驶汽车纳米学位的最近宣布,将这两种热门技术结合到课程材料中是顺理成章的。这不是隐晦的批评:这些技术是非常互补的,代表了事实上的技术必要的结合。

回到课程,它包含了视频讲座以及大量相关材料,从经过验证的 Python 和深度学习入门教程到历史性自动驾驶车辆信息。

课程依赖于 DeepTesla 和 DeepTraffic 模拟器,并计划在学期末安排一些嘉宾讲座。有趣的是,公众(非 MIT 学生)甚至可以在网站上注册账户。

相关:

-

进入机器学习职业之前需要阅读的 5 本电子书

-

1 月你不能忽视的 5 个机器学习项目

-

自动化机器学习的现状

更多相关内容

掌握微积分的 5 门免费课程

原文:

www.kdnuggets.com/2022/10/5-free-courses-master-calculus.html

如果你希望理解机器学习算法是如何工作的,数学是不可避免的。线性代数、统计学、概率论和微积分是学习算法内部原理的四个关键子领域。本文列出了学习微积分的课程,但让我们首先了解为什么需要学习微积分。

为什么你需要学习微积分?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 部门

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 部门

你需要了解微积分才能计算导数,例如,调整神经网络反向传播中的神经元权重。实质上,你需要微积分来理解一组输入与输出变量之间的关联。这种多属性的研究被称为多元微积分,应用于计算函数的最小值和最大值、导数、成本函数等。

来源:图像由 Freepik 上的 storyset 提供

学习微积分的前提条件

现在我们了解了为什么微积分是理解机器学习算法如何工作的一个重要前提条件,让我们来学习你需要掌握哪些技能来学习微积分。

你应该对代数、几何和三角学有一个合理的理解,以掌握微积分。此外,我强烈推荐阅读这篇由可汗学院撰写的优秀文章,该文章强调了在开始微积分课程之前所需的关键技能。

学习微积分的五门免费课程列表

1. 可汗学院的微积分 1

可汗学院的视频和讲解使得学习任何新的数学概念变得非常简单,即使是新手也能轻松理解,并且通常被高度推荐。微积分课程涵盖了极限、连续性、积分、导数等基本和高级主题,如链式法则、二阶导数等。

2. 由 Jon Krohn 讲授的《机器学习的微积分》

这是一个由 Jon Krohn 制作的56 个视频播放列表。它涵盖了微积分的基础,如偏导数、增量法、幂法则等。Jon 还创建了一个类似的线性代数课程,作为理解当代机器学习和数据科学技术的基础概念。

3. 机器学习数学:多变量微积分– 伦敦帝国学院

本课程是 Coursera 平台上“机器学习数学专修”系列的一部分。这是一个自定进度的课程,具有灵活的截止日期,非常适合在职专业人士。完成课程总共需要 18 小时,由伦敦帝国学院提供。

根据课程列表页面,它帮助学习者建立对以下概念的理解:

-

多变量微积分用于构建许多常见的机器学习技术

-

函数的梯度

-

构建对函数的近似

-

神经网络在训练神经网络中的作用

-

微积分在线性回归模型中的应用

你也可以在这里观看这个在线专修的播放列表。

4. 悉尼大学的微积分导论

这是一个中级课程,总共需要 59 小时,分五周完成。课程由副教授 David Easdown 授课,由悉尼大学提供。课程解释了基础概念,如预备微积分、切线、极限等。课程在 Coursera 上提供,完成后可获得可分享的证书。

5. MIT 的 18.01x 单变量微积分

这是 MIT 提供的一个高级课程,旨在掌握微积分的概念,并学习如何计算导数和积分。课程的关键收获在于,它不仅解释了几何解释,还通过实际应用帮助学习这些数学概念。

引用课程网页,学习者将理解

-

解释函数的导数和积分的各种方法,以及如何计算这些量

-

如何使用函数的线性和二次近似来简化计算并洞察系统行为

-

导数和积分的应用,例如优化生产成本或计算建筑梁上的应力

-

参数化曲线和极坐标的微积分

-

如何通过一系列简单函数来近似复杂函数

该项目是由三门课程组成——微分、积分和坐标系统,以及无穷级数。每门课程需要每周投入 6-10 小时,课程总时长约为 13-15 周。

额外推荐

一个额外的提示是来自 Jason Brownlee 的七天微积分迷你课程。他是一位 AI/ML 专家,擅长将理论和数学密集的机器学习概念以实际和代码导向的形式进行讲解。

他的迷你课程涵盖了机器学习中常用的微积分概念,并包括 python 练习。课程为期七天,期望学习者具备机器学习模型、python 和线性代数的基础知识。该课程涵盖的关键概念包括微分、积分、向量函数的梯度、反向传播、优化等。

在每节课结束时,课程建议你完成一个类似于上节课所教内容的作业,并在课程结束时分享结果。

总结

为了帮助你成为一名熟悉机器学习算法内部运作的数据科学家,本文分享了五个免费课程来掌握微积分概念。希望你能在数据科学之旅中找到这些课程列表有用。

Vidhi Chugh 是一位获奖的 AI/ML 创新领袖和 AI 伦理学家。她在数据科学、产品和研究的交汇处工作,以提供商业价值和洞察力。她是数据驱动科学的倡导者,也是数据治理领域的领先专家,致力于建立可信赖的 AI 解决方案。

更多相关主题

5 门免费课程掌握线性代数

原文:

www.kdnuggets.com/2022/10/5-free-courses-master-linear-algebra.html

介绍

我们的前三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您组织的 IT 工作

3. Google IT 支持专业证书 - 支持您组织的 IT 工作

数据科学是一个流行词,很多爱好者希望学习其基础知识,以在这一领域中获得丰厚的职业前景。线性代数是学习数据转换技术(如预处理、降维等)的重要概念之一。

来源: 图片由 rawpixel.com 提供于 Freepik

如何选择合适的课程?

有很多课程可以选择,但选择适合您需求的正确课程是很困难的。决定正确课程的多个因素包括:

-

您手头上有多少时间?例如,如果您已经了解了这些概念但需要复习,那么您可以选择一门课程来快速浏览关键主题。

-

您是否在寻找高级话题并希望深入了解该学科?

-

有些学习者喜欢播放列表风格的视频,而其他人则喜欢通过解决练习题来巩固对概念的理解

-

您是否愿意为课程付费,还是选择从免费的课程列表中学习?如果您像我一样相信教育应该对所有人开放,那么有一个好消息。最近,免费课程的数量有所增加,这有助于您迅速提升技能,并使您成为一名自学成才的数据科学家。

这篇文章的确切意图就是通过列出五门免费课程来帮助您轻松找到学习数据科学线性代数基础的资源。

为什么需要学习线性代数?

在我直接列出课程之前,让我先解释一些常见的问题——我们为什么需要学习线性代数?它与数据科学和机器学习概念有什么关系?

机器学习算法通常需要了解标量、向量和矩阵,以计算损失函数、特征值、协方差矩阵等。此外,线性代数在神经网络、正则化技术、推荐系统、奇异值分解(SVD)、主成分分析(PCA)等领域也被广泛使用。

免费掌握线性代数的五门课程:

现在我们了解了掌握线性代数概念的重要性,接下来让我们找出五门免费课程,以掌握这些概念:

1) 3Blue1Brown 的线性代数精髓

这是一个包含 16 个视频的播放列表,包括交叉乘积、点积、特征向量、特征值等概念。3Blue1Brown 是一个 YouTube 频道,专注于通过独特的可视化技术以易于理解的方式教授数学概念。尽管它不算作正式的课程,但由于其独特的数学发明和可视化主题,该频道已被推荐在我们的列表中。

2) Khan Academy 的线性代数

这是一门很好的课程,用于学习线性代数的基本知识,如向量积、线性变换、求行列式等。如果你希望快速复习基础知识,可以参考这个链接。

3) AI 应用课程中的线性代数

这是一个短课程,包含一个 10 个视频的播放列表,重点讲解为什么你需要学习线性代数以应用于机器学习。该课程是一个入门课程,可以在 90 分钟内很好地理解线性代数的概念。

Khan Academy 和 3Blue1Brown 的视频容易理解,能够帮助你作为初学者快速上手。一旦你从这些资源中学会了基本概念,你就可以开始学习下面推荐的更深入、更全面的课程内容。

4) 德克萨斯大学奥斯汀分校在 EDX 上的线性代数 - 从基础到前沿

该课程由罗伯特·范·德·盖恩教授讲授,包括短视频和可视化内容,之后是练习和编程作业。

该课程持续 15 周,需要每周 6-10 小时的学习时间。最棒的是它是自学课程,可以根据学习者的便利完成。

课程提供两种格式——验证(付费)和审计(免费)轨道。如果你希望获得完成证书并有权访问评分作业和考试,则需要选择验证,即付费轨道。你可以在这里查看每个轨道的更多详细信息。

5) 伦敦帝国学院在 Coursera 上的机器学习数学:线性代数

这个课程是“机器学习数学专业化”系列的一部分,并且评分很高(4.7/5)。这门课程的独特之处在于,它不仅解释了理论概念,还通过 Python 代码帮助学习者理解和实现这些想法。

对于没有足够 Python 背景的学习者,这门课程也适合入门,因为它通过短小的代码块和重点概念进行指导。课程持续四周,需要 19 小时完成。

摘要

这篇文章列出了五个流行的课程来掌握线性代数。最棒的是,所有列出的课程都是免费的,并且按从初级到更高级的概念进行排名。虽然机器学习社区不断质疑是否有必要学习线性代数以入门机器学习,我还是强烈推荐采用更灵活的方法,持续迭代并参考这些课程,以规划你的机器学习算法之旅。

Vidhi Chugh 是一位获奖的 AI/ML 创新领导者和 AI 伦理学家。她在数据科学、产品和研究的交汇处工作,旨在提供业务价值和洞察力。她倡导以数据为中心的科学,并在数据治理方面是领先专家,致力于构建值得信赖的 AI 解决方案。

更多相关主题

5 免费的 AI 和 ChatGPT 课程,从 0 到 100

原文:

www.kdnuggets.com/5-free-courses-on-ai-and-chatgpt-to-take-you-from-0-100

图片来源:DALLE 3

生活在这个时代真是太棒了。而现在学习 AI 元素,比如生成式 AI,特别是 ChatGPT,再好不过了!很多人对这个领域感兴趣,但有些人需要更多的知识来达到目标。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的轨道。

1. Google 网络安全证书 - 快速进入网络安全职业的轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在的组织的 IT 工作

本博客提供了来自哈佛、IBM、DeepLearning.AI 等可信机构的免费课程列表。

让我们开始吧。

Python 人工智能简介(哈佛)

这是一个为期 7 周的自学课程,学习如何在 Python 中使用机器学习来进行人工智能研究。在这门课程中,你将学习现代人工智能的不同概念和算法。你将深入探讨实际应用案例,如手写识别和机器翻译。

你不仅会学习到相关知识,还有机会参与实际项目,这将使你能够将理论知识应用于机器学习和人工智能的不同方面,并将其融入到自己的 Python 程序中。

到课程结束时,你将对机器学习中使用的库和人工智能的原理有深刻的了解,以便你可以构建自己的智能系统。

人工智能基础知识(IBM)

AI 无处不在,每个人都在谈论它。如果你对它了解不多——这门课程就是为你准备的。在这门课程中,你将掌握人工智能的基础知识,并理解其应用及机器学习、深度学习和神经网络等关键概念。

你还将深入探讨与 AI 相关的伦理问题,这是目前非常热门的话题。通过这门课程,你还将获得有关如何开始 AI 新职业的专家建议。

数据与 AI 基础(Linux)

链接: Linux Foundation - 数据与 AI 基础

Linux 是一种操作系统,通过他们提供的课程,你将学习人工智能的基础知识,以及 Linux Foundation AI & Data 项目生态系统的概述。这是一个为期 10 周的课程,采用自我节奏学习,适合任何对人工智能感兴趣的人,无论其职业背景和技术知识水平如何。

该课程将为你提供进入 Linux Foundation AI & Data 生态系统的机会,这与开源工具相关,帮助你继续发展新的数据和人工智能技能。如前所述,这个课程对来自金融、制造等各种行业的任何人都有帮助。

通过这个课程,你将能够了解人工智能技术领域中可用的不同职业选择。

微调大型语言模型(DeepLearning.AI)

链接: 深度学习 - 微调大型语言模型

你们中的一些人可能已经对人工智能和大型语言模型(LLMs)有了较好的了解,并可能希望完善技能或学习新知识。这个与 DeepLearning.AI 合作的课程将通过一个快速的 1 小时课程讲解微调 LLM 的基础知识。

你将了解微调与提示工程的不同之处,以及何时使用这两者,同时获得使用真实数据集的实践经验,并学习如何将这些工具和技术应用到自己的项目中。

如果你对 Python 语言已经比较熟悉,并且对深度学习框架如 PyTorch 和微调的应用有较好的理解,那么这个课程适合你。

人工智能项目

链接: 人工智能项目

在科技领域,有很多很棒的资源供你学习和发展新技能。然而,重要的是要记住,你必须在实际场景中应用这些技能——以项目的形式。

这个课程旨在帮助学习者将人工智能的解决方案和模型应用于实际问题。你将学习人工神经网络(ANNs)、时间序列预测、聊天机器人等内容。

总结

这个博客针对的是人工智能领域的新手,但不限于初学者。如果你想提升现有技能或适应现有技能,这些免费课程可以帮助你快速入门,而无需花费一分钱!

Nisha Arya是一位数据科学家、自由技术写作人,以及 KDnuggets 的编辑和社区经理。她特别感兴趣于提供数据科学职业建议或教程,并围绕数据科学的理论知识展开讨论。Nisha 涉及广泛的主题,并希望探索人工智能如何有益于人类生命的长寿。作为一个热衷学习者,Nisha 寻求拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关内容

2024 年微软提供的 5 门免费 AI 课程

原文:

www.kdnuggets.com/5-free-courses-on-ai-with-microsoft-for-2024

图片来源:编辑

新的一年开始了。你想实现你的目标。想要探索新领域?想要职业转型?这可能会让人感到畏惧。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理。

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理。

你不知道从哪里开始,也不确定哪个课程最适合你实现职业目标。你不确定该走哪条路。这一切可能让人感到过于压倒。

本博客旨在提供帮助。

如果你考虑职业转型,特别是与 AI 相关的方向,你来对地方了。微软提供了一些非常棒的免费资源,帮助你达到目标。

在支付课程费用或回到大学之前,尽可能多地吸收免费的内容将是你最好的起步方式。免费资源可以帮助你判断这是否是你真正想做的事情。

AI 初学者

链接:AI 初学者

微软提供了一个为期 12 周、24 节课的课程,帮助你了解人工智能的世界。

在 12 周内,你将学习到 AI 的简介与历史、符号 AI、神经网络简介、计算机视觉、自然语言处理以及其他 AI 技术。

使用 Azure OpenAI 服务

你可能在 2023 年听到了很多关于 OpenAI 的消息。现在是时候深入了解了!

随着大型语言模型(LLMs)越来越受欢迎,一些人可能对学习它们更感兴趣。提示工程和生成式 AI 正是科技界关注的焦点,你也可以通过这个课程深入了解。

从学习提示工程开始,然后深入了解负责任的生成式 AI 基础知识。通过使用 GitHub Copilot 和 Azure OpenAI 将所学知识付诸实践。

如果你想继续学习 Azure OpenAI,你可以提升你的生成式 AI 技能!

自定义机器学习模型

链接:自定义机器学习模型

现在你对 AI 和 Azure AI 服务有了一个很好的概述,接下来你可能会想要深入了解更底层的内容——机器学习模型。这时你将理解 AI 背后的真正美丽。

另一个学习路径将帮助你发现构建和运行你自己数据模型的工具。提升你的机器学习模型本身就是一种技能。

你将学习如何创建计算机视觉解决方案、处理和翻译文本、从表单中提取数据、自动化机器学习模型选择,并部署和使用模型。

使用 Azure AI 构建应用

想要进一步了解 Azure 吗?让我们通过包含文章、YouTube 视频和实际模块内容的学习资料来深入探讨。

这个课程将帮助你了解使用 Azure AI 服务构建 AI 驱动应用的工具。如果生成性 AI 是你的兴趣所在,你可以使用 Azure OpenAI 服务开发解决方案,还可以在 Microsoft Copilot Studio 中探索聊天机器人和其他 AI 模型。

在日常工作中使用 AI

链接:在日常工作中使用 AI

这样你将有机会了解 AI 及其基本原理,然后通过构建自定义机器学习模型和应用程序将其付诸实践。你可能会想,‘AI 如何融入我的日常生活?’。

这个课程正是讲解这些内容。虽然这些内容推荐给开发者,但这可能是你想要的路径。

通过 GitHub Copilot 简化你的工作,首先学习 AI 与 GitHub Copilot 的配合方式。

总结

就这样,你离实现 2024 年的目标又近了一步,享受一些很棒的免费资源。请在评论区告诉我们你对内容的喜爱之处!

Nisha Arya是一名数据科学家、自由技术写作员,以及 KDnuggets 的编辑和社区经理。她特别关注提供数据科学职业建议或教程及理论知识。Nisha 涉及广泛的话题,希望探索人工智能如何有利于人类寿命的不同方式。作为一名热衷学习者,Nisha 致力于拓展她的技术知识和写作技能,同时帮助他人。

更多相关话题

5 个免费课程助你进入数据分析领域

原文:

www.kdnuggets.com/5-free-courses-to-break-into-data-analytics

图像由 DALLE-3 生成

如果你想转行进入数据领域,学习数据分析非常有帮助。这就是为什么我们整理了这份免费数据分析课程的列表,帮助你启动你的学习之旅!

我们的 3 个顶级课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

即使你是一个对数据领域充满热情的绝对初学者,你也会发现这些课程非常有用。因为它们针对的是有志于成为数据专业人士的人,并且不需要先前的编程经验。

让我们开始吧。

1. Google 数据分析专业证书

Google 数据分析专业证书 是 Coursera 上最受欢迎的专业化之一,全球近 200 万学习者参与其中。这个认证项目旨在让你迅速掌握数据分析的基础知识,以帮助你在不到 6 个月的时间内获得入门级的数据分析职位。它也不需要任何先前的经验。

该专业化包括 8 门课程,帮助你学习使用 SQL、电子表格、Tableau 和 R 编程进行数据分析的基础知识。Google 数据分析证书项目包括以下课程:

-

基础知识:数据,数据,无处不在

-

提出问题以做出数据驱动的决策

-

为探索准备数据

-

将数据从脏数据处理为干净数据

-

分析数据以回答问题

-

通过可视化艺术分享数据

-

使用 R 编程进行数据分析

-

Google 数据分析总结项目:完成一个案例研究

注意:如果你有兴趣获得 Google 数据分析专业化证书,你需要拥有 Coursera Plus 订阅。如果你无法支付证书费用,你可以考虑申请经济援助。不过,你可以免费审计课程并访问课程材料。

2. 针对 Excel 用户的 Python 数据分析

谷歌数据分析专业证书应该让你对数据分析领域有了良好的掌握,并掌握了一些基本工具,如电子表格、SQL、R 和 Tableau。

既然你已经熟练使用电子表格,你可以学习用于数据分析的 Python。Python 不仅比 R 更容易学习,而且应用范围更广。

Excel 用户的数据分析与 Python 课程由 freeCodeCamp 提供,是一门免费课程,用于学习 Python 数据分析的基础。它从教你如何设置 Python 开发环境和使用 Jupyter notebooks 开始。

本课程包括以下三个模块:

-

模块 1: Hello world(涵盖 Python 基础)

-

模块 2: Pandas 简介

-

模块 3: Pandas 中的透视表简介

这门课程应该帮助你打下用 Python 分析数据的基础,然后可以根据需要进行扩展。

3. freeCodeCamp 的 Python 数据分析

链接: Python 数据分析认证

既然你已经掌握了 Python 数据分析的基础,现在是时候进一步学习了。Python 数据分析,这是 freeCodeCamp 提供的免费认证课程,将教你 Python 数据分析库的所有内容,同时还会进行简单项目的实践。

你将学习使用 Python 库 NumPy、pandas、matplotlib 和 Seaborn:

-

Jupyter notebooks 基础

-

NumPy

-

Pandas

-

数据清洗

-

数据可视化

-

从各种来源读取数据

-

解析 HTML

你将在这个认证中构建的项目包括:

-

均值-方差-标准差计算器

-

人口数据分析器

-

医疗数据可视化工具

-

页面浏览时间序列可视化工具

-

海平面预测器

这个认证完全免费。在完成课程后,你需要完成所有项目才能领取证书。

4. 谷歌高级数据分析专业证书

链接: 谷歌高级数据分析专业证书

谷歌高级数据分析专业证书将帮助你深入了解 Python 数据分析,同时学习统计学概念和构建机器学习模型。本专业还提供了一个结业项目的机会,以应用你所学的知识。

本专业的课程如下:

-

数据科学基础

-

开始使用 Python

-

超越数字: 将数据转化为洞察

-

统计学的力量

-

回归分析: 简化复杂的数据关系

-

机器学习的基础知识

-

谷歌高级数据分析结业项目

注意:与 Google 数据分析专业证书一样,你可以免费旁听 Google 高级数据分析专项。

5. IBM 数据分析师专业证书

IBM 数据分析师专业证书是 IBM 在 Coursera 上提供的另一个全面的数据分析专项,它将帮助你学习所有基础知识和必备工具,以启动你的数据分析职业生涯。

该认证也适合初学者,因此你无需具备编程和数据分析的先前经验。通过一系列课程和顶点项目,该专项将帮助你在以下方面提高熟练度:

-

Python 和 SQL 基础

-

Excel 和 Tableau

-

使用 API 和网络服务

-

Python 数据科学库

推荐的时间框架大约为 4 个月,每周学习约 10 小时。以下是该数据分析师专业证书的课程:

-

数据分析导论

-

数据分析基础知识

-

使用 Excel 和 Cognos 进行数据可视化和仪表盘

-

Python 在数据科学、AI 和开发中的应用

-

数据科学的 Python 项目

-

数据库和 SQL 在 Python 中的数据科学

-

使用 Python 进行数据可视化

-

IBM 数据分析师顶点项目

注意:与其他 Coursera 专项课程一样,你可以免费旁听此课程。

总结

希望你觉得这份数据分析课程列表对你有帮助。如果你打算很快转向数据分析领域,祝你学习顺利。

如果你在寻找数据岗位市场的技巧,请阅读 你在找数据科学工作时遇到的 7 个困难原因。

Bala Priya C**** 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和喝咖啡!目前,她正在通过撰写教程、使用指南、观点文章等与开发者社区分享她的知识。Bala 还创建了有趣的资源概述和编码教程。

更多相关内容

掌握数据工程的 5 门免费课程

原文:

www.kdnuggets.com/5-free-courses-to-master-data-engineering

数据领域正处于激动人心的时刻,数据工程师在其中发挥着重要作用。通过准备和管理数据基础设施,数据工程师提供了数据收集、存储、处理和分析所需的工具。这就是为什么数据工程师在数据驱动的公司中扮演着重要角色。

我们的 Top 3 课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升您的数据分析水平

2. Google 数据分析专业证书 - 提升您的数据分析水平

3. Google IT 支持专业证书 - 支持您的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持您的组织进行 IT 工作

在这样一个重要的角色下,公司愿意支付相当高的薪资来聘请数据工程师解决数据基础设施问题。那么,我们如何才能掌握数据工程的艺术呢?这里有五门免费的课程可以帮助您提升职业生涯。

IBM:面向所有人的数据工程基础

让我们从 IBM 在 edX 上的精彩数据工程课程 开始。这门课程旨在向初学者介绍数据工程基础,为更高级的应用场景做好准备。

我喜欢这门课程,因为它为我提供了数据工程的基础,即使我是一名数据科学家。我相信这门课程将为初学者提供掌握数据工程师所需的技能。

通过这门课程,您将学习到的核心概念包括:

-

数据工程师概念

-

工作流管理

-

关系型数据库

-

数据湖

-

数据存储

-

IBM 云计算

这些课程也可以自定进度学习,因此您可以在分配的时间内学习而不会感到受限。

Google 数据工程师学习路径

在了解了 IBM 之后,您还应该查看 Google 提供的内容。在他们的 Cloud Skill Boost 中,有一个 数据工程师学习路径,可以通过 Google 云平台提升您的数据工程师技能。

在学习路径中,您将通过 13 门为初学者和专业人士设计的课程学习各种数据工程技能。在这些课程中,您将了解以下技能:

-

Google 云计算

-

数据管道

-

数据仓库

-

数据湖

-

数据存储

-

无服务器数据处理

和之前的课程一样,这门课程也是自学进度的,你可以按照自己的节奏完成。随着未来云计算的发展,这门课程将为你在未来的雇主面前提供优势。

Meta 数据库工程师专业证书

让我们继续介绍由另一家知名公司 Meta 提供的免费数据工程课程。Meta 数据库工程师专业证书课程将重点提升数据工程师的技能,即数据库。

数据工程师负责整个数据流;这一流的一个重要部分是拥有一个强大的数据库。如果没有可靠的数据库,整个数据生态系统将会崩溃。这就是为什么 Meta 为任何愿意在数据库领域开辟自己道路的人提供这门课程。

在这门课程中,你将学习以下技能:

-

数据库基础

-

数据库结构

-

数据库客户端

-

版本控制

-

高级 MySQL

通过 9 门课程和灵活的时间安排,你可以轻松提升自己的技能。

UC San Diego 大数据专业化

专业课程对你的数据工程师职业至关重要,因为它可以让你脱颖而出。免费的课程UC San Diego 大数据专业化将为你在大数据领域奠定基础。

在数据工程领域,大数据是一个复杂的问题,需要特定的方法。数据工程师需要能够设计数据流,使公司能够处理和利用大数据,而这正是这门课程的核心内容。在这门课程中,你将学习:

-

大数据基础

-

大数据管理

-

大数据集成与处理

-

图形分析与大数据

该系列有 6 门课程,时间安排灵活。估计如果每周学习 10 小时,你可以在 3 个月内完成课程。

数据工程 Zoomcamp

数据工程 Zoomcamp是由Ankush Khanna、Victoria Perez Mola和Alexey Grigorev为初学者开设的免费课程,由社区提供支持。

这些课程将从领域专家那里为你提供完整的数据工程视角,并为你准备好工作。通过 9 周的学习,你将掌握以下技能:

-

数据工程师基础

-

数据工作流和编排

-

数据仓库

-

数据管道

-

分析工程

这门课程有两种学习方式:自学进度和学习小组课程。学习小组注册有其开放时间表,因此请持续关注他们的页面。

结论

为了做出数据驱动的决策,公司需要支持这一过程的数据基础设施。数据工程师承担着提供复杂数据工作流的任务。要掌握数据工程技能,我们可以通过本文讨论的五门课程进行学习。借助著名讲师提供的结构化课程,这些课程将帮助你了解一切,获得数据工程师职位。

Cornellius Yudha Wijaya**** 是一位数据科学助理经理和数据撰稿人。他在全职工作于印尼安联的同时,热衷于通过社交媒体和写作平台分享 Python 和数据技巧。Cornellius 在各种 AI 和机器学习主题上撰写文章。

更多相关主题

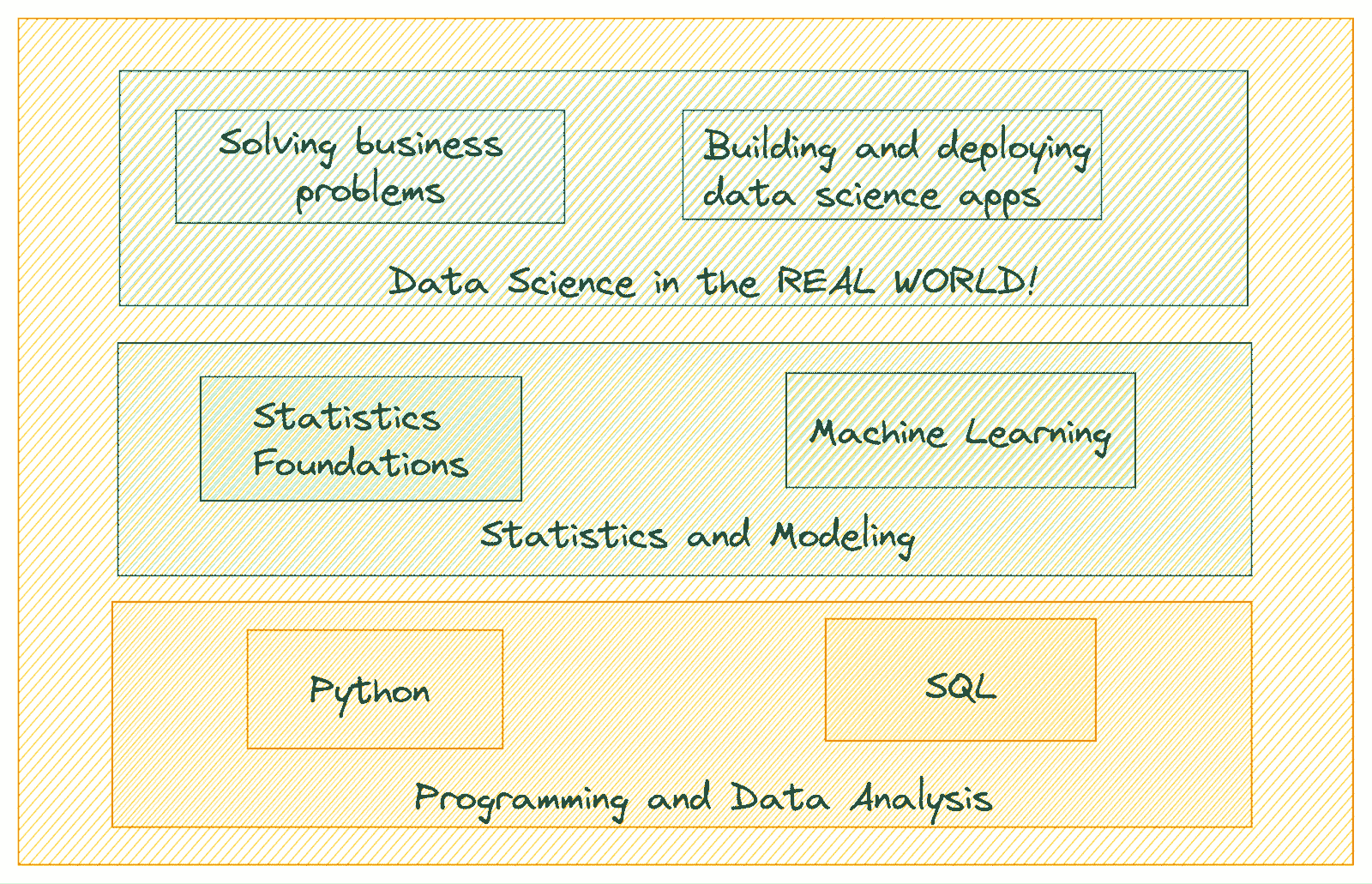

5 门免费课程掌握数据科学

作者图片

你是一个有志于成为数据专业人士并想要启动数据科学职业吗?如果是的话,你可能在考虑各种选择:在线课程、训练营、硕士学位等。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路

1. Google 网络安全证书 - 快速进入网络安全职业道路

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织中的 IT

3. Google IT 支持专业证书 - 支持你的组织中的 IT

但如果你有足够的动力,有几个高质量的免费资源可以帮助你达到目标。在这里,我们编制了五门免费课程的列表,可以帮助你学习并掌握数据科学。

从编程基础到构建和部署数据科学应用,这些课程将教会你成功转型所需的一切。

让我们直接深入!

1. Python for Everybody

Python for Everybody,由密歇根大学的查尔斯·塞弗伦斯教授讲授,是学习 Python 的绝佳课程。它从零开始教授 Python 编程——涵盖了处理数据时所需了解的一切。

你还可以结合使用 Python for Everybody 书籍 与课程。课程涵盖以下广泛主题:

-

使用 Python 编程基础

-

Python 数据结构

-

条件执行、循环和迭代

-

函数

-

正则表达式

-

网络服务和联网程序

-

数据可视化

课程链接: Python for Everybody

2. 使用 Python 进行数据分析

现在你已经掌握了 Python 基础,是时候使用 Python 分析数据了。Jovian 提供的 Python 数据分析(在 freeCodeCamp 的 YouTube 频道上)是一个免费课程,它将帮助你学习使用数据科学库,包含多个练习和课程项目。

这门课程从 Python 编程基础开始(这对你来说应该是一个复习),逐渐介绍 Python 数据分析库。最后以一个关于探索性数据分析的课程项目结束。

以下是课程大纲概述:

-

Python 基础

-

使用 NumPy 进行数值计算

-

使用 pandas 分析表格数据

-

使用 Matplotlib 和 Seaborn 进行可视化

-

课程项目:探索性数据分析

课程链接:Python 数据分析

3. 数据库和 SQL

数据科学中的数据库介绍概述了数据专业人员必备的数据库技能。

从设计数据库到编写高效的 SQL 查询及更多,数据库和 SQL 是你数据职业生涯中必备的技能。这个数据库和 SQL课程来自 freeCodeCamp,将教你以下内容:

-

数据库基础

-

SQL 基础

-

CRUD 操作

-

函数、连接和并集

-

嵌套查询

-

设计数据库模式

课程链接:数据库和 SQL

4. 推断统计学简介

除了高中数学——微积分、概率和线性代数,你还需要在统计学方面有坚实的基础,才能在数据科学领域取得卓越成绩。

推断统计学简介来自 Udacity 的免费课程库,将教你以下概念——同时包含编码练习以测试你的技能:

-

估计

-

假设检验

-

t 检验

-

方差分析

-

卡方检验

-

相关性

-

回归分析

课程链接:推断统计学简介

5. 机器学习 Zoomcamp

目前列出的课程应当帮助你掌握 Python 基础、数据分析和统计学基础。

现在是时候开始构建和部署机器学习模型了。机器学习 Zoomcamp由 DataTalks.Club 提供,是学习机器学习基础的绝佳课程,通过以代码为主的方式进行。它还涵盖了包括模型部署和深度学习在内的广泛主题。

课程大纲包括以下内容:

-

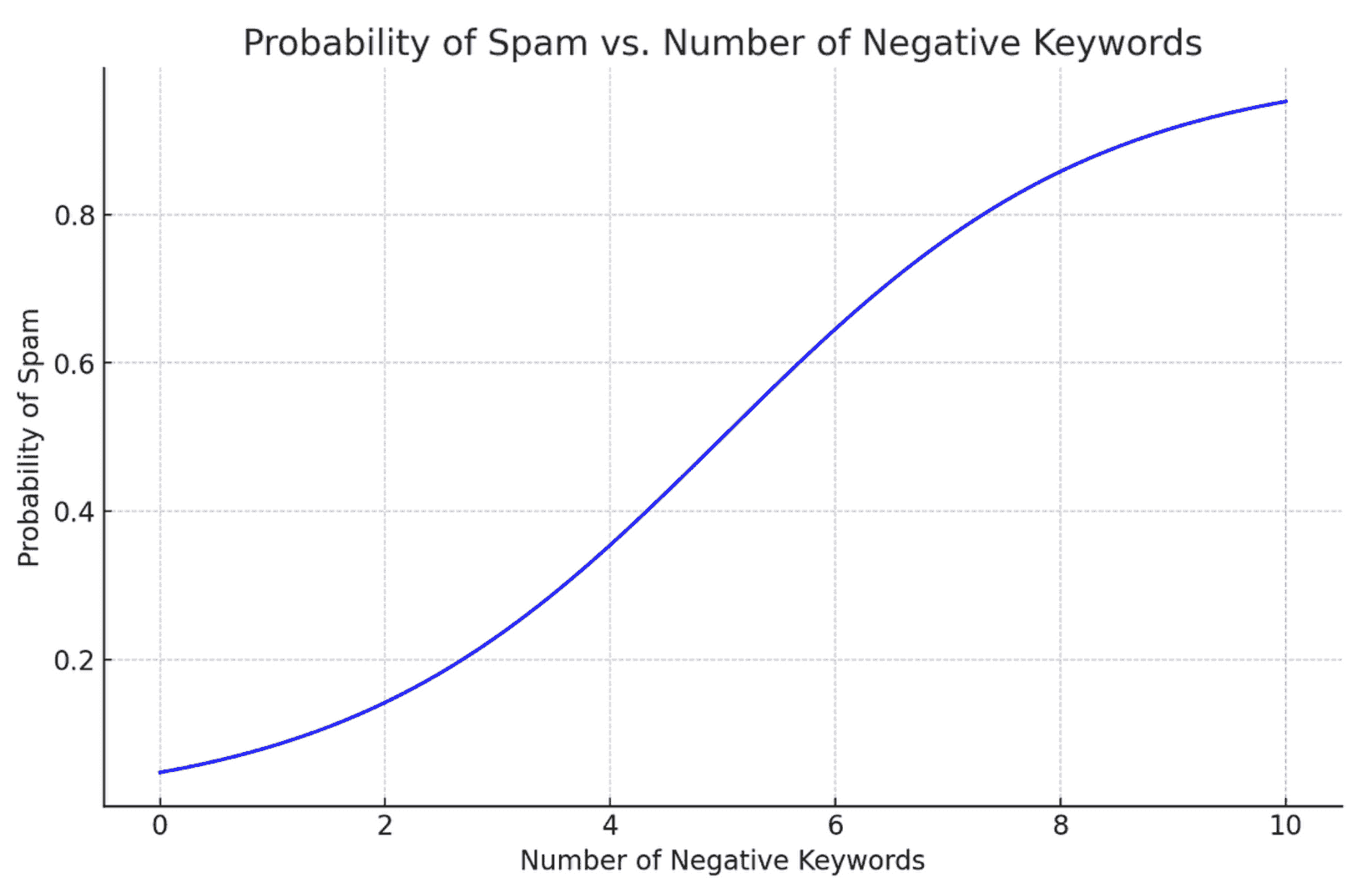

回归分析

-

分类

-

评估机器学习模型

-

部署机器学习模型

-

决策树和集成学习

-

神经网络和深度学习

-

Kubernetes 和 TensorFlow Serving

课程链接:机器学习 Zoomcamp

总结

我希望你发现这些推荐课程有帮助。大多数课程要求你进行编码、构建、拆解和学习。因此,你将拥有一个良好的基础。

即使你在学习这些课程时,也要在旁边构建你的作品集。你的目标应该是构建一些有趣的项目,以展示你的优势和技能。如果你需要一些灵感来开始,可以查看 3 个数据科学项目保证让你获得工作。祝学习愉快!

Bala Priya C** 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她致力于通过撰写教程、操作指南、观点文章等,学习并与开发者社区分享她的知识。Bala 还创建了引人入胜的资源概述和编程教程。**

更多相关内容

5 门免费课程,掌握生成式人工智能

你是否希望深入探索生成式人工智能的激动人心的世界?

我们的前三推荐课程

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

正如你所知道的,生成式人工智能目前正处于最前沿,并自 ChatGPT 推出以来已经掀起了整个世界的风暴。技能需求量很高,但由于这一领域尚处于起步阶段且不断变化,紧跟最新进展对这一新兴领域尤为重要。

无论你是人工智能广泛领域的初学者还是希望提升现有技能,都有许多免费的课程可以帮助你掌握这项前沿技术。以下是五门可以启动或提升你在生成式人工智能领域旅程的课程。

1. 生成式人工智能初学者课程

这门来自微软的综合性 12 课时课程教授构建生成式人工智能应用的基础知识。每节课包括一个视频介绍、书面材料、包含代码示例的 Jupyter Notebook、挑战任务和额外资源。你将学习诸如理解生成式人工智能和大型语言模型、提示工程、构建各种应用以及为 AI 应用设计用户体验等主题。

课程链接:生成式人工智能初学者课程

2. 生成式人工智能基础

这门 Databricks 课程通过四个视频提供生成式人工智能的基础知识,包括大型语言模型(LLMs)。它涵盖了生成式人工智能的各个方面,如应用、成功策略以及潜在的风险和挑战。在完成课程并通过知识测试后,你可以获得一个徽章,以便在 LinkedIn 个人资料或简历中分享。

课程链接:生成式人工智能基础

3. 生成式人工智能学习路径简介

由 Google Cloud Skills Boost 提供的这门入门级微学习课程概述了生成式 AI 概念,探讨了大型语言模型、负责任的 AI 原则以及 Google 工具,用于开发自己的生成式 AI 应用。课程包括生成式 AI 简介、大型语言模型简介、负责任的 AI 简介、生成式 AI 基础和负责任的 AI:使用 Google Cloud 应用 AI 原则。完成课程后可获得徽章。

课程链接:生成式 AI 学习路径简介

4. 与大型语言模型一起学习生成式 AI

这门 AWS 课程提供了对生成式 AI 的全面理解,重点讲解了基于 LLM 的 AI 生命周期、变换器架构、模型优化以及实际部署方法。该课程旨在为具有基础 LLM 知识的开发者提供关于有效训练和部署这些模型的最佳实践。先前的 Python 经验和基本的机器学习概念是先决条件,使得这是一门中级课程。

课程链接:与大型语言模型一起学习生成式 AI

5. 适用于每个人的生成式 AI

由 Deeplearning.AI 提供,并由 AI 专家 Andrew Ng 教授的《适用于每个人的生成式 AI》课程,专注于理解和应用生成式 AI 于各种背景中。课程涵盖了生成式 AI 的基本原理、功能和局限性,并包括在提示工程和高级 AI 应用中的实际练习。参与者将探索现实世界的应用,参与生成式 AI 项目,了解其对商业和社会的影响。旨在为学习者提供有关 AI 项目生命周期、潜在机会以及生成式 AI 技术相关风险的知识。

课程链接:适用于每个人的生成式 AI

总结

这些课程为任何对学习和掌握生成式 AI 感兴趣的人提供了一系列很好的起点。它们提供了实践见解、基础知识和开发及部署 AI 应用的实践经验。随着你的进步,记得通过项目实践和构建展示你技能与创意的作品集来应用你新获得的知识,这一领域正迅速发展。

祝学习顺利!

Matthew Mayo (@mattmayo13) 拥有计算机科学硕士学位和数据挖掘研究生文凭。作为 KDnuggets 和 Statology 的总编辑,以及 Machine Learning Mastery 的特约编辑,Matthew 旨在使复杂的数据科学概念变得易于理解。他的职业兴趣包括自然语言处理、语言模型、机器学习算法以及探索新兴 AI。他致力于在数据科学社区中普及知识。Matthew 从 6 岁起便开始编程。

更多相关话题

5 个免费课程,掌握机器学习

原文:

www.kdnuggets.com/5-free-courses-to-master-machine-learning

图片由 DALLE-3 生成

机器学习在数据领域变得越来越受欢迎。但通常有一种观念认为,要成为机器学习工程师,你需要拥有高级学位。然而,这并不完全正确。因为技能和经验始终优于学位。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

如果你正在阅读这篇文章,你可能是数据领域的新手,并希望作为机器学习工程师起步。也许你已经作为数据分析师或 BI 分析师在数据领域工作,并希望转向机器学习角色。

无论你的职业目标是什么,我们已精心策划了一份完全免费的机器学习课程列表,以帮助你在机器学习方面获得熟练度。我们包括了帮助你理解理论和构建机器学习模型的课程。

开始吧!

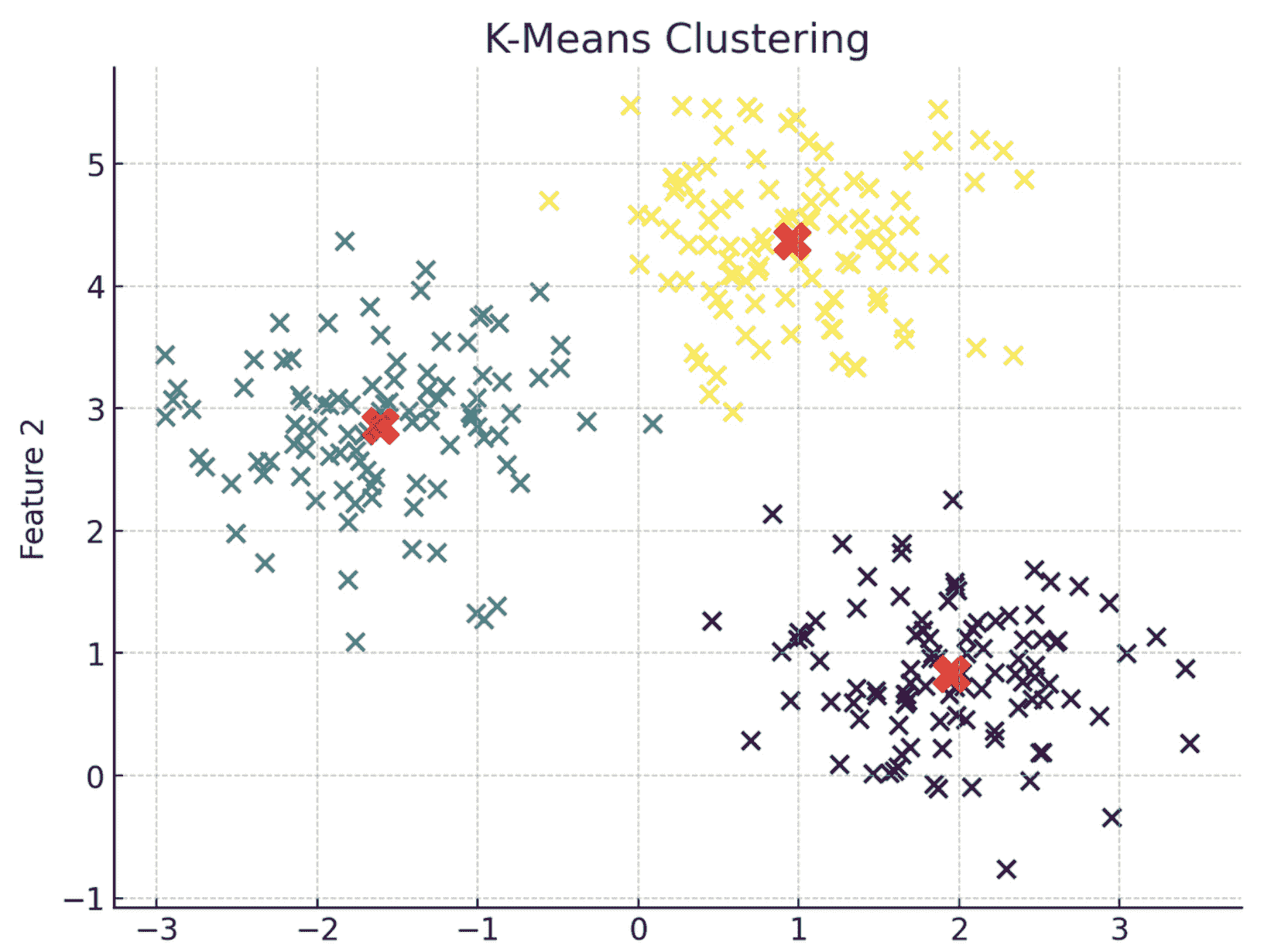

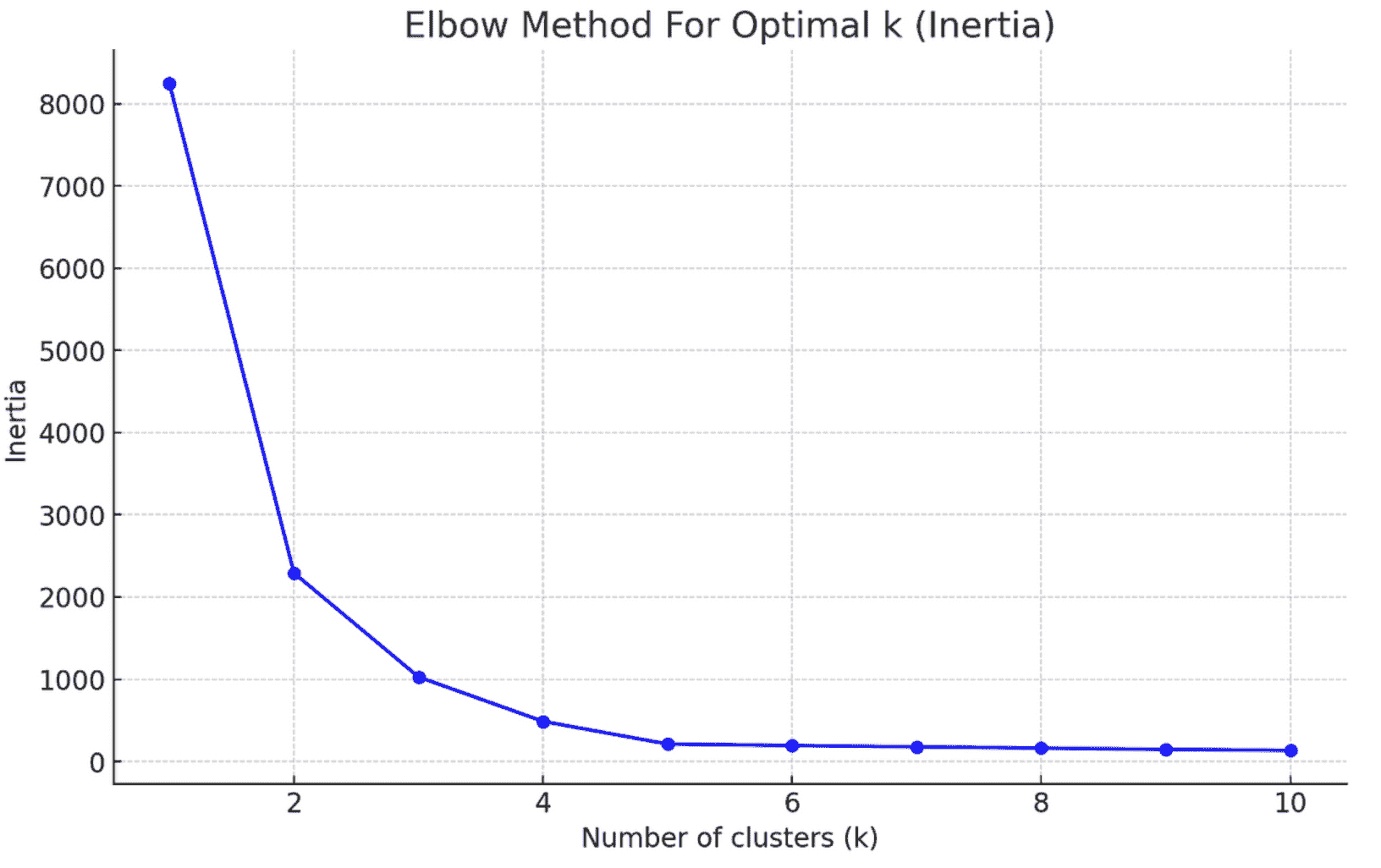

1. 适合所有人的机器学习

如果你在寻找一个易于访问的机器学习课程,适合所有人的机器学习是适合你的。

由 Kylie Ying 教授,本课程采取代码优先的方法,在 Google Colab 中构建简单有趣的机器学习模型。启动自己的笔记本并在学习足够理论的同时构建模型是一种很好的熟悉机器学习的方法。

该课程使机器学习概念变得易于理解,并涵盖以下主题:

-

机器学习简介

-

K-最近邻

-

朴素贝叶斯

-

逻辑回归

-

线性回归

-

K 均值聚类

-

主成分分析(PCA)

课程链接:适合所有人的机器学习

2. Kaggle 机器学习课程

Kaggle 是参与现实世界数据挑战、建立数据科学作品集以及磨练模型构建技能的绝佳平台。此外,Kaggle 团队还有一系列微型课程来让你快速掌握机器学习的基础知识。

你可以查看以下(微型)课程。每个课程通常需要几个小时来完成并完成练习:

-

机器学习简介

-

中级机器学习

-

特征工程

机器学习简介 课程涵盖以下主题:

-

机器学习模型如何工作

-

数据探索

-

模型验证

-

欠拟合和过拟合

-

随机森林

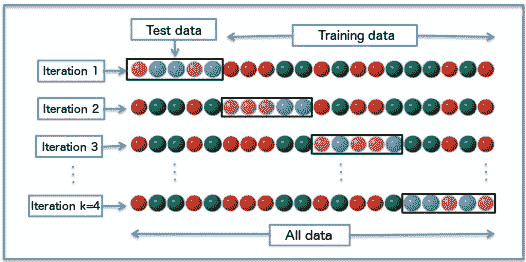

在中级机器学习课程中,你将学习:

-

处理缺失值

-

处理分类变量

-

机器学习管道

-

交叉验证

-

XGBoost

-

数据泄漏

特征工程 课程涵盖:

-

互信息

-

创建特征

-

K 均值聚类

-

主成分分析

-

目标编码

建议按上述顺序学习课程,以便在从一个课程转到下一个课程时,你已具备必要的前提知识。

课程链接:

3. 使用 Scikit-Learn 的 Python 机器学习

使用 Scikit-Learn 的 Python 机器学习 在 FUN MOOC 平台上是由 scikit-learn 核心团队开发的免费自学课程。

它涵盖了广泛的主题,帮助你学习使用 scikit-learn 构建机器学习模型。每个模块包含视频教程和配套的 Jupyter 笔记本。你需要对 Python 编程和 Python 数据科学库有一定的熟悉度,以充分利用课程。

课程内容包括:

-

预测建模管道

-

评估模型性能

-

超参数调优

-

选择最佳模型

-

线性模型

-

决策树模型

-

模型集成

课程链接:使用 Scikit-Learn 的 Python 机器学习

4. 机器学习速成课程

机器学习速成课程来自 Google,是另一个学习机器学习的好资源。从模型构建的基础到特征工程等,本课程将教你如何使用 TensorFlow 框架构建机器学习模型。

该课程分为三个主要部分,大部分课程内容在机器学习概念部分:

-

机器学习概念

-

机器学习工程

-

现实世界中的机器学习系统

上这门课程,你需要对高中数学、Python 编程和命令行有一定的了解。

机器学习概念部分包括:

-

机器学习基础

-

TensorFlow 介绍

-

特征工程

-

逻辑回归

-

正则化

-

神经网络

机器学习工程部分涵盖:

-

静态 vs 动态训练

-

静态 vs 动态推断

-

数据依赖

-

公平性

而《现实世界中的机器学习系统》是一组案例研究,用于理解现实世界中如何进行机器学习。

课程链接: 机器学习速成课程

5. CS229: 机器学习

到目前为止,我们已经看到了一些课程,它们在专注于构建模型的同时,给你提供了理论概念的初步了解。

虽然这是一开始的好选择,但你将需要更详细地了解机器学习算法的工作原理。这对破解技术面试、职业发展和进入机器学习研究非常重要。

CS229: 机器学习 由斯坦福大学提供,是最受欢迎且强烈推荐的机器学习课程之一。本课程将提供与一个学期的大学课程相同的技术深度。

你可以在线访问讲座和讲座笔记。本课程涵盖以下广泛主题:

-

监督学习

-

无监督学习

-

深度学习

-

泛化和正则化

-

强化学习和控制

课程链接: CS229: 机器学习

总结

希望你找到有用的资源来帮助你在机器学习之旅中!这些课程将帮助你获得理论概念和实际模型构建的良好平衡。

如果你已经熟悉机器学习且时间有限,我建议查看《使用 scikit-learn 的 Python 机器学习》以深入了解 scikit-learn,并参考 CS229 以获取基本的理论基础。祝学习愉快!

Bala Priya C**** 是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交叉点上工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和咖啡!目前,她正在通过撰写教程、操作指南、意见文章等,与开发者社区分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。

更多相关话题

5 门免费课程掌握数据科学数学

原文:

www.kdnuggets.com/5-free-courses-to-master-math-for-data-science

图片由storyset on Freepik提供

在学习数据科学时,建立良好的数学基础将使你的学习之旅更轻松且更有效。即使你已经获得了你的第一个数据职位,学习数据科学的数学基础也只会进一步提升你的技能。

我们的三大推荐课程

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

从探索性数据分析到构建机器学习模型,拥有良好的数学基础,如线性代数和统计学,将使你更好地理解为什么你做什么。所以即使你是初学者,这个课程列表也将帮助你学习:

-

基础数学技能

-

微积分

-

线性代数

-

概率和统计

-

优化

听起来有趣,是吗?让我们开始吧!

1. 数据科学数学技能 – 杜克大学

数据科学课程要求你在数学方面有一定的基础。具体来说,大多数课程假设你对高中代数和微积分感到舒适。如果还没有,也不用担心。

数据科学数学技能课程,由杜克大学在 Coursera 上提供,将帮助你在尽可能短的时间内掌握数学基础。课程内容包括:

-

问题解决

-

函数和图形

-

微积分简介

-

概率简介

建议你在开始其他深入探讨特定数学主题的课程之前,先学习这门课程。

链接: 数据科学数学技能 – 杜克大学在 Coursera 上的课程

2. 微积分 – 3Blue1Brown

当我们谈论数据科学中的数学时,微积分绝对是你应该熟悉的内容。但大多数学习者发现高中微积分令人畏惧(我也经历过!)。然而,这部分是因为我们学习的方式——主要关注概念、少量说明性示例和大量练习题。

但如果有有用的可视化帮助你从直觉到方程,专注于为什么,你会更好地理解和学习微积分。

微积分课程由 3Blue1Brown 的 Grant Sanderson 讲授,正是我们所有人需要的!通过一系列带有超级有用的可视化的课程——尽可能从几何到公式——这门课程将帮助你学习以下内容以及更多:

-

极限和导数

-

幂法则、链式法则、积法则

-

隐式微分

-

高阶导数

-

泰勒级数

-

积分

线性代数 – 3Blue1Brown

作为数据科学家,你所处理的数据集本质上是维度为 num_samples x num_features 的矩阵。因此,你可以将每个数据点视为特征空间中的一个向量。所以理解矩阵的工作原理、矩阵的常见操作、矩阵分解技术都是重要的。

如果你喜欢了 3Blue1Brown 的微积分课程,那么你可能同样会喜欢 Grant Sanderson 的线性代数课程,甚至可能更加喜欢。线性代数课程将帮助你学习以下内容:

-

向量和向量空间的基础

-

线性组合、跨度和基

-

线性变换和矩阵

-

矩阵乘法

-

3D 线性变换

-

行列式

-

逆矩阵、列空间和零空间

-

点积和叉积

-

特征值和特征向量

-

抽象向量空间

概率与统计 – Khan Academy

统计学和概率是你数据科学工具箱中极好的技能。但这些技能绝不是易于掌握的。然而,掌握基础并在其上构建相对较容易。

统计与概率课程来自 Khan Academy,将帮助你学习开始更有效地处理数据所需的概率和统计知识。以下是涵盖的主题概述:

-

分类和定量数据分析

-

数据分布建模

-

概率

-

计数、排列和组合

-

随机变量

-

抽样分布

-

置信区间

-

假设检验

-

卡方检验

-

方差分析(ANOVA)

如果你对深入研究统计感兴趣,也可以查看 5 个免费课程掌握数据科学中的统计。

链接: 统计与概率 - 可汗学院

5. 机器学习中的优化 - ML Mastery

如果你曾经训练过机器学习模型,你会知道算法学习模型参数的最佳值。在后台,它运行优化算法以找到最佳值。

机器学习优化速成课程来自 Machine Learning Mastery,是一个全面的资源,用于学习机器学习中的优化。

该课程采用代码优先的方法,使用 Python。因此,在了解优化的重要性后,你将编写 Python 代码来查看流行的优化算法的实际效果。以下是涵盖的主题概述:

-

优化的必要性

-

网格搜索

-

SciPy 中的优化算法

-

BFGS 算法

-

爬山算法

-

模拟退火

-

梯度下降

链接: 机器学习优化速成课程 - MachineLearningMastery.com

总结

我希望你发现这些资源有帮助。由于这些课程大多数是针对初学者的,你应该能够掌握所有基本的数学知识,而不会感到不堪重负。

如果你在寻找学习 Python 用于数据科学的课程,可以阅读 5 个免费课程,掌握数据科学中的 Python。

祝学习愉快!

Bala Priya C**** 是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇点工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正在通过编写教程、指南、评论文章等来学习和分享知识。Bala 还创建了引人入胜的资源概述和编程教程。

相关主题

5 个免费课程掌握 MLOps

图片由Microsoft Bing生成

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在数据驱动决策的今天,仅仅创建机器学习(ML)模型是不够的。组织需要的不仅仅是构建模型——他们需要成功地部署、管理并持续改进这些模型在现实世界中的表现。想象一下:你构建了一个超级智能的系统来预测天气模式,但除非你确保它每天都在工作,并且随着新数据变得更聪明,否则它就像是一个在棚子里积灰的强大工具。这就是 MLOps 的作用。

如果你对将你的 MLOps 技能提升到下一个水平感到好奇,并想知道如何将你出色的模型转化为现实世界的解决方案,这篇文章将是你的指南。我将向你介绍五个免费课程,这些课程将 MLOps 分解为易于理解的部分。无论你是刚起步还是已经是机器学习的专家,这里都有适合你的课程。

MLOps 的 Python 基础

MLOps 的 Python 基础课程

这个课程将教你在 MLOps 角色中成功所需的基本 Python 技能。它涵盖了 Python 编程语言的基础知识,包括数据类型、函数、模块和测试技术。它还涉及如何有效地处理数据集和其他数据科学任务,使用 Pandas 和 NumPy。在这个课程中,通过一系列动手练习,你将获得在 MLOps 工作流程中使用 Python 的实践经验。课程结束时,你将掌握编写 Python 脚本来自动化常见 MLOps 任务的必要技能。

这个课程非常适合那些希望进入 MLOps 领域的人或那些希望提升 Python 技能的经验丰富的 MLOps 专业人员。

涵盖的主题:

-

数据探索

-

分类:垃圾邮件过滤

-

排名:优先收件箱

-

回归:预测页面浏览量

-

正则化:文本回归

-

优化:破解代码

-

PCA: 构建市场指数

-

MDS: 视觉探索美国参议员相似性

-

kNN: 推荐系统

-

分析社交图谱

-

模型比较

MLOps 入门

链接: MLOps 入门

MLOps 入门课程

既然你已经复习了 Python,现在是时候深入了解一些实质性的内容了!这门课程《MLOps 入门》是 Udemy 上的一门免费教程,教你如何提供一个端到端的机器学习开发过程,以设计、构建和管理 AI 模型生命周期。

这门课程由 Prem Naraindas(一位经验丰富的 MLOps 从业者)讲授,并包括多个动手练习。到课程结束时,你将对 MLOps 的基础有一个良好的理解,并能够将其应用到你的工作中。

涵盖主题:

-

MLOps 概述

-

MLOps 工具和平台

-

创建管道

-

自动化模型训练、评估、实验

-

部署和监控

-

服务

-

扩展

-

MLOps 最佳实践

生产环境下的机器学习工程(MLOps)专业化

生产环境下的机器学习工程专业化

如果你准备从理论知识转向实际的机器学习编码,你需要参加 Coursera 上的《生产环境下的机器学习工程(MLOps)专业化》课程。这门由 deeplearning.ai 提供的综合性专业化课程,专为那些有 Tensorflow 经验并对实践应用和动手编码经验充满热情的程序员设计。此课程非常适合那些掌握 Python 和 TensorFlow 并希望直接进入 MLOps 领域的人!

最棒的是,这门课程由 Andrew Ng(谷歌的领先 AI 推广者)、Lawrence Moroney 和 Robert Crowe(来自谷歌)讲授。

涵盖主题:

-

生产就绪的机器学习系统

-

数据管道和模型管理技术

-

概念漂移

-

模型训练

-

基于云的 MLOps 工具

-

模型监控

-

模型优化

-

Tensorflow 生产(TFX)

MLOps | 机器学习操作专业化

链接: 机器学习操作专业化

机器学习操作专业化

这个全面的课程系列是为那些有编程知识并对学习 MLOps 感兴趣的个人设计的。课程将教你如何使用 Python 和 Rust 进行 MLOps 任务,使用 GitHub Copilot 提高生产力,并利用 Amazon SageMaker、Azure ML 和 MLflow 等平台。你还将学习如何使用 Hugging Face 微调大型语言模型(LLMs),并理解 ONNX 格式下可持续高效的二进制嵌入模型的部署。课程还将为你在 MLOps 领域的各种职业道路做好准备,如数据科学、机器学习工程、云 ML 解决方案架构和人工智能(AI)产品管理。

这个全面的课程系列非常适合特别是那些有编程知识的个人,例如软件开发人员、数据科学家和研究人员。

涵盖的主题:

-

微软 Azure

-

大数据

-

数据分析

-

Python 编程

-

Github

-

机器学习

-

云计算

-

数据管理

-

DevOps

-

亚马逊网络服务(Amazon AWS)

-

Rust 编程

-

MLOps

Made With ML MLOps 课程

Made With ML MLOps 课程

Goku Mohandas 开发了一个卓越且公开访问的端到端机器学习系统课程。Made with ML 是最受欢迎的 GitHub 存储库之一,已有超过 30,000 人注册此课程。

Made with ML 课程涵盖了机器学习的基础知识以及模型部署、测试和生产监控的复杂性。Goku 的课程解释了引入概念的基本思想,提供了实用的基于项目的作业,并为学生提供了一些在 MLOps 角色中成功所需的软件工程最佳实践。

涵盖的主题:

-

机器学习基础

-

端到端系统开发

-

部署策略

-

测试方法

-

模型监控

-

概念背后的直觉

-

实践项目作业

-

软件工程最佳实践

结论

MLOps 是一个迅速发展的领域,对技能娴熟的专业人员有着很高的需求。通过掌握 MLOps,你可以开启新的职业机会,并在世界上产生真正的影响。借助这五个免费课程,你可以迈出成为 MLOps 专家的第一步。那么你还在等什么呢?立即注册并开始学习吧!

如果你是机器学习和 MLOps 的初学者,你可能想看看我们的文章掌握机器学习的 5 本免费书籍。但如果你想直接深入 MLOps,只打算选择一两门课程,我建议你参加Andrew Ng 的机器学习工程生产(MLOps)专业化和Made with MLOps课程。

我们很想知道,哪些课程在你的机器学习旅程中发挥了关键作用。欢迎在下面的评论中分享你的想法!

Kanwal Mehreen**** Kanwal 是一位机器学习工程师和技术作家,对数据科学以及人工智能与医学的交汇处充满深厚的热情。她共同撰写了电子书《利用 ChatGPT 最大化生产力》。作为 2022 年 APAC 的 Google Generation Scholar,她倡导多样性和学术卓越。她还被认定为 Teradata 多样性技术学者、Mitacs Globalink 研究学者和哈佛 WeCode 学者。Kanwal 还是变革的热心倡导者,她创立了 FEMCodes 以赋能女性进入 STEM 领域。

相关话题

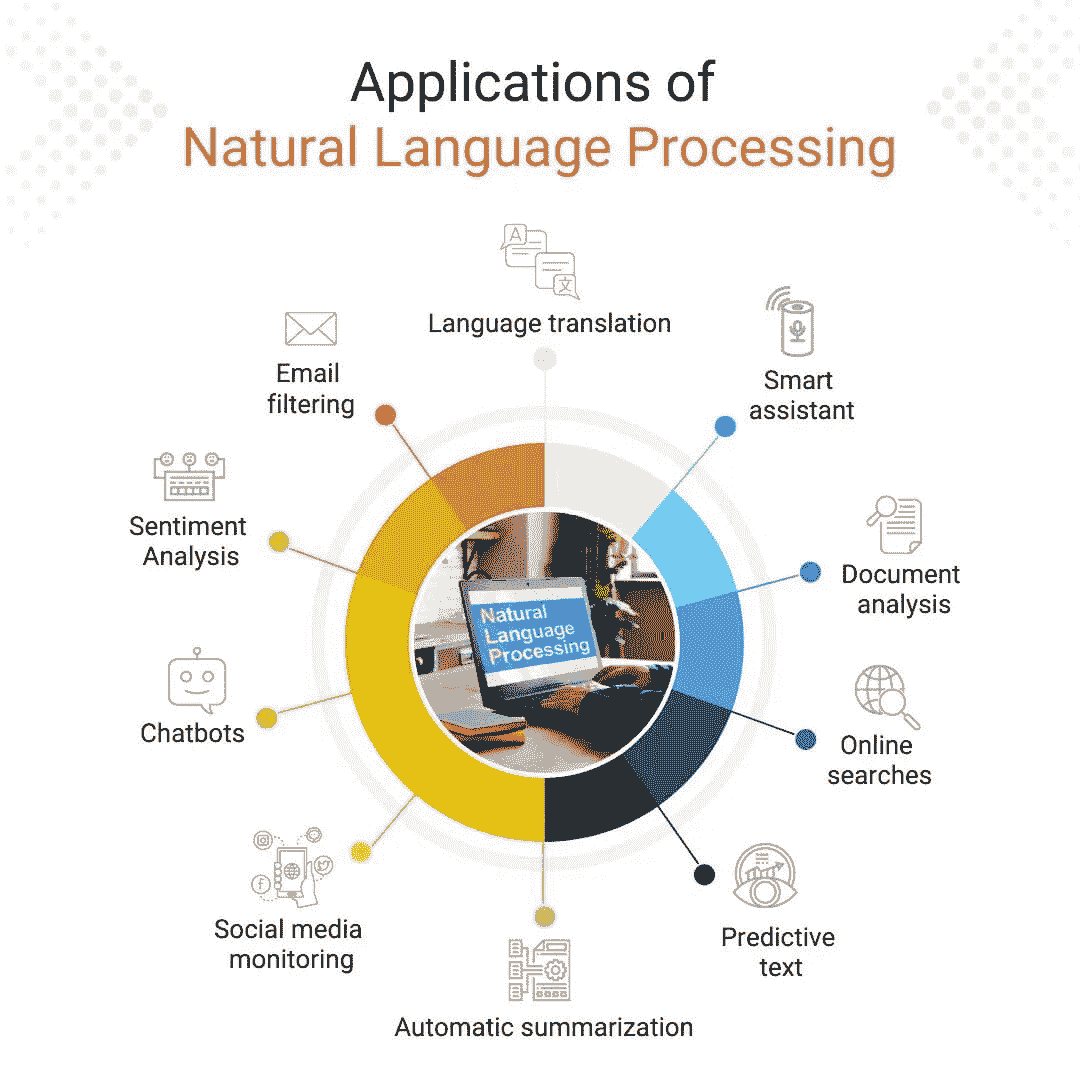

5 门免费课程,掌握自然语言处理

原文:

www.kdnuggets.com/5-free-courses-to-master-natural-language-processing

作者图片

自从知名的大型语言模型(LLMs)如 ChatGPT 推出以来,许多人对语言的使用产生了兴趣。我们正在看到这些 LLMs 对我们日常生活的巨大影响,有些人希望转向这一蓬勃发展的领域。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

然而,当你考虑转行时,首先想到的是如何迈入新领域。这些步骤有时可能非常昂贵。你可能需要回到大学,或报名参加认证课程等。

想要提升职业发展和技能提升却不考虑成本是很困难的。话虽如此,对于那些正在关注自然语言处理(NLP),想了解更多,或希望将职业发展方向转向此领域的人,这篇博客适合你。

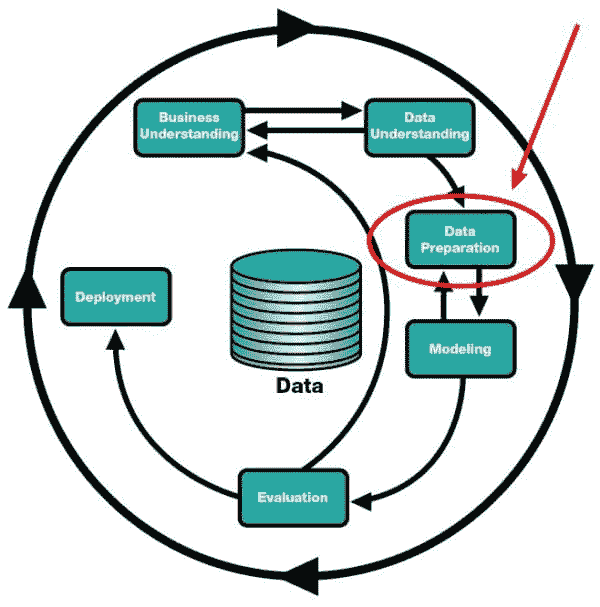

数据科学基础专门化

链接:数据科学基础专门化

级别:初学者

时长:1 个月,每周 10 小时

如果你是数据科学领域的新手,或者需要对该领域的基础知识进行补充,请查看由加州大学欧文分校提供的这一初学者专门化课程。

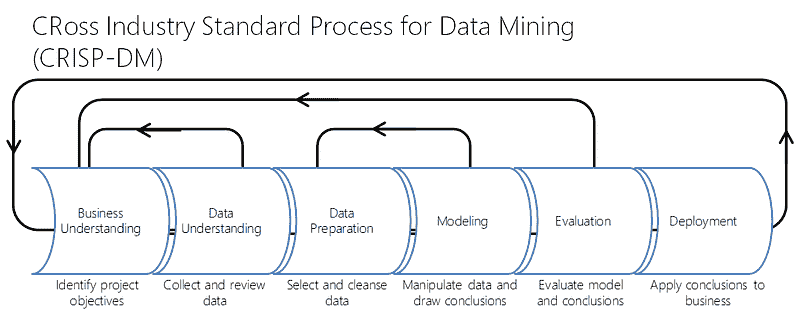

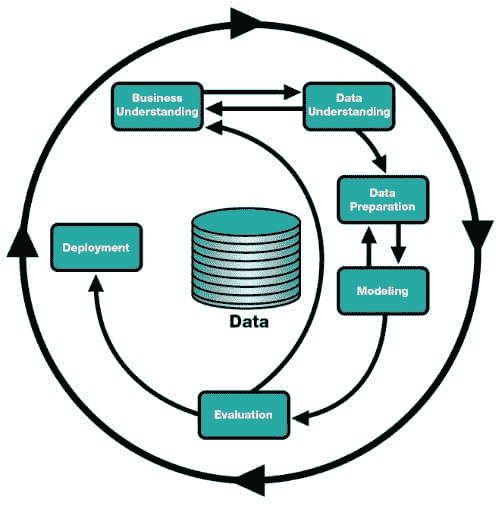

在本课程中,你将获得数据科学基础的概述,深入了解关键的数据科学技能、技术和概念。课程开始于基础概念,如分析分类、跨行业数据挖掘标准流程和数据诊断,然后继续比较数据科学与经典统计技术。课程还概述了数据科学中最常用的技术,包括数据分析、统计建模、数据工程、大数据的数据处理、数据挖掘算法、数据质量、修复和一致性操作。

Python 中的自然语言处理入门

级别:中级

时长:4 小时

如果你需要掌握自然语言处理的基础知识,可以查看 DataCamp 提供的 Python 入门自然语言处理课程。

在这门课程中,你将学习自然语言处理的基础知识,例如如何识别和分离单词、如何提取文本中的主题,以及如何构建自己的假新闻分类器。你还将学习如何使用基本的库,如 NLTK,以及利用深度学习解决常见自然语言处理问题的库。这门课程将为你在 Python 学习中继续处理和解析文本打下基础。

无编程构建 AI 驱动的聊天机器人

级别:初级

时长:约 12 小时

如果你对聊天机器人中的自然语言处理更感兴趣,这门由 IBM 提供的初级课程将讲解聊天机器人的好处及其在客户支持等任务中的有用性。你将学习如何使用 Watson Assistant 创建一个有用的聊天机器人,而无需编写任何代码,同时指定行为和语气,以提升聊天机器人并使其用户友好。开发、测试并部署一个聊天机器人到 WordPress 网站并进行互动。

这门单独的课程是两个专业课程的一部分:IBM AI Developer Professional Certificate和AI Foundations for Everyone Specialization。如果你对更深入的课程感兴趣,可以查看这些课程。

自然语言处理专业课程

链接:自然语言处理专业课程

级别:中级

时长:每周 10 小时,持续 3 个月

如果你对自然语言处理有基本了解并准备提升技能,可以查看 DeepLearning.AI 提供的中级专业课程。

在这门课程中,你将使用逻辑回归、朴素贝叶斯和词向量来实现情感分析、完成类比和翻译单词。你还将使用动态编程、隐马尔可夫模型和词嵌入来实现自动更正、自动完成和识别单词的词性标记。课程还包括使用递归神经网络、LSTMs、GRUs 和 Siamese 网络进行情感分析、文本生成和命名实体识别,以及使用编码器-解码器、因果和自注意力进行机器翻译完整句子、文本摘要、构建聊天机器人和问答系统。

Google Cloud 上的自然语言处理

级别:高级

时长:约 13 小时

如果你准备提升到下一个层次,可以查看 Google 提供的自然语言处理课程。该课程介绍了解决 Google Cloud 上自然语言处理问题的产品和解决方案。此外,它探索了使用 Vertex AI 和 TensorFlow 开发自然语言处理项目的过程、技术和工具。

你还将认识到 Google Cloud 上的 NLP 产品和解决方案,使用 Vertex AI 的 AutoML 创建端到端的 NLP 工作流。学习如何使用 TensorFlow 构建不同的 NLP 模型,包括 DNN、RNN、LSTM 和 GRU。识别高级 NLP 模型,如编码器-解码器、注意力机制、变换器和 BERT,并理解迁移学习,应用预训练模型来解决 NLP 问题。

这门课程是Google Cloud 上的高级机器学习专项课程的一部分。

总结

在这篇博客中,我希望能够带你探索如果你对 NLP 行业感兴趣,可以选择的不同课程。如果你知道任何值得推荐的课程,请在评论中告诉我!

Nisha Arya 是一名数据科学家、自由职业技术作家,同时担任 KDnuggets 的编辑和社区经理。她特别关注提供数据科学职业建议或教程,并围绕数据科学的理论知识进行讲解。Nisha 涵盖了广泛的主题,并希望探索人工智能如何促进人类生命的长寿。作为一个渴望学习者,Nisha 寻求拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关主题

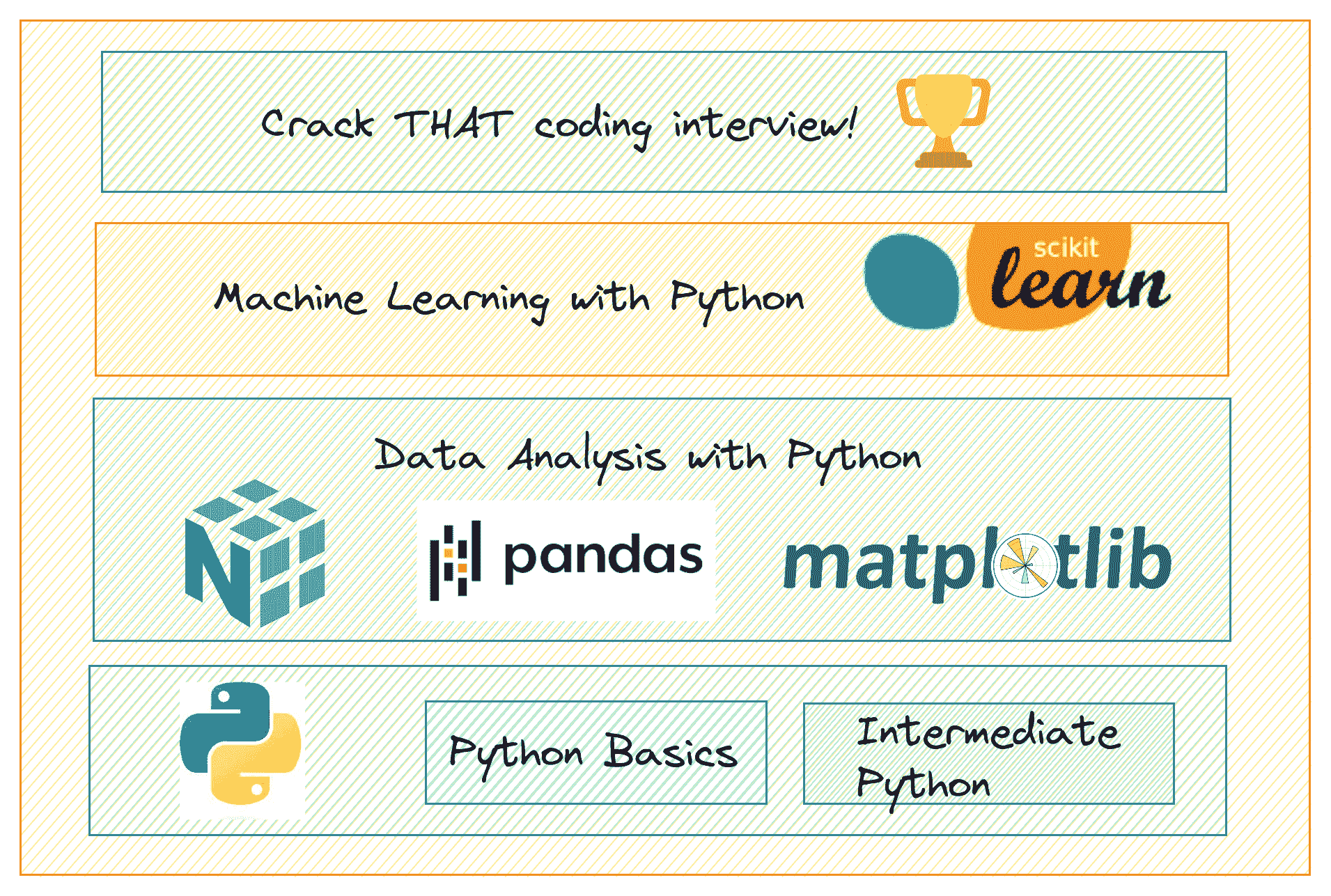

5 个免费课程掌握数据科学中的 Python

原文:

www.kdnuggets.com/5-free-courses-to-master-python-for-data-science

作者提供的图片

学习 Python 对于想要转行数据职业的人来说非常有帮助。但有很多需要学习的内容:从 Python 编程基础到数据分析、机器学习以及破解编码面试。那么你如何找到最佳的学习资源呢?

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

为了帮助你,我们编制了一份课程清单,帮助你掌握 Python 在数据科学中的应用。无论你是初学者还是经验丰富的专业人士,希望刷新你的 Python 技能,这些课程都适合你。推荐的课程将帮助你学习以下内容:

-

Python 基础

-

Python 数据科学库

-

使用 Python 进行数据分析和机器学习

-

使用 Python 进行数据结构和算法

让我们开始吧。

1. 初学者的 Python

Mosh 的初学者 Python课程将帮助你熟悉 Python 编程的绝对基础。

在大约一个小时内,你可以掌握以下基础知识:

-

变量

-

接收输入

-

类型转换

-

字符串

-

运算符及运算符优先级

-

if 语句

-

while 和 for 循环

-

列表和元组

链接:初学者的 Python

2. 中级 Python 编程

现在你掌握了基础知识,你可以参加这个中级 Python 编程课程。该课程从讨论各种 Python 内置数据结构开始,并继续讲解语言的更高级特性。

本课程涵盖的主题包括:

-

Python 的内置数据结构

-

集合

-

itertools

-

Lambda 函数

-

异常和错误

-

日志记录

-

处理 JSON

-

随机数生成

-

装饰器

-

生成器

-

多线程和多进程

-

函数参数

-

浅拷贝与深拷贝

-

上下文管理器

链接:中级 Python 编程

3. 使用 Python 进行数据分析

一旦你对 Python 有了良好的掌握,你可以继续学习各种 Python 数据科学库。

Python 数据分析 认证将帮助你学习所有必要的 Python 数据科学库:

-

NumPy

-

Pandas

-

Matplotlib

-

Seaborn

你还将构建一些数据分析项目。你应完成这些项目以获得 Python 数据分析认证。

链接: Python 数据分析认证

4. 使用 Python 和 Scikit-Learn 的机器学习

你现在应该能够熟练使用 Python 编程并操作 Python 数据科学库。现在你可以开始探索机器学习。

使用 Python 和 Scikit-Learn 的机器学习 将帮助你了解机器学习算法的理论(如何工作)和使用 scikit-learn 实现这些算法。该课程还将教你如何规划和实施机器学习项目,并构建和部署机器学习应用。

这是所涉及主题的概述:

-

线性回归和梯度下降

-

用于分类的逻辑回归

-

决策树和随机森林

-

如何接近机器学习项目

-

使用 XGBoost 的梯度提升机

-

从零开始的机器学习项目

-

以课堂形式部署机器学习项目

链接: 使用 Python 和 Scikit-Learn 的机器学习

5. Python 中的数据结构和算法

在数据科学面试过程中,你应该首先破解编码面试,才能进入下一个阶段。为了破解它们,并使你的编码练习更有效,你应首先在数据结构和算法方面打下坚实的基础。

Python 中的数据结构和算法 是一个免费课程,将帮助你学习基本的数据结构和算法,重点是 Python。

只需遵循数据结构和算法课程,你将学习到以下内容

-

二分查找、链表和复杂度

-

二叉搜索树、遍历和递归

-

哈希表和 Python 字典

-

排序算法、分治法

-

递归和动态编程

-

图算法

-

Python 面试问题、技巧和建议

链接: Python 中的数据结构和算法

总结

希望你觉得这些课程有帮助。我们整理了一份全面的课程列表,将帮助你在 Python 数据科学方面变得熟练。

如果你还记得,我们的课程从 Python 编程的基础开始,到使用 Python 进行数据分析和机器学习。我们还包括了一门课程,帮助你学习数据结构和算法的基础,以备编码面试之需。祝学习愉快,编码顺利!

Bala Priya C是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇点上工作。她的兴趣和专长包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和咖啡!目前,她正致力于通过撰写教程、操作指南、观点文章等方式学习和分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。

更多相关话题

5 个免费课程,掌握数据科学中的 SQL

原文:

www.kdnuggets.com/5-free-courses-to-master-sql-for-data-science

编辑器提供的图片

SQL 是所有数据专业人员必备的技能。然而,掌握 SQL 是一个持续的过程。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

在这里,我们汇编了一份五个非常有用且免费的 SQL 课程列表,帮助你学习并精通 SQL。这些课程涵盖了数据科学所需的所有 SQL:从基础关系数据库和 SQL 到 NoSQL 数据库等。

无论你是 SQL 新手还是想要提升 SQL 技能,这些课程都将帮助你提升水平。让我们来看看这些课程吧!

1. SQL 教程 – 初学者完整数据库课程

这门课程向你介绍 SQL 和数据库管理系统的基础知识。你将学习:

-

CRUD 操作

-

模式设计

-

聚合

-

嵌套查询

-

连接和联合

-

函数和触发器

-

实体关系图

2. Mode SQL 教程

链接:Mode SQL 教程

Mode 的 SQL 教程 是最全面的课程之一,帮助你学习如何使用 SQL 查询关系数据库表并回答业务问题。

这门课程的结构是由 4 个模块组成的:

-

基础 SQL

-

中级 SQL

-

高级 SQL

-

SQL 分析培训

在基础 SQL 模块中,你将学习和实践:

-

SELECT、LIMIT 和 WHERE 子句

-

比较和逻辑运算符

-

LIKE、IN 和 BETWEEN 运算符

-

IS NULL

-

AND、OR、NOT 运算符

-

ORDER BY

在中级 SQL 部分,你将学习:

-

聚合函数

-

按组和 HAVING

-

DISTINCT

-

不同类型的连接

在高级 SQL 模块中,你将学习以下内容:

-

数据类型:日期和字符串

-

数据处理

-

SQL 字符串函数和窗口函数

-

子查询

-

性能调优

然后你将在 SQL 分析培训模块中处理真实世界的案例研究。

3. 数据科学的 SQL 基础

Coursera 上的数据科学 SQL 基础专业课程将教授你在数据科学职业中几乎所有需要的 SQL 知识。

该专业课程中的课程如下:

-

数据科学中的 SQL

-

使用 SQL 进行数据整理分析和 AB 测试

-

使用 Spark SQL 的分布式计算

-

数据科学 SQL 顶点项目

注意: 这个专业课程在 Coursera 上提供,所以你可以免费试听。不过,如果你需要获得认证证书,你应该拥有 Coursera Plus 订阅。如果你无法支付证书费用,你也可以申请经济援助。

4. SQL 与 NoSQL

链接: NoSQL 与 SQL – 你应该使用哪种类型的数据库?

作为数据科学家,你必须同时使用关系型和 NoSQL 数据库。在深入了解 NoSQL 数据库之前,理解 SQL 和 NoSQL 数据库的特点以及它们的使用场景是很有帮助的。

在这个关于 SQL 与 NoSQL 数据库 的简短课程中,你将探索以下内容:

-

关系型和 NoSQL 数据库的特点

-

NoSQL 数据库的需求

-

每种数据库类型的优缺点

-

何时使用 RDBMS 与 NoSQL 数据库

5. NoSQL 数据库教程 – 初学者完整课程

在这个关于 NoSQL 数据库的简短课程中,你将探索不同类型的 NoSQL 数据库,并且还会进行项目实践。你将学习到:

-

为什么你应该使用 NoSQL 数据库

-

表格数据库

-

文档数据库

-

图形数据库

-

键值数据库

-

多模型类型

总结

希望你发现这份 SQL 课程汇编对数据科学有帮助。你可以免费参加所有这些课程。如果你已经对 SQL 有一定了解,你可以选择仅学习数据科学中的 SQL 专业课程。

Bala Priya C**** 是来自印度的开发者和技术写作者。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和喝咖啡!目前,她正在通过编写教程、操作指南、观点文章等,学习和分享她的知识给开发者社区。Bala 还创建了引人入胜的资源概述和编码教程。

主题更多信息

5 门免费课程助你掌握数据科学统计学

原文:

www.kdnuggets.com/5-free-courses-to-master-statistics-for-data-science

图片由 pch.vector 在 Freepik 提供

如果你想成为一名熟练的数据科学家,你应该知道如何理解和分析数据。统计学在这方面非常重要。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

然而,学习统计学可能会感觉困难,尤其是对于没有数学或计算机科学背景的人。但不用担心,我们整理了一份统计课程列表——从入门统计到稍微高级的概念——你可以免费参加这些课程。

你不必完成所有这些课程才能在数据科学领域掌握统计学。因此,请随意查看你特别感兴趣的课程。开始吧!

注意:你可以在 Coursera 上免费旁听以下所有课程。

1. 统计学导论

统计学导论课程来自斯坦福大学,是一门很好的统计学入门课程。该课程旨在教授理解和分析数据所需的所有统计思维概念。

这是课程内容的概述:

-

数据探索的引言和描述性统计

-

数据生成和抽样

-

概率

-

正态近似和二项分布

-

抽样分布和中心极限定理

-

回归分析

-

置信区间

-

显著性检验

-

重新抽样

-

分类数据分析

-

单因素方差分析(ANOVA)

-

多重比较

链接: 统计学导论

2. 基础统计学

基础统计学课程来自阿姆斯特丹大学,这也是一个适合初学者的统计课程。该课程要求你对 R 编程有所了解,并涵盖以下主题:

-

数据探索

-

相关性和回归分析

-

概率和概率分布

-

抽样分布

-

置信区间和显著性测试

链接: 基础统计学

3. 数据科学中的统计学与 Python

数据科学中的统计学与 Python由 IBM 提供,作为数据科学基础与 Python 和 SQL 专业化的一部分。

这门课程将教你如何使用 Python 进行统计测试并解释统计分析的结果。课程内容如下:

-

Python 基础

-

介绍和描述统计学

-

数据可视化

-

概率分布介绍

-

假设检验

-

回归分析

4. 统计学的力量

统计学的力量由 Google 提供,作为他们 Google 高级数据分析专业证书的一部分。

从总结数据集到进行假设检验以及使用概率分布进行数据建模,这门课程还侧重于使用 Python 进行统计分析。课程内容包括:

-

统计学导论

-

概率

-

采样

-

置信区间

-

假设检验导论

链接: 统计学的力量

5. 使用 Python 进行统计学

使用 Python 的统计学专业化由密歇根大学提供,教授如何使用 Python 进行数据可视化、统计推断和建模。它还强调将你需要回答的业务问题与相关的数据分析方法相连接的重要性。

这是一个包含三门课程的专业化项目,涵盖了所需的理论知识以及 Python 编程作业,帮助你应用所学的所有内容。该专业化项目的课程如下:

-

使用 Python 理解和可视化数据

-

使用 Python 进行推断统计分析

-

使用 Python 拟合统计模型

总结

就这些了。我们介绍了五门可以免费学习统计学并提升数据科学技能的课程。

因为这些课程大多数侧重于使用 Python 编程和运行统计测试,而不仅仅是学习理论概念,我相信你会发现有很多机会来应用你所学到的知识。祝学习愉快,继续编码!

Bala Priya C** 是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正在通过撰写教程、操作指南、观点文章等,学习并与开发者社区分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。**

更多相关主题

2023 年必须阅读的 5 本免费数据科学书籍

原文:

www.kdnuggets.com/2023/01/5-free-data-science-books-must-read-2023.html

图片由作者提供

如果你和我一样是一个书迷,你应该开始关注那些免费的数据科学书籍。这些书将教你 Python 编程、数据科学的艺术、机器学习,并介绍新的工具和框架。此外,一些书籍像网站一样构建,以便你可以探索、搜索和互动。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

1. 正确学习 Python

《正确学习 Python》 是一本适合初学者的书,专门为那些想学习 Python 但不知道从何开始的人准备。你可以下载这本书或使用网页界面在线阅读。每一章都有一个 YouTube 教程,详细解释语法和功能。

书封面

你可以阅读书籍,观看教程,甚至在免费的在线 IDE Replit 上练习代码。它涵盖了你开始数据科学职业生涯所需的所有基础知识。

本书涵盖:

-

Python 设置和基础

-

变量、表达式和语句

-

创建第一个 Python 程序

-

函数

-

条件语句

-

复杂函数。

-

迭代

-

字符串

-

元组

-

事件处理,异常

-

列表,字典,模块,文件

-

算法,类,对象,面向对象编程,继承

-

PyGame,递归,队列

-

链表,栈,树

2. 数据科学的艺术

Roger D. Peng 等人的《数据科学的艺术》 将数据分析表现为理解问题、探索数据、进行正式建模、解释结果和沟通发现的艺术。

书封面

这本书不仅关注统计和编码,还教你批判性思维。你将学习如何细化问题,进行探索性数据分析,应用线性回归或随机森林,并解释结果以提供可操作的见解。

本书涵盖:

-

分析的周期

-

陈述和细化问题

-

探索性数据分析

-

使用模型探索数据

-

推理:入门

-

形式化建模

-

推理与预测:对建模策略的影响

-

解释你的结果

-

沟通

3. 命令行中的数据科学

命令行中的数据科学是我最喜欢的书籍,我在 KDnuggets 博客上写了详细的评价。你可以选择从 Amazon 购买这本书,也可以免费阅读在线版本。在线版本具有互动性,并带有有趣的功能。

书籍封面

本书通过示例介绍了执行各种数据科学任务所需的基本命令行工具。你可以在终端中完成数据清洗、数据分析和可视化,以及训练机器学习模型。

书中涵盖:

-

获取数据

-

创建命令行工具

-

数据清洗

-

使用 Make 进行项目管理

-

探索数据

-

并行管道

-

数据建模

-

多语言数据科学

4. 使用 Scikit-Learn、Keras 和 TensorFlow 的动手机器学习

使用 Scikit-Learn、Keras 和 TensorFlow 的动手机器学习将从头开始教你所有关于机器学习的知识。你将学习如何使用 Scikit-Learn、Keras 和 TensorFlow 构建基础到深度学习模型。你将学习分类、RNNs、CNNs、NLP、GANs 和强化学习模型。

书籍封面

在阅读本书之前,你需要了解本书假设你已经掌握了 Python 及 NumPy、pandas、matplotlib 等库的基础知识。

书中涵盖:

-

从头到尾的机器学习项目

-

分类

-

训练模型

-

支持向量机

-

决策树

-

集成学习

-

降维

-

RNNs 和 CNNs

-

自然语言处理

-

GANs

-

强化学习

-

规模化训练和部署模型

5. 实用深度学习(面向程序员)

实用深度学习(面向程序员)是一本纸质书、一本基于网页的书籍,以及一门介绍如何使用 fastai 和 PyTorch 进行深度学习的课程。这是我最喜欢的课程和书籍。你将学习所有关于神经网络的知识,而无需深入数学或编程。这门课程适合任何了解 Python 基础的人。

书籍封面

书中涵盖:

-

从模型到生产

-

数据伦理

-

训练数字分类器

-

图像分类

-

其他计算机视觉问题

-

训练最先进的模型

-

协同过滤深入探讨

-

表格建模深入分析

-

NLP 深入分析:RNNs

-

使用 fastai 的中级 API 进行数据清洗

-

从头开始的语言模型

-

卷积神经网络

-

ResNets

-

应用架构深入分析

-

训练过程

-

从基础开始的神经网络

-

使用 CAM 进行 CNN 解释

-

从头开始的 fastai 学习者

结论

这五本书都非常棒,我强烈推荐给任何对数据科学职业感到怀疑的初学者。此外,这些书还附有实用指南、代码示例和视觉辅助,以简单的方式解释复杂的术语。

希望你喜欢我的列表。如果你有任何推荐,请在评论中提到,我会尝试将它们添加到下一个列表中。

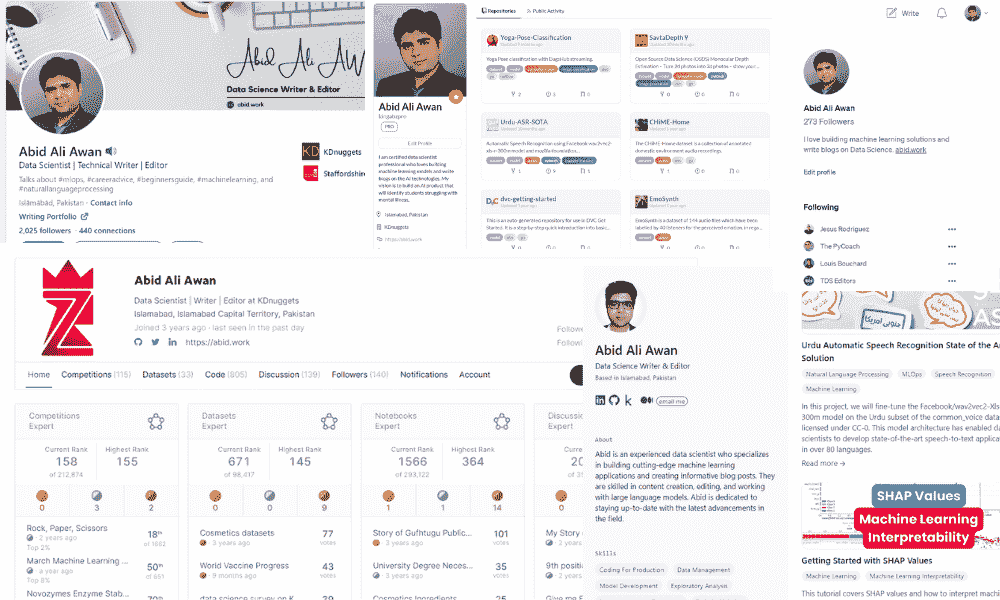

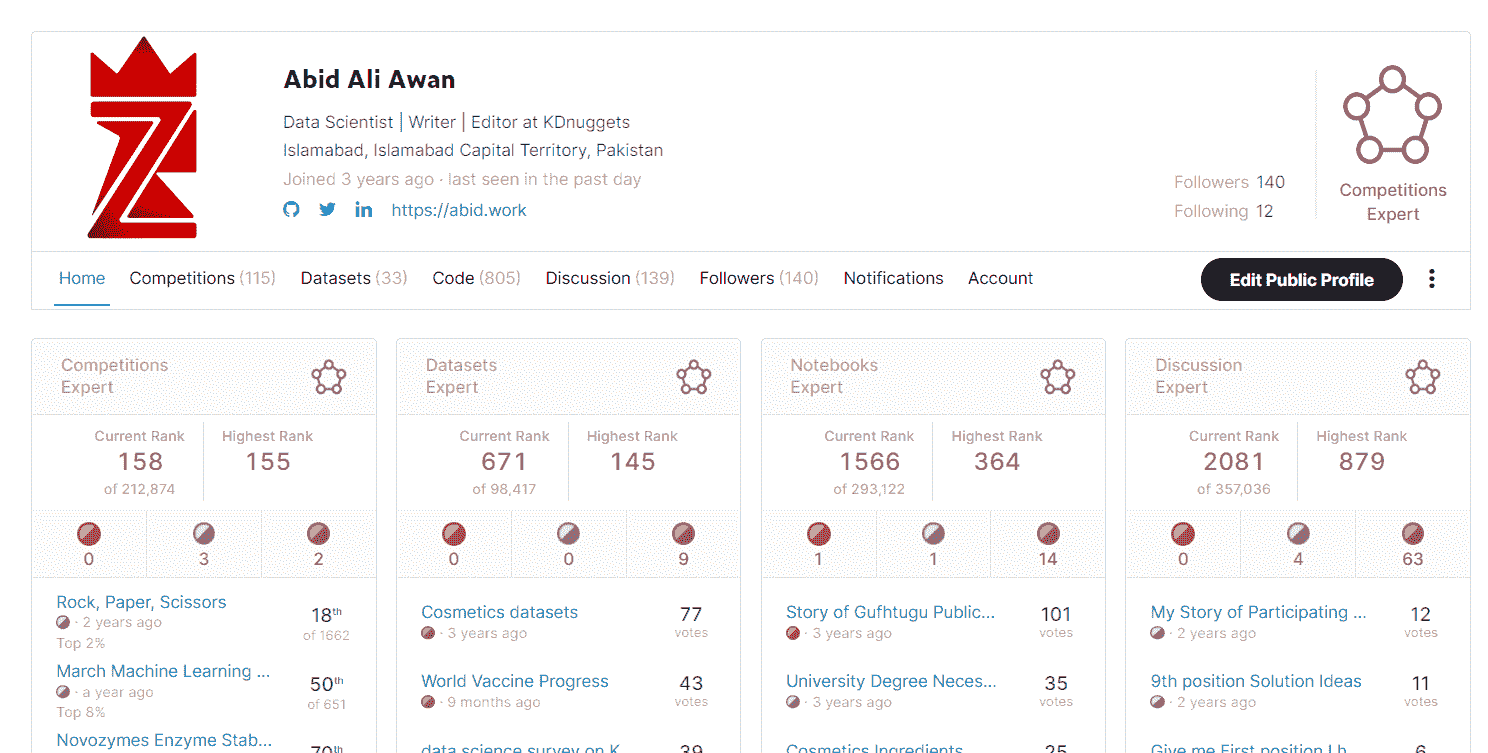

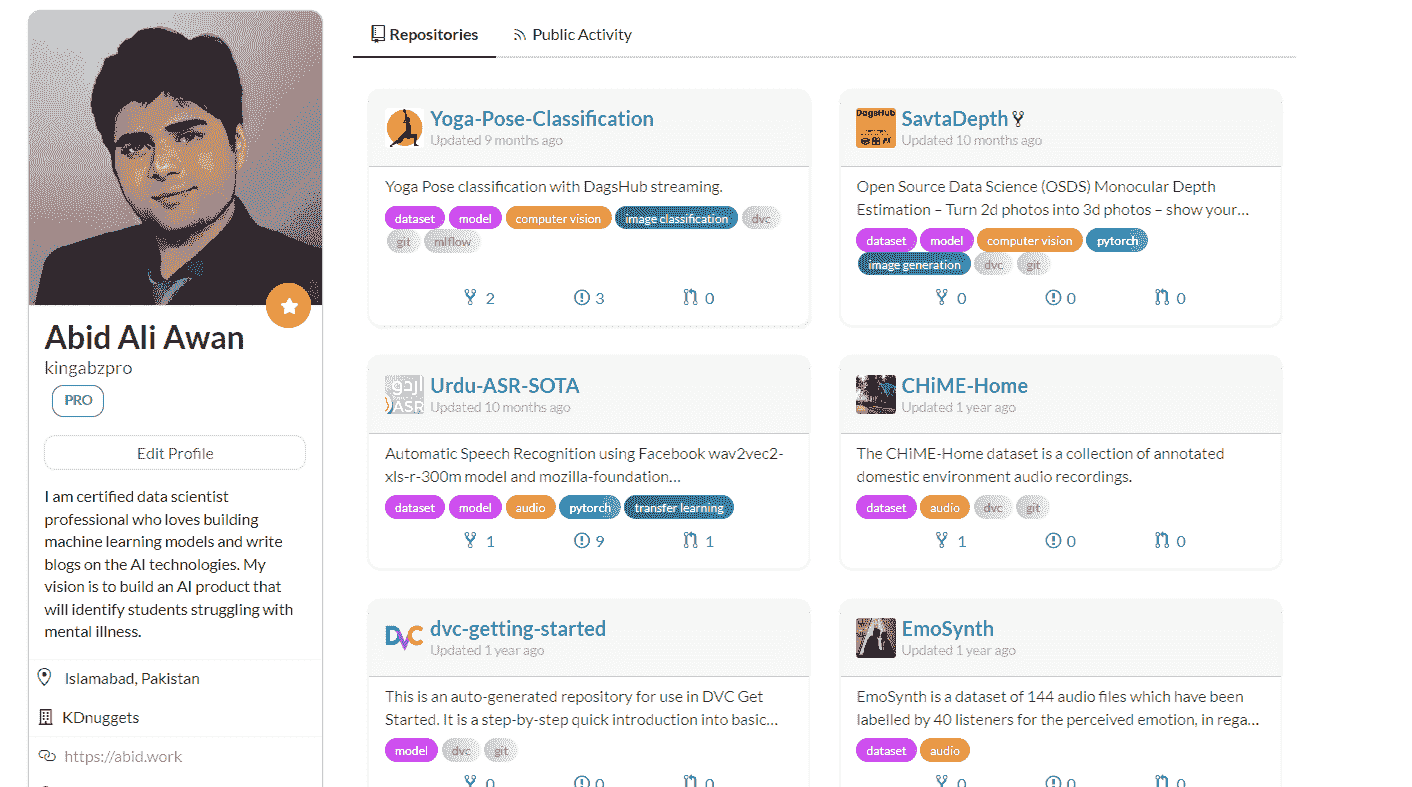

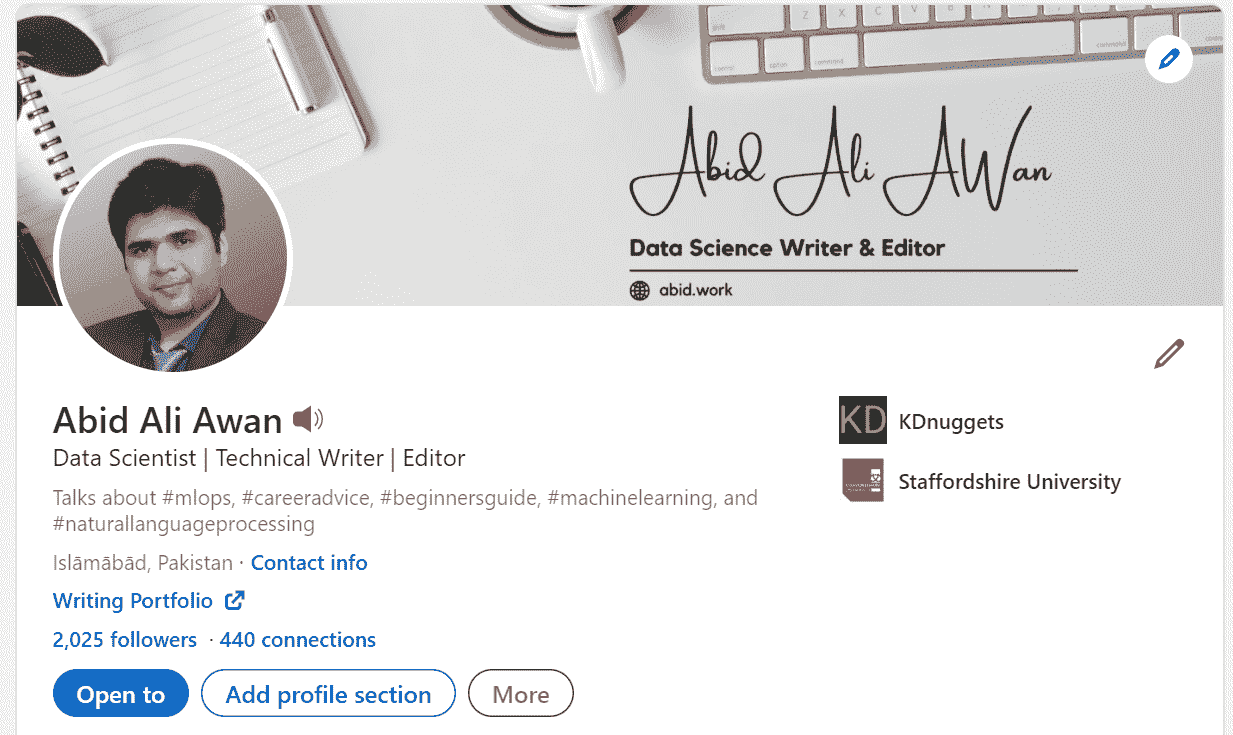

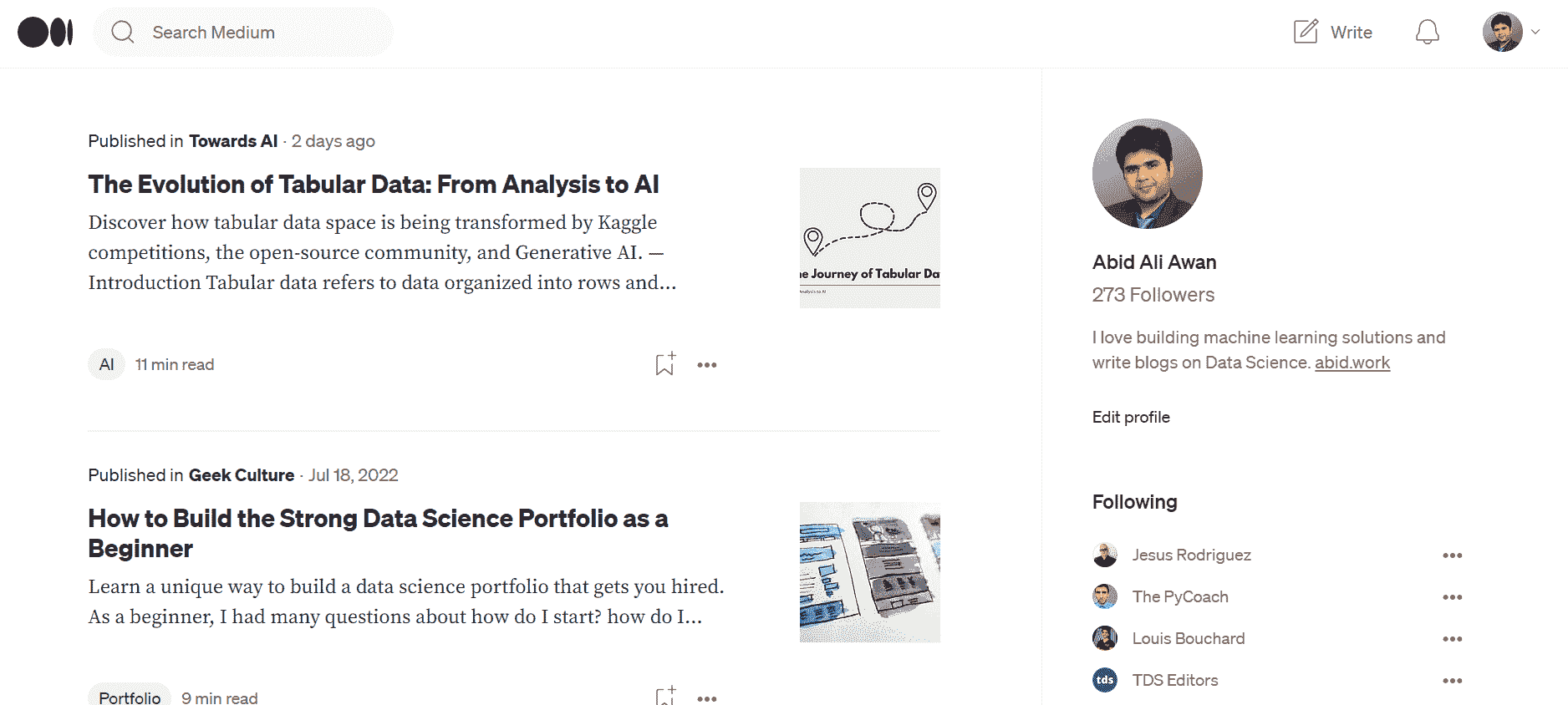

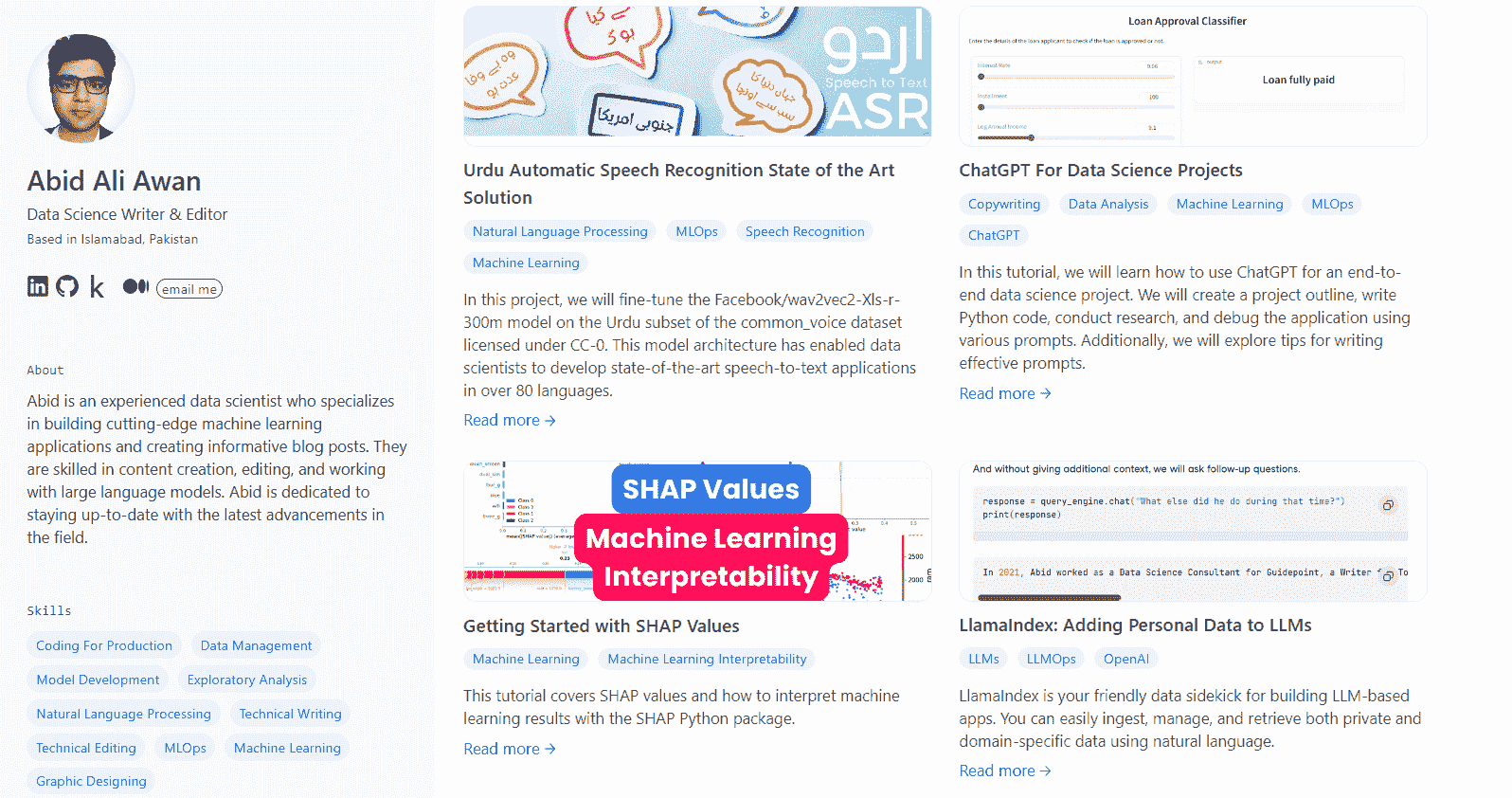

Abid Ali Awan(@1abidaliawan)是一位认证的数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作和撰写关于机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为那些正在与心理健康问题作斗争的学生开发一个 AI 产品。

更多相关内容

进入机器学习职业之前需要阅读的 5 本电子书

原文:

www.kdnuggets.com/2016/10/5-free-ebooks-machine-learning-career.html

请注意,尽管网上有许多免费的机器学习电子书,包括许多非常著名的书籍,但我选择跳过这些“常规书籍”,寻求更少为人知晓的、更具小众特色的选项。

对机器学习职业感兴趣?不知道从哪里开始?那么,总有这里,一个关于在 Python 生态系统中追求机器学习的教程集合。如果你想了解更多,你可以查看这里,获取 MOOCs 和在线讲座的概述,来自自由提供的大学讲座。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

当然,没有什么可以替代严格的正式教育,但假设因为某些原因这种教育不在计划之中。并非所有机器学习职位都需要博士学位;这真的取决于你想在机器学习的哪个领域中定位自己。看看这篇激励人心的文章,作者在一年内从对机器学习的几乎没有了解到在工作中积极有效地运用技术。

想在入门级研究生机器学习课程和在线教程中获得平衡吗?正如几百年来一样,书籍是一个很好的选择。😃 当然,如今我们可以即时访问免费的数字书籍,这使得这一选择非常有吸引力。请查看以下免费的电子书,这些书籍都适合初学者阅读,同时涵盖了各种不同的概念和材料。

1. 机器学习简介

斯坦福大学的 Nils J. Nilsson 在 1990 年代中期整理了这些笔记。在你对学习 90 年代的内容感到不屑之前,请记住,基础就是基础,无论它是在何时写成的。

当然,自从编写本书以来,机器学习领域已经取得了许多重要进展,正如 Nilsson 本人所说,但这些笔记以直接而集中的方式涵盖了许多仍被认为是相关的基础材料。书中没有涉及过去几十年的进展,作者们常常在介绍性文本中侧面提及这些内容。然而,书中包含了大量关于统计学习、学习理论、分类及各种算法的信息,引人入胜。在不到 200 页的篇幅下,可以相当迅速地阅读完毕。

这本关于机器学习的书籍由 Shai Shalev-Shwartz 和 Shai Ben-David 编写。与之前的书籍相比,这本书较新、篇幅较长且更为高级,但也是一个合乎逻辑的下一步。它将深入探讨更多的算法、其描述,并提供实践方面的桥梁。对理论的关注应该对新手明确其重要性,以真正理解驱动机器学习算法的内容。高级理论部分涵盖了一些可能超出新手范围或兴趣的概念,但也可以选择查看。

3. 贝叶斯推理与机器学习

这本关于贝叶斯机器学习的入门书籍是我所知道的最知名的书籍之一,并且恰好有一个免费的在线版本可供获取。明尼苏达大学的 Arindam Banerjee 在 Amazon 评价 中这样评价:

这本书广泛涵盖了概率机器学习,包括离散图模型、马尔可夫决策过程、潜变量模型、高斯过程、随机和确定性推理等。该材料非常适合高级本科生或图形模型或概率机器学习的入门研究生课程。全书使用了大量的图表和示例,并且附带了一个广泛的软件工具箱...

应注意,所提到的工具箱是用 MATLAB 实现的,而 MATLAB 已不再是默认的机器学习实现语言,至少通常情况下不是。然而,这个工具箱并不是这本书唯一的优点。

这为那些对概率机器学习感兴趣的人提供了一个很好的起点。

4. 深度学习

这是 Goodfellow、Bengio 和 Courville 即将出版的深度学习书籍,官方网页上有一个免费的最终草稿版本。

以下两个摘录来自该书的官方网站,一个提供了内容概述,另一个让几乎所有有兴趣阅读这本书的人放心:

《深度学习》教科书旨在帮助学生和从业者进入机器学习领域,尤其是深度学习。该书的在线版本现已完成,将继续在线免费提供。印刷版将很快上市。

其中一个目标受众是学习机器学习的大学生(本科生或研究生),包括那些刚开始从事深度学习和人工智能研究的学生。另一个目标受众是没有机器学习或统计背景的软件工程师,但希望快速掌握相关知识并开始在其产品或平台中使用深度学习。

要找到一个更好的资源来全面学习深度学习,你将面临很大的困难。

5. 强化学习:导论

萨顿和巴托的权威经典正在进行改版。这是第二版草稿的链接,目前正在进展中(并且在此期间免费提供)。

强化学习现在是一个极具研究兴趣的领域,原因很充分。鉴于其在 AlphaGo 中的成功、高度关注、在自动驾驶汽车及类似系统中的潜力以及与深度学习的结合,很难相信强化学习(毫无疑问将在任何形式的“通用人工智能”(或类似事物)中发挥重要作用)会消失。实际上,这些都是为什么这本书的第二版正在进行的原因。

你可以感受到这本书在强化学习领域的重要性,因为它被简单地称为“萨顿和巴托”。这篇亚马逊评论由 David Tan 撰写,很好地总结了这本书(并消除了关于“是否太复杂难以理解”的疑虑):

这本书以示例和对强化学习的直观介绍和定义开始。接下来的 3 章讨论了强化学习的 3 种基本方法:动态规划、蒙特卡罗方法和时序差分方法。后续章节在这些方法基础上进行扩展,涵盖整个解决方案和算法范围。

这本书对普通计算机学生来说非常易读。可能唯一难度较大的章节是第八章,它涉及一些神经网络概念。

请记住,上述内容针对的是第一版;它也适用于第二版。

祝你在从免费的电子书中学习更多关于机器学习的过程中顺利。查看下面的相关链接,获取更多相关的电子书资源。

相关:

-

数据爱好者必备的 10 本重要书籍

-

进入数据科学或大数据职业前需要阅读的 5 本电子书

-

60+ 本关于大数据、数据科学、数据挖掘、机器学习、Python、R 等的免费书籍

更多主题

5 个免费的 Google 课程助你成为软件工程师

原文:

www.kdnuggets.com/5-free-google-courses-to-become-a-software-engineer

图片来源:作者

进入科技领域的时机从未如此激动人心。对于熟练的软件工程师的需求不断增长。那么,即使你是自学成才,没有计算机科学学位,你如何获得软件工程师职位呢?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

为了帮助你实现目标,我们整理了这份来自 Google 的免费课程和指南列表。这些资源将帮助你学习以下内容:

-

编程基础

-

使用 Python 编程

-

数据结构和算法

-

软件工程原则

还有更多内容。这样你可以免费学习所需的一切,以获得软件工程师职位。

1. 编程基础

如果你没有编程经验,可以从编程基础课程开始。

在这个课程中,你将学习基本的编程概念,如:

-

变量和操作符

-

控制流

-

字符串和数组

这将提供编程的高层次概述,以便你可以通过参加其他课程在这些基础上进一步学习。

链接:编程基础

2. Python

要进入软件工程领域,你需要至少熟练掌握一种编程语言。Python 容易学习,你可以直接开始做项目。此外,Python 在编程面试中非常实用。

Google's Python 课程将帮助你通过讲座视频、文本材料和编程练习来学习 Python 编程。以下是你将学到的内容概述:

-

Python 基础

-

列表和字符串

-

排序

-

字典和文件

-

正则表达式

-

实用工具(来自 Python 标准库)

链接:Python

3. 数据结构和算法

一旦你学会了如何编程,理解数据结构和算法的工作原理对于解决问题是基本的。这对于编程面试也非常重要。

数据结构与算法合集将帮助你学习和实践以下内容:

-

哈希表

-

链表

-

树

-

字典树

-

栈和队列

-

堆

-

图

-

运行时分析

-

搜索和排序

-

递归和动态编程

链接: 数据结构与算法

4. 面试准备

我们迄今审阅的资源将帮助你学习编程、数据结构和算法。从根本上说,这些都是你应了解的内容,以应对编码和技术面试。

但是如何策略性地准备技术面试呢?这就是面试准备指南派上用场的地方。

指南中的资源将帮助你了解如何:

-

为编码面试做准备

-

技术面试中的沟通

-

练习编码面试问题和模拟面试

链接: 面试准备

5. 软件工程原则

作为软件工程师,你应该编写干净且文档齐全的代码,易于理解和维护。因此,你也应该熟悉编写可维护和清晰代码的原则。

软件工程原则课程涵盖以下主题:

-

测试和调试

-

使用开源工具

-

设计和文档

链接: 软件工程原则

总结

所以如果你想启动你的软件工程师职业生涯,我希望你能在学习过程中发现这些课程的帮助。正如你可能猜到的,这些课程是免费的,但需要你付出勤奋的努力、兴趣和练习来破解面试并获得软件工程师职位。所以继续努力!

如果你特别寻找帮助你进行编码面试准备的资源,可以查看 5 门免费大学课程以攻克编码面试。

Bala Priya C是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇点工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正在通过编写教程、指南、评论文章等来学习和分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。

更多相关内容

5 个免费托管平台用于机器学习应用

原文:

www.kdnuggets.com/2022/05/5-free-hosting-platform-machine-learning-applications.html

作者提供的图片

在完成机器学习项目后,是时候展示你的模型表现如何了。你可以创建前端应用程序或使用 REST API。随着 Streamlit、Gradio 和 FAST API 的引入,创建前端应用程序变得轻松自如。这些 Web 框架只需几行代码即可创建交互式用户界面。与公众分享你的工作有助于你建立强大的数据科学作品集。它也帮助非技术人员理解你的项目。因此,在构建 Web 应用程序后,是时候将应用程序部署到云服务器上了。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

在这篇博客中,我们将了解五个最佳免费的机器学习演示托管平台。我将分享我在每个平台上的经验,并解释它们为何独特。

1. Hugging Face Spaces

Spaces 已成为机器学习社区的新亮点。我使用这个平台来部署几乎所有的机器学习演示。它通过 Git 提供了简单的部署选项,并为环境和 Python 包相关的问题提供了友好的解决方案。Spaces 允许你部署 Streamlit、Gradio 和基于 HTML 的 Web 应用程序。它速度快且可靠,服务器运行时间长。你甚至不需要上传模型或数据。它与 Hugging Face 数据集和模型的集成无缝。此外,Gradio 允许我们使用回调保存和更新标记数据集,这是一个非常令人兴奋的功能。

Spaces 是社区主导的机器学习演示共享平台。你可以找到计算机视觉、音频、自然语言处理、表格数据甚至简单仪表板的 Web 应用程序。你可以将你的应用程序保持私密或与公众分享。这个平台的最佳部分是,它为你提供了许多功能而不收取任何费用。Hugging Face 确实在让机器学习变得更加民主化。

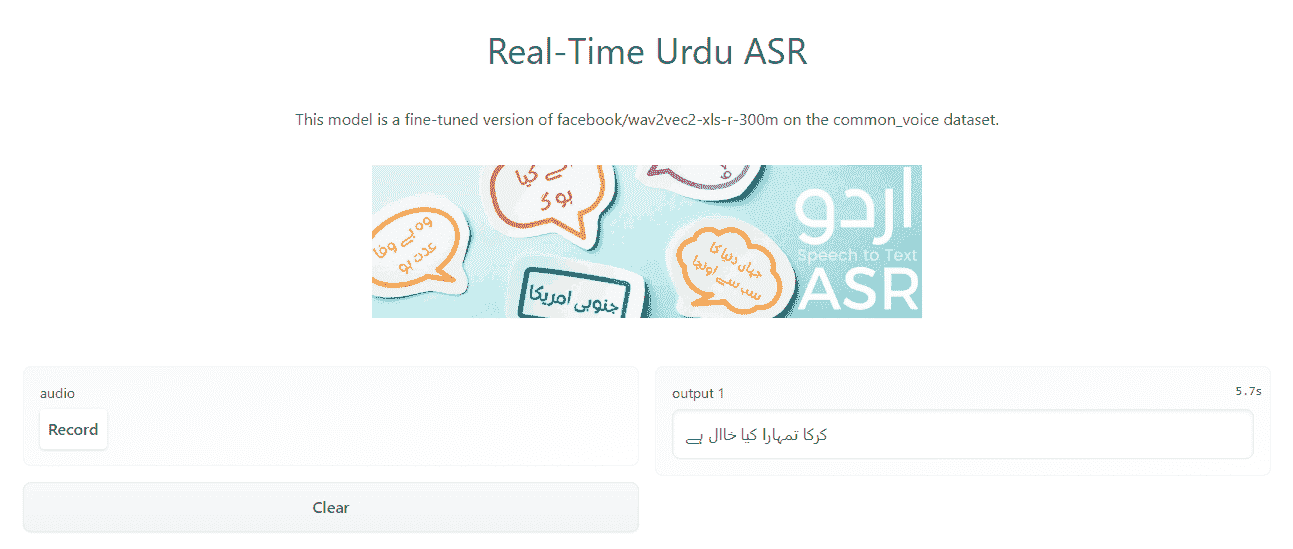

Gradio 应用在 Spaces 上: 实时乌尔都语 ASR

2. Streamlit Cloud

Streamlit Cloud 允许你免费部署一个私人和无限制的公共 Streamlit 应用。该平台提供了一键部署选项,支持 GitHub 集成。简而言之,你将代码推送到 GitHub 仓库,Streamlit 云会自动检测更改并重建服务器。此外,你可以享受与数据源的安全集成、身份验证、Streamlit 项目的协作,以及最多 1 GB 的存储空间。

我喜欢 Streamlit Cloud,因为它完全是为 Streamlit 开源 Web 框架量身定制的。每个新版本,平台在速度、正常运行时间和可访问性方面都在不断改进。它对初学者友好,提供了无忧的部署体验。

Cloud 上的 Streamlit 应用: Traingenerator

3. Heroku

Heroku 是一个用于部署各种 Web 应用程序的云平台。你可以从小做起,然后随着时间的推移扩展项目。Heroku 支持最流行的编程语言、数据库和 Web 框架。此外,你可以找到大量的集成用于日志记录、电子邮件通知、测试、仪表盘、图像处理和 DevOps。

我第一次使用托管服务是 Heroku,我发现修改和部署更改到服务器相当容易。你可以使用 GitHub 集成、Heroku CLI 和 Git 远程部署你的应用。我由于存储限制停止使用它,但我仍然认为它是数据应用程序的顶级托管平台之一。易于使用和多个集成使其成为我前三个首选的 Web 开发平台。

深度学习 Streamlit 应用在 Heroku 上: dagshub-pc-app.herokuapp.com

教程: 将 Streamlit WebApp 部署到 Heroku 使用 DAGsHub

4. Deta

Deta 最适合微服务。你可以免费部署 REST API 或 Node.JS 应用,提供免费的存储和数据库。Deta 提供了其风格的 SQL 数据库和大容量存储服务。除此之外,你还可以安排运行、自定义域名,并添加 API 密钥。

在我第一次使用 Deta 时,我完全被 Deta CLI 和服务器提供的简洁性和强大功能所吸引。我甚至写了一篇博客: 部署你的第一个机器学习 API。我花了 5 分钟理解文档、安装 CLI 并部署我的机器学习应用。如果你想创建自己的机器学习微服务并启动自己的公司,那么 Deta 是最好的起点。

FastAPI ML 应用在 Deta 上: fastapimlproject.deta.dev/docs

5. Replit

Replit是一个云集成开发环境(IDE),为各种项目提供免费计算、存储和托管服务。它是一个由社区驱动的平台,人们(主要是学生)在这里分享与游戏、网页设计、微服务构建,甚至创建新框架相关的项目。

它如何帮助我们构建机器学习应用程序?在每个项目中,你可以运行一个临时服务器,并使用公共 URL 托管你的应用程序。例如,创建一个 FastAPI 机器学习应用程序,当你按下运行按钮时,它会自动启动一个带有 URL 的 Web 服务器,你可以分享这个 URL。你可以使用 ping 技巧保持服务器在线,或者购买 Pro 版本。

目前,我在运行四个强化学习机器人、三个 NLP 聊天机器人和一个 FastAPI 项目。你可以在一个地方创建和部署应用程序,而无需担心依赖关系或开发问题。这是我尝试新事物和测试 API 的首选平台。如果你是编程初学者,想进入机器学习的世界,那么从 Replit 开始吧。

Replit 上的应用程序: DailoGPT-RickBot

Abid Ali Awan(@1abidaliawan)是一位认证数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络构建一款 AI 产品,帮助那些在精神健康方面挣扎的学生。

相关话题

5 本免费的 Julia 数据科学书籍

原文:

www.kdnuggets.com/2023/06/5-free-julia-books-data-science.html

作者提供的图片

你可能经常听到关于 Julia 以及它为何是数据科学未来的讨论,但你不知道从何开始。我有一个完美的解决方案。你可以通过查看关于 Julia 编程语言的精彩免费书籍列表来为软件工程和数据科学相关任务做好准备。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

你将学习有关 Julia 数据框架、数据可视化、机器学习以及创建和运行网络服务的库。此外,你还将学习面向对象编程、元编程和并行计算。

1. 《Think Julia》

《Think Julia: How to Think Like a Computer Scientist》由 Ben Lauwens 和 Allen B. Downey 编写,是一本适合所有想学习 Julia 的读者的书,从初学者到经验丰富的程序员皆可。

图书封面

本书从 Julia 的介绍开始,解释了它是什么、如何工作以及为什么与其他编程语言不同。作者随后简要回顾了 Julia 的历史,并讨论了它当前的发展和未来潜力。

本书通过简单的示例来说明每个概念,并在每章末尾提供练习题以巩固学习。

本书还涵盖了更高级的主题,包括数组、矩阵、字符串和输入/输出。此外,它还涉及面向对象编程、元编程和并行计算。

2. 《Julia 作为第二语言》

《Julia 作为第二语言》由 Erik Engheim 编写,是一本适合已经熟悉其他编程语言的程序员的入门指南,帮助他们将 Julia 学习为第二语言。

本书从 Julia 及其历史的介绍开始,接着讨论了它的特性、优点和独特的卖点。它将 Julia 与其他流行编程语言,如 Python、MATLAB 和 R 进行了比较。

书籍封面

书中还涵盖了面向对象编程、函数式编程和高级主题,如数组、矩阵、字符串以及输入/输出。作者还涉及了元编程、并行计算以及如何使用外部库和包。

3. 使用 Julia 进行统计分析

使用 Julia 进行统计分析 由 Hayden Klok 和 Yoni Nazarathy 编写,是一本关于使用 Julia 编程语言进行统计分析的全面指南。适合任何希望学习如何使用 Julia 进行统计分析和建模的人。

书籍封面

书中涵盖了基本语法,接着介绍了统计学基础,包括概率论、描述性统计、统计推断、统计方法和模型,包括线性回归、逻辑回归、聚类和时间序列分析。

书中还涵盖了如何处理外部数据源,包括 CSV 文件和数据库,以及如何使用 Julia 的绘图库可视化数据。

你将学习统计分析中的可重复性以及如何组织和记录代码和数据。

4. Julia 数据科学

Julia 数据科学 由 Storopoli、Huijzer 和 Alonso 编写,是一本开源且开放访问的书籍,介绍了如何使用 Julia 编程进行数据科学相关任务。

书中首先解释了什么是数据科学和软件工程,然后解释了为什么你应该花时间学习那些在招聘信息中从未提到的语言。

书籍封面

书本开始介绍 Julia 语法、数据结构、文件系统和标准库。然后,转到数据分析和建模所需的重要主题,使用数据框和数据可视化库。

这本书写得很好,易于理解,为初学者或有经验的数据科学家提供了数据分析和建模库的全面介绍。

5. Julia 数据分析

Julia 数据分析 由 Bogumi? Kami?ski 编写,是一本实用指南,适合经验丰富的数据分析师、程序员以及希望学习如何使用 Julia 进行有效数据分析和报告的初学者。

书籍封面

这本书分为两个部分。

第一部分是关于 Julia 编程的基础,你将学习语法、循环和数据结构。接着,你将学习在创建可扩展项目时 Julia 语言中重要的元素。

第二部分涉及数据分析的工具箱。在这一部分,你将学习如何使用数据框处理数据,清洗、操作和转换数据以进行分析,并创建一个用于分享数据分析结果的网页服务。

Abid Ali Awan (@1abidaliawan) 是一位认证数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作和撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为那些在心理健康方面挣扎的学生打造一款人工智能产品。

更多相关主题

5 门免费 MIT 数学课程,助你学习数据科学

原文:

www.kdnuggets.com/5-free-mit-courses-to-learn-math-for-data-science

图片由作者提供

作为数据专业人士,你可能知道数学对数据科学至关重要。数学是数据科学的基础:从理解数据点如何在向量空间中表示到优化算法寻找模型的最佳参数等等。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

掌握数学基础知识有助于你在面试中表现出色,并深入理解你实现的算法。我们在这里整理了麻省理工学院(MIT)提供的关于以下数学主题的免费课程:

-

线性代数

-

微积分

-

统计学

-

概率

你可以在麻省理工学院开放课程平台上学习这些课程。充分利用这些课程,提高你的数据科学技能!

1. 线性代数

除了熟悉高中数学外,线性代数是数据科学中最重要的数学主题。由 Gilbert Strang 教授讲授的超受欢迎的线性代数课程是你可以选修的最佳数学课程之一。对于此课程及后续课程,请完成习题集并尝试考试以测试你的理解。

课程分为以下三个主要模块:

-

方程组 Ax = b 和四个矩阵子空间

-

最小二乘法、行列式和特征值

-

正定矩阵及其应用

链接: 线性代数

2. 单变量与多变量微积分

对微积分有良好的理解对掌握数据科学概念至关重要。你应该熟练掌握单变量和多变量微积分的计算、导数、偏导数、链式法则等。以下是关于单变量和多变量微积分的两个课程。

微积分 I:单变量微积分课程涵盖:

-

微分

-

积分

-

坐标系统与无穷级数

一旦你对单变量微积分感到熟练,可以继续学习多变量微积分课程,该课程涵盖:

-

向量和矩阵

-

偏导数

-

平面上的双重积分和线积分

-

3D 空间中的三重积分和曲面积分

课程链接:

3. 概率系统分析与应用概率

概率是数据科学中另一个重要的数学主题,良好的概率基础对掌握数学建模、统计分析和推断至关重要。

概率系统分析与应用概率课程是一个很好的资源,涵盖以下主题:

-

概率模型和公理

-

条件概率和贝叶斯规则

-

独立性

-

计数

-

离散与连续随机变量

-

连续贝叶斯规则

链接: 概率系统分析与应用概率

4. 应用统计学

要在数据科学中获得精通,你需要对统计学有坚实的基础。应用统计学课程涵盖了许多在数据科学中相关的应用统计概念。

下面是所涵盖的主题列表:

-

参数推断

-

最大似然估计

-

矩

-

假设检验

-

拟合优度

-

回归分析

-

贝叶斯统计

-

主成分分析

-

广义线性模型

如果你对深入探讨统计学感兴趣,可以查看5 Free Courses to Master Statistics for Data Science。

链接: 应用统计学

5. 机器学习及其他领域的矩阵微积分

你应该已经通过单变量和多变量微积分课程对优化有一定了解。但在机器学习中,你可能会遇到需要矩阵微积分和任意向量空间微积分的大规模优化问题。

机器学习及其他领域的矩阵微积分将帮助你在你所学的线性代数和微积分课程的基础上进一步深入。这可能是这个列表中最高级的课程。但如果你打算进行数据科学的研究生课程或想探索机器学习和研究,它将非常有帮助。

以下是该课程所涵盖的一些主题:

-

作为线性算子的导数;在任意向量空间上的线性近似

-

以矩阵作为输入或输出的函数的导数

-

矩阵分解的导数

-

多维链式法则

-

正向和反向模式的手动与自动微分

你还可以探索许多其他的近似和优化算法。

总结

如果你想掌握数据科学中的数学,这些课程列表应该足以让你学习所有你需要的内容——无论是进入机器学习研究还是获得数据科学的高级学位。

如果你还在寻找更多的课程来学习数据科学中的数学,可以阅读5 门免费课程掌握数据科学中的数学。

Bala Priya C**** 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交叉点上工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和喝咖啡!目前,她正在通过编写教程、操作指南、观点文章等方式学习和分享知识。Bala 还创建了引人入胜的资源概述和编码教程。

更多相关内容

五门免费在线课程,学习数据工程基础

原文:

www.kdnuggets.com/5-free-online-courses-to-learn-data-engineering-fundamentals

作者提供的图片 | Canva

如果你打算成为数据工程师,所需学习的工具和技能可能会让人感到不知所措。数据工程职位的描述要求很多,这使得很多人选择回避。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

然而,只要你掌握了基础知识,就不需要过于担心所有要求。学习数据工程的基础可以帮助你顺利开展数据工程师的职业生涯。

在这篇博客中,我将介绍五门免费在线课程,帮助你学习数据工程的基础知识。

面向所有人的数据工程

链接: 面向所有人的数据工程

正如标题所述,无论你是刚开始还是已经完成了一半——这门由 DataCamp 提供的课程适合所有对数据工程感兴趣的人。这是一门无代码的数据工程入门课程,你将学习所有有关数据工程师的知识。

你将学习数据工程师如何奠定基础,以及这如何帮助数据科学家完成他们的任务。理解数据工程师和数据科学家的区别非常重要。从数据存储到数据处理技术,这将帮助你学习如何开发数据管道,以及如何在数据工程项目中使用并行计算和云计算。

数据工程初学者课程

链接: 数据工程初学者课程

也许你不喜欢按照书面的课程大纲学习,想要感觉像在课堂环境中。这门由 freeCodeCamp 提供的 3 小时数据工程初学者课程可以满足你的需求。

在这门面向初学者的课程中,你将学习数据工程的基本要素。你将了解数据库、Docker 和分析工程,探索像使用 Airflow 构建数据管道这样的高级主题,并参与使用 Spark 进行批处理和使用 Kafka 进行流数据处理。课程的最后一个部分是一个全面的项目,考验你创建完整端到端管道的技能。

ASUx: 数据工程

链接:ASUx: 数据工程

在 5 周内,每周 1-9 小时,你将获得由亚利桑那州立大学提供的数据工程入门知识。在本课程中,你将通过互动视频来帮助你理解分析概念和软件。