KDNuggets-博客中文翻译-十一-

KDNuggets 博客中文翻译(十一)

原文:KDNuggets

使用 BERT 进行长文本文档分类

原文:

www.kdnuggets.com/2022/02/classifying-long-text-documents-bert.html

由 Sinequa 提供

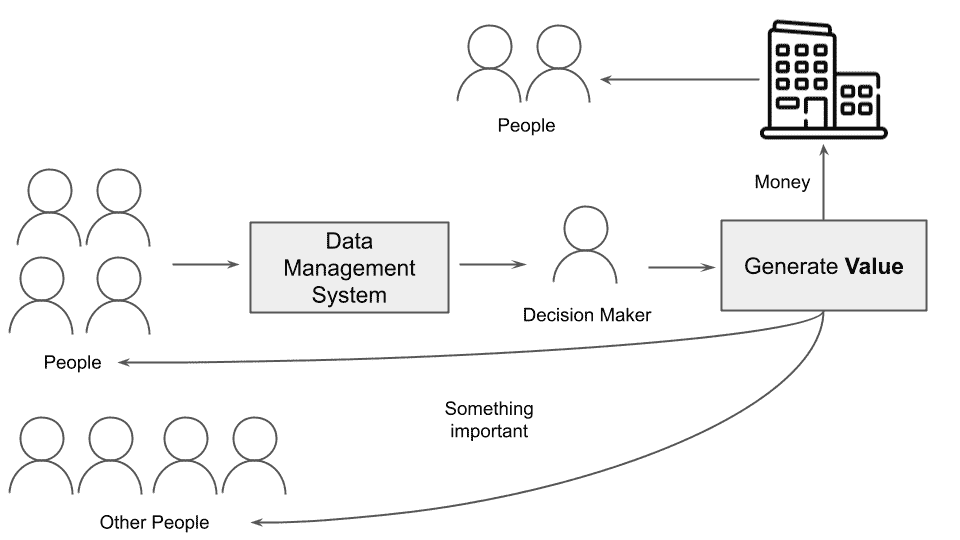

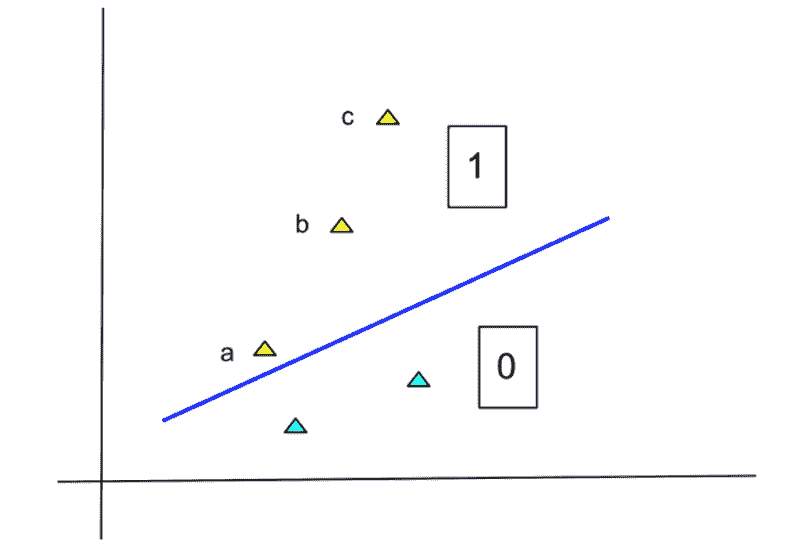

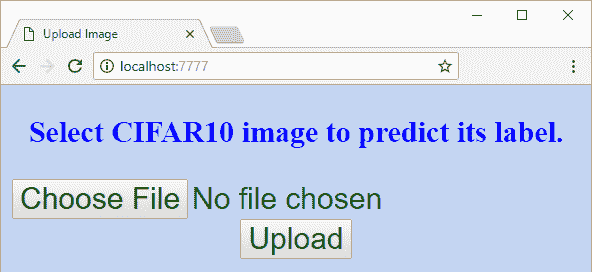

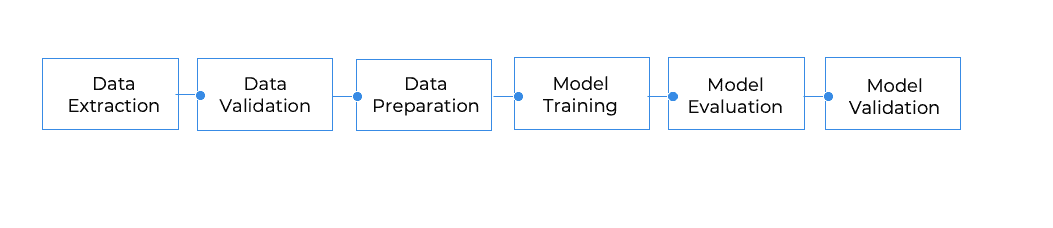

我们想要实现什么目标?

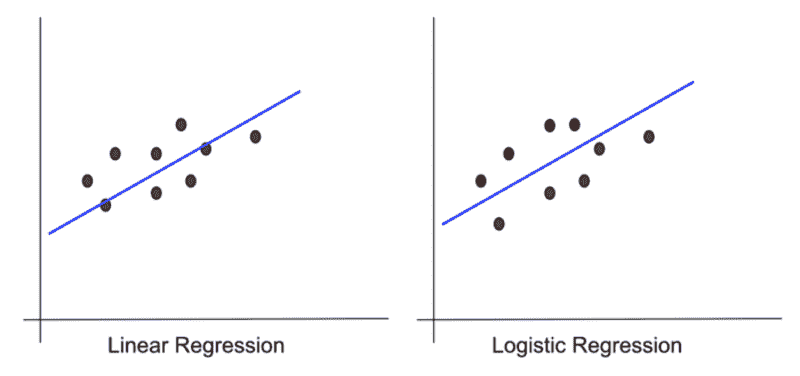

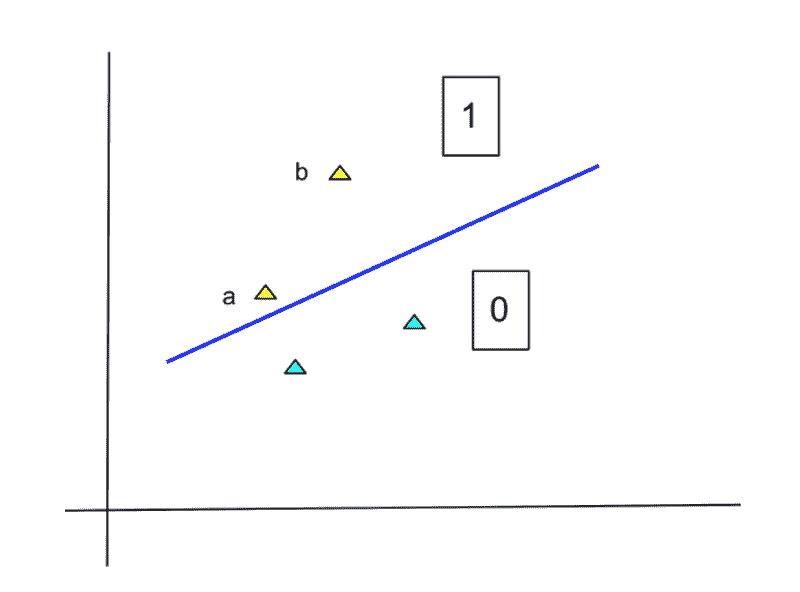

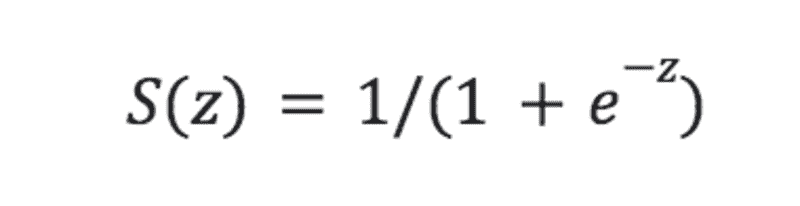

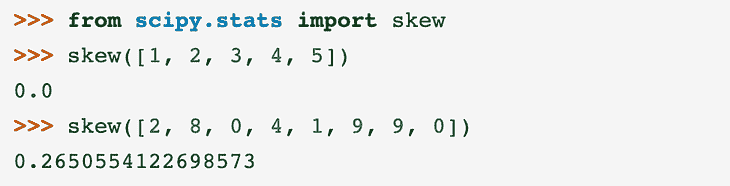

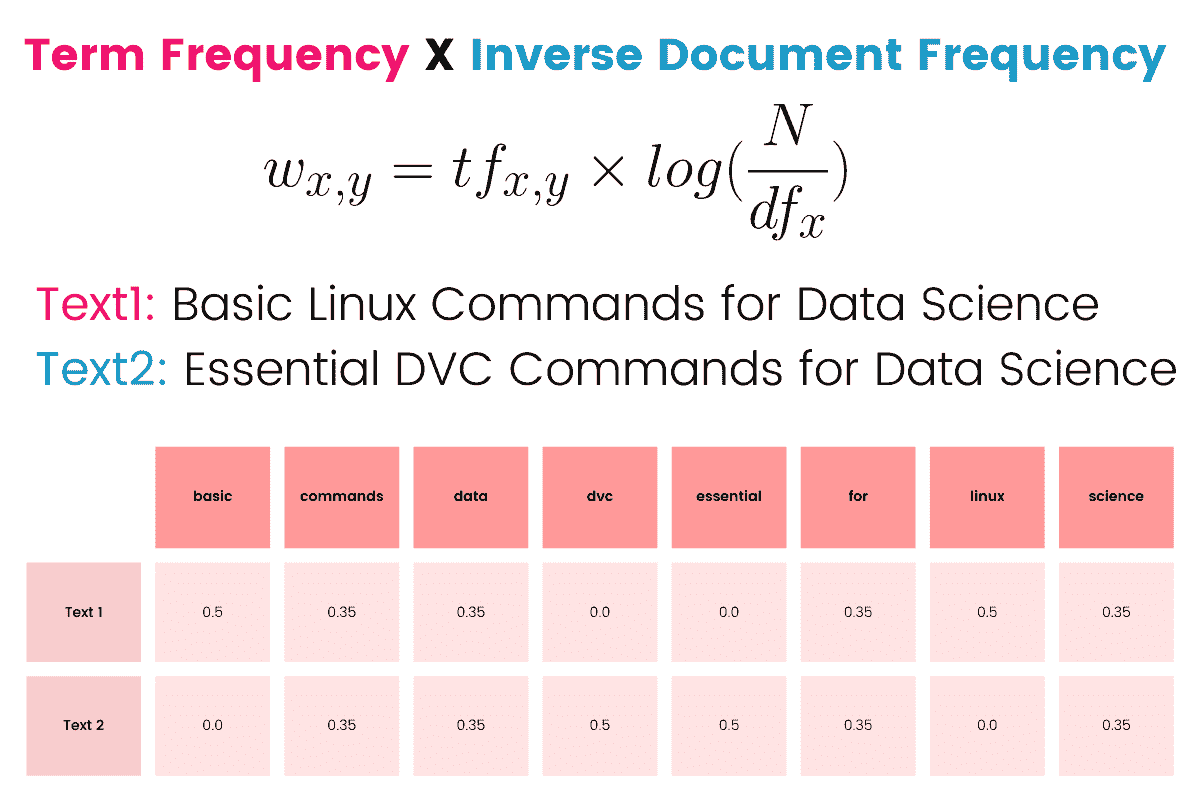

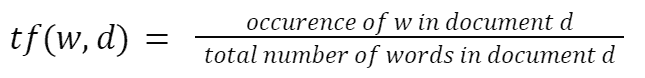

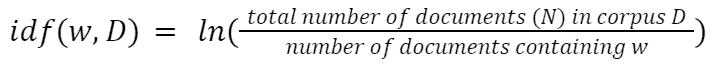

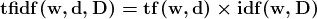

我们想将文本分类到预定义的类别中,这是 NLP 中非常常见的任务。多年来,简单文档的经典方法是使用TF-IDF生成特征,并将其与逻辑回归结合。以前我们在 Sinequa 用来进行文本分类时依赖于这一套方案,剧透一下,使用这里介绍的模型,我们将非常嘈杂和长文档数据集的基线从 5%提高到了 30%。这种旧方法有两个主要问题:特征稀疏性,我们通过压缩技术解决了这一问题,以及词匹配问题,我们通过利用 Sinequa 强大的语言学能力(主要通过我们自家开发的分词器)来克服。

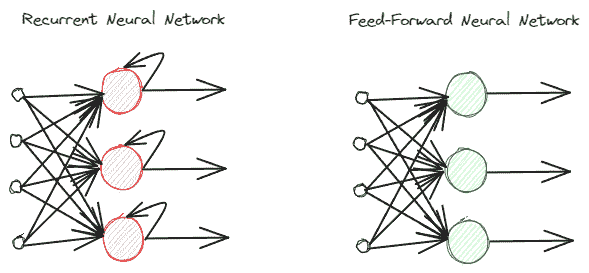

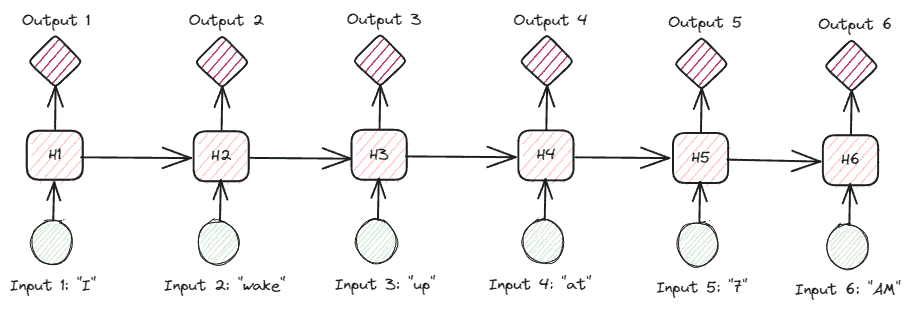

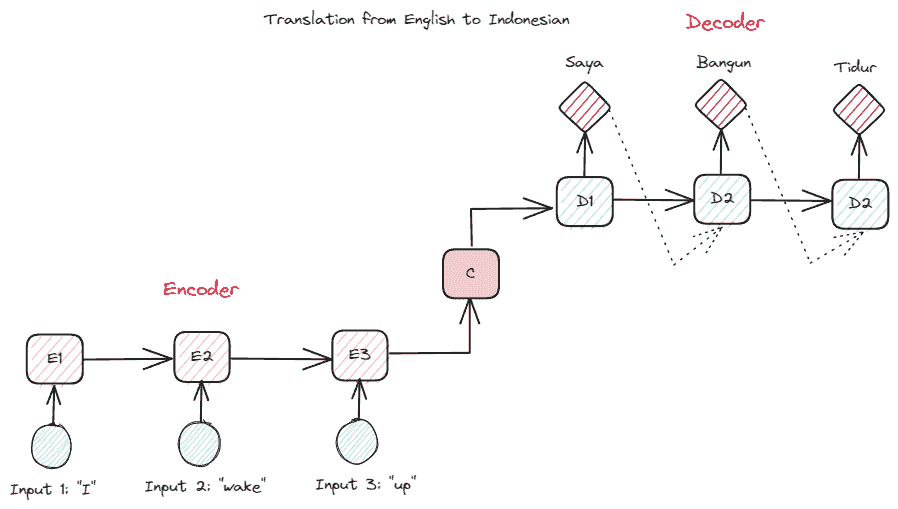

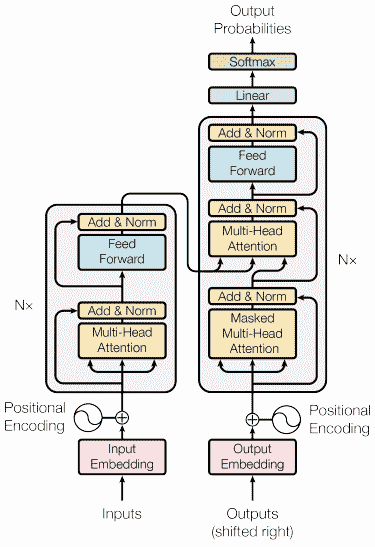

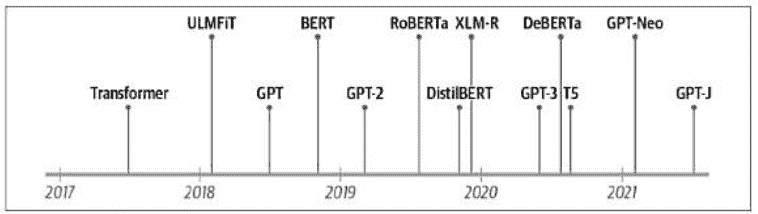

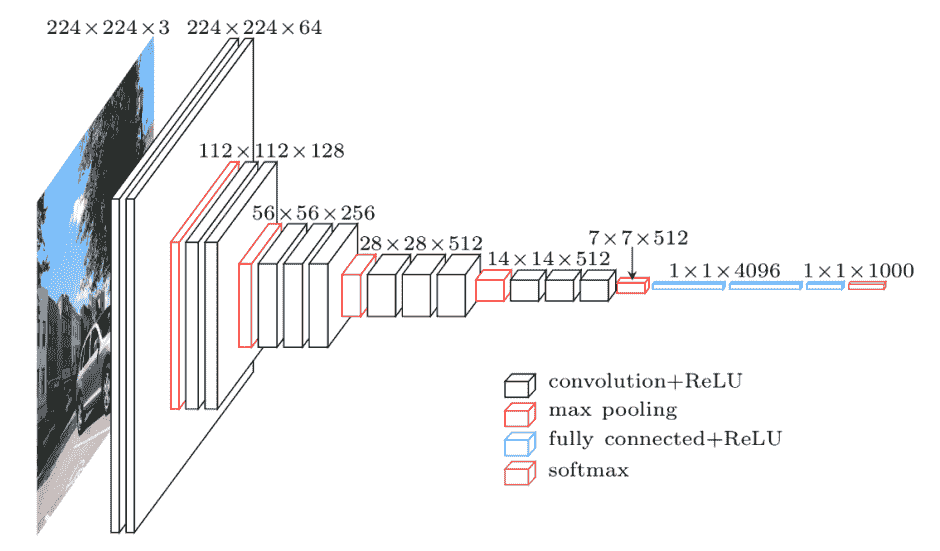

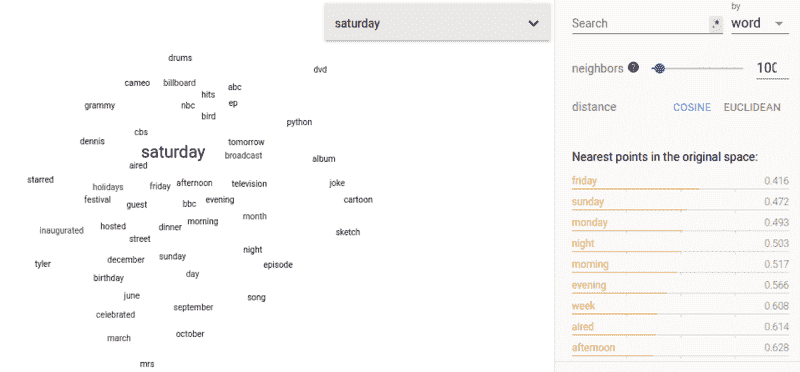

后来,语言模型的潘多拉盒子被打开了(这些模型在海量语料库上进行无监督预训练,并在下游监督任务中进行微调),TF-IDF 基础的技术不再是最先进的。这些语言模型可能是word2vec与 LSTM 或 CNN、ELMo,以及最重要的 Transformer(2017 年:arxiv.org/pdf/1706.03762.pdf)。

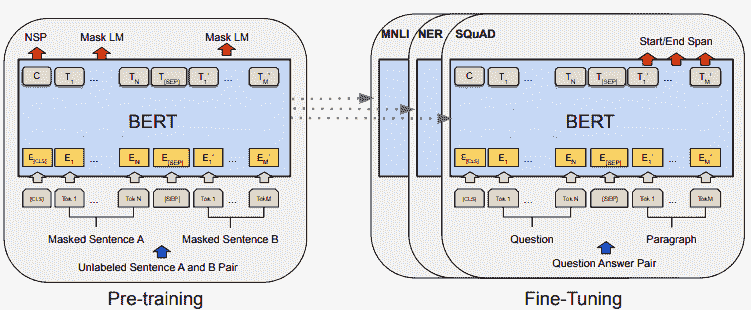

BERT是一个基于 Transformer 的语言模型,近年来获得了大量关注,因为它远远超越了所有 NLP 基线,并成为构建我们文本分类的自然选择。

那么挑战是什么呢?

基于 Transformer 的语言模型如 BERT 在理解语义上下文方面表现出色(这是词袋方法所无法做到的),因为它们专门为此目的而设计。如引言中所述,BERT 在所有 NLP 基线测试中表现优异,但正如我们在科学界所说的,“没有免费的午餐”。像 BERT 这样的模型提供的广泛语义理解带来了一个大问题:它无法处理非常长的文本序列。基本上,这个限制是 512 个标记(标记是文本中的一个词或子词),这大致相当于两到三段维基百科内容,而我们显然不希望仅仅考虑如此小的文本子部分进行分类。

为了说明这一点,考虑将全面的产品评论分类为正面或负面评论的任务。前几句话或段落可能只包含产品的描述,可能需要进一步阅读评论才能理解评论者是否真正喜欢这个产品。如果我们的模型不能涵盖全部内容,可能无法做出正确的预测。因此,我们的模型的一个要求是捕捉文档的上下文,同时正确管理文档开头和结尾之间的长期依赖关系。

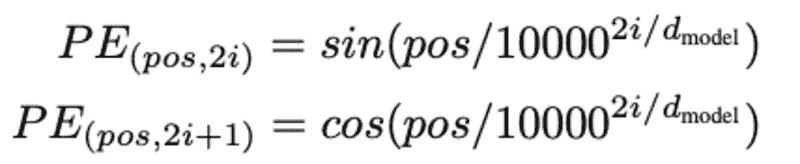

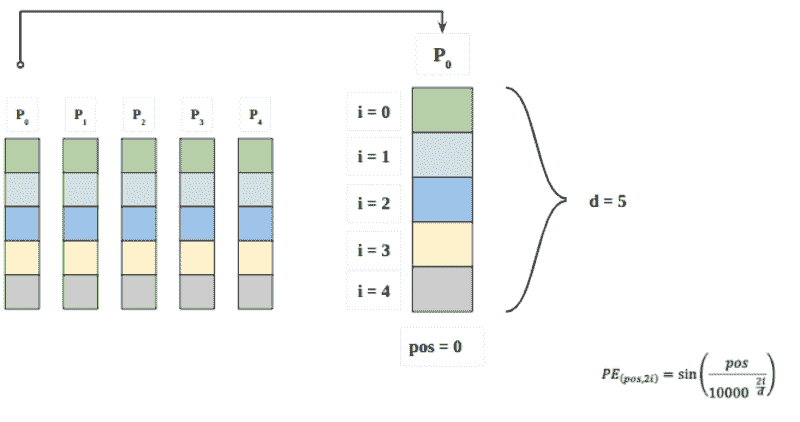

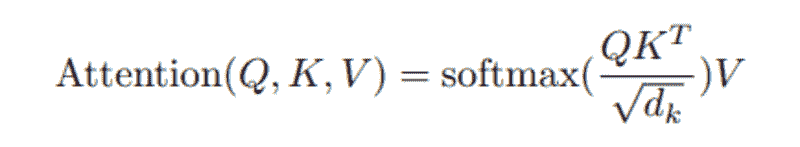

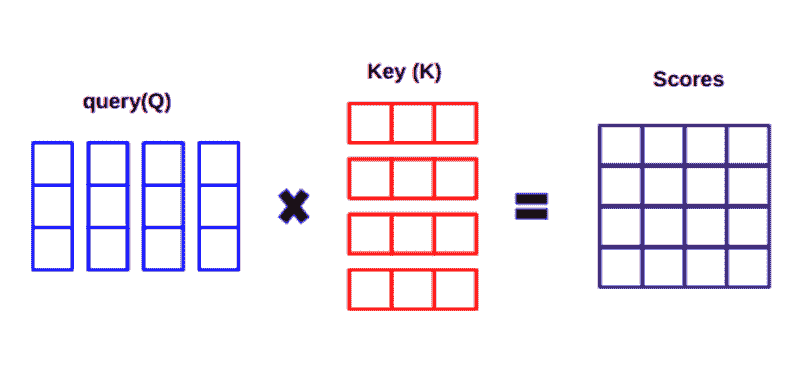

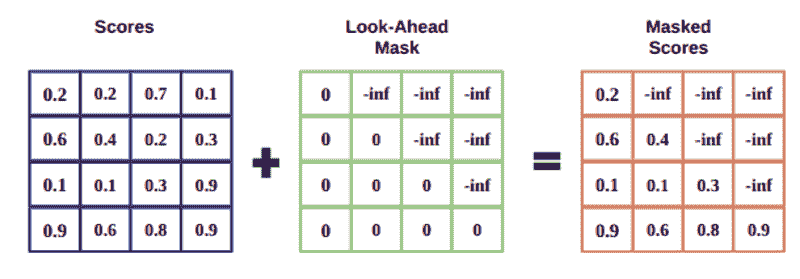

从技术上讲,核心限制是内存占用,它随着标记数量的增加而按平方增长,同时使用的预训练模型具有由 Google 等公司确定的固定大小。这是预期中的情况,因为每个标记都“注意” [https://arxiv.org/pdf/1706.03762.pdf] 到每个其他标记,因此需要一个 [N x N] 的注意力矩阵,其中 [N] 是标记的数量。例如,BERT 接受最多 512 个标记,这很难称为长文本。超过 512 个标记很快就会达到甚至现代 GPU 的极限。

在生产环境中使用 Transformers 另一个出现的问题是由于模型的大小(BERT base 具有 110M 参数)以及平方成本导致推理非常缓慢。因此,我们的目标不仅是找到一个在训练过程中适合内存的架构,还要找到一个在推理过程中也能合理快速响应的架构。

我们在这里面临的最后一个挑战是基于各种特征类型构建一个模型:当然包括长文本,还包括附加的文本元数据(如标题、摘要等)和类别(如位置、作者等)。

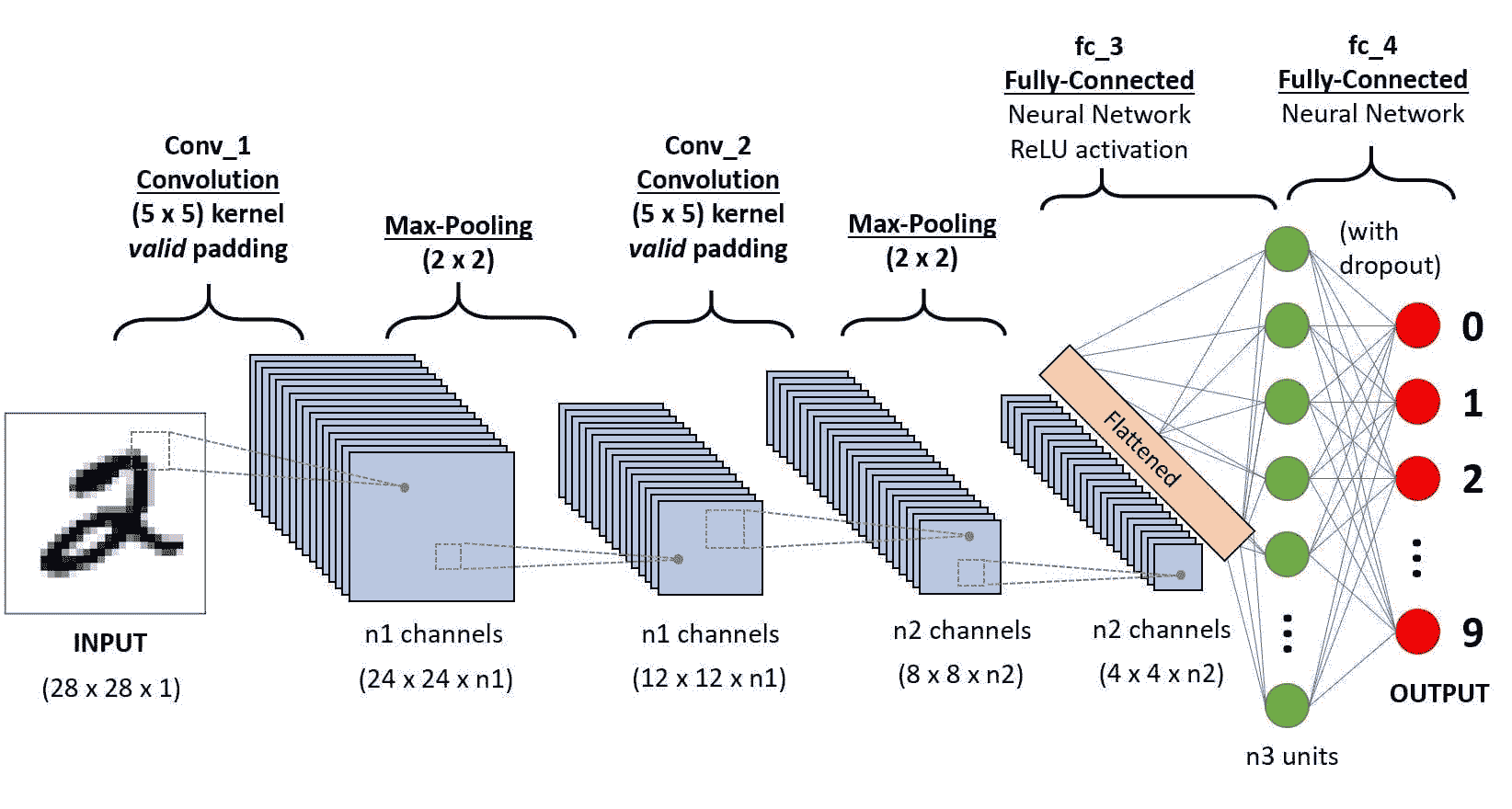

那么,如何处理非常长的文档呢?

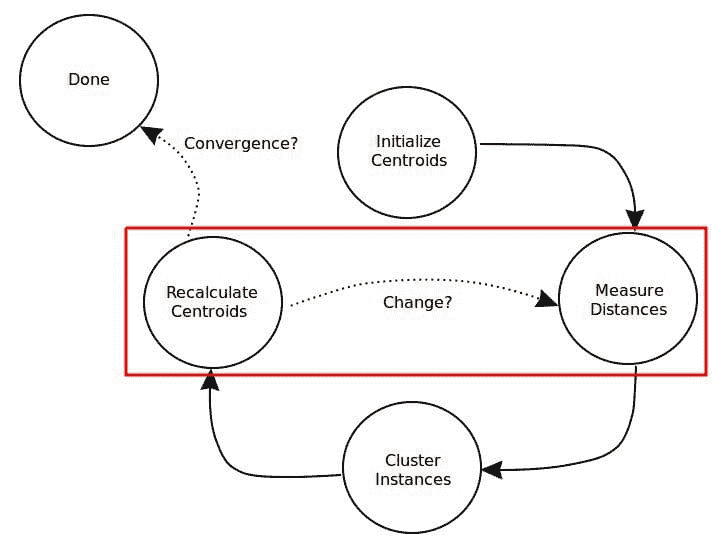

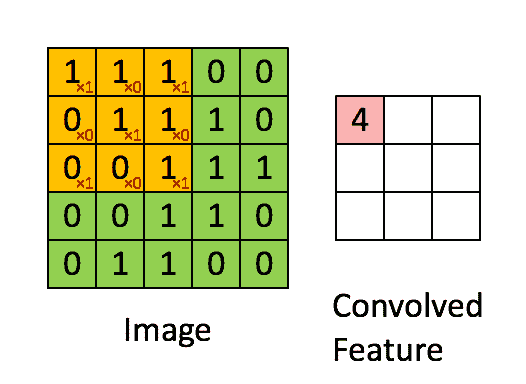

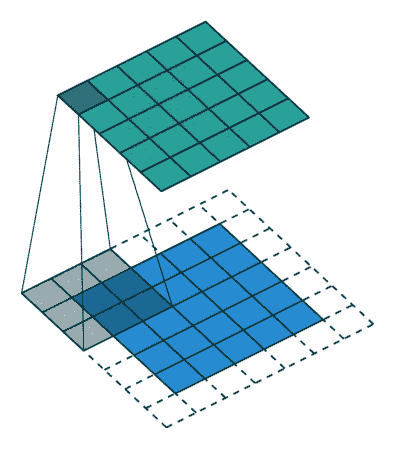

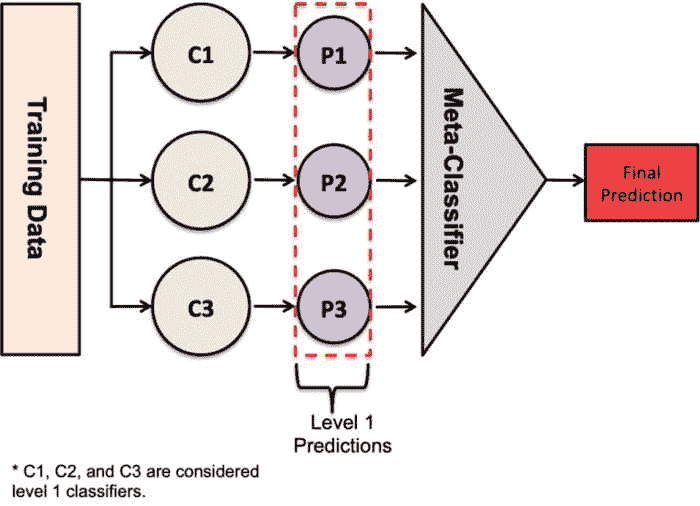

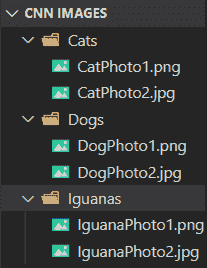

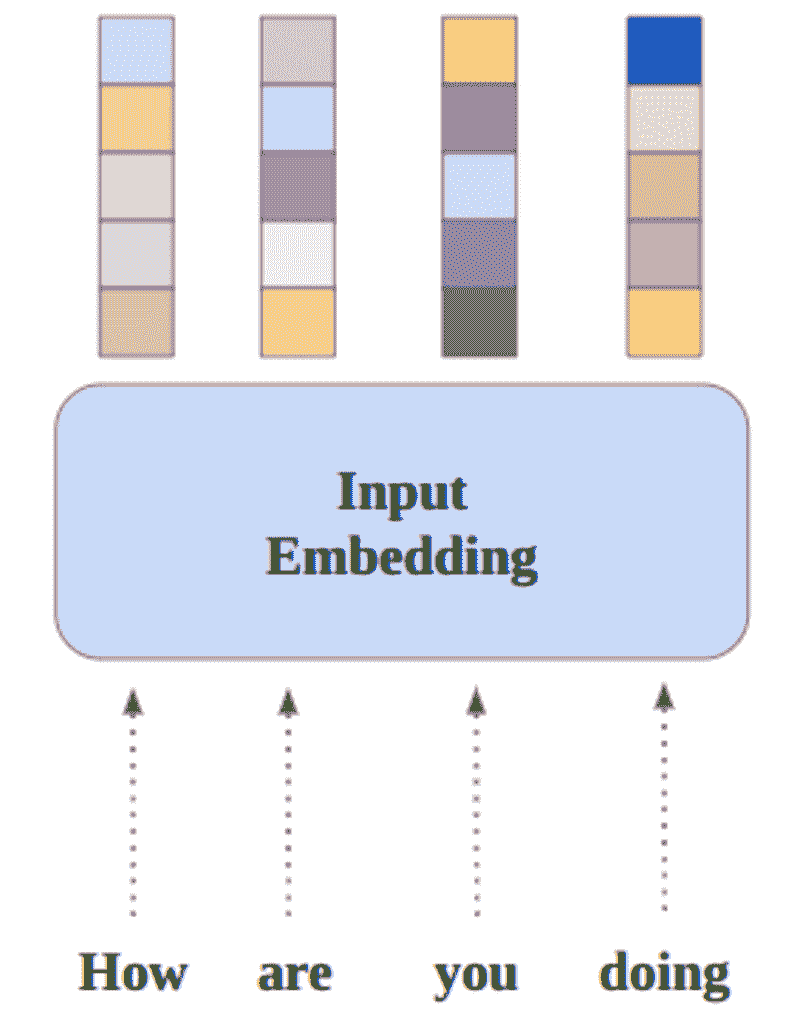

主要的想法是将文档拆分成更短的序列,并将这些序列输入到 BERT 模型中。我们为每个序列获得 CLS 嵌入并合并这些嵌入。合并有几种可能性,我们尝试了:

-

卷积神经网络(CNN)

-

长短期记忆网络(LSTM)

-

Transformers(用来聚合 Transformers,没错 😃)

我们在不同标准文本分类语料库上的实验表明,使用额外的 Transformer 层来合并生成的嵌入效果最佳,而不会引入大量计算成本。

想要正式描述,对吧?

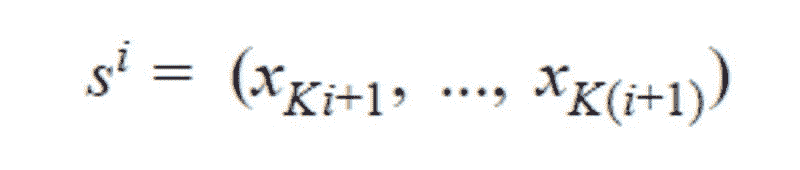

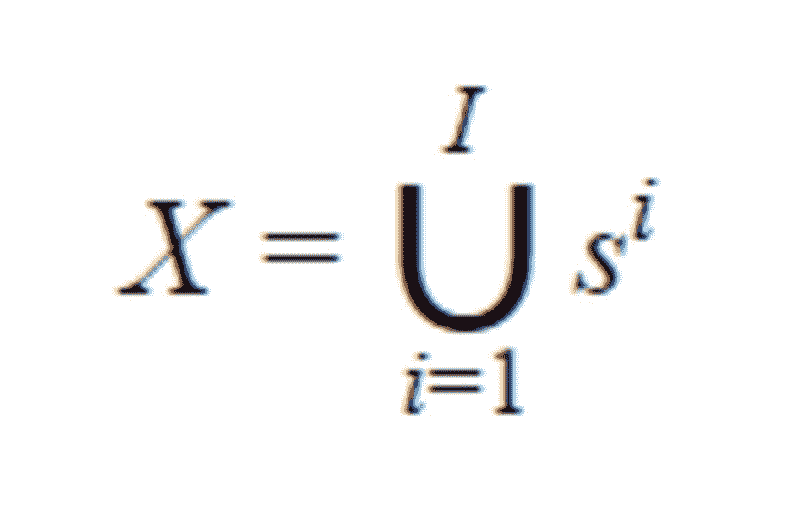

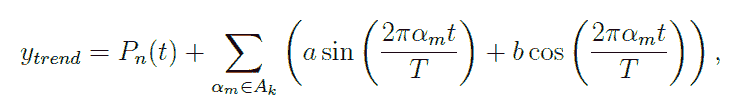

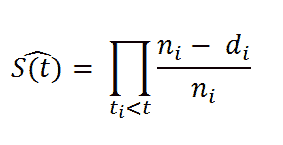

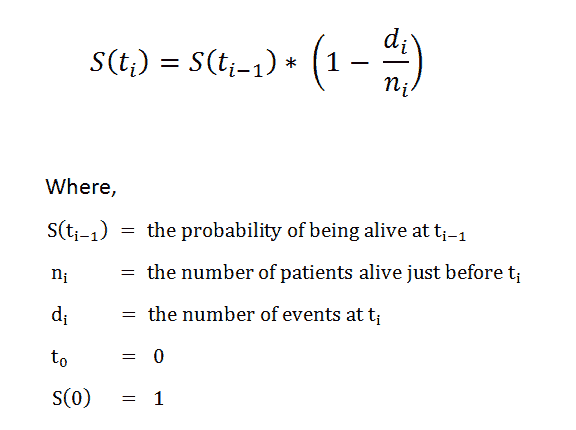

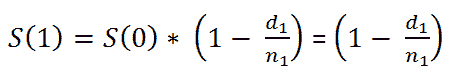

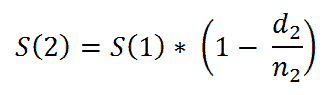

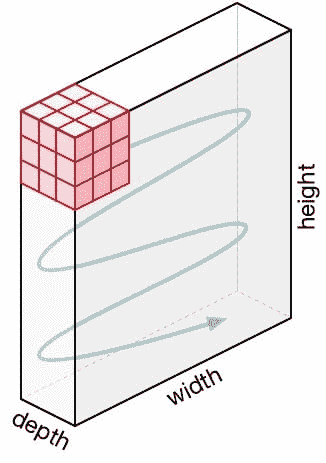

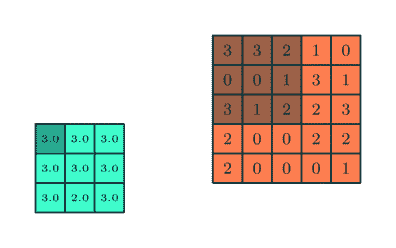

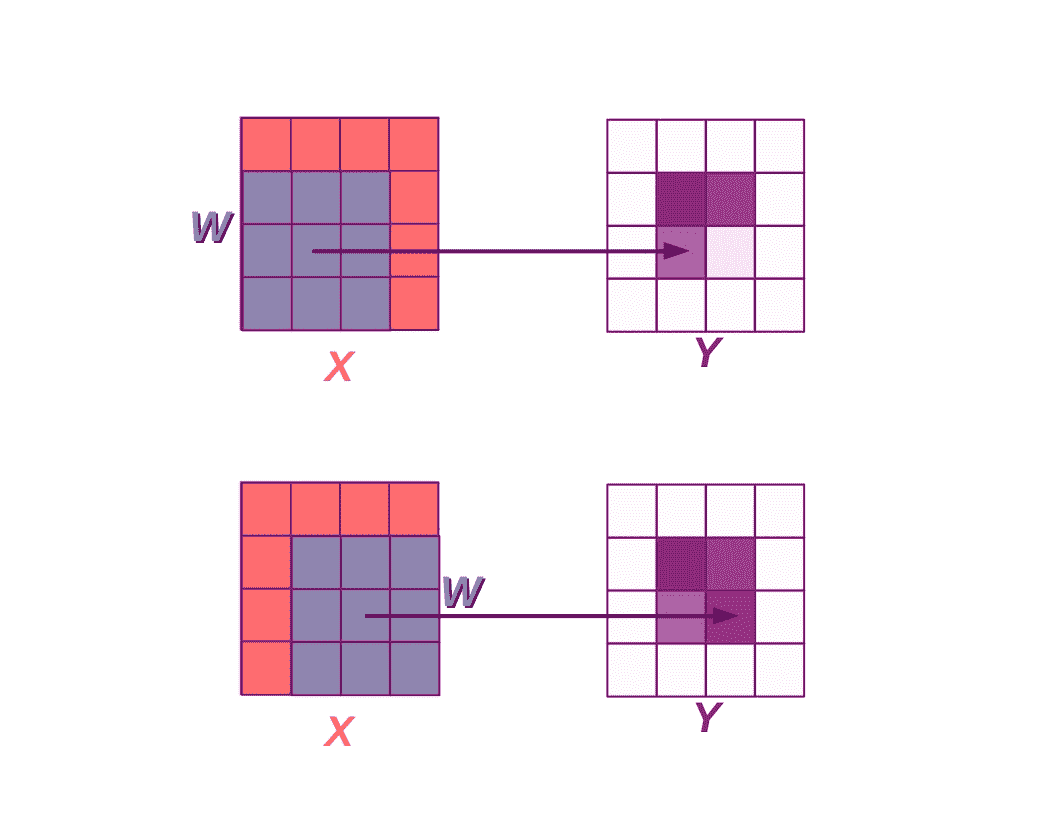

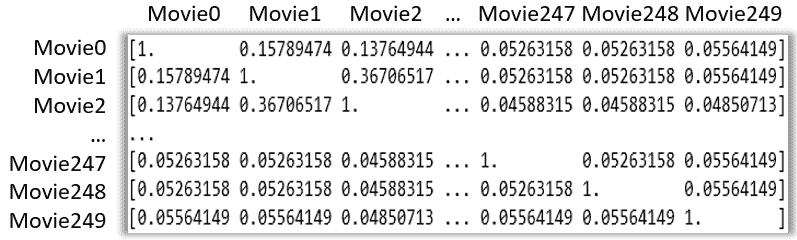

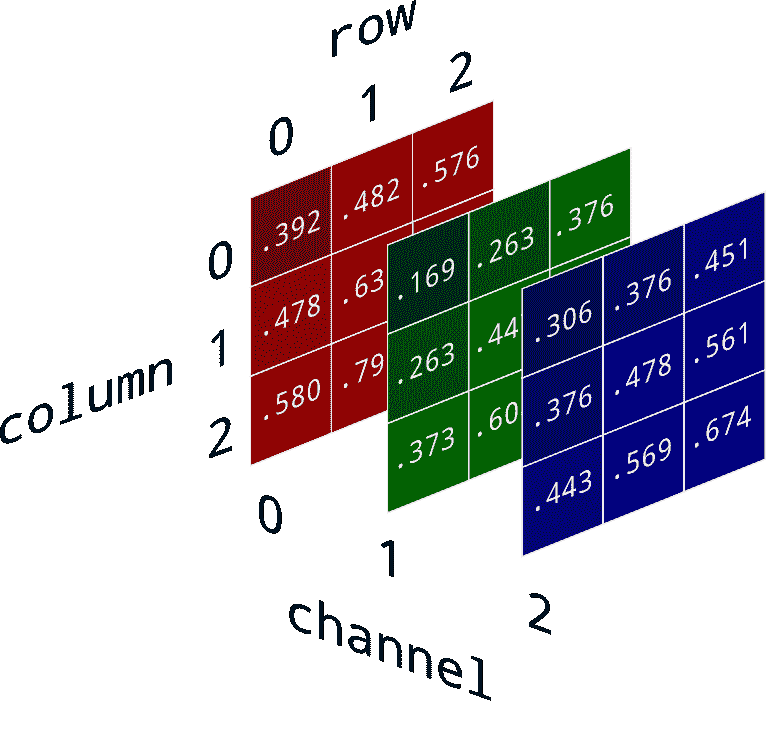

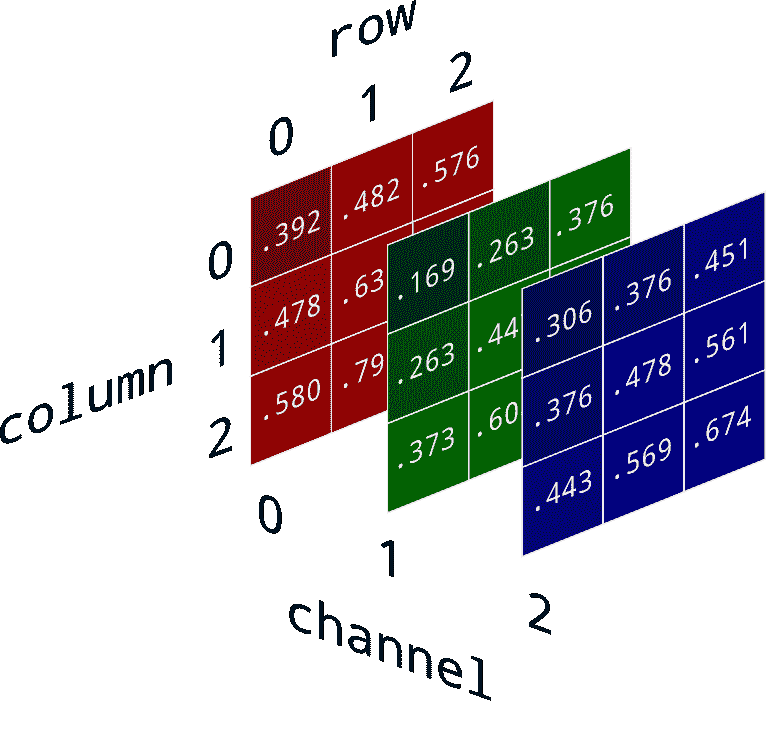

我们考虑一个具有 L 标签的文本分类任务。对于一个文档 D,其由 WordPiece 分词 提供的标记可以表示为 X =( x₁, …, xₙ),其中 N 为 D 中标记的总数。设 K 为最大序列长度(对于 BERT 为 512)。设 I 为 D 中 K 个标记或更少的序列数,它由 I=⌊ N/K ⌋ 给出。

请注意,如果文档中的最后一个序列的大小小于 K,它将用 0 填充,直到 Kᵗʰ 索引。如果 sⁱ 其中 i ∈ {1, .., I} 是 D 中第 i 个具有 K 元素的序列,我们有:

我们可以注意到

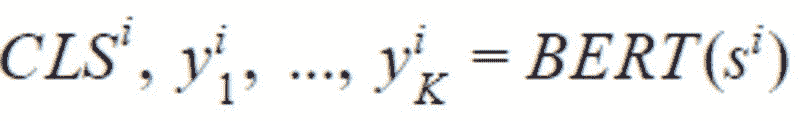

BERT 返回 CLS 嵌入以及每个 token 的嵌入。

让我们定义 BERT 为文档的第 i 个序列返回的每个 token 的嵌入,如下所示:

其中 CLS 是插入到每个输入 BERT 的文本序列前的特殊 token 的嵌入,通常被认为是总结整个序列的嵌入。

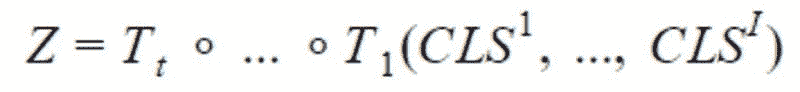

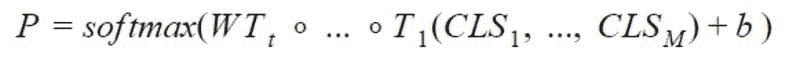

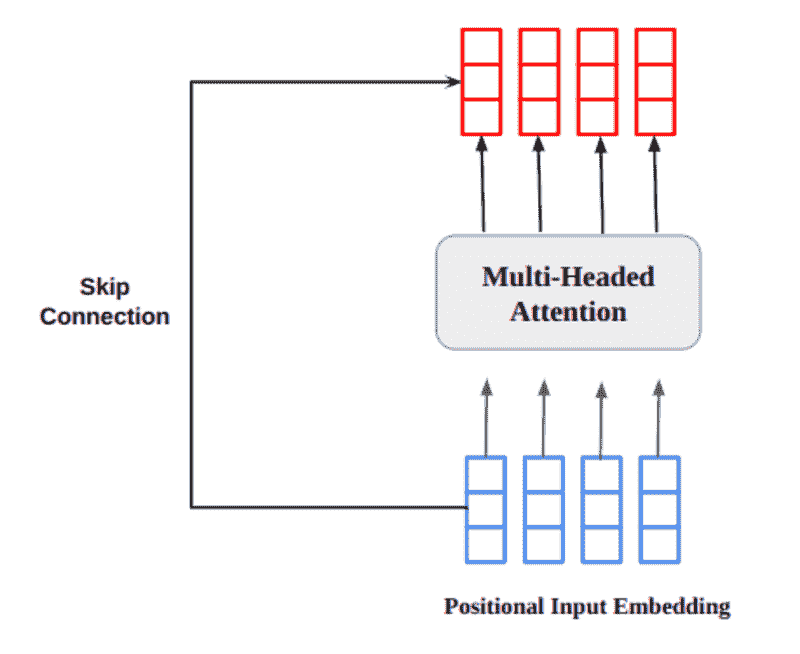

为了结合这些序列,我们只使用 CLSᵢ,不使用 y。我们使用 t 个变换器 T₁, …,Tₜ 来获得最终向量,以便输入到网络的最后一个全连接层:

其中 ∘ 是函数复合操作。

给定最后一个全连接层的权重 W ∈ ℝᴸˣᴴ,其中 H 是变换器的隐藏大小,偏置 b ∈ ℝᴸ

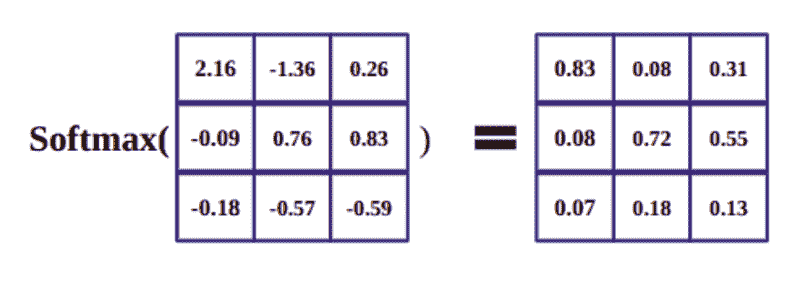

概率 P ∈ ℝᴸ 由以下公式给出:

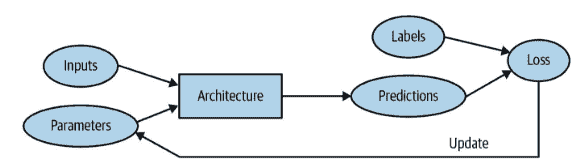

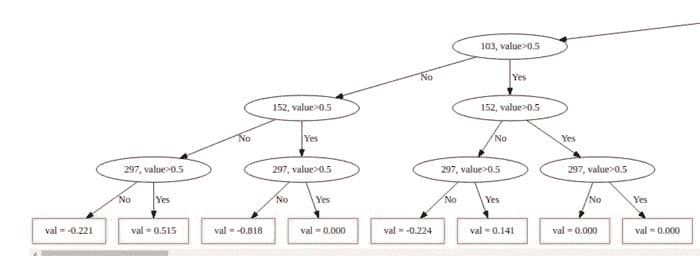

最后,对向量 P 应用 argmax 返回预测的标签。有关上述架构的总结,您可以查看图 1。

上述架构使我们能够利用 BERT 进行文本分类任务,绕过变换器的最大序列长度限制,同时保持对多个序列的上下文。让我们看看如何将其与其他类型的特征结合。

如何处理元数据?

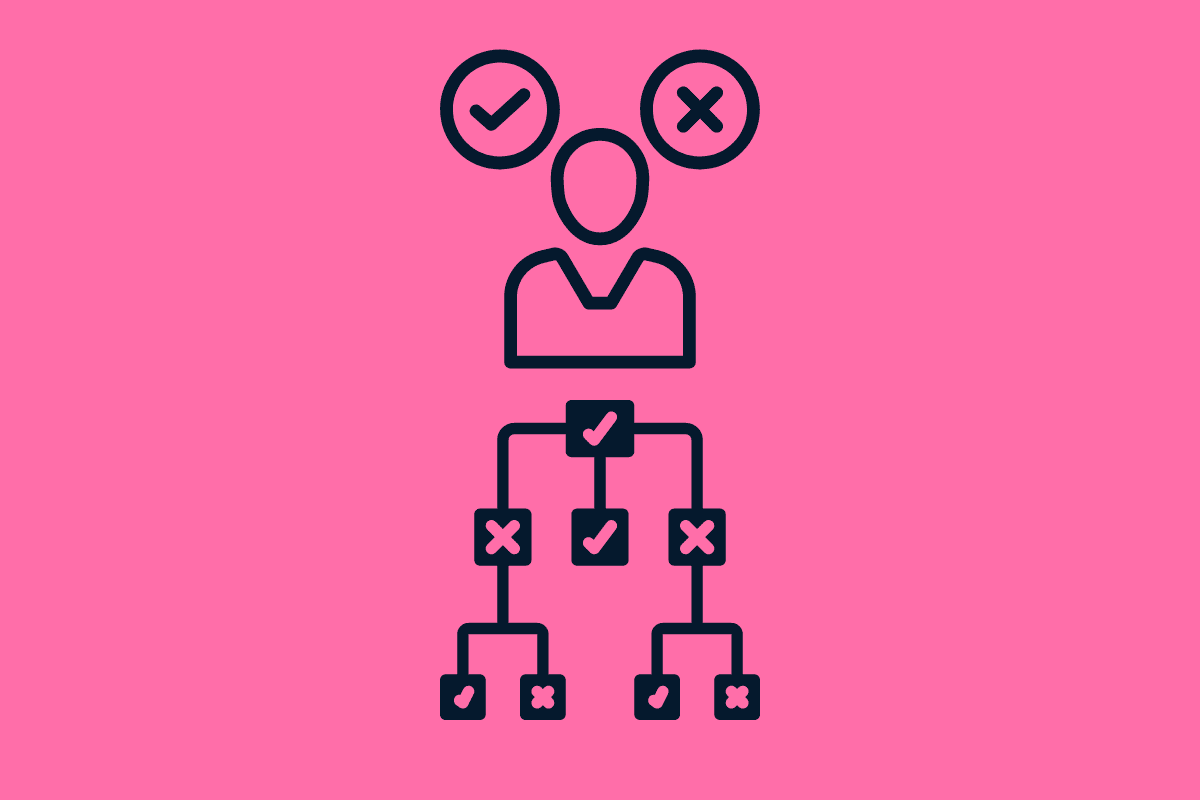

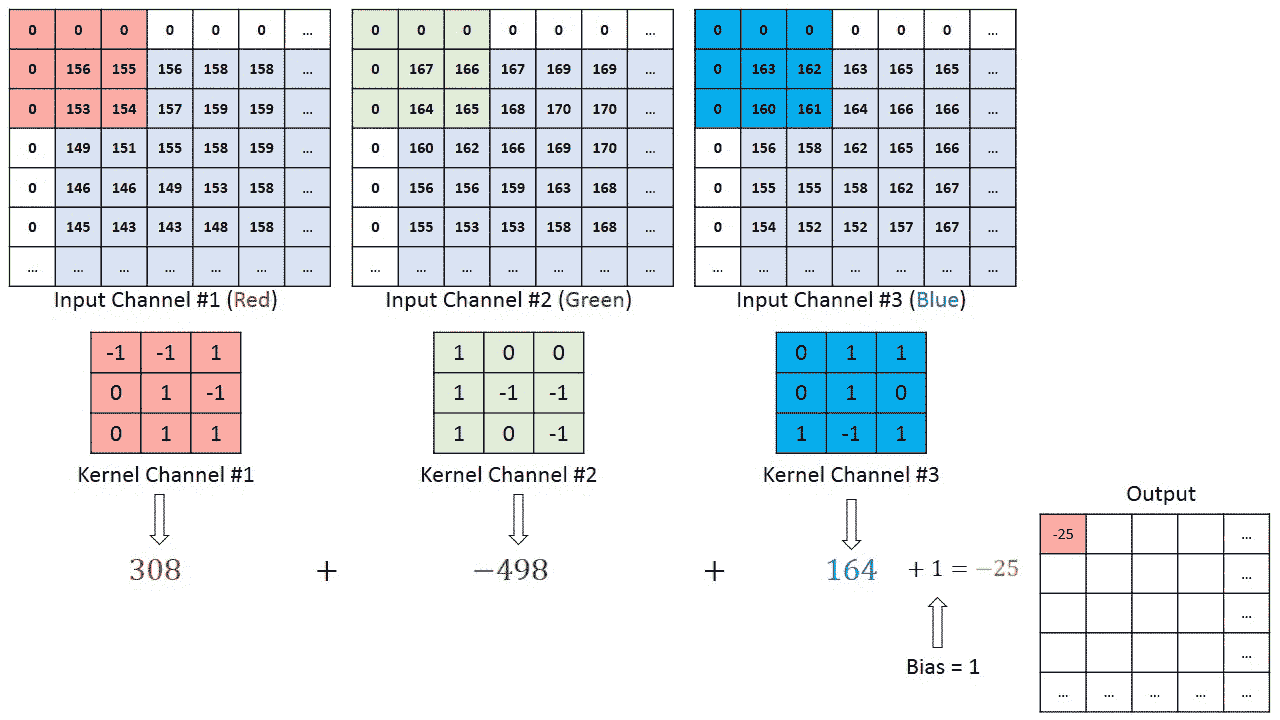

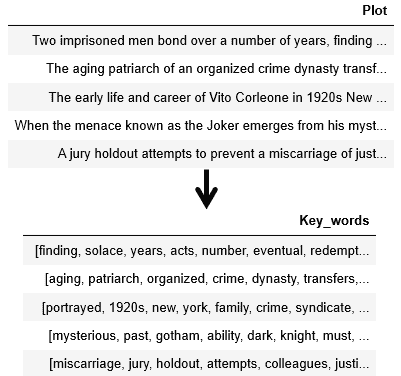

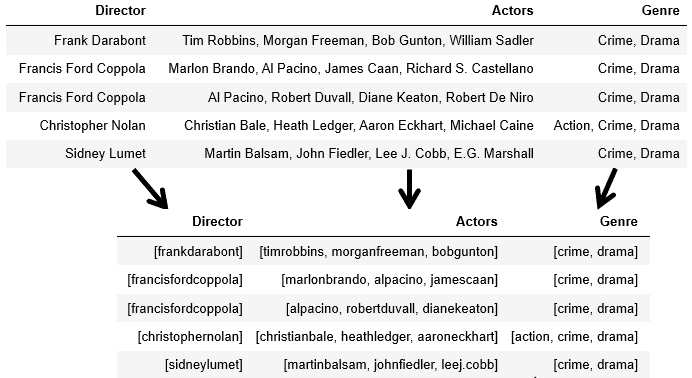

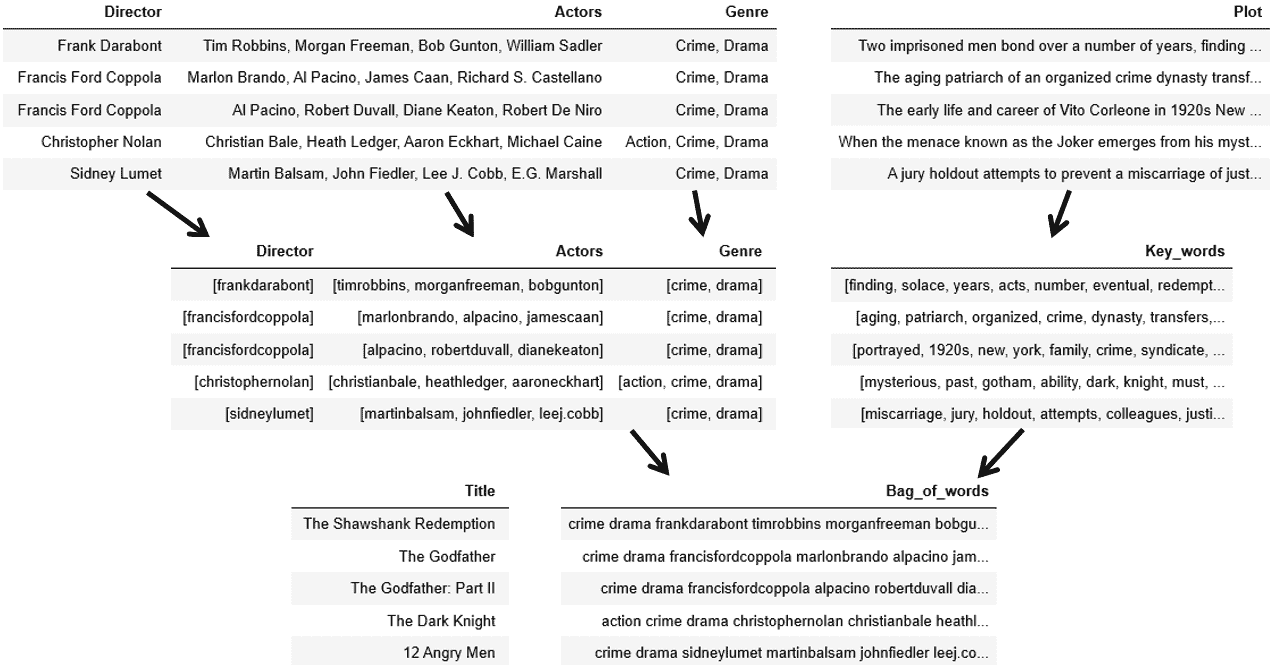

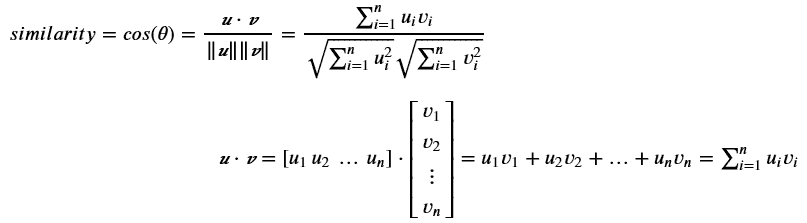

文档通常不仅仅包含其内容,还可能有我们分为两个组的元数据:文本元数据和分类元数据。

文本元数据

文本元数据是指短文本,它(在分词后)具有相对较少的 token 数量。这是为了能够完全适配到我们的语言模型中。此类元数据的典型示例包括标题或摘要。

给定一个具有 M 个元数据注释的文档。让

是 BERT 为每个元数据生成的 CLS 嵌入。使用与上述相同的技术来获取概率向量,如下所示:

分类元数据

分类元数据可以是表示类别的数值或文本值。数值可以是页数,而文本值可以是出版商名称或地理位置。

处理此类特征的一种常见方法是实现 宽和深架构。我们的实验表明,这个网络的深度部分产生的结果已经足够好,而宽度部分是不必要的。

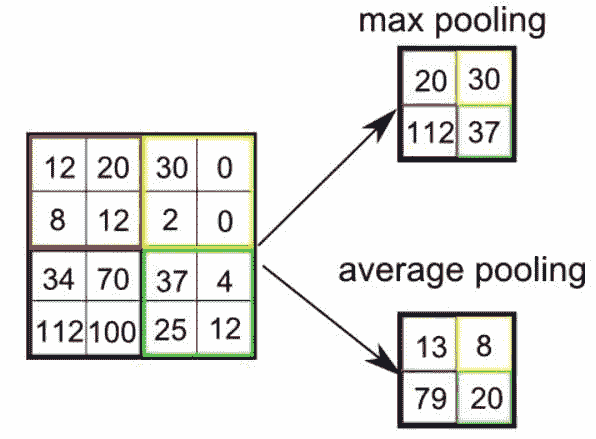

我们使用 one-hot 编码将分类元数据编码为一个单一的跨类别向量。然后,将该编码传递到嵌入层,该层学习每个不同类别的向量表示。最后一步是对结果嵌入矩阵应用池化层。

我们考虑了最大池化、平均池化和最小池化,并发现使用平均池化对我们的测试语料库效果最好。

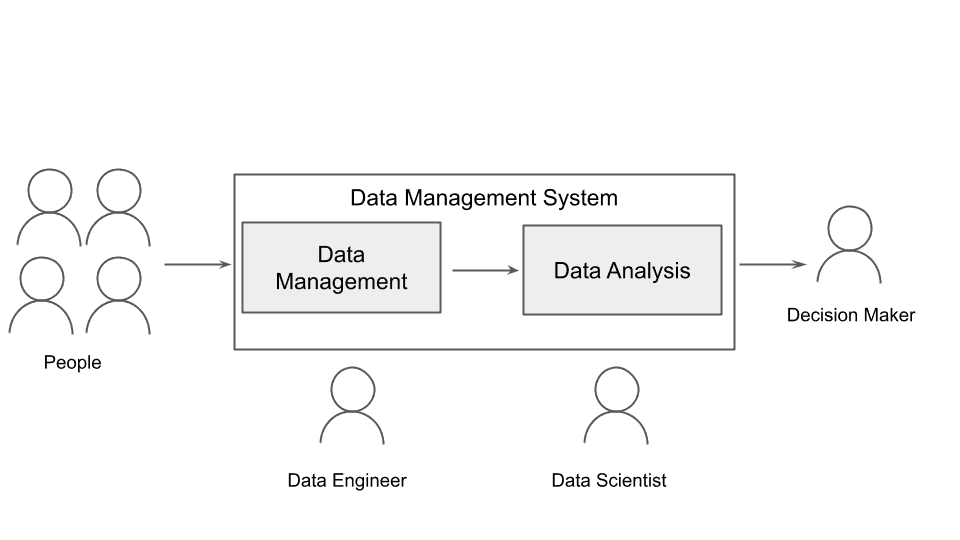

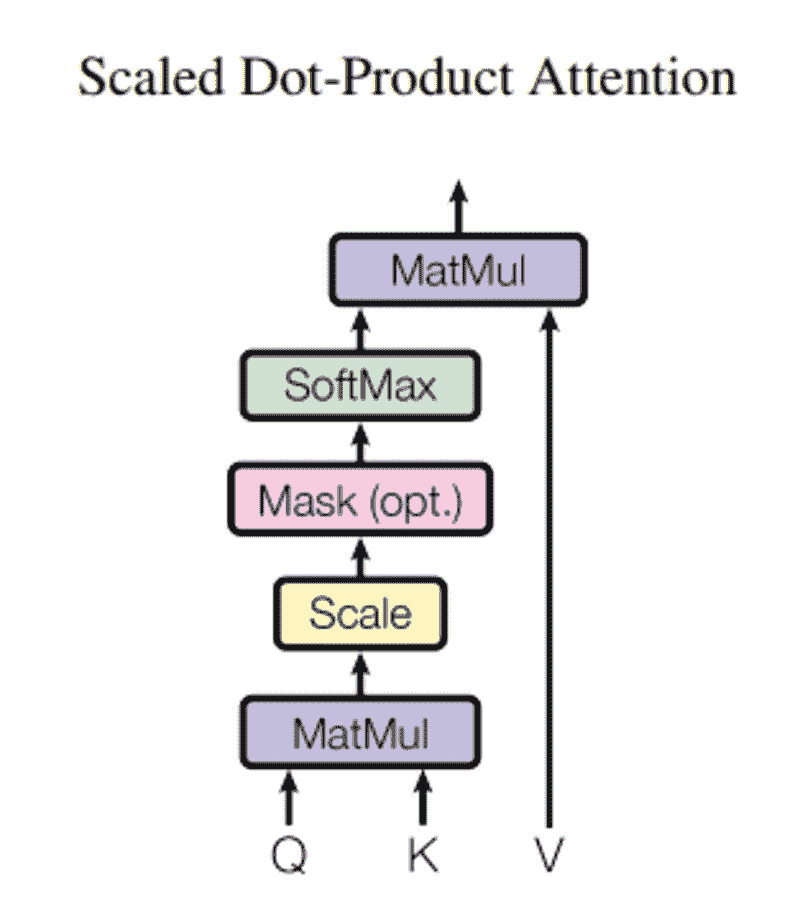

完整的架构是怎样的?

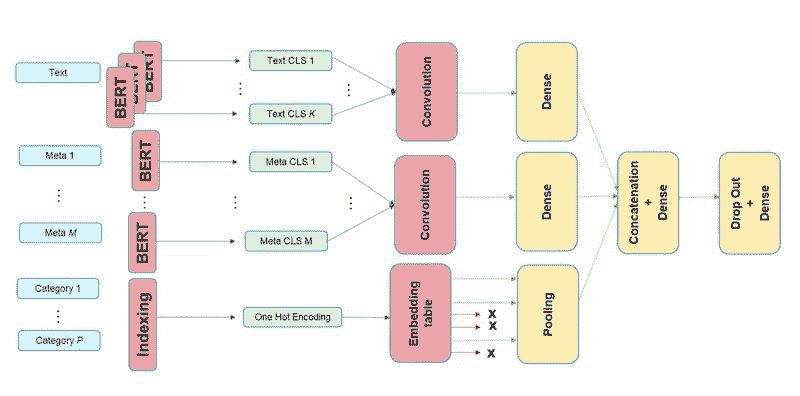

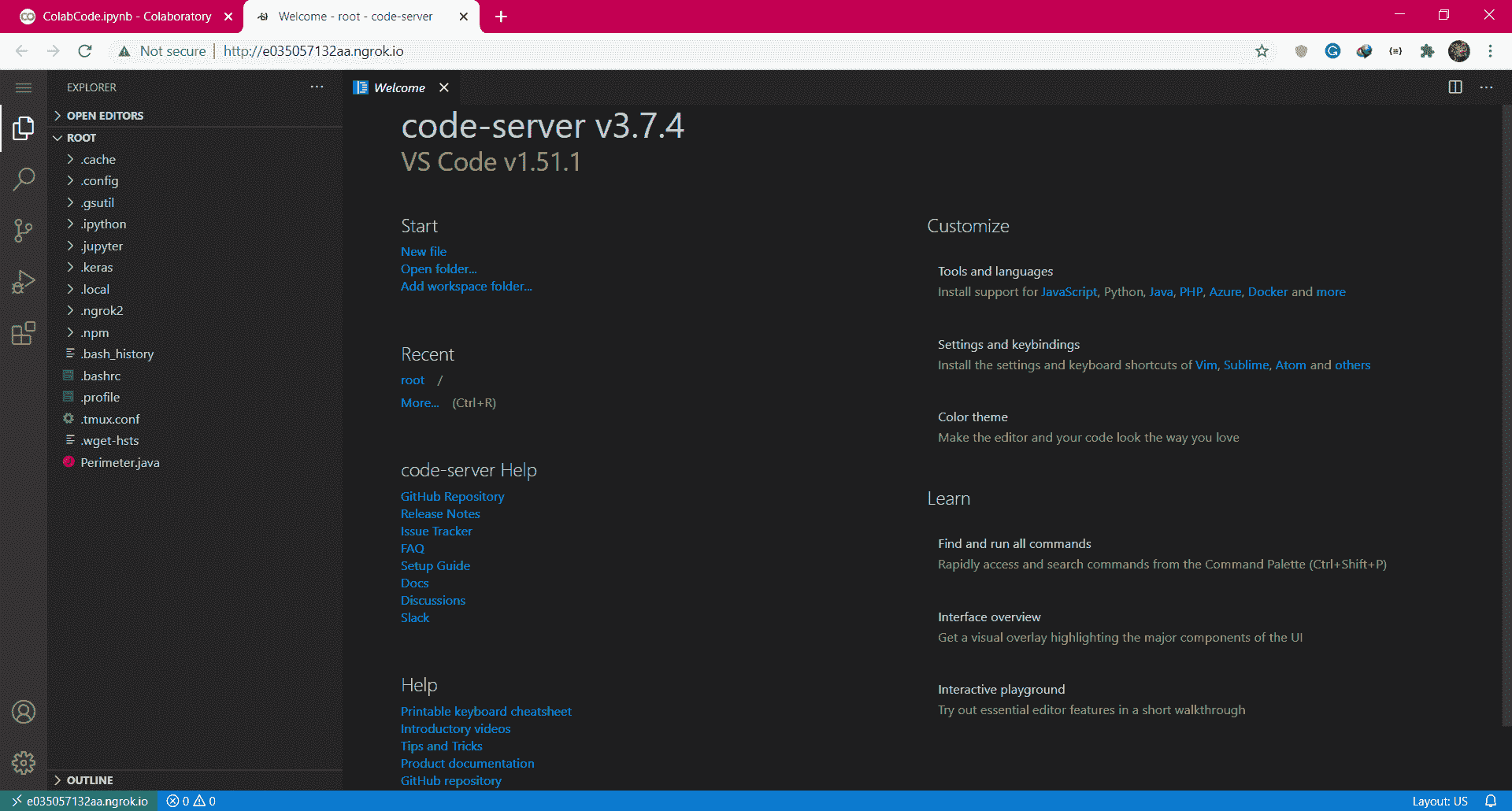

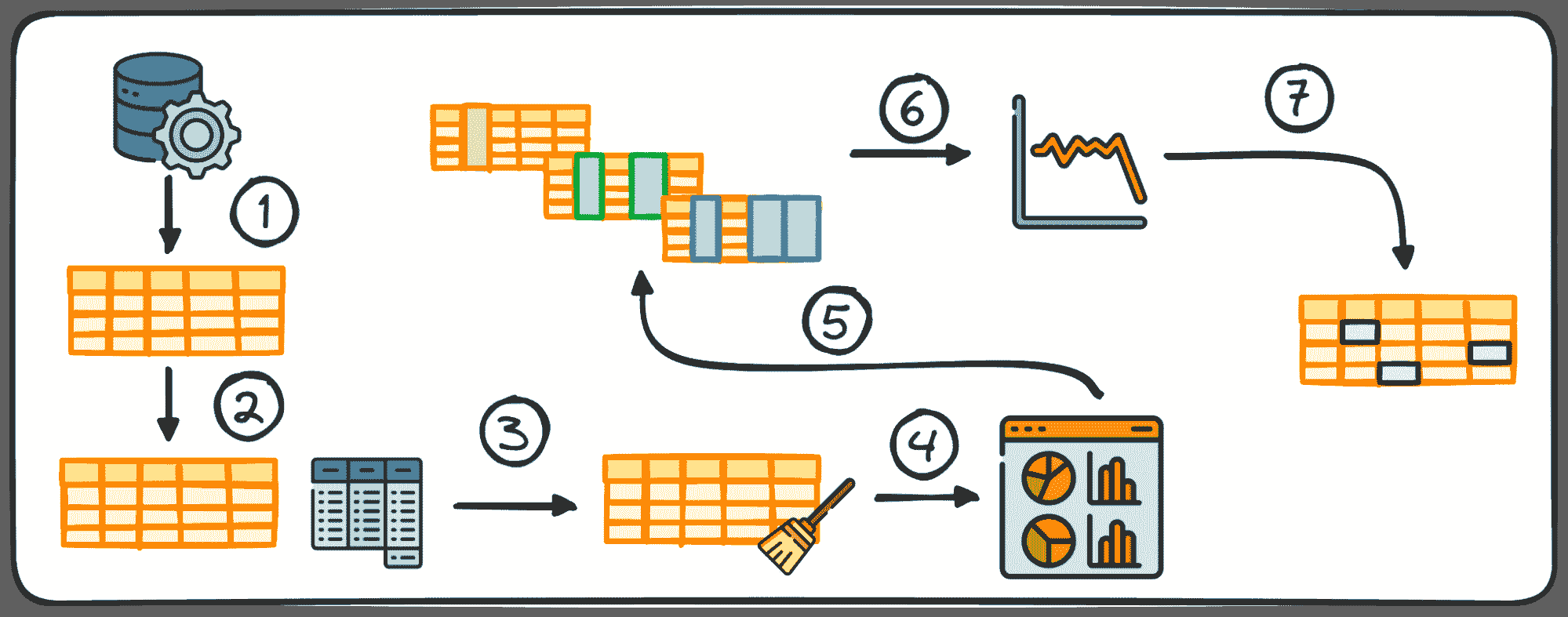

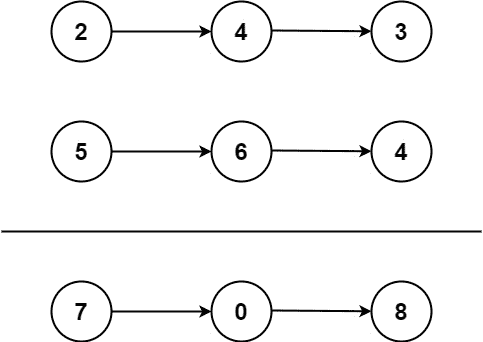

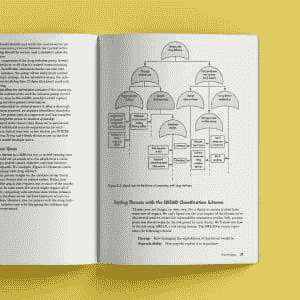

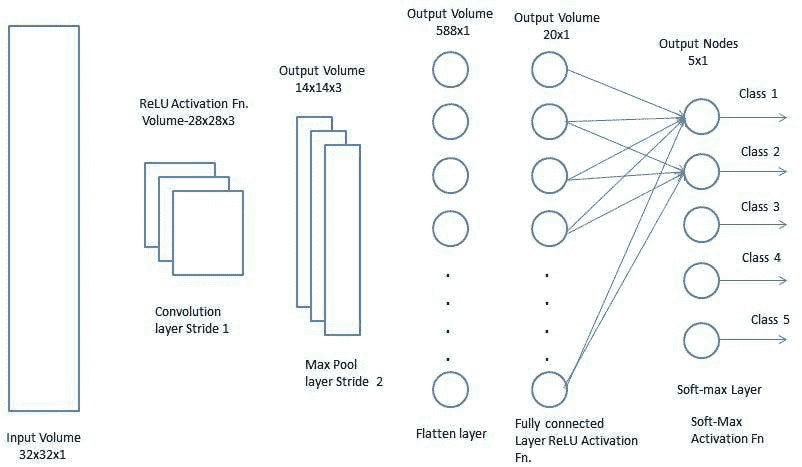

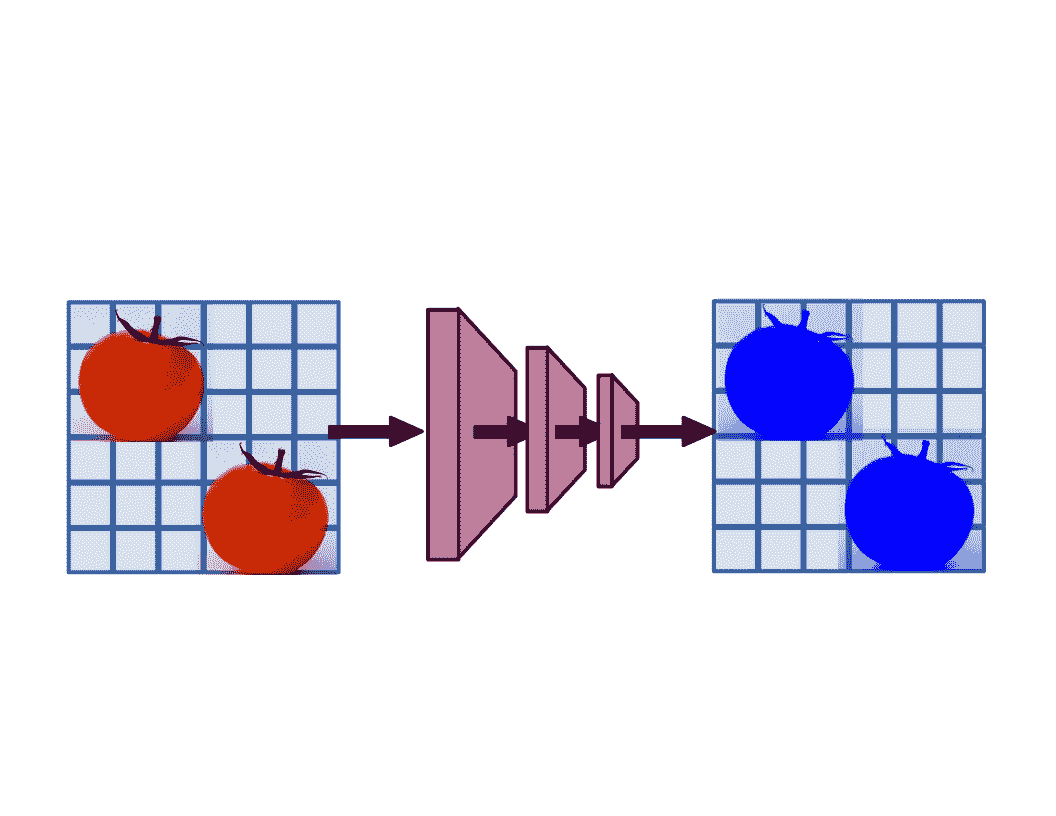

希望你坚持到现在,下面的图示将有助于进一步澄清问题。

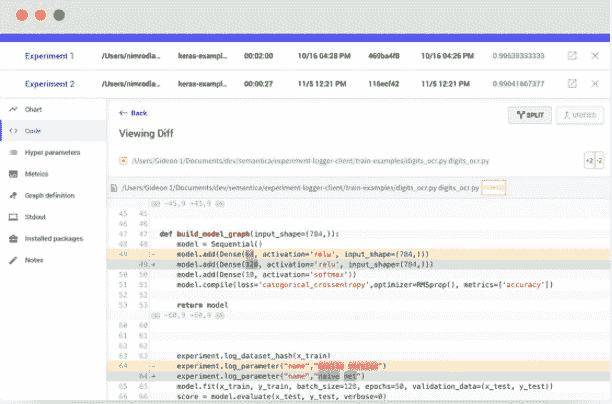

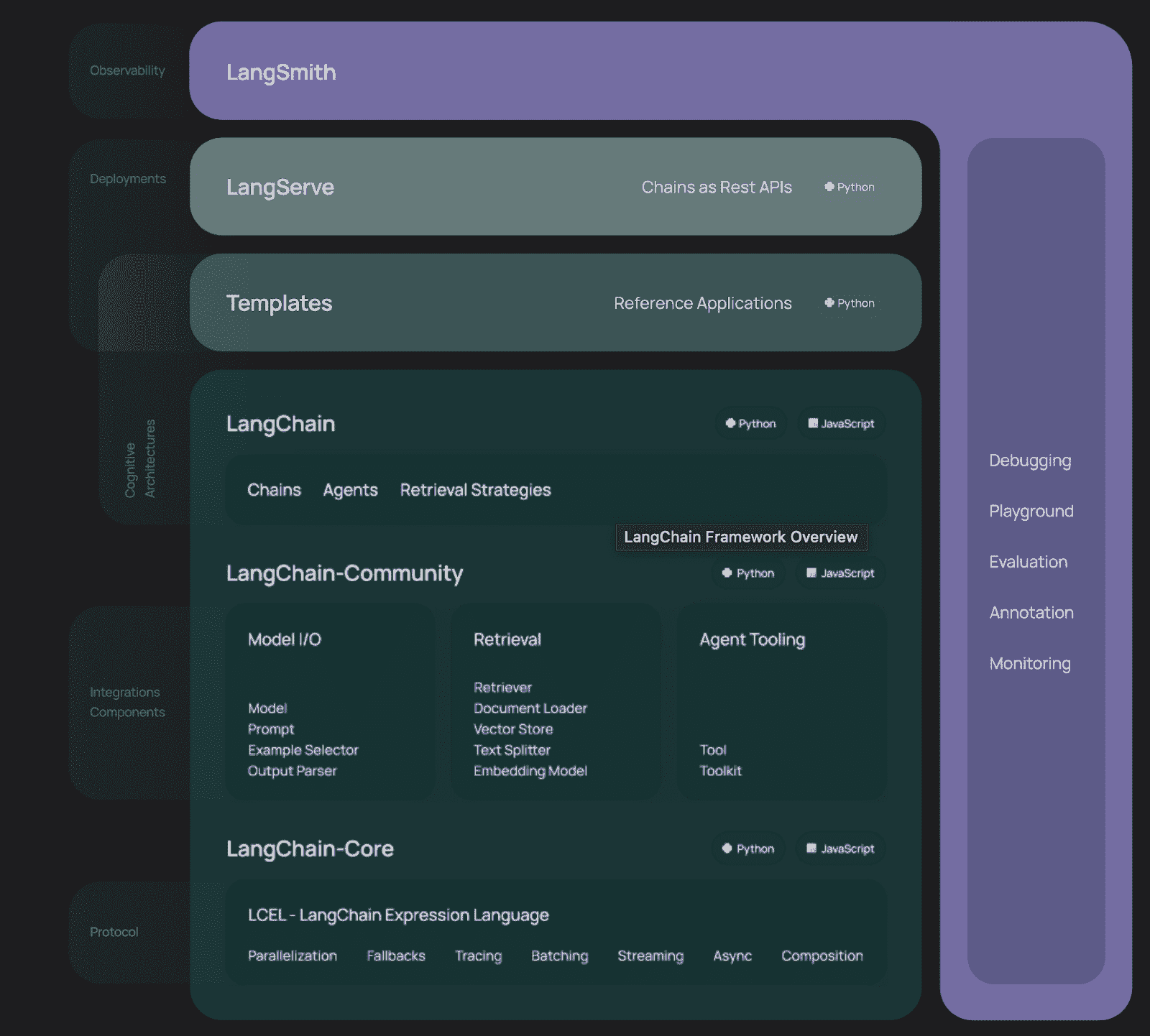

图 1

有三个子模型,一个用于文本,另一个用于文本元数据,最后一个用于分类元数据。三个子模型的输出仅仅是串联成一个单一的向量,然后通过一个 dropout 层,最后进入一个具有 softmax 激活的最后密集层进行分类。

你可能已经注意到,在架构中描绘了多个 BERT 实例,这不仅用于文本输入,还用于文本元数据。由于 BERT 需要训练许多参数,我们决定不为每个子模型包含一个单独的 BERT 模型,而是共享一个模型的权重。共享权重确实减少了模型使用的 RAM(使得可以使用更大的批量大小进行训练,从而在某种程度上加速训练),但它并不会改变推理时间,因为无论权重是否共享,BERT 执行的次数依然是一样的。

推理时间怎么样?

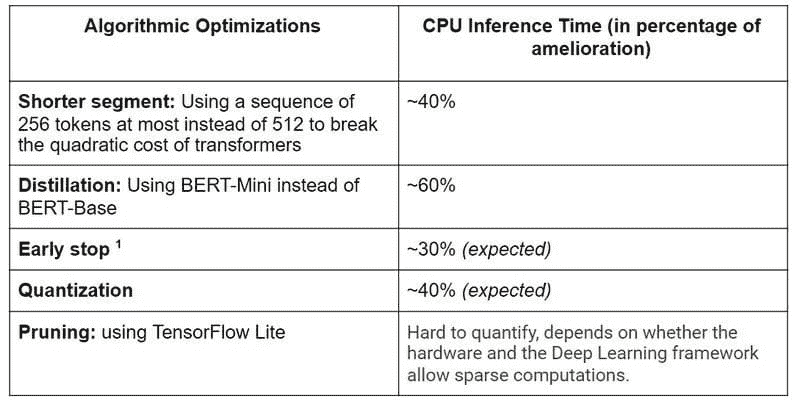

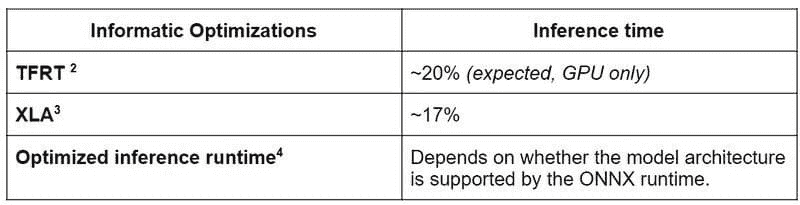

到现在,你一定已经猜到包含如此多的 BERT 模型调用并不是免费的。确实,运行这样的模型推理计算代价昂贵。然而,有几个技巧可以提高推理时间。以下内容我们将重点讨论 CPU 推理,因为这在生产环境中非常重要。

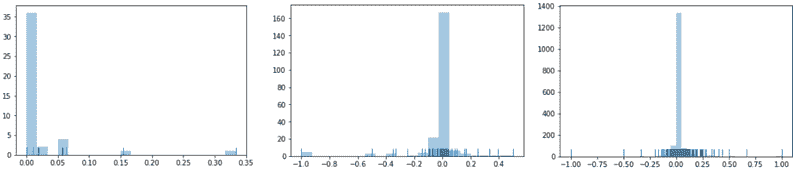

对于进行的实验,有几点说明:

-

我们考虑了一个仅包含文本特征的简化模型。

-

我们将每个文档使用的 tokens 限制为 25,600 个,这大致相当于 130,000 个字符(如果文档包含英文文本)。

-

我们用具有上述最大长度的文档进行实验。实际上,文档的大小各不相同,由于我们在模型中使用了动态大小的张量,因此短文档的推理时间显著更快。作为一个经验法则,使用一个长度是原文档一半的文档,推理时间会减少 50%。

参考文献

还有什么可以做的?

线性 Transformer

构建一种类似于 Transformer 的架构,但没有时间和内存的二次复杂度,目前是一个非常活跃的研究领域。一旦预训练模型发布,有几个候选者绝对值得尝试:

-

Linformer [

arxiv.org/pdf/2006.04768.pdf] -

BigBird [

arxiv.org/pdf/2007.14062.pdf] -

改革者 [

arxiv.org/pdf/2001.04451.pdf](仅 O(N log(N)) 复杂度) -

Performers [

arxiv.org/pdf/2009.14794.pdf] -

等等…

对非常有前景的 Longformer 模型进行的初步测试未能成功执行。我们尝试使用 Hugging Face 的 TensorFlow 实现来训练 LongFormer 模型。然而,似乎该实现尚未进行内存优化,因为即使在具有 48 GB 内存的大型 GPU 上也无法训练。

推理时间是任何需要在生产中运行的 ML 项目的基石,因此我们计划在未来使用这种“线性 Transformer”,除此之外还会进行剪枝和量化。

我们完成了吗?

是的,感谢你坚持到最后。如果你对我们的模型有任何问题或评论,请随时留言。我们非常乐意听取你的意见。

原文。经许可转载。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

更多相关主题

使用 Pandas 管道函数进行更清晰的数据分析

原文:

www.kdnuggets.com/2021/01/cleaner-data-analysis-pandas-pipes.html

comments

我们的前三个课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路。

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路。

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

3. Google IT Support Professional Certificate - 支持组织的 IT 工作

3. Google IT Support Professional Certificate - 支持组织的 IT 工作

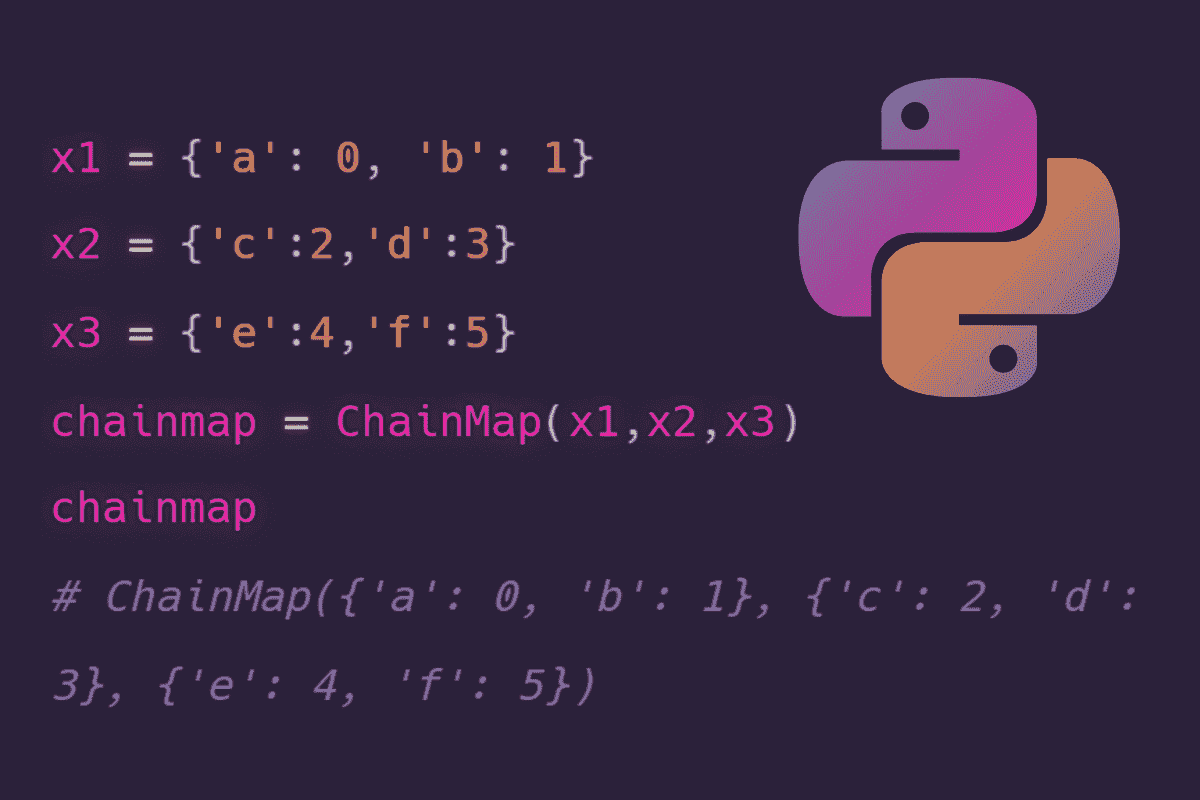

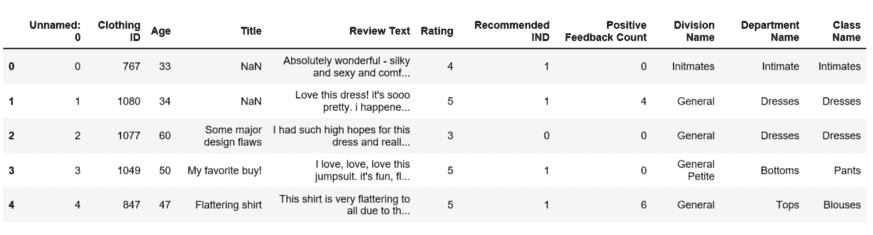

Pandas 是一个广泛使用的数据分析和处理库,提供了众多功能和方法,以实现强大且高效的数据分析过程。

在典型的数据分析或清理过程中,我们可能会执行许多操作。随着操作数量的增加,代码开始变得杂乱且难以维护。

克服此问题的一种方法是使用 Pandas 的管道函数。管道函数的作用是允许以链式方式组合多个操作。

在本文中,我们将通过示例了解如何使用管道函数来生成更清晰、更易维护的代码。

我们首先将在单独的步骤中对样本数据框进行数据清理和处理。之后,我们将使用管道函数将这些步骤合并。

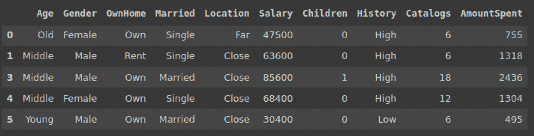

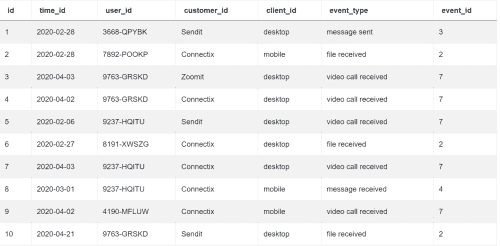

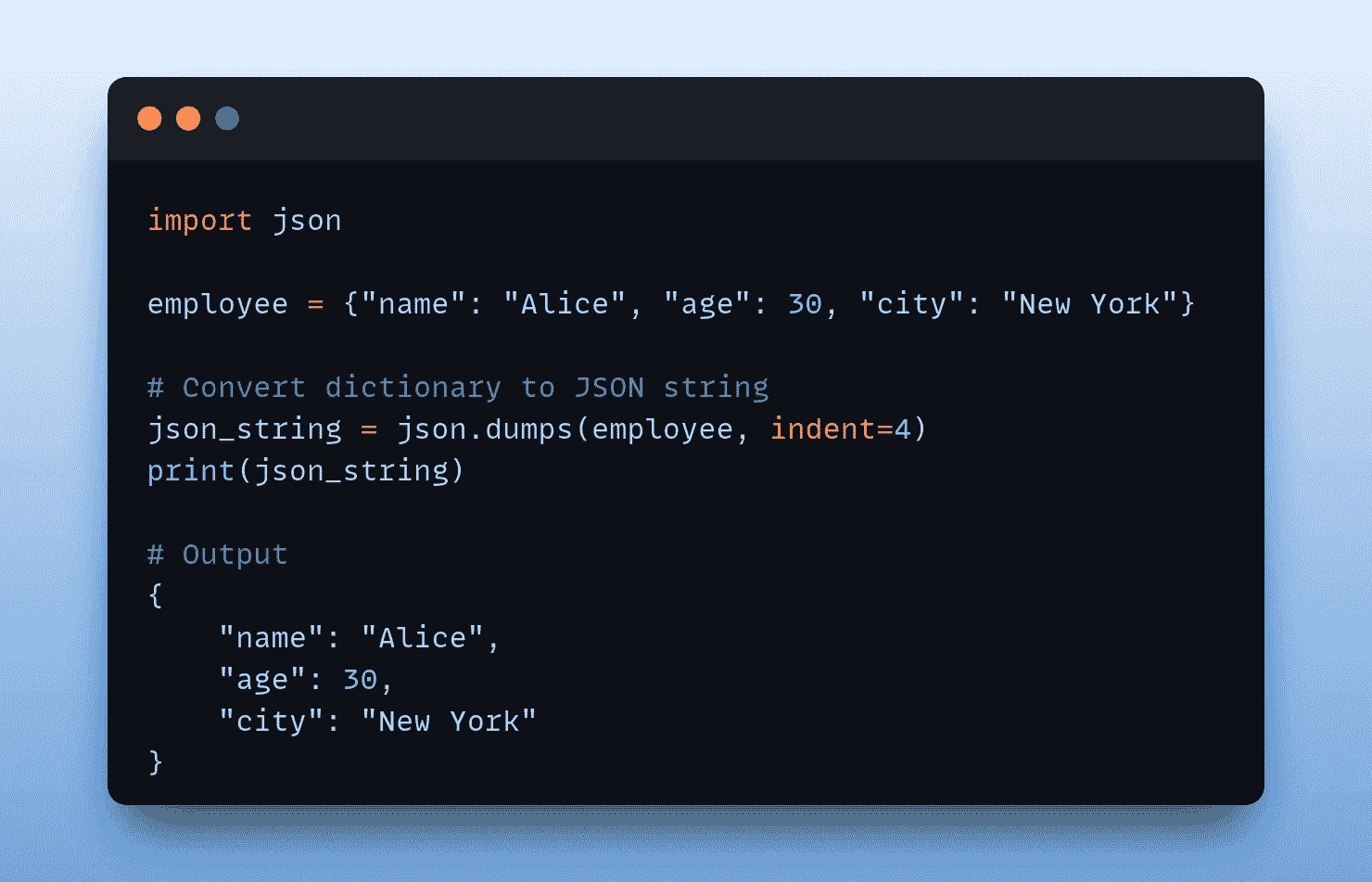

首先导入库并创建数据框。

import numpy as np

import pandas as pd

marketing = pd.read_csv("/content/DirectMarketing.csv")

marketing.head()

(图片由作者提供)

数据集包含有关营销活动的信息。可在 Kaggle 上 这里 获取。

我想做的第一个操作是删除缺失值很多的列。

thresh = len(marketing) * 0.6

marketing.dropna(axis=1, thresh=thresh, inplace=True)

上面的代码删除了缺失值占 40% 或更多的列。我们传递给 dropna 函数的 thresh 参数值表示所需的最小非缺失值数量。

我还想删除一些异常值。在工资列中,我希望保留在第 5 百分位数和第 95 百分位数之间的值。

low = np.quantile(marketing.Salary, 0.05)

high = np.quantile(marketing.Salary, 0.95)

marketing = marketing[marketing.Salary.between(low, high)]

我们通过使用 numpy 的 quantile 函数找到所需范围的下限和上限。这些值随后用于过滤数据框。

需要注意的是,检测异常值的方法有很多种。实际上,我们使用的方法有些表面化。还有更现实的替代方案。然而,这里重点是管道函数。因此,你可以实现最适合你任务的操作。

数据框包含许多分类变量。如果类别的数量相对于总数值比较少,最好使用类别数据类型而不是对象。这可以根据数据大小节省大量内存。

以下代码将遍历对象数据类型的列。如果类别的数量少于总值的 5%,则该列的数据类型将更改为类别。

cols = marketing.select_dtypes(include='object').columns

for col in cols:

ratio = len(marketing[col].value_counts()) / len(marketing)

if ratio < 0.05:

marketing[col] = marketing[col].astype('category')

我们完成了三步数据清洗和处理。根据任务的不同,步骤的数量可能更多。

让我们创建一个管道来完成所有这些任务。

管道函数接受函数作为输入。这些函数需要以数据框作为输入,并返回一个数据框。因此,我们需要为每个任务定义函数。

def drop_missing(df):

thresh = len(df) * 0.6

df.dropna(axis=1, thresh=thresh, inplace=True)

return df

def remove_outliers(df, column_name):

low = np.quantile(df[column_name], 0.05)

high = np.quantile(df[column_name], 0.95)

return df[df[column_name].between(low, high, inclusive=True)]

def to_category(df):

cols = df.select_dtypes(include='object').columns

for col in cols:

ratio = len(df[col].value_counts()) / len(df)

if ratio < 0.05:

df[col] = df[col].astype('category')

return df

你可能会争辩说,如果我们需要定义函数,那有什么意义?这似乎并没有简化工作流程。对于一个特定的任务你是对的,但我们需要从更广泛的角度思考。考虑你多次进行相同的操作。在这种情况下,创建一个管道可以使过程更简单,并提供更清晰的代码。

我们提到过管道函数接受一个函数作为输入。如果我们传递给管道函数的函数有任何参数,我们可以将这些参数与函数一起传递给管道函数。这使得管道函数更加高效。

例如,remove_outliers 函数接受一个列名作为参数。该函数会去除该列中的异常值。

我们现在可以创建我们的管道。

marketing_cleaned = (marketing.

pipe(drop_missing).

pipe(remove_outliers, 'Salary').

pipe(to_category))

它看起来整洁而干净。我们可以根据需要添加任意多的步骤。唯一的标准是管道中的函数应该接受一个数据框作为参数并返回一个数据框。就像使用 remove_outliers 函数一样,我们可以将函数的参数作为参数传递给管道函数。这种灵活性使管道更加有用。

一个重要的事情是,管道函数会修改原始数据框。如果可能,我们应该避免更改原始数据集。

为了克服这个问题,我们可以在管道中使用原始数据框的副本。此外,我们可以在管道的开始阶段添加一个步骤,以创建数据框的副本。

def copy_df(df):

return df.copy()

marketing_cleaned = (marketing.

pipe(copy_df).

pipe(drop_missing).

pipe(remove_outliers, 'Salary').

pipe(to_category))

我们的管道现在完成了。让我们比较原始数据框和清洗后的数据框,以确认它正在正常工作。

marketing.shape

(1000,10)

marketing.dtypes

Age object

Gender object

OwnHome object

Married object

Location object

Salary int64

Children int64

History object

Catalogs int64

AmountSpent int64

marketing_cleaned.dtypes

(900,10)

marketing_cleaned.dtypes

Age category

Gender category

OwnHome category

Married category

Location category

Salary int64

Children int64

History category

Catalogs int64

AmountSpent int64

管道如预期般工作。

结论

管道提供了更清晰、更易于维护的数据分析语法。另一个优点是它们自动化了数据清洗和处理的步骤。

如果你反复进行相同的操作,你应该考虑创建一个管道。

感谢阅读。如果你有任何反馈,请告诉我。

个人简介: Soner Yıldırım 是一位数据科学爱好者。查看他的作品集。

原文。经授权转载。

相关内容:

-

数据清理:任何数据科学项目成功的秘密成分

-

SQL 数据清理与整理

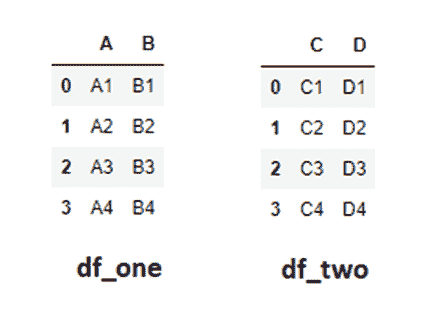

-

在 Python 中合并 Pandas 数据框

更多相关内容

在 Pandas 中清理和预处理文本数据以用于 NLP 任务

原文:

www.kdnuggets.com/cleaning-and-preprocessing-text-data-in-pandas-for-nlp-tasks

图片由作者提供

清理和预处理数据通常是构建由数据驱动的 AI 和机器学习解决方案中最令人畏惧但又至关重要的阶段,而文本数据也不例外。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

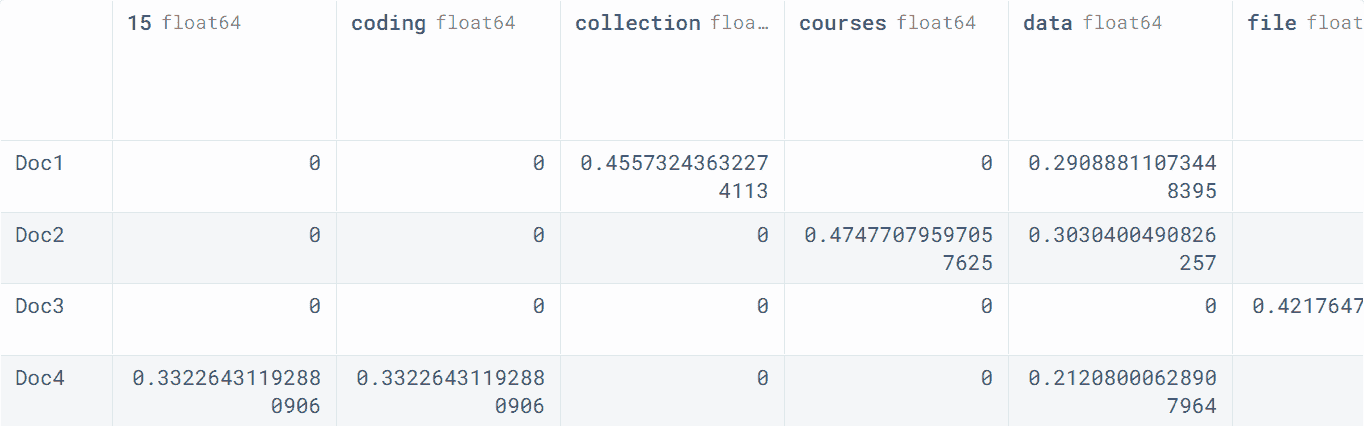

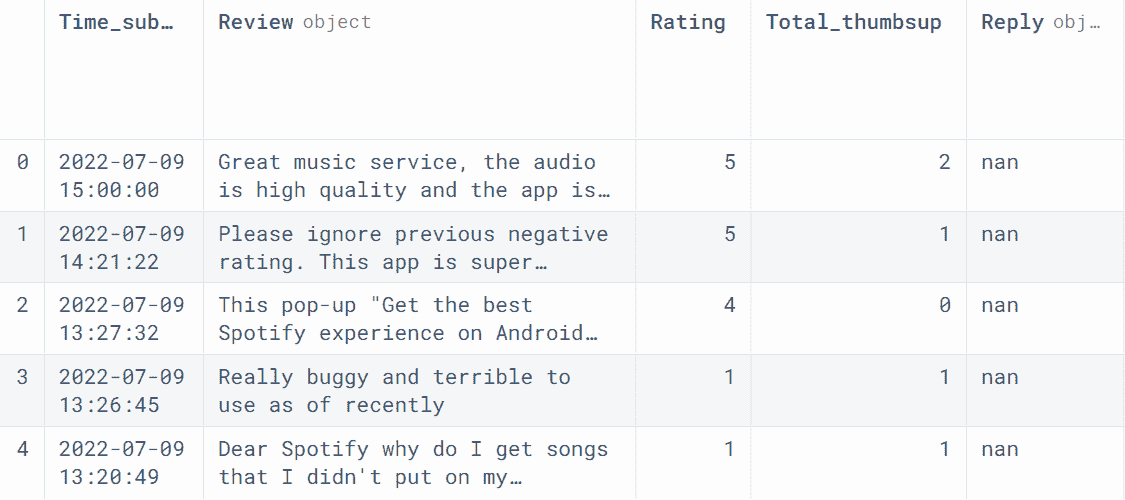

本教程破冰地解决了为 NLP 任务(如语言模型(LMs)可以解决的任务)准备文本数据的挑战。通过将你的文本数据封装在 pandas DataFrames 中,以下步骤将帮助你准备文本数据,以便被 NLP 模型和算法处理。

将数据加载到 Pandas DataFrame 中

为了保持本教程简单明了并专注于理解必要的文本清理和预处理步骤,让我们考虑一个包含四个单属性文本数据实例的小样本,这些实例将被移动到一个 pandas DataFrame 实例中。从现在起,我们将在这个 DataFrame 对象上应用每个预处理步骤。

import pandas as pd

data = {'text': ["I love cooking!", "Baking is fun", None, "Japanese cuisine is great!"]}

df = pd.DataFrame(data)

print(df)

输出:

text

0 I love cooking!

1 Baking is fun

2 None

3 Japanese cuisine is great!

处理缺失值

你注意到示例数据实例中的'None'值了吗?这被称为缺失值。缺失值由于各种原因通常会被收集,往往是偶然的。关键点是:你需要处理这些值。最简单的方法是检测并删除包含缺失值的实例,如下代码所示:

df.dropna(subset=['text'], inplace=True)

print(df)

输出:

text

0 I love cooking!

1 Baking is fun

3 Japanese cuisine is great!

规范化文本以保持一致

规范化文本意味着标准化或统一那些在不同实例中可能以不同格式出现的元素,例如日期格式、全名或大小写敏感性。规范化文本的最简单方法是将所有文本转换为小写,如下所示。

df['text'] = df['text'].str.lower()

print(df)

输出:

text

0 i love cooking!

1 baking is fun

3 japanese cuisine is great!

去除噪音

噪音是指不必要或意外收集的数据,如果处理不当,可能会妨碍后续的建模或预测过程。在我们的示例中,我们假设像“!”这样的标点符号在后续的 NLP 任务中是不需要的,因此我们通过使用正则表达式检测文本中的标点符号来进行噪音去除。Python 的're'包用于基于正则表达式匹配进行文本操作。

import re

df['text'] = df['text'].apply(lambda x: re.sub(r'[^\w\s]', '', x))

print(df)

输出:

text

0 i love cooking

1 baking is fun

3 japanese cuisine is great

对文本进行分词

分词可以说是进行 NLP 和语言模型使用前最重要的文本预处理步骤之一 - 以及将文本编码为数字表示 - 它包括将每个文本输入拆分成一系列片段或标记。在最简单的情况下,标记通常与单词相关,但在复合词等某些情况下,一个单词可能会导致多个标记。某些标点符号(如果它们之前没有被作为噪音去除)有时也会被识别为独立的标记。

这段代码将我们三个文本条目中的每一个分割成单独的单词(标记),并将其添加为 DataFrame 中的新列,然后显示更新后的数据结构及其两列。应用的简化分词方法被称为简单的空格分词:它仅使用空格作为检测和分隔标记的标准。

df['tokens'] = df['text'].str.split()

print(df)

输出:

text tokens

0 i love cooking [i, love, cooking]

1 baking is fun [baking, is, fun]

3 japanese cuisine is great [japanese, cuisine, is, great]

移除停用词

一旦文本被分词,我们会过滤掉不必要的标记。这通常是停用词的情况,比如冠词“a/an, the”或连词,这些词对文本没有实际语义贡献,应被移除以便后续有效处理。这个过程依赖于语言:下面的代码使用 NLTK 库下载英语停用词字典,并从标记向量中过滤掉它们。

import nltk

nltk.download('stopwords')

stop_words = set(stopwords.words('english'))

df['tokens'] = df['tokens'].apply(lambda x: [word for word in x if word not in stop_words])

print(df['tokens'])

输出:

0 [love, cooking]

1 [baking, fun]

3 [japanese, cuisine, great]

词干提取和词形还原

快完成了!词干提取和词形还原是可能根据具体任务使用的附加文本预处理步骤。词干提取将每个标记(单词)还原为其基础或根形式,而词形还原则进一步将其还原为词形或基础词典形式,取决于上下文,例如“best” -> “good”。为了简化起见,我们在这个示例中将只应用词干提取,使用 NLTK 库中实现的 PorterStemmer,借助 wordnet 数据集的词根关联。得到的词干词保存在 DataFrame 中的新列中。

from nltk.stem import PorterStemmer

nltk.download('wordnet')

stemmer = PorterStemmer()

df['stemmed'] = df['tokens'].apply(lambda x: [stemmer.stem(word) for word in x])

print(df[['tokens','stemmed']])

输出:

tokens stemmed

0 [love, cooking] [love, cook]

1 [baking, fun] [bake, fun]

3 [japanese, cuisine, great] [japanes, cuisin, great]

将文本转换为数字表示

最后但同样重要的是,计算机算法包括 AI/ML 模型并不理解人类语言,而是数字,因此我们需要将我们的词向量映射到数字表示中,通常称为嵌入向量,或简称为嵌入。下面的示例将“tokens”列中的分词文本转换为 TF-IDF 向量化方法(这是经典 NLP 的黄金时代中最受欢迎的方法之一)来将文本转换为数字表示。

from sklearn.feature_extraction.text import TfidfVectorizer

df['text'] = df['tokens'].apply(lambda x: ' '.join(x))

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(df['text'])

print(X.toarray())

输出:

[[0\. 0.70710678 0\. 0\. 0\. 0\. 0.70710678]

[0.70710678 0\. 0\. 0.70710678 0\. 0\. 0\. ]

[0\. 0\. 0.57735027 0\. 0.57735027 0.57735027 0\. ]]

就这样!尽管对我们来说可能显得难以理解,这种我们预处理文本的数字表示就是智能系统,包括 NLP 模型,能够理解并且在挑战性语言任务如文本情感分类、总结或甚至翻译成另一种语言时表现得异常出色的内容。

下一步是将这些数字表示输入到我们的 NLP 模型中,让它施展魔法。

伊万·帕洛马雷斯·卡拉斯科萨 是一位在人工智能、机器学习、深度学习和大型语言模型方面的领导者、作家、演讲者和顾问。他培训和指导他人在实际应用中利用人工智能。

更多相关内容

澄清“提升”相关问题

原文:

www.kdnuggets.com/2019/06/clearing-air-around-boosting.html

评论

评论

作者 Puneet Grover, 帮助机器学习。

注意: 尽管这篇文章稍微偏重数学,但你仍然可以通过阅读前两节,即 介绍 和 历史,理解提升和梯度提升的核心工作。之后的部分是对不同梯度提升算法论文的解释。

这是我 Concepts 类别中的一篇文章,可以在我的 GitHub 仓库 这里 找到。

目录

-

介绍

-

历史(袋装、随机森林、提升和梯度提升)

-

AdaBoost

-

XGBoost

-

LightGBM

-

CatBoost

-

进一步阅读

-

参考文献

注意: 本文配有在我 GitHub 仓库中的Jupyter Notebook:[ClearingAirAroundBoosting]

1) 介绍

提升 是一种集成元算法,主要用于减少监督学习中的偏差和方差。

如今,提升算法是获得各种问题和情境下最先进结果的最常用算法之一。它已成为解决任何机器学习问题或竞赛的首选方法。现在,

-

这种提升算法的巨大成功背后的原因是什么?

-

它是如何产生的?

-

我们可以期待未来发生什么?

我将通过这篇文章尝试回答所有这些问题以及更多问题。

2) 历史 ^

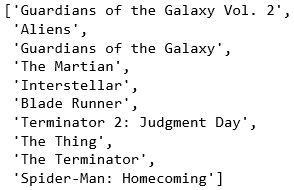

照片来源 Andrik Langfield 在 Unsplash

提升基于 Kearns 和 Valiant(1988, 1989)提出的问题:“一组 弱学习器 能否创建一个 强学习器?”

罗伯特·沙皮雷在 1990 年论文中对凯恩斯和瓦利安特提出的问题的肯定回答在机器学习和统计学中产生了重大影响,最显著的是导致了 Boosting 的发展。

在 Bagging 方法中,还有一些其他集成方法在同一时期出现,可以说它们是现代梯度提升算法的子集,它们包括:

- Bagging(Bootstrap Aggregating):(即自助采样 + 聚合)

Bagging 是一种集成元算法,有助于提高稳定性和准确性。它还帮助减少方差,从而减少过拟合。

在 bagging 中,如果我们有 N 个数据点,并且我们想要生成‘m’个模型,那么我们将从数据中取出一些数据的分数[通常是(1–1/e)≈63.2%],从数据中重复‘m’次并重复一些行,使其长度等于 N 个数据点(尽管其中一些是冗余的)。现在,我们将在这些‘m’个数据集上训练‘m’个模型,然后得到‘m’组预测。然后我们将这些预测进行汇总以获得最终预测。

它可以与神经网络、分类和回归树以及线性回归中的子集选择一起使用。

- 随机森林:

随机森林(或随机决策森林)方法是一种集成学习方法,通过构建大量决策树来操作。它有助于减少在决策树模型(具有较高深度值)中常见的过拟合。

随机森林结合了“bagging”思想和特征的随机选择,以构建一个决策树集合来对抗方差。与 bagging 一样,我们为决策树创建自助采样训练集,但现在在树生成过程中每次进行分裂时,我们只选择总特征数的一部分[通常为√n 或 log2(n)]。

这些方法,自助采样和子集选择,使树之间更不相关,有助于更多地减少方差,因此以更具概括性的方法减少过拟合。

- Boosting:

以上方法使用了互斥模型的平均以减少方差。Boosting略有不同。Boosting 是一种序列集成方法。对于总数为‘n’的树,我们以序列方式添加树的预测(即我们添加第二棵树来提高第一棵树的性能,或者说尝试纠正第一棵树的错误,依此类推)。所以我们所做的是,从目标值中减去第一模型的预测值乘以常数(0<λ≤1),然后将这些值作为目标值来拟合第二模型,依此类推。我们可以将其视为:新模型尝试纠正之前模型/之前模型的错误。Boosting 可以通过一个公式来概括:

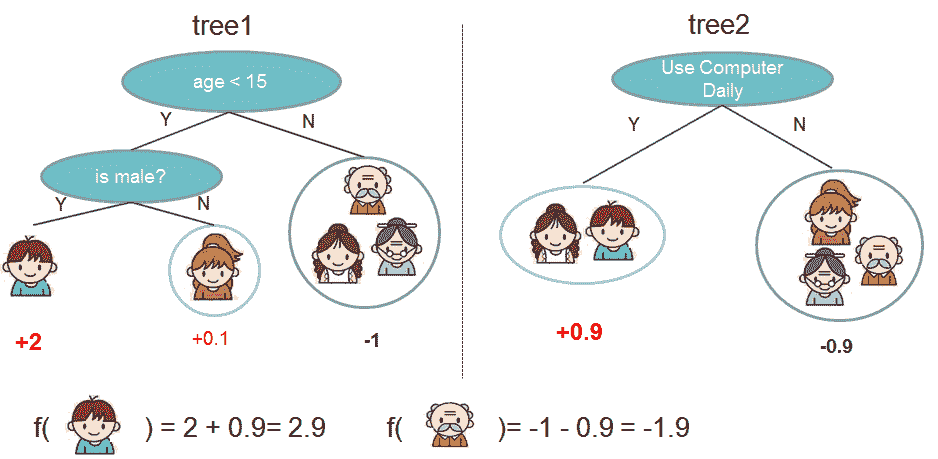

示例:预测某人是否会喜欢计算机游戏。[来源:XGBoost 文档]

即最终预测是所有模型预测的总和,每个预测乘以一个小常数(0<λ≤1)。这是一种观察提升算法的另一种方式。

实际上,我们尝试从每个学习器(这些都是弱学习器)中学习少量关于目标的信息,这些学习器试图改进先前的模型,然后将它们汇总以获得最终预测(这是可能的,因为我们只拟合先前模型的残差)。因此,每个顺序学习器试图预测:

(初始预测) — (λ * 前述学习器所有预测的总和)

每个树预测器也可以根据其表现具有不同的 λ 值。

- 梯度提升:

在梯度提升中,我们使用一个损失函数,在每次拟合周期中进行评估(就像在深度学习中一样)。Jerome H. Friedman 首次提出的论文集中于最终函数的加性扩展,类似于我们上面看到的内容。

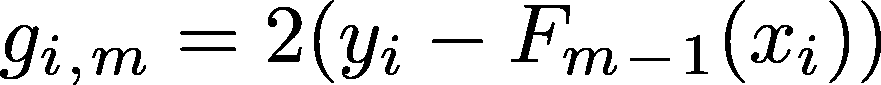

我们首先预测一个目标值(例如,γ),这是一个给出最小误差的常数(即第一次预测是 F0 = γ)。之后我们计算数据集中每个点相对于我们之前输出的梯度。因此,我们计算误差函数相对于之前模型所有输出总和的梯度,在平方误差的情况下是:

相对于该数据点所有值之和的梯度(即第 i 个梯度)

这样我们就得到了相对于之前模型所有输出的梯度。

我们为什么要这样计算梯度?

在神经网络中,计算所有参数(即所有神经节点)梯度是很直接的,因为神经网络在所有层中只是线性(或某个梯度容易计算的函数)组合,因此通过反向传播(相对于所有参数)计算梯度并更新它们更为容易。但是在决策树中,我们无法计算输出相对于任何参数(如深度、叶子数量、分裂点等)的梯度,因为这并不直接(实际上是抽象的)。

- Friedman 使用每个输出的误差梯度(误差函数)并将模型拟合到这些梯度。

这如何有助于获得更好的模型?

每个输出的梯度表示我们应该朝哪个方向移动以及移动多少,以获得该特定数据点/行的更好结果,将树拟合问题转化为优化问题。我们可以使用任何可微分且可以针对我们当前任务进行定制的损失函数,这在普通提升方法中是不可能的。例如,我们可以使用 MSE 进行回归任务,用 Log Loss 进行分类任务。

这里梯度如何用于获得更好的结果?

与提升算法不同,在提升算法中,我们在第i次迭代时学习了一部分输出(目标),而第(i+1)棵树会尝试预测剩余的部分,即我们对残差进行拟合;而在梯度提升中,我们计算相对于所有数据点/行的梯度,这告诉我们要前进的方向(负梯度)以及前进的幅度(可以看作是梯度的绝对值),并在这些梯度上拟合一棵树。

这些梯度基于我们的损失函数(选择以比其他方法更好地优化问题),反映了我们希望对预测进行的变化。例如,在凸损失函数中,我们会随着残差的增加而得到梯度的指数增加的倍数,而残差是线性增加的。因此,收敛时间更好。这取决于损失函数和优化方法。

这为数据点的梯度区域提供了类似的更新,因为它们将有相似的梯度。现在我们将找到该区域的最佳值,这将为该区域提供最小的误差。(即树拟合)

在这之后,我们将这些预测添加到之前的预测中,以获得本阶段的最终预测。

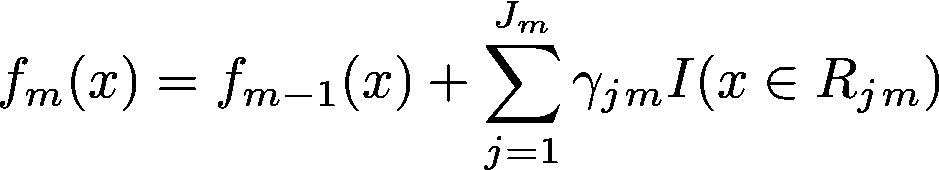

其中 γjm 是第 j 区域第 m 棵树的预测值,Jm 是第 m 棵树的区域数量。因此,为该区域添加 γ 乘以身份,若数据点在当前区域,则为 1。

这为每个数据点/行提供了新的预测。

正常提升和梯度提升的基本区别在于,在正常提升中,我们将下一模型拟合到残差上,而在梯度提升中,我们将下一模型拟合到残差的梯度上。嗯……梯度提升实际上使用损失函数,因此我们将下一模型拟合到该损失函数的梯度(其中通过使用之前的预测找到梯度)。

注意开始

进一步可能的改进:

目前的梯度提升库远不止这些,例如:

-

树的约束(例如

max_depth,或num_leaves等) -

缩减(即

learning_rate) -

随机采样(行采样,列采样)[在树和叶子级别]

-

惩罚学习(L1 回归,L2 回归等)[这需要修改的损失函数,正常提升无法实现]

-

以及更多……

这些方法(其中一些)在一种称为 随机梯度提升的提升算法中实现。

注意结束

3) AdaBoost

照片由 Mehrshad Rajabi 提供,来自 Unsplash

这是第一个在机器学习领域留下巨大印记的提升算法。它由 Freund 和 Schapire(1997)开发,这里是相关论文。

除了顺序地添加模型的预测(即提升)外,它还为每个预测添加权重。它最初是为分类问题设计的,其中它增加了所有错误分类样本的权重,并减少了所有正确分类样本的权重(虽然也可以应用于回归)。因此,下一个模型将更多地关注权重较大的样本,而较少关注权重较小的样本。

他们还使用一个常数来缩小每棵树的预测值,这个常数的值是在拟合过程中计算得出的,并且取决于拟合后的误差。误差越大,该树的常数值就越小。这使得预测更准确,因为我们从不够准确的模型中学习较少,从更准确的学习器中学习更多。

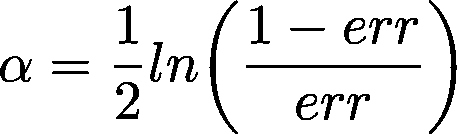

它最初用于两类分类,并选择输出为{-1, +1},其中:

-

它以每个数据点的权重相等= 1/N(其中,N:数据点数量)开始,

-

然后,它使用初始权重(最初相同)拟合第一个分类模型 h_0(x)到训练数据上,

-

然后计算总误差,并基于此更新所有数据点的权重(即增加错误分类的权重,减少正确分类的权重)。总误差在计算该特定树的缩小常数时也变得有用(即我们计算常数α,对于大误差较小,对于小误差较大,并用于缩小和权重计算)。

- 最终,当前轮次的预测结果会在与α相乘后加到之前的预测结果上。由于最初是分类为+1 或-1,因此最终预测结果取最后一轮的预测符号:

其中 α_i 是第 i 个常数(前一位置),h_i 是第 i 个模型预测值

(AdaBoost 不是基于梯度的)

4) XGBoost

照片由 Viktor Theo 提供,来源于 Unsplash

XGBoost 试图在先前的梯度提升算法基础上进行改进,以提供更好、更快和更具通用性的结果。

它在梯度提升的基础上进行了一些不同的和新的改进,例如:

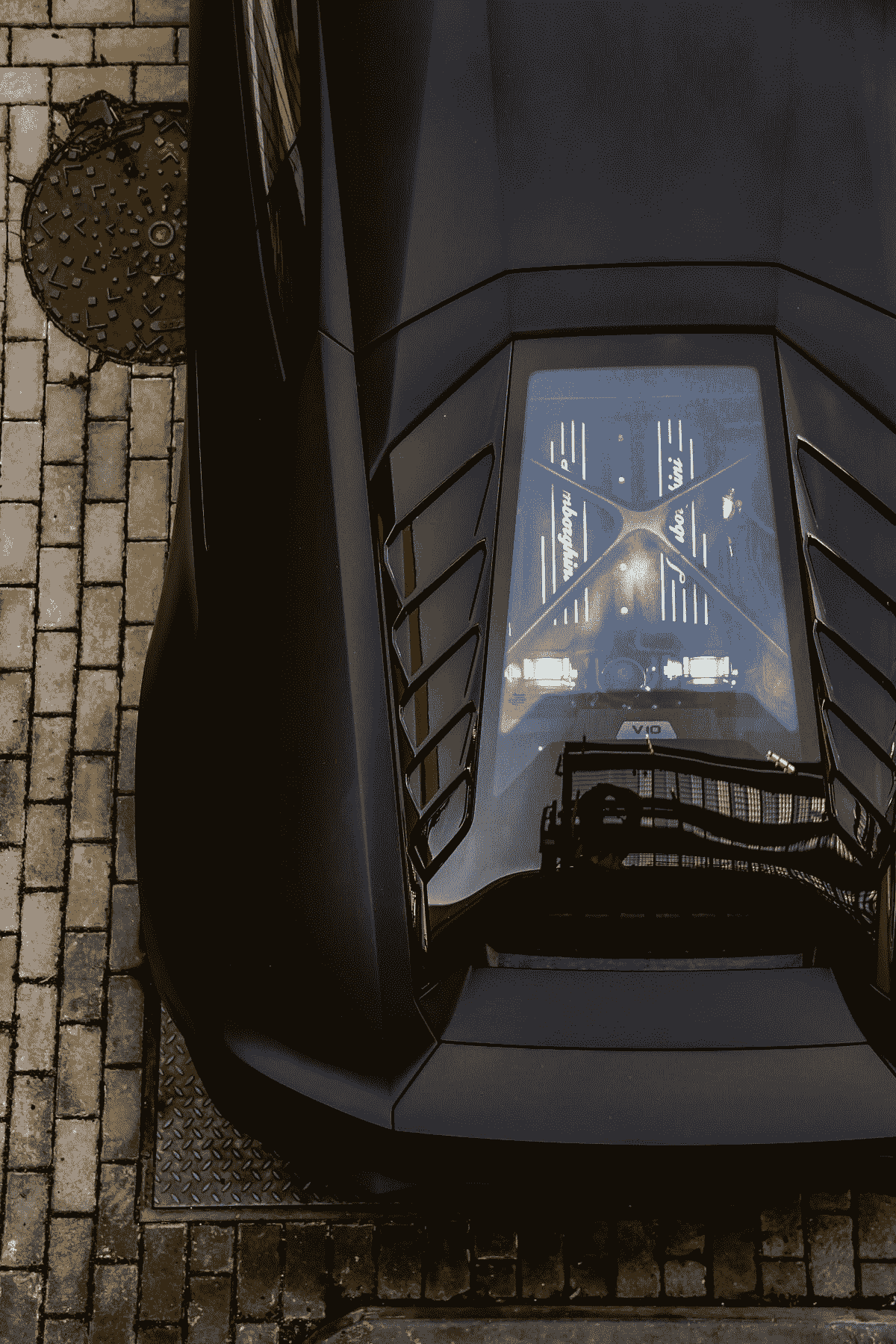

- a) 正则化学习目标:

与许多其他目标函数实现类似,这里建议向损失函数中添加一个额外的函数来惩罚模型的复杂性(如 LASSO、Ridge 等),称为正则化项。这有助于模型避免过拟合数据。

一些损失函数 + (一些正则化函数以控制模型的复杂性)

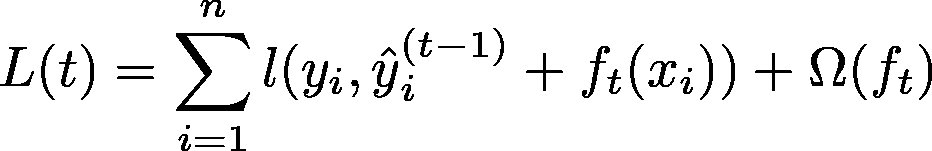

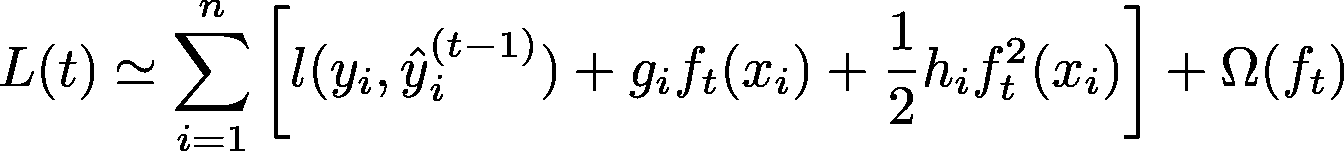

现在,对于具有加法性质的梯度提升,我们可以将第‘t’次预测写作 F_t(x) = F_t-1(x) + y_hat_t(x),即此轮预测加上所有先前预测的总和。损失函数:

经过泰勒级数近似后,可以写成:

其中 g_i 和 h_i 是损失函数的梯度和 Hessian,即损失函数的一阶和二阶导数

为什么到二阶?

仅使用一阶梯度的梯度提升算法面临收敛问题(只有在步长较小的情况下才可能收敛)。而且它对损失函数的近似效果相当好,加上我们不希望增加计算量。

然后通过将损失函数的梯度设置为零,从而找到损失函数的最优值,并通过损失函数找到用于分裂的函数。(即,分裂后损失的变化函数)

通过将上述公式的导数设置为零来发现。[最优变化值]

- b) 收缩和列子采样:

它还为每棵树增加了收缩,以减少单棵树的影响,并对列进行子采样,以对抗过拟合并减少方差,如历史部分所讨论的。

- c) 不同的分裂查找算法:

梯度提升算法遍历所有可能的分裂,以找到该级别的最佳分裂。然而,如果我们的数据非常庞大,这可能是一个昂贵的瓶颈,因此许多算法使用某种近似或其他技巧来寻找一个特别好的分裂,而不是最佳分裂。因此,XGBoost 查看特定特征的分布,并选择一些百分位数(或分位数)作为分裂点。

注意:

为了近似分裂的查找,这些方法也被使用,而不是百分位数方法:

- 通过构造梯度统计的近似直方图。2) 通过使用其他变体的分箱策略。

它建议选择一个值,称之为 q,现在从[0, 100]的分位数范围中,几乎每个 q 分位值都被选为分裂的候选点。将会大约有 100/q 个候选点。

它还添加了稀疏感知分裂查找,这在稀疏的 BigData 数组中可能很有帮助。

- d) 为了提高速度和空间效率:

它建议将数据划分为块,内存中的块。每个块中的数据以压缩列(CSC)格式存储,其中每列按相应的特征值存储。因此,在块中对列进行线性搜索足以获取该列的所有分裂点。

块格式使得在线性时间内找到所有拆分变得容易,但当需要获取这些点的梯度统计时,它变成了非连续的梯度统计提取(因为梯度仍然以之前的格式存在,其中块值指向它们的梯度),这可能导致缓存缺失。为了解决这个问题,他们制定了缓存感知算法用于梯度累积。在这种算法中,每个线程都会获得一个内部缓冲区。这个缓冲区用于以小批量的方式获取梯度并进行累积,而不是按顺序从这里获取一些梯度,再从那里获取一些梯度。

找到最佳块大小也是一个问题,它可以帮助最佳利用并行性并最大程度地减少缓存缺失。

它还提出了一个叫做块分片的方案。它在多个磁盘上交替写入数据(如果你有这些磁盘的话)。所以,当它想读取一些数据时,这种设置可以帮助同时读取多个块。例如,如果你有 4 个磁盘,这四个磁盘可以在一个单位时间内读取 4 个块,实现 4 倍的速度提升。

5) LightGBM

照片由 Severin D. 提供,来自 Unsplash

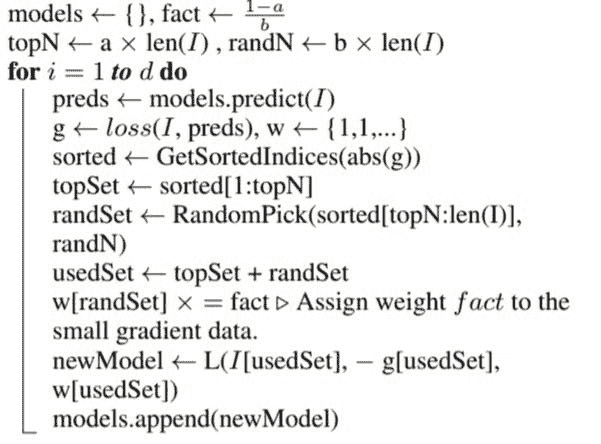

这篇论文提出了两种技术来加速整体的 Boosting 过程。

对于第一个,它提出了一种方法,在这种方法中,他们不必为特定模型使用所有数据点,而不会损失太多的信息增益。它被称为基于梯度的单侧采样(GOSS)。在这种方法中,他们计算损失函数的梯度,然后按绝对值排序。它还有一个证明,证明梯度值较大的值对信息增益的贡献更大,因此它建议忽略许多梯度较低的数据点。

因此,为特定模型选择一部分顶部梯度和从其余部分中选择不同的部分(从剩余梯度中随机选择),对随机梯度集施加较低的权重,因为它们的梯度值较低,不应对当前模型贡献太多。

获取损失的梯度,排序,取顶部梯度集和其余的随机梯度,减少随机梯度的权重,然后将此模型添加到之前模型的集合中。

需要注意的一点是,LightGBM 使用基于直方图的算法,将连续特征值分成离散的箱子。这加速了训练并减少了内存使用。

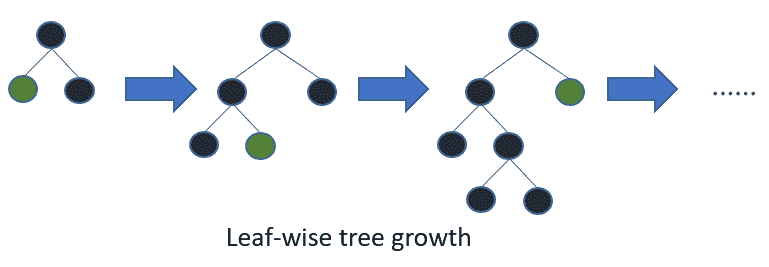

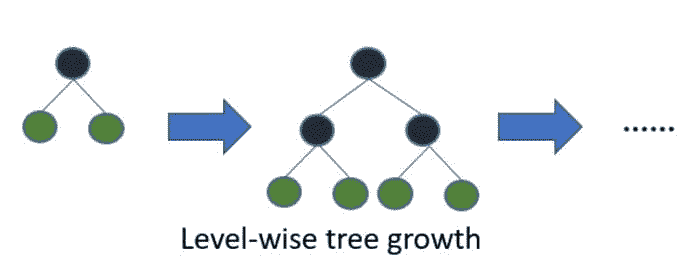

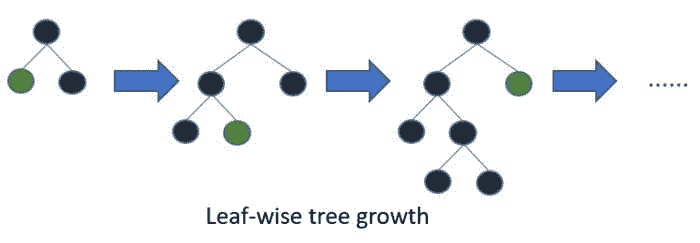

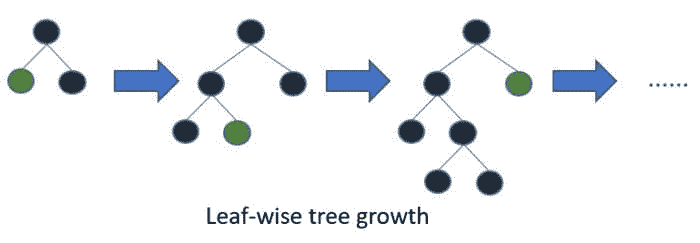

此外,他们使用了一种不同的决策树,它优化叶节点而不是普通决策树的深度(即,它枚举所有可能的叶子节点,并选择错误最少的一个)。

对于第二种方法,它提出了一种将许多特征组合成一个新特征的方法,从而在减少数据维度的同时不会丢失太多信息。这种方法称为独占特征捆绑(EFB)。它表示,在高维数据的世界中,存在许多相互排斥的列。为什么?因为高维数据有许多高度稀疏的列,可能有许多列在同一时间内没有取任何值(即,通常只有其中一个取非零值,即相互排斥)。因此,他们建议将这些特征捆绑成一个,没有冲突超过某个预设值(即,它们在许多点上在相同数据点没有非零值,即它们并非完全相互排斥,但在某种程度上是相互排斥)。为了区分来自不同特征的每个值,它建议对来自不同特征的值添加不同的常数,这样来自一个特征的值会落在一个特定的范围内,而来自其他特征的值则不在该范围内。例如,假设我们有三个特征要组合,所有特征的范围是 0-100。因此,我们将对第二个特征加 100,对第三个特征加 200,以获得三个特征的三个范围,分别为 0, 100)、[100, 200) 和 [200, 300)。在基于树的模型中,这种做法是可以接受的,因为它不会影响通过分裂获得的信息增益。

本文着重于提升算法面临的一个问题,即泄漏,目标泄漏。在提升中,多个模型在训练示例上进行拟合依赖于目标值(用于计算残差)。这会导致测试集中目标值的偏移,即预测偏移。因此,它提出了一种绕过这个问题的方法。

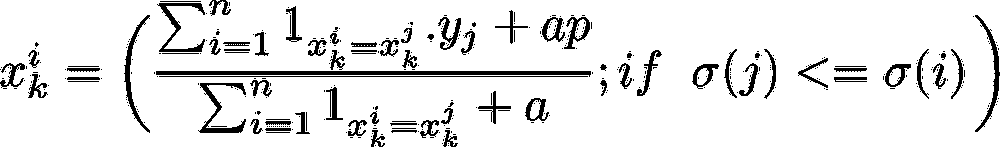

此外,它还提出了一种将类别特征转换为目标统计量(TS)的方法(如果处理不当可能会导致目标泄漏如果做错了)。

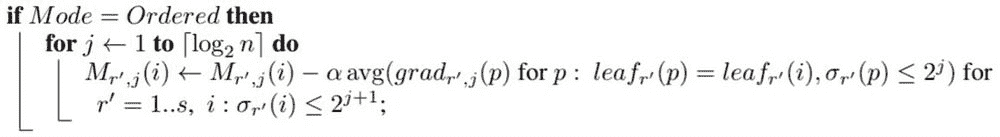

提出了一个叫做有序提升的算法,帮助防止目标泄漏,以及一个处理分类特征的算法。虽然两者都使用了某种叫做排序原则的方法。

首先,为了将分类特征转换为目标统计(TS)。如果你了解均值编码或目标编码的分类特征,特别是 K 折均值编码,这将很容易理解,因为这只是稍作调整。他们为了避免目标泄漏但仍能进行目标编码,是从数据集中获取第 i 个元素的(i-1)个元素,以获得该元素的特征值(即,如果第 i 个元素上方有 7 个相同类别的元素,则他们取这些值的目标均值来获得第 i 个元素的特征值)。

如果 i,j 属于同一类别,则平均目标值仅在该元素在本次迭代的随机排列中位于第 i 个元素之上时才计算(如声明中的条件)。‘a’和‘p’是防止等式下溢的参数。

其次,为了使算法预测偏移稳健,它提出了一个称为有序提升的算法。在每次迭代中,它独立地抽取一个新的数据集 D_t,并通过将当前模型应用于此数据集来获取未偏移的残差(因为这是一个不同的数据集),然后拟合一个新模型。实际上,他们将新数据点添加到之前的数据点中,从而为当前迭代中新添加的数据点提供至少未偏移的残差。

对于 i=1..n,从随机排列 r中计算 avg(如果它属于同一叶子节点的梯度),仅在排列 r中该叶子节点位于 2^(j+1) th 点之上时计算。[通过添加新预测更新模型]

使用此算法,我们可以为'n'个示例制作’n’个模型。但由于时间考虑,我们只制作 log_2(n)个模型。因此,第一个模型拟合 2 个示例,第二个模型拟合 4 个,以此类推。

CatBoost 也使用一种不同的决策树,称为盲树。在这种树中,相同的分裂标准用于树的整个层级。这种树是平衡的,且不容易过拟合。

在盲树中,每个叶子索引可以编码为长度等于树深度的二进制向量。这个事实在 CatBoost 模型评估器中被广泛使用:它首先将所有浮点特征和所有独热编码特征二值化,然后使用这些二进制特征来计算模型预测。这有助于以非常快的速度进行预测。

7) 进一步阅读

-

Trevor Hastie; Robert Tibshirani; Jerome Friedman (2009). 统计学习的元素:数据挖掘、推断与预测(第 2 版)。纽约:Springer。 (ISBN 978–0–387–84858–7)

-

所有参考文献

8) 参考文献

-

Trevor Hastie; Robert Tibshirani; Jerome Friedman (2009). 统计学习的要素: 数据挖掘、推断与预测(第 2 版)。纽约: Springer. (ISBN 978–0–387–84858–7)

-

论文 — 提升简介 — Yoav Freund, Robert E. Schapire(1999) — AdaBoost

-

论文 — CatBoost: 无偏提升与分类特征 — Prokhorenkova, Gusev 等 — v5 (2019)

-

YouTube — CatBoost — 新一代梯度提升 — 安娜·维罗妮卡·多罗戈什

-

渐进式介绍梯度提升算法 — MachineLearningMastery

原文. 经允许转载。

资源:

相关:

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 方面的工作

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 方面的工作

了解更多相关信息

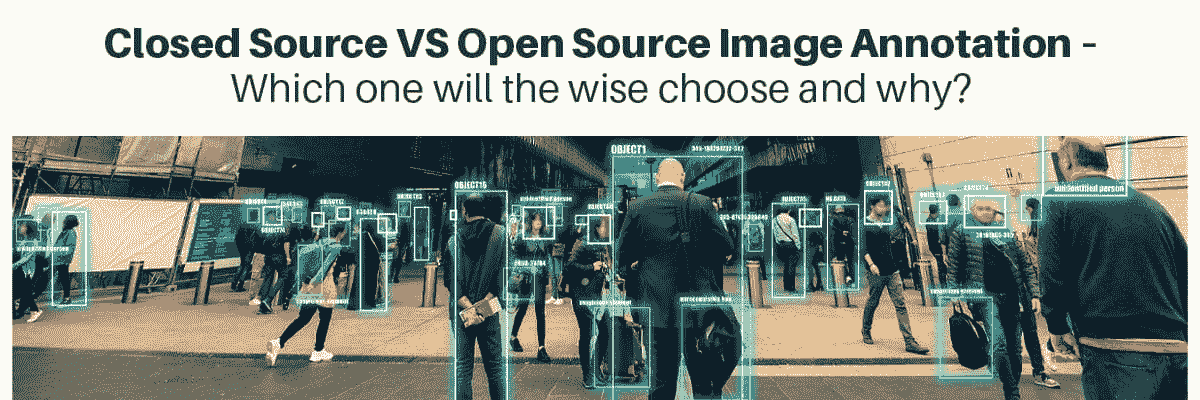

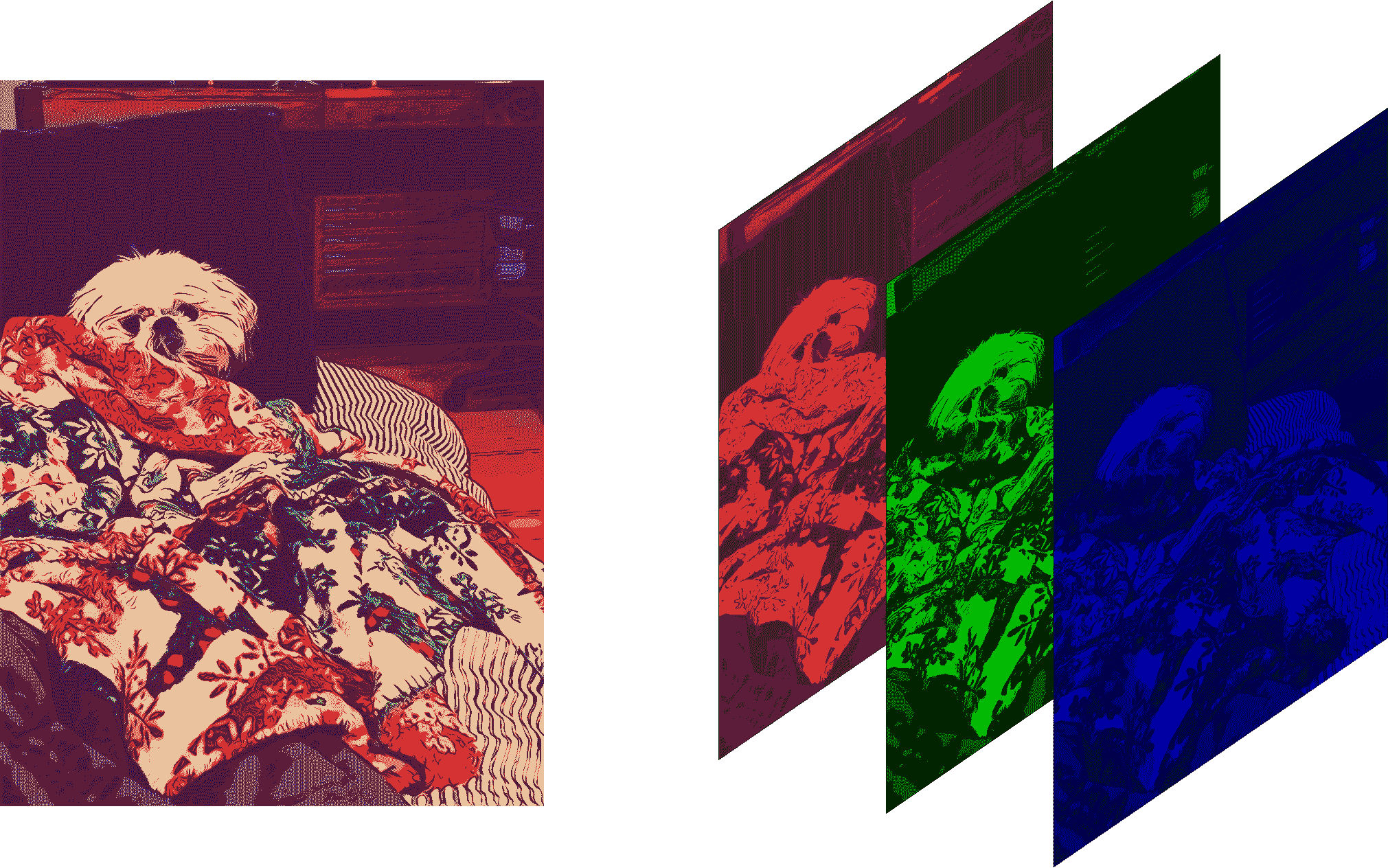

关闭源代码与开源图像注释

原文:

www.kdnuggets.com/closed-source-vs-open-source-image-annotation

计算机是否可以被训练来识别猫的可爱程度?那你会想做些什么呢?是否在猫的图片上难以集中注意力?你是否是那些希望为了方便而想要改变的技术爱好者之一?你还记得当你想让计算机相信停车标志不是让行标志时,试图说服计算机这一点的情景吗?这不再是技术爱好者们的担忧。为了让你在注释和标记过程中保持参与和娱乐,有大量的开源工具可以选择。图像注释工具的使用在像素化混乱的世界中崭露头角。通过使用注释工具,可以快速而高效地识别图像。因此,机器将能够像人类一样理解世界,计算机程序也将能够做出更好的决策。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

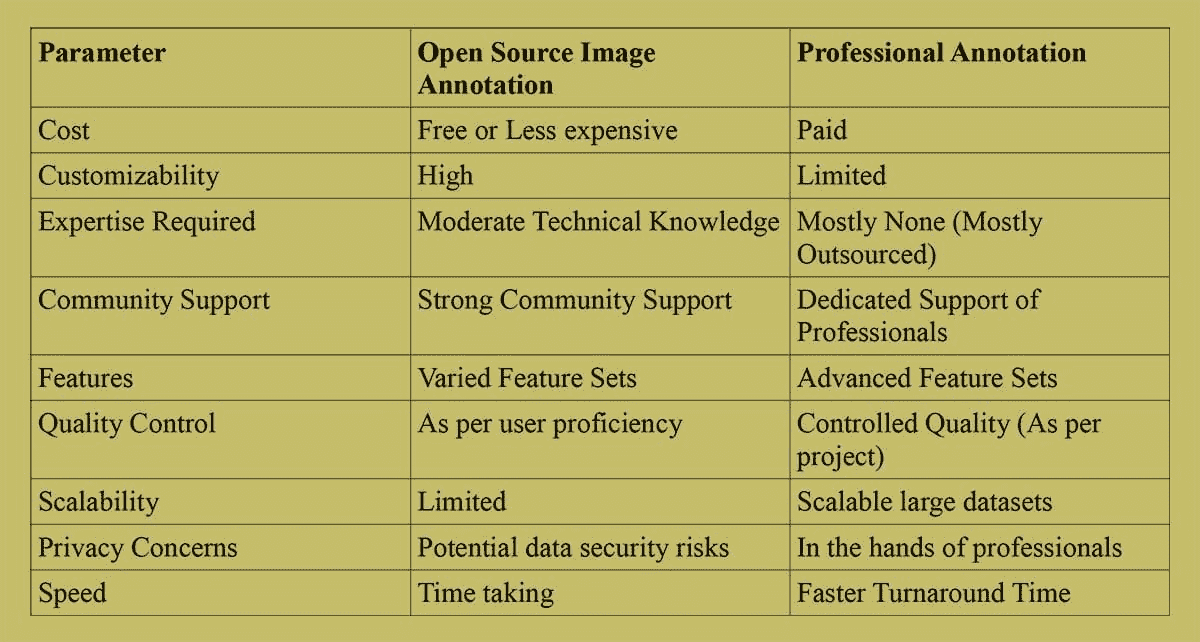

我们所生活的数字世界迅速发展,这为图像注释工具的准确性、公正性和快速性提出了要求。从自动驾驶汽车、医疗、增强现实、农业和机器人,到电子商务——对人工智能的依赖正在增加。因此,对可靠且高效的图像注释资源的需求也在迅速增长。在这篇文章中,我们将比较开源和闭源图像注释,并引用实际例子得出一个积极的结论。

准确的图像注释

作为 AI 模型的训练数据,图像注释既费时又繁琐,但值得付出努力,因为它是算法成功的关键。每张图像必须经过注释,以便机器能够正确读取(没有错误或偏见)。为了开发高质量的无错误 AI 模型,图像注释过程必须具有准确性和精确性。因此,我们获得的结果可以说是公正、准确且精确的。

优势:开源图像注释工具的强大功能

毋庸置疑,由于价格实惠、易于访问和定制功能,开源图像标注正在获得越来越多的关注。由于大多数开源工具正在不断改进,这吸引了用户获取免费的附加功能。

缺点:开源图像标注的挑战

尽管最初免费或较便宜的工具可能会很吸引人。开源工具可能只是那些关注可扩展性、创新和持续发展的人的临时试用工具。此外,并不是所有的开源工具都足够强大以产生高质量的输出。标注和标记每张图像或视频的准确性越高,如果你真的试图通过 AI 改造传统实践,你将会受益更多。

准确标注图像:工具和技术

无论是通过开源工具还是闭源工具。图像标注对于提高机器学习算法的能力至关重要,以确保它们能准确识别和解释视觉数据。当图像按标准进行标注时,AI 模型能够正常运行,并识别图像中呈现的对象、区域和特征。

一些开源标注工具的例子

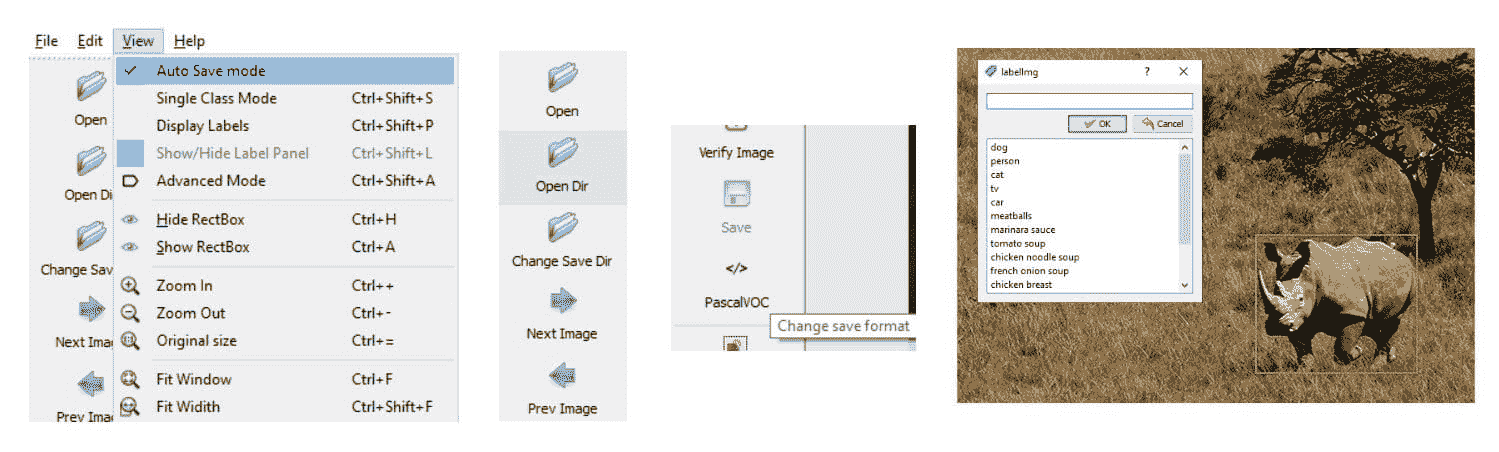

LabelImg 是一个常用的图像标注工具,允许用户在对象周围绘制边界框并添加标签。它是使用 Python 和 Qt 库实现的。这里是一个仓库 - github.com/tzutalin/labelImg

一旦你安装了 LabelImg 并准备好一组待标注的图像,你可以使用下面提到的 python 脚本为每张图像打开 LabelImg。标注后的图像将以 XML 文件的形式保存。

## https://github.com/tzutalin/labelImg

import os

import subprocess

image_dir = "/path/to/your/image/directory"

# List all image files in the directory

image_files = [f for f in os.listdir(image_dir) if f.endswith(".jpg") or f.endswith(".png")]

# Path to LabelImg executable

labelimg_executable = "/path/to/labelImg.py"

# Loop through the image files and open LabelImg for annotation

for image_file in image_files:

image_path = os.path.join(image_dir, image_file)

subprocess.call([labelimg_executable, image_path])

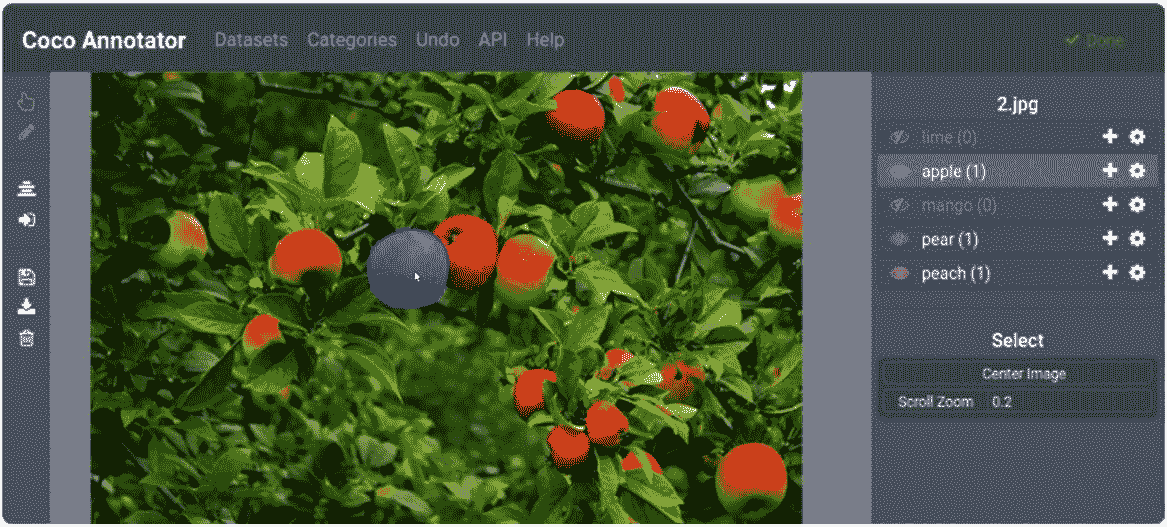

COCO Annotator 是一个专为 COCO 格式图像标注设计的基于网页的工具。它以支持多种类型的标注而闻名,如边界框、多边形和关键点。这个标注工具使用 JavaScript 和 Django 构建。

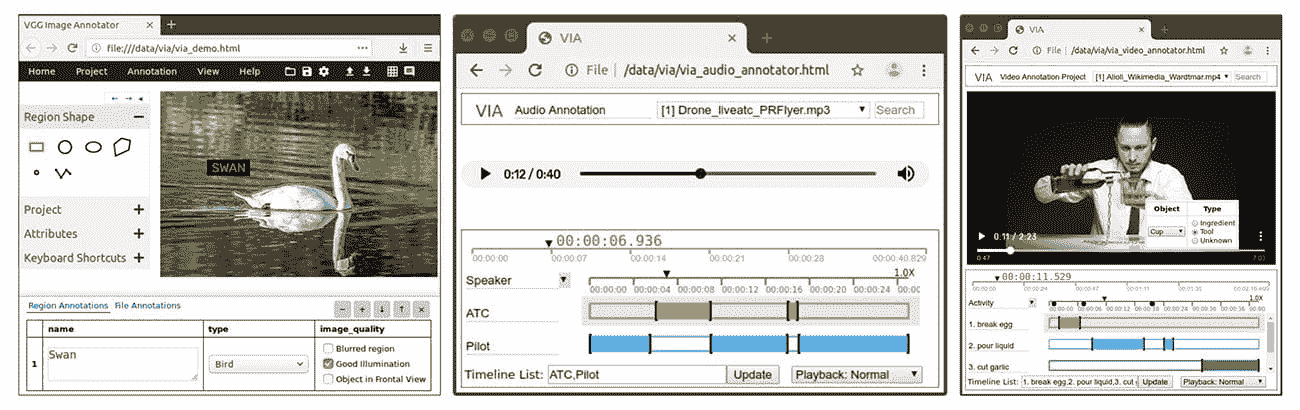

VGG 图像标注工具(VIA)是由牛津大学视觉几何组开发的图像标注工具。它允许用户自由标注不同类型的对象,包括点、线和区域。VIA 提供的界面对标注图像来说非常用户友好且直观。

一些闭源标注工具的例子

Labelbox 是一个平台,允许用户对图像进行标注,任务包括物体检测、图像分割和分类。这个工具提供了众多协作功能,可以高效地与机器学习框架集成。

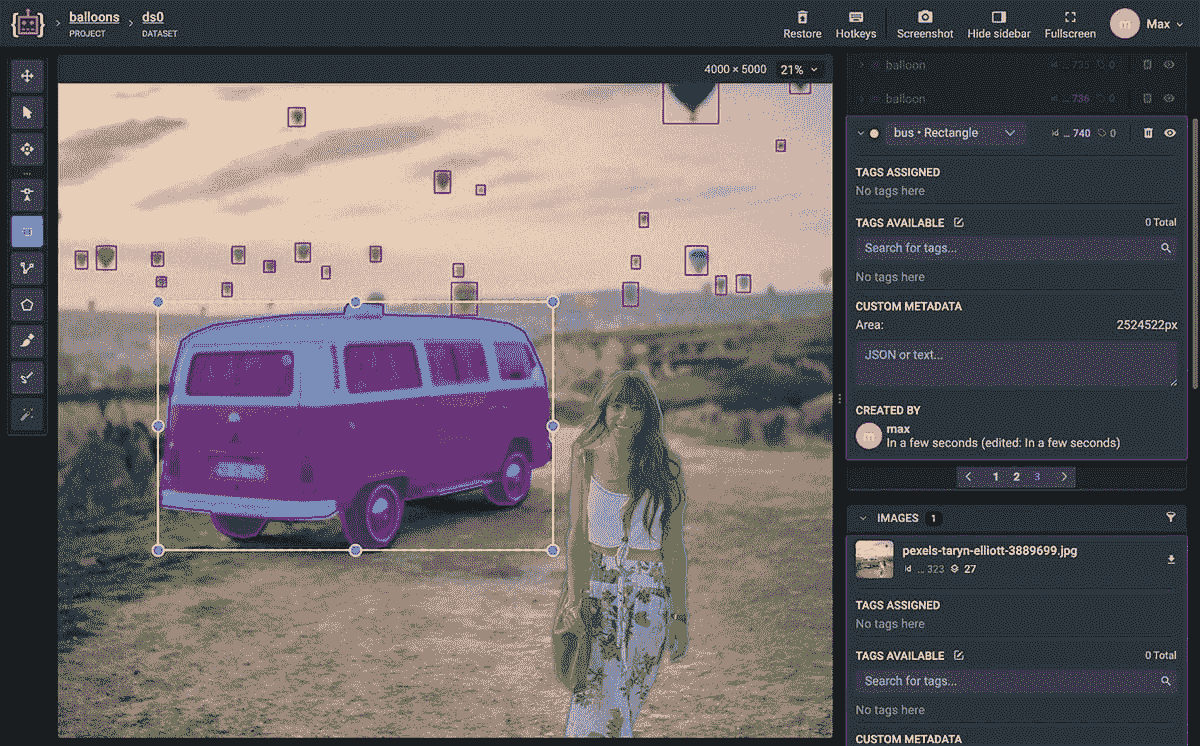

Supervisely - 该工具支持图像注释,并提供数据版本控制和模型部署等功能。

图像注释工具的应用及案例

图像注释工具用于各个行业中的图像注释。使用图像注释工具,如行人、车辆和交通标志,自动驾驶汽车能够安全导航并做出明智的决策。此外,自动驾驶汽车能够安全行驶并做出明智的决策。因此,在医疗成像中,图像注释帮助医疗专业人员进行无误的诊断。基于这些信息,患者可以获得有效的治疗。除了对产品进行分类和提高搜索功能外,电子商务平台还利用图像注释来改善客户的整体购物体验,提升他们的体验。以下提到的例子展示了图像注释工具在不同领域的多样性和重要性。

现实生活中的图像注释

让我们通过检查一些现实生活中的例子来了解图像注释工具的实际应用:

1. 自动驾驶车辆

为了使自动驾驶车辆能够无故障地感知和导航环境,必须使用可靠的图像注释工具。这些上述工具通过检测行人、车辆和交通标志,帮助自动驾驶车辆做出明智的决策。因此,确保每次乘车的乘客安全。

2. 医学成像

说到医疗行业,放射科医生正在享受人工智能解决方案的优势。临床医生利用人工智能获取有用的医学数据,帮助他们更准确地阅读和分析 X 光片、CT 扫描和/或磁共振图像。通过更好的数据和对患者疾病的可见性,医生能够以更好的关怀和谨慎来治疗患者。

3. 视觉搜索在电子商务中的作用

在电子商务行业中,图像注释的使用非常广泛。产品按功能、颜色、风格和视觉搜索等多个参数进行分类,以便使客户的购物旅程更加轻松、愉快和便捷。

4. 增强现实(AR)

图像注释在增强现实(AR)应用中用于将虚拟对象和信息根据现实世界环境正确放置。从对象的深度、尺度和方向开始,一切都被注释,以提供给用户一个真实而沉浸的 AR 体验。

5. 机器人技术与自动化

机器人专业人士可以借助图像标注工具来操控物体。当机器人被标注上相关属性时,它们能够有效地感知和与环境互动。

最后的思考

尽管开源图像标注工具的受欢迎程度确实在上升,但它们也带来了许多缺点。使用开源图像标注工具很难扩展大型项目并确保高质量的标注图像。因此,选择闭源工具将是一个明智的选择。

如果你是一个技术爱好者,你可能会想了解更多关于提示工程在人工智能中的影响。

Mirza Arique Alam 是一位充满激情的人工智能与机器学习作者和出版作者。他在人工智能与技术的交汇处创作引人入胜且信息丰富的内容,旨在激励和教育世界,展示人工智能的无限潜力。目前,他与 Cogito 和 Anolytics 合作。

更多相关话题

缩小人类理解与机器学习之间的差距:可解释人工智能作为解决方案

图片由 Bing 图像创作者提供

介绍

你是否曾打开你最喜欢的购物应用程序,看到的第一件事是推荐一个你甚至不知道需要的产品,但由于及时的推荐你最终购买了它?或者你是否打开你常用的音乐应用程序,看到一个被遗忘的宝藏由你最喜欢的艺术家推荐在最上面,作为“你可能喜欢”的内容感到高兴?无论是知道还是不知道,我们今天都遇到由人工智能(AI)生成的决策、行动或体验。虽然这些体验中的一些是相当无害的(比如精准的音乐推荐),但有些可能会引起一些不安(“这个应用怎么知道我一直在考虑进行减肥计划?”)。当涉及到关于自己和亲人的隐私问题时,这种不安会升级为担忧和不信任。然而,了解如何或为什么会推荐某些内容,可以帮助缓解一些这种不安。

这就是可解释人工智能(Explainable AI,简称 XAI)的作用所在。随着人工智能系统变得越来越普及,理解这些系统如何做出决策的需求也在增长。本文将探讨 XAI,讨论可解释 AI 模型中的挑战,介绍使这些模型更具可解释性的进展,并为公司和个人提供在产品中实施 XAI 的指导,以促进用户对人工智能的信任。

什么是可解释人工智能?

可解释人工智能(XAI)是指 AI 系统能够提供其决策或行动的解释的能力。XAI 填补了 AI 系统决策与最终用户理解为什么做出该决策之间的重要差距。在人工智能出现之前,系统通常是基于规则的(例如,如果客户购买裤子,则推荐皮带;或者如果某人打开“智能电视”,则在固定的三个选项之间循环推荐#1)。这些经历提供了一种可预测的感觉。然而,随着人工智能的普及,倒推为什么会显示某些内容或某些决策是如何由产品做出的并不简单。可解释人工智能可以在这些情况下提供帮助。

可解释的 AI(XAI)允许用户理解 AI 系统做出某个决策的原因以及决策所依据的因素。例如,当你打开音乐应用时,你可能会看到一个名为“因为你喜欢泰勒·斯威夫特”的部件,接着是类似泰勒·斯威夫特歌曲的流行音乐推荐。或者你可能打开一个购物应用,看到“基于你最近的购物历史的推荐”,接着是婴儿产品推荐,因为你在最近几天购买了一些婴儿玩具和衣物。

XAI 在 AI 做出高风险决策的领域尤为重要。例如,算法交易和其他金融建议、医疗保健、自动驾驶汽车等。能够提供决策解释有助于用户理解决策理由,识别因训练数据引入的模型偏见,纠正决策错误,并帮助建立人类与 AI 之间的信任。此外,随着日益增加的监管指南和法律要求,XAI 的重要性只会不断增长。

XAI 的挑战

如果 XAI 能够向用户提供透明度,那为什么不使所有 AI 模型都具备可解释性呢?有几个挑战阻碍了这一目标的实现。

高级 AI 模型如深度神经网络在输入和输出之间有多个隐藏层。每一层接受来自前一层的输入,对其进行计算,然后将结果传递给下一层。层与层之间的复杂交互使得跟踪决策过程以使其可解释变得困难。这就是为什么这些模型通常被称为黑箱的原因。

这些模型还处理高维数据,如图像、音频、文本等。解释每一个特征的影响以确定哪个特征对决策的贡献最大是具有挑战性的。简化这些模型以提高可解释性会导致性能下降。例如,更简单且“易于理解”的模型如决策树可能会牺牲预测性能。因此,为了可预测性而在性能和准确性之间进行权衡也是不可接受的。

XAI 的进展

随着对 XAI 的需求日益增长以继续建立人类对 AI 的信任,近年来在这一领域取得了一些进展。例如,一些模型如决策树或线性模型使可解释性相当明显。还有一些符号或基于规则的 AI 模型专注于信息和知识的明确表示。这些模型通常需要人为定义规则并向模型提供领域信息。随着这一领域的积极发展,也出现了结合深度学习与可解释性的混合模型,最大限度地减少了性能上的牺牲。

实施 XAI 的产品指南

赋予用户更多理解 AI 模型决策原因的能力,有助于促进对模型的信任和透明度。这可以导致人机之间改进的、互利的合作,其中 AI 模型帮助人类做出透明的决策,而人类则帮助调整 AI 模型以消除偏差、不准确和错误。

以下是公司和个人可以在其产品中实施 XAI 的一些方式:

-

选择可解释的模型 – 在可解释的 AI 模型能满足需求且表现良好的情况下,应优先选择这些模型。例如,在医疗保健领域,像决策树这样的简单模型可以帮助医生理解 AI 模型推荐某种诊断的原因,这有助于建立医生与 AI 模型之间的信任。应使用提高可解释性的特征工程技术,如独热编码或特征缩放。

-

使用事后解释 – 使用像特征重要性和注意力机制这样的技术生成事后解释。例如,LIME(局部可解释模型无关解释)是一种解释模型预测的技术。它生成特征重要性分数,以突出每个特征对模型决策的贡献。例如,如果你最终“喜欢”某个播放列表推荐,LIME 方法会尝试添加和移除播放列表中的某些歌曲,并预测你喜欢该播放列表的可能性,从而得出播放列表中歌曲的艺术家在你喜欢或不喜欢该播放列表中扮演了重要角色。

-

与用户的沟通 – 可以使用像 LIME 或 SHAP(SHapley Additive exPlanations)这样的技术,提供关于具体局部决策或预测的有用解释,而不必解释模型的所有复杂性。还可以利用激活图或注意力图等视觉提示,突出输入与模型生成的输出之间的相关性。像 Chat GPT 这样的新技术可以用来简化复杂的解释,以用户可以理解的简单语言表达。最后,给予用户一定的控制权,以便他们与模型互动,这有助于建立信任。例如,用户可以尝试以不同的方式调整输入,以查看输出的变化。

-

持续监测 – 公司应实施机制来监控模型的性能,并在检测到偏差或漂移时自动发出警报。应定期更新和微调模型,并进行审计和评估,以确保模型符合监管法律并满足伦理标准。最后,即使很少,也应有人参与提供反馈和必要的修正。

结论

总结来说,随着人工智能的不断发展,构建可解释的人工智能(XAI)变得至关重要,以维持用户对人工智能的信任。通过采用上述指导方针,公司和个人可以构建更透明、易于理解和简单的人工智能。公司越多地采用 XAI,用户与人工智能系统之间的沟通就会越好,用户也会越有信心让人工智能改善他们的生活。

Ashlesha Kadam 领导着亚马逊音乐的全球产品团队,为来自 45 多个国家的数百万客户在 Alexa 和亚马逊音乐应用(网页、iOS、Android)上打造音乐体验。她还是女性科技领域的热情倡导者,担任 Grace Hopper Celebration(全球最大的女性科技会议,参会者超过 3 万人,来自 115 个国家)的计算机与人类交互(HCI)分会的联合主席。在空闲时间,Ashlesha 喜欢阅读小说、听商业科技播客(当前最爱 - Acquired),在美丽的太平洋西北地区徒步旅行,以及和丈夫、儿子及 5 岁的金毛猎犬共度时光。

我们的前三推荐课程

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

更多相关主题

云计算、数据科学和 ML 趋势 2020–2022:巨头之战

原文:

www.kdnuggets.com/2021/01/cloud-computing-data-science-ml-trends-2020-2022-battle-giants.html

评论

由 George Vyshnya,SBC 联合创始人/CTO

每次你看到一个巨头时,你必须知道那个巨头可能在其他地方只是个侏儒! ― Mehmet Murat ildan

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

介绍

我将致力于一系列文章,分享 Kaggle “2020 年数据科学和机器学习现状”调查中收集的数据见解 (www.kaggle.com/c/kaggle-survey-2020)。

调查涵盖了很多不同的话题,每一个话题都值得单独讨论各自的趋势。

备注:

-

Kaggle (www.kaggle.com) 是一个由全球各地的数据科学家和机器学习者组成的社区,成员技能和背景各异。社区拥有约 300 万活跃成员。虽然从社会学角度来看,它并不完全代表全球数据科学和 ML 专业人士的总体情况,但它仍然构成了该领域从业者和专业人士的重要部分。因此,调查结果确实可以对数据科学和 AI/ML 行业在未来几年可能的发展方向进行有价值的预测。

-

你可以查看仓库

github.com/gvyshnya/state-of-data-science-and-ml-2020以了解本文讨论的每个见解是如何发现的。

巨头之战

在这篇文章中,我们将探讨参与调查的数据科学和 ML 专业人士对云计算平台和产品的受欢迎程度。特别是,它将涵盖

-

云平台使用情况

-

云计算产品使用情况

-

云 ML 产品使用情况

-

大数据平台

-

BI 工具(主要是基于云的工具)

本章的叙述线将经常附带关于市场上前三大云服务提供商的好消息和机会

-

亚马逊 Web 服务 (AWS)

-

Google Cloud Platform (GCP)

-

Microsoft Azure Cloud (MS Azure)

注意:

- 调查组织者将非专业人士定义为学生、失业者以及从未在云中花费过任何钱的回应者。其他所有人被视为专业人士

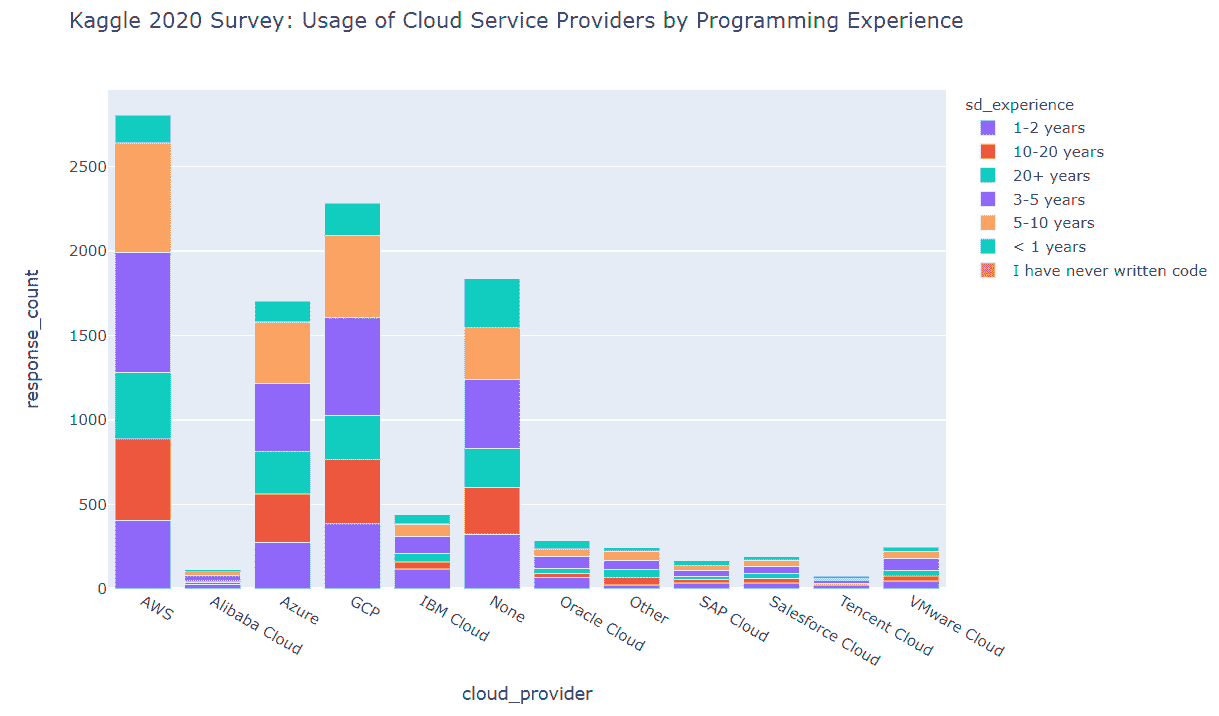

云服务提供商的使用

我们发现 Kaggle 调查的回应者中前三名的云服务提供商是

-

AWS

-

GCP

-

MS Azure

其余的云服务提供商目前似乎在与上述前三名提供商的竞争中失去了竞争优势。

同时,值得注意的是,“无”类别略微超过了 MS Azure 条形图的大小,这意味着市场可能尚未被云服务提供商的产品饱和。

我们还看到具有 3–5 年和 5–10 年编程经验的专业人士是前三大云服务提供商中最大的用户群体。具有 10 年以上经验的高级专业人士在前三大平台的云服务用户中占比相对较少(根据市场营销优先级,特别的行动来教育这些高级专业人士可能有助于更好地推广云服务)。

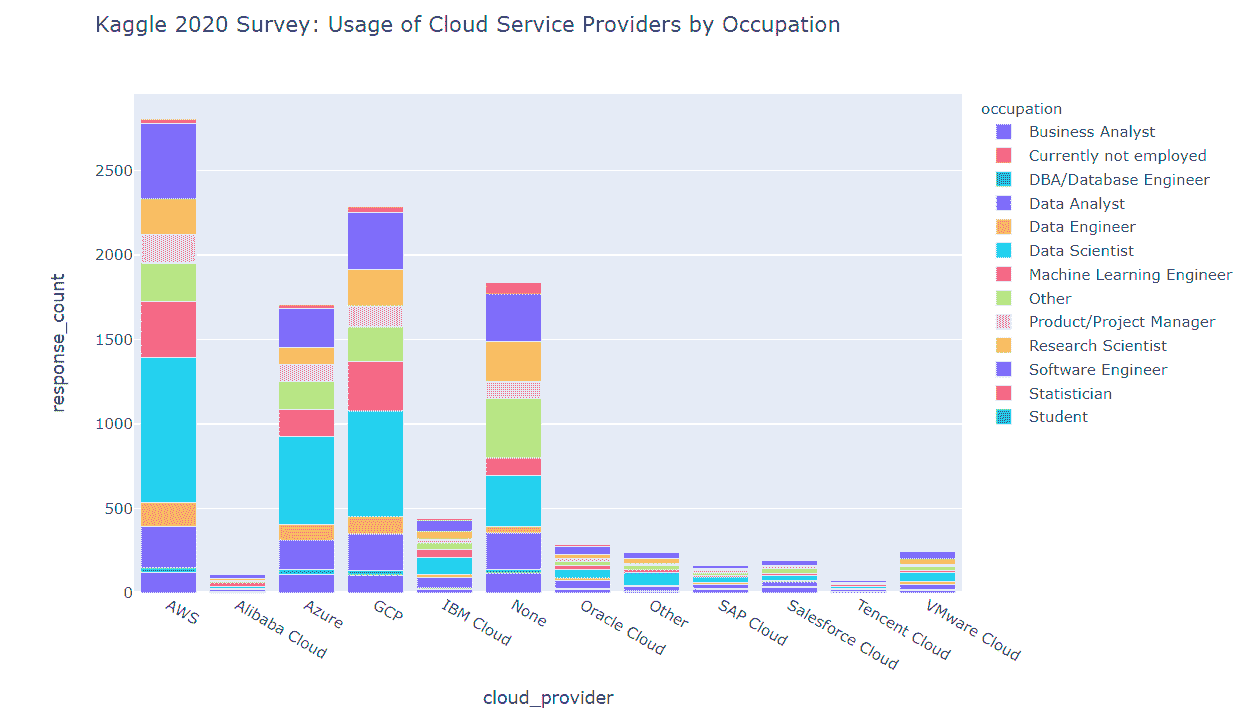

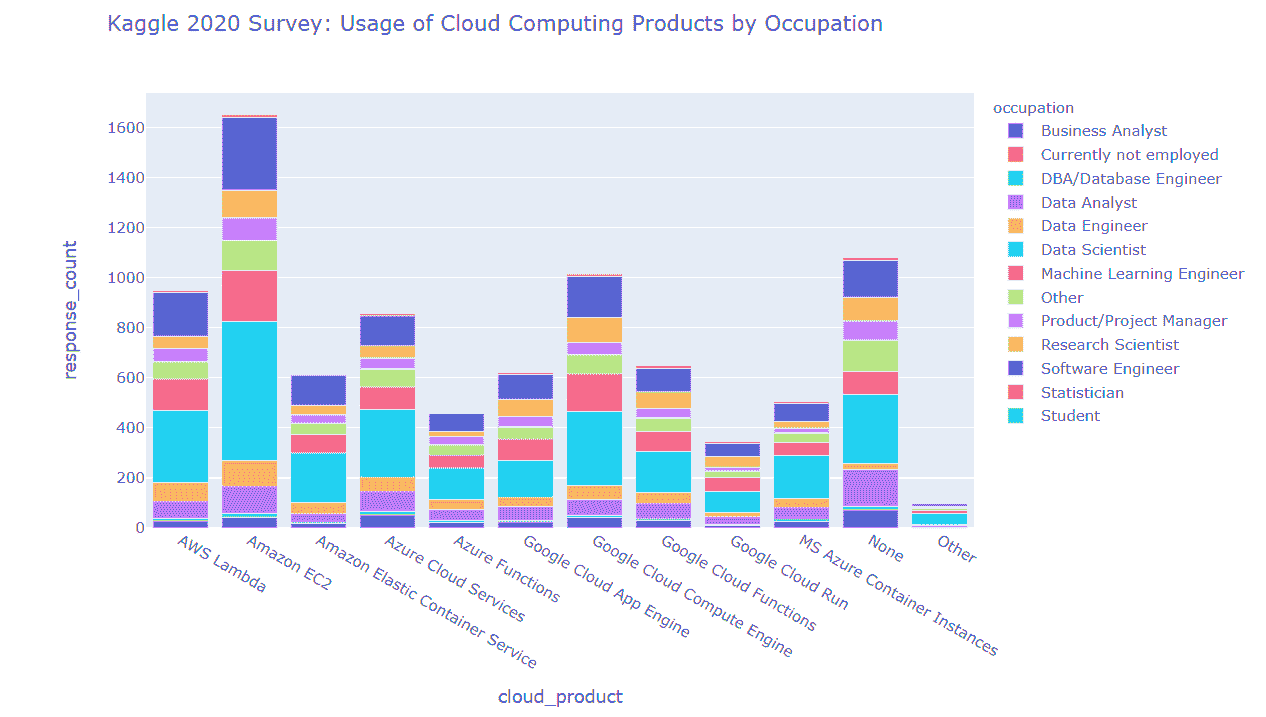

正如我们所看到的,前三大云服务提供商的用户大多数符合以下角色

-

数据科学家

-

软件工程师

第三名职位由以下人员担任

-

机器学习工程师(AWS,GCP)

-

数据分析师(MS Azure)

正如之前所述,“其他”职业组本身范围过大,未来的调查中可能值得将其拆分为更细化的类别。我们看到,“其他”组在每个云服务平台用户中占据了相当大的比例(尽管在任何平台的前三名列表中都未出现)。

就用户职业和编程经验而言,前三大云服务提供商共享以下相同的趋势

-

数据科学家中具有 3–5 年和 5–10 年编程经验的用户是调查回应者中 AWS 的主要用户群体

-

在软件工程师、机器学习工程师和数据分析师组中,具有 3–5 年和 5–10 年经验的专业人士占主导地位

-

在研究科学家、数据工程师、DBA、统计学家和其他组中,具有 10 年以上经验的专业人士占据了最大的用户比例

-

在产品/项目管理组中,具有 5 年以上经验的专业人士占据了最大的用户比例

-

在商业分析师组中,我们看到具有 1–2 年经验的用户占据主导地位

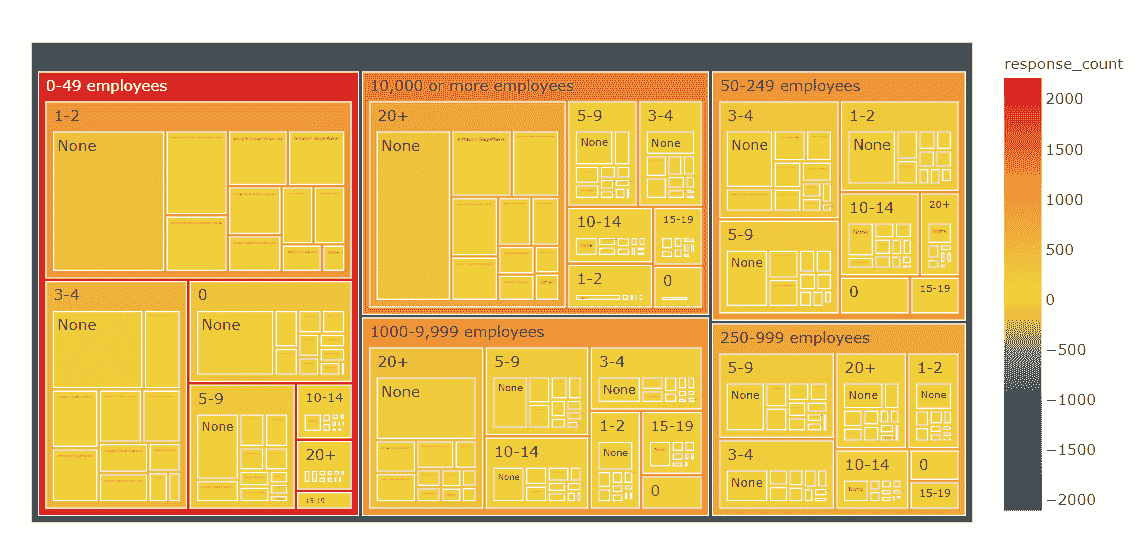

就组织环境而言,最能使用云服务的数据科学和机器学习专业人士可以在以下领域找到

-

员工人数为 0–49 的组织中,拥有 1–2 名专门从事数据科学工作的员工

-

员工人数超过 10000 的组织中,拥有 20 名以上专门从事数据科学工作的员工

因此我们可以得出结论,AWS、GCP 和 MS Azure 在相同类型的组织/用户中进行激烈竞争。

云计算产品的使用

我们发现

-

在云计算引擎领域,Amazon EC2 比 Google(Google Cloud Computing Engine)和 MS Azure(Azure Cloud Services)的竞争对手更受欢迎

-

在云函数领域,AWS Lambda 比 Google(Google Cloud Functions)和 MS Azure(Azure Functions)的竞争对手更受欢迎

-

在云容器运行器领域,Amazon Elastic Container Service 比 Google(Google Cloud Run)和 MS Azure(MS Azure Container Instances)的竞争对手更受欢迎

-

Google 在云计算引擎和云函数领域位居第二,在云容器运行器领域位居第三

-

有大量回应为“无”,这很可能表明整个云计算应用市场尚未饱和

在用户角色方面,所有上述云计算产品的用户都担任以下角色(从上到下)

-

数据科学家

-

软件工程师

-

机器学习工程师

-

数据分析师

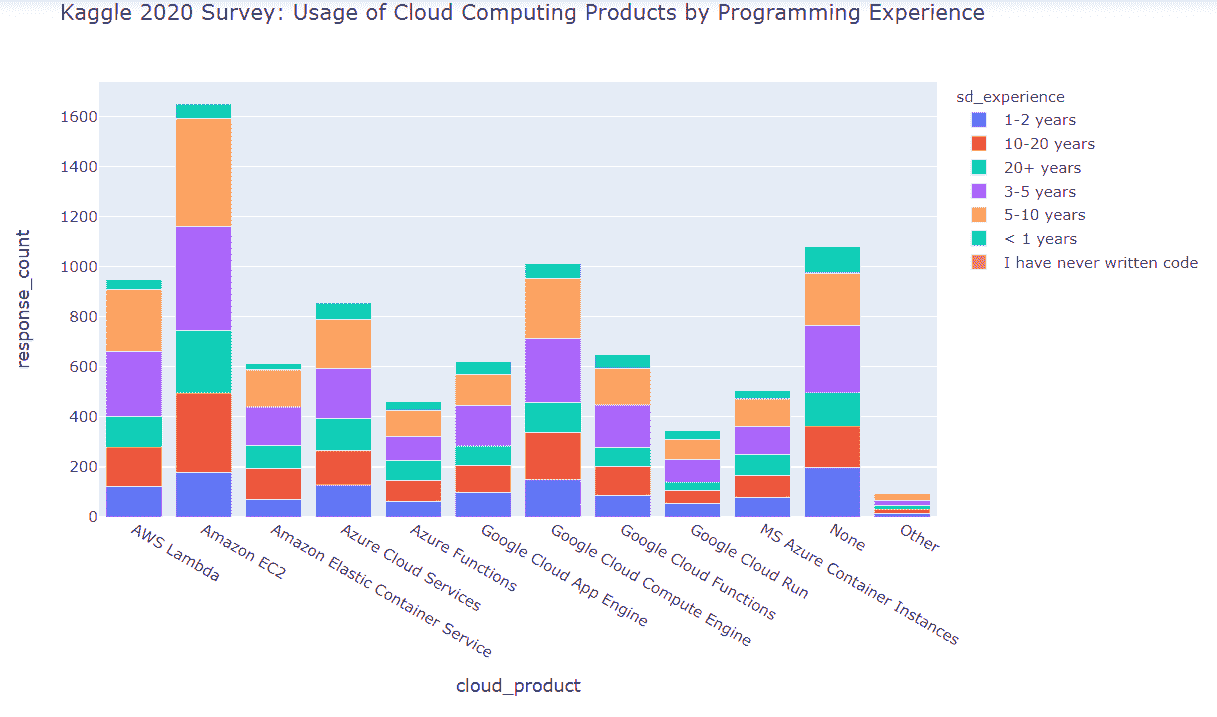

编程经验对云计算产品使用的影响

除了上述见解外,我们还看到,云计算产品用户的顶尖数量按编程经验划分为以下几个群体

-

5–10 年的经验

-

3–5 年的经验

-

10–20 年的经验

初级和超级资深(20 年以上编程经验)的覆盖程度似乎较低。

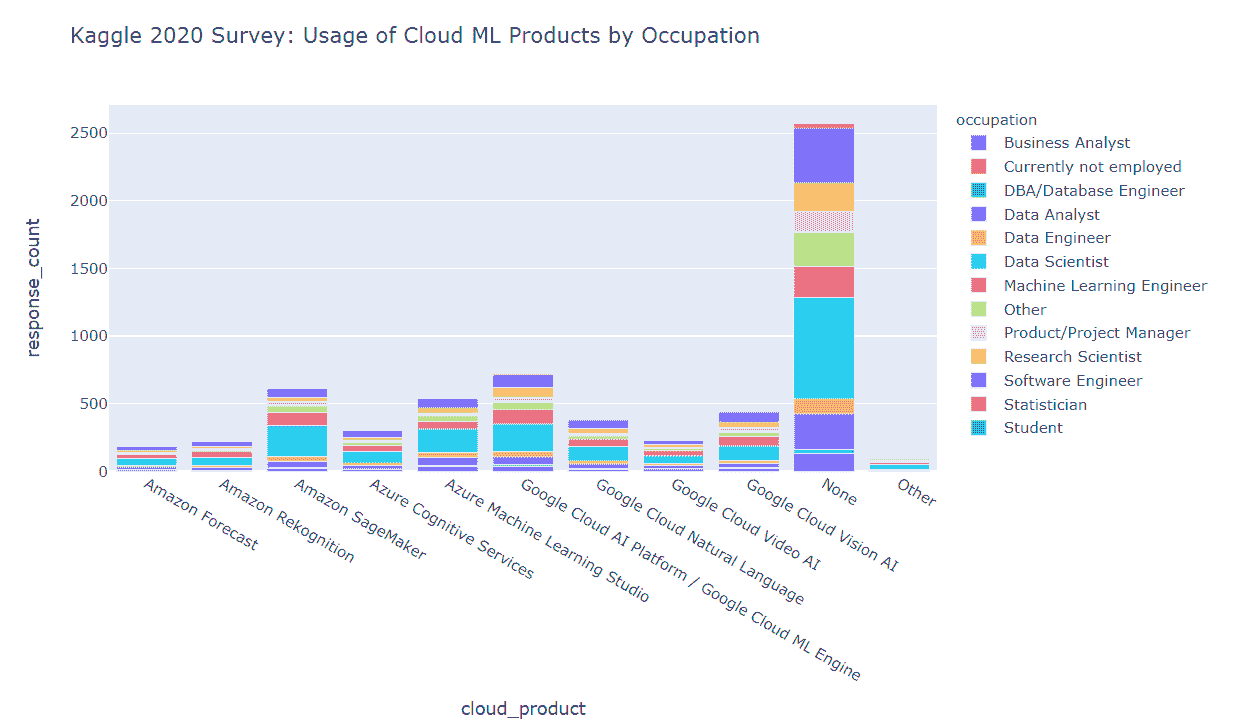

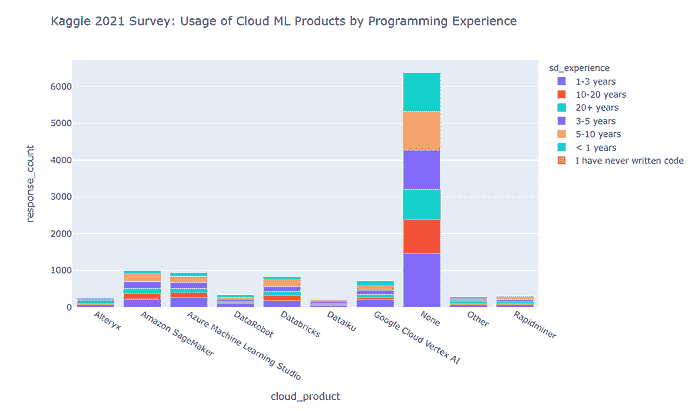

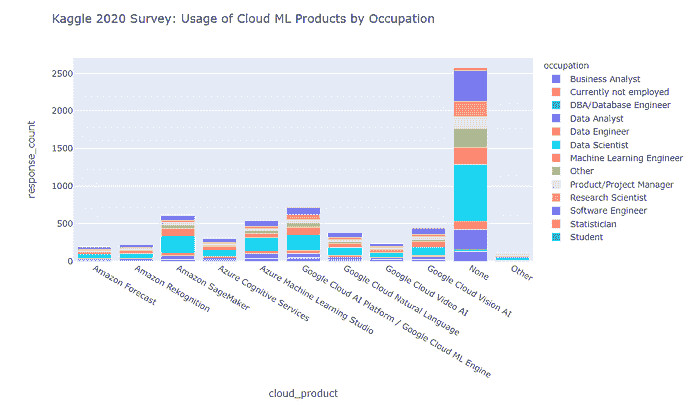

云机器学习产品使用情况

我们发现

-

Google Cloud AI Platform / Google Cloud ML Engine 在机器学习云产品使用方面的“提名”领先

-

第二和第三名分别是 Amazon SageMaker 和 Azure Machine Learning Studio

-

数据科学家是云机器学习产品的主要用户(针对每个调查的产品)

-

有一大部分回应者表示他们根本不使用云机器学习产品——这表明市场尚未饱和,还有很好的增长潜力,但需要解决市场推广和最终用户障碍

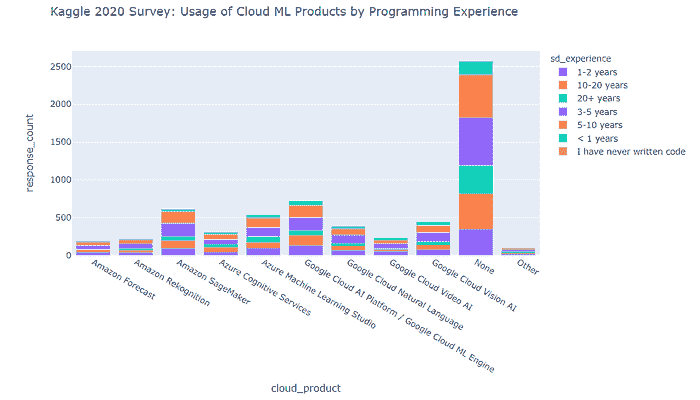

编程经验对云机器学习产品使用的影响

除了上述见解外,我们还可以看到云机器学习产品主要被具有以下编程经验的回应者使用

-

3–5 年

-

5–10 年

按组织规模和数据科学能力分类的云机器学习产品使用情况

我们发现,在每个规模类别的大多数组织目前都不使用任何云机器学习产品。

对于那些使用它们的少数人来说,有以下有趣的见解

-

在小型组织(0–49 名员工)中,Google Cloud AI Platform / Google Cloud ML Engine 占据主导地位

-

在中型组织(50–249 名员工)中,Google Cloud AI Platform / Google Cloud ML Engine 和 Amazon SageMaker 不分上下

-

对于较大规模的公司(250+名员工),数据科学团队的规模通常与首选的云 ML 产品相关(较小的团队更倾向于使用 Google Cloud AI Platform / Google Cloud ML Engine,而拥有 20+人的数据科学团队则更倾向于使用 Amazon SageMaker)。

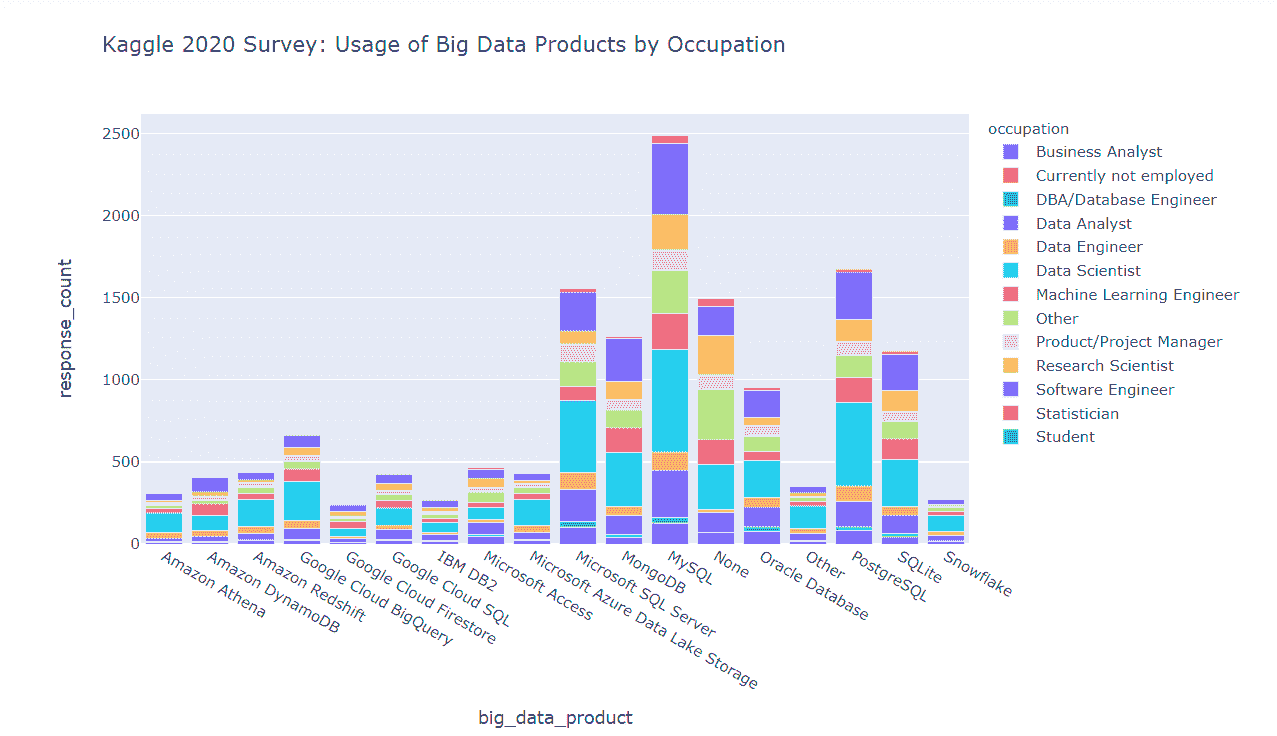

按职业分类的大数据产品使用情况

我们发现

-

总体前 3 名列表由三个关系型 DBMS 平台(MySQL、PostgreSQL、MS SQL Server)组成。

-

MongoDB 作为一种非关系型数据库平台,在列表中排名第 4。

-

列表中的其他关系型 DBMS 平台(Oracle、IBM DB2、SQLite)在 MongoDB 之后。

-

在真正基于云的大数据产品领域,Google BigQuery 超越了其 Amazon 和 MS Azure 竞争对手(Amazon Redshift、Amazon Athena、Amazon DynamoDB 和 Microsoft Azure Data Lake Storage)。

-

Google Cloud SQL 实例的受欢迎程度仍低于 MySQL 和 PostgreSQL 的“原生”关系型数据库实例。

-

MS Access 在业内仍在使用。

-

数据科学家是本列表中每种产品的主要用户。

按用户职业和编程经验分类的大数据产品使用模式

我们发现

-

MySQL 和 PostgreSQL 是各职业中最受欢迎的数据库管理平台。

-

MongoDB 在软件工程师中非常受欢迎(尽管不如 MySQL 和 PostgreSQL 受欢迎)。

按组织规模和数据科学能力分类的大数据产品使用模式

我们发现

-

除了超大型组织外,几乎所有组织都主要使用 MySQL、PostgreSQL 和 MongoDB 来满足其数据管理需求。

-

超大型组织(10000+名员工)更倾向于使用 MySQL、MS SQL Server、Oracle 和 PostgreSQL。

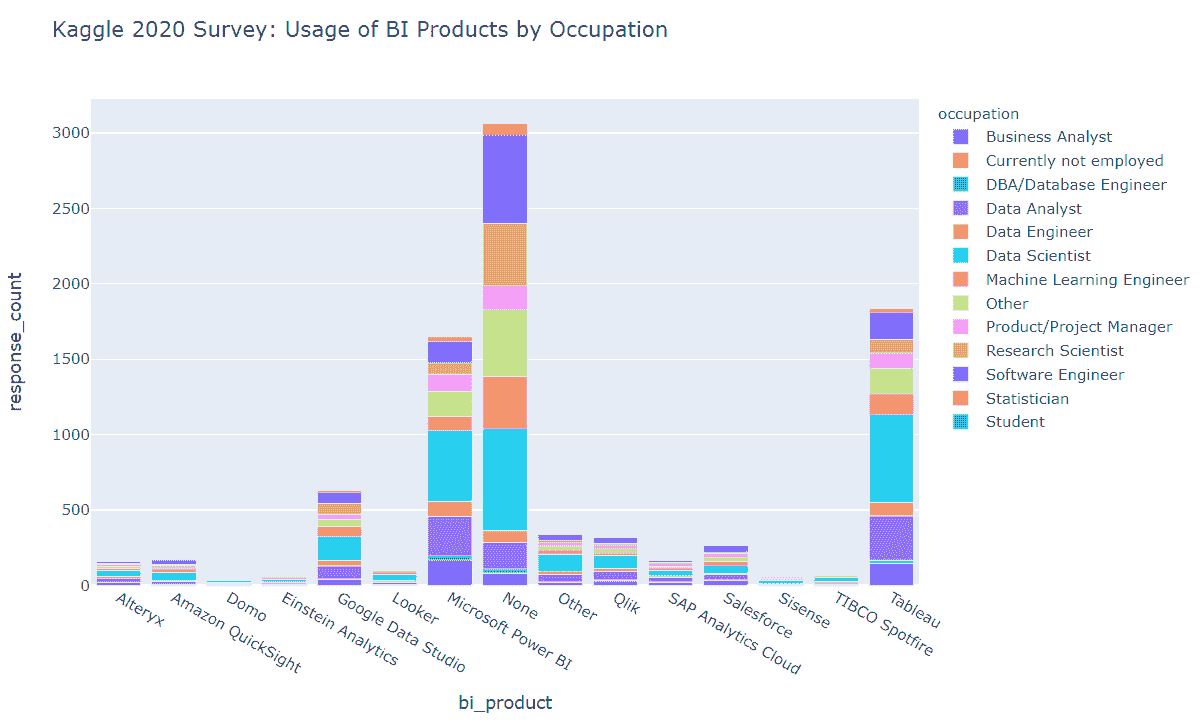

BI 工具的使用情况

我们发现

-

Tableau 和 MS Power BI 显著超越其他竞争对手。

-

Google Data Studio 成为上述领先 BI 产品的挑战者,排名第三。

-

数据科学家、数据分析师、研究科学家和机器学习工程师是 BI 工具的最频繁用户。

-

大量调查回应者表示他们根本不使用 BI 工具。

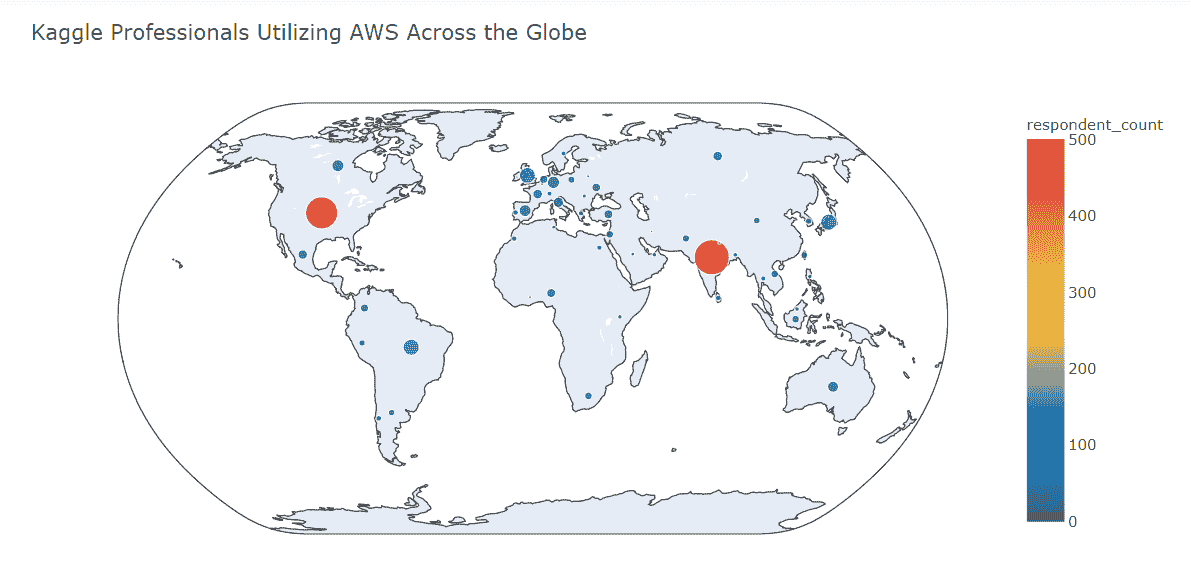

全球范围内的 AWS 专业用户

我们发现

-

AWS 在印度和美国的调查回应者中最受欢迎。

-

巴西、日本和英国在使用 AWS 的这些国家中排名第 2 层级。

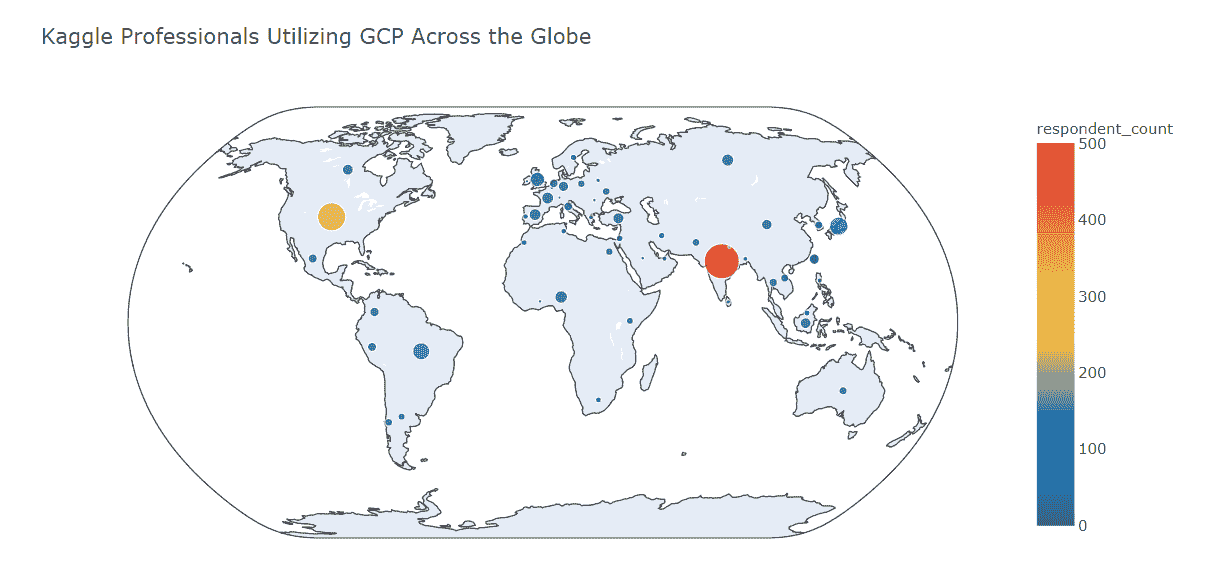

全球范围内的 GCP 专业用户

我们发现

-

印度是 GCP 使用最广泛的国家。

-

美国排名第二,但远低于印度(与 AWS 不同,印度和美国的排名相对接近)。

-

日本和巴西在使用 AWS 的这些国家中排名第 2 层级。

-

在英国、加拿大和澳大利亚,GCP 的受欢迎程度低于 AWS。

-

GCP 在土耳其、印度尼西亚和俄罗斯的表现优于 AWS

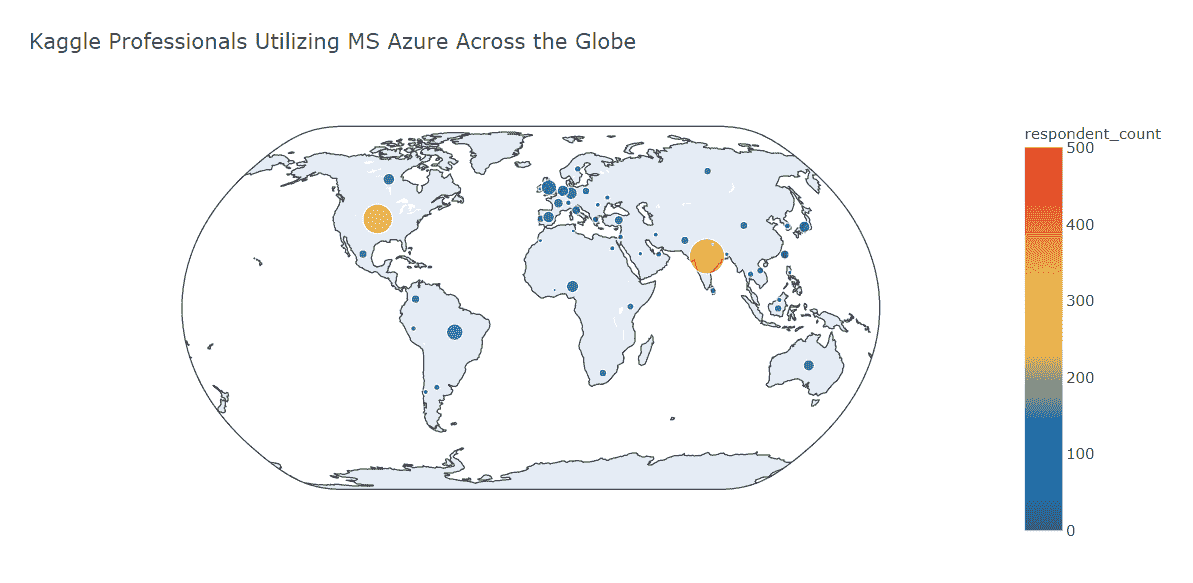

全球 MS Azure 专业用户

我们发现

-

MS Azure 用户数量最多的国家是印度(尽管在这里 MS Azure 远远落后于 AWS 和 GCP)

-

美国在排名中位居第二,MS Azure 用户数量与美国的 GCP 用户数量相当

-

在 MS Azure 用户数量方面,巴西属于第二梯队

-

在大多数国家(美国除外),MS Azure 用户数量少于 GCP 和 AWS 用户数量

摘要

在这篇文章中,我们回顾了数据科学和机器学习行业专业人士使用云计算平台、产品和工具的现状。这些不仅仅是他们在 2020 年底的偏好。这些都是最有可能决定 2021–2022 年趋势的基石。

未来几年在数据科学和机器学习行业,云计算巨头们在争夺头脑、资源和预算的战斗中将至关重要。尽管 AWS 的位置仍然看起来比其他顶级竞争对手更强,但 GCP 带来的挑战可能成为未来市场重塑的复杂部分。同时,MS Azure 似乎在北美保持着强势地位(虽然在其他大陆的渗透机会相对较少,尤其是与 AWS 和 GCP 相比)。

然而,我们进入了全球动荡的时代。2021 年,星辰之年的年份,可能会在我们生活的各个方面给我们带来意想不到的惊喜。

备注: 你可以查看这个库 github.com/gvyshnya/state-of-data-science-and-ml-2020 来查看上述每一项洞见是如何被发现的。

简介: 乔治·维什尼亚 是 SBC 的联合创始人兼首席技术官,帮助首席执行官和首席技术官通过实施智能 AI、BI 和 Web 解决方案来增加收入。

原文。已获转载许可。

相关:

-

2021 年人工智能(AI)趋势前五名

-

2020 年数据科学和机器学习现状:3 项关键发现

-

2020 年必须掌握的 5 项数据科学技能

更多相关内容

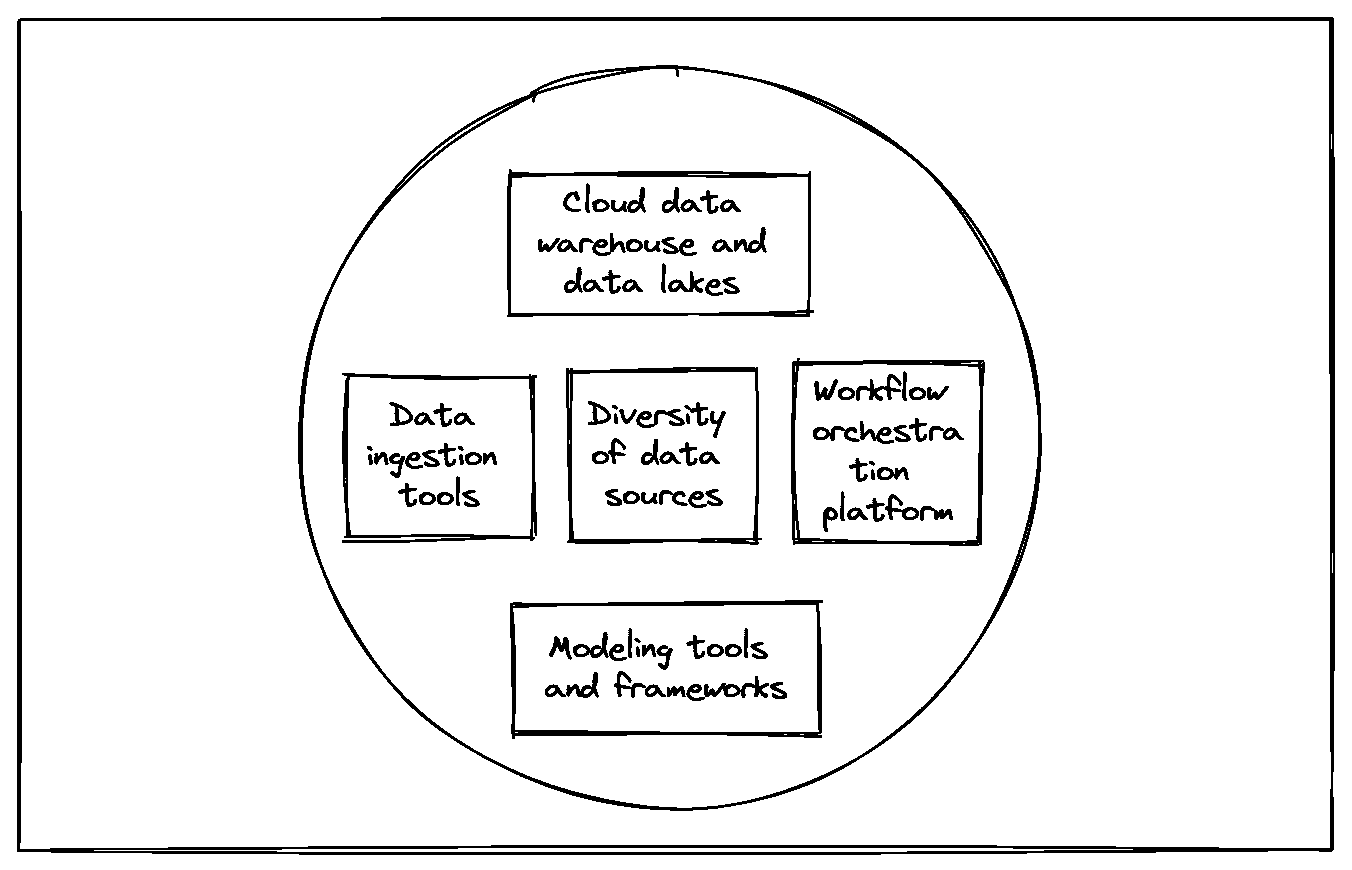

云计算如何提升数据科学工作流程

原文:

www.kdnuggets.com/2023/08/cloud-computing-enhances-data-science-workflows.html

图片来源:Rakicevic Nenad

如果数据是世界上最宝贵的资源,那么数据科学就是其最具影响力的过程。随着更多组织意识到需要数据科学以保持竞争优势,这一实践在各行各业变得越来越重要。这种快速增长在很大程度上是有益的,但也可能带来一些挑战。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

数据量和处理需求正在以比传统工作流程更快的速度飙升。数据科学团队需要更好的方式来管理这些不断增加的需求,而云计算提供了一个理想的解决方案。以下是五个原因。

1. 降低成本

云计算的成本效率是其最大的优势之一。实施和维护本地服务器可能非常昂贵,需要大量的初期投资和持续的劳动及 IT 成本。在云上存储和处理数据可以消除许多这些开支。

在云模型中,你不需要购买或维护自己的设备。考虑到现代数据科学可能需要的处理能力,这可以带来巨大的节省。你也只需为你使用的资源付费,因此任何随着增长而产生的成本都反映了实际的数据量增长,没有多余的费用。

2. 简化工作流程

云还可以简化数据科学工作流程。软件即服务(SaaS)解决方案让你能够获得可能无法负担的计算速度和容量。因此,你可以进行更复杂的计算,减少处理延迟。

云系统还将曾经分开的数据库和工作负载整合在一起。这种整合消除了在应用程序之间切换的浪费时间,并减少了数据输入和传输错误的风险。错误的数据可能显著阻碍操作效率,因此这种可靠性进一步提高了生产力。

3. 提升安全性

尽管对云计算安全性的担忧依然存在,云计算实际上有几个安全优势。绝大多数云安全漏洞来自人为错误,而非云本身的技术缺陷。然而,SaaS 模型可以让高安全性变得更加可及。

云服务提供商通常拥有数据科学家可能无法负担或在内部实施的高级安全功能。这可能包括自动监控、自动合规和广泛的加密备份。在云中,网络分段也更容易,这使得零信任和类似的安全架构变得更易于实现。

4. 扩展数据容量

使用云计算还可以让你存储和处理比本地解决方案更多的数据。数据科学应用通常在信息更多时效果最佳,但在内部系统上管理大量数据会迅速变得昂贵和低效。

全球数据量预计将在 2025 年超过 180 泽字节。这可以让数据科学变得比以往更可靠,但前提是你拥有支持这种规模存储和分析的能力。云计算使得在本地实施这一级别的存储和分析成为可能,而成本将会过高。

5. 改善可扩展性

类似地,云计算比传统的数据科学工作流程更具扩展性。以传统方式扩展能力意味着购买和设置额外的服务器,这既昂贵又可能打乱当前的工作流程。使用云计算,你只需支付更高的费用来获得更多的容量,并能立即获得。

考虑到数字数据当前的增长速度,快速的扩展性至关重要。然而,如果你需要缩减运营规模,在云中进行缩减仍然比传统方式更具成本效益。随着容量的减少,你的费用也会减少,确保缩减不会导致浪费未使用的硬件。

现代数据科学需要云计算

当今的数据科学工作流程必须快速、可靠、安全,并能处理大量工作负荷。随着这些需求的增加,传统的本地设置迅速变得不足。

云计算提供了数据科学团队所需的可负担性、效率、安全性、容量和扩展性。利用这一机会将帮助你最大化数据科学应用的回报。

April Miller 是 ReHack 杂志的消费技术主编。她拥有创作优质内容并吸引流量的记录。

更多相关话题

云机器学习透视:2021 年的惊喜,2022 年的预测

原文:

www.kdnuggets.com/2021/12/cloud-ml-perspective-surprises-2021-projections-2022.html

由George Vyshnya,SBC 的联合创始人/首席技术官

~ 生活就是一系列的适应性测试。— 威廉·约瑟夫·多诺万

引言

在我 2021 年 1 月发表在 KDnuggets 上的文章中,我对 2021 年的云计算和云机器学习行业做出了以下预测

-

未来几年对于云计算巨头在数据科学和机器学习行业争夺思想、资源和预算将至关重要。虽然 AWS 的位置依然比其他主要竞争对手更强,但来自 GCP 的挑战可能是未来市场重塑的复杂部分。同时,MS Azure 似乎在北美保持着强势地位(而在与 AWS 和 GCP 相比中,进入其他大陆的机会较小)。

-

然而,我们进入了全球动荡的时代。2021 年,星辰之年,可能会在我们生活的各个方面带来意想不到的惊喜

我必须承认这两个预测都得到了实现。

巨头之战中,AWS、GCP 和 MS Azure 在争夺市场份额和收入的竞争中持续进行,各大巨头在全球范围内定位其产品时都有其强项和弱点。

至于惊喜,它确实发生了。在云机器学习行业中,我们观察到了 2021 年几个难以预测的现象

***- Google ***在最近将其单独的云机器学习产品整合到统一产品平台(Google Cloud Vertex AI)后,市场份额下降了

***- Databricks ***跃升为云机器学习市场的前三大产品,取代了 Google 的竞争产品

让我们回顾 2021 年的云机器学习市场(偶尔也回顾 2020 年的实际情况)。本文接下来的部分将揭示行业洞察。

注意:在挖掘洞察时,使用了 Kaggle 对‘2020 年数据科学和机器学习现状’的调查数据(www.kaggle.com/c/kaggle-survey-2020)以及对‘2021 年数据科学和机器学习现状’的调查数据(www.kaggle.com/c/kaggle-survey-2021)。

Databricks 突破壁垒及 2021 年其他云机器学习趋势

我们可以发现许多关于 2021 年云机器学习行业的吸引人事实和趋势。它们如下

-

Google 在 2021 年将其所有云机器学习产品整合到新的统一平台(即 Google Cloud Vertex AI)中的举措,并未带来 Google 在企业(商业)云机器学习市场的市场份额增长。

-

此外,Big Three Cloud Giants 中的主要 Cloud ML 竞争者——Amazon SageMaker 和 Azure ML Studio——在其市场地位上有所提升,并且到 2021 年成为了市场的最终领导者(Amazon SageMaker 排名第一,略微领先于 Azure ML Studio)。

-

我们可以看到 Databricks 在 2021 年的 Cloud ML 产品排名中位居第三(高于 Google Cloud Vertex AI,略低于 Amazon SageMaker 和 Azure ML Studio)。

-

其他 Cloud ML 竞争产品(DataRobot、Dataiku、Alteryx、Rapidminer)远远落后于 Databricks 和 Google Cloud Vertex AI。

-

Amazon SageMaker 在 Cloud ML 市场中连续两年(2020–2021)保持领先地位。

-

尽管如此,大量受访者表示他们在日常活动中根本不使用 Cloud ML(需要注意的是,‘None’在 2020 年和 2021 年可能有不同的含义,因为 2020 年和 2021 年调查中提供的 Cloud ML 产品列表差异很大)。

-

Databricks 在 2021 年对 Google 的统一 AI 平台发起了强有力的进攻(因此,Google 最近决定投资 Databricks 可能是 Databricks 市场份额在 2021 年显著增长的触发因素)。

-

Cloud ML 行业领头羊——Amazon SageMaker 和 Azure ML Studio——在 2021 年底保持了相对强势的地位,相比于 Databricks 和 Google Cloud Vertex AI。

-

印度和美国是 Kaggle 2021 调查问卷中 Cloud ML 产品用户最多的前两大国家。

-

Amazon SageMaker 在印度和美国都占据了领先地位。

-

Azure Machine Learning Studio 在印度排名第二。

-

Databricks 在美国排名第二,并且在 2022 年在英国和欧盟国家也有良好的增长潜力。

-

ML 支出最多的公司更倾向于使用 Amazon SageMaker 和 Databricks,而 Azure ML Studio 在这种排名中位列第三(Google Cloud Vertex AI 则远远落后)。

-

Google Cloud Vertex AI 在中等和小规模 ML 支出公司的地位更好(这可能是一个未来将这些公司转化为高支付客户的机会);它有可能在 2022 年在北美和欧盟以外的多个地点探索增长机会。

现在我们来详细了解一下上述洞察背后的数据驱动故事。

注意:如果你对详细复现我的发现感兴趣,欢迎查看 Github 仓库中的相关 Jupyter 笔记本(github.com/gvyshnya/kaggle-2021-survey)。

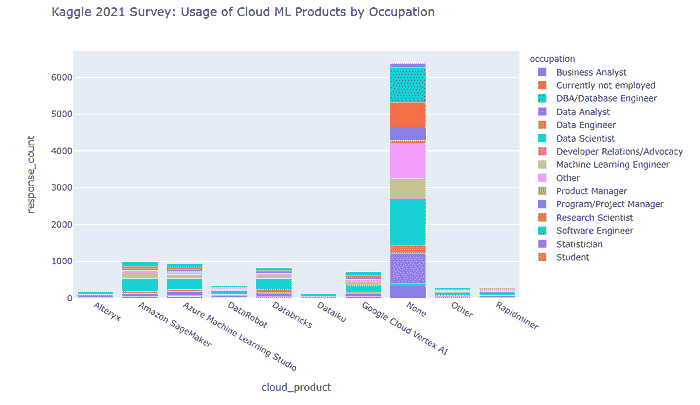

按职业和编程经验划分的 Cloud ML 产品使用情况(2020–2021)

让我们回顾一下 2021 年调查中提到的 Cloud ML 产品是如何被调查参与者使用的(根据他们的职业和编程经验进行分类)。

2021 年按职业分类的情况如下:

关于主要 Cloud ML 产品用户的编程经验,情况如下所示。

从上面的图表中可以明显看出,

-

大部分受访者在日常活动中不使用任何 Cloud ML 产品。

-

在少数使用这些工具的受访者中,数据科学家占主导地位。

-

Amazon SageMaker 和 Azure ML Studio 在使用人数方面领先。

-

来自 Google 的竞争产品(即 Google Cloud Vertex AI)落后于领导者,同时也落后于今年调查中出现的挑战者产品(即 Databricks)。

-

其他挑战者产品(DataRobot、Dataiku、Alteryx、Rapidminer)远远落后于领导者。

-

此外,Cloud ML 产品的使用最多的是具有 1–3 年和 10–20 年编程经验的专业人士。

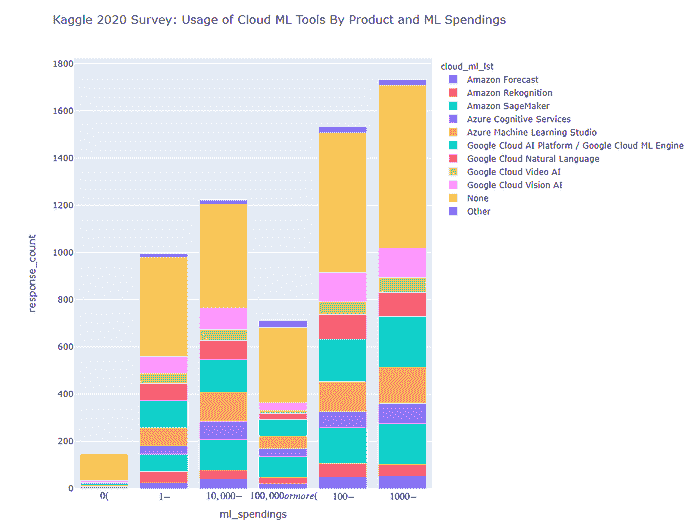

现在,让我们回顾一下 2020 年调查中提到的 Cloud ML 产品如何被参与者使用(按职业和编程经验分类)。

截至 2020 年的按职业分类如下所示。

2020 年按编程经验分布的 Cloud ML 产品用户如下所示。

我们可以看到,

-

Google Cloud AI Platform / Google Cloud ML Engine 在 2020 年领先了机器学习云产品的使用“提名”。

-

第二和第三名分别是 Amazon SageMaker 和 Azure Machine Learning Studio。

-

数据科学家是云机器学习产品的主要用户(针对每个调查的产品)。

-

有一大部分受访者表示他们完全不使用云机器学习产品——这表明市场尚未饱和,仍有良好的增长潜力,但需要解决市场营销和终端用户的障碍。

-

此外,截至 2020 年,我们看到具有 3–5 年和 5–10 年编程经验的专业人士使用云机器学习产品最多。

如果我们分别汇总 2020 年和 2021 年的观察结果,我们会看到,

-

Google 在 2021 年将所有 Cloud ML 产品整合到新的统一平台(即 Google Cloud Vertex AI)上的举措,并未导致 Google 在企业(商业)Cloud ML 市场中的市场份额增长。

-

此外,三大云巨头中的主要 Cloud ML 竞争者——Amazon SageMaker 和 Azure ML Studio——改善了他们的市场位置,并成为截至 2021 年的最终市场领导者(其中 Amazon SageMaker 排名第一,略微领先于 Azure ML Studio)。

-

Azure Cognitive Services 在 2021 年被排除在调查之外,因此很难估算其在 Kagglers 中的市场位置相较于 2020 年的变化。

-

很难估算挑战者云机器学习产品(DataRobot、Databricks、Dataiku、Alteryx、Rapidminer)在 2021 年与 2020 年的市场地位变化,因为这些产品在 2020 年的调查中未被列出。

-

然而,我们可以看到,到 2021 年,Databricks 在云机器学习产品排名中位居第三(高于 Google Cloud Vertex AI,略低于 Amazon SageMaker 和 Azure ML Studio)。

-

其他云机器学习挑战者产品(DataRobot、Dataiku、Alteryx、Rapidminer)远低于 Databricks 和 Google Cloud Vertex AI。

-

尽管如此,大多数受访者表示他们在日常活动中根本不使用云机器学习(Cloud ML)(需要注意的是,2020 年和 2021 年的“无”可能有很大不同,因为 2020 年和 2021 年调查选项中云机器学习产品列表有着显著差异)。

如果我们尝试结合上述观察与 Databricks 在 2021 年 2 月至 8 月间取得的主要业务发展、融资和宣传进展(详见附录),我们可以说

-

Databricks 在 2021 年对 Google 的统一 AI 平台进行了强力进攻(因此 Google 最近决定投资 Databricks 可能是 Databricks 市场份额在 2021 年良好增长的触发因素)。

-

云机器学习行业领头羊——Amazon SageMaker 和 Azure ML Studio——在 2021 年底保持了相对于 Databricks 和 Google Cloud Vertex AI 的强势地位。

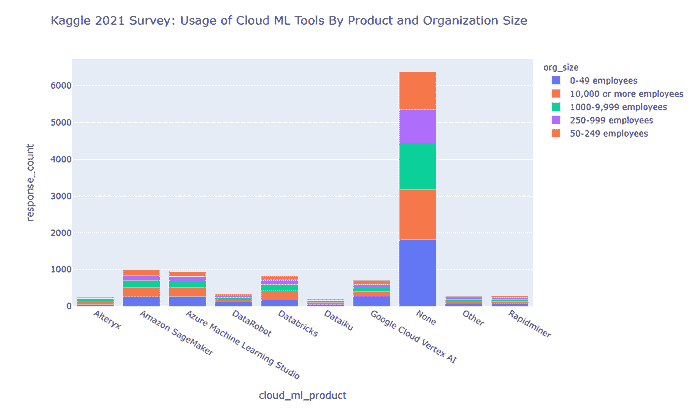

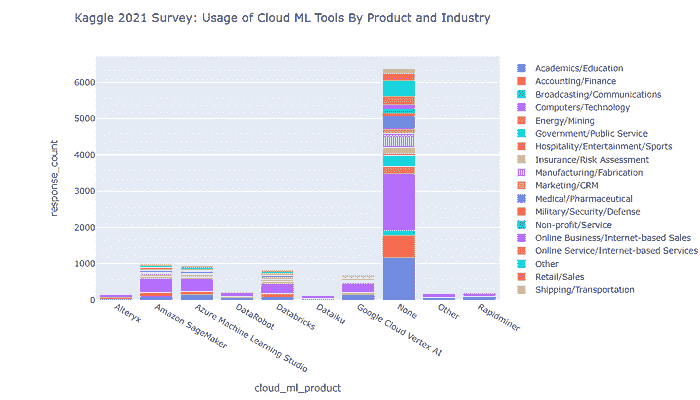

按组织规模和行业划分的云机器学习工具使用情况(2021 年)

关于各种规模组织中云机器学习的使用情况(截至 2021 年),我们观察到以下情况

很明显

-

到 2021 年,各行业中许多组织不使用云机器学习产品。

-

计算机/技术行业的公司最常使用云机器学习,学术/教育行业排在第二位,会计/金融行业排在第三位。

-

对于每种正在审查的云机器学习产品,大多数用户都来自计算机/技术行业。

-

对于 Azure Machine Learning Studio 和 Google Cloud Vertex AI,第二受欢迎的行业是学术/教育。

-

对于 Amazon SageMaker 和 Databricks,第二受欢迎的行业是会计/金融。

关于 2021 年按行业划分的云机器学习用户,其情况如下

我们发现

-

到 2021 年,各行业中许多组织不使用云机器学习产品。

-

Google Cloud Vertex AI 和 DataRobot 在最小规模(0–49 名员工)的组织中最受欢迎。

-

Azure Machine Learning Studio 和 Amazon SageMaker 在最小(0–49 名员工)和最大(10k+名员工)规模的组织中同样受欢迎。

-

Databricks 在大型组织(分别为 10k+和 1000–9999 名员工)中更受欢迎。

云机器学习和组织内机器学习支出

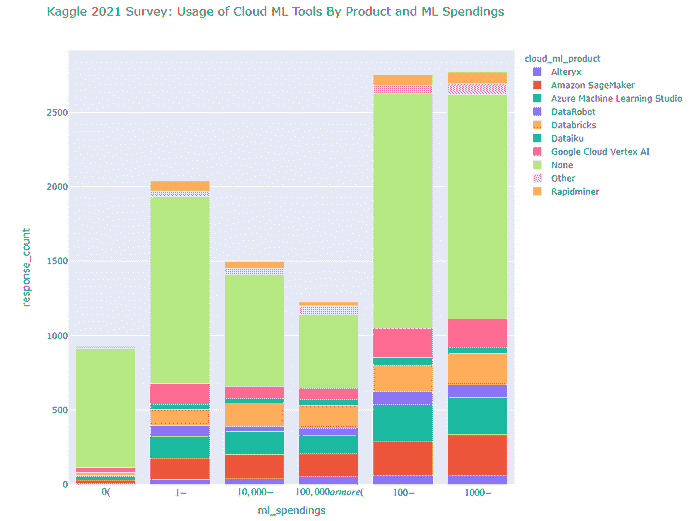

2021 年的情况如下图所示

正如我们所见,2021 年的行业趋势如下

-

机器学习支出最多的公司更倾向于使用 Amazon SageMaker 和 Databricks

-

Azure ML Studio 在这种排名中位列第三

-

Google Cloud Vertex AI 在机器学习支出较多的组织中远远落后于上述三位领导者

-

Google Cloud Vertex AI 在中小型机器学习支出的公司中的表现更佳(这可能是将这些公司转化为 2022 年付费客户的机会)

-

其他云机器学习产品远远落后

如果我们回顾 2020 年,可以看到下面的图景

显然

-

截至 2020 年,Amazon SageMaker 在每一个机器学习支出类别中显然都处于领先地位(2021 年也是如此)。

-

截至 2020 年,Azure ML Studio 和当时的一个 Google Cloud ML 产品(Google Cloud AI Platform/Google Cloud ML Engine)几乎平分秋色,位居第二,仅次于 Amazon SageMaker。

云机器学习地理分布(2021)

让我们看看参与 Kaggle 2021 调查的领先云机器学习产品用户的地理分布。

首先,需要指出的是印度和美国是拥有最多机器学习工程师的国家。

话虽如此,让我们看看每个领先的云机器学习产品的地理洞察。

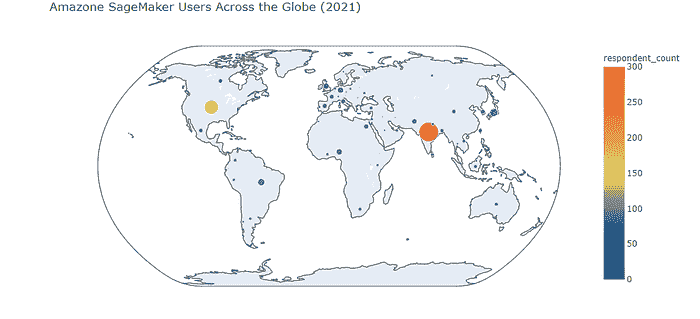

Amazon SageMaker

正如我们所见,Amazon SageMaker 用户的地理分布表明

-

印度排名第一(看起来 Azure SageMaker 在这个国家也是最受欢迎的云机器学习产品)

-

美国排名第二

-

其他国家远远落后于印度和美国

-

日本在 Amazon SageMaker 用户基础中排名第三(在 Kaggle 2021 调查的受访者中)

-

我们可以看到该产品在巴西、英国、欧盟国家和尼日利亚的适度受欢迎程度

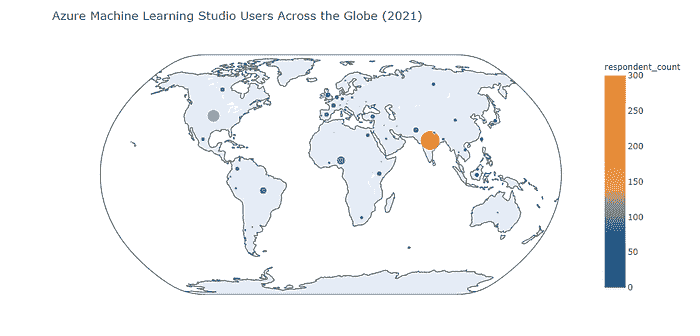

Azure Machine Learning Studio

正如我们所见,Azure Machine Learning Studio 用户的地理分布表明

-

印度是产品用户的主要地区(其在印度的受欢迎程度仅略低于 Amazon SageMaker 的受欢迎程度)

-

美国排名第二(不过,Azure Machine Learning Studio 在受欢迎程度上远低于 Amazon SageMaker)

-

其他国家远远落后于印度和美国

-

尼日利亚在 Amazon SageMaker 用户基础中排名第三(在 Kaggle 2021 调查的受访者中)

-

我们可以看到该产品在巴西、英国、欧盟国家、巴基斯坦和肯尼亚的适度受欢迎程度

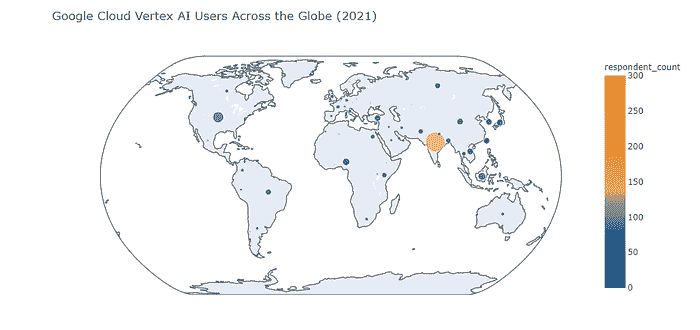

Google Cloud Vertex AI

正如我们所见,Google Cloud Vertex AI 用户的地理分布表明

-

印度是产品用户的主要地区(尽管其在印度的受欢迎程度远低于 Amazon SageMaker 和 Azure Machine Learning Studio 的受欢迎程度)

-

美国排名第二(不过,与印度一样,它在美国的受欢迎程度远低于 Amazon SageMaker 和 Azure Machine Learning Studio 的受欢迎程度)。

-

其他国家远远落后于印度和美国。

-

令人惊讶的是,印度尼西亚在 Google Cloud Vertex AI 的热门地点排名中位列第三。

-

全球有一系列国家在产品使用调查受访者数量上接近印度尼西亚(尼日利亚、台湾、中国、日本、韩国、土耳其)——这些地区可能是 Google Cloud Vertex AI 销售和收入增长的潜在机会。

-

加拿大、英国和欧盟国家对 Google Cloud Vertex AI 的兴趣非常低(这可以通过某些国家和行业政策来解释,这些政策在欧盟和英国偏向 MS Azure 和 Amazon AWS)。

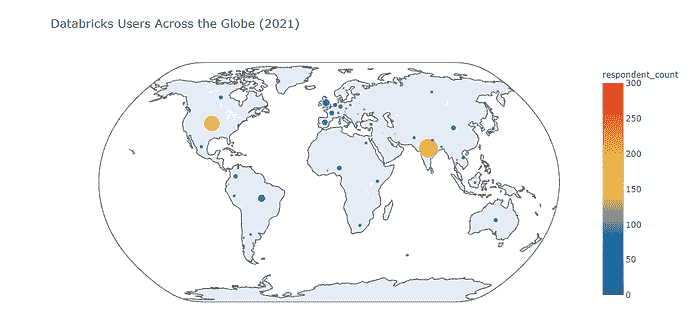

Databricks

正如我们所见,Databricks 用户的地理分布表明

-

印度是 2021 年调查受访者中 Databricks 用户最多的国家(Databricks 在印度的表现优于 Google Cloud Vertex AI,而在 Amazon SageMaker 和 Azure Machine Learning AI 方面则逊色)。

-

美国在全球产品用户数量方面排名第二(Databricks 实际上在美国排名第二,仅次于 Amazon SageMaker,超越了 Azure Machine Learning 和 Google Cloud Vertex AI)。

-

其他国家远远落后于印度和美国。

-

巴西在全球“Databricks 排名”中位列第三(不过,英国和欧盟国家与其差距不大)。

2022 年的前景是什么?

上述趋势将无疑塑造 2022 年行业的未来。从我在数据驱动的钻研中收集的洞察来看,我可以预测

-

作为 2020-2021 年的行业领导者,Amazon SageMaker 将在 2022 年继续保持全球领先地位。

-

Databricks 作为云 ML 产品在 2022 年的进一步扩展可能会受到持续讨论的影响,即在 Spark 上进行 ML 是否是一个好主意(虽然 Spark ML 库在 BigData 规模数据集上非常强大,但 Spark 和 Databricks 的某些 API 缺陷仍然存在一些批评空间)。

-

尽管有提到的 Spark ML 争论,Databricks 很可能进一步提升其在美国和中国的领先地位,并在 2022 年在英国和欧盟国家也有良好的增长潜力。

-

Azure ML Studio 的产品在“Databricks 攻势”下相当受保护,因为 Azure Cloud 平台曾经将 Databricks 视为仅仅是 BigData 工程工具(Azure Databricks 服务已经在这一角色运行了几年)。

-

Google Cloud Vertex AI 可能会探索在 2022 年北美和欧盟以外的多个地点增长的机会,瞄准那里的中型和快速增长的公司。

-

在 2022 年,Google Cloud ML 生态系统的变革者可能是 BigQuery ML 的广泛推广;由于它可以成为 Databricks 的大数据规模机器学习解决方案的真正替代品,它可能会在即将到来的一年中改变云计算机器学习工具的格局。

方法论与参考文献

本文基于 Kaggle 的《2020 年数据科学与机器学习现状》(www.kaggle.com/c/kaggle-survey-2020)和《2021 年数据科学与机器学习现状》(www.kaggle.com/c/kaggle-survey-2021)调查数据中的见解。

Kaggle (www.kaggle.com) 是一个全球性的社区,由来自世界各地、具有不同技能和背景的数据科学家和机器学习者组成。这个社区拥有超过 300 万的活跃成员。尽管从社会学的角度来看,它并不能严格代表全球数据科学和机器学习专业人士的整体人口,但它仍然占据了该领域的一个重要比例。因此,这项调查的结果可以真正预测数据科学和 AI/ML 行业在未来几年可能的发展方向。

我的 Kaggle 2020 调查和 Kaggle 2021 调查的全面 EDA 风格笔记本如下所示:

-

www.kaggle.com/gvyshnya/kaggle-2020-survey-associated-insights -

www.kaggle.com/gvyshnya/kaggle-2021-ml-and-ds-survey-comprehensive-eda

收集本文描述的见解的数据驱动工具的源代码可以在 GitHub 的github.com/gvyshnya/kaggle-2021-survey仓库中找到。

我的文章《云计算、数据科学与机器学习趋势 2020–2022:巨头之战》已于 2021 年 1 月由 KDNuggets 发布,详见 /2021/01/cloud-computing-data-science-ml-trends-2020-2022-battle-giants.html。

你还可以在《2021 年 AI 现状报告》中找到许多有趣的见解(www.stateof.ai/)。

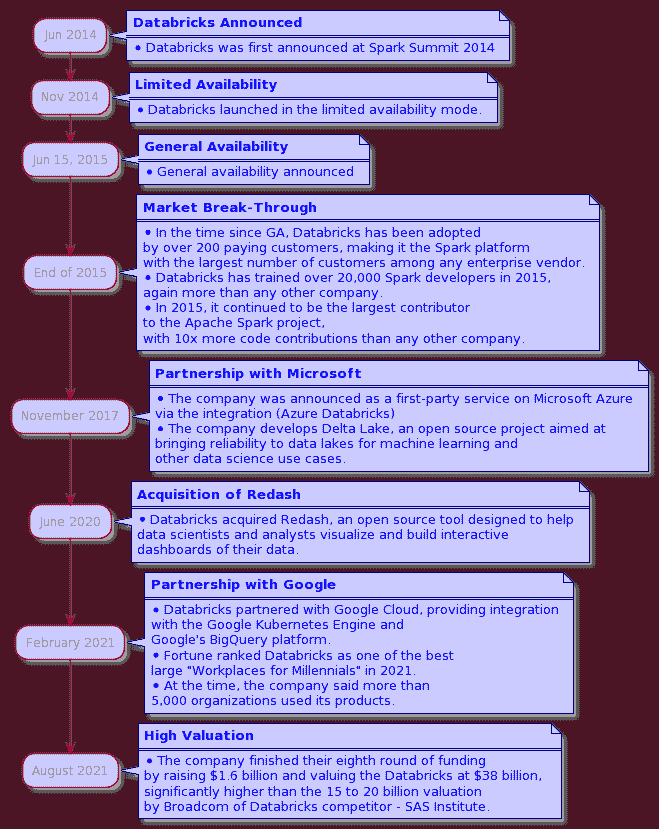

附录:Databricks 的历史

自 2015 年推出基于 Apache Spark 的数据平台以来,Databricks 已发展成为一个一站式的数据(非)结构化存储、自动化 ETL、协作数据科学笔记本、使用 SQL 的商业智能和基于开源 MLflow 的全栈机器学习的平台。有趣的是,所有三大主要云供应商——亚马逊、谷歌和微软——都在 2021 年 2 月投资了 Databricks。

Databricks 的总部位于旧金山。它在加拿大、英国、荷兰、新加坡、澳大利亚、德国、法国、日本、中国和印度也有业务。

由于该公司截至 2021 年 2 月已获得三大云计算巨头(亚马逊、微软和谷歌)的投资,并且截至 2021 年 8 月的估值超过竞争对手,成为行业中的强劲竞争者。从这个角度来看,Databricks 的产品/服务具有潜在的

-

部分蚕食其他大数据、云机器学习和 AutoML 产品,来自三大云计算提供商(AWS、微软 Azure、谷歌云平台)

-

在云机器学习和企业 AutoML 领域(如 H20.ai、DataRobot 等)与竞争产品形成强劲竞争

下图展示了公司的企业历史关键点

个人简介:George Vyshnya 是 SBC 的联合创始人/首席技术官,帮助首席执行官和首席技术官通过实施智能 AI、BI 和 Web 解决方案来增长收入。

原文。经许可转载。

相关内容:

-

2020-2022 年云计算、数据科学和机器学习趋势:巨头之战

-

人工智能、分析、机器学习、数据科学、深度学习研究在 2021 年的主要发展及 2022 年的关键趋势

-

2021 年主要发展及 2022 年人工智能、数据科学、机器学习技术的关键趋势

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 需求

3. Google IT 支持专业证书 - 支持你组织的 IT 需求

更多相关信息

云存储的采用是企业当前的紧迫需求

原文:

www.kdnuggets.com/2022/02/cloud-storage-adoption-need-hour-business.html

社交媒体、物联网设备和传感器的激增导致数据爆炸性增长。虽然更多的数据总是受欢迎的,但它带来了自身的一系列挑战,特别是在数据管理方面。数据如果没有得到有效管理,就等于没有数据。

根据 IDC 的研究,组织预计数据(主要是非结构化数据)每年增长 30-40%。所以,如果一家企业今天处理和管理约 10PB 的数据,假设明年它将管理 14PB 的数据。现在,这种数据的指数级增长问题在于,它迫使企业迅速扩展和适应。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

扩展本地数据中心意味着需要通过投资硬件来承担巨大的成本,然后处理维护问题。而且,这一切不能随时完成。

在这种情况下,似乎只有一个解决方案——云存储。难怪云存储市场正在蓬勃发展。IDC 预计到 2025 年,全球 87%的总存储将存储在云端。

市场上的大牌如 Netflix、ETSY 和通用电气已经纷纷上车,小型和中型企业的转变只是时间问题。

那么,云存储提供了什么是本地数据中心所没有的?从表面上看,你可能会说是便利性,因为它让你的数据随时随地可用。但这种快速的转变是否合理?实际上,云存储还有更多的东西值得深入了解。

云存储市场

预计云存储市场将从 2020 年的 501 亿美元增长到 2025 年的 1373 亿美元,年复合增长率为 22%。市场上有几个主要参与者,如 Amazon Web Services、Google 和 Microsoft 等。

这些顶级云服务提供商提供三种类型的云存储解决方案:对象存储、块存储和文件存储。对象存储非常适合处理非结构化数据,如图像和视频。对象存储与其他存储方式的区别在于使用了元数据。一些常见的对象存储示例包括 Amazon S3、Google Cloud 和 Azure Blob 存储。

文件存储以文件和文件夹的层次结构呈现非结构化数据。虽然它不像对象存储那样灵活,但它在市场上也越来越受欢迎。

块存储更适合结构化数据。它提供了高吞吐量和低延迟的数据访问。

每种存储类型都适用于不同的用例,因此在迁移到云端之前,组织必须分析自己的需求。

云计算能提供什么?

由于向云存储的急剧转变,云计算必须向企业提供有价值的提议。让我们探讨一下为何无论规模大小的企业都应该考虑迁移到云端。

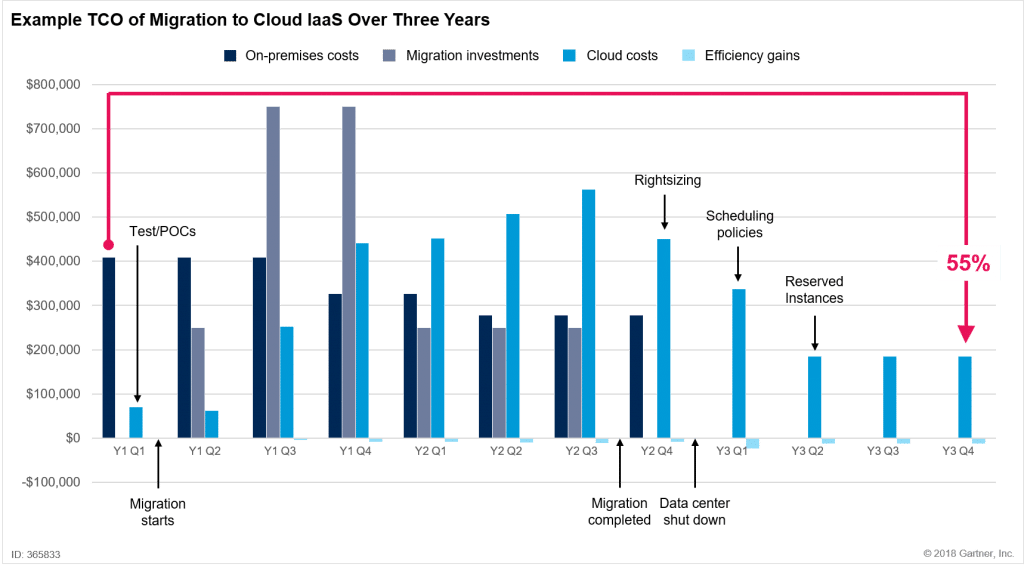

1. 成本效益

迁移到云端意味着您不再需要投资昂贵的硬件、软件和人力资源来维护本地数据中心。一些公司由于迁移过程复杂和成本高而犹豫不决。然而,随着组织学习适应,云计算的成本会降低。一个易于使用的云数据集成工具也可以帮助使过程无缝并降低成本。

上面的图表来自 Gartner,展示了云计算和迁移的初始成本,但一旦云迁移完成,云计算的成本比本地数据中心低 55%。

此外,云存储选项的最佳部分是它提供了成本效益高的存储层,因此您可以根据数据的使用情况管理存储成本。例如,Azure Blob 存储具有三种访问层级:热存储、冷存储和归档存储。热存储的访问成本低,但存储成本高,非常适合当前数据。相反,归档层的存储成本低但访问成本高,更适合历史数据。

2. 可扩展性

使用传统的本地数据中心时,您必须请专家增加额外的硬件并提升服务器的容量。这不仅会导致成本增加,还会造成停机时间,这是如今的公司无法承受的。

当数据存储有限时,它会影响整个组织快速增长和创新的能力。工程师变得更多地参与数据基础设施的维护,而不是关注实际问题,同时响应市场变化也需要时间。

今天的公司变得更加灵活,云计算是支持他们速度的现代解决方案。借助云计算,您可以通过简单的几次点击来增加或减少资源,并仅为实际使用的部分付费。

3. 安全性

在这个黑客变得越来越臭名昭著的时代,安全问题已成为组织面临的重大问题。数据中心容易受到黑客攻击,我们并非夸大其词。2014 年,Target(塔吉特)遭受攻击,4000 万张借记卡和信用卡信息被盗。2015 年,JP Morgan Chase(摩根大通)也发生了类似的黑客事件。这是其中之一最大的黑客事件,8000 万个账户遭到泄露。黑客利用了加密软件中的漏洞,获取了金融机构的信息。

云计算并非无懈可击。然而,它设计得足以抵御大多数黑客攻击甚至自然灾害。然而,当选择云计算与本地部署时,云计算始终是更好的选择,因为运行数据中心不是组织的核心竞争力或主要业务。因此,他们更适合使用像 Amazon 这样的公司提供的专业服务。

是时候做出转变了

云计算是现代企业的解决方案。它安全、成本效益高,并且减轻了你的负担,使你可以专注于核心业务。迁移过程可能最初看起来令人畏惧,但从长远来看,云计算绝对比本地数据中心更有价值。

附加资源

全球云存储市场(2020 年至 2025 年)- 容器化的兴起带来了机遇

Jeveria Rahim 是 Astera Software 的内容策略师。作为一名市场营销专家,技术爱好者和内心的作家,Javeria Rahim 喜欢与世界分享她的观点。她对让生活变得更轻松的云数据集成技术充满热情。

更多相关话题

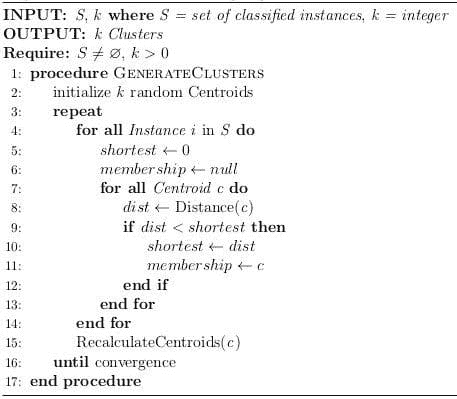

众包中的聚类:方法论与应用

原文:

www.kdnuggets.com/2021/11/clustering-crowdsourcing-methodology-applications.html

评论

作者:Daniil Likhobaba,Toloka 的分析师。

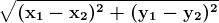

聚类是将一组对象分组的任务,使得同一组(称为簇)中的对象彼此之间比与其他组中的对象更相似。在大多数情况下,聚类需要知道对象之间的距离,这通常以距离矩阵的形式呈现。然而,距离的函数通常是未知的,或者聚类规则无法定义。因此,描述标记指令中的过程并利用众包来进行数据聚类更为合理。遗憾的是,目前没有现成的管道用于此目的,而大多数相关论文都限于理论。我们希望能找到一种更实际的解决方案。这就是我们最终得到的结果。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速通道进入网络安全职业

1. Google 网络安全证书 - 快速通道进入网络安全职业

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 部门

3. Google IT 支持专业证书 - 支持你的组织 IT 部门

配对对象标记

起初,我们重现了 Larsen 等人(WWW'20) 的一个简单算法,其中所有标记的数据被分为两个簇。为此,我们需要对这两个对象子集进行两次比较,然后使用专门的算法汇总数据。尽管如此,两个簇任务相当少见。此外,进行包含所有对象的配对子集比较是非常昂贵的。最后,该算法提供了一个单一集合及其补集,从技术上讲,这不算真正的聚类。但我们必须从某处开始。

数据来自 Leipzig 语料库集合 – 各 360 个英语和德语单词。

众包执行者必须指示显示的两个词是否属于同一种语言。结果令人惊讶地好:每种语言组中 98% 的词汇被正确识别。这是一个令人鼓舞的第一步。但由于我们希望找到更高效的解决方案,我们继续寻找可行的替代方案。

多次比较

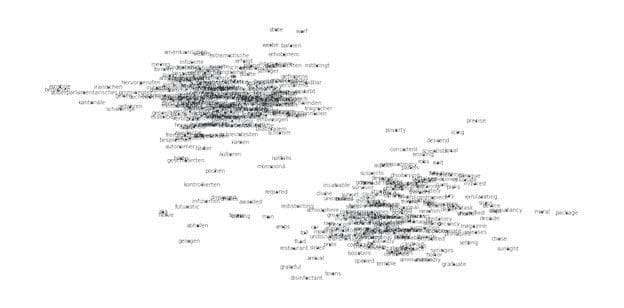

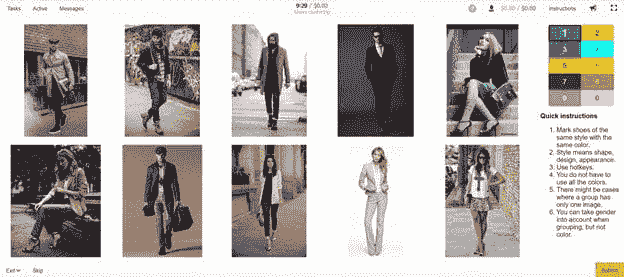

在Gomes et al. 论文NIPS'11)中,作者建议了一种可以处理任意数量图像聚类的方法。其工作原理如下:我们从一个包含图像和颜色调色板的页面开始。执行者选择一种颜色并用它标记相似的图像。然后,执行者选择另一种颜色,根据另一个共享特征将另一组图像分组。如此重复,直到所有图像都被上色标记。

任务是随机创建的。主要参数是每张图像显示的平均页面数量。这个数字必须为每种情况选择,或者根据数据集大小来定义。标记数据与文章中提供的概率模型进行汇总,然后算法随后生成聚类。值得注意的是,这种方法不需要已知的对象之间的距离。

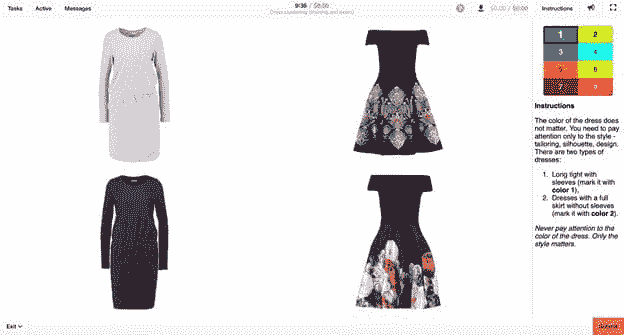

按风格对鞋子进行聚类

为了测试上述方法,我们从SIGMOD/PODS'20 Toloka 教程中获取了一个包含 100 张穿着衣物的图像的数据集。为了跳过机器学习已经训练过的内容,我们要求众包参与者根据风格对物体进行分组,而不考虑颜色。这样做的逻辑是,大多数人能够区分不同的时尚风格,即使我们无法总是用语言描述任何特定风格的定义特征。指令包含了一些特征和细节,帮助参与者,例如高跟鞋。

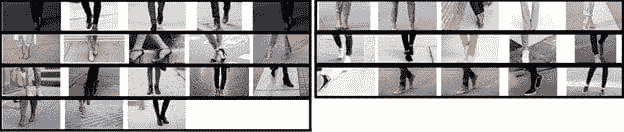

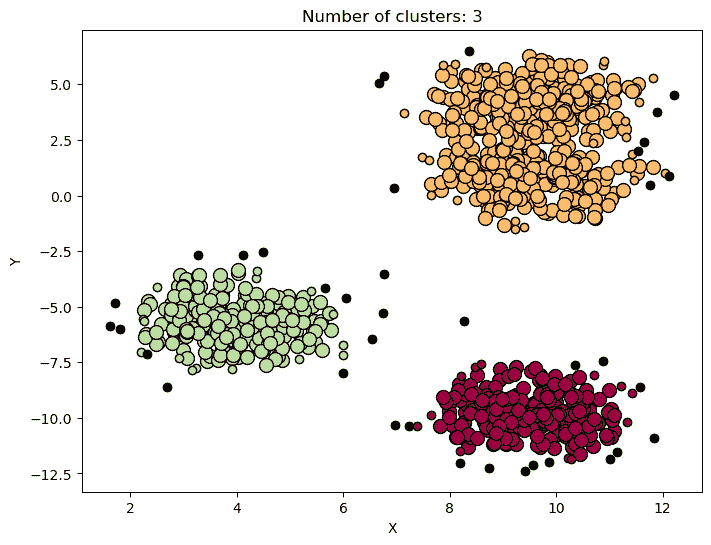

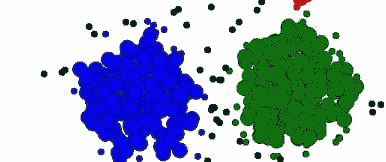

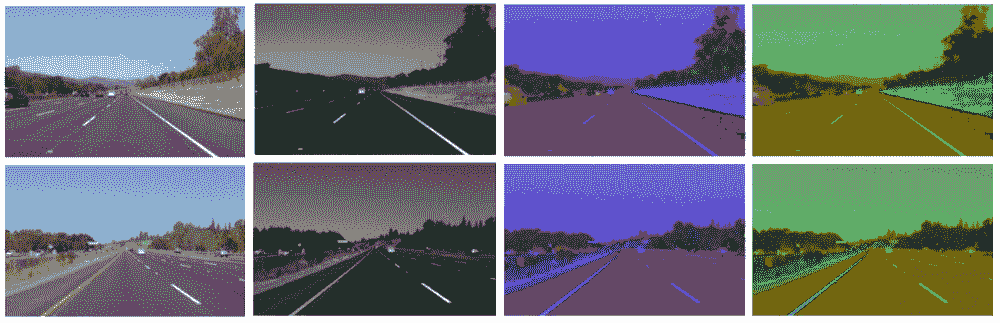

最终,我们得到了七个易于识别的鞋子聚类。其中包括男鞋、女靴、运动鞋和其他四种。我们很高兴看到女鞋和女凉鞋形成了两个独立的聚类。每个聚类的样本图像如下所示。

可以浏览所有子集,亲眼看到聚类的整齐程度,即使是肉眼也能观察到。这种方法对我们证明了有效,但我们决定进一步探讨。

按风格对鞋子进行聚类

现在,我们想在更大数据集上测试这种方法。我们从Feidegger数据集中取了 2,000 张连衣裙的图片,并再次决定按风格对它们进行聚类。然而,与鞋子不同,连衣裙通常包含更多特征,这就是为什么我们需要为完成这项任务的群众表演者制定一套准确但简洁的指示。

主要困难在于我们无法向表演者描述所有可能性和特殊情况,因为我们实际上不知道这个数据集的结构。我们向Crowd Solutions Architect (CSA)团队的Toloka同事寻求帮助。他们帮助我们配置了质量控制,创建了一个带有培训计划的实践池,并撰写了适当的指示。结果,任务对表演者变得明确,这反过来提高了标注质量。

这些指示没有包含任何最坏情况或所有分组标准。我们建议表演者专注于确定连衣裙的风格、细节层次(例如,领口的大小但不是其形状),并识别具有总体相似或不同外观的连衣裙的图片。我们想解释可以使用什么逻辑来比较连衣裙,概述基本的聚类方法,但不列出任何具体特征供表演者在实际标注过程中记忆和依赖。

培训过程中难度逐步增加,从两个连衣裙的比较开始,最终增加到八件连衣裙。关键规则在通往最终考试的过程中进行了讲解,最终考试由多张具有明显差异的图片组成。

之后,俄语被添加为界面语言,并为随后的任务设置了每页最多八张图片。这是为了简化任务,将每页的平均处理时间缩短到 40 秒。

在任务过程中,有一个方面特别引人关注——负责预期图像数量的页面参数。该参数与数据集大小的关系被确定,这告诉我们成功聚合所需的对象比较数量。我们最终得到了 12 个易于解释的簇:其中包括蓬松的无袖连衣裙、长袖连衣裙、针织连衣裙等等。下图展示了我们获得的每个簇中的一些对象。

收获

通过这些努力,我们确认了通过众包进行聚类确实是可能的,并且效果非常好。我们获得的质量达到了预期,并且我们制定了一个可复制的流程。此外,我们找到了一种让说明对参与者更清晰的方法,并为任务创建了合适的界面。关键是,这一切都在没有我们最初采用的配对比较的情况下完成。标记时间不长,成本也比预期的便宜。

我们目前正在通过Chang 等(NIPS '11)的众包评价方法评估结果标记的质量。他们建议使用入侵者,即在聚类中添加一个故意不正确的对象,并要求参与者找到它。参与者越频繁地选择这个明显错误的对象而不是聚类中的其他对象,我们认为质量越高。

我们认为,使用众包进行聚类可能在电子商务、搜索结果排名以及在任何领域调查未知数据集结构时会很有用。

相关:

更多相关话题

使用 scikit-learn 进行聚类:无监督学习教程

原文:

www.kdnuggets.com/2023/05/clustering-scikitlearn-tutorial-unsupervised-learning.html

图片由作者提供

聚类是一种流行的无监督机器学习技术,这意味着它用于目标变量或结果变量未提供的数据集。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在无监督学习中,算法的任务是识别数据中的模式和关系,而无需任何预先存在的知识或指导。

聚类的作用是什么?它将相似的数据点分组,使我们能够发现数据中的隐藏模式和关系。

在本文中,我们将探索可用的不同聚类算法及其各自的应用场景,以及用于评估聚类结果质量的重要评价指标。

我们还将演示如何使用流行的 Python 库 scikit-learn 同时开发多个聚类算法。

最后,我们将突出一些最著名的实际应用案例,讨论所使用的算法和评价指标。

但首先,让我们熟悉一下聚类算法。

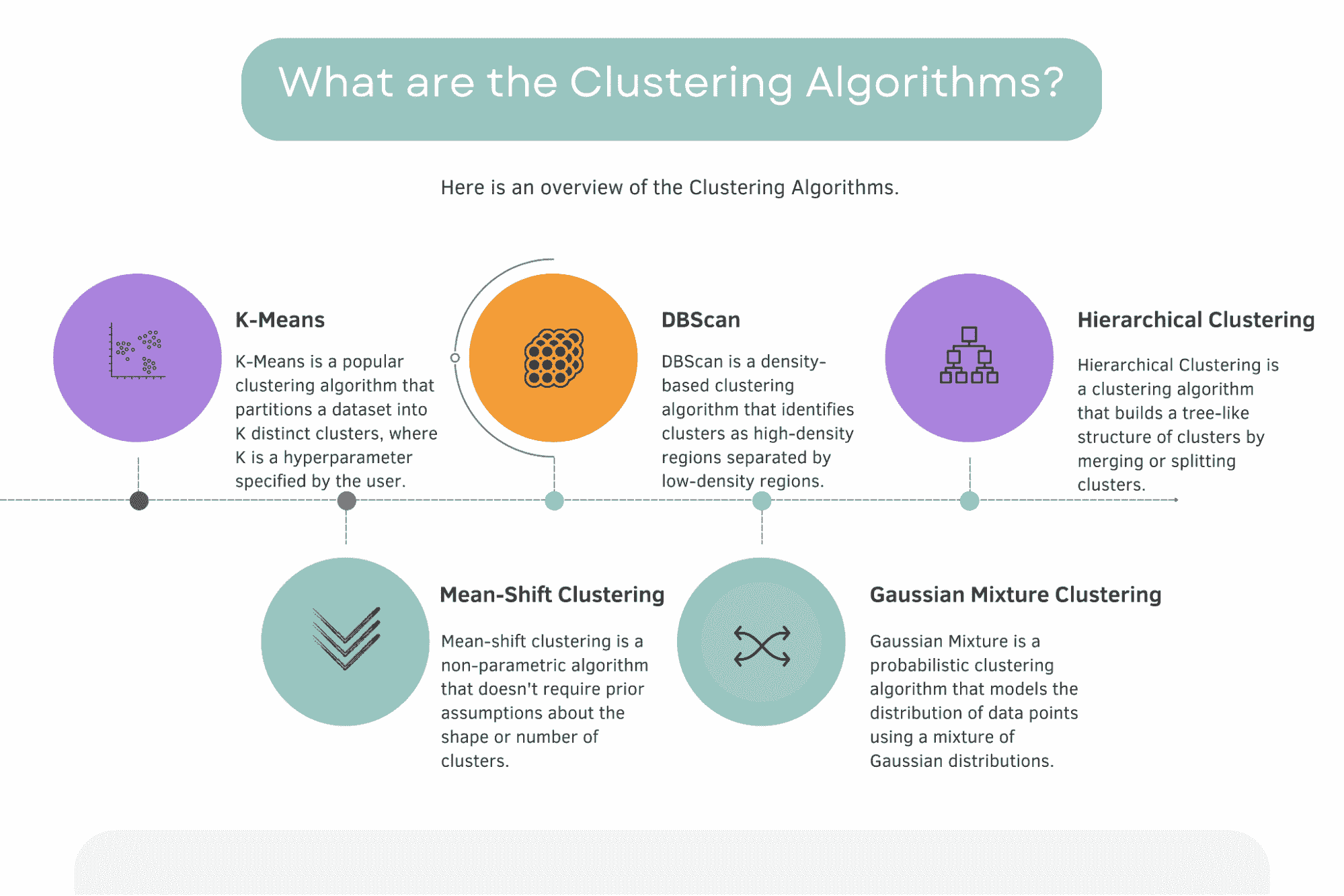

聚类算法是什么?

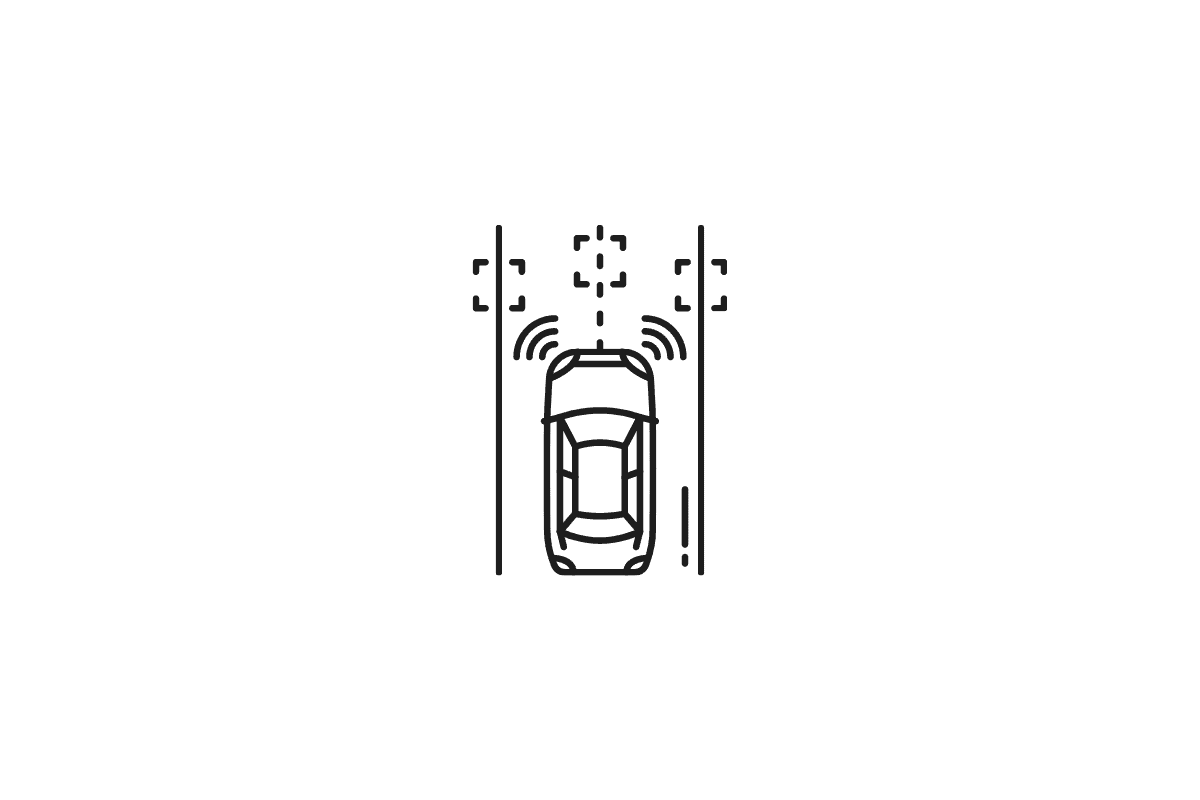

以下是聚类算法的概述及简短定义。

图片由作者提供

根据 scikit-learn 官方文档,现有 11 种不同的聚类算法:K-Means、Affinity propagation、Mean Shift、Special Clustering、Hierarchical Clustering、Agglomerative Clustering、DBScan、Optics、Gaussian Mixture、Birch、Bisecting K-Means。

在这里你可以找到官方文档。

本节将探讨五种最著名和最重要的聚类算法。它们是 K-Means、Mean-Shift、DBScan、高斯混合模型和层次聚类。

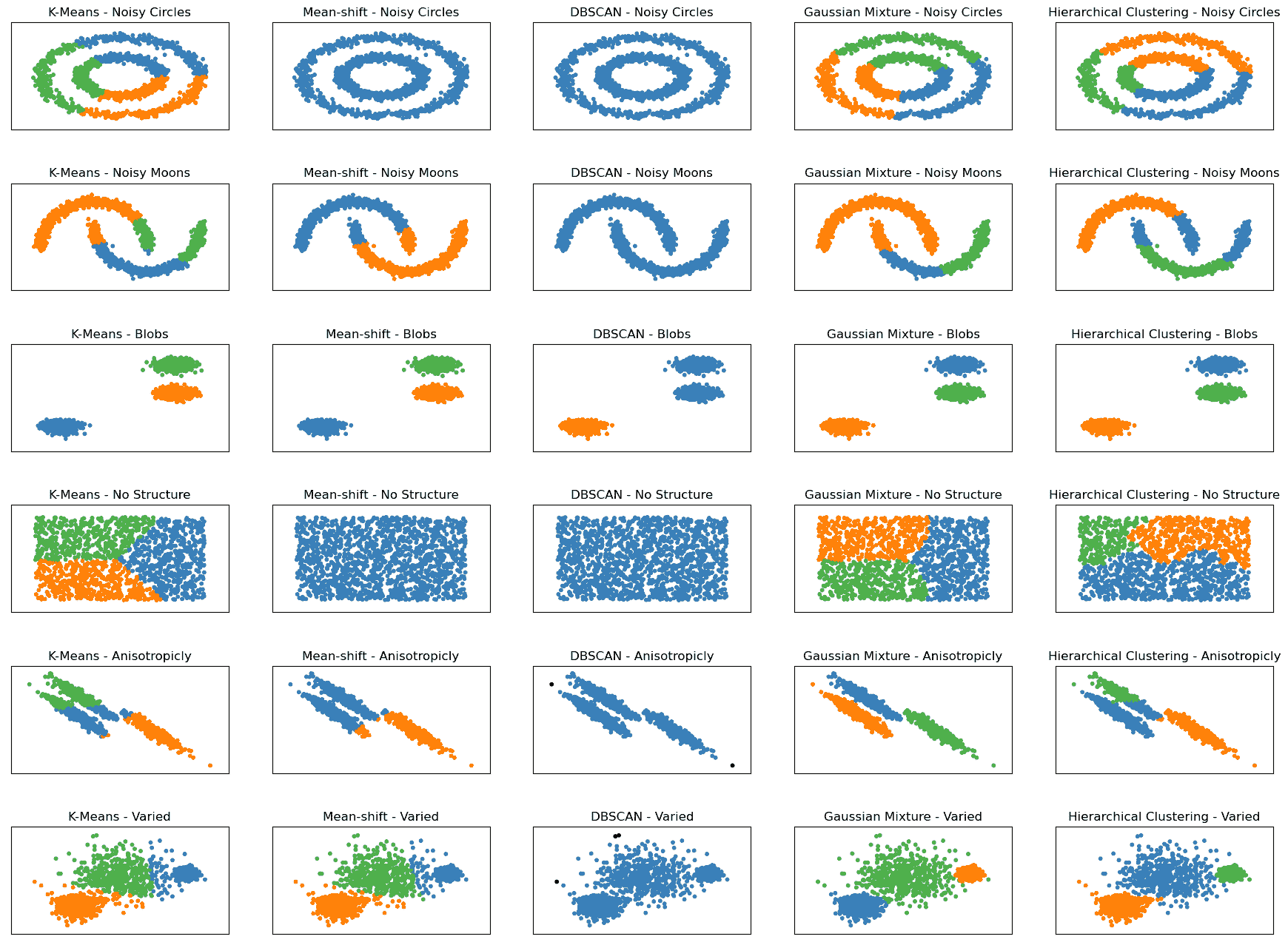

在深入探讨之前,我们来看一下下面的图表。它展示了这五种算法在六个不同结构的数据集上的表现。

聚类算法 - 作者提供的图片

在 scikit-learn 文档 中,您将找到类似的图形,这些图形启发了上面的图片。我将其限制在五种最著名的聚类算法上,并在算法名称旁边添加了数据集的结构,例如 K-Means - 噪声月牙或 K-Means 变化。

显示了六种不同的数据集,全部由 scikit-learn 生成:

-

噪声圆形: 该数据集由一个大圆和一个不完全居中的小圆组成。数据中还加入了随机的高斯噪声。

-

噪声月牙: 该数据集由两个交错的半月形状组成,这些形状不是线性可分的。数据中还加入了随机的高斯噪声。

-

斑点: 该数据集由随机生成的斑点组成,这些斑点在大小和形状上相对均匀。数据集包含三个斑点。

-

无结构: 该数据集由随机生成的数据点组成,没有固有的结构或聚类模式。

-

各向异性分布: 该数据集由随机生成的各向异性分布的数据点组成。这些数据点通过特定的变换矩阵生成,以使它们沿某些轴延长。

-

变化: 该数据集由具有不同方差的随机生成的斑点组成。数据集包含三个斑点,每个斑点具有不同的标准差。

查看这些图形以及每种算法在这些图形上的表现,将帮助我们比较算法在每个数据集上的性能。如果您的数据与这些图形中的结构相似,这可能会对您的数据项目有所帮助。

现在让我们深入了解这五种算法,从 K-Means 算法开始。

K-Means

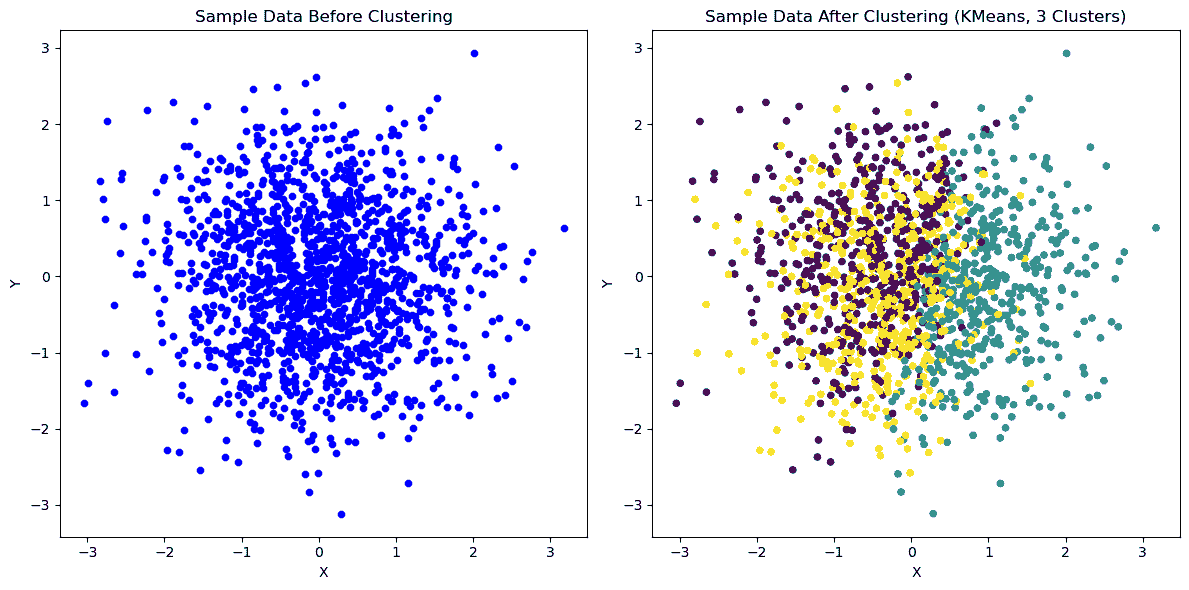

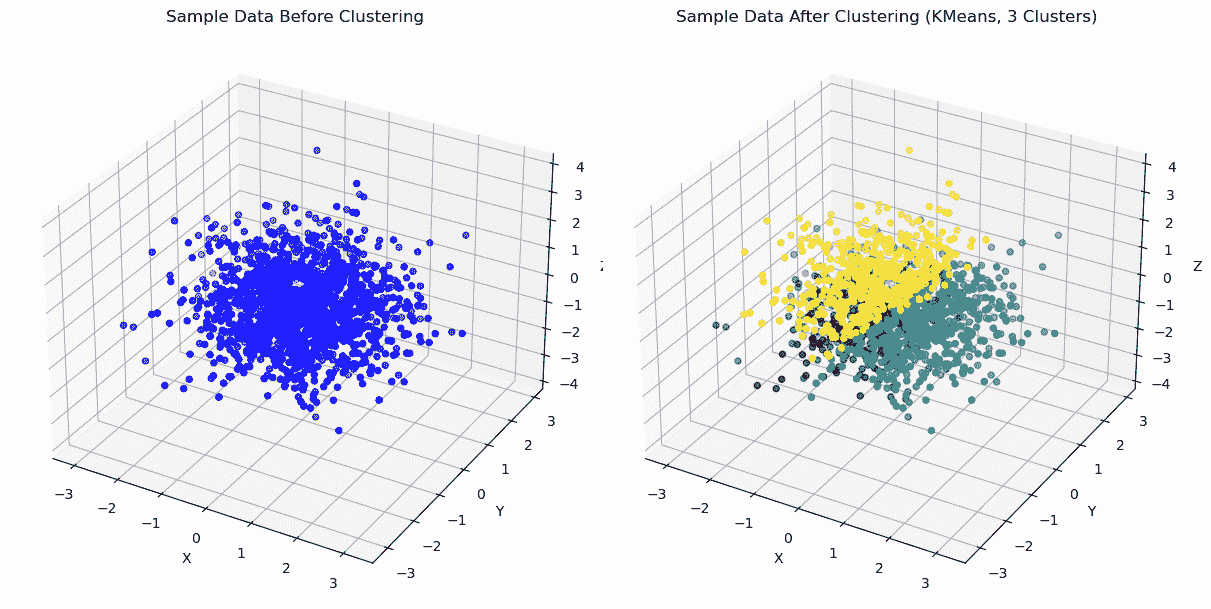

K-Means 2D | 作者提供的图片

K Means 3D | 作者提供的图片

K-Means 是一种流行的聚类算法,它将数据集划分为 K 个不同的聚类,其中 K 是用户指定的超参数。

该算法通过将每个数据点分配到最近的聚类中心,并根据该聚类中所有数据点的平均值重新计算中心点来工作。

该过程持续进行,直到中心点不再移动或达到指定的最大迭代次数。

它还被应用于各种实际场景,如电子商务中的客户细分、医疗保健中的疾病聚类以及计算机视觉中的图像压缩。

要了解 K-Means 或其他算法的实际应用,请继续阅读。我们将在后续部分讨论这些内容。

DBScan

DBScan | 图片由作者提供

DBScan(基于密度的空间聚类与噪声)是一种基于密度的聚类算法,通过将高密度区域与低密度区域分隔开来识别簇。

算法根据密度阈值和最小点数将彼此接近的点分组在一起。

DBScan 常用于异常检测、空间聚类和图像分割,目标是识别数据中的不同簇,同时处理噪声或异常数据点。

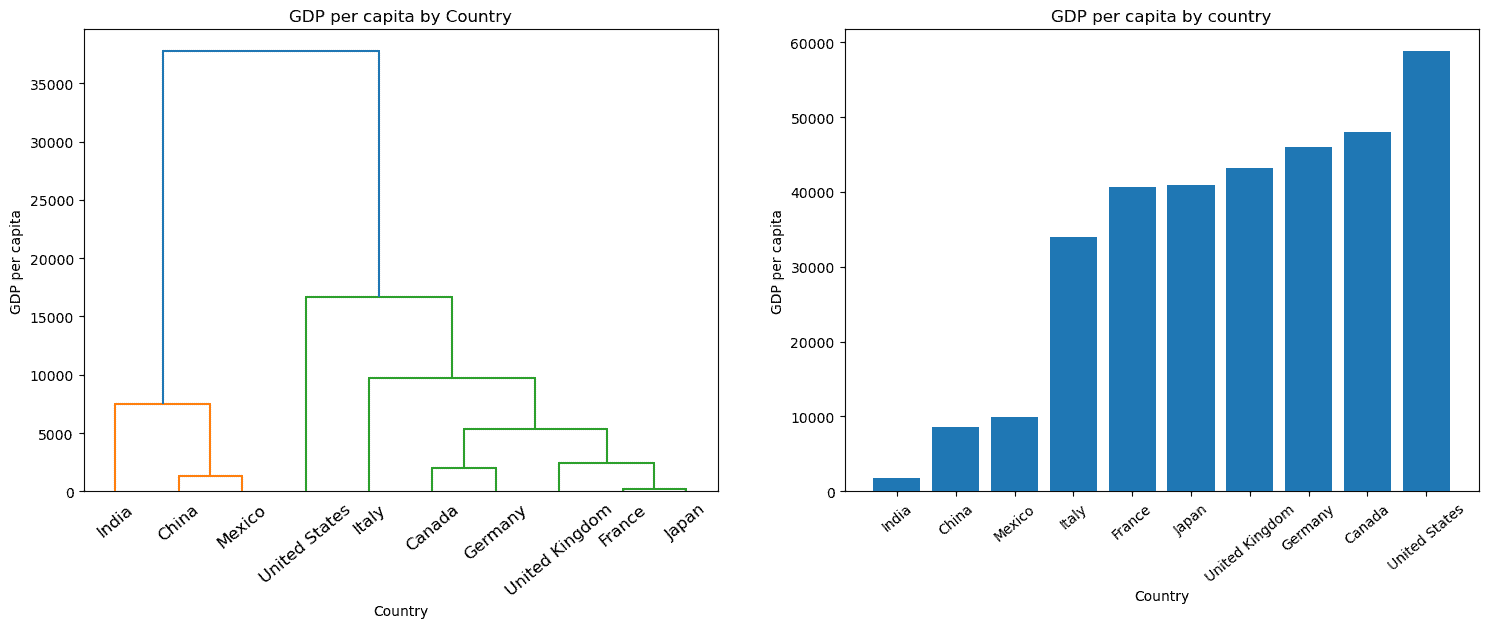

层次聚类

层次聚类 | 图片由作者提供

层次聚类是一种通过合并或分裂簇来构建树状结构的聚类算法。

根据采用的方法,算法可以是聚合型(自下而上)或分裂型(如上图所示)。

层次聚类已在各种实际应用中使用,如社交网络分析、图像分割和生态研究,其目标是识别簇与子簇之间的有意义关系。

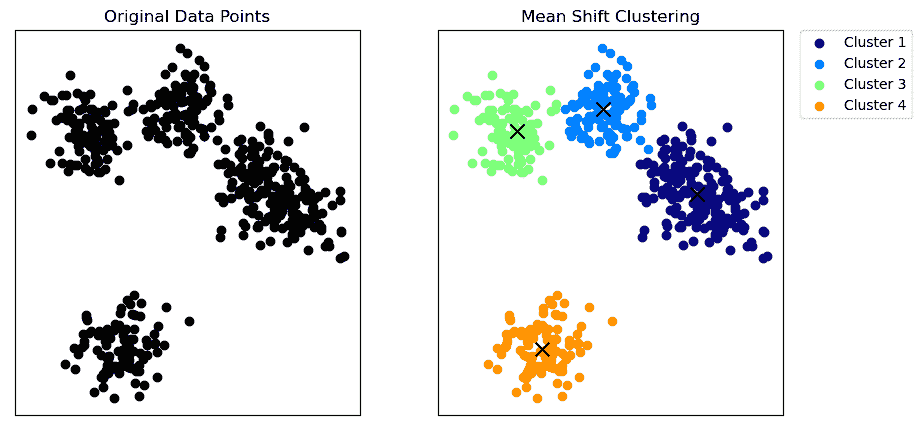

Mean-Shift 聚类

Mean-Shift 聚类 | 图片由作者提供

Mean-shift 聚类是一种非参数算法,不需要对簇的形状或数量进行先验假设。

该算法通过将每个数据点向局部均值(上图中的 x)移动直到收敛来工作,其中核密度函数估计局部均值。

Mean-shift 算法将簇识别为特征空间中的高密度区域。

Mean-shift 聚类已在实际应用中使用,例如图像分割、视频监控中的物体跟踪以及 网络入侵检测中的异常检测,其目标是识别数据中的不同区域或模式。

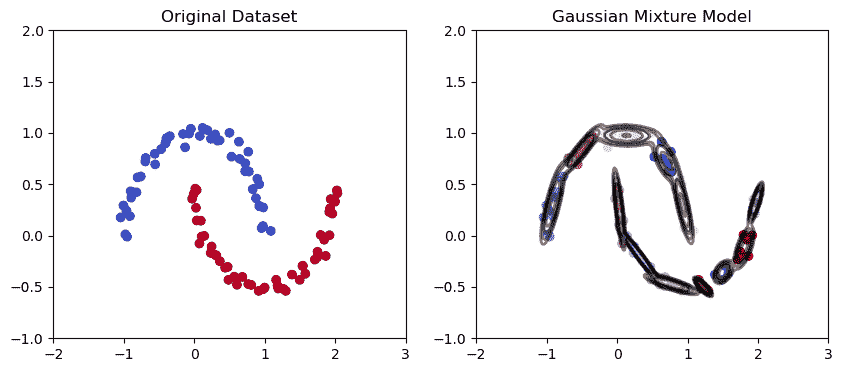

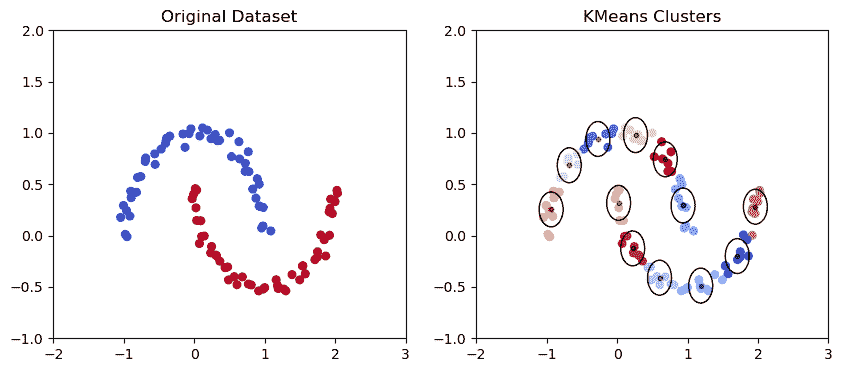

高斯混合聚类

高斯混合模型在月牙形数据集中的应用 | 图片由作者提供

K Means 聚类模型在月牙形数据集中的应用 | 图片由作者提供

高斯混合模型是一种概率聚类算法,通过高斯分布的混合来建模数据点的分布。该算法将一组高斯分布拟合到数据上,其中每个高斯分布对应一个独立的簇。

高斯混合模型已在各种实际应用中使用,如语音识别、基因表达分析和面部识别,其目标是对数据的潜在分布进行建模,并根据拟合的高斯分布识别聚类。

从上图可以看出,高斯混合模型在捕捉椭圆形数据点的趋势和绘制椭圆形聚类方面具有更好的能力。

总体而言,每种聚类算法都有其独特的优缺点。算法的选择取决于具体问题和数据集的特征。

理解每种算法的细微差别及其使用场景对于实现准确和有意义的结果至关重要。

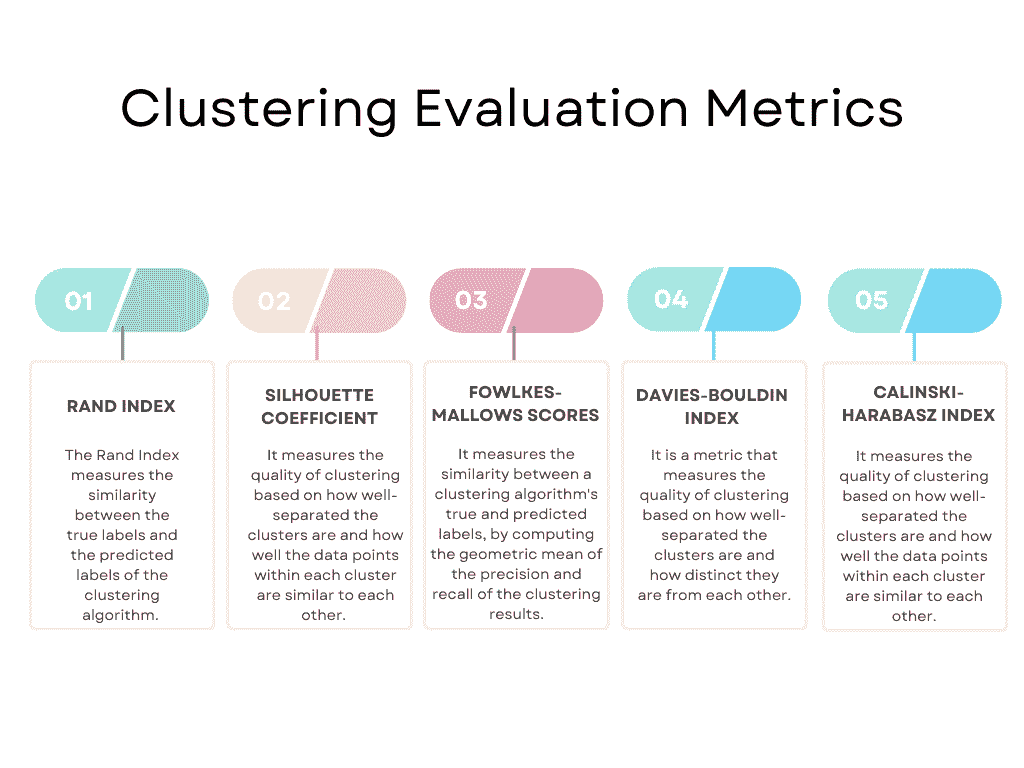

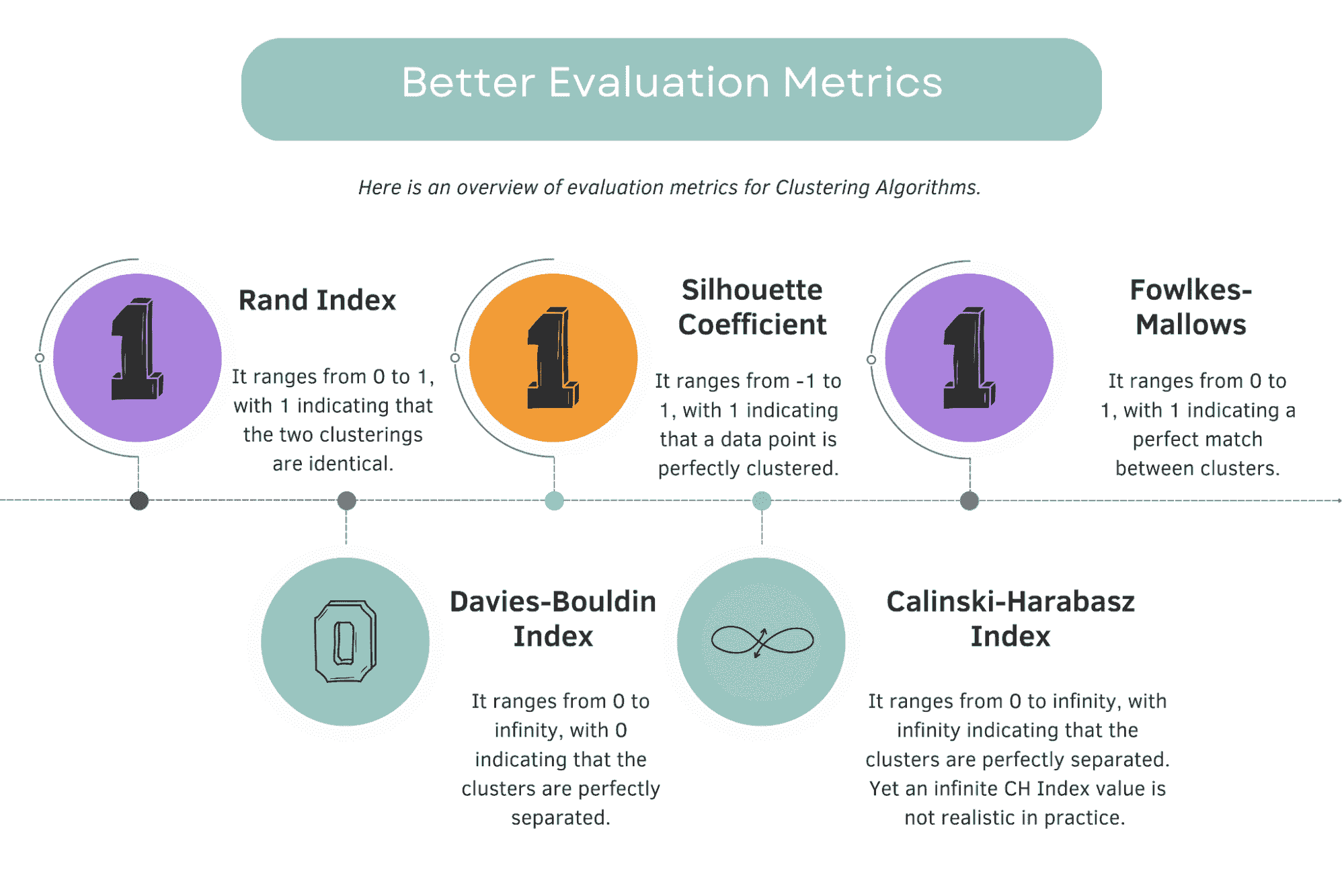

聚类评估指标

应用算法后,你需要评估其性能,以查看是否有改进的空间,或在算法性能不符合标准时更改算法。为此,你应该使用评估指标。

这里是最流行的一些概述。

图片来源:作者

当然,这些并不是全部。你可以在 scikit-learn 上获取完整的列表。它列出了以下评估指标:Rand 指数、基于互信息的分数、轮廓系数、Fowlkes-Mallows 分数、同质性、完整性、V 计量、Calinski-Harabasz 指数、Davies-Bouldin 指数、混淆矩阵、配对混淆矩阵。

这里你可以查看官方文档。

我们将坚持使用流行的算法,并从 Rand 指数开始。

Rand 指数

Rand 指数评估真实聚类标签与预测聚类标签之间的相似性。

该指数的范围从 0 到 1,其中 1 表示真实标签和预测标签之间的完美匹配。

Rand 指数通常用于图像分割、文本聚类和文档聚类等领域,其中数据的真实标签是已知的。

轮廓系数

轮廓系数基于聚类的分离程度和每个聚类内部数据点的相似度来衡量聚类的质量。

该系数的范围从 -1 到 1,其中 1 表示聚类分离良好且紧凑,-1 表示聚类不正确。

轮廓系数通常用于市场细分、客户画像和产品推荐,其目标是基于客户行为和偏好识别有意义的聚类。

Fowlkes-Mallows 分数

Fowlkes-Mallows 指数以两位研究人员的名字命名,Edward Fowlkes 和 S.G. Mallows,他们在 1983 年提出了这一指标。

该指数衡量聚类算法的真实标签与预测标签之间的相似性。

该分数的范围从 0 到 1,其中 1 表示真实标签和预测标签之间的完美匹配。

Fowlkes-Mallows 分数通常用于图像分割、文本聚类和文档聚类,其中数据的真实标签是已知的。

Davies-Bouldin 指数

Davies-Bouldin 指数以两位研究人员 David L. Davies 和 Donald W. Bouldin 的名字命名,他们在 1979 年提出了这一指标。

该指数的范围从 0 到无穷大,较低的值表示更好的聚类质量。

它对于识别数据中的最佳簇数量和检测簇重叠或彼此过于相似的情况非常有用。然而,该指数假设簇是球形的且具有相似的密度,这在现实世界的数据集中可能并不总是成立。

Davies-Bouldin 指数通常用于市场细分、客户画像和产品推荐,其目标是基于客户行为和偏好识别有意义的簇。

Calinski-Harabasz 指数

Calinski-Harabasz 指数以 T. Calinski 和 J. Harabasz 的名字命名,他们在 1974 年提出了这一指标。

Calinski-Harabasz 指数根据簇之间的分离程度和每个簇内的数据点相似度来衡量聚类质量。

该指数的范围从 0 到无穷大,较高的值表示更好的聚类效果。

Calinski-Harabasz 指数通常用于市场细分、客户画像和产品推荐,其目标是基于客户行为和偏好识别有意义的簇。

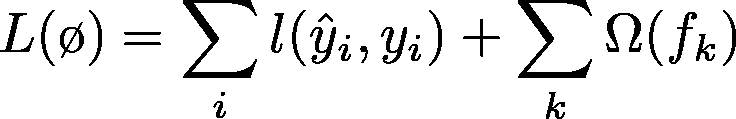

比较评价指标

图片作者

对于 Rand 指数、轮廓系数和 Fowlkes-Mallows 分数,较高的值表示更好的聚类性能。

最佳得分是 1。

对于 Davies-Bouldin 指数,较低的值表示更好的聚类性能。

最佳得分是 0。

对于 Calinski-Harabasz 指数,最高得分表示更好的性能。

最佳得分是 ∞。(无穷大。)

理论上,Calinski-Harabasz (CH) 指数的最佳得分应该是无穷大,因为这表明簇间离散度远高于簇内离散度。然而,在实践中实现无穷大的 CH 指数值是不现实的。

最佳得分没有固定的上限,因为它依赖于具体的数据和聚类情况。

别忘了:没有哪个算法或脚本是完美的。如果你在这些评价指标中达到了最佳得分,你的模型很可能存在过拟合。

如何在 scikit-learn 中一次性开发多个聚类算法?

这里的目的是对 Iris 数据集应用多个聚类算法,并使用不同的评价指标计算其性能。

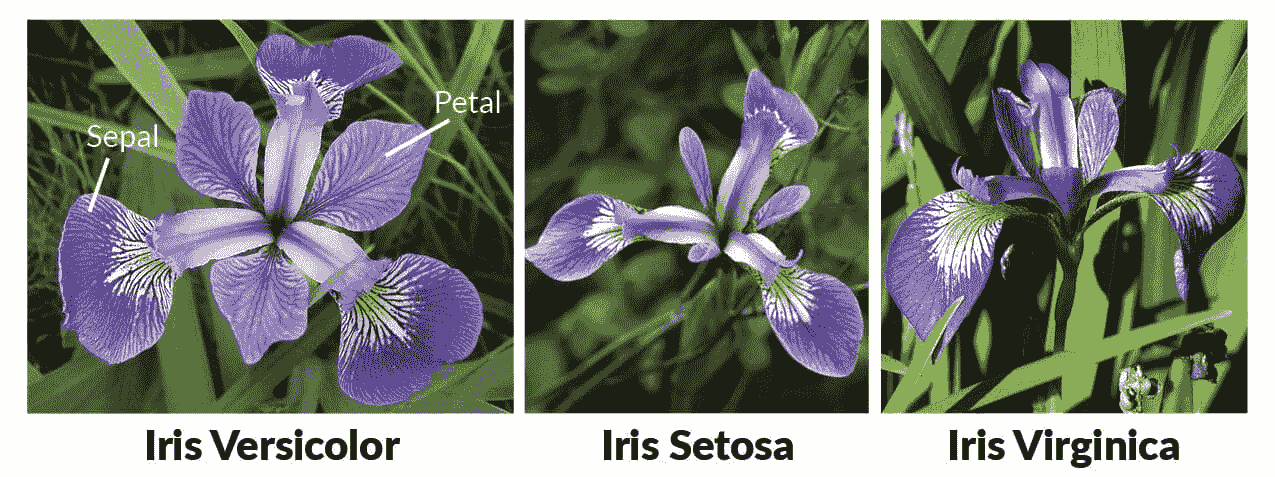

在这里我们将使用 IRIS 数据集。

你可以在 这里 找到这个数据集。

鸢尾花数据集是一个著名的多类分类数据集,包含 150 个鸢尾花样本,每个样本具有四个特征(萼片和花瓣的长度和宽度)。

图片来源 R 语言机器学习入门

数据集中有三个类别,代表三种不同类型的鸢尾花。

数据集通常用于机器学习和模式识别任务,特别是用于测试和比较不同的分类算法。它由英国统计学家和生物学家 Ronald Fisher 于 1936 年引入。

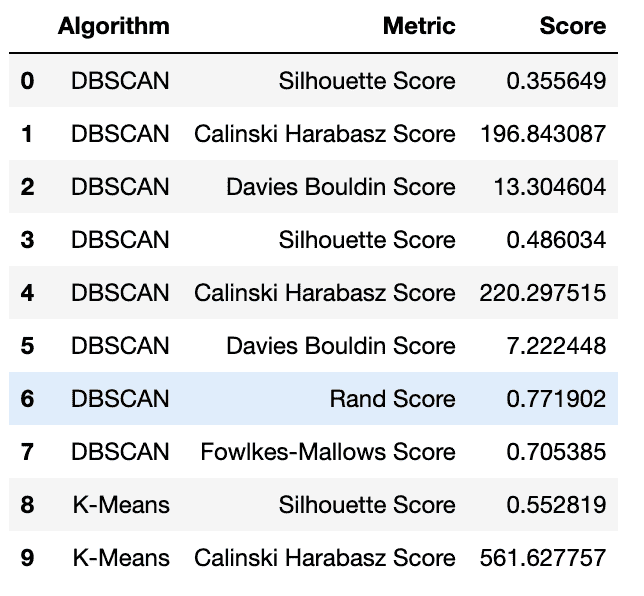

这里我们将编写代码,导入加载数据集所需的库,实施五种聚类算法(DBSCAN、K-Means、层次聚类、高斯混合模型和均值漂移),并使用五个指标评估它们的性能。

为此,我们将把评估指标和算法添加到字典中,并用两个 for 循环相互应用它们。

但我们这里有一个例外。rand_score 和 fowlkes_mallows_score 函数将聚类结果与真实标签进行比较,因此我们将添加if-else 块来提供这些结果。

然后我们将把这些结果添加到数据框中,以进行进一步分析。

这是代码。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.datasets import load_iris

from sklearn.cluster import (

DBSCAN,

KMeans,

AgglomerativeClustering,

MeanShift,

)

from sklearn.mixture import GaussianMixture

from sklearn.metrics import (

silhouette_score,

calinski_harabasz_score,

davies_bouldin_score,

rand_score,

fowlkes_mallows_score,

)

# Load the Iris dataset

iris = load_iris()

X = iris.data

y = iris.target

# Implement clustering algorithms

dbscan = DBSCAN(eps=0.5, min_samples=5)

kmeans = KMeans(n_clusters=3, random_state=42)

agglo = AgglomerativeClustering(n_clusters=3)

gmm = GaussianMixture(n_components=3, covariance_type="full")

ms = MeanShift()

# Evaluate clustering algorithms with three evaluation metrics

labels = {

"DBSCAN": dbscan.fit_predict(X),

"K-Means": kmeans.fit_predict(X),

"Hierarchical": agglo.fit_predict(X),

"Gaussian Mixture": gmm.fit_predict(X),

"Mean Shift": ms.fit_predict(X),

}

metrics = {

"Silhouette Score": silhouette_score,

"Calinski Harabasz Score": calinski_harabasz_score,

"Davies Bouldin Score": davies_bouldin_score,

"Rand Score": rand_score,

"Fowlkes-Mallows Score": fowlkes_mallows_score,

}

for name, label in labels.items():

for metric_name, metric_func in metrics.items():

if metric_name in ["Rand Score", "Fowlkes-Mallows Score"]:

score = metric_func(y, label)

else:

score = metric_func(X, label)

pred_df = pred_df.append(

{"Algorithm": name, "Metric": metric_name, "Score": score},

ignore_index=True,

)

# Display the DataFrame

pred_df.head(10)

这是输出结果。

预测数据框 | 图片由作者提供

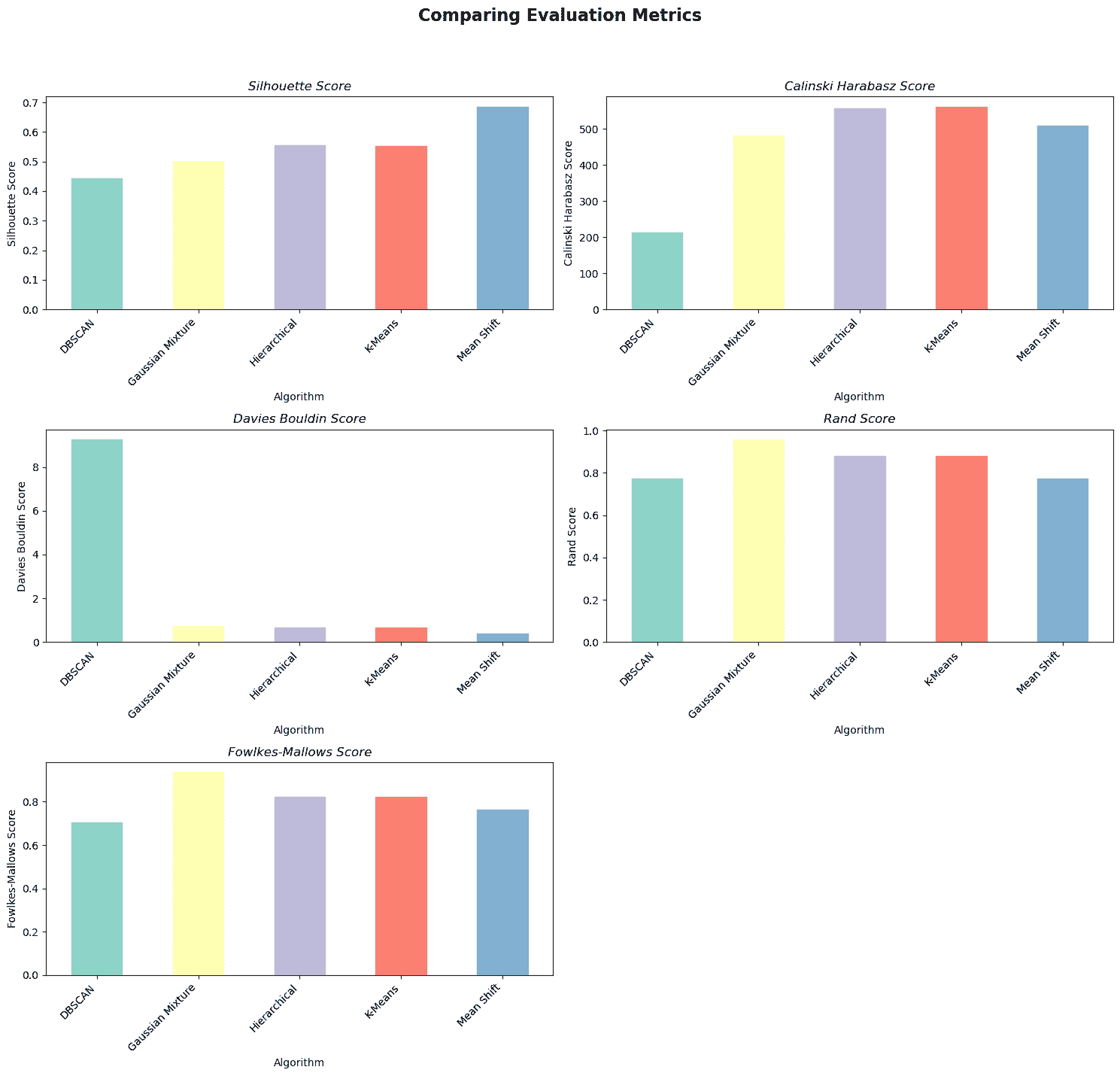

现在,让我们制作一个可视化图表,以更好地查看结果。这里的目的是创建聚类算法评估指标的可视化图。

以下代码将数据透视为算法作为列,指标作为行,然后为每个指标生成条形图。这允许对不同评估指标的聚类算法性能进行轻松比较。

这是代码。

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

# Pivot the data to have algorithms as columns and metrics as rows

pivoted_df = pred_df.pivot(

index="Metric", columns="Algorithm", values="Score"

)

# Define the three metrics to plot

metrics = [

"Silhouette Score",

"Calinski Harabasz Score",

"Davies Bouldin Score",

]

# Define a colormap to use for each algorithm

cmap = plt.get_cmap("Set3")

# Plot a bar chart for each metric

fig, axs = plt.subplots(nrows=1, ncols=3, figsize=(15, 5))

# Add a main title to the figure

fig.suptitle("Comparing Evaluation Metrics", fontsize=16, fontweight="bold")

for i, metric in enumerate(metrics):

ax = pivoted_df.loc[metric].plot(kind="bar", ax=axs[i], rot=45)

ax.set_xticklabels(ax.get_xticklabels(), ha="right")

ax.set_ylabel(metric)

ax.set_title(metric, fontstyle="italic")

# Iterate through the algorithm names and set the color for each bar

for j, alg in enumerate(pivoted_df.columns):

ax.get_children()[j].set_color(cmap(j))

plt.show()

这是输出结果。

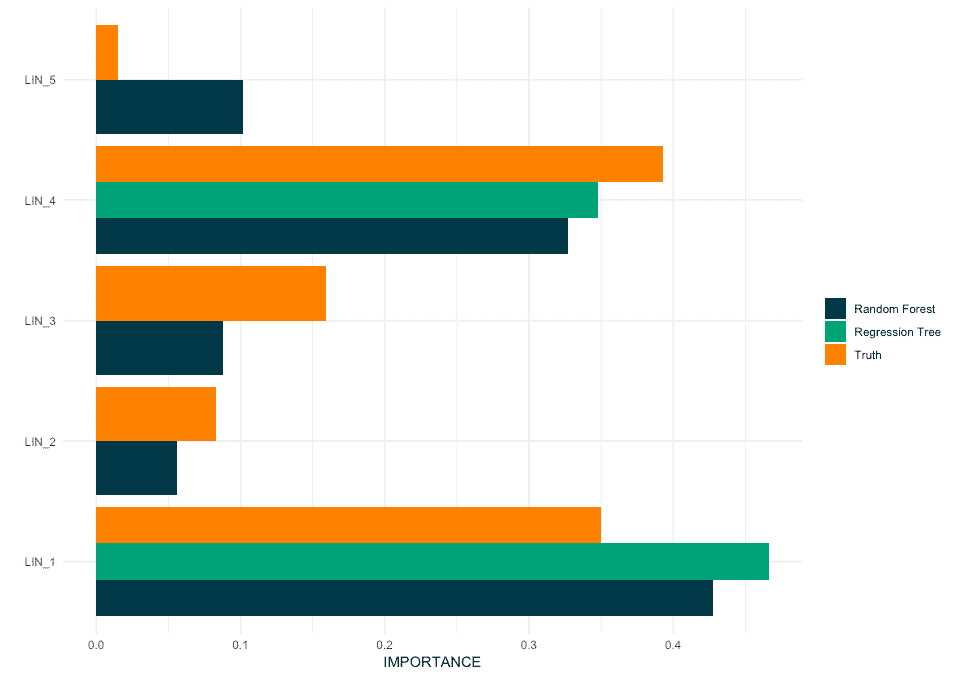

图片由作者提供

总结来说,均值漂移算法根据轮廓系数和戴维斯-鲍尔丁分数表现最佳。

K-Means 算法在 Calinski Harabasz 分数上表现最佳,而 GMM 算法在 Rand 分数和 Fowlkes-Mallows 分数上表现最佳。

聚类算法之间没有明显的赢家,因为每种算法在不同的指标上表现良好。

最佳算法的选择取决于具体需求以及在聚类问题中对每个评估指标的重要性分配。

聚类的实际应用

现在,让我们看看我们算法和评估指标的实际例子,以进一步掌握逻辑。

这里是我们将详细讨论的例子的概述。

作者提供的图像

超市连锁个性化

作者提供的图像

实际例子:一家超市连锁希望为其客户创建个性化的营销活动。他们使用 K-Means 聚类根据客户的购买习惯、人口统计数据和店铺访问频率来细分客户。这些细分帮助公司量身定制营销信息,以更好地吸引和服务客户。

算法: K-Means 聚类

K-Means 被选择是因为它是一个简单、高效且广泛使用的聚类算法,适用于大数据集。它可以快速识别模式并根据输入特征创建明确的客户细分。

评估指标: Silhouette Score

Silhouette Score 用于评估客户细分的质量,通过测量每个数据点在其分配的聚类内的适配度,与其他聚类进行比较。这有助于确保聚类是紧凑且分离良好的,这对于创建有效的个性化营销活动至关重要。

欺诈交易

作者提供的图像

实际例子:一家信用卡公司希望检测欺诈交易。他们使用 DBSCAN 根据交易金额、时间和地点等因素对交易进行聚类。那些不符合任何聚类的异常交易会被标记为潜在欺诈,进行进一步调查。

算法: DBSCAN

DBSCAN 被选择是因为它是一个基于密度的聚类算法,能够识别形状和大小各异的聚类,并检测不属于任何聚类的噪声点。这使它适合检测异常模式或离群点,如潜在的欺诈交易。

评估指标: Silhouette Score

选择 Silhouette Score 作为评估指标是因为它有助于评估 DBSCAN 的有效性,通过将正常交易与表示欺诈的潜在离群点分开。

更高的 Silhouette Score 表示常规交易的聚类之间分隔良好,噪声点(离群点)也被有效分离。这种分离使得识别和标记显著偏离正常模式的可疑交易变得更容易。

癌症基因组学关系

作者提供的图像

现实生活中的例子:研究癌症基因组学的研究人员希望理解不同类型癌细胞之间的关系。他们使用层次聚类根据基因表达模式对细胞进行分组。得到的簇帮助他们识别癌症类型之间的共性和差异,并开发针对性的治疗方法。

算法:凝聚层次聚类

选择凝聚层次聚类是因为它创建了一个树状结构(树状图),这使研究人员能够以多层次的粒度可视化和解释癌细胞之间的关系。这种方法可以揭示嵌套的子群体,并帮助研究人员理解基于基因表达模式的癌症类型的层次组织。

评估指标:Calinski-Harabasz 指数

选择 Calinski-Harabasz 指数是因为它测量了簇间离散度与簇内离散度的比率。对于癌症基因组学,它帮助研究人员评估基于基因表达模式的癌细胞分组的质量,判断组间是否明显且分隔良好。

自主驾驶汽车

作者提供的图像

现实生活中的例子:一家自动驾驶汽车公司希望提高汽车识别周围物体的能力。他们使用均值漂移聚类将汽车摄像头捕捉的图像根据颜色和纹理分割成不同的区域,这帮助汽车识别和跟踪行人及其他车辆等物体。

算法:均值漂移聚类

选择均值漂移聚类是因为它是一种非参数的基于密度的算法,可以自动适应数据的底层结构和规模。

这使得它特别适合于图像分割任务,其中簇或区域的数量可能事先未知,并且区域的形状可能复杂且不规则。

评估指标:Fowlkes-Mallows 评分(FMS)

选择 Fowlkes-Mallows 评分是因为它测量了两个聚类之间的相似性,通常将算法的输出与真实的聚类进行比较。

在自动驾驶汽车的背景下,FMS 可以用于评估均值漂移聚类算法在分割图像方面的效果,相较于人工标注的分割结果。

新闻推荐

作者提供的图像

实际案例:一个在线新闻平台希望将文章分组,以改善对用户的内容推荐。他们使用 Gaussian Mixture Models 根据从文本中提取的特征(如词频和术语共现)对文章进行聚类。通过识别不同的主题,该平台可以推荐与用户兴趣更相关的文章。

算法:Gaussian Mixture Model (GMM) 聚类

选择 Gaussian Mixture Models 是因为它们是一种概率生成方法,可以建模复杂的重叠簇。这对文本数据特别有用,因为文章可能属于多个主题或具有共享特征。GMM 可以捕捉这些细微差别,并提供软聚类,为每篇文章分配属于每个主题的概率。

评估指标:Silhouette Coefficient

选择 Silhouette Coefficient 是因为它衡量了簇的紧密性和分离度,有助于评估主题分配的质量。

更高的 Silhouette Coefficient 表明一个主题内的文章彼此更相似,并且与其他主题明显不同,这对准确的内容推荐至关重要。

如果你想了解更多关于无监督算法的信息,你可以在这里获取更多资料:“Unsupervised Learning Algorithms”。还可以查看“Supervised vs Unsupervised Learning”,这两种方法是机器学习领域我们应该了解的。

结论

总之,聚类是一种重要的无监督学习技术,用于在没有预先了解类标签的情况下发现数据中的相似性或模式。

我们讨论了不同的聚类算法,包括 K-Means、Mean Shift、DBScan、Gaussian Mixture 和 Hierarchical Clustering,以及它们的应用场景和实际应用。

此外,我们还探索了各种评估指标,包括 Silhouette Coefficient、Calinski-Harabasz Index 和 Davies-Bouldin Index,这些指标帮助我们评估聚类结果的质量。

我们还学习了如何使用 scikit-learn 同时开发多个聚类算法,并使用我们已发现的指标对其进行评估。

最后,我们讨论了一些利用聚类算法解决实际问题的热门应用。

如果你还有问题,这里有一篇文章解释了Clustering and its algorithms。

聚类有广泛的应用,从市场营销中的客户细分到计算机视觉中的图像识别,它是发现数据中隐藏模式和洞察的重要工具。

内特·罗西迪 是一名数据科学家和产品策略专家。他还是一名兼任教授,教授分析学,并且是StrataScratch,一个帮助数据科学家准备顶级公司面试问题的平台的创始人。可以通过Twitter: StrataScratch或LinkedIn与他联系。

更多相关主题

聚类释放:理解 K-Means 聚类

原文:

www.kdnuggets.com/2023/07/clustering-unleashed-understanding-kmeans-clustering.html

图片来源:作者

在分析数据时,我们的目标是发现隐藏的模式并提取有意义的洞察。让我们进入基于 ML 的新类别,即无监督学习,其中一个强大的算法用于解决聚类任务的是 K-Means 聚类算法,它彻底改变了数据理解的方式。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

K-Means 已成为机器学习和数据挖掘应用中的一种有用算法。在这篇文章中,我们将深入探讨 K-Means 的工作原理、使用 Python 实现,以及探索其原则、应用等。所以,让我们开始这段旅程,揭示隐藏的模式并利用 K-Means 聚类算法的潜力。

什么是 K-Means 算法?

K-Means 算法用于解决属于无监督学习类别的聚类问题。借助这个算法,我们可以将观察数据分组到 K 个簇中。

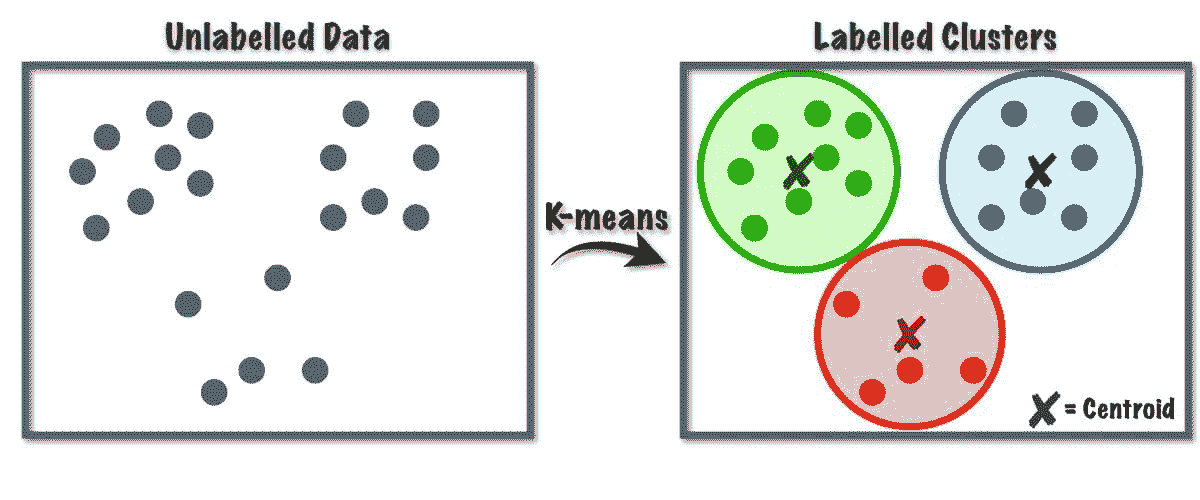

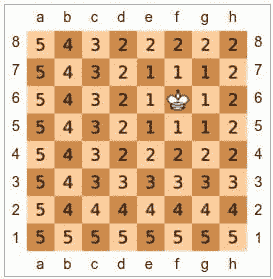

图 1 K-Means 算法工作原理 | 图片来自 Towards Data Science

这个算法内部使用向量量化,通过这种方式,我们可以将数据集中的每个观察值分配到距离最小的簇中,这是聚类算法的原型。这个聚类算法在数据挖掘和机器学习中常用于根据相似性度量将数据分区成 K 个簇。因此,在这个算法中,我们需要最小化观察值与其对应质心之间的平方和距离,这最终会产生明显且同质的簇。

K-Means 聚类的应用

以下是这个算法的一些标准应用。K-Means 算法在工业应用中常用于解决与聚类相关的问题。

-

客户细分: K-means 聚类可以根据客户的兴趣对不同客户进行细分。它可以应用于银行、电信、电子商务、体育、广告、销售等。

-

文档聚类: 在这种技术中,我们将把一组文档中相似的文档归为一类,从而在相同的簇中得到相似的文档。

-

推荐引擎: 有时,K-means 聚类可用于创建推荐系统。例如,你想向朋友推荐歌曲。你可以查看那个人喜欢的歌曲,然后使用聚类来找到类似的歌曲,并推荐最相似的那些。

还有许多更多应用,我相信你已经想到了一些,可能会在本文下方的评论区分享。

使用 Python 实现 K-Means 聚类

在本节中,我们将开始在一个数据集上使用 Python 实现 K-Means 算法,这在数据科学项目中主要使用。

1. 导入必要的库和依赖项

首先,让我们导入实现 K-means 算法所需的 Python 库,包括 NumPy、Pandas、Seaborn、Marplotlib 等。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sb

2. 加载和分析数据集

在此步骤中,我们将通过将数据存储在 Pandas 数据框中来加载学生数据集。要下载数据集,请参考这里的链接。

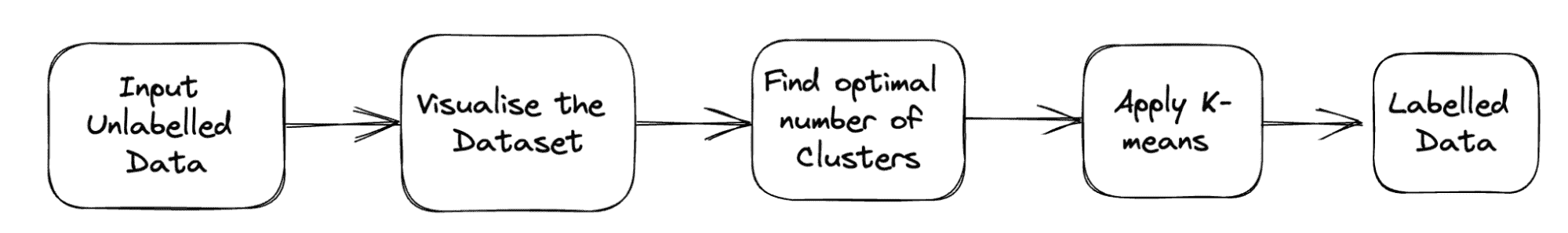

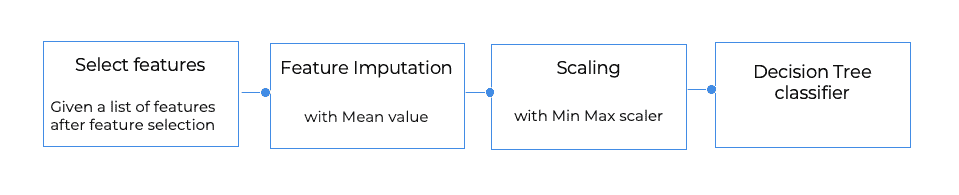

问题的完整管道如下所示:

图 2 项目管道 | 图片来源:作者

df = pd.read_csv('student_clustering.csv')

print("The shape of data is",df.shape)

df.head()

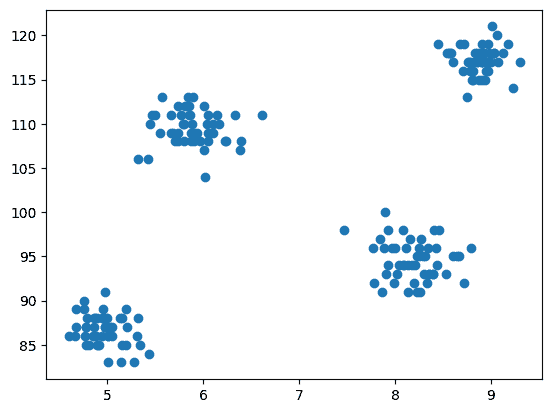

3. 数据集的散点图

现在进入建模步骤,我们需要可视化数据,因此我们使用 matplotlib 绘制散点图,以检查聚类算法如何工作并创建不同的簇。

# Scatter plot of the dataset

import matplotlib.pyplot as plt

plt.scatter(df['cgpa'],df['iq'])

输出:

图 3 散点图 | 图片来源:作者

4. 从 Scikit-learn 的 Cluster 类中导入 K-Means

现在,由于我们需要实现 K-Means 聚类,我们首先导入 cluster 类,然后我们将 KMeans 作为该类的模块。

from sklearn.cluster import KMeans

5. 使用肘部法找到 K 的最优值

在此步骤中,我们将找到 K 的最优值,这是实现算法时的一个超参数。K 值表示我们必须为数据集创建多少个簇。直观地找到这个值是不可能的,因此,为了找到最优值,我们将创建 WCSS(簇内平方和)和不同 K 值之间的图,并选择给我们最小 WCSS 值的 K。

# create an empty list for store residuals

wcss = []

for i in range(1,11):

# create an object of K-Means class

km = KMeans(n_clusters=i)

# pass the dataframe to fit the algorithm

km.fit_predict(df)

# append inertia value to wcss list

wcss.append(km.inertia_)

现在,让我们绘制肘部图以找到 K 的最优值。

# Plot of WCSS vs. K to check the optimal value of K

plt.plot(range(1,11),wcss)

输出:

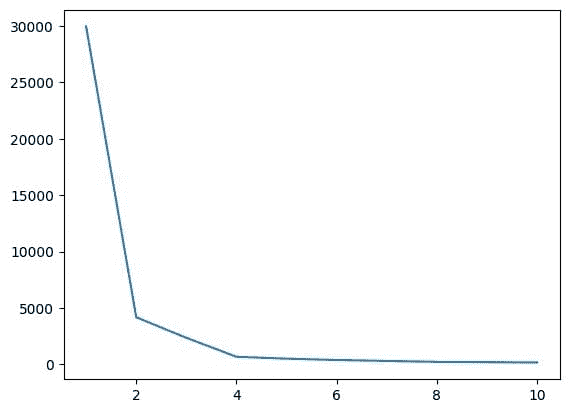

图 4 肘部图 | 图片来源:作者

从上述肘部图中,我们可以看到在 K=4 时,WCSS 的值有一个下降,这意味着如果我们将最佳值设置为 4,那么聚类将提供良好的性能。

6. 使用最佳 K 值拟合 K-Means 算法

我们已经完成了 K 的最佳值的寻找。现在,让我们进行建模,我们将创建一个 X 数组,存储所有特征的完整数据集。在这里无需分离目标和特征向量,因为这是一个无监督问题。之后,我们将创建一个 KMeans 类的对象,并用选定的 K 值对数据集进行拟合。最后,我们打印 y_means,它表示不同聚类的均值。

X = df.iloc[:,:].values # complete data is used for model building

km = KMeans(n_clusters=4)

y_means = km.fit_predict(X)

y_means

7. 检查每个类别的聚类分配

让我们检查数据集中哪些点属于哪个聚类。

X[y_means == 3,1]

到目前为止,我们为中心初始化使用了 K-Means++ 策略,现在,让我们改为使用随机中心初始化,而不是 K-Means++,并通过相同的过程比较结果。

km_new = KMeans(n_clusters=4, init='random')

y_means_new = km_new.fit_predict(X)

y_means_new

检查有多少值匹配。

sum(y_means == y_means_new)

8. 聚类的可视化

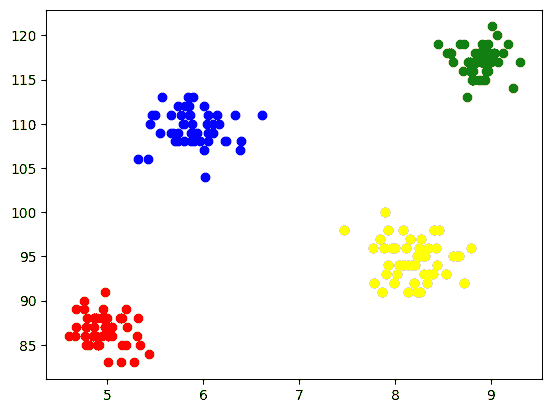

为了可视化每个聚类,我们在坐标轴上绘制它们,并通过不同的颜色来区分,这样我们可以很容易地看到形成的 4 个聚类。

plt.scatter(X[y_means == 0,0],X[y_means == 0,1],color='blue')

plt.scatter(X[y_means == 1,0],X[y_means == 1,1],color='red')

plt.scatter(X[y_means == 2,0],X[y_means == 2,1],color='green')

plt.scatter(X[y_means == 3,0],X[y_means == 3,1],color='yellow')

输出:

图 5 聚类形成的可视化 | 作者提供的图像

9. K-Means 在三维数据上的应用

由于之前的数据集有 2 列,我们面临的是二维问题。现在,我们将使用相同的一组步骤处理三维问题,并尝试分析代码在 n 维数据上的可重复性。

# Create a synthetic dataset from sklearn

from sklearn.datasets import make_blobs # make synthetic dataset

centroids = [(-5,-5,5),(5,5,-5),(3.5,-2.5,4),(-2.5,2.5,-4)]

cluster_std = [1,1,1,1]

X,y = make_blobs(n_samples=200,cluster_std=cluster_std,centers=centroids,n_features=3,random_state=1)

# Scatter plot of the dataset

import plotly.express as px

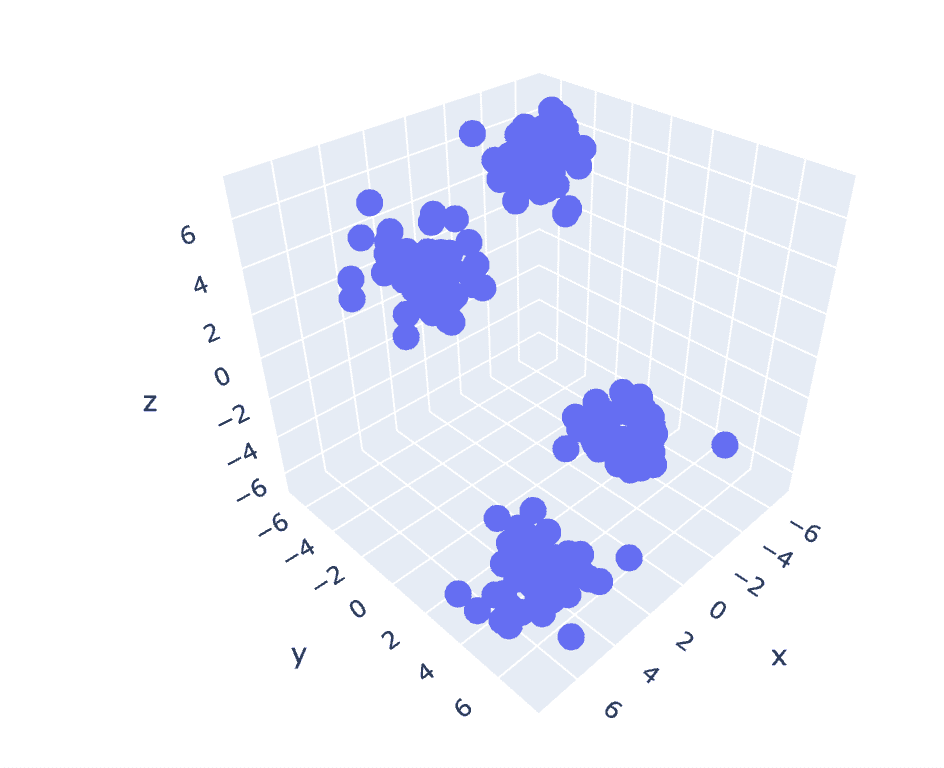

fig = px.scatter_3d(x=X[:,0], y=X[:,1], z=X[:,2])

fig.show()

输出:

图 6 三维数据集的散点图 | 作者提供的图像

wcss = []

for i in range(1,21):

km = KMeans(n_clusters=i)

km.fit_predict(X)

wcss.append(km.inertia_)

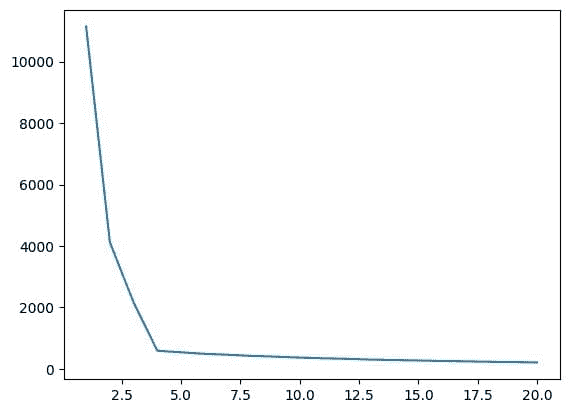

plt.plot(range(1,21),wcss)

输出:

图 7 肘部图 | 作者提供的图像

# Fit the K-Means algorithm with the optimal value of K

km = KMeans(n_clusters=4)

y_pred = km.fit_predict(X)

# Analyse the different clusters formed

df = pd.DataFrame()

df['col1'] = X[:,0]

df['col2'] = X[:,1]

df['col3'] = X[:,2]

df['label'] = y_pred

fig = px.scatter_3d(df,x='col1', y='col2', z='col3',color='label')

fig.show()

输出:

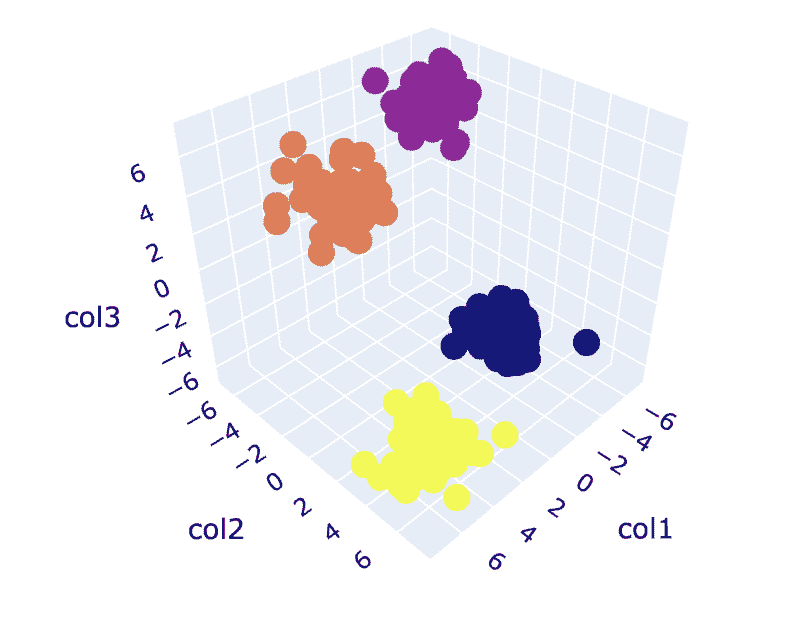

图 8. 聚类可视化 | 作者提供的图像

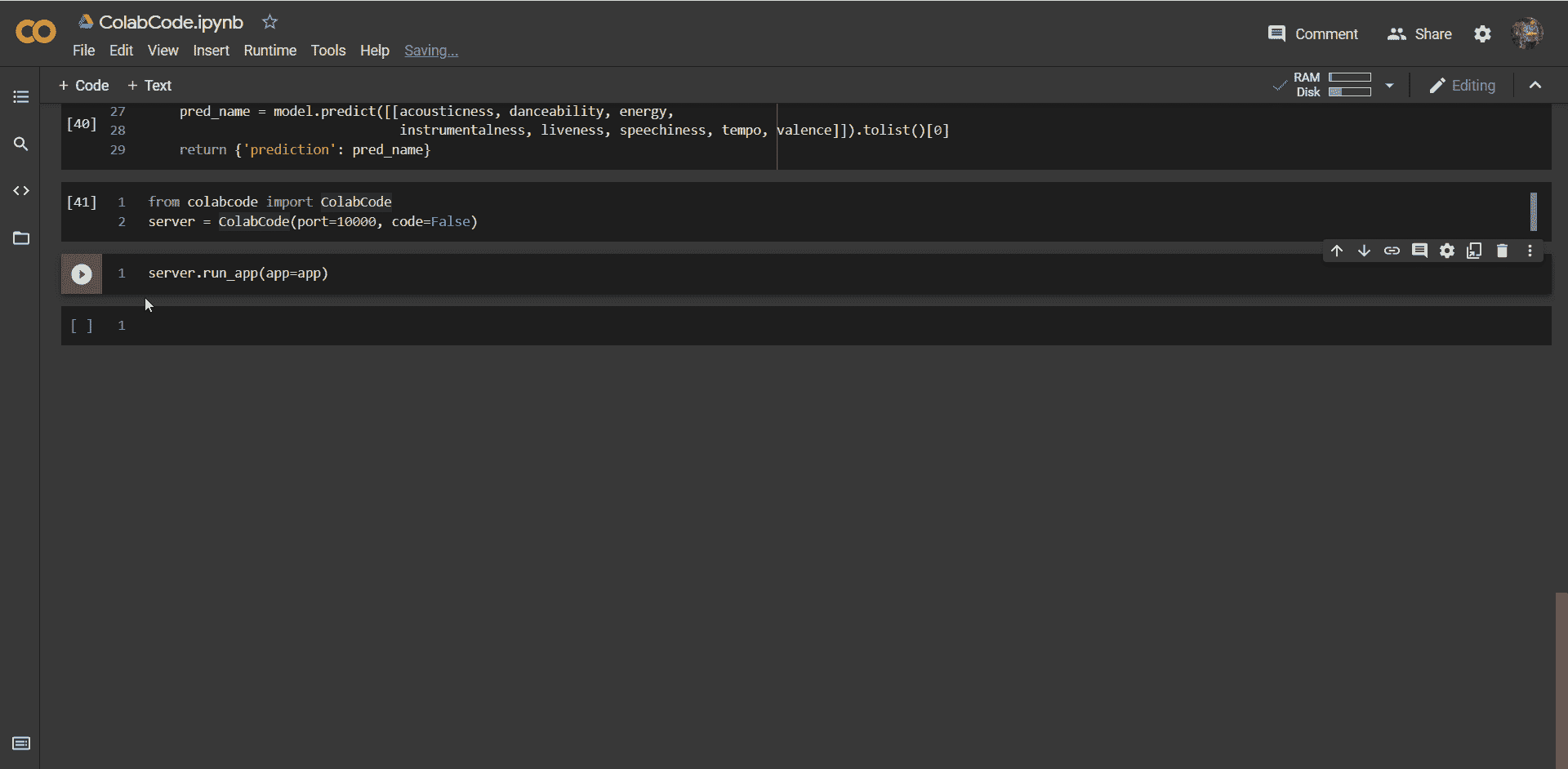

您可以在这里找到完整的代码 - Colab Notebook

总结

这完成了我们的讨论。我们讨论了 K-Means 的工作原理、实现和应用。总之,实施聚类任务是一种广泛使用的无监督学习算法,提供了一种简单而直观的方法来对数据集的观察值进行分组。该算法的主要优点在于,利用所选的相似性度量将观察值分成多个集合,同时借助实施该算法的用户。

然而,根据第一步质心的选择,我们的算法表现不同,可能收敛到局部或全局最优解。因此,选择要实施的聚类数、数据预处理、处理异常值等,对于获得良好的结果至关重要。但是,如果我们深入了解这个算法的局限性之外,K-Means 是一种有助于探索性数据分析和各种领域模式识别的有用技术。

Aryan Garg 是一名电气工程学士学位学生,目前在本科最后一年。他对网页开发和机器学习领域感兴趣,并且追求了这一兴趣,渴望在这些方向上进一步工作。

更多关于这个话题

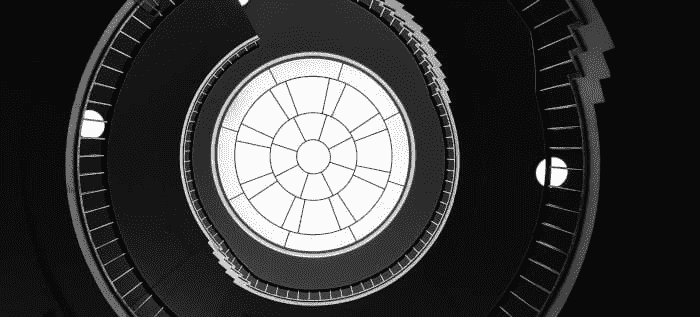

如何在机器学习模型中使用持续学习,6 月 19 日网络研讨会

原文:

www.kdnuggets.com/2019/05/cnvrg-io-continual-learning-ml-models.html

赞助帖子。

学术界和实践者都认为,持续学习(CL)是迈向人工智能的基本步骤。CL 是指模型从数据流中持续学习的能力。在实践中,这意味着支持模型在生产环境中随着新数据的到来,自主学习和适应。CL 的理念是模拟人类在其生命周期中不断获取、微调和转移知识和技能的能力。生产中的模型 CL 将提高准确性,并使 AI 更接近真实的人类智能。

加入数据科学专家、cnvrg.io 首席执行官 Yochay Ettun,他将讨论生产中的持续学习。本次网络研讨会将探讨持续学习,并帮助你将持续学习应用到你的生产模型中,使用如 Tensorflow、Kubernetes 和 cnvrg.io 等工具。本次面向专业数据科学家的网络研讨会将介绍如何在生产中监控模型,以及如何设置自动适应的机器学习。

关键要点包括:

-

理解持续学习

-

通过 CL 优化准确性

-

如何使用 TensorFlow 应用 CL

-

如何实现自动适应的机器学习

-

适应数据分布的变化

-

应对异常值

-

生产中的再训练

-

适应新任务

-

将机器学习管道部署到生产中

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

更多相关主题

数据科学家的编码习惯

原文:

www.kdnuggets.com/2020/05/coding-habits-data-scientists.html

评论

作者:David Tan,ThoughtWorks。

最初发布于 ThoughtWorks Insights。经许可转载。

作为一个 ML 从业者,你会知道代码很快就会失控。一个出色的 ML 模型很容易变成一个难以理解的大块代码。因此,修改代码变得痛苦且容易出错,同时 ML 从业者在演进其 ML 解决方案时变得越来越困难。

本文分享了一些识别增加代码复杂性的坏习惯的技巧,以及有助于我们分解复杂性的习惯。它现在也是一个视频系列,涵盖了以下主题:

-

如何重构 Jupyter notebook

-

针对你的 ML 代码库的自动化测试

-

如何使用 IDE 提高生产力

-

在 17 分钟内入门 Docker

如果你尝试过机器学习或数据科学,你会知道代码可以迅速变得混乱。

通常,训练 ML 模型的代码是用 Jupyter notebooks 编写的,里面充满了(i)副作用(例如打印语句、格式化的数据框、数据可视化)和(ii)没有任何抽象、模块化和自动化测试的粘合代码。虽然这对于旨在教授机器学习过程的笔记本可能没问题,但在实际项目中,这会变成一个难以维护的混乱。缺乏良好的编码习惯使得代码难以理解,因此,修改代码变得痛苦且容易出错。这使得数据科学家和开发人员在演进其 ML 解决方案时变得越来越困难。

在本文中,我们将分享识别增加代码复杂性的不良习惯的技巧,以及有助于我们分解复杂性的习惯。

复杂性的贡献因素是什么?

管理软件复杂性的最重要技巧之一是设计系统,使开发人员在任何给定时间只需要面对总体复杂性的一小部分。 - John Ousterhout

要处理复杂性,我们必须首先了解它的样子。当某物是由相互关联的部分组成时,它就是复杂的。每当我们以添加另一个活动部分的方式编写代码时,我们就增加了复杂性,并且需要在脑海中记住更多的内容。

虽然我们不能——也不应尝试——逃避问题的本质复杂性,但我们经常通过不良实践如:

-

没有抽象。 当我们在单个 Python 笔记本或脚本中编写所有代码而没有将其抽象成函数或类时,我们迫使读者阅读大量代码行并弄清楚“如何”来了解代码的功能。

-

长函数做多个事情。 这迫使我们在处理函数的一部分时必须在脑海中保持所有中间数据转换。

-

没有单元测试。 当我们重构时,确保没有破坏任何东西的唯一方法是重新启动内核并运行整个笔记本。即使我们只想处理其中的一小部分,我们也被迫承担整个代码库的复杂性。

复杂性是不可避免的,但可以进行分隔。在我们的家庭中,当我们没有主动组织和理顺物品的放置位置、原因和方式时,杂乱就会积累,本应简单的任务(例如,找钥匙)变得不必要地耗时和令人沮丧。我们的代码库也是如此。新代码不断被添加用于数据清理、特征工程、错误修复、处理新数据等。除非我们严格维护我们的代码库并不断重构(而且没有单元测试我们无法重构),否则混乱和复杂性是不可避免的。

在本文的其余部分,我们将分享一些增加复杂性的常见不良习惯和帮助管理复杂性的更好习惯:

-

保持代码简洁

-

使用函数来抽象复杂性

-

尽快将代码从 Jupyter 笔记本中提取出来

-

应用测试驱动开发

-

进行小而频繁的提交

减少复杂性的习惯

保持代码简洁

不洁净的代码通过使代码难以理解和修改来增加复杂性。因此,修改代码以响应业务需求变得越来越困难,有时甚至是不可能的。

一种糟糕的编码习惯(或称为“代码异味”)是死代码。死代码是已经执行但其结果从未在其他计算中使用的代码。死代码是开发人员在编写代码时不得不记住的另一件无关紧要的事。例如,对比这两个代码示例:

# bad example

df = get_data()

print(df)

# do_other_stuff()

# do_some_more_stuff()

df.head()

print(df.columns)

# do_so_much_stuff()

model = train_model(df)

# good example

df = get_data()

model = train_model(df)

关于清洁代码的实践已经在 几种语言中广泛书写,包括 Python。我们已经调整了这些“清洁代码”原则,你可以在这个 clean-code-ml 仓库中找到它们:

-

设计 (代码示例)

- 不要暴露你的内部实现(保持实现细节隐藏)

-

可有可无的 (代码示例)

-

删除死代码

-

避免使用打印语句(即使是像 head()、df.describe()、df.plot() 这样的夸张打印语句)

-

-

变量(代码示例)

- 变量名应该揭示意图

-

函数(代码示例)

-

使用函数来保持代码的“DRY” (不要重复自己)

-

函数应该做一件事

-

使用函数来抽象复杂性

函数通过抽象复杂的实现细节并用更简单的表示——它的名称——来简化我们的代码。

想象你在一家餐厅,你得到了一份菜单。这个菜单不是告诉你菜品的名称,而是详细列出了每道菜的食谱。例如,其中一道菜是:

第 1 步。在一个大锅中,加热油。加入胡萝卜、洋葱和芹菜;搅拌至洋葱变软。加入香草和大蒜,再煮几分钟。

第 2 步。加入扁豆、番茄和水。将汤煮沸后转小火炖煮 30 分钟。加入菠菜并煮至菠菜变软。最后,用醋、盐和胡椒调味。

如果菜单隐藏了菜谱中的所有步骤(即实现细节),而只给出了菜品的名称(一个接口,即菜品的抽象),对我们来说会更容易(答案是:那是扁豆汤)。

为了说明这一点,这里是来自 Kaggle Titanic 比赛的一个笔记本中的代码示例,重构前后对比。

# bad example

pd.qcut(df['Fare'], q=4, retbins=True)[1] # returns array([0., 7.8958, 14.4542, 31.275, 512.3292])

df.loc[ df['Fare'] <= 7.90, 'Fare'] = 0 df.loc[(df['Fare'] > 7.90) & (df['Fare'] <= 14.454), 'Fare'] = 1 df.loc[(df['Fare'] > 14.454) & (df['Fare'] <= 31), 'Fare'] = 2 df.loc[ df['Fare'] > 31, 'Fare'] = 3

df['Fare'] = df['Fare'].astype(int)

df['FareBand'] = df['Fare']

# good example (after refactoring into functions)

df['FareBand'] = categorize_column(df['Fare'], num_bins=4)

通过将复杂性抽象为函数,我们得到了什么?

-

可读性。我们只需阅读接口(即

categorize_column())即可了解其功能。我们不必阅读每一行代码或在互联网上搜索我们不理解的内容(例如pd.qcut)。如果我还是不理解这个函数的功能,我可以查看它的单元测试或定义。 -

因为现在它是一个函数,我们可以很容易地为其编写单元测试。如果我们不小心更改了它的行为,单元测试会失败,并在毫秒内给我们反馈。

-

为任何列(例如“Age”或“Income”)重复相同的转换,我们只需要一行(而不是七行)代码。

当我们重构为函数时,我们的整个笔记本可以简化并变得更优雅:

# 糟糕的例子

# good example

df = impute_nans(df, categorical_columns=['Embarked'],

Continuous_columns =['Fare', 'Age'])

df = add_derived_title(df)

df = encode_title(df)

df = add_is_alone_column(df)

df = add_categorical_columns(df)

X, y = split_features_and_labels(df)

# an even better example. Notice how this reads like a story

prepare_data = compose(impute_nans,

add_derived_title,

encode_title,

add_is_alone_column,

add_categorical_columns,

split_features_and_labels)

X, y = prepare_data(df)

我们的心理负担现在大大减少了。我们不再被迫处理大量的实现细节来理解整个流程。相反,抽象(即函数)抽象了复杂性,告诉我们它们的功能,免去了我们在弄清楚它们如何实现时所需的心理努力。

尽快将代码从 Jupyter 笔记本中剥离出来

在室内设计中,有一个概念(“平面表面法则”)指出“家或办公室中的任何平面表面都倾向于积累杂物。” Jupyter 笔记本是机器学习世界的平面表面。

当然,Jupyter 笔记本非常适合快速原型开发。但这也是我们倾向于放入许多东西的地方——粘合代码、打印语句、被夸大的打印语句(df.describe() 或 df.plot())、未使用的导入语句,甚至堆栈跟踪。尽管我们尽了最大努力,但只要笔记本存在,混乱往往会积累。

笔记本很有用,因为它们给我们快速反馈,这通常是我们在面对新数据集和新问题时所需要的。然而,笔记本变得越长,获取我们更改是否有效的反馈就越困难。

相反,如果我们将代码提取到函数和 Python 模块中,并且有单元测试,测试运行器会在几秒钟内对我们的更改进行反馈,即使有数百个函数也是如此。

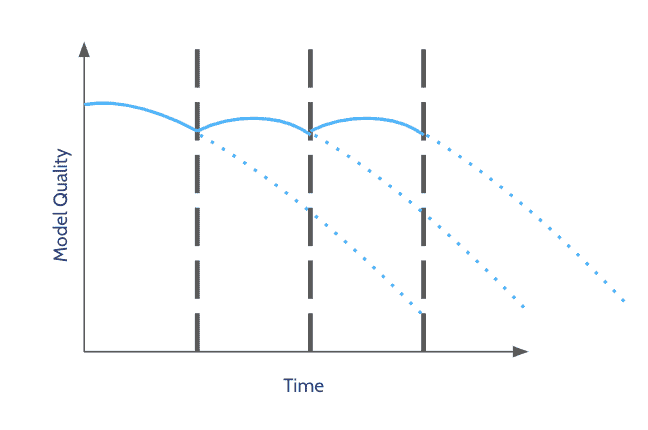

图 1: 代码越多,笔记本就越难快速反馈我们是否一切正常。

因此,我们的目标是尽早将代码从笔记本中迁移到 Python 模块和包中。这样,它们可以在单元测试和领域边界的安全范围内。这将通过提供逻辑组织代码和测试的结构来帮助管理复杂性,并使我们更容易发展我们的机器学习解决方案。

那么,我们如何将代码从 Jupyter 笔记本中移出呢?

假设你已经在 Jupyter 笔记本中有了代码,你可以遵循这个过程:

图 2: 如何重构 Jupyter 笔记本。

这个过程每一步的详细信息(例如,如何以监视模式运行测试)可以在 clean-code-ml 仓库中找到。

应用测试驱动开发

到目前为止,我们已经讨论了在代码已经写在笔记本之后编写测试。这种推荐并不是理想的,但总比没有单元测试要好得多。

有一个误解认为我们不能将测试驱动开发(TDD)应用于机器学习项目。对我们来说,这显然是不正确的。在任何机器学习项目中,大部分代码涉及数据转换(例如数据清洗、特征工程),而小部分代码才是实际的机器学习。这样的数据转换可以写成纯函数,对于相同的输入返回相同的输出,因此我们可以应用 TDD 并获得其好处。例如,TDD 可以帮助我们将大型复杂的数据转换拆解为可以逐个处理的小问题。

至于测试代码的实际机器学习部分是否按预期工作,我们可以编写功能测试以验证模型的指标(如准确性、精确度等)是否高于我们预期的阈值。换句话说,这些测试验证模型是否按照我们的预期运行(因此得名功能测试)。以下是一个示例:

import unittest

from sklearn.metrics import precision_score, recall_score

from src.train import prepare_data_and_train_model

class TestModelMetrics(unittest.TestCase):

def test_model_precision_score_should_be_above_threshold(self):

model, X_test, Y_test = prepare_data_and_train_model()

Y_pred = model.predict(X_test)

precision = precision_score(Y_test, Y_pred)

self.assertGreaterEqual(precision, 0.7)

进行小而频繁的提交

当我们不进行小而频繁的提交时,我们会增加心理负担。当我们在处理当前问题时,早期的更改仍显示为未提交,这在视觉上和潜意识中都造成了干扰,使我们更难以专注于当前问题。

例如,请看下面的第一张和第二张图片。你能找出我们正在处理哪个函数吗?哪张图片让你更容易理解?

当我们进行小而频繁的提交时,我们会获得以下好处:

-

减少视觉干扰和认知负担。

-

如果代码已经被提交,我们不必担心意外地破坏工作中的代码。

-

除了红-绿-重构方法,我们还可以使用红-红-红-回退方法。如果我们不小心破坏了什么,我们可以轻松回退到最新提交,然后重试。这可以避免我们在解决关键问题时,浪费时间撤销意外创建的问题。

那么,提交的大小要小到什么程度才算足够小呢?当存在一组逻辑相关的更改并且测试通过时,尝试进行提交。一种技巧是留意提交信息中的“and”一词,例如,“添加探索性数据分析并将句子拆分为标记并重构模型训练代码。”这三项更改可以拆分成三次逻辑提交。在这种情况下,你可以使用git add --patch将代码分批暂存以便提交。

结论

“我不是一个伟大的程序员;我只是一个有着良好习惯的好程序员。” - Kent Beck,极限编程和 xUnit 测试框架的先驱

这些习惯帮助我们管理机器学习和数据科学项目中的复杂性。我们希望这些习惯也能帮助你在数据项目中变得更加灵活和高效。

简介: David在 ThoughtWorks 工作了 2 年,在决定转行做软件工程之前,他在政府部门从事非技术性工作。在过去两年中,他参与了多个机器学习的副项目,包括股票市场价格预测、欺诈保护以及啤酒数量图像识别。他还是 ThoughtWorks JumpStart!计划的培训师。David 对敏捷软件开发和知识共享充满热情。在空闲时间,他喜欢和家人一起度过时光,作为一个新晋爸爸。

相关:

我们的前三推荐课程

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。