KDNuggets-博客中文翻译-十五-

KDNuggets 博客中文翻译(十五)

原文:KDNuggets

揭示糟糕科学

图片由 LoganArt 在 Pixabay 提供

许多广泛接受的科学理论后来被证明是错误的,正如这篇简短的 文章 所展示的。这怎么会发生?

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 在 IT 支持中为你的组织提供帮助

3. 谷歌 IT 支持专业证书 - 在 IT 支持中为你的组织提供帮助

首先,科学仍在发展中,我们对许多基本现象的理解仍远未完成。另一个原因是,科学——至少在我们的星球上——是由人类进行的,而我们人类有许多缺陷。各种偏见、资金冲突、自我膨胀和纯粹的无能是一些可能破坏任何研究的非常人性化的因素。

科学家有时正确,但报道这些的记者却错误。很少有记者曾做过科学家,大多数人接受的科学培训与他们的读者或观众大致相同。然而,公平地说,许多科学家自己也在研究方法和统计学方面的课程有限,正如我在 统计错误即使科学家也会犯 中指出的那样。**

同行评审有时像是朋友评审,而且,一些研究在完全没有经过同行评审的情况下就登上了头版。很少有科学出版物的编辑和审稿人是统计学家——统计学家不多,他们有自己的工作。在“较软”的领域,标准可能甚至更不严格。

零假设显著性测试(NHST)多年来遭到统计学家的严厉批评。许多人会记得这来自于初级统计学课程。虽然表面上看似简单,NHST 被广泛误解和滥用。

《美国统计学家》已专门为此及相关主题刊出了一个开放获取的专刊。简而言之,一个重要的问题是,p值大于 0.05 的发现比统计显著的发现更不容易被接受发表,甚至不容易提交发表。这被称为出版偏倚或文件抽屉问题。

然而,“负面发现”与统计显著结果同样重要,而且许多潜在的重要研究结果显然从未公之于众。由于知识的积累是科学的本质,这是一个严重的问题,直到最近才开始引起许多统计学家长期以来认为应当重视的关注。统计显著性与决策显著性也不完全相同。

另一个原因是,小样本研究在许多领域中很常见。尽管一个庞大的样本并不自动意味着结果可以被信任,但当样本较小时,效应量的估计在研究之间变异性更大。相反,当样本量较大时, trivial 的效应量可能具有统计显著性,并且在某些情况下,获得广泛的宣传。

非实验性(观察性)研究在许多学科中普遍存在,并且在大数据时代似乎正经历繁荣。虽然随机实验并不总是可行或伦理的,但这并不意味着非实验性研究就足够。

我在倾向得分:它们是什么以及它们的作用和元分析与市场研究**中总结了一些这些问题。简而言之,非实验性研究中的效应量估计通常变异性更大——可靠性较低。再次回到出版偏倚...

每年在世界各地进行成千上万的研究,这意味着即使标准普遍较高,也会有大量的劣质科学。科学是艰难的。以下是需要注意的一些问题。

横断面数据与纵向数据。原因应当先于其效果,在观察性研究中,当数据仅涉及一个时间点时,通常无法确定这种排序。然而,当数据在多个时间点收集时,我们通常可以确认假设中的原因是否确实在其假设的效果之前出现。一般来说,纵向数据允许更广泛的分析,这可以帮助我们更好地理解变量之间的相互关系。

生态研究 通常存在问题,因为研究的单位是群体,因此不能对个体研究参与者做出推断。研究人员通常没有关于个体水平的暴露和疾病的数据。

非概率抽样。 推断统计学假设使用概率抽样。当数据来源于便利样本或其他非概率样本时,很难确定结果可以推广到哪个总体。

WEIRD参与者。 在一些领域,如流行病学和药理学,参与者可能甚至不是人类。例如,从老鼠到人类的推广需要许多假设。

线性无阈值模型 (LNT). 这是一种高度简化的剂量反应模型,受到了严厉的批评。在商业中,通常假设“剂量”(例如顾客体验的各个方面)与“反应”(例如对公司的总体满意度)之间存在线性(直线)关系。这通常是合理的,但并非总是如此,在毒理学等领域中,这种假设可能没有意义,因为已知非常小的剂量通常没有效果,并且超出某个水平后,毒性不再随剂量增加。

不适当的统计模型。 这可能很难检测,但可以说在任何学科中,统计使用不当并不少见。适当的统计模型也可能以不恰当的方式使用。

不充分的协变量控制。 这在观察性研究中尤为常见,其中可能重要的背景变量并未始终得到调整。在一些研究中,连续变量如年龄被分组为宽泛的类别,导致信息丢失。因此,声称该变量已经“控制”可能是有问题的。

遗漏变量。 重要变量可能未能提供,或者出于某种原因被排除在分析之外。许多研究因此受到批评。

未考虑其他解释。 多种原因可能导致相同的效果,而未考虑竞争解释会削弱研究的可信度。与遗漏变量类似,这可能是偶然的,也可能是故意的。

未对多重比较进行校正。 同一数据上的统计检验彼此并不独立。因此,如果在四种类型的患者中进行成对比较,在标准的 0.05 alpha 水平下需要进行六次检验,而这些比较的整体置信水平大约为 75%,而非 95%。

使用替代变量作为因变量。 通常,无法直接测量结果,研究人员必须依赖替代变量。医疗研究中的一个例子是使用测试结果来指示某种特定疾病的存在。虽然使用替代变量不一定是缺陷,但在一些研究中可能会出现问题。

未对测量误差进行调整。 在大多数研究中,变量是带有误差的。在某些情况下,如人格评估或能力测量,误差可能很大。一般来说,测量误差会削弱相关性,因此x 和 y 之间的关系可能比基于相关性或其他关联测量的结果更强。困扰调查的测量误差之一是回应风格,例如,当被调查者倾向于使用量表的高端而不管所评估的内容。

开采直到发现 似乎是一些研究人员的座右铭,这是被称为HARKing的一种特别危险的失职形式的表现。Stuff Happens对这个复杂的主题进行了更多阐述。

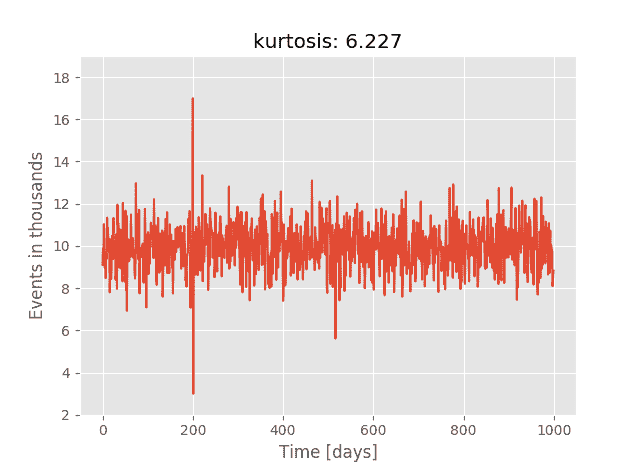

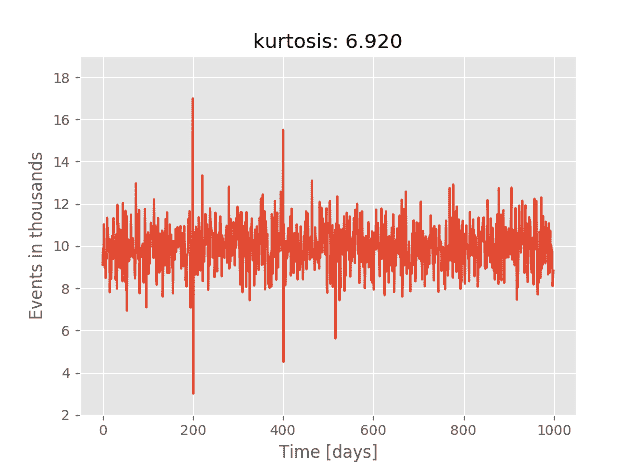

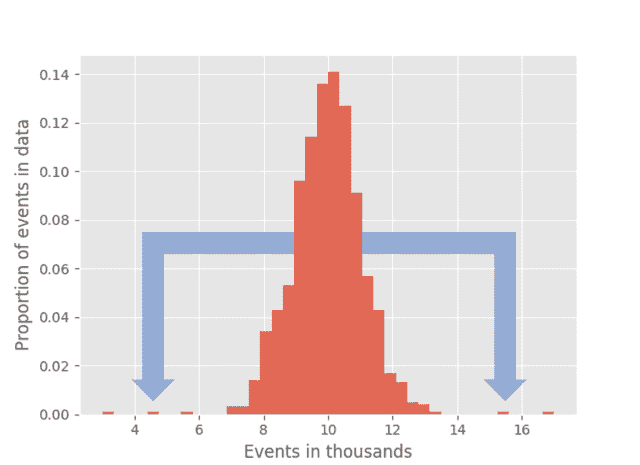

回归均值 是一种统计现象,可能使重复数据中的自然变异看起来像是真实的变化。当异常大的或异常小的测量值往往会被接近均值的测量值所跟随时,就会发生这种现象。这种现象可能使教育项目或疗法看起来有效,但实际上并非如此。

"影响人数百万。" 这样的标题可能掩盖了统计上为零的小效应。我们需要考虑这些令人惊恐的数字是基于何种基数计算得出的。

使用新的未经检验的方法论。 新的并不总是更好,经过验证的方法论通常比那些尚未经过独立研究人员和统计学家检验的创新方法更值得信赖。

与其他研究的冲突。 一个有争议的发现可能打破了现有的范式,但也可能表明方法论不当或统计使用不当。

资助冲突 可能会削弱研究的可信度,但对资助冲突的指控本身也可能以可疑的方式获得资助。

生态谬误、辛普森悖论 和 伯克森偏差 是其他需要注意的问题。

流行的名言“谎言、该死的谎言和统计数据”的起源不确定,尽管它被归因于马克·吐温、迪斯雷利以及其他几位。不过,不论其来源如何,它并不指现代统计学领域,当时统计学刚刚开始出现。很可能,它涉及的是官方数据,这也是统计学最初的含义。以下是一些用统计数据说谎的方法。

通过重复建立“真相” 是一种非常常见的策略,约瑟夫·戈培尔——一个著名的欺骗专家——明确推荐了这种方法。很少有人仔细审视主张,更少有人会记住同一个人或组织过去做出的错误预测。

稻草人论证和“反驳”是常见的,就像人身攻击一样,这些都特别有利于那些自己有事情要隐藏的人。

以例外概括和使稀有事件看似典型也是常用的策略。将可能的与可信的、可信的与事实混淆,是这一主题的一个变种。

还有挑选数据、模型和先前的研究。一种挑选数据的形式是仅选择支持自己观点的时间序列的一部分。“调整”数据虽然比直接伪造要逊色,但也是一种相关技术。巧妙的、尽管值得怀疑的数据或统计模型解释是另两种不道德的武器。

计算机模拟 有时被误称为实验,并且模拟数据微妙地被当作经验数据。现在,制造一个计算机模型来“证明”自己的理论比以往任何时候都容易。

社会本质上是等级化的,而人类倾向于二元思维,因此权威往往被引用,科学或政策问题的辩论常常呈现出好人对坏人的色彩。误传权威的真实观点也并不罕见。

我们还常常在频率、百分比和比例之间挣扎,这一点我们需要非常注意。例如,我们可能会读到如果政策制定者做了某事或不做某事,可能会影响到数百万人。然而,仔细阅读所引用的证据可能会揭示一个非常微弱的效应大小,其置信区间或可信区间可能与零重叠。将一个微小的比例乘以数亿或数十亿人会得出一个令人恐惧的数字。另外,请记住,“50% 增加”可能意味着从 0.001 到 0.0015。

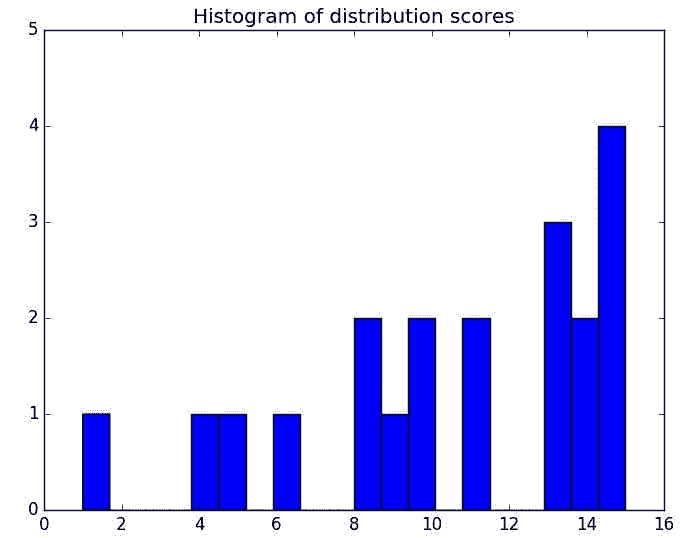

我还没有提到数据可视化,它们很容易欺骗我们。许多人被误导相信随机意味着均匀,实际上,均匀分布的数据很可能并非随机。此外,还有我称之为打地鼠的现象,迅速列举一个又一个可疑的主张而不回应对任何一个主张的批评。

统计思维,在科学中至关重要,并非天生具备。没有人生来就是统计学家,教育课程中经常对统计学有所忽略。

总结来说,严谨的科学是具有挑战性的,任何研究都可以受到质疑。欺骗是人类本性的一部分,科学家、人类、记者和政策制定者都是如此。我们也是如此,必须小心,不要仅仅因为研究令人兴奋、让我们感到安慰或符合我们的信念就信任它。

凯文·格雷 是 Cannon Gray 的总裁,该公司是一家市场科学和分析咨询公司。他在尼尔森、坎塔尔、麦肯和 TIAA-CREF 拥有超过 30 年的市场研究经验。

更多相关话题

让决策树在现实世界中变得清晰

原文:

www.kdnuggets.com/demystifying-decision-trees-for-the-real-world

作者提供的图片

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

决策树将复杂的决策分解为简单、易于遵循的阶段,因此类似于人类大脑的功能。

在数据科学中,这些强大的工具被广泛应用于数据分析和决策指导。

在这篇文章中,我将介绍决策树的运作方式,提供现实世界的例子,并给出一些提升决策树效果的建议。

决策树的结构

从根本上说,决策树是简单明了的工具。它们将复杂的选项分解为更简单的顺序选择,从而反映了人类的决策过程。现在让我们深入探讨构成决策树的主要元素。

节点、分支和叶子

三个基本组件定义了一个决策树:叶子、分支和节点。每一个都是决策过程中的绝对关键。

-

节点:它们是决策点,通过这些点,树根据输入数据做出决定。在表示所有数据时,根节点是起始点。

-

分支:它们关联决策的结果并连接节点。每个分支对应一个潜在的结果或决策节点的值。

-

叶子:决策树的终点是叶子,有时称为叶节点。每个叶节点提供一个特定的结果或标签;它们反映最后的选择或分类。

概念示例

假设你在根据温度决定是否外出。“下雨吗?”根节点会问。如果是的话,你可能会找到一条指向“带伞”的分支。但这种情况不应该发生;另一条分支可以说“戴太阳镜”。

这些结构使得决策树易于解读和可视化,因此在各个领域都很受欢迎。

现实世界示例:贷款审批冒险

想象一下:你是格林戈茨银行的一名巫师,决定谁能获得贷款购买他们的新扫帚。

-

根节点:“他们的信用评分是否很神奇?”

-

如果是 → 分支到“批准,快得比你说魁地奇还快!”

-

如果否 → 分支到“检查他们的精灵金币储备。”

-

如果高 →,“批准,但要留意他们。”

-

如果低 → “拒绝,速度比 Nimbus 2000 还快。”

-

import pandas as pd

from sklearn.tree import DecisionTreeClassifier

from sklearn import tree

import matplotlib.pyplot as plt

data = {

'Credit_Score': [700, 650, 600, 580, 720],

'Income': [50000, 45000, 40000, 38000, 52000],

'Approved': ['Yes', 'No', 'No', 'No', 'Yes']

}

df = pd.DataFrame(data)

X = df[['Credit_Score', 'Income']]

y = df['Approved']

clf = DecisionTreeClassifier()

clf = clf.fit(X, y)

plt.figure(figsize=(10, 8))

tree.plot_tree(clf, feature_names=['Credit_Score', 'Income'], class_names=['No', 'Yes'], filled=True)

plt.show()

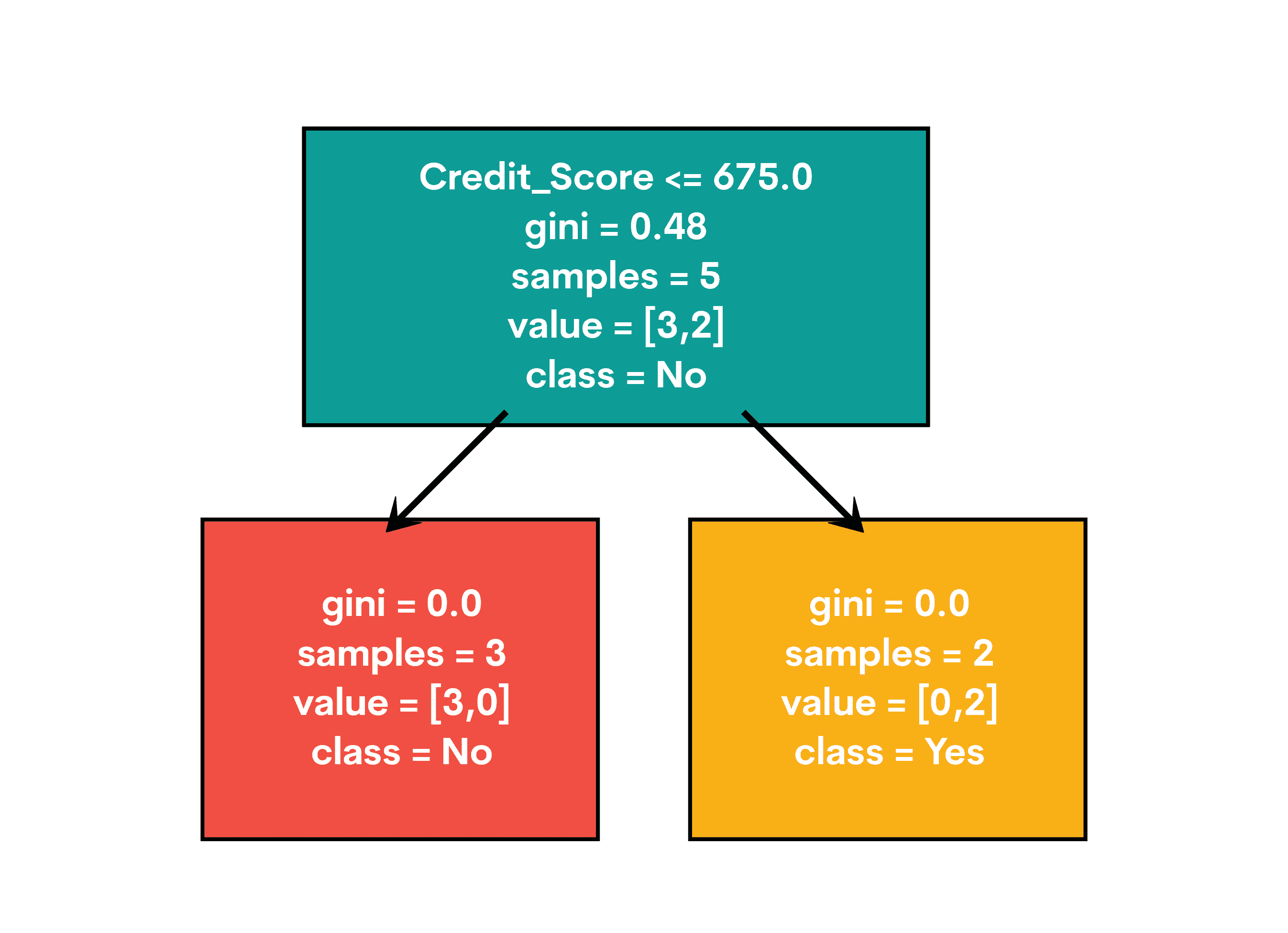

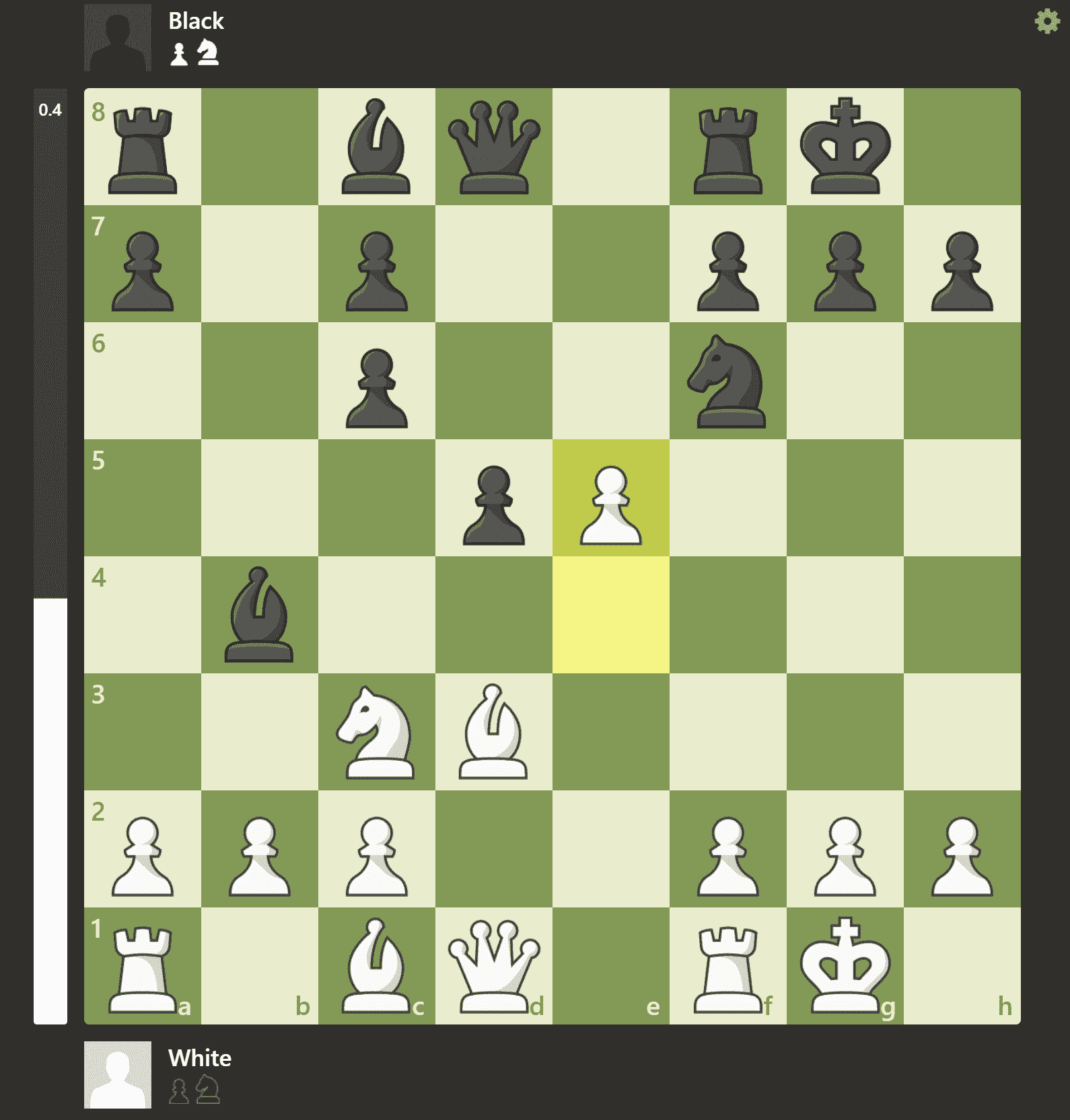

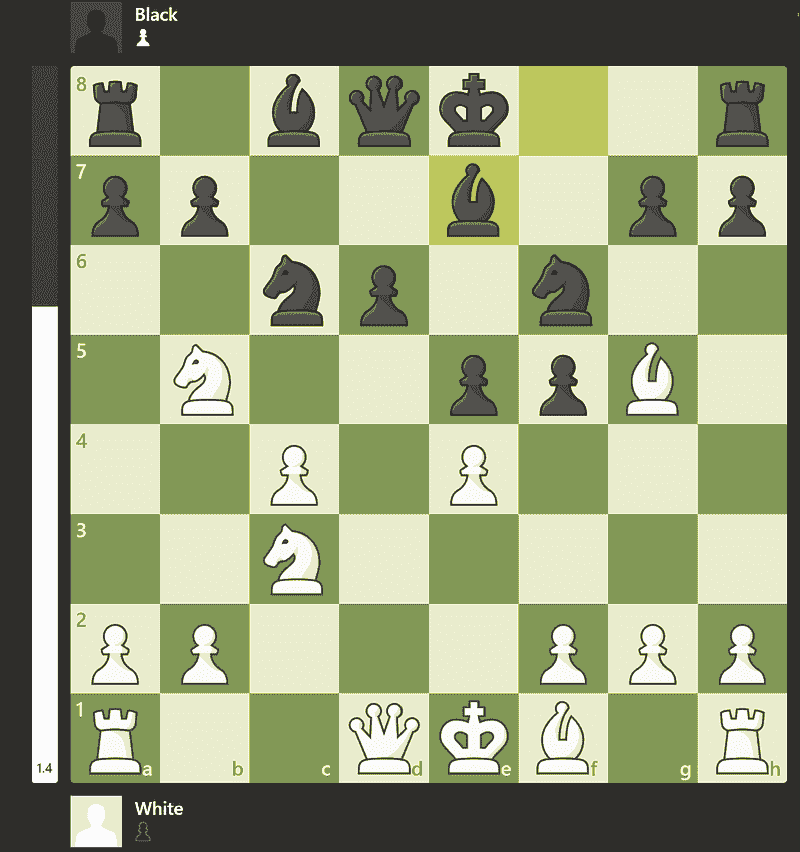

这是输出结果。

当你运行这个魔法时,你会看到一棵树出现!它就像贷款批准的掠夺者地图:

当你运行这个魔法时,你会看到一棵树出现!它就像贷款批准的掠夺者地图:

-

根节点在 Credit_Score 上进行划分

-

如果小于等于 675,我们向左前进

-

如果大于 675,我们向右行进

-

叶子节点显示我们的最终决定:“是”表示批准,“否”表示拒绝

太棒了!你刚刚创建了一个决策制定的水晶球!

思维挑战:如果你的生活是一个决策树,根节点问题会是什么?“今天早上喝咖啡了吗?”可能会引出一些有趣的分支!

决策树:在分支背后

决策树的功能类似于流程图或树状结构,通过一系列的决策点来工作。它们从将数据集划分为更小的部分开始,然后建立一个决策树来配合它。我们应该关注这些树如何处理数据划分和不同变量的方式。

划分标准:基尼不纯度和信息增益

选择最佳质量来划分数据是构建决策树的主要目标。可以通过信息增益和基尼不纯度提供的标准来确定这个过程。

-

基尼不纯度:想象一下你在玩猜测游戏。如果你随机选择一个标签,你会经常出错吗?这就是基尼不纯度所衡量的。基尼系数越低,我们的猜测越准确,树也就越快乐。

-

信息增益:你可以将其比作神秘故事中的“啊哈!”时刻。信息增益衡量提示(属性)在解决案件中所起的帮助程度。更大的“啊哈!”意味着更多的增益,这意味着树更加兴奋!

要预测客户是否会从你的数据集中购买某个产品,你可以从基本的人口统计信息开始,比如年龄、收入和购买历史。这个方法考虑了所有这些因素,并找出能够将买家和其他人区分开的因素。

处理连续数据和分类数据

我们的树探员可以调查所有类型的信息。

对于容易改变的特征,如年龄或收入,树设置了一个测速点。“30 岁以上的人,请走这边!”

对于分类数据,如性别或产品类型,这更像是一种排列。“智能手机在左边;笔记本电脑在右边!”

现实世界的冷案:客户购买预测器

为了更好地理解决策树的工作原理,我们来看看一个实际的例子:使用客户的年龄和收入来预测他们是否会购买产品。

为了预测人们会买什么,我们将创建一个简单的集合和决策树。

代码的描述

-

我们导入像 pandas 这样的库来处理数据,从 scikit-learn 导入 DecisionTreeClassifier 来构建树,使用 matplotlib 来展示结果。

-

创建数据集:使用年龄、收入和购买状态来制作一个样本数据集。

-

准备特征和目标:目标变量(购买)和特征(年龄、收入)已经设置好。

-

训练模型:利用这些信息设置和训练决策树分类器。

-

查看决策树:最后,我们绘制决策树,以便观察决策过程。

这是代码。

import pandas as pd

from sklearn.tree import DecisionTreeClassifier

from sklearn import tree

import matplotlib.pyplot as plt

data = {

'Age': [25, 45, 35, 50, 23],

'Income': [50000, 100000, 75000, 120000, 60000],

'Purchased': ['No', 'Yes', 'No', 'Yes', 'No']

}

df = pd.DataFrame(data)

X = df[['Age', 'Income']]

y = df['Purchased']

clf = DecisionTreeClassifier()

clf = clf.fit(X, y)

plt.figure(figsize=(10, 8))

tree.plot_tree(clf, feature_names=['Age', 'Income'], class_names=['No', 'Yes'], filled=True)

plt.show()

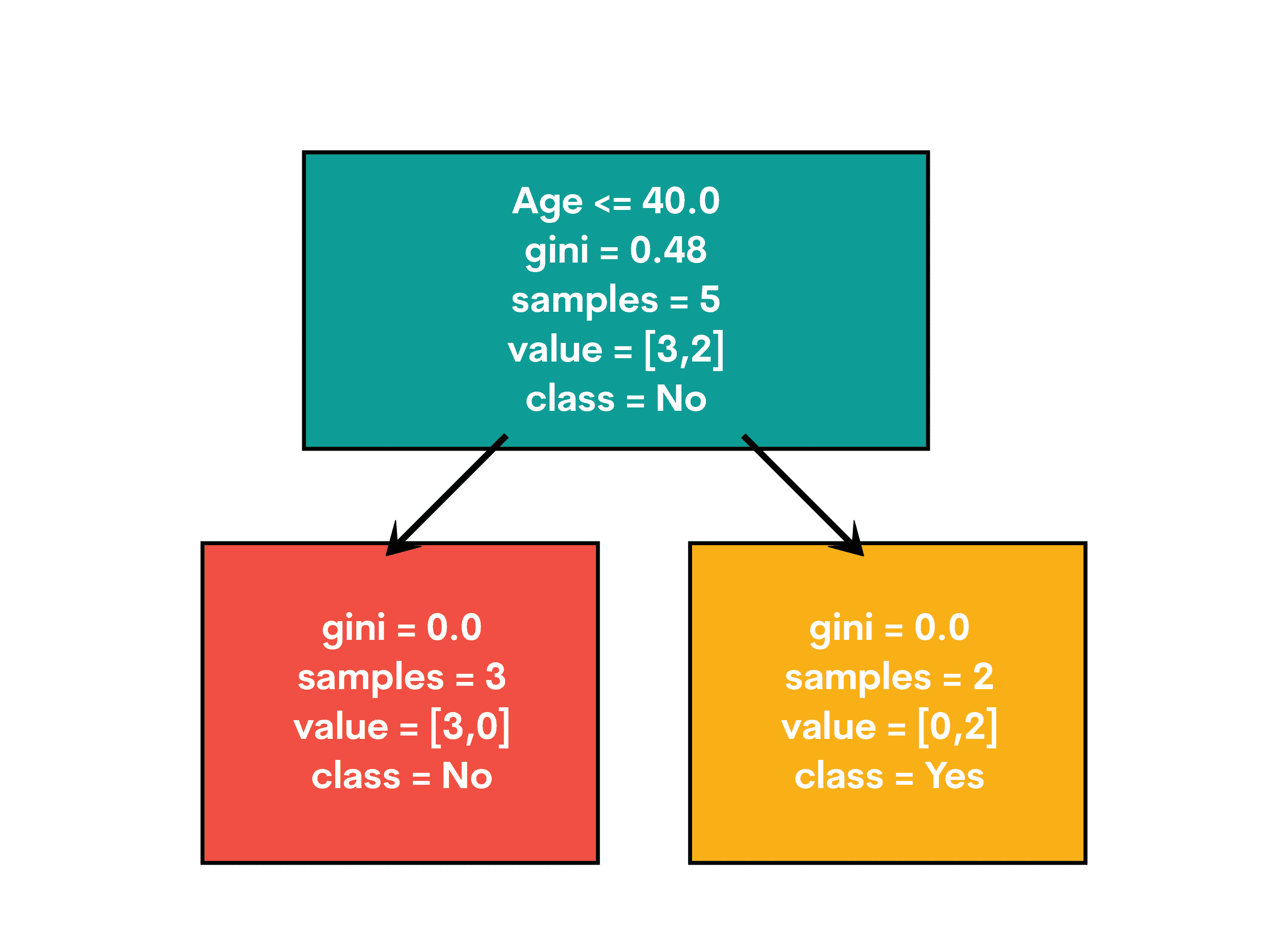

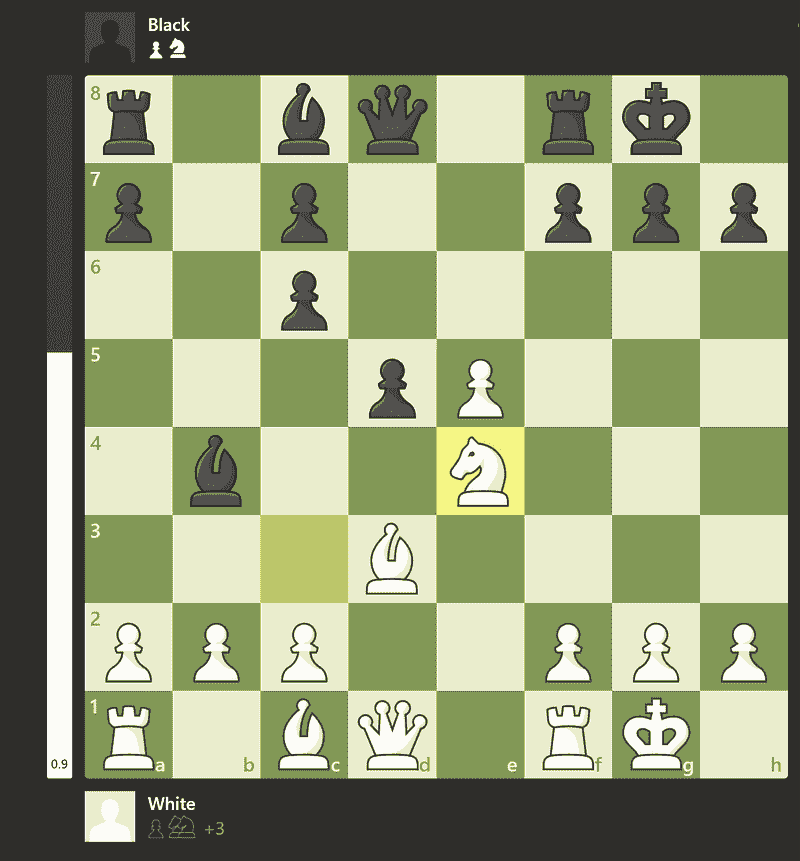

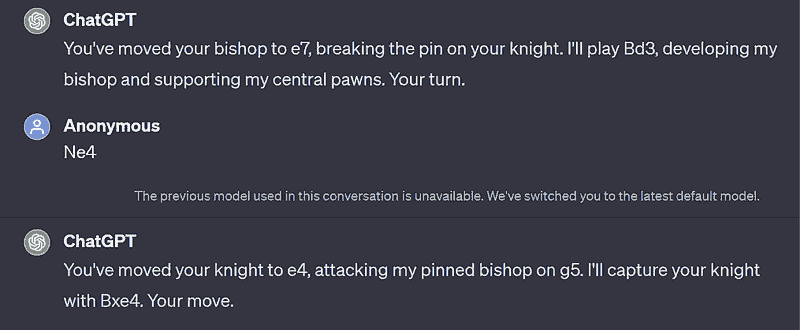

这是输出结果。

最终决策树将展示如何根据年龄和收入来划分树,以确定客户是否可能购买某个产品。每个节点是一个决策点,分支显示不同的结果。最终决策由叶节点展示。

现在,让我们来看看面试在现实世界中的应用吧!

现实世界应用

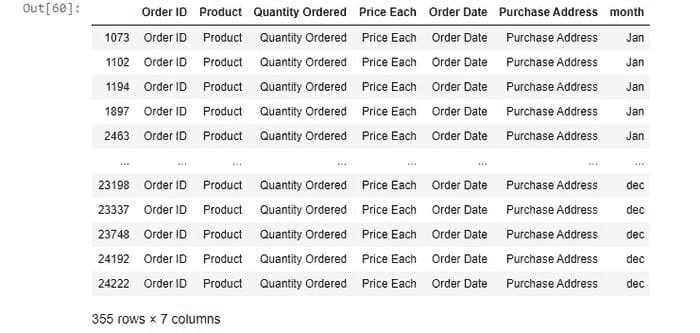

该项目被设计为 Meta(Facebook)数据科学职位的家庭作业,目标是构建一个分类算法,预测 Rotten Tomatoes 上的电影是否标记为“烂片”、“新鲜”或“认证新鲜”。

这是该项目的链接:platform.stratascratch.com/data-projects/rotten-tomatoes-movies-rating-prediction

现在,让我们将解决方案拆解为可编码的步骤。

逐步解决方案

-

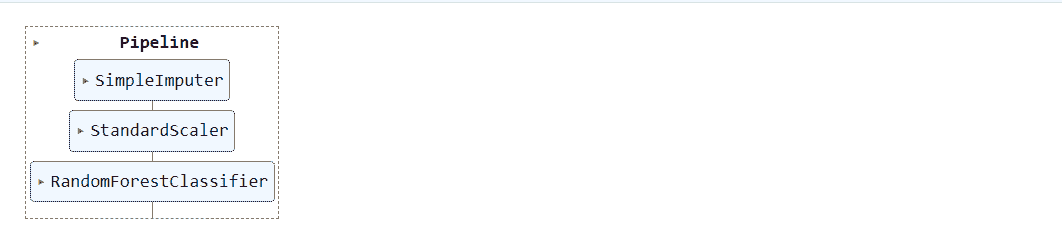

数据准备:我们将根据 rotten_tomatoes_link 列合并两个数据集。这将为我们提供一个包含电影信息和评论的综合数据集。

-

特征选择与工程:我们将选择相关特征并执行必要的转换,包括将类别变量转换为数值变量、处理缺失值和标准化特征值。

-

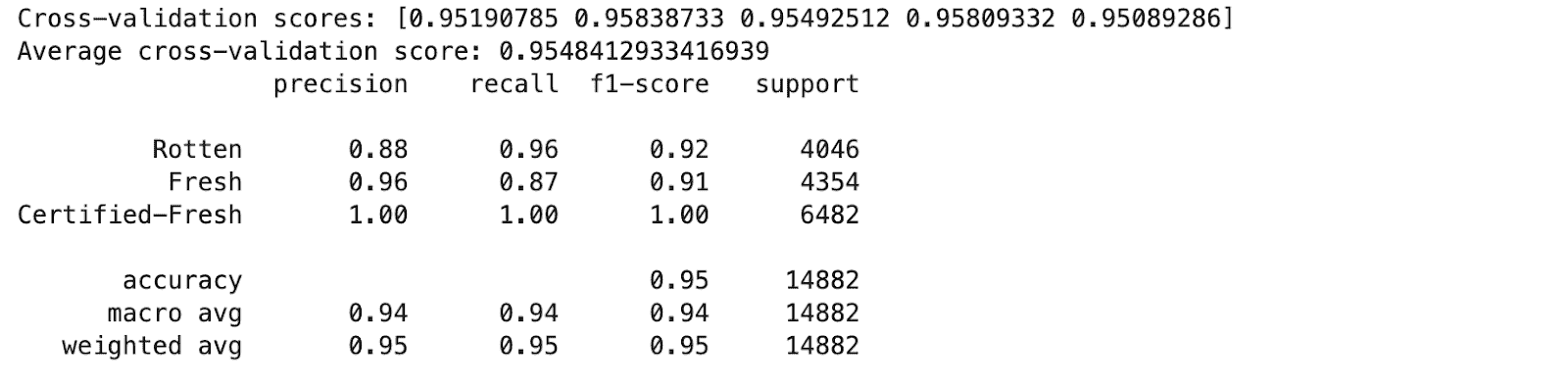

模型训练:我们将对处理后的数据集训练决策树分类器,并使用交叉验证评估模型的稳定性。

-

评估:最后,我们将使用准确率、精确率、召回率和 F1 分数等指标来评估模型的性能。

这是代码。

import pandas as pd

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import classification_report

from sklearn.preprocessing import StandardScaler

movies_df = pd.read_csv('rotten_tomatoes_movies.csv')

reviews_df = pd.read_csv('rotten_tomatoes_critic_reviews_50k.csv')

merged_df = pd.merge(movies_df, reviews_df, on='rotten_tomatoes_link')

features = ['content_rating', 'genres', 'directors', 'runtime', 'tomatometer_rating', 'audience_rating']

target = 'tomatometer_status'

merged_df['content_rating'] = merged_df['content_rating'].astype('category').cat.codes

merged_df['genres'] = merged_df['genres'].astype('category').cat.codes

merged_df['directors'] = merged_df['directors'].astype('category').cat.codes

merged_df = merged_df.dropna(subset=features + [target])

X = merged_df[features]

y = merged_df[target].astype('category').cat.codes

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.3, random_state=42)

clf = DecisionTreeClassifier(max_depth=10, min_samples_split=10, min_samples_leaf=5)

scores = cross_val_score(clf, X_train, y_train, cv=5)

print("Cross-validation scores:", scores)

print("Average cross-validation score:", scores.mean())

clf.fit(X_train, y_train)

y_pred = clf.predict(X_test)

classification_report_output = classification_report(y_test, y_pred, target_names=['Rotten', 'Fresh', 'Certified-Fresh'])

print(classification_report_output)

这是输出结果。

该模型在各类中显示出高准确率和 F1 分数,表明性能良好。让我们来看一下关键要点。

关键要点

-

特征选择对模型性能至关重要。内容评分、类型、导演、时长和评分被证明是有价值的预测因子。

-

决策树分类器有效捕捉了电影数据中的复杂关系。

-

交叉验证确保模型在不同数据子集上的可靠性。

-

在“认证新鲜”类别中表现出色的情况下,值得进一步调查可能的类别不平衡。

-

该模型在预测电影评分和提升如 Rotten Tomatoes 平台的用户体验方面显示出良好的前景。

提升决策树:将你的幼苗成长为参天大树

现在,你已经成长了第一棵决策树。令人印象深刻!但为何止步于此?让我们将这棵幼苗变成一棵森林巨人,让 Groot 也感到嫉妒。准备好增强你的树了吗?让我们深入了解吧!

剪枝技术

剪枝是一种通过去除对目标变量预测能力较小的部分来缩减决策树大小的方法。这有助于特别减少过拟合。

-

前剪枝:通常称为早期停止,这涉及立即停止树的生长。在训练之前,模型会被指定参数,包括最大深度(max_depth)、分裂节点所需的最小样本数(min_samples_split)和叶节点所需的最小样本数(min_samples_leaf)。这防止了树的过度复杂化。

-

后剪枝:这种方法将树生长到最大深度,然后移除那些贡献不大的节点。虽然计算成本比前剪枝更高,但后剪枝可能更有效。

集成方法

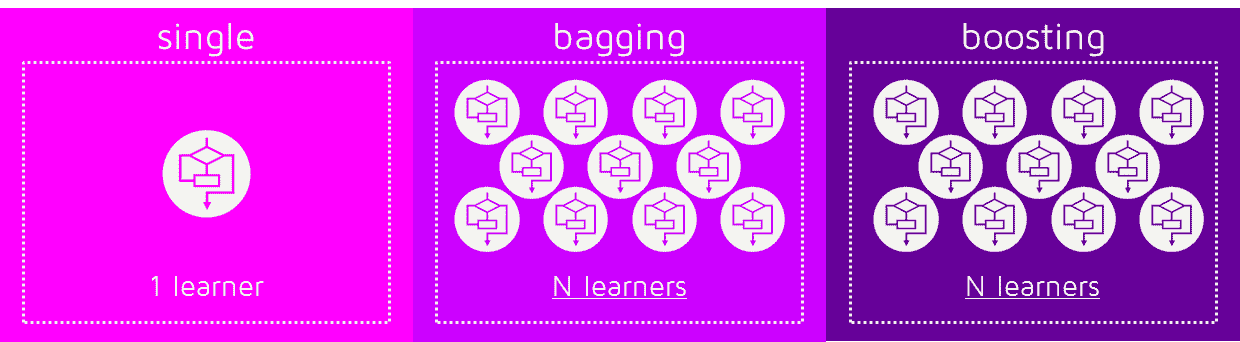

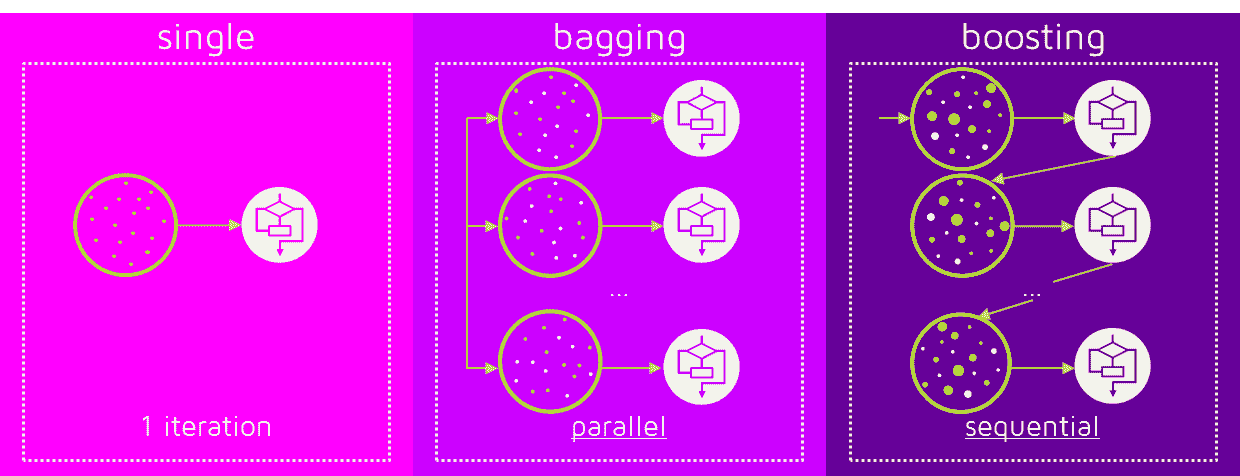

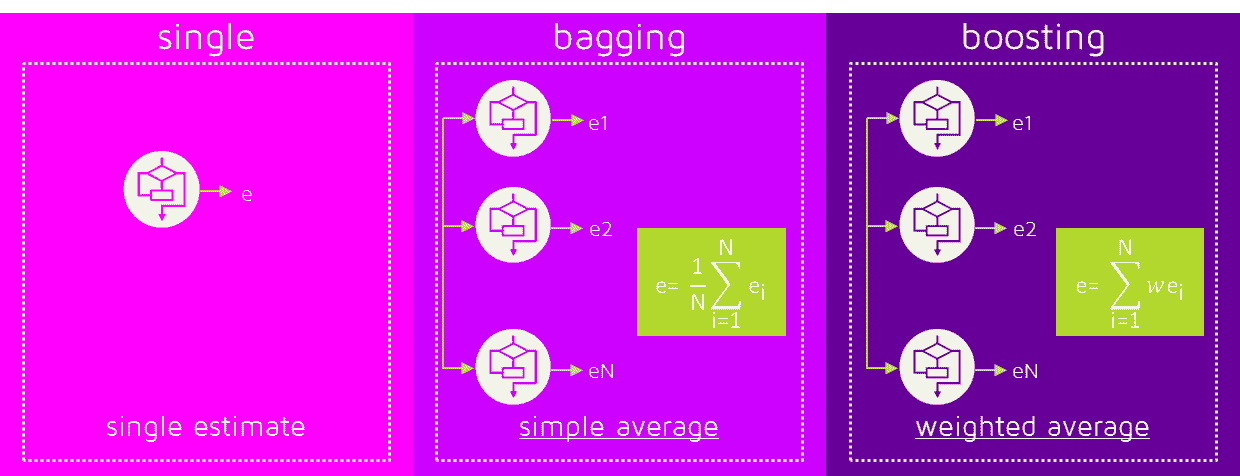

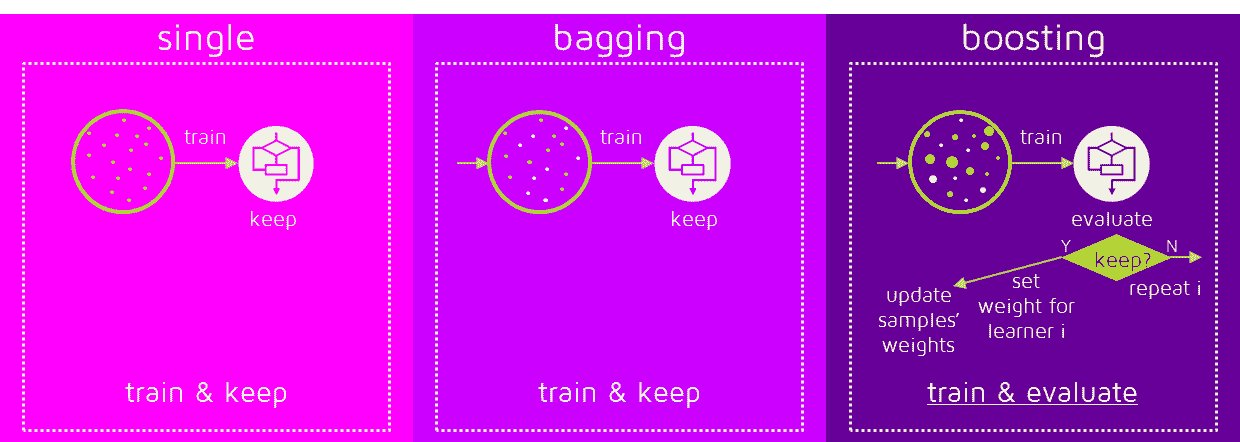

集成技术将多个模型结合以产生超过单一模型的性能。应用于决策树的两种主要集成技术是装袋法和提升法。

-

装袋法(Bootstrap Aggregating):该方法在数据的多个子集(通过有放回抽样生成)上训练多个决策树,然后对它们的预测结果取平均。一个常用的装袋技术是随机森林。它减少了方差并有助于防止过拟合。查看 "决策树与随机森林算法" 深入了解决策树算法及其扩展“随机森林算法”相关的一切。

-

提升:提升方法依次创建树,每棵树都试图修正下一棵树的错误。提升技术在算法中包括 AdaBoost 和梯度提升。这些算法通过强调难以预测的示例,有时能提供更精确的模型。

超参数调优

超参数调优是确定决策树模型的最佳超参数集合以提升其性能的过程。可以通过使用如网格搜索或随机搜索等方法,评估多个超参数组合以找出最佳配置。

结论

在本文中,我们讨论了决策树的结构、工作机制、实际应用以及提升决策树性能的方法。

练习决策树对于掌握其使用和理解其细微差别至关重要。处理实际数据项目也可以提供宝贵的经验,提升解决问题的技能。

内特·罗西迪 是一名数据科学家,专注于产品策略。他还是一位兼职教授,教授分析学,并且是 StrataScratch 的创始人,该平台帮助数据科学家通过来自顶级公司的真实面试问题准备面试。内特撰写关于职业市场的最新趋势,提供面试建议,分享数据科学项目,并涵盖所有 SQL 相关内容。

更多相关主题

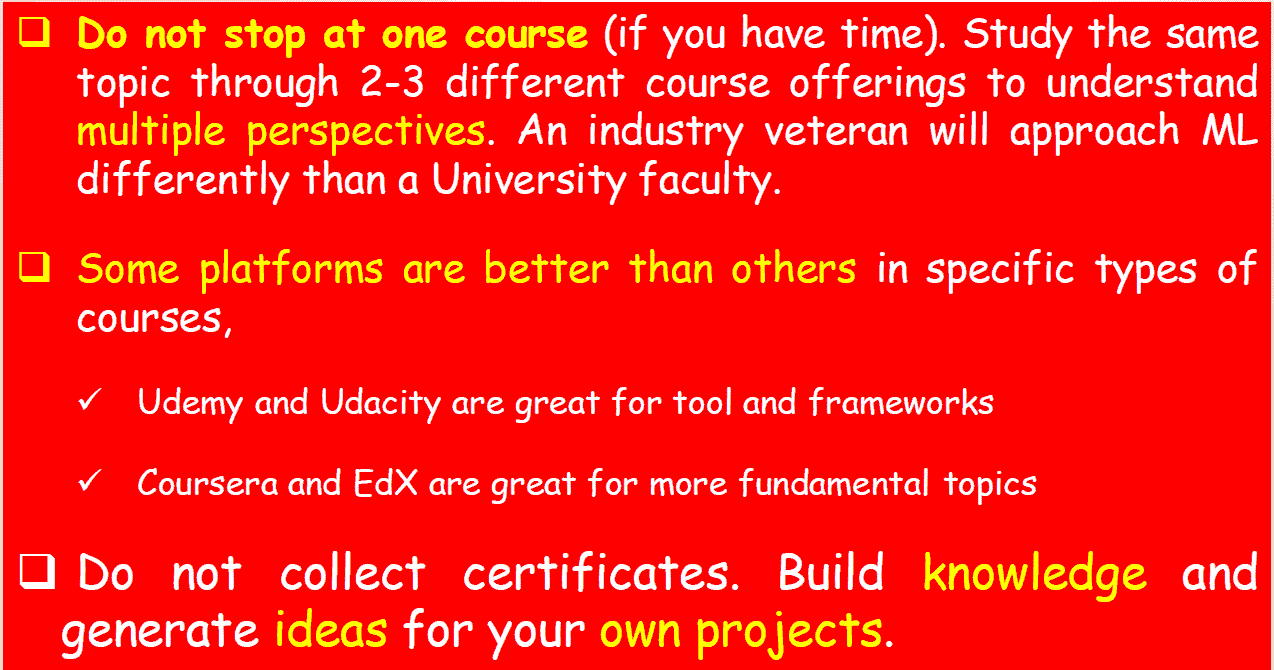

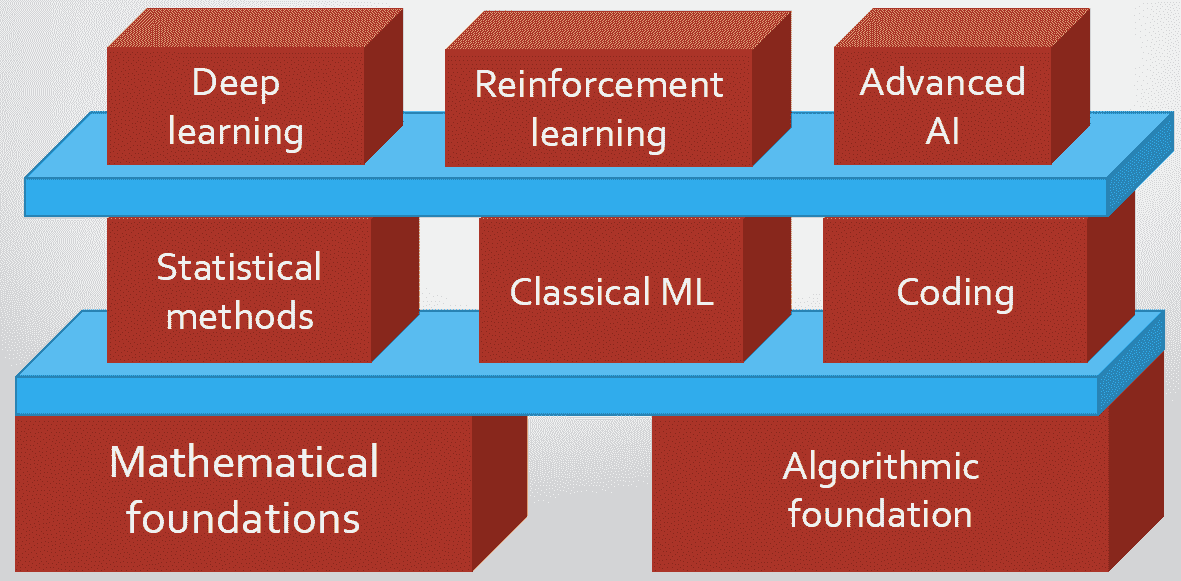

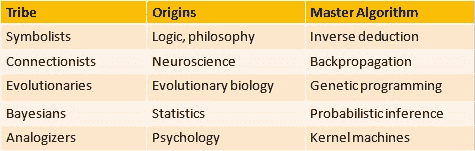

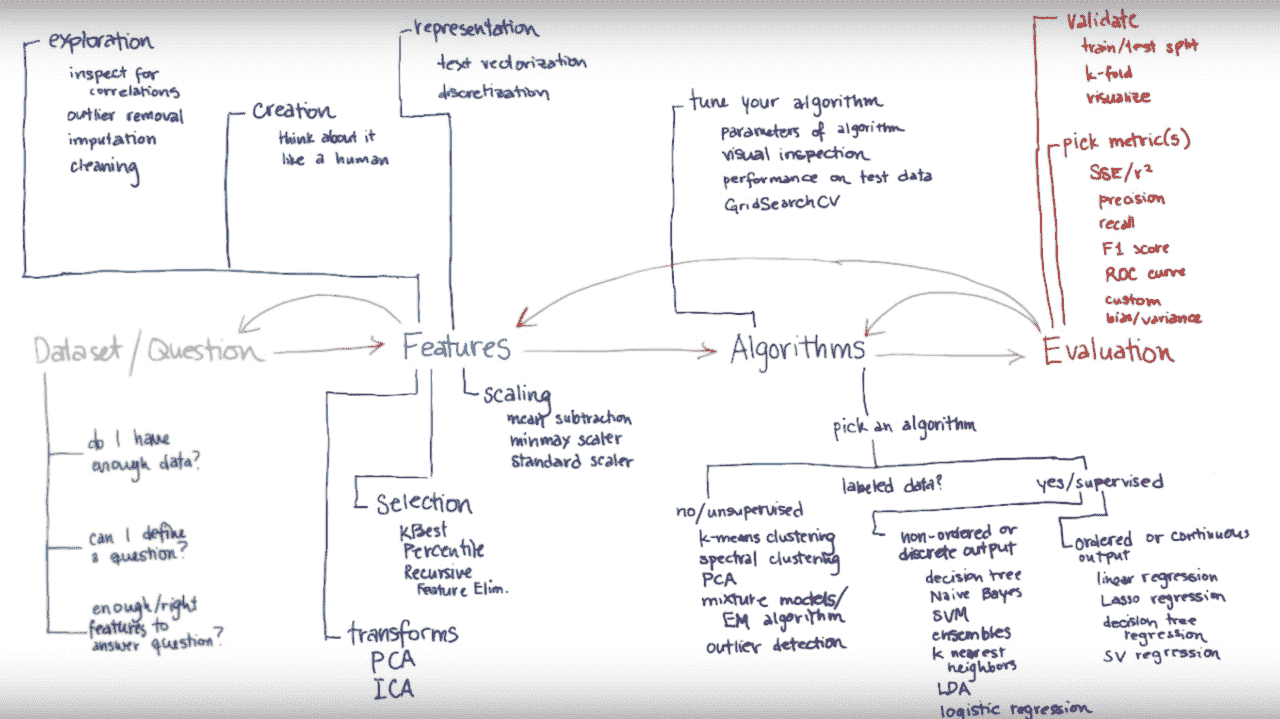

揭示机器学习

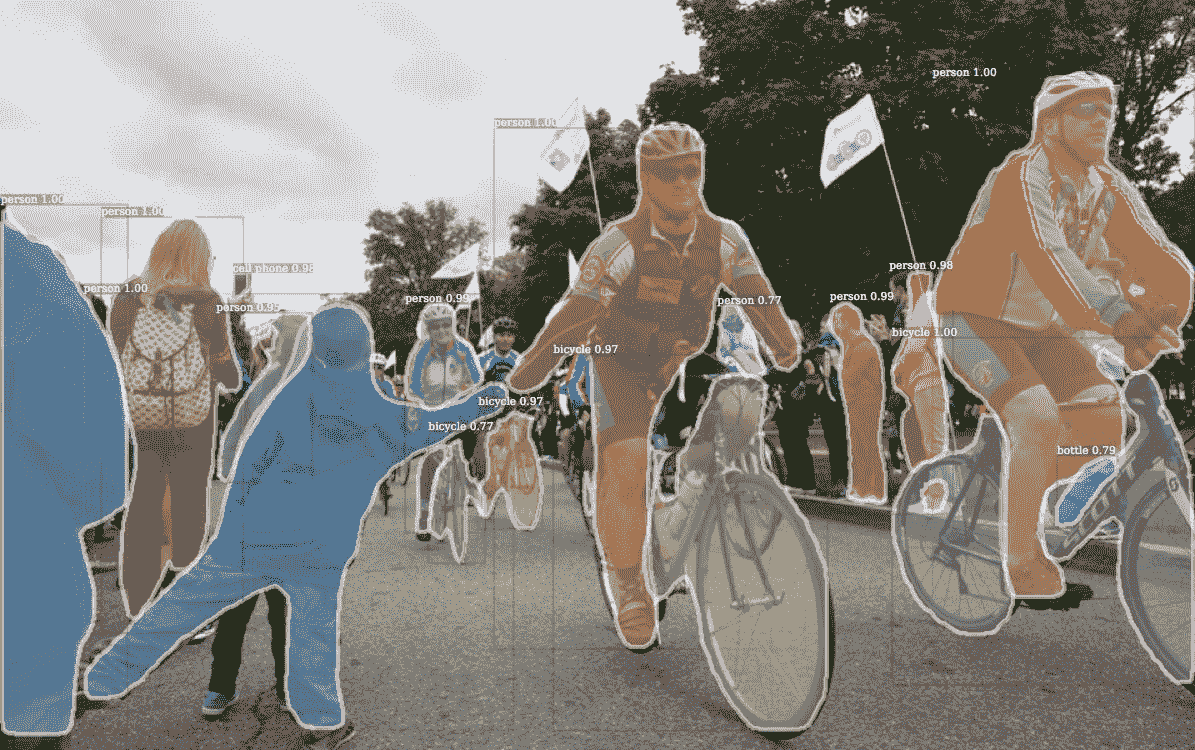

作者提供的图片

传统与变革:回顾与展望

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

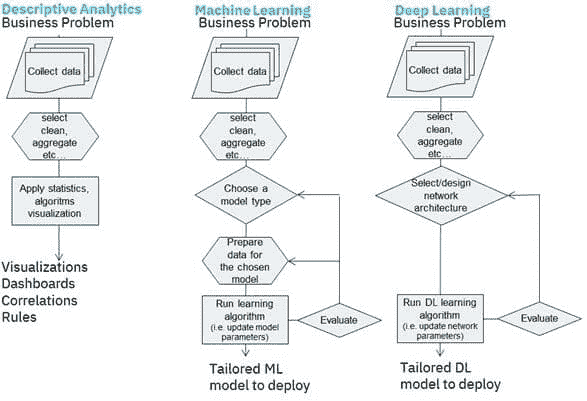

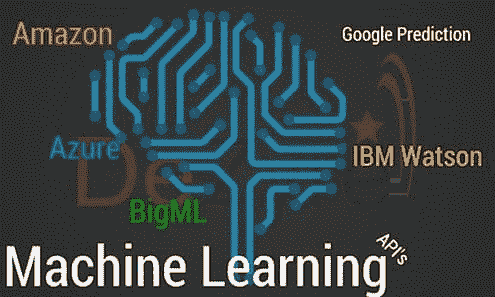

传统上,计算机需要遵循一套明确的指令。例如,如果你想让计算机执行两个数字的加法,你必须逐步详细说明每一个步骤。然而,随着数据的复杂性增加,这种手动逐步指令的方法变得不够用了。

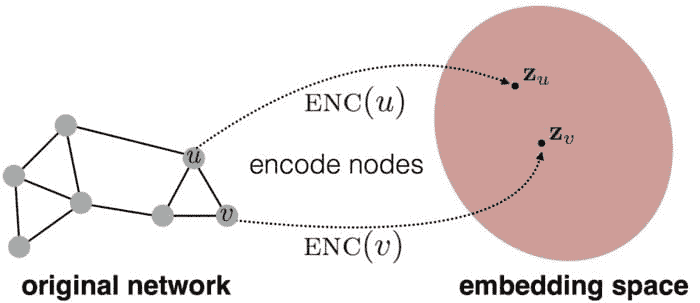

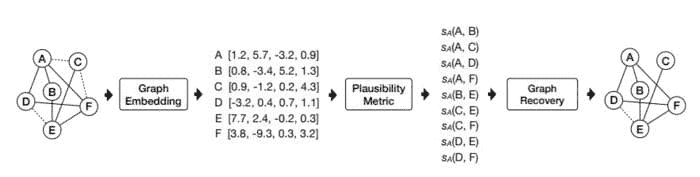

这就是机器学习作为游戏改变者出现的地方。我们希望计算机通过示例学习,就像我们通过经验学习一样。想象一下教一个孩子骑自行车,通过几次示范,然后让他摔倒、自己摸索和学习。这就是机器学习的理念。这项创新不仅改变了行业,还成为了现代世界中不可或缺的必要性。

学习基础知识

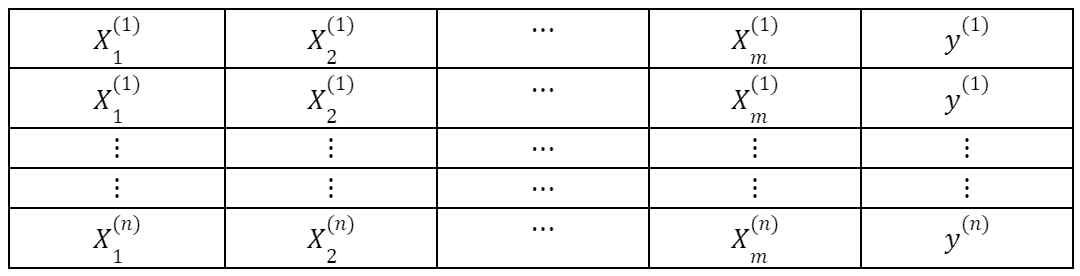

现在我们对“机器学习”这一术语有了基本了解,让我们熟悉一些基本术语:

数据

数据是机器学习的命脉。它指的是计算机用于学习的信息。这些信息可以是数字、图片或计算机可以理解的其他任何内容。进一步分为两个类别:

-

训练数据: 这些数据指的是我们用来教计算机的示例。

-

测试数据: 在学习后,我们使用一些新的、未见过的数据来测试计算机的表现,这些数据被称为测试数据。

标签和特征

想象一下,你在教一个孩子如何区分不同的动物。动物的名称(如狗、猫等)将是标签,而这些动物的特征(如腿的数量、毛发等)则是帮助你识别它们的特征。

模型

这是机器学习过程的结果。它是数据中模式和关系的数学表示。就像在探索新地方后绘制一张地图一样。

机器学习的类型

机器学习有四种主要类型:

监督式机器学习

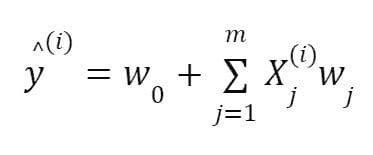

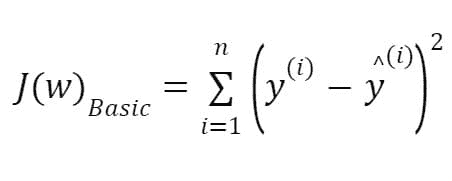

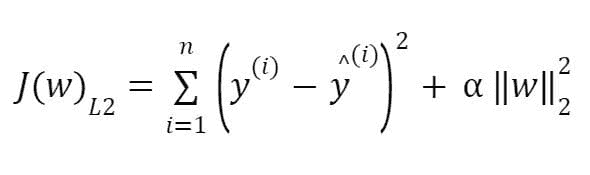

它也被称为指导学习。我们向机器学习算法提供标签数据集,其中正确的输出已知。基于这些示例,它学习数据中的隐藏模式,并可以预测或正确分类新数据。监督学习中的常见类别包括:

-

分类: 将事物分类到不同的类别中,例如将图片分类为猫或狗,将电子邮件分类为垃圾邮件或非垃圾邮件等。

-

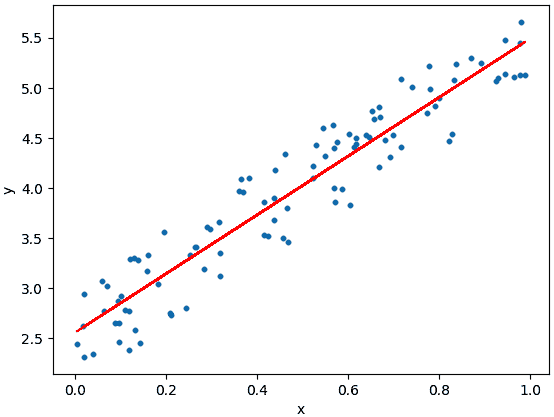

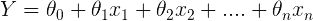

回归: 它涉及预测数值,例如房价、你的 GPA 或基于某些特征的销售数量。

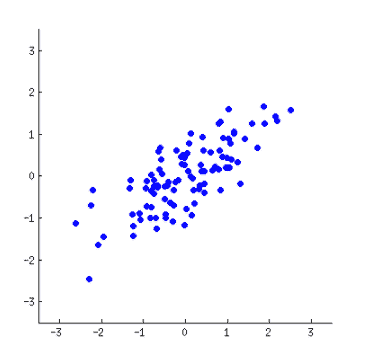

无监督机器学习

这里计算机接收没有标签的数据,没有事先的提示,它会自行探索隐藏的模式。想象一下,你被交给了一盒拼图,没有图案,你的任务是将相似的拼图块分组,以形成完整的图片。聚类是最常见的无监督学习类型,其中相似的数据点被分组到一个组中。例如,我们可以使用聚类将相似的社交媒体帖子分组,用户可以关注他们感兴趣的子主题。

半监督机器学习

半监督学习包含标签数据集和未标签数据集的混合,其中标签数据集作为识别数据模式的指导点。例如,你给厨师提供了一份主要食材的清单,但没有提供完整的食谱。所以虽然他们没有食谱,但有一些可能帮助他们入门的提示。

强化学习

强化学习也称为通过实践学习。它与环境互动,并根据其行为获得奖励或惩罚。随着时间的推移,它学会了最大化奖励并表现良好。想象一下你在训练一只小狗,当它表现良好时你给予积极反馈(奖励),当它表现不佳时你不给予奖励。随着时间的推移,小狗学会了哪些行为会带来奖励,哪些不会。

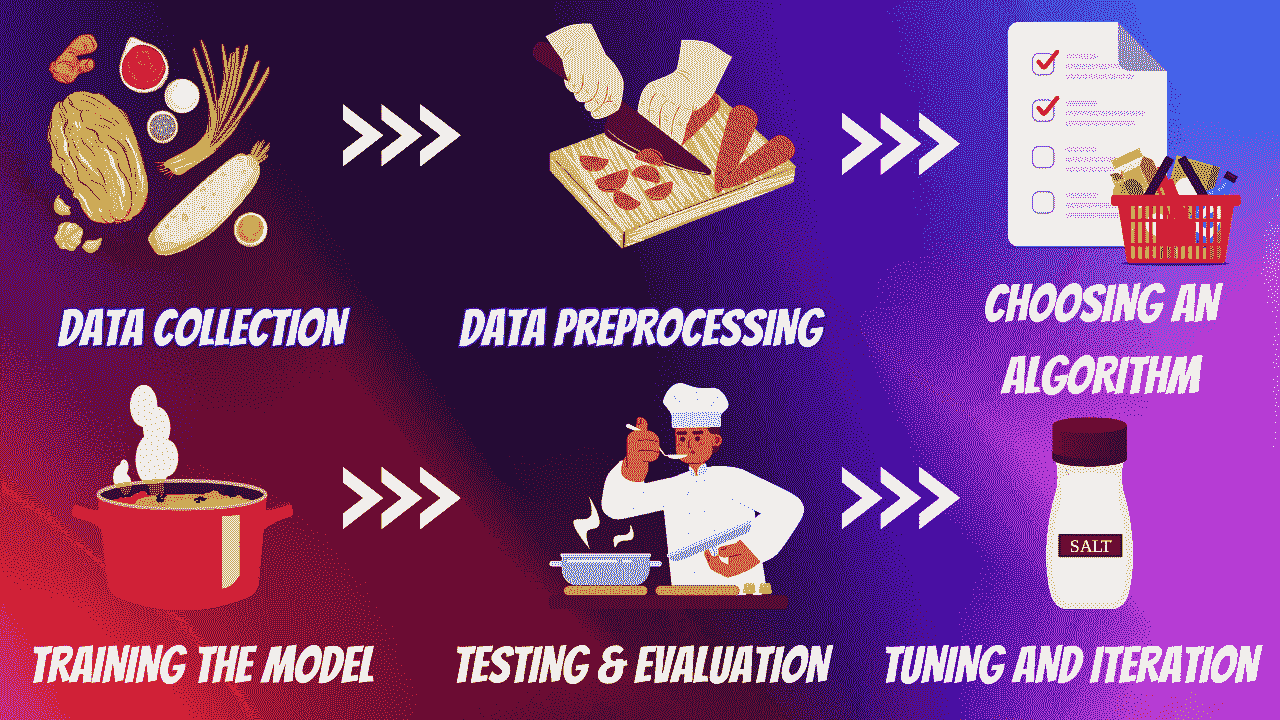

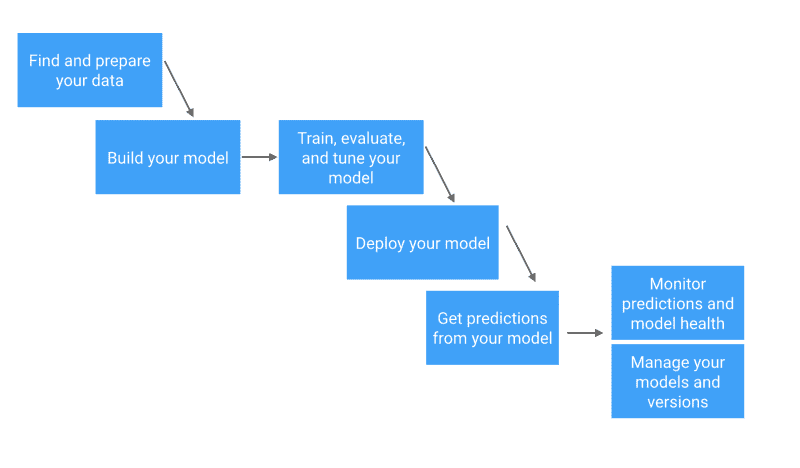

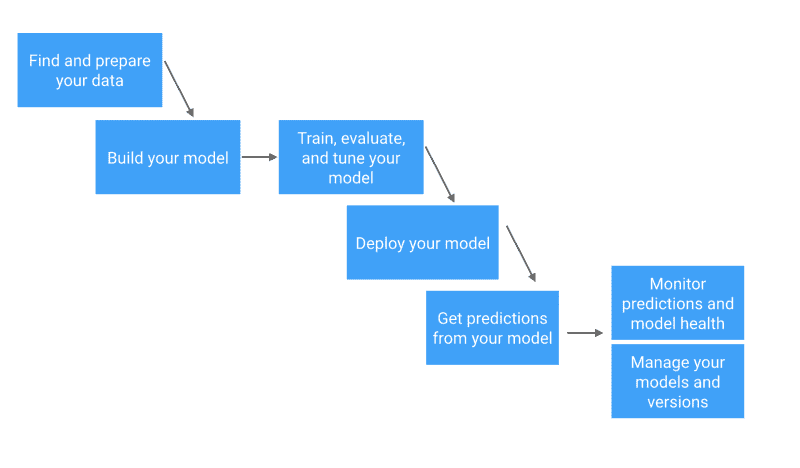

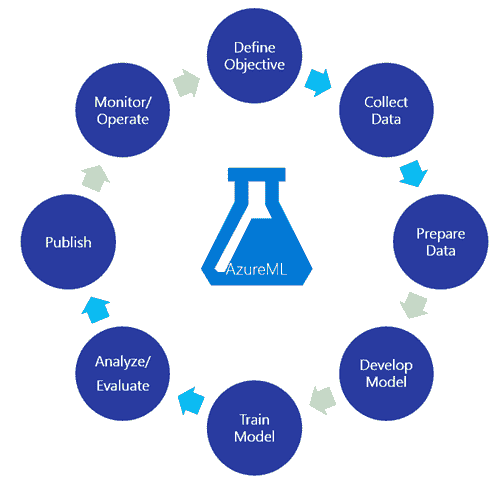

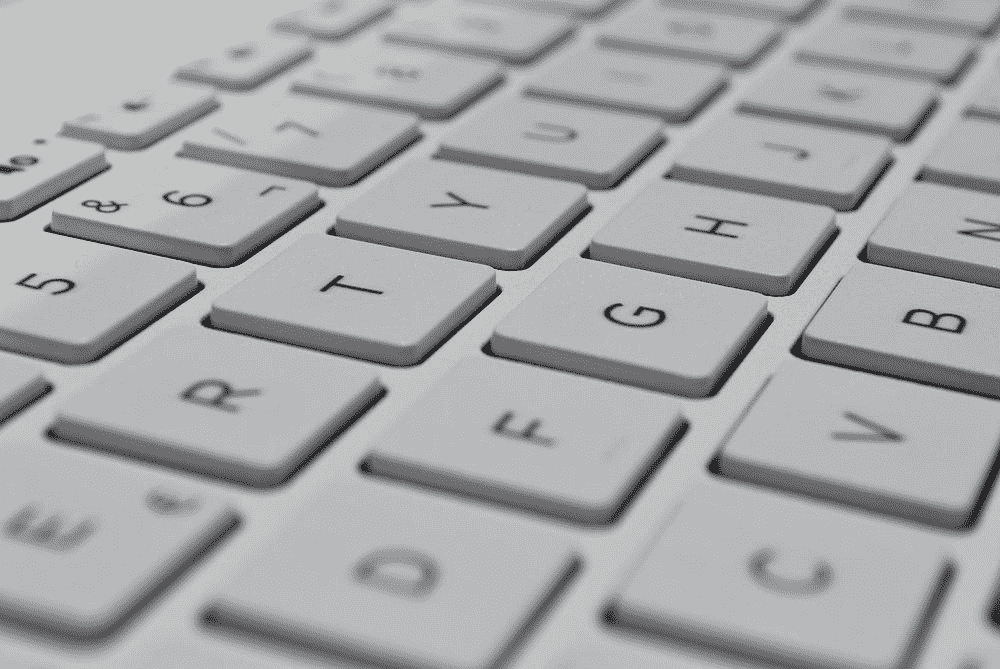

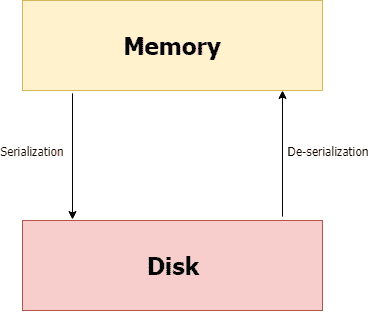

高级机器学习过程

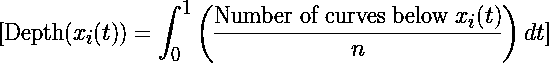

机器学习,就像烹饪艺术一样,拥有将原始、不同的元素转化为深刻见解的神奇能力。就像一位熟练的厨师巧妙地结合各种食材来制作美味的菜肴一样。以下是执行机器学习任务的 6 个基本步骤:

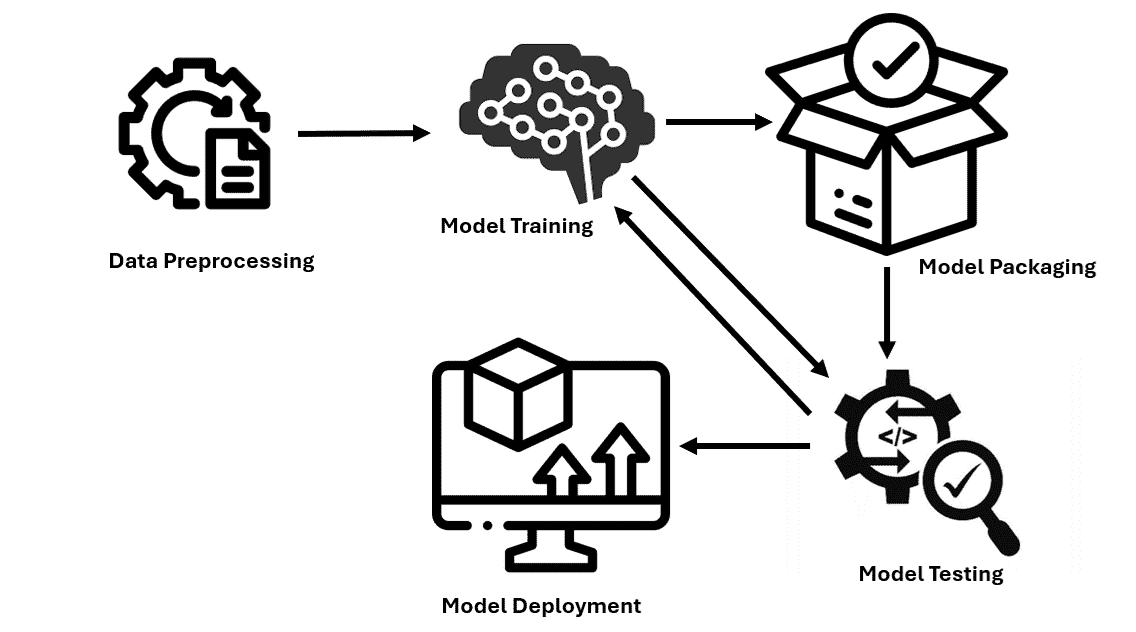

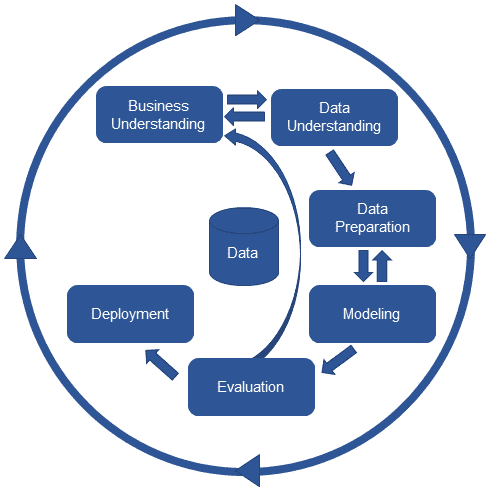

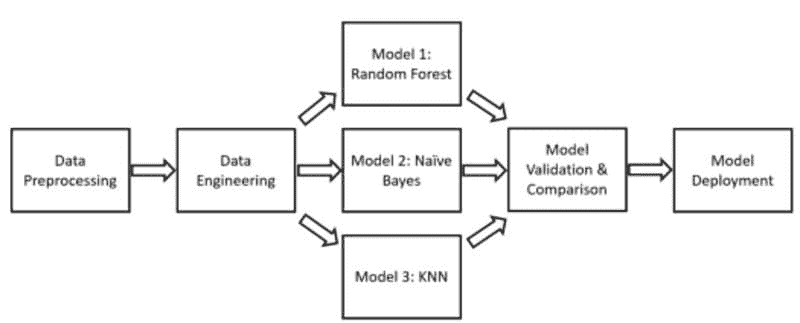

作者提供的图片

1. 数据收集

数据是一个重要的资源,其质量非常重要。多样化、更相关的数据会带来更好的结果。你可以把它想象成厨师从不同的市场收集各种食材。

2. 数据预处理

我们的大多数数据并不是以期望的形式存在的。就像在烹饪前洗净、切割和准备食材一样,数据预处理涉及清理和组织数据以供学习过程使用。一些常见的问题包括缺失数据、异常值、格式不正确等。

3. 选择算法

就像选择特定菜肴的食谱一样,你需要根据你要解决的问题选择算法。这一选择也可能会受到你拥有的数据类型的影响。

4. 训练模型

想象一下烹饪过程,我们等待味道融合。同样地,我们让模型从训练数据中学习。学习率是一个重要概念,它决定了模型在每次训练迭代中的步伐大小。如果一次加了太多盐或香料,菜肴可能会变得过于浓烈。相反,如果加得太少,味道可能无法完全发展。学习率找到逐渐增强味道的完美平衡。

5. 测试与评估

一旦学习过程结束,我们使用特殊的测试数据对其进行测试,就像在与他人分享之前品尝菜肴并检查其外观一样。常见的评估指标包括准确性、精确度、召回率和 F1 分数,具体取决于当前的问题。

6. 调优和迭代

就如同调整调料或配料来完善菜肴一样,你通过引入更多变量、选择不同的学习算法和调整参数或学习率来微调模型。

总结

在我们结束对机器学习基础的探索时,请记住这全在于赋予计算机在最小的人为干预下学习和做出决策。保持好奇,并留意我们的下一篇文章,我们将深入探讨各种机器学习算法。以下是一些适合初学者进一步探索的资源:

Kanwal Mehreen 是一位有志的软件开发者,对数据科学和人工智能在医学中的应用充满兴趣。Kanwal 被选为 2022 年 Google Generation Scholar APAC 区域奖学金获得者。Kanwal 喜欢通过撰写有关趋势话题的文章来分享技术知识,并热衷于改善女性在科技行业中的代表性。

主题相关

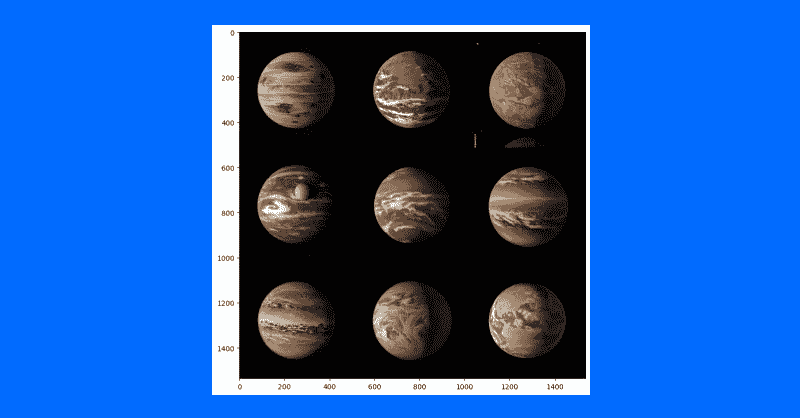

基于密度的空间聚类(DBSCAN)

原文:

www.kdnuggets.com/2017/10/density-based-spatial-clustering-applications-noise-dbscan.html

由 Abhijit Annaldas, Microsoft 提供。

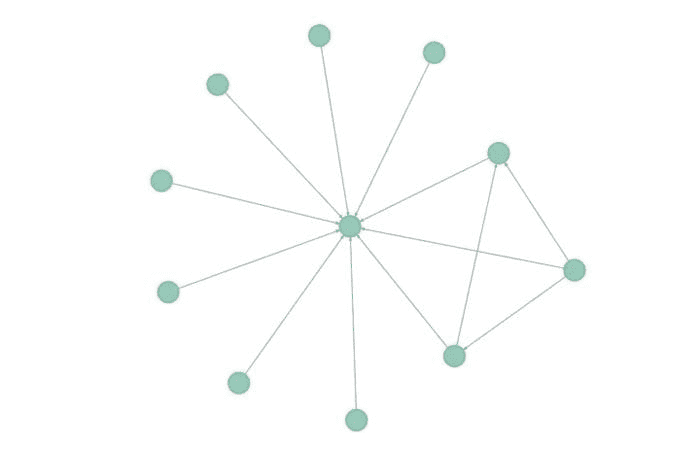

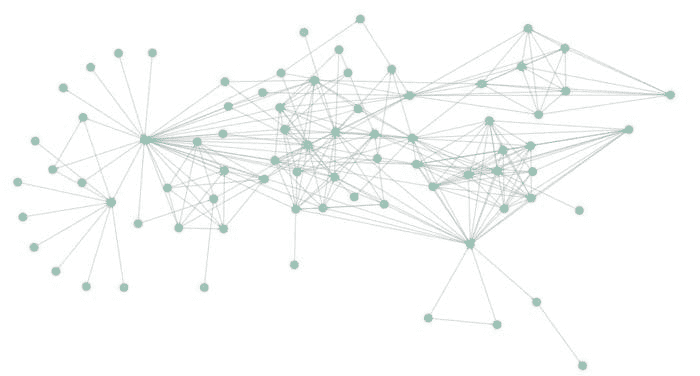

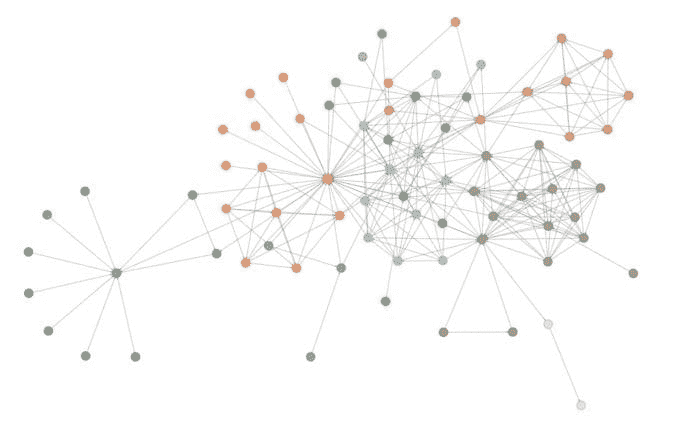

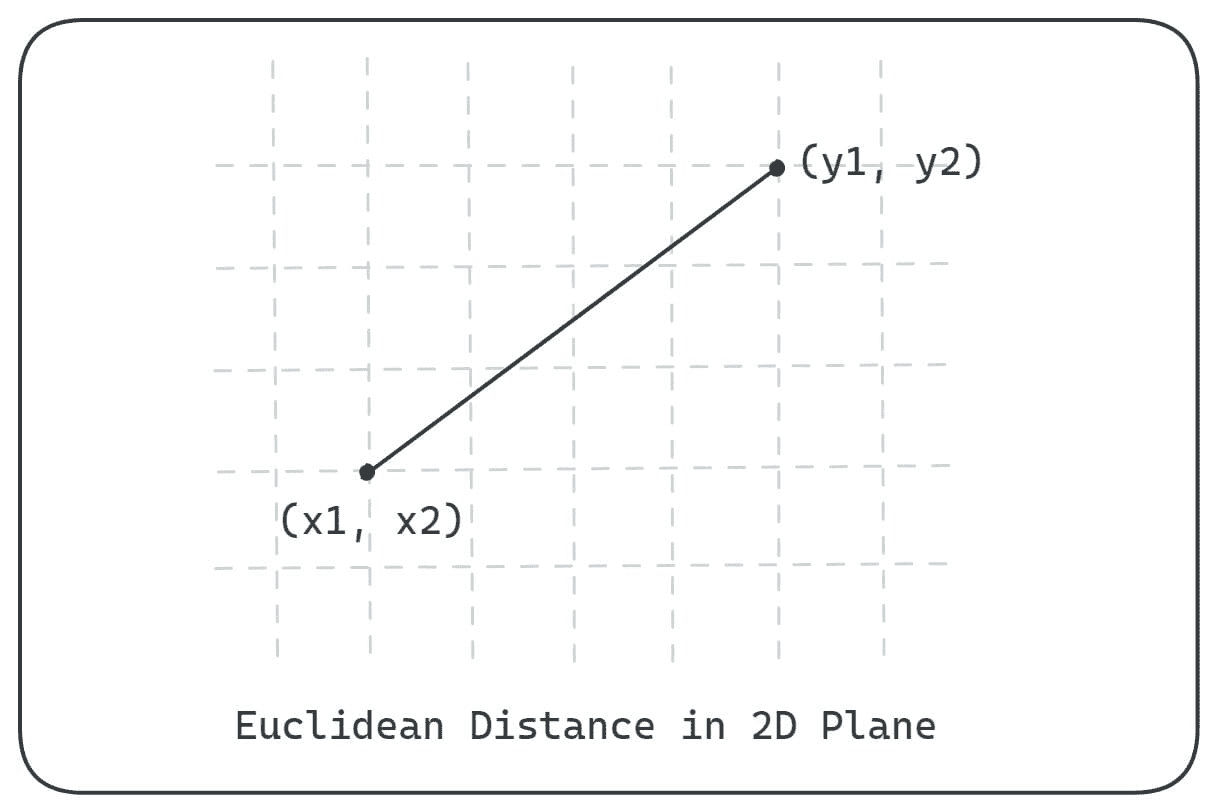

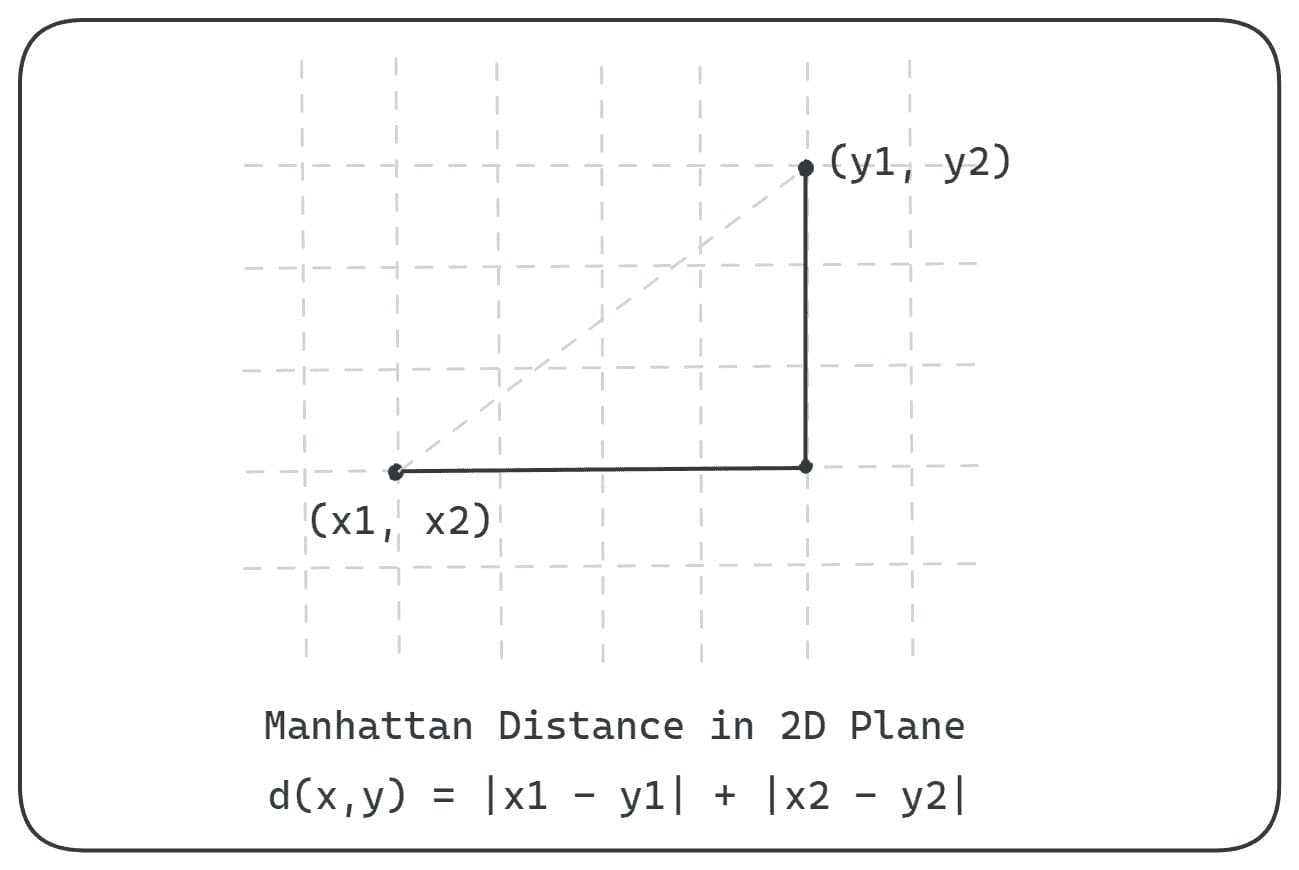

DBSCAN 是一种不同类型的聚类算法,具有一些独特的优势。正如名称所示,该方法更加关注观测值的接近度和密度来形成簇。这与 K-Means 很不同,在 K-Means 中,观测值成为由最近的中心点表示的簇的一部分。DBSCAN 聚类可以识别离群值,即不会属于任何簇的观测值。由于 DBSCAN 聚类也能够识别簇的数量,因此在我们不知道数据中可能有多少个簇时,它在无监督学习中非常有用。

K-Means 聚类可能将松散相关的观测值聚集在一起。即使观测值在向量空间中相距甚远,每个观测值最终也会成为某个簇的一部分。由于簇依赖于簇元素的均值,每个数据点在形成簇的过程中发挥作用。数据点的微小变化 可能 会影响聚类结果。由于簇的形成方式,DBSCAN 大大减少了这个问题。

在 DBSCAN 中,聚类发生基于两个重要参数,即:

-

邻域 (n) - 点与(核心点 - 下面讨论)之间的截止距离,以使其被视为簇的一部分。通常称为 epsilon(缩写为 eps)。

-

最小点数 (m) - 形成簇所需的最小点数。通常称为 minPts。

DBSCAN 聚类完成后,会出现三种类型的点,即:

-

核心 - 这是一个点,该点自身距离 n 内至少有 m 个点。

-

边界 - 这是一个点,该点至少与一个核心点的距离为 n。

-

噪声 - 这是一个既不是核心点也不是边界点的点。它在距离 n 内的点少于 m 个。

DBSCAN 聚类可以总结为以下步骤...

-

对数据集中的每个点 P,识别距离 n 内的点 pts。

-

如果 pts >= m,将 P 标记为 核心 点

-

如果 pts < m 且核心点距离 n,将 P 标记为 边界 点

-

如果 pts < m,将 P 标记为 噪声 点

-

-

为了便于解释,假设 一个 核心 点及其距离 n 内的所有点 组成一个核心集。所有重叠的核心集被分组到一个簇中。就像多个单独的图被连接形成一个连通图的集合。

由于聚类完全依赖于参数 n 和 m(如上所述),正确选择这些值非常重要。虽然对该领域有较好的领域知识有助于选择这些参数的良好值,但也有一些方法可以在没有深厚领域专业知识的情况下相对准确地估算这些参数。

查看 DBSCAN 演示于 sklearn 示例 并尝试使用 sklearn.cluster.DBSCAN 在 sklearn 中实现。

个人简介:Abhijit Annaldas 是一名软件工程师和狂热学习者,他在机器学习领域获得了相当程度的知识和专业技能。他通过学习新事物和不懈练习,日益提高自己的专业能力,并且自 2012 年 6 月以来,在微软印度担任软件工程师,拥有丰富的经验,构建了多种企业级应用,涉及多种 Microsoft 和开源技术。

原文。经许可转载。

相关:

-

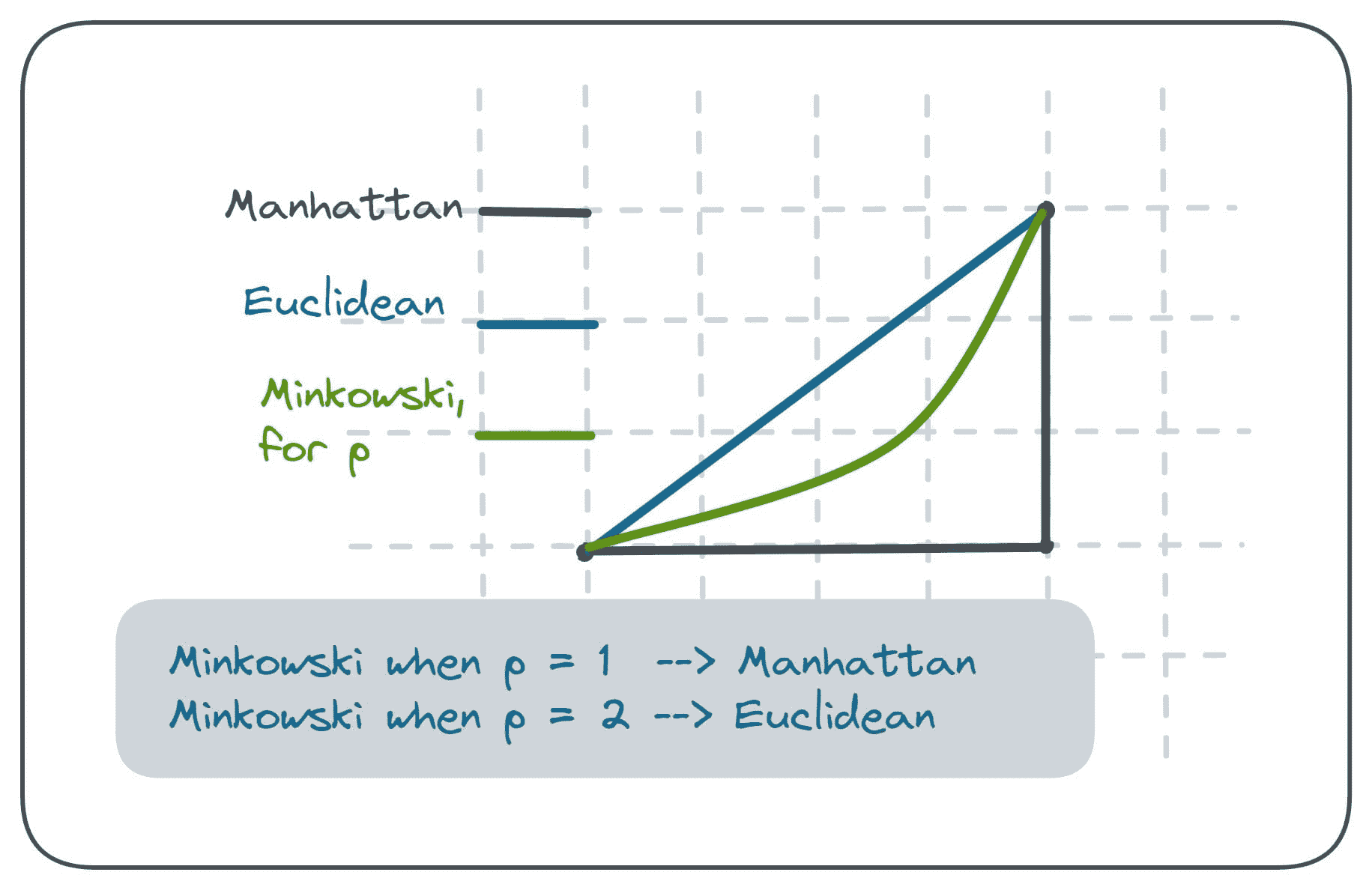

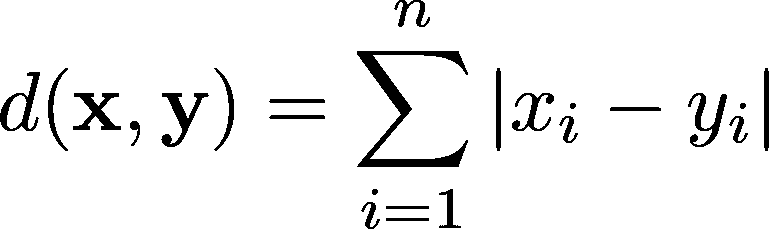

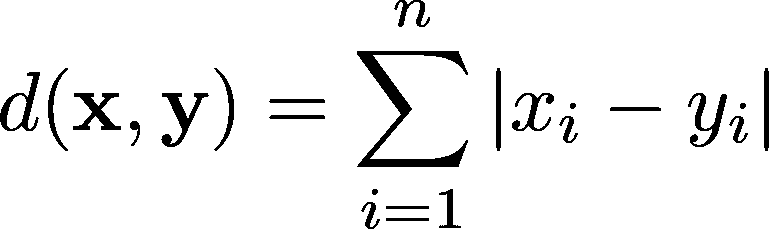

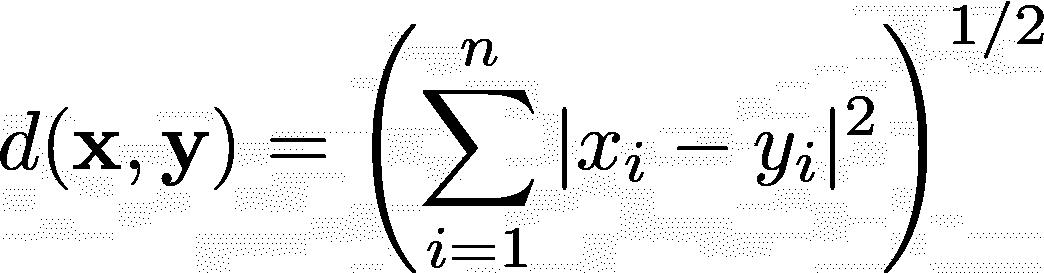

用 Python 和 SciPy 比较距离测量

-

必须知道:如何确定最有用的聚类数?

-

文本聚类:从非结构化数据中获取快速洞察

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

更多相关内容

功能数据中的密度核深度异常检测

原文:

www.kdnuggets.com/density-kernel-depth-for-outlier-detection-in-functional-data

图像由 DALLE-3 生成

介绍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

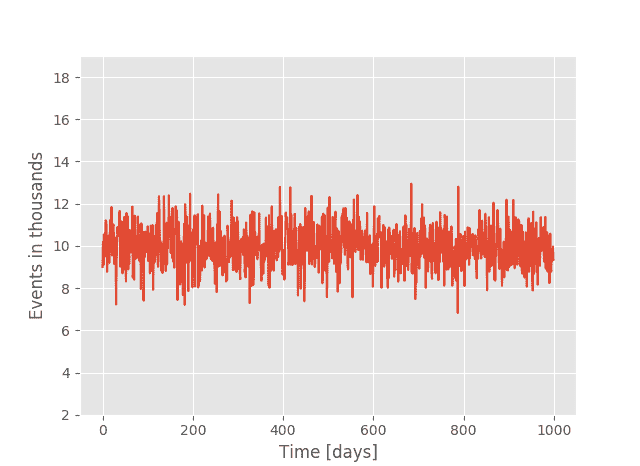

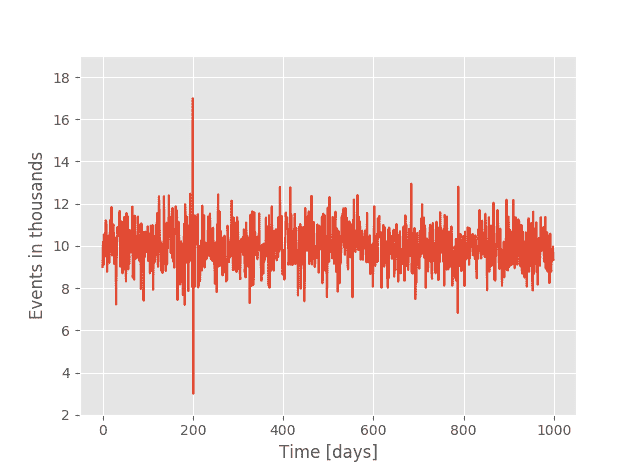

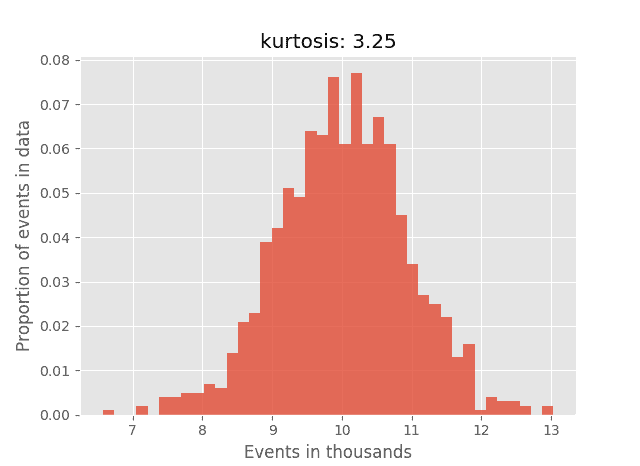

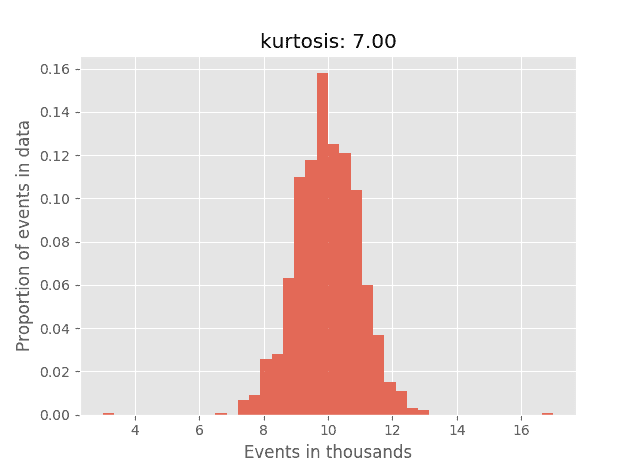

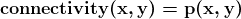

在当今大数据集和复杂数据模式的时代,检测异常值或离群点的艺术与科学变得更加细致。尽管传统的异常检测技术能够有效处理标量或多变量数据,但功能数据——即由曲线、表面或任何连续体组成的数据——带来了独特的挑战。为了解决这一问题,已经开发出一种开创性的技术,即“密度核深度”(DKD)方法。

在这篇文章中,我们将深入探讨 DKD 的概念及其在功能数据异常检测中的影响,站在数据科学家的角度来看。

1. 理解功能数据

在深入探讨 DKD 的复杂性之前,了解功能数据的定义是至关重要的。与传统的标量数据点不同,功能数据由曲线或函数组成。可以把它想象成将整个曲线作为一个数据观察值。这类数据通常出现在时间上连续测量的情况,比如一天中的温度曲线或股市轨迹。

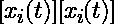

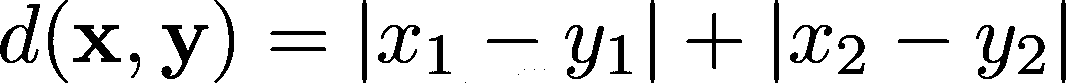

给定一个在域D上观察到的n条曲线的数据集,每条曲线可以表示为:

2. 功能数据中异常检测的挑战

对于标量数据,我们可能会计算均值和标准差,然后基于数据点距离均值的标准差数量来确定异常值。

对于功能数据,这种方法更为复杂,因为每个观察值都是一条曲线。

一种测量曲线中心性的办法是计算其相对于其他曲线的“深度”。例如,使用一种简单的深度度量:

其中 n 是曲线的总数。

虽然上述内容是简化表示,但实际上,功能数据集可能包含数千条曲线,这使得视觉离群点检测具有挑战性。像深度度量这样的数学公式提供了一种更结构化的方法来评估每条曲线的中心性,并可能检测到离群点。

在实际场景中,需要更高级的方法,如密度核深度,以有效确定功能数据中的离群点。

3. DKD 的工作原理

DKD 通过将每条曲线在每个点的密度与该点上整个数据集的总体密度进行比较来工作。密度通过核方法进行估计,这些方法是非参数技术,允许在复杂的数据结构中估计密度。

对于每条曲线,DKD 在每个点上评估其“异常性”,并将这些值在整个领域上积分。结果是一个代表曲线深度的单一数字。较低的值表示潜在的离群点。

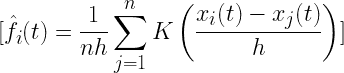

给定曲线 Xi?(t) 在点 t 的核密度估计定义为:

其中:

-

K (.) 是核函数,通常是高斯核。

-

h 是带宽参数。

核函数 K (.) 和带宽 h 的选择可以显著影响 DKD 值:

-

核函数:由于其平滑特性,高斯核常被使用。

-

带宽 ?:它决定了密度估计的平滑度。通常使用交叉验证方法来选择最佳的 h。

3. 密度核深度计算

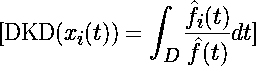

曲线 Xi?(t) 在点 t 相对于整个数据集的深度计算为:

其中:

每条曲线得到的 DKD 值提供了其中心性的度量:

-

DKD 值较高的曲线更接近数据集的中心。

-

DKD 值较低的曲线是潜在的离群点。

4. 使用 DKD 进行功能数据分析的优势

灵活性:DKD 对数据的基础分布没有强假设,使其对各种功能数据结构都很通用。

可解释性:通过为每条曲线提供一个深度值,DKD 使理解哪些曲线是中心的,哪些是潜在的离群点变得直观。

效率:尽管复杂,DKD 在计算上是高效的,使其适用于大型功能数据集。

5. 实际应用

想象一个场景,其中数据科学家正在分析患者 24 小时内的心率曲线。传统的异常值检测可能会将偶尔的高心率读数标记为异常。然而,使用功能数据分析和 DKD,整个异常的心率曲线——可能指示心律失常——可以被检测到,提供对患者健康的更全面视角。

结论

随着数据复杂性的不断增长,用于分析这些数据的工具和技术必须同步演变。密度核深度提供了一种有前景的方法来应对功能数据的复杂格局,确保数据科学家能够自信地检测异常值并从中得出有意义的见解。虽然 DKD 只是数据科学家工具箱中的众多工具之一,但它在功能数据分析中的潜力是不可否认的,并且有望为未来更复杂的分析技术铺平道路。

Kulbir Singh**** 是分析和数据科学领域的杰出领袖,拥有超过二十年的信息技术经验。他的专业知识广泛,包括领导力、数据分析、机器学习、人工智能(AI)、创新解决方案设计和问题解决。目前,Kulbir 担任 Elevance Health 的健康信息经理。Kulbir 对人工智能(AI)的进步充满热情,创办了 AIboard.io,这是一个致力于创建以 AI 和医疗保健为中心的教育内容和课程的创新平台。

更多相关内容

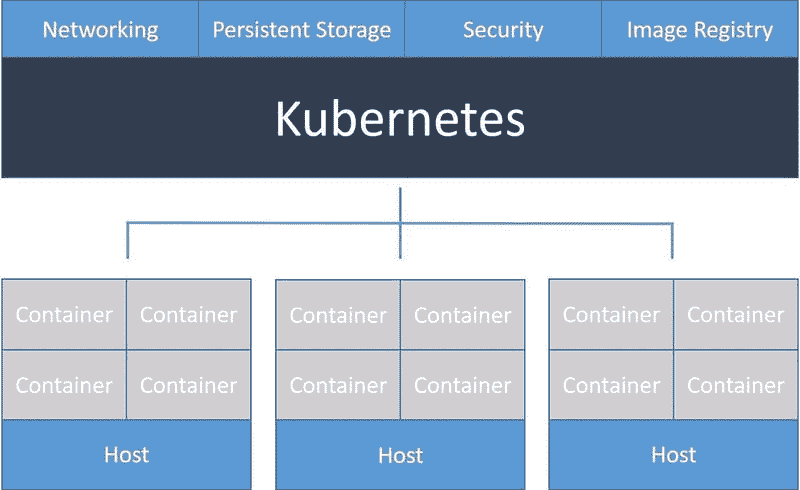

如何在 Kubernetes 中部署 Flask API 并将其与其他微服务连接

原文:

www.kdnuggets.com/2021/02/deploy-flask-api-kubernetes-connect-micro-services.html

评论

作者:Rik Kraan, Vantage AI

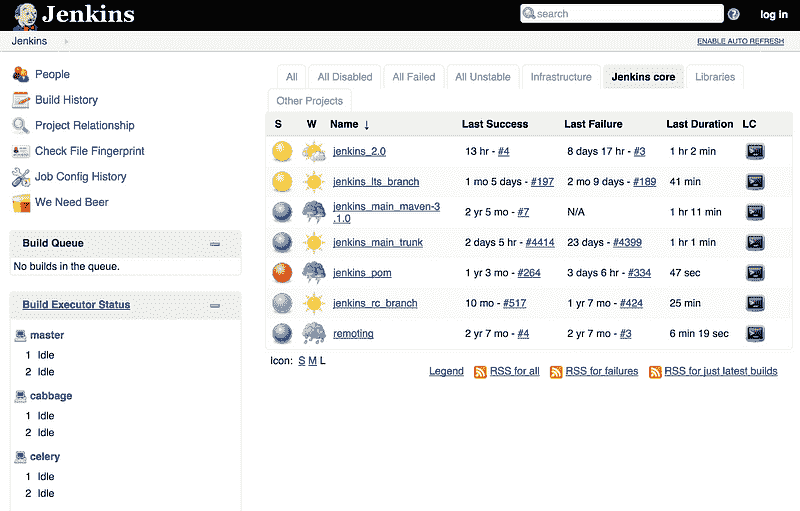

Kubernetes 是一个强大的容器编排工具,它自动化了 容器 的部署和管理。如果你有一个简单的轻量级应用,由一个服务组成,不用考虑使用 Kubernetes。Kubernetes 的优势在于,当你的应用具有 微服务 架构并且多个组件协同工作时,它会显现出来。它是一个‘自动化部署、扩展和管理容器化应用的开源系统’,具有以下几个优势:

-

根据需求进行简单(自动)扩展

-

通过分配负载以使应用在部分故障时仍能正常运行,从而使应用具有容错能力

-

自动化健康检查和自我修复过程

-

处理微服务之间的通信,并将传入的流量均匀分配到所有资源上

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

初次使用 Kubernetes 可能会让人感到畏惧,但如果你掌握其主要概念,并在 官方网站 上进行一些练习,你可以相对轻松地入门。

在本博客中,我将:

-

提供 Kubernetes 主要概念的快速概述

-

演示如何启动自己的本地集群

-

在集群上部署 MySQL 数据库

-

设置一个作为 REST API 与数据库通信的 Flask 应用

网络。照片由 Alina Grubnyak 提供,来自 Unsplash

Kubernetes 基础

在这一部分,我将介绍 Kubernetes 的基础知识而不涉及过多细节;可以通过阅读官方文档深入了解。

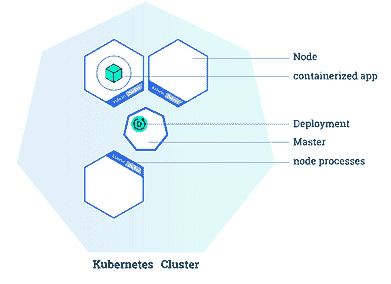

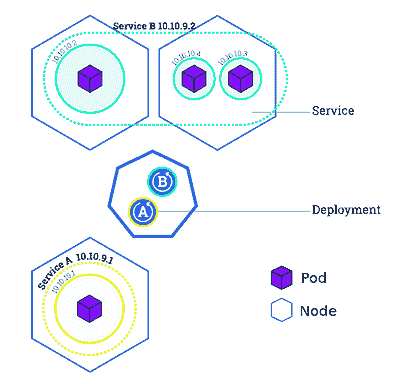

一个 Kubernetes 集群由一个主节点和一个或多个工作节点组成。这种架构是 Kubernetes 的主要特征之一。如你所见,你的微服务分布在不同的节点上,以便在其中一个工作节点故障时保持健康。主节点负责管理集群,并通过 API 让你与集群进行通信。默认情况下,工作节点 配备了一些组件,包括预安装的软件,以便运行流行的容器服务如Docker 和 containerd。

部署你自己应用程序到 Kubernetes 集群上有三个主要概念是必不可少的:部署、Pods 和服务。

- 一个部署 是一组指令,提供给主节点,用于创建和更新你的应用程序。根据这些指令,主节点 将调度并在各个工作节点上运行你的应用程序。部署会持续由主节点监控。如果你的应用程序的某个实例出现故障(例如,如果工作节点出现故障),它将被自动替换为一个新实例。

Kubernetes 集群与部署(来源:kubernetes.io/docs/tutorials/kubernetes-basics/deploy-app/deploy-intro/)

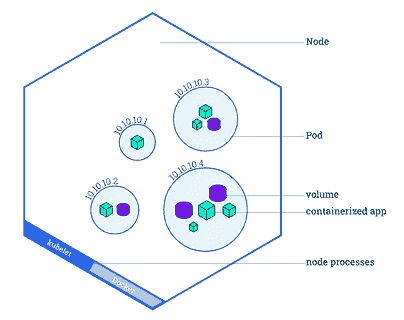

- 一个Pod 是 Kubernetes 平台中的原子单位。它代表一个或多个容器及这些容器共享的一些资源(共享存储、唯一的集群 IP 地址等)。如果你创建一个部署,该部署将创建带有容器的pods。每个pod 都绑定到一个工作节点。需要理解的是,一个工作节点可以拥有多个pods,如果当前的工作节点出现故障,这些pods 将会在另一个可用的工作节点上重新创建。

带有多个 pods 的工作节点概述(来源:kubernetes.io/docs/tutorials/kubernetes-basics/explore/explore-intro/)

- 一个service基本上定义了一组逻辑上的pods并定义了访问它们的策略。这是必要的,因为pods可能会停止并重启(例如,如果工作节点被删除或崩溃)。一个service在一组 pods 之间路由流量,并允许 pods 在不影响应用程序的情况下死亡和复制。在定义一个服务时,你可以指定服务的类型。默认情况下,Kubernetes 创建一个 ClusterIP 服务,这使得你的service只能从集群内部访问。你可能想将一些services(例如前端)暴露给外界。在这种情况下,你可以创建一个LoadBalancer服务,它创建一个外部负载均衡器并分配一个固定的外部 IP,使其可以从集群外部访问(例如在你的浏览器中)。

一个包含 3 个工作节点、若干个 pods 和两个将 pods 绑定在一起的服务(A & B)的集群(来源:kubernetes.io/docs/tutorials/kubernetes-basics/expose/expose-intro/)

开始使用自己的集群

如果你想让你的集群快速运行:本博客中的所有代码(以及一个说明性的 Readme)可以在此处找到。我们将构建的应用程序由两个微服务组成:

-

一个 MySQL 数据库

-

一个实现 API 以访问和执行数据库 CRUD(创建、读取、更新、删除)操作的 Flask 应用程序。

先决条件:请确保已安装

*kubectl*和*minikube*(https://kubernetes.io/docs/tasks/tools/)。并确保你的Docker CLI通过命令*eval $(minikube docker-env)*使用集群中的Docker daemon。不用担心:如果你重启终端,你将自动使用自己的Docker daemon。最后通过命令*minikube start*启动本地集群。

首先:在设置 MySQL 数据库时,我们需要考虑两件事。1) 要访问数据库,我们需要配置一些凭据;2) 我们需要一个持久卷,以防节点意外关闭时不会丢失所有数据。

创建密钥

Kubernetes 有自己处理敏感信息的方法,通过配置 Kubernetes Secrets。这可以通过一个简单的 YAML 文件完成。这些secrets可以通过指定环境变量(稍后我们将看到)被集群中的任何pod访问。Secrets应该指定为base64 编码字符串。因此,我们首先需要通过终端获取密码的编码版本:echo -n <super-secret-passwod> | base64。复制输出并将其嵌入到以下secrets.yml文件中的db_root_password字段中。metadata.name字段很重要,因为我们需要在后面的阶段中指定它,所以一定要记住它。

现在你可以通过终端将秘密添加到集群中:kubectl apply -f secrets.yml。然后通过kubectl get secrets检查是否成功。

持久卷

持久卷是一个生命周期独立于Pod的存储资源。这意味着如果pod崩溃,存储将继续存在。由于 Kubernetes 可以在任何时候重新启动pods,因此将数据库存储设置为persistent volume是一种良好的实践。persistent volume可以是本地文件系统上的目录,也可以是云提供商的存储服务(例如 AWS Elastic Block Storage 或 Azure Disk)。创建persistent volume时可以指定其类型。在本教程中,你将使用hostPath类型,这将在你的minikube节点上创建一个卷。然而,在生产环境中,确保使用其他类型(参见文档),因为使用hostPath类型时,如果删除 minikube 节点,数据将会丢失。

使应用程序使用persistent volume包括两个部分:

-

指定卷的实际存储类型、位置、大小和属性。

-

指定一个persistent volume claim,请求部署所需的特定大小和访问模式的持久卷。

创建一个persistent-volume.yml文件,并指定大小(在本例中为 2GB)、访问模式以及文件存储的路径。spec.persistentVolumeReclaimPolicy指定了如果persistent volume claim被删除时应该执行的操作。对于像MySQL数据库这样的有状态应用程序,你希望在删除声明时保留数据,以便手动检索或备份数据。默认的回收策略是继承自persistent volume的类型,因此在 yml 文件中始终指定它是一种良好的实践。

你可以通过kubectl apply -f persistent-volume.yml再次添加存储。然后通过kubectl describe pv mysql-pv-volume和kubectl describe pvc mysql-pv-claim查看你创建的资源的详细信息。由于你创建了一个主机路径类型的persistent volume,你可以通过登录到 minikube 节点minikube ssh并导航到指定路径(/mnt/data)来查找数据。

部署 MySQL 服务器

在我们的秘密和持久卷(声明)就位后,我们可以开始构建我们的应用程序。首先,我们将部署一个 MySQL 服务器。拉取最新的 mysql 镜像 docker pull mysql 并创建 mysql-deployment.yml 文件。关于这个文件,有几件事值得提及。我们指定仅启动一个 Pod(spec.replicas: 1)。该部署将管理所有带有标签 db 的 Pod,标签由 spec.selector.matchLabels.app: db 指定。template 字段及其所有子字段指定了 pod 的特征。它将运行 mysql 镜像,名称也为 mysql,并在 flaskapi-secrets secret 中查找 db_root_password 字段,将其值设置为 MYSQL_ROOT_PASSWORD 环境变量。此外,我们指定了一个容器暴露的端口,以及持久卷应该挂载的路径 spec.selector.template.spec.containers.volumeMounts.mountPath: /var/lib/mysql。在底部,我们还指定了一个名为 mysql 的 LoadBalancer 类型的服务,以便我们可以通过该服务访问我们的数据库。

现在你可以通过 kubectl apply -f mysql-deployment.yml 部署 MySQL 服务器。然后通过 kubectl get pods 查看 Pod 是否正在运行。

创建数据库和表格

在实现 API 之前,我们必须做的最后一件事是初始化 MySQL 服务器上的数据库和模式。我们可以使用多种方法来完成这项工作,但为了简单起见,让我们通过新创建的 service 访问 MySQL 服务器。由于运行 MySQL service 的 Pod 仅能从集群内部访问,你需要启动一个作为 mysql-client 的临时 Pod:

-

通过终端设置

mysql-client:kubectl run -it --rm --image=mysql --restart=Never mysql-client -- mysql --host mysql --password=<your_password>。填写你在 secrets.yml 文件中指定的(解码)密码。 -

创建数据库、表格和模式。你可以做任何你喜欢的事,但为了确保样本 Flask 应用程序能够正常工作,请按照以下步骤操作:

CREATE DATABASE flaskapi;

USE flaskapi;

CREATE TABLE users(user_id INT PRIMARY KEY AUTO_INCREMENT, user_name VARCHAR(255), user_email VARCHAR(255), user_password VARCHAR(255));

部署 API

最后是时候部署你的 REST API 了。以下示例展示了一个实现了只有两个端点的 Flask 应用程序的示例。一个用于检查 API 是否正常工作,另一个用于在我们的数据库中创建用户。在 GitHub 的 repo 中,你可以找到具有读取、更新和删除数据库条目的端点的 Python 文件。连接到数据库 API 的密码是从创建的 secrets 中检索的。其余的环境变量(例如 MYSQL_DATABASE_HOST)则从之前实现的 MySQL service 中检索(稍后我将解释如何确保 Flask 应用程序能够访问这些信息)。

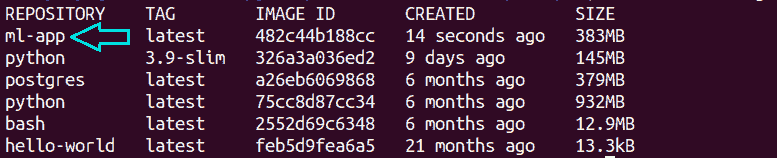

要在 Kubernetes 集群中部署这个应用,你需要通过创建一个简单的 Dockerfile 来制作这个 Flask 应用的镜像。没有特别之处,准备你的容器,安装所需的软件包,复制文件夹内容并运行 Flask 应用。前往 GitHub 仓库 查找构建镜像所需的 Dockerfile 和 requirements.txt 文件。在你可以将 Flask 应用部署到 Kubernetes 集群之前,你首先需要构建镜像并将其命名为 flask-api,命令为 docker build . -t flask-api。

现在是定义 deployment 和 service 的时候了,目的是为了实现一个 RESTful API 的 Flask 应用。部署将启动 3 个 Pod(在 flaskapp-deployment.yml 的 spec.replicas: 3 字段中指定)。在每个这些 pods 中,将从你刚刚构建的 flask-api 镜像创建一个容器。为了确保 Kubernetes 使用本地构建的镜像(而不是从外部仓库如 Dockerhub 下载镜像),请确保将 imagePullPolicy 设置为 never。为了确保 Flask 应用可以与数据库通信,应该设置一些环境变量。db_root_password 是从你创建的 secrets 中获取的。每个启动的容器都继承包含所有正在运行的 services 信息的环境变量,包括 IP 和 port 地址。因此,你不必担心在 Flask 应用中指定 MySQL 数据库的 host 和 port。最后,你将定义一个 LoadBalancer 类型的 service,以便在三个 Pod 之间分配传入的流量。

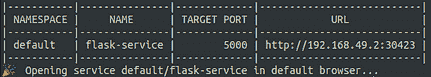

向 API 发起请求

你现在可以使用我们的 API 并与数据库交互。最后一步是通过终端暴露 API service:minikube service flask-service。你现在会看到类似的内容

访问提供的 URL,你将看到 Hello World 消息,以确保你的 API 正常运行。现在你可以使用你喜欢的请求服务如 Postman 或 curl 在终端中与 API 交互。要创建一个用户,提供一个 json 文件,其中包含 name、email 和 pwd 字段。例如:curl -H "Content-Type: application/json" -d '{"name": "<user_name>", "email": "<user_email>", "pwd": "<user_password>"}' <flask-service_URL>/create。如果你也实现了 API 的其他方法(如在 GitHub 仓库 中定义),你现在可能可以通过以下命令查询数据库中的所有用户:curl <flask-service_URL>/users。

结论

在你的终端中使用 curl。要创建用户,提供一个包含 name、email 和 pwd 字段的json文件。例如:curl -H "Content-Type: application/json" -d '{"name": "<user_name>", "email": "<user_email>", "pwd": "<user_password>"}' <flask-service_URL>/create。如果你还实现了 API 的其他方法(如GitHub 仓库中定义的那样),你现在可以通过以下命令查询数据库中的所有用户:curl <flask-service_URL>/users。

在这个动手教程中,你将设置部署、服务和Pods,通过部署 Flask 应用实现一个 RESTful API,并将其与其他微服务(在此案例中是 MySQL 数据库)连接。你可以在本地持续运行,也可以在云等远程服务器上实现并投入生产。欢迎克隆仓库并根据需要调整 API,或者添加其他微服务。

如果你有任何额外的问题、意见或建议,随时与我联系!

简介: Rik Kraan 是一位医学博士,拥有放射学博士学位,目前在Vantage AI,一家位于荷兰的数据科学咨询公司担任数据科学家。可以通过 rik.kraan@vantage-ai.com 与他联系。

原文。经授权转载。

相关:

-

Kubernetes 与 Amazon ECS 对数据科学家的比较

-

使用 Python 和 Heroku 创建并部署你的第一个 Flask 应用

-

数据科学与 DevOps 的结合:Jupyter、Git 和 Kubernetes 下的 MLOps

更多相关主题

部署机器学习模型是什么意思?

原文:

www.kdnuggets.com/2020/02/deploy-machine-learning-model.html

评论

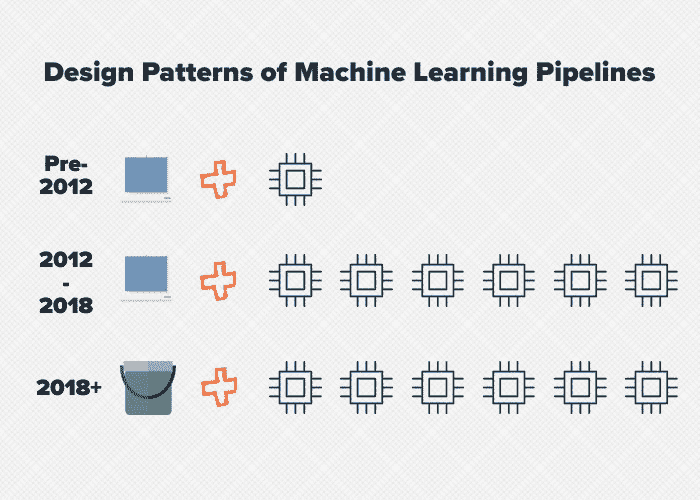

由 Luigi Patruno、数据科学家和 ML in Production 的创始人。

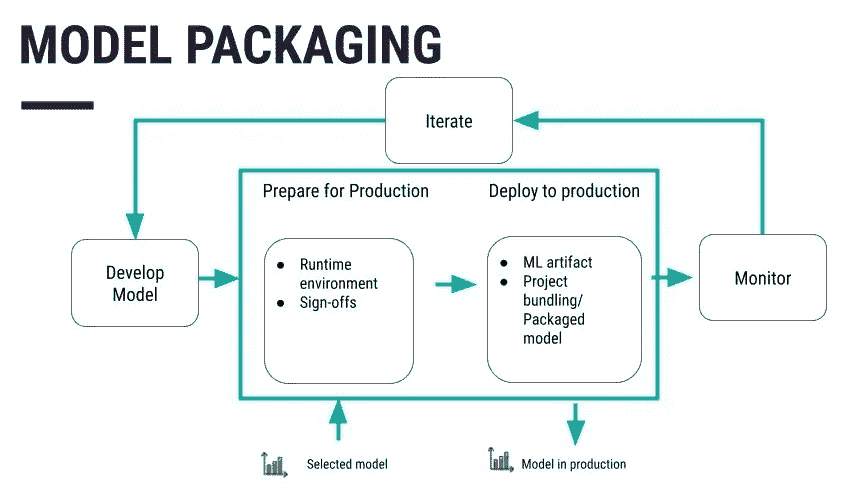

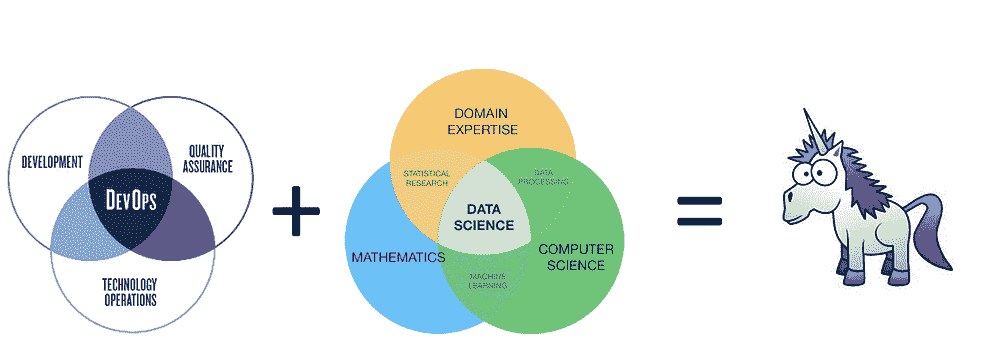

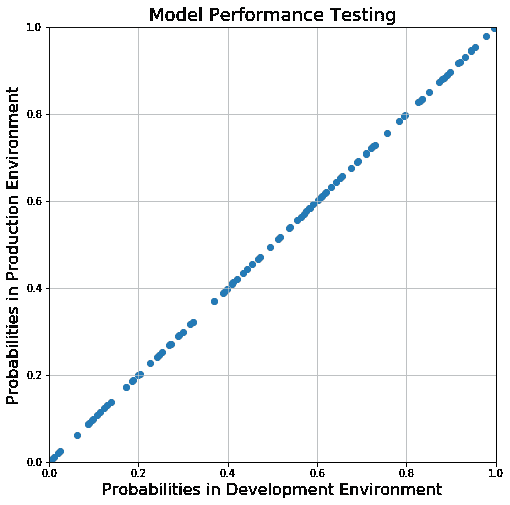

我最近向Twitter 社区询问了他们在机器学习方面最大的痛点,以及他们的团队在 2020 年的工作重点。最常提到的痛点之一是部署机器学习模型。更具体地说,“你如何以自动化、可重现和可审计的方式部署机器学习模型?”

好问题!

在教授机器学习时,很少讨论 ML 部署的话题。训练算法和神经网络架构往往是重点,因为这些是“核心”机器学习思想。我并不反对这一点,但我认为如果数据科学家不能部署模型,他将无法为业务增加多少价值。

如果你搜索有关如何部署模型的资源,你会发现很多关于编写 Flask API 的博客文章。虽然这些文章做得很好,但并非所有 ML 模型都需要部署在 Flask API 后面。实际上,有时这会适得其反。这些文章很少讨论部署模型时需要考虑的因素、可使用的各种工具以及其他重要概念。这些话题非常广泛,一篇博客文章无法全面覆盖。

这就是为什么我写了一个关于部署机器学习模型的多部分博客系列。该系列将讨论部署机器学习模型的意义、部署模型时需要考虑的因素、使用的软件开发策略以及需要利用的工具和框架。如果你希望在每篇文章发布时收到通知,请留下你的电子邮件地址!

在讨论任何工具之前,我们先问一个问题:部署模型是什么意思?

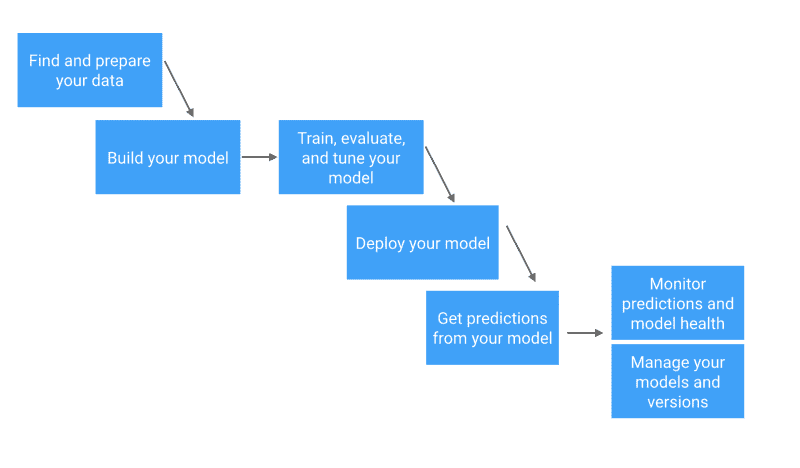

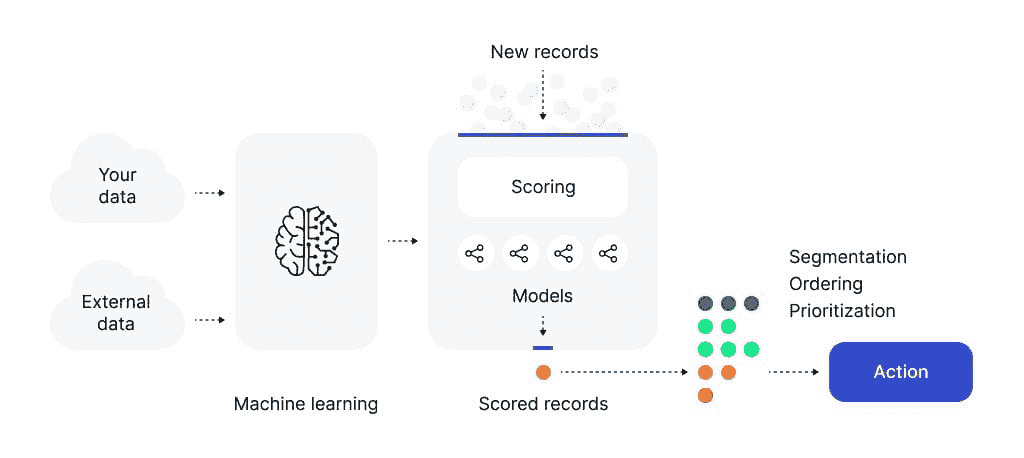

部署机器学习模型是什么意思?

在考虑使用什么工具来部署模型之前,你需要对部署的意义有一个清晰的理解。为了获得这种理解,将自己置身于软件工程师的角度是很有帮助的。软件工程师如何看待“部署”代码?将代码的部署概念转移到机器学习领域时会发生什么?将部署视为软件工程师而非数据科学家,将显著简化部署模型的含义。

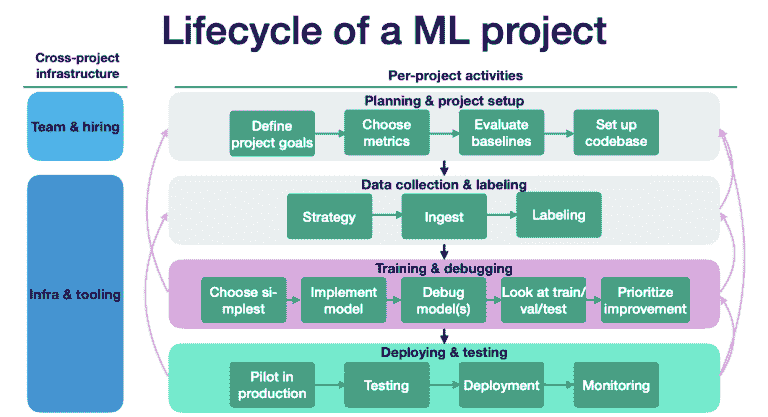

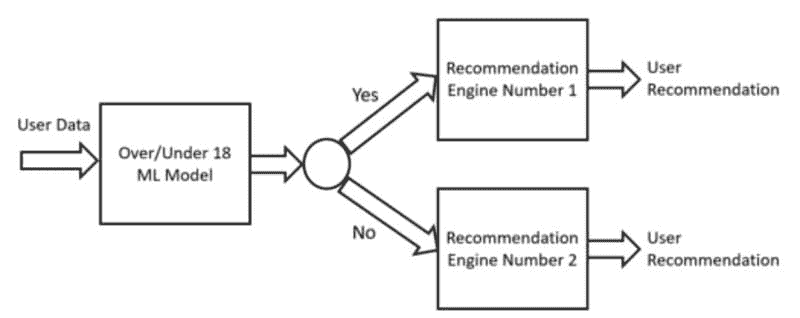

为了理解部署 ML 模型的含义,让我们简要讨论一下 ML 项目的生命周期。假设一位产品经理 (PM) 发现了一些用户需求,并确定可以使用机器学习来解决这个问题。这将涉及创建一个新产品或通过机器学习功能增强现有产品,通常以监督学习模型的形式。

产品经理将与 ML 团队负责人会面,通过定义项目目标、选择指标和设置代码库来规划项目。如果存在适当的训练和验证数据,项目将交给数据科学家或 ML 工程师处理特征工程和模型选择的迭代过程。

此阶段的目标是构建一个预测性能水平达到或超过规划阶段设定目标的模型。在这些初始阶段,驱动这个项目的用户需求仍未得到满足。即使存在一个达到最低预测性能要求的模型,这些需求也不会得到满足。

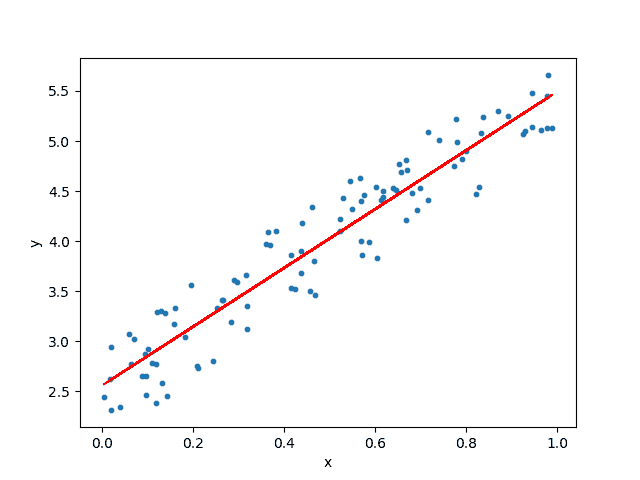

只有当一个机器学习模型的洞察定期提供给其构建目标的用户时,这个模型才会开始为组织创造价值。将训练好的 ML 模型的预测提供给用户或其他系统的过程被称为部署。部署与特征工程、模型选择或模型评估等常规机器学习任务完全不同。

因此,部署在缺乏软件工程或 DevOps 背景的数据科学家和 ML 工程师中并不十分理解。但幸运的是,这些技能并不难学。通过实践,任何数据科学家都可以学习如何将模型部署到生产环境中。

你如何决定如何部署?

要决定如何部署一个模型,你需要了解最终用户应该如何与模型的预测进行互动。这最好通过几个示例来理解。我们将从一个非常简单的用例开始,逐步增加复杂性。

部署示例 1:部署潜在客户评分模型

假设一位数据科学家为一组精通 SQL 的技术分析师构建了一个潜在客户评分模型。这些分析师希望根据潜在客户转化为客户的可能性将新的潜在客户分组。

每天早晨,他们希望利用数据库中的数据来创建/更新他们在 BI 工具中维护的仪表盘。

由于分析师知道 SQL 并期望将模型评分存储在数据库中,“部署”潜在客户评分模型意味着为新的潜在客户生成每日评分,并将这些评分存储在分析师的数据库中。

部署的关键方面是

-

预测可以在一组新潜在客户上生成,

-

这些预测需要每天提供,并且

-

预测需要存储在数据库中。部署过程需要满足这三项约束条件,以便机器学习模型能为业务带来价值。

考虑一个稍微复杂一点的情况。

销售部门负责人了解了模型,并希望将模型的见解提供给他的账户执行者。自然地,也让我们感到遗憾的是,账户执行者不知道 SQL,因此在这种情况下,将预测存储在数据库中还不够。

产品经理决定,为了增加业务价值,必须在账户执行者使用的 CRM 工具中显示潜在客户评分。

之前示例中的部署方面 1 和 2(为一组潜在客户生成预测并每天生成一次)仍然有效,但方面 3 不再适用。部署涉及将分数从数据库流入 CRM 工具。这将涉及设置额外的 ETL 过程。

部署示例 2:部署推荐系统

对于我们的最终示例,假设我们考虑一下推荐系统——机器学习的一个流行应用,如何进行部署。假设我们在一家电子商务公司工作,该公司希望向用户展示购买产品的推荐。我们将考虑两种部署的变体。

场景 1:公司希望在用户登录到网站或移动应用程序后展示产品推荐。预测需要在任何时候都可以获取,这对我们的部署提出了延迟约束,影响我们是否能够在用户登录时即时生成预测,或是必须提前生成并缓存预测。部署必须使模型的预测对移动应用和网页应用都可用。因此,将我们的部署与这些应用程序分离是可取的。

场景 2:公司希望向现有客户的营销邮件中添加 5 条推荐。这些邮件每周发送给用户两次;一封邮件在周一下午发送,另一封在周五早上发送。在这种情况下,可以同时计算所有用户的推荐并进行缓存。与之前的场景相比,延迟要求要宽松得多。将这些推荐存储在数据库中就足够了。生成邮件的过程可以在数据库中查找用户的推荐,并将前 5 条推荐添加到个性化邮件中。

从这些示例中,我们可以看到,确定如何部署机器学习模型时需要考虑多个因素。这些因素包括:

-

预测应生成的频率

-

是否应该一次生成单个实例的预测,还是一批实例的预测

-

访问模型的应用程序数量

-

这些应用程序的延迟要求

结论

机器学习模型的自动化部署是 2020 年数据科学家和机器学习工程师面临的最大难题之一。由于模型只有在洞察定期提供给最终用户时才能为组织增值,因此机器学习从业者必须了解如何尽可能简单高效地部署他们的模型。确定如何部署模型的第一步是理解最终用户应如何与模型的预测进行互动。

原文。经授权转载。

简介:Luigi Patruno是一位数据科学家和机器学习顾问。他目前是 2U 的数据科学总监,领导一个负责构建机器学习模型和基础设施的数据科学团队。作为顾问,Luigi 帮助公司通过应用现代数据科学方法来生成战略业务和产品倡议的价值。他创办了MLinProduction.com以收集和分享将机器学习应用于实际操作的最佳实践,并且他还教授了统计学、数据分析和大数据工程的研究生课程。

相关:

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持组织的 IT 需求

3. Google IT 支持专业证书 - 支持组织的 IT 需求

更多相关内容

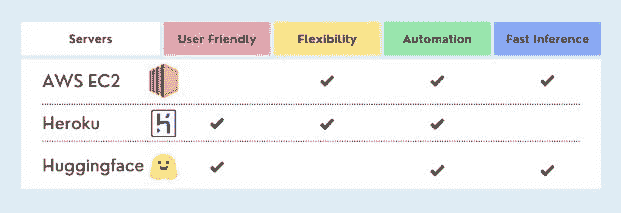

如何将机器学习/深度学习模型部署到网络

原文:

www.kdnuggets.com/2021/04/deploy-machine-learning-models-to-web.html

评论

如果你已经在机器学习领域工作了一段时间,你一定创建过一些机器学习或深度学习模型。你一定会想,人们会如何使用你的 Jupyter notebook?答案是他们不会。

我们的前三个课程推荐

1. Google 网络安全证书 - 加入网络安全职业的快车道

1. Google 网络安全证书 - 加入网络安全职业的快车道

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

人们无法使用你的 Jupyter notebooks,你需要将你的模型部署为 API 或完整的网络服务,或在移动设备、Raspberry PI 等上。

在本文中,你将学习如何将深度学习模型部署为 REST API,并添加一个表单以获取用户输入,并返回模型的预测结果。

我们将使用 FastAPI 创建 API 并免费部署到 Heroku 上。

第 1 步:安装

你需要安装必要的软件包。

1. FastAPI + Uvicorn

我们将使用 FastAPI 来处理 API,并使用 Uvicorn 服务器来运行和托管这个 API。

$ pip install fastapi uvicorn

2. Tensorflow 2

我们将在本教程中使用 Tensorflow 2,你可以使用你选择的框架。

$ pip install tensorflow==2.0.0

3. Heroku

你可以在 Ubuntu 上通过终端直接使用以下命令安装 Heroku,

$ sudo snap install --classic heroku

在 macOS 上,你可以通过以下方式安装,

$ brew tap heroku/brew && brew install heroku

对于 Windows,你可以从官方 网站 安装压缩文件。

4. Git

你还需要安装 git 并在 GitHub 上创建一个帐户,以便我们可以直接推送到 GitHub 并将主分支连接到我们的 Heroku,这样它就会自动部署。

你可以使用apt在 Debian 上安装 git。

$ sudo apt install git-all

要在 Windows 上安装,你可以直接从 这里下载。

要在 macOS 上安装,你可以安装 XCode 命令行工具并运行以下命令来激活它,

git --version

你也可以从 macOS 上的 git 官网 安装。

第 2 步:创建我们的深度学习模型

我们将创建一个简单的深度学习模型,该模型与情感分析相关。使用的数据集可以从 Kaggle下载,与 GOP 推文相关。

我们将创建这个模型、训练它并保存,以便我们可以在 API 中使用保存的模型,而不必每次 API 启动时都训练模型权重。我们将在文件 model.py 中创建这个模型。

import pandas as pd

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Embedding, LSTM, SpatialDropout1D

from sklearn.model_selection import train_test_split

import re

在这里,我们导入了重要的库,这些库将帮助我们创建模型和清理数据。我不会深入探讨深度学习模型或 Tensorflow 的工作原理。有关详细信息,你可以查看 KDnuggets 上的文章,对于情感分析模型的工作,请查看 CNVRG 上的文章。

我们将使用 Pandas 读取数据。

data = pd.read_csv('archive/Sentiment.csv')

# Keeping only the neccessary columns

data = data[['text','sentiment']]

我们将创建一个函数,使用正则表达式移除推文中的不需要的字符。

def preProcess_data(text):

text = text.lower()

new_text = re.sub('[^a-zA-z0-9\s]','',text)

new_text = re.sub('rt', '', new_text)

return new_text

data['text'] = data['text'].apply(preProcess_data)

我们将使用 Tensorflow 的分词器对数据集进行分词,并使用 Tensorflow 的 pad_sequences 对序列进行填充。

max_fatures = 2000

tokenizer = Tokenizer(num_words=max_fatures, split=' ')

tokenizer.fit_on_texts(data['text'].values)

X = tokenizer.texts_to_sequences(data['text'].values)

X = pad_sequences(X, 28)

Y = pd.get_dummies(data['sentiment']).values

现在我们将数据集拆分为训练集和测试集。

X_train, X_test, Y_train, Y_test = train_test_split(X,Y, test_size = 0.20)

现在是设计和创建深度学习模型的时候了。我们将简单地使用嵌入层和一些带有 dropout 的 LSTM 层。

embed_dim = 128

lstm_out = 196

model = Sequential()

model.add(Embedding(max_fatures, embed_dim,input_length = X.shape[1]))

model.add(SpatialDropout1D(0.4))

model.add(LSTM(lstm_out, dropout=0.3, recurrent_dropout=0.2, return_sequences=True))

model.add(LSTM(128,recurrent_dropout=0.2))

model.add(Dense(3,activation='softmax'))

model.compile(loss = 'categorical_crossentropy', optimizer='adam',metrics = ['accuracy'])

我们现在将拟合模型。

batch_size = 512

model.fit(X_train, Y_train, epochs = 10, batch_size=batch_size, validation_data=(X_test, Y_test))

现在深度学习模型已经训练完成,我们将保存模型,以便每次重新加载服务器时无需重新训练。我们只需使用训练好的模型。请注意,我没有进行太多超参数调优或模型改进,你可以自行进行以部署改进后的模型。

model.save('sentiment.h5')

在这里,我们已将模型保存为 'hdf5' 格式。你可以在 这篇文章 中了解更多关于模型保存和加载的信息。

第 3 步:使用 FAST API 创建 REST API

我们将使用 FAST API 创建一个 REST API。我们将创建一个名为 app.py 的新文件。我们将首先进行重要的导入。

import numpy as np

from fastapi import FastAPI, Form

import pandas as pd

from starlette.responses import HTMLResponse

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

import tensorflow as tf

import re

在这里,我们从 FastAPI 库中导入了 FastAPI 和 Form,通过这些我们将为 API 创建一个输入表单和端点。我们还从 starlette.response 中导入了 HTMLResponse,这将帮助我们创建输入表单。

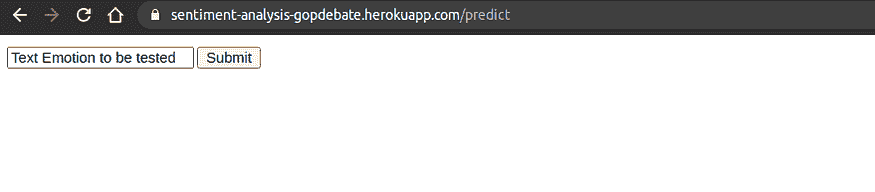

我们将首先创建一个输入表单,以便用户可以输入数据,即我们可以测试情感的测试字符串。

app = FastAPI()

@app.get('/predict', response_class=HTMLResponse)

def take_inp():

return '''

<form method="post">

<input maxlength="28" name="text" type="text" value="Text Emotion to be tested" />

<input type="submit" />'''

我们在第一行创建了 FastAPI 应用,并在 /predict 路由上使用了 get 方法,这将返回一个 HTML 响应,以便用户可以看到真实的 HTML 页面,并使用 post 方法在表单中输入数据。我们将利用这些数据进行预测。

你现在可以通过运行以下命令来启动你的应用程序。

uvicorn app:app --reload

这将使你的应用程序在 localhost 上运行。在 http://127.0.0.1:8000/predict 路由下,你可以看到输入表单。

现在让我们定义一些辅助函数,这些函数将用于预处理数据。

data = pd.read_csv('archive/Sentiment.csv')

tokenizer = Tokenizer(num_words=2000, split=' ')

tokenizer.fit_on_texts(data['text'].values)

def preProcess_data(text):

text = text.lower()

new_text = re.sub('[^a-zA-z0-9\s]','',text)

new_text = re.sub('rt', '', new_text)

return new_text

def my_pipeline(text):

text_new = preProcess_data(text)

X = tokenizer.texts_to_sequences(pd.Series(text_new).values)

X = pad_sequences(X, maxlen=28)

return X

这些函数本质上执行相同的工作,用于清理和预处理数据,这些函数已在我们的 model.py 文件中使用。

现在我们将在 "/predict" 路由上创建一个 POST 请求,以便可以将使用表单发布的数据传递到我们的模型中,并进行预测。

@app.post('/predict')

def predict(text:str = Form(...)):

clean_text = my_pipeline(text) #clean, and preprocess the text through pipeline

loaded_model = tf.keras.models.load_model('sentiment.h5') #load the saved model

predictions = loaded_model.predict(clean_text) #predict the text

sentiment = int(np.argmax(predictions)) #calculate the index of max sentiment

probability = max(predictions.tolist()[0]) #calulate the probability

if sentiment==0:

t_sentiment = 'negative' #set appropriate sentiment

elif sentiment==1:

t_sentiment = 'neutral'

elif sentiment==2:

t_sentiment='postive'

return { #return the dictionary for endpoint

"ACTUALL SENTENCE": text,

"PREDICTED SENTIMENT": t_sentiment,

"Probability": probability

}

现在代码有点多。让我们来拆解它。我们在 POST 请求上定义了一个路由 "/predict",表单中的数据将作为我们的输入。我们在函数参数中将其指定为Form(…)。我们将文本传递给 pipeline 函数,以便它可以返回清理和预处理后的数据,然后我们可以将其输入到加载的模型中并获取预测。我们可以使用 numpy 的argmax函数来获取最高预测的索引。我们可以使用 Python 的max函数来挑选最大概率。请注意,FastAPI 的端点必须返回一个字典或一个Pydantic 基础模型。

现在你可以通过以下方式运行你的应用程序:

$ uvicorn app:app --reload

在 "/predict" 路由上,你可以给模型提供输入。

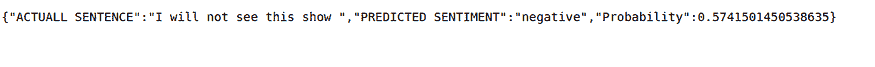

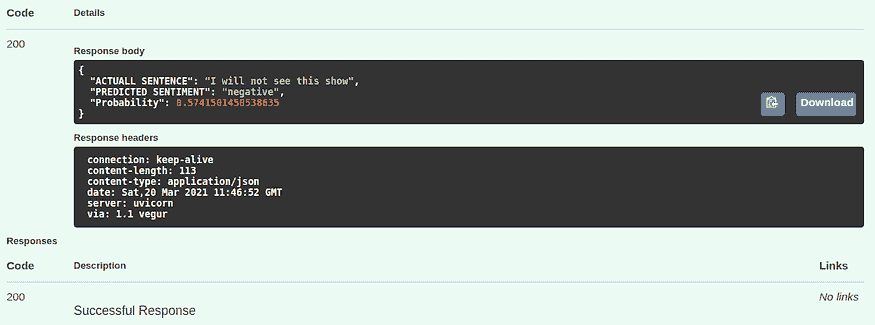

模型将预测情感并返回结果。

我们还可以在主页上创建一个虚拟路由,即“/”,以确保它也能正常工作。

@app.get('/')

def basic_view():

return {"WELCOME": "GO TO /docs route, or /post or send post request to /predict "}

你可以在这里查看完整的代码:

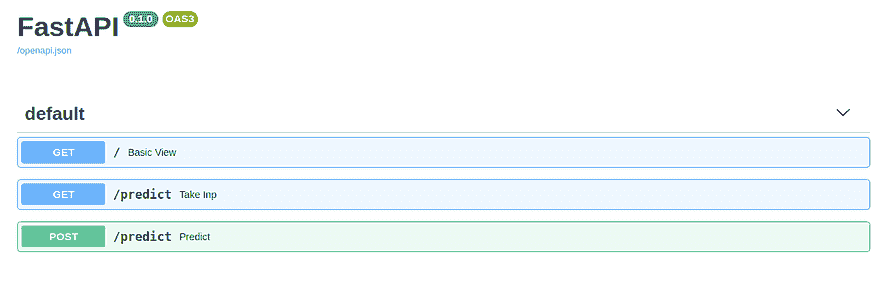

FastAPI 上的文档路由

FastAPI 为每个应用程序提供了一个出色的“/docs”路由,你可以在这里测试你的 API 以及它的请求和路由。

在我们的 API 中,总共有 3 个路由:

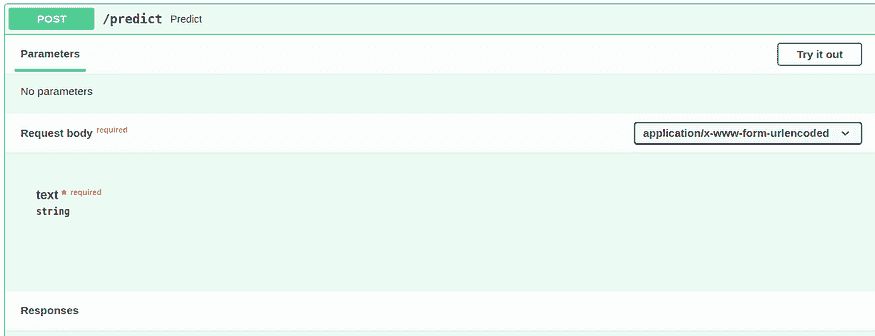

我们可以通过点击它们来测试所有 3 个请求。我们将测试最重要的一个,即对预测路由的 POST 请求,它执行所有的计算。

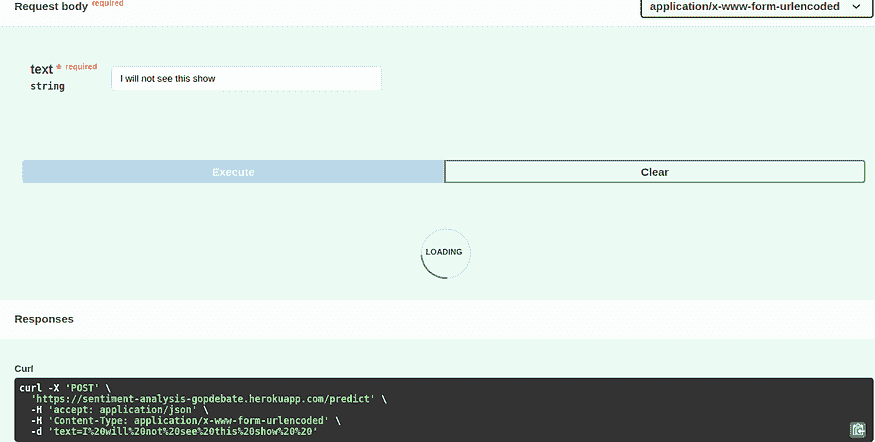

点击“尝试一下”以传入所需的文本并获取其情感:

现在你可以在响应中检查结果:

响应状态码 200 表示请求成功,你将得到一个有效的期望输出。

第 4 步:添加有助于部署的适当文件

要为你的应用程序在 Heroku 上定义 Python 版本,你需要在你的文件夹中添加一个runtime.txt文件。在该文件中,你可以定义你的 Python 版本。只需在其中写入合适的 Python 版本。注意这是一个敏感文件,所以确保以指定的正确格式写入,否则 Heroku 会报错。

python-3.6.13

要在 Heroku 上运行 uvicorn 服务器,你需要添加一个 Procfile。注意这个文件没有扩展名。只需创建一个名为“Procfile”的文件。在 Procfile 中添加以下命令。

web: uvicorn app:app --host=0.0.0.0 --port=${PORT:-5000}

请注意,你需要在 0.0.0.0 上运行服务器,并且端口应该是 5000。

另一个重要的文件是requirments.txt文件。将你项目所需的所有重要库添加到其中。

sklearn

fastapi

pandas

pydantic

tensorflow==2.0.0

uvicorn

h5py==2.10.0

python-multipart

你可以添加一个.gitignore文件来忽略你不需要的文件:

__pycache__

model.py

第 5 步:在 Github 上部署

下一步是在 GitHub 上部署这个 Web 应用程序。你需要在 GitHub 上创建一个新的仓库。然后打开命令行并将目录更改为项目目录。

你需要初始化仓库:

$ git init

然后添加所有文件:

$ git add -A

提交所有文件:

$ git commit -m "first commit"

将分支更改为 main:

$ git branch -M main

将文件夹连接到 GitHub 上的仓库:

$ git remote add origin https://github.com/username/reponame.git

推送仓库:

$ git push -u origin main

第 6 步:在 Heroku 上部署

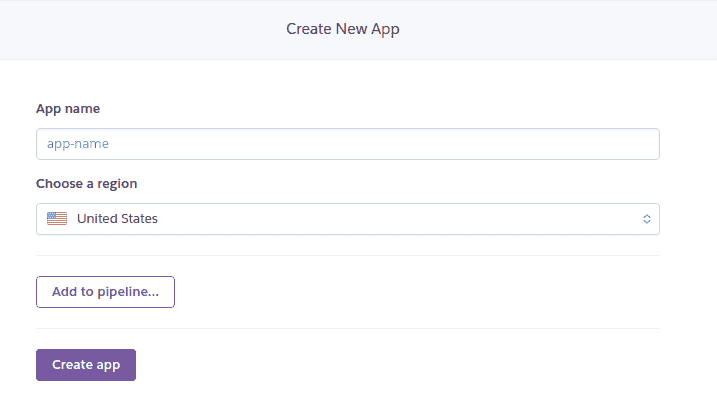

你需要在 Heroku 仪表板上创建一个新的应用程序。

为你的应用程序选择一个合适的名称。

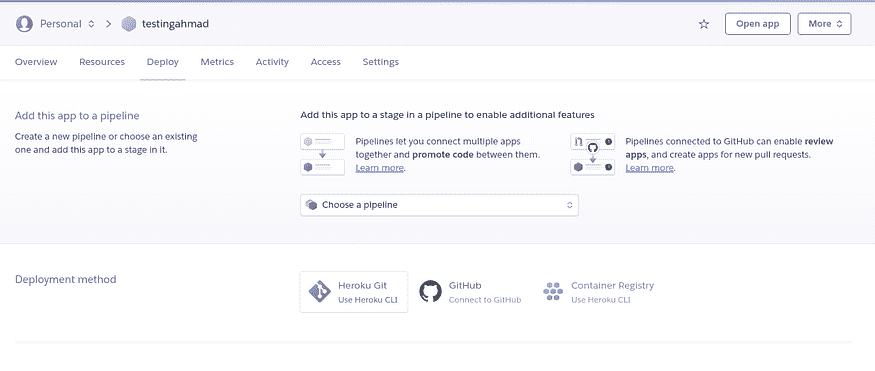

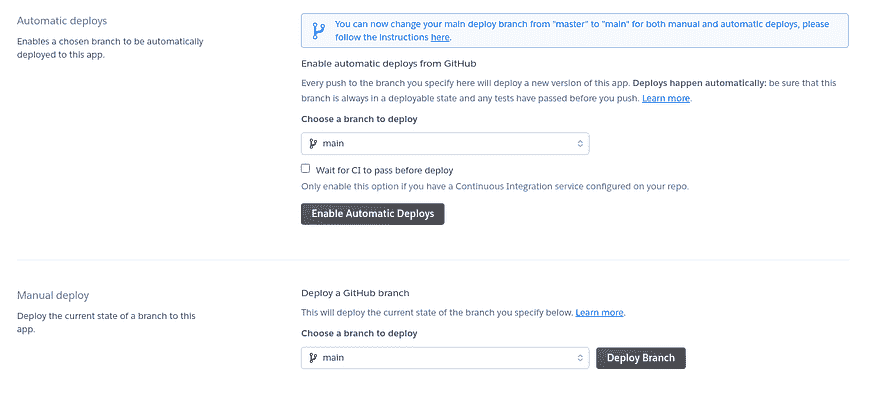

在部署部分,在部署方法中选择 GitHub。

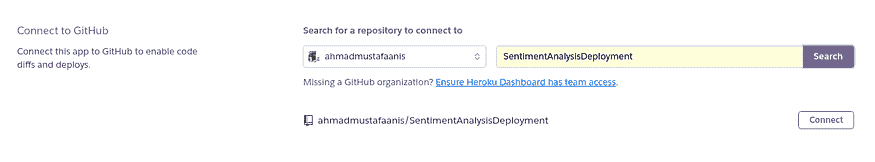

在这里搜索你的仓库,并连接到它。

你可以选择自动部署,这样每次在 GitHub 上的部署分支有变更时,应用程序将自动部署。第一次需要手动部署应用程序。然后每次你在 GitHub 上更新部署分支时,它将会自动部署。

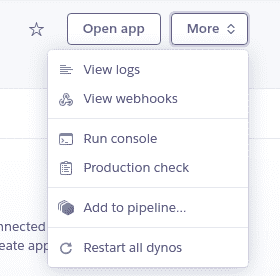

点击“部署分支”将启动部署过程,你可以通过点击“更多”来查看日志,这可以帮助你查看应用程序的日志,如果遇到错误,你可以看到。

一旦构建成功,你可以点击“打开应用程序”来检查你的应用程序。你可以访问你在应用程序中之前定义的所有路由,并进行测试。

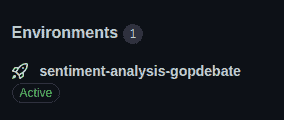

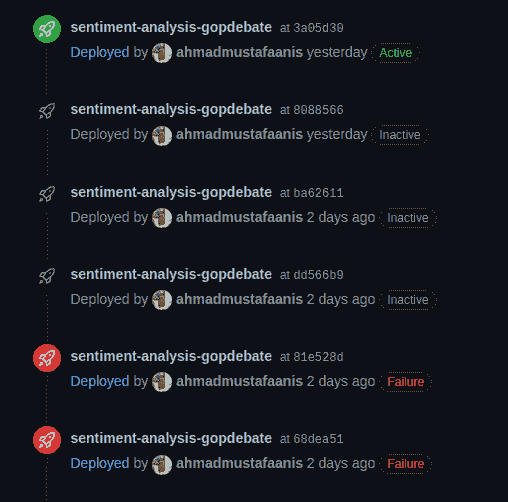

查看部署历史

你可以通过检查 GitHub 上底部左侧的环境标签来查看应用程序的部署历史记录。

这也会显示所有的部署历史记录。

使用 Python Requests 访问你的 API

你可以访问你的 API,这意味着你可以在你的普通代码中使用这个 API 来执行情感分析任务。

import requests #install using pip if not already

url = 'https://sentiment-analysis-gopdebate.herokuapp.com/predict'

data = {'text':'Testing Sentiments'} #test is the function params

resp = requests.post(url, data=data) #post request

print(resp.content)

你将收到的输出就像在端点中看到的一样。

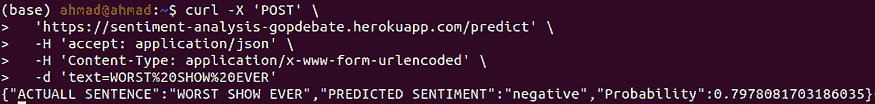

使用 Curl 访问你的 API

Curl 是一个命令行工具(你可以从这里下载),用于从命令行发起请求。我们可以使用以下命令发送请求。

$ curl -X 'POST' \

'https://sentiment-analysis-gopdebate.herokuapp.com/predict' \

-H 'accept: application/json' \

-H 'Content-Type: application/x-www-form-urlencoded' \

-d 'text=WORST%20SHOW%20EVER

在 -X 参数之后我们提到了请求的类型,即 POST 请求。然后 -H 显示我们的 API 使用的头部信息,分别是 application/JSON 和内容类型。接着我们需要使用 -d 参数提供数据并传递文本。要添加空格,请使用 %20。

你可以在我的 GitHub 仓库这里查看完整的代码。

学习成果

在这篇文章中,你学会了如何通过 Heroku 和 GitHub 将你的机器学习/深度学习模型部署为 REST API。你还学会了如何使用 Python requests 模块和 CURL 访问该 API。

相关:

更多相关主题

在 AWS Fargate 上部署机器学习管道

原文:

www.kdnuggets.com/2020/07/deploy-machine-learning-pipeline-aws-fargate.html

评论

由 Moez Ali,PyCaret 创始人兼作者

总结

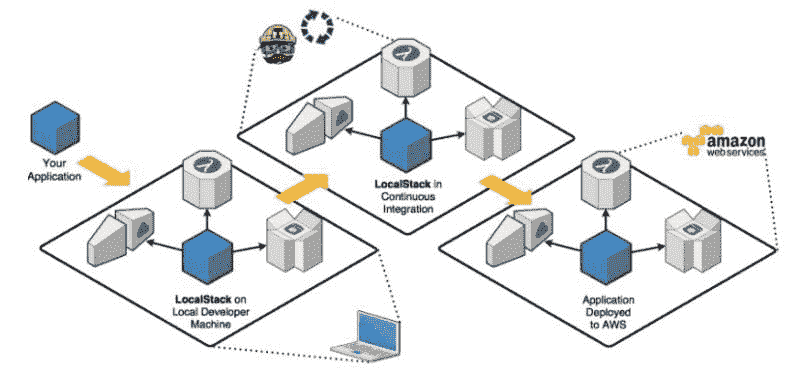

在我们 上一篇文章 中,我们展示了如何在云中开发机器学习管道,使用 PyCaret 容器化,并通过 Google Kubernetes Engine 作为 Web 应用进行服务。如果你以前没有听说过 PyCaret,请阅读这个 公告 以了解更多。

在本教程中,我们将使用之前构建和部署的相同机器学习管道和 Flask 应用。这一次,我们将演示如何使用 AWS Fargate 将机器学习管道容器化并进行无服务器部署。

???? 本教程的学习目标

-

什么是容器?什么是 Docker?什么是 Kubernetes?

-

什么是 Amazon Elastic Container Service (ECS)?

-

什么是 AWS Fargate 和无服务器部署?

-

构建并推送 Docker 镜像到 Amazon Elastic Container Registry。

-

使用 AWS 管理的基础设施(即 AWS Fargate)创建并执行任务定义。

-

看到一个实际运行的 Web 应用,它使用训练好的机器学习管道实时预测新数据点。

本教程将涵盖从本地构建 Docker 镜像、将其上传到 Amazon Elastic Container Registry、创建集群,然后使用 AWS 管理的基础设施(即 AWS Fargate)定义和执行任务的整个工作流程。

在过去,我们已经涵盖了在其他云平台如 Azure 和 Google 上的部署。如果你对了解这些感兴趣,可以阅读以下故事:

???? 本教程所需工具箱

PyCaret

PyCaret 是一个开源的、低代码的 Python 机器学习库,用于训练和部署机器学习管道和模型到生产环境中。PyCaret 可以通过 pip 轻松安装。

pip install pycaret

Flask

Flask 是一个允许你构建 web 应用程序的框架。web 应用程序可以是商业网站、博客、电子商务系统,或是利用训练模型从实时提供的数据中生成预测的应用程序。如果你还没有安装 Flask,你可以使用 pip 来安装它。

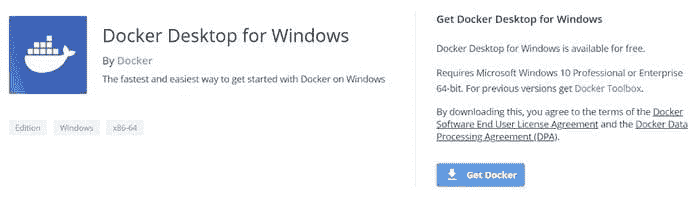

Docker Toolbox for Windows 10 Home

Docker 是一个旨在通过使用容器简化应用程序创建、部署和运行的工具。容器用于将应用程序与其所有必要组件(如库和其他依赖项)打包,并作为一个整体进行分发。如果你以前没有使用过 Docker,本教程还涵盖了在Windows 10 Home上安装 Docker Toolbox(遗留版)。在前一教程中,我们讲解了如何在Windows 10 Pro 版上安装 Docker Desktop。

亚马逊网络服务(AWS)

亚马逊网络服务(AWS)是一个全面且广泛采用的云平台,由亚马逊提供。它在全球数据中心提供超过 175 种功能齐全的服务。如果你以前没有使用过 AWS,你可以注册一个免费账户。

✔️让我们开始吧……

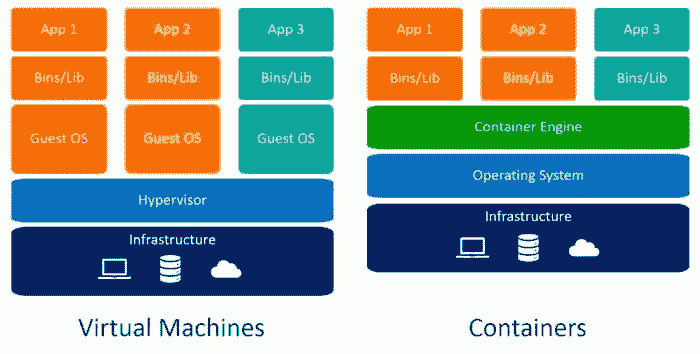

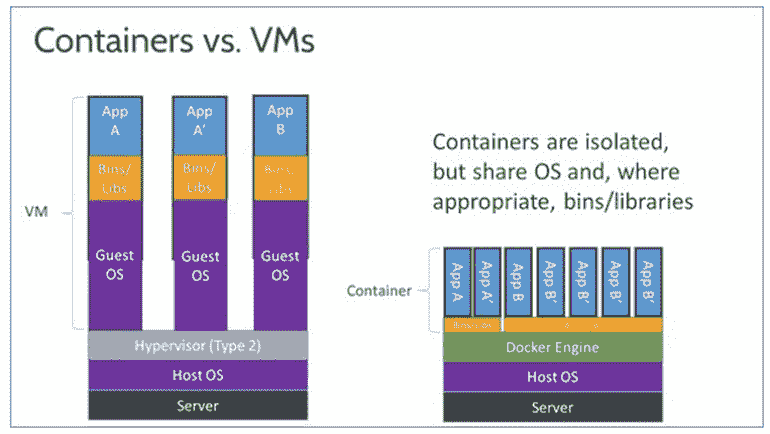

什么是容器?

在我们开始使用 AWS Fargate 进行实现之前,先来了解一下什么是容器,以及我们为什么需要它?

www.freepik.com/free-photos-vectors/cargo-ship

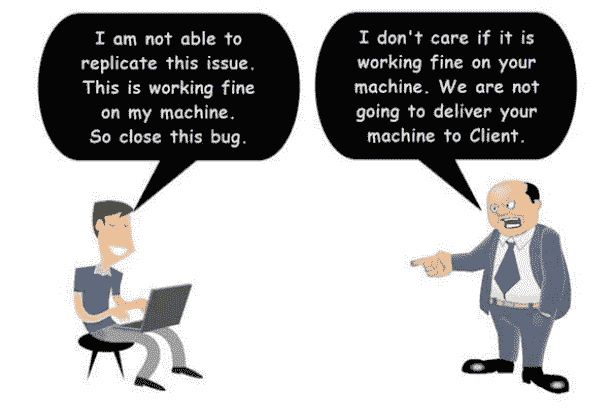

你是否曾遇到过这样的情况:你的代码在你的电脑上运行良好,但当朋友尝试运行完全相同的代码时,它却无法运行?如果你的朋友重复完全相同的步骤,他或她应该会得到相同的结果,对吧?这个一词答案就是环境。你朋友的环境与你的不同。

环境包括什么?→ 包括编程语言(如 Python)以及构建和测试应用程序时使用的所有库和依赖项的确切版本。

如果我们能创建一个可以转移到其他机器的环境(例如:你朋友的电脑或像 Google Cloud Platform 这样的云服务提供商),我们就可以在任何地方重现结果。因此,容器 是一种软件类型,它打包了应用程序及其所有依赖项,使得应用程序能够在一个计算环境到另一个计算环境之间可靠运行。

什么是 Docker?

Docker 是一家公司,提供名为Docker的软件,允许用户构建、运行和管理容器。虽然 Docker 的容器是最常见的,但也有其他不那么知名的替代品,如LXD和LXC。

现在你在理论上理解了容器是什么以及 Docker 如何用于容器化应用程序,让我们设想一个场景,你需要在一组机器上运行多个容器,以支持一个企业级的机器学习应用程序,在白天和夜晚处理不同的工作负载。这在现实生活中相当常见,虽然听起来简单,但手动完成是非常繁重的工作。

你需要在正确的时间启动正确的容器,搞清楚它们如何互相通信,处理存储问题,应对失败的容器或硬件以及其他各种问题!

管理数百个甚至数千个容器以保持应用程序正常运行的整个过程被称为 容器编排。现在不要被技术细节困住。

此时,你必须认识到管理实际应用程序需要多个容器,并且管理所有基础设施以保持容器运行是繁琐、手动且具有管理负担的。

这将我们引向 Kubernetes。

什么是 Kubernetes?

Kubernetes 是一个由 Google 于 2014 年开发的开源系统,用于管理容器化应用程序。简单来说,Kubernetes 是一个用于在一群机器上运行和协调容器化应用程序的系统。

由 chuttersnap 在 Unsplash 拍摄的照片

虽然 Kubernetes 是由 Google 开发的开源系统,但几乎所有主要的云服务提供商都将 Kubernetes 作为托管服务提供。例如:亚马逊弹性 Kubernetes 服务 (EKS) 由亚马逊提供,Google Kubernetes 引擎 (GKE) 由 Google 提供,和 Azure Kubernetes 服务 (AKS) 由微软提供。

到目前为止,我们已经讨论和理解了:

✔️ 一个 容器

✔️ Docker

✔️ Kubernetes

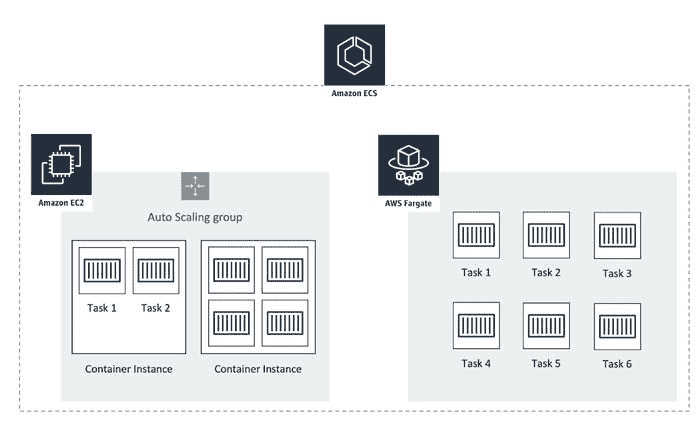

在介绍 AWS Fargate 之前,还剩下一件事要讨论,那就是亚马逊自家的容器编排服务 Amazon Elastic Container Service (ECS)。

AWS 弹性容器服务 (ECS)

亚马逊弹性容器服务 (Amazon ECS) 是亚马逊自家研发的容器编排平台。ECS 的理念类似于 Kubernetes (它们都是编排服务)。

ECS 是 AWS 原生服务,这意味着它只能在 AWS 基础设施上使用。另一方面,EKS 基于 Kubernetes,这是一个开源项目,适用于运行在多云(AWS、GCP、Azure)甚至本地环境中的用户。

亚马逊还提供了一种基于 Kubernetes 的容器编排服务,称为 Amazon Elastic Kubernetes Service (Amazon EKS)。 尽管 ECS 和 EKS 的目的非常相似,即 编排容器化应用程序,但在定价、兼容性和安全性方面存在一些差异。没有最佳答案,解决方案的选择取决于使用案例。

无论你使用的是哪种容器编排服务(ECS 或 EKS),你可以通过两种方式来实现底层基础设施:

-

手动管理集群和底层基础设施,如虚拟机/服务器(也称为 AWS 中的 EC2 实例)。

-

无服务器 — 完全不需要管理任何东西。只需上传容器即可。← 这就是 AWS Fargate。

Amazon ECS 底层基础设施

AWS Fargate — 为容器提供无服务器计算

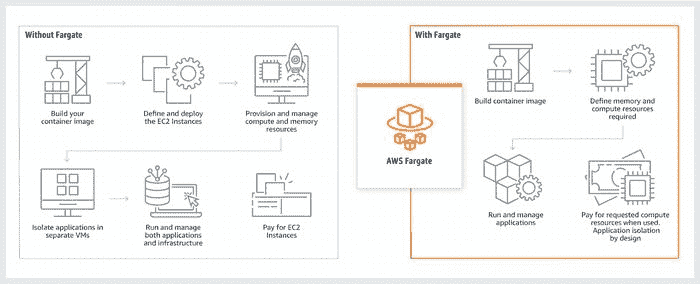

AWS Fargate 是一种无服务器计算引擎,支持与 Amazon Elastic Container Service (ECS) 和 Amazon Elastic Kubernetes Service (EKS) 一起使用。Fargate 使你能够专注于构建应用程序。Fargate 消除了配置和管理服务器的需要,允许你按应用程序指定和支付资源,并通过设计上的应用隔离来提高安全性。

Fargate 分配合适的计算资源,消除了选择实例和扩展集群容量的需要。你只为运行容器所需的资源付费,因此无需担心资源过度配置或额外服务器的费用。

AWS Fargate 的工作原理 — aws.amazon.com/fargate/

哪种方法更好没有最优答案。选择无服务器还是手动管理 EC2 集群取决于具体的使用案例。一些可以帮助你做出选择的指针包括:

ECS EC2(手动方法)

-

你完全依赖于 AWS。

-

你有一个专门的运维团队来管理 AWS 资源。

-

你在 AWS 上已有现有的足迹,即你已经在管理 EC2 实例

AWS Fargate

-

你没有一个庞大的运维团队来管理 AWS 资源。

-

你不想承担操作责任或希望减少操作责任。

-

你的应用程序是无状态的 (无状态应用程序是指在一个会话中生成的客户端数据不会保存到下一次会话中使用的应用程序)。

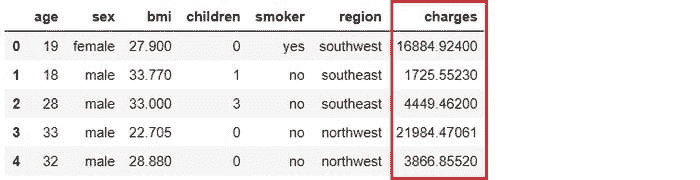

设置业务背景

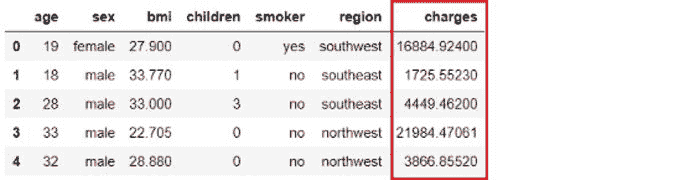

一家保险公司希望通过更好地预测住院时的患者费用来改善其现金流预测,使用的是人口统计数据和基本的患者健康风险指标。

(数据源)

目标

构建和部署一个 Web 应用程序,其中患者的群体和健康信息输入到一个基于 Web 的表单中,然后输出预测的费用金额。

任务

-

训练和开发用于部署的机器学习管道。

-

使用 Flask 框架构建 Web 应用程序。它将使用训练好的 ML 管道实时生成新数据点的预测。

-

将 Docker 镜像构建并推送到 Amazon Elastic Container Registry。

-

创建并执行一个任务,使用 AWS Fargate 无服务器基础设施部署应用程序。

由于我们已经在初始教程中涵盖了前两个任务,我们将快速回顾它们,然后关注上面列表中的剩余项目。如果你有兴趣了解更多关于使用 PyCaret 开发机器学习管道和使用 Flask 框架构建 Web 应用程序的内容,请阅读 本教程。

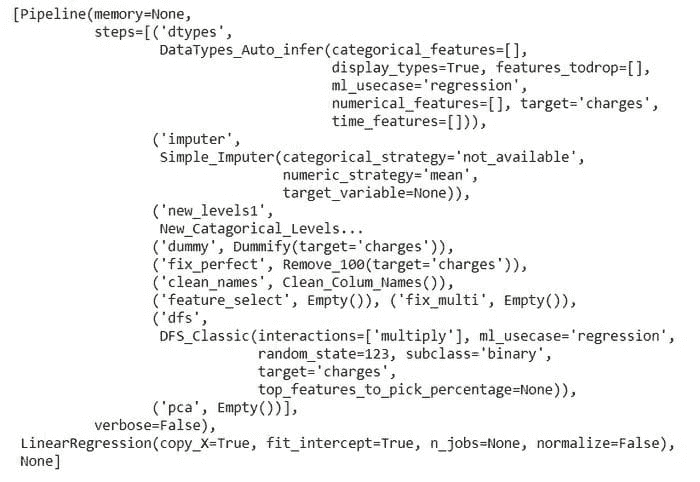

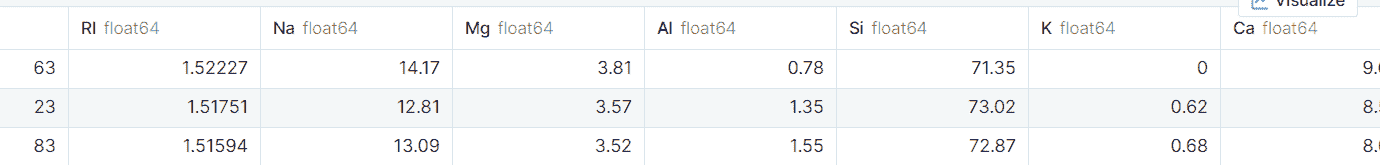

???? 开发机器学习管道

我们在 Python 中使用 PyCaret 训练和开发机器学习管道,该管道将作为我们 Web 应用程序的一部分。机器学习管道可以在集成开发环境(IDE)或 Notebook 中开发。我们使用了 Notebook 来运行以下代码:

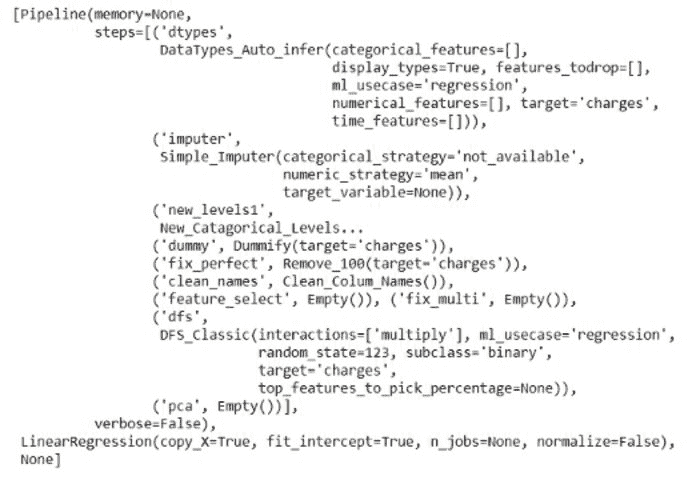

当你在 PyCaret 中保存模型时,基于 **setup() **函数中定义的配置创建了整个转换管道。所有相互依赖关系都自动协调。查看存储在‘deployment_28042020’变量中的管道和模型:

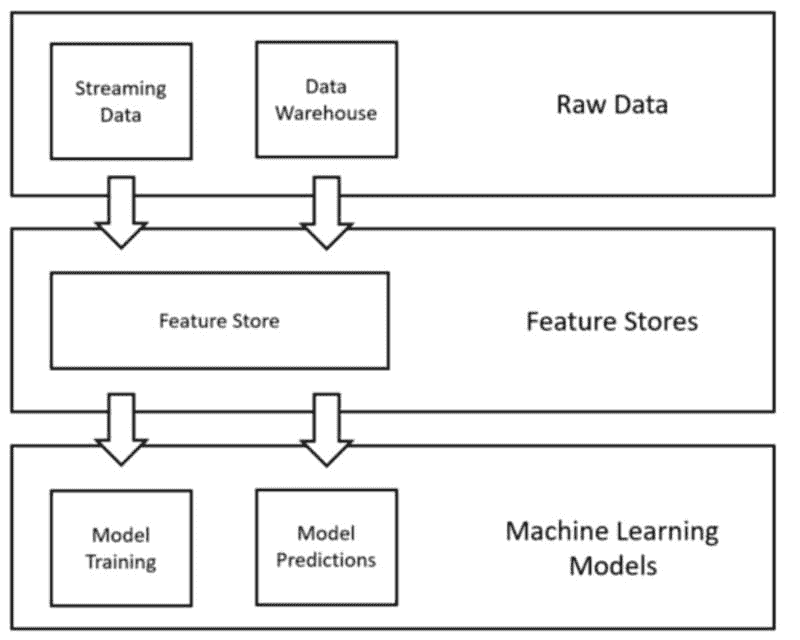

使用 PyCaret 创建的机器学习管道

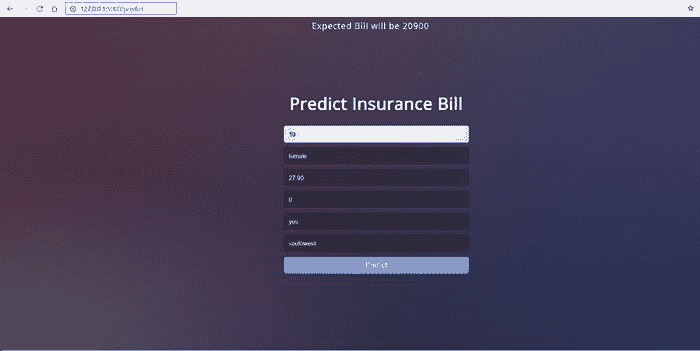

???? 构建 Web 应用程序

本教程不专注于构建 Flask 应用程序。这里只是为了完整性进行讨论。现在我们的机器学习管道已准备好,我们需要一个 Web 应用程序来连接到我们训练好的管道,以实时生成新数据点的预测。我们使用 Python 中的 Flask 框架创建了 Web 应用程序。此应用程序分为两个部分:

-

前端(使用 HTML 设计)

-

后端(使用 Flask 开发)

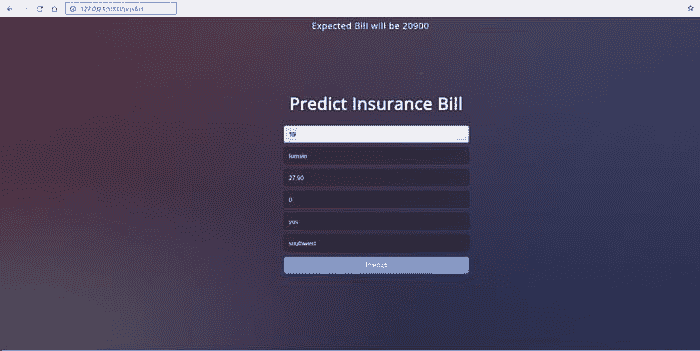

这就是我们的 Web 应用程序的样子:

本地机器上的 Web 应用程序

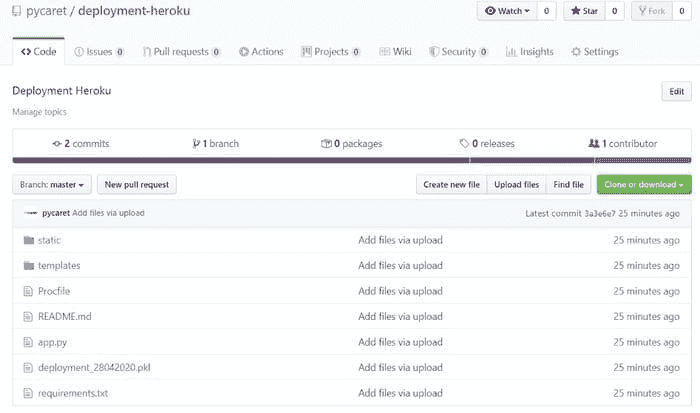

如果你到目前为止没有跟上进度,没关系。你可以从 GitHub 上简单地 fork 这个 仓库。这就是此时你的项目文件夹的样子:

使用 AWS Fargate 部署 ML 管道的 10 个步骤:

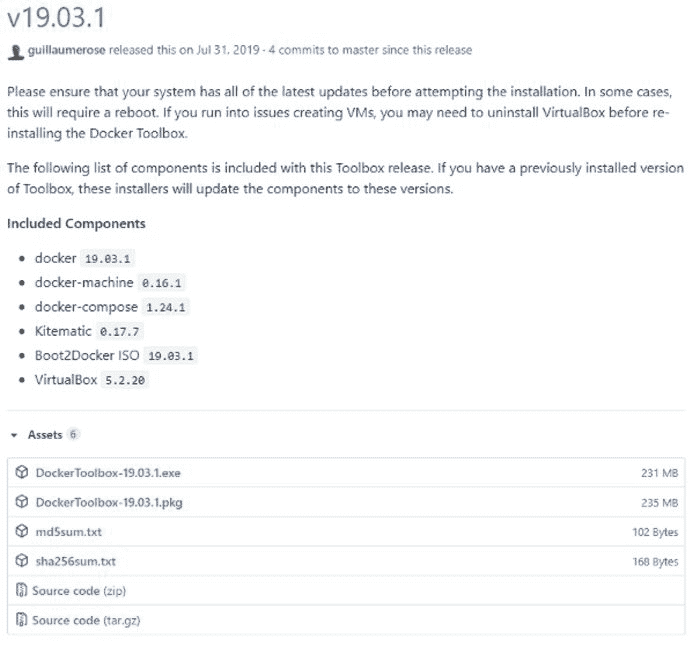

???? 步骤 1 — 安装 Docker Toolbox(适用于 Windows 10 家庭版)

为了在本地构建 Docker 镜像,你需要在计算机上安装 Docker。如果你使用的是 Windows 10 64 位:专业版、企业版或教育版(构建版本 15063 或更高),你可以从 DockerHub 下载 Docker Desktop。

然而,如果你使用的是 Windows 10 家庭版,你需要从 Docker 的 GitHub 页面 安装最后一版的旧版 Docker Toolbox(v19.03.1)。

github.com/docker/toolbox/releases

下载并运行 DockerToolbox-19.03.1.exe 文件。

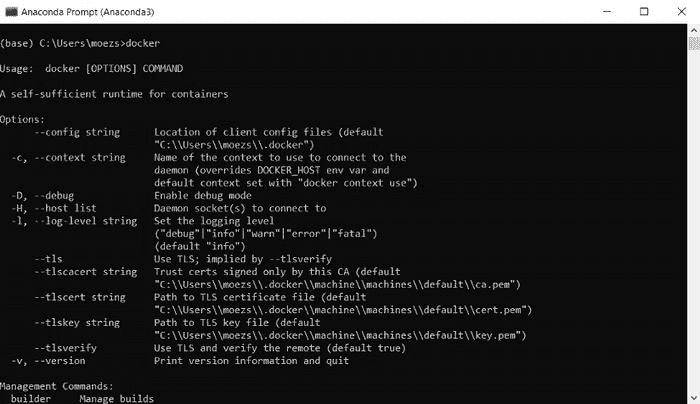

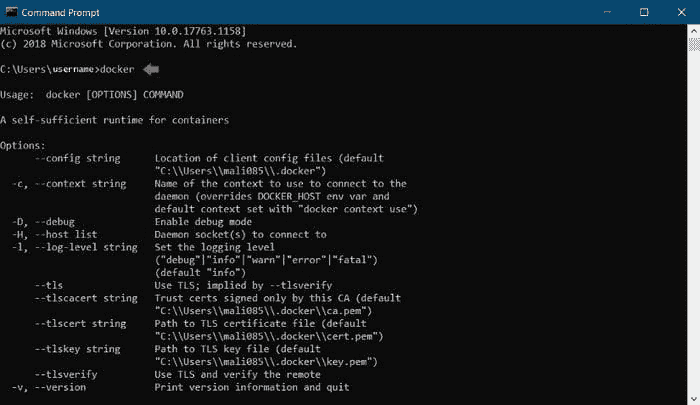

检查安装是否成功的最简单方法是打开命令提示符并输入‘docker’。它应该打印出帮助菜单。

使用 Anaconda Prompt 检查 Docker

???? 步骤 2— 创建 Dockerfile

创建 Docker 镜像的第一步是在项目目录中创建一个 Dockerfile。Dockerfile 只是一个包含一组指令的文件。这个项目的 Dockerfile 如下:

Dockerfile 是区分大小写的,必须与其他项目文件一起放在项目文件夹中。Dockerfile 没有扩展名,可以使用任何文本编辑器创建。你可以从这个 GitHub 存储库 下载本项目中使用的 Dockerfile。

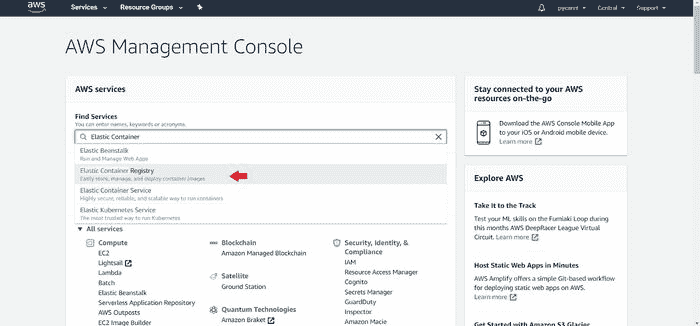

???? 步骤 3— 在 Elastic Container Registry (ECR) 中创建一个存储库

(a) 登录到你的 AWS 控制台并搜索 Elastic Container Registry:

AWS 控制台

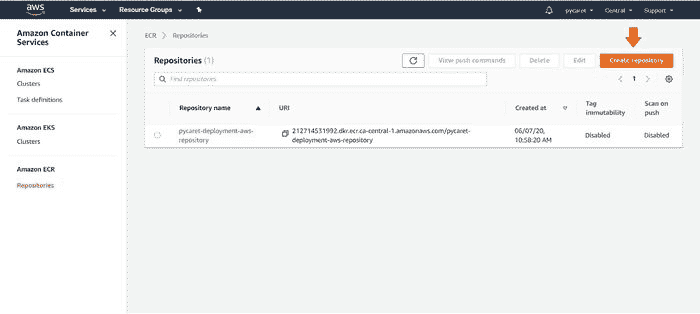

(b) 创建一个新的存储库:

在 Amazon Elastic Container Registry 上创建新存储库

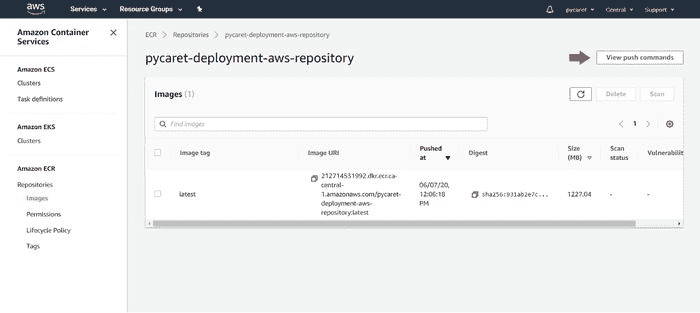

为了这个演示,我们创建了‘pycaret-deployment-aws-repository’。

(c) 点击“查看推送命令”:

pycaret-deployment-aws-repository

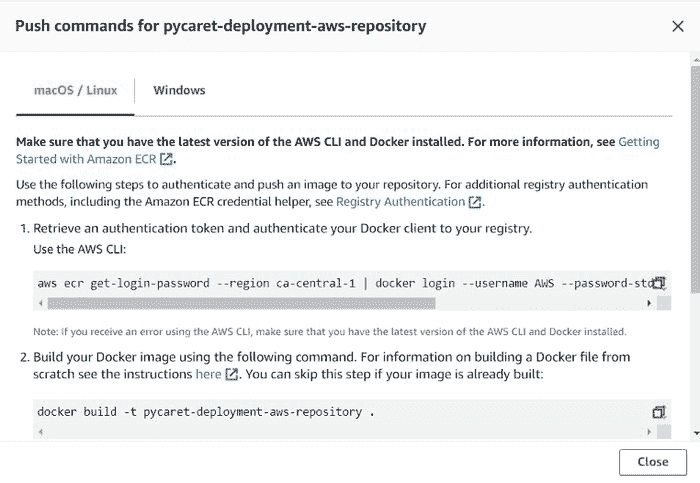

(d) 复制推送命令:

pycaret-deployment-aws-repository 的推送命令

???? 步骤 4— 执行推送命令

使用 Anaconda Prompt 导航到你的项目文件夹,并执行你在上一步中复制的命令。下面的代码仅用于演示,可能无法直接使用。要获得正确的执行代码,你必须从存储库中的“查看推送命令”获取一份代码。

在执行这些命令之前,你必须位于包含 Dockerfile 和其他代码的文件夹中。

**Command 1**

aws ecr get-login-password --region ca-central-1 | docker login --username AWS --password-stdin 212714531992.dkr.ecr.ca-central-1.amazonaws.com**Command 2**

docker build -t pycaret-deployment-aws-repository .**Command 3**

docker tag pycaret-deployment-aws-repository:latest 212714531992.dkr.ecr.ca-central-1.amazonaws.com/pycaret-deployment-aws-repository:latest**Command 4**

docker push 212714531992.dkr.ecr.ca-central-1.amazonaws.com/pycaret-deployment-aws-repository:latest

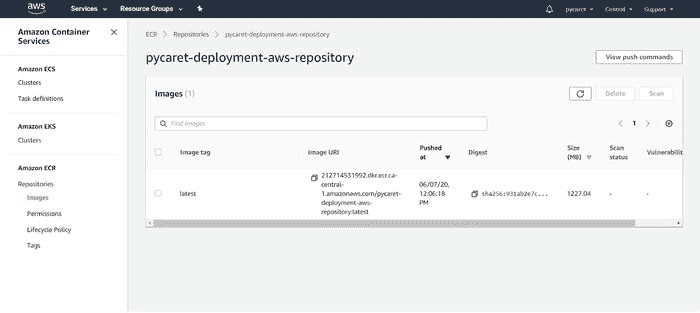

???? 步骤 5— 检查你上传的镜像

点击你创建的存储库,你将看到在上述步骤中上传的镜像的 URI。复制镜像 URI(在下面的步骤 7 中会用到)。

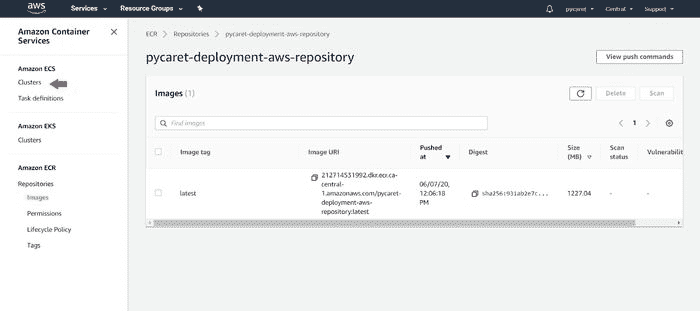

???? 步骤 6 — 创建和配置集群

(a) 点击左侧菜单中的“集群”:

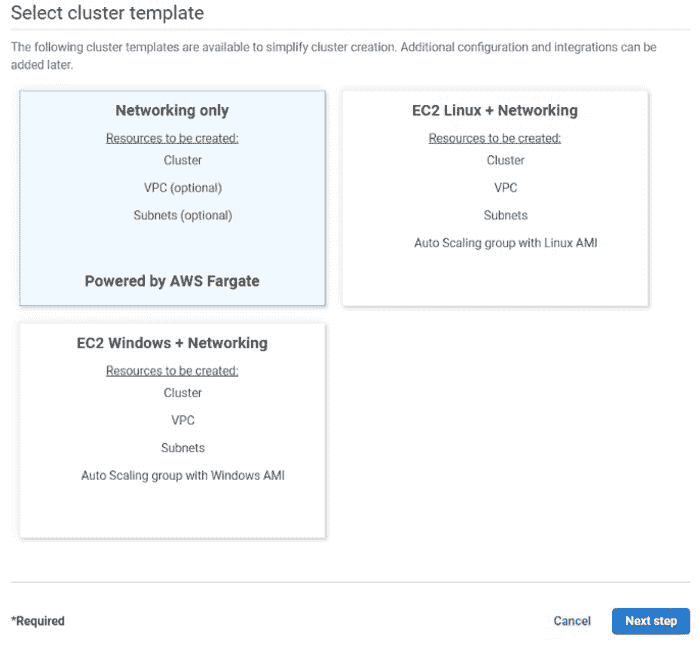

创建集群 — 步骤 1

(b) 选择“仅网络”并点击下一步:

选择仅网络模板

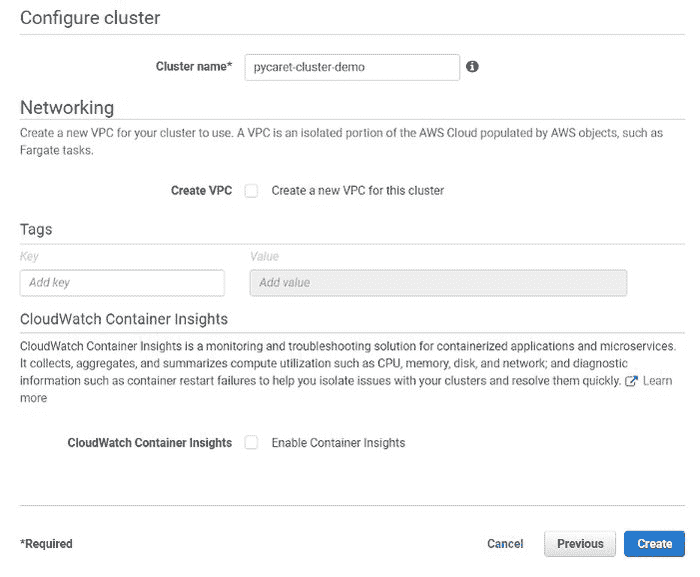

(c) 配置集群(输入集群名称)并点击创建:

配置集群

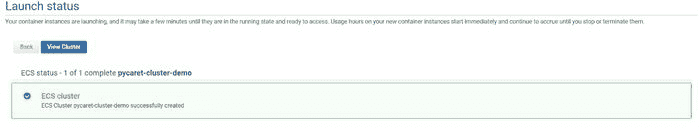

(d) 集群创建完成:

集群已创建

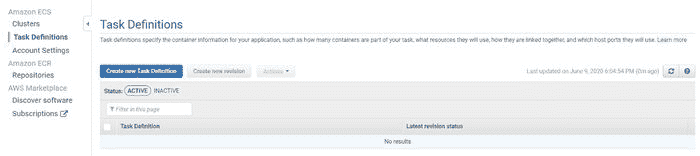

???? 步骤 7— 创建一个新的任务定义

一个任务定义是运行 Amazon ECS 中的 Docker 容器所必需的。您可以在任务定义中指定的一些参数包括:每个容器使用的 Docker 镜像。每个任务或任务中每个容器使用的 CPU 和内存量。

(a) 点击“创建新任务定义”:

创建新任务定义

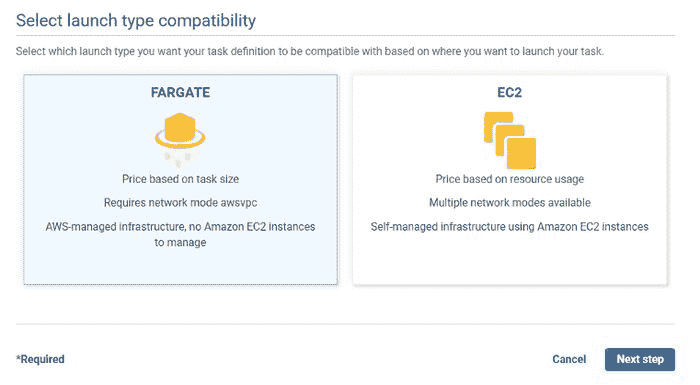

(b) 选择“FARGATE”作为启动类型:

选择启动类型兼容性

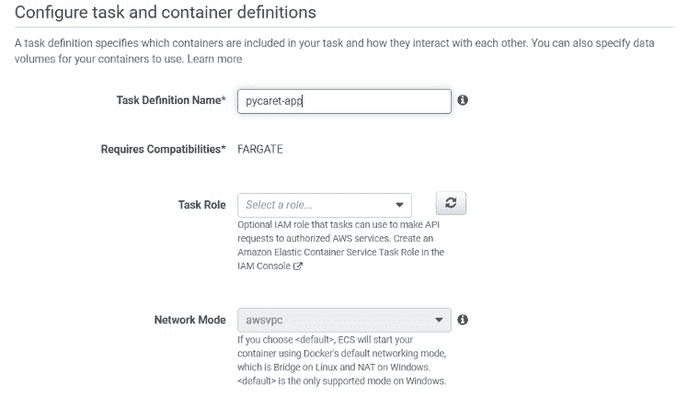

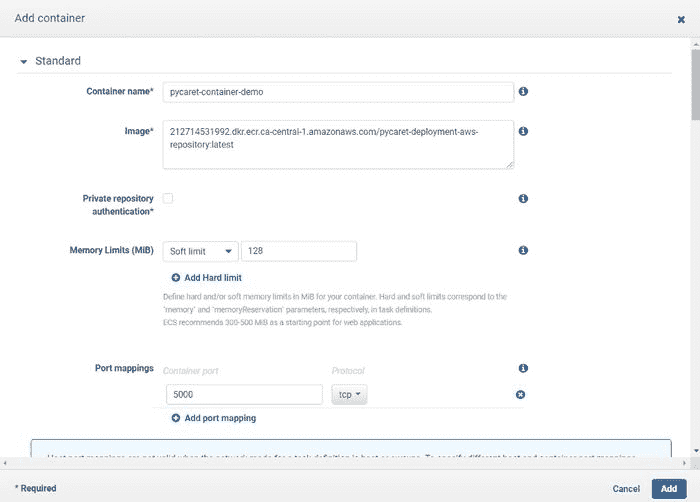

(c) 填写详细信息:

配置任务和容器定义(第一部分)

配置任务和容器定义(第二部分)

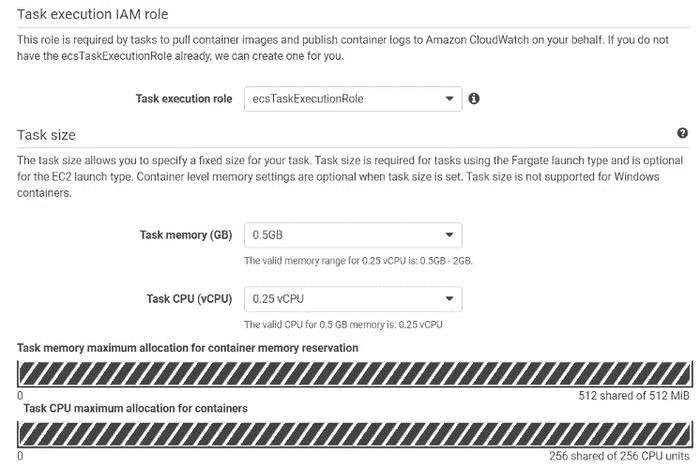

(d) 点击“添加容器”并填写详细信息:

在任务定义中添加容器

(e) 点击右下角的“创建任务”。

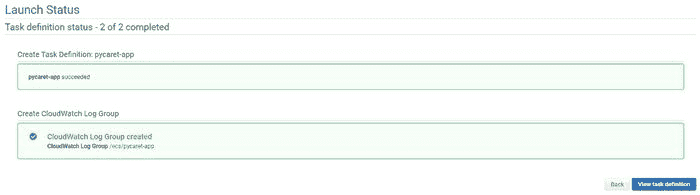

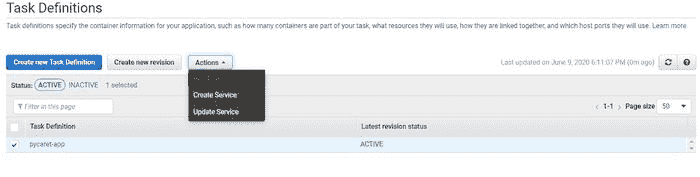

???? 第 8 步 — 执行任务定义

在第 7 步中,我们创建了一个将启动容器的任务。现在我们将通过点击“运行任务”在操作下执行任务。

执行任务定义

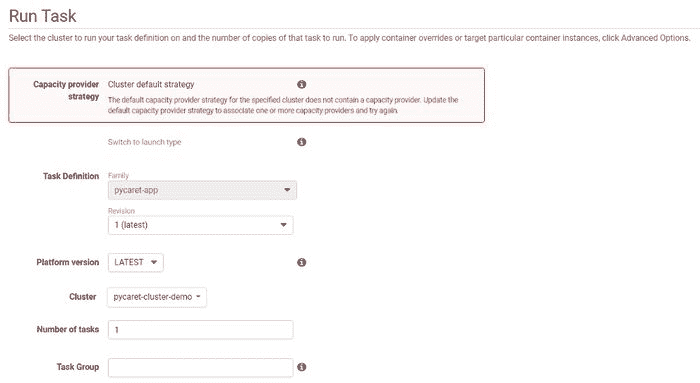

(a) 点击“切换启动类型”将类型更改为 Fargate:

运行任务 — 第一部分

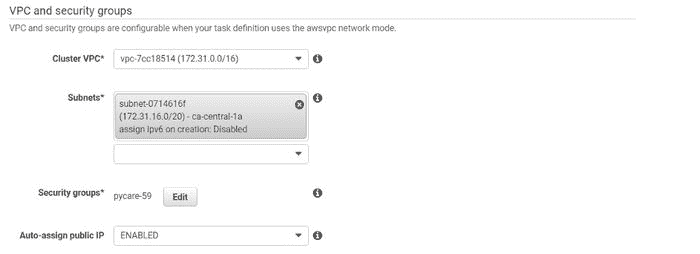

(b) 从下拉菜单中选择 VPC 和子网:

运行任务 — 第二部分

(c) 点击右下角的“运行任务”:

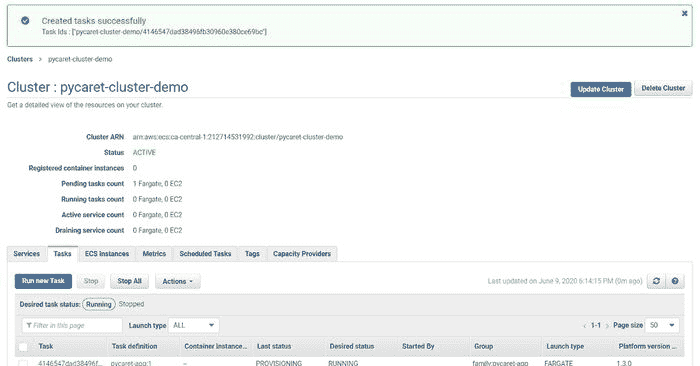

任务创建成功

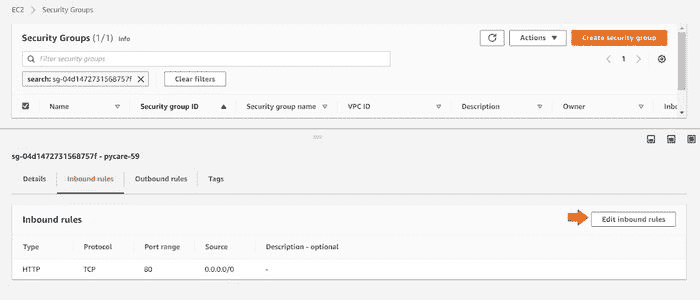

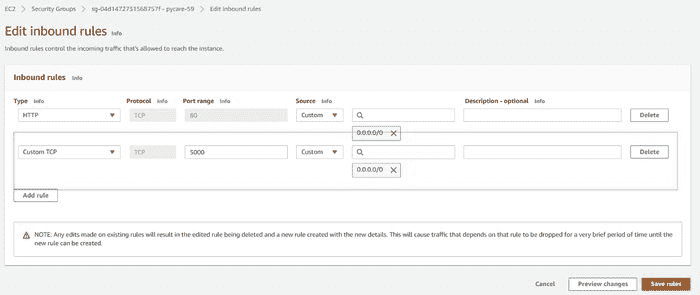

???? 第 9 步— 从网络设置中允许入站端口 5000

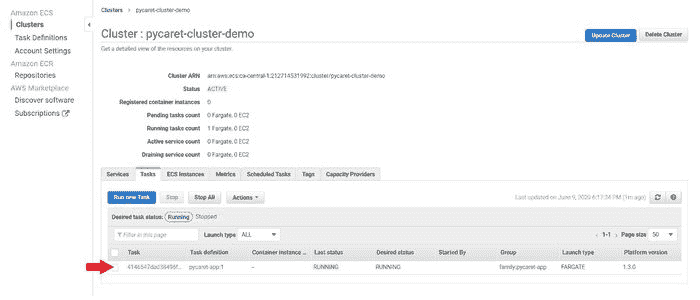

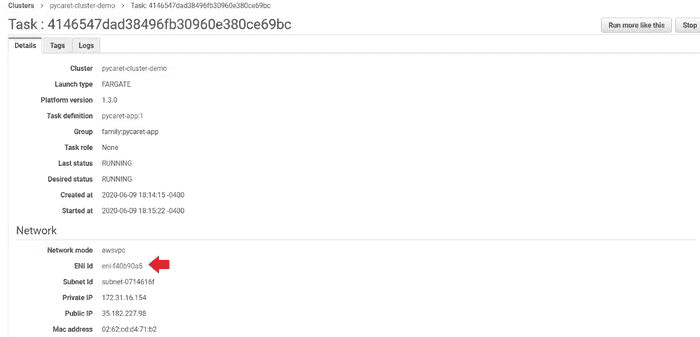

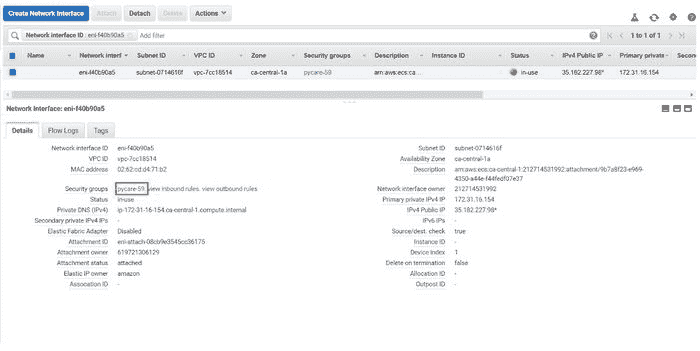

在我们可以在公共 IP 地址上查看应用运行之前的最后一步是通过创建新规则来允许端口 5000。为此,请按以下步骤操作:

(a) 点击任务

(b) 点击 ENI Id:

(c) 点击安全组

(d) 点击“编辑入站规则”

(e) 添加端口 5000 的自定义 TCP 规则

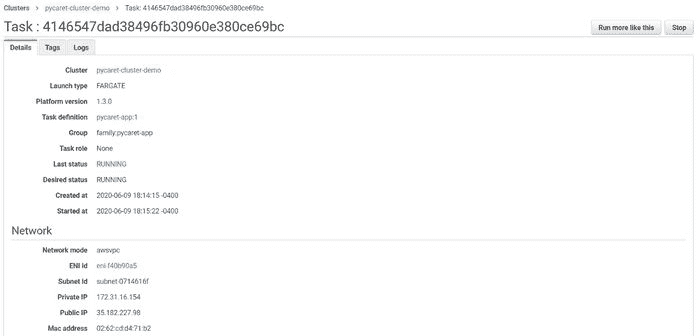

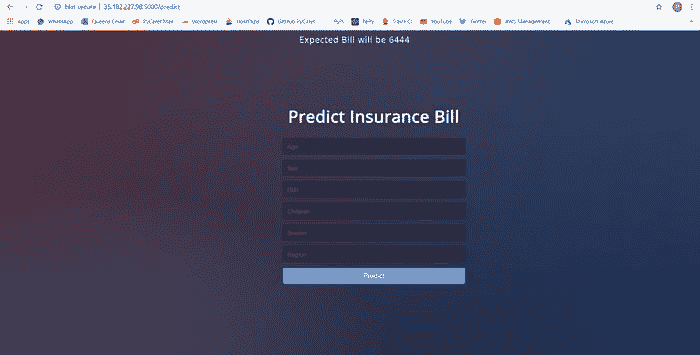

???? 第 10 步 — 查看应用运行情况

使用公共 IP 地址和端口 5000 访问应用程序。

任务定义日志

最终应用上传至35.182.227.98:5000

注意: 在这篇文章发布时,该应用将从公共地址中移除,以限制资源消耗。

PyCaret 2.0.0 即将来临!

我们收到了来自社区的热烈支持和反馈。我们正在积极改进 PyCaret,并为下一个版本做准备。PyCaret 2.0.0 将更大更好。如果你想分享你的反馈并帮助我们进一步改进,你可以在网站上 填写此表单 或在我们的 GitHub 或 LinkedIn 页面留言。

关注我们的 LinkedIn 和订阅我们的 YouTube 频道,以了解更多关于 PyCaret 的信息。

想了解特定模块吗?

从 1.0.0 版本首次发布开始,PyCaret 提供了以下模块供使用。点击下面的链接查看 Python 中的文档和工作示例。

另见:

PyCaret 入门教程在 Notebook 中:

你想要贡献吗?

PyCaret 是一个开源项目。欢迎大家贡献。如果你想贡献,请随时处理 开放问题。拉取请求将接受 dev-1.0.1 分支上的单元测试。

如果你喜欢 PyCaret,请在我们的 GitHub 仓库 上给我们 ⭐️。

Medium: medium.com/@moez_62905/

LinkedIn: www.linkedin.com/in/profile-moez/

推特: twitter.com/moezpycaretorg1

简介: Moez Ali 是一位数据科学家,也是 PyCaret 的创始人兼作者。

原文。已获许可转载。

相关:

-

使用 Docker 容器将机器学习管道部署到云

-

构建并部署你的第一个机器学习 web 应用

-

宣布 PyCaret 1.0.0

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

更多相关内容

使用 Docker 容器将机器学习管道部署到云端

原文:

www.kdnuggets.com/2020/06/deploy-machine-learning-pipeline-cloud-docker.html

评论

由 Moez Ali,PyCaret 的创始人和作者

回顾

在我们 上一篇文章中,我们展示了如何使用 PyCaret 和 Flask 框架在 Python 中开发机器学习管道并将其作为 web 应用进行部署。如果你以前没有听说过 PyCaret,请阅读此 公告 以了解更多。

在本教程中,我们将使用之前构建和部署的相同机器学习管道和 Flask 应用。这次我们将演示如何使用 微软 Azure Web 应用服务将机器学习管道作为 web 应用进行部署。

为了在 Microsoft Azure 上部署机器学习管道,我们需要在一个叫做“Docker”的软件中将我们的管道容器化。如果你不知道什么是容器化,没关系—本教程正是关于这个内容的。

???? 本教程的学习目标

-

什么是容器?什么是 Docker?我们为什么需要它?

-

在你的本地计算机上构建 Docker 文件并将其发布到 Azure 容器注册表 (ACR)。

-

使用我们上传到 ACR 的容器在 Azure 上部署一个 web 服务。

-

查看一个实际操作中的网络应用,使用训练好的机器学习管道对新的数据点进行实时预测。

在我们上一篇文章中,我们介绍了模型部署的基础知识及其必要性。如果你想了解更多关于模型部署的内容, 点击这里 阅读我们的上一篇文章。

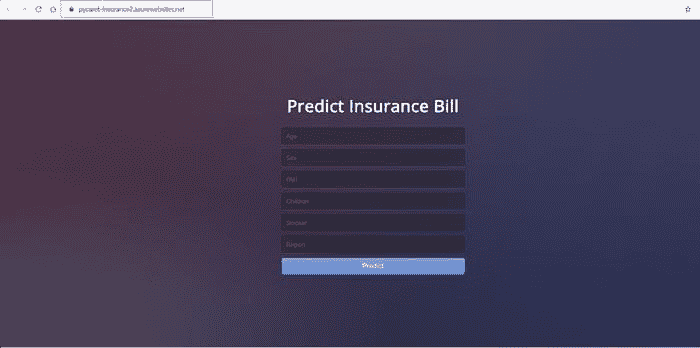

本教程将涵盖从本地构建容器到将其推送到 Azure 容器注册表,再到将我们预训练的机器学习管道和 Flask 应用部署到 Azure Web 服务的整个工作流程。

工作流程:创建图像 → 本地构建容器 → 推送到 ACR → 在云端部署应用

???? 本教程的工具箱

PyCaret

PyCaret 是一个开源、低代码的 Python 机器学习库,用于训练和部署机器学习管道和模型到生产环境中。PyCaret 可以通过 pip 轻松安装。

pip install **pycaret**

Flask

Flask是一个允许你构建网络应用程序的框架。网络应用程序可以是商业网站、博客、电子商务系统,或者是一个使用训练过的模型实时生成预测的应用程序。如果你没有安装 Flask,可以使用 pip 进行安装。

Docker

Docker是一个旨在通过使用容器来简化创建、部署和运行应用程序的工具。容器用于将应用程序及其所有必要组件(例如库和其他依赖项)打包在一起,并将其作为一个整体进行传输。如果你以前没有使用过 Docker,本教程还涵盖了在 Windows 10 上安装 Docker 的过程。

Microsoft Azure

Microsoft Azure是一组用于在大规模全球网络上构建、管理和部署应用程序的云服务。其他常用于部署机器学习管道的云服务包括Amazon Web Services (AWS)、Google Cloud、IBM Cloud和Alibaba Cloud。我们将在未来的教程中涵盖它们中的大多数。

如果你以前没有使用过 Microsoft Azure,你可以在这里注册一个免费账户。当你第一次注册时,你会获得一个 30 天的免费信用额度。你可以通过按照本教程来利用这些信用额度构建你自己的网络应用程序。

什么是容器,为什么我们需要它?

你是否遇到过这样的问题:你的 Python 代码(或任何其他代码)在你的计算机上运行正常,但当你的朋友尝试运行完全相同的代码时,却无法运行?如果你的朋友重复完全相同的步骤,他们应该得到相同的结果,对吧?这个问题的答案是环境。你朋友的 Python 环境与你的不同。

环境包括什么?→ Python(或你使用过的任何其他语言)以及构建和测试应用程序所使用的所有库和依赖项及其确切版本。

如果我们能以某种方式创建一个可以转移到其他计算机(例如:你朋友的计算机或像 Microsoft Azure 这样的云服务提供商)的环境,我们就可以在任何地方重现结果。

因此,容器是一种软件,它打包了一个应用程序及其所有依赖项,以便该应用程序在不同的计算环境中可靠地运行。

“当你想到容器时,就要想到容器。”

www.freepik.com/free-photos-vectors/cargo-ship

这是理解数据科学中容器的最直观的方式。它们就像船上的集装箱,其目标是将一个容器的内容与其他容器隔离,以免混淆。这正是数据科学中使用容器的目的。

现在我们理解了容器背后的隐喻,让我们看看创建应用隔离环境的其他选择。一个简单的替代方案是为每个应用程序使用一台独立的机器。

(1 台机器 = 1 个应用 = 无冲突 = 一切正常)

使用单独的机器是直接的,但它无法超越使用容器的好处,因为为每个应用程序维护多台机器是昂贵的,维护起来如同噩梦且难以扩展。简而言之,在许多实际场景中,这并不切实际。

创建隔离环境的另一个替代方案是虚拟机。在这里,容器更为可取,因为它们需要更少的资源,非常便携,并且启动速度更快。

虚拟机 vs. 容器

你能发现虚拟机和容器之间的区别吗?使用容器时,你不需要客操作系统。想象一下在虚拟机上运行 10 个应用程序。这将需要 10 个客操作系统,而使用容器时则无需这些操作系统。

我了解容器,但 Docker 是什么?

Docker 是一家提供软件(也称为 Docker)的公司,允许用户构建、运行和管理容器。虽然 Docker 的容器最为常见,但也有其他不那么著名的替代方案,如 LXD 和 LXC,它们提供容器解决方案。

在本教程中,我们将使用Docker Desktop for Windows创建一个容器,并将其发布到 Azure 容器注册表中。然后,我们将使用该容器部署一个 web 应用。

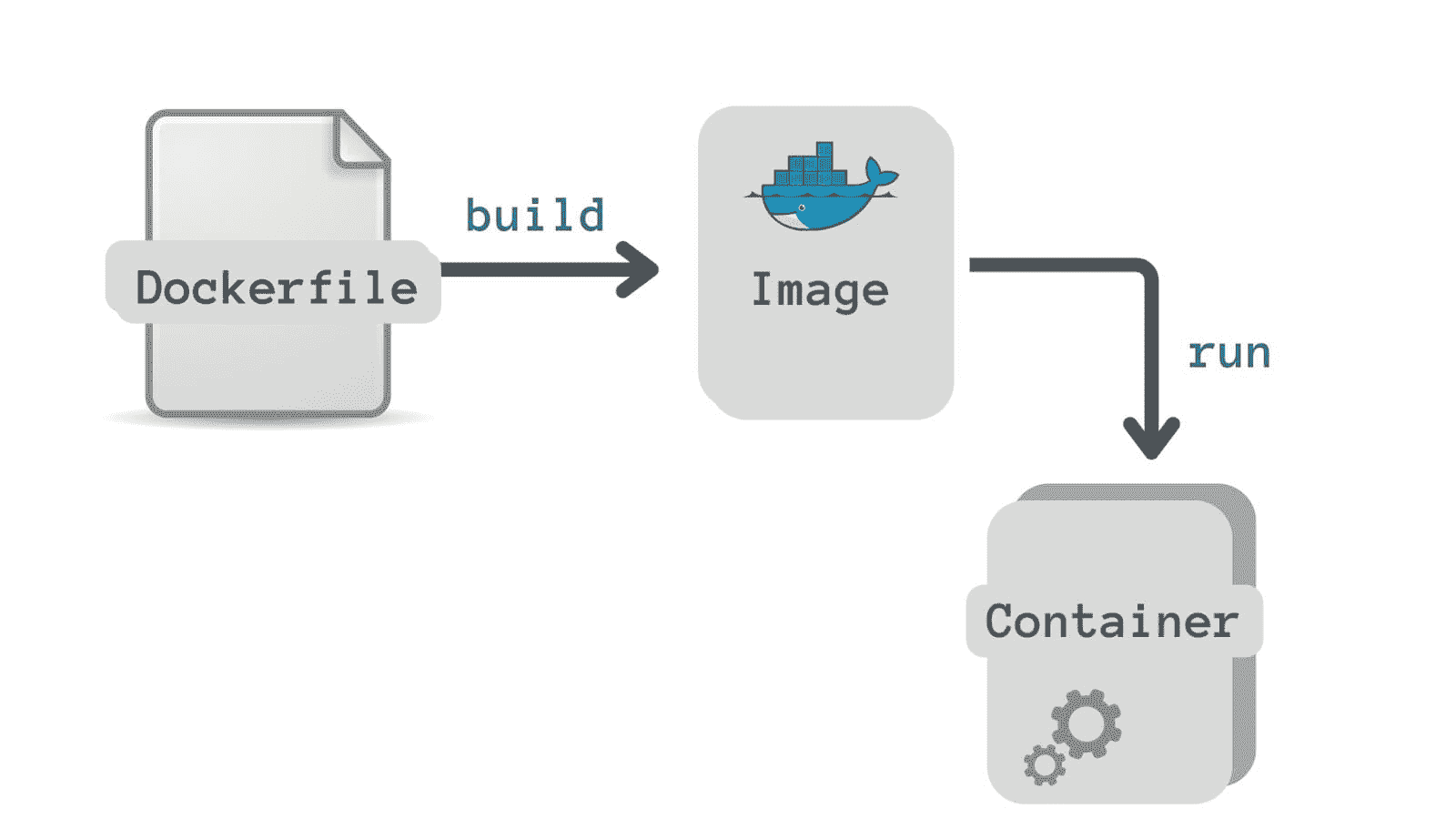

Docker 镜像 vs. Docker 容器

Docker 镜像和 Docker 容器有什么区别?这是最常被问到的问题,所以让我们马上澄清。虽然有许多技术定义,但直观的理解是将 Docker 镜像看作是创建容器的模具。镜像本质上是容器的快照。

如果你更倾向于稍微技术性的定义,那么可以这样理解:Docker 镜像在运行时会转变为容器,当它们在 Docker 引擎上运行时。

打破炒作:

到头来,Docker 只是一个包含几行指令的文件,保存在你的项目文件夹中,文件名为“Dockerfile”。

另一种看待 docker 文件的方法是,它们就像你在自己厨房里发明的食谱。当你与其他人分享这些食谱,并且他们按照完全相同的步骤操作时,他们也能制作出相同的菜肴。同样,你可以将你的 docker 文件分享给其他人,他们可以基于这个 docker 文件创建镜像并运行容器。

现在你已经了解了容器、docker 以及为什么我们应该使用它们,让我们快速设定业务背景。

设定业务背景

一家保险公司希望通过更好地预测患者费用来改善现金流预测,方法是使用在住院时的基本人口统计和患者健康风险指标。

(数据来源)

目标

构建和部署一个 Web 应用程序,在其中输入患者的基本信息和健康信息,然后输出预测的费用金额。

任务

-

训练并开发用于部署的机器学习管道。

-

使用 Flask 框架构建一个 Web 应用程序。它将使用训练好的 ML 管道实时生成新数据点的预测。

-

创建一个 docker 镜像和容器。

-

将容器发布到 Azure 容器注册表(ACR)。

-

通过发布到 ACR,将 Web 应用程序部署到容器中。一旦部署,它将公开可用,并可以通过 Web URL 访问。

由于我们在上一个教程中已经涵盖了前两个任务,我们将快速回顾这些任务,并重点关注上述列表中的剩余任务。如果你对使用 PyCaret 开发机器学习管道和使用 Flask 框架构建 Web 应用程序感兴趣,你可以阅读我们的 最后一个教程。

???? 开发机器学习管道

我们在 Python 中使用 PyCaret 进行机器学习管道的训练和开发,这将作为我们 Web 应用程序的一部分。机器学习管道可以在集成开发环境(IDE)或笔记本中开发。我们使用笔记本运行以下代码:

当你在 PyCaret 中保存模型时,基于在setup()函数中定义的配置会创建整个转换管道。所有的相互依赖关系会自动协调。查看存储在‘deployment_28042020’变量中的管道和模型:

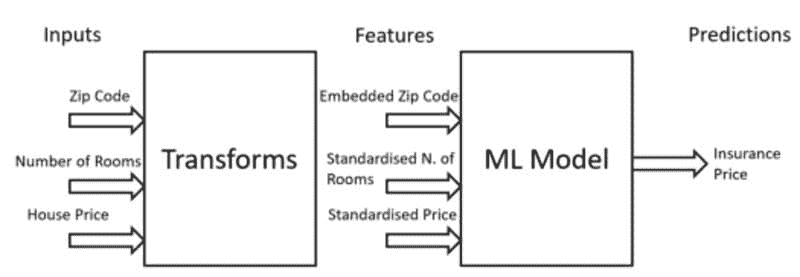

使用 PyCaret 创建的机器学习管道

???? 构建 Web 应用程序

本教程不专注于构建 Flask 应用程序。这里只是为了完整性进行讨论。现在我们的机器学习管道已经准备好,我们需要一个可以连接到训练管道以实时生成新数据点预测的网页应用程序。我们使用 Python 中的 Flask 框架创建了这个网页应用程序。这个应用程序分为两个部分:

-

前端(使用 HTML 设计)

-

后端(使用 Flask 开发)

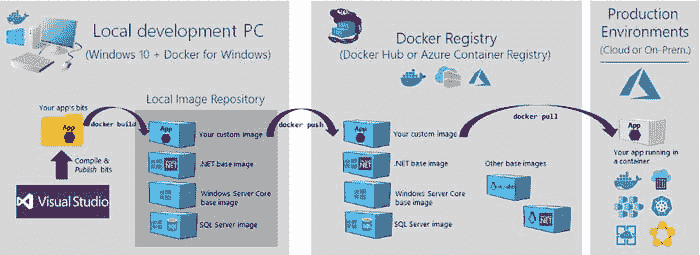

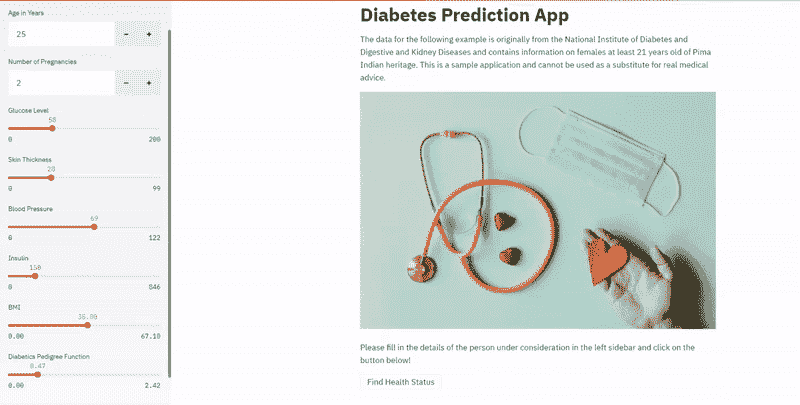

这就是我们的网页应用的样子:

本地机器上打开的网页应用

如果你想查看这个网页应用的实际效果,请 点击这里 打开一个部署在 Heroku 上的网页应用(可能需要几分钟才能打开)。

如果你没有跟随操作,也没关系。你可以从 GitHub 上直接 fork 这个 代码库。如果你不知道如何 fork 一个 repo,请 阅读这个 官方 GitHub 教程。到这个时候,你的项目文件夹应该是这样的:

github.com/pycaret/deployment-heroku

现在我们有了一个完全功能的网页应用程序,我们可以开始使用 Docker 将应用程序容器化。

部署 ML 管道到 docker 容器的 10 个步骤:

???? 第 1 步 — 安装 Windows 版 Docker Desktop

你可以在 Mac 和 Windows 上使用 Docker Desktop。根据你的操作系统,你可以从 这个链接 下载 Docker Desktop。在本教程中,我们将使用 Windows 版本的 Docker Desktop。

hub.docker.com/editions/community/docker-ce-desktop-windows/

检查安装是否成功的最简单方法是打开命令提示符并输入‘docker’。它应该会打印出帮助菜单。

命令提示符

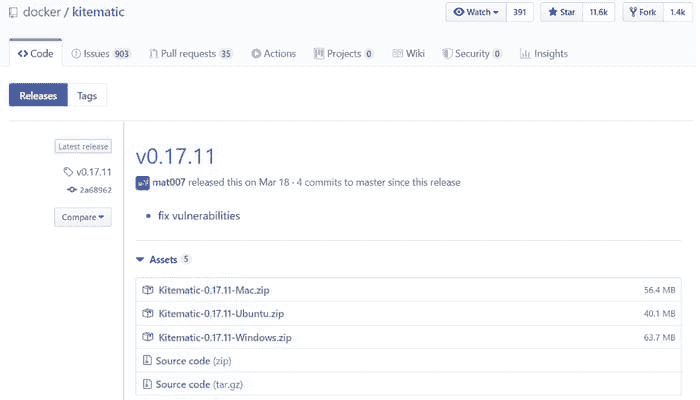

???? 第 2 步 — 安装 Kitematic

Kitematic 是一个直观的图形用户界面(GUI),用于在 Windows 或 Mac 上运行 Docker 容器。你可以从 Docker 的 GitHub 仓库 下载 Kitematic。

github.com/docker/kitematic/releases

下载后,只需将文件解压到所需位置。

???? 第 3 步 — 创建 Dockerfile

创建 Docker 镜像的第一步是创建一个 Dockerfile。Dockerfile 只是一个包含一组指令的文件。这个项目的 Dockerfile 长这样:

Dockerfile 区分大小写,必须与其他项目文件一起放在项目文件夹中。Dockerfile 没有扩展名,可以使用任何编辑器创建。我们使用了 Visual Studio Code 来创建它。

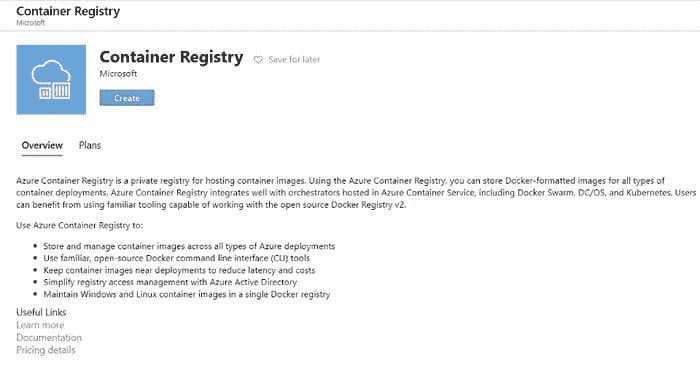

???? 第 4 步——创建 Azure 容器注册表

如果你没有 Microsoft Azure 账户或之前未使用过,可以 注册 免费注册。当你首次注册时,会获得 30 天的免费信用额度。你可以利用这笔信用额度在 Azure 上构建和部署 web 应用程序。注册后,请按照以下步骤操作:

-

登录到

portal.azure.com。 -

点击“创建资源”。

-

搜索“容器注册表”并点击“创建”。

-

选择订阅、资源组和注册表名称(在我们的例子中:pycaret.azurecr.io 是我们的注册表名称)

portal.azure.com → 登录 → 创建资源 → 容器注册表

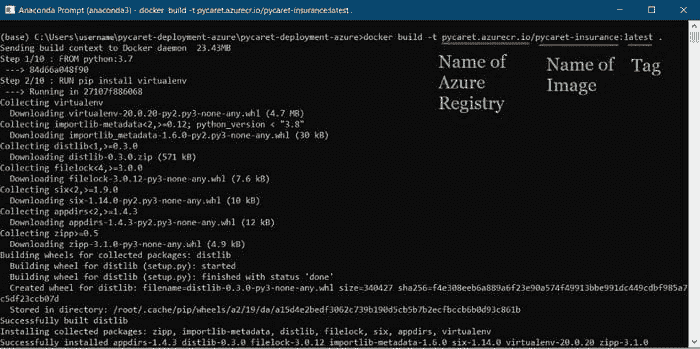

???? 第 5 步——构建 Docker 镜像

在 Azure 门户中创建注册表后,第一步是使用命令行构建一个 Docker 镜像。导航到项目文件夹并执行以下代码。

docker build -t pycaret.azurecr.io/pycaret-insurance:latest .

使用 Anaconda 提示符构建 Docker 镜像

-

pycaret.azurecr.io 是你在 Azure 门户上创建资源时得到的注册表名称。

-

pycaret-insurance 是镜像名称,latest 是标签。这个标签可以是你想要的任何名称。

???? 第 6 步——从 Docker 镜像运行容器

现在图像已经创建,我们将在本地运行一个容器并测试应用程序,然后再将其推送到 Azure 容器注册表。要在本地运行容器,请执行以下代码:

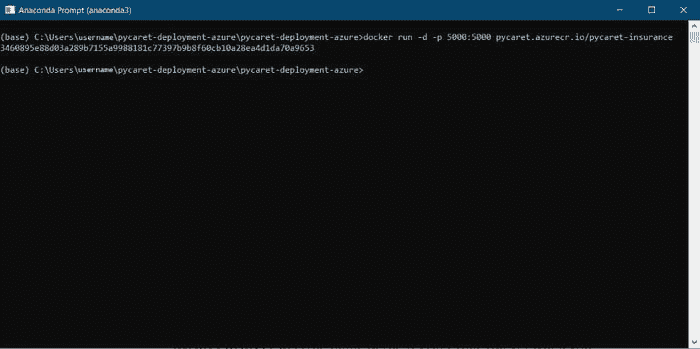

docker run -d -p 5000:5000 pycaret.azurecr.io/pycaret-insurance

一旦此命令成功执行,它将返回创建的容器的 ID。

本地运行 Docker 容器

???? 第 7 步——在本地计算机上测试容器

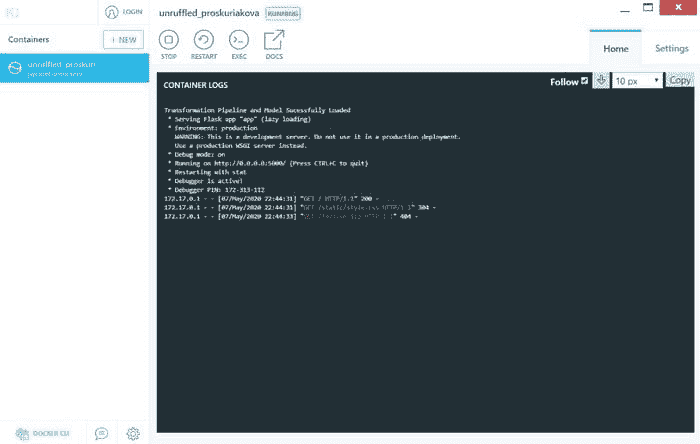

打开 Kitematic,你应该能看到一个正在运行的应用程序。

Kitematic — 一个用于在 Mac 和 Windows 操作系统上管理容器的图形用户界面

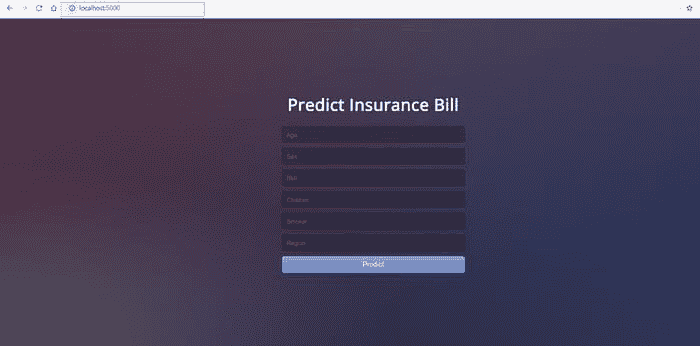

你可以通过在互联网浏览器中访问 localhost:5000 来查看应用程序的实际效果。它应该会打开一个 web 应用程序。

本地容器上运行的应用程序(localhost:5000)

完成后,请确保使用 Kitematic 停止应用程序,否则它会继续占用计算机上的资源。

???? 第 8 步——验证 Azure 凭据

在将容器上传到 ACR 之前的最后一步是验证本地计算机上的 Azure 凭据。请在命令行中执行以下代码:

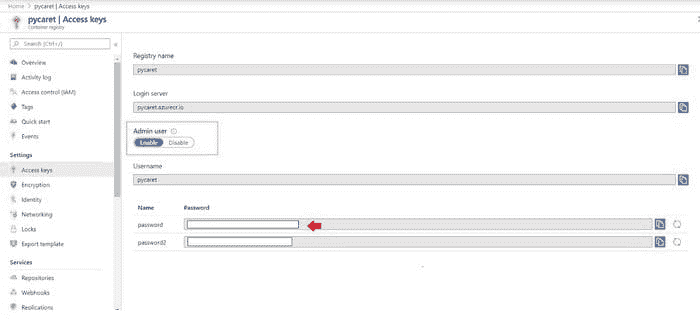

docker login pycaret.azurecr.io

系统会提示你输入用户名和密码。用户名是你的注册表名称(在此示例中,用户名为“pycaret”)。你可以在你创建的 Azure Container Registry 资源的访问密钥下找到你的密码。

portal.azure.com → Azure Container Registry → 访问密钥

???? 第 9 步——将容器推送到 Azure Container Registry

现在你已认证到 ACR,你可以通过执行以下代码将你创建的容器推送到 ACR:

docker push pycaret.azurecr.io/pycaret-insurance:latest

根据容器的大小,推送命令可能需要一些时间来将容器传输到云端。

???? 第 10 步——创建一个 Azure Web 应用并查看你的模型的实际效果

要在 Azure 上创建 Web 应用,请按照以下步骤操作:

-

登录

portal.azure.com。 -

点击创建资源。

-

搜索 Web 应用并点击创建。

-

将你在(步骤 9 中)推送的 ACR 镜像链接到你的应用。

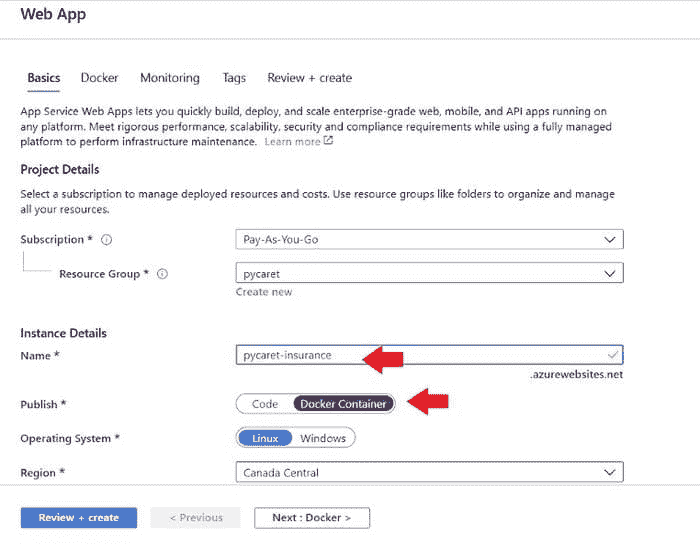

portal.azure.com → Web 应用 → 创建 → 基本设置

portal.azure.com → Web 应用 → 创建 → Docker

BOOM!! 现在应用已在 Azure Web Services 上运行。

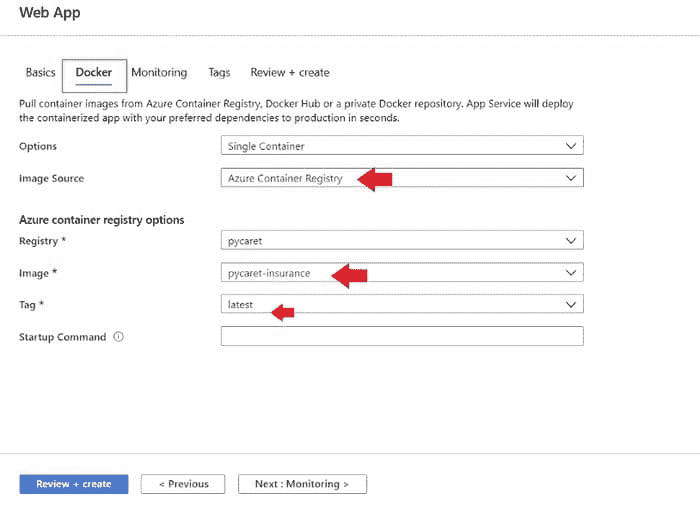

https://pycaret-insurance2.azurewebsites.net

注意: 当本故事发布时,来自 pycaret-insurance2.azurewebsites.net 的应用将被移除以限制资源消耗。

GitHub 仓库链接用于 Heroku 部署。** (不使用 docker) **

下一个教程

在下一个关于部署机器学习管道的教程中,我们将深入探讨如何使用 Google Cloud 和 Microsoft Azure 的 Kubernetes 服务来部署机器学习管道。

关注我们的 LinkedIn 并订阅我们的 YouTube 频道,了解更多关于 PyCaret 的信息。

重要链接

PyCaret 1.0.1 即将到来!

我们收到了来自社区的巨大支持和反馈。我们正在积极改进 PyCaret,并准备我们的下一次发布。PyCaret 1.0.1 将会更大更好。如果你想分享你的反馈并帮助我们进一步改进,你可以在网站上填写这个表格或在我们的GitHub或LinkedIn页面留下评论。

想了解某个特定模块吗?

从 1.0.0 版本开始,PyCaret 提供了以下模块可供使用。点击下面的链接查看 Python 中的文档和工作示例。

另见:

PyCaret 入门教程在 Notebook 中:

你想要参与吗?

PyCaret 是一个开源项目,欢迎大家参与。如果你想参与,请随时处理开放问题。拉取请求必须包含 dev-1.0.1 分支上的单元测试。

如果你喜欢 PyCaret,请在我们的GitHub 仓库上给我们⭐️。

Medium : medium.com/@moez_62905/

LinkedIn : www.linkedin.com/in/profile-moez/

Twitter : twitter.com/moezpycaretorg1

简介: Moez Ali 是一名数据科学家,同时也是 PyCaret 的创始人和作者。

原文。经许可转载。

相关:

-

宣布 PyCaret 1.0.0

-

构建并部署你的第一个机器学习 Web 应用

-

使用 PyCaret 在 Power BI 中进行机器学习

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

更多相关话题

使用 Heroku 部署机器学习 Web 应用程序

原文:

www.kdnuggets.com/2022/04/deploy-machine-learning-web-app-heroku.html

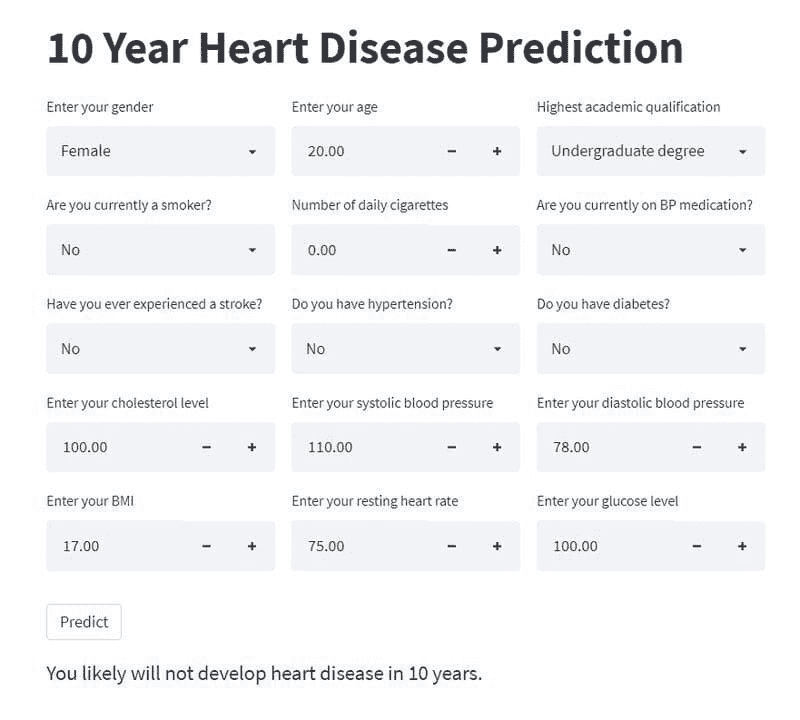

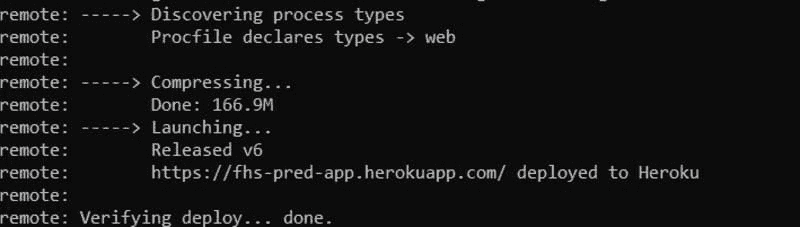

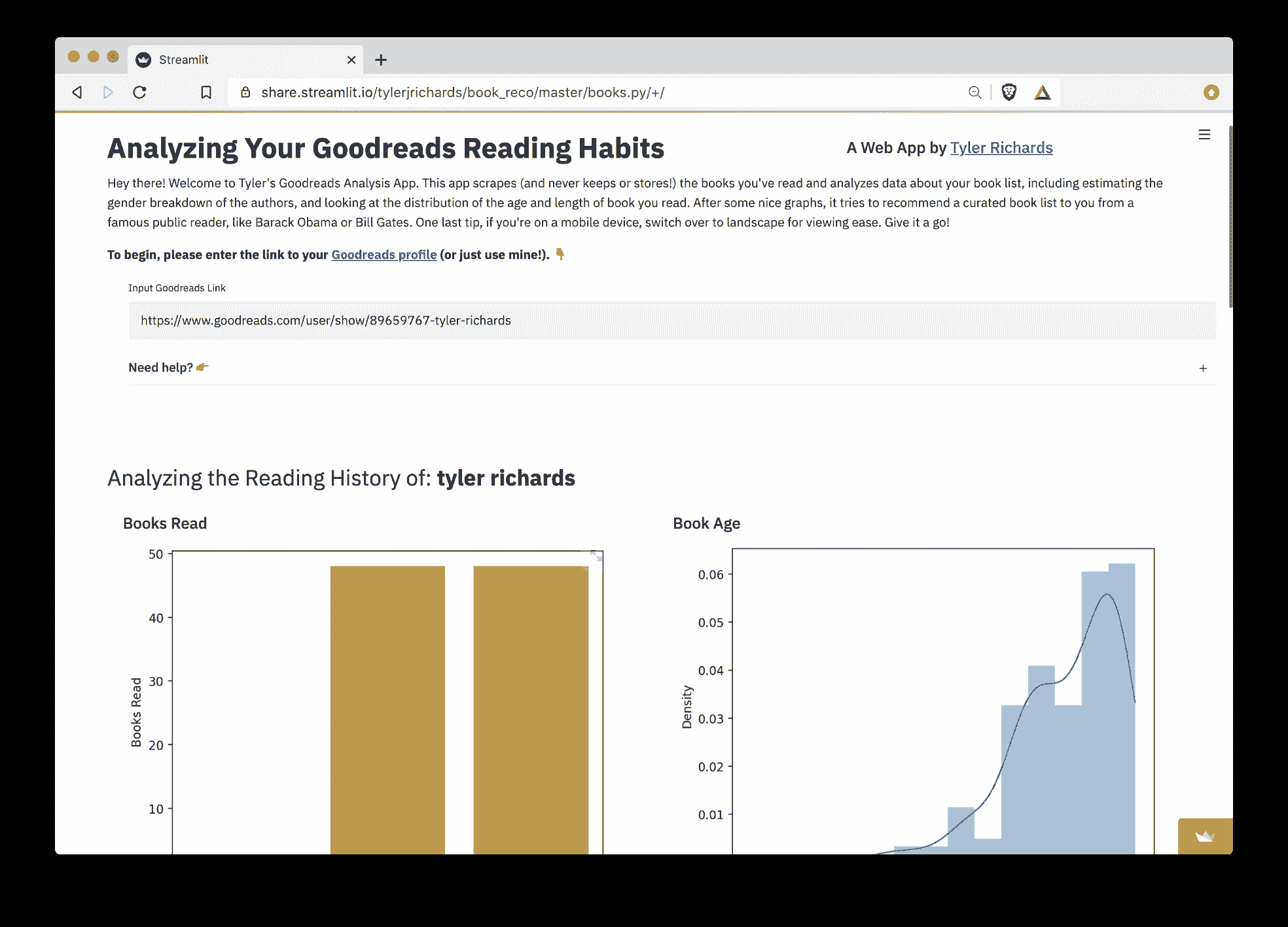

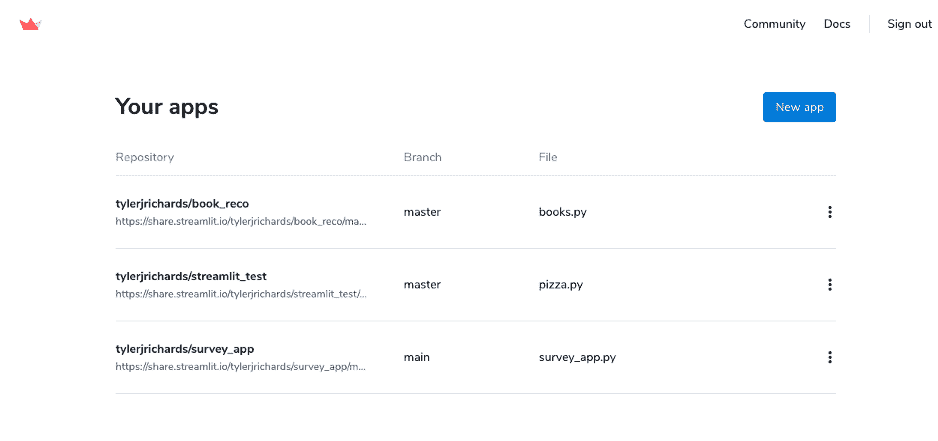

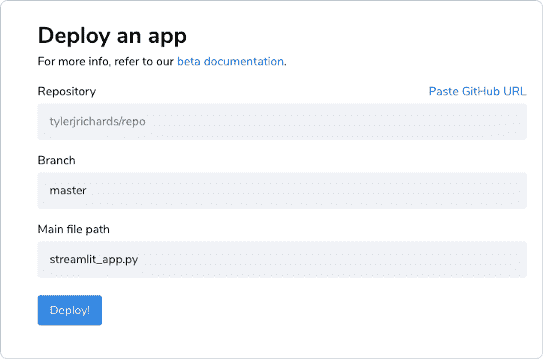

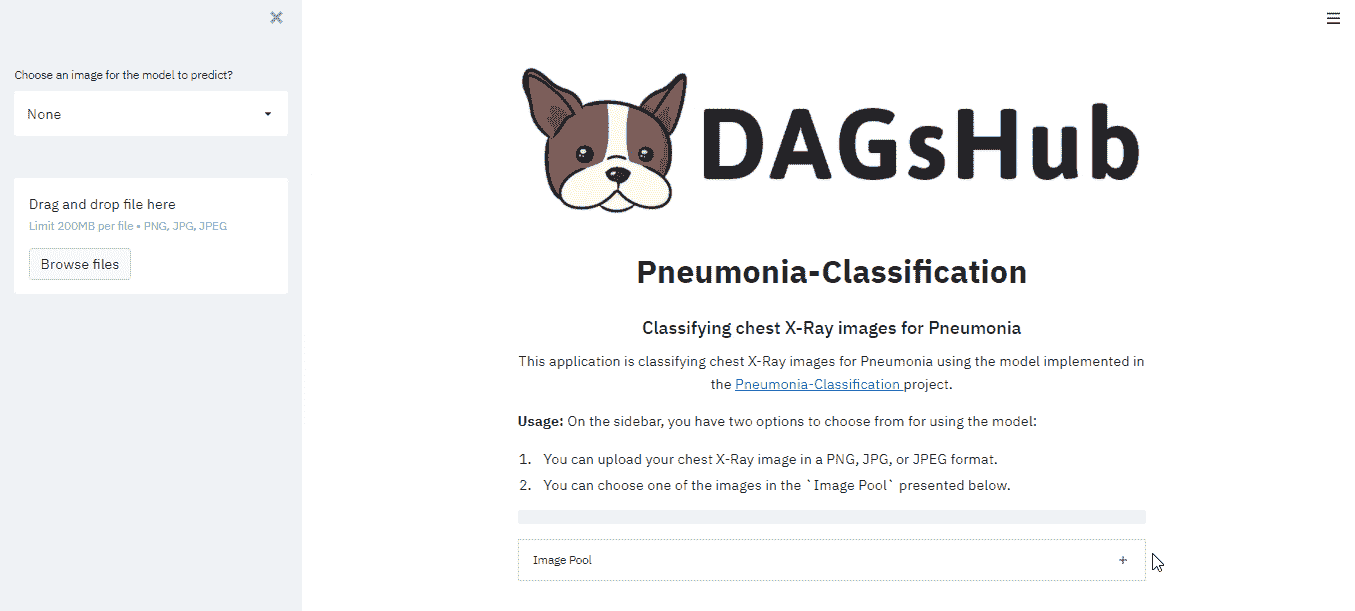

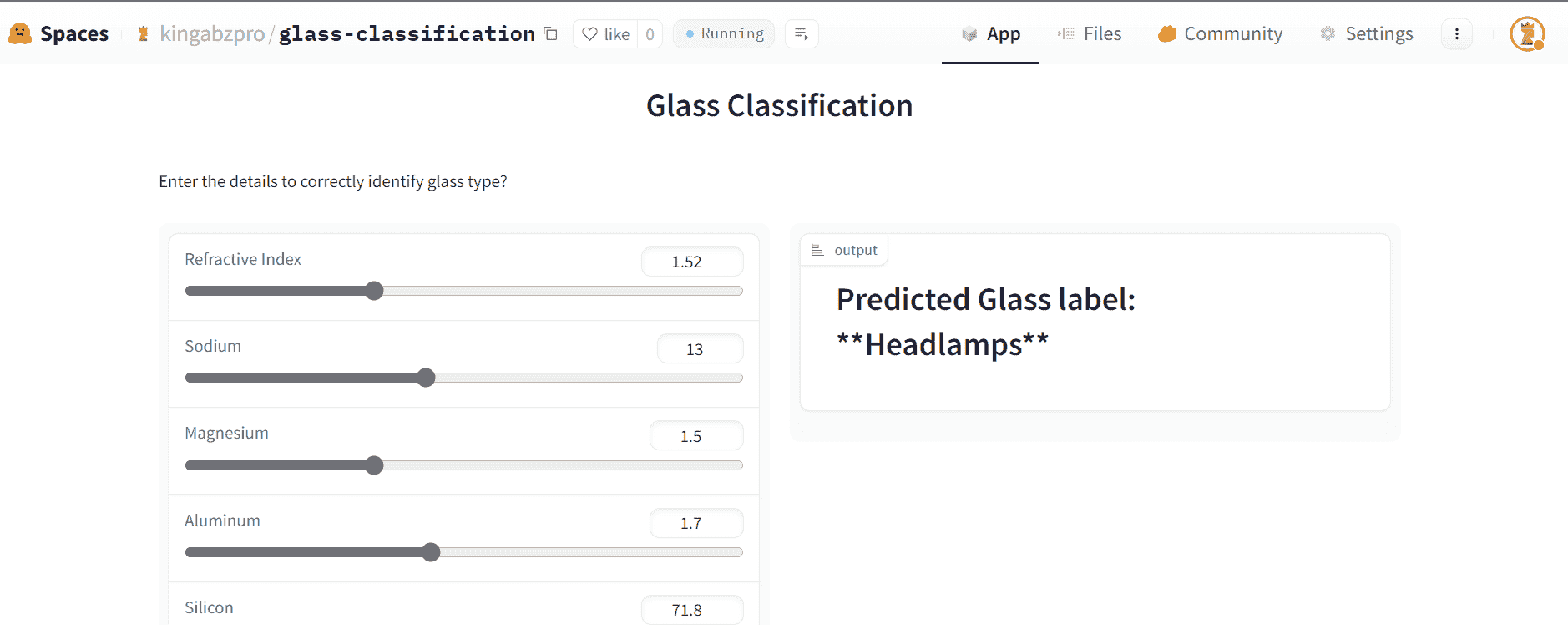

在之前的 博客文章 中,我展示了如何使用 Streamlit 库在 Python 中构建机器学习 Web 应用程序。最终产品看起来是这样的:

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

这是一个允许用户输入有关健康和生活方式信息的应用程序,并返回一个输出,预测一个人在 10 年内患心脏病的可能性。

如果你想了解更多关于模型以及应用程序如何构建的信息,可以通过这个 教程 来学习。

否则,你可以简单地访问这个 Github 仓库 并克隆它。它包含了构建和部署 Web 应用程序所需的所有代码文件。

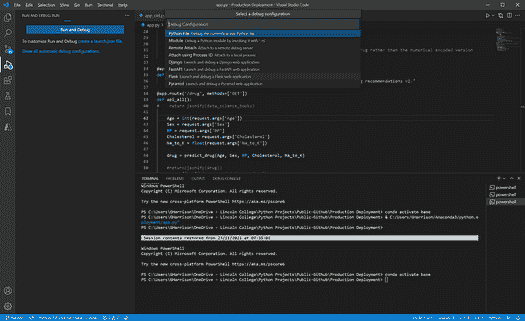

步骤 0:前置条件

要运行 Streamlit web 应用程序并将其部署到 Heroku,你需要安装一个非 GUI 的 Python 代码编辑器(Jupyter Notebook 不够用)。我目前使用的是 Visual Studio Code,但 PyCharm 和 Atom 也是不错的替代选择。

完成后,确保使用‘pip’命令安装这三个库—— Streamlit、Joblib 和 Pandas。

第一步:在本地运行应用程序

现在环境已准备好,尝试在本地运行应用程序以检查一切是否正常。

打开你的终端并输入以下代码行:

streamlit run streamlit_fhs.py

然后,打开浏览器并访问 localhost:8501。你应该会看到一个类似这样的 Web 应用程序:

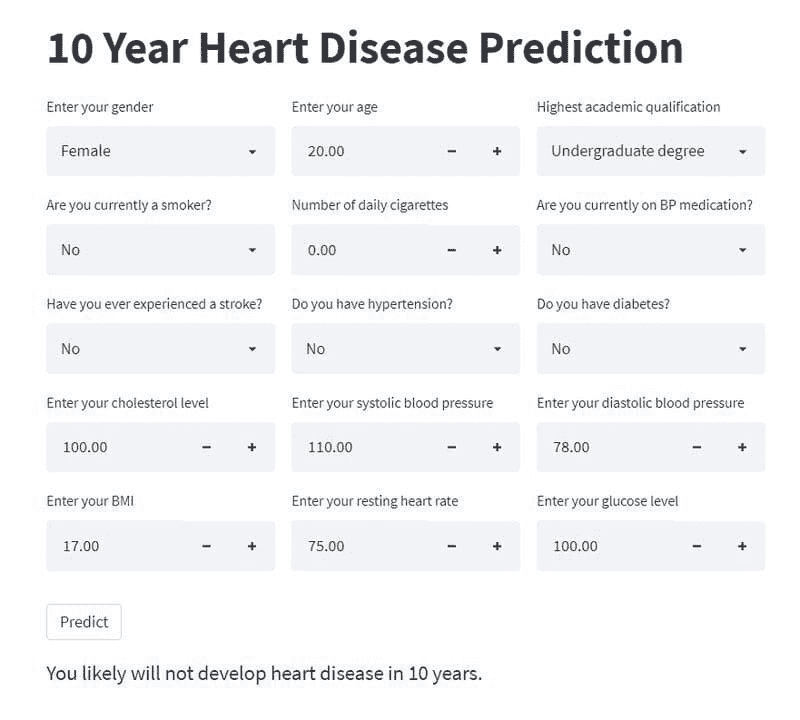

第两步:创建必要的文件

我们的文件夹目前有三个文件:

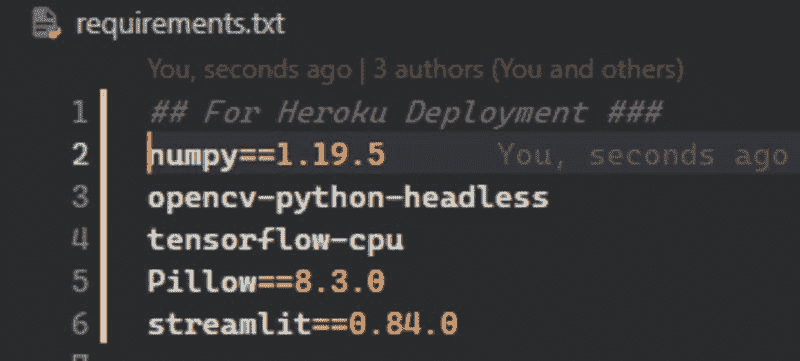

为了成功将应用部署到 Heroku,我们需要创建另外三个文件:

1. requirements.txt

首先,创建一个文本文件并命名为 requirements.txt。然后,将以下内容粘贴到文件中:

pandas==1.3.2

gunicorn==19.9.0

streamlit==1.5.1

joblib==1.1.0

sklearn==0.22

2. Procfile

接下来,你需要创建一个 Procfile。它告诉 Heroku 你的应用程序位置以及如何启动它。

要创建 Procfile,只需打开终端并导航到你刚刚克隆的文件夹。输入以下命令:

echo web: gunicorn app:app >Procfile

3. setup.sh

最后,创建一个名为 setup.sh 的文件,内容如下:

mkdir -p ~/.streamlit/

echo "\ [server]\n\

headless = true\n\

port = $PORT\n\

enableCORS = false\n\

\n\" > ~/.streamlit/config.toml

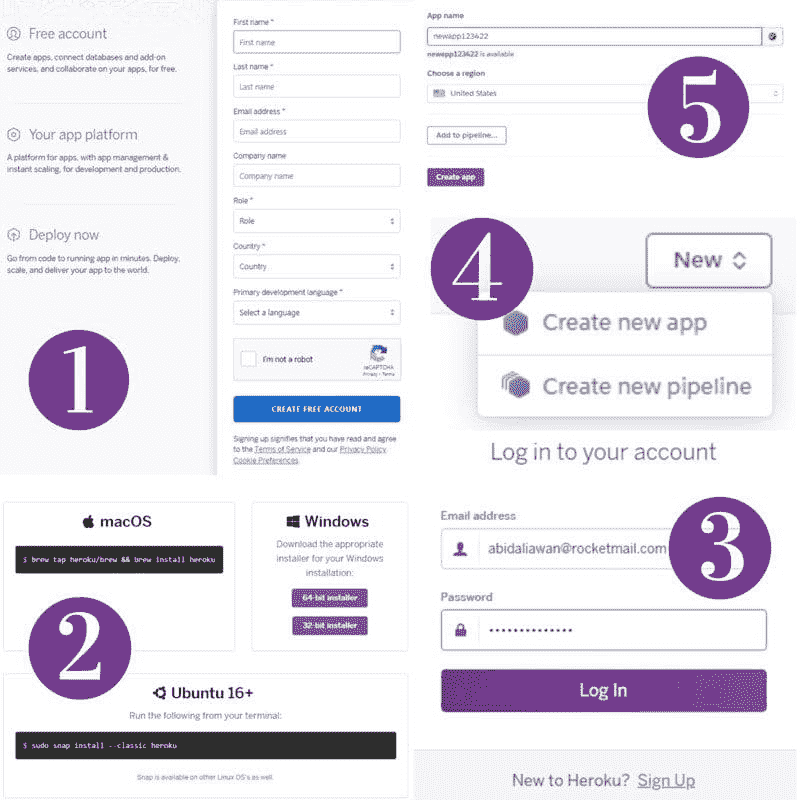

第三步:设置 Heroku

现在,你需要 创建一个免费的 Heroku 账户。

完成后,下载 Heroku CLI 并运行可执行文件。

为了确保你已成功安装 Heroku,在终端中输入以下命令:

heroku --version

如果你收到“命令未找到”的错误,这意味着某些东西出错了,Heroku 在你的设备上未正确设置。否则,你的安装成功了,你可以进入下一步。

第四步:部署 Web 应用

再次打开终端并导航到你的应用程序所在的目录。

输入以下命令:

heroku create my_app

注意:你可以将“my_app”替换为你选择的任何名称。

然后,你需要初始化并将代码推送到 Git。为此,在终端中输入以下命令:

git init

git add .

git commit -m "first commit"

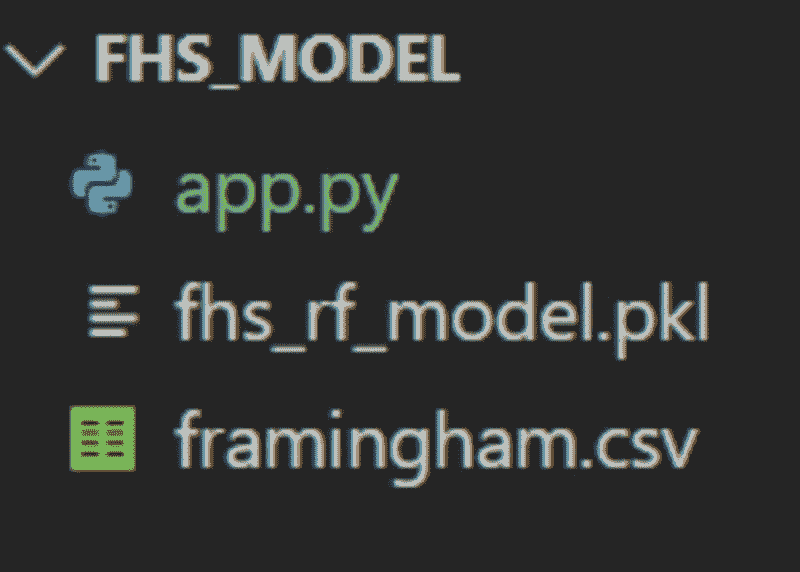

最后,运行这两个命令将你的代码部署到 Heroku:

heroku git:remote -a my_app

git push heroku master

注意:再次记得将 my_app 改为你的应用名称。

完成后,你会在终端上看到类似这样的输出:

上面显示的链接是你的应用所在的位置,你现在可以在线访问它。以下是我的 Web 应用的 URL:fhs-pred-app.herokuapp.com/。

就这样!如果你正确执行了所有步骤,你现在已经部署了一个功能齐全的 Web 应用,你可以通过一个链接与其他人分享。

Natassha Selvaraj 是一位自学成才的数据科学家,热衷于写作。你可以在 LinkedIn 上与她联系。

了解更多相关内容

如何将 PyTorch Lightning 模型部署到生产环境中

原文:

www.kdnuggets.com/2020/11/deploy-pytorch-lightning-models-production.html

评论

由 Caleb Kaiser,Cortex Labs

来源: Pexels

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

从机器学习的角度来看,主要趋势之一是越来越多的项目专注于将软件工程原则应用于机器学习。例如,Cortex 重新创建了无服务器函数的部署体验,但用于推理管道。类似地,DVC 实现了现代版本控制和 CI/CD 管道,但用于机器学习。

PyTorch Lightning 有类似的理念,只是应用于训练。该框架提供了一个 PyTorch 的 Python 包装器,使数据科学家和工程师可以编写干净、可管理且高效的训练代码。

作为那些部分原因是因为厌倦了编写样板代码而建立了完整部署平台的人,我们非常喜欢 PyTorch Lightning。怀着这种精神,我整理了这份关于将 PyTorch Lightning 模型部署到生产环境中的指南。在过程中,我们将探讨几种将 PyTorch Lightning 模型导出以纳入推理管道的不同选项。

部署 PyTorch Lightning 模型进行推理的所有方式

有三种方法可以将 PyTorch Lightning 模型导出以供服务:

-

将模型保存为 PyTorch 检查点

-

将模型转换为 ONNX

-

将模型导出为 Torchscript

我们可以用 Cortex 服务这三种方式。

1. 直接打包和部署 PyTorch Lightning 模块

从最简单的方法开始,让我们在没有任何转换步骤的情况下部署一个 PyTorch Lightning 模型。

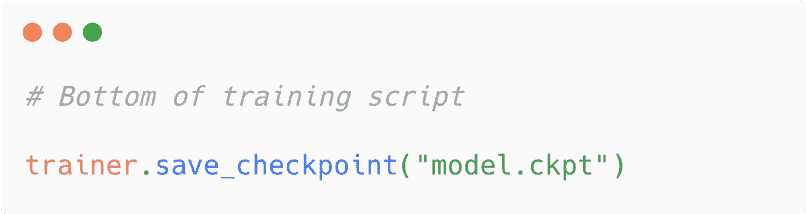

PyTorch Lightning Trainer,一个抽象样板训练代码的类(想想训练和验证步骤),具有一个内置的 save_checkpoint() 函数,可以将你的模型保存为 .ckpt 文件。要将模型保存为检查点,只需将以下代码添加到你的训练脚本中:

来源:作者

现在,在我们开始服务这个检查点之前,重要的是要注意,虽然我一直说“PyTorch Lightning 模型”,但 PyTorch Lightning 是 PyTorch 的一个封装——项目的 README 上明确写道“PyTorch Lightning 只是组织好的 PyTorch”。因此,导出的模型是一个普通的 PyTorch 模型,可以相应地提供服务。

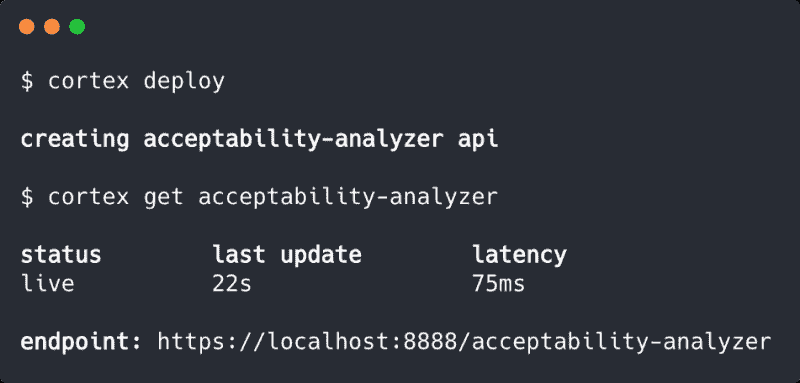

有了保存的检查点,我们可以在 Cortex 中很容易地服务模型。如果你对 Cortex 不熟悉,可以 在这里快速了解,但 Cortex 的部署过程的简单概述是:

-

我们用 Python 为我们的模型编写一个预测 API

-

我们在 YAML 中定义我们的 API 基础设施和行为

-

我们使用 CLI 中的命令部署 API

我们的预测 API 将使用 Cortex 的 Python Predictor 类来定义一个 init() 函数来初始化 API 并加载模型,以及一个 predict() 函数来在查询时提供预测:

相当简单。我们从训练代码中重新利用一些代码,添加一点推理逻辑,仅此而已。需要注意的一点是,如果你将模型上传到 S3(推荐),你需要添加一些逻辑来访问它。

接下来,我们在 YAML 中配置我们的基础设施:

再次,简单。我们给 API 命名,告诉 Cortex 我们的预测 API 在哪里,并分配一些 CPU。

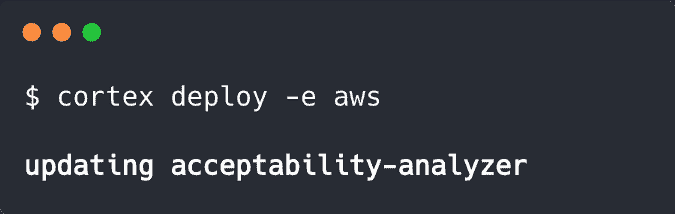

接下来,我们进行部署:

来源:作者

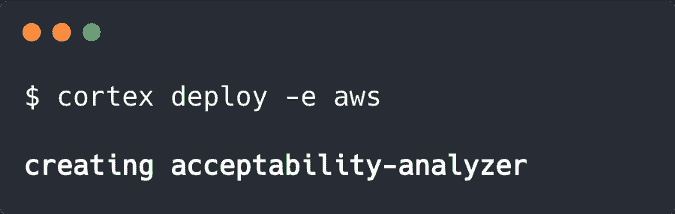

请注意,我们也可以将模型部署到由 Cortex 启动和管理的集群中:

来源:作者

所有部署中,Cortex 会将我们的 API 容器化,并将其公开为网络服务。在云部署中,Cortex 配置负载均衡、自动缩放、监控、更新以及许多其他基础设施功能。

就这样!现在我们有一个实时的 web API,根据请求从我们的模型中提供预测。

2. 导出为 ONNX 并通过 ONNX Runtime 提供服务

现在我们已经部署了一个普通的 PyTorch 检查点,让我们稍微复杂化一下。

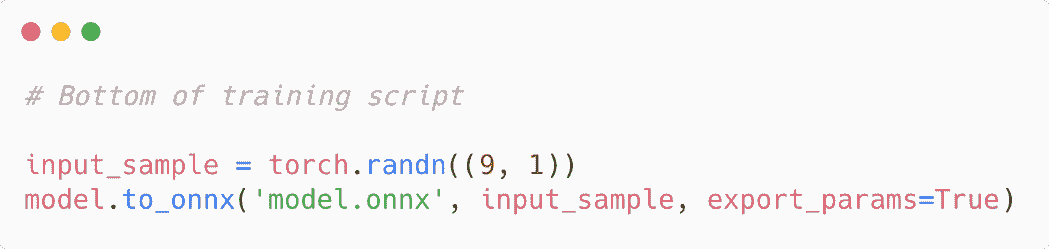

PyTorch Lightning 最近增加了一个方便的抽象层,用于将模型导出为 ONNX(之前,你可以使用 PyTorch 内置的转换函数,但需要更多的样板代码)。要将你的模型导出为 ONNX,只需在你的训练脚本中添加这段代码:

来源:作者

请注意,你的输入样本应该模拟实际模型输入的形状。

一旦你导出了 ONNX 模型,你可以使用 Cortex 的 ONNX Predictor 来服务。代码基本相同,过程也完全一样。例如,这是一个 ONNX 预测 API:

基本上是一样的。唯一的区别是,我们不是直接初始化模型,而是通过 onnx_client 访问它,这是 Cortex 启动的一个 ONNX Runtime 容器,用于提供模型服务。

我们的 YAML 看起来也相当相似:

我在这里添加了一个监控标志,只是为了展示配置的简便性,虽然有一些 ONNX 特定的字段,但除此之外,它还是相同的 YAML。

最后,我们使用之前相同的 $ cortex deploy 命令进行部署,我们的 ONNX API 现已上线。

3. 使用 Torchscript 的 JIT 编译器序列化

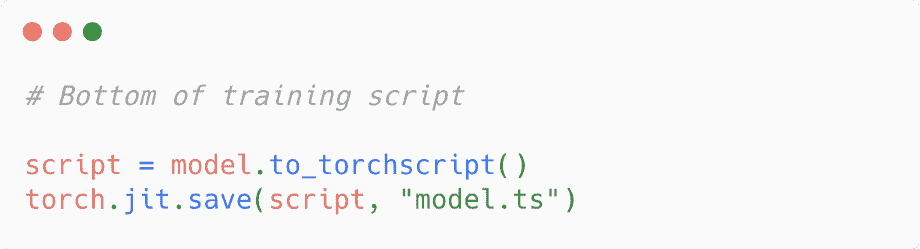

对于最终部署,我们将 PyTorch Lightning 模型导出到 Torchscript 并使用 PyTorch 的 JIT 编译器进行服务。要导出模型,只需将以下内容添加到你的训练脚本中:

来源:作者

这个 Python API 与普通的 PyTorch 示例几乎一样:

YAML 保持不变,CLI 命令当然也一致。如果需要,我们实际上可以通过简单地用新的脚本替换旧的 predictor.py 脚本,然后重新运行 $ cortex deploy 来更新之前的 PyTorch API:

来源:作者

Cortex 在这里自动执行滚动更新,即启动一个新的 API 然后与旧的 API 交换,防止模型更新之间出现任何停机时间。

就是这样。现在你有一个完全操作的实时推理预测 API,能够从 Torchscript 模型中提供预测。

那么,你应该使用哪种方法呢?

这里显而易见的问题是哪个方法表现最好。事实是没有简单的答案,因为这取决于你的模型。

对于像 BERT 和 GPT-2 这样的 Transformer 模型,ONNX 可以提供惊人的优化(我们测得 在 CPU 上吞吐量提升了 40 倍)。对于其他模型,Torchscript 的表现可能优于普通 PyTorch —— 尽管这也有一些 caveats,因为并非所有模型都能顺利导出到 Torchscript。

幸运的是,使用任何选项进行部署都非常简单,你可以同时测试这三种方法,看看哪一种在你的特定 API 上表现最好。

个人简介:Caleb Kaiser (@KaiserFrose) 是 Cortex Labs 创始团队成员之一,他帮助维护 Cortex。

原文。经许可转载。

相关内容:

-

PyTorch 多 GPU 指标库及新 PyTorch Lightning 发布的更多内容

-

Pytorch Lightning vs PyTorch Ignite vs Fast.ai

-

训练 Lightning 快速神经网络的 9 个技巧

更多相关内容

将你的 PyTorch 模型部署到生产环境

原文:

www.kdnuggets.com/2019/03/deploy-pytorch-model-production.html

评论

由 Nicolás Metallo,Audatex

在上一篇关于训练 Choripan 分类器的文章中,我们讨论了如何使用 PyTorch 和 Google Colab 进行训练。接下来,我们将探讨如果你想将最近训练的模型作为 API 部署,可以采取哪些步骤。关于如何使用 Fast.ai 进行此操作的讨论正在进行中(更多),可能会持续到 PyTorch 发布其官方 1.0 版本。你可以在 Fast.ai 论坛、PyTorch 文档/论坛及其各自的 GitHub 仓库中找到更多信息。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

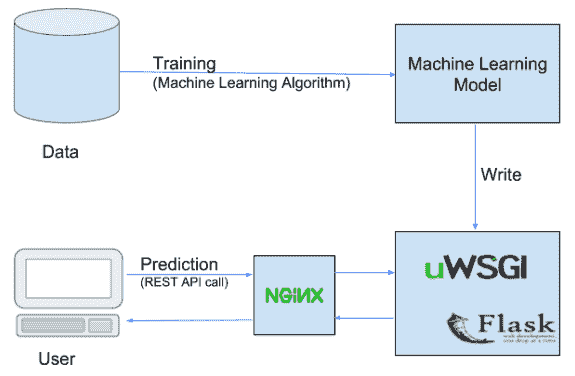

保存和加载模型

推荐你查看PyTorch 文档,它是一个很好的起点,简而言之,有两种序列化和恢复模型的方法。一种是仅加载权重,另一种是加载整个模型(包括权重)。你需要首先创建一个模型来定义其架构,否则你将得到一个只包含权重值的 OrderedDict。这两种选项都适用于推断和/或从以前的检查点恢复模型训练。

1. 使用 torch.save() 和 torch.load()

这种保存/加载过程使用了最直观的语法,涉及的代码最少。以这种方式保存模型会使用 Python 的 pickle 模块保存整个模块。这种方法的缺点是序列化数据绑定到模型保存时使用的特定类和确切目录结构。这是因为 pickle 不保存模型类本身,而是保存指向包含类的文件的路径,该路径在加载时使用。因此,当在其他项目或重构后使用时,代码可能会出现各种问题。

保存模型

torch.save(learner.model, PATH)

有时 pickle 无法序列化一些模型创建函数(例如在旧版本的 Fastai 中发现的 resnext_50_32x4d),因此你需要使用 dill。这是解决方法。

import dill as dill

torch.save(learner.model, PATH, pickle_module=dill)

你可以在这篇 文章 中阅读有关 pickle 限制的更多信息。一个常见的 PyTorch 约定是使用 .pt 或 .pth 文件扩展名保存模型。

加载模型

# Model class must be defined somewhere

model = torch.load(PATH)

model.eval()

2. 使用 state_dict

在 PyTorch 中,torch.nn.Module 模型的可学习参数(例如权重和偏差)包含在模型的 parameters 中(通过 model.parameters() 访问)。state_dict 只是一个 Python 字典对象,将每一层映射到其参数张量。注意,只有具有可学习参数的层(卷积层、线性层等)才会在模型的 state_dict 中有条目。

我们需要以与最初定义和创建模型时相同的方式重新初始化模型,并确保创建模型所需的变量、类、函数可用,无论是通过模块导入还是直接在同一个脚本/文件中。使用这种方法的一个潜在优势是,如果参数相同,你可以使用更新的脚本加载旧模型,它也是官方文档推荐的 方法。另一个需要记住的事情是 state_dict 接受的是字典对象,而不是保存对象的路径,因此你不能使用 model.load_state_dict(PATH) 来加载。

保存模型

torch.save(model.state_dict(), PATH)

加载模型

model = TheModelClass(*args, **kwargs) # Model class must be defined somewhere

model.load_state_dict(torch.load(PATH))

model.eval() # run if you only want to use it for inference

加载后运行 model.eval(),因为你通常会有 BatchNorm 和 Dropout 层,它们在构建时默认是训练模式。如果你想恢复模型训练,则不需要调用 model.eval()。

由于我们已经使用 Fastai 进行了训练,我们可以调用 [Learner.save](https://docs.fast.ai/basic_train.html#Learner.save) 和 [Learner.load](https://docs.fast.ai/basic_train.html#Learner.load) 来保存和加载模型(更多信息请参见 文档)。这会在后台运行 state_dict(),因此只会保存模型参数,而不是模型结构。这意味着你需要运行 create_cnn 方法来从给定的结构中获取一个预训练模型(与之前用于训练模型的结构相同,例如 models.resnet34),并且要为你的数据设置一个合适的自定义头。模型会保存在 path/model_dir 目录中,并且 .pth 扩展名会在这两个操作中自动添加。

使用 Flask 进行简单部署

在我们使用 Google Colab 提供的免费 GPU 训练完分类器后,我们准备在本地进行推理。我们可以在本地或云端进行推理,并且有许多不同的选项(AWS、Paperspace、Google Cloud 等)可供选择。由于我还有一些免费的 Amazon AWS 额度,我将使用一个预装了多个 ML 库的 Amazon AMI,并在 t2.medium 实例上托管。以下是一些在你的端运行 Docker 镜像的简单说明(在不进行 GPU 训练时应该差不多)。

即开即用的 Docker 镜像

Jupyter Docker Stacks 是一种快速启动 notebook 并使用最新库的绝佳方式。这些是即开即用的 Docker 镜像,包含 Jupyter 应用程序和交互式计算工具。在 官方文档 中了解更多关于它们的信息。我们将使用来自 此仓库 的 Jupyter Notebook 数据科学栈。

一旦你 安装 了 Docker,打开终端,cd 进入你的工作目录,然后运行

$ docker run --rm -p 8888:8888 -e JUPYTER_ENABLE_LAB=yes -v "$PWD":/home/jovyan/work jupyter/datascience-notebook:e5c5a7d3e52d

这将创建一个你可以登录的服务器,你可以在那里连接到 Jupyter notebook。你可以直接从那里运行一些命令,也可以通过获取 container id、在终端中输入 docker ps,然后运行 bash 或任何命令在 Docker 容器中执行。

$ docker exec -it {container-id} /bin/bash

安装 PyTorch 和 Fastai

根据你的机器配置,你可能希望在 GPU 或 CPU 上运行推理。在我们的例子中,我们将所有操作都在 CPU 上进行,因此你需要运行以下命令来安装最新的 PyTorch。

pip install torch_nightly -f https://download.pytorch.org/whl/nightly/cpu/torch_nightly.html

现在你可以通过 pip install fastai 安装 Fastai。

创建 Flask 应用程序

通过运行安装 Flask 库

pip install -U flask

我们将创建一个名为 flask_app 的文件夹和两个新的 Python 文件 server.py(包含加载模型权重和运行推理服务器的代码)以及 settings.py(设置一些基本参数,为未来提供更多灵活性)。以下是 flask_app/settings.py 可能的示例。然后我们将使用 from settings import * 导入到 server.py 中。

# add your custom labels

labels = ['Not Choripan', 'Choripan']

# set your data directory

data_dir = 'data'

# set the URL where you can download your model weights

MODEL_URL = 'https://s3.amazonaws.com/nicolas-dataset/stage1.pth' # example weights

# set some deployment settings

PORT = 8080

现在我们可以查看 flask_app/server.py。这第一部分将导入库和设置。

# flask_app/server.py

# import libraries

print('importing libraries...')

from flask import Flask, request, jsonify

import logging

import random

import time

from PIL import Image

import requests, os

from io import BytesIO

# import fastai stuff

from fastai import *

from fastai.vision import *

import fastai

# import settings

from settings import * # import

print('done!\nsetting up the directories and the model structure...')

为了运行我们的单图像推理预测,我们首先需要创建一个新的模型,遵循我们训练时使用的相同文件夹结构。这就是为什么我们将基于之前在 settings.py 中设置的标签创建一个新的空目录。

# set dir structure

def make_dirs(labels, data_dir):

root_dir = os.getcwd()

make_dirs = ['train', 'valid', 'test']

for n in make_dirs:

name = os.path.join(root_dir, data_dir, n)

for each in labels:

os.makedirs(os.path.join(name, each), exist_ok=True)

make_dirs(labels=labels, data_dir=data_dir) # comes from settings.py

path = Path(data_dir)

一旦 path 被定义,我们将创建一个新的 learn 模型并下载 Choripan 分类器 的预训练权重。

# download model weights if not already saved

path_to_model = os.path.join(data_dir, 'models', 'model.pth')

if not os.path.exists(path_to_model):

print('done!\nmodel weights were not found, downloading them...')

os.makedirs(os.path.join(data_dir, 'models'), exist_ok=True)

filename = Path(path_to_model)

r = requests.get(MODEL_URL)

filename.write_bytes(r.content)

print('done!\nloading up the saved model weights...')

fastai.defaults.device = torch.device('cpu') # run inference on cpu

empty_data = ImageDataBunch.single_from_classes(

path, labels, tfms=get_transforms(), size=224).normalize(imagenet_stats)

learn = create_cnn(empty_data, models.resnet34)

learn = learn.load('model')

网上已经有很多很棒的 教程 详细介绍了 Flask 的使用,因此我不会多讲 Flask 是如何工作的。我创建了一个 predict 函数,该函数接受作为输入的 URL,通过 learn.predict(img) 获得预测类别,然后返回一个 json。

print('done!\nlaunching the server...')

# set flask params

app = Flask(__name__)

@app.route("/")

def hello():

return "Image classification example\n"

@app.route('/predict', methods=['GET'])

def predict():

url = request.args['url']

app.logger.info("Classifying image %s" % (url),)

response = requests.get(url)

img = open_image(BytesIO(response.content))

t = time.time() # get execution time

pred_class, pred_idx, outputs = learn.predict(img)

dt = time.time() - t

app.logger.info("Execution time: %0.02f seconds" % (dt))

app.logger.info("Image %s classified as %s" % (url, pred_class))

return jsonify(pred_class)

if __name__ == '__main__':

app.run(host="0.0.0.0", debug=True, port=PORT)

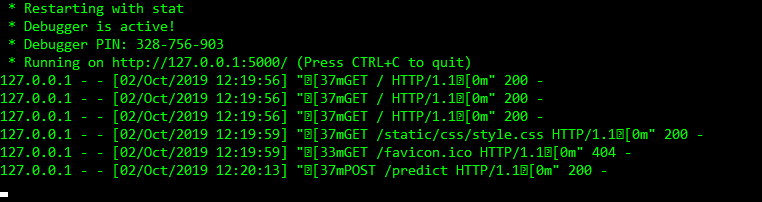

一旦完成这些,我们可以进入终端,切换到 flask_app 目录,并运行 python server.py。我们应该会看到类似的内容。

* Serving Flask app "server" (lazy loading)

* Environment: production

WARNING: Do not use the development server in a production environment.

Use a production WSGI server instead.

* Debug mode: on

* Running on http://0.0.0.0:8080/ (Press CTRL+C to quit)

* Restarting with stat

importing libraries...

done!

setting up the directories and the model structure...

done!

loading up the saved model weights...

done!

launching the server...

* Debugger is active!

* Debugger PIN: 261-786-850

就这些! 现在我们可以从终端运行类似这样的命令(我正在运行一个 AWS 实例)。以这张图片为例。

$ curl http://ec2-100-24-34-242.compute-1.amazonaws.com:8080/predict?url=https://media.minutouno.com/adjuntos/150/imagenes/028/853/0028853430.jpg

"Choripan"

从服务器端来看,它的样子是这样的

[2018-11-13 16:49:32,245] INFO in server: Classifying image https://media.minutouno.com/adjuntos/150/imagenes/028/853/0028853430.jpg

[2018-11-13 16:49:33,836] INFO in server: Execution time: 1.35 seconds

[2018-11-13 16:49:33,858] INFO in server: Image https://media.minutouno.com/adjuntos/150/imagenes/028/853/0028853430.jpg classified as Choripan

不错! 你现在拥有了自己的“Choripan/Not Choripan” API。如果你想提升到下一个层次,请查看 Flask 文档中的这个教程 以部署到生产环境和/或 另一个教程,如果你想将 Flask 应用程序 Docker 化(你也可以使用 docker-compose)。

部署到生产环境的其他方法

1. 使用 Clipper 的图像分类示例

在 ClipperTutorials GitHub 上有一个很棒的 ipynb 文件,你可以跟随它了解一切的基本工作原理。他们提供了一个 Docker 镜像,或者你可以直接运行他们的 Amazon AMI。遗憾的是,这仅适用于 PyTorch 0.4.0,这使得将其转换为最新预览版本的 PyTorch 和 Fastai 训练的模型变得非常麻烦。不过,它与示例预训练模型配合得很好。

创建 ClipperConnection

要启动 Clipper,你必须首先创建一个 [ClipperConnection](http://docs.clipper.ai/en/develop/#clipper-connection) 对象,并指定你想要使用的 ContainerManager 类型。在这种情况下,你将使用 DockerContainerManager。

from clipper_admin import ClipperConnection, DockerContainerManager

clipper_conn = ClipperConnection(DockerContainerManager())

启动 Clipper

现在你已经拥有了一个 ClipperConnection 对象,你可以启动一个 Clipper 集群。

以下命令将启动 3 个 Docker 容器:

-

查询前端:查询前端容器监听传入的预测请求,并将其调度和路由到已部署的模型。

-

管理前端:管理前端容器管理和更新集群的内部配置状态,例如跟踪已部署的模型和已注册的应用程序端点。

-

一个 Redis 实例:Redis 用于持久存储 Clipper 的内部配置状态。默认情况下,Redis 在端口 6380 上启动,而不是标准 Redis 默认端口 6379,以避免与已经运行的 Redis 实例发生冲突。

clipper_conn.start_clipper()

clipper_addr = clipper_conn.get_query_addr()

查看 Clipper 启动的容器。

!docker ps --filter label=ai.clipper.container.label

创建应用程序

app_name = "squeezenet-classsifier"

default_output = "default"

clipper_conn.register_application(

name=app_name,

input_type="bytes",

default_output=default_output,

slo_micros=10000000)

当你列出已注册的应用程序时,你应该会看到新注册的 squeezenet-classifier 应用程序。

clipper_conn.get_all_apps()

加载一个示例预训练的 PyTorch 模型

from torchvision import models, transforms

model = models.squeezenet1_1(pretrained=True)

PyTorch 模型不能仅通过 pickle 序列化并加载。相反,它们必须使用 PyTorch 的原生序列化 API 保存。因此,你不能使用通用的 Python 模型部署工具来将模型部署到 Clipper。相反,你将使用 Clipper 的 PyTorch 部署工具进行部署。Docker 容器在启动时将从序列化的模型检查点中加载并重建模型。

预处理

# First we define the preproccessing on the images:

normalize = transforms.Normalize(

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]

)

preprocess = transforms.Compose([

transforms.Scale(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

normalize

])

# Then we download the labels:

labels = {int(key):value for (key, value)

in requests.get('https://s3.amazonaws.com/outcome-blog/imagenet/labels.json').json().items()}

定义预测函数并添加指标

import clipper_admin.metrics as metrics

def predict_torch_model(model, imgs):

import io

import PIL.Image

import torch

import clipper_admin.metrics as metrics

metrics.add_metric("batch_size", 'Gauge', 'Batch size passed to PyTorch predict function.')

metrics.report_metric('batch_size', len(imgs)) # TODO: Fill in the batch size

# We first prepare a batch from `imgs`

img_tensors = []

for img in imgs:

img_tensor = preprocess(PIL.Image.open(io.BytesIO(img)))

img_tensor.unsqueeze_(0)

img_tensors.append(img_tensor)

img_batch = torch.cat(img_tensors)

# We perform a forward pass

with torch.no_grad():

model_output = model(img_batch)

# Parse Result

img_labels = [labels[out.data.numpy().argmax()] for out in model_output]

return img_labels

Clipper 必须从互联网下载这个 Docker 镜像,所以可能需要一点时间。

from clipper_admin.deployers import pytorch as pytorch_deployer

pytorch_deployer.deploy_pytorch_model(

clipper_conn,

name="pytorch-model",

version=1,

input_type="bytes",

func=predict_torch_model, # predict function wrapper

pytorch_model=model, # pass model to function

)

现在将生成的 pytorch-model 链接到之前创建的应用 squeezenet-classsifier。

clipper_conn.link_model_to_app(app_name="squeezenet-classsifier", model_name="pytorch-model")

就这样!

如何使用 Requests 查询 API

import requests

import json

import base64

clipper_addr = 'localhost:1337'

for img in ['img1.jpg', 'img2.jpg', 'img3.jpg']: # example with local images

req_json = json.dumps({

"input":

base64.b64encode(open(img, "rb").read()).decode() # bytes to unicode

})

response = requests.post(

"http://%s/%s/predict" % (clipper_addr, 'squeezenet-classsifier'),

headers={"Content-type": "application/json"},

data=req_jsn)

print(response.json())

停止 Clipper

如果遇到问题并希望完全停止 Clipper,你可以通过调用 [ClipperConnection.stop_all()](http://docs.clipper.ai/en/latest/#clipper_admin.ClipperConnection.stop_all) 来实现。

clipper_conn.stop_all()

当你最后列出所有 Docker 容器时,你应该会看到所有 Clipper 容器都已停止。

!docker ps --filter label=ai.clipper.container.label

2. 使用来自 Zeit 的 Now

论坛讨论中的另一个选项是使用 Now 服务,来自 Zeit。你可以参考 Fast.ai 文档中的 这个指南。我尝试过这个方法,但没有得到准确的结果(可能是由于归一化问题)。看起来很有前景。

你只需运行这些命令一次。第一次安装 Now 的 CLI(命令行界面)。

sudo apt install npm # if not already installed

sudo npm install -g now

下一步下载基于 Fast.ai 课程 2 的模型部署 入门包。

wget https://github.com/fastai/course-v3/raw/master/docs/production/zeit.tgz

tar xf zeit.tgz

cd zeit

上传你的训练模型文件

将你的训练模型文件(例如 stage-2.pth)上传到 Google Drive 或 Dropbox 等云服务。复制该文件的下载链接。注意:下载链接是直接启动文件下载的链接,通常与提供下载视图的分享链接不同(如有需要,使用 rawdownload.now.sh/)。

根据你的模型自定义应用

-

打开

app目录中的server.py文件,并用上面复制的 URL 更新model_file_url变量。 -

在同一文件中,用你期望的模型类别更新

classes = ['black', 'grizzly', 'teddys']行。

部署

在终端中,确保你在 zeit 目录下,然后输入:

now

第一次运行时,它会提示输入你的电子邮件地址,并为你创建一个 Now 帐户。账户创建后,再次运行以部署你的项目。

每次使用 now 部署时,它都会为应用创建一个唯一的 部署 URL。其格式为 xxx.now.sh,在部署应用时会显示。

3. 使用 Torch Script 和 PyTorch C++ API

这些是 PyTorch 官方 1.0 版本即将推出的一些最新变化。你可以按照这篇文档中的说明操作,或查看 Udacity 的 Intro to Deep Learning with PyTorch 课程的最后一章,其中详细讲解了这些步骤。这只是主要步骤的概述。

import torch

import torchvision

# An instance of your model.

model = torchvision.models.resnet18()

# An example input you would normally provide to your model's forward() method.

example = torch.rand(1, 3, 224, 224)

# Use torch.jit.trace to generate a torch.jit.ScriptModule via tracing.

traced_script_module = torch.jit.trace(model, example)

# Save the model

traced_script_module.save("model-resnet18-jit.pt")

构建一个最小化的 C++ 应用程序

-

按照 这些步骤 操作,构建

example-app.cpp和CMakeLists.txt。 -

安装 Anaconda 并在你的机器上运行 CMAKE。你可以通过他们的 binaries 安装它,或者如果你使用的是 MacOS,输入

brew install cmake(通过 这些 指令安装homebrew)。如果你遇到 CMAKE 问题,记得直接从 这里 下载 X-Code 命令行工具的.dmg(在我的情况下是 MacOS 10.14)。 -

从 这里 安装 Caffe2 并运行

conda install pytorch-nightly-cpu -c pytorch

PyTorch, Libtorch, C++ 和 NodeJS

结论

我尽力总结了一些部署你最近训练的 PyTorch 模型的选项。希望这对你有帮助,期待阅读你的评论。

简介: Nicolás Metallo 是一位获奖企业家,拥有近 10 年的专业经验。他毕业于纽约大学,获得技术管理与创新硕士学位,并担任管理顾问和自由深度学习工程师。Nicolas 还是 INVIP Labs Inc. 的共同创始人,这是一个通过计算机视觉帮助盲人和低视力者更好地理解环境的社会企业。他对数据科学的特别兴趣在于为城市提供数据,使其更加互联、高效、韧性强、充满活力和繁荣。

原文。已获得许可转载。

相关:

更多相关内容

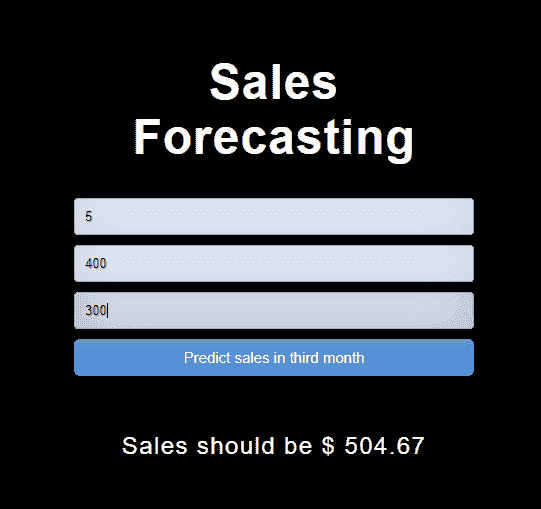

部署你的第一个机器学习 API

原文:

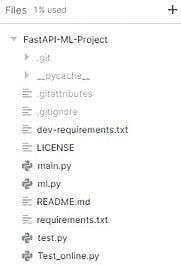

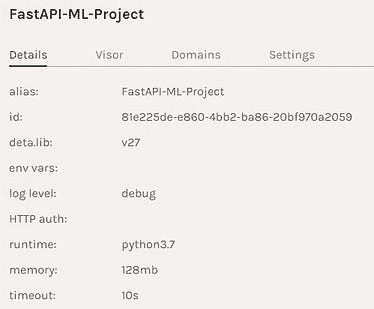

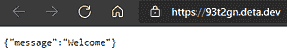

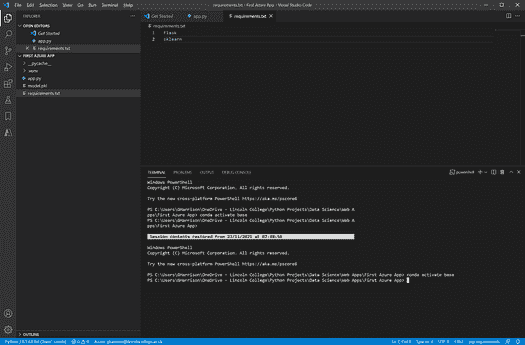

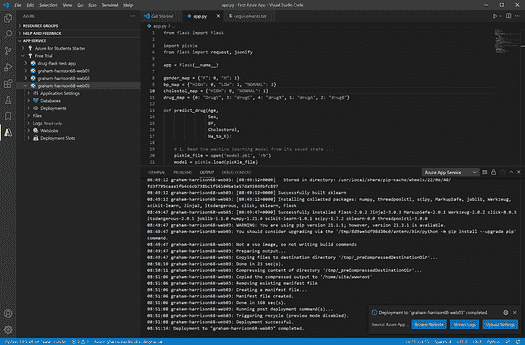

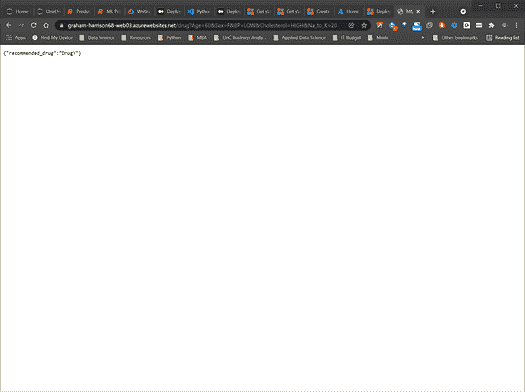

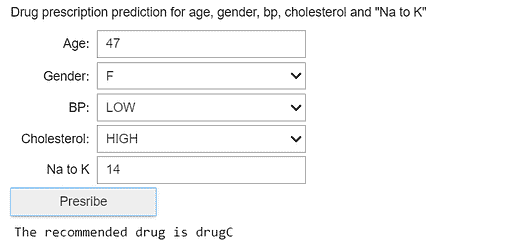

www.kdnuggets.com/2021/10/deploying-first-machine-learning-api.html

comments