KDNuggets-博客中文翻译-十四-

KDNuggets 博客中文翻译(十四)

原文:KDNuggets

数据科学家职位薪资分析

原文:

www.kdnuggets.com/2023/04/data-scientist-job-salaries-analysis.html

图片来源:Tima Miroshnichenko

数据科学和机器学习在运动、艺术、空间、医学、医疗保健等多个领域越来越受到关注。了解这些数据科学家在全球不同地区的薪资和就业现状将会很有启发性。

我们的前三课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

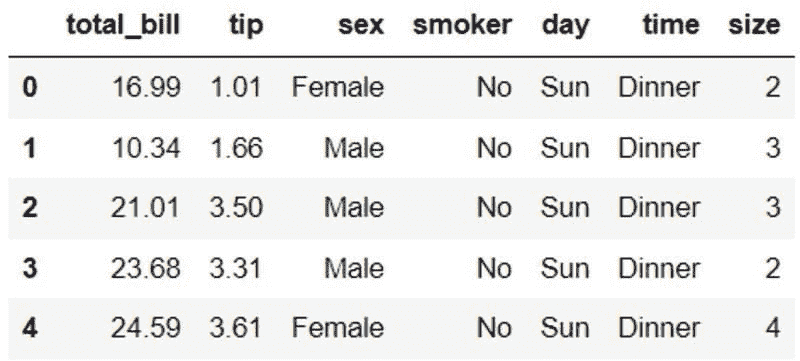

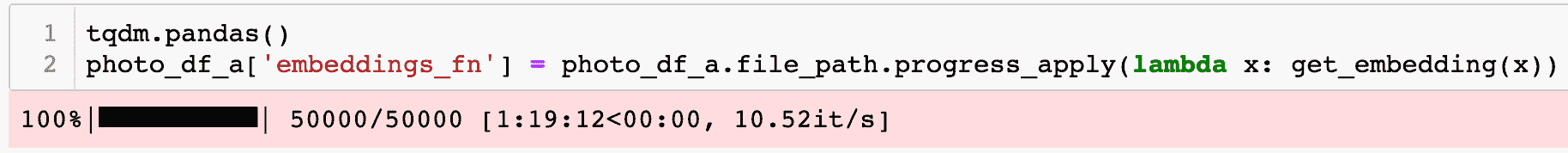

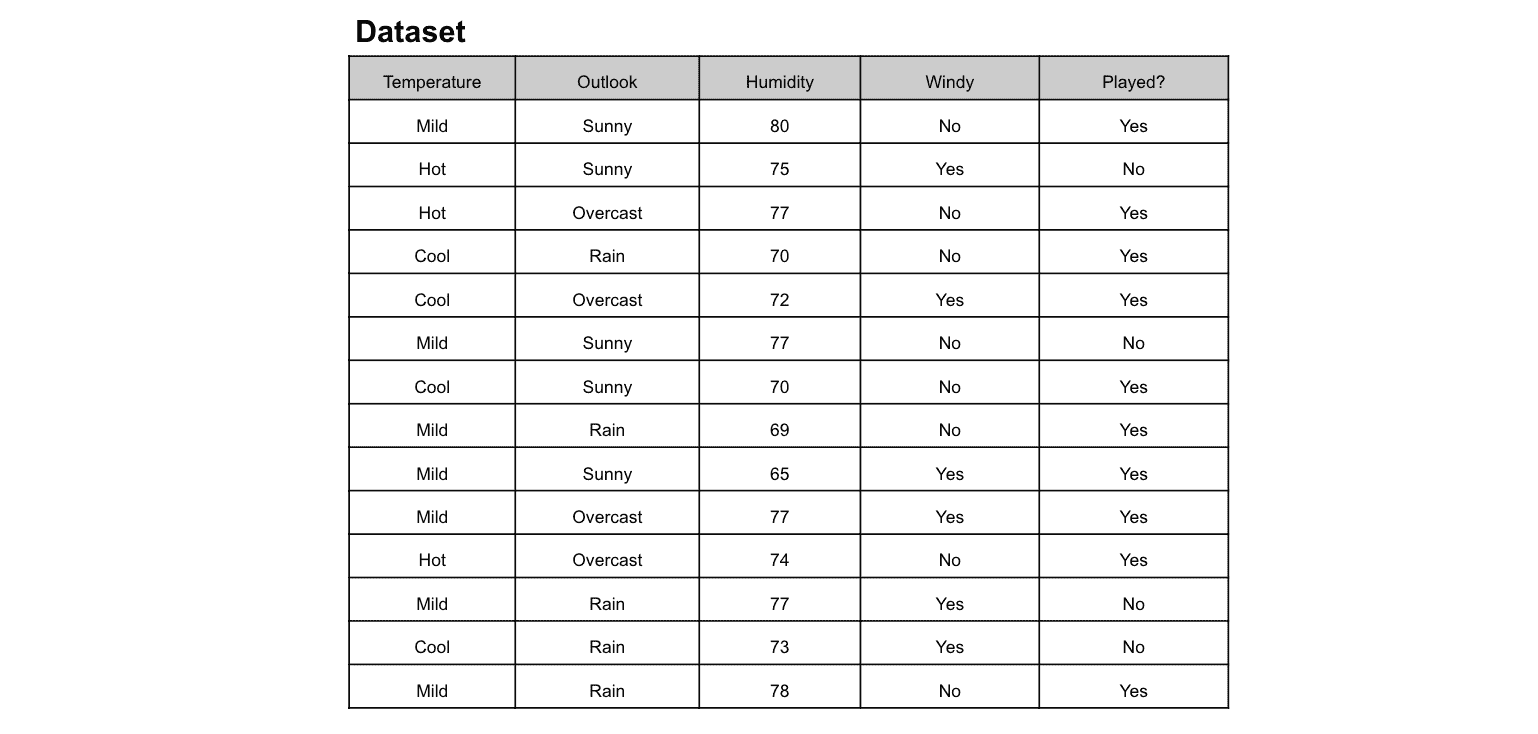

数据集下载自 Kaggle(链接见下方),我们将对数据进行探索性分析和可视化。www.kaggle.com/datasets/ruchi798/data-science-job-salaries

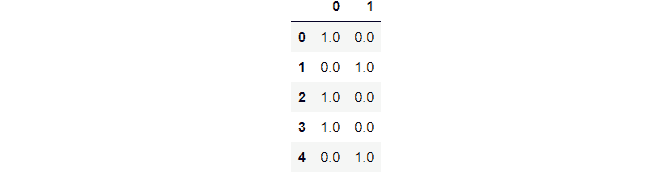

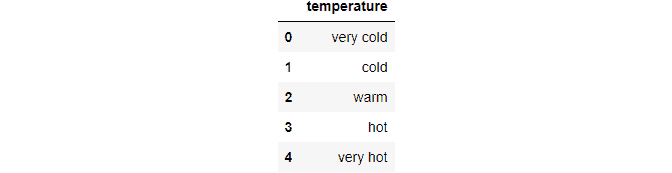

数据集根据经验水平分为以下几类:

-

EN: 入门级

-

MI: 中级

-

SE: 高级

-

EX: 高级管理层

数据集根据就业类型分为以下几类:

-

FT: 全职

-

PT: 兼职

-

CT: 合同制

-

FL: 自由职业者

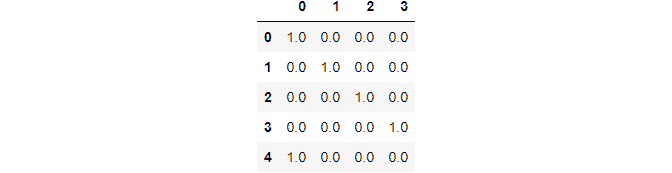

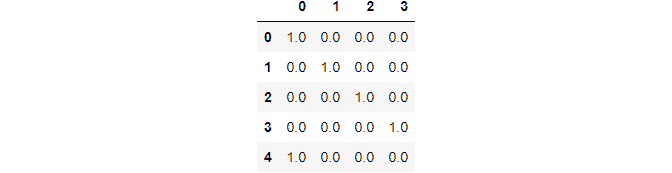

数据集根据公司规模分为以下几类:

-

S: 小型

-

M: 中级

-

L: 大型

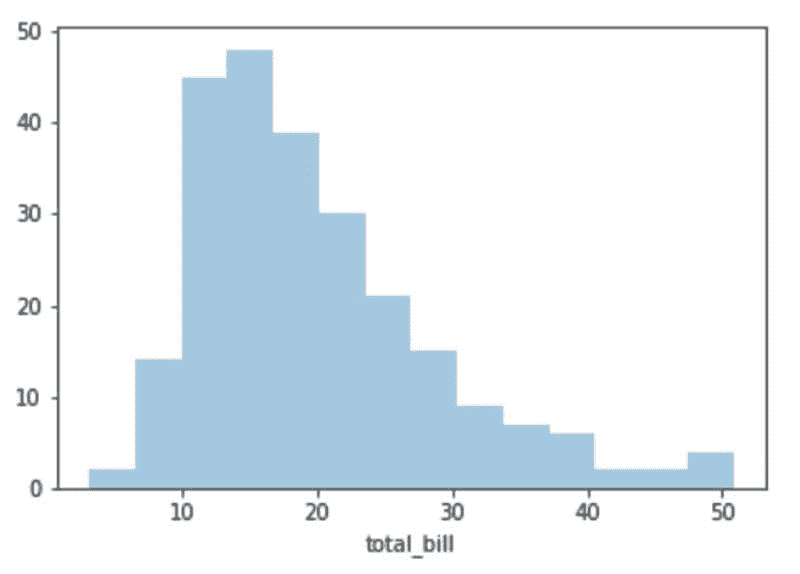

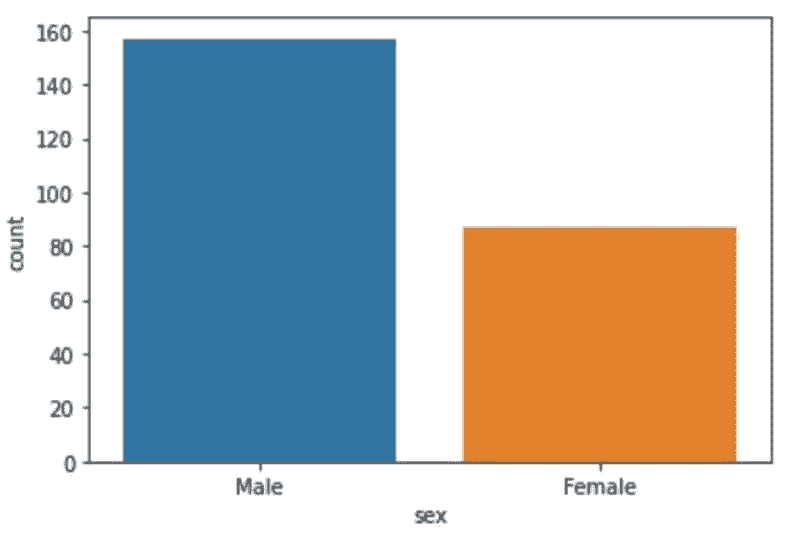

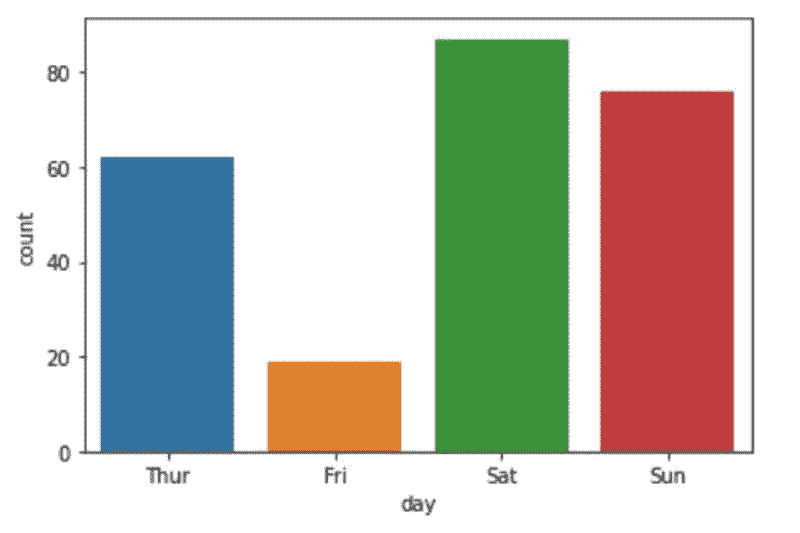

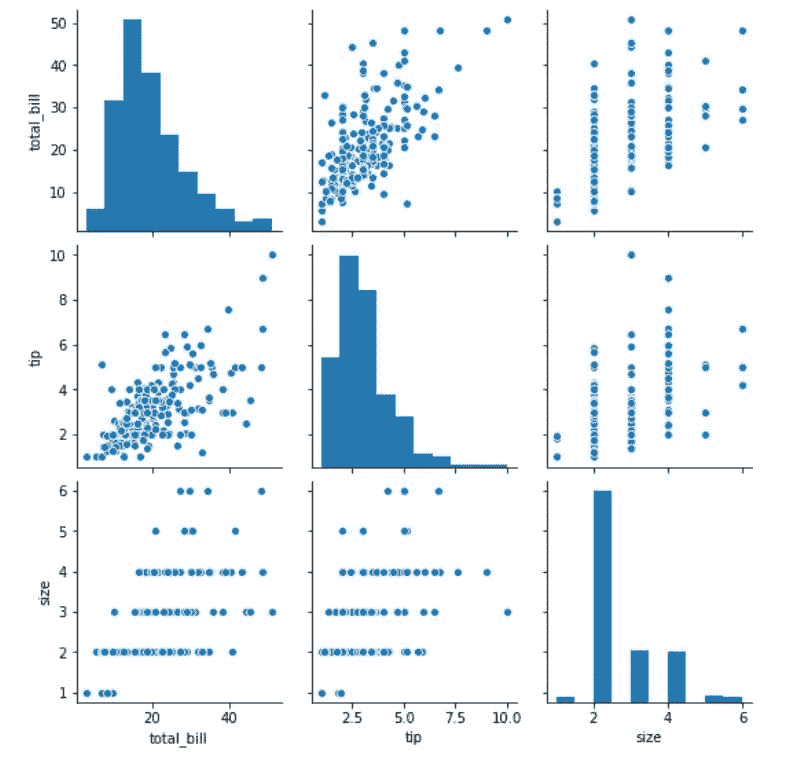

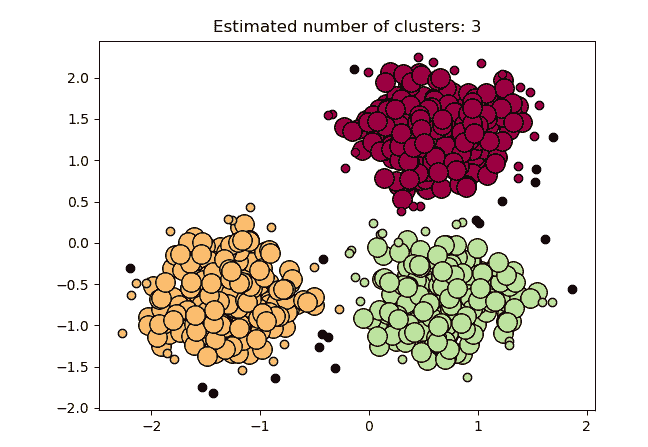

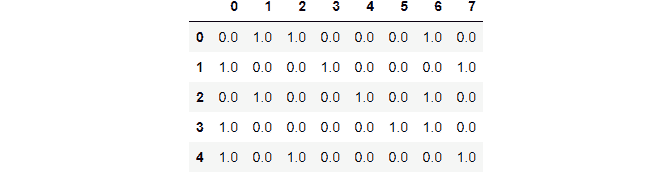

探索性分析与可视化

在本节中,我们将对给定的数据集进行探索性数据分析和可视化。以下项目在议程上:

-

经验水平的分布

-

工作类型的分布

-

基于经验水平的数据科学职位薪资比较

-

基于就业类型的数据科学职位薪资比较

-

基于经验水平和公司规模的薪资比较

-

比较全球数据科学家的薪资

-

平均薪资与货币的关系

-

平均薪资与地点的关系

-

前 10 名数据科学职位

-

远程工作状态与时间的关系

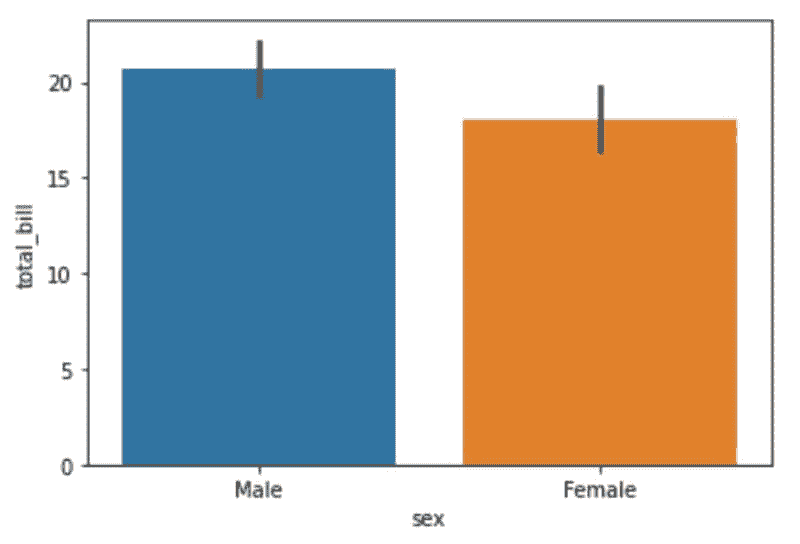

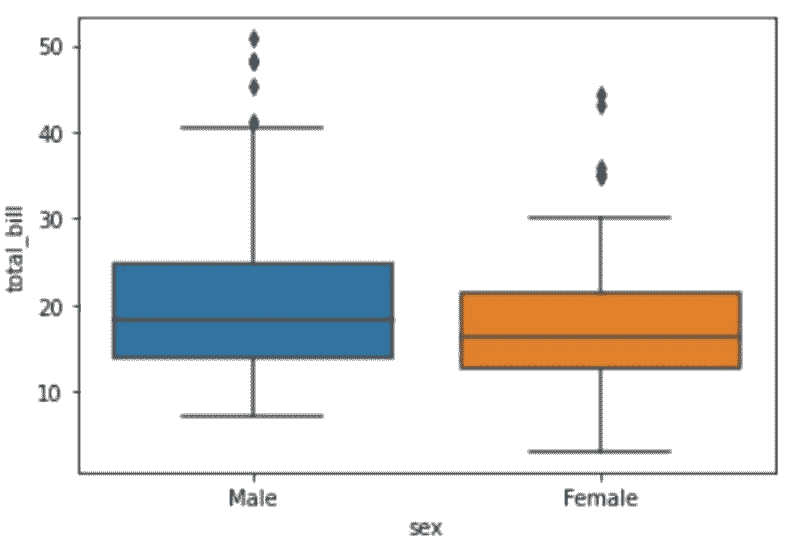

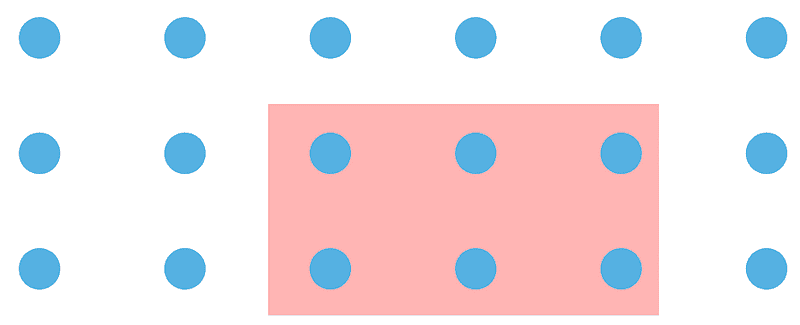

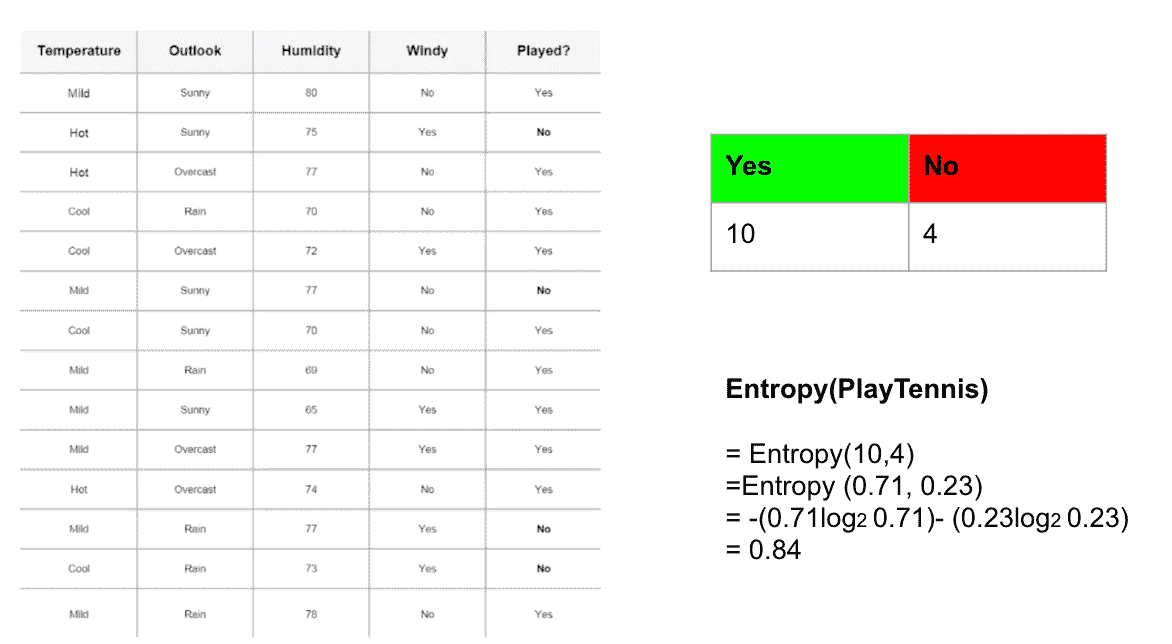

数据集中,14.5%的成员为应届生,而大部分名额由高级工程师填补,占 46.1%。

在 2020 至 2022 年期间,62.8%的成员因 Covid-19 危机转为居家工作模式。稍后,我们将看到这一趋势回归正常。

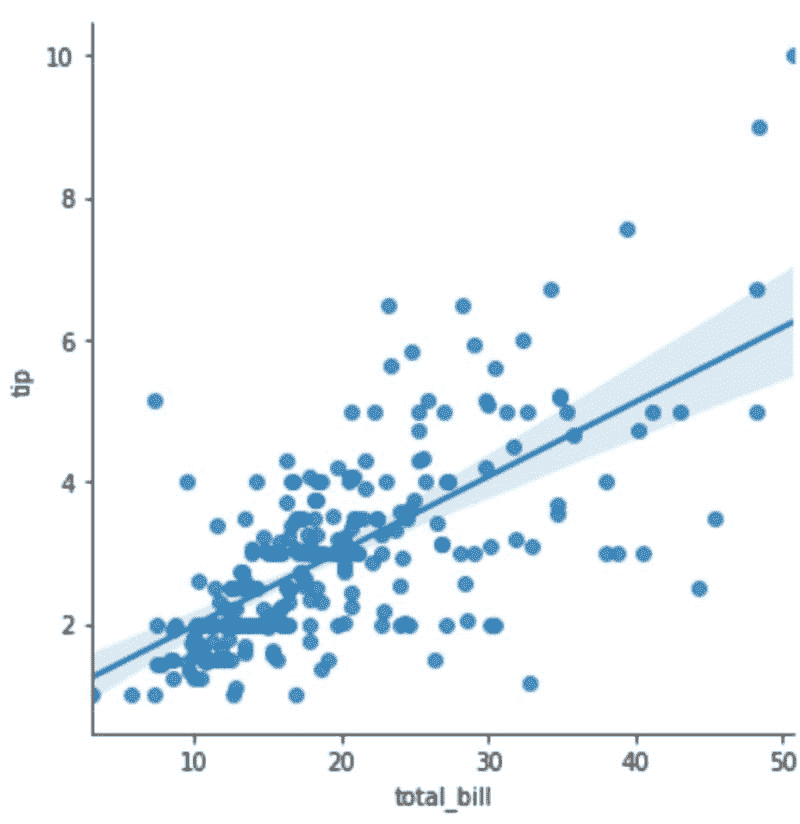

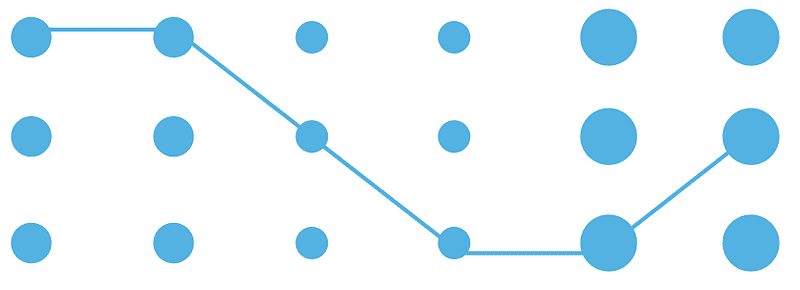

自然可以看出,经验越丰富,薪资也越高。然而,在最高的执行级别,薪资的变动幅度明显大于其他级别。

看起来合同制工作在所有类型的工作中收入最高,尽管其薪资变动幅度也很大。一个有趣的观察是,自由职业者的收入高于兼职工作者,但其薪资变动几乎是成比例的。

在之前的‘经验水平’与‘薪资’图表中添加‘公司规模’这一维度可以揭示更多信息。高级职位的薪资平均与执行级别薪资相符。此外,小公司的高级职位薪资平均几乎与相应公司规模的执行级别薪资一致。

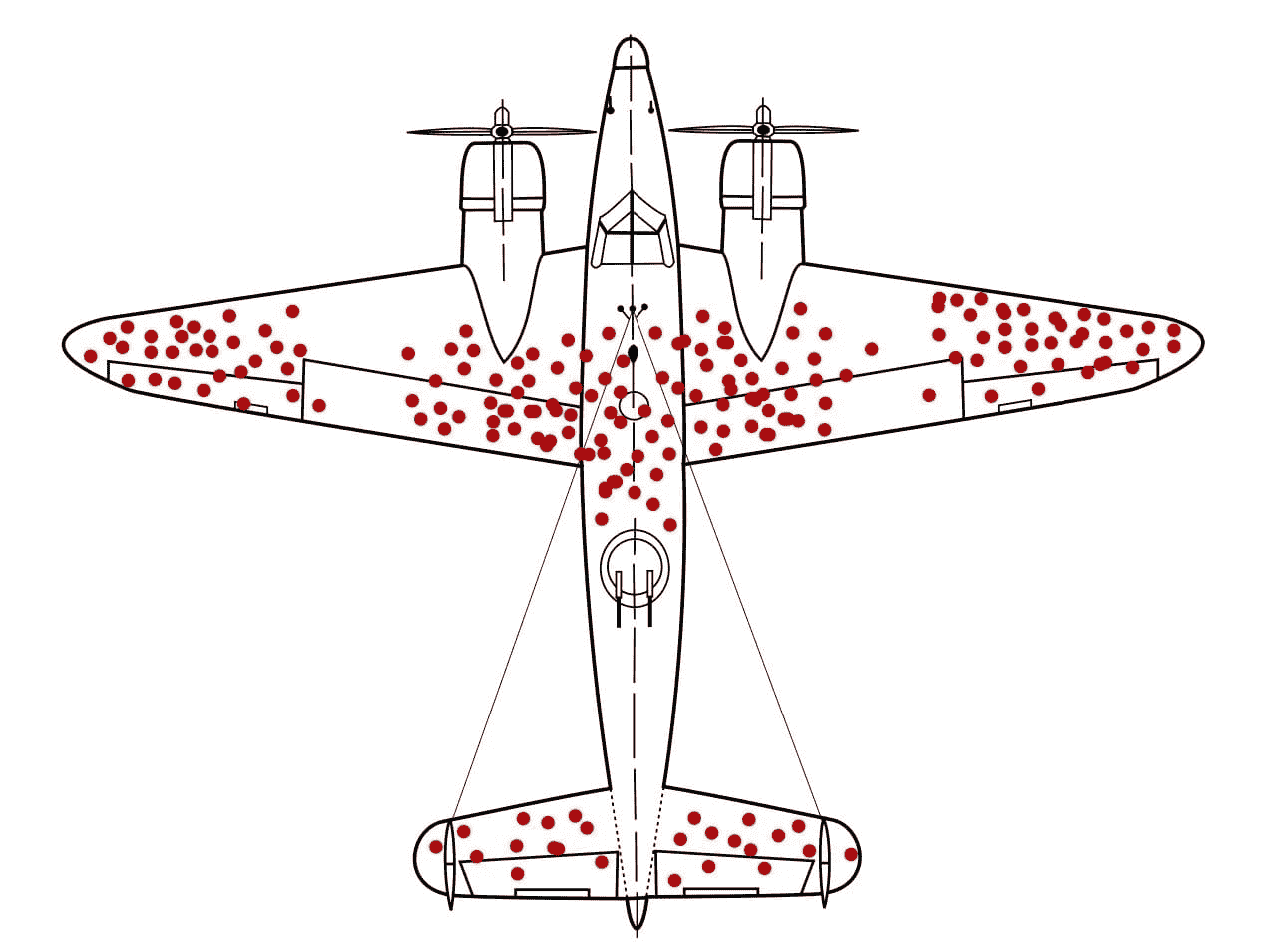

通过对薪资列求和,我们得到的数据非常偏向于美国。这可能是因为许多数据科学职位都在美国创建,数据主要在美国收集,或者数据收集表单可能是英文的,并且该表单可能在非英语国家流传。然而,为了线性化数据,我们将对薪资列进行 log10 转换,并使用这些缩放值来绘制地图的颜色。

薪资总和可能不是一个正确的比较指标,因为某些国家的条目可能比其他国家更多。因此我们绘制了保持 log10 缩放的平均薪资图。这能更好地反映全球薪资情况。

可以观察到大多数数据科学职位在美国,并且美国的薪资也最高。加拿大(CA)、日本(JP)、德国(DE)、英国(GB)、西班牙(ES)、法国(FR)、希腊(GR)和印度(IN)在职位薪资和数量方面依次排名(日本除外)。

将平均薪资作为货币的函数进行分析显示,薪资最高的是以美元支付,其次是瑞士法郎和新加坡元。这个图表受到特定货币价值的严重影响,因为图表左侧的大多数货币相对于美元具有较高的价值。

公司的位置在确定平均薪资方面也起着至关重要的作用。根据平均薪资绘制了前 10 个国家。

可以观察到数据科学家是最常见的职位,其次是数据工程师和数据分析师。

由于 Covid-19 危机,大多数工作转向了在家办公模式,但随着疫苗的推出,一切开始恢复正常。

推论与结论

对给定的数据科学职位薪资数据集进行了详细的数据分析。可以得出以下结论:

-

数据科学是几乎所有行业中最受欢迎和新兴的领域之一,如医疗保健、体育、艺术等。

-

探索了全球数据科学家的平均薪资变动情况。

-

薪资在不同雇佣类型(如合同制、全职等)之间的变化非常关键。

-

随着经验的增长,薪资的变化呈上升曲线。

-

由于新冠疫情危机,工作环境从在家工作转回到正常状态。

参考文献与未来工作

所有有用的链接如下:

Nikhil Purao 目前在印度理工学院古瓦哈提分校攻读技术硕士学位,专注于数据与决策科学。作为一名人工智能爱好者,他热衷于利用先进的分析技术和人工智能推动业务增长和改善结果。通过学习,他对该领域最新的工具和技术有了深入了解,并致力于保持在这一激动人心的学科前沿。无论是从复杂数据集中挖掘关键见解,还是开发前沿解决方案,他总是渴望迎接新挑战并与他人合作以取得成功。

原文。经许可转载。

更多相关话题

数据科学家是适合你的职业道路吗?坦诚的建议

原文:

www.kdnuggets.com/2014/03/data-scientist-right-career-path-candid-advice.html

评论

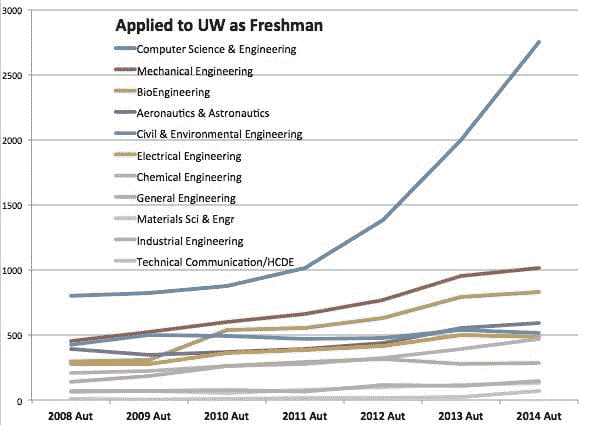

评论 如今,数据科学家(或相关角色如数据经理、统计学家、数据分析师等)无疑是最受追捧的职业之一。为了应对这一跨行业趋势,一些顶尖大学已经启动了专门的数据科学项目。

如今,数据科学家(或相关角色如数据经理、统计学家、数据分析师等)无疑是最受追捧的职业之一。为了应对这一跨行业趋势,一些顶尖大学已经启动了专门的数据科学项目。

被巨大的机会、优厚的薪酬和对商业领袖的曝光所吸引,许多人在没有彻底评估该角色的日常职责、所需态度以及技术与商业技能平衡的情况下,转向数据科学家的职业道路。

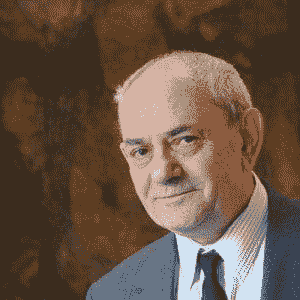

为了向数据科学 aspirant 提供一个清晰的、现实的数据科学家角色图景,帮助他们与自身性格和职业抱负进行评估,我最近与Paco Nathan,一位拥有 25 年以上行业经验的数据科学专家进行了讨论。他坦率、详细的回答很可能会让许多人大开眼界。

Paco Nathan 的简短个人介绍见帖子末尾。

Anmol Rajpurohit:数据科学家被称为 21 世纪最性感的职业。你同意吗?你会给那些考虑从事长期数据科学职业的人什么建议?

Paco Nathan: 我不同意。很少有人具备执行这个角色所需的广泛技能,也没有足够的耐心去获得这些技能,更没有去达到这一点的愿望。

作为自测:

-

![自测]() 准备对一个未知数据集进行分析和可视化,同时不耐烦的利益相关者在你肩膀上盯着,并提出尖锐的问题;要准备好对结果的置信度做出定量论证

准备对一个未知数据集进行分析和可视化,同时不耐烦的利益相关者在你肩膀上盯着,并提出尖锐的问题;要准备好对结果的置信度做出定量论证 -

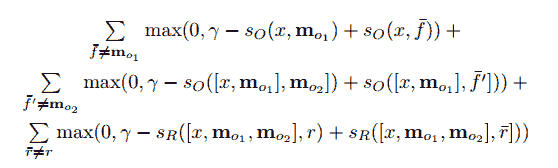

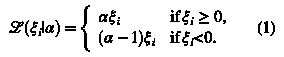

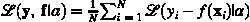

用 25 个字以内描述“损失函数”和“正则化项”,比较/对比几个示例,并展示如何为模型透明性、预测能力和资源需求结构化各种权衡

-

向执行团队提出重组建议,这可能意味着解雇一些排名靠前的人

-

采访 3 到 4 个对你的项目持敌对态度的不同部门,以获取他们不愿释放的数据集的元数据

-

在一个超过 1000 节点的集群中,构建、测试并部署一个关键任务应用程序,实时服务水平协议(SLA)高效完成

-

在没有对方帮助的情况下,调试别人编写的至少 2000 行长的间歇性 bug

-

利用集成方法来增强你正在开发的预测模型

-

在与来自 3-4 个完全与您之前工作无关的领域的人进行配对编程时,要在截止日期前完成工作

如果现在对以上列出的每一项都感到完全不舒适,那么我的建议是避免将“数据科学”作为职业。

数据科学家这个词在 2012 年左右作为一种新角色显得“性感”,如 DJ Patil、Hilary Mason 等所提。然而,并不是每个人都能获得 4 亿美元 IPO 的一部分!(完全公开:我在其 IPO 之前被邀请加入 LinkedIn 三次,但固执地追求其他机会;那里的团队真是优秀!)

大约在 2012 年:那是当时,现在是现在。实际的数据科学工作包括:

-

一些从“绿地”状态创新的机会,但并不多

-

大多是被召入一个现有的项目——这个项目以某种方式处于风险中

-

向权力说出真相(这并不有趣,但这是角色的本质)

重申 DJ 和其他人之前清楚表述的观点:大多数与数据相关的问题是社会/组织性的(例如,数据孤岛、缺乏元数据、矩阵组织内斗等),否则关键洞察力可能已经在那个组织内显现。

我有一种预感,大部分有趣的电子商务工作已经完成——大玩家将继续获得丰厚收入,但现在的工作大多在硅谷之外。或者说,其他行业来到这里学习、合作、购买等。

例如,孟山都在旧金山推出了一家私人股本公司,实际上可以比几乎任何风险投资公司以更优惠的条件投资农业数据项目。与此同时,该地区的风险投资公司几乎忽视了在重要领域的与数据相关的项目——Khosla 除外。在过去几个月里,他们收购了硅谷内的业务单位:Climate Corp、Solum 等,顺便说一下,这些都是由 Khosla 资助的。预计这种趋势会继续。

例如,孟山都在旧金山推出了一家私人股本公司,实际上可以比几乎任何风险投资公司以更优惠的条件投资农业数据项目。与此同时,该地区的风险投资公司几乎忽视了在重要领域的与数据相关的项目——Khosla 除外。在过去几个月里,他们收购了硅谷内的业务单位:Climate Corp、Solum 等,顺便说一下,这些都是由 Khosla 资助的。预计这种趋势会继续。

从我的角度看,现在数据领域的大问题不在于广告技术,而是现实问题:粮食供应、干旱/洪水、能源安全、医疗保健、电信、除石油依赖之外的交通运输、更智能的制造、森林砍伐监测、海洋学分析等。

此外,IT 预算在数据洞察方面仍然存在巨大缺陷。太多预算投入到“数据工程”的神职中,且预算往往用于已经清理过的数据。我发现,硅谷的“产品管理”概念几乎与数据的有效使用相对立:在许多情况下,产品经理的激励措施可能会阻碍公司内部数据的使用。

因此,我们的价值通常会体现在:

-

编写代码以准备数据

-

自动化流程以改进特征工程和模型比赛

-

向权力说出真相

第一个讲述了 IT 预算被错误分配的问题,第二个讲述了产品管理几乎系统性地敌视有效使用数据。第三个讲述了作为数据科学家的几项重要贡献,包括向高管提供确凿证据以解雇其他高管并使公司回到正轨。再次强调,行业干扰具有影响。

对于刚刚起步的人来说,要非常小心选择工作地点。如果一家公司声称有“优秀的工程技术”但数据使用情况不足(大约 2014 年),那么他们不是工作台上最锋利的工具;选择其他公司开始吧。寻找导师。加入那些得到金融或运营部门强力支持的团队(这些部门通常理解数据和变异),而尽量避免那些得到工程或营销部门支持的团队(这些部门通常不理解数据的有效使用)。

对于刚刚起步的人来说,要非常小心选择工作地点。如果一家公司声称有“优秀的工程技术”但数据使用情况不足(大约 2014 年),那么他们不是工作台上最锋利的工具;选择其他公司开始吧。寻找导师。加入那些得到金融或运营部门强力支持的团队(这些部门通常理解数据和变异),而尽量避免那些得到工程或营销部门支持的团队(这些部门通常不理解数据的有效使用)。

推荐,不一定按顺序。

-

学会利用不断发展的 Py 数据栈:IPython、Pandas、scikit-learn 等。

-

学会领导跨学科团队。

-

获得 1 个以上数据/分析/编程领域之外的经验。

-

扎实掌握设计基础并将其应用于数据可视化。

-

尽一切可能成为更好的写作者和演讲者(除学术会议外)。

-

参与会议;发布博客、演讲等(招聘经理忽略简历,寻找在线发布的内容)。

-

扎实掌握抽象代数、贝叶斯统计、线性代数、凸优化。

-

研究流数据的算法和框架(未来的大用例不是批处理)。

-

学习 Scalding 和具有类型安全性的函数式编程。

-

避免商业智能(像避瘟疫一样)。

-

避免任何被称为“ Hadoop 生态系统”或“ Hadoop 作为操作系统”的内容。

Paco Nathan 是大数据领域的“玩家/教练”,在大型应用程序的创新数据团队中领导了 10 多年。作为分布式系统、机器学习和企业数据工作流程的专家,Paco 是 O'Reilly 的作者,并且是包括 The Data Guild、Mesosphere、Marinexplore、Agromeda 和 TagThisCar 在内的几家公司顾问。Paco 从斯坦福大学获得了数学科学学士学位和计算机科学硕士学位,拥有超过 25 年的技术行业经验,涵盖了从贝尔实验室到早期初创公司的经历。

Paco Nathan 是大数据领域的“玩家/教练”,在大型应用程序的创新数据团队中领导了 10 多年。作为分布式系统、机器学习和企业数据工作流程的专家,Paco 是 O'Reilly 的作者,并且是包括 The Data Guild、Mesosphere、Marinexplore、Agromeda 和 TagThisCar 在内的几家公司顾问。Paco 从斯坦福大学获得了数学科学学士学位和计算机科学硕士学位,拥有超过 25 年的技术行业经验,涵盖了从贝尔实验室到早期初创公司的经历。

更多相关内容。

如何成为没有 STEM 学位的数据科学家

原文:

www.kdnuggets.com/2021/09/data-scientist-without-stem-degree.html

评论

1. 学习数据科学所有支柱的基础

“数据科学”是一个模糊的术语——它对不同公司可能意味着不同的东西,而且有许多与数据科学家相关的技能。

也就是说,我推荐你学习一些核心技能。以下技能对任何数据科学家都至关重要:SQL、Python、统计学、机器学习。我也建议你按此顺序学习这些技能。虽然听起来很多,但这与大学时你每学期需要完成 4-6 门课程并无不同!

让我们深入探讨每个技能。

A) SQL

SQL 是数据的语言,无疑是任何数据科学家最重要的技能。SQL 用于操作数据、分析数据、构建仪表板、构建数据管道、编写查询以供模型使用等等。

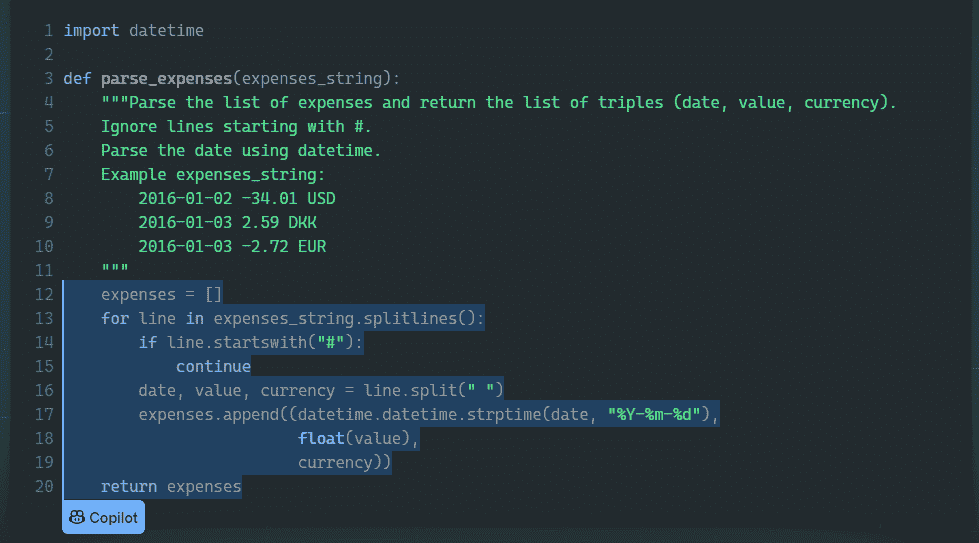

B) Python 和 Pandas

Python(或任何脚本语言)作为基础,能够进行诸如构建 ML 模型、网络数据抓取、构建自动化脚本等多种操作。

Pandas 是一个用于数据操作和分析的 Python 库。我个人在 Jupyter notebook 中探索数据时更倾向于使用 Pandas 而不是 SQL。

以下是我学习 Python 和 Pandas 时用到的最有用的资源:

C) 统计学

数据科学/机器学习本质上是统计学的现代版本。首先学习统计学,你会在学习机器学习概念和算法时轻松得多!尽管最初几周可能看起来没有实际收获,但后续的收益将会很值得。

以下是我学习统计学时用到的最有用的资源:

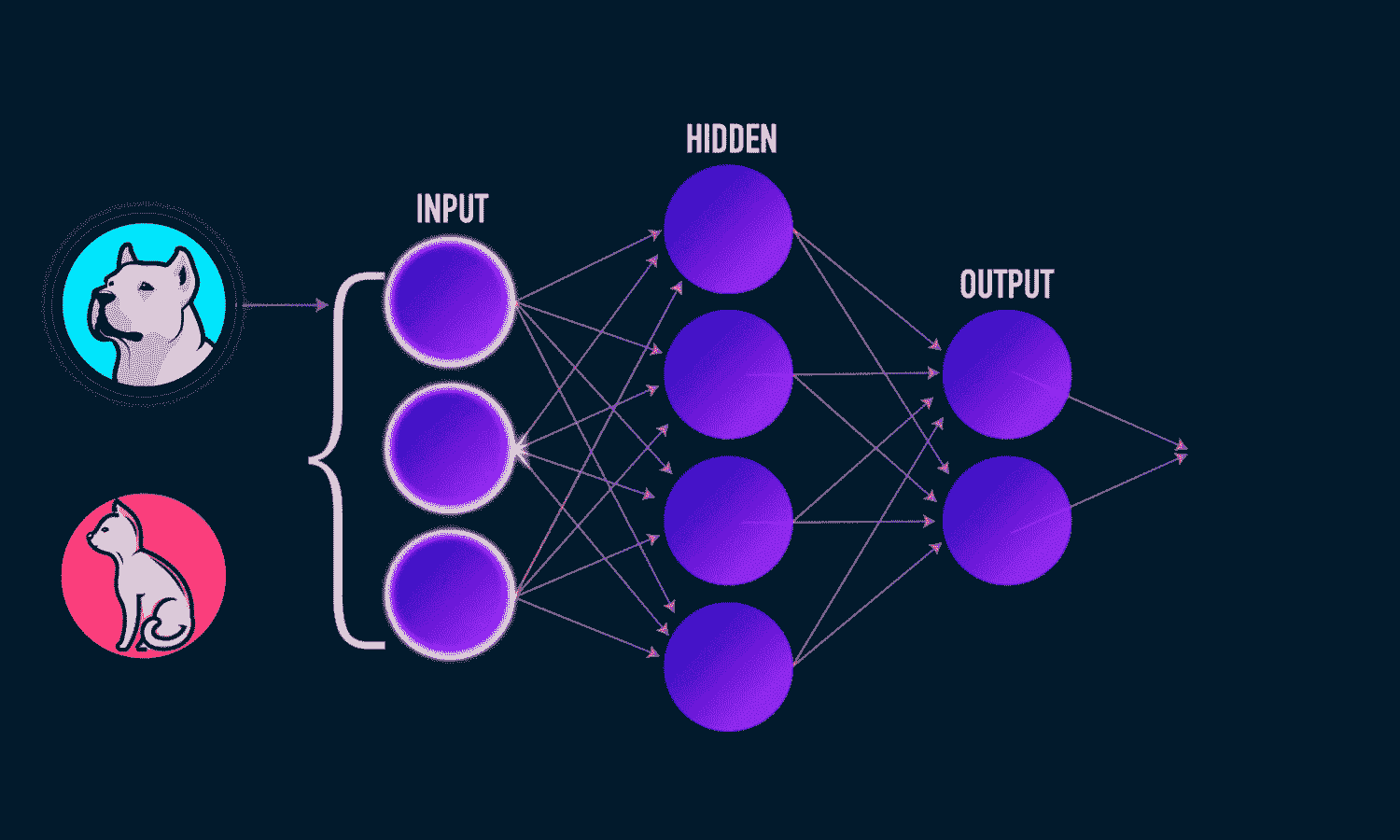

D) 机器学习

机器学习不仅有趣和激动人心,而且是所有数据科学家必须具备的技能。虽然建模占数据科学家时间的一小部分,但它的重要性不容忽视。

以下是我学习机器学习时用到的最有用的资源:

2. 完成 1-3 个个人数据科学项目

一旦你打下了基础,加速学习的最佳方式就是完成一些数据科学项目。最简单的方法是去Kaggle,选择一个数据集,创建一个预测模型或一些数据可视化。记住,你的前几个项目不会很出色!但重要的是你随着时间的推移如何进步。

这里有一些我过去完成的数据科学项目,你可以用来获得灵感!

当你继续学习和实践数据科学技能时,还有其他方法可以让自己成为更有价值的数据科学候选人,这也是我接下来要分享的建议。

3. 探索非传统的经验机会

成为数据科学家最困难的部分是如何在没有经验的情况下获得第一个机会。然而,以下是一些即使没有经验也可以获得经验的方法:

非营利机会

最近,我看到了一篇由苏珊·柯里·西维克(Susan Currie Sivek)撰写的资源丰富的文章, 提供了几个组织,你可以在这些组织中找到从事真实数据科学项目的机会。

如果你正在寻找更多的经验来丰富你的简历,我强烈推荐你查看这些。

参加比赛

在我看来,没有比通过比赛展示你已经准备好从事数据科学工作更好的方式了。Kaggle 举办了各种比赛,涉及构建模型以优化某些指标。

你现在可以尝试的两个比赛是:

在 Medium 上开设博客

是的,我有些偏颇,但请听我说。你会惊讶于 Medium 上有多少数据相关的专业人士。他们喜欢看到信息丰富、有见地和有趣的内容。利用 Medium 来撰写你的学习心得,解释复杂的话题,或者展示你的数据科学项目吧!

我特别建议你为出版物 Towards Data Science 撰写文章,因为他们目前拥有近 500,000 名关注者。

如果你需要一些灵感,可以查看我的项目演示,葡萄酒质量预测。

4. 寻找类似于数据科学家职位的工作

我知道我将面临艰难的挑战,尤其是没有作为数据科学家的经验。然而,寻找类似于数据科学家职位的工作将显著增加你成为数据科学家的机会。原因在于相关工作将给你在商业环境中处理实际数据的机会。

你不需要是数据科学家才能从事‘数据科学’工作

这里有一些你可以寻找的数据科学相关职位:

-

商业智能分析师

-

数据分析师

-

产品分析师

-

增长营销分析师 / 营销分析

-

定量分析师

除了上述两点,还有一个提示显著提高了我作为数据科学家的声誉。

5. 考虑获得定量领域的硕士学位

大多数数据科学职位列表要求硕士学位,因为通常需要高水平的技术技能。如果你发现上述两个建议没有成功,我建议你考虑定量领域(计算机科学、统计学、数学、分析等)的硕士项目。

就个人而言,我选择了乔治亚理工学院的分析学硕士项目,原因有很多:

-

它不需要定量领域的学士学位。

-

如果你想同时工作和学习,它有一个在线项目。

-

整个项目只需$10K 美元。

尽管如此,市场上有几个选项,我强烈建议你在做出决定之前花时间探索所有选项!

相关:

更多相关话题

数据科学家在欧洲做什么,他们的价值多少?

原文:

www.kdnuggets.com/2020/01/data-scientist-worth-europe.html

评论

在 12 月,我们分享了一些关于数据科学家价值的见解,数据主要集中在美国,同时也有一些额外的地理数据。随着Big Cloud 年度调查报告的发布,我们现在有了一些高质量的数据和可视化,帮助我们更好地了解全球数据科学家的价值。

这次我们将关注欧洲,特别是数据科学专业人士报告使用的技能、这些专业人士的薪资以及报告中的有趣见解。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

来自 Big Cloud 的报告:

自 2016 年以来,Big Cloud 致力于每年制作一些最大和最好的数据科学薪资报告。在超过 1300 个回应和 33 个问题后,我们自豪地宣布这是迄今为止我们为欧洲策划的最丰富的数据调查!

本报告将深入探讨 2019/2020 年度来自各背景、年龄和地点的欧洲地区专业人士提供的见解。今年贡献最多的来自德国、法国、英国、荷兰和瑞士。由于这些国家的数据点最多,因此这些国家是我们本报告的主要关注点。

更具体地说,大多数受访者来自以下城市:

-

巴黎

-

柏林

-

慕尼黑

-

伦敦

-

阿姆斯特丹

-

汉堡

-

苏黎世

-

剑桥

-

法兰克福

-

马德里

谁是受访者?

今年参与我们调查的最大群体是 24%的男性数据科学家,年龄在 25-34 岁之间。与去年相比,角色的变化似乎更大,数据科学家的数量减少了 15%,数据工程师的数量增加了 6%,C 级参与者的数量增加了 3%。

男性与女性参与者的比例保持不变。

超过一半的调查参与者拥有硕士学位,其次是博士学位(+4%)和学士学位(+2%)逐年稳步增加。然而,选择继续深造的人数持续下降,今年仅占 3%(2018 年为 3.45%)。

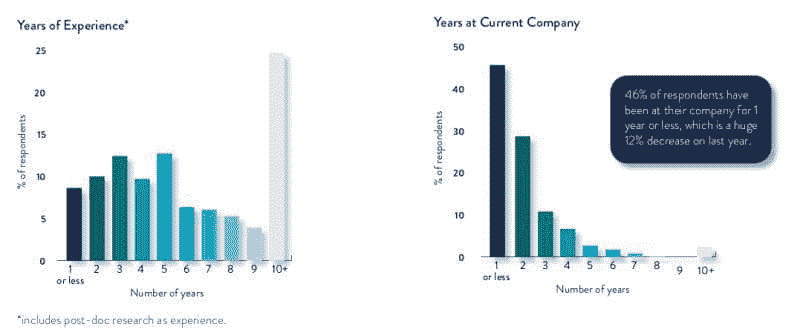

受访者的工作年限和在当前公司工作的年限如图 1 所示。

图 1:受访者的工作年限和在当前公司工作的年限。

调查受访者的主要行业是:

-

技术/信息技术

-

咨询

-

电子商务

-

金融科技

-

学术/教育

-

软件

-

医疗保健

-

保险

-

汽车

-

市场营销

请注意,本报告所依据的基础数据不可用。

现在我们对调查参与者有了一定了解,让我们来看看报告,从技能开始。

数据科学技能

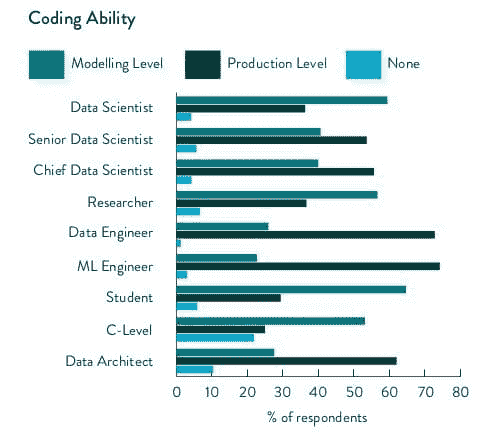

调查研究的部分数据科学技能维度包括编程语言、编程能力和使用的方法。

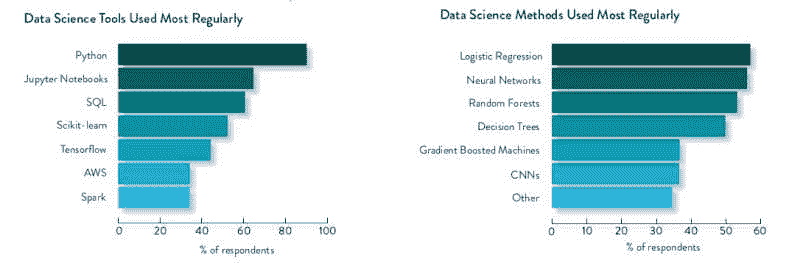

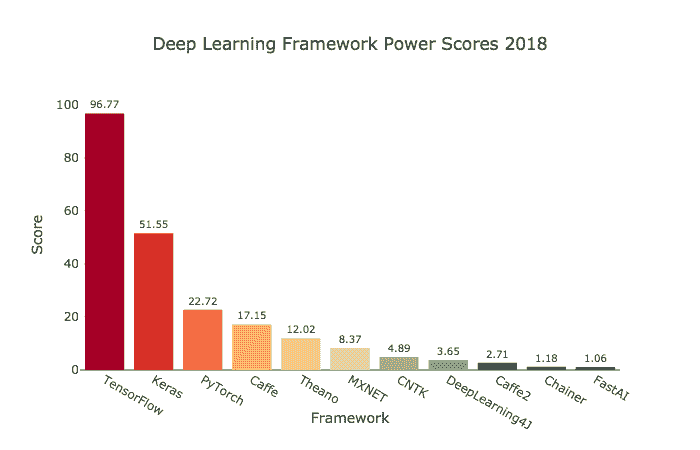

图 2:最常用的数据科学工具和最常用的数据科学方法。

在数据科学方法方面,从参与者中获得了以下信息:

[L]ogistic 回归、神经网络和随机森林是三种最受欢迎的选择,大约 56%的受访者表示使用它们。与数据科学家工具偏好相比,他们选择的数据科学方法种类更加多样。调查中的其他选项(未进入前七名)包括 34%的集成方法、31%的贝叶斯技术和 28%的支持向量机。

具体到编码方面,受访者的数据讲述了以下故事:

[A] 高达 70%的受访者表示他们使用 Python 作为主要建模编程语言。这比 2019 年的调查增加了 10%。9%使用 R,4%使用 SQL,4%使用 Java。此外,还有 3%的受访者表示他们不进行编码。

66%的受访者表示,他们的主要生产编程语言也是 Python。另有 9%表示 Java,还有 7%使用 Scala 或完全不进行编码。6%使用 C++

图 3:按职位类型划分的编程能力。

受访者花费多少时间进行编码?

29%的受访者每周花费 11-20 小时进行编码,这与我们 2019 年的调查结果相同。只有 14%的受访者表示他们每周花费 31 小时以上进行编码,而 7%的人完全不进行编码。总体而言,回应非常多样,这可能反映了参与者的资历差异。

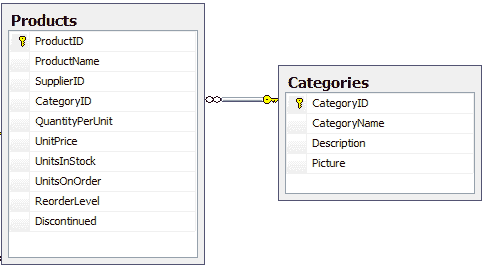

受访者还指出,目前处理的最受欢迎的数据类型,按顺序排列如下:

-

关系数据

-

文本数据

-

图像数据

-

其他

-

视频数据

数据科学薪资

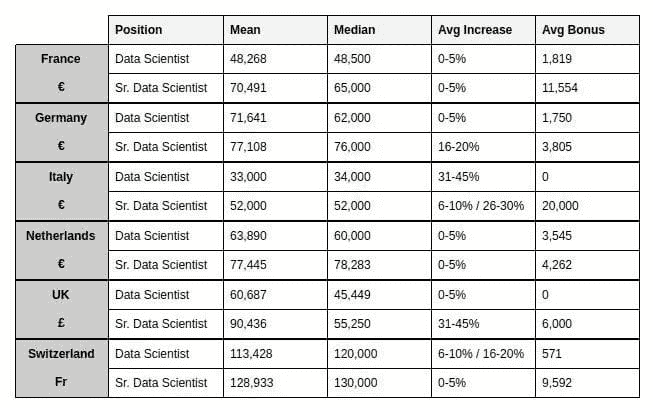

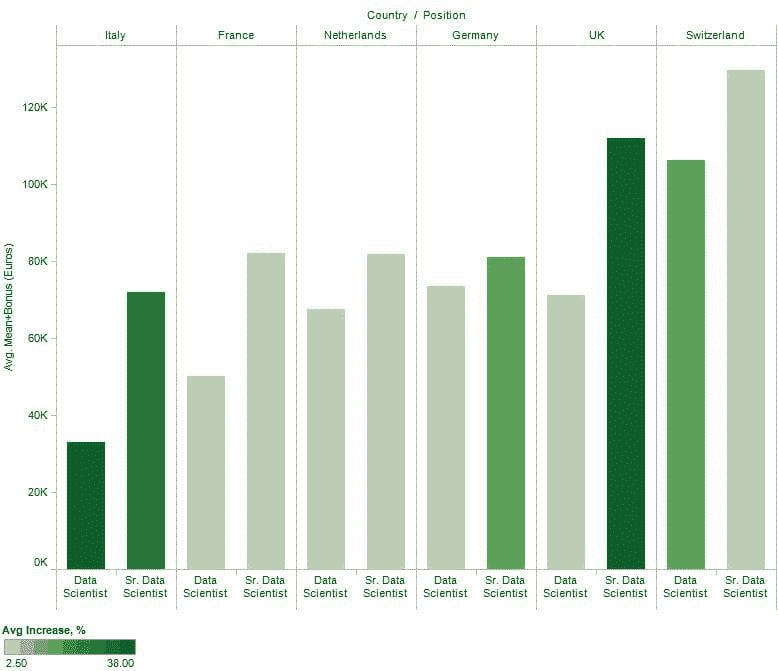

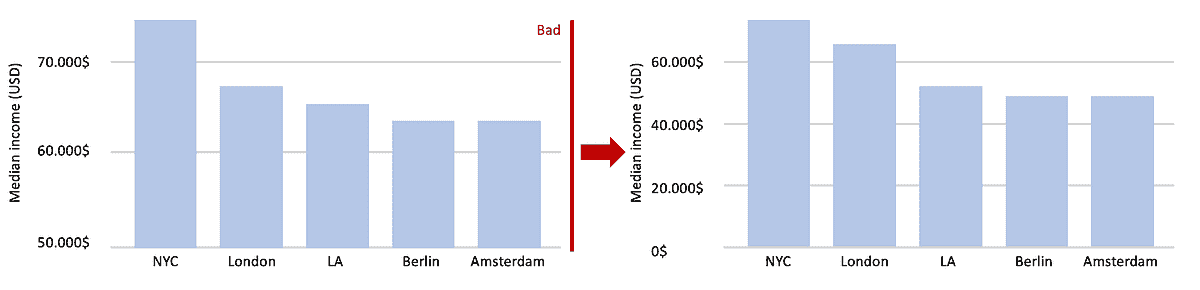

尽管调查包含了多个数据科学相关角色的薪资数据,但这很快就进入了比较苹果和橙子的领域。为了进行有意义的比较,我们将查看“数据科学家”和“高级数据科学家”的平均工资、中位工资、平均涨幅和平均奖金在 6 个国家(法国、德国、意大利、荷兰、瑞士、英国)的数据点(见图 4),这些国家在报告中被特别提及。

图 4:6 个调查参与者最多的国家的平均工资、中位工资、平均涨幅、平均奖金(标注了本地货币)。

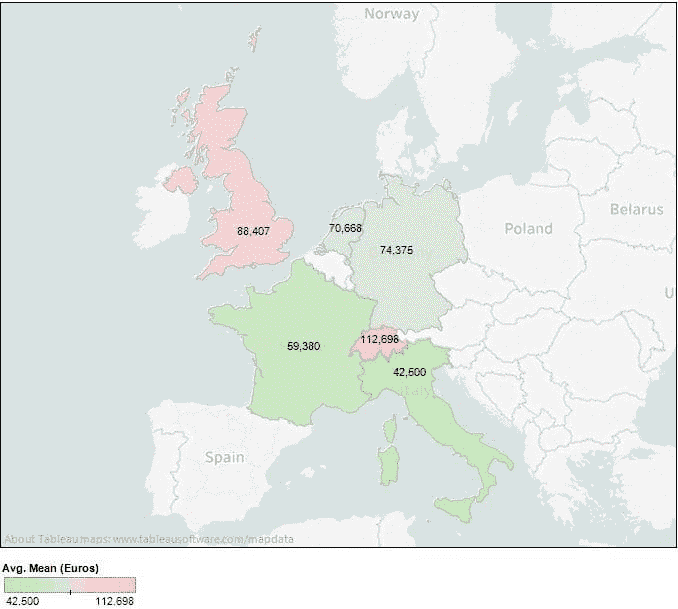

让我们来绘制这些数据。图 5 可视化了上述图表中 6 个国家的平均工资,本地货币已转换为本文发布时的欧元价值。

图 5:6 个调查参与者最多的国家的数据科学家的平均工资(以欧元计)。

为了更全面地描绘欧洲数据科学家的价值,图 6 绘制了同 6 个国家的数据科学家和高级数据科学家的平均工资 + 奖金(以欧元计),并通过柱状颜色强度描绘了薪资涨幅百分比。

图 6:6 个调查参与者最多的国家的平均工资 + 奖金(以欧元计)和涨幅百分比。

在薪资满意度方面,结果并不令人震惊;然而,稍微多于一半的受访者似乎认为他们的薪资和福利套餐是令人满意的。

当被问到“在 1 到 10 的尺度上(10 为最容易),你认为找到新工作的难易程度如何?”时,调查参与者最常回答的是“3”。

结论

欧洲显然不是一个单一的整体,这在调查回应中很明显。各国之间的薪资差异确实存在,但这本身并没有讲述完整的故事,没有考虑生活成本差异。虽然这应该是显而易见的,并且超出了薪资调查的范围,但值得明确指出。

除了原始数据外,一个突出的事项是参与者认为替代的数据科学职位的可用性以及转移到这些职位的难易程度似乎相对较低。这是一种个人感知,但在决定是否寻找新角色时,感知和现实一样重要。

你可以 在这里阅读完整报告。

相关:

-

数据科学家值多少钱?

-

人工智能:薪资飞涨

-

数据科学家:为什么雇佣他们如此昂贵?

更多相关主题

数据科学家的价值是多少?

评论

2019 年在分析、数据科学和机器学习领域是充满事件的一年。新的趋势、新的工具、新的视角……我们最近整理了一组三篇文章,结合了几十位专家的见解,以描绘 2019 年的关键事件,并对 2020 年(以及可能的未来)进行预测。这些文章从研究、技术和行业的不同视角探讨了主题。如果感兴趣,你可以在这里找到:

-

AI、分析、机器学习、数据科学、深度学习研究 2019 年的主要进展及 2020 年的关键趋势

-

AI、分析、机器学习、数据科学、深度学习技术 2019 年的主要进展及 2020 年的关键趋势

-

行业 AI、分析、机器学习、数据科学对 2020 年的预测

在已经成为一种传统的做法中,KDnuggets 的朋友 Xavier Amatriain 再次撰写了他对 AI/ML 年度进展的回顾,你可以在这里找到。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

本文将对数据科学及相关薪资进行快照式的回顾,以总结另一年的结束。为了找到一个对比点,并尽力寻找可以相互比较的对象,我们将重点关注数据科学家在美国的角色,同时也会考虑一些相关职位和几个额外国家的情况。

数据科学家的薪资是多少?

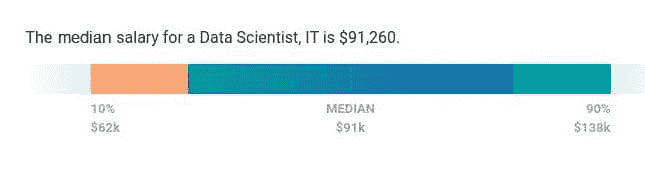

为了了解情况,我们来看一下 Payscale,报告(最近更新于 2019 年 10 月 22 日)称,美国的数据科学家中位薪资为$91,260,范围在$62k - $138k 之间(见图 1)。

图 1:数据科学家中位薪资

但基本薪资并不是全部。Payscale 还报告说,中位数奖金为$8,042,范围在$1k - $17k 之间,中位数利润分享为$5,139,范围在$970 - $15k 之间(见图 2)。

图 2:数据科学家薪资、奖金、利润分享范围

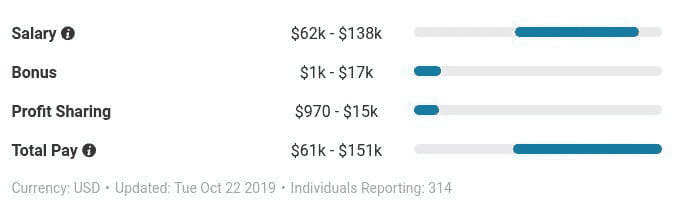

通常,任何职位的经验多少与薪资有相关性,这至少部分基于合理的推理。图 3 显示了与经验年限相称的薪资趋势。

图 3:与经验年限相称的数据科学家薪资

通过这条回归线和按经验年限分组的标签,你可以看到薪资的上升趋势以及基于不同经验水平的合理预期薪资。显然,一名新的数据科学家在其第一个职位上不应期望得到中位数薪资(有十年经验的人也不应如此),上述内容有助于回答什么是合理的期望。

了解Robert Half 的说法关于数据科学家薪资的不同视角(2019 年 9 月 10 日):

这些 IT 专业人士利用他们在统计学和建模方面的知识,来理解来自各种来源的复杂数据。要获得$125,250 的中位数薪资,数据科学家需要具备商业敏锐度和沟通能力,除此之外,还需要统计学、数学和计算机科学的专业知识。了解 Python 或 Java 等编程语言通常也是工作所需的技能。

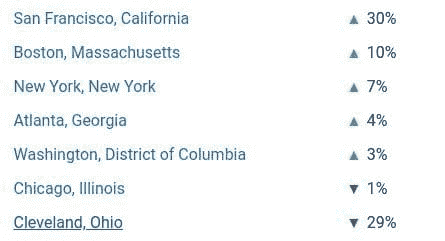

地理位置如何影响你的薪资?为了回答这个问题,图 4 展示了 Payscale 对几个美国城市薪资差异的分析。

图 4:按地点的薪资差异

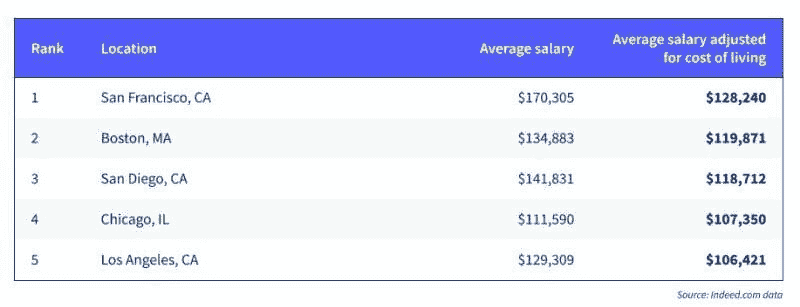

对于那些了解技术中心相对吸引力和美国生活成本差异的人来说,这不应令人感到惊讶。此外,Indeed 的报告显示数据科学家在以下 5 个美国城市拥有最高的总体薪资(见图 5)。

图 5:美国数据科学薪资最高的城市

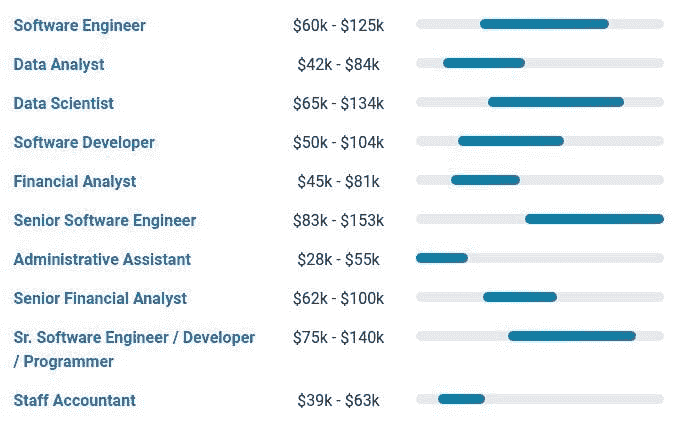

到目前为止,我们对数据科学家薪资的理解与相关职位薪资相比如何(或“相关”职位根据 Payscale 的定义)?请参见下方的图 6。

图 6:相关职位薪资

显然这些“相关”职位存在一些问题,但有几个职位提供了一些有限的相关对比。

关于职位薪资比较的更多额外有用的见解,让我们看看 Stack Overflow 编程薪资计算器(2019 年 10 月 16 日)。此报告概述了薪资计算器,该计算器“基于 Stack Overflow 开发者调查的综合数据,这些庞大而广泛的调查数据使我们能够建立一个准确的模型,反映全球范围内编码工作薪酬的趋势。”

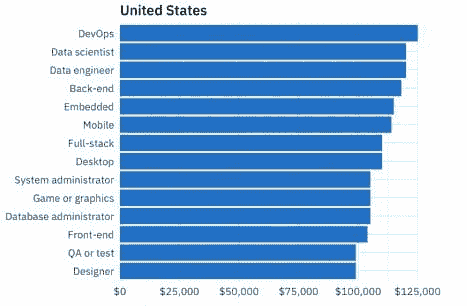

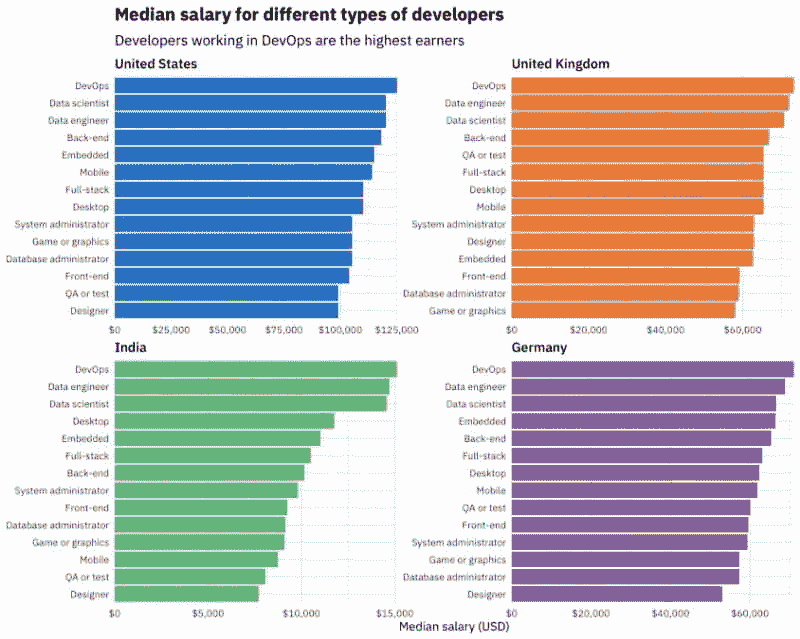

继续关注美国,图 7 显示了 Stack Overflow 报告中不同类型开发者的中位薪资。

图 7:不同类型开发者的中位薪资(美国)

数据角色,如数据科学家和数据工程师,在薪资排名中高居开发者类型的顶端。Stack Overflow 提供了这一观察结果:

[W]e 在这里有证据表明,高薪资的数据科学家和数据工程师可以仅凭高学历和丰富经验来解释。数据科学家薪资很高,但不比受过类似教育的从事其他工作的开发者高。(拥有学士学位甚至更高学位的人,编码薪资显著提高。)近年来,数据科学和数据工程工作已从极端的异类位置逐步转向主流软件工作领域。

虽然将数据科学家视为“开发者”有些问题,但在技术层面上,当代编码数据科学家所具备的技能与开发者的技能之间无疑有很多重叠。话虽如此,高等教育作为数据科学家薪资高的主要(他们暗示为唯一)因素的评论并非离谱。然而,这些可能是苹果和橘子的比较;我们需要访问类似高学历的数据科学家以及其他开发者的薪资原始数据(如果有的话),才能得出这样的结论。

最后,让我们利用 Stack Overflow 的调查为我们的讨论引入国际视角。图 8 关注了 4 个国家中不同类型开发者的最高薪资:

图 8:不同类型开发者的中位薪资(美国、英国、德国、印度)

那么,2019 年的数据科学家薪资是多少?结果显示,这是一个非常好的问题……但没有明确的答案。当然,你可能已经知道,完成后不会有一个单一的、神奇的数字。然而,你现在确实拥有一些数据来帮助做出合理的预测,了解在各种不同情况下公平薪资的情况。让我们看看 2020 年数据科学家薪资讨论带来了什么。

相关:

-

数据科学家:为什么他们的聘用费用如此昂贵?

-

人工智能:薪资飞涨

-

2019 年 Stackoverflow 调查中的 R 用户薪资

更多相关主题

数据科学家如何在全球就业市场中竞争

原文:

www.kdnuggets.com/2021/09/data-scientists-compete-global-job-market.html

评论

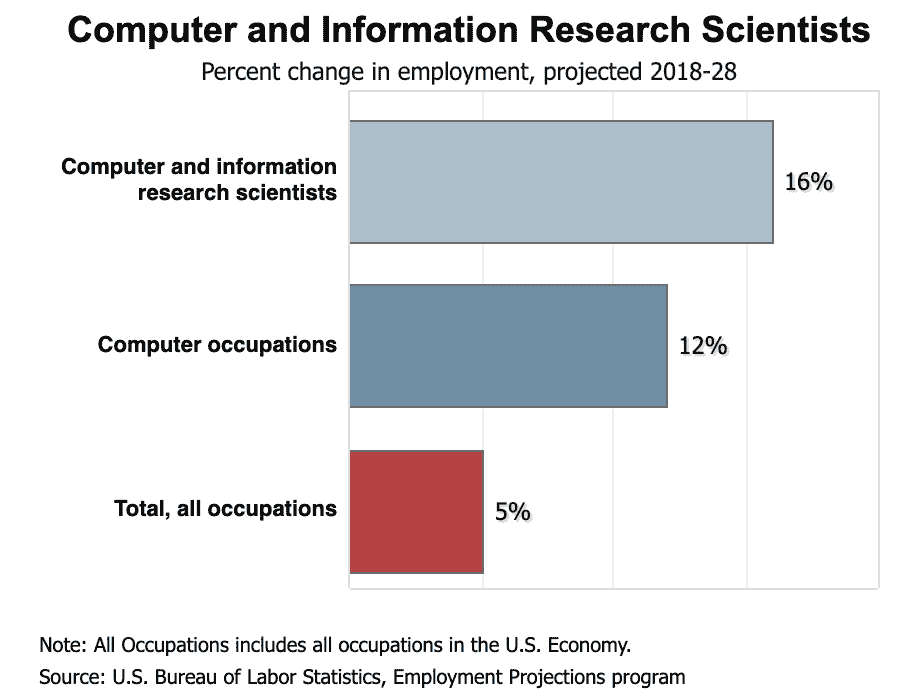

数据科学家的就业市场比以往任何时候都更加活跃,并预计在未来几年将迅速增长。美国劳工统计局预测,到 2026 年,职位数量将增长约 28%。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

公司正在投入大量资金进行市场研究和商业分析,为长期数据科学家和新入行者创造新的机会。与此同时,就业市场也变得更加竞争。随着数据科学职位变得对企业越来越重要,职位的平均薪酬也在上升,这促使招聘经理更加仔细地审查新员工。

希望保持竞争力或进入这一领域的数据科学家需要采用正确的方法。这些技巧将帮助他们寻找并获得新职位。

全球数据科学就业市场的现状

人们生成的信息比以往更多——专家认为,到 2025 年,全球数据将超出 175 泽字节。与此同时,AI 和大数据分析的创新使得大数据集对企业的价值比以往任何时候都要高——但前提是他们与经过培训的科学家合作,才能发现所需的洞察。

半数的调查企业已使用 AI以某种方式,并且更多企业表示他们计划在不久的将来进一步投资于数据驱动的解决方案。

现在,一条数据科学职位的招聘信息收到数百份申请并不罕见。更高的需求也意味着更高的薪酬,企业在招聘这些职位时变得更加谨慎。

作为回应,许多招聘经理正在夸大新数据科学职位的要求——要求更强的资质、更丰富的经验和额外的关键字。即使是具有良好资格或强大学术记录的数据科学家,现在也无法保证获得职位。

在全球就业市场中保持竞争力的最佳实践

希望进入该领域或获得新职位的数据科学家需要正确的策略来取得成功。这六个建议将帮助已有经验的专业人士和行业新手找到工作。

1. 知道使用正确的词汇

熟悉热门行业关键字——如 Python、SQL、AI 和数据分析——可以帮助你编写出更有效传达你技能的 CV 和简历,并通过招聘经理常用的简历筛选器。

跟上不断变化的行业需求也可以帮助你保持竞争力。虽然 Python 仍然是必备技能,但越来越多的企业期望熟悉深度学习、梯度提升机和大数据分析。许多公司还期望申请者过去使用过各种数据挖掘和分析方法。

2. 传达对行业标准工具的熟悉程度

当申请期望具备人工智能知识的职位时,强调数据科学和机器学习的知识可能有助于你获得面试机会。

同时,应避免关键字堆砌,即不自然地在简历中填充关键字以击败简历筛选器或吸引招聘经理的注意。尽量仅在简历或 CV 中使用与说明你的独特背景和数据科学技能集相关的关键字。

3. 了解大企业如何寻找数据科学专业人士

研究大型公司如何招聘数据科学家也可以帮助你改进简历和 CV。AI 和 ML 公司 Daitaku 最近在案例研究中出现,探讨了它如何在国际上寻找数据科学家。报告强调了技能集比地理位置更为重要。

4. 利用通用求职最佳实践

求职最佳实践通常也对寻找新职位的数据科学家有帮助。针对每个申请的职位量身定制你的 CV 和求职信会多花一些精力,但这有助于你在面试前传达你的特定技能,并展示你如何适合某个职位。

5. 与其他数据科学家建立联系

积极与其他数据科学家和寻找专业人士的招聘人员建立联系,可以帮助你扩大网络,更容易找到与你的技能和经验水平相匹配的职位。

在等待招聘经理的回复期间,你也可以寻找短期工作,以帮助你进一步提升技能,并在简历上增加一两个要点。

6. 考虑自由职业工作

需要数据科学家的企业但难以填补新职位,可能会向合格的申请者提供临时和自由职业工作。像 UpWork 这样的自由职业平台和求职板块可以为你提供这些职位的线索。

展望未来:数据科学家如何保持竞争力

数据科学家的职位空缺比以往更多,但这并不意味着市场竞争变得不那么激烈。数据科学的日益重要和技能人才的短缺使得公司在招聘时非常谨慎。

希望找到新职位或进入市场的数据科学家应保持对行业趋势的关注,并熟悉各种数据挖掘和分析技术。求职的最佳实践——如定制简历和谨慎使用关键词——也能帮助他们获得面试机会。

通过运用这些技巧,你可以在竞争激烈的环境中脱颖而出,找到理想的数据科学职位。

简介:德文·帕蒂达 是一位大数据和技术作家,也是 ReHack.com 的主编。

相关:

-

如何成功成为一名自由职业数据科学家

-

数据专业人士如何在简历中添加更多变化

-

自动化如何改善数据科学家的角色

更多相关话题

没有数据工程技能的数据科学家将面临严峻的现实

原文:

www.kdnuggets.com/2021/09/data-scientists-data-engineering-skills.html

评论

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

你可能读过关于数据科学家和数据工程师区别的文章。我一直认为这个区别很明确。数据工程师准备好数据,然后数据科学家在这些数据上工作。

然而,经过我作为数据科学家的工作,我对这一区别的看法发生了剧烈变化。

数据科学的一切都始于数据。你的机器学习模型的质量与输入的数据同样重要。垃圾进,垃圾出!没有合适的数据,数据科学家无法通过某种魔法创造有价值的产品。

合适的数据并不总是立即可用。大多数情况下,将原始数据转换为适当格式的责任将落在数据科学家身上。

除非你在一家大型科技公司工作,该公司有专门的数据工程师和数据科学家团队,否则你应该具备处理一些数据工程任务的能力和技能。这些任务涵盖了广泛的操作,我将在文章的其余部分详细阐述。

毕竟有什么区别呢?

我想阐述一下数据工程师的工作和数据科学家之间的关系。

数据工程师就是数据工程师。数据科学家应该既是数据科学家,又是数据工程师。

这可能看起来是一个有争议的说法。然而,我想强调的是,在我开始作为数据科学家工作之前,我的观点是不同的。我曾经认为数据工程师和数据科学家是两个独立的实体。

在文章的剩余部分,我将尝试解释为什么数据科学家应该既是数据科学家又是数据工程师。

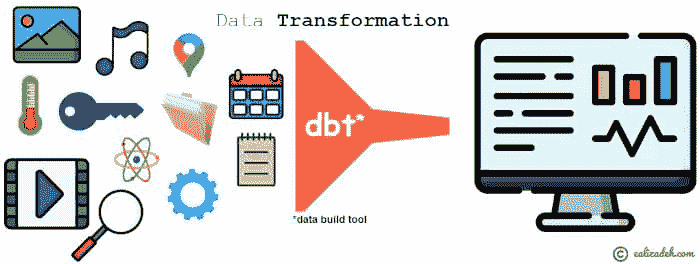

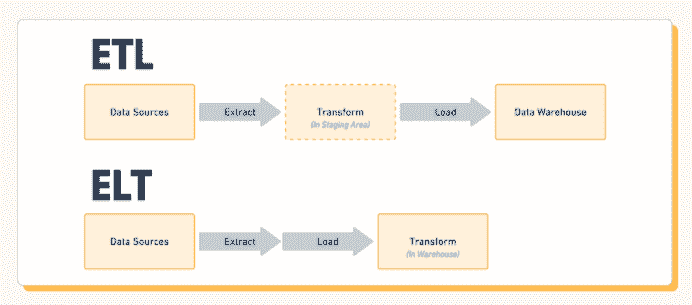

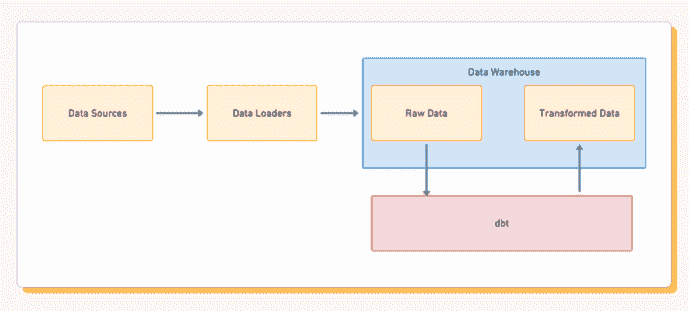

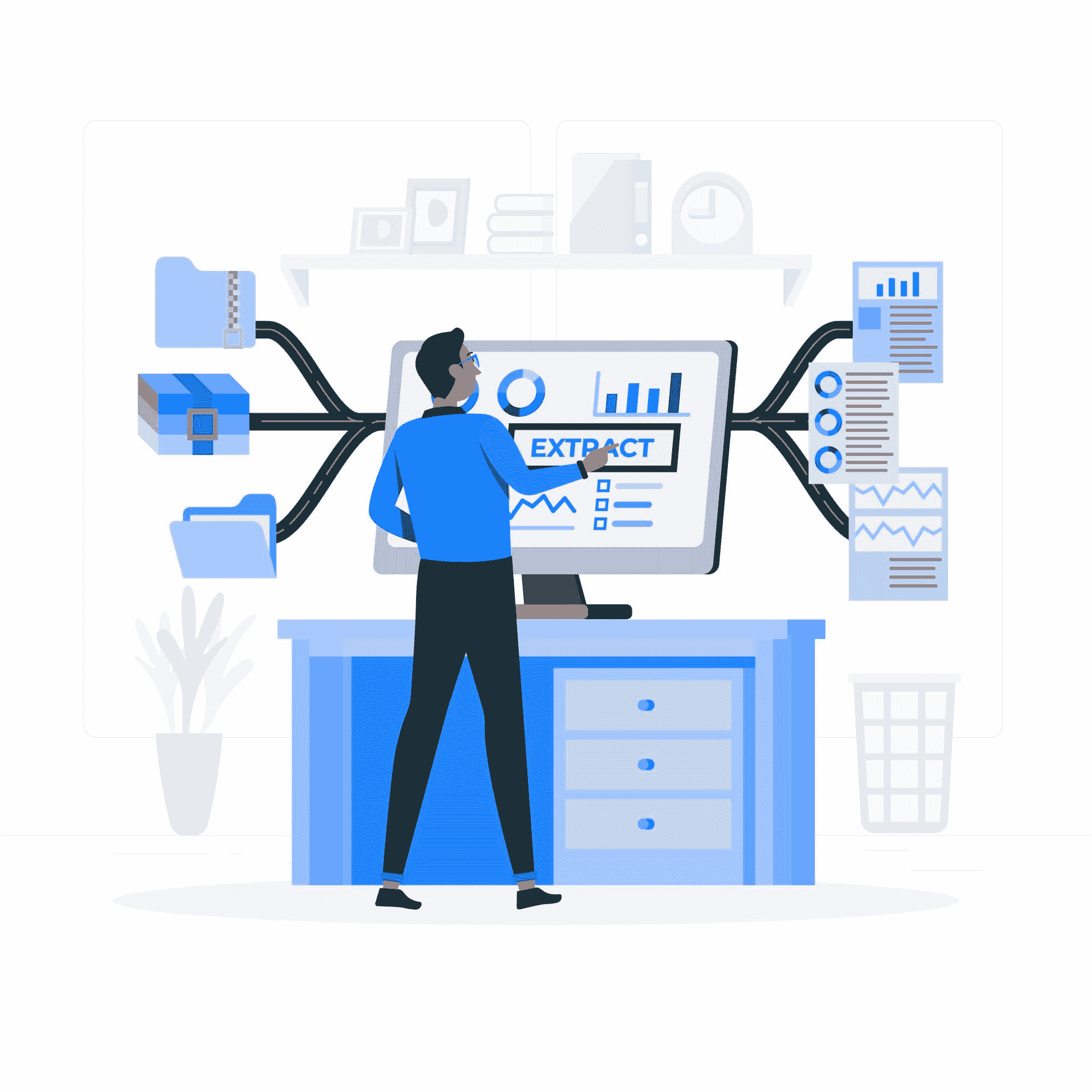

比如说,数据工程师会进行一系列称为 ETL(提取、转换、加载)的操作。这包括从一个或多个来源收集数据,应用一些转换,然后将其加载到另一个来源中。

如果数据科学家被期望执行 ETL 操作,我绝对不会感到惊讶。数据科学仍在发展中,大多数公司没有明确分开的数据工程师和数据科学家角色。因此,数据科学家应该能够执行一些数据工程任务。

如果你期望仅仅在使用现成数据运行机器学习算法,你会在刚开始工作时就面临严峻的现实。

你可能需要编写一些 SQL 存储过程来预处理客户端数据。也有可能你会从几个不同的来源收到客户端数据。你的工作将是提取和组合这些数据。然后,你需要将它们加载到一个单一的来源中。为了编写高效的存储过程,你需要广泛的 SQL 技能。

ETL 程序的转换部分涉及许多数据清理和操作步骤。如果你处理大规模数据,SQL 可能不是最佳选择。此时,分布式计算是更好的替代方案。因此,数据科学家也应熟悉分布式计算。

在分布式计算中,你的最佳伙伴可能是 Spark。它是一个用于大规模数据处理的分析引擎。我们可以将数据和计算分布在集群上,以实现显著的性能提升。

如果你熟悉 Python 和 SQL,那么适应 Spark 不会很困难。你可以使用 PySpark,这是一种 Spark 的 Python API。

关于集群工作,最佳环境是云。虽然有多种云提供商,但 AWS、Azure 和 Google Cloud Platform(GCP)领先于前。

虽然 PySpark 代码在所有云提供商中都是相同的,但环境设置和集群创建方式有所不同。它们允许通过脚本或用户界面创建集群。

在集群上进行分布式计算是一个完全不同的世界。它与在你的计算机上进行分析完全不同。它具有非常不同的动态。评估集群性能和选择集群的最佳工作节点数量将是你主要关注的问题。

结论

长话短说,数据处理将成为你作为数据科学家的重要部分。我所说的重要,是指你 80%以上的时间都将用于数据处理。数据处理不仅仅是清理和操作数据。它还包括 ETL 操作,这通常被认为是数据工程师的工作。

我强烈推荐熟悉 ETL 工具和概念。如果你有机会进行实践,那将非常有帮助。

认为作为数据科学家你只会处理机器学习算法是一个天真的想法。这确实是一个重要的任务,但它只会占用你时间的一小部分。

原文。转载已获许可。

相关:

更多相关话题

数据科学家和数据工程师如何协作?

原文:

www.kdnuggets.com/2022/08/data-scientists-data-engineers-work-together.html

图片由 fauxels 提供,通过 Pexels

数据科学家和数据工程师如何协作?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

数据科学家和数据工程师常常被初学者混淆,特别是那些在数据科学领域没有显著经验的人。虽然他们的工作乍一看可能似乎相似,但实际上存在一些重要的根本差异。如果你正在考虑数据科学的职业生涯,了解这两个领域的不同之处非常重要,以确定哪个领域可能更适合你的技能和兴趣。

数据科学家的工作是什么?

数据科学家 直接参与分析方面的工作。他们处理数据模型,提出特定问题的解决方案,并探索数据科学领域的极限,以寻找应对挑战的合适方法。数据科学家的工作涉及大量数学和对数据科学背后统计概念的深刻理解。强大的数学和统计背景对于成为数据科学家并在知名公司获得职位是必要的。

数据工程师的工作是什么?

另一方面,数据工程师 更多地关注于解决方案的实际技术实施。一旦科学家提出了一个模型,工程师就需要弄清楚如何将其整合到整体的数据处理流程中。数据工程师必须小心平衡他们所工作的系统的可访问性、灵活性和性能。

他们还必须尽可能全面地理解他们正在使用的技术栈。在实施解决方案时,数据工程师需要确定应该使用哪些语言、数据库和其他技术组件来组建最终结果。通常需要大量的脚本编写来将所有部分连接起来。

两个角色如何协作?

观察数据科学家和数据工程师的一个好方法是通过建筑师和土木工程师的类比。建筑师提出最初的计划,而工程师则在考虑结构限制和其他类似问题的同时实施这些计划。在数据科学的世界里也是如此。数据科学家进行规划,数据工程师则构建和实施。

尽管如此,这两个角色也紧密合作以提出最终解决方案。在双方都拥有良好的沟通技巧非常重要,因为通常需要整合想法和限制,这必须以不削弱任何人项目参与的方式进行。优秀的数据科学家和工程师的组合在这种通常混乱的工作环境中可以证明是不可或缺的。

哪条职业路径适合你?

如果你想参与数据科学,选择你是否想成为数据科学家或数据工程师是重要的。如果你喜欢数学并探索该领域的理论概念,作为数据科学家的工作可能更适合你。你需要对统计学、线性代数以及其他各种数学领域有很好的理解。你还需要阅读大量的已发表论文,以便对该领域如何整体联系有一个良好的理解。

另一方面,如果你喜欢“动手实践”,经常发现自己编写脚本来自动化工作,重新安排管道的部分以提高效率,并担心技术限制,那么作为数据工程师的工作可能非常适合你。这是一个非常技术性的领域,你不一定需要对数学基础有很好的理解才能成功。但这确实会有帮助。

为什么了解两方都值得

无论你选择哪一方,花些时间熟悉两端的概念都是一个好主意。一名优秀的数据工程师必须至少了解他们实现的模型最初是如何形成的,而一名优秀的数据科学家则必须了解他们可能遇到的粗略限制。这就是为什么这些领域中的最佳专家通常都会投入一些精力去学习另一方的工作方式。这在尝试传达复杂概念时也会非常有用。

无论你是决定先专注于一方面,然后再涉猎另一面,还是最初将注意力分散于两者之间,都由你决定。两种方法都可行,这取决于个人偏好。无论你选择哪个方向,Springboard 都有相关课程可以加深你的理解,并让你在感兴趣的领域中为求职做好准备。如果你对这一方面感兴趣,Springboard 的数据科学职业课程是一个很好的起点。

赖利·普雷杜姆 曾在多个数据领域,如产品和数据分析,以及数据科学和数据/分析工程领域,具有丰富的专业经验。他热衷于写作和教学,并喜欢为在线社区提供学习材料,专注于一般学习以及职业发展。赖利在他的Medium 博客上编写编码教程。

更多相关主题

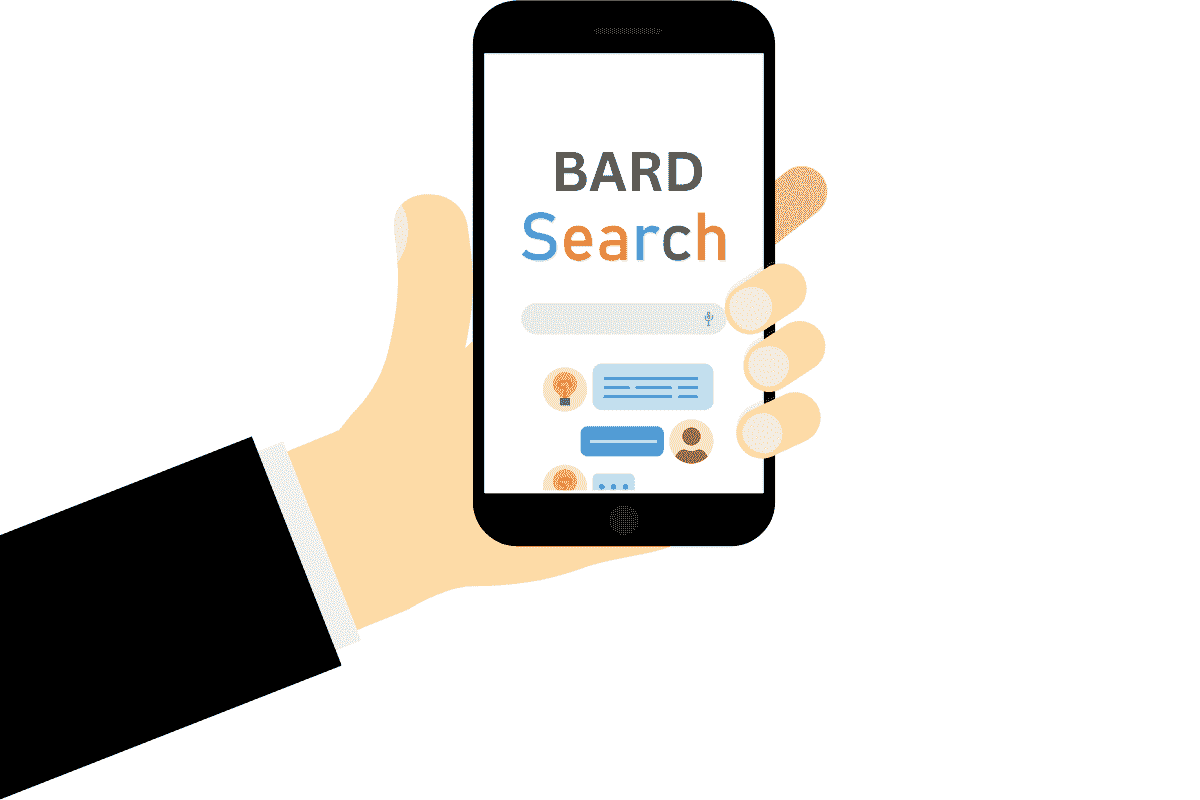

为什么数据科学家期望谷歌 Bard 提供有缺陷的建议

原文:

www.kdnuggets.com/2023/02/data-scientists-expect-flawed-advice-google-bard.html

图片由编辑提供

在最近的宣传活动中,谷歌向世界展示了 Bard 的首次亮相,这是科技巨头试图取代极受欢迎的 AI 聊天机器人 ChatGPT 的尝试。尽管这次活动可能旨在为谷歌的 AI 聊天尝试制造轰动,但它很快成为了展示这些神秘 AI 聊天服务可能出错的公众示范。

根据路透社的首次报道,Bard 给出了不准确的回应,导致 Alphabet (GOOGL) 的股价在演示当天下跌了多达 9%。对于许多数据社区成员来说,这并不令人惊讶;原因如下。

Bard 的广告有什么问题?

问题:当被问及如何向 9 岁的孩子介绍令人惊叹的詹姆斯·韦布太空望远镜 (JWST) 时,Bard 错误地将其描述为“……用于拍摄地球太阳系外第一张行星的照片”。这一回答很快被识别为错误,因为地球太阳系外第一张行星的照片是在 2004 年由欧洲南方天文台的大型望远镜 (VLT) 拍摄的。

什么是谷歌 Bard?

谷歌首席执行官 Sundar Pichai 称 Bard 为“对话式 AI 服务”。如果这听起来很熟悉,你可能在过去几个月里遇到过谈论 ChatGPT 的众多在线影响者之一。

对这项 AI 突破的看法差异很大。赞成者讨论革命性计划或分享利用聊天机器人快速发展业务的兴奋点。ChatGPT 最受欢迎的用例之一是自动化重复性任务。另一方面,批评者对其能力提出了有缺陷的观点——认为聊天机器人的功能取代了人类的研究和批判性思维。谷歌 Bard 将引发类似的讨论。

什么是 LaMDA?

谷歌的 Bard 基于 LaMDA,这是公司在 2021 年推出的语言模型,LaMDA 本身建立在公司流行的开源神经网络架构 Transformer 上。

有趣的是,LaMDA 是通过对话进行训练的,使其比以前的语言模型更自然地回应人类对话。(如果 LaMDA 这个名字听起来很熟悉,也许你会记得有一个谷歌工程师认为LaMDA 已经具有意识。)

2021 年 5 月宣布的谷歌 LaMDA 首次亮相,是讨论其模型优势的机会,宣布特别关注其回应的真实性。两年后,在 Bard 宣布期间,记者很快发现了一个事实错误。这对谷歌的实施意味着什么?我们将拭目以待。

谷歌 Bard 有何不同于 LaMDA?

鉴于两者的相似之处,一些人问,这款新产品有什么不同?谷歌谦虚地声称,它的新服务将“世界知识的广度”添加到 LaMDA 已经令人印象深刻的对话技能中。它还承诺提升模型的能力,提供比普通聊天机器人更多的指导和研究。简而言之,Bard 依赖于 LaMDA,而 LaMDA 不依赖于 Bard。

同时请注意,谷歌计划通过 Bard API 链接向开发者开放服务,使其比普通聊天机器人更具吸引力。虽然用户已经可以与 LaMDA 进行自由流畅的对话,但谷歌 Bard 承诺通过包括公司提供的全方位谷歌搜索服务的相同信息来提升对话。

与直觉相反,Bard 的事实错误不应削弱这个新服务的承诺价值。谷歌的搜索结果从未承诺绝对准确。搜索者应始终考虑其来源。即使在发布了令人印象深刻的聊天机器人之后,这一事实仍然成立。

使用谷歌 Bard 的方法

数据科学家并不是唯一对使用谷歌 Bard 感到兴奋的人。皮查伊设想这项服务将帮助任何使用谷歌的人。他的承诺?Bard 简化复杂话题。考虑以下使用案例:

找到复杂问题的简单答案

想象一下你想去度假。谷歌现有的搜索可以轻松回答你知道要去哪里时的问题,并帮助你查找特定日期的价格。但皮查伊将这个新聊天机器人比作和朋友对话。

你应该能够开始一个关于工作的项目的对话,将复杂的研究文章分解成最重要的要点,然后在接下来的几周内请求应用这些要点的推荐。

Bard 还可以在销售团队培训中提供帮助,在你招待挑剔食客时提供晚餐推荐,以及讨论最新的漫威电影的精彩部分。谷歌已经在其产品中实施了 AI,但随着新聊天机器人的发展,这一过程将会扩展。所有这些,你无需离开你熟悉的搜索引擎。

自动化常规任务

谷歌已经与市场整合,使你可以直接从其界面购买商品和进行预订。谷歌 Bard 可能允许你通过对话实现这一点。Alexa 可能能启动你的 Spotify 播放列表,但想象一下与 AI 协作,为你的下一次公路旅行策划配乐,同时你开车上班。

参与社区对话

社交网络往往助长在线争论,奖励有争议的观点,并为网络喷子提供额外曝光。这导致许多人放弃了 2010 年代流行的平台。谷歌 Bard 可以为小众社区策划对话,连接好奇的头脑,同时过滤掉仇恨言论和虚假信息。

使用谷歌 Bard 的潜在陷阱

不足为奇的是,这个新聊天机器人引起了很多关注,至少部分原因是它广泛的应用潜力。对棋盘游戏爱好者和项目经理来说,它的吸引力是一样的。皮查伊在新闻稿中遗漏了一些重要点,这些点在最近的非凡太空摄影误归属事件中变得更加明显。这里还有一些需要考虑的点。

聊天机器人不必讲真话

像 ChatGPT 这样的流行对话代理内置了伦理指导。例如,它不应讲冷笑话或故意误导你。但这并不总是适用于 AI 聊天系统。

查看这项关于人工智能在棋盘游戏外交中的应用的最新研究,重点关注谈判和形成联盟的能力。研究还强调了对任何违背承诺的方实施处罚。看到团队专注于构建促进可信沟通的 AI 策略令人鼓舞,但请考虑这对不慎的数据科学家意味着什么。

随着聊天机器人技术的发展,我们应当更多考虑提供服务者的动机。在进行谈判(金融服务、交易、薪资谈判)时,聊天机器人可能会故意误导用户。

机器学习并不能消除偏见

数据科学社区已经很清楚机器学习中的偏见。像他们的人类同行一样,对话聊天机器人经常表现出确认偏见和偏见偏见。谷歌 Bard 无疑会考虑到这些问题中的一些,但我们应当对新发布的第三方应用保持警惕。

虽然谷歌聘请了一些世界上最优秀的数据科学家,但这家科技巨头也并非没有缺陷。记得那位提出一些令人不便的问题的伦理学研究者吗?她表达了对环境成本、难以理解的模型、错误导向的研究努力以及传播虚假信息潜在风险的担忧。

所有数据集都有缺陷

从本质上讲,聊天机器人依赖于自然语言处理(NLP)模型。但没有任何数据集能够代表完整的真相。深度学习可能有助于为对话伙伴提供更自然的回答,并在最佳情况下缓解一些数据集的局限性。但尽管你最喜欢的网红可能会说什么,没有任何聊天机器人是神。

引用乔治·博克斯的话:“. . . 没有必要问‘模型是否真实?’ 如果‘真实’是指‘全部真实’,答案必须是‘不’。唯一感兴趣的问题是‘模型是否具有启发性和实用性?’”

如何访问谷歌 Bard

谷歌已经向“受信任的测试者”提供了 Bard,但公司承诺在几周内进行更广泛的发布。这意味着开发者应该在密歇根州上半岛的雪融化之前获得谷歌的轻量级版本。

这对谷歌搜索的更新意味着什么?我们还得拭目以待。谷歌已经在使用人工智能来改进视觉搜索结果。我预计今年和明年会有很多变化。我期待着探索 Bard 作为商业工具的潜力。

如何开始使用 Bard 进行数据科学?

如果你想入门数据科学,我们列出了我们的一些推荐课程。这些课程在深度和范围上各不相同,所以一定要找到适合你技能水平的选项。那些考虑转行的人可以从头开始学习这个行业,虽然许多人选择学习像 Python 这样的编程语言作为进入该领域的起点。

从零开始学习数据科学

所有初学者都应熟悉数学,特别是数据科学统计学。这些技能对编程、数据评估、数据讲述及大多数其他工作部分都很重要。确定数据趋势的相关性需要以理解统计显著性作为起点。

作为数据科学家学习编程

数据科学涵盖了企业的各种功能,因此数据科学家需要学习多种语言。常见技能包括 Python、R、Hadoop、SQL 和 Apache Spark。为了深入了解这个主题,我们还讨论了如何学习数据科学。

作为专业人士实施人工智能

对于那些希望在自己领域应用机器学习、自然语言处理和其他现代技术的专业人士,请查看斯坦福大学人工智能专业项目。

总结思考

如果你对 Google Bard 感到兴奋,你并不孤单。如果你对它感到紧张、害怕或困惑,你也并不孤单。数据爱好者们了解聊天机器人如何提供建议,我们可以预期未来任何基于大型语言模型的技术都会出现类似的错误。

Jim Markus 管理 Hackr.io 及 VentureKite 旗下的网站组合。他主持了热门财经播客《节俭生活》,并共同创办了《墨与血决斗社》,这是一个在美国各大会议上出现的戏剧写作活动。他还是一位获奖的游戏设计师。

更多相关话题

数据科学家将在 10 年内灭绝

原文:

www.kdnuggets.com/2021/06/data-scientists-extinct-10-years.html

评论

作者:Mikhail Mew,研究员,投资者,数据科学家

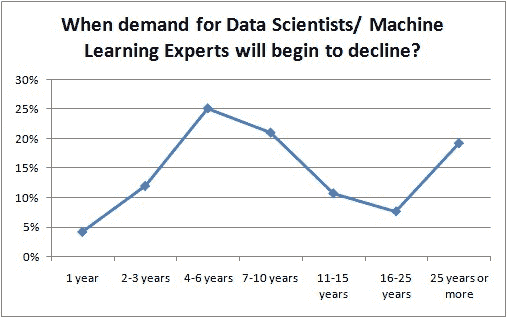

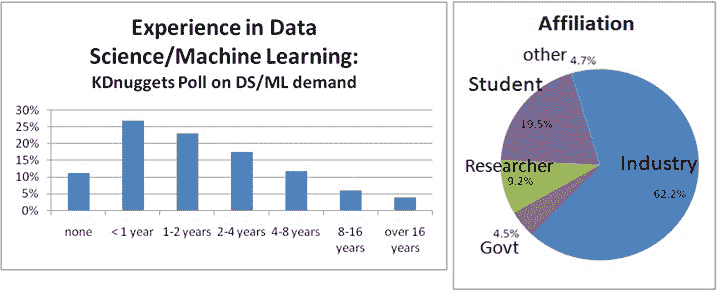

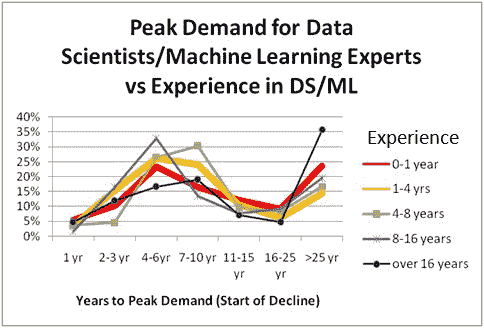

以下是受此博客启发的 KDnuggets 投票结果:

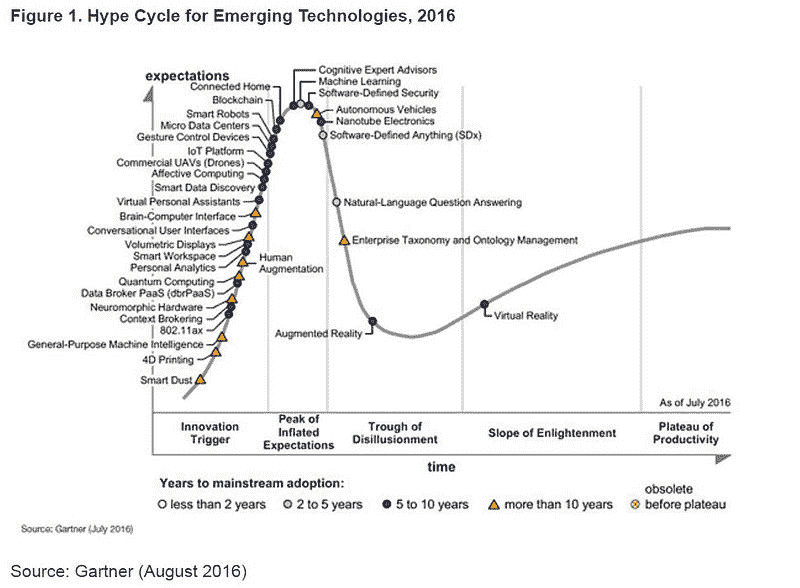

随着 AI 的进步不断取得飞跃,数据科学的基本水平变得越来越民主化。传统的领域入门障碍,如缺乏数据和计算能力,已被不断涌现的数据创业公司(有些每天只需一杯咖啡的费用即可访问)和强大的云计算所消除,后者移除了对昂贵现场硬件的需求。作为先决条件的三位一体之一,技能和知识的实施,已经成为数据科学最普遍的方面。无需费力寻找在线教程,它们标语如“秒级实现 X 模型”,“仅用几行代码将 Z 方法应用于你的数据”。在数字世界中,即时满足已成为游戏规则。虽然改善的可及性乍看无害,但在闪亮的新软件库和模型之下,数据科学的真正目的变得模糊,有时甚至被遗忘。因为数据科学的目的并非仅仅为了运行复杂模型,或优化任意的性能指标,而是作为解决现实世界问题的工具。

一个简单但易于理解的例子是 Iris 数据集。多少人使用它来演示一个算法,而不去考虑什么是花萼,更不用说我们为什么要测量它的长度了?虽然这些对于可能更关心增加新模型的初学者来说可能显得微不足道,但对于记录了这些属性的植物学家埃德加·安德森来说,这并非小事,他这样做是为了理解鸢尾花的变异。尽管这是一个人为设置的例子,它却展示了一个简单的观点:主流已经更加关注“做”数据科学而不是“应用”数据科学。然而,这种不匹配并不是数据科学家衰退的根本原因,而是一种症状。要理解问题的根源,我们必须退一步,俯瞰全局。

数据科学有一个奇特的区别,它是少数几个没有特定领域的研究领域之一。药学学生成为药剂师,法律学生成为律师,会计学生成为会计师。那么数据科学学生是否必须成为数据科学家呢?但数据科学家是哪个领域的呢?数据科学的广泛应用证明了它是一把双刃剑。一方面,它是一个强大的工具箱,可以应用于任何产生和捕获数据的行业。另一方面,这些工具的一般适用性意味着用户在实际使用之前,很少会对这些行业有真正的领域知识。然而,在数据科学崛起的初期,这个问题并不重要,因为雇主们急于利用这项新兴技术,却没有完全理解它是什么以及如何将其完全融入公司中。

然而,近十年后,商业环境及其运作方式已发生变化。它们现在追求数据科学的成熟,拥有大规模的团队,并以行业标准为基准。紧迫的招聘需求已经转向理解业务、相关行业以及其利益相关者的问题解决者和批判性思考者。仅仅能够操作几个软件包或重复几行代码已经不够,数据科学从业者也不再以编程能力来定义。这从无代码、AutoML 解决方案如 DataRobot、RapidMiner 和 Alteryx 的日益流行中得到了证明。

这意味着什么?

数据科学家将在 10 年内消失(或多或少),至少这个角色头衔会消失。未来,被统称为数据科学的技能将由新一代数据敏锐的业务专家和主题领域专家承担,他们能够将深厚的领域知识融入分析中,无论他们是否会编程。他们的职称将反映他们的专业知识,而不是他们展示这些知识的方式,无论是合规专家、产品经理还是投资分析师。我们不需要回顾太久就能找到历史先例。在电子表格刚出现时,数据录入专家曾是备受青睐的,但如今,正如《数据讲故事》一书的作者科尔·努斯鲍默·克纳夫利克(Cole Nussbaumer Knaflic)恰如其分地观察到的那样,熟练使用微软办公套件已成为基本要求。在此之前,能够用打字机盲打被认为是一项专业技能,但随着个人计算机的普及,这也变得司空见惯。

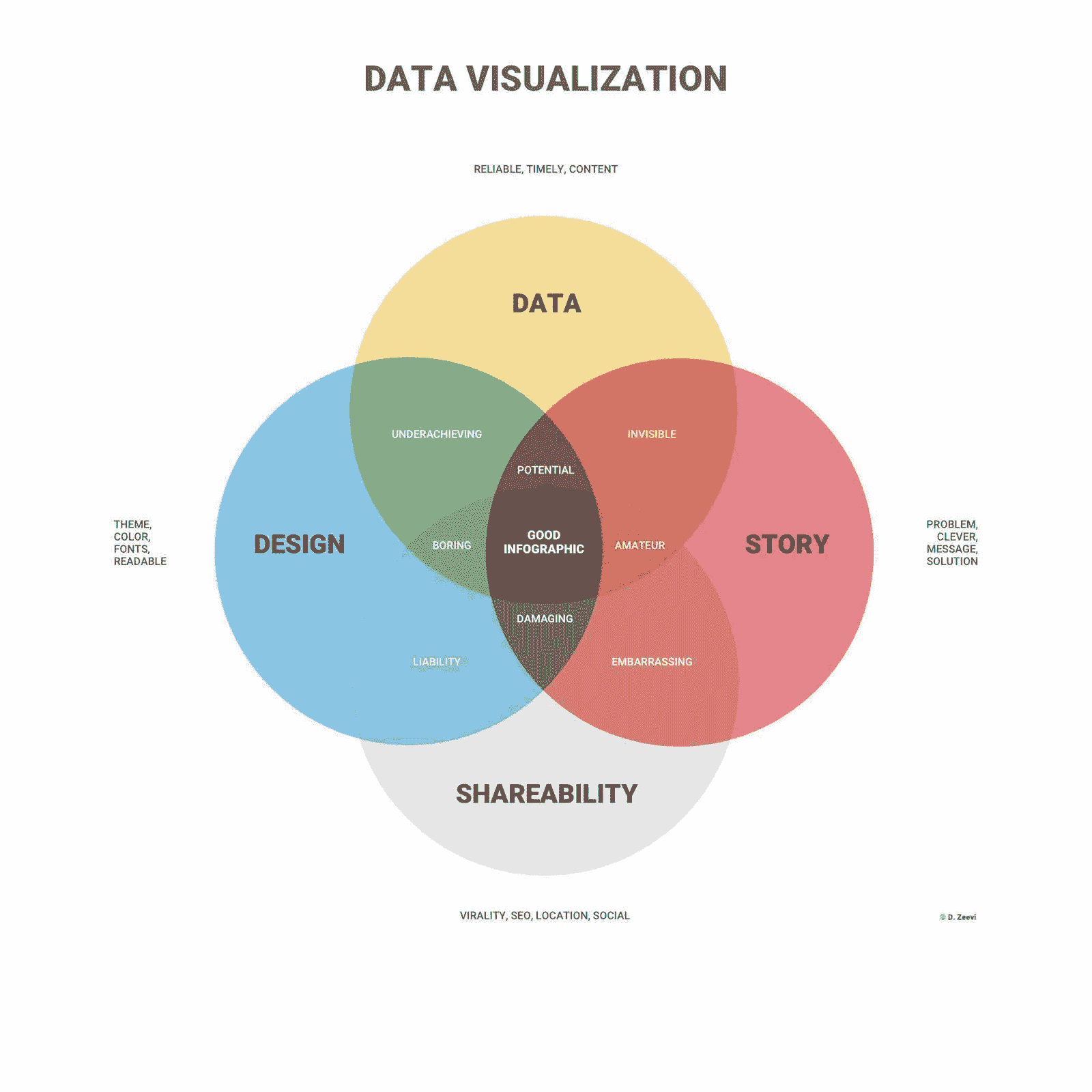

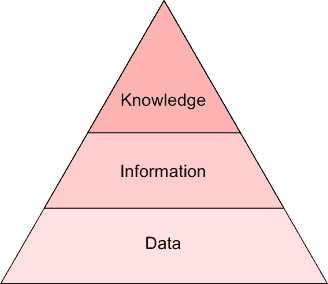

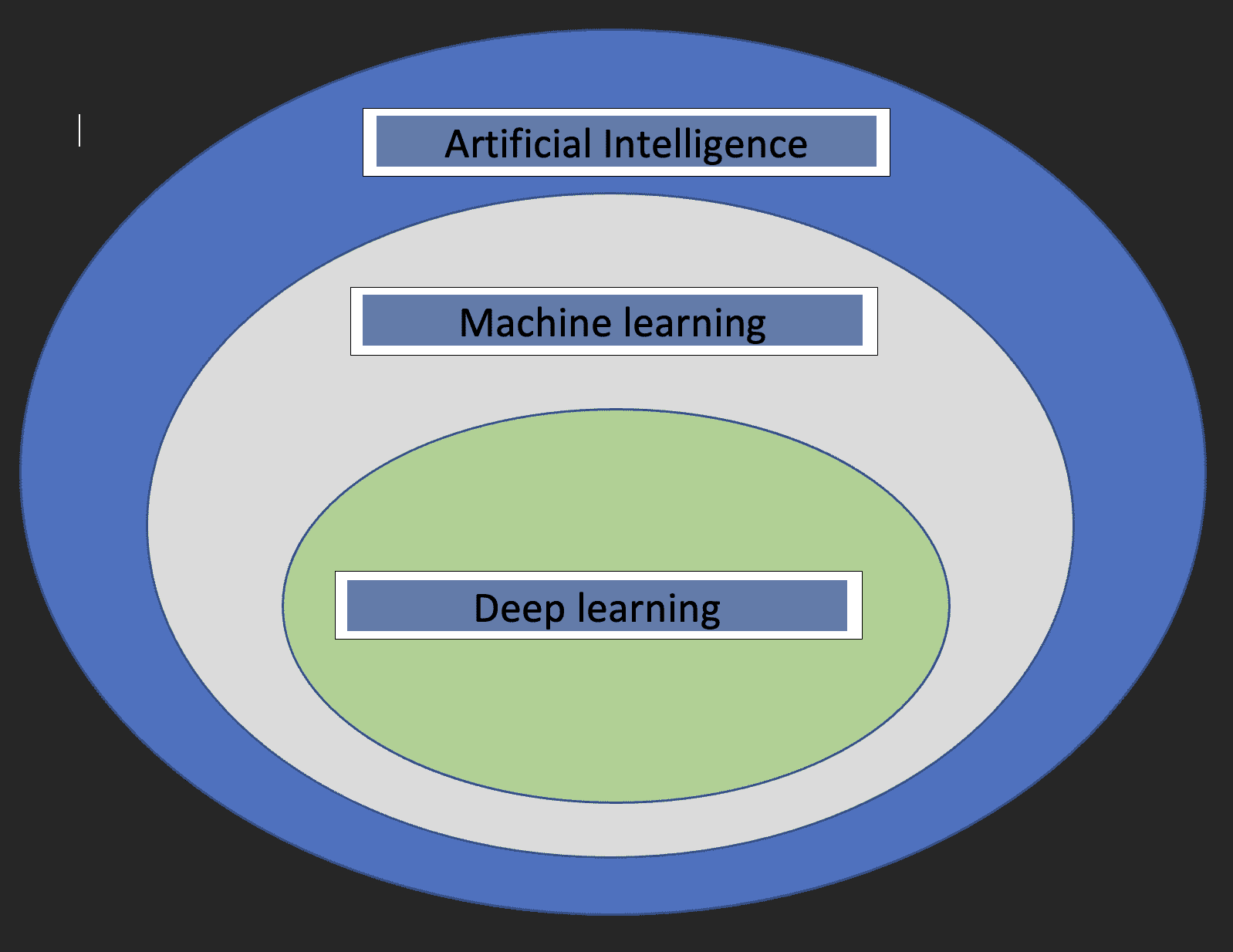

最后,对于那些考虑从事数据科学职业或开始学习的人来说,时常参考你无疑会遇到的韦恩图可能会对你有益。它将数据科学描述为统计学、编程和领域知识的汇聚。尽管它们在交集区域中占据了相等的份额,但有些领域的权重可能会比其他领域更高。

免责声明:观点仅代表我个人的观察和经验。如果你不同意,也没关系,欢迎进行富有成效的讨论。

简介:米哈伊尔·缪 是一名研究员、投资者和数据科学家,同时也是一名好奇的观察者,提供投资和机器学习交汇处的见解和思考。

原文。经许可转载。

相关:

-

数据科学家应如何与利益相关者沟通

-

使用 BERT 构建求职知识图谱

-

高效能数据科学家的五种思维方式

更多相关话题

数据科学家如何引起 CFO 的关注(以及为什么你需要这样做)

原文:

www.kdnuggets.com/2021/12/data-scientists-get-ear-cfos-want.html

评论

图片由 StartupStockPhotos 提供于 Pixabay

数据科学家掌握着无限的可能性。其中许多可能性存在于商业智能和数据分析的领域。这些学科可以在商业环境中发挥重要作用,其中发现增长机会、识别低效以及超越竞争对手至关重要。

我们的前三名课程推荐

1. Google 网络安全证书 - 加速你的网络安全职业生涯。

1. Google 网络安全证书 - 加速你的网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持

数据专家可以通过了解首席财务官(CFO)关心的信息和报告来引起他们的注意。数据科学可以提供有价值的商业智能和预测。以下是如何引起 CFO 的关注,给公司提供高质量的分析,并在过程中提升你的价值和职业生涯。

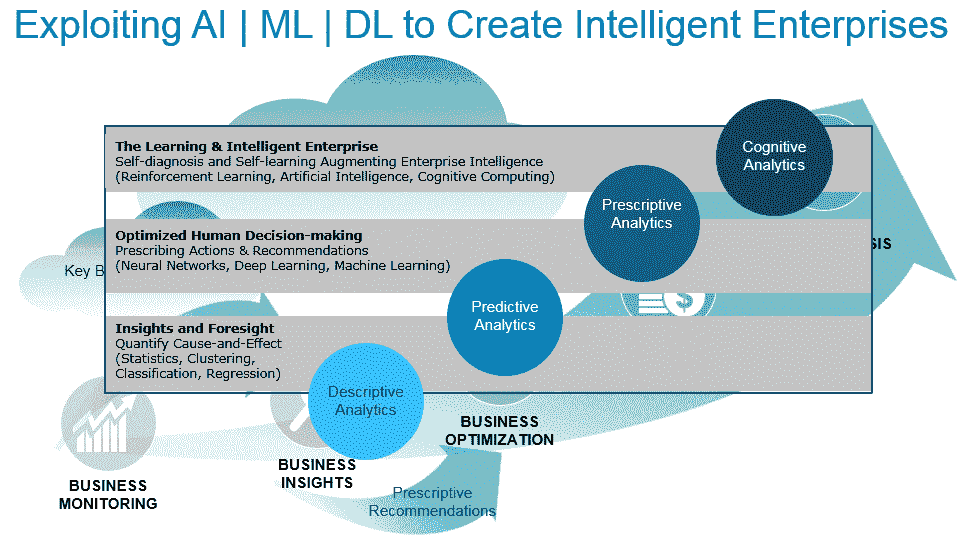

了解不同类型的商业分析的价值

商业分析预计将在 2030 年成为一个 $6840 亿的行业。那些能够帮助公司和 CFO 在这场军备竞赛中取得领先的数据科学家往往能够稳固自己的职位并展示其价值。

为了实现这一点,数据科学家必须了解 主要的商业分析类型以及它们如何应用于以数据为驱动的企业规划。

1. 描述性分析

这一商业分析分支提供了对过去事件的见解,如公司绩效和更广泛的行业趋势。研究过去发生的事情帮助公司了解自身的弱点和优势。

对于首席财务官来说,这可能包括市场波动、现金流问题、员工流动和消费模式等。其他因素也会影响公司的灵活性和未来的准备情况。

2. 诊断分析

诊断性商业分析建立在描述性分析发现的基础上。它对公司数据进行更细致的调查,以发现隐藏的风险和问题,并最终阐明事情发生的原因。

这是未来战略规划的重要组成部分。清楚地看到低效发生的地方或浪费的地方可以大大简化首席财务官的工作。

3. 预测性分析

预测性商业分析实现了最初收集组织数据的承诺。历史信息帮助数据科学家和决策者理解事件或趋势重现的可能性。在商业环境中,这包括预测劳动力的增长或减少,考虑未来需求和购买行为的变化,以及检测金融欺诈或网络安全事件。

财务规划和分析行业的专家表示,公司使用的方法进展并不像许多人期望的那样快。在数据分析专业人员需求未得到满足的就业市场中,强大的专业知识使该领域的工作更加抢手。根据一些统计数据,2021 年美国的空缺职位大约有 140,000 个。

4. 规范性分析

这种类型的商业分析是之前分析的综合。规范性分析将当前的洞察与关于未来的理性数据驱动推断相结合,并将其转化为首席财务官和其他决策者关心的语言。

将规范性分析和商业智能应用于首席财务官角色

将原始数据转换为分析,再到为高层管理人员提供可操作的建议的过程还缺少一些步骤。其中最关键的涉及报告工具。

数据科学家可以轻松找到有关商业智能工具的客观评价和仪表板。他们需要了解如何提取决策者关心的信息,以便与首席财务官和高层管理人员有效沟通,

一些最有可能引起首席执行官、首席财务官和其他决策者兴趣的仪表板包括以下内容:

-

收入和支出仪表板

-

趋势仪表板

-

资产负债表仪表板

-

KPI 仪表板

-

基准仪表板

-

方差和异常仪表板

目前市场上的许多工具提供了针对特定业务领域预设计的模板。各种产品还可能包括数据阶段和数据仓储功能,以组织可用数据——这是从中挖掘任何附加价值的第一步。

在许多业务领域和关键工作流中,这种以数据为导向的思想交流正成为创新和业务精简的热土。这些是一些数据科学正在定义更精简、更清晰、更盈利和透明的企业结构的地方:

-

财务规划和商业模型: 理解这一领域的数据科学家可以帮助公司建立响应迅速的定价结构,了解反馈的使用方式,并主动且详细地跟踪收入。

-

工程、研究与开发: 如果通过描述性和预测性分析来了解新产品或服务的投资价值,这个过程将会顺利得多。

-

扩展、可扩展性、税务和财务: 进入新领域或进行收购不能仅仅依靠高层次的假设。了解可能的税务和财务影响,并研究目标人群以引导扩展方向,都依赖于数据科学及其科学家。

-

采购: 数据科学不断构建新工具,帮助公司更详细地跟踪其原材料和人员。运行高效的操作是实现可持续性的部分,而数据科学可以揭示使供应链更高效的机会。

数据科学家能否成为首席财务官?

是否有一种途径可以让以业务智能为导向的数据科学家成为首席财务官?答案是肯定的——而且成功案例也描述了这种进阶过程。

例如,有一位数据监控系统专家——该系统旨在识别欺诈迹象或寻找投资机会——将其大数据驱动的财务策略知识转化为首席财务官的角色。这里所利用的风险洞察和业务机会,以及公司角色的跃升,之所以成为可能,是因为这位科学家知道如何充分利用“数据废料”。

数据监控和金融科技领域的机器学习只是数据科学家角色与首席财务官角色互补的一个例子。在商业智能报告和对每天产生的 exabytes 信息的深入分析之间,如果数据科学家知道如何抓住机会,他们能为决策者提供很多帮助。

简介:德文·帕提达 是一名大数据和技术作家,同时也是ReHack.com的主编。

相关:

-

2021 年数据科学家招聘的顶级行业

-

数据科学家如何在全球就业市场竞争

-

如何成功成为自由职业数据科学家

更多相关话题

数据科学家可以从定性研究中学到什么

原文:

www.kdnuggets.com/2016/07/data-scientists-learn-from-qualitative-research.html

评论

评论

由 Alyona Medelyan, Thematic。

开放性调查问题通常提供最有用的见解,但如果你处理的是数百或数千人的回答,总结这些回答会让你头疼不已。如果你是数据科学家,你可以尝试使用 NLP 库或 API,但调试它们很困难,结果往往难以解释。如果你没有定性研究的背景,这篇文章将帮助你学习来自长期从事文本工作的人的最佳实践,这些文本也被称为定性数据。

从文本到代码再到分析

什么是编码,为什么它很重要?

当提到“巨量数据”这样的术语时,它们几乎总是指定量数据:那些可以很容易用数字或类别表示的数据。统计和机器学习技术“喜欢”数字。另一方面,文本虽然难以处理,但却很重要!定性研究人员认为,单靠数字无法解决问题。他们认为,通过采访人们并让他们回答开放性问题,你可以学到比仅仅查看硬数据更多的东西。

例如 NPS 调查。NPS 得分是根据“你有多大可能性向朋友或家人推荐我们,0 到 9 分”的数字答案计算得出的,这将给你一个公司绩效的单一指标。但要提高这个指标,你需要关注“你为什么给我们这个分数?”的开放性问题的回答。

在定性研究过程中产生了大量的文本,为了得出结论,使用了一种叫做编码的技术。问卷调查中让受访者自由作答的问题也被称为开放性问题。每个回应被称为逐字稿。对每个回应进行“编码”或“标记”有助于捕捉回应的内容,从而有效地总结整个调查结果。

如果我们将编码与 NLP 方法用于分析文本进行比较,在某些情况下编码可以类似于文本分类,而在其他情况下则类似于关键词提取。接下来,我们将探讨编码的内容以及可以使用的不同方法论。我们通常会提到如何手动执行任务,但如果你打算使用自动化解决方案,这些知识将帮助你理解重要的内容以及如何选择有效的方法。

什么是编码框架?

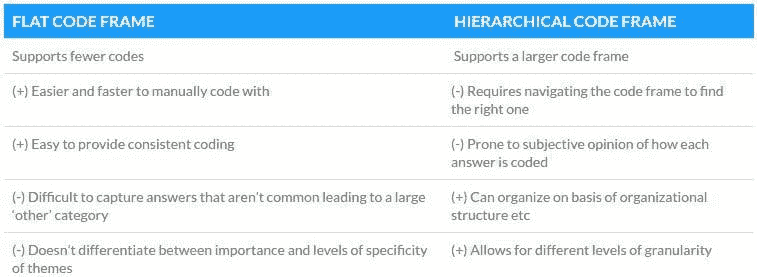

创建代码时,它们被放入一个编码框架中。这个框架很重要,因为它代表了组织结构,并影响编码结果的使用方式。框架有两种类型:‘平面’和‘层次化’:

-

平面框架意味着所有代码被视为具有相同的具体性和重要性水平。虽然这种框架易于理解,但如果它变得庞大,组织和导航会很困难。

-

层次化框架捕捉了代码之间的分类关系。它们允许你在编码和分析结果时应用不同的粒度级别。

层次化框架的一个有趣应用是支持情感差异。如果顶层代码描述回应的内容,中层代码可以描述其正面或负面,而第三层描述属性或具体主题。下面展示了这种类型的编码框架的示例。

在层次化编码框架中使用情感

代码框架的优缺点

编码框架的覆盖面和灵活性

一个非常重要的考虑因素是编码框架的大小和覆盖面。在编码时,重要的是将包含相同主题的回应,即使表达方式不同,也归入同一个代码。例如,代码‘清洁’可以覆盖提到‘干净’、‘整洁’、‘脏’、‘多尘’等词汇和‘看起来像垃圾场’、‘可以从地板上吃东西’等短语。这要求编码员对每个代码及其覆盖面有良好的理解。代码少且框架固定会使决策更容易。代码多,特别是在平面框架中,会更难,因为可能存在模糊性,有时不清楚回应的确切含义。手动编码还要求编码员记住或能够找到所有相关代码,这在大型编码框架中更困难。

最后,编码框架应灵活。对调查进行编码是一项成本高昂的任务,尤其是手动完成时,因此结果应能在不同的上下文中使用。想象一下:你正在尝试回答“人们对客户服务的看法是什么”这个问题,并创建捕捉关键答案的代码。然后你发现同样的调查回应中还有许多关于公司产品的评论。为了回答“人们对我们产品的评价是什么”,你可能需要从头开始编码!创建一个灵活且覆盖面广的编码框架(见下文的归纳风格)是未来获取价值的好方法。

演绎和归纳编码风格

手动编码开放式问题的两种方法是什么,哪一种更好?

演绎编码使用预先存在的框架

使用演绎编码时,你从预定义的代码集开始。这些代码可能来自现有的分类法、覆盖业务部门的代码或行业特定术语。这通常意味着这些代码是由项目目标驱动的,旨在报告特定问题。例如,如果调查是关于客户体验的,你已经知道你对因呼叫等待时间产生的问题感兴趣,那么这将是其中一个代码。这有一个好处,就是你可以保证你感兴趣的项目会被覆盖,但你需要小心偏见。当你使用预先存在的编码框架时,你会带有一种偏见,预设答案的可能性,并可能会遗漏自然从人们的回应中出现的主题。

当你使用预先存在的编码框架时,你会带有一种偏见,预设答案的可能性,并可能会遗漏自然从人们的回应中出现的主题。

归纳编码使用抽样和重新编码

替代的编码风格是归纳法,通常称为“扎根法”。在这种方法中,你一开始没有任何代码,所有的代码都直接来源于调查回应。这个过程是迭代的:

-

你读取了一份数据样本

-

创建覆盖样本的代码

-

重新阅读样本并应用代码

-

阅读新的数据样本,应用代码并记录代码不匹配的地方

-

创建新的代码

-

返回并重新编码所有已编码的回应

-

从第 4 步重复。

如果你添加了一个新的代码,将现有的代码拆分成两个,或改变其描述,请确保审查所有可能受到影响的回应的代码。否则,调查开始和结束时相近的回应可能会被分配不同的代码!

如何选择好的代码

在决定创建哪些代码时,需要考虑几件事。

-

确保覆盖。代码应覆盖尽可能多的相关调查回应。这意味着代码应比评论本身更通用,以便能够覆盖其他回应。当然,这需要与分析的有用性相平衡。例如,“产品”是一个非常广泛的代码,会有很高的覆盖率,但有用性有限。另一方面,“产品在使用 3 小时后停止工作”是非常具体的,不太可能覆盖许多回应。

-

避免共性。虽然有相似的代码是可以的,但它们之间应该有明显的区别。在数学中,这被称为正交性,表示两个事物的独立性。“客户服务”和“产品”是正交的,而“客户服务”和“客户支持”可能有细微的差别,但不是正交的,可能作为相同的代码更好。

-

创建对比。尽量创建相互对比的代码。这允许将同一事物的正面和负面元素分别提取。例如,“有用的产品功能”和“不必要的产品功能”就是具有对比性的代码。

-

减少数据。我们来看看两个极端的情况:代码数量等于评论数量,或者每个代码适用于所有响应。在这两种情况下,编码练习都是毫无意义的。因此,试着考虑如何减少数据点的数量,以便有效地进行分析。上述“产品使用三小时后停止工作”的例子就未能通过这一测试。更有效的代码应该是“产品使用后停止”。

编码的准确性

无论使用演绎过程还是归纳过程,都很难确保一致性。这是因为编码者的思维框架和过去的经验会影响他们的解释方式。这意味着不同的人在面对相同的任务时,很可能会对适当的代码产生不同的看法。实际上,一项研究表明,同一个人在不同的日子对同一份调查进行编码会产生不同的结果。

通过记录所有决策和思考过程来缓解这个问题。应用现有代码或决定是否需要新的代码时,请回顾这些记录。这一过程还意味着代码的选择可以得到证据的支持。

确保准确性的另一种更昂贵的方法是通过有意测试编码的可靠性。‘测试—重测’方法涉及同一个人对数据进行两次编码而不查看结果。‘独立编码者’方法则在同一份调查中使用第二个编码者。在这两种情况下,结果会被比较一致性,并根据需要进行修正。

摘要 / TLDR

-

数据科学家在分析文本时可以向定性研究者学习

-

编码是将代码分配到开放性回答或其他类型的文本数据上的过程,然后这些文本可以像数值数据一样进行分析。

-

代码框架是一组代码,可以是平面的(使用更简单更快速)和层次的(更强大)

-

代码框架需要具有良好的覆盖面,并且灵活以允许对开放性回答进行全面和多样化的分析。

-

归纳编码(没有预定义的代码框架)更困难,但偏差较小

-

在创建代码时,请确保它们彼此对比并减少数据

-

准确性意味着一致的编码,这可以通过在编码过程中记录和回顾决策来实现。

简介: Alyona Medelyan,博士,专注于从文本中提取意义。她是一位自然语言处理和机器学习领域的顾问,并在这些主题上进行国际演讲。在 Thematic 她帮助企业理解客户反馈和情感。关注她的 Twitter @zelandiya 或通过 medelyan.com 联系她。

原文。经许可转载。

相关:

-

自然语言处理的内部更新

-

HPE Haven OnDemand 文本提取 API 开发者备忘单

-

文本分析:是什么让你的手机比调查分析更智能

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关内容

数据科学家是否应该对 COVID19 和其他生物事件进行建模

原文:

www.kdnuggets.com/2020/04/data-scientists-model-covid19-biological-events.html

评论

数据科学家的角色多年来一直在扩展。从用统计数据处理数字,到构建可扩展的数据库,再到构建生产级的机器学习或深度学习模型。生物统计学和流行病学是统计学的高度专业化领域,大学为其提供不同的学位课程。

生物统计学家使用的统计技术可能是你目前的日常数据科学家从未听说过的。这是一个很好的例子,说明缺乏领域知识会暴露你作为一个不知所措、只是跟随趋势的人。虽然社区中已知建立预测模型以查看谁更可能在泰坦尼克号上幸存或对鸢尾花进行分类作为数据科学之旅的一部分,但对于如全球大流行这样正在杀害数十万人甚至数百万人的更严重问题,或许应该给予更多的谨慎。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

流行病学家和生物统计学家

流行病学是研究疾病在特定人群和环境中的频率和分布的学科。流行病学是公共健康的重要方面,因为它涉及对人群中疾病的理解和风险评估。流行病学家通常具有生物学、医学和病毒学等领域的科学背景。这是流行病学家建立领域知识的方式,从而能够理解他们所建模的内容。

生物统计学是将统计技术应用于健康相关领域的科学研究,包括医学、流行病学和公共卫生。拥有统计学学位的人可能会成为零售、人口统计、房地产、经济学、金融等领域的数据分析师。生物科学则是一个完全不同的领域,需要单独的资格认证。

现在,数据科学家可能来自非统计/数学背景,突然开始建模疾病数据以展示他们的技能。这并不是展示你知识的正确数据类型。每个人都需要知道自己是否有能力正确处理这些数据。已经发布了大量虚假和误导性内容,这进一步玷污了数据科学家的职业,因为这表明仍然有人对数据一无所知,只关心使用 Python 中的随机森林或 xgboost 模型,而不是 R(因为 R 显然已经不再像以前那样酷)并在 LinkedIn 上推广,希望能让招聘人员或高级数据科学家留下深刻印象。

COVID-19 预测、达克效应和数据科学家的希波克拉底誓言由 Raj Iqbal 完美总结了这一点。达克效应简单来说就是当一个人高估自己的能力时,实际上他们完成任务的能力非常低。

预测 COVID-19

以下内容摘自这里。

预测和时间序列专家 Rob J Hyndman 表示,为了使预测相对准确,有三个主要因素:

-

我们对影响其因素的理解程度;

-

可用数据的多少;

-

预测是否会影响我们试图预测的内容。

例如,明天的股票价格预测准确性较低,因为上述因素 1 和 3 并未得到满足。首先,影响股票价格变化的因素并没有得到特别好的理解,并且至少部分依赖于人类心理学。其次,广泛宣传的股票市场预测可以直接影响许多投资者的行为。

上述三个因素并非都适用于疾病,但我们可以看到第二点因实际病例数量被低估而成为问题。第二个问题是,COVID-19 的预测可能会影响我们试图预测的内容,因为各国政府正在做出反应,有些比其他国家更好。除非能够考虑到减缓传播的各种措施,否则使用现有数据的简单模型将会产生误导。

他和其他科学家使用分 compartments 流行病学模型来模拟感染过程。最简单的模型是基于将人口中的活跃个体分类为易感、传染或康复——因此它们被称为 SIR 模型。

结论

尽管数据科学家的任务是分析数据以提供见解,但我们有责任认识到我们的才能应如何使用,以及何时退一步让真正的专家带领前进。传染病建模是一个过于专业和敏感的领域,不应盲目发表意见。我们需要意识到我们何时被需要,何时不被需要。

相关内容:

-

用 AI 对抗冠状病毒:利用深度学习和计算机视觉改进检测

-

数据科学家应避免的 5 个统计陷阱

-

数据科学家应对 COVID-19 的 5 种方式及 5 个应避免的行动

更多相关主题

数据科学家,你需要知道如何编码

原文:

www.kdnuggets.com/2021/06/data-scientists-need-know-code.html

评论

由 Tyler Folkman,Branded Entertainment Network 的 AI 负责人

图片由 Roman Synkevych 提供,来源于 Unsplash

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

我知道你在想什么——“我当然知道如何编码,你疯了吗?”

你每天在 Jupyter 笔记本中编写大量代码,数百行。显然,你会编码。并不是说你是在手动或在 Excel 中训练机器学习模型(尽管这是可能的)。

那我可能是什么意思呢?

我不愿意打击你,但大多数数据科学家做的编码我不认为是真正的编程。你是使用编程语言作为探索数据和构建模型的工具。但你创建的程序并不是你真正考虑的,只要它能完成工作就好。

你的代码通常很混乱,可能甚至不能按顺序运行(这要归功于笔记本)。你可能从未编写过单元测试,也几乎不了解如何编写良好、可重用的函数。

但是,随着数据科学越来越多地嵌入到实际产品中,这种类型的代码将不够用。你不能信任糟糕的代码,把你不信任的代码放到产品中会导致大量的技术债务和糟糕的用户体验。

“好吧,好吧,但我是一名数据科学家,不是软件工程师,”你说。我构建模型,清理代码是其他人的问题。虽然这在一些公司可能有效,但我现在深信,更好的模式是数据科学家学习如何编写更好的代码。你可能永远不会成为顶级的软件工程师,但数据科学家可以通过一些努力编写值得信赖并投入生产的代码。

从你的函数开始

在学习如何提升你的代码时,从你如何编写函数开始。大多数代码只是函数(或可能是类)的系列,如果你能学会编写相当好的函数,这将大大改善你的代码质量。

你的函数至少应该:

-

只做一件事

-

拥有文档。

-

使用良好的变量名。

虽然关于如何编写干净函数的书籍有很多,但这三个方面是一个很好的起点。

你不应该有一个函数看起来像是在尝试做超过一件事。一些迹象表明你的函数可能做得太多:

-

它的长度超过了一个屏幕,或者大约 30 行代码(根据我的经验)。

-

由于函数做的事情太多,清晰命名函数非常困难。

-

它包含了大量的 if/else 代码块,这些代码块实际上应该被拆分成独立的函数。

只做一件事的函数很重要,因为它使你的代码更容易理解、管理和测试(稍后会详细讲到测试)。

任何投入生产的函数都应该有文档字符串,该字符串应描述函数的功能,提供输入参数的信息,并可能提供一些简单的使用示例。未来你会感谢自己拥有良好的文档化函数,而其他人也会更容易理解你的代码。

最后,请使用易于理解和有用的变量名。太多的数据科学家习惯使用“a”、“a1”和“a2”这样的变量名。短小而无帮助的变量名在试验时更快输入,但在将代码投入生产时,确保你的变量名能帮助他人理解你的代码。

移除 Print 语句。

数据科学家常常使用 print 语句来显示发生的情况。然而,在生产环境中,这些 print 语句应当被移除(如果不再需要)或转换为日志语句。

日志记录应当是你与代码之间传达信息和错误的方式。一个值得查看的 Python 库是 Loguru,它使日志记录变得更简单。它自动处理了大多数麻烦的日志记录部分,感觉更像是使用 print 语句。

使用风格指南。

编程中的风格指南旨在使多人可以更轻松地在同一代码上工作,但使得这些代码看起来仿佛是由一个人编写的。

为什么这很重要?

当你拥有一致的风格时,代码的浏览和理解会变得更容易。使用风格指南时,发现 bug 会变得更轻松。遵循标准的代码编写方式会使你和他人更容易浏览代码。这意味着你不必花费太多时间去理解代码的格式,而可以专注于代码的功能及其是否正确有效。

PEP 8 可能是最广泛使用的 Python 风格指南。不过,还有很多其他风格指南。另一个受欢迎的风格指南来源是 Google,因为他们公开了内部风格指南。

重要的是你选择一种并尽量坚持。一个让这变得更容易的方法是使你的 IDE 检查样式错误,并设置样式检查,如果不遵循样式指南,阻止代码被推送。你还可以进一步提交,使用自动格式化工具,它会自动格式化你的代码以符合标准。Python 中一个流行的工具是 Black。

编写测试

我发现大多数数据科学家害怕测试,因为他们不太知道如何开始测试。

事实上,许多数据科学家已经在运行我所称之为临时测试。我发现数据科学家在笔记本中快速运行一些“健康检查”以验证新函数是很常见的。你通过一些简单的测试用例,确保函数按预期运行。

软件工程师称这个过程为单元测试。

不同的是,数据科学家通常会删除这些临时测试并继续前进。相反,你需要保存这些测试,并确保每次在代码推送之前都运行这些测试,以确保没有破坏。

要开始使用 Python,我建议使用 pytest。使用 pytest,你可以轻松创建测试,并一次性运行它们以确保它们通过。一个简单的开始方式是有一个名为“tests”的目录,在该目录内有以“test.”开头的 Python 文件。例如,你可以有“test_addition.py”。

*# content of test_addition.py*

**def** add(x, y):

**return** x + y

**def** test_add():

**assert** add(3, 2) == 5

通常,你会将实际的函数放在另一个 Python 文件中,并将其导入到你的测试模块中。你通常不需要测试 Python 加法,但这只是一个非常简单的例子。

在这些测试模块中,你可以保存你函数的所有“健康检查”。通常的好做法是不仅测试常见情况,还要测试边界情况和潜在错误情况。

注意:测试有许多不同类型。我认为单元测试是数据科学家开始测试的最佳选择。

做代码审查

在我们列出的编写更好代码的顶级事项中,最后但同样重要的是代码审查。

代码审查是指在你将代码提交到主分支之前,另一位在你领域内擅长编写代码的人对你的代码进行审查。这一步骤确保最佳实践得到遵循,并希望能够发现任何不良代码或错误。

审查你代码的人最好至少和你一样擅长编写代码,但即使让一个更初级的人审查你的代码也仍然可以非常有益。

人们有时会懒惰,并且很容易让这种懒惰影响到我们的代码。知道有人会审查你的代码是一个很好的激励,使你花时间编写优质代码。这也是我发现的最有效的改进方法。让更有经验的同事审查你的代码并提供改进建议是无价的。

为了让审查你代码的人更容易理解,尽量保持新代码量的小规模。小而频繁的代码审查效果更好。不频繁的大规模代码审查效果很差。没有人愿意审查上千行代码。这些审查往往提供较差的反馈,因为审查者无法花足够的时间真正理解这么多代码。

提升你的编码技能

我希望这篇文章能激励你花时间学习如何编写更好的代码。这并不一定很难,但确实需要时间和努力来提升。

如果你遵循这 5 个建议,我相信你会注意到你的代码质量有显著提升。

你的未来自己和同事会感谢你。

查看我的 免费课程,了解如何部署机器学习模型。

简介:泰勒·福克曼 是 Branded Entertainment Network 的 AI 主管。获取泰勒的免费 创建惊人数据科学项目的 5 步流程。

原文。经许可转载。

相关:

-

顶级编程语言及其用途

-

未来 5 年会出现数据科学工作短缺吗?

-

这些软技能可能决定你的数据科学职业生涯的成败

更多相关主题

数据科学家需要专业化以在科技寒冬中生存

原文:

www.kdnuggets.com/2023/08/data-scientists-need-specialize-survive-tech-winter.html

照片由Ingo Joseph提供

硅谷的温度最近很凉。毫无疑问,我们正处于科技寒冬。风险投资资金已经枯竭,数百家公司正在通过裁员来行使它们的权力,人工智能正在逼近每个人,导致额外的失业和不确定性威胁。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的信息技术

3. Google IT 支持专业证书 - 支持您的组织的信息技术

数据科学家们感到困惑:我的工作安全吗?这也不奇怪。曾经被誉为最性感职业的工作现在看起来已经不那么吸引人了。

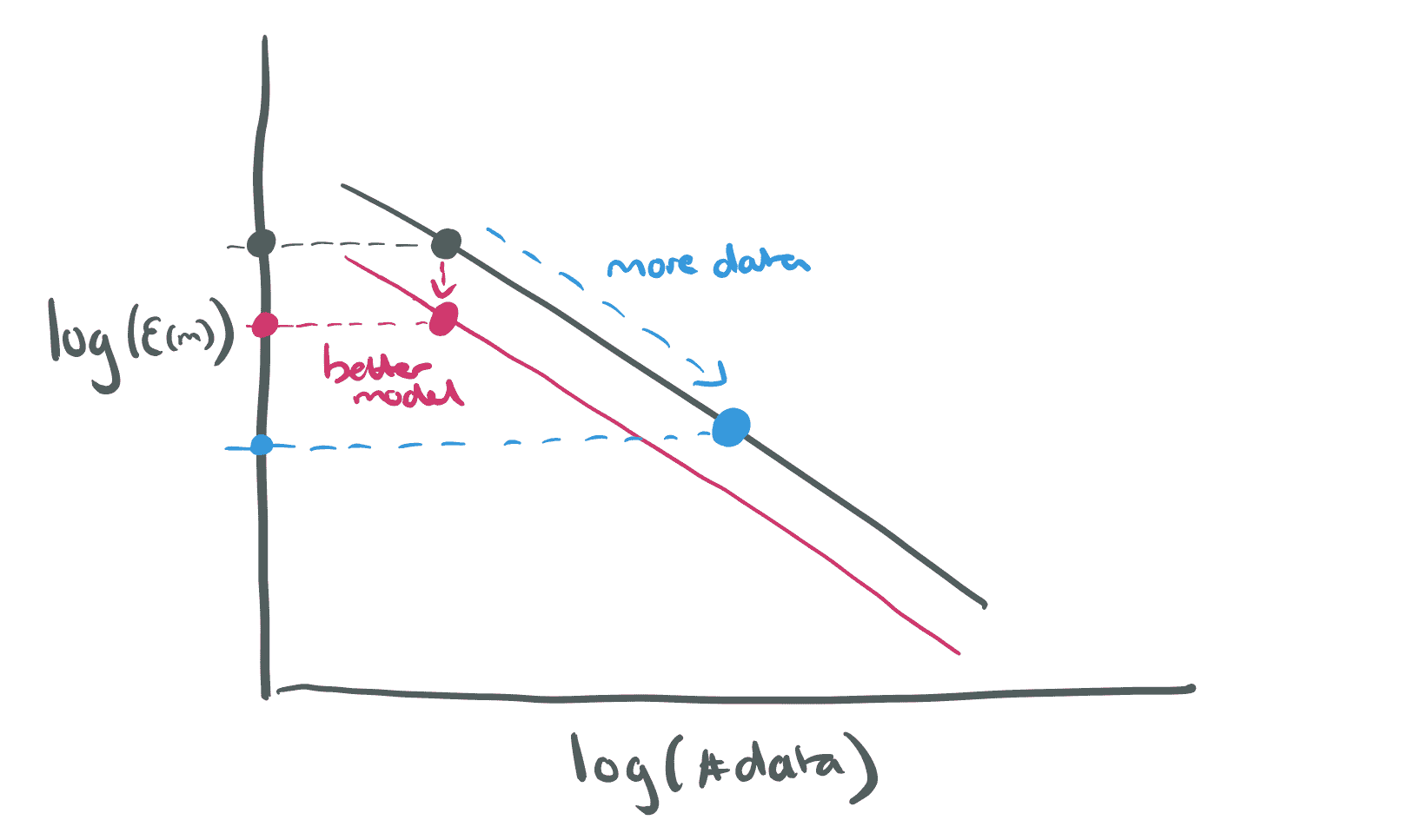

从整体来看,数据科学的工作前景仍然乐观——劳动统计局仍然预测未来十年将增长 36%,远高于美国平均行业增长率 5%。但正如成千上万的被裁数据科学家所告知的,统计数据并不能作为失业的盾牌。答案是什么?一些专家建议,专业化是脱颖而出并使自己不容易被解雇的最佳方式之一。“随着数据的影响力增长和技术的发展,数据团队中将需要特定的角色来最大化效率,”财富杂志的作者梅根·马拉斯写道。

我同意。任何数据科学家都会告诉你,这份工作会根据你老板当天需要什么而有所不同——电子表格、演示文稿、开发 ETL 管道或设计实验。

图片来自Twitter

所有数据科学家共有的特点是随着数据量和重要性的增长,职责也在扩展。

数据科学家可以通过专业化来更好地区分自己,而不是继续尝试做所有事情。通过选择一个技能或领域,更容易明确他们的价值主张,在竞争激烈的就业市场中保持相关性和价值。

为什么专业化能帮助数据科学家保住工作

在我开始使用StrataScratch之前,我是一个普通的通才数据科学家。我不断学习新技能和技术,以跟上快速发展的领域。但当然,有一天我意识到我需要与众不同。我决定专注于基础设施以及如何通过基础设施支持数据科学工作。我的基础设施工作改变了团队中数据科学家的工作方式,使他们能够比以前更快地交付模型和结果。

在专注于数据科学基础设施几年后,我在生物技术领域找到了数据战略的工作。我很快意识到我的专业化在就业市场上给了我显著的优势,因为拥有我这样特定技能和经验的人很少。这也意味着我能够获得更高的薪水和职位,因为我在一个焦点领域的深厚知识使我能够晋升到一个更高级别的位置,仅仅因为我拥有更多的知识和经验来影响团队中的其他数据科学家。

不过,这只是我的故事。专业化可以以几种不同的方式提供帮助,具体取决于你当前的情况和总体目标。

图片来源:作者

争取工作安全

在我最喜欢的《老爸老妈的浪漫史》一集中,马歇尔因朋友巴尼的帮助而在一家律师事务所找到了工作。巴尼告诉他必须成为“某种”人物。也许是零食人员、按摩人员或游戏人员。那是避免被变化无常的老板解雇的唯一办法。

有时候情景喜剧说得对。通才可以被其他通才替代。作为专家,你的价值要高得多。很容易说:“不,我们不能解雇马歇尔,因为他是我们的营销分析人员。他是帮助我们建立所有营销和销售管道的人。他对团队至关重要。”

击败竞争对手

对数据科学家的需求很大,但对数据科学学位的需求也在增长。再加上公司现在开始考虑非传统背景的人,你就有了竞争的配方。

图片来自Geekwire

通过专注,你可以减少工作市场上的竞争。例如,如果你专注于自然语言处理(NLP),你确实会限制可以竞争的工作数量。但你将会更受欢迎,因为 NLP 专家远少于数据科学家。

追逐金钱

老实说,追求数据科学职业不能仅仅是为了金钱。专注也是如此。但如果你发现自己对工作中的某个特定部分感兴趣,值得知道的是,专家的薪资高于普通人,不论普通人掌握多少技能。

看看 Indeed 的数据,作为一个参考:数据科学家的平均基本工资是每年 127k 美元。相比之下,机器学习工程师的薪资为\([155k](https://www.indeed.com/career/machine-learning-engineer/salaries?from=career),或者[后端开发者](https://blog.boot.dev/backend/how-much-do-backend-devs-make/#:~:text=Backend%20developers%20enjoy%20an%20average,not%20to%20mention%20comprehensive%20benefits.)的薪资为\)158k。

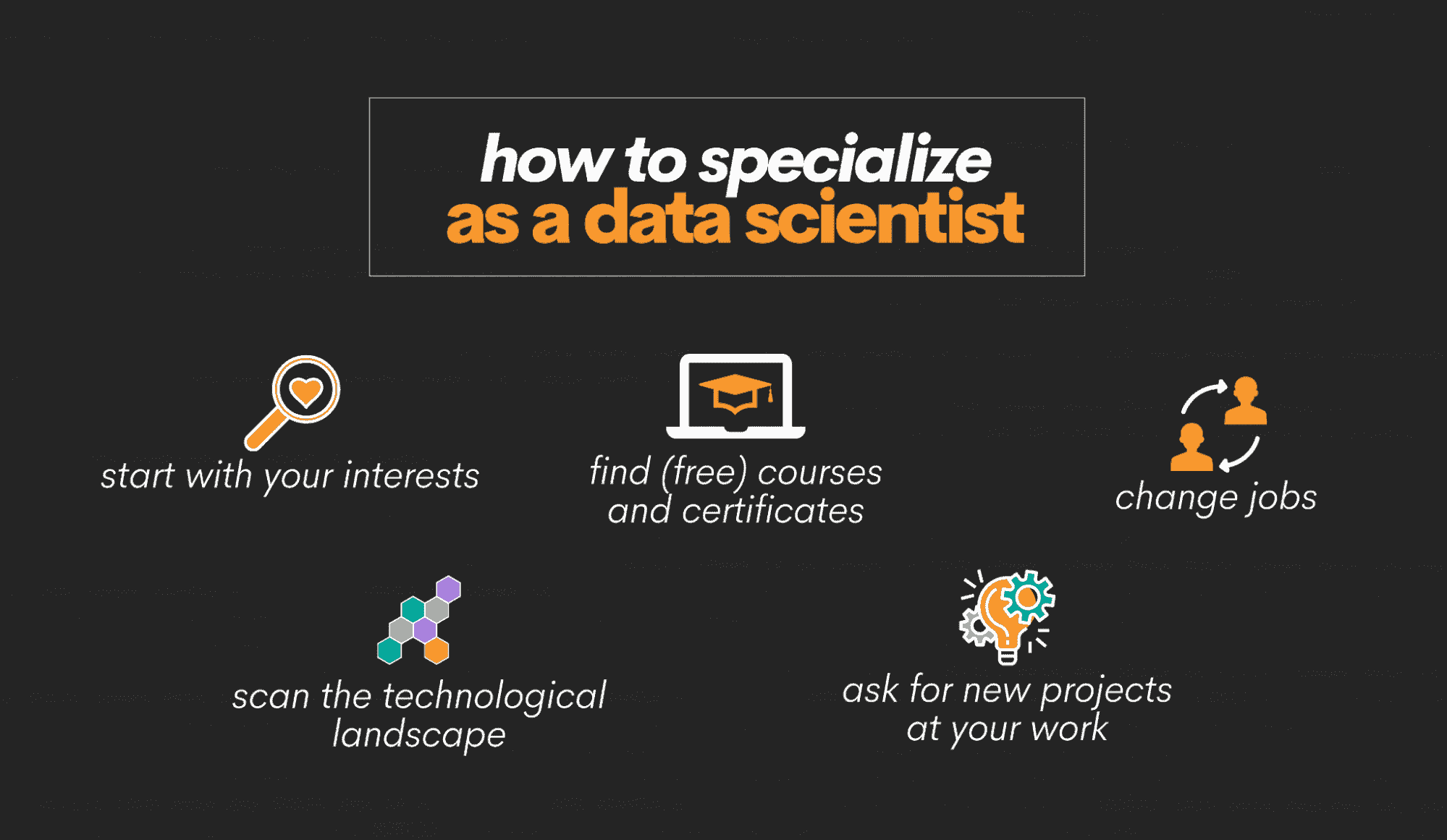

如何成为专注的数据科学家

好的,你已经认识到专注的价值。那么,你该如何专注呢?让我们来分解步骤。

图片由作者提供

从你的兴趣开始

如果你要专注,你需要确保你对你将要专注的领域感兴趣。这不能只是为了钱;还必须是你喜欢做的事情。从你的兴趣开始。

你对什么充满热情?你发现自己在空闲时间里从事什么样的项目?通过确定你的兴趣,你可以开始看到自己可能专注的领域。了解你热衷的工作类型的一种方法是尝试理解你对哪些工作感到兴奋?例如,在一个项目中,你通常更兴奋于做基础设施工作?还是建模工作?或者数据清理工作?弄清楚你喜欢做什么,然后深入探索。

观察技术景观

技术景观不断变化,保持对最新趋势的了解非常重要。例如,看看 Meta。在花费了数年和巨额资金投入到元宇宙后,他们现在正在转向人工智能,以及其他所有主要科技公司。

一旦你列出了感兴趣的主题清单,寻找那些活动频繁和需求旺盛的领域。这将帮助你确定可以专攻的领域以及可能有机会让你脱颖而出的地方。

一个很好的地方是 Indeed。 这篇文章虽然有点旧,但我喜欢这个想法。作者从 Indeed 抓取了提到特定语言和城市的招聘信息。他们发现 R、SQL 和 Python 位居前列。你还可以查看StackOverflow 的开发者调查。他们对热门技术有相当准确的把握,因此值得一看。

寻找免费的课程和证书

一旦你确定了感兴趣的领域,寻找免费的课程和证书来帮助你提升技能。不要从昂贵的课程开始;先从免费的课程入手,看看这些知识是否能扎根。

目前有很多免费的资源,包括在线课程、书籍和练习平台。利用它们来提升你的数据科学技能和知识。一旦你感觉有了足够的信心,你可能会想做一些项目来建立你的作品集。

在工作中请求新项目

如果你已经在担任数据科学家的职位,寻找展示新技能的机会。与老板和同事讨论你的兴趣,看看是否有任何项目可以让你发展技能。通过接受工作中的新挑战,你可以在你选择的专业领域中积累经验和专业知识。

例如,如果你对自然语言处理感兴趣,你可以申请参与一个涉及分析客户反馈数据或开发客户服务聊天机器人的项目。如果你更倾向于计算机视觉,看看是否有与图像识别或视频分析相关的项目,你可以参与其中。

有时候,业务需求决定了你下一个项目的方向。例如,作为数据科学家,我的第一个项目之一是创建一个自然语言处理算法,用于通过 Twitter 推文跟踪食源性疾病爆发。我没有建立自然语言处理算法的培训,因此我不得不从头开始,并在项目期间尽可能多地学习。这是一个极好的学习经历,有助于提升我作为数据科学家的技能。

更换工作

最终,你可能会面临跳槽的时机。如果你的老板只把你看作是一个全能的数据科学家,你可能需要转到一家新公司,展示你新的职业方向。有时候,你可能会对雇主的业务需求(例如,总是相同的需求)、技术栈和团队结构感到厌倦。如果你每天上班没有激情学习,那么可能是时候探索让你成长和学习的新机会了。

寻找与你新技能匹配的职位,并申请这些职位。通过换工作,你可以重新开始,并向新雇主展示你的新专业技能。

沉没成本还是专业化——选择权在你

作为一名数据科学家,专注是明智的。但希望这不仅仅是一个好的职业选择——专注于我的领域给了我更多的角色清晰度,以及乐趣和目标。我的老板们对我应该做的事情有了更好的理解,并能够给我更多有用的 KPI。我更清楚如何创造价值。我也能够满足我的兴趣。

按照这些步骤,你可以开始专注于成为一名数据科学家,并在竞争激烈的就业市场中脱颖而出。记住,专注不仅仅是为了提升你的就业能力;它是关于追求你的兴趣,并建立一个你喜欢的职业生涯。祝好运!

Nate Rosidi 是一名数据科学家,专注于产品策略。他还是一名兼职教授,教授分析学,同时也是 StrataScratch 的创始人,该平台帮助数据科学家通过顶级公司的真实面试问题来准备面试。可以通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

相关话题

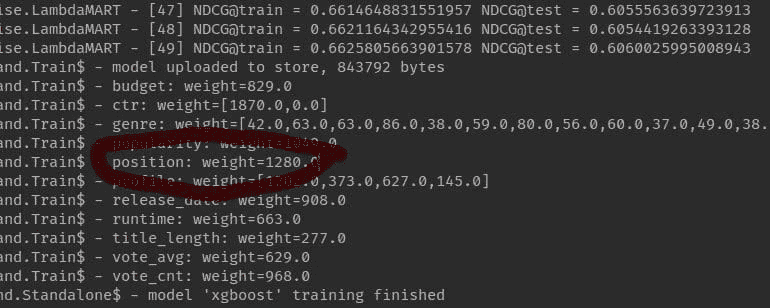

数据科学家应该使用 LightGBM 的 3 个理由

原文:

www.kdnuggets.com/2022/01/data-scientists-reasons-lightgbm.html

介绍

有许多优秀的 Python 提升库供数据科学家利用。其中包括 XGBoost 和新推出的 CatBoost 算法。然而,有一种算法结合了这些算法的某些特征,使其成为数据科学家的必备工具。虽然这些好处在学习和教育方面很棒,但更重要的是,它在需要快速的专业环境中表现尤为出色。接下来,我将讨论 LightGBM [1] 的好处以及它们如何与您的数据科学工作密切相关。

分类编码

图片由 米哈伊尔·瓦西里耶夫 提供,来自 Unsplash [2]

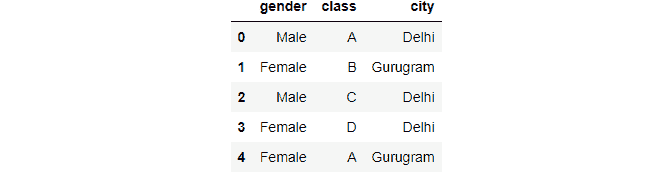

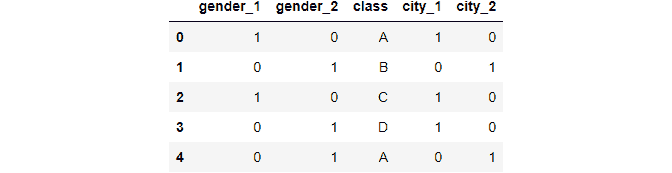

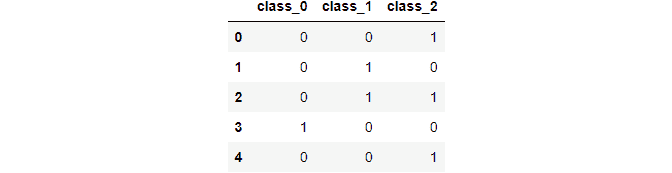

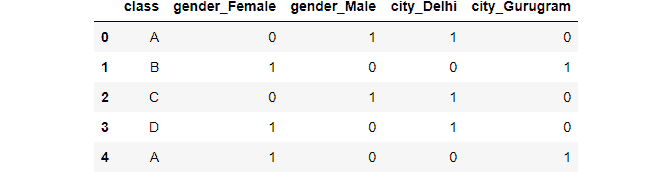

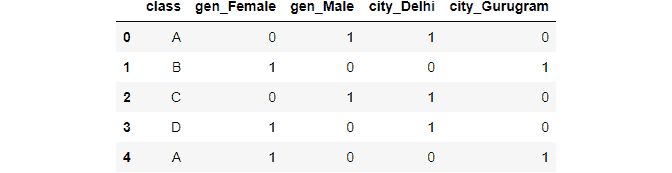

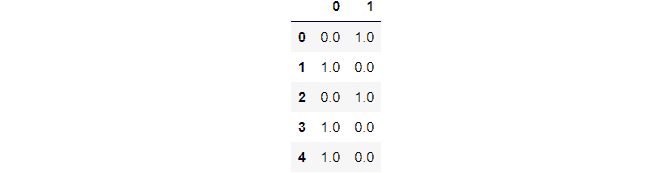

这个库的最佳特性之一是对分类特征的支持。虽然很多数据科学家可能使用独热编码为一个分类特征创建大量新列,但这个库允许你使用 categorical_feature 参数来指定分类特征。

虽然独热编码很有用,但在学术界,例如在 Jupyter Notebook 中,它在专业环境中可能不那么有用。假设你有 10 个分类特征,每个特征有 100 个独特的 bin,这将扩展到 1,000 个新列。这不仅使你的数据框变得稀疏,而且还使你的模型变得非常缓慢。这种稀疏性的另一个令人焦虑的结果是,当你需要将特征转换为生产代码供软件工程师在你的预测服务和部署中使用时(如果你有这种设置的话),这对双方来说可能会令人困惑和难以处理。

以下是使用 LightGBM 进行分类编码的一些好处:

-

更容易对分类特征进行编码

-

更容易使用

-

更容易与其他数据科学家、软件工程师、后台工程师和产品经理合作

-

可以保留原始列名

-

可以利用分类特征的好处,而不是使用独热编码进行传统的数值转换

-

这些好处可以最终使你的模型更快、更准确

快速

图片由 安迪·比尔斯 提供,来自 Unsplash [3]。

不仅仅是对类别特征进行编码使你的模型更快,LightGBM 还具备一些其他技巧来提高训练和预测速度。LightGBM 使用了 GOSS 和 EFB,或称为基于梯度的单侧采样(Gradient-based One-Side Sampling)和排他特征绑定(Exclusive Feature Binding),以及基于直方图的分裂方法。

以下是为什么快速的 LightGBM 模型对专业人士有用的原因:

-

并不是每个工作都允许你花费几周或几个月来制定模型,有些甚至可能希望在同一周内得到一个——或者至少是一个概念验证模型

-

这种更快的建模可以让你更快地测试特征和参数,最终使你在更快的环境中工作得更好

-

可以测试更多特征,而不会像其他算法那样显著减慢模型速度

它简单、快速,当有很多人依赖你的模型时,速度快可以让你更高效地帮助业务。

准确

图片由 Silvan Arnet 拍摄,来源于 Unsplash [4]。

XGBoost、CatBoost 和 LightGBM 都是准确的模型。是的,最终这取决于你的问题、特征和数据,但总体而言,这些算法在你执行了必要步骤后会产生准确的结果。

因为你可以使用类别特征,所以你更有可能得到一个准确的模型,比起只能执行独热编码的算法要更好。LightGBM 的分裂方式也可以导致更准确的模型。不过,重要的是要注意你需要防止过拟合。

以下是 LightGBM 更准确的一些原因,以及它如何在职业上帮助你的:

-

分裂方法

-

类别特征支持

-

当然,每个人都希望有一个更准确的模型,特别是在业务中(只需要确保你没有过拟合)

总结

虽然这些好处很简单,但它们非常重要,并且使你的工作变得更加轻松。因此,你的公司——包括利益相关者和工程师,会对你使用 LightGBM 感到满意。

总结一下,这里是一些在职业上使用 LightGBM 的主要好处:

-

类别编码

-

快速

-

准确

我希望你觉得我的文章既有趣又有用。如果你同意或不同意这些好处,请随时在下面评论。为什么或为什么不?你认为 LightGBM 还有哪些其他重要的好处需要指出?这些内容当然可以进一步澄清,但我希望我能够对 LightGBM 提供一些启示。

请随时查看我的 Medium 个人资料。

参考文献

[1] 微软公司,LightGBM 文档,(2022)

[2] 图片由 Mikhail Vasilyev 提供,来源于 Unsplash,(2017 年)

[3] 图片由 Andy Beales 提供,来源于 Unsplash,(2015 年)

[4] 图片由 Silvan Arnet 提供,来源于 Unsplash,(2020 年)

Matthew Przybyla (Medium) 是位于德克萨斯州 Favor Delivery 的高级数据科学家。他拥有南美 Methodist University 的数据科学硕士学位。他喜欢撰写关于数据科学领域的趋势话题和教程,从新算法到数据科学家日常工作经验的建议。Matt 喜欢突出数据科学的商业方面,而不仅仅是技术方面。欢迎通过 LinkedIn 联系 Matt。

我们的前 3 名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

更多相关主题

数据科学家:如何推销你的项目和你自己

原文:

www.kdnuggets.com/2021/11/data-scientists-sell-project.html

评论

由 Ilro Lee,NSW 客户服务部高级分析单元经理

照片由 JohnnyGreig 提供,拍摄于 Canva

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域

1. 谷歌网络安全证书 - 快速进入网络安全领域

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

在数据科学行业,仅仅成为一名熟练的数据科学家是不够的——你还需要推销你的项目和你自己。推销一个想法或你自己的一步是制定一个有效的电梯推介,说明你的价值主张以及你的项目与其他项目的不同之处。在这篇博客文章中,我们将讨论电梯推介如何运作,它们包含了什么,以及数据科学家的电梯推介示例。

1. 什么是电梯推介

你和一位高管被困在电梯里,你只有 15 秒的时间来给自己和你的项目留下良好的第一印象。你会怎么说?你在一个网络活动中,一位行业领袖要求你向她介绍你的项目。你能简洁而有说服力地描述你的项目/产品吗?

在你心中,你想说的是“你即将和我一起踏上改变你一生的冒险。我是你所有问题的答案,更重要的是,你需要一个完全理解你需求的合作伙伴。”对吧?但我们知道,这样的表达实际上并不容易实现。你只有 15 秒钟来抓住他们的注意力。我们需要能够提供一个精心设计的电梯推介。

2. 为什么你需要知道如何进行一个好的电梯推介

你应该学习如何为你的项目提供有效的电梯推介,原因有两个。首先,你可能需要在工作或面试中展示一个项目。其次,这也是练习简明扼要地描述复杂主题和想法的好方法——这正是数据科学家所做的!你可能不会认为知道如何推销自己能使你在工作中更有效,但电梯推介是展示演讲和让数据科学项目对他人有吸引力的好练习。

3. 成功的电梯推介的组成部分

你会发现关于如何开发电梯推介的无尽建议和意见。然而,我认为我们应该系统地进行这项工作,这意味着公式应基于证据和研究。因此,这个公式来源于市场研究领域……他们知道如何进行市场推广!!

你需要两个高级组件。你必须明确你的价值主张和你的差异化。

价值主张:

-

具体描述你的项目所针对的细分市场。很难让别人相信你正在做的东西能帮助每个人,这也为项目设定了背景。

-

描述那些对当前环境不满的群体。

-

描述你正在开发的产品/服务以及它解决了什么具体问题。

你的差异化:

-

描述替代方案(可能是你的竞争对手或当前可用的产品/服务)

-

描述一种与当前可用产品/服务不同的具体(而非所有)功能或特点。

4. 电梯推介公式

针对 [目标客户/用户群体],

他们对 [当前可用的产品/服务] 感到不满意

我们的产品/服务是一个 [新产品类别]

它提供了一个 [关键问题解决能力]

与 [产品/服务替代品] 不同,

我们已经组装了 [针对特定应用的关键产品/服务功能]

5. 我如何使用这些功能的示例

示例 1:

针对 政治竞选活动经理,

他们对 传统的调查产品感到不满意,

我们的应用程序是一款 新型调查产品

它提供 在 24 小时内设计、实施并获得结果的能力。

与 其他需要超过 5 天才能完成的传统调查产品不同,

我们已经组装了 一款快速、经济且相对准确的调查产品。

示例 2:

针对 前线刑事调查员,

他们对 显示过多不必要信息的通用仪表盘感到不满,

我们的应用程序是一款 新型智能产品

它提供 一个高度定制的、启用机器学习的风险评估工具,使调查员能够揭示潜在犯罪分子的隐藏网络。

与 当前提供的信息往往不太有用的仪表盘不同,

我们已经组装了 一款智能产品,允许他们在已知和未知的感兴趣演员之间建立联系。

这些是我使用过的真实案例。它有效,并且肯定能引起他们的注意。告诉我你的看法。

简历:Ilro Lee 是 NSW 顾客服务部高级分析单元的经理。

原文。经许可转载。

相关:

-

5 件事让数据科学家与其他职业区别开来

-

不要浪费时间建立你的数据科学网络

-

数据科学家职业路径:从新手到首份工作

相关话题

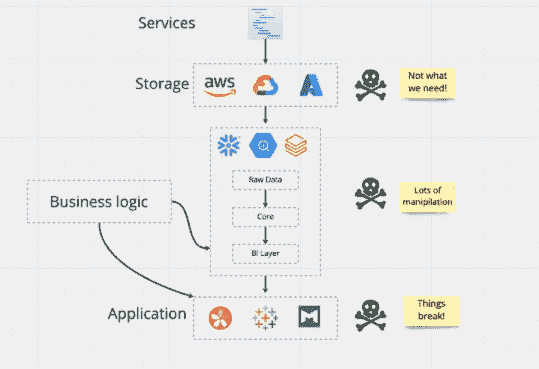

不受欢迎的观点——数据科学家应该更多地从端到端

原文:

www.kdnuggets.com/2020/09/data-scientists-should-be-more-end-to-end.html

评论

由尤金·闫,亚马逊应用科学专家,作家和演讲者。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

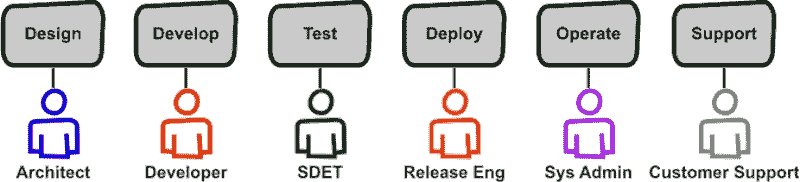

最近,我看到了一条关于数据科学和机器学习中不同角色的Reddit 讨论线程: 数据科学家、决策科学家、产品数据科学家、数据工程师、机器学习工程师、机器学习工具工程师、AI 架构师等。

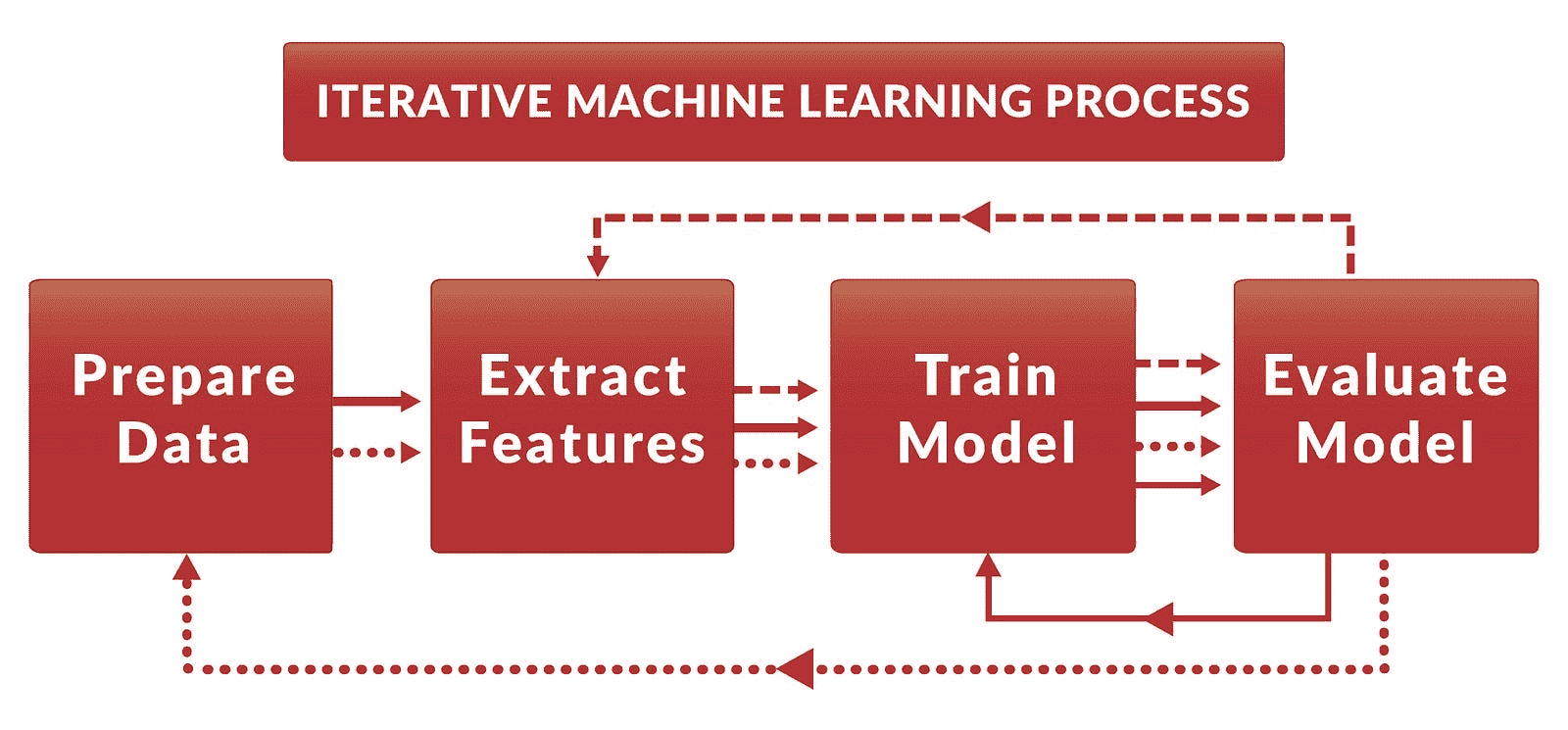

我发现这让人感到担忧。当数据科学过程(问题框定、数据工程、机器学习、部署/维护)分散在不同的人手中时,很难做到高效。这会导致协调开销、责任分散以及缺乏全局视角。

在我看来,我相信数据科学家通过从端到端的方式可以更有效。在这里,我将讨论好处和反对观点,如何成为端到端,以及Stitch Fix 和 Netflix的经验。

从开始(确定问题)到结束(解决问题)

你可能见过类似的标签和定义,例如:

我发现这些定义比我更喜欢的要具备更强的规定性。相反,我有一个简单(且务实)的定义:端到端数据科学家能够识别并解决数据问题以提供价值。为了实现这一目标,他们将佩戴所需的(或较少的)多种帽子。他们还会学习和应用有效的技术、方法和过程。在整个过程中,他们会提出以下问题:

-

问题是什么?为什么重要?

-

我们能解决这个问题吗?我们应该如何解决?

-

估计值是多少?实际值是多少?

数据科学流程

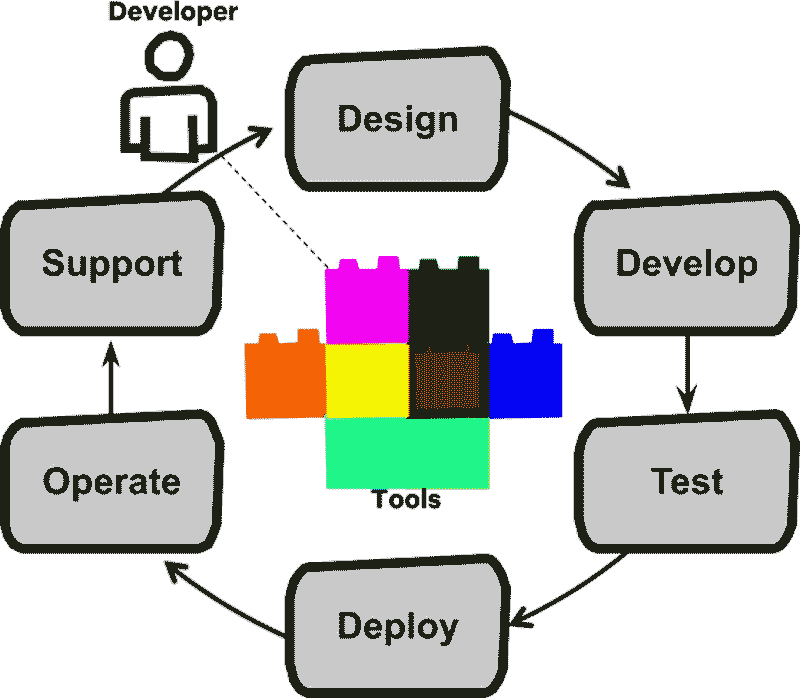

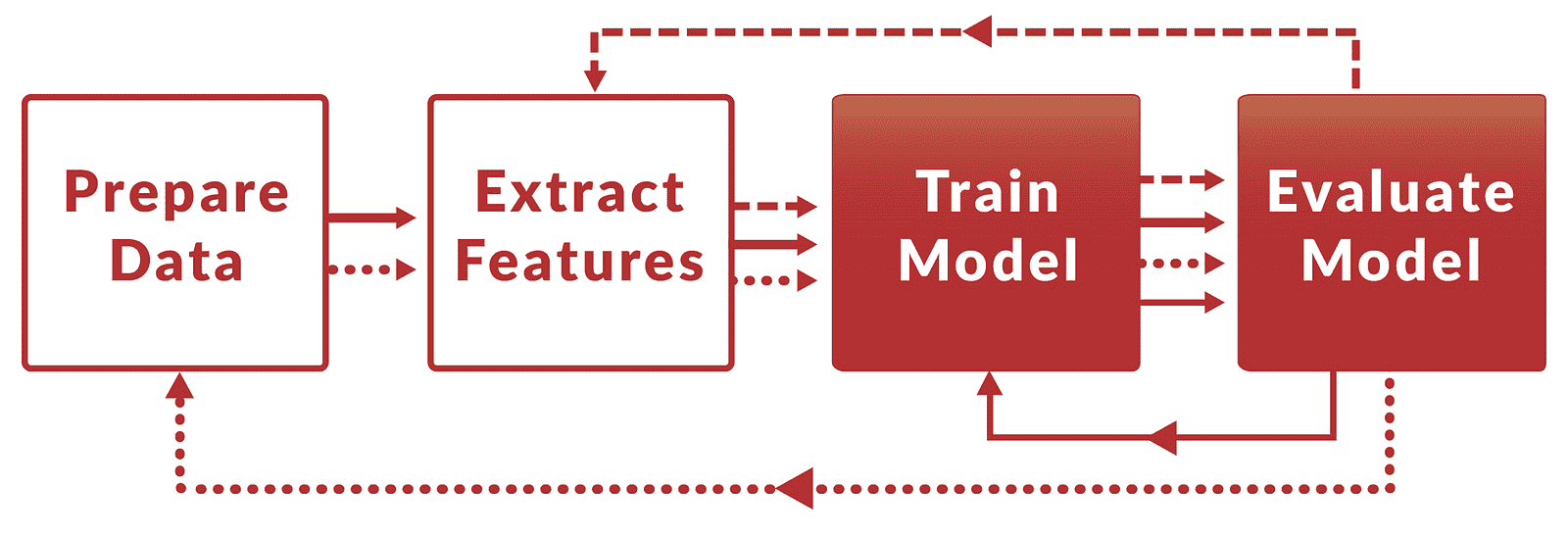

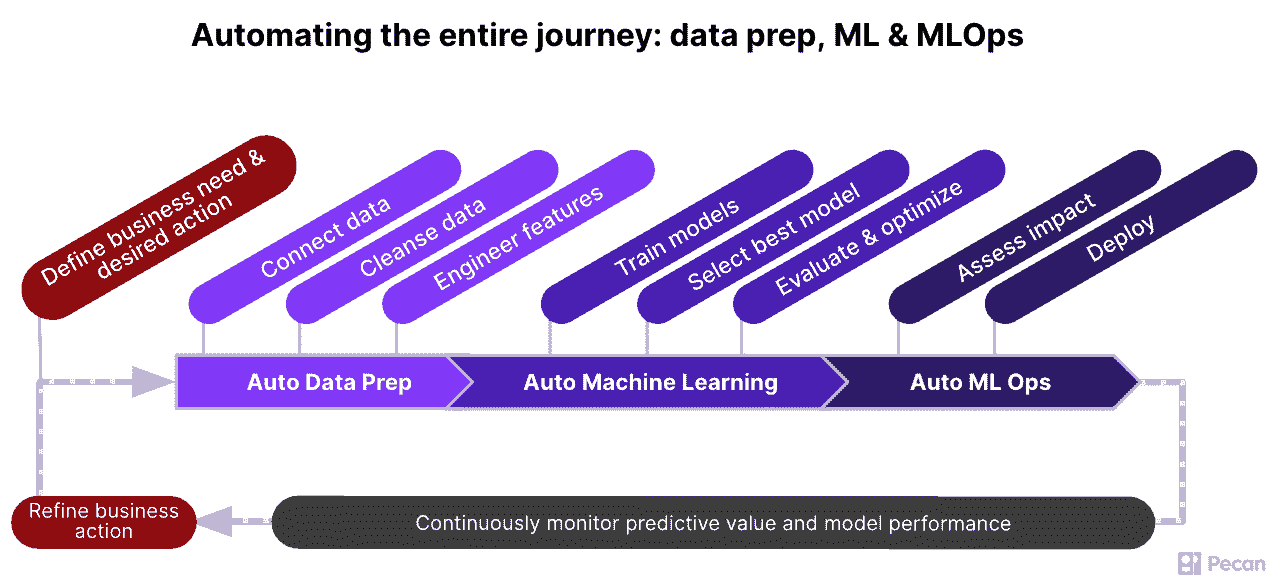

另一种定义端到端数据科学的方法是通过流程。这些流程通常很复杂,我在主要讨论中省略了它们。尽管如此,这里有一些以供你参考:

如果这些流程看起来繁重且令人不知所措,不用担心。你不必完全采纳它们——可以逐步开始,保留有效的部分,并调整其余部分。

.

更多的背景信息,更快的迭代,更大的满意度

对于大多数数据科学角色来说,更多的端到端经验提升了你产生有意义影响的能力。(尽管如此,还有一些角色专注于机器学习。)

端到端工作提供了更高的背景信息。 虽然专业化角色可以提高效率,但它减少了背景信息(对于数据科学家而言),并导致次优的解决方案。

忘记整体图景的诀窍是近距离观察一切。——查克·帕拉纽克

在没有上游问题的完整背景信息的情况下,很难设计出整体解决方案。假设转换率下降,项目经理提出了改进搜索算法的请求。然而,最初导致下降的原因是什么?可能有多种原因:

-

产品:是否存在欺诈/质量差的产品减少了客户信任?

-

数据管道:数据质量是否受到影响,或者是否存在延迟/中断?

-

模型刷新:模型是否没有定期/正确刷新?

更常见的是,问题和解决方案往往在机器学习之外。改进算法的解决方案会忽略根本原因。

同样,在不了解下游工程和产品约束的情况下开发解决方案是有风险的。没有意义:

-

如果基础设施和工程师无法支持,构建近实时推荐器

-

如果无限滚动推荐器不适合我们的产品和应用

通过端到端的工作,数据科学家将拥有完整的背景,能够识别正确的问题并开发可用的解决方案。这也可能导致一些专业人员因其狭窄的背景而可能忽视的创新想法。总体而言,这提高了交付价值的能力。

沟通和协调开销减少。 拥有多个角色会带来额外的开销。让我们来看一个例子:数据工程师(DE)清理数据和创建特征,数据科学家(DS)分析数据和训练模型,机器学习工程师(MLE)进行部署和维护。

一位程序员在一个月内能完成的工作,两位程序员在两个月内也能完成。——弗雷德里克·P·布鲁克斯

数据工程师(DE)和数据科学家(DS)需要就哪些数据是(和不是)可用的、如何清理数据(例如,异常值、标准化)以及应该创建哪些特征进行沟通。类似地,数据科学家(DS)和机器学习工程师(MLE)必须讨论如何部署、监控和维护模型,以及模型的更新频率。当出现问题时,我们需要三个人在场(可能还有项目经理 PM),以确定根本原因和解决步骤。

这也会导致额外的协调工作,因为在执行和按顺序传递工作时,时间表需要保持一致。如果数据科学家(DS)想要尝试额外的数据和功能,我们需要等待数据工程师(DE)处理数据并创建功能。如果一个新的模型准备好进行 A/B 测试,我们还需要等待机器学习工程师(MLE)将其(转换为生产代码)并部署。

尽管实际开发工作可能需要几天,但来回的沟通和协调可能需要几周,甚至更长时间。通过端到端的数据科学家,我们可以最大限度地减少这些额外开销,并防止技术细节在传递过程中丢失。

(但是,端到端的数据科学家真的能做到这一切吗?我认为可以。虽然数据科学家在某些任务上可能不如数据工程师(DE)或机器学习工程师(MLE)熟练,但他们能够有效地执行大多数任务。如果他们需要帮助来扩展或强化,他们总是可以寻求专业数据工程师(DE)和机器学习工程师(MLE)的帮助。)

沟通和协调的成本

哈佛心理学家理查德·哈克曼(Richard Hackman)显示,一个团队中的关系数量是N(N-1) / 2,其中N是人数。这导致链接的指数增长,其中:

- 一支 7 人的初创团队有 21 个链接需要维护

- 一组 21 人(即三支初创团队)拥有 210 个链接

- 一组 63 人拥有近 2000 个链接。

在我们简单的例子中,只有三种角色(即六个链接)。但随着 PM、BA 和其他成员的加入,沟通和协调成本呈现出超过线性的增长。因此,虽然每增加一名成员会提高团队整体生产力,但增加的开销意味着生产力以递减的速度增长。(亚马逊的two-pizza teams是可能的解决方案。)

迭代和学习的速度提高。 在更大的背景和更少的开销下,我们现在可以更快地迭代、失败(即学习)并交付价值。

这对开发数据和算法产品尤为重要。与软件工程(一个更为成熟的领域)不同,我们不能在开始构建之前完成所有的学习和设计——我们的蓝图、架构和设计模式还不够完善。因此,快速迭代对于设计-构建-学习的循环至关重要。

责任感和担当意识更强。 数据科学过程分布在多人之间可能导致责任的扩散,更糟糕的是,可能会出现“社会懒散”现象。

一个常见的反模式是“抛砖引玉”。例如,DE 创建特征并将数据库表抛给 DS,DS 训练模型并将 R 代码抛给 MLE,MLE 将其转换为 Java 进行生产。

如果出现翻译失误或结果意外,谁负责?有了强烈的责任文化,每个人都会在各自的角色中挺身而出。但没有这种文化,工作可能退化为掩盖责任和指责他人,同时问题仍然存在,客户和业务也会受到影响。

让全程数据科学家对整个过程负责可以缓解这种问题。他们应该被赋予从头到尾的行动权限,从客户问题和输入(即原始数据)到输出(即部署的模型)和可衡量的结果。

责任扩散与社会懒散

责任扩散: 当有其他人在场时,我们不太可能承担责任和采取行动。如果我们知道还有其他人也在关注情况,个人就会感到责任感和紧迫感减少。

这种现象的一种形式是Bystander effect,其中Kitty Genovese在她居住的街对面公寓楼外被刺伤。虽然有 38 名目击者看见或听见了攻击,但没有人报警或提供帮助。

社会懈怠:我们在团队中工作时的努力比单独工作时少。19 世纪 90 年代,Ringelmann 让人们在单独和团队中拉绳子。他测量了他们拉的用力程度,发现团队成员在拉绳子时的努力程度通常低于单独工作的个体。

对于(一些)数据科学家来说,这可以带来更高的动力和工作满意度, 这与自主性、精通和目的密切相关。

-

自主性: 通过能够独立解决问题。端到端的数据科学家能够识别和定义问题,构建自己的数据管道,并部署和验证解决方案,而不是等待和依赖他人。

-

精通: 从端到端的问题、解决方案和结果。他们也可以根据需要掌握领域和技术。

-

目的:通过深度参与整个过程,他们与工作和结果有更直接的联系,从而增强了目的感。

但我们也需要专家

然而,全面掌握所有领域并不适合每个人(和每个团队),原因包括:

想要专注于 机器学习,或许是机器学习中的某个特定领域,如神经文本生成(参见:GPT-3 primer)。虽然全面掌握是有价值的,但我们也需要这些世界级的专家在研究和工业中推动边界。我们在机器学习中拥有的许多东西来自学术界和纯研究努力。

没有人通过成为一个通才来获得伟大。你不会通过分散注意力来提高某项技能。达到下一个水平的唯一方法是专注。 – 约翰·C·麦克斯韦

缺乏兴趣。 并不是每个人都热衷于与客户和企业互动,以定义问题、收集需求和编写设计文档。同样,也不是每个人都对软件工程、生产代码、单元测试和 CI/CD 管道感兴趣。

在大型、高杠杆的系统上工作,其中 0.01%的改进会产生巨大的影响。 例如,算法交易和广告。在这种情况下,需要超专业化来挖掘这些改进。

其他人也提出了为什么数据科学家应该专注于某一领域(而不是全面掌握)的理由。以下是一些文章,提供平衡和反驳的观点:

学习的最佳方式是通过实践

如果你仍然渴望更全面,我们现在将讨论如何做到这一点。在此之前,未涉及具体技术,这里是全面数据科学家常用的技能类别:

-

产品:理解客户问题,定义和优先排序需求

-

沟通:促进团队之间的合作,获得支持,编写文档,分享结果

-

数据工程:将数据从 A 点移动和转换到 B 点

-

数据分析:理解和可视化数据,A/B 测试与推断

-

机器学习:通常包括实验、实施和度量

-

软件工程:生产代码实践,包括单元测试、文档、日志记录

-

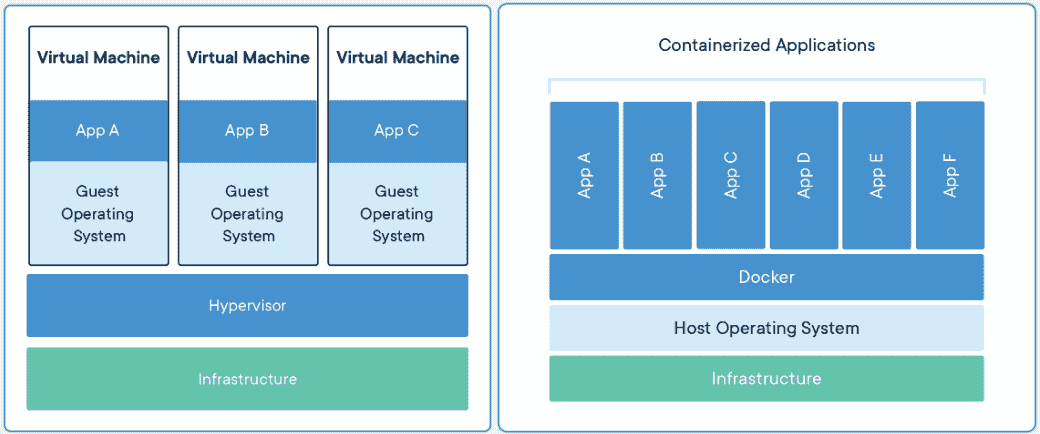

运维:基本的容器化和云熟练度,构建和自动化工具

(这个列表既不是强制性的,也不是详尽无遗的。大多数项目并不需要全部这些。)

这里有四种方法可以让你更接近成为一名全面的数据科学家:

学习正确的书籍和课程。(好吧,这不是通过实践学习,但我们都需要从某处开始)。我会关注那些涵盖隐性知识的课程,而非具体工具。虽然我没有找到这样的材料,但我听说全栈深度学习有很好的评价。

自己做完整的项目以获得整个过程的第一手经验。冒着简化的风险,以下是我会采取的一些步骤及其相关技能。

听而忘之,看而记之,做而理解。——孔子

从识别要解决的问题和确定成功指标(产品)开始。接着,找到一些原始数据(即非 Kaggle 竞赛数据);这可以让你清理和准备数据,并创建特征(数据工程)。然后,尝试各种机器学习模型,检查学习曲线、误差分布和评估指标(数据科学)。

在选择一个模型之前,评估每个模型的性能(例如,查询延迟、内存占用),并编写一个基本的inference class用于生产(软件工程)。 (你可能还想构建一个简单的用户界面)。然后,将其容器化并通过你首选的云提供商在线部署,让其他人使用(运维)。

一旦完成,额外付出努力分享你的工作。你可以为你的网站写一篇文章,或在聚会上讲述(沟通)。通过有意义的视觉效果和表格展示你在数据中发现的内容(数据分析)。在 GitHub 上分享你的工作。公开学习和工作是获取反馈和寻找潜在合作者的好方法。

通过像DataKind这样的组织进行志愿服务。 DataKind 与社会组织(如非政府组织)和数据专业人士合作,以解决人道主义问题。通过与这些非政府组织合作,你将有机会作为团队的一部分,处理真实(且非常复杂)的数据来解决实际问题。

虽然志愿者可能会被分配具体角色(例如,PM,DS),但你总是欢迎跟随和观察。你将看到(并学习)PM 如何与非政府组织合作来构建问题框架、定义解决方案,并围绕它组织团队。你将从其他志愿者那里学到如何使用数据来开发有效的解决方案。参加类似黑客马拉松的DataDives和长期的DataCorps是贡献于数据科学过程端到端的一个绝佳方式。

加入一个类似初创公司的团队。 注意:类似初创公司的团队并不等同于初创公司。大型组织中有些团队以类似初创公司的方式运作(例如,双比萨团队),而初创公司中也可能由专才组成。寻找一个精干的团队,在那里你受到鼓励并有机会进行端到端的工作。

在 Stitch Fix 和 Netflix 中的端到端

Stitch Fix的 Eric Colson 最初是由于对“过程效率的吸引”而被吸引到功能型分工中(即data science pin factory)。但经过反复试验,他发现端到端的数据科学家更为高效。现在,Stitch Fix 不再为专业化和生产力组织数据团队,而是为了学习和开发新的数据与算法产品来组织它们。

数据科学的目标不是执行。而是学习和开发新的业务能力。……没有蓝图;这些是具有固有不确定性的全新能力。……你所需要的所有元素必须通过实验、试错和迭代来学习。— Eric Colson

他建议数据科学角色应更加通用,拥有广泛的责任,不依赖于技术职能,并优化学习。因此,他的团队招聘和培养可以进行概念化、建模、实施和测量的通才。当然,这依赖于一个可靠的数据平台,该平台可以抽象掉基础设施设置、分布式处理、监控、自动故障转移等的复杂性。

端到端的数据科学家提升了 Stitch Fix 的学习和创新能力,使他们能够发现并构建更多的业务能力(相比于专业团队)。

Netflix的 Edge Engineering 最初有专门的角色。然而,这在产品生命周期中造成了低效。代码发布花费的时间更长(几周而非几天),部署问题的检测和解决也花费了更长时间,生产问题需要多次反复沟通。

极端情况下,每个功能区域/产品由 7 个人负责(source)。

为了解决这个问题,他们尝试了全周期开发者,这些开发者被授权跨越整个软件生命周期进行工作。这需要思维方式的转变——开发者不仅要考虑设计和开发,还要考虑部署和可靠性。

与多个角色和人员不同,我们现在有了完整周期开发(source)。

为了支持全周期开发者,集中团队构建了工具来自动化和简化常见的开发流程(例如,构建和部署管道、监控、管理回滚)。这些工具可以在多个团队之间重复使用,起到倍增效应,并帮助开发者在整个周期内有效工作。

通过全周期开发者的方法,边缘工程能够更快地迭代(而不是在团队之间协调),实现更快和更常规的部署。

这对我有效吗?以下是一些例子

在 IBM,我在一个团队中创建了员工的职位推荐。运行整个管道需要很长时间。我认为通过将数据准备和特征工程管道移到数据库中可以将时间缩短一半。但数据库人员没有时间进行测试。我不耐烦,进行了一些基准测试,将整体运行时间减少了 90%。这使我们可以更快地进行实验,并节省了生产中的计算成本。

在构建 Lazada 的排名系统时,我发现 Spark 对于数据管道是必要的(因为数据量大)。然而,我们的集群只支持 Scala API,而我对此不熟悉。不想等待(数据工程支持),我选择了更快但痛苦的方式来弄清楚 Scala Spark 并自己编写管道。这可能将开发时间减少了一半,并让我更好地理解数据,从而构建了更好的模型。

在一次成功的 A/B 测试后,我们发现业务利益相关者不信任模型。因此,他们手动选择展示的顶级产品,从而降低了在线指标(例如,点击率,转化率)。为了了解更多情况,我去了我们的市场(例如,印尼,越南)。通过相互教育,我们能够解决他们的担忧,减少手动覆盖的数量,并获得收益。

在上面的例子中,超出常规 DS & ML 职位范围有助于更快地交付更多价值。在最后一个例子中,有必要解除我们数据科学工作的阻碍。

尝试一下

你现在可能不是端到端的。这没关系——很少有人是。不过,考虑一下它的好处,并朝着它靠近一点。

哪些方面会不成比例地提升你作为数据科学家的交付能力?与客户和利益相关者的更多互动以设计更全面、创新的解决方案?构建和协调自己的数据管道?对工程和产品限制有更大的认识,以便更快地整合和部署?

不受欢迎的观点:数据科学家应该更具端到端能力。

尽管这种做法(过于泛泛而谈!)受到批评,我发现它可以带来更多的背景、更快的迭代、更大的创新——更多的价值,速度更快。

更多细节和 Stitch Fix & Netflix 的经验

t.co/aOBjuBSsSz— Eugene Yan (@eugeneyan) 2020 年 8 月 12 日

原文。经许可转载。

简介: Eugene Yan(@eugeneyan)在消费者数据和技术的交叉点工作,构建帮助客户的机器学习系统。Eugene 还撰写有关如何在数据科学、学习和职业生涯中取得成效的文章。目前,Eugene 是亚马逊的一名应用科学家,帮助用户阅读更多内容,从阅读中获得更多收益。

相关内容:

更多相关主题

数据科学家在生成式 AI 时代仍然需要吗?

原文:

www.kdnuggets.com/2023/06/data-scientists-still-needed-age-generative-ai.html

使用稳定扩散技术创建的图像

恰好两年前,我写了一篇名为“数据科学家将在 10 年内灭绝”的观点文章。令我惊讶的是,这篇文章成为我在 Medium 和 KDnuggets 上阅读量最高的文章之一。然而,反响却是两极分化的。这篇文章引发了我成年生活中收到的最多批评。我预言了 21 世纪最性感(也是最需求)工作的消亡,而我的同行们对此提出了异议,但我接受了反馈,生活继续前行。快进到现在,两年的时间带来了如此大的变化。ChatGPT 风靡全球,与此同时,特定角色将被淘汰的叙述被更大的议题所掩盖——人力资本在各个行业中的过时。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

革命似乎一夜之间发生了。但我们这些密切关注深度学习进展的人都知道,事实并非如此。ChatGPT 是数十年研究的积累,不可思议地汇聚成了一个不起眼的聊天机器人。ChatGPT 成功的核心在于它使 AI 民主化。掌握代码和拥有深厚的技术知识不再是进入门槛,前沿深度学习的可及性已超越了学术研究和大科技公司,任何有 wifi 和电子邮件地址的人都可以触及。

为什么数据科学家已经灭绝?

我从未想过我们会处于如此速度、规模和性质的技术革命的边缘。在 LLM 和文本到图像模型之前,生成式 AI (GAI) 很大程度上与 Ian Goodfellow 的生成对抗网络 (GANs) 同义。它被誉为近年来 AI 研究的重大贡献之一,体现了使用一对神经网络生成合成的、照片级真实的图像。我们这些曾经使用过 GAN 的人都知道,它们训练起来 notoriously difficult,即使实施正确,当时的应用场景也有限。因此,生成深度学习带来了最新一轮的进展,这更令人惊叹。

那么,为什么 ChatGPT(及其 GAI 伙伴)会使数据科学家面临灭绝的边缘呢?让我们回顾一下两年前的原始论点:

-

仅仅能复述代码和使用软件包的能力将不再定义数据科学家,因为低代码/无代码解决方案已经变得越来越普遍。

-

工作和分析数据的能力将成为许多角色的假定技能,就像计算技能和 MS Office 知识一样。

-

在这种范式下,能够解决现实世界问题的领域专家将会表现出色。数据科学将成为他们工具箱的一部分。

-

鉴于上述情况,通才数据科学家将被领域专家取代。

鉴于此,我们可以看到,GAI 几乎促进了上述每一个点。它可以直接从文本提示中生成代码、分析数据集和查询结果。对能够使用 ChatGPT 的 AI 准备专业人员的需求已经开始渗透到职位描述中,我们知道尽管使用 GAI 可以带来生产力的提升,但 AI 仍然容易产生幻觉,它仍可能出错,这进一步强调了深厚领域专业知识在应对这些情况中的必要性。总之,这还不到 10 年,只用了两年。

然而,数据科学家灭绝并不意味着从事数据科学的人工会变得过时,实际上恰恰相反。当我们回顾历史时,在过去 200 年里,我们经历了几次技术革命,包括蒸汽动力、大规模生产和个人计算等。每一次技术革命都使我们的生产力超过上一次,因为我们的角色和与技术的关系不断演变,这一概念在经济理论中根深蒂固(Solow 增长模型)。在当前环境下,企业正在创造和捕获比以往更多的数据,因此数据科学技能将始终有需求,但未来的数据科学家不会被称为数据科学家,他们将以产品经理、营销专家或投资分析师等名称出现。数据科学家灭绝了,数据科学万岁。

免责声明:观点和意见仅代表作者本人。

Michael Wang 是一位拥有超过 10 年行业经验的投资与数据科学从业者,涉足金融科技、投资、交易及教学等多个领域。他是 WhyPred 的首席顾问及创始人,该公司是一家将金融市场专业知识与人工智能和机器学习相结合的分析咨询公司。

更多相关话题

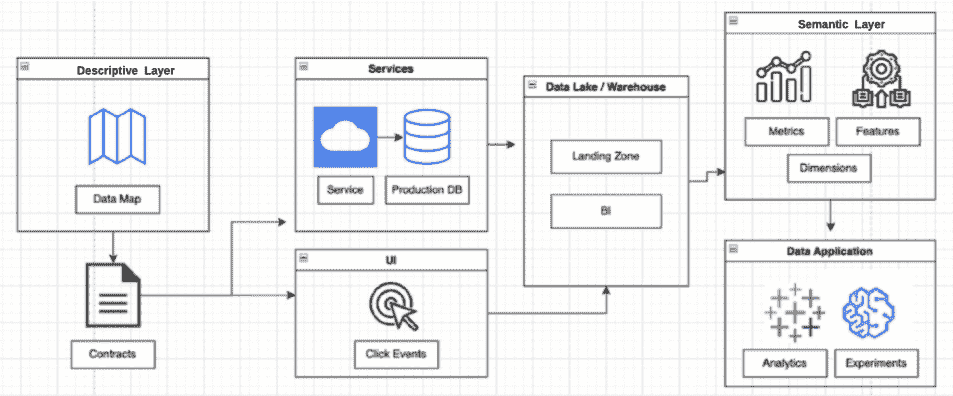

数据来源 101

评论

作者 Ayswarrya G,内容策略师,Atlan

开始接触数据世界可能会让人感到不知所措。大数据、替代数据、原始数据、内部数据——这份清单还在继续。一个常见的困惑是这些术语之间的区别,理解这些区别非常重要。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

这就是原因。

数据收集是数据生命周期的第一步之一——为了分析数据,你需要首先获取所有需要的数据(这不难理解,对吧?)。

为了收集正确的数据,你需要知道在哪里找到它,并确定收集它所涉及的努力。

这就是我写这篇文章的原因,为了回答最基本的问题:你需要的(或可能需要的)所有数据来自哪里?

数据来源

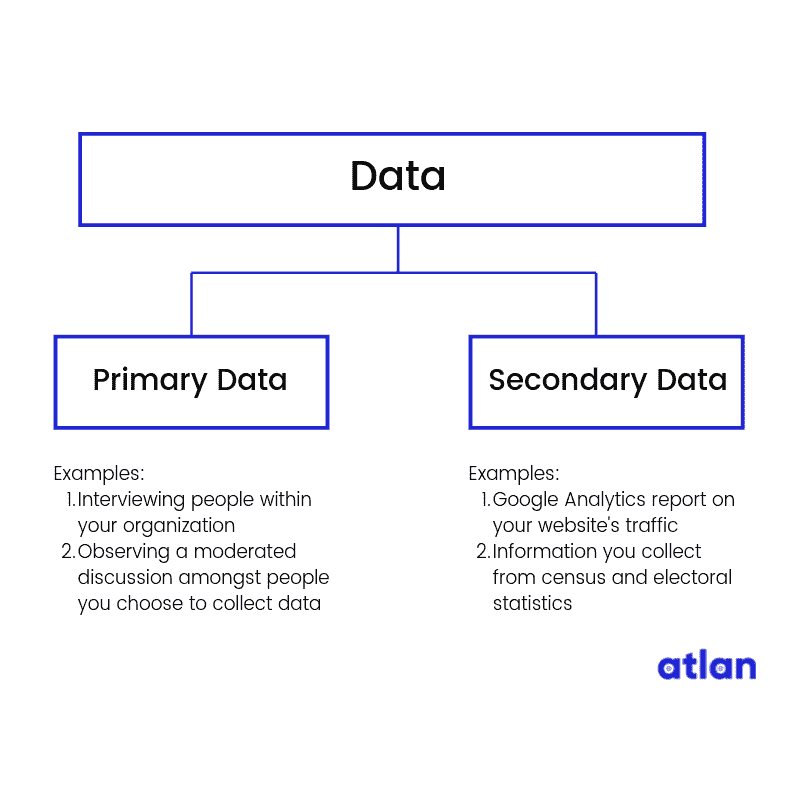

在查看数据来源之前,我们先了解一下原始数据和次级数据。

原始数据 — 你自己创建的数据

当你自己创建你想要的数据时,这被称为原始数据。如果你采访人们以收集对你产品的反馈,那么采访数据就是原始数据。

次级数据 — 从其他地方收集的数据

当你从其他人拥有的来源收集数据时,这被称为次级数据。如果你使用谷歌分析的数据来了解有多少人访问你的网站,那你就是在使用次级数据。这仍然是关于你组织的数据,但这是由一个次级组织(在我们的例子中是谷歌)为你收集的。

到目前为止,还不错,对吧?

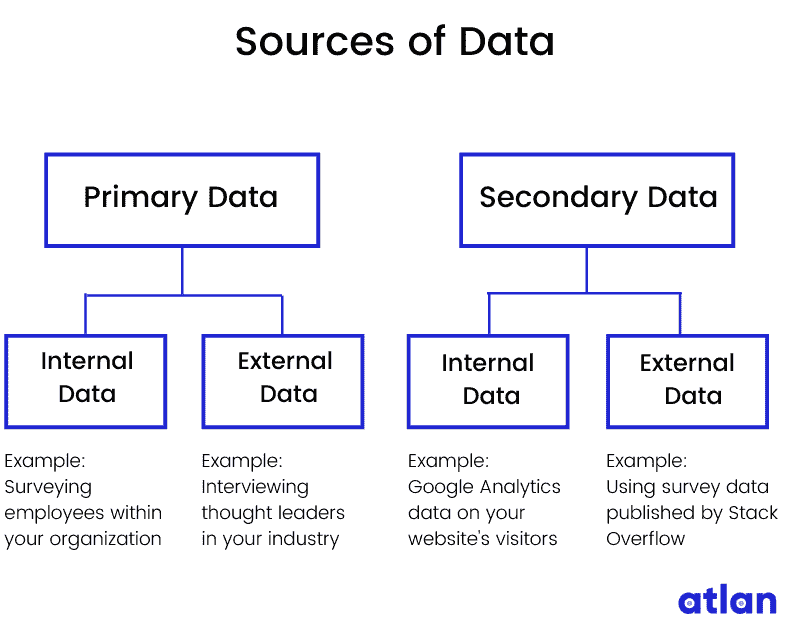

现在让我们在这个基础上继续。数据来源可以是内部的,也可以是外部的。

内部数据 — 你创建、拥有或控制的数据

内部数据是你组织拥有、控制或收集的私人数据。你的组织的销售数据或财务数据就是内部数据的例子。

注意我说的是你创建、拥有或控制的数据?

这是有原因的。内部数据可以是原始的也可以是次级的。

当你通过调查你组织内的人员并利用这些洞察来展示影响工作场所生产力的因素时,这些数据就是内部数据和原始数据。

另一方面,当你使用 Google Analytics 的数据来显示大多数网站访问者搜索的是替代数据产品时,这些数据是内部和次级的。

外部数据 — 来自外部来源的数据

外部数据是从组织外部来源收集的数据。这些数据可能是:

-

公开可用的数据,例如人口普查、选举统计、税务记录和互联网搜索

-

来自第三方的私有数据,如亚马逊、Facebook、Google、沃尔玛以及像 Experian 这样的信用报告机构

外部数据也可以是主要数据或次级数据吗?如果你在考虑这些问题,你就走在正确的轨道上了!

当你与全球的数据科学领导者进行访谈时,你正在收集主要数据,但来源于外部。所以,这些数据是外部的和主要的。

当你使用像 Kaggle 或 Stack Overflow 这样的数字出版物进行的访谈数据时,你使用的是外部的和次级的数据。

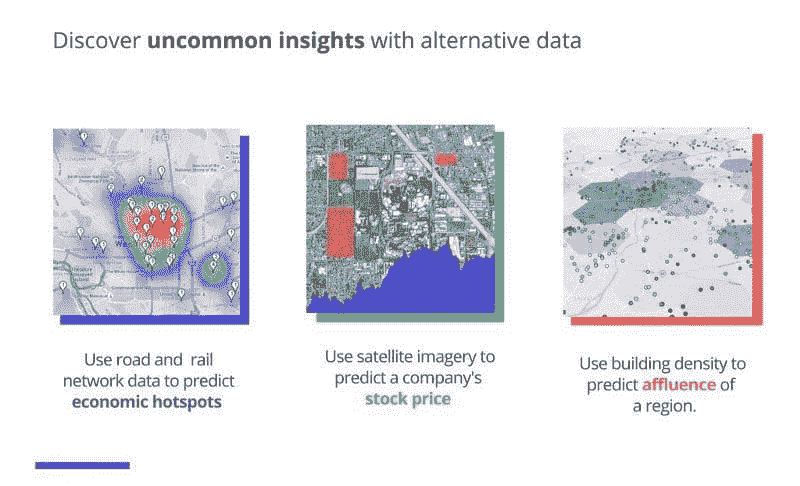

但是等一下……难道不是还有一种叫做替代数据的吗?

等等!我正要提到这个。

替代数据是复杂、独特且大多数未被探索的次级数据。为了理解替代数据,让我们快速绕道 2 分钟,了解一下大数据。

大数据

大数据指的是海量的结构化、半结构化或非结构化数据,这些数据过于复杂,传统的数据系统(关系数据库和数据仓库)无法处理。

数据的格式

结构化什么?

数据有多种格式。以下是我对两种最主要格式的简要介绍:

-

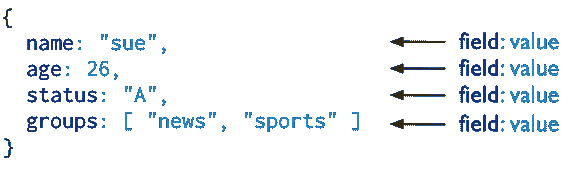

结构化数据:在关系数据库中以固定格式组织的数据(可以想象成你存储在计算机上的文件)

-

非结构化数据:没有特定格式的数据(可以想象成监控数据);Gartner估计超过 80%的企业数据是非结构化的。

大数据的例子包括社交媒体数据📱、交易数据📈(股票价格、购买历史)、传感器数据(位置数据、天气数据)以及卫星数据📡。(这里有一篇关于今天世界上大数据的有趣阅读)

IBM 的大数据 4Vs。图片来源:IBM Big Data & Analytics Hub

传统数据系统 无法完全处理如此大量的非结构化数据。

分析大数据需要复杂的大数据技术(这是另一个话题,但如果你很急,可以查看这个有用的 wiki 了解大数据技术)。

我们的快速绕道到此结束。

因此,替代数据被认为是大数据。最初,对冲基金利用租金和水电费等非财务信息来估算个人的借贷风险。这些数据改变了金融行业(请参见 这篇文章 了解对冲基金如何使用替代数据)。

很快,其他行业也意识到了它的潜力以及如何帮助他们保持竞争优势。

替代数据当前使用的一些示例。图片来源: Humans of Data

一些常见的替代数据集示例包括:

-

卫星数据

-

位置信息

-

财务交易

-

在线浏览活动

-

社交媒体帖子

-

产品评论

最终话语

这样你就对世界数据的来源有了大致了解。这里有一张图,快速总结了各种数据来源。

附言:在过去几个月里,我一直在参与一个名为 The Atlan Data Wiki 的社区项目——这是一个有趣、有帮助、无行话的百科全书,用于导航数据宇宙。如果你喜欢我的文章, 请查看这个 wiki ,我用类似的方法处理其他数据主题。我很想听听你的想法。

个人简介:Ayswarrya G (@Ayswarrya) 认为优秀的写作可以改变世界。目前,她负责 Atlan 的 Humans of Data 出版物和 Data Wiki。在闲暇时间,她要么在旅行,要么在练习法语。

相关:

-

了解你的数据:第一部分

-

处理机器学习中数据缺乏的 5 种方法

-

了解你的数据:第二部分

更多相关主题

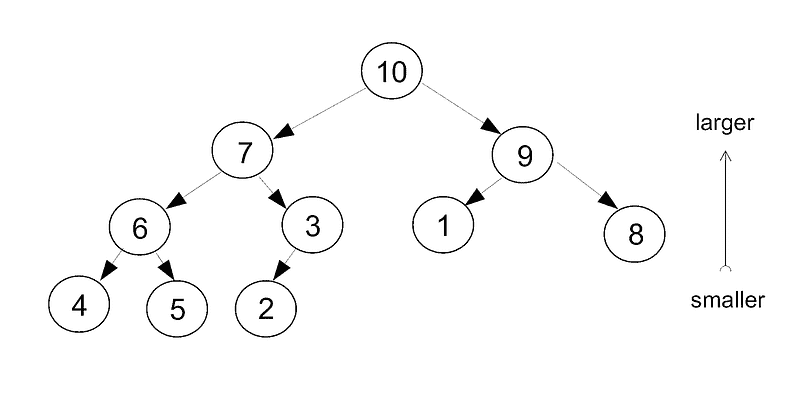

与机器学习算法相关的数据结构

原文:

www.kdnuggets.com/2018/01/data-structures-related-machine-learning-algorithms.html/2

评论

评论

堆

堆是另一种分层、有序的数据结构,类似于树,但与水平排序不同,它具有垂直排序。这种排序适用于层级结构,但不适用于跨层级:父节点总是比它的两个子节点都要大,但高等级的节点不一定比直接在其下方的低等级节点要大。

插入和检索都是通过提升来完成的。一个元素首先被插入到最高可用的位置。然后它与其父节点进行比较,并提升直到达到正确的等级。要从堆中取出一个元素,两个子节点中较大的一个被提升到缺失的位置,然后那两个子节点中较大的一个被提升,以此类推,直到所有元素都被提升到相应的等级。

通常,最高等级的值会从堆的顶部取出以对列表进行排序。与树不同,大多数堆只是存储在一个数组中,元素之间的关系只是隐含的。

栈

栈的定义是“先进后出”。一个元素被pushed到栈的顶部,它会覆盖之前的元素。必须先popped顶部元素,才能访问其他元素。

栈主要用于解析语法和实现计算机语言。

有许多机器学习应用场景中,特定领域语言(DSL)是完美的解决方案。例如,libAGF 库使用递归控制语言将二分类推广到多分类。使用特殊字符来重复先前的选项,但由于语言是递归的,该选项必须取自相同的层级或更高层级。这是通过栈来实现的。

队列

队列的定义是“先进先出”。想象一下银行柜台前的排队(对于那些还记得互联网银行之前的时代的人来说)。队列在实时编程中非常有用,这样程序可以保持一个待处理的任务列表。

设想一个记录运动员分段时间的应用。你输入号码牌并按回车,但在你做这件事的时间里,下一个运动员已经通过了。所以你输入一系列最近接近的运动员的号码牌,然后按另一个键来注册下一个队列中的运动员已通过。

集合

一个集合由一个无序的、不重复的元素列表组成。如果你添加了一个已经在集合中的元素,则不会发生变化。由于机器学习中的许多数学运算涉及集合,因此它们是非常有用的数据结构。

关联数组

在关联数组中,有两种类型的数据以对的形式存储:键和其关联的值。数据结构本质上是关系型的:值由其键来访问。由于训练数据也通常是关系型的,这种数据结构似乎非常适合机器学习问题。

在实践中,它的使用并不多,部分原因是大多数关联数组仅是单维的,而机器学习数据通常是多维的。

关联数组适合用于构建字典。

假设你正在构建一个 DSL,想要存储一个函数和变量的列表,并需要区分它们。

“sin” → function

“var” → variable

“exp” → function

“x” → variable

“sqrt” → function

“a” → variable

在“sqrt”上查询会返回“function”。

自定义数据结构

随着你处理更多问题,你肯定会遇到那些标准食谱箱中没有最佳结构的情况。你需要设计自己的数据结构。

考虑一个多类分类器,它将二元分类器推广到处理具有多个类别的分类问题。一种明显的解决方案是二分法:递归地将类别分成两组。你可以使用类似于二叉树的结构来组织二元分类器,但层次化解决方案并不是解决多类问题的唯一方法。

考虑几个划分,然后用来同时解决所有类别概率。

最一般的解决方案是将两者结合起来,因此每个层次化的划分不一定是二元的,而可以通过非层次化的多类分类器来解决。这是libAGF库中采用的方法。

更复杂的数据结构也可以由基本结构组成。考虑一个稀疏矩阵类。在稀疏矩阵中,大多数元素为零,仅存储非零元素。我们可以将每个元素的位置和值作为一个三元组存储,并将它们放在一个可扩展数组中。

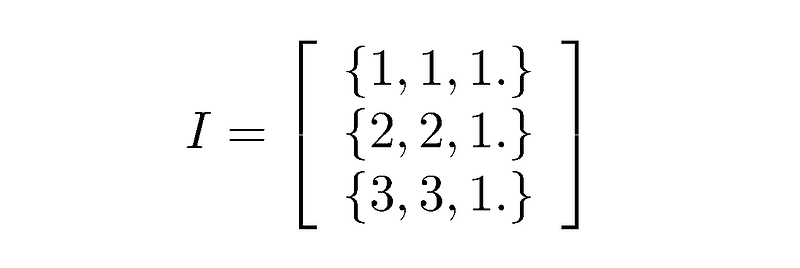

考虑 3 乘 3 的单位矩阵:

结论

数据结构本身有时并不那么有趣。真正让它们有趣的是你可以用它们解决的各种问题。

对于我做的大部分工作,我使用了许多基本的固定长度数组。我主要使用更复杂的数据结构使程序运行得更顺畅,与外界的接口更友好,用户体验也更佳。与过去的 Fortran 程序相比,后者在改变网格大小时需要忍受近半小时的编译周期(我实际上参与过这样的程序!)。

即使你一时无法想到应用场景,我仍然认为了解像栈和队列这样的数据结构是有益的。你永远不知道它们何时会派上用场。

真的很复杂的人工智能应用可能会使用诸如有向图和无向图的东西,这实际上只是树和链表的泛化。如果你无法处理链表,那你将如何构建前者?

问题

如果你想自己实践并实现机器学习算法的数据结构,可以尝试解决下面的一些问题:

-

将矩阵-向量乘法代码片段封装成一个名为matrix_times_vector的子程序。设计该子程序的调用语法。

-

使用struct, typedef或class,将向量和矩阵封装成一对抽象类型,分别称为vect和matrix。为这些类型设计一个 API。

-

在线找到至少三个做上述工作的库。

-

下载并安装 LIBSVM 库。考虑“svm.cpp”中第 316 行的Kernel::k_function方法。用于存储向量的数据结构的优缺点是什么?

-

你会如何重构 LIBSVM 库中的核函数计算?

-

文本中描述的哪些数据结构是抽象类型?

-

你可以使用什么内部表示或数据结构来实现抽象数据类型?有没有任何不在上面列表中的数据结构?

-

使用二叉树设计一个关联数组。

-

考虑 LIBSVM 中的向量类型。如何用它来表示稀疏矩阵?与上面描述的稀疏矩阵类相比,这有什么优缺点?查看完整类型。每种表示方法的优缺点是什么?

-

实现一个树排序和一个堆排序。现在使用相同的数据结构找出前k个元素。这对哪个常见的机器学习算法有用?

-

在你喜欢的编程语言中实现你最喜欢的数据结构。

简介: Peter Mills 对科学充满热情,感兴趣于大气物理学、混沌理论和机器学习。

原文。经授权转载。

相关:

-

初学者的前 10 种机器学习算法

-

IT 工程师需要学习多少数学才能进入数据科学领域?

-

数据科学家主要只做算术,这其实是好事

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的捷径

1. 谷歌网络安全证书 - 快速进入网络安全职业的捷径

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关内容

数据转换:标准化与归一化

原文:

www.kdnuggets.com/2020/04/data-transformation-standardization-normalization.html

图片来源于 365datascience

数据转换是数据处理中的基本步骤之一。当我第一次学习特征缩放技术时,术语scale、standardise和normalize经常被使用。然而,找到关于何时使用这些术语的信息相当困难。因此,我将在本文中解释以下关键方面:

-

标准化和归一化之间的区别

-

何时使用标准化,何时使用归一化

-

如何在 Python 中应用特征缩放

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

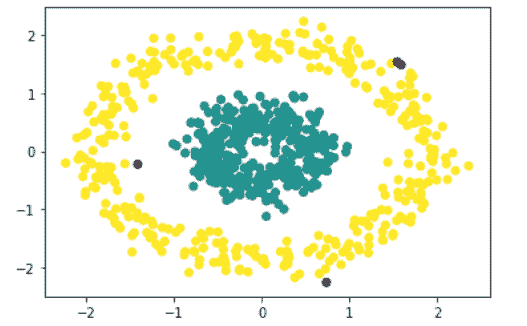

特征缩放是什么意思?

在实际操作中,我们经常在同一数据集中遇到不同类型的变量。一个重要的问题是这些变量的范围可能相差很大。使用原始尺度可能会对范围大的变量赋予更多权重。为了处理这个问题,我们需要在数据预处理的步骤中,对自变量或数据的特征应用特征重缩放技术。术语normalisation和standardisation有时可以互换使用,但它们通常指的是不同的概念。

应用特征缩放的目标是确保特征几乎在相同的尺度上,以便每个特征同样重要,并且让大多数机器学习算法更容易处理。

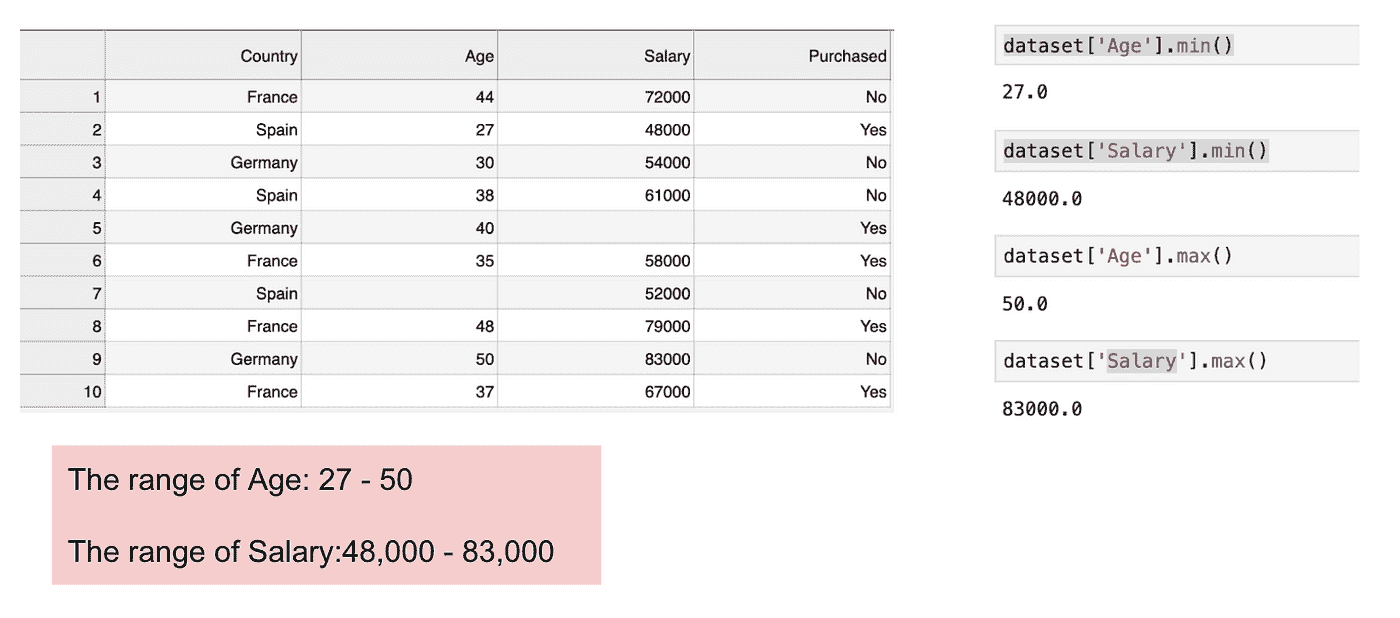

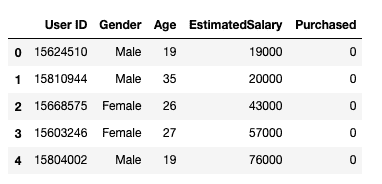

示例

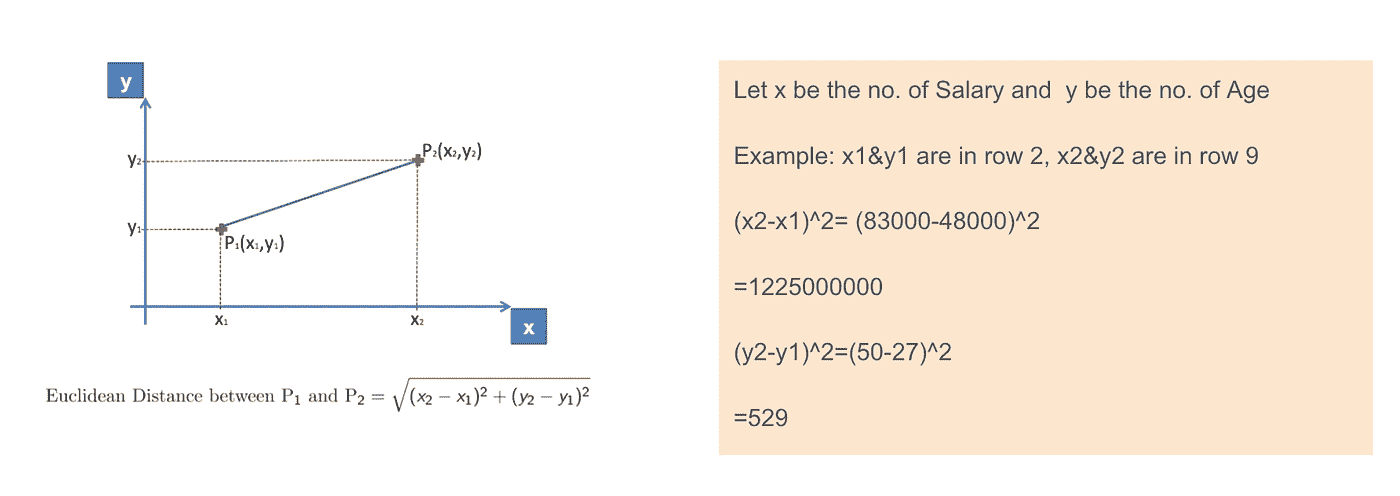

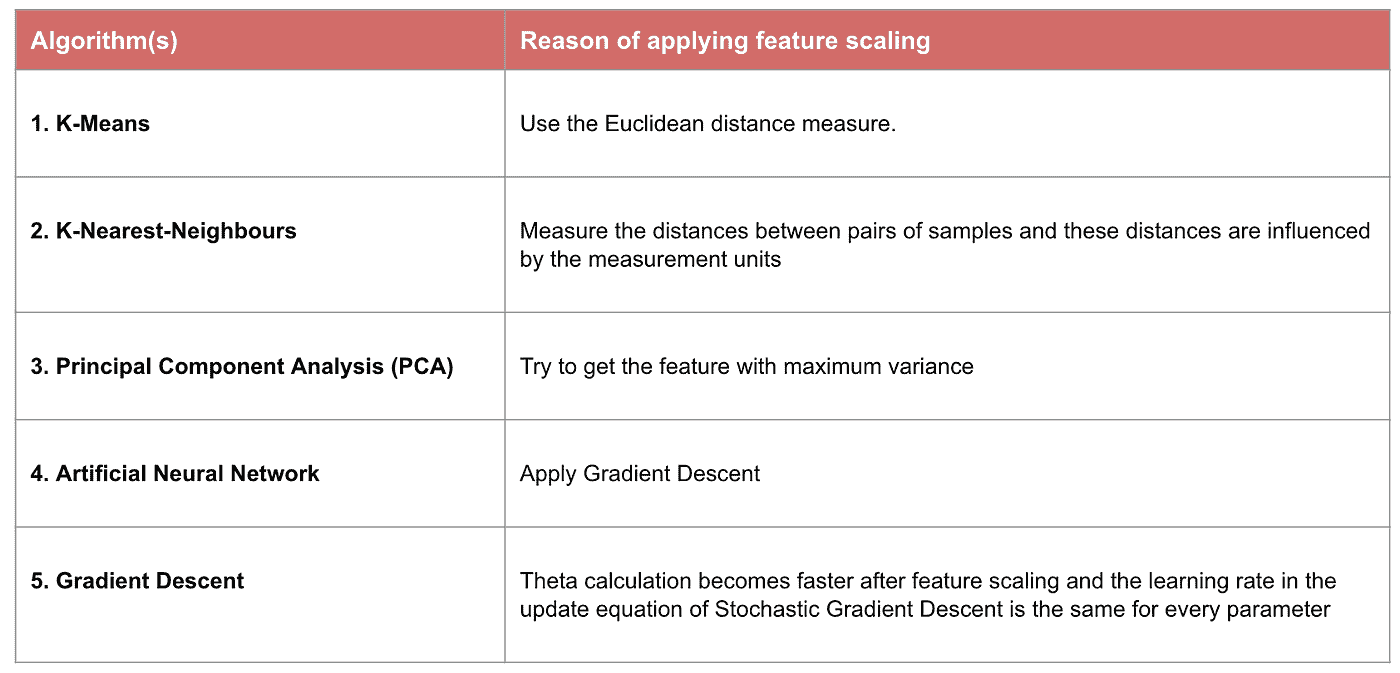

这是一个包含一个自变量(Purchased)和 3 个因变量(Country、Age 和 Salary)的数据集。我们可以很容易地发现这些变量的尺度不同,因为Age的范围从 27 到 50,而Salary的范围从 48 K 到 83 K。Salary的范围远大于Age的范围。这会导致我们模型中的一些问题,因为许多机器学习模型,如 k-means 聚类和最近邻分类,是基于欧几里得距离的。

关注年龄和薪资

当我们计算欧几里得距离的公式时,(x2-x1)²的数量远大于(y2-y1)²的数量,这意味着如果不进行特征缩放,欧几里得距离将主要由薪资决定。年龄的差异对整体差异的贡献较小。因此,我们应该使用特征缩放将所有值调整到相同的量级,从而解决这个问题。为此,主要有两种方法:标准化和归一化。

欧几里得距离的应用。

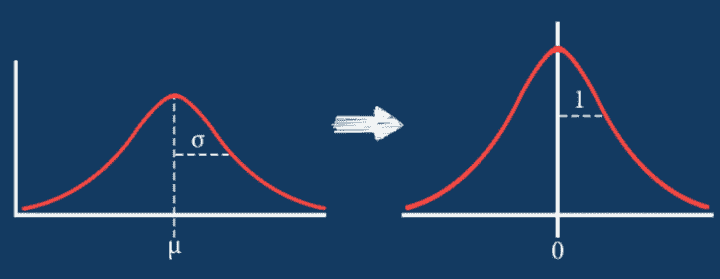

标准化

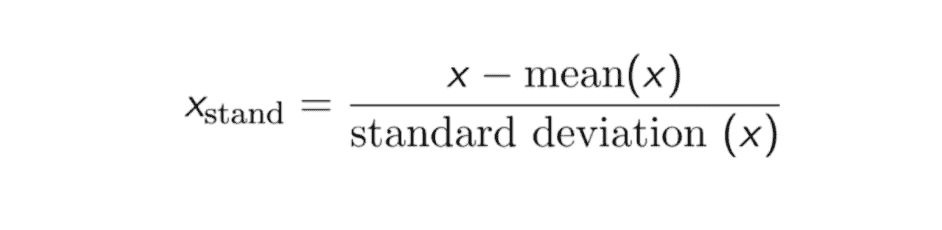

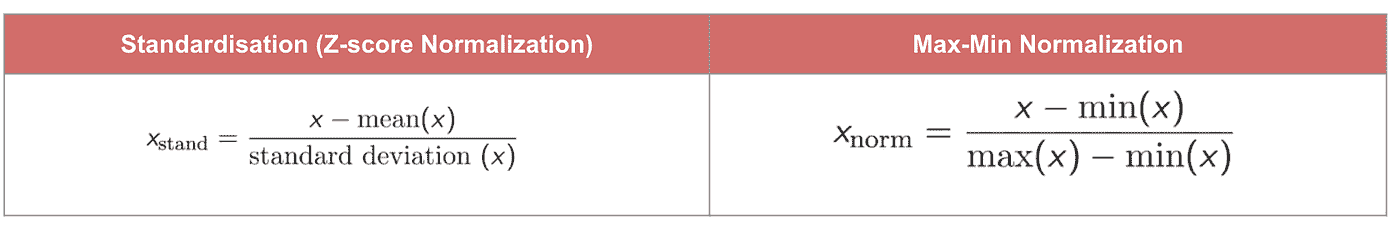

标准化(或Z-score 归一化)的结果是特征将被重新缩放,以确保均值和标准差分别为 0 和 1。公式如下所示:

该技术是将特征值重新缩放到 0 和 1 之间,这对于优化算法(如梯度下降)非常有用,这些算法在机器学习中用于加权输入(例如回归和神经网络)。重新缩放也用于使用距离测量的算法,例如 K-最近邻(KNN)。

#Import library

from sklearn.preprocessing import StandardScaler

sc_X = StandardScaler()

sc_X = sc_X.fit_transform(df)

#Convert to table format - StandardScaler

sc_X = pd.DataFrame(data=sc_X, columns=["Age", "Salary","Purchased","Country_France","Country_Germany", "Country_spain"])

sc_X

最大-最小归一化

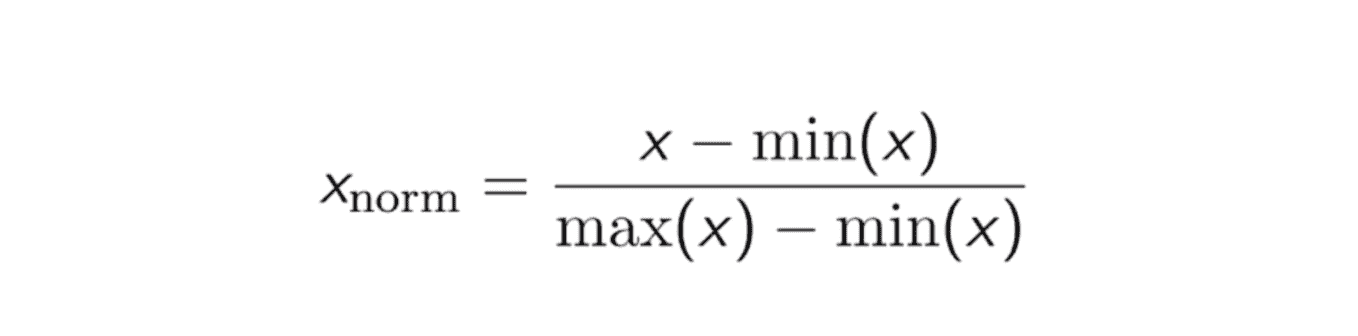

另一种常见的方法是所谓的最大-最小归一化(Min-Max scaling)。该技术将特征重新缩放到 0 和 1 之间。对于每个特征,该特征的最小值被转换为 0,最大值被转换为 1。一般公式如下所示:

最大-最小归一化的公式

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

scaler.fit(df)

scaled_features = scaler.transform(df)

#Convert to table format - MinMaxScaler

df_MinMax = pd.DataFrame(data=scaled_features, columns=["Age", "Salary","Purchased","Country_France","Country_Germany", "Country_spain"])

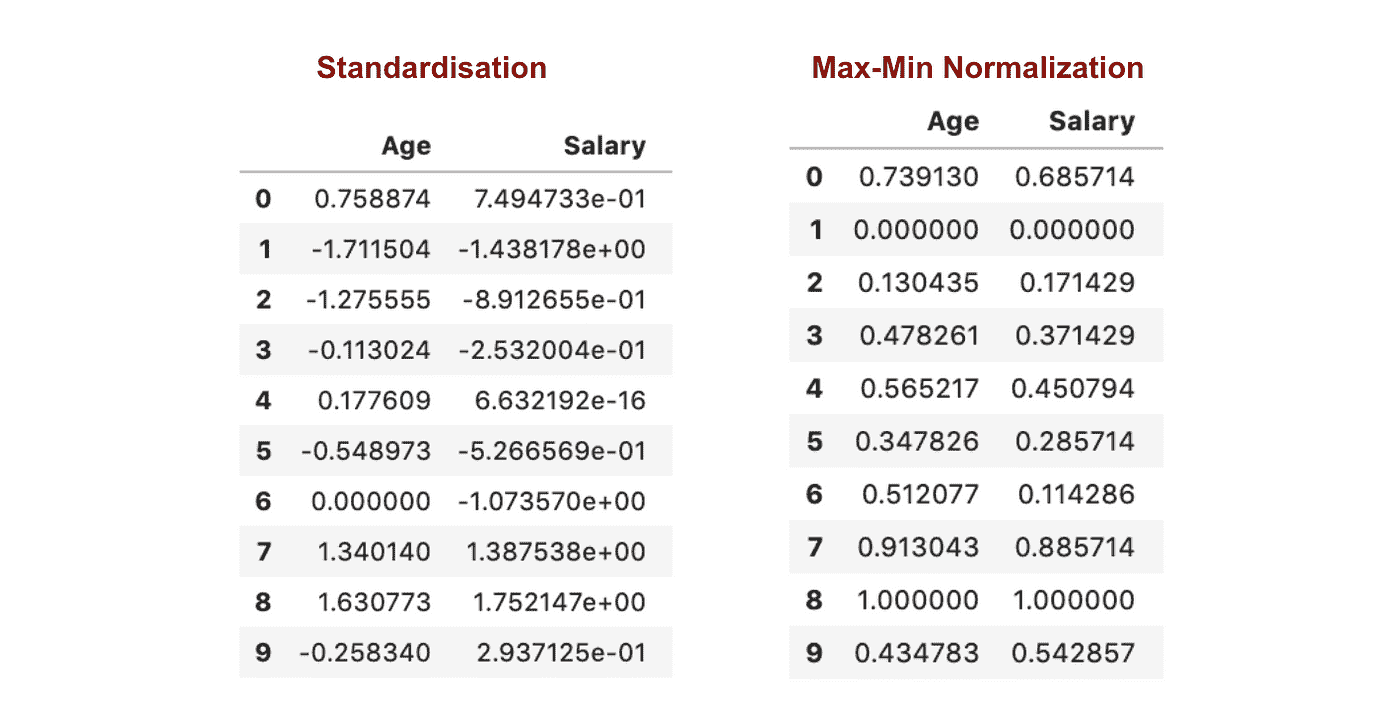

标准化与最大-最小归一化

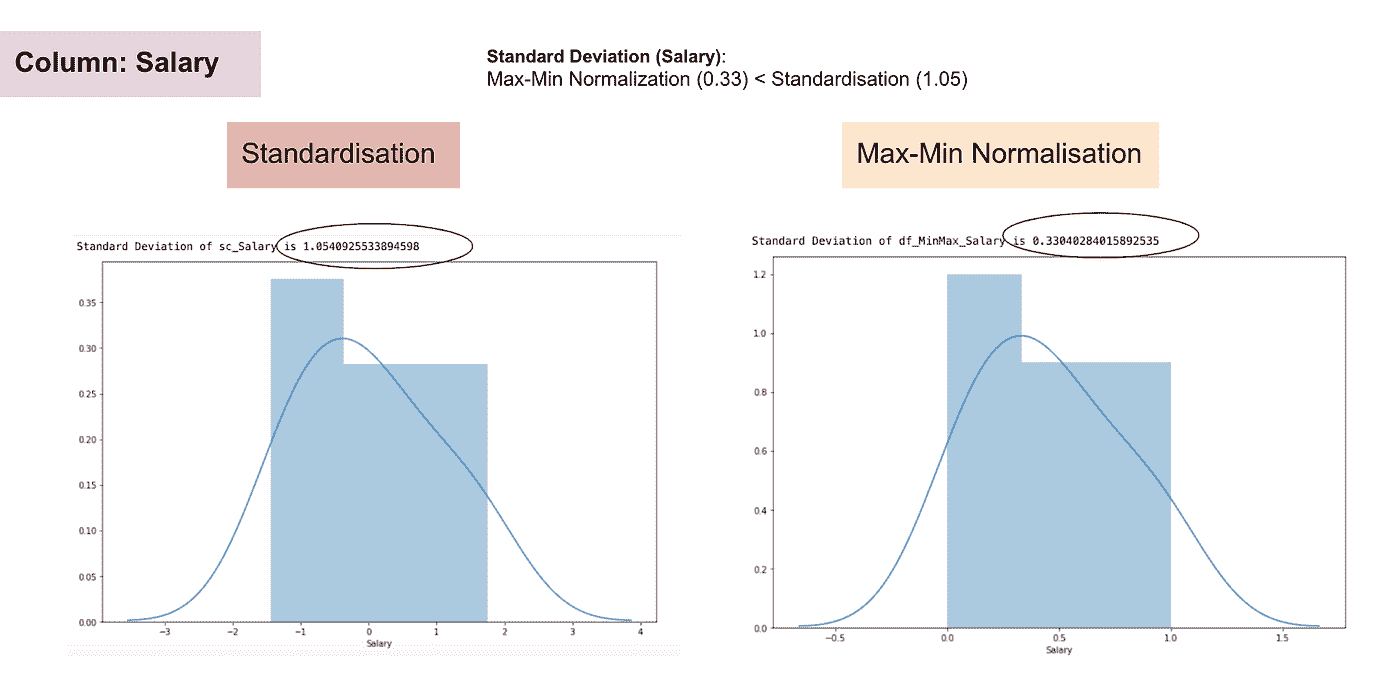

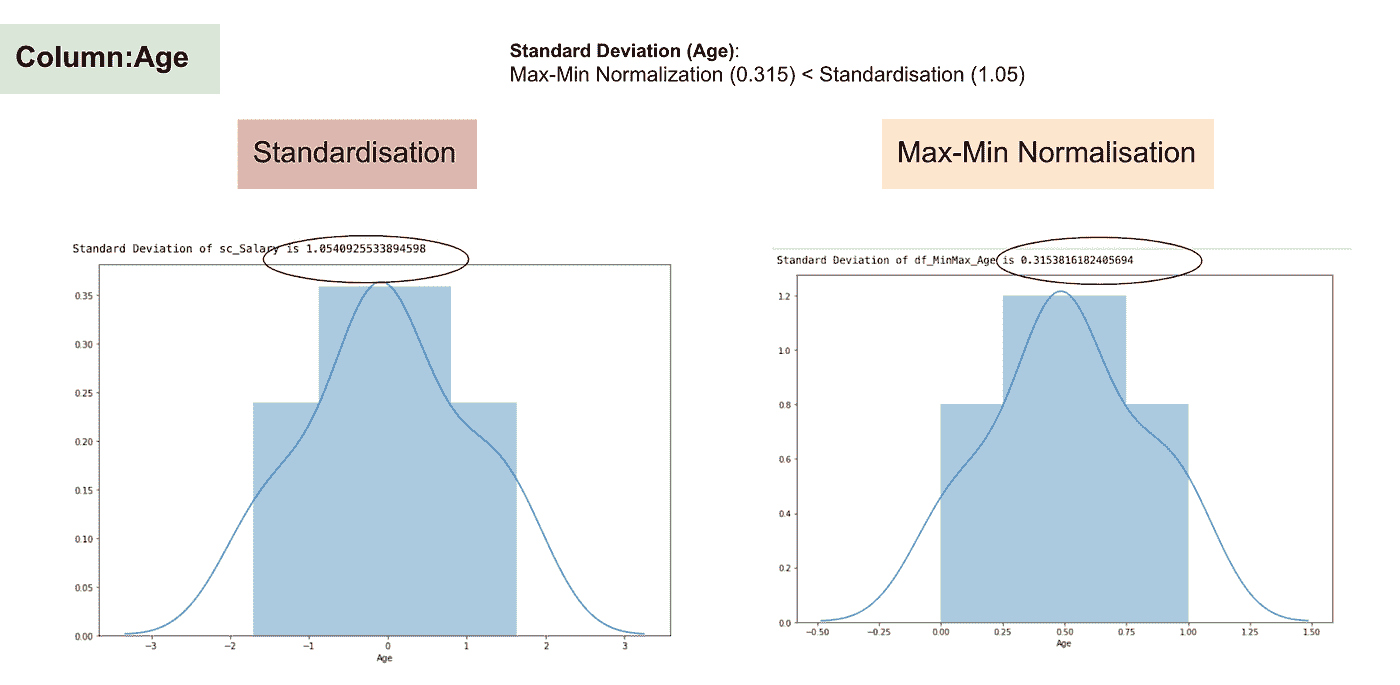

与标准化相比,通过最大-最小归一化过程我们会获得较小的标准差。让我利用上面的数据集更详细地说明这一点。

特征缩放后

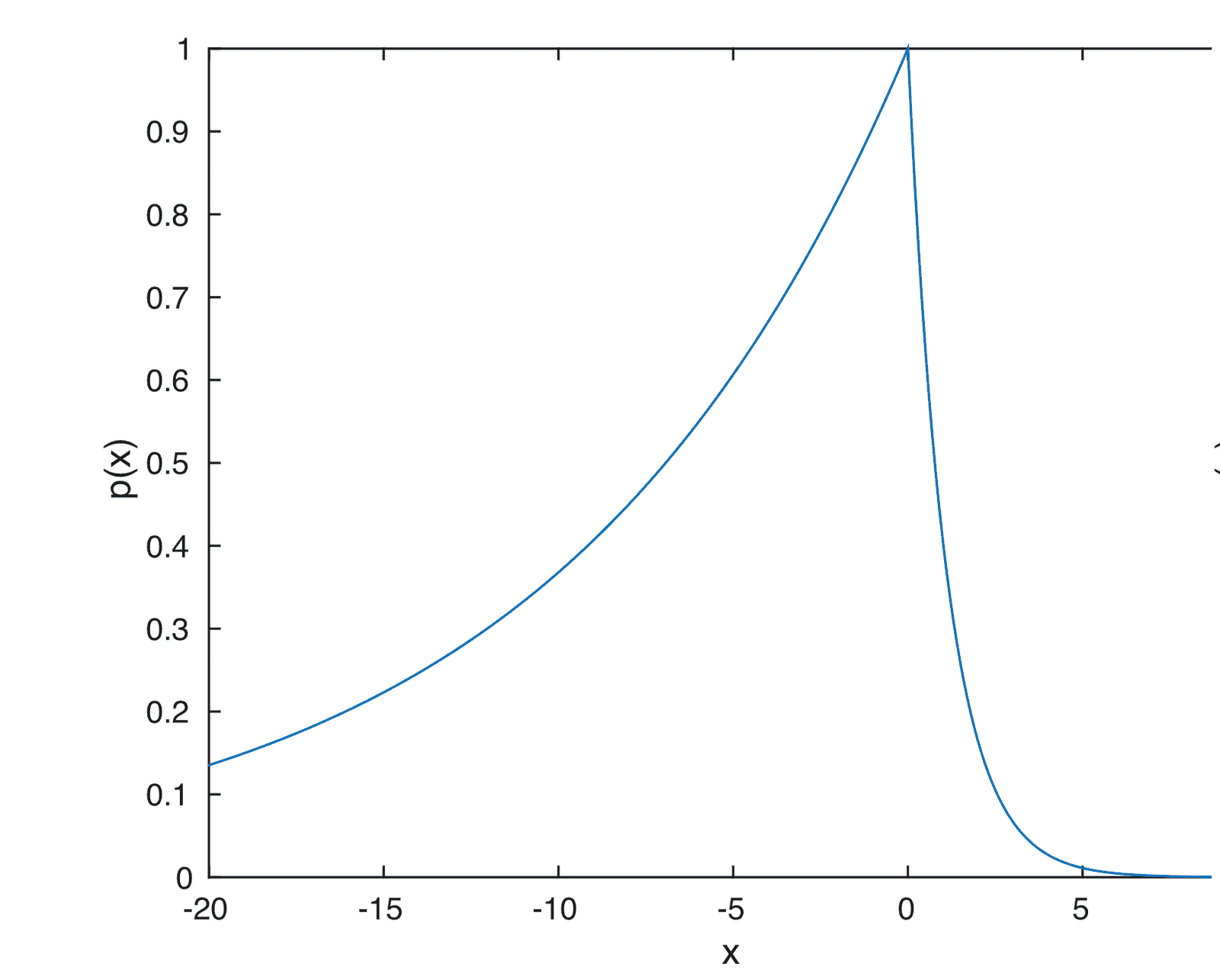

薪资的正态分布和标准差

年龄的正态分布和标准差

从上述图表中,我们可以明显看到,在数据集中应用最大-最小归一化生成的标准差(薪资和年龄)小于使用标准化方法。这表明如果使用最大-最小归一化缩放数据,数据将更集中在均值附近。

因此,如果你的特征(列)中有异常值,归一化你的数据将把大部分数据缩放到一个小区间,这意味着所有特征将具有相同的尺度,但对异常值的处理不好。标准化对异常值更为稳健,在许多情况下,它优于 Max-Min 归一化。

特征缩放的重要性

一些机器学习模型基本上是基于距离矩阵的,也称为基于距离的分类器,例如 K 最近邻、SVM 和神经网络。特征缩放对这些模型至关重要,特别是当特征的范围差异很大时。否则,范围较大的特征在计算距离时将有较大影响。

Max-Min 归一化通常允许我们对具有不同尺度的数据进行转换,以使得没有特定维度主导统计数据,并且不需要对数据的分布做出非常强的假设,例如 k 最近邻和人工神经网络。然而,归一化 对异常值的处理并不好。相反,标准化允许用户更好地处理异常值,并且有助于某些计算算法(如梯度下降)的收敛。因此,我们通常更倾向于使用标准化而不是 Min-Max 归一化。

示例:哪些算法需要特征缩放

注意:如果一个算法不是基于距离的,则特征缩放不重要,包括朴素贝叶斯、线性判别分析和基于树的模型(梯度提升、随机森林等)。

总结:现在你应该知道

-

使用特征缩放的目的

-

标准化和归一化之间的区别

-

需要应用标准化或归一化的算法

-

在 Python 中应用特征缩放

请在此处找到代码和数据集这里。

原文。经许可转载。

Clare Liu 是一名在香港金融科技(银行)行业工作的数据科学家。热衷于解决数据科学和机器学习中的谜团。加入我,开始自学之旅吧。

更多相关内容

数据之信:数据中心的人工智能

原文:

www.kdnuggets.com/2022/10/data-trust-data-centric-ai.html

图片由作者提供

在 2012 年,作者比约恩·布洛辛(Björn Bloching)、拉尔斯·卢克(Lars Luck)和托马斯·拉姆格(Thomas Ramge)出版了《数据之信》(In Data We Trust):《客户数据如何革新我们的经济》。这本书详细讲述了许多公司如何将所有需要的信息掌握在手中。公司不再需要根据直觉和市场做出决策,而是可以使用数据流来更好地理解未来的趋势以及下一步的行动方案。

随着数据特别是人工智能领域的不断增长,越来越多的人持怀疑态度。一些人可能会说,数据的使用和自主功能改善了我们的日常生活,而另一些人则对他们的数据如何被使用以及人工智能的发展如何对人类产生严重影响感到担忧。

尽管人工智能已经证明能够产生一些令人印象深刻的结果,但它也曾失败过——甚至包括谷歌和亚马逊这样的巨头。例如,在 2019 年,亚马逊的 Rekognition 软件在由马萨诸塞州 ACLU 进行的面部识别测试中错误地将 27 名职业运动员与超级碗冠军的通缉照片匹配。

这些失败可能对人工智能的持续发展产生重大影响。人们自然会失去信任并希望远离它。失败并非来自人工智能本身,而是来自于输入和使用在这些模型中生成虚假输出的数据。

这就是我们需要信任数据并实施数据中心人工智能的地方。

什么是数据中心的人工智能?

如果你曾经在科技行业或从事机器学习模型工作,你会看到人们专注于软件、模型等的构建。然而,如果正确的输入产生了错误的输出,这可能会导致软件的失败。

例如,花费数年时间试图打造一辆外观美观、引擎强劲且配备所有新技术的汽车,如果你现在的燃料质量差到连车都启动不了,更别提到达目的地了,那有什么意义呢?

对吧?垃圾进,垃圾出。

人工智能也是一样。如果花费数小时构建一个模型,但一旦将数据输入其中,它就会产生错误,那有什么意义呢?

数据中心的人工智能(Data-Centric AI)是一个专注于数据的系统,而非代码。我并不是说它不使用代码,当然,它是使用的。它系统性地工程化用于构建人工智能系统的数据,并将这些数据与代码中的有价值元素相结合。

我们需要什么类型的数据?

为了使人工智能模型值得信赖并产生准确的输出,它需要干净和多样的数据。没有这两个数据元素,你可能无法在未来做出准确的决策。质量 > 数量。

如果你的数据不够干净或多样,它自然会降低性能并产生输出错误。不干净或不多样的数据会使模型感到困惑,因为它需要额外 10 倍的努力来理解数据。那么,我们可以使用什么工具来确保我们拥有干净、多样的数据呢?

数据标注

标注数据是将不干净的数据转变为干净数据的重要环节,为此你可以使用数据标注工具。标注工具可以快速注释图像和其他形式的数据,例如用于文档分类的命名实体识别(NER)。

数据标注工具帮助数据科学家、工程师和其他数据专家提高模型的整体准确性和性能。

标签工具可以且建议与下述本体论相关联使用。

本体论

拥有本体论。本体论是对信息系统中符号意义的规范说明。它是一个定义的虚拟目录,充当你的字典。本体论在数据标注过程中像一个参考点或丰富的资源库。

人类在环

如上所述,将人类引入你的过程可以帮助你获得干净的数据。人工智能整体上是在试图将人类智能模拟到计算机中,那么,什么比实际引入人类到这个过程中更好的方法来改善这个过程呢?

人类在环利用人类专业知识来训练良好的人工智能,通过让他们参与系统的构建、微调和模型测试。这将有助于确保数据标注工具有效工作,输出的准确性得到提升,并且整体决策更好。

数据质量管理

这是否是额外的费用?是的。它会在长远中对你有帮助吗?当然。如果你要做某件事,最好第一次就做好,而不是需要重复几次才能做对。虽然你可能一开始会把它视为额外的费用,但随着时间的推移,质量管理可以为你节省大量的时间和金钱。

通过数据质量管理,你将能够识别数据中的错误,并在过程早期解决这些问题,避免造成过多的损害。

数据增强

数据增强是一组技术,用于通过从现有数据生成新数据点来人工增加可用数据量。这是通过对现有数据点进行小的修改来创建新的数据点。

通过在现有数据中创建这些变化并生成新的数据点,模型变得更加稳健,能够学会做出符合现实世界的预测。数据点越多,数据越多样化——模型就能学会提升其整体准确性和性能。

结论

上述所有工具都能帮助我们应对当前世界在人工智能方面面临的挑战。这是一场范式转变,公司们每天都在加入这个行列。技术专家知道如何构建模型和人工智能能做什么,但现在的重点是如何改进它,我们已经理解这基于我们使用的数据。

尼莎·阿亚 是一名数据科学家和自由技术作家。她特别关注提供数据科学职业建议或教程及理论知识。她还希望探索人工智能如何有益于人类寿命的不同方式。作为一个热衷学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关内容

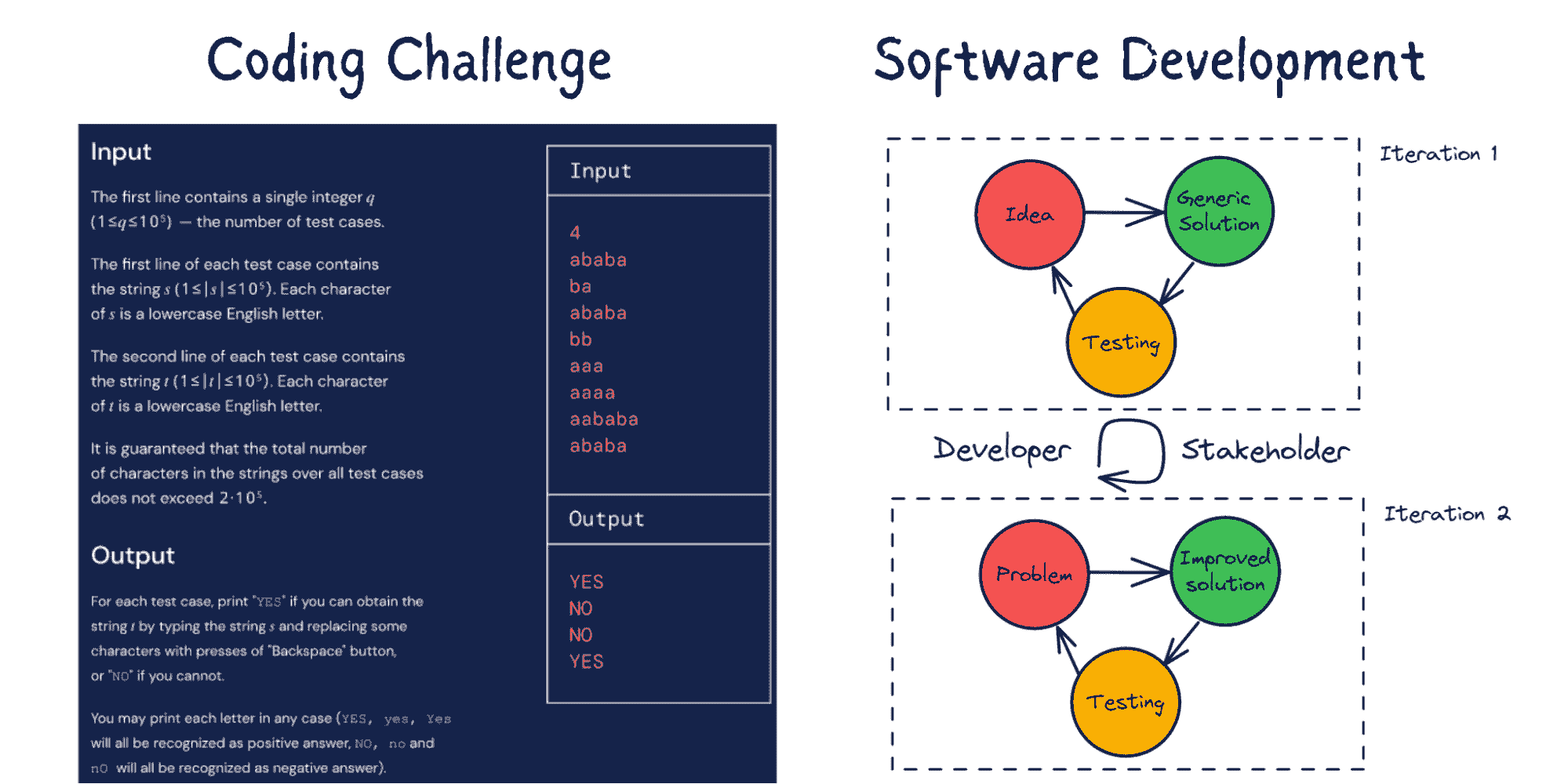

数据验证和数据核查 – 从词典到机器学习

原文:

www.kdnuggets.com/2021/03/data-validation-data-verification-dictionary-machine-learning.html

评论

由 Aditya Aggarwal,高级分析实践负责人,和 Arnab Bose,首席科学官,Abzooba

通常,当我们谈论数据质量时,我们会将数据验证和数据验证互换使用。然而,这两个术语是不同的。本文将从 4 个不同的背景理解它们的区别:

-

验证和验证的词典含义

-

一般来说,数据验证和数据验证之间的区别

-

从软件开发的角度来看,验证与验证的区别

-

从机器学习的角度来看,数据验证和数据核查之间的区别

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

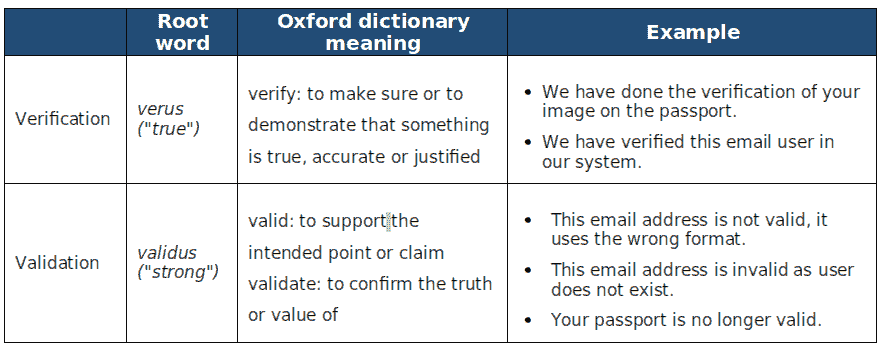

1. 验证和验证的词典含义

表 1 解释了验证和验证这两个词的词典含义以及一些例子。

表 1:验证和验证的词典含义

总结来说,验证关注的是真实性和准确性,而验证关注的是支持观点的强度或主张的正确性。验证检查方法的正确性,而验证检查结果的准确性。

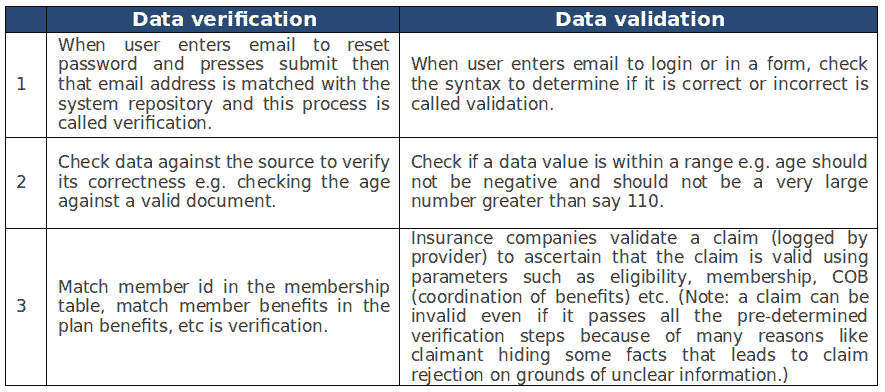

2. 数据验证和数据核查的一般区别

现在我们理解了这两个词的字面意思,让我们深入探讨“数据验证”和“数据核查”之间的区别。

-

数据验证:确保数据的准确性。

-

数据验证:确保数据的正确性。

让我们通过表 2 中的例子来详细说明。

表 2:“数据验证”和“数据验证”的例子

3. 从软件开发的角度来看验证与验证的区别

从软件开发的角度来看,

-

验证是为了确保软件质量高、工程设计良好、健壮且无错误,而不涉及其可用性。

-

验证是为了确保软件的可用性和满足客户需求的能力。

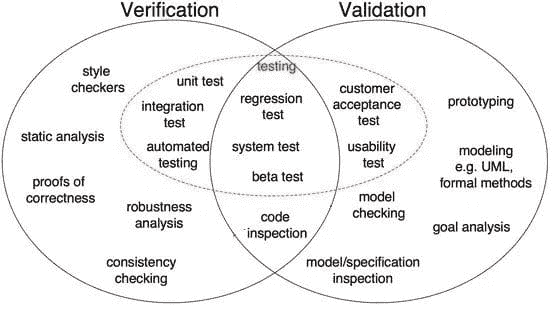

图 1:软件开发中验证与验证的区别 (来源)

如图 1 所示,正确性证明、鲁棒性分析、单元测试、集成测试等都是验证步骤,这些任务旨在验证具体的内容。软件输出会与期望的输出进行核对。另一方面,模型检查、黑箱测试、可用性测试等都是验证步骤,这些任务旨在了解软件是否满足需求和期望。

4. 从机器学习角度看数据验证与数据验证的区别

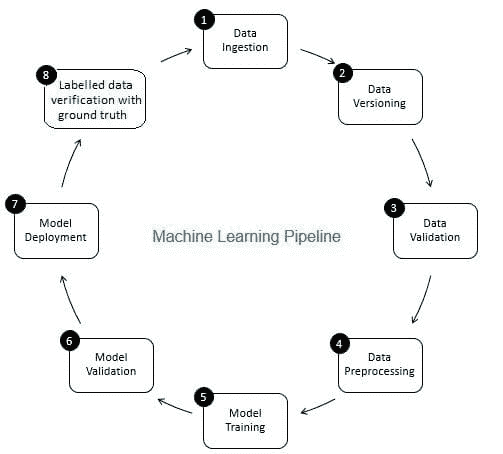

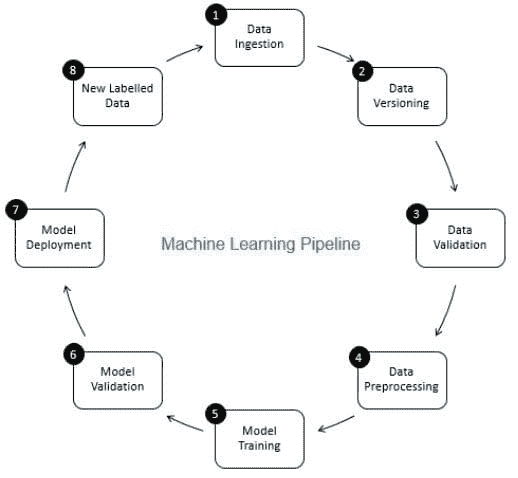

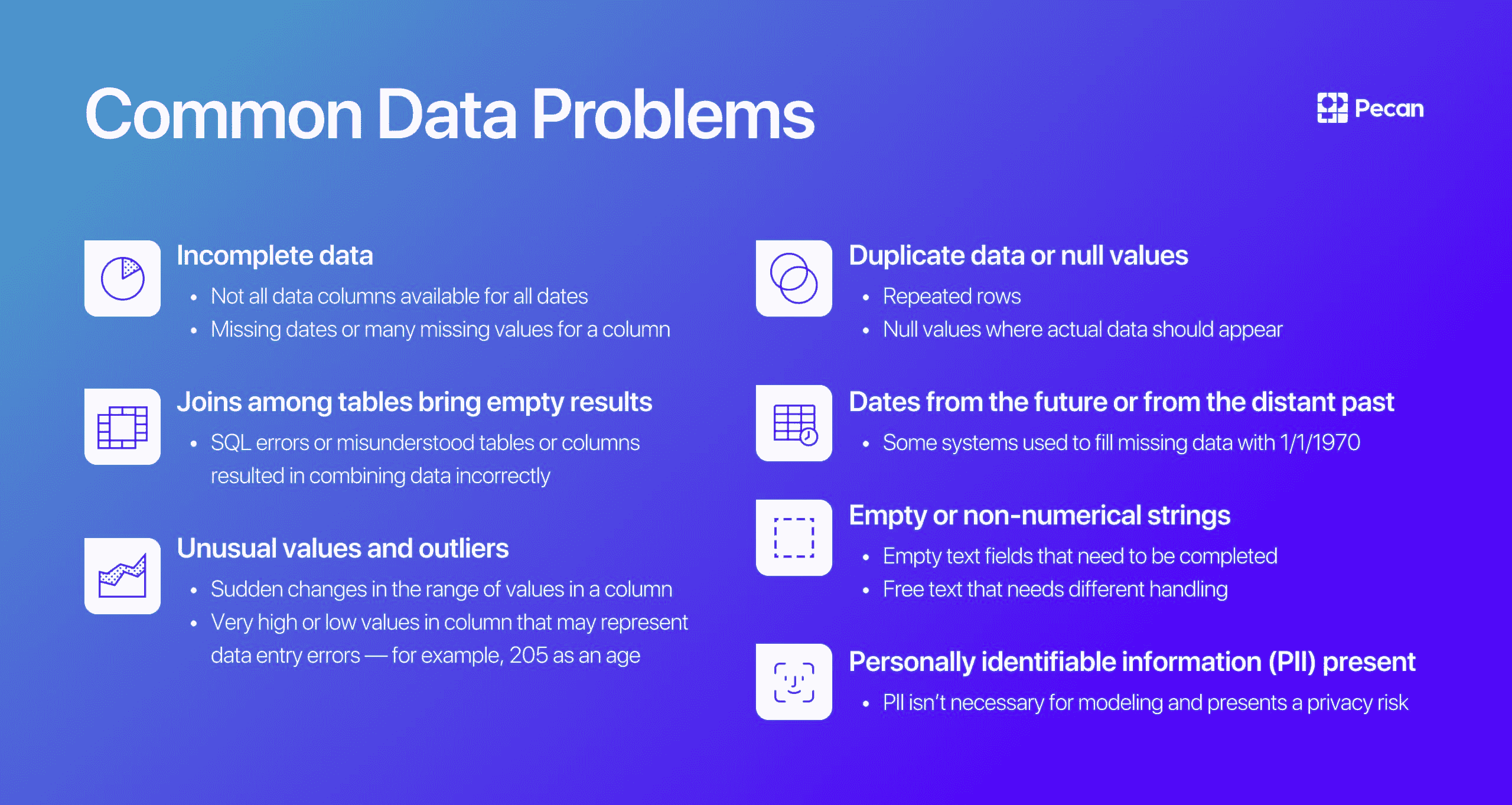

数据验证在机器学习流程中的角色是作为守门员。它确保数据的准确性和及时更新。数据验证主要在新数据获取阶段进行,即在机器学习流程的第 8 步,如图 2 所示。该步骤的示例包括识别重复记录并进行去重,以及清理客户信息中的不匹配,如地址或电话号码。

另一方面,数据验证(在机器学习流程的第 3 步)确保从第 8 步添加到学习数据中的增量数据质量良好,并且(从统计属性角度看)与现有的训练数据类似。例如,这包括发现数据异常或检测现有训练数据与新数据之间的差异。否则,增量数据中的任何数据质量问题/统计差异可能被忽视,从而导致训练错误可能随着时间的推移积累,并降低模型准确性。因此,数据验证在早期阶段检测增量训练数据中的显著变化(如有),有助于根本原因分析。

图 2:机器学习流程的组成部分

Aditya Aggarwal 在 Abzooba Inc. 担任数据科学实践主管。Aditya 拥有超过 12 年的经验,通过数据驱动的解决方案推动业务目标,专注于预测分析、机器学习、商业智能及业务策略,涉及多个行业。

阿尔纳布·博斯博士 是数据分析公司 Abzooba 的首席科学官,并且是芝加哥大学的兼职教师,教授机器学习与预测分析、机器学习运维、时间序列分析与预测、以及健康分析等课程。他是一位拥有 20 年预测分析行业经验的专家,喜欢利用非结构化和结构化数据来预测并影响医疗保健、零售、金融和运输领域的行为结果。他目前的关注领域包括利用机器学习进行健康风险分层和慢性病管理,以及机器学习模型的生产部署和监控。

相关:

-

MLOps – “为什么需要?”和“它是什么”?

-

我的机器学习模型没有学习。我该怎么办?

-

数据可观测性,第二部分:如何使用 SQL 构建自己的数据质量监控工具

更多相关主题

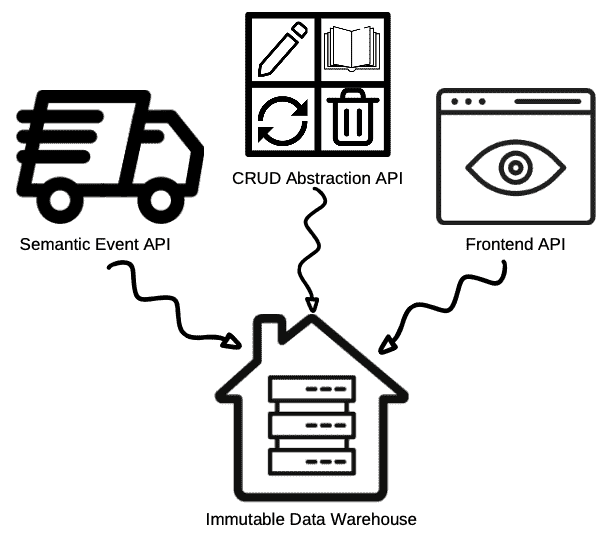

数据验证在机器学习中是至关重要的,而非可选的

原文:

www.kdnuggets.com/2021/05/data-validation-machine-learning-imperative.html

评论

作者:Aditya Aggarwal,数据科学实践负责人 & Arnab Bose,首席科学官,Abzooba

在生产环境中运作一个机器学习(ML)模型需要远比在学术界或研究中创建和验证模型要复杂得多。生产中的 ML 应用程序可以是一个包含多个组件顺序运行的管道,如图 1 所示。在我们达到管道中的模型训练之前,需要执行多个组件,如数据摄取、数据版本控制、数据验证和数据预处理。在这里,我们将讨论数据验证,并将本文安排如下:

-

什么是数据验证?

-

为什么需要数据验证?

-

数据验证面临哪些挑战?

-

数据验证组件是如何工作的?

-

市场上可用的数据验证组件示例。

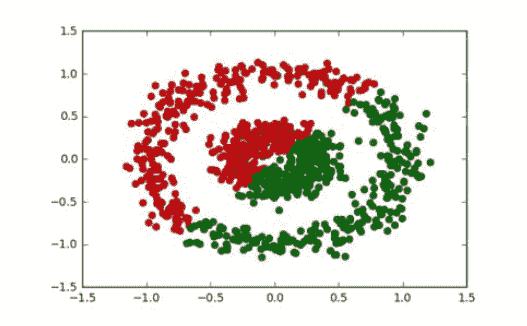

图 1:机器学习流程中的组件

1) 什么是数据验证?

数据验证意味着检查源数据的准确性和质量,在训练新模型版本之前进行。它确保稀有或增量数据中出现的异常不会被默默忽略。 它侧重于检查新数据的统计数据是否符合预期(例如特征分布、类别数量等)。根据目标和约束,可以执行不同类型的验证。机器学习流程中的一些目标示例如下 -

-

增量数据中是否有异常或数据错误?如果有,请向团队发出警报进行调查。

-

在模型训练过程中是否有任何数据假设被违反?如果有,请向团队发出警报进行调查。

-

训练数据和服务数据之间是否有显著差异?或者,是否有连续数据的差异被添加到训练数据中?如果有,请发出警报以调查训练和服务代码堆栈中的差异。

数据验证步骤的输出应该是信息丰富的,以便数据工程师可以对其采取行动。此外,它还需要具有高精度,因为过多的假警报会轻易失去可信度。

2) 为什么需要数据验证?

机器学习模型容易受到数据质量差的影响,正如古老的谚语所说“垃圾进垃圾出”。

在生产环境中,模型会周期性地使用新增的增量数据进行重新训练(频率可高达每日),并将更新的模型推送到服务层。模型在服务时使用新进入的数据进行预测,并且同样的数据会添加实际标签后用于重新训练。这确保了新生成的模型能够适应数据特征的变化。

然而,服务层中新进入的数据可能会发生变化,原因包括引入错误的代码更改或训练和服务堆栈之间的差异。随着时间的推移,错误的摄取数据将成为训练数据的一部分,这将开始降低模型的准确性。由于每次迭代中新添加的数据通常只是总体训练数据的一小部分,因此模型准确性的变化很容易被忽视,错误会随着时间的推移不断增加。

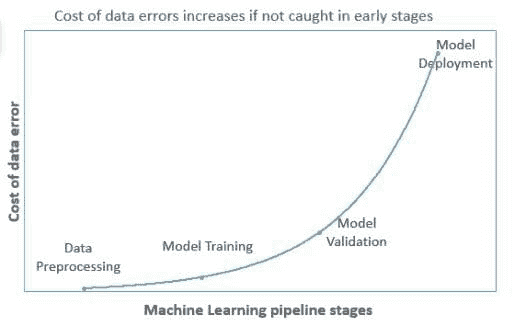

因此,在早期阶段捕捉数据错误非常重要,因为这将减少数据错误的成本,随着错误在管道中进一步传播,成本必然会增加(如图 2 所示)。

图 2:机器学习管道中的数据错误成本

3) 数据验证面临哪些挑战?

数据科学家在开发数据验证组件时面临各种挑战,例如

-

为具有少量列的数据集创建数据验证规则听起来很简单。然而,当数据集中的列数增加时,这将变成一项庞大的任务。

-

追踪和比较历史数据集中的指标以找出每列的历史趋势中的异常需要数据科学家花费大量时间。

-

现在的应用程序预计会全天候运行,在这种情况下,数据验证需要自动化。数据验证组件应该足够智能,能够刷新验证规则。

4) 数据验证组件如何工作?

把数据验证组件想象成 ML 应用程序的一个哨岗,阻止低质量数据进入。它会检查每一条即将添加到训练数据中的新数据。如图 3 所示,数据验证框架可以总结为 5 个步骤:

-

根据一组规则计算训练数据的统计信息

-

计算需要验证的摄取数据的统计信息

-

将验证数据的统计信息与训练数据的统计信息进行比较

-

存储验证结果并采取自动化措施,如删除行、限制或调整值

-

发送通知和警报以供审批

图 3:数据验证工作流程(点击放大)

5) 市场上可用的数据验证组件示例

亚马逊研究 [1] 和谷歌研究 [2] 提出了非常相似的数据验证组件构建方法。总体而言,这两种方法遵循了图 2 所示的相同工作流程。我们将在这里讨论这两种方法。

5.1) 亚马逊研究(Deequ)的数据验证单元测试方法

在软件工程中,工程师编写单元测试来测试他们的代码。同样,也应该定义单元测试来测试传入的数据。作者定义了一个框架来定义这个组件,该框架遵循以下原则 -

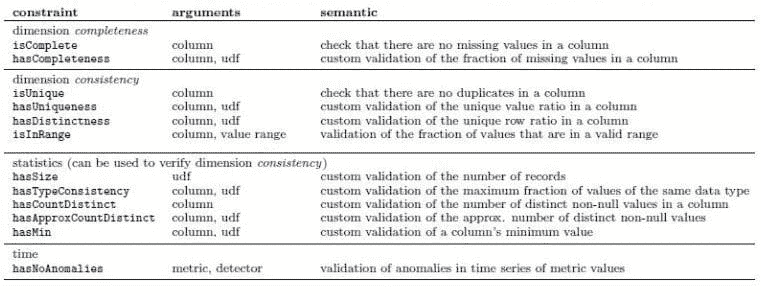

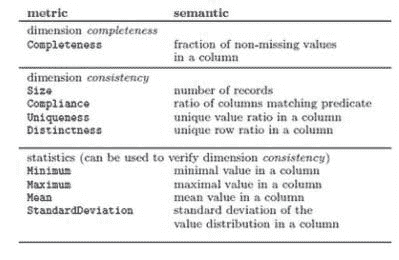

a) 声明约束:用户定义数据应该是什么样的。通过在数据上声明检查,按不同列组合约束来实现。表 1 中显示了约束列表。

b) 计算度量:根据声明的约束,将其转换为可测量的度量,如下表 2 所示。这些度量可以计算并在手头数据和增量数据之间进行比较。

c) 分析和报告: 根据随时间收集的度量,预测增量数据中的度量是否异常。作为规则,如果新度量值比之前的均值多出三倍标准差,用户可以让系统发出“警告”;如果多出四倍标准差,则抛出“错误”。根据分析,报告失败的约束,包括导致约束失败的值(s)。

表 1:用于编排用户定义数据质量检查的约束

表 2:基于约束的可计算度量

表 2:基于约束的可计算度量

5.2) 谷歌研究(Tensorflow 数据验证)的数据模式方法

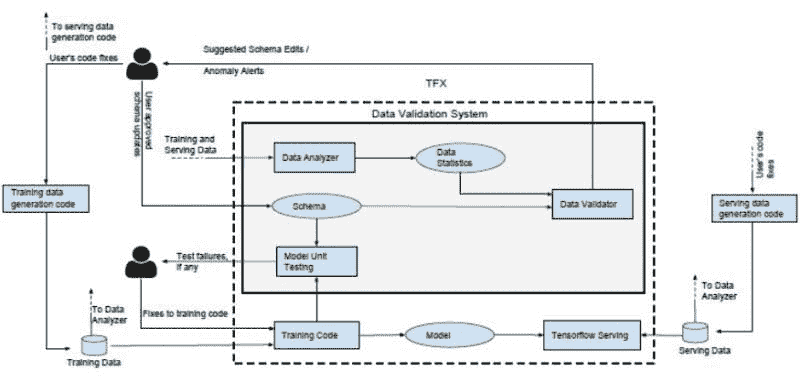

谷歌研究提出了非常相似的技术,但采用了数据管理系统中“经过实战考验”的原则,并将其定制用于机器学习。该技术首先将对正确数据的期望进行编码,然后利用这些期望的统计数据和用户定义的验证模式进行数据验证。 该数据验证框架包含3 个子组件,如图 4 所示。

-

数据分析器 - 计算定义数据所需的一组预定义数据统计信息

-

数据验证器 - 根据通过模式指定的数据属性进行检查。此模式是数据验证器执行的前提。此模式列出了所有特征的基本检查和与机器学习相关的检查的约束。

-

模型单元测试器 - 使用通过模式生成的合成数据检查训练代码中的错误

该框架为用户提供了能力

-

通过检测数据中的异常来验证单批增量数据

-

检测连续增量训练数据批次之间的显著变化。一些异常在检查单个批次时不可见,但在查看连续批次时会显现。

-

查找训练代码中未反映在数据中的假设(例如,如果训练代码中的特征预期应有 log(),则不应有负值或字符串值)。目标是涵盖那些未被添加到模式中的约束。此过程分为两个步骤

-

生成符合模式约束的合成训练示例

-

生成的数据会通过训练代码进行迭代以检查错误

-

图 4: 谷歌研究的机器学习数据验证

亚马逊研究和谷歌研究的方法都为用户提供了建议,比如亚马逊框架中的约束和谷歌框架中更新模式的推荐。这两种方法都将数据视为机器学习管道中的一等公民,并在将数据输入系统之前进行数据验证。然而,仍有一些值得注意的区别。

表格 3: 数据验证库的差异

| Deequ(亚马逊) | Tensorflow 数据验证(谷歌) | |

|---|---|---|

| 1 | 无可用可视化 | 使用谷歌 Facets 提供可视化。总结了每个特征的统计数据,并比较训练数据和验证数据。 |

| 2 | 通过聚合之前保存的训练统计数据和新数据统计数据来重新计算训练统计数据。 | 每次运行时计算整个训练数据的统计数据,除非另有指定。这可能会变得计算开销较大。 |

| 3 | 除了基于阈值或相对/绝对差异进行异常检测,还提供基于运行平均值和标准差的异常检测能力。 | 提供基于阈值或相对/绝对差异的异常检测能力。 |

| 4 | 仅支持 SparkDataFrame 数据。 | 支持 pandas dataframe、csv,且与 TFRecord 配合最佳。 |

参考文献

-

S. Schelter, D. Lange, P. Schmidt, M. Celikel, F. Biessmann 和 A. Grafberger,“大规模数据质量验证的自动化”,发表于 VLDB 基金会,卷 11,第 12 期:1781-1794,2018 年。可用:

www.vldb.org/pvldb/vol11/p1781-schelter.pdf -

E. Breck, M. Zinkevich, N. Polyzotis, S. Whang 和 S. Roy,“机器学习的数据验证”,发表于第二届 SysML 会议,帕洛阿尔托,加州,美国,2019 年。可用:

mlsys.org/Conferences/2019/doc/2019/167.pdf

阿迪提亚·阿格尔瓦尔担任 Abzooba Inc.的数据科学实践负责人。凭借超过 12 年的数据驱动解决方案推动业务目标的经验,阿迪提亚专注于预测分析、机器学习、商业智能和商业战略。他是 Abzooba 的高级分析实践负责人,领导着一个 50 多人的充满活力的数据科学团队,使用机器学习、深度学习、自然语言处理和计算机视觉解决有趣的商业问题。他为客户提供人工智能方面的思想领导,将其商业目标转化为分析问题和数据驱动解决方案。在他的领导下,多个组织实现了任务自动化、降低了运营成本、提高了团队生产力,并改善了收入和利润。他开发了如代位索赔引擎、价格推荐引擎、物联网传感器预测维护等解决方案。阿迪提亚拥有印度技术学院(IIT)德里的技术学士学位和商业管理辅修学位。

阿纳布·博斯博士是 Abzooba 的首席科学官,该公司是一家数据分析公司,并且是芝加哥大学的兼职教员,教授机器学习、预测分析、机器学习操作、时间序列分析与预测以及健康分析等课程。他是一位拥有 20 年预测分析行业经验的专家,喜欢使用结构化和非结构化数据来预测和影响医疗保健、零售、金融和交通领域的行为结果。他目前的研究重点包括使用机器学习进行健康风险分层和慢性病管理,以及机器学习模型的生产部署和监控。阿纳布在许多电气和电子工程师协会(IEEE)会议和期刊上发表了书籍章节和审稿论文。他曾获得美国控制会议最佳演讲奖,并在美国、澳大利亚和印度的大学和公司中发表过关于数据分析的讲座。阿纳布拥有南加州大学的电气工程硕士和博士学位,以及印度技术学院卡拉格普尔分校的电气工程学士学位。

相关:

-

MLOps——“为什么需要它?”和“它是什么”?

-

数据验证和数据核实——从字典到机器学习

-

如何开始使用 SQL 管理数据质量并进行扩展

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 部门

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 部门

更多相关话题

机器学习的数据验证

原文:

www.kdnuggets.com/2020/01/data-validation-machine-learning.html

评论  来源

来源

数据是维持机器学习运行的基本保障。无论机器学习和/或深度学习模型有多强大,如果数据质量差,它永远无法达到预期效果。随机噪声(即使模式难以识别的数据点)、某些类别变量的低频率、目标类别的低频率(如果目标变量是类别型的)和不正确的数值等,都是数据可能干扰模型表现的方式。虽然验证过程无法直接发现问题,但有时可以显示模型的稳定性存在问题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

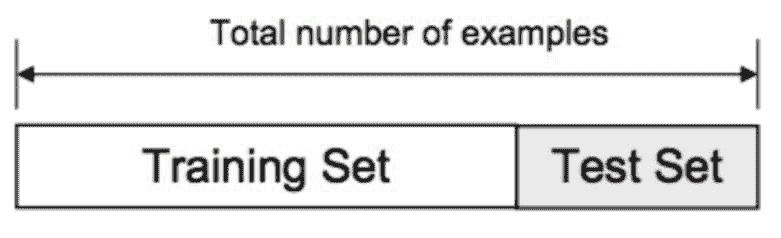

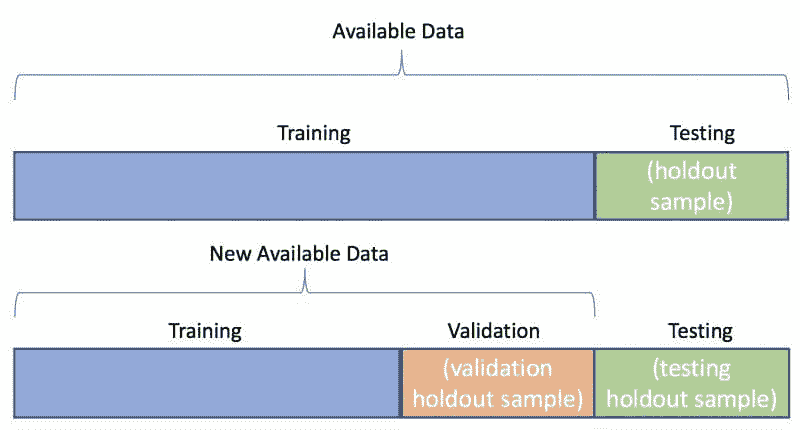

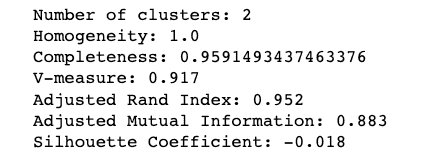

训练/验证/测试分割

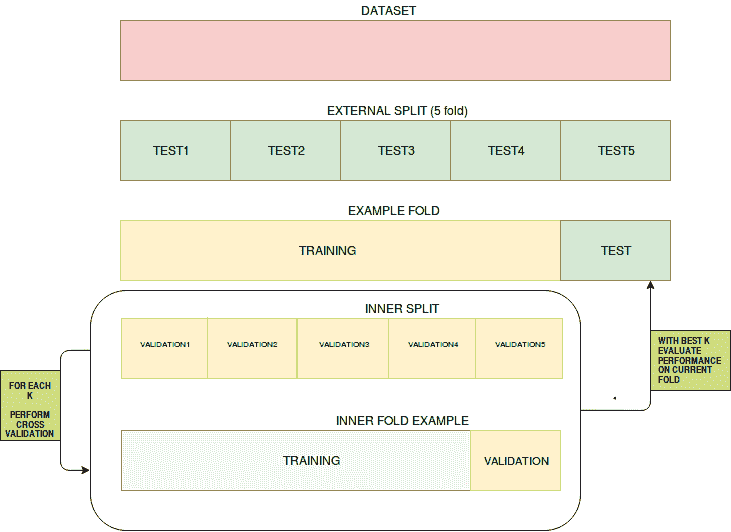

验证数据的最基本方法(即在测试模型之前调整超参数)是对数据进行训练/验证/测试分割。典型的比例可能是 80/10/10,以确保你仍然有足够的训练数据。训练模型后,用户将进入验证结果并通过验证集调整超参数,直到达到满意的性能指标。一旦这一阶段完成,用户将使用测试集对模型进行测试,以预测和评估性能。

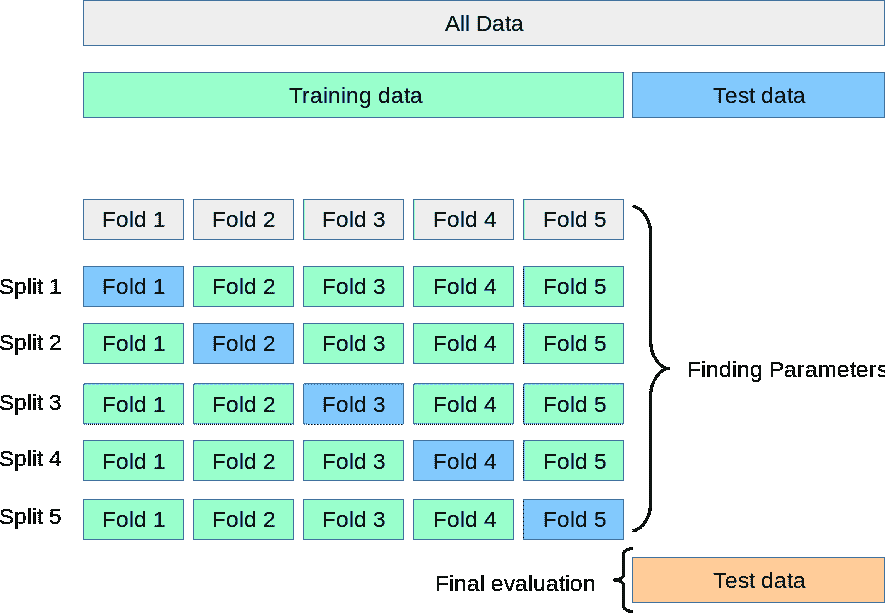

交叉验证

交叉验证是一种评估统计预测模型在独立数据集上表现的技术。其目的是确保模型和数据能够良好配合。交叉验证在训练阶段进行,用户将评估模型是否容易出现欠拟合或过拟合。用于交叉验证的数据必须来自目标变量的相同分布,否则我们可能会对模型在实际中的表现产生误导。

交叉验证有不同的类型,例如:

*** K 折交叉验证**

- 在我们希望尽可能多地保留数据用于训练阶段,而不冒将宝贵数据丢失到验证集的风险时,k 折交叉验证可以提供帮助。这种技术不要求训练数据放弃一部分作为验证集。在这种情况下,数据集被分成k个折叠,其中一个折叠将用作测试集,其余的将用作训练数据集,这个过程会重复n次,具体由用户指定。在回归中,结果的平均值(如 RMSE、R-Squared 等)将作为最终结果。在分类设置中,结果的平均值(即准确率、真正率、F1 等)将作为最终结果。

.

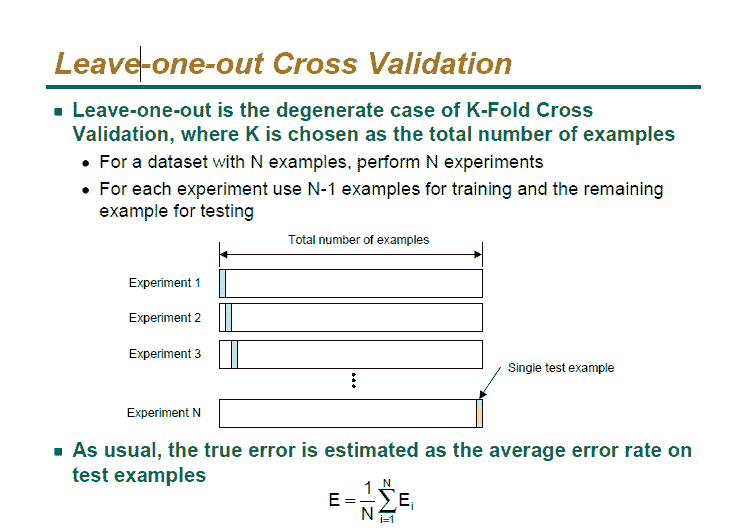

- 留一验证(LOOCV)

- 留一验证与 k 折交叉验证类似。该迭代过程将进行n次,具体次数由用户指定。

数据集将被分为 n-1 个数据集,被移除的数据集将是测试数据。性能的测量方式与 k 折交叉验证相同。

验证数据集让用户对模型的稳定性有信心。随着机器学习渗透社会的各个方面并被应用于我们的日常生活,确保模型能够代表我们的社会变得更加重要。过拟合和欠拟合是数据科学家在模型构建过程中面临的两大常见陷阱。验证是你的模型在性能优化和在长时间内稳定的关键步骤,之后才需要重新训练。

相关

-

常见的机器学习障碍

-

入门机器学习的书籍

-

你应该在数据科学项目中使用交叉验证的 5 个理由

更多关于此主题

使用 Pandera 进行 PySpark 应用的数据验证

原文:

www.kdnuggets.com/2023/08/data-validation-pyspark-applications-pandera.html

照片由 Jakub Skafiriak 提供,来源于 Unsplash

如果你是数据从业者,你会认识到数据验证在确保准确性和一致性方面的重要性。这在处理大型数据集或来自不同来源的数据时尤为关键。然而,Pandera Python 库可以帮助简化和自动化数据验证过程。Pandera 是一个 开源库,精心设计以简化模式和数据验证任务。它在 pandas 的稳健性和多功能性基础上构建,并引入了一个直观且富有表现力的 API,专门用于数据验证目的。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求