KDNuggets-博客中文翻译-十七-

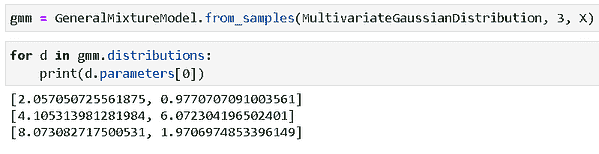

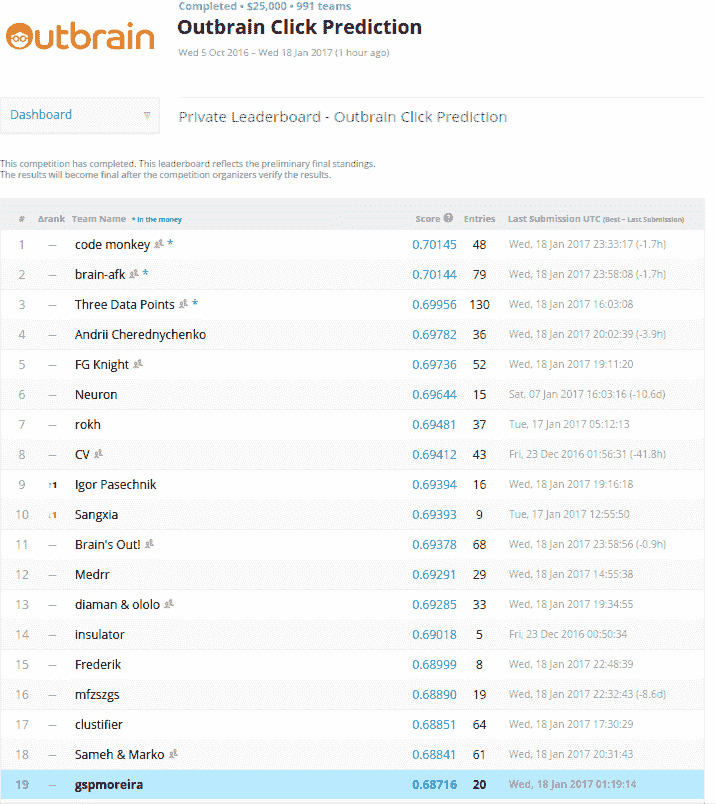

KDNuggets 博客中文翻译(十七)

原文:KDNuggets

解释正态分布的 68-95-99.7 规则

原文:

www.kdnuggets.com/2018/07/explaining-68-95-99-7-rule-normal-distribution.html

评论

评论

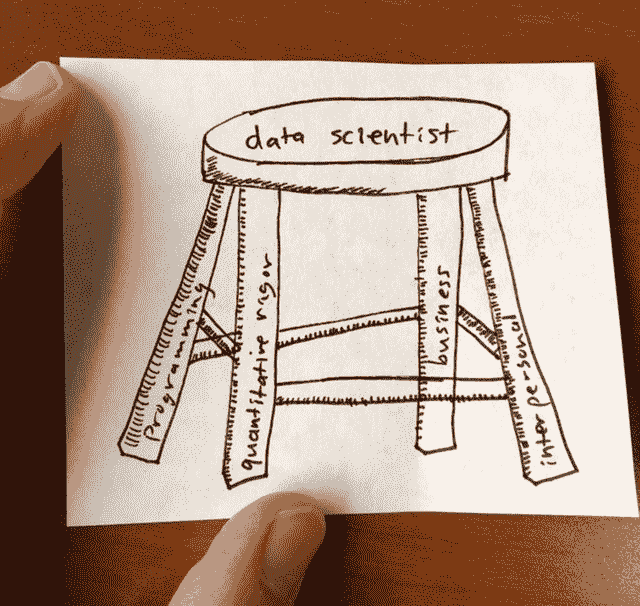

作者 Michael Galarnyk,数据科学家

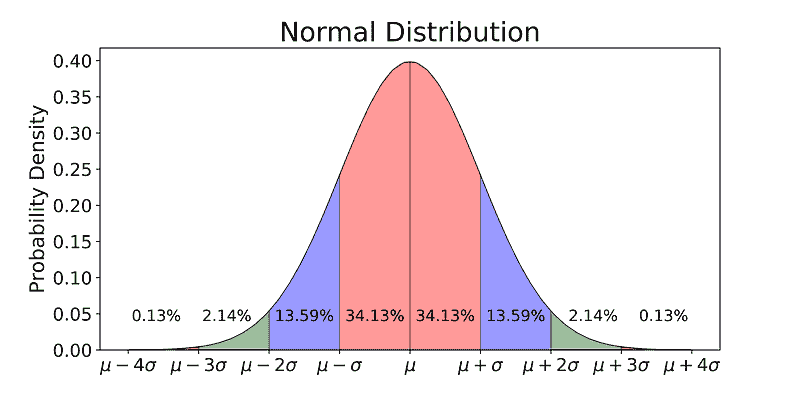

68% 的数据在一标准差内,95% 的数据在两标准差内,99.7% 的数据在三标准差内

我们的前三个课程推荐

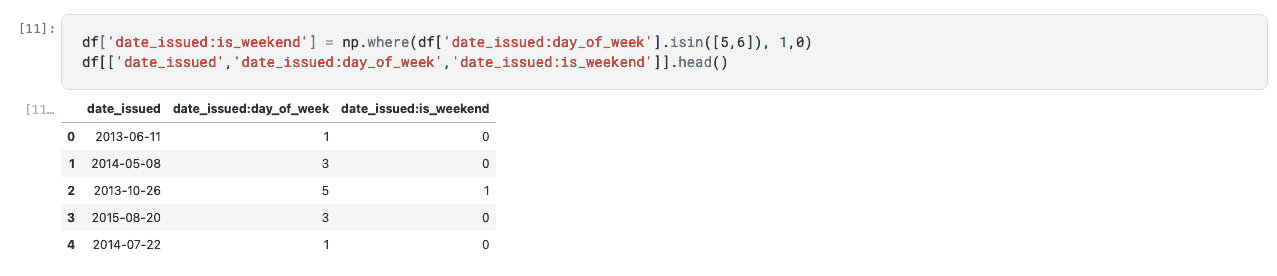

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

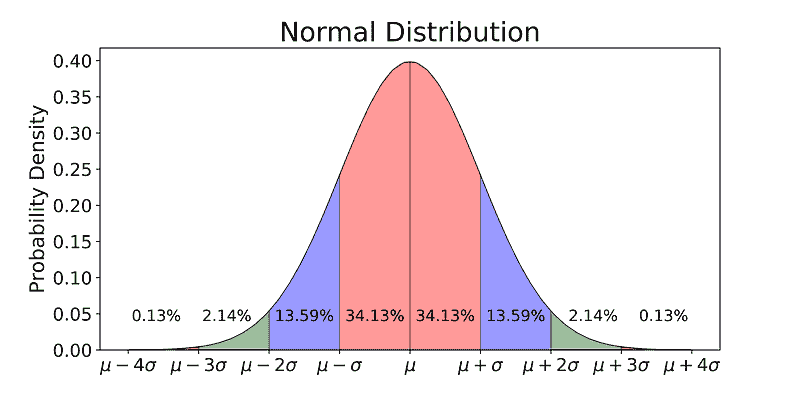

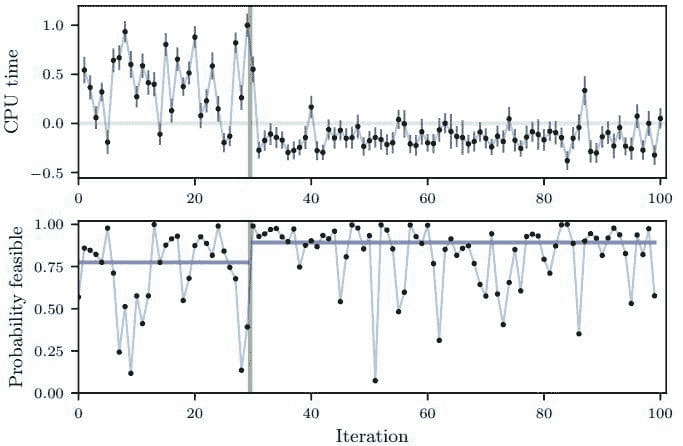

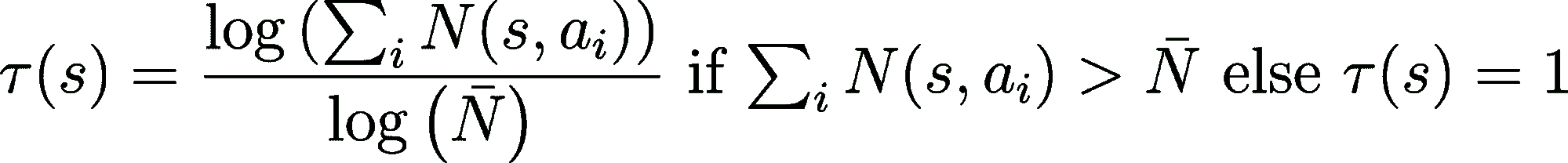

正态分布通常与68-95-99.7 规则相关,如上图所示。68% 的数据在均值(μ)的一标准差(σ)内,95% 的数据在均值(μ)两标准差(σ)内,99.7% 的数据在均值(μ)三标准差(σ)内。

本文解释了这些数字是如何得出的,希望它们能对你未来的工作更具解释性。如常所述,用于推导这些结果(包括图表)的代码可以在我的github上找到。接下来,我们开始吧!

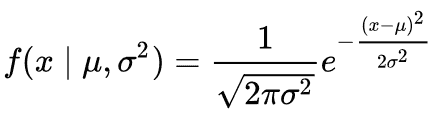

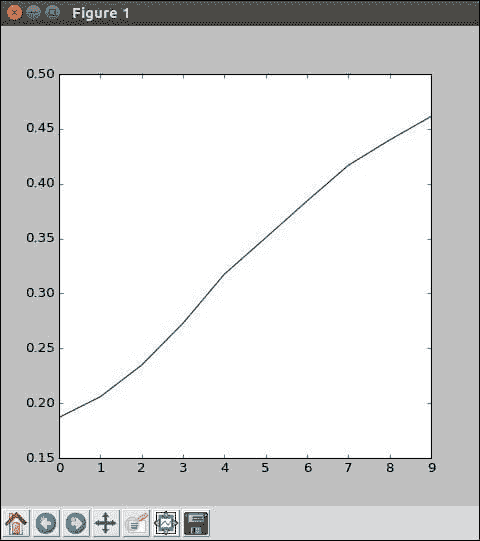

概率密度函数

要理解百分比的来源,了解概率密度函数(PDF)是非常重要的。PDF 用于指定随机变量落在特定值范围内的概率,而不是取某个特定值。这个概率由该变量的 PDF 在该范围内的积分给出——也就是说,它由密度函数下方但在水平轴之上以及范围的最低值和最高值之间的面积给出。这个定义可能不太容易理解,因此让我们通过绘制正态分布的概率密度函数来澄清这一点。下面的方程是正态分布的概率密度函数

正态分布的 PDF

我们通过假设均值(μ)为 0 和标准差(σ)为 1 来简化问题。

正态分布的 PDF

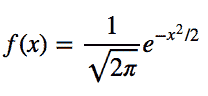

既然函数更简单了,我们来绘制这个范围从-3 到 3 的函数图像。

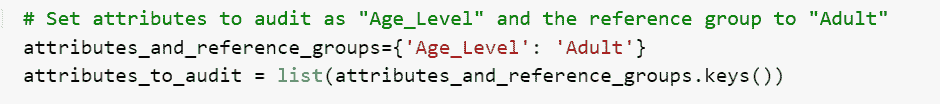

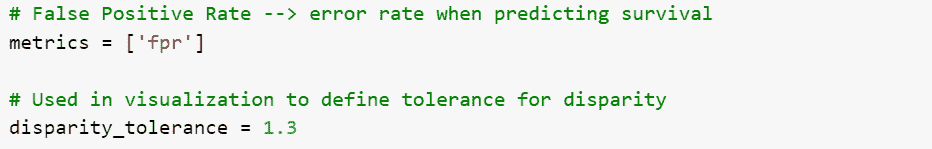

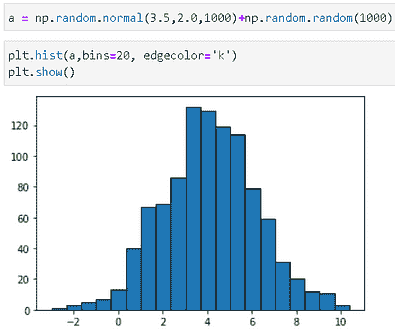

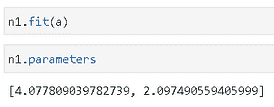

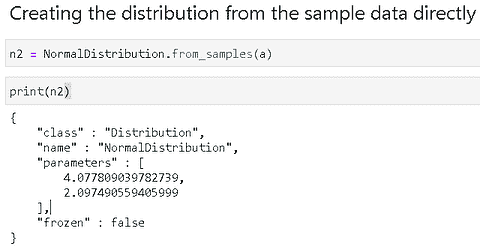

# Import all libraries for the rest of the blog post

from scipy.integrate import quad

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-3, 3, num = 100)

constant = 1.0 / np.sqrt(2*np.pi)

pdf_normal_distribution = constant * np.exp((-x**2) / 2.0)

fig, ax = plt.subplots(figsize=(10, 5));

ax.plot(x, pdf_normal_distribution);

ax.set_ylim(0);

ax.set_title('Normal Distribution', size = 20);

ax.set_ylabel('Probability Density', size = 20);

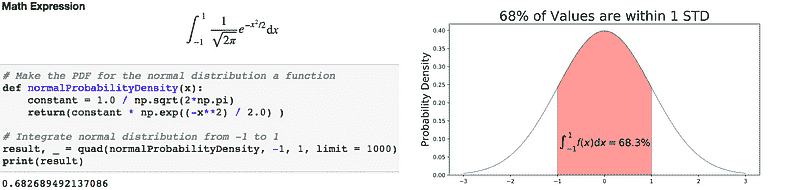

上述图形并未显示事件的概率,而是它们的概率密度。要获取特定范围内事件的概率,我们需要进行积分。假设我们想找到一个随机数据点落在均值 1 个标准差范围内的概率,我们需要从-1 积分到 1。这可以通过 SciPy 完成。

# Make a PDF for the normal distribution a function

def normalProbabilityDensity(x):

constant = 1.0 / np.sqrt(2*np.pi)

return(constant * np.exp((-x**2) / 2.0) )

# Integrate PDF from -1 to 1

result, _ = quad(normalProbabilityDensity, -1, 1, limit = 1000)

print(result)

积分正态分布的 PDF 代码(左)和积分的可视化(右)。

68%的数据落在均值(μ)1 个标准差(σ)以内。

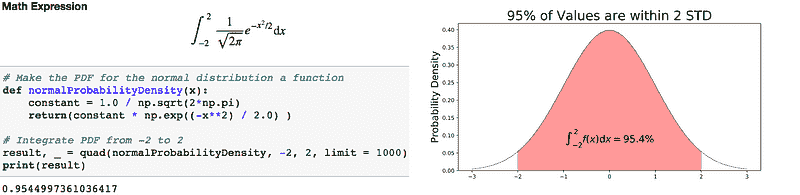

如果你想找到一个随机数据点落在均值的 2 个标准差范围内的概率,你需要从-2 积分到 2。

积分正态分布的 PDF 代码(左)和积分的可视化(右)。

95%的数据落在均值(μ)2 个标准差(σ)以内。

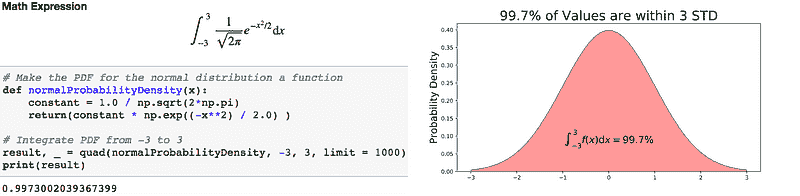

如果你想找到一个随机数据点落在均值的 3 个标准差范围内的概率,你需要从-3 积分到 3。

积分正态分布的 PDF 代码(左)和积分的可视化(右)。

99.7%的数据落在均值(μ)3 个标准差(σ)以内。

需要注意的是,对于任何 PDF,曲线下的面积必须为 1(从函数范围内抽取任何数字的概率总是 1)。

你还会发现,观察值也可能偏离均值 4、5 甚至更多个标准差,但如果你有正态或接近正态分布,这种情况是非常罕见的。

未来的教程将涵盖如何将这些知识应用于箱型图和置信区间,但这将留到以后。如果你对教程有任何问题或想法,可以在下方评论或通过Twitter与我联系。

简历:Michael Galarnyk 是一名数据科学家和企业培训师。他目前在斯克里普斯转化研究所工作。你可以在 Twitter (twitter.com/GalarnykMichael),Medium (medium.com/@GalarnykMichael) 和 GitHub (github.com/mGalarnyk) 找到他。

原文。经许可转载。

相关内容:

-

Jupyter Notebook for Beginners: A Tutorial

-

Why Data Scientists Love Gaussian

-

描述性统计:数据科学的强大矮子

更多相关内容

解释“黑箱”机器学习模型:SHAP 的实际应用

评论

由Norman Niemer,首席数据科学家

动机

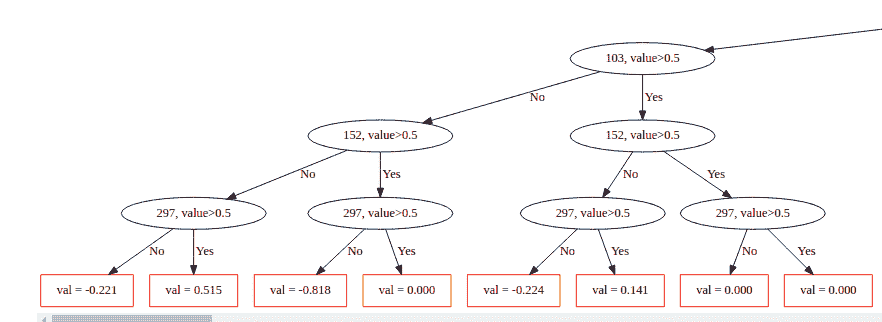

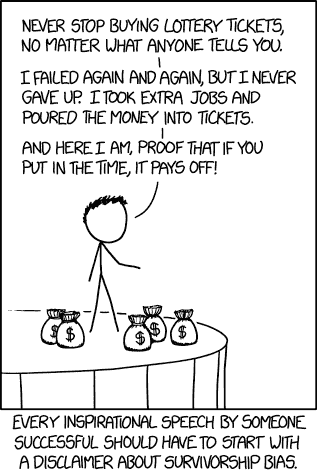

GBM 模型经过实际测试证明是强大的模型,但由于缺乏可解释性而受到影响。通常,数据科学家会查看变量重要性图,但它们不足以解释模型的工作原理。为了最大限度地提高模型用户的接受度,使用 SHAP 值来回答常见的可解释性问题,并建立对模型的信任。

在这篇文章中,我们将对一个简单的数据集训练一个 GBM 模型,并学习如何解释模型的工作原理。这里的目标不是解释数学如何运作,而是向非技术用户解释输入变量如何与输出变量相关,以及如何进行预测。

我们使用的数据集是ISLR提供的广告数据集,你可以在d6t github上获取所用的代码。

设置

# processing

import d6tflow, d6tpipe

import pandas as pd

import numpy as np

import pathlib

# viz

import seaborn as sns

import plotly.express as px

import matplotlib.pyplot as plt

import matplotlib

# modeling

import statsmodels.api as sm

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

from sklearn.inspection import plot_partial_dependence

from sklearn.model_selection import cross_validate

import lightgbm

import shap

首先,构建高效的数据科学工作流程

如在数据科学家常犯的 10 个编码错误中解释的,为了构建一个高效的数据科学工作流程,我们将使用文件管理器d6tpipe和工作流管理器d6tflow。

api = d6tpipe.APIClient()

pipe = d6tpipe.Pipe(api, 'intro-stat-learning')

pipe.pull()

# preprocessing workflow

class TaskProcessRawData(d6tflow.tasks.TaskPqPandas):

def run(self):

df = pd.read_csv(pipe.dirpath/'Advertising.csv', usecols=[1,2,3,4])

self.save(df)

@d6tflow.requires(TaskProcessRawData)

class TaskFeatures(d6tflow.tasks.TaskPqPandas):

def run(self):

df = self.inputLoad()

df['target']=df['sales']

df['radio']=-df['radio'] # force negative relationship

df['tv_radio']=df['TV']*df['radio'] # interaction effect

self.save(df)

print('preprocessing workflow:')

d6tflow.preview([TaskFeatures()])

preprocessing workflow:

└─--[TaskFeatures-{} (COMPLETE)]

└─--[TaskProcessRawData-{} (COMPLETE)]

其次,构建模型前不要没有直觉关于它应该做什么

如在数据科学家常犯的 10 个统计错误中解释的,你需要形成对模型应如何工作的经济直觉。

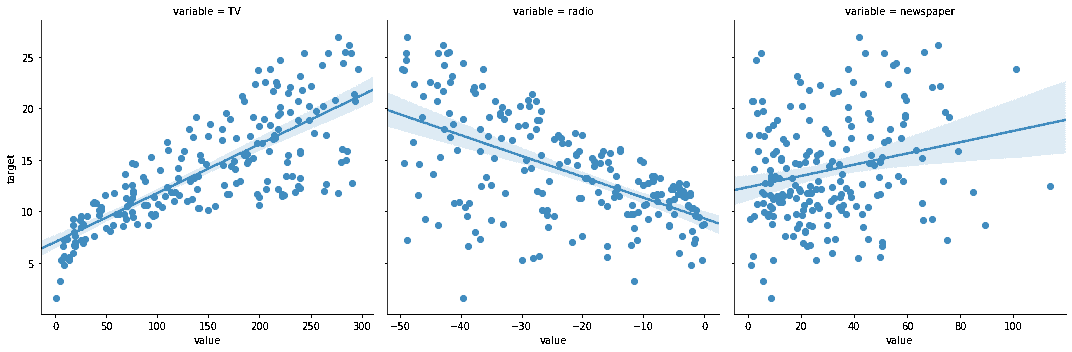

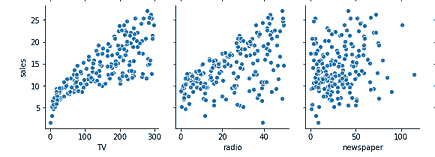

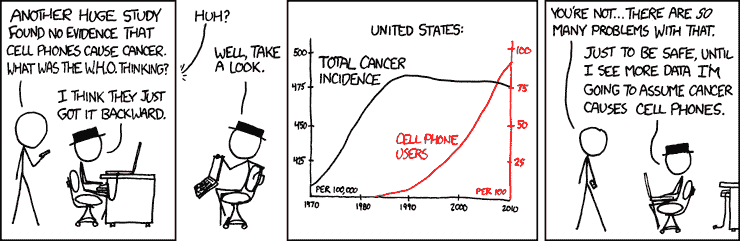

广告数据集展示了销售额与电视、广播和报纸广告支出的关系。通过查看散点图,我们可以看出电视和广播是有效的营销渠道,因为销售额与这些渠道的支出密切相关。但请注意,广播有负面影响,而电视有正面影响(注意我们强制了广播的负相关关系)。报纸似乎只有边际影响。最后,电视和广播之间似乎存在交互效应。

df_train = TaskFeatures().outputLoad()

cfg_col_X = ['TV', 'radio', 'newspaper'] # base features

cfg_col_X_interact = cfg_col_X+['tv_radio'] # includes interaction variable

cfg_col_Y = 'target'

df_trainX, df_trainY = df_train[cfg_col_X], df_train[cfg_col_Y]

dfp = df_train.melt(id_vars=cfg_col_Y,value_vars=cfg_col_X)

sns.lmplot(x="value", y="target", col="variable", data=dfp, sharex=False);

现在训练一个“黑箱”机器学习模型

GBM 模型经过实际测试证明是强大的模型,但由于缺乏可解释性而受到影响。让我们训练模型,看看如何解释它。我们将使用LightGBM。

m_lgbm = lightgbm.LGBMRegressor()

m_lgbm.fit(df_trainX,df_trainY)

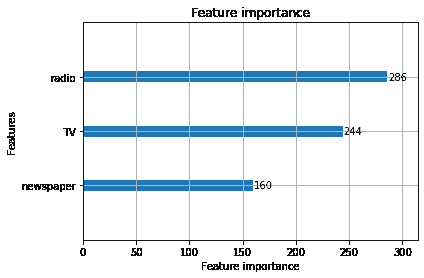

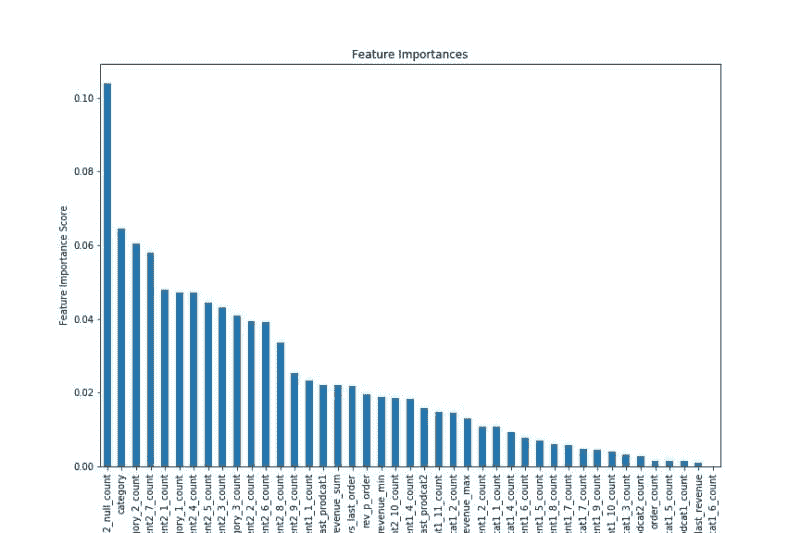

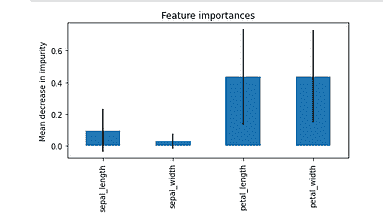

为什么变量重要性图不起作用

正如其名,变量重要性图告诉你输入和输出变量之间关系的强度。但为了信任一个模型,用户通常希望了解更多:影响是正向还是负向,是线性的还是非线性的?是否存在有效或无效的情况?他们希望看到模型是否符合他们的经济直觉。

在我们的例子中,重要性图没有显示出我们确定的报纸支出与负相关关系。这可能会让模型用户感到困惑,他们可能仅凭这一图表不会信任模型。

lightgbm.plot_importance(m_lgbm);

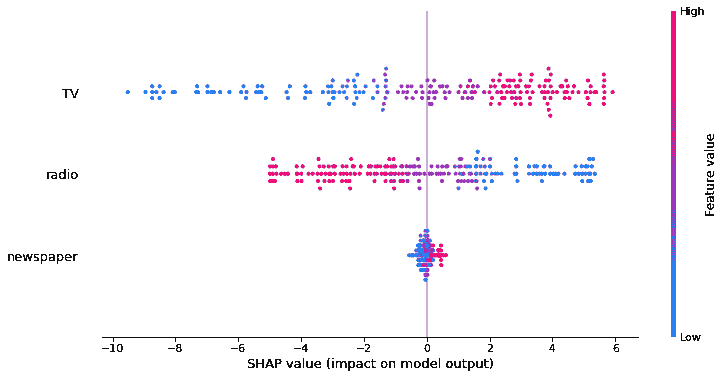

用 SHAP 解释模型

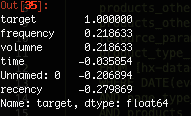

SHAP 使你能够看到每个输入对输出变量的方向性影响,这为模型用户提供了关于模型工作原理的重要直觉。

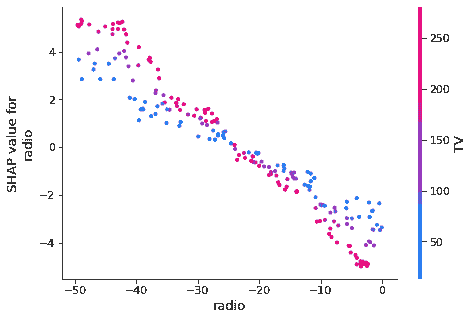

如你所见,模型确实显示了电视支出较高时销售额较高,而收音机支出较高时销售额较低。这与我们的直觉一致,并使模型用户相信你的模型是正确的。

explainer = shap.TreeExplainer(m_lgbm, df_trainX)

shap_values = explainer.shap_values(df_trainX)

shap.summary_plot(shap_values, df_trainX, plot_size=(12,6))

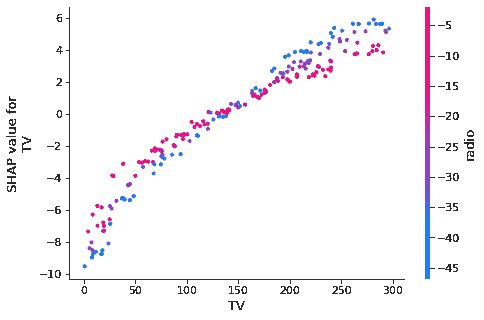

你也可以在散点图中调查“拟合”值,以更详细地可视化输入和输出变量之间的关系。这对于更复杂的关系和理解互动效应非常有用。

在这种情况下,关系是线性的,并且电视和收音机之间存在互动(你可以通过运行 OLS 并包含tv_radio变量来确认)。

for col in cfg_col_X:

shap.dependence_plot(col, shap_values, df_trainX)

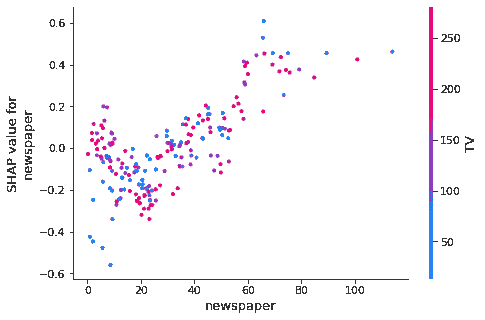

那么部分依赖图呢?

这些方法也有效。它们的优点在于其输出与实际目标变量的尺度一致。这不同于 Shapley 值,它展示了相对于平均预测的边际影响。

matplotlib.rcParams['figure.figsize'] = (12,6)

plot_partial_dependence(m_lgbm, df_trainX, range(df_trainX.shape[1]))

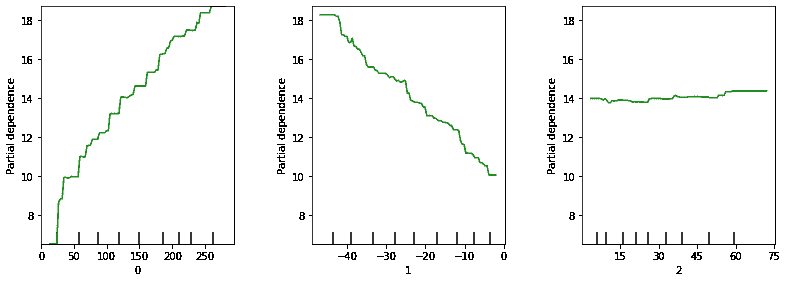

解释最新的预测

这是实践中常遇到的另一个问题:你已经训练了模型,并使用最新数据进行预测。模型用户不仅想知道预测值,还想知道为什么你的模型做出这个预测。SHAP 可以解释单个预测,并解释每个输入变量如何影响总体预测。

在这里,我们可以看到最新的预测值是[13.18]。电视提高了预测值,而收音机降低了预测值。报纸的影响几乎可以忽略。这与我们的预期一致。

shap.force_plot(explainer.expected_value, shap_values[-1,:], df_trainX.iloc[-1,:],matplotlib=True)

哪里可以了解更多?

理解 SHAP

构建高效的数据科学工作流

使用 Databolt 加速数据科学

简介: 诺曼·尼默 是一家大型资产管理公司的首席数据科学家,他提供数据驱动的投资见解。他拥有哥伦比亚大学的金融工程硕士学位以及伦敦 Cass 商学院的银行与金融学士学位。

原始。经授权转载。

相关:

-

数据科学家常犯的 10 大编码错误

-

数据科学家常犯的 10 大统计错误

-

你的机器学习代码可能糟糕的 4 个原因

我们的 3 大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你在 IT 方面的组织

3. Google IT 支持专业证书 - 支持你在 IT 方面的组织

更多相关话题

解释可解释的对话 AI

原文:

www.kdnuggets.com/2022/10/explaining-explainable-ai-conversations.html

在短短的二三十年内,人工智能(AI)已从科幻小说的页面走向现代社会的基石技术之一。机器学习(ML)的成功催生了几乎无法计数的新 AI 应用,从自主机器和生物特征识别到预测分析和聊天机器人。

近年来,人工智能的一个新兴应用是对话智能(CI)。虽然自动聊天机器人和虚拟助手关注的是人机互动,但 CI 旨在更详细地探索人际互动。从人类对话中监测和提取数据,包括语气、情感和背景,其潜力似乎是无限的。

例如,呼叫中心互动的数据可以生成并记录,从说话者比例和客户满意度到通话摘要和行动点,全部自动归档。这将大幅减少呼叫中心处理中的繁文缛节,为客服代表提供更多与客户交谈的时间。而且,生成的数据甚至可以用于制定员工培训计划,并识别和奖励出色的工作表现。

但仍然缺少一些东西——信任。以这种方式部署人工智能极其有用,但目前仍然需要企业的信任。

我们信任人工智能吗?

作为企业,也作为整个社会,我们在人工智能系统上投入了大量信任。社交媒体公司如 Twitter 现在使用基于 AI 的算法来打击仇恨言论,保障用户在线安全。全球的医疗服务提供者越来越多地利用 AI,从能够进行患者分类的聊天机器人到可以帮助病理学家进行更准确诊断的算法。英国政府最近采用了一种名为“Connect”的 AI 工具来帮助解析税务记录和检测欺诈行为。甚至还有利用 AI 改善执法效果的例子,如使用面部识别、群体监控和步态分析等工具来识别嫌疑犯。

我们为了一个更高效、连接和无缝的世界而做出这个信任的飞跃。这个世界建立在“大数据”之上,我们需要 AI 来帮助我们管理数据流并将其用到实处。在宏观层面和个体企业中,这都是如此。但尽管我们对 AI 技术的依赖越来越大,我们对其内部工作却知之甚少。随着数据量的增加,以及 AI 做出判断的路径变得更加复杂,我们作为人类已经失去了理解和追溯这些路径的能力。我们所剩下的是一个几乎无法解释的“黑箱”。

这就引出了一个问题:如果我们无法理解这些决策是如何做出的,我们怎么能信任基于 AI 的决策?这对于希望确保系统正常运行、符合正确的监管标准或最大化效率的企业来说,越来越成为一种挫折。考虑一下亚马逊的招聘团队,他们在意识到自己的秘密 AI 招聘工具存在性别偏见后不得不放弃了该工具。他们以为自己找到了招聘的“圣杯”——一个能够扫描数百份简历并挑选出前几名进行审核的工具,节省了大量工作时间。通过重复和强化,AI 竟然说服自己男性候选人比女性候选人更可取。如果团队盲目信任 AI——虽然时间非常短暂——公司的后果将会是毁灭性的。

在商业挫折和对过度信任 AI 的担忧方面,CI 的新兴领域是一个理想的例证。

对话智能如何获得信任?

人际互动的世界多年来一直是 AI 创新的热土。使用自然语言处理(NLP)创建聊天机器人或将语音转录为文本是一回事,但从对话中得出意义和理解则完全是另一回事。这就是对话智能(CI)所做的。它超越了确定性的“A 到 B”结果,旨在分析对话中不那么明确的方面,如语调、情感和意义。

如果在呼叫中心使用 CI,例如,它可能用于确定接听员的效果、客户的情绪状态,或提供带有行动要点的自动通话摘要。这些是复杂且主观的互动,不一定有对错之分。如果呼叫中心打算利用 CI 来简化互动、培训代理并更新客户记录,它需要对基础 AI 的有效性有信心。这就是可解释 AI 或“XAI”发挥作用的地方。

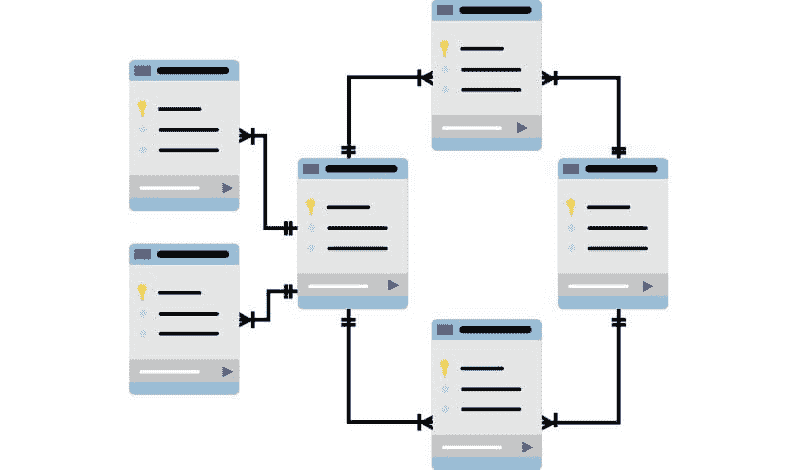

每个企业都是不同的,对于系统应学习和预测的内容有不同的定义。解决方案必须提供相对于使用系统的人类行为者的预测的完整视图,以便他们可以持续批准或拒绝系统所做的预测。与其采用一个黑箱式的深度学习系统来执行任务,不如采用一个模块化的系统,其中对系统预测的每个方面都有完全的透明度和控制。例如,可以使用确定性可编程系统来跟踪通话情绪、寻找话题、生成摘要、检测特定方面(如支持通话中的问题类型或客户反馈通话中的请求)等,而不是一个单一的深度学习系统来完成所有这些任务。通过创建这样的模块化架构,整体对话智能解决方案将建立为可追溯和确定的。

揭开面纱

当人工智能处理过程简单且确定时,对这些过程的信任从未成为问题。现在,这些过程变得更加复杂和不透明,如上述 CI 示例所示,信任已经成为希望投资人工智能的企业的关键。在他仍然相关的十年前的论文中,Mariarosaria Taddeo 提到这被称为“电子信任”——人类如何信任计算机化的过程,以及我们在多大程度上允许人工智能代理参与这种关系。

可解释人工智能(XAI)是机器学习中的一个新兴领域,旨在使这些人工智能代理完全透明且更易于解释。美国的国防高级研究计划局(DARPA)是追求 XAI 解决方案的领先组织之一。DARPA 认为,人工智能系统的潜力被其无法向人类用户解释其行为的能力严重阻碍。换句话说,组织对人工智能缺乏信任阻碍了他们探索人工智能和机器学习所能提供的全部可能性。

目标是创建一套机器学习技术,能够生成可解释的模型,使人类用户能够理解和管理下一代人工智能解决方案。这些机器学习系统将能够解释其推理,识别自身的优势和不足,并传达它们如何从输入的数据中“学习”。对于 DARPA 来说,这是一种推动其所称的第三代人工智能系统的努力,届时机器将能够理解其操作的上下文和环境。

为了充分实现人工智能的潜力,我们需要从“0”和“1”中迈出一步,引入更多主观分析。技术已经存在,我们只需要更多的信任理由。

Surbhi Rathore 是 Symbl.ai 的首席执行官兼联合创始人。Symbl 正在实现她对一个可编程平台的愿景,该平台使开发者和企业能够在其产品和工作流程中大规模地监控、操作和遵守语音、视频对话,而无需建立内部的数据科学专业知识。

更多相关话题

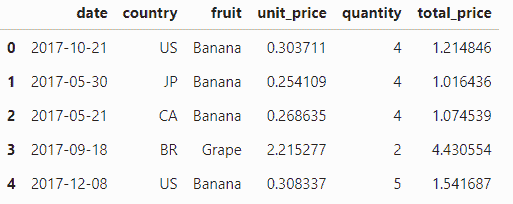

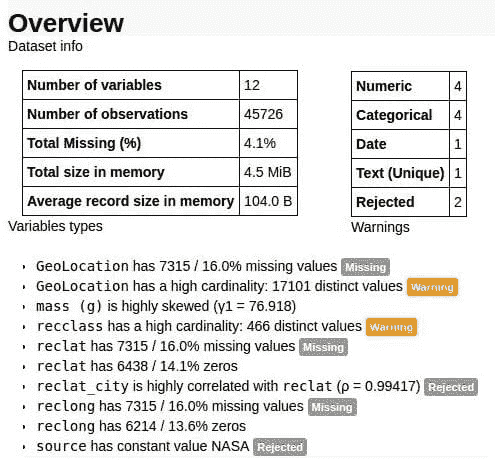

Python 中的探索性数据分析

原文:

www.kdnuggets.com/2017/07/exploratory-data-analysis-python.html

作者:Chloe Mawer 和 Jonathan Whitmore,硅谷数据科学。

今年早些时候,我们写了关于探索性数据分析的价值的文章以及你为何应关心。在那篇文章中,我们从很高的层面介绍了探索性数据分析(EDA)是什么,以及数据科学家和业务利益相关者为何应该将其视为其分析项目成功的关键。然而,那篇文章可能让你想知道:我该如何自己进行 EDA?

上个月,我的同事高级数据科学家 Jonathan Whitmore 和我在PyCon上教授了一门名为Python 中的探索性数据分析的教程——你可以在这里观看。在这篇文章中,我们将总结教程的目标和内容,然后提供跟随的指示,以便你开始发展自己的 EDA 技能。

教程目标

本教程的目标是帮助参与者:

-

通过在各种探索阶段提出问题并指出需要注意的事项,培养 EDA 的思维方式

-

学习如何有效调用一些基本的 EDA 方法,以便理解数据集并为更高级的分析做好准备。这些基本方法包括:

-

切片和切分

-

计算汇总统计数据

-

数值和分类数据的基本绘图

-

基于地图的地理空间数据基本可视化

-

使用 Jupyter Notebook 小部件进行交互式探索

-

我们将 EDA 视为一棵树:每次进行 EDA 时,你都会执行一系列基本步骤(树的主干),但在每个步骤中,观察会引导你探索其他方向(树枝),提出你想解答的问题或需要检验的假设。

你追寻的树枝将取决于你觉得有趣或相关的内容。因此,你在跟随本教程进行实际探索时将是你自己的。我们没有答案或结论,认为你应该对数据集得出什么结论。我们的目标仅仅是帮助你使探索尽可能有效,并让你享受选择跟随哪些分支的乐趣。

教程大纲

演讲包括以下内容:

-

探索性数据分析简介:我总结了 EDA 的动机以及我们在教程中深入探讨的一般策略。

-

Jupyter Notebooks 入门:我们的教程涉及通过一系列 Jupyter Notebooks 进行操作,因此 Jonathan 对那些从未见过它们的人做了一个快速介绍。我们甚至从一位参与者那里学到了一项新技巧!

-

Redcard 数据集的探索性分析:Jonathan 进行了一项关于数据集的探索性分析,该数据集来源于一篇有趣的论文,该论文在《自然》上发布,并附有评论。论文的核心问题在标题中有所反映:“许多分析师,一个数据集:如何透明地展示分析选择的变化如何影响结果”。作者招募了约 30 个分析团队,每个团队都被赋予了相同的研究问题:“足球裁判是否更可能对深色肤色的球员出示红牌,而不是浅色肤色的球员?”并提供了相同的数据。数据集来自 2012-13 年欧洲足球(足球)职业联赛中的球员。包括球员的年龄、身高、体重、位置、肤色评级等数据。然后比较各团队的结果,查看不同的数据查看方式如何得出不同的统计结论。丰富的数据集提供了充足的机会来进行探索性数据分析。从决定层级领域位置,到身高或体重的分位数。我们展示了几种有用的库,包括标准库如 pandas,以及较少见的库如

missingno、pandas-profiling和pivottablejs。 -

AQUASTAT 数据集的探索性分析:在这一部分,我将对粮农组织(FAO)的 AQUASTAT 数据集进行探索。这些数据集提供了关于水资源可用性和使用情况的指标,以及自 1952 年起每五年报告的各国其他人口统计数据。该数据集通常被称为面板数据或纵向数据,因为它是针对相同主题(在此案例中为国家)重复收集的数据。我们讨论了将其作为面板数据进行探索的方法,以及仅关注数据横截面(在各国收集的单一时间段的数据)的方法。这些数据也是地理空间的,因为每个观测值都对应一个地理定位区域。我们展示了如何在 Python 中在地图上查看非常基本的数据,但地理空间分析是一个深奥的领域,我们在查看这个数据集时只是触及了它的表面。我们推荐PySAL 教程作为 Python 中地理空间分析的入门介绍。

在家跟随学习

为了充分利用本教程,我们建议你实际操作我们开发的 Jupyter notebooks。你可以通过以下两种方式之一来完成:

-

在云端通过 Microsoft Azure notebooks:设置一个账户,然后克隆 这个库。克隆此库将允许你在线打开、编辑和运行每一个 Jupyter notebook,无需担心设置 Jupyter notebooks 和 Python 环境。此服务是免费的,你的 notebooks 可以保存以备将来使用,没有任何限制。需要了解的唯一事项是,虽然 notebooks 会被无限期保存,但在工作会话结束后,数据或其他非 notebook 文件不会被保存。数据可以导入并分析,但任何 notebook 外的结果必须在离开之前下载。

在家跟随教程,你可以随时暂停。我们在三小时的教程中讲解了大量材料(并且需要应对一些技术问题,这些问题在 65+人使用不同操作系统和各种公司防火墙的实践教程中不可避免!)。为了充分利用内容,我们建议你在教程中暂停,当有建议尝试某些分析时,亲自进行尝试。

EDA 的可能性是无穷的,即使对于单个数据集。你可能希望以不同的方式查看数据,我们欢迎你通过 github 仓库中的拉取请求提交你自己对一个或两个数据集的 EDA notebooks。我们将提供反馈并批准 PR,使你的方法可以与其他开发 EDA 技能的人分享。

Chloe Mawer 背景为地球物理学和水文学,擅长利用数据进行预测并提供有价值的见解。她在学术研究和工程方面的经验使她能够解决新问题并创造实用有效的解决方案。

Jonathan Whitmore 是 SVDS 的数据科学家。在完成天体物理学的博士后职位后,Jonathan 成为计算和天文学方面的受欢迎演讲者。他对将机器学习和统计技术应用于行业问题感到兴奋,并开发了新颖的数据分析技术。

原文。经许可转载。

相关:

-

探索性数据分析的价值

-

Jupyter 生态系统导航简要指南

-

数据科学的 Jupyter Notebook 最佳实践

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路

1. Google 网络安全证书 - 快速进入网络安全职业道路

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

更多相关内容

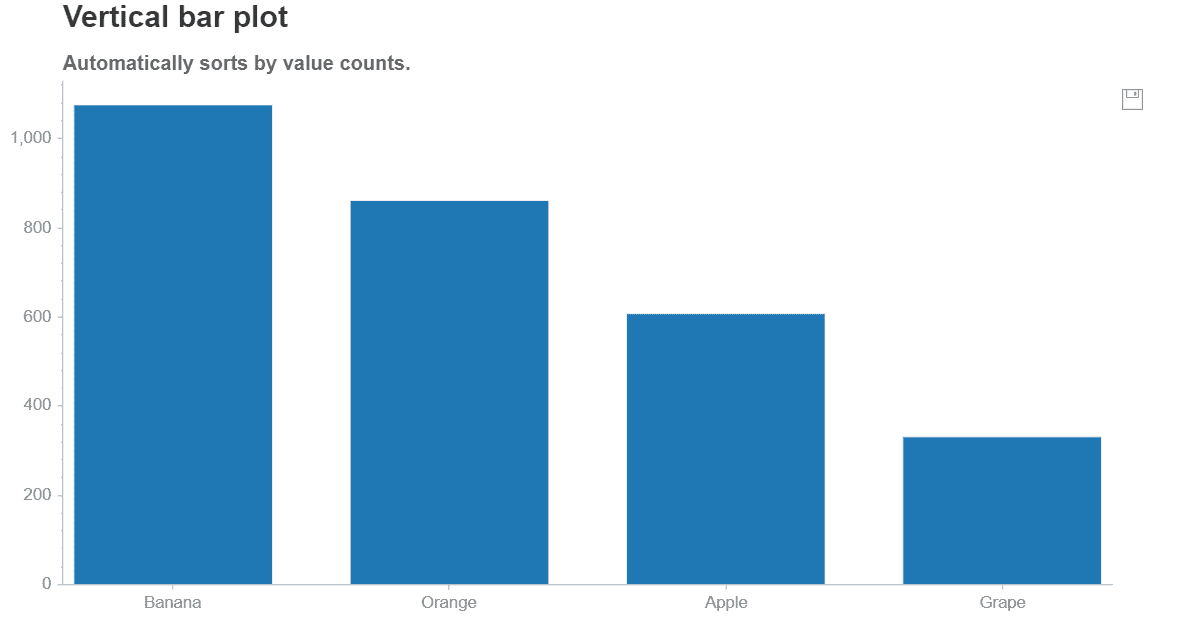

类别数据分析

原文:

www.kdnuggets.com/2020/07/exploratory-data-analysis-steroids.html

评论

作者 Diego Lopez Yse,数据科学家

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在的组织的 IT

3. Google IT 支持专业证书 - 支持你所在的组织的 IT

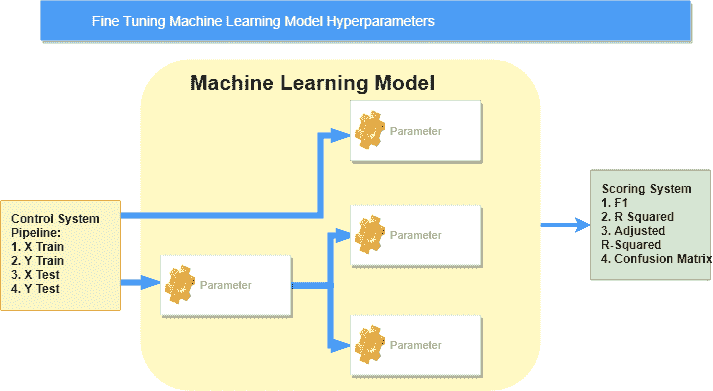

机器学习讨论通常集中在算法及其性能上:如何提高模型准确性或减少错误率、在特征工程方面表现出色或微调超参数。但在任何事情之前有一个概念:探索性数据分析,或称 EDA。

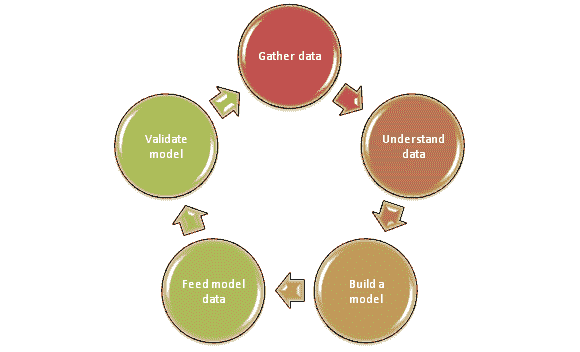

EDA 是在我们开始使用任何模型之前对数据进行理解。 这完全有道理,对吧?如果我们还不了解我们的数据,我们将使用什么模型呢?

在机器学习模型出现之前,就有了 EDA

这是数据科学中的一个核心方面,有时会被忽视。你所做的任何事情的第一步都应该是了解你的数据:理解它,与之熟悉。你试图从数据中得到什么答案?你使用了哪些变量,它们是什么意思?从统计的角度来看它是什么样的?数据格式是否正确?是否有缺失值?是否有重复值?异常值呢?

随着数据量的增加,这个概念变得更加重要:想象一下尝试解析成千上万或数百万条记录并理解它们。接下来,我想分享我的 Python 方法,以最有效的方式回答这些问题。

描述数据集

对于这篇文章,我使用了世界银行的经济数据集,描述了一些全球关键因素,如 GDP、人口水平、面积等。你可以在这里找到数据集和完整代码。

首先,我们需要导入一些库:

import pandas as pd

import numpy as np

import seaborn as sns

import xlrd

Pandas、Numpy 和 Seaborn 在任何 EDA 练习中都是关键的。由于我们使用的是 Excel 文件作为数据源,因此“xlrd”包仅在我们的示例中需要。

现在,让我们导入数据集:

df = pd.read_excel(“wbdata.xlsx”)

看一下数据:

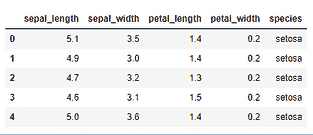

df.head()

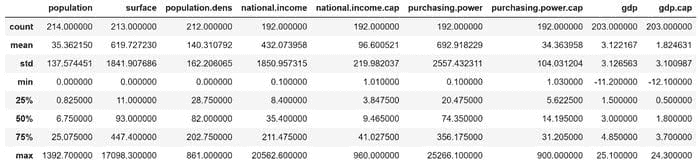

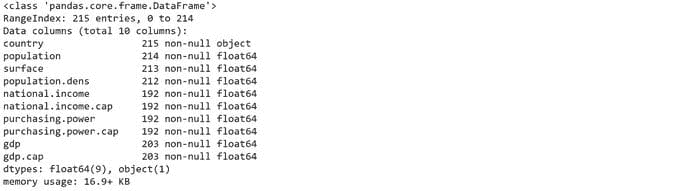

df.describe()

数据集中数值变量的一些基本统计信息。

df.shape

查看数据集结构的一种快速方法:215 行和 10 列。

df.dtypes

检查变量类型:除了国家名称是字符串,其余都是浮点数。有关如何更改变量类型的教程,请访问这里。

df.info()

在这里我们看到一些变量有空值(例如,“人口”变量有 1 行缺失值,“面积”有 2 行,等等)。我们将看到如何处理这些空值。

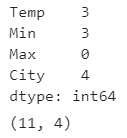

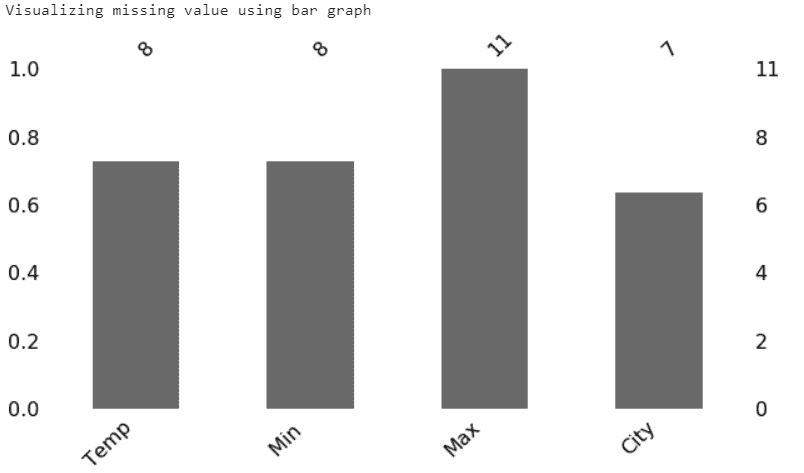

缺失值

缺失值可能由不同原因引起,如数据输入错误或记录不完整。这非常常见,并可能对从数据中得出的结论产生重大影响。

我们已经看到这个数据集有几个缺失值,但让我们看看如何测试任何数据集。你可能想问的第一个问题是:是否有缺失值?

print(df.isnull().values.any())

接下来,你可能想检查它们有多少:

print(df.isnull().sum().sum())

现在,让我们回顾一下这些缺失值的总结

print(df.isnull().sum())

你看到什么熟悉的东西吗?这就是.info() 函数的另一面。处理缺失值有不同的策略,没有一种通用的方法。对于这个例子,我们将丢弃这些缺失值,因为进行填补没有意义:

df1 = df.copy()df1.dropna(inplace=True)

我们回顾一下新数据集:

df1.info()

188 条记录仍然存在,没有空值。现在我们准备继续前进。

你可以在这里找到处理缺失值的其他方法。

可视化

让我们用 Seaborn 可视化新的数据集:

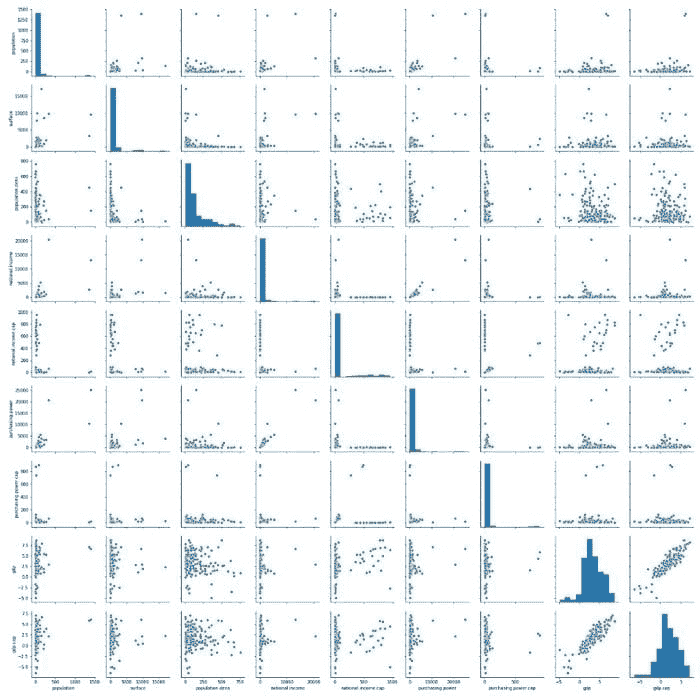

sns.pairplot(df1)

这样你可以快速识别异常值、聚类和变量之间明显的相关性。

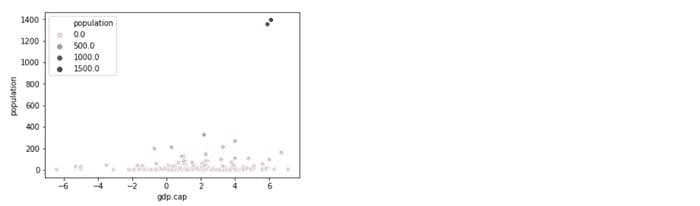

让我们结合“gdp”和“人口”变量:

sns.scatterplot(x='gdp.cap', y='population', data=df1, hue='population')

你看到右上角的两个明显的异常值了吗?有两个国家的总人口水平与其他数据有极端的差异。你可以通过单独分析“人口”变量来验证这个观察结果:

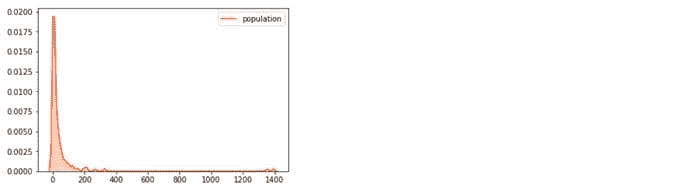

sns.kdeplot(df1[‘population’], shade=True, color=’orangered’)

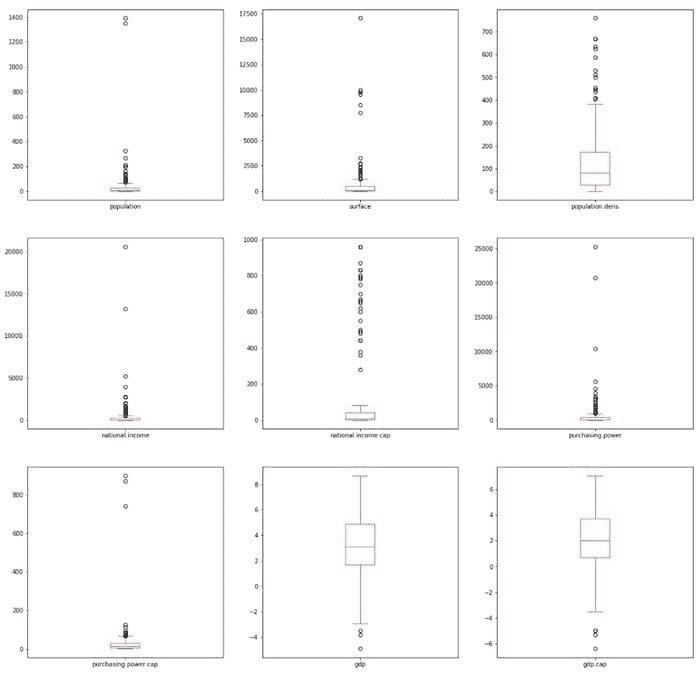

检测异常值的另一种方法是绘制箱线图:

df1.plot(kind=’box’, subplots=True, layout=(3,3), sharex=False, sharey=False, figsize=(20, 20), color=’deeppink’)

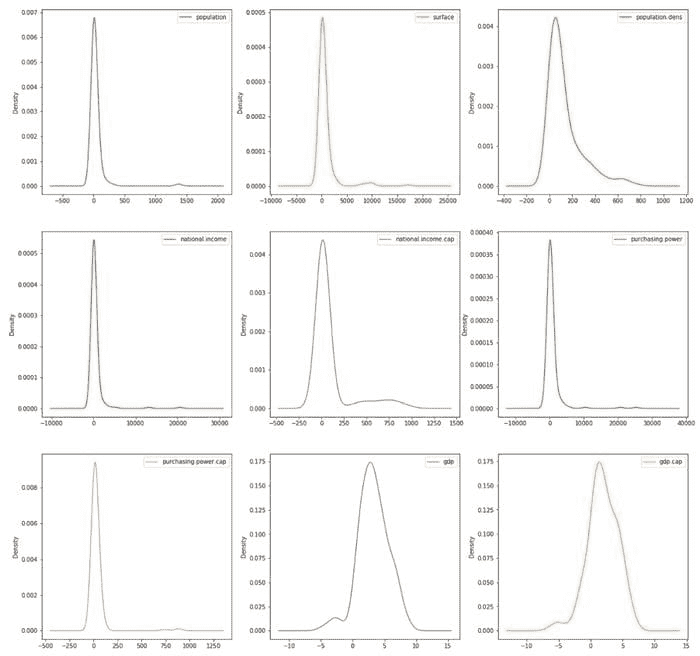

你还可以展示这些变量的密度图并分析它们的偏态:

df1.plot(kind=’density’, subplots=True, layout=(3,3), sharex=False, figsize=(20, 20))

查看这个链接获取额外的 Seaborn 样式提示。

在这个例子中,我故意没有处理异常值,但有多种方法可以处理它们。你可以在这里找到一些异常值识别和处理的例子。

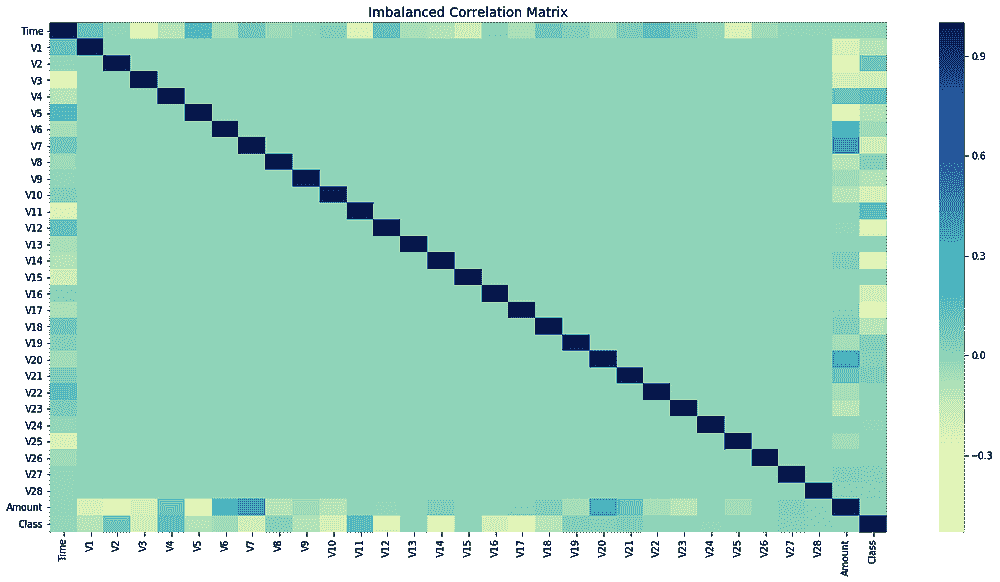

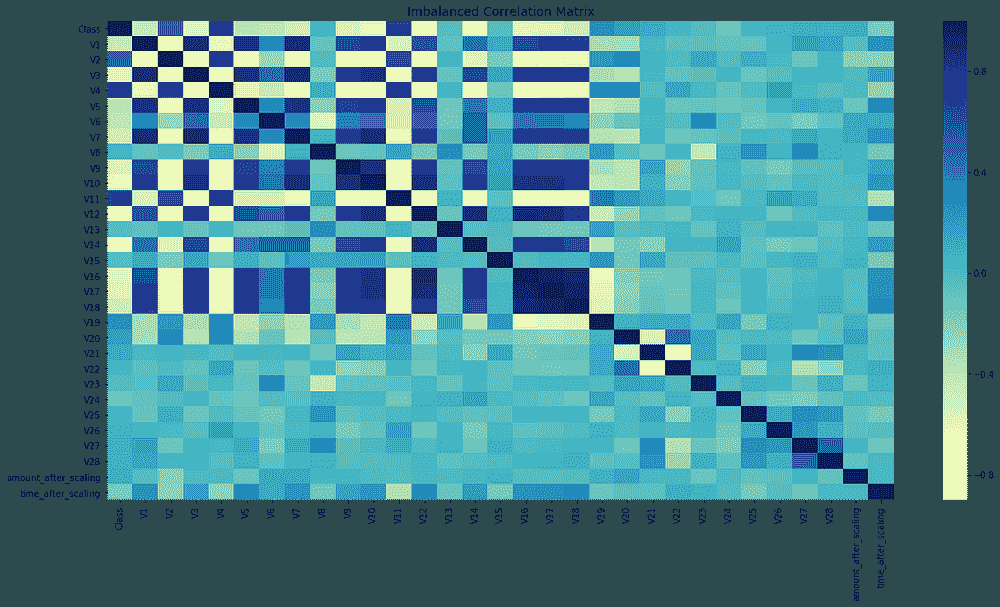

相关性

相关变量将节省你大量的分析时间,而且这是在对数据进行任何假设之前的必要步骤。相关性仅计算数值变量,因此了解数据集中的变量类型非常重要。

你可以在这里找到其他非数值变量的系数。

mask = np.tril(df1.corr())

sns.heatmap(df1.corr(), fmt=’.1g’, annot = True, cmap= ‘cool’, mask=mask)

我已遮蔽了左下角的值,以避免重复并提供更清晰的视图。右侧的值刻度也提供了一个快速参考指南,用于极端值:你可以轻松发现变量之间的高相关性和低相关性(例如,“国民收入”与“购买力”具有高度正相关性)

在这里找到更多自定义相关矩阵的方法。

最后的思考

探索性数据分析对理解任何数据集至关重要。在这里,你可以提供见解并做出发现。这里是你将知识付诸实践的地方。

但探索性数据分析需要大量的准备工作,因为现实世界中的数据很少是干净和同质的。人们常说,80%的数据科学家的宝贵时间都花在寻找、清理和组织数据上,剩下的 20%才用于实际分析。

与此同时,完美是善的敌人,你需要在有限的时间内推动你的见解。为分析准备数据是不可避免的,而你如何做将决定你的探索性数据分析的质量。

对这些话题感兴趣?在Linkedin或Twitter上关注我

简历:Diego Lopez Yse是一位拥有不同领域(资本市场、生物技术、软件、咨询、政府、农业)国际背景的经验丰富的专业人士。始终是团队成员。擅长商业管理、分析、金融、风险、项目管理和商业运营。拥有数据科学和企业金融硕士学位。

原文。已获得许可转载。

相关:

-

如何准备你的数据

-

数据科学项目准备的奇妙四步

-

时间复杂度:如何衡量算法的效率

更多相关主题

探索性数据分析技术针对非结构化数据

原文:

www.kdnuggets.com/2023/05/exploratory-data-analysis-techniques-unstructured-data.html

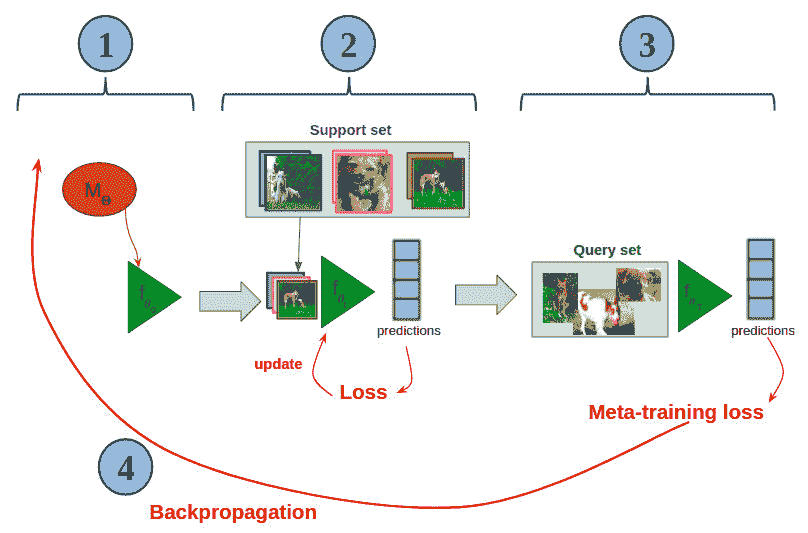

作者提供的图片

探索性数据分析是机器学习开发生命周期中至关重要的阶段之一,在进行任何实际数据分析项目时,这个阶段几乎占据了整个项目时间的 50-60%。因为我们需要处理的原始数据必须在应用机器学习算法之前进行处理,以获得最佳性能。此步骤必须包括以下内容:

-

这涉及更好地分析和总结数据集,以理解其潜在的模式、关系和趋势。

-

这使分析师能够识别重要的数据特征,检测异常值或离群点,并确定预测未来结果的最合适建模技术。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

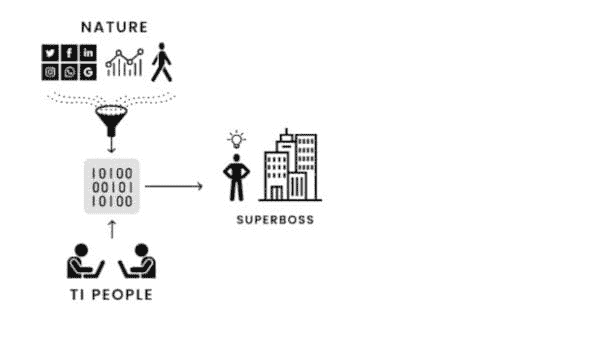

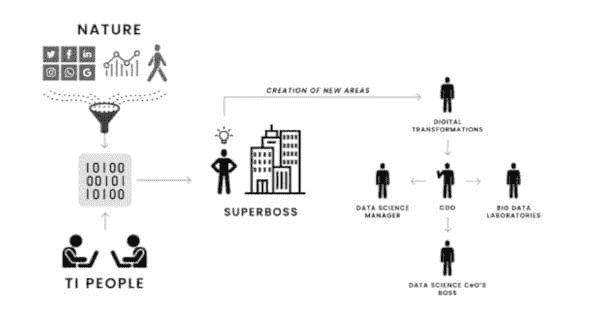

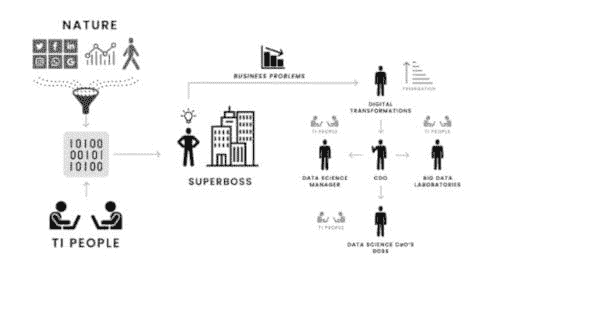

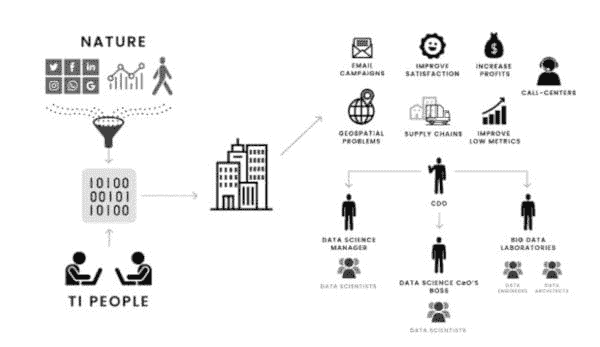

让我们通过一个故事来理解 EDA 在数据分析中的重要性。

通过一个故事理解 EDA 的重要性

从前,一家小公司刚刚在市场上开展业务。该公司拥有一组对其角色充满热情的专业人员,他们以一种能使整个公司获利的方式工作。随着公司在员工或产品用户方面的增长,管理团队意识到他们需要帮助来理解用户或客户对公司提供的产品或服务的需求和行为。

为了克服这个问题,他们开始招聘一些技术专业人员。最终,他们找到了一位数据分析师来更好地理解客户数据。该分析师能够从数据中找到重要信息或洞察。他们雇佣的分析师在类似类型的技术或项目中有很好的实际操作经验,主要工作于探索性数据分析。

因此,对于这个问题,他们开始以伦理的方式通过网络抓取从多个 API 收集数据,包括公司网站、社交媒体账号、论坛等。在数据收集之后,他们开始清理和处理数据,以便能够从中发现一些见解。他们使用了统计技术,如假设检验和商业智能工具,来探索数据并使用模式识别技术揭示隐藏的模式。

在创建了数据管道后,他们观察到公司客户最感兴趣的是购买环保和可持续的产品。基于这些见解,公司管理层推出了环保和可持续产品。因此,基于这些更新,新产品受到客户的欢迎,公司收入也开始增长。管理层开始意识到探索性数据分析的重要性,并雇佣了更多的数据分析师。

因此,在这篇文章中,受上述故事的启发,我们将了解数据管道中探索性数据分析阶段的不同技术,并使用这一过程中的流行工具,通过这些工具你可以为你的公司发现价值连城的见解。本文为初学者和经验丰富的数据分析师提供了 EDA 及其在数据科学中重要性的全面概述。

实施的不同技术

为了理解 EDA 中使用的每种技术,我们将通过一个数据集并使用 Python 数据科学库(如 NumPy、Pandas、Matplotlib 等)来实现它。

我们将在分析中使用的数据集是 Titanic 数据集,可以从这里下载。我们将使用 train.csv 进行模型训练。

1. 导入必要的库和依赖项

在实施之前,首先让我们导入将要使用的不同 EDA 技术所需的库,包括

-

用于矩阵操作的 NumPy,

-

用于数据分析的 Pandas,和

-

用于数据可视化的 Matplotlib 和 Seaborn。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sb

2. 加载和分析数据集

在导入所有必要的库之后,我们将使用 Pandas 数据框加载 Titanic 数据集。然后,我们可以开始执行不同的数据预处理技术,以准备数据进行进一步建模和概括。

passenger_data = pd.read_csv('titanic.csv')

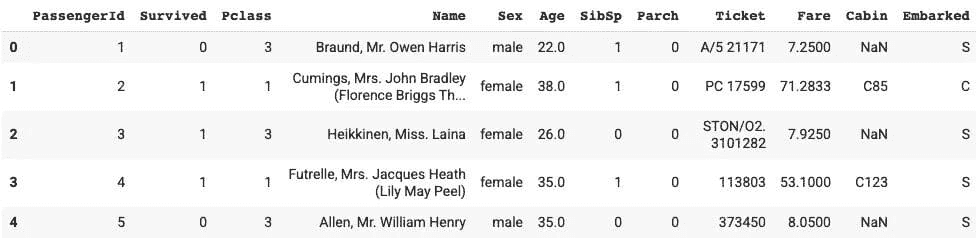

passenger_data.head(5)

输出:

图 1 | 图片来源:作者

3. 获取统计摘要

以下分析提供了数据中所有数值列的统计信息。我们可以从这个函数中获得的统计信息有:

-

计数,

-

平均值和中位数

-

标准差

-

最小值和最大值

-

不同四分位数值

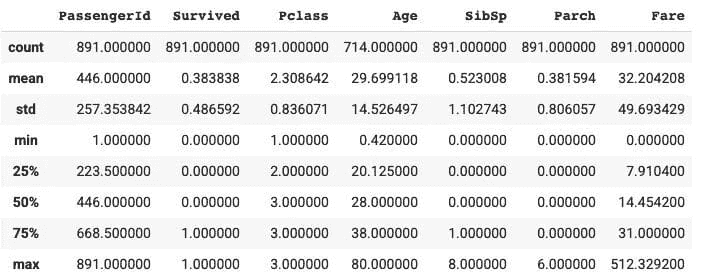

passenger_data.describe()

输出:

图 2 | 图片来源:作者

通过解释上述输出,我们可以看到共有 891 名乘客,平均生存率为 38%。年龄列的最小值和最大值在 0.42 到 80 之间,平均年龄约为 30 岁。此外,至少 50%的乘客没有兄弟姐妹/配偶,至少 75%的乘客没有父母/孩子,票价列的值变化很大。

让我们尝试通过从头编写代码来计算生存率。

4. 计算乘客的总体生存率

为了计算总体生存率,我们首先选择“Survived”列,检查值为 1 的行,然后计算所有这些行的数量。最后,为了找到百分比,我们将其除以总行数并打印出来。

survived_data = passenger_data[passenger_data['Survived'] == 1]

survived = survived_data.count().values[1]

survival_percent = (survived/891) * 100

print('The percentage of survived people in training data are {}'.format(survival_percent))

输出:

The percentage of survived people in training data are 38.38383838383838

5. 按性别和“Pclass”列计算生存率

现在,我们需要使用一个聚合操作符来查找不同列的生存率,我们将使用“gender”和“Pclass”列,然后应用均值函数来找到并打印出来。

survival_rate = passenger_data[['Pclass', 'Sex','Survived']].groupby(['Pclass', 'Sex'], as_index = False).mean().sort_values('Survived', ascending = False)

print(survival_rate)

输出:

Pclass Sex Survived

0 1 female 0.968085

2 2 female 0.921053

4 3 female 0.500000

1 1 male 0.368852

3 2 male 0.157407

5 3 male 0.135447

6. 将 Passenger Id、Survived 和 Pclass 的数据类型更改为字符串

由于某些列的数据类型不同,我们将所有这些列转换为固定的数据类型,即字符串。

Cols = [ 'PassengerId', 'Survived', 'Pclass' ]

for index in Cols:

passenger_data[index] = passenger_data[index].astype(str)

passenger_data.dtypes

7. 数据集中的重复行

在进行数据建模时,如果存在重复行,我们的性能可能会降低。因此,建议始终删除重复行。

passenger_data.loc[passenger_data.duplicated(), :]

8. 创建直方图以检查数据分布

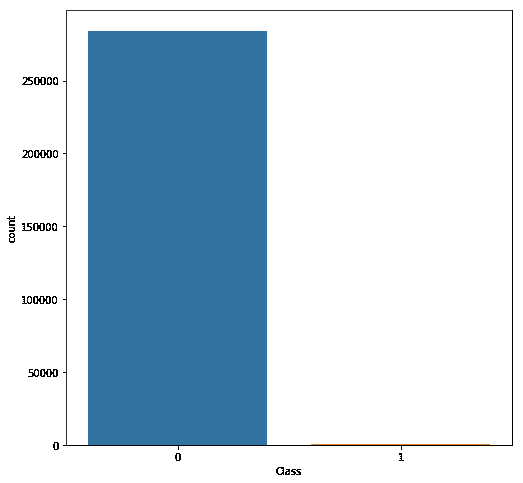

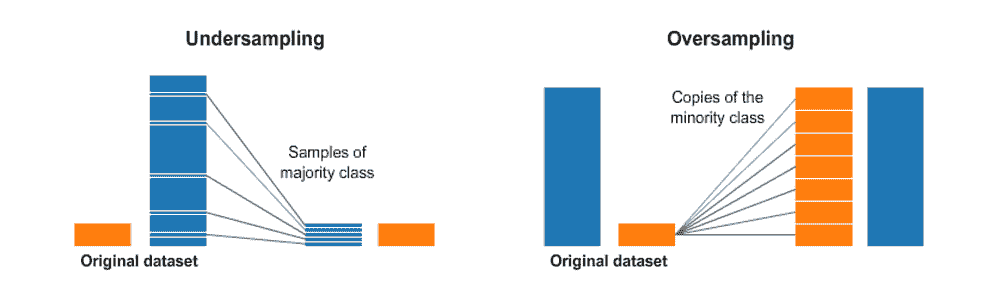

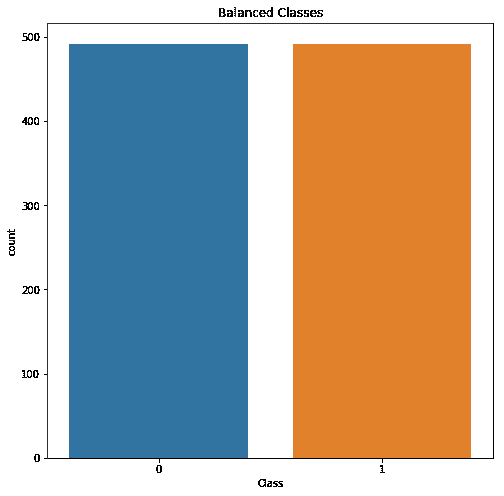

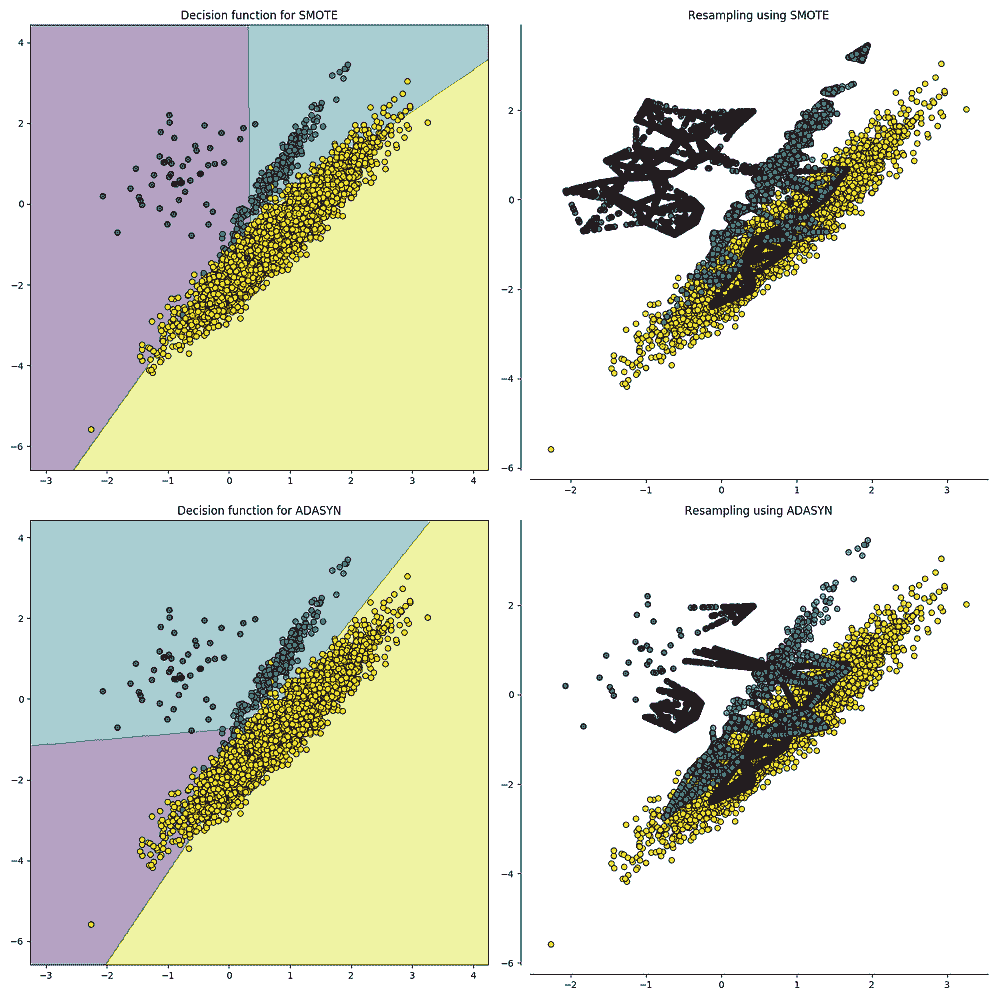

为了找出基于该列可能值的生存列分布,以便检查类别偏差,如果存在任何问题,我们可以应用如过采样、欠采样、SMOTE 等技术来克服这些问题。

sb.set_style("white")

g = sb.FacetGrid(data = train[train['Age'].notna()], col = 'Survived')

g.map(plt.hist, "Age");

输出:

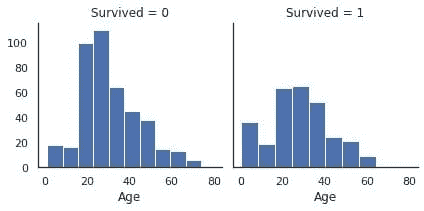

图 3 | 作者提供的图片

现在,如果我们比较上述两个分布,那么建议使用相对频率而不是绝对频率,通过使用累计密度函数等。由于我们以 Age 列为例,绝对频率的直方图显示 20-30 岁年龄组的受害者明显多于幸存者。

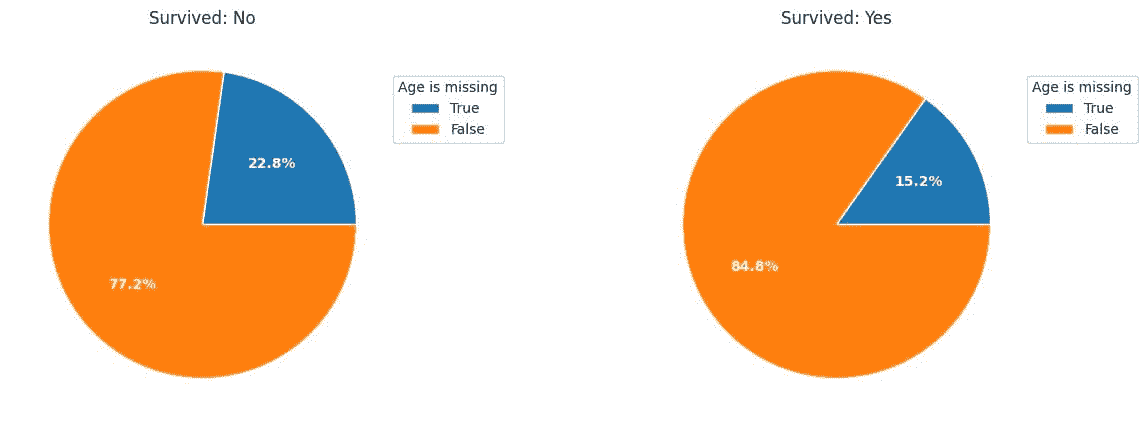

9. 绘制按生存情况的年龄缺失值百分比

在这里,我们创建了饼图来找出按生存值划分的缺失值百分比,然后查看分区情况。

dt0 = train['Age'][train['Survived']=='0']

dt1 = train['Age'][train['Survived']=='1']

plt.figure(figsize = [15, 5])

plt.subplot(1, 2, 1)

age_na_pie(dt0)

plt.title('Survived: No');

plt.subplot(1, 2, 2)

age_na_pie(dt1)

plt.title('Survived: Yes');

输出:

图 4 | 作者提供的图片

饼图显示,年龄缺失的乘客更可能成为受害者。

10. 查找每列的缺失值数量

passenger_data.isnull().sum()

从输出中,我们观察到“Cabin”列有最多的缺失值,因此我们将从分析中删除该列。

11. 每列的空值百分比

passenger_data.isna().sum()/passenger_data.shape[0]

在年龄列中,大约 20%的数据缺失,Cabin 列中的数据缺失率约为 77%,Embarked 列中的数据缺失率为 0.2%。我们的目标是在建模之前处理缺失数据。

12. 从数据集中删除“Cabin”列

删除 Cabin 列,因为它有许多缺失值。

drop_column = passenger_data.drop(labels = ['Cabin'], axis = 1)

print(drop_column)

为了处理“年龄”列,首先,我们将检查年龄列的数据类型,并将其转换为整数数据类型,然后用年龄列的中位数填补所有缺失值。

datatype = passenger_data.info('Age')

fill_values = passenger_data['Age'].fillna(int(passenger_data['Age'].median()),inplace=True)

print(fill_values)

经过这些步骤,我们的数据集在缺失值、异常值等方面看起来很好。现在,如果我们应用机器学习算法来发现数据集中的模式,然后在测试数据上进行测试,模型的表现将比没有进行预处理和探索性数据分析或数据清洗的数据要好。

从 EDA 中获得的总结性见解

下面是幸存者的特征与受害者的比较。

-

幸存者可能有父母或子女陪伴;与其他人相比,他们的票价更贵。

-

儿童比所有年龄组的受害者更有可能幸存。

-

年龄缺失的乘客不太可能成为幸存者。

-

拥有更高 pclass(SES)的乘客更有可能幸存。

-

女性比男性更有可能幸存。

-

Cherbourg 的乘客比 Queenstown 和 Southampton 的乘客有更高的生存机会。

你可以在这里找到完整代码的 Colab 笔记本 - Colab Notebook。

结论

这结束了我们的讨论。当然,探索性数据分析(EDA)中还有许多技术超出了我在这里所覆盖的内容,这取决于我们在问题陈述中使用的数据集。总之,了解你的数据,在用它来训练模型之前进行 EDA 是有益的。这种技术在任何数据科学项目中都起着至关重要的作用,使我们的简单模型在项目中表现更好。因此,每位有志成为数据科学家、数据分析师、机器学习工程师和分析经理的人都需要充分掌握这些技术。

直到那时,请继续阅读和学习。如果有任何问题或建议,请随时通过 Linkedin 与我联系。

Aryan Garg 是一名电气工程专业的本科生,目前在本科学习的最后一年。他对网页开发和机器学习领域感兴趣。他已经追求了这个兴趣,并渴望在这些方向上进一步发展。

更多相关话题

轻松在笔记本电脑上探索 LLMs

原文:

www.kdnuggets.com/2023/04/explore-llms-easily-laptop-openplayground.html

图片由编辑提供

大型语言模型(LLM)是一个深度学习语言模型,旨在理解、解释和生成自然语言;它通常由数百万到数十亿个神经网络参数组成,并通过自我监督进行训练。著名的 LLM 包括 GPT-4、BERT 和 LLAMA。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

访问 LLM 有时比较棘手,因为我们必须遵守环境要求和规格,这成为学习 LLM 的门槛。幸运的是,我们可以使用一个名为 openplayground 的 Python 包,在我们的笔记本电脑上高效地实验各种 LLM。

什么是 openplayground,我们如何从中受益?让我们进一步探索。

探索 openplayground

Python 包 openplaygorund 自我介绍为一个可以在笔记本电脑上运行的 LLM 游乐场,它们说得对。它是一个我们可以实验模型、调整参数、进行模型比较,并通过友好的用户界面追踪日志历史的游乐场。它们还使用来自多个实体的著名 LLM,如 OpenAI、HuggingFace 等。

我们如何开始使用 openplaygorund?让我们从安装软件包开始。

pip install openplayground

然后在终端中运行以下命令。

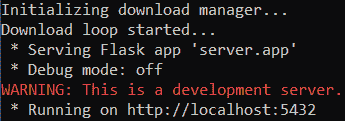

openplayground run

在终端中,你将获得以下信息。

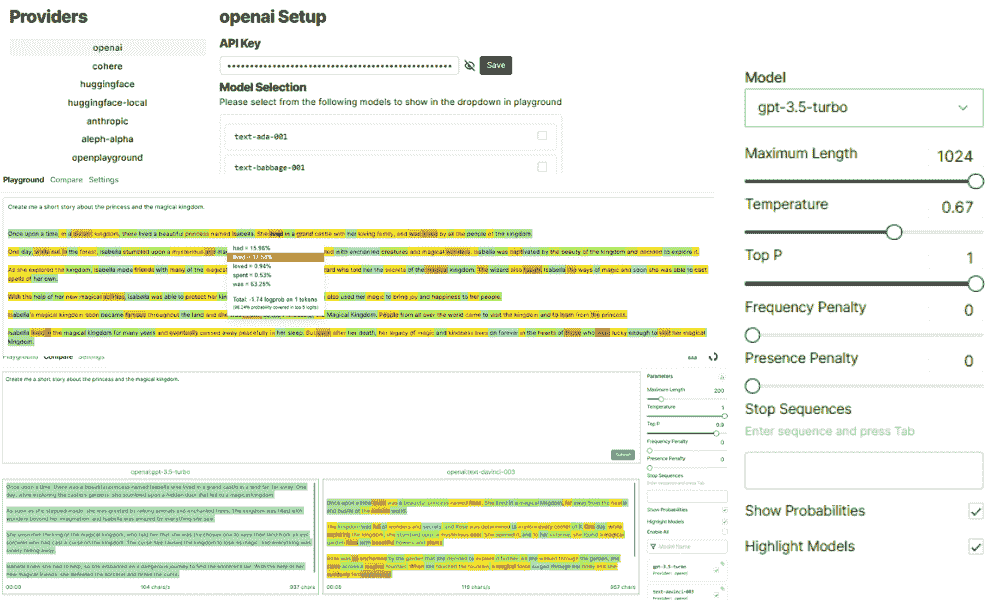

图片由作者提供

openplayground 正在运行,你必须访问本地主机以使用游乐场用户界面。

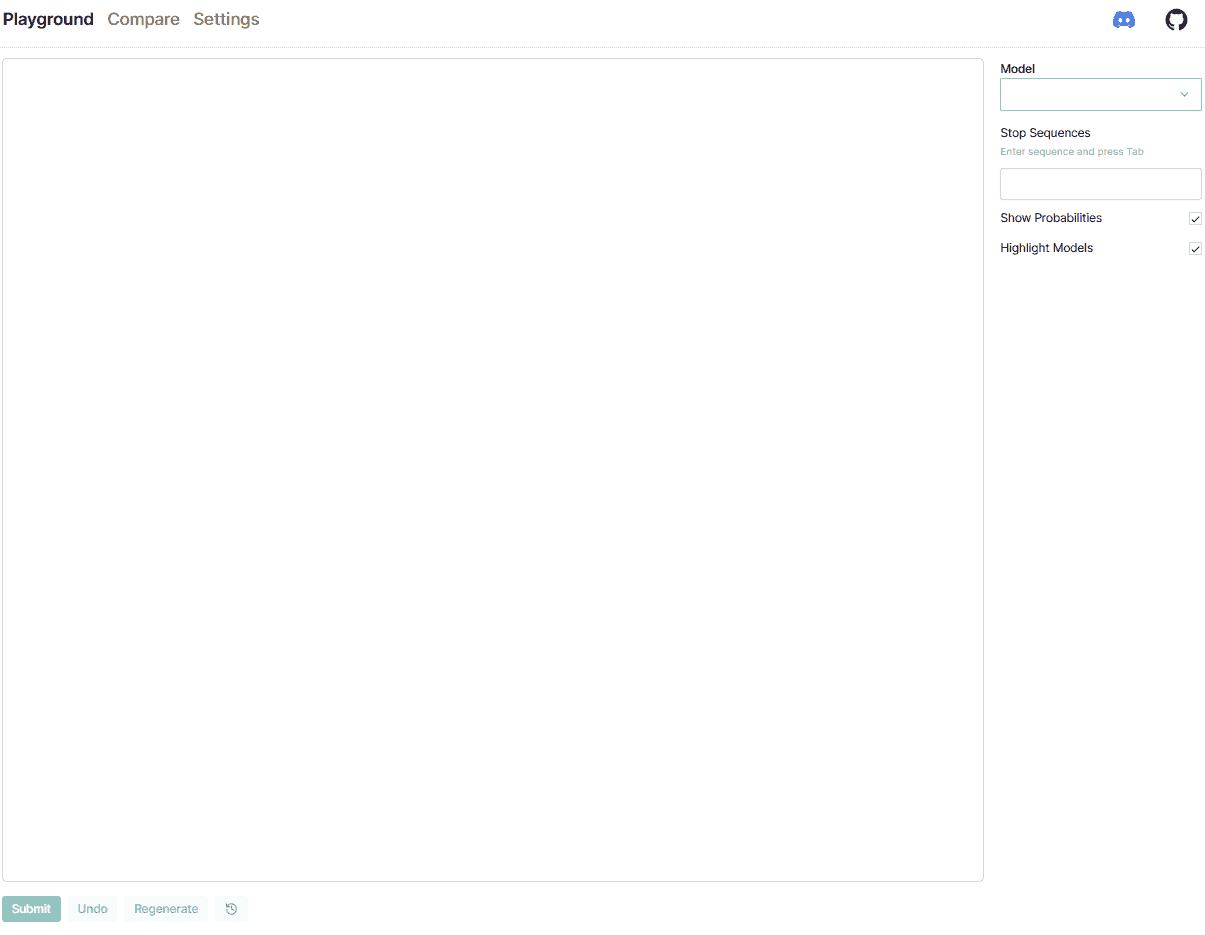

图片由作者提供

在用户界面中,你会看到三个部分:Playground、Compare 和 Settings。我们首先去 Settings 选项卡,因为在提供必要信息之前我们无法进行工作。

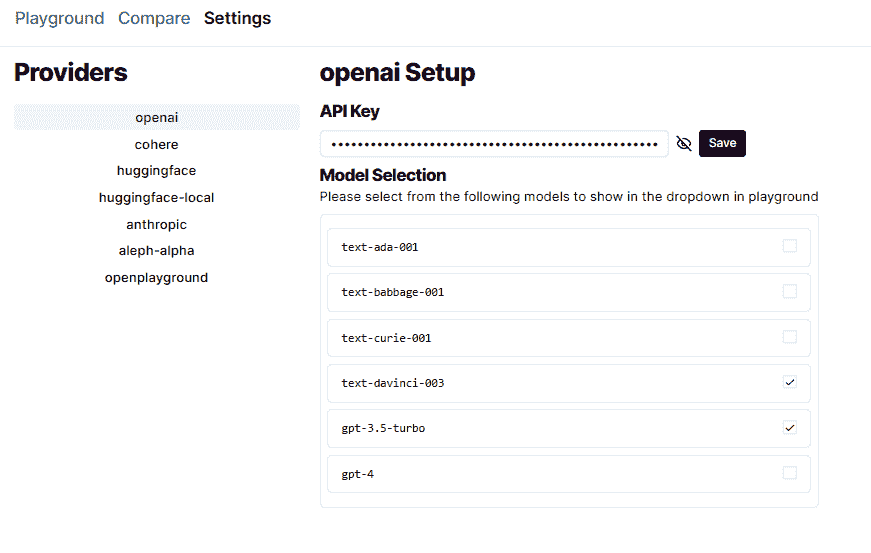

当你打开设置时,会有一个“提供者”部分供你选择。对于本文示例,我们将使用来自 OpenAI 的提供者。点击 OpenAI 并提供 API 密钥,以便所有模型都可以在 openplayground 中访问,如下图所示。

图片来源:作者

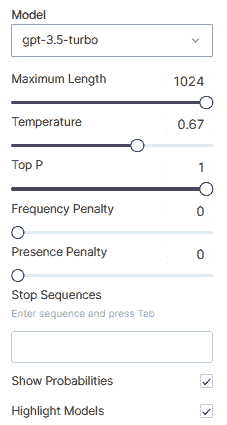

启用你想要的模型,然后返回到 Playground 标签页。当你已经选择了一个模型时,右侧会有额外的参数可以调整。

图片来源:作者

这些参数使我们可以轻松地探索和实验 LLM 模型的结果。让我们尝试一个简单的提示:“给我创建一个关于公主和魔法王国的短篇故事。”

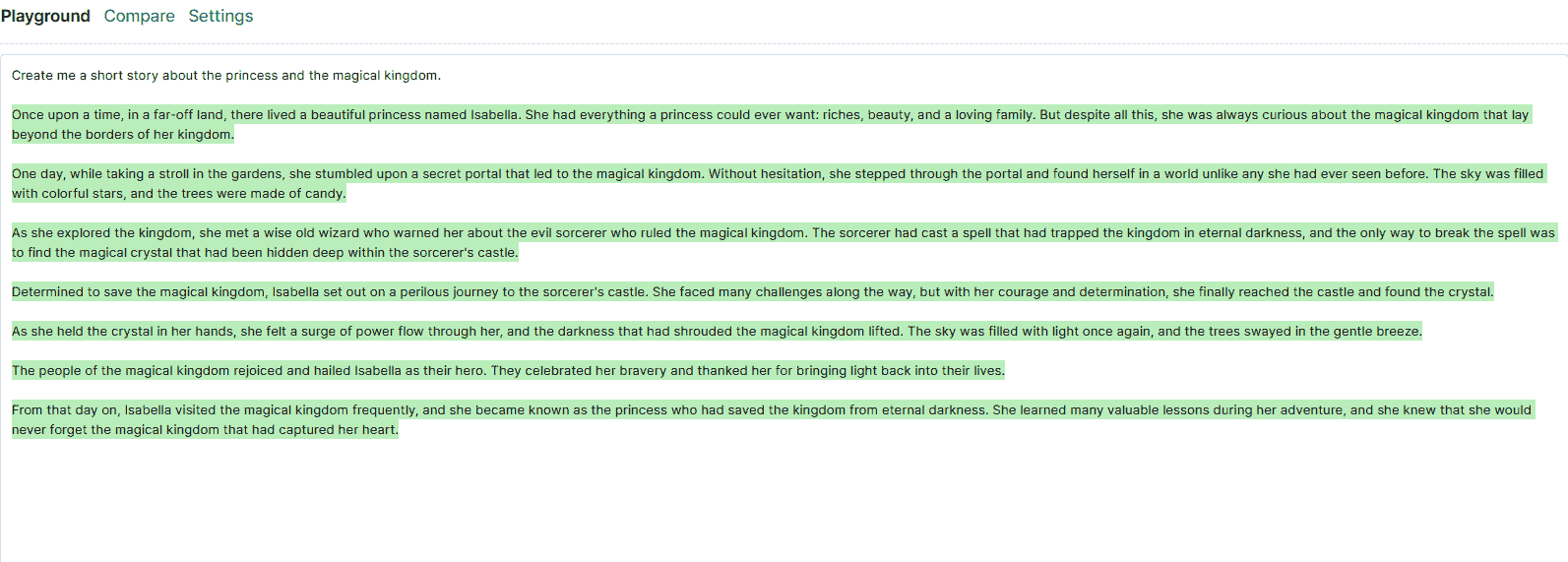

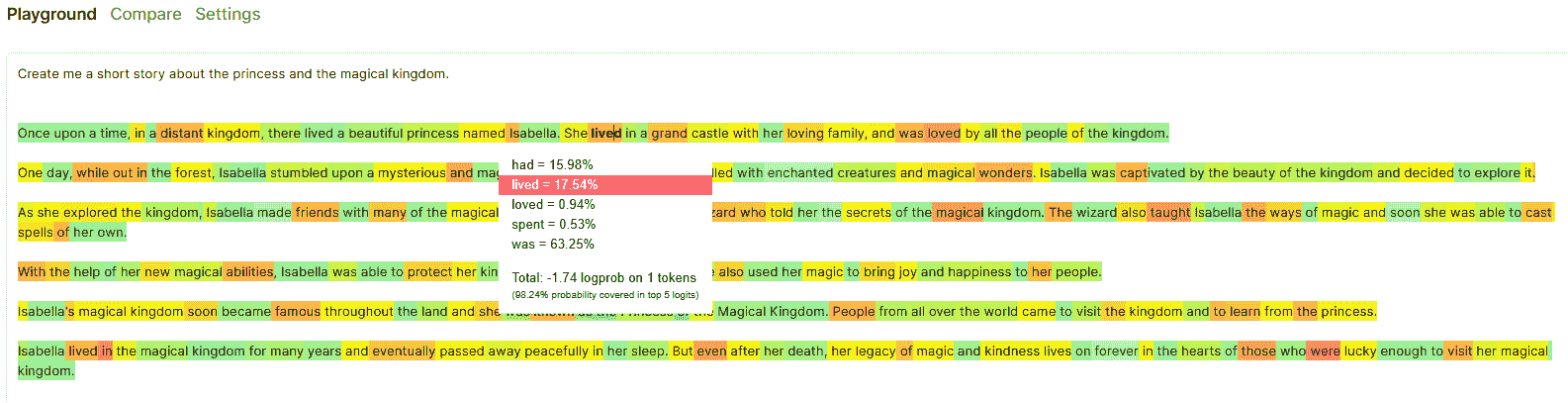

图片来源:作者

生成的文本会显示为绿色。如果启用“显示概率”,你可以获取令牌生成的概率(如果模型允许)。例如,‘text-DaVinci-03’ 模型可以显示这些概率。让我们再次提交提示,并查看结果。

图片来源:作者

将鼠标悬停在令牌上会显示令牌出现的概率有多高。此外,还有关于前 5 个令牌的信息,这些令牌可能成为生成的文本。

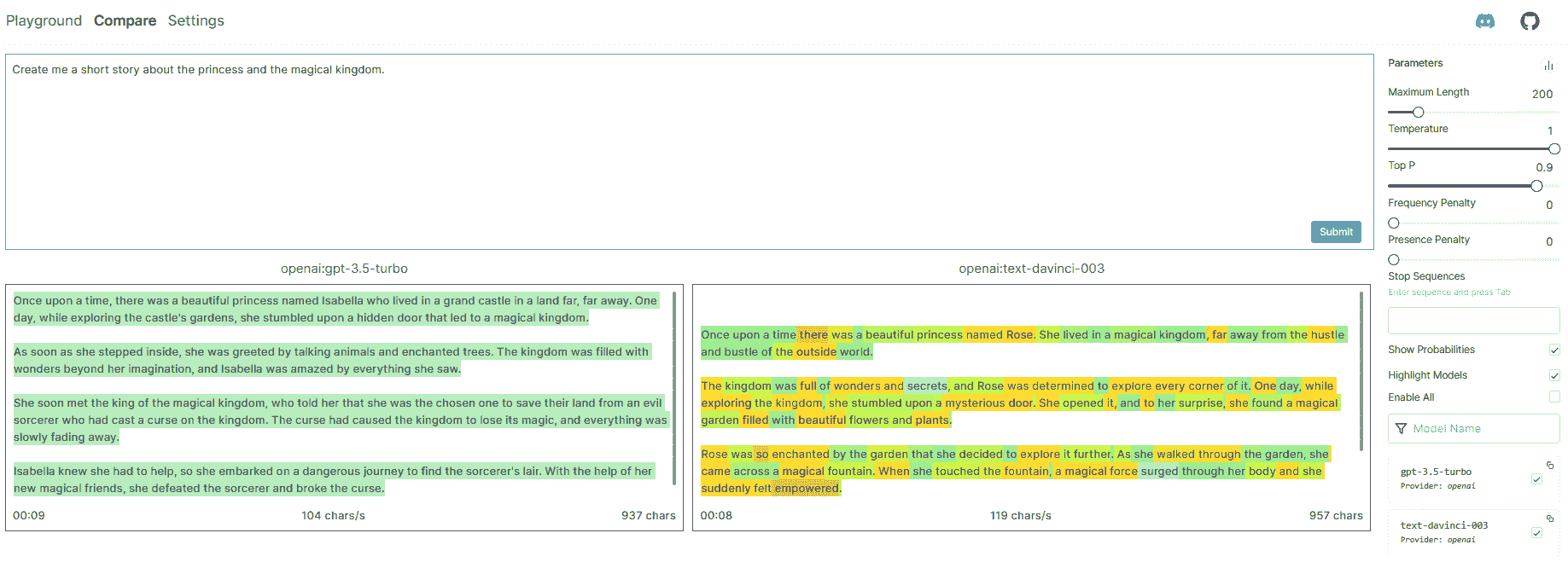

进入“比较”标签页,我们可以比较使用相同参数生成的各种 LLM 模型文本。让我们尝试使用与之前示例相同的提示。

图片来源:作者

“比较”标签提供了生成文本的两个或更多不同 LLM 模型的信息。信息包括令牌、模型生成文本的速度、所花时间和字符数。

尝试使用来自多个提供商的各种模型进行实验,以便从使用 openplayground 中获得更多价值。

结论

大型语言模型(LLM)是一个能够理解、解释和生成文本的模型。通过 openplayground,我们可以拥有一个简单的用户界面来探索和实验多个 LLM。

Cornellius Yudha Wijaya 是一位数据科学助理经理和数据撰写者。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。

更多相关主题

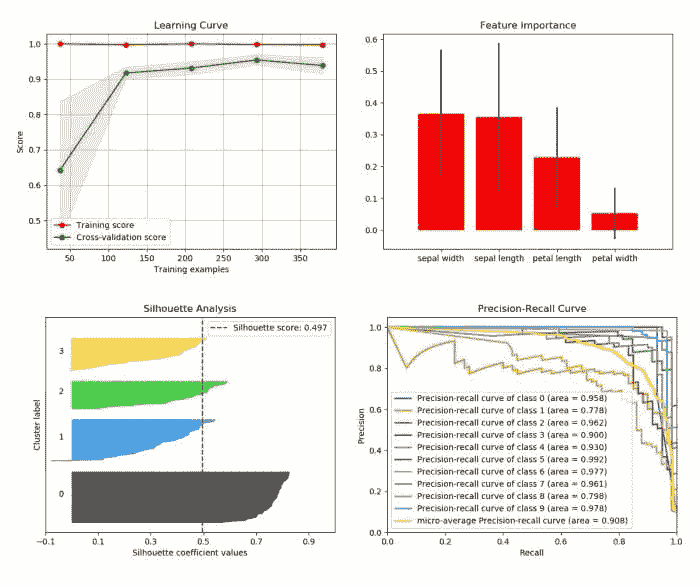

探索生物信息学与机器学习的世界

原文:

www.kdnuggets.com/2019/09/explore-world-bioinformatics-machine-learning.html

评论

生物信息学是一个利用计算从生物数据中提取知识的研究领域。它包括数据的收集、存储、检索、处理和建模,以便通过算法和软件的开发进行分析、可视化或预测。

我们可以用更简单的方式来引用“生物信息学涉及用于理解和处理生物数据的计算和数学方法。”

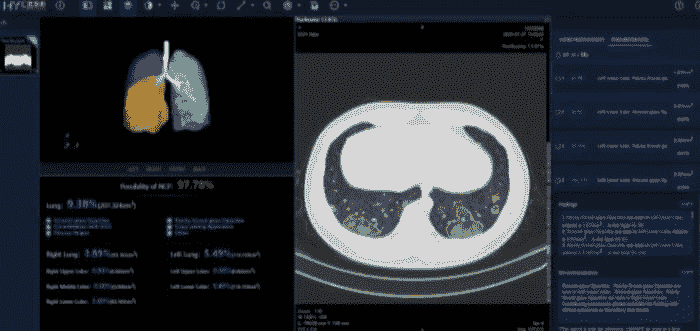

这是一个跨学科领域,开发新的计算方法来分析生物数据并进行生物发现。例如,基因组学和遗传学中的两个典型任务是对一个生物体的完整 DNA 序列进行测序和注释。在神经科学中,神经影像学技术,如计算机断层扫描(CT)、正电子发射断层扫描(PET)、功能性磁共振成像(fMRI)和扩散张量成像(DTI),用于研究活体大脑并理解神经系统的内部机制。

机器学习在生物学和神经影像数据中的应用为生物医学工程开辟了新的前沿:提高我们对复杂疾病如癌症或神经退行性和精神障碍的理解。这一领域的进展最终可以导致自动诊断工具和精准医疗的发展,精准医疗包括根据个体的变异性、生活方式和环境,制定定制化的医疗方案。

在机器学习算法出现之前,生物信息学算法必须手动编程,这对于诸如蛋白质结构预测等问题而言,极其困难。

机器学习技术,如深度学习,使得算法能够利用自动特征学习,这意味着仅根据数据集,算法就可以学习如何将多个特征组合成更抽象的特征集,从而进行进一步的学习。这种对输入数据进行多层次学习模式的方式,使得这些系统在训练大型数据集时可以做出相当复杂的预测。近年来,可用生物数据集的规模和数量急剧增加,使生物信息学研究人员能够利用这些机器学习算法。

机器学习已应用于六个生物学领域:基因组学、蛋白质组学、微阵列、系统生物学、中风诊断和文本挖掘。

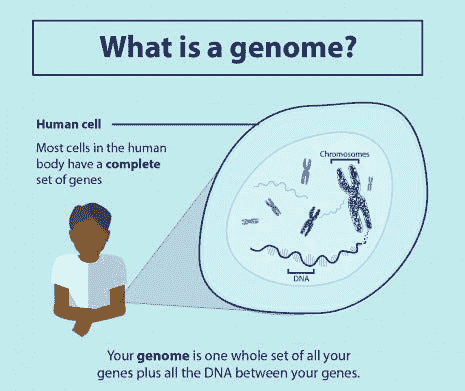

基因组学

这是一个跨学科的生物学领域,专注于基因组的结构、功能、演化、绘图和编辑。基因组是一个生物体完整的 DNA 集合,包括所有基因。对能够自动确定给定 DNA 序列中蛋白质编码基因位置的机器学习系统的需求越来越大,这一问题在计算生物学中被称为基因预测。要了解更多基因组学信息,请点击这里。

蛋白质组学

蛋白质组学是对蛋白质组的大规模研究。蛋白质组是指在一个生物体、系统或生物学背景下产生的蛋白质集合。

蛋白质,由氨基酸链组成,其功能大部分来自于蛋白质折叠,在此过程中它们形成了三维结构。这种结构由多个折叠层组成,包括一级结构(即氨基酸的平坦链)、二级结构(α螺旋和β折叠)、三级结构和四级结构。

蛋白质二级结构预测是这一子领域的主要关注点,因为进一步的蛋白质折叠(三级和四级结构)是基于二级结构来确定的。解决蛋白质的真实结构是一个极其昂贵且耗时的过程,因此需要能够通过直接分析氨基酸序列来准确预测蛋白质结构的系统。在机器学习之前,研究人员需要手动进行这种预测。

目前最先进的二级结构预测使用一种称为 DeepCNF(深度卷积神经场)的系统,该系统依赖于人工神经网络的机器学习模型,以在将蛋白质序列中的氨基酸分类为三种结构类别(螺旋、折叠或线圈)时达到约 84%的准确率。

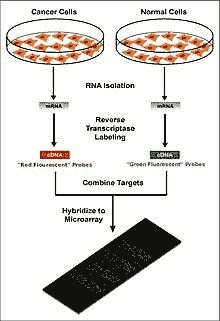

微阵列

微阵列,一种实验室芯片,用于自动收集大量生物材料的数据。机器学习可以帮助分析这些数据,并已应用于表达模式识别、分类和基因网络引导。

这项技术对于监测基因组内基因的表达尤其有用,帮助基于哪些基因被表达来诊断不同类型的癌症。在这一领域的主要问题之一是根据收集的数据识别哪些基因被表达。

机器学习为解决这一问题提供了潜在的解决方案,因为可以使用各种分类方法进行识别。最常用的方法有径向基函数网络、深度学习、贝叶斯分类、决策树和随机森林。

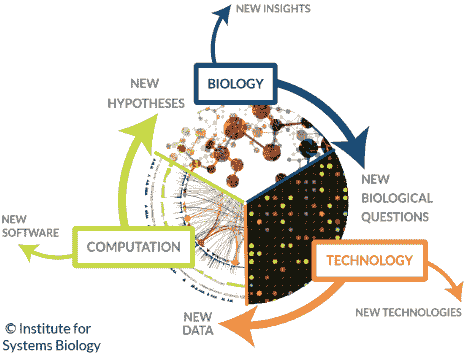

系统生物学

系统生物学专注于研究系统中简单生物组件复杂相互作用所产生的涌现行为。这些组件可以包括 DNA、RNA、蛋白质和代谢物等分子。

机器学习已经被用于帮助建模这些复杂的生物系统相互作用,涉及的领域包括基因网络、信号转导网络和代谢途径。概率图模型,一种用于确定不同变量之间结构的机器学习技术,是建模基因网络的最常用方法之一。此外,机器学习还被应用于系统生物学问题,例如使用一种称为马尔可夫链优化的技术识别转录因子结合位点。基于自然进化过程的机器学习技术——遗传算法,已被用于建模基因网络和调控结构。

中风诊断

用于分析神经影像学数据的机器学习方法被用于帮助诊断中风。三维卷积神经网络(CNN)和支持向量机(SVM)方法常常被使用。

文本挖掘

可用生物出版物的增加导致了在所有来源中搜索和汇编与给定主题相关的所有信息难度增加的问题。这项任务被称为知识提取。这对于生物数据收集是必要的,这些数据随后可以输入机器学习算法,以生成新的生物学知识。机器学习可以使用诸如自然语言处理(NLP)等技术来完成这项知识提取任务,从数据库中的人类生成的报告中提取有用的信息。

该技术已被应用于寻找新药物靶点,因为这项任务需要检查存储在生物数据库和期刊中的信息。蛋白质数据库中的蛋白质注释通常不能反映每种蛋白质的完整已知知识集,因此必须从生物医学文献中提取额外的信息。机器学习已被应用于基因和蛋白质功能的自动注释、蛋白质亚细胞定位的确定、DNA 表达阵列的分析、大规模蛋白质相互作用分析和分子相互作用分析。

现在让我们在生物信息学数据集中实现支持向量机(SVM)算法,看看它是如何工作的。

利用支持向量机(SVM)进行基因表达监测的癌症分子分类

尽管癌症分类在过去 30 年中有所改进,但仍然没有一种通用的方法来识别新的癌症类别(类别发现)或将肿瘤分配到已知类别(类别预测)。该数据集来自 Golub 等人在 1999 年发表的概念验证研究。该研究展示了如何通过基因表达监测(通过 DNA 微阵列)对新病例进行分类,从而提供了一种通用的方法来识别新的癌症类别并将肿瘤分配到已知类别。

目标是使用 SVM 算法对急性髓系白血病(AML)和急性淋巴细胞白血病(ALL)的患者进行分类。

数据集可以从Kaggle下载。

让我们开始编码:

从加载三个基本的 python 库开始:

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

加载数据集:

Train_Data = pd.read_csv("/.../bioinformatics/data_set_ALL_AML_train.csv")

Test_Data = pd.read_csv("/.../bioinformatics/data_set_ALL_AML_independent.csv")

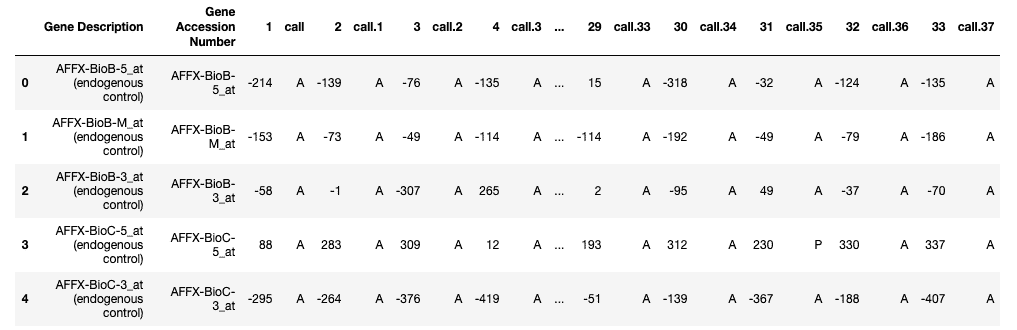

labels = pd.read_csv("/.../bioinformatics/actual.csv", index_col = 'patient')Train_Data.head()

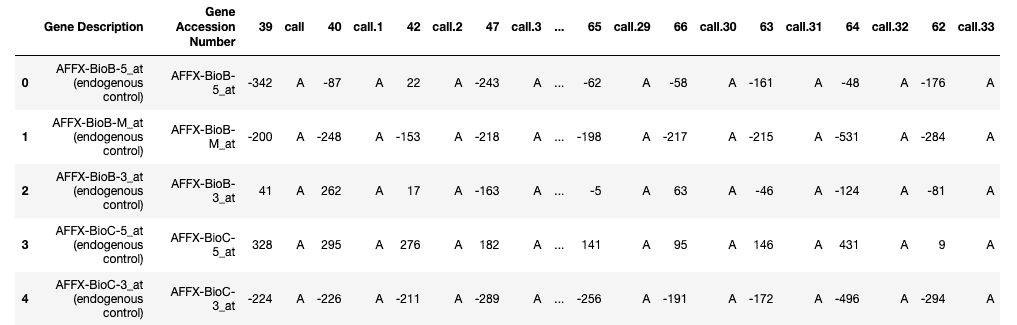

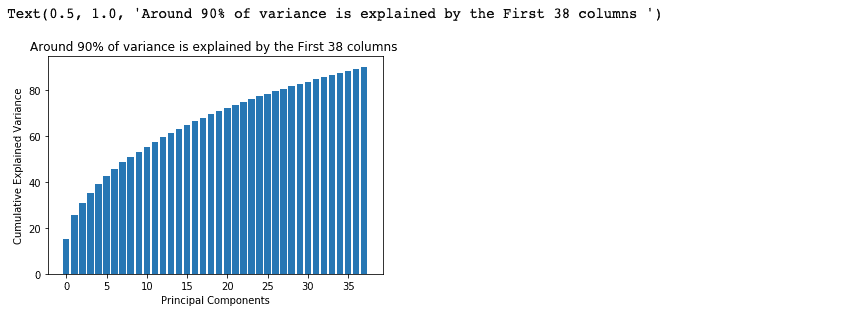

训练数据

Test_Data.head()

测试数据

关于数据集:

-

每一行代表一个不同的基因。

-

第 1 列和第 2 列是关于该基因的描述。

-

每个编号的列是标签数据中的一个患者。

-

每个患者有 7129 个基因表达值——即每个患者每个基因都有一个值。

-

训练数据包含第 1 到第 38 位患者的基因表达值。

-

测试数据包含第 39 到第 72 位患者的基因表达值。

现在检查两个数据集中是否有空值(这些数据集中没有空值)。

print(Train_Data.isna().sum().max())

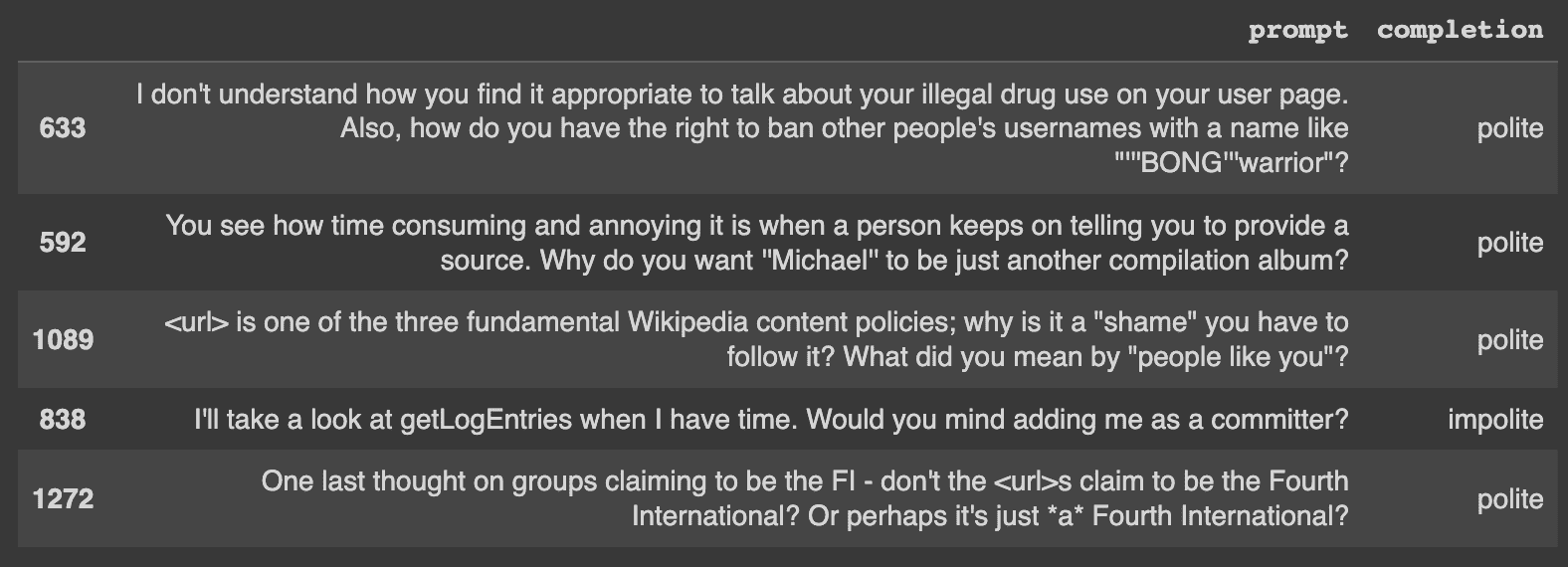

print(Test_Data.isna().sum().max())

现在从训练数据和测试数据中删除列‘call’,因为它没有任何统计相关性。

cols = [col for col in Test_Data.columns if 'call' in col]

test = Test_Data.drop(cols, 1)

cols = [col for col in Train_Data.columns if 'call' in col]

train = Train_Data.drop(cols, 1)

现在将所有数据集连接起来并转置最终的连接数据。

patients = [str(i) for i in range(1, 73, 1)]

df_all = pd.concat([train, test], axis = 1)[patients]

df_all = df_All.T

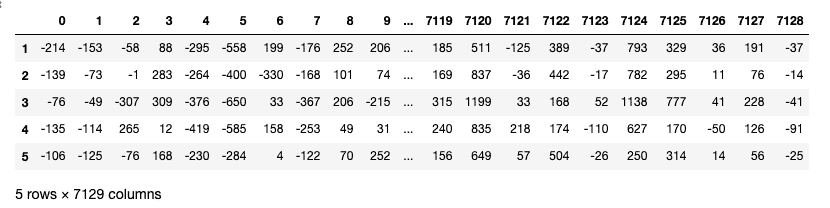

df_all

转置后,行已转换为列(7129 列/特征)。

现在将 patient 列转换为数值,并创建虚拟变量(将类别转换为数值),因为‘cancer’是一个具有 2 个类别(ALL,AML)的分类列。

df_all["patient"] = pd.to_numeric(patients)

labels["cancer"]= pd.get_dummies(Actual.cancer, drop_first=True)

现在在patient列上连接数据框df_all和labels。

Data = pd.merge(df_all, labels, on="patient")

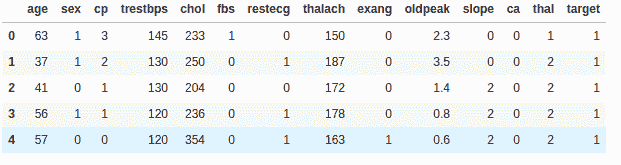

Data.head()

数据

我们的下一步是创建两个变量X(自变量矩阵)和y(因变量向量)。

X, y = Data.drop(columns=["cancer"]), Data["cancer"]

接下来,我们将 75%的数据分为训练集,将 25%的数据分为测试集。test_size变量是我们实际指定测试集比例的地方。

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X,y,test_size = 0.25, random_state= 0)

下一步是规范化数据,因为如果我们仔细查看数据,自变量的值范围差异很大。因此,当自变量的值差异很大时,我们使用特征缩放以确保所有值保持在可比范围内。

from sklearn.preprocessing import StandardScaler

sc_X = StandardScaler()

X_train = sc_X.fit_transform(X_train)

X_test = sc_X.transform(X_test)

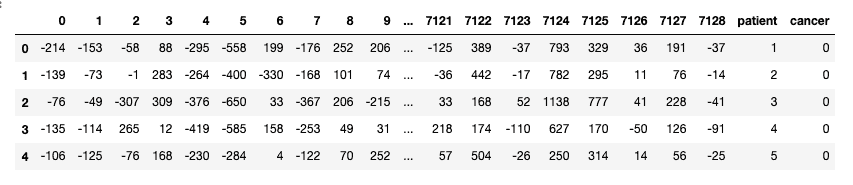

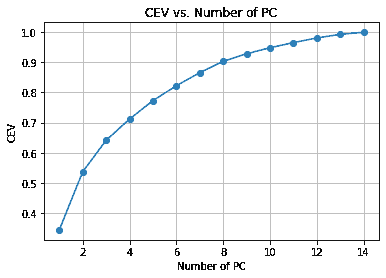

我们正在处理的列/特征数量非常庞大。我们有 72 行和 7129 列。基本上,我们需要减少特征的数量(降维)以去除维度诅咒的可能性。

为了减少维度/特征的数量,我们将使用最流行的降维算法,即PCA(主成分分析)。

为了执行 PCA,我们必须选择我们希望数据中包含的特征/维度数量。

from sklearn.decomposition import PCA

pca = PCA()

X_train = pca.fit_transform(X_train)

X_test = pca.transform(X_test)

total=sum(pca.explained_variance_)

k=0

current_variance=0

while current_variance/total < 0.90:

current_variance += pca.explained_variance_[k]

k=k+1

上述代码给出了k=38。

现在我们选择 k=38,并对我们的自变量应用 PCA。

from sklearn.decomposition import PCA

pca = PCA(n_components = 38)

X_train = pca.fit_transform(X_train)

X_test = pca.transform(X_test)cum_sum = pca.explained_variance_ratio_.cumsum()

cum_sum = cum_sum*100

plt.bar(range(38), cum_sum)

plt.ylabel("Cumulative Explained Variance")

plt.xlabel("Principal Components")

plt.title("Around 90% of variance is explained by the First 38 columns ")

注意:- PCA 可能会导致在没有或低特征相关性的 数据集上模型性能下降,或者不符合线性假设。

下一步是将我们的数据适配到支持向量机(SVM)算法中,但在此之前我们将进行超参数优化。

超参数优化或调整是选择学习算法的最佳超参数集的问题。超参数是用于控制学习过程的参数值。相比之下,其他参数的值是通过学习得到的。

我们将使用来自 sklearn 的 GridSearchCV 来选择最佳的超参数。

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVCparameters = [{'C': [1, 10, 100, 1000], 'kernel': ['linear']},

{'C': [1, 10, 100, 1000], 'kernel': ['rbf'], 'gamma': [0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9]}]search = GridSearchCV(SVC(), parameters, n_jobs=-1, verbose=1)

search.fit(X_train, y_train)

现在检查我们 SVM 算法的最佳参数。

best_parameters = search.best_estimator_

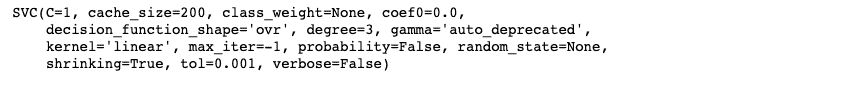

最佳超参数

现在让我们训练我们的 SVM 分类模型。

model = SVC(C=1, cache_size=200, class_weight=None, coef0=0.0,

decision_function_shape='ovr', degree=3, gamma='auto_deprecated',

kernel='linear', max_iter=-1, probability=False, random_state=None,

shrinking=True, tol=0.001, verbose=False)

model.fit(X_train, y_train)

是时候做一些预测了:

y_pred=model.predict(X_test)

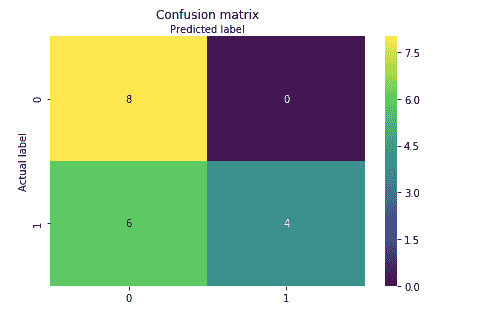

评估模型性能:

from sklearn.metrics import accuracy_score, confusion_matrixfrom sklearn import metrics

print('Accuracy Score:',round(accuracy_score(y_test, y_pred),2))

#confusion matrix

cm = confusion_matrix(y_test, y_pred)Output:

Accuracy Score: 0.67

混淆矩阵并使用热图进行可视化。

class_names=[1,2,3]

fig, ax = plt.subplots()from sklearn.metrics import confusion_matrix

import seaborn as snscm = confusion_matrix(y_test, y_pred)class_names=['ALL', 'AML']

fig, ax = plt.subplots()

tick_marks = np.arange(len(class_names))

plt.xticks(tick_marks, class_names)

plt.yticks(tick_marks, class_names)

sns.heatmap(pd.DataFrame(cm), annot=True, cmap="viridis" ,fmt='g')

ax.xaxis.set_label_position("top")

plt.tight_layout()

plt.title('Confusion matrix', y=1.1)

plt.ylabel('Actual label')

plt.xlabel('Predicted label')

混淆矩阵的热图

好吧,这个例子表明,如果你只是预测每个患者都有 AML,你的正确率会比错误率高。

因此,我们的 SVM 分类模型以 67%的准确率预测了癌症患者,这显然不是很好。你可以尝试不同的分类器,如随机森林、K-NN、梯度提升、xgboost 等,并比较每个模型的准确率。

结论

在这篇文章中,我们展示了如何使用分类机器学习算法来预测患者的癌症。

我认为,要让机器学习真正蓬勃发展,关键在于更好的生物信息学数据。目前健康和生物信息学数据的统计能力相当差。它们通常要么信号较差(基因组学),要么噪声/偏差较高(电子健康记录),要么样本量较小。

好了,这就是本文的全部内容。我希望大家喜欢阅读,请在评论区分享您的建议/观点/问题。

你也可以通过LinkedIn联系我,提出任何问题。

感谢阅读!!!

个人简介: Nagesh Singh Chauhan 是一名数据科学爱好者,对大数据、Python、机器学习感兴趣。

原文。经许可转载。

相关内容:

-

友好的支持向量机介绍

-

使用 K-最近邻分类心脏病

-

使用 K-Means 聚类进行图像分割简介

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升您的数据分析技能。

2. Google 数据分析专业证书 - 提升您的数据分析技能。

3. Google IT 支持专业证书 - 支持您的组织 IT 工作。

3. Google IT 支持专业证书 - 支持您的组织 IT 工作。

更多相关内容

探索蛮力 K-最近邻算法

原文:

www.kdnuggets.com/2020/10/exploring-brute-force-nearest-neighbors-algorithm.html

评论

Murugan Yuvaraaj,Praxis 商学院

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 在 IT 方面支持你的组织

3. Google IT 支持专业证书 - 在 IT 方面支持你的组织

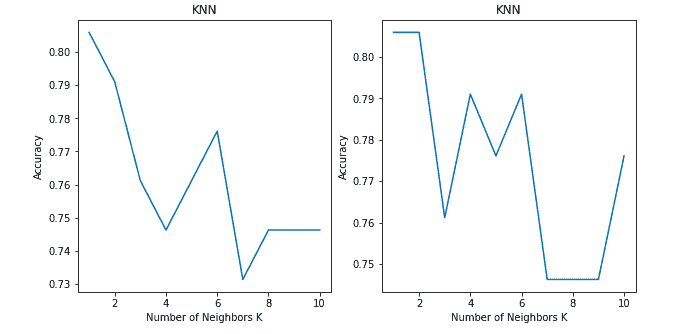

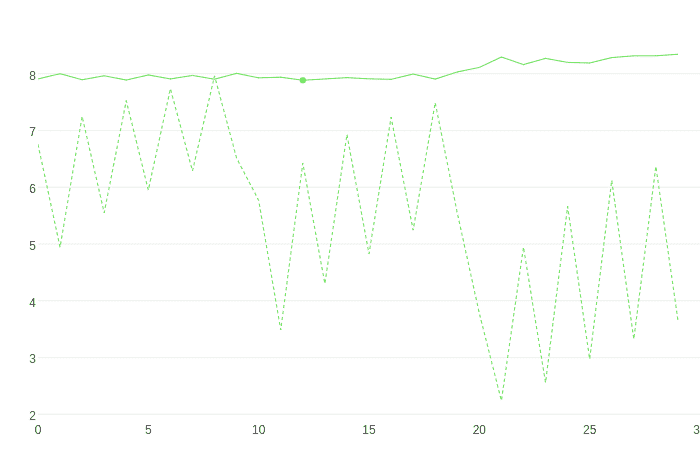

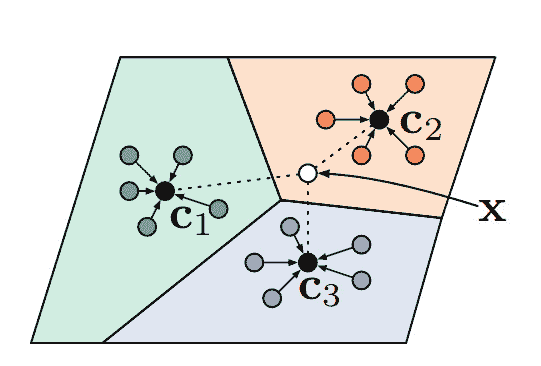

你发现这两个图之间有什么不同吗?

两者都显示了 K 值在 1 到 10 之间的分类问题的准确率。

两个图都使用了 KNN 分类模型,采用了 'Brute-force' 算法和 'Euclidean' 距离度量在相同数据集上。那么为什么两个图之间的准确率会有所不同呢?

在回答那个问题之前,让我带你浏览一下 KNN 算法的伪代码。

希望大家都对 k 最近邻算法有所了解。如果没有,你可以在 www.analyticsvidhya.com/blog/2018/03/introduction-k-neighbours-algorithm-clustering/ 阅读其基础知识。

我们可以通过以下步骤实现 KNN 模型:

-

加载数据

-

初始化 k 的值

-

为了获得预测的类别,从 1 遍历到所有训练数据点的总数。

-

计算测试数据和每行训练数据之间的距离。这里我们将使用欧几里得距离作为我们的距离度量,因为它是最流行的方法。还可以使用其他度量方法,如切比雪夫、余弦等。

-

根据距离值按升序排序计算得到的距离

-

从排序数组中获取前 k 行

-

获取这些行中最频繁的类别

-

返回预测的类别

对于我们的分析,让我们只关注第 7 步,获取这些行中最频繁的类别。

在获取前 k 行之后,我们从这些行中挑选出最频繁的类别(众数)。这存在一个小问题。

在奇数 k 邻居的情况下,列表中总会有一个多数类别。因此,奇数 k 邻居不会出现问题。

那么对于偶数 k 邻居数量以及两个或更多类别获得相同多数的情况怎么办呢?

KNN 算法也可以为数据集提供高准确率,即使对于偶数 k 邻居。它并不局限于仅使用奇数 k 邻居来获取多数类别。

例如:

如果 k = 4,并且我们列表中有类别 A = 2 和类别 B = 2。在这种情况下,算法将选择位于前 K 行的类别,而不是查看距离度量。

为了解决这个问题,我们在算法中使用了距离 - 模式 - 距离作为偶数 K 个邻居的标准。

我们的算法与暴力搜索算法的工作方式相同,但对于偶数 K 邻居,它所带来的差异是巨大的。

我们的算法做的事情很简单。它从距离度量中取出前 K 行。在奇数 K 值的情况下,它取大多数类别。对于偶数 K 行,选择大多数类别。如果有两个或更多类别具有大多数,则这两个或更多主要类别的距离将再次进入距离度量循环,检查哪个类别的距离度量最低,并将该类别选择为主要类别。

让我们来看一个如何工作的示例。

我们的分析使用了企鹅数据集。

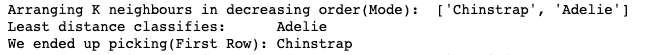

暴力搜索算法:

在这里我们设置了 k = 4。

类别‘Chinstrap’和‘Adelie’的模式为 2。在根据模式排列 K 个邻居后,暴力搜索选择了第一个类别,而不是选择距离度量中最小距离的类别。

这影响了当 k 值为偶数时暴力搜索算法的准确性。

我们的模型:

我们的模型能够在偶数邻居情况下提高准确性。

结果:

我比较了我们的模型与暴力搜索的准确性,结果如下。

| K | 暴力搜索 | 我们的模型 |

|---|---|---|

| 1 | 0.805 | 0.805 |

| 2 | 0.746 | 0.805 |

| 3 | 0.761 | 0.761 |

| 4 | 0.746 | 0.791 |

| 5 | 0.776 | 0.776 |

| 6 | 0.716 | 0.791 |

| 7 | 0.746 | 0.746 |

| 8 | 0.686 | 0.746 |

| 9 | 0.746 | 0.746 |

| 10 | 0.701 | 0.776 |

我还比较了结果与kd 树和球树算法,结果相似。

GitHub 链接: github.com/myuvarajmp/Exploring_KNN_Algorithm

感谢您的时间,并且请对我的反馈宽容,因为这是我的第一篇文章。

个人简介: Murugan Yuvaraaj 是印度班加罗尔 Praxis 商学院的学生。

相关内容:

-

初学者指南:R 中的 K-最近邻算法,从零到英雄

-

K 最近邻算法的介绍及示例

-

使用 K-最近邻算法分类心脏病

更多相关内容

探索使用 Python 的数据清理技术

原文:

www.kdnuggets.com/2023/04/exploring-data-cleaning-techniques-python.html

图片来源:freepik.com

在实际的数据科学项目中,用于分析的数据可能包含多个缺陷,例如缺失数据、冗余数据、数据条目格式不正确、数据中的异常值等。数据清理指的是将原始数据进行预处理和转换,以便将其呈现为适合进一步分析的形式,例如描述性分析(数据可视化)或处方分析(模型构建)。必须使用干净、准确、可靠的数据进行后续分析,因为“坏数据导致糟糕的预测模型”。

我们的三大课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

2. Google Data Analytics Professional Certificate - 提升您的数据分析能力

2. Google Data Analytics Professional Certificate - 提升您的数据分析能力

3. Google IT Support Professional Certificate - 支持您的组织的 IT

3. Google IT Support Professional Certificate - 支持您的组织的 IT

Python 中的多个库,包括 pandas 和 numpy,可用于数据清理和转换。这些库提供了广泛的方法和功能来执行任务,包括处理缺失值、消除异常值,以及将数据转换为模型友好的格式。此外,消除冗余特征或将高度相关的特征组合成一个特征可能会导致维度减少。使用特征较少的数据集训练模型将提高模型的计算效率。此外,使用特征较少的数据集构建的模型更容易解释,并且具有更好的预测能力。

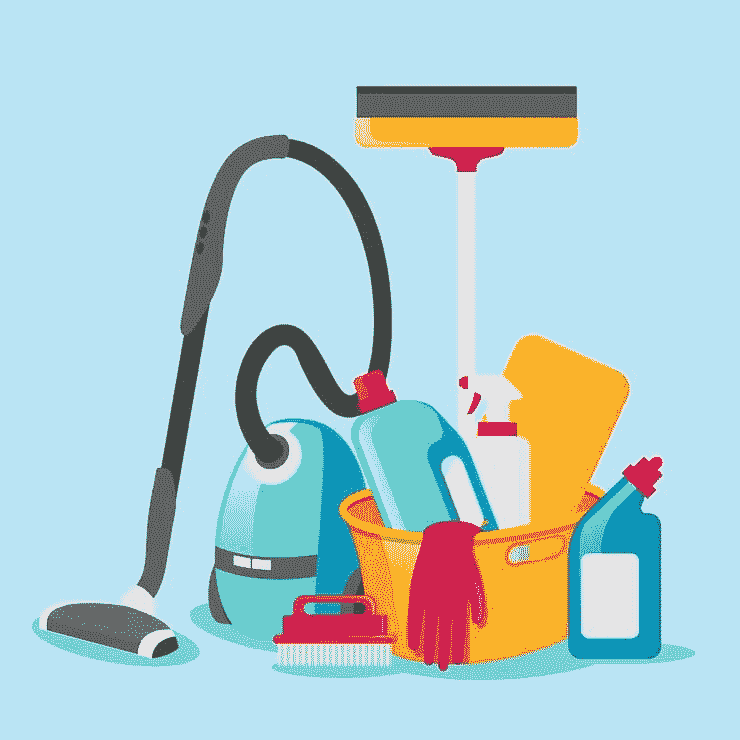

在本文中,我们将探索 Python 中用于清理、处理和转换数据的各种工具和技术。我们将使用下面展示的data.cvs 数据集演示数据清理技术:

data.csv 展示了多种缺陷,例如重复数据、NaN 等。数据由作者创建。

Python 数据清理库

在 Python 中,可以使用一系列库和工具,包括 pandas 和 NumPy,来清理数据。例如,pandas 中的 dropna()、drop_duplicates() 和 fillna() 函数分别可用于处理缺失数据、删除缺失数据和删除重复行。scikit-learn 工具包提供了处理离群值的工具(例如 SimpleImputer 类)和将数据转换为模型可以使用的格式的工具,例如用于标准化数值数据的 StandardScaler 类和用于归一化数据的 MinMaxScaler。

在本文中,我们将探讨在 Python 中可以使用的各种数据清理技术,以便为机器学习模型准备和预处理数据。

处理缺失数据

处理缺失数据是数据集中最重要的缺陷之一。Python 的 pandas 包提供了几种处理缺失数据的方法,包括dropna()和fillna()。dropna() 方法用于消除任何具有缺失值的列或行。例如,下面的代码将消除所有至少有一个缺失值的行:

import pandas as pd

data = pd.read_csv('data.csv')

data = data.dropna()

fillna() 函数可用于用特定值或方法填充缺失值。例如,以下代码将用数据中的平均年龄填充 'age' 列中的缺失值:

import pandas as pd

data = pd.read_csv('data.csv')

data['age'].fillna(data['age'].mean(), inplace=True)

处理离群值

处理离群值是典型的数据清理活动。那些与其余数据差异较大的值被视为离群值。这些因素需要小心处理,因为它们对模型的性能有显著影响。在 Python 的 scikit-learn 工具包中,RobustScaler 类用于处理离群值。通过删除中位数并根据四分位范围来缩放数据,可以使用该类来对数据进行缩放。

from sklearn.preprocessing import RobustScaler

data = pd.read_csv('data.csv')

scaler = RobustScaler()

data = scaler.fit_transform(data)

编码分类变量

另一个常见的数据清理任务是将数据转换为模型可以使用的格式。例如,在分类数据可以用于模型之前,必须将其转换为数值数据。pandas 包中的 get_dummies() 方法允许将类别数据转换为数值数据。在下面的示例中,类别特征‘Department’被转换为数值数据:

import pandas as pd

data = pd.read_csv('data.csv')

data = pd.get_dummies(data, columns=['Department'])

删除重复数据

在数据清理过程中,还必须消除重复数据。要从 Python DataFrame 中删除重复的行,可以使用 pandas 包提供的drop_duplicates() 方法。例如,下面的代码将消除数据中的所有冗余行:

import pandas as pd

data = pd.read_csv('data.csv')

data = data.drop_duplicates()

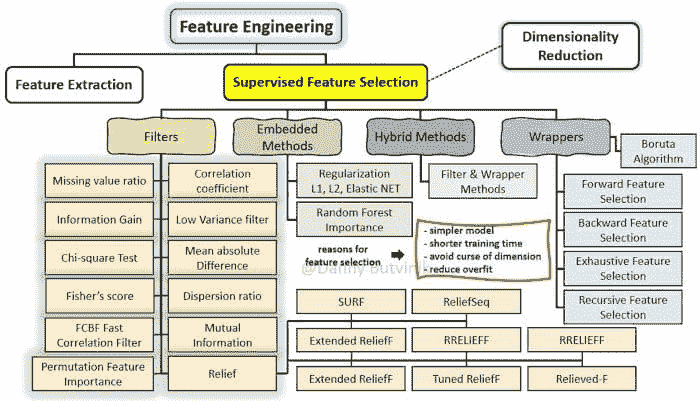

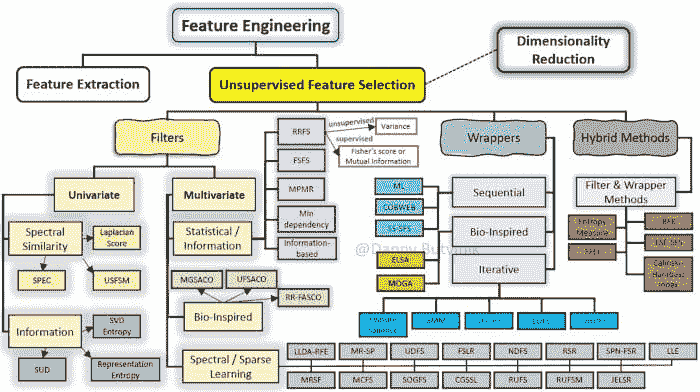

特征工程

特征选择和特征工程是数据清理的关键组成部分。选择数据集中仅相关特征的过程称为特征选择,而从现有特征中构建新特征的过程称为特征工程。下面的代码演示了特征工程的过程:

import pandas as pd

from sklearn.preprocessing import StandardScaler

# read the data into a pandas dataframe

df = pd.read_excel("data.csv")

# create a feature matrix and target vector

X = df.drop(["Employee ID", "Date of Joining"], axis=1)

y = df["Salary"]

# scale the numerical features

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X[["Age", "Experience"]])

# concatenate the scaled features with the categorical features

gender_dummies = pd.get_dummies(X["Gender"], prefix="Gender")

X_processed = pd.concat(

[gender_dummies, pd.DataFrame(X_scaled, columns=["Age", "Experience"])],

axis=1,

)

print(X_processed)

在上述代码中,我们首先通过删除'员工编号'和'入职日期'列来创建特征矩阵 (X),然后创建一个包含'薪资'列的目标向量 (y)。接着,我们使用 scikit-learn 的 StandardScaler() 函数对数值特征'年龄'和'经验'进行缩放。

接下来,我们为分类列'性别'创建虚拟变量,并将其与缩放后的数值特征连接起来,创建最终处理后的特征矩阵 (X_processed)。

请注意,所使用的具体特征提取技术将取决于数据以及分析的具体要求。同时,在应用任何机器学习模型之前,重要的是将数据拆分为训练集和测试集,以避免过拟合。

结论

总之,数据清洗是机器学习过程中的一个重要阶段,因为它确保用于分析(描述性或规定性)的数据质量高。准备和预处理数据的重要方法包括转换数据格式、删除重复数据、处理缺失数据、异常值检测、特征工程和特征选择。Pandas、NumPy 和 scikit-learn 只是特征工程和数据清洗众多库和工具中的一部分。

本杰明·O·塔约 是一名物理学家、数据科学教育者和作家,同时也是 DataScienceHub 的创始人。此前,本杰明曾在中央俄克拉荷马大学、大峡谷大学和匹兹堡州立大学教授工程学和物理学。

更多相关内容

使用直方图探索数据分布

原文:

www.kdnuggets.com/2023/05/exploring-data-distributions-histograms.html

图片来自 Bing 图像生成器

直方图是一种数据可视化工具,在数据科学和统计学中广泛用于探索数据的分布。要创建直方图,首先将感兴趣的特征值分组到区间中,然后统计每个区间内的数据条目总数,这些数值表示计数。直方图是数据值(自变量)和计数(因变量)的图示。通常,被绘制的特征表示水平轴,而计数表示垂直轴。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

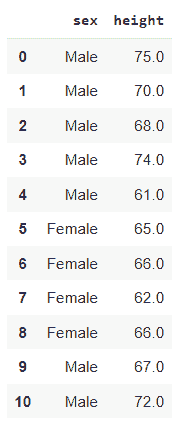

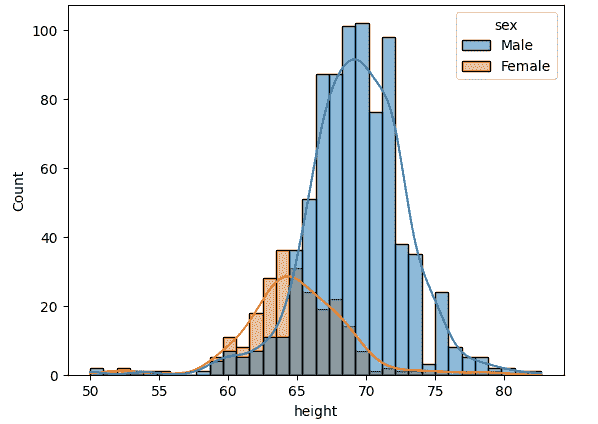

使用直方图探索男性和女性身高数据分布

为了说明如何使用直方图探索数据分布,我们将使用 heights 数据集。该数据集包含男性和女性的身高数据。

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

# obtain dataset

df = pd.read_csv('https://raw.githubusercontent.com/bot13956/Bayes_theorem/master/heights.csv')

# display head of dataset

pd.head()

heights 数据集的头部信息显示了男性和女性的身高(以英寸为单位)。图片由作者提供。

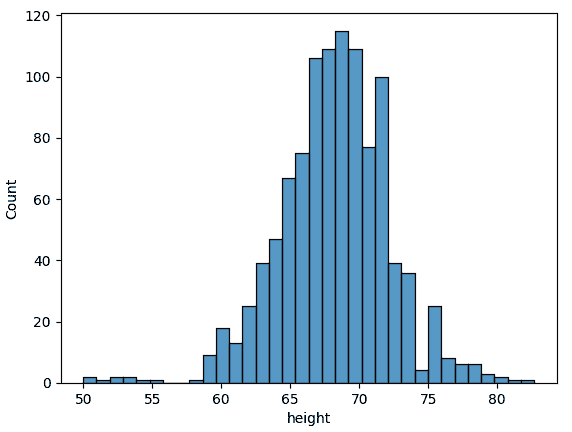

所有身高的直方图

我们可以使用以下代码绘制所有身高的分布。

sns.histplot(data = df, x="height")

plt.show()

直方图显示了数据集中所有身高的分布。图片由作者提供。

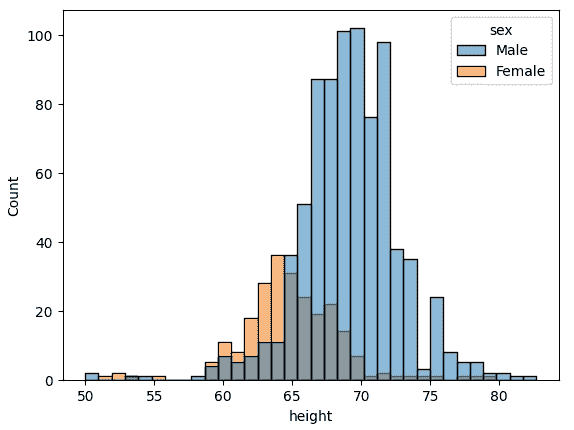

显示男性和女性身高类别的直方图

由于数据集是分类的,我们可以生成如下所示的男性和女性身高分布的直方图。

sns.histplot(data=df, x="height", hue="sex")

plt.show()

显示男性和女性身高分布的直方图。图片由作者提供。

男性和女性身高的独立直方图

我们可以绘制男性和女性身高的独立直方图,如下所示。

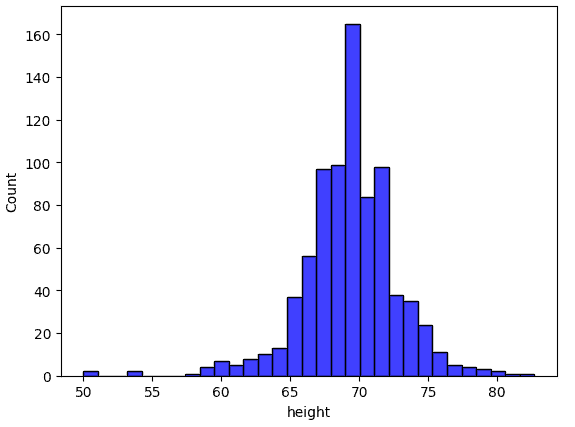

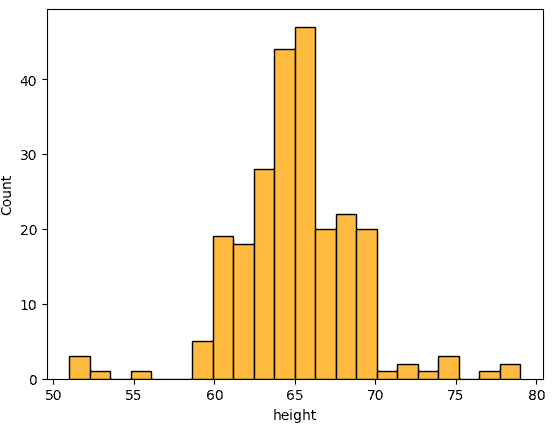

sns.histplot(data = df[df.sex=='Male']['height'], color='blue')

plt.show()

显示男性身高分布的直方图。图片由作者提供。

sns.histplot(data = df[df.sex=='Female']['height'], color='orange')

plt.show()

显示女性身高分布的直方图。图片由作者提供。

带有核密度估计图的直方图

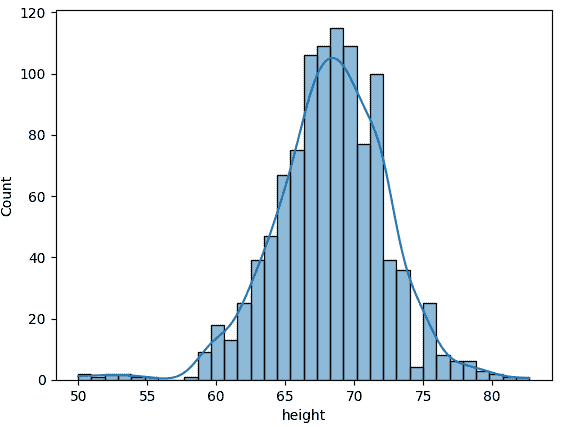

可以添加核密度估计(KDE)图以平滑直方图,并估计数据的概率分布。

sns.histplot(data = df, x = 'height', KDE = 'True')

plt.show()

带有 KDE 图的全部身高数据直方图。图片由作者提供。

sns.histplot(data=df, x="height", hue="sex", KDE = 'True')

plt.show()

带有核密度估计图的男性和女性身高分布直方图。图片由作者提供。

显然,我们从上图中可以观察到,身高数据是双峰的,分别对应男性和女性类别。

摘要

总结来说,我们回顾了使用直方图探索数据分布的方法。使用身高数据集,我们展示了为数据集中的每个类别生成直方图的重要性。我们还展示了如何使用核密度估计图(KDE)平滑直方图,以产生近似的连续分布曲线。

本杰明·O·泰约 是一位物理学家、数据科学教育者和作家,同时也是 DataScienceHub 的所有者。此前,本杰明曾在中央俄克拉荷马大学、大峡谷大学和匹兹堡州立大学教授工程学和物理学。

更多相关内容

探索数据网格:数据架构的范式转变

原文:

www.kdnuggets.com/exploring-data-mesh-a-paradigm-shift-in-data-architecture

图片由作者提供

随着技术、组织和业务需求的变化,数据架构在过去十年左右发生了演变。但这种演变是否足够显著?大多数组织通常采用集中式数据架构。这种架构设计上将数据整合在一个单一的框架下,通常由专门的数据团队进行管理。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

虽然集中式数据架构在确保安全性和更好治理方面有效,但在可扩展性、灵活性和可访问性等方面存在局限性。

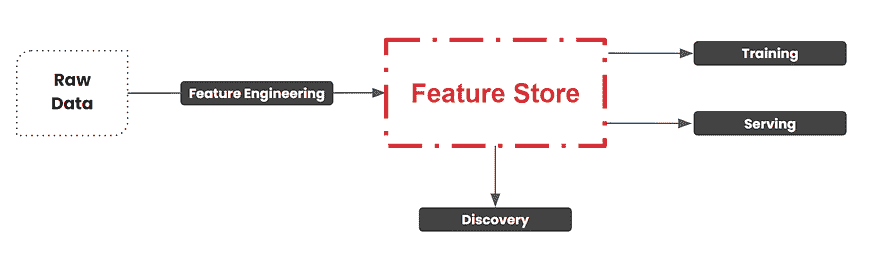

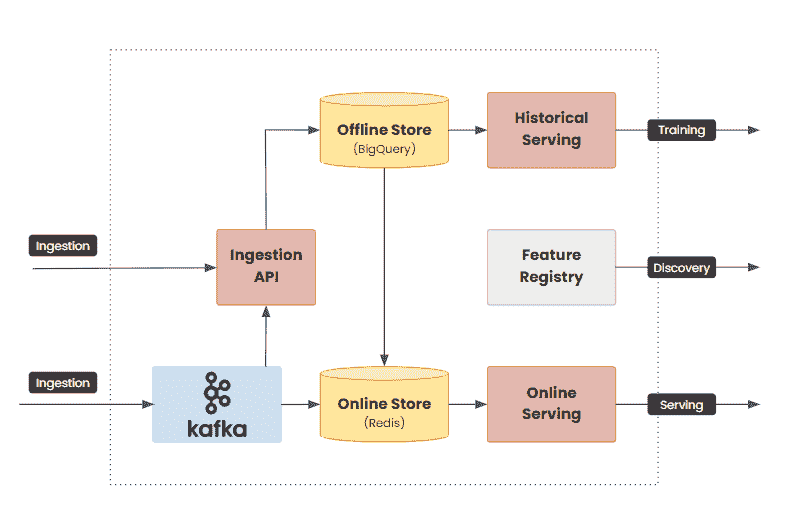

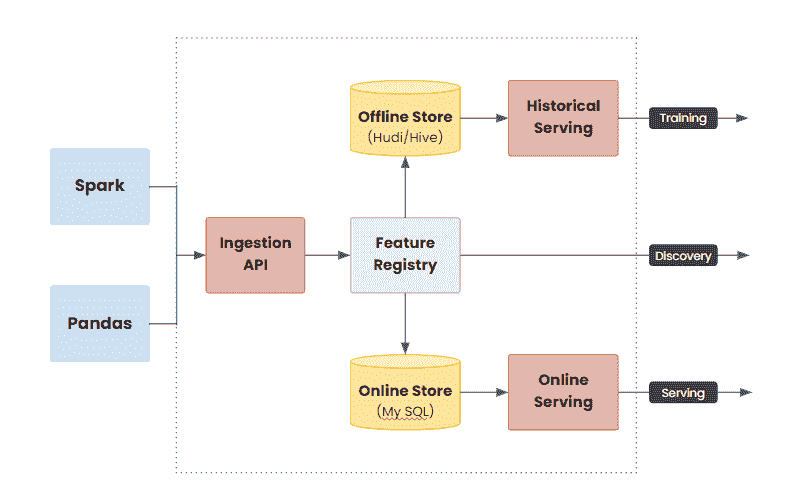

引入数据网格,这一概念(几乎)类似于软件架构中的微服务。数据网格旨在去中心化数据管理,正如微服务专注于去中心化应用组件一样。它将数据所有权和责任分配给特定领域的团队,承认数据是一个战略资产,最好在源头进行管理。

在本文中,我们将探讨数据网格、其关键原则、需要考虑的因素以及与数据网格架构采用相关的挑战。

什么是数据网格?

数据网格的概念最早由扎马克·德赫加尼提出,见于文章《"如何从单体数据湖过渡到分布式数据网格"》,该文章概述了数据网格背后的原则和概念。这篇文章以及数据社区中的后续讨论在普及数据网格架构方面发挥了重要作用。

数据网格是一种现代的数据架构和管理方法,与传统的集中式数据模型不同。它引入了一种去中心化的结构来组织、分配和利用组织的数据资产。

在数据网格中,数据所有权和责任在特定领域的团队或数据产品团队之间分配,使他们能够在各自的领域内自主管理数据。

这种去中心化的方法旨在解决集中式数据模型相关的局限性,例如可扩展性挑战、数据孤岛和响应变化数据需求的速度缓慢。通过赋予领域特定团队独立管理数据的权力,数据网格在组织内推广了数据自主性、灵活性和责任感的文化。它还提高了对各种数据源的高效处理,同时保持对数据质量和相关性的关注。

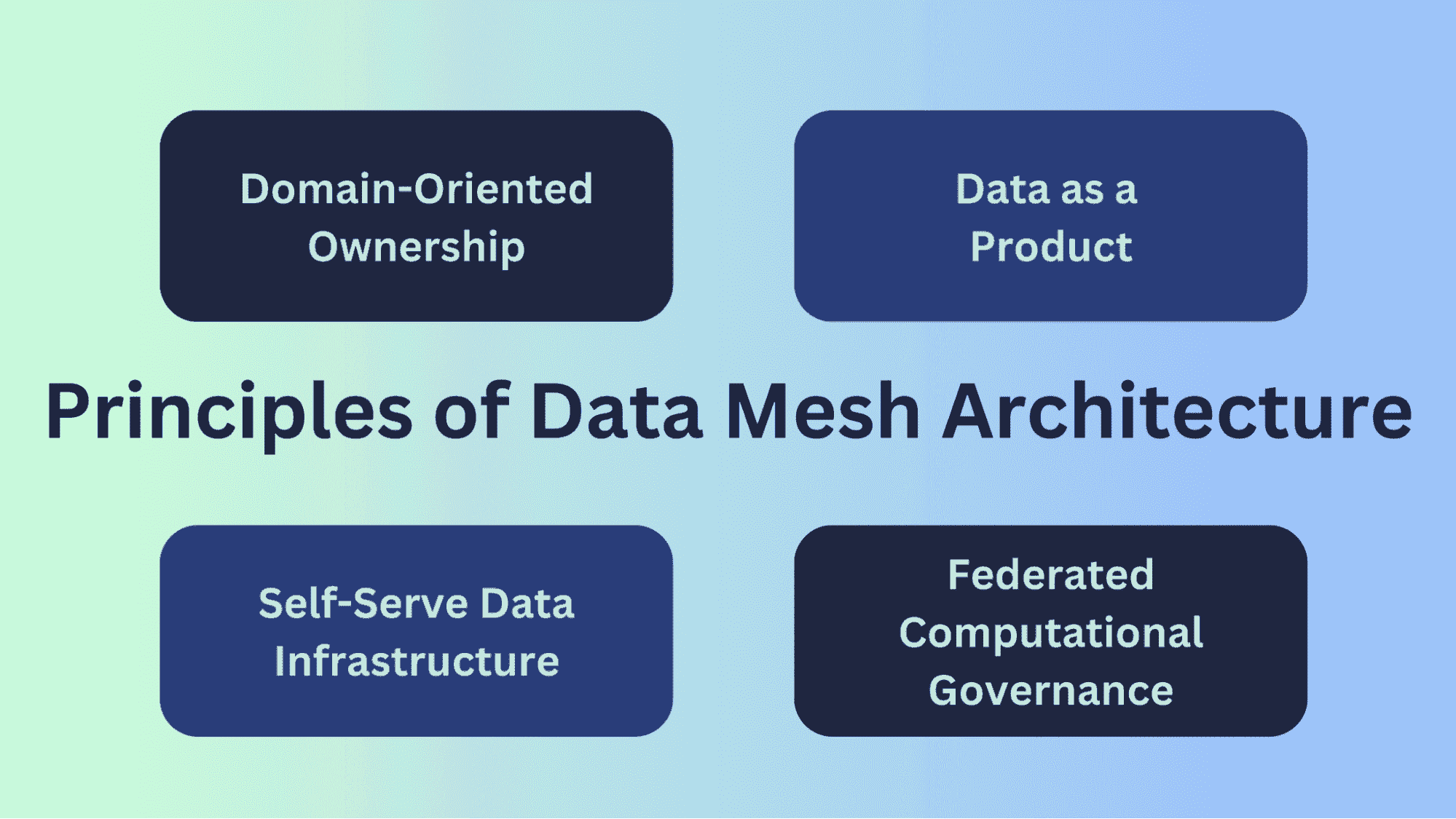

数据网格架构中的关键原则

数据网格架构建立在一系列旨在解决数据在组织内及跨组织扩展和管理挑战的原则上。这些原则为去中心化和更具可扩展性的数据管理方法提供了基础。

图片来源:作者

面向领域的所有权

在数据网格中,数据所有权是去中心化并分布在组织内的各个领域或业务单元之间。每个领域对其特定专业或功能领域内生成和使用的数据负责。这一原则承认领域专家最适合理解和管理其各自领域内的数据。

面向领域的所有权改善了数据质量和准确性,因为那些离数据源最近的人对其背景有深刻理解,并能确保其完整性。这也促进了对数据的所有权和责任感,鼓励领域团队维持高水平的数据标准。

数据作为产品

数据在数据网格中被视为一种产品,而非业务操作的副产品。每个领域负责交付定义明确的数据产品,这些产品经过设计、打包,并提供给组织内的其他领域使用。这些数据产品具有清晰的定义、访问机制和服务级别协议(SLA)。

将数据视为产品鼓励数据生产者专注于向消费者提供高质量和有价值的数据。它还确保数据产品的设计考虑到用户需求,使数据对更广泛的利益相关者更加可访问和可用。

自助数据基础设施

数据网格促进了自助数据基础设施的发展,使数据消费者(如数据分析师、数据科学家、业务用户)能够独立访问和处理数据。这种基础设施包括数据目录、数据发现机制和数据处理管道,使消费者能够找到、理解和利用数据,而无需过多依赖集中式数据工程团队。

自助数据基础设施减少了瓶颈并加快了数据访问,赋予更多用户操作数据的能力。它在组织内实现了数据民主化,使数据更加可访问,并加速了洞察和决策的过程。

联邦计算治理

为了在去中心化的数据架构中维护数据质量、安全性和合规性,数据网格采用了联邦计算治理。每个领域定义并执行其自身的治理政策,针对其数据的具体需求进行调整。虽然可能存在全球标准和指南,但各个领域有自主权来管理其数据资产。

这平衡了全球数据标准的需求与各个领域所需的灵活性。它允许各领域根据其独特的数据挑战调整治理实践,同时确保数据保持安全、合规和高质量。

因此,这四个关键数据网格原则共同旨在通过促进以下方面来解决大组织在数据操作扩展中的挑战:

-

去中心化,

-

数据产品思维,

-

自助服务,和

-

有效的治理。

通过实施这些原则,组织可以释放数据资产的全部潜力,改善领域团队之间的协作,使数据成为所有利益相关者更有价值且更可获取的资源。

实施数据网格?以下是需要考虑的因素

向数据网格过渡通常涉及组织内部的重大文化转变。数据网格鼓励协作、共享所有权和数据产品思维,使数据实践与组织不断发展的文化和价值观更紧密地对齐。以下是组织在实施数据网格时可能考虑的一些因素。

业务目标与战略

任何数据架构的重大转变都应与组织的更广泛业务目标和战略目标对齐。

实施数据网格应被视为战略性推动者,提升组织有效利用数据的能力,以实现其整体目标和目标。

现有基础设施

组织在评估数据网格的可行性时,必须评估和考虑当前的数据基础设施和投资。

向数据网格过渡可能需要对现有技术栈和基础设施进行调整,因此将这些方面与新方法对齐至关重要。

数据复杂性与规模

当组织面临日益增长的数据复杂性和规模时,必须考虑替代的数据管理方法。数据网格提供了可扩展性和适应性,尤其是在处理日益复杂和大规模的数据环境时。

因此,当数据的体积、种类或速度使得中心化管理变得困难,或当不同业务单位或领域的数据需求各异时,数据网格是一个不错的选择。

数据治理与合规性

维护数据质量、隐私、安全性和合规性是数据管理中的一个挑战性方面,特别是在去中心化的环境中。

数据网格策略必须有效应对这些复杂性,确保数据治理实践和监管要求得到满足。

数据可访问性和所有权

在拥有分布式数据源和多样化领域的组织中,传统的集中式数据管理可能不够充分。实施数据网格将数据所有权与领域特定团队对齐,使他们能够对自己的数据负责,这在这种环境中尤其有价值。

此外,为了促进整个组织的数据驱动决策,至关重要的是使数据更易于访问。数据网格使数据访问民主化,允许更广泛的用户访问和利用数据,从而改善各部门或团队的决策。

采用数据网格架构中的挑战

从集中式数据架构迁移到数据网格并非没有挑战。在本节中,我们将深入探讨其中的一些挑战,从治理到监控。

数据治理

在数据网格中,数据治理变得更加复杂,因为数据分布在多个领域和团队中。确保这些领域中的数据质量、隐私、安全性和合规性标准的一致性可能会面临挑战:

-

确定数据所有权和数据治理任务的责任,例如定义数据模式和访问控制,当多个团队参与时可能会面临挑战。

-

开发和执行与数据网格去中心化特性相符的数据治理政策和实践需要精心规划。

数据发现

在去中心化的数据网格中,发现和访问数据可能会很有挑战性。确保数据得到适当的编目、标记和记录对于促进数据发现至关重要。一些策略包括:

-

实施有效的元数据管理实践,为数据集提供上下文和描述,使用户更容易理解可用的数据资源。

-

开发和维护数据目录或元数据仓库,允许用户高效地搜索和查找相关数据集。

数据所有权

在数据网格中,为每个数据领域和数据产品提供清晰一致的数据所有权和责任定义至关重要。确定谁负责维护、更新和策划数据可能会很困难,尤其是当涉及多个利益相关者时。组织可以通过以下方式解决这一挑战:

-

确保数据所有者拥有必要的权力和资源,以有效管理其数据领域。

-

建立解决与数据所有权和责任相关的冲突或争议的机制。

监控与可观测性

在数据网格中,监控数据管道和数据产品的健康状况、性能和可靠性可能会很复杂。一些策略包括:

-

实施强大的监控和可观测性工具及实践,以跟踪不同领域的数据质量、延迟和使用情况。

-

开发警报和报告机制以快速识别和解决可能影响数据可用性或可靠性的问题。

我们已经突出了数据网格实施中的一些挑战。这些更像是组织在过渡到去中心化的数据网格架构时应该注意的检查点。

结论

数据网格(Data Mesh)因此是数据架构的范式转变,提供了对集中式模型挑战的解决方案。我们讨论了分散数据所有权、推动数据产品思维和实现自助访问的好处。然而,成功实施需要仔细考虑文化和技术因素,并采取积极的数据治理方法。

Bala Priya C** 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交叉点上工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正在通过编写教程、使用指南、观点文章等与开发者社区分享她的知识。Bala 还制作引人入胜的资源概述和编码教程。**

更多相关主题

探索 Google 最新 AI 工具:初学者指南

原文:

www.kdnuggets.com/exploring-googles-latest-ai-tools-a-beginners-guide

图片来源:作者

人工智能已经成为近年来发展最快的领域之一。这些新技术将永远改变世界,为我们提供了一个重要的选择:

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

拥抱人工智能来优化我们的工作流程,或完全忽视它。

如果你正在阅读这篇文章,我很确定你属于第一类:你想利用 AI 来提升日常任务。

然而,存在一个重大问题。主要公司正努力通过向市场推出各种不同的应用来区分自己。这使得了解所有现有的选项变得困难。

本文旨在介绍 Google 的顶级 AI 应用,并指导你如何开始使用它们。

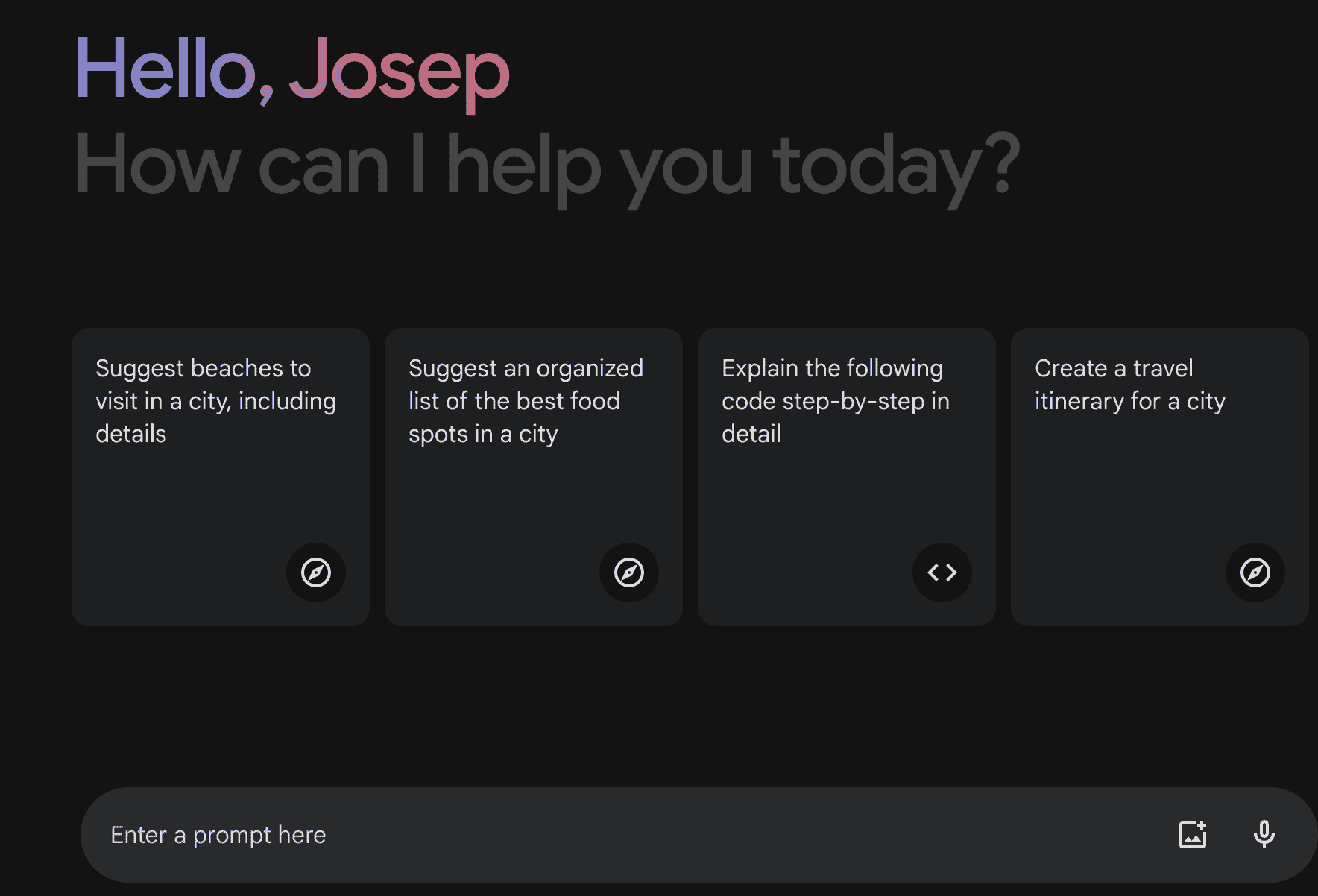

Google Gemini

Gemini 是一个先进的大型语言模型(LLM),是 OpenAI 的 GPT 模型的直接竞争对手,免费供所有人使用!

Gemini 主界面的截图

它集成了 Google 在 AI 领域的广泛研究,提供更准确、上下文感知的回应,使其在聊天机器人、虚拟助手和其他语言基础的 AI 解决方案中极为有效。使 Gemini 成为市场上最佳 LLM 之一的几个关键特征包括:

-

免费使用:无需支付。

-

多模态能力:能够处理图像和文档。

-

用户友好界面:易于使用。

开始使用

要开始使用 Google 的 Gemini,你只需要一个 Google 账户。你可以直接前往 Gemini 的主界面,今天就开始与其聊天吧。

Google 云

一组在 Google 基础设施上运行的云计算服务。它提供多种服务,包括计算、存储、分析和机器学习。可用于构建、训练和部署 AI 模型及解决方案。

其主要 AI 服务包括:

-

AutoML:为具备基础机器学习知识的用户设计,配备即用型 API。其主要工具包括 AutoML Vision 或 AutoML Natural Language 等。

-

Vertex AI:一个管理平台,简化了 ML 生命周期,从数据准备到模型部署和监控。

-

自然语言 API:一个直观的工具,用于处理自然语言,支持情感分析、实体识别和语法分析。

入门指南

要开始使用,只需一个 Google Cloud 账户。如果你是新用户,你将获得 300 美元的免费试用积分,期限为 90 天。

账户创建后,你可以通过 Google Cloud Console 访问这些工具。

TensorFlow

TensorFlow 是一个开源框架,用于从零开始创建和训练 ML 模型。它兼容多种编程语言,如 Python 和 Java。

TensorFlow 的主要功能包括:

-

综合生态系统:TensorFlow 提供了支持整个 ML 项目生命周期的工具:模型构建、训练和部署。

-

社区:它是一个使用广泛的工具,拥有丰富的文档和活跃的社区。

-

跨平台:使用 TensorFlow Lite,模型可以部署在各种设备上,从智能手机到物联网设备。

入门指南

使用 pip 安装 TensorFlow:

pip install tensorflow

然后你可以探索 TensorFlow 网站上提供的各种教程。

Google 实验

这是一个 AI 项目和实验的集合。它提供了一种互动方式来探索 AI 的能力,许多项目可供直接互动。它使用了 Google 的硬件组件和软件工具。

主要功能包括:

-

教育工具:大多数项目设计为以互动和有趣的方式教授基本的 AI 和 ML 概念。

-

互动演示:你可以与 AI 模型互动,查看它们如何响应不同的输入。

入门指南

访问 Google 实验以探索可用的项目。许多实验包括代码和说明,适合对技术细节感兴趣的人。

AI Hub

Google AI Hub 是一个你可以分享和部署 ML 模型和管道的平台。其主要目标是促进用户和企业之间的协作,利用预构建的模型和解决方案。

其主要功能包括:

-

预训练模型:访问由 Google 和其他用户预训练的模型库。

-

协作:与社区分享你的模型和解决方案,并发现其他用户的模型。

-

与 Google Cloud 的集成:与其他 Google Cloud 服务无缝集成,用于部署和监控。

入门指南

AI Hub 是 Google Cloud 的一部分,因此你需要一个 Google Cloud 账户才能访问。

浏览 AI Hub 寻找符合你需求的模型和解决方案。

总结

Google 提供了多种工具,帮助你开始 AI 和机器学习之旅。通过探索并利用这些工具,你可以优化工作流程、提升日常任务,并在这个快速发展的领域中保持领先!

Josep Ferrer是来自巴塞罗那的分析工程师。他毕业于物理工程专业,目前从事于应用于人类移动的数据科学领域。他还是一名兼职内容创作者,专注于数据科学和技术。Josep 涵盖了 AI 领域不断爆炸的应用。

更多相关主题

探索 Python 中 itertools 的无限迭代器

原文:

www.kdnuggets.com/exploring-infinite-iterators-in-python-itertools

作者提供的图像

介绍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

如其名称所示,无限迭代器是一种特殊类型的迭代器,可以无限生成值。与像列表、元组和字典这样的内置迭代器最终会结束不同,无限迭代器可以产生源源不断的值流。这些迭代器有时也被称为无限生成器或序列。它们在模拟、生成序列、处理实时数据等问题的解决中有广泛应用。

Python 的 Itertools 库提供了三种内置的无限迭代器。

-

Count

-

Cycle

-

Repeat

1. Count

count() 函数生成从指定值和步长开始的无限数字。count 迭代器的语法如下:

itertools.count(start=0, step=1)

它有两个可选参数:“start”和“stop”,默认值分别为 0 和 1。“Start”表示计数的初始值,而“step”表示用于增加计数的增量。

让我们通过一个例子来分析这个函数。如果你需要生成一个步长为 3 的数字序列,就像 3 的乘法表一样,你可以使用以下代码:

from itertools import count

counter = count(3,3)

print("The table of 3 is:")

for i in range(10):

print(f"3 x {i+1} = {next(counter)}")

输出

The table of 3 is:

3 x 1 = 3

3 x 2 = 6

3 x 3 = 9

3 x 4 = 12

3 x 5 = 15

3 x 6 = 18

3 x 7 = 21

3 x 8 = 24

3 x 9 = 27

3 x 10 = 30

2. Cycle

cycle() 函数创建一个迭代器,并无限重复传递的容器中的所有项。以下是 cycle 迭代器的语法:

itertools.cycle(iterable)

这里的“iterable”参数可以是 Python 中的任何可迭代数据结构,如列表、元组、集合等。考虑一个交通灯控制系统的例子,该系统不断循环显示不同的灯光。在不同颜色的灯光之间循环时不执行其他动作。我们将使用 5 秒的等待时间来显示结果。

from itertools import cycle

import time

lights = ["red", "green", "yellow"]

cycle_iterator = cycle(lights)

while True:

print(f"Current light is: {next(cycle_iterator)}")

time.sleep(5)

输出

Current light is: red

Current light is: green

Current light is: yellow

Current light is: red

Current light is: green

Current light is: yellow

你将在大约 25 秒后看到这个输出。

3. Repeat

repeat() 函数生成指定数量的无限序列。当你需要无限生成单个值时,它非常有用。repeat 迭代器的语法如下:

itertools.repeat(value, times=inf)

我们这里有两个参数:“value”是你想要无限生成的数字,而“times”是一个可选参数,用于指定你想要生成该数字的次数。“times”的默认值是无限,意味着除非你明确指定有限的数字,否则它将不断打印。例如,如果你需要生成数字“9”三次,可以使用以下代码:

from itertools import repeat

iterator = repeat(9, 3)

for value in iterator:

print(value)

输出

9

9

9

结论

这些无限迭代器在我们需要处理数据流的场景中非常有用。“count”、“cycle”和“repeat”迭代器使我们能够更高效、优雅地解决问题。尽管使用它们需要谨慎,因为它们可能导致无限循环,但如果用得当,它们可以成为解决编程问题的宝贵资源。希望你喜欢这篇文章,如果你有任何分享,欢迎在下面的评论框中提出建议。

Kanwal Mehreen** Kanwal 是一名机器学习工程师和技术作家,对数据科学及 AI 与医学的交汇处有着深厚的热情。她共同编著了电子书《利用 ChatGPT 最大化生产力》。作为 2022 年 APAC 区的 Google Generation Scholar,她倡导多样性和学术卓越。她还被认可为 Teradata 多样性技术学者、Mitacs Globalink 研究学者以及 Harvard WeCode 学者。Kanwal 是变革的热情倡导者,创办了 FEMCodes 以赋能 STEM 领域的女性。

更多相关话题

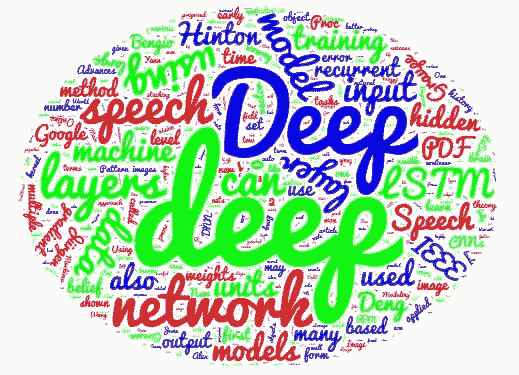

探索 AI/DL 的最新趋势:从元宇宙到量子计算

原文:

www.kdnuggets.com/2023/07/exploring-latest-trends-aidl-metaverse-quantum-computing.html

图片由编辑提供

人工智能(AI)领域在不断发展,几种新兴趋势正在塑造这个领域,有潜力对各个行业和日常生活产生重大影响。最近的 AI 突破的推动力之一是深度学习(DL),也称为人工神经网络(ANNs)。深度学习在自然语言处理(NLP)、计算机视觉、强化学习和生成对抗网络(GANs)等领域显示了显著的进展。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

使深度学习(DL)更加迷人的是它与神经科学的紧密联系。研究人员常常从人脑的复杂性和功能中汲取洞察,以开发深度学习技术和架构。例如,卷积神经网络(CNNs)、激活函数和人工神经网络(ANNs)中的人工神经元都受到人脑生物神经元的结构和行为的启发。

尽管 AI/DL 和神经科学已经产生了显著影响,但还有一个领域拥有更大的变革潜力——量子计算。量子计算有潜力彻底改变计算能力,并在包括 AI 在内的多个领域解锁前所未有的进展。其进行复杂计算和同时处理大量数据的能力开启了新的可能性前沿。

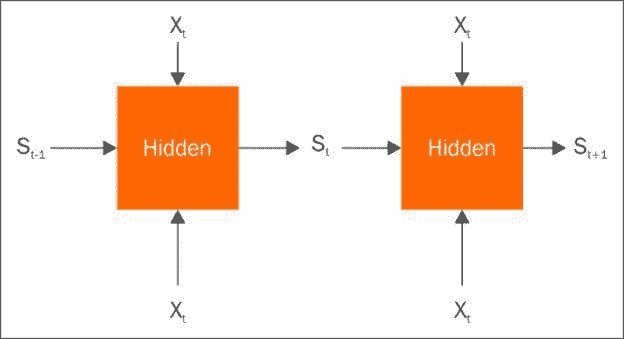

深度学习

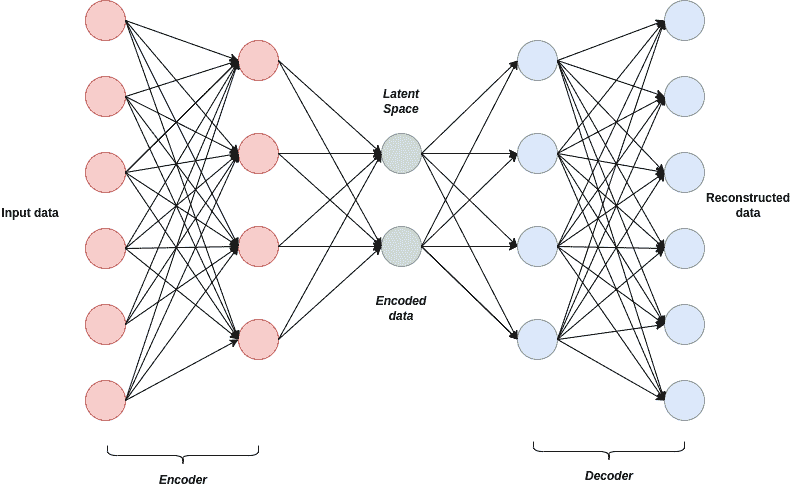

现代人工神经网络(ANNs)因其复杂的结构而获得了 "深度学习" 的称号。这些网络是一种机器学习模型,灵感来源于人脑的结构和功能。由多个相互连接的神经元层组成,ANNs 在数据流经网络时进行处理和转换。"深度" 一词指的是网络的深度,这由其结构中的隐藏层数量决定。传统的 ANNs 通常只有几个隐藏层,使其相对较浅。相比之下,深度学习模型可以具有数十层甚至数百层隐藏层,使其深度显著增加。这种增加的深度使得深度学习模型能够捕捉数据中的复杂模式和层次特征,从而在前沿机器学习任务中表现出色。

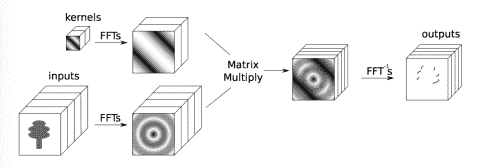

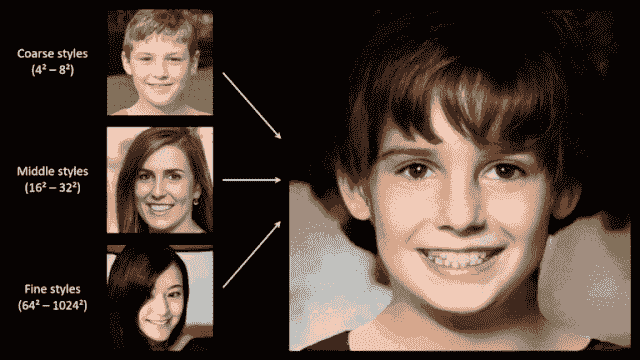

深度学习的一个显著应用是图像到文本和文本到图像生成。这些任务依赖于诸如生成对抗网络(GANs)或 变分自编码器(VAEs) 这样的深度学习技术,从庞大的数据集中学习文本与图像之间的复杂关系。这些模型在多个领域找到应用,包括计算机图形学、艺术、广告、时尚、娱乐、虚拟现实、游戏体验、数据可视化和讲故事。

VAE 算法的架构

尽管取得了显著进展,深度学习仍面临许多挑战和限制。主要的障碍在于计算资源和能源效率。深度学习模型通常需要大量的计算资源,如强大的 GPU(图形处理单元)或专用硬件,以高效地执行预测。这种对广泛计算基础设施的依赖可能限制了资源不足的研究人员或组织对深度学习的访问。此外,训练和运行深度学习模型可能会消耗大量的能源。随着模型规模每年不断增长,能源效率问题变得越来越重要。

大型模型

除了围绕大型语言模型和视觉模型的技术考虑外,全球范围内的政府带来了一个意想不到的挑战。这些治理机构正在推动对 AI 模型的监管,并要求模型拥有者,包括 ChatGPT 等平台,解释其模型的内部工作原理。然而,像 OpenAI、微软或谷歌这样的主要实体,甚至 AI 科学界,都没有对这些问题给出具体的答案。他们承认对这些模型有一般性的了解,但无法准确指出为何模型会提供某种特定的回应。最近的事件,例如 ChatGPT 在意大利被禁用和埃隆·马斯克指控微软未经授权使用 Twitter 数据,都只是更大问题的开始。显然,主要 IT 公司之间正在酝酿一场新斗争,涉及谁可以声称拥有“最大模型”和 哪些数据可以用于这些模型。

在一篇名为《AI 时代已经来临》的最新博客文章中,微软联合创始人比尔·盖茨称赞了 ChatGPT 和相关的 AI 进展为“革命性”。盖茨强调了需要“革命性”解决方案来应对当前面临的挑战。因此,这促使人们重新评估诸如“版权”、“大学考试”以及甚至对“学习”本质的哲学探讨等概念。

神经科学

在他最近的书籍《千脑理论》中,J. Hawkins 提出了一个关于人脑如何处理信息和产生智能行为的新颖且不断发展的观点。千脑理论认为,大脑像是一个由成千上万个独立的迷你大脑组成的网络,每个迷你大脑负责同时处理感觉输入和产生运动输出。根据这一理论,新皮层,即大脑外层与高级认知功能相关的部分,由众多功能上独立的柱状结构组成,这些柱状结构可以类比为迷你大脑。

该理论建议,新皮层中的每个柱状结构学习并建模来自周围环境的感觉输入,并对未来的感觉输入做出预测。这些预测随后与实际的感觉输入进行比较,任何差异都会被用来更新柱状结构中的内部模型。这个不断的预测和比较过程形成了新皮层处理信息和产生智能行为的基础。

根据千脑理论,各种感觉输入(如视觉、听觉和触觉)在独立的列中处理。这些列的输出随后被结合起来,以创建对世界的统一感知。这种非凡的能力使大脑能够整合来自不同感觉通道的信息,并形成对周围环境的连贯表征。

千脑理论中的一个关键概念是“稀疏表示”。这一概念突出了人脑中只有一部分神经元在任何给定时间是活跃的或发射的,而其余神经元则相对不活跃或静默。稀疏编码通过减少冗余或不必要的神经活动,使大脑能够高效地处理和编码信息。稀疏表示的一个重要好处是其能够实现大脑中的选择性更新。在这个过程中,只有活跃的神经元或神经通路会在响应新信息或经历时被更新或修改。

这种选择性更新机制使大脑能够通过将资源集中在最相关的信息或任务上,而不是同时更新所有神经元,从而高效地适应和学习。神经元的选择性更新在神经可塑性中发挥了关键作用,神经可塑性指的是大脑通过学习和经验改变和适应的能力。它使大脑能够根据持续的认知和行为需求来完善其表征和连接,同时节省能源和计算资源。

Numenta 理论的实际应用已显而易见。例如,最近与 Intel 的合作已经在自然语言处理和计算机视觉等各种使用案例中带来了显著的性能提升。得益于这一合作,客户可以实现性能提高从 10 倍到 100 倍以上。

元宇宙

尽管许多人将注意力集中在大型语言模型上,Meta 采取了一种独特的方法。在一篇标题为"从人类活动和模拟互动的视频中学习的机器人"的博客文章中,Meta AI 团队强调了一个名为“莫拉维克悖论”的有趣概念。根据这一论点,AI 中最具挑战性的问题围绕感知运动技能,而非抽象思维或推理。为了支持这一观点,该团队宣布了在通用体现在 AI 代理领域的两个重大进展。

-

首先,他们引入了人工视觉皮层,称为 VC-1。这一突破性的感知模型是第一个提供广泛感知运动技能、环境和具身支持的模型。

-

此外,Meta 团队开发了一种名为自适应(感知运动)技能协调(ASC)的创新方法。这种方法在机器人移动操控的严苛任务中达到了近乎完美的表现,成功率高达 98%。它涉及到导航到一个物体、拾取物体、移动到另一个位置、放置物体并重复这些动作——所有这些都在物理环境中完成。

Meta 的这些进展标志着从对大型语言模型的主要关注转变。通过优先考虑感知运动技能和具身人工智能,它们促进了能够以更全面、更细致的方式与世界互动的智能体的发展。

尽管基于统计方法,ChatGPT 模型获得了大量的炒作和不成比例的公众关注。相比之下,Meta 最近的突破代表了实质性的科学进展。这些成就为虚拟现实(VR)和机器人技术领域的革命性扩展奠定了基础。我们强烈推荐阅读完整文章,以获得见解,并为即将到来的人工智能创新浪潮做好准备,因为这将以显著的方式塑造这些领域的未来。

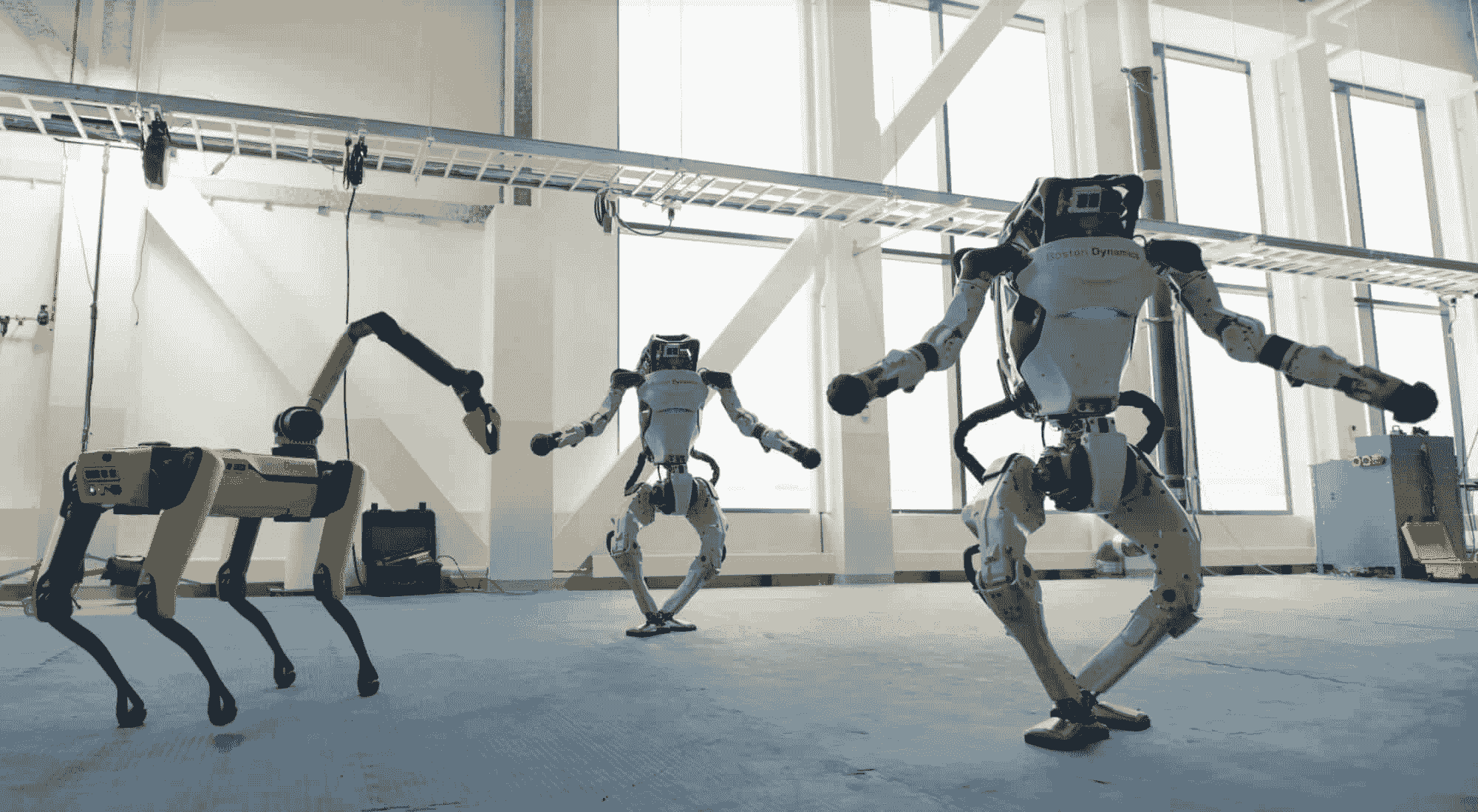

机器人技术

目前,领域中有两款显著的机器人是Atlas和Spot (robodog),这两款机器人均可在网上轻松购买。这些机器人代表了工程学上的显著成就,但它们的能力仍受到缺乏先进“智能”的限制。这正是 Meta 人工视觉皮层发挥作用的地方,可能会带来突破性的改变。通过将机器人技术与人工智能结合,它有可能彻底改变许多行业和领域,包括制造业、医疗保健、运输、农业和娱乐等。Meta 人工视觉皮层有望增强这些机器人的能力,并为机器人技术领域的前所未有的进步铺平道路。

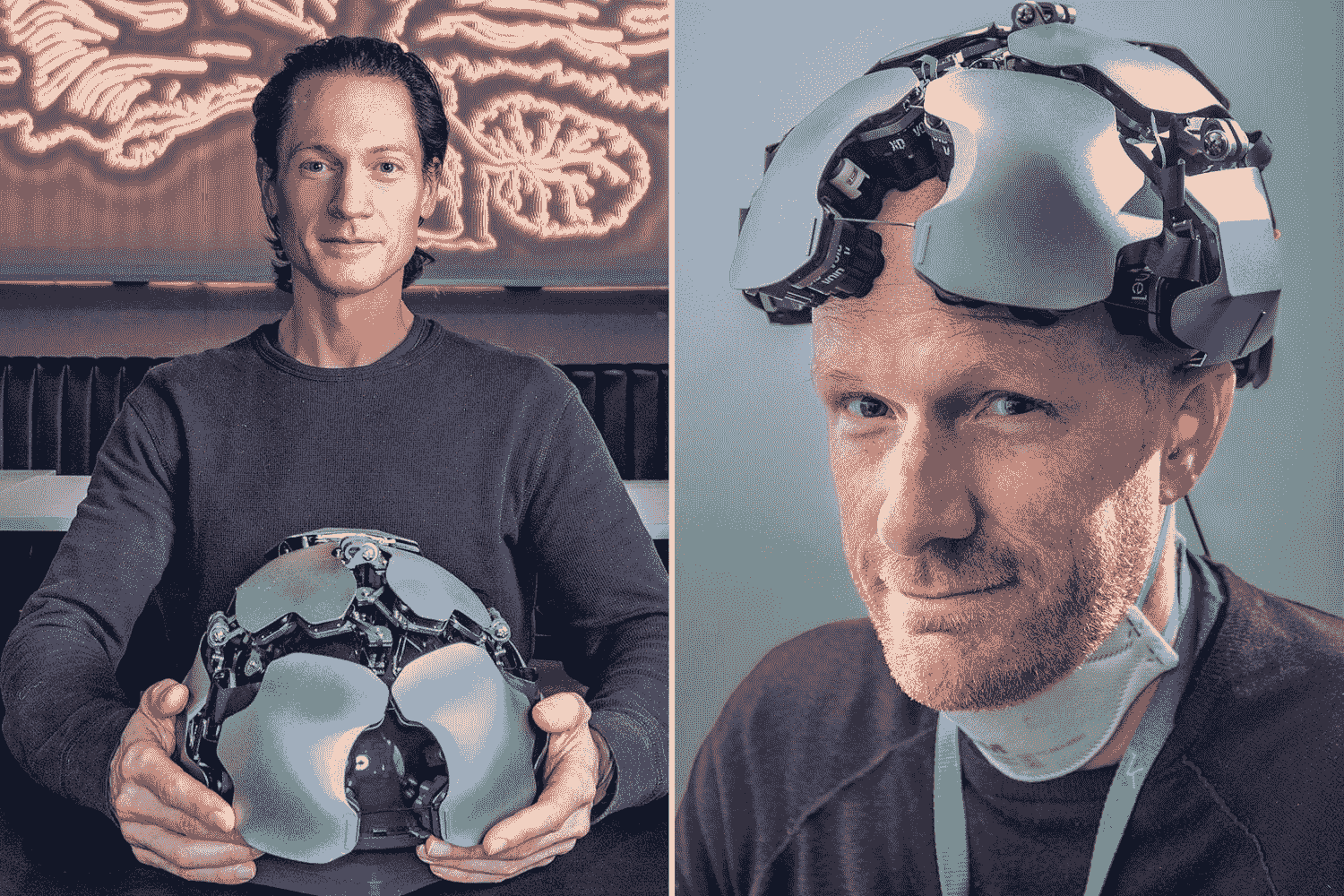

波士顿动力的 Atlas 和 Spot 机器人

人类的新接口:脑-计算机/脑-脑接口

尽管可能会担心被人工智能超越,但人脑具有现代人工智能所缺乏的关键优势:神经可塑性。神经可塑性,也称为脑可塑性,指的是大脑在结构和功能上对经验、学习和环境变化的惊人适应能力。然而,尽管有这种优势,人脑仍然缺乏与其他人脑或人工智能系统的先进通信方法。为了克服这些限制,开发新的脑接口是必要的。

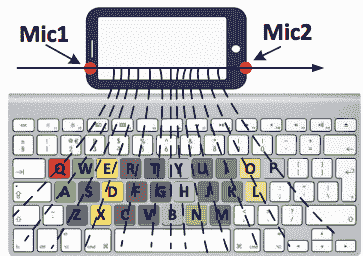

由于传统的沟通方式,如视觉、听觉或打字,速度有限,难以与现代人工智能模型竞争。为了解决这个问题,正在探索基于直接脑神经网络电活动的新接口。进入现代脑机接口(BCIs)的领域,这些前沿技术实现了大脑与外部设备或系统之间的直接通信和互动,绕过了传统的外围神经系统路径。BCIs 的应用领域包括神经假体、神经康复、沟通、残疾人士控制、认知增强和神经科学研究。此外,BCIs 最近也涉足了虚拟现实娱乐领域,例如'Galea'等设备,可能成为我们日常现实的一部分。

另一个有趣的例子是Kernel Flow,这是一种能够从大脑皮层捕获脑电图(EEG)和全头覆盖的类似功能性磁共振成像(fMRI)数据的设备。凭借这些能力,我们有可能最终直接从梦境中创造虚拟世界。

与非侵入性的 BCIs 如'Galea'和'Kernel'相比,Neuralink由埃隆·马斯克创办,采用了不同的方法,推广侵入式脑植入。一些人称其为“与外界的插口”,提供比任何现代非侵入式 BCIs 更广泛的通信渠道。侵入式 BCIs 的另一个重要优势是潜在的双向通信。想象一个未来,信息无需通过我们的眼睛或耳朵,而是可以直接传递到我们的大脑皮层。

布莱恩·约翰逊(左)Kernel Flow

量子计算

如果神经科学和人脑尚不够吸引人,还有一个令人费解的话题可以探索:量子计算机。这些非凡的机器有可能在某些计算任务中超越经典计算机。利用量子叠加和纠缠——现代物理学的前沿——量子计算机可以执行并行计算,更高效地解决特定问题。包括大数因式分解、解决复杂优化问题、模拟量子系统,以及量子传输这一未来概念。这些进展有望彻底改变加密学、药物发现、材料科学和金融建模等领域。要体验量子编程,你可以访问 www.quantumplayground.net 并 在几分钟内编写你的第一个量子脚本。

尽管未来本质上是不确定的,但有一点是明确的:人类未来的轨迹将由个人、社区、机构和政府的选择和行动所塑造。我们必须共同努力,追求积极的变革,解决紧迫的全球问题,促进包容性和可持续性,并共同努力创造一个更美好的未来。

Ihar Rubanau 是 Sigma Software Group 的高级数据科学家

相关话题

探索 Python 中的自然排序

作者提供的图片

什么是自然排序,我们为什么需要它?

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在处理 Python 可迭代对象如列表时,排序是一项常见操作。要对列表进行排序,可以使用列表方法 sort() 来就地排序,或使用 sorted() 函数返回排序后的列表。

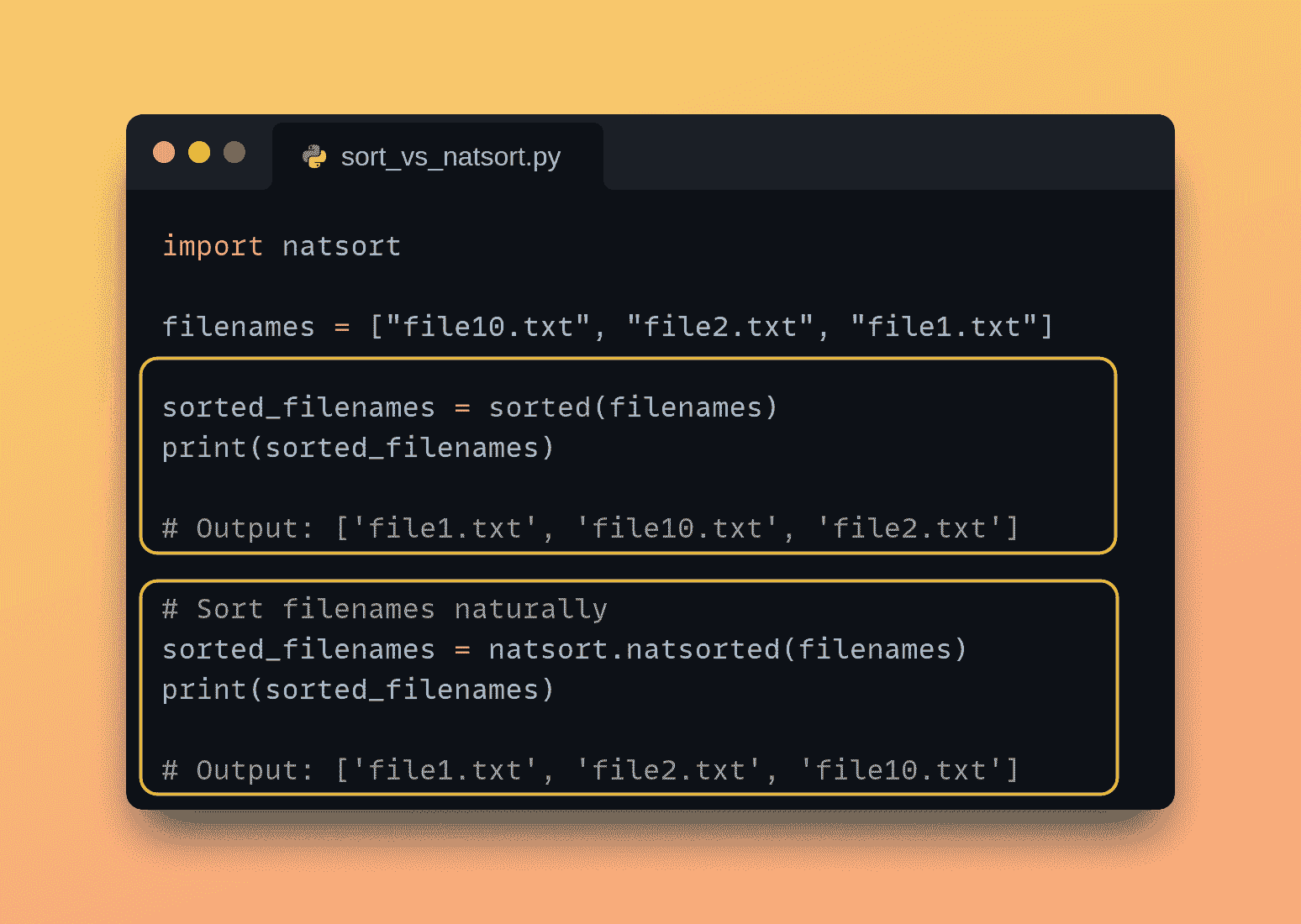

sorted() 函数在处理数字或包含字母的字符串列表时效果很好。但是,对于包含字母数字字符的字符串,如文件名、目录名、版本号等情况呢?sorted() 函数执行的是字典序排序。

看这个简单的例子:

# List of filenames

filenames = ["file10.txt", "file2.txt", "file1.txt"]

sorted_filenames = sorted(filenames)

print(sorted_filenames)

你将得到如下输出:

Output >>> ['file1.txt', 'file10.txt', 'file2.txt']

好吧,'file10.txt' 出现在 'file2.txt' 之前,不是我们所期望的直观排序顺序。这是因为 sorted() 函数使用字符的 ASCII 值进行排序,而不是数字值。引入自然排序。

自然排序是一种排序技术,它以反映元素自然顺序的方式对元素进行排列,特别是对于字母数字数据。与字典序排序不同,自然排序会解释字符串中的数字值,并据此进行排列,从而得到更有意义和符合预期的序列。

在本教程中,我们将使用 Python 库 natsort 探索自然排序。

入门

要开始使用,你可以通过 pip 安装 natsort 库:

$ pip3 install natsort

最佳实践是,在项目中使用虚拟环境安装所需的软件包。由于 natsort 需要 Python 3.7 或更高版本,请确保使用的是最新的 Python 版本,最好是 Python 3.11 或更高版本。要了解如何管理不同的 Python 版本,请阅读 Python 版本太多了?Pyenv 来拯救你。

自然排序基础示例

我们将从自然排序有用的简单用例开始:

-

排序文件名:在处理包含数字的文件名时,自然排序确保文件按自然直观的顺序排列。

-

版本排序:自然排序也有助于对版本号字符串进行排序,确保版本根据其数字值而非 ASCII 值进行排序。这可能不会反映所需的版本顺序。

现在让我们继续编写这些示例代码。

排序文件名

现在我们已经安装了 natsort 库,可以将其导入到我们的 Python 脚本中,使用该库提供的不同函数。

让我们重新回顾排序文件名的第一个例子(就是我们在教程开始时看到的那个),其中字典序排序的结果并不是我们想要的。

现在让我们使用natsorted()函数对相同的列表进行排序,如下所示:

import natsort

# List of filenames

filenames = ["file10.txt", "file2.txt", "file1.txt"]

# Sort filenames naturally

sorted_filenames = natsort.natsorted(filenames)

print(sorted_filenames)

在这个例子中,来自 natsort 库的natsorted()函数被用来自然地排序文件名列表。结果是文件名按预期的数字顺序排列:

Output >>> ['file1.txt', 'file2.txt', 'file10.txt']

排序版本号

让我们再来看一个类似的例子,我们有表示版本的字符串:

import natsort

# List of version numbers

versions = ["v-1.10", "v-1.2", "v-1.5"]

# Sort versions naturally

sorted_versions = natsort.natsorted(versions)

print(sorted_versions)

在这里,natsorted()函数被应用于自然地排序版本号列表。结果排序列表保持了版本的正确数字顺序:

Output >>> ['v-1.2', 'v-1.5', 'v-1.10']

使用键自定义排序

使用内置的sorted()函数时,你可能已经使用了key参数进行自定义。同样,sorted()函数也接受可选的key参数,你可以用它来根据特定的标准进行排序。

让我们举一个例子:我们有file_data,它是一个元组列表。元组中的第一个元素(索引 0 处)是文件名,第二个元素(索引 1 处)是文件大小。

假设我们想按文件大小升序排序。因此,我们将key参数设置为lambda x: x[1],这样就使用了索引 1 处的文件大小作为排序键:

import natsort

# List of tuples containing filename and size

file_data = [

("data_20230101_080000.csv", 100),

("data_20221231_235959.csv", 150),

("data_20230201_120000.csv", 120),

("data_20230115_093000.csv", 80)

]

# Sort file data based on file size

sorted_file_data = natsort.natsorted(file_data, key=lambda x:x[1])

# Print sorted file data

for filename, size in sorted_file_data:

print(filename, size)

以下是输出结果:

data_20230115_093000.csv 80

data_20230101_080000.csv 100

data_20230201_120000.csv 120

data_20221231_235959.csv 150

不区分大小写的字符串排序

自然排序还有另一个有用的场景,就是当你需要对字符串进行不区分大小写的排序时。基于 ASCII 值的字典序排序将不会给出期望的结果。

为了进行不区分大小写的排序,我们可以将alg设置为natsort.ns.IGNORECASE,这将在排序时忽略大小写。alg键控制natsorted()使用的算法:

import natsort

# List of strings with mixed case

words = ["apple", "Banana", "cat", "Dog", "Elephant"]

# Sort words naturally with case-insensitivity

sorted_words = natsort.natsorted(words, alg=natsort.ns.IGNORECASE)

print(sorted_words)

在这里,包含混合大小写的单词列表被自然地按不区分大小写的方式排序:

Output >>> ['apple', 'Banana', 'cat', 'Dog', 'Elephant']

总结

就这样!在本教程中,我们回顾了字典序排序的局限性以及自然排序如何成为处理字母数字字符串的良好替代方案。你可以在GitHub上找到所有代码。

我们从简单的例子开始,也了解了如何基于自定义键排序以及在 Python 中处理不区分大小写的排序。接下来,你可以探索natsort 库的其他功能。在另一个 Python 教程中再见。直到那时,继续编程!

Bala Priya C**** 是来自印度的开发者和技术写作人员。她喜欢在数学、编程、数据科学和内容创作的交汇点工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和咖啡!目前,她正在通过编写教程、使用指南、意见文章等与开发者社区分享她的知识。Bala 还创建了引人入胜的资源概述和编码教程。

更多相关话题

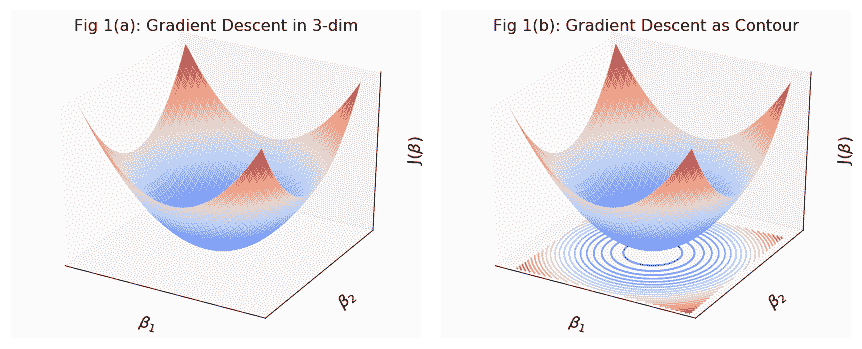

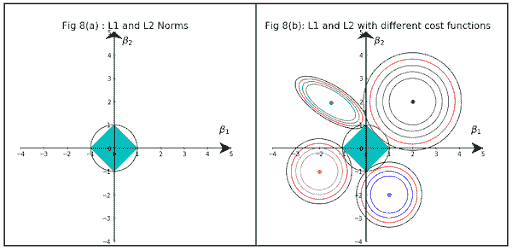

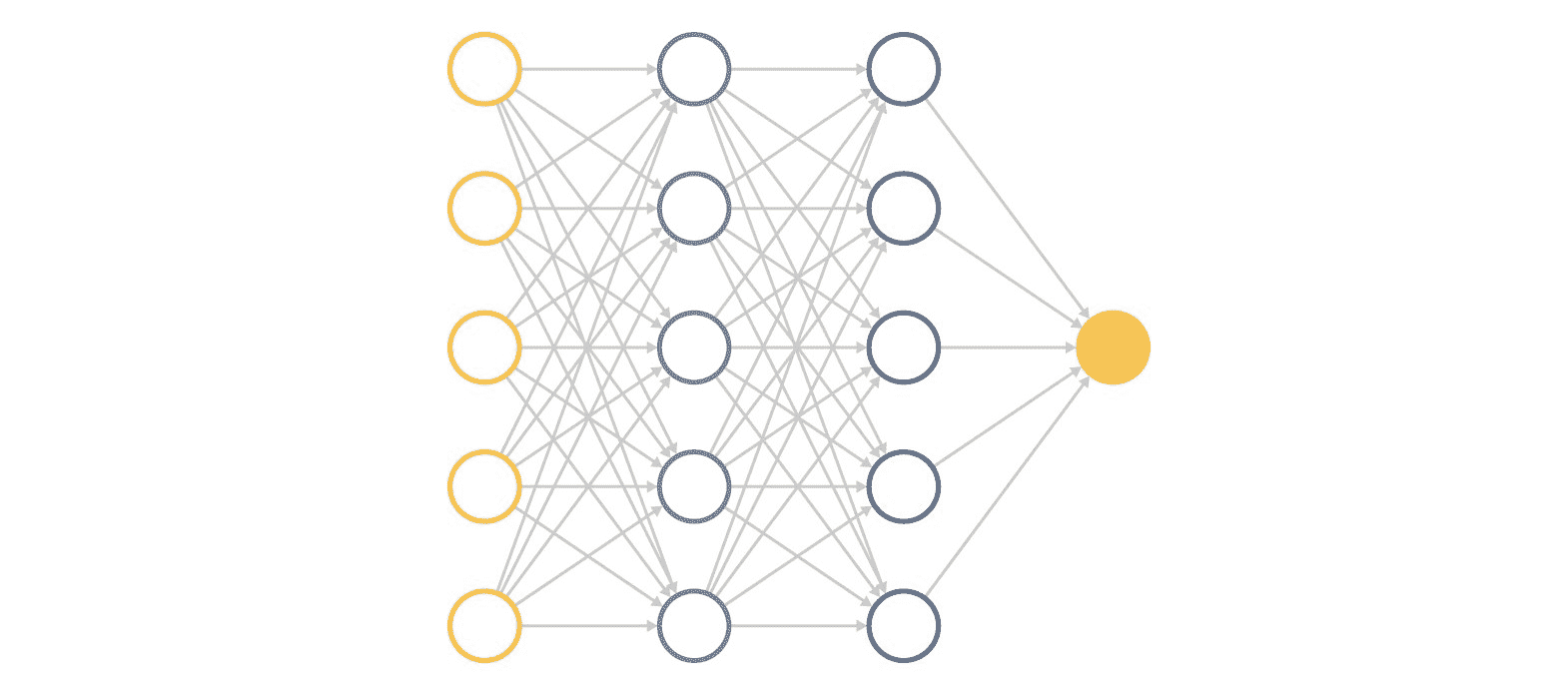

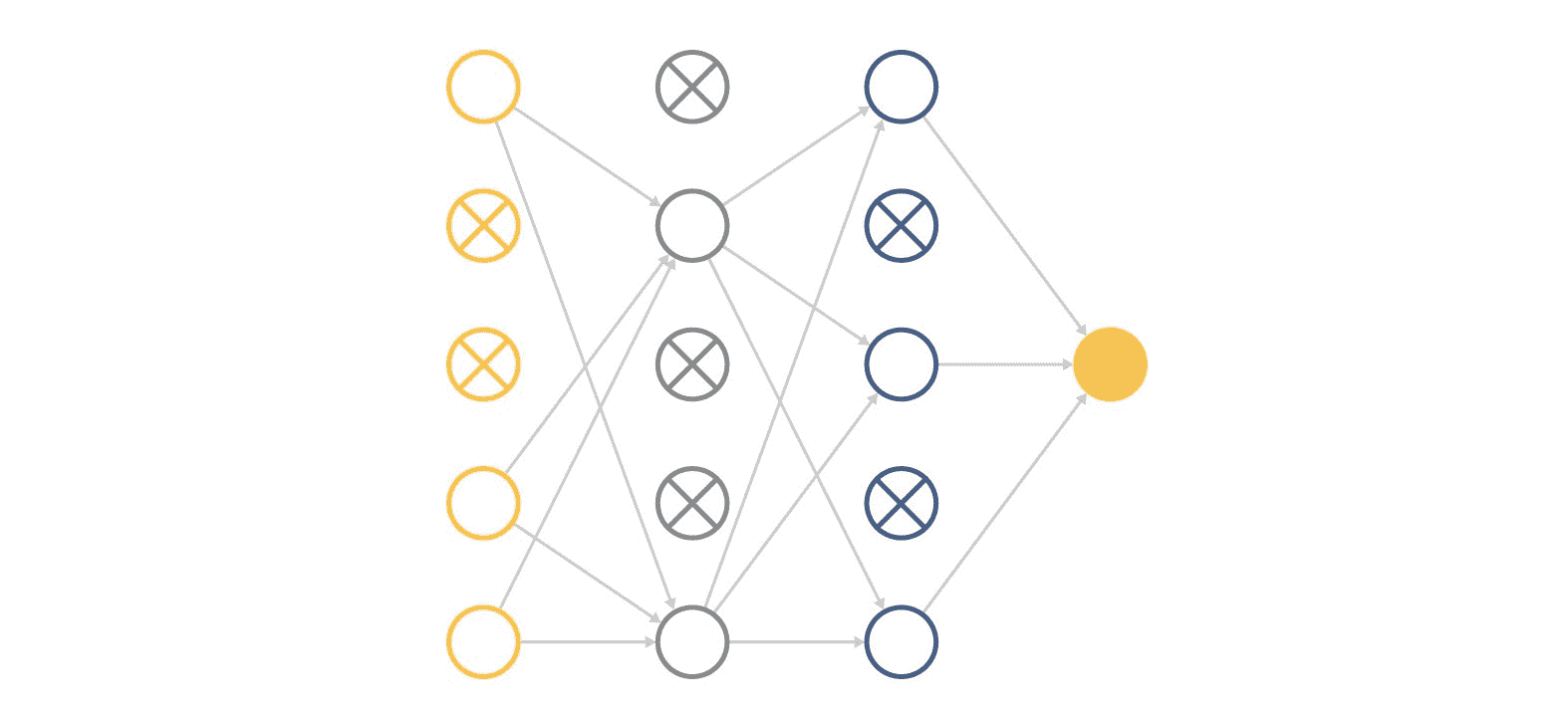

探索神经网络

想象一下,一台机器像人脑一样思考、学习和适应,并发现数据中的隐藏模式。

这项技术,神经网络(NN),算法在模拟认知。稍后我们将深入探讨神经网络是什么以及它们如何运作。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业

1. Google 网络安全证书 - 快速进入网络安全职业

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

在这篇文章中,我将向你解释神经网络(NN)的基本方面——结构、类型、实际应用和定义操作的关键术语。

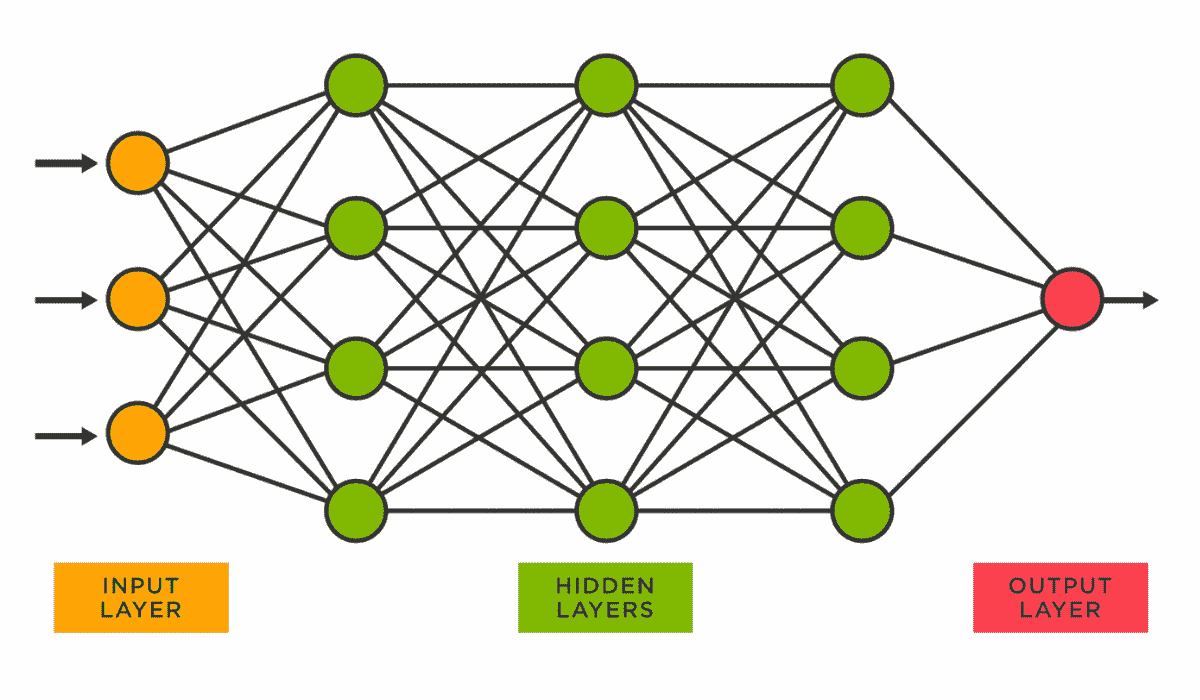

什么是神经网络?

来源: vitalflux.com

称为神经网络(NN)的算法试图在数据中寻找关系,模拟人脑的操作以“学习”数据。

神经网络可以与深度学习和机器学习相结合。因此,首先解释这些术语将是有益的。让我们开始吧。

神经网络与深度学习与机器学习

神经网络构成了深度学习的基础,深度学习是机器学习的一个子集。虽然机器学习模型从数据中学习并进行预测,但深度学习更深入,可以处理大量数据,识别复杂模式。

如果你想了解更多关于机器学习算法的信息,可以阅读这篇文章。

此外,这些神经网络已经成为许多领域的核心部分,作为众多现代技术的支柱,这些应用范围从面部识别到自然语言处理,我们将在后续部分中看到。

让我们探索神经网络在提升日常生活中发挥重要作用的一些常见领域。

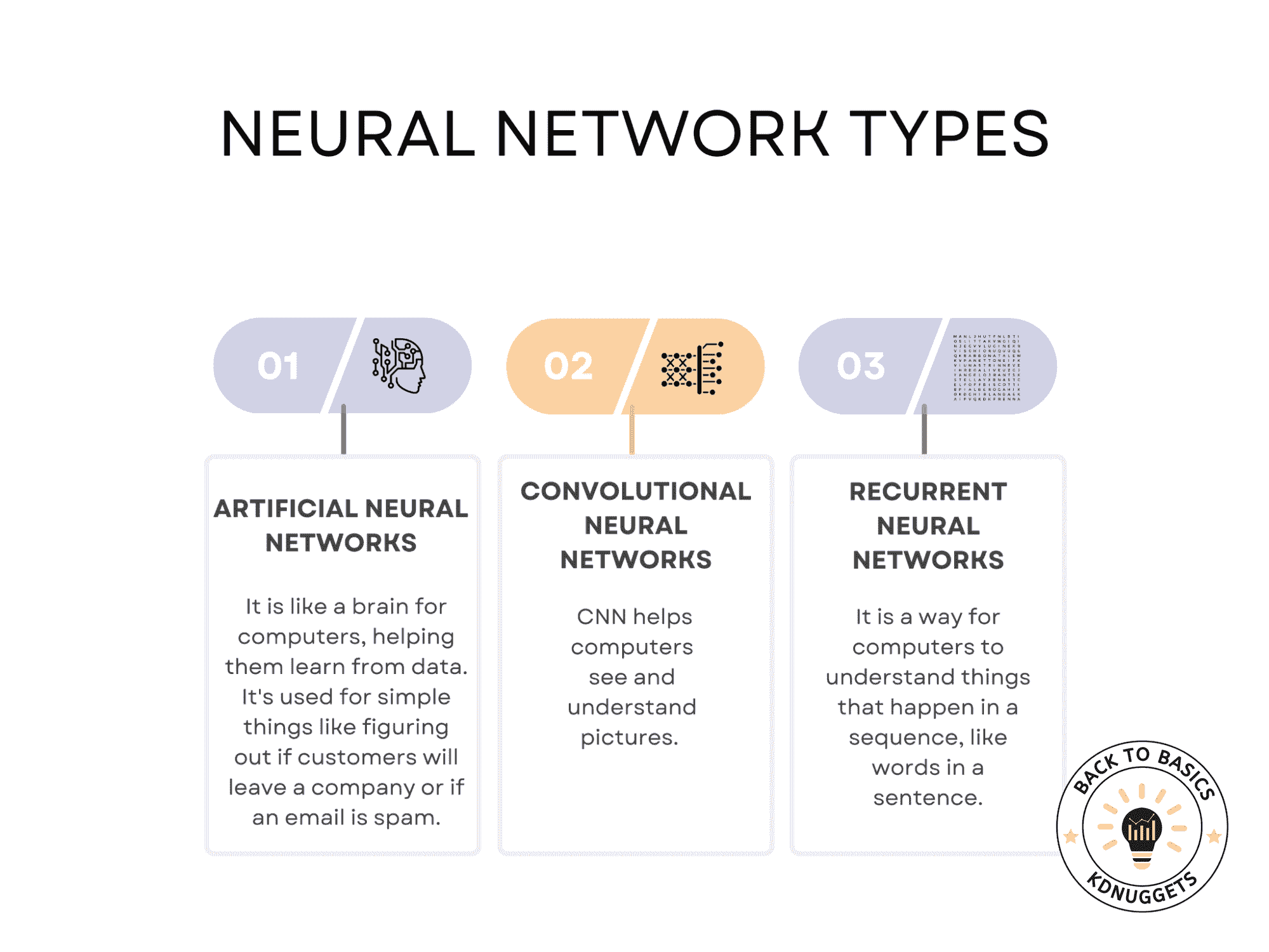

神经网络的类型

现实世界的应用丰富了对神经网络的理解,凭借准确、高效的解决方案革新了各行业的传统方法。

让我们突显一些神经网络推动创新和改变日常体验的有趣例子,包括神经网络类型。

作者提供的图片

人工神经网络(ANN):

人工神经网络(ANN)的架构受到人脑生物神经网络的启发。网络由相互连接的层组成,包括输入层、隐藏层和输出层。每一层包含多个神经元,这些神经元与相邻层的每个神经元相连。

随着数据在网络中流动,每个连接应用一个权重,每个神经元应用一个激活函数,如 ReLU、Sigmoid 或 Tanh。这些函数引入非线性,使网络能够从错误中学习并做出复杂决策。

在训练过程中,使用称为反向传播的技术来调整这些权重。这种技术使用梯度下降来最小化预定义的损失函数,旨在使网络的预测尽可能准确。

ANN 使用案例

客户流失预测

人工神经网络分析用户行为、购买历史和与客服的互动等多个特征,以预测客户离开服务的可能性。

人工神经网络可以建模这些特征之间的复杂关系,提供细致的视角,对于准确预测客户流失至关重要。

销售预测

人工神经网络利用历史销售数据和其他变量,如营销支出、季节性和经济指标,来预测未来销售。

他们从错误中学习并调整变量之间复杂的非线性关系的能力使他们非常适合这个任务。

垃圾邮件过滤

人工神经网络分析邮件的内容、上下文和其他特征,以将其分类为垃圾邮件或非垃圾邮件。

他们可以学习识别新的垃圾邮件模式,并随着时间的推移进行调整,这使他们在过滤不需要的消息时非常有效。

CNN(卷积神经网络):

卷积神经网络(CNNs)专门用于涉及空间层次结构的任务,如图像识别。网络使用称为卷积层的专用层,将一系列滤波器应用于输入图像,生成一组特征图。

这些特征图随后通过池化层,减少其维度,使网络在计算上更高效。最后,一个或多个全连接层进行分类。

训练过程涉及反向传播,类似于人工神经网络(ANNs),但调整以保持特征的空间层次结构。

CNN 使用案例

图像分类

卷积神经网络应用一系列滤波器和池化层来自动识别图像中的层次模式。

他们减少维度并关注重要特征的能力使他们在图像分类中既高效又准确。

对象检测

卷积神经网络不仅分类,还通过绘制边界框来定位图像中的对象。

该架构设计用于识别空间层次结构,使其能够在单个图像中识别多个对象。

图像分割

卷积神经网络可以将标签分配给图像中的每个像素,将其分类为属于特定对象或背景。

网络的粒度像素级理解使其非常适合于医疗成像等需要精确分割的任务。

RNN(循环神经网络):

循环神经网络(RNNs)的不同之处在于它们具有内部循环或递归结构,使它们能够存储信息。这使得它们非常适合处理序列数据,因为每个神经元可以利用其内部状态记住序列中前一个时间步的信息。

在处理数据时,网络会考虑当前和之前的输入,从而形成一种短期记忆。然而,RNNs 可能会遇到梯度消失和爆炸等问题,这使得学习数据中的长期依赖关系变得困难。

为了解决这些问题,开发了更高级的版本,如长短期记忆(LSTM)和门控递归单元(GRU)网络。

RNN 使用案例

语音转文本

RNNs 接受音频序列作为输入,产生文本序列作为输出,考虑到口语语言中的时间依赖关系。

RNNs 的递归性质使其能够考虑音频输入的序列,使其擅长理解人类语音中的上下文和细微差别。

机器翻译

RNNs 将一个语言的序列转换为另一个语言的序列,考虑整个输入序列以产生准确的输出序列。

序列到序列学习能力保持语言之间的上下文,使翻译更准确且具有上下文相关性。

情感分析

RNNs 分析文本序列以识别和提取观点和情感。

RNNs 中的记忆特性有助于捕捉文本序列中的情感积累,使其适合用于情感分析任务。

结论

展望未来,前景承诺神经网络的持续进步和特殊应用场景。随着算法的发展,以处理更复杂的数据,它们将在医疗、交通、金融等领域解锁新的可能性。

要学习神经网络,做一个实际项目非常有效。从面部识别到疾病预测,它们正在重塑我们的生活和工作方式。

在本文中,我们回顾了其基本原理、面部检测和识别等实际例子,以及更多内容。

感谢阅读!

Nate Rosidi 是一名数据科学家和产品战略专家。他还是一名兼职教授,教授分析学,并且是StrataScratch的创始人,该平台帮助数据科学家准备来自顶级公司的真实面试问题。他可以通过Twitter: StrataScratch或LinkedIn与他联系。

更多相关话题

探索 GPT-4 的能力和局限性

原文:

www.kdnuggets.com/2023/07/exploring-power-limitations-gpt4.html

作者提供的图片

曾经好奇过更新更先进的 GPT-4 与其前身 ChatGPT 3.5 的比较吗?

GPT-4 有什么独特之处?它的局限在哪里?

随着我们深入探讨语言模型的局限性及其潜在应用,理解这些细微差别至关重要。

在这段人工智能领域的探索旅程中,我们将突出 ChatGPT 4 的独特功能、其创新插件及其如何革新我们解决数据科学领域技术问题的方式。

从解决统计和概率的复杂性,到应对复杂的建模问题和 Python、SQL 或 R 的编程查询,我们将探讨 GPT-4 在数据科学中的各种助力方式。

所以,系好安全带,跟随我们踏上这段探索之旅,剖析 GPT-4 及其如何重塑我们对数据科学的理解!

ChatGPT 3.5 和 ChatGPT 4

GPT-3.5,也被称为 ChatGPT,是由 OpenAI 于 2022 年 11 月公开的。

它迅速在全球范围内流行,甚至在某些时候由于超出服务器容量而导致 OpenAI 推出了付费版 ChatGPT Plus 以应对需求。

GPT-4 于 3 月 14 日发布,相较于 GPT-3.5 有了显著升级。

它具有先进的推理能力,即使它可以从数据中生成意义而非文本(如图片),目前的 ChatGPT+ 版本仍然仅支持文本输出。

GPT-4 的问题解决能力比 GPT-3.5 更为准确。

目前,ChatGPT+ 的付费版每月费用为 $20,但它有一定的限制,比如每 3 小时最多 25 条消息。

此外,微软的搜索引擎 Bing 也在运行定制版的 GPT-4。

欲了解更多信息,请查看 OpenAI 网站上关于 GPT-4 的官方博客文章。

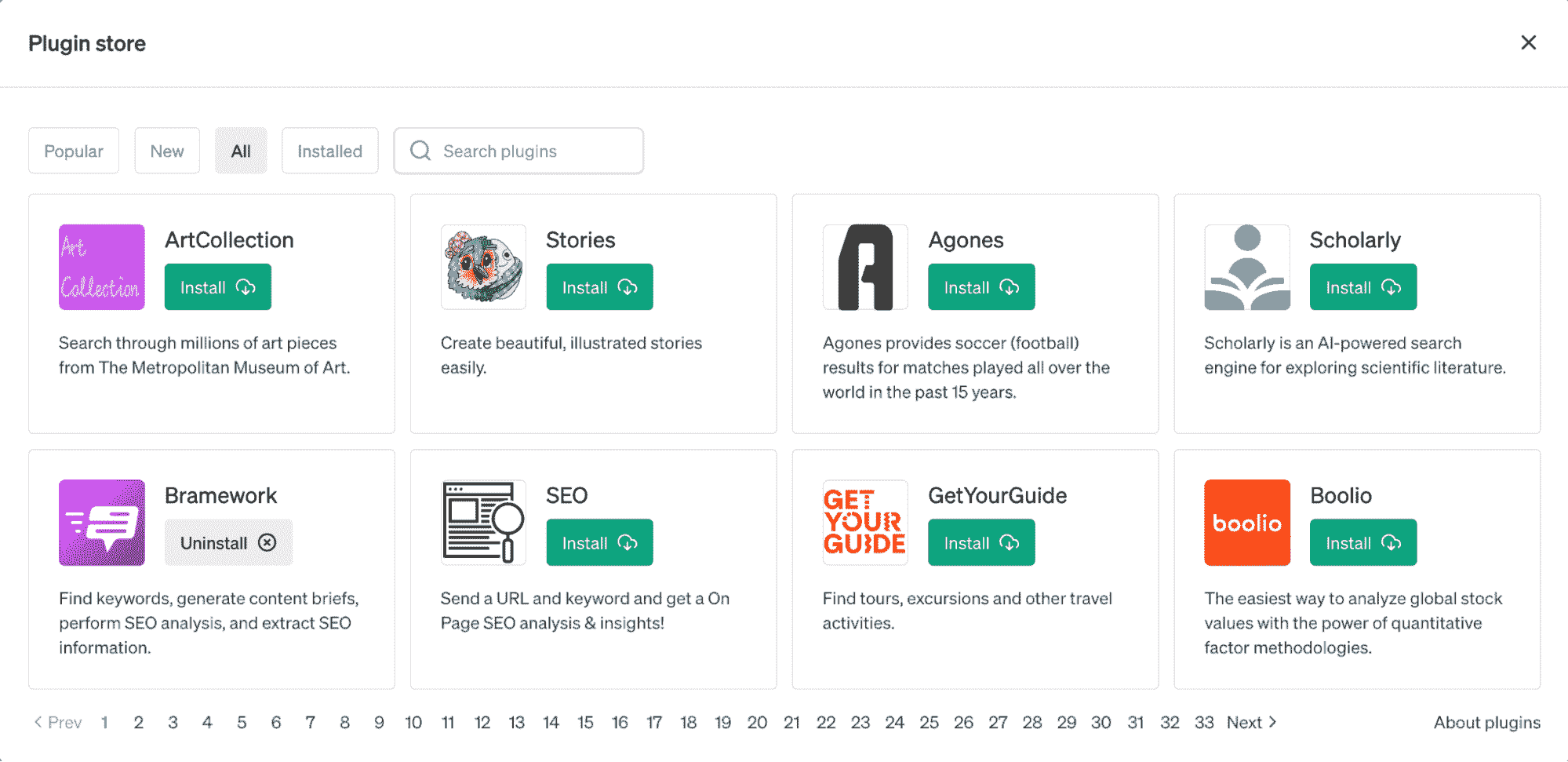

ChatGPT 插件

来源: chat.openai.com/

OpenAI 于 3 月 23 日推出了 ChatGPT 的新功能——插件。

这些工具旨在增强语言模型的能力,使其能够获取最新信息并执行计算。

这些插件的推出是逐步进行的,以评估它们的实际使用、影响以及潜在的安全和对齐问题。

各种公司,包括 KAYAK、Klarna、Milo、Shopify、Slack、Speak、Wolfram、Zapier 等,已经开发了初步的一套插件。

这些插件提供了广泛的功能,例如旅行规划、杂货订购、计算访问和实时数据检索。

OpenAI 还提供了两个插件:网页浏览器 和 代码解释器。

虽然网页浏览器允许你通过 GPT 模型的能力访问网络,但代码解释器将帮助你通过简单的提示来处理和分析数据。

其中一些插件,如 Noteable 和 Wolfram,在数据科学中尤其有用。

这些插件旨在增加 ChatGPT 的实用性。

GPT-4 能否用于回答数据科学中的技术问题?

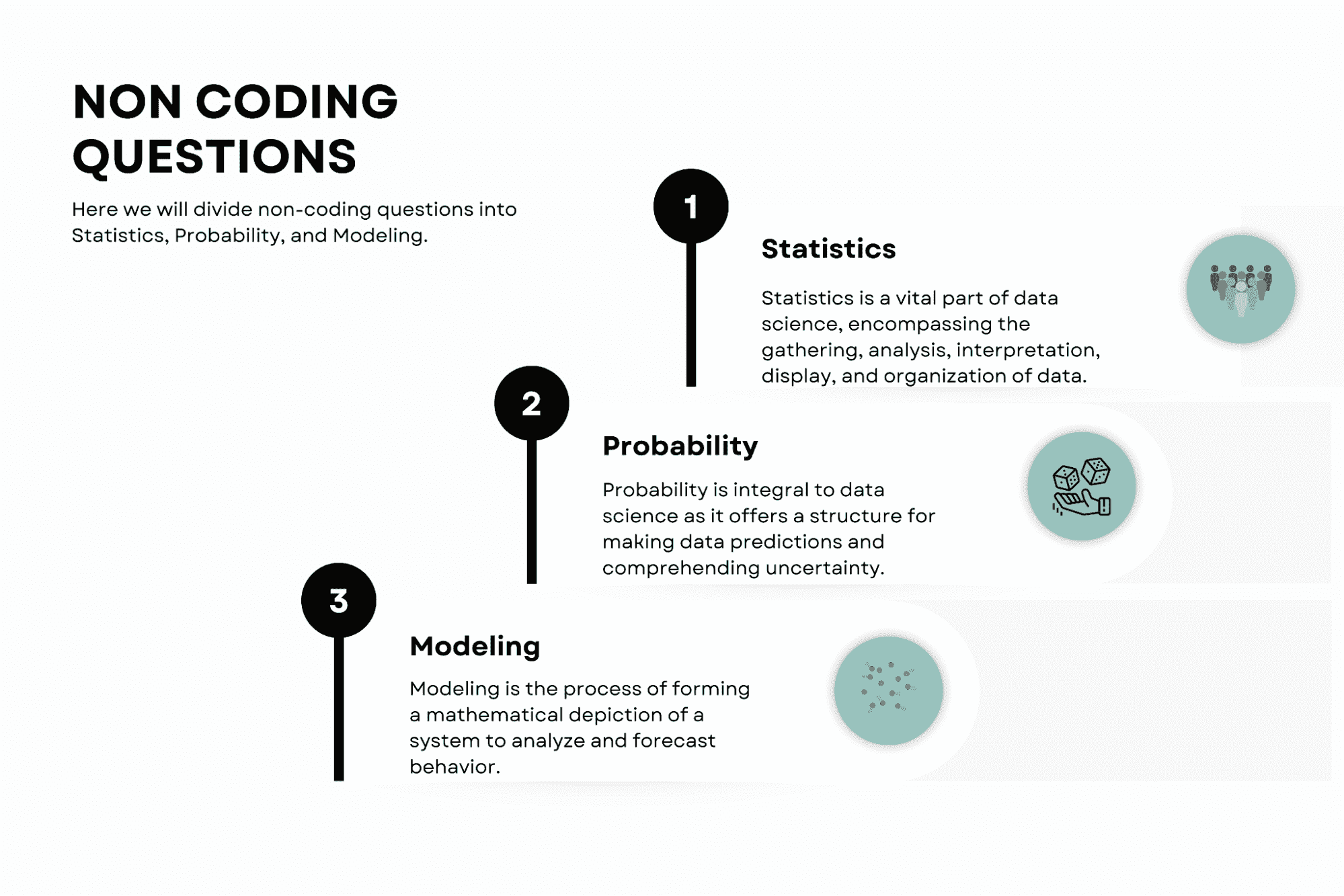

我们可以将数据科学问题分为非编码和编码面试问题。

通过测试 ChatGPT-4 在这些方面的能力,我们将更好地理解 ChatGPT-4 如何用于回答数据科学中的技术问题。

让我们从非编码问题开始。

非编码问题

在这里,我们将把非编码问题分为统计、概率和建模。

图片由作者提供

统计学

统计学对数据科学至关重要,包括数据收集、分析、解释、展示和组织。

GPT-4 能够回答有关统计概念的问题,提供对复杂统计原理的全面理解。

以这种方式使用 GPT-4 可以提高对统计理论的理解,并帮助数据科学家从数据中提取有意义的洞察。

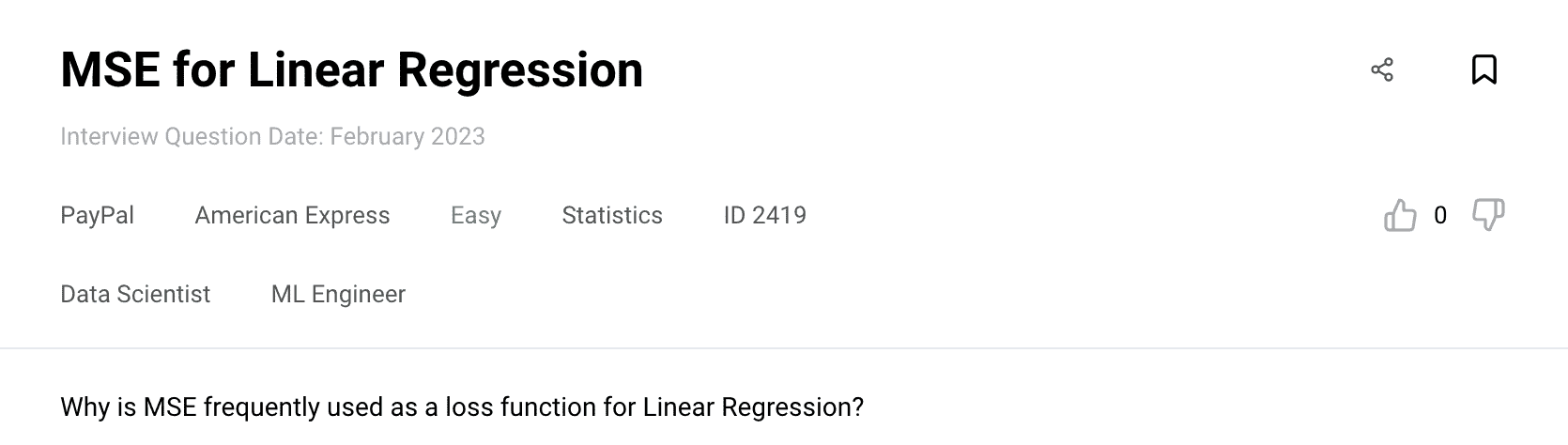

这里是我们将用来测试 Chat 能力的 统计问题。我们将使用 Wolfram 插件,它在计算时帮助用户。

此外,使用 ChatGPT-4 及其插件时有一个重要的注意事项:它们可能很好,但并不完美,所以一定要始终双重检查输出,因为它可能是错误的。

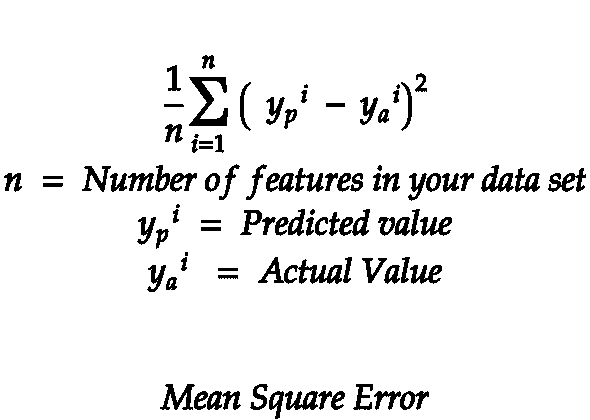

提示:为什么均方误差(MSE)常被用作线性回归的损失函数?

(使用 Wolfram 插件,提供公式)

ChatGPT:MSE 的公式是:

其中:

-

![方程]() 是观察数

是观察数 -

![方程]() 是实际值和

是实际值和 -

![方程]() 是预测值。

是预测值。

以下是 MSE 常被使用的原因:

-

可微性:MSE 是一个光滑且可微的函数。这一点很重要,因为优化算法,如梯度下降,依赖于函数的导数来寻找最小值。

-

对异常值的敏感性:均方误差中的平方项给予较大误差更高的权重。这意味着模型对异常值更敏感,会试图最小化较大的误差。

-

可解释性:均方误差易于解释,因为它表示预测值与实际值之间的平均平方差。较低的均方误差表示模型与数据的拟合更好。

-

凸性:均方误差(MSE)导致了一个凸损失函数的地形。凸问题有一个唯一的全局最小值,使得使用优化算法解决这些问题更容易。

-

与 OLS 的一致性:在线性回归中,最小化均方误差等同于最小化普通最小二乘法(OLS)中的残差,OLS 是估计线性回归模型参数的标准方法。

作者注:尽管均方误差有这些优点,但它并不是每个回归问题的最佳选择。根据数据和问题的具体特征,其他损失函数可能更为合适。

控制

ChatGPT 的回答详细且正确。

概率

概率在数据科学中至关重要,因为它为做出数据预测和理解不确定性提供了结构。它可以详细说明这些概念,解释数学计算和特定事件的可能性背后的逻辑。

这帮助数据科学家构建模型并做出基于概率推理的智能决策。

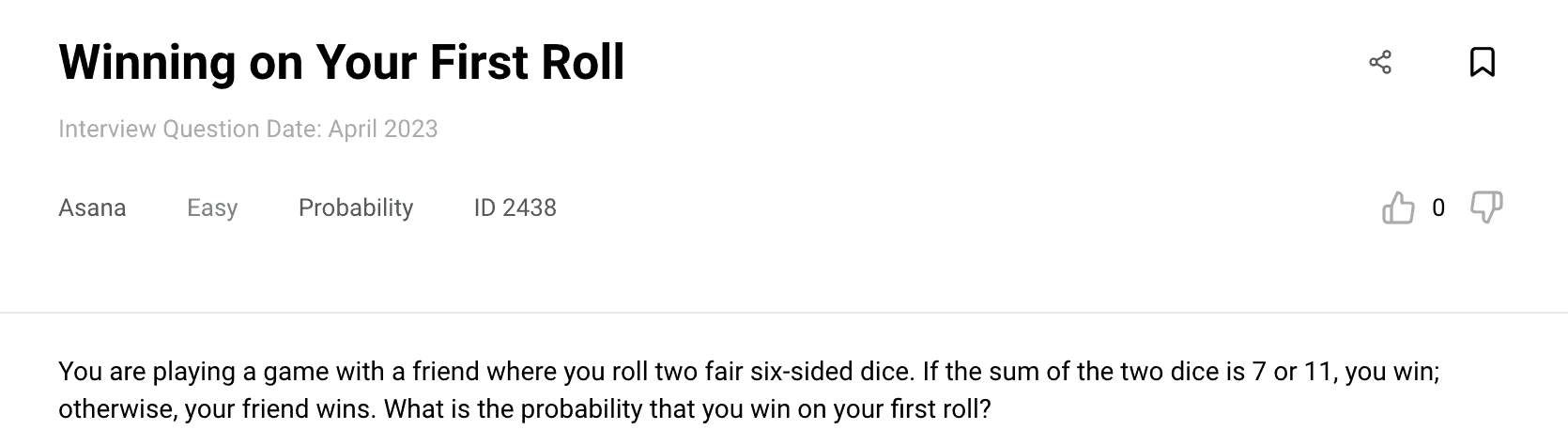

这是概率问题 ChatGPT 会尝试解决的。

问题:你和朋友玩一个游戏,掷两个公平的六面骰子。如果两个骰子的总和是 7 或 11,你就赢了;否则,你的朋友赢。你第一次掷骰子的获胜概率是多少?

ChatGPT:要确定第一次掷骰子的获胜概率,我们需要计算有利结果(获胜结果)的数量,并将其除以所有可能结果的总数。

在这种情况下,每个骰子有 6 种可能的结果,因为它们是公平的六面骰子。因此,掷两个骰子的所有可能结果的总数是:6 × 6 = 36

要在第一次掷骰子时获胜,两个骰子的总和必须是 7 或 11。我们可以如下计算有利结果的数量:

-

总和为 7:有 6 种方式可以实现这一结果:(1, 6)、(2, 5)、(3, 4)、(4, 3)、(5, 2)和(6, 1)。

-

总和为 11:有 2 种方式可以实现这一结果:(5, 6) 和 (6, 5)。

因此,总共有 6 + 2 = 8 种有利结果。

现在,我们可以通过将有利结果的数量除以所有可能结果的总数来计算第一次掷骰子的获胜概率:

第一次掷骰子的获胜概率 = 有利结果的数量 / 可能结果的总数 = 8 / 22 = 2 / 9 = 0.222

因此,你第一次掷骰子的胜率大约是 0.222 或 22.2%。

控制

输出是正确的,与平台上的解决方案匹配。

建模

建模是形成系统数学描述以分析和预测行为的过程。

它可以帮助数据科学家理解概念、假设、实现和结果的解释。这将导致对数据的预测和理解的改进。

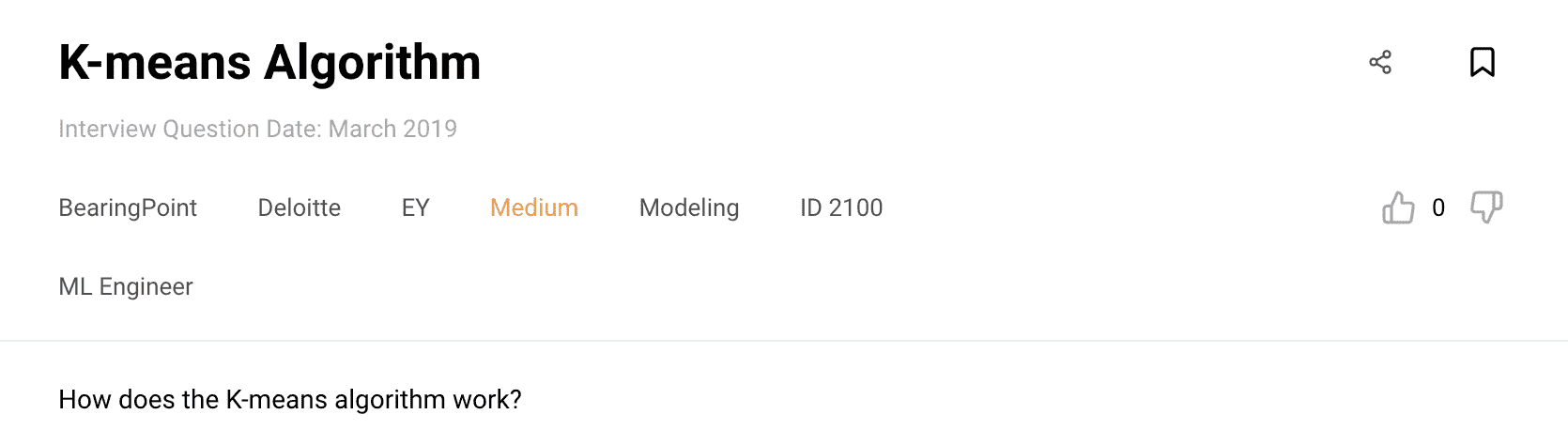

这里是我们将要测试的 建模问题。

提示 : K-means 算法是如何工作的?

ChatGPT : K-means 算法是一种迭代聚类算法,旨在将给定的数据集划分为 K 个簇,其中 K 是用户定义的参数。

它的工作原理如下:

-

初始化:从数据集中随机选择 K 个数据点作为簇的初始质心(代表点)。

-

分配:根据距离度量(通常是欧几里得距离)将每个数据点分配给最近的质心。此步骤形成 K 个簇。

-

更新:通过取分配给每个簇的所有数据点的均值来重新计算簇的质心。此步骤旨在找到更好的质心,以代表每个簇的中心。

-

迭代:重复分配和更新步骤,直到收敛。收敛发生在质心停止显著变化或达到最大迭代次数时。

-

输出:算法返回最终的 K 个簇,其中每个数据点属于最近的质心所在的簇。

K-means 算法旨在最小化簇内平方距离的总和,也称为惯性或总簇内方差。它假设簇是球形的,并具有相等的方差。然而,根据质心的初始化,算法可能会收敛到次优解。

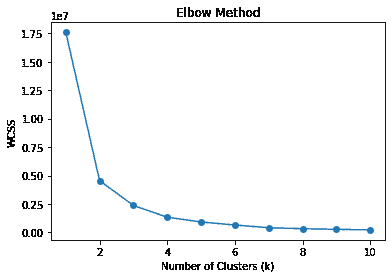

为了提高 K-means 的性能,可以应用各种技术,例如使用多个初始化、执行更智能的质心初始化方法(如 K-means++),或使用肘部法来确定 K 的最佳值。

需要注意的是,K-means 对初始质心的选择敏感,可能在处理包含非线性或不规则形状簇的数据集时遇到困难。在这种情况下,像 DBSCAN 或高斯混合模型(GMM)等替代聚类算法可能更合适。

控制

ChatGPT 的回答详细且正确。

编码问题

编码对数据科学家来说是必需的。它包括使用 Python 进行数据处理和机器学习,使用 SQL 进行数据库处理,以及使用 R 进行统计计算。GPT-4 可以协助解决编码问题。

图片由作者提供

让我们在编码问题上测试 ChatGPT-4,从 Python 开始。

Python

Python 在数据科学社区中是一种受欢迎的语言,因为它的用户友好性和强大的库,如 pandas、numpy 和 scikit-learn。

GPT-4 可以协助调试 Python 代码、推荐最佳编码实践,甚至为特定任务生成代码片段。

现在让我们用以下问题来尝试一下。

问题 1

这是我将输入到 ChatGPT-4 的 问题。

提示:

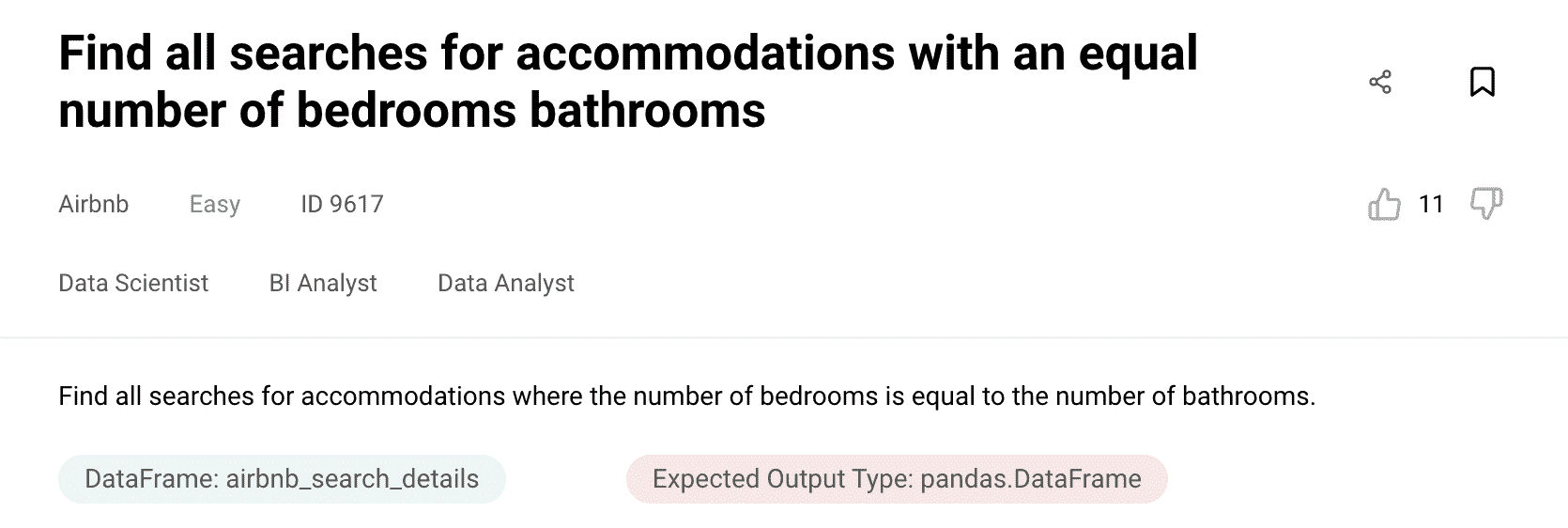

我的数据集名称是 airbnb_search_details,以下是更多信息;

未命名: 0:int64

id:int64

price:float64

property_type: object

room_type: object

amenities:object

accommodates:int64

bathrooms:int64

bed_type:object

cancellation_policy:object

cleaning_fee:bool

city:object

host_identity_verified:object

host_response_rate:object

host_since:datetime64[ns]

neighbourhood:object

number_of_reviews:int64

review_scores_rating:float64

zipcode:int64

bedrooms:int64

beds:int64

问题是:找出所有卧室数量等于浴室数量的住宿搜索。确保预期输出类型为数据框。

作者备注: 要将数据集输入到 Chat 中,只需像下面示例一样从平台上复制它。

ChatGPT: 要找出所有卧室数量等于浴室数量的住宿搜索,你可以使用以下 Python 代码:

import pandas as pd

# Assuming 'airbnb_search_details' is the DataFrame containing your dataset

# Replace 'airbnb_search_details' with the actual name of your DataFrame if different

# Filter the DataFrame based on the condition: number of bedrooms == number of bathrooms

result = airbnb_search_details[airbnb_search_details['bedrooms'] == airbnb_search_details['bathrooms']]

# Display the resulting DataFrame

print(result)

控制

实际上,ChatGPT 的大部分回答都正确,除了最后一行。没有必要使用 print 函数打印结果数据框,因此当代码更新如下时,解决方案是有效的。

import pandas as pd

# Assuming 'airbnb_search_details' is the DataFrame containing your dataset

# Replace 'airbnb_search_details' with the actual name of your DataFrame if different

# Filter the DataFrame based on the condition: number of bedrooms == number of bathrooms

result = airbnb_search_details[airbnb_search_details['bedrooms'] == airbnb_search_details['bathrooms']]

# Display the resulting DataFrame

result

问题 2

这是我将输入到 ChatGPT-4 的 问题。

我将基本上复制并粘贴我提示中的所有信息。

提示:

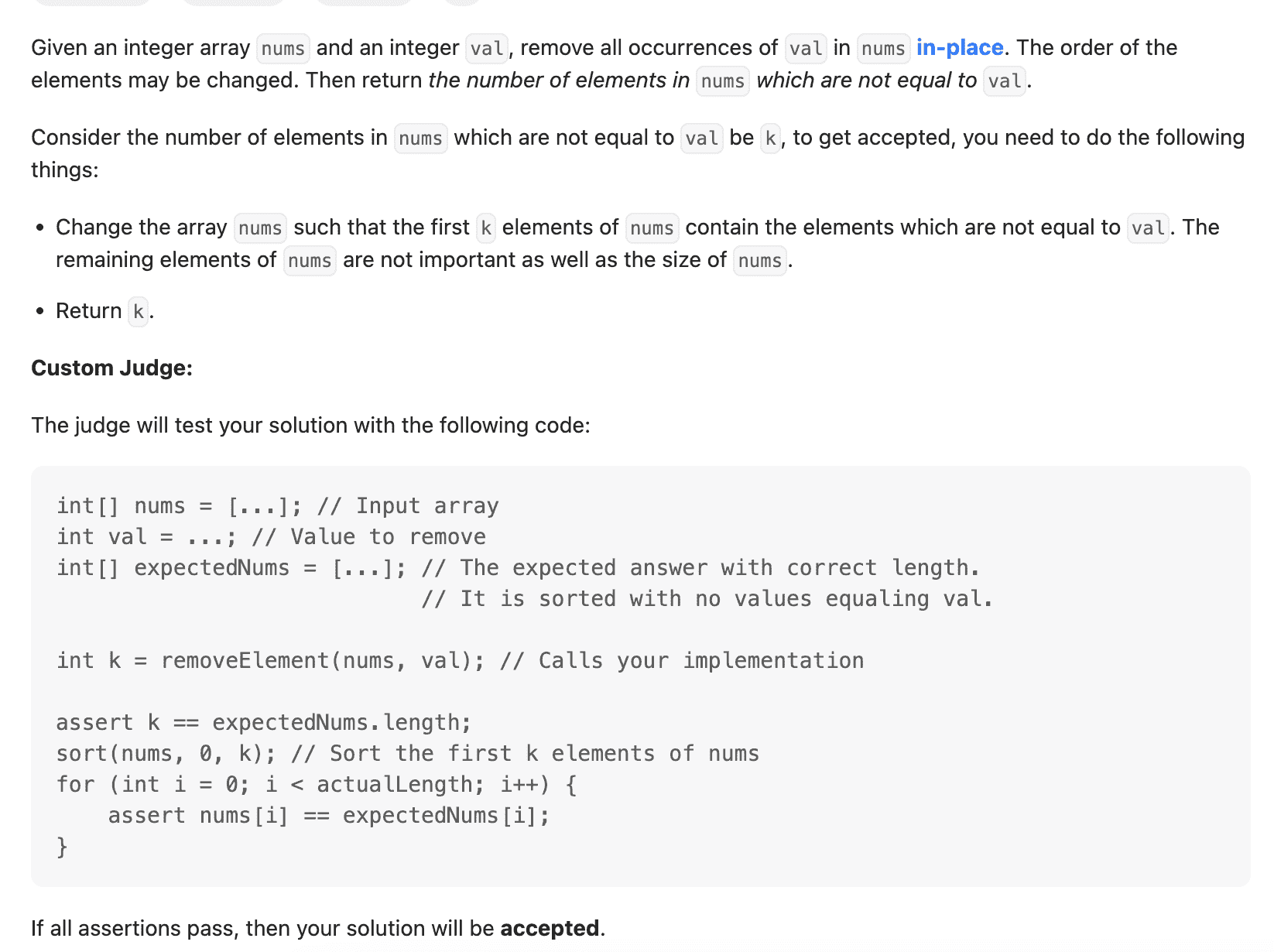

给定一个整数数组 nums 和一个整数 val,在 nums 中就地移除所有 val 的出现。元素的顺序可能会改变。然后返回 nums 中不等于 val 的元素个数。

考虑到 nums 中不等于 val 的元素个数为 k,要被接受,你需要做以下事情:

更改数组 nums,使得 nums 的前 k 个元素包含不等于 val 的元素。剩余的 nums 元素以及 nums 的大小都不重要。

返回 k。

自定义评判器:

法官将用以下代码测试你的解决方案:

int[] nums = [...]; // 输入数组

int val = ...; // 要移除的值

int[] expectedNums = [...]; // 预期的正确长度答案。

// 它已排序且没有值等于 val。

int k = removeElement(nums, val); // 调用你的实现

assert k == expectedNums.length;

sort(nums, 0, k); // 对 nums 的前 k 个元素进行排序

for (int i = 0; i < actualLength; i++) {

assert nums[i] == expectedNums[i];

}

如果所有断言通过,那么你的解决方案将被接受。

示例 1:

输入: nums = [3,2,2,3], val = 3

输出: 2, nums = [2,2,,]

解释: 你的函数应该返回 k = 2,nums 的前两个元素为 2。

无论你在返回的 k 之后留下什么(因此它们是下划线)都无所谓。

示例 2:

输入: nums = [0,1,2,2,3,0,4,2], val = 2

输出: 5, nums = [0,1,4,0,3,,,_]

解释: 你的函数应该返回 k = 5,nums 的前五个元素包含 0, 0, 1, 3 和 4。

注意这五个元素可以以任何顺序返回。

无论你在返回的 k 之后留下什么(因此它们是下划线)都无所谓。

限制条件:

0 <= nums.length <= 100

0 <= nums[i] <= 50

0 <= val <= 100

解决方案格式;

class Solution:

def removeElement(self, nums: List[int], val: int) -> int:

ChatGPT: 这是用 Python 实现的解决方案:

class Solution:

def removeElement(self, nums: List[int], val: int) -> int:

k = 0 # Counter for elements not equal to val

# Iterate through the array

for i in range(len(nums)):

if nums[i] != val:

nums[k] = nums[i] # Move the element to the kth position

k += 1

return k

解决方案使用双指针方法原地修改 nums 数组,并计算不等于 val 的元素数量。变量 k 用于跟踪下一个非 val 元素应该放置的位置。

算法遍历数组,每当遇到一个不等于 val 的元素时,它就被移动到第 k 个位置,并且 k 增加。最后,k 表示不等于 val 的元素的数量。

你可以使用提供的自定义判题代码测试解决方案,以验证它是否对给定示例产生预期的输出并通过断言。

控制

代码工作正常,无需任何更新。

SQL

SQL 对于处理数据库至关重要。GPT-4 可以帮助制定 SQL 查询、提升数据库效率,并掌握复杂的 SQL 概念。

问题 1

这是我们将尝试解决的 SQL 问题。

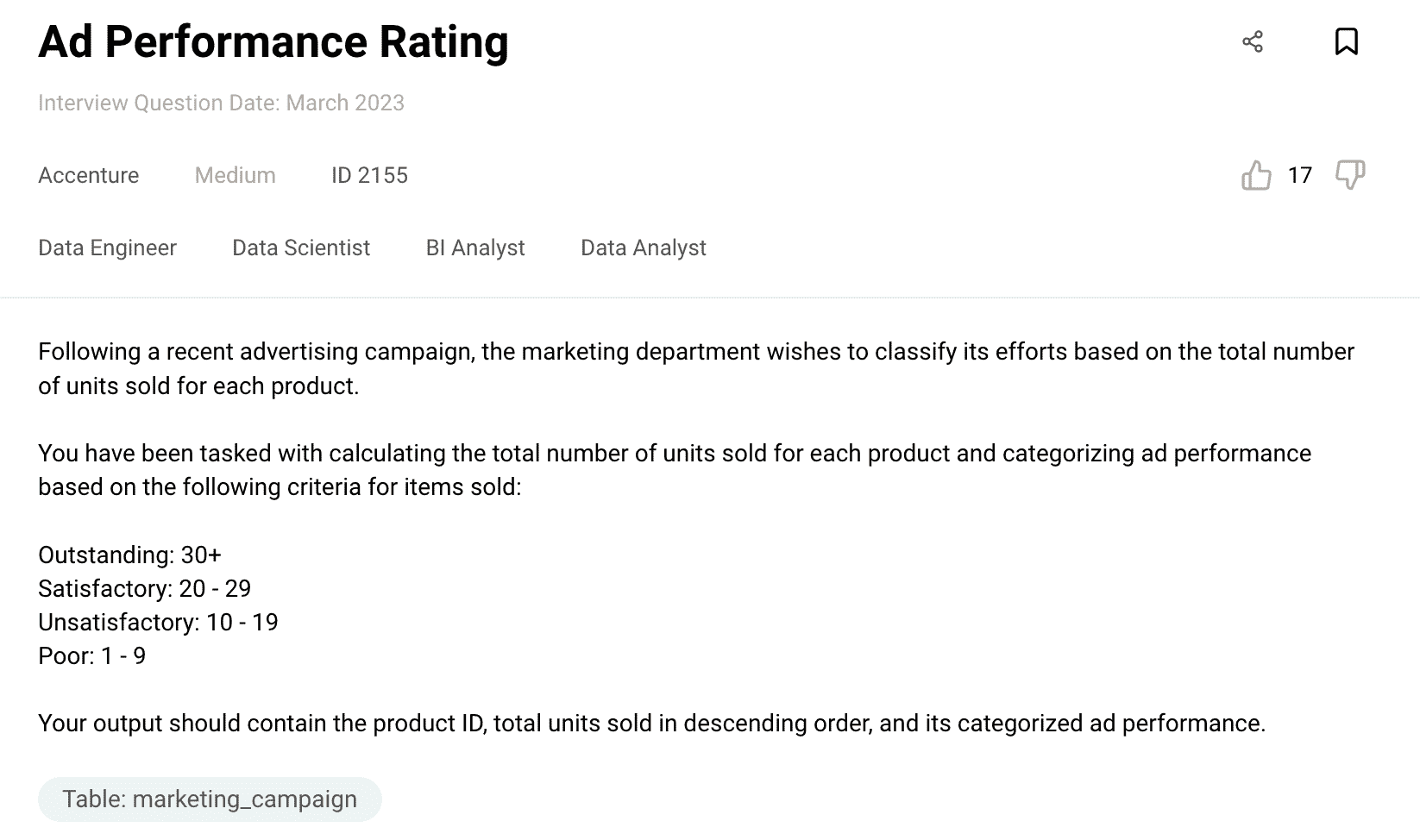

提示 : 问题如下:在最近的广告活动之后,营销部门希望根据每种产品的总销售量对其工作进行分类。

你需要计算每种产品的总销售量,并根据以下标准对广告表现进行分类:

优秀: 30+

满意: 20 - 29

不满意: 10 - 19

差: 1 - 9

你的输出应该包含产品 ID、按降序排列的总销售量以及其分类的广告表现。

我的数据集名称是 marketing_campaign,以下是数据类型。

marketing_campaign

user_id: int

created_at: datetime

product_id: int

quantity: int

price: int

这是期望的输出:

product_id total_sold ad_performance

105 41 杰出

102 29 满意

114 23 满意

118 22 满意

120 21 满意

使用 MySQL 解决此问题。

ChatGPT:要使用 MySQL 解决此任务,您可以编写一个查询来计算每个产品的总销售单位,并根据给定的标准对广告效果进行分类。

以下是查询:

SELECT

product_id,

SUM(quantity) AS total_sold,

CASE

WHEN SUM(quantity) >= 30 THEN 'Outstanding'

WHEN SUM(quantity) BETWEEN 20 AND 29 THEN 'Satisfactory'

WHEN SUM(quantity) BETWEEN 10 AND 19 THEN 'Unsatisfactory'

WHEN SUM(quantity) BETWEEN 1 AND 9 THEN 'Poor'

END AS ad_performance

FROM

marketing_campaign

GROUP BY

product_id

ORDER BY

total_sold DESC;

在这个查询中,我们选择 product_id,计算数量的总和作为 total_sold,并使用 CASE 语句根据 total_sold 的值对广告效果进行分类。查询按 product_id 分组,按 total_sold 降序排列,并提供所需的输出。

确保将“marketing_campaign”替换为数据库中表的实际名称。

运行此查询将为您提供包含 product_id、total_sold 和 ad_performance 的预期结果,根据标准进行分类。

控制

代码运行完美,无需任何更新。

问题 2

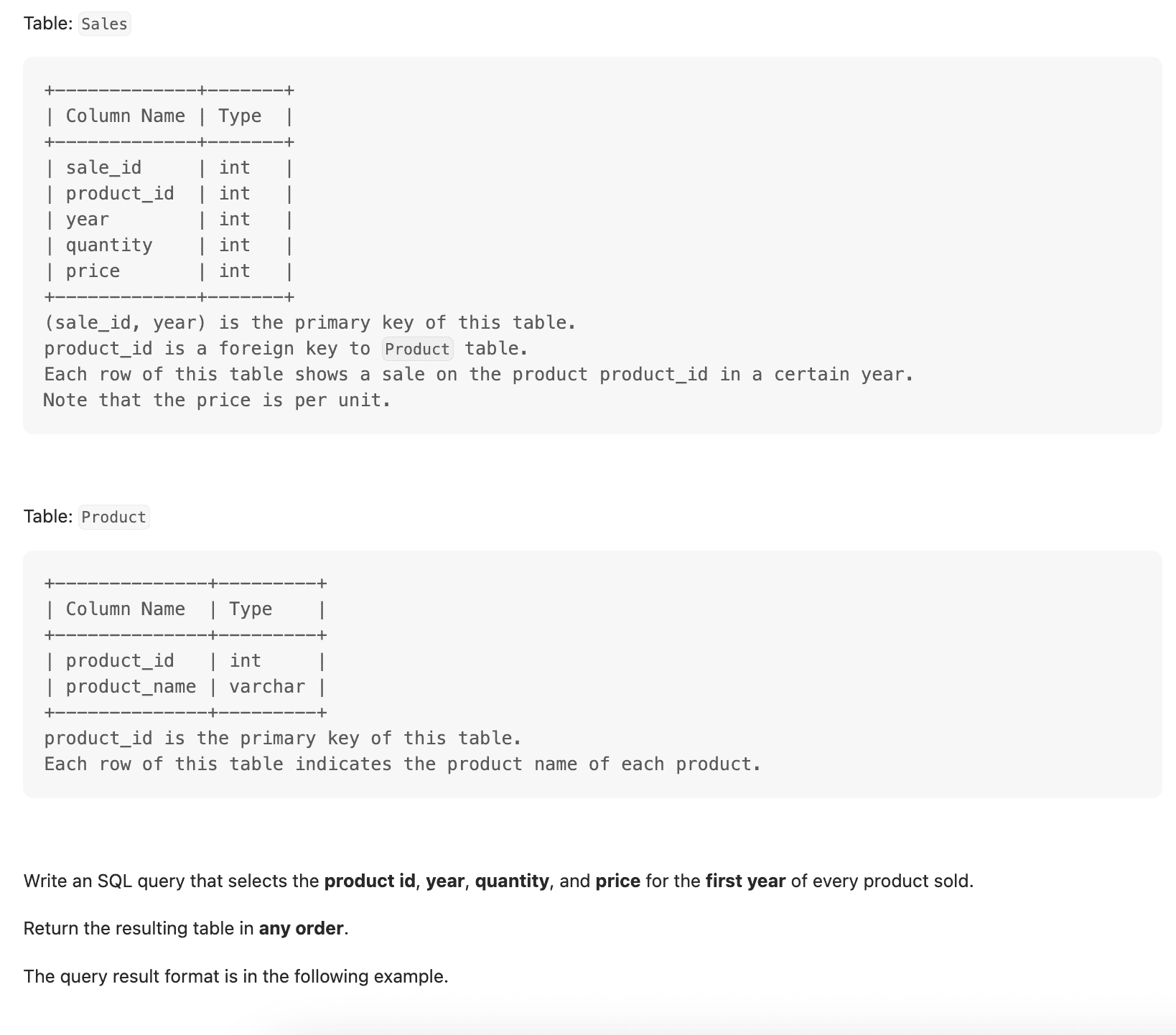

这里是 第二个 SQL 问题 来自 LeetCode。

提示 : 表:Sales

+-------------+-------+

| 列名 | 类型 |

|---|

+-------------+-------+

| sale_id | int |

|---|---|

| product_id | int |

| year | int |

| quantity | int |

| price | int |

+-------------+-------+

(sale_id, year) 是该表的主键。product_id 是 Product 表的外键。

该表的每一行显示了某一年中 product_id 产品的销售情况。请注意价格是每单位的。

表:Product

+--------------+---------+

| 列名 | 类型 |

|---|

+--------------+---------+

| product_id | int |

|---|---|

| product_name | varchar |

+--------------+---------+

product_id 是该表的主键。

该表的每一行表示每个产品的产品名称。

编写一个 SQL 查询,选择每个销售的产品的产品 id、年份、数量和价格的第一个年份。

返回结果表可以按任何顺序。

查询结果格式如下例所示。

示例 1:

输入:

销售表:

+---------+------------+------+----------+-------+

| sale_id | product_id | year | quantity | price |

|---|

+---------+------------+------+----------+-------+

| 1 | 100 | 2008 | 10 | 5000 |

|---|---|---|---|---|

| 2 | 100 | 2009 | 12 | 5000 |

| 7 | 200 | 2011 | 15 | 9000 |

+---------+------------+------+----------+-------+

产品表:

+------------+--------------+

| product_id | product_name |

|---|

+------------+--------------+

| 100 | 诺基亚 |

|---|---|

| 200 | 苹果 |

| 300 | 三星 |

+------------+--------------+

输出:

+------------+------------+----------+-------+

| product_id | first_year | quantity | price |

|---|

+------------+------------+----------+-------+

| 100 | 2008 | 10 | 5000 |

|---|---|---|---|

| 200 | 2011 | 15 | 9000 |

+------------+------------+----------+-------+

ChatGPT: 要选择每个产品销售的第一年的产品 ID、年份、数量和价格,你可以使用以下 SQL 查询:

SELECT s.product_id, s.year AS first_year, s.quantity, s.price

FROM Sales s

JOIN (

SELECT product_id, MIN(year) AS first_year

FROM Sales

GROUP BY product_id

) t ON s.product_id = t.product_id AND s.year = t.first_year

ORDER BY s.product_id;

解释:

-

子查询(SELECT product_id, MIN(year) AS first_year FROM Sales GROUP BY product_id)使用 MIN() 函数选择每个产品的最小年份,并按 product_id 分组结果。

-

主查询将 Sales 表与子查询连接,基于匹配的 product_id 和 year 列,以检索每个产品的第一年的销售记录。

-

从 Sales 表中返回所选列,包括 product_id、年份(作为 first_year)、数量和价格,匹配记录。

-

结果按 product_id 升序排列。

查询将返回每个产品销售的第一年的产品 ID、年份、数量和价格,如示例输出所示。

控制

代码正常工作,无需更新。

R

R 是一种专为统计评估和数据可视化而构建的语言。GPT-4 可以支持理解 R 语言的细微差别、调试 R 代码以及使用各种 R 包进行数据分析。

问题

这是编码 问题。

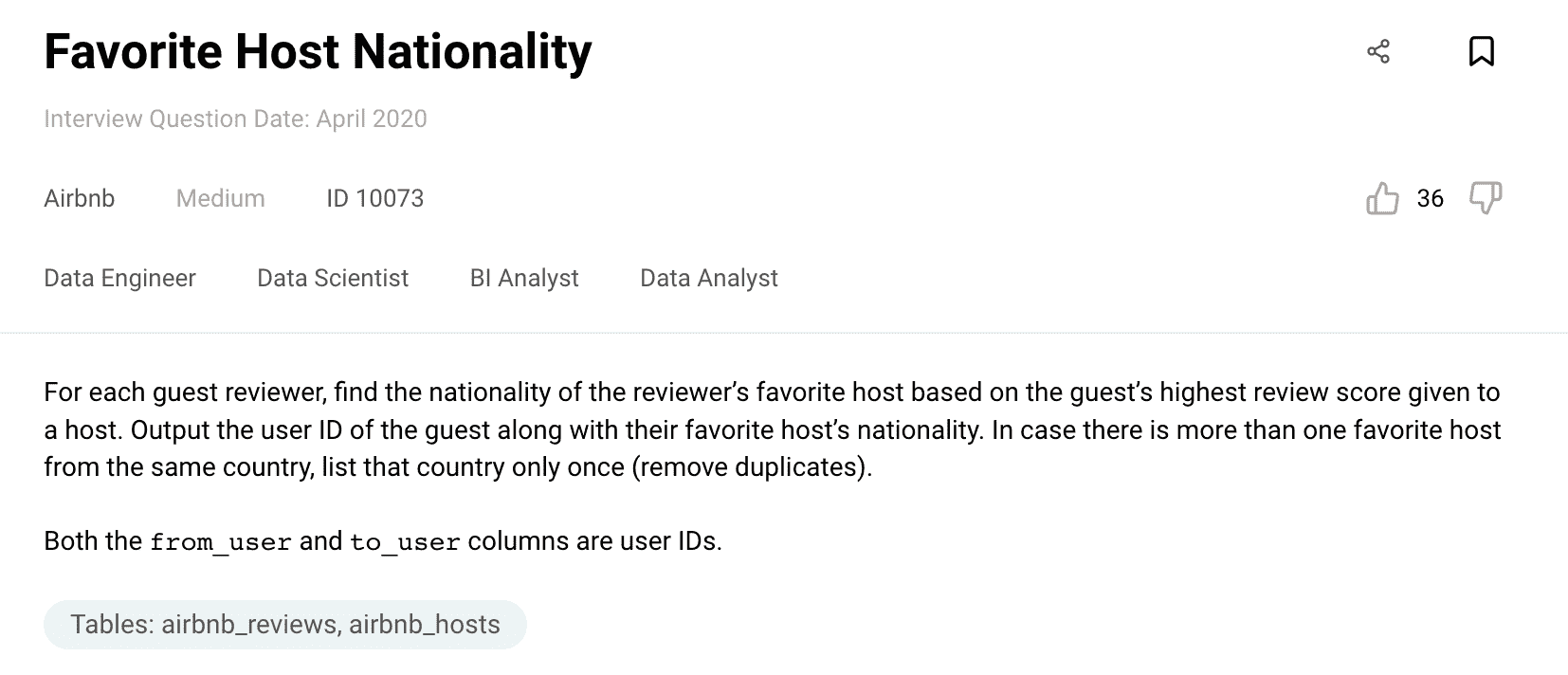

提示:

问题是:对于每个客人评论者,根据客人给主机的最高评分找到评论者最喜欢的主机的国籍。输出客人的用户 ID 以及他们最喜欢的主机的国籍。如果有多个来自同一国家的最喜欢的主机,只列出该国家一次(去除重复)。

from_user 和 to_user 列都是用户 ID。

预期输出如下:

from_user 国籍

0 卢森堡

1 巴西

2 澳大利亚

3 澳大利亚

4 巴西

数据框如下:

airbnb_reviews

from_user:int64

to_user:int64

from_type: object

to_type: object

review_score:int64

airbnb_hosts

host_id: int64

nationality: object

gender: object

age:int64

使用 R 解决这个问题。

提示:

使用 [column_name] 选择数据框中的特定列,然后选择值等于 '==' 的行。

使用 .groupby(column_name) 按指定列对数据框进行分组,然后使用 max() 获取每组的最高分数。

对原始数据框和分组数据框执行内连接,以使用 pd.merge(dataframe1, dataframe2, on = common_table_keys) 获取分组数据框的相应属性/详细信息。

对结果数据框和 airbnb_hosts 执行内连接。

使用 [[ column_name/s ]] 选择数据框中的指定列,然后使用 drop_duplicates(column_name) 获取指定列中的唯一值。

ChatGPT: 要使用 R 解决此任务,你可以按照以下步骤进行:

-

从 'airbnb_reviews' 数据框中选择必要的列,并过滤出 'from_type' 为 'guest' 的行。

-

按 'from_user' 对过滤后的数据框进行分组,并使用 max() 函数获取每位客人的最高评价分数。

-

在原始数据框和分组数据框之间执行内连接,基于 'from_user' 和 'review_score' 列,以获取每位客人的最高评价分数对应的行。

-

在结果数据框和 'airbnb_hosts' 数据框之间执行另一个内连接,基于 'to_user' 和 'host_id' 列,以获取喜爱的主机的国籍。

-

从最终连接的数据框中选择 'from_user' 和 'nationality' 列。

-

使用 distinct() 函数根据 'nationality' 列删除重复行。

这是实现此功能的代码:

# Select necessary columns from airbnb_reviews and filter rows where from_type is 'guest'

filtered_reviews <- airbnb_reviews[airbnb_reviews$from_type == 'guest', c('from_user', 'to_user', 'review_score')]

# Group by from_user and get the maximum review score for each guest

max_scores <- aggregate(review_score ~ from_user, filtered_reviews, max)

# Perform inner join to get the rows with the maximum review score for each guest

joined_df <- merge(filtered_reviews, max_scores, by = c('from_user', 'review_score'))

# Perform inner join with airbnb_hosts to get the nationality of the favorite host

final_df <- merge(joined_df, airbnb_hosts, by.x = 'to_user', by.y = 'host_id')

# Select the necessary columns from the final joined dataframe

result <- final_df[, c('from_user', 'nationality')]

# Remove duplicate rows based on nationality

distinct_result <- distinct(result, .keep_all = TRUE)

# Print the final result

distinct_result

运行此代码将会得到预期的输出,其中包含 'from_user'(客人 ID)和他们喜爱主机的相应 'nationality'。

控制

代码运行正常,无需任何更新。

奖金:使用 ChatGPT 进行数据项目

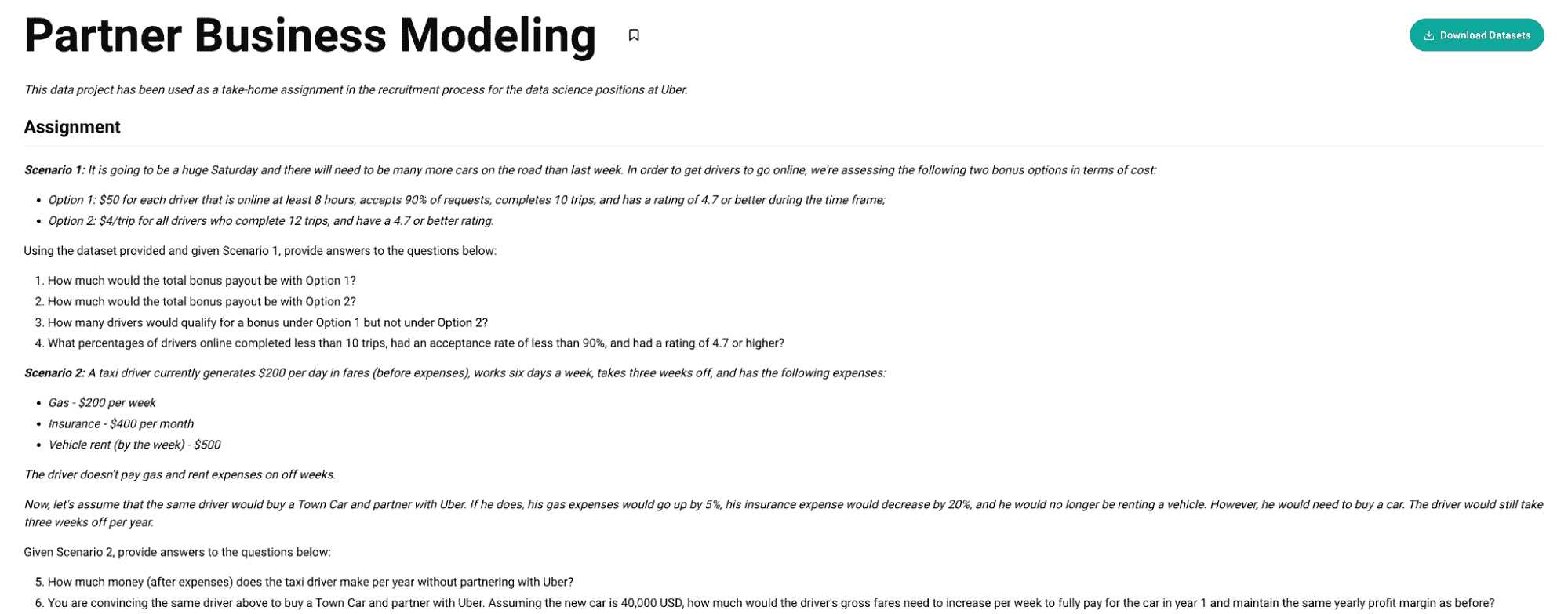

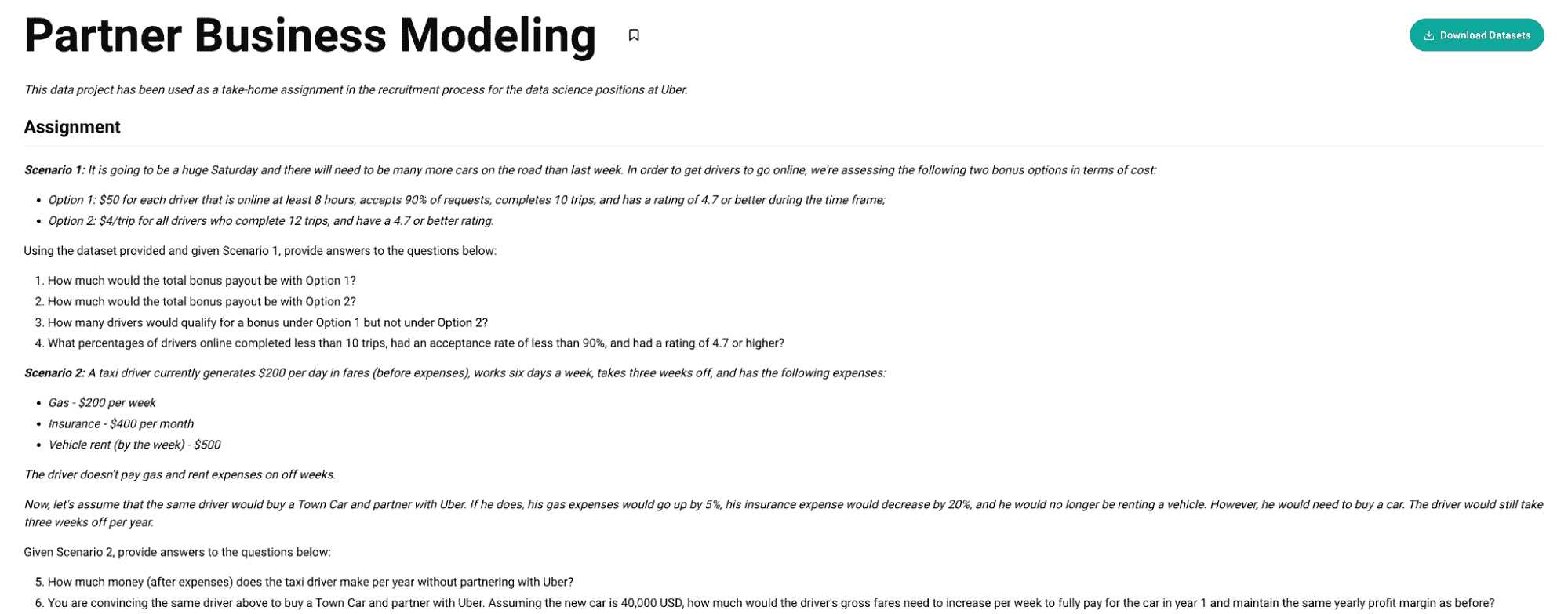

我们将测试 ChatGPT 的数据项目 已在 Uber 的数据科学职位招聘过程中作为家庭作业使用过。

总的来说,有两种不同的情况;

情况 1:这将是一个繁忙的星期六,道路上需要比上周更多的车辆。为了让司机上线,我们正在评估以下两种奖励选项的成本:

-

选项 1:每位在线时间达到 8 小时、接受 90% 请求、完成 10 次行程且评分为 4.7 或更高的司机,奖励 $50;

-

选项 2:所有完成 12 次行程且评分为 4.7 或更高的司机,每次行程奖励 $4。

情况 2:一名出租车司机目前每天的收入为 $200(不包括费用),每周工作六天,休息三周,费用如下:

-

油费 - 每周 $200

-

保险 - 每月 $400

-

车辆租赁(按周计算)- $500

司机在休息周不需要支付油费和租赁费用。

ChatGPT 文件上传器

现在,要进行数据项目,我们需要 ChatGPT 文件上传器 Chrome 扩展。它将允许你将文件上传到 ChatGPT。

如果你已经有一个代码解释器插件,则无需此操作——只需使用该插件上传文件。

欲了解更多信息,请观看这个 视频。

在设置文件上传扩展后,让我们尝试解决这个数据项目。

打开 ChatGPT 并点击此扩展的按钮。

你将看到如下所示的提交按钮。

来源: chat.openai.com/

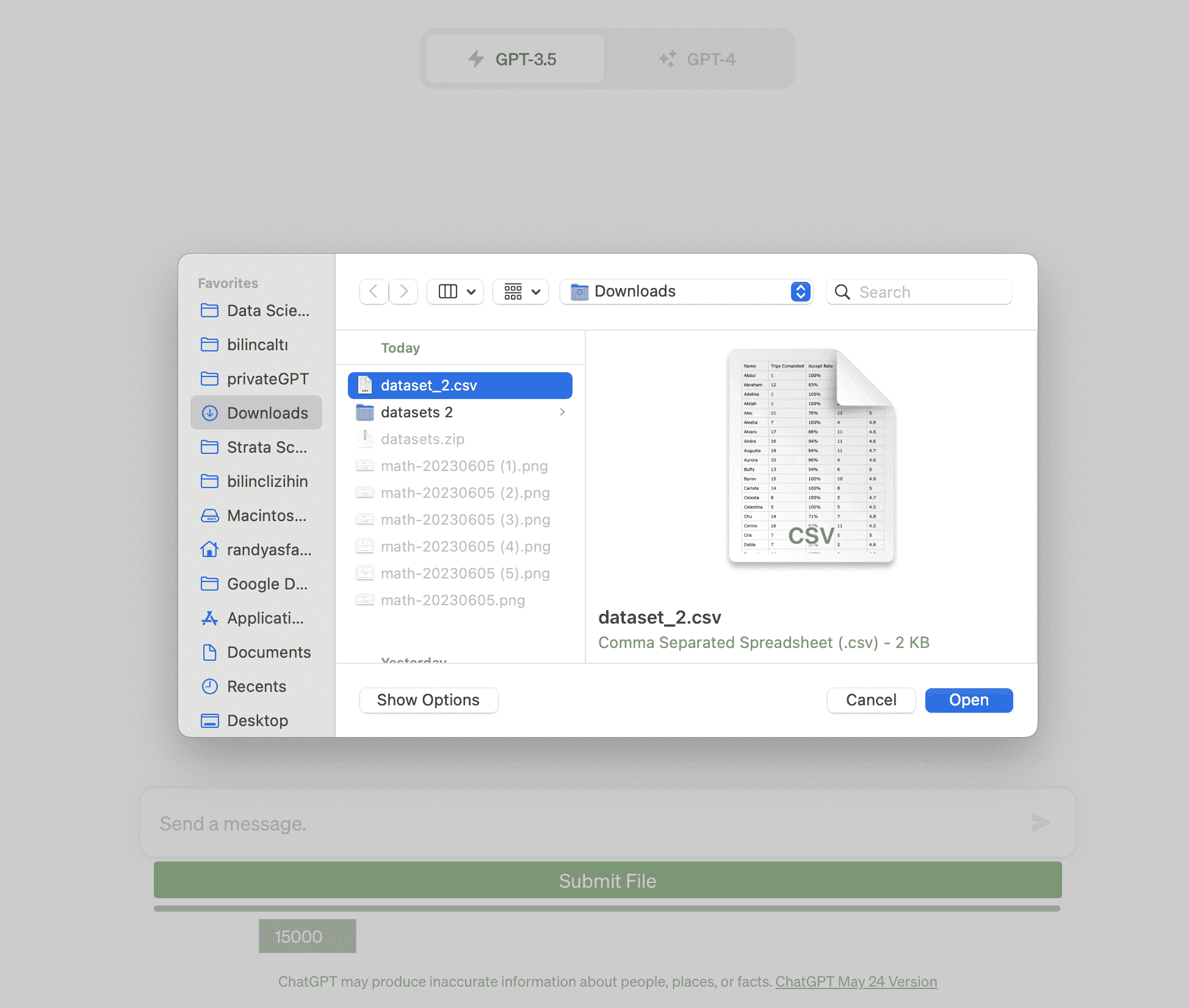

现在,让我们先通过使用我们的数据集文件并点击“提交文件”按钮来喂给 ChatGPT 数据集。

来源: chat.openai.com/

加载数据集后,ChatGPT 将提示数据集。

来源: chat.openai.com/

现在,这里是你应该用来解决此数据项目的提示。

提示: 根据操作情境和提供的数据集,使用 Python 回答以下问题

任务

情境 1:将会有一个大型的星期六,需要比上周更多的车辆上路。为了让司机上线,我们正在评估以下两种奖金选项的成本:

选项 1:每位司机在线至少 8 小时,接受 90% 的请求,完成 10 次行程,并且在此时间段内评分为 4.7 或更高,奖金为 $50;

选项 2:每次行程 $4,适用于所有完成 12 次行程且评分为 4.7 或更高的司机。

使用提供的数据集和给定的情境 1,回答以下问题: