KDNuggets-博客中文翻译-十六-

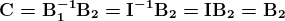

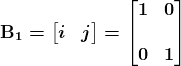

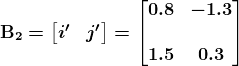

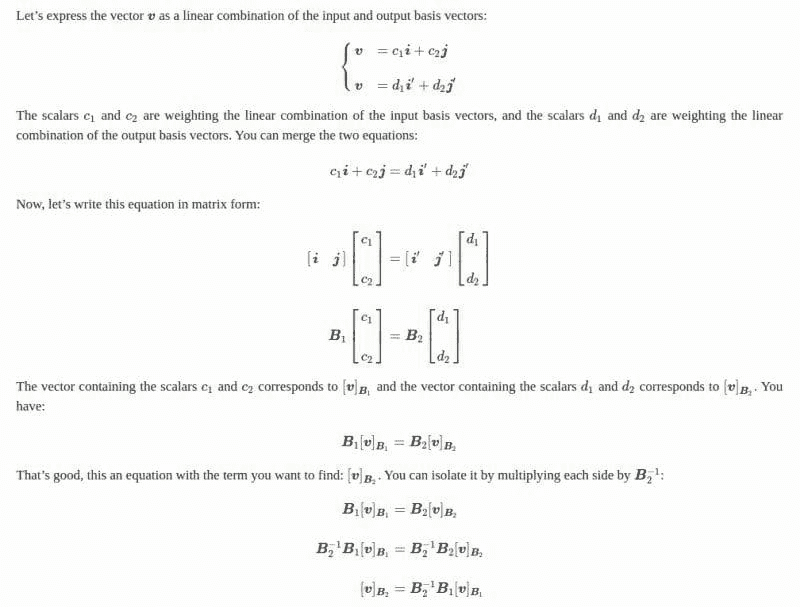

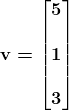

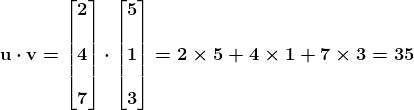

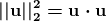

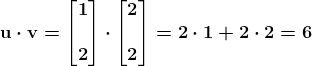

KDNuggets 博客中文翻译(十六)

原文:KDNuggets

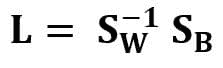

使用 TensorFlow 进行简单的图像数据集增强

原文:

www.kdnuggets.com/2020/02/easy-image-dataset-augmentation-tensorflow.html

评论

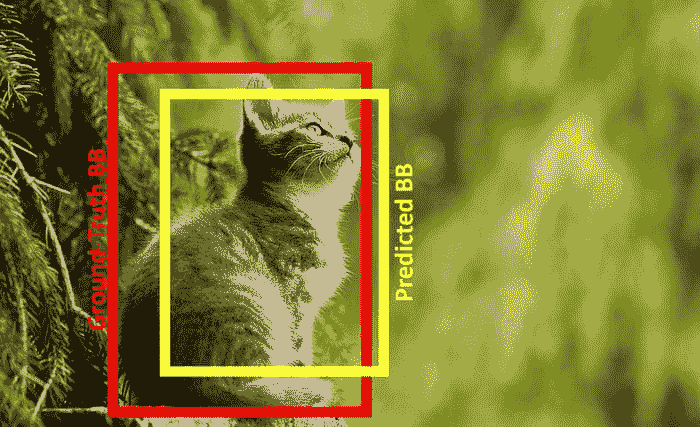

图片来源:Nanonets

我们的前三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持组织的 IT 工作

3. Google IT 支持专业证书 - 支持组织的 IT 工作

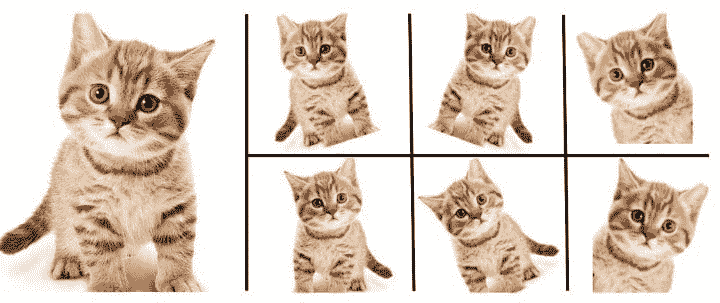

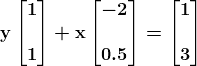

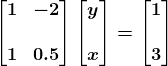

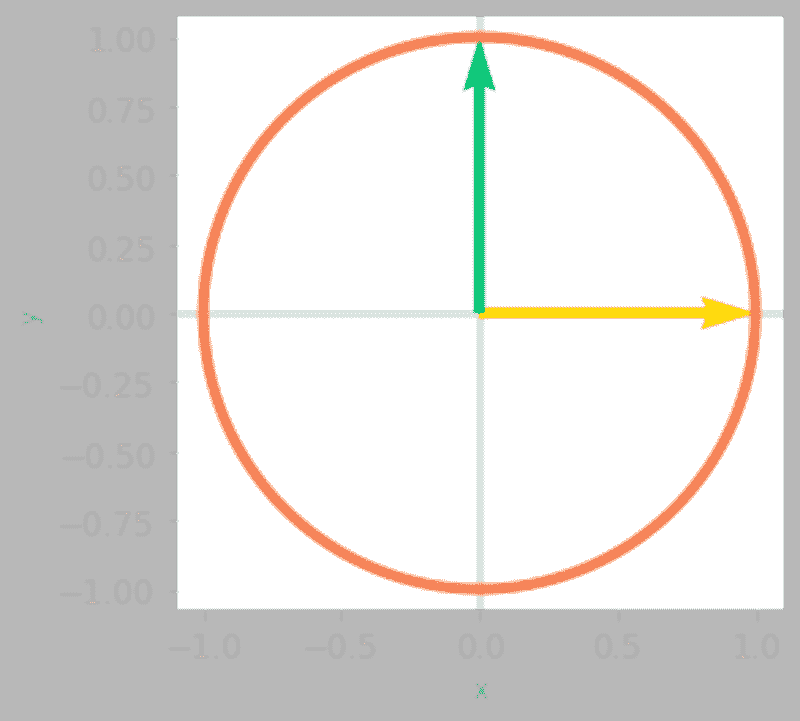

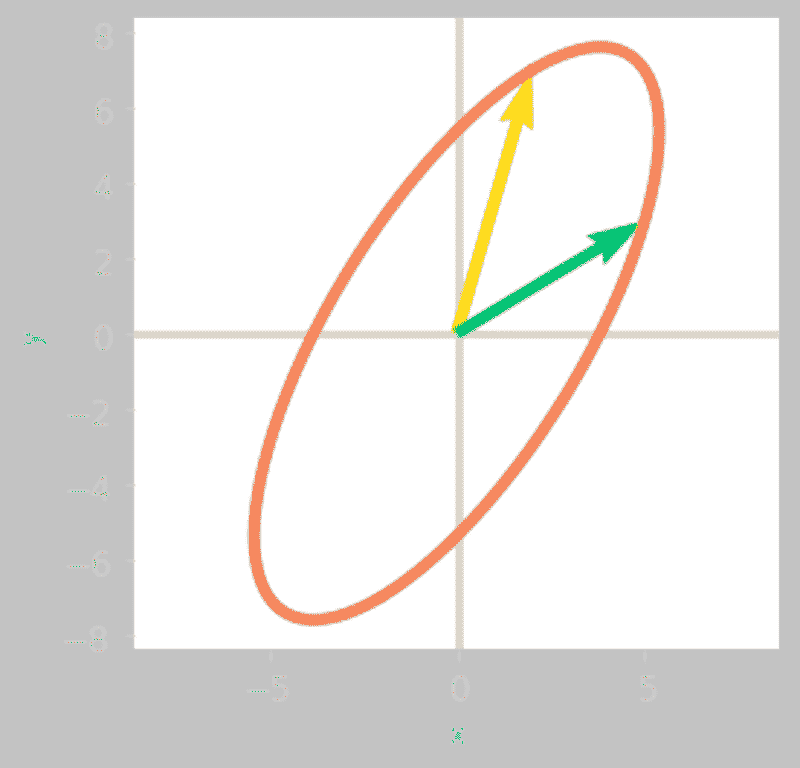

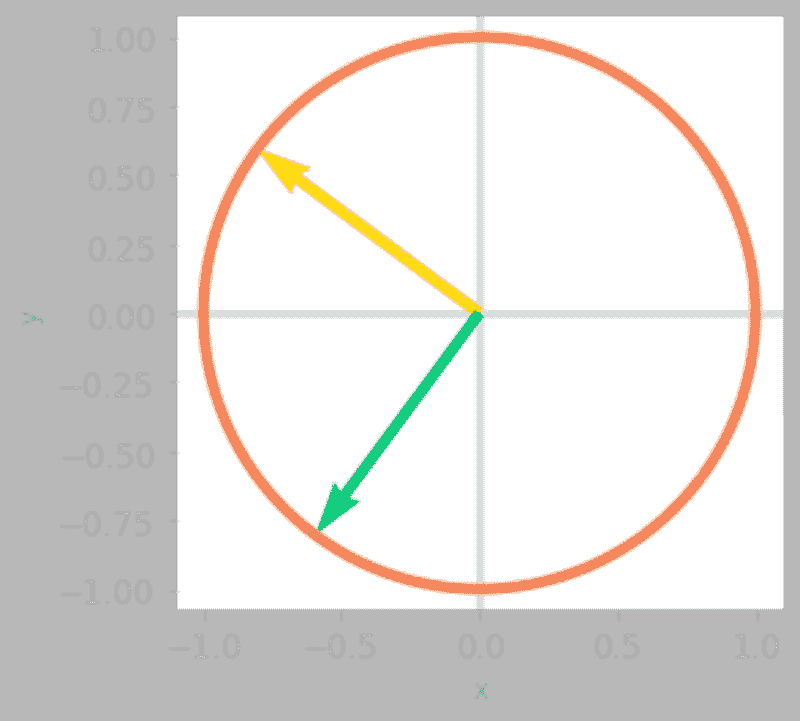

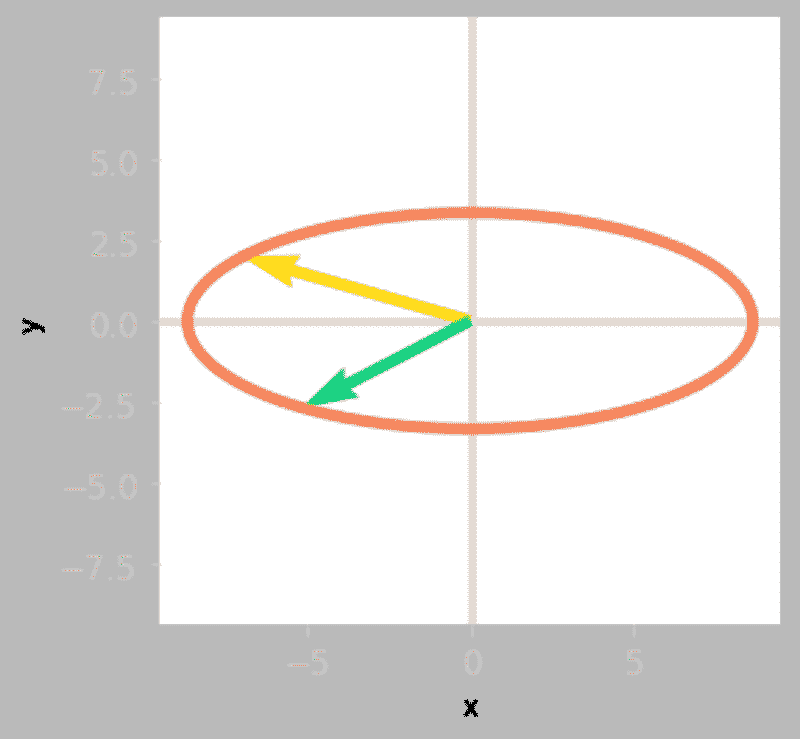

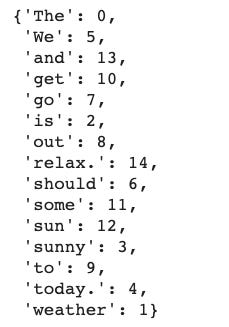

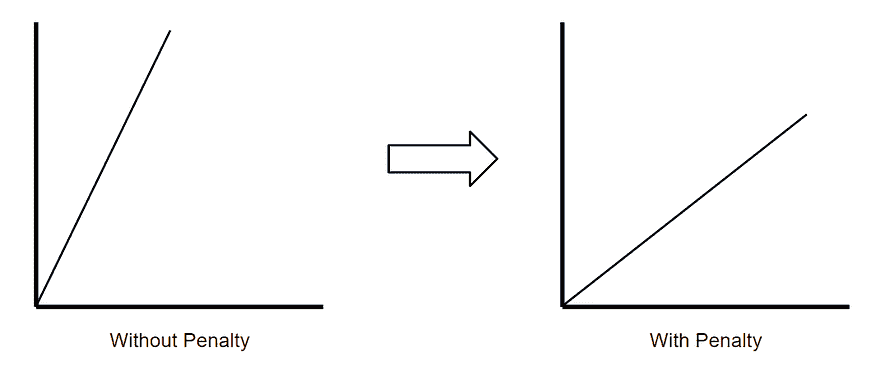

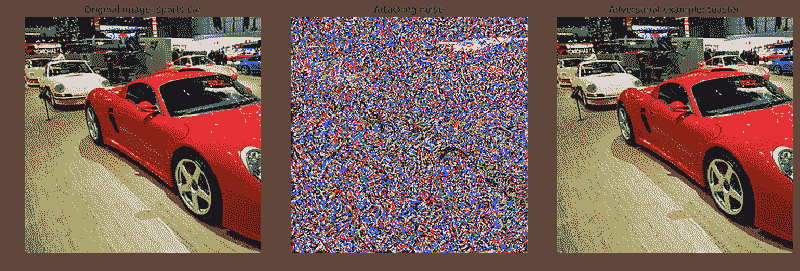

图像分类的成功,至少在很大程度上,取决于大量可用的训练数据。暂且不谈诸如过拟合等问题,训练数据越多,你建立一个有效模型的机会就越大。

但当我们没有大量训练数据时,我们该怎么办?对于这个特定问题,立刻想到的几种广泛方法是迁移学习和数据增强。

迁移学习 是将现有机器学习模型应用于原本不打算用于这些场景的过程。这种利用可以节省训练时间,并扩展现有机器学习模型的实用性,这些模型可能在大数据集上经过了长时间的训练。如果我们在大数据集上训练一个模型,然后可以将结果调整为在我们较小的数据集上有效。至少,这就是我们的想法。

数据增强 是在不需要手动收集任何新数据的情况下,增加现有训练数据集的大小和多样性。这些增强的数据是通过对现有数据执行一系列预处理转换来获取的,这些转换可以包括水平和垂直翻转、倾斜、裁剪、旋转等,尤其是在图像数据的情况下。总的来说,这些增强的数据能够模拟各种微妙不同的数据点,而不仅仅是重复相同的数据。这些“附加”图像的微小差异应该足够帮助训练出一个更强大的模型。再说一次,这就是我们的想法。

本文重点介绍了在 TensorFlow 中解决图像训练数据量不足问题的第二种方法——数据增强的实际实施,而迁移学习的类似实际处理将在稍后时间进行。

图像增强的帮助

由于卷积神经网络学习图像特征,我们希望确保这些特征以各种方向出现,以便经过训练的模型能够识别出人的腿在图像中可以呈现为垂直或水平。例如。数据增强除了增加原始数据点的数量外,还能通过使用图像旋转等变换来帮助我们。另一个例子,我们还可以使用水平翻转来帮助模型训练,以识别猫是否直立或被倒置拍摄。

数据增强不是万能药;我们不应该期望它解决所有的小数据问题,但在许多情况下它可能是有效的,并且通过将其作为全面模型训练方法的一部分进行扩展,比如与转移学习等其他数据集扩展技术一起使用。

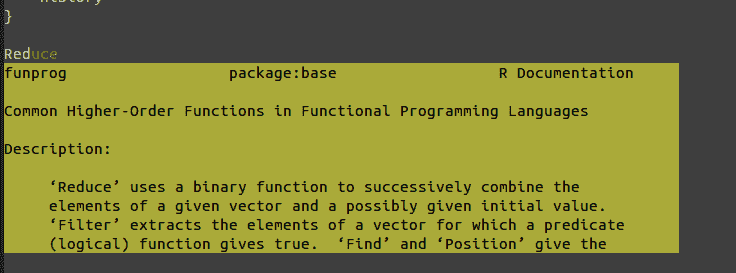

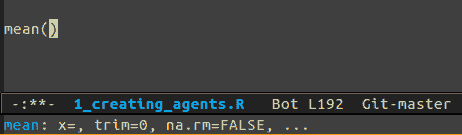

TensorFlow 中的图像增强

在 TensorFlow 中,数据增强是通过ImageDataGenerator类完成的。这非常简单易懂。每个周期都会循环整个数据集,并根据所选选项和数值对数据集中的图像进行变换。这些变换是在内存中执行的,因此不需要额外的存储(尽管可以使用save_to_dir参数将增强图像保存到磁盘,如果需要的话)。

如果你在使用 TensorFlow,你可能已经在使用ImageDataGenerator仅用于缩放现有图像,而没有进行额外的数据增强。这可能如下所示:

py` train_datagen = ImageDataGenerator(rescale=1./255) ```py ````

一个更新的ImageDataGenerator,其执行数据增强,可能如下所示:

py` train_datagen = ImageDataGenerator( rotation_range=20, width_shift_range=0.2, height_shift_range=0.2, shear_range=0.2, zoom_range=0.2, horizontal_flip=True, vertical_flip=True, fill_mode='nearest') ```py ````

这都意味着什么?

-

**rotation_range**- 随机旋转的度数范围;在上述示例中为 20 度 -

**width_shift_range**- 总宽度的比例(如果值<1,如此处所示),用于随机水平平移图像;在上述示例中为 0.2 -

**height_shift_range**- 总高度的比例(如果值<1,如此处所示),用于随机垂直平移图像;在上述示例中为 0.2 -

**shear_range**- 用于剪切变换的逆时针剪切角度,单位为度;在上述示例中为 0.2 -

**zoom_range**- 随机缩放的范围;在上述示例中为 0.2 -

**horizontal_flip**- 随机水平翻转图像的布尔值;在上述示例中为 True -

**vertical_flip**- 随机垂直翻转图像的布尔值;在上述示例中为 True -

**fill_mode**- 输入边界外的点根据“constant”,“nearest”,“reflect”或“wrap”填充;在上述示例中为 nearest

然后,你可以指定训练(以及可选的验证,如果你创建了一个验证生成器)数据的位置,例如,使用ImageDataGenerator的flow_from_directory选项,然后在训练过程中使用fit_generator训练模型,将这些增强的图像流入你的网络。以下是一个这样的代码示例:

py` train_generator = train_datagen.flow_from_directory( 'data/train', target_size=(150, 150), batch_size=32, class_mode='binary') # 假设模型已定义... history = model.fit_generator( train_generator, steps_per_epoch=100, epochs=100, verbose=2) ```py ````

这就是全部内容。TensorFlow 中轻松图像数据集增强的简介。

相关:

-

高级特征工程和预处理的 4 个技巧

-

最新 Scikit-learn 版本中的 5 个伟大新功能

-

使用非最大抑制算法的行人检测

更多相关内容

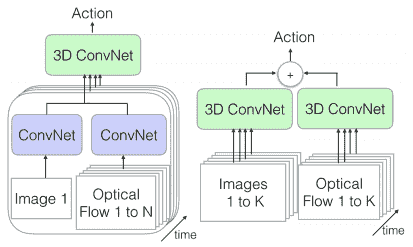

使用 PyCaret + MLflow 轻松实现 MLOps

评论

由 Moez Ali,PyCaret 创始人及作者

PyCaret

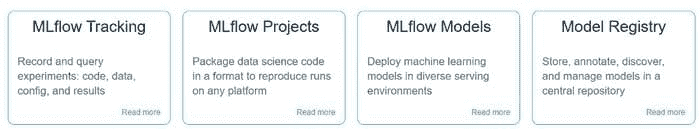

PyCaret 是一个开源的低代码机器学习库和端到端模型管理工具,使用 Python 构建,用于自动化机器学习工作流。它以易用性、简洁性和能够快速高效地构建和部署端到端 ML 原型而闻名。

PyCaret 是一个替代性的低代码库,可以用几行代码替代数百行代码。这使得实验周期变得极其快速和高效。

PyCaret — 一个在 Python 中的开源低代码机器学习库

要了解更多关于 PyCaret 的信息,你可以查看他们的 GitHub。

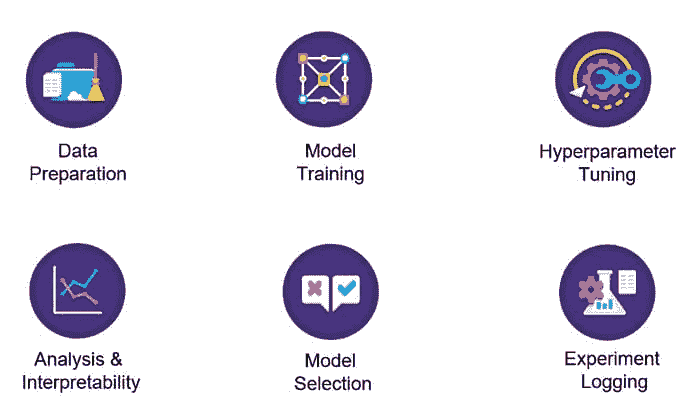

MLflow

MLflow 是一个开源平台,用于管理 ML 生命周期,包括实验、可重复性、部署和中央模型注册。MLflow 目前提供四个组件:

MLflow 是一个开源平台,用于管理 ML 生命周期

要了解更多关于 MLflow 的信息,你可以查看 GitHub。

安装 PyCaret

安装 PyCaret 非常简单,只需几分钟时间。我们强烈建议使用虚拟环境,以避免与其他库的潜在冲突。

PyCaret 的默认安装是一个精简版,仅安装硬性依赖项 列于此处。

**# install slim version (default)** pip install pycaret**# install the full version**

pip install pycaret[full]

当你安装 PyCaret 的完整版时,所有的可选依赖项也会被安装 列于此处。MLflow 是 PyCaret 的依赖项,因此无需单独安装。

???? 让我们开始吧

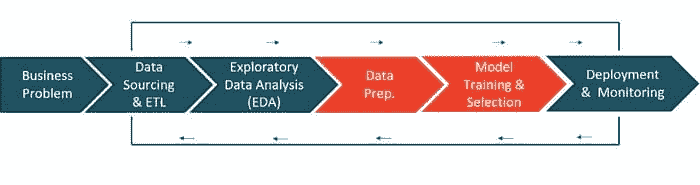

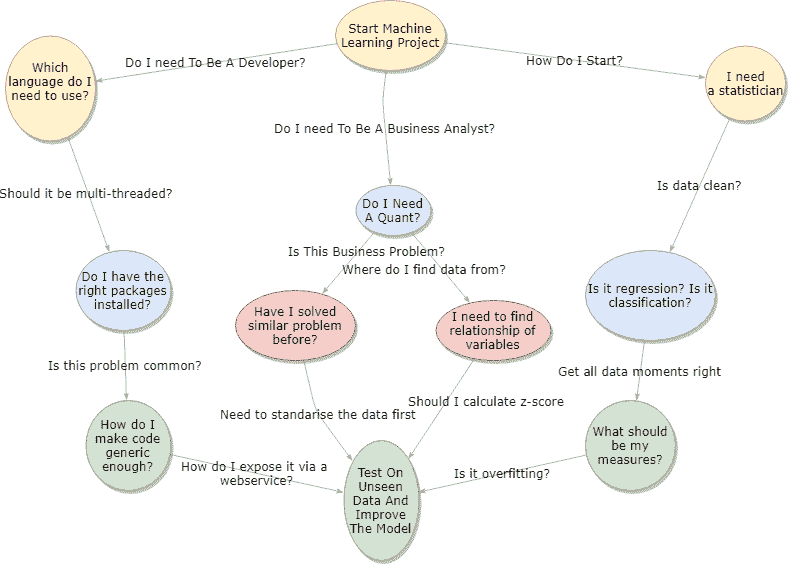

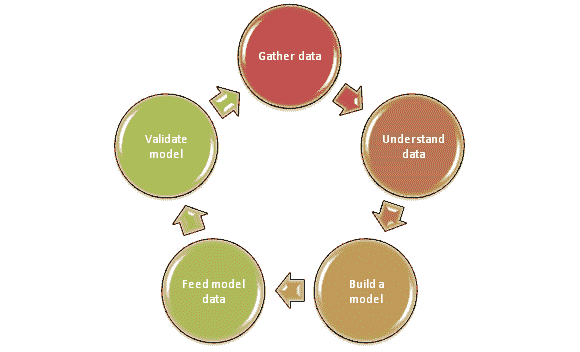

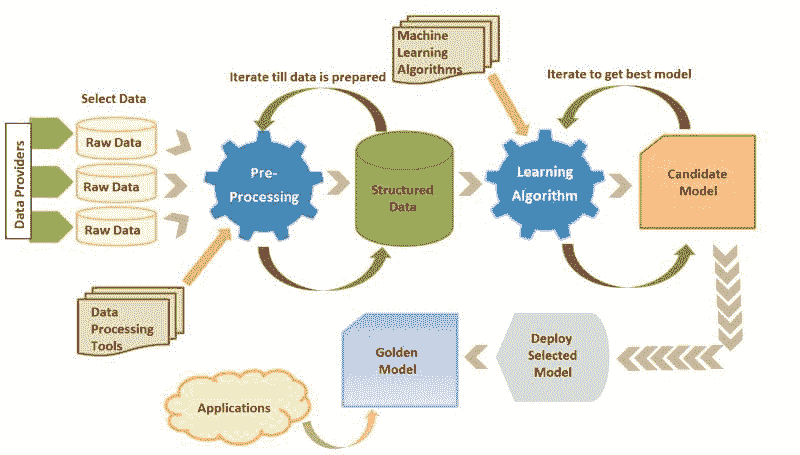

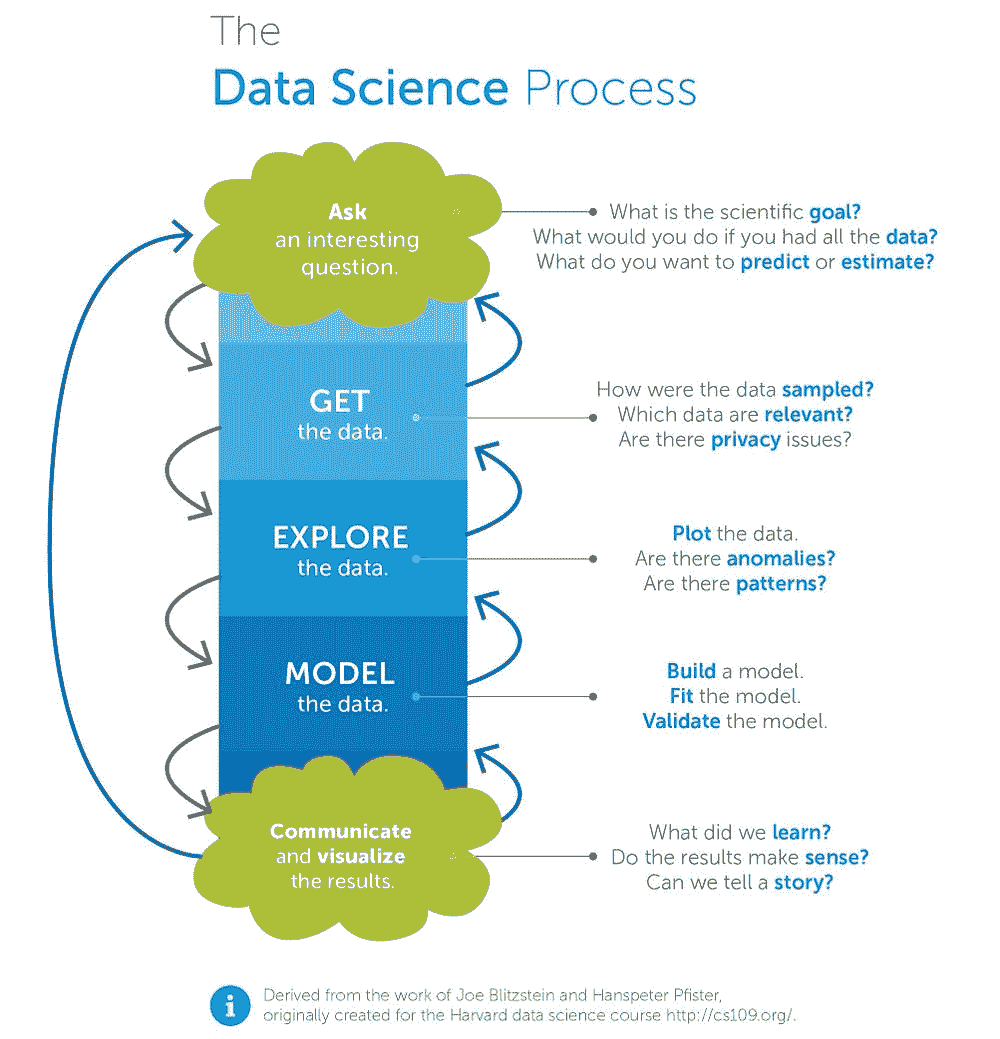

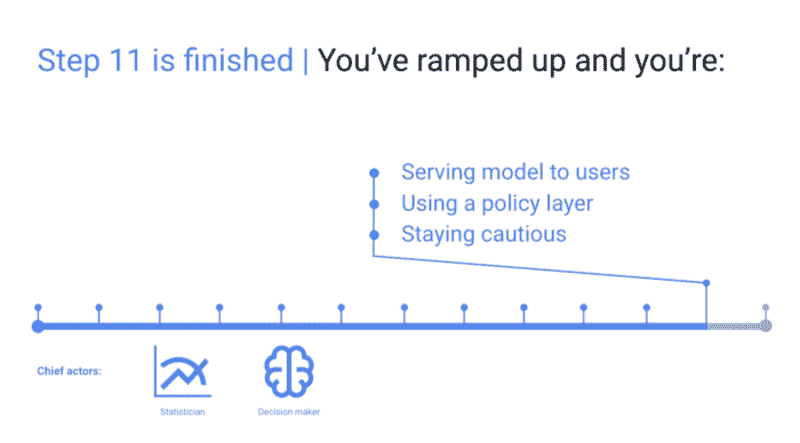

在我讨论 MLOps 之前,让我们先简单谈谈机器学习生命周期的高层次概述:

机器学习生命周期 — 作者提供的图像(从左到右阅读)

-

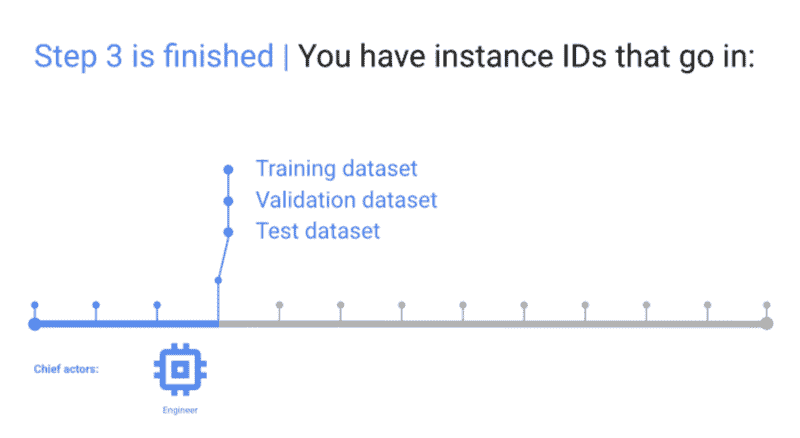

商业问题 — 这是机器学习工作流的第一步。根据用例和问题的复杂性,完成这一阶段可能需要几天到几周的时间。在这一阶段,数据科学家会与领域专家(SME)会面,以了解问题、采访关键利益相关者、收集信息,并设定项目的整体期望。

-

数据来源与 ETL — 一旦理解了问题,就可以利用在面谈中获得的信息从企业数据库中提取数据。

-

探索性数据分析(EDA) — 模型还没有开始。EDA 是你分析原始数据的阶段。你的目标是探索数据并评估数据的质量、缺失值、特征分布、相关性等。

-

数据准备 — 现在是时候准备数据以进行模型训练了。这包括将数据划分为训练集和测试集、填补缺失值、进行独热编码、目标编码、特征工程、特征选择等。

-

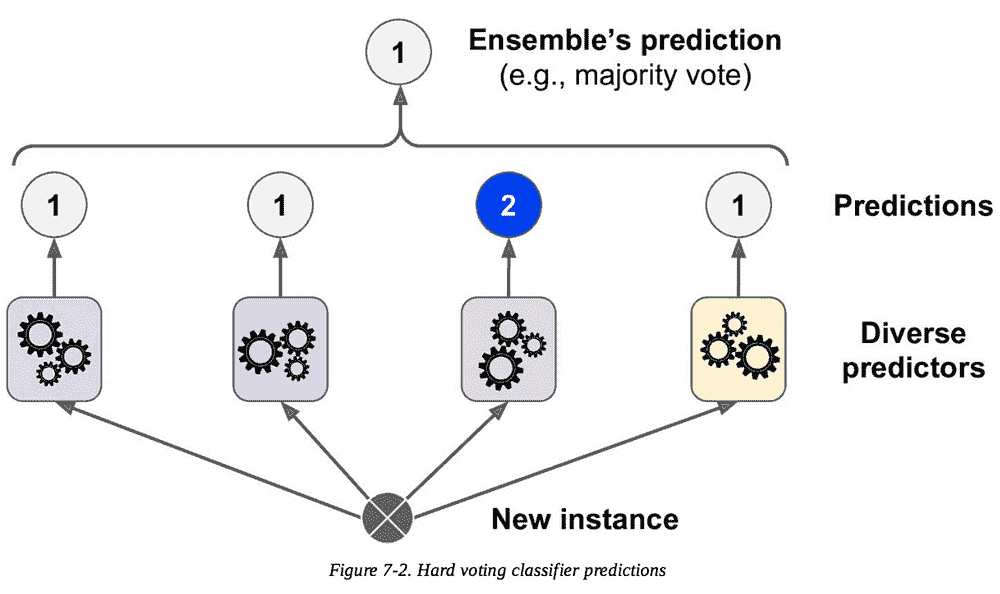

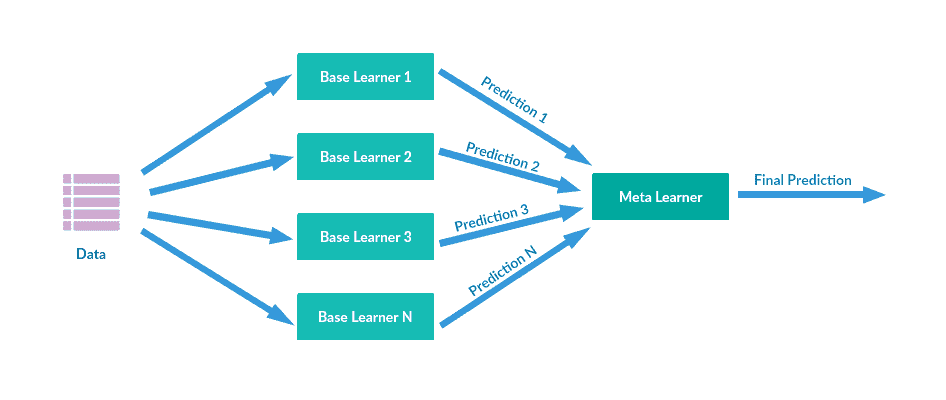

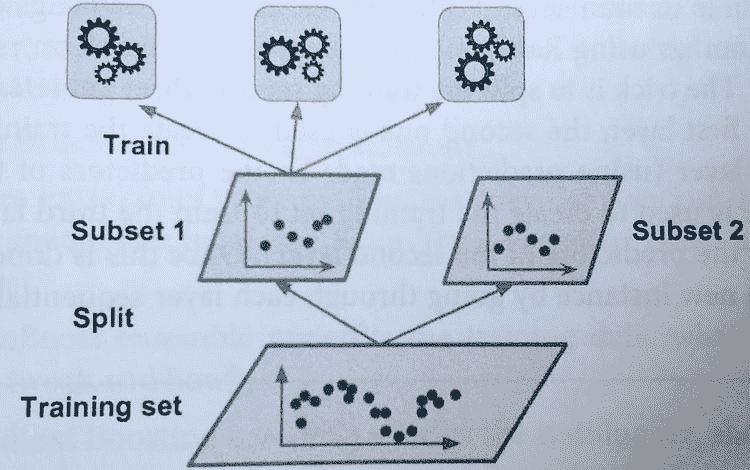

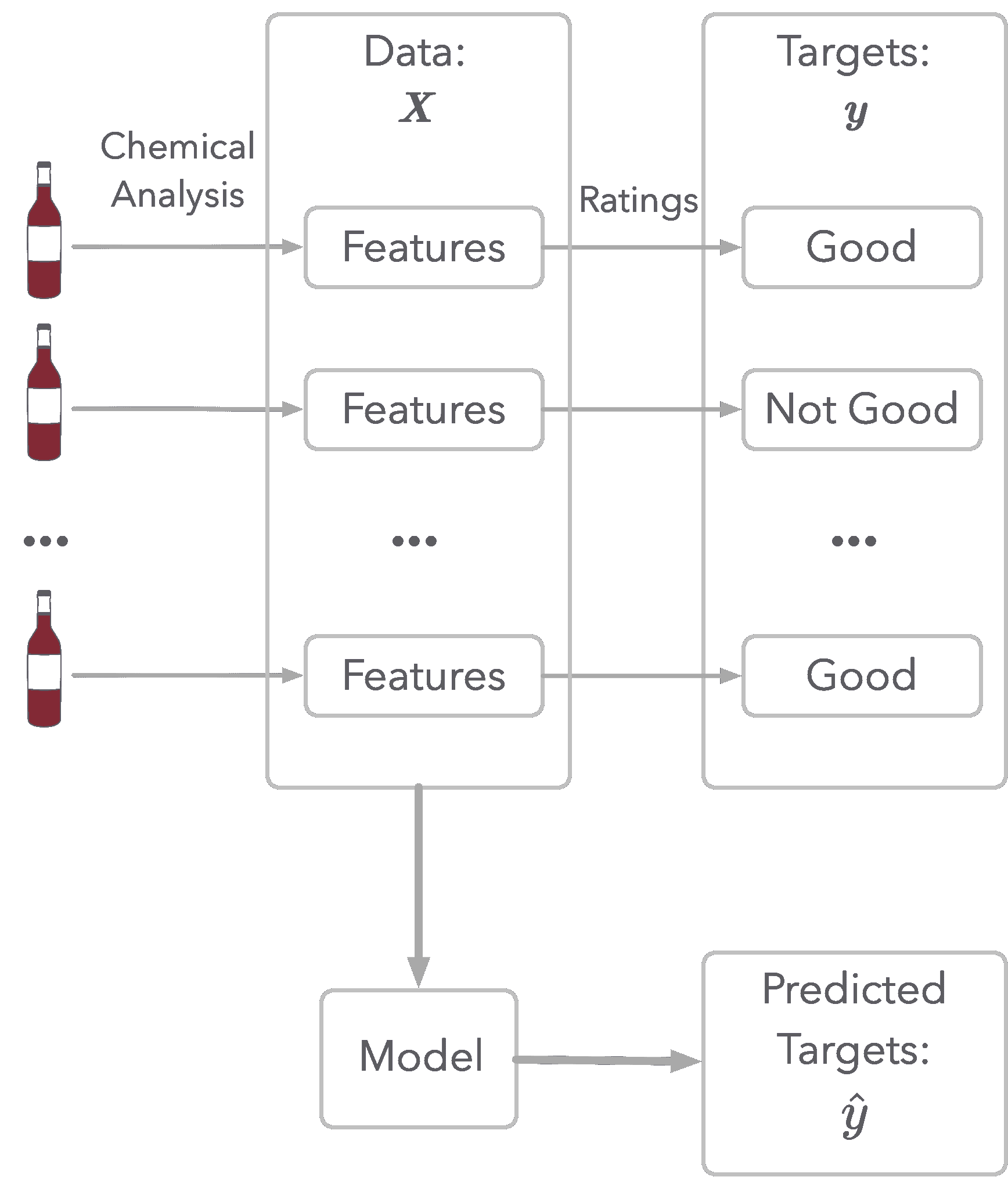

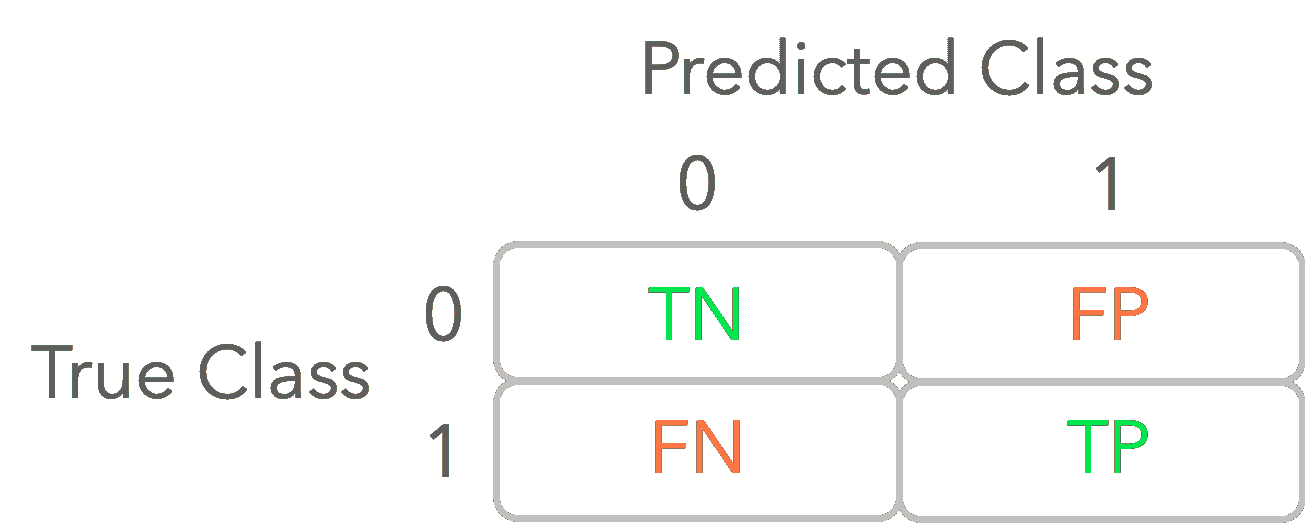

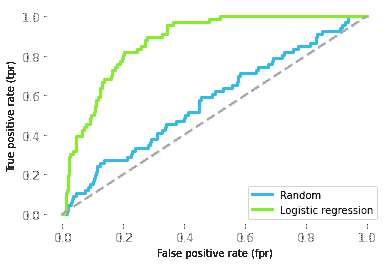

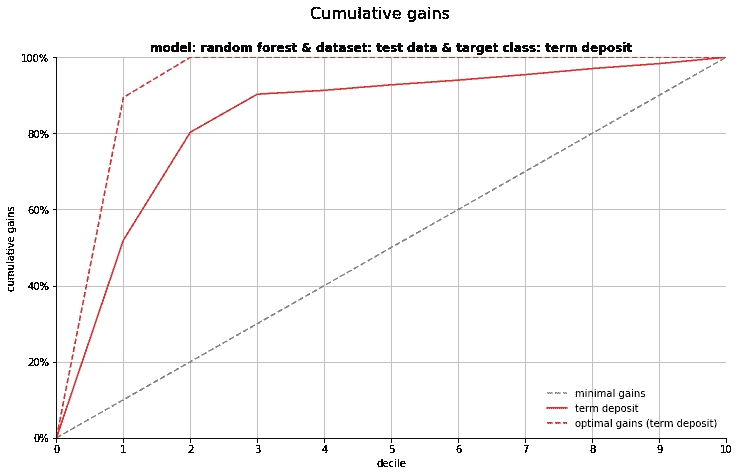

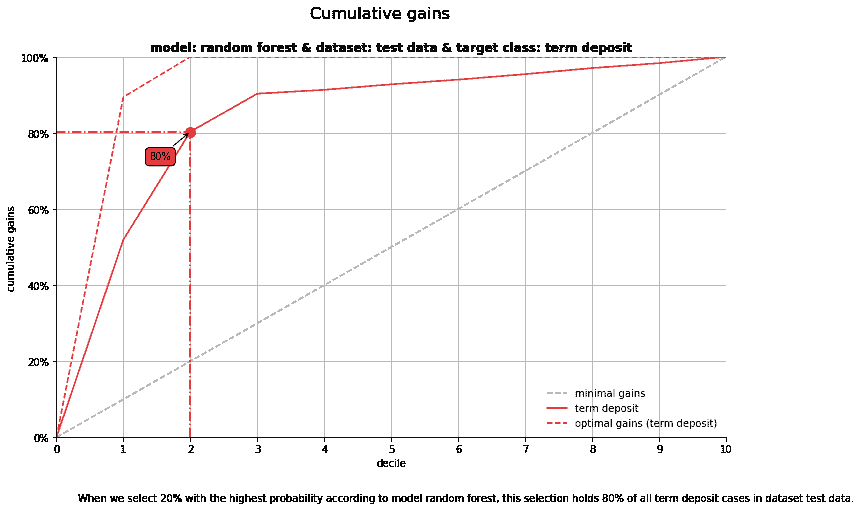

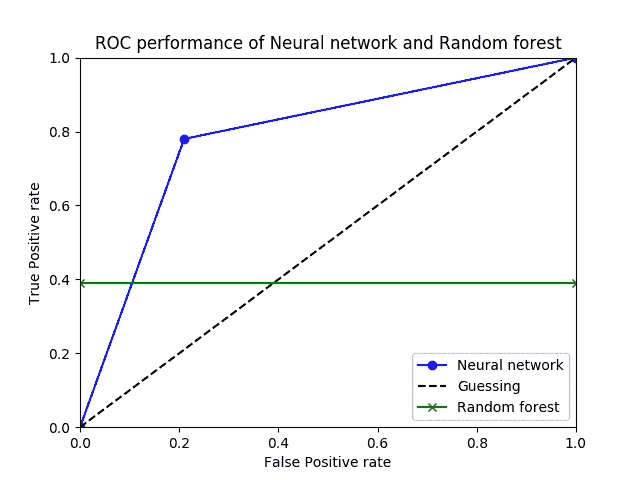

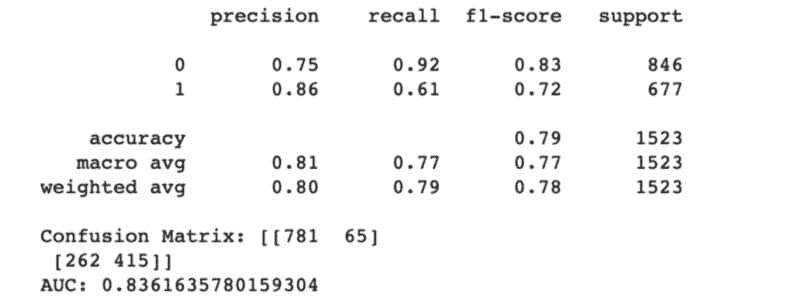

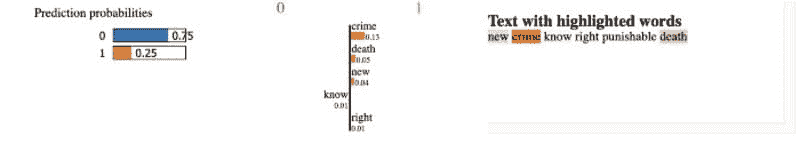

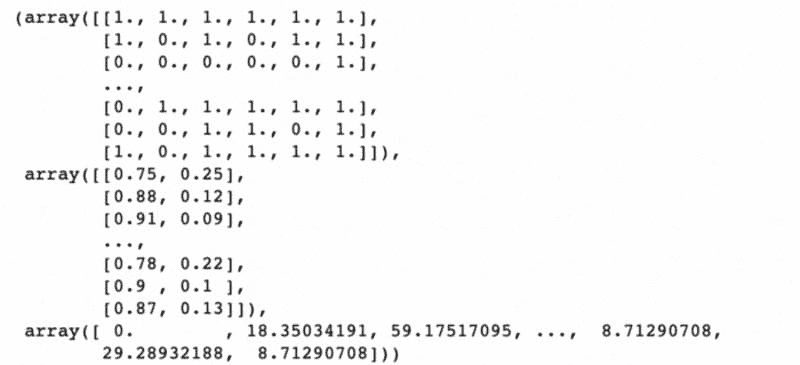

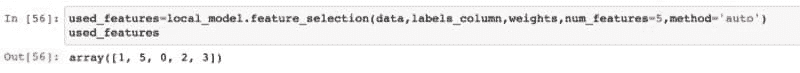

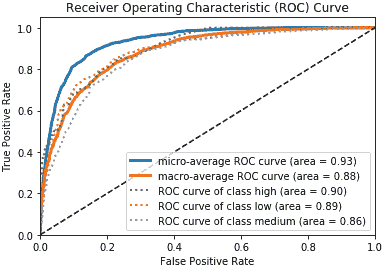

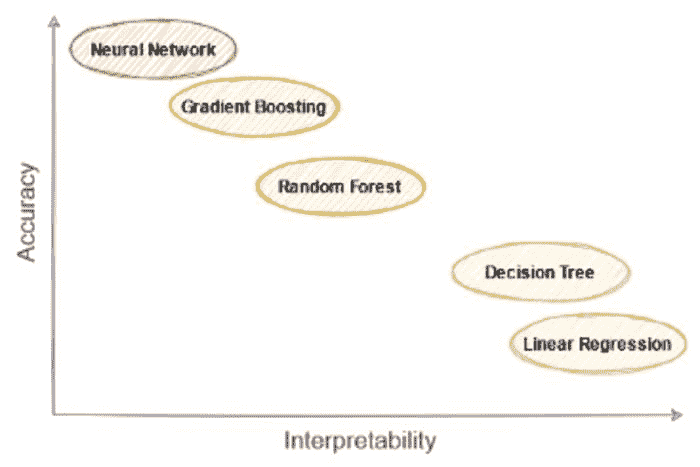

模型训练与选择 — 这是每个人都期待的步骤。这包括训练一组模型、调整超参数、模型集成、评估性能指标、模型分析(如 AUC、混淆矩阵、残差等),最后选择一个最佳模型进行生产部署以供业务使用。

-

部署与监控 — 这是最后一步,主要涉及 MLOps。这包括将最终模型打包、创建 Docker 镜像、编写评分脚本,然后使它们协同工作,最后将其发布为 API,以便用于对通过管道传入的新数据进行预测。

传统的做法相当繁琐、耗时,并且需要大量的技术知识,可能在一个教程中无法涵盖。不过,在本教程中,我将使用 PyCaret 来演示数据科学家如何高效地完成这些任务。在我们进入实际操作之前,让我们多谈谈 MLOps。

???? 什么是 MLOps?

MLOps 是一种工程学科,旨在将机器学习开发(即实验(模型训练、超参数调整、模型集成、模型选择等),通常由数据科学家执行)与机器学习工程和运维结合起来,以标准化和简化机器学习模型在生产中的持续交付。

如果你是一个完全的初学者,你可能对我说的内容一无所知。没关系。让我给你一个简单、非技术性的定义:

MLOps 是一系列技术工程和运维任务,使你的机器学习模型可以被组织内的其他用户和应用程序使用。基本上,这是一种将你的工作(即机器学习模型)在线发布的方式,以便其他人可以使用它们并实现一些业务目标。

这是对 MLOps 的一个非常简化的定义。实际上,它涉及的工作和好处比这要多一些,但如果你对这些内容还不熟悉,这个定义是一个很好的开始。

现在,让我们按照上图所示的相同工作流程进行实际演示,确保你已经安装了 pycaret。

???? 商业问题

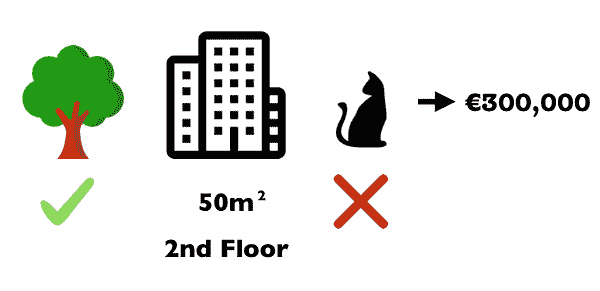

对于本教程,我将使用达顿商学院发布的一个非常受欢迎的案例研究,已发表在Harvard Business上。该案例讲述了两个将来要结婚的人的故事。一个名叫Greg的男子想买一个戒指向名叫Sarah的女孩求婚。问题是要找出 Sarah 会喜欢的戒指,但在得到好友的建议后,Greg 决定购买一颗钻石,让 Sarah 可以自己决定。Greg 随后收集了 6000 颗钻石的数据,包括它们的价格和属性,如切工、颜色、形状等。

???? 数据

在本教程中,我将使用一个非常受欢迎的案例数据集,该数据集由达顿商学院发布,已发表在Harvard Business上。本教程的目标是根据钻石的属性(如克拉重量、切工、颜色等)预测钻石价格。你可以从PyCaret’s repository下载数据集。

**# load the dataset from pycaret** from pycaret.datasets import get_data

data = get_data('diamond')

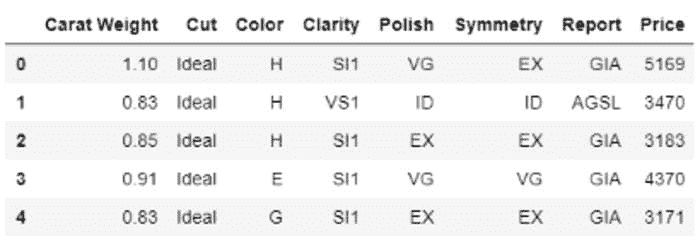

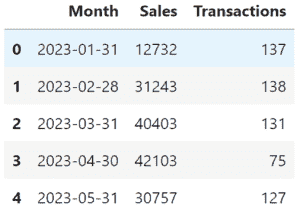

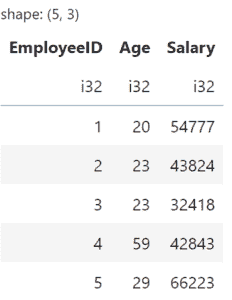

数据的样本行

???? 探索性数据分析

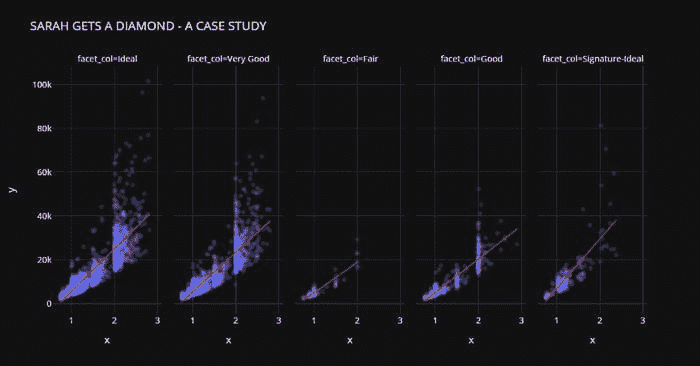

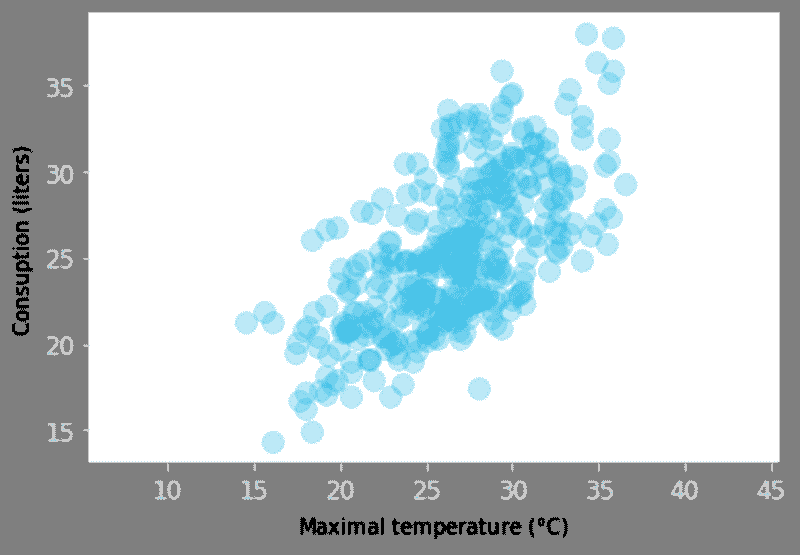

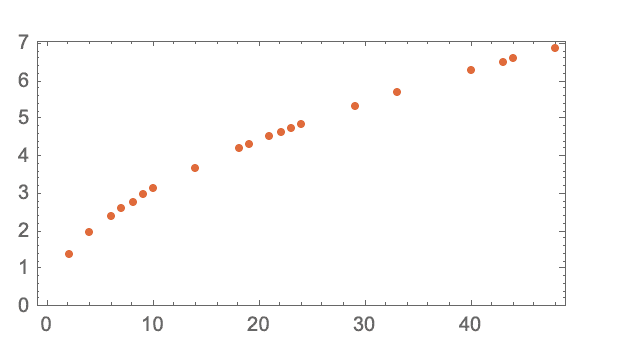

我们来做一些快速可视化,以评估独立特征(重量、切工、颜色、清晰度等)与目标变量即Price之间的关系。

**# plot scatter carat_weight and Price**

import plotly.express as px

fig = px.scatter(x=data['Carat Weight'], y=data['Price'],

facet_col = data['Cut'], opacity = 0.25, template = 'plotly_dark', trendline='ols',

trendline_color_override = 'red', title = 'SARAH GETS A DIAMOND - A CASE STUDY')

fig.show()

Sarah 获得一个钻石案例研究

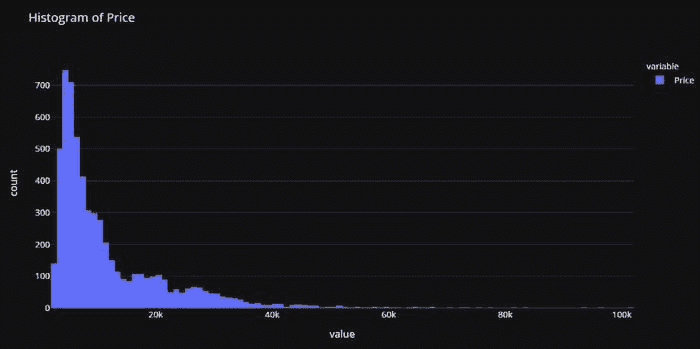

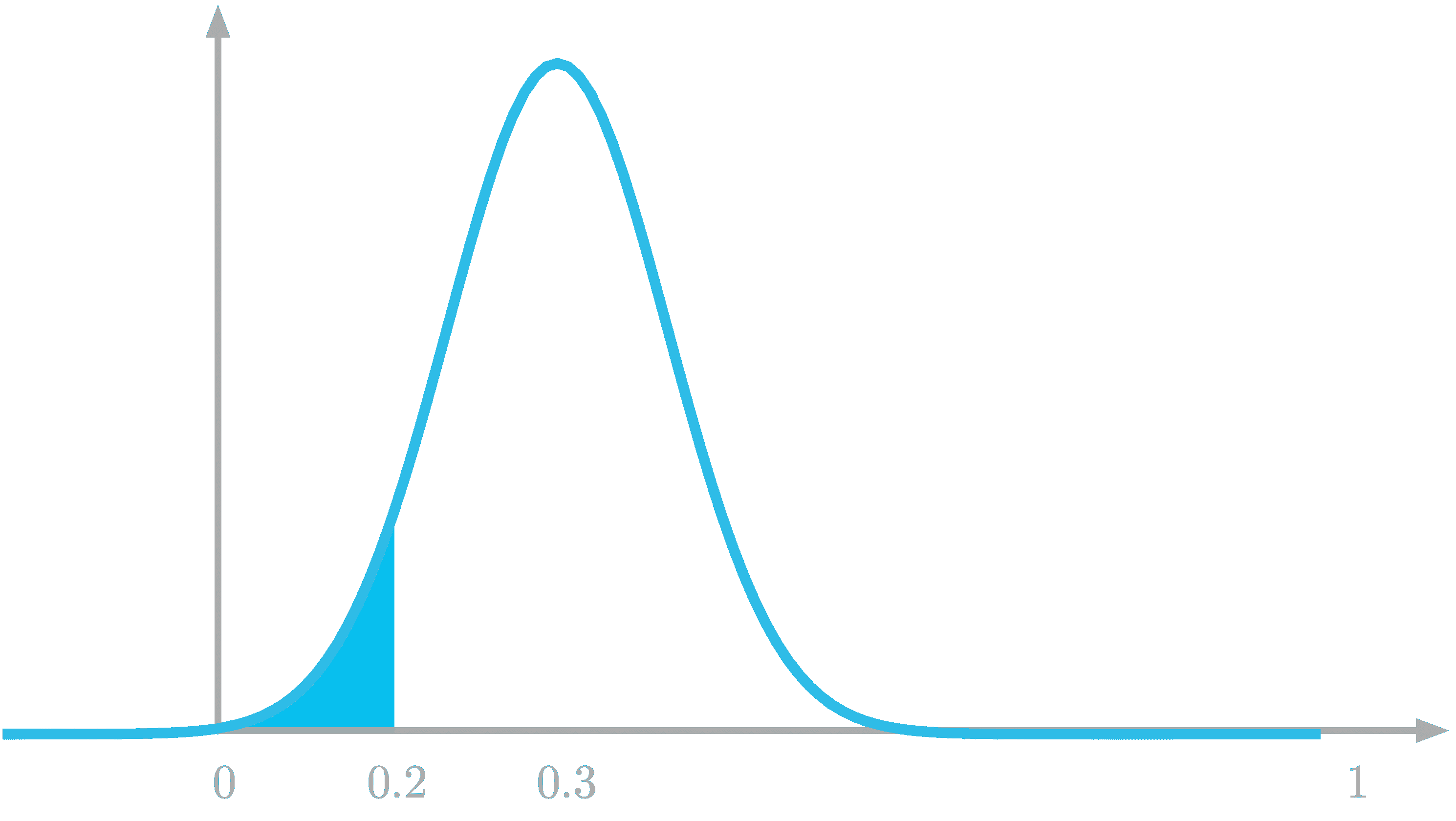

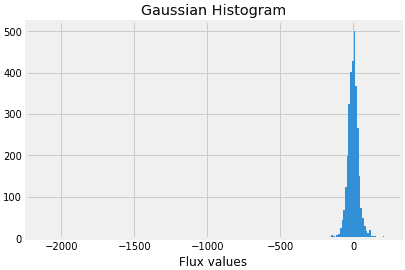

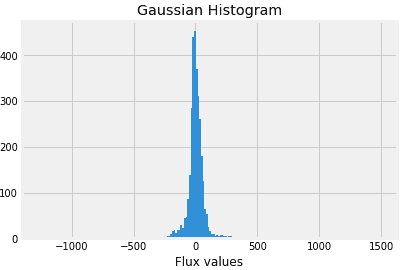

让我们检查一下目标变量的分布情况。

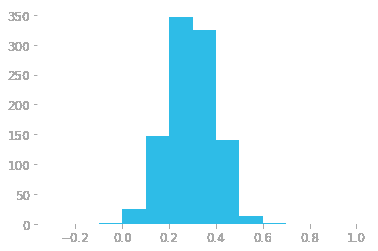

**# plot histogram**

fig = px.histogram(data, x=["Price"], template = 'plotly_dark', title = 'Histogram of Price')

fig.show()

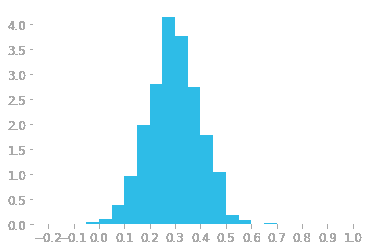

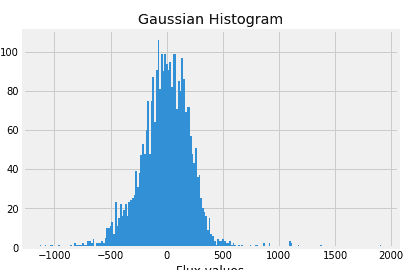

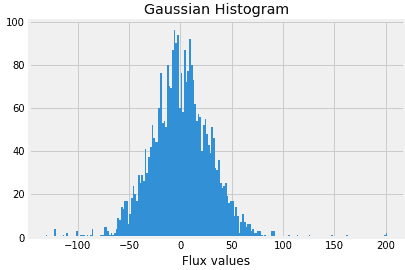

注意到 Price 的分布是右偏的,我们可以快速检查对数变换是否能使 Price 大致符合正态分布,从而给假设正态性的算法一个公平的机会。

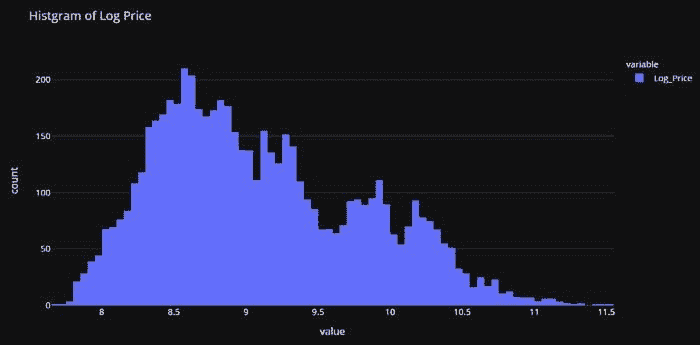

import numpy as np**# create a copy of data**

data_copy = data.copy()**# create a new feature Log_Price**

data_copy['Log_Price'] = np.log(data['Price'])**# plot histogram**

fig = px.histogram(data_copy, x=["Log_Price"], title = 'Histgram of Log Price', template = 'plotly_dark')

fig.show()

这证实了我们的假设。变换将有助于消除偏斜,使目标变量大致符合正态分布。基于此,我们将在训练模型之前对 Price 变量进行变换。

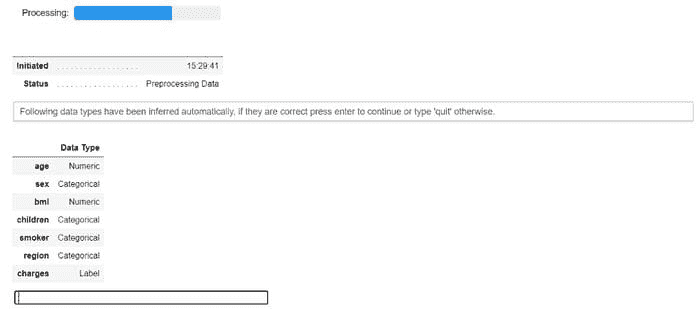

???? 数据准备

在 PyCaret 的所有模块中,setup 是任何机器学习实验中第一个也是唯一的必需步骤。这个函数处理所有训练模型之前所需的数据准备工作。除了执行一些基本的默认处理任务外,PyCaret 还提供了各种预处理功能。要了解 PyCaret 中所有预处理功能的更多信息,你可以查看这个链接。

**# initialize setup**

from pycaret.regression import *

s = setup(data, target = 'Price', transform_target = True, log_experiment = True, experiment_name = 'diamond')

pycaret.regression 模块中的 setup 函数

当你在 PyCaret 中初始化 setup 函数时,它会对数据集进行分析,并推断所有输入特征的数据类型。如果所有数据类型都正确推断,你可以按回车继续。

注意:

-

我已传递了

log_experiment = True和experiment_name = 'diamond',这将告诉 PyCaret 在建模阶段自动记录所有的指标、超参数和模型工件。这是通过与MLflow的集成实现的。 -

我还在

setup中使用了transform_target = True。PyCaret 会在后台使用 box-cox 变换来转换Price变量。它影响数据分布的方式类似于对数变换(技术上不同)。如果你想了解更多关于 box-cox 变换的信息,可以参考这个链接。

从设置中输出 — 为了展示而截断

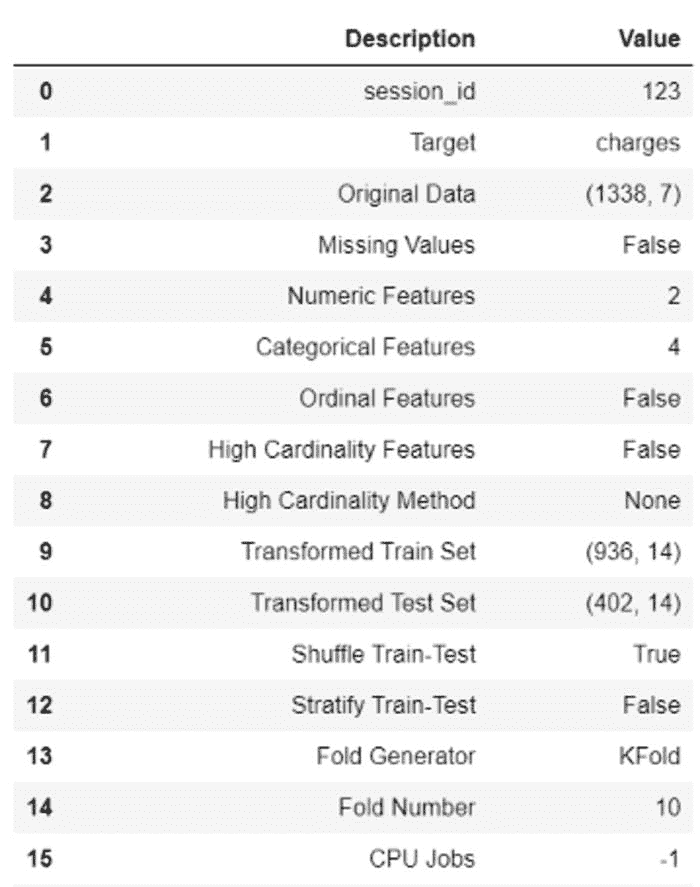

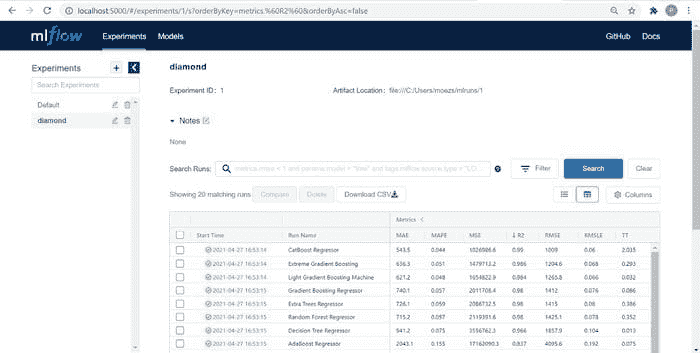

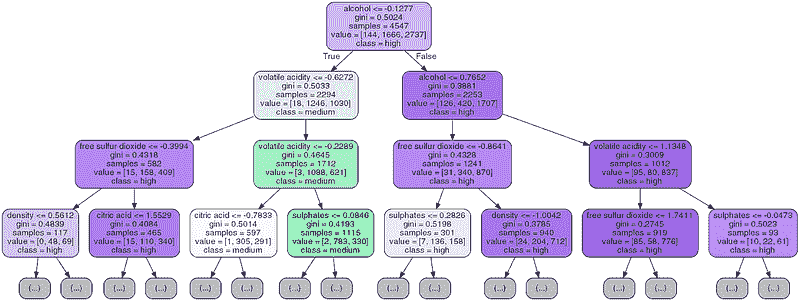

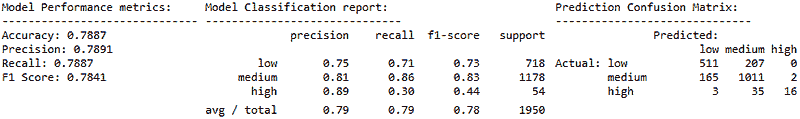

???? 模型训练与选择

现在数据已准备好进行建模,让我们通过使用compare_models函数开始训练过程。它将训练模型库中的所有算法,并使用 k 折交叉验证评估多个性能指标。

**# compare all models**

best = compare_models()

从compare_models的输出

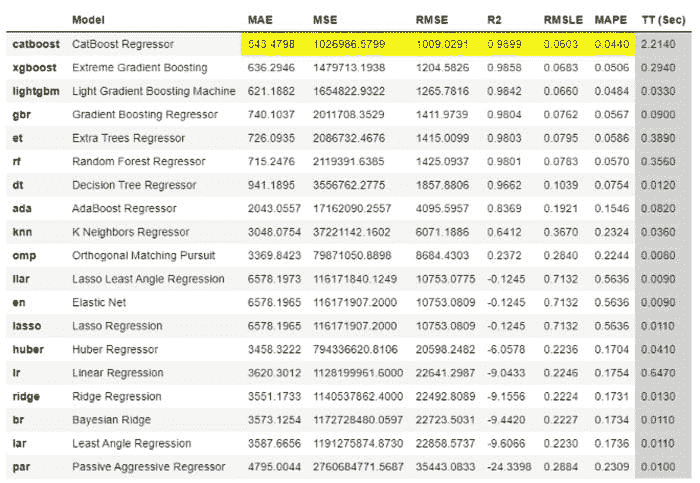

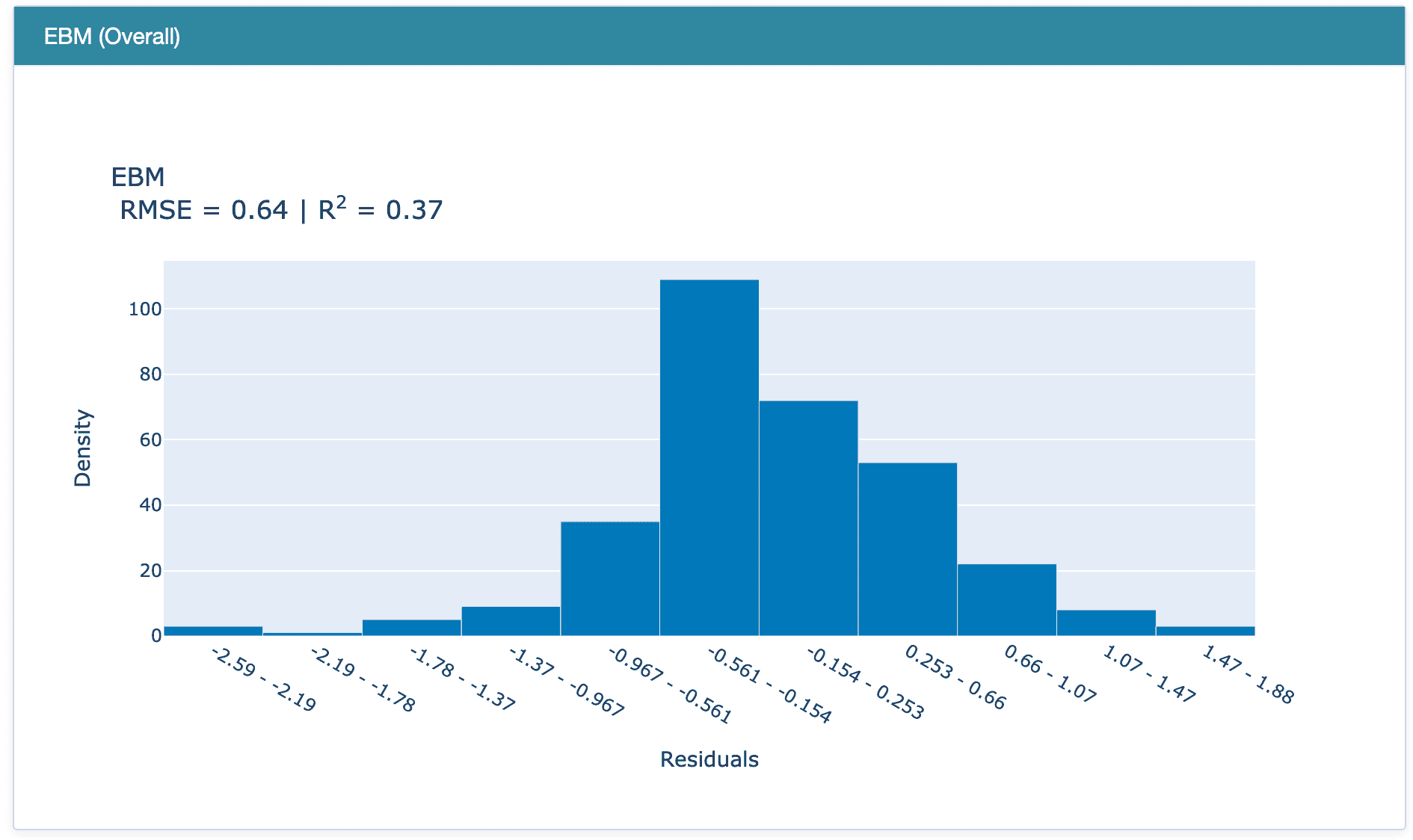

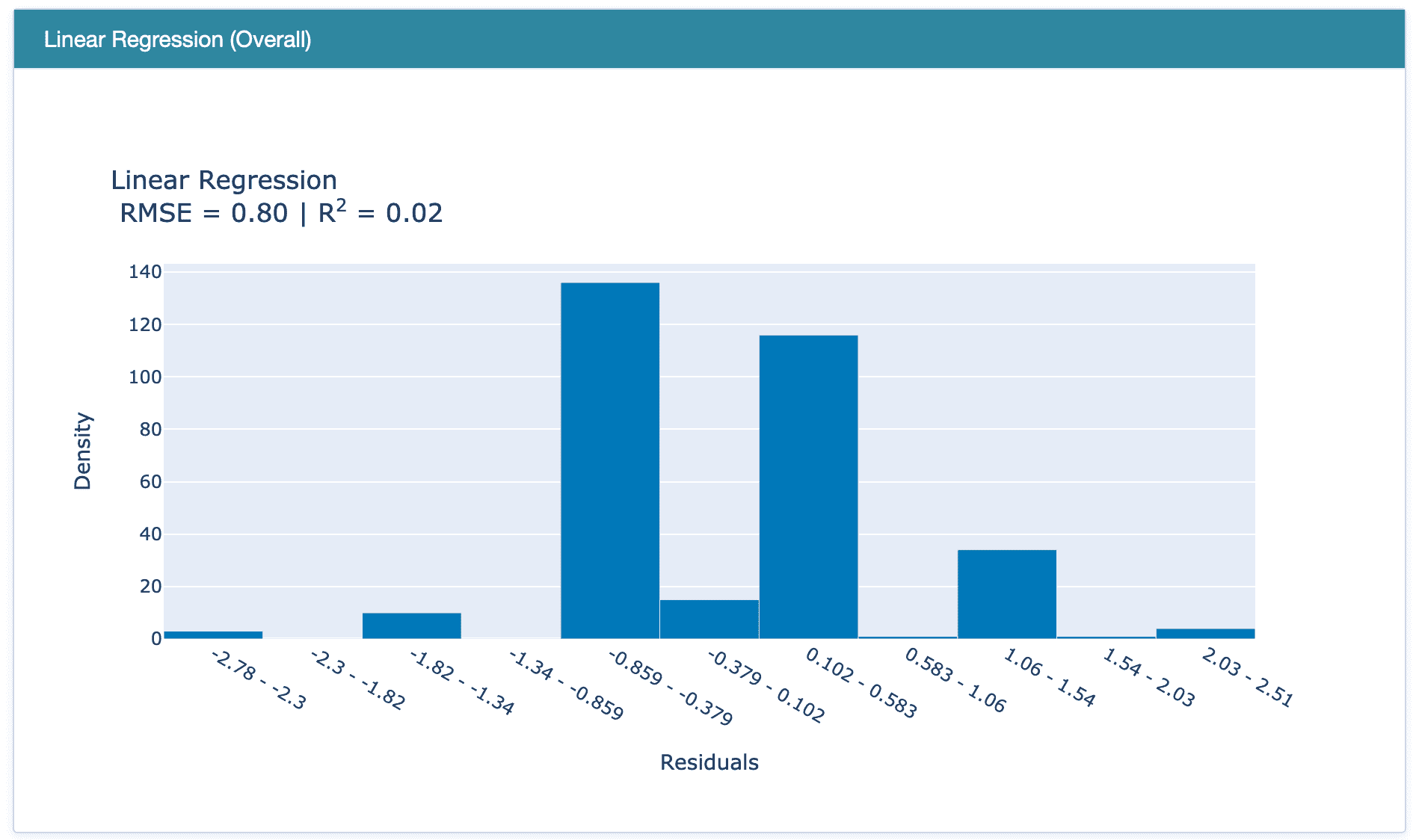

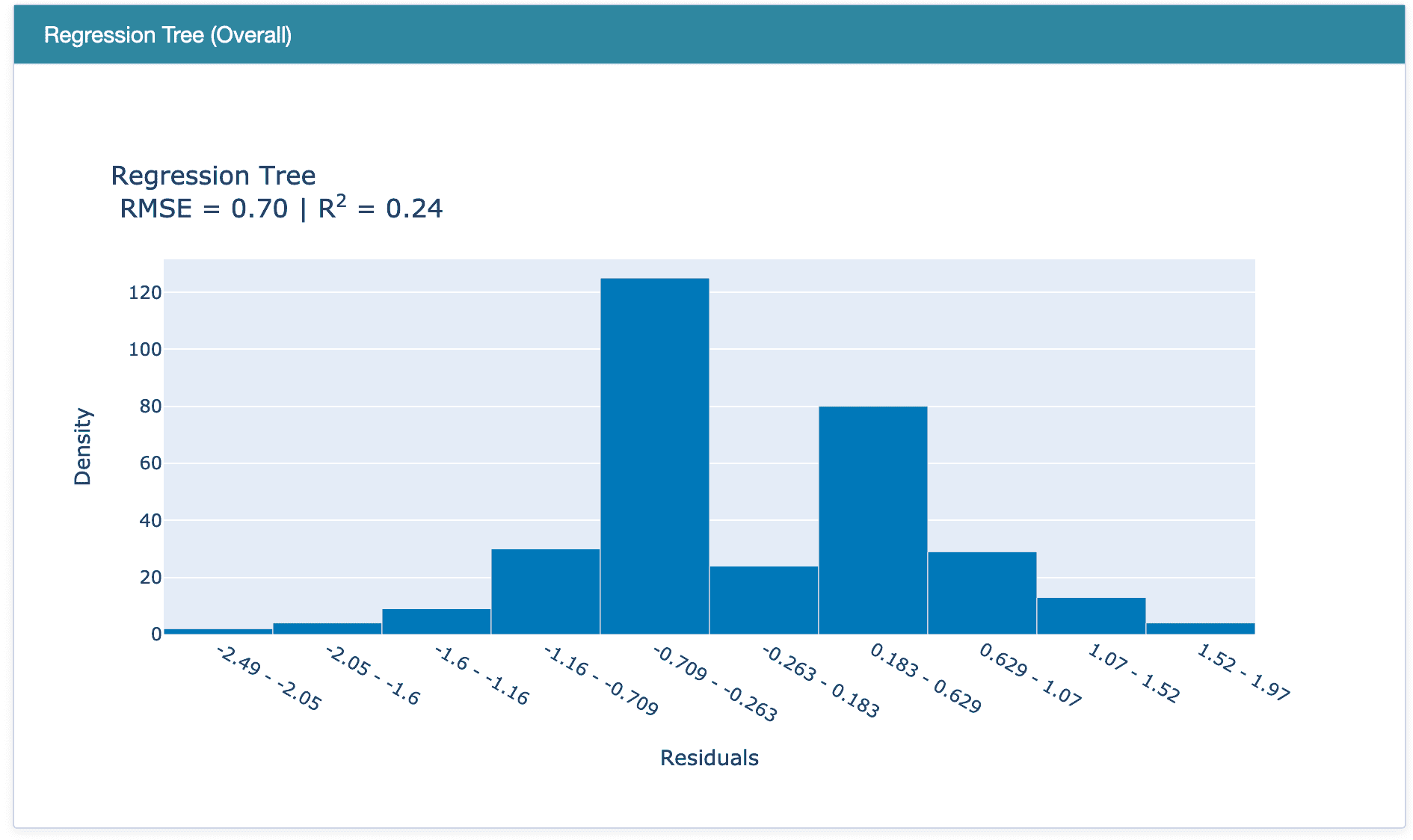

**# check the residuals of trained model**

plot_model(best, plot = 'residuals_interactive')

最佳模型的残差和 QQ 图

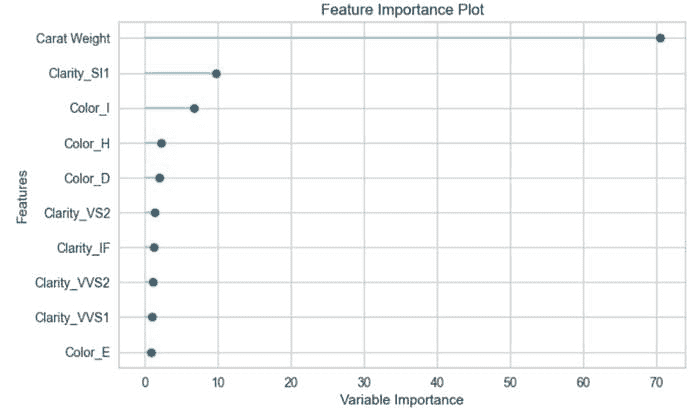

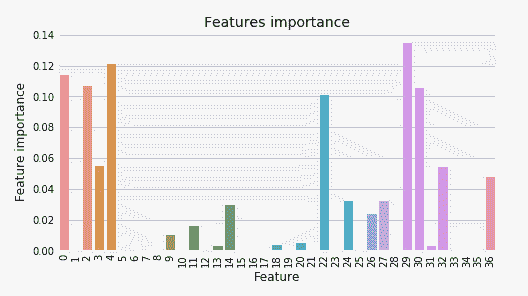

**# check feature importance**

plot_model(best, plot = 'feature')

确定并保存 Pipeline

现在我们来确定最佳模型,即在整个数据集(包括测试集)上训练最佳模型,然后将 Pipeline 保存为 pickle 文件。

**# finalize the model**

final_best = finalize_model(best)**# save model to disk** save_model(final_best, 'diamond-pipeline')

save_model函数会将整个 Pipeline(包括模型)保存为本地磁盘上的 pickle 文件。默认情况下,它会将文件保存到你的 Notebook 或脚本所在的文件夹中,但如果你愿意,也可以传递完整路径:

save_model(final_best, 'c:/users/moez/models/diamond-pipeline'

???? 部署

记得我们在 setup 函数中传递了log_experiment = True和experiment_name = 'diamond'。让我们看看 PyCaret 在后台借助 MLflow 完成的神奇操作。要查看这些神奇操作,我们来启动 MLflow 服务器:

**# within notebook (notice ! sign infront)** !mlflow ui**# on command line in the same folder** mlflow ui

现在打开你的浏览器并输入“localhost:5000”。它将打开一个像这样的用户界面:

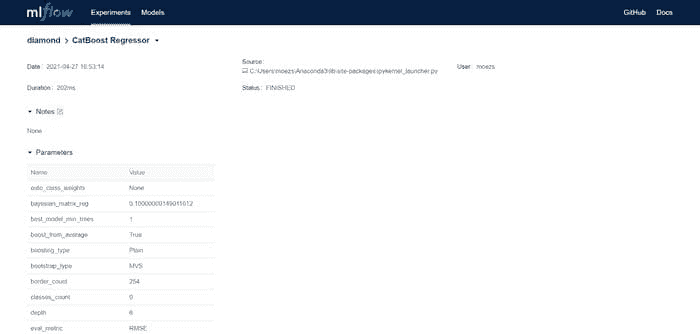

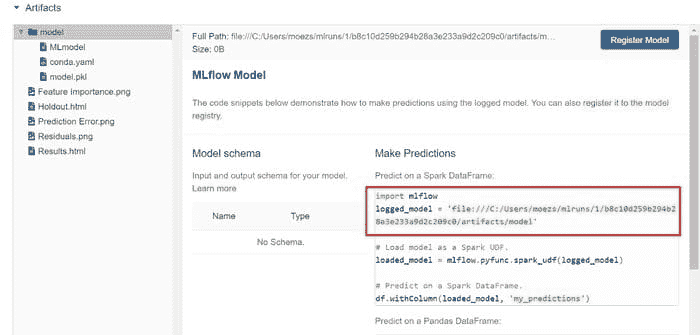

上表中的每一项代表一次训练运行,结果为一个训练好的 Pipeline 以及一堆元数据,如运行的日期时间、性能指标、模型超参数、标签等。让我们点击其中一个模型:

第一部分 — CatBoost 回归器

第二部分 — CatBoost 回归器(续)

第二部分 — CatBoost 回归器(续)

注意你有一个logged_model的地址路径。这是使用 Catboost 回归器训练的 Pipeline。你可以使用load_model函数来读取这个 Pipeline。

**# load model**

from pycaret.regression import load_model

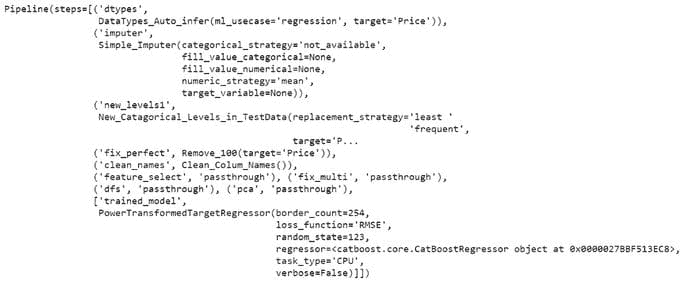

pipeline = load_model('C:/Users/moezs/mlruns/1/b8c10d259b294b28a3e233a9d2c209c0/artifacts/model/model')**# print pipeline** print(pipeline)

从print(pipeline)的输出

现在我们使用这个 Pipeline 来生成新数据的预测

**# create a copy of data and drop Price** data2 = data.copy()

data2.drop('Price', axis=1, inplace=True)**# generate predictions** from pycaret.regression import predict_model

predictions = predict_model(pipeline, data=data2)

predictions.head()

从管道生成的预测

哇!我们现在可以从训练好的管道中获取推断结果了。恭喜,如果这是你的第一次。注意到所有的转换,如目标转换、独热编码、缺失值填补等,都是在后台自动完成的。你得到一个实际规模的预测数据框,这正是你关心的。

敬请期待!

我今天展示的只是众多可以使用 MLflow 从 PyCaret 提供的训练管道中服务的方式之一。在下一个教程中,我计划展示如何使用 MLflow 的本地服务功能来注册你的模型、为其版本并作为 API 提供服务。

使用这个轻量级的 Python 工作流自动化库,你可以实现无限可能。如果你觉得这很有用,请不要忘记在我们的 GitHub 仓库上给我们⭐️。

想了解更多关于 PyCaret 的信息,请关注我们的 LinkedIn 和 Youtube。

加入我们的 Slack 频道。邀请链接 这里。

你可能也会感兴趣:

使用 PyCaret 2.0 在 Power BI 中构建你自己的 AutoML

在 Google Kubernetes Engine 上部署机器学习管道

使用 AWS Fargate 无服务器架构部署 PyCaret 和 Streamlit 应用

使用 PyCaret 和 Streamlit 构建并部署机器学习网页应用

在 GKE 上部署使用 Streamlit 和 PyCaret 构建的机器学习应用

重要链接

安装 PyCaret Notebook 教程 贡献于 PyCaret

想了解某个特定模块吗?

点击下面的链接查看文档和实际示例。

个人简介: Moez Ali 是数据科学家,同时也是 PyCaret 的创始人和作者。

原文。经授权转载。

相关:

-

PyCaret 的多时间序列预测

-

将机器学习管道部署到云端使用 Docker 容器

-

GitHub 是你需要的最佳 AutoML

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关主题

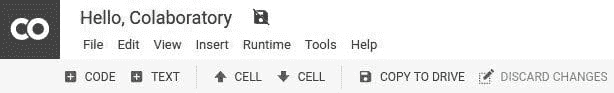

简单、一键式 Jupyter 笔记本

原文:

www.kdnuggets.com/2019/07/easy-one-click-jupyter-notebooks.html

评论

评论 社会对数据科学家的印象

社会对数据科学家的印象

数据科学可以是一件有趣的事情!

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

实际上,我们做的大部分工作就是在探索数据,同时试图提取其中隐藏的信息。这就像我们在未知的丛林中寻找宝藏!

但这并不总是轻松有趣的。

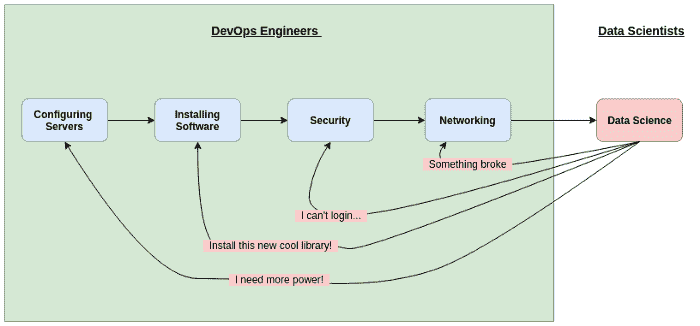

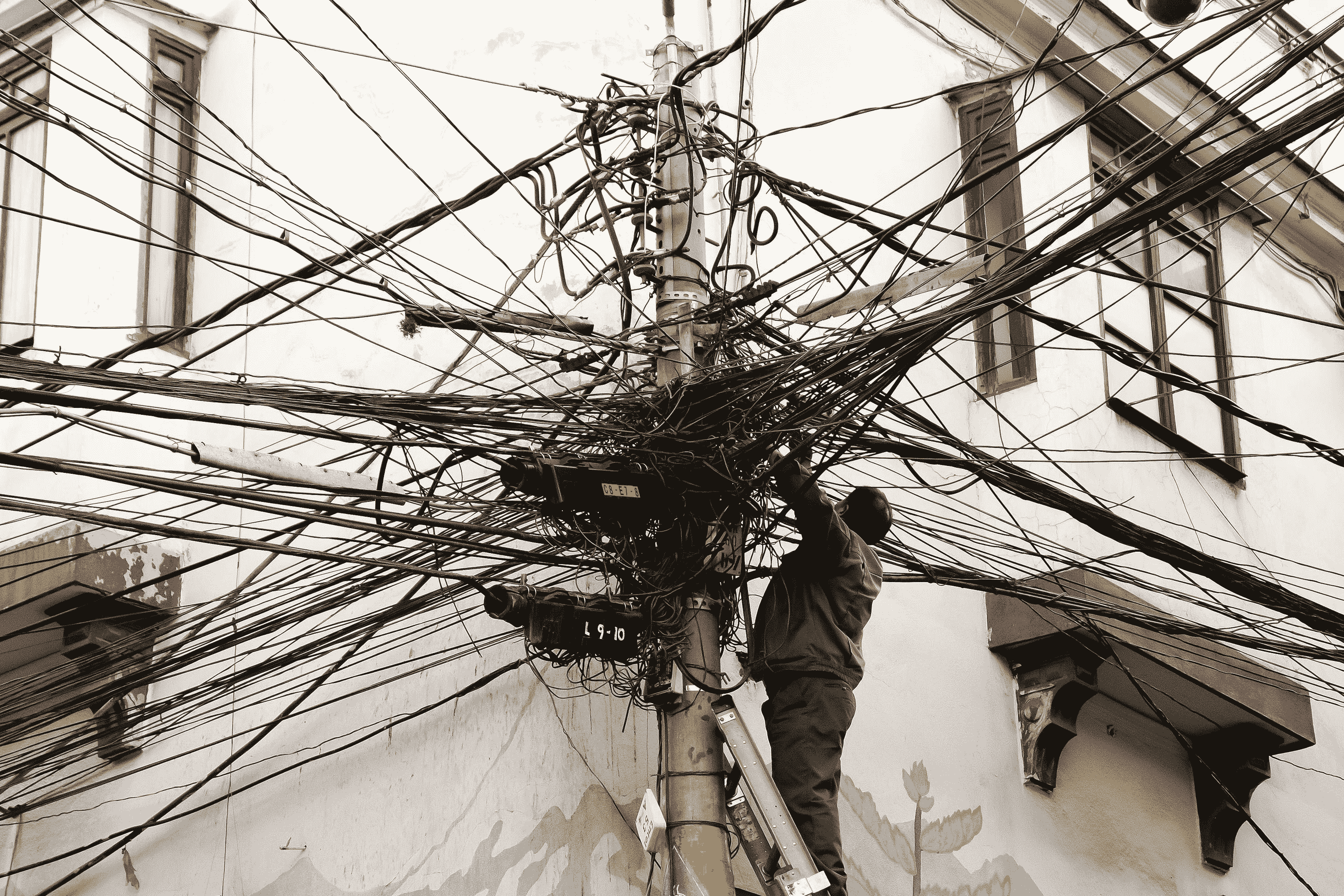

在幕后,为数据科学家工作的平台设置涉及许多内容。创建服务器、安装必要的软件和环境、设置安全协议等等。

完成所有这些工作通常需要一位专门的 DevOps 工程师。他需要了解云服务、操作系统、网络的各个细节,并且对设置数据科学和机器学习软件有一定的了解。

但如果有一种方法可以绕过所有这些繁琐的 DevOps 工作,直接进入数据科学呢?

一项名为Saturn Cloud的新服务可以让数据科学家实现这一点:跳过繁琐的设置,直接进入数据科学的工作!

Saturn Cloud 和数据科学的 DevOps

花点时间想想为数据科学家有效工作而设置环境所需的所有工作。对于许多公司,这看起来像是:

-

创建和配置服务器。理想情况下,这些服务器应该在服务器性能和实例数量上都能轻松扩展。

-

在所有服务器上安装软件。软件应该易于更新。

-

配置安全性。保护任何敏感数据、代码或机器学习模型

-

配置网络。服务器应在特定端口和特定人员的访问下可用。

所有这些都需要大量时间,尤其是第 1 步和第 2 步。许多数据科学家甚至看不到这些过程的发生——他们只看到最终产品。但建立所有这些基础设施确实是一项挑战,其中一些需要持续更新。

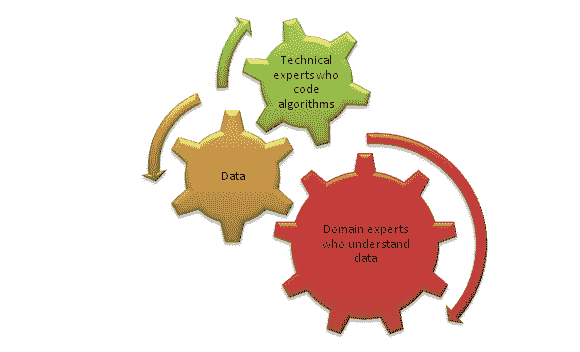

DevOps 工程师不断迎合数据科学家不断变化的需求

DevOps 工程师不断迎合数据科学家不断变化的需求

Saturn Cloud 自称为云托管数据科学,允许数据科学家轻松地在云上配置和托管他们的工作,而无需专门的 DevOps。然后你可以在由系统创建并托管在你指定的服务器上的 Jupyter Notebook 中工作。

软件、网络、安全和库的所有设置都由 Saturn Cloud 系统自动处理。数据科学家可以专注于实际的数据科学,而不是繁琐的基础设施工作。

这个想法是,用户(你和我,数据科学家)可以简单地指定我们需要的计算资源,输入我们需要的软件库列表,而 Saturn Cloud 系统将处理其余的设置。

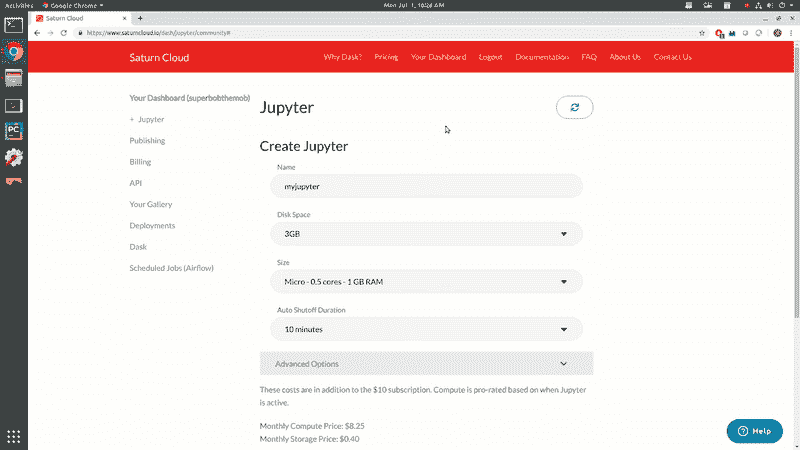

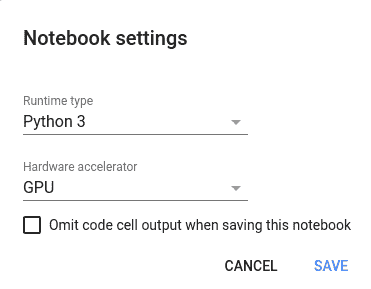

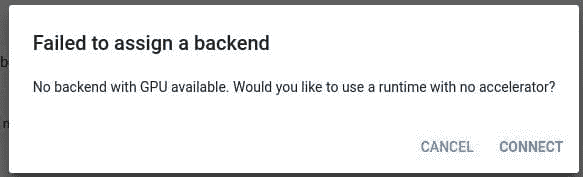

如何使用托管的 Jupyter Notebooks

要开始,简单地访问Saturn Cloud 网站并创建一个帐户。基本计划完全免费,你可以先在环境中玩耍以熟悉操作。

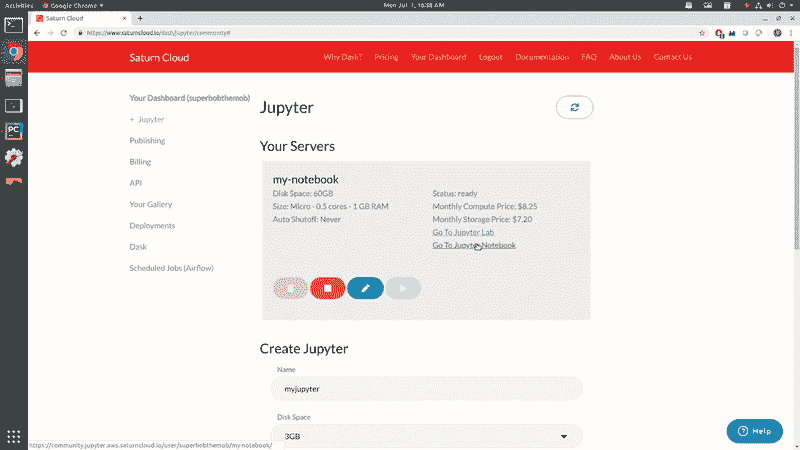

进入后,点击“Your Dashboard”标签页开始创建一个托管 Jupyter Notebook 的服务器。下面的视频展示了如何创建你的服务器!

你基本上需要经过以下步骤:

-

为你的 notebook 指定一个名称

-

指定你想要的存储量

-

指定你想使用的 CPU 或 GPU

-

如果需要,设置自动关机

-

列出你希望在系统上安装的任何软件包或库

一旦你点击创建按钮,你的服务器将自动根据所需的设置和软件创建。当创建完成后——瞧!你的云托管 Jupyter Notebook 已准备好进行数据科学工作!

在仪表板顶部,你会看到启动、停止、编辑和删除你的 Notebook 云服务器的按钮。在本教程的下一部分,我已经编辑了我的服务器以安装 pandas 和 matplotlib。

要访问你的云托管 Jupyter Notebook,请点击“Go To Jupyter Notebook”链接。将打开一个包含 Jupyter Notebook 界面的标签页,你可以在其中创建你的 Python 3 notebook!

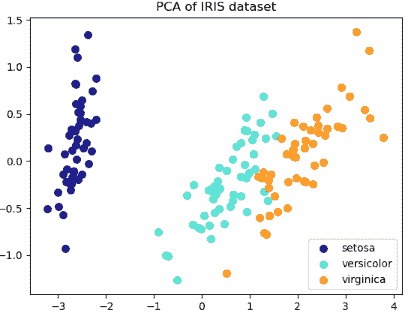

我已经在下面的视频中创建了我的 notebook。一旦你的 notebook 创建完成,你就可以开始编码了!我已经准备了一些代码来绘制 Iris 花卉数据集。Saturn Cloud 能够顺利无缝地运行所有内容。

除了托管 Jupyter Notebooks,Saturn Cloud 还允许你publish your notebooks,可以选择公开或私密。当你发布笔记本时,你将获得一个网址,可以与任何想要运行你笔记本的人分享:随时随地。看看我的这个吧!

喜欢学习吗?

在twitter上关注我,我会发布最新最好的 AI、技术和科学信息!也可以在LinkedIn与我联系!

简介: George Seif 是认证极客以及 AI / 机器学习工程师。

原文。经许可转载。

相关:

-

数据科学家的 DevOps:驯服独角兽

-

操作性机器学习:成功 MLOps 的七个考虑因素

-

将机器学习应用于 DevOps

更多相关主题

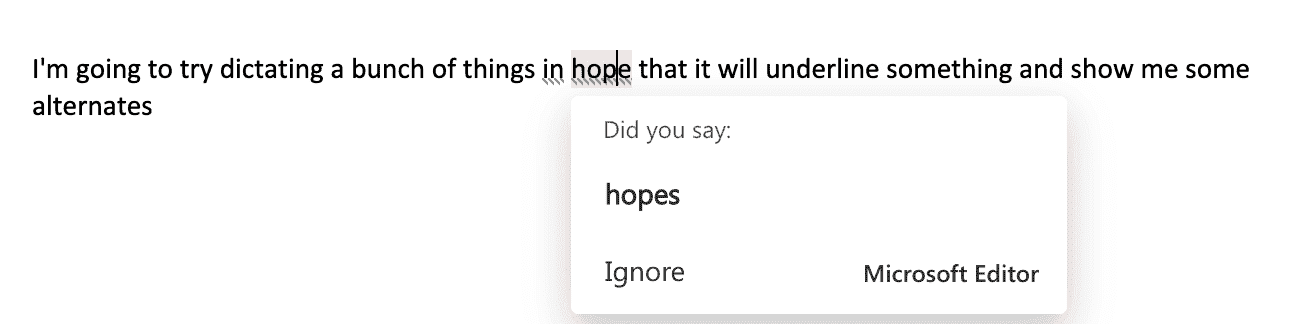

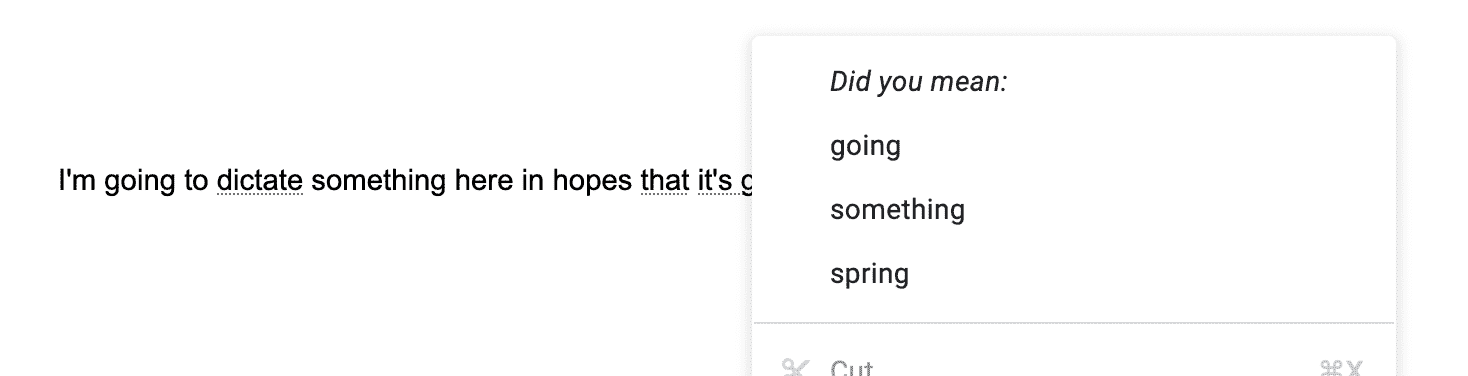

使用 Python 进行简单的语音转文本

评论

作者:Dhilip Subramanian,数据科学家和 AI 爱好者

来源:信息时代

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

语音是最常见的交流方式,世界上大多数人依赖语音进行沟通。语音识别系统基本上将口语语言翻译成文本。现实生活中有许多语音识别系统的例子。例如,苹果的 SIRI 能够识别语音并将其转换为文本。

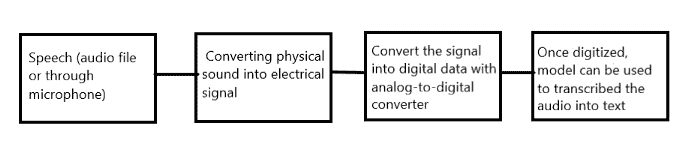

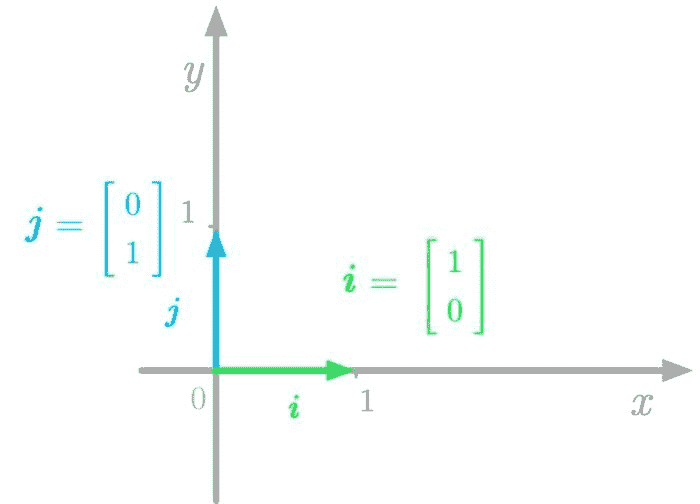

语音识别是如何工作的?

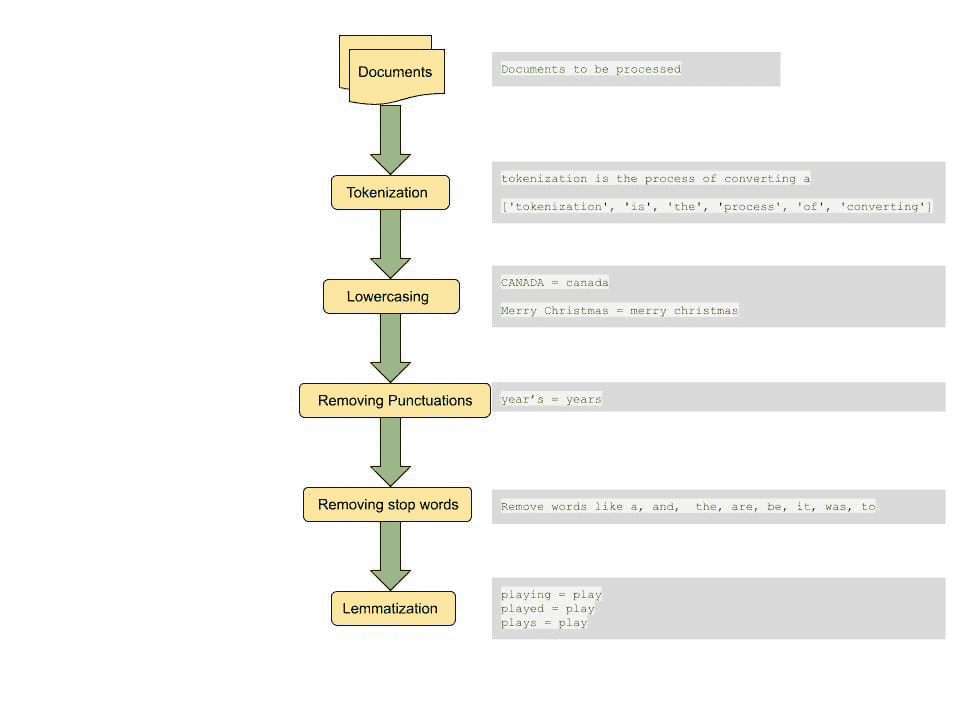

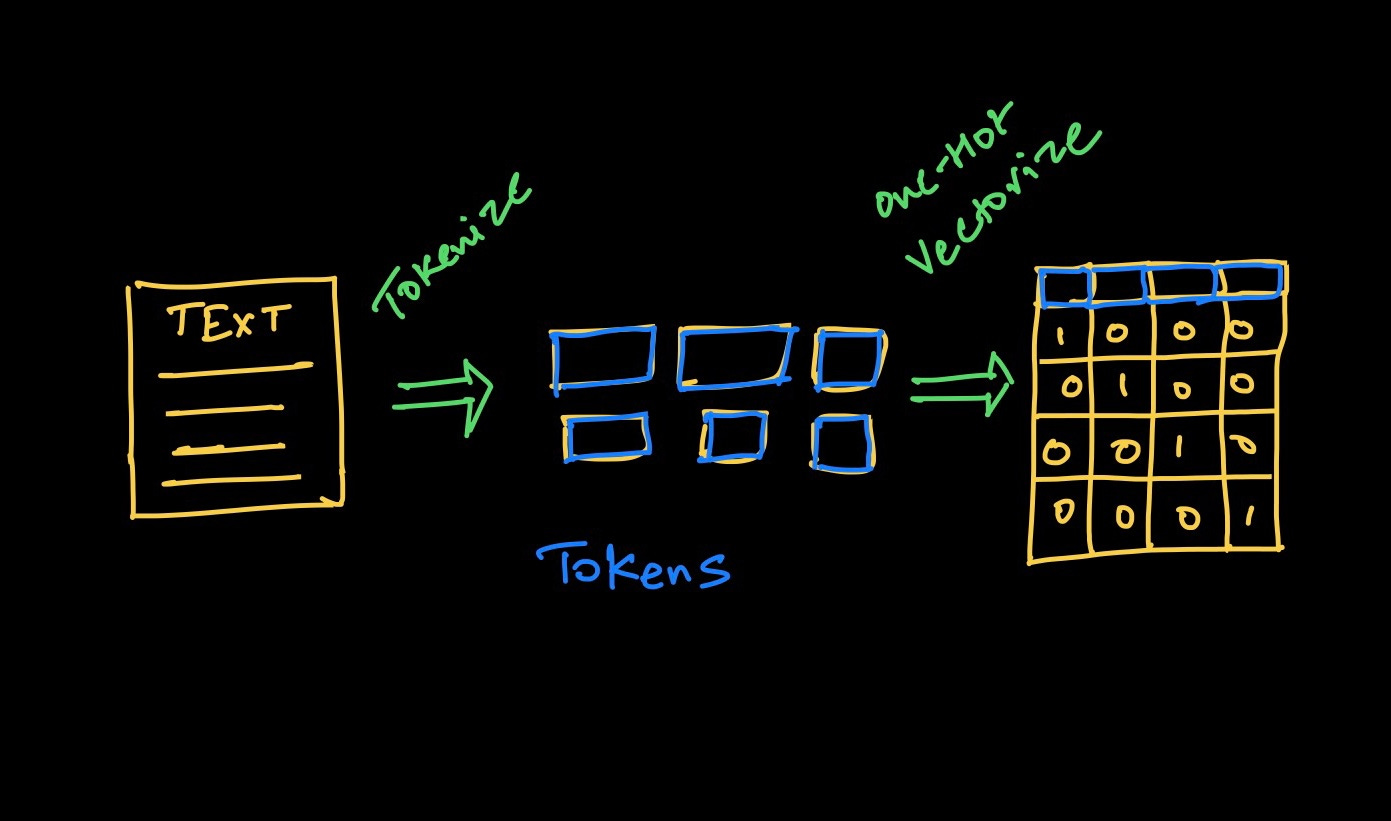

语音识别过程

隐马尔可夫模型(HMM)和深度神经网络模型用于将音频转换为文本。详细的过程超出了本博客的范围。在本博客中,我展示了如何使用 Python 将语音转换为文本。这可以通过“Speech Recognition” API 和 “PyAudio” 库来完成。

语音识别 API 支持多个 API,在本博客中我使用了谷歌语音识别 API。更多详情,请查看这里。它有助于将语音转换为文本。

Python 库

!pip install SpeechRecognition

将音频文件转换为文本

步骤:

-

导入语音识别库

-

初始化识别器类以识别语音。我们正在使用谷歌语音识别。

-

语音识别支持的音频文件格式:wav, AIFF, AIFF-C, FLAC。在这个例子中我使用了‘wav’文件

-

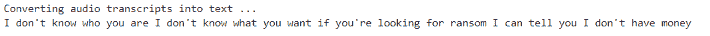

我使用了《特工绍特》电影音频片段,内容为“我不知道你是谁,我不知道你想要什么。如果你在寻找赎金,我可以告诉你,我没有钱”

-

默认情况下,谷歌识别器读取英语。它支持不同的语言,更多细节请查看文档。

代码

#import library

import speech_recognition as sr

# Initialize recognizer class (for recognizing the speech)

r = sr.Recognizer()

# Reading Audio file as source

# listening the audio file and store in audio_text variable

with sr.AudioFile('I-dont-know.wav') as source:

audio_text = r.listen(source)

# recoginize_() method will throw a request error if the API is unreachable, hence using exception handling

try:

# using google speech recognition

text = r.recognize_google(audio_text)

print('Converting audio transcripts into text ...')

print(text)

except:

print('Sorry.. run again...')

输出

那么如何转换不同的音频语言呢?

例如,如果我们要读取法语音频文件,则需要在 recogonize_google 中添加语言选项。其余代码保持不变。请参阅更多文档

#Adding french langauge option

text = r.recognize_google(audio_text, language = "fr-FR")

输出

麦克风语音转文本

步骤:

- 我们需要安装 PyAudio 库,它用于通过麦克风和扬声器接收音频输入和输出。基本上,它帮助我们通过麦克风获取声音。

!pip install PyAudio

- 我们需要使用 Microphone 类,而不是音频文件源。其余步骤相同。

代码

#import library

import speech_recognition as sr

# Initialize recognizer class (for recognizing the speech)

r = sr.Recognizer()

# Reading Microphone as source

# listening the speech and store in audio_text variable

with sr.Microphone() as source:

print("Talk")

audio_text = r.listen(source)

print("Time over, thanks")

# recoginize_() method will throw a request error if the API is unreachable, hence using exception handling

try:

# using google speech recognition

print("Text: "+r.recognize_google(audio_text))

except:

print("Sorry, I did not get that")

我刚刚说了“你好吗?”

输出

试试说其他语言怎么样?

再次,我们需要在 recognize_google()中添加所需的语言选项。我用泰米尔语(印度语言)说话,并在语言选项中添加“ta-IN”。

# Adding "tamil language"

print(“Text: “+r.recognize_google(audio_text, language = “ta-IN”))

我刚刚用泰米尔语说了“你好吗”,它准确地打印了泰米尔语文本。

输出

注意:

Google 语音识别 API 是一种将语音转换为文本的简单方法,但它需要互联网连接才能操作。

在这篇博客中,我们看到如何使用 Google 语音识别 API 将语音转换为文本。这对于 NLP 项目尤其是处理音频转录数据非常有帮助。如果你有任何补充,请随时留言!

感谢阅读。继续学习,敬请关注更多内容!

个人简介: Dhilip Subramanian 是一名机械工程师,并完成了分析学硕士学位。他在数据相关的多个领域,包括 IT、市场营销、银行、电力和制造业,拥有 9 年的专业经验。他对自然语言处理和机器学习充满热情。他是SAS 社区的贡献者,并喜欢在 Medium 平台上撰写关于数据科学各个方面的技术文章。

原文。已获得许可转载。

相关:

-

使用 Python 轻松进行语音合成

-

数据科学的五个酷炫 Python 库

-

Docker: 数据科学家的容器化

更多相关内容

如何用原生 Python 编写 SQL

技术矢量图由 freepik 创建 - www.freepik.com

你经常编写 SQL 吗?你是否经常从 Python 中调用这些 SQL?能够通过 Python 链接 SQL 数据库并定义、操作和查询它们的想法是否吸引你?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

SQLModel 是一个用于在纯 Python 中与 SQL 数据库交互的 Python 库。它的设计动机包括直观性、易用性、兼容性和健壮性。SQLModel 使用 Python 的 类型注解,由 Pydantic 强制和管理,以及 SQLAlchemy,即“Python SQL 工具包和对象关系映射器”,用于其 SQL 交互。

这个库是由 Sebastián Ramírez,即 FastAPI 的作者编写的,这两个库设计上无缝协作。

SQLModel 的关键特性,直接取自项目的 GitHub 仓库,包含:

- 编写直观:编辑器支持优秀。处处有自动完成。减少调试时间。设计上易于使用和学习。减少阅读文档的时间。

- 易于使用:它具有合理的默认值,并且在底层做了大量工作,以简化你编写的代码。

- 兼容:设计上与 FastAPI、Pydantic 和 SQLAlchemy 兼容。

- 可扩展:你拥有 SQLAlchemy 和 Pydantic 所提供的所有强大功能。

- 简短:最小化代码重复。一个类型注解可以完成大量工作。不需要在 SQLAlchemy 和 Pydantic 中重复模型。

让我们快速看看 SQLModel 是如何工作的。

创建 SQLModel 模型(SQL 表)

想要使用 SQLModel 创建一个表格吗?

这是一个简单的 示例,来自库的 GitHub 仓库中的代码片段。

from typing import Optional

from sqlmodel import Field, SQLModel

class Hero(SQLModel, table=True):

id: Optional[int] = Field(default=None, primary_key=True)

name: str

secret_name: str

age: Optional[int] = None

在上述代码中,Hero 类是一个 SQLModel 对象。SQLModel 对象等同于 SQLModel 库中的 SQL 表。类属性,如 id 和 name,是表中的列。

创建行(表实例)

想要在表中创建一行,也就是一个数据实例?

这是一个来自库的 GitHub 仓库的示例,演示了如何操作。请注意,每一行都是上面定义模型的一个实例。

hero_1 = Hero(name="Deadpond", secret_name="Dive Wilson")

hero_2 = Hero(name="Spider-Boy", secret_name="Pedro Parqueador")

hero_3 = Hero(name="Rusty-Man", secret_name="Tommy Sharp", age=48)

请注意,仅使用了传统的 Python 代码来创建表并逐行输入数据,无需 SQL 代码作为 Python 对象和后端 SQL 数据库之间的中介。

写入 SQL 数据库

请注意,目前尚未将任何表或数据写入现有数据库,可以按如下方式实现。以下完整代码示例基于上述代码。

from typing import Optional

from sqlmodel import Field, Session, SQLModel, create_engine

class Hero(SQLModel, table=True):

id: Optional[int] = Field(default=None, primary_key=True)

name: str

secret_name: str

age: Optional[int] = None

hero_1 = Hero(name="Deadpond", secret_name="Dive Wilson")

hero_2 = Hero(name="Spider-Boy", secret_name="Pedro Parqueador")

hero_3 = Hero(name="Rusty-Man", secret_name="Tommy Sharp", age=48)

engine = create_engine("sqlite:///database.db")

SQLModel.metadata.create_all(engine)

with Session(engine) as session:

session.add(hero_1)

session.add(hero_2)

session.add(hero_3)

session.commit()

上述代码将把一个新表写入现有数据库,并添加 3 个“英雄”条目。

当然,SQLModel 还可以做很多其他事情。有关库可以实现的所有内容及其实现方法,请查看完整文档。

马修·梅奥 (@mattmayo13) 是数据科学家以及 KDnuggets 的主编,这是一个开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络以及机器学习的自动化方法。马修拥有计算机科学硕士学位和数据挖掘研究生文凭。他可以通过 editor1 at kdnuggets[dot]com 联系到。

更多相关主题

使用 Faker 在 Python 中生成简单的合成数据

原文:

www.kdnuggets.com/2021/11/easy-synthetic-data-python-faker.html

评论

真实的数据,来自真实世界,是数据科学的黄金标准,这一点可能很明显。当然,诀窍在于能够找到所需的真实世界数据。有时候,你会很幸运地发现所需的数据触手可及,格式符合要求,而且数量正好。

我们的三大推荐课程

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

然而,现实世界的数据通常不足以满足项目需求。在这种情况下,可以使用合成数据代替真实数据或用来增强不足够大的数据集。人工制造数据的方法有很多,其中一些远比其他方法复杂。然而,也有一些相对简单的选项,例如,Faker 就是 Python 中的一个解决方案。

来自 Faker 的文档:

Faker 是一个生成假数据的 Python 包。无论你是需要为数据库进行引导,创建美观的 XML 文档,填充你的持久化存储以进行压力测试,还是匿名化从生产服务中获得的数据,Faker 都能满足你的需求。

可以使用 pip 安装 Faker:

pip install faker

导入并实例化一个 Faker 实例的方式如下:

from faker import Faker

fake = Faker()

Faker 的基本使用

Faker 的使用非常简单。让我们先看几个示例。

对于我们的第一个技巧,让我们生成一个假名字。

print(fake.name())

Deborah Brooks

其他数据类型怎么样?

# generate an address

print(fake.address())

# generate a phone number

print(fake.phone_number())

# generate a date

print(fake.date())

# generate a social security number

print(fake.ssn())

# generate some text

print(fake.text())

123 Danielle Forges Suite 506

Stevenborough, RI 36008

968-491-2711

1974-05-27

651-27-9994

Weight where while method. Rock final environmental gas provide. Remember continue sure. Create resource determine fine. Else red across participant. People must interesting spend some us.

Faker 优化

如果你对特定地区的数据感兴趣呢?例如,如果我想生成一种在墨西哥会出现的西班牙名字怎么办?

fake = Faker(['es_MX'])

for i in range(10):

print(fake.name())

Diana Lovato

Ing. Ariadna Palacios

Salvador de la Fuente

Margarita Naranjo

Alvaro Prado Melgar

Tomás Menchaca

Conchita Francisca Velázquez Zedillo

Ivonne Ana Luisa Bueno

Ramiro Raquel Vélez Urbina

Porfirio Esther Irizarry Varela

生成的输出可以通过使用 Faker 的权重设置进一步优化:

Faker 构造函数接受一个与性能相关的参数叫做

use_weighting。它指定是否尝试使值的频率匹配真实世界的频率(例如,英文名字 Gary 的出现频率会远高于名字 Lorimer)。如果use_weighting为False,则所有项目被选择的机会相等,选择过程也更快。默认值是True。

让我们看看一些美国英语的示例是如何工作的:

fake = Faker(['en_US'], use_weighting=True)

for i in range(20):

print(fake.name())

Mary Mckinney

Margaret Small

Dominic Carter

Elizabeth Gibson

Kelsey Garcia

Chelsea Bradford

Robert West

Timothy Howe

Gary Turner

Cynthia Strong

Joshua Henry

Amanda Jenkins

Jacqueline Daniels

Catherine Jones

Desiree Hodge

Shannon Mason DVM

Marcia West

Dustin Parrish

Christopher Rodriguez

Brett Webb

将此与未使用加权的类似输出进行比较:

fake = Faker(['en_US'], use_weighting=False)

for i in range(20):

print(fake.name())

Mr. Benjamin Horton

Miss Maria Hardin

Tina Good DDS

Dr. Terry Barr MD

Meredith Mason

Roberta Velasquez

Mr. Tim Woods V

Marilyn Conway

Mr. Dwayne Leblanc III

Dr. Dan Krause IV

Mia Newman DVM

Thomas Small

Joseph Holmes

Dr. Tanner Zhang

Alan Dixon

Miss Rebecca Davila DVM

Joseph Becker MD

Dr. Erin Pugh PhD

Mr. Ernest Juarez

Ross Thompson

注意,例如,在生成的“样本”中,医生的数量不成比例。

更全面的示例

假设我们要为一家国际公司生成一些虚假的客户数据记录,我们希望模拟现实世界中名字的分布,并将这些数据保存到 CSV 文件中,以便后续在某种数据科学任务中使用。为了清理数据,我们还将把生成的地址中的换行符替换为逗号,并完全移除生成文本中的换行符。

这是一个代码片段,可以实现这一点,展示了 Faker 在几行代码中的强大功能。

from faker import Faker

import pandas as pd

fake = Faker(['en_US', 'en_UK', 'it_IT', 'de_DE', 'fr_FR'], use_weighting=True)

customers = {}

for i in range(0, 10000):

customers[i]={}

customers[i]['id'] = i+1

customers[i]['name'] = fake.name()

customers[i]['address'] = fake.address().replace('\n', ', ')

customers[i]['phone_number'] = fake.phone_number()

customers[i]['dob'] = fake.date()

customers[i]['note'] = fake.text().replace('\n', ' ')

df = pd.DataFrame(customers).T

print(df)

df.to_csv('customer_data.csv', index=False)

id name ... dob note

0 1 Burkhardt Junck ... 1982-08-11 Across important glass stop. Score include rel...

1 2 Ilja Weihmann ... 1975-03-24 Iusto velit aspernatur nemo. Aliquid ipsum ita...

2 3 Agnolo Tafuri ... 1990-10-03 Aspernatur fugit voluptatibus. Cumque accusant...

3 4 Sig. Lamberto Cutuli ... 1973-01-15 Maiores temporibus beatae. Ipsam non autem ist...

4 5 Marcus Turner ... 2005-12-17 Témoin âge élever loi.\nFatiguer auteur autori...

... ... ... ... ... ...

9995 9996 Miss Alexandra Waters ... 1985-01-20 Commodi omnis assumenda sit ratione non. Commo...

9996 9997 Natasha Harris ... 2003-10-26 Voluptatibus dolore a aspernatur facere. Aliqu...

9997 9998 Adrien Marin ... 1983-05-29 Et unde iure. Reiciendis doloribus dignissimos...

9998 9999 Nermin Heydrich ... 2005-03-29 Plan moitié charge note convenir.\nSang précip...

9999 10000 Samuel Allen ... 2011-09-29 Total gun economy adult as nor. Age late gas p...

[10000 rows x 6 columns]

我们还有一个包含所有数据的 customer_data.csv 文件,供进一步处理和使用。

生成的客户数据 CSV 文件的截图

上面提到的特定类型数据生成器——如姓名、地址、电话等——称为提供者。通过启用 Faker 生成专门类型的数据,学习如何扩展其功能,使用标准提供者和社区提供者。

查看 Faker 的GitHub 仓库和文档,了解更多功能并立即创建你自己的数据集。

相关内容:

-

在 Python 中创建带有异常签名的合成时间序列

-

教 AI 用合成数据分类时间序列模式

-

3 个数据获取、注释和增强工具

更多相关内容

使用 Python 进行简单的文本到语音转换

评论

作者 Dhilip Subramanian,数据科学家和 AI 爱好者

文本到语音 (TTS) 技术可以朗读数字文本。它可以将计算机、智能手机、平板电脑上的文字转换为音频。还可以朗读各种文本文件,包括 Word 文档、页面文档、在线网页。TTS 可以帮助那些在阅读上有困难的孩子。许多工具和应用程序可以将文本转换为语音。

Python 附带了许多方便且易于访问的库,本文将探讨如何使用 Python 实现文本到语音的功能。

来源:www.youtube.com/watch?v=eiP-12qHM-c

Python 中提供了不同的 API 以将文本转换为语音。其中一个 API 是 Google 文字转语音,通常称为 gTTS API。该库非常易于使用,它将输入的文本转换为可以保存为 mp3 文件的音频文件。它支持多种语言,并且语音可以以两种可用的音频速度之一传递,即快或慢。更多详情可在 这里 找到

将文本转换为语音

代码:

导入 gTTS 库和 “os” 模块以播放转换后的音频

from gtts import gTTS

import os

创建要转换为音频的文本

text = “Global warming is the long-term rise in the average temperature of the Earth’s climate system”

gTTS 支持多种语言。请参阅文档 这里。选择了 ‘en’ -> 英语,并存储在语言变量中

language = ‘en’

创建一个名为 speech 的对象,并将文本和语言传递给引擎。标记 slow = False,这告诉模块转换后的音频应具有较高的速度。

speech = gTTS(text = text, lang = language, slow = False)

将转换后的音频保存为名为 ‘text.mp3’ 的 mp3 文件

speech.save(“text.mp3”)

播放转换后的文件,使用 Windows 命令 ‘start’ 后跟 mp3 文件的名称。

os.system(“start text.mp3”)

输出

text.mp3 文件

The output of the above program saved as text.mp3 file. Mp3 file should be a voice saying, 'Global warming is the long-term rise in the average temperature of the Earth’s climate system'

将文本文件转换为语音

在这里,将文本文件转换为语音。读取文本文件并传递给 gTTS 模块

代码

导入 gTTS 和 os 库

from gtts import gTTS

import os

读取文本文件并存储到名为 text 的对象中。我的文件名是 “draft.txt”

file = open("draft.txt", "r").read().replace("\n", " ")

选择语言为英语

language = ‘en’

将文本文件传递给 gTTS 模块并存储到 speech 中

speech = gTTS(text = str(file), lang = language, slow = False)

将转换后的音频保存为名为 ‘voice.mp3’ 的 mp3 文件

speech.save("voice.mp3")

播放 mp3 文件

os.system("start voice.mp3")

输出

将 draft.txt 文件转换为 voice.mp3

Draft.txt file saved as a voice.mp3 file.Play the Mp3 file to listen the text presented in the draft.txt file

注意:

GTTS 是一个简单的文本转语音工具,但它需要互联网连接,因为它完全依赖 Google 来获取音频数据。

感谢阅读。继续学习,敬请关注更多内容!

简介: Dhilip Subramanian 是一位机械工程师,拥有分析学硕士学位。他在 IT、营销、银行、电力和制造等多个数据相关领域拥有 9 年的经验。他对 NLP 和机器学习充满热情。 他是 SAS 社区的贡献者,并且喜欢在 Medium 平台上撰写有关数据科学各个方面的技术文章。

原文。经授权转载。

相关:

-

五款酷炫的 Python 数据科学库

-

Python 中文本挖掘:步骤和示例

-

2019 深度学习语音合成指南

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持组织的 IT 工作

3. Google IT 支持专业证书 - 支持组织的 IT 工作

更多相关内容

电子书:使用 R 学习数据科学 – 免费下载

原文:

www.kdnuggets.com/2021/09/ebook-learn-data-science-r.html

comments

由 Narayana Murthy,数据科学家。

我很高兴宣布我的电子书 使用 R 学习数据科学 已发布。它可以作为限时赠书 下载。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

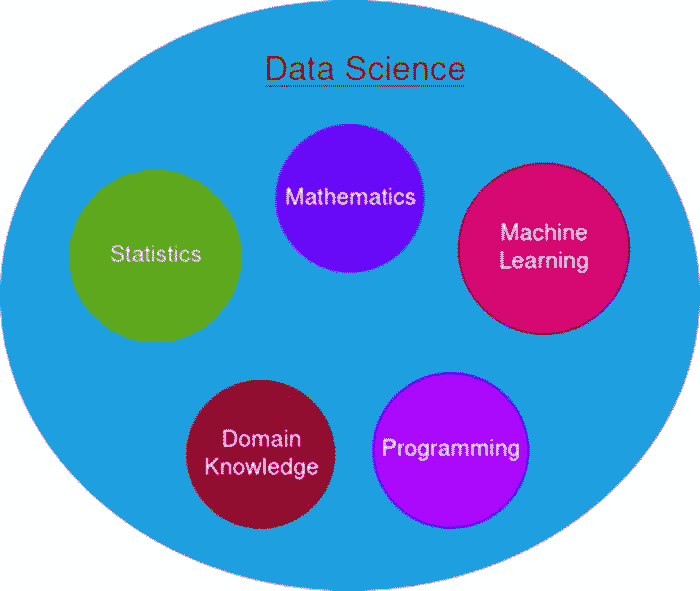

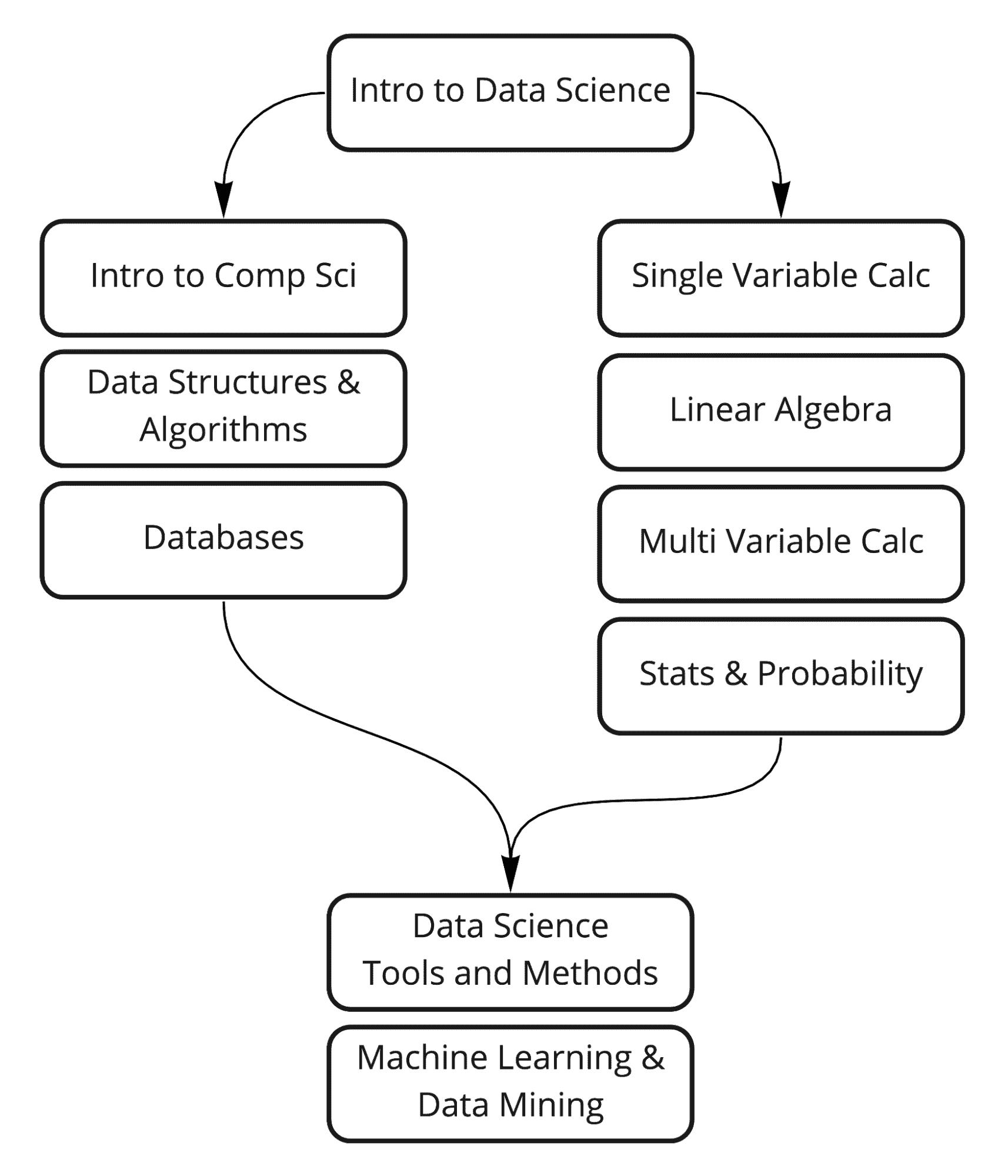

学习数据科学

数据科学是各种技能的结合。数据科学家需要精通统计学、数学、编程及其他技能。

所以合乎逻辑的问题是,从哪里开始?

统计学

统计学是理解和解释数据的科学。它是数据科学的核心。开始的最佳选择之一是 Pluralsight 的 统计学基础 课程。它涵盖了描述统计学和推断统计学。

编程语言

Python、R 和 Julia 是数据科学项目中流行的编程语言。每种语言都有其独特的优点。Python 是最受欢迎的数据科学语言,而 Julia 是最快的。推荐学习 核心 Python 课程来掌握 Python 语言。

R 语言是初学者、学术人员和领域专家的最佳选择。学习数据科学和像 Python 这样的通用语言同时进行会让人感到不知所措。R 语言作为数据科学语言,更容易掌握。它有良好的社区支持。

机器学习

机器学习是自动构建模型的科学。它是人工智能的一个子集。在掌握统计学和编程之后学习机器学习。书籍 线性代数与数据学习 涵盖了简单和高级的主题。它将线性代数与深度学习和神经网络结合起来进行讲解。

使用 R 学习数据科学 简介

针对特定主题的课程能很好地理解数据科学概念。能够在一个地方学习所有技能将是非常好的。

用 R 学习数据科学 涵盖统计学、基础数学、R 语言、可视化和机器学习算法。内容精准完整,书长达 250 页。

章节包括:

-

入门

-

统计学与 R

-

数学

-

数据整理

-

探索性数据分析

-

机器学习

-

机器学习类型

-

高级监督学习

-

实践项目

-

数据科学的应用案例

-

最终说明

撰写这本书对我来说是一次很棒的经历。该书在 Goodreads 和 LibraryThing 上获得了积极反馈。下载 电子书。希望你喜欢阅读,期待你的反馈。

简介: Narayana Nemani 目前担任首席数据科学家,参与数据科学的教学和研究。

相关:

更多相关内容

开源数据科学/机器学习生态系统的 6 个组成部分;Python 是否宣布击败了 R?

原文:

www.kdnuggets.com/2018/06/ecosystem-data-science-python-victory.html

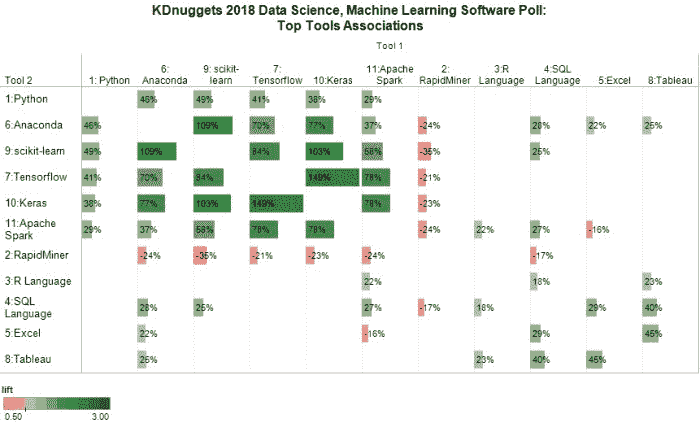

评论 在 5 月,我们报告了第 19 届 KDnuggets 软件调查的初步结果:Python 蚕食 R:2018 年分析、数据科学、机器学习的顶级软件:趋势与分析。

评论 在 5 月,我们报告了第 19 届 KDnuggets 软件调查的初步结果:Python 蚕食 R:2018 年分析、数据科学、机器学习的顶级软件:趋势与分析。

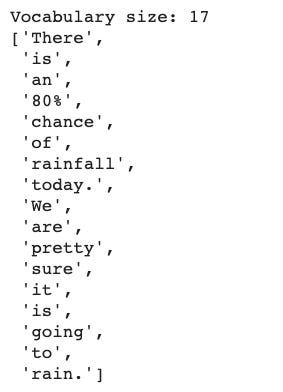

在这里,我们更详细地查看哪些工具能够很好地配合使用。我们去年确定的开源 Python 友好的数据科学工具新兴生态系统已有新成员 - 见下文。

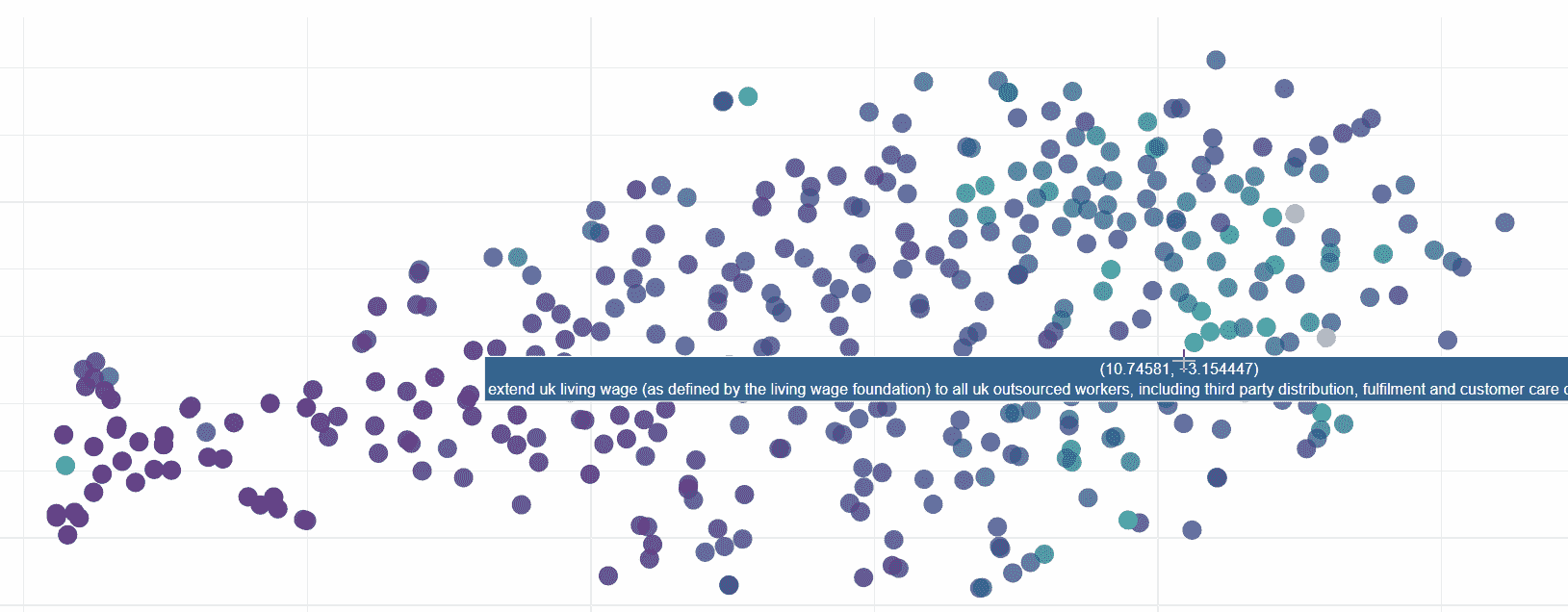

我们在文章末尾提供了一个匿名数据集的链接 - 请告诉我你在数据中发现了什么,并请发布或通过电子邮件将结果发给我。

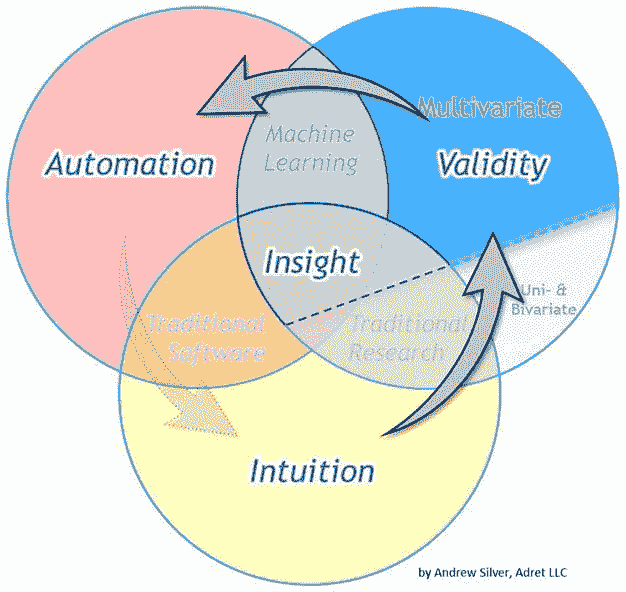

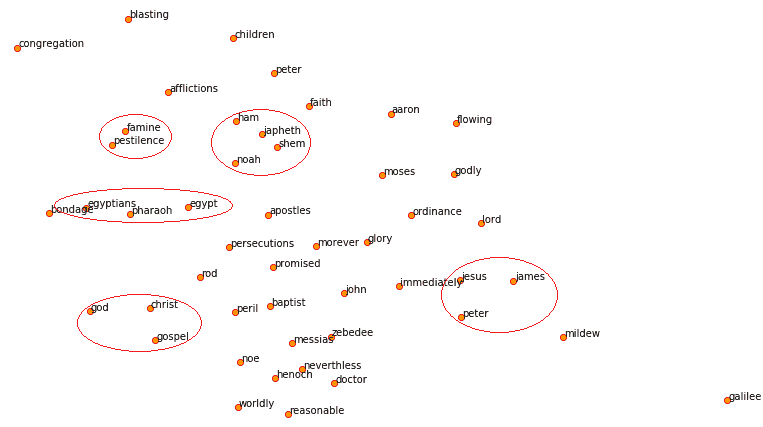

首先,我们查看哪些工具是相互配合的,为了使图表易于理解,我们选择了至少有 400 票的工具。共有 11 种这样的工具,这种选择也有意义,因为第 11 名(Apache Spark,有 442 票)与第 12 名(Java,309 票)之间存在较大差距。

有许多方法可以衡量两个二元特征之间关联的显著性,比如卡方检验或 T 检验,但我们使用了与我们的 2016 年分析和 2017 年分析相同的 Lift 度量。

然后,我们将关联最强的工具组合在一起,从 Tensorflow 和 Keras 开始,直到得到下面的图 1。为了减少杂乱,我们还过滤了图表,只显示 abs(Lift1) > 15%的关联。

图 1:数据科学、机器学习顶级工具关联,2018 年

条形长度对应于 lift1 的绝对值,颜色表示 lift 值(绿色:关联较强,红色:关联较弱)。工具前面的数字是它们在 KDnuggets 2018 软件调查中的排名,例如 Python 排名第 1,RapidMiner 排名第 2,等等。

我们注意到一组包含 6 种主要工具的现代开源数据科学生态系统,它们是:Python、Anaconda、scikit-learn、Tensorflow、Keras 和 Apache Spark。

Rapidminer 与上述所有工具有小的负相关,也没有与其他工具强烈关联。

R 与 Apache Spark、SQL 和 Tableau 有小的正相关。

另一个出现的组是 3 种支持数据科学和机器学习的工具,它们经常一起使用:SQL、Excel 和 Tableau。

我们注意到,虽然下面的图表相对于对角线是对称的(右上三角形与左下三角形相等),但在完整图表中,比在一半图表中更容易看到模式。

提升度定义:

提升度 (X & Y) = pct (X & Y) / ( pct (X) * pct (Y) )

其中 pct(X) 是选择 X 的用户百分比。

提升度 (X&Y) > 1 表示 X&Y 一起出现的频率高于它们独立时的预期频率,

如果 X 和 Y 的出现频率与它们独立时的预期频率相符,则提升度 = 1,并且

如果 X 和 Y 一起出现的频率低于预期,则提升度 < 1(负相关)

为了更容易观察差异,我们定义

提升度 1 (X & Y) = 提升度 (X & Y) - 1

Python 与 R

接下来我们比较 Python 与 R。

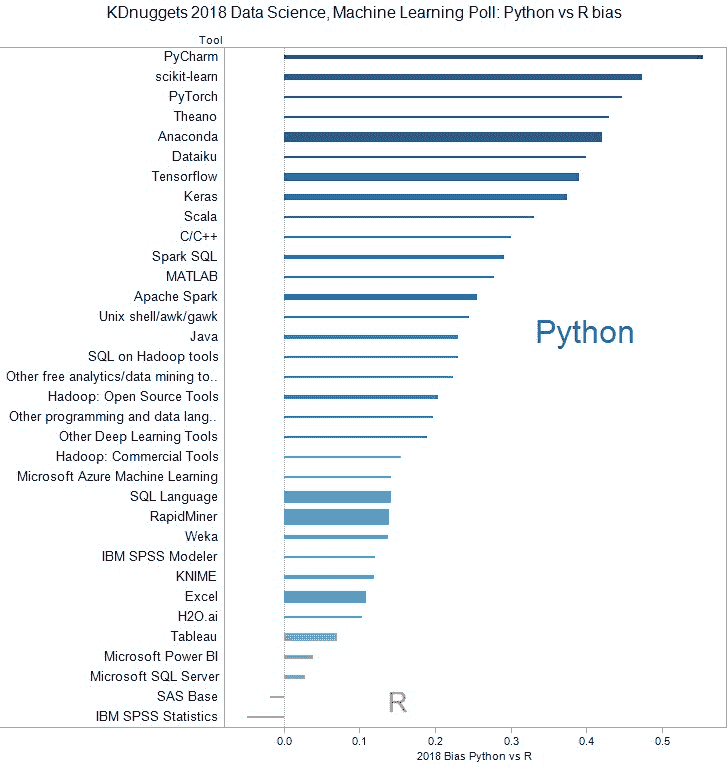

设 with_Py(X) = 使用 Python 的工具 X 的百分比,以及 with_R(X) 为使用 R 的工具 X 的百分比。为了可视化每个工具与 Python 或 R 的接近程度,我们使用了一个非常简单的度量 Bias_Py_R(X) = with_Py(X) - with_R(X),如果工具更常与 Python 一起使用则为正值,如果更常与 R 一起使用则为负值。

在图 2 中,我们绘制了最受欢迎的工具的偏见,这些工具至少获得了 100 票。正如我们所见,几乎所有工具都偏向于 Python。唯一的两个例外是 IBM SPSS Statistics 和 SAS Base。作为对比,在类似的 2017 年分析中,有 10 个这样的工具:SAS Base、Microsoft 工具、Weka、RapidMiner、Tableau 和 Knime,几乎所有这些工具的使用量都与 Python 一起增加。

图 2:KDnuggets 2018 数据科学、机器学习投票:Python 与 R 的偏见

图 2:KDnuggets 2018 数据科学、机器学习投票:Python 与 R 的偏见

Python 是否战胜了 R?

我认为不是这样,因为 R 是一个极其优秀的平台,具有巨大的深度和广度,广泛用于数据分析和可视化,它仍然占有约 50% 的市场份额。我预计 R 会被许多数据科学家使用很长时间,但未来,我期待 Python 生态系统会有更多的发展和活力。

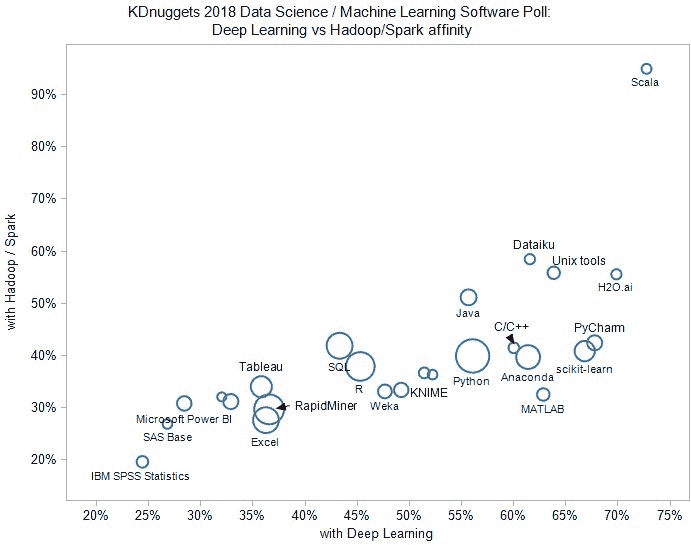

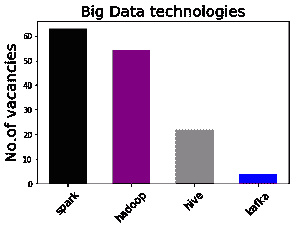

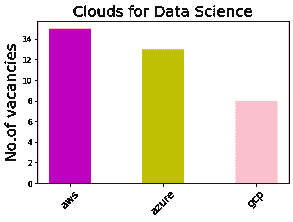

大数据与深度学习

大数据(Spark / Hadoop 工具)在 KDnuggets 2018 软件投票中被 33% 的受访者使用,这与 2017 年的比例完全相同。这表明,大多数数据科学家处理的是中小数据,不需要 Hadoop / Spark,或者他们使用的是其他云端解决方案。

然而,深度学习工具的比例从 32% 增长到了 43%。

对于每个工具 X,我们计算它与 Spark/Hadoop 工具的使用频率(纵轴),以及它与深度学习工具的使用频率(横轴)。

这是一个显示了顶级工具的图表(获得超过 100 票),排除了深度学习和大数据工具本身。

图 3:KDnuggets 2018 数据科学、机器学习投票:深度学习与 Spark/Hadoop 亲和度

图 3:KDnuggets 2018 数据科学、机器学习投票:深度学习与 Spark/Hadoop 亲和度

我们注意到 Scala 是在深度学习和大数据中最常用的语言。图表在左下角较重,几乎每个工具在深度学习中的使用频率都高于在大数据中的使用频率。

这是匿名调查数据的 CSV 格式链接,包含以下列

-

Nrand: 记录 ID(随机化,记录顺序与投票顺序无关)

-

region: usca: 美国/加拿大,euro: 欧洲,asia: 亚洲,ltam: 拉丁美洲,afme: 非洲/中东,aunz: 澳大利亚/新西兰

-

Python: 如果 Votes(最后一列)中包含 Python,则为 1,否则为 0。

-

RapidMiner: 如果 Votes 中包含 RapidMiner,则为 1,否则为 0。

-

R language: 如果 Votes 中包含“R Language”,则为 1,否则为 0。我们使用“R Language”而不是 R,以便更容易进行正则表达式匹配。

-

SQL Language: 如果 Votes 中包含“SQL Language”,则为 1,否则为 0。

-

Excel: 如果 Votes 中包含 Excel,则为 1,否则为 0。

-

Anaconda: 如果 Votes 中包含 Anaconda,则为 1,否则为 0。

-

Tensorflow: 如果 Votes 中包含 Tensorflow,则为 1,否则为 0。

-

Tableau: 如果 Votes 中包含 Tableau,则为 1,否则为 0。

-

scikit-learn: 如果 Votes 中包含 scikit-learn,则为 1,否则为 0。

-

Keras: 如果 Votes 中包含 KNIME,则为 1,否则为 0。

-

Apache Spark: 如果 Votes 中包含 Apache Spark,则为 1,否则为 0。

-

With DL: 如果 Votes 中包含深度学习工具,则为 1,否则为 0。

-

With BD: 如果 Votes 中包含大数据工具,则为 1,否则为 0。

-

ntools: Votes 中的工具数量

-

Votes: 投票列表,用分号“;”分隔

请告诉我你的发现!

相关:

-

Python 蚕食 R:2018 年分析、数据科学、机器学习的顶级软件:趋势与分析。

-

新兴生态系统:数据科学和机器学习软件分析,2017 年

-

分析、数据科学、机器学习软件的最新领导者、趋势和惊喜调查,2017 年

更多相关内容

EDISON 数据科学框架用于定义数据科学职业

原文:

www.kdnuggets.com/2016/10/edison-data-science-framework.html

作者:Yuri Demchenko,阿姆斯特丹大学,荷兰

摘要

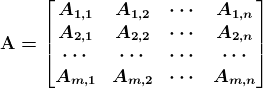

数据科学技术的有效使用需要新的能力和技能,并要求新的职业来支持研究数据生命周期的所有阶段,从数据生产和输入到数据处理、存储以及获得的科学结果的发布和传播。本文介绍了 EDISON 数据科学框架(EDSF),包括建立未来数据科学专业人员可持续毕业和培训所需的概念性、指导性和政策性组件。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

介绍

现代研究需要新的专业人员,这些人员能够支持研究数据生命周期的所有阶段,从数据生产和输入到数据处理、存储以及科学结果的发布和传播,这些可以统称为数据科学职业系列。未来的数据科学家必须具备数据挖掘与分析、信息可视化与沟通、统计学、工程学和计算机科学等方面的知识(并获得相关的能力和技能),并在未来的工作和专业领域中积累经验。尽管数据科学家是数据相关职业系列中的关键职业,其他职业则专注于数据生命周期的其他阶段和支持基础设施。

文章描述了所提出的 EDISON 数据科学框架(EDSF)的主要组件,该框架作为定义数据科学职业系列的基础。还提供了有关数据科学能力框架(CF-DS)和数据科学知识体系(DS-BoK)的更多详细信息,这些对于定义一致且可定制的数据科学课程至关重要。

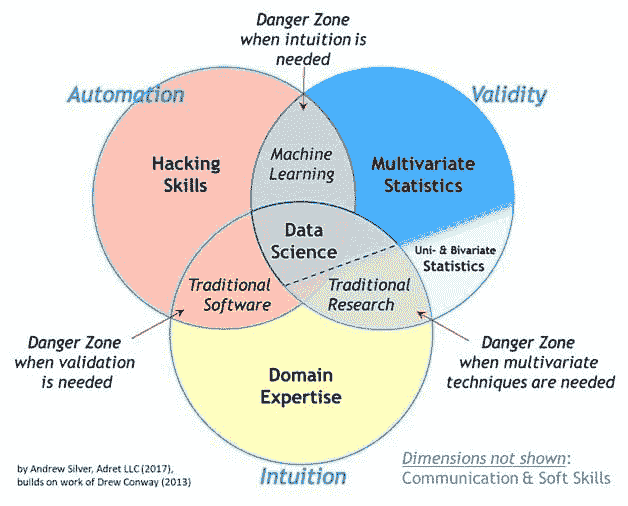

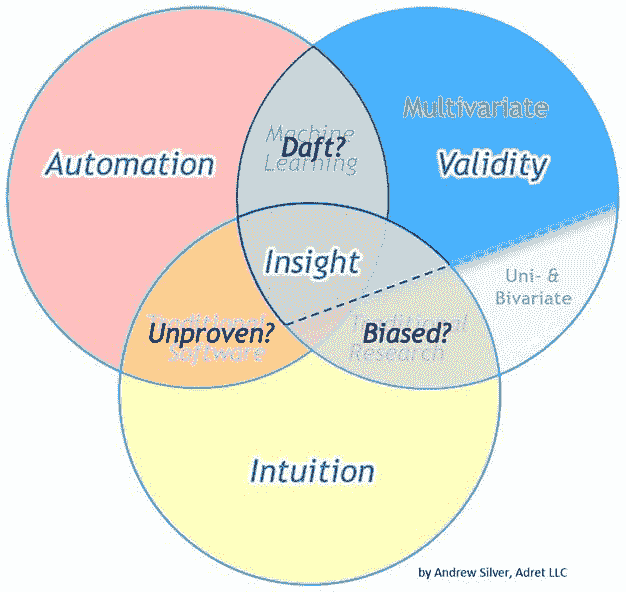

EDISON 数据科学框架

图 1 下方展示了 EDISON 数据科学框架(EDSF)的主要组件,这些组件为数据科学职业的发展提供了概念基础(包括对相关文档的参考):

-

CF-DS – 数据科学能力框架(CF-DS,2016)

-

DS-BoK – 数据科学知识体系(DS-BoK,2016)

-

MC-DS – 数据科学模型课程(MC-DS, 2016)

-

DSP – 数据科学专业档案和职业分类(DSP, 2016)

-

数据科学分类法和科学学科分类

提出的框架为数据科学专业生态系统的其他组成部分提供了基础,例如

-

EDISON 在线教育环境(EOEE)

-

教育和培训市场及目录

-

数据科学社区门户(CP),还包括个别能力基准测试和个性化教育路径构建的工具

核心数据科学能力和专业档案的认证框架

图 1: EDISON 数据科学框架组成部分。

数据科学能力框架和知识体系

数据科学能力框架(CF-DS)是 EDISON 数据科学框架的基石,并用于定义数据科学知识体系(DS-BoK)和数据科学模型课程(MC-DS)等组成部分。CF-DS 的定义符合欧洲电子能力框架(e-CF3.0),并提供了将数据科学相关能力和技能扩展到 e-CF3.0 的建议。

图 2 说明了主要的 CF-DS 能力组及其相互关系:

-

数据分析,包括统计方法、机器学习和业务分析

-

工程:软件和基础设施

-

学科/科学领域能力和知识

-

数据管理、整理、保存

-

科学或研究方法(针对研究职业)和业务流程管理(针对业务相关职业)

确定的能力领域为定义数据科学相关工作的教育和培训项目、技能再培训和专业认证提供了更好的基础。对科学研究方法和技术的了解使数据科学家职业不同于所有以往的职业。

数据管理和研究方法(或业务流程管理)被放置在两个外圈,以强调这些能力和知识是所有数据科学专业人员所需的。建议在所有数据科学课程中都包括数据管理(或特别是研究数据管理)和研究方法。

(a)数据科学能力组(针对一般或研究导向的职业)。

(b)面向业务的职业的数据科学能力组。

图 2: 确定的数据科学能力组之间的关系,分为(a)一般或研究导向和(b)商业导向的职业/角色

CF-DS 为数据科学知识体系(DS-BoK)的定义提供了基础,该知识体系涵盖了专业人员执行其职业所有数据相关过程所需的知识。知识体系通常定义了课程内容,并通过可以为特定学员组定义的学习成果与 CF-DS 相关联。

数据科学知识体系与模型课程

根据 CF-DS 能力组定义,DS-BoK 应包含以下知识领域组 (KAG):

-

KAG1-DSDA: 数据分析组,包括机器学习、统计方法和商业分析

-

KAG2-DSENG: 数据科学工程组,包括软件和基础设施工程

-

KAG3-DSDM: 数据管理组,包括数据策展、数据保存和数据基础设施

-

KAG4-DSRM: 科学或研究方法组

-

KAG5-DSBP: 业务流程管理组

高校可以使用 DS-BoK 作为参考,定义他们需要在课程中覆盖的知识领域,这取决于他们在研究或行业中的主要需求组。领域特定的知识可以作为学术教育的一部分或作为研究生的专业培训在工作场所获得。普遍认为,“新鲜”的数据科学家需要 2-3 年才能熟练掌握其职业技能。

提出的数据科学模型课程为构建可定制的数据科学课程提供了两个基本组件:(1)基于 CF-DS 能力定义学习成果(LO),包括不同熟练程度的区分,例如使用布卢姆分类法,(2)定义映射到目标职业组学习成果的学习单元(LU),这些单元需要根据现有的学术学科分类,如计算机科学分类(CCS,2012),来定义。

进一步发展

所展示的 EDSF 包括由供应和需求双方的主要利益相关者实施的组件:大学、职业培训机构、标准化机构、认证和认证机构、公司及其人力资源部门,以成功管理数据相关工作的能力和职业发展。提出的 DS-CF 已在众多研讨会和社区论坛上广泛讨论。它已经被少数与 EDISON 项目相关的机构使用。发布的供公众评论的 DS-BoK 和 MC-DS 文档将需要进一步的开发和专家验证,以定义具体的知识领域。这将通过涉及相关知识领域的专家,并与 IEEE、ACM、DAMA、IIBA 等专业社区合作来完成。该项目将与合作伙伴和领先大学一起进行 DS-BoK 和 MC-DS 的试点实施,并收集从业者的反馈。所有 EDISON 项目产品均在创意共享许可下公开提供。

致谢

EDISON 项目在 H20202 资助协议编号 675419 下由欧洲委员会支持。本文是 SciDataCon2016 会议论文的更新版,最初发布于 www.scidatacon.org/2016/sessions/98/poster/75/

简介: 是阿姆斯特丹大学系统与网络工程领域的高级研究员。他的主要研究领域包括大数据和数据密集型技术、电子科学、云计算和跨云架构、基于云的服务设计、一般安全架构以及面向云服务和数据中心应用的分布式访问控制基础设施。他负责协调欧洲资助的 EDISON 项目,该项目旨在为欧洲研究和工业建立数据科学职业的基础。

参考文献

Andrea Manieri 等, 2015,《数据科学专业揭秘:EDISON 项目如何促进数据科学家广泛认可的职业形象》,发表于第七届 IEEE 国际云计算技术与科学会议(CloudCom2015)的论文集中,2015 年 11 月 30 日至 12 月 3 日,加拿大温哥华

CCS, 2012,2012 年 ACM 计算分类系统 [在线] www.acm.org/about/class/class/2012

CF-DS, 2016,《数据科学能力框架(CF-DS)》。EDISON 草稿 V0.6,2016 年 3 月 10 日 [在线] www.edison-project.eu/data-science-competence-framework-cf-ds

Demchenko, Y., E.Gruengard, S.Klous, 2014, 构建有效的大数据课程的教学模型。 见于第 6 届 IEEE 国际云计算技术与科学会议及研讨会 (CloudCom2014),2014 年 12 月 15-18 日,新加坡

DS-BoK, 2016, 数据科学知识体系 (DS-BoK)。EDISON 草稿 V0.1,2016 年 3 月 20 日 [在线] www.edison-project.eu/data-science-body-knowledge-ds-bok

DSP, 2016, 数据科学专业档案定义 (CF-DS)。EDISON 草稿 v0.1,2016 年 7 月 11 日 [在线] www.edison-project.eu/data-science-professional-profiles-dsp

eCFv3.0, 2014, 欧洲 e-能力框架 3.0。适用于所有行业领域的 ICT 专业人员的共同欧洲框架。CWA 16234:2014 第一部分 [在线] ecompetences.eu/wp-content/uploads/2014/02/European-e-Competence-Framework-3.0_CEN_CWA_16234-1_2014.pdf

EDISON 项目:构建数据科学职业 [在线] www.edison-project.eu/

ESCO, 2016, ESCO (欧洲技能、能力、资格和职业) 框架 [在线] ec.europa.eu/esco/portal/#modal-one

MC-DS, 2016, 数据科学模型课程 (MC-DS),EDISON 草稿 v0.1,2016 年 6 月 11 日 [在线] www.edison-project.eu/data-science-model-curriculum-mc-ds

NIST, 2015, NIST SP 1500-1 NIST 大数据互操作框架 (NBDIF):第 1 卷:定义,2015 年 9 月 [在线] nvlpubs.nist.gov/nistpubs/SpecialPublications/NIST.SP.1500-1.pdf

相关:

-

分析、大数据、数据科学、机器学习的证书与认证

-

分析、数据挖掘和数据科学的证书

-

分析、数据科学、机器学习的教育

更多相关主题

高效的小型语言模型:微软的 13 亿参数 phi-1.5

原文:

www.kdnuggets.com/effective-small-language-models-microsoft-phi-15

图片来源:作者

当你以为你已经听够了有关大型语言模型(LLMs)的新闻时,微软研究院再次搅动了市场。2023 年 6 月,微软研究院发布了一篇名为 “教材就是你所需的一切” 的论文,在其中他们介绍了 phi-1,一个新的大型代码语言模型。phi-1 是一个基于 Transformer 的模型,具有 13 亿参数,在 8 个 A100 GPU 上训练了 4 天,使用了来自网络的“教科书质量”数据。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你在 IT 领域的组织

3. Google IT 支持专业证书 - 支持你在 IT 领域的组织

看来 LLM 正变得越来越小。

什么是 phi-1.5?

现在,微软研究院向你介绍 phi-1.5,这是一个具有 13 亿参数的 Transformer,它使用了与 phi-1 相同的数据来源进行训练。如上所述,phi-1 在高质量的教科书数据上进行训练,而 phi-1.5 仅在合成数据上进行训练。

phi-1.5 使用了 32xA100-40G GPU,并在 8 天内成功训练完成。phi-1.5 的目标是打造一个开源模型,它可以在研究社区中发挥作用,使用一个不受限制的小型模型,这样可以探索与 LLM 相关的不同安全挑战,例如减少有害内容、增强可控性等。

通过使用‘合成数据生成’方法,phi-1.5 在自然语言测试中的表现相当于规模大 5 倍的模型,并且在更困难的推理任务中表现优于大多数 LLM。

相当令人印象深刻,对吧?

该模型的学习过程非常有趣。它从多种来源获取数据,包括 StackOverflow 上的 Python 代码片段、合成的 Python 教科书以及由 GPT-3.5-turbo-0301 生成的练习。

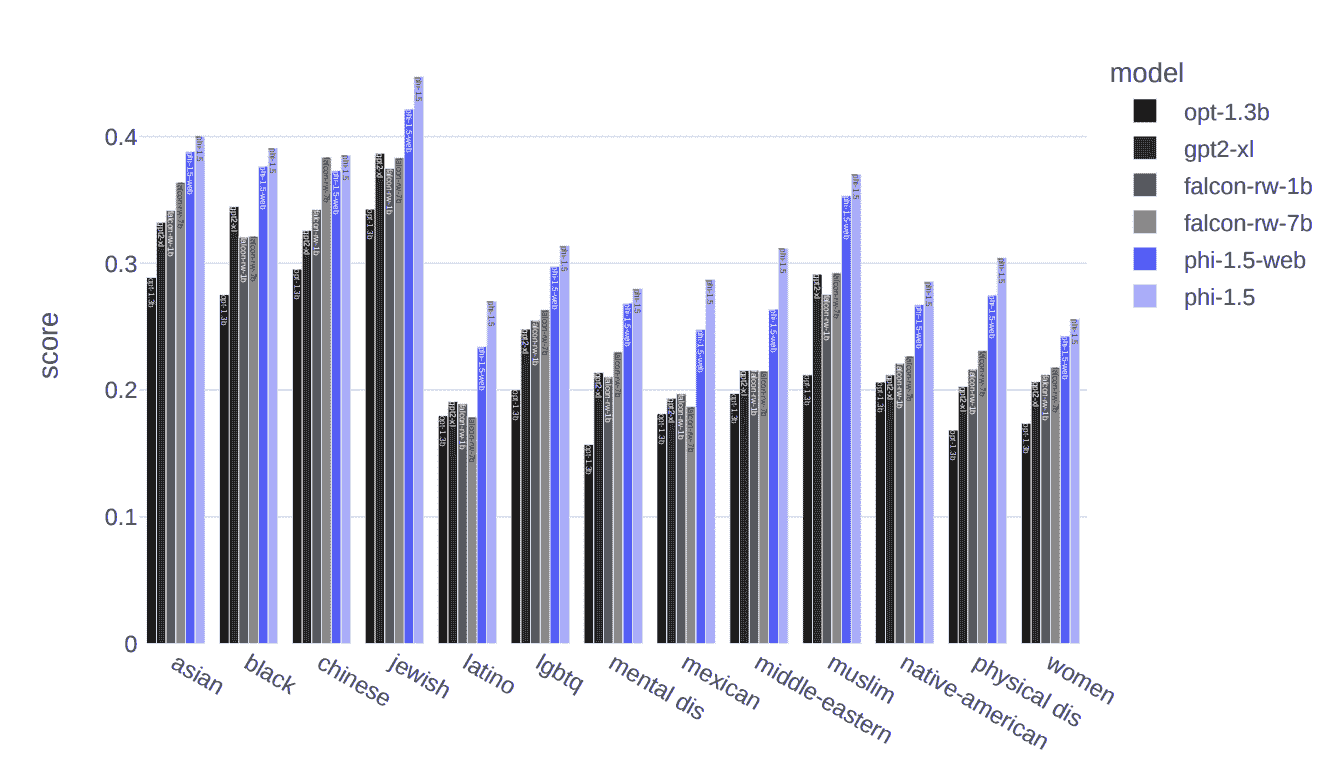

处理有害内容和偏见

LLM 的一个主要挑战是有害内容和偏见内容。微软研究院旨在克服这一持续挑战,即有害/冒犯性内容和推广特定意识形态的内容。

用于训练模型的合成数据生成的响应,相较于其他 LLMs 如 Falcon-7B 和 Llama 2–7B,生成有害内容的倾向较低,如下图所示:

图片来源于教科书就是你所需的 II:phi-1.5 技术报告

基准测试

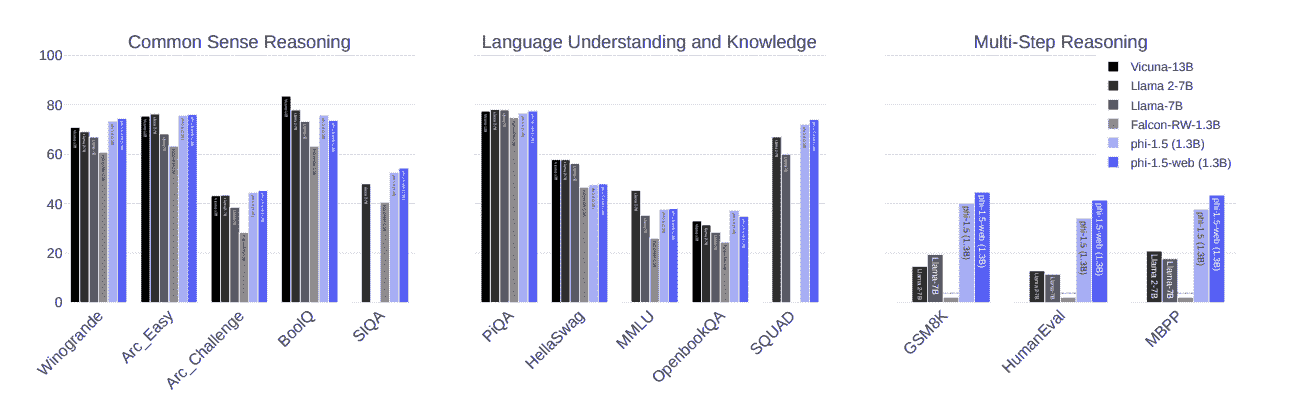

下图展示了 phi-1.5 在 3 个基准测试中表现略优于最先进的模型,如 Llama 2–7B、Llama-7B 和 Falcon-RW-1.3B,测试包括常识推理、语言技能和多步骤推理。

图片来源于教科书就是你所需的 II:phi-1.5 技术报告

这是怎么做的?

教科书式的数据使用方式使得 LLMs 中对这种数据的使用与从互联网提取的数据有所不同。为了进一步评估模型如何处理有害内容,使用了 ToxiGen,并设计了 86 个提示,手动标记为“通过”、“失败”或“未理解”,以更好地了解模型的局限性。

也就是说,phi-1.5 通过了 47 个提示,失败了 34 个提示,并且没有理解 4 个提示。使用 HumanEval 方法评估模型的结果显示,phi-1.5 的评分高于其他知名模型。

主要收获:

以下是你应该了解的关于 phi-1.5 的主要要点:

-

是一个基于 transformer 的模型

-

是一个专注于下一个词预测目标的 LLM

-

经过了 300 亿个 token 的训练

-

使用了 32xA100-40G GPUs

-

成功在 8 天内完成训练

Nisha Arya 是一位数据科学家、自由技术撰稿人以及 KDnuggets 的社区经理。她特别感兴趣于提供数据科学职业建议或教程和理论知识。她还希望探索人工智能如何能够或已经在延长人类寿命方面发挥作用。她是一个热衷学习的人,寻求拓宽技术知识和写作技能,同时帮助指导他人。

更多相关话题

机器学习的有效测试

原文:

www.kdnuggets.com/2022/01/effective-testing-machine-learning.html我们在PyData Global 2021上展示了这个博客系列的简短版本。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的捷径。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

本博客系列描述了一种我在过去几年中开发的策略,用于有效测试机器学习项目。鉴于机器学习项目的不确定性,这是一种逐步的策略,你可以随着项目的成熟而采纳;它包括测试示例,以提供这些测试在实践中的清晰概念,并且完整的项目实现可在 GitHub 上获取。到文章末尾,你将能够开发出更强健的机器学习管道。

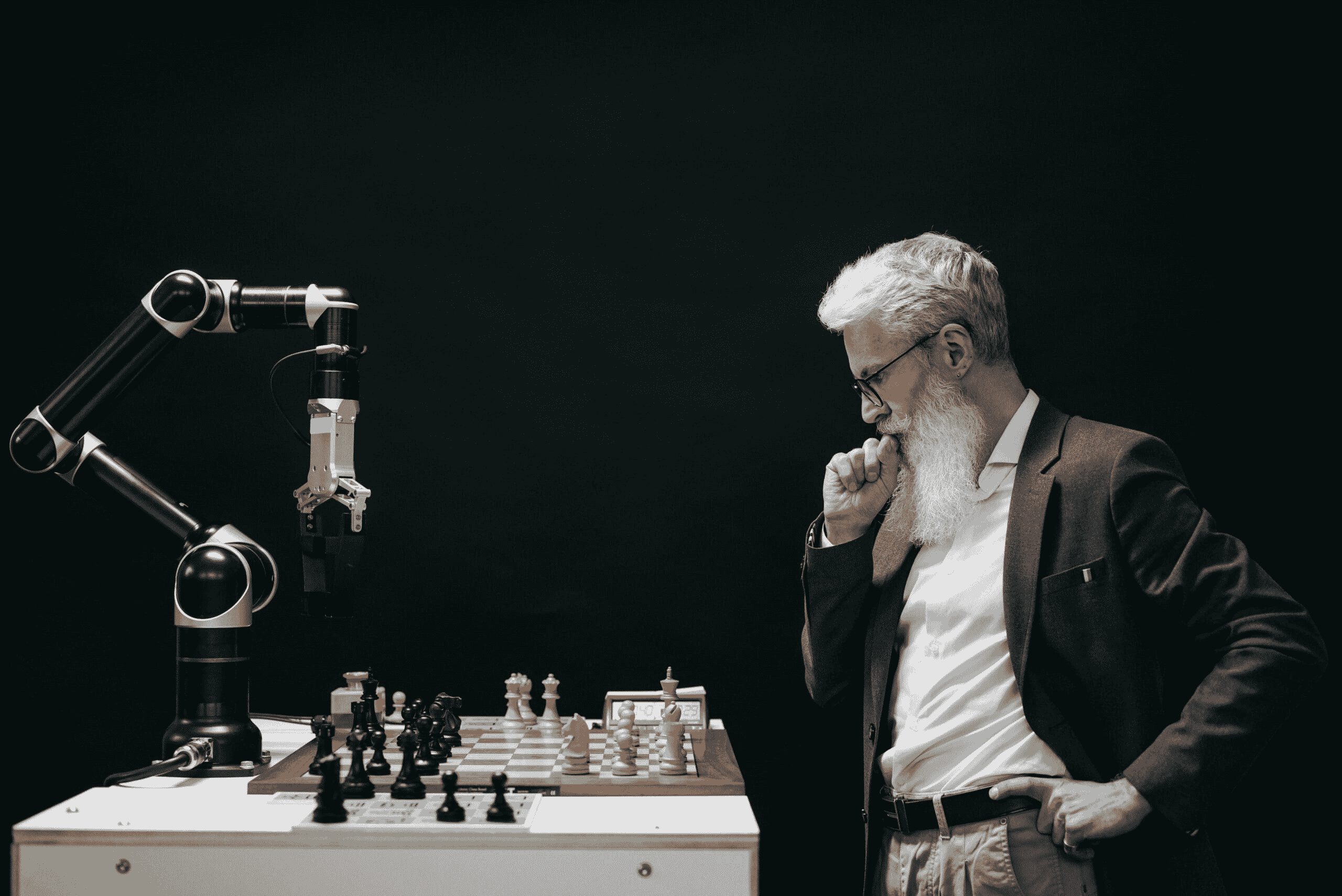

测试机器学习项目的挑战

测试机器学习项目是具有挑战性的。训练一个模型是一个长时间运行的任务,可能需要数小时,并且具有非确定性的输出,这与我们测试软件所需的快速和确定性过程正好相反。一年前,我发布了一篇关于测试数据密集型项目的帖子,以使持续集成成为可能。我后来将这篇博客文章转化为演讲,并在PyData 2020上进行了展示。但之前的工作仅涵盖了数据管道测试的通用方面,并没有涉及机器学习模型的测试。

需要明确的是,测试和监控是两回事。测试是一个离线过程,允许我们评估代码是否按预期工作(即,生成高质量的模型)。相反,监控涉及检查已部署的模型,以确保它正常工作。因此,测试发生在部署之前;监控发生在部署之后。

我在本文中使用了pipeline 和 task 这两个术语。任务是一个工作单元(通常是一个函数或脚本);例如,一个任务可以是下载原始数据的脚本,另一个任务可以是清理这些数据。另一方面,管道只是按预定义顺序执行的一系列任务。构建由小任务组成的管道的动机是使我们的代码更具可维护性和更易于测试;这与我们开源框架的目标一致,旨在帮助数据科学家使用 Jupyter 构建更具可维护性的项目。在接下来的部分中,你将看到一些示例 Python 代码;我们使用pytest、pandas 和Ploomber。

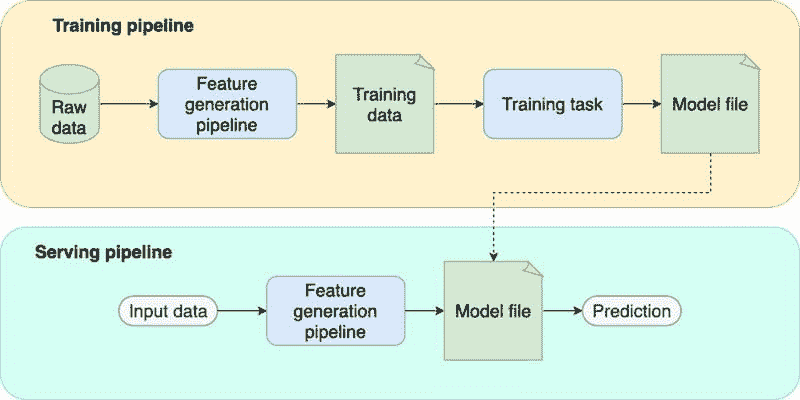

机器学习管道的各个部分

在我们描述测试策略之前,让我们分析一个典型的 ML 管道的样子。通过分别分析每个部分,我们可以清楚地阐明其在项目中的作用,并相应地设计测试策略。一个标准的 ML 管道具有以下组件:

-

特征生成管道。 一系列计算,用于处理原始数据并将每个数据点映射到特征向量。请注意,我们在训练和服务时都会使用这个组件。

-

训练任务。 接收训练集并生成模型文件。

-

模型文件。 来自训练任务的输出。它是一个包含学习到的参数的单一文件。此外,它可能包括预处理程序,如缩放或独热编码。

-

训练管道。 封装了训练逻辑:获取原始数据,生成特征,并训练模型。

-

服务管道。(也称为推理管道)封装了服务逻辑:获取新观察值,生成特征,通过模型传递特征,并返回预测结果。

可能会出什么问题?

为了激励我们的测试策略,让我们列举每个部分可能出现的问题:

特征生成管道

-

无法运行管道(例如,设置问题、代码损坏)。

-

无法重现之前生成的训练集。

-

管道生成低质量的训练数据。

训练任务

-

无法训练模型(例如,缺少依赖项、代码损坏)。

-

使用高质量数据运行训练任务生成低质量模型。

模型文件

-

生成的模型质量低于我们当前生产中的模型。

-

模型文件与服务管道集成不正确。

服务管道

-

无法提供预测(例如,缺少依赖项、代码损坏)。

-

训练和服务时的预处理不匹配(即训练-服务偏差)。

-

传入无效原始数据时输出预测。

-

传入有效数据时崩溃。

请注意,这不是一个详尽的列表,但涵盖了最常见的问题。根据你的使用情况,可能还有其他潜在问题,重要的是列出它们以便定制你的测试策略。

测试策略

在开发机器学习模型时,我们迭代的速度越快,成功的机会就越大。与传统的软件工程项目不同(例如,注册表单),机器学习项目存在很多不确定性:使用哪些数据集?尝试哪些特征?使用什么模型?由于我们事先不知道这些问题的答案,我们必须尝试一些实验并评估它们是否产生更好的结果。由于这种不确定性,我们必须在迭代速度和测试质量之间取得平衡。如果我们迭代 太快,可能会编写粗糙的代码;如果我们花太多时间彻底测试每一行代码,就无法足够快地改进我们的模型。

这个框架稳步提高你的测试质量。策略包括五个层级;当达到最后一层时,你的测试已经足够健壮,可以自信地将新的模型版本推送到生产环境。

测试层级

-

冒烟测试。 我们通过在每次

git push时运行代码来确保其正常工作。 -

集成测试和单元测试。 测试任务的输出和数据转换。

-

分布变化和服务管道。 测试数据分布的变化以及测试我们能否加载模型文件并进行预测。

-

训练与服务偏差。 测试训练和服务逻辑的一致性。

-

模型质量。 测试模型质量。

简要介绍如何使用 pytest 进行测试

如果你之前使用过 pytest,可以跳过此部分。

测试是检查我们的代码是否正常工作的短程序。例如:

# test_math.py

from my_math_project import add, subtract

def test_add():

assert add(1, 1) == 2

def test_subtract():

assert subtract(43, 1) == 42

测试是一个运行一些代码并 断言 其输出的函数。例如,上一个文件有两个测试:test_add 和 test_substract,组织在一个名为 test_math.py 的文件中;通常每个模块一个文件(例如,test_math.py 测试 math.py 模块中的所有函数)。测试文件通常放在 tests/ 目录下:

tests/

test_math.py

test_stuff.py

...

test_other.py

测试框架如 pytest 允许你收集所有测试,执行它们并报告哪些测试失败,哪些测试成功:

# collect rests, run them, and report results

pytest

一个典型的项目结构如下:

src/

exploratory/

tests/

src/ 包含你项目的管道任务和其他实用函数。exploratory/ 包含探索性笔记本,你的测试放在 tests/ 目录中。src/ 中的代码必须可以从其他两个目录中导入。实现这一点的最简单方法是 打包你的项目。否则,你需要处理 sys.path 或 PYTHONPATH。

如何导航示例代码

示例代码可在 这里找到。该仓库有五个分支,每个分支实现了我将在接下来的部分中描述的测试级别。由于这是一种渐进策略,你可以通过从 第一个分支开始,逐步查看项目的演变。

该项目使用了 Ploomber,我们的开源框架来实现管道。因此,你可以在pipeline.yaml文件中查看管道规格。要查看我们用于测试管道的命令,请打开 .github/workflows/ci.yml,这是一个 GitHub Actions 配置文件,用于告诉 GitHub 在每次git push时运行特定的命令。

虽然不是严格必要的,但你可能会想查看我们的 Ploomber 入门教程以了解基本概念。

请注意,本博客文章中显示的代码片段是通用的(它们不使用任何特定的管道框架),因为我们想要用一般术语解释概念;然而,仓库中的示例代码使用了 Ploomber。

一级:冒烟测试

冒烟测试是最基本的测试级别,应在你开始项目时立即实施。冒烟测试不会检查代码的输出,只会确保它能够运行。虽然这看起来过于简单,但比完全没有测试要好得多。

记录依赖项

列出外部依赖项是启动任何软件项目的第一步,因此在创建你的 虚拟环境时,确保记录运行项目所需的所有依赖项。例如,如果使用pip,你的requirements.txt文件可能如下所示:

ploomber

scikit-learn

pandas

创建虚拟环境后,创建另一个文件(requirements.lock.txt)来记录所有依赖项的已安装版本。你可以使用pip freeze > requirements.lock.txt命令(在运行pip install -r requirements.txt后执行)生成类似如下内容的文件:

ploomber==0.13

scikit-learn==0.24.2

pandas==1.2.4

# more packages required by your dependencies...

记录具体的依赖项版本可以确保这些包的更改不会破坏你的项目。

另一个重要的考虑因素是将你的依赖列表保持尽可能简短。通常,你在开发时需要一组依赖项,但在生产环境中不需要。例如,你可能会使用matplotlib进行模型评估图,但在进行预测时不需要它。强烈建议将开发和部署的依赖项分开。依赖项过多的项目增加了遇到版本冲突的风险。

测试特性生成管道

你项目的第一个里程碑必须是获得一个端到端的特征生成管道。编写一些代码来获取原始数据,进行一些基本清洗,并生成一些特征。一旦你有了一个完整的端到端流程,你必须确保它是可重复的:删除原始数据,并检查你是否可以重新运行该流程并获得相同的训练数据。

一旦你有了这个,就可以实施第一个测试;用原始数据的一个样本(比如 1%)运行管道。目标是使这个测试运行快速(不超过几分钟)。你的测试应如下所示:

from my_project import generate_features_and_label

def test_generate_training_set():

my_project.generate_features_and_label(sample=True)

请注意,这只是一个基本测试;我们没有检查管道的输出!然而,这个简单的测试允许我们检查代码是否运行。每当我们执行git push时,运行此测试是至关重要的。如果你使用 GitHub,可以通过GitHub Actions完成,其他 git 平台也有类似功能。

测试训练任务

在生成特征后,你会训练一个模型。训练任务接受一个训练集作为输入,并输出一个模型文件。测试模型训练过程具有挑战性,因为我们不能轻易定义给定某些输入(训练集)的期望输出(模型文件)——主要因为我们的训练集变化迅速(即添加、删除特征)。因此,在这个阶段,我们的第一个测试只检查任务是否运行。由于我们暂时忽略输出,我们可以使用数据样本来训练模型;记住,这个冒烟测试必须在每次推送时执行。因此,让我们扩展之前的示例,以涵盖特征生成和模型训练:

from my_project import generate_features_and_label, train_model

def test_train_model():

# test we can generate features

X, y = my_project.generate_features_and_label(sample=True)

# test we can train a model

model = train_model(X, y)

在示例代码库中,我们使用 Ploomber,因此我们通过调用ploomber build来测试功能管道和训练任务,这会执行管道中的所有任务。

第二级:集成测试和单元测试

将管道模块化为小任务,以便我们可以单独测试输出,这一点至关重要。在实现了第二个测试级别后,你将实现两件事:

-

确保用于训练模型的数据达到最低质量水平。

-

分别测试代码中行为定义明确的部分。

让我们讨论第一个目标。

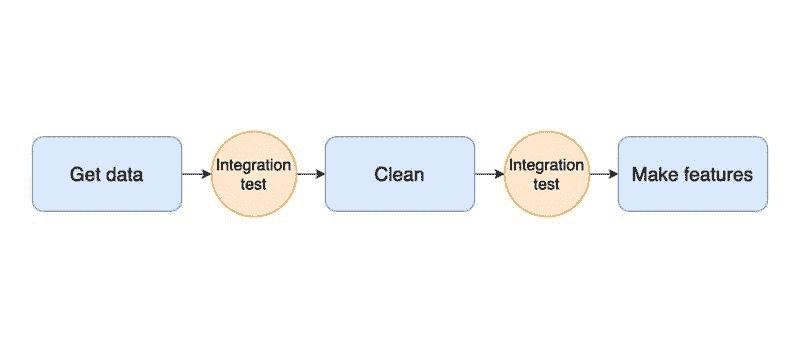

集成测试

测试数据处理代码是复杂的,因为其目标是主观的。例如,假设我让你测试一个接受数据框并清洗它的函数。你会如何测试?数据清洗的目的是提高数据质量。然而,这样的概念依赖于数据的具体情况和你的项目。因此,你需要定义清洁数据的概念,并将其转化为集成测试,尽管在这种情况下,我们可以使用数据质量测试这一术语来更精确。

集成测试的理念适用于管道中的所有阶段:从下载数据到生成特征:你需要定义每个阶段的期望。我们可以在下图中看到集成测试的图形表示:

例如,要为数据清理函数(我们称之为clean)添加集成测试,我们在函数体的末尾运行一些检查来验证其输出质量。常见的检查包括没有空值、数值列在预期范围内或分类值在预定义的值集合中:

def clean(df)

# clean data frame with raw data

# ...

# ...

# integration test: check age column has a minimum value of 0

assert df.age.min() > 0

这种测试形式与我们在第一部分介绍的测试有所不同。单元测试存在于tests/文件夹中并可以独立运行,但集成测试在你执行训练管道时运行。 失败的测试意味着你的数据假设不成立,需要重新定义数据假设(这意味着需要相应地更新测试),或者你的清理程序应更改以确保测试通过。

你可以通过在每个任务结束时添加断言语句来编写集成测试,而不需要额外的框架。然而,一些库可以提供帮助。例如,Ploomber 支持在任务完成时运行一个函数。

这是实现示例的集成测试在我们的样本代码库中。

单元测试

在你的每个任务中(例如,clean内部),你可能会有更小的例程;这些代码部分应作为独立函数编写并进行单元测试(即,在tests/目录中添加测试)。

编写单元测试的一个良好候选场景是对列中的单个值进行转换。例如,假设你正在使用心脏病数据集,并创建一个函数将chest_pain_type分类列中的整数映射到其对应的可读值。你的clean函数可能如下所示:

import transform

def clean(df):

# some data cleaning code...

# ...

df['chest_pain_type'] = transform.chest_pain_type(df.chest_pain_type)

# ...

# more data cleaning code...

与一般的clean过程不同,transform.chest_pain_type具有明确的、客观定义的行为:它应将整数映射到对应的可读值。我们可以通过指定输入和预期输出将其转化为单元测试。

def test_transform_chest_pain_type():

# sample input

series = pd.Series([0, 1, 2, 3])

# expected output

expected = pd.Series([

'typical angina',

'atypical angina',

'non-anginal pain',

'asymptomatic',

])

# test

assert transform.chest_pain_type(series).equals(expected)

单元测试必须在所有即将到来的测试级别上持续进行。因此,每当你遇到具有明确目标的逻辑时,将其抽象成函数并单独测试。

这是一个实现示例的单元测试在样本代码库中。

接下来

到目前为止,我们已经实施了一种基本策略,确保我们的特征生成管道生成的数据具有最低质量标准(集成测试或数据质量测试),并验证数据转换的正确性(单元测试)。在本系列的下一部分中,我们将添加更强大的测试:测试分布变化,确保我们的训练和服务逻辑一致,并检查我们的管道是否生成高质量的模型。

如果你想知道第二部分何时发布,请订阅我们的 新闻通讯,关注我们的 Twitter 或 LinkedIn。

爱德华多·布兰卡斯 是 Ploomber 的联合创始人之一。Ploomber 是一家获得 Y Combinator 资助的公司,帮助数据科学家快速构建数据管道。我们通过允许他们开发模块化管道并在任何地方部署它们来实现这一目标。在此之前,他是 Fidelity Investments 的数据科学家,负责部署首个面向客户的资产管理机器学习模型。爱德华多拥有哥伦比亚大学的数据科学硕士学位和蒙特雷科技大学的机电工程学士学位。

原文。经许可转载。

更多相关主题

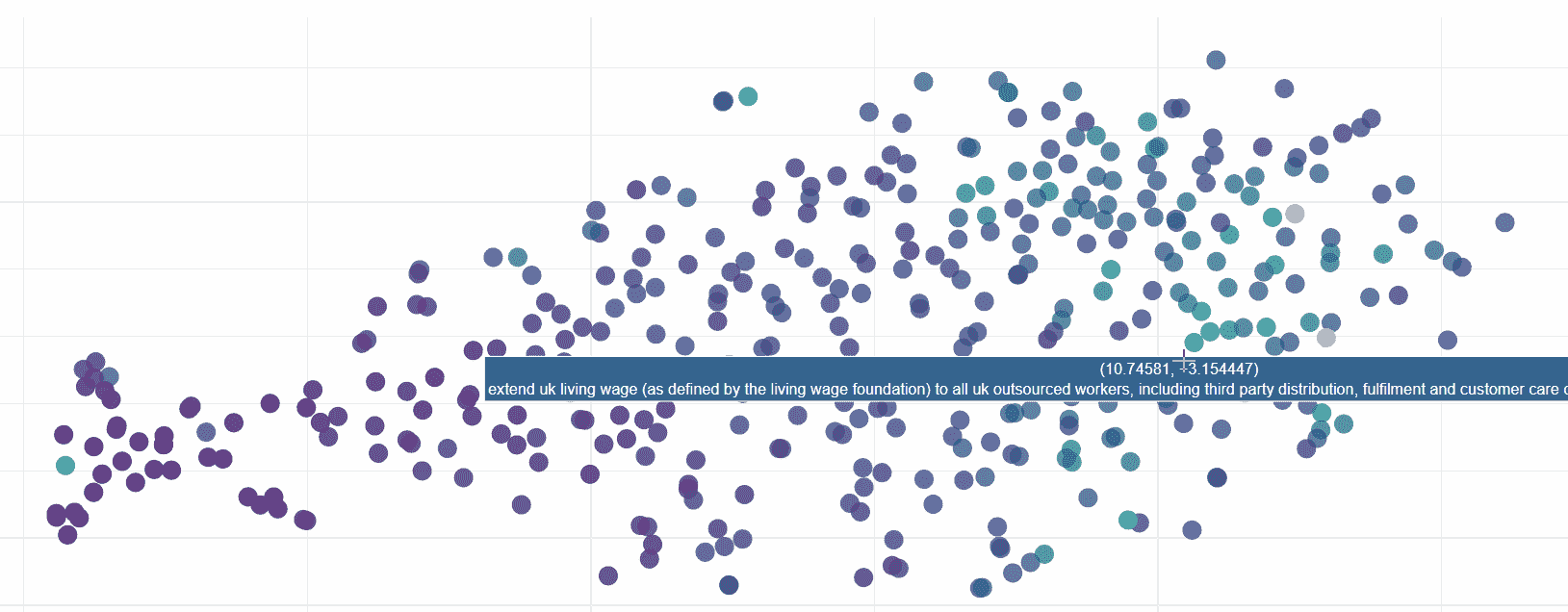

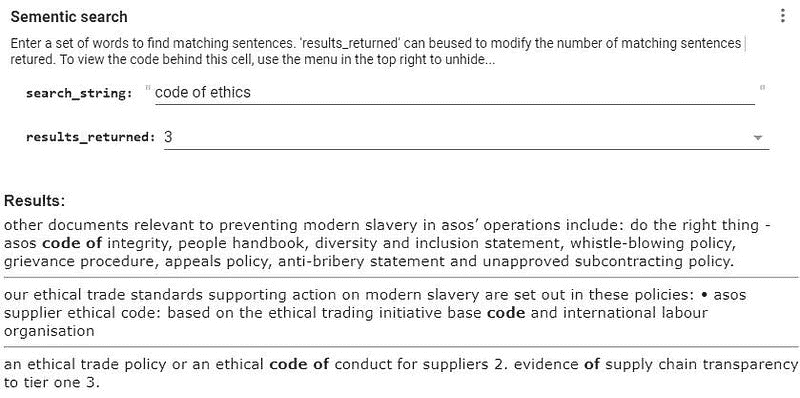

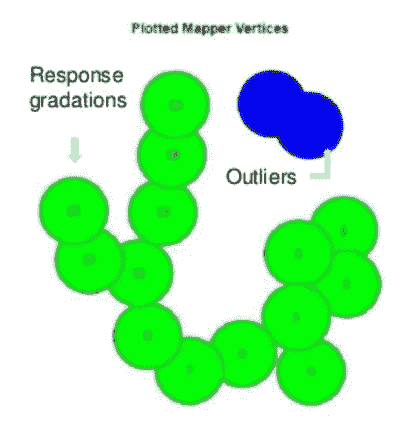

如何在数据过载时代有效获取消费者洞察

原文:

www.kdnuggets.com/2020/09/effectively-obtain-consumer-insights-data-overload-era.html

评论

作者:Patrícia Osorio,共同创始人兼首席市场官,Birdie

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

COVID-19 疫情对我们的日常生活产生了诸多影响。组织讨论的最重要因素之一是数字化转型的加速以及其在数据和技术方面的影响。正如《经济学人》所指出的,疫情的一个明显后果将是“数据驱动的服务将渗透到生活的方方面面。”这带来了另一个问题,就是大量的数据以及如何从中获取有价值的消费者洞察。大家都知道了解客户的重要性,但在信息过载的时代,如何做到这一点呢?

什么是数据过载?

信息过载是由 Debra Brass(前 J&J 全球总裁)在 2013 年创造的术语,描述了一种现实,即数据的过度可用性使得其分析变得复杂,以至于在某些情况下,它变得无效,无法对有洞察力的分析做出贡献。它阻碍了公司做出有效的决策,因为他们在面对如此多的数据时无法采取行动。

这种问题背景很可能是由于公司在数据收集能力上的迅速演变,但未能跟上正确集成和分析这些数据的能力。虽然这一问题可能影响整个公司,但对营销、客户服务、销售和消费者洞察等面向客户的团队尤其成问题。

一些研究估计,营销或消费者洞察高管最多将 80%的时间花在分析消费者数据上。在这些高管中,只有五分之一认为他们拥有合适的工具。电子商务平台上客户评论数量的指数级增长就是一个很好的例子。消费者不仅写更多评论,还在线上提出和回答更多问题,生成了大量具有挑战性的数据进行分析。

这既是一个机会也是一个问题:随着消费者评论和对话的增加,公司有机会获取这些数据,并以非常客观的方式实时了解其消费者,比以往更快。但他们如何在仍在为数据过载而挣扎并且未能获得所需洞察时探索新的消费者信息来源呢?

如何将数据转化为消费者洞察

答案是利用智能系统。这一概念由 Greylock Partners(软件行业最重要的投资基金之一)提出,许多人视其为数据分析领域下一波重大创新。智能系统作为一个额外的层次,连接了记录系统——存储数据的平台,如 CRM 或 ERP 平台——和互动系统——用于捕捉数据的互动平台(如客户服务或消息工具)。

智能系统的主要价值主张在于连接来自不同来源的数据——这些数据在大多数情况下未被充分利用,因为公司甚至无法访问它们——以便从这些数据中生成深刻的见解。通过实施这些智能系统,公司不仅可以减少将自身数据与电子表格连接的工作,还可以更轻松地将新的数据源纳入分析中,减少技术挑战,实现流畅的工作流程,从而提高每个操作周期的质量。

回到今天的背景,正是这样的解决方案似乎缺失。我们都有数据的访问权限,但在大多数情况下,我们不确定该寻找什么:我们分析错误的数据,只关注收集内容的一部分而看不到其与其他部分的关联,甚至选择了错误的度量标准来衡量。更重要的是,我们花更多的时间试图理解过去,而不是规划未来。

因此,我们不仅做出错误的决策,还浪费了大量时间将精力集中在对成功无关的行动上。Gartner 的研究显示,到 2023 年,数据智能和消费者洞察领域的 60%将减半,仅仅是因为无法从捕获的数据中生成价值。

市场营销和消费者洞察的高管需要减少在 Excel 上花费数小时处理和连接多个数据源的负担,以便- 也许- 得到相关的见解。

消费者洞察的未来:决策智能

随着"脏数据"每年使美国经济损失 3.1 万亿美元和每天产生 2.5 亿亿字节的数据,消费者洞察的未来与智能系统有直接关系并不足为奇。名字?决策智能。

决策智能是一个框架,旨在帮助将人工智能(AI)、机器学习(ML)和文本分析应用于实际业务决策,优先考虑业务并将技术投入使用。根据 Gartner,到 2023 年,超过 33%的大型组织将拥有从事决策智能的分析师。

它之所以如此强大,是因为它将商业目标、方面和问题与人工智能和预测分析的能力相连接,利用多个数据源来发展洞察力并预测未来。

简介: Patrícia Osorio 拥有超过 10 年的市场营销和业务发展经验。她在 USP 获得法学学位,在 FGV-EAESP 获得商业管理学位后,于 2007 年加入 Arizona,领导市场营销部门,并负责产品创新和新市场开发项目,如公司国际化(向阿根廷、智利、哥伦比亚和英国的客户销售,并在阿根廷开设办公室)以及数字产品开发。她还共同创办了 HomeRefill,一个在线订阅电子商务平台,以及 GVAngels,一个已经在巴西初创企业投资超过 100 万美元的天使投资集团。Pat 是由 Growth Tribe(欧洲)毕业的增长黑客,拥有在巴西和美国的 B2B 增长和获取经验。她与 Alex 一起看到了利用产品数据获得见解的机会,并在 2017 年底起草了Birdie的第一个版本。

相关内容:

-

坦率地说:我们在数据中淹没

-

向大数据提问的 3 个关键数据科学问题

-

客户流失预测:全球绩效研究

更多相关内容

如何有效使用 Pandas GroupBy

原文:

www.kdnuggets.com/2023/01/effectively-pandas-groupby.html

Pandas 是一个功能强大且广泛使用的开源库,用于使用 Python 进行数据操作和分析。它的一个关键特性是能够使用 groupby 函数通过基于一个或多个列将数据框分成组,然后对每个组应用各种聚合函数。

图片来自 Unsplash

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 维护

3. Google IT 支持专业证书 - 支持你的组织进行 IT 维护

groupby 函数非常强大,因为它允许你快速总结和分析大数据集。例如,你可以根据特定列对数据集进行分组,并计算每个组中剩余列的均值、总和或计数。你还可以通过多个列进行分组,以获得对数据的更详细理解。此外,它还允许你应用自定义聚合函数,这对于复杂的数据分析任务是一个非常强大的工具。

在本教程中,你将学习如何使用 Pandas 的 groupby 函数来对不同类型的数据进行分组并执行不同的聚合操作。通过本教程,你应该能够使用这个函数以多种方式分析和总结数据。

实践代码示例

当概念经过充分练习后就会内化,这也是我们接下来要做的,即实际操作 Pandas 的 groupby 函数。建议使用 Jupyter Notebook 来完成本教程,因为你可以在每一步查看输出结果。

生成示例数据

导入以下库:

-

Pandas: 创建数据框并应用分组

-

Random - 用于生成随机数据

-

Pprint - 用于打印字典

import pandas as pd

import random

import pprint

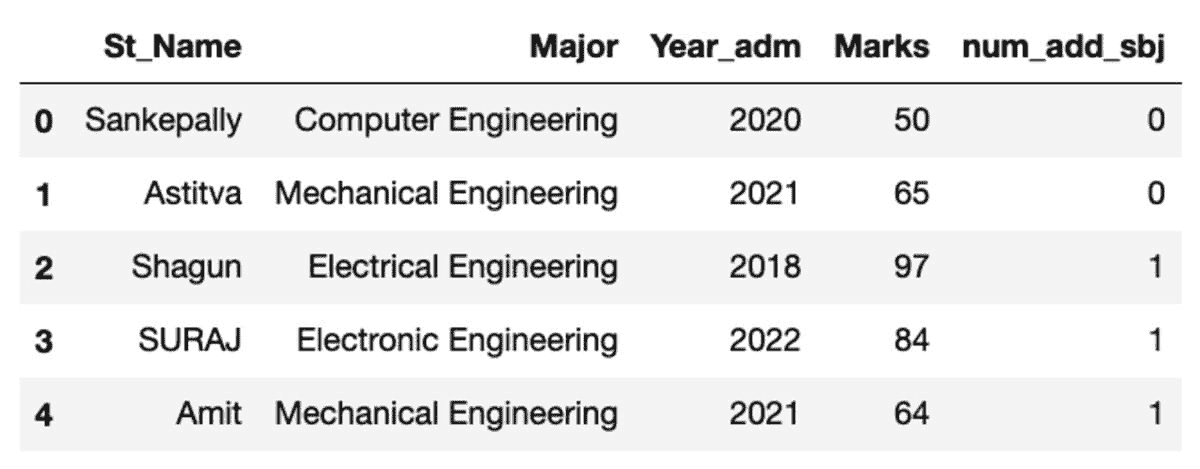

接下来,我们将初始化一个空的数据框,并填入每一列的值,如下所示:

df = pd.DataFrame()

names = [

"Sankepally",

"Astitva",

"Shagun",

"SURAJ",

"Amit",

"RITAM",

"Rishav",

"Chandan",

"Diganta",

"Abhishek",

"Arpit",

"Salman",

"Anup",

"Santosh",

"Richard",

]

major = [

"Electrical Engineering",

"Mechanical Engineering",

"Electronic Engineering",

"Computer Engineering",

"Artificial Intelligence",

"Biotechnology",

]

yr_adm = random.sample(list(range(2018, 2023)) * 100, 15)

marks = random.sample(range(40, 101), 15)

num_add_sbj = random.sample(list(range(2)) * 100, 15)

df["St_Name"] = names

df["Major"] = random.sample(major * 100, 15)

df["yr_adm"] = yr_adm

df["Marks"] = marks

df["num_add_sbj"] = num_add_sbj

df.head()

额外提示 – 更简洁的方法是创建一个包含所有变量及其值的字典,然后将其转换为数据框。

student_dict = {

"St_Name": [

"Sankepally",

"Astitva",

"Shagun",

"SURAJ",

"Amit",

"RITAM",

"Rishav",

"Chandan",

"Diganta",

"Abhishek",

"Arpit",

"Salman",

"Anup",

"Santosh",

"Richard",

],

"Major": random.sample(

[

"Electrical Engineering",

"Mechanical Engineering",

"Electronic Engineering",

"Computer Engineering",

"Artificial Intelligence",

"Biotechnology",

]

* 100,

15,

),

"Year_adm": random.sample(list(range(2018, 2023)) * 100, 15),

"Marks": random.sample(range(40, 101), 15),

"num_add_sbj": random.sample(list(range(2)) * 100, 15),

}

df = pd.DataFrame(student_dict)

df.head()

数据框的外观如下所示。在运行此代码时,由于我们使用的是随机样本,某些值可能不会匹配。

创建分组

让我们按“Major”科目分组数据,并应用组过滤以查看有多少记录落入此组。

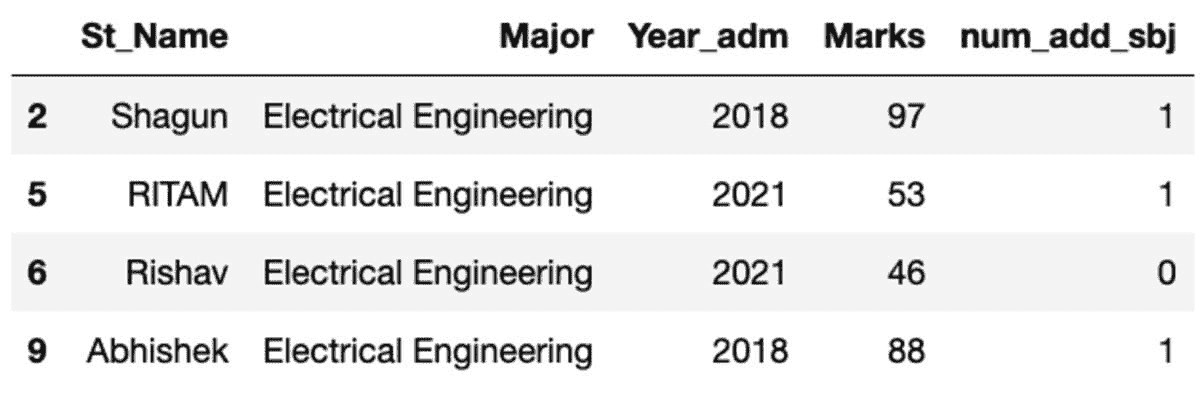

groups = df.groupby('Major')

groups.get_group('Electrical Engineering')

所以,四名学生属于电气工程专业。

你也可以按多个列分组(在此情况下为 Major 和 num_add_sbj)。

groups = df.groupby(['Major', 'num_add_sbj'])

注意,所有可以应用于单列组的聚合函数都可以应用于多列组。在接下来的教程中,让我们以单列为例深入探讨不同类型的聚合。

让我们使用“Major”列上的groupby创建组。

groups = df.groupby('Major')

应用直接函数

假设你想找到每个 Major 的平均分数。你会怎么做?

-

选择 Marks 列

-

应用均值函数

-

应用

round函数将成绩四舍五入到两位小数(可选)

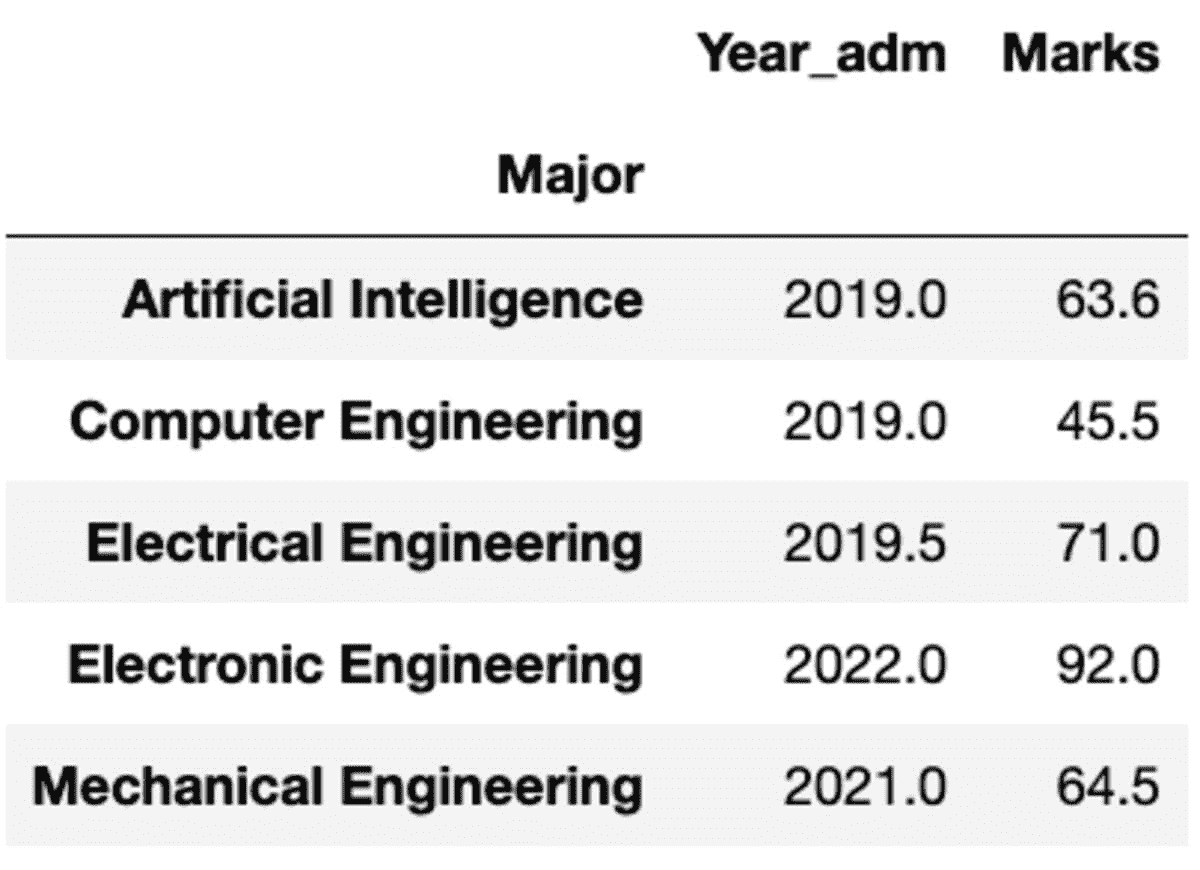

groups['Marks'].mean().round(2)

Major

Artificial Intelligence 63.6

Computer Engineering 45.5

Electrical Engineering 71.0

Electronic Engineering 92.0

Mechanical Engineering 64.5

Name: Marks, dtype: float64

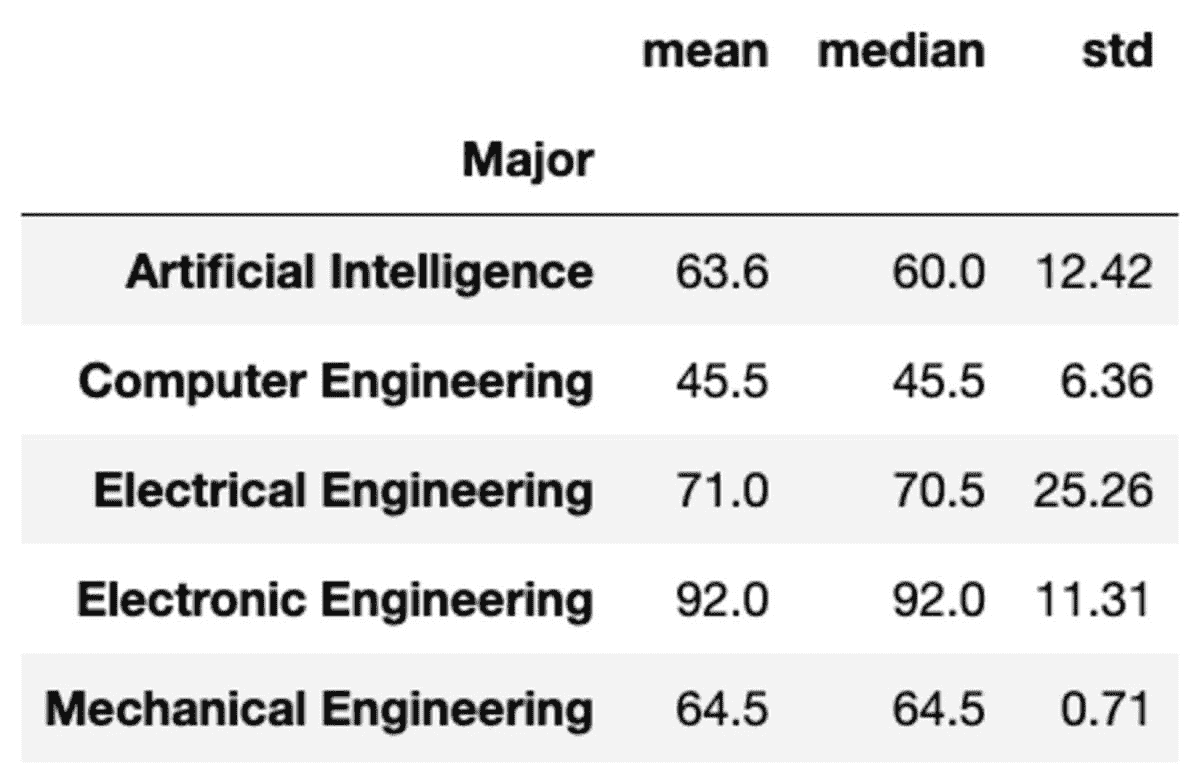

聚合

另一种实现相同结果的方法是使用如下所示的聚合函数:

groups['Marks'].aggregate('mean').round(2)

你也可以通过将函数作为字符串列表传递给组来应用多个聚合。

groups['Marks'].aggregate(['mean', 'median', 'std']).round(2)

但如果你需要对不同的列应用不同的函数怎么办?不用担心。你也可以通过传递{column: function}对来做到这一点。

groups.aggregate({'Year_adm': 'median', 'Marks': 'mean'})

变换

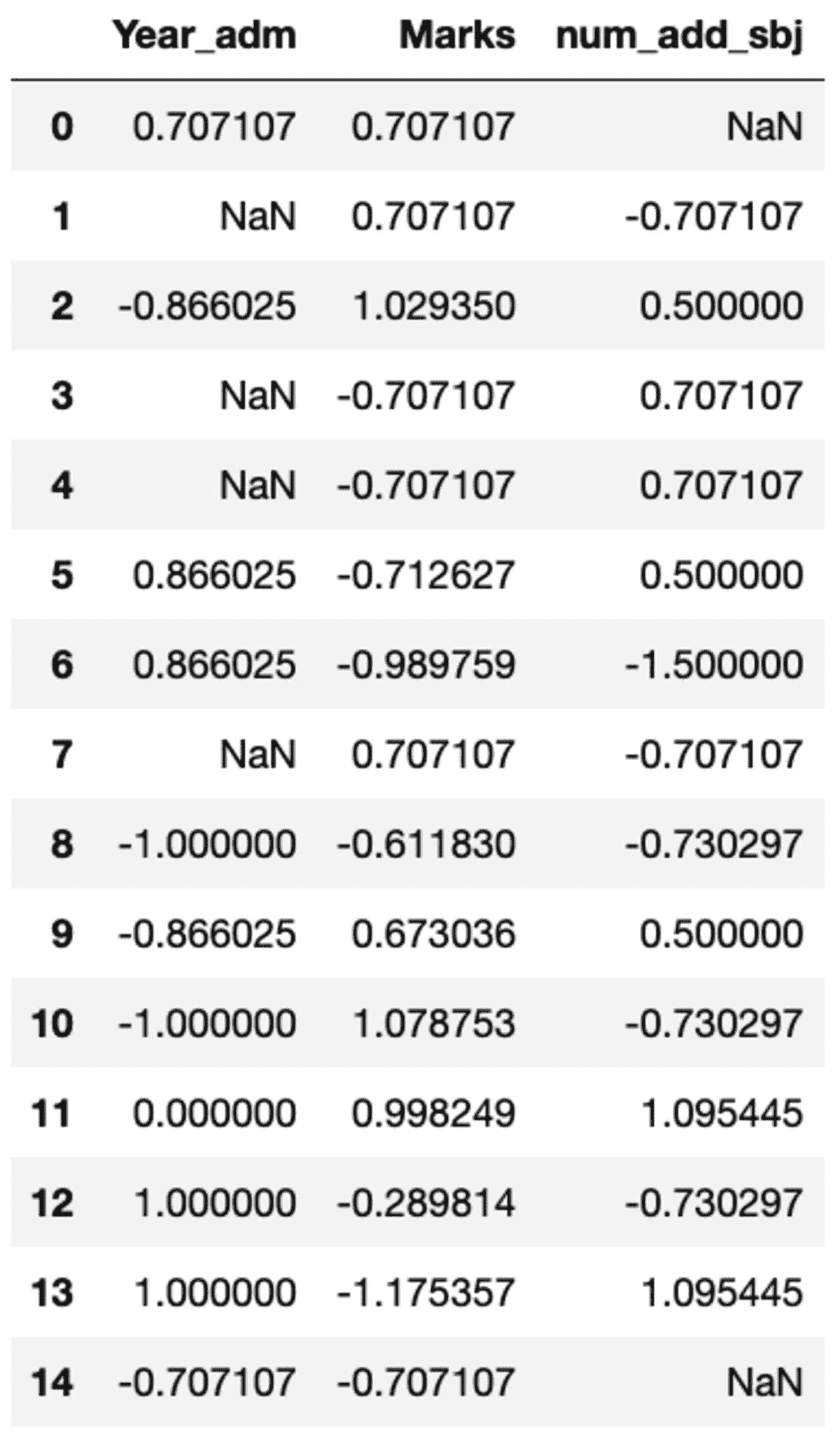

你可能需要对特定列执行自定义变换,这可以通过使用groupby()轻松实现。让我们定义一个类似于 sklearn 的预处理模块中的标准缩放器。你可以通过调用transform方法并传递自定义函数来变换所有列。

def standard_scalar(x):

return (x - x.mean())/x.std()

groups.transform(standard_scalar)

注意,“NaN”表示标准差为零的组。

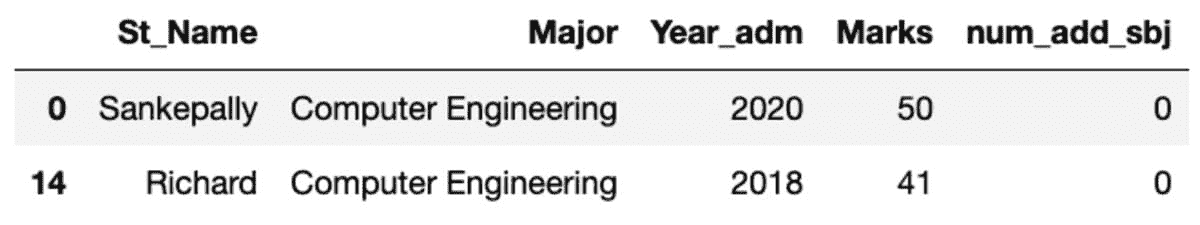

过滤

你可能想检查哪个“Major”表现不佳,即平均“Marks”低于 60 的那个。这需要你对组应用一个带有函数的过滤方法。下面的代码使用一个 lambda 函数来实现过滤结果。

groups.filter(lambda x: x['Marks'].mean() < 60)

首先

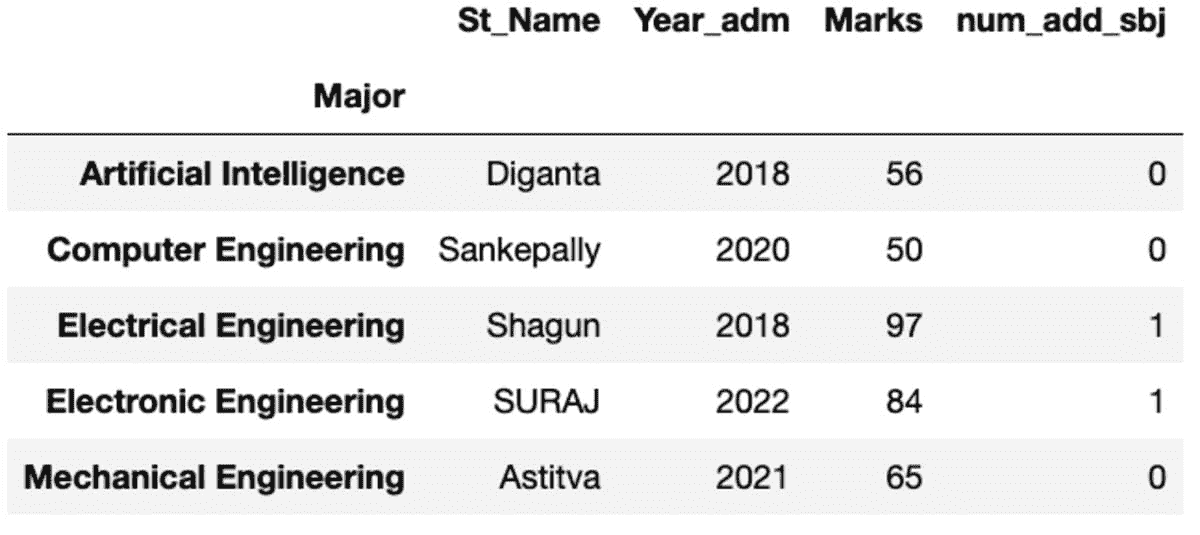

它给你按索引排序的第一个实例。

groups.first()

描述

“describe”方法返回给定列的基本统计数据,如计数、均值、标准差、最小值、最大值等。

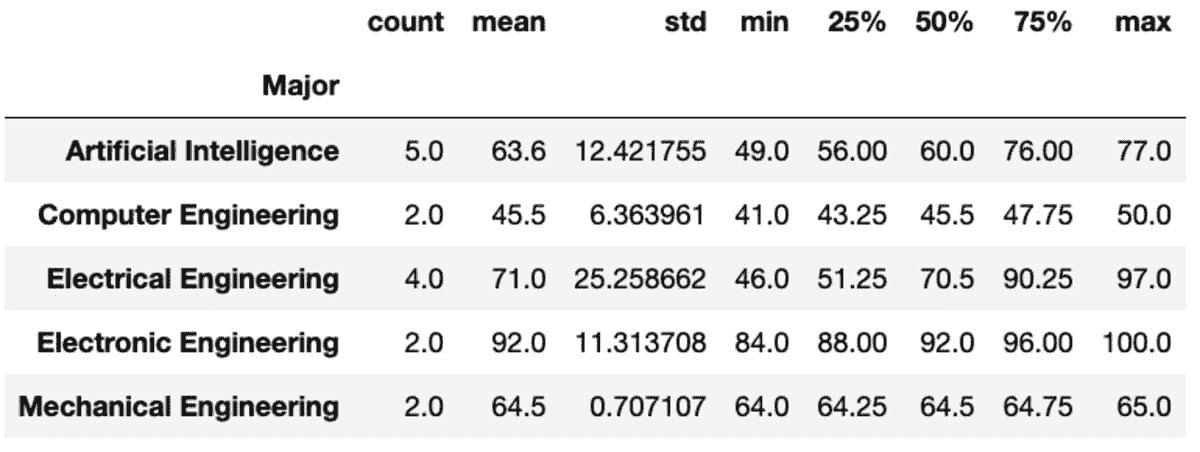

groups['Marks'].describe()

大小

Size,如名称所示,返回每组的大小,即记录数量。

groups.size()

Major

Artificial Intelligence 5

Computer Engineering 2

Electrical Engineering 4

Electronic Engineering 2

Mechanical Engineering 2

dtype: int64

计数和唯一值

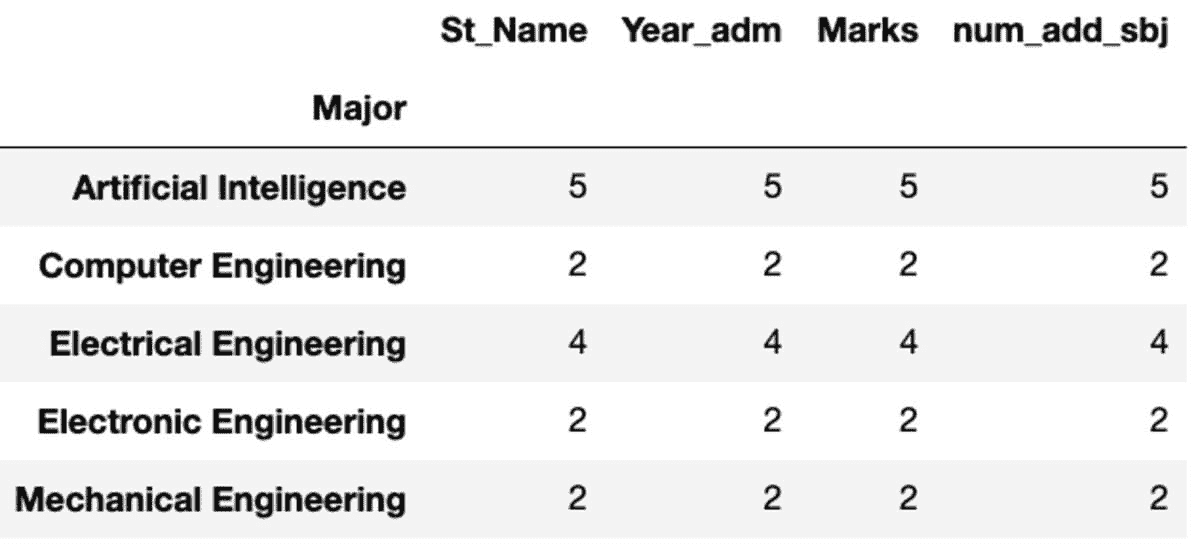

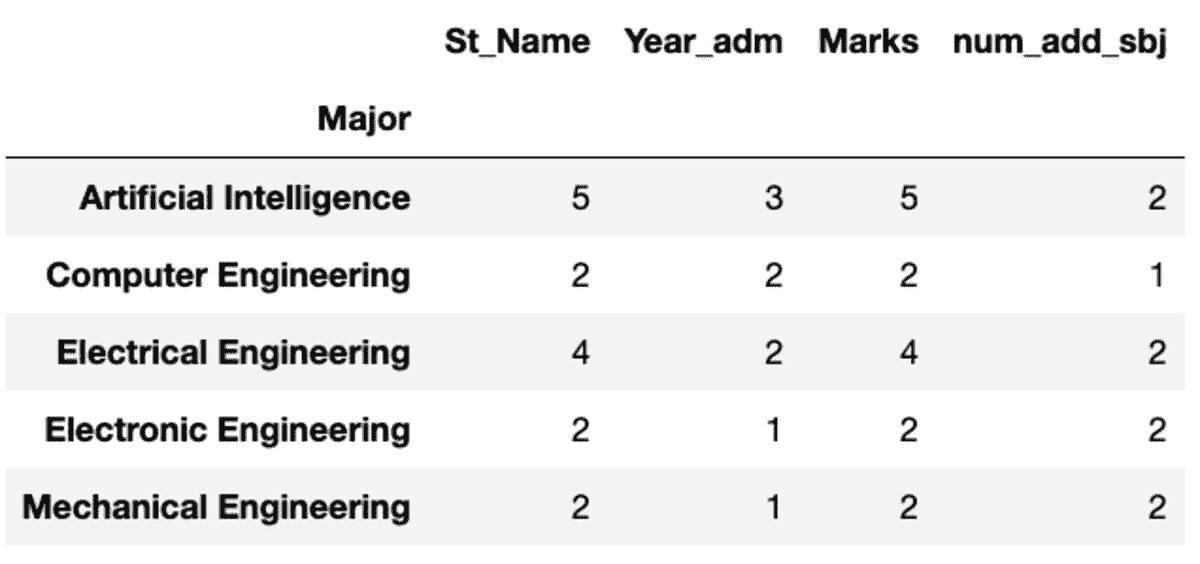

“Count”返回所有值,而“Nunique”仅返回该组中的唯一值。

groups.count()

groups.nunique()

重命名

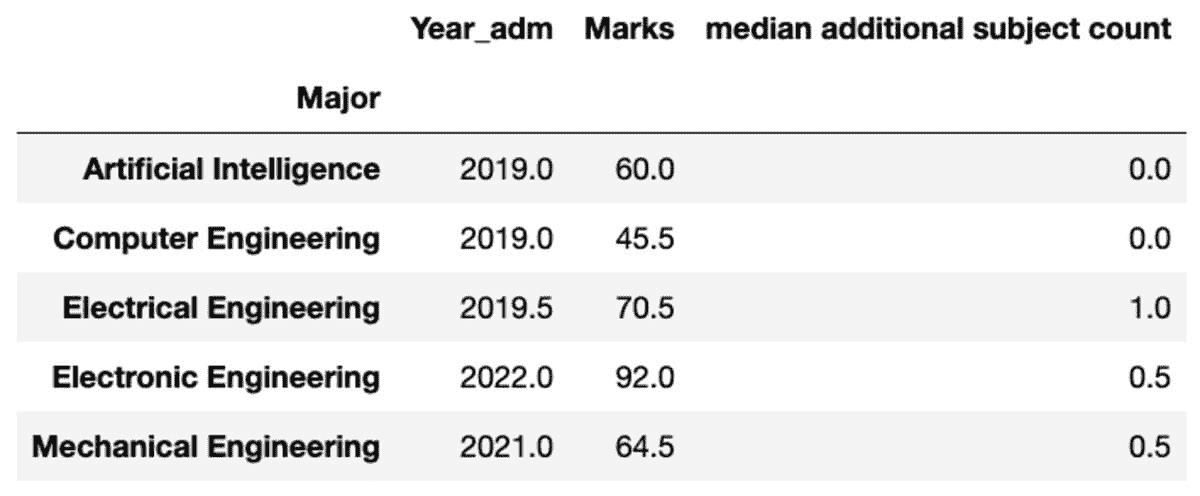

你也可以根据自己的偏好重命名聚合列的名称。

groups.aggregate("median").rename(

columns={

"yr_adm": "median year of admission",

"num_add_sbj": "median additional subject count",

}

)

充分利用 groupby 函数。

-

明确 groupby 的目的: 你是想通过一列对数据进行分组,以获取另一列的均值?还是通过多列对数据进行分组,以获取每组中的行数?

-

了解数据框的索引: groupby 函数使用索引来分组数据。如果你想通过某列对数据进行分组,确保该列被设置为索引,或者可以使用.set_index()

-

使用适当的聚合函数:可以与各种聚合函数一起使用,如 mean()、sum()、count()、min()、max()。

-

使用 as_index 参数: 当设置为 False 时,此参数告诉 pandas 将分组列用作常规列而不是索引。

你还可以将 groupby()与其他 pandas 函数(如 pivot_table()、crosstab()和 cut())结合使用,以从数据中提取更多洞察。

摘要

groupby 函数是数据分析和处理的强大工具,因为它允许你根据一个或多个列对数据行进行分组,然后对这些组执行聚合计算。教程展示了如何通过代码示例使用 groupby 函数的各种方法。希望它能帮助你理解这些选项及其在数据分析中的作用。

Vidhi Chugh 是一位人工智能策略师和数字化转型领导者,她在产品、科学和工程交汇处工作,致力于构建可扩展的机器学习系统。她是一位获奖的创新领导者、作者和国际演讲者。她的使命是使机器学习民主化,并打破行话,让每个人都能参与这场变革。

了解更多相关话题

ChatGPT 在学校的影响以及为什么它被禁止

原文:

www.kdnuggets.com/2023/06/effects-chatgpt-schools-getting-banned.html

图片由编辑提供

ChatGPT 在许多应用场景中既引起了兴奋也引发了担忧。它最显著——也是最具争议的——用途之一是它在学校中的使用。随着 ChatGPT 的受欢迎程度持续飙升,许多学区正在禁止它,但它对教育的潜在积极作用也在增长。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面

学校为什么禁止 ChatGPT

理解这个问题的两个方面很重要。首先,这里列出了学校禁止 ChatGPT 的一些主要原因。

抄袭问题

对 ChatGPT 在学校中的最普遍担忧是它的抄袭倾向。像所有 AI 模型一样,ChatGPT 并不一定创造新内容,而是编译、总结和重新表述现有工作。学生可以轻松地使用它来完成他们的作业,就像偷别人的论文并交上去一样。

许多工具可以检测到 ChatGPT 生成的内容,因此发现试图作弊的学生相对容易。然而,即使学生只是将其作为研究工具,他们也可能无法找到 ChatGPT 提供的信息的原始来源,从而导致意外抄袭。模型训练数据背后人员缺乏同意也引发了进一步的抄袭问题。

准确性存疑

在学校使用 ChatGPT 也可能妨碍学生教育的质量。ChatGPT 提供的答案并不总是准确的,即使它们很有说服力,这可能导致学生相信误导性或完全错误的信息。

这些事实上的不准确性可能比抄袭更难检测,尤其是当涉及教师不太熟悉的话题时。因此,在研究或作为教学工具中使用它可能会传播错误信息。

隐私问题

ChatGPT 还存在一些隐私问题。该平台收集了大量用户数据,其隐私控制有限且不明显。考虑到教育行业在去年最容易遭受勒索软件攻击,这确实是一个重大问题。

学生可能不知道在使用 ChatGPT 时,他们正在提供多少个人信息或该网站如何使用这些信息。这使大量高度敏感的数据面临风险。

ChatGPT 的作弊以外的用途

尽管存在这些担忧,但 ChatGPT 在学校中有几个积极方面。以下是教育系统如何利用这个聊天机器人来使学生和教师都受益。

简化行政管理

教师和其他员工可以使用 ChatGPT 来自动化一些行政任务,比如安排时间表和数据录入。这种自动化将使他们有更多时间与学生互动,从而改善教育成果。

近50%的独立学校使用五种或更多在线解决方案来管理行政工作。这会导致很多断层、低效和不必要的成本。利用像 ChatGPT 这样的工具来简化这些幕后工作流程,将有助于减少时间和费用。

提高参与度

教育工作者还可以使用 ChatGPT 来使课程对学生更具吸引力。研究发现,当技术在他们的学习中发挥作用时,学生会更加投入和舒适,而像 ChatGPT 这样的新技术可能特别有用。

学生可以使用 ChatGPT 来制定他们自己充实的研究论文大纲,这有助于他们学习什么是高质量的文章。或者,教师可以使用 ChatGPT 来展示 AI 的工作原理,或强调在在线资源中关注偏见和虚假信息的重要性。

为 AI 未来做准备

学校也可以考虑教学生如何使用 ChatGPT 及类似工具。生成性 AI 无疑将在许多未来的业务中发挥作用,因此学习如何负责任地使用 AI 是即将到来的这一代的关键技能。

一些专家预测58%的现有劳动力将需要提升技能,以便在新技术改变他们的角色和职责时有效工作。教育系统可以通过在学生进入职场前为他们提供 AI 素养来领先于这一趋势。ChatGPT 的易用性使其成为实现这一目标的理想工具。

生成性 AI 可能永远改变教育

生成式 AI 平台如 ChatGPT 将改变许多行业的运作方式。教育领域可能也会发生类似变化,无论是通过采纳新政策来限制技术,还是积极拥抱它。

在学校使用 ChatGPT 有许多好处,但仍面临重大障碍。如果学校系统能以谨慎的态度对待,并考虑这些缺点,他们可以利用这些优势来改善未来的教育。

April Miller 是 ReHack 杂志的消费者技术管理编辑。她有创建优质内容的丰富经验,这些内容能够吸引流量到她所工作的出版物中。

更多相关话题

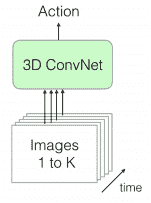

高性能深度学习,第一部分

原文:

www.kdnuggets.com/2021/06/efficiency-deep-learning-part1.html

评论

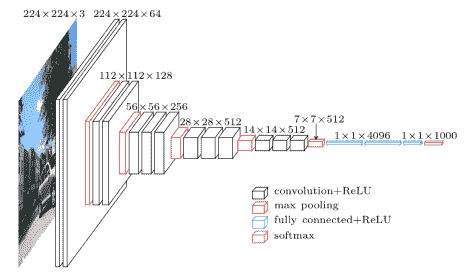

机器学习在今天的应用中无处不在。它在没有单一算法完美解决问题的领域中天然适用,并且在算法需要很好地预测正确输出的情况下,有大量未见过的数据。与我们期望确切最优解的传统算法问题不同,机器学习应用可以容忍近似答案。深度学习与神经网络在过去十年里一直是训练新机器学习模型的主流方法。它的崛起通常归因于 2012 年的 ImageNet [1] 竞赛。那一年,多伦多大学的一个团队提交了一个深度卷积网络(AlexNet [2],以首席开发者 Alex Krizhevsky 命名),表现比下一个最佳提交好 41%。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的捷径。

1. Google 网络安全证书 - 快速进入网络安全职业的捷径。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

深度和卷积网络之前已经被尝试过,但总是未能兑现承诺。卷积层最早由 LeCun 等人在 90 年代提出 [3]。同样,80 年代、90 年代等也提出了几种神经网络。深度网络为什么花了这么长时间才超越手工调整特征工程的模型?

这次的不同之处在于多个因素的结合:

-

计算:AlexNet 是早期依赖图形处理单元(GPU)进行训练的模型之一。

-

算法:一个关键的修复是激活函数使用了 ReLU。这使得梯度可以更深地反向传播。之前的深度网络使用了 sigmoid 或 tanh 激活函数,这些函数在非常小的输入范围内饱和到 1.0 或 -1.0。因此,输入变量的变化导致梯度非常微小(如果有的话),当层数很多时,梯度实际上消失了。

-

数据:ImageNet 拥有超过 1000 个类别的 100 万张以上的图像。随着互联网产品的出现,从用户行为中收集标注数据也变得更加便宜。

深度学习模型的快速增长

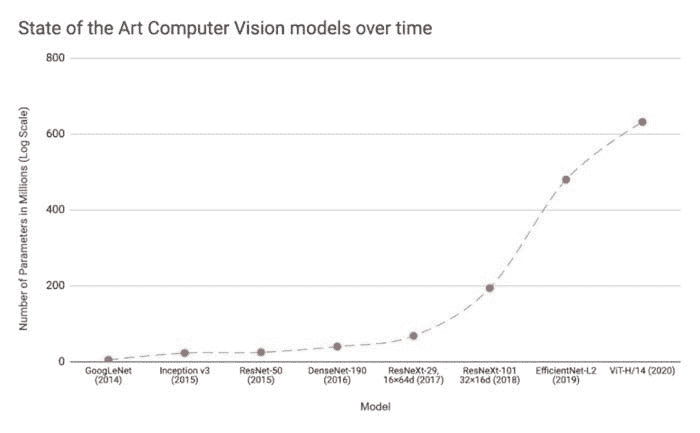

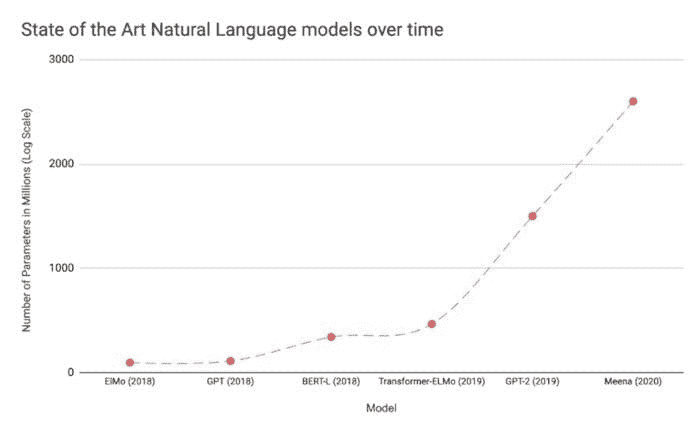

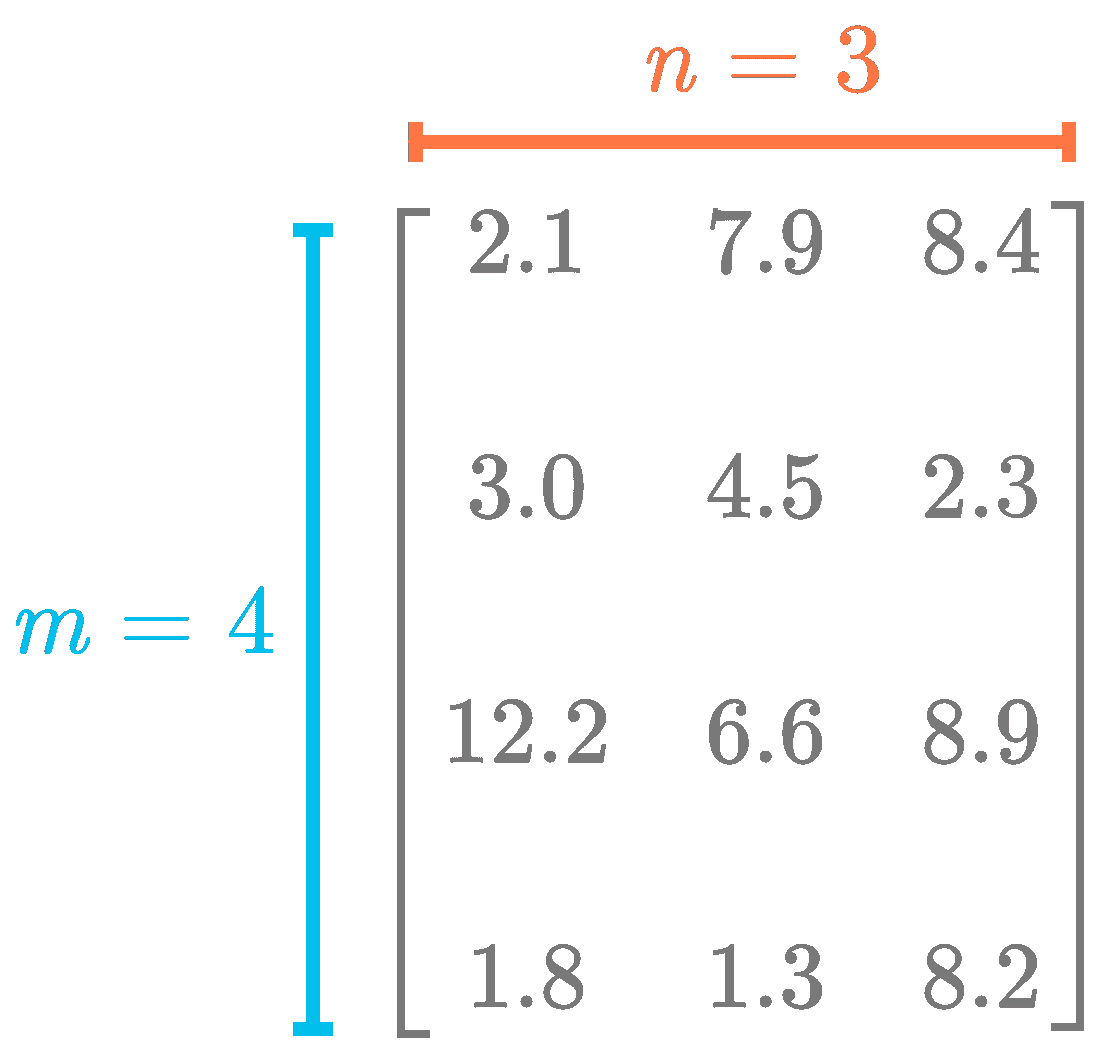

由于这项开创性的工作,出现了创建更深网络、参数数量越来越大的竞赛。几种模型架构如 VGGNet、Inception、ResNet 等,在随后的几年中相继打破了 ImageNet 比赛的记录。这些模型也已在实际应用中投入使用。

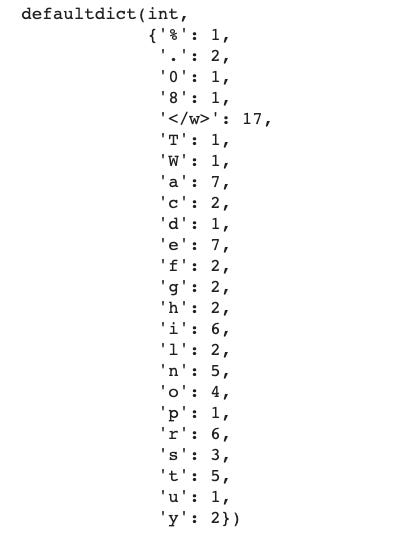

图 1:流行的计算机视觉和自然语言深度学习模型参数数量的增长趋势 [4]。

我们在自然语言理解(NLU)领域看到了类似的效果,其中 Transformer 架构显著超过了 GLUE 任务的之前基准。随后,BERT 和 GPT 模型在 NLP 相关任务上均显示出了改进。BERT 产生了几种优化其各种方面的相关模型架构。GPT-3 通过生成与给定提示相匹配的逼真文本引起了关注。这两者都已投入生产。BERT 用于 Google 搜索以提高结果的相关性,而 GPT-3 作为 API 供感兴趣的用户使用。

如所推测,深度学习研究一直集中于提高最先进的技术,因此,我们在图像分类、文本分类等基准测试中看到了持续的进步。每一次神经网络的新突破都导致了网络复杂度的增加、参数数量的增加、训练网络所需的资源量、预测延迟等。

像 GPT-3 这样的自然语言模型现在训练一次就需要花费数百万美元 [5]。这还不包括尝试不同超参数组合(调优)或手动或自动实验架构的成本。这些模型通常还拥有数十亿(或万亿)个参数。

与此同时,这些模型的卓越性能也推动了在之前受限于现有技术的新任务上的应用需求。这就产生了一个有趣的问题,即这些模型的传播受到其效率的限制。

更具体地说,我们在进入这一深度学习新时代时,面临以下问题,其中模型变得越来越大,并且跨越不同领域:

-

可持续的服务器端扩展:训练和部署大型深度学习模型的成本很高。虽然训练可能是一次性成本(或者使用预训练模型时可能免费),但长时间部署和进行推理仍可能是昂贵的。还有一个非常实际的关注点是用于训练和部署这些大型模型的数据中心的碳足迹。像谷歌、脸书、亚马逊等大型组织每年在数据中心的资本支出上花费数十亿美元。因此,任何效率提升都是非常重要的。

-

启用设备端部署:随着智能手机、物联网设备的普及,部署在这些设备上的应用必须是实时的。因此,需要设备端机器学习模型(即模型推理直接在设备上进行),这使得优化模型以适应运行设备变得非常重要。

-

隐私与数据敏感性:在用户数据可能涉及敏感处理或受各种限制(如欧洲的 GDPR 法规)的情况下,使用尽可能少的数据进行训练至关重要。因此,高效地使用少量数据训练模型意味着需要收集的数据更少。类似地,使设备上的模型能够运行意味着模型推理可以完全在用户设备上进行,而无需将输入数据发送到服务器端。

-

新应用:效率还将使得在现有资源约束下无法实现的应用成为可能。

-

模型爆炸:通常,可能会有多个机器学习模型在同一设备上同时服务。这进一步减少了单个模型的可用资源。这可能发生在服务器端,多个模型共存在同一台机器上,或者在应用中,不同的模型用于不同的功能。

高效深度学习

我们上述识别出的核心挑战是效率。虽然效率可能是一个过载的术语,但让我们探讨两个主要方面。

-

推理效率:这主要涉及部署模型进行推理(计算给定输入的模型输出)时需要问的问题。模型是否小巧?是否快速等等?更具体地说,模型有多少参数?磁盘大小、推理期间的内存消耗、推理延迟等是多少?

-

训练效率:这涉及到训练模型时需要问的一些问题,比如模型需要多长时间训练?需要多少设备进行训练?模型是否可以适应内存?还可能包括诸如,模型需要多少数据才能在给定任务上达到预期的性能?

如果我们有两个模型在给定任务上表现相同,我们可能会选择在上述一个或理想情况下两个方面表现更好的模型。如果在推理受限(如移动和嵌入设备)或昂贵(云服务器)的设备上部署模型,关注推理效率可能是值得的。同样,如果在有限或昂贵的训练资源下从头开始训练大型模型,开发针对训练效率设计的模型将有所帮助。

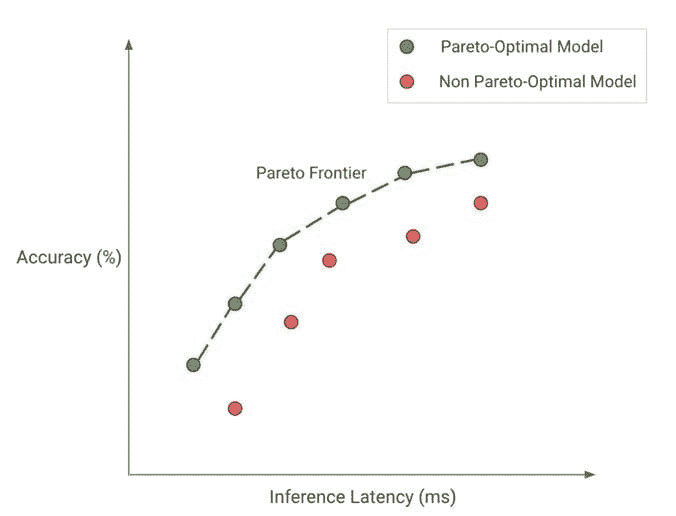

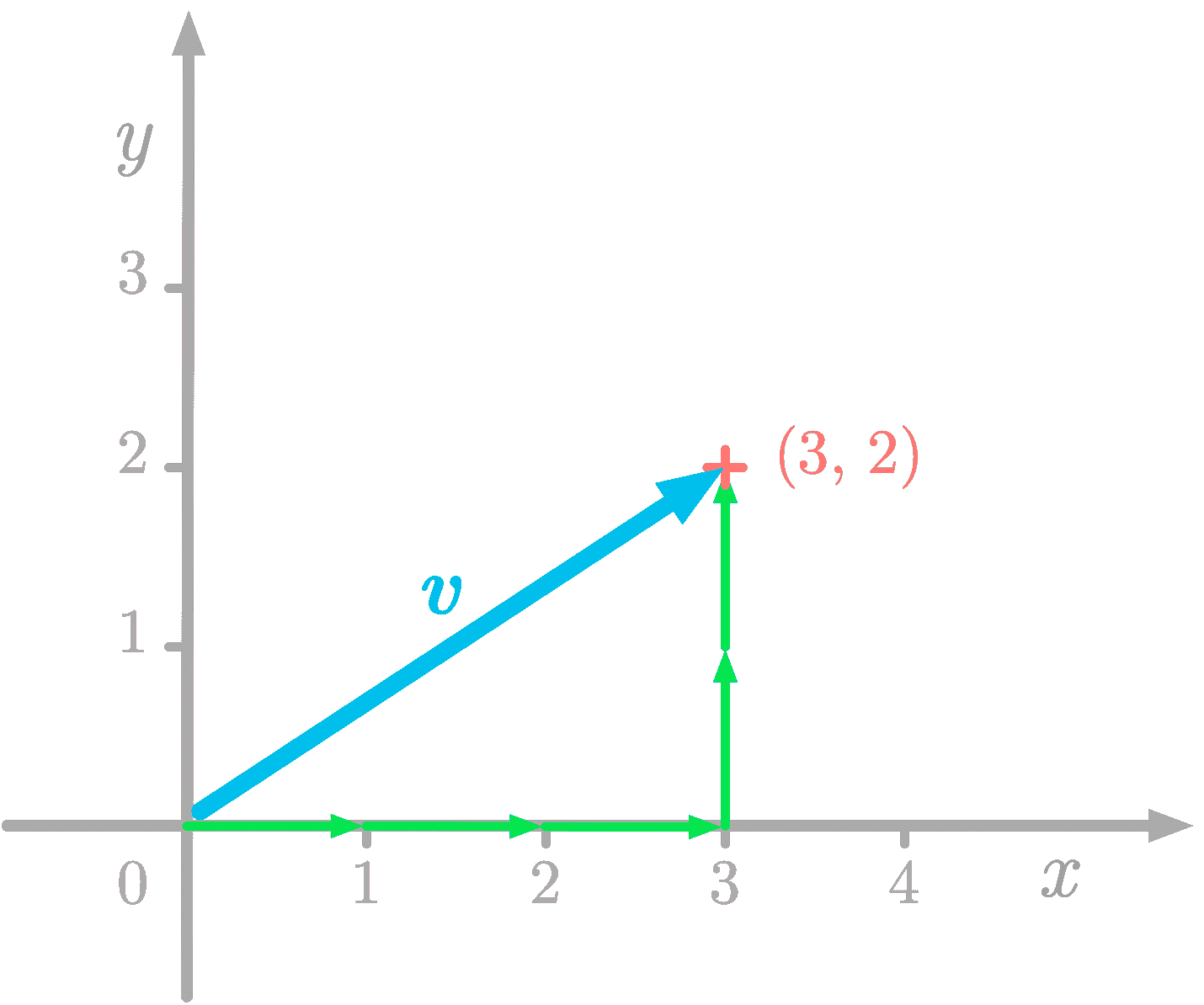

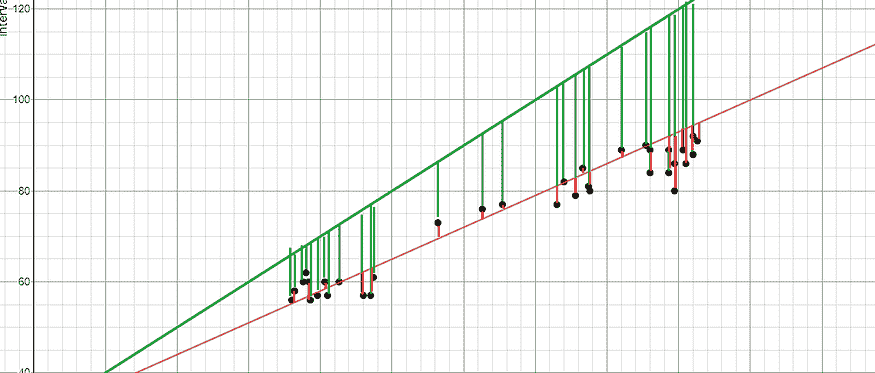

图 2: 帕累托最优性:绿色点代表帕累托最优模型(共同形成帕累托前沿),其中没有其他模型(红色点)在相同的推理延迟下获得更好的准确性,反之亦然。

无论我们优化的目标是什么,我们都希望达到帕累托最优性。这意味着我们选择的任何模型都是在我们关心的权衡中表现最好的。例如,在图 2 中,绿色点代表帕累托最优模型,其中没有其他模型(红色点)在相同的推理延迟下获得更好的准确性,反之亦然。总之,帕累托最优模型(绿色点)形成了我们的帕累托前沿。帕累托前沿的模型从定义上讲比其他模型更高效,因为它们在给定的权衡中表现最好。因此,当我们寻求效率时,我们应该考虑发现和改进帕累托前沿。

高效的深度学习可以定义为一组算法、技术、工具和基础设施,它们共同作用,使用户能够训练和部署帕累托最优模型,这些模型在训练和/或部署时消耗较少的资源,同时达到类似的结果。

现在我们已经激发了这个问题,在下一篇文章中,我们将讨论深度学习效率的五个支柱。

参考文献

[1] Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li, 和 Li Fei-Fei. 2009. ImageNet: 一个大规模层次化图像数据库。2009 年 IEEE 计算机视觉与模式识别大会。248–255. https://doi.org/10.1109/CVPR.2009.5206848

[2] Alex Krizhevsky, Ilya Sutskever, 和 Geoffrey E Hinton. 2012. 使用深度卷积神经网络进行 Imagenet 分类。神经信息处理系统进展 25 (2012), 1097–1105。

[3] 卷积网络: yann.lecun.com/exdb/lenet/index.html

[4] PapersWithCode: paperswithcode.com/

[5] Tom B Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, 等. 2020. 语言模型是少量样本学习者。arXiv 预印本 arXiv:2005.14165 (2020)。

简介: Gaurav Menghani(@GauravML)是 Google Research 的高级软件工程师,他领导着旨在优化大型机器学习模型的研究项目,以实现高效的训练和推理,这些模型可以在从微控制器到基于 Tensor Processing Unit(TPU)的服务器等各种设备上运行。他的工作对 YouTube、Cloud、Ads、Chrome 等领域的超过 10 亿活跃用户产生了积极的影响。他还是即将出版的 Manning Publication 的《高效机器学习》一书的作者。在 Google 之前,Gaurav 在 Facebook 工作了 4.5 年,并对 Facebook 的搜索系统和大规模分布式数据库做出了重要贡献。他拥有纽约州立大学石溪分校的计算机科学硕士学位。

相关:

更多相关主题

效率是生物神经元与人工神经元之间的区别

图片由 macrovector 提供 在 Freepik 上

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

机器学习取得了重大进展,但正如本系列所讨论的,它与大脑的工作方式没有太多相似之处。本系列第八部分探讨了生物神经元的一个方面,到目前为止,这一方面使它们远远领先于人工神经元:它们的效率。

您的大脑包含约 860 亿个神经元,这些神经元被挤在略超过一升的体积中。虽然机器学习可以做许多人脑做不到的事情,但大脑能够进行连续的语音识别、视觉解读以及许多其他任务,同时消耗约 12 瓦特的能量。相比之下,我的笔记本电脑消耗约 65 瓦特,而我的台式机消耗超过 200 瓦特,它们都无法运行当前使用的大型机器学习网络。

大脑是如何实现这种卓越效率的?我将其归因于三个关键因素:

-

大脑是物理和化学的,而不是电子的。

-

大脑中的神经元实际上非常慢。

-

神经元只有在发出脉冲时才需要能量。

尽管我们可以使用电子仪器测量神经元中的电压,但它们的基本操作是化学的。离子从膜的一侧迁移到另一侧,离子分子的取向发生变化。这与计算机有根本性的不同,计算机中电子的移动速度是光速。显然,大脑中的分子在静止时不需要任何外部能量,而将钠离子(例如)从膜的一侧移动到另一侧所需的能量微不足道。

正如我在本系列之前的文章中提到的,神经元的尖峰频率最高为 250Hz,神经信号以悠闲的 2m/s 速度传播。如果我们将 CPU 的速度减慢到类似的步伐,它们的能量消耗也会减少,但永远不会像生物神经元那样少。

真实的区别在于,神经元除了在发放时几乎不需要能量。此外,它们并不经常发放。通过将大脑的总能量除以通过化学计算出的发放能量,可以得出神经元平均每两秒发放一次的结论。显然,像视觉和听觉这样的连续过程必须几乎持续运行,消耗更多的能量。因此,为了使事物平均化,我们必须得出结论,大脑中很大一部分神经元几乎不会发放。因此,代表特定记忆的神经元(例如你的祖母)可能只有在你想到她时才会发放。

但还有一种更深层次的思考方式。CPU 在高速运行时使用一定量的能量(而非闲置或休眠),并且无论处理的数据是什么,都会使用这种量的能量。例如,加两个数,加 0+0 所需的能量与加 12,345 + 67,890 基本相同。神经元则不同。

这种区别是神经形态计算运动的起源。在脑模拟器中,只有当神经元发放时才需要处理,因此桌面 CPU 每秒可以处理多达 25 亿个突触。神经形态芯片利用这一效果,以比传统机器学习过程少得多的能量产生 AI 结果。

尽管神经形态系统在朝着更像大脑的架构方向发展,但它们通常仍使用完全不神经形态的 ML 反向传播算法。

"本系列的最后一篇文章将总结机器学习与大脑不一样的诸多原因——以及一些相似之处。"

查尔斯·西蒙 是一位全国知名的企业家和软件开发者,也是 FutureAI 的首席执行官。西蒙是《计算机会反叛吗?:为人工智能的未来做准备》的作者,也是 Brain Simulator II 的开发者,这是一个 AGI 研究软件平台。欲了解更多信息,请访问此处。

更多相关话题

如何通过云计算高效扩展数据科学项目

原文:

www.kdnuggets.com/2023/05/efficiently-scale-data-science-projects-cloud-computing.html

作者提供的图像

无法过分强调数据在做出明智决策中的重要性。在今天的世界里,企业依赖数据来推动战略、优化运营,并获得竞争优势。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

然而,随着数据量的指数增长,组织甚至个人项目中的开发者可能会面临高效扩展数据科学项目以处理大量信息的挑战。

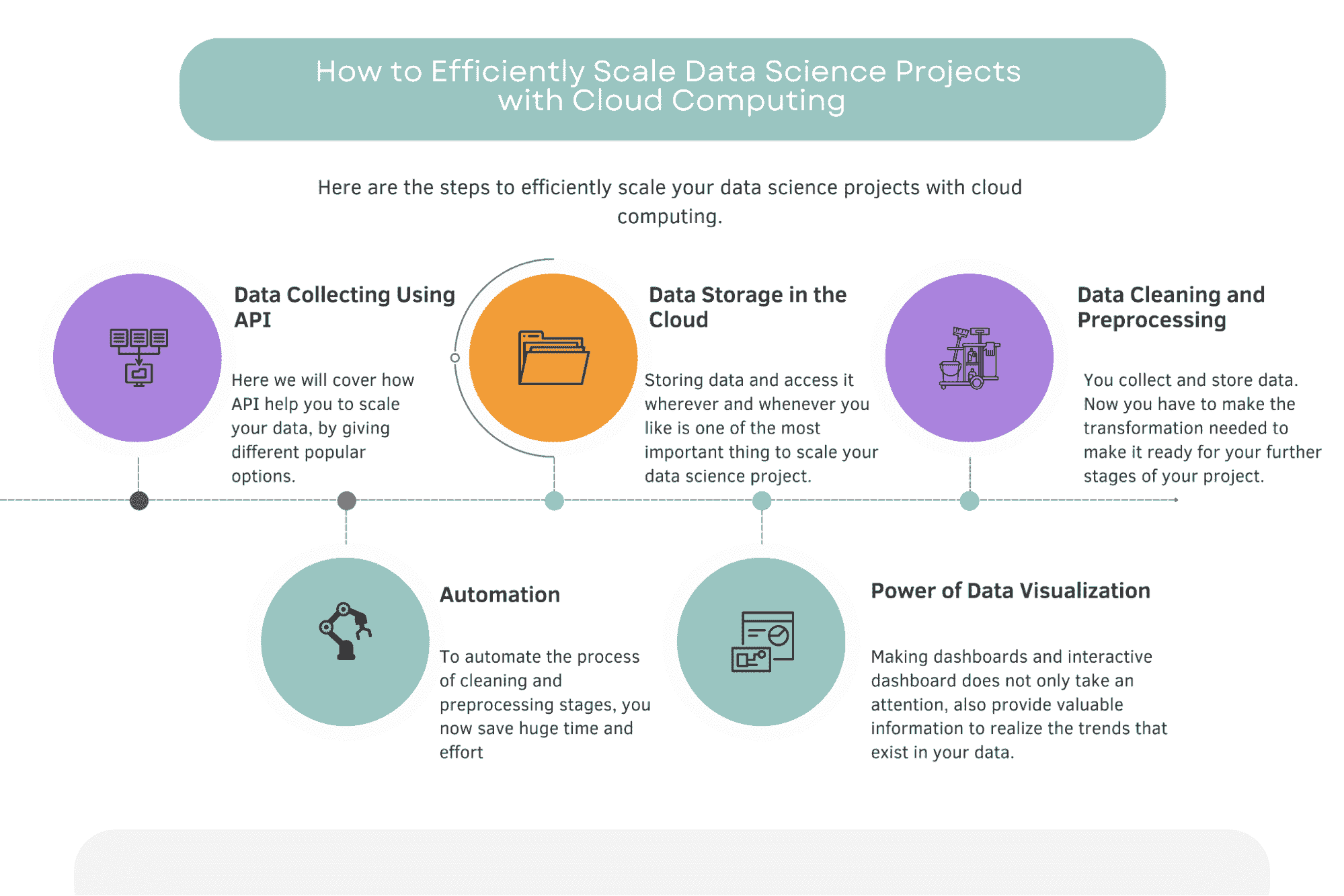

为了应对这一问题,我们将讨论五个关键组件,这些组件有助于成功扩展数据科学项目:

-

使用 APIs 进行数据收集

-

云中的数据存储

-

数据清洗和预处理

-

使用 Airflow 进行自动化

-

数据可视化的力量

这些组件对于确保企业收集更多数据并将其安全存储在云端以便于访问、使用预编写的脚本清理和处理数据、自动化流程,以及通过与云存储连接的互动仪表盘利用数据可视化的力量至关重要。

简而言之,这些是我们将在本文中介绍的方法,用于扩展您的 数据科学项目。

但要了解其重要性,我们不妨先看看在云计算出现之前,您可能会如何扩展您的项目。

云计算之前

作者提供的图像

在云计算出现之前,企业不得不依赖本地服务器来存储和管理数据。

数据科学家必须将数据从中央服务器移动到他们的系统中进行分析,这是一项耗时且复杂的过程。设置和维护本地服务器可能非常昂贵,并且需要持续的维护和备份。

云计算彻底改变了企业处理数据的方式,通过消除对物理服务器的需求并提供按需扩展的资源。

现在,让我们开始数据收集,以扩展你的数据科学项目。

图片由作者提供

使用 API 进行数据收集

图片由作者提供

在每个数据项目中,第一阶段是数据收集。

为你的项目和模型提供持续的、最新的数据对提升模型性能和确保其相关性至关重要。

收集数据的最有效方法之一是通过 API,这样可以程序化地从各种来源访问和检索数据。

API 已成为数据收集的一种流行方法,因为它们能够提供来自各种来源的数据,包括社交媒体平台、金融机构和其他网络服务。

让我们覆盖不同的用例,看看如何完成这些操作。

Youtube API

在这个视频中,使用了 Google Colab 进行编码,并通过 Requests 库进行测试。

使用了 YouTube API 来检索数据,并获得了 API 调用的响应。

数据发现存储在'items'键下。

数据被解析,并创建了一个循环来遍历这些项目。

进行了第二次 API 调用,数据被保存到 Pandas DataFrame 中。

这是在你的数据科学项目中使用 API 的一个很好的例子。

Quandl 的 API

另一个例子是 Quandl API,它可以用来访问金融数据。

在 Data Vigo 的视频中,这里,他解释了如何使用 Python 安装 Quandl,如何在 Quandl 的官方网站上找到所需的数据,并通过 API 访问金融数据。

这种方法使你可以轻松为你的金融数据项目提供必要的信息。

Rapid API

正如你所见,通过使用不同的 API,有许多不同的选项可以扩展你的数据。要发现适合你需求的正确 API,你可以探索像 RapidAPI 这样的平台,它提供了覆盖各种领域和行业的广泛 API。通过利用这些 API,你可以确保你的数据科学项目始终提供最新的数据,从而使你能够做出明智的数据驱动决策。

云端数据存储

图片由作者提供

现在,你收集了数据,但应该存储在哪里呢?

在数据科学项目中,安全且可访问的数据存储是至关重要的。

确保你的数据既安全,防止未授权访问,又能方便授权用户访问,这样可以确保顺利操作和团队成员之间的高效协作。

基于云的数据库已成为解决这些需求的热门方案。

一些流行的基于云的数据库包括 Amazon RDS、Google Cloud SQL 和 Azure SQL 数据库。

这些解决方案可以处理大量数据。

利用这些基于云的数据库的著名应用程序包括运行在 Microsoft Azure 上的 ChatGPT,展示了云存储的强大和有效性。

让我们看看这个用例。

Google Cloud SQL

要设置 Google Cloud SQL 实例,请按照以下步骤操作。

-

前往 Cloud SQL 实例页面。

-

点击“创建实例”。

-

点击“选择 SQL Server”。

-

输入你的实例 ID。

-

输入密码。

-

选择你想使用的数据库版本。

-

选择实例托管的区域。

-

根据你的偏好更新设置。

有关更详细的说明,请参阅官方 Google Cloud SQL 文档。此外,你还可以阅读这篇文章,它为从业人员解释了 Google Cloud SQL,提供了一个全面的指南,帮助你入门。

通过利用基于云的数据库,你可以确保数据安全存储且易于访问,使你的数据科学项目能够顺利高效地运行。

数据清理和预处理

图片由作者提供

你收集了数据并将其存储在云端。现在是时候转换数据以便进行进一步的处理了。

因为原始数据通常包含错误、不一致和缺失值,这些问题可能会对模型的性能和准确性产生负面影响。

适当的数据清理和预处理是确保数据准备好进行分析和建模的关键步骤。

Pandas 和 NumPy

创建一个用于清理和预处理的脚本涉及使用 Python 等编程语言,并利用 Pandas 和 NumPy 等流行库。

Pandas 是一个广泛使用的库,提供数据处理和分析工具,而 NumPy 是 Python 中用于数值计算的基础库。这两个库提供了清理和预处理数据的基本功能,包括处理缺失值、过滤数据、重塑数据集等。

Pandas 和 NumPy 在数据清理和预处理中至关重要,因为它们提供了一种强大而高效的方法来操作和转换数据,使数据转变为结构化格式,便于机器学习算法和数据可视化工具使用。

一旦你创建了一个数据清理和预处理脚本,你可以将其部署到云端以实现自动化。这确保了你的数据得到一致和自动的清理与预处理,简化了你的数据科学项目。

AWS Lambda 上的数据清理

要在 AWS Lambda 上部署数据清理脚本,你可以按照这个初学者示例中的步骤来处理 CSV 文件。这个示例演示了如何设置 Lambda 函数、配置必要的资源,并在云中执行脚本。

通过利用基于云的自动化的强大功能和 Pandas、NumPy 等库的能力,你可以确保你的数据是干净、结构良好的,并且准备好进行分析,从而最终提供更准确、更可靠的洞察。

自动化

图片由作者提供

那么,我们如何自动化这个过程呢?

Apache Airflow

Apache Airflow 非常适合这个特定任务,因为它允许编程创建、调度和监控工作流。

它允许你使用 Python 代码定义复杂的多阶段管道,使其成为自动化数据收集、清理和预处理任务的理想工具,在数据分析项目中尤为重要。

使用 Apache Airflow 自动化 COVID 数据分析

让我们在示例项目中看看它的使用情况。

示例项目:使用 Apache Airflow 自动化 COVID 数据分析。

在这个示例项目中,这里,作者演示了如何使用 Apache Airflow 自动化 COVID 数据分析管道。

-

创建 DAG(有向无环图)文件

-

从数据源加载数据。

-

清理和预处理数据。

-

将处理后的数据加载到 BigQuery

-

发送电子邮件通知:

-

将 DAG 上传到 Apache Airflow

通过遵循这些步骤,你可以使用 Apache Airflow 创建一个自动化的 COVID 数据分析管道。

这个管道将处理数据收集、清理、预处理和存储,同时在成功完成后发送通知。

使用 Airflow 进行自动化简化了你的数据科学项目,确保你的数据得到一致的处理和更新,使你能够根据最新的信息做出明智的决策。

数据可视化的力量

图片由作者提供

数据可视化在数据科学项目中发挥着至关重要的作用,它将复杂的数据转化为易于理解的视觉效果,使利益相关者能够快速掌握洞察,识别趋势,并根据呈现的信息做出更明智的决策。

简而言之,它将以互动的方式为你提供信息。

有几种工具可用于创建交互式仪表板,包括 Tableau、Power BI 和 Google Data Studio。

每种工具都提供了独特的功能和能力,帮助用户创建视觉上吸引人且信息丰富的仪表板。

将仪表板连接到你的云数据库

要将云数据集成到仪表板中,首先选择一个符合你需求的云数据集成工具。将该工具连接到你首选的云数据源,并映射你希望在仪表板上显示的数据字段。

接下来,选择合适的可视化工具,以清晰简洁的方式展示你的数据。通过引入筛选器、分组选项和钻取功能来增强数据探索。

确保你的仪表板自动刷新数据,或根据需要配置手动更新。

最后,彻底测试仪表板的准确性和可用性,进行必要的调整以提升用户体验。

将 Tableau 连接到你的云数据库 - 用例

Tableau 提供了与云数据库的无缝集成,使你可以轻松将云数据连接到仪表板。

首先,识别你使用的数据库类型,因为 Tableau 支持多种数据库技术,如 Amazon Web Services(AWS)、Google Cloud 和 Microsoft Azure。

然后,建立云数据库和 Tableau 之间的连接,通常使用 API 密钥以确保安全访问。

Tableau 还提供了多种云数据连接器,可以轻松配置以访问来自多个云源的数据。

有关在 AWS 上部署单个 Tableau 服务器的逐步指南,请参考这份详细文档。

另外,你可以探索一个演示Amazon Athena 与 Tableau 之间连接的用例,包含截图和解释。

结论

扩展数据科学项目的云计算好处包括改进的资源管理、成本节约、灵活性,以及专注于数据分析而非基础设施管理。

通过采用云计算技术并将其整合到你的数据科学项目中,你可以提升可扩展性、效率和数据驱动项目的整体成功。

通过在数据科学项目中采用云计算技术,你还可以实现改进的决策制定和数据洞察。随着你不断探索和采用云解决方案,你将更好地处理不断增长的数据量和复杂性。

这将最终赋能你的组织,基于从结构良好且高效管理的数据管道中获得的有价值洞察,做出更智能的数据驱动决策。

在这篇文章中,我们讨论了使用 API 进行数据收集的重要性,并探索了各种工具和技术以简化云中的数据存储、清理和预处理。我们还涵盖了数据可视化在决策中的强大影响,并突出了使用 Apache Airflow 自动化数据管道的好处。

充分利用云计算的好处来扩展你的数据科学项目,将使你能够完全挖掘数据的潜力,并引导你的组织在日益竞争的数据驱动行业中迈向成功。

Nate Rosidi 是一名数据科学家和产品战略专家。他还担任分析学兼职教授,并且是 StrataScratch 的创始人,该平台帮助数据科学家通过顶级公司的真实面试问题准备面试。通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

更多相关话题

人员分析的努力是否值得结果?

原文:

www.kdnuggets.com/2022/09/efforts-people-analytics-worth-outcome.html

图片来源:Yan Krukov

创建职场中的多样性、公平性和包容性(DEI)责任在近年来变得越来越重要。今天,员工几乎期望他们的雇主制定 DEI 目标,以创建更具包容性和可达性的办公室。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

然而,实施和实现与 DEI 相关的计划需要正确的流程,包括使用人员分析。以下是关于 DEI 如何使用这些数据以及为什么值得的更多信息。

数据为何对 DEI 举措至关重要

现实是,雇主无法了解员工的问题,除非他们使用数据,特别是人员分析。许多组织投入资源进行 DEI,但没有具体目标来支持他们的员工,而这正是 DEI 对希望做出改变的企业最具影响力的地方。

这就是人员分析可以帮助的地方。企业可以通过跟踪招聘、投诉、晋升和其他人力资源指标等数据,制定更有意图和有意义的计划,朝着 DEI 目标努力。例如,审视招聘实践可以揭示偏见,从而告知相关团队为什么某些部门可能不够多样化。

没有这些数据,组织领导者无法了解令人担忧的趋势所在,因此无法发现并应用正确的解决方案。

使用人员分析推动 DEI

不幸的是,尽管70% 的企业高管指出在现代商业世界中人员分析至关重要,但一些研究表明只有7% 的公司领导关注团队问题。这种数字差异的原因可能是使用人员分析需要持续的努力,并且实施过程中可能会遇到障碍导致延迟。

即使是最先进的技术公司,也可能在正确实施数据管理和其他关键步骤方面遇到困难,从而使使用人员分析变得不那么有价值。此外,团队可能会抵制变革,使得高层管理者难以完全实现其计划。

从基本层面上看,许多组织并未意识到人员分析可以帮助他们朝着目标前进,特别是在 DEI(多样性、公平性和包容性)方面。理解人员分析对 DEI 的好处是第一步。接下来,公司必须开始跟踪员工的各种数据,这是一项复杂的任务。

人员分析在正确使用时支持 DEI

简而言之,组织可以通过使用人员分析来为具体目标奠定基础,从而建立多样化、公平和包容的工作环境。然而,数据无法帮助企业,除非他们知道如何使用它。投入精力来测量和分析人员分析是值得的,只要高层管理者清楚地理解其目的。

这是一些组织高层在致力于使人员分析对他们的 DEI 目标有价值时应考虑的方面:

-

数据管理和资源: 拥有一个专门的数据管理团队和支持调查结果的正确资源对于 DEI 的人员分析成功至关重要。最有效的公司有工程师来帮助他们的人员分析团队。

-

对总体目标的理解: 当组织中的每一个关键人物都对 DEI 达成共识时,他们可以与数据工程团队更好地合作,以实现他们设定的目标。这一部分还包括与员工沟通 DEI 倡议以及团队在这一过程中取得的成就。

-

数据创意: 无论是用于 DEI 还是其他用途,那些成功使用人员分析的组织在如何定位和使用数据方面都很有创意。数据来源可能看起来有限,但团队应跳出框框,以新的方式利用信息来支持 DEI。

总体而言,在工作场所使用人员分析进行 DEI 是值得的,尤其是当组织了解如何正确使用它时。

人员分析可以帮助工作场所整合 DEI

随着越来越多的员工关注创建欢迎、包容的工作环境,企业应内部寻求改变。使用人员分析来衡量工作环境的各个方面可以帮助组织实现 DEI 目标,但他们首先必须有一个适当测量员工数据的计划。跟踪人员分析是实施 DEI 的必要且有价值的步骤。

德文·帕提达是一位大数据和技术作家,同时也是ReHack.com的主编。

更多相关话题

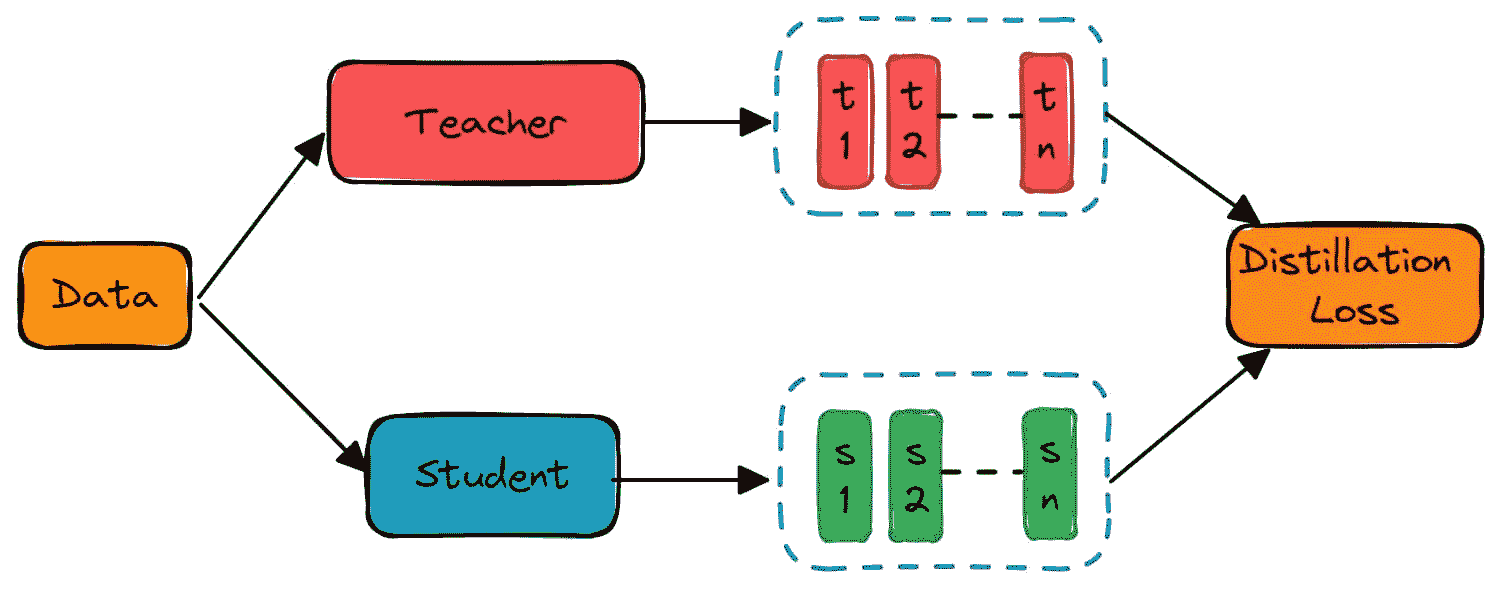

8 种创新的 BERT 知识蒸馏论文改变了 NLP 的格局

编辑的图像

文章总结了从众多 BERT 知识蒸馏相关论文中精心挑选出的八篇论文。NLP 模型压缩和加速是一个活跃的研究领域,并在行业中广泛应用,以向终端用户提供低延迟的功能和服务。

直截了当说,BERT 模型用于将词语转换为数字,并使你能够在文本数据上训练机器学习模型。为什么?因为机器学习模型接受的输入是数字而非词语。

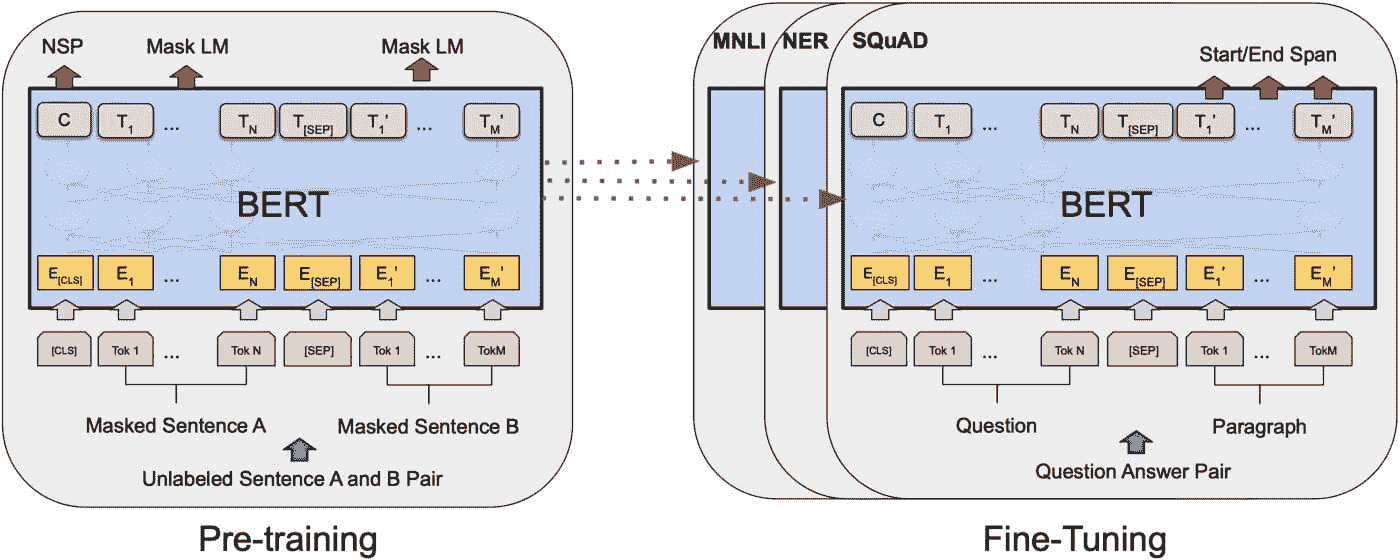

图片来源 Devlin et al., 2019

为什么 BERT 如此受欢迎?

首先,BERT 是一种语言模型,它提升了多个任务的高性能。BERT(双向编码器表示从 Transformers)于 2018 年发布,通过在广泛的 NLP 任务中提供前所未有的结果,引发了机器学习社区的轰动,尤其是在语言理解和问答方面。

BERT 的主要吸引力在于使用 Transformer 的双向训练,Transformer 是一种突出的语言建模注意力模型。但就我的叙述而言,这里有几个使 BERT 更加出色的方面:

-

它是开源的

-

NLP 中掌握语境丰富文本的最佳技术

-

双向特性

所有论文都呈现了 BERT 使用中的特定观点。

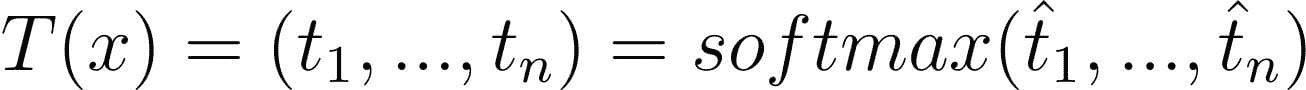

论文 1

DistilBERT,BERT 的蒸馏版本:更小、更快、更便宜、更轻量

作者们提出了一种技术,旨在预训练一个较小的通用语言表示模型,称为 DistilBERT,该模型可以在多种任务上进行微调,并且表现出色,类似于其较大的同行。虽然大多数先前的工作研究了利用蒸馏来构建特定任务模型,但我们在预训练阶段利用了知识蒸馏。我们展示了可以将 BERT 模型的大小减少 40%,同时保留 97% 的语言理解能力,并且速度提高 60%。损失函数包含语言建模损失、蒸馏损失和余弦距离损失。使用的数据与原始 BERT 模型使用的数据相同。此外,DistilBERT 在八个 16GB V100 GPU 上训练了大约 90 小时。

让我们假设

对于输入 x,教师输出:

学生输出:

考虑到 softmax 及其相关符号,我们稍后会回到这个话题。然而,如果我们希望 T 和 S 接近,可以对 S 应用交叉熵损失,以 T 作为目标。这就是我们所谓的教师-学生交叉熵损失:

- 蒸馏损失:此损失与典型的知识蒸馏损失相同:

-

蒙版语言建模损失(MLM)

-

发现余弦嵌入损失(Lcos)是有益的,它对齐了学生和教师隐藏状态向量的方向。

T(x)是教师向量输出,S(x)是学生向量输出 来源

关键要点: 这是一种在线蒸馏技术,其中教师模型和学生模型进行训练。

论文 2

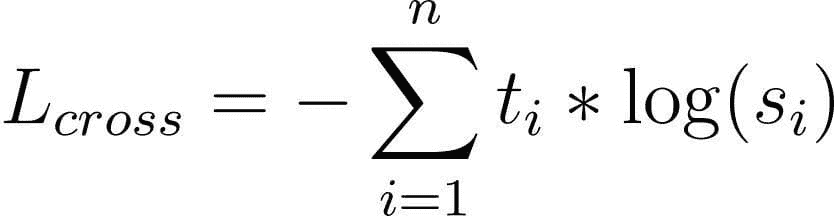

本文提出了一种通用技术,用于利用预训练语言模型进一步优化文本生成,排除了特定的参数共享、特征提取或使用辅助任务进行增强。他们提出的条件 MLM 机制利用在大规模语料库上预训练的无监督语言模型,然后调整到监督的序列到序列任务。所提供的蒸馏方法通过仅提供软标签分布间接影响文本生成模型,因此是模型不可知的。关键点如下。

-

BERT 训练的 MLM 目标不是自回归的;它以同时考虑过去和未来上下文的方式进行训练。

-

新颖的 C-MLM(条件蒙版语言建模)任务需要额外的条件输入。

从 BERT 中提取知识以进行文本生成的示意图。 来源

此外,这里使用的知识蒸馏技术与原始蒸馏研究论文中使用的技术相同,我们在老师网络生成的软标签上训练学生网络。

那么,这篇研究论文与其他论文相比有什么突出的地方呢?以下是解释。

这里的关键思想是将 BERT 中的知识蒸馏到一个能够生成文本的学生模型,而之前的工作仅关注模型压缩以完成与老师模型相同的任务。然后,对 BERT 模型进行微调,使微调后的模型可以用于文本生成。

我们以语言翻译为例,X 是源语言句子,Y 是目标语言句子。

第一阶段: BERT 模型的微调

-

输入数据:将 X 和 Y 连接在一起,Y 中 15% 的词汇被随机屏蔽

-

标签:来自 Y 的屏蔽词汇

第二阶段: 微调 BERT 模型到 Seq2Seq 模型的知识蒸馏

-

老师:第一阶段的微调 BERT 模型

-

学生:Seq2Seq 模型,例如基于注意力的 RNN、Transformer 或任何其他序列生成模型

-

输入数据和标签:来自微调 BERT 模型的软目标

论文 3

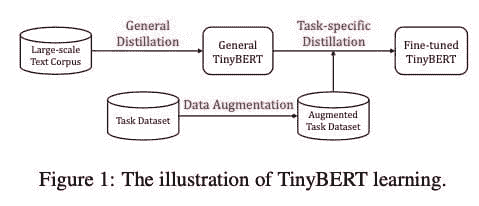

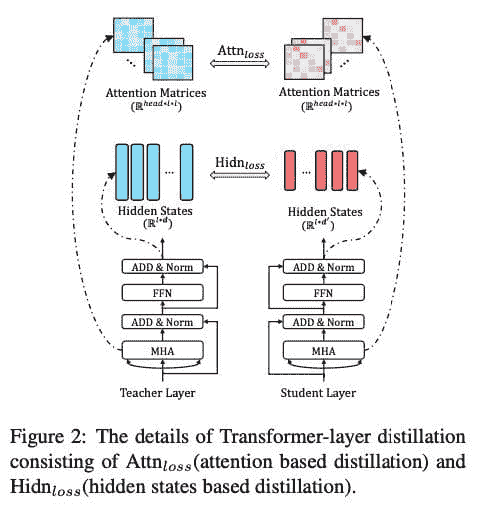

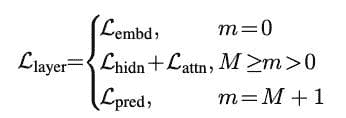

本文提出了一种新颖的 Transformer 蒸馏技术,专门用于 Transformer 基础模型的知识蒸馏 (KD)。通过利用这种新颖的 KD 方法,可以有效地将大型教师 BERT 中编码的知识转移到小型学生 Tiny-BERT 中。然后,我们引入了一个新的两阶段学习框架,用于 TinyBERT,该框架在预训练和任务特定学习阶段都执行 Transformer 蒸馏。该框架确保 TinyBERT 能够捕捉 BERT 的通用领域和任务特定知识。

具有四层的 TinyBERT 在经验上有效,其性能达到其老师 BERT-Base 在 GLUE 基准测试中的 96.8% 以上,同时体积小 7.5 倍,推理速度快 9.4 倍。四层的 TinyBERT 也明显优于 4 层最新的 BERT 蒸馏基准,仅使用约 28% 的参数和约 31% 的推理时间。此外,六层的 TinyBERT 性能与其老师 BERT-Base 相当。

此外,本文提出了三大组件用于蒸馏 Transformer 网络。

- Transformer 层蒸馏: 包括基于注意力的蒸馏和基于隐藏状态的蒸馏:

-

嵌入层蒸馏: 像对隐层状态进行蒸馏一样,对嵌入层进行知识蒸馏。

-

预测层蒸馏: 就像Hinton原作中一样,知识蒸馏是针对从教师模型中获得的预测进行的。此外,TinyBERT 模型的整体损失结合了上述三种损失:

TinyBERT 训练的主要步骤如下:

-

通用蒸馏: 以未微调的原始 BERT 作为教师,并以大规模文本语料作为训练数据。现在对通用领域的文本进行 Transformer 蒸馏,得到可以进一步微调以进行下游任务的通用 TinyBERT。由于层数、神经元等较少,这种通用 TinyBERT 的表现比 BERT 差。

-

任务特定蒸馏: 以微调后的 BERT 作为教师,训练数据为任务特定训练集。

关键要点: 这是一种离线蒸馏技术,其中教师模型 BERT 已经预训练完成。然后,他们进行了两个独立的蒸馏过程:一个用于通用学习,另一个用于任务特定学习。通用蒸馏的第一步涉及对各种层的蒸馏:注意力层、嵌入层和预测层。

论文 4

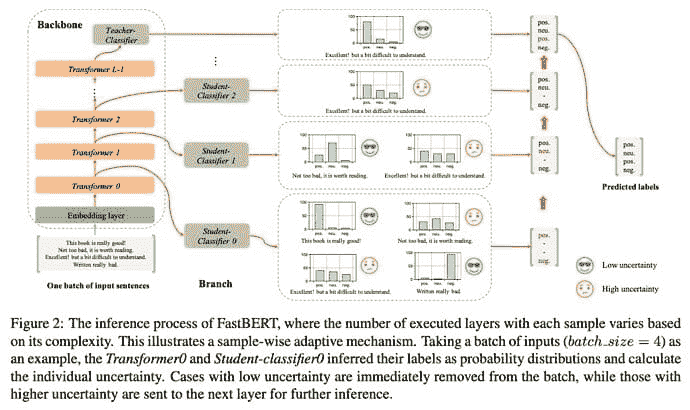

FastBERT: 一种具有自适应推理时间的自蒸馏 BERT

他们提出了一种全新的可调速度的 FastBERT,具有自适应推理时间。推理时的速度可以根据不同需求灵活调整,同时避免了样本的冗余计算。此外,该模型采用了独特的自蒸馏机制进行微调,进一步提高了计算效率,同时性能损失最小。我们的模型在十二个英文和中文数据集上取得了令人满意的结果。如果在不同的加速阈值下进行速度与性能的折中,它的速度可以比 BERT 提高 1 到 12 倍的范围。

与类似工作的比较:

-

TinyBERT: 通过使用通用领域和任务特定的微调来进行两阶段学习。

-

DistilBERT: 引入了三重损失

FastBERT 的优势是什么?

该工作首次将自蒸馏(训练阶段)和自适应机制(推理阶段)技术应用于 NLP 语言模型,以提高效率。

模型架构

FastBERT 模型由主干和分支组成:

-

骨干:它包含三部分:嵌入层、包含 Transformer 堆栈的编码器以及教师分类器。嵌入层和编码器层与 BERT 的相同。最后,我们有一个教师分类器,用于提取任务特定的特征,以便下游任务使用软最大函数。

-

分支:这些包含学生分类器

-

具有与教师相同的架构

-

被添加到每个变压器块的输出中,以启用早期输出

训练阶段

对骨干和学生分类器使用单独的训练步骤。在一个模块训练时,另一个模块的参数始终被冻结。三步:

-

骨干预训练:使用 BERT 模型的典型预训练。这里没有变化。可以在此步骤中自由加载高质量的训练模型。

-

骨干微调:对于每个下游任务,使用任务特定的数据来微调骨干和教师分类器。在这个阶段,没有启用学生分类器。

-

学生分类器的自蒸馏:现在我们的教师模型已经训练好,我们获取其输出。这种软标签输出质量高,包含原始嵌入和概括性知识。这些软标签用于训练学生分类器。我们可以在这里自由使用无限量的未标记数据。这项工作不同于以往的工作,因为这项工作使用相同的模型作为教师和学生模型。

自适应推断

让我们谈谈推断时间。使用 FastBERT 时,推断是自适应执行的,即模型内执行的编码层数可以根据输入样本的复杂性进行调整。

在每个变压器层中,计算学生分类器输出的不确定性,并根据阈值确定是否可以终止推断。以下是自适应推断机制的工作原理:

-

在 FastBERT 的每一层中,相应的学生分类器预测每个样本的标签,并测量不确定性。

-

不确定性低于某个阈值的样本将被筛选到早期输出,而不确定性高于阈值的样本将转移到下一层。

-

阈值较高时,较少的样本被发送到更高层,以保持推断速度更快,反之亦然。

论文 5

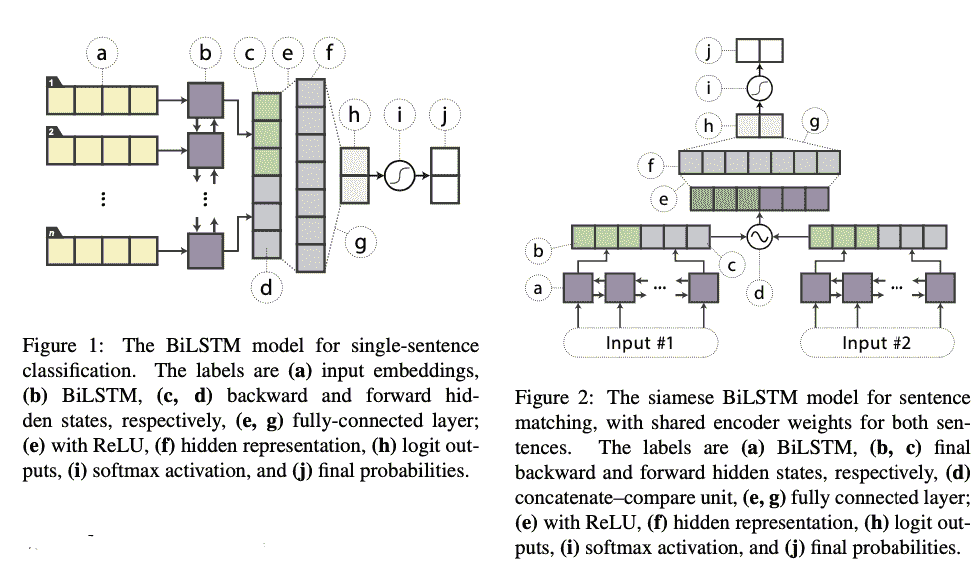

在本文中,作者展示了即使没有架构修改、外部训练数据或额外输入特征,基础的轻量级神经网络也可以具有竞争力。他们提出将 BERT 知识蒸馏到单层双向长短期记忆网络(BiLSTM)及其同类模型,用于句子对任务。在大量的重述、自然语言推理和情感分类数据集中,他们在参数量大约少 100 倍,推理时间减少 15 倍的情况下,取得了与 ELMo 相当的结果。此外,他们的方法包括对教师和 BiLSTM 学生模型进行微调。此工作的主要动机包括:

-

简单的架构模型能否在文本建模中捕捉到与 BERT 模型相当的表示能力?

-

研究将知识从 BERT 转移到 BiLSTM 模型的有效方法。

蒸馏的数据增强

小数据集可能不足以让教师完全表达其知识,因此使用从教师模型生成的伪标签的大型未标记数据集来扩充训练集。在这项工作中,提出了一些用于任务无关的数据增强的启发式方法:

-

掩码:随机将句子中的一个词替换为类似于 BERT 训练的 [MASK] 标记。

-

POS 引导的词替换:用同一词性标签的另一个词替换句子中的一个词,例如,“猪吃什么?”被扰动为“猪怎么吃?”

-

N-gram 采样:一种更激进的掩码形式,从输入示例中选择 n-gram 样本,其中 n 从 {1,2,3,4,5} 中随机选择。

论文 6

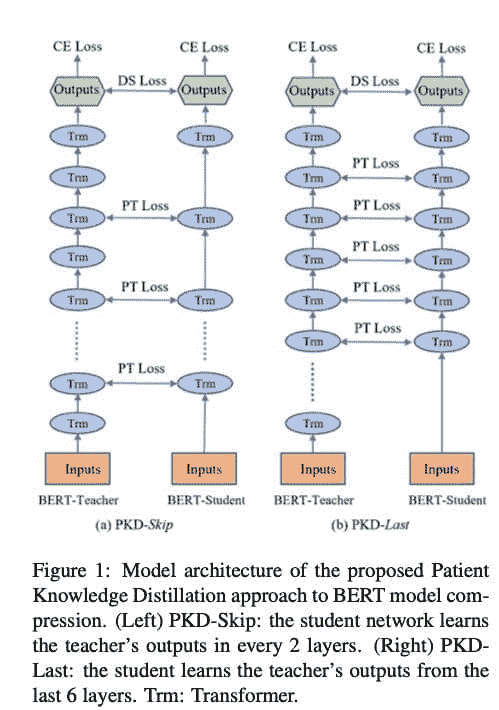

作者提出了一种患者知识蒸馏方法,将原始的大型模型(教师)压缩成一个同样有效的轻量级浅层网络(学生)。他们的方法与之前的知识蒸馏方法有很大不同,因为早期的方法仅使用教师网络最后一层的输出进行蒸馏;而我们的学生模型则耐心地从教师模型的多个中间层中学习,以进行渐进的知识提取,遵循两种策略:

-

PKD-Last:学生模型从教师的最后 k 层中学习(假设最后几层包含了对学生最重要的信息)。

-

PKD-Skip:学生模型从教师的每个 k 层中学习。

他们在多个数据集和不同的 NLP 任务上进行了实验,证明所提出的 PKD 方法比标准蒸馏方法(Hinton et al., 2015)表现更好,泛化能力更强。

为什么不从教师模型的所有隐藏状态中学习?

原因是这可能会计算上非常昂贵,并且可能会给学生模型引入噪声。

论文 7

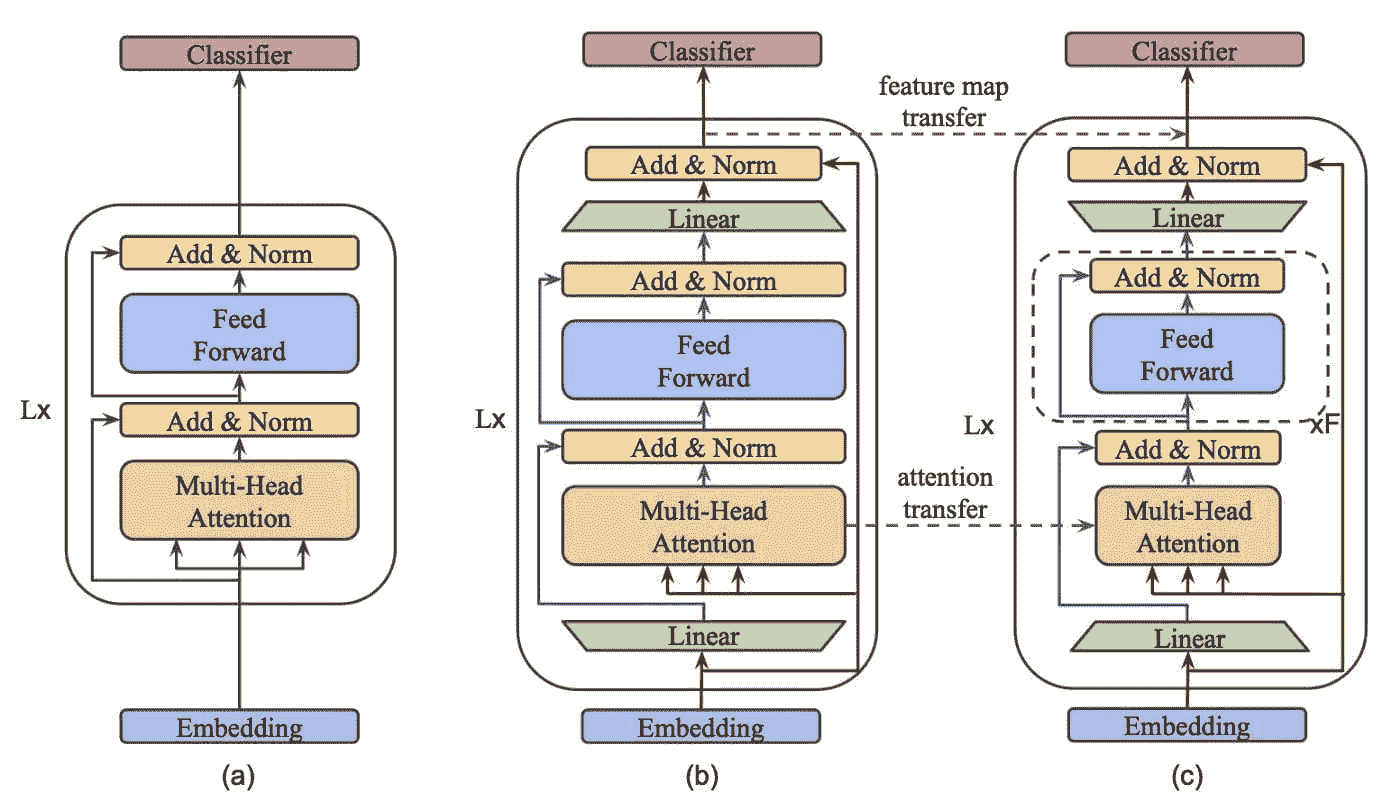

MobileBERT:一种紧凑的无任务专用 BERT,适用于资源受限设备

他们提出了 MobileBERT,用于压缩和加速流行的 BERT 模型。像原始 BERT 一样,MobileBERT 是不依赖任务的;即,通过简单的微调,可以通用地应用于各种下游 NLP 任务。MobileBERT 是 BERTʟᴀʀɢᴇ的精简版本,同时配备了瓶颈结构,并在自注意力机制和前馈网络之间进行了精心设计的平衡。

训练步骤

第一步: 首先训练一个特别设计的教师模型,即包含反向瓶颈的 BERTʟᴀʀɢᴇ模型。

第二步: 从这位教师模型向 MobileBERT 进行知识转移。

变压器块的架构可视化,如(a) BERT,(b) MobileBERT 教师,以及(c) MobileBERT 学生。标记为“Linear”的绿色梯形图被称为瓶颈。来源

(a) BERT;(b) 反向瓶颈 BERT(IB-BERT);以及© MobileBERT。在(b)和©中,红色线条表示块间流动,而蓝色线条表示块内流动。MobileBERT 通过逐层模仿 IB-BERT 进行训练。

如果你读到这里,你值得一个击掌。MobileBERT 在变压器块中展示了瓶颈,这使得从更大的教师模型中提取知识到更小的学生模型的过程更加平滑。这种方法减少了学生模型的宽度,而不是深度,这在给定的实验中产生了更高效的模型。MobileBERT 强调了这样一个信念,即在初始蒸馏过程之后,确实可以使学生模型进行微调。

此外,结果还表明,这在实践中也成立,因为 MobileBERT 可以在 GLUE 上达到 BERT-base 99.2%的性能,同时参数减少 4 倍,并且在 Pixel 4 手机上的推理速度快 5.5 倍!

论文 8

论文的关键关注点如下:

-

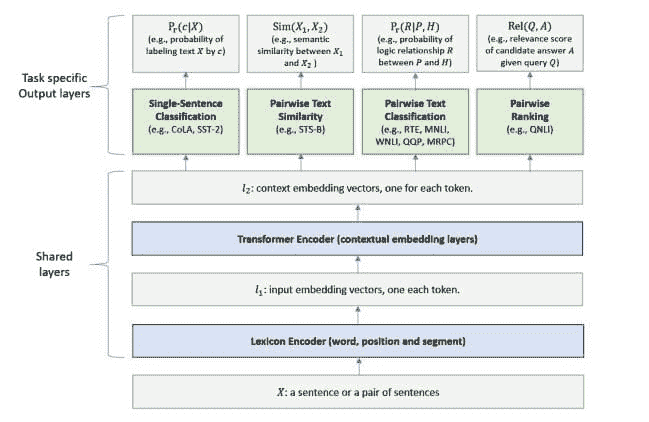

训练一个多任务神经网络模型,该模型结合了多个自然语言理解任务的损失。

-

从第一步生成多个模型的集成,这些模型本质上是通过从头开始训练多个多任务模型获得的。

-

最终步骤是对前一步的模型集进行知识蒸馏。

MT-DNN 模型用于表示学习的架构 (Liu et al., 2019)。较低层在所有任务中共享,而顶部层则是任务特定的。输入 X(可以是一个句子或一组句子)首先表示为一系列嵌入向量,每个单词一个,在 l1 层中。然后,Transformer 编码器捕捉每个单词的上下文信息,并在 l2 层中生成共享的上下文嵌入向量。最后,额外的任务特定层生成每个任务的任务特定表示,随后进行分类、相似性评分或相关性排序所需的操作。来源

多任务学习的知识蒸馏过程。选择一组具有任务特定标签训练数据的任务。然后,为每个任务训练一个不同的神经网络(教师)。教师用于生成每个任务特定训练样本的一组软目标。考虑到多个任务的训练数据集的软目标,使用多任务学习和反向传播来训练一个单一的 MT-DNN(学生),如算法 1 所述,除了如果任务 t 有教师,则第 3 行的任务特定损失是两个目标函数的平均值,一个用于正确目标,另一个用于教师分配的软目标。来源

成就:在 GLUE 数据集上,蒸馏的 MT-DNN 在 9 个自然语言理解任务中的 7 个任务上创造了新的最先进结果,包括没有教师的任务,将 GLUE 基准(单模型)推高到 83.7%。

我们展示了蒸馏的 MT-DNN 几乎保留了由集成模型所取得的所有改进,同时保持模型大小与原始 MT-DNN 模型相同。

附注

现代最先进的自然语言处理模型在生产中难以应用。知识蒸馏提供了应对这些问题及其他问题的工具,但它也有其独特之处。

参考文献

-

提高几乎任何机器学习算法性能的一个非常简单的方法是训练多种不同的模型……arxiv.org](https://arxiv.org/abs/1503.02531)

-

我们介绍了一种新的语言表示模型,称为 BERT,代表双向编码器表示…arxiv.org](https://arxiv.org/abs/1810.04805)

-

大规模预训练语言模型如 BERT 在语言理解任务中取得了巨大成功…arxiv.org](https://arxiv.org/abs/1911.03829)

-

DistilBERT,一个 BERT 的蒸馏版本:更小、更快、更便宜、更轻量

随着大规模预训练模型在自然语言处理(NLP)中的迁移学习变得越来越普遍…arxiv.org](https://arxiv.org/abs/1910.01108)

-

语言模型预训练,如 BERT,显著提升了许多自然语言处理任务的性能…arxiv.org](https://arxiv.org/abs/1909.10351)

-

提高几乎所有机器学习算法性能的一种非常简单的方法是训练许多不同的模型…arxiv.org](https://arxiv.org/abs/1503.02531)

-

预训练语言模型如 BERT 已被证明非常高效。然而,它们通常在计算上…arxiv.org](https://arxiv.org/abs/2004.02178)

-