KDNuggets-博客中文翻译-十八-

KDNuggets 博客中文翻译(十八)

原文:KDNuggets

你应该选择哪种 BERT 风格用于你的 QA 任务?

评论

作者 Olesya Bondarenko,Tangible AI

图片由 Evan Dennis 提供,来源于 Unsplash

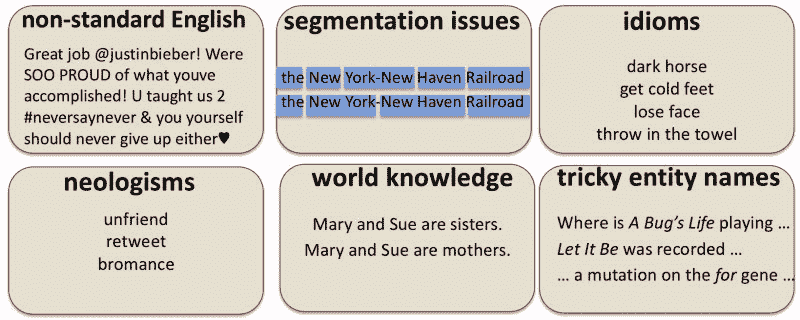

得益于开源自然语言处理库的丰富、策划的数据集和迁移学习的强大功能,制作一个智能聊天机器人从未如此简单。使用 Transformers 库构建一个基本的问答功能可以像这样简单:

from transformers import pipeline# Context: a snippet from a Wikipedia article about Stan Lee

context = """

Stan Lee[1] (born Stanley Martin Lieber /ˈliːbər/; December 28, 1922 - November 12, 2018) was an American comic book

writer, editor, publisher, and producer. He rose through the ranks of a family-run business to become Marvel Comics'

primary creative leader for two decades, leading its expansion from a small division of a publishing house to

multimedia corporation that dominated the comics industry.

"""nlp = pipeline('question-answering')

result = nlp(context=context, question="Who is Stan Lee?")

下面是输出结果:

{'score': 0.2854291316652837,

'start': 95,

'end': 159,

'answer': 'an American comic book writer, editor, publisher, and producer.'}

哇!它工作了!

那个低信心评分有点令人担忧。稍后我们讨论 BERT 检测不可能问题和无关背景的能力时,你会看到它的影响。

然而,花时间选择适合你任务的正确模型将确保你能从你的对话代理中获得最佳的开箱即用性能。你对语言模型和基准数据集的选择将决定你的聊天机器人的表现。

BERT(双向编码表示转换器)模型在复杂的信息提取任务中表现非常出色。它们不仅能够捕捉单词的含义,还能捕捉上下文。在选择模型(或采用默认选项)之前,你可能需要评估候选模型的准确性和资源(RAM 和 CPU 周期),以确保它确实符合你的期望。在这篇文章中,你将看到我们如何使用斯坦福问答数据集(SQuAD)对我们的 QA 模型进行基准测试。还有许多其他优秀的问答数据集,你可能也想使用,包括微软的NewsQA、CommonsenseQA、ComplexWebQA等。为了最大化应用的准确性,你需要选择一个代表你期望的问题、答案和上下文的基准数据集。

Huggingface Transformers 库拥有大量针对各种任务的预训练模型:情感分析、文本总结、同义改写,当然还有问答。我们从可用的模型库中选择了一些候选问答模型。果然,许多模型已经在 SQuAD 数据集上进行了微调。太棒了!这里是我们将要评估的几个 SQuAD 微调模型:

-

distilbert-base-cased-distilled-squad

-

bert-large-uncased-whole-word-masking-finetuned-squad

-

ktrapeznikov/albert-xlarge-v2-squad-v2

-

mrm8488/bert-tiny-5-finetuned-squadv2

-

twmkn9/albert-base-v2-squad2

我们在 SQuAD 的两个版本(版本 1 和版本 2)上使用我们选择的模型进行了预测。它们之间的区别在于,SQuAD-v1 只包含可回答的问题,而 SQuAD-v2 还包含不可回答的问题。为了说明这一点,让我们来看下面来自 SQuAD-v2 数据集的例子。问题 2 的答案无法从维基百科提供的上下文中推导出来:

问题 1:“诺曼底位于哪个国家?”

问题 2:“谁在 1000 年代和 1100 年代将他们的名字给予了诺曼底?”

上下文:“诺曼人(Norman: Nourmands; French: Normands; Latin: Normanni)是指在 10 世纪和 11 世纪将他们的名字给予法国诺曼底地区的人。他们的祖先是来自丹麦、冰岛和挪威的诺斯(‘诺曼’源自‘诺斯人’)劫掠者和海盗,他们在他们的领袖罗洛的带领下,同意对西法兰克国王查理三世宣誓效忠。通过几代人与当地的法兰克人和罗马高卢人的融合,他们的后代逐渐与西法兰克的加洛林文化融合。诺曼人的独特文化和民族身份最初在 10 世纪上半叶出现,并在随后的几个世纪中不断发展。”

我们理想的模型应该能够充分理解上下文以生成答案。

让我们开始吧!

要在 Transformers 中定义模型和分词器,我们可以使用 AutoClasses。在大多数情况下,AutoModels 可以自动从模型名称中推导出设置。我们只需要几行代码来完成设置:

from tqdm import tqdm

from transformers import AutoTokenizer, AutoModelForQuestionAnsweringmodelname = 'bert-large-uncased-whole-word-masking-finetuned-squad'tokenizer = AutoTokenizer.from_pretrained(modelname)

model = AutoModelForQuestionAnswering.from_pretrained(modelname)

我们将以人类水平的表现作为我们的准确性目标。SQuAD 排行榜提供了这个任务的人类水平表现,即 87%的准确率和 89%的 F1 得分。

你可能会问,“他们怎么知道人类表现是什么?”以及“他们说的是哪些人?”那些斯坦福研究人员很聪明。他们只是使用了同一组标记 SQuAD 数据集的众包人群。对于测试集中的每个问题,他们让多个人工提供不同的答案。为了获得人类得分,他们只是将其中一个答案留出来,并检查它是否与其他答案匹配,使用了与评估机器模型相同的文本比较算法。这种“留一个人类答案”的数据集的平均准确性就是机器所要追求的人类水平得分。

为了在我们的数据集上运行预测,首先我们需要将下载的 SQuAD 文件转换为计算机可解释的特征。幸运的是,Transformers 库已经提供了一套方便的函数来完成这一任务:

from transformers import squad_convert_examples_to_features

from transformers.data.processors.squad import SquadV2Processorprocessor = SquadV2Processor()

examples = processor.get_dev_examples(path)

features, dataset = squad_convert_examples_to_features(

examples=examples,

tokenizer=tokenizer,

max_seq_length=512,

doc_stride = 128,

max_query_length=256,

is_training=False,

return_dataset='pt',

threads=4, # number of CPU cores to use

)

我们将使用 PyTorch 及其 GPU 功能(可选)来进行预测:

import torch

from torch.utils.data import DataLoader, SequentialSamplereval_sampler = SequentialSampler(dataset)

eval_dataloader = DataLoader(dataset, sampler=eval_sampler, batch_size=10)all_results = []

def to_list(tensor):

return tensor.detach().cpu().tolist()for batch in tqdm(eval_dataloader):

model.eval()

batch = tuple(t.to(device) for t in batch) with torch.no_grad():

inputs = {

"input_ids": batch[0],

"attention_mask": batch[1],

"token_type_ids": batch[2]

} example_indices = batch[3] outputs = model(**inputs) # this is where the magic happens for i, example_index in enumerate(example_indices):

eval_feature = features[example_index.item()]

unique_id = int(eval_feature.unique_id)

重要的是,模型输入应该针对 DistilBERT 模型(例如 distilbert-base-cased-distilled-squad)进行调整。由于 DistilBERT 与 BERT 或 ALBERT 的实现差异,我们应该排除“token_type_ids”字段,以避免脚本出错。其他所有内容将保持完全相同。

最后,为了评估结果,我们可以应用来自 Transformers 库的 squad_evaluate() 函数:

from transformers.data.metrics.squad_metrics import squad_evaluateresults = squad_evaluate(examples,

predictions,

no_answer_probs=null_odds)

这是由 squad_evaluate 生成的示例报告:

OrderedDict([('exact', 65.69527499368314),

('f1', 67.12954950681876),

('total', 11873),

('HasAns_exact', 62.48313090418353),

('HasAns_f1', 65.35579306586668),

('HasAns_total', 5928),

('NoAns_exact', 68.8982338099243),

('NoAns_f1', 68.8982338099243),

('NoAns_total', 5945),

('best_exact', 65.83003453213173),

('best_exact_thresh', -21.529870867729187),

('best_f1', 67.12954950681889),

('best_f1_thresh', -21.030719757080078)])

现在让我们比较对我们两个基准数据集 SQuAD-v1 和 SQuAD-v2 生成的精确答案准确率(“exact”)和 f1 分数。所有模型在没有负面样本的数据集(SQuAD-v1)上的表现明显更好,但我们有一个明确的赢家(ktrapeznikov/albert-xlarge-v2-squad-v2)。总体而言,它在两个数据集上的表现都更好。另一个好消息是我们为这个模型生成的报告与作者发布的 报告 完全一致。准确率和 f1 分数稍微逊色于人类水平,但对于像 SQuAD 这样具有挑战性的数据集来说仍然是一个很好的结果。

表 1:5 个模型在 SQuAD v1 和 v2 上的准确率得分

我们将在下一个表格中比较 SQuAD-v2 预测的完整报告。看起来 ktrapeznikov/albert-xlarge-v2-squad-v2 在两个任务上表现几乎一样好:(1)识别可回答问题的正确答案,和(2)筛选出可回答的问题。有趣的是,bert-large-uncased-whole-word-masking-finetuned-squad 在第一个任务(可回答的问题)上提供了大约 5% 的显著提升,但在第二个任务上完全失败。

表 2:不可回答问题的单独准确率得分

我们可以通过调整 null 阈值来优化模型在识别不可回答问题方面的表现,以获得最佳的 f1 分数。请记住,最佳的 f1 阈值是由 squad_evaluate 函数计算的输出之一(best_f1_thresh)。以下是当我们应用来自 SQuAD-v2 报告的 best_f1_thresh 时 SQuAD-v2 预测指标的变化情况:

表 3:调整后的准确率得分

尽管这种调整有助于模型更准确地识别不可回答的问题,但它以回答问题的准确性为代价。这个权衡应该在你的应用背景下仔细考虑。

让我们使用 Transformers QA 流水线测试三种最佳模型,并提出一些我们自己的问题。我们从一篇关于计算语言学的维基百科文章中挑选了以下未见示例:

context = '''

Computational linguistics is often grouped within the field of artificial intelligence

but was present before the development of artificial intelligence.

Computational linguistics originated with efforts in the United States in the 1950s to use computers to automatically translate texts from foreign languages, particularly Russian scientific journals, into English.[3] Since computers can make arithmetic (systematic) calculations much faster and more accurately than humans, it was thought to be only a short matter of time before they could also begin to process language.[4] Computational and quantitative methods are also used historically in the attempted reconstruction of earlier forms of modern languages and sub-grouping modern languages into language families.

Earlier methods, such as lexicostatistics and glottochronology, have been proven to be premature and inaccurate.

However, recent interdisciplinary studies that borrow concepts from biological studies, especially gene mapping, have proved to produce more sophisticated analytical tools and more reliable results.[5]

'''

questions=['When was computational linguistics invented?',

'Which problems computational linguistics is trying to solve?',

'Which methods existed before the emergence of computational linguistics ?',

'Who invented computational linguistics?',

'Who invented gene mapping?']

请注意,最后两个问题在给定的上下文中是无法回答的。以下是我们测试的每个模型的结果:

Model: bert-large-uncased-whole-word-masking-finetuned-squad

-----------------

Question: When was computational linguistics invented?

Answer: 1950s (confidence score 0.7105585285134239)

Question: Which problems computational linguistics is trying to solve?

Answer: earlier forms of modern languages and sub-grouping modern languages into language families. (confidence score 0.034796690637104444)

Question: What methods existed before the emergence of computational linguistics?

Answer: lexicostatistics and glottochronology, (confidence score 0.8949566496998465)

Question: Who invented computational linguistics?

Answer: United States (confidence score 0.5333964470000865)

Question: Who invented gene mapping?

Answer: biological studies, (confidence score 0.02638426599066701)

Model: ktrapeznikov/albert-xlarge-v2-squad-v2

-----------------

Question: When was computational linguistics invented?

Answer: 1950s (confidence score 0.6412413898187204)

Question: Which problems computational linguistics is trying to solve?

Answer: translate texts from foreign languages, (confidence score 0.1307672173261354)

Question: What methods existed before the emergence of computational linguistics?

Answer: (confidence score 0.6308010582306451)

Question: Who invented computational linguistics?

Answer: (confidence score 0.9748902345310917)

Question: Who invented gene mapping?

Answer: (confidence score 0.9988990117797236)

Model: mrm8488/bert-tiny-5-finetuned-squadv2

-----------------

Question: When was computational linguistics invented?

Answer: 1950s (confidence score 0.5100432430158293)

Question: Which problems computational linguistics is trying to solve?

Answer: artificial intelligence. (confidence score 0.03275686739784334)

Question: What methods existed before the emergence of computational linguistics?

Answer: (confidence score 0.06689302592967117)

Question: Who invented computational linguistics?

Answer: (confidence score 0.05630986208743849)

Question: Who invented gene mapping?

Answer: (confidence score 0.8440988190788303)

Model: twmkn9/albert-base-v2-squad2

-----------------

Question: When was computational linguistics invented?

Answer: 1950s (confidence score 0.630521506320747)

Question: Which problems computational linguistics is trying to solve?

Answer: (confidence score 0.5901262729978356)

Question: What methods existed before the emergence of computational linguistics?

Answer: (confidence score 0.2787252009804586)

Question: Who invented computational linguistics?

Answer: (confidence score 0.9395531361082305)

Question: Who invented gene mapping?

Answer: (confidence score 0.9998772777192002)

Model: distilbert-base-cased-distilled-squad

-----------------

Question: When was computational linguistics invented?

Answer: 1950s (confidence score 0.7759537003546768)

Question: Which problems computational linguistics is trying to solve?

Answer: gene mapping, (confidence score 0.4235580072416312)

Question: What methods existed before the emergence of computational linguistics?

Answer: lexicostatistics and glottochronology, (confidence score 0.8573431178602817)

Question: Who invented computational linguistics?

Answer: computers (confidence score 0.7313878935375229)

Question: Who invented gene mapping?

Answer: biological studies, (confidence score 0.4788379586462099)

如你所见,仅凭单个数据点很难评估模型,因为结果差异很大。虽然每个模型对第一个问题(“计算语言学是什么时候发明的?”)给出了正确答案,但其他问题则更具挑战性。这意味着即使是我们最好的模型也可能需要在自定义数据集上进行进一步调整,以实现更好的效果。

要点:

-

开源预训练(和微调过的!)模型可以为你的自然语言处理项目提供快速启动。

-

在做其他事情之前,尽量复现作者报告的原始结果(如果可用)。

-

对模型进行准确性基准测试。即使是对完全相同的数据集进行微调的模型,也可能表现出很大的差异。

个人简介:Olesya Bondarenko 是 Tangible AI 的首席开发者,她负责推动 QAry 变得更智能。QAry 是一个你可以信赖的开源问答系统,适用于最私密的数据和问题。

原文。经允许转载。

相关:

-

BERT、RoBERTa、DistilBERT、XLNet:使用哪一个?

-

在 Python 中使用文本相似性检测的简单问答系统

-

利用 NLP 识别争议

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织中的 IT 工作

3. Google IT 支持专业证书 - 支持你组织中的 IT 工作

更多相关话题

FluDemic – 利用 AI 和机器学习抢占疾病先机

原文:

www.kdnuggets.com/2021/04/fludemic-ai-machine-learning-disease.html

评论

由DataDriven Health提供,AI 技术公司,致力于转变人口健康和综合监测。

2314 exabytes。这是估计在 2020 年生成的医疗数据量,来自世界经济论坛。换句话说,如果一个千兆字节相当于地球的大小,那么一个艾字节则相当于太阳的大小。

图片来源。

我们必须利用机器学习的力量来分析大量数据,从中获得有意义的见解,以帮助改善公共健康。COVID-19 大流行造成了全球灾难、严重的人员损失和前所未有的社会经济干扰。但如果我们能够在疫情扩散之前预测并阻止这一激增,那会怎样呢?

我们的动机

冠状病毒爆发使传染病建模成为焦点。这正是 FluDemic 大显身手的地方。我们的目标是通过数据协助政府、卫生系统管理者、社区领导和所有人做出前瞻性决策。我们的数据科学家和分析师密切合作,研究传播模式,了解各种社会经济影响,并使用专有的机器学习算法创建预测模型。FluDemic 目前提供了一个平台,用于跟踪和预测 COVID-19 和流感样疾病(ILI)。

我们如何增加价值?

FluDemic 在本质上有三种方式来发挥作用:

1. 疾病追踪:

对于 COVID-19,FluDemic 跟踪几个关键指标,如病例、死亡、检测数据、疫苗接种率和住院率。对于流感,跟踪的指标包括门诊访问中与 ILI 相关的比例、肺炎和流感死亡率、阳性检测率以及 ILI 活动水平。

COVID-19 的度量条。

流感的度量条。

除了原始值之外,我们还提供了标准化的时间和人口调整指标视图,使我们的观众能够真实地了解实际情况。这些指标在两个维度上进行跟踪:

-

空间:用于在县、市和国家之间进行地理视图。这种可视化评估哪个地区最有效地应对疾病。

-

时间:用于疫情的时间视图。这有助于评估关键政策决策的有效性。它还捕捉了疾病的趋势,无论是上升还是下降。

2. 热点检测与预测:

监测疾病的空间分布并识别病例集中最多的地方,为公共卫生官员提供了关键信息。提前一到两周预测这些热点有助于帮助官员有效和高效地将稀缺资源,如个人防护装备、医院床位和疫苗,分配到最需要的地区。FluDemic 关注多个群体并预测哪些地理区域最容易出现未来的激增、爆发和社会经济风险。

纽约州的人口调整 COVID-19 病例的 7 天预测。

3. 社区意识与影响:

由于疾病传播最终掌握在公众手中,无论他们是否遵守社交距离和戴口罩等各种政策,因此了解他们行为的潜在后果至关重要。流动数据通过地理位置和不同类别的地点(如零售和休闲、杂货和药店、公园、交通站点、工作场所和住宅)显示了随时间变化的移动趋势。此外,FluDemic 的社会经济风险指标提供了基于地点的感染和死亡风险的定性视图。

仅将冠状病毒大流行称为健康危机是过于天真的。根据世界卫生组织(WHO)的说法,“全球 33 亿劳动力中的近一半面临失去生计的风险。” FluDemic 通过跟踪失业率来揭示一些情况。许多企业已经破产,更多的企业面临生存威胁。这些影响通过综合领先指标(CLI)得到体现,CLI 显示了经济活动的波动,以及信心指数,这些指数反映了国家商业前景和家庭支出。

如果你对了解更多关于该网站的内容感兴趣,请查看这个简短的 FluDemic 教程:

数据和建模

供 FluDemic 使用的数据来源种类繁多。对于 COVID-19,多个不同的来源提供了病例、死亡、检测、住院、流动、失业、信心指数、社交距离措施和疫苗接种的关键数据。对于流感,数据来源包括流感样疾病(ILI)、肺炎和流感死亡、疫苗接种率和检测等指标。有关数据来源的详细信息,请查看FluDemic的关于部分。

尽管有各种可用的信息,但建模流行病过程仍然面临几个挑战。隐私和保密问题使得在个人层面公开数据变得困难。因此,许多可用的信息都是在总体水平上。像个人的既往病史这样的关键信息无法在公共模型中考虑。在处理大规模数据时,我们需要认识到数据的收集过程和质量在各州之间差异很大。例如,流感监测是一个自愿过程,每个州以不同的完整性和不同的延迟报告其信息。这种报告制度的差异往往会掩盖更细微的区域差异。

现代疫情的建模也受到高度互联的世界中的现实情况的复杂影响,在这种世界中,长途旅行的频率可以在几周内将疫情升高为全球现象。仅考虑局部传播是不够的。模型必须纳入人口的连通性。为了平衡这一点,我们现在拥有比以往更多、更好的数据来量化这种行为。

我们将传染病的发展分为四个阶段:暴露、感染、住院和致死(例如,使用公开数据估计 COVID-19 相关住院和死亡的个体风险)。这一过程始于暴露阶段,即一个或多个未感染者接触到一个感染者。虽然暴露可以发生在家中或杂货店,但当未受保护的人群在一起待较长时间时,暴露风险会加剧。室内用餐在酒吧和餐厅或参加现场活动可能会导致大量人同时暴露于疾病,即使只有很小一部分参与者感染。暴露之后,每种传染病都有一个潜伏期,在此期间病毒感染身体并繁殖。经过这段时间后,症状会出现,个人可能会接受检测并记录为病例。建模挑战在于识别潜伏期的统计分布,并将其纳入跟踪暴露诱发情况的模型中。

在一部分人群中,感染者健康状况严重恶化,导致住院,偶尔还会死亡。然而,住院和随后的死亡都存在时间延迟,这些延迟因人而异,通常与患者的既往病史、治疗护理的可及性和质量相关。在我们的人群模型中,我们利用时间延迟分布及其卷积来追踪从感染到死亡的进程。我们还注意到,对于像 COVID-19 这样的新型疾病,治疗方案随着疫情的进展而不断演变,病例致死率也是如此。由于疫情高峰期间医院床位——特别是 ICU 床位和呼吸机——的紧张,优质护理的可及性受到影响。尽管复杂,了解病例和住院情况的状态使我们能够展望预期的死亡情况。

纽约州每日按人口调整的 7 天滚动平均病例和死亡预测。

热点地区被定义为在考虑预期变化后,每日病例或死亡人数异常高的县。利用序列时间序列模型和时间延迟回归量来预测每个县的每日病例和死亡趋势。结果预测经过人口规模化处理,并使用七天滚动平均进行平滑,从而帮助我们识别新兴热点。

美国各地死亡风险的变异性。

为了将特定县的病例和死亡与基础的人口统计和社会经济因素联系起来,我们计算与人口规模化感染(发病率)和死亡(死亡率)相关的风险因素。主要的人口统计和社会经济因素包括县的人口及人口密度,以及年龄、收入和家庭规模分布。在疫情期间,行为因素如流动性和口罩使用等也会影响风险模型。

与社会经济风险相关的诸多因素并不是彼此独立的——每个因素提供一些独立信息,同时也是常见模式的度量。我们通过各种技术如主成分分析将这些信息拆解为独立组合,这也使我们能够减少独立模型参数的数量,从而使风险估计更为稳健(例如,COVID-19 大流行中的社会经济状况和心血管健康)。

建模风险的第二个重要方面是术语贡献的固有非线性。让我们考虑一下口罩使用情况、流动性和人口密度。每个术语单独都会对社会经济风险产生影响。然而,它们结合在一起时,效果更为强烈。一个人口密度大、流动性高的县会看到口罩使用的影响远大于一个人口稀少的县或一个人们倾向于呆在家的县。这些非线性效应通过使用包含所有交叉项的顺序多项式回归在我们的模型中得到考虑。

下一步是什么?

公开可用的数据常常存在报告错误、显著延迟和较低的地理颗粒度。这给模型的准确性和可操作性带来了挑战。通过 FluDemic 的高级版,我们专注于利用健康系统提供的大量临床级数据。这些数据经过匿名化、聚合处理,并输入到机器学习模型中,从而提供更高的准确性。使该解决方案更具可操作性的关键改进有:

-

数据是实时/接近实时的。

-

数据提供了患者人群的洞察——包括患者的年龄、性别和共病情况。机器学习模型提供了与不同队列相关的更多具体信息,这对于资源调动和有针对性的消息传递至关重要。

-

地理颗粒度为普查区和街区组级别。

-

住院数据仅在机构级别提供,而非在州级别,这对于资源调动尤其重要。

-

病例数据来源于“金源”系统,如确诊实验室测试结果或 COVID-19 和流感的处方。

-

基因组测序将加速开发病毒基因组监测网络,该网络将预测并提醒相关方未来的疫情高峰,评估新变种带来的威胁,并为我们未来不可避免的大流行做好准备。此模型将增强对其他当前传染病(如流感)的监测和预测。

除了 COVID-19 和流感,机器学习模型还将应用于糖尿病、癌症、慢性阻塞性肺病(COPD)和充血性心力衰竭(CHF)等不同的治疗领域。

Bio: 由 Data Driven Health 团队提供,该公司专注于通过人工智能技术转变人群健康和综合监测。

相关:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

更多相关内容

2018 年机器学习/人工智能的关注重点应该是什么?

评论

评论

作者:Vijay Srinivas Agneeswaran,SapientRazorfish。

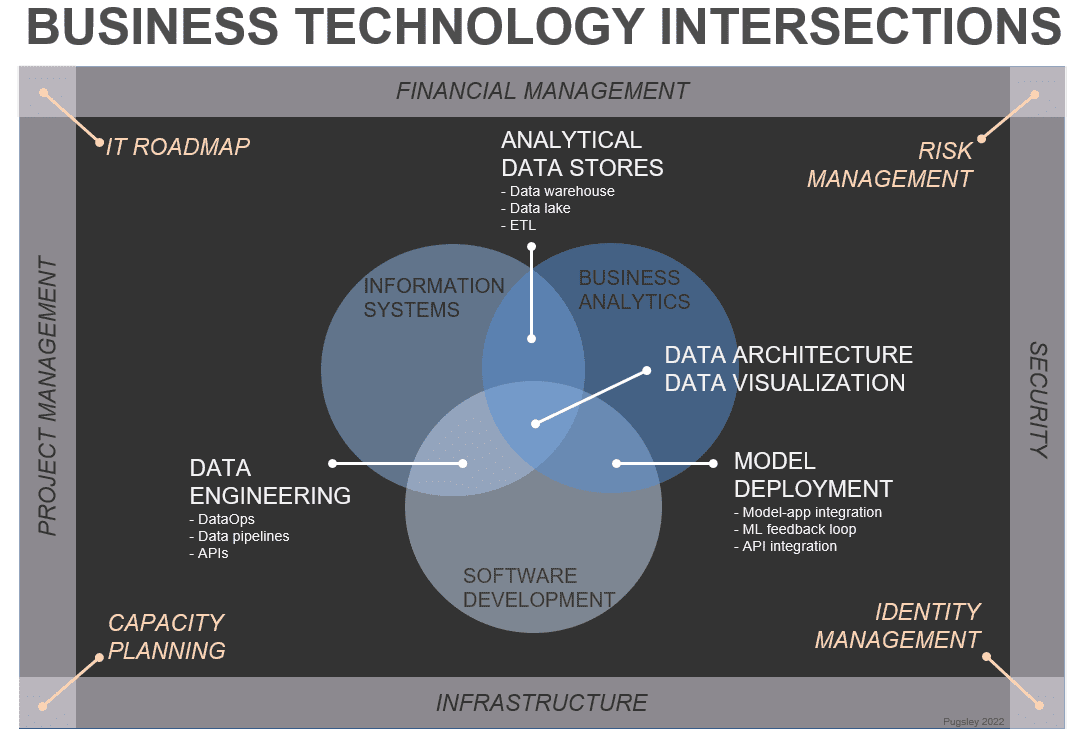

机器学习的生产化

这是 2018 年最重要的关注领域。大多数企业已经完成了机器学习的概念验证,并寻求通过全面的生产实施算法来实现数据的全部价值。这个领域的关键技术可能是 Clipper。Clipper 是来自伯克利大学 Rise 实验室的最先进的机器学习服务系统,利用分布式计算概念来扩展模型,使用容器化模型部署来处理任何平台创建的模型,并执行跨框架缓存和批处理,以利用像 GPU 这样的并行架构。最后,Clipper 还可以通过像集成和多臂强盗这样的机器学习技术执行跨框架模型组合。

另一个有趣的技术与模型选择有关,称为 autoML——类似于 Uber 的 Michelangelo。许多开源框架如 TPot 和 AutoSKLearn 已出现,帮助自动搜索多个模型的空间,使用适当的超参数并选择最适合当前任务的模型。模型管理是指跟踪生产中数百个模型的能力,包括模型/分析的传承——例如,每个模型在何种数据集上评估了哪些指标及结果,实质上是模型开发、再训练和更新的整个周期等。ModelDB 是该领域的一个可能选择。

另一个有趣的工作来自 MapR——名为机器学习物流(Machine Learning Logistics)的工作,其核心理念是 Rendezvous 架构。Rendezvous 架构的关键元素包括基于流的微服务和容器化,以及促进警报和诱饵的 DataOps 风格设计。诱饵是一个对输入数据不进行任何操作的模型——它用于保存输入流的副本。警报是一个提供参考或基准的模型,用于与其他模型进行比较。Rendezvous 架构允许模型被大程度地监控,并且可以测量模型漂移,使得新的模型能够逐步、无缝地接管。

深度学习将继续存在

最近有一些论文揭示了深度学习的局限性,包括著名的文章作者加里·马库斯和KDNuggets上的这篇文章。加里认为,深度学习的局限性主要来源于仅有有限的数据进行训练,而实际中可能需要无限的数据才能实现完美的泛化。KDNuggets 文章展示了深度学习网络在分类任务中如何容易受到输入图像扰动以及随机(无意义)图像的欺骗,这些扰动和图像会导致高置信度的错误分类。

然而,正如谷歌深度思维团队在使用深度学习结合强化学习进行 Atari 游戏系统或 AlphaGo 的研究中所展示的,深度学习是非常有用的,并且可以与其他已知的机器学习技术结合,产生出色的结果。

使用深度学习的一个常见问题是超参数调优。一种最近的方法展示了如何通过强化学习的方法组合某些形式的递归网络,这些网络可以在显著程度上超越现有系统。

另一篇最近的论文提出了如何使用深度学习来预测小分子的量子力学性质——它展示了深度学习(特别是消息传递神经网络这种特定形式的深度学习)可以应用于图结构数据,并且对图同构是不变的。

隐式信号与显式信号

人们会撒谎,尤其是在调查中。因此,使用调查来理解用户行为的传统方法似乎不再奏效。这在 Netflix 中尤为明显,当时他们发现经典影片的评分非常高,但实际上并未被观看。这在 Google 搜索中也很明显,并且是最近 Strata Data 主题演讲的内容。Google 研究人员指出,在对马里兰州毕业生的调查中,只有 2%的人表示他们的 CGPA 低于 2.5,而实际情况是 11%的人 CGPA 低于 2.5。类似地,在另一个调查中,40%的工程师表示他们是公司中前 5%的工程师。Google 搜索是数字真相血清,人们在上面比在任何调查或其他平台上更为诚实。这也告诉我们,我们应该关注隐性信号(如人们在 Netflix 上实际观看的内容),而不是依赖于调查的显性反馈来理解消费者行为。这在 Pinterest 开发的一些推荐系统中也有所体现,如在这场keynote speech中记录的那样;他们使用了用户如何与钉子互动的隐性信号(保存钉子、重新钉其他用户的钉子、搜索钉子以及用户不喜欢或忽略的推荐),并能够根据基于图的推荐引擎为用户推荐适当的个性化内容。

模型解释性

模型解释性或可解释性是机器学习算法解释其为何以某种方式做出预测的能力。由于训练数据中看到的多个欺诈案例,系统可能将其推断为欺诈交易。随着越来越多的机器学习模型在金融、保险、零售甚至医疗等多个领域投入生产,模型解释性变得越来越重要。这个领域的一个新兴技术包括Skater和Lime等。

超越深度学习的人工智能

Libratus,另一个最近的游戏系统,将纳什均衡和博弈论结合起来,解决了像扑克这样的不完全信息游戏,并在动态竞争定价和产品组合优化中得到应用。Libratus 的三个主要组件包括:

-

游戏抽象器——计算游戏的一个更小且易于解决的抽象,并为该抽象计算博弈论策略。

-

第二个模块构建了子游戏的精细抽象(几轮后的游戏状态),并使用一种称为嵌套子游戏求解的技术来解决它。

-

第三个模块是自我改进器,它为游戏创建蓝图策略,填充蓝图抽象的部分,并计算这些分支的博弈论方法。

强化学习是数据科学家工具包中的另一个重要工具。它现在与深度学习结合,开发出深度强化学习网络,例如来自谷歌的网络。

机器学习时代的隐私。

数据隐私及其相关的数据保护法律,包括《通用数据保护条例》(GDPR),在这方面非常重要。例如,GDPR 规定必须获得用户的同意才能收集个人数据。用户还拥有询问所收集数据的权利,以及修改、删除数据或反对使用个人数据进行定向的权利(如果他们愿意的话)。数据处理者根据 GDPR 也有一定的义务。GDPR 将在 2018 年影响所有数据产品的设计。

确保数据管道和基础设施的安全不仅重要,确保商业智能(BI)和分析的安全也同样重要。这时,隐私保护分析变得相关,并在 2018 年将变得极为重要。保障 BI 安全的相关技术是 Uber 与伯克利大学 Rise Labs 最近联合开发的,基于所谓的弹性敏感度,它结合了局部敏感度机制与一般等值连接,确保 SQL 查询的差分隐私。

对于深度学习模型,隐私保护分析是通过一种名为联邦学习的技术实现的,该技术由谷歌推广。它基于一个集中式参数服务器,托管所有学习所需的参数。每部手机可以下载这些参数,利用本地数据来改进模型,并生成一个小的更新消息,然后发送回参数服务器。服务器从多部手机中聚合更新,并在中心更新模型参数。联邦学习的有趣之处在于数据都是本地的,而学习是全球性的。每部手机通过使用自己的本地数据并在本地进行计算来更新模型——将机器学习与将数据存储在云端解耦。这一技术在 Android 的 Gboard(谷歌键盘)中得到了应用。

上述通过联邦学习进行的单一模型训练确实存在一些挑战,如高通信开销、滞后者和容错性问题,以及将模型与数据适配的统计挑战。这些问题通过 CMU 的近期研究得到解决,该研究使用联邦核化多任务学习来应对统计挑战,通过使用多个模型并同时更新它们,而系统挑战则由 MOCHA——分布式优化模型来解决。

原文。经授权转载。

相关:

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

更多相关话题

一种美味的数据科学方法

原文:

www.kdnuggets.com/2017/01/foodpairing-tasty-approach-data-science.html

作者:Natalia Hernandez,Foodpairing。

当品牌准备创建新风味时,总会有一个构思阶段,开发者会问自己“我们接下来可以创造什么?”在 Foodpairing,我们通过结合消费者行为数据和科学分析的混合方法帮助品牌回答这个问题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

当然,当公司试图自己回答这个问题时,他们会在模糊的前期阶段花费过多时间(这是新产品风味构思与开发开始之间的时间)。

在风味线开发的这一阶段,调查无效且昂贵,趋势报告过于笼统,无法为企业提供可操作的洞察。公司只能依赖直觉——这是一种高成本的风险。

我们将构建新风味线的方法命名为消费者风味智能(CFI),它缩短了产品开发过程中的模糊前期阶段。

方法

消费者行为数据是 CFI 核心要素之一,因为它提供了关于消费者对新风味和口味期望的大量洞察。

我们在注意到公司面临三大日益严重的挑战以开发新风味线后,开发了这种方法。

首先,消费者不再完全忠于品牌——千禧一代的风味口味迅速变化,为了跟上这一变化,新产品不断上架。

第二,76%的新产品线扩展在一年内失败——我们将其归因于市场模糊前期缺乏精准。

第三,新一代敏捷公司已进入市场。例如,当地的工艺生产商通过高质量、符合潮流的产品创建强大的品牌。他们的开发周期比跨国公司短,从而缩短了市场上市时间。

总体而言,这为公司尝试新风味线创造了一个普遍风险较高的环境。为了解决这些众多挑战,我们创建了一个从更全面的角度考察市场的解决方案。

我们的数据科学家挖掘公共在线数据,这为我们提供了总体趋势洞察。然后,我们使用分子方法对食品进行分析。在这里,我们分析气味并测量其与其他风味的兼容性。我们还进行品牌分析,使用定性方法描述品牌本身,包括其视觉识别和语调,以及特定产品的属性,如质地和口味。然后,我们可以根据品牌身份分析对风味选项进行评分。

图 1:Foodpairing 如何可视化其匹配食材的方法。他们的分析识别出潜在的气味(如水果味、蔬菜味等)及其在成分中的主导程度。然后,他们可以将其与具有互补成分的其他成分连接起来。

现在是数据科学与食品行业结合的时候了

采用科学、消费者数据、厨师灵感的市场研究方法的主要好处是它减少了研发团队试错的成本。

当前在模糊前端的工具箱已经不再足够。市场营销经理、研发厨师和研发经理缺乏可操作的市场和消费者洞察。如今,研究技术在评估阶段效果很好,但在创意生成阶段效果却不佳。

当数据成为创意的核心时,从市场营销到研发的利益相关者可以共同参与决策,对齐公司目标,并帮助提高成功推出的机会。

对我们来说,确保在正确的时刻将正确的风味推出到正确的市场是至关重要的。这是使新风味系列成功的关键。我们提供的市场研究与消费者当前和未来的偏好紧密相关。

我们不断投资于与市场关键参与者建立更多独特的数据合作伙伴关系。这使我们能够增强预测能力。

此外,我们真的希望快速消费品/食品行业对“大数据”的普遍不信任能减少。我们看到数据和数据驱动的策略如何改变了电影、音乐和汽车等行业。

我们觉得现在是时候在食品和饮料行业拥抱“数据科学”了。我们通过在市场研究组织中变得更加活跃来推动这一进程,以提高行业的可见性。作为市场研究圈的外部人士,我们对挑战该领域的参与者始终思考数据的下一个应用感到兴奋。

简介:Natalia Hernandez 是 Foodpairing 的数据科学家。她拥有来自马德里 IE 商学院的商业分析和大数据硕士学位以及工业工程学士学位。Natalia 的第一大热情是食物。在完成工程学学位之前,她曾就读于烹饪学校。

相关:

-

WCAI 研究机会,4 月 24 日:他说,她买了——用户生成的评论和购买行为

-

营养与主成分分析:教程

更多相关内容

预测未来事件:AI 和 ML 的能力与局限性

原文:

www.kdnuggets.com/2023/06/forecasting-future-events-capabilities-limitations-ai-ml.html

图片来自 Bing 图像创作者

ML 和 AI 能否应用于预测未来?

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

预测未来是一项具有挑战性的任务,但越来越多地使用机器学习和人工智能来尝试实现。这些技术有可能彻底改变我们在金融、医疗保健和自然灾害等各个领域的预测方式。它们能够基于数据中的模式和趋势进行预测,但这些预测的准确性可能会因使用的数据质量和数量以及模型的复杂性而有所不同。由于有许多变量可能影响结果,因此很难确定地预测未来事件。此外,关于未来事件的预测,例如自然灾害或世界领导人,也可能受到人类行为和决策的影响,这些是难以建模的,并且目前超出了 ML 和 AI 的能力,它们尚未足够先进,无法以高精度预测未来事件。

目前使用 ML 和 AI 的预测现状

如今,ML 和 AI 的预测应用已经出现在各个领域。一些例子包括在金融领域,算法被用于高精度地预测股票市场价格。在医疗保健领域,机器学习算法被用来预测患者发展某种疾病的风险。在自然灾害领域,算法被用来预测洪水或飓风的可能性。然而,这些预测并不总是准确的,还有若干挑战需要克服。

然而,重要的是要注意,虽然这些模型和算法可以提供有用的预测和预报,但它们也受到一些进一步讨论的因素的限制。

预测的局限性

机器学习和人工智能可以对未来事件做出预测,但这些预测的准确性高度依赖于用于训练模型的数据的质量和数量,以及被预测任务的复杂性。其中一个最新的案例是 ChatGPT,这是一个人工智能语言模型,无法观察世界或经历事件,它只能基于训练数据中的模式和关系生成预测。一些限制包括:

-

数据不足:为了做出准确的预测,机器学习和人工智能模型需要大量的数据进行学习。对于某些类型的事件,可能没有足够的数据来训练模型。

-

任务的复杂性:一些事件本质上比其他事件更复杂。例如,预测股票市场是一个高度复杂的任务,因为有许多不同的因素可以影响股价。

-

不可预测的事件:一些事件,如自然灾害,难以预测,因为它们是由不可预测的因素引起的。

-

人类行为难以建模:许多事件依赖于人类行为,而人类行为很难预测。例如,预测选举结果可能很困难,因为这取决于人们如何投票,而投票行为受情感、信仰和背景等多种因素的影响。

-

对世界的理解有限:我们对世界的许多事物仍然不了解,模型只能预测它们所训练的内容。

-

数据中的偏差:如果用于训练模型的数据有某种偏差,那么模型做出的预测也会有偏差。

这些限制是否足够强大以至于使预测未来事件成为不可能?

很难说预测未来事件是否是不可能的。预测基于不完整的信息,而未来的复杂性和不确定性使得准确预测变得具有挑战性。

然而,随着技术的进步和数据的日益丰富,预测未来事件变得越来越可能。

改进预测的方法

预测未来事件是一个复杂的任务,需要理解影响事件的基本因素以及建模这些因素之间相互作用的能力。没有一种通用的方法来预测未来事件,但可以使用的一些方法包括:

-

数据驱动的方法:这种方法涉及分析历史数据以识别模式和趋势,并利用这些模式对未来事件做出预测。这种方法在金融、天气预报和体育预测等领域被广泛使用。

-

专家意见:从在该领域拥有深厚理解的专家那里获得见解,可以用于做出预测。这些专家可能会利用他们自己的经验和知识,以及数据驱动的方法来做出预测。使用诸如机器学习(ML)、人工智能(AI)和专家知识等技术的组合非常重要。

-

模拟:构建计算机模型来模拟影响事件的因素之间的相互作用,可以用于做出预测。这种方法在天气预报、工程学和经济学等领域中被广泛使用。

-

情景规划:这种方法涉及创建一组合理的未来情景,然后利用这些情景来指导决策。这种方法可以用于预测未来事件,例如通过考虑不同的可能行动及其可能的结果,来预测世界领导人的行动。

-

持续监测和更新预测:未来是不断变化的,因此重要的是不断监测预测,并在有新信息出现时更新它们。

-

了解预测的局限性和不确定性:预测永远不会是 100%准确的,因此重要的是以一定的怀疑态度看待它们,并将其与其他信息来源结合考虑。

此外,即使预测是准确的,也可能无法采取行动。例如,如果一个预测说自然灾害即将发生,但没有办法采取措施预防,那么这个预测就没有用。因此,在做出预测时,考虑预测的可操作性非常重要。

结论

预测是决策的重要工具,但也存在局限性。机器学习和人工智能有潜力革新我们的预测方式,但理解这些预测的局限性也很重要。通过收集更多数据、开发更先进的模型、从专家那里获取见解以及纳入多个情景,预测可以得到改进。然而,使用这些预测时要谨慎,不要过于依赖它们。

Parisi Shalini 是一名数据工程师,对探索那些提出有趣问题但没有现成答案的领域充满热情。她喜欢深入未知领域的兴奋感,那些领域尚未被揭示的知识使她充满激情。

进一步了解此主题

忘掉 ChatGPT,这款全新的 AI 助手遥遥领先,将永远改变你的工作方式

原文:

www.kdnuggets.com/2023/08/forget-chatgpt-new-ai-assistant-leagues-ahead-change-way-work-forever.html

作者提供的图像

我使用 ChatGPT 和 Bard 已有一段时间,这些工具已成为我工作流程的重要部分。我依赖它们生成代码、进行统计测试、理解新术语,并制作分析报告和总结。然而,当我切换到 Poe 后,体验显著改善。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

在这篇文章中,我将解释为什么我停止使用 ChatGPT,并且为什么我认为 Poe 是各种数据科学任务的更佳替代方案。

什么是 Poe

Poe 是一个聊天机器人服务,允许你使用最先进的模型,如 Claude +、GPT-3.5-Turbo、GPT-4、LlaMA 2、PaLM 和所有新型 LLM 模型。此外,它将使用户能够使用初始提示创建和共享可定制的聊天机器人。Poe 速度快,易于使用,并提供准确的答案。

来自 Poe 的图像

我更喜欢使用 Poe 而非 ChatGPT 和 Bard,因为 Poe 更快、更准确,并且提供更多功能。Poe 允许我一键清除上下文,而在 ChatGPT 上,我必须开始一个新的聊天会话。Poe 让我可以一键在 Claude+ 和 Sage 等模型之间切换,而 ChatGPT 仅提供 GPT-4 和 GPT-3.5-Turbo。

Poe 的特点

来自 Poe 的图像

Poe 的主要特点:

-

速度: Poe 的加载和响应速度比 ChatGPT 快得多。

-

模型范围: Poe 提供了更多种类的 AI 模型,这些模型提供比 GPT-3.5-Turbo 更准确的答案。

-

模型切换的简便性: 你可以通过单击轻松切换 AI 模型。

-

自定义聊天机器人: 你可以根据个人偏好通过提供初始提示来创建可定制的聊天机器人。

-

社区聊天机器人: 你可以访问和探索其他 Poe 用户为特定任务创建的聊天机器人。

-

简洁性: 注册和开始使用 Poe 非常简单明了。

-

高级访问: 付费订阅可以让你访问更多高级模型,如 GPT-4 和 Claude。

-

应用程序: Poe 既有 Android 版也有 iOS 版。

-

稳定性: 它不会崩溃或出现 bug。

-

易用性: 清除上下文并开始新的聊天非常简单。

我如何用于数据科学任务

你需要了解这些生成型 AI 聊天机器人是你的助手。它们可以帮助你完成各种任务,从写文章到构建端到端的数据科学项目。

我通常使用 Poe 来编写和创建内容结构。如果我不喜欢 Claude-Instant 的回答,我会询问 ChatGPT 或 Google PaLM。这使我能够选择最佳回复。此外,我还使用 Poe 来:

-

代码生成: 我使用 Poe 生成 Python、R 和 SQL 代码,用于特定任务,如清理数据、执行统计测试和构建机器学习模型。它帮助调试我的代码,甚至生成完整的代码示例来构建网页应用。

-

内容写作: Poe 帮助改善我的博客文章和教程的语法和结构。它还总结了长文档,并生成更好的标题和摘录。

-

技术学习: 我请 Poe 解释新的数据科学技术和统计测试,帮助我学习新技能。

-

数据分析和探索: Poe 生成代码以清理、探索、分析和建模我的数据。它帮助验证数据质量并识别问题。

-

翻译: 我利用 Poe 进行代码和文本的翻译。

总的来说,Poe 是一个有用的助手,可以完成许多重复的任务,从而释放出我的时间用于更高层次的工作和决策。它显著提高了我作为数据科学家的生产力。

结束语

让我们开始使用它,感受不同。我已经使用 Poe Free 三个月了,并且不打算回到官方的 ChatGPT 或 Bard。如果我想从 ChatGPT 生成回复,我会在 Poe 中切换模型。就是这么简单快捷。

如果你有兴趣了解我如何利用其他 AI 工具来提升我的数据科学和内容创作技能,请在评论中告诉我,我将来会写关于这些工具的文章。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专家,喜欢构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络构建一个 AI 产品,帮助那些与心理健康问题斗争的学生。

了解更多相关信息

为什么你应该忘记数据科学代码中的for-loop,而拥抱向量化

原文:

www.kdnuggets.com/2017/11/forget-for-loop-data-science-code-vectorization.html

评论

评论

我们都曾经使用for-loops来处理需要遍历长列表元素的大多数任务。我相信几乎所有阅读这篇文章的人,在高中或大学时,都用 for-loop 编写了他们的第一个矩阵或向量乘法代码。for-loop 长久以来一直服务于编程社区。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

然而,它也带来了一些问题,当处理大型数据集(如当今大数据时代的数百万条记录)时,执行速度往往较慢。这对于像 Python 这样的解释型语言尤其如此,如果你的循环体很简单,循环本身的解释器开销可能是相当大的开销。

幸运的是,在几乎所有主要编程生态系统中都有替代方案。Python 有一个很棒的选择。

Numpy,简写自Numerical Python,是 Python 生态系统中进行高性能科学计算和数据分析所需的基础包。它是几乎所有更高级工具如Pandas和scikit-learn的基础。TensorFlow使用 NumPy 数组作为基本构建块,在此基础上构建了他们的 Tensor 对象和用于深度学习任务的 graphflow(这在长列表/向量/矩阵数字上的线性代数操作中使用频繁)。

Numpy 提供的两个最重要的优势是:

-

ndarray,一个快速且节省空间的多维数组,提供向量化的算术操作和复杂的广播功能 -

进行快速数据数组操作的标准数学函数无需编写循环

你会经常听到数据科学、机器学习和 Python 社区中的说法,即由于其向量化实现和许多核心例程用 C 编写,Numpy 的速度要快得多(基于CPython 框架)。

这确实是事实(这篇文章是一个很好的演示,展示了与 Numpy 一起使用的各种选项,甚至使用 Numpy API 编写裸骨的 C 例程)。Numpy 数组是同质类型的紧密打包数组。相比之下,Python 列表是指向对象的指针数组,即使它们都是同一类型。因此,你可以获得引用局部性的好处。许多 Numpy 操作是用 C 实现的,避免了 Python 中循环的通用开销、指针间接访问以及每个元素的动态类型检查。速度提升取决于你正在执行的操作。[对于数据科学和现代机器学习任务,这是一个宝贵的优势],因为数据集的大小通常达到百万,甚至亿万记录,你不想使用 for 循环及其相关负担来迭代处理它。

如何通过一个中等大小数据集的例子来明确证明这一点?

这是我 Github 代码的链接(Jupyter notebook),它展示了在几行简易代码中,Numpy 操作与常规 Python 编程构造如for 循环、map 函数或列表推导式的速度差异。

我只是概述基本流程:

-

创建一个中等数量的浮点数列表,最好从类似高斯或均匀随机的连续统计分布中抽取。我选择了 100 万个作为演示。

-

从列表中创建一个

ndarray对象,即向量化。 -

编写简短的代码块来遍历列表,并对列表执行数学操作,例如取 10 为底的对数。使用 for 循环、map 函数和列表推导式。每次使用

time.time()函数来确定处理 100 万条记录所需的总时间。

t1=time.time()

for item in l1:

l2.append(lg10(item))

t2 = time.time()

print("With for loop and appending it took {} seconds".format(t2-t1))

speed.append(t2-t1)

- 使用 Numpy 的内置数学方法 (

np.log10) 对ndarray对象执行相同操作。计时。

t1=time.time()

a2=np.log10(a1)

t2 = time.time()

print("With direct Numpy log10 method it took {} seconds".format(t2-t1))

speed.append(t2-t1)

- 将执行时间存储在列表中,并绘制一个条形图以显示比较差异。

这是结果。你可以通过运行 Jupyter notebook 中的所有单元格重复整个过程。每次都会生成一组新的随机数字,因此确切的执行时间可能会有些许变化,但总体趋势将始终相同。你可以尝试其他数学函数/字符串操作或其组合,以检查这种情况是否普遍适用。

这是一本由法国神经科学研究员编写的开源在线书籍,涉及这一主题。在这里查看。

简单数学操作的执行速度比较条形图

如果你有任何问题或想分享的想法,请通过tirthajyoti[AT]gmail.com联系作者。你也可以查看作者的GitHub 仓库,获取更多有趣的 Python、R 或 MATLAB 代码片段以及机器学习资源。

个人简介:Tirthajyoti Sarkar 是半导体技术专家、机器学习/数据科学热衷者、电气工程博士、博客作者和作家。

原文。经许可转载。

相关:

-

使用 Numpy 矩阵的实用参考

-

科学 Python 简介(及其背后的数学) – NumPy

-

Python 数据准备案例文件:基于组的插补

相关阅读

忘记 PIP、Conda 和 requirements.txt!改用 Poetry,稍后感谢我

原文:

www.kdnuggets.com/2023/07/forget-pip-conda-requirementstxt-poetry-instead-thank-later.html

图片由我使用 Midjourney 制作

库 A 需要 Python 3.6。库 B 依赖于库 A,但需要 Python 3.9,库 C 依赖于库 B,但需要与 Python 3.6 兼容的库 A 的特定版本。

欢迎来到依赖地狱!

由于没有外部数据科学包的原生 Python 很差劲,数据科学家经常发现自己陷入如上所示的两难依赖情况。

像 PIP、Conda 或可笑的 requirements.txt 文件这样的工具无法解决这个问题。实际上,依赖地狱在很大程度上正是由于它们的存在。因此,为了结束这些痛苦,Python 开源社区开发了名为 Poetry 的迷人工具。

Poetry 是一个集成的项目和依赖管理框架,在 GitHub 上拥有超过 25k 星标。本文将介绍 Poetry,并列出它为数据科学家解决的问题。

开始吧。

安装

虽然 Poetry 可以通过 PIP 安装为库,但建议将其系统范围内安装,以便你可以在任何地方的 CLI 上调用 poetry。以下是适用于 Unix 类系统的安装脚本命令,包括 Windows WSL2:

curl -sSL https://install.python-poetry.org | python3 -

如果因为某些奇怪的原因,你使用 Windows Powershell,以下是适用的命令:

(Invoke-WebRequest -Uri https://install.python-poetry.org -UseBasicParsing).Content | py -

要检查 Poetry 是否正确安装,你可以运行:

$ poetry -v

Poetry (version 1.5.1)

Poetry 还支持各种 Shell(如 Bash、Fish、Zsh 等)的 Tab 补全。了解更多信息 在这里。

1. 所有项目的结构一致

由于 Poetry 是一款集成工具,你可以从项目开始到结束都使用它。

当开始一个新项目时,你可以运行 poetry new project_name。它将创建一个几乎准备好构建和发布到 PyPI 的默认目录结构:

$ poetry new binary_classification

Created package binary_classification in binary_classification

$ ls binary_classification

README.md binary_classification pyproject.toml tests

$ tree binary_classification/

binary_classification

├── pyproject.toml

├── README.md

├── binary_classification

│ └── __init__.py

└── tests

└── __init__.py

但我们数据科学家很少创建 Python 包,因此建议你自己开始项目,并在其中调用 poetry init:

$ mkdir binary_classification

$ poetry init

CLI 会询问你一系列设置问题,但你可以将大多数留空,因为它们可以稍后更新:

GIF. 由我制作。

init 命令会生成 Poetry 的最重要文件 - pyproject.toml。该文件包含一些项目元数据,但最重要的是,它列出了依赖项:

$ cat pyproject.toml

[tool.poetry]

name = "binary-classification"

version = "0.1.0"

description = "A binary classification project with scikit-learn."

authors = ["Bex Tuychiev <bex>"]

readme = "README.md"

packages = [{include = "binary_classification"}]

[tool.poetry.dependencies]

python = "³.9"

[build-system]

requires = ["poetry-core"]

build-backend = "poetry.core.masonry.api"</bex>

目前,tool.poetry.dependencies 下唯一的依赖项是 Python 3.9(我们稍后将了解 ^ 的含义)。让我们添加更多库。

如果你想了解

pyproject.toml文件中的所有字段的作用,请跳转到 这里。

2. 依赖项规格说明

要为你的项目安装依赖项,你不再需要直接使用 PIP 或 Conda。相反,你将开始使用 poetry add library_name 命令。

这是一个示例:

$ poetry add scikit-learn@latest

添加 @latest 标志会从 PyPI 安装 Sklearn 的最新版本。也可以在没有任何标志(约束)的情况下添加多个依赖项:

$ poetry add requests pandas numpy plotly seaborn

add 的美妙之处在于,如果指定的包没有任何版本约束,它会找到所有包的版本,使其能够解决,即在一起安装时不会抛出任何错误。它还会检查 pyproject.toml 中已经指定的依赖项。

$ cat pyproject.toml

[tool.poetry]

...

[tool.poetry.dependencies]

python = "³.9"

numpy = "¹.25.0"

scikit-learn = "¹.2.2"

requests = "².31.0"

pandas = "².0.2"

plotly = "⁵.15.0"

seaborn = "⁰.12.2"

让我们尝试将 numpy 降级到 v1.24,看看会发生什么:

$ poetry add numpy==1.24

...

Because seaborn (0.12.2) depends on numpy (>=1.17,<1.24.0 || >1.24.0) ...

version solving failed.

Poetry 不会允许这种情况发生,因为降级版本会与 Seaborn 冲突。如果这是 PIP 或 conda,它们会很乐意安装 Numpy 1.24,然后对我们露出笑容,随着噩梦的开始。

除了标准安装,Poetry 提供了一种多功能的语法来定义版本约束。这种语法允许你指定确切版本,设置版本范围的边界(大于、小于或介于之间),并固定主版本、次版本或补丁版本。以下表格取自 Poetry 文档(MIT 许可证),作为示例。

脚本要求:

波浪号要求:

通配符要求:

欲了解更多高级约束规格说明,请访问 Poetry 文档的 这个页面。

3. 环境管理

Poetry 的核心特性之一是以最有效的方式将项目环境与全局命名空间隔离。

当你运行 poetry add library 命令时,发生的情况如下:

-

如果你在已经激活虚拟环境的现有项目中初始化了 Poetry,

library将被安装到该环境中(它可以是任何环境管理器,如 Conda、venv 等)。 -

如果你创建了一个空项目,使用

poetry new或在没有激活虚拟环境时使用init初始化 Poetry,Poetry 会为你创建一个新的虚拟环境。

当情况 2 发生时,结果环境将位于 /home/user/.cache/pypoetry/virtualenvs/ 文件夹下。Python 可执行文件也会在某处。

要查看当前激活的 Poetry 创建的环境,你可以运行poetry env list:

$ poetry env list

test-O3eWbxRl-py3.6

binary_classification-O3eWbxRl-py3.9 (Activated)

要在 Poetry 创建的环境之间切换,你可以运行poetry env use命令:

$ poetry env use other_env

你可以从这里了解更多关于环境管理的知识。

4. 完全可复现的项目

当你运行add命令时,Poetry 会生成一个poetry.lock文件。它不会像1.2.*那样指定版本约束,而是锁定你使用的库的确切版本,比如1.2.11。所有后续的poetry add或poetry update运行将修改锁定文件以反映变化。

使用这样的锁定文件可以确保使用你项目的人能够在他们的机器上完全复现环境。

人们长期以来使用像requirements.txt这样的替代品,但其格式非常松散且容易出错。一个典型的人为创建的requirements.txt并不全面,因为开发人员通常不愿意列出他们使用的确切库版本,只是说明版本范围,或者更糟糕的是,简单地写下库名称。

然后,当其他人尝试用pip install -r requirements.txt复现环境时,PIP 自身尝试解决版本约束,这就是为什么你最终可能会遇到依赖地狱的原因。

使用 Poetry 和锁定文件时,这种情况不会发生。因此,如果你在一个已经存在requirements.txt的项目中初始化 Poetry,你可以通过以下方式将依赖添加进去:

$ poetry add `cat requirements.txt`

并删除requirements.txt。

但请注意,像 Streamlit 或 Heroku 这样的服务仍然需要旧的requirements.txt文件用于部署。在使用这些服务时,你可以通过以下命令将你的poetry.lock文件导出为文本格式:

$ poetry export --output requirements.txt

要遵循的工作流程

我希望留下这篇文章,提供一个将 Poetry 集成到任何数据项目中的逐步工作流程。

步骤 0: 安装 Poetry 以适配你的系统。

步骤 1: 使用mkdir创建一个新项目,然后在其中调用 [poetry init](https://python-poetry.org/docs/cli/#init)来初始化 Poetry。如果你想将项目转换为 Python 包,可以使用`[poetry new project_name](https://python-poetry.org/docs/cli/#new)`创建项目。

py` 第 2 步:使用 poetry add lib_name 安装并添加依赖项。也可以手动编辑 pyproject.toml 文件,将依赖项添加到 [tool.poetry.dependencies] 部分。在这种情况下,你需要运行 poetry install 来解决版本约束并安装库。完成这一步后,Poetry 会为项目创建一个虚拟环境,并生成一个 `poetry.lock` 文件。 第 3 步:初始化 Git 和其他工具,如 [DVC](https://medium.com/towards-data-science/data-version-control-for-the-modern-data-scientist-7-dvc-concepts-you-cant-ignore-bb2433ccec88),并开始跟踪相关文件。将 `pyproject.toml` 和 `poetry.lock` 文件放到 Git 下。 第 4 步:开发你的代码和模型。要运行 Python 脚本,必须使用 `poetry run python script.py`,以便使用 Poetry 的虚拟环境。 第 5 步:测试你的代码并进行必要的调整。对数据分析或机器学习算法进行迭代,尝试不同的技术,并根据需要优化你的代码。 可选步骤: 1. 要更新已安装的依赖项,请使用 `poetry update library` 命令。`update` 仅在 `pyproject.toml` 内的约束条件下工作,因此请查看 [这里的警告](https://python-poetry.org/docs/managing-dependencies/)。 2. 如果你从带有 requirements.txt 的项目开始,可以使用 poetry add cat requirements.txt 来自动添加和安装依赖项。 3. 如果你想导出 `poetry.lock` 文件,可以使用 `poetry export --output requirements.txt`。 4. 如果你为项目选择了包结构 (`poetry add`),可以使用 `poetry build` 构建包,准备好推送到 PyPI。 5. 使用 `poetry env use other_env` 在虚拟环境之间切换。 通过这些步骤,你将确保不会再次陷入依赖地狱。 感谢阅读! **[Bex Tuychiev](https://www.linkedin.com/in/bextuychiev/)** 是 Medium 上的前 10 名 AI 作者和 Kaggle 大师,拥有超过 15k 的关注者。他喜欢撰写详细的指南、教程和笔记本,涉及复杂的数据科学和机器学习主题,风格略带讽刺。 [原文](https://medium.com/towards-artificial-intelligence/forget-pip-conda-requirements-txt-use-poetry-instead-and-thank-me-later-226a0bc38a56)。转载许可。 * * * ## 我们的前 3 个课程推荐  1. [Google 网络安全证书](https://www.kdnuggets.com/google-cybersecurity) - 快速进入网络安全职业的快车道。  2. [Google 数据分析专业证书](https://www.kdnuggets.com/google-data-analytics) - 提升你的数据分析技能  3. [Google IT 支持专业证书](https://www.kdnuggets.com/google-itsupport) - 支持你的组织 IT * * * ### 更多相关主题 * [用 Poetry 与 Conda 和 Pip 管理 Python 依赖项](https://www.kdnuggets.com/managing-python-dependencies-with-poetry-vs-conda-pip) * [停止在数据科学项目中硬编码 - 改用配置文件](https://www.kdnuggets.com/2023/06/stop-hard-coding-data-science-project-config-files-instead.html) * [你应该使用线性回归模型的 3 个理由,而不是…](https://www.kdnuggets.com/2021/08/3-reasons-linear-regression-instead-neural-networks.html) * [忘记 ChatGPT,这个新 AI 助手领先数倍,将…](https://www.kdnuggets.com/2023/08/forget-chatgpt-new-ai-assistant-leagues-ahead-change-way-work-forever.html) * [Pip 安装 YOU:创建 Python 库的初学者指南](https://www.kdnuggets.com/pip-install-you-a-beginners-guide-to-creating-your-python-library) * [KDnuggets™ 新闻 22:n06,2 月 9 日:数据科学编程…](https://www.kdnuggets.com/2022/n06.html) py

忘记讲故事;帮助人们导航

原文:

www.kdnuggets.com/2021/03/forget-telling-stories-help-people-navigate.html

评论

优秀的报告和可视化应该创建一个行动路径,引导用户通过分析过程并最终采取行动以改善业务。目标不仅仅是讲述故事,而是帮助用户从数据到行动。

以下是该框架的简单信息图:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

点击图片放大

让我们从“当前状态”的一批关键绩效指标(KPI)开始。这些是你会放在高管仪表板上的主要可视化图表。它们让人们对业务中的关键指标有一个整体的了解。那么,哪些 KPI 能够讲述组织的当前故事呢?

下一步是寻找显著的信号、变化或事件。在我们的报告中,我们应该使用明亮的颜色和引人注目的图标来突出变化的数据。

每个主要 KPI 和警报都需要配备一个或多个深入挖掘的路径来探索细节。这些是补充的可视化图表。深入挖掘的路径需要简单且清晰地链接。理想情况下,每个部门或业务流程都有自己的深入挖掘区域或文件夹。

现在我们必须超越单纯的数据倾倒。人们希望被引导到推荐路线来解决问题。并不是每个图表中的每个变化都有一个自动推荐的最佳路线,但许多有。如果某个 SKU 的库存低,有几个跟随的路线,那为何不直接在报告上标记出来呢?如果一个部门的成本增长快于计划,你是否有标准的方法来解决问题?如果有,那么就列出那些标准行动,正好在信息需要和有用的地方,因为信息被消耗时。

最后,我们需要通过在报告中嵌入链接到相关应用程序来帮助用户采取行动。如果库存低,下面的 KPI 下方添加一个链接到仓库管理软件。如果某个地区的销售额下降,在 KPI 的底部添加一个链接到 Salesforce 或你的 CRM 系统以便后续跟进。

我们可以通过使用框架中的五个步骤将我们的报告工具转变为导航工具。

简介: Stan Pugsley 是一位数据仓库和分析顾问,隶属于总部位于犹他州盐湖城的Eide Bailly 技术咨询公司。他还是犹他大学 Eccles 商学院的兼职教授。你可以通过电子邮件联系作者。

相关:

-

讲述一个精彩的数据故事:一个可视化决策树

-

数据科学与商业智能的比较解析

-

每个数据科学家应该知道的 5 个概念

更多相关话题

被遗忘的算法

原文:

www.kdnuggets.com/2020/02/forgotten-algorithm-monte-carlo-simulation.html

评论

由 Ian Xiao,Dessa 的参与负责人

TL;DR — 当我们谈论机器学习时,我们通常会想到监督学习和无监督学习。在这篇文章中,我想讨论一个经常被遗忘但同样强大的算法:蒙特卡洛模拟。我将分享一个通用设计框架和一些技术,并提供一个互动工具。最后,你还可以在文章末尾找到一些好的模拟工具列表。

免责声明: 这不是由 Streamlit 赞助的,也不是我提到的任何工具或我工作的任何公司赞助的。我将数据科学和机器学习视为可互换的。*

喜欢你读到的内容? 关注我在 Medium、LinkedIn 和 Twitter 上。

不应得的那个

在近期的机器学习(ML)崛起中,监督学习和无监督学习算法,如使用 深度学习 的分类和使用 KNN 的聚类,得到了大多数关注。当这些算法获得热情社区的高度赞扬时,一些同样强大而优雅的技术却在角落里静静地等待。它的名字是 蒙特卡洛 — 这个在原子物理学、现代金融和赌博中被遗忘而不应得的英雄(或者说是恶棍,这取决于你对这些问题的看法)。

注意:为了简洁,我将监督学习和无监督学习方法称为“ML 算法”,将蒙特卡洛方法称为“模拟”。

简短历史

斯坦尼斯瓦夫·乌拉姆、恩里科·费米 和 约翰·冯·诺伊曼 — 洛斯阿拉莫斯的天才们 — 在 1930 年代发明、改进并推广了蒙特卡洛方法,目的并不那么高尚 (提示:不是为了原子弹)。观看视频了解更多。

蒙特卡洛模拟简短历史(YouTube)

什么是蒙特卡洛模拟?

如果我用一句话总结蒙特卡洛模拟,这里是:假装做一亿次,直到我们大概知道现实是什么。

在技术(和更严肃的)层面上,蒙特卡洛方法的目标是 近似 结果的期望,以考虑各种输入、不确定性和系统动态。这个视频介绍了一些对有兴趣的人来说的高级数学。

蒙特卡洛近似,YouTube

为什么使用模拟?

如果我必须强调仿较于机器学习算法的一个(过于简单化的)优势,那就是:探索。我们使用仿真来理解任何规模系统的内部工作(例如:世界、社区、公司、团队、个人、车队、汽车、车轮、原子等)

通过虚拟仿真重新创建系统,我们可以计算和分析假设结果,而无需实际改变世界或等待真实事件发生。换句话说,仿真允许我们提出大胆的问题并制定战术来管理各种未来结果,而风险和投资相对较小。

什么时候使用仿真,而不是机器学习?

根据本杰明·舒曼,一位著名的仿真专家,仿真是过程驱动的,而机器学习是数据中心的。要产生良好的仿真效果,我们需要理解系统的过程和基本原理。相比之下,我们可以仅通过使用数据仓库中的数据和一些现成的算法来创建合理的预测。

换句话说,创建良好的仿真在财务和认知上通常更昂贵。我们为什么还要使用仿真?

好吧,考虑三个简单的问题:

-

你是否在数据仓库中有数据来表示业务问题?

-

你是否有足够的数据——无论是数量上还是质量上——来构建一个好的机器学习模型?

-

预测是否比探索更重要(例如,提出假设性问题并制定支持业务决策的战术)?

如果你对这些问题的回答是“否”,那么你应该考虑使用仿真而不是机器学习算法。

如何设计蒙特卡洛仿真?

要创建一个蒙特卡洛仿真,至少需要遵循一个 3 步过程:

仿真过程,作者分析

如你所见,创建一个蒙特卡洛仿真仍然需要数据,更重要的是,需要对系统动态有一定了解(例如销售量和价格之间的关系)。要获得这种知识,通常需要与专家交谈,研究流程,以及观察实际业务操作。

Yet Another Simulator

要查看基本概念如何实现,你可以访问Yet Another Simulator——这是我使用Streamlit开发的一个交互式工具。

在欢迎页面上,你可以尝试各种输入设置,并观察根据你应用的函数,结果如何变化。

Yet Another Simulator的欢迎页面,作者的工作

除了基本示例外,该工具还包括 4 个案例研究,讨论了各种设计技术,如影响图、敏感性分析、优化和将机器学习与仿真相结合。

例如,在CMO 示例中,我讨论了如何使用影响图来帮助设计一个模拟以解决广告预算分配问题。

影响图,作者的工作

最终,你将踏入数据科学家的角色,建议首席营销官(CMO)。你的目标是帮助 CMO 决定广告支出金额,探索各种情景,并提出在不同不确定性下最大化回报的策略。

广告预算分配,作者的工作

我希望这些示例能说明蒙特卡罗模拟的工作原理,它相较于机器学习算法的优势,以及如何使用不同的设计技巧设计有用的模拟。

一些案例研究仍在积极开发中。请在此处注册,以便在它们准备好时接到通知。

总结

我希望这篇文章提供了对蒙特卡罗方法的另一种视角;在今天的机器学习讨论中,我们常常忽视这样一个有用的工具。模拟具有许多传统机器学习算法无法提供的优势——例如,在巨大不确定性下探索重大问题的能力。

在即将发布的文章中,我将讨论如何在实际商业环境中结合机器学习和模拟以获得两者的最佳效果,以及如何阐明不同模拟情景的含义。

通过关注我的Medium、LinkedIn或Twitter保持关注。**

下次见,

伊恩

如果你喜欢这篇文章,你可能也会喜欢这些:

如何使用 Streamlit 和 DevOps 工具构建和部署机器学习应用

如何不在机器学习项目中应用敏捷

我如何应对部署机器学习的无聊日子

数字、五种战术解决方案和快速调查

很多数据科学家没充分考虑的一件事

如何为现实世界设计和实现强化学习

流行工具

当我讨论仿真时,很多人会询问工具建议。这里有一份我了解的工具列表,选择适合你需求的工具。请享用。

-

AnyLogic (这可能是模拟专业人士的首选工具;免费增值)

-

Simio (免费增值)

-

Yasai (Excel 插件,免费)

-

Oracle Crystal Ball (免费增值)

-

SimPy (Python 包,免费)

-

Hash (创企,当前处于隐秘模式。创始团队相当强大。可能是免费增值)

参考资料

决策树的历史 — pages.stat.wisc.edu/~loh/treeprogs/guide/LohISI14.pdf

聚类的历史 — link.springer.com/chapter/10.1007/978-3-540-73560-1_15

将仿真与机器学习结合的时机 — www.benjamin-schumann.com/blog/2018/5/7/time-to-marry-simulation-models-and-machine-learning

仿真的分类 — gamingthepast.net/theory-practice/simulation-design-guide/

蒙特卡洛方法及其工作原理 — www.palisade.com/risk/monte_carlo_simulation.asp

简介:Ian Xiao 是 Dessa 的参与负责人,负责在企业中部署机器学习。他领导业务和技术团队部署机器学习解决方案,并为 F100 企业改进市场营销和销售。

原文. 经许可转载。

相关:

-

数据科学很无聊(第一部分)

-

我们创建了一个懒惰的 AI

-

12 小时机器学习挑战:使用 Streamlit 和 DevOps 工具构建并部署应用

我们的前三课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织 IT 工作

3. Google IT 支持专业证书 - 支持您的组织 IT 工作

更多相关话题

Forrester 与 Gartner 关于数据科学平台和机器学习解决方案的对比

原文:

www.kdnuggets.com/2017/04/forrester-gartner-data-science-platforms-machine-learning.html

评论 上个月,领先的分析公司 Forrester 发布了他们的“ Forrester Wave™”:2017 年第一季度预测分析和机器学习解决方案报告,由 Mike Gualtieri 编写。

评论 上个月,领先的分析公司 Forrester 发布了他们的“ Forrester Wave™”:2017 年第一季度预测分析和机器学习解决方案报告,由 Mike Gualtieri 编写。

预测分析和机器学习是现在最重要的技术之一,正如 KDnuggets 读者所知,Forrester 预计 PAML 市场在 2021 年前将实现 15% 的复合年增长率(CAGR)。

报告审查并评估了 14 家公司的战略、当前产品和市场表现。结果汇总在图 1 中。

图 1: Forrester Wave™:预测分析和机器学习解决方案,2017 年第一季度

(来源:Forrester Research, Inc. 未经授权的复制、引用或分发均被禁止)

领导者:

-

SAS 重新构想其数据科学产品组合 并将其数据科学解决方案整合到 SAS Visual Suite 下。它将世界一流的数据准备、可视化、数据分析、模型构建和模型部署集于一体。

-

IBM 喜爱开源。 SPSS 仍然是 IBM 数据科学平台的核心,但 IBM 还推出了来自 Spark 技术中心的 SystemML,并为数据科学编程者引入了数据科学体验。

-

SAP 将预测模型与业务应用直接连接。 SAP 提供全面的数据科学工具来构建模型,同时也是全球最大的企业应用公司。

-

Angoss 准备好成为你的主要解决方案。 Angoss KnowledgeSEEKER 是数据科学团队必备的工具,它通过美观且全面的可视化工具帮助构建决策和策略树。

-

RapidMiner 将广度和深度融入美丽的包装中。 RapidMiner 大力投资重新设计其视觉界面,使其成为我们在此次评估中见过的最简洁和流畅的界面。

-

KNIME 的充满活力的开源社区提高了生产力。 KNIME 不是大公司,但它拥有一个大社区的贡献者,不断推动平台向前发展,如生物信息学和图像处理等功能。

-

FICO 通过模型使企业决策更智能。 FICO 的广泛实际经验造就了一种解决方案,专注于大型组织中首席数据科学家和普通数据科学家的需求。

强劲表现者:

-

H2O.ai 将算法放在首位。 H2O.ai 以开发开源、集群分布式机器学习算法而闻名,这些算法早在 2011 年当大数据需求迫切时便已存在。H2O 还提供 Sparkling Water 用于在 Apache Spark 上创建、管理和运行工作流,并提供 Steam 用于部署模型。

-

Microsoft 不仅仅是企业的 R 解决方案。 Microsoft 为希望使用 R 编程语言的 数据科学家 提供 Microsoft R,该语言支持可调用的集群分布式算法。它还为希望使用更传统可视化开发工具的数据科学家提供 Azure Machine Learning。

-

Alpine Data 专注于协作。 Alpine Data 的可视化工具为数据工程师、数据科学家和业务利益相关者提供了分工合作构建模型的能力。

-

Dataiku 实现了代码与点击的完美结合。 Dataiku(名字受到日本俳句的启发)提供的数据科学平台允许编码人员在需要时使用笔记本,但在生产力关键时使用可视化工具来构建工作流。

-

Statistica 又一次找到了新家。 Statistica 成立于 1984 年,最初名为 Statsoft,并于 2014 年被 Dell 收购。现在,它成为了新重启的 Quest Software 的一部分。

竞争者:

-

Domino Data Labs 希望编码人员在开源环境中协作,该解决方案旨在整合最流行的开源编码工具和库,为数据科学编码团队提供统一的界面。

-

Salford Systems 强调准确性和自动化,并因其实施特定方法(如 CART、MARS、Random Forests 和 TreeNet)而受到大大小小客户的喜爱。

这些排名与

我尝试了类似 Gartner 报告 的重叠式比较,但结果图像过于拥挤,难以阅读。所以这里是一些亮点:

-

保持领导者地位:SAS、IBM、SAP

-

从 2015 年的强劲表现者到 2017 年的领导者:RapidMiner、KNIME、Angoss、FICO

-

保持强劲表现者地位:Microsoft(在产品提供上有所提升)、Alpine Data、Statistica/Quest(在战略上有所下降)

-

2017 年的新加入者:Domino Data Labs、Dataiku、H20.ai、Salford Systems

-

2017 年下滑的公司:Alteryx、Predixion Software、Oracle

Forrester 的评估与 Gartner 2017 Magic Quadrant for Data Science Platforms 的比较如何?

Gartner 和 Forrester 使用不同的方法论,但在两种情况下,代表公司距离图表左下角的圆圈越远,表现越好。我们测量了每家公司这一距离,将其标准化,使最大距离为 95,最小距离为 5,并在下图 Figure 2 中绘制。

在 Gartner 或 Forrester 图表中都未出现的公司距离值为负(-1)。

图 2:2017 年 Q1 Gartner 与 Forrester 对数据科学、预测分析和机器学习平台的评估

圆圈的大小对应于估计的供应商规模,颜色为 Forrester 标签,形状(圆圈的填充程度)为 Gartner 标签。

总共涉及 17 家公司:13 家同时出现在两个报告中,3 家仅出现在 Gartner(下文简称 G)中,1 家仅出现在 Forrester(下文简称 F)中。

我们看到几个集群:

-

强劲领导者:SAS、IBM、RapidMiner 和 KNIME 被 G 和 F 都评为领导者。

-

领导者:Angoss、SAP 和 FICO 在 F 中是领导者,但在 G 中仅为利基/远见者。

-

强劲竞争者:H2O.ai、微软和 Statistica/Quest 在 F 中是强劲表现者,在 G 中是远见者/挑战者

-

竞争者:Alpine Data、Domino、Dataiku:F 中的强劲表现者/竞争者,G 中的远见者

-

玩家:Salford Systems、Teradata、Alteryx、MathWorks:只有一个排名

如果您是客户,可以从Forrester获取 Forrester Wave™: 预测分析与机器学习解决方案,Q1 2017,或从SAP、RapidMiner或报告中好评提到的其他公司下载。

相关:

-

Forrester Wave™ 大数据预测分析 2015:赢家与输家

-

Gartner 数据科学平台 – 更深入的分析

-

Gartner 2017 年数据科学平台魔力象限:赢家与输家

更多相关话题

什么是基础模型,它们如何工作?

图片来自 Adobe Firefly

什么是基础模型?

基础模型是建立在大量数据基础上的预训练机器学习模型。这是人工智能(AI)领域的一项突破性发展。由于它们能够从大量数据中学习并适应广泛的任务,这些模型作为各种 AI 应用的基础。它们在庞大的数据集上进行预训练,并可以微调以执行特定任务,使其非常灵活和高效。

基础模型的例子包括用于自然语言处理的 GPT-3 和用于计算机视觉的 CLIP。在这篇博客中,我们将深入探讨基础模型是什么,它们是如何工作的,以及它们对不断发展的人工智能领域的影响。

基础模型的工作原理

基础模型,如 GPT-4,通过在大规模数据语料库上预训练一个巨大的神经网络,然后在特定任务上对模型进行微调,从而使其能够在语言任务上执行广泛的操作,且只需最少的任务特定训练数据。

预训练与微调

在大规模无监督数据上进行预训练:基础模型通过从大量无监督数据中学习来开始其旅程,例如来自互联网的文本或大型图像集合。这个预训练阶段使模型能够掌握数据中的基本结构、模式和关系,帮助它们形成强大的知识基础。

在任务特定标记数据上进行微调:预训练后,基础模型使用较小的标记数据集对特定任务进行微调,例如情感分析或物体检测。这一微调过程使模型能够提高技能,并在目标任务上表现出色。

迁移学习与零样本能力

基础模型在迁移学习中表现出色,迁移学习指的是它们将从一个任务中获得的知识应用于新的相关任务的能力。一些模型甚至展示了零样本学习能力,这意味着它们可以在没有任何微调的情况下处理任务,仅依赖于预训练期间获得的知识。

模型架构与技术

变换器在自然语言处理(例如,GPT-3,BERT):变换器以其创新的架构彻底改变了自然语言处理(NLP),使得语言数据的处理更加高效和灵活。NLP 基础模型的例子包括 GPT-3,它在生成连贯文本方面表现出色,而 BERT 在各种语言理解任务中表现出色。

视觉变换器和多模态模型(例如,CLIP,DALL-E):在计算机视觉领域,视觉变换器作为处理图像数据的强大方法已经出现。CLIP 是一种多模态基础模型,能够理解图像和文本。DALL-E 另一个多模态模型,展示了从文本描述生成图像的能力,展示了将自然语言处理和计算机视觉技术结合在基础模型中的潜力。

基础模型的应用

自然语言处理

情感分析:基础模型在情感分析任务中表现出色,它们根据文本的情感对其进行分类,如积极、消极或中立。这一能力在社交媒体监测、客户反馈分析和市场研究等领域得到了广泛应用。

文本摘要:这些模型还可以生成长文档或文章的简明摘要,使用户能够快速掌握要点。文本摘要具有许多应用,包括新闻聚合、内容策划和研究辅助。

计算机视觉

目标检测:基础模型在识别和定位图像中的对象方面表现出色。这一能力在自动驾驶汽车、安全监控系统和机器人等应用中尤为重要,因为准确的实时目标检测至关重要。

图像分类:另一个常见的应用是图像分类,基础模型根据图像内容对其进行分类。这一能力已被用于各种领域,从组织大型照片收藏到利用医学影像数据诊断医疗条件。

多模态任务

图像描述:通过利用对文本和图像的理解,多模态基础模型可以生成图像的描述性字幕。图像描述在视觉障碍用户的辅助工具、内容管理系统和教育材料中具有潜在用途。

视觉问答:基础模型还可以处理视觉问答任务,它们提供关于图像内容的问题的答案。这一能力为客户支持、互动学习环境和智能搜索引擎等应用开辟了新可能。

未来的前景和发展

模型压缩和效率的进展

随着基础模型变得越来越大和复杂,研究人员正在探索压缩和优化它们的方法,以便在资源有限的设备上部署,并减少其能源足迹。

改进应对偏见和公平性的技术

解决基础模型中的偏见对于确保公平和伦理的 AI 应用至关重要。未来的研究可能会集中于开发识别、衡量和减轻训练数据和模型行为中偏见的方法。

开源基础模型的合作努力

AI 社区正日益协作,创建开源基础模型,促进合作、知识共享和对尖端 AI 技术的广泛访问。

结论

基础模型代表了 AI 的重大进步,能够在自然语言处理、计算机视觉和多模态任务等多个领域应用高性能的多功能模型。

基础模型对 AI 研究和应用的潜在影响

随着基础模型的不断发展,它们可能会重塑 AI 研究并推动众多领域的创新。它们在启用新应用和解决复杂问题方面的潜力巨大,预示着一个 AI 日益融入我们生活的未来。

Saturn Cloud 是一个灵活的数据科学和机器学习平台,支持 Python、R 等多种语言。进行扩展、协作,并利用内置的管理功能来帮助你运行代码。启动一个具有 4TB RAM 的笔记本,添加 GPU,连接到分布式工作集群等等。Saturn 还自动化了 DevOps 和 ML 基础设施工程,让你的团队可以专注于分析。

原文。经授权转载。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

更多相关信息

数据科学基础:免费电子书

原文:

www.kdnuggets.com/2020/07/foundations-data-science-free-ebook.html

评论

我们本周再次推出了新的免费电子书。这次我们将讨论一本名为数据科学基础的书,作者是 Avrim Blum、John Hopcroft 和 Ravindran Kannan。这本书的名字本身就表明了它的重要性。幸运的是,它的内容也确实支持了这一点。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你组织的 IT

3. Google IT 支持专业证书 - 支持你组织的 IT

首先,这本书的结构与典型的数据科学书籍不同。在我看来,它的章节及其进展并不符合标准当代数据科学教材的模式。从下面列出的目录可以看出,该书真正地涵盖了广泛的不同主题,而不是简单地将数据科学与机器学习等同起来,并按照这种方式进行进展:

-

引言

-

高维空间

-

最佳拟合子空间和奇异值分解(SVD)

-

随机游走和马尔可夫链

-

机器学习

-

大规模数据问题的算法:流处理、草图绘制和抽样

-

聚类

-

随机图

-

主题模型、非负矩阵分解、隐马尔可夫模型和图模型

-

其他主题

-

小波

-

附录

书中涵盖了各种高级主题,并且早期就包括了关于高维空间、子空间以及随机游走或马尔可夫链的章节,这增强了该书的概述风格。这也让我想起另一部你可能熟悉的数据科学经典书籍,大规模数据集挖掘。强调这本书侧重于“基础”,你不会在其中找到最新的神经网络架构。然而,如果你希望最终理解一些更复杂的数据科学问题解决方法的原因和原理,那么你会发现《数据科学基础》是很有用的。

矩阵分解、图论、核方法、聚类理论、流处理、梯度下降、数据采样;这些都是你在解决数据科学问题时将会大有裨益的概念,它们也是实现更复杂方法的基本构建块。如果没有梯度下降,你无法理解神经网络。如果没有图论,你不能分析社交媒体网络。如果你不能理解何时及为何从数据中采样,你构建的模型将毫无价值。

与我们最近介绍的其他一些书籍(例如统计学习的元素和理解机器学习)类似,这本书无所顾忌地理论化。书中没有代码,没有依赖的 Python 库,也没有含糊其辞。只有深入的解释,帮助你理解这些不同的主题,只要你愿意花时间阅读。

作者撰写此书的动机在书籍介绍的这一摘录中得到了体现:

虽然计算机科学的传统领域仍然非常重要,但未来的研究人员将越来越多地涉及使用计算机从大量数据中理解和提取可用信息,而不仅仅是如何在特定明确定义的问题上使计算机有用。考虑到这一点,我们编写了这本书,涵盖我们预计在未来 40 年内会有用的理论,就像对自动机理论、算法和相关主题的理解在过去 40 年中给予学生优势一样。一个主要的变化是对概率、统计和数值方法的重视增加。

在许多当代书籍中,数据科学被简化为一系列编程工具,只要掌握了这些工具,就可以完成数据科学任务。这些书籍似乎较少关注与代码脱离的基本概念和理论。这本书则是与这种趋势相反的好例子,它无疑会为你提供必要的理论知识,使你以扎实的基础迎接数据科学的职业生涯。

相关:

-

统计学习入门:免费电子书

-

理解机器学习:免费电子书

-

统计学习的元素:免费电子书

更多相关话题

解释 AI 和机器学习的四种方法

原文:

www.kdnuggets.com/2018/12/four-approaches-ai-machine-learning.html

评论

评论

作者:Jay Budzik,首席技术官,ZestFinance

高级机器学习(ML)是人工智能(AI)的一个子集,使用更多的数据和复杂的数学方法来做出更好的预测和决策。它驱动了自动驾驶汽车、Netflix 推荐系统以及大量的银行欺诈检测。银行和贷款机构可以利用 ML 与传统的信用评分技术结合,找到更好的借款人,并拒绝更多不良借款人,从而赚取更多的钱。但由于技术的“黑箱”特性,ML 的采用受到了阻碍。ML 模型极其复杂。如果无法解释其决策,你无法安全或准确地运行信用模型。

我们真正希望从 AI 可解释性中得到三样东西:一致性、准确性和性能。市场上有一些技术被宣传为解决这种“黑箱”问题。谨防上当。这些技术往往不一致、不准确、计算成本高,和/或未能发现不可接受的结果,例如基于种族和性别的歧视。其中一些技术已经使用了很长时间,对于旧的建模方法,如逻辑回归,非常有效。但它们在 ML 上效果不佳。

在 ZestFinance,我们在 ZAML 软件工具中构建了新的可解释性数学方法,这些方法可以快速地将 ML 模型的内部工作从创建到部署变得透明。你可以使用这些工具实时监控模型健康状况。你可以相信结果是公平和准确的。我们还自动化了报告生成,所以你只需按一下按钮即可生成所有符合规定所需的文档。

在这篇论文中,我们比较了几种流行的可解释性技术(包括我们的 ZAML 技术),描述了它们的相对优缺点,并展示了每种技术在一个简单建模问题上的表现。我们进行的测试显示,ZAML 比这些其他方法更准确、一致和快速。

四种可解释性技术的解释

目前推广的三种常见机器学习可解释性技术分别是 LOCO、置换影响和 LIME。LOCO,代表“留一列”的意思,通过将一个变量“遗漏”并重新计算模型的预测值。其思路是,如果分数变化很大,那么被遗漏的变量一定非常重要。置换影响(PI),也称为置换重要性,用一个随机选择的值替代一个变量,并重新计算模型的预测值。与 LOCO 类似,其思路是,如果分数变化很大,那么被扰乱的变量一定非常重要。LIME,代表局部可解释的模型无关解释,拟合一个新的线性模型在给定申请人的真实数据值和真实模型对这些合成值的得分周围的局部邻域内。然后使用这个新的线性近似模型来解释更复杂的模型的行为。本质上,你是将一个非常复杂的模型假装成简单的,以便进行解释。

ZestFinance 的 ZAML 软件使用了一种来自博弈论和多元微积分的专有解释方法,适用于实际的基础模型。ZAML 可解释性通过查看每个变量与其他变量的交互,来确定每个变量对最终得分的相对重要性。下方的清单比较了这四种可解释性技术在七个重要能力上的表现。我们还为每种技术添加了在解释两个常见机器学习模型时的准确性、一致性和速度的测试评分。准确性通过平均排名相关性来衡量,或者说解释与实际基准的偏差有多大。一致性通过方差来衡量,即解释的差异在所有申请人中的变化程度。速度是生成数据集中所有行解释所需的时间。

让我们解读一下这个清单

对于高风险业务应用(如信用风险建模),机器学习模型的解释必须满足多种要求,以便其具有可信性,其中最重要的是准确性、一致性和性能,即预测速度。上面的图表总结了你可能听说的四种技术在一个极其简单的模型上的表现。对于现实世界中的可解释性问题,例如信用风险建模中普遍存在的问题,性能差异可能更为明显。我们使用了一个简单的模型来展示这些差异,旨在说明即使是只有两个变量的模型,也无法像 ZAML 可解释性那样准确地用 LOCO、PI 或 LIME 解释。如果一种可解释性技术在解释最简单的“玩具”模型时都很困难,那么在涉及大量资金的现实世界应用中信任它可能是不明智的。

LOCO、LIME 和 PI 在准确性、一致性或速度方面都有缺陷。LOCO 和 PI 通过一次分析一个特征来工作。这意味着随着模型变量数量的增加,算法运行变得更慢、更昂贵。LOCO、LIME 和 PI 只关注模型的输入和输出,这意味着它们获取的信息比像 ZAML 这样查看模型内部结构的解释器少得多。外部探测模型(即输入和输出)是一个不完美的过程,容易导致潜在的错误和不准确性。分析重新拟合和/或代理模型,如 LOCO 和 LIME 所要求的,而不是分析你的最终模型,也存在问题。我们认为分析真实模型非常重要——如果不这样做,你将面临很多风险。

在尝试解释高级机器学习模型时,重要的是你的解释能全面捕捉特征的影响,或与其他特征的关系。单变量分析,如 LOCO 和 PI 通常采用的,将无法正确捕捉这些特征交互和相关效应。准确性再次受到影响。解释器还应从全局而不仅仅是局部角度计算特征解释。假设你建立了一个模型来理解为什么科比·布莱恩特是一位伟大的篮球运动员。仅仅使用局部特征重要性进行解释将表明他的身高并不是问题,因为从模型的角度看,所有与科比接近的 NBA 球员也都很高。但你不能否认科比的 6 英尺 6 英寸的身高与他为何打得这么好有关系。再一次,不准确性出现了。

大多数建模技术也有称为超参数的调节旋钮,可以自动调整以使模型更准确。对于解释器来说,没有实际等同于这种“自动调优”操作的东西。这使得对从解释器如 LIME 获得的结果充满信心变得非常困难,因为无法确定你是否正确设置了像数据区域大小这样的超参数。设置得过小,数据会在模型的高维空间中变得非常稀疏。设置得过宽,你将违反 LIME 的局部线性假设。

一致的解释器使用真实数据。LIME 和 PI 使用非真实数据来探测模型。假设你建立了一个包含收入、债务和债务收入比率的模型。PI 会独立地逐列打乱。这意味着当 PI 通过打乱分析债务收入比率时,它将不再是债务特征除以收入特征。由于训练数据中的所有数据保持了这种关系,因此以这种方式查询模型应该被视为未定义的行为。

即使解释中的轻微不准确也可能导致灾难性的结果,例如发布基于年龄、性别、种族或民族的歧视模型,或发布不稳定且产生高违约率的模型,这可能导致借贷业务的资金流失。一个模型可解释性技术应该在给定相同的输入和模型时提供相同的答案。不准确或不一致的模型可解释性技术可能看似提供了风险管理的一些保证,但如果结果不准确,它们对业务利益相关者和监管机构几乎没有价值或保证。

速度和效率也很重要。在模型构建过程中以及模型应用时,模型可解释性应被频繁使用,以便为每个基于模型的决策生成解释。缓慢和低效的技术限制了可解释性的实用性:如果你需要等待一整夜才能获得结果,你会减少分析的频率,从而获得关于模型运行的见解也会减少。这意味着你在改进模型上投入的时间会减少。

对可解释性技术进行测试

我们将对这四种可解释性技术的比较更进一步,并进行了一个实验,评估这些方法在简单建模问题上相对于真实值的表现。在这个测试中,我们使用了一个基于竞争博弈理论计算出的参考值作为真实值。参考值衡量了给定模型输入变量引入的平均边际效益。它通过穷举所有可能的变量组合来实现这一点。计算参考值需要创建指数数量的模型变体,每个变体包含不同的变量组合。通过了解模型的比较表现,我们可以量化模型中每个变量的价值。

在我们的实验中,我们评估了四种技术在解释两个机器学习模型和“月亮”数据集方面的表现。这是一个简单的、包含 100,000 行的双变量数据集,通常用于本科机器学习课程中,以演示线性模型的局限性。

“月亮”分类任务是建立一个模型,使用仅 X 和 Y 坐标将浅橙色数据点与深橙色数据点分开。线性模型无法很好地完成这一任务。要查看这一点,只需在上图中画一条直线,注意到直线两侧都有黄色和绿色数据点。没有一条直线可以分开橙色区域。月亮数据集提供了一个简单的例子,展示了机器学习方法对变量交互的敏感性,并且比只能创建线性模型的旧方法如逻辑回归更好地捕捉数据的真实形状。

我们构建了两个机器学习分类模型,分别使用了 XGBoost,一个流行的树集合诱导算法,以及 Tensorflow,一个流行的神经网络包。在撰写本文时,这两种方法都被认为是最顶尖的机器学习建模技术。随后,我们将各种可解释性方法应用于生成的树和神经网络模型。结果如下所示。

对于梯度提升树,LIME、PI 和 LOCO 在面对非常简单的建模问题时产生的错误率较高且方差更大,甚至与 ZAML 相比。还要注意的是,LIME 的计算速度要慢得多。虽然 PI 和 LOCO 在这种两变量模型测试中看起来更合理,但随着行列数的增加,这些方法的速度很快变得非常慢。对于像我们在信用风险建模工作中每天遇到的大型数据集,它们变得不切实际。我们曾经等待了几个小时甚至几天才获得 LOCO、PI 和 LIME 的解释。根据我们的经验,ZAML 方法在单台笔记本电脑或普通计算机上计算时间不超过几秒,即使是对具有数千个变量的模型也是如此。

对于神经网络,LIME、PI 和 LOCO 也产生了更高的错误率和方差。与在梯度提升树上的表现一致,LIME 的速度非常慢。对感兴趣的人来说,比较每种方法与参考值的散点图已包含在下面的附录中。

结论

并非所有可解释性技术都是一样的。即使在像二维“月亮”数据集这样简单的建模问题上,只有 100,000 行数据,我们也展示了 ZAML 的可解释性比其他方法更准确、更一致,且通常更快。在处理如信用风险建模等高风险业务问题时,确保核心可解释性方法正确至关重要,以便你了解模型的工作情况并能够管理其应用所带来的风险。如果你使用的核心可解释性数学产生了错误的答案,可能会让你的业务陷入严重麻烦。

简介:Jay Budzik 是一位产品和技术领导者,有通过应用 AI 和 ML 创建新产品和服务的优秀收入增长记录。

原文。转载已获许可。

资源:

相关:

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求。

更多相关话题

数据准备中的四个基本步骤

原文:

www.kdnuggets.com/2021/10/four-basic-steps-data-preparation.html

评论

由Rosaria Silipo撰写,KNIME 数据科学布道主管

数据准备的步骤是什么?我们是否需要针对特定问题采取具体步骤?答案并不那么简单:实践和知识将为每种情况设计最佳方案。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

首先,数据准备有两种类型:KPI 计算用于从原始数据中提取信息,以及数据科学算法的数据准备。前者依赖于领域和业务,而后者则更为标准化。

在这篇博客文章中,我们专注于准备数据以供机器学习算法使用的操作。这些数据操作有很多,其中一些更为通用,而另一些则更针对特定情况。当你考虑到有整门大学课程专注于数据准备操作时,这个话题太广泛,无法在一篇简短的文章中涵盖所有内容。

我们希望在这里介绍四个非常基础且非常通用的机器学习算法数据准备步骤。我们将描述在特定示例中如何及为什么应用这些转换。

-

归一化

-

转换

-

缺失值插补

-

重采样

我们的例子:流失预测

让我们以数据科学中的一个简单例子来说明:流失预测。简单来说,流失预测旨在区分那些有流失风险的客户和其他客户。通常,使用公司 CRM 系统中的数据,包括客户行为、人口统计信息和收入特征。有些客户流失,有些则没有。这些数据然后用于训练一个预测模型,以区分这两类客户。

这个问题是一个二分类问题。输出类别(流失)只有两个可能的值:流失“是”和流失“否”。任何分类算法都适用:决策树、随机森林、逻辑回归等。逻辑回归有点像历史算法,运行快速且易于解释。我们将采用它来解决这个问题。

让我们开始构建我们的工作流程。首先,我们从两个独立的文件中读取数据,一个 CSV 文件和一个 Excel 文件,然后应用逻辑回归,最后将模型写入文件。

但别急,Nelly!让我们先查看数据。

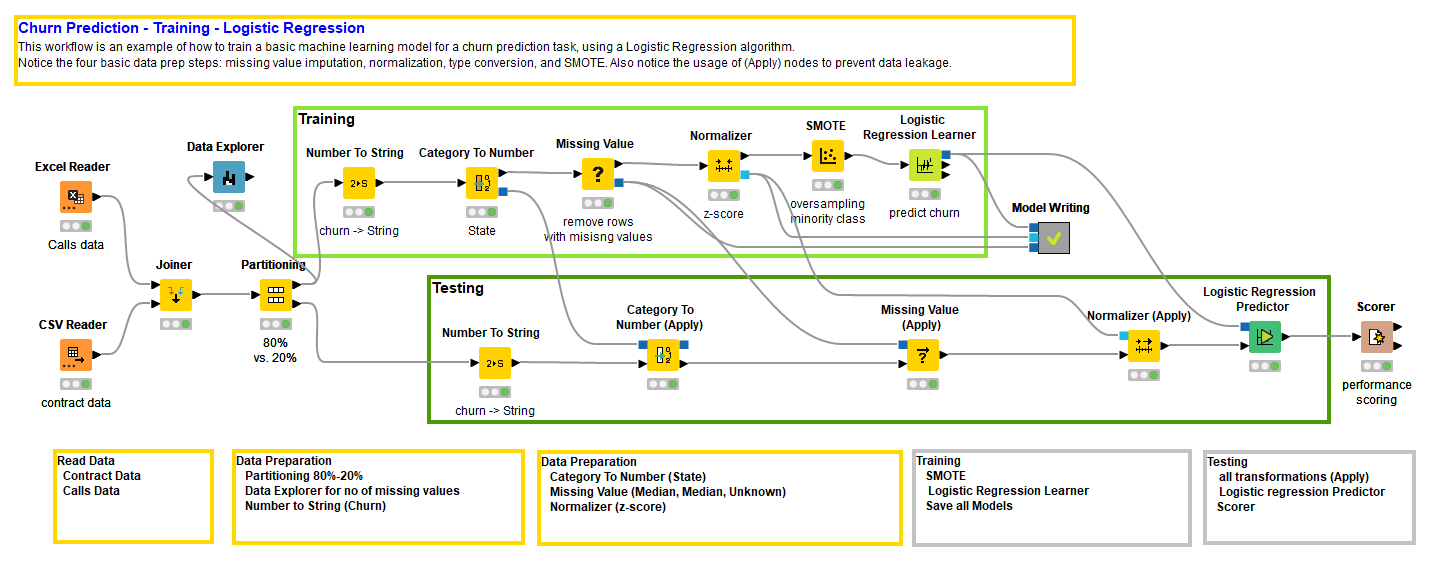

图 1. 训练和评估逻辑回归模型的工作流程,包括四个常见的数据准备步骤(点击放大)。

将数据分区以生成两个数据子集

训练一个模型还不足以声称我们有一个好的模型。我们还需要通过在单独的数据子集上使用准确性或误差度量来评估它。换句话说,我们需要创建一对不重叠的子集——训练集和测试集——从原始数据集中随机抽取。为此,我们使用分区节点。分区节点从输入数据表中随机提取数据,按其配置窗口中指定的比例,生成两个数据子集并在两个输出端口输出。

训练集将由逻辑回归学习器节点用于训练模型,测试集将由逻辑回归预测器节点和后续的评分节点用于评分模型。逻辑回归预测器节点生成客户流失预测,而评分节点评估这些预测的准确性。

在这里,我们没有将分区操作包含在数据准备操作中,因为它并不会真正改变数据。然而,这只是我们的看法。如果你想将分区包含在数据准备操作中,只需将标题从“四”改为“数据准备的五个基本步骤” 😃

1. 标准化

接下来,逻辑回归需要将输入数据标准化到区间[0, 1],如果能够高斯标准化则更好。任何包括距离或方差的算法都将在标准化的数据上有效。这是因为具有较大范围的特征会影响方差和距离的计算,可能会主导整个算法。由于我们希望所有输入特征被平等考虑,因此数据的标准化是必要的。

例如,决策树依赖于概率,不需要标准化数据,但逻辑回归依赖于方差,因此需要先前的标准化;许多聚类算法,如 k-Means,依赖于距离,因此需要标准化;神经网络使用激活函数,其参数落在[0,1]之间,因此也需要标准化;等等。你将学会识别哪些算法需要标准化及其原因。

逻辑回归确实需要高斯标准化的数据。因此,必须引入一个Normalizer节点来标准化训练数据。

2. 转换

逻辑回归在数值属性上工作。这对于原始算法来说是正确的。有时,在一些包中,你会看到逻辑回归也接受分类的,即名义输入特征。在这种情况下,逻辑回归学习函数内部实现了一个准备步骤,将分类特征转换为数字。通常,逻辑回归只在数值特征上工作。

由于我们希望掌控操作,而不是盲目地将转换操作委托给逻辑回归扩展包,因此我们可以自行实现这个转换步骤。实际上,我们希望将一个名义列转换为一个或多个数值列。这里有两个选项:

-

索引编码。每个名义值被映射为一个数字。

-

独热编码。每个名义值创建一个新列,其单元格根据原始列中该值的存在与否填充 1 或 0。

索引编码解决方案从一个名义列生成一个数值列。然而,由于映射函数,它在两个值之间引入了人为的数值距离。

独热编码解决方案不会引入任何人为距离。然而,它从一个原始列生成许多列,因此增加了数据集的维度,并人为地加重了原始列的权重。

没有完美的解决方案。最终这是在准确性和速度之间的妥协。

在我们的案例中,原始数据集中有两个分类列:State和Phone。Phone是一个唯一的 ID,用于识别每个客户。由于它不包含关于客户行为或合同的任何一般信息,我们在分析中不会使用它。State则相反,可能包含相关信息。某个州的客户可能由于当地竞争者的存在,更倾向于流失。

为了转换输入特征State,我们使用了基于索引的编码,通过Category to Number节点实现。

在光谱的另一端,我们有目标列Churn,其中包含有关客户是否流失(1)或未流失(0)的信息。许多分类器训练算法要求类别标签的目标列为分类的。在我们的案例中,Churn 列最初被读取为数值(0/1),必须转换为分类类型,通过Number To String节点。

3. 缺失值填充

逻辑回归的另一个缺点是它不能处理数据中的缺失值。一些逻辑回归学习函数包括缺失值策略。然而,正如我们之前所说的,我们希望控制整个过程。让我们也决定缺失值填补的策略。

文献中有很多缺失值填补的策略。你可以在文章“缺失值填补:综述”中查看详细信息。

最简单的策略就是忽略有缺失值的数据行。这是粗糙的,但如果我们有多余的数据,并不算错。当数据很少时,这就变得有问题了。在这种情况下,仅仅因为某些特征缺失而丢弃一些数据,可能不是最聪明的决定。

如果我们对领域有一些了解,我们就会知道缺失值的含义,并且能够提供一个合理的替代值。

由于我们一无所知,数据集也确实不大,我们需要找到一些替代方案。如果我们不想思考,那么采用中位数、均值或最频繁值是一个合理的选择。如果我们一无所知,就选择多数值或中间值。这是我们在这里采用的策略。

然而,如果我们想稍微思考一下,我们可能想通过 数据探索器 节点对数据集进行一些统计分析,以估计缺失值问题的严重性。如果缺失值问题严重,我们可以在受影响最严重的列中隔离那些有缺失值的行。从这些观察中,可能会得到一个合理的替代值的想法。当然,在实施缺失值策略后,我们这样做了。事实上,数据探索器节点的视图显示我们的数据集没有缺失值。完全没有。哦,好吧!让我们把缺失值节点留在那里以完成工作。

4. 重采样

现在最后一个基本问题:目标类别在数据集中是否均匀分布?

在我们的情况下,它们并不是这样。两个类别之间存在 85%(未流失)对 15%(流失)的不平衡。当一个类别比另一个类别少得多时,训练算法可能会忽视这个类别。如果不平衡不是很严重,那么在分区节点中使用分层抽样策略进行随机数据抽取应该足够了。然而,如果不平衡较强,如本例所示,则可能需要在训练算法之前进行一些重采样。

要进行重采样,你可以选择对多数类别进行欠采样,或者对少数类别进行过采样,这取决于你处理的数据量以及是否可以承担丢弃多数类别数据的奢侈。这种数据集不大,因此我们决定使用 SMOTE 算法对少数类别进行过采样。

防止数据泄漏

现在,我们必须对测试集重复所有这些变换,使用与工作流的训练分支中定义的完全相同的变换。为了防止数据泄漏,我们不能将测试数据用于任何这些变换的制作。因此,在工作流的测试分支中,我们使用了(应用)节点,仅仅将变换应用于测试数据。

请注意,没有 SMOTE(应用)节点。这是因为我们要么重新应用 SMOTE 算法来对测试集中的少数类进行过采样,要么采用考虑类别不平衡的评估指标,如 Cohen’s Kappa。我们选择用 Cohen’s Kappa 指标来评估模型质量。

打包和结论

我们已经完成了工作流的最后一步(你可以从 KNIME Hub 下载工作流 数据准备的四个基本步骤)。我们已经准备了训练数据,对其进行了预测算法训练,使用完全相同的变换准备了测试数据,将训练好的模型应用于测试数据,并将预测结果与实际类别进行评分。评分器 节点生成了多个准确度指标来评估模型的质量。我们选择了 Cohen’s Kappa,因为它可以衡量算法在两个类别上的表现,即使它们高度不平衡。

我们得到了接近 0.4 的 Cohen’s Kappa。这是我们能做的最好结果吗?我们应该尝试回到之前的步骤,调整一些参数,看看是否能得到更好的模型。与其手动调整参数,我们甚至可以引入优化周期。查看免费的电子书 从建模到模型评估,了解更多展示模型性能的评分技术。

我们现在结束这篇文章,介绍了四种非常基础的数据变换。我们邀请你深入了解这四种变换,并探索其他数据变换,例如降维、特征选择、特征工程、异常值检测、PCA 等。

简介: Rosaria Silipo 不仅是数据挖掘、机器学习、报告和数据仓库领域的专家,她还成为了 KNIME 数据挖掘引擎的公认专家,关于这一点她已出版了三本书:《KNIME Beginner’s Luck》、《The KNIME Cookbook》和《The KNIME Booklet for SAS Users》。之前,Rosaria 曾为欧洲多家公司担任自由数据分析师。她还曾在 Viseca(苏黎世)领导 SAS 开发组,在 Spoken Translation(加州伯克利)使用 C# 实现语音转文本和文本转语音接口,并在 Nuance Communications(加州门罗公园)开发了多种语言的语音识别引擎。Rosaria 于 1996 年获得意大利佛罗伦萨大学的生物医学工程博士学位。

首次发布于 KNIME 博客

原文. 经许可转载。

相关:

-

使用 dplyr 在 R 中进行数据准备,附带备忘单!

-

混乱的数据是美丽的

-

基于机器学习的自动数据标注

更多相关主题

数据科学家的四项工作

评论

由罗杰·D·彭、@jhubiostat教授;《R 编程数据科学》作者;@simplystats。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

2019 年,我写了一篇关于数据科学的支柱的文章,尝试提炼数据科学家的关键技能。在文章中,我写道:

当我问自己“什么是数据科学?”时,我倾向于思考以下五个组成部分。数据科学是(1)将设计思维应用于数据问题;(2)创建和管理数据转换和处理的工作流程;(3)通过协商人际关系来识别背景、分配资源和描述数据分析产品的受众;(4)应用统计方法来量化证据;(5)将数据分析信息转化为连贯的叙述和故事。

我的观点是,如果你是一位优秀的数据科学家,那么你在数据科学的五个支柱方面都很出色。相反,如果你在所有五个支柱上都很擅长,那么你很可能是一位优秀的数据科学家。

我对这些技能的感觉还是一样的,但我现在的感觉是,这篇文章实际上让数据科学家的工作看起来比实际要简单。这是因为它将所有这些技能包裹成一个工作,而实际上,数据科学需要在四个工作中都表现出色。为了说明我的意思,我们必须退一步,问一个更基本的问题。

数据科学的核心是什么?

这是一个每个人都在问的问题,我认为也很难回答。任何领域中,总有一些问题的区分

-

这个领域的核心是什么?

-

那些人在该领域通常做些什么?

如果还不清楚,这些问题并不是一样的。例如,在统计学中,根据大多数博士项目的课程,领域的核心涉及统计方法、统计理论、概率论,也许还有一些计算。数据分析通常不会在正式课堂上教授(即在教室里),而是作为论文或研究项目的一部分来掌握。许多标记为“数据科学”或“数据分析”的课程只是教授更多的方法,如机器学习、聚类或降维。正式的软件工程技术通常也不会被教授,但在实践中往往会被使用。

可以说,数据分析和软件工程是统计学家做的事情,但这并不是该领域的核心。是否正确无关紧要。我只是想说,我们必须在某处做出区分。统计学家总是会做比该领域核心更多的工作。

在数据科学领域,我认为我们正在共同盘点数据科学家往往做什么。问题在于,目前看起来一片混乱。传统统计确实倾向于成为活动的核心,但计算机科学、软件工程、认知科学、伦理学、沟通等也一样。这几乎不能定义为领域的核心,而只是活动的枚举。

问题是,我们能否定义出所有数据科学家都在做的事情?如果我们必须教所有数据科学学生一些东西,而不知道他们未来可能去哪里,这会是什么呢?我认为在某个阶段,所有数据科学家都必须参与到基本的数据分析迭代中。

数据分析迭代

基本数据分析迭代分为四个部分。一旦问题确定并且获得或收集数据的计划可用,我们可以做以下事情:

-

构建一个预期结果集合

-

设计/构建/应用一个数据分析系统到数据上

-

诊断分析系统输出中的异常

-

做出一个决策关于下一步要做什么

虽然这个迭代对于许多人可能熟悉或显而易见,但这种熟悉掩盖了其中的复杂性。特别是,每一步迭代都需要数据科学家扮演不同的角色,涉及非常不同的技能。这就像是一场独角戏,其中数据科学家在从一个步骤到下一个步骤时需要换装。这就是我所说的数据科学家的四个角色。

四个角色

基本数据分析迭代的每一个步骤都要求数据科学家扮演四种不同的角色:(1) 科学家;(2) 统计学家;(3) 系统工程师;(4) 政治家。让我们更详细地了解每个角色。

科学家

科学家提出问题并负责了解科学的现状以及关键的知识缺口。科学家还设计任何收集新数据的实验并执行数据收集。科学家必须与统计学家合作,设计一个数据分析系统,并最终从任何数据分析中构建一个预期结果集。

科学家在开发一个能够产生我们预期结果集的系统中发挥着关键作用。这个系统的组件可能包括文献综述、元分析、初步数据或来自同事的轶事数据。我在这里广泛使用“科学家”这个术语。在其他环境中,这可能是政策制定者或产品经理。

统计学家

统计学家与科学家合作,设计分析系统来分析任何数据收集工作的生成数据。他们指定系统如何运行,生成什么输出,并获取实现系统所需的资源。统计学家利用统计理论和个人经验来选择将要应用的分析系统的不同组件。

统计学家在这里的角色是将数据分析系统应用于数据并生成数据分析输出。该输出可以是回归系数、均值、图表或预测。但必须生成某种可以与我们的预期结果集进行比较的东西。如果输出偏离了我们的预期结果集,那么接下来的任务是确定这种偏差的原因。

系统工程师

一旦将分析系统应用于数据,只有两种可能的结果:

-

输出符合我们的期望,或者

-

输出不符合我们的期望(异常)。

在出现异常的情况下,系统工程师的责任是基于对数据收集过程、分析系统和科学知识状态的了解,诊断异常的潜在根本原因。

最近,Emma Vitz 在推特上写道:

如何向初级人员教授调试技能?我觉得这是一项非常重要的技能,但似乎我们没有结构化的教学框架。

对于软件和数据分析来说,挑战在于错误或意外行为可能来自任何地方。任何复杂的系统由多个组件组成,其中一些可能是你的责任,而许多则是他人的。但错误和异常不会尊重这些边界!可能会有一个在一个组件中发生的问题,只有在你查看数据分析输出时才会被发现。

因此,如果你负责诊断问题,那么你有责任调查系统中每个组件的行为。如果这是你不太熟悉的内容,那么你需要变得熟悉它,要么通过自学,要么(更可能地)与实际负责的人交谈。

数据分析输出中常见的意外行为源于数据收集过程,但分析数据的统计学家可能不负责这一方面。尽管如此,识别异常的系统工程师必须回过头来,与统计学家和科学家沟通,以搞清楚每个组件的工作原理。

最终,系统工程师的任务是全面审视所有影响数据分析输出的活动,以识别任何偏差。一旦这些根本原因被解释清楚,我们就可以决定如何处理这些新信息。

政治家

政治家的工作是做出决策,同时平衡各方利益,以实现合理的结果。我认识的大多数统计学家和科学家会对被认为是政治家或认为政治会在任何形式的科学中发挥作用感到反感。然而,我的想法更基础:在任何数据分析迭代中,我们都在不断地做出关于该做什么的决策,同时考虑各种冲突因素。为了化解这些冲突并达成合理的协议,必须具备一种关键技能,即谈判。

在数据分析迭代的各个阶段,政治家必须就以下方面进行谈判:(1)分析中成功的定义;(2)执行分析的资源;以及(3)在看到分析系统的输出并诊断出任何异常的根本原因后,决定下一步该做什么。关于下一步该做什么的决定从根本上涉及数据和科学之外的因素。

政治家必须确定问题的利益相关者是谁,以及他们究竟想要什么(而不是他们的立场是什么)。例如,一位研究人员可能会说:“我们需要 p 值小于 0.05。”那是他们的立场。但他们想要的更可能是“在高影响力期刊上发表文章。”另一个例子可能是一个研究人员需要赶上紧迫的发表截止日期,而另一个研究人员则想进行耗时(但更可靠)的分析。显然,立场相冲突,但可以说,两位研究人员共享相同的目标,即严格的高影响力出版物。

识别职位与潜在需求是谈判合理结果的关键任务。根据我的经验,这一过程很少涉及数据(尽管数据可能用于某些论证)。这一过程的主导因素往往是各方之间的关系性质和资源的限制(如时间)。

应用迭代

如果你在阅读此内容时发现自己说“我不是 X”,其中 X 是科学家、统计学家、系统工程师或政治家,那么很可能你在数据科学方面存在不足。我认为一个好的数据科学家必须在这些领域中具备一些技能,以完成基本的数据分析迭代。

在任何给定的分析中,迭代可以从一次应用到几十次甚至几百次。如果你曾经制作过同一数据集的两个图,那么你可能已经进行了两次迭代。尽管迭代的具体细节和频率在应用中可能会有所不同,但核心性质和涉及的技能变化不大。

原文。经许可转载。

相关:

更多相关话题

分析、数据挖掘、数据科学的四种主要语言

原文:

www.kdnuggets.com/2014/08/four-main-languages-analytics-data-mining-data-science.html

评论作者:Gregory Piatetsky,@kdnuggets,2014 年 8 月 18 日。

评论作者:Gregory Piatetsky,@kdnuggets,2014 年 8 月 18 日。

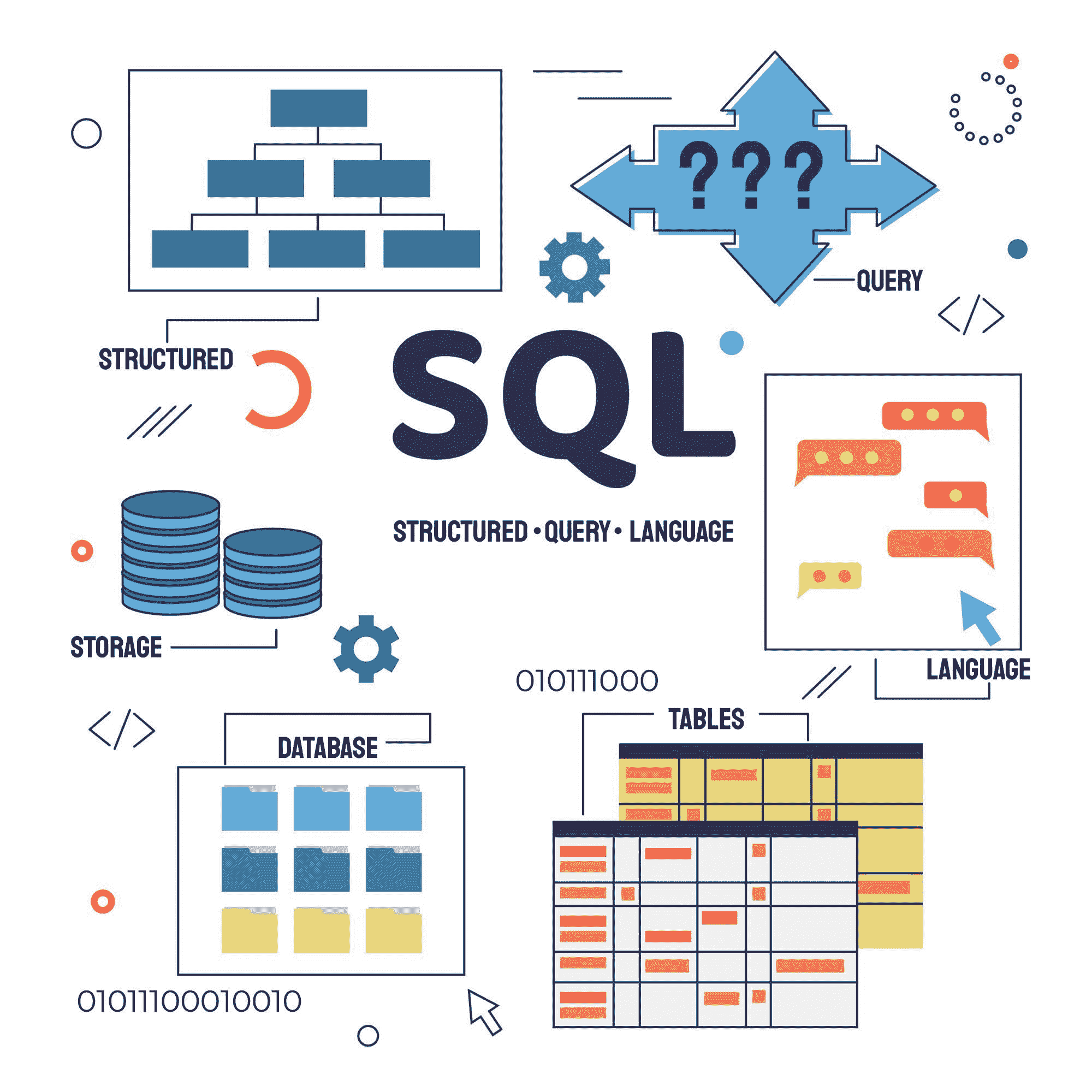

有时高层次的数据科学平台对于特定的分析任务来说是不够的,数据科学家需要转向更低层次的统计/编程语言。

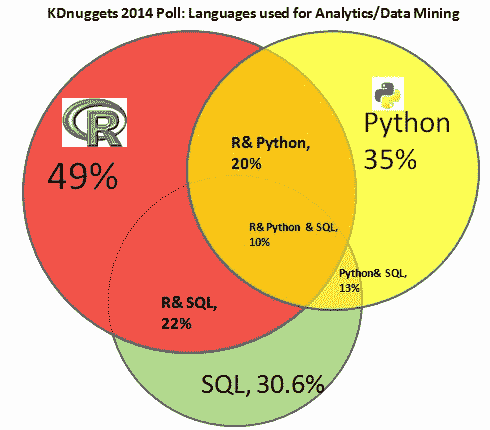

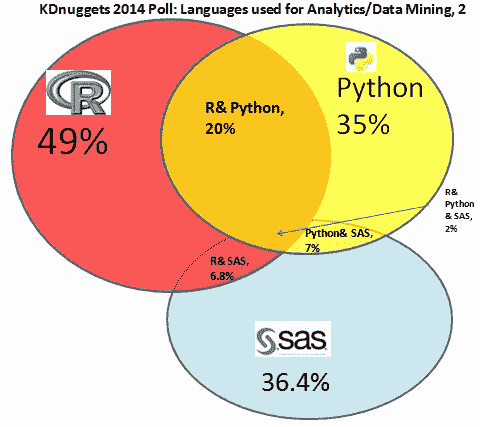

最后的 KDnuggets 投票调查询问了

你在 2014 年分析/数据挖掘/数据科学工作中使用了哪些编程/统计语言?

结果显示,主要的 4 种语言 - R、Python、SAS 和 SQL - 占据了主导地位 - 91% 的受访者使用了其中之一。

与类似的 KDnuggets 投票调查比较

在 2013 年:你在分析/数据挖掘中使用了哪些编程/统计语言,在 2012 年,我们注意到了一些变化和趋势。

1. 2014 年 SAS 用户参与度大幅增加,这可能部分受到 KDnuggets 读者组成变化的驱动,也可能由于此调查在 SAS 用户中的知名度提高。SAS 用户中有很高比例的“孤立”投票 - 在 2014 年,58% 的人表示他们仅使用 SAS,而 2013 年这一比例为 26%。2014 年 R 的“孤立”投票比例为 20.5%,Python 为 14%,SQL 仅为 4.5%。

2. 四大主流语言的整合 - R、SAS、Python 和 SQL。91% 的所有投票者至少使用过其中一种。几乎所有其他语言在数据挖掘任务中的受欢迎程度有所下降,包括 Java、Unix shell、MATLAB、C/C++、Perl、Octave、Ruby、Lisp 和 F#。

这里是一个维恩图,显示了 R、Python 和 SQL 之间的显著重叠。百分比表示选择该选项的投票者比例,例如,20% 的所有投票者使用了 R 和 Python,而 10% 的人使用了 R、Python 和 SQL。圆圈和交集的面积大致对应投票者的比例。

这里是一个类似的维恩图,展示了 R、Python 和 SAS 之间的重叠。我们看到 SAS 与 R 和 Python 的独立性更强,大约 2/3 的 SAS 用户没有使用 R 或 Python。

3. 2014 年增长最快的语言是

-

Julia,增长 316%,从 2013 年的 0.7% 增至 2014 年的 2.9%

-

SAS,增长 76%,从 2013 年的 20.8% 增至 2014 年的 36.4%

-

Scala,增长 74%,从 2013 年的 2.2% 增至 2014 年的 3.9%

4. 使用比例下降幅度最大的语言 为:

-

F#,下降 100%,从 2013 年的 1.7%降至 2014 年的零

-

C++/C,下降 60%,从 2013 年的 9.3%降至 2014 年的 3.6%

-

GNU Octave,下降 57%,从 2013 年的 5.6%降至 2014 年的 2.4%

-

MATLAB,下降 50%,从 2013 年的 12.5%降至 2014 年的 6.3%

-

Ruby,下降 44%,从 2013 年的 2.2%降至 2014 年的 1.3%

-

Perl,下降 41%,从 2013 年的 4.5%降至 2014 年的 2.6%

这里是更多详细信息的表格:

| 2014 年你在分析/数据挖掘/数据科学工作中使用了哪些编程/统计语言? |

|---|

| 使用语言 |  2014 年选民比例(总计 719 人)

2014 年选民比例(总计 719 人)  2013 年选民比例(总计 713 人)

2013 年选民比例(总计 713 人)

2012 年选民比例(总计 579 人) |

2012 年选民比例(总计 579 人) |

| R(2014 年 352 名选民) |    |

|---|---|

| SAS(262) |    |

| Python(252) |    |

| SQL(220) |    |

| Java(89) |    |

| Unix shell/awk/sed(63) |    |

| Pig Latin/ Hive/其他基于 Hadoop 的语言(61) |    |

| SPSS(58) |  未询问 未询问 未询问 未询问 |

| MATLAB(45) |    |

| Scala(28) |    |

| C/C++(26) |    |

| Julia(21) |    |

| 其他低级语言 (20) |    |

| Perl (19) |    |

| GNU Octave (17) |    |

| Ruby (9) |    |

| Lisp/Clojure (5) |    |

| F# (0) | 0%  2012 年未被提及 2012 年未被提及 |

除了其他编程语言,威廉·德温内尔提到了编译的 BASIC(PowerBASIC)。

地区参与情况为

-

美国/加拿大: 51.6%

-

欧洲: 26.7%

-

亚洲: 13.3%

-

拉丁美洲: 3.7%

-

非洲/中东: 3.5%

-

澳大利亚/新西兰: 2.0%

这与 2013 年类似,但亚洲和非洲/中东(以以色列和土耳其为主)的参与更多,而拉丁美洲的参与则减少(主要是巴西的减少,也许仍因世界杯失利而受到打击)。

更多相关话题

帮助准确确定分析工程项目范围的四个问题

原文:

www.kdnuggets.com/2019/10/four-questions-scope-analytics-engineering-project.html

评论

由 Tristan Handy,Fishtown Analytics 创始人兼首席执行官。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速通道进入网络安全职业生涯。

1. Google 网络安全证书 - 快速通道进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能。

2. Google 数据分析专业证书 - 提升你的数据分析技能。

3. Google IT 支持专业证书 - 支持你的组织 IT。

3. Google IT 支持专业证书 - 支持你的组织 IT。

在 Fishtown Analytics,我们以两周的冲刺周期销售和交付分析工程项目,每个周期都有固定的价格和交付物。在如此紧凑的时间表和明确的结果下交付是非常紧张的!我们在这方面做得相当好:我们已经完成了超过 1000 个冲刺,其中超过 95% 准时交付。

结果是,我们在确定分析项目范围方面变得非常擅长。我们发现,如果我们提前回答四个问题,我们可以显著减少在为时已晚之前发现问题的机会。事实上,早期发现问题是按时交付分析工作的最重要因素。如果你花一周时间走上一条道路,结果发现是死胡同,那是一段巨大的浪费时间。关键是要在陷入困境之前预见到死胡同。

我们的主动问题识别方法已经变得直观——这是我们大家自然会做的事情,因为我们都曾在炉子上烫过手,知道这样做更好:“我本该知道我需要检查那些 ID 是否能匹配。操。”

这是一个如此重要的话题,以至于我想花时间使我们的直观、潜在知识更为明确,并与更大的社区分享。因为这项技能不仅仅是为顾问准备的:任何使用 敏捷方法进行数据团队管理 的人,或者任何管理数据项目截止日期的人,都应该关心。

为什么? 数据团队成功的关键在于建立信任储备 ——这就是你如何从所有业务利益相关者那里获得“受信任顾问”地位的方式,以及如何最终影响业务的轨迹。我们通过提供高质量、经过测试和准确的数据来赢得信任。我们还通过对项目的过程设定明确期望并一再兑现来建立信任。

以下是我们在 Fishtown Analytics 主动识别问题并按时交付分析工程项目时提出的四个问题。

1. 我是否从原始来源获得了数据?

数据相关但来自错误系统的情况并不罕见。一个常见的例子是:你的公司可能在 Marketo 中存储营销数据,但它通过现有的 Salesforce 集成被引入到数据仓库中。使用 Marketo 数据而非 Salesforce 数据并不错误,但却有风险。双重集成将有更多失败的机会,数据也可能不像原始数据那样详细或完整。最好是直接从数据的源头获取所有数据。

实际上,这里有很多这样的例子。你应该信任:

-

是 Shopify 的收费还是 Stripe 的? 我会选择 Stripe 的用于财务/收入相关的情况,而 Shopify 的用于电子商务相关的情况。

-

Mixpanel 的事件还是 Segment 的? 我几乎总是选择 Segment,因为大多数公司将数据通过 Segment 推送到 Mixpanel。

-

Hubspot 的归因还是 Snowplow 的? 我相信你的网络分析工具(在这种情况下是 Snowplow)需要成为你网络事件数据的权威来源,从而成为你的归因来源。

当你开始一个项目时,坚持直接从源头获取数据是一件有趣的事,因为在某些方面,这并不非常务实。支付额外的集成费用通常有明确的价格标签,而且一开始并不清楚它的价值。为什么你拥有的数据“不够好”?答案是,基于最基本的真实数据源建立你的分析将节省大量的时间、挫折、变通方法和混乱的代码。

如果你有真正的原始数据,你就几乎无所不能:如果一个问题可以回答,你就能回答它。如果你在与一位 VP 开会时,他问:“我们能按获取来源来切分潜在客户吗?”答案要么是“可以”,要么是“我们使用的系统没有提供这样的数据。”如果你没有原始数据,你有时只能回答“根据我们目前的分析管道无法做到这一点。”这并不令人信服。

如果你没有原始数据,请做两件事:

-

试着直接获取这些数据。这可能像设置 Stitch 或 Fivetran 集成一样简单,或者可能需要自定义集成。

-

如果你无法获取原始数据并需要依赖于次级数据源,请提醒你的利益相关者潜在的缺陷,以便每个人对项目有正确的期望。概述你能提供的分析范围,以及如果能够获取原始数据时需要的再加工量。只要你明确告知利益相关者潜在的下游影响,基于 expediency 做出决策本身没有什么问题。

2. 数据源是否足够细粒度?

根据Kimball,重要的是“坚持使用与原始来源和收集过程紧密相关的丰富、表达性强的原子级数据。” 我完全同意:细粒度数据给你更多的选择,而汇总数据则有限制。

实践中最常见的一个例子是 Google Analytics 通过 API 导出的数据与 Google Analytics 360 自动加载到 Bigquery 中的数据之间的差异。通过 API,GA 只会提供汇总指标,而 GA 360 会将每一个会话和每一个事件导出到 Bigquery 中。汇总数据仅在创建极高层次的分析时有用,例如页面浏览量或独立访客的趋势线。利用细粒度数据,你可以回答任何问题——多触点归因、漏斗分析、A/B 测试等。

理想情况下,你希望能访问来源数据系统中绝对最细粒度的数据。在这个早期阶段,你还不知道将来会被要求调查的所有后续问题,你希望能够跟踪任何可能的线索。即使你的顶层问题可以通过汇总导出得到答案,你的后续问题几乎肯定无法回答。

实际上了解你所交互的数据源系统非常重要。

-

如果是 SaaS 产品,阅读 API 文档。API 会提供什么数据?好的 API 会提供你所需的所有对象;优秀的 API 会在这些对象上提供变更跟踪。例如,Salesforce API 会提供一个包含所有机会及其状态变化的历史表。这表明,机会历史表对 Salesforce 管道报告的一个大部分至关重要。

-

如果是内部产品数据库,请阅读所有可用的内部文档或与有经验的工程师坐下来了解产品中存储的数据。

总体来说,你离事件越近,情况就越好。如果你拥有一个系统的所有状态变更,你总是可以在任何给定时间点重建该状态——这是一种非常强大的状态。例如,你实际需要的唯一 Stripe API 端点是事件端点:从那个单一端点,你可以在任何时间点推导出所有其他端点的输出。你可以用类似的方式使用 Mailchimp 的事件表来分析电子邮件营销表现。

幸运的是,大多数 Stitch 和 Fivetran 集成默认会提取最大粒度的数据——这两个产品都是为现代分析栈构建的,旨在给予你完全的控制。然而,还是需要自己进行检查。前不久,我在与客户制定销售管道报告的计划时,发现 Stitch Close.io 集成(这是社区支持的)不包含机会历史端点。这显著改变了项目的范围,因为我们实际上无法在不将该额外端点添加到集成中的情况下进行所需的分析。最好在一开始就发现这个问题。

3. 这个数据集以前用过吗?

如果你的组织以前没有使用过来自某个数据管道的数据,你应该将其视为有罪,直到证明其清白。数据未使用过的情况下,可能存在大量错误方式,而且许多错误是微妙的。主要有两个类别:

-

加载错误。在加载过程中可能会出现错误,导致你的数据仓库中的数据不正确。即使你处理的是 Stitch 和 Fivetran 集成,错误总会发生。每次我看到集成出现问题时,都是由于最奇怪、最深奥的问题,每个问题都是独一无二的。

-

意外的加载行为。有时,加载发生的方式是你意想不到的。例如,Stitch 将许多它称之为“报告表”的表作为不可变日志进行加载,然后提供如何从这些表中查询的具体指示。如果你不阅读它们的指示,而是直接开始编写查询,你会得到令人困惑的错误数据。

这两种类型的错误都可以通过在建立关键任务分析之前对新数据集进行数据审计来捕捉。审计数据集究竟意味着什么?对我们来说,这意味着在表格上生成直观的指标,并将这些指标与另一个系统(通常是数据提取自的系统)中的输出进行比较。例如,我们经常计算订单和收入,并将这些指标与我们在 Shopify 中本地获得的结果进行比较。这些指标计算起来非常简单,如果数字匹配,你可以立即对数据集的状态有很高的信心。

原始数据的问题通常是跨切的:它们会影响表中的所有记录或某个日期范围内的所有记录。如果你审核 2-3 个指标,你通常可以对数据质量感到相当满意。

如果你的组织曾经使用过来自某个数据摄取管道的数据,那么你有责任去学习已经建立的内容。如果你使用的是 dbt:

-

查阅使用 dbt 文档进行的现有建模工作。

-

阅读所有模型和列的描述文本,确保你真正理解代码。

-

查找 git 提交历史中的作者,询问是否有任何你需要知道的注意事项。

不要只是说“算了”,然后从头开始你的工作。 分析工程技术债务和错误的主要来源是多个代码库试图转化和分析本质上相同的数据。两个代码路径意味着双倍的错误面和无限的混淆机会。跟踪之前的工作并不总是容易,但将现有代码库融入其中,而不是从零开始,是至关重要的。我见过一些团队不愿意以这种方式协作编写代码,而是每个分析师都建立自己的孤岛。这是一种极其低效的数据团队做法。

4. 是否存在必要的关键字来将所有数据连接在一起?

新的分析通常会基于现有概念,通过将新数据附加到已经建模的数据上。通常的做法是从你的应用数据库或购物车开始,然后向外扩展到其他数据系统:事件跟踪、客户成功、广告、电子邮件等。当你将这些系统引入你的管道和数据模型时,你需要至少一个关键字来连接数据。

这看起来应该相当简单,但通常情况并非如此。以下是一些例子:

-

你在 Salesforce 实例中将试用注册登记为线索,但提交到 Salesforce 的营销网站上的网页表单在流程中的那个点没有用户的账户号码。没有关键字!

-

你的事件跟踪在过去一周只显示了 15,000 个识别用户,但你的应用数据库确信在同一时间段内有 20,000 个用户登录。你的事件跟踪管道的用户识别代码是“漏的”——一些识别调用丢失了!哪些?

-

你想跟踪整个漏斗中的客户获取成本(CAC),从广告支出开始。但当你整合来自各种广告来源的数据时,你意识到市场团队没有在他们使用的链接中添加 URL 参数!没有这些参数,你就无法将来自你仓库其余部分的数据与广告成本数据连接起来。

这种情况经常发生,知道在哪里寻找问题至关重要。如果两个系统之间缺少一个密钥,可能会使整个分析项目陷入停滞,因为通常 a) 添加密钥涉及从组织的其他部分引入利益相关者,b) 没有办法追溯获取数据。

确保在深入之前检查你的密钥。如果缺少密钥,请与利益相关者合作创建它们。这种“过程仪表化”是优秀分析工程师的关键部分:你不能总是指望业务流程自然输出所需的数据,有时你需要卷起袖子确保数据被收集。

在深入之前了解答案

作为顾问,我必须有一个强有力的流程:如果我对一个迭代范围估算错误,这可能意味着接下来的两周我将没有足够的睡眠。或者这可能意味着我们在项目上亏损——风险是真实的。这就是为什么我(以及 Fishtown 的每个人)如此专注于精确范围估算。

在内部数据团队中,风险同样很高,但反馈通常不如外部那样明确或即时。你的利益相关者会注意到如果你持续错过截止日期或未能交付关键结果,他们可能不会直接告诉你。给同事直接反馈往往很困难——你上次说“你们团队错过了那个截止日期导致我错过了季度承诺的 OKR,我很生气”是什么时候?

即使没有明确说明,数据团队一致未能交付可预测的结果也会损害信任,从而影响团队对更大组织的影响力。通过在项目范围确定阶段识别问题,并与利益相关者沟通你的方法的局限性,避免这种结果。

原文。经许可转载。

简介: Tristan Handy目前正在构建 Fishtown Analytics,以帮助获得风险投资的公司通过构建工具来实施先进的分析,从而促进一种有主见的分析工作流程。

相关:

更多相关话题

四种异常值检测技术

原文:

www.kdnuggets.com/2018/12/four-techniques-outlier-detection.html

评论

作者:Maarit Widmann, Moritz Heine, Rosaria Silipo,KNIME的数据科学家

异常值或离群值在训练机器学习算法或应用统计技术时可能是一个严重的问题。它们通常是测量误差或特殊系统条件的结果,因此不能描述基础系统的常见功能。实际上,最佳实践是在进行进一步分析之前实施异常值去除阶段。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

但等一下!在某些情况下,异常值可以为我们提供关于整个系统的局部异常的信息;因此,异常值检测是一个有价值的过程,因为它们可以提供关于数据集的额外信息。

有许多技术可以检测并选择性地去除数据集中的异常值。在这篇博文中,我们展示了KNIME Analytics Platform中四种最常用的 - 传统和新型 - 异常值检测技术的实现。

数据集和异常值检测问题

我们用于测试和比较所提议的异常值检测技术的数据集是著名的航空公司数据集。该数据集包括 2007 年至 2012 年间美国国内航班的信息,如起飞时间、到达时间、起始机场、目的地机场、空中时间、起飞延误、到达延误、航班号、船只号、承运人等。这些列中有些可能包含异常值,即离群值。

从原始数据集中,我们提取了 1500 个从芝加哥奥黑尔机场(ORD)出发的航班样本,数据来自 2007 年和 2008 年。

为了展示所选的异常值检测技术的工作原理,我们集中于在机场的平均到达延误时间方面寻找异常值,这些时间是基于所有降落在特定机场的航班计算得出的。我们寻找那些显示出异常平均到达延误时间的机场。

四种异常值检测技术

数值异常值

这是在一维特征空间中最简单的非参数异常值检测方法。这里,异常值是通过IQR(四分位距)来计算的。

计算第一个和第三个四分位数(Q1, Q3)。然后,异常值是位于四分位距之外的数据点 x[i]。即:

使用四分位数乘数值k=1.5,范围限制是箱形图的典型上须和下须。

该技术通过在KNIME Analytics Platform中构建的工作流中的 Numeric Outliers 节点实现(图 1)。

Z-Score

Z-score 是一种在一维或低维特征空间中的参数化异常值检测方法。

该技术假设数据服从高斯分布。异常值是分布尾部的数据点,因此远离均值。距离的远近取决于为标准化数据点 z[i]设置的阈值 z[thr],计算公式如下:

其中 x[i]是数据点,μ是所有 x[i]的均值, 是所有 x[i]的标准差。

异常值是一个标准化的数据点,其绝对值大于 z[thr]。即:

常用的 z[thr]值为 2.5、3.0 和 3.5。

该技术通过在 KNIME 工作流中的 Row Filter 节点实现(图 1)。

DBSCAN

该技术基于DBSCAN聚类方法。DBSCAN 是一种在一维或多维特征空间中基于密度的非参数异常值检测方法。

在 DBSCAN 聚类技术中,所有数据点被定义为核心点、边界点或噪声点。

-

核心点是距离ℇ内至少有MinPts个邻居的数据点。

-

边界点是核心点在距离ℇ内的邻居,但在距离ℇ内的邻居少于MinPts。

-

所有其他数据点都是噪声点*,也被识别为异常值。

异常值检测因此依赖于所需的邻居数MinPts、距离ℇ以及选择的距离度量,如欧几里得或曼哈顿距离。

该技术通过图 1 中的 KNIME 工作流中的 DBSCAN 节点实现。

隔离森林

这是一种用于大数据集的非参数方法,适用于一维或多维特征空间。

该方法中的一个重要概念是隔离数。

隔离数是隔离一个数据点所需的分裂次数。通过以下步骤确定分裂次数:

-

随机选择一个点“a”进行隔离。

-

随机选择一个数据点“b”,它位于最小值和最大值之间,并且与“a”不同。

-

如果“b”的值低于“a”的值,“b”的值将成为新的下限。

-

如果“b”的值大于“a”的值,“b”的值将成为新的上限。

-

只要在上限和下限之间存在其他数据点,程序就会重复执行。

与隔离非离群点相比,隔离离群点所需的拆分较少,即离群点的隔离数低于非离群点。因此,如果数据点的隔离数低于阈值,则定义为离群点。

阈值是基于数据中估计的离群点百分比定义的,这是该离群点检测算法的起点。

关于隔离森林技术的解释和图片可参考 quantdare.com/isolation-forest-algorithm/。

这一技术通过在 Python Script 节点内使用几行 Python 代码在图 1 中的 KNIME 工作流中实现。

from sklearn.ensemble import IsolationForest

import pandas as pd

clf = IsolationForest(max_samples=100, random_state=42)

table = pd.concat([input_table['Mean(ArrDelay)']], axis=1)

clf.fit(table)

output_table = pd.DataFrame(clf.predict(table))

Python Script 节点是 KNIME Python Integration 的一部分,它允许你在 KNIME 工作流中编写/导入 Python 代码。

在 KNIME 工作流中的实现

KNIME Analytics Platform 是一个开源的数据科学软件,涵盖了从数据摄取和数据混合到数据可视化、从机器学习算法到数据清理、从报告到部署等所有数据需求。它基于图形用户界面进行可视化编程,使其非常直观易用,大大缩短了学习时间。

它设计为支持不同的数据格式、数据类型、数据来源、数据平台,以及外部工具,例如 R 和 Python。它还包括用于分析非结构化数据(如文本、图像或图表)的多个扩展。

KNIME Analytics Platform 中的计算单元是小的彩色块,称为“节点”。将节点一个接一个地组装在管道中,实现了数据处理应用程序。管道称为“工作流”。

考虑到所有这些特性——开源、可视化编程和与其他数据科学工具的集成——我们选择了它来实现本文中描述的四种离群点检测技术。

实现这四种离群点检测技术的最终 KNIME 工作流见图 1。工作流:

-

在 Read data 元节点内读取数据样本。

-

在 Preproc 元节点内预处理数据,并计算每个机场的平均到达延误。

-

在下一个名为“延误密度”的元节点中,它标准化数据,并将标准化的平均到达延误的密度与标准正态分布的密度进行绘制。

-

使用四种选定的技术检测异常值。

-

使用 KNIME 与 Open Street Maps 的集成,在 MapViz 元节点中可视化美国的异常机场。

图 1: 实现四种异常检测技术的工作流程:数值异常值、Z-score、DBSCAN、孤立森林。该工作流程可在 KNIME EXAMPLES 服务器上找到,路径为 02_ETL_Data_Manipulation/01_Filtering/07_Four_Techniques_Outlier_Detection/Four_Techniques_Outlier_Detection。

检测到的异常值

在图 2-5 中,您可以看到不同技术检测到的异常机场。

蓝色圆圈代表没有异常行为的机场,而红色方块代表有异常行为的机场。平均到达延迟时间定义了标记的大小。

一些机场被所有技术一致识别为异常值:斯波坎国际机场 (GEG)、伊利诺伊大学威拉德机场 (CMI) 和哥伦比亚大都会机场 (CAE)。斯波坎国际机场 (GEG) 是最大的异常值,其平均到达延迟时间非常长 (180 分钟)。

然而,还有一些其他机场仅被部分技术识别。例如,路易斯·阿姆斯特朗新奥尔良国际机场 (MSY) 仅被孤立森林和 DBSCAN 技术发现。

请注意,对于这个特定的问题,Z-Score 技术识别出最少的异常值,而 DBSCAN 技术识别出最多的异常机场。

只有 DBSCAN 方法 (MinPts=3, ℇ=1.5, 距离度量欧氏) 和孤立森林技术 (估计异常值百分比 10%) 能在早到方向上找到异常值。

图 2: 使用数值异常值技术检测的异常机场

图 3: 使用 z-score 技术检测的异常机场

图 4: 使用 DBSCAN 技术检测的异常机场

图 5: 使用孤立森林技术检测的异常机场

摘要

在这篇博客文章中,我们描述并实现了四种不同的异常检测技术在一维空间中:2007 年至 2008 年间所有美国机场的平均到达延迟时间,如航空公司数据集中所述。

我们研究的四种技术是数值异常值、Z-Score、DBSCAN 和孤立森林方法。其中一些适用于一维特征空间,有些适用于低维空间,还有一些扩展到高维空间。有些技术需要标准化和检查维度的高斯分布,有些需要距离度量,还有一些需要计算均值和标准差。

有三个机场被所有异常检测技术识别为异常值。然而,只有部分技术(DBSCAN 和 Isolation Forest)能够识别分布左尾中的异常值,即那些平均上航班到达时间早于预定到达时间的机场。

参考文献

本博客文章的理论基础来自:

- Santoyo, Sergio. (2017 年 9 月 12 日). 异常检测技术的简要概述 [博客文章]。

相关:

-

使用标准差在 Python 中去除异常值

-

如何让你的机器学习模型对异常值具有鲁棒性

-

8 个可能毁掉你预测的常见陷阱

更多相关内容

数据科学家的傅里叶变换

原文:

www.kdnuggets.com/2020/02/fourier-transformation-data-scientist.html

评论

图片来源:Shutterstock

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路

1. Google 网络安全证书 - 快速进入网络安全职业道路

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

介绍

傅里叶变换是数学中最深刻的见解之一,但不幸的是,其意义深藏在一些荒谬的方程式中。

傅里叶变换是一种将某物拆分为一堆正弦波的方法。像往常一样,名字来自很久以前的一个人,傅里叶。

在数学术语中,傅里叶变换是一种将信号转化为其组成成分和频率的技术。

傅里叶变换不仅广泛应用于信号(如无线电、声学等)处理,还用于图像分析,如边缘检测、图像过滤、图像重建和图像压缩。例如:傅里叶变换在透射电子显微镜图像中有助于检查样本的周期性。周期性——意味着模式。傅里叶变换可以扩展有关分析样本的信息。

为了更好地理解,考虑一个信号 x(t):

如果我们对另一个信号做同样的处理,并选择相同的时间点进行幅度测量。

另一个信号 y(t):

当我们同时发出这两个信号或将它们加在一起时会发生什么?

当我们在同一时间发出这两个信号时,我们得到一个新信号,即这两个信号的幅度之和。这是因为这两个信号被加在一起。

将两个信号相加:z(t) = x(t) + y(t)

如果我们只得到一个信号(即信号 x(t)和 y(t)的和),我们能恢复原始信号 x(t)和 y(t)吗?

是的,这就是傅里叶变换的作用。它接受一个信号并将其分解为组成它的频率。

在我们的例子中,傅里叶变换会将信号 z(t)分解成其组成频率,就像信号 x(t)和 y(t)一样。

傅里叶变换的作用是将我们从时间域移动到频率域。

如果有人想知道,我们如何从频率域返回到时间域?

我们可以通过使用逆傅里叶变换(IFT)来实现这一点。

你需要了解的数学知识。

“任何连续信号在时间域中可以通过无限正弦波序列唯一且明确地表示。”

这是什么意思?

这意味着,如果我们有一个由某个函数x(t)生成的信号,那么我们可以得到另一个函数f(t),使得:

因此,无论信号的强度如何,我们都可以找到一个函数f(t),它是无限正弦波序列的和,能够完美地表示信号。

现在,提出的问题是,我们如何在上述方程中找到系数,因为这些值将决定输出的形状,从而决定信号。

因此,为了获得这些系数,我们使用傅里叶变换,而傅里叶变换的结果是一组系数。因此,我们用X(w)表示傅里叶系数,它是频率的函数,通过解积分得到:

傅里叶变换表示为不定积分:

X(w):傅里叶变换

x(t):逆傅里叶变换

傅里叶变换和逆傅里叶变换

此外,当我们实际计算上述积分时,会得到这些复数,其中a和b对应于我们追求的系数。

连续傅里叶变换将无限持续时间的时间域信号转换为由无限多个正弦波组成的连续谱。在实际应用中,我们处理的是离散采样的信号,通常在固定间隔内采样,并且具有有限持续时间或周期性。为此,经典傅里叶变换算法可以表示为离散傅里叶变换(DFT),它将函数的有限序列等间隔采样转换为离散时间傅里叶变换的等长度序列:

所以,这本质上就是离散傅里叶变换。我们可以进行这种计算,它会产生一个形式为a + *i*b的复数,其中包含傅里叶级数的两个系数。

现在,我们知道如何采样信号和如何应用离散傅里叶变换。最后,我们想做的是,想要摆脱复数 *i*,因为它在 mllib 或 systemML 中不被支持,可以通过一种称为欧拉公式的方法来实现,该公式如下:

因此,如果我们将欧拉公式代入傅里叶变换方程并进行求解,它将产生实部和虚部。

如你所见,X 由格式为 a+ib 或 a-ib 的复数组成。因此,如果你解上述方程,你将得到傅里叶系数 a 和 b。

现在,如果你在f(t)方程中代入a和b的值,你可以根据其频率定义一个信号。

在实际操作中,我们使用快速傅里叶变换(FFT)算法,它递归地将离散傅里叶变换(DFT)分解为更小的 DFT,从而显著降低所需的计算时间。DFT 的时间复杂度是2N²,而 FFT 的时间复杂度是2NlogN。

为什么在表示信号时使用余弦和正弦函数?

尽管正弦和余弦函数最初是基于直角三角形定义的,但在当前情况下,考虑那个观点并不是最佳选择。你可能已经被教导识别正弦函数为“对边除以斜边”,但现在是时候换一个稍微不同的视角了。

考虑单位圆:

在笛卡尔平面上。假设一条通过原点的直线在逆时针方向上与 ????-轴成角θ,直线与圆的交点为 (cosθ, sinθ)。

想一想。这个观点与之前的观点相关吗?两种定义是相同的。

假设我们开始旋转这条直线,使θ线性增加。你会得到如下结果:

正弦函数和余弦函数在多种情况下可以说是最重要的周期函数:

-

SHM 振荡器中位移、速度和加速度随时间变化的周期函数是正弦函数。

-

每个粒子都有波动性,反之亦然。这是德布罗意的波粒二象性。波动总是某些物理量的正弦函数(如电磁波的电场和声波的压力)。

声音本身是通过能够压缩和扩展的材料介质传播的压力扰动。声音波沿点的压力随时间呈正弦变化。

傅里叶变换的收敛性

如果一个点以恒定速度绕圆圈移动,它离地面的高度描绘了一个正弦函数。点移动的速度对应于频率,圆圈的半径对应于振幅。

添加 1 个圆圈,

添加 2 个圆圈,

添加 9 个圆圈:

几乎是一个离散波形。

由于傅里叶定理,我们可以用适当频率和半径的圆生成任何信号。

我使用了 Dan Shiffman 的代码从coding challenge #125制作动画。你可以从他的GitHub获取 JavaScript 代码并自行尝试。

人工智能中的傅里叶变换

傅里叶变换是一个线性函数,为了引入非线性,使用了卷积。

两个信号的乘积的傅里叶变换是这两个信号的卷积。

设 x(t) 和 y(t) 为两个具有卷积 X(t)*Y(t) 的函数,F 代表傅里叶变换,那么