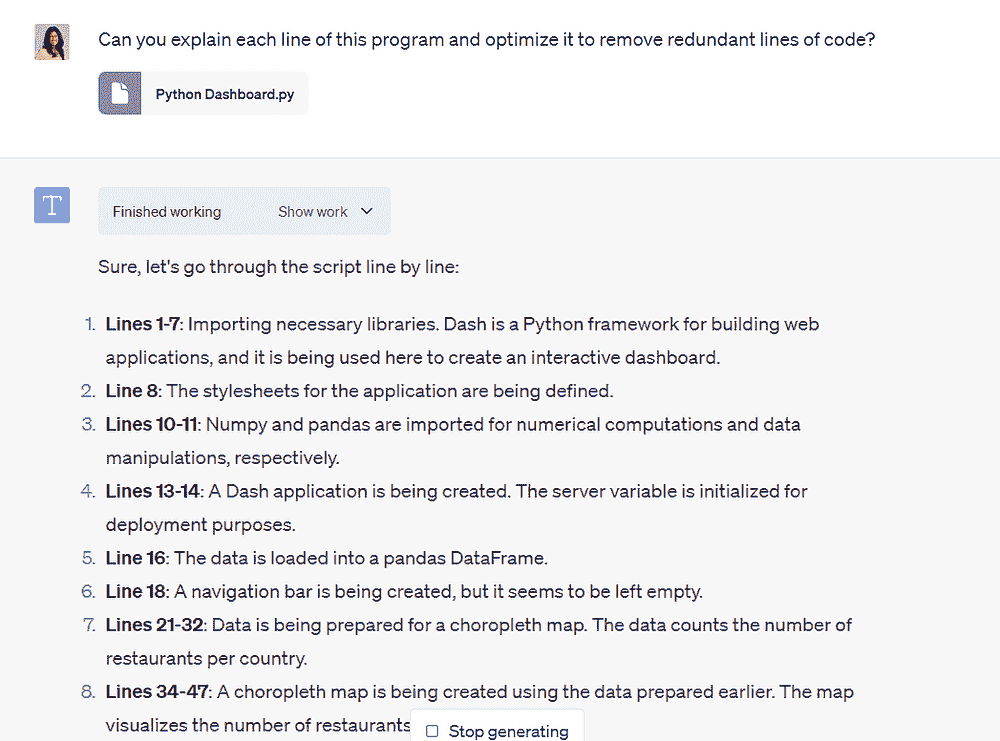

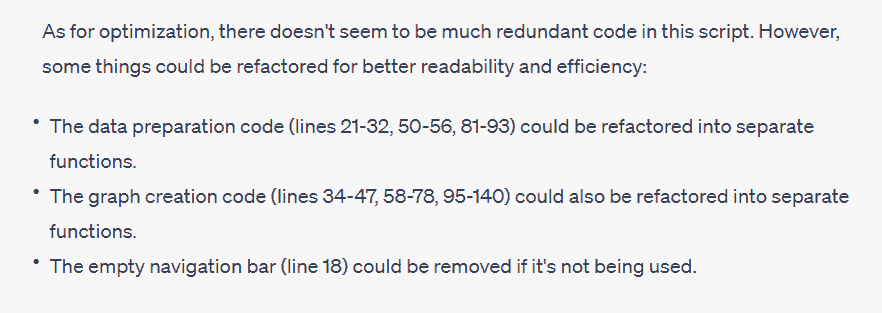

KDNuggets-博客中文翻译-十-

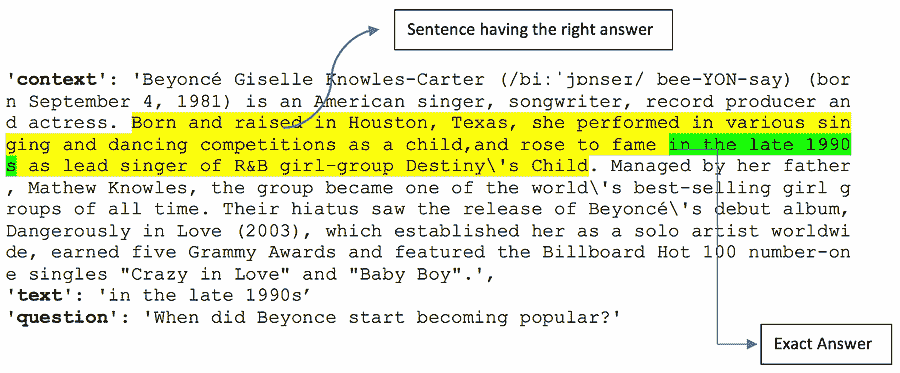

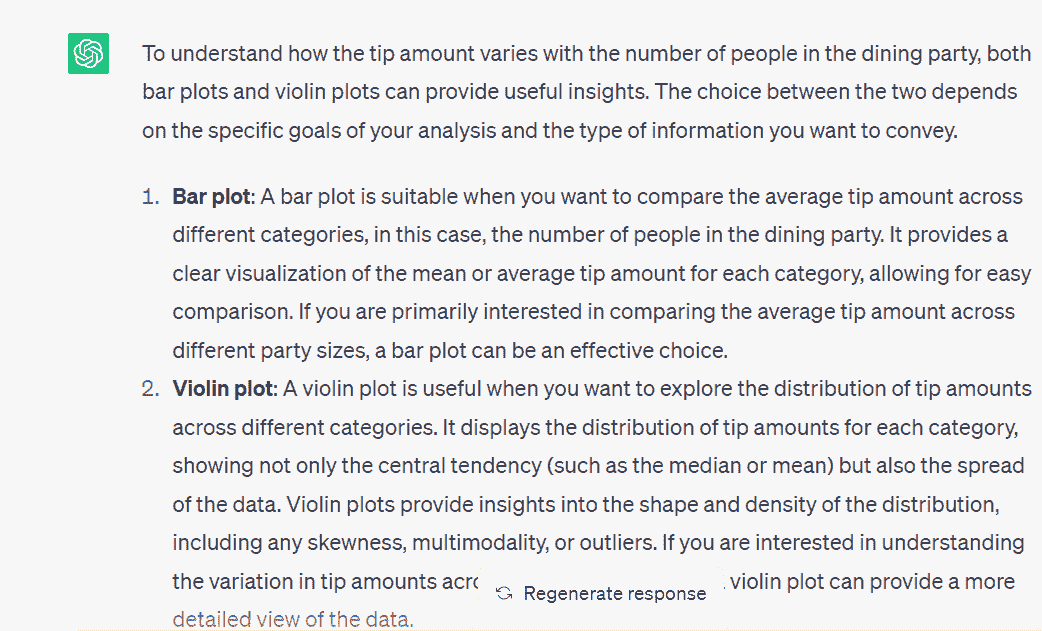

KDNuggets 博客中文翻译(十)

原文:KDNuggets

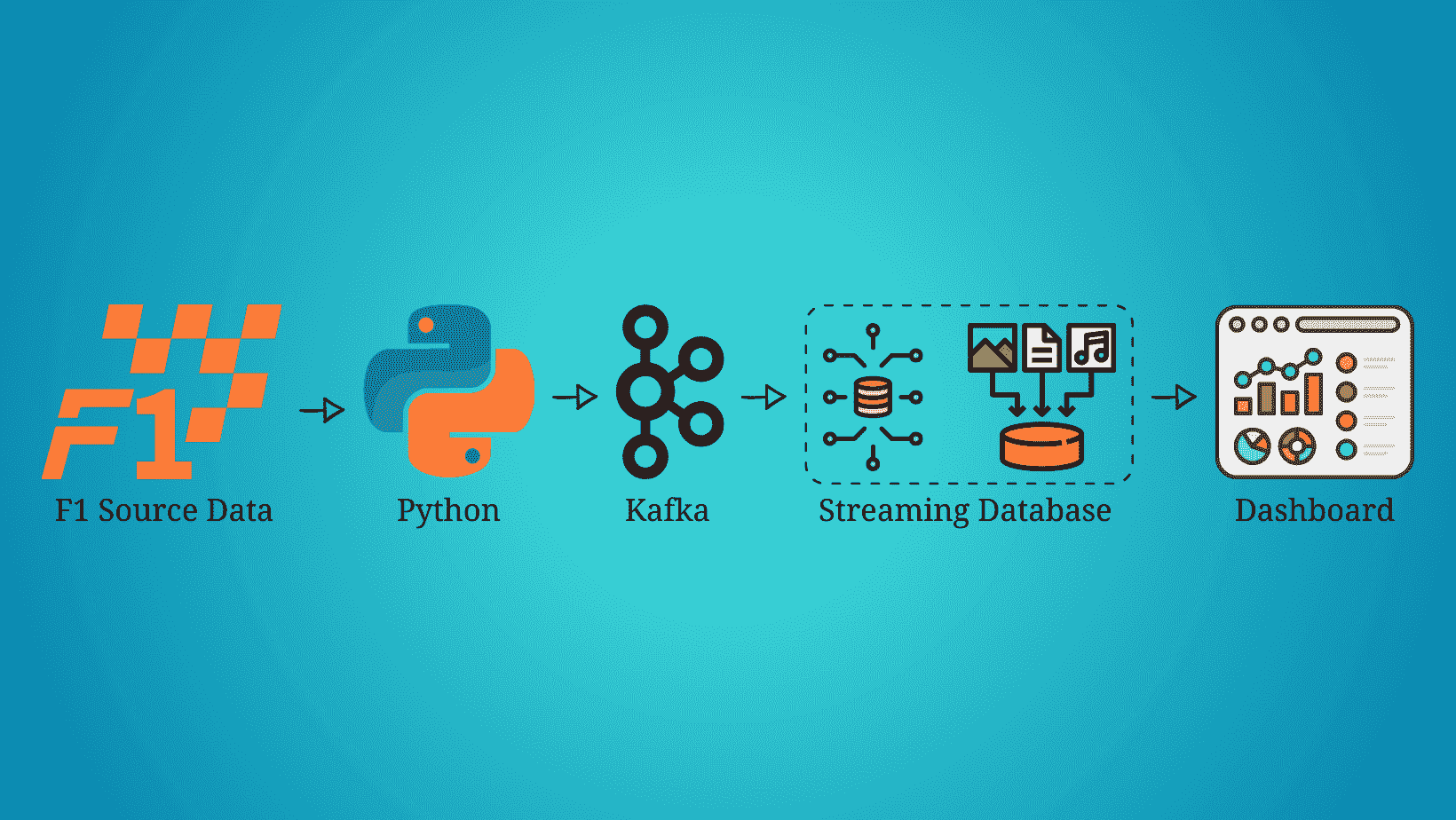

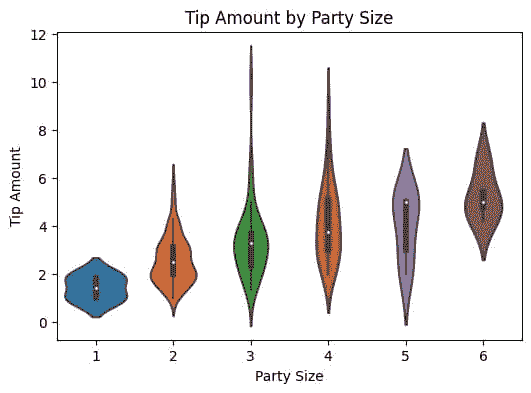

构建 Formula 1 流式数据管道与 Kafka 和 Risingwave

原文:

www.kdnuggets.com/building-a-formula-1-streaming-data-pipeline-with-kafka-and-risingwave

实时数据已经到来并且会持续存在。毫无疑问,每天流式数据的数量都在指数级增长,我们需要找到提取、处理和可视化数据的最佳方法。例如,每辆 Formula 1 汽车在一个比赛周末产生约 1.5 TB 的数据(来源)。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

在这篇文章中,我们不会流式传输汽车的数据,而是会流式传输、处理和可视化比赛的数据,模拟我们在 Formula 1 比赛中实时进行。在开始之前,重要的是要提到这篇文章不会关注每种技术是什么,而是如何在流式数据管道中实现它们,因此需要对 Python、Kafka、SQL 和数据可视化有一定了解。

前提条件

-

F1 源数据:在这个数据流管道中使用的 Formula 1 数据是从 Kaggle 下载的,可以在 Formula 1 世界锦标赛(1950 - 2023) 中找到。

-

Python: 这个管道是用 Python 3.9 构建的,但任何高于 3.0 的版本都应该可以使用。有关如何下载和安装 Python 的更多详细信息,可以在 官方 Python 网站 上找到。

-

Kafka: Kafka 是这个流式数据管道中使用的主要技术之一,因此在开始之前安装它是很重要的。这个流式数据管道是在 MacOS 上构建的,因此使用了 brew 来安装 Kafka。更多详细信息可以在 官方 brew 网站 上找到。我们还需要一个 Python 库来将 Kafka 与 Python 一起使用。这个管道使用了 kafka-python。安装详细信息可以在它们的 官方网站 上找到。

-

RisingWave(流数据库): 市场上有多种流数据库,但本文使用的且最佳的之一是 RisingWave。开始使用 RisingWave 非常简单,只需几分钟。有关如何入门的完整教程可以在他们的官方网站上找到。

-

Grafana 仪表盘: 在这个流媒体管道中使用了 Grafana 来实时可视化 Formula 1 数据。有关如何开始使用的详细信息可以在这个网站上找到。

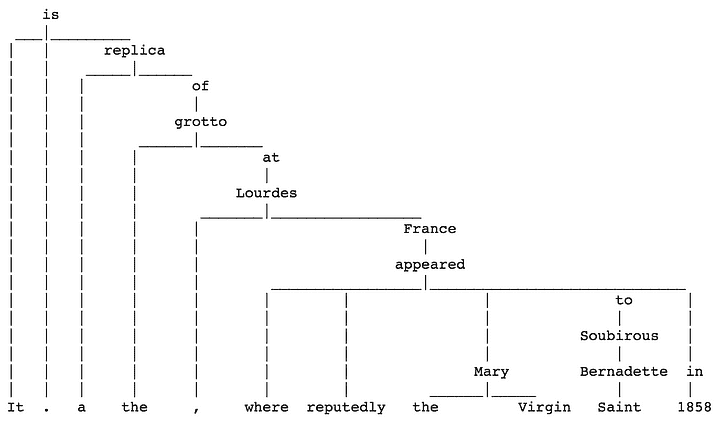

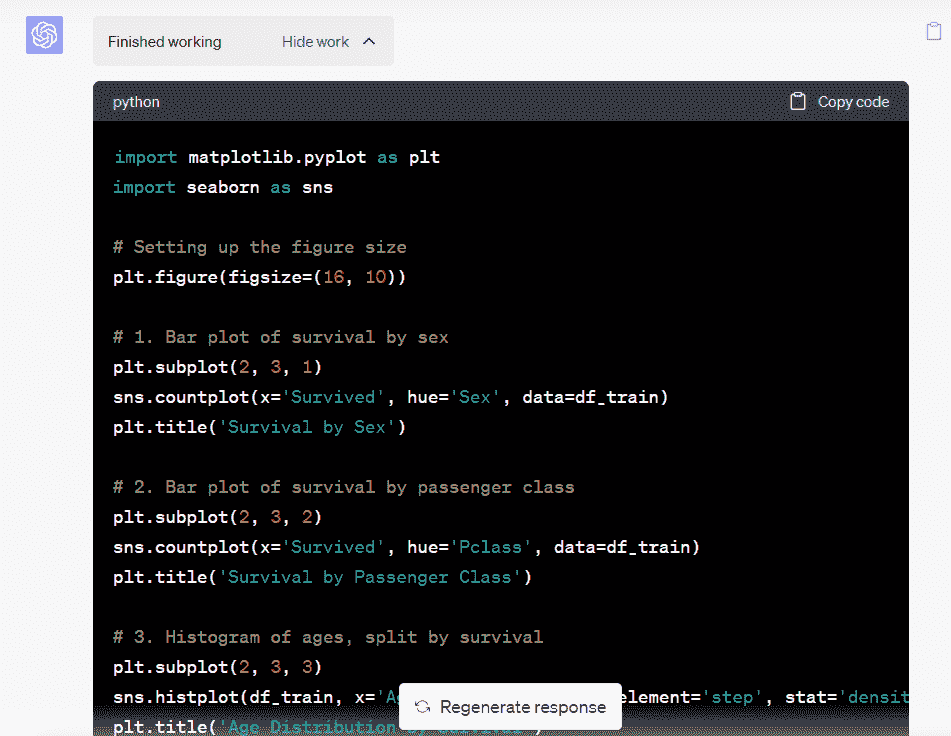

流数据源

现在我们已经有了所有先决条件,是时候开始构建 Formula 1 数据流管道了。源数据存储在一个 JSON 文件中,所以我们需要提取它并通过 Kafka 主题发送。为此,我们将使用以下 Python 脚本。

作者提供的代码

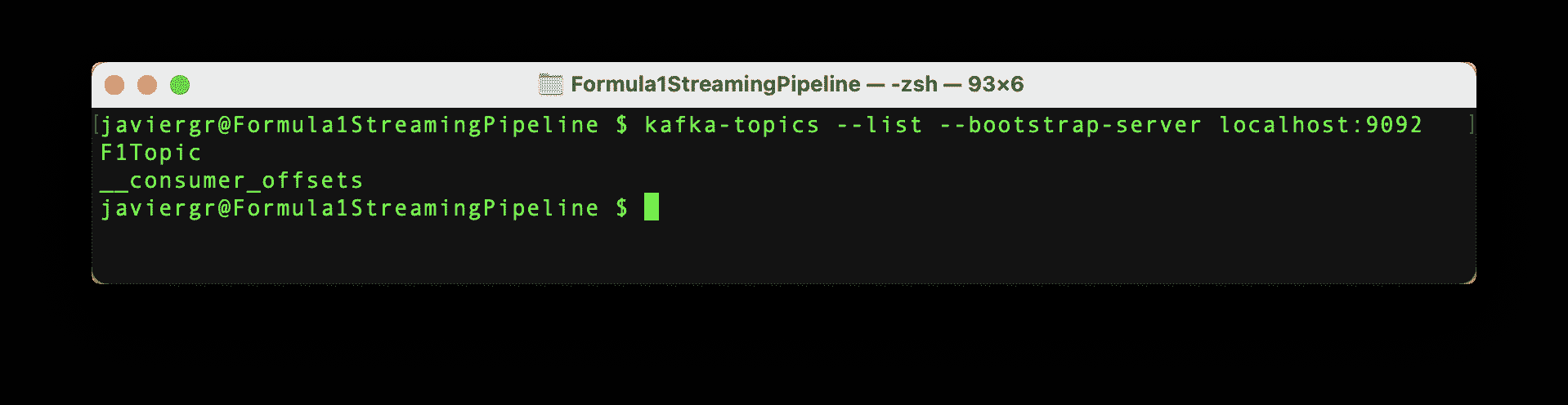

设置 Kafka

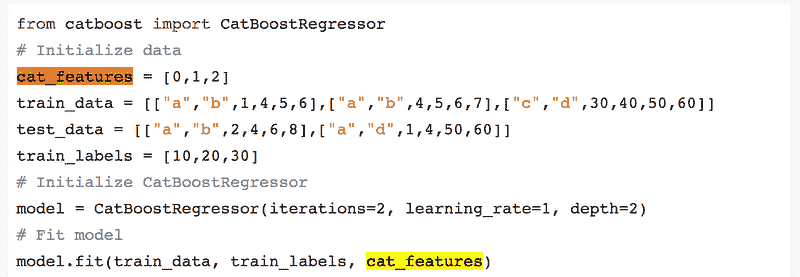

用于流数据的 Python 脚本已准备好开始流数据,但 Kafka 主题 F1Topic 尚未创建,所以我们需要创建它。首先,我们需要初始化 Kafka。为此,我们必须启动 Zookeper,然后启动 Kafka,最后使用以下命令创建主题。请记住,Zookeper 和 Kafka 应在不同的终端中运行。

作者提供的代码

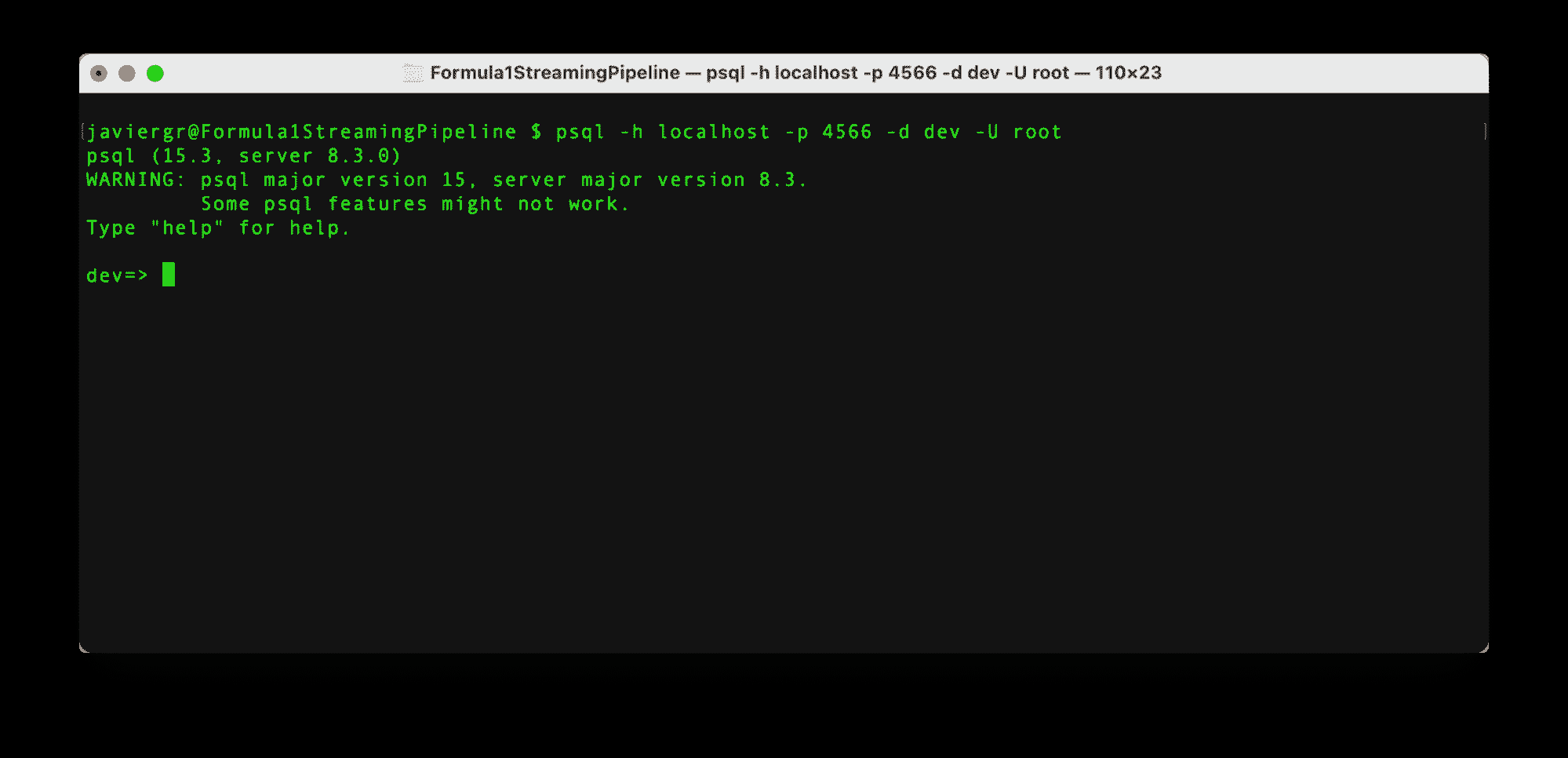

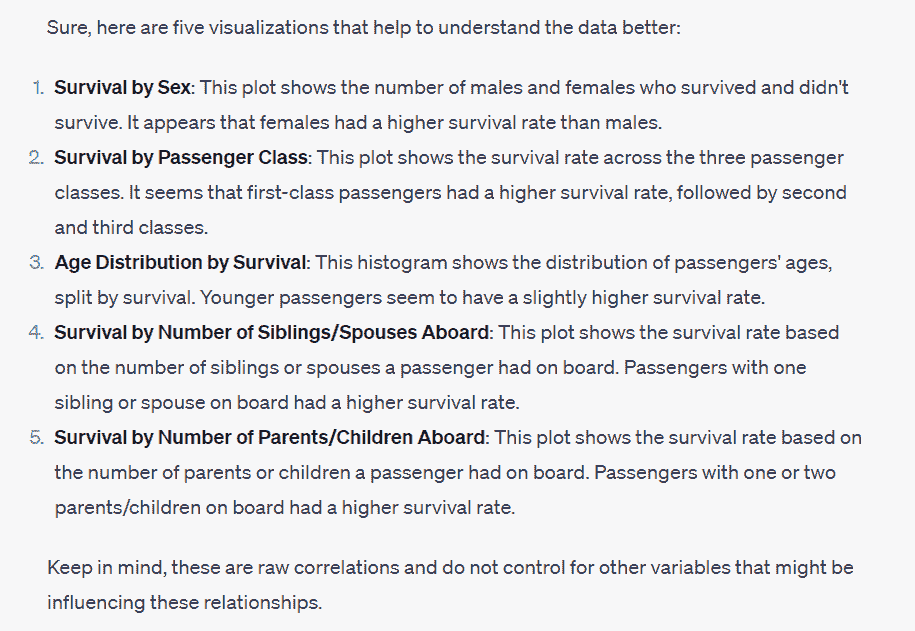

设置流数据库 RisingWave

一旦安装了 RisingWave,就很容易启动它。首先,我们需要初始化数据库,然后通过 Postgres 交互式终端 psql 连接它。要初始化流数据库 RisingWave,我们必须执行以下命令。

作者提供的代码

上述命令在游乐场模式下启动 RisingWave,其中数据暂时存储在内存中。该服务设计为在 30 分钟不活动后自动终止,所有存储的数据在终止时将被删除。此方法仅推荐用于测试,RisingWave Cloud 应用于生产环境。

当 RisingWave 启动并运行后,就可以通过以下命令在新的终端中通过 Postgress 交互式终端连接它。

作者提供的代码

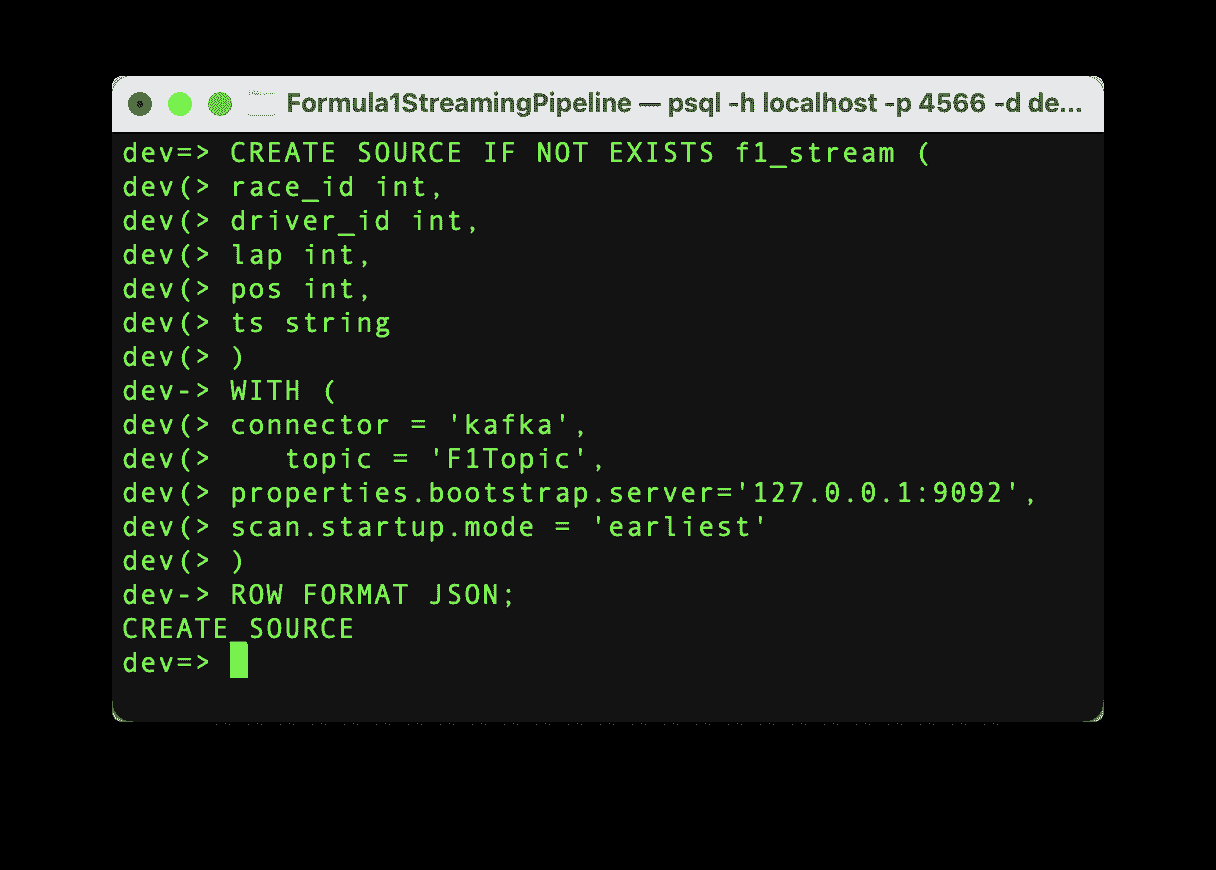

一旦建立了连接,就可以开始从 Kafka 主题中提取数据。为了将流数据导入 RisingWave,我们需要创建一个源。这个源将建立 Kafka 主题和 RisingWave 之间的通信,所以让我们执行以下命令。

作者提供的代码

如果命令成功运行,我们将看到消息“CREATE SOURCE”,并且源已经创建。需要强调的是,一旦源创建完成,数据不会自动导入到 RisingWave 中。我们需要创建一个物化视图来启动数据的流动。这个物化视图还将帮助我们在下一步中创建 Grafana 仪表板。

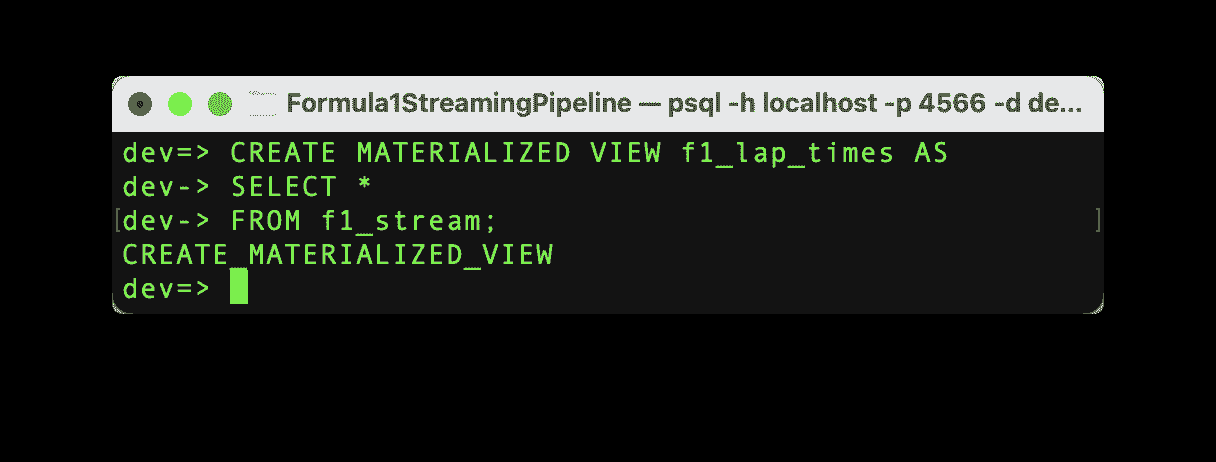

让我们用以下命令创建具有与源数据相同架构的物化视图。

作者提供的代码

如果命令成功运行,我们将看到消息“CREATE MATERIALIZED_VIEW”,并且物化视图已创建,现在可以进行测试了!

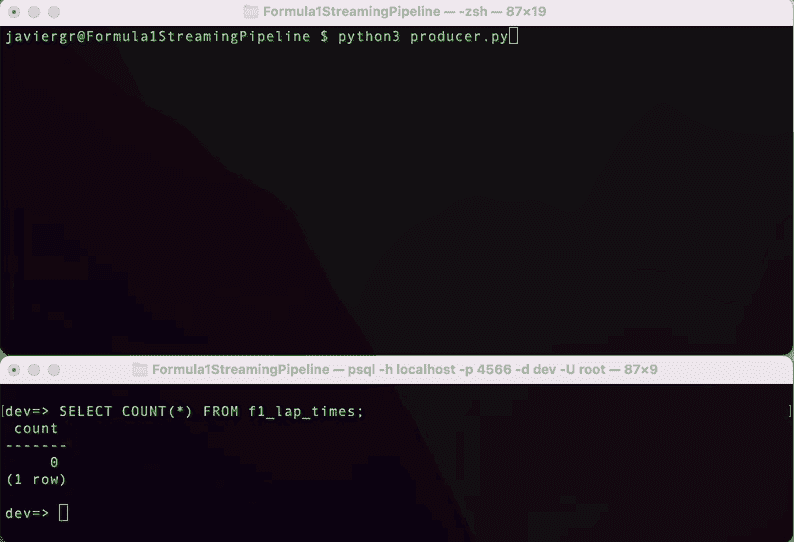

执行 Python 脚本以开始流式传输数据,并在 RisingWave 终端实时查询数据。RisingWave 是一个兼容 Postgres 的 SQL 数据库,因此如果你熟悉 PostgreSQL 或任何其他 SQL 数据库,一切将会顺利进行,你可以轻松查询流数据。

如你所见,流式处理管道现在已经启动并运行,但我们还没有充分利用流数据库 RisingWave 的所有优势。我们可以添加更多的表来实时连接数据,构建一个功能完善的应用程序。

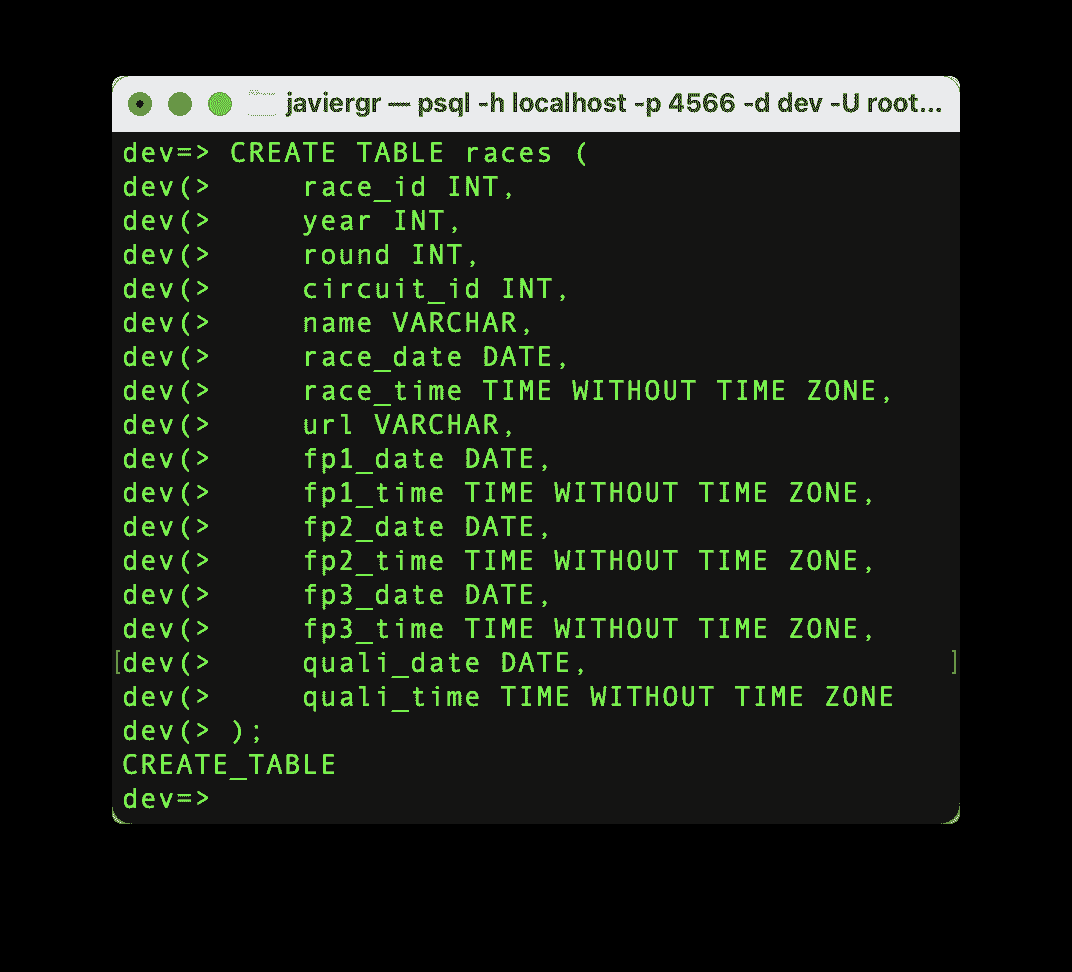

让我们创建比赛表,以便我们可以将流数据与比赛表连接,并获取比赛的实际名称,而不是比赛 id。

作者提供的代码

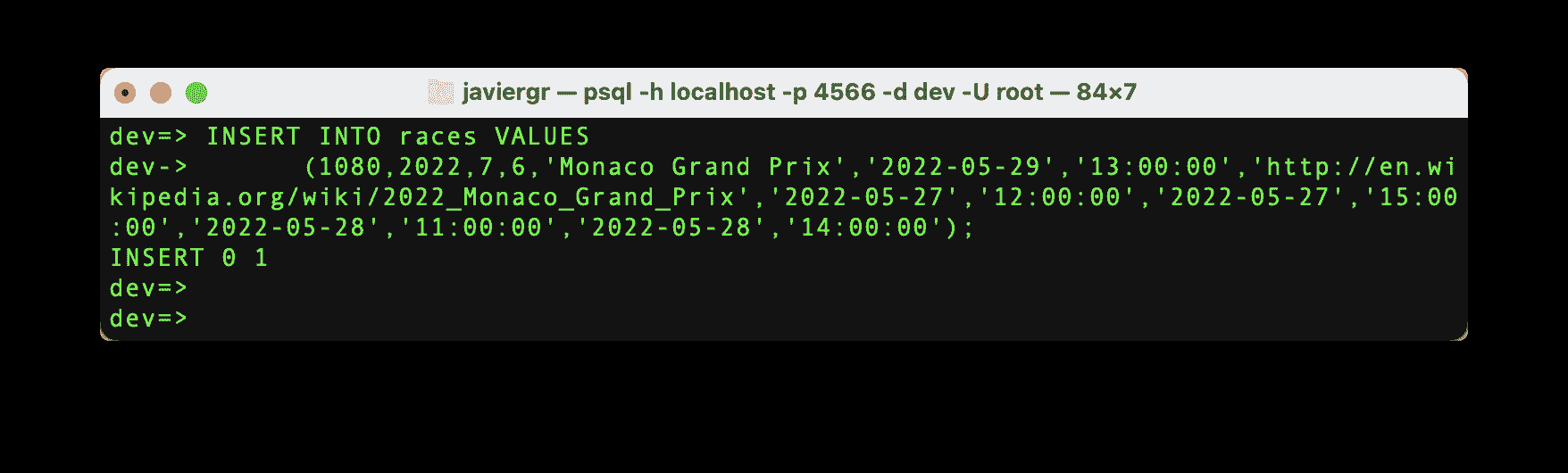

现在,让我们为我们需要的特定比赛 id 插入数据。

作者提供的代码

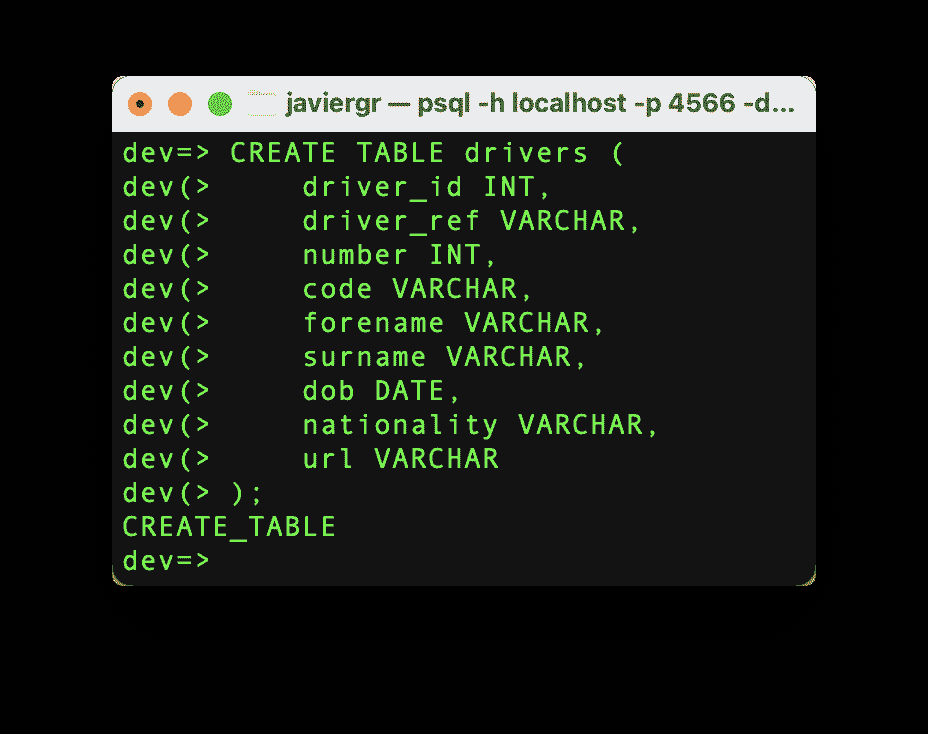

让我们按照相同的程序进行,但这次用司机的表格。

作者提供的代码

最后,让我们插入司机的数据。

作者提供的代码

我们已经准备好表格来开始连接流数据,但我们需要一个物化视图,所有的魔法都将在这里发生。让我们创建一个物化视图,在实时中查看前 3 名的位置,连接司机 id 和比赛 id 以获取实际名称。

作者提供的代码

最后但同样重要的是,让我们创建最后一个物化视图,以查看一个司机在整个比赛中获得第一名的次数。

作者提供的代码

现在,是时候构建 Grafana 仪表板,并通过物化视图实时查看所有连接的数据了。

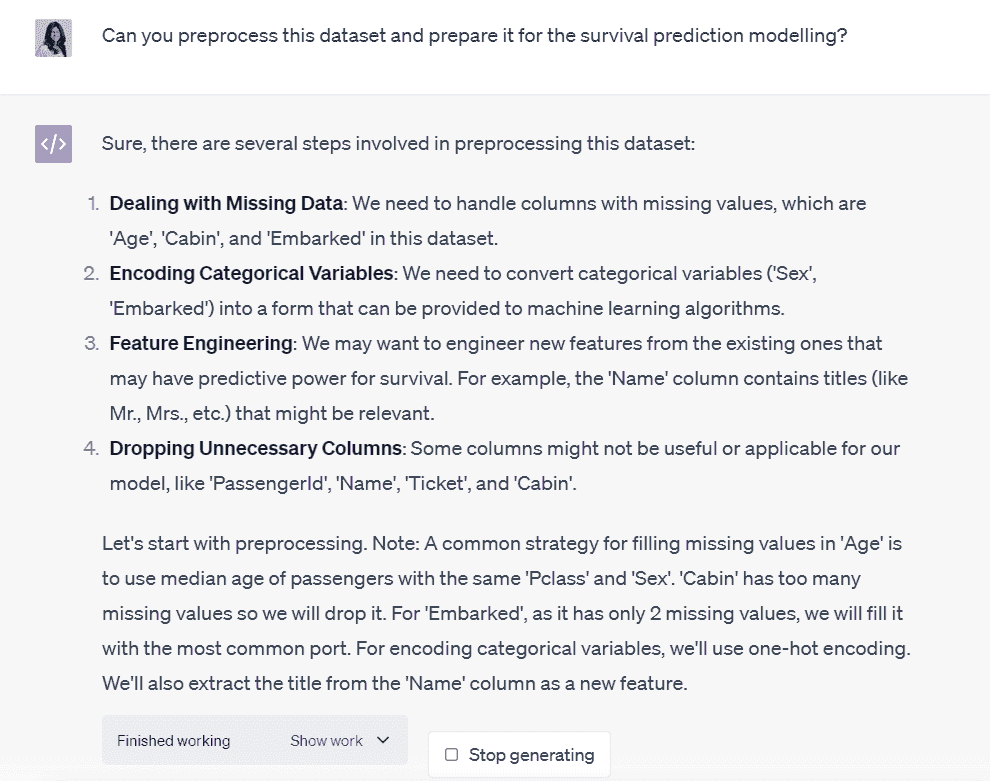

设置 Grafana 仪表板

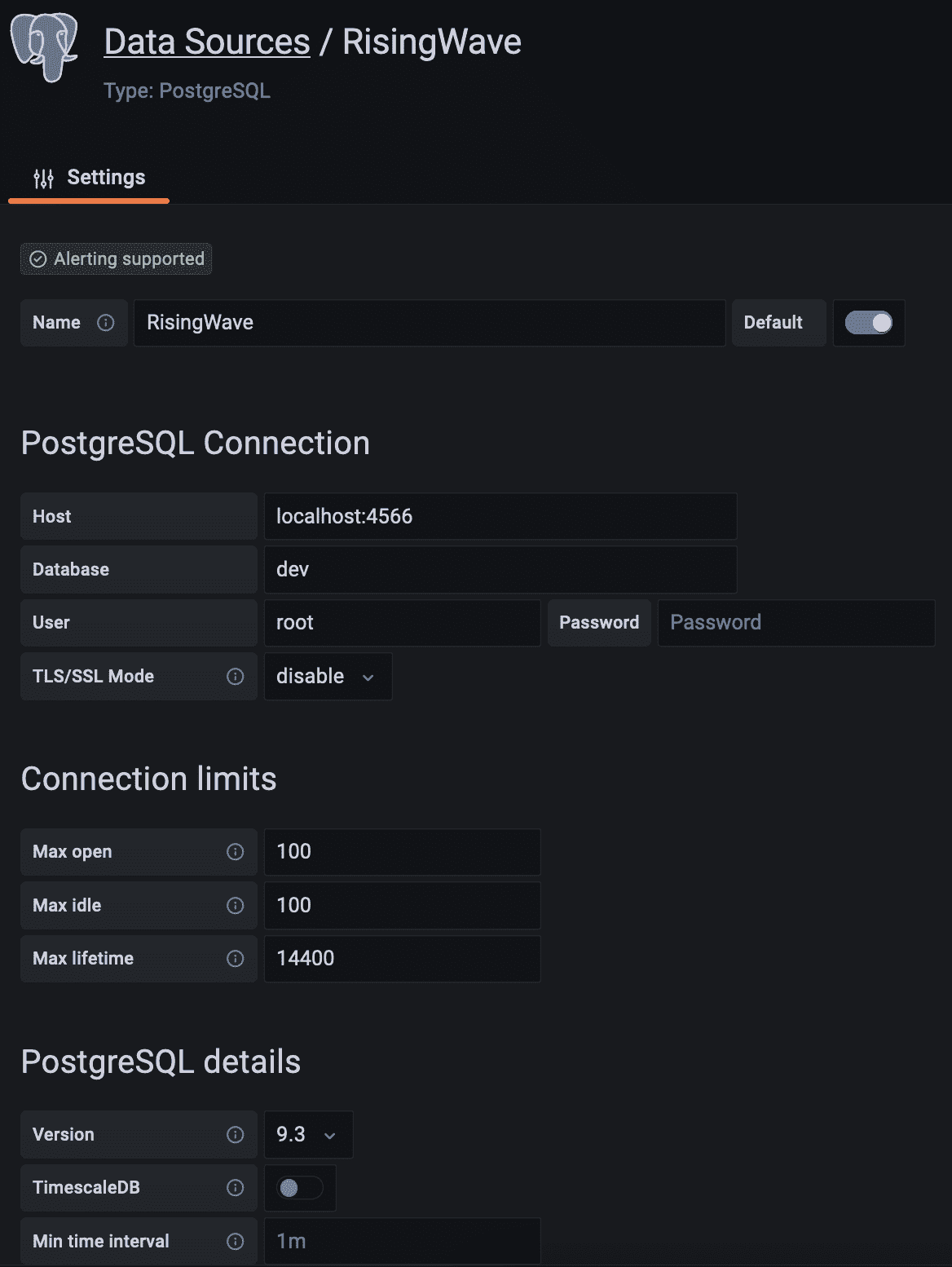

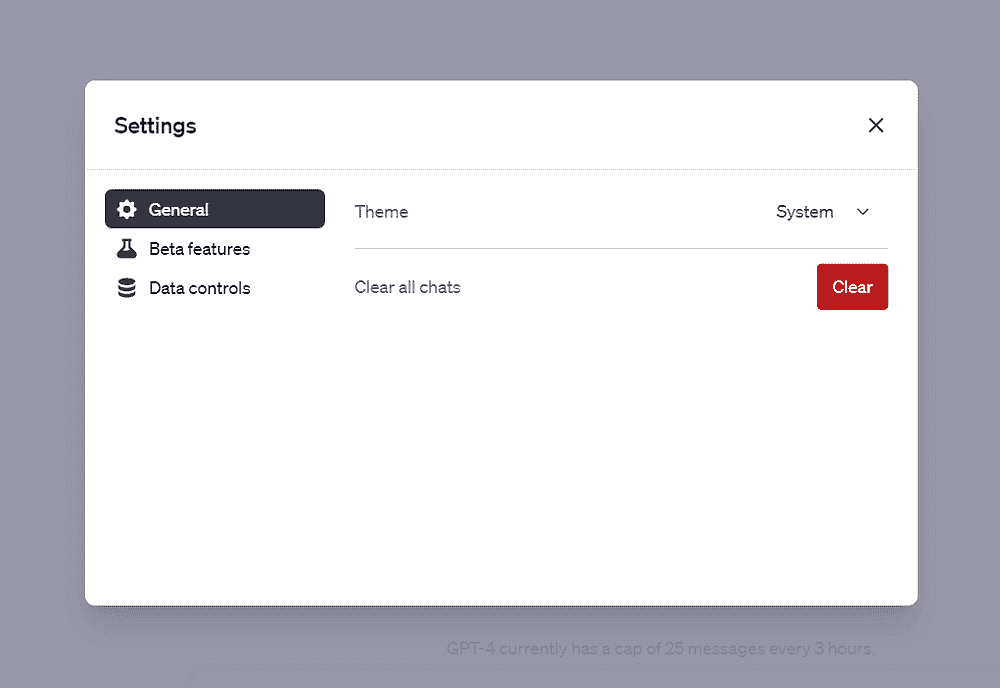

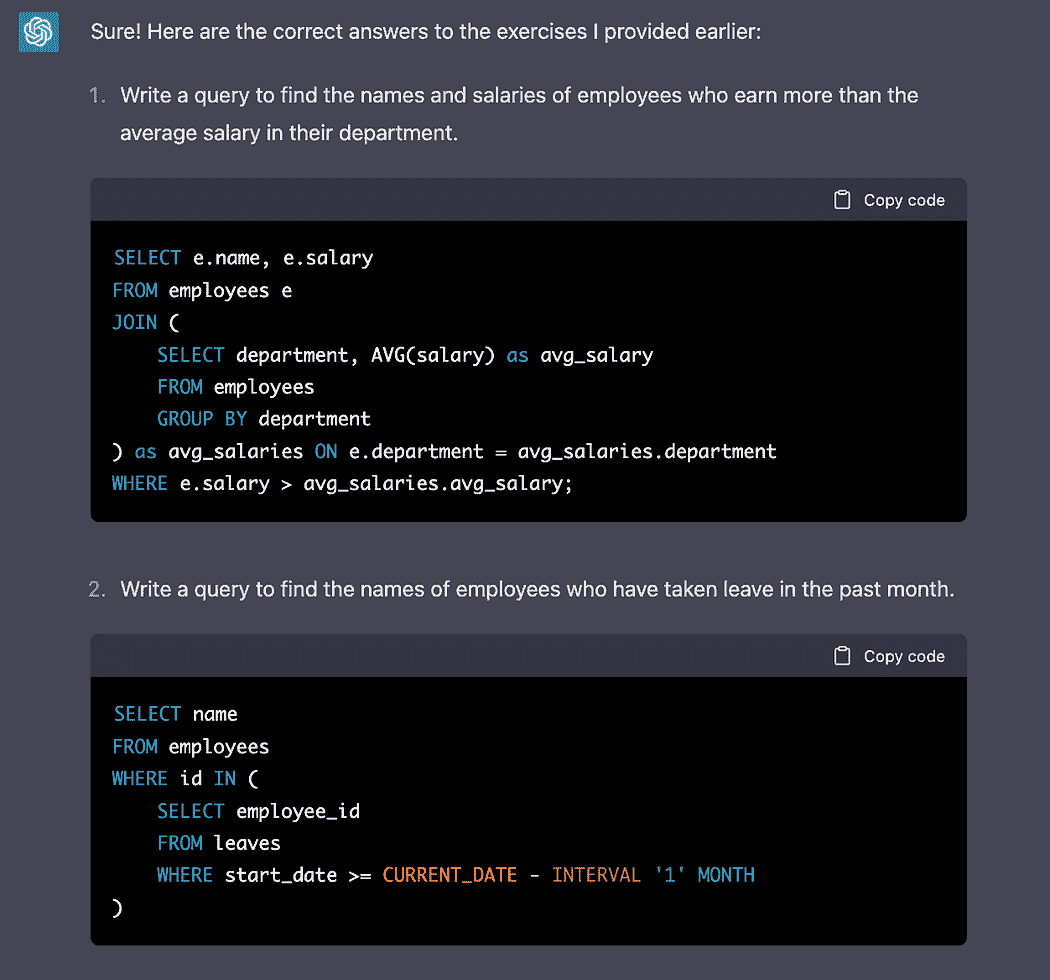

流数据管道的最后一步是实时仪表板中的数据可视化。在创建 Grafana 仪表板之前,我们需要创建一个数据源,以建立 Grafana 和我们的流数据库 RisingWave 之间的连接,按照以下步骤进行。

-

转到 配置 > 数据源。

-

点击添加数据源按钮。

-

从支持的数据库列表中选择 PostgreSQL。

-

填写 PostgreSQL 连接字段,如下所示:

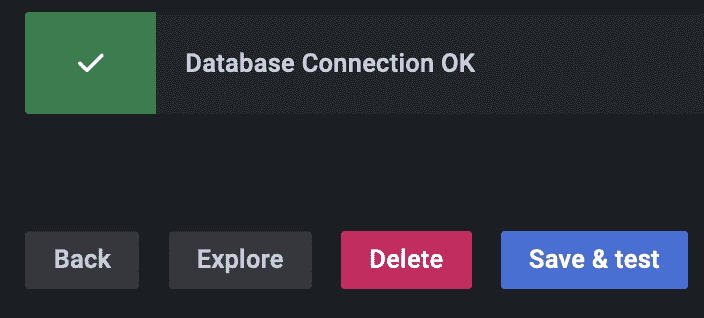

向下滚动并点击保存和测试按钮。数据库连接现在已建立。

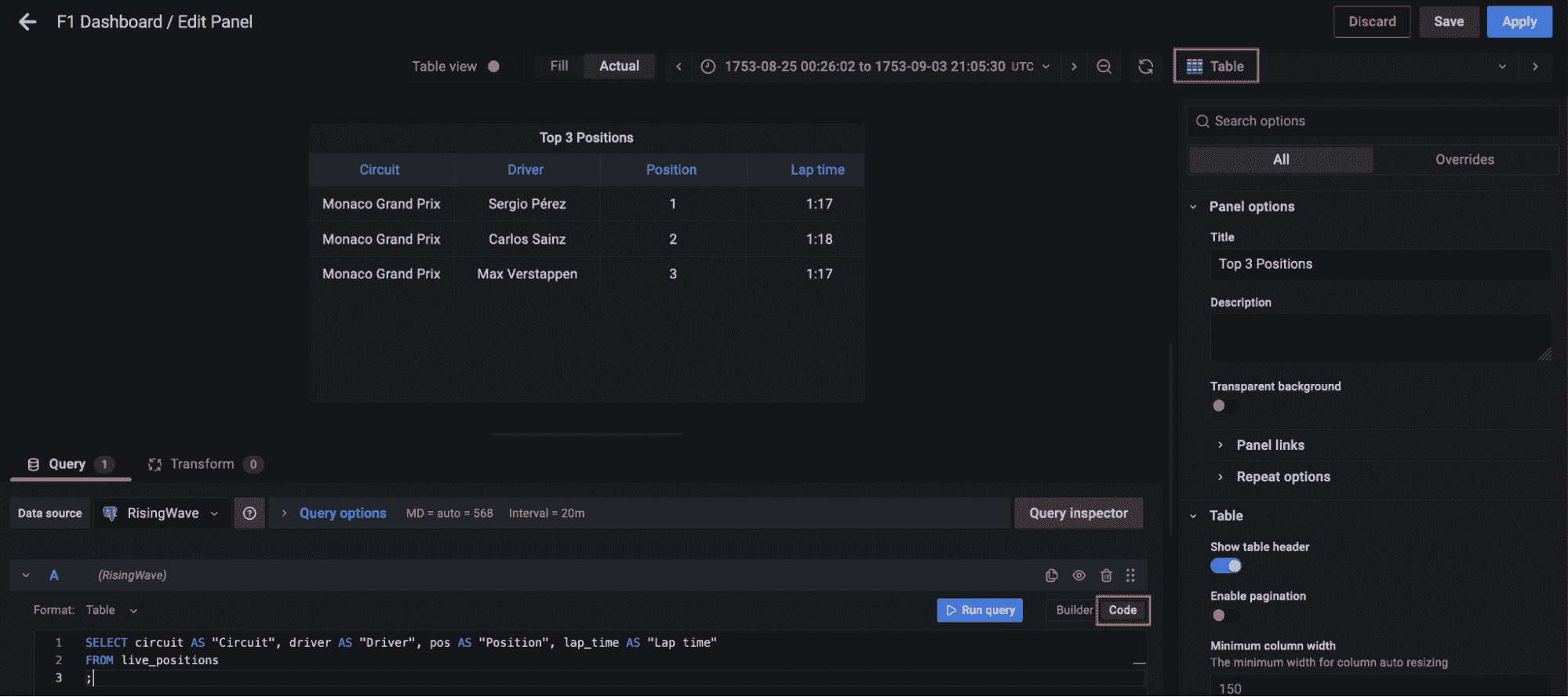

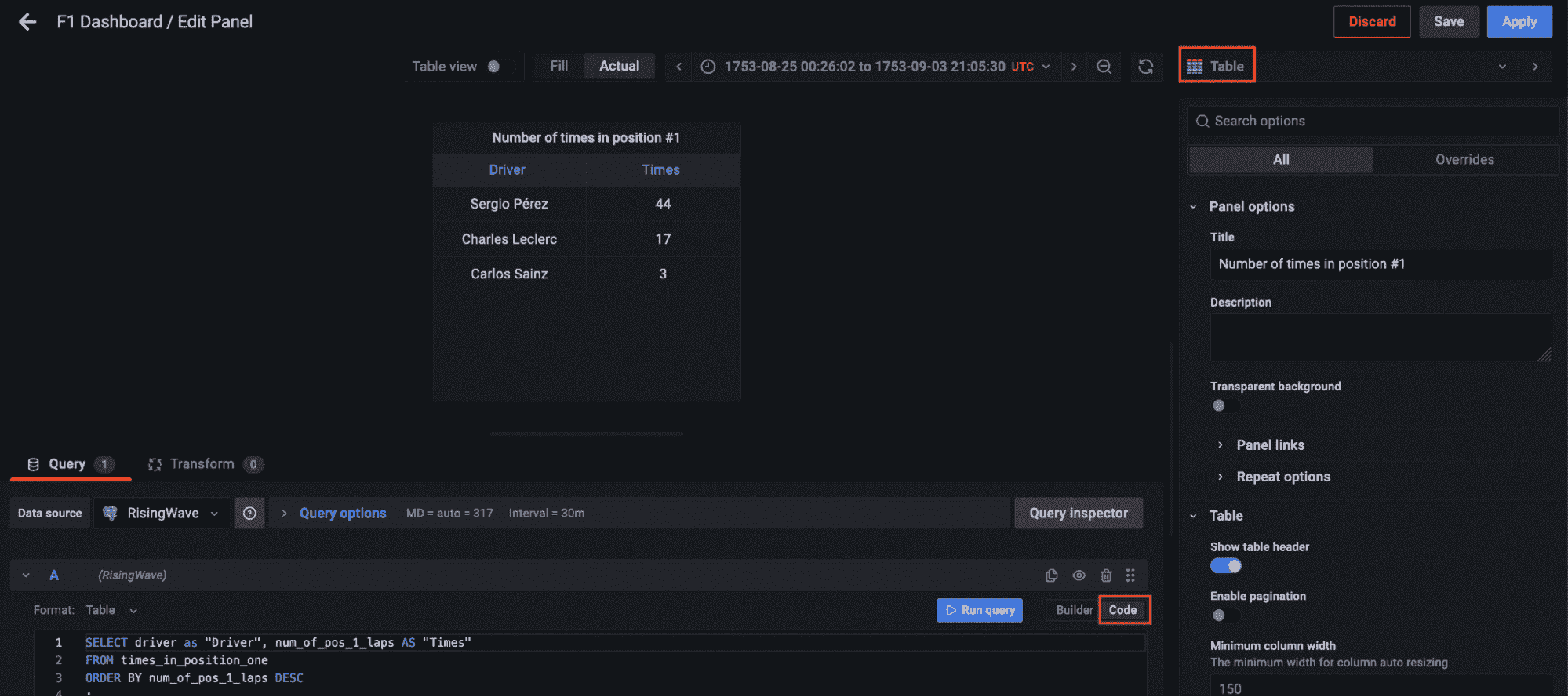

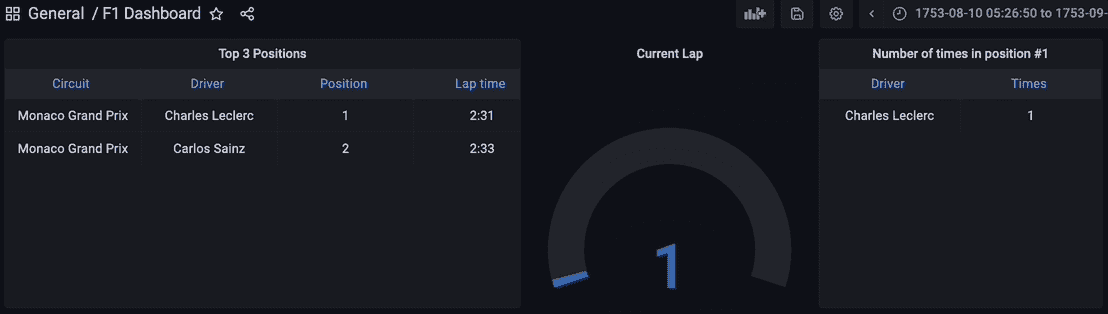

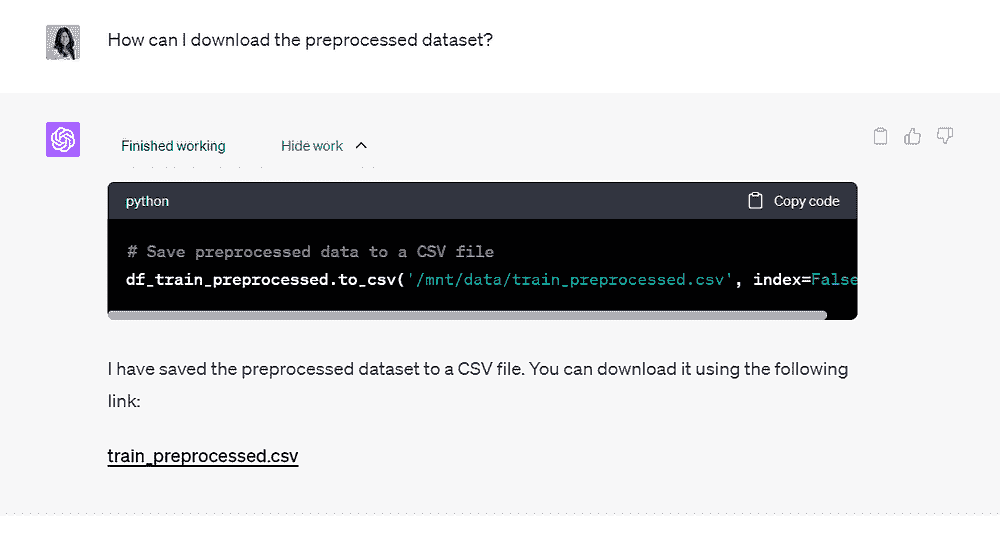

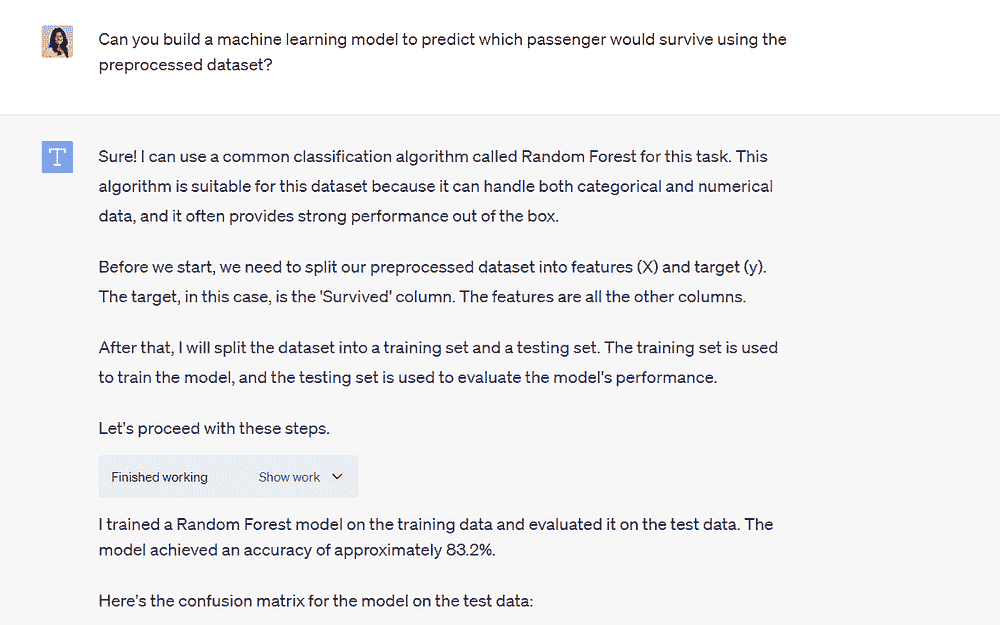

现在转到左侧面板中的仪表板,点击新建仪表板选项,添加一个新面板。选择表格可视化,切换到代码选项卡,查询物化视图 live_positions,我们可以看到前 3 名位置的连接数据。

作者代码

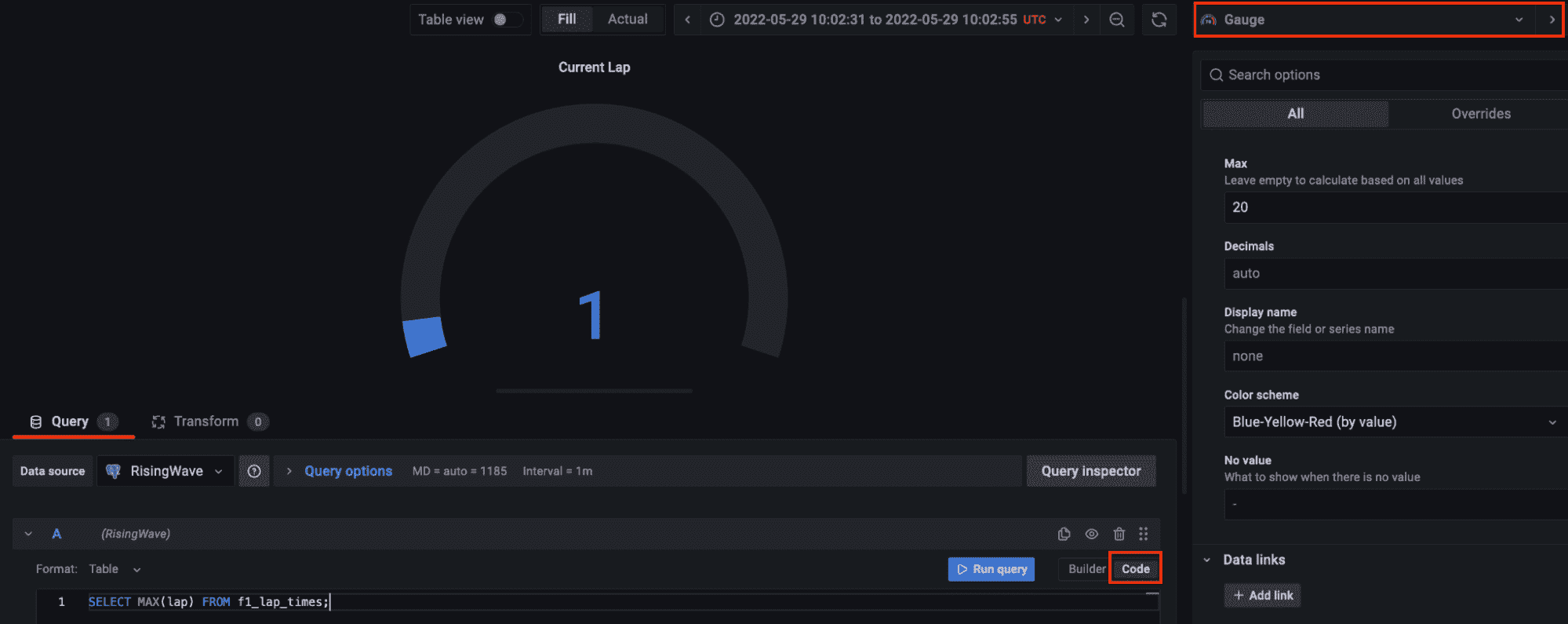

让我们添加另一个面板以可视化当前圈数。选择仪表可视化,在代码选项卡中查询流数据中可用的最大圈数。仪表的自定义由你决定。

作者代码

最后,让我们添加另一个面板以查询物化视图 times_in_position_one,并实时查看在整个比赛过程中车手获得第一名的位置次数。

作者代码

结果可视化

最终,所有流数据管道的组件都已启动并运行。Python 脚本已经执行,开始通过 Kafka 主题流式传输数据,流式数据库 RisingWave 正在实时读取、处理和连接数据。物化视图 f1_lap_times 从 Kafka 主题中读取数据,Grafana 仪表板中的每个面板都是不同的物化视图,这些视图实时连接数据,通过物化视图对比赛和车手表进行的连接来显示详细数据。Grafana 仪表板查询物化视图,所有处理过程都因为在流式数据库 RisingWave 中处理的物化视图而得到简化。

哈维尔·格拉纳多斯 是一名高级数据工程师,他喜欢阅读和写作关于数据管道的内容。他专注于云管道,主要是在 AWS 上,但他总是探索新技术和新趋势。你可以在 Medium 上找到他,网址是 https://medium.com/@JavierGr

更多相关话题

构建 GPU 机器与使用 GPU 云

原文:

www.kdnuggets.com/building-a-gpu-machine-vs-using-the-gpu-cloud

编辑图片

图形处理单元(GPU)的出现以及它们解锁的指数级计算能力,对初创公司和企业业务而言都是一个划时代的时刻。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

GPUs 提供了强大的计算能力,能够执行涉及 AI、机器学习 和 3D 渲染等技术的复杂任务。

然而,在利用这种大量计算能力时,科技界在理想解决方案上面临十字路口。你应该构建一个专用的 GPU 机器还是利用 GPU 云?

本文深入探讨了这一争论的核心,剖析了每种选择的成本影响、性能指标和可扩展性因素。

什么是 GPU?

GPU(图形处理单元)是设计用来快速渲染图形和图像的计算机芯片,通过几乎瞬时完成数学计算。历史上,GPU 常与个人游戏电脑相关联,但它们也用于专业计算,技术进步需要额外的计算能力。

GPU 最初的开发是为了减少现代图形密集型应用程序对 CPU 的工作负载,通过并行处理渲染 2D 和 3D 图形,这种方法涉及多个处理器处理单个任务的不同部分。

在商业中,这种方法有效地加速了工作负载,并提供足够的处理能力,以支持人工智能(AI)和机器学习(ML)建模等项目。

GPU 使用案例

近年来,GPU 发展迅速,变得比早期的 GPU 更加可编程,使其能够在广泛的应用场景中使用,例如:

-

使用 Blender 和 ZBrush 等软件,快速渲染实时的 2D 和 3D 图形应用程序

-

视频编辑和视频内容创建,特别是 4k、8k 或高帧率的作品

-

提供图形能力以在现代显示器上显示视频游戏,包括 4k。

-

加速机器学习模型,从基本的图像转换为 jpg到用全面的前端几分钟内部署自定义调整的模型

-

共享 CPU 工作负载,以在各种应用中提供更高的性能

-

提供训练深度神经网络所需的计算资源

-

挖掘比特币和以太坊等加密货币

重点在于神经网络的开发,每个网络由多个节点组成,每个节点在更广泛的分析模型中执行计算。

GPU 可以通过更高的并行处理增强这些模型在深度学习网络中的性能,从而创建具有更高容错性的模型。因此,现在市场上有许多专门为深度学习项目打造的 GPU,例如最近发布的 H200。

构建 GPU 机器

许多企业,特别是初创公司,选择自己构建 GPU 机器,因为它们具有成本效益,同时提供与 GPU 云解决方案相同的性能。然而,这并不是说这样的项目没有挑战。

在这一部分,我们将讨论构建 GPU 机器的利弊,包括预期的成本以及机器管理,这可能会影响安全性和可扩展性等因素。

为什么要自己构建 GPU 机器?

构建本地 GPU 机器的关键好处是成本,但这样的项目通常需要显著的内部专业知识。持续维护和未来的修改也是可能使这种解决方案不可行的考虑因素。但是,如果这样的构建在你们团队的能力范围内,或者你们找到了可以为你们交付项目的第三方供应商,财务上的节省可能是显著的。

建议为深度学习项目构建一个可扩展的 GPU 机器,特别是在考虑到云 GPU 服务的租赁成本时,如Amazon Web Services EC2、Google Cloud 或 Microsoft Azure。尽管对于希望尽快启动项目的组织来说,托管服务可能更为理想。

让我们考虑构建一个本地自建 GPU 机器的两个主要好处:成本和性能。

成本

如果一个组织正在为人工智能和机器学习项目开发一个大型数据集的深度神经网络,那么运营成本有时可能飙升。这可能阻碍开发者在模型训练期间交付预期结果,并限制项目的可扩展性。因此,财务影响可能导致产品缩减,甚至是一个不适合目的的模型。

建设一个现场自管理的 GPU 机器可以大幅降低成本,为开发者和数据工程师提供他们在广泛迭代、测试和实验中所需的资源。

然而,这只是触及了本地构建和运行的 GPU 机器的表面,尤其是对于开源 LLM 而言,这些 LLM 越来越受欢迎。随着实际用户界面的出现,你可能很快会看到你友好的邻居牙医在后台运行几台 4090,用于如保险验证、日程安排、数据交叉引用等任务。

性能

大规模深度学习和机器学习训练模型/算法需要大量资源,这意味着它们需要极高性能的处理能力。对于需要渲染高质量视频的组织来说也是如此,员工可能需要多个基于 GPU 的系统或最先进的 GPU 服务器。

自建的 GPU 系统推荐用于生产规模的数据模型及其训练,一些 GPU 能够提供双精度,这一特性使用 64 位表示数字,提供更大的数值范围和更好的小数精度。然而,这种功能仅在依赖非常高精度的模型中才是必需的。推荐的双精度系统选项是 Nvidia 的本地 Titan 系列 GPU 服务器。

操作

许多组织缺乏管理本地 GPU 机器和服务器的专业知识和能力。这是因为内部 IT 团队需要能够配置基于 GPU 的基础设施以实现最高性能的专家。

此外,缺乏专业知识可能导致安全性不足,从而出现被网络犯罪分子利用的漏洞。未来可能需要扩展系统也可能带来挑战。

使用 GPU 云

本地 GPU 机器在性能和成本效益方面提供了明显的优势,但前提是组织拥有必要的内部专家。这就是为什么许多组织选择使用 GPU 云服务,如 Saturn Cloud,它提供了完全托管的服务以增加简便性和安心。

云 GPU 解决方案使深度学习项目对更广泛的组织和行业变得更加可及,许多系统能够匹配自建 GPU 机器的性能水平。GPU 云解决方案的出现是人们越来越多地投资于 AI 开发的主要原因之一,尤其是像 Mistral 这样的开源模型,其开源特性非常适合“可租用的 vRAM”,并在无需依赖大型供应商(如 OpenAI 或 Anthropic)的情况下运行 LLM。

成本

根据组织的需求或正在训练的模型,云 GPU 解决方案可能会更便宜,只要每周所需的小时数是合理的。对于较小、数据量较少的项目,可能不需要投资昂贵的 H100 对,GPU 云解决方案提供按合同基础以及各种月度计划的形式,从爱好者到企业都能满足需求。

性能

有一系列的 CPU 云选项能够匹配 DIY GPU 机器的性能水平,提供最佳平衡的处理器、准确的内存、高性能磁盘和每实例八个 GPU 来处理各自的工作负载。当然,这些解决方案可能会有一定费用,但组织可以安排按小时计费,以确保只为使用的部分付费。

操作

云 GPU 相对于自建 GPU 的关键优势在于其操作,专家团队随时准备协助解决任何问题并提供技术支持。自建 GPU 机器或服务器需要内部管理,或者需要第三方公司远程管理,这会产生额外费用。

使用 GPU 云服务,任何如网络故障、软件更新、电力中断、设备故障或磁盘空间不足的问题都能快速解决。实际上,借助完全托管的解决方案,这些问题几乎不会发生,因为 GPU 服务器会被最佳配置,以避免任何过载和系统故障。这意味着 IT 团队可以专注于业务的核心需求。

结论

在选择自建 GPU 机器还是使用 GPU 云时,取决于具体的使用案例,大型数据密集型项目需要额外的性能而不产生显著的成本。在这种情况下,自建系统可能提供所需的性能而不会有高额的月度费用。

另外,对于缺乏内部专业知识或不需要顶级性能的组织,托管的云 GPU 解决方案可能更为合适,由提供商负责机器的管理和维护。

Nahla Davies****是一名软件开发者和技术写作人。在将全部精力投入技术写作之前,她曾管理过—在许多其他有趣的事情中—担任一家 Inc. 5000 实验品牌组织的首席程序员,该组织的客户包括三星、时代华纳、Netflix 和索尼。

了解更多相关内容

使用 Hugging Face Transformers 构建推荐系统

原文:

www.kdnuggets.com/building-a-recommendation-system-with-hugging-face-transformers

在现代时代,我们依赖手机和计算机上的软件。许多应用程序,如电子商务、电影流媒体、游戏平台等,改变了我们的生活,因为这些应用程序使事情变得更加简单。为了更进一步,企业通常会提供能够根据数据进行推荐的功能。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您组织的 IT

3. Google IT 支持专业证书 - 支持您组织的 IT

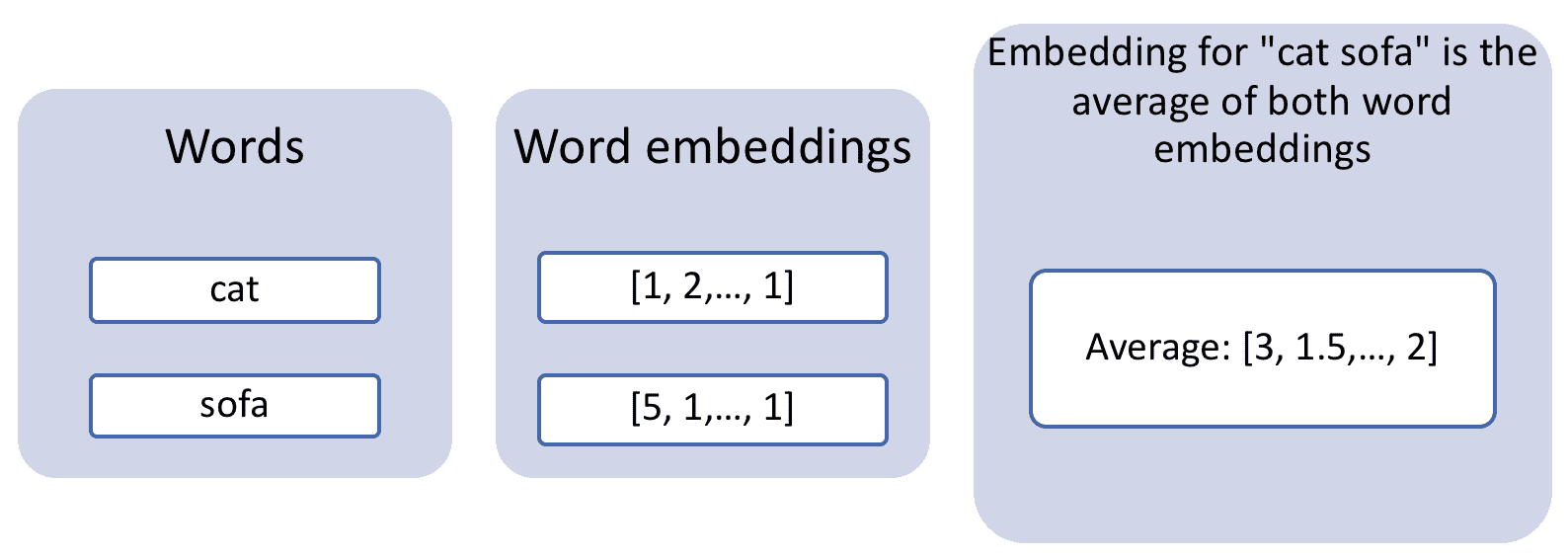

推荐系统的基础是根据输入预测用户可能感兴趣的内容。系统将根据项目之间的相似性(基于内容的过滤)或行为(协作过滤)提供最接近的项目。

有许多推荐系统架构的方法,我们可以使用Hugging Face Transformers包。如果你不知道,Hugging Face Transformers 是一个开源的 Python 包,允许 API 轻松访问所有支持文本处理、生成等任务的预训练 NLP 模型。

本文将使用 Hugging Face Transformers 包基于嵌入相似度开发一个简单的推荐系统。让我们开始吧。

使用 Hugging Face Transformers 开发推荐系统

在开始教程之前,我们需要安装所需的包。为此,您可以使用以下code:

pip install transformers torch pandas scikit-learn

您可以通过他们的网站选择适合您环境的版本进行Torch安装。

至于数据集示例,我们将使用来自Kaggle的动漫推荐数据集示例。

一旦环境和数据集准备好,我们将开始教程。首先,我们需要读取数据集并进行准备。

import pandas as pd

df = pd.read_csv('anime.csv')

df = df.dropna()

df['description'] = df['name'] +' '+ df['genre'] + ' ' +df['type']+' episodes: '+ df['episodes']

在上述代码中,我们使用 Pandas 读取数据集并删除了所有缺失的数据。然后,我们创建了一个名为“description”的特征,其中包含了可用数据中的所有信息,如名称、类型、类别和集数。这个新列将成为我们推荐系统的基础。如果能有更完整的信息,例如动漫情节和概要,会更好,但我们暂时就用这个吧。

接下来,我们将使用 Hugging Face Transformers 加载嵌入模型并将文本转换为数值向量。具体来说,我们将使用句子嵌入来转换整个句子。

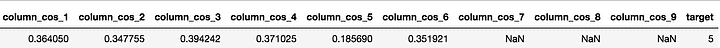

推荐系统将基于我们将要执行的所有动漫“描述”的嵌入。我们将使用余弦相似度方法,它衡量两个向量的相似度。通过测量动漫“描述”嵌入与用户查询输入嵌入之间的相似度,我们可以获得精准的推荐项目。

嵌入相似度方法听起来简单,但与经典的推荐系统模型相比,它可能更为强大,因为它能够捕捉词语之间的语义关系,为推荐过程提供上下文意义。

在本教程中,我们将使用 Hugging Face 的嵌入模型句子变换器。为了将句子转换为嵌入,我们将使用以下代码。

from transformers import AutoTokenizer, AutoModel

import torch

import torch.nn.functional as F

def mean_pooling(model_output, attention_mask):

token_embeddings = model_output[0] #First element of model_output contains all token embeddings

input_mask_expanded = attention_mask.unsqueeze(-1).expand(token_embeddings.size()).float()

return torch.sum(token_embeddings * input_mask_expanded, 1) / torch.clamp(input_mask_expanded.sum(1), min=1e-9)

tokenizer = AutoTokenizer.from_pretrained('sentence-transformers/all-MiniLM-L6-v2')

model = AutoModel.from_pretrained('sentence-transformers/all-MiniLM-L6-v2')

def get_embeddings(sentences):

encoded_input = tokenizer(sentences, padding=True, truncation=True, return_tensors='pt')

with torch.no_grad():

model_output = model(**encoded_input)

sentence_embeddings = mean_pooling(model_output, encoded_input['attention_mask'])

sentence_embeddings = F.normalize(sentence_embeddings, p=2, dim=1)

return sentence_embeddings

尝试嵌入过程,并用以下代码查看向量结果。不过,我不会展示输出,因为它相当长。

sentences = ['Some great movie', 'Another funny movie']

result = get_embeddings(sentences)

print("Sentence embeddings:")

print(result)

为了简化操作,Hugging Face 维护了一个用于嵌入句子变换器的 Python 包,这将把整个转换过程缩减到 3 行代码。请使用以下代码安装必要的包。

pip install -U sentence-transformers

然后,我们可以用以下代码将整个动漫“描述”转换为嵌入。

from sentence_transformers import SentenceTransformer

model = SentenceTransformer('sentence-transformers/all-MiniLM-L6-v2')

anime_embeddings = model.encode(df['description'].tolist())

当嵌入数据库准备好后,我们会创建一个函数来接收用户输入并执行余弦相似度,以作为推荐系统。

from sklearn.metrics.pairwise import cosine_similarity

def get_recommendations(query, embeddings, df, top_n=5):

query_embedding = model.encode([query])

similarities = cosine_similarity(query_embedding, embeddings)

top_indices = similarities[0].argsort()[-top_n:][::-1]

return df.iloc[top_indices]

现在一切准备就绪,我们可以尝试推荐系统。以下是从用户输入查询中获取前五个动漫推荐的示例。

query = "Funny anime I can watch with friends"

recommendations = get_recommendations(query, anime_embeddings, df)

print(recommendations[['name', 'genre']])

Output>>

name \

7363 Sentou Yousei Shoujo Tasukete! Mave-chan

8140 Anime TV de Hakken! Tamagotchi

4294 SKET Dance: SD Character Flash Anime

1061 Isshuukan Friends.

2850 Oshiete! Galko-chan

genre

7363 Comedy, Parody, Sci-Fi, Shounen, Super Power

8140 Comedy, Fantasy, Kids, Slice of Life

4294 Comedy, School, Shounen

1061 Comedy, School, Shounen, Slice of Life

2850 Comedy, School, Slice of Life

结果是所有的喜剧动漫,因为我们想要搞笑的动漫。它们大多数也包括了适合与朋友一起观看的类型。当然,如果我们有更详细的信息,推荐会更好。

结论

推荐系统是一种根据输入预测用户可能感兴趣内容的工具。使用 Hugging Face Transformers,我们可以构建一个利用嵌入和余弦相似度方法的推荐系统。嵌入方法非常强大,因为它能够考虑文本的语义关系和上下文意义。

Cornellius Yudha Wijaya**** 是一名数据科学助理经理和数据撰稿人。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据的技巧。Cornellius 在各种 AI 和机器学习主题上进行撰写。

更多相关主题

构建基于内容的书籍推荐引擎

原文:

www.kdnuggets.com/2020/07/building-content-based-book-recommendation-engine.html

评论

作者:Dhilip Subramanian,数据科学家和人工智能爱好者

如果我们计划购买任何新产品,通常会询问朋友、研究产品特性、将产品与类似产品进行比较、阅读互联网上的产品评论,然后做出决定。如果这一过程能够自动完成并有效地推荐产品,那将多么方便?推荐引擎或推荐系统就是这个问题的答案。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT 需求

3. Google IT 支持专业证书 - 支持您的组织的 IT 需求

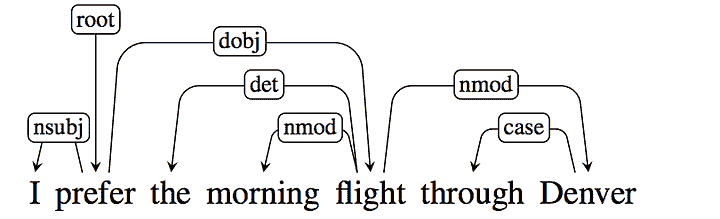

基于内容的过滤和基于协同的过滤是两种流行的推荐系统。在本博客中,我们将看到如何使用 Goodreads.com 数据构建一个简单的基于内容的推荐系统。

基于内容的推荐系统

基于内容的推荐系统通过使用项目之间的相似性来向用户推荐项目。这个推荐系统根据产品的描述或特征来推荐产品或项目。它通过产品的描述来识别产品之间的相似性。它还考虑用户的历史记录,以推荐类似的产品。

例如:如果用户喜欢 Sidney Sheldon 的小说《告诉我你的梦想》,则推荐系统会推荐用户阅读其他 Sidney Sheldon 的小说,或者推荐一个“非虚构”类型的小说。(Sidney Sheldon 的小说属于非虚构类型)。

如前所述,我们正在使用 goodreads.com 数据,并且没有用户的阅读历史。因此,我们使用了一个简单的基于内容的推荐系统。我们将通过使用书名和书籍描述来构建两个推荐系统。

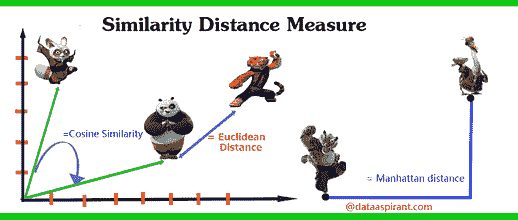

我们需要找到与给定书籍相似的书籍,然后将这些相似的书籍推荐给用户。我们如何判断给定的书籍是相似还是不相似?这里使用了相似性度量来找出这一点。

来源:dataaspirant

有不同的相似度度量方法可用。我们的推荐系统使用了余弦相似度来推荐书籍。有关相似度度量的更多详细信息,请参阅此文章。

数据

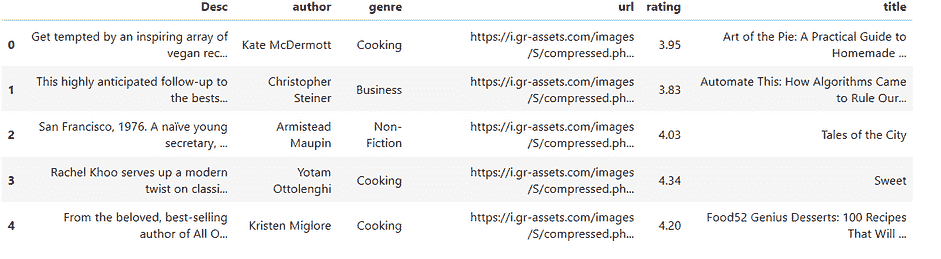

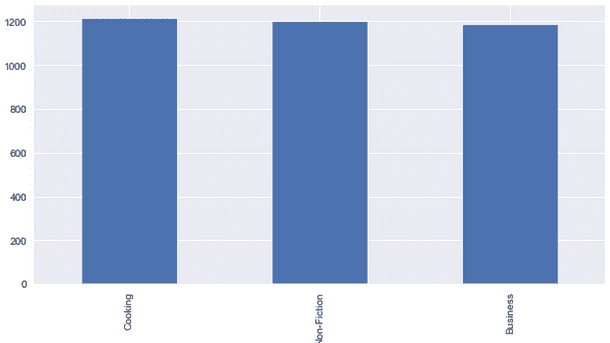

我从 goodreads.com 抓取了与商业、非小说和烹饪类别相关的书籍详细信息。

# Importing necessary libraries

import pandas as pd

import numpy as np

import pandas as pd

import numpy as np

from nltk.corpus import stopwords

from sklearn.metrics.pairwise import linear_kernel

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.feature_extraction.text import TfidfVectorizer

from nltk.tokenize import RegexpTokenizer

import re

import string

import random

from PIL import Image

import requests

from io import BytesIO

import matplotlib.pyplot as plt

%matplotlib inline

# Reading the file

df = pd.read_csv("goodread.csv")

#Reading the first five records

df.head()

#Checking the shape of the file

df.shape()

我们的数据集中总共有 3592 本书籍详细信息。它包含六列:

-

title -> 书名

-

评分 -> 用户给出的书籍评分

-

类别 -> 分类(书籍类型)。我只取了商业、非小说和烹饪这三种类别用于这个问题

-

作者 -> 书籍作者

-

Desc -> 书籍描述

-

url -> 书封面图片链接

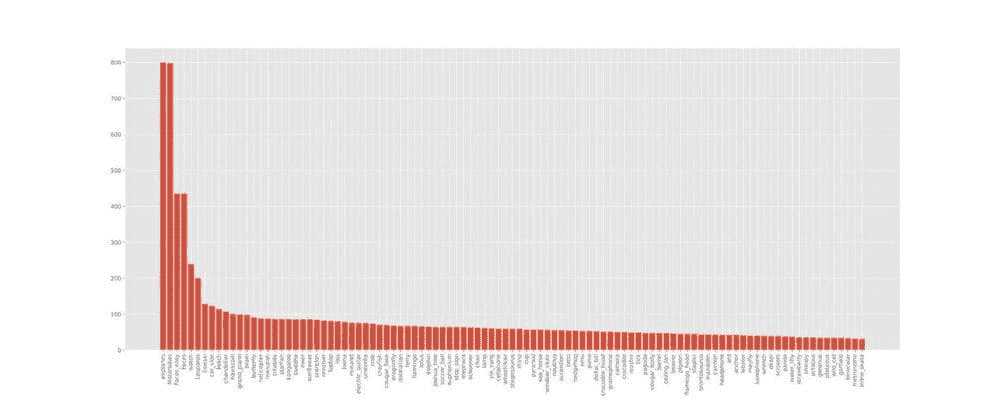

探索性数据分析

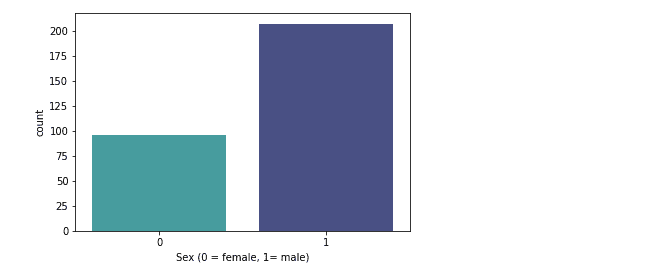

类别分布

# Genre distribution

df['genre'].value_counts().plot(x = 'genre', y ='count', kind = 'bar', figsize = (10,5) )

随机打印书名和描述

# Printing the book title and description randomly

df['title'] [2464]

df['Desc'][2464]

# Printing the book title and description randomly

df['title'] [367]

df['Desc'][367]

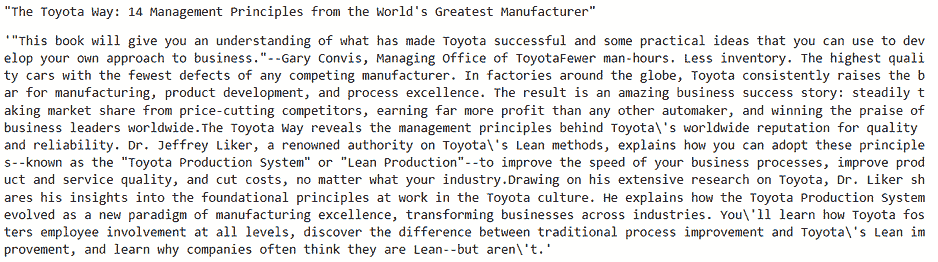

书籍描述 — 单词计数分布

# Calculating the word count for book description

df['word_count'] = df2['Desc'].apply(lambda x: len(str(x).split()))# Plotting the word count

df['word_count'].plot(

kind='hist',

bins = 50,

figsize = (12,8),title='Word Count Distribution for book descriptions')

我们没有很多长篇的书籍描述。很明显,goodreads.com 提供的是简短的描述。

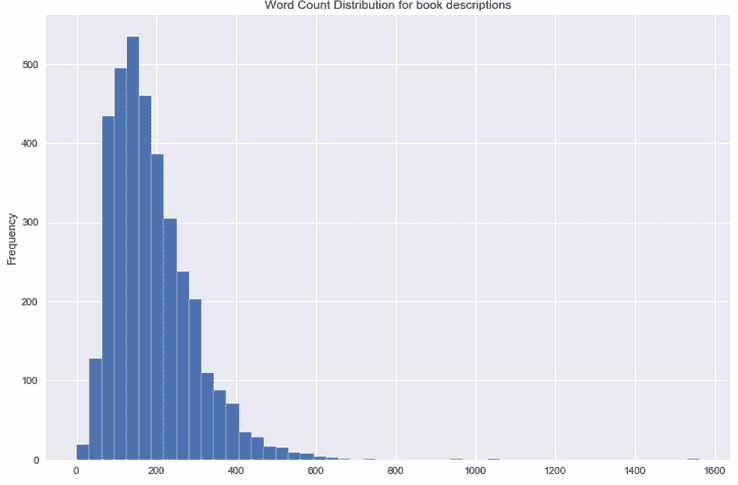

书籍描述中常见词性标签的分布

from textblob import TextBlob

blob = TextBlob(str(df['Desc']))

pos_df = pd.DataFrame(blob.tags, columns = ['word' , 'pos'])

pos_df = pos_df.pos.value_counts()[:20]

pos_df.plot(kind = 'bar', figsize=(10, 8), title = "Top 20 Part-of-speech tagging for comments")

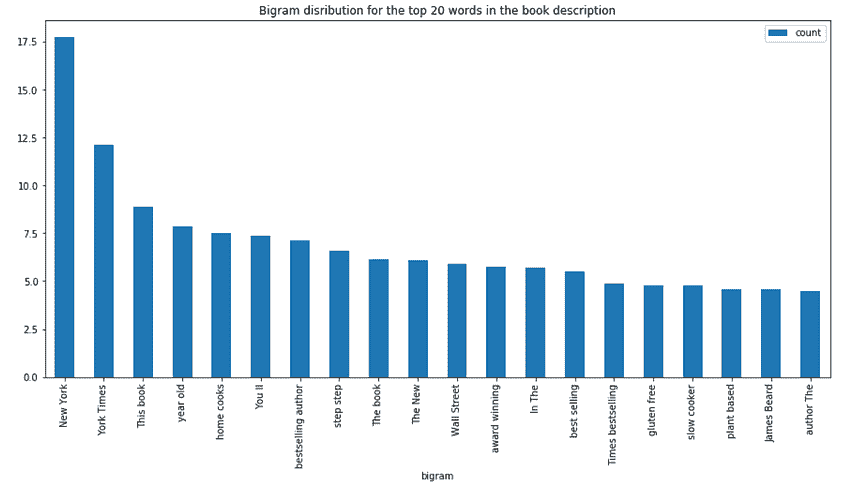

书籍描述的双词分布

#Converting text descriptions into vectors using TF-IDF using Bigram

tf = TfidfVectorizer(ngram_range=(2, 2), stop_words='english', lowercase = False)

tfidf_matrix = tf.fit_transform(df['Desc'])

total_words = tfidf_matrix.sum(axis=0)

#Finding the word frequency

freq = [(word, total_words[0, idx]) for word, idx in tf.vocabulary_.items()]

freq =sorted(freq, key = lambda x: x[1], reverse=True)

#converting into dataframe

bigram = pd.DataFrame(freq)

bigram.rename(columns = {0:'bigram', 1: 'count'}, inplace = True)

#Taking first 20 records

bigram = bigram.head(20)

#Plotting the bigram distribution

bigram.plot(x ='bigram', y='count', kind = 'bar', title = "Bigram disribution for the top 20 words in the book description", figsize = (15,7), )

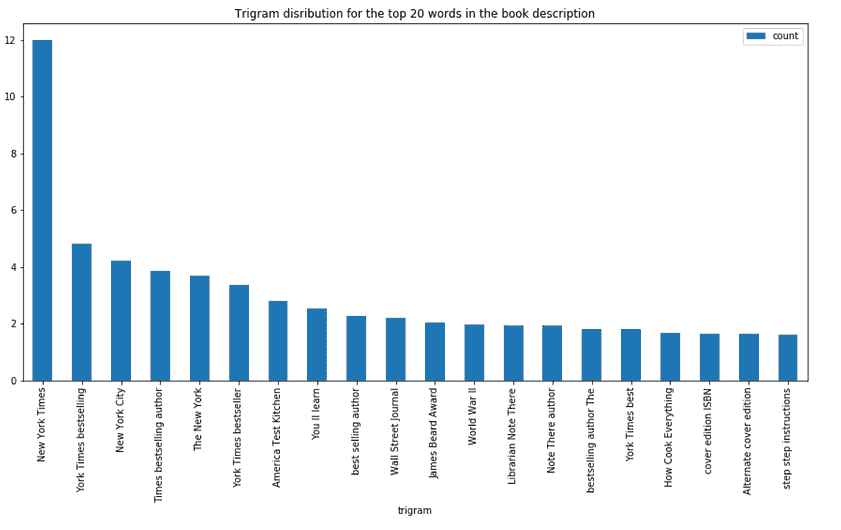

书籍描述的三词分布

#Converting text descriptions into vectors using TF-IDF using Trigram

tf = TfidfVectorizer(ngram_range=(3, 3), stop_words='english', lowercase = False)

tfidf_matrix = tf.fit_transform(df['Desc'])

total_words = tfidf_matrix.sum(axis=0)

#Finding the word frequency

freq = [(word, total_words[0, idx]) for word, idx in tf.vocabulary_.items()]

freq =sorted(freq, key = lambda x: x[1], reverse=True)#converting into dataframe

trigram = pd.DataFrame(freq)

trigram.rename(columns = {0:'trigram', 1: 'count'}, inplace = True)

#Taking first 20 records

trigram = trigram.head(20)

#Plotting the trigramn distribution

trigram.plot(x ='trigram', y='count', kind = 'bar', title = "Bigram disribution for the top 20 words in the book description", figsize = (15,7), )

文本预处理

清理书籍描述。

# Function for removing NonAscii characters

def _removeNonAscii(s):

return "".join(i for i in s if ord(i)<128)

# Function for converting into lower case

def make_lower_case(text):

return text.lower()

# Function for removing stop words

def remove_stop_words(text):

text = text.split()

stops = set(stopwords.words("english"))

text = [w for w in text if not w in stops]

text = " ".join(text)

return text

# Function for removing punctuation

def remove_punctuation(text):

tokenizer = RegexpTokenizer(r'\w+')

text = tokenizer.tokenize(text)

text = " ".join(text)

return text

# Function for removing the html tags

def remove_html(text):

html_pattern = re.compile('<.*?>')

return html_pattern.sub(r'', text)

# Applying all the functions in description and storing as a cleaned_desc

df['cleaned_desc'] = df['Desc'].apply(_removeNonAscii)

df['cleaned_desc'] = df.cleaned_desc.apply(func = make_lower_case)

df['cleaned_desc'] = df.cleaned_desc.apply(func = remove_stop_words)

df['cleaned_desc'] = df.cleaned_desc.apply(func=remove_punctuation)

df['cleaned_desc'] = df.cleaned_desc.apply(func=remove_html)

推荐引擎

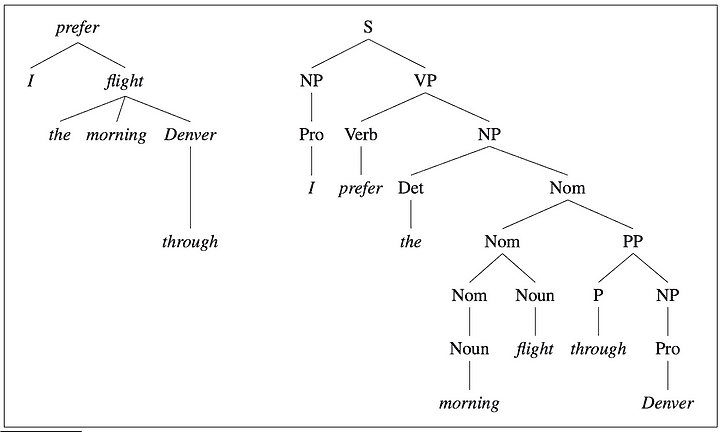

我们将基于书名和书籍描述构建两个推荐引擎。

-

使用 TF-IDF 和双词组将每本书的标题和描述转换为向量。有关更多详细信息,请参见TF-IDF。

-

我们正在构建两个推荐引擎,一个基于书名,另一个基于书籍描述。模型基于标题和描述推荐相似书籍。

-

使用余弦相似度计算所有书籍之间的相似性。

-

定义一个函数,该函数以书名和类别作为输入,并返回基于标题和描述的前五本相似推荐书籍。

基于书名的推荐

# Function for recommending books based on Book title. It takes book title and genre as an input.def recommend(title, genre):

# Matching the genre with the dataset and reset the index

data = df2.loc[df2['genre'] == genre]

data.reset_index(level = 0, inplace = True)

# Convert the index into series

indices = pd.Series(data.index, index = data['title'])

** #Converting the book title into vectors and used bigram**

tf = TfidfVectorizer(analyzer='word', ngram_range=(2, 2), min_df = 1, stop_words='english')

tfidf_matrix = tf.fit_transform(data['title'])

# Calculating the similarity measures based on Cosine Similarity

sg = cosine_similarity(tfidf_matrix, tfidf_matrix)

# Get the index corresponding to original_title

idx = indices[title]# Get the pairwsie similarity scores

sig = list(enumerate(sg[idx]))# Sort the books

sig = sorted(sig, key=lambda x: x[1], reverse=True)# Scores of the 5 most similar books

sig = sig[1:6]# Book indicies

movie_indices = [i[0] for i in sig]

# Top 5 book recommendation

rec = data[['title', 'url']].iloc[movie_indices]

# It reads the top 5 recommended book urls and print the images

for i in rec['url']:

response = requests.get(i)

img = Image.open(BytesIO(response.content))

plt.figure()

print(plt.imshow(img))

基于书名“史蒂夫·乔布斯”和类别“商业”进行推荐:

recommend("Steve Jobs", "Business")

输出

我们以《史蒂夫·乔布斯》这本书作为输入,模型基于书名的相似性推荐其他史蒂夫·乔布斯的书籍。

基于书籍描述的推荐

我们通过将书籍描述转换为向量来使用上述相同的函数。

# Function for recommending books based on Book title. It takes book title and genre as an input.def recommend(title, genre):

global rec

# Matching the genre with the dataset and reset the index

data = df2.loc[df2['genre'] == genre]

data.reset_index(level = 0, inplace = True)

# Convert the index into series

indices = pd.Series(data.index, index = data['title'])

**#Converting the book description into vectors and used bigram**

tf = TfidfVectorizer(analyzer='word', ngram_range=(2, 2), min_df = 1, stop_words='english')

tfidf_matrix = tf.fit_transform(data['cleaned_desc'])

# Calculating the similarity measures based on Cosine Similarity

sg = cosine_similarity(tfidf_matrix, tfidf_matrix)

# Get the index corresponding to original_title

idx = indices[title]# Get the pairwsie similarity scores

sig = list(enumerate(sg[idx]))# Sort the books

sig = sorted(sig, key=lambda x: x[1], reverse=True)# Scores of the 5 most similar books

sig = sig[1:6]# Book indicies

movie_indices = [i[0] for i in sig]

# Top 5 book recommendation

rec = data[['title', 'url']].iloc[movie_indices]

# It reads the top 5 recommend book url and print the images

for i in rec['url']:

response = requests.get(i)

img = Image.open(BytesIO(response.content))

plt.figure()

print(plt.imshow(img))

让我们基于书籍《哈利·波特与阿兹卡班的囚徒》和类型“非虚构”进行推荐:

recommend("Harry Potter and the Prisoner of Azkaban", "Non-Fiction")

输出

我们提供了《哈利·波特与阿兹卡班的囚徒》和“非虚构”作为输入,模型推荐了另外五本与我们输入相似的《哈利·波特》书籍。

再来一个推荐:

recommend("Norwegian Wood", "Non-Fiction")

上述模型根据描述推荐了五本与《挪威的森林》相似的书籍。

这只是一个简单的基本级推荐系统。现实世界中的推荐系统更为强大和先进。我们可以通过添加其他元数据(如作者和类型)来进一步改进上述系统。

此外,我们还可以使用 Word2Vec 进行基于文本的语义推荐。我已经使用 Word2Vec 构建了一个推荐引擎。请查看这里。

感谢阅读。如果您有任何补充,请随时留下评论!

简介:Dhilip Subramanian 是一位机械工程师,已完成分析学硕士学位。他拥有 9 年的经验,专注于与数据相关的各种领域,包括 IT、营销、银行、电力和制造业。他对自然语言处理和机器学习充满热情。他是SAS 社区的贡献者,喜欢在 Medium 平台上撰写有关数据科学各个方面的技术文章。

原文。经授权转载。

相关:

-

探索数据科学的真实世界

-

五个很酷的 Python 库用于数据科学

-

使用 Python 轻松进行语音转文本

更多相关话题

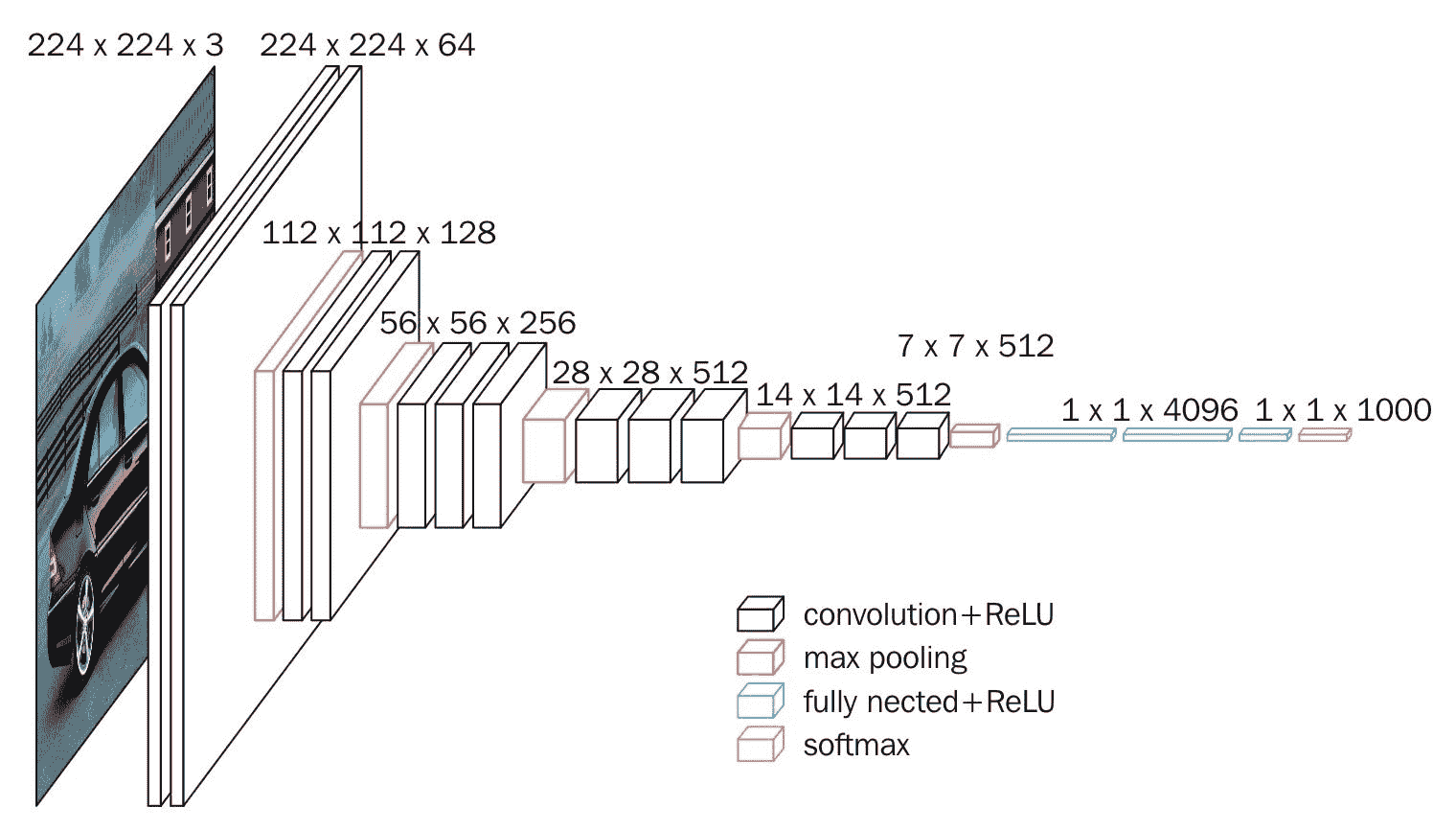

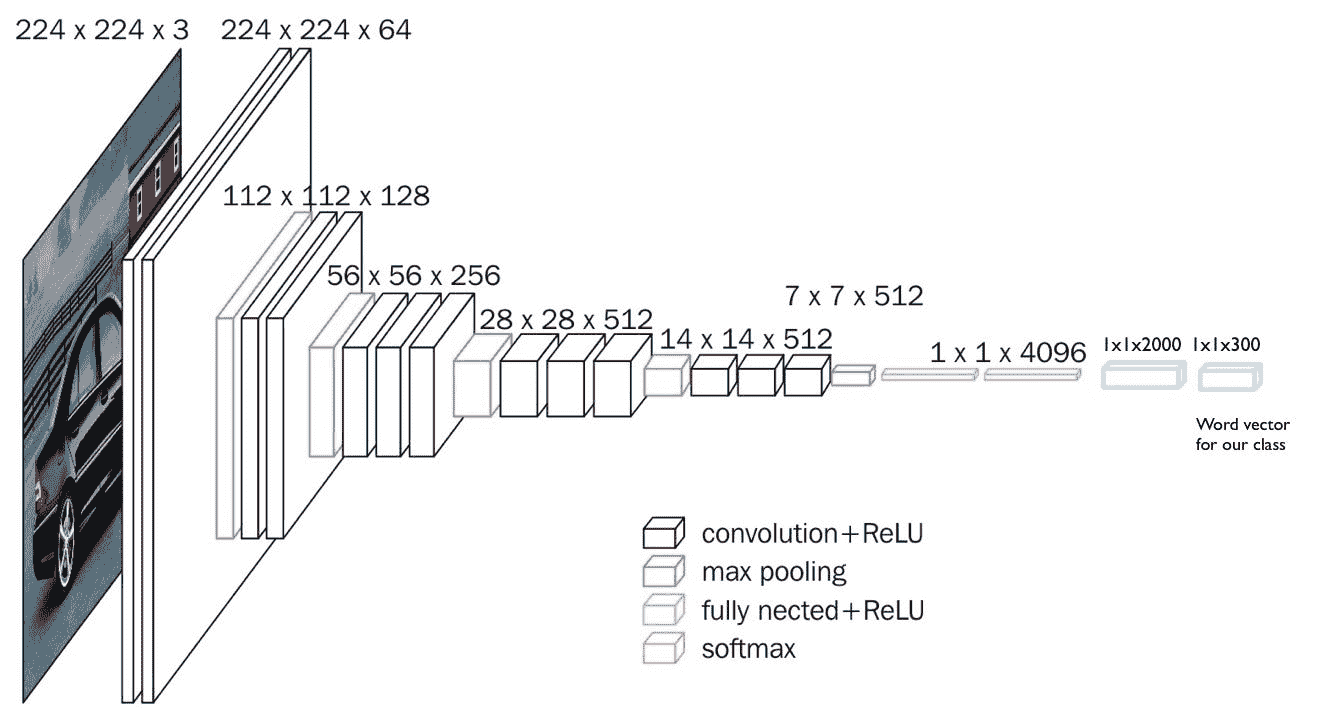

从头开始使用 NumPy 构建卷积神经网络

原文:

www.kdnuggets.com/2018/04/building-convolutional-neural-network-numpy-scratch.html

评论

使用 ML/DL 库中已有的模型在某些情况下可能很有帮助。但为了更好的控制和理解,你应该尝试自己实现这些模型。本文展示了如何仅使用 NumPy 实现 CNN。

卷积神经网络(CNN)是分析多维信号(如图像)的最先进技术。已经有许多库实现了 CNN,如 TensorFlow 和 Keras。这些库将开发者与一些细节隔离开,只提供了一个抽象的 API,以简化开发过程并避免实现中的复杂性。但实际上,这些细节可能会有所不同。有时候,数据科学家需要深入这些细节以提升性能。在这种情况下,解决方案是自己构建每个模型的部分。这可以对网络进行尽可能高的控制。此外,推荐实现这些模型以更好地理解它们。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求。

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求。

本文使用仅 NumPy 库创建 CNN。仅创建了三个层,即卷积(conv 简写)、ReLU 和最大池化。涉及的主要步骤如下:

-

读取输入图像。

-

准备滤波器。

-

卷积层:对输入图像应用每个滤波器进行卷积。

-

ReLU 层:对特征图(卷积层的输出)应用 ReLU 激活函数。

-

最大池化层:对 ReLU 层的输出应用池化操作。

-

堆叠卷积、ReLU 和最大池化层。

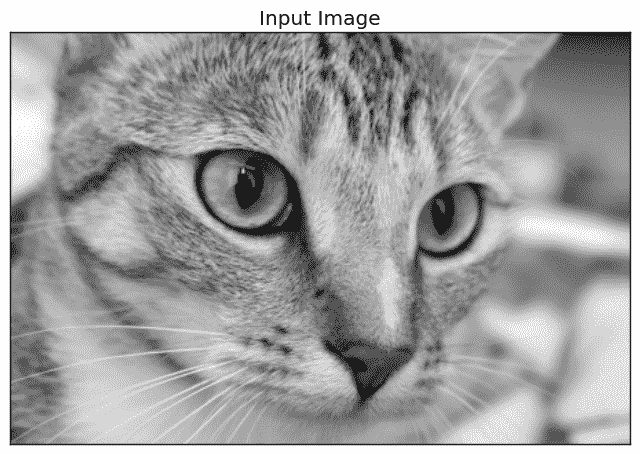

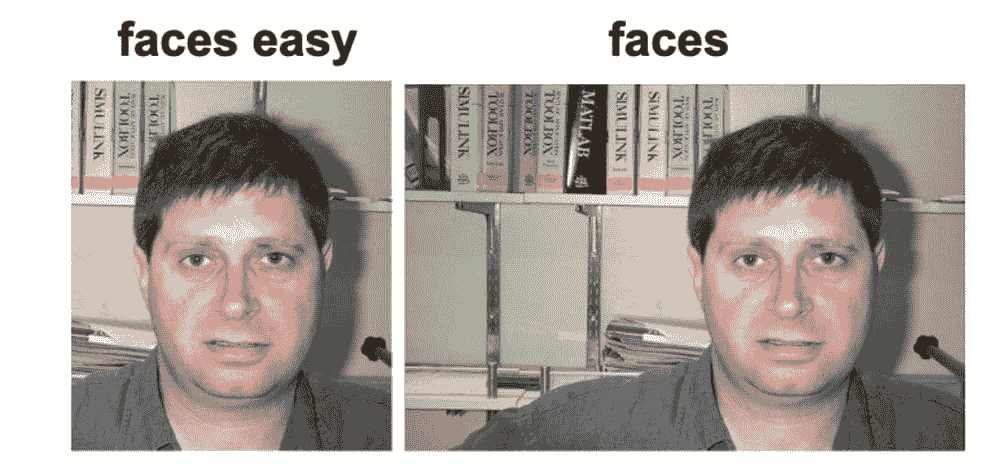

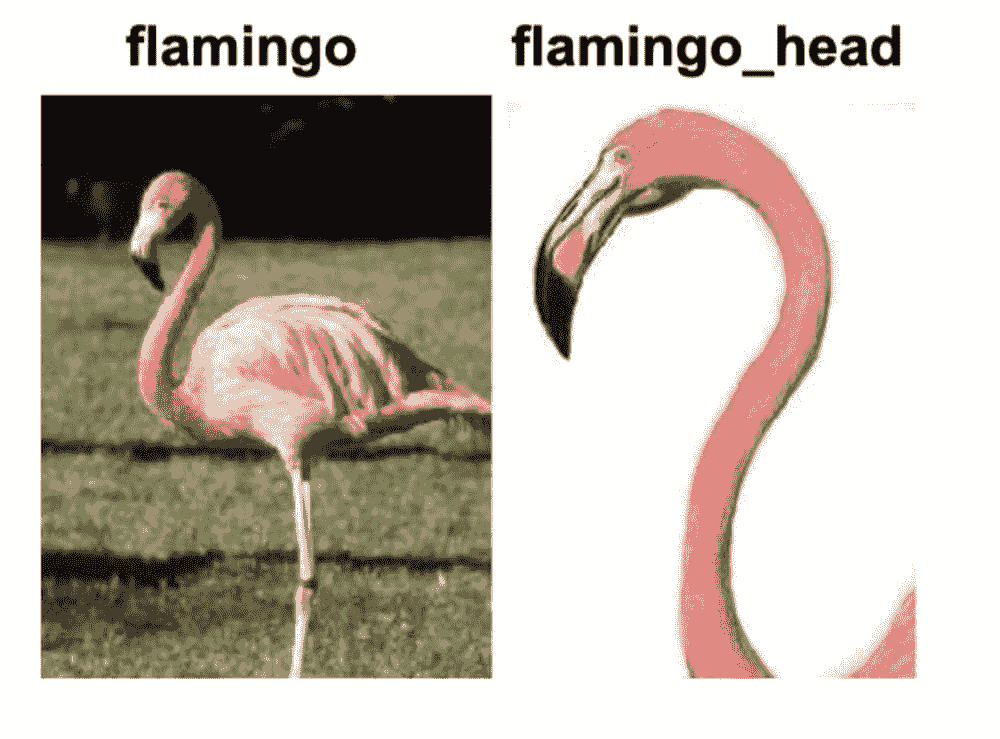

1. 读取输入图像

以下代码从 skimage Python 库中读取一个已存在的图像,并将其转换为灰度图像。

1\. import skimage.data

2\. # Reading the image

3\. img = skimage.data.chelsea()

4\. # Converting the image into gray.

5\. img = skimage.color.rgb2gray(img)

读取图像是第一步,因为接下来的步骤依赖于输入的大小。图像转换为灰度后如下所示。

2. 准备滤波器

以下代码为第一个卷积层(l1 的简写)准备滤波器库:

1\. l1_filter = numpy.zeros((2,3,3))

根据滤波器的数量和每个滤波器的大小创建一个零数组。创建了2个3x3大小的滤波器,因此零数组的大小为(2=num_filters,3=num_rows_filter,3=num_columns_filter)。滤波器的大小被选择为二维数组而无深度,因为输入图像是灰度图像且没有深度(即二维)。如果图像是 RGB 的,有 3 个通道,则滤波器大小必须为(3,3,3=深度)。

滤波器组的大小由上面的零数组指定,而不是滤波器的实际值。可以通过以下方式覆盖这些值以检测垂直和水平边缘。

1\. l1_filter[0, :, :] = numpy.array([[[-1, 0, 1],

2\. [-1, 0, 1],

3\. [-1, 0, 1]]])

4\. l1_filter[1, :, :] = numpy.array([[[1, 1, 1],

5\. [0, 0, 0],

6\. [-1, -1, -1]]])

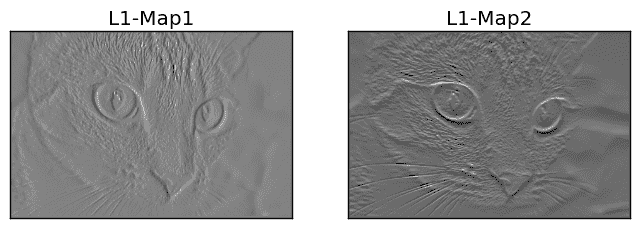

3. 卷积层

在准备好滤波器后,接下来是对输入图像进行卷积。下一行使用名为conv的函数对图像和滤波器组进行卷积:

1\. l1_feature_map = conv(img, l1_filter)

该函数只接受两个参数,即图像和滤波器组,具体实现如下。

1\. def conv(img, conv_filter):

2\. if len(img.shape) > 2 or len(conv_filter.shape) > 3: # Check if number of image channels matches the filter depth.

3\. if img.shape[-1] != conv_filter.shape[-1]:

4\. print("Error: Number of channels in both image and filter must match.")

5\. sys.exit()

6\. if conv_filter.shape[1] != conv_filter.shape[2]: # Check if filter dimensions are equal.

7\. print('Error: Filter must be a square matrix. I.e. number of rows and columns must match.')

8\. sys.exit()

9\. if conv_filter.shape[1]%2==0: # Check if filter diemnsions are odd.

10\. print('Error: Filter must have an odd size. I.e. number of rows and columns must be odd.')

11\. sys.exit()

12\.

13\. # An empty feature map to hold the output of convolving the filter(s) with the image.

14\. feature_maps = numpy.zeros((img.shape[0]-conv_filter.shape[1]+1,

15\. img.shape[1]-conv_filter.shape[1]+1,

16\. conv_filter.shape[0]))

17\.

18\. # Convolving the image by the filter(s).

19\. for filter_num in range(conv_filter.shape[0]):

20\. print("Filter ", filter_num + 1)

21\. curr_filter = conv_filter[filter_num, :] # getting a filter from the bank.

22\. """

23\. Checking if there are mutliple channels for the single filter.

24\. If so, then each channel will convolve the image.

25\. The result of all convolutions are summed to return a single feature map.

26\. """

27\. if len(curr_filter.shape) > 2:

28\. conv_map = conv_(img[:, :, 0], curr_filter[:, :, 0]) # Array holding the sum of all feature maps.

29\. for ch_num in range(1, curr_filter.shape[-1]): # Convolving each channel with the image and summing the results.

30\. conv_map = conv_map + conv_(img[:, :, ch_num],

31\. curr_filter[:, :, ch_num])

32\. else: # There is just a single channel in the filter.

33\. conv_map = conv_(img, curr_filter)

34\. feature_maps[:, :, filter_num] = conv_map # Holding feature map with the current filter.

35\. return feature_maps # Returning all feature maps.

该函数首先确保每个滤波器的深度等于图像通道的数量。在下面的代码中,外层if检查通道和滤波器是否具有深度。如果已经存在深度,则内层if检查它们是否不相等。如果不匹配,脚本将退出。

1\. if len(img.shape) > 2 or len(conv_filter.shape) > 3: # Check if number of image channels matches the filter depth.

2\. if img.shape[-1] != conv_filter.shape[-1]:

3\. print("Error: Number of channels in both image and filter must match.")

此外,滤波器的大小应为奇数,并且滤波器的维度应相等(即行数和列数都是奇数且相等)。这通过以下两个if块进行检查。如果条件不满足,脚本将退出。

1\. if conv_filter.shape[1] != conv_filter.shape[2]: # Check if filter dimensions are equal.

2\. print('Error: Filter must be a square matrix. I.e. number of rows and columns must match.')

3\. sys.exit()

4\. if conv_filter.shape[1]%2==0: # Check if filter diemnsions are odd.

5\. print('Error: Filter must have an odd size. I.e. number of rows and columns must be odd.')

6\. sys.exit()

不满足上述任何条件证明滤波器深度与图像适配,卷积可以应用。通过滤波器对图像进行卷积的过程开始于初始化一个数组以存放卷积输出(即特征图),并通过以下代码指定其大小:

1\. # An empty feature map to hold the output of convolving the filter(s) with the image.

2\. feature_maps = numpy.zeros((img.shape[0]-conv_filter.shape[1]+1,

3\. img.shape[1]-conv_filter.shape[1]+1,

4\. conv_filter.shape[0]))

由于没有步幅和填充,特征图的大小将等于(img_rows-filter_rows+1,image_columns-filter_columns+1,num_filters),如上代码所示。请注意,每个滤波器都有一个输出特征图。这就是为什么滤波器组中的滤波器数量(conv_filter.shape[0])被用来作为第三个参数来指定大小。

1\. # Convolving the image by the filter(s).

2\. for filter_num in range(conv_filter.shape[0]):

3\. print("Filter ", filter_num + 1)

4\. curr_filter = conv_filter[filter_num, :] # getting a filter from the bank.

5\. """

6\. Checking if there are mutliple channels for the single filter.

7\. If so, then each channel will convolve the image.

8\. The result of all convolutions are summed to return a single feature map.

9\. """

10\. if len(curr_filter.shape) > 2:

11\. conv_map = conv_(img[:, :, 0], curr_filter[:, :, 0]) # Array holding the sum of all feature maps.

12\. for ch_num in range(1, curr_filter.shape[-1]): # Convolving each channel with the image and summing the results.

13\. conv_map = conv_map + conv_(img[:, :, ch_num],

14\. curr_filter[:, :, ch_num])

15\. else: # There is just a single channel in the filter.

16\. conv_map = conv_(img, curr_filter)

17\. feature_maps[:, :, filter_num] = conv_map # Holding feature map with the current filter.

外层循环遍历滤波器组中的每个滤波器,并根据这一行返回它以供进一步处理:

1\. curr_filter = conv_filter[filter_num, :] # getting a filter from the bank.

如果要卷积的图像有多个通道,则滤波器的深度必须等于这些通道的数量。在这种情况下,卷积是通过将每个图像通道与滤波器中的相应通道进行卷积来完成的。最终,结果的总和将是输出特征图。如果图像只有一个通道,那么卷积将直接进行。确定这种行为是在if-else块中完成的:

1\. if len(curr_filter.shape) > 2:

2\. conv_map = conv_(img[:, :, 0], curr_filter[:, :, 0]) # Array holding the sum of all feature map

3\. for ch_num in range(1, curr_filter.shape[-1]): # Convolving each channel with the image and summing the results.

4\. conv_map = conv_map + conv_(img[:, :, ch_num],

5\. curr_filter[:, :, ch_num])

6\. else: # There is just a single channel in the filter.

7\. conv_map = conv_(img, curr_filter)

你可能会注意到,卷积是通过一个叫做conv_的函数来实现的,这与conv函数不同。函数conv只是接受输入图像和滤波器组,但不会自行执行卷积。它只是将每一组输入-滤波器对传递给conv_函数。这只是为了使代码更易于调试。以下是conv_函数的实现:

1\. def conv_(img, conv_filter):

2\. filter_size = conv_filter.shape[0]

3\. result = numpy.zeros((img.shape))

4\. #Looping through the image to apply the convolution operation.

5\. for r in numpy.uint16(numpy.arange(filter_size/2,

6\. img.shape[0]-filter_size/2-2)):

7\. for c in numpy.uint16(numpy.arange(filter_size/2, img.shape[1]-filter_size/2-2)):

8\. #Getting the current region to get multiplied with the filter.

9\. curr_region = img[r:r+filter_size, c:c+filter_size]

10\. #Element-wise multipliplication between the current region and the filter.

11\. curr_result = curr_region * conv_filter

12\. conv_sum = numpy.sum(curr_result) #Summing the result of multiplication.

13\. result[r, c] = conv_sum #Saving the summation in the convolution layer feature map.

14\.

15\. #Clipping the outliers of the result matrix.

16\. final_result = result[numpy.uint16(filter_size/2):result.shape[0]-numpy.uint16(filter_size/2),

17\. numpy.uint16(filter_size/2):result.shape[1]-numpy.uint16(filter_size/2)]

18\. return final_result

它遍历图像并提取与滤波器大小相等的区域,如下行所示:

1\. curr_region = img[r:r+filter_size, c:c+filter_size]

然后,它在区域和滤波器之间执行逐元素乘法,并将它们相加以根据这些行获得一个单一的值作为输出:

1\. #Element-wise multipliplication between the current region and the filter.

2\. curr_result = curr_region * conv_filter

3\. conv_sum = numpy.sum(curr_result) #Summing the result of multiplication.

4\. result[r, c] = conv_sum #Saving the summation in the convolution layer feature map.

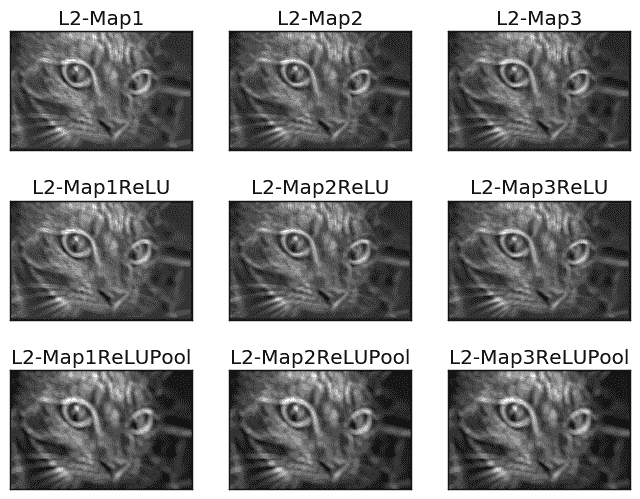

在对每个滤波器进行卷积后,特征图由conv函数返回。下图显示了此卷积层返回的特征图。

这种层的输出将应用于 ReLU 层。

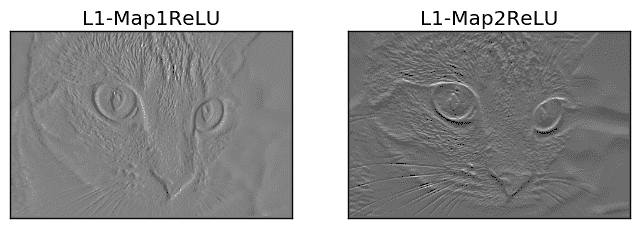

4. ReLU 层

ReLU 层在每个由卷积层返回的特征图上应用 ReLU 激活函数。它通过以下代码行调用relu函数:

l1_feature_map_relu = relu(l1_feature_map)

relu函数的实现如下:

1\. def relu(feature_map):

2\. #Preparing the output of the ReLU activation function.

3\. relu_out = numpy.zeros(feature_map.shape)

4\. for map_num in range(feature_map.shape[-1]):

5\. for r in numpy.arange(0,feature_map.shape[0]):

6\. for c in numpy.arange(0, feature_map.shape[1]):

7\. relu_out[r, c, map_num] = numpy.max(feature_map[r, c, map_num], 0)

这非常简单。只需循环遍历特征图中的每个元素,如果元素大于 0,则返回特征图中的原始值。否则,返回 0。ReLU 层的输出在下图中显示。

ReLU 层的输出会应用到最大池化层中。

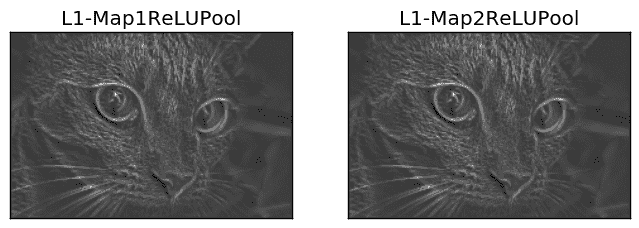

5. 最大池化层

最大池化层接受 ReLU 层的输出,并根据以下行应用最大池化操作:

1\. l1_feature_map_relu_pool = pooling(l1_feature_map_relu, 2, 2)

它使用pooling函数实现,如下所示:

1\. def pooling(feature_map, size=2, stride=2):

2\. #Preparing the output of the pooling operation.

3\. pool_out = numpy.zeros((numpy.uint16((feature_map.shape[0]-size+1)/stride),

4\. numpy.uint16((feature_map.shape[1]-size+1)/stride),

5\. feature_map.shape[-1]))

6\. for map_num in range(feature_map.shape[-1]):

7\. r2 = 0

8\. for r in numpy.arange(0,feature_map.shape[0]-size-1, stride):

9\. c2 = 0

10\. for c in numpy.arange(0, feature_map.shape[1]-size-1, stride):

11\. pool_out[r2, c2, map_num] = numpy.max(feature_map[r:r+size, c:c+size])

12\. c2 = c2 + 1

13\. r2 = r2 +1

该函数接受三个输入,即 ReLU 层的输出、池化掩模尺寸和步幅。它简单地创建一个空数组,正如之前所述,用于保存该层的输出。该数组的大小根据尺寸和步幅参数来指定,如下行所示:

1\. pool_out = numpy.zeros((numpy.uint16((feature_map.shape[0]-size+1)/stride),

2\. numpy.uint16((feature_map.shape[1]-size+1)/stride),

3\. feature_map.shape[-1]))

然后它通过外层循环按通道逐个处理输入,外层循环使用循环变量map_num。对于输入中的每个通道,应用最大池化操作。根据使用的步幅和尺寸,区域被裁剪,最大值会被返回到输出数组中,如下行所示:

pool_out[r2, c2, map_num] = numpy.max(feature_map[r:r+size, c:c+size])

这种池化层的输出在下图中显示。请注意,即使池化层的输出在图中看起来与输入相同,它的尺寸仍然小于输入。

6. 堆叠层

到目前为止,包含卷积、ReLU 和最大池化层的 CNN 架构已经完成。可能还会有一些其他层需要堆叠在之前的层之上,如下所示。

1\. # Second conv layer

2\. l2_filter = numpy.random.rand(3, 5, 5, l1_feature_map_relu_pool.shape[-1])

3\. print("\n**Working with conv layer 2**")

4\. l2_feature_map = conv(l1_feature_map_relu_pool, l2_filter)

5\. print("\n**ReLU**")

6\. l2_feature_map_relu = relu(l2_feature_map)

7\. print("\n**Pooling**")

8\. l2_feature_map_relu_pool = pooling(l2_feature_map_relu, 2, 2)

9\. print("**End of conv layer 2**\n")

前一卷积层使用了3个随机生成的过滤器。这就是为什么从该卷积层会产生3个特征图。后续的 ReLU 和池化层也是如此。这些层的输出如下所示。

1\. # Third conv layer

2\. l3_filter = numpy.random.rand(1, 7, 7, l2_feature_map_relu_pool.shape[-1])

3\. print("\n**Working with conv layer 3**")

4\. l3_feature_map = conv(l2_feature_map_relu_pool, l3_filter)

5\. print("\n**ReLU**")

6\. l3_feature_map_relu = relu(l3_feature_map)

7\. print("\n**Pooling**")

8\. l3_feature_map_relu_pool = pooling(l3_feature_map_relu, 2, 2)

9\. print("**End of conv layer 3**\n")

下图展示了前面层的输出。前一卷积层只使用了一个过滤器。这就是为什么只有一个特征图作为输出。

但请记住,每一层的输出都是下一层的输入。例如,这些线条接受之前的输出作为它们的输入。

1\. l2_feature_map = conv(l1_feature_map_relu_pool, l2_filter)

2\. l3_feature_map = conv(l2_feature_map_relu_pool, l3_filter)

7. 完整代码

完整代码可以在 github (github.com/ahmedfgad/NumPyCNN) 上找到。代码中包含了使用Matplotlib库可视化每一层输出的功能。

简介: Ahmed Gad 于 2015 年 7 月获得埃及 Menoufia 大学计算机与信息学院(FCI)信息技术专业的优秀荣誉学士学位。由于在学院中排名第一,他于 2015 年被推荐到埃及某研究所担任助教,随后于 2016 年回到学院担任助教和研究员。他目前的研究兴趣包括深度学习、机器学习、人工智能、数字信号处理和计算机视觉。

原文. 经许可转载。

相关:

-

逐步推导卷积神经网络从全连接网络

-

学习率在人工神经网络中有用吗?

-

通过正则化避免过拟合

更多相关主题

使用 Prefect 构建数据管道

图片来源:作者 | Canva

在本教程中,我们将学习 Prefect,这是一款现代工作流编排工具。我们将从使用 Pandas 构建数据管道开始,然后将其与 Prefect 工作流进行比较,以便更好地理解。最后,我们将部署我们的工作流并在仪表板上查看运行日志。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

什么是 Prefect?

Prefect 是一个工作流管理系统,旨在协调和管理复杂的数据工作流,包括机器学习(ML)管道。它提供了一个构建、调度和监控工作流的框架,使其成为管理 ML 操作(MLOps)的重要工具。

Prefect 提供任务和流程管理,允许用户定义依赖关系并高效地执行工作流。具有状态管理和可观察性等功能,Prefect 提供有关任务状态和历史的洞察,帮助调试和优化。它配备了一个高度互动的仪表板,让你可以安排、监控和集成各种其他功能,这些功能将改善你的 MLOps 流程。你甚至可以通过几次点击设置通知和集成其他 ML 框架。

Prefect 作为一个开源框架和托管云服务提供,进一步简化了你的工作流程。

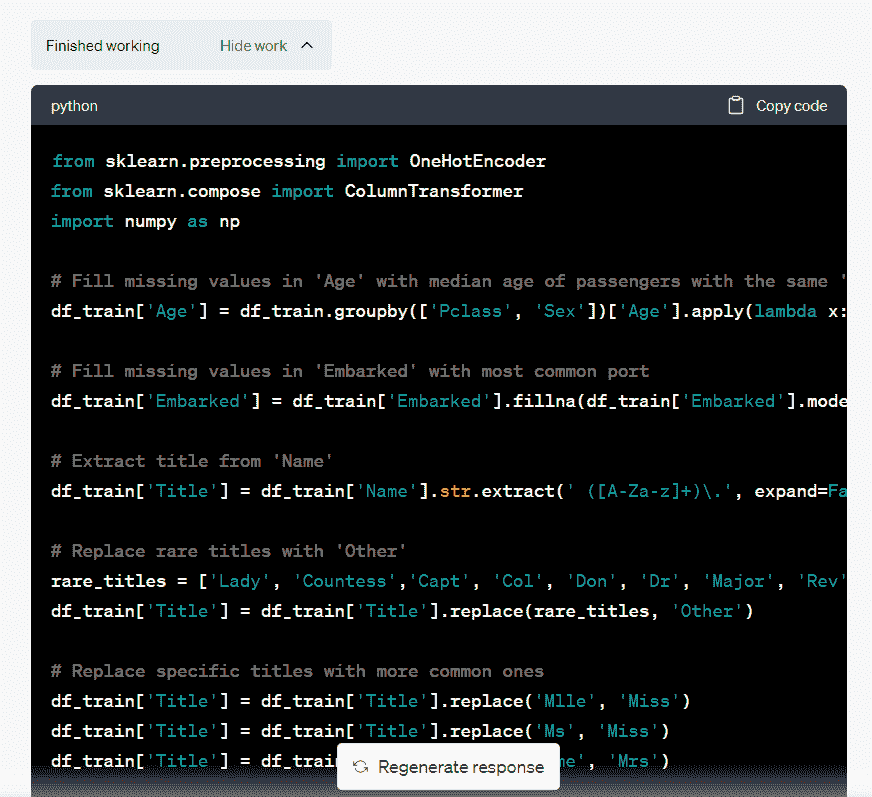

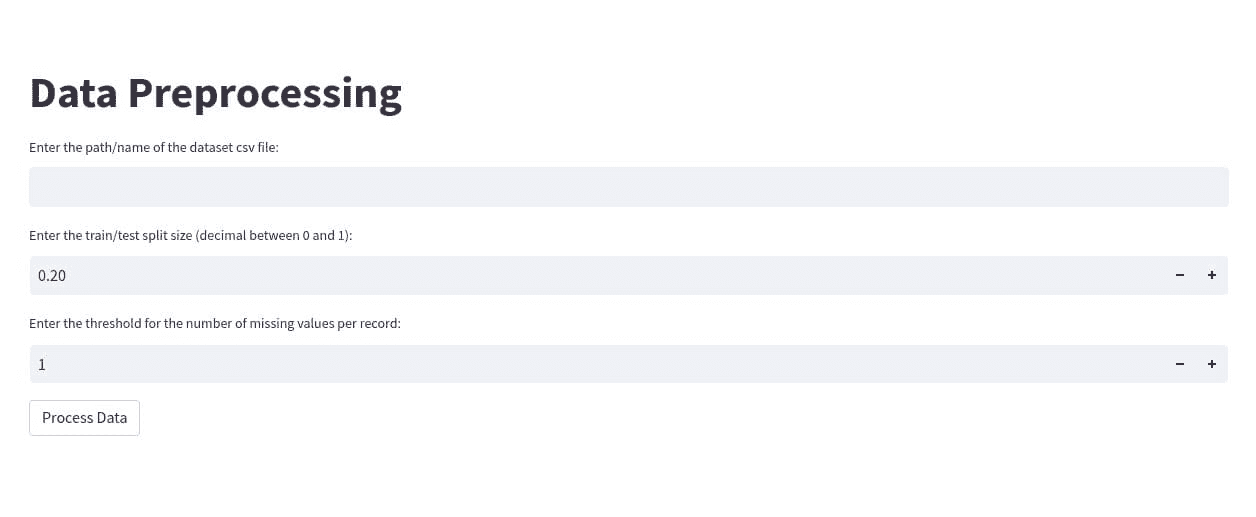

使用 Pandas 构建数据管道

我们将复制我在之前教程中使用的数据管道(使用 Pandas 构建数据科学管道—KDnuggets),以便你了解每个任务在管道中的工作方式以及如何将它们结合起来。我在这里提到它,以便你可以清楚地比较完美的数据管道与普通管道的区别。

import pandas as pd

def load_data(path):

return pd.read_csv(path)

def data_cleaning(data):

data = data.drop_duplicates()

data = data.dropna()

data = data.reset_index(drop=True)

return data

def convert_dtypes(data, types_dict=None):

data = data.astype(dtype=types_dict)

## convert the date column to datetime

data["Date"] = pd.to_datetime(data["Date"])

return data

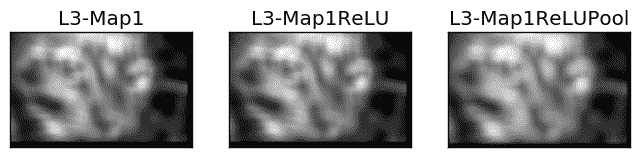

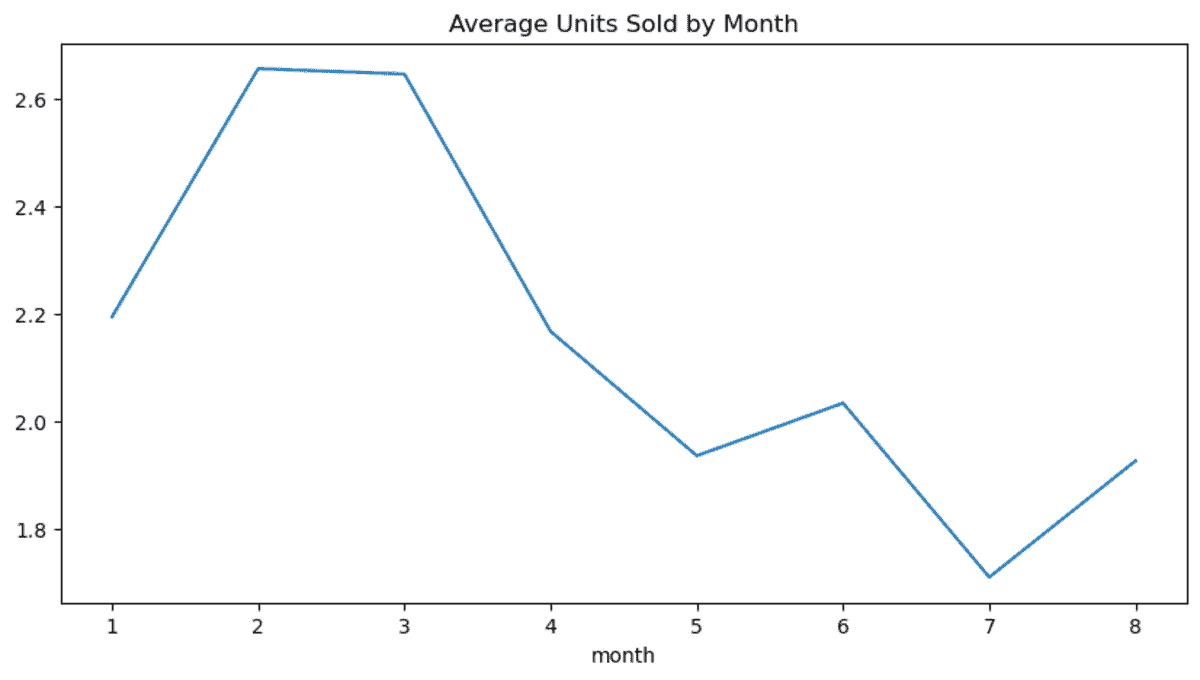

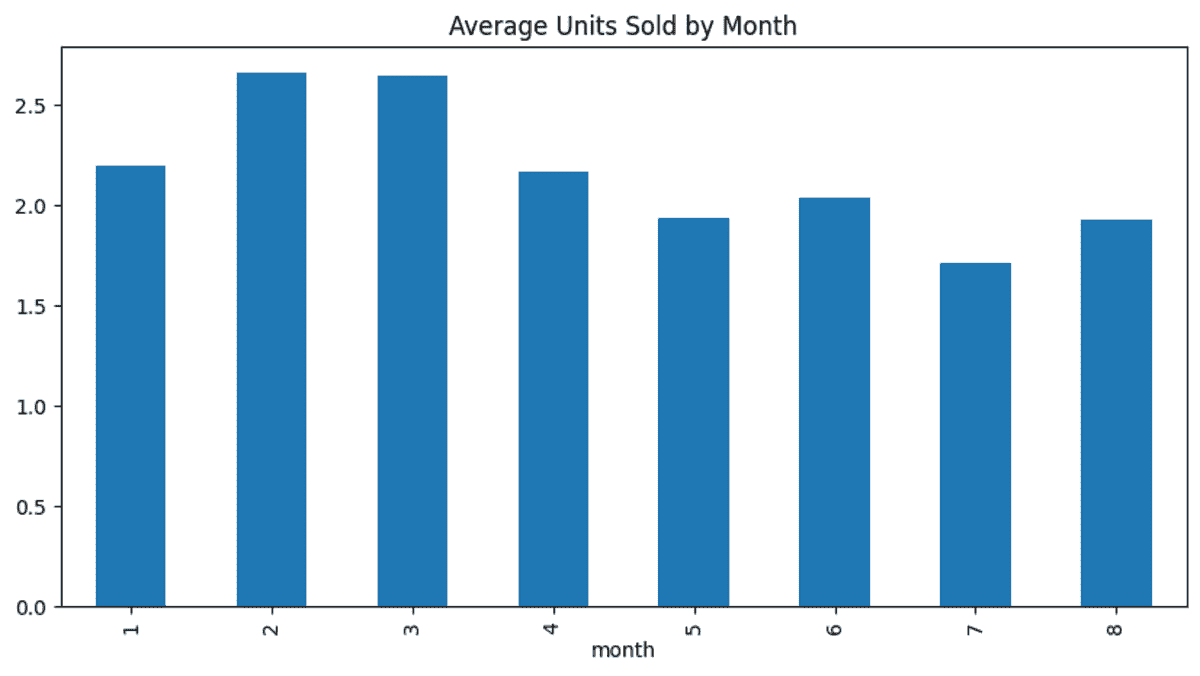

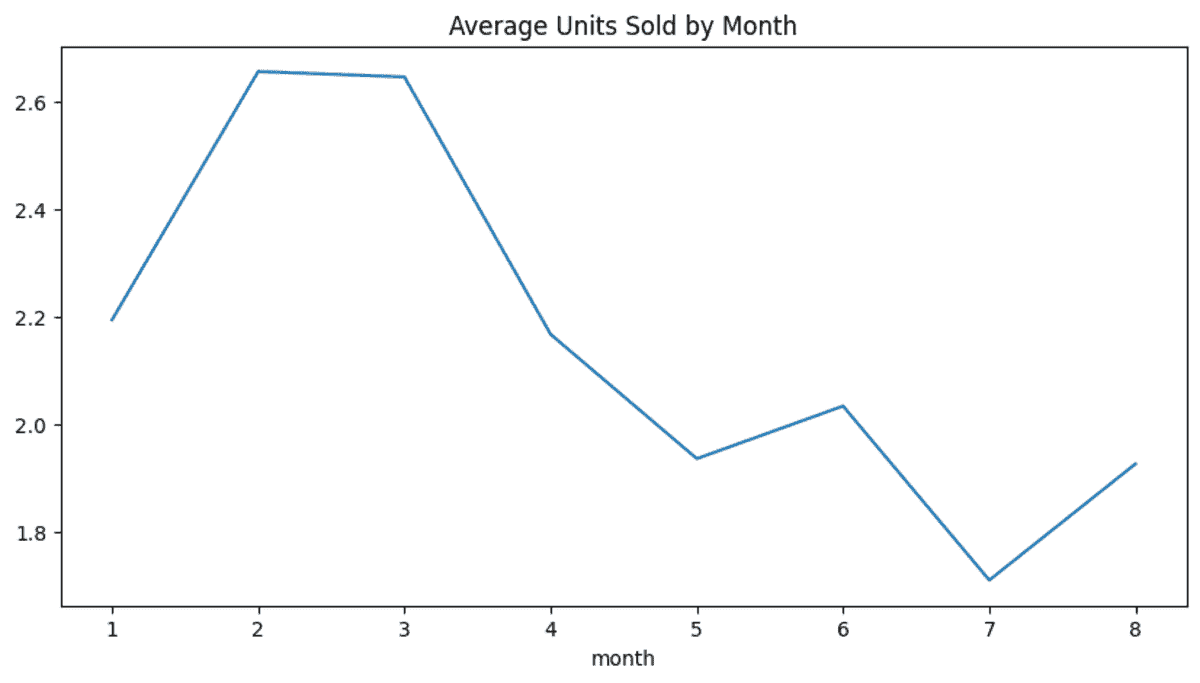

def data_analysis(data):

data["month"] = data["Date"].dt.month

new_df = data.groupby("month")["Units Sold"].mean()

return new_df

def data_visualization(new_df, vis_type="bar"):

new_df.plot(kind=vis_type, figsize=(10, 5), title="Average Units Sold by Month")

return new_df

path = "Online Sales Data.csv"

df = (

pd.DataFrame()

.pipe(lambda x: load_data(path))

.pipe(data_cleaning)

.pipe(convert_dtypes, {"Product Category": "str", "Product Name": "str"})

.pipe(data_analysis)

.pipe(data_visualization, "line")

)

当我们运行上述代码时,每个任务将按顺序运行并生成数据可视化。除此之外,它不会做其他事情。我们可以安排它、查看运行日志,甚至集成第三方工具进行通知或监控。

使用 Prefect 构建数据管道

现在我们将使用相同的数据集 在线销售数据集 - 热门市场数据 来构建相同的管道,但使用 Prefect。我们将首先使用 PIP 命令安装 Prefect 库。

$ pip install prefect

如果你查看下面的代码,你会发现实际上没有什么变化。函数是相同的,只是增加了 Python 装饰器。每一步的管道都有 @task 装饰器,而组合这些步骤的管道有 @flow 装饰器。此外,我们还保存了生成的图形。

import pandas as pd

import matplotlib.pyplot as plt

from prefect import task, flow

@task

def load_data(path):

return pd.read_csv(path)

@task

def data_cleaning(data):

data = data.drop_duplicates()

data = data.dropna()

data = data.reset_index(drop=True)

return data

@task

def convert_dtypes(data, types_dict=None):

data = data.astype(dtype=types_dict)

data["Date"] = pd.to_datetime(data["Date"])

return data

@task

def data_analysis(data):

data["month"] = data["Date"].dt.month

new_df = data.groupby("month")["Units Sold"].mean()

return new_df

@task

def data_visualization(new_df, vis_type="bar"):

new_df.plot(kind=vis_type, figsize=(10, 5), title="Average Units Sold by Month")

plt.savefig("average_units_sold_by_month.png")

return new_df

@flow(name="Data Pipeline")

def data_pipeline(path: str):

df = load_data(path)

df_cleaned = data_cleaning(df)

df_converted = convert_dtypes(

df_cleaned, {"Product Category": "str", "Product Name": "str"}

)

analysis_result = data_analysis(df_converted)

new_df = data_visualization(analysis_result, "line")

return new_df

# Run the flow!

if __name__ == "__main__":

new_df = data_pipeline("Online Sales Data.csv")

print(new_df)

我们将通过提供 CSV 文件的位置来运行数据管道。它将按顺序执行所有步骤并生成运行状态的日志。

14:18:48.649 | INFO | prefect.engine - Created flow run 'enlightened-dingo' for flow 'Data Pipeline'

14:18:48.816 | INFO | Flow run 'enlightened-dingo' - Created task run 'load_data-0' for task 'load_data'

14:18:48.822 | INFO | Flow run 'enlightened-dingo' - Executing 'load_data-0' immediately...

14:18:48.990 | INFO | Task run 'load_data-0' - Finished in state Completed()

14:18:49.052 | INFO | Flow run 'enlightened-dingo' - Created task run 'data_cleaning-0' for task 'data_cleaning'

14:18:49.053 | INFO | Flow run 'enlightened-dingo' - Executing 'data_cleaning-0' immediately...

14:18:49.226 | INFO | Task run 'data_cleaning-0' - Finished in state Completed()

14:18:49.283 | INFO | Flow run 'enlightened-dingo' - Created task run 'convert_dtypes-0' for task 'convert_dtypes'

14:18:49.288 | INFO | Flow run 'enlightened-dingo' - Executing 'convert_dtypes-0' immediately...

14:18:49.441 | INFO | Task run 'convert_dtypes-0' - Finished in state Completed()

14:18:49.506 | INFO | Flow run 'enlightened-dingo' - Created task run 'data_analysis-0' for task 'data_analysis'

14:18:49.510 | INFO | Flow run 'enlightened-dingo' - Executing 'data_analysis-0' immediately...

14:18:49.684 | INFO | Task run 'data_analysis-0' - Finished in state Completed()

14:18:49.753 | INFO | Flow run 'enlightened-dingo' - Created task run 'data_visualization-0' for task 'data_visualization'

14:18:49.760 | INFO | Flow run 'enlightened-dingo' - Executing 'data_visualization-0' immediately...

14:18:50.087 | INFO | Task run 'data_visualization-0' - Finished in state Completed()

14:18:50.144 | INFO | Flow run 'enlightened-dingo' - Finished in state Completed()

最终,你将获得转换后的数据框和可视化结果。

部署 Prefect 管道

为了部署 Prefect 管道,我们需要首先将代码库移动到 Python 文件 data_pipe.py。之后,我们将修改运行管道的方式。我们将使用 .server 函数来部署管道,并将 CSV 文件作为参数传递给该函数。

data_pipe.py:

import pandas as pd

import matplotlib.pyplot as plt

from prefect import task, flow

@task

def load_data(path: str) -> pd.DataFrame:

return pd.read_csv(path)

@task

def data_cleaning(data: pd.DataFrame) -> pd.DataFrame:

data = data.drop_duplicates()

data = data.dropna()

data = data.reset_index(drop=True)

return data

@task

def convert_dtypes(data: pd.DataFrame, types_dict: dict = None) -> pd.DataFrame:

data = data.astype(dtype=types_dict)

data["Date"] = pd.to_datetime(data["Date"])

return data

@task

def data_analysis(data: pd.DataFrame) -> pd.DataFrame:

data["month"] = data["Date"].dt.month

new_df = data.groupby("month")["Units Sold"].mean()

return new_df

@task

def data_visualization(new_df: pd.DataFrame, vis_type: str = "bar") -> pd.DataFrame:

new_df.plot(kind=vis_type, figsize=(10, 5), title="Average Units Sold by Month")

plt.savefig("average_units_sold_by_month.png")

return new_df

@task

def save_to_csv(df: pd.DataFrame, filename: str):

df.to_csv(filename, index=False)

return filename

@flow(name="Data Pipeline")

def run_pipeline(path: str):

df = load_data(path)

df_cleaned = data_cleaning(df)

df_converted = convert_dtypes(

df_cleaned, {"Product Category": "str", "Product Name": "str"}

)

analysis_result = data_analysis(df_converted)

data_visualization(analysis_result, "line")

save_to_csv(analysis_result, "average_units_sold_by_month.csv")

# Run the flow

if __name__ == "__main__":

run_pipeline.serve(

name="pass-params-deployment",

parameters=dict(path="Online Sales Data.csv"),

)

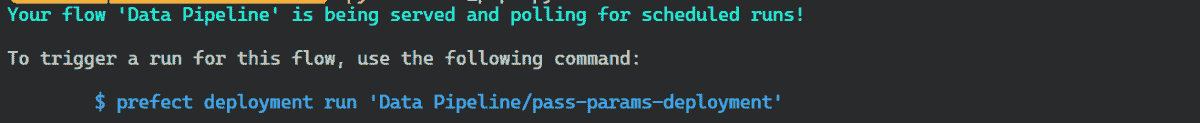

$ python data_pipe.py

当我们运行 Python 文件时,会收到一条消息,说明要运行已部署的管道,我们需要使用以下命令:

启动一个新的终端窗口并输入命令以触发此流的运行。

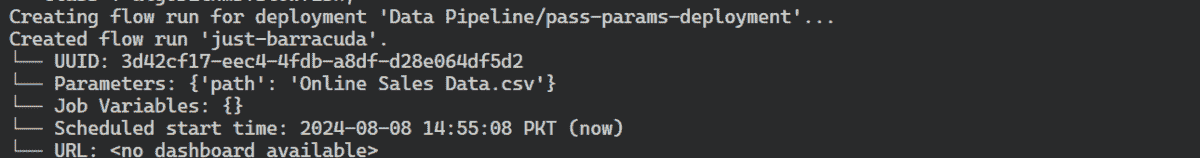

$ prefect deployment run 'Data Pipeline/pass-params-deployment'

正如我们所见,流运行已启动,这意味着管道在后台运行。我们始终可以回到第一个终端窗口以查看日志。

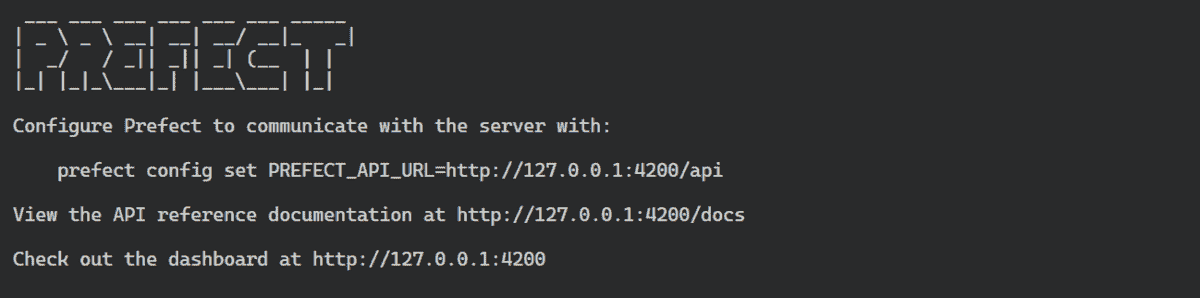

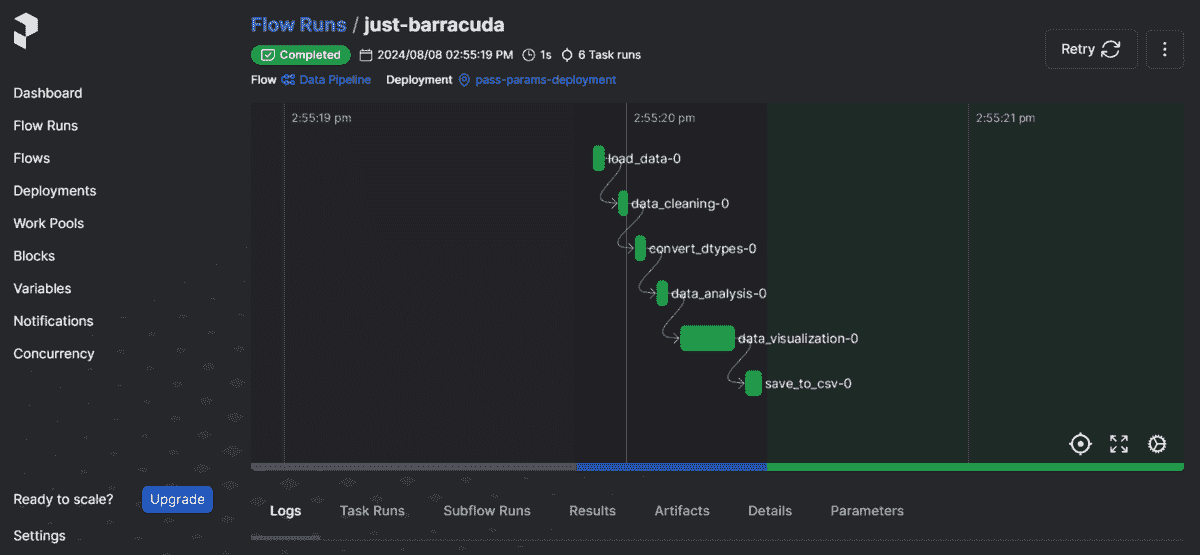

要在仪表板中查看日志,我们需要通过输入以下命令来启动 Prefect 仪表板:

$ prefect server start

点击仪表板链接以在您的网络浏览器中启动仪表板。

仪表板包含各种选项卡和与管道、工作流以及运行相关的信息。要查看当前运行,请导航到“流运行”选项卡并选择最新的流运行。

所有源代码、数据和信息都可以在 Kingabzpro/Data-Pipeline-with-Prefect GitHub 仓库中找到。请不要忘记 ⭐ 赞一下。

结论

使用适当的工具构建数据管道对于扩展数据工作流和避免不必要的故障是必要的。通过使用 Prefect,你可以调度运行、调试管道,并将其与多个你已经使用的第三方工具集成。它易于使用,并且具有许多你会喜欢的功能。如果你是 Prefect 的新手,我强烈推荐查看 Prefect Cloud。他们提供免费的小时数,让用户体验云平台并熟悉工作流管理系统。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作,并撰写关于机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是使用图神经网络构建一个 AI 产品,以帮助面临心理健康问题的学生。

更多相关内容

构建数据管道以创建大语言模型应用程序

原文:

www.kdnuggets.com/building-data-pipelines-to-create-apps-with-large-language-models

DALL-E 3 生成的图像

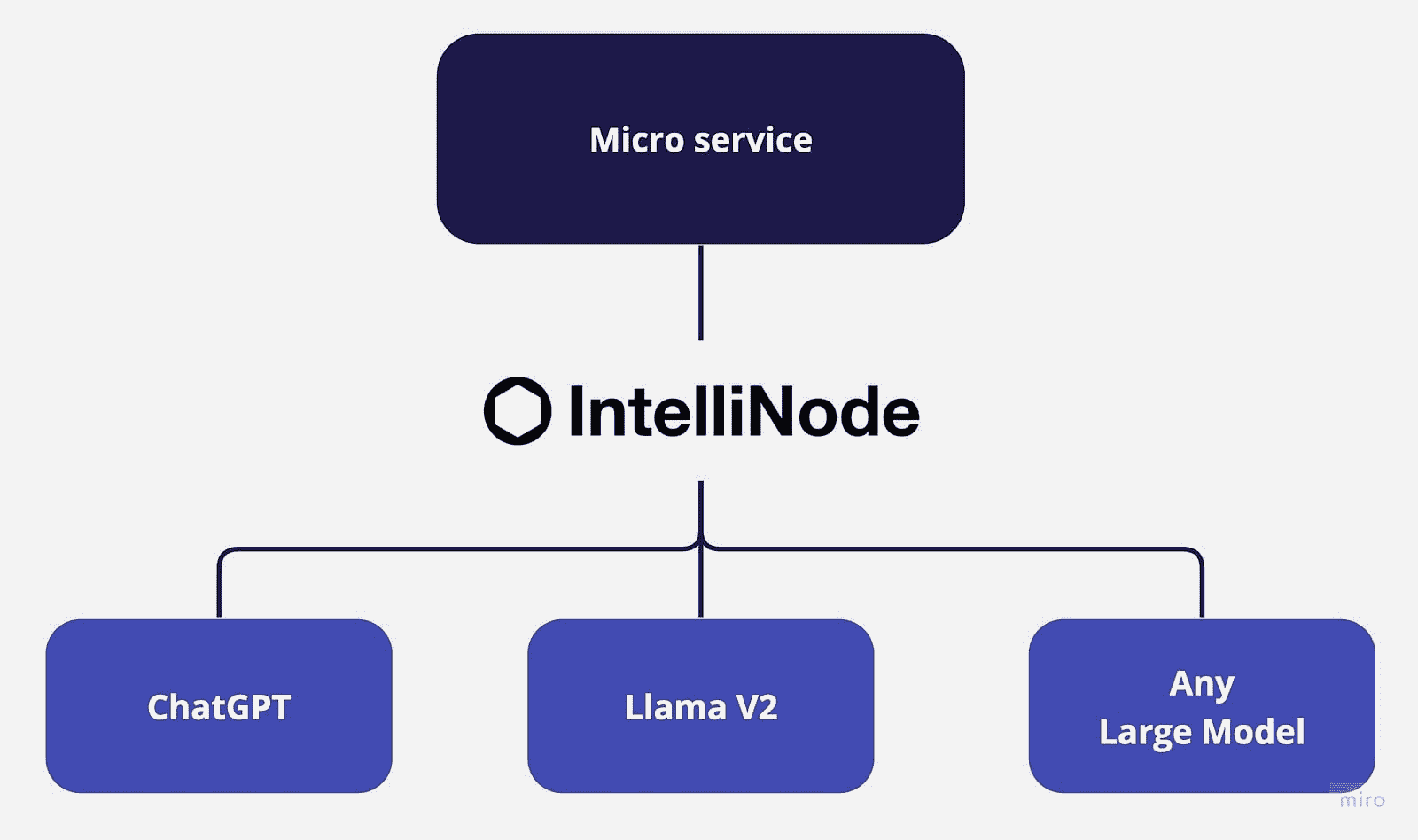

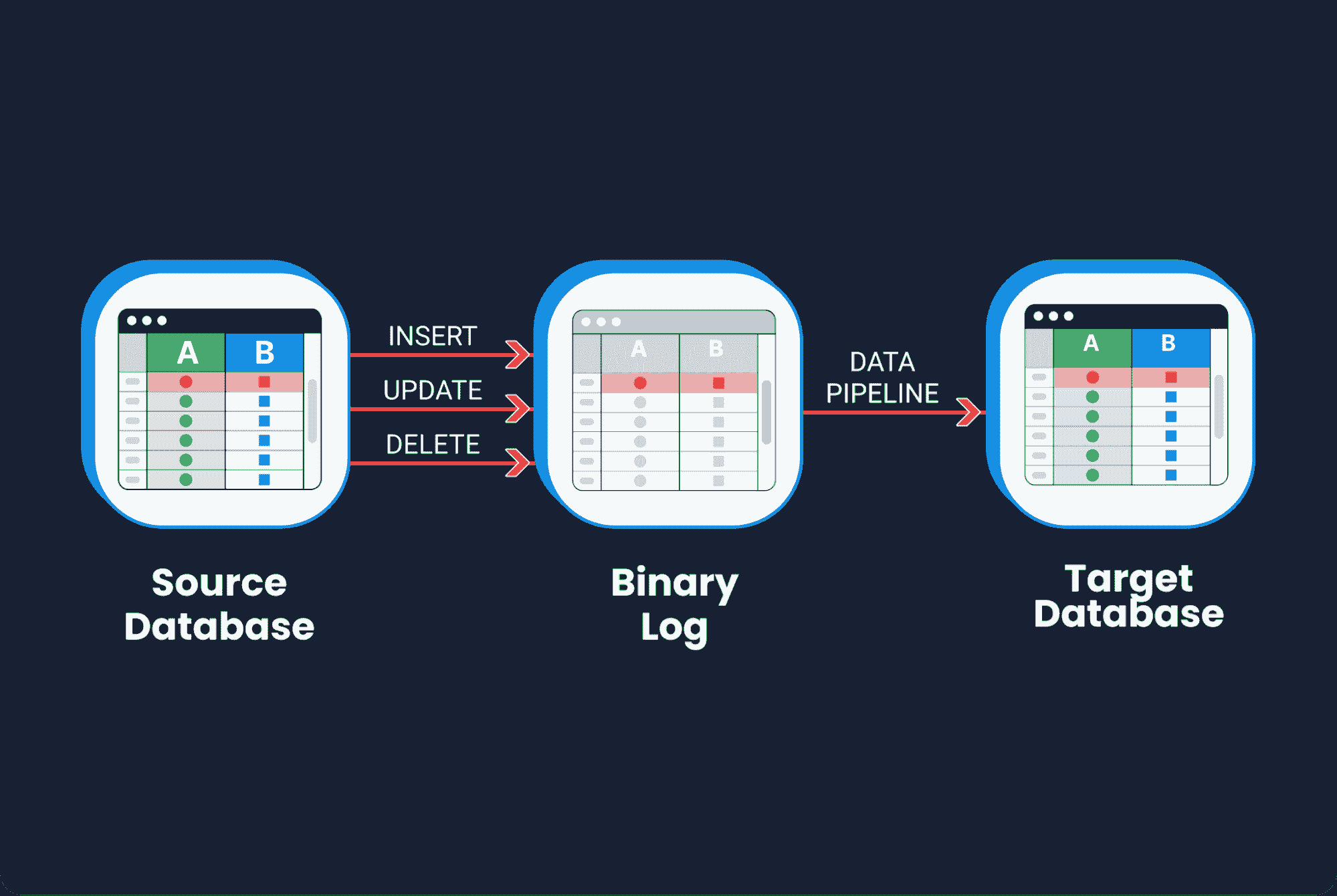

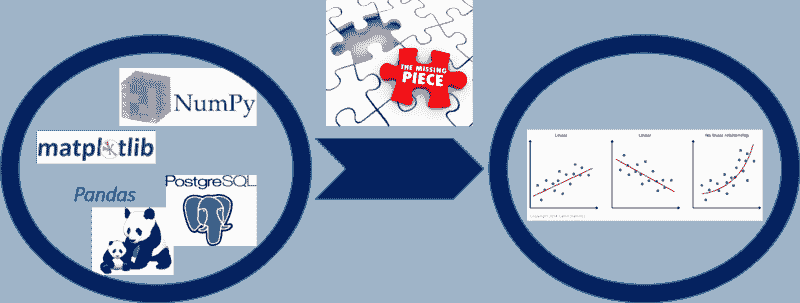

企业目前追求两种 LLM 驱动应用程序的方法——微调和检索增强生成(RAG)。从很高的层面来看,RAG 接受一个输入,并根据来源(例如,公司维基)检索一组相关/支持的文档。这些文档与原始输入提示一起被连接作为上下文,输入到 LLM 模型中,生成最终响应。RAG 似乎是将 LLM 推向市场的最受欢迎的方法,尤其是在实时处理场景中。支持这种方法的 LLM 架构大多数情况下包括构建有效的数据管道。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

在这篇文章中,我们将探讨 LLM 数据管道中的不同阶段,以帮助开发人员实施与其数据配合的生产级系统。跟随我们,了解如何导入、准备、丰富和提供数据,以驱动 GenAI 应用程序。

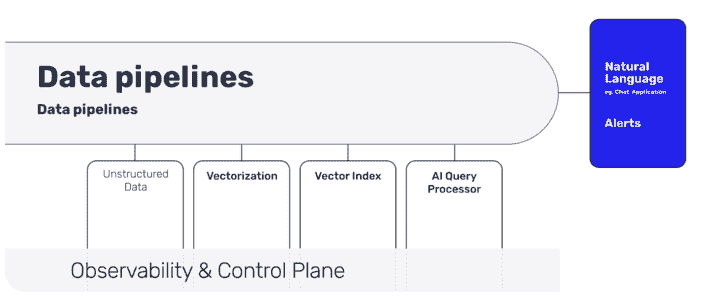

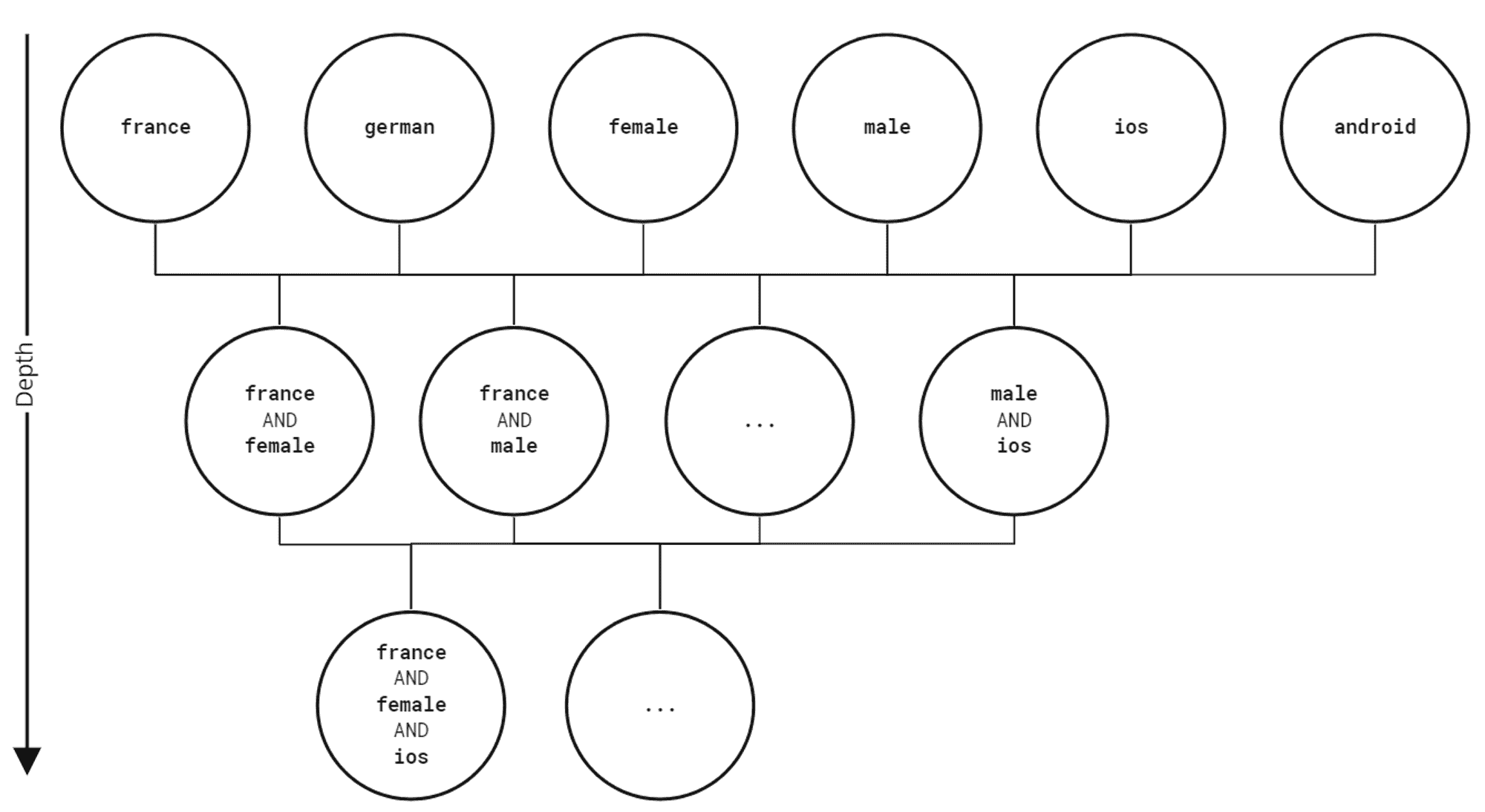

大语言模型(LLM)管道的不同阶段是什么?

这些是 LLM 管道的不同阶段:

非结构化数据的导入

向量化与丰富(包含元数据)

向量索引(实时同步)

AI 查询处理器

自然语言用户交互(通过聊天或 API)

非结构化数据的导入

第一步是收集正确的数据,以帮助实现业务目标。如果你正在构建面向消费者的聊天机器人,那么你必须特别注意将使用哪些数据。数据来源可以从公司门户(例如,Sharepoint、Confluent、文档存储)到内部 API。理想情况下,你希望从这些来源到索引有一个推送机制,以便你的 LLM 应用程序能够为最终用户提供最新的信息。

组织在提取文本数据以进行 LLM 上下文训练时,应实施数据治理政策和协议。组织可以通过审计文档数据来源,列出敏感级别、许可条款和来源来入手。识别需要修订或排除的数据。

这些数据源也应评估质量——多样性、大小、噪音水平、冗余。低质量数据集会稀释来自LLM 应用的响应。你甚至可能需要一个早期文档分类机制来帮助后续正确的存储。

即使在快速发展的 LLM 开发中,遵循数据治理的保护措施也能降低风险。前期建立治理框架可以减轻许多后续问题,并支持可扩展、稳健的文本数据提取用于上下文学习。

通过 Slack、Telegram 或 Discord API 拉取消息可以实时获取数据,这有助于 RAG,但原始对话数据中包含噪音——拼写错误、编码问题和奇怪的字符。实时过滤带有攻击性内容或敏感个人信息(可能是 PII)的消息是数据清理的重要部分。

带有元数据的向量化

元数据如作者、日期和对话上下文进一步丰富数据。将外部知识嵌入向量中有助于更智能和有针对性的检索。

一些与文档相关的元数据可能存在于门户或文档的元数据中,但如果文档附属于业务对象(例如案例、客户、员工信息),则需要从关系数据库中提取这些信息。如果有数据访问的安全问题,这是你可以添加安全元数据的地方,这也有助于后续检索阶段。

关键步骤是使用 LLM 的嵌入模型将文本和图像转换为向量表示。对于文档,你需要先进行分块,然后使用本地零样本嵌入模型进行编码。

向量索引

向量表示必须存储在某处。这就是使用向量数据库或向量索引高效存储和索引这些信息作为嵌入的地方。

这将成为你的“LLM 真实来源”,并且必须与数据源和文档保持同步。实时索引变得重要,如果你的 LLM 应用正在服务客户或生成与业务相关的信息。你要避免你的 LLM 应用与数据源不同步。

使用查询处理器进行快速检索

当你拥有数百万份企业文档时,根据用户查询获取正确内容变得具有挑战性。

这是管道早期阶段开始增加价值的地方:通过元数据添加清洗和数据丰富,最重要的是数据索引。这种上下文添加有助于增强提示工程。

用户互动

在传统的管道环境中,你将数据推送到数据仓库,分析工具将从仓库中提取报告。在 LLM 管道中,最终用户界面通常是一个聊天界面,它在最简单的层面上接受用户查询并回应查询。

摘要

这种新型管道的挑战不仅在于获取一个原型,还在于将其投入生产。这时,企业级监控解决方案来跟踪你的管道和向量存储变得非常重要。从结构化和非结构化数据源获取业务数据的能力成为一个重要的架构决策。LLMs 代表了自然语言处理的最前沿,构建企业级数据管道以支持 LLM 驱动的应用程序使你始终处于前沿。

这里可以访问一个可用的实时流处理框架。

Anup Surendran**** 是 Pathway 的产品营销负责人,专注于将 AI 产品推向市场。他曾与有两个成功退出(SAP 和 Kroll)的初创公司合作,并喜欢教授他人如何利用 AI 产品提高组织内的生产力。

更多相关主题

使用 Pandas 构建数据科学管道

原文:

www.kdnuggets.com/building-data-science-pipelines-using-pandas

使用 ChatGPT 生成的图像

Pandas 是最受欢迎的数据处理和分析工具之一,以其易用性和强大功能而著称。但您是否知道,您还可以使用它来创建和执行数据管道以处理和分析数据集?

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的捷径

1. Google 网络安全证书 - 快速进入网络安全职业的捷径

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持组织的 IT 工作

3. Google IT 支持专业证书 - 支持组织的 IT 工作

在本教程中,我们将学习如何使用 Pandas 的 pipe 方法来构建端到端的数据科学管道。该管道包括数据摄取、数据清理、数据分析和数据可视化等多个步骤。为了突出这种方法的优点,我们还将比较基于管道的代码与非管道替代方案,以便让您清晰了解其差异和优势。

什么是 Pandas 管道?

Pandas pipe 方法是一种强大的工具,允许用户以清晰且可读的方式链接多个数据处理函数。此方法可以处理位置参数和关键字参数,使其适用于各种自定义函数。

简而言之,Pandas pipe 方法:

-

增强代码可读性

-

实现函数链式调用

-

适应自定义函数

-

改善代码组织

-

高效处理复杂转换

这里是 pipe 函数的代码示例。我们将 clean 和 analysis Python 函数应用于 Pandas DataFrame。管道方法将首先清理数据,然后执行数据分析,最后返回结果。

(

df.pipe(clean)

.pipe(analysis)

)

Pandas 无管道代码

首先,我们将编写一段不使用管道的简单数据分析代码,以便在使用管道简化数据处理管道时进行清晰的比较。

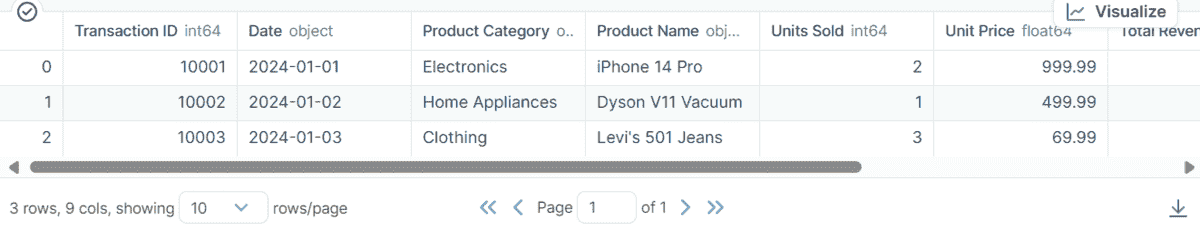

在本教程中,我们将使用来自 Kaggle 的 在线销售数据集 - 流行市场数据,该数据集包含不同产品类别的在线销售交易信息。

- 我们将加载 CSV 文件并显示数据集中的前三行。

import pandas as pd

df = pd.read_csv('/work/Online Sales Data.csv')

df.head(3)

-

通过删除重复项和缺失值来清理数据集,并重置索引。

-

转换列类型。我们将“产品类别”和“产品名称”转换为字符串类型,并将“日期”列转换为日期类型。

-

为了进行分析,我们将从“日期”列中创建一个“月份”列。然后,计算每个月销售单位的平均值。

-

可视化每月平均销售单位的柱状图。

# data cleaning

df = df.drop_duplicates()

df = df.dropna()

df = df.reset_index(drop=True)

# convert types

df['Product Category'] = df['Product Category'].astype('str')

df['Product Name'] = df['Product Name'].astype('str')

df['Date'] = pd.to_datetime(df['Date'])

# data analysis

df['month'] = df['Date'].dt.month

new_df = df.groupby('month')['Units Sold'].mean()

# data visualization

new_df.plot(kind='bar', figsize=(10, 5), title='Average Units Sold by Month');

这非常简单,如果你是数据科学家或数据科学学生,你将知道如何执行大多数这些任务。

使用 Pandas Pipe 构建数据科学管道

要创建一个端到端的数据科学管道,我们首先需要使用 Python 函数将上述代码转换为适当的格式。

我们将为以下内容创建 Python 函数:

-

加载数据: 这需要一个 CSV 文件的目录。

-

数据清理: 这需要原始 DataFrame 并返回清理后的 DataFrame。

-

转换列类型: 这需要一个干净的 DataFrame 和数据类型,并返回一个具有正确数据类型的 DataFrame。

-

数据分析: 这需要来自前一步的 DataFrame,并返回包含两列的修改后的 DataFrame。

-

数据可视化: 这需要一个经过修改的 DataFrame 和可视化类型来生成可视化图表。

def load_data(path):

return pd.read_csv(path)

def data_cleaning(data):

data = data.drop_duplicates()

data = data.dropna()

data = data.reset_index(drop=True)

return data

def convert_dtypes(data, types_dict=None):

data = data.astype(dtype=types_dict)

## convert the date column to datetime

data['Date'] = pd.to_datetime(data['Date'])

return data

def data_analysis(data):

data['month'] = data['Date'].dt.month

new_df = data.groupby('month')['Units Sold'].mean()

return new_df

def data_visualization(new_df,vis_type='bar'):

new_df.plot(kind=vis_type, figsize=(10, 5), title='Average Units Sold by Month')

return new_df

我们现在将使用 pipe 方法将所有上述 Python 函数串联在一起。如我们所见,我们已将文件路径提供给 load_data 函数,将数据类型提供给 convert_dtypes 函数,并将可视化类型提供给 data_visualization 函数。我们将使用可视化折线图,而不是柱状图。

构建数据管道使我们能够在不改变整体代码的情况下尝试不同的场景。你在标准化代码并使其更具可读性。

path = "/work/Online Sales Data.csv"

df = (pd.DataFrame()

.pipe(lambda x: load_data(path))

.pipe(data_cleaning)

.pipe(convert_dtypes,{'Product Category': 'str', 'Product Name': 'str'})

.pipe(data_analysis)

.pipe(data_visualization,'line')

)

最终结果看起来非常棒。

结论

在这个简短的教程中,我们了解了 Pandas pipe 方法以及如何使用它来构建和执行端到端的数据科学管道。这个管道使你的代码更加可读、可重复和更有组织。通过将 pipe 方法集成到你的工作流程中,你可以简化数据处理任务,提升项目的整体效率。此外,一些用户发现使用 pipe 而不是 .apply() 方法可以显著提高执行速度。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,喜欢构建机器学习模型。目前,他专注于内容创作和撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是使用图神经网络构建一个 AI 产品,帮助那些在精神健康方面挣扎的学生。

更多相关话题

建立数据科学作品集:机器学习项目第一部分

原文:

www.kdnuggets.com/2016/07/building-data-science-portfolio-machine-learning-project-part-1.html/2

选择角度

我们可以在 Fannie Mae 数据集上采取几种方向。我们可以:

-

尝试预测房屋止赎后的销售价格。

-

预测借款人的还款历史。

-

在贷款获取时确定每笔贷款的评分。

重要的是要坚持一个角度。试图同时关注太多事物会使项目难以有效实施。选择一个具有足够细微差别的角度也很重要。以下是一些没有太多细微差别的角度示例:

-

确定哪些银行向 Fannie Mae 出售的贷款被止赎的次数最多。

-

确定借款人信用评分的趋势。

-

探索哪些类型的房屋最常被止赎。

-

探索贷款金额与止赎销售价格之间的关系

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

上述所有角度都很有趣,如果我们专注于讲故事的话会很棒,但对于一个运营项目来说并不太合适。

使用 Fannie Mae 数据集,我们将尝试通过仅使用在贷款获取时可用的信息来预测贷款是否会在未来被止赎。实际上,我们将为任何抵押贷款创建一个“评分”,以告诉我们 Fannie Mae 是否应该购买它。这将为我们提供一个很好的基础,并成为一个很棒的作品集项目。

理解数据

我们快速查看一下原始数据文件。以下是 2012 年第 1 季度获取数据的前几行:

100000853384|R|OTHER|4.625|280000|360|02/2012|04/2012|31|31|1|23|801|N|C|SF|1|I|CA|945||FRM|

100003735682|R|SUNTRUST MORTGAGE INC.|3.99|466000|360|01/2012|03/2012|80|80|2|30|794|N|P|SF|1|P|MD|208||FRM|788

100006367485|C|PHH MORTGAGE CORPORATION|4|229000|360|02/2012|04/2012|67|67|2|36|802|N|R|SF|1|P|CA|959||FRM|794

以下是 2012 年第 1 季度性能数据的前几行:

100000853384|03/01/2012|OTHER|4.625||0|360|359|03/2042|41860|0|N||||||||||||||||

100000853384|04/01/2012||4.625||1|359|358|03/2042|41860|0|N||||||||||||||||

100000853384|05/01/2012||4.625||2|358|357|03/2042|41860|0|N||||||||||||||||

在开始编写代码之前,花些时间真正理解数据是非常有用的。这在运营项目中尤为关键——因为我们不能互动地探索数据,所以如果我们事先不发现某些细微之处,它们可能更难被察觉。在这种情况下,第一步是阅读 Fannie Mae 网站上的材料:

阅读这些文件后,我们知道一些关键事实,这些事实将帮助我们:

-

每个季度都有一个获取文件和一个绩效文件,从

2000年开始到现在。数据存在一年的滞后,所以截至本文编写时,最新的数据来自2015年。 -

文件采用文本格式,以管道符号 (

|) 作为分隔符。 -

文件没有标题,但我们有每列内容的列表。

-

所有文件加在一起包含

22百万笔贷款的数据。 -

因为绩效文件包含以前年份获取的贷款信息,所以早期年份获取的贷款将有更多的绩效数据(即

2014年获取的贷款不会有太多绩效历史)。

这些小的信息片段将为我们节省大量时间,因为我们在规划项目结构和处理数据时。

结构化项目

在我们开始下载和探索数据之前,重要的是要考虑我们将如何结构化项目。在构建端到端项目时,我们的主要目标是:

-

创建有效的解决方案

-

拥有一个快速运行且资源消耗最小的解决方案

-

使其他人能够轻松扩展我们的工作

-

让其他人更容易理解我们的代码

-

尽可能少写代码

为了实现这些目标,我们需要良好地结构化项目。结构良好的项目遵循几个原则:

-

将数据文件与代码文件分开。

-

将原始数据与生成的数据分开。

-

拥有一个

README.md文件,引导人们安装和使用项目。 -

拥有一个

requirements.txt文件,其中包含运行项目所需的所有包。 -

拥有一个

settings.py文件,其中包含在其他文件中使用的任何设置。- 例如,如果你在多个 Python 脚本中读取相同的文件,最好让它们都导入

settings并从集中位置获取文件名。

- 例如,如果你在多个 Python 脚本中读取相同的文件,最好让它们都导入

-

拥有一个

.gitignore文件,防止大文件或秘密文件被提交。 -

将任务的每一步拆分成可以单独执行的文件。

- 例如,我们可能有一个文件用于读取数据,一个用于创建特征,另一个用于进行预测。

-

存储中间值。例如,一个脚本可能会输出一个文件,供下一个脚本读取。

- 这使我们能够在不重新计算所有内容的情况下更改数据处理流程。

我们的文件结构很快将如下所示:

loan-prediction

├── data

├── processed

├── .gitignore

├── README.md

├── requirements.txt

├── settings.py

创建初始文件

首先,我们需要创建一个loan-prediction文件夹。在该文件夹内,我们需要创建一个data文件夹和一个processed文件夹。第一个文件夹用于存储我们的原始数据,第二个文件夹用于存储任何中间计算值。

接下来,我们将创建一个.gitignore文件。.gitignore文件将确保某些文件被 git 忽略,不会推送到 GitHub。一个很好的示例是 OSX 在每个文件夹中创建的.DS_Store文件。一个好的.gitignore文件起点可以在这里。我们还希望忽略数据文件,因为它们非常大,且 Fannie Mae 的条款阻止我们重新分发,因此我们应在文件末尾添加两行:

data

processed

这里是该项目的一个.gitignore文件示例。

接下来,我们需要创建README.md,这将帮助人们理解项目。.md 表示文件使用了 Markdown 格式。Markdown 允许你写纯文本,同时可以根据需要添加一些花哨的格式。这里是一个关于 Markdown 的指南。如果你将名为README.md的文件上传到 GitHub,GitHub 会自动处理 Markdown,并展示给查看该项目的任何人。这里是一个示例。

目前,我们只需在README.md中写一个简单的描述:

Loan Prediction

-----------------------

Predict whether or not loans acquired by Fannie Mae will go into foreclosure. Fannie Mae acquires loans from other lenders as a way of inducing them to lend more. Fannie Mae releases data on the loans it has acquired and their performance afterwards [here](http://www.fanniemae.com/portal/funding-the-market/data/loan-performance-data.html).

现在,我们可以创建一个requirements.txt文件。这将使其他人更容易安装我们的项目。我们还不完全知道将使用哪些库,但这是一个好的起点:

pandas

matplotlib

scikit-learn

numpy

ipython

scipy

上述库是 Python 中用于数据分析任务的最常用库,可以合理地假设我们将使用大多数这些库。这里是该项目的一个要求文件示例。

在创建requirements.txt之后,你应该安装这些包。对于这篇文章,我们将使用Python 3。如果你还没有安装 Python,你可以考虑使用Anaconda,这是一个 Python 安装器,它同时安装上述所有包。

最后,我们可以创建一个空的settings.py文件,因为我们还没有任何项目设置。

简历:Vik Paruchuri 是一位驻旧金山的数据科学家和开发者。他是 Dataquest 的创始人,你可以在舒适的浏览器中学习数据科学。

简历:Vik Paruchuri 是一位驻旧金山的数据科学家和开发者。他是 Dataquest 的创始人,你可以在舒适的浏览器中学习数据科学。

如果你喜欢这个,你可能也会喜欢阅读我们“构建数据科学作品集”系列中的其他文章:

原文。已获得许可转载。

相关:

-

实际学习数据科学的 5 个步骤

-

Python 中的统计数据分析

-

用 Python 矿工 Twitter 数据 第一部分:收集数据

更多相关内容

在 10 天内构建数据科学产品

原文:

www.kdnuggets.com/2018/07/building-data-science-product-10-days.html

评论

评论

由邓厚涛撰写,Instacart 的数据科学家。

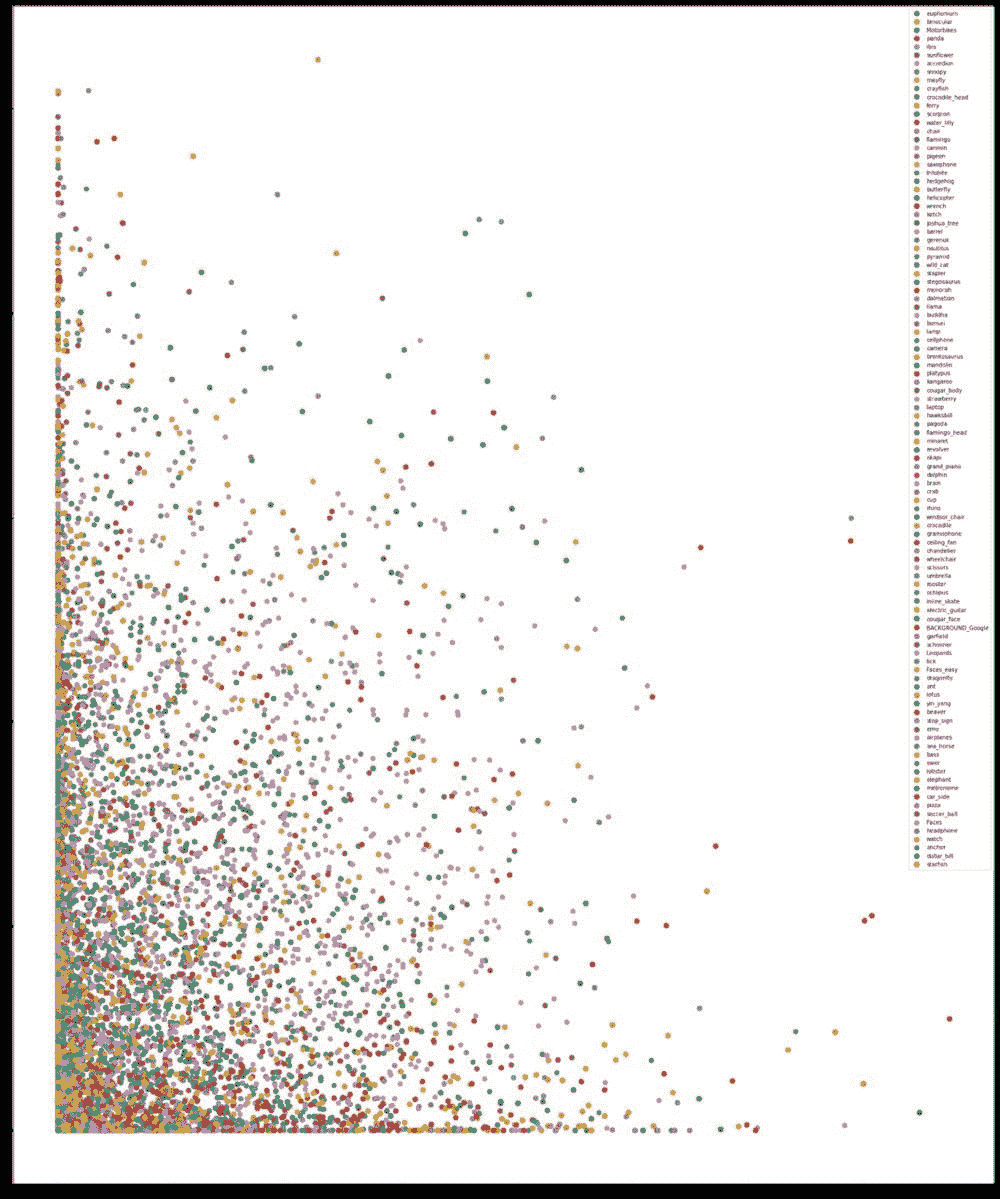

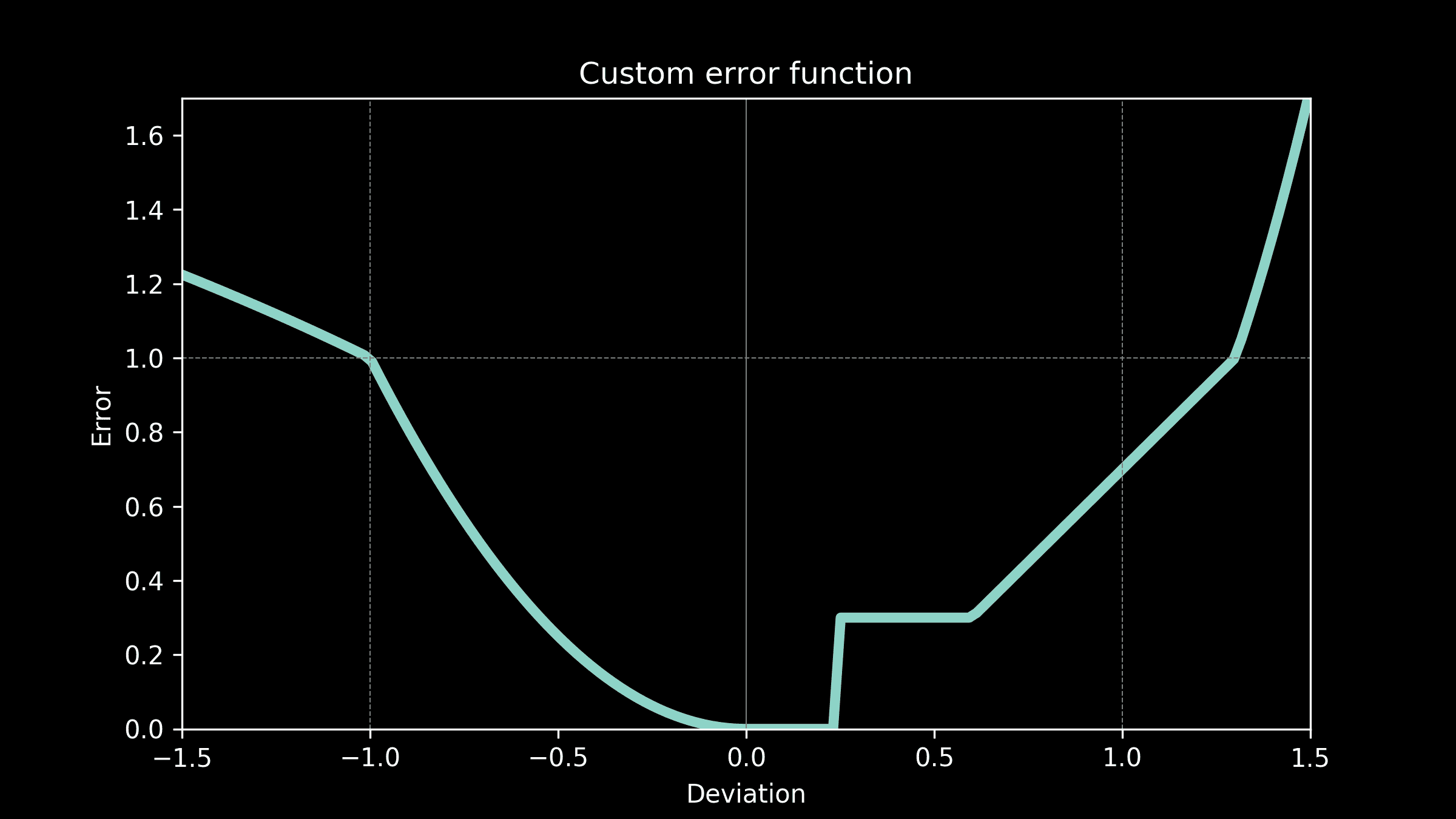

在初创公司,我们经常有机会从头开始创建产品。本文将分享如何快速构建有价值的数据科学产品,以我在 Instacart 的第一个项目为例。

我们的前三课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

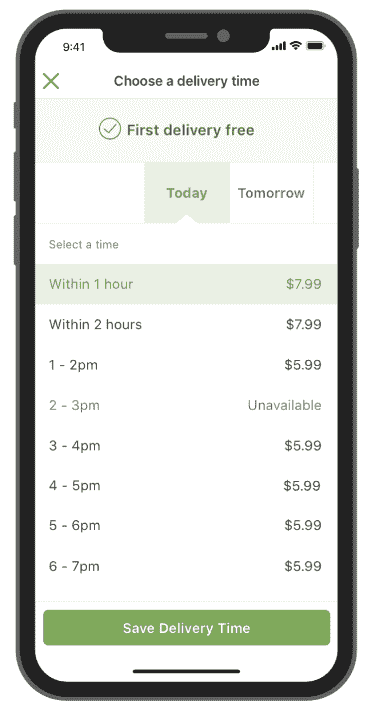

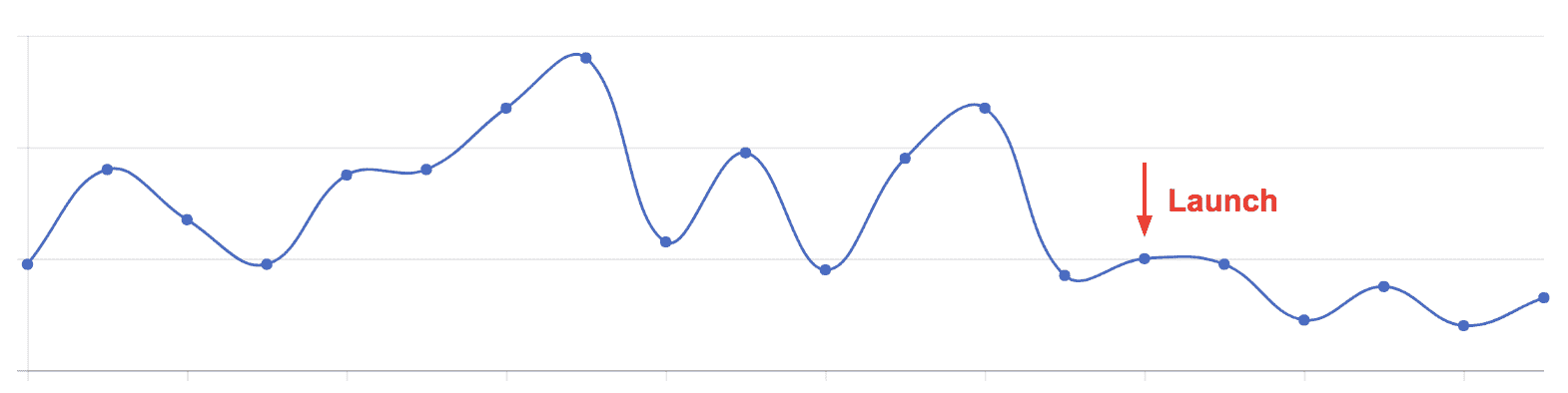

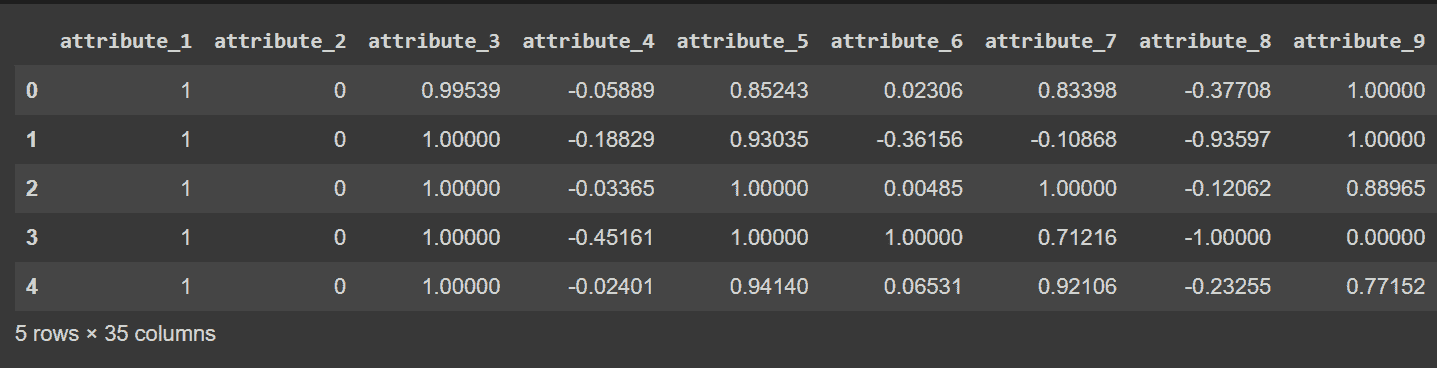

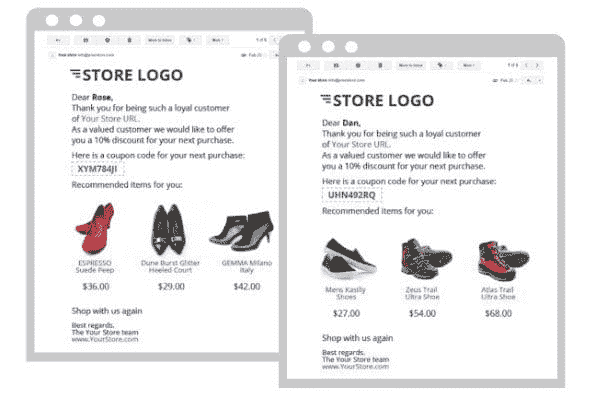

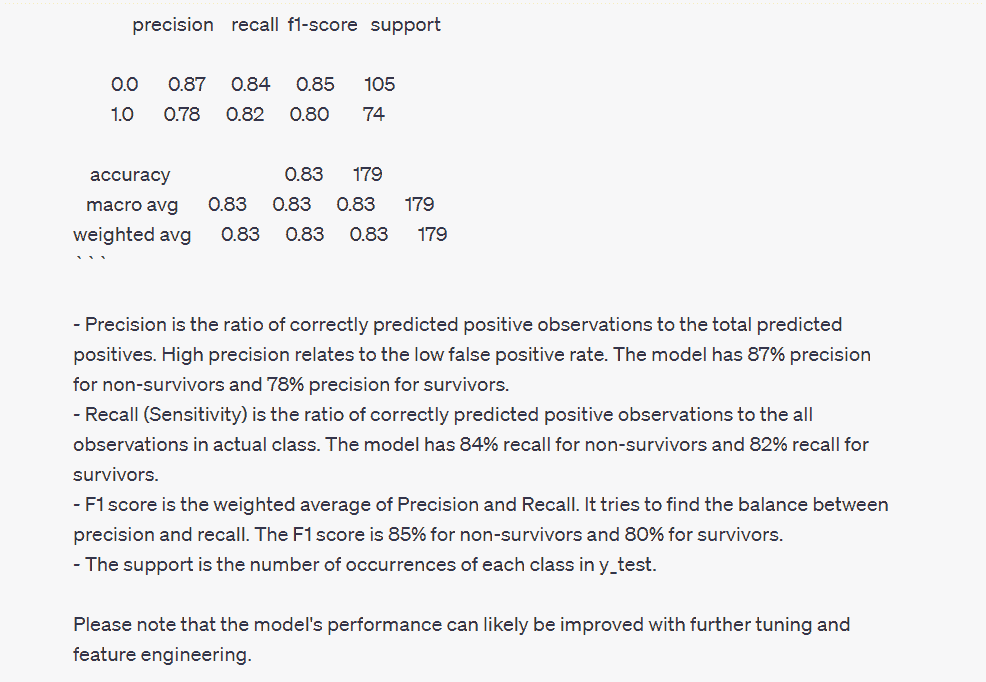

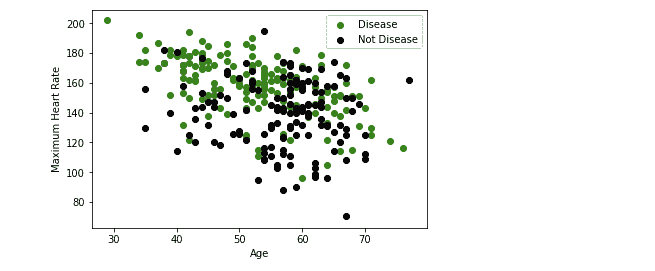

问题是这样的。在 Instacart 上将商品添加到购物车后,客户可以在结账时选择一个交付窗口(如图 1 所示)。然后,Instacart 的购物者会尽量在窗口内将杂货送到客户手中。在高峰期,我们的系统经常接受超过购物者处理能力的订单,有些订单会延迟交付。

我们决定利用数据科学来解决延迟问题。我们的想法是使用数据科学模型来估算每个窗口的交付能力,当订单数量达到其容量时,窗口将关闭。

这是我们如何在 10 天内构建一个 v1 产品的。

图 1。客户可以选择一个可用的交付窗口,以便将食品杂货送达。

第 1 天。规划

我们从规划开始,以便能够专注于正确的工作并快速开发解决方案。

-

首先,我们定义了衡量项目进展的指标。

-

其次,我们确定了一个可实现且影响较大的领域(低悬果实)。

-

第三,我们提出了一个可以快速实施的简单解决方案。

指标。每日报晚交付的百分比被用来衡量延迟情况。我们不希望过早关闭交付窗口,错失可以按时交付的订单。因此,每日交付数量被用作反向指标。(我们现在使用购物者利用率作为反向指标。)

低悬果实。数据显示,对于延迟交付较多的日子,大多数订单是在前一天下的。因此,我们决定专注于次日交付窗口(图 1中的“明天”窗口)。

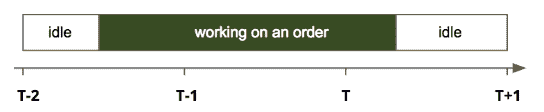

解决方案。为了在时间窗口T(T和T+1之间)内交付订单,顾客可能会在T之前开始处理订单。图 2 展示了顾客在窗口T-2开始处理订单,并在窗口T交付订单。由于大多数订单耗时不到两小时,因此交付窗口T的容量主要依赖于T、T-1和T-2时间窗口的顾客数量。

图 2。顾客在订单上花费时间的示意图。假设线性关系,交付窗口T的容量可以表示为

capacity(T) = a+b0#shoppers(T)+b1#shoppers(T-1)+b2#shoppers(T-2)*

还有其他因素(例如天气)也可能影响容量,但我们决定从简单开始。

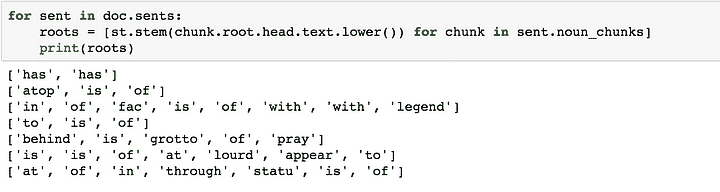

第 2–3 天。对模型的第一次迭代

我们遵循了典型的建模过程:特征工程、创建训练和测试数据,并比较不同的模型。然而,一旦我们认为模型足够准确,就没有再投入更多时间在模型上。首先,模型只是系统的一部分。其次,模型准确度的提高不一定会转化为指标的同等提升。

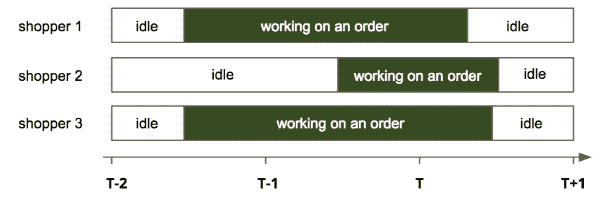

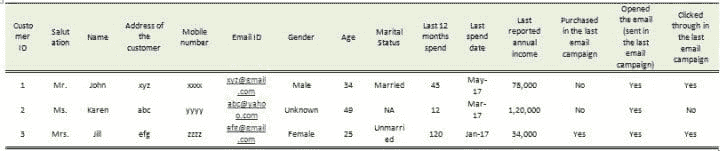

特征和数据。对于过去的每个交付窗口,我们有以下数据:在窗口内交付的订单,以及顾客在订单上花费的时间。图 3 展示了在时间窗口T(T和T+1之间)内交付的三笔订单,其中窗口T-2有 2 名顾客工作,而窗口T-1和T均有 3 名顾客工作。图 4 展示了从此示例创建的一行数据。

图 3。对于在时间窗口 T(T和T+1之间)内交付的三笔订单,窗口T-2有 2 名顾客工作,而窗口T-1和T均有 3 名顾客工作。

图 4。图 3 中示例创建的一行数据。

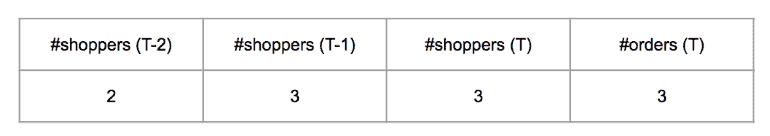

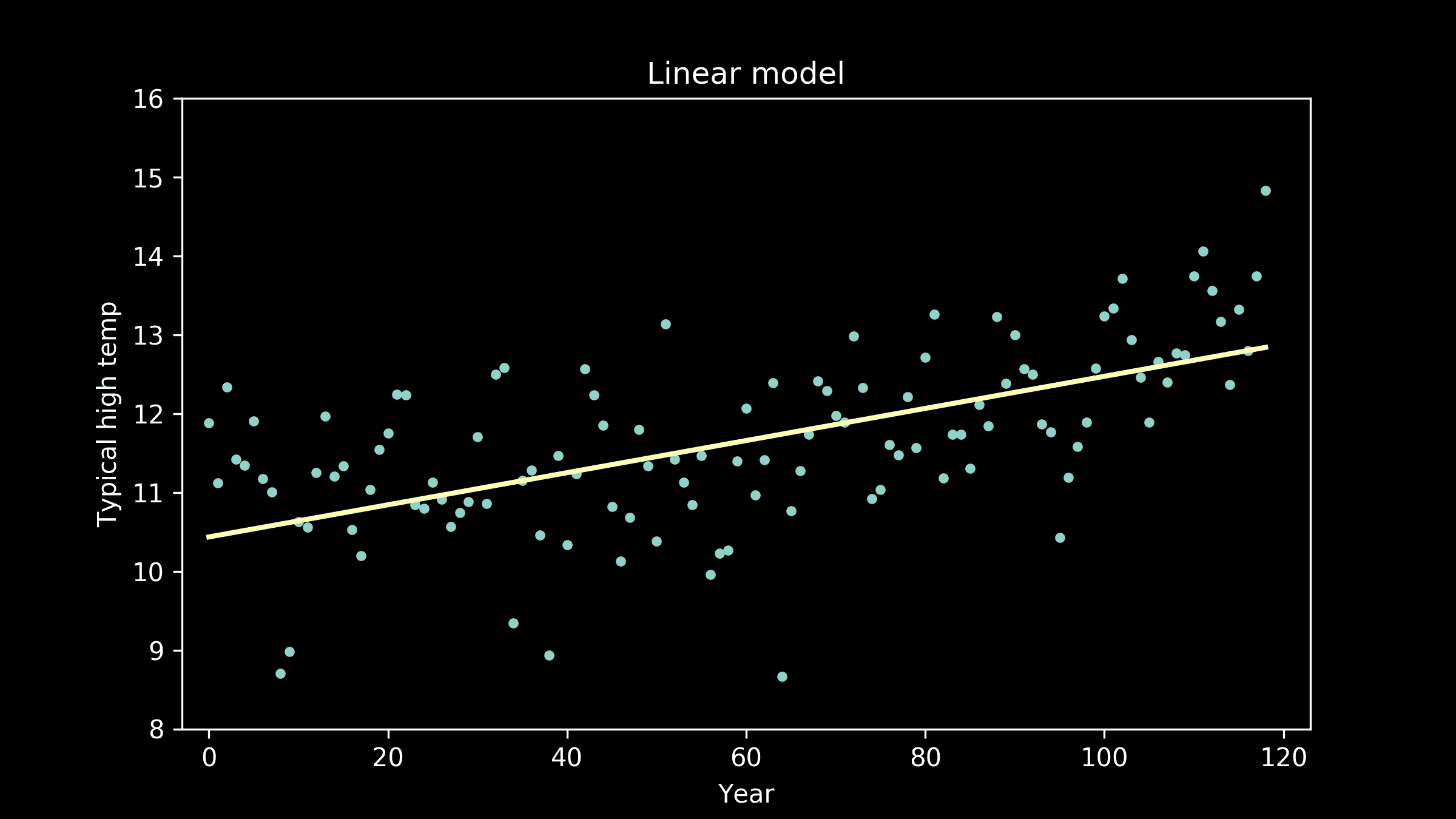

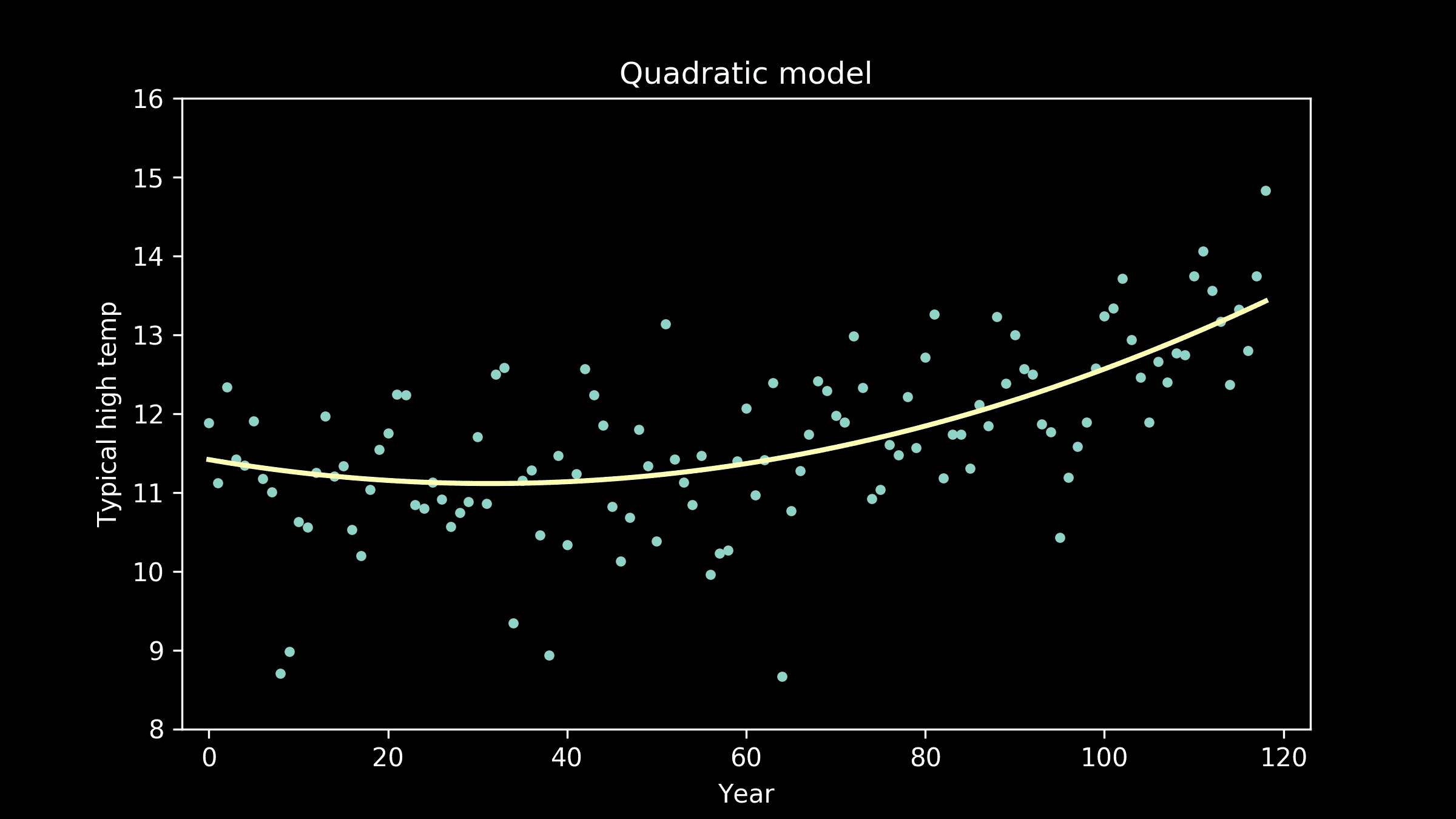

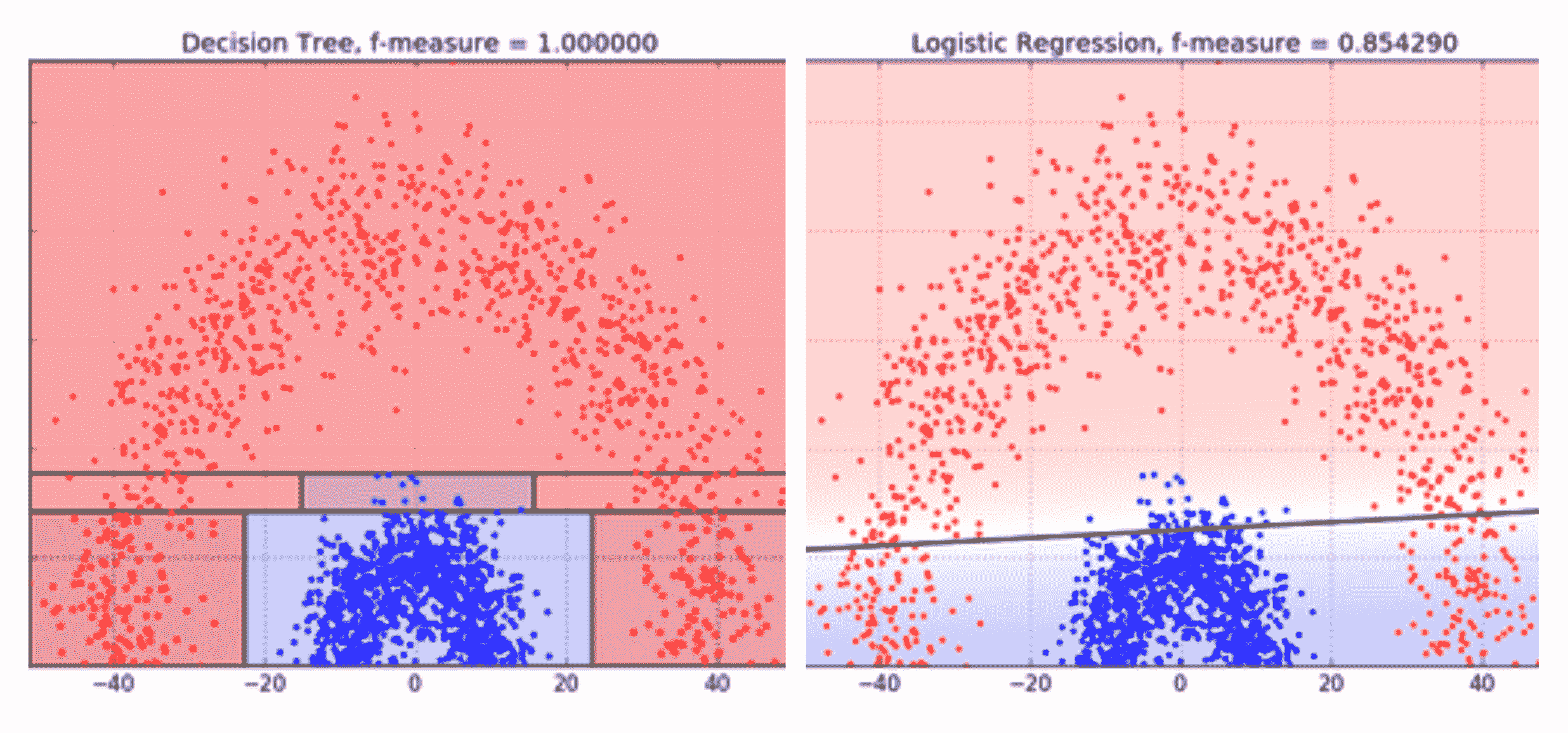

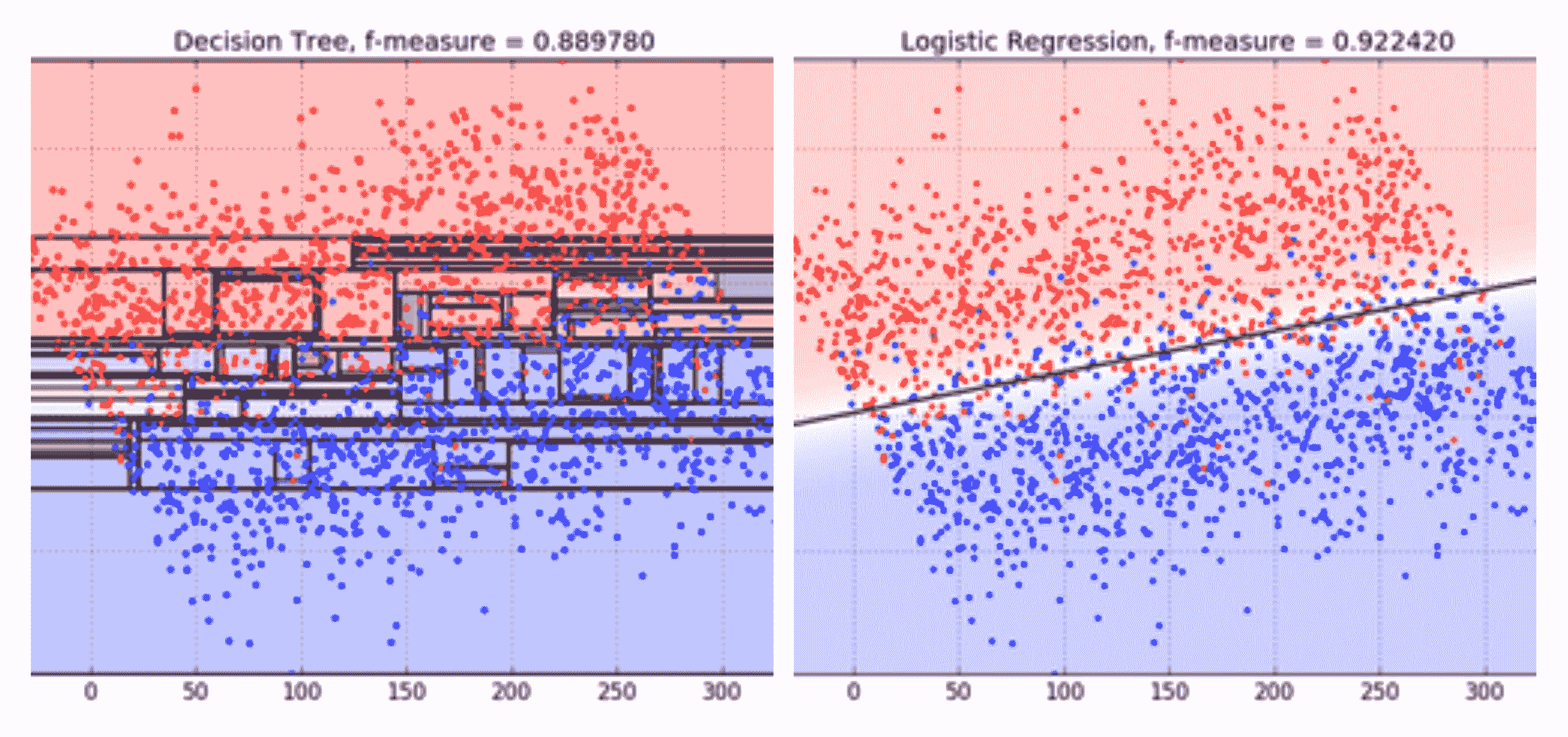

线性模型。以#orders(T)作为响应变量,其他变量作为预测因子,我们在训练数据集上建立了线性模型,并在验证数据集上进行了测试。模型的形式如下

#orders(T) = a+b0#shoppers(T)+b1#shoppers(T-1)+b2#shoppers(T-2)*

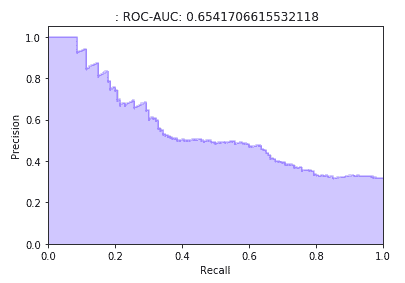

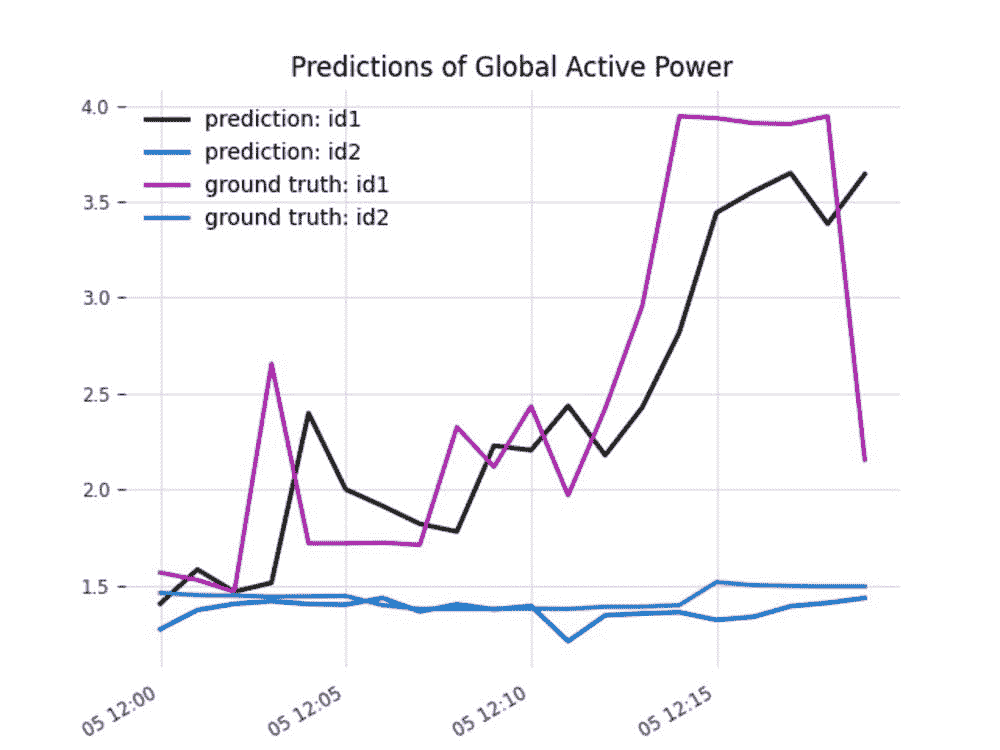

验证数据的预测值与实际值的比较见图 5(左)。每个预测值的实际值均值和 45 度线也被绘制出来。

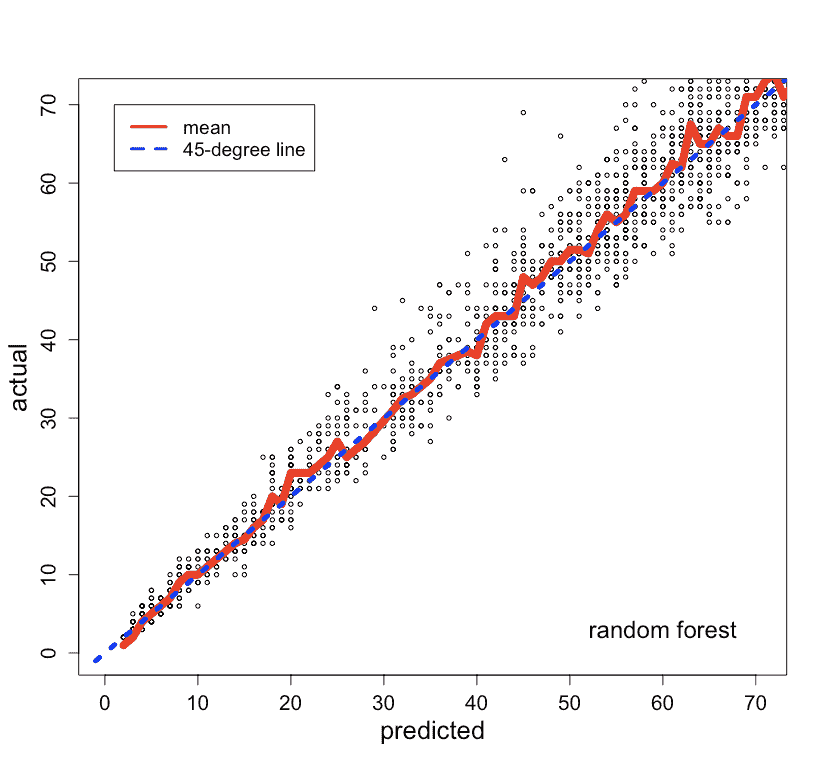

非线性模型。我们建立了一个随机森林模型进行比较。预测值与实际值的比较见图 5(右)。随机森林模型的表现并没有显著优于线性模型,因此我们决定使用更容易解释和实施的线性模型。

预测。使用线性模型,我们可以通过以下公式估算未来交付窗口T的容量

capacity(T) = a+b0#shoppers(T)+b1#shoppers(T-1)+b2#shoppers(T-2)*

注意,在这个公式中,#shoppers(t) 表示在未来时间窗口 t(t=T,T-1 或 T-2)安排的购物者数量。

图 5。线性模型(左)和随机森林模型(右)的预测与实际图。

第 4-5 天。端到端集成

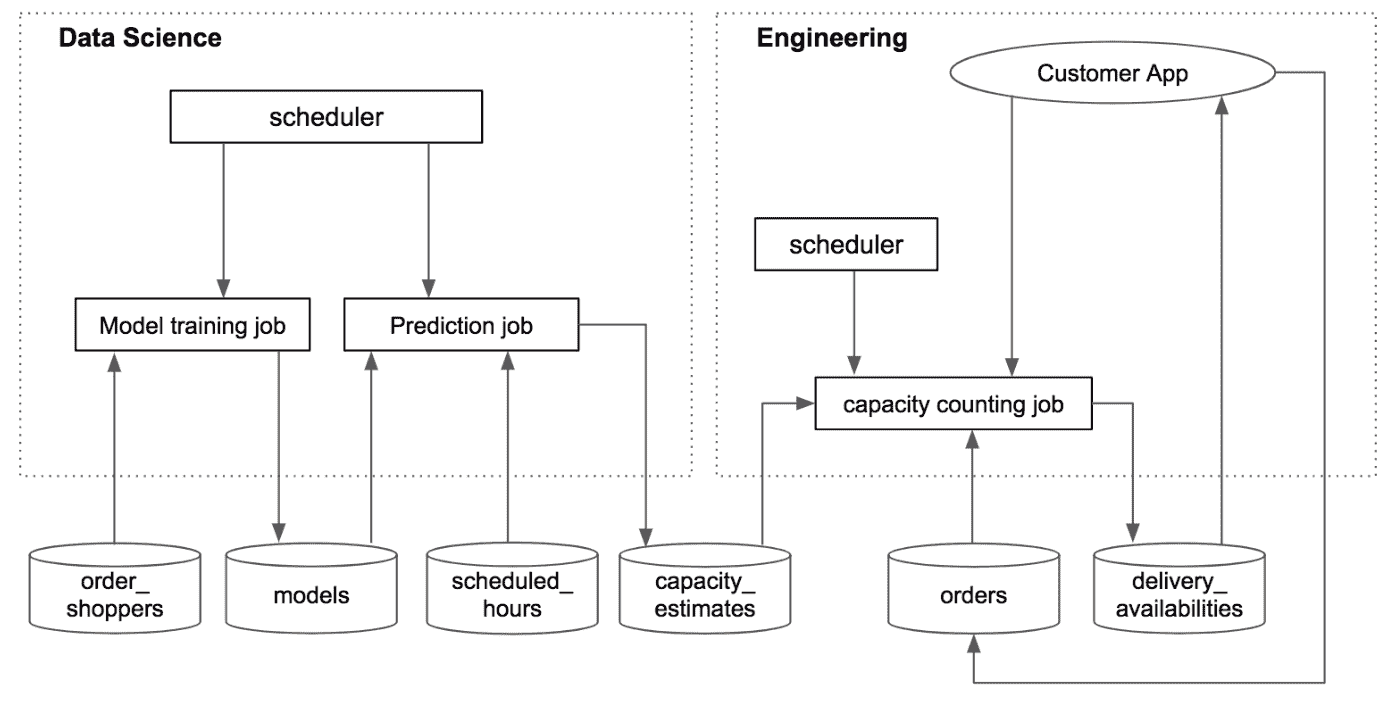

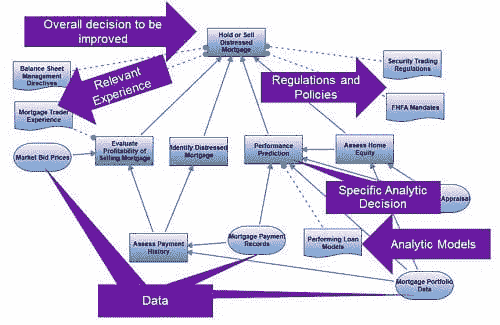

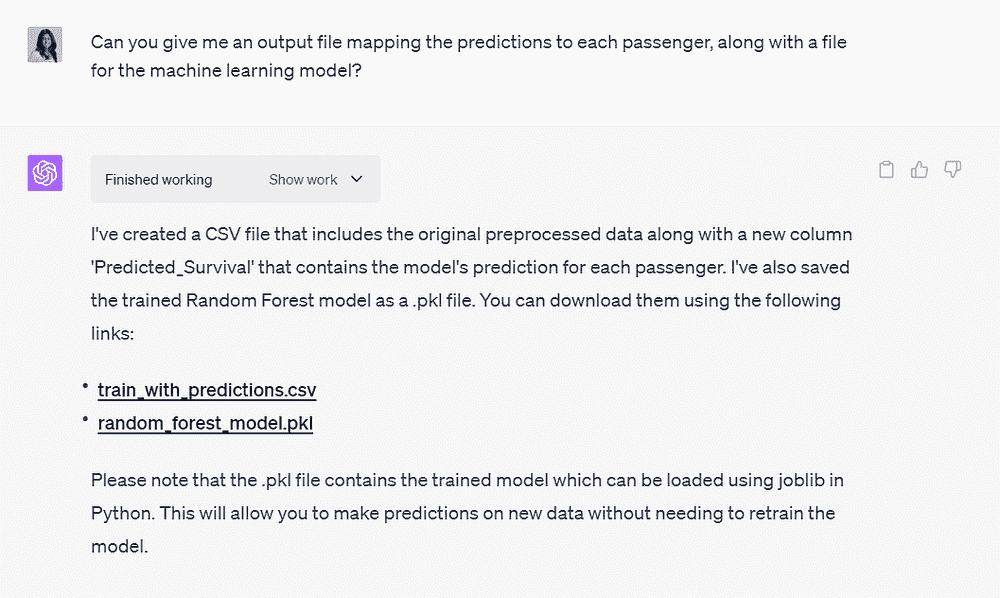

我们使用数据库作为数据科学与工程组件之间的接口。通过这种方式,可以减少数据科学和工程之间的依赖(与将数据科学模型嵌入工程代码中相比),并明确不同组件的所有权。图 6 展示了系统的工作原理。

数据科学组件。有两个数据科学任务,模型训练任务和预测任务,均由 cron(一个基于时间的调度器)在预定的频率下触发。模型训练任务每周运行一次,获取最新的 order_shoppers 数据(订单和购物者在订单上花费的时间),拟合模型并将其保存到数据库表(models)中。预测任务每晚运行一次,获取模型和 scheduled_hours(未来计划的购物者小时)数据,并估算未来交付窗口的容量。然后将这些估算保存到 capacity_estimates 表中。

工程组件。容量计数任务的创建是为了消耗容量估算,并提供每个窗口的交付可用性给客户应用。该任务计划每分钟运行一次,获取容量估算和现有订单,计算交付窗口是否可用,并将可用性信息保存到 delivery_availabilities 表中。此外,当客户下订单时,订单信息将保存到 orders 表中,并触发容量计数任务。

图 6。数据科学与工程组件的集成。

第 6-8 天。模型的第二次迭代

我们对容量估算进行了合理性检查,发现并修复了两个建模问题。

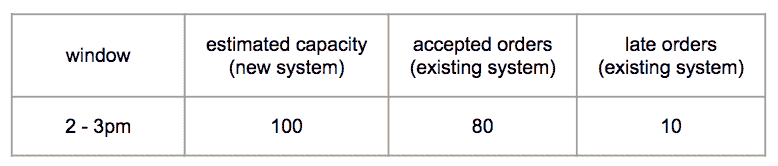

合理性检查。我们运行了生成未来交付窗口容量估算的预测任务。然后,在一个窗口变得过时时,我们将窗口的估算容量与现有系统实际接受的订单进行了比较。我们发现,在一些情况下,现有系统接受的订单少于估算容量,但有显著的延迟(如图 7 所示)。这表明这些情况下的容量被高估了。基于这一见解,我们发现了两个问题。

图 7。通过将容量估算与现有系统接受的订单进行比较来验证容量估算。

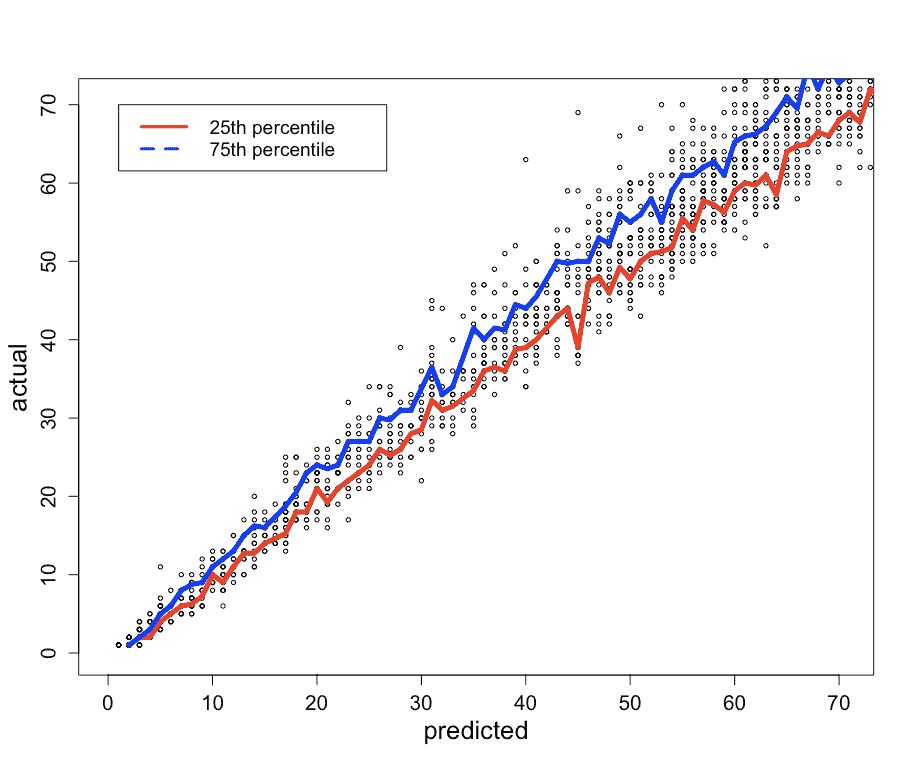

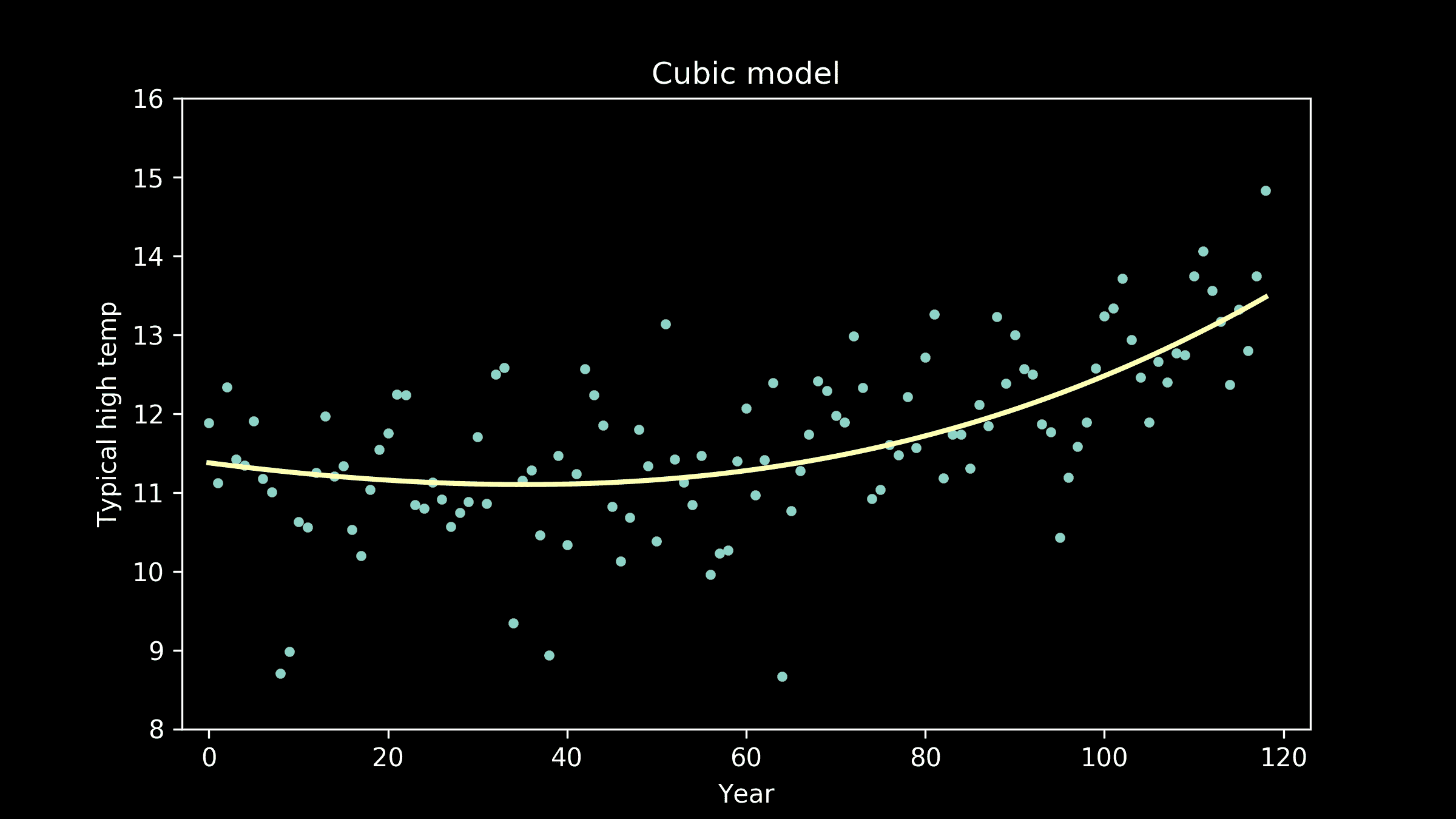

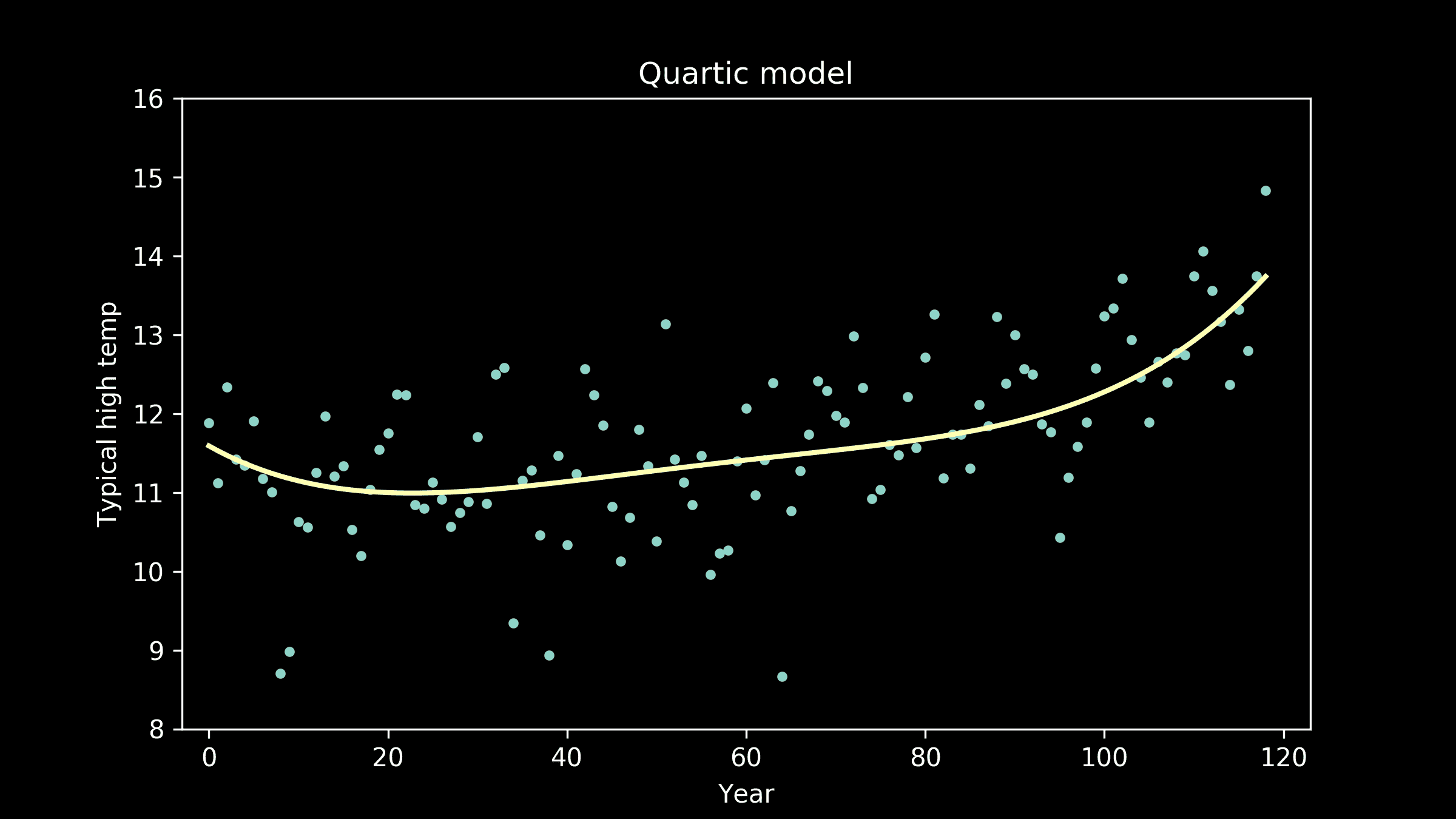

问题 1:均值预测。我们构建的模型预测的是均值。从图 5(左侧)可以看到,有些数据点低于均值线。这些数据点的均值预测会高估容量。为了解决这个问题,我们构建了预测区间,并使用了较低的百分位水平。图 8 显示了第 25 百分位和第 75 百分位水平。

问题 2:数据不一致。#shoppers用于预测的是未来时间段内计划中的顾客数量,并且顾客可以在时间段之前取消预约。然而,#shoppers用于模型训练的数据没有包含取消的时间。因此,预测和训练所用的数据不一致。为了解决这个问题,我们估算了取消率并将其纳入公式中。

capacity(T) = a+b0#shoppers(T)*****{1-cancelation_rate(T)}***+ …

图 8。每个预测值的实际值的第 25 百分位和第 75 百分位值。

第 9–10 天。调整

在将新系统推出给客户之前,我们进行了内部测试(未影响客户)并做出了相应调整。

百分位水平。我们调整了百分位水平,以通过上一节提到的合理性检查。

缓存。通过缓存(在服务器上存储经常使用的数据,以避免重复调用数据库),使任务变得更快。

启动

图 9 显示了产品发布时段每天的晚点交货百分比。新系统实现了大幅减少晚点交货的目标(而不减少交货数量)。这是一次迅速的成功。自首次推出以来,我们继续迭代,包括估算同日交货窗口的容量。

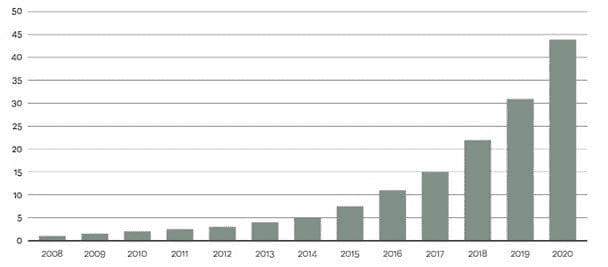

图 9。每天的晚点交货百分比。

收获

作为第一次加入初创公司的数据科学家,我在快速构建有价值的数据科学产品中学到了以下经验

-

确定有影响力且可实现的工作

-

减少工程和数据科学组件之间的依赖

-

专注于提高指标,而不一定是模型准确性

-

从简单开始并快速迭代

四年后,Instacart 现在是一家更大的公司,但这些经验仍然适用于我们进行的数据科学项目,以快速交付业务价值。

注:Andrew Kane 参与了工程组件的初版,Tahir Mobashir 和 Sherin Kurian 参与了后续版本的开发。

原文。经许可转载。

相关:

更多相关内容

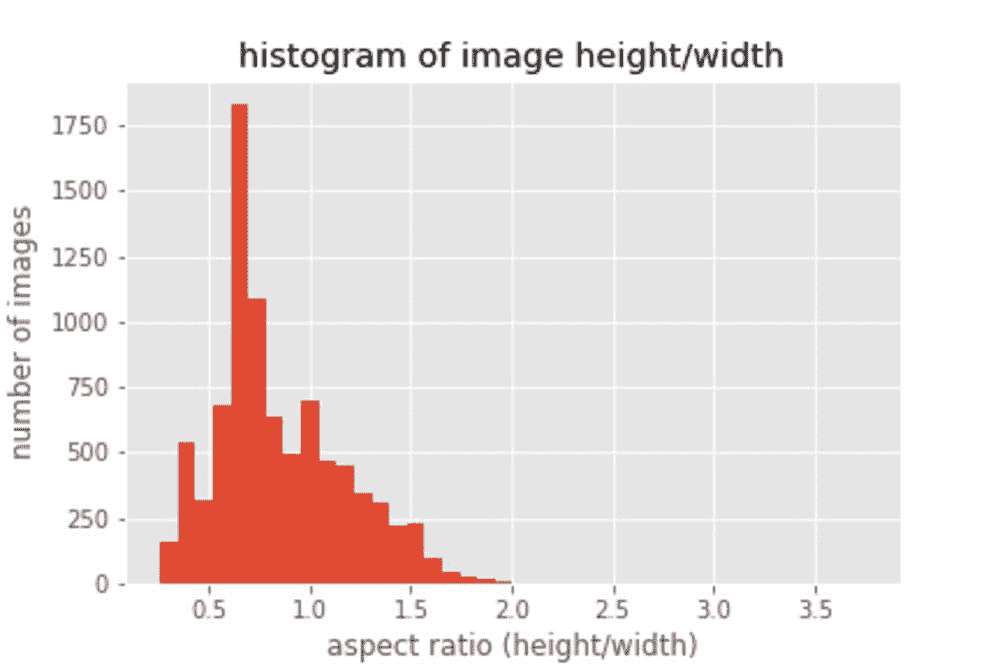

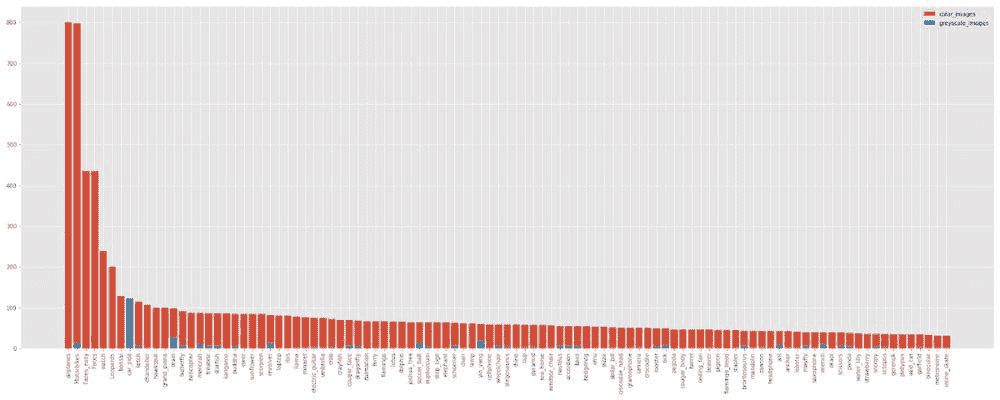

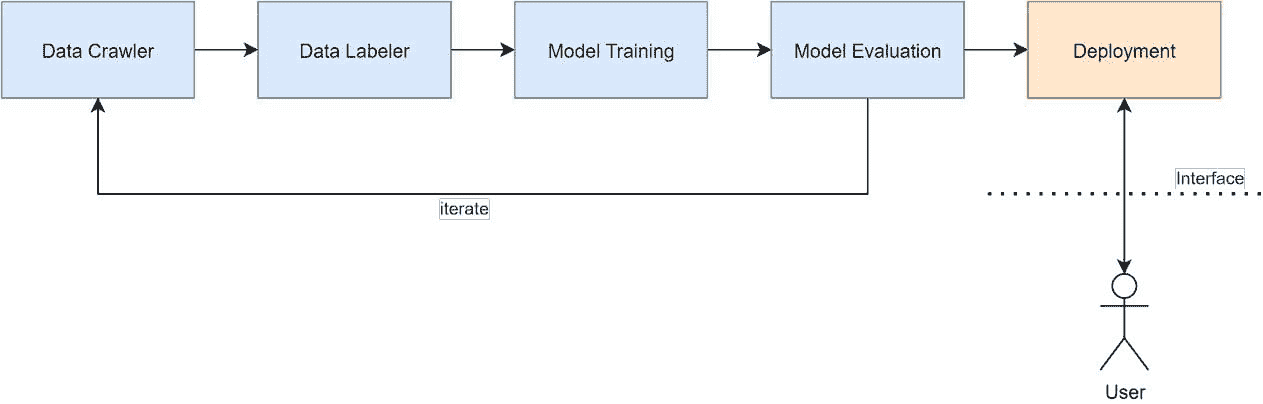

使用 fastai 构建深度学习项目——从模型训练到部署

原文:

www.kdnuggets.com/2020/11/building-deep-learning-projects-fastai-model-training-deployment.html

评论

由 Harshit Tyagi,顾问,网页与数据科学讲师

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

深度学习正在许多学科中引发革命性变化。随着 TensorFlow、PyTorch 和现在的fastai等库的出现,它也变得更加易于领域专家和 AI 爱好者使用。

fastai 的使命是民主化深度学习,这是一个致力于帮助从初学者到熟练的深度学习从业者,利用最新研究中的最先进模型和技术实现世界级成果的研究机构。

目标

本博客将带您了解如何使用fastai开发狗分类器的过程。目标是学习如何轻松入门深度学习模型,并能够在使用预训练模型的情况下,以有限的数据获得接近完美的结果。

先决条件

开始的唯一先决条件是知道如何使用 Python 编码,并且熟悉高中数学。

您将学到的内容

-

导入库并设置笔记本

-

使用 Microsoft Azure 收集图像数据

-

将下载的数据转换为 DataLoader 对象

-

数据增强

-

使用模型训练清理数据

-

导出训练好的模型

-

从您的 Jupyter Notebook 中构建应用程序

导入库并设置笔记本

在开始构建我们的模型之前,我们需要从这一组笔记本中导入所需的库和工具函数,这些笔记本是为了介绍使用 fastai 和 PyTorch 进行深度学习而开发的。

让我们安装 fastbook 包以设置笔记本:

!pip install -Uqq fastbook

import fastbook

fastbook.setup_book()

然后,让我们从 fastbook 包和 fastai 视觉小部件 API 中导入所有函数和类:

from fastbook import *

from fastai.vision.widgets import *

使用 Microsoft Azure 收集图像数据

对于大多数类型的项目,你可以在各种 数据存储库和网站 上找到数据。为了开发一个狗分类器,我们需要狗的图片,互联网上有很多狗的图片可供选择。

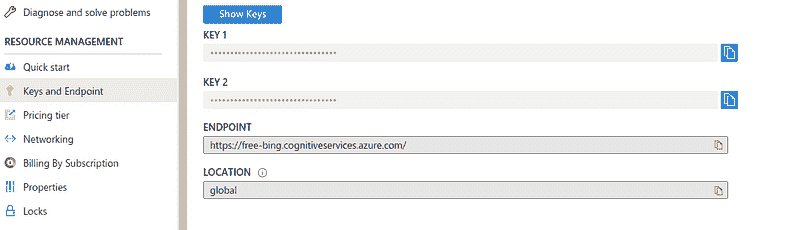

为了下载这些图片,我们将使用由 Microsoft Azure 提供的 Bing 图像搜索 API。因此,请在 Microsoft Azure 上注册一个免费帐户,你将获得价值 200 美元的积分。

进入你的门户,使用 这个快速入门 创建一个新的认知服务资源。启用 Bing 图像搜索 API,然后从左侧面板中的Keys and Endpoint选项中复制 密钥 到你的资源中。

使用检索到的密钥,将这些密钥设置到环境中,如下所示:

key = os.environ.get('AZURE_SEARCH_KEY', '<YOUR_KEY>')

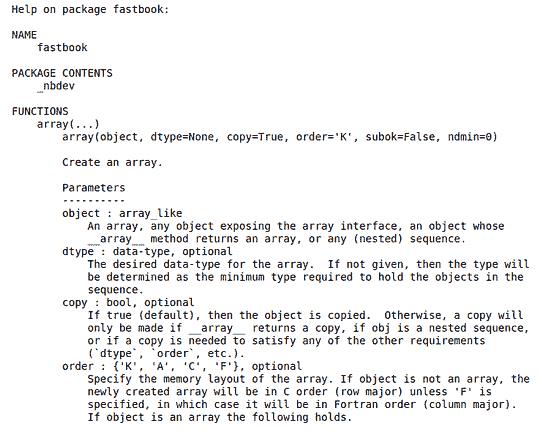

现在,fastbook 提供了几个实用函数,比如search_images_bing,它返回与你的搜索查询对应的 URL。我们可以使用 help 函数了解这些函数:

help(fastbook)

你可以在这个帮助指南中查看search_image_bing函数。该函数接受你上面定义的资源的密钥和搜索查询,我们可以使用attrgot方法访问搜索结果的 URL:

results = search_images_bing(key, 'german shepherd dogs')

images = results.attrgot('content_url')

len(images)

我们已经获得了 150 个德国牧羊犬图片的 URL:

现在,我们可以使用download_url函数下载这些图片。但首先让我们定义我们想要的狗的类型。在本教程中,我将处理三种类型的狗,德国牧羊犬、黑狗和拉布拉多。

现在,让我们定义一个狗的类型列表:

dog_types = ['german shepherd', 'black', 'labrador']

path = Path('dogs')

然后你需要定义你的图片将被下载到的路径以及每个狗类的文件夹的语义名称。

if not path.exists():

path.mkdir()

for t in dog_types:

dest = (path/t)

print(dest)

dest.mkdir(exist_ok=True)

results = search_images_bing(key, '{} dog'.format(t))

download_images(dest, urls=results.attrgot('content_url'))

这将创建一个“dogs”目录,其中包含每种类型狗图像的 3 个目录。

之后,我们将搜索查询(即 dog_type)和密钥传递给搜索函数,然后使用下载函数从搜索结果中下载所有 URL 到它们各自的目标(dest)目录中。

我们可以使用get_image_file函数检查下载到路径的图片:

files = get_image_files(path)

files

验证图像

你还可以检查文件中损坏文件/图像的数量:

corrupt = verify_images(files)

corrupt##output: (#0) []

你可以通过将unlink方法映射到损坏文件列表来删除所有损坏的文件(如果有的话):

corrupt.map(Path.unlink);

就这样,我们已经准备好 379 张狗的图片来训练和验证我们的模型。

将下载的数据转换为 DataLoader 对象

现在,我们需要一种机制来为我们的模型提供数据,fastai 提供了 DataLoaders 的概念,它存储传递给它的多个 DataLoader 对象,并将它们作为 training 和 validation 集提供。

现在,为了将下载的数据转换为 DataLoader 对象,我们需要提供四个内容:

-

我们正在处理什么类型的数据

-

如何获取项目列表

-

如何标记这些项目

-

如何创建验证集

现在,要创建这些 DataLoaders 对象以及上述信息,fastai 提供了一个灵活的系统,称为 数据块 API。我们可以使用参数和 API 提供的转换方法数组来指定 DataLoader 创建的所有细节:

dogs = DataBlock(

blocks=(ImageBlock, CategoryBlock),

get_items=get_image_files,

splitter=RandomSplitter(valid_pct=0.2, seed=41),

get_y=parent_label,

item_tfms=Resize(128)

)

在这里,我们有一些需要理解的参数:

-

blocks — 这指定了特征变量(图像)和目标变量(每个图像的类别)

-

get_items — 检索底层项目,在我们的例子中是图像,我们有一个

**get_image_files**函数,它返回该路径下所有图像的列表。 -

splitter — 根据提供的方法拆分数据;我们使用随机拆分,将 20% 的数据保留用于验证集,并指定种子以在每次运行时获得相同的拆分。

-

get_y — 目标变量称为 y;为了创建标签,我们使用

**parent_label**函数,该函数获取文件所在文件夹的名称作为其标签。 -

item_tfms — 我们有不同大小的图像,这会导致问题,因为我们总是将一批文件发送到模型,而不是单个文件;因此,我们需要通过将图像调整为标准大小然后将它们组合成张量来预处理这些图像,以便通过模型。我们在这里使用

**Resize**转换。

现在,我们有了 DataBlock 对象,它需要通过提供数据集的路径转换为 DataLoader:

dls = dogs.dataloaders(path)

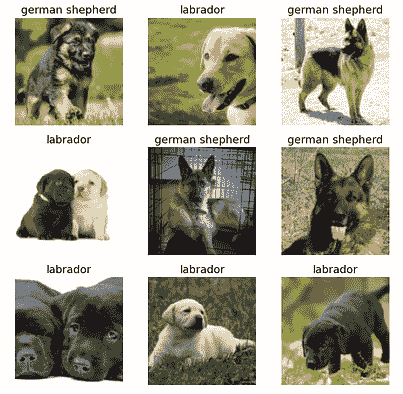

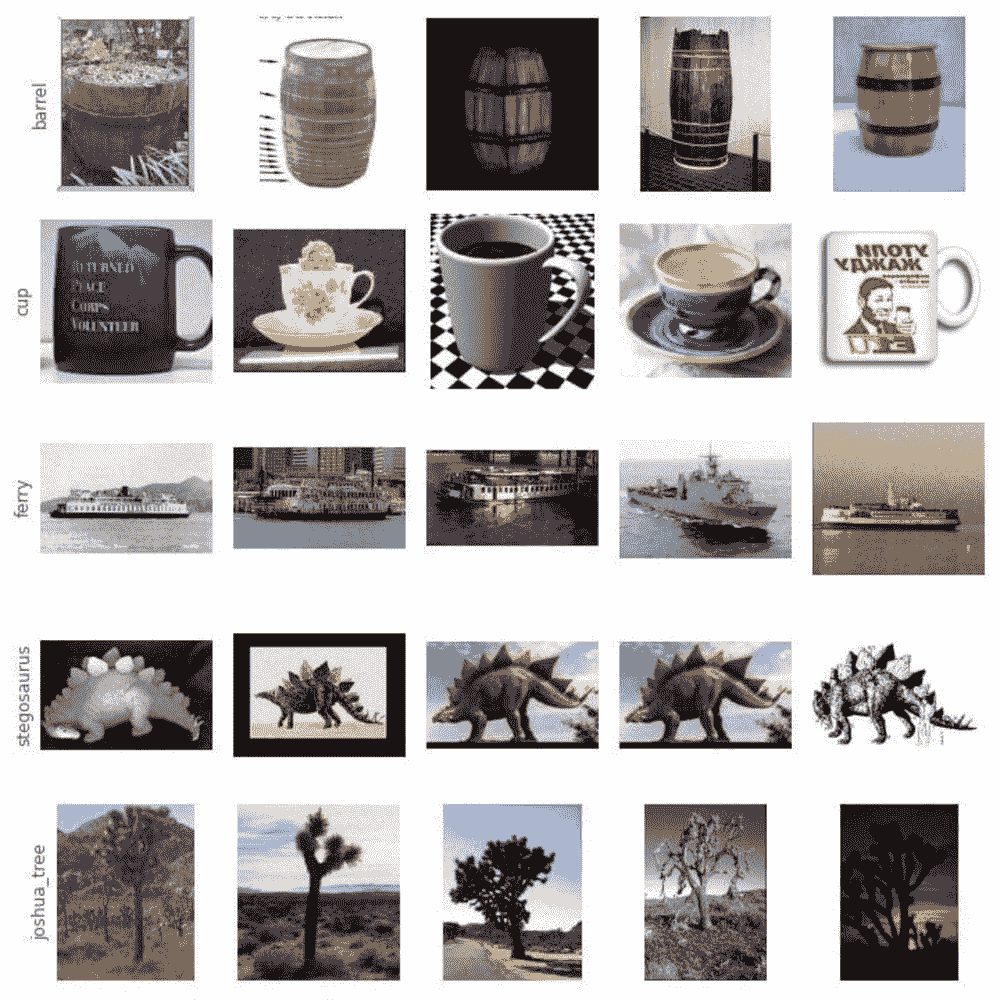

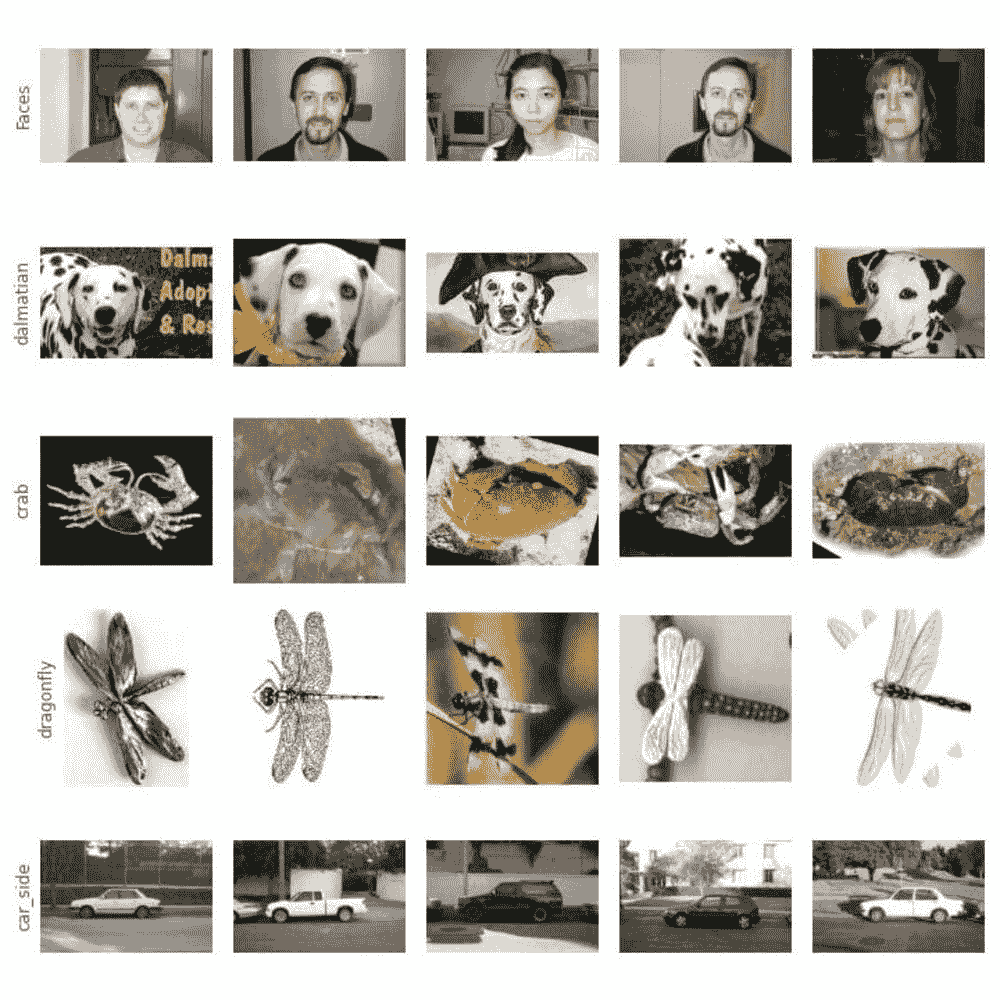

然后,我们可以使用 show_batch 方法检查 DataLoader 对象中的图像。

dls.valid.show_batch()

数据增强

我们可以对这些图像应用转换,以创建输入图像的随机变化,使其看起来不同但仍表示相同的事实。

我们可以旋转、扭曲、翻转或改变图像的亮度/对比度以创建这些变化。我们还有一个标准的增强集合,封装在 aug_transforms 函数中,对于大多数计算机视觉数据集效果很好。

现在,我们可以将这些转换应用于整个图像批次,因为所有图像现在都是相同的大小(224 像素,图像分类问题的标准),使用以下方法:

##adding item transformationsdogs = dogs.new(

item_tfms=RandomResizedCrop(224, min_scale=0.5),

batch_tfms=aug_transforms(mult=2)

)

dls = dogs.dataloaders(path)

dls.train.show_batch(max_n=8, nrows=2, unique=True)

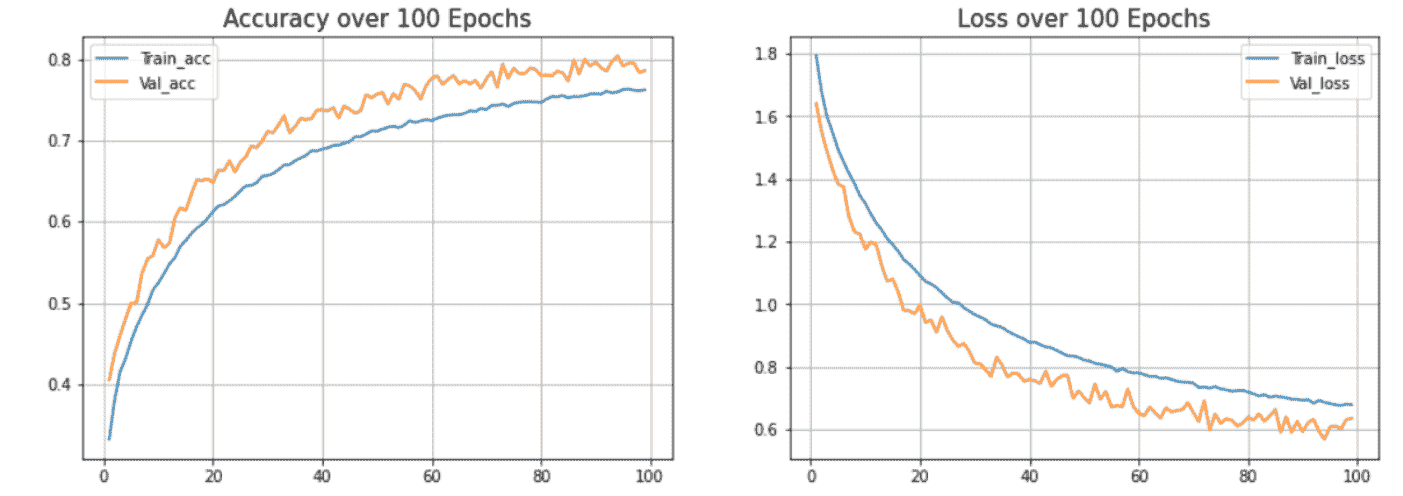

模型训练和数据清洗

是时候用这些有限数量的图像来训练模型了。 fastai 提供了许多架构,这使得使用迁移学习变得非常容易。我们可以使用适用于大多数应用程序/数据集的预训练模型创建卷积神经网络(CNN)模型。

我们将使用 ResNet 架构,它对许多数据集和问题都很快且准确。**resnet18** 中的 18 代表神经网络中的层数。我们还传递度量标准来测量模型预测的质量,使用数据加载器中的验证集。我们使用 error_rate 来表示模型预测错误的频率:

model = cnn_learner(dls, resnet18, metrics=error_rate)

model.fine_tune(4)

fine_tune 方法类似于其他机器学习库中的 fit() 方法。现在,为了训练模型,我们需要指定训练模型的轮数(epochs)。

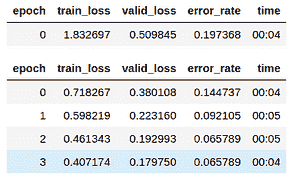

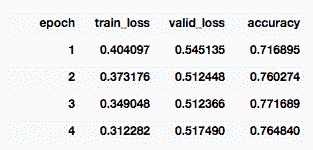

在这里,我们仅训练了 4 个周期:

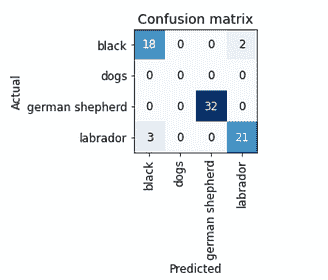

我们还可以使用混淆矩阵可视化预测结果,并将其与实际标签进行比较:

interp = ClassificationInterpretation.from_learner(learn)

interp.plot_confusion_matrix()

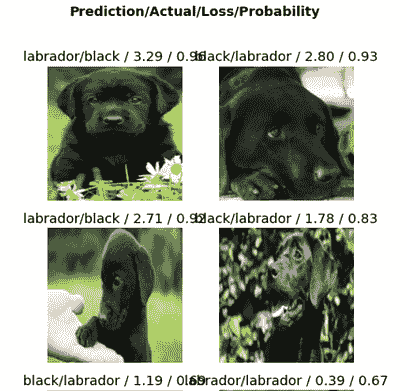

如你所见,我们只有五个错误预测。让我们查看损失最大的图像,即数据集中损失最高的图像:

interp.plot_top_losses(6, nrows=3)

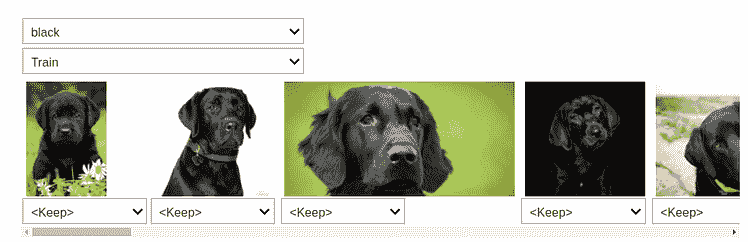

你可以看到,模型在黑色和拉布拉多之间混淆了。因此,我们可以使用 ImageClassifierCleaner 类将这些图像指定为特定类别。

将模型传递给该类,它将打开一个具有直观 GUI 的数据清理小部件。我们可以更改训练集和验证集图像的标签,并查看损失最高的图像。

将每张图像添加到其正确的类别后,我们必须使用以下方法将它们移动到正确的目录中:

for idx,cat in cleaner.change():

shutil.move(str(cleaner.fns[idx]), str(path/cat).split('.')[0] +"_fixed.jpg")

导出训练好的模型

经过几轮超参数调整后,一旦你对模型满意,就需要保存它,以便我们可以将其部署到服务器上,用于生产环境。

在保存模型时,我们需要保存模型架构和对我们有价值的训练参数。 fastai 提供了 export() 方法,将模型保存为扩展名为 .pkl 的 pickle 文件。

model.export()

path = Path()

path.ls(file_exts='.pkl')

然后我们可以加载模型,并通过将图像传递给加载的模型来进行推断:

model_inf = load_learner(path/'export.pkl')

使用此加载的模型进行推断:

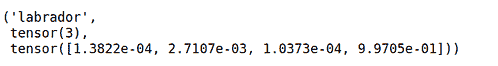

model_inf.predict('dogs/labrador/00000000.jpg')

我们可以检查模型数据加载器词汇表中的标签:

model_inf.dls.vocab

从 Jupyter Notebook 构建应用程序

下一步是创建一个可以与朋友、同事、招聘人员等分享的应用程序。要创建应用程序,我们需要添加互动元素,以便我们可以尝试和测试应用程序的功能,并且需要将其作为网页发布到网上,这包括通过像 Flask 这样的框架进行部署或直接使用 Voila。

你可以简单地使用 Voila 将这个 Jupyter Notebook 转换为一个独立的应用程序。我没有在这里涵盖它,但你可以查看我的博客/视频,其中详细介绍了这个过程。

使用 Python 和 Voila 构建 COVID-19 分析仪表板

从你的 jupyter notebook 创建一个具有互动可视化和灵活性的仪表板。

部署

我在我的帖子中介绍了部署 ML 模型:

端到端 ML 项目教程系列的第二部分

但如果你想要另一种简单且免费的 Voila 应用程序部署方式,你可以使用 Binder。按照这些步骤在 Binder 上部署应用程序:

-

将你的笔记本添加到 GitHub 仓库。

-

将那个仓库的 URL 插入到 Binder 的 URL 字段中。

-

将文件下拉菜单更改为选择 URL。

-

在 “URL to open” 字段中,输入

/voila/render/<*name>*.ipynb -

点击右下角的剪贴板按钮以复制 URL 并将其粘贴到安全的地方。

-

点击启动。

就这样,你的狗分类器上线了!

如果你想观看我执行所有这些步骤的视频版本,这里有博客的视频:

Harshit 的数据科学

通过这个频道,我计划推出几个 涵盖整个数据科学领域的系列。以下是你应该订阅 频道 的原因:

-

这些系列将涵盖每个主题和子主题所需/要求的所有高质量教程,例如 数据科学基础的 Python。

-

项目和说明 以实施迄今为止学习的主题。了解新的认证、训练营和资源,以通过诸如Google 的 TensorFlow 开发者证书考试之类的认证。

简介:Harshit Tyagi 是一位顾问及网页与数据科学讲师。

原文。已获授权转载。

相关:

-

与《深度学习编程》同行 10 天

-

在 AWS 上使用 Docker Swarm、Traefik 和 Keycloak 部署安全可扩展的 Streamlit 应用

-

扩展机器学习模型的 5 个挑战

更多相关主题

关于构建有效的数据科学团队

原文:

www.kdnuggets.com/2019/03/building-effective-data-science-teams.html

评论

评论

由 Saurav Dhungana 创始人 @craftdatalabs。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

随着数据科学和 AI 进入几乎所有行业,构建能够成功实施 AI 项目的团队的挑战也随之而来。对那种完美融合了统计学家、程序员和沟通者的“数据科学家”的需求从未如此之高。但随着尘埃落定,我们开始听到关于 失败项目和 失望专业人士的故事。

你可能听说过一些高价组建的专家团队一次次失败。作为一名在多个行业工作的数据科学顾问,我有机会亲眼见证了这种趋势。许多人倾向于认为数据科学是一个新兴领域,并预期它在成为主流的过程中会有成长的阵痛,但我们忘记了这个领域的起源。这是我通过自己的经历反思成功数据团队的特质,并帮助商业领袖和高管制定更好的 AI 策略的尝试。

不要忘记你的根基

首先,我们需要将数据科学视为现有学科的自然演变,而不是全新领域。毕竟,在计算机时代开始之前,我们就已经在处理数据,而 AI 的概念至少从 1960 年代就存在。其他学科如数据库中的知识发现、决策支持系统、商业智能、数据挖掘、分析、预测分析等已经存在很长时间。它们的主要目标是从数据中提取有意义的模式,并利用这些模式获得洞察力并为未来做出决策。

数据科学是这种趋势的最新体现,这一趋势得益于互联网时代可用数据量和种类的急剧增加。它还受到相对便宜的计算能力和机器学习算法的新突破的推动,这些突破能够利用这些丰富的数据。这些新算法的复杂性和数学精细程度进一步产生了对能够理解它们的高级学位人员的突然需求,因此人工智能竞赛开始了。

尽管这项技术看起来很新颖,但我坚信我们可以从神话和较早学科中遵循的最佳实践中学到很多。

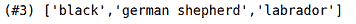

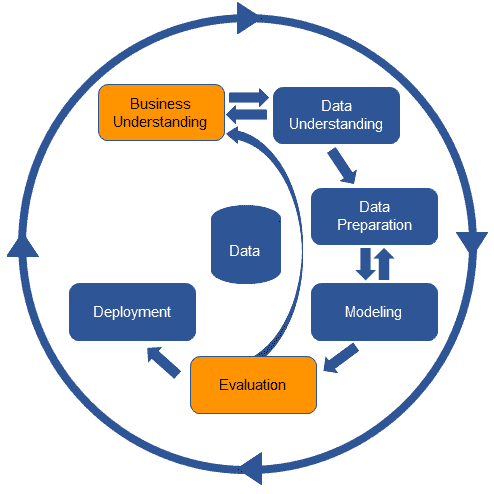

CRISP-DM

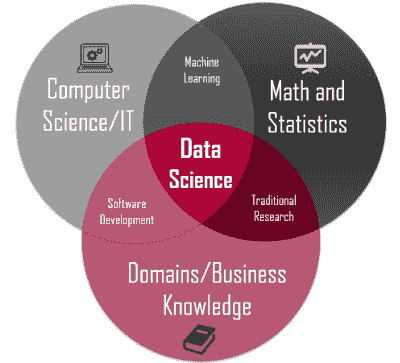

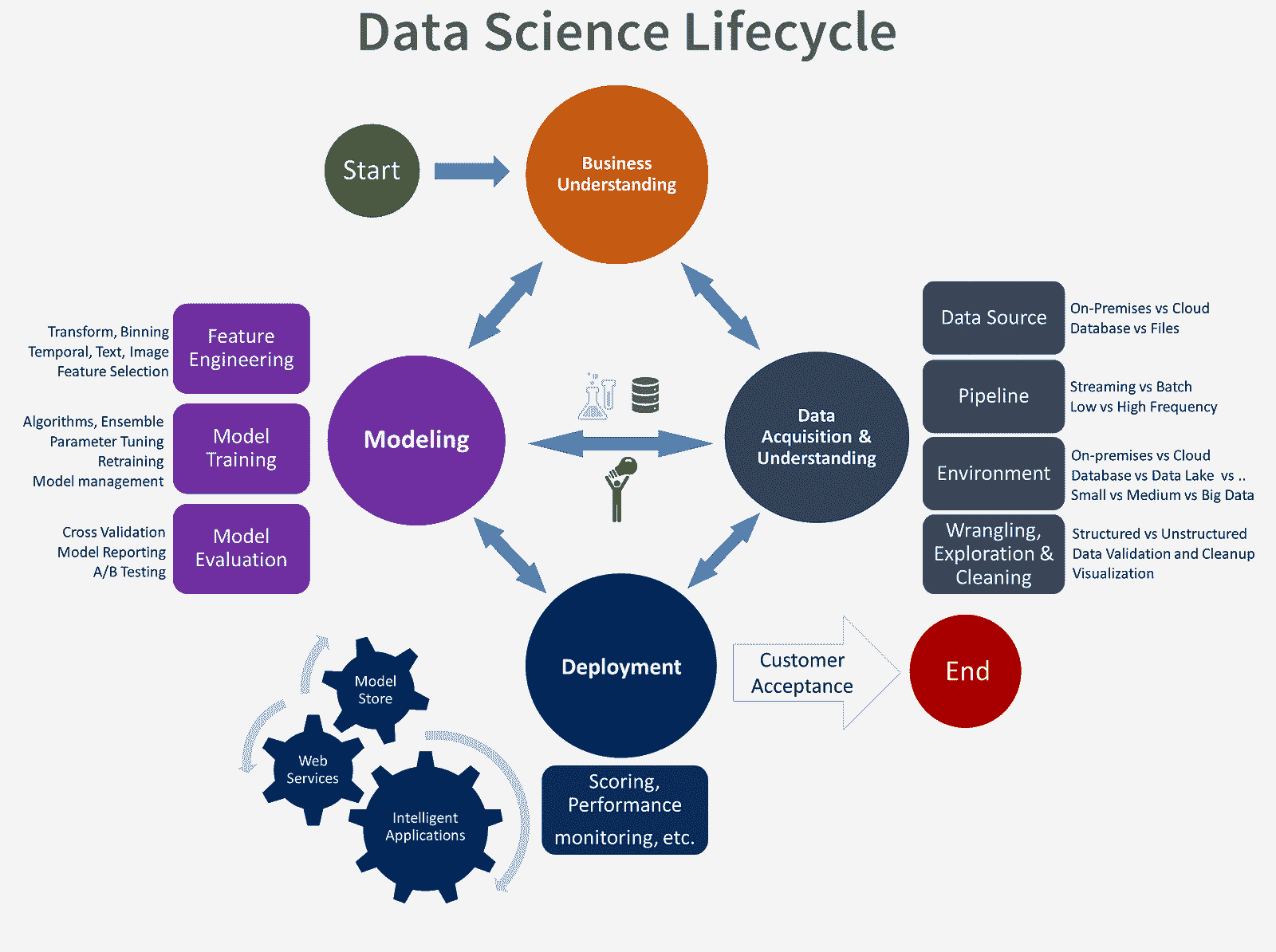

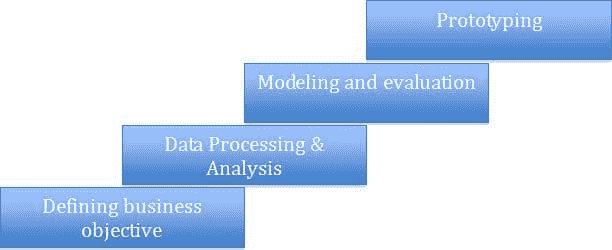

最明显且经常被忽视的工具是CRISP-DM标准。这是一个自 1990 年代以来存在的结构化分析项目的工业流程。

主要思想是将分析项目分为几个明确的阶段。这些阶段是——业务理解、数据理解、数据准备、建模、评估和部署。

照片:Luminus

尽管这个过程有一些不足之处,并且标准最近没有更新,但这六个阶段仍然很有用。在我看来,每个数据专业人士都应该阅读并理解这些阶段,以真正发挥作用。

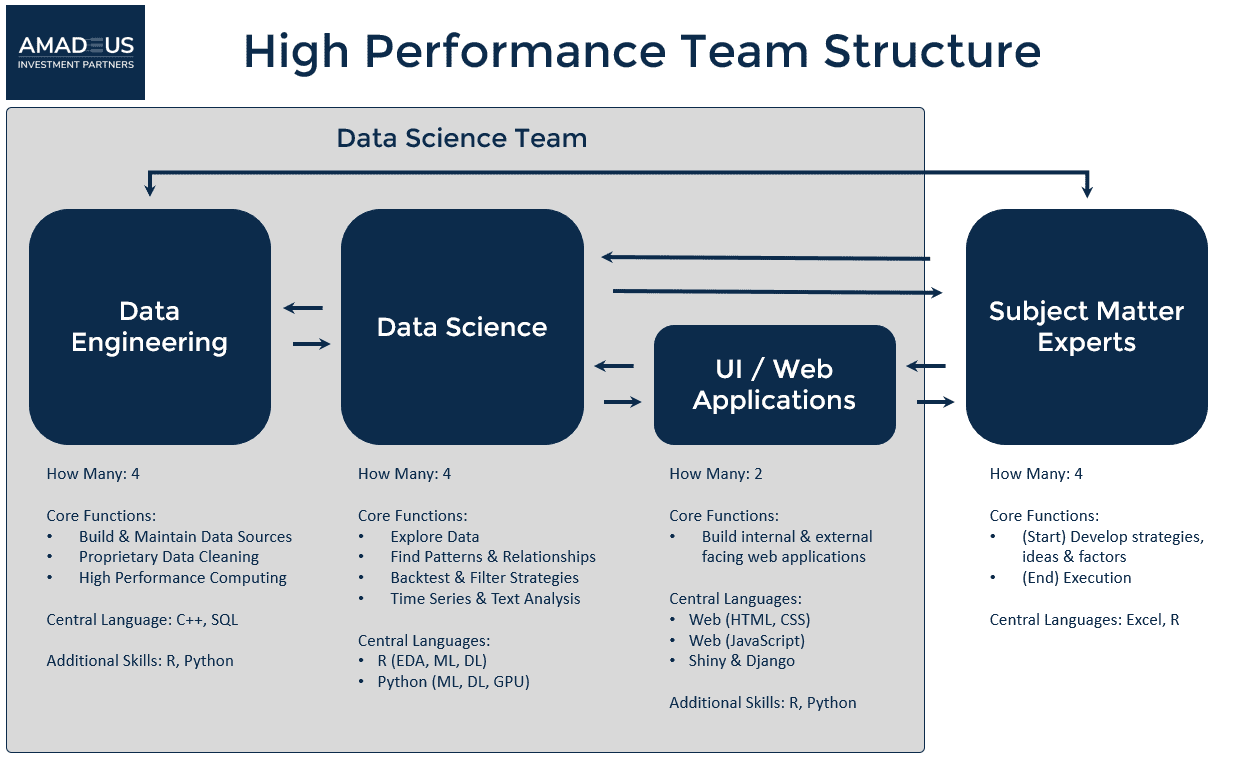

Team Data Science Process (TDSP)

数据科学是一个本质上迭代的过程,CRISP-DM 的主要缺点是它没有很好地融入这一点。

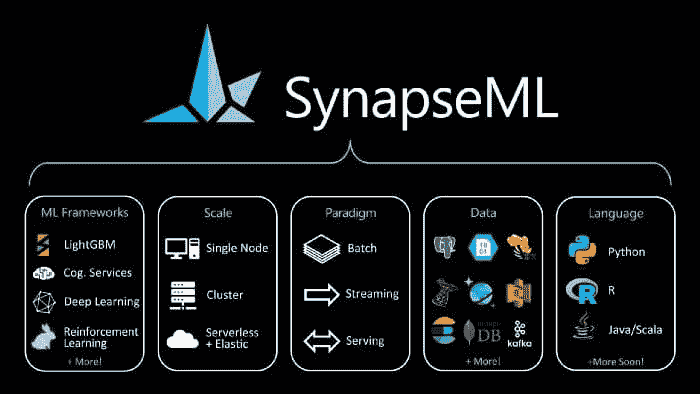

TDSP是微软的一种现代数据科学生命周期过程,它在旧方法上进行了改进。可以把它看作是 CRISP-DM 在云计算时代进行敏捷开发改造的结果。

照片:Microsoft

你的公司可能有根据你所做的工作量身定制的过程,但了解这些基础流程真的很有帮助。

秘密成分?

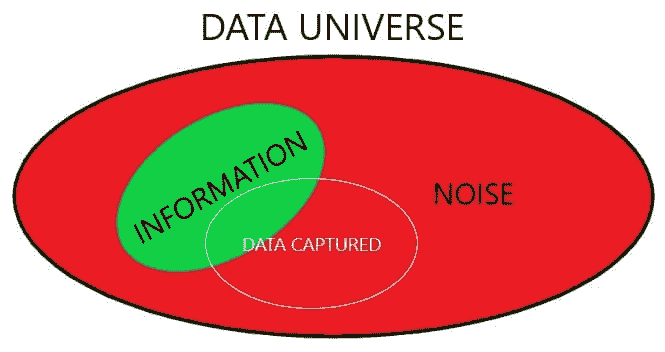

好吧,这有点儿是个 trick question。我看到很多公司常常过于关注最新和最先进的算法和计算处理器,而忽视了数据。我们可能有大量的数据,但这些数据的质量不是理所当然的。好数据仍然很难收集,因此可能成为你所拥有的主要竞争优势。最好的算法无法保证好的模型,除非你提供好的数据。正如人们所说——垃圾进,垃圾出。

人工智能最被忽视的方面之一是大多数算法通过开源软件或通过云服务以非常低的成本提供。可以说,人工智能算法已经或将通过这些库和服务商品化。

我的建议是首先将你的数据科学路线图拆分为每个人都同意的简单应用案例,这些案例可以在几周内实现。同时确保数据是可以获取的,投资回报和/或交付物是明确定义的,并且数据团队遵循迭代执行的过程。

在你从这些循环中学到了一些经验后,你将更好地应对更复杂和风险更大的应用案例。

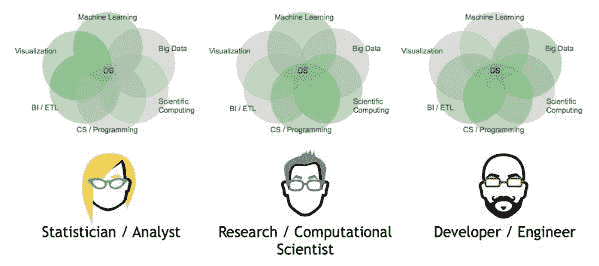

A 团队

现在我们已经讨论了如何规划我们的数据科学项目,我想谈谈如何创建一个数据团队来执行这些计划。我不会深入探讨像在哪里招聘或招聘流程应该如何的问题,而是关注团队的正确组成。

照片:Hudson UK

正如我在本文开头提到的,关于数据科学家的定义或职责存在许多困惑。考虑到这一职位的声望,任何曾经从事数据工作的人似乎都把它写在了简历上。我认为是时候摆脱这一点,根据人们实际做的工作来制定专业的职位名称了。

就像我们不期望医生知道每一种医疗程序或诊断一样,我们也不应该期望有人在人工智能领域精通一切。我们必须有专业人员,他们了解自己技能和职责的边界,并能够与他人合作完成任务。当然,这并不意味着没有人能在多个领域表现出色或成为通才,就像我们在医学中有全科医生一样。数据科学在很大程度上是一项团队运动。

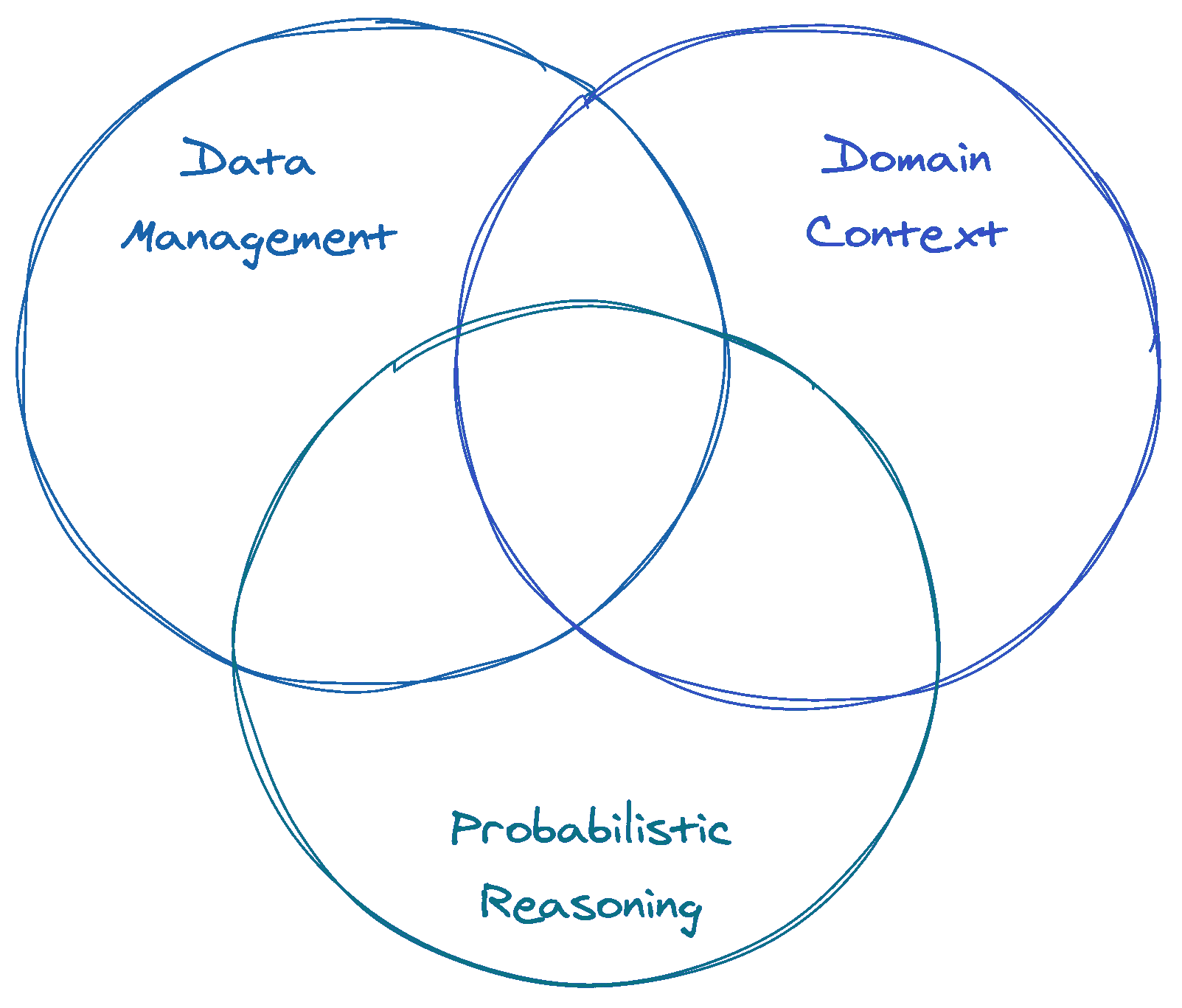

照片:Business Science

由于数据是任何数据科学战略中最重要的元素,首先你需要的是数据工程师。数据工程师通常是那些具备良好的编程和硬件技能的人,能够构建你的数据基础设施。根据你的数据规模,他们通常能熟练操作大数据和云技术,知道如何构建数据管道、设计数据库并从中提取数据。他们会知道如何在基本层面查看数据,并进行简单的汇总以检查数据质量,但不一定擅长分析数据。

在建立好数据基础设施后,你将需要能够处理这些数据的人,他们需要清理、分析数据、进行实验并传达结果。根据你的业务需求,具体的技能要求有所不同。大多数情况下,这项工作由擅长数据处理和清理、创建统计推断或预测模型、运行实验、绘制结果、制作报告并向高层利益相关者提供见解的数据分析师来完成。他们通常会在 Jupyter notebook 或 Rstudio 中工作,具备编程、统计学和机器学习的知识。然而,我们不应该期望他们编写生产级别的代码。

这引出了下一个角色。如果你正在建立一个数据产品,你的团队中需要有机器学习工程师。这些人不是那些构建机器学习算法的研究人员,而是数据驱动的软件开发人员,他们熟悉各种数据科学库,并知道如何基于分析师开发的模型编写生产级别的代码。为了完成这项工作,他们必须与数据工程师密切合作,或者在较小的团队中,也可以由数学背景强的数据工程师来完成。希望进入数据科学领域的大多数开发人员应该考虑这是一个很好的职业选择。

有时候,拥有一位更注重设计的数据可视化专家来制作高度精致的图表和报告以传达分析结果也是很有用的。

我倾向于认为数据科学家是那些在所有上述角色中都表现优于平均水平的人,并且知道如何与领域专家合作以交付结果。这些领域专家通常是你团队或组织之外的合作者,你将他们引入来利用他们在医学、金融、经济学、市场营销、法律等领域的专业知识。

如果你在处理需要一些定制或专有数据科学算法的问题时,可能就需要雇佣具有博士学位或核心研究背景的人。他们可能对像对话 AI、计算机视觉、机器人学、强化学习、图形模型等 AI 领域的理论和算法有深刻的理解。我个人倾向于称这种角色为研究工程师或研究科学家。

数据科学团队中另一个重要但较少讨论的角色是数据科学经理或数据科学负责人。对于较小的团队,拥有一位对所有不同角色有深入了解的资深团队成员来领导团队可能就足够了。但一旦团队扩大,你可能需要拥有强大技术和商业战略背景的人。

数据科学经理是实践型领导者,他们将构建你数据科学战略的基础,招募并组建你的团队,确保每个人之间的互动,获得所需的数据和信息,并制定整个团队可以遵循的流程。他们是数据团队与组织其他部分、合作者和高管的接口。他们将复杂的人工智能术语翻译成非专家能够理解的语言,并确保他们的工作与组织整体战略保持一致。

经理还需要扮演一个常被忽视的重要角色,那就是制定团队的数据治理和伦理标准。大多数进入这个领域的专业人士都学到了执行工作的技术技能,但我很少看到关于数据隐私和分析结果伦理沟通的重要性被提及。这导致了如Facebook 丑闻这样的案例,使我们的领域名誉受损。在我看来,拥有一个了解并执行这些价值观的团队成员,是让你在同行中脱颖而出的关键。

这些是我对成功的数据科学团队的看法。主要的要点是——如果我们从简单的战略开始,选择正确的人才在合适的时间,利用从之前领域中积累的知识,并制定最适合你的团队和目标的流程,那么没有理由你不能成为一个有效的数据驱动型组织。

简介:Saurav Dhungana是一位经验丰富的数据科学和数据可视化专家,也是@craftdatalabs 的创始人。

原文。经许可转载。

资源:

相关:

更多相关主题

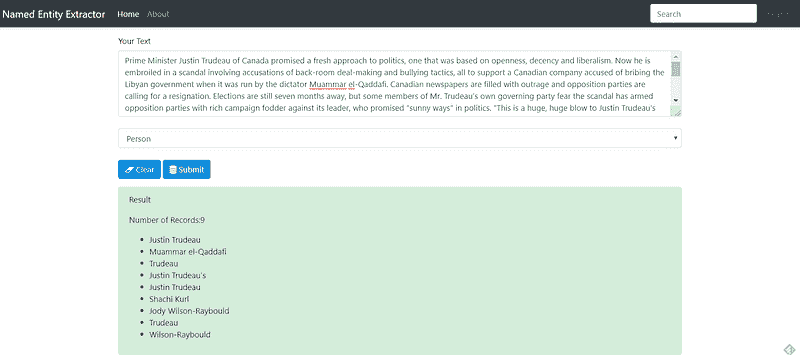

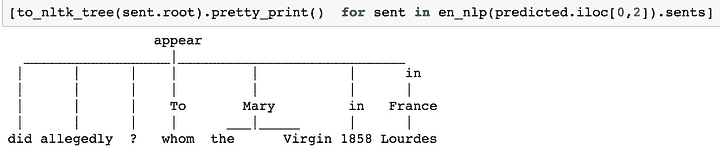

使用 SpaCy 自动提取命名实体的 Flask API

原文:

www.kdnuggets.com/2019/04/building-flask-api-automatically-extract-named-entities-spacy.html

注释

注释

作者:Susan Li,高级数据科学家

图片来源:Pixabay

目前大量的非结构化文本数据提供了丰富的信息源,如果数据可以被结构化的话。命名实体识别 (NER)(也称为命名实体提取)是从半结构化和非结构化文本源中构建知识的第一步之一。

只有在进行 NER 后,我们才能至少揭示信息中包含了谁和什么。因此,数据科学团队将能够看到一个结构化的表示,展示一个语料库中所有人名、公司名、地点等的名称,这可以作为进一步分析和研究的起点。

在 上一篇文章中,我们学习并实践了 如何使用 NLTK 和 spaCy 构建命名实体识别器。为了更进一步,创建有用的东西,本文将介绍如何使用 spaCy 开发和部署一个简单的命名实体提取器,并通过 Flask API 用 Python 服务它*。

一个 Flask API

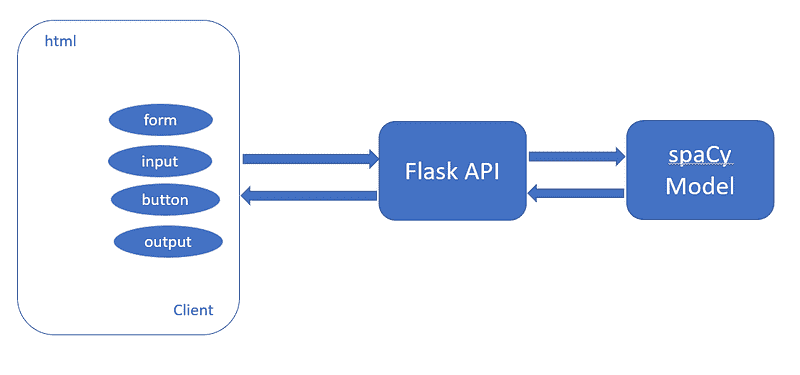

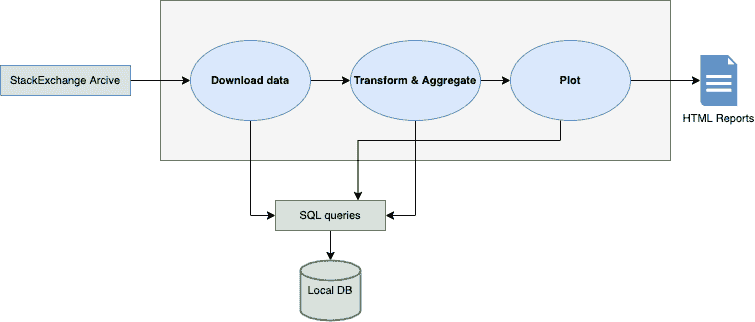

我们的目标是构建一个 API,我们提供文本,例如《纽约时报》文章(或任何文章)作为输入,我们的命名实体提取器将识别并提取四种类型的实体:组织、人物、地点和金额。基本架构如下:

图 1

为了构建 API,我们需要创建两个文件:

-

index.html用于处理 API 的模板。 -

app.py用于处理请求并返回输出文件。

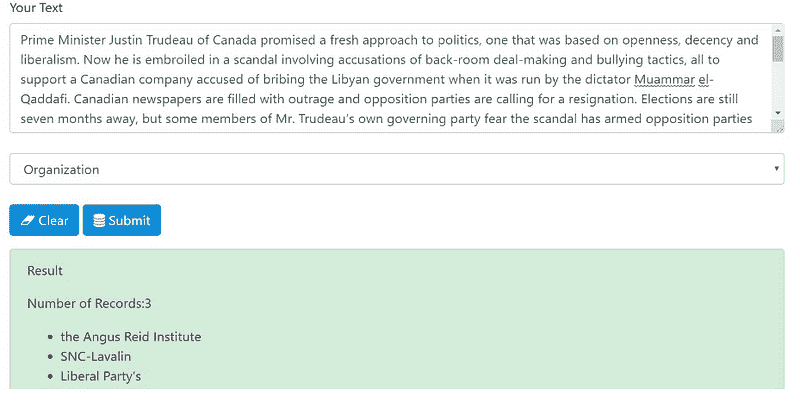

最终产品将如下所示:

图 2

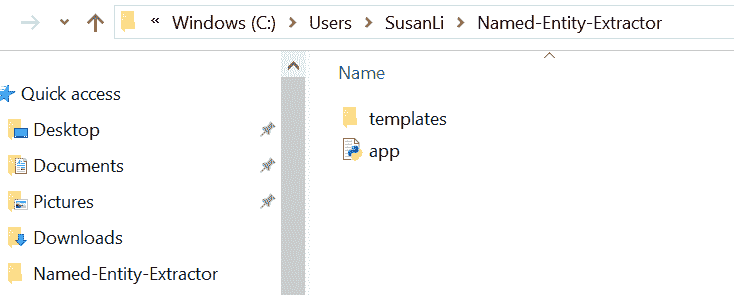

我们从构建 API 开始,逐步创建两个文件。我们的项目文件夹结构如下:

- 我们的项目位于 ***Named-Entity-Extractor ***文件夹中。

图 3

templates目录与创建的 app.py 文件在同一文件夹中。

图 4

- index.html 位于 templates 文件夹中。

index.html

-

我们将我们的应用命名为“命名实体提取器”

-

使用 BootstrapCDN,将 stylesheet

<link>复制粘贴到我们的<head>中,放在所有其他样式表之前,以加载我们的 CSS。 -

获取 Bootstrap 的导航头部,从 a template for a simple informational website 获取 navbar。它包含一个称为 jumbotron 的大召唤框和三个支持内容。

-

从模板的 source code 中复制粘贴 navbar 代码。

-

Bootstrap 需要一个容器元素来包裹站点内容并容纳我们的网格系统。

-

在我们的案例中,对于第一个容器,我们将创建一个垂直表单,其中包含两个输入字段,一个“清除”按钮和一个“提交”按钮。

-

文本表单控件使用

form-control类进行样式化。 -

我们为用户提供了四个任务选项(即命名实体提取任务),它们是:Organization,Person,Geopolitical 和 Money。

-

第二个容器为用户的操作提供上下文反馈消息,即命名实体提取的结果。

-

我们不仅希望将命名实体提取结果打印给用户,还希望打印每个命名实体提取的结果数量。

-

将 JavaScript 复制粘贴到我们 HTML 页面接近末尾的

<script>标签中,紧接着闭合的</body>标签之前。

app.py

我们的 app.py 文件相当简单且易于理解。它包含将由 Python 解释器执行以运行 Flask Web 应用程序的主要代码,其中包括用于识别命名实体的 spaCy 代码。

-

我们将应用作为单一模块运行;因此,我们用参数

__name__初始化了一个新的 Flask 实例,让 Flask 知道它可以在与自身所在目录相同的目录中找到 HTML 模板文件夹(templates)。 -

我们使用路由装饰器(

@app.route('/'))来指定应触发index函数执行的 URL。 -

我们的

index函数简单地渲染了位于templates文件夹中的index.htmlHTML 文件。 -

在

process函数内部,我们对用户输入的原始文本应用 nlp,并从原始文本中提取预定的命名实体(Organization,Person,Geopolitical 和 Money)。 -

我们使用

POST方法将表单数据传输到服务器的消息体中。最后,通过在app.run方法中设置debug=True参数,我们进一步激活了 Flask 的调试器。 -

我们使用

run函数仅在 Python 解释器直接执行此脚本时才运行应用程序,这通过使用if语句与__name__ == '__main__'进行确保。

我们快完成了!

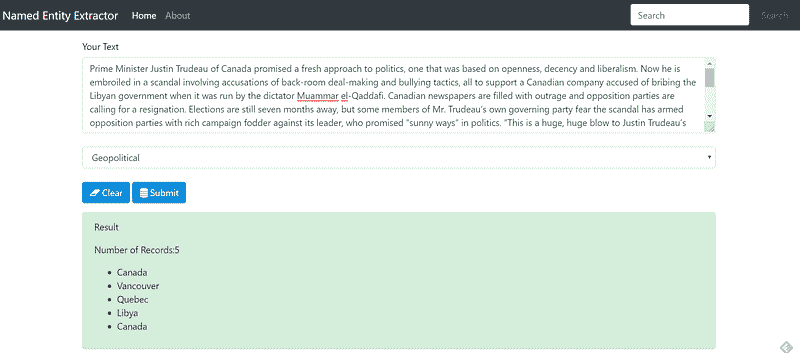

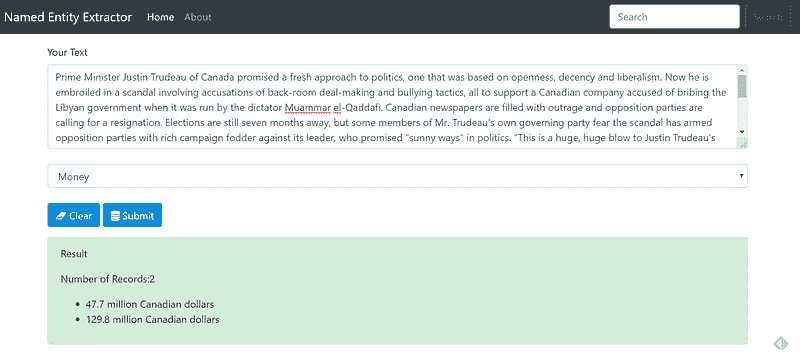

尝试我们的 API

-

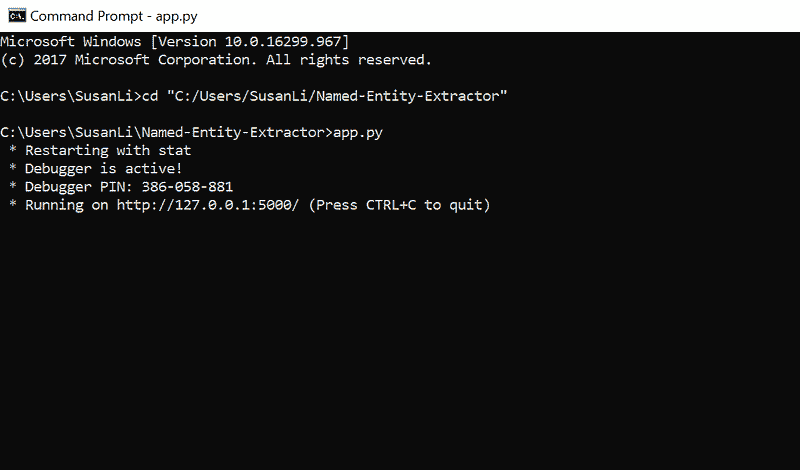

启动 **命令提示符。

-

进入我们的 命名实体提取器 文件夹。

图 5

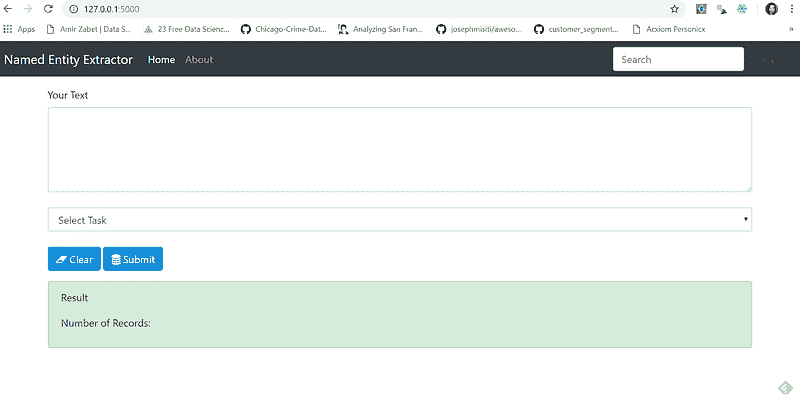

- 打开你的 Web 浏览器,将 “

127.0.0.1:5000/” 粘贴到地址栏中,我们将看到这个表单:

图 6

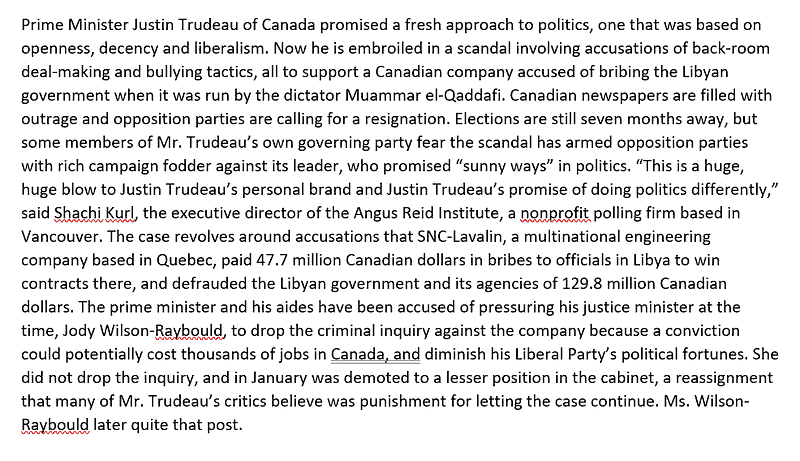

- 我从 nytimes复制粘贴了一些文章段落,这是一个加拿大故事:

图 7

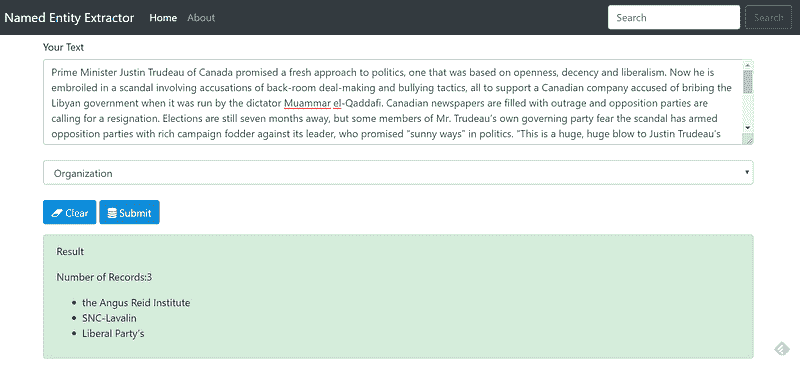

- 在“选择任务”下选择“Organization”,然后点击“提交”,我们得到的是:

图 8

- 很好。让我们尝试“Person”实体:

图 9

- “Geopolitical”实体:

图 10

- “Money”实体:

图 11

完成了!

如果你按照以上步骤操作并达到了这里,恭喜你!你已经以零成本创建了一个简单但有效的命名实体提取器!回头看,我们只需要创建两个文件,所需的只是开源库和学习如何使用它们来创建这两个文件。

通过构建这样的应用,你已经学会了新技能,并使用这些技能创造了有用的东西。

完整源代码可在这个 代码库找到。祝周一愉快!

参考:

个人简介: Susan Li 正在通过一篇文章改变世界。她是位于加拿大多伦多的高级数据科学家。

原文。经许可转载。

相关:

-

你需要了解的关于 NLP 和机器学习的文本预处理

-

利用迁移学习和弱监督廉价构建 NLP 分类器

-

简单神经网络与 LSTM 时间序列预测介绍

我们的前三个课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业。

1. Google Cybersecurity Certificate - 快速进入网络安全职业。

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

3. Google IT Support Professional Certificate - 支持你的组织进行 IT 工作

3. Google IT Support Professional Certificate - 支持你的组织进行 IT 工作

更多相关内容

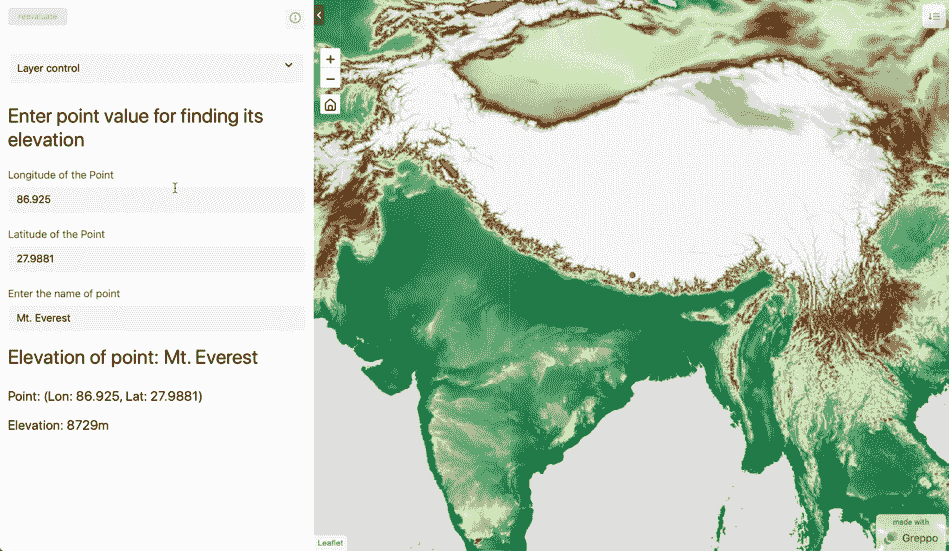

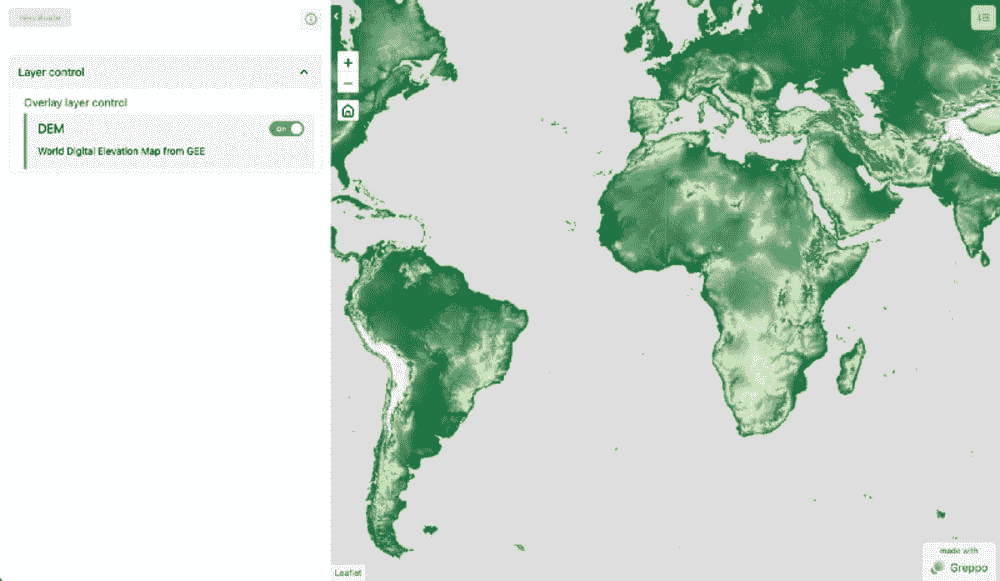

使用 Google Earth Engine 和 Greppo 在 Python 中构建地理空间应用

原文:

www.kdnuggets.com/2022/03/building-geospatial-application-python-google-earth-engine-greppo.html

使用 Greppo 和 GEE 的最终网络应用。图像由作者提供。

Google Earth Engine 是数据科学家工具箱中处理地理空间数据的一个了不起的工具。然而,使用 GEE 代码编辑器构建网络应用需要一个陡峭的学习曲线。基于 JavaScript 的应用创建器对仅使用 Python 的数据科学家而言需要大量时间投入。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

Greppo 是弥补这一差距的完美工具。

在这篇博客文章中,我将使用 Greppo 构建一个流行的 GEE 用例(数字高程模型 DEM)的网络应用。我将带你了解 GEE 的基础知识、客户端-服务器模型、API 的工作原理以及 GEE 数据模型。了解这些背景后,文章将使用 Greppo 创建一个使用 GEE Python 接口的应用,并突出 Greppo 的思维模型和易用界面。

注意:这里的所有代码都是用 Python 编写的。它们从 文档** 中的 GEE 示例 JavaScript 代码移植而来**。

入门指南

在开始之前,你需要获取 Google Earth Engine 的访问权限。请按 这里的说明进行注册 并获取访问权限。

这是一个关于 Greppo 的简要教程以及如何使用它:在 Python 中使用 Greppo 构建地理空间仪表板

接下来,让我们设置 Python 环境以安装依赖项。要了解什么是 Python 环境及如何设置它,阅读此处。将以下包安装到 Python 环境中。

pip install earthengine-api greppo

网络应用的代码将放在 app.py 中,应用程序通过命令行使用命令 greppo serve app.py 提供和运行。

注意:要在命令行中运行greppo命令,你需要激活安装了 greppo 的 Python 环境。文件 app.py 可以重命名,但确保在运行命令greppo serve app.py时处于该文件所在的文件夹中,或者在相对文件夹结构greppo serve /demo/folder/app.py中。

Greppo 的 GitHub 仓库:github.com/greppo-io/greppo

如有任何问题,请通过GitHub上的“issues”或在Discord 频道联系我们。

GEE 认证与初始化

要使用 Google Earth Engine,你需要创建一个服务帐户并获取与该帐户关联的访问密钥文件。这只需几分钟,但确保按照说明正确操作。请按照这里的说明进行操作。要使用服务帐户和密钥文件,请使用以下代码进行初始化。

注意:确保将 key-file.json 保存在其他位置,最好安全地保存在计算机的根文件夹中,并且不要提交到公共仓库中。

理解 GEE 的客户端-服务器模型

正如 GEE 的开发文档所说,Earth Engine 不像你之前用过的任何 GIS 或地理空间工具。GEE 主要是一个云平台,所有处理都在云端完成,而不是在你的机器上。你与 GEE 的互动仅仅是将指令翻译并发送到 GEE 的云平台。为了更好地理解这一点,我们需要深入了解 GEE 的客户端与服务器以及其惰性计算模型。

客户端与服务器

从我之前提到的开始,GEE 主要是一个云平台。它让你在云端进行所有处理。那么,你如何访问这些处理功能呢?

这里就是earthengine-api库发挥作用的地方。Python 包earthengine-api为客户端(也就是你)提供了作为服务器对象代理的对象,这些对象在云端传递和处理。

为了更好地理解客户端-服务器模型,我们以客户端中的字符串变量和服务器中的字符串变量为例。在客户端创建字符串并打印其类型时,我们得到的是 Python 的class str对象来表示字符串。如果我们想将字符串发送到服务器进行使用或操作,我们会使用ee.String将数据包装在一个代理容器中,这样服务器就可以读取。更具体地说,ee.objects是ee.computedObject,它是代理对象的父类。

客户端字符串

client_string = 'I am a Python String object'

print(type(client_string))

服务器端字符串

server_string = ee.String('I am proxy ee String object!');

print(type(server_string))

代理对象不包含任何实际的数据或处理函数/算法。它们只是服务器(云平台)上对象的句柄,仅仅传达要在服务器上执行的指令。可以把它看作是使用代码与服务器沟通的一种方式,为此你需要将数据和指令包装在 ee.computedObject 特定类型的容器中。

当对数据进行循环或使用条件语句时,这种理解变得更加重要。要执行这些操作,需要将指令发送到服务器以执行。要了解这些是如何实现的,查看此页面 获取更多详细信息。

惰性计算模型(延迟执行)

从上面的内容我们知道,earthengine-api 包仅用于向服务器发送指令。那么,执行是如何以及何时发生的呢?

客户端库 earthengine-api 将所有指令编译成 JSON 对象并发送到服务器。然而,这并不会立即执行。执行会被推迟,直到有请求结果。结果请求可以是 print 语句,或者是要显示的 image 对象。

这种按需计算会影响返回给客户端(即用户)的内容。earthengine-api 的结果是一个指向 GEE 瓦片服务器的 URL,其中包含需要提取的数据。因此,在提到的兴趣区域内的图像会被选择性地处理。兴趣区域由客户端显示中的地图的缩放级别和中心位置确定。当你移动和缩放时,图像会被处理并发送给客户端以供查看。因此,这些图像是惰性计算的。

使用 Greppo 结合 GEE

使用 Greppo 显示和可视化 Earth Engine 图像对象是相当简单的,你只需要使用:app.ee_layer()。GEE 中存储地理空间数据的基本数据类型是,

-

Image:Earth Engine 中的基本栅格数据类型。 -

ImageCollection:图像的堆叠或时间序列。 -

Geometry:Earth Engine 中的基本矢量数据类型。 -

Feature:带有属性的 Geometry。 -

FeatureCollection:一组特征。

了解 GEE 的客户端-服务器和惰性计算模型后,我们可以推测这些数据类型是按需处理的,在请求其可视化时。

那么,如何将 Greppo 与 GEE 结合使用?

通过一个例子来解释是最好的。首先,我们从 app 的搭建开始。你需要从 greppo 中导入 app 对象,因为它将是你与前端沟通的入口点。接下来,你需要 import ee,验证你的 Earth Engine 身份,并使用上述服务账户的凭据初始化你的会话。

接下来,让我们从目录中选择数据集。在这里,我们使用 USGS/SRTMGL1_003 获取数字高程图。我们首先需要为 DEM 图像数据中所有大于 0 的值获取一个地面掩码,为此我们使用 dem.get(0)。接下来,我们需要在 DEM 上应用掩码,只可视化土地区域,为此我们使用 dem.updateMask(dem.gt(0)),并将结果指定为我们要可视化的 ee_dem。由于所有数据存储为 int16(值在 32767 和 -32768 之间的矩阵),我们需要使用调色板来可视化矩阵。

要添加调色板,我们创建一个可视化参数对象,其中包含生成 RGM 或灰度图像的指令。在这里,我们使用包含以下 Hex 值的调色板:[‘006633’, ‘E5FFCC’, ‘662A00’, ‘D8D8D8’, ‘F5F5F5’],并将其线性映射到指定的 min -> #006633 和 max -> #F5F5F5 对应的值。

注意:DEM 中存储的数据是栅格,表示为矩阵,每个单元格包含表示该单元格的点的海拔高度(单位:米)。

要在使用 Greppo 的 Web 应用程序中可视化此地图,你只需使用 app.ee_layer()。ee_object 是地球引擎图像对象,vis_param 是可视化参数字典,name 对应于在 Web 应用前端使用的唯一标识符,而 description 是可选的,用于向应用用户提供额外的说明。有关更多信息,请参见文档 此处。

上一步骤的 Web 应用视图。图片由作者提供。

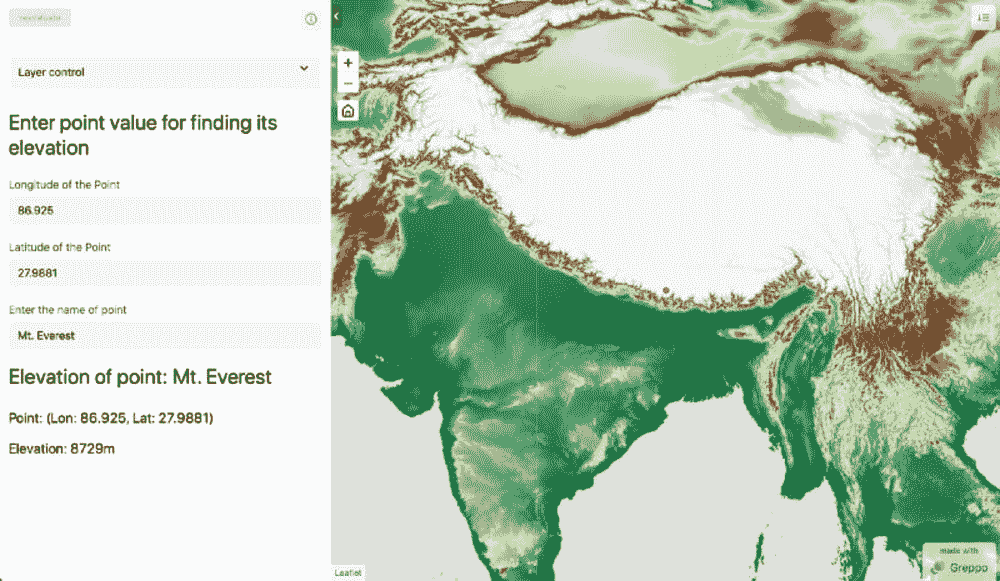

端到端通信:完整 Web 应用

到目前为止,我们只看到了如何在 Greppo 中可视化地球引擎对象。然而,Greppo 能够实现前端和后端之间的复杂交互。我们来举一个找到用户指定点的海拔高度的例子。我们将使用 Greppo 的三个 API 特性。

-

app.display():在前端显示文本或 Markdown。 -

app.number():前端中的数字输入功能,供用户输入一个值。与之绑定的后端变量将更新为用户指定的值。 -

app.text():前端中的文本输入功能,供用户输入一个值。与之绑定的后端变量将更新为用户指定的值。

有关更多详细信息,请参见 文档此处。

让我们开始使用 app.display(name 是唯一标识符,值是显示的文本,可以是多行字符串)来为 Web 应用用户显示一些文本。之后,让我们创建两个数字输入框,每个用于输入点的经度和纬度,使用 app.number()。

app.number() 接受名称(前端显示的标识符)和值(此元素的默认值)。接下来,我们还将创建一个文本输入框,用于获取点的名称,使用app.text(),并将name和value作为app.number()中提到的参数。

使用该点的纬度和经度,我们现在可以创建一个带有可视化参数color: ‘red’的地球引擎 Geometry 对象。我们可以使用上述提到的app.ee_layer()来显示这个对象。

要查找该点的高程,我们使用sample方法在 DEM 对象上进行地球引擎操作。我们在 DEM 中对该点进行采样以获取 DEM 的属性。我们从输出中获取第一个点,并使用.get方法查找与高程属性相关的值。最后,我们组合一个多行字符串来显示输出。

注:要在初始加载时将地图居中于某个点并设置缩放级别,请使用app.map(center=[lat, lon], zoom=level)。

带有交互功能的 Web 应用视图。图像由作者提供。

结论

我们的目标是使用 Python 完全创建一个 Web 应用,利用 Google Earth Engine 的数据和计算功能以及 Greppo 的 Web 应用开发库。我们了解了 GEE 的工作原理,了解了如何将 Greppo 与 GEE 集成。学会使用app.ee_layer(), app.display(), app.number() 和 app.text()来创建一个完整的 Web 应用,实现前端和后端的全程通信。

演示的所有文件可以在这里找到: github.com/greppo-io/greppo-demo/tree/main/ee-demo