KDNuggets-博客中文翻译-三十一-

KDNuggets 博客中文翻译(三十一)

原文:KDNuggets

在 Azure Databricks 上使用 Spark、Python 或 SQL

原文:

www.kdnuggets.com/2020/08/spark-python-sql-azure-databricks.html

评论

作者 Ajay Ohri,数据科学经理

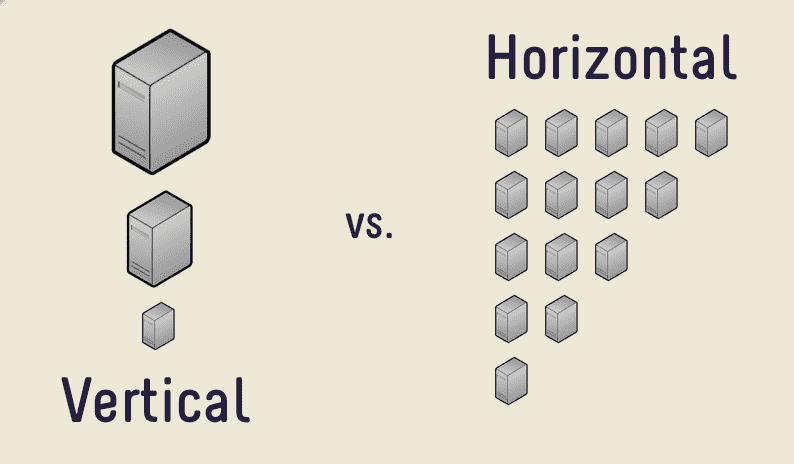

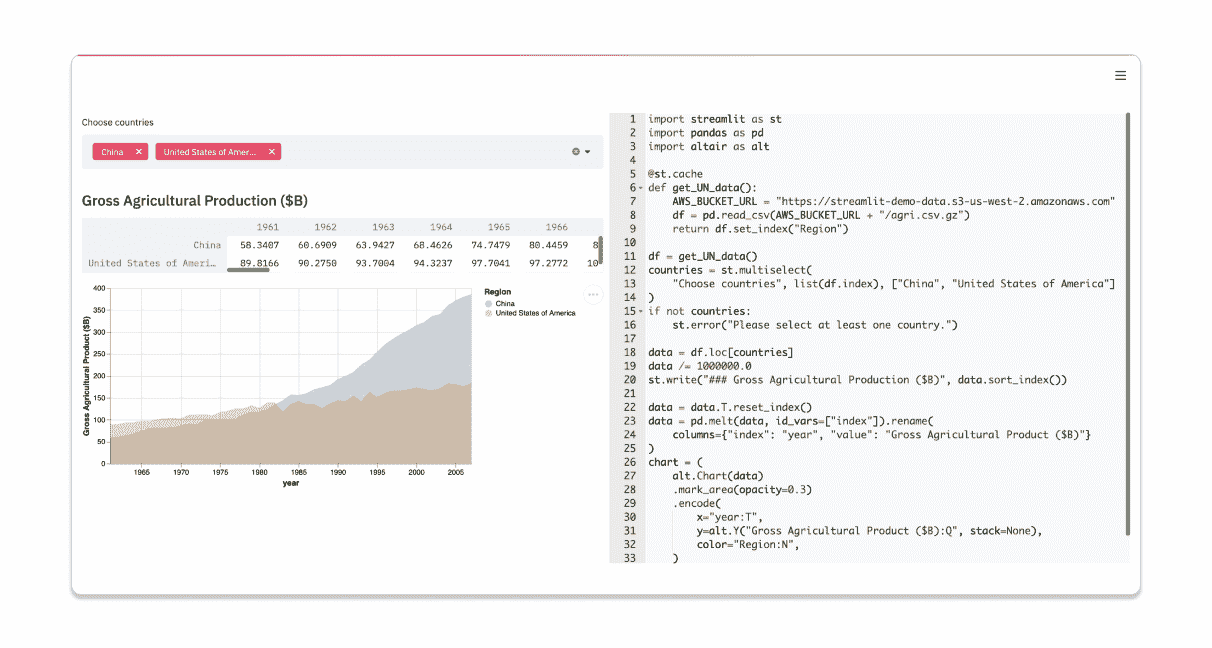

Azure Databricks 是一个基于 Apache Spark 的大数据分析服务,旨在支持数据科学和数据工程,由微软提供。它支持协作工作以及 Python、Spark、R 和 SQL 等多种语言的使用。在 Databricks 上工作具有云计算的优势——可扩展、低成本、按需的数据处理和存储。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织在 IT 领域

3. Google IT 支持专业证书 - 支持您的组织在 IT 领域

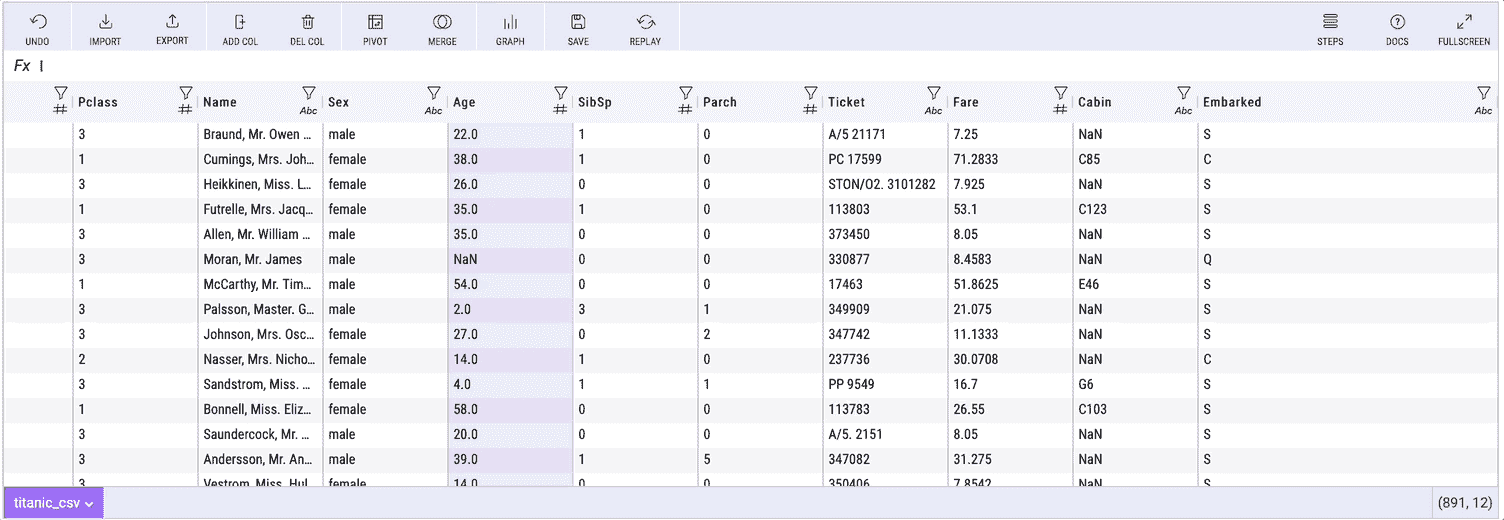

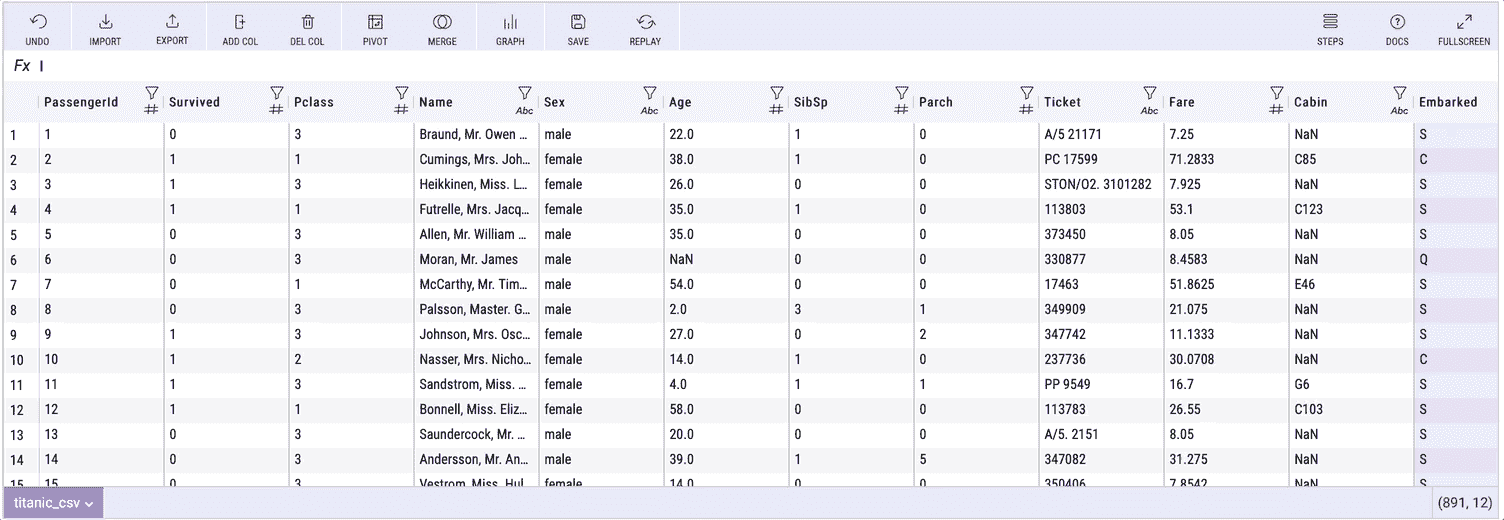

在这里,我们探讨了一些在 Python、PySpark 和 SQL 之间互换工作的方式。我们学习如何通过先上传 CSV 文件然后在笔记本中创建来导入数据。我们学习如何将 SQL 表转换为 Spark 数据框,并将 Spark 数据框转换为 Python Pandas 数据框。我们还学习如何将 Spark 数据框转换为永久或临时 SQL 表。

为什么我们需要学习如何在 SQL、Spark 和 Python Pandas 数据框之间互换代码?SQL 适合编写简洁易读的数据处理代码,Spark 适合处理大数据和机器学习,而 Python Pandas 可用于从数据处理、机器学习到 seaborn 或 matplotlib 库中的绘图等各种任务。

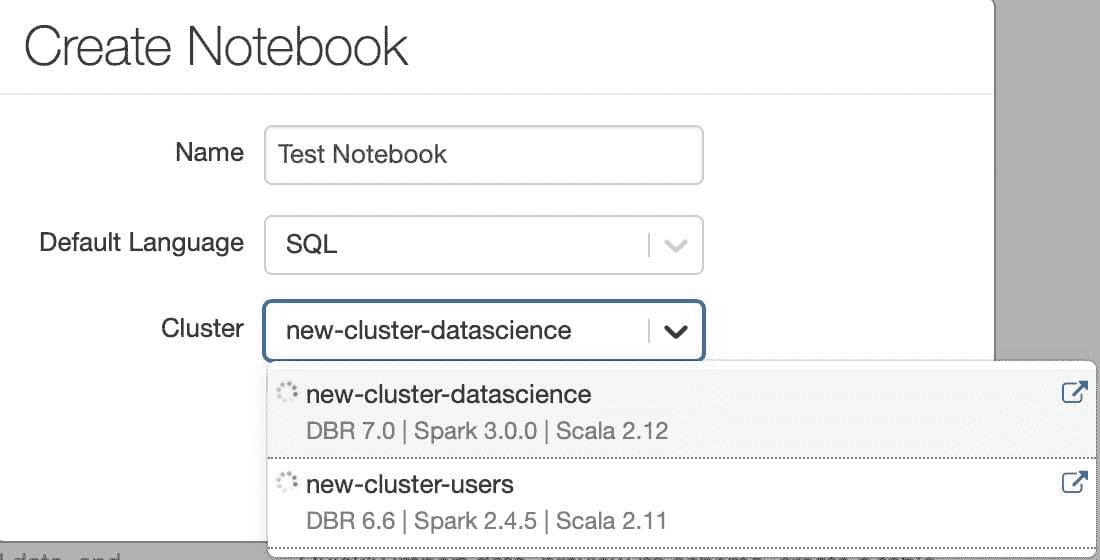

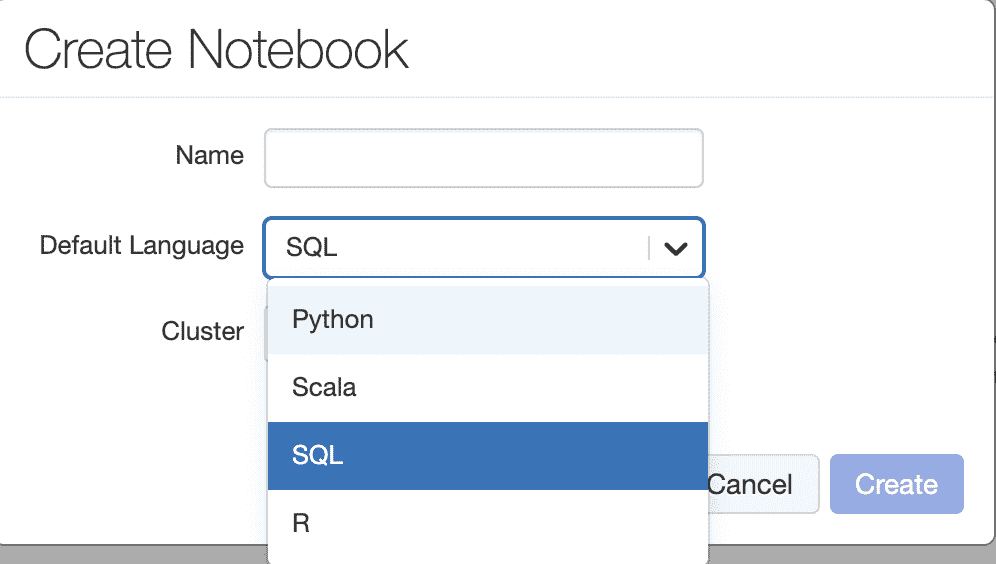

我们选择 SQL 笔记本以便于操作,然后选择适当的集群及其内存、核心、Spark 版本等。即使是 SQL 笔记本,我们也可以通过在单元格中的代码前面输入 %python 来编写 Python 代码。

现在让我们开始数据输入、数据检查和数据互换的基础知识。

步骤 1 读取上传的数据

%python

# Reading in Uploaded Data

# File location and type

file_location = "/FileStore/tables/inputdata.csv"

file_type = "csv"

# CSV options

infer_schema = "false"

first_row_is_header = "true"

delimiter = ","

# The applied options are for CSV files. For other file types, these will be ignored.

df = spark.read.format(file_type) \

.option("inferSchema", infer_schema) \

.option("header", first_row_is_header) \

.option("sep", delimiter) \

.load(file_location)

display(df)

步骤 2 从 SPARK 数据框创建一个临时视图或表

%python

#Create a temporary view or table from SPARK Dataframe

temp_table_name = "temp_table"

df.createOrReplaceTempView(temp_table_name)

步骤 3 从 SPARK 数据框创建永久 SQL 表

--Creating Permanent SQL Table from SPARK Dataframe

permanent_table_name = "cdp.perm_table"

df.write.format("parquet").saveAsTable(permanent_table_name)

步骤 4 检查 SQL 表

--Inspecting SQL Table

select * from cdp.perm_table

步骤 5 将 SQL 表转换为 SPARK 数据框

%python

#Converting SQL Table to SPARK Dataframe

sparkdf = spark.sql("select * from cdp.perm_table")

步骤 6 检查 SPARK 数据框

%python

#Inspecting Spark Dataframe

sparkdf.take(10)

步骤 7 将 Spark 数据框转换为 Python Pandas 数据框

%python

#Converting Spark Dataframe to Python Pandas Dataframe

%python

pandasdf=sparkdf.toPandas()

步骤 8 检查 Python 数据框

%python

#Inspecting Python Dataframe

pandasdf.head()

参考文献

-

Azure Databricks 简介 -

www.slideshare.net/jamserra/introduction-to-azure-databricks-83448539 -

Dataframes 和 Datasets -

docs.databricks.com/spark/latest/dataframes-datasets/index.html -

优化 PySpark 与 pandas DataFrames 之间的转换 -

docs.databricks.com/spark/latest/spark-sql/spark-pandas.html -

pyspark 包 -

spark.apache.org/docs/latest/api/python/pyspark.html

个人简介: Ajay Ohri 是数据科学经理(Publicis Sapient),并且是《R for Cloud Computing》和《Python for R Users》以及其他 4 本数据科学书籍的作者。

相关:

-

Dataproc 上的 Apache Spark 与 Google BigQuery 比较

-

使用 Kubernetes 对 PySpark 进行容器化

-

数据科学的 5 个 Apache Spark 最佳实践

更多相关主题

Spark SQL 用于实时分析

原文:

www.kdnuggets.com/2015/09/spark-sql-real-time-analytics.html

由 Sumit Pal 和 Ajit Jaokar 编写,(FutureText)。

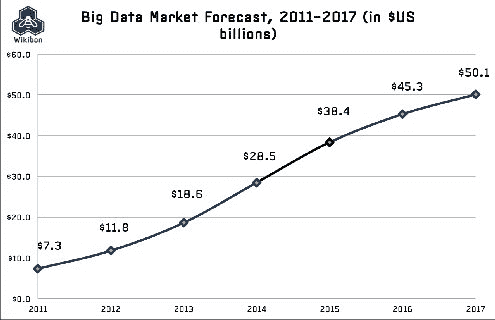

本文是即将推出的物联网数据科学从业者课程在伦敦的一部分。如果你想成为物联网的数据科学家,这个密集课程非常适合你。我们涵盖了传感器融合、时间序列、深度学习等复杂领域。我们使用 Apache Spark、R 语言以及领先的物联网平台。有关更多信息,请联系 info@futuretext.com。

概述

这是讨论 Spark 在物联网实时分析中使用 SQL 的 3 部分系列文章的第一部分。第一部分讨论了使用 Spark 的 SQL 的技术基础。第二部分讨论了使用 Spark SQL 进行实时分析。最后,第三部分讨论了一个物联网实时分析的用例。

介绍

在第一部分中,我们讨论了 Spark SQL 以及为什么它是实时分析的首选方法。Spark SQL 是 Apache Spark 中的一个模块,它将关系处理与 Spark 的函数式编程 API 集成。自 1.0 版本以来,Spark SQL 就是 Spark Core 的一部分。它可以与现有的 Hive 部署并行运行 HiveQL/SQL,或替代现有的 Hive 部署。它可以连接到现有的 BI 工具。它在 Python、Scala 和 Java 中都有绑定。它为框架提供了两个重要的补充。首先,它提供了关系和过程处理之间的紧密集成,具有与过程式 Spark API 集成的声明性 DataFrame API。其次,它包括一个可扩展的优化器,使用 Scala 构建,利用其强大的模式匹配能力,使得添加可组合规则、控制代码生成和定义扩展变得容易。

Spark SQL 的目标和目标

尽管关系方法已被应用于解决大数据问题,但它对许多大数据应用来说仍然不够充分。直到最近,关系和过程方法一直保持分离,迫使开发人员选择其中一种范式。Spark SQL 框架结合了这两种模型。

正如他们所说,“读取数据的最快方式就是根本不读取它”。

Spark SQL 支持在 Spark 程序(通过 RDDs)和外部数据源上的关系处理。它可以轻松支持新的数据源,包括半结构化数据和适用于查询联合的外部数据库。

Spark SQL 通过以下方式帮助这一理念

-

通过使用各种列式格式将数据转换为更高效的格式(从存储、网络和 IO 的角度来看)

-

使用数据分区

-

使用数据统计跳过数据读取

-

将谓词推送到存储系统

-

尽可能晚地优化,直到获取有关数据管道的所有信息

在内部,Spark SQL 和 DataFrame 利用 Catalyst 查询优化器智能地规划查询的执行。

Spark SQL

Spark SQL 可以支持批处理或流处理 SQL。使用 RDDs,核心 Spark 框架支持批处理工作负载。RDD 可以指向静态数据集,Spark 的丰富 API 可用于操作在内存中以惰性求值处理的批数据集。

流处理 + SQL 和 DataFrames

让我们快速了解一下在 Spark 核心框架中什么是 RDD,什么是 DStream,这些是本文讨论的基本构建块。

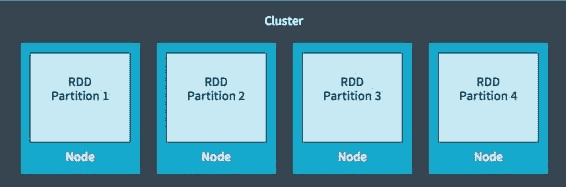

Spark 在 RDDs(弹性分布式数据集)上操作,这是一种内存中的数据结构。每个 RDD 代表数据的一部分,这些数据被分区到集群中的数据节点。RDD 是不可变的,当应用变换时会创建新的 RDD。RDDs 在并行中操作,使用诸如映射、过滤等变换/操作。这些操作在所有分区上同时进行。RDDs 是弹性的,如果由于节点崩溃而丢失某个分区,可以从原始来源重建它。

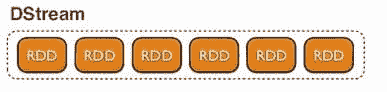

Spark Streaming 提供了一种称为 DStream(离散流)的抽象,它是一个连续的数据流。DStreams 可以从输入数据流或 Kafka、Flume 等源创建,或通过对其他 DStreams 应用操作创建。DStream 本质上是 RDD 的序列。

由 DStreams 生成的 RDD 可以转换为 DataFrames 并使用 SQL 查询。该流可以通过 Spark 的 JDBC 驱动程序暴露给任何外部应用程序,进行 SQL 查询。流数据的批次存储在 Spark 的工作内存中,可以通过 SQL 或 Spark 的 API 进行交互式查询。

StreamSQL 是一个 Spark 组件,它结合了 Catalyst 和 Spark Streaming 来对 DStreams 执行 SQL 查询。StreamSQL 扩展了 SQL 以支持流,具有以下操作:

-

对流进行 SELECT 以计算函数或筛选不需要的数据(使用 WHERE 子句)

-

将流与一个或多个数据集进行 JOIN,以生成新的流。

-

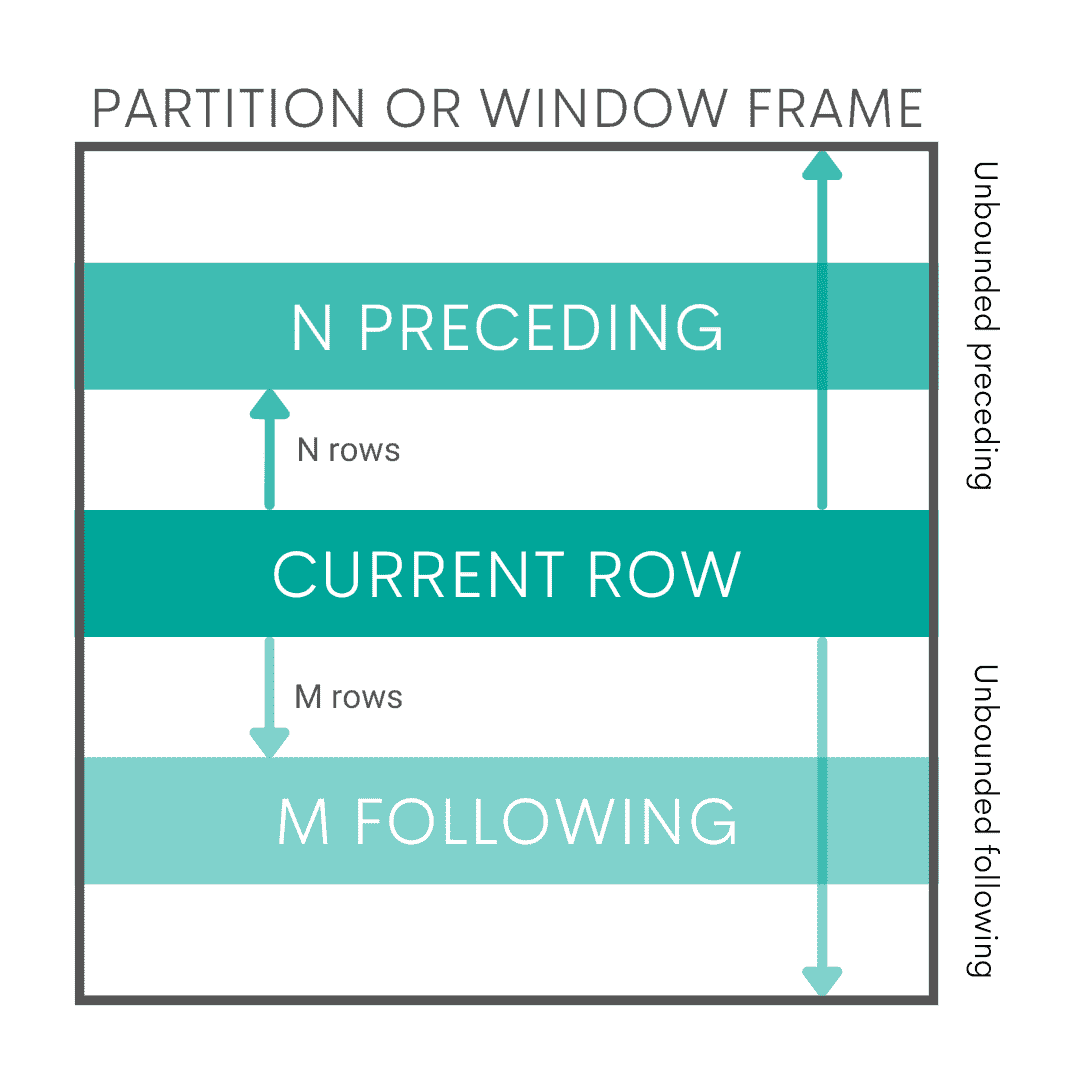

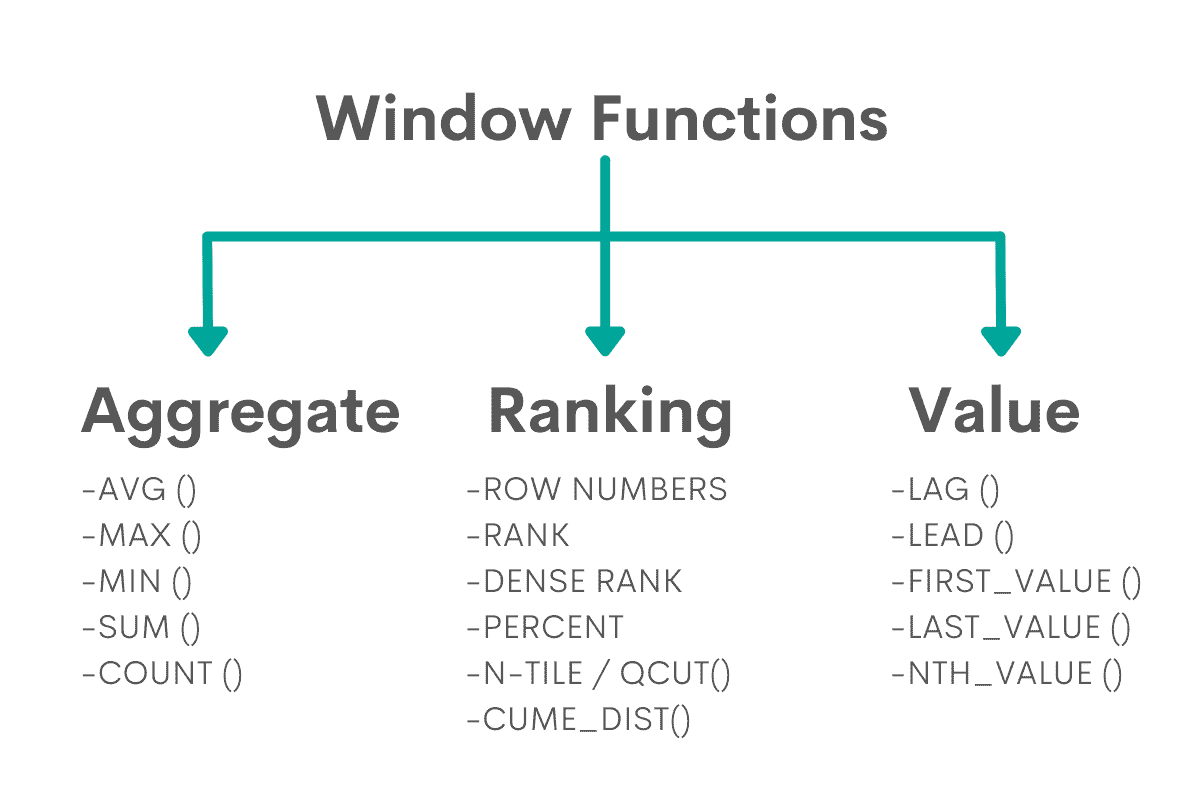

窗口化和聚合 – 流可以被限制以创建有限的数据集。窗口化允许基于字段值的复杂消息选择。一旦创建了有限的批次,可以应用分析。

Spark SQL 具有以下组件

组件

Spark SQL 核心

-

以 RDD 执行查询

-

读取多种文件格式的数据集,如 Parquet、JSON、Avro 等。

-

读取 SQL 和 NOSQL 数据源

Hive 支持

- HQL、MetaStore、SerDes、UDFs

Catalyst 优化器

-

它优化了关系代数 + 表达式

-

它进行查询优化。

Spark SQL 解决的问题

Spark SQL 提供了一个统一的框架,无需将数据移出集群。无需安装或集成额外的模块。它提供了一个统一的加载/保存接口,无论数据源和编程语言是什么。

下面的示例显示了从 avro 加载数据并将其转换为 parquet 是多么简单。

val df = sqlContext.load("mydata.avro", "com.databricks.spark.avro") df.save("mydata.parquet", "parquet")

Spark SQL 具有统一的框架来解决批处理和流处理中的相同分析问题,这一直是数据处理中的圣杯。已有框架可以很好地处理其中之一,并在可扩展性、性能和功能集方面表现良好,但在 Spark / Spark SQL 之前,拥有一个同时处理批处理和流处理的统一框架是不可行的。通过 Spark 框架,相同的代码(逻辑)可以用于批处理数据 – RDDs 或流处理数据集(DStreams – 离散化流)。DStream 只是一系列的 RDDs。这种表示方式允许批处理和流处理工作负载无缝工作。这大大减少了代码维护开销,并减少了对两种不同技能集的开发者的培训需求。

从 JDBC 数据源读取

从 JDBC 读取的数据源已作为 Spark SQL 的内置数据源添加。Spark SQL 可以从任何支持 JDBC 的现有关系数据库中提取数据。示例包括 mysql、postgres、H2 等。从这些系统中的一个读取数据就像创建指向外部表的虚拟表一样简单。然后,可以轻松地读取该表的数据,并与 Spark SQL 支持的任何其他数据源进行联接。

Spark SQL 与数据框架

数据框架是分布式的行集合,按命名列组织,是一种选择、过滤、聚合和绘制结构化数据的抽象 – 之前称为 SchemaRDD。

DataFrame API 可以对外部数据源和 Spark 的内置分布式集合执行关系操作。

DataFrame 在 Spark 程序中提供了丰富的关系/过程集成功能。DataFrames 是结构化记录的集合,可以使用 Spark 的过程 API 进行操作,或者使用新的关系 API 进行更丰富的优化。它们可以直接从 Spark 的内置分布式对象集合中创建,从而在现有的 Spark 中进行关系处理。

DataFrames 比 Spark 的过程 API 更方便和高效。它们使得使用 SQL 语句在一次操作中计算多个聚合变得容易,这在传统的函数式 API 中很难表达。

与 RDDs 不同,DataFrames 会跟踪其模式并支持各种关系操作,从而实现更优化的执行。它们通过反射推断模式。

Spark DataFrames 是惰性的,每个 DataFrame 对象表示一个计算数据集的逻辑计划,但在用户调用特殊的“输出操作”如保存之前不会执行。这使得所有操作能够进行丰富的优化。

DataFrames 使 Spark 的 RDD 模型得以演变,提供简化的方法来过滤、聚合和投影大数据集,从而使 Spark 开发者更快、更容易地处理结构化数据。DataFrames 可在 Spark 的 Java、Scala 和 Python API 中使用。

Spark SQL 的数据源 API 可以从各种数据源和数据格式中读取和写入 DataFrames——包括 Avro、parquet、ORC、JSON、H2。

减少代码编写的示例——使用普通 RDDs 和 DataFrame API 的 SQL

以下的 Scala 示例展示了等效的代码——一个使用 Spark 的 RDD API,另一个使用 Spark 的 DataFrame API。我们有一个对象——People——包括 firstname、lastname、age 作为属性,目标是获取按 firstname 分组的年龄基本统计数据。

case class People(firstname: String, lastname: String, age: Intger) val people = rdd.map(p => (people.firstname, people.age)).cache()

// RDD 代码 val minAgeByFN = people.reduceByKey( scala.math.min(_, _) ) val maxAgeByFN = people.reduceByKey( scala.math.max(_, _) ) val avgAgeByFN = people.mapValues(x => (x, 1)) .reduceByKey((x, y) => (x._1 + y._1, x._2 + y._2)) val countByFN = people.mapValues(x => 1).reduceByKey(_ + _)

// Data Frame 代码 df = people.toDF people = df.groupBy("firstname").agg( min("age"), max("age"), avg("age"), count("*"))

由于 Catalyst 优化器,DataFrames 比使用普通 RDDs 更快。DataFrames 提供与 SQL 和 Pig 等关系查询语言相同的操作。

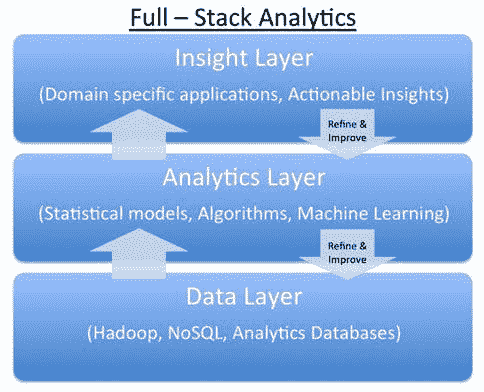

使用 Spark SQL 解决流式分析的方案

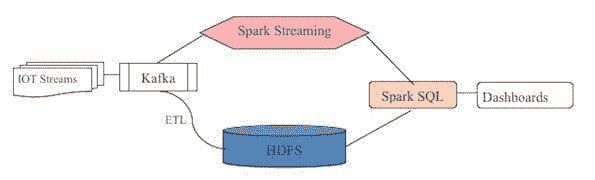

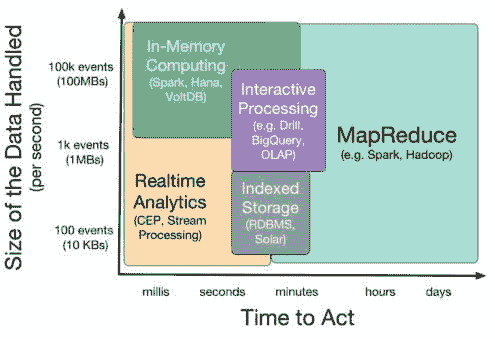

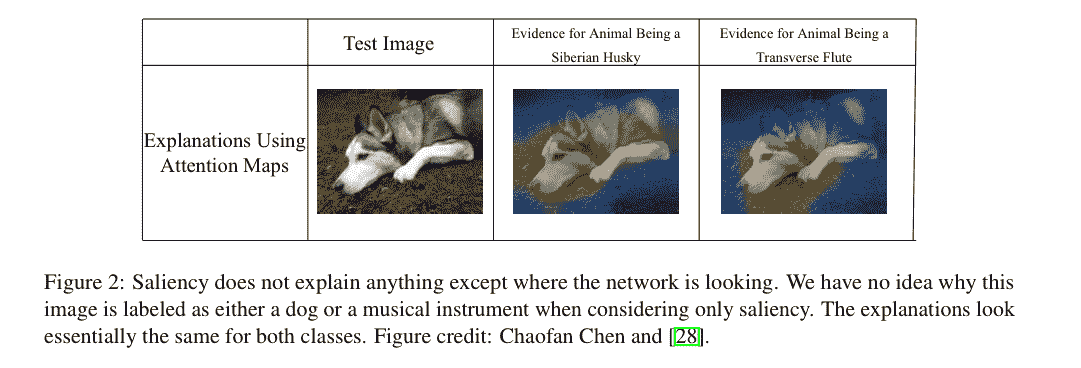

下图展示了我们使用 Spark SQL 进行实时分析的方法。这遵循了构建实时分析系统的 Lambda 架构模式,适用于大规模流数据。

Spark SQL 的缺点

与任何运行在 Hadoop 集群上的工具一样——服务水平协议(SLA)并不依赖于引擎的速度——而是依赖于系统上运行的其他并发用户的数量。

对于初次使用者来说,Spark SQL 代码有时过于简洁,难以理解正在做什么。需要一些经验和实践来习惯 Spark SQL 代码的编码风格和隐式性。

结论

Spark SQL 是核心 Spark API 的重要进化。尽管 Spark 的原始函数式编程 API 相当通用,但它仅提供了有限的自动优化机会。Spark SQL 使 Spark 更加易于使用。

本文旨在为下一组文章奠定基础,这些文章将探讨在物联网领域使用 Spark SQL 进行实时分析。

参考文献:

StreamSQL – en.wikipedia.org/wiki/StreamSQL

StreamSQL – github.com/thunderain-project/StreamSQL

简历: Sumit Pal 是一位大数据、可视化和数据科学顾问。他还是一名软件架构师和大数据爱好者,构建端到端的数据驱动分析系统。Sumit 曾在微软(SQL 服务器开发团队)、甲骨文(OLAP 开发团队)和 Verizon(大数据分析团队)工作,拥有 22 年的职业生涯。目前,他为多个客户提供数据架构和大数据解决方案的建议,并进行 Spark、Scala、Java 和 Python 的实际编码。Sumit 在 sumitpal.wordpress.com/ 撰写博客。

Ajit Jaokar (@AjitJaokar) 从事数据科学和物联网的研究与咨询。他的工作基于他在牛津大学和马德里理工大学的教学,涵盖了物联网、数据科学、智能城市和电信领域。

相关内容:

-

使用 Apache Spark 介绍大数据

-

50+ 数据科学和机器学习备忘单

-

大数据的“重大”问题:Hadoop 还是 Spark?

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

3. Google IT 支持专业证书 - 支持你组织的 IT 部门

更多相关内容

85%的数据科学项目失败——以下是如何避免

原文:

www.kdnuggets.com/2021/09/sparkbeyond-avoid-data-science-projects-fail.html

赞助文章。

由 Sparkbeyond 提供。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的信息技术

3. Google IT 支持专业证书 - 支持您的组织的信息技术

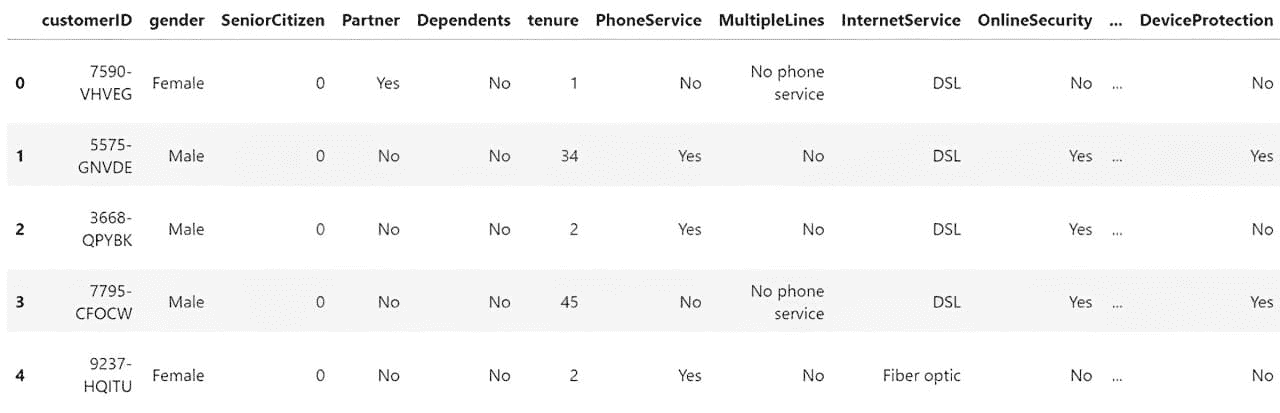

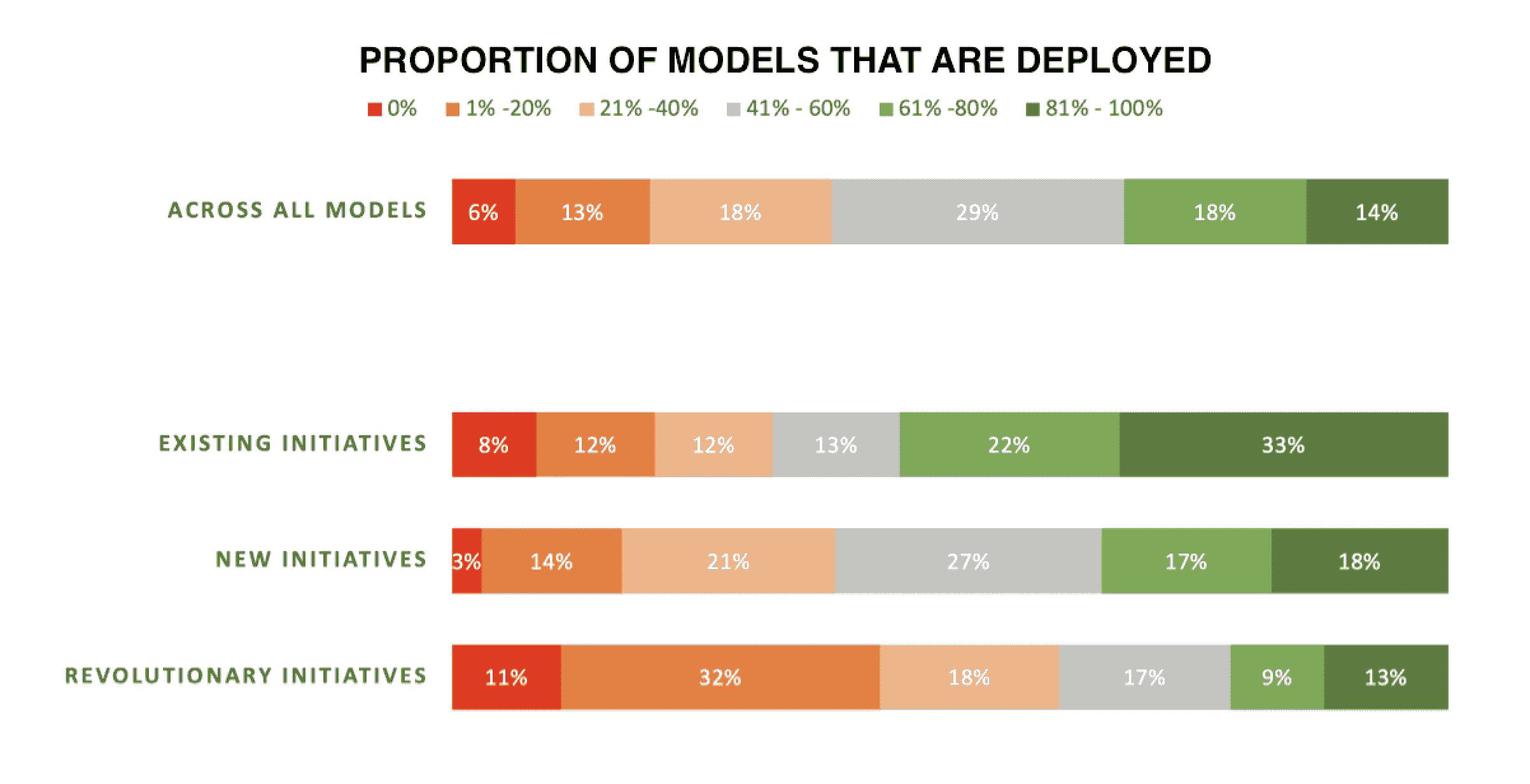

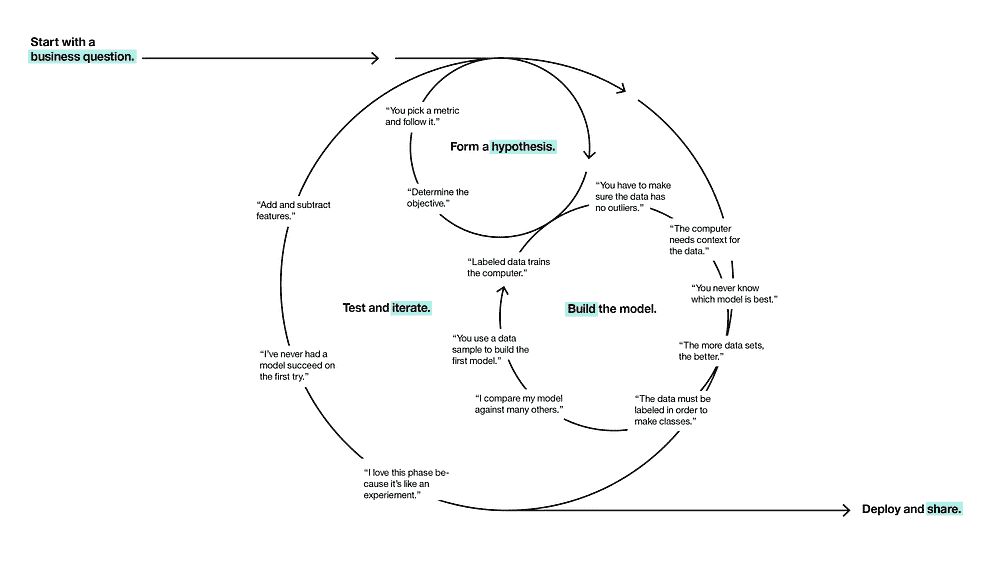

85%的数据科学项目失败。那么你如何避免成为这一统计数据的一部分?这里有一些数据科学家可以避免的常见陷阱。

1. 超越预测

毫无疑问,预测建模是数据科学的一大优势——特别是在我们知道结果超出我们控制范围的情况下,预测成为唯一的选择。但是,为什么要将数据科学仅限于预测呢?

例如,我们是否应该简单地接受客户流失的事实,并对那些最有风险的客户提供保留优惠?还是我们应该了解人们为何可能流失,并让他们一开始就成为更满意的客户?

我们需要超越仅仅构建预测模型,深入挖掘潜在驱动因素。显然,这比构建模型要复杂得多,因为发现开放性问题的根本原因远比构建模型要复杂。如果你想塑造未来而不是被未来塑造,你需要发现驱动你问题的因素。

2. 你知道你想知道什么吗?

将商业问题转化为数据科学用例时,第一个问题通常是:“我的目标变量是什么?”这个问题并不像你想的那么简单。

常见的分析用例通常有多个角度。例如,以保险索赔为例。我们希望了解哪些索赔总体上风险较低,可以加速处理。此外,我们还想知道哪些需要通过其他保险公司进行分诊,或者哪些可能没有保障。每个目标通常有不同的驱动因素,使用传统方法,探索五个用例将需要付出五倍的努力。为了创造可持续的业务影响,这还不够。

3. 今天有效的东西明天可能无关紧要

疫情的波动暴露了一个众所周知的问题,即仅仅对最新数据进行模型重新校准。重新校准只能使你的模型正确解读呈现给它们的信息——这些信息是由数据科学家提供的特征中编码的。但那些在过去被丢弃或忽视的信息呢?因为在过去,它们并不重要。

尽管上述问题看起来各不相同,但有一种方法可以提供解决方案:利用人工智能大规模生成假设。

进一步阅读

处理机器学习模型中的稀疏特征

原文:

www.kdnuggets.com/2021/01/sparse-features-machine-learning-models.html

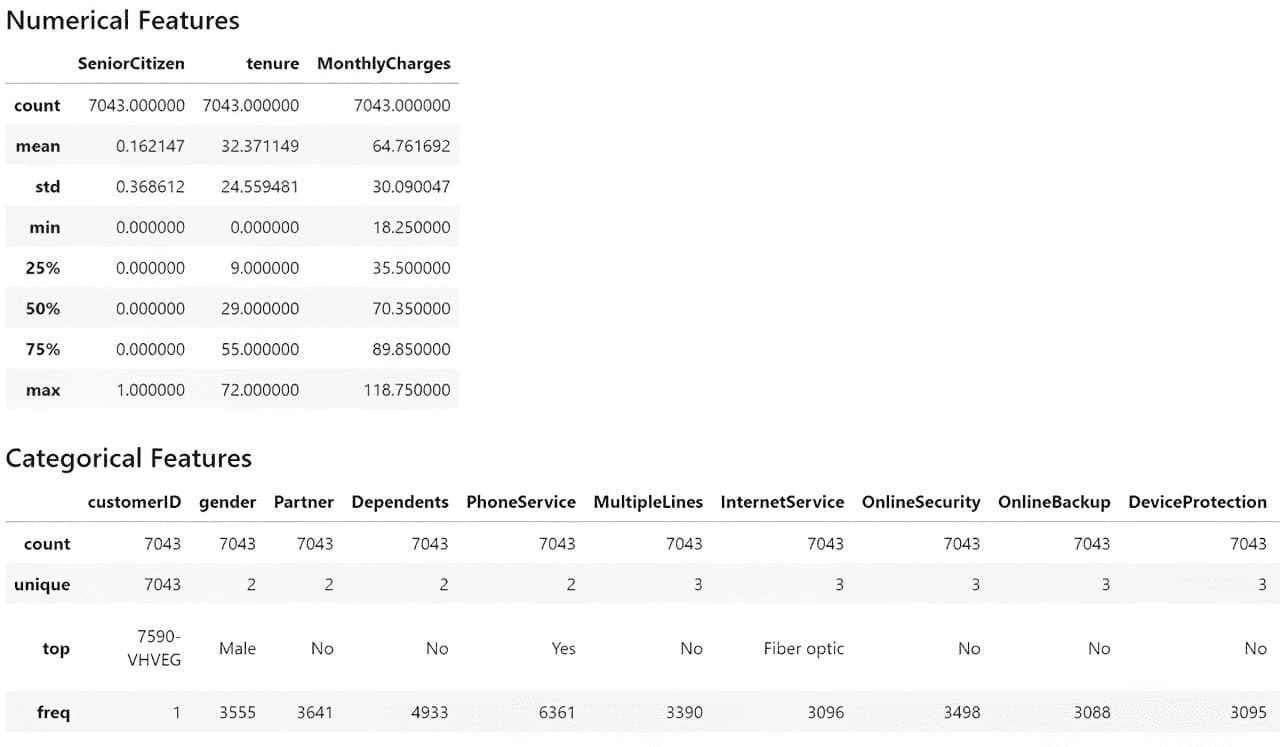

什么是稀疏特征?

我们的前三个课程推荐

1. 谷歌网络安全证书 - 加速进入网络安全领域的职业生涯。

1. 谷歌网络安全证书 - 加速进入网络安全领域的职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

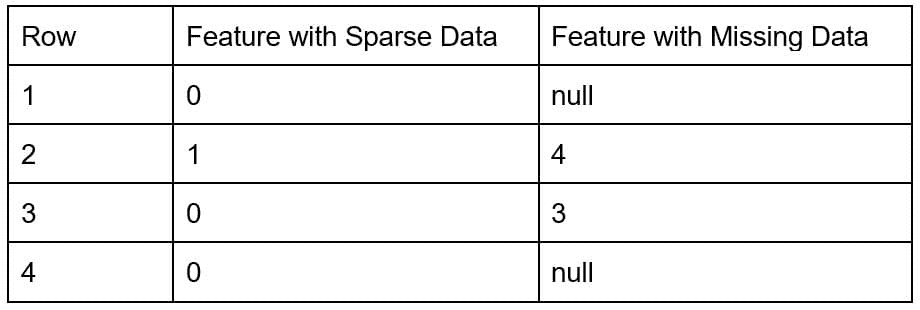

稀疏数据的特征是那些大多数值为零的特征。这与缺失数据的特征不同。稀疏特征的例子包括一热编码词的向量或类别数据的计数。另一方面,稠密数据的特征则主要具有非零值。

稀疏数据和缺失数据有什么区别?

当数据缺失时,意味着许多数据点是未知的。另一方面,如果数据是稀疏的,则所有数据点都是已知的,但其中大多数值为零。

为了说明这一点,有两种特征类型。稀疏数据的特征有已知的值(= 0),但缺失数据的特征有未知的值(= null)。无法知道应该在 null 值的行中填入什么值。

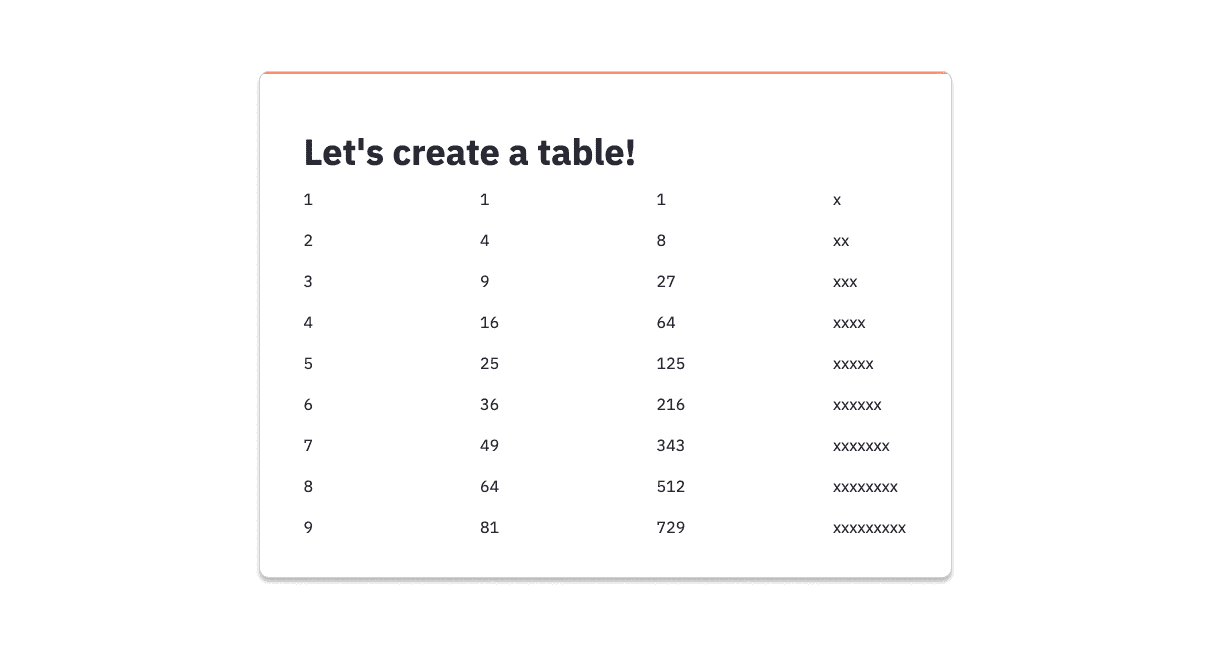

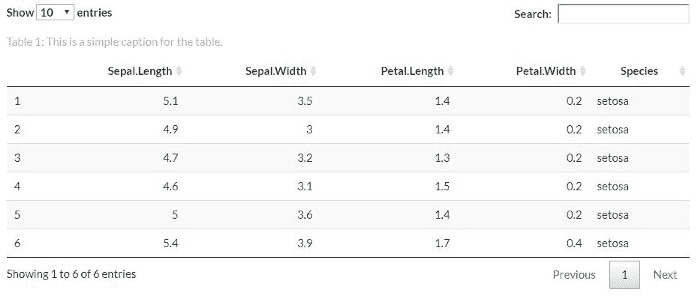

表 1. 两种特征类型的示例数据。

为什么稀疏特征使机器学习变得困难?

稀疏特征常见的问题包括:

-

如果模型具有许多稀疏特征,这将增加模型的空间和时间复杂度。线性回归模型将拟合更多的系数,而基于树的模型将具有更大的深度以考虑所有特征。

-

如果特征具有稀疏数据,模型算法和诊断措施可能会表现出未知的行为。Kuss [2002] 表明,当数据稀疏时,拟合优度检验是有缺陷的。

-

如果特征过多,模型会拟合训练数据中的噪声。这称为过拟合。当模型过拟合时,当投入生产时,它们无法对新数据进行泛化。这会对模型的预测能力产生负面影响。

-

一些模型可能低估稀疏特征的重要性,偏爱较密集的特征,即使稀疏特征可能具有预测能力。基于树的模型尤其容易出现这种情况。例如,随机森林会过高估计具有更多类别的特征的重要性,而忽略那些类别较少的特征。

处理稀疏特征的方法

1. 从模型中移除特征

稀疏特征可能会引入噪声,模型会捕捉到这些噪声并增加模型的内存需求。为了解决这个问题,可以将这些特征从模型中移除。例如,在文本挖掘模型中去除稀有词,或者 移除低方差的特征。然而,具有重要信号的稀疏特征在这个过程中不应被移除。

LASSO 正则化可以用来减少特征的数量。基于规则的方法,例如设置特征的方差阈值,也可能会有帮助。

2. 使特征密集

-

主成分分析(PCA):PCA 方法可以将特征投影到主成分的方向上,并从最重要的主成分中选择。

-

特征哈希:在特征哈希中,稀疏特征可以使用哈希函数分配到所需数量的输出特征中。需要小心选择足够多的输出特征以防止哈希碰撞。

3. 使用对稀疏特征具有鲁棒性的模型

一些版本的机器学习模型对稀疏数据具有鲁棒性,可以用来代替改变数据的维度。例如,熵加权 k-means 算法比常规的 k-means 算法更适合这个问题。

结论

稀疏特征在机器学习模型中很常见,特别是在 one-hot 编码形式中。这些特征可能会导致机器学习模型出现过拟合、特征重要性不准确和高方差等问题。建议通过特征哈希或移除特征等方法对稀疏特征进行预处理,以减少对结果的负面影响。

Arushi Prakash 博士 是亚马逊的一名应用科学家,她在劳动力分析领域解决令人兴奋的科学挑战。在获得化学工程博士学位后,她转向数据科学。她喜欢写作、演讲和阅读有关科学、职业发展和领导力的内容。

更多相关话题

Python 中的稀疏矩阵表示

原文:

www.kdnuggets.com/2020/05/sparse-matrix-representation-python.html

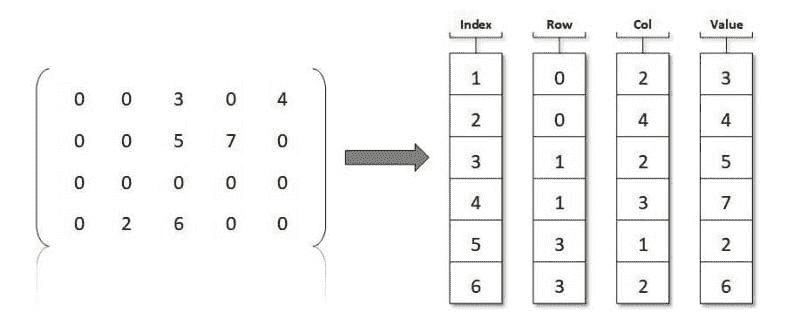

大多数机器学习从业者习惯于在将数据输入机器学习算法之前采用矩阵表示法。矩阵是理想的形式,通常行表示数据集实例,列表示特征。

稀疏矩阵是大多数元素为零的矩阵。这与密集矩阵相对,后者的区分特征你现在可能已经能自己弄明白了。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速通道进入网络安全职业生涯。

1. Google 网络安全证书 - 快速通道进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

图片来源:TU 柏林

我们的数据通常是密集的,每个实例的特征列都被填满。如果我们使用有限数量的列来全面描述某些事物,一般来说,给定数据点的描述值需要充分发挥作用,以提供有意义的表示:一个人、一张图片、一朵鸢尾花、房价、潜在的信用风险。

但有些类型的数据在其表示中并不需要如此冗长。想想关系。我们可能需要捕捉大量潜在事物的关系状态,但在这些事物的交集处,我们可能只需记录“是的,有关系”或“不是,没有关系”。

这个人是否购买了那个物品?那句话中是否包含这个词?在任何给定的句子中可能出现很多潜在的词,但实际出现的词却不多。同样,虽然市场上可能有很多销售的物品,但任何一个人实际上购买的物品却不多。

这是稀疏矩阵在机器学习中发挥作用的一种方式。想象一下列代表销售项,行代表购物者。在每个给定项没有被给定购物者购买的交集处,将有一个“无”(空)表示,比如 0. 只有在给定购物者购买了给定项的交集处才需要有“是”表示,比如 1. 对于给定句子中的单词出现情况也是如此。你可以看到为什么这样的矩阵会包含很多零,即它们会是稀疏的。

稀疏矩阵的一个问题是它们可能会对内存造成很大的压力。假设你采用标准的方法来表示一个 2x2 矩阵,那么每个空的表示都需要在内存中分配,尽管没有捕捉到有用的信息。这种内存压力还会持续到永久存储中。在标准的矩阵表示方法中,我们被迫记录事物的缺失,而不仅仅是存在。

但等等,一定还有更好的方法!

确实有。稀疏矩阵不必以标准矩阵形式表示。有很多方法可以缓解这种标准形式对计算系统的压力,而恰好在流行的 Python 机器学习工具包 Scikit-learn 中,一些算法接受这些稀疏表示作为输入。熟悉这些方法可以节省你的时间、麻烦和精力。

我们如何更好地表示这些稀疏矩阵?我们需要一种方式来跟踪零值不在的位置。怎样用一个两列的表格,其中一列跟踪row,col(行,列)位置的非零项,另一列记录对应的值?请记住,稀疏矩阵不必仅仅包含零和一;只要大多数元素是零,无论非零元素是什么,矩阵就是稀疏的。

我们还需要确定创建稀疏矩阵的顺序——是逐行处理,每遇到一个非零元素就存储它,还是逐列处理?如果决定逐行处理,恭喜你,你刚刚创建了一个压缩稀疏行矩阵。如果逐列处理,你现在拥有的是一个压缩稀疏列矩阵。方便的是,Scipy 支持这两种方法。

让我们来看一下如何创建这些矩阵。首先,我们在 Numpy 中创建一个简单的矩阵。

import numpy as np

from scipy import sparse

X = np.random.uniform(size=(6, 6))

print(X)

[[0.79904211 0.76621075 0.57847599 0.72606798 0.10008544 0.90838851]

[0.45504345 0.10275931 0.0191763 0.09037216 0.14604688 0.02899529]

[0.92234613 0.78231698 0.43204239 0.61663291 0.78899765 0.44088739]

[0.50422356 0.72221353 0.57838041 0.30222171 0.25263237 0.55913311]

[0.191842 0.07242766 0.17230918 0.31543582 0.90043157 0.8787012 ]

[0.71360049 0.45130523 0.46687117 0.96148004 0.56777938 0.40780967]]

然后我们需要将大多数矩阵元素置为零,使其变为稀疏矩阵。

X[X < 0.7] = 0

print(X)

[[0.79904211 0.76621075 0\. 0.72606798 0\. 0.90838851]

[0\. 0\. 0\. 0\. 0\. 0\. ]

[0.92234613 0.78231698 0\. 0\. 0.78899765 0\. ]

[0\. 0.72221353 0\. 0\. 0\. 0\. ]

[0\. 0\. 0\. 0\. 0.90043157 0.8787012 ]

[0.71360049 0\. 0\. 0.96148004 0\. 0\. ]]

现在我们将标准矩阵 X 存储为压缩稀疏行矩阵。为此,元素按照从左到右的顺序逐行遍历,并在遇到时输入到这个压缩矩阵表示中。

X_csr = sparse.csr_matrix(X)

print(X_csr)

(0, 0) 0.799042106215471

(0, 1) 0.7662107548809229

(0, 3) 0.7260679774297479

(0, 5) 0.9083885095042665

(2, 0) 0.9223461264672205

(2, 1) 0.7823169848589594

(2, 4) 0.7889976504606654

(3, 1) 0.7222135307432606

(4, 4) 0.9004315651436953

(4, 5) 0.8787011979799789

(5, 0) 0.7136004887949333

(5, 3) 0.9614800409505844

瞧!

那么压缩稀疏列矩阵怎么样呢?在其创建过程中,元素按照从上到下的顺序逐列遍历,并在遇到时输入到压缩表示中。

X_csc = sparse.csc_matrix(X)

print(X_csc)

(0, 0) 0.799042106215471

(2, 0) 0.9223461264672205

(5, 0) 0.7136004887949333

(0, 1) 0.7662107548809229

(2, 1) 0.7823169848589594

(3, 1) 0.7222135307432606

(0, 3) 0.7260679774297479

(5, 3) 0.9614800409505844

(2, 4) 0.7889976504606654

(4, 4) 0.9004315651436953

(0, 5) 0.9083885095042665

(4, 5) 0.8787011979799789

注意结果稀疏矩阵表示之间的差异,特别是相同元素值的位置差异。

如前所述,许多 Scikit-learn 算法接受形状为 [num_samples, num_features] 的 scipy.sparse 矩阵作为 Numpy 数组的替代,因此目前没有迫切需要将它们转换回标准的 Numpy 表示形式。也可能存在内存限制阻止这种转换(回想一下,这是采用这种方法的主要原因之一)。但为了演示,以下是如何将稀疏的 Scipy 矩阵表示转换回 Numpy 多维数组。

print(X_csr.toarray())

[[0.79904211 0.76621075 0\. 0.72606798 0\. 0.90838851]

[0\. 0\. 0\. 0\. 0\. 0\. ]

[0.92234613 0.78231698 0\. 0\. 0.78899765 0\. ]

[0\. 0.72221353 0\. 0\. 0\. 0\. ]

[0\. 0\. 0\. 0\. 0.90043157 0.8787012 ]

[0.71360049 0\. 0\. 0.96148004 0\. 0\. ]]

那么两种表示方式之间的内存需求差异呢?让我们再次通过这个过程,从一个更大的标准 Numpy 矩阵开始,然后计算每种表示方式所使用的内存(以字节为单位)。

import numpy as np

from scipy import sparse

X = np.random.uniform(size=(10000, 10000))

X[X < 0.7] = 0

X_csr = sparse.csr_matrix(X)

print(f"Size in bytes of original matrix: {X.nbytes}")

print(f"Size in bytes of compressed sparse row matrix: {X_csr.data.nbytes + X_csr.indptr.nbytes + X_csr.indices.nbytes}")

Size in bytes of original matrix: 800000000

Size in bytes of compressed sparse row matrix: 360065312

在这里你可以看到,压缩矩阵形式相比标准 Numpy 表示方式在内存上的显著节省,大约 360 兆字节对比 800 兆字节。这节省了 440 兆字节,并且几乎没有时间开销,因为格式之间的转换经过高度优化。显然,这些稀疏的 SciPy 矩阵也可以直接创建,从而节省了中间内存消耗的步骤。

现在想象一下你正在处理一个庞大的数据集,并考虑通过正确使用稀疏矩阵格式所能享受的内存节省(以及相关的存储和处理时间)。

Matthew Mayo (@mattmayo13) 是数据科学家和 KDnuggets 的总编辑,KDnuggets 是开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络以及自动化机器学习方法。Matthew 拥有计算机科学硕士学位和数据挖掘研究生文凭。他的联系方式是 editor1 at kdnuggets[dot]com。

相关话题更多内容

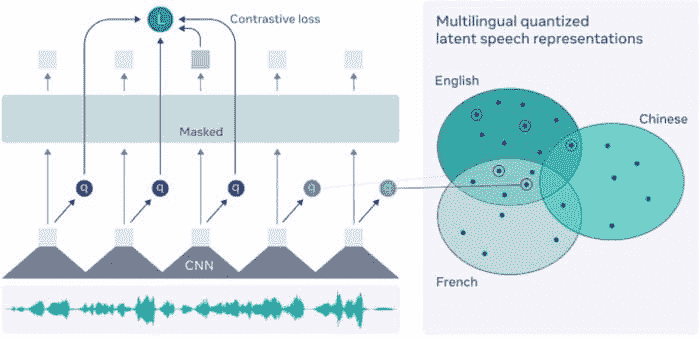

使用 Wav2Vec 2.0 进行语音转文本

评论

由 Dhilip Subramanian,数据科学家和 AI 爱好者

在我之前的博客中,我解释了如何使用 Speech Recognition 库和 Google 语音识别 API 将语音转换为文本。在本博客中,我们将探讨如何使用 Facebook Wav2Vec 2.0 模型将语音转换为文本。

Facebook 最近推出并 开源了他们的新框架,用于从原始音频数据中自监督学习表示,称为 Wav2Vec 2.0。Facebook 研究人员声称,这个框架可以使 自动语音识别模型 仅凭 10 分钟的转录语音数据实现。

众所周知,Transformers 在自然语言处理中的作用重大。Hugging Face transformers 的最新版本是 4.30,它包含了 Wav2Vec 2.0。这是 Transformers 中首个包含的自动语音识别模型。

模型架构超出了本博客的范围。有关详细的 Wav2Vec 模型架构,请查看 这里。

让我们看看如何使用 Hugging Face transformers 通过一些简单的代码将音频文件转换为文本。

安装 Transformer 库

# Installing Transformer

!pip install -q transformers

导入必要的库

# Import necessary library

# For managing audio file

import librosa

#Importing Pytorch

import torch

#Importing Wav2Vec

from transformers import Wav2Vec2ForCTC, Wav2Vec2Tokenizer

Wav2Vec2 是一个语音模型,它接受一个浮点数组,该数组对应于语音信号的原始波形。Wav2Vec2 模型使用连接时序分类(CTC)进行训练,因此模型输出需要使用 Wav2Vec2Tokenizer 进行解码(参考: Hugging Face)

阅读音频文件

在这个示例中,我使用了来自电影《Taken》的 Liam Neeson 著名对话音频片段,其中说 “我会找你,我会找到你,我会杀了你”

请注意,Wav2Vec 模型是在 16 kHz 频率下预训练的,因此我们需要确保我们的原始音频文件也被重采样为 16 kHz 采样率。我使用了在线 音频工具转换 将“Taken”音频片段重采样为 16kHz。

使用 librosa 库加载音频文件,并提到我的音频片段大小为 16000 Hz。它将音频片段转换为数组,并存储到‘audio’变量中。

# Loading the audio file

audio, rate = librosa.load("taken_clip.wav", sr = 16000)

# printing audio

print(audio)

array([0., 0., 0., ..., 0., 0., 0.], dtype=float32)

# printing rate

print(rate)

16000

导入预训练的 Wav2Vec 模型

# Importing Wav2Vec pretrained model

tokenizer = Wav2Vec2Tokenizer.from_pretrained("facebook/wav2vec2-base-960h")

model = Wav2Vec2ForCTC.from_pretrained("facebook/wav2vec2-base-960h")

下一步是获取输入值,将音频(数组)传递给分词器,并希望我们的张量采用 PyTorch 格式而不是 Python 整数。return_tensors = “pt” 仅仅是 PyTorch 格式。

# Taking an input value

input_values = tokenizer(audio, return_tensors = "pt").input_values

获取 logits 值(非标准化值)

# Storing logits (non-normalized prediction values)

logits = model(input_values).logits

将 logits 值传递给 softmax 以获取预测值

# Storing predicted ids

prediction = torch.argmax(logits, dim = -1)

将音频转换为文本

最后一步是将预测结果传递给分词器解码器以获取转录文本

# Passing the prediction to the tokenzer decode to get the transcription

transcription = tokenizer.batch_decode(prediction)[0]

# Printing the transcription

print(transcription)

'I WILL LOOK FOR YOU I WILL FIND YOU AND I WILL KILL YOU'

它完全匹配我们的音频片段。

在这篇博客中,我们了解了如何使用 Transformers 中的预训练 Wav2Vec 模型将语音转换为文本。这对 NLP 项目尤其是处理音频转录数据非常有帮助。如果你有任何补充,请随时留言!

你可以在我的 GitHub 仓库 中找到完整的代码和数据。

感谢阅读。继续学习,敬请关注更多内容!

参考

简介:Dhilip Subramanian 是一名机械工程师,已完成分析学硕士学位。他在数据相关的多个领域拥有 9 年的经验,包括 IT、市场营销、银行、电力和制造业。他对 NLP 和机器学习充满热情。他是SAS 社区的贡献者,喜欢在 Medium 平台上撰写有关数据科学各个方面的技术文章。

原文。经许可转载。

相关:

-

使用 Python 进行简单的语音转文本

-

入门 5 个必备的自然语言处理库

-

Hugging Face Transformers 包 – 这是什么,如何使用

我们的前 3 名课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关主题

如何使用索引加速 SQL 查询 [Python 版]

原文:

www.kdnuggets.com/2023/08/speed-sql-queries-indexes-python-edition.html

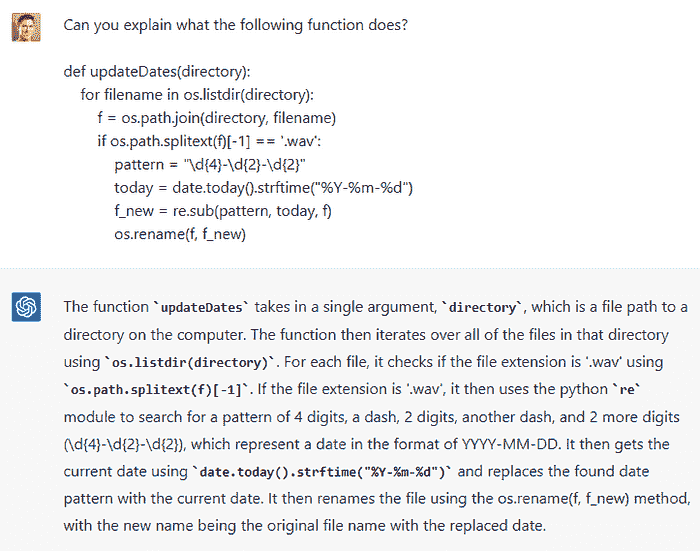

![如何使用索引加速 SQL 查询 [Python 版]](../Images/6dd7f74dcf25f10a17a48f0c17ae157a.png)

图片由作者提供

假设你在翻阅一本书的页面。你想更快地找到你正在寻找的信息。你会怎么做?你可能会查找术语的索引,然后跳到引用特定术语的页面。SQL 中的索引 与书籍中的索引类似。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在的组织 IT

3. Google IT 支持专业证书 - 支持你所在的组织 IT

在大多数实际系统中,你会对包含大量行(比如数百万行)的数据库表运行查询。需要对所有行进行全表扫描以检索结果的查询会非常慢。如果你知道经常需要基于某些列查询信息,你可以在这些列上创建数据库索引。这将显著加快查询速度。

那么今天我们将学习什么?我们将学习如何在 Python 中连接和查询 SQLite 数据库—使用 sqlite3 模块。我们还将学习如何添加索引以及如何提升性能。

要跟随本教程进行编码,你的工作环境中应安装 Python 3.7+ 和 SQLite。

注意:本教程中的示例和输出样本适用于 Ubuntu LTS 22.04 上的 Python 3.10 和 SQLite3(版本 3.37.2)。

在 Python 中连接到数据库

我们将使用 内置的 sqlite3 模块。在开始运行查询之前,我们需要:

-

连接到数据库

-

创建一个数据库游标来运行查询

连接到数据库时,我们将使用来自 sqlite3 模块的 connect() 函数。一旦建立连接,我们可以在连接对象上调用 cursor() 来创建一个数据库游标,如下所示:

import sqlite3

# connect to the db

db_conn = sqlite3.connect('people_db.db')

db_cursor = db_conn.cursor()

在这里我们尝试连接到数据库 people_db。如果数据库不存在,运行上述代码片段将为我们创建 SQLite 数据库。

创建表格并插入记录

现在,我们将在数据库中创建一个表格,并填充记录。

让我们在 people_db 数据库中创建一个名为 people 的表格,包含以下字段:

-

name

-

email

-

job

# main.py

...

# create table

db_cursor.execute('''CREATE TABLE people (

id INTEGER PRIMARY KEY,

name TEXT,

email TEXT,

job TEXT)''')

...

# commit the transaction and close the cursor and db connection

db_conn.commit()

db_cursor.close()

db_conn.close()

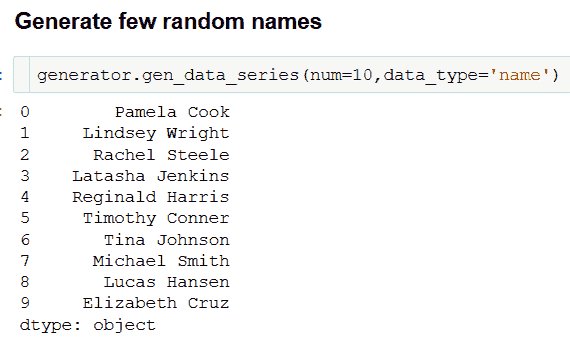

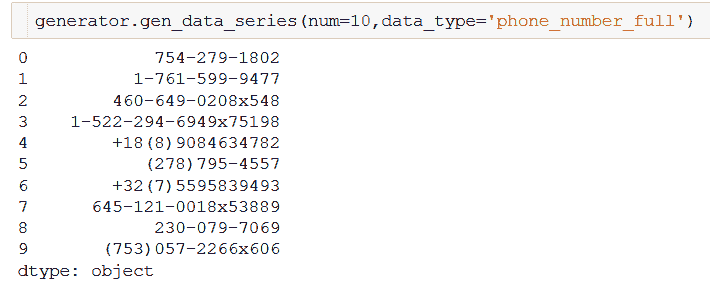

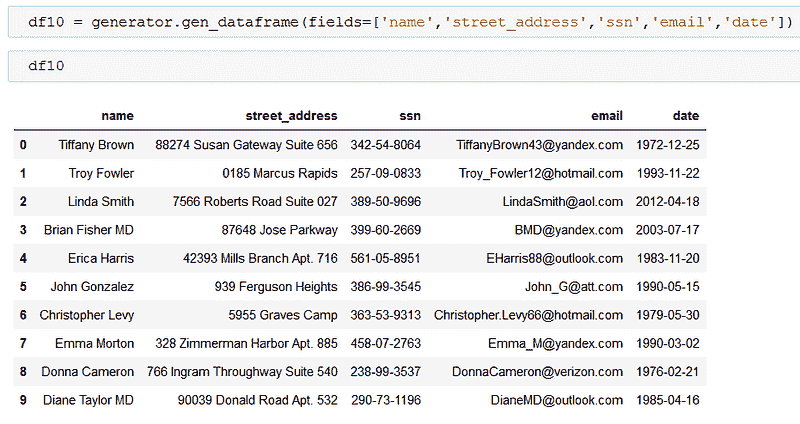

使用 Faker 生成合成数据

现在我们必须将记录插入到表中。为此,我们将使用 Faker——一个用于合成数据生成的 Python 包——通过 pip 安装:

$ pip install faker

安装 faker 后,你可以将 Faker 类导入到 Python 脚本中:

# main.py

...

from faker import Faker

...

下一步是生成并插入记录到 people 表中。为了让我们了解索引如何加速查询,让我们插入大量记录。在这里,我们将插入 100K 条记录;将 num_records 变量设置为 100000。

然后,我们做以下操作:

-

实例化一个

Faker对象fake并设置种子,以确保结果的可重现性。 -

使用名字和姓氏——通过在

fake对象上调用first_name()和last_name()——获取一个姓名字符串。 -

通过调用

domain_name()生成一个虚假的域名。 -

使用名字和姓氏以及域名生成电子邮件字段。

-

使用

job()为每个记录获取一个工作。

我们生成并插入记录到 people 表中:

# create and insert records

fake = Faker() # be sure to import: from faker import Faker

Faker.seed(42)

num_records = 100000

for _ in range(num_records):

first = fake.first_name()

last = fake.last_name()

name = f"{first} {last}"

domain = fake.domain_name()

email = f"{first}.{last}@{domain}"

job = fake.job()

db_cursor.execute('INSERT INTO people (name, email, job) VALUES (?,?,?)', (name,email,job))

# commit the transaction and close the cursor and db connection

db_conn.commit()

db_cursor.close()

db_conn.close()

现在 main.py 文件包含以下代码:

# main.py

# imports

import sqlite3

from faker import Faker

# connect to the db

db_conn = sqlite3.connect('people_db.db')

db_cursor = db_conn.cursor()

# create table

db_cursor.execute('''CREATE TABLE people (

id INTEGER PRIMARY KEY,

name TEXT,

email TEXT,

job TEXT)''')

# create and insert records

fake = Faker()

Faker.seed(42)

num_records = 100000

for _ in range(num_records):

first = fake.first_name()

last = fake.last_name()

name = f"{first} {last}"

domain = fake.domain_name()

email = f"{first}.{last}@{domain}"

job = fake.job()

db_cursor.execute('INSERT INTO people (name, email, job) VALUES (?,?,?)', (name,email,job))

# commit the transaction and close the cursor and db connection

db_conn.commit()

db_cursor.close()

db_conn.close()

运行这个脚本——一次——以用 num_records 数量的记录填充表格。

查询数据库

现在我们有了包含 100K 记录的表格,让我们对 people 表运行一个示例查询。

让我们运行一个查询来:

-

获取工作职位为 ‘Product manager’ 的记录的姓名和电子邮件,

-

将查询结果限制为 10 条记录。

我们将使用 time 模块的默认计时器来获取查询的大致执行时间。

# sample_query.py

import sqlite3

import time

db_conn = sqlite3.connect("people_db.db")

db_cursor = db_conn.cursor()

t1 = time.perf_counter_ns()

db_cursor.execute("SELECT name, email FROM people WHERE job='Product manager' LIMIT 10;")

res = db_cursor.fetchall()

t2 = time.perf_counter_ns()

print(res)

print(f"Query time without index: {(t2-t1)/1000} us")

这是输出结果:

Output >>

[

("Tina Woods", "Tina.Woods@smith.com"),

("Toni Jackson", "Toni.Jackson@underwood.com"),

("Lisa Miller", "Lisa.Miller@solis-west.info"),

("Katherine Guerrero", "Katherine.Guerrero@schmidt-price.org"),

("Michelle Lane", "Michelle.Lane@carr-hardy.com"),

("Jane Johnson", "Jane.Johnson@graham.com"),

("Matthew Odom", "Matthew.Odom@willis.biz"),

("Isaac Daniel", "Isaac.Daniel@peck.com"),

("Jay Byrd", "Jay.Byrd@bailey.info"),

("Thomas Kirby", "Thomas.Kirby@west.com"),

]

Query time without index: 448.275 us

你还可以通过在命令行中运行 sqlite3 db_name 来调用 SQLite 命令行客户端:

$ sqlite3 people_db.db

SQLite version 3.37.2 2022-01-06 13:25:41

Enter ".help" for usage hints.

要获取索引列表,你可以运行 .index:

sqlite> .index

由于当前没有索引,所以不会列出任何索引。

你还可以这样检查查询计划:

sqlite> EXPLAIN QUERY PLAN SELECT name, email FROM people WHERE job='Product Manager' LIMIT 10;

QUERY PLAN

`--SCAN people

这里的查询计划是 扫描所有行,这效率较低。

在特定列上创建索引

要在特定列上创建数据库索引,你可以使用以下语法:

CREATE INDEX index-name on table (column(s))

假设我们需要频繁查找具有特定职位名称的个人记录。创建一个 people_job_index 索引在 job 列上会有所帮助:

# create_index.py

import time

import sqlite3

db_conn = sqlite3.connect('people_db.db')

db_cursor =db_conn.cursor()

t1 = time.perf_counter_ns()

db_cursor.execute("CREATE INDEX people_job_index ON people (job)")

t2 = time.perf_counter_ns()

db_conn.commit()

print(f"Time to create index: {(t2 - t1)/1000} us")

Output >>

Time to create index: 338298.6 us

尽管创建索引需要这么长时间,但这只是一次性操作。当运行多个查询时,你仍然会获得显著的加速。

现在如果你在 SQLite 命令行客户端运行 .index,你将得到:

sqlite> .index

people_job_index

使用索引查询数据库

如果你现在查看查询计划,你应该能够看到我们现在使用 job 列上的索引 people_job_index 来搜索 people 表:

sqlite> EXPLAIN QUERY PLAN SELECT name, email FROM people WHERE job='Product manager' LIMIT 10;

QUERY PLAN

`--SEARCH people USING INDEX people_job_index (job=?)

你可以重新运行 sample_query.py。只需修改 print() 语句,看看查询现在需要多长时间:

# sample_query.py

import sqlite3

import time

db_conn = sqlite3.connect("people_db.db")

db_cursor = db_conn.cursor()

t1 = time.perf_counter_ns()

db_cursor.execute("SELECT name, email FROM people WHERE job='Product manager' LIMIT 10;")

res = db_cursor.fetchall()

t2 = time.perf_counter_ns()

print(res)

print(f"Query time with index: {(t2-t1)/1000} us")

这是输出结果:

Output >>

[

("Tina Woods", "Tina.Woods@smith.com"),

("Toni Jackson", "Toni.Jackson@underwood.com"),

("Lisa Miller", "Lisa.Miller@solis-west.info"),

("Katherine Guerrero", "Katherine.Guerrero@schmidt-price.org"),

("Michelle Lane", "Michelle.Lane@carr-hardy.com"),

("Jane Johnson", "Jane.Johnson@graham.com"),

("Matthew Odom", "Matthew.Odom@willis.biz"),

("Isaac Daniel", "Isaac.Daniel@peck.com"),

("Jay Byrd", "Jay.Byrd@bailey.info"),

("Thomas Kirby", "Thomas.Kirby@west.com"),

]

Query time with index: 167.179 us

我们看到查询现在执行大约需要 167.179 微秒。

性能改进

对于我们的示例查询,使用索引查询大约快 2.68 倍。我们在执行时间上获得了 62.71% 的百分比加速。

你还可以尝试运行更多查询:涉及在 job 列上进行过滤的查询,并查看性能改进。

另外请注意:由于我们仅在工作列上创建了索引,如果你运行涉及其他列的查询,查询的速度不会比没有索引时快。

总结与下一步

我希望本指南帮助你了解如何通过在频繁查询的列上创建数据库索引来显著提高查询速度。这是关于数据库索引的介绍。你还可以创建多列索引、同一列的多个索引等。

你可以在这个 GitHub 仓库找到本教程中使用的所有代码。祝编程愉快!

Bala Priya C 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和喝咖啡!目前,她正在通过编写教程、操作指南、观点文章等与开发者社区分享她的知识。

更多相关主题

使用 NumExpr 包加速你的 Numpy 和 Pandas

原文:

www.kdnuggets.com/2020/07/speed-up-numpy-pandas-numexpr-package.html

评论

图片来源:Pixabay和作者制作的拼贴图

介绍

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

Numpy 和 Pandas 可能是数据科学(DS)和机器学习(ML)任务中最广泛使用的两个核心 Python 库。不用多说,评估数值表达式的速度对这些 DS/ML 任务至关重要,这两个库在这方面表现也不负众望。

在底层,它们使用快速且优化的向量化操作(尽可能多)来加速数学运算。许多文章已经讨论了 Numpy 如何比普通的 Python 循环或基于列表的操作要优越得多(尤其是当你可以向量化你的计算时)。

与标准 Python 列表的比较

使用 Python 进行数据科学:将你的条件循环转为 Numpy 向量

甚至对条件循环进行向量化,以加速整体数据转换,是值得的。

在这篇文章中,我们展示了如何使用一个名为‘NumExpr’的简单扩展库来提升数学运算的速度,这些运算由核心的 Numpy 和 Pandas 生成。

让我们看看它的实际效果

示例 Jupyter 笔记本可以在我的 Github 仓库中找到。

安装 NumExpr 库

首先,我们需要确保我们拥有numexpr库。所以,正如预期的那样,

pip install numexpr

该项目托管在这里的 Github 上。它来自PyData稳定版,这是一个隶属于 NumFocus 的组织,也促成了 Numpy 和 Pandas 的诞生。

根据源信息,“NumExpr 是一个快速的数值表达式求值器,用于 NumPy。使用它,操作数组的表达式会得到加速,并且使用的内存更少,相比于在 Python 中进行相同的计算。此外,它的多线程能力可以利用所有核心——这通常会导致相比于 NumPy 有显著的性能提升。” (source)

这是详细文档和各种用例示例。

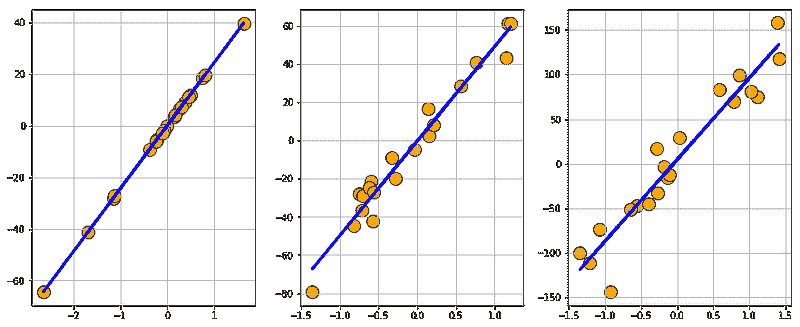

简单的向量-标量操作

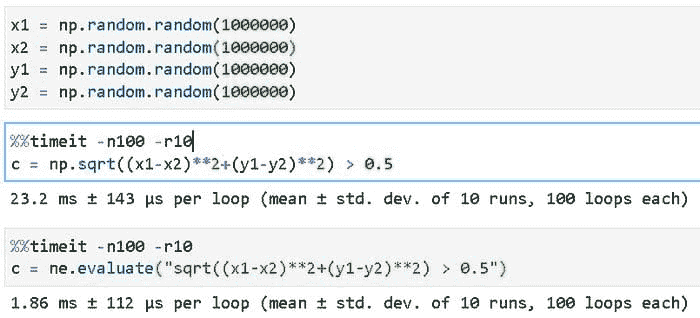

我们从简单的数学操作开始——将标量数字(比如 1)添加到 Numpy 数组。为了使用 NumExpr 包,我们只需将相同的计算包裹在符号表达式中的特殊方法 evaluate 下。以下代码将清楚地说明使用方法,

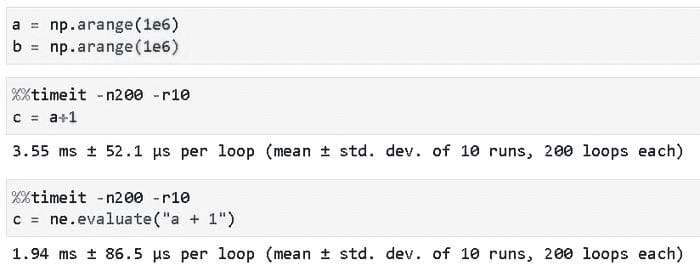

哇!这真是太神奇了!我们只需将熟悉的 a+1 Numpy 代码写成符号表达式 "a+1" 的形式,并传递给 ne.evaluate() 函数。我们得到了显著的速度提升——从 3.55 毫秒到 1.94 毫秒,平均值。

请注意,我们在 10 次循环测试中运行了相同的计算 200 次,以计算执行时间。当然,结果的准确性在一定程度上取决于底层硬件。欢迎你在你的机器上进行评估,看看你得到了什么改进。

涉及两个数组的算术运算

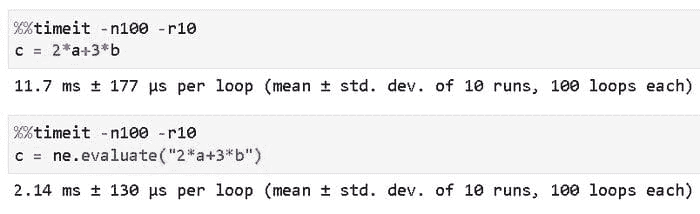

让我们再提升一点,涉及两个数组,可以吗?以下是使用两个数组评估简单线性表达式的代码,

这是计算时间的显著提升,从11.7 毫秒到 2.14 毫秒,平均值。

涉及更多数组的稍微复杂的操作

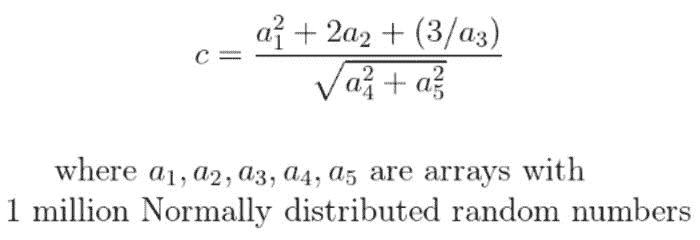

现在,让我们进一步提升,涉及更多数组在稍微复杂的有理函数表达式中。假设,我们想评估以下表达式,涉及五个 Numpy 数组,每个数组有一百万个随机数(从正态分布中抽取),

这是代码。我们创建了一个形状为(1000000, 5)的 Numpy 数组,并从中提取了五个(1000000,1)向量以用于有理函数。此外,请注意 NumExpr 方法中的符号表达式如何本地理解‘sqrt’(我们只需写sqrt)。

哇!这显示了一个巨大的速度提升从 47 毫秒到 ~ 4 毫秒,平均值。事实上,你会发现表达式越复杂,涉及的数组越多,Numexpr 的速度提升越显著!

逻辑表达式/布尔过滤

事实证明,我们不仅限于简单的算术表达式,如上所示。Numpy 数组的一个最有用的特性是将它们直接用于涉及逻辑运算符如 > 或 < 的表达式中,以创建布尔过滤器或掩码。

我们可以使用 NumExpr 来加速筛选过程。这里是一个示例,我们检查涉及 4 个向量的欧几里得距离度量是否大于某个阈值。

这种筛选操作在数据科学/机器学习管道中随处可见,你可以想象通过战略性地将 Numpy 评估替换为 NumExpr 表达式可以节省多少计算时间。

复数!

我们可以很容易地从实数域跳到虚数域。NumExpr 对复数同样有效,复数是 Python 和 Numpy 原生支持的。这里是一个示例,也展示了对数等超越操作的使用。

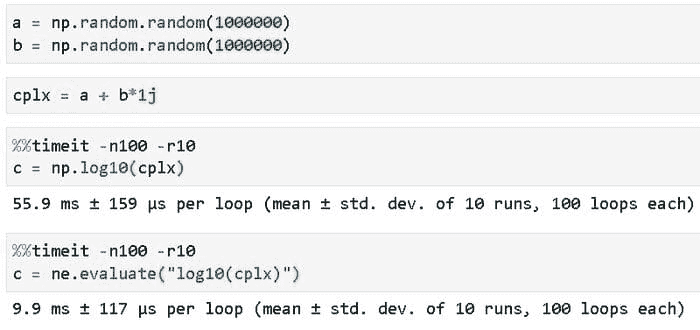

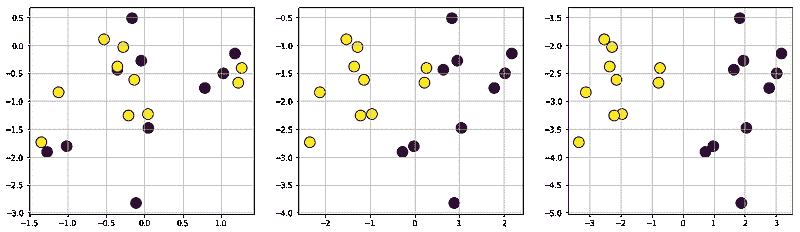

数组大小的影响

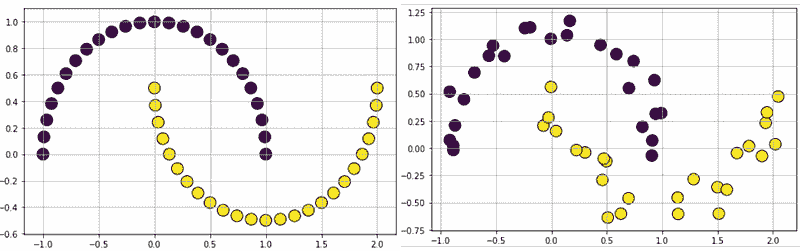

接下来,我们检查 Numpy 数组大小对速度提升的影响。为此,我们选择一个简单的条件表达式,如 2*a+3*b < 3.5 并绘制各种大小下的相对执行时间(在 10 次运行后取平均值)。代码在 Notebook 中,最终结果如下所示,

图像来源:作者代码生成

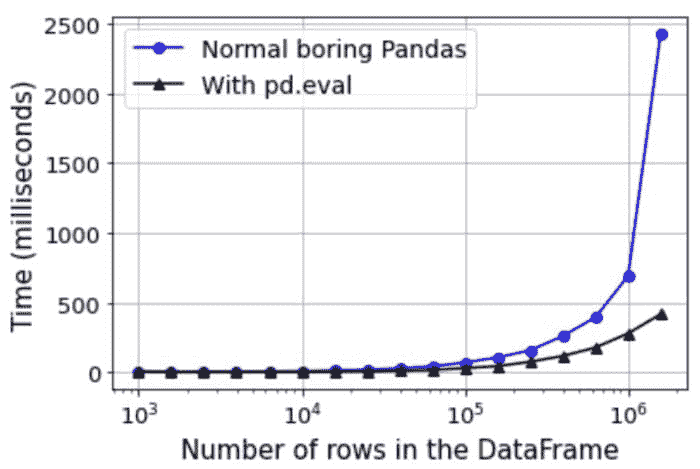

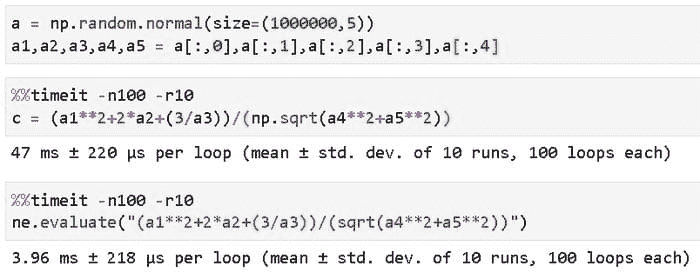

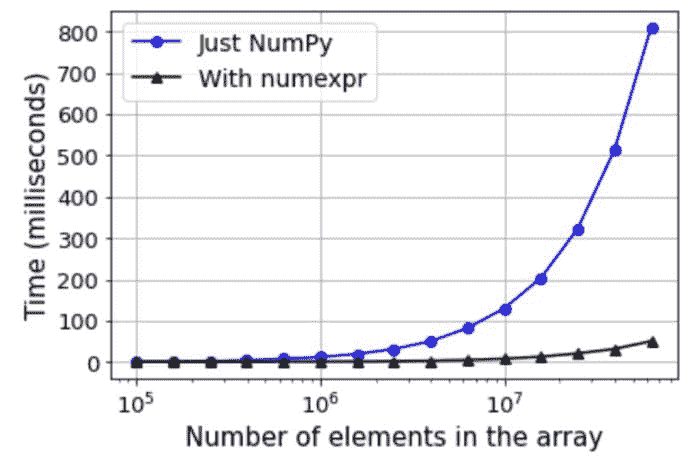

Pandas “eval” 方法

这是一个 Pandas 方法,它评估一个 Python 符号表达式(作为字符串)。默认情况下,它使用 NumExpr 引擎以实现显著的加速。以下是来自 官方文档的摘录,

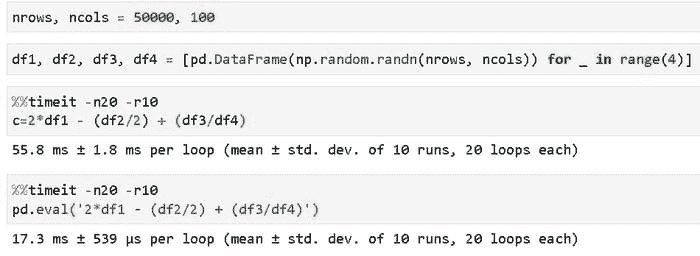

我们用以下代码展示一个简单示例,其中我们构造了四个各有 50000 行和 100 列的 DataFrame(填充了均匀随机数),并对这些 DataFrame 进行非线性变换——一种使用原生 Pandas 表达式,另一种使用 pd.eval() 方法。

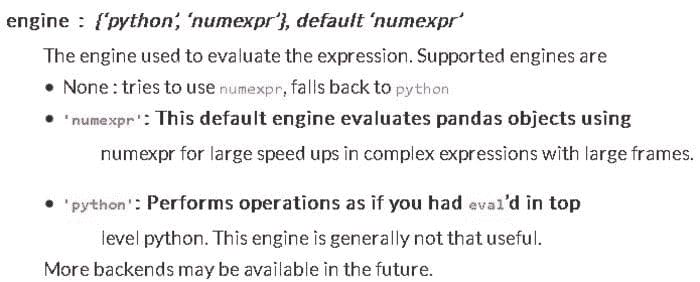

DataFrame 大小的影响

我们对 DataFrame 的大小(行数,列数固定为 100)对速度改进的影响进行了类似的分析。结果如下所示,

图像来源:作者代码生成

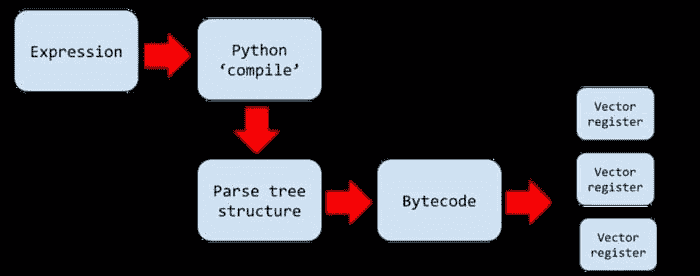

它的工作原理和支持的运算符

NumExpr 的工作方式的细节有些复杂,涉及到对底层计算架构的优化使用。你可以 在这里阅读。

简短说明

基本上,表达式是使用 Python 的compile函数编译的,变量被提取并建立了一个解析树结构。然后将该树编译成一个字节码程序,描述了使用所谓的‘向量寄存器’(每个寄存器宽 4096 个元素)的逐元素操作流。速度提升的关键是 Numexpr 的一次处理一块元素的能力。

NumExpr 评估流程,来源:作者使用 Google Drawing 制作

它跳过了 Numpy 使用临时数组的做法,这会浪费内存,并且对于大数组无法放入缓存内存。

此外,虚拟机完全用 C 语言编写,使其比原生 Python 更快。它还支持多线程,允许在合适的硬件上更快地并行处理操作。

支持的操作符

NumExpr 支持广泛的数学操作符,但不支持条件操作符,如if或else。完整的操作符列表可以在这里找到。

线程池配置

你还可以通过设置环境变量NUMEXPR_MAX_THREAD来控制用于大数组并行操作的线程数量。目前,最大可能的线程数为 64,但超过底层 CPU 节点上可用的虚拟核心数并没有实际的好处。

总结

在本文中,我们展示了如何利用基于虚拟机的特殊表达式评估范式来加速 Numpy 和 Pandas 中的数学计算。虽然这种方法可能不适用于所有任务,但数据科学、数据处理和统计建模管道的很大一部分可以在代码变化最小的情况下受益于此。

另外,你可以查看作者的GitHub** 代码库**以获取机器学习和数据科学的代码、想法和资源。如果你像我一样,对 AI/机器学习/数据科学充满热情,请随时在 LinkedIn 上添加我或在 Twitter 上关注我。

简介: Tirthajyoti Sarkar 是 ON Semiconductor 的高级首席工程师。

原文。已获许可转载。

相关:

-

使用 pdpipe 构建 Pipelines

-

Dask 中的机器学习

-

Google 的新解释性 AI 服务

更多相关话题

如何通过一行代码将 Pandas 提速 4 倍

评论

Pandas 是处理 Python 数据的首选库。它易于使用,并且在处理不同类型和大小的数据时相当灵活。它拥有大量的不同函数,使得数据操作变得轻而易举。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

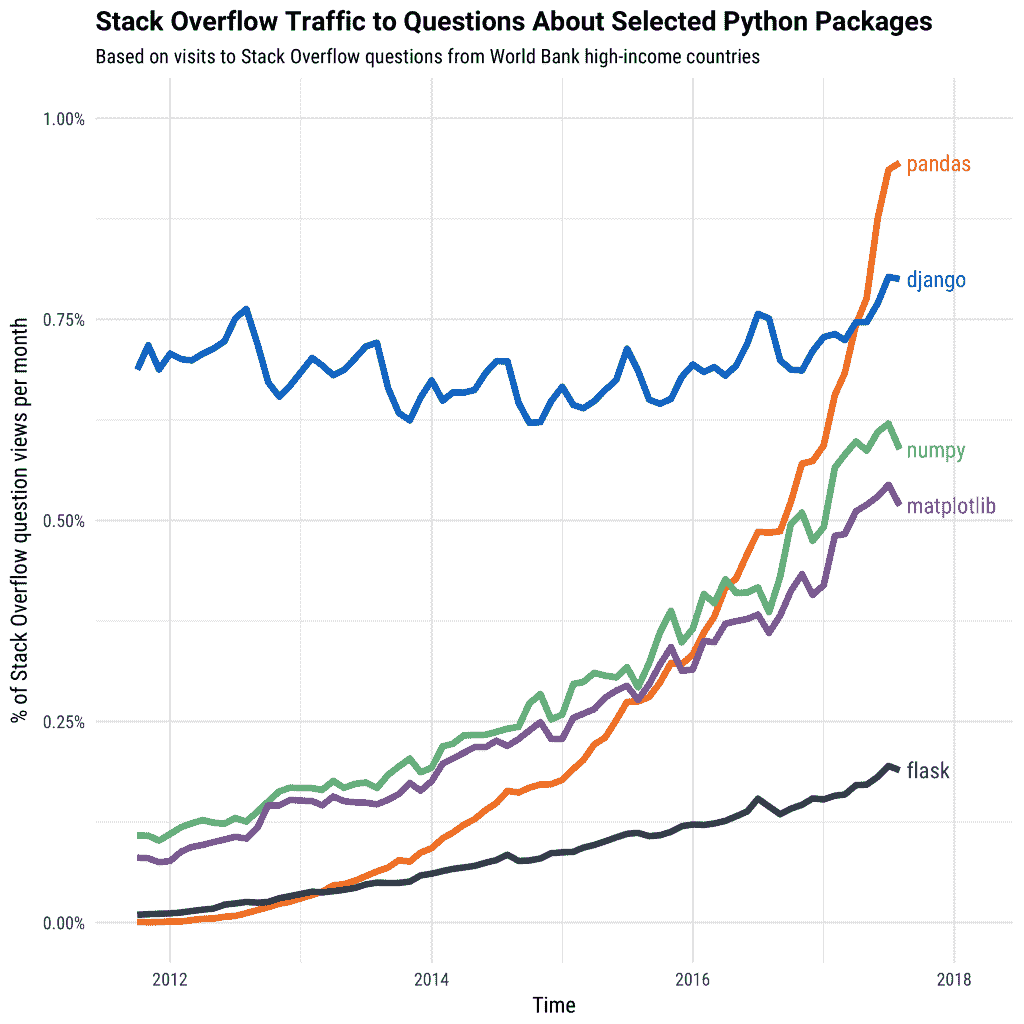

各种 Python 包的受欢迎程度随时间变化。 来源

但有一个缺点:Pandas 对于较大的数据集是慢的。

默认情况下,Pandas 以单个进程使用单个 CPU 核心来执行其函数。这对于较小的数据集效果很好,因为你可能不会注意到速度上的太大差异。但对于更大的数据集和更多的计算,当仅使用单个核心时,速度会大幅下降。它一次只能对一个数据集进行计算,而这些数据集可能有数百万甚至数十亿行。

然而,大多数现代数据科学机器至少有2 个 CPU 核心。这意味着,在两个 CPU 核心的示例中,默认情况下,计算机的 50% 或更多处理能力在使用 Pandas 时不会被使用。当你使用到 4 核心(现代 Intel i5)或 6 核心(现代 Intel i7)时,情况变得更糟。Pandas 本身并没有设计成能有效利用这些计算能力。

Modin 是一个新的库,旨在通过自动将计算分配到系统上所有可用的 CPU 核心来加速 Pandas。凭借这一点,Modin 声称能够在任何大小的 Pandas DataFrame 上获得几乎线性的加速。

让我们看看它是如何工作的,并通过一些代码示例进行演示。

Modin 如何与 Pandas 一起进行并行处理

给定一个 Pandas DataFrame,我们的目标是以最快的方式对其执行某种计算或处理。这可能是对每一列计算均值,使用.mean(),通过groupby对数据进行分组,使用drop_duplicates()去除所有重复项,或使用其他内置的 Pandas 函数。

在前一部分中,我们提到 Pandas 仅使用一个 CPU 核心进行处理。自然,这成为了一个重大瓶颈,特别是对于较大的 DataFrame,资源不足的问题尤为明显。

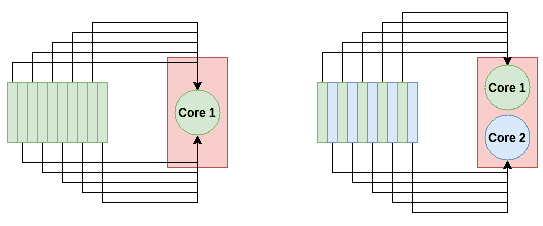

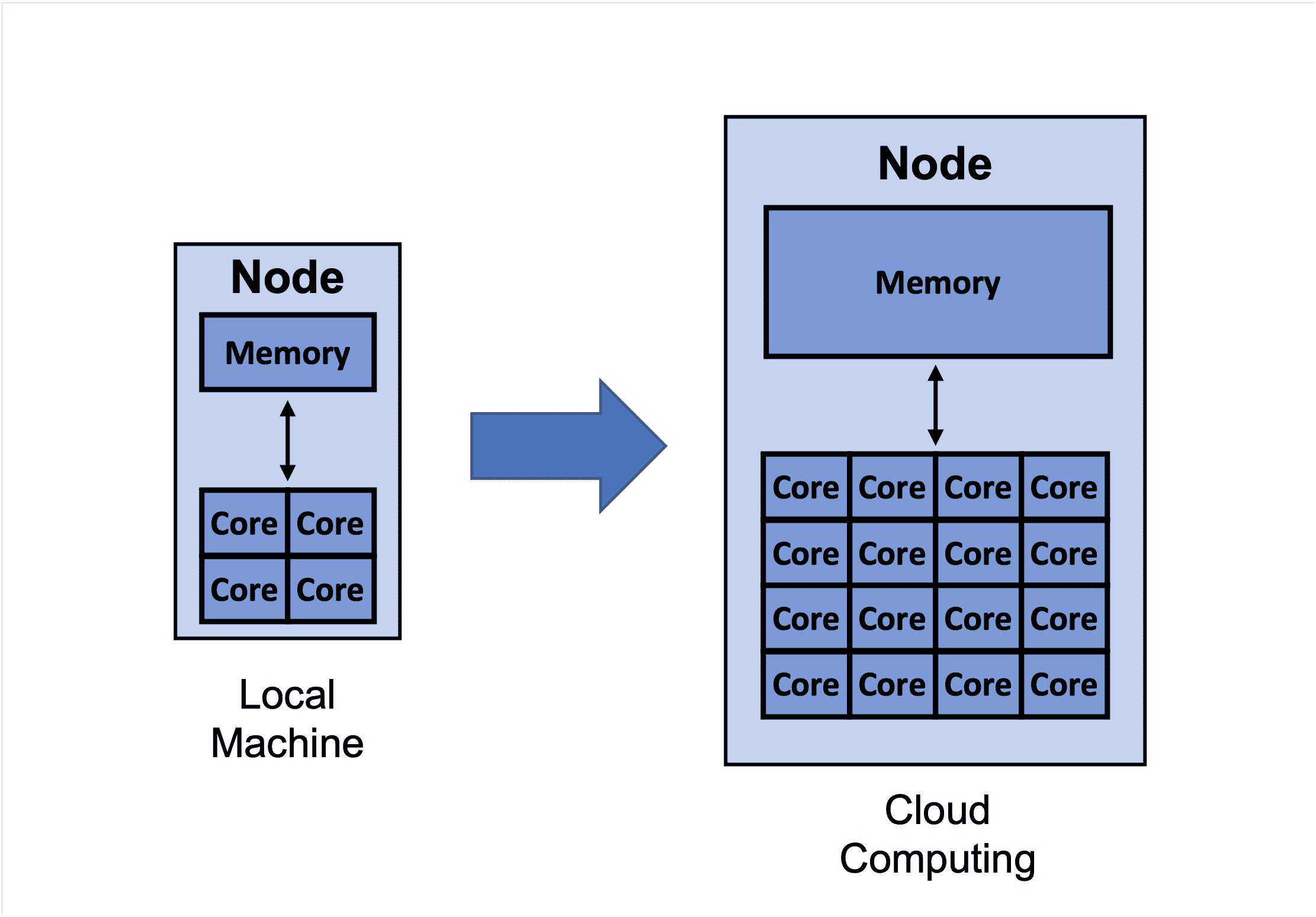

理论上,将计算并行化就像在每个可用的 CPU 核心上对不同的数据点应用该计算一样简单。对于 Pandas DataFrame,一个基本的想法是将 DataFrame 划分为几块,块数等于 CPU 核心的数量,然后让每个 CPU 核心在其块上运行计算。最后,我们可以汇总结果,这是一项计算上便宜的操作。

多核系统如何更快地处理数据。对于单核处理(左),所有 10 个任务都去一个节点。对于双核处理(右),每个节点承担 5 个任务,从而将处理速度加倍。

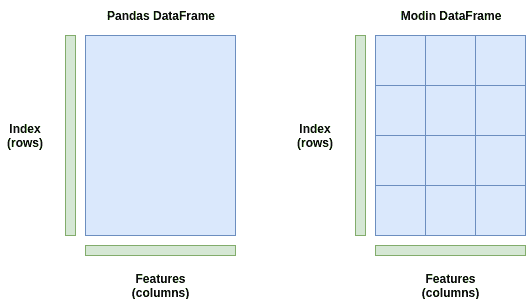

这正是 Modin 所做的。它将你的 DataFrame 切分成不同的部分,使每个部分可以发送到不同的 CPU 核心。Modin 在行和列之间对 DataFrame 进行分区。这使得 Modin 的并行处理可扩展到任意形状的 DataFrame。

想象一下,如果你有一个列很多但行较少的 DataFrame。一些库只在行之间进行分区,这在这种情况下效率较低,因为我们有更多的列而不是行。但使用 Modin,由于分区是在两个维度上进行的,因此并行处理在各种形状的 DataFrame 中都保持高效,无论它们是较宽(列很多)、较长(行很多)还是两者兼具。

Pandas DataFrame(左)作为一个块存储,只发送到一个 CPU 核心。Modin DataFrame(右)在行和列之间进行分区,每个分区可以发送到系统中不同的 CPU 核心,最多可达到系统的核心数。

上图是一个简单的示例。Modin 实际上使用一个分区管理器,它可以根据操作的类型改变分区的大小和形状。例如,可能有一个操作需要整个行或整个列。在这种情况下,分区管理器会以其能找到的最优方式进行分区和分配到 CPU 核心。它具有灵活性。

为了进行并行处理的繁重工作,Modin 可以使用Dask或Ray。它们都是具有 Python API 的并行计算库,你可以在运行时选择使用其中一个。Ray 目前是更安全的选择,因为它更稳定——Dask 后端是实验性的。

不过,理论说够了。让我们来看看代码和速度基准测试吧!

测试 Modin 速度

安装和使用 Modin 的最简单方法是通过 pip。以下命令安装 Modin、Ray 以及所有相关的依赖:

pip install modin[ray]

在接下来的示例和基准测试中,我们将使用CS:GO Competitive Matchmaking Data来自 Kaggle。CSV 的每一行包含了 CS:GO 竞技比赛中一轮的数据。

目前我们将专注于实验最大的 CSV 文件(有几个),叫做esea_master_dmg_demos.part1.csv,大小为 1.2GB。如此大的文件,我们应该能够看到 Pandas 的性能下降情况以及 Modin 如何帮助我们。测试时,我将使用一款i7–8700k CPU,它有 6 个物理核心和 12 个线程。

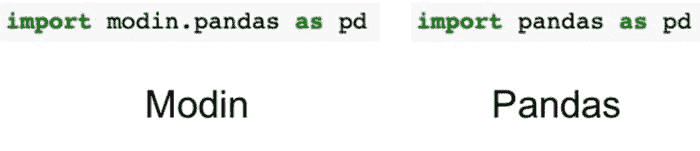

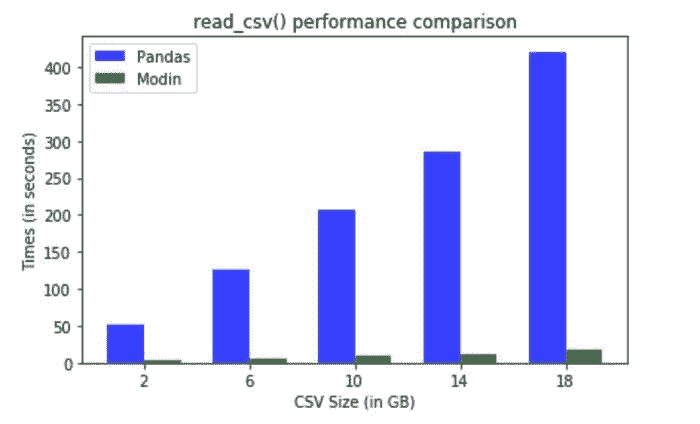

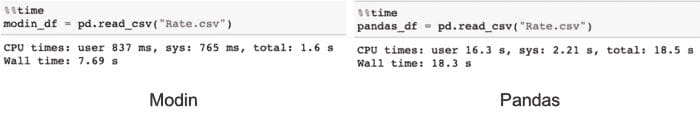

我们进行的第一个测试是用我们熟悉的read_csv()读取数据。Pandas 和 Modin 的代码完全一样。

为了测量速度,我导入了time模块,并在read_csv()前后加了time.time()。结果是 Pandas 加载数据从 CSV 到内存花费了 8.38 秒,而 Modin 只用了 3.22 秒。这是 2.6 倍的加速。仅仅通过更改导入语句就取得这样的速度提升,算是不小的进步!

让我们对 DataFrame 进行几个较重的处理。连接多个 DataFrame 是 Pandas 中常见的操作——我们可能有几个或更多的 CSV 文件包含数据,需要逐个读取并连接。我们可以轻松地使用pd.concat()函数来完成,Pandas 和 Modin 都能做到。

我们预计 Modin 在这种操作中表现会很好,因为它处理大量数据。代码如下所示。

在上面的代码中,我们将 DataFrame 自身连接了 5 次。Pandas 在 3.56 秒内完成了连接操作,而 Modin 在 0.041 秒内完成,速度提升了 86.83 倍!即使我们只有 6 个 CPU 核心,DataFrame 的分区也大大提高了速度。

Pandas 中常用来清理 DataFrame 的一个函数是.fillna()函数。这个函数查找 DataFrame 中的所有 NaN 值,并用你选择的值替换它们。这里有很多操作。Pandas 必须遍历每一行每一列来查找 NaN 值并进行替换。这是应用 Modin 的绝佳机会,因为我们重复执行了很多简单操作。

这次,Pandas 执行* .fillna()* 用了 1.8 秒,而 Modin 只用了 0.21 秒,实现了 8.57 倍的加速!

警告和最终基准

那么,Modin 总是这么快吗?

嗯,不总是这样。

有些情况下,Pandas 实际上比 Modin 更快,即使是在这个有 5,992,097(几乎 600 万)行的大数据集上。下表显示了我运行的一些实验中 Pandas 和 Modin 的运行时间。

正如你所见,有些操作中 Modin 明显更快,通常是在读取数据和查找值时。其他操作,如进行统计计算,在 Pandas 中要快得多。

使用 Modin 的实用技巧

Modin 仍然是一个相对年轻的库,正在不断开发和扩展。因此,并不是所有 Pandas 函数都已完全加速。如果你尝试使用一个尚未加速的 Modin 函数,它将默认回退到 Pandas,因此不会有代码错误或故障。有关 Modin 支持的 Pandas 方法的完整列表,请参见 此页面。

默认情况下,Modin 将使用你机器上的所有 CPU 核心。在某些情况下,你可能希望限制 Modin 可以使用的 CPU 核心数量,尤其是当你想将计算能力用于其他地方时。我们可以通过 Ray 的初始化设置限制 Modin 可以访问的 CPU 核心数量,因为 Modin 在后台使用了 Ray。

import ray

ray.init(num_cpus=4)

import modin.pandas as pd

在处理大数据时,数据集的大小超过系统内存(RAM)的情况并不少见。Modin 有一个特定的标志,我们可以将其设置为true,以启用其 out of core 模式。Out of core 基本上意味着 Modin 会将你的磁盘用作内存的溢出存储,允许你处理比 RAM 大得多的数据集。我们可以设置以下环境变量来启用此功能:

export MODIN_OUT_OF_CORE=true

结论

这样你就了解了!这是使用 Modin 加速 Pandas 函数的指南。只需更改导入语句即可完成,操作非常简单。希望你在至少一些情况下发现 Modin 对加速你的 Pandas 函数有用。

相关:

更多相关话题

如何使用 Modin 加速 Pandas

评论

由Michael Galarnyk提供,Anyscale 的开发者关系

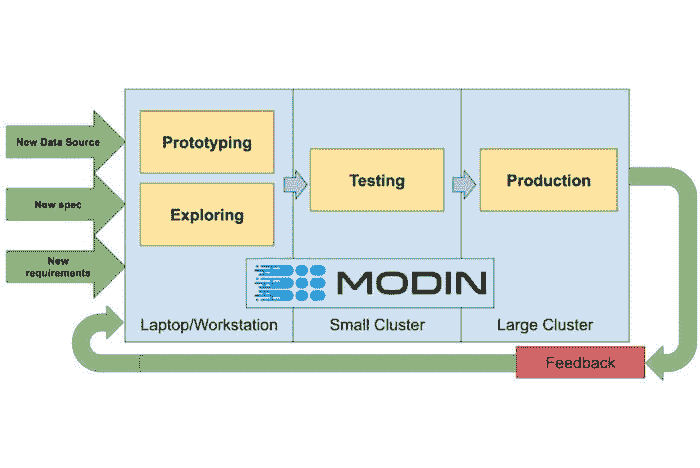

Modin 的一个目标是让数据科学家可以对小型(千字节)和大型数据集(泰字节)使用相同的代码。图片由Devin Petersohn提供。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

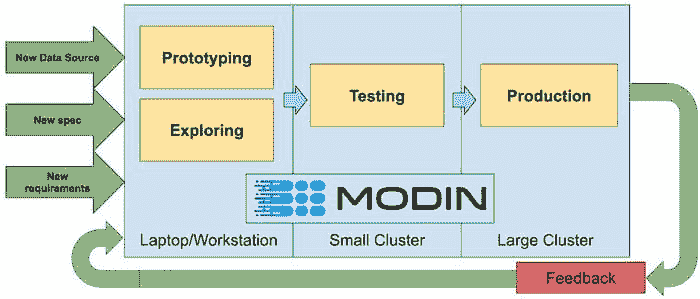

pandas 库提供了易于使用的数据结构,如 pandas DataFrames 以及数据分析工具。pandas 的一个问题是,它在处理大量数据时可能较慢。它并非设计用于分析 100 GB 或 1 TB 的数据集。幸运的是,存在Modin库,它具备了通过更改一行代码来扩展 pandas 工作流程的能力,并与 Python 生态系统和Ray集群集成。此教程介绍了如何开始使用 Modin 以及它如何加速你的 pandas 工作流程。

如何开始使用 Modin

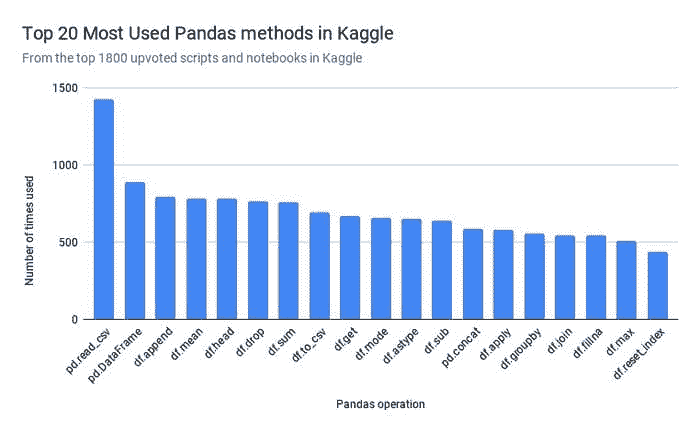

为了确定优先在 Modin 中实现哪些 Pandas 方法,Modin 的开发者抓取了 1800 个最受欢迎的 Python Kaggle Kernels(代码)。

Modin 对 pandas API 的覆盖率超过 90%,重点关注最常用的 pandas 方法,如 pd.read_csv、pd.DataFrame、df.fillna 和 df.groupby。这意味着如果你有大量数据,你可以更快地执行大多数与 pandas 库相同的操作。本节重点介绍一些常用的操作。

要开始使用,你需要安装 modin。

pip install “modin[all]” # Install Modin dependencies and modin’s execution engines

pip 安装时别忘了“”

导入 Modin

Modin 的一个主要优势是它不需要你学习新的 API。你只需更改你的导入语句。

import modin.pandas as pd

你只需更改你的导入语句以使用 Modin。

加载数据(read_csv)

Modin 在处理较大的数据集时表现尤为出色 (图像来源)

本教程使用的数据集来自于 健康保险市场 数据集,约 2GB。下面的代码将数据读取到 Modin DataFrame 中。

modin_df = pd.read_csv("Rate.csv”)

在这种情况下,由于 Modin 将工作转移到主线程之外以实现异步处理,因此速度更快。文件是并行读取的。性能提升的很大一部分来自于异步构建 DataFrame 组件。

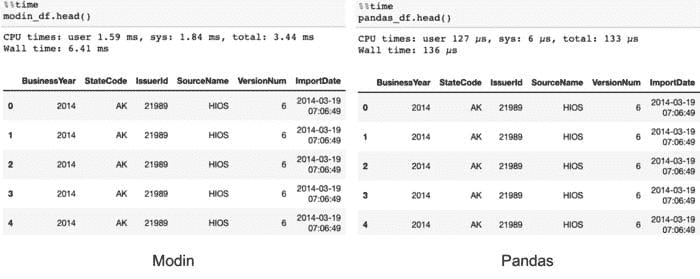

head

下面的代码使用了 head 命令。

# Select top N number of records (default = 5)

modin_df.head()

在这种情况下,Modin 的速度较慢,因为它需要将数据汇总在一起。然而,用户在交互式工作流中不应能察觉到这种差异。

groupby

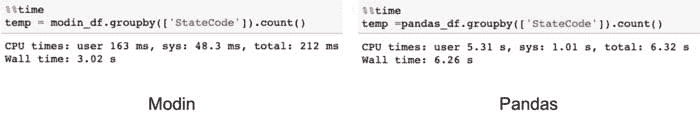

类似于 Pandas,Modin 也具有 groupby 操作。

df.groupby(['StateCode’]).count()

请注意,计划进一步优化 Modin 中 groupby 操作的性能。

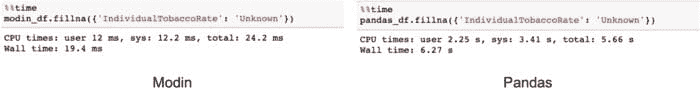

fillna

使用 fillna 方法填充缺失值在 Modin 中可以更快。

modin_df.fillna({‘IndividualTobaccoRate’: ‘Unknown’})

默认使用 Pandas 实现

如前所述,Modin 的 API 涵盖了 Pandas API 的大约 90%。对于尚未覆盖的方法,Modin 将默认使用 Pandas 实现,如下面的代码所示。

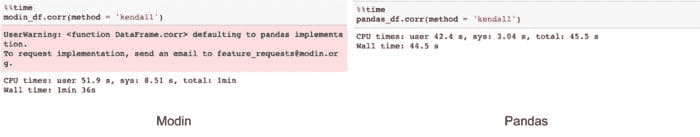

modin_df.corr(method = ‘kendall’)

当 Modin 默认使用 Pandas 时,你会看到一个警告。

尽管默认使用 Pandas 会有性能损失,但无论命令是否在 Modin 中实现,Modin 都会完成所有操作。

如果某个方法未实现,它将默认使用 Pandas。

Modin 的文档 解释了这一过程的工作原理。

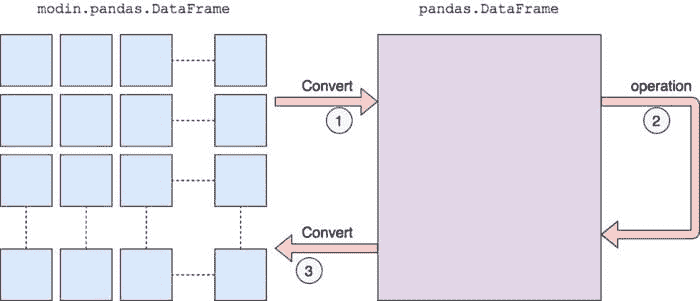

我们首先将其转换为 Pandas DataFrame,然后执行操作。从分区的 Modin DataFrame 转换到 Pandas 会有性能损失,因为涉及通信成本和 Pandas 的单线程特性。一旦 Pandas 操作完成,我们会将 DataFrame 转换回分区的 Modin DataFrame。这样,默认使用 Pandas 之后执行的操作将会得到 Modin 的优化。

Modin 如何加速你的 Pandas 工作流

Modin 使 Pandas 工作流更快的三种主要方式是通过其多核/多节点支持、系统架构和易用性。

多核/多节点支持

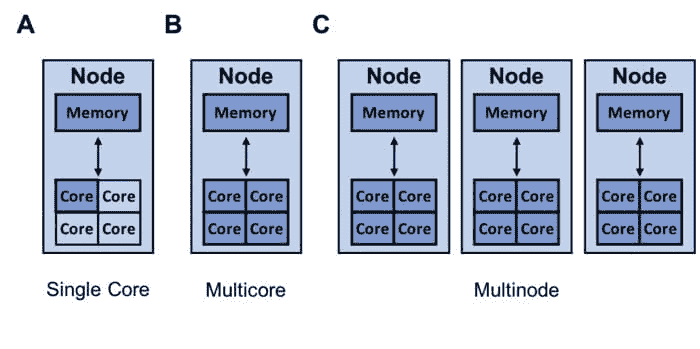

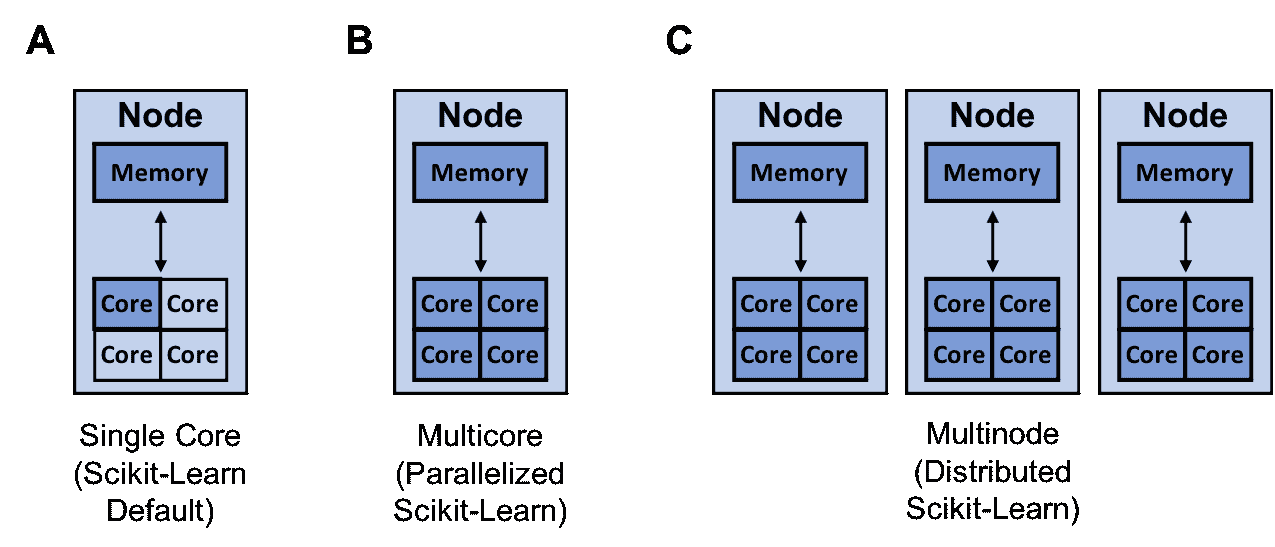

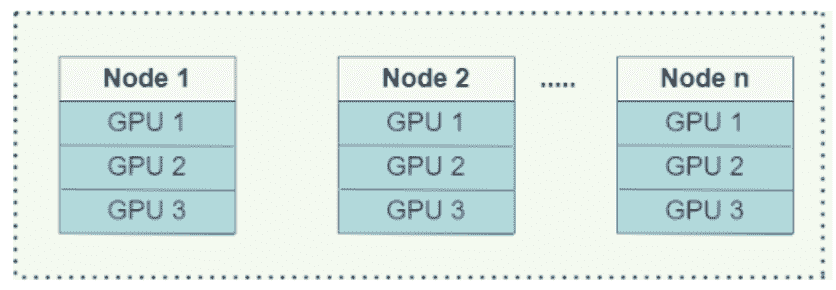

Pandas 只能利用单核,而 Modin 能够有效地利用所有可用的硬件。图像展示了 Modin 可以利用的资源(深蓝色),这些资源具有多个核心(B)和可用的多个节点(C)。

pandas 库只能利用一个核心。由于今天几乎所有计算机都有多个核心,因此通过让 Modin 利用计算机上的所有核心,可以大大加快你的 pandas 工作流程。

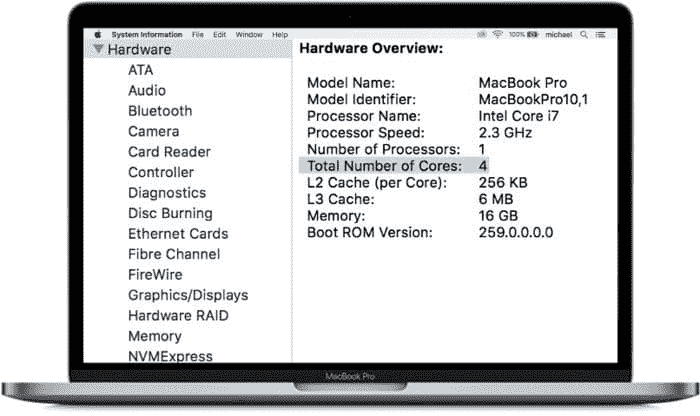

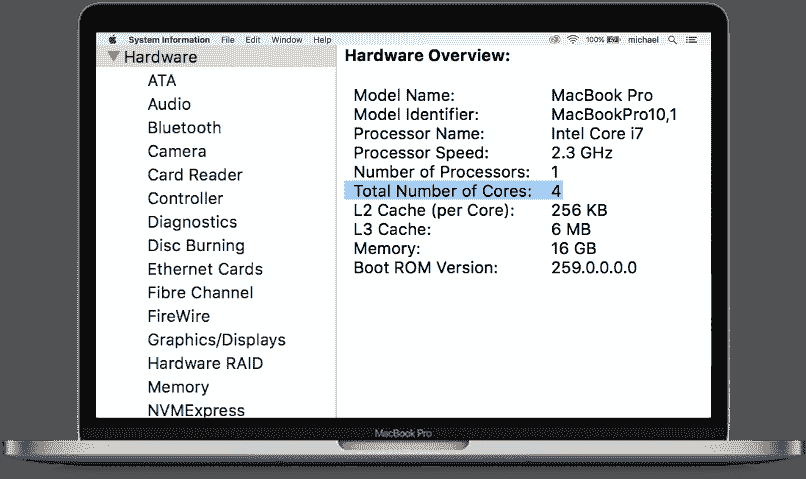

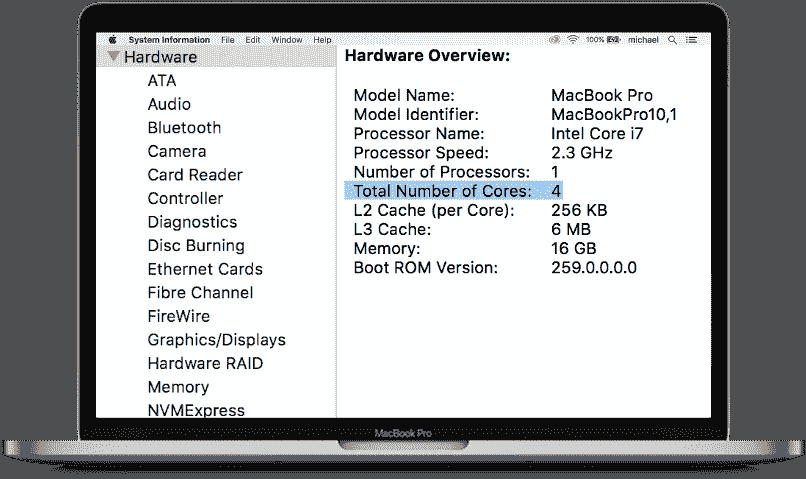

在本文中,你可以将上面的 MacBook 视为一个具有 4 个核心的单节点。

如果你希望将代码扩展到超过 1 个节点,Modin 提供了一个用于在本地和云提供商/集群之间切换的 API。

系统架构

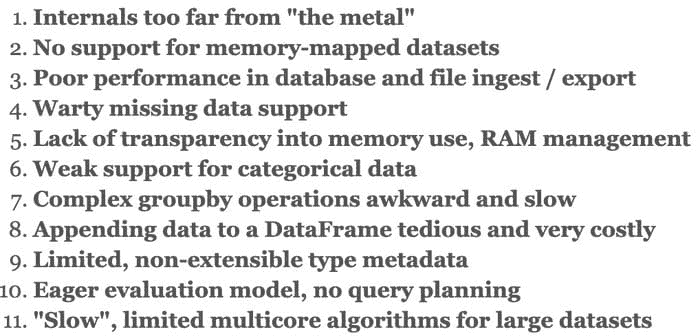

Modin 比 pandas 更快的另一个原因是 pandas 自身的实现方式。pandas 的创造者 Wes McKinney 发表了一个著名的演讲“10 Things I Hate about Pandas”,讨论了 pandas 的一些灵活性和性能问题。

Wes McKinney 对 pandas 的一些问题与性能有关。

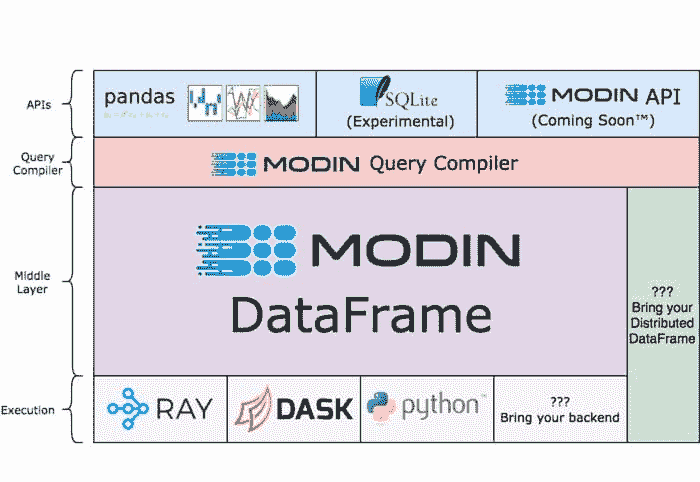

Modin 努力解决这些问题。要了解其方法,重要的是理解一些系统架构。下图概述了 Modin 组件的一般分层视图及每个主要部分的简要描述。

Modin 的系统架构

API 层:这是面向用户的层,主要是 Modin 对 pandas API 的覆盖。SQLite API 处于实验阶段,Modin API 仍在设计中。

Modin 查询编译器:除了其他职责,查询编译器层紧密遵循 pandas API,但去除了大多数重复。

Modin DataFrame 层:这是 Modin 优化的数据帧代数发生的地方。

执行:虽然 Modin 也支持像 Dask 这样的其他执行引擎,但最常用的执行引擎是 Ray,你可以在下一节中了解更多。

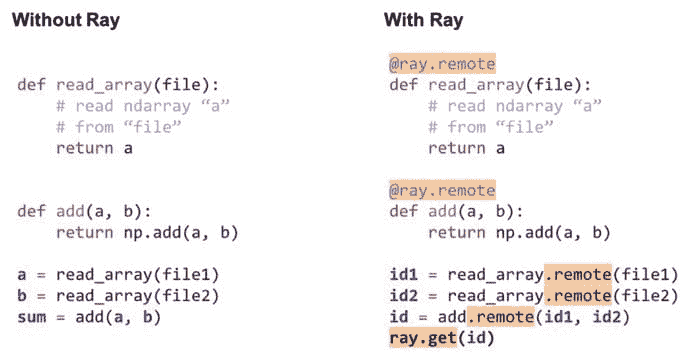

什么是 Ray

Ray 使并行和分布式处理的工作更接近你的期望(图片来源)。

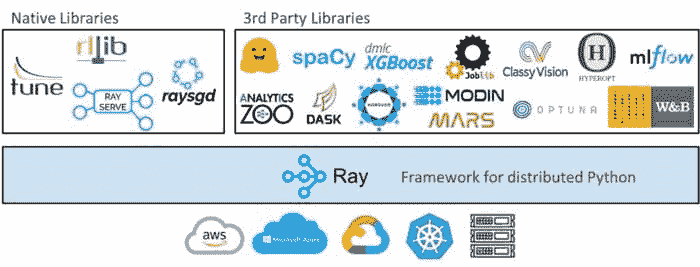

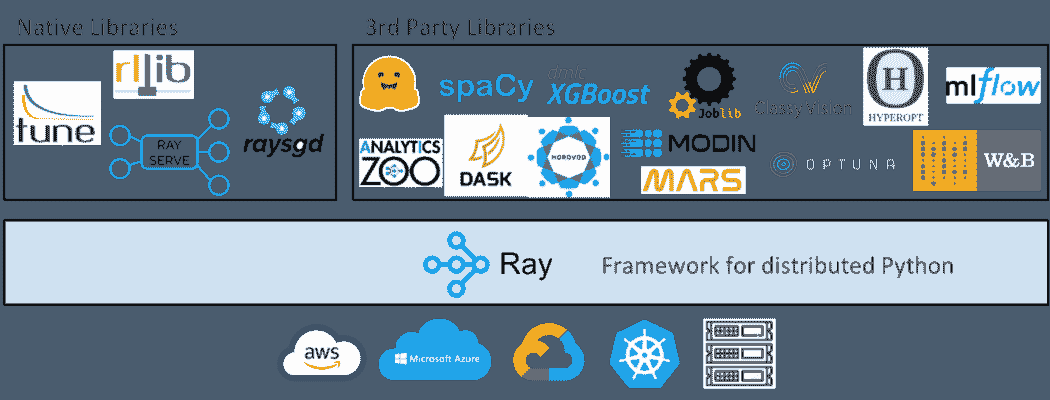

Ray 是 Modin 的默认执行引擎。本节简要介绍了 Ray 是什么以及它如何作为不止是执行引擎来使用。

上面的图表显示,从高层次来看,Ray 生态系统由核心 Ray 系统和用于数据科学的可扩展库组成,如 Modin。它是一个用于 扩展 Python 应用程序 的库,能够在多个核心或机器上运行。它有几个主要优势,包括:

-

简单性:你可以在不重写代码的情况下扩展你的 Python 应用程序,并且相同的代码可以在一台机器上或多台机器上运行。

-

鲁棒性:应用程序能够优雅地处理机器故障和抢占。

-

性能:任务以毫秒级延迟运行,扩展到数万个核心,并且以最小的序列化开销处理数值数据。

由于 Ray 是一个通用框架,社区在其基础上构建了许多库和框架,以完成不同的任务,如 Ray Tune 用于各种规模的超参数调优,Ray Serve 用于易于使用的可扩展模型服务,以及 RLlib 用于强化学习。它还具有 与 scikit-learn 等机器学习库的集成 以及对 数据处理库如 PySpark 和 Dask 的支持。

虽然你不需要学习如何使用 Ray 来使用 Modin,但下面的图像显示,通常只需添加几行代码就能将一个简单的 Python 程序转换为在计算集群上运行的分布式程序。

如何使用 Ray 将一个简单的程序转换为分布式程序的示例(代码说明)。

结论

Modin 的一个目标是允许数据科学家使用相同的代码来处理小(千字节)和大(千兆字节)数据集。图片来自 Devin Petersohn。

Modin 允许你使用相同的 Pandas 脚本来处理笔记本电脑上的 10KB 数据集以及集群上的 10TB 数据集。这得益于 Modin 易于使用的 API 和系统架构。这一架构能够利用 Ray 作为执行引擎,使得扩展 Modin 更加简单。如果你对 Ray 有任何问题或想法,请随时通过 Discourse 或 Slack 加入我们的社区。

简介:Michael Galarnyk 在 Anyscale 从事开发者关系工作,Anyscale 是 Ray 项目 的背后公司。你可以在 Twitter、Medium 和 GitHub 找到他。

原文。经许可转载。

相关:

-

使用 PyTorch 和 Ray 开始分布式机器学习

-

将 sklearn 训练速度提高 100 倍

-

如何加速 Scikit-Learn 模型训练

更多相关内容

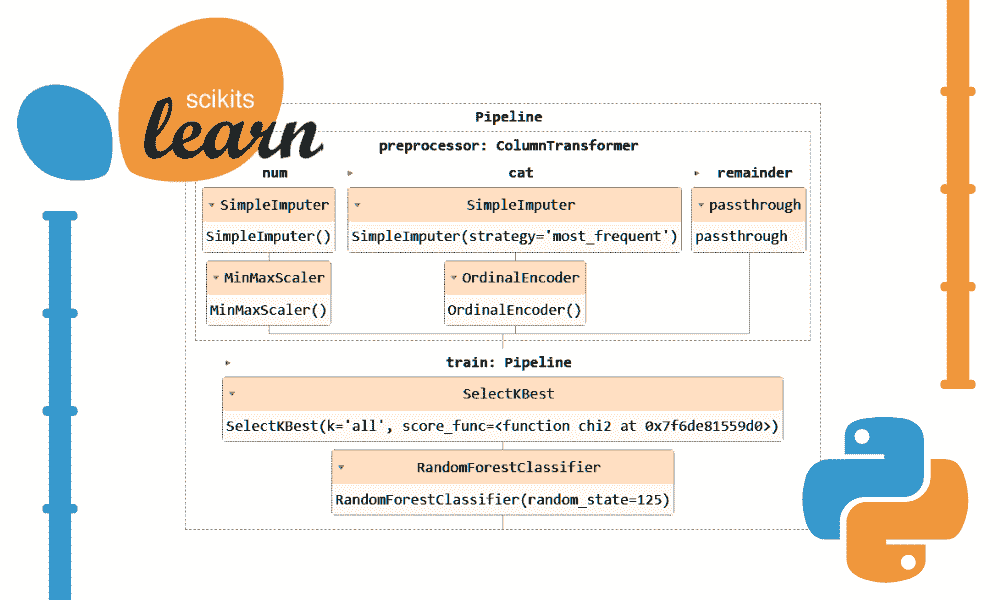

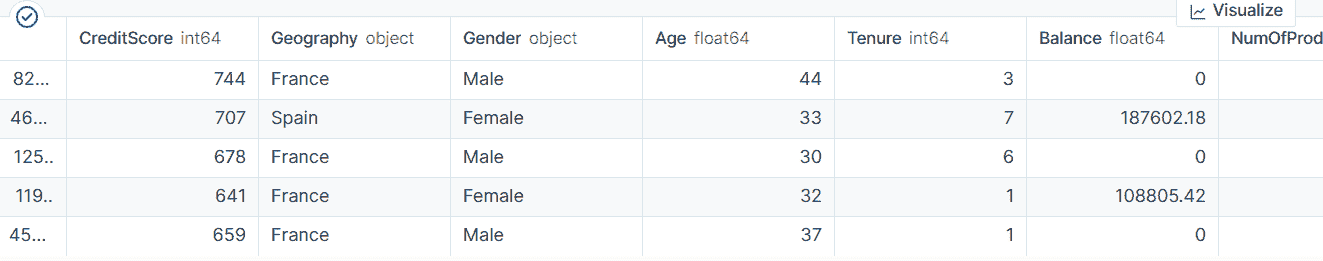

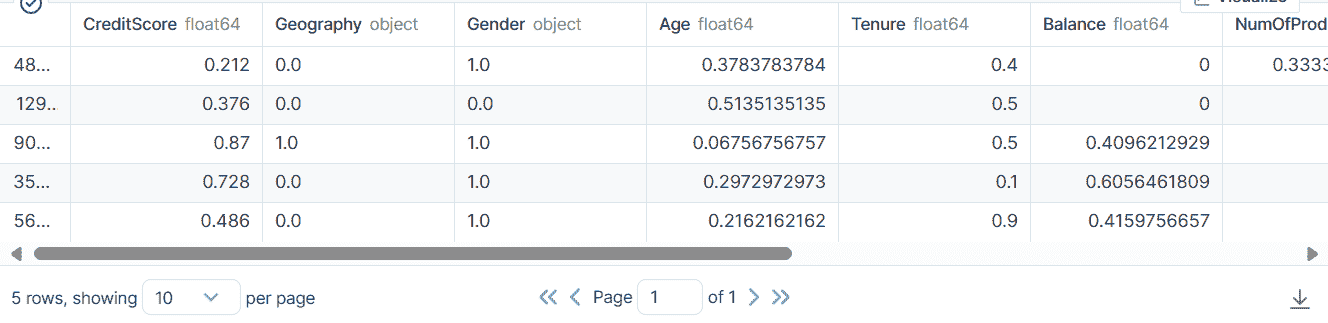

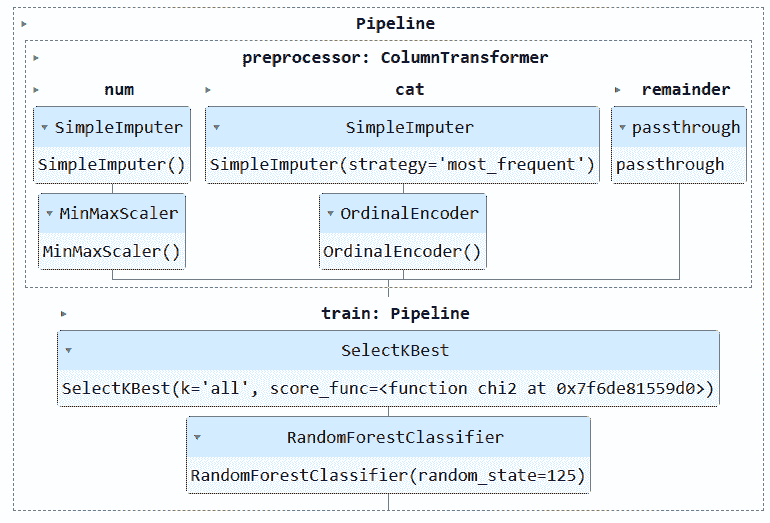

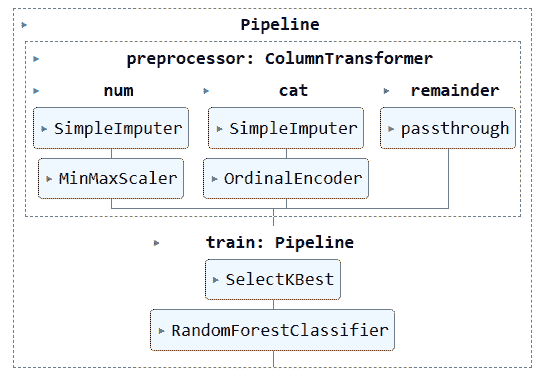

如何加速 Scikit-Learn 模型训练

原文:

www.kdnuggets.com/2021/02/speed-up-scikit-learn-model-training.html

评论

作者:Michael Galarnyk,Anyscale 的开发者关系

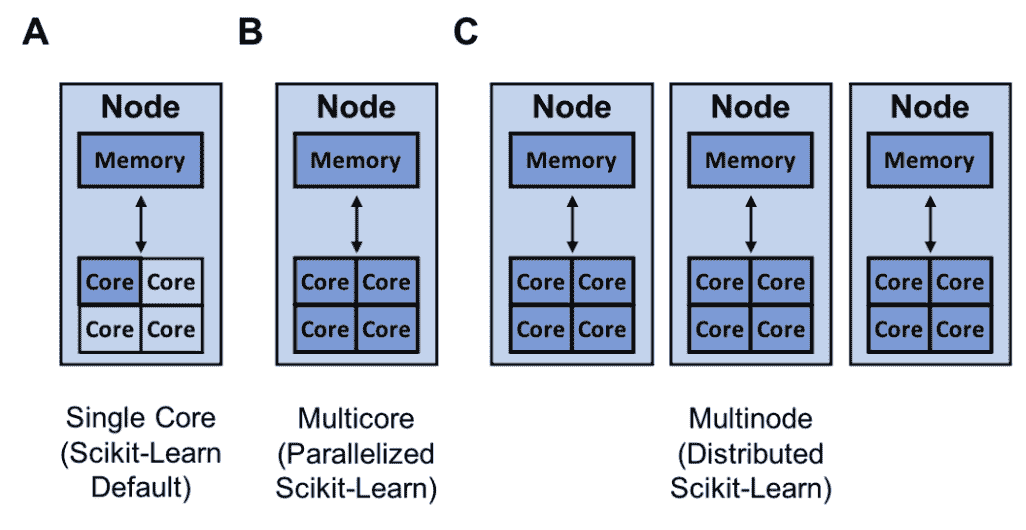

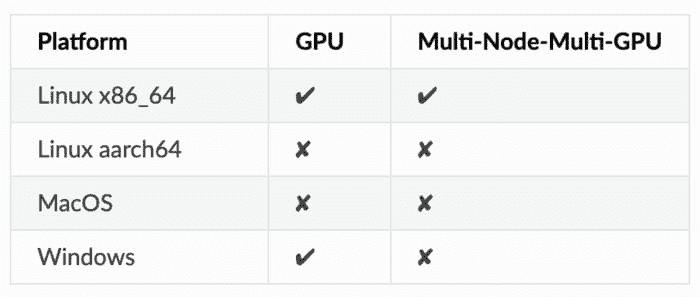

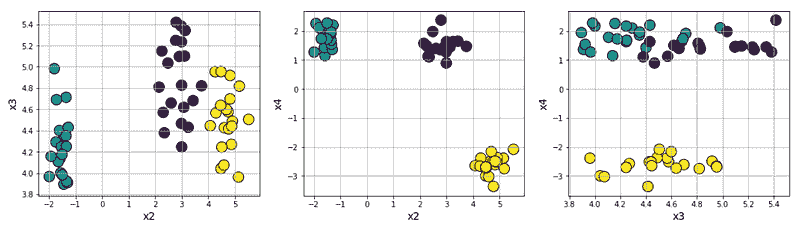

scikit-learn 可以利用的资源(深蓝色),用于单核(A),多核(B)和多节点训练(C)

Scikit-Learn 是一个易于使用的 Python 机器学习库。然而,有时候 scikit-learn 模型的训练可能需要很长时间。问题是,如何在最短时间内创建最佳的 scikit-learn 模型?解决这个问题的方法有很多,比如:

这篇文章概述了每种方法,讨论了一些局限性,并提供了加速机器学习工作流程的资源!

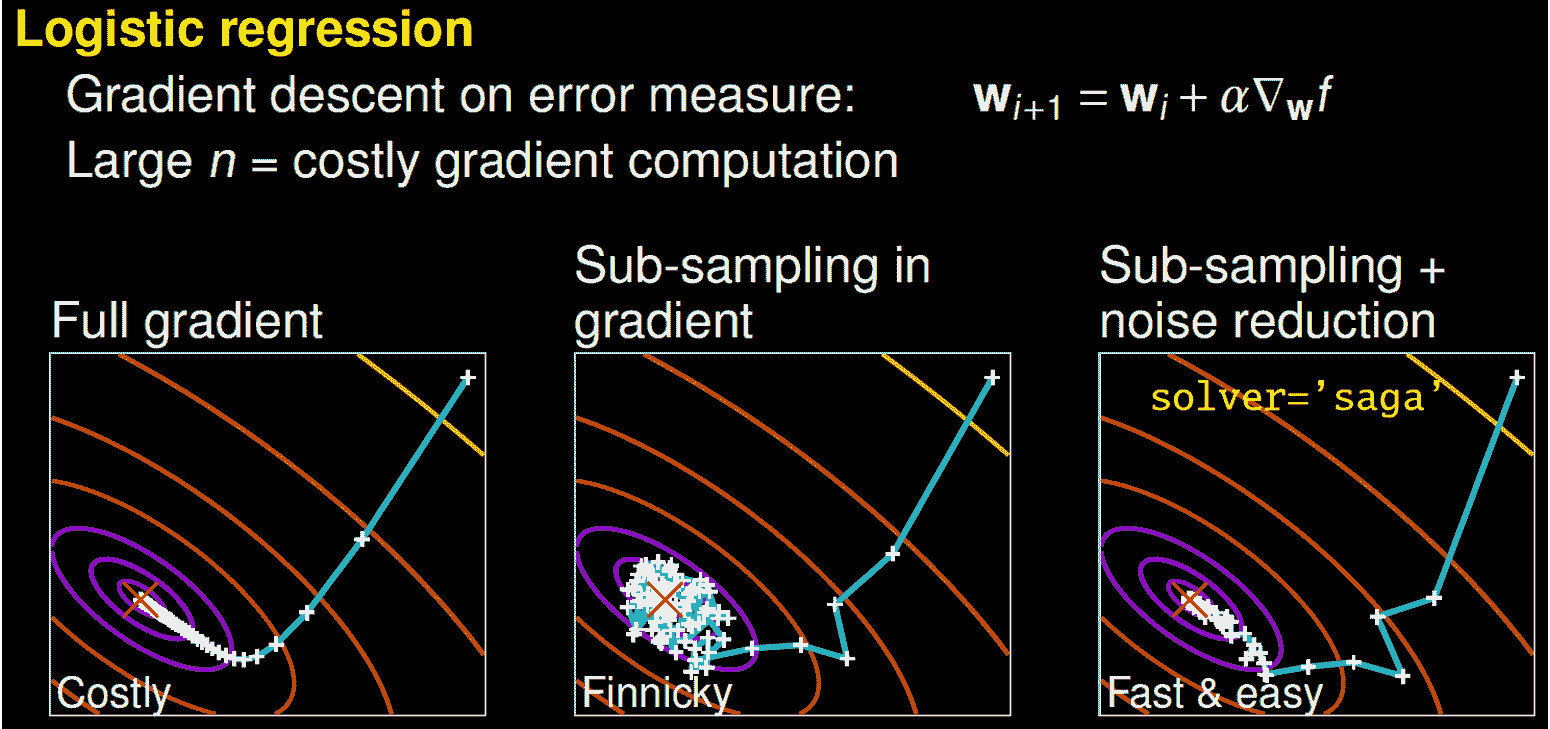

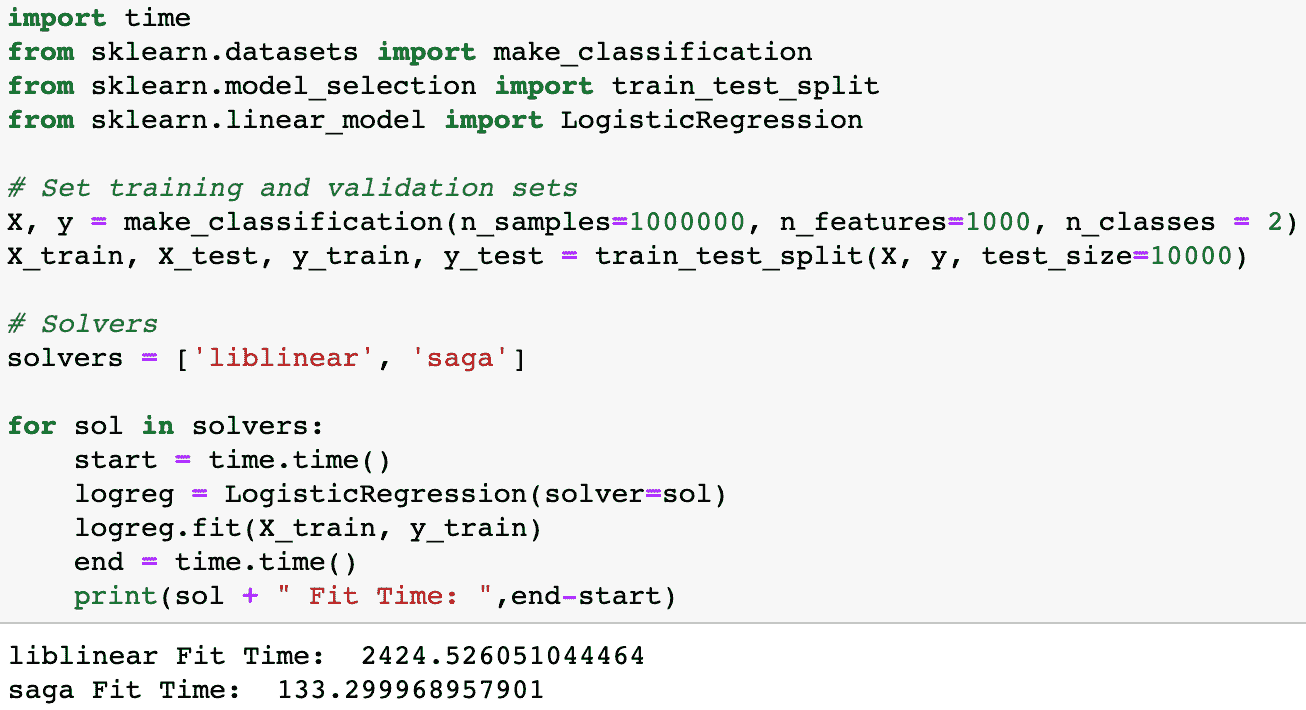

更换你的优化算法(求解器)

一些求解器可能需要更长的时间来收敛。图片来源于Gaël Varoquaux 的演讲。

更好的算法让你能更好地利用相同的硬件。通过更高效的算法,你可以更快地产生最优模型。一种方法是更换你的优化算法(求解器)。例如,scikit-learn 的逻辑回归允许你选择‘newton-cg’,‘lbfgs’,‘liblinear’,‘sag’,和‘saga’等求解器。

为了理解不同求解器的工作原理,我建议你观看由 scikit-learn 核心贡献者Gaël Varoquaux的演讲。用他的话来说,一个完整的梯度算法(liblinear)收敛速度快,但每次迭代(以白色+表示)可能非常昂贵,因为它需要使用所有的数据。在一个子采样的方法中,每次迭代计算便宜,但收敛速度可能会慢得多。一些算法如‘saga’实现了两者的最佳结合。每次迭代计算便宜,而且由于方差减少技术,算法收敛迅速。重要的是要注意,快速收敛在实践中并不总是重要,不同的求解器适用于不同的问题。

为问题选择合适的求解器可以节省大量时间(代码示例)。

要确定哪个求解器适合你的问题,你可以查看 文档 以了解更多信息!

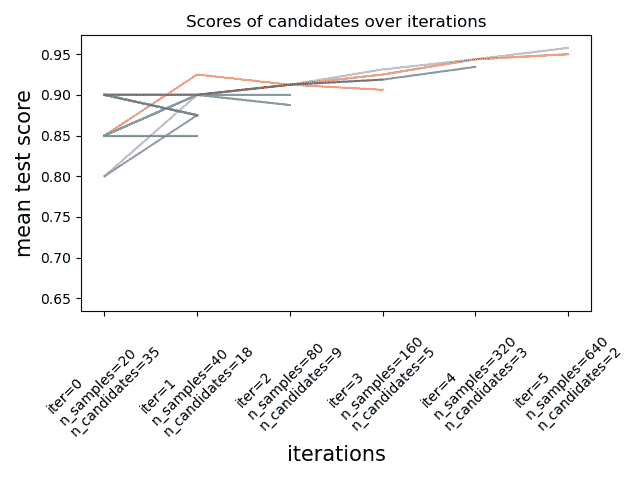

不同的超参数优化技术(网格搜索、随机搜索、早停)

为了实现大多数 scikit-learn 算法的高性能,你需要调整模型的超参数。超参数是模型的参数,在训练过程中不会更新。它们可以用于配置模型或训练函数。Scikit-Learn 本身包含了一些 超参数调整技术,如网格搜索(GridSearchCV),它详尽地考虑了所有参数组合,以及 随机搜索(RandomizedSearchCV),它从具有指定分布的参数空间中抽取给定数量的候选。最近,scikit-learn 增加了实验性的超参数搜索估计器:缩减网格搜索(HalvingGridSearchCV)和缩减随机搜索(HalvingRandomSearch)。

逐步缩减是 scikit-learn 版本 0.24.1(2021 年 1 月)中的一个实验性新功能。图像来自 文档。

这些技术可以用于通过 逐步缩减 来搜索参数空间。上面的图像显示了所有超参数候选在第一次迭代时用少量资源进行评估,之后更有前景的候选被选择,并在每次迭代中分配更多资源。

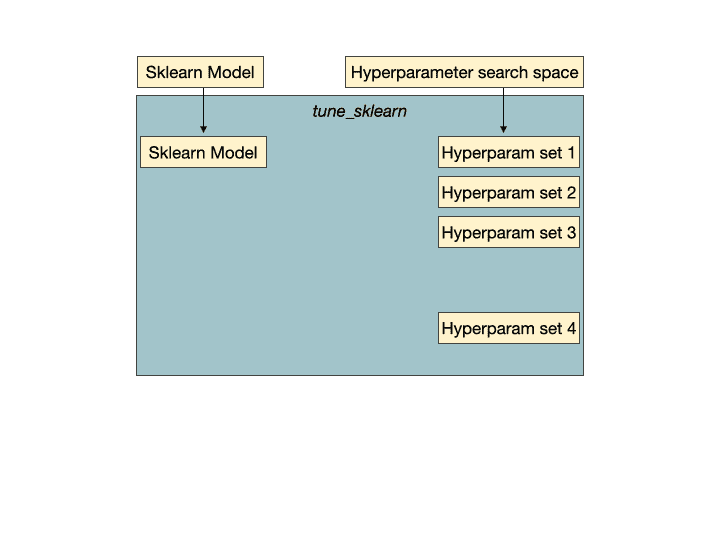

虽然这些新技术很令人兴奋,但有一个名为 Tune-sklearn 的库提供了前沿的超参数调整技术(贝叶斯优化、早停和分布式执行),这些技术相比网格搜索和随机搜索能够显著提高速度。

早停法的实际应用。超参数集 2 是一组不太有前景的超参数,它们会被 Tune-sklearn 的早停机制检测到,并提前停止以避免浪费时间和资源。图片来自 GridSearchCV 2.0。

Tune-sklearn 的特性包括:

-

与 scikit-learn API 的一致性:通常只需修改几行代码即可使用 Tune-sklearn (示例)。

-

现代超参数调优技术的可访问性:可以轻松修改代码以利用诸如贝叶斯优化、早停法和分布式执行等技术

-

框架支持:不仅支持 scikit-learn 模型,还支持其他 scikit-learn 包装器,如 Skorch (PyTorch)、KerasClassifiers (Keras) 和 XGBoostClassifiers (XGBoost)。

-

可扩展性:该库利用了 Ray Tune——一个用于分布式超参数调优的库,以高效且透明的方式在多个核心甚至多台机器上并行化交叉验证。

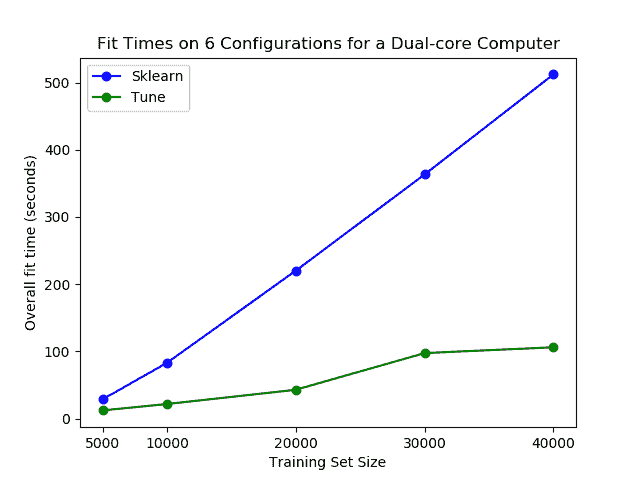

也许最重要的是,tune-sklearn 的速度如下面的图片所示。

你可以在普通笔记本电脑上看到使用 tune-sklearn 的显著性能差异。图片来自 GridSearchCV 2.0。

如果你想了解更多关于 tune-sklearn 的信息,可以查看这篇 博客文章。

使用 joblib 和 Ray 进行训练的并行化或分布式处理

scikit-learn 可以利用的资源(深蓝色)用于单核心(A)、多核心(B)和多节点训练(C)

另一种提高模型构建速度的方法是通过 joblib 和 Ray 实现训练的并行化或分布式处理。默认情况下,scikit-learn 使用单个核心训练模型。需要注意的是,今天几乎所有的计算机都有多个核心。

就本博客而言,你可以将上面的 MacBook 视为一个具有 4 个核心的单节点。

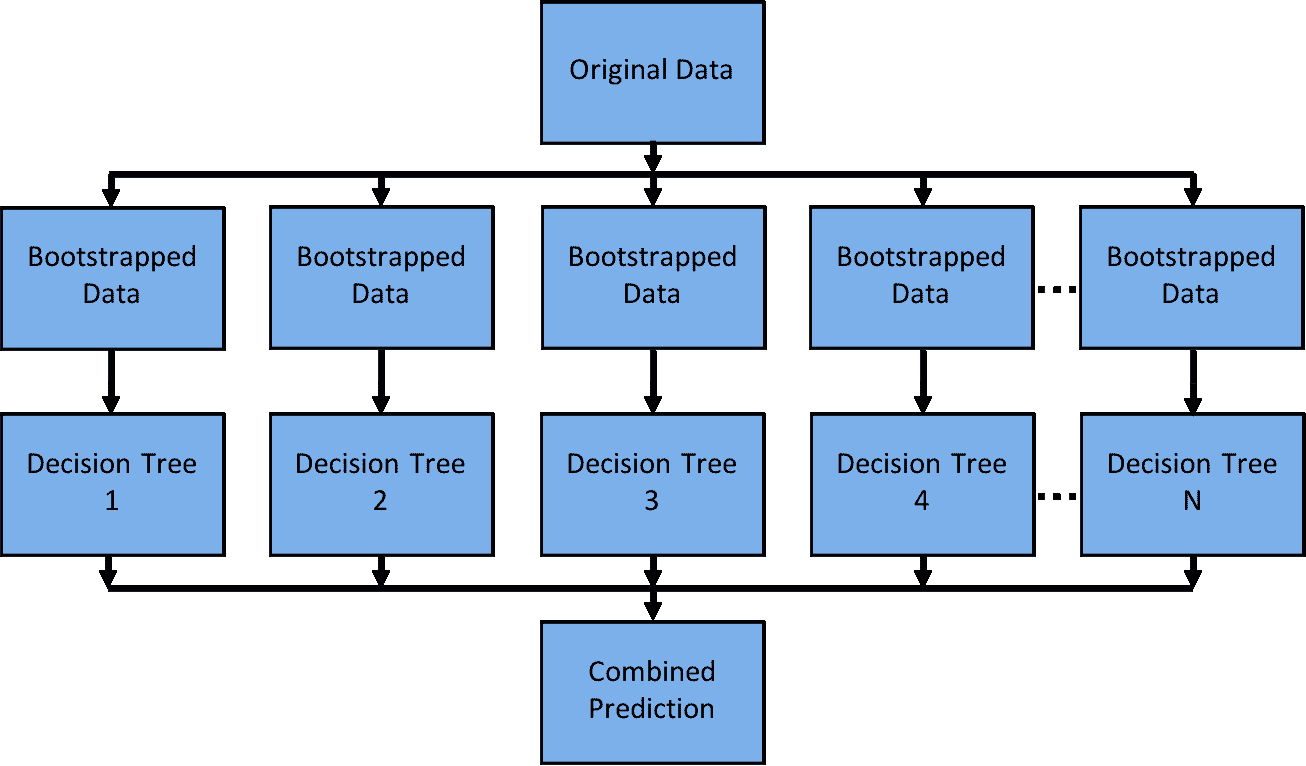

因此,通过利用计算机上的所有核心,你可以大大加速模型的训练。如果你的模型具有较高的并行度,如随机森林®,这尤其适用。

随机森林® 是一个容易并行化的模型,因为每棵决策树相互独立。

Scikit-Learn 可以通过joblib,默认使用‘loky’后端来并行化单节点上的训练。Joblib 允许你在‘loky’、‘multiprocessing’、‘dask’和‘ray’等后端之间进行选择。这是一个很好的功能,因为‘loky’后端是为单节点优化的,而不是为运行分布式(多节点)应用程序优化的。运行分布式应用程序可能引入许多复杂性,例如:

-

在多台机器上调度任务

-

高效地转移数据

-

从机器故障中恢复

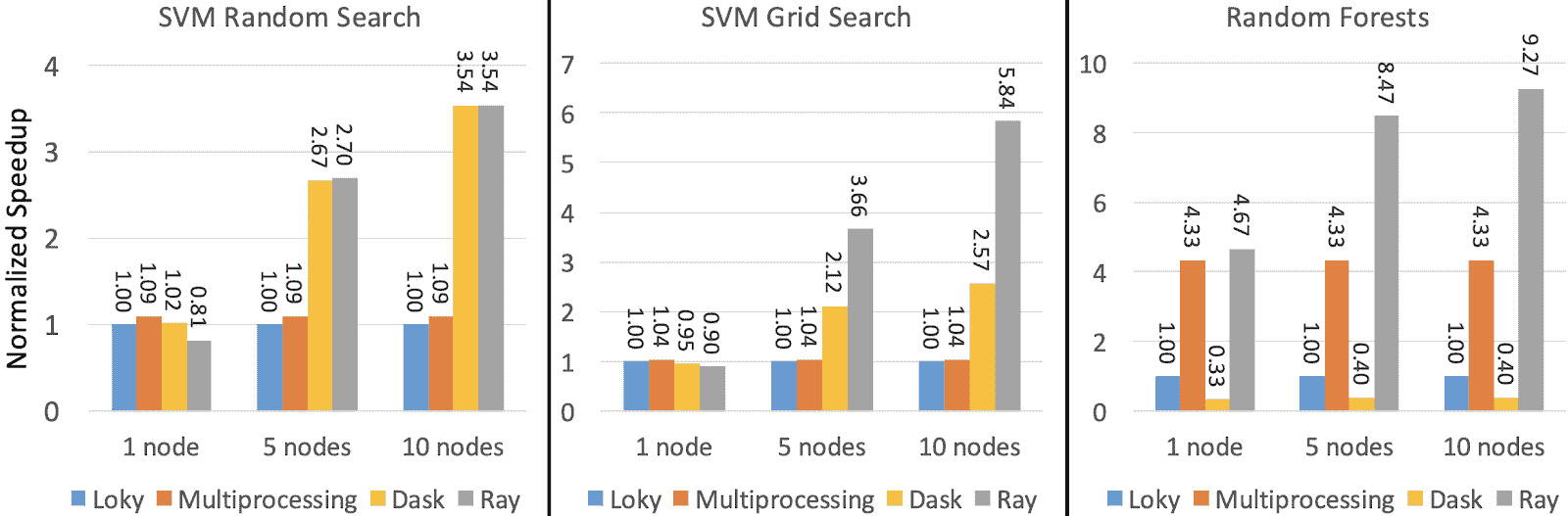

幸运的是,‘ray’后端可以为你处理这些细节,保持简单,并提供更好的性能。下图显示了 Ray、Multiprocessing 和 Dask 相对于默认‘loky’后端的规范化加速。

性能在每个 32 核心的一个、五个和十个 m5.8xlarge 节点上进行测量。Loky 和 Multiprocessing 的性能不依赖于机器数量,因为它们在单台机器上运行。图片来源。

如果你想了解如何快速并行化或分布式你的 scikit-learn 训练,你可以查看这篇博客文章。

结论

本文介绍了几种方法,你可以在最短时间内构建出最佳的 scikit-learn 模型。其中一些方法是 scikit-learn 本身提供的,比如更改优化函数(求解器),或使用实验性的超参数优化技术,如 HalvingGridSearchCV 或 HalvingRandomSearch。你还可以使用如 Tune-sklearn 和 Ray 的库作为插件,进一步加快模型构建速度。如果你对 Tune-sklearn 和 Ray 有任何问题或想法,请随时通过 Discourse 或 Slack 加入我们的社区。

个人简介:Michael Galarnyk 在 Anyscale 担任开发者关系职位,该公司是 Ray 项目 的背后团队。你可以在 Twitter、Medium 和 GitHub 上找到他。

原文。经授权转载。

相关内容:

-

终极 Scikit-Learn 机器学习备忘单

-

Python 列表和列表操作

-

K-Means 比 Scikit-learn 快 8 倍,误差低 27 倍,仅需 25 行代码

我们的前三课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路

1. Google 网络安全证书 - 快速进入网络安全职业道路

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

更多相关内容

如何加速 XGBoost 模型训练

原文:

www.kdnuggets.com/2021/12/speed-xgboost-model-training.html

作者:Michael Galarnyk,数据科学专业人士

梯度提升算法广泛应用于监督学习。虽然它们功能强大,但训练时间可能很长。极端梯度提升,或称 XGBoost,是一个开源的梯度提升实现,旨在提升速度和性能。然而,即使是 XGBoost 的训练有时也会很慢。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业领域。

1. Google 网络安全证书 - 快速进入网络安全职业领域。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

有很多方法可以加速这个过程,例如:

-

更改树构建方法

-

利用云计算

本文将回顾每种方法的优缺点,并介绍如何入门。

更改你的树构建算法

XGBoost 的 tree_method 参数允许你指定要使用的树构建算法。为你的问题选择合适的树构建算法(exact、approx、hist、gpu_hist、auto)可以帮助你更快地生成优化模型。现在让我们来回顾这些算法。

这是一个准确的算法,但在每次分裂查找过程中,它会遍历所有输入数据条目,因此不具有很好的扩展性。在实际应用中,这意味着较长的训练时间。它也不支持分布式训练。你可以在原始的 XGBoost 论文 中了解更多关于该算法的信息。

尽管准确算法是准确的,但当数据不完全适合内存时,它的效率较低。原始 XGBoost 论文 中的近似树方法使用分位数草图和梯度直方图。

在 LightGBM 中使用的近似树方法,与 approx 的实现有些许不同(例如使用一些性能改进,如 bins 缓存)。这通常比 approx 更快。

由于 GPU 在许多机器学习应用中至关重要,XGBoost 提供了一个支持外部内存的 GPU 实现的 hist 算法gpu_hist。 它比 hist 快得多,并且使用的内存明显更少。请注意,XGBoost 在某些操作系统上没有原生支持GPU。

这是参数的默认值。根据数据集的大小,XGBoost 将选择“最快的方法”。对于小数据集,将使用 exact。对于大数据集,将使用 approx。请注意,尽管 hist 和 gpu_hist 通常更快,但在这种启发式方法中,它们并未被考虑。

如果你运行这个 代码,你将看到使用 gpu_hist 运行模型可以节省大量时间。在我的计算机上,处理一个相对较小的数据集(100,000 行,1000 个特征),将 hist 更改为 gpu_hist 将训练时间减少了约一半。

利用云计算

云计算不仅允许你使用比本地计算机更多的核心和内存,还可以让你访问像 GPU 这样的专业资源。

最后一部分主要讨论了选择更高效的算法,以更好地利用可用的计算资源。然而,有时可用的计算资源不够,你可能需要更多。例如,下面图片中的 MacBook 只有 4 个核心和 16GB 内存。此外,它运行在 MacOS 上,而在写作时,XGBoost 尚未对其提供 GPU 支持。

对于本文的目的,你可以将上面的 MacBook 视为一个具有 4 个核心的单节点。

解决这个问题的一种方法是利用更多的云资源。使用云服务提供商不是免费的,但它们通常允许你使用比本地计算机更多的核心和内存。此外,如果 XGBoost 不支持你的本地计算机,选择一个 XGBoost 支持 GPU 的实例类型也是很简单的。

如果你想尝试加速云端训练,以下是来自 Jason Brownlee 的文章 的步骤概览,介绍如何在 AWS EC2 实例上训练 XGBoost 模型:

1. 设置 AWS 账户(如有需要)

2. 启动 AWS 实例

3. 登录并运行代码

4. 训练 XGBoost 模型

5. 关闭 AWS 实例(仅在使用时支付实例费用)

如果您选择比本地更强大的实例,您会发现云端训练速度更快。请注意,使用 XGBoost 进行多 GPU 训练实际上需要分布式训练,这意味着您需要多个节点/实例来完成此任务。

使用 Ray 进行分布式 XGBoost 训练

到目前为止,本教程已介绍通过更改树构建算法和通过云计算增加计算资源来加快训练速度。另一种解决方案是通过XGBoost-Ray分布式训练 XGBoost 模型,它利用了 Ray。

什么是 Ray?

Ray 是一个快速、简单的分布式执行框架,使得扩展应用程序和利用先进的机器学习库变得容易。使用 Ray,您可以将顺序运行的 Python 代码通过最小的代码更改转换为分布式应用程序。如果您想了解 Ray 和 actor 模型,可以在这里了解更多。

虽然本教程探讨了 Ray 如何简化 XGBoost 代码的并行化和分布式处理,但需要注意的是,Ray 及其生态系统还简化了普通 Python 代码以及现有库的分布式处理,例如scikit-learn、LightGBM、PyTorch等。

如何开始使用 XGBoost-Ray

要开始使用 XGBoost-Ray,您首先需要安装它。

pip install "xgboost_ray"

由于与核心 XGBoost API 完全兼容,您只需进行少量代码更改即可将 XGBoost 训练从单台机器扩展到拥有数百个节点的集群。

XGBoost-Ray 支持多节点/多 GPU 训练。在单台机器上,GPU 通过 NCCL 进行梯度通信。在节点之间,它们使用 Rabit 代替 (了解更多)。

如下代码所示,API 与 XGBoost 非常相似。高亮部分显示了与普通 XGBoost API 不同的代码部分。

from xgboost_ray import RayXGBClassifier, RayParams

from sklearn.datasets import load_breast_cancer

from sklearn.model_selection import train_test_split

seed = 42

X, y = load_breast_cancer(return_X_y=True)

X_train, X_test, y_train, y_test = train_test_split(

X, y, train_size=0.25, random_state=42

)

clf = RayXGBClassifier(

n_jobs=4, # In XGBoost-Ray, n_jobs sets the number of actors

random_state=seed)

# scikit-learn API will automatically convert the data

# to RayDMatrix format as needed.

# You can also pass X as a RayDMatrix, in which case

# y will be ignored.

clf.fit(X_train, y_train)

pred_ray = clf.predict(X_test)

print(pred_ray)

pred_proba_ray = clf.predict_proba(X_test)

print(pred_proba_ray)

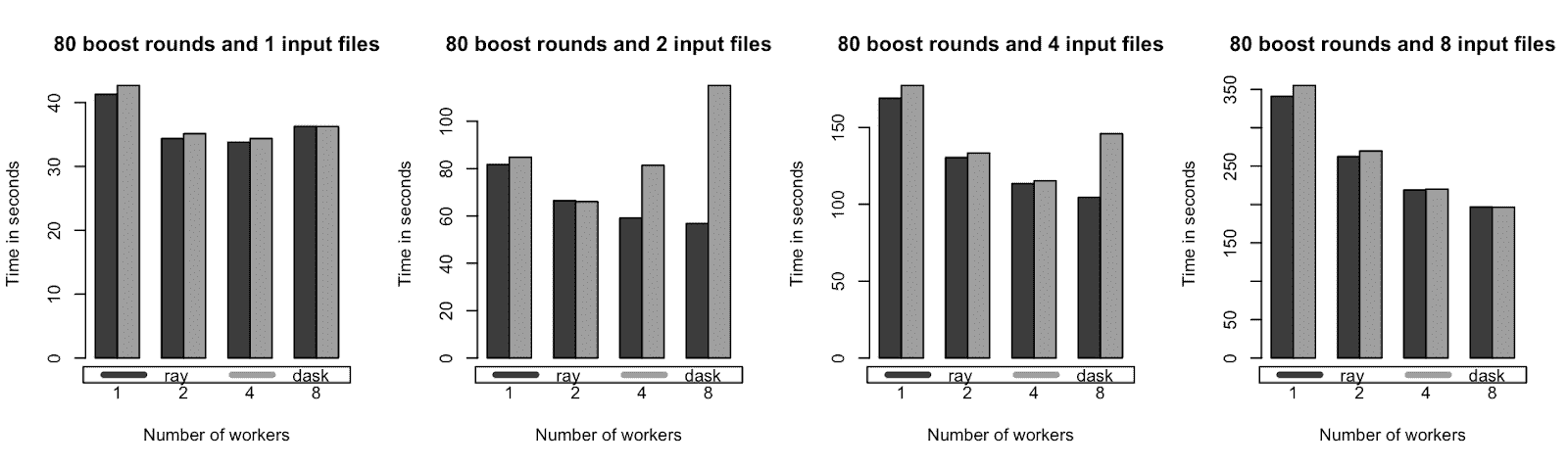

上述代码展示了使用 XGBoost-Ray 你需要对代码进行多小的修改。虽然你不需要 XGBoost-Ray 来训练乳腺癌数据集, 之前的一篇文章 在不同数量的工作节点(1 到 8)上对几个数据集大小(约 1.5M 到 12M 行)进行了基准测试,以展示它在单节点上处理更大数据集的表现。

单节点基准测试的训练时间(时间越少越好)。XGBoost-Ray 和 XGBoost-Dask 在单个 AWS m5.4xlarge 实例(具有 16 核心和 64 GB 内存)上表现相似。

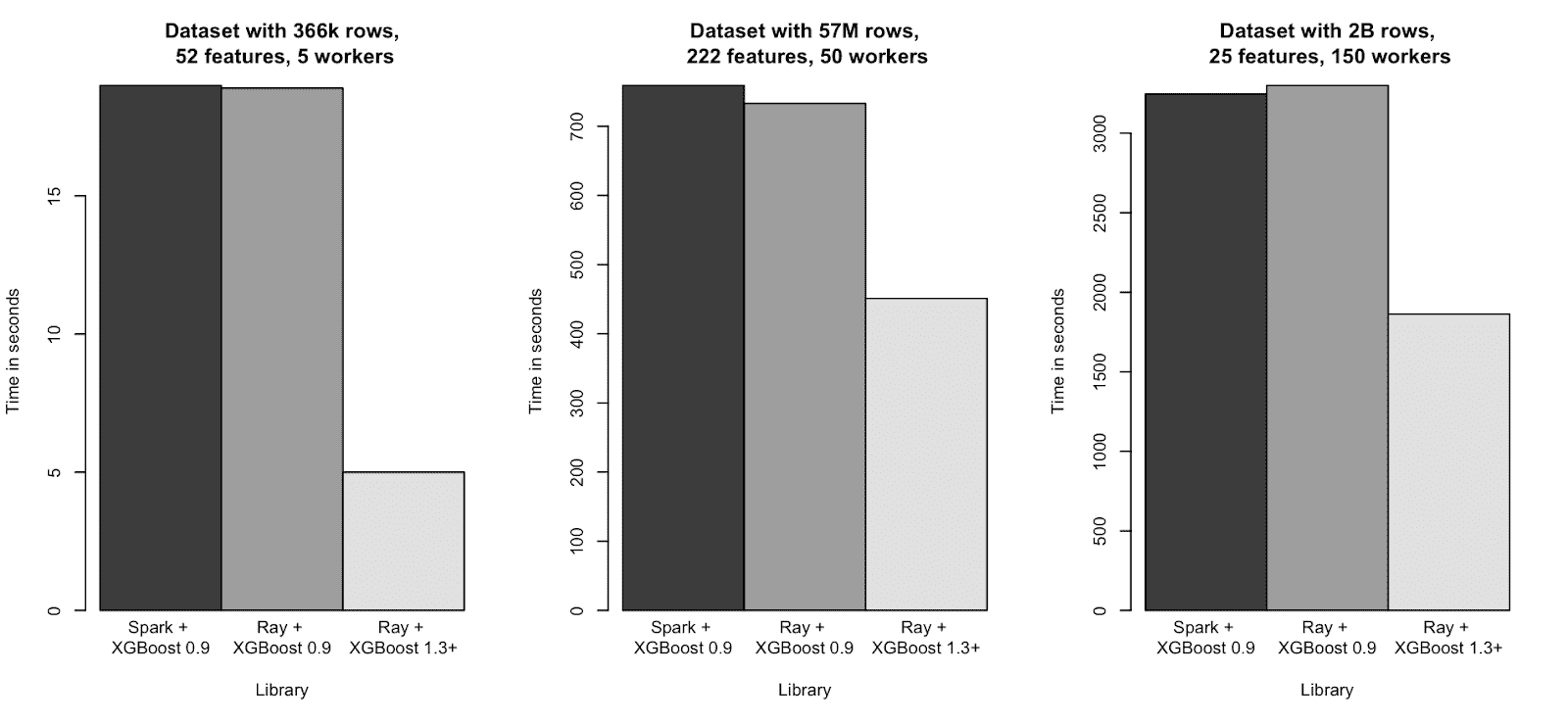

XGBoost-Ray 在多节点(分布式)设置下也表现出色,如下图所示。

在几个合成数据集大小范围(约 400k 到 2B 行)上的多节点训练时间(时间越少越好)。XGBoost-Ray 和 XGBoost-Spark 表现相似。

如果你想了解更多关于 XGBoost-Ray 的内容, 可以查看这篇关于 XGBoost-Ray 的文章。

结论

本文介绍了几种加速 XGBoost 模型训练的方法,比如更改树构建方法、利用云计算以及在 Ray 上分布式 XGBoost。如果你对 Ray 上的 XGBoost 有任何问题或想法,请随时通过 Discourse 或 Slack 加入我们的社区。如果你想了解 Ray 的最新动态, 可以关注 @raydistributed 在 Twitter 上 并 订阅 Ray 通讯。

简介: Michael Galarnyk 是一名数据科学专家,并在 Anyscale 从事开发者关系工作。

原文. 经许可转载。

更多相关话题

使用 Numpy 加速你的 Python 代码的一个简单技巧

原文:

www.kdnuggets.com/2019/06/speeding-up-python-code-numpy.html

评论

评论

Python 非常庞大。

在过去几年中,Python 的受欢迎程度迅速增长。其重要原因之一是数据科学、机器学习和人工智能的兴起,这些领域都有高层次的 Python 库可供使用!

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在使用 Python 进行这些工作时,通常需要处理非常大的数据集。这些大型数据集直接读取到内存中,并作为 Python 数组、列表或字典进行存储和处理。

处理如此庞大的数组可能会很耗时;这实际上就是问题的本质。你有成千上万、数百万甚至数十亿的数据点。每个数据点处理过程中增加的微秒会因为数据规模的巨大而显著拖慢你的速度。

慢速方式

处理大型数据集的慢速方式是使用原始 Python。我们可以通过一个非常简单的例子来演示这一点。

下面的代码将 1.0000001 的值自乘 500 万次!

import time

start_time = time.time()

num_multiplies = 5000000

data = range(num_multiplies)

number = 1

for i in data:

number *= 1.0000001

end_time = time.time()

print(number)

print("Run time = {}".format(end_time - start_time))

我家里有一台相当不错的 CPU,Intel i7–8700k,加上 32GB 的 3000MHz RAM。尽管如此,将这 500 万个数据点相乘仍然需要 0.21367 秒。如果我将num_multiplies的值改为 10 亿次,处理时间变成了 43.24129 秒!

让我们再试一个带有数组的例子。

我们将构建一个大小为 1000x1000 的 Numpy 数组,每个元素的值为 1,再尝试将每个元素乘以一个浮点数 1.0000001。代码如下。

在同一台机器上,将这些数组值乘以 1.0000001 的常规浮点循环耗时 1.28507 秒。

import time

import numpy as np

start_time = time.time()

data = np.ones(shape=(1000, 1000), dtype=np.float)

for i in range(1000):

for j in range(1000):

data[i][j] *= 1.0000001

data[i][j] *= 1.0000001

data[i][j] *= 1.0000001

data[i][j] *= 1.0000001

data[i][j] *= 1.0000001

end_time = time.time()

print("Run time = {}".format(end_time - start_time))

什么是矢量化?

Numpy 被设计成在矩阵操作中高效。更具体地说,大多数 Numpy 中的处理都是矢量化的。

矢量化涉及将数学运算,如我们在这里使用的乘法,表示为作用于整个数组,而不是它们的单个元素(如我们的 for 循环)。

通过矢量化,底层代码被并行化,以便操作可以在多个数组元素上同时运行,而不是一个一个地遍历它们。只要你应用的操作不依赖于其他数组元素,即“状态”,那么矢量化将给你带来一些良好的加速效果。

遍历 Python 数组、列表或字典可能会很慢。因此,Numpy 中的矢量化操作被映射到高度优化的 C 代码,使它们比标准 Python 对应操作快得多。

快速方法

这是做事的快速方法——按照 Numpy 被设计的方式来使用它。

在寻求加速的过程中,我们可以遵循几个要点:

-

如果对数组进行 for 循环,那么很有可能我们可以用一些内置的 Numpy 函数来替代它

-

如果我们看到任何类型的数学运算,很有可能我们可以用一些内置的 Numpy 函数来替代它

这两个要点都非常关注将非矢量化的 Python 代码替换为优化过的、矢量化的低级 C 代码。

查看我们之前第一个示例的快速版本,这次进行了 10 亿次乘法运算。

我们做了一件非常简单的事情:我们发现有一个 for 循环中重复了多次相同的数学操作。这应该立即提示我们去寻找可以替代它的 Numpy 函数。

我们找到了一种——power 函数,它简单地对输入值应用一定的幂。代码运行速度大幅提升至 7.6293e-6 秒——这就是一个

import time

import numpy as np

start_time = time.time()

num_multiplies = 1000000000

data = range(num_multiplies)

number = 1

number *= np.power(1.0000001, num_multiplies)

end_time = time.time()

print(number)

print("Run time = {}".format(end_time - start_time))

将值乘入 Numpy 数组的想法非常类似。我们看到我们使用了双重 for 循环,并且应该立即意识到应该有更快的方法。

方便的是,如果我们直接将 1.0000001 标量相乘,Numpy 会自动对我们的代码进行矢量化。因此,我们可以像对待 Python 列表一样编写乘法操作。

以下代码演示了这一点,并在 0.003618 秒内运行——这是 355 倍的加速!

import time

import numpy as np

start_time = time.time()

data = np.ones(shape=(1000, 1000), dtype=np.float)

for i in range(5):

data *= 1.0000001

end_time = time.time()

print("Run time = {}".format(end_time - start_time))

喜欢学习吗?

在 twitter 上关注我,我会发布关于最新和最棒的 AI、技术和科学的内容!也可以在 LinkedIn 上与我联系!

推荐阅读

想了解更多关于 Python 编程的内容吗?Python Crash Course 书籍是学习 Python 编程的最佳资源!

另外提醒一下,我通过亚马逊联盟链接支持这个博客,因为分享好书对大家都有帮助!作为亚马逊会员,我从合格的购买中获得收益。

简介: George Seif 是一位认证的极客和 AI / 机器学习工程师。

原文。经许可转载。

相关:

-

为什么你应该更频繁地使用 .npy 文件

-

为什么你应该忘记数据科学代码中的‘for-loop’,而拥抱矢量化

-

处理 NumPy 矩阵:一个实用的初步参考

更多相关话题

使用 NumPy 加速你的 Python 代码

原文:

www.kdnuggets.com/speeding-up-your-python-code-with-numpy

NumPy 是一个常用于数学和统计应用的 Python 包。然而,有些人仍然不知道 NumPy 可以帮助加速我们的 Python 代码执行。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

NumPy 能够加速 Python 代码执行的原因有几个,包括:

-

NumPy 在循环中使用 C 代码而不是 Python

-

更好的 CPU 缓存过程

-

数学运算中的高效算法

-

能够使用并行操作

-

在大数据集和复杂计算中内存高效

出于多种原因,NumPy 在提高 Python 代码执行效率方面非常有效。本教程将展示 NumPy 如何加速代码处理的例子。让我们来看看。

NumPy 在加速 Python 代码执行中的作用

第一个例子比较了 Python 列表和 NumPy 数组的数值运算,它们获取具有预期值结果的对象。

例如,我们希望从两个相加的列表中得到一个数字列表,所以我们执行了向量化操作。我们可以用以下代码进行实验:

import numpy as np

import time

sample = 1000000

list_1 = range(sample)

list_2 = range(sample)

start_time = time.time()

result = [(x + y) for x, y in zip(list_1, list_2)]

print("Time taken using Python lists:", time.time() - start_time)

array_1 = np.arange(sample)

array_2 = np.arange(sample)

start_time = time.time()

result = array_1 + array_2

print("Time taken using NumPy arrays:", time.time() - start_time)

Output>>

Time taken using Python lists: 0.18960118293762207

Time taken using NumPy arrays: 0.02495265007019043

正如你在上面的输出中看到的,NumPy 数组的执行速度比 Python 列表要快,从而获得相同的结果。

在整个例子中,你会发现 NumPy 的执行速度更快。让我们看看是否要进行聚合统计分析。

array = np.arange(1000000)

start_time = time.time()

sum_rst = np.sum(array)

mean_rst = np.mean(array)

print("Time taken for aggregation functions:", time.time() - start_time)

Output>>

Time taken for aggregation functions: 0.0029935836791992188

NumPy 可以非常快速地处理聚合函数。如果我们与 Python 执行进行比较,可以看到执行时间的差异。

list_1 = list(range(1000000))

start_time = time.time()

sum_rst = sum(list_1)

mean_rst = sum(list_1) / len(list_1)

print("Time taken for aggregation functions (Python):", time.time() - start_time)

Output>>

Time taken for aggregation functions (Python): 0.09979510307312012

在相同结果下,Python 的内置函数会比 NumPy 花费更多时间。如果我们有更大的数据集,Python 完成这些操作的时间会比 NumPy 长得多。

另一个例子是当我们尝试进行原地操作时,我们可以看到 NumPy 会比 Python 示例快得多。

array = np.arange(1000000)

start_time = time.time()

array += 1

print("Time taken for in-place operation:", time.time() - start_time)

list_1 = list(range(1000000))

start_time = time.time()

for i in range(len(list_1)):

list_1[i] += 1

print("Time taken for in-place list operation:", time.time() - start_time)

Output>>

Time taken for in-place operation: 0.0010089874267578125

Time taken for in-place list operation: 0.1937870979309082

例子的关键点在于,如果你有机会使用 NumPy,那么效果会更好,因为处理速度会更快。

我们可以尝试更复杂的实现,使用矩阵乘法来观察 NumPy 相比于 Python 的速度。

def python_matrix_multiply(A, B):

result = [[0 for _ in range(len(B[0]))] for _ in range(len(A))]

for i in range(len(A)):

for j in range(len(B[0])):

for k in range(len(B)):

result[i][j] += A[i][k] * B[k][j]

return result

def numpy_matrix_multiply(A, B):

return np.dot(A, B)

n = 200

A = [[np.random.rand() for _ in range(n)] for _ in range(n)]

B = [[np.random.rand() for _ in range(n)] for _ in range(n)]

A_np = np.array(A)

B_np = np.array(B)

start_time = time.time()

python_result = python_matrix_multiply(A, B)

print("Time taken for Python matrix multiplication:", time.time() - start_time)

start_time = time.time()

numpy_result = numpy_matrix_multiply(A_np, B_np)

print("Time taken for NumPy matrix multiplication:", time.time() - start_time)

Output>>

Time taken for Python matrix multiplication: 1.8010151386260986

Time taken for NumPy matrix multiplication: 0.008051872253417969

如你所见,NumPy 在更复杂的活动中也更快,比如使用标准 Python 代码的矩阵乘法。

我们可以尝试更多的例子,但 NumPy 应该比 Python 内置函数的执行时间更快。

结论

NumPy 是一个强大的数学和数值处理包。与标准 Python 内置函数相比,NumPy 的执行时间会更快。这就是为什么,如果适用,尝试使用 NumPy 来加速我们的 Python 代码。

Cornellius Yudha Wijaya**** 是一名数据科学助理经理和数据撰稿人。在 Allianz Indonesia 全职工作期间,他喜欢通过社交媒体和写作分享 Python 和数据技巧。Cornellius 涉及各种 AI 和机器学习主题的写作。

更多相关话题

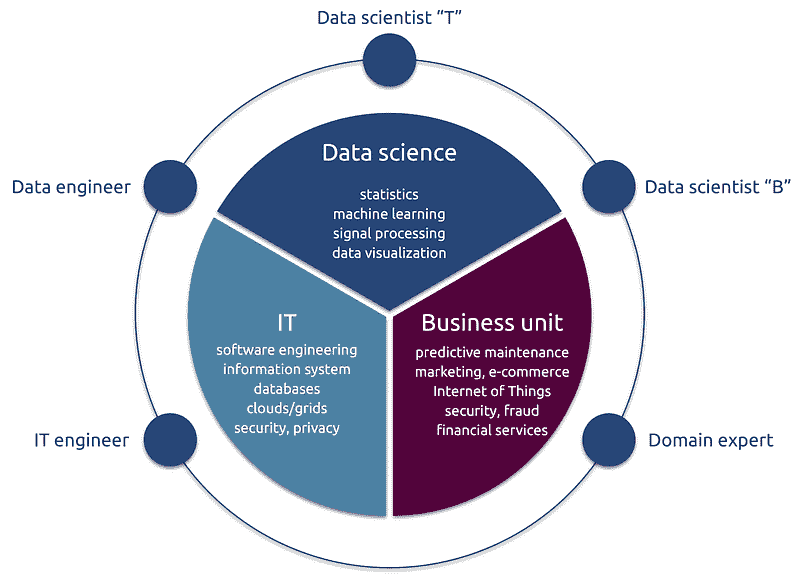

数据科学技能的分裂:个人与团队方法

原文:

www.kdnuggets.com/2014/01/split-on-data-science-skills-individual-vs-team-approach.html

评论作者:Gregory Piatetsky,2014 年 1 月 21 日。

评论作者:Gregory Piatetsky,2014 年 1 月 21 日。

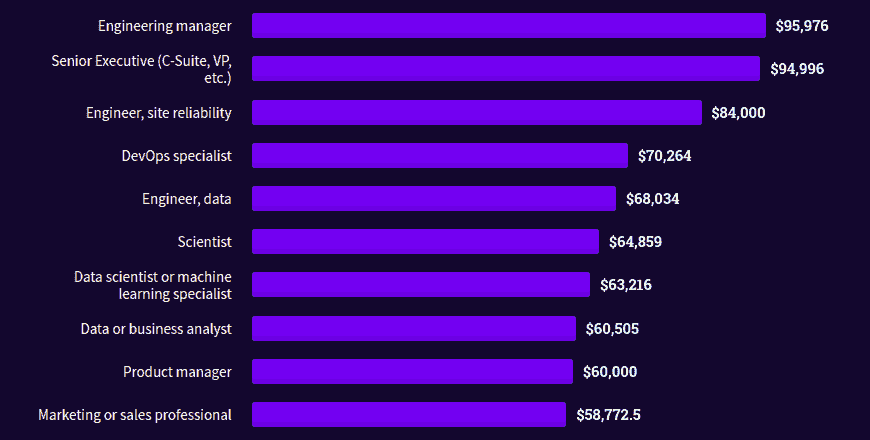

大多数数据科学职位(和任务)要求结合多种技能,如

大多数数据科学职位(和任务)要求结合多种技能,如

-

统计/机器学习,

-

黑客技能,

-

数据库,

-

以及行业/领域知识。

有一些多才多艺(“独角兽”)的数据科学家具备所有所需技能,但数量不足以填补预计的140-190,000 名深度分析专家和 150 万名分析经理/分析师(仅美国)的缺口。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的 IT 组织

3. Google IT 支持专业证书 - 支持你的 IT 组织

最新的 KDnuggets 民意调查询问了:哪种方法更好?

| 数据科学任务需要统计、黑客、数据库、商业、演示及其他技能的稀有组合,但找到具备所有所需技能的多才多艺(“独角兽”)数据科学家非常困难。哪种方法更好: [总票数 304 票]

|

| 个人:寻找并培养具有所有(或大部分)所需技能的多才多艺的数据科学家(135) |  |

|---|---|

| 不确定(33) |  |

| 团队:组建一个数据科学团队,每个成员主要专注于一项技能(136) |  |

这项调查源于 Michael Mout 在 KDnuggets 上发布的最近文章《数据科学定义的错误在哪里》,引发了关于是否能够找到具备所有所需技能的数据科学家,或者这些角色是否更适合由团队填补的激烈讨论 - 参见《独角兽数据科学家与数据科学团队》。

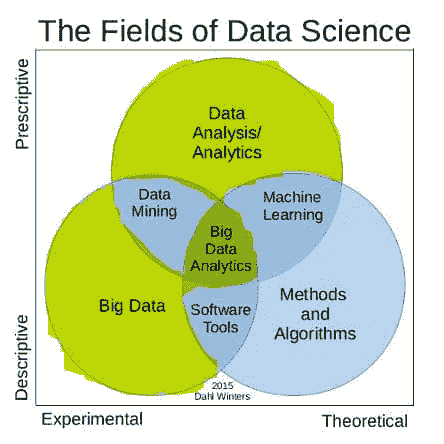

Michael Mout 将数据科学技能分为三个主要领域:数学和统计、计算和数据库。

著名的 数据科学维恩图,由 Drew Conway 于 2010 年提出,其组成部分略有不同:黑客技能、数学与统计学以及领域/业务知识。

部分差异,如 David Gillman 在下方评论的那样是

大公司需要一个团队。中小企业需要一到两个人。

显然,如果中小企业只能雇佣一个人,他们会尽量寻找一个更全面的人才。

大公司将拥有一个数据科学家团队。然而,即使是能够负担得起大团队的大公司也应该决定是寻求并培训难以获得但多才多艺的人,还是尝试通过专家团队完成任务。

调查结果在团队和个人方法的支持者之间平均分配,但在区域分析中出现了有趣且反直觉的差异。

来自美国的受访者,传统上被认为更加个人主义(如美国宪法中的“生命、自由和追求幸福”所体现),实际上更倾向于团队方法,而欧洲和亚洲的受访者则倾向于个人方法:欧洲。加拿大的受访者与美国的观点截然不同,强烈支持团队方法,而澳大利亚/新西兰的选民尽管人数较少,却是最具个人主义的。

以下是按区域划分的结果。条形高度对应受访者数量。

| 区域 | % 个人方法 | % 不确定 | % 团队方法 |

|---|---|---|---|

| 美国 (147) |  41% 41% |

12% 12% |

47% 47% |

| 欧洲 (76) |  51% 51% |

12% 12% |

37% 37% |

| 亚洲 (41) |  51% 51% |

2% 2% |

46% 46% |

| 拉丁美洲 (12) |  42% 42% |

17% 17% |

42% 42% |

| 非洲和中东 (12) |  33% 33% |

8% 8% |

58% 58% |

| 加拿大 (11) |  18% 18% |

9% 9% |

73% 73% |

| 澳大利亚/新西兰 (5) |  80% 80% |

20% 20% |

0% |

评论

C. Magaret,通过 Disqus

让我们回到大约 20 年前,当时出现了一种席卷全球的疯狂新趋势,称为万维网。有些人说它将改变世界,其他人则认为不那么回事,有些人觉得它发展得太快了,还有些愤世嫉俗者宣称这只是一个短暂的时尚。

在网络的青铜时代,赋予网络生命的专业和业余从业者是被称为“网页管理员”的全能型技术专家。要成为一个合格的网页管理员,你需要掌握一系列(当时)晦涩的技能:系统管理、网络管理、编程、界面设计和图形设计等。网页管理员通常独自工作,或在一个小型的网页管理员团队中,来实现组织的网络目标。

如今,网络无处不在。它在几乎每个人的生活中扮演着重要角色,已经成为地球上几乎每个组织的核心部分,还有大量的企业专门从事网络货币化。网络带来了数据库,促进了新技术的发展,推动了交互用户界面设计的极限,并且某些基本服务已经被商品化到微不足道的地步。今天的网络范围和成熟度之大,使得拥有一个全能型的网页管理员已经不再切实可行。对于从事网络业务的人来说,我提到的每一种网页管理员技能(还有更多)都已经被划分为由专家负责的独立学科。虽然界面设计师可能会了解 SOAP 的工作原理,并因此成为更好的界面设计师,但他们不会从事 API 的后端编程工作。他们会将这部分留给开发者。

简单来说,网络已经超越了传统的网页管理员。虽然你可能会找到为某个小组织工作的老式网页管理员,但要想实现高效和高质量的网络工作,仅仅依靠一小组通才是不够的。他们需要拥有专业的团队。

上述内容让我联想到关于通才与专家数据科学家的争论。如果“数据科学”作为一个领域预期要发展和成熟到工业规模,那么“数据科学”将超越数据科学家,当然你会看到专业化,通常表现为项目团队,我已经在大型数据驱动的组织中看到了这种情况。人们有自然的技能组合,他们倾向于承担那些符合其优势的责任,对于在数据科学领域实践的大型组织而言,拥有一个由具备明确责任的人员组成的项目团队将带来更高效的工作流程和更好的最终产品,而且更易于管理。这是一种更自然和有纪律的商业方式。

Sam Steingold

我认为两种选择都不现实。将所有三种技能(数学/统计、黑客、商业)结合起来非常困难。我认为最佳的方法是找一个优秀的数学/统计人员,然后通过添加必要的人来弥补他的不足。即,数据团队应该围绕一个拥有强大数学/统计背景的人建立。

凯瑟琳·巴特勒,数据科学团队还是个人?

我同意很难找到那种“独角兽”,但我也相信你需要比单一领域的专家更全面的个人。在招募时,我寻找能够填补团队空白的个人,但如果我在计算技能上有所欠缺,我绝不会雇佣一个没有像矿工那样的好奇心和创造力的程序员,或没有获取商业知识和解释分析结果能力的人,或没有将洞见提炼成强有力演示能力的人。我认为这取决于你的团队规模,是否有招聘领域专家的奢侈,或者是否需要让每一个全职员工发挥作用,并寻找更多的全能型人才,偶尔有领域专家。

格雷厄姆·穆利尔,第 4 选项 - 两者皆可!

我投了“个人”选项,但实际上我希望有一个第四个选项,用于招募和培训多技能的个人,辅以一个更广泛的团队,以更深入地覆盖所有方面。

这就是我目前在 Syngenta 设置的新数据科学职能中所做的。我很幸运拥有一个能够作为个人数据科学家高效运作的小团队,他们具备正确的技能和领域知识。他们是一个更大团队的一部分,能够处理和存储数据集,整合数据,构建本体,制作数据可视化等。这应该有助于扩展他们的专业知识并更广泛地传播好处。

大卫·吉尔曼,团队与个人

大公司需要一个团队。中小企业需要一两个个人。

讽刺地说,“团队”是任何项目中必须分享或分配责任的必要元素。

乔治·R,团队与个人

团队方法对于组织的可持续努力更为健康。找到真正的数据分析明星是困难且昂贵的。即使你雇佣了那个具备全部技能的杰出个人,她也可能不会长期留下。团队方法允许更快速地访问解决数据问题所需的各个组成部分。如果团队成员离开,找到一个在缺失组件上非常优秀的人会容易得多。

加里·霍沃斯,个人与团队

啊,但你假设团队之间会互相交流并且“提出正确的问题”,恐怕这只存在于教科书中。我在数据行业工作了 30 年,所以这是经验之谈。工具已经有所改进,但这仅占所需技能的 10-20%。我回答了个人,但正如之前的评论者所说,实际上很少有人具备这种多学科的技能——这是一种特殊的技能。所以在缺乏这种技能的情况下,你确实需要一个团队。你可以主张一个非常小的 2-3 人的团队,但如果技能分布在 10 个人身上,对我来说并不够。这关乎如何将各种不同的组件结合起来,即数据分析加上背景加上领域经验,这才是关键。

理查德·D·阿维拉,数据科学团队还是个人?

我在 2000 年 4 月写了我的第一个“分析程序”。那是一个球面上的地理聚类算法。我做了数学运算,编写了代码,运行了数据,进行了验证,但对结果在 150 万条记录中的含义毫无头绪。我们有一位运营分析师,他理解了所显示的内容,接着好事就发生了。分析推理/领域知识/领域背景只能通过真正的领域工作来获得。我确实同意数据分析的三个关键能力是:分析/领域知识、数学、计算。要成为一个有效的“数据科学家”,一个人需要具备三者中的两个。在我从事数据分析的时间里(2000 年 4 月),我只遇到过一个具备所有三方面技能并能解决实际问题的人。这一学科的技术层面非常广泛——想想所有所需的数学、算法和计算技术专长。

领域专业知识的适配问题我也无法理解。我会把那些声称能做三者兼备的人视为天真或傲慢。这两种特质可能会导致数据分析项目或系统开发失败。仅仅因为你能想象一只独角兽,并不意味着它能存在于我们生活的这个物理世界中。正确进行数据分析几乎总是需要一个团队。

通过 LinkedIn 选择的评论

比尔·温克勒,美国人口普查局首席研究员

对于最复杂的一组算法(甚至可能涉及理论/计算突破),很难在一个人身上找到合适的技能,即使这个人有很长时间来发展这些技能。

多年来,有许多大型软件开发项目和数据仓库创建项目,我们还可以添加一些大数据项目。所有这些项目都需要某些技能,其中一些在项目早期是不为人知的。根据一些 IEEE CS 和 ACM 文章,很多项目(超过 50%)都失败了。

迈克尔·希迪罗格鲁和我参与了一些成功的团队,这些团队开发了非常大的、通用的计算机系统。在大多数项目中,有一个时刻是一个人能够开发出新的方法/算法,使整体工作取得成功。这个方法可能涉及高级运筹学(集合覆盖,整数规划)或计算机科学(近似字符串比较,非常先进的索引/搜索/检索),这些技能在统计学家、经济学家或参与这些团队项目的 IT 编程人员中并不常见。

一些团队随后尝试开发类似系统,因为这些团队了解我们开发的系统(或在荷兰、西班牙和意大利开发的类似系统)。大多数项目失败了(即使经过多次尝试)。共同点是成功的团队具备适当的分析/理论/算法技能。在少数情况下,IT 领域提供了补充技能,但大多数关键突破是由统计学家和经济学家提供的(通常是具备很好的编程技能的博士生)。

如果有像清理和去重国家文件集、然后合并国家文件集以进行后续统计分析以调整链接错误(因为通常没有唯一标识符)这样的大数据情况,那么需要先进的计算方法。

Winkler, W. E. (2011), "清理和使用行政名单:记录链接及建模/编辑/填补的快速计算算法方法",在 2011 年 11 月于西班牙马德里举行的 ESSnet 数据集成会议论文集( www.ine.es/e/essnetdi_ws2011/ppts/Winkler.pdf )。

我确实意识到,有大量的快速项目(1-6 个月),其中一个人具备适合特定分析的一组技能。两个问题:(1)如果你在较小的情况下创建了输入文件/结构并编写了一个在一周内运行的软件,你如何意识到可以编写比这快 10-100 倍的软件?(2)如果你使用统计或其他软件包,你如何知道算法是否正确执行计算?

作者:托马斯·斯派德尔

比尔·温克勒的评论非常有见地。我可以理解与行政数据集进行记录链接的问题(噩梦)。

我认为,分歧源于在一个仍然模糊定义的新领域中的有限经验。这几乎是不可避免的。那些认为专业化是过时方法的人,可能习惯于那些对表面知识足够的项目。他们可能没有意识到,但他们也拥有专业知识。

作者:弗雷迪·霍尔韦达

敏捷开发提供了 T 型资源的概念。因此,我选择了个人方法:“寻找并培养具备所有(或大部分)所需技能的多面手数据科学家”,并补充说每个数据科学家应在每项技能上只有一定深度(“T”字形的横杠),并在一到两个技能上有深度掌握(“T”字形的竖杠)。

由劳拉·斯奎尔,SAS 销售工程经理

博客系列展示了如何制定高级分析策略

构建分析梦想团队的专业人才:SME、数据准备员、数据管理员、IT、分析师、思想领袖、倡导者

由威尔·斯坦顿

随着分析领域(以及数据科学家)不断以有时似乎是指数级的速度发展,我认为大多数公司(尽管不是所有公司)更倾向于团队方法。因此,组建一个合适的数据科学家团队来处理特定项目/问题/机会。数据科学家团队可以由在一到两个领域具有互补深度的个人组成,并且对其他领域有一定了解,从而使团队具备广度和深度的知识——我认为这是单个数据科学家无法实现的(尽管我遇到过一些自认为在所有领域,包括新兴领域,均具备广度和深度的个人——并非所有人都同意他们的自我评价)。然而,就像大多数事情一样,这种方法取决于许多假设/现实,包括问题的复杂性、公司的规模、公司内人才的可用性等。

由多萝西·休伊特-桑切斯

也许我看到的职位发布与你看到的不同。这些职位发布要求一切,包括所有额外要求。这与职位名称无关。这就是为什么招聘人员说找不到合格的人才。这真是荒谬。我曾在多个职位上工作。当我是 DBA 时,我仍然需要进行业务分析、收集需求、为业务和数据分析师重写查询并参与决策支持会议。这都是工作的一部分。作为顾问或主管,我仍然需要完成所有这些角色及更多。因此,职位角色和标题之间的界限非常模糊。

嗯,如果我再加入统计学、机器学习和 Hadoop,情况会怎样呢?

由斯特凡·卡拉吉尔

在我的职业生涯中,我遇到了两种类型的人:一种是喜欢在多个领域学习尽可能多技能的广泛型人才(通才),另一种是倾向于在某一领域成为专家的专业型人才(专才)。直到最近,公司主要寻找的是专家,但现在发现他们需要更多的通才:解决复杂问题往往需要借鉴多个领域的方法(生物学、物理学、社会学……)。我的看法是,最佳的团队应包括通才和专才。

埃里克·金

这是我从一开始就遇到的几个问题之一,那就是有些人随意冠以“数据科学家”的称号。除了需要涵盖的各种职能外,大多数从业者并没有足够的个性来在技术层面和软技能方面同时管理战略问题。我认为只有少数非常独特的人才能胜任这个角色……这使得“数据科学”应该是一个团队功能,而不是个人称号。

更多相关话题

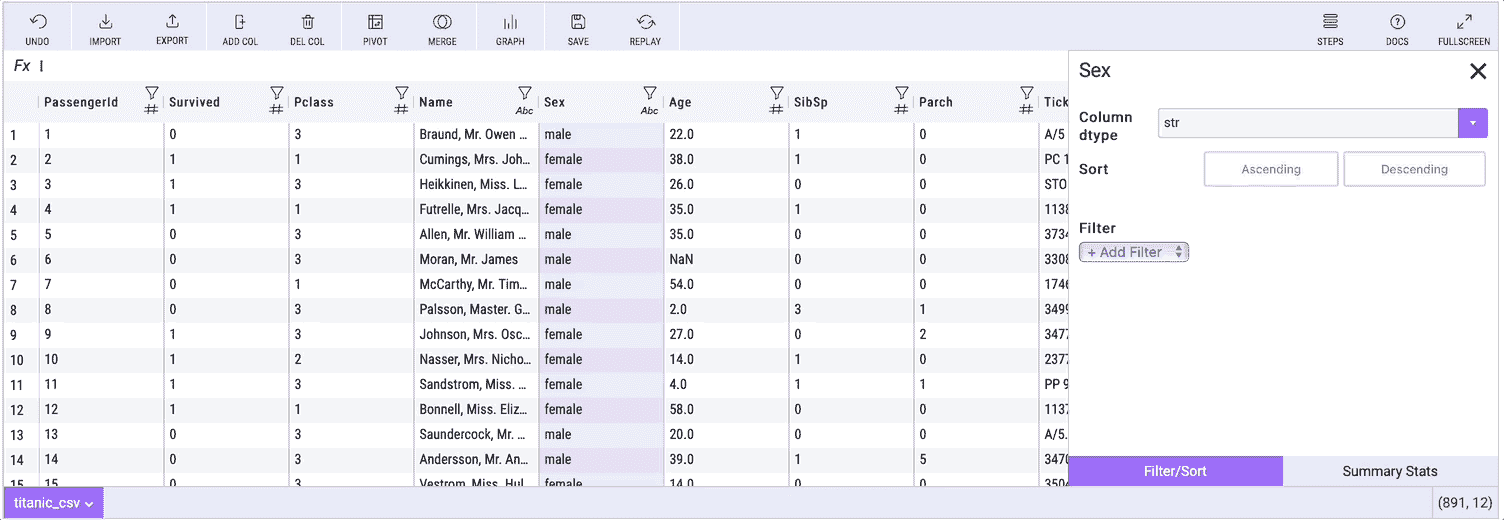

生成 Python 的电子表格:Mito JupyterLab 扩展

原文:

www.kdnuggets.com/2021/11/spreadsheet-generates-python-mito-jupyterlab-extension.html

评论

作者 Roman Orac,高级数据科学家

图片由 Joshua Sortino 提供,来源于 Unsplash

Mito 是一个用于 Python 的电子表格界面

Mito 允许你将数据框或 CSV 文件传入电子表格界面。它具有 Excel 的感觉,但每次编辑都会在下面的代码单元中生成等效的 Python 代码。最理想的情况下,这可以成为快速完成数据分析的绝佳方法。

使用 Mito 进行探索性数据分析(作者制作的可视化)

如果你错过了我关于 Mito 的其他文章:

开始使用 Mito

这里是完整的安装说明。

要安装 Mito 包,请在终端中运行以下命令:

python -m pip install mitoinstaller

python -m mitoinstaller install

然后在 Jupyter Lab 中打开一个笔记本并调用 mitosheet:

import mitosheet

mitosheet.sheet()

Mitosheet 可以在分析的任何阶段调用。你可以在表单调用中将数据框传递给 Mitosheet 作为参数。

mitosheet.sheet(df)

你可以使用导入按钮从本地文件中安装数据。

Mito 数据分析功能

Mito 提供了一系列功能,允许用户清理、处理和探索数据。这些功能中的每一个都会在下面的代码单元中生成等效的 Python 代码。

在 Mito 中,你可以:

-

过滤

-

数据透视

-

合并

-

图表

-

查看汇总统计数据

-

使用电子表格公式

-

还有更多…

对于这些编辑中的每一个,Mito 都会在下面的代码单元中生成 Pandas 代码,用户可以将其用于分析或发送给同事。

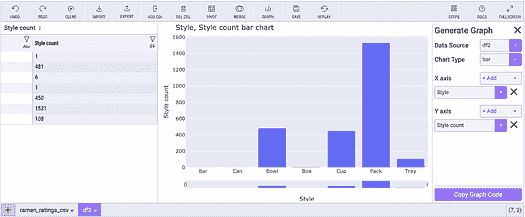

下面是使用 Mito 创建数据透视表的样子:

Mito 的数据透视表(作者制作的可视化)

生成的示例数据透视表代码如下(代码是自动文档化的):

# Pivoted ramen_ratings_csv into df3

unused_columns = ramen_ratings_csv.columns.difference(set(['Style']).union(set(['Brand'])).union(set({'Style'})))

tmp_df = ramen_ratings_csv.drop(unused_columns, axis=1)

pivot_table = tmp_df.pivot_table(

index=['Style'],

columns=['Brand'],

values=['Style'],

aggfunc={'Style': ['count']}

)# Flatten the column headers

pivot_table.columns = [flatten_column_header(col) for col in pivot_table.columns.values]

下面是查看列的汇总统计数据的过程:

使用 Mito 的汇总统计(作者制作的可视化)

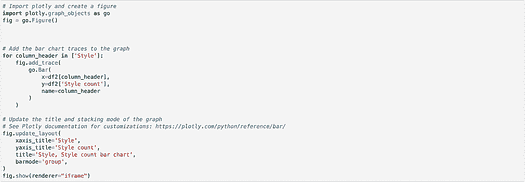

生成可视化代码

正确获取 Python 数据可视化的语法可能是一个耗时的过程。Mito 允许你在点击环境中生成图表,然后给出这些图表的等效代码。

创建图表后,点击“复制图表代码”按钮:

使用 Mito 制作图表(图像由作者制作)

然后将代码粘贴到任何代码单元格中。Mito 允许进行可重复的可视化过程。

Mito 生成代码(图像由作者制作)

结论

Mito 是生成 Python 代码的快速方法,特别适合那些熟悉 Excel 的人。它节省了很多去 Stack Overflow 或 Google 查找正确语法的时间。

Mito 绝对值得尝试,尽管它会在引入更多图表类型和更好的批量编辑能力(批量删除列、重命名等)时变得更加有价值。

离开之前

如果你喜欢阅读这些故事,何不成为一个Medium 付费会员呢?每月 $5,你将获得无限访问数万篇故事和作者的权限。如果你使用我的链接注册,* 我将获得一小笔佣金。*

由 Courtney Hedger 拍摄,来源于 Unsplash

个人简介:Roman Orac 是一位机器学习工程师,在改进文档分类和项目推荐系统方面取得了显著成功。Roman 具有管理团队、指导初学者和向非工程师解释复杂概念的经验。

原文。经授权转载。

相关:

-

在 Jupyter Notebook 中分析 Python 代码

-

Python 序列的 5 个高级技巧

-

用 Faker 生成 Python 合成数据

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

更多相关主题

你免费的 70 页数据科学职业指南

原文:

www.kdnuggets.com/2018/03/springboard-guide-career-data-science.html

赞助帖子。

你是否想进入数据科学行业但不太知道从哪里开始?做数据科学,你必须能够找到和处理大型数据集。你通常需要理解和使用编程、数学和技术沟通技能。

在进入数据科学之前,你应该能够回答一些问题:你如何进入这一行业?你需要什么技能才能成为数据科学家?哪里有最好的数据科学职位?

为了回答这些问题(以及更多问题),我们整理了一份全面的获取你的第一份数据科学工作指南。

在本指南中,我们将逐步带你了解打破数据科学壁垒所需的一切,包括:

-

行业概览——从“数据科学”这一术语的历史,到学习正确的编程语言,再到理解所需的数学和统计学。

-

与顶级公司的数据科学家的真实采访。他们会分享他们如何进入这一行业。

-

你在数据科学角色中成功所需的技能以及如何建立项目组合。

-

可操作的建议,包括寻找工作、如何建立网络以及如何发展招聘经理所寻找的软技能。

如果你对数据科学感到好奇,或你已经决定数据科学是适合你的职业,今天下载免费的指南 并开始为你的数据科学新职业而努力!

更多相关话题

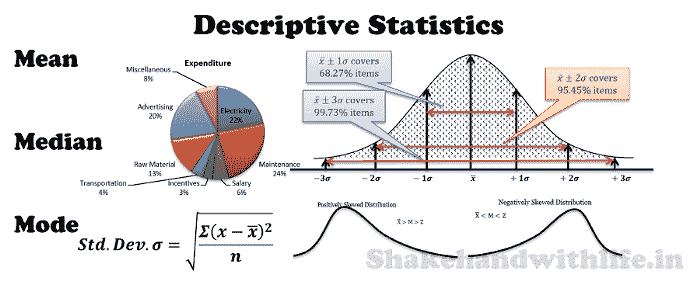

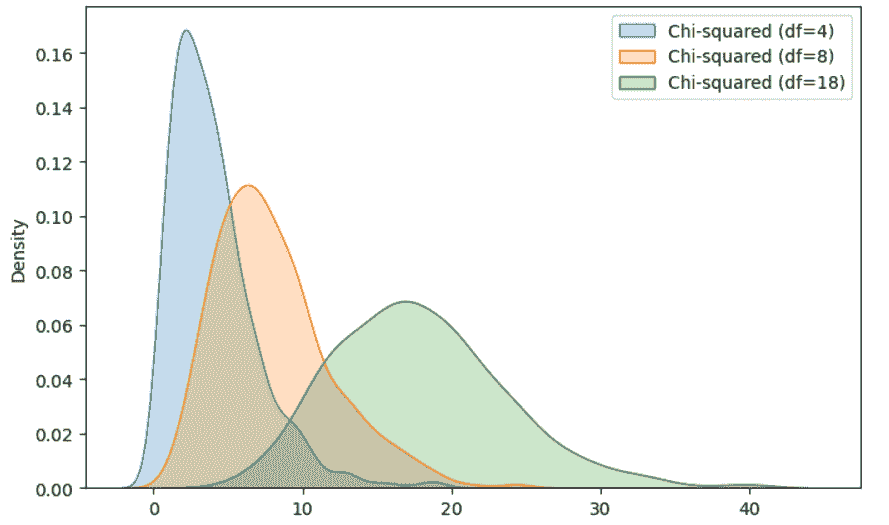

学习数据科学统计学的顶级资源

原文:

www.kdnuggets.com/2021/12/springboard-top-resources-learn-data-science-statistics.html

赞助帖子。

图片来源:Lukas from Pexels

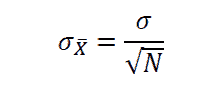

统计学是数据科学的核心,两个领域之间的联系越来越紧密。如果你希望在数据科学领域取得长足的进展,深入理解统计学概念是非常重要的,而这一基础的建立可能需要一段时间。Springboard 的数据科学职业课程是一个很好的起点,如果你认真对待提升自己在这一领域的技能,它应该是你首先要迈出的步骤之一。让我们来看看统计学在数据科学中的当前状态,以及你可以做些什么来加速学习。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道

1. Google 网络安全证书 - 快速进入网络安全职业轨道

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

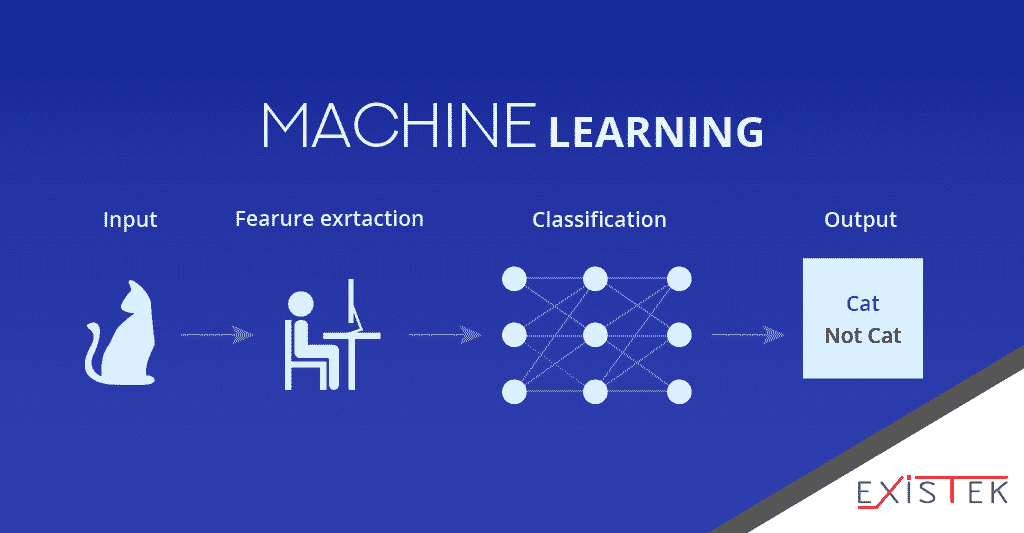

统计学在数据科学中的作用

有些人喜欢说机器学习只是统计学加上额外的层次,虽然这可能有些夸张,但这句话中确实有一些真理。这也适用于数据科学的广泛领域。处理数据、识别数据中的模式以及预测未来数据集中的趋势,最终都归结于正确应用各种统计技术。现代数字解决方案的帮助使得这一过程变得更加容易,因为它们可以以快速的速度处理大量数据。

需要关注的统计学领域

对大多数人来说,扎实的统计学基础将大大助力于成为数据科学家,即使没有深入研究任何特定的子领域。你需要一般性地培养像统计学家一样思考的能力,并将适当的推理方法应用于你遇到的情况。这将比学习任何特定的狭窄专业领域更有帮助。

更重要的是,你需要培养理解你所做的事情以及你如何得出结论的能力。数据科学中很大一部分是黑箱,尤其是涉及人工智能时。这可能会让人误以为只需将一堆预制模型应用于某个情况,得到一些结果,然后结束一天。

但如果你无法解释驱使你到达那个点的实际统计推理,专家们不会认真对待你。这也将帮助你理解你遇到的问题的局限性。你可能不会立即知道正确的解决方案,但理解领域的局限性至少能帮助你将注意力引导到正确的方向。

实现一些基本模型

无论你选择专注于哪个方面,你都应该在学习过程中经历一些基本模型。用你自己的资源和研究从零开始实现这些模型,将有助于你更深入地理解这个领域是如何工作的,以及不同概念之间的联系。

你应该从基本线性回归开始。这是统计学和数据科学中最容易理解的概念之一,它将为你打开一些可能感兴趣的额外领域。进行朴素贝叶斯分类。网上有很多关于这个主题的资源,这应该是另一个相对简单的任务,同时仍能为你提供大量关于数据科学中统计学基础的有价值知识。

有用的入门资源

在线培训课程是你最好的朋友。它们能提供你理解后续概念所需的深入知识。有很多地方可以学习数据科学中的统计学,你应该花时间比较一些最受欢迎的课程。

一些可以帮助你走上正轨的有用书籍包括彼得·布鲁斯和安德鲁·布鲁斯的《数据科学实用统计学》;卡梅伦·戴维森-皮隆的《黑客的贝叶斯方法》;以及布拉德利·埃夫隆和特雷弗·哈斯蒂的《计算机时代的统计推断》。这些书籍很容易找到,在社区中也非常受欢迎,所以你应该有很多机会与他人讨论你所学到的知识。

需要记住的事项

统计学和数据科学之间的联系很紧密,而在数据科学领域取得进展而不投入一些统计学方面的努力是困难的。与此同时,你在数据科学中取得较高进展所需的理解水平并不像你想象的那样高。对许多人来说,复习我们上面概述的基本概念,并完成一些培训课程,应该足以让他们入门并全面介绍这一领域。

正如我们之前提到的,如果你对数据科学职业感兴趣,可以查看 Springboard 的数据科学职业课程。它将为你提供目前能找到的最深入的领域概述,并帮助你理解提升技能所需的概念。同时,也要尽可能多与人交流——数据科学正在经历许多积极的发展,现在是与其他专家讨论最新发现的绝佳时机。

更多相关内容

使用机器学习进行销售预测

原文:

www.kdnuggets.com/2017/05/springml-sales-forecasting-using-machine-learning.html

赞助帖子。

作者:Girish Reddy,SpringML。

销售预测是组织常见的任务。这通常涉及使用电子表格的手动密集过程,需要来自组织各个层级的输入。这种方法引入了偏差,通常在季度初的几周内并不准确。实际上,那段时间准确的预测最为重要,因为在季度最后一周提供准确的预测价值不大。

尽管预测过程往往复杂,但确定其准确性却很简单。只需等到预测期结束(例如季度末),然后将预测与实际情况进行比较即可。我们对我们的模型的准确性充满信心,并邀请销售领导参与我们的人类与机器预测对决——给我们一天时间使用你的数据,我们将提供基于算法的、公正的预测。在季度末,你可以通过与内部预测进行比较来评估我们的结果。通过访问 www.springml.com/sales-forecasting-challenge并提交表单来开始。这个过程简单易行,可以让你快速看到机器学习能为你的组织带来什么。

SpringML 的应用通过执行自动运行的机器学习模型来简化预测,并提供客户销售指标的每月或季度预测(例如收入、ACV、数量)。这些模型使用历史数据来评估趋势和季节性,以及当前机会管道来预测未来 6 个月或 12 个月的情况。准确的预测可以帮助组织做出明智的业务决策。它提供了关于公司如何管理其资源——人力、时间和资金的洞察。

以下是构成我们预测集成的各种技术。

-

使用贝叶斯模型(R 中的 BSTS 包)、树基技术以及其他传统方法如 ARIMA 进行时间序列预测。

-

包含时间序列的预测因子——这些可以是任何对模型有价值的变量,例如产品使用情况、用户数量、营销支出等。根据需要包括外部数据,如行业趋势、人口统计信息等。

-

通过对开放机会运行分类算法来评估当前管道数据——这构成了集成的一部分。

-

在最终确定最佳模型集之前,评估过去几个月的集成效果。

由于预测基于数据驱动,因此该解决方案允许用户执行“如果”分析。这是一种工具,允许销售负责人确定某些因素对销售数字的影响。这种分析帮助他们确定可以使用哪些杠杆,以及这些杠杆对销售产生的影响,无论是正面还是负面。这种高级“如果”分析基于机器学习,每次用户与工具互动时,模型都会执行。一些用于此分析的变量包括销售代表数量、平均交易持续时间、平均交易金额、赢单率百分比。例如,销售经理可以查看如果增加招聘会发生什么,或者确定折扣计划的影响。该功能列表是可配置的,可以包括对公司更有意义的其他因素。

通过发送电子邮件至info@springml.com了解更多信息

该主题的更多内容

SQL 案例研究:帮助初创公司 CEO 管理数据

原文:

www.kdnuggets.com/2018/09/sql-case-study-helping-startup-ceo-manage-data.html/2

评论

评论

表中存在多少行?

我们想知道这个初创公司有多少人。我们通过使用 count(*) 计算行数来实现:

SELECT COUNT(*)

FROM startup;

列中有多少行具有最小值?

我们想知道在初创公司中哪些人的薪水最低以及有多少人。让我们尝试这个查询:

SELECT *

FROM startup

WHERE salary = MIN(salary);

这将导致一个错误,提示:

ERROR: aggregate functions are not allowed in WHERE

聚合函数如 COUNT()、MIN()、MAX()、AVG()、SUM() 等,它们将列中的值作为输入并返回一个单一值(或 NULL)。这里 MIN() 在 WHERE 子句之后使用,因此我们可以通过检查薪水是否等于最小值(或不是)来实现,这个最小值我们可以从另一个查询中获取,而不是通过聚合来获取,如下所示:

SELECT MIN(salary)

FROM startup;

但这将产生不合理的值,即 1000$,那么发生了什么?!

这是因为排序顺序,如果你对 ASCII 排序顺序感兴趣,可以查看这个链接。

那么,我们现在应该怎么做?

实际上,我在创建表的开始阶段做了一些效率不高的事情,那就是将薪水列存储为 varchar。原因存在于这个stackoverflow 问题的RidFilter的回答中。

相信与否,我处理过一些类似的数据。它包括存储为 varachar 的美元符号,因此让我们修复它,以便能够对其进行操作。

从字符串中删除字符:

这个问题可以通过首先删除美元符号,然后将该 varchar 转换为可以是整数的数值来解决。

SELECT REPLACE(salary, '$', '')

FROM startup;

这个 REPLACE() 函数将导致薪水列中的值去除美元符号(即用空替换 $),但请注意这并没有编辑到表中。所以,下次我们需要操作时需要使用它。此外,请注意,这一列仍然是字符串而非数值,因此我们需要将其转换为小数。

现在,我们可以对转换后的薪水值应用 MIN():

SELECT MIN(

CAST(

REPLACE(salary, '$', '')

as DECIMAL))

FROM startup;

CAST() 函数将新的薪水列转换为小数值。

记住,我们在初创公司表中仍然看到带有美元符号的薪水。

为了在表中去除美元符号,我们使用 UPDATE() 函数:

UPDATE startup

SET salary = REPLACE(salary, '$', '');

现在,我们回到我们的难题,即找出初创公司中薪水最低的人员。

SELECT *

FROM startup

WHERE CAST(salary AS DECIMAL) = 800;

我们可以只使用一个带有子查询的查询,而不是最后两个独立的查询:

SELECT *

FROM startup

WHERE CAST(

salary AS DECIMAL) = (

SELECT MIN( CAST(salary AS DECIMAL) ) FROM startup );

我们还可以使用 COUNT(*) 进行计数:

SELECT COUNT(*)

FROM startup

WHERE CAST(salary AS DECIMAL) = 800;

最低薪水的三个人:

我们希望获取初创公司中薪资最低的三名工程师。我们可以通过首先使用 ORDER BY 子句并跟随 ASC,或者仅使用 ORDER BY,这将默认按升序排列输出。

SELECT *

FROM startup

ORDER BY

CAST( salary AS DECIMAL );

添加 ‘LIMIT 3’ 将带来前三个对应薪资最低的行。

薪资最高的三名:

注意我们做了什么改变!

SELECT *

FROM startup

ORDER BY

CAST( salary AS DECIMAL ) DESC

LIMIT 3;

总薪资:

假设 CEO 想了解薪资总成本,我们可以使用聚合函数 SUM() 来实现。

SELECT SUM(

CAST( salary AS DECIMAL )

) FROM startup;

向表中添加列:

假设他现在想雇佣女性,因此他会添加一个名为 sex 的列。这可以通过 ALTER 子句完成:

ALTER TABLE

startup

ADD sex char(1);

我们应该这样更新每一行:

UPDATE startup

SET sex = 'M'

WHERE id = 1;

使用 for 循环:

当然,如果我们手动操作,这会很繁琐。因此,我们应该改用循环。

SQL 没有循环,但可以在过程性语言函数或 ‘Do’ 语句中使用,如 这里 所答:

DO

$do$

BEGIN

FOR i IN 2..8 LOOP

UPDATE startup2 set sex = 'M' WHERE id = i;

END LOOP;

END

$do$;

(类似)直方图:

其中一个可能的要求是了解某事发生的频率。我们可以通过计算每个城市值的每行出现次数来获取城市在初创公司工程师中的频率。这就是我们使用 GROUP BY 子句的原因:

SELECT city, COUNT(*)

FROM startup

GROUP BY city;

这类似于直方图;它展示了值出现的频率。

如果我们跟随 AS,可以为任何列命名:

SELECT city, COUNT(*) AS frequency

FROM startup

GROUP BY city;

希望你觉得这篇文章有用。如果你想了解我在获得第一个数据科学实习之前的故事,我在 Medium 上写了一篇 文章。如果你想看到更多更新和挑战,请关注我:

-

Linkedin:

www.linkedin.com/in/ezzeddinabdullah/ -

Medium:

medium.com/@ezzeddinabdullah -

Twitter:

twitter.com/EzzEddinAbdulah

简历: Ezz El Din Abdullah 是前数据科学实习生和编程导师。

相关:

-

SQL 备忘单

-

SQL 中的可扩展随机行选择

-

选择 SQL 还是不选择 SQL:这是一个问题!

我们的前 3 门课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织进行 IT 管理

3. Google IT 支持专业证书 - 支持您的组织进行 IT 管理

主题更多信息

SQL 速查表

评论

评论

SQL(结构化查询语言)是一种用于编程的领域特定语言,旨在查询数据库。与任何语言一样,拥有常见查询和函数名称的列表作为参考是有用的。我们希望这张速查表对你有所帮助:

基本关键字

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

在我们深入了解一些基本常见查询之前,让我们先看看你将会遇到的一些关键字:

| 关键字 | 说明 |

|---|---|

| SELECT | 用于声明要查询的列。使用 * 表示所有 |

| FROM | 声明从哪个表/视图等中选择 |

| WHERE | 引入条件 |

| = | 用于将值与指定输入进行比较 |

| LIKE | 与 WHERE 子句一起使用的特殊运算符,用于在列中搜索特定模式 |

| GROUP BY | 将相同的数据安排成组 |

| HAVING | 指定仅返回汇总值符合指定条件的行。由于 WHERE 关键字不能与汇总函数一起使用,因此使用此关键字 |

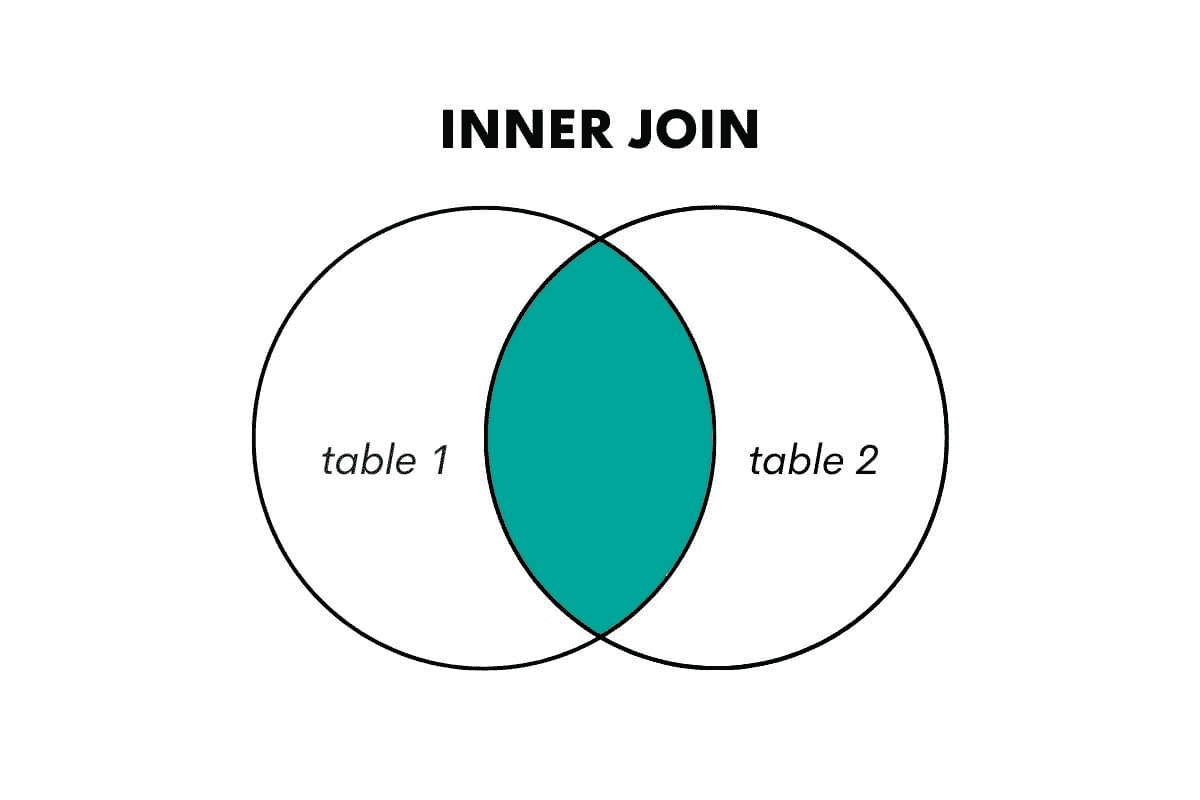

| INNER JOIN | 返回所有主键记录在一个表中等于另一个表的主键记录的行 |

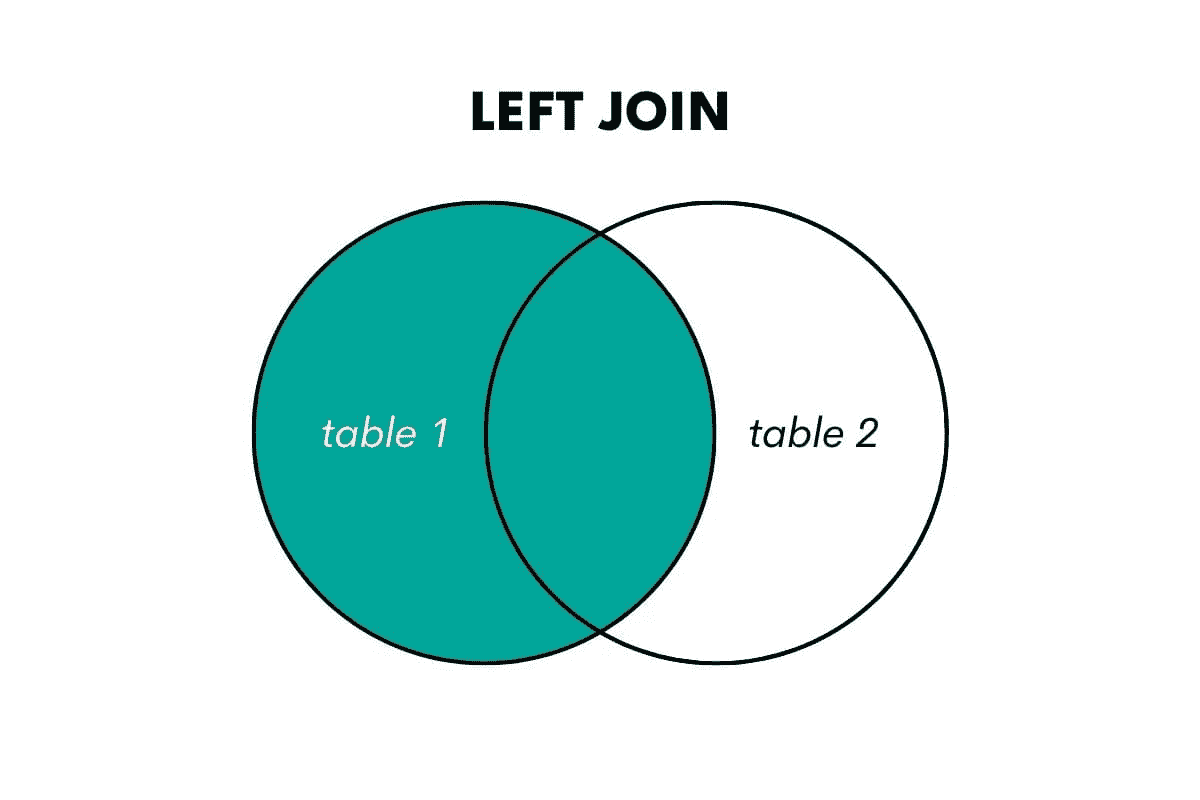

| LEFT JOIN | 返回“左”(第一个)表中的所有行及其在右(第二个)表中匹配的行 |

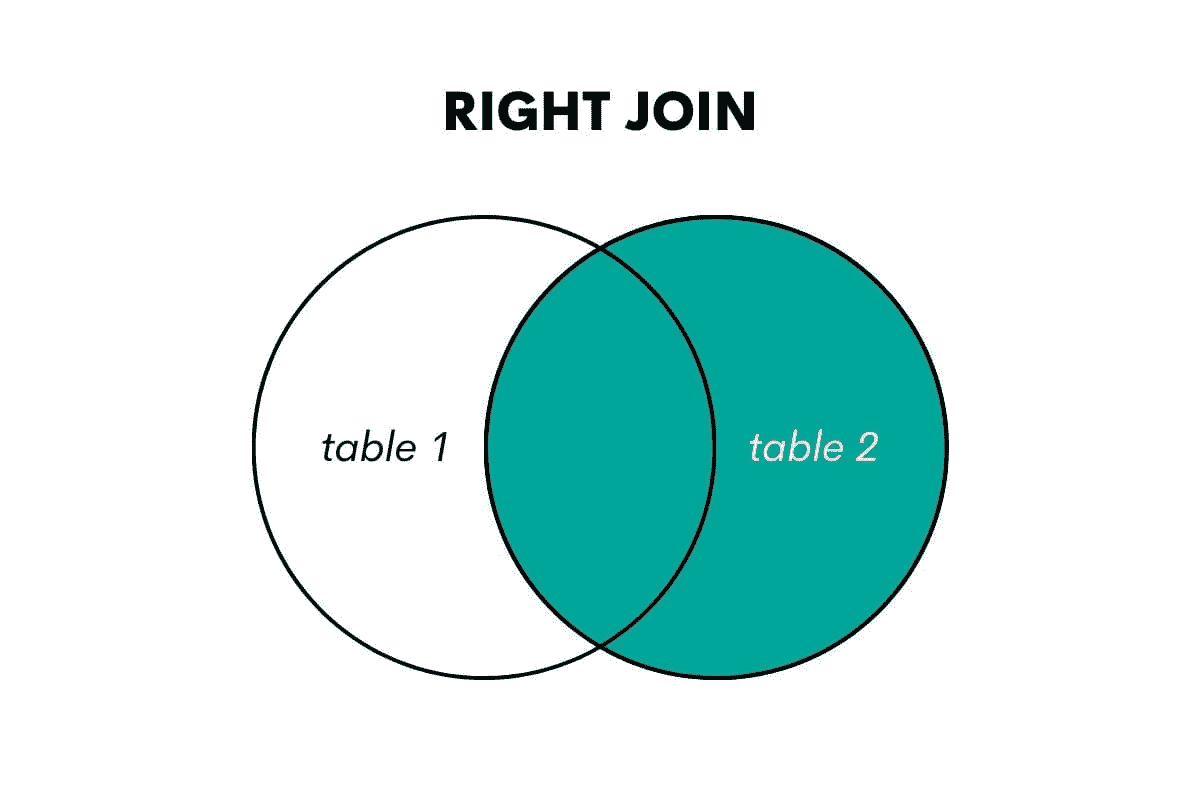

| RIGHT JOIN | 返回“右”(第二个)表中的所有行及其在左(第一个)表中匹配的行 |

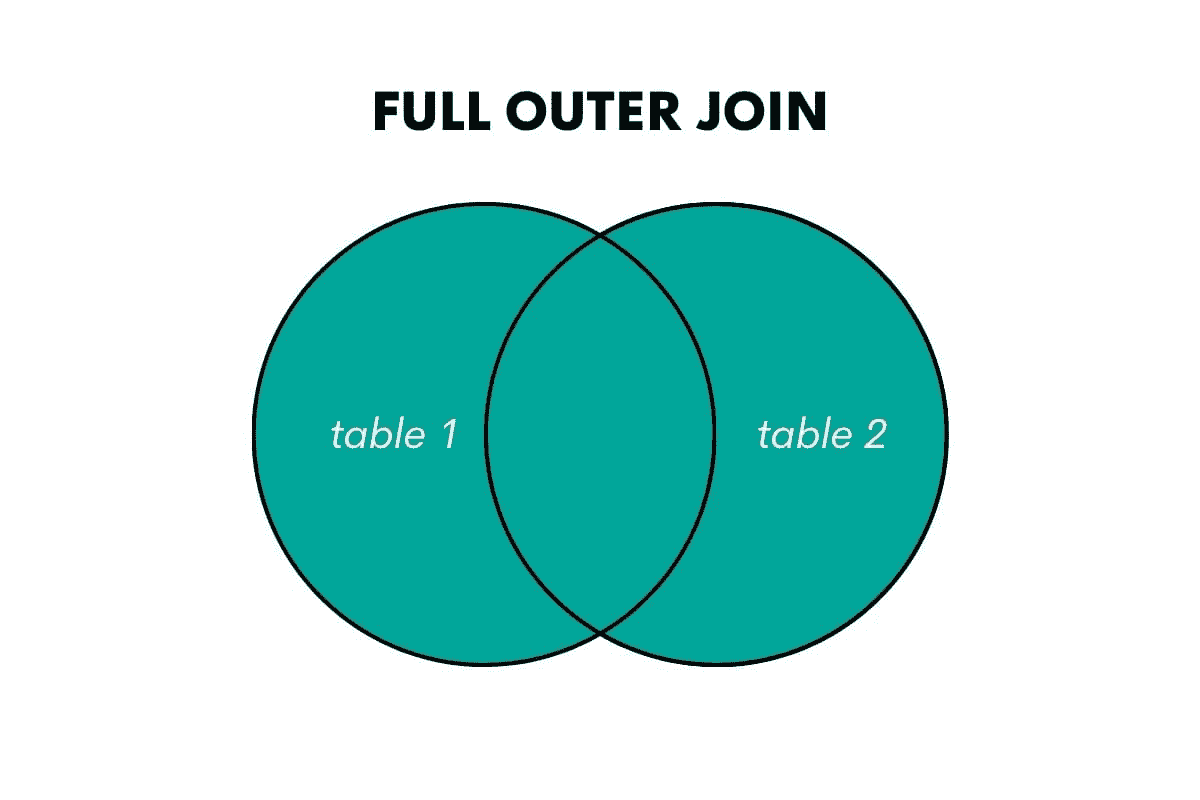

| FULL OUTER JOIN | 返回在左表或右表中匹配的行 |

汇报汇总函数

在数据库管理中,汇总函数是一种将多行的值分组形成单一值的函数。它们对汇报很有用,一些常见汇总函数的示例如下:

| 函数 | 说明 |

|---|---|

| COUNT | 返回某个表/视图中的行数 |

| SUM | 累加值 |

| AVG | 返回一组值的平均值 |

| MIN | 返回组中的最小值 |

| MAX | 返回组中的最大值 |

从表中查询数据

数据库表是以垂直列和水平行的模型存储的数据元素(值)的集合。使用以下任一方法在 SQL 中查询表:

| SQL | 解释 |

|---|---|

| SELECT c1 FROM t | 从名为 t 的表中选择列 c1 的数据 |

| SELECT * FROM t | 从名为 t 的表中选择所有行和列 |

| SELECT c1 FROM t****WHERE c1 = ‘test’ | 从名为 t 的表中选择列 c1 的数据,其中 c1 的值为‘test’ |

| SELECT c1 FROM t****ORDER BY c1 ASC (DESC) | 从名为 t 的表中选择列 c1 的数据,并按 c1 排序,可以是升序(默认)或降序 |

| SELECT c1 FROM t****ORDER BY c1LIMIT n OFFSET offset | 从名为 t 的表中选择列 c1 的数据,跳过指定的行偏移量,并返回接下来的 n 行 |

| SELECT c1, aggregate(c2)FROM tGROUP BY c1 | 从名为 t 的表中选择列 c1 的数据,并使用聚合函数对行进行分组 |

| SELECT c1, aggregate(c2)FROM tGROUP BY c1HAVING condition | 从名为 t 的表中选择列 c1 的数据,使用聚合函数对行进行分组,并使用‘HAVING’子句筛选这些组 |

从多个表中查询数据

除了从单个表中查询数据,SQL 还允许从多个表中查询数据:

| SQL | 解释 |

|---|---|

| SELECT c1, c2FROM t1INNER JOIN t2 on condition | 从名为 t1 的表中选择列 c1 和 c2,并在 t1 和 t2 之间执行内连接 |

| SELECT c1, c2FROM t1LEFT JOIN t2 on condition | 从名为 t1 的表中选择列 c1 和 c2,并在 t1 和 t2 之间执行左连接 |

| SELECT c1, c2FROM t1RIGHT JOIN t2 on condition | 从名为 t1 的表中选择列 c1 和 c2,并在 t1 和 t2 之间执行右连接 |

| SELECT c1, c2FROM t1FULL OUTER JOIN t2 on condition | 从名为 t1 的表中选择列 c1 和 c2,并在 t1 和 t2 之间执行全外连接 |

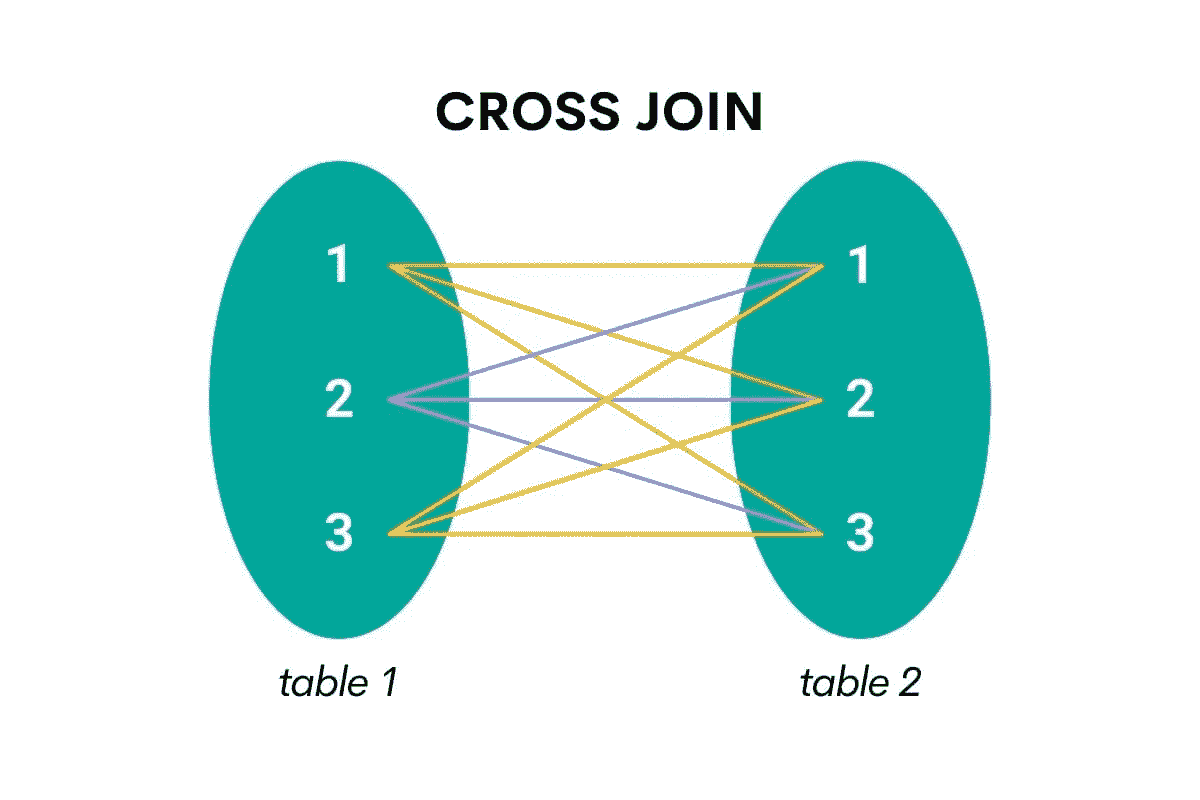

| SELECT c1, c2FROM t1CROSS JOIN t2 | 从名为 t1 的表中选择列 c1 和 c2,并生成表中行的笛卡尔积 |

| SELECT c1, c2****FROM t1, t2 | 同上 - 从名为 t1 的表中选择列 c1 和 c2,并生成表中行的笛卡尔积 |

| SELECT c1, c2FROM t1 AINNER JOIN t2 B on condition | 从名为 t1 的表中选择列 c1 和 c2,并使用 INNER JOIN 子句将其连接到自身 |

使用 SQL 操作符

SQL 操作符是保留字或字符,主要用于 SQL 语句中的 WHERE 子句以执行操作:

| SQL | 解释 |

|---|---|

| SELECT c1 FROM t1UNION [ALL]SELECT c1 FROM t2 | 从名为 t1 的表中选择列 c1,并从名为 t2 的表中选择列 c1,将这两个查询的结果合并 |

| SELECT c1 FROM t1INTERSECTSELECT c1 FROM t2 | 从名为 t1 的表中选择列 c1,并从名为 t2 的表中选择列 c1,返回两个查询的交集 |

| SELECT c1 FROM t1MINUSSELECT c1 FROM t2 | 从名为 t1 的表中选择列 c1 和从名为 t2 的表中选择列 c1,并从第一个结果集中减去第二个结果集 |

| SELECT c1 FROM t****WHERE c1 [NOT] LIKE pattern | 从名为 t 的表中选择列 c1,并使用模式匹配 % 查询行 |

| SELECT c1 FROM t****WHERE c1 [NOT] in test_list | 从名为 t 的表中选择列 c1,并返回在 test_list 中(或不在) 的行 |

| SELECT c1 FROM t****WHERE c1 BETWEEN min AND max | 从名为 t 的表中选择列 c1,并返回 c1 在 min 和 max 之间的行 |

| SELECT c1 FROM t****WHERE c1 IS [NOT] NULL | 从名为 t 的表中选择列 c1,并检查值是否为 NULL |

数据修改

数据修改是 SQL 的关键部分,除了添加和删除数据外,还能修改现有记录:

| SQL | 解释 |

|---|---|

| INSERT INTO t(column_list)****VALUES(value_list) | 向名为 t 的表中插入一行数据 |

| INSERT INTO t(column_list)****VALUES (value_list), (value_list), … | 向名为 t 的表中插入多行数据 |

| INSERT INTO t1(column_list)****SELECT column_list FROM t2 | 将 t2 中的行插入到名为 t1 的表中 |

| UPDATE tSET c1 = new_value | 在表 t 的列 c1 中更新所有行的新值 |

| UPDATE tSET c1 = new_value, c2 = new_value****WHERE condition | 更新表 t 中符合条件的行的列 c1 和 c2 的值 |

| DELETE FROM t | 从名为 t 的表中删除所有行 |

| DELETE FROM tWHERE condition | 从名为 t 的表中删除所有符合某条件的行 |

视图

视图是一个虚拟表,是查询的结果。它们非常有用,通常用作安全机制,允许用户通过视图访问数据,而不是直接访问基础表:

| SQL | 解释 |

|---|---|

| CREATE VIEW view1 ASSELECT c1, c2FROM t1****WHERE condition | 创建一个视图,包含来自名为 t1 的表的列 c1 和 c2,其中符合某一条件。 |

索引

索引用于通过减少需要访问的数据库页面数量来加速查询性能:

| SQL | 解释 |

|---|---|

| CREATE INDEX index_nameON t(c1, c2) | 在表 t 的列 c1 和 c2 上创建索引 |

| CREATE UNIQUE INDEX index_name****ON t(c3, c4) | 在表 t 的列 c3 和 c4 上创建唯一索引 |