KDNuggets-博客中文翻译-三十五-

KDNuggets 博客中文翻译(三十五)

原文:KDNuggets

利用 Pandas AI 进行数据分析

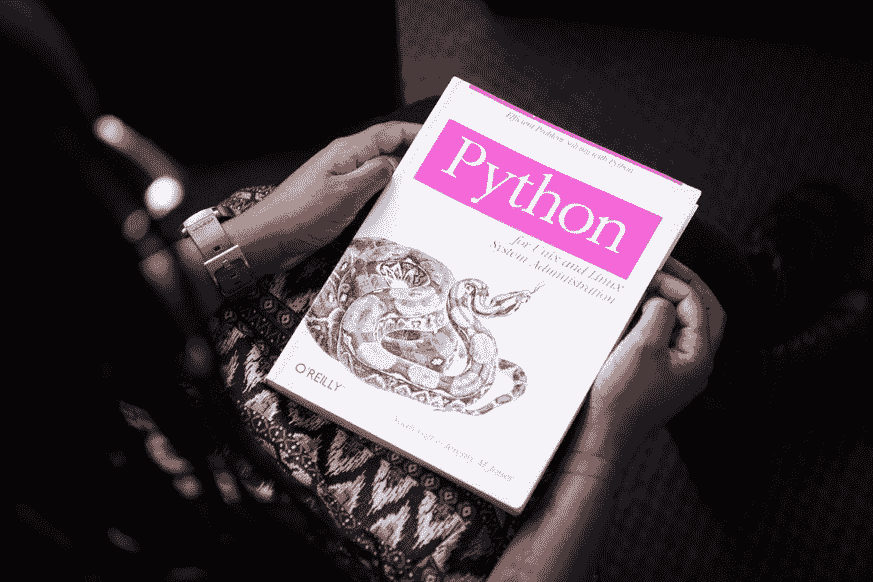

你在使用 Python 的数据领域中是否很熟练?如果是的话,我敢打赌你们大多数人都使用 Pandas 进行数据处理。

如果你不知道,Pandas是一个专门为数据分析和处理开发的开源 Python 软件包。它是使用最广泛的软件包之一,也是你在开始 Python 数据科学之旅时通常会学习的一个。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业。

1. Google 网络安全证书 - 快速入门网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

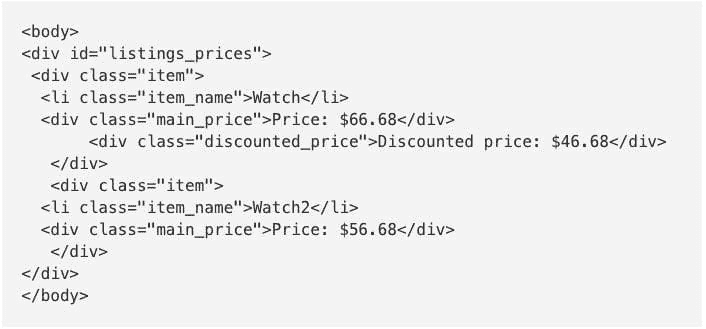

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你在 IT 方面的组织

3. Google IT 支持专业证书 - 支持你在 IT 方面的组织

那么,Pandas AI 是什么?我想你读这篇文章是因为你想了解它。

好吧,正如你所知,我们正处在一个生成 AI 无处不在的时代。想象一下,如果你可以使用生成 AI 对你的数据进行数据分析,那将会容易很多。

这就是 Pandas AI 带来的效果。通过简单的提示,我们可以快速分析和处理数据集,而无需将数据发送到其他地方。

本文将探讨如何利用 Pandas AI 进行数据分析任务。在文章中,我们将学习以下内容:

-

Pandas AI 设置

-

使用 Pandas AI 进行数据探索

-

使用 Pandas AI 进行数据可视化

-

Pandas AI 高级用法

如果你准备好了,就让我们开始吧!

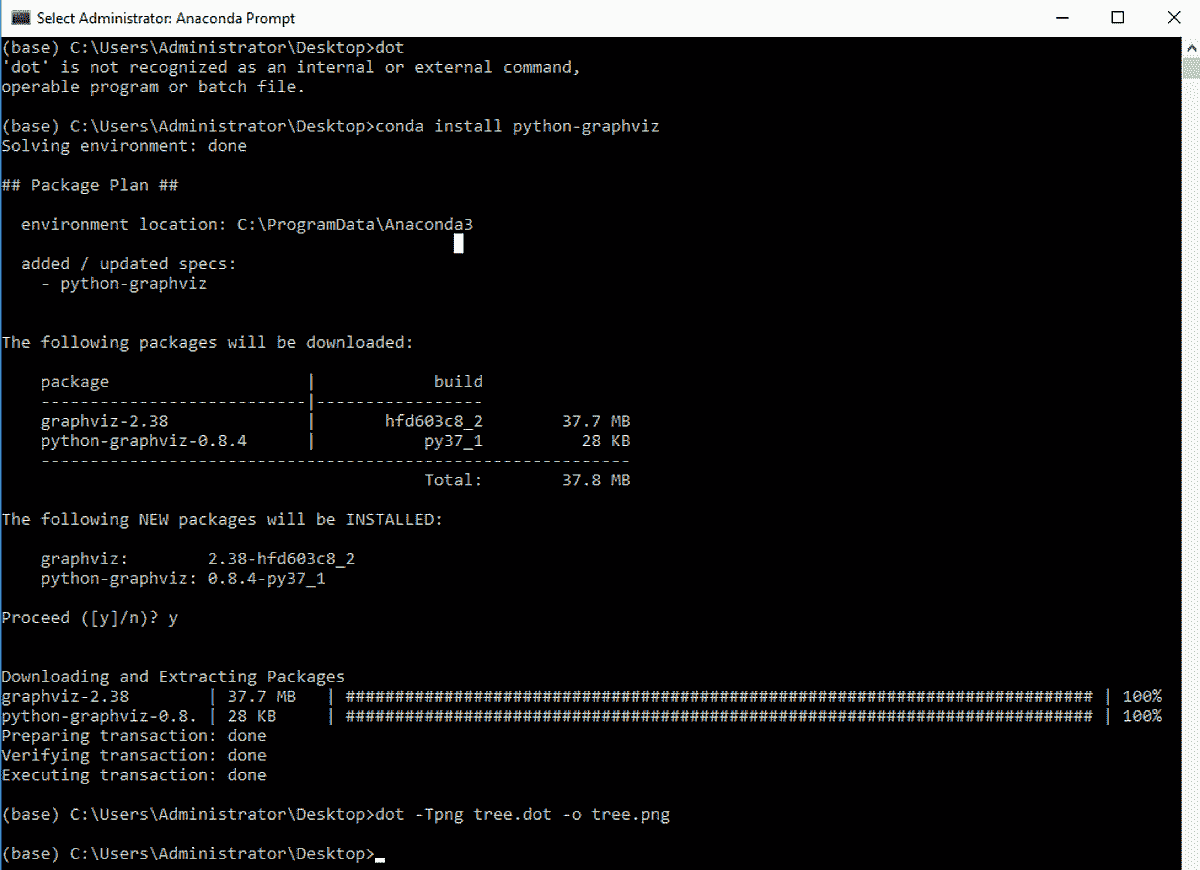

Pandas AI 设置

Pandas AI是一个 Python 软件包,它将大型语言模型(LLM)功能实现到 Pandas API 中。我们可以使用标准的 Pandas API 和生成 AI 增强功能,使 Pandas 成为一个对话工具。

我们主要想使用 Pandas AI 是因为该软件包提供的简单过程。该软件包可以使用简单的提示自动分析数据,而无需复杂的代码。

介绍够了,让我们动手实践吧。

首先,我们需要在其他任何事情之前安装这个软件包。

pip install pandasai

接下来,我们必须设置我们想用于 Pandas AI 的 LLM。有几种选择,例如 OpenAI GPT 和 HuggingFace。然而,本教程中我们将使用 OpenAI GPT。

将 OpenAI 模型设置到 Pandas AI 中是直接的,但你需要 OpenAI API 密钥。如果你没有,可以在他们的网站上获取。

如果一切准备就绪,让我们使用下面的代码设置 Pandas AI LLM。

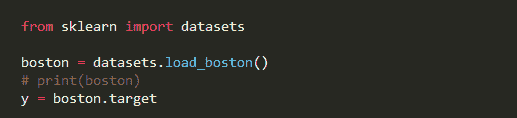

from pandasai.llm import OpenAI

llm = OpenAI(api_token="Your OpenAI API Key")

你现在准备好使用 Pandas AI 进行数据分析了。

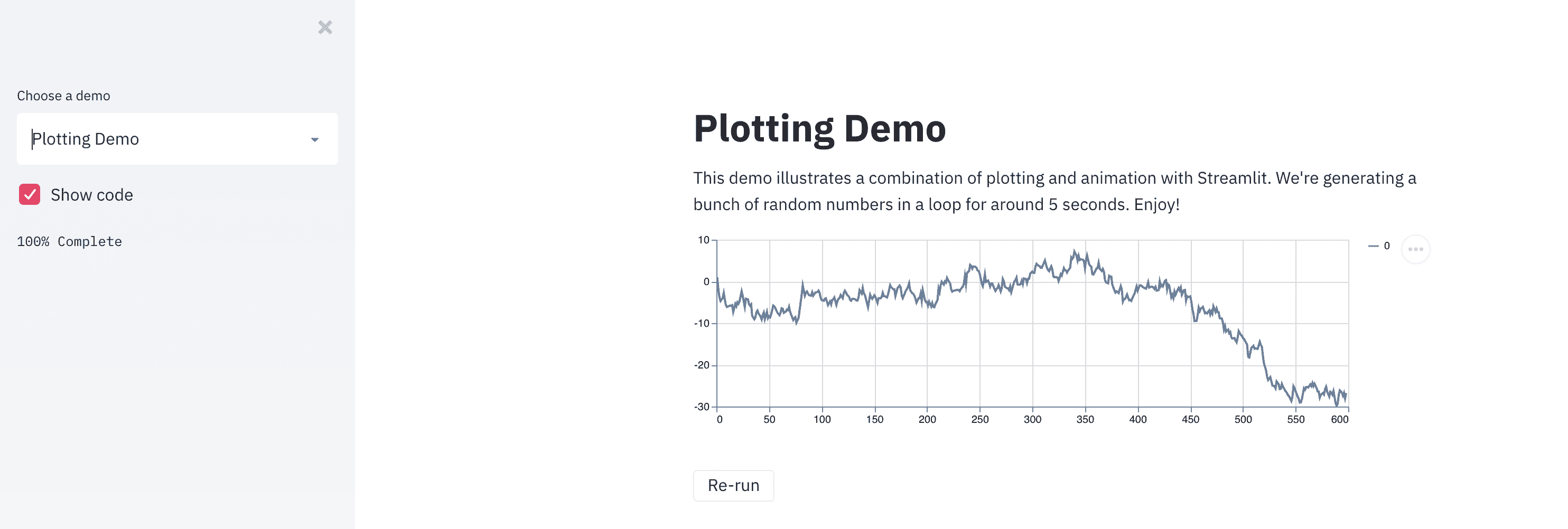

使用 Pandas AI 进行数据探索

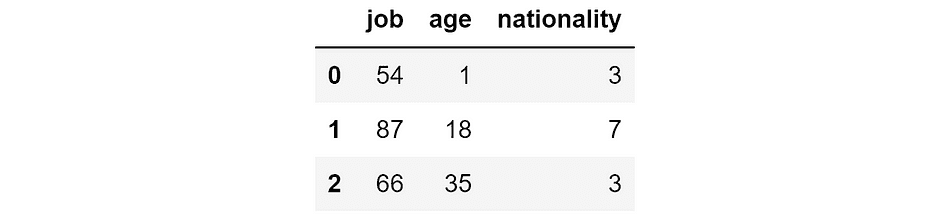

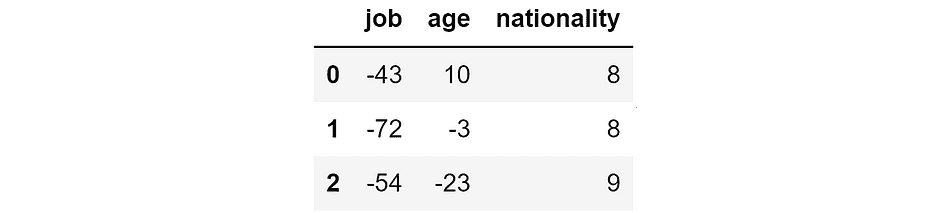

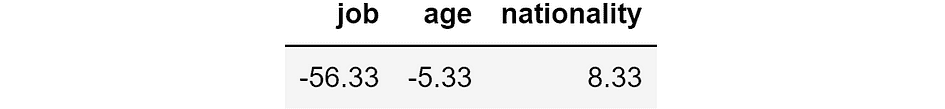

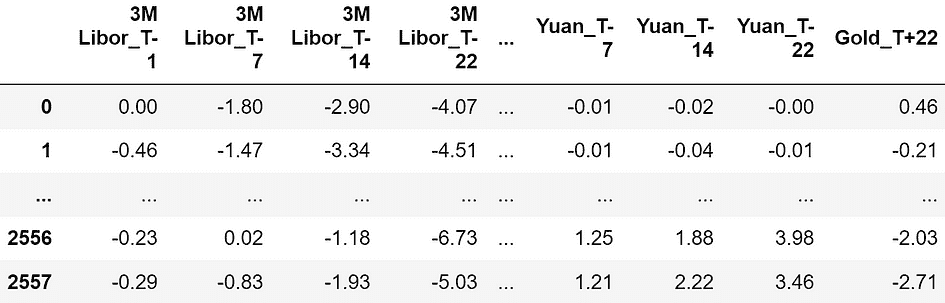

让我们从一个示例数据集开始,尝试使用 Pandas AI 进行数据探索。我将在这个示例中使用 Seaborn 包中的 Titanic 数据。

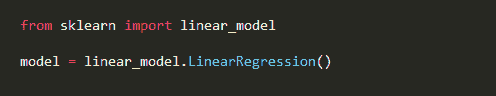

import seaborn as sns

from pandasai import SmartDataframe

data = sns.load_dataset('titanic')

df = SmartDataframe(data, config = {'llm': llm})

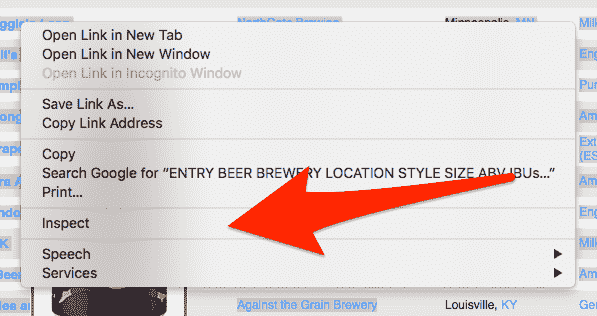

我们需要将它们传递到 Pandas AI 智能数据框对象中以启动 Pandas AI。之后,我们可以在我们的 DataFrame 上执行对话活动。

让我们尝试一个简单的问题。

response = df.chat("""Return the survived class in percentage""")

response

乘客幸存的百分比是:38.38%

根据提示,Pandas AI 可以提出解决方案并回答我们的问题。

我们可以向 Pandas AI 提问,它会在 DataFrame 对象中提供答案。例如,这里有几个用于分析数据的提示。

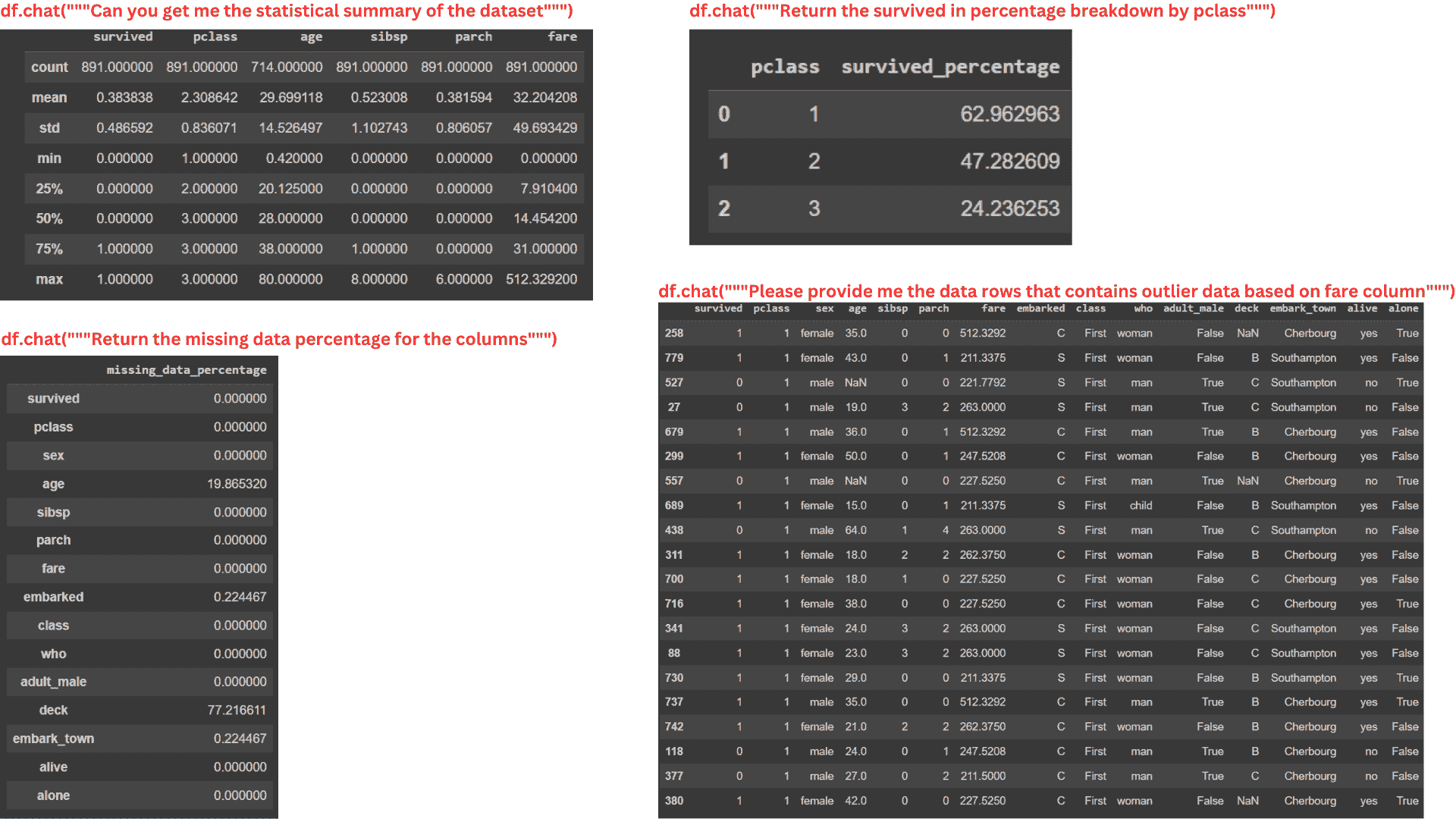

#Data Summary

summary = df.chat("""Can you get me the statistical summary of the dataset""")

#Class percentage

surv_pclass_perc = df.chat("""Return the survived in percentage breakdown by pclass""")

#Missing Data

missing_data_perc = df.chat("""Return the missing data percentage for the columns""")

#Outlier Data

outlier_fare_data = response = df.chat("""Please provide me the data rows that

contains outlier data based on fare column""")

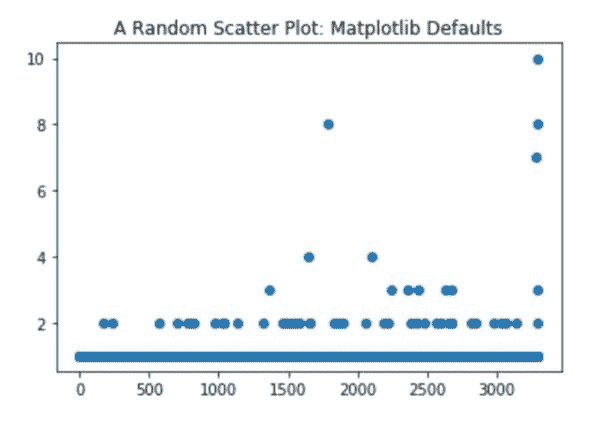

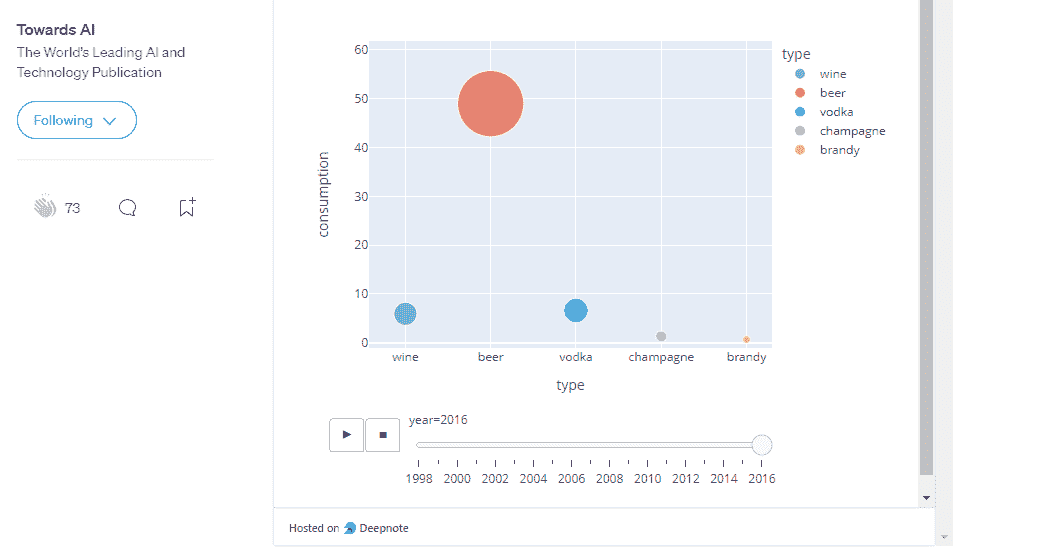

图片由作者提供

从上面的图片可以看出,即使提示相当复杂,Pandas AI 也可以提供 DataFrame 对象的信息。

然而,Pandas AI 无法处理过于复杂的计算,因为这些包的功能受限于我们传递给 SmartDataFrame 对象的 LLM。未来,我相信 Pandas AI 能够处理更详细的分析,因为 LLM 能力在不断发展。

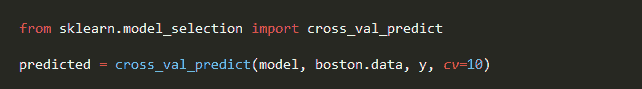

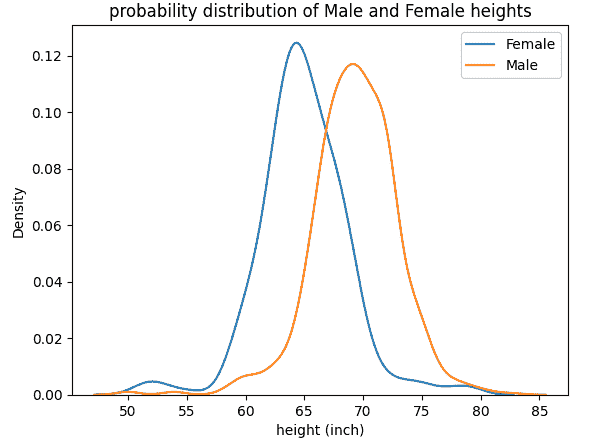

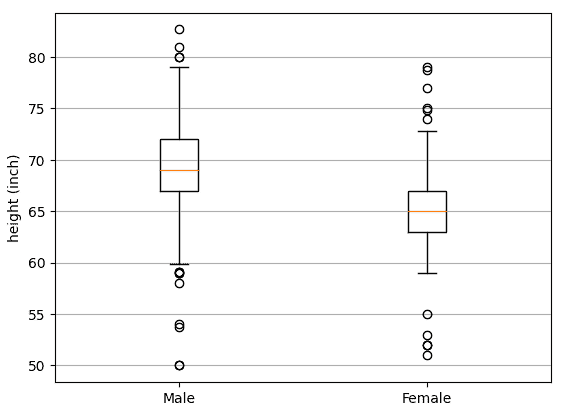

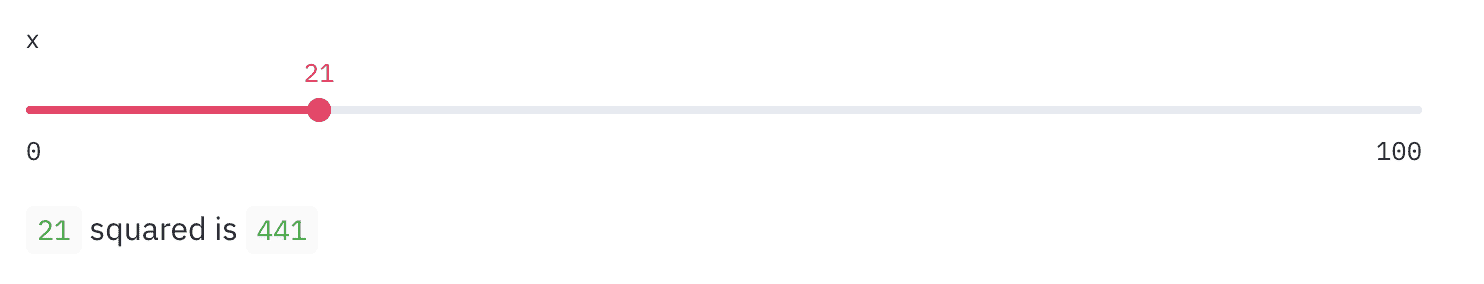

使用 Pandas AI 进行数据可视化

Pandas AI 对于数据探索非常有用,可以执行数据可视化。只要我们指定提示,Pandas AI 就会给出可视化输出。

让我们尝试一个简单的例子。

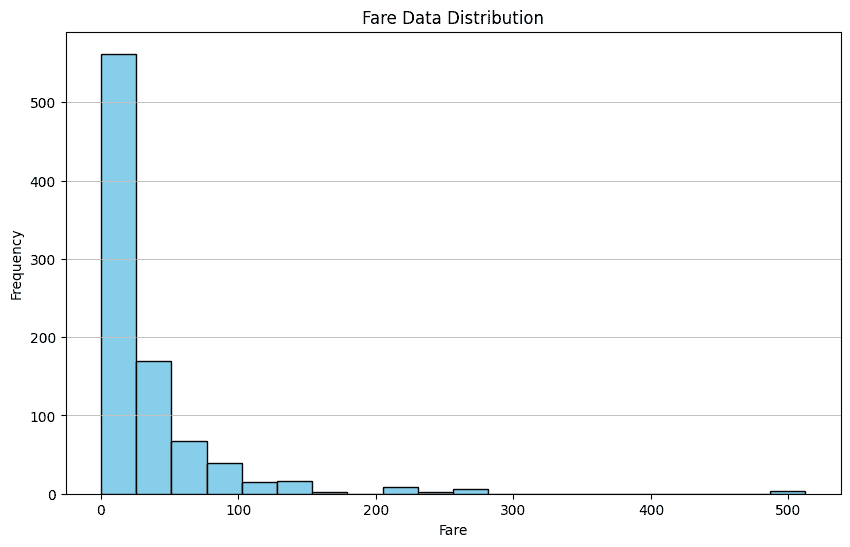

response = df.chat('Please provide me the fare data distribution visualization')

response

图片由作者提供

在上面的示例中,我们要求 Pandas AI 可视化 Fare 列的分布。输出是数据集的柱状图分布。

就像数据探索一样,你可以进行任何类型的数据可视化。然而,Pandas AI 仍然无法处理更复杂的可视化过程。

这里有一些使用 Pandas AI 进行数据可视化的其他示例。

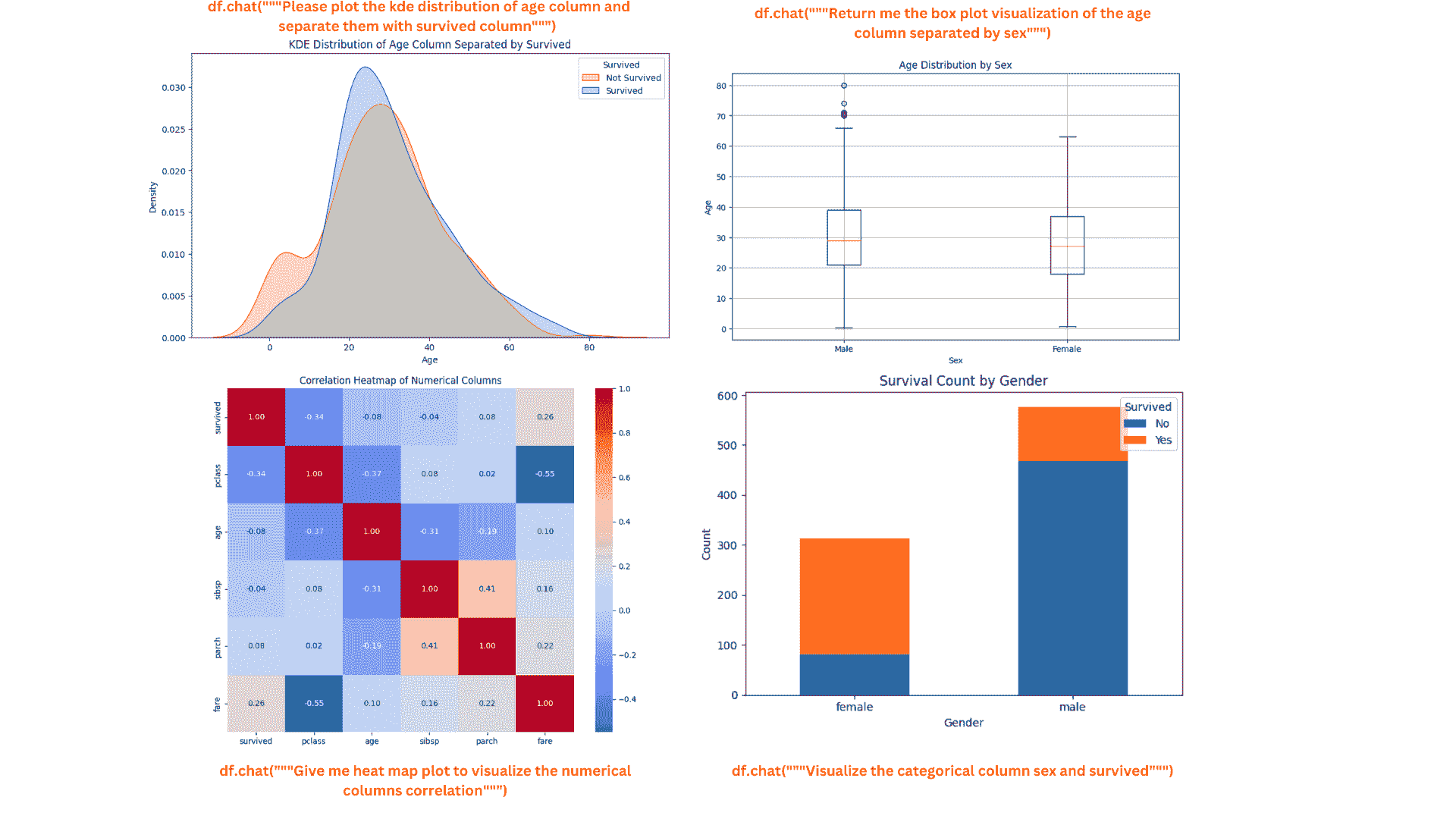

kde_plot = df.chat("""Please plot the kde distribution of age column and separate them with survived column""")

box_plot = df.chat("""Return me the box plot visualization of the age column separated by sex""")

heat_map = df.chat("""Give me heat map plot to visualize the numerical columns correlation""")

count_plot = df.chat("""Visualize the categorical column sex and survived""")

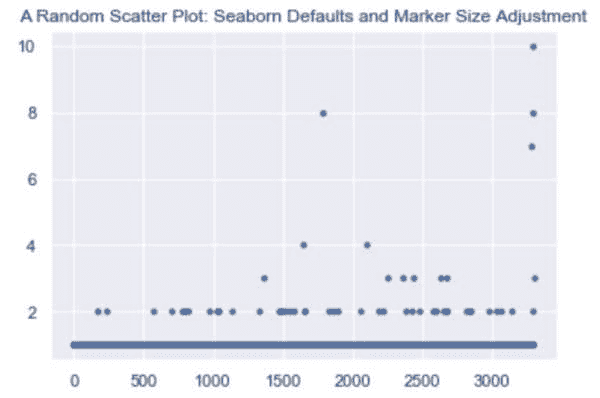

图片由作者提供

图表看起来很美观整洁。如果有必要,你可以继续向 Pandas AI 询问更多细节。

Pandas AI 高级使用

我们可以使用 Pandas AI 的几个内置 API 来改善 Pandas AI 的体验。

缓存清理

默认情况下,Pandas AI 对象中的所有提示和结果都存储在本地目录中,以减少处理时间并缩短 Pandas AI 调用模型所需的时间。

然而,这个缓存有时可能会使 Pandas AI 的结果无关紧要,因为它们会考虑过去的结果。因此,清除缓存是一个好习惯。你可以使用以下代码来清除缓存。

import pandasai as pai

pai.clear_cache()

你还可以在开始时关闭缓存。

df = SmartDataframe(data, {"enable_cache": False})

通过这种方式,从一开始就没有提示或结果被存储。

自定义标题

可以将一个示例 DataFrame 传递给 Pandas AI。如果你不想与 LLM 共享一些私人数据或只是想向 Pandas AI 提供一个示例,这将非常有帮助。

要做到这一点,你可以使用以下代码。

from pandasai import SmartDataframe

import pandas as pd

# head df

head_df = data.sample(5)

df = SmartDataframe(data, config={

"custom_head": head_df,

'llm': llm

})

Pandas AI 技能与代理

Pandas AI 允许用户传递示例函数,并通过 Agent 决策执行它。例如,下面的函数将两个不同的 DataFrame 合并,我们传递一个样本绘图函数给 Pandas AI 代理执行。

import pandas as pd

from pandasai import Agent

from pandasai.skills import skill

employees_data = {

"EmployeeID": [1, 2, 3, 4, 5],

"Name": ["John", "Emma", "Liam", "Olivia", "William"],

"Department": ["HR", "Sales", "IT", "Marketing", "Finance"],

}

salaries_data = {

"EmployeeID": [1, 2, 3, 4, 5],

"Salary": [5000, 6000, 4500, 7000, 5500],

}

employees_df = pd.DataFrame(employees_data)

salaries_df = pd.DataFrame(salaries_data)

# Function doc string to give more context to the model for use of this skill

@skill

def plot_salaries(names: list[str], salaries: list[int]):

"""

Displays the bar chart having name on x-axis and salaries on y-axis

Args:

names (list[str]): Employees' names

salaries (list[int]): Salaries

"""

# plot bars

import matplotlib.pyplot as plt

plt.bar(names, salaries)

plt.xlabel("Employee Name")

plt.ylabel("Salary")

plt.title("Employee Salaries")

plt.xticks(rotation=45)

# Adding count above for each bar

for i, salary in enumerate(salaries):

plt.text(i, salary + 1000, str(salary), ha='center', va='bottom')

plt.show()

agent = Agent([employees_df, salaries_df], config = {'llm': llm})

agent.add_skills(plot_salaries)

response = agent.chat("Plot the employee salaries against names")

Agent 会决定是否使用我们分配给 Pandas AI 的函数。

结合技能和 Agent 可以为你的 DataFrame 分析提供更可控的结果。

结论

我们已经了解到使用 Pandas AI 来帮助数据分析工作是多么简单。利用 LLM 的力量,我们可以将数据分析工作中的编码部分限制到最小,而专注于关键工作。

在这篇文章中,我们了解了如何设置 Pandas AI,如何使用 Pandas AI 进行数据探索和可视化,以及进阶用法。你可以用这个包做更多的事情,访问他们的文档以获取更多信息。

Cornellius Yudha Wijaya**** 是一名数据科学助理经理和数据撰稿人。在全职工作于 Allianz Indonesia 期间,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。Cornellius 涉猎了各种 AI 和机器学习主题。

更多相关话题

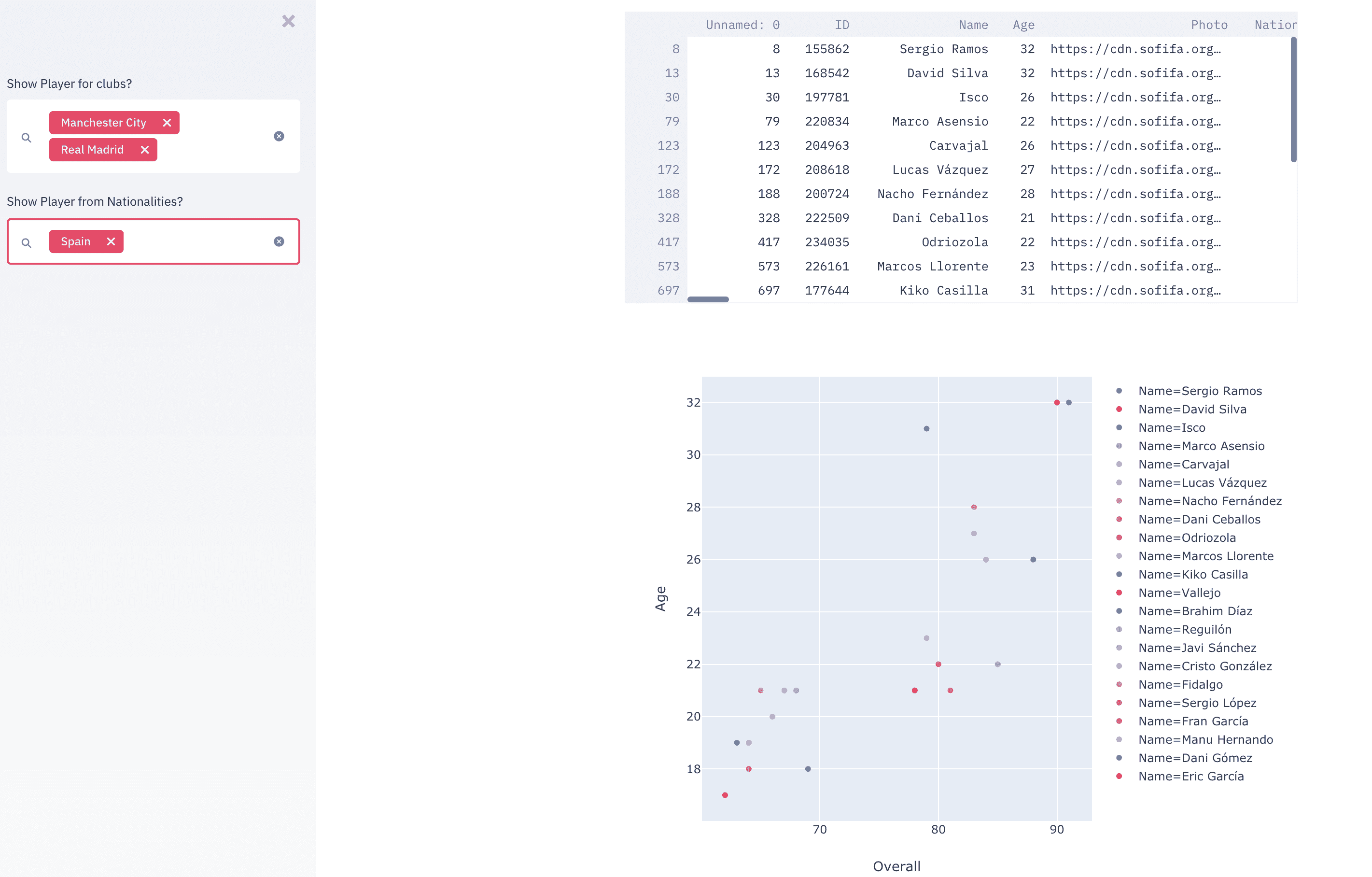

数据科学家和人工智能产品的 UX 设计指南

原文:

www.kdnuggets.com/2018/08/ux-design-guide-data-scientists-ai-products.html

评论

评论

由 Syed Sadat Nazrul, 分析科学家

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全领域的职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

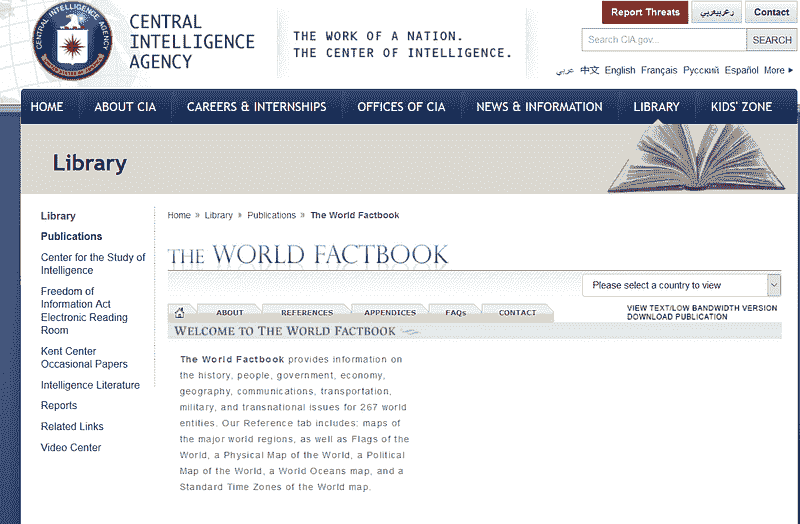

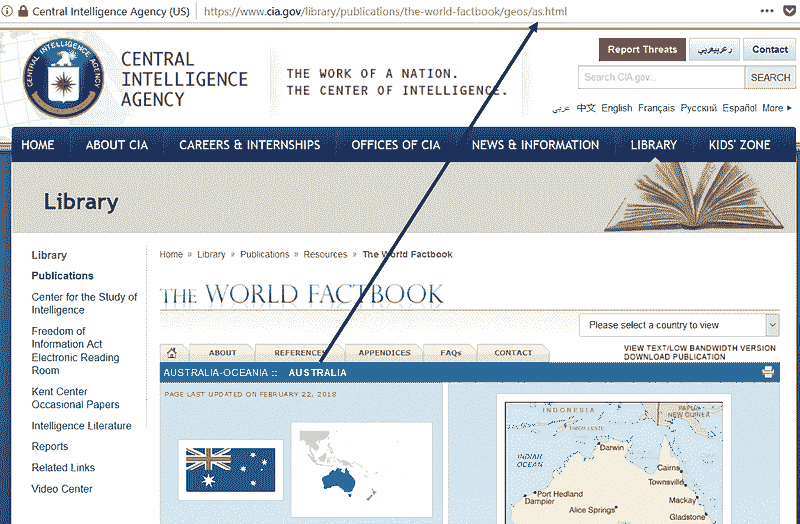

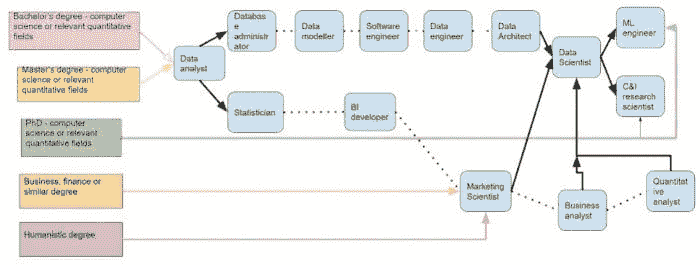

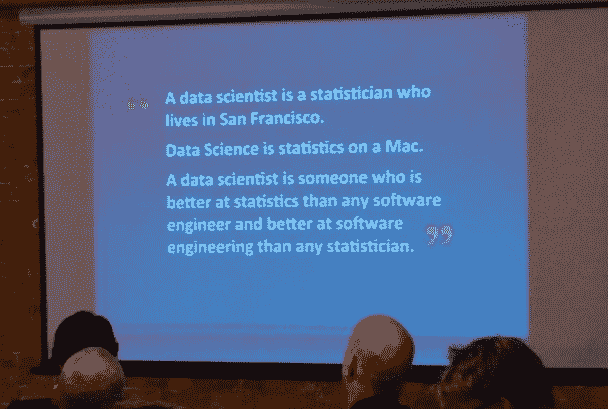

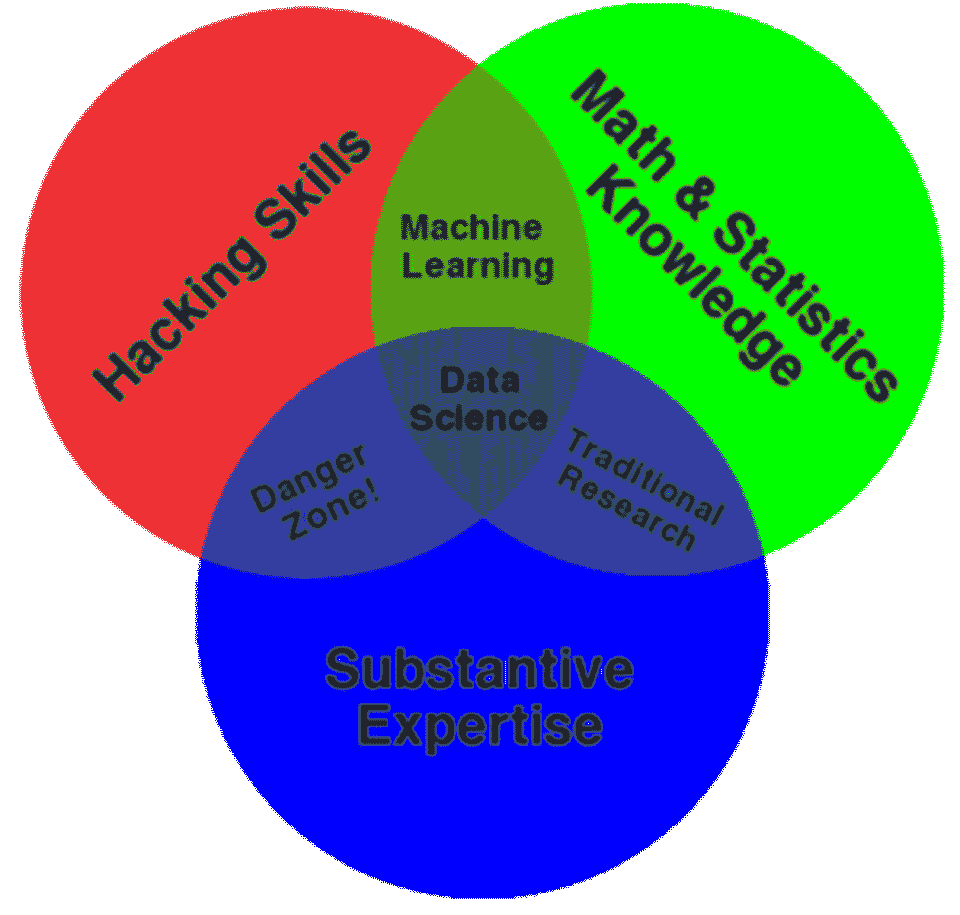

在寻找针对人工智能产品的 UX 设计策略时,我发现几乎没有相关材料。在我找到的少数资料中,大多数要么过于领域特定,要么完全集中于网页用户界面的视觉设计。我遇到的最好文章是 Vladimir Shapiro 的 “人工智能的 UX:信任作为设计挑战” 和 Dávid Pásztor 的 “AI UX:设计优秀 AI 产品的 7 个原则”。意识到 UX 设计师和数据科学家之间存在一个真正的知识差距,我决定尝试从数据科学家的角度来解决这些需求。因此,我的假设是读者对数据科学有一定的基础理解。对于数据科学背景很少或没有的 UX 设计师,我避免使用复杂的数学和编程(虽然我鼓励阅读 Michael Galarnyk 的 “如何建立数据科学作品集” 和我的 “数据科学面试指南”)。

人工智能正在占据我们日常生活的几乎每一个方面。这将改变我们的行为方式以及我们对这些产品的期望。作为设计师,我们的目标是创建有用且易于理解的产品,以便为这个模糊的新世界带来清晰度。最重要的是,我们希望利用人工智能的力量使人们的生活变得更加轻松和愉悦。

识别关键目标

即使在我们尝试设计产品之前,我们也需要了解我们产品试图解决的整体商业模式。一些常见的问题包括:

-

这个模型试图解决什么业务问题?是分类问题还是回归问题?

-

最终用户是谁?他们是技术人员还是非技术人员?他们期望从这个产品中获得什么价值?

-

数据是静态的还是动态的?模型是基于状态的还是无状态的?收集的数据的粒度和质量如何?我们如何最好地呈现这些信息?是否有像 PCI、HIPAA 或 GDPR 这样的数据使用监管限制?

-

这个模型的更大影响是什么?市场有多大?这个市场中的其他参与者是谁?他们是补充你的产品还是直接竞争对手?转换成本是多少?需要考虑哪些关键的监管、文化、社会经济和技术趋势?

更好地理解最终产品将使我们能够更有效地满足需求。我推荐的一些相关书籍包括 Bernard Marr 的《智能公司:证据管理的五个成功步骤》和 Alexander Osterwalder 的《商业模式生成:愿景者、游戏改变者和挑战者的手册》。

构建可解释的模型

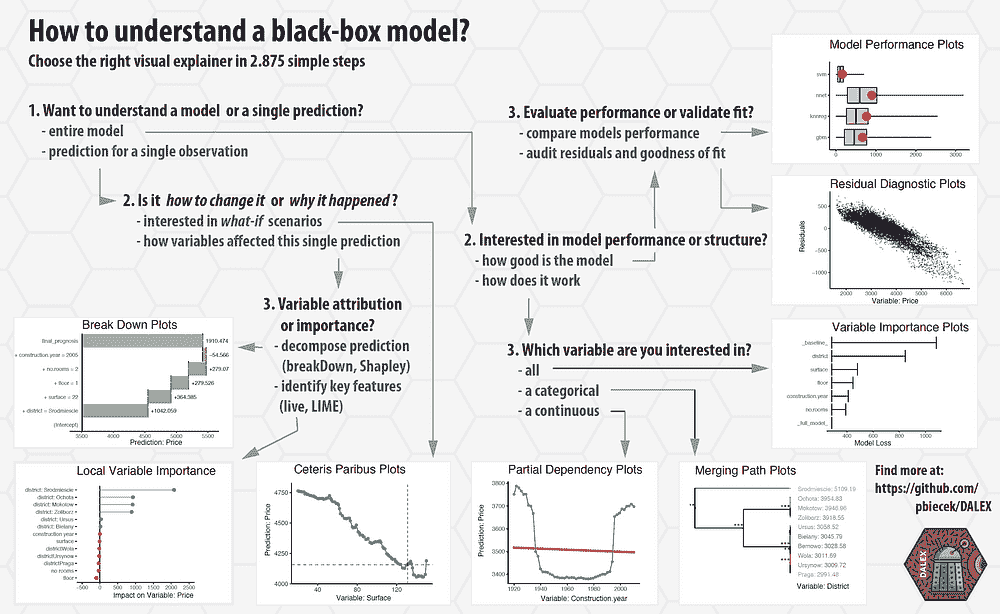

虽然大多数人都追求准确的模型,但常常忽略了理解模型为什么会这样做。模型的优点和缺点是什么?为什么它会对给定的输入特征提供这样的预测?虽然这个问题看似简单,但许多行业需要将其作为产品价值主张的一部分来提供答案。

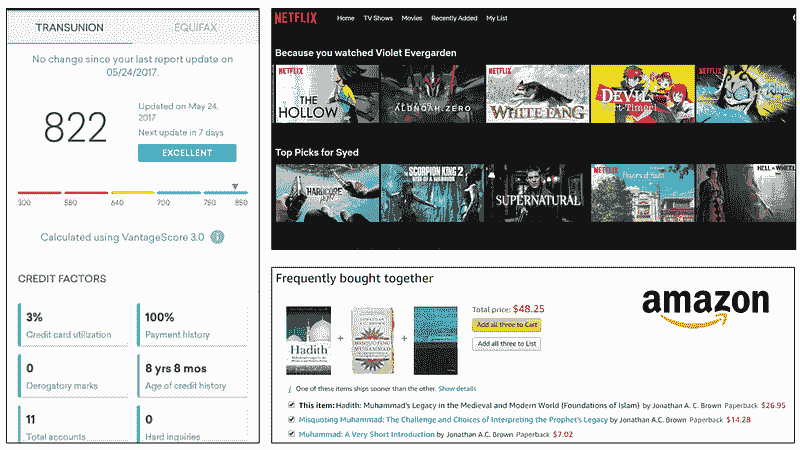

在 Credit Karma、Netflix 和 Amazon 上的模型解释

下面是一些实际使用案例,在这些案例中,最终用户需要对模型进行解释:

-

为什么你的信用评分没有比现在更高?

-

为什么 Amazon 会推荐我购买某些产品?

-

为什么自动驾驶汽车在识别行人之后仍然发生了碰撞?

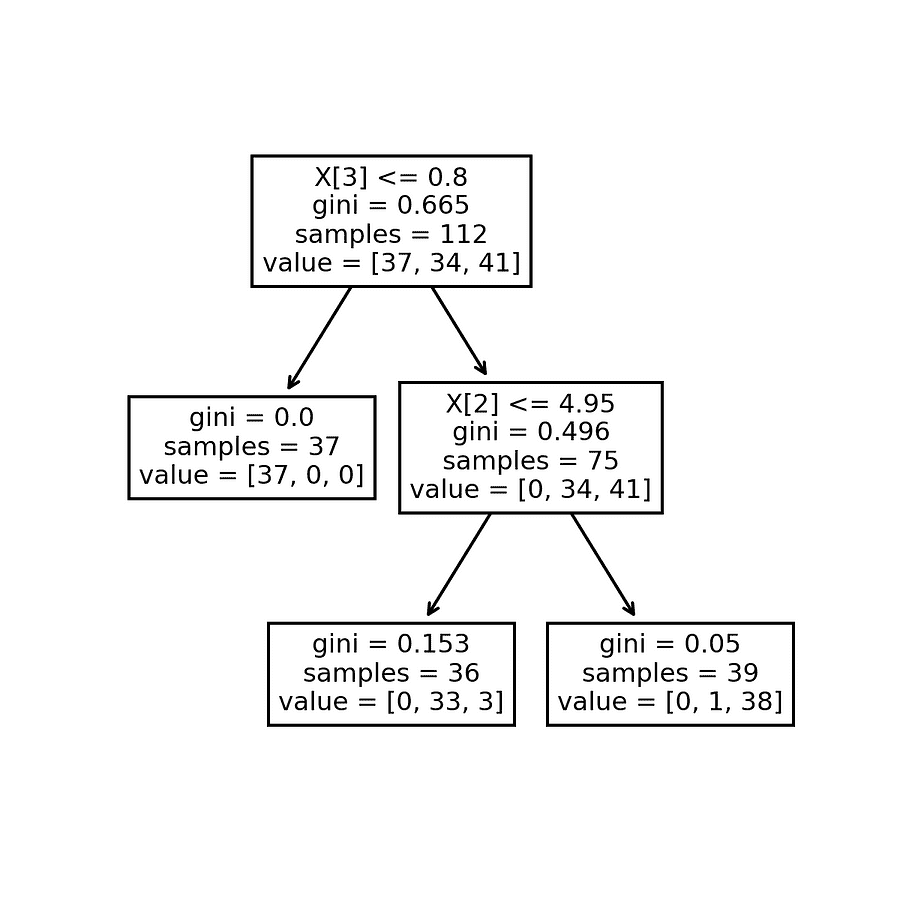

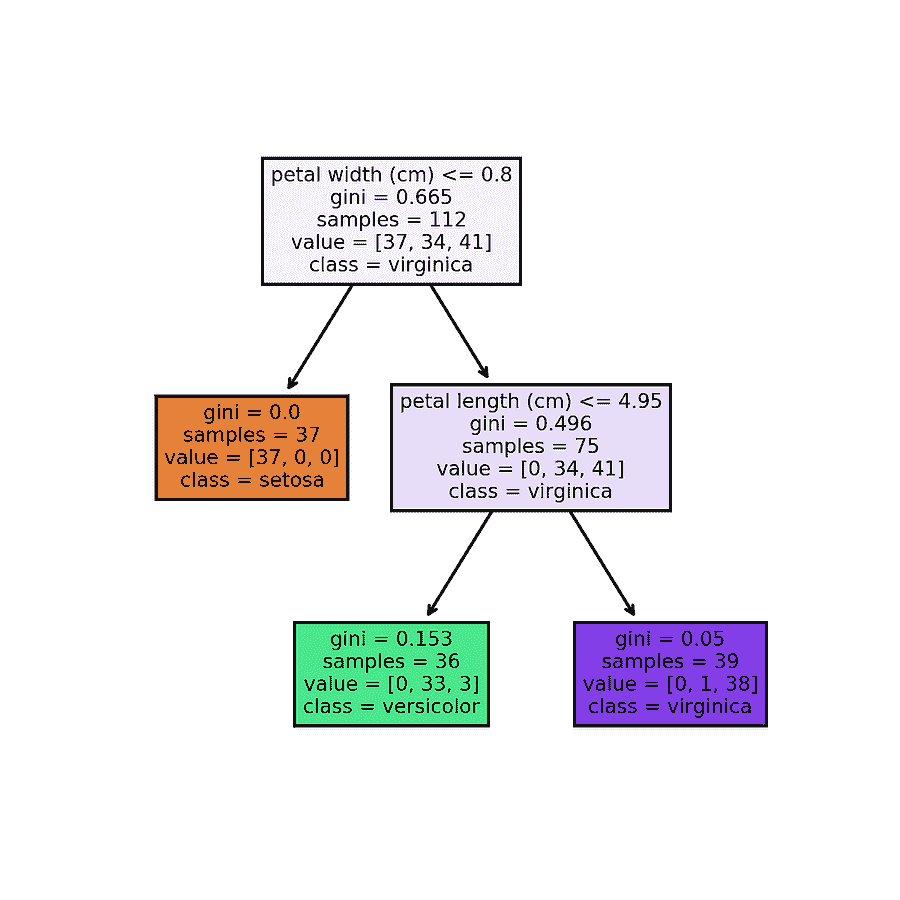

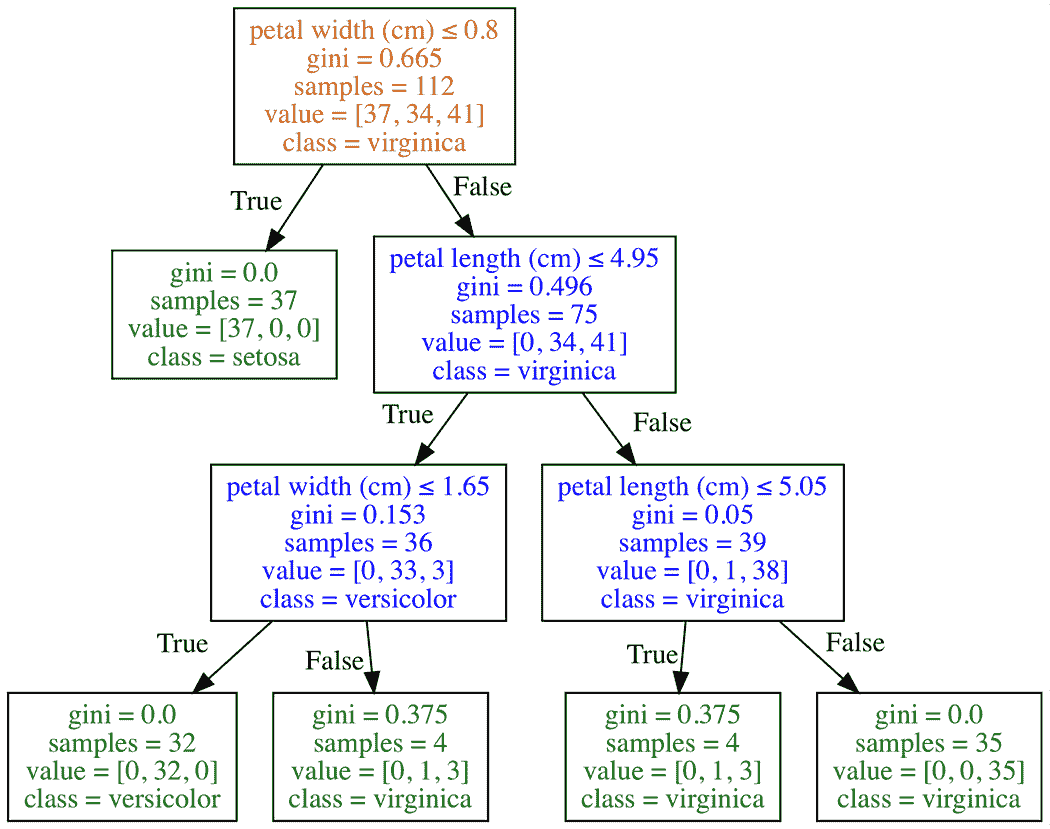

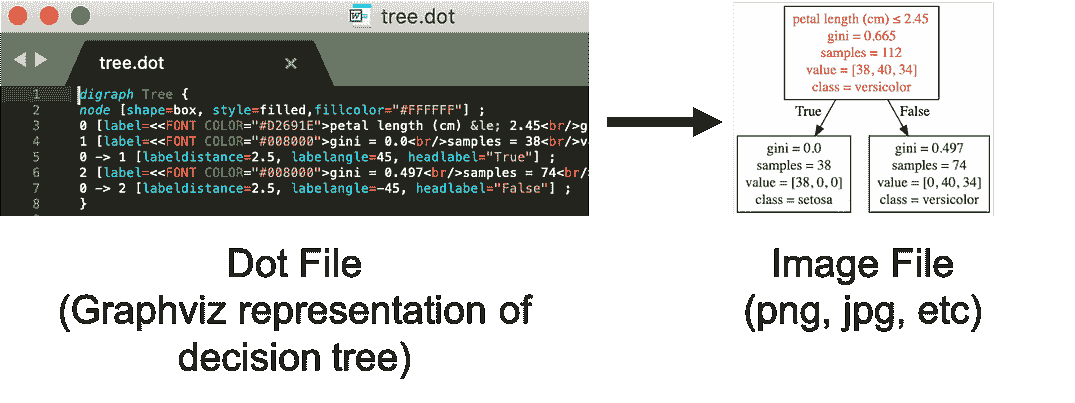

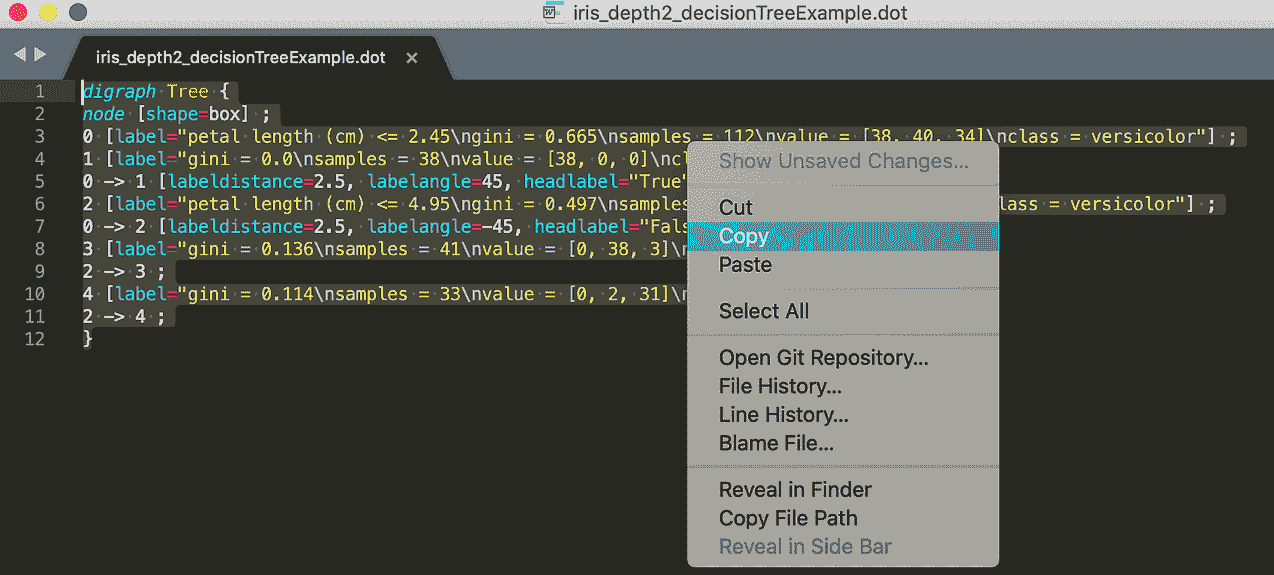

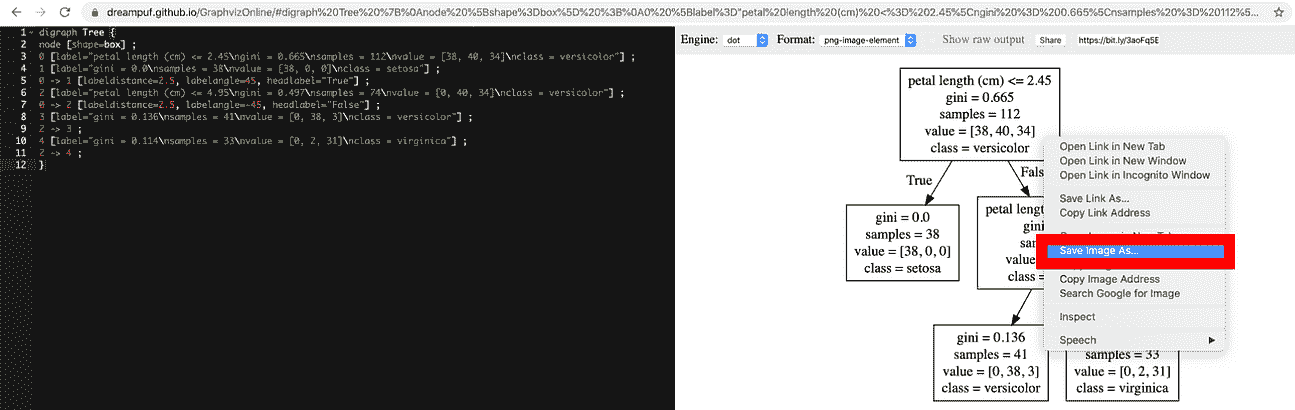

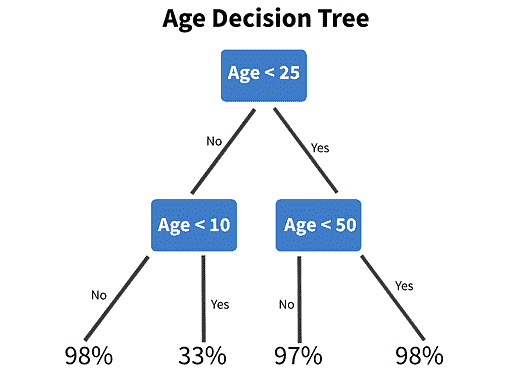

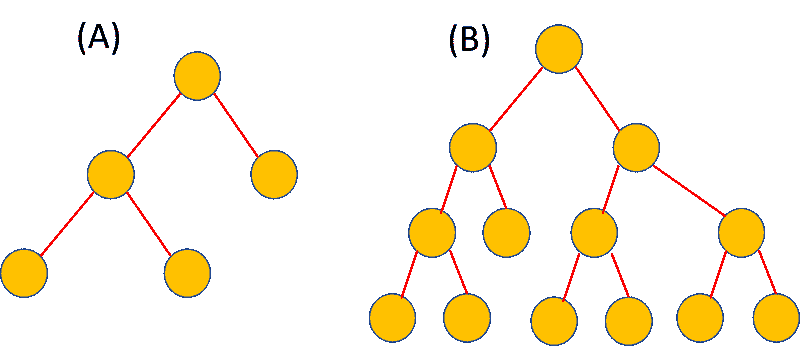

大多数机器学习模型,如决策树和逻辑回归,天生是可解释的。我们可以分析权重系数,可视化树形结构或计算熵,以预测对最终预测的主要贡献(详细信息请见这里)。虽然过去大多数商业问题依赖于简单的可解释模型,但“黑箱”模型,如神经网络,已经开始变得非常流行。这是因为神经网络在处理复杂决策边界的问题(例如图像和语音识别)时提供了更高的准确性和更低的成本。然而,相比于大多数传统模型,神经网络的解释难度要大得多。对于技术水平较低的团队来说,分析神经网络是一项复杂的任务。

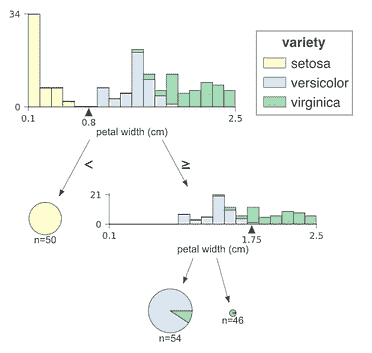

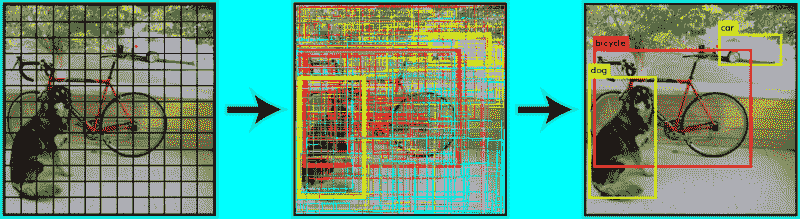

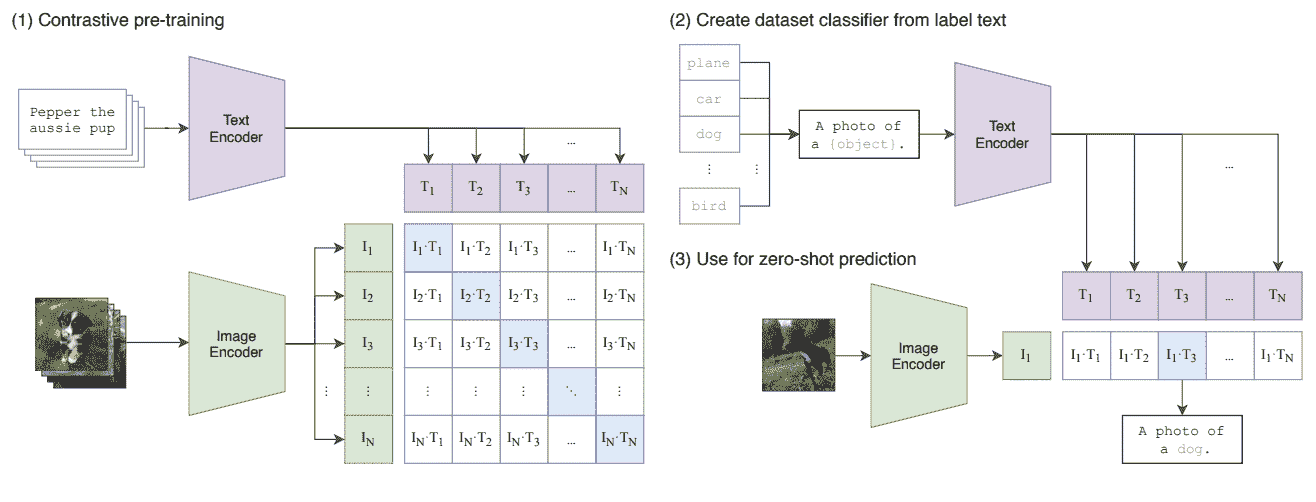

一些神经网络模型比其他模型更容易解释,例如下面的图像识别模型。

可视化图像分类模型的卷积神经网络(来源:Simonyan et al. 2013)

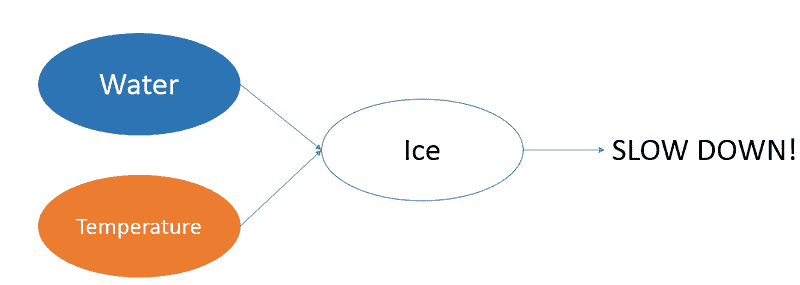

有时,我们可以根据预测和输入推断出工程特征。例如,模型可能没有针对道路上冰的特征。然而,如果模型接受到的输入包括道路上的水和道路表面温度,我们可以直观地认为冰的存在可以通过隐藏层中的特征工程来推导出来。特斯拉自动驾驶导致致命事故就是需要在自动驾驶领域中使用可解释 AI 的一个例子。

神经网络如何在隐藏层中创建更高阶特征的示例,应用于自动驾驶车辆

欲了解更多关于可解释模型的信息,请查看Lars Hulstaer的“解释机器学习模型”。

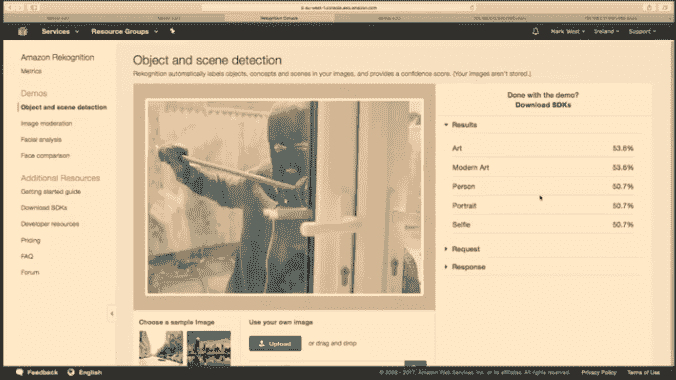

模型解释不一定需要是数学的。定性地观察输入及其对应的输出通常可以提供有价值的见解。下面是一个智能安全摄像头错误地将窃贼识别为自拍者,仅仅因为他拿着杆子像自拍杆一样。

来源:Mark West — 使用 Raspberry Pi Zero、Node.js 和云构建智能安全摄像头

处理边缘情况

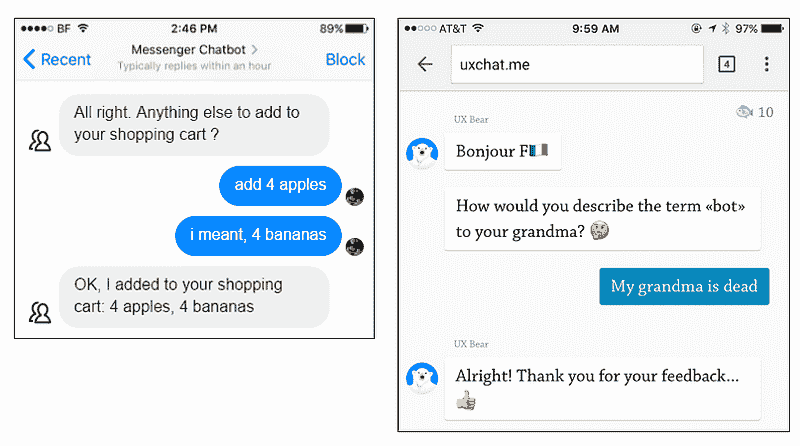

AI 可以生成内容并采取以前无人想到的行动。对于这些不可预测的情况,我们必须花费更多时间测试产品,寻找奇怪、有趣甚至令人不安的边界情况。一个例子是下面聊天机器人的误解。

聊天机器人对意外用户命令的失败

在实际环境中进行广泛测试可以帮助最小化这些错误。收集生产模型的清晰日志可以帮助调试出现的意外问题。有关测试和 DevOps 相关主题的更多信息,请阅读我的“数据科学家的 DevOps: 驯服独角兽”。

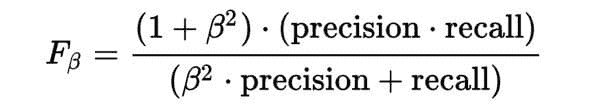

从终端用户的角度来看,关于产品功能的清晰沟通可以帮助他们理解这些意外情况。例如,在许多情况下,模型必须在精确度和召回率之间做出权衡。

-

优化召回率 意味着机器学习产品将使用它找到的所有正确答案,即使它会显示一些错误的答案。假设我们构建一个可以识别猫图片的 AI。如果我们优化召回率,算法会列出所有的猫,但狗也会出现在结果中。

-

优化精确度 意味着机器学习算法只会使用明显正确的答案,但可能会遗漏一些边界正面案例(比如看起来像狗的猫?)。它只会显示猫,但会遗漏一些猫。它不会找到所有正确的答案,只会找到明显的情况。

在我们从事 AI 用户体验(AI UX)工作时,我们帮助开发者决定优化的方向。提供关于人类反应和人类优先事项的有意义见解,可能是 AI 项目中设计师最重要的工作。

管理期望

虽然相信一个模型可以解决世界上任何情境是很诱人的,但理解其局限性并在与终端用户沟通这些局限性时保持透明是很重要的。在她的演讲“我们对信任的误解”中,英国哲学家 Onora O’Neil 指出了信任的三个组成部分:能力、诚实 和 可靠性。保持透明可以向客户展示我们有足够的能力、诚实和可靠性来维持成功商业所需的长期关系。否则,当产品无法交付时,满足过高的期望并失去信任将更加困难。

金融产品是很好的例子。根据政府规定,您的信用评分可能只考虑价值超过 $2000 的资产。因此,任何低于 $2000 的资产在计算您的信用评分时不会被模型考虑。网络安全产品也有类似的情况。如果模型以每天或每周的频率收集数据,您不能期望模型监控 DDoS 攻击。

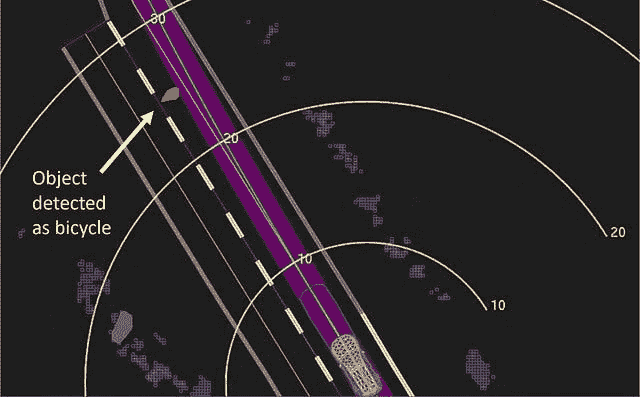

在碰撞前 1.3 秒,Uber 的汽车决定需要紧急制动——但没有能力自行完成这项操作。黄色带显示了米数,紫色则表示了汽车的行驶路径。(来源:国家运输安全委员会)

这种情况在最近的 Uber 无人驾驶汽车事故 中尤为明显:

报告中提到,碰撞前约 1 秒,“自驾系统判断需要紧急制动以减轻碰撞。”然而,Uber 并不允许其系统自行执行紧急制动操作。为了避免“车辆行为不稳定”——比如猛踩刹车或避开塑料袋——Uber 依赖其人工操作员观察道路并在出现问题时接管控制。

自然反应是摄像头没有捕捉到自行车。然而,摄像头确实识别了行人,但系统选择不停车。这是因为模型并未设计为完全替代司机。

提供反馈的机会

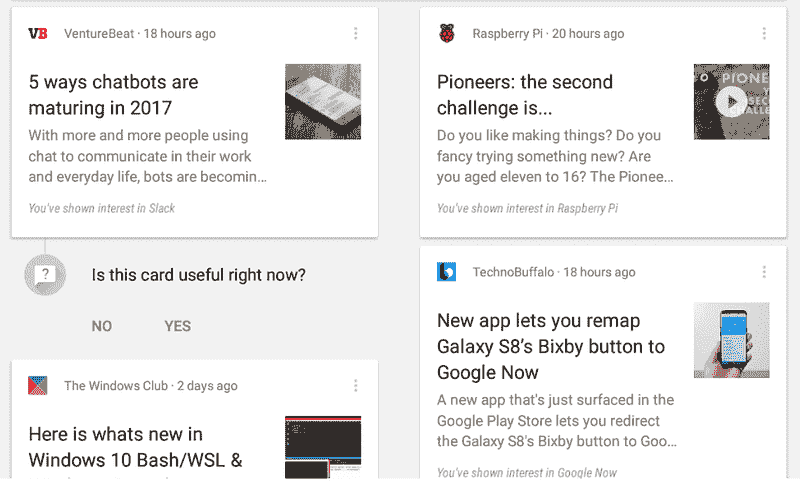

优秀的用户体验设计的目标是交付一个令最终用户满意的产品。为了确保用户获得他们想要的东西,提供他们反馈 AI 内容的机会是必要的。这可以包括电影的评分系统或让银行知道他们的信用卡交易是否存在欺诈行为。以下是来自 Google Now 的一个示例。

Google Now 请求对推荐系统的预测提供反馈

记住,用户反馈也可以作为你模型的训练数据。如果我们将更多数据输入到机器学习算法中,AI 产品的用户体验将变得越来越好。

最终总结

到头来,AI 的设计目的是解决问题并让生活更轻松。人本设计必须始终贯穿于成功产品的开发过程中。不满足客户需求是主要行业破产和被更好服务提供商取代的原因。理解客户需求是前进的关键。

如果你有想法或评论,随时订阅我的博客并在 Twitter 上关注我。

感谢 Wendy Wong。

个人简介:Syed Sadat Nazrul 白天利用机器学习追踪网络和金融犯罪分子,晚上则撰写有趣的博客。

原文。经许可转载。

相关内容:

-

数据科学家的 DevOps:驯服独角兽

-

来自 Google Assistant 的视角:我们是否变得依赖 AI?

-

AI 和数据科学中的十大角色

更多相关话题

梯度消失问题:原因、后果及解决方案

原文:

www.kdnuggets.com/2022/02/vanishing-gradient-problem.html

图片由编辑提供

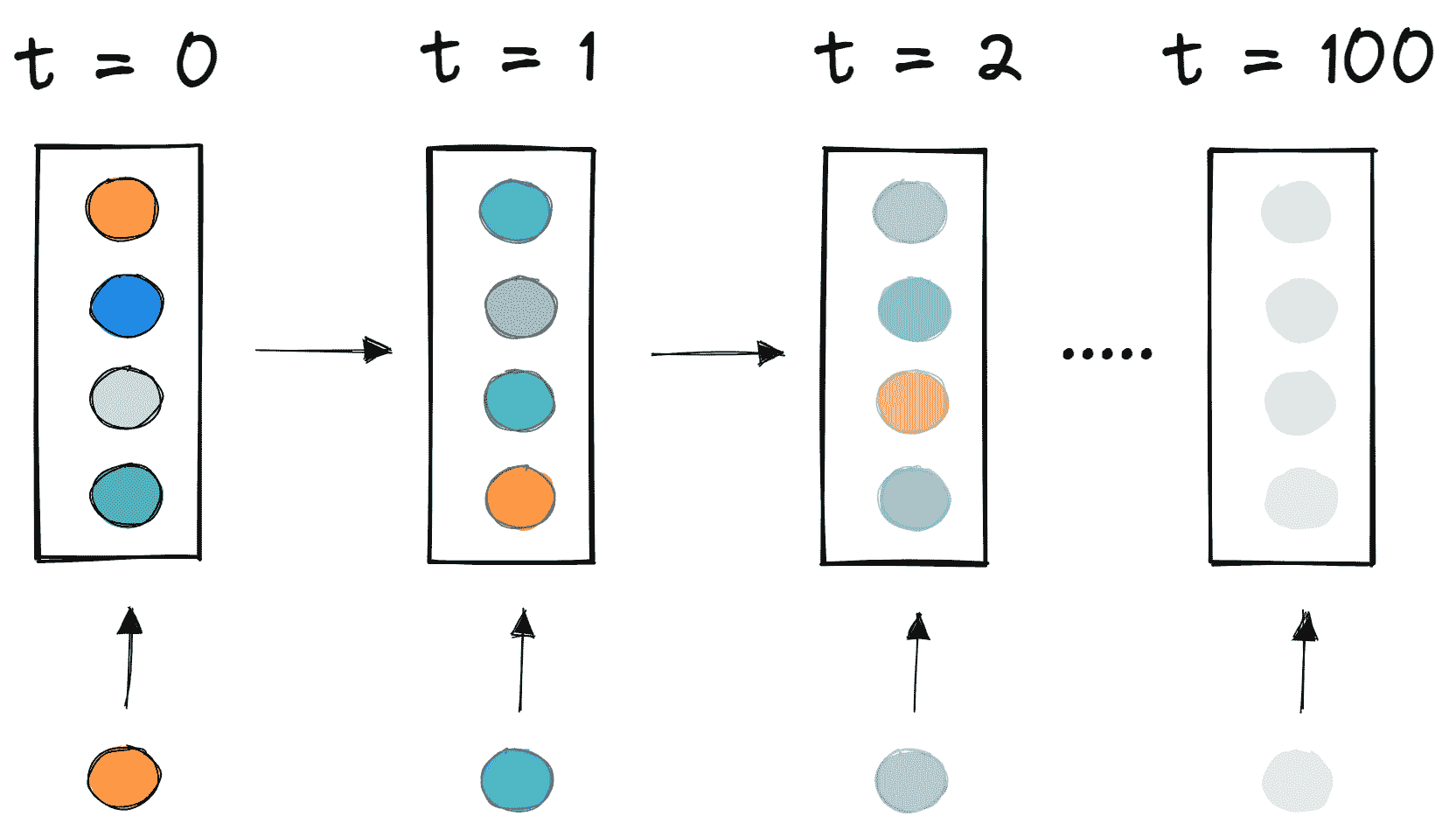

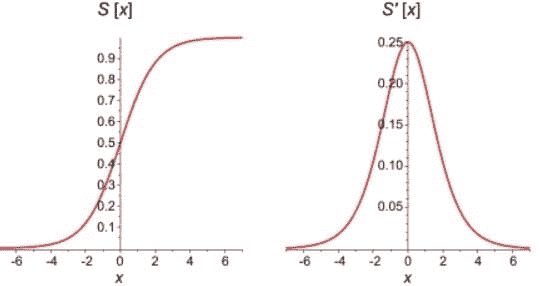

Sigmoid 函数是用于开发深度神经网络的最流行的激活函数之一。Sigmoid 函数的使用限制了深度神经网络的训练,因为它导致了梯度消失问题。这使得神经网络的学习速度变慢,甚至在某些情况下完全无法学习。这篇博客文章旨在描述梯度消失问题,并解释使用 Sigmoid 函数如何导致这个问题。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT

3. Google IT 支持专业证书 - 支持你组织的 IT

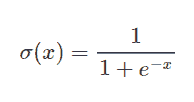

Sigmoid 函数

Sigmoid 函数在神经网络中经常用于激活神经元。它是一个具有特征 S 形状的对数函数。函数的输出值介于 0 和 1 之间。Sigmoid 函数用于在二分类问题中激活输出层。它的计算公式如下:

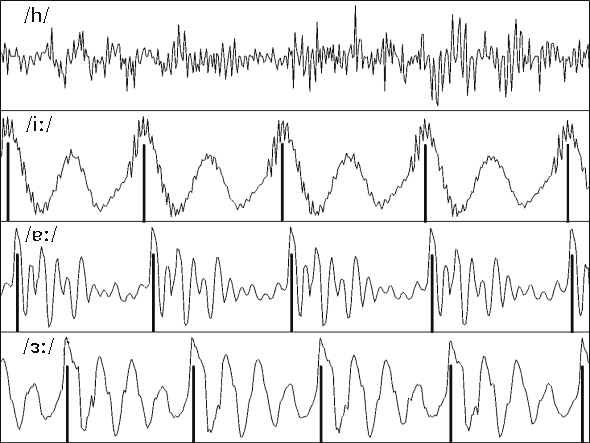

在下面的图表中,你可以看到 Sigmoid 函数本身及其导数的比较。Sigmoid 函数的一阶导数是钟形曲线,其值范围从 0 到 0.25。

我们对神经网络如何执行前向传播和反向传播的了解对于理解梯度消失问题至关重要。

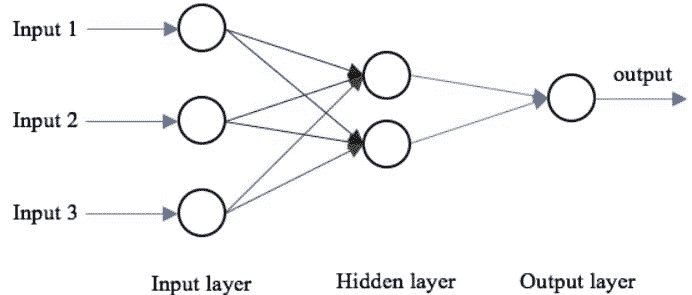

前向传播

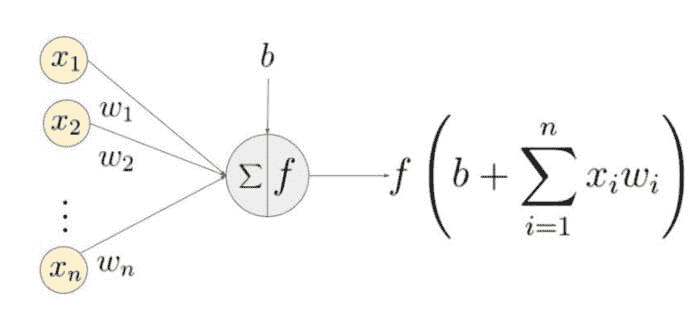

神经网络的基本结构包括输入层、一个或多个隐藏层和一个输出层。网络的权重在前向传播过程中被随机初始化。输入特征在每个隐藏层节点处与相应的权重相乘,并在每个节点处加上一个偏置。然后,这个值通过激活函数转换为节点的输出。为了生成神经网络的输出,隐藏层输出乘以权重加上偏置值,然后使用另一个激活函数进行转换。这将是神经网络对给定输入值的预测值。

反向传播

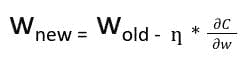

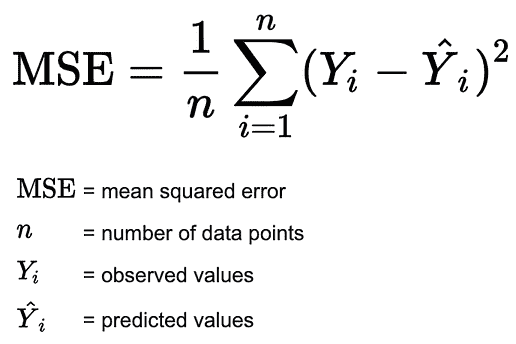

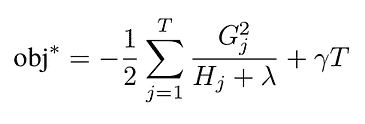

当网络生成输出时,损失函数(C)表示它预测输出的准确性。网络执行反向传播以最小化损失。反向传播方法通过调整神经网络的权重和偏置来最小化损失函数。在此方法中,损失函数的梯度相对于网络中的每个权重进行计算。

在反向传播中,节点的新权重(w[new])是通过旧权重(w[old])和学习率(ƞ)与损失函数梯度的乘积来计算的。

利用偏导数链式法则,我们可以将损失函数的梯度表示为所有节点的激活函数相对于其权重的梯度的乘积。因此,网络中节点的更新权重依赖于每个节点激活函数的梯度。

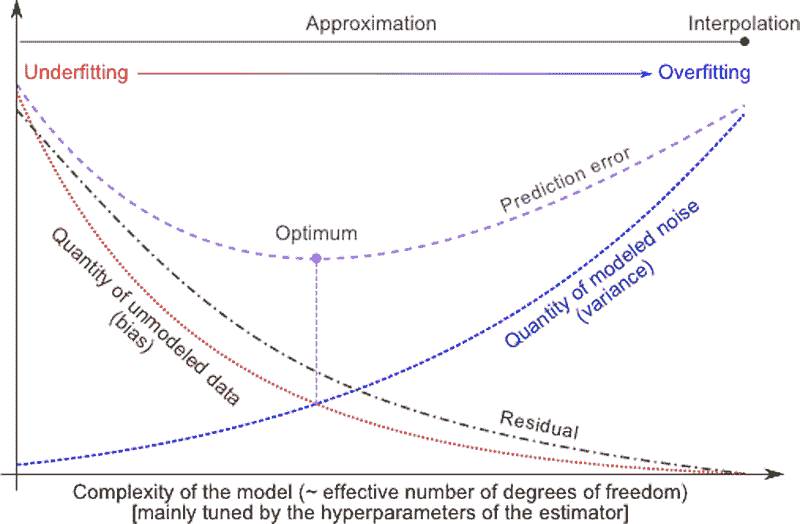

对于具有 sigmoid 激活函数的节点,我们知道 sigmoid 函数的偏导数最大值为 0.25。当网络中层数增加时,导数的乘积值会减少,直到某个点,损失函数的偏导数接近零,偏导数消失。我们称之为消失梯度问题。

在浅层网络中,sigmoid 函数可以使用,因为梯度的小值不会造成问题。然而,对于深层网络,消失梯度可能对性能产生重大影响。由于导数消失,网络的权重保持不变。在反向传播过程中,神经网络通过更新其权重和偏置来减少损失函数。在具有消失梯度的网络中,权重无法更新,因此网络无法学习。结果是网络性能下降。

克服问题的方法

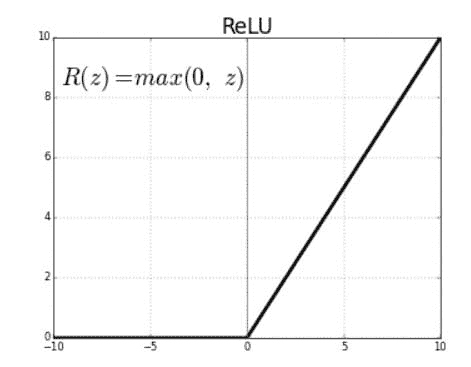

梯度消失问题是由用于创建神经网络的激活函数的导数引起的。解决这个问题的最简单方法是替换网络的激活函数。可以用 ReLU 等激活函数代替 sigmoid。

修正线性单元(ReLU)是激活函数,当它们应用于正输入值时会生成正线性输出。如果输入为负值,该函数将返回零。

ReLU 函数的导数定义为对于大于零的输入为 1,对于负输入为 0。下面共享的图表显示了 ReLU 函数的导数。

如果在神经网络中用 ReLU 函数代替 sigmoid 函数进行激活,损失函数的偏导数值将为 0 或 1,这防止了梯度消失。因此,ReLU 函数可以防止梯度消失。使用 ReLU 的问题是,当梯度值为 0 时,节点被视为死节点,因为权重的旧值和新值保持不变。这种情况可以通过使用 leaky ReLU 函数来避免,该函数防止梯度降到零值。

避免梯度消失问题的另一种技术是权重初始化。这是将初始值分配给神经网络中的权重的过程,以便在反向传播过程中,权重不会消失。

总之,梯度消失问题源于用于创建神经网络的激活函数的偏导数的特性。使用 Sigmoid 激活函数的深度神经网络中,这个问题可能会更加严重。通过使用像 ReLU 和 leaky ReLU 这样的激活函数,可以显著减少这个问题。

蒂娜·雅各布 对数据科学充满热情,认为生活就是不断学习和成长,无论遇到什么。

了解更多相关话题

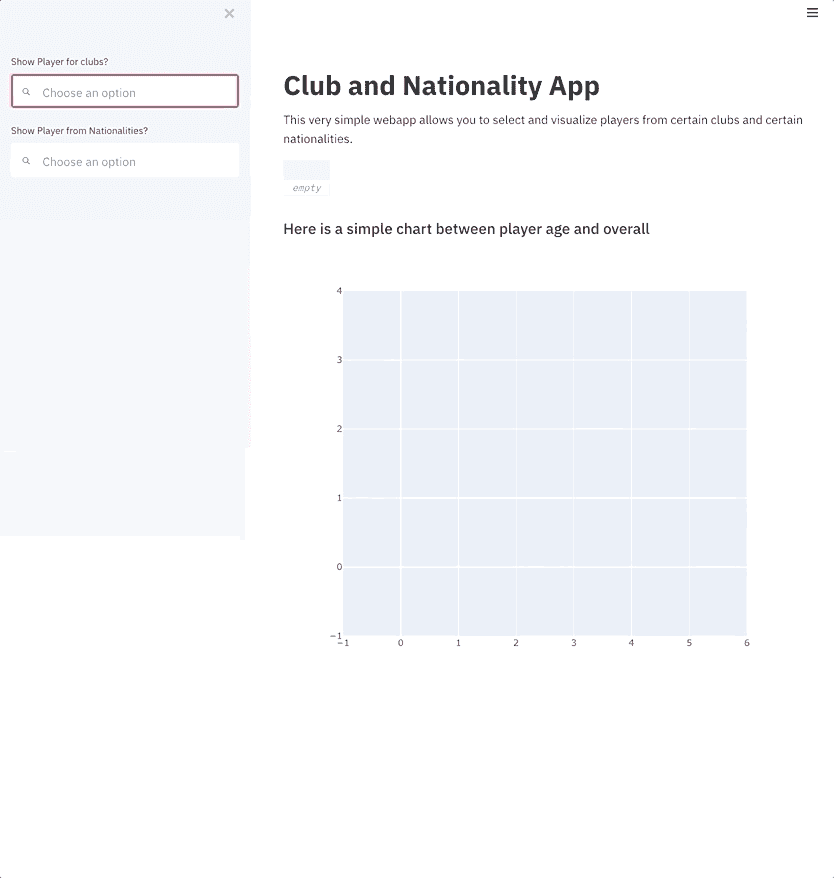

变分自编码器详细解析

原文:

www.kdnuggets.com/2018/11/variational-autoencoders-explained.html

评论

评论

在这系列的 上一篇文章中,我介绍了变分自编码器(VAE)框架,并解释了其背后的理论。

在这篇文章中,我将更详细地解释 VAE,换句话说——我将提供一些代码 😃

阅读本文后,你将理解实现 VAE 所需的技术细节。

作为一个额外的点,我将向你展示如何通过对一些潜在向量维度施加特殊角色,模型可以生成基于数字类型的图像。

该模型将使用 MNIST 进行训练——手写数字数据集。输入是 ℝ[28∙28] 中的图像。

接下来,我们将定义我们要使用的超参数。

随意尝试不同的值,以感受模型如何受到影响。笔记本可以在 这里找到。

该模型

该模型由三个子网络组成:

-

给定 x(图像),将其编码为潜在空间上的分布——在上一篇文章中称之为 Q(z|x)。

-

给定 z 在潜在空间中(图像的代码表示),将其解码为它所表示的图像——在上一篇文章中称之为 f(z)。

-

给定 x,通过将其映射到大小为 10 的层来分类其数字,其中第 i 个值包含第 i 个数字的概率。

前两个子网络是基本的 VAE 框架。

第三个子网络用作 辅助任务,它将强制某些潜在维度编码图像中的数字。让我解释一下动机:在上一篇文章中我解释过,我们不在乎潜在空间的每个维度持有什么信息。模型可以学习编码它认为对任务有价值的任何信息。由于我们对数据集非常熟悉,我们知道数字类型应该很重要。我们希望通过提供这些信息来帮助模型。此外,我们将使用这些信息生成基于数字类型的图像,稍后我会解释。

给定数字类型,我们将其使用 one hot 编码,即大小为 10 的向量。这 10 个数字将被连接到潜在向量中,因此在将该向量解码成图像时,模型将利用数字信息。

有两种方法可以为模型提供 one hot 编码向量:

-

将其作为输入添加到模型中。

-

将其作为标签添加,这样模型将必须自行预测:我们将添加另一个子网络来预测大小为 10 的向量,其中损失是与期望的 one hot 向量的交叉熵。

我们将选择第二个选项。为什么?嗯,在测试时我们可以以两种方式使用模型:

-

提供一张图像作为输入,并推断出一个潜在向量。

-

提供一个潜在向量作为输入,并生成一张图像。

由于我们也想支持第一个选项,因此我们不能向模型提供数字作为输入,因为在测试时我们将不知道它。因此,模型必须学习预测它。

现在我们理解了组成模型的所有子网络,我们可以对其进行编码。编码器和解码器背后的数学细节可以在上一篇文章中找到。

训练

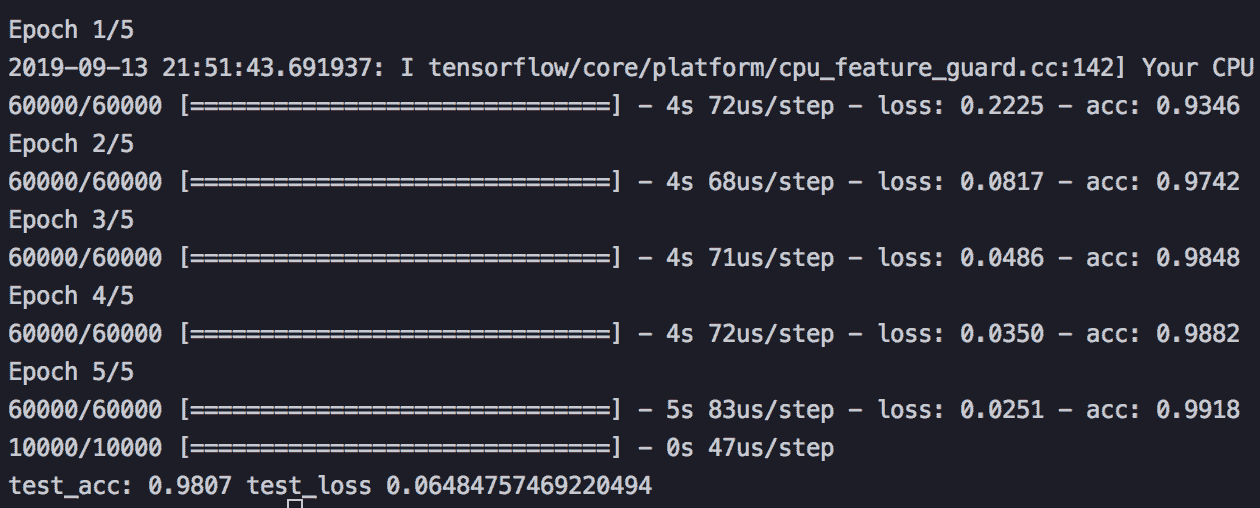

我们将训练模型来优化两个损失——VAE 损失和分类损失——使用 SGD。

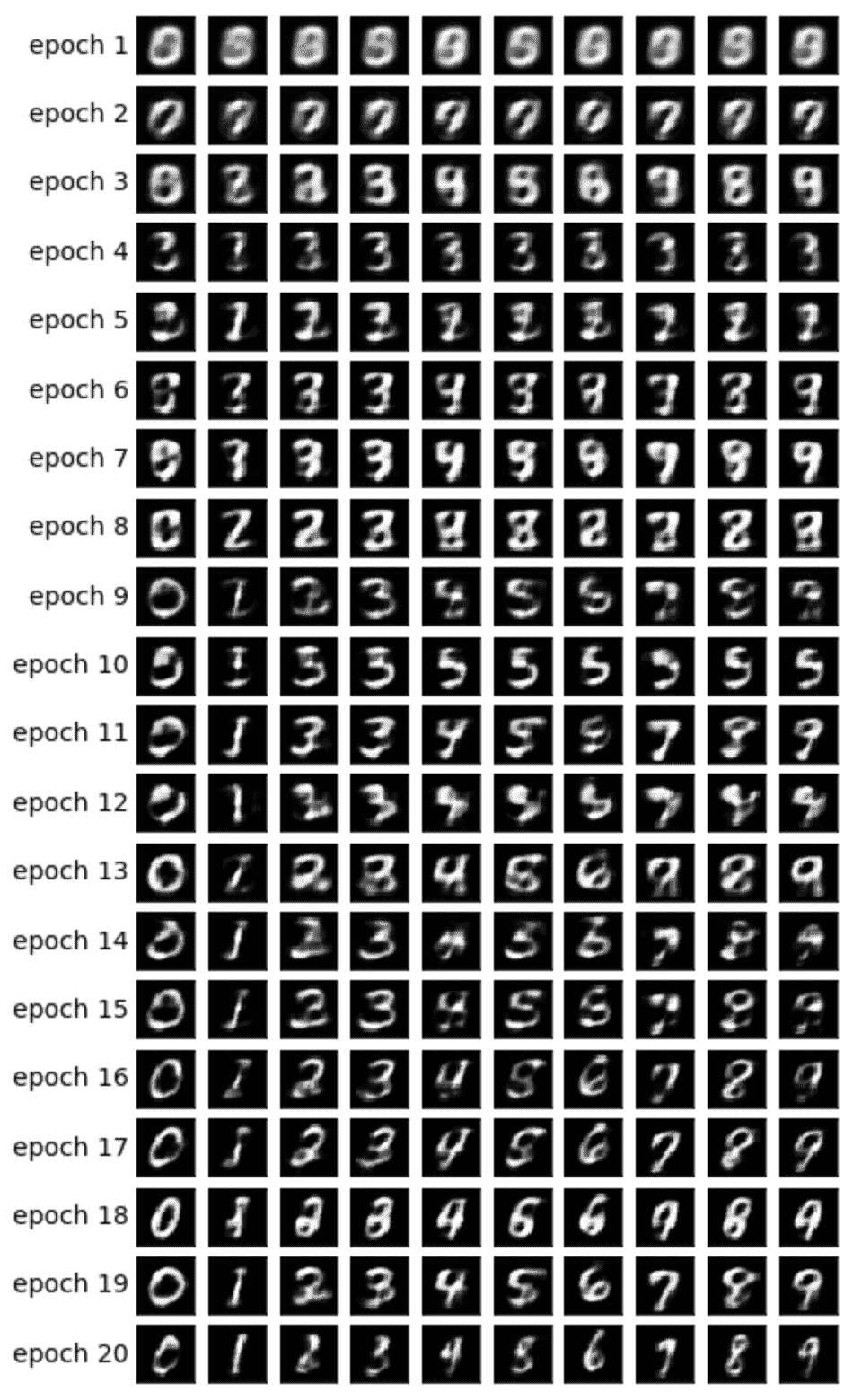

在每个纪元结束时,我们将采样潜在向量并将其解码成图像,以便我们可以可视化模型的生成能力如何随着纪元的推移而改善。采样方法如下:

-

根据我们想要生成图像的数字,确定用于数字分类的维度。如果我们想生成数字 2 的图像,这些维度将设置为 [0010000000]。

-

随机采样其他维度,根据先验——多变量高斯分布。我们将使用这些采样值来生成给定纪元中的所有不同数字。通过这种方式,我们可以感受到其他维度中编码了什么,例如笔画风格。

步骤 1 的直觉是,在收敛之后,模型应该能够使用这些维度来分类输入图像中的数字。另一方面,这些维度也用于解码步骤以生成图像。这意味着解码器子网络学会了当这些维度具有与数字 2 相对应的值时,它应该生成该数字的图像。因此,如果我们手动设置这些维度以包含数字 2 的信息,我们将得到该数字的生成图像。

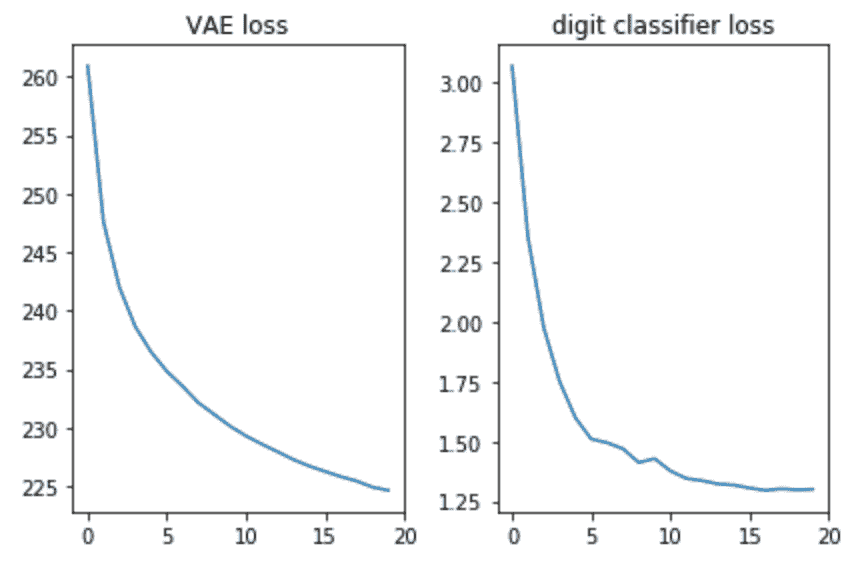

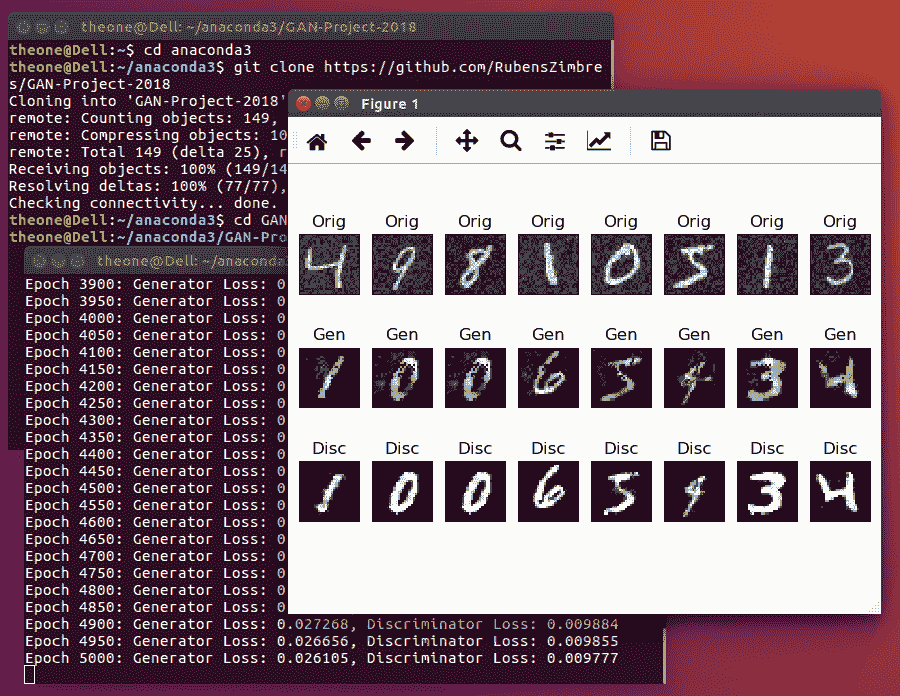

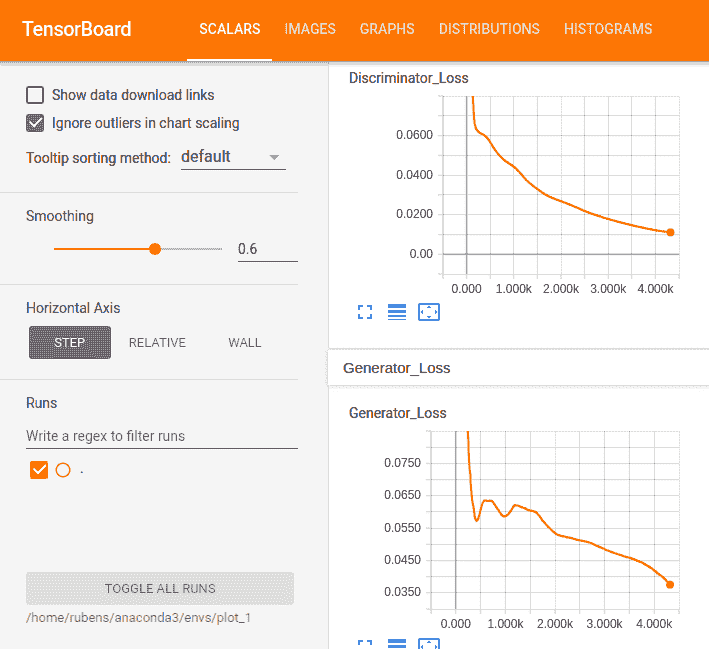

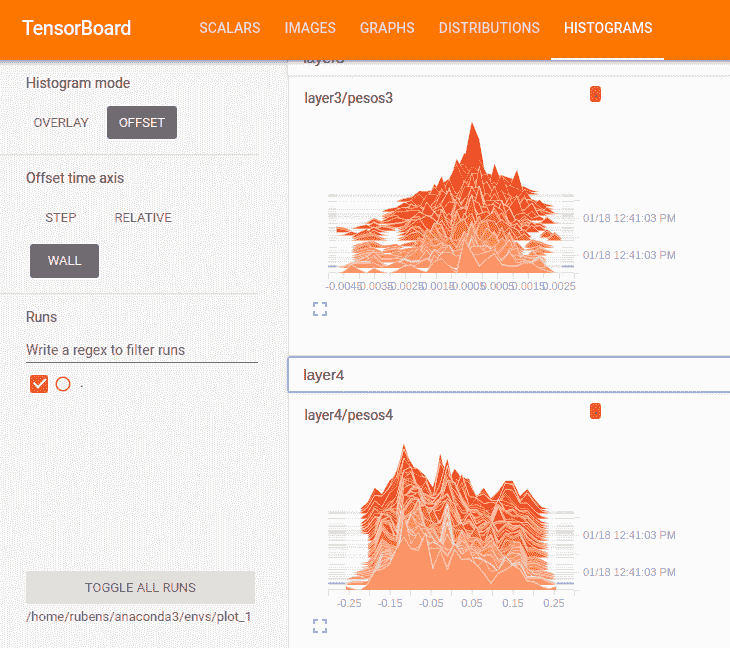

让我们验证两个损失是否看起来不错,即——是否在减少:

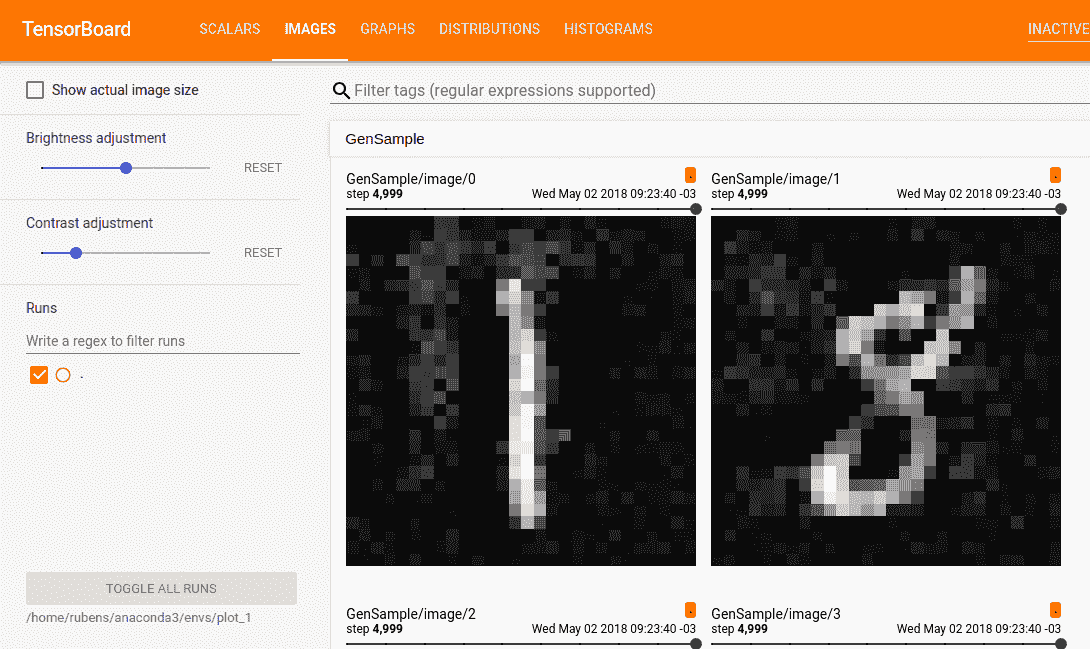

此外,让我们绘制生成的图像,看看模型是否确实能够生成数字的图像:

最终想法

很高兴看到使用简单的前馈网络(没有花哨的卷积)我们能够在仅仅 20 个纪元后生成漂亮的图像。模型学会了相当快地使用特殊的数字维度——在第 9 纪元时,我们已经看到了我们尝试生成的数字序列。

每个纪元使用不同的随机值来处理其他维度,因此我们可以看到风格在不同纪元之间的差异,并且在每个纪元内部是相似的——至少在一些纪元中是这样。例如,在第 18 纪元中,所有数字都比第 20 纪元更粗体。

我邀请你打开 这个笔记本 并玩一玩 VAE。例如,超参数的值对生成的图像有很大的影响。玩得开心 😃

简介: Yoel Zeldes 是 Taboola 的算法工程师,也是一位对深度学习特别感兴趣的机器学习爱好者。

原文。经许可转载。

资源:

相关:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

更多相关话题

2018 年数据科学和人工智能的 7 大 R 包

原文:

www.kdnuggets.com/2019/01/vazquez-2018-top-7-r-packages.html/2

评论

评论

4. DataExplorer — 自动化数据探索和处理

github.com/boxuancui/DataExplorer

探索性数据分析 (EDA) 是数据分析/预测建模的初步和重要阶段。在此过程中,分析师/建模者将首先查看数据,从而生成相关假设并决定下一步。然而,EDA 过程有时可能会很麻烦。这个 R 包旨在自动化大多数数据处理和可视化工作,以便用户可以专注于研究数据并提取洞见。

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

安装

该包可以直接从 CRAN 安装。

install.packages("DataExplorer")

使用方法

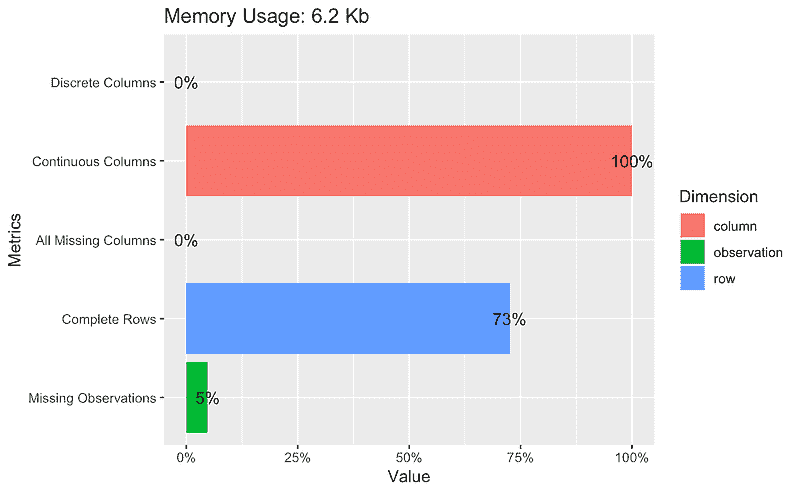

使用该包你可以创建如下报告、图表和表格:

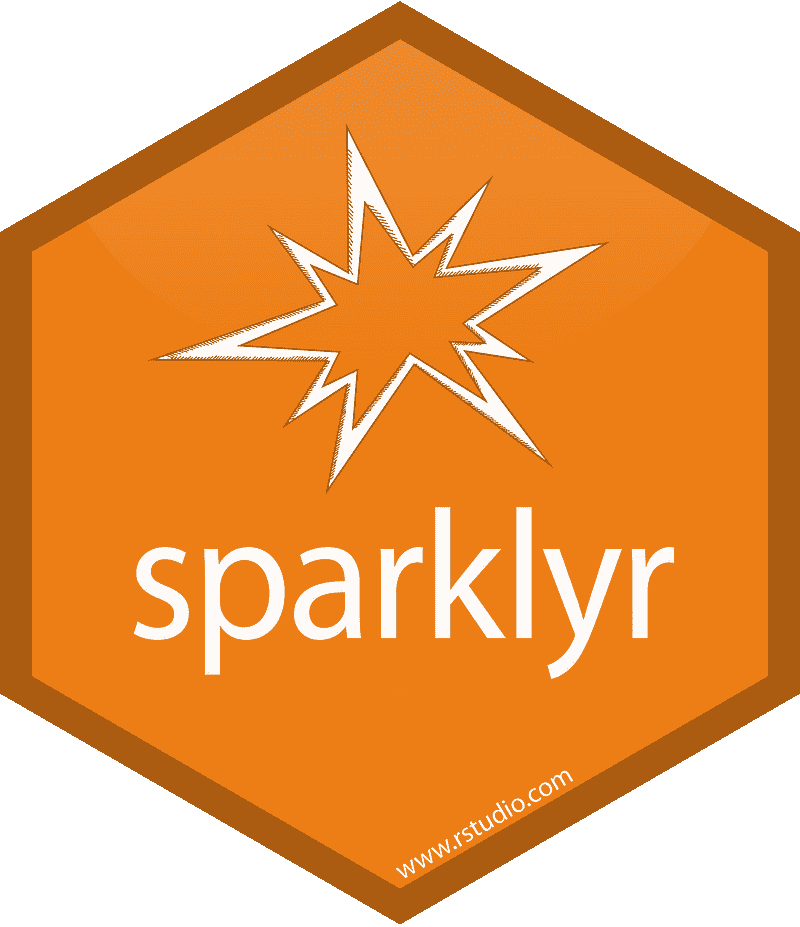

## Plot basic description for airquality data

plot_intro(airquality)

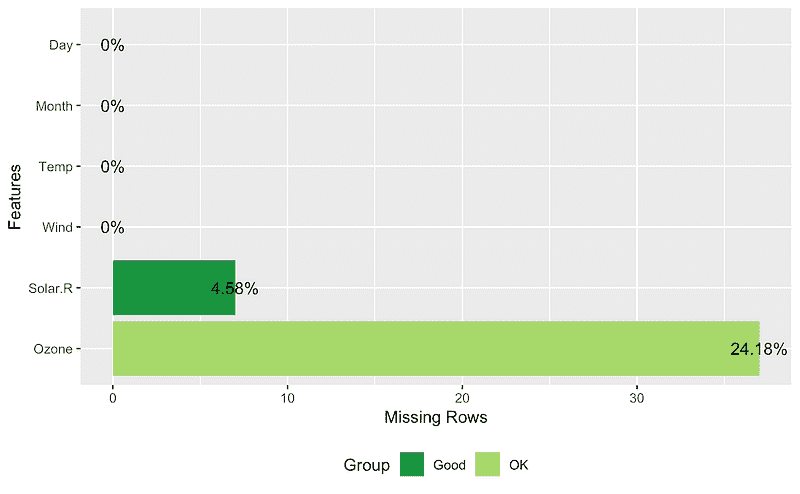

## View missing value distribution for airquality data

plot_missing(airquality)

## Left: frequency distribution of all discrete variables

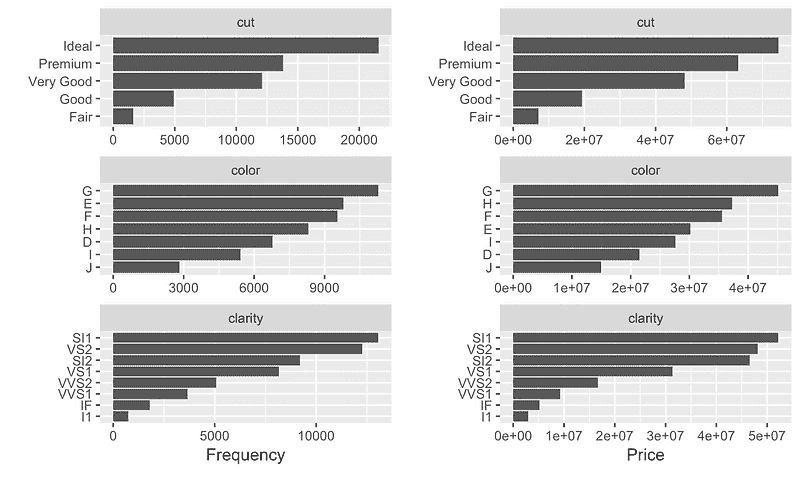

plot_bar(diamonds)

## Right: `price` distribution of all discrete variables

plot_bar(diamonds, with = "price")

## View histogram of all continuous variables

plot_histogram(diamonds)

你可以在该包的官方网站上找到更多类似的内容:

[自动化数据探索和处理

自动化数据探索过程用于分析任务和预测建模,以便用户可以专注于…boxuancui.github.io](https://boxuancui.github.io/DataExplorer/)

在这个小册子中:

[DataExplorer 介绍

本文件介绍了 DataExplorer 包,并展示了它如何帮助你完成不同的任务…boxuancui.github.io](https://boxuancui.github.io/DataExplorer/articles/dataexplorer-intro.html)

3. Sparklyr — Apache Spark 的 R 接口

Sparklyr 使你能够:

-

从 R 连接到 Spark。sparklyr 包提供了一个

完成 dplyr 后端。

-

过滤和聚合 Spark 数据集,然后将其带入 R 进行

分析和可视化。

-

使用 Spark 的分布式machine learning库从 R 中访问。

-

创建扩展来调用完整的 Spark API 并提供

与 Spark 包的接口。

安装

你可以按照以下方式从 CRAN 安装 Sparklyr 包:

install.packages("sparklyr")

你还应该安装一个本地版本的 Spark 以便于开发:

library(sparklyr)

spark_install(version = "2.3.1")

使用

使用 Spark 的第一步始终是创建上下文并连接到本地或远程集群。

在这里,我们将通过spark_connect函数连接到 Spark 的本地实例:

library(sparklyr)

sc <- spark_connect(master = "local")

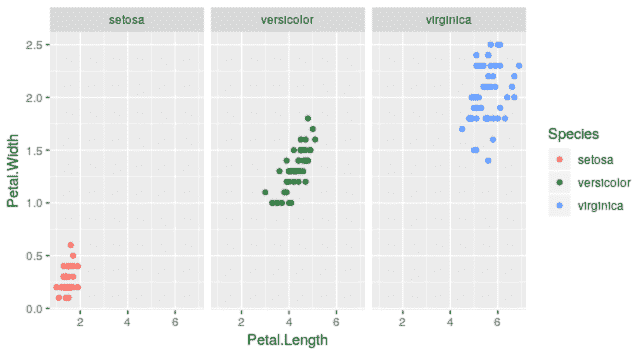

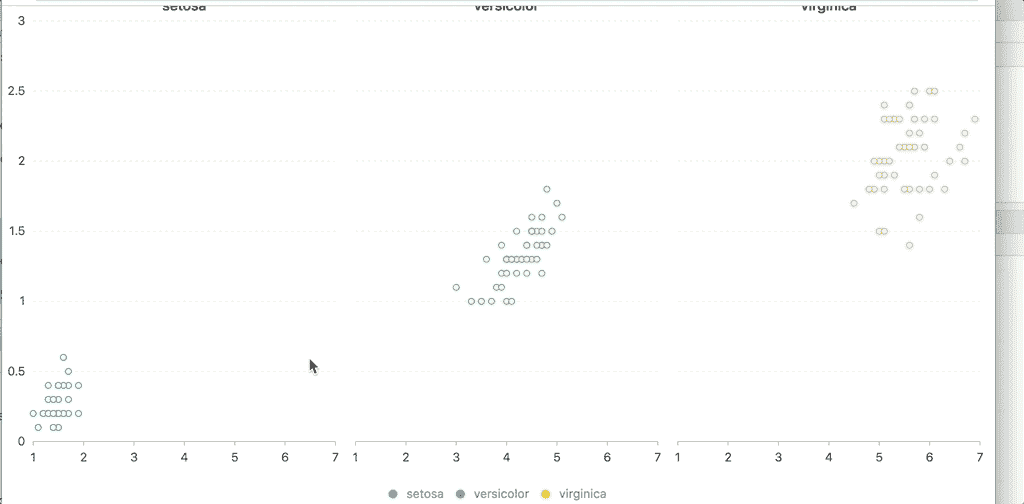

将 sparklyr 与 dplyr 和 ggplot2 结合使用

我们将通过将一些数据集从 R 复制到 Spark 集群开始(请注意,您可能需要安装 nycflights13 和 Lahman 包以执行此代码):

install.packages(c("nycflights13", "Lahman"))

library(dplyr)

iris_tbl <- copy_to(sc, iris)

flights_tbl <- copy_to(sc, nycflights13::flights, "flights")

batting_tbl <- copy_to(sc, Lahman::Batting, "batting")

src_tbls(sc)

## [1] "batting" "flights" "iris"

首先,这里有一个简单的过滤示例:

# filter by departure delay and print the first few records

flights_tbl %>% filter(dep_delay == 2)

## # Source: lazy query [?? x 19]

## # Database: spark_connection

## year month day dep_time sched_dep_time dep_delay arr_time

## <int> <int> <int> <int> <int> <dbl> <int>

## 1 2013 1 1 517 515 2 830

## 2 2013 1 1 542 540 2 923

## 3 2013 1 1 702 700 2 1058

## 4 2013 1 1 715 713 2 911

## 5 2013 1 1 752 750 2 1025

## 6 2013 1 1 917 915 2 1206

## 7 2013 1 1 932 930 2 1219

## 8 2013 1 1 1028 1026 2 1350

## 9 2013 1 1 1042 1040 2 1325

## 10 2013 1 1 1231 1229 2 1523

## # ... with more rows, and 12 more variables: sched_arr_time <int>,

## # arr_delay <dbl>, carrier <chr>, flight <int>, tailnum <chr>,

## # origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>, hour <dbl>,

## # minute <dbl>, time_hour <dttm>

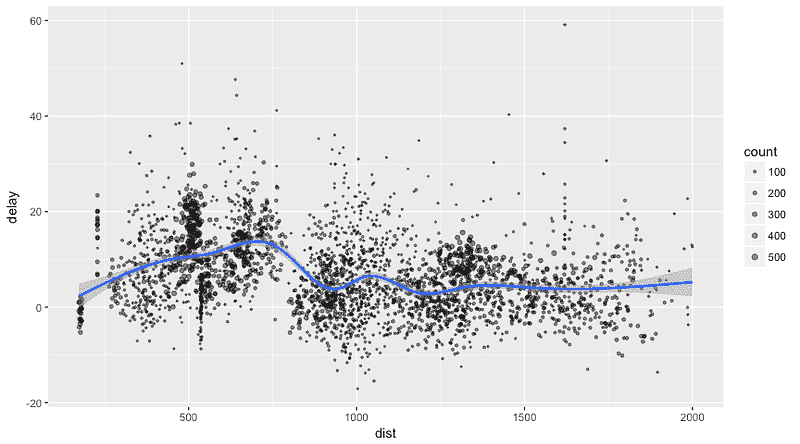

让我们绘制飞行延迟的数据:

delay <- flights_tbl %>%

group_by(tailnum) %>%

summarise(count = n(), dist = mean(distance), delay = mean(arr_delay)) %>%

filter(count > 20, dist < 2000, !is.na(delay)) %>%

collect

# plot delays

library(ggplot2)

ggplot(delay, aes(dist, delay)) +

geom_point(aes(size = count), alpha = 1/2) +

geom_smooth() +

scale_size_area(max_size = 2)

## `geom_smooth()` using method = 'gam'

使用 Sparklyr 进行机器学习

你可以通过 Sparklyr 中的machine learning函数在 Spark 集群中编排机器学习算法。这些函数连接到建立在 DataFrames 之上的高层 API,帮助你创建和调整机器学习工作流程。

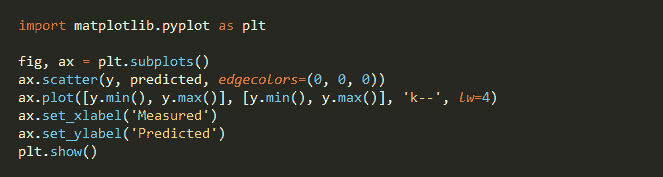

这里是一个示例,我们使用ml_linear_regression来拟合一个线性回归模型。我们将使用内置的mtcars数据集来查看是否可以根据汽车的重量(wt)和引擎的气缸数(cyl)预测汽车的燃油消耗(mpg)。我们将假设mpg与每个特征之间的关系是线性的。

*# copy mtcars into spark*

mtcars_tbl <- copy_to(sc, mtcars)

*# transform our data set, and then partition into 'training', 'test'*

partitions <- mtcars_tbl %>%

filter(hp >= 100) %>%

mutate(cyl8 = cyl == 8) %>%

sdf_partition(training = 0.5, test = 0.5, seed = 1099)

*# fit a linear model to the training dataset*

fit <- partitions$training %>%

ml_linear_regression(response = "mpg", features = c("wt", "cyl"))

fit

## Call: ml_linear_regression.tbl_spark(., response = "mpg", features = c("wt", "cyl"))

##

## Formula: mpg ~ wt + cyl

##

## Coefficients:

## (Intercept) wt cyl

## 33.499452 -2.818463 -0.923187

对于 Spark 生成的线性回归模型,我们可以使用summary()来了解我们的拟合质量以及每个预测变量的统计显著性。

summary(fit)

## Call: ml_linear_regression.tbl_spark(., response = "mpg", features = c("wt", "cyl"))

##

## Deviance Residuals:

## Min 1Q Median 3Q Max

## -1.752 -1.134 -0.499 1.296 2.282

##

## Coefficients:

## (Intercept) wt cyl

## 33.499452 -2.818463 -0.923187

##

## R-Squared: 0.8274

## Root Mean Squared Error: 1.422

Spark 机器学习支持广泛的算法和特征变换,如上所示,使用 dplyr 管道轻松地将这些函数串联在一起。

在这里了解更多关于使用 sparklyr 进行机器学习的信息:

[sparklyr

一个 R 接口到 Sparkspark.rstudio.com](http://spark.rstudio.com/mlib/)

更多关于该包和示例的信息请查看这里:

[sparklyr

一个 R 接口到 Sparkspark.rstudio.com](http://spark.rstudio.com/)

2. Drake — 一个专注于 R 的可重复性和高性能计算的管道工具包

Drake 编程

不,开玩笑的。其实这个包的名字是drake!

这是一个非常棒的包。我会创建一个单独的帖子来详细介绍它,所以敬请期待!

Drake 是一个作为通用工作流管理器的包,用于数据驱动的任务。当其依赖项发生变化时,它会重新构建中间数据对象,并在结果已经最新时跳过工作。

此外,并非每次运行都从头开始,已完成的工作流有可触及的可重复性证据。

可重复性、良好的管理和实验跟踪对于轻松测试他人的工作和分析都是必要的。这在数据科学中非常重要,你可以在这里阅读更多内容:

来自 Zach Scott:

[数据科学的可重复性危机

什么是数据科学中的可重复性,为什么我们应该关心它?towardsdatascience.com](https://towardsdatascience.com/data-sciences-reproducibility-crisis-b87792d88513)

[迈向可重复性:平衡隐私与公开

在数据安全与研究公开之间,是否可能存在一个恰到好处的选项?towardsdatascience.com](https://towardsdatascience.com/toward-reproducibility-balancing-privacy-and-publication-77fee2366eee)

以及我写的一篇文章 😃

[用 MLflow 管理你的机器学习生命周期——第一部分。

可重复性、良好的管理和实验跟踪对于轻松测试他人的工作以及…towardsdatascience.com](https://towardsdatascience.com/manage-your-machine-learning-lifecycle-with-mlflow-part-1-a7252c859f72)

使用 drake,你可以自动

-

启动自上次以来发生变化的部分。

-

跳过其余部分。

安装

*# Install the latest stable release from CRAN.*

install.packages("drake")

*# Alternatively, install the development version from GitHub.*

install.packages("devtools")

library(devtools)

install_github("ropensci/drake")

安装自 CRAN 时存在一些已知错误。有关这些错误的更多信息,请访问:

我遇到了一些错误,因此建议您现在从 GitHub 安装该包。

好的,让我们用一个小变化来重现一个简单的示例:

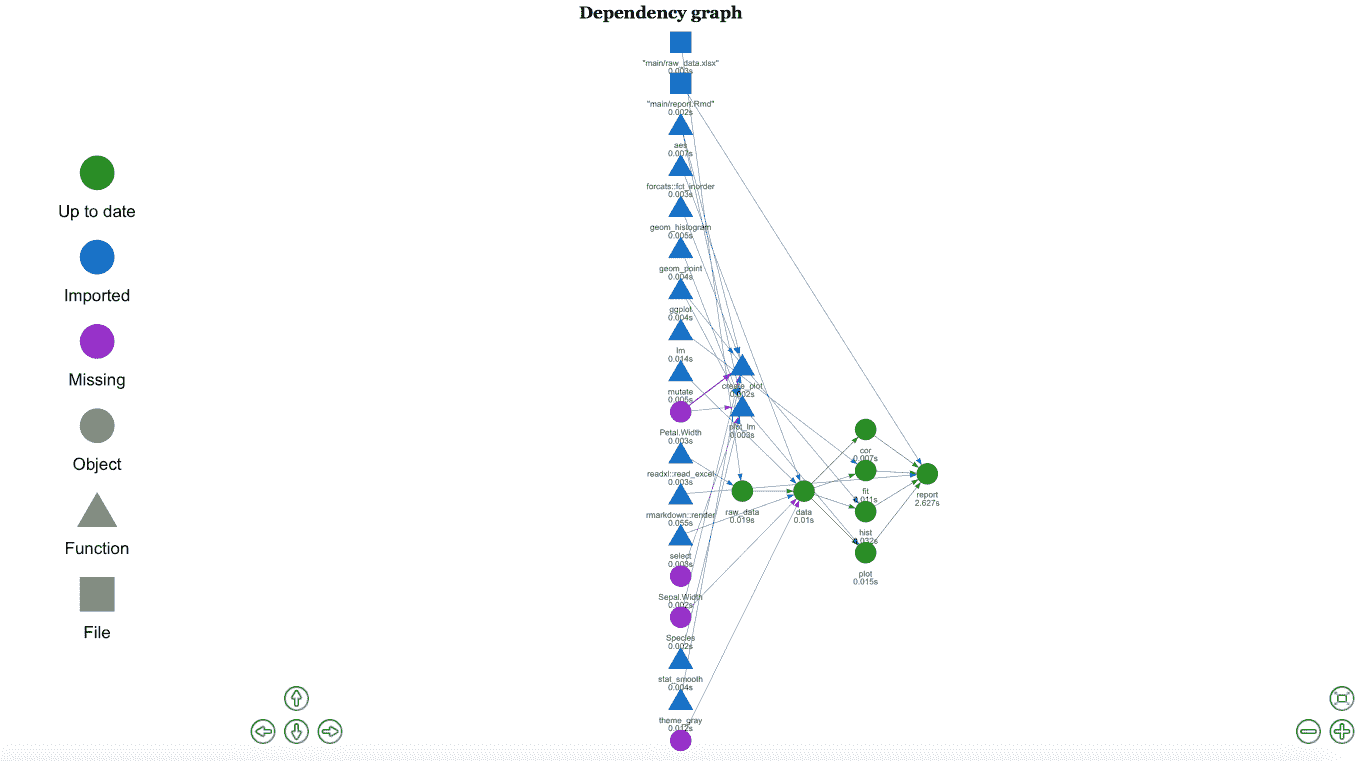

我在 drake 的主要示例中添加了一个简单的图形来查看线性模型。使用这段代码,你正在为执行整个项目创建一个计划。

首先,我们读取数据。然后我们为分析做好准备,创建一个简单的直方图,计算相关性,拟合模型,绘制线性模型,最后创建一个 rmarkdown 报告。

我用于最终报告的代码在这里:

如果我们更改了一些函数或分析,当我们执行计划时, drake 会知道发生了什么变化,并且只会运行这些变化。它会创建一个图形,以便你可以看到发生了什么:

分析图

在 Rstudio 中,这个图形是交互式的,你可以将其保存为 HTML 以便后续分析。

还有更多了不起的功能,你可以用 drake 做到,我会在未来的帖子中展示 😃

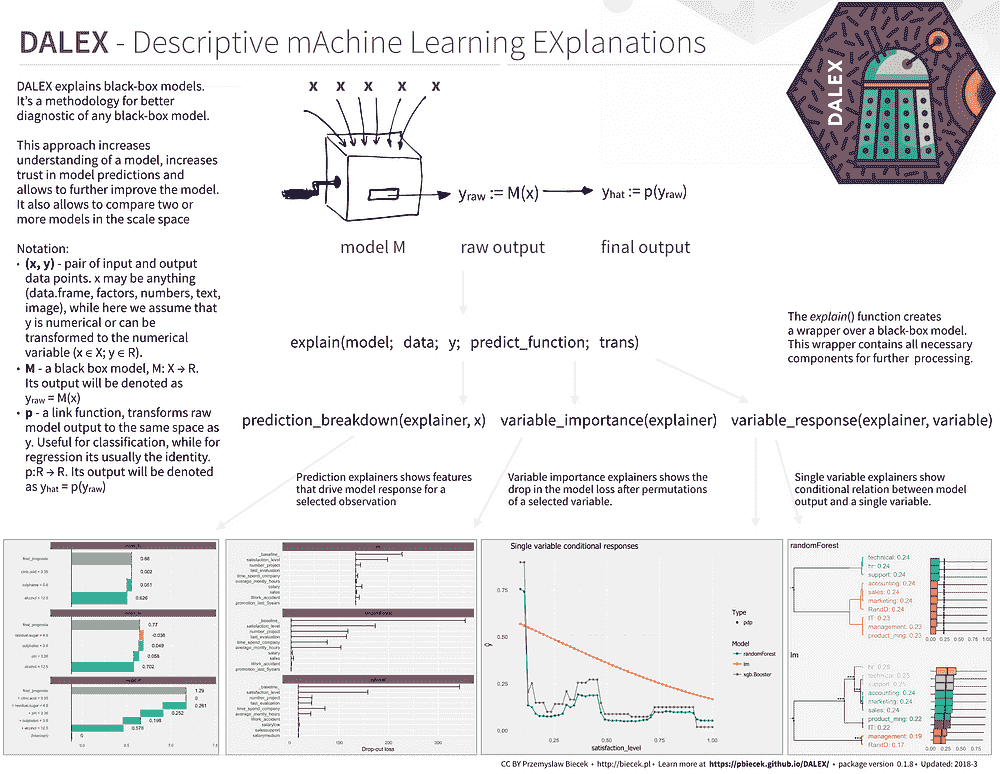

1. DALEX——描述性机器学习解释

解释机器学习模型并不总是容易的。然而,对于各种商业应用来说,这一点非常重要。幸运的是,有一些很棒的库可以帮助我们完成这项任务。例如:

[thomasp85/lime]

lime——局部可解释的模型无关解释(原始 Python 包的 R 版)github.com](https://github.com/thomasp85/lime)

(顺便说一下,有时候一个简单的 ggplot 可视化可以帮助你解释模型。有关更多信息,请查看下面由 Matthew Mayo 撰写的精彩文章)

[机器学习模型解释:概述]

关于机器学习解释的文章出现在 O’Reilly 的博客上,时间在三月,由 Patrick Hall、Wen…www.kdnuggets.com](/2017/11/interpreting-machine-learning-models-overview.html)

在许多应用中,我们需要知道、理解或证明输入变量如何在模型中使用,以及它们如何影响最终的模型预测。DALEX 是一组工具,帮助解释复杂模型的工作原理。

从 CRAN 安装,只需运行:

install.packages("DALEX")

他们有关于如何与不同的 ML 包一起使用 DALEX 的精彩文档:

极好的备忘单:

这里有一个互动笔记本,你可以在其中了解更多关于这个包的信息:

[Binder(测试版)]

编辑描述mybinder.org](https://mybinder.org/v2/gh/pbiecek/DALEX_docs/master?filepath=jupyter-notebooks%2FDALEX.ipynb)

最后,一些书籍风格的 DALEX、机器学习和解释性文档:

[DALEX:描述性机器学习解释]

不要相信黑箱模型。除非它能自我解释。pbiecek.github.io](https://pbiecek.github.io/DALEX_docs/)

在原始仓库中查看:

[pbiecek/DALEX]

DALEX——描述性机器学习解释github.com](https://github.com/pbiecek/DALEX)

并记得给它加星星 😃

感谢Ciencia y Datos团队的出色帮助,提供了这些摘要。

也感谢你阅读这篇文章。我希望你在这里找到了一些有趣的内容 :)。如果这些文章对你有帮助,请与朋友分享!

如果你有问题,可以在 Twitter 上关注我:

法维奥·瓦斯克斯 (@FavioVaz) | Twitter

Favio Vázquez(@FavioVaz)的最新推文。数据科学家。物理学家和计算工程师。我有一个…… twitter.com

以及 LinkedIn:

法维奥·瓦斯克斯 — 创始人 — Ciencia y Datos | LinkedIn

查看法维奥·瓦斯克斯在 LinkedIn 上的资料,世界上最大的专业社区。法维奥在他们的…… www.linkedin.com

希望在那里见到你 😃

简历:法维奥·瓦斯克斯 是一名物理学家和计算机工程师,致力于数据科学和计算宇宙学。他对科学、哲学、编程和音乐充满热情。他是 Ciencia y Datos 的创始人,这是一个西班牙语的数据科学出版物。他热衷于迎接新挑战,与优秀的团队合作,并解决有趣的问题。他参与了 Apache Spark 的合作,帮助开发 MLlib、Core 和文档。他喜欢将自己的知识和专业技能应用于科学、数据分析、可视化和自动学习,以帮助世界变得更美好。

原文。经许可转载。

相关:

-

2018 年数据科学和 AI 的 7 个顶级 Python 库

-

2018 年数据科学的 20 个顶级 R 库

-

我们最喜欢的 5 个免费可视化工具

更多相关内容

向量数据库用于 LLMs、生成式 AI 和深度学习

原文:

www.kdnuggets.com/vector-database-for-llms-generative-ai-and-deep-learning

图片来源:编辑

理解向量数据库

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

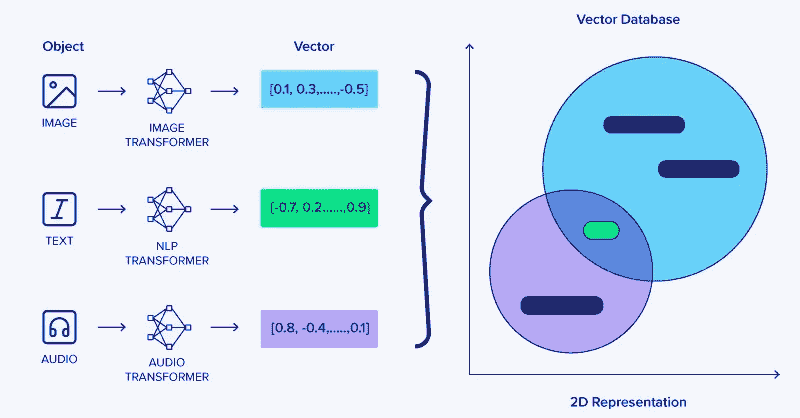

向量数据库是一种专门设计用于存储和管理向量数据的数据库,通过任意但相关的坐标来关联数据。与处理标量数据(如数字、字符串或日期)的传统数据库不同,向量数据库经过优化以处理高维数据点。但首先我们必须谈谈向量嵌入。

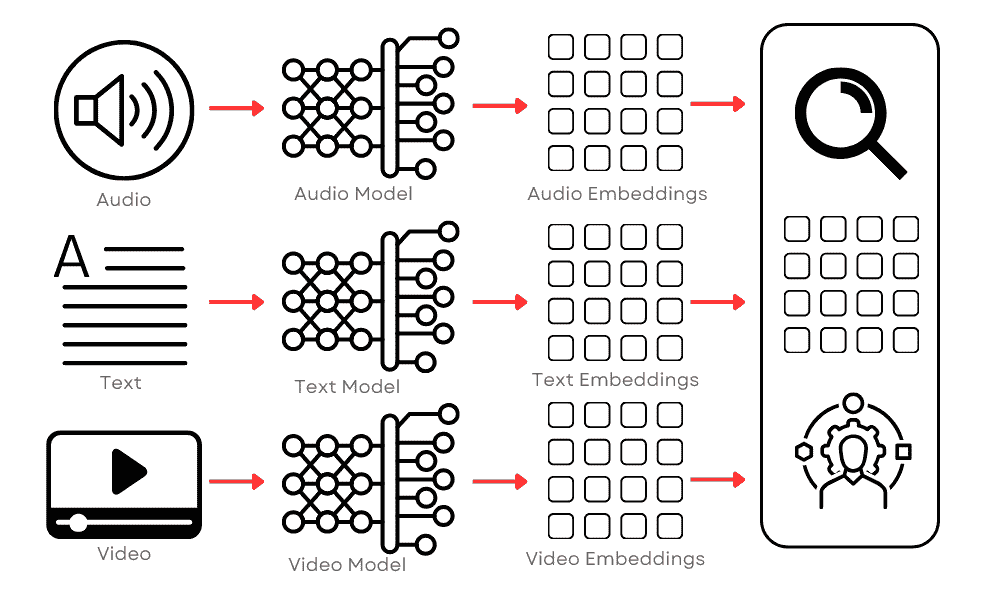

向量嵌入是一种在自然语言处理(NLP)中使用的方法,将单词表示为低维空间中的向量。这种技术简化了模型如 Word2Vec、GloVe 或 BERT 处理的复杂数据。这些现实世界的嵌入非常复杂,通常具有数百维,捕捉单词的细微属性。

那么我们如何在 AI 和深度学习等领域受益于向量呢?向量数据库通过提供高效和可扩展的解决方案来存储、搜索和检索高维数据,为机器学习和 AI 领域带来了显著的好处。

数据库使用数学运算,如距离度量,来高效地搜索、检索和操作向量。这种组织方式使得数据库能够通过比较向量中的数值,快速找到和分析相似或相关的数据点。因此,向量数据库非常适合用于类似性搜索等应用,目标是识别和检索与给定查询向量紧密相关的数据点。这在图像识别、自然语言处理和推荐系统等应用中尤为有用。

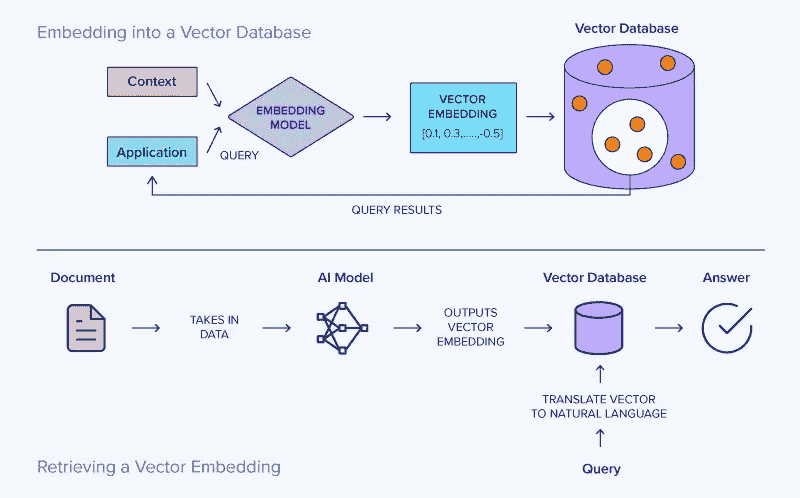

最初,这个过程涉及将一些文本存储在指定的向量数据库中。接收到的文本会使用选择的 AI 模型转换为向量形式。接下来,创建的向量将被存储在向量数据库中。

当发出搜索提示时,它也会被转换为向量以进行比较。系统然后识别出相似度最高的向量并返回它们。最后,这些向量会被翻译回自然语言并呈现给用户作为搜索结果。

向量数据库与大型语言模型(LLMs)

向量数据库与如 GPT-4 这样的大型语言模型(LLMs)的集成彻底改变了 AI 系统理解和生成自然语言的方式。LLMs 能够进行深度上下文分析的能力是这些模型在广泛数据集上进行训练的结果,使它们能够掌握语言的细微差别,包括习语表达、复杂的句子结构,甚至文化细微差别。

这些模型可以通过将词语、句子和更大的文本段落转换为高维向量嵌入来实现这一点,这些向量表示的不仅仅是文本,还封装了文本中的上下文和语义关系,从而使 LLMs 能够更好地理解更复杂的思想和情况。

向量数据库在管理这些复杂向量方面起着关键作用。它们存储和索引高维数据,使得大型语言模型(LLMs)能够高效地检索和处理信息。这一能力对于语义搜索应用尤为重要,在这些应用中,目标是理解和回应自然语言查询,提供基于属性相似度的结果,而不仅仅是关键词匹配。

大型语言模型(LLMs)使用这些向量来关联词语和思想,反映了人类对语言的理解。例如,LLMs 可以识别同义词、隐喻,甚至文化参考,这些语言关系被表示为数据库中的向量。这些向量在数据库中的相对位置可以指示它们所代表的思想或词语的接近程度,使模型能够进行智能关联和推断。这些数据库中存储的向量不仅表示字面文本,还表示相关的思想、概念和上下文关系。这种安排允许对语言进行更细致和复杂的理解。

此外,用户可以将冗长的文档分割成多个向量,并使用一种称为检索增强生成(Retrieval Augmented Generation, RAG)的技术自动将它们存储在向量数据库中。检索增强生成(RAG)是一种自然语言处理和人工智能领域的技术,通过引入外部知识检索步骤来增强文本生成过程。这种方法对于创建产生更具信息性、准确性和上下文相关性的响应的 AI 模型特别有用。

这种方法在解决传统 LLMs 的一个关键局限性方面至关重要——它们依赖于在初始训练阶段获得的固定数据集,这些数据集随着时间的推移可能会变得过时或缺乏具体细节。

向量数据库在生成型 AI 中的作用

继续讨论,生成型 AI 是 LLMs 和向量数据库的重要应用。生成型 AI 涵盖了如图像生成、音乐创作和文本生成等技术,这些技术的显著进步部分得益于向量数据库的有效使用。

向量数据库在提高生成型 AI 系统能力方面也起着关键作用,通过高效管理其所需和产生的复杂数据。专用的变换器对于将图像、音频和文本等各种对象转换为其对应的综合向量表示至关重要。

在类似 LLMs 的生成型 AI 应用中,高效分类和检索内容的能力至关重要。例如,在图像生成中,向量数据库可以存储图像的特征向量。这些向量表示图像的关键特征,如颜色、纹理或风格。当生成模型需要创建新图像时,它可以参考这些向量,以找到并使用类似的现有图像作为灵感或背景。这个过程有助于创建更准确和具有上下文相关性的生成内容。

向量数据库与 LLMs 的集成促进了更多创新的应用,例如跨模态 AI 任务。在这些任务中,将两个不同的向量实体匹配在一起进行 AI 任务。这包括将文本描述转换为图像或反之的任务,其中理解和转换不同类型的向量表示是关键。

向量数据库在处理生成型 AI 系统中的用户交互数据方面也发挥了重要作用。通过将用户的偏好、行为或响应编码为向量,这些数据库使生成模型能够根据每个用户量身定制其输出。

在音乐推荐系统中,例如,用户交互如播放的歌曲、跳过的曲目以及每首歌的播放时间被转换为向量。这些向量随后告知 AI 用户的音乐品味,使其能够推荐更可能引起用户共鸣的歌曲。随着用户偏好的变化,向量数据库不断更新向量表示,使 AI 能够保持与这些变化同步。这种动态适应是保持个性化 AI 应用相关性和有效性的关键。

结论

向量数据库代表了数据管理技术的一次重大飞跃,特别是在其对 AI 和机器学习的应用中。通过高效处理高维向量,这些数据库已成为先进 AI 系统操作和开发中的重要组成部分,包括 LLMs、生成型 AI 和深度学习。

它们存储、管理和快速检索复杂数据结构的能力不仅提升了这些系统的性能,还在 AI 应用中开辟了新可能。从 LLMs 中的语义搜索到深度学习中的特征提取,向量数据库是现代 AI 最激动人心的进展的核心。随着 AI 继续在复杂性和能力上增长,向量数据库的重要性只会增加,巩固了它们作为 AI 和机器学习未来关键组成部分的地位。

原文。已获得许可转载。

Kevin Vu 管理着 Exxact Corp 博客,并与许多才华横溢的作者合作,他们撰写关于深度学习不同方面的内容。

更多相关内容

什么是向量数据库,它们为什么对大语言模型重要?

原文:

www.kdnuggets.com/2023/06/vector-databases-important-llms.html

图片由编辑提供

当你在 Twitter、LinkedIn 或新闻源上浏览时间线时 - 你可能会看到关于聊天机器人、大语言模型和 GPT 的一些内容。很多人都在谈论大语言模型,因为每周都有新的模型发布。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在的组织的 IT

由于我们目前生活在 AI 革命中,重要的是要理解许多新应用依赖于向量嵌入。因此,让我们深入了解向量数据库以及它们为什么对大语言模型如此重要。

什么是向量数据库?

首先定义一下向量嵌入。向量嵌入是一种数据表示方式,它携带语义信息,帮助人工智能系统更好地理解数据,同时能够保持长期记忆。无论你在尝试学习什么新的内容,重要的元素就是理解主题并记住它。

嵌入是由 AI 模型生成的,例如包含大量特征的 LLM,这使得它们的表示难以管理。嵌入表示数据的不同维度,帮助 AI 模型理解不同的关系、模式和隐藏结构。

使用传统标量数据库进行向量嵌入是一项挑战,因为它无法处理或跟上数据的规模和复杂性。考虑到向量嵌入的复杂性,你可以想象它需要的专用数据库。这就是向量数据库发挥作用的地方。

向量数据库为向量嵌入的独特结构提供了优化的存储和查询能力。它们通过比较值和找到彼此之间的相似性,提供了便捷的搜索、高性能、可扩展性和数据检索。

听起来很不错,对吧?确实有解决向量嵌入复杂结构的方法。是的,但也不完全是。向量数据库的实施非常困难。

直到现在,向量数据库仅被那些不仅能够开发它们而且还能管理它们的科技巨头使用。向量数据库成本高,因此确保它们得到正确校准以提供高性能是非常重要的。

向量数据库是如何工作的?

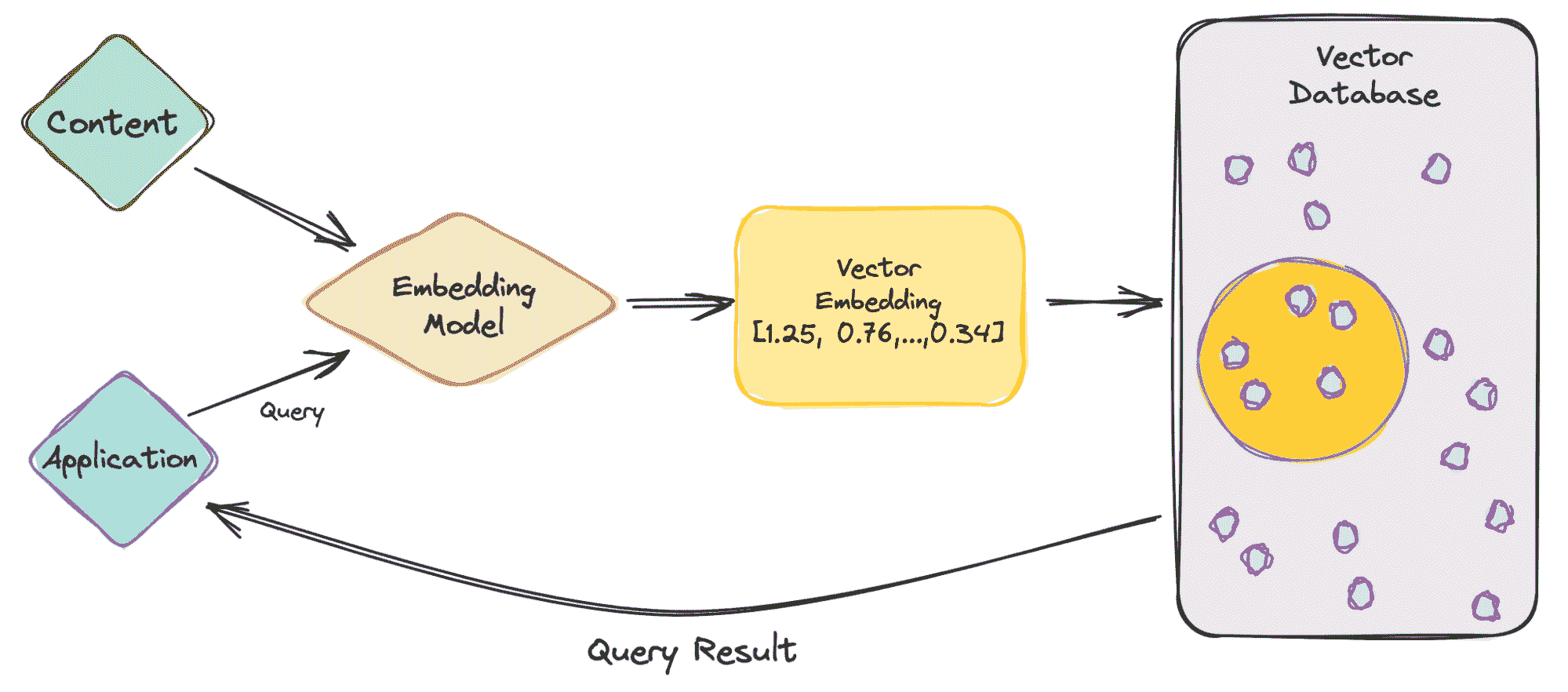

现在我们对向量嵌入和数据库有了一些了解,让我们深入了解它是如何工作的。

作者提供的图片

让我们从一个简单的例子开始,涉及像 ChatGPT 这样的 LLM。该模型具有大量的数据和内容,并为我们提供了 ChatGPT 应用程序。

那么,让我们逐步了解一下。

-

作为用户,你会将查询输入到应用程序中。

-

你的查询随后被插入到嵌入模型中,该模型根据我们想要索引的内容创建向量嵌入。

-

然后,向量嵌入会根据嵌入所基于的内容移动到向量数据库中。

-

向量数据库生成输出并将其作为查询结果发送回用户。

当用户继续进行查询时,它会经过相同的嵌入模型,以创建嵌入来查询该数据库以获取类似的向量嵌入。向量嵌入之间的相似性基于创建嵌入的原始内容。

想了解更多关于它在向量数据库中如何工作的内容吗?让我们进一步学习。

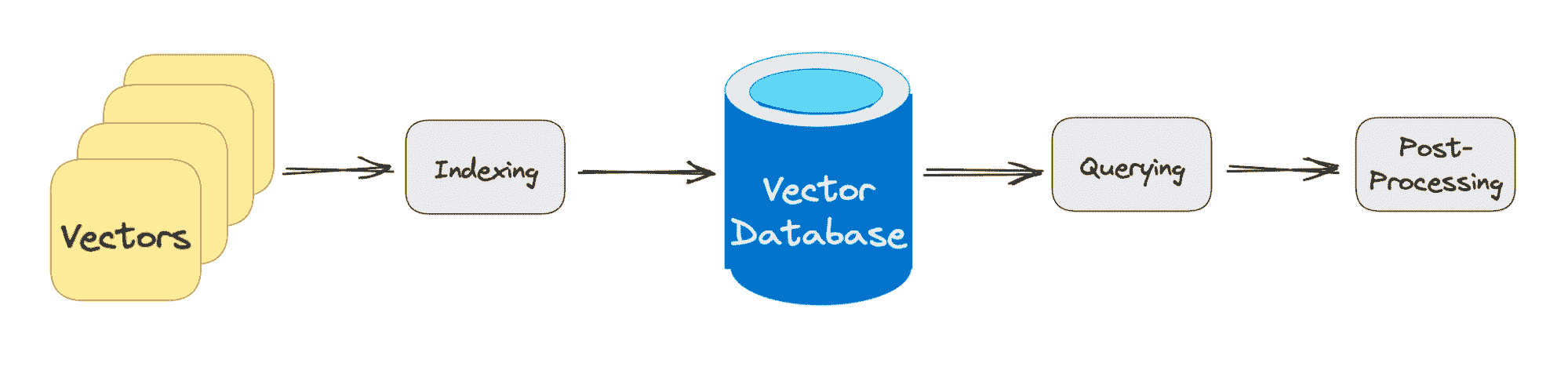

作者提供的图片

传统数据库通过在行和列中存储字符串、数字等进行工作。当从传统数据库中查询时,我们是查询与我们的查询匹配的行。然而,向量数据库处理的是向量而非字符串等。向量数据库还应用了相似性度量,用于帮助找到与查询最相似的向量。

向量数据库由不同的算法组成,这些算法都有助于近似最近邻(ANN)搜索。这通过哈希、基于图的搜索或量化实现,这些算法被组装成一个管道,以检索查询向量的邻居。

结果基于查询的接近程度或近似程度,因此主要考虑的元素是准确性和速度。如果查询输出较慢,则结果的准确性越高。

向量数据库查询经过的三个主要阶段是:

1. 索引

如上述示例所解释,一旦向量嵌入移动到向量数据库,它将使用各种算法将向量嵌入映射到数据结构中,以便更快地进行搜索。

2. 查询

在完成搜索后,向量数据库将查询的向量与索引中的向量进行比较,应用相似性度量以找到最近的邻居。

3. 后处理

根据你使用的向量数据库,该数据库将对最终的最近邻进行后处理,以生成对查询的最终输出。也可能会对最近邻进行重新排序,以便将来参考。

总结

随着人工智能的不断发展和每周发布的新系统,向量数据库的增长发挥了重要作用。向量数据库使公司能够通过准确的相似性搜索更有效地互动,为用户提供更好、更快的输出。

所以,下次你在 ChatGPT 或 Google Bard 中输入查询时,想想它处理查询以输出结果的过程。

尼莎·阿里亚 是一名数据科学家、自由技术作家及 KDnuggets 的社区经理。她特别感兴趣于提供数据科学职业建议或教程及数据科学的理论知识。她还希望探索人工智能如何有助于人类寿命的延续。作为一个热心学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关话题

向量数据库在 AI 和 LLM 使用案例中的应用

原文:

www.kdnuggets.com/vector-databases-in-ai-and-llm-use-cases

使用 Ideogram.ai 生成的图像

因此,你可能会听到各种向量数据库的术语。有些人可能理解这些术语,有些人则不然。如果你不太了解也没关系,因为向量数据库近年来才成为一个更加突出的话题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

向量数据库因生成式 AI,尤其是大型语言模型(LLM)的普及而变得越来越受欢迎。

许多大型语言模型产品,如 GPT-4 和 Gemini,通过为我们的输入提供文本生成能力来帮助我们的工作。实际上,向量数据库在这些大型语言模型产品中扮演了重要角色。

但是,向量数据库是如何工作的?它们在大型语言模型中的相关性是什么?

上述问题是我们将在本文中回答的。好吧,让我们一起来探索它们吧。

向量数据库

向量数据库是一种专门的数据库存储,用于存储、索引和查询向量数据。它通常针对高维向量数据进行了优化,因为这通常是机器学习模型,特别是大型语言模型的输出。

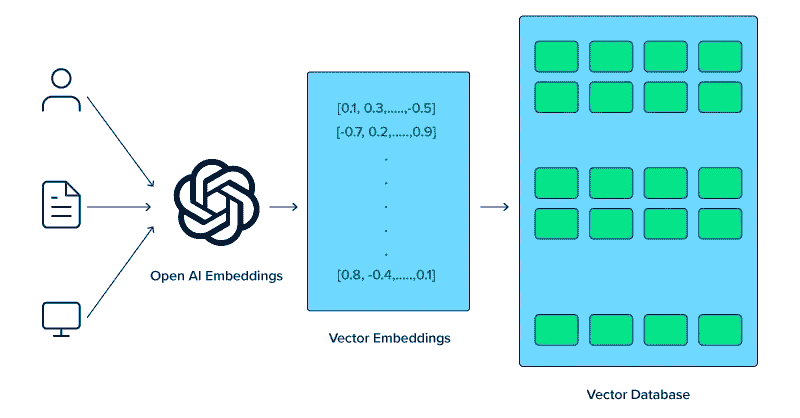

在向量数据库的背景下,向量是数据的数学表示。每个向量由表示数据位置的数值点数组成。向量通常用于大型语言模型中,因为向量比文本数据更容易处理。

在大型语言模型空间中,模型可能会有文本输入,并将其转换为表示文本语义和句法特征的高维向量。这一过程我们称之为嵌入。简单来说,嵌入是将文本转换为带有数值数据的向量的过程。

嵌入通常使用一种称为嵌入模型的神经网络模型来表示嵌入空间中的文本。

让我们使用一个示例文本:“我爱数据科学”。使用 OpenAI 的 text-embedding-3-small 模型表示它们会生成一个 1536 维的向量。

[0.024739108979701996, -0.04105354845523834, 0.006121257785707712, -0.02210472710430622, 0.029098540544509888,...]

向量中的数字是模型嵌入空间中的坐标。它们共同形成了来自模型的句子意义的独特表示。

向量数据库将负责存储这些嵌入模型输出。用户可以根据需要查询、索引和检索向量。

也许介绍足够了,让我们进入更技术的实际操作。我们将尝试使用一个开源向量数据库 Weaviate 来建立和存储向量。

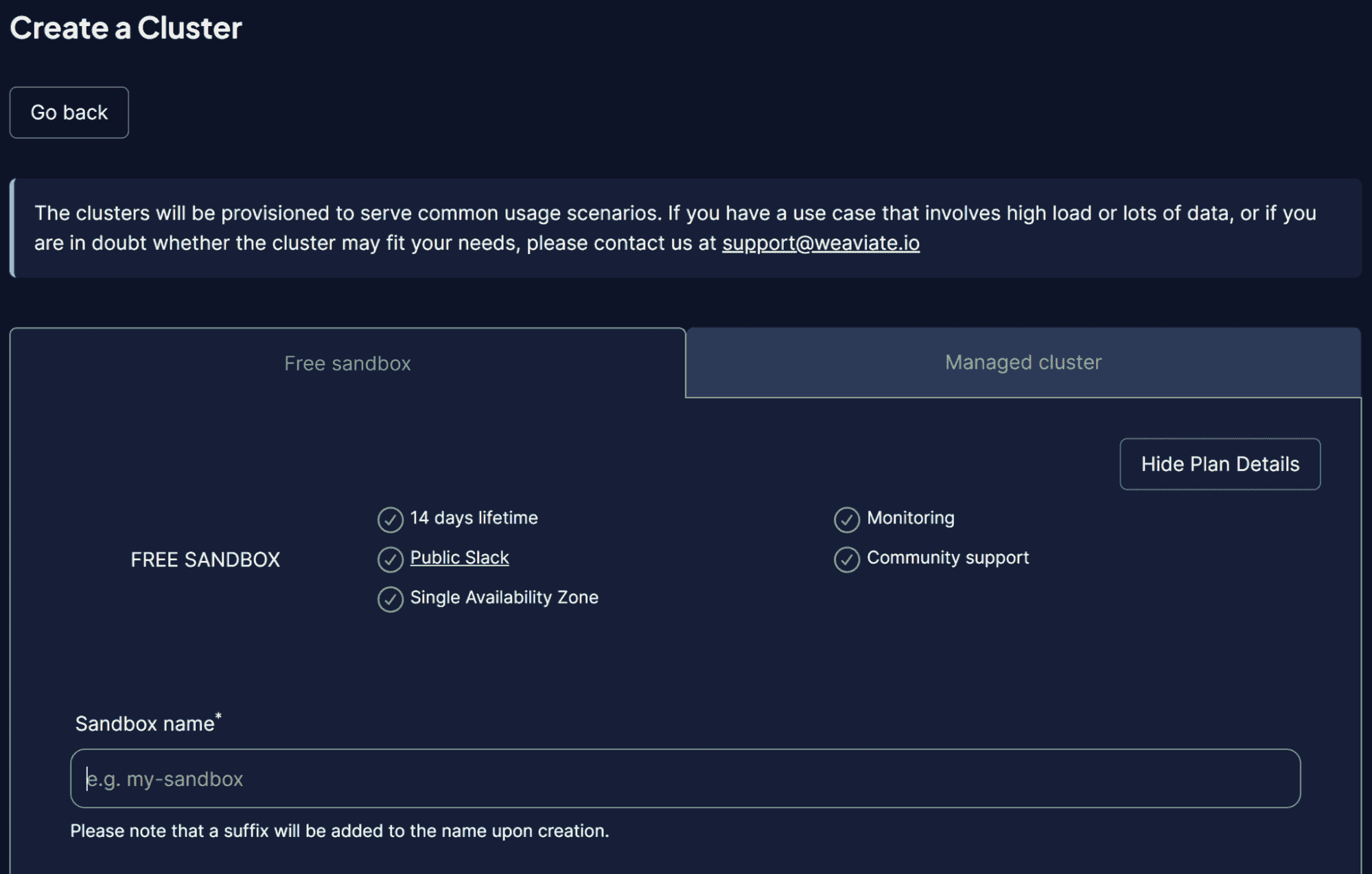

Weaviate 是一个可扩展的开源向量数据库,作为一个框架用于存储我们的向量。我们可以在 Docker 等实例中运行 Weaviate 或使用 Weaviate Cloud Services (WCS)。

要开始使用 Weaviate,我们需要使用以下代码安装相关包:

pip install weaviate-client

为了简化操作,我们将使用 WCS 的沙箱集群作为我们的向量数据库。Weaviate 提供了一个 14 天的免费集群,我们可以使用它来存储向量,而无需注册任何支付方式。为此,您需要首先在他们的 WCS 控制台 上注册。

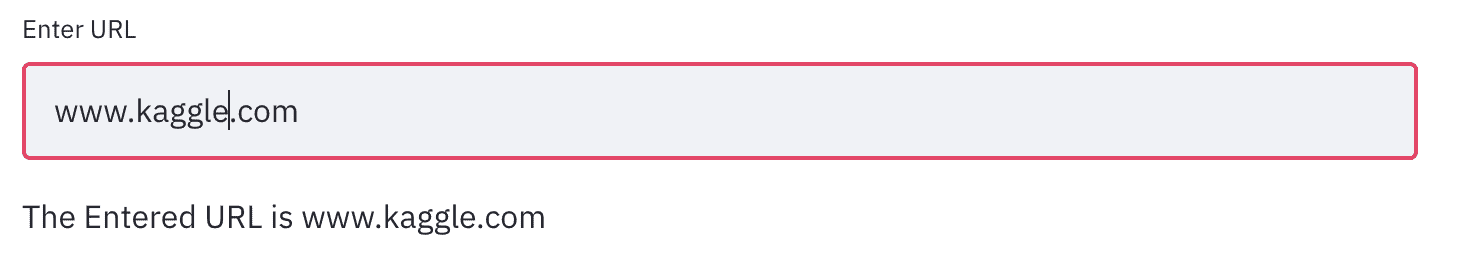

进入 WCS 平台后,选择创建集群并输入您的 Sandbox 名称。用户界面应如下图所示。

图片来源:作者

别忘了启用身份验证,因为我们还希望通过 WCS API 密钥访问该集群。集群准备好后,找到 API 密钥和集群 URL,我们将用来访问向量数据库。

一旦准备好,我们将模拟将第一个向量存储在向量数据库中。

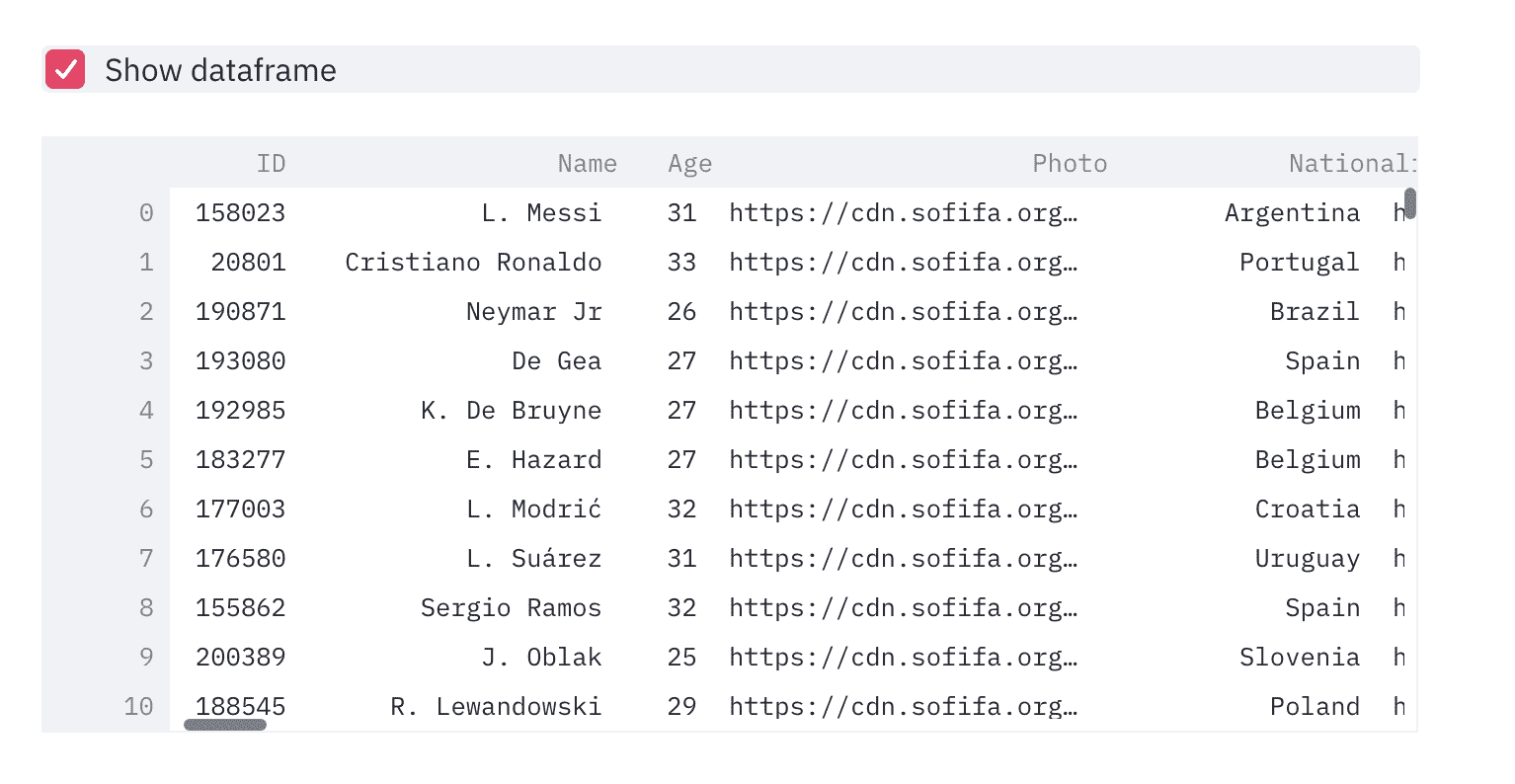

对于向量数据库存储示例,我将使用 Kaggle 上的 Book Collection 示例数据集。我只会使用前 100 行和 3 列(标题、描述、简介)。

import pandas as pd

data = pd.read_csv('commonlit_texts.csv', nrows = 100, usecols=['title', 'description', 'intro'])

让我们先把数据放在一边,连接到我们的向量数据库。首先,我们需要使用 API 密钥和集群 URL 设置远程连接。

import weaviate

import os

import requests

import json

cluster_url = "Your Cluster URL"

wcs_api_key = "Your WCS API Key"

Openai_api_key ="Your OpenAI API Key"

client = weaviate.connect_to_wcs(

cluster_url=cluster_url,

auth_credentials=weaviate.auth.AuthApiKey(wcs_api_key),

headers={

"X-OpenAI-Api-Key": openai_api_key

}

)

一旦设置好客户端变量,我们将连接到 Weaviate Cloud 服务并创建一个类来存储向量。Weaviate 中的类是数据集合,类似于关系数据库中的表名。

import weaviate.classes as wvc

client.connect()

book_collection = client.collections.create(

name="BookCollection",

vectorizer_config=wvc.config.Configure.Vectorizer.text2vec_openai(),

generative_config=wvc.config.Configure.Generative.openai()

)

在上面的代码中,我们连接到 Weaviate 集群并创建了一个 BookCollection 类。该类对象还使用了 OpenAI text2vec 嵌入模型对文本数据进行向量化,并使用 OpenAI 生成模块。

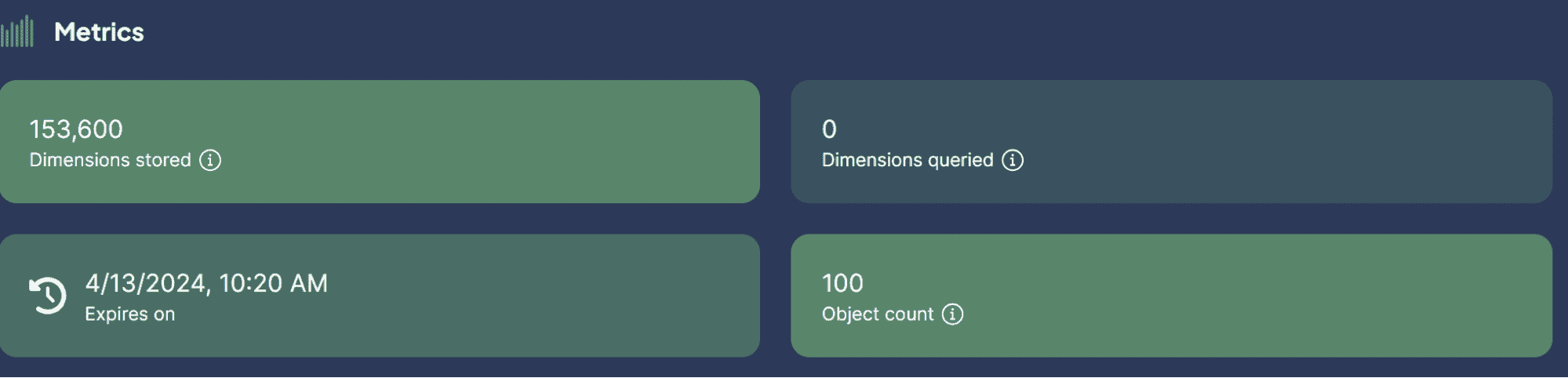

让我们尝试将文本数据存储到向量数据库中。为此,您可以使用以下代码。

sent_to_vdb = data.to_dict(orient='records')

book_collection.data.insert_many(sent_to_vdb)

图片来源:作者

我们已经成功地将数据集存储在向量数据库中!这有多简单?

现在,您可能对向量数据库与 LLM 的使用场景感到好奇。这就是我们接下来要讨论的内容。

向量数据库和 LLM 用例

一些 LLM 可以与向量数据库结合使用的用例。让我们一起探索这些用例。

语义搜索

语义搜索是通过使用查询的含义来搜索数据,以检索相关结果,而不是仅依赖传统的基于关键字的搜索。

这个过程涉及利用查询的 LLM 模型嵌入,并在我们的矢量数据库中进行嵌入相似性搜索。

让我们尝试使用 Weaviate 根据特定查询执行语义搜索。

book_collection = client.collections.get("BookCollection")

client.connect()

response = book_collection.query.near_text(

query="childhood story,

limit=2

)

在上述代码中,我们尝试使用 Weaviate 进行语义搜索,以查找与查询童年故事密切相关的前两本书。语义搜索使用我们之前设置的 OpenAI 嵌入模型。结果可以在下面看到。

{'title': 'Act Your Age', 'description': 'A young girl is told over and over again to act her age.', 'intro': 'Colleen Archer has written for \nHighlights\n. In this short story, a young girl is told over and over again to act her age.\nAs you read, take notes on what Frances is doing when she is told to act her age. '}

{'title': 'The Anklet', 'description': 'A young woman must deal with unkind and spiteful treatment from her two older sisters.', 'intro': "Neil Philip is a writer and poet who has retold the best-known stories from \nThe Arabian Nights\n for a modern day audience. \nThe Arabian Nights\n is the English-language nickname frequently given to \nOne Thousand and One Arabian Nights\n, a collection of folk tales written and collected in the Middle East during the Islamic Golden Age of the 8th to 13th centuries. In this tale, a poor young woman must deal with mistreatment by members of her own family.\nAs you read, take notes on the youngest sister's actions and feelings."}

如你所见,上述结果中没有直接提及童年故事。然而,结果仍然与一个旨在儿童的故事密切相关。

生成搜索

生成搜索可以定义为语义搜索的扩展应用。生成搜索,或称为检索增强生成(RAG),利用 LLM 提示与从矢量数据库中检索的数据进行语义搜索。

使用 RAG,查询搜索的结果被处理到 LLM 中,因此我们可以以我们想要的形式获得结果,而不是原始数据。让我们尝试使用矢量数据库进行 RAG 的简单实现。

response = book_collection.generate.near_text(

query="childhood story",

limit=2,

grouped_task="Write a short LinkedIn post about these books."

)

print(response.generated)

结果可以在下面的文本中看到。

Excited to share two captivating short stories that explore themes of age and mistreatment. "Act Your Age" by Colleen Archer follows a young girl who is constantly told to act her age, while "The Anklet" by Neil Philip delves into the unkind treatment faced by a young woman from her older sisters. These thought-provoking tales will leave you reflecting on societal expectations and family dynamics. #ShortStories #Literature #BookRecommendations 📚

如你所见,数据内容与之前相同,但现在已经用 OpenAI LLM 处理,以提供一个简短的 LinkedIn 帖子。这样,当我们希望从数据中获得特定形式的输出时,RAG 非常有用。

RAG 问答

在我们之前的示例中,我们使用查询获取了所需的数据,RAG 将这些数据处理成预期的输出。

然而,我们可以将 RAG 功能转变为一个问答工具。我们可以通过将它们与 LangChain 框架结合来实现这一点。

首先,让我们安装必要的包。

pip install langchain

pip install langchain_community

pip install langchain_openai

然后,让我们尝试导入所需的包并初始化变量,以使 RAG 问答工作。

from langchain.chains import RetrievalQA

from langchain_community.vectorstores import Weaviate

import weaviate

from langchain_openai import OpenAIEmbeddings

from langchain_openai.llms.base import OpenAI

llm = OpenAI(openai_api_key = openai_api_key, model_name = 'gpt-3.5-turbo-instruct', temperature = 1)

embeddings = OpenAIEmbeddings(openai_api_key = openai_api_key )

client = weaviate.Client(

url=cluster_url, auth_client_secret=weaviate.AuthApiKey(wcs_api_key)

)

在上述代码中,我们设置了 LLM 用于文本生成、嵌入模型和 Weaviate 客户端连接。

接下来,我们将 Weaviate 连接设置为矢量数据库。

weaviate_vectorstore = Weaviate(client=client, index_name='BookCollection', text_key='intro',by_text = False, embedding=embeddings)

retriever = weaviate_vectorstore.as_retriever()

在上述代码中,将 Weaviate 数据库 BookCollection 设置为 RAG 工具,以便在提示时搜索‘intro’特性。

然后,我们将使用下面的代码从 LangChain 创建问答链。

qa_chain = RetrievalQA.from_chain_type(

llm=llm, chain_type="stuff", retriever = retriever

)

一切现在都准备好了。让我们尝试使用下面的代码示例进行 RAG 问答。

response = qa_chain.invoke(

"Who is the writer who write about love between two goldfish?")

print(response)

结果显示在下面的文本中。

{'query': 'Who is the writer who write about love between two goldfish?', 'result': ' The writer is Grace Chua.'}

使用矢量数据库作为存储所有文本数据的地方,我们可以实现 RAG 与 LangChain 一起执行问答。这有多棒?

结论

向量数据库是一种专门的存储解决方案,旨在存储、索引和查询向量数据。它通常用于存储文本数据,并与大型语言模型(LLMs)结合实施。本文将尝试进行向量数据库 Weaviate 的动手设置,包括语义搜索、检索增强生成(RAG)和基于 RAG 的问答等示例用例。

Cornellius Yudha Wijaya 是一名数据科学助理经理和数据撰写员。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。Cornellius 涉猎多种人工智能和机器学习主题。

更多相关主题

使用 NumPy Linalg 范数的向量和矩阵范数

原文:

www.kdnuggets.com/2023/05/vector-matrix-norms-numpy-linalg-norm.html

作者提供的图片

Numerical Python 或 NumPy 是一个流行的 Python 科学计算库。NumPy 库有大量内置功能,用于创建 n 维数组并对其进行计算。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

如果你对数据科学、计算线性代数和相关领域感兴趣,学习如何计算向量和矩阵的范数会很有帮助。本教程将教你如何使用 NumPy 的linalg模块中的函数来做到这一点。

要进行代码编写,你需要在开发环境中安装 Python 和 NumPy。为了使 print() 语句中的 f-strings 正常工作,你需要安装 Python 3.8 或更高版本。

让我们开始吧!

什么是范数?

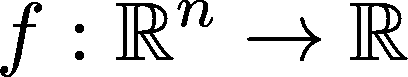

在本讨论中,我们将首先查看向量范数。稍后我们会讨论矩阵范数。从数学上讲,范数是一个从 n 维向量空间到实数集合的函数(或映射):

注意:范数也可以定义在复数向量空间上,C^n → R 也是一种有效的范数定义。但在本讨论中,我们将限制在实数向量空间。

范数的性质

对于 n 维向量x = (x1,x2,x3,...,xn),x 的范数通常表示为 ||x||,应满足以下性质:

-

||x|| 是非负量。对于向量x,范数 ||x|| 总是大于或等于零。当且仅当向量x是全零向量时,||x|| 才等于零。

-

对于两个向量x = (x1,x2,x3,...,xn) 和 y = (y1,y2,y3,...,yn),它们的范数 ||x|| 和 ||y|| 应满足三角不等式:||x + y|| <= ||x|| + ||y||。

-

此外,所有范数都满足 ||αx|| = |α| ||x||,其中 α 为标量。

常见的向量范数:L1、L2 和 L∞ 范数

一般来说,n 维向量x = (x1,x2,x3,...,xn)的 Lp 范数(或 p-范数)对于 p >= 0 定义为:

让我们来看看常见的向量范数,即 L1、L2 和 L∞ 范数。

L1 范数

L1 范数等于向量中所有元素绝对值的总和:

L2 范数

将 p =2 代入一般的 Lp 范数方程,我们得到向量的 L2 范数的以下表达式:

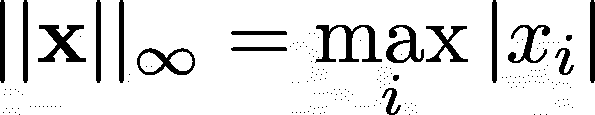

L∞ 范数

对于给定的向量 x,L∞ 范数是 x 元素 绝对 值中的 最大值:

验证这些范数是否满足前面列出的范数属性是相当简单的。

如何在 NumPy 中计算向量范数

NumPy 中的 linalg 模块包含我们可以用来计算范数的函数。

在开始之前,让我们初始化一个向量:

import numpy as np

vector = np.arange(1,7)

print(vector)

Output >> [1 2 3 4 5 6]

NumPy 中的 L2 范数

让我们从 NumPy 中导入 linalg 模块:

from numpy import linalg

norm() 函数用于计算矩阵和向量的范数。此函数需要一个必需的参数——我们需要计算范数的向量或矩阵。此外,它还接受以下 可选 参数:

-

ord决定了计算的范数的阶数,以及 -

axis指定了计算范数的轴。

当我们在函数调用中没有指定 ord 时,norm() 函数默认计算 L2 范数:

l2_norm = linalg.norm(vector)

print(f"{l2_norm = :.2f}")

Output >> l2_norm = 9.54

我们可以通过明确将 ord 设置为 2 来验证这一点:

l2_norm = linalg.norm(vector, ord=2)

print(f"{l2_norm = :.2f}")

Output >> l2_norm = 9.54

NumPy 中的 L1 范数

要计算向量的 L1 范数,请调用 norm() 函数,设置 ord = 1:

l1_norm = linalg.norm(vector, ord=1)

print(f"{l1_norm = :.2f}")

Output >> l1_norm = 21.00

由于我们的示例 vector 仅包含正数,我们可以验证在这种情况下 L1 范数等于元素的总和:

assert sum(vector) == l1_norm

NumPy 中的 L∞ 范数

要计算 L∞ 范数,将 ord 设置为 'np.inf':

inf_norm = linalg.norm(vector, ord=np.inf)

print(f"{inf_norm = }")

在这个例子中,我们得到 6,向量中的 最大 元素(绝对值意义上):

Output >> inf_norm = 6.0

在 norm() 函数中,你还可以将 ord 设置为 '-np.inf'。

neg_inf_norm = linalg.norm(vector, ord=-np.inf)

print(f"{neg_inf_norm = }")

如你所猜,负的 L∞ 范数返回向量中的 最小 元素(绝对值意义上):

Output >> neg_inf_norm = 1.0

关于 L0 范数的说明

L0 范数给出向量中非零元素的数量。从技术上讲,这不是一个范数。它实际上是一个伪范数,因为它违反了 ||αx|| = |α| ||x|| 的属性。这是因为,即使向量被一个标量乘以,非零元素的数量 保持不变。

要获取向量中非零元素的数量,将 ord 设置为 0:

another_vector = np.array([1,2,0,5,0])

l0_norm = linalg.norm(another_vector,ord=0)

print(f"{l0_norm = }")

在这里,another_vector 有 3 个非零元素:

Output >> l0_norm = 3.0

理解矩阵范数

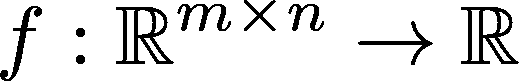

到目前为止,我们已经看到如何计算向量范数。就像你可以将向量范数视为从 n 维向量空间到实数集合的映射一样,矩阵范数是从 m x n 矩阵空间到实数集合的映射。数学上,你可以表示为:

常见的矩阵范数包括 Frobenius 范数和核范数。

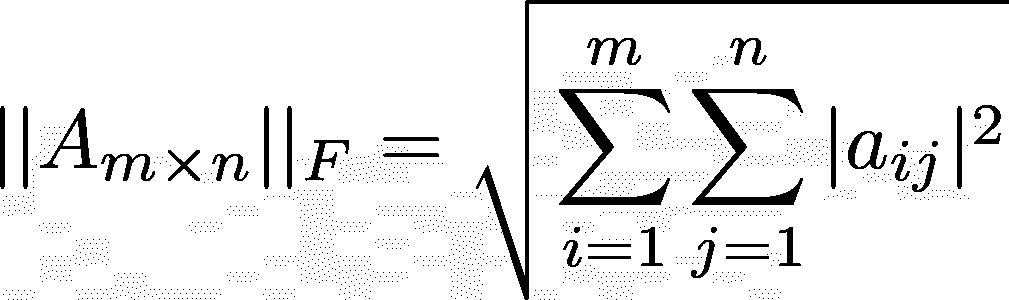

Frobenius 范数

对于一个 m x n 的矩阵 A,其中 m 行 n 列,Frobenius 范数由下式给出:

核范数

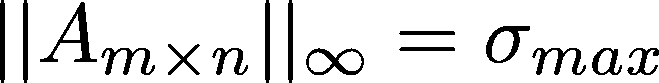

奇异值分解(SVD)是一种矩阵分解技术,用于主题建模、图像压缩和协同过滤等应用。

SVD 将输入矩阵分解为一个左奇异向量矩阵(U)、一个奇异值矩阵(S)和一个右奇异向量矩阵(V_T)。而核范数是矩阵的最大奇异值。

如何在 NumPy 中计算矩阵范数

继续讨论如何在 NumPy 中计算矩阵范数,让我们将 vector 重塑为一个 2 x 3 的矩阵:

matrix = vector.reshape(2,3)

print(matrix)

Output >>

[[1 2 3]

[4 5 6]]

NumPy 中的矩阵 Frobenius 范数

如果你不指定 ord 参数,norm() 函数默认计算 Frobenius 范数。

让我们通过将 ord 设置为 'fro' 来验证这一点:

frob_norm = linalg.norm(matrix,ord='fro')

print(f"{frob_norm = :.2f}")

Output >> frob_norm = 9.54

当我们不传入可选的 ord 参数时,我们也得到 Frobenius 范数:

frob_norm = linalg.norm(matrix)

print(f"{frob_norm = :.2f}")

Output >> frob_norm = 9.54

总结来说,当 norm() 函数以矩阵作为输入时,默认返回矩阵的 Frobenius 范数。

NumPy 中的矩阵核范数

要计算矩阵的核范数,你可以传入矩阵并在 norm() 函数调用中将 ord 设置为 'nuc':

nuc_norm = linalg.norm(matrix,ord='nuc')

print(f"{nuc_norm = :.2f}")

Output >> nuc_norm = 10.28

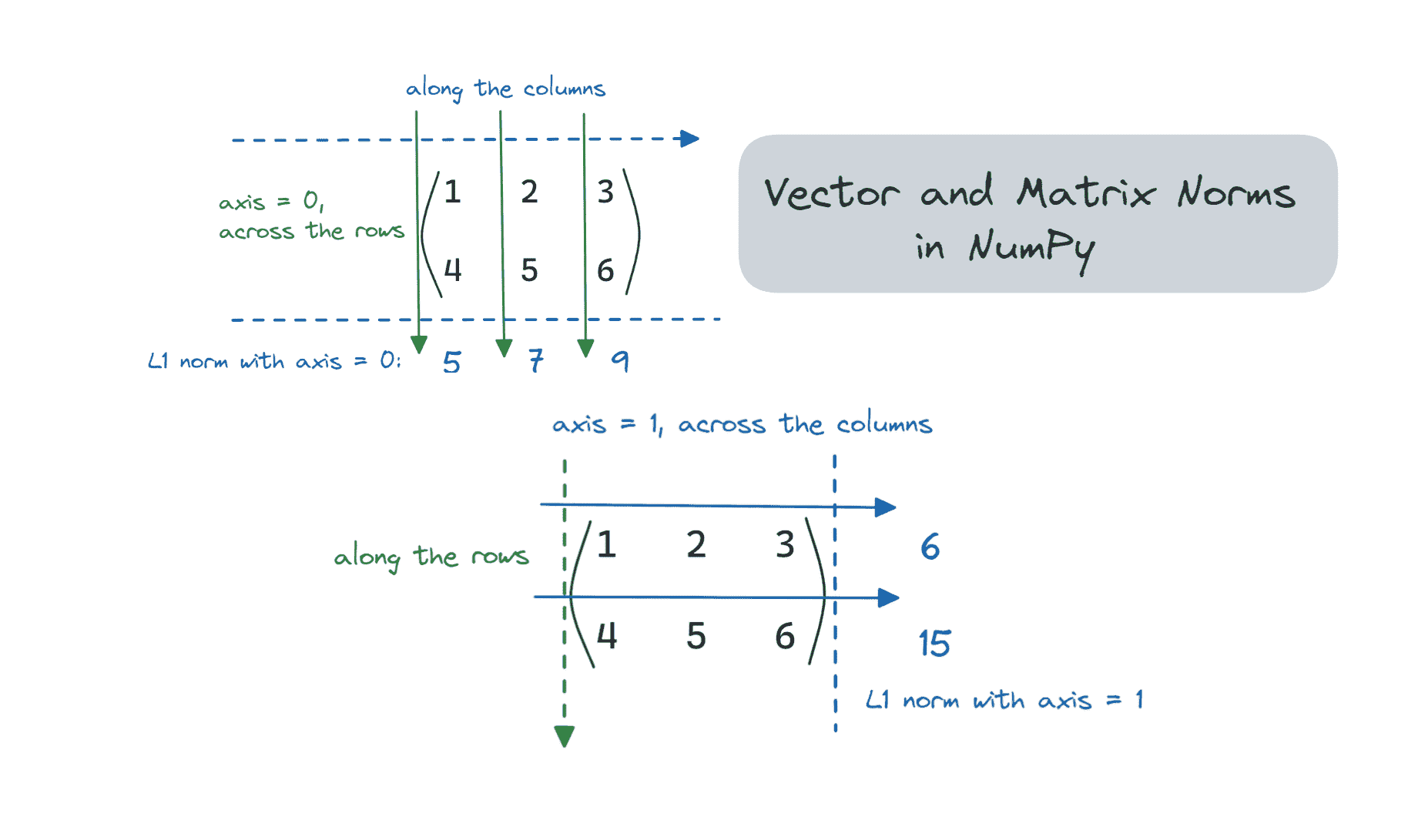

沿特定轴的矩阵范数

我们通常不会在矩阵上计算 L1 和 L2 范数,但 NumPy 允许你计算任意 ord 的矩阵(2D 数组)和其他多维数组的范数。

让我们看看如何在特定轴上计算矩阵的 L1 范数——沿行和列。

类似地,我们可以设置 axis = 1。

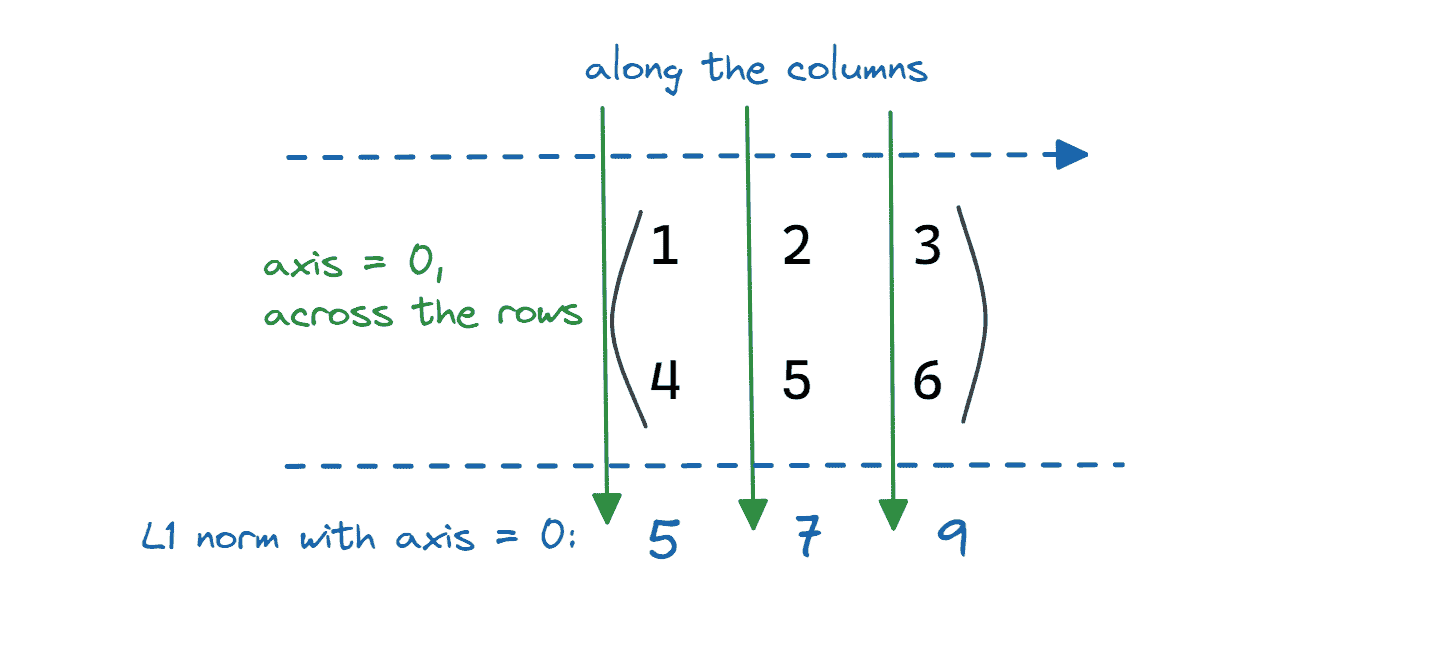

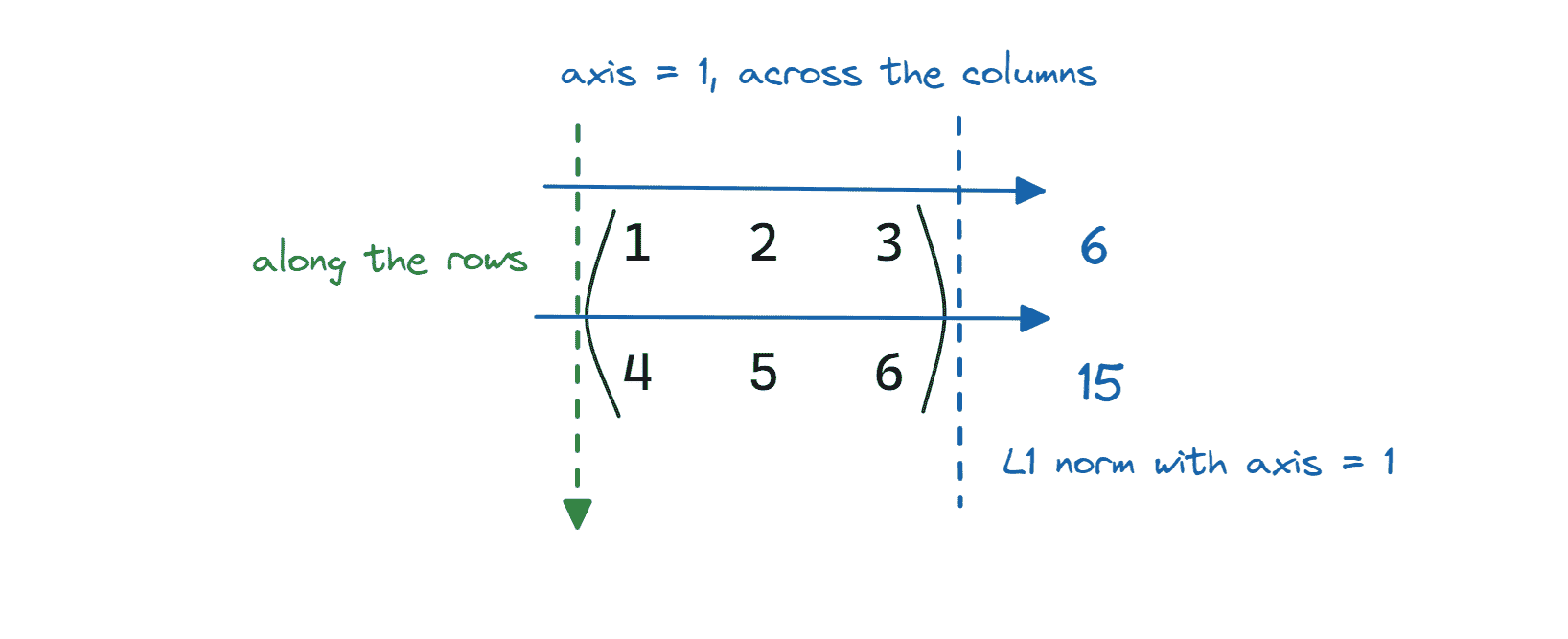

axis = 0 表示矩阵的行。如果设置 axis = 0,则计算矩阵的 L1 范数是 跨行(或沿列)进行的,如下所示:

图片由作者提供

让我们在 NumPy 中验证这一点:

matrix_1_norm = linalg.norm(matrix,ord=1,axis=0)

print(f"{matrix_1_norm = }")

Output >> matrix_1_norm = array([5., 7., 9.])

类似地,我们可以设置 axis = 1。

axis = 1 表示矩阵的列。因此,通过设置 axis = 1 计算矩阵的 L1 范数是 跨列(沿行)进行的。

图片由作者提供

matrix_1_norm = linalg.norm(matrix,ord=1,axis=1)

print(f"{matrix_1_norm = }")

Output >> matrix_1_norm = array([ 6., 15.])

我建议你试验 ord 和 axis 参数,并尝试不同的矩阵,直到你掌握它。

结论

我希望你现在明白了如何使用 NumPy 计算向量和矩阵范数。然而,需要注意的是,Frobenius 范数和核范数仅对矩阵定义。因此,如果你计算向量或维度超过两个的多维数组,你会遇到错误。这就是本教程的全部内容!

Bala Priya C 是一位技术作家,喜欢创作长篇内容。她的兴趣领域包括数学、编程和数据科学。她通过编写教程、使用指南等方式与开发者社区分享她的学习成果。

更多相关主题

矢量化的随机数生成器真的有用吗?

原文:

www.kdnuggets.com/2018/08/vectorized-random-number-generators-actually-useful.html

评论

评论

作者:丹尼尔·勒梅尔,魁北克大学

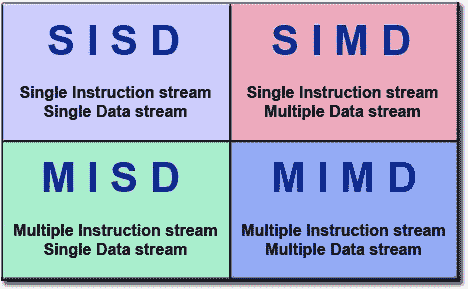

我们的处理器受益于“SIMD”指令。这些指令可以同时操作多个值,从而大大加速某些算法。早些时候,我报告过,你可以通过使用 SIMD 指令将常见(快速)随机数生成器如 PCG 和 xorshift128+ 的速度提高三到四倍。

一位读者挑战我:这在实际中真的有用吗?

在一些问题中,随机数生成对性能至关重要。例如,许多模拟场景就属于这种情况。最简单且最为人知的可能就是数组的随机打乱。标准算法相当简单:

for (i = size; i > 1; i--) {

var j = random_number(i);

switch_values(array, i, j);

}

如果你感兴趣,O’Neill 写了一整篇关于这个特定问题的博客文章。

那么我能否使用 SIMD 指令加速数组的打乱?

因此,我快速组合了一个矢量化打乱算法和一个常规(标量)打乱算法,它们都使用了 O’Neill 的 PCG32。最终结果?当数组在缓存中时,我使用 SIMD 指令几乎将速度翻倍:

| SIMD 打乱 | 每个条目 3.5 个周期 |

|---|---|

| 标量打乱 | 每个条目 6.6 个周期 |

我的代码可以在这里找到。我并没有做任何复杂的操作,所以我预计可以做得更好。我的唯一目标是演示 SIMD 随机数生成器的实际应用性。

个人简介: 丹尼尔·勒梅尔 是魁北克大学的计算机科学教授。他的研究集中在软件性能和索引方面。他是一个技术乐观主义者。

原文。经许可转载。

相关:

-

随机性的惊人复杂性

-

2026 年人工智能中的常识…

-

深度学习是万能钥匙吗?

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持组织的信息技术需求

3. Google IT 支持专业证书 - 支持组织的信息技术需求

了解更多相关主题

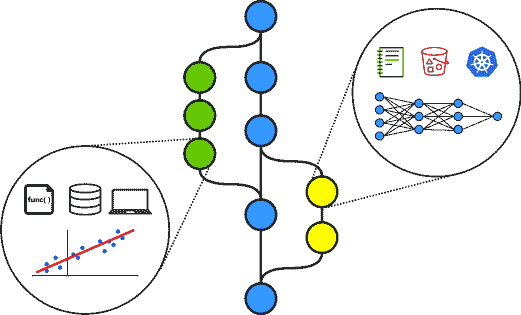

数据科学的版本控制:跟踪机器学习模型和数据集

评论

由 Vipul Jain,应用数据科学家

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT 需求

3. Google IT 支持专业证书 - 支持你所在组织的 IT 需求

毋庸置疑,GIT 是版本控制系统的圣杯!Git 在版本控制源代码方面表现出色。但与软件工程不同,数据科学项目还有额外的大型文件,如数据集、训练模型文件、标签编码等,这些文件的大小很容易达到几 GB,因此无法使用 GIT 进行跟踪。

告诉我解决方案?

令人惊叹的一群人来自 dvc.org/ 创建了这个名为 DVC 的工具。DVC 帮助我们对大型数据文件进行版本控制,类似于我们使用 git 对源代码文件进行版本控制。同时,DVC 可以在 GIT 之上完美运行,使其更加出色!

大多数时候,数据科学工作流中忽略了数据集和模型的跟踪。现在有了 DVC,我们可以跟踪所有的工件——这将使数据科学家更高效,因为我们不必手动记录为了达到状态而做了什么,同时也不必在处理数据和构建模型以重现相同状态时浪费时间。

DVC 的好处

-

轻松处理大型文件——使得重用和可重复性变得非常简单

-

与 Git 兼容——在 git 之上工作

-

存储无关——支持 GCS/S3/Azure 以及更多存储数据

让我们开始吧!

安装

安装非常简单,使用以下命令:

pip install dvc

要验证安装,请在终端中输入 dvc,如果你看到一堆 DVC 命令选项,那么你就走在正确的道路上了。

在演示中,我将使用 dvc-sample 仓库,项目结构如下:

dvc-sample

├── artifacts

│ ├── dataset.csv

│ └── model.model

└── src

├── preprocessor.py

└── trainer.py

该仓库具有简单的结构;有一个 src 文件夹,其中包含 Python 脚本(由 git 版本控制),以及一个 artifacts 文件夹,其中包含所有数据集、模型文件和其他较大的 artifacts(需要由 dvc 进行控制)。

初始化 dvc

我们首先需要在项目根目录中初始化 dvc。我们使用下面的命令完成:

dvc init

(这与 git init 非常相似,我们只需在设置项目时做一次)

此时,我们已经将 dvc 支持添加到项目中。但我们仍然需要指定我们想用 dvc 进行版本控制的文件夹。在这个例子中,我们将对 artifacts 文件夹进行版本控制。我们使用下面的命令来完成:

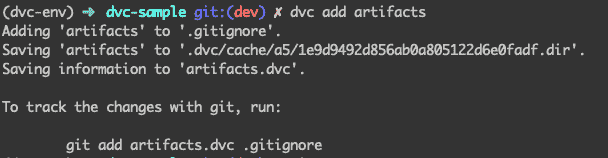

dvc add artifacts

上述声明做了两件事 -:

-

使用

dvc指定我们要跟踪的文件夹(创建一个元文件

artifacts.dvc) -

将相同的文件夹添加到

.gitignore(因为我们不再希望使用 git 跟踪该文件夹)

执行上述命令后,dvc 会告诉我们将上述两个文件添加到 git

现在我们使用下面的命令将这些文件添加到 git 中:

git add .

git commit -m 'Added dvc files'

注意:这里需要注意的是:artifacts 文件夹的元文件由 git 跟踪,而实际的 artifacts 文件由 dvc 跟踪。在这种情况下,artifacts.dvc 由 git 跟踪,而 artifacts 文件夹中的内容由 dvc 跟踪。

如果现在这不太清楚也没关系,我们稍后会详细查看。

此时,我们已经将

*dvc*添加到我们的项目中,并且还添加了我们想要用 dvc 跟踪的文件夹。

现在让我们看一下典型的机器学习工作流(简化版):

-

我们有一个数据集

-

我们使用 Python 脚本对上述数据集进行一些预处理

-

我们使用 Python 脚本训练一个模型

-

我们有一个模型文件,这是步骤 #3 的输出

上述是一个重复的过程;由于我们使用多个数据集和不同的预处理管道来构建和测试各种机器学习模型,因此我们希望对其进行版本控制,以便在需要时轻松重现之前的版本。

对于上述场景,我们使用 git 跟踪 #2 和 #3,因为这些是较小的代码文件。而使用 dvc 跟踪 #1 和 #4,因为这些文件可能非常大(最多几 GB)

再次查看目录结构以获得更多清晰度:

dvc-sample

├── artifacts

│ ├── dataset.csv #1

│ └── model.model #4

└── src

├── preprocessor.py #2

└── trainer.py #3

为了简化起见,在任何给定时刻——上述 4 个文件中的每一个都将是它们所属的版本。

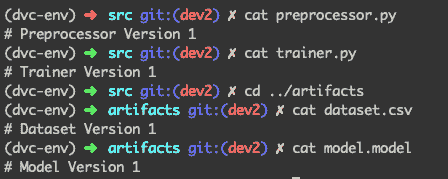

假设我们已经编写了第一个版本的预处理器和训练脚本,这些脚本用于在数据集上构建模型。现在这 4 个文件看起来是这样的:

版本 1 中文件的状态

跟踪大文件

现在我们需要提交我们的代码和 artifacts(数据集和模型文件),我们分三步完成:

1. 我们使用 dvc 跟踪 artifacts 中的更改

dvc add artifacts/

(这会跟踪工件文件夹内的最新版本文件,并修改artifacts.dvc元文件)

2. 使用git跟踪代码脚本的更改和更新的元文件(artifacts.dvc)

git add .

git commit -m 'Version 1: scripts and dvc files'

3. 使用git将这个项目状态标记为experiment01

(这将帮助我们以后回滚到某个版本)

git tag -a experiment01 -m 'experiment01'

我们已经成功使用git和dvc分别保存了版本 1 的脚本和工件。

现在假设我们正在进行一个新实验,其中包含不同的数据集和修改过的脚本。这 4 个文件现在看起来是这样的:

版本 2 时的文件状态

现在我们重复相同的 3 个步骤来跟踪版本 2。

1. 使用dvc跟踪artifacts的更改

dvc add artifacts/

2. 使用git跟踪代码脚本的更改和更新的元文件(artifacts.dvc)

git add .

git commit -m 'Version 2: scripts and dvc files'

3. 使用git将这个项目状态标记为experiment02

git tag -a experiment02 -m 'experiment02'

在这个阶段,我们已经跟踪了版本 2 的脚本和工件。

切换版本——重现代码和工件

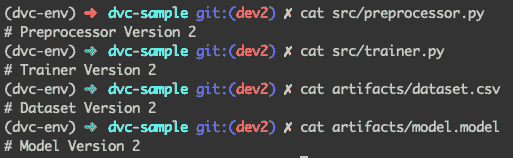

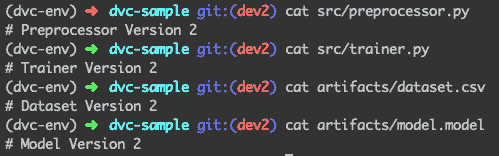

现在真正的考验来了,是时候看看我们是否可以轻松跳转到两个文件夹中的任何一个版本了。首先——让我们看看项目的当前状态:

当前状态:版本 2

从文件内容可以看出,我们现在处于版本 2。

(我们查看内容以获得更好的直觉,在实际操作中,我们可以查看 git 提交消息或标签)

现在假设我们意识到版本 1 更好,我们想要回滚(脚本以及数据集和模型)到版本 1。让我们看看如何用几个简单的命令做到这一点:

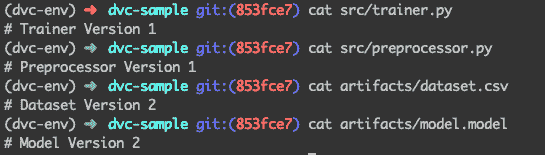

1. 我们签出到experiment01标签

git checkout experiment01

执行以下命令后,项目状态看起来是这样的:

你注意到了什么吗?

你可以看到脚本已更改为版本 1。太好了!

但工件仍然是版本 2。没错!这是因为,到目前为止,我们使用了git进行回滚——这回滚了代码脚本和artifacts.dvc元文件的版本。现在,由于元文件已经回滚到我们想要的版本,我们只需要使用dvc进行签出

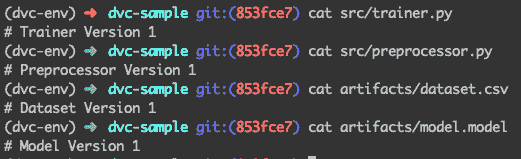

dvc checkout

这将根据当前版本(v1)的artifacts.dvc文件更改artifacts文件夹中的文件。

再次查看文件:

所有文件回滚到版本 1

万岁!我们成功地将版本 2 回滚到版本 1——无论是脚本还是大型数据集和模型文件。

简单来说,我们仅仅看了如何在两个版本之间切换和工作。上述过程同样适用于几百个实验——使我们能够快速迭代而无需手动记录或担心在需要时重新生成早期实验的状态。

结论

DVC 是一个很好的工具,用于版本控制大型文件,如数据集和训练模型文件,正如我们使用 git 对源代码进行版本控制一样。它帮助我们实现不同 ML 实验的工件可重复性,节省了处理数据和构建模型的时间。

其他阅读

简介: Vipul Jain 是一名数据科学家,专注于机器学习,拥有从构思到生产的端到端数据产品构建经验。拥有在生产环境中构建 A/B 测试实验框架的经验。能够将技术概念有效地呈现给非技术利益相关者。

原文。经许可转载。

相关:

-

如何利用机器学习自动化 GitHub 上的任务以获取乐趣和利润

-

处理机器学习中数据不足的 5 种方法

-

处理小数据的 7 个技巧

更多相关内容

版本控制机器学习实验与跟踪实验

原文:

www.kdnuggets.com/2021/12/versioning-machine-learning-experiments-tracking.html

由 Maria Khalusova 撰写,Iterative 的高级开发者倡导者

摄影: Debby Hudson 在 Unsplash

在进行机器学习项目时,通常会进行大量实验,以寻找一种算法、参数和数据预处理步骤的组合,从而产生最适合当前任务的模型。为了跟踪这些实验,数据科学家们曾经将其记录在 Excel 表格中,因为当时缺乏更好的选择。然而,由于主要是手动操作,这种方法存在一些缺点。比如,它容易出错、不方便、速度慢,并且与实际实验完全脱节。

幸运的是,在过去几年中,实验跟踪技术取得了长足的进展,我们看到市场上出现了许多能够改善实验跟踪方式的工具,例如 Weights&Biases、MLflow 和 Neptune。通常,这些工具提供了一个 API,你可以从代码中调用以记录实验信息。然后,这些信息会存储在数据库中,你可以使用仪表盘进行可视化比较。一旦你更改了代码,就不再需要担心忘记记录结果——这会自动为你完成。仪表盘有助于可视化和共享。

这是跟踪已完成工作的一个重大改进,但…… 在仪表盘上发现产生最佳指标的实验并不自动转化为准备好部署的模型。你可能需要首先重现最佳实验。然而,你直接观察到的跟踪仪表盘和表格与实际实验的连接较弱。因此,你仍然可能需要半自动地追踪你的步骤,拼接出准确的代码、数据和管道步骤来重现实验。这能自动化吗?

在这篇博客文章中,我想谈谈实验的版本控制,而不是跟踪实验,以及这如何在实验跟踪的好处基础上带来更容易的可重复性。

为了实现这一点,我将使用 DVC,这是一款开源工具,主要以数据版本控制而闻名(毕竟这也是它名字的一部分)。然而,这款工具实际上可以做很多事情。例如,你可以使用 DVC 定义机器学习管道,运行多个实验,并比较指标。你还可以对所有参与实验的移动部分进行版本控制。

实验版本控制

要开始版本控制实验,你需要从任何 Git 仓库初始化 DVC,如下所示。请注意,DVC 期望你的项目按照一定的逻辑结构组织,你可能需要稍微重新组织一下文件夹。

$ dvc exp init -i

This command will guide you to set up a default stage in dvc.yaml.

See [`dvc.org/doc/user-guide/project-structure/pipelines-files`](https://dvc.org/doc/user-guide/project-structure/pipelines-files). DVC assumes the following workspace structure:

├── data

├── metrics.json

├── models

├── params.yaml

├── plots

└── srcCommand to execute: python src/train.py

Path to a code file/directory [src, n to omit]: src/train.py

Path to a data file/directory [data, n to omit]: data/images/

Path to a model file/directory [models, n to omit]:

Path to a parameters file [params.yaml, n to omit]:

Path to a metrics file [metrics.json, n to omit]:

Path to a plots file/directory [plots, n to omit]: logs.csv

──────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────

default:

cmd: python src/train.py

deps:

- data/images/

- src/train.py

params:

- model

- train

outs:

- models

metrics:

- metrics.json:

cache: false

plots:

- logs.csv:

cache: false

Do you want to add the above contents to dvc.yaml? [y/n]: yCreated default stage in dvc.yaml. To run, use "dvc exp run".

See [`dvc.org/doc/user-guide/experiment-management/running-experiments`](https://dvc.org/doc/user-guide/experiment-management/running-experiments).

你可能还会注意到 DVC 假设你将参数和指标存储在文件中,而不是通过 API 进行日志记录。这意味着你需要修改代码以从 YAML 文件中读取参数,并将指标写入 JSON 文件。

最后,在初始化时,DVC 自动创建一个基本流程并将其存储在 dvc.yaml 文件中。这样,你的训练代码、流程、参数和指标现在都保存在可以版本控制的文件中。

实验即代码方法的好处

干净的代码

以这种方式设置后,你的代码不再依赖于实验跟踪 API。你不需要在代码中插入跟踪 API 调用来将实验信息保存到中央数据库,而是将其保存在可读文件中。这些文件始终可以在你的仓库中找到,你的代码保持干净,依赖项减少。即使没有 DVC,你也可以通过 Git 阅读、保存和版本化实验参数和指标,尽管使用纯 Git 不是比较机器学习实验的最方便方式。

$ git diff HEAD~1 -- params.yaml

diff --git a/params.yaml b/params.yaml

index baad571a2..57d098495 100644

--- a/params.yaml

+++ b/params.yaml

@@ -1,5 +1,5 @@

train:

epochs: 10

-model:

- conv_units: 16

+model:

+ conv_units: 128

可复现性

实验跟踪数据库无法捕捉到你需要复现实验的所有信息。其中一个常常缺失的重要部分是运行实验所需的完整流程。让我们来看看dvc.yaml文件,它是生成的流程文件。

$ cat dvc.yaml

stages:

default:

cmd: python src/train.py

deps:

- data/images

- src/train.py

params:

- model

- train

outs:

- models

metrics:

- metrics.json:

cache: false

plots:

- logs.csv:

cache: false

这个流程捕捉了运行实验的命令、参数和其他依赖项、指标、图表以及其他输出。它有一个单一的default阶段,但你可以根据需要添加任意多的阶段。当将实验的所有方面都视为代码时,包括流程,任何人都更容易复现实验。

减少噪音

在仪表盘中,你可以看到所有的实验,我指的是所有的实验。在某个时刻,你会有很多实验,你需要排序、标记和过滤它们以保持跟进。通过实验版本控制,你在共享和组织事情时有更多的灵活性。

例如,你可以在一个新的 Git 分支中尝试一个实验。如果出现问题或结果不尽如人意,你可以选择不推送该分支。这样你可以减少在实验跟踪仪表盘中可能遇到的一些不必要的杂乱。

同时,如果某个实验看起来有前景,你可以将它和你的代码一起推送到你的仓库,以保持结果与代码和流程的同步。结果与相同的人共享,并且已经按照你现有的分支名称进行了组织。你可以继续在该分支上迭代,如果实验差异过大,可以启动新的分支,或者合并到主分支,使其成为你的主要模型。

为什么使用 DVC?

即使没有 DVC,你也可以将代码更改为从文件中读取参数,并将指标写入其他文件,并使用 Git 跟踪更改。然而,DVC 在 Git 之上添加了一些特定于 ML 的功能,可以简化比较和复现实验的过程。

大型数据版本控制

大型数据和模型在 Git 中难以跟踪,但使用 DVC,你可以使用自己的存储来跟踪它们,同时它们与 Git 兼容。当初始化 DVC 时,它开始跟踪models文件夹,使 Git 忽略它,但仍存储和版本控制它,以便你可以在任何地方备份版本,并与实验代码一起查看它们。

单命令可复现性

编码整个实验管道是实现可复现性的良好第一步,但它仍然需要用户执行该管道。使用 DVC,你可以通过单个命令复现整个实验。不仅如此,它还会检查缓存的输入和输出,并跳过重新计算之前生成的数据,这有时可以节省大量时间。

$ dvc exp run

'data/images.dvc' didn't change, skipping

Stage 'default' didn't change, skippingReproduced experiment(s): exp-44136

Experiment results have been applied to your workspace.To promote an experiment to a Git branch run:dvc exp branch <exp> <branch>

更好的分支组织

虽然 Git 分支是一种灵活的实验组织和管理方式,但通常实验太多而无法适应任何 Git 分支工作流。DVC 跟踪实验,因此你不需要为每个实验创建提交或分支:

$ dvc exp show

┏━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━┳━━━━━━━━━┳━━━━━━━━┓

┃Experiment ┃ Created ┃ loss ┃ acc ┃

┡━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━╇━━━━━━━━━╇━━━━━━━━┩

│workspace │ - │ 0.25183 │ 0.9137 │

│mybranch │ Oct 23, 2021 │ - │ - │

│├──9a4ff1c [exp-333c9] │ 10:40 AM │ 0.25183 │ 0.9137 │

│├──138e6ea [exp-55e90] │ 10:28 AM │ 0.25784 │ 0.9084 │

│├──51b0324 [exp-2b728] │ 10:17 AM │ 0.25829 │ 0.9058 │

└─────────────────────────┴──────────────┴─────────┴────────┘

一旦你决定哪些实验值得与团队分享,它们可以转换为 Git 分支:

$ dvc exp branch exp-333c9 conv-units-64

Git branch 'conv-units-64' has been created from experiment 'exp-333c9'.

To switch to the new branch run:git checkout conv-units-64

这样,你将避免在你的仓库中创建混乱的分支,并可以专注于仅比较有前途的实验。

结论

总结来说,实验版本控制允许你将实验以一种方式编码,使你的实验日志始终与进入实验的确切数据、代码和管道相关联。你可以控制哪些实验最终与同事共享以供比较,这可以防止混乱。

最终,复现一个版本化的实验变得像运行单个命令一样简单,如果某些管道步骤有缓存的输出仍然相关,甚至可能比最初的时间更短。

感谢你坚持看到文章的最后!要了解更多关于使用 DVC 管理实验的信息, 查看文档

简介:Maria Khalusova (@mariaKhalusova)是 Iterative 的高级开发者倡导者。她从事开源 MLOps 工具的工作。

原文。经许可转载。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 事务

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 事务

更多相关话题

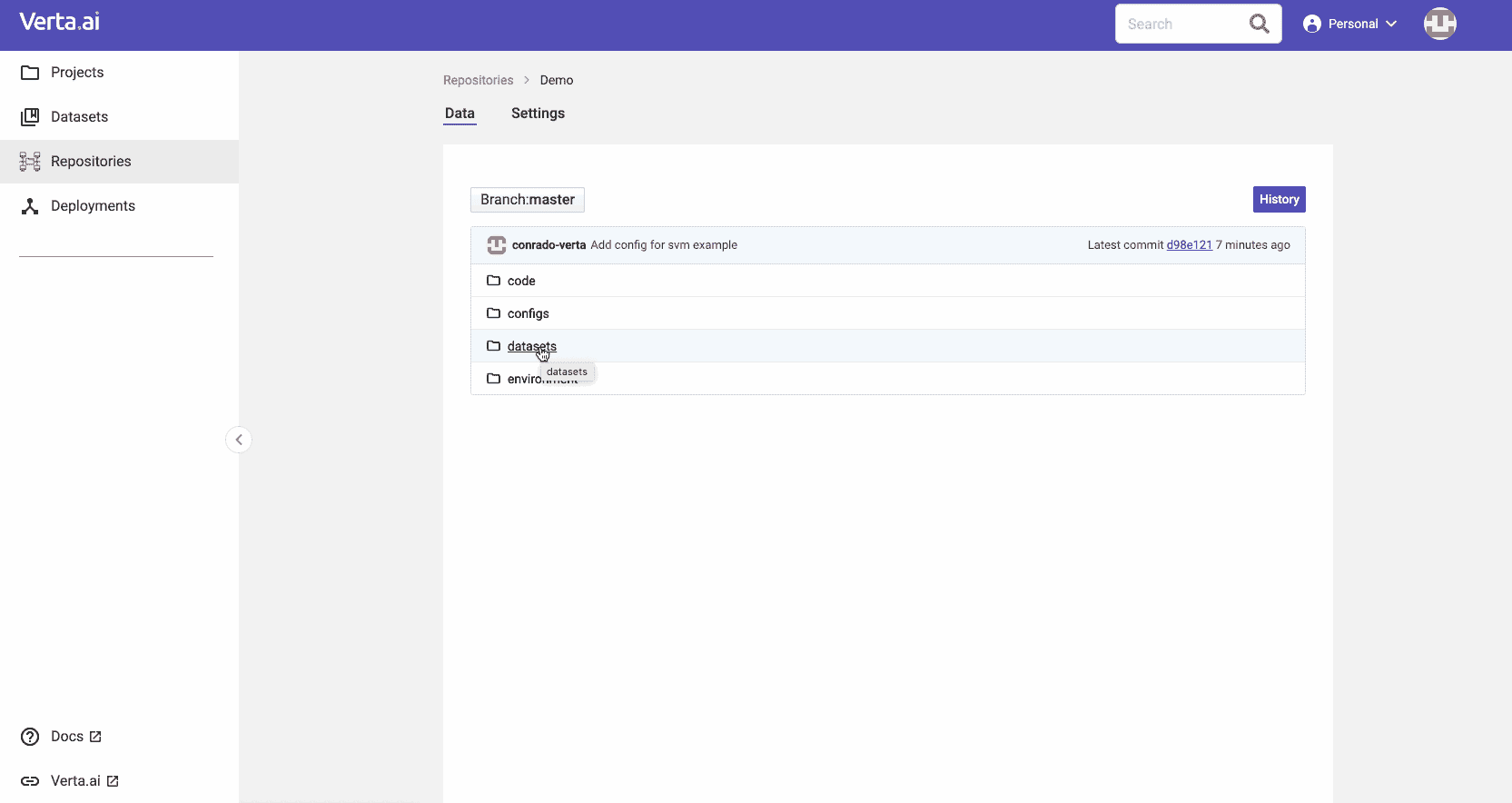

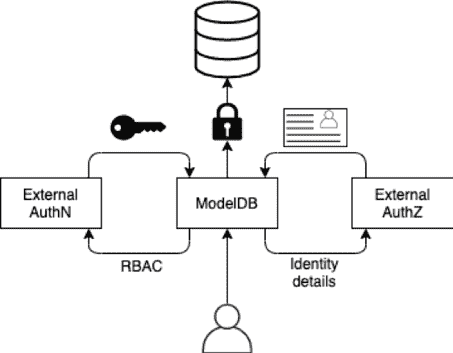

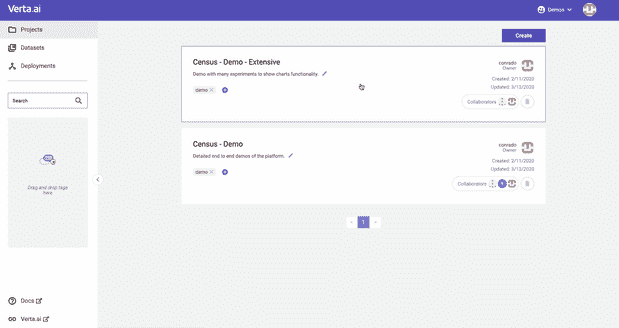

ModelDB 2.0 已经到来!

赞助帖子。

自从我们编写 ModelDB 1.0 这一开创性的模型版本管理系统以来,我们学到了很多,并且适应不断发展的生态系统成为一项挑战。因此,我们决定从头开始重建,以支持一个量身定制的模型版本管理系统,使机器学习的开发和部署变得可靠、安全和可重复。

我们很高兴地宣布 ModelDB 2.0 现已发布! 感谢所有启发并帮助设计、测试和验证此次发布的合作伙伴。

在详细介绍此重大版本之前,让我们快速查看 ModelDB 2.0 的新特性:

-

基于 API 的分层客户端,允许轻松扩展功能并与框架集成

-

与流行的机器学习框架集成,如 pytorch、scikit-learn、tensorflow 等

-

工件管理 以可靠地跟踪训练过程的结果

-

基于 Git 的版本控制 用于模型的所有组件

-

为公司模型开发提供单一视图

-

用户管理支持 用于身份验证、RBAC 授权和工作区隔离

模型版本管理

当我们最初创建 ModelDB 1.0 时,我们仅追踪有关模型的元数据。然而,与许多组织(包括受监管行业及其他领域)合作,将其模型投入实际使用后,我们发现这还不够。尽管元数据非常详尽,但它不能让你回到模型的特定状态。比如,仅靠元数据,你无法回到三个月前模型创建时的确切状态。因此,我们基于 Git 的灵感,构建了新的模型版本管理解决方案,以管理创建模型的所有要素:数据集、代码、环境和配置。

通过新的版本管理功能,你可以:

-

对模型的所有组件进行版本控制,如 Python 或 Docker 环境、S3 数据集、笔记本代码和超参数集合。机器学习具有多样性,没有单一工具能解决所有问题。你还可以使用标准企业工具(Java 和数据库)轻松扩展现有类型以满足你的需求。

-

集成不同的版本管理解决方案,如 Git、数据库、对象存储、容器库以及许多其他隔离源。使用适合管理每个模型要素的工具,我们将帮助你跟踪所有这些要素的变化。我们还为那些没有原生版本管理系统的提供版本管理系统。

-

像 Git 一样或像 API 一样使用,这允许与 GitOps 和笔记本生态系统之间的任何东西集成。你可以使用我们的客户端来操作你关心的对象,而不必担心基于磁盘系统的限制。但你也可以在 ModelDB 和你的本地 Git 之间进行同步。

-

提交、回滚、分支、比较和合并 仓库中的任何更改,就像你对 Git 一样。专门的工具可以操作模型的组成部分,通过嵌入应用知识而不是仅仅假设所有内容都是文本,从而使体验更加顺畅。享受 GitOps 的所有好处,而无需直接操作 Git,获得真正的 MLOps 体验!

我们将发布一系列关于版本创建幕后工作的博客文章。 订阅我们的新闻通讯,以便不错过它们!

安全实验管理

ModelDB 1.0 能够存储模型信息,但不支持身份验证和授权。这些都是确保数据安全的关键功能,尤其是对于企业。因此,在 ModelDB 2.0 中,我们现在终于添加了必要的接口,使你可以准确知道谁做了什么以及何时做的,确保只有授权用户可以访问。这也将使用户能够为不同团队隔离实验集。

新版本使你能够:

-

通过 RBAC 控制访问 实验,定义谁可以执行操作。API 是公开的,任何人都可以根据自己的使用案例实现它们。ModelDB 将根据其知道的资源管理角色的创建,并检查每个用户操作的权限。你还可以利用我们的企业版提供的完全集成的解决方案!我们有团队和组织的用户管理,还可以与不同的身份验证系统集成。

-

使用工作区 来进行隔离,为环境之间提供完全的隔离。你可以用它来区分开发和生产模型,甚至可以在团队之间进行隔离。

-

识别 模型、版本更改及任何其他组件的作者。了解团队中谁可以协助解决问题,或者谁是联系模型的最佳人选。时刻了解组织中的人员情况。

我们还将分享我们 RBAC 系统背后的设计原则,这些原则通过分析最佳实践得出解决方案。 订阅我们的新闻通讯,以便在它们发布时收到通知!

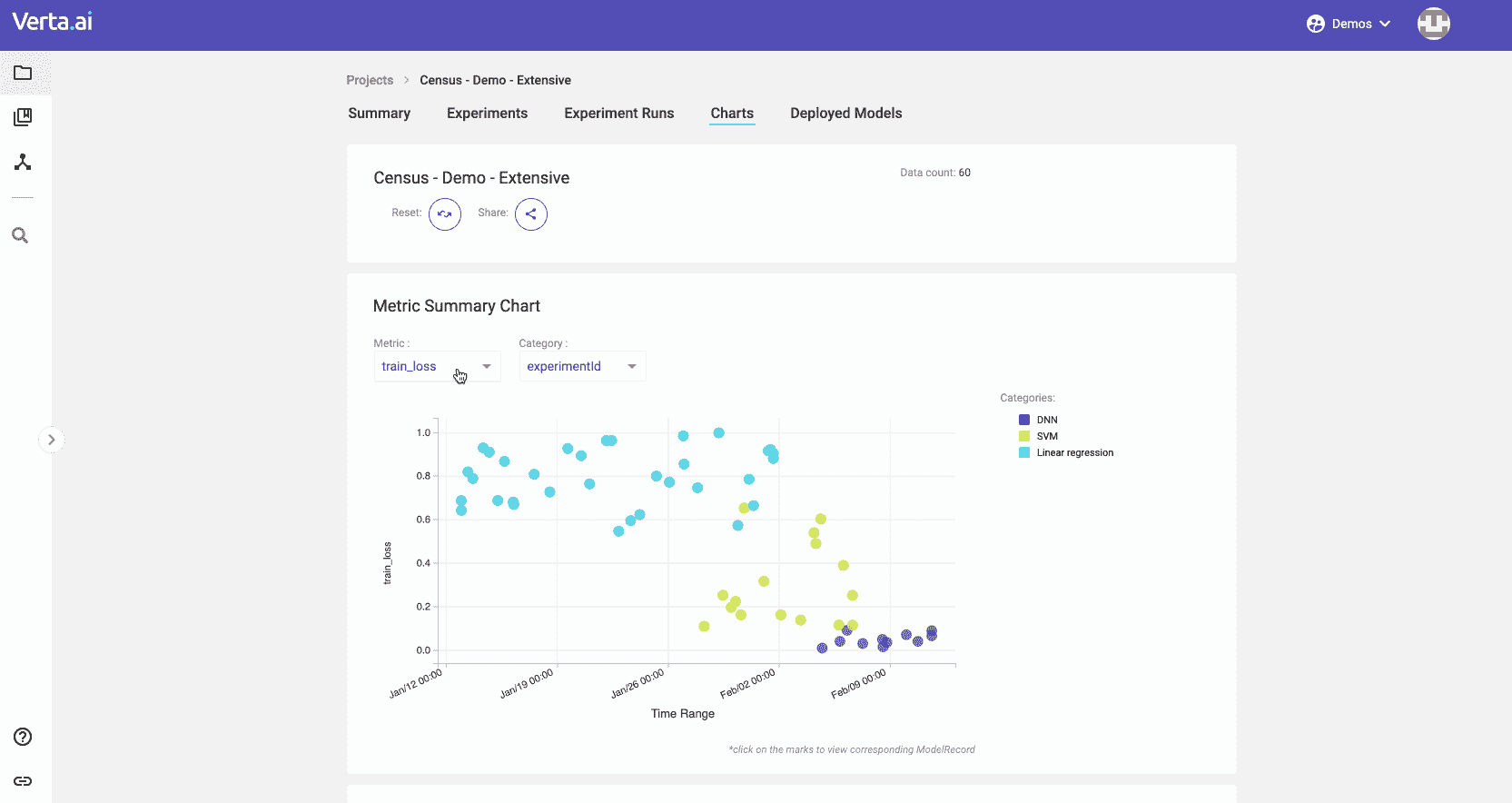

集中化仪表盘

ModelDB 中一个用户最喜欢的功能是网页体验,它允许他们全面查看他们所做的实验。在这个新版本中,我们更加注重通过我们的用户界面构建出色的用户体验,以帮助我们的用户更轻松地浏览他们的模型。

使用 ModelDB 2.0,你可以:

-

组织你的工作,利用项目、实验、运行、标签、描述以及任何你需要的东西来导航多个开发前沿,确保不会丢失任何内容。

-

搜索和筛选 模型以找到你需要的。我们可以根据运行的任何特征进行筛选,包括指标和超参数。你可以使用我们的用户界面或客户端对找到的模型进行迭代。

-

管理输入和输出 模型过程中的数据,将输入保存到我们的版本控制中。我们提供专门的输出类型用于指标、观察和一些类型的工件。你也可以将任何二进制文件作为工件保存,我们将为你在对象或文件存储系统中管理存储。

-

分析图表 以了解所有模型的表现。我们提供最先进的分析工具,帮助你和你的团队理解最佳的努力方向。

-

比较不同版本 的模型,以了解哪些发生了变化以及如何影响质量。只需存储开发过程中所有的信息,并了解项目在多个迭代中的演变。

如果你想更好地利用你和你的团队所做的所有建模工作,报名参加我们的 即将到来的网络研讨会。我们将展示如何通过让你专注于建模来提高建模速度!

立即开始

我们提供了 ModelDB 2.0 的多种格式:

-

Docker 容器

-

Helm 模板

-

AMIs

-

随你所想 😃

我们希望确保每个人都能迈出通向敏捷和稳健建模的第一步!查看我们的 Git 仓库 或注册我们的 SaaS 服务。我们很期待听到你的反馈,欢迎加入我们的 Slack,讨论如何继续改进 ML 版本控制。

附言:我们正在招聘。如果这个领域让你兴奋,请告诉我们!

关于 Verta:

Verta.ai 构建了一个完整的机器学习模型生命周期的软件,涵盖了从模型版本控制到模型部署和监控,并通过协作功能将所有环节紧密联系在一起,让你的 AI 和 ML 团队能够快速推进而不出错。我们是 MIT CSAIL 的一个衍生公司,开发了 ModelDB,这是第一个开源模型管理系统之一。

我们的三大课程推荐

1. Google 网络安全证书 - 加速你的网络安全职业生涯。

1. Google 网络安全证书 - 加速你的网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT 需求

3. Google IT 支持专业证书 - 支持你所在组织的 IT 需求

了解更多相关话题

数据科学家的虚拟演示技巧

原文:

www.kdnuggets.com/2021/11/virtual-presentation-tips-data-scientists.html

评论

迈克尔·伯克,Tubi 的数据科学家

沟通是数据科学工作中最具挑战性的方面之一。以下是我的笔记……

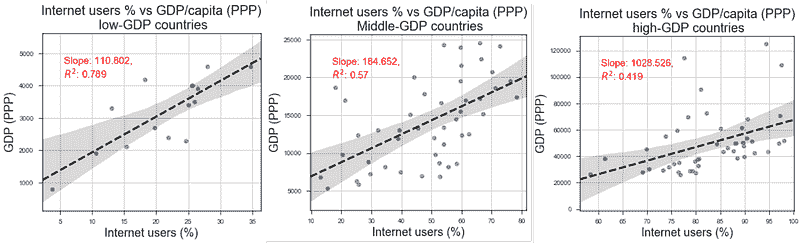

网络的看法

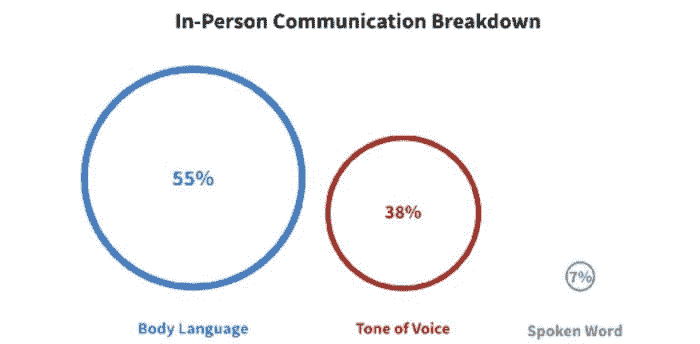

有一句基于研究的老话说,93% 的沟通是非语言的。55% 的沟通是肢体语言,38% 是声音语调,7% 是口头表达。

图 1:沟通故障。图像来源:作者。

视频通话中的肢体语言沟通会发生什么?通常,它会消失。

你应该尝试弥补那 55%,更多地强调语调和口头表达。

一些有用的建议以夸大语调的变化和调整音量来弥合肢体语言的差距。增加面部表情和手势也可以提高演示的接受度。这可能看起来不自然,但如果你录制你的演讲并重新观看,你会惊讶于这些变化看起来是多么自然和有魅力。

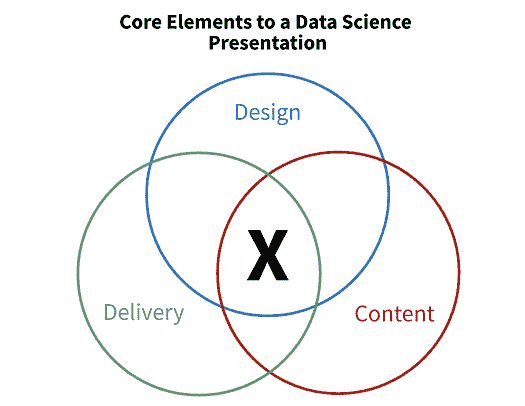

另一个有趣的想法是内容、设计和交付框架 — 源。

图 2:内容、设计、交付框架。图像来源:作者。

后两者,即设计和交付,分别指的是简约的幻灯片设计和复杂主题的简单措辞。然而,内容部分非常有趣。

简而言之,文章认为你的听众只会从你的演讲中记住一句话,所以要让它有意义。为此,你需要了解他们的技术水平、期望以及对项目的先前了解。如果你将演讲量身定制给你的观众,你可以使这句话具有意义。

一个非常简单的技巧是将其他团队的视觉效果融入到你的演示中。例如,展示一个支持你论点的用户体验研究视频。通过利用先前的工作,你可以节省时间,创建一个引人入胜的演示,并在公司内建立关系。

我认为

尽管有这些精彩的想法,但互联网上的大多数信息都是常识。在本节中,我们将重点关注那些不那么明显的策略。让我们深入探讨……

1 — 进入你的观众的思维

对于超过 ~10 人的会议,安全起见,可以假设其中一个人不想参加。他们和你一样都是忙碌的人。

因此,尽量了解什么能让你的观众兴奋。 兴奋是推动工作的动力,它使你的工作更显眼,从而更具影响力。

虽然各组织的角色差异很大,但大多数数据科学家在选择和开发自己的项目上有一定自由。如果你的工作成功涉及利益相关者的支持,你必须让他们对项目感到兴奋。就这么简单。

不幸的是,这没有明确的捷径,但以下是一些对我有效的做法:

-

早早地并经常地社交化你的想法。 通过在项目过程中向团队成员和利益相关者获取反馈,你可以激发兴趣,并产生更有价值的最终项目。相信我,这些努力是值得的。

-

了解你的老板的老板关心什么。 如果你知道什么会让高层管理人员兴奋,你也会知道什么会让低层管理人员兴奋。安排一次快速的单独会谈,并提出好的问题。

通过将你的工作与激动人心的想法联系起来,你可以显著提高演示的价值。

2 — 提前结束会议

不必要的信息是有害的。你可能认为展示你的步骤和假设对听众有益,但在大多数情况下并非如此。

通过包含对理解不必要的信息,你正在……

-

增加认知负荷。 这会减少注意力,降低信任度,并且经常导致在演示过程中多任务处理。

-

潜意识地影响听众。 每个人都有确认偏误,这会影响他们确认自己的信念。如果你给听众额外的信息,他们更容易被吸引人的想法所吸引,忽略关键结论。

-

浪费时间和金钱。 时间就是金钱。试试这个练习——加总一下通话中每个人的每小时工资。呈现不必要的信息是昂贵的。

一个简单但有效的替代方法是尽量提前结束会议。 我的一位团队成员因为总是提前结束会议而受到利益相关者和数据科学家们的喜爱。虽然这个规则有明显的例外,但这些例外比你想象的要少得多。

如果你旨在提前结束会议,你必须做到结构化、简明扼要和相关。

3 — 一些 80/20 的小贴士

上述两个部分可能需要付出较多劳动,因此这里有一些简单的小贴士,希望能让你在 20%的时间内获得 80%的结果。

-

适应你的沟通风格。 如果你是正式的演讲者,就要正式地讲话。如果你讲笑话,就讲笑话。通过利用你自然的谈话方式,你会变得更自信、更易于亲近,从而更有效。

-

从结论开始和结束。通过以结论开始演示,你可以减少认知负担,让听众更深入地思考你的观点。通过在最后重申结论,你可以促进心理分块,这有助于记忆并帮助他们利用新信息。

-

少说“嗯”和“像”。重复使用这些词语会让你听起来更愚蠢。抱歉。这里有一些基础代码,用于一个制作得很差但免费的“嗯/像”检测器。

-

对于技术概念,把它当作一个黑箱处理。大多数听众不关心方法如何工作,他们关心的是它的作用。所以你只需要解释输入和输出即可。

感谢阅读!上述所有资源对我和我的职业生涯都产生了很大影响。请分享你自己的经验。

简介:迈克尔·伯克 (michaeldberk.com/) 是 Tubi 的数据科学家。

原文. 已获授权转载。

相关:

-

如何发现机器学习模型中的弱点

-

不要浪费时间建立你的数据科学网络

-

5 个使数据科学家与其他职业区别开来的因素

更多相关内容

数据科学:参观旧金山著名电影拍摄地点

原文:

www.kdnuggets.com/2016/07/visiting-famous-movie-locations-san-francisco.html

评论

评论

作者:Juraj Kapasny,Knoyd

让数据科学向您展示通过旧金山著名电影拍摄地点的最佳路线

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

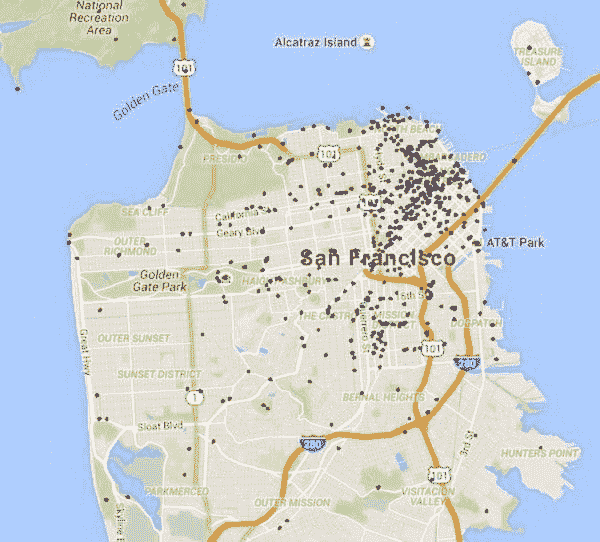

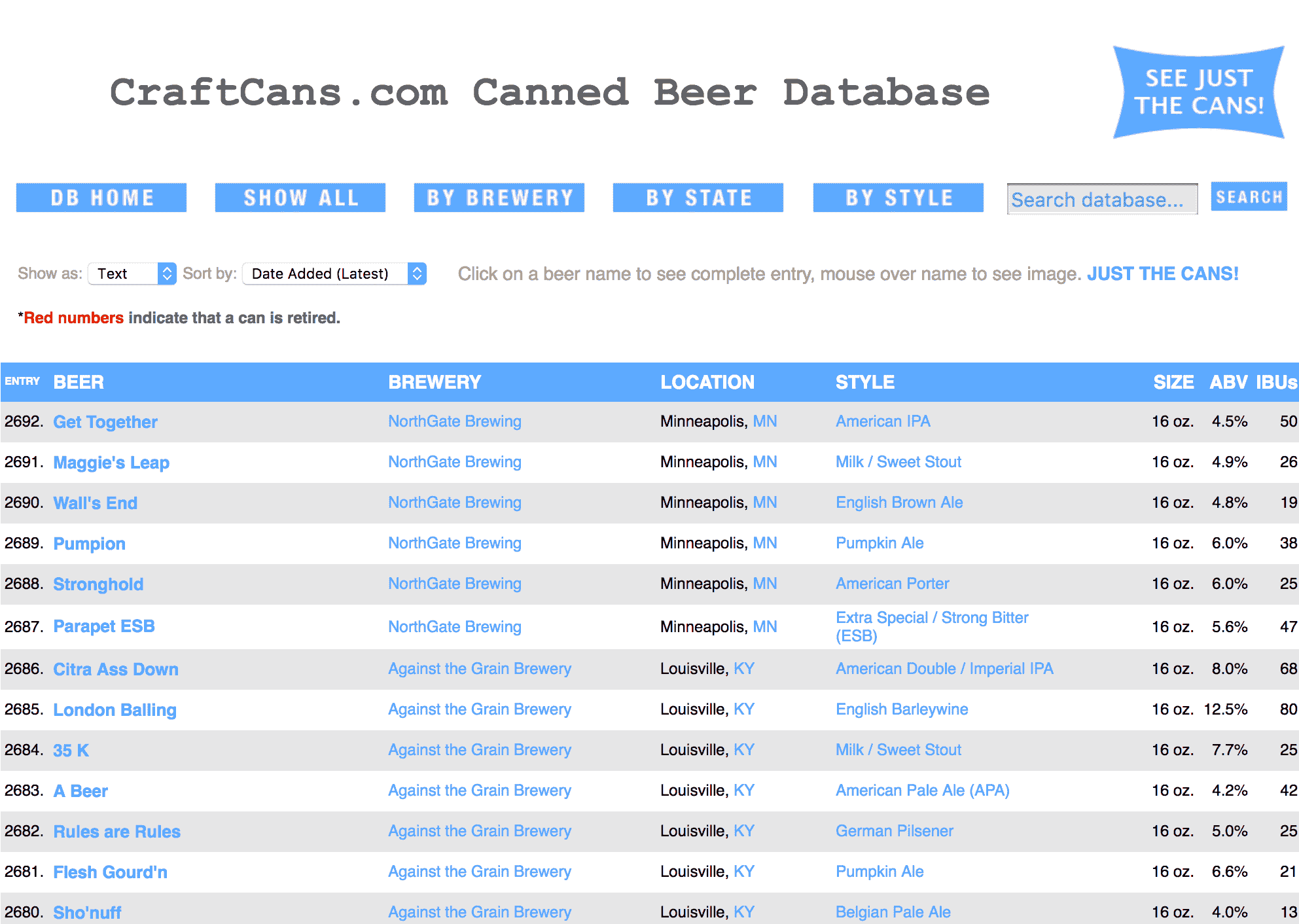

在这篇博客中,我们查看了旧金山的电影拍摄地点。通过使用谷歌地点 API 和 IMDb API,我们选择了黄金之城中每个电影爱好者在城里时应该参观的地方。

原数据集下载自 SF OpenData 网站,该网站提供关于旧金山的许多数据集。除了之前提到的电影地点外,您还可以在那里找到例如旧金山机场举办的所有展览、移动食品设施许可、航空噪音投诉数据、航空旅客统计等信息。

我们的基础数据集包括以下列:

-

标题(电影名称)

-

发布年份

-

地点(地点标识)

-

趣闻(如果有的话)

-

制作公司

-

发行商

-

导演

-

作者

-

演员 1(电影的主角)

-

演员 2(电影的第二主角(如果有的话))

-

演员 3(电影的第三主角(如果有的话))

包含了唯一标识地点的地点特征。然而,关于经纬度的信息缺失,所以我们无法立即将这些地点绘制到地图上。我们通过谷歌地点 API 找到了所有地点的地理坐标,并使用 Python 库 gmplot 将它们绘制在地图上。

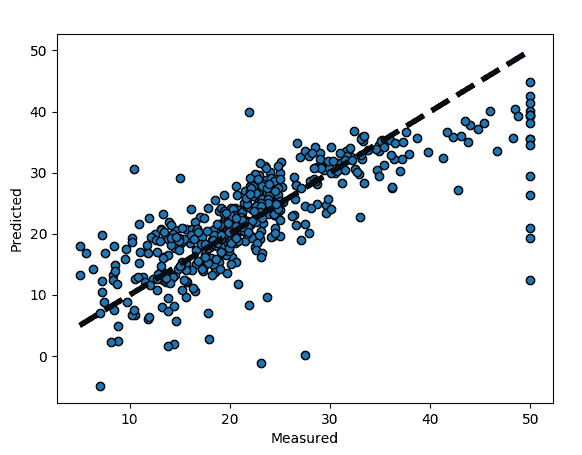

接下来,我们只关注了拍摄了更著名电影的地点。为了确定这些电影,我们使用了 IMDb API。关于这些电影的所有信息,包括平均评分和总票数,均从 imdb.com 下载。根据平均评分,拍摄于旧金山的顶级电影有:

| 电影 | 评分 | 投票数量 |

|---|---|---|

| 阿甘正传 | 8.8 | 1,234,615 |

| Sense8 | 8.4 | 63,164 |

| 十三号星期五 | 8.3 | 82,126 |

| 寻找 | 8.3 | 10,696 |

| 我记得妈妈 | 8.3 | 3,857 |

另一方面,IMDb 上投票数量最多的电影是:

| 电影 | 评分 | 投票数 |

|---|---|---|

| 福雷斯特·甘普 | 8.8 | 1,234,615 |

| 印第安纳·琼斯与最后的十字军 | 8.3 | 509,609 |

| 猩球崛起:黎明之战 | 7.6 | 313,938 |

| 蚁人 | 7.4 | 301,246 |

| 哥斯拉 | 6.5 | 299,385 |

利用这些评分和投票的组合,我们选择了前 7 部电影:福雷斯特·甘普、印第安纳·琼斯与最后的十字军、猩球崛起:黎明之战、蚁人、游戏、哥斯拉和毕业生。这些电影与旧金山的 36 个电影拍摄地点相关联。

为了对这些位置进行图形分析,我们需要找到一种方法来相应地设置图的边。为此,我们使用了一个叫做 Google API 的便利工具,它可以计算任何两个地理位置之间的驾车、骑行或步行距离。这些旅行时间被作为每对位置(节点或顶点)之间的边值。我们使用前 7 部电影中的地点,结合这些地点之间的骑行和驾车距离来构建图。此外,每个位置只创建了 2 条边,即到 2 个最近地点的边。这样做的逻辑是避免使用长时间旅行的路径。

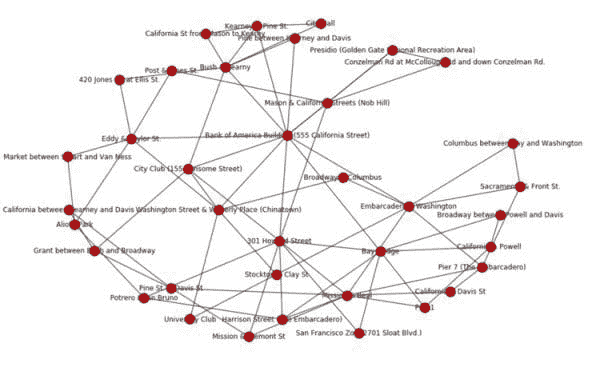

在下面,你可以看到图的可视化和简单分析。这个图的边是根据位置之间的骑行距离创建的。

作为分析电影位置的下一步,我们研究了特定位置的中介中心性。中介中心性等于从所有顶点(在我们的情况下是位置)到所有其他顶点经过该节点的最短路径数量。一个中介中心性高的位置对在顶级电影位置网络中人员的转移有很大的影响,假设人们总是寻找最短路径。我们使用基于驾车和骑行距离的边来比较具有最大中介中心性的地点。我们得出了以下结果:

骑行时中介中心性最高的地点:

-

美国银行大楼(555 加州街)

-

301 霍华德街

-

海滨大道与华盛顿街

-

使命街与比尔街

-

海湾大桥

驾车时中介中心性最高的地点:

-

美国银行大楼(555 加州街)

-

华盛顿街与韦弗利广场(中国城)

-

城市俱乐部(155 桑索姆街)

-

海滨大道与华盛顿街

-

海湾大桥

我们可以看到,当使用驾车距离时,有两个地方发生了变化:301 霍华德街和使命街与比尔街被华盛顿街与韦弗利广场(中国城)以及城市俱乐部(155 桑索姆街)分别替代。这意味着电影迷在驾车出行时更可能经过旧金山的中国城。

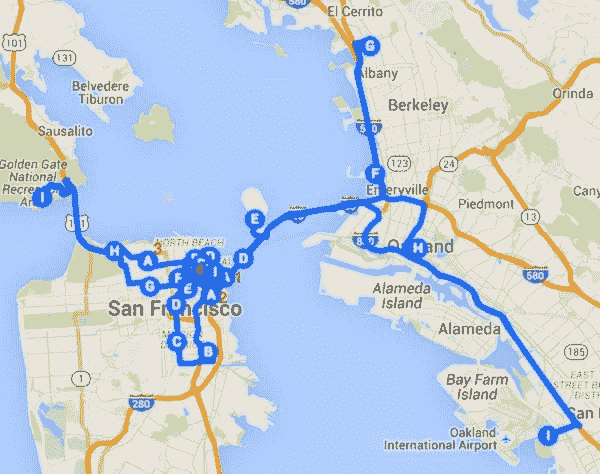

最后,我们研究了旅行商问题(TSP),并将其应用于我们的数据集。TSP 是一个优化问题,旨在寻找访问给定地点集合的最短可能路线。使用随机起点和迭代算法,我们得出了一个电影爱好者应该沿着的路线,如果他们想访问所有著名电影中的有趣地点。

你可以在下面看到最佳路线的可视化。谷歌仅支持 1 条路线中的 10 个地点,因此创建了四层。每层的描述以 A 开头,以 J 结束,J 与下一层的 A 重叠。每层的开始部分用数字标记,以便更易读。

这是最佳路线行程,从哈里森街(码头街)开始,到使命街与比尔街结束:

-

0(A) - 哈里森街 - 码头街(游戏)

-

1(B) - 使命街与弗里蒙特街交汇处(哥斯拉)

-

2(C) - 霍华德街 301 号(游戏)

-

3(D) - 海湾大桥(毕业生)

-

4(E) - 行政大楼 - 宝岛(印第安纳·琼斯与最后的十字军)

-

5(F) - 加州街与鲍威尔街交汇处(猩球崛起:黎明之战)

-

6(G) - 码头 1(哥斯拉)

-

7(H) - 百老汇街在鲍威尔街与戴维斯街之间(蚁人)

-

8(I) - 加州街与戴维斯街交汇处(哥斯拉)

-

9(J-A) - 市政厅(猩球崛起:黎明之战)

-

10(B) - 波特雷罗街与圣布鲁诺街交汇处(哥斯拉)

-

11(C) - 阿里奥托公园(猩球崛起:黎明之战)

-

12(D) - 市场街在斯图尔特街与 VData Science 之间(蚁人)

-

13(E) - 艾迪街与泰勒街交汇处(哥斯拉)

-

14(F) - 乔治街 420 号与艾利斯街交汇处(蚁人)

-

15(G) - 波士顿街与乔治街交汇处(哥斯拉)

-

16(H) - 总统公园 - 金门国家休闲区(游戏)

-

17(I) - 康泽尔曼路在麦考洛赫路与康泽尔曼路下方(蚁人)

-

18(J-A) - 梅森街与加州街交汇处 - 诺布山(游戏)

-

19(B) - 百老汇街与哥伦布街交汇处(哥斯拉)

-

20(C) - 萨克拉门托街与前街交汇处(哥斯拉)

-

21(D) - 码头 7 - 码头街(哥斯拉)

-

22(E) - 码头街与华盛顿街交汇处(哥斯拉)

-

23(F) - 布什街与基尔尼街交汇处(哥斯拉)

-

24(G) - 加州街从梅森到基尔尼(猩球崛起:黎明之战)

-

25(H) - 基尔尼街与松树街交汇处(哥斯拉)

-

26(I) - 斯托克顿街与克雷街交汇处(哥斯拉)

-

27(J-A) - 大学俱乐部(猩球崛起:黎明之战)

-

28(B) - 松树街在基尔尼街与戴维斯街之间(蚁人)

-

29(C) - 华盛顿街与韦弗利广场 - 中国城(游戏)

-

30(D) - 哥伦布街在湾区与华盛顿街之间(蚁人)

-

31(E) - 美国银行大楼 - 555 加州街(游戏)

-

32(F) - 城市俱乐部 - 155 桑索姆街(游戏)

-

33(G) - 格兰特街在布什街与百老汇街之间(蚁人)

-

34(H) - 松树街与戴维斯街交汇处(哥斯拉)

-

35(I) - 使命街与比尔街交汇处(哥斯拉)

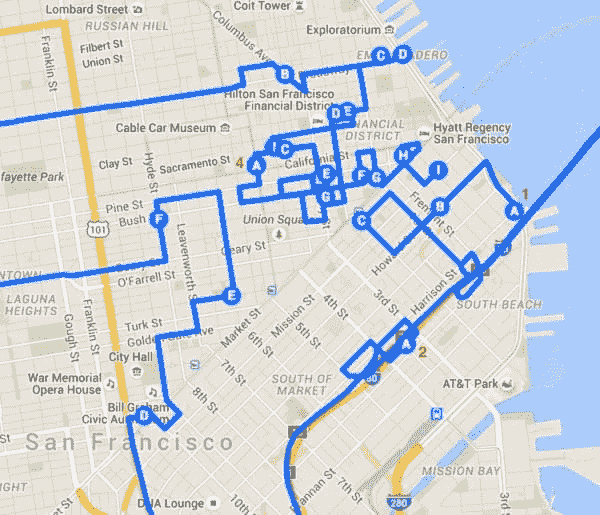

在更详细的旧金山市中心地图上:

如果你感兴趣,可以自己查看来自海湾城市的其他数据源 - 我们肯定会去做的。

简介: Juraj Kapasny 是 Knoyd 的联合创始人和数据科学家,数据挖掘爱好者,曾任职于 Teradata(维也纳,奥地利)。他曾参与过许多客户特定项目,涉及电信、金融或汽车等行业,帮助客户从数据中获取额外的见解和价值。

相关内容:

-

OpenText 数据可视化 – 红地毯版

-

哪些电影续集真的更好?数据科学的答案

-

大数据如何在推荐系统中改变我们的生活

更多相关内容

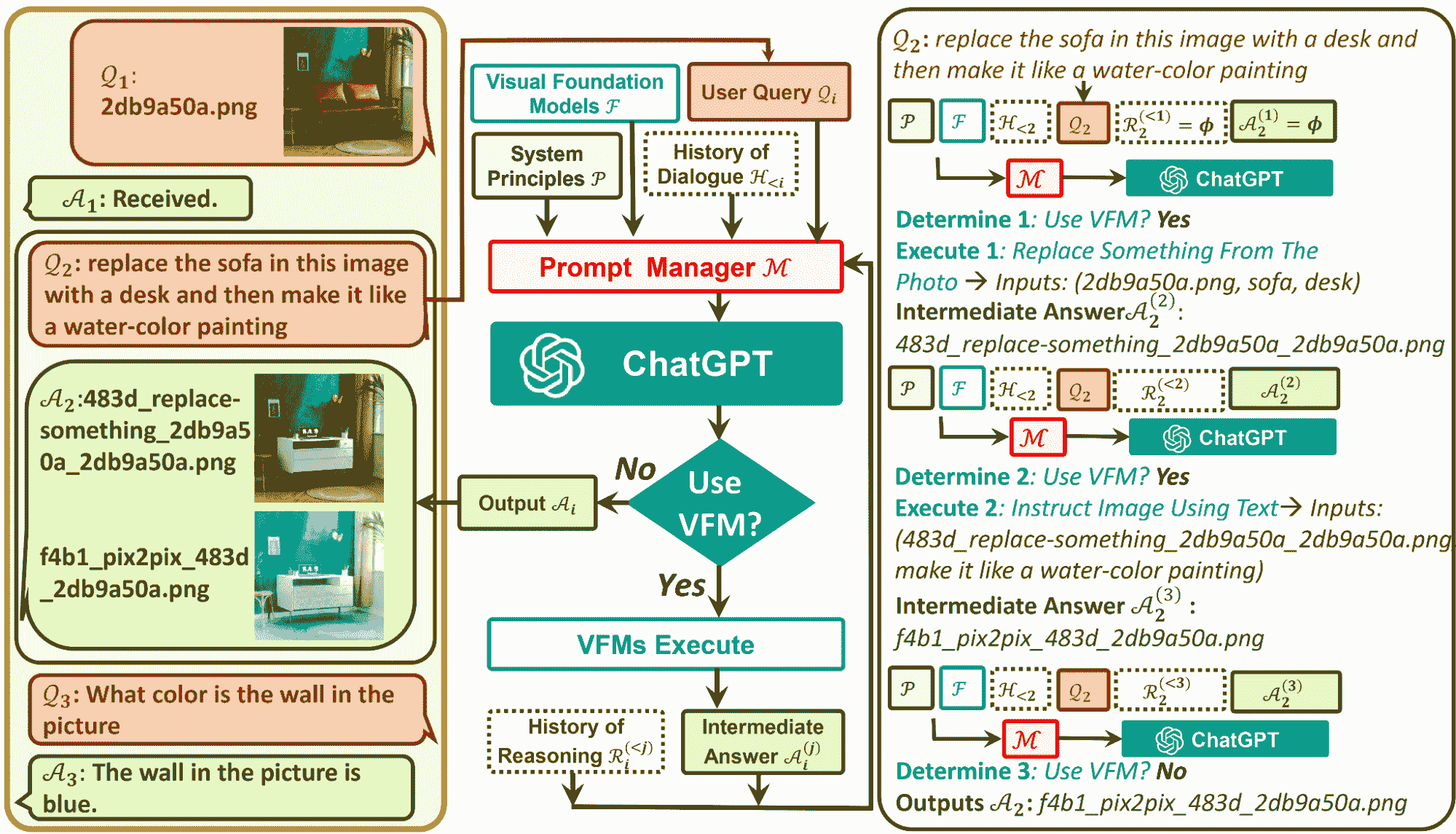

Visual ChatGPT:微软结合 ChatGPT 和 VFM

原文:

www.kdnuggets.com/2023/03/visual-chatgpt-microsoft-combine-chatgpt-vfms.html

图片由作者提供

当我们以为已经消化了足够多的大型语言模型(LLMs)新闻时,微软亚洲研究院团队带来了 Visual ChatGPT。Visual ChatGPT 克服了 ChatGPT 无法处理视觉信息的现有限制,因为它只训练了一种语言模式。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

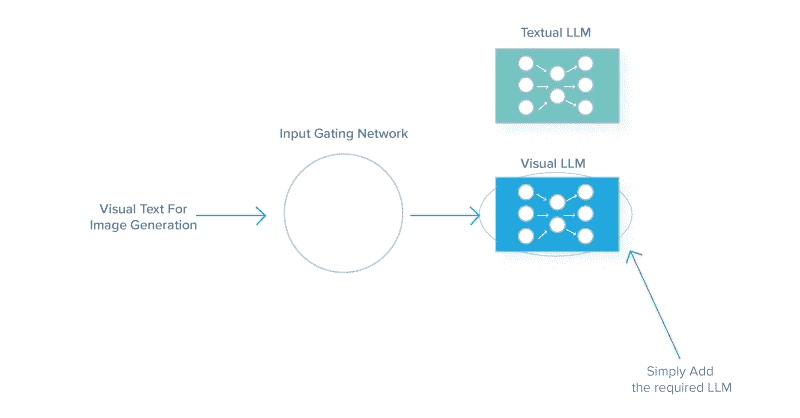

什么是 Visual ChatGPT?

Visual ChatGPT 是一个结合了 Visual Foundation Models(VFM)的系统,帮助 ChatGPT 更好地理解、生成和编辑视觉信息。VFM 能够指定输入输出格式,将视觉信息转换为语言格式,并处理 VFM 的历史记录、优先级和冲突。

因此,Visual ChatGPT 是一个 AI 模型,它在 ChatGPT 的限制与允许用户通过聊天沟通并生成视觉内容之间架起了桥梁。

ChatGPT 的限制

ChatGPT 在过去几周和几个月里成为了大多数人的谈话话题。然而,由于其语言训练能力,它不允许处理和生成图像。

你有像 Visual Transformers 和 Steady Diffusion 这样的视觉基础模型,它们具有惊人的视觉能力。这就是语言和图像模型结合创造了 Visual ChatGPT 的地方。

什么是 Visual Foundation Models?

Visual Foundation Models 用于汇集计算机视觉中使用的基本算法。它们将标准计算机视觉技能转移到 AI 应用程序上,以处理更复杂的任务。

Visual ChatGPT 中的 Prompt Manager 包含 22 个 VFM,包括 Text-to-Image、ControlNet、Edge-To-Image 等。这帮助 ChatGPT 将图像的所有视觉信号转换为语言,以便 ChatGPT 更好地理解。那么 Visual ChatGPT 是如何工作的呢?

Visual ChatGPT 是如何工作的?

Visual ChatGPT 由不同的组件组成,帮助大型语言模型 ChatGPT 理解视觉信息。

Visual ChatGPT 的架构组件

-

用户查询:这是用户提交查询的地方

-

提示管理器:这将用户的视觉查询转换为语言格式,以便 ChatGPT 模型可以理解。

-

视觉基础模型:这结合了各种 VFMs,如 BLIP(Bootstrapping Language-Image Pre-training)、稳定扩散、ControlNet、Pix2Pix 等。

-

系统原则:这提供了 Visual ChatGPT 的基本规则和要求。

-

对话历史:这是系统与用户的第一次交互和对话。

-

推理历史:这使用不同 VFMs 过去的推理来解决复杂的查询。

-

中级回答:利用 VFMs,模型将尝试输出几个具有逻辑理解的中级答案。

图片来自于 微软 GitHub

更多关于提示管理器的信息

你们中的一些人可能认为这是一种强制性的解决方法,用于让 ChatGPT 处理视觉内容,因为它仍然将图像的所有视觉信号转换为语言。当上传图像时,提示管理器会合成一个内部聊天记录,其中包含文件名等信息,以便 ChatGPT 更好地理解查询内容。

例如,用户输入图像的名称将作为操作历史记录,然后提示管理器将协助模型通过‘推理格式’来确定需要对图像进行的操作。你可以将其视为模型在 ChatGPT 选择正确的 VFM 操作之前的内部思考。

在下图中,你可以看到提示管理器如何为 Visual ChatGPT 启动规则:

图片来自于 Visual ChatGPT:用视觉基础模型进行对话、绘图和编辑

开始使用 Visual ChatGPT

要开始你的 Visual ChatGPT 之旅,你需要先运行 Visual ChatGPT 演示:

# create a new environment

conda create -n visgpt python=3.8

# activate the new environment

conda activate visgpt

# prepare the basic environments

pip install -r requirement.txt

# download the visual foundation models

bash download.sh

# prepare your private openAI private key

export OPENAI_API_KEY={Your_Private_Openai_Key}

# create a folder to save images

mkdir ./image

# Start Visual ChatGPT !

python visual_chatgpt.py

你还可以在 微软的 Visual ChatGPT GitHub 上了解更多信息。确保查看他们对每个视觉基础模型的 GPU 内存使用情况。

Visual ChatGPT 的应用案例

那么 Visual ChatGPT 能做什么呢?

图像生成

你可以要求 Visual ChatGPT 从零开始创建图像,提供描述。你的图像将在几秒钟内生成,具体取决于可用的计算能力。其基于稳定扩散的合成图像生成使用文本数据。

更改图像背景

再次使用稳定扩散,Visual ChatGPT 可以更改你输入图像的背景。用户可以提供任何背景更改的描述,稳定扩散模型将对图像的背景进行修复。

更改颜色图像及其他效果

你还可以根据提供给应用程序的描述来更改图像的颜色和应用效果。Visual ChatGPT 将使用各种预训练模型和 OpenCV,来改变图像颜色、突出图像边缘等。

修改图像

Visual ChatGPT 允许你通过编辑和修改图像中的对象来删除或替换图像的某些方面,方法是向应用程序提供有针对性的文本描述。然而,值得注意的是,这一功能需要更多的计算能力。

Visual ChatGPT 的局限性

众所周知,组织总会有一些不完美之处,需要不断改进以提升服务。

计算机视觉与大型语言模型的结合

Visual ChatGPT 在很大程度上依赖于 ChatGPT 和 VFMs,因此,这些单独方面的准确性和可靠性会影响 Visual ChatGPT 的性能。使用大型语言模型和计算机视觉的结合需要大量的提示工程,并且可能难以实现高效的性能。

隐私与安全

Visual ChatGPT 能够轻松地插拔 VFMs,这可能会让一些用户担心安全和隐私问题。微软需要进一步研究如何确保敏感数据不被泄露。

自我纠错模块

Visual ChatGPT 研究人员遇到的一个限制是由于 VFMs 的失败和提示的多样性导致生成结果不一致。因此,他们得出结论,需要开发一个自我纠错模块,以确保生成的输出与用户请求的内容一致,并能够进行必要的修正。

高量 GPU 需求

为了充分利用 Visual ChatGPT 并使用 22 个 VFMs,你需要大量的 GPU RAM,例如 A100\。根据任务的不同,确保你了解完成任务所需的 GPU 量。

总结

尽管 Visual ChatGPT 仍有其局限性,但这是在同时使用大型语言模型和计算机视觉方面的一项重大突破。如果你想了解更多关于 Visual ChatGPT 的信息,可以阅读这篇论文:Visual ChatGPT: Talking, Drawing and Editing with Visual Foundation Models

Visual ChatGPT 是否类似于 ChatGPT4?如果你尝试过这两者,你的意见是什么?请在下面留言!

Nisha Arya 是一名数据科学家、自由技术写作者以及 KDnuggets 的社区经理。她特别感兴趣于提供数据科学职业建议或教程以及数据科学的理论知识。她还希望探索人工智能在延长人类生命方面的不同方式。她是一个渴望学习的人,寻求拓宽技术知识和写作技能,同时帮助指导他人。

更多相关话题

神经网络反向传播算法的可视化解释

原文:

www.kdnuggets.com/2016/06/visual-explanation-backpropagation-algorithm-neural-networks.html

假设我们真的喜欢登山,并为了增加一点额外的挑战,我们这次蒙上眼睛,以便看不到我们的位置,也不知道何时完成了我们的“目标”,即到达山顶。

由于我们看不到前方的路径,我们让直觉引导我们:假设山顶是山的“最高”点,我们认为最陡峭的路径最有效地将我们引向山顶。

我们通过迭代地“感知”周围并朝着最陡峭的上升方向迈出一步来解决这个挑战——我们称之为“梯度上升”。但如果我们到达一个无法进一步上升的点怎么办?即,每个方向都向下?此时,我们可能已经到达了山顶,但也可能只是到达了一个较小的高原……我们并不知道。从本质上讲,这只是梯度上升优化的一个类比(基本上是通过梯度下降最小化成本函数的对立面)。然而,这并非特指反向传播,而只是最小化一个凸成本函数(如果只有一个全局最小值)或非凸成本函数(具有局部最小值,如“高原”让我们以为达到了山顶)的其中一种方法。借助一点视觉辅助,我们可以将一个只有一个参数的非凸成本函数(蓝色球为我们当前位置)形象化如下:

现在,反向传播就是在多个“层级”上反向传播成本。例如,如果我们有一个多层感知器,我们可以将前向传播(将输入信号通过网络,并通过相应的权重计算输出)形象化如下:

在反向传播中,我们“简单地”反向传播误差(我们通过比较计算出的输出和已知的正确目标输出来计算的“成本”,然后用来更新模型参数):

这可能是在预备微积分之后很久的事了,但它本质上都是基于我们用于嵌套函数的简单链式法则

与其“手动”完成这些工作,不如使用计算工具(称为“自动微分”),而反向传播基本上是这种自动微分的“反向”模式。为什么是反向而不是前向?因为计算上更便宜!如果我们使用前向方式,我们将逐层相乘大矩阵,直到将一个大矩阵与输出层中的一个向量相乘。然而,如果我们从反向开始,也就是从将一个矩阵与一个向量相乘开始,我们得到另一个向量,以此类推。所以,我认为反向传播的美在于我们进行的是更高效的矩阵-向量乘法,而不是矩阵-矩阵乘法。

简介:Sebastian Raschka 是一名数据科学家和机器学习爱好者,对 Python 和开源有着极大的热情。《Python 机器学习》的作者。密歇根州立大学。

原文。经许可转载。

相关内容:

-

深度学习何时比 SVM 或随机森林效果更好?

-

分类发展作为一种学习机器

-

为什么从头实现机器学习算法?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业生涯。

1. 谷歌网络安全证书 - 快速入门网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

了解更多相关内容

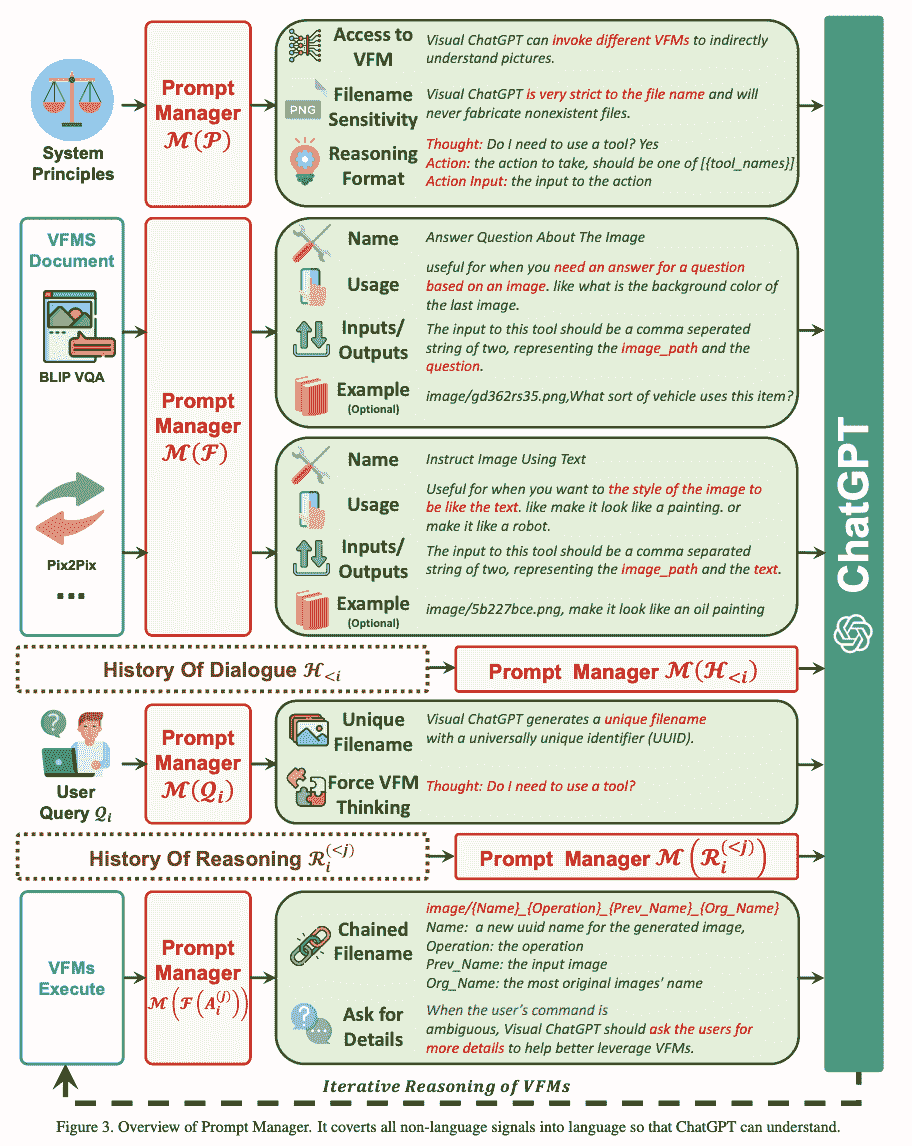

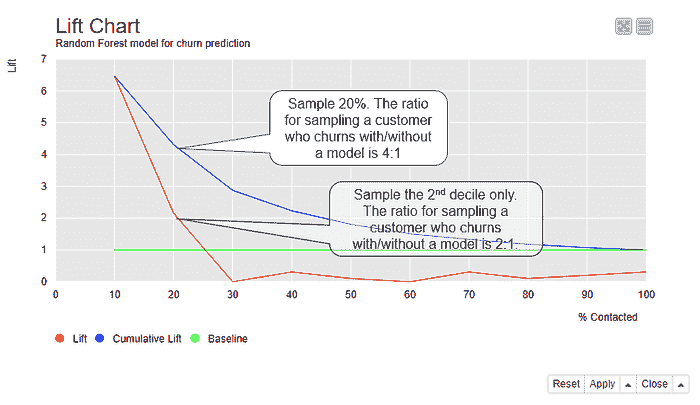

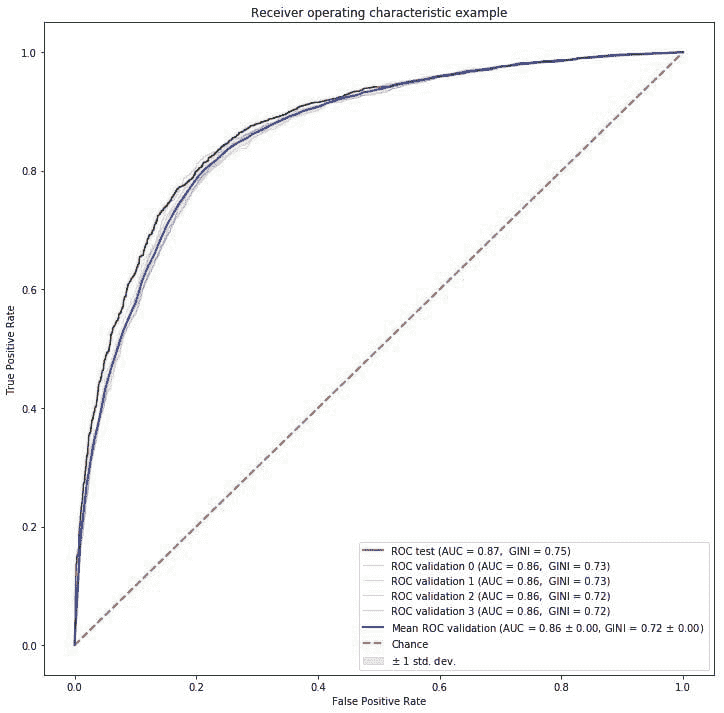

分类模型的可视化评分技术

原文:

www.kdnuggets.com/2021/11/visual-scoring-techniques-classification-models.html

评论

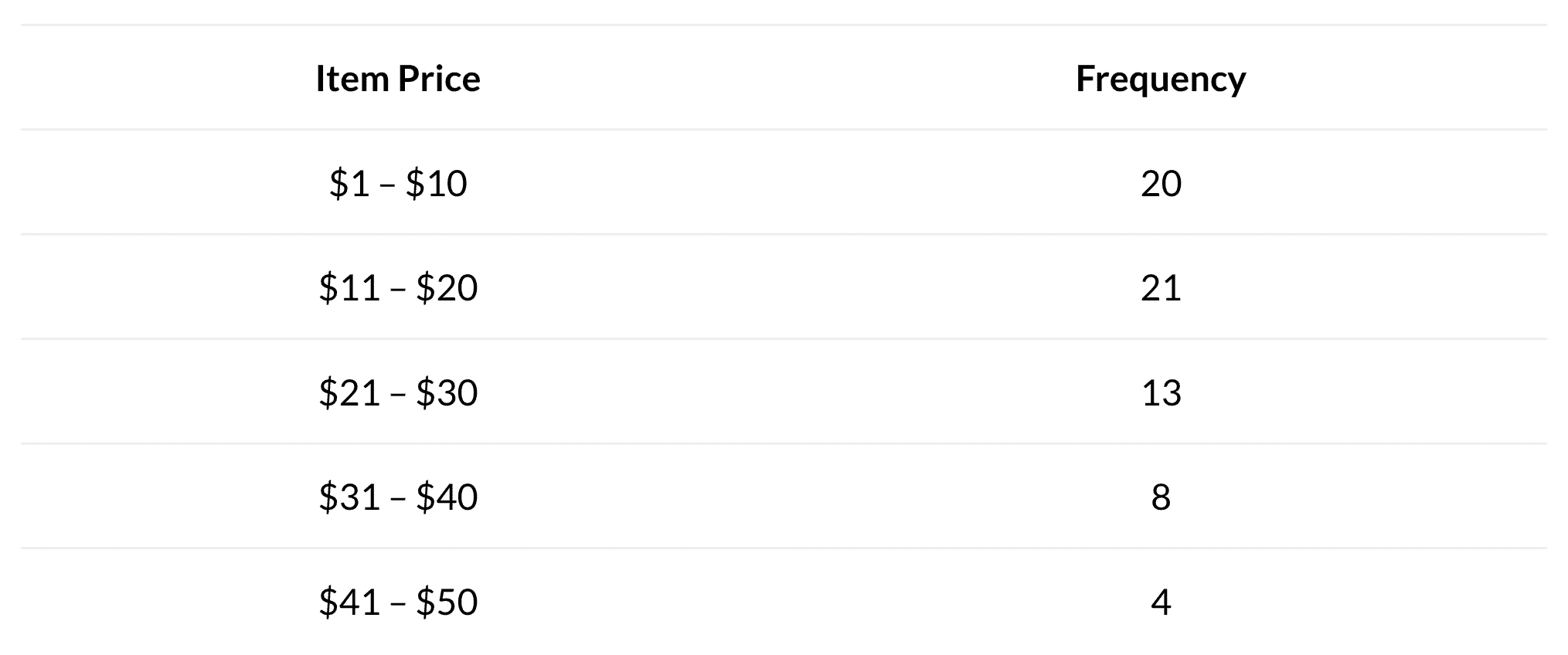

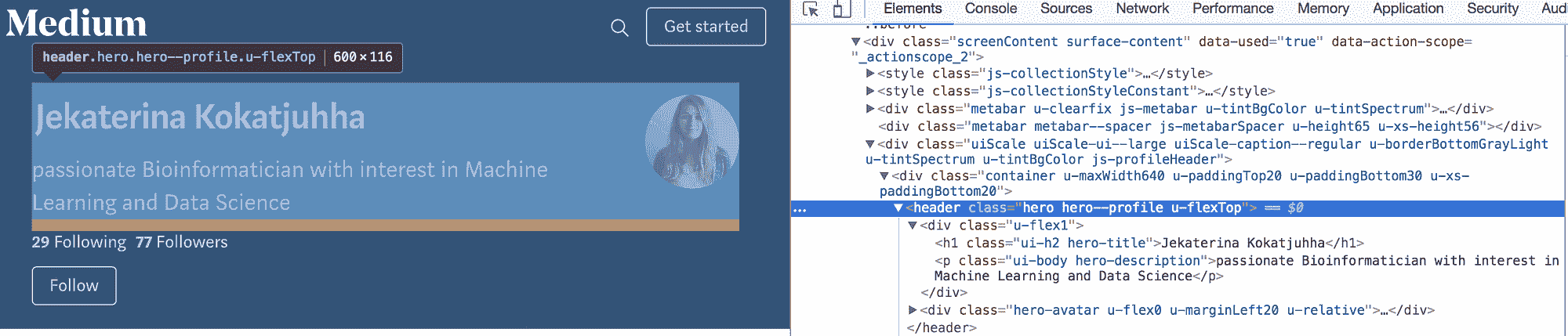

由 Maarit Widmann,数据科学家,KNIME

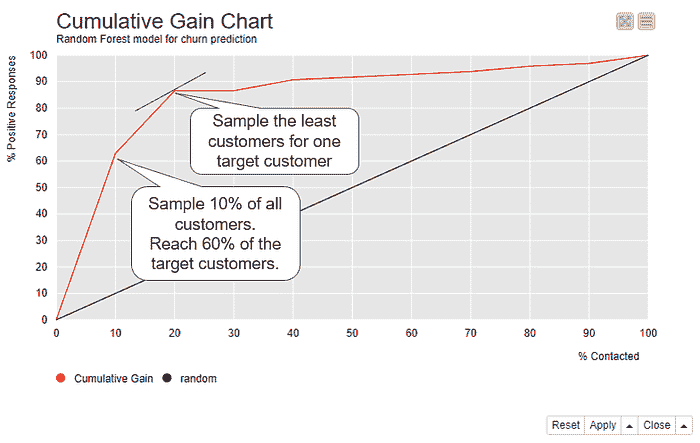

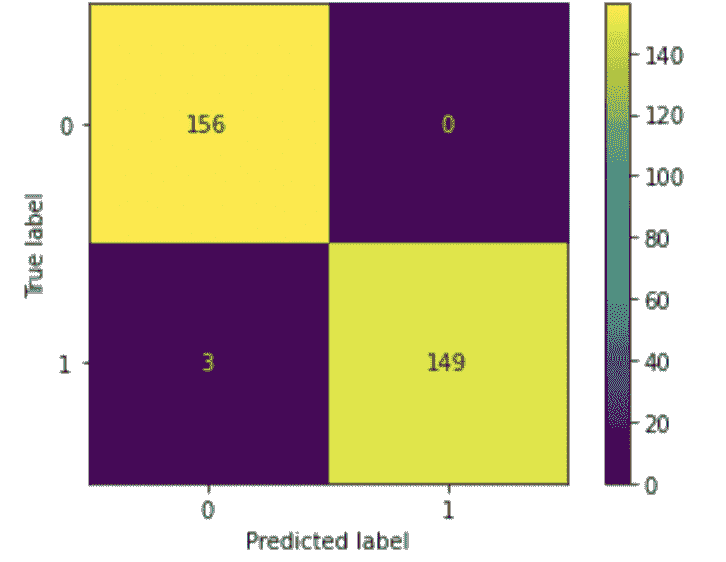

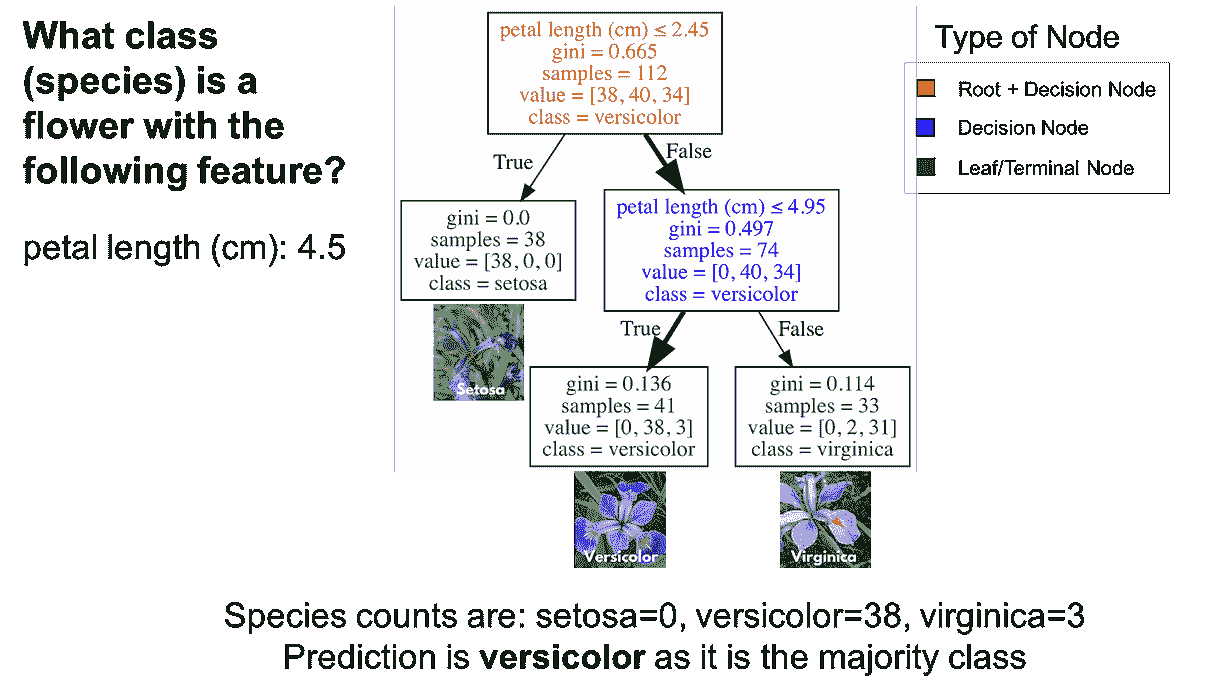

99%的准确性对于流失预测模型来说好吗?如果实际情况是 1%的客户流失,99%的客户未流失,那么模型的表现与随机猜测相当。如果 10%的客户流失,90%的客户未流失,那么模型的表现则优于随机猜测。

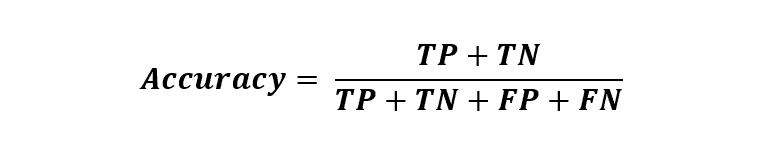

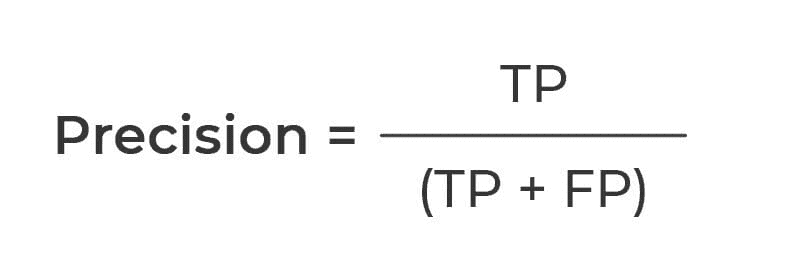

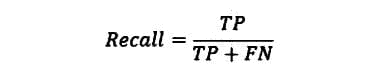

准确性统计信息,如总体准确性,量化了机器学习模型在新数据上的预期表现,没有任何基线,例如随机猜测或现有模型。

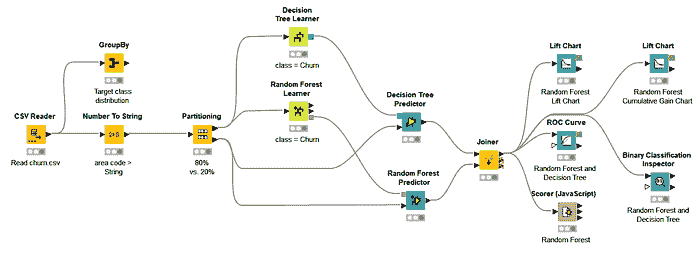

这就是为什么我们还需要可视化模型评估——或评分——技术,这些技术显示模型在更广泛背景下的表现:对于不同的分类阈值,相对于其他模型,以及从资源使用的角度。在本文中,我们解释了如何通过 ROC 曲线、提升图和累计增益图来评估分类模型,并提供了在 KNIME 工作流中实际实施的链接,“分类模型的可视化评分技术”。

用例:流失预测模型

我们将通过一个用于流失预测的随机森林模型(100 棵树)展示可视化模型评估技术的实用性。

我们使用的数据集包含 3333 个电信客户的数据,包括他们的合同数据和电话使用情况,数据可在GitHub上获得。目标列“Churn?”显示客户是否流失(True)或未流失(False)。483 名客户(14%)流失,2850 名客户(86%)未流失。

模型的准确性统计信息如图 1 所示。

-

总体准确性大约为 94%,这意味着在测试数据中的每 100 个客户中,有 94 个获得了正确的类别预测,无论是流失 = True 还是流失 = False。

-

敏感性值在True类别大约为 59%。这意味着在每 10 个流失的客户(Churn=True)中,大约 6 个被正确预测为流失,而剩余的 4 个被错误预测为未流失。

-

特异性值在True类别大约为 99%,这表明几乎所有未流失的客户(Churn=False)都被正确分类。

图 1. 混淆矩阵、类别统计信息以及随机森林模型在流失预测中的总体准确性统计信息。

比较不同分类阈值下的性能

准确率统计是基于实际和预测的目标类计算的。预测的类别,这里是True和False,是基于模型预测的类别概率(或得分),范围在 0 到 1 之间。在二分类问题中,模型输出两个概率,每个类一个。默认情况下,具有最高概率的类别决定了预测类别,在二分类问题中,这意味着概率超过 0.5 的类别被预测。然而,有时不同的分类阈值可能会导致更好的性能。如果是这种情况,我们可以在 ROC 曲线中发现它。

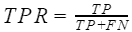

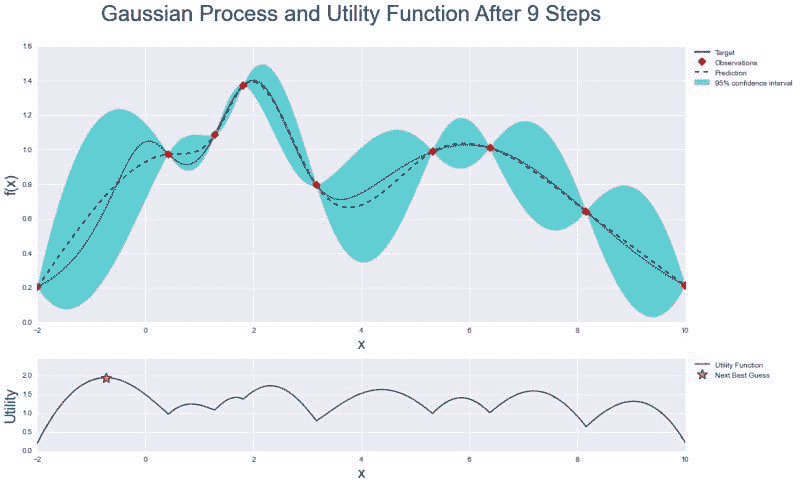

ROC 曲线

一个ROC 曲线(接收操作特征曲线)绘制了模型在不同分类阈值下的性能,使用两个指标:x 轴上的假阳性率和 y 轴上的真正率。

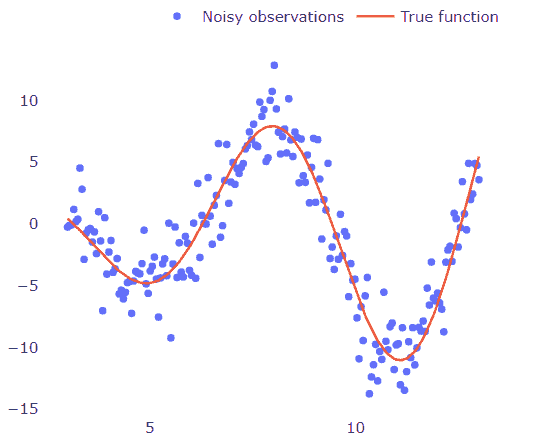

在二分类任务中,其中一个目标类被任意假定为正类,而另一个类成为负类。在我们的流失预测问题中,我们选择了True作为正类,False作为负类。

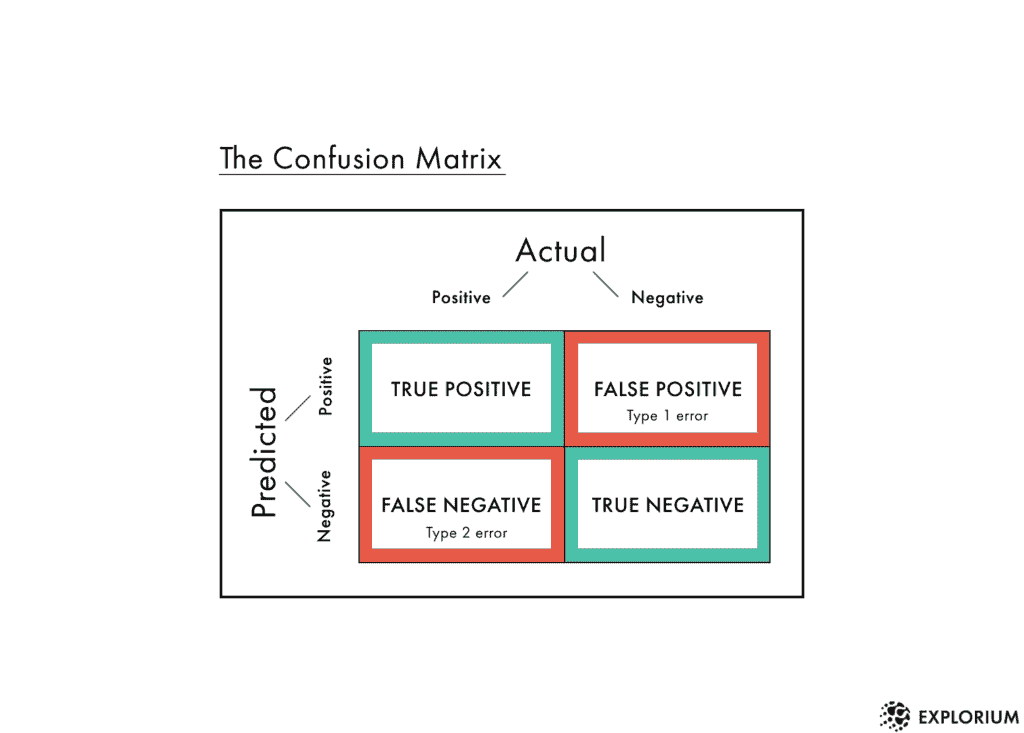

真阳性(TP)、假阴性(FN)、假阳性(FP)和真阴性(TN)的数量,如图 1 所示,用于计算假阳性率和真正率*。

- 假阳性率

衡量的是未流失的客户比例,但这些客户被错误地预测为流失。这等于1-specificity。

- 真正率

衡量的是流失客户的比例,以及这些客户被正确预测为流失。这等于sensitivity。

ROC 曲线底部左角的第一个点表示使用最大阈值 1.0获得的假阳性率(FPR)和真正率(TPR)。使用这个阈值,所有P(Churn=True) > 1.0的客户将被预测为流失,即没有客户被预测为流失,无论是正确还是错误,因此 FPR 和 TPR 都是 0.0。

ROC 曲线中的第二个点是通过降低阈值绘制的,例如降低 0.1。现在所有P(Churn=True) > 0.9的客户将被预测为流失。阈值仍然较高,但现在有可能一些客户会被预测为流失,因此产生小的非零 TPR 或 FPR 值。所以,这个点将在 ROC 曲线中接近上一个点的位置。

第三点是通过进一步降低阈值绘制的,依此类推,直到我们到达为最小分类阈值 0.0绘制的曲线的最后一点。使用这个阈值,所有客户都被分配到正类True,无论是否正确,因此 TPR 和 FPR 都是 1.0。

完美模型会产生 TPR=1.0 和 FPR=0.0. 相反,随机分类器总是对正类做出相等数量的正确和错误预测,这对应于 FPR=TPR 的黑色对角线。每个 ROC 曲线中都报告了这条线,作为无用模型的参考。

请注意,模型的表现当然可能比随机猜测更差,但这可能是数据科学家的错误,而不是模型的错误!只需采用模型决策的相反方向即可实现表现更好的解决方案。

图 2 显示了一个 ROC 曲线,为随机森林模型绘制,用于流失预测。注意与随机猜测对应的黑色线。

图 2. ROC 曲线显示了所有可能分类阈值从 0 到 1 的假阳性率(x 轴)和真实阳性率(y 轴)。

模型的最佳分类阈值应尽可能接近左上角——具有 TPR=1.0 和 FPR=0.0——这是完美模型占据的位置。这个最佳点与(0.0, 1.0)的切线最接近。使用这个最佳分类阈值,我们每个真实阳性的假阳性最少。我们的示例模型平均预测

当我们使用最佳分类阈值时,每个假阳性的真实阳性,如图 2 所示。

如果我们将这些数字与图 1 中的类别统计数据进行比较,我们可以看到,在优化分类阈值后,灵敏度从 59%显著提高到 85%,而特异性仅稍微降低,从 99%降到 1–0.05= 95%。

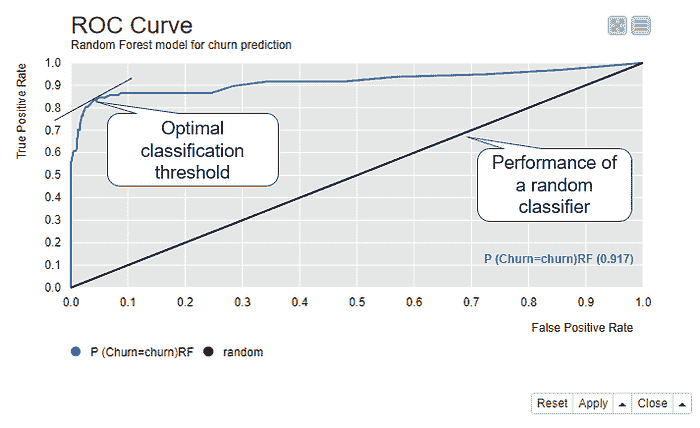

比较多个模型

ROC 曲线对于比较模型也很有用。让我们为相同的流失预测任务训练另一个模型——决策树,并将其表现与随机森林模型进行比较。

图 3 显示了同一视图中的两个 ROC 曲线。蓝色曲线是随机森林模型的,橙色曲线是决策树的。在这种情况下,更接近左上角的曲线,即随机森林模型的蓝色曲线,意味着表现更好。视图还显示了右下角两个模型的曲线下面积(AuC)统计数据。这测量了每个 ROC 曲线下的面积,并允许对性能进行更精细的比较。

图 3. 两个模型的 ROC 曲线——一个随机森林模型和一个决策树模型——用于流失预测。离左上角更近且 AuC 统计量更大的模型表现更好。

使用模型节省资源

除了获得准确预测外,我们还可以通过模型节省资源。在我们的流失预测示例中,预测之后会有某种行动,而这些行动需要资源,例如减少收入或增加时间投入。模型可以帮助我们更高效地利用资源:接触更少的客户,但仍能触达更多可能流失的客户。

提升和累计增益图对比了资源使用情况与正确预测的效果。

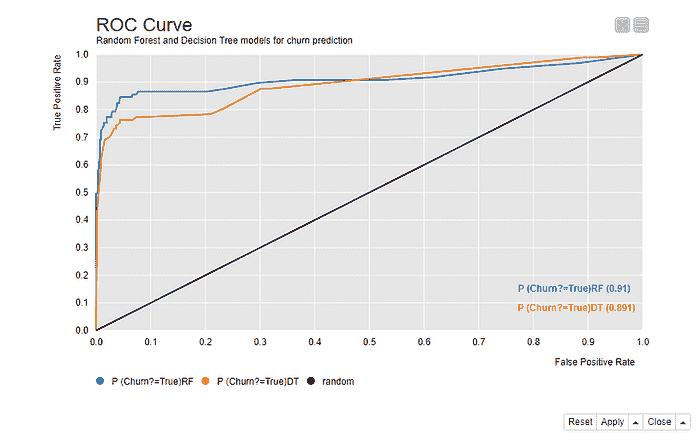

提升图

提升图比较了在根据模型预测提取的样本中达到的目标客户数量——这里是流失的客户——与随机样本中的目标客户数量。

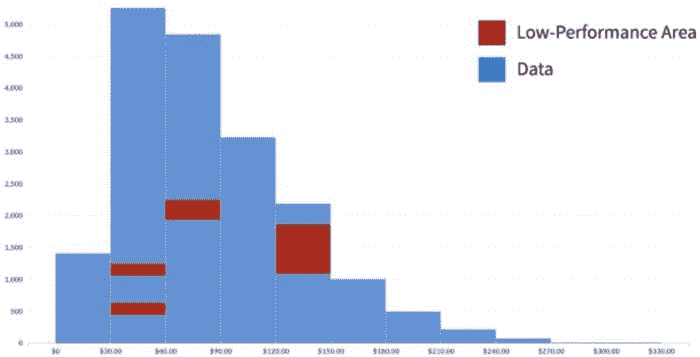

图 4 显示了随机森林模型的提升图。x 轴展示了按照预测的正类概率从高到低排序的每个十分位的数据。例如,如果我们有 100 位客户,第一个十分位包含 10 位具有最高预测正类概率的客户,也就是最有可能流失的 10 位客户。在第二个十分位,我们有另外 10 位客户,其概率低于前 10 位客户,但高于剩下的 80 位客户。第十个十分位包含了概率最低的 10 位客户,即最不可能流失的 10 位客户。

图 4. 提升图显示了基于模型预测的样本中达到目标客户的比例与随机样本中的比例的对比。

累积提升线(蓝线)所示的提升是从按照 x 轴展示的有序数据中抽取的样本中达到目标客户的比例与在随机样本中的比例。第一个十分位的提升大约为 6。由于原始数据中有 14% 的客户流失,随机样本中达到目标客户的概率为 14%。如果我们从 100 位客户中随机抽取 10 位客户,我们期望能接触到 0.1410=1.4 位目标客户。如果我们从有序数据中抽取前 10 位客户,我们期望能接触到 6 倍,即 61.4=8.4 位目标客户。

如果我们将样本量再增加 10%,累计提升约为 4。现在我们将在 20 位客户的随机样本中达到 0.1420=2.8 位目标客户,而在有序数据的样本中达到 42.8=11.2 位目标客户。我们采样的数据越多,即使是随机采样,也会有更多的目标客户被接触到。这解释了为什么累计提升与基线(绿色线)的差异在第十个十分位时减少。

提升线(红色线条)展示了每个分位的提升情况。前两个分位的提升值高于基准线,从第三个分位开始则低于基准线。这意味着,如果我们从 100 个客户中抽取第一个分位样本,我们预计会有 61.4 = 8.4 个目标客户。如果我们抽取第二个分位而不抽取第一个分位,我们预计会有 21.4 = 2.8 个目标客户。如果我们抽取第 3 到第 10 个分位中的任何一个,我们预计最多会有 0.25*1.4=0.35 个目标客户,因为在这 80%的数据中,提升值保持在 0 到 0.25 之间的非常低水平。

累积增益图

累积增益图展示了在不同样本量下可以达到的目标客户比例。类似于提升图,累积增益图在 x 轴上展示了按照正类概率排序的数据。在 y 轴上展示了达到的目标客户比例。

图 5 展示了随机森林模型的累积增益图。如果我们跟随曲线,可以看到如果我们仅抽取 10%的客户,即那些概率最高的客户,我们预计能覆盖到大约 60%的流失客户(y 轴)。如果我们抽取 20%的客户,依然是那些概率最高的客户,我们预计能覆盖到超过 80%的流失客户。这个点还与左上角的切线距离最近。在这个样本量下,达到一个目标客户所需的平均样本量是最低的。

图 5. 累积增益图展示了当我们联系按照其正类概率排序的 10%、20%、……、100%客户时,我们能达到的目标客户比例。

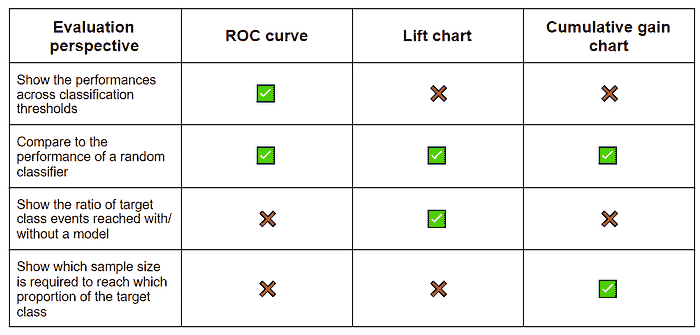

视觉模型评估技术 — 总结

表 1 收集了上述描述的技术,并总结了它们关于模型性能的报告。这些视觉技术通过展示最佳分类阈值、将性能与随机猜测进行比较、在一个视图中比较多个模型以及指示最佳样本量和质量来补充准确性统计数据。

ROC 曲线展示了不同分类阈值下的性能,比对了模型与随机猜测的表现,并且也比较了多个模型的性能。提升图和累积增益图则显示了模型是否能使我们投入更少的资源仍能达到期望的结果。

这些视觉技术补充但不替代准确性统计数据。为了全面评估模型,查看这两者都是很好的做法。

表 1. 分类模型视觉评估技术的总结。

小贴士与技巧

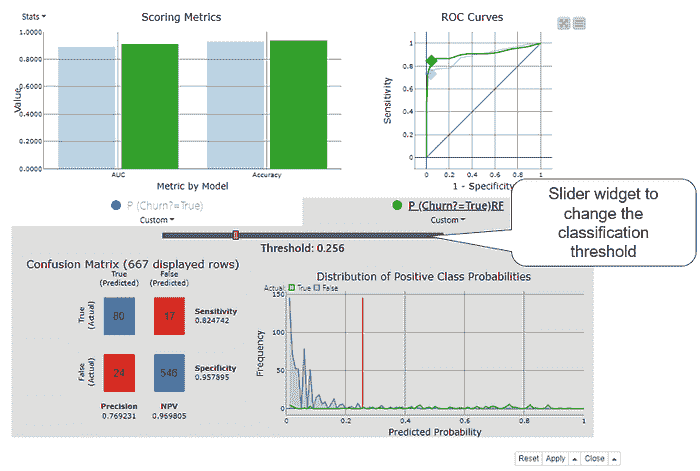

KNIME Analytics Platform 提供了一个 Binary Classification Inspector 节点,可以用来比较多个模型的准确性统计数据和 ROC 曲线,并找到最佳分类阈值。其交互视图(图 6)显示:

-

整体准确性和类别统计数据的条形图

-

ROC 曲线

-

混淆矩阵

-

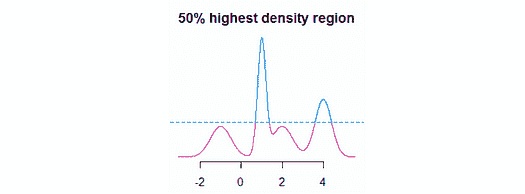

正类概率的分布

-

一个用于分类阈值的滑块小部件

图 6. Binary Classification Inspector 节点的交互视图显示了一个用于准确性统计、ROC 曲线、混淆矩阵和正类概率分布的条形图。在调整分类阈值时,所有视图都会更新。

Binary Classification Inspector 节点视图的顶部部分显示准确性统计数据的条形图和 ROC 曲线。每个模型用不同的颜色显示,这里绿色代表随机森林模型,蓝色代表决策树。我们可以通过点击彩色条选择一个模型进行更详细的检查。我们在图 6 中选择了随机森林模型。视图的底部部分被激活,显示所选模型的混淆矩阵和正类概率的分布。橙色垂直线表示当前分类阈值。

默认情况下,分类阈值为 0.5。使用阈值滑块小部件,我们可以改变这个值:向左调整至接近零,或向右调整至接近 1。当我们这样做时,视图中的所有其他图表和图形会根据新的分类阈值自动调整。例如,当我们向左移动阈值时,ROC 曲线中的点会向右移动。当点到达最佳阈值位置时,我们停止移动阈值,在这种情况下,图 6 显示最佳阈值为 0.256。这是随机森林模型的最佳分类阈值。与默认的 0.5 相差很大!

文章中介绍的 Binary Classification Inspector 视图和视觉模型评估技术已在 “分类模型的视觉评分技术” 工作流(图 7)中实现。你可以从 KNIME Hub 免费检查和下载。

图 7. 一个 KNIME 工作流,用于构建流失预测模型并使用视觉技术进行评估。

简历:Maarit Widmann 是 KNIME 宣传团队中的数据科学家;KNIME 自学课程的作者,以及 KNIME 讲师主导课程的教师。

首次发布于 高级数据科学的低代码。

原文。经许可转载。

相关:

-

指标重要性,第一部分:评估分类模型

-

我希望在构建第一个模型时就了解的 4 个机器学习概念

-

ROC 曲线解释

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

更多相关主题

使用 Folium 在 Python 中可视化地理空间数据

原文:

www.kdnuggets.com/2018/09/visualising-geospatial-data-python-folium.html

评论

由Parul Pandey提供

数据可视化是一个更广泛的术语,描述了通过将数据放置在视觉上下文中来帮助人们理解数据重要性的任何努力。模式、趋势和关联可以通过视觉方式轻松展示,否则可能在文本数据中被忽视。它是数据科学家工具包的基本组成部分。创建可视化很简单,但创建好的可视化则困难得多。它需要细致的眼光和大量的专业知识来创建既简单又有效的可视化。今天有强大的可视化工具和库,它们重新定义了可视化的意义。

使用 Python 的优点在于它提供了满足各种数据可视化需求的库。其中一个库是Folium,它对于可视化地理数据(Geo data)非常有用。地理数据(Geo data)科学是数据科学的一个子集,涉及基于位置的数据,即对象及其在空间中的关系的描述。

前提条件

本教程假设你具备基本的 Python 和 Jupyter notebook 知识,并熟悉 Pandas 库。

Folium 简介

Folium 是一个强大的 Python 数据可视化库,主要用于帮助人们可视化地理空间数据。使用 Folium,可以创建世界上任何位置的地图,只要知道其经纬度值。此外,Folium 创建的地图本质上是交互式的,所以在地图渲染后可以进行缩放,这是一项非常有用的功能。

Folium 利用了 Python 生态系统在数据处理方面的优势以及 Leaflet.js 库在制图方面的优势。数据在 Python 中处理,然后通过 folium 在 Leaflet 地图中可视化。

安装

在使用 Folium 之前,可能需要通过以下两种方法之一在系统上安装它:

$ pip install folium

或

$ conda install -c conda-forge folium

数据集

下载数据集

我们将使用世界发展指标数据集,该数据集是 Kaggle 上的一个开放数据集。我们将使用数据集中的‘indicators.csv’文件。

由于我们处理的是地理空间地图,因此还需要国家坐标来进行绘制。从这里下载文件。

文件也可以从我的github 仓库下载。

探索数据集

世界发展指标数据集只是从世界银行实际提供的数据集中稍作修改的版本。它包含了从 1960 年到 2015 年,来自约 247 个国家的超过一千个年度经济发展指标。一些指标包括:

1\. Adolescent fertility rate (births per 1,000 women)

2\. CO2 emissions (metric tons per capita)

3\. Merchandise exports by the reporting economy

4\. Time required to build a warehouse (days)

5\. Total tax rate (% of commercial profits)

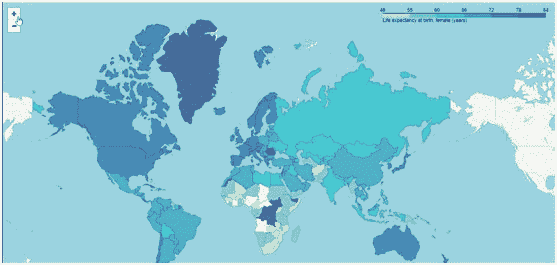

6\. Life expectancy at birth, female (years)

开始使用

-

转到 Jupyter Notebooks 并导入所需的库。确保在与数据相同的文件夹中创建 Jupyter 笔记本,以方便操作。

-

设置国家坐标

-

读取数据库并探索数据库

代码:

import folium

import pandas as pd

country_geo = 'world-countries.json'

data = pd.read_csv('Indicators.csv')

data.shape

data.head()

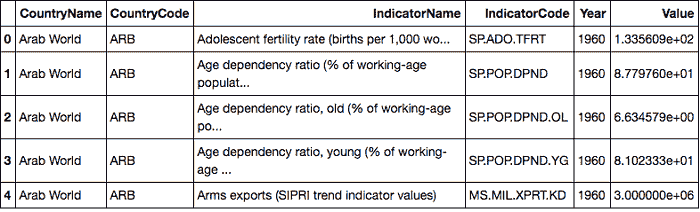

我们得到如下结果。看来这些指标数据集中,不同国家有不同的指标,包含了指标的年份和数值。

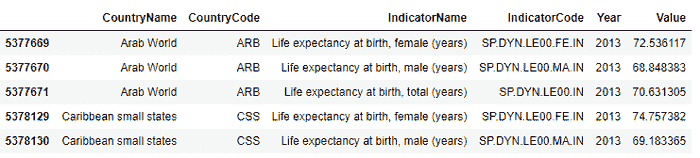

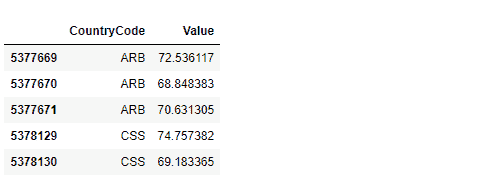

出生时女性预期寿命(年)似乎是一个很好的调查指标。因此,我们提取 2013 年所有国家的预期寿命数据。我们只是随机选择了这一年。

同时,我们来设置绘图的数据,仅保留国家代码和我们绘制的数值。我们还需要提取指标名称,以便在图例中使用。

代码:

# select Life expectancy for females for all countries in 2013

hist_indicator = 'Life expectancy at birth'

hist_year = 2013

mask1 = data['IndicatorName'].str.contains(hist_indicator)

mask2 = data['Year'].isin([hist_year])

# apply our mask

stage = data[mask1 & mask2]

stage.head()

#Creating a data frame with just the country codes and the values we want plotted.

data_to_plot = stage[['CountryCode','Value']]

data_to_plot.head()

# labelling the legend

hist_indicator = stage.iloc[0]['IndicatorName']

创建 Folium 交互地图

现在我们实际上要创建 Folium 交互地图。我们将创建一个相对较高缩放级别的地图。接下来,我们将使用内置方法 choropleth 来附加国家的地理 json 和绘图数据。

代码:

# Setup a folium map at a high-level zoom

map = folium.Map(location=[100, 0], zoom_start=1.5)

# choropleth maps bind Pandas Data Frames and json geometries.