KDNuggets-博客中文翻译-三十四-

KDNuggets 博客中文翻译(三十四)

原文:KDNuggets

如何利用 TPU 免费将 Keras 模型训练速度提高 20 倍

原文:

www.kdnuggets.com/2019/03/train-keras-model-20x-faster-tpu-free.html

评论

评论

作者:Chengwei Zhang,上海工业技术研究院 / 程序员 / 创客

有段时间,我一直很满足于在一张 GTX 1070 显卡上训练我的模型,该显卡单精度约为 8.18 TFlops,然后谷歌在 Colab 上开放了他们的免费 Tesla K80 GPU,具有 12GB RAM,速度略快,为 8.73 TFlops。直到最近,Cloud TPU 选项以 180 TFlops 出现在 Colab 的运行时类型选择器中。在这个快速教程中,你将学习如何将现有的 Keras 模型转换为 TPU 模型,并在 Colab 上以免费方式训练,速度比我的 GTX1070 快 20 倍。

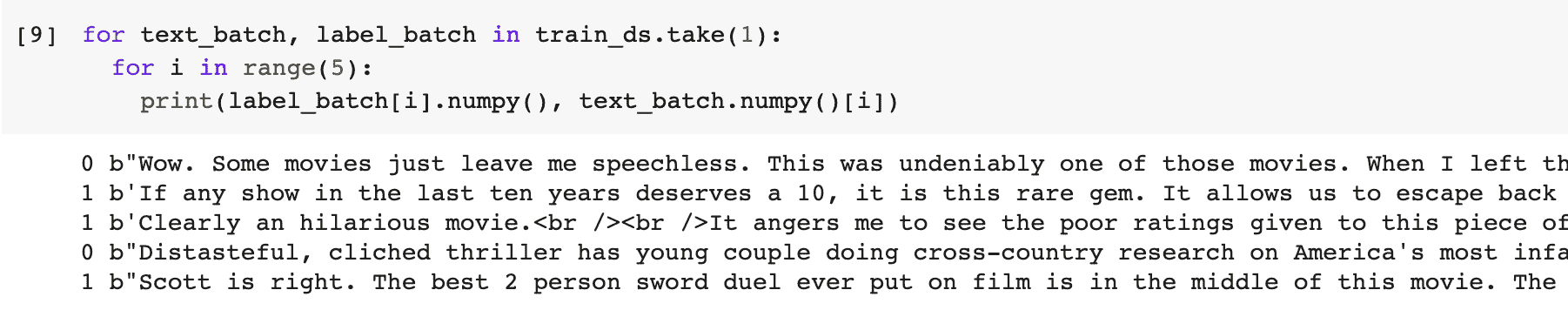

我们将构建一个易于理解但足够复杂的 Keras 模型,以便稍微热身 Cloud TPU。在 IMDB 情感分类任务上训练 LSTM 模型是一个很好的例子,因为 LSTM 的训练计算开销可能比 Dense 和卷积等其他层更大。

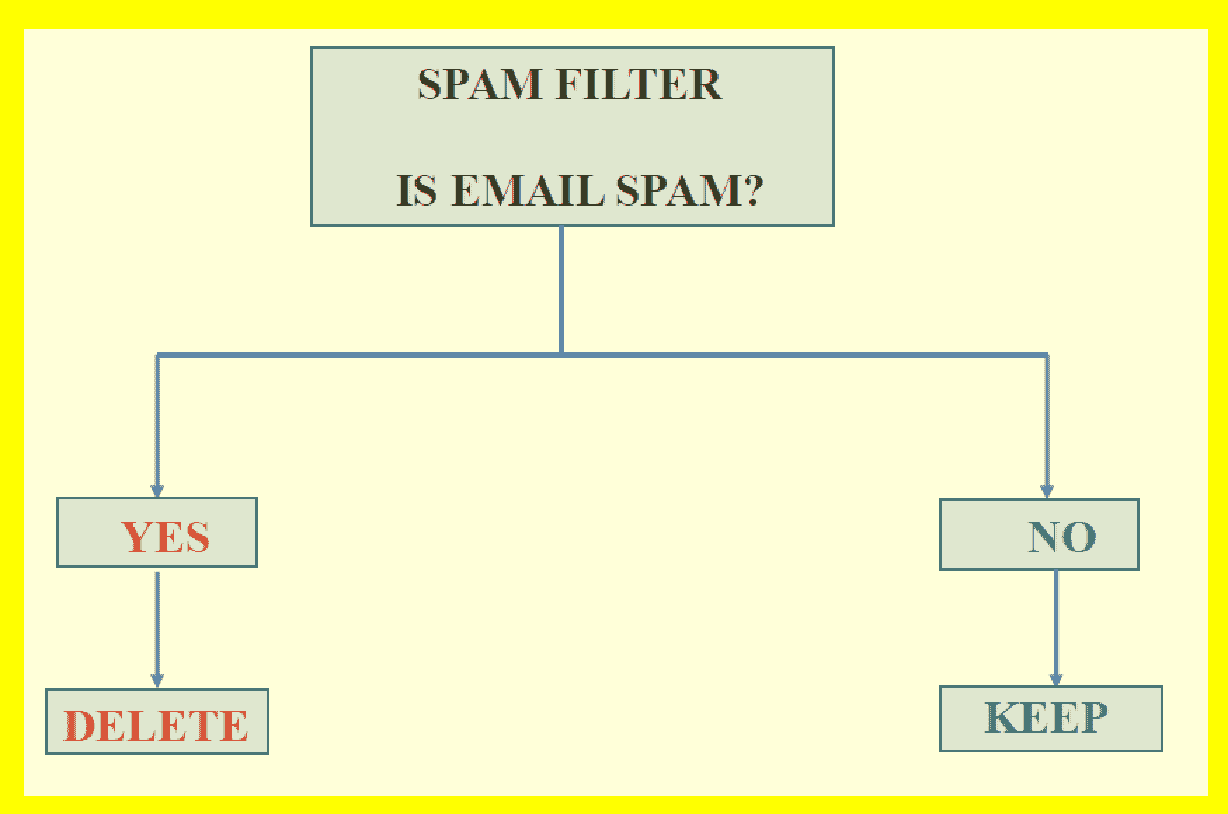

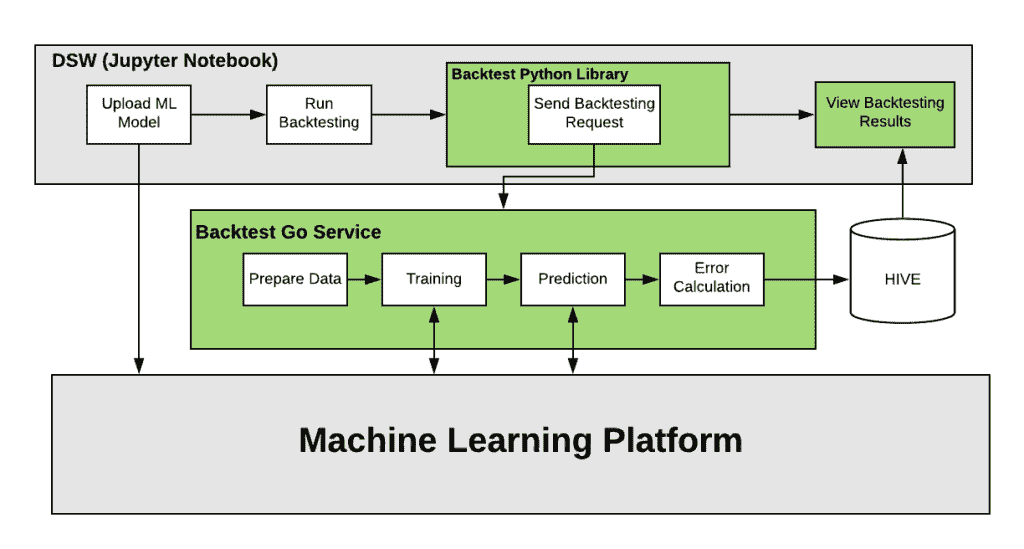

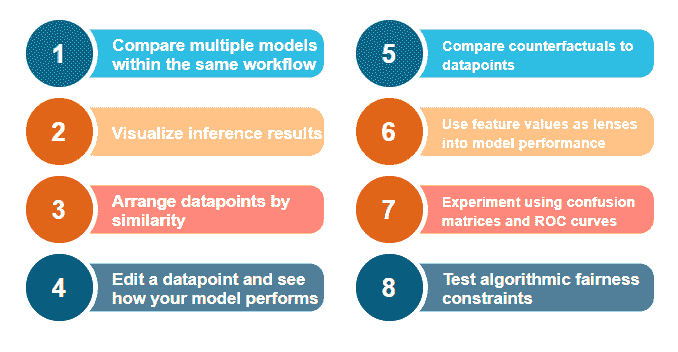

工作流程概述,

-

构建一个用于训练的 Keras 模型,在功能性 API 中使用静态输入

batch_size。 -

将 Keras 模型转换为 TPU 模型。

-

使用静态

batch_size * 8训练 TPU 模型,并将权重保存到文件中。 -

构建一个用于推断的 Keras 模型,保持相同的结构,但批量输入大小可变。

-

加载模型权重。

-

使用推断模型进行预测。

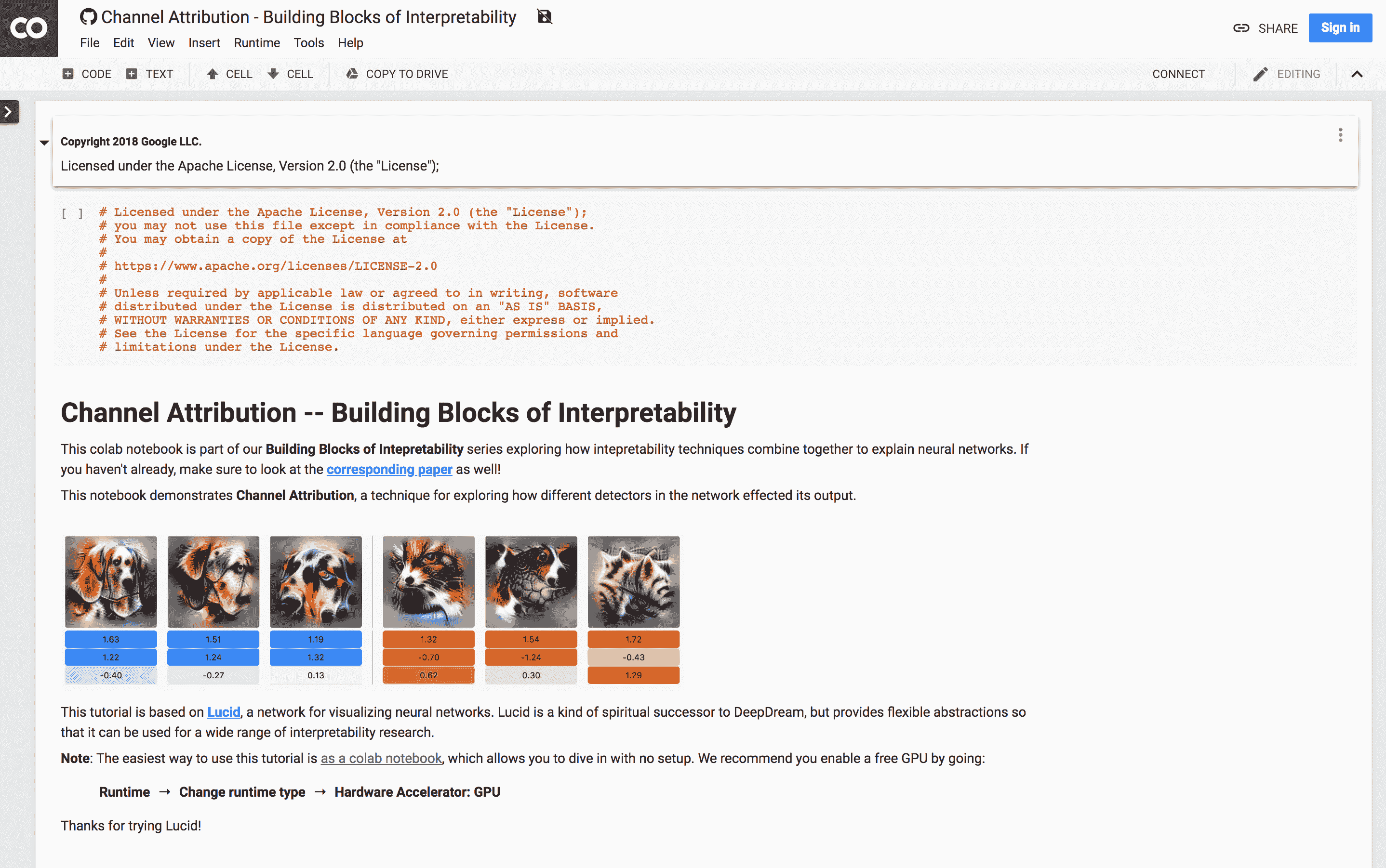

你可以在阅读的同时玩转 Colab Jupyter 笔记本——Keras_LSTM_TPU.ipynb。

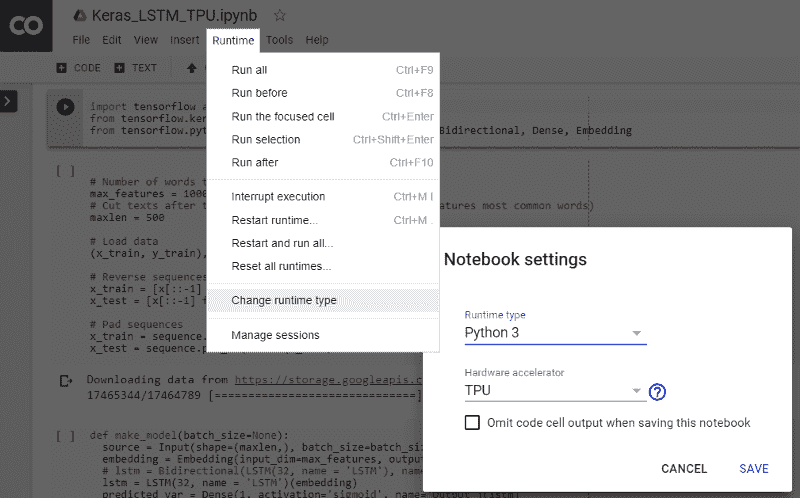

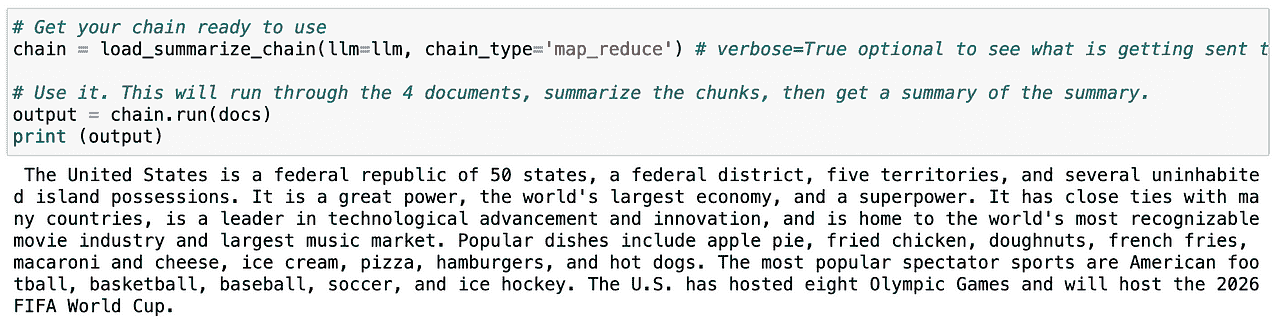

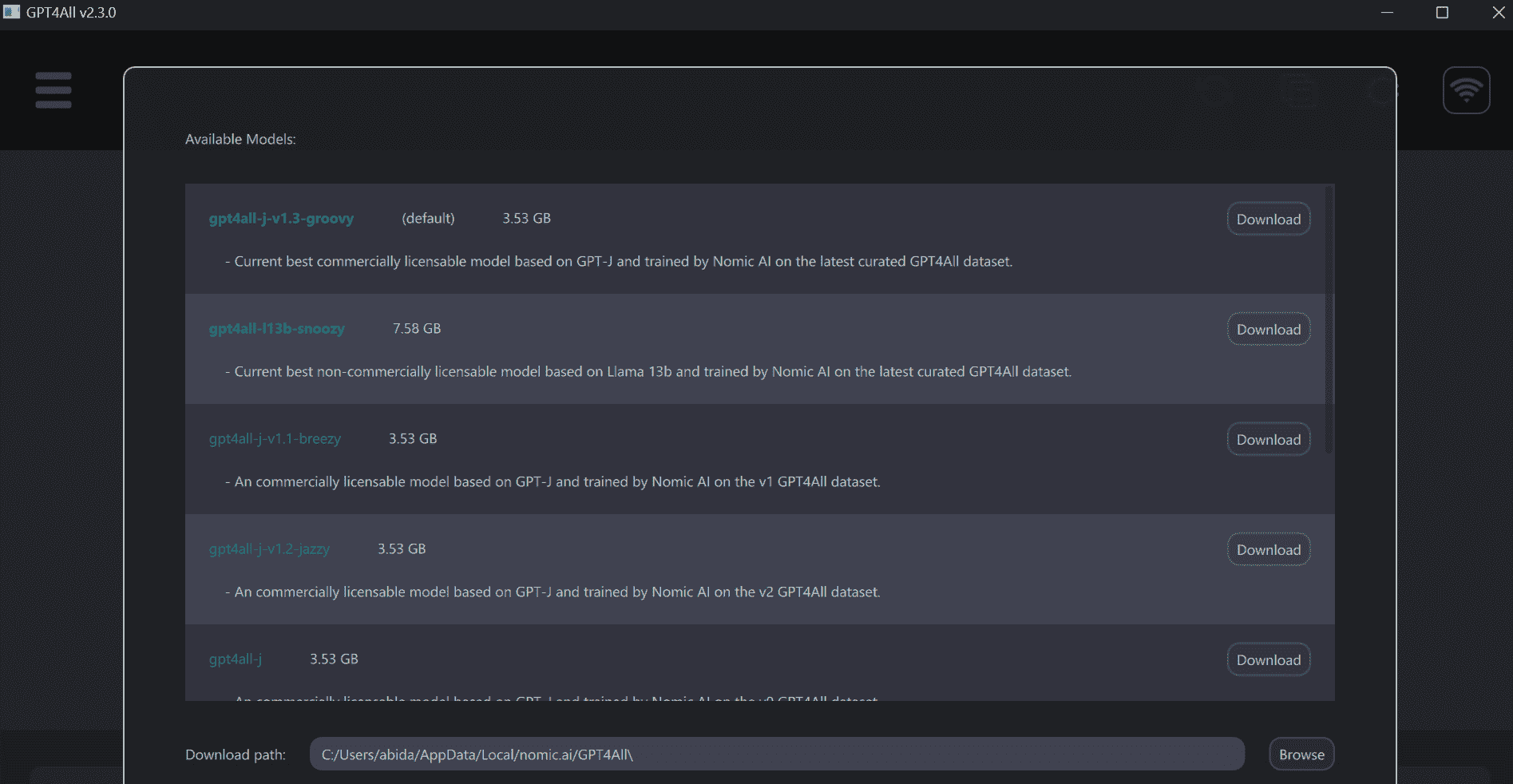

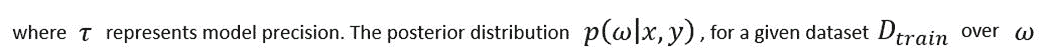

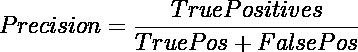

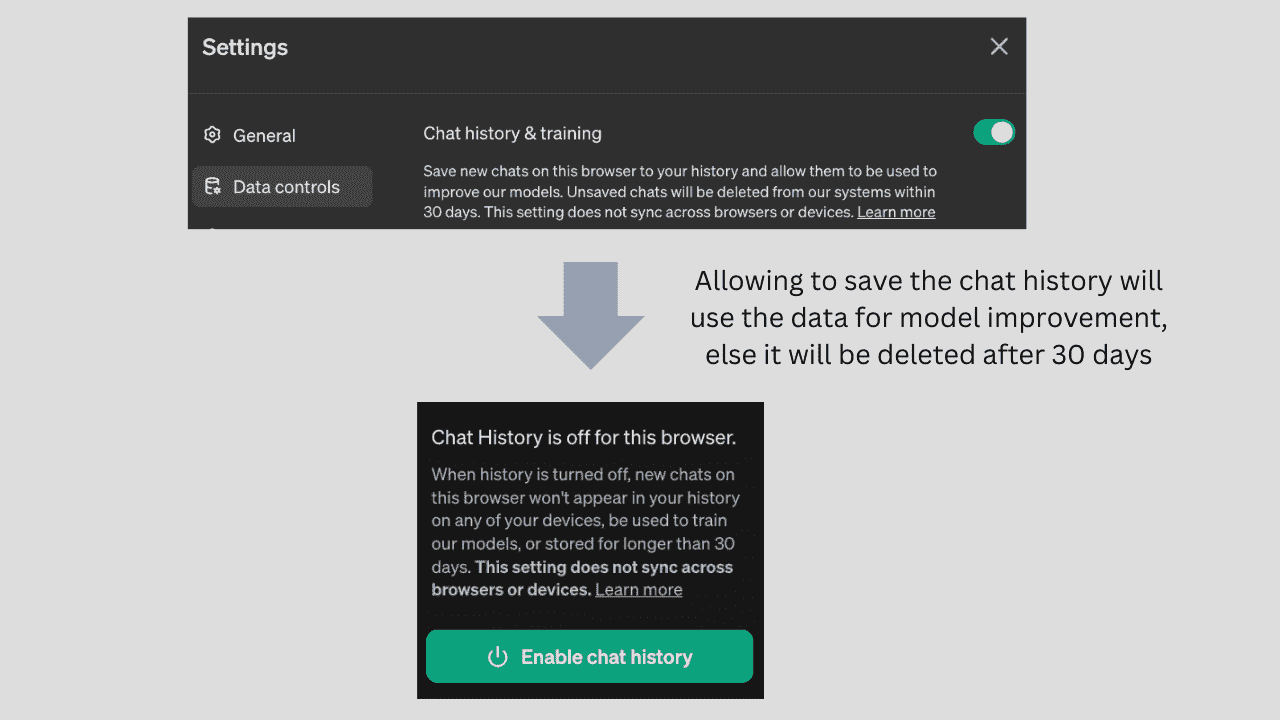

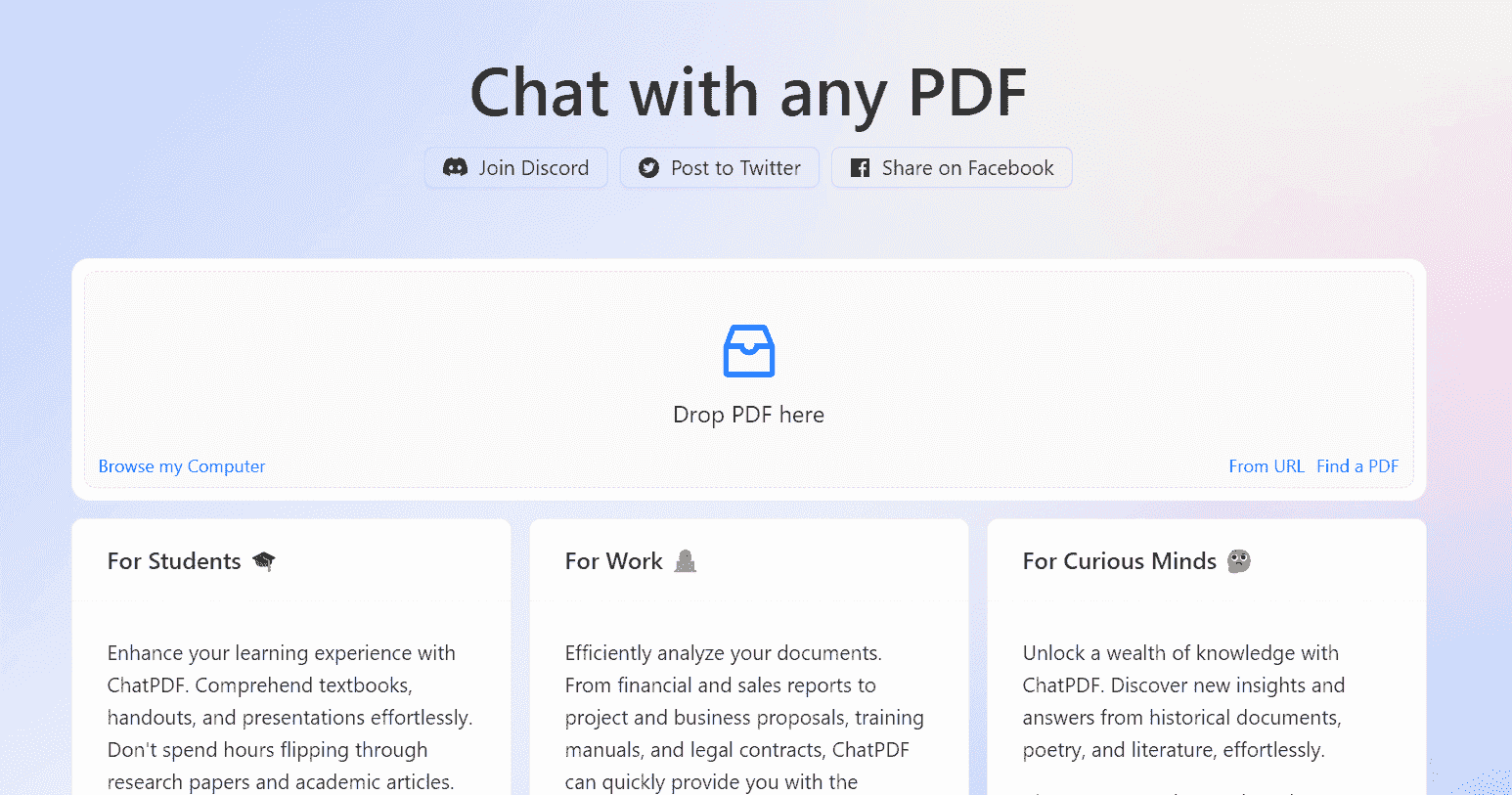

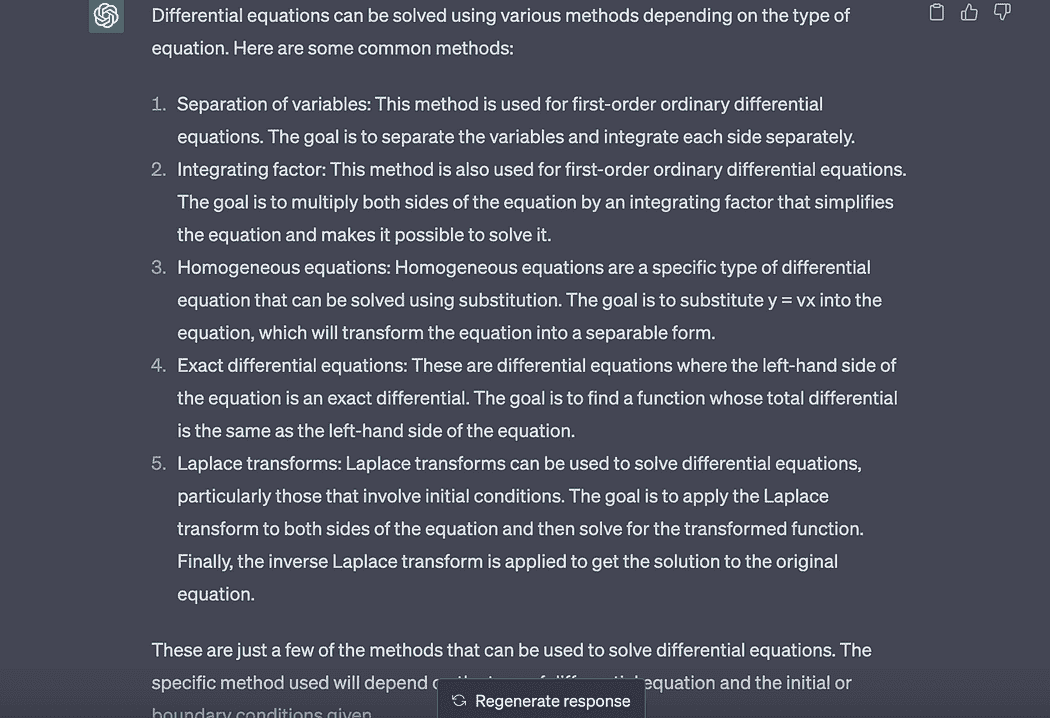

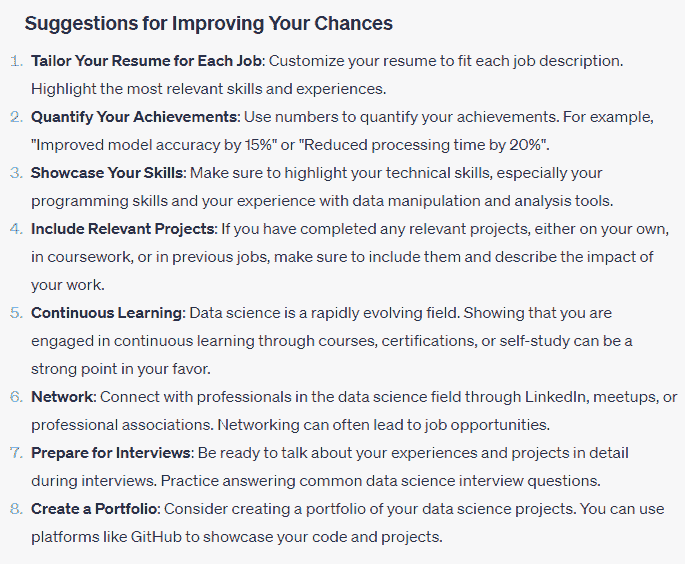

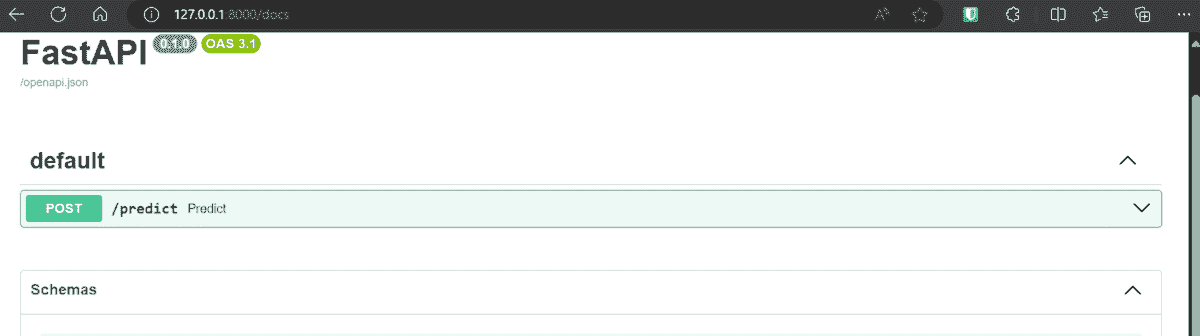

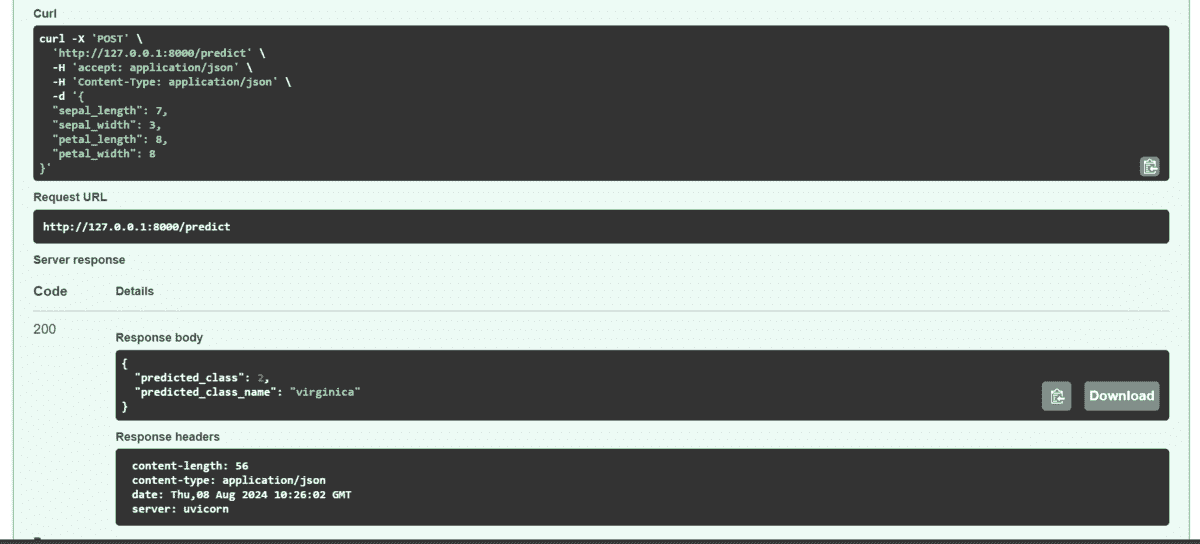

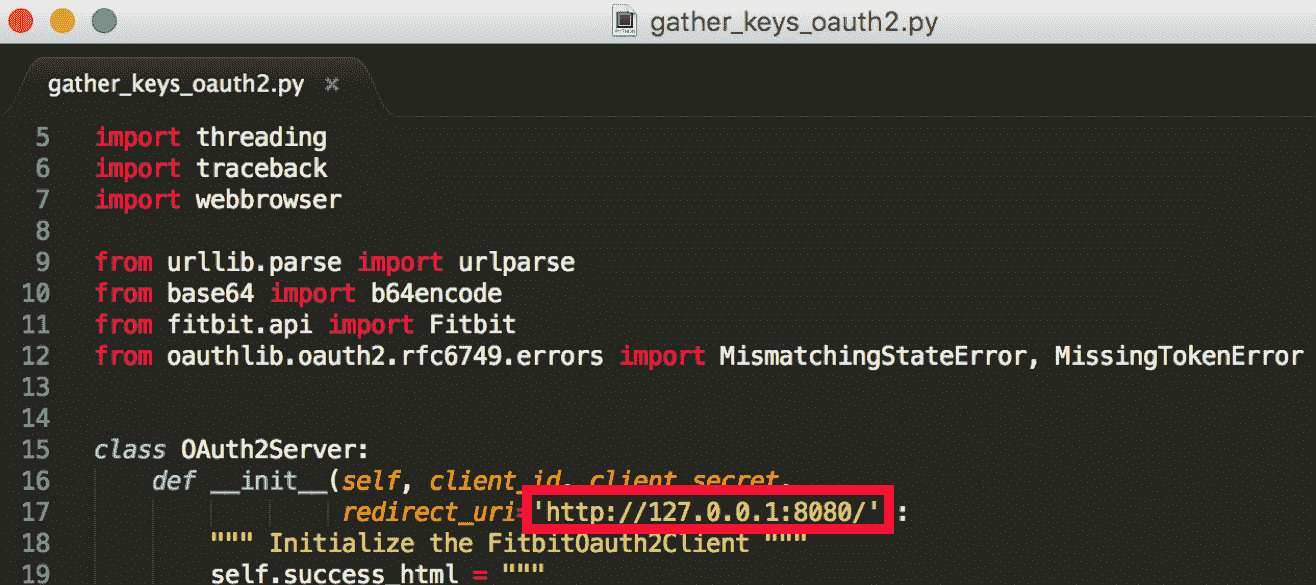

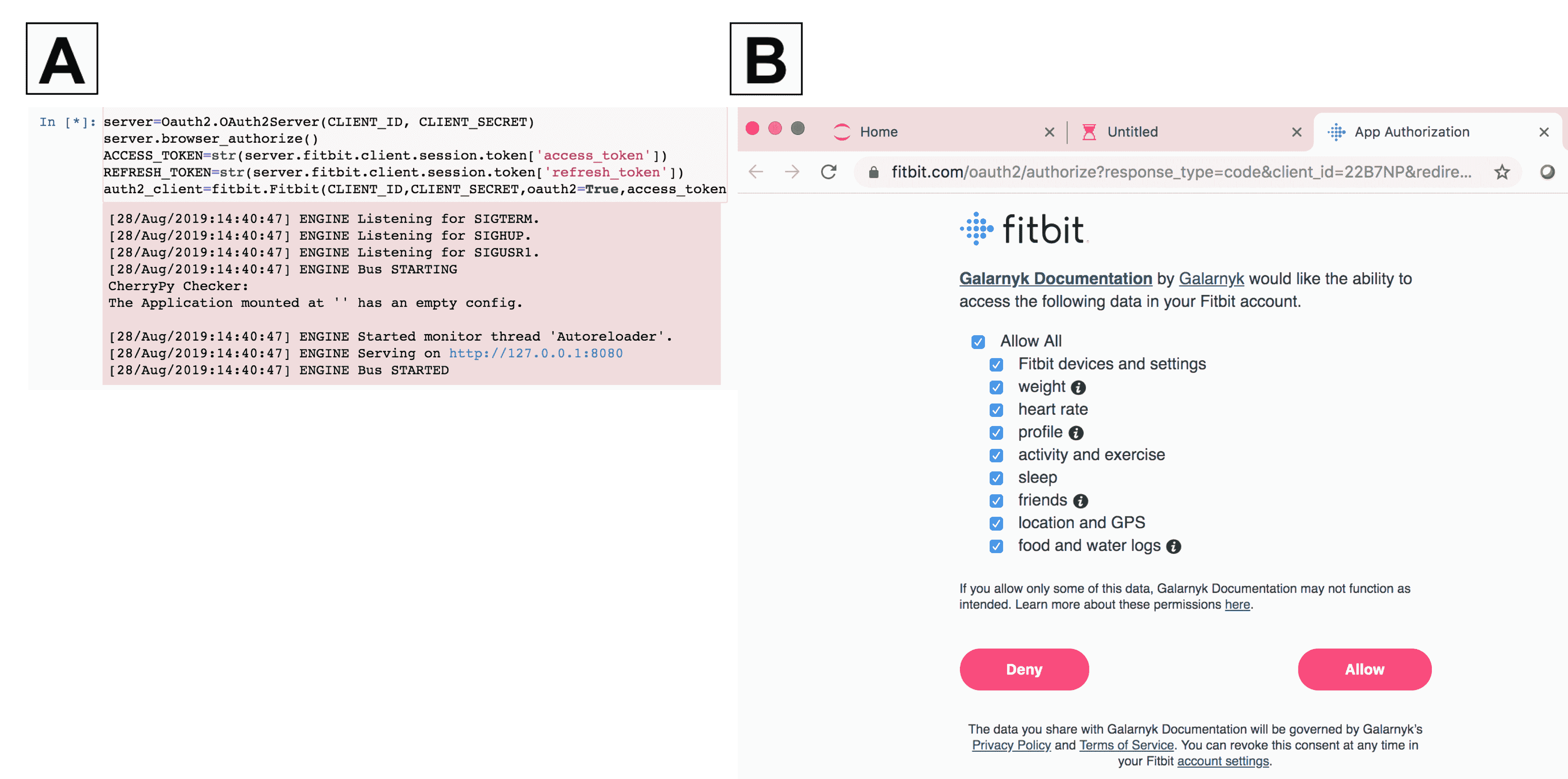

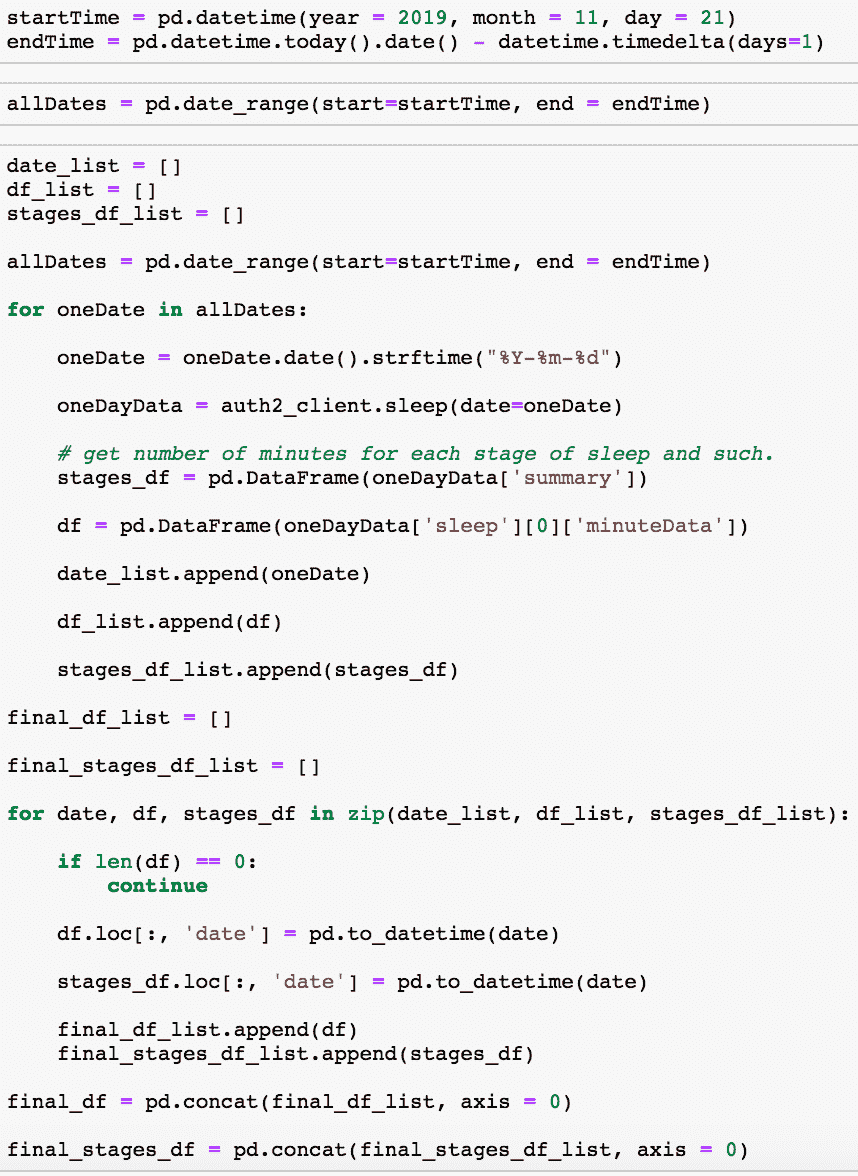

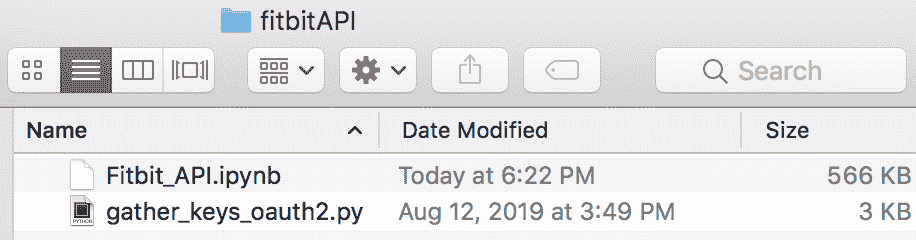

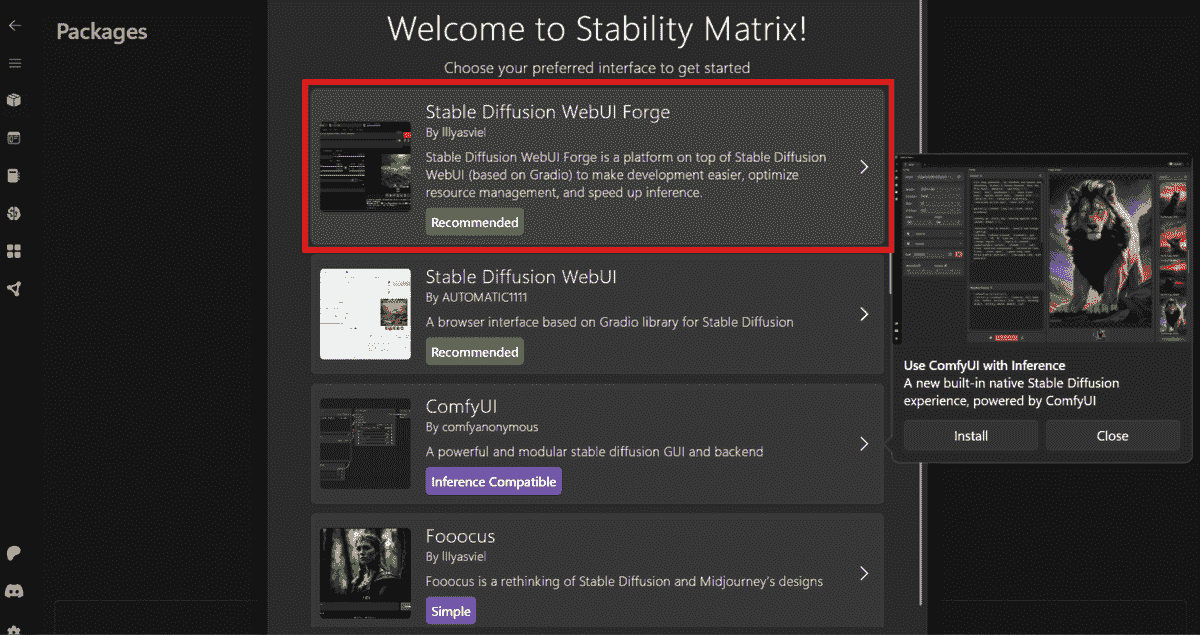

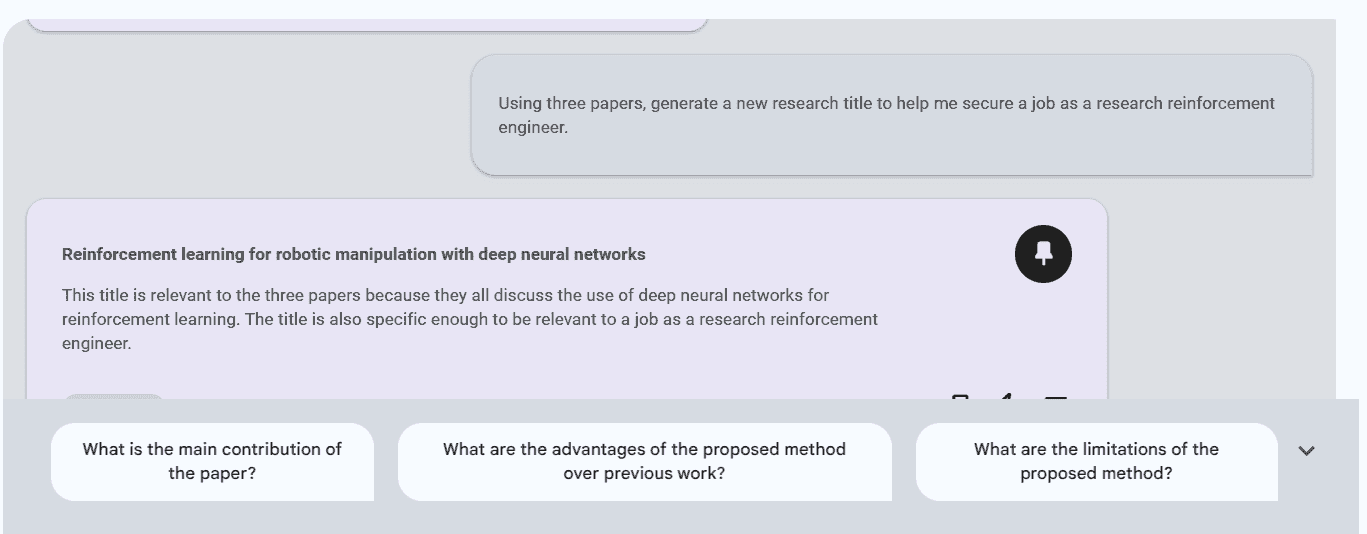

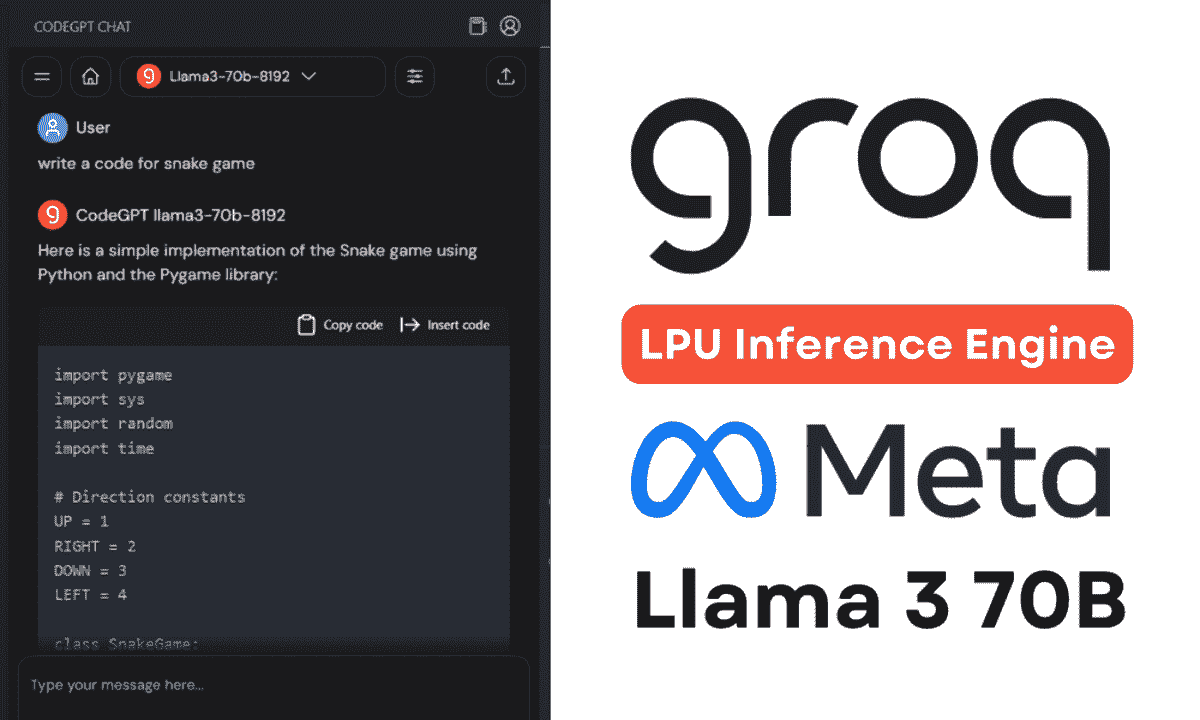

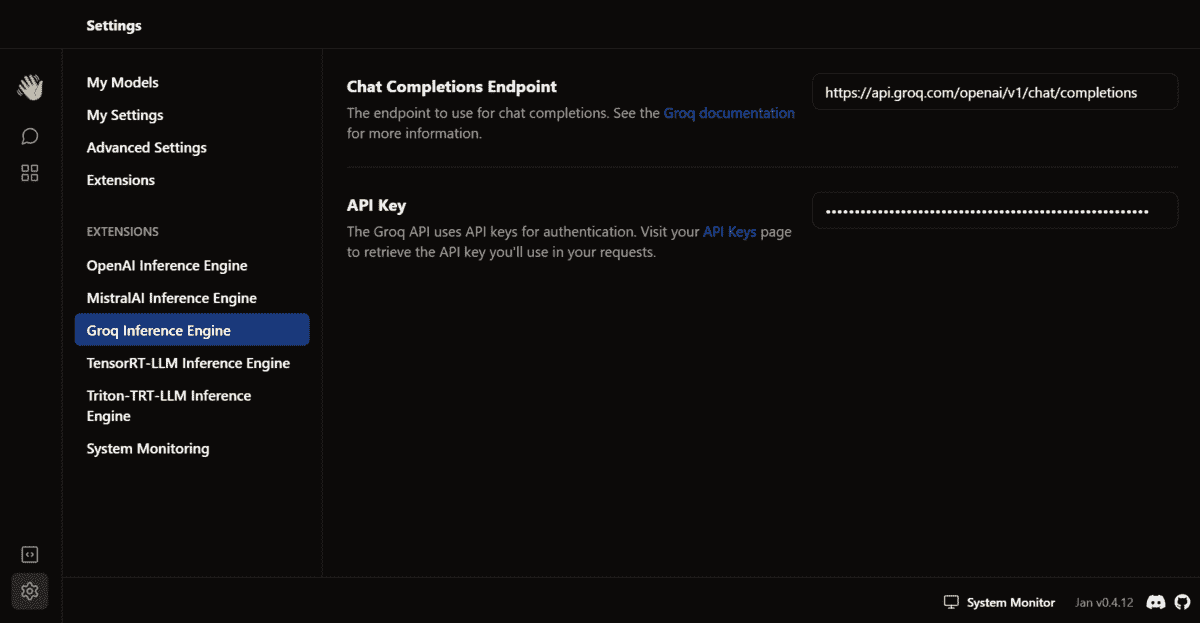

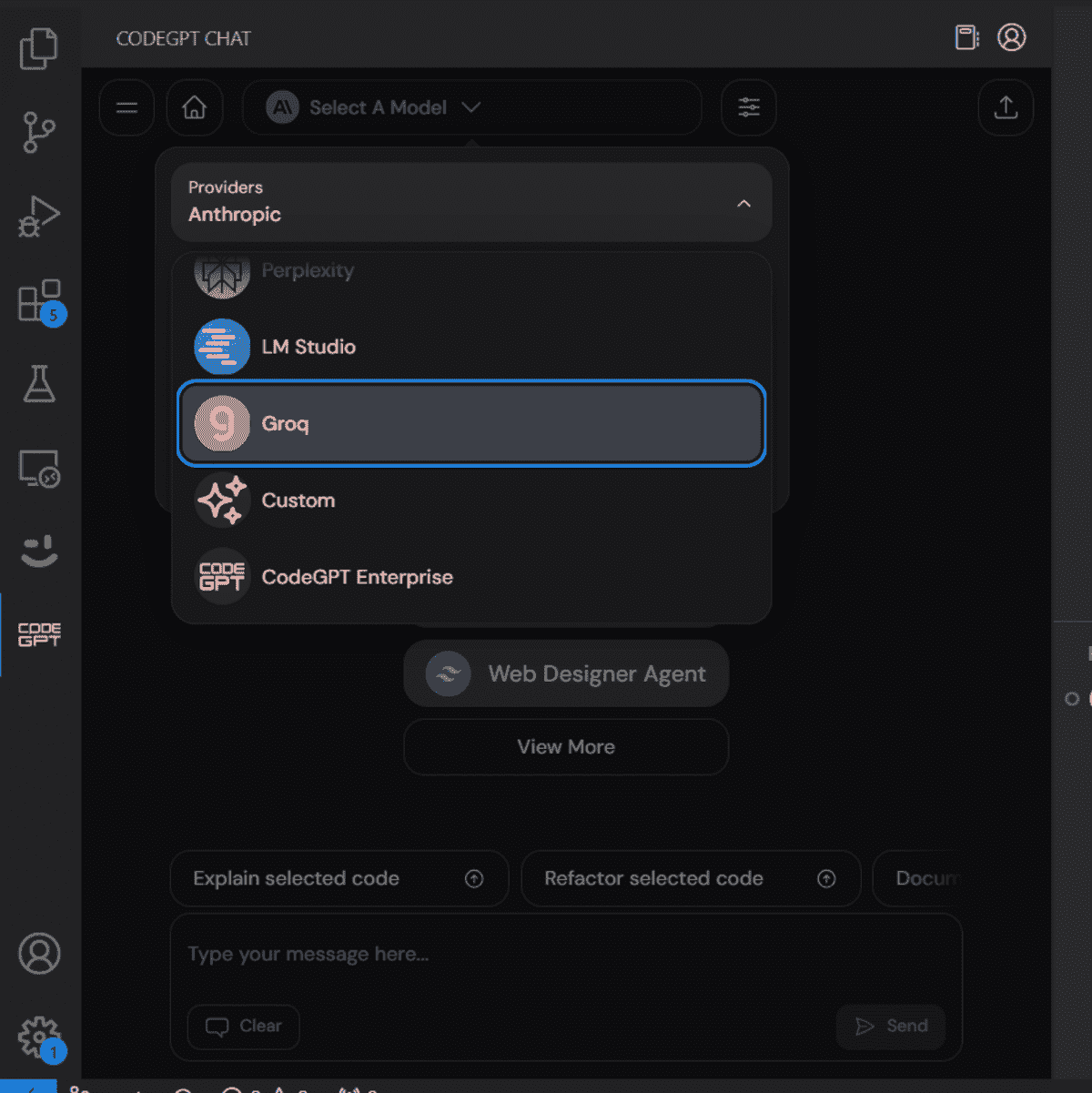

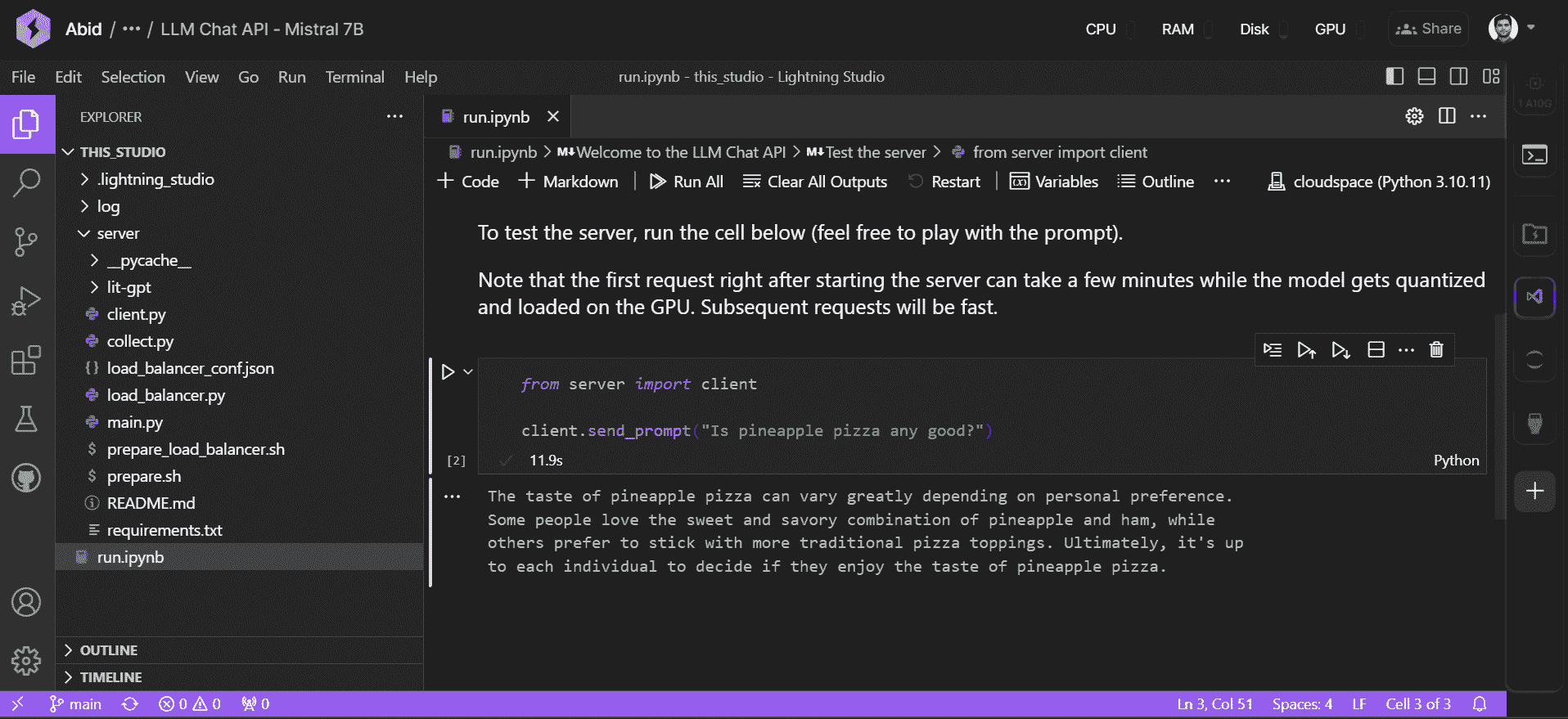

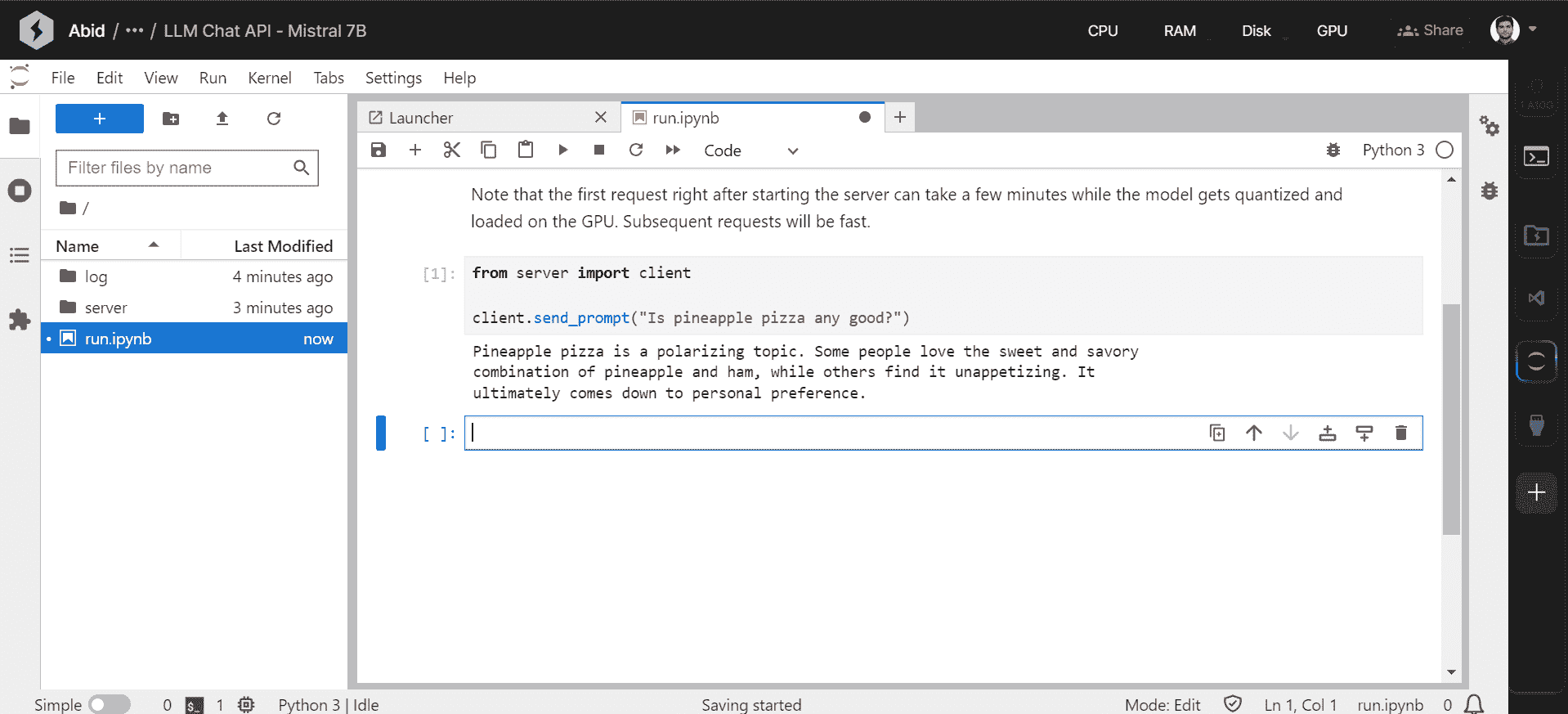

首先,按照下图中的说明激活 Colab 运行时中的 TPU。

激活 TPU

激活 TPU

静态输入批量大小

在 CPU 和 GPU 上运行的输入管道大多不受静态形状要求的限制,而在 XLA/TPU 环境中,静态形状和批量大小是强制要求的。

Cloud TPU 包含 8 个 TPU 核心,这些核心作为独立的处理单元进行操作。除非使用所有八个核心,否则 TPU 不会被充分利用。为了通过矢量化完全加速训练,我们可以选择比在单个 GPU 上训练相同模型时更大的批量大小。总批量大小为 1024(每核心 128)通常是一个不错的起点。

如果你打算训练一个较大的模型,批量大小过大时,尝试逐渐减少批量大小,直到它适合 TPU 内存,同时确保总批量大小是 64 的倍数(每核心的批量大小应为 8 的倍数)。

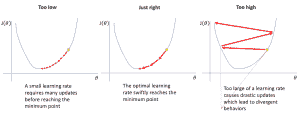

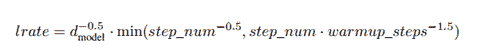

还值得提到的是,当使用更大的批次大小进行训练时,通常可以安全地增加优化器的学习率,以实现更快的收敛。你可以在这篇论文中找到参考——“准确的大规模小批量 SGD: 1 小时内训练 ImageNet”。

在 Keras 中,为了定义一个静态的批次大小,我们使用其函数式 API 然后为 Input 层指定batch_size参数。注意,模型在一个函数中构建,该函数接受一个batch_size参数,因此我们可以稍后返回以创建另一个模型,用于在 CPU 或 GPU 上运行的推理,这需要接受可变批次大小的输入。

import tensorflow as tf

from tensorflow.python.keras.layers import Input, LSTM, Bidirectional, Dense, Embedding

def make_model(batch_size=None):

source = Input(shape=(maxlen,), batch_size=batch_size,

dtype=tf.int32, name='Input')

embedding = Embedding(input_dim=max_features,

output_dim=128, name='Embedding')(source)

lstm = LSTM(32, name='LSTM')(embedding)

predicted_var = Dense(1, activation='sigmoid', name='Output')(lstm)

model = tf.keras.Model(inputs=[source], outputs=[predicted_var])

model.compile(

optimizer=tf.train.RMSPropOptimizer(learning_rate=0.01),

loss='binary_crossentropy',

metrics=['acc'])

return model

training_model = make_model(batch_size=128)

此外,使用 tf.train.Optimizer 而不是标准的 Keras 优化器,因为 Keras 优化器对 TPU 的支持仍在实验阶段。

将 Keras 模型转换为 TPU 模型

tf.contrib.tpu.keras_to_tpu_model 函数将 tf.keras 模型转换为等效的 TPU 版本。

import os

import tensorflow as tf

# This address identifies the TPU we'll use when configuring TensorFlow.

TPU_WORKER = 'grpc://' + os.environ['COLAB_TPU_ADDR']

tf.logging.set_verbosity(tf.logging.INFO)

tpu_model = tf.contrib.tpu.keras_to_tpu_model(

training_model,

strategy=tf.contrib.tpu.TPUDistributionStrategy(

tf.contrib.cluster_resolver.TPUClusterResolver(TPU_WORKER)))

然后我们使用标准的 Keras 方法来训练、保存权重和评估模型。注意,由于输入样本均匀分布在 8 个 TPU 核心上,batch_size 设置为模型输入 batch_size 的八倍。

history = tpu_model.fit(x_train, y_train,

epochs=20,

batch_size=128 * 8,

validation_split=0.2)

tpu_model.save_weights('./tpu_model.h5', overwrite=True)

tpu_model.evaluate(x_test, y_test, batch_size=128 * 8)

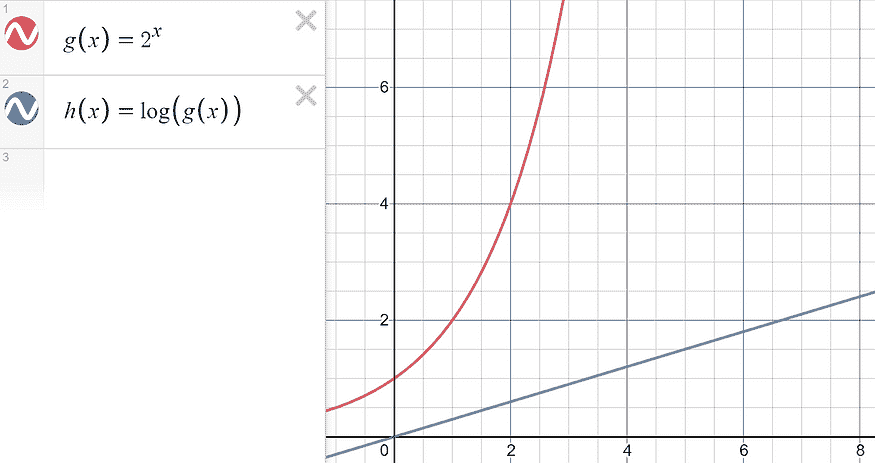

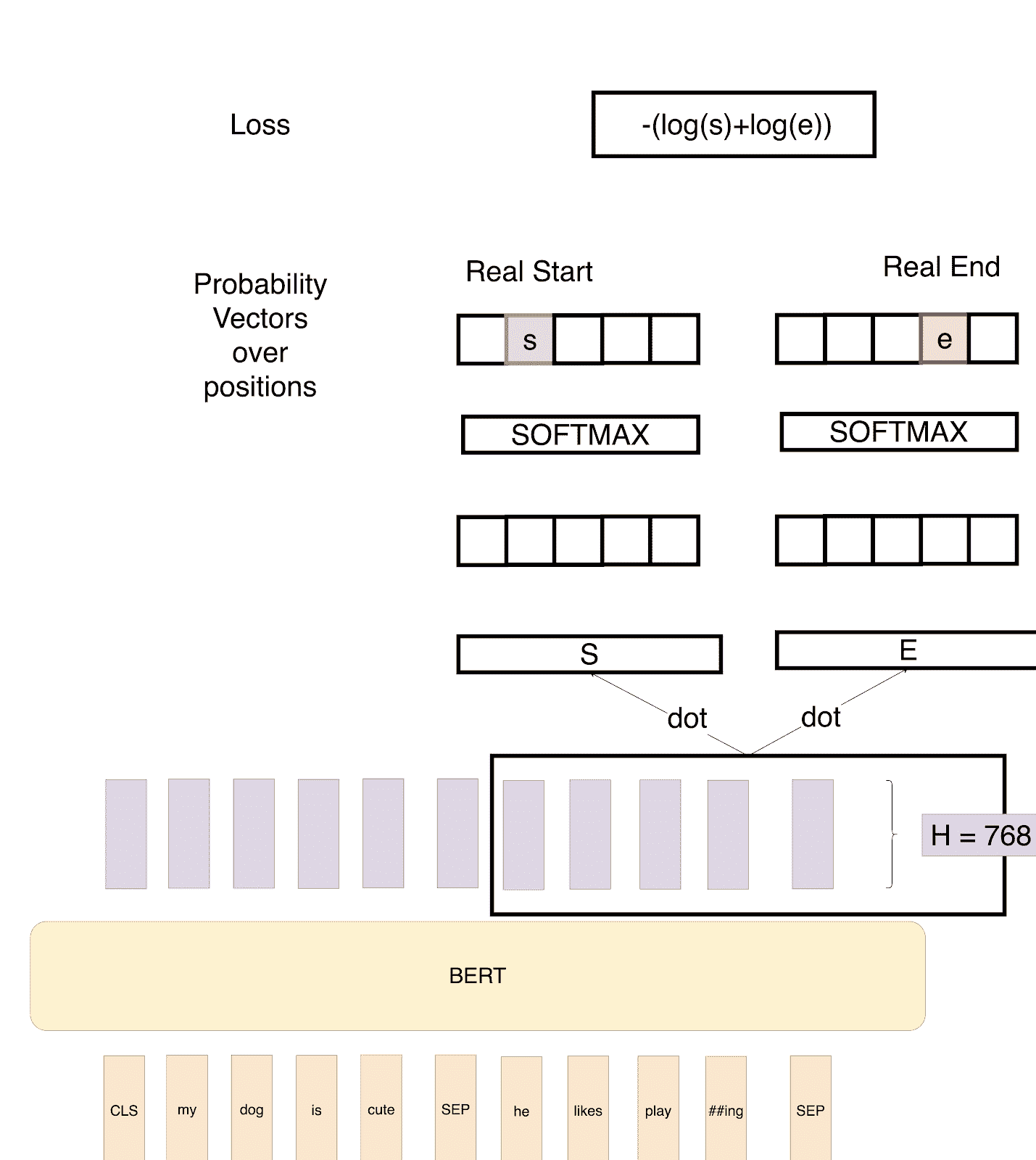

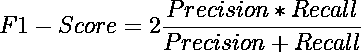

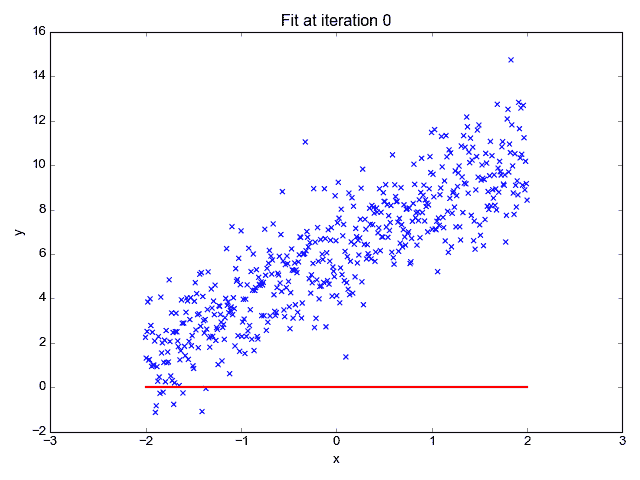

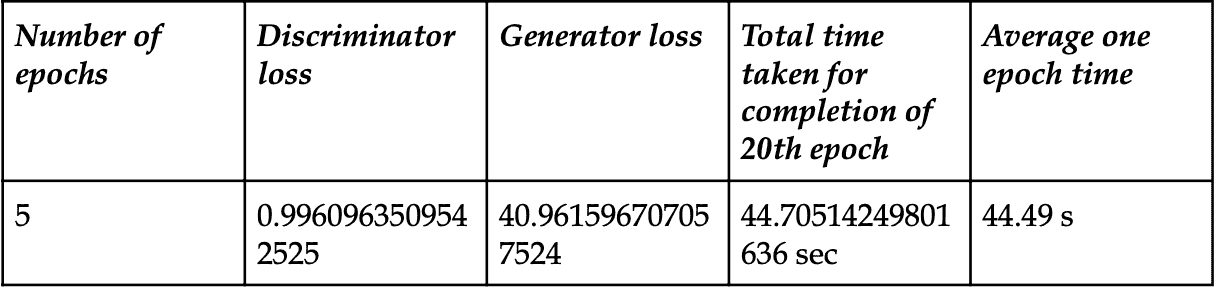

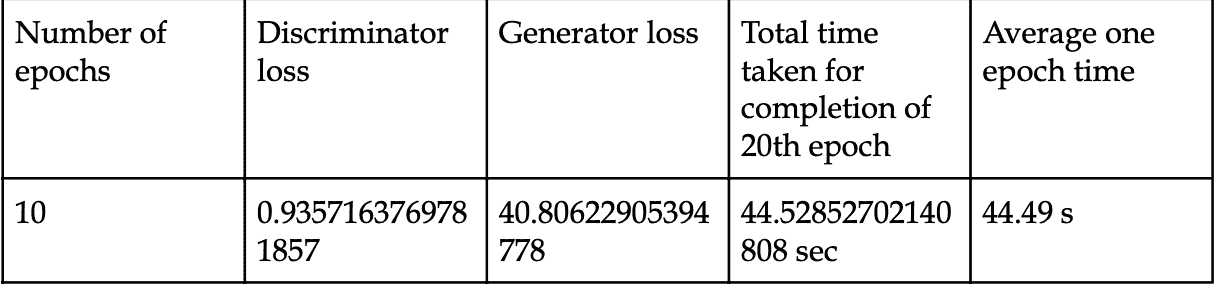

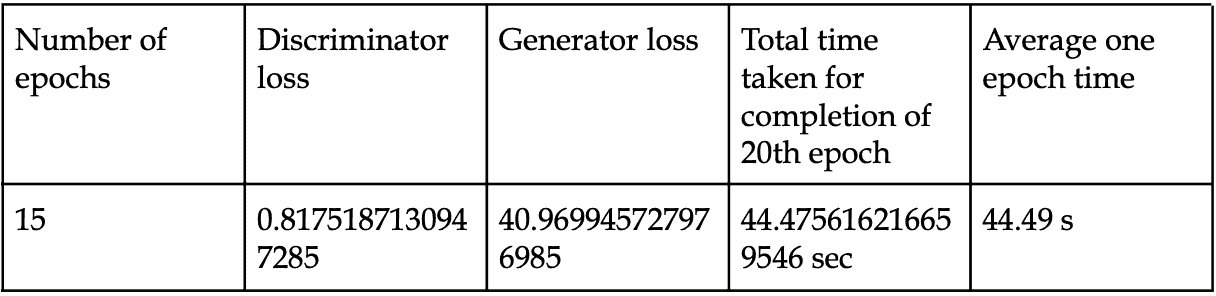

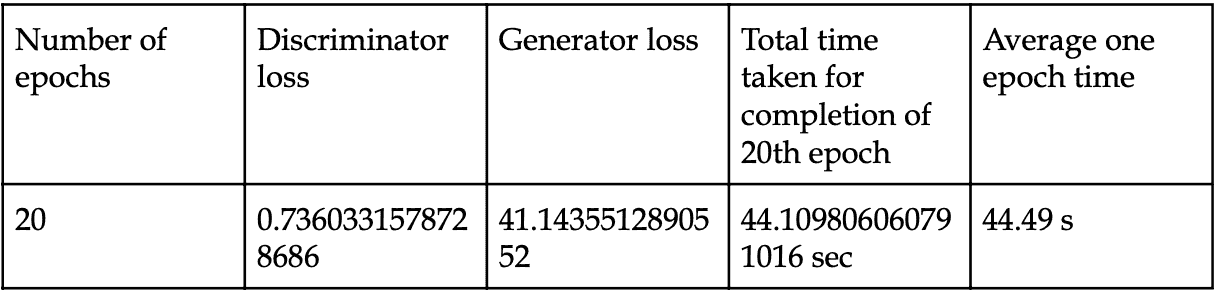

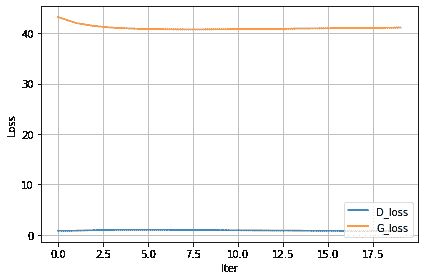

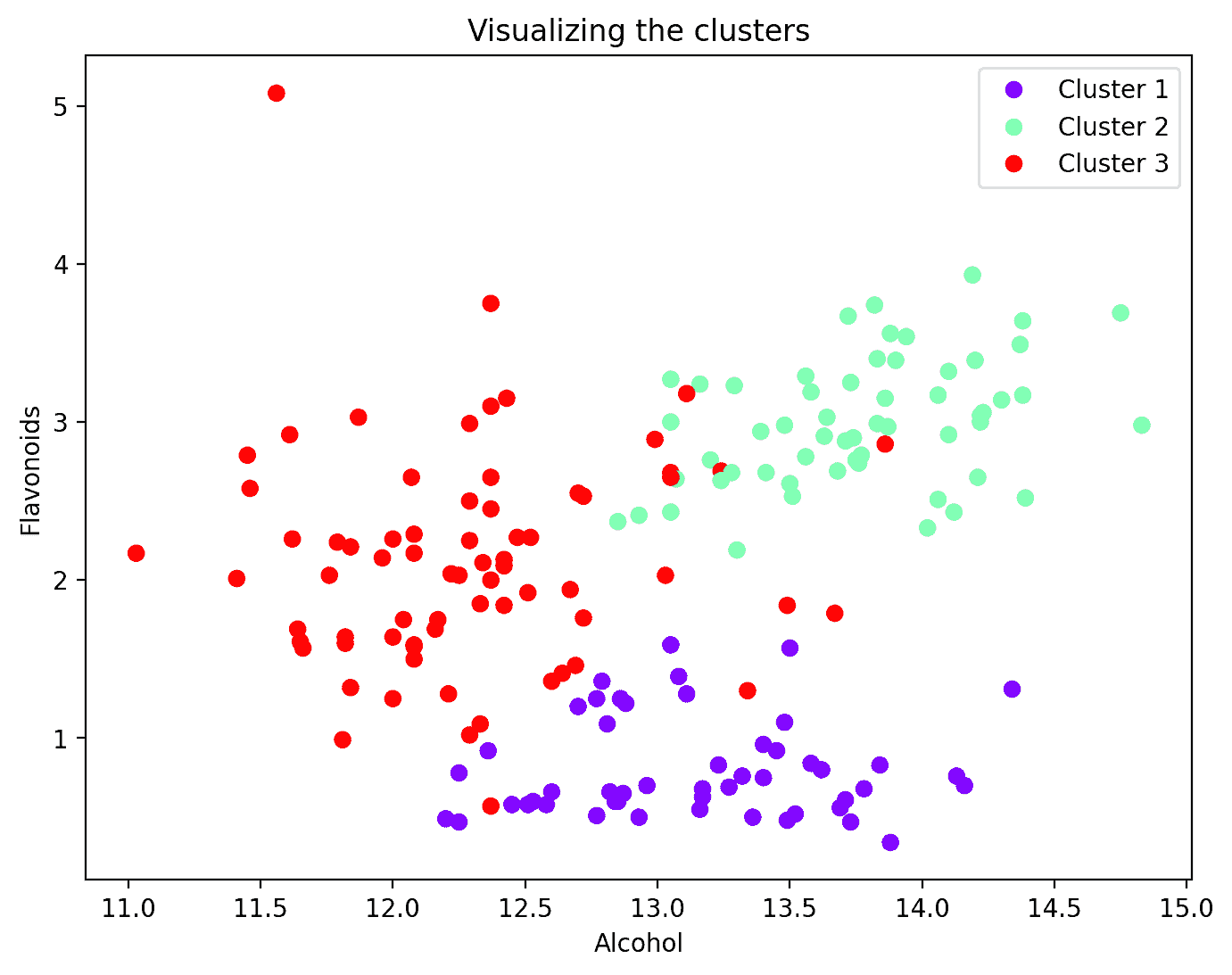

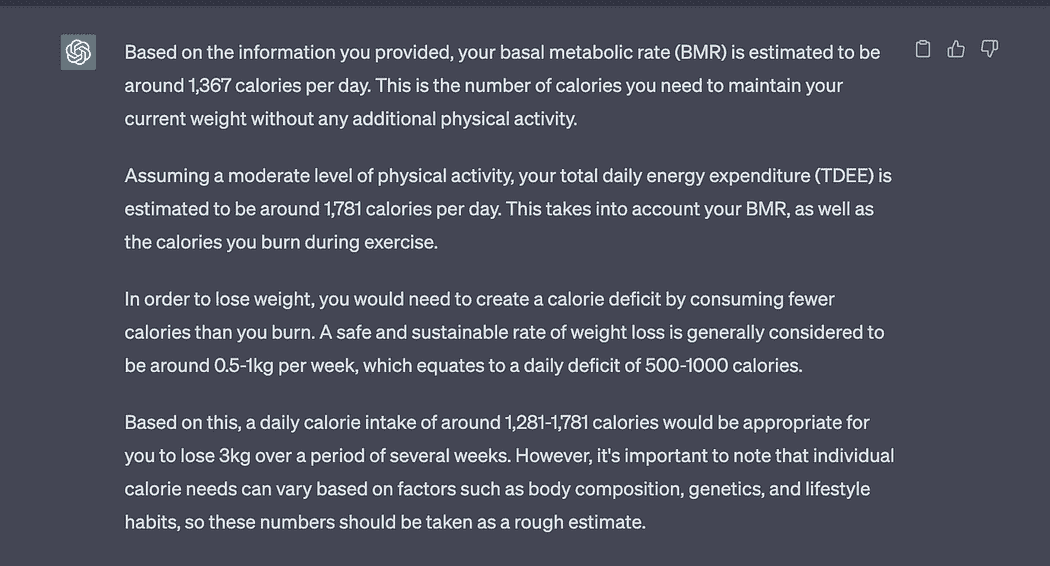

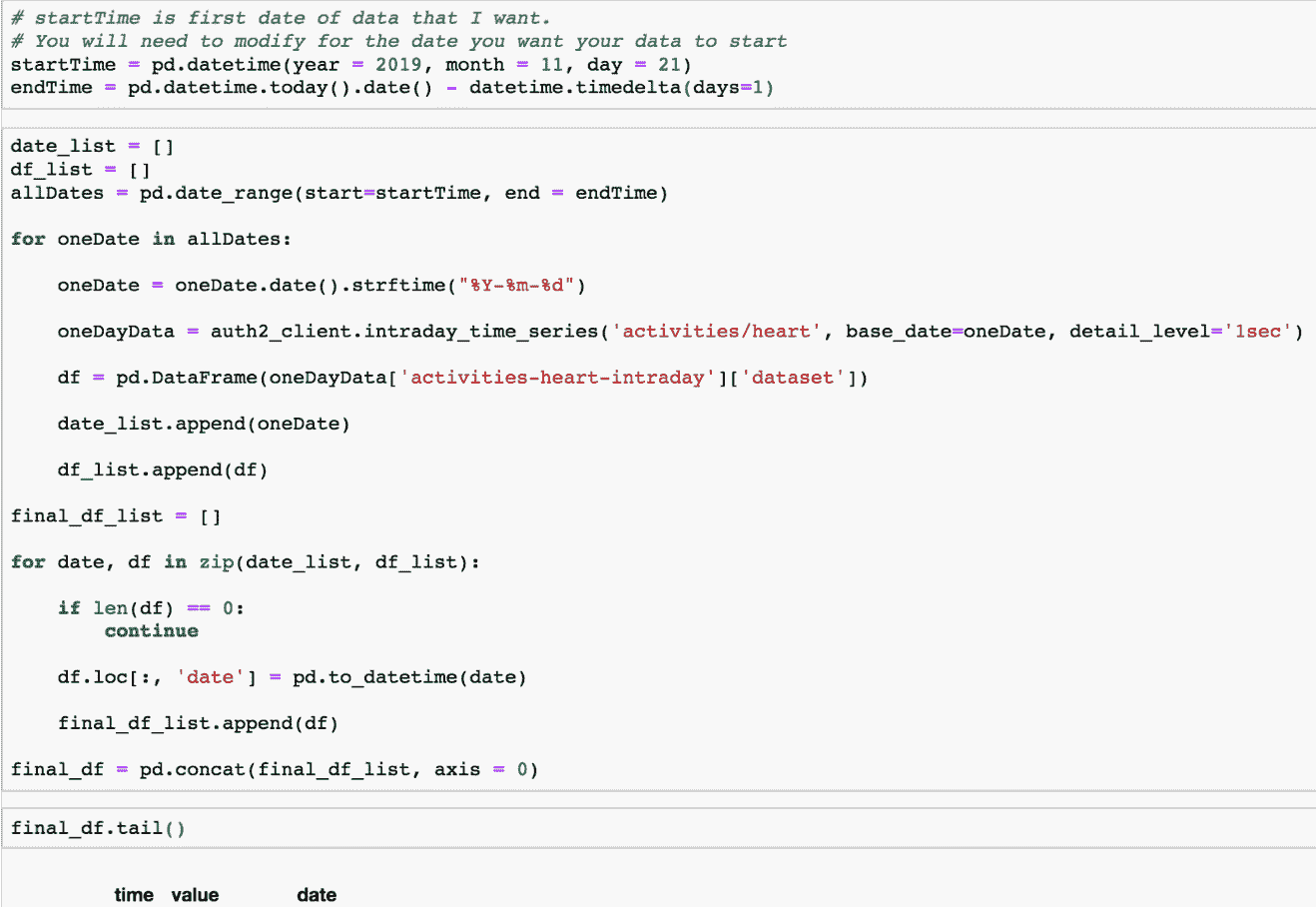

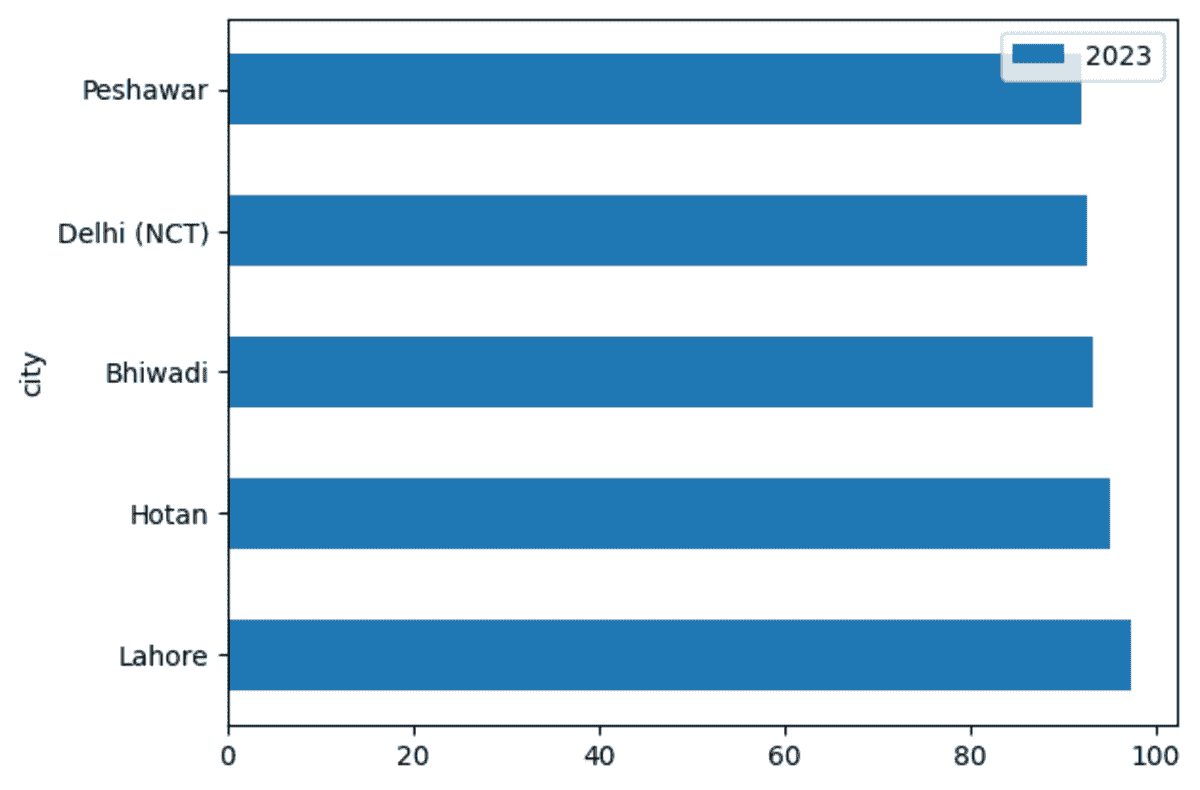

我设置了一个实验来比较在我的 Windows PC 上本地运行的单个 GTX1070 和 Colab 上的 TPU 之间的训练速度,结果如下。

GPU 和 TPU 都接受 128 的输入批次大小,

GPU: 每个 epoch 179 秒。20 个 epoch 达到 76.9% 的验证准确率,总共 3600 秒。

TPU: 每个 epoch 5 秒,除了第一个 epoch 需要 49 秒。20 个 epoch 达到 95.2% 的验证准确率,总共 150 秒。

TPU 在 20 个 epoch 后的验证准确率高于 GPU,这可能是由于一次训练 8 批次每批次 128 个样本所致。

在 CPU 上进行推理

一旦我们有了模型权重,我们可以像往常一样加载它,并在另一个设备如 CPU 或 GPU 上进行预测。我们还希望推理模型能够接受灵活的输入批次大小,这可以通过之前的make_model()函数来实现。

inferencing_model = make_model(batch_size=None)

inferencing_model.load_weights('./tpu_model.h5')

inferencing_model.summary()

你可以看到推理模型现在接受可变的输入样本,

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

Input (InputLayer) (None, 500) 0

_________________________________________________________________

Embedding (Embedding) (None, 500, 128) 1280000

_________________________________________________________________

LSTM (LSTM) (None, 32) 20608

_________________________________________________________________

Output (Dense) (None, 1) 33

=================================================================

然后你可以使用标准的 fit()、evaluate() 函数与推理模型一起使用。

结论和进一步阅读

本快速教程展示了如何利用 Google Colab 上免费的 Cloud TPU 资源更快地训练 Keras 模型。

简介:Chengwei Zhang 是一名对深度学习和自然语言处理领域感兴趣的程序员。

原文。经许可转载。

相关:

-

在 Google Colab 中使用 Hyperas 调整 Keras 超参数

-

使用 Keras 长短期记忆(LSTM)模型预测股票价格

-

3 个必备的 Google Colaboratory 提示和技巧

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在的组织的 IT

更多相关主题

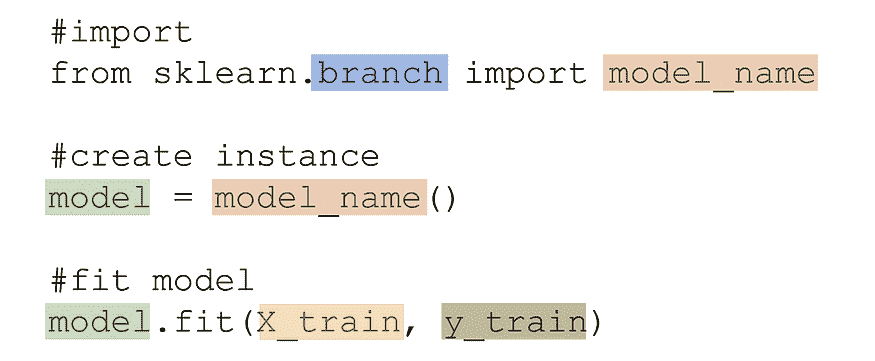

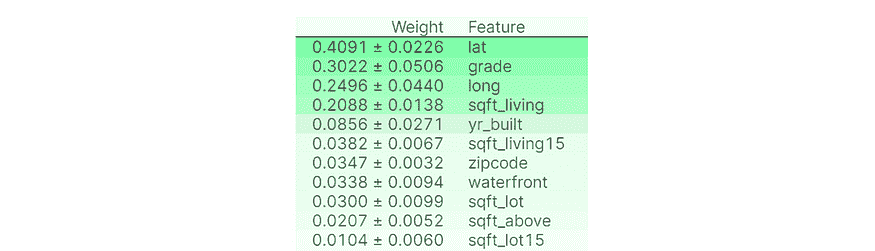

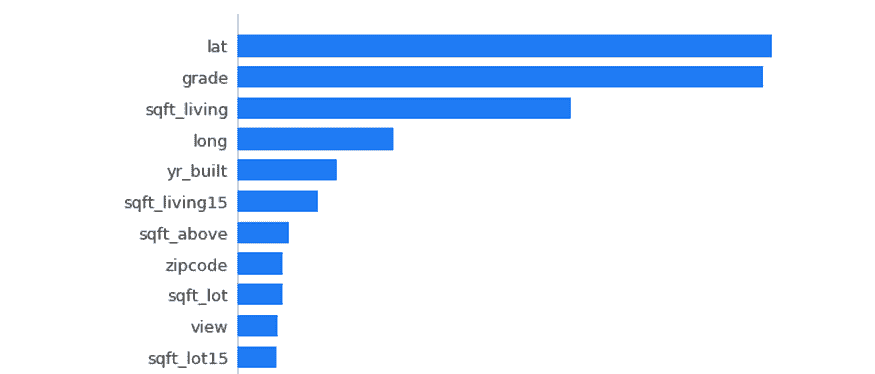

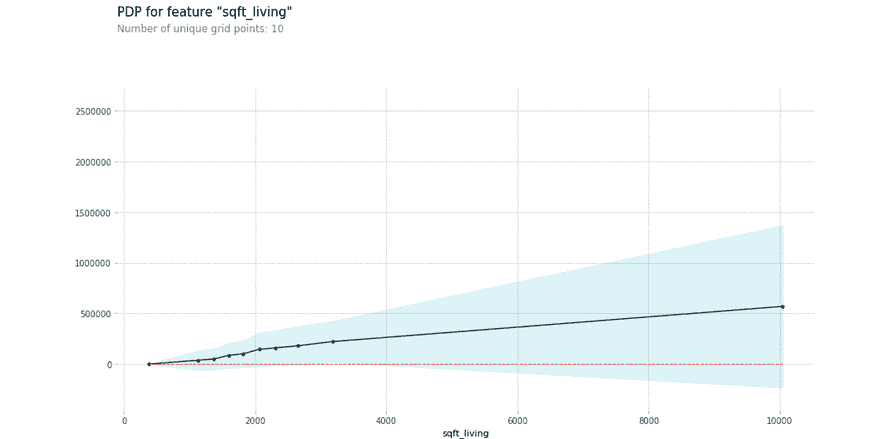

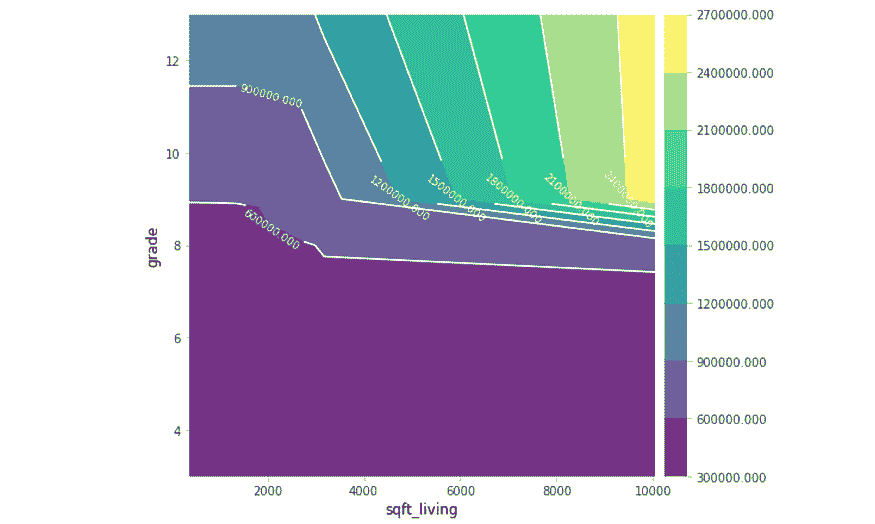

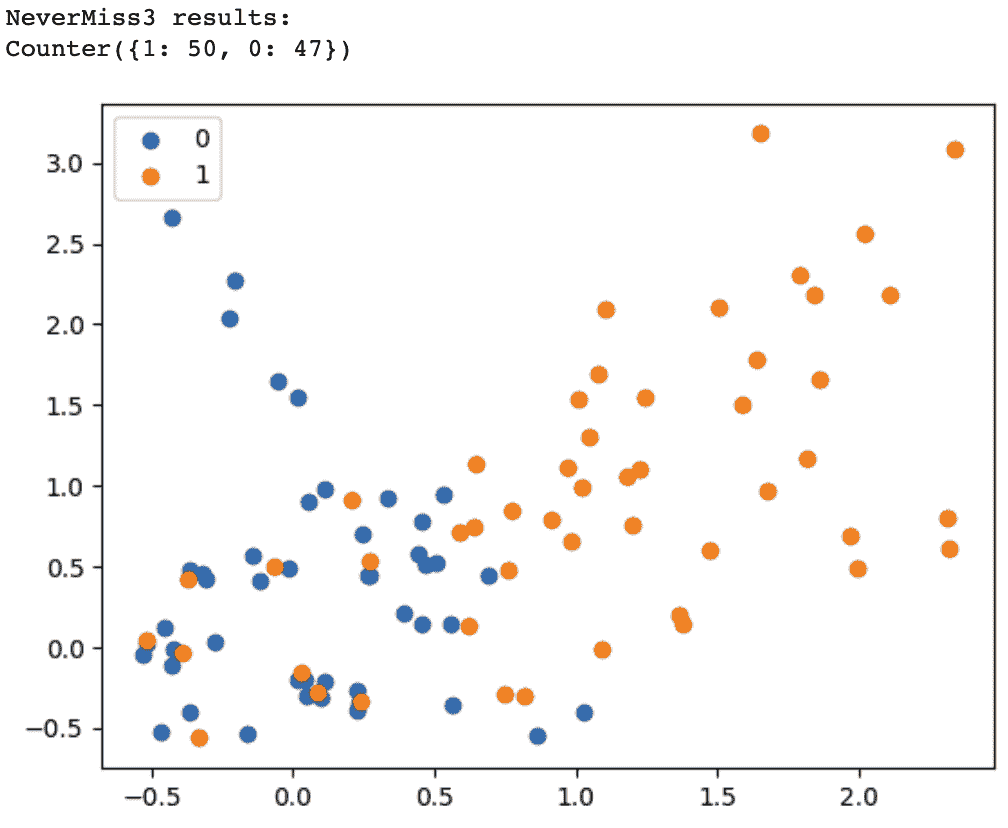

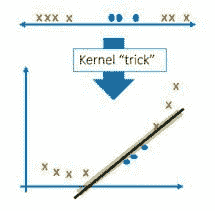

训练 sklearn 快速 100 倍

评论

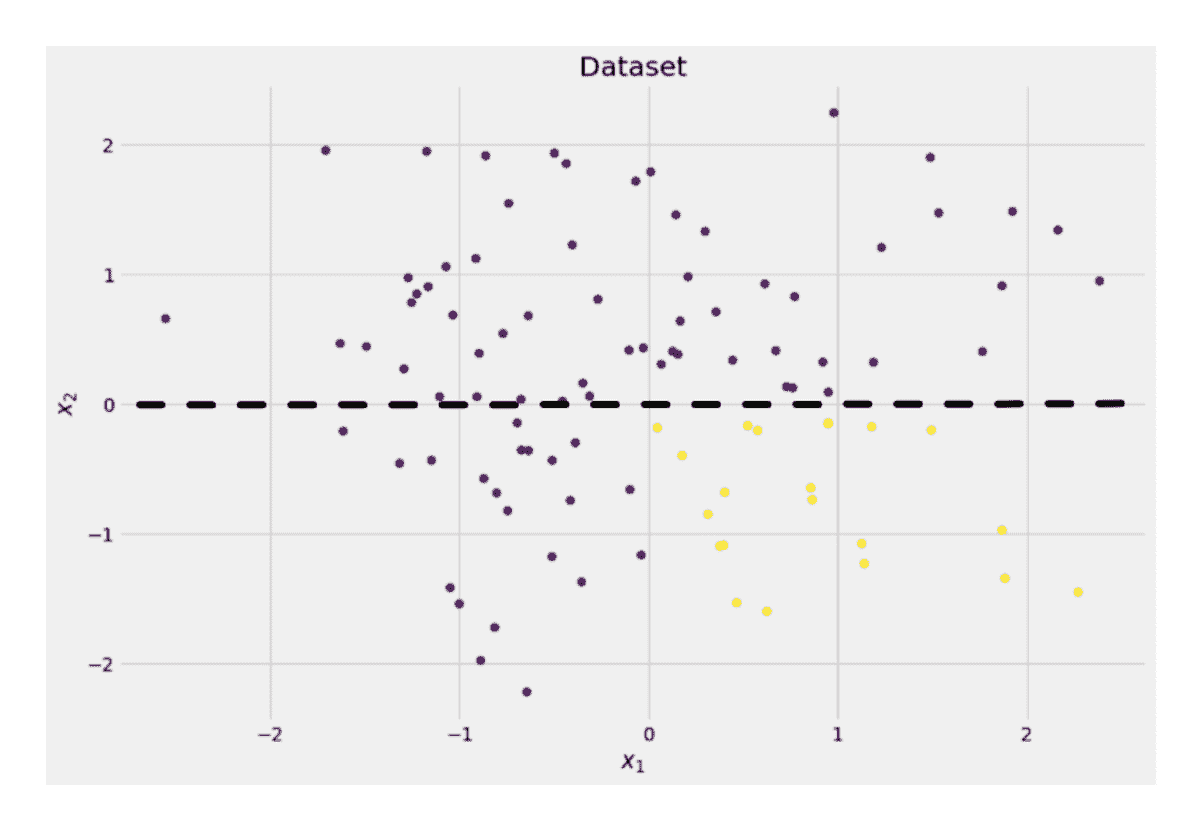

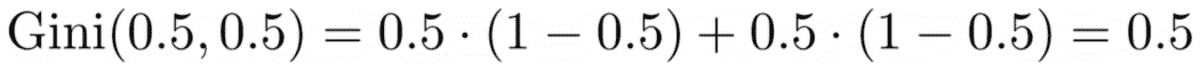

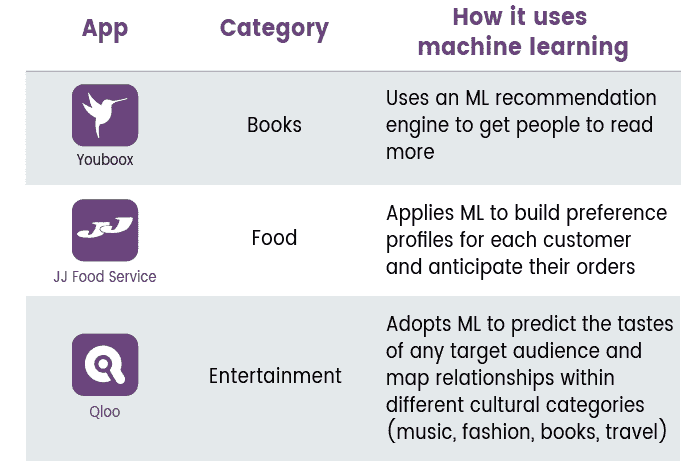

作者:Evan Harris,Ibotta, Inc. 机器学习与数据科学经理

在 Ibotta,我们训练了大量的机器学习模型。这些模型驱动了我们的推荐系统、搜索引擎、定价优化引擎、数据质量等。它们为数百万用户提供预测,用户在使用我们的移动应用时会与这些模型互动。

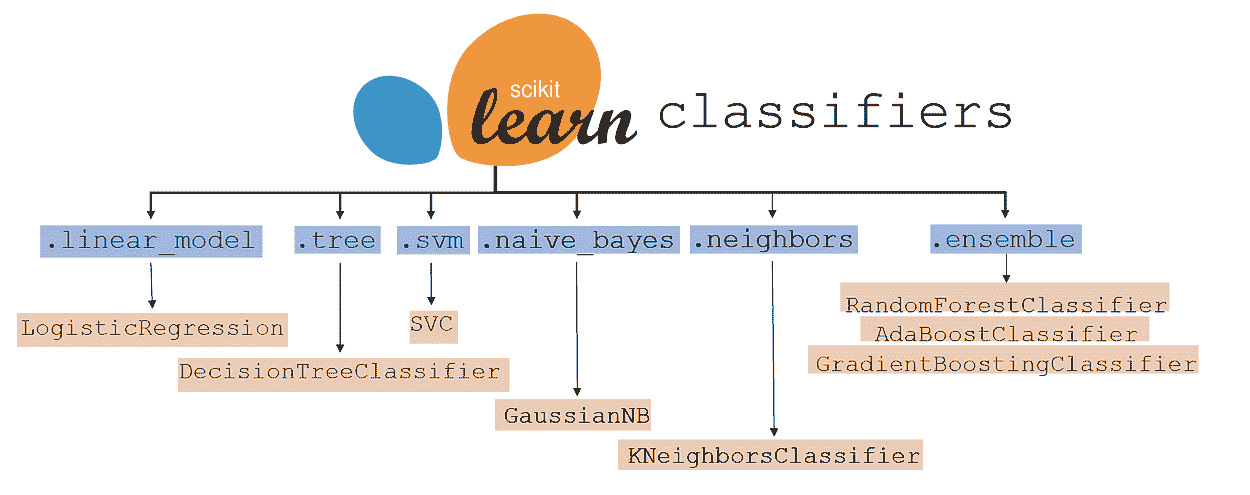

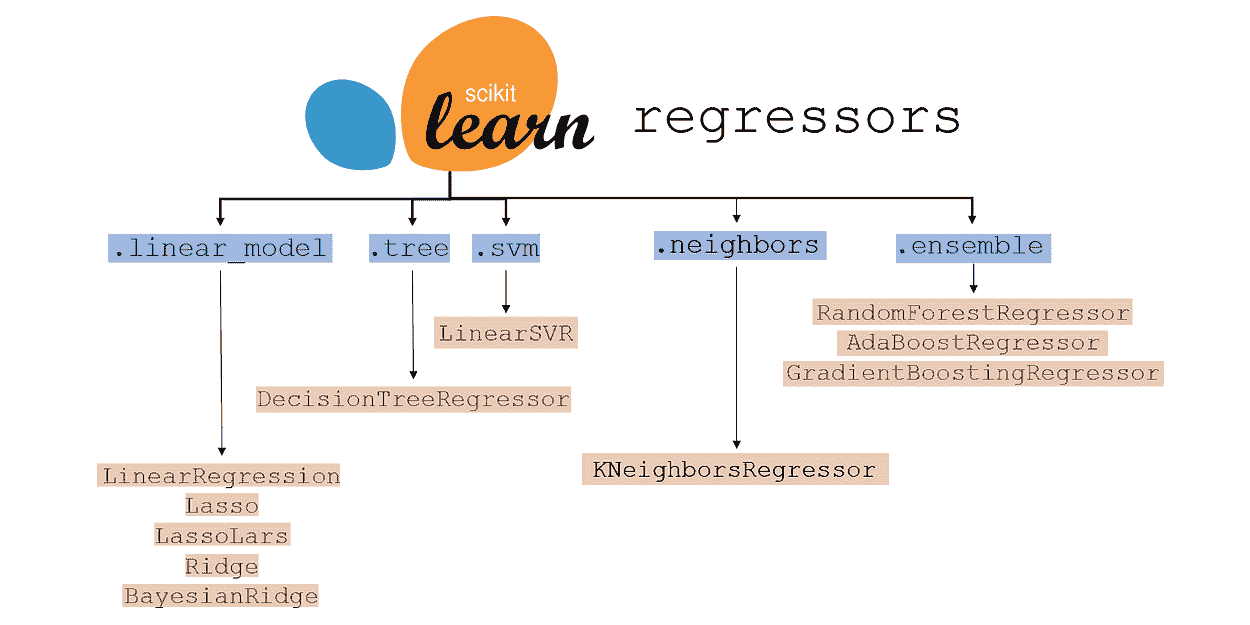

虽然我们用Spark处理了很多数据,但我们首选的机器学习框架是scikit-learn。随着计算成本的降低以及机器学习解决方案的市场时间变得越来越关键,我们探索了加速模型训练的选项。解决方案之一是将 Spark 和 scikit-learn 的元素结合成我们自己的混合解决方案。

介绍 sk-dist

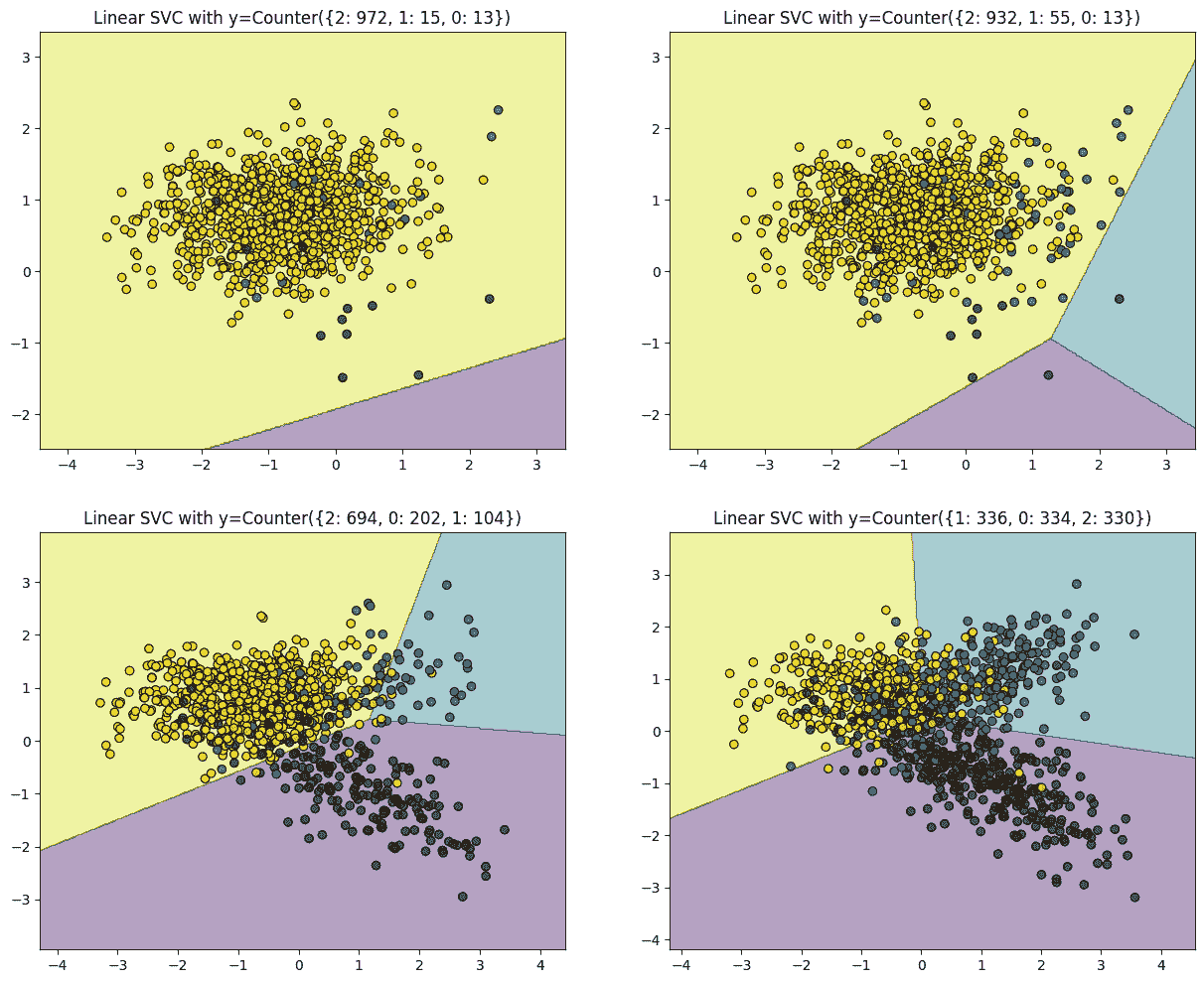

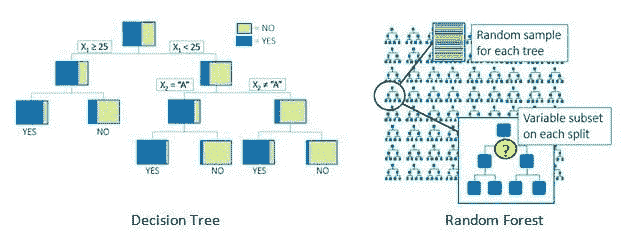

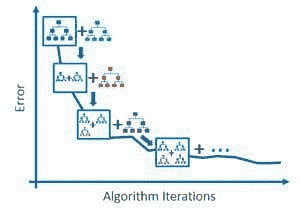

我们很高兴地宣布我们的开源项目sk-dist的上线。该项目的目标是提供一个通用框架,以便在 Spark 中分发 scikit-learn 元估计器。元估计器的例子包括决策树集成(随机森林 和 额外随机树)、超参数调优器(网格搜索 和 随机搜索)以及多类技术(一对其余 和 一对一)。

我们的主要动机是填补传统机器学习模型分发选项中的空白。在神经网络和深度学习的领域之外,我们发现,训练模型的大部分计算时间并不是用来在单一数据集上训练单一模型。大部分时间用于在多个数据集的多个迭代上训练多个模型,使用像网格搜索或集成这样的元估计器。

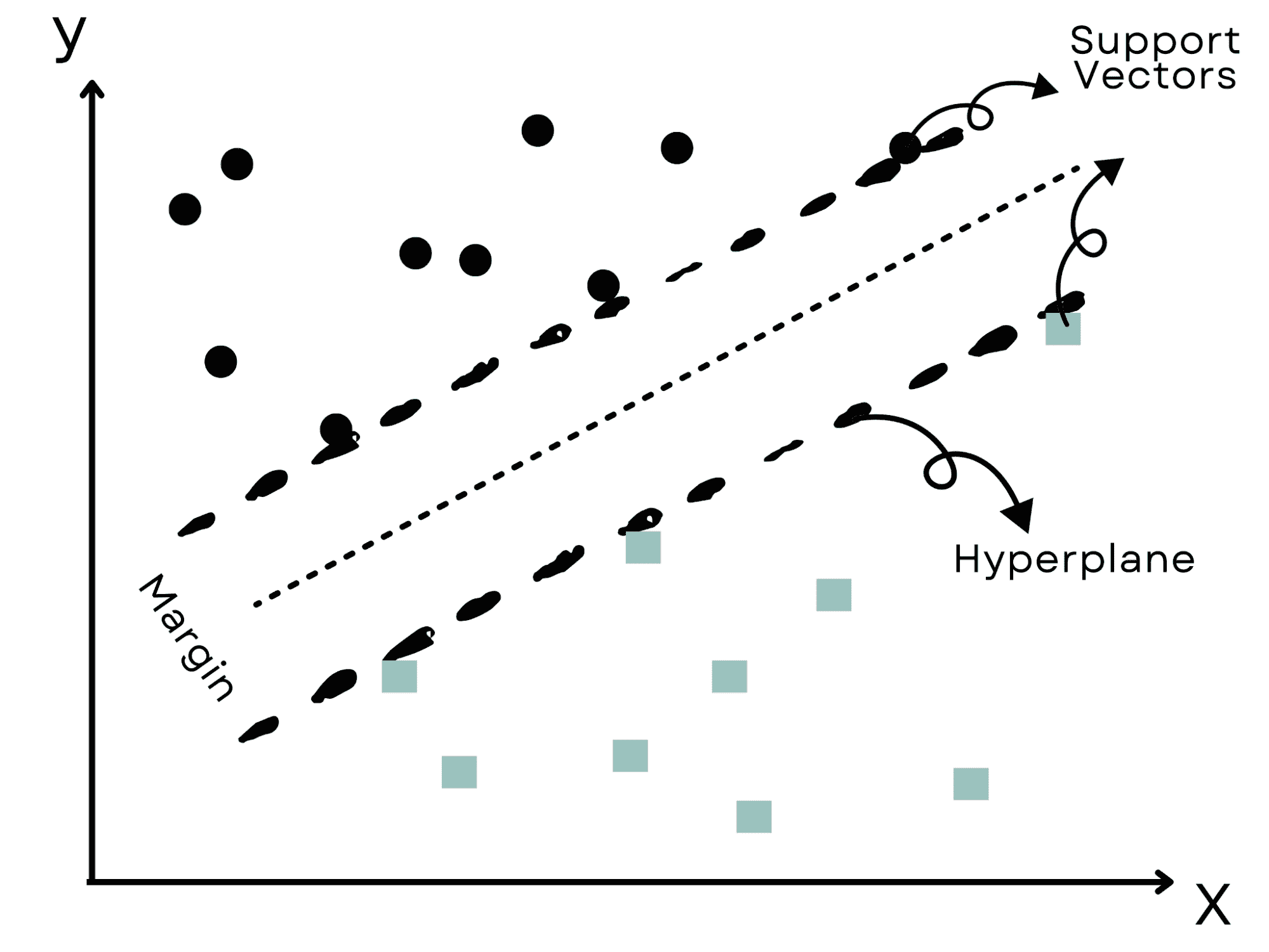

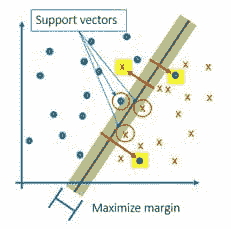

示例

考虑一下 手写数字数据集。在这里,我们已经对手写数字图像进行了编码,以便进行适当分类。我们可以在单台机器上非常快速地训练一个 支持向量机 处理 1797 条记录的数据集。这只需不到一秒钟。但超参数调整需要在不同的训练数据子集上进行多个训练作业。

如下所示,我们构建了一个总共需要 1050 个训练作业的参数网格。在具有超过一百个核心的 Spark 集群上使用 sk-dist 只需 3.4 秒。此作业的总任务时间为 7.2 分钟,这意味着在没有并行化的情况下,单台机器上训练将需要这么长时间。

import timefrom sklearn import datasets, svm

from skdist.distribute.search import DistGridSearchCV

from pyspark.sql import SparkSession # instantiate spark session

spark = (

SparkSession

.builder

.getOrCreate()

)

sc = spark.sparkContext # the digits dataset

digits = datasets.load_digits()

X = digits["data"]

y = digits["target"] # create a classifier: a support vector classifier

classifier = svm.SVC()

param_grid = {

"C": [0.01, 0.01, 0.1, 1.0, 10.0, 20.0, 50.0],

"gamma": ["scale", "auto", 0.001, 0.01, 0.1],

"kernel": ["rbf", "poly", "sigmoid"]

}

scoring = "f1_weighted"

cv = 10# hyperparameter optimization

start = time.time()

model = DistGridSearchCV(

classifier, param_grid,

sc=sc, cv=cv, scoring=scoring,

verbose=True

)

model.fit(X,y)

print("Train time: {0}".format(time.time() - start))

print("Best score: {0}".format(model.best_score_))------------------------------

Spark context found; running with spark

Fitting 10 folds for each of 105 candidates, totalling 1050 fits

Train time: 3.380601406097412

Best score: 0.981450024203508

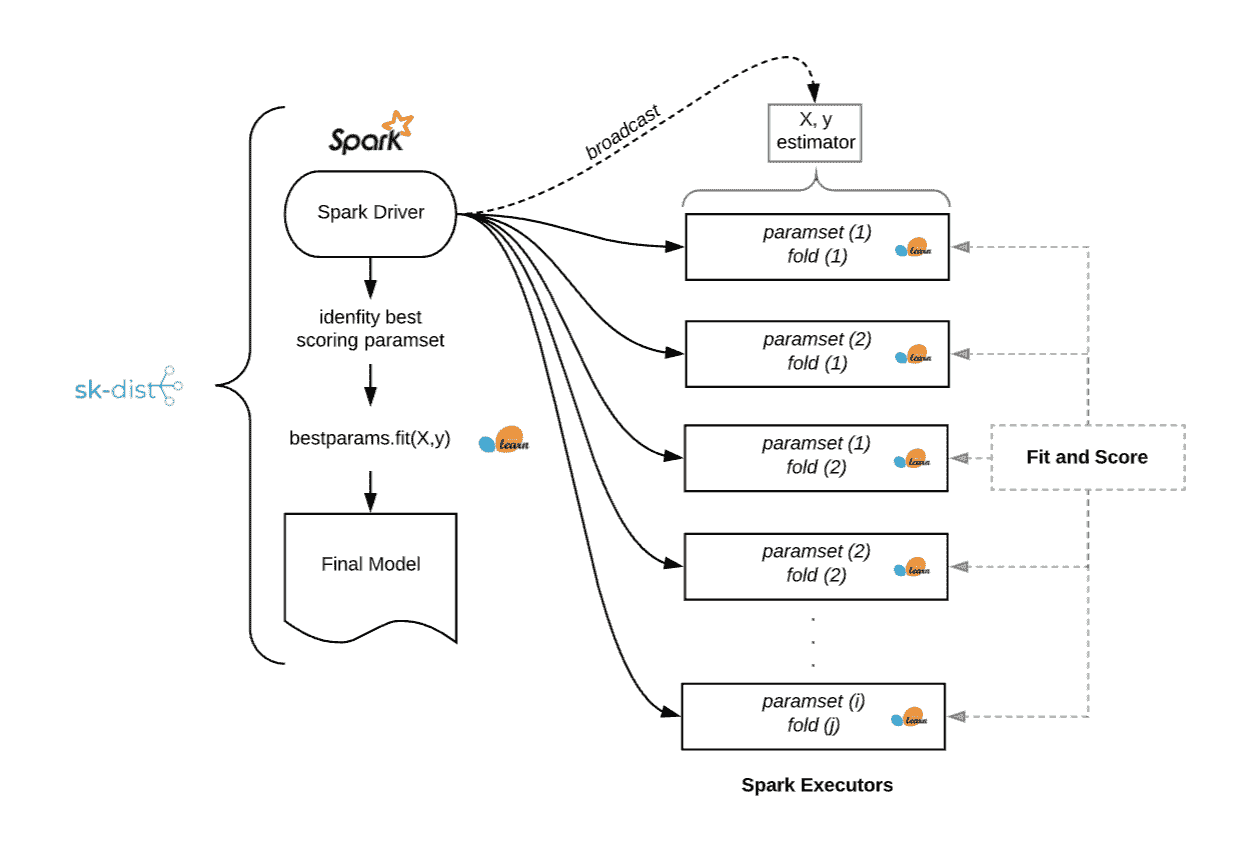

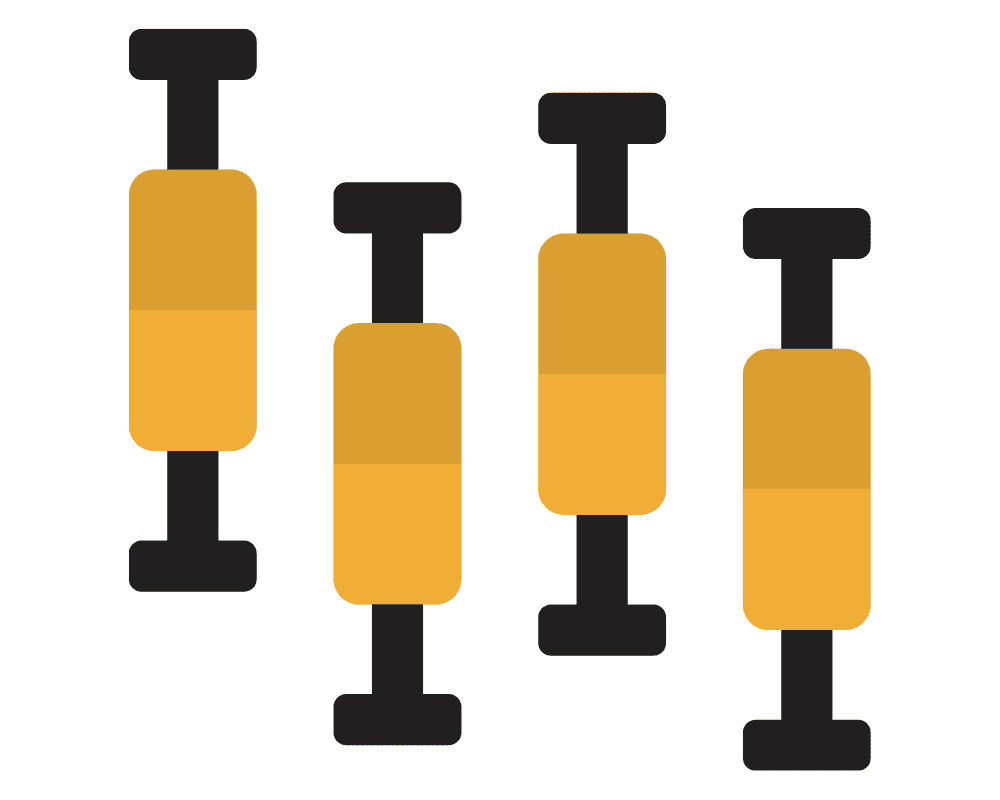

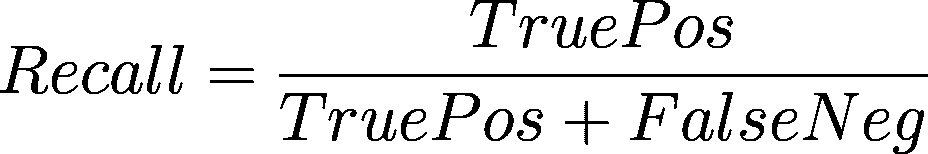

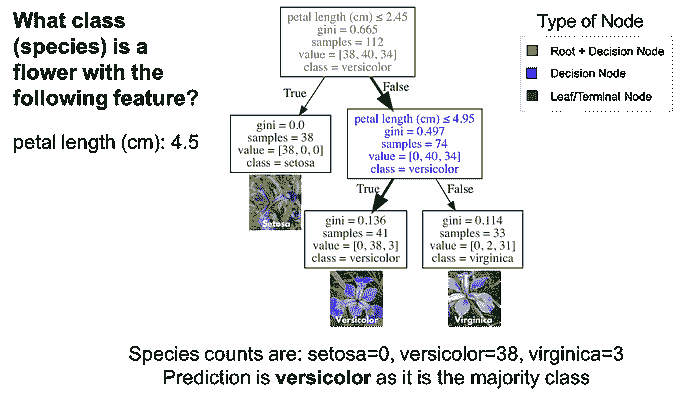

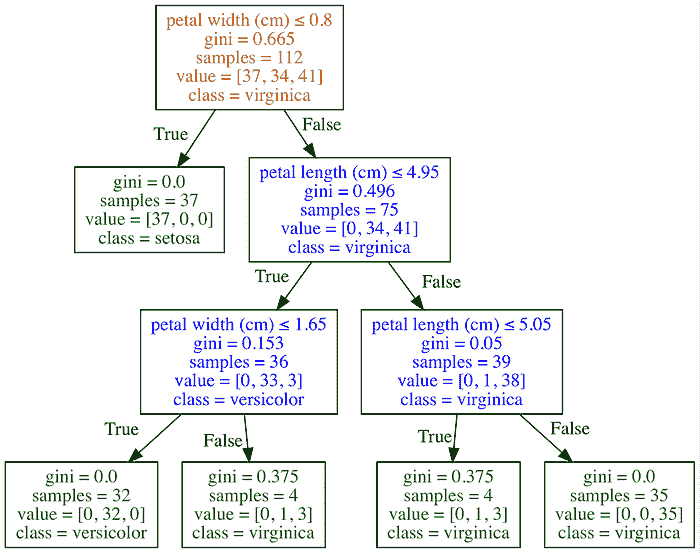

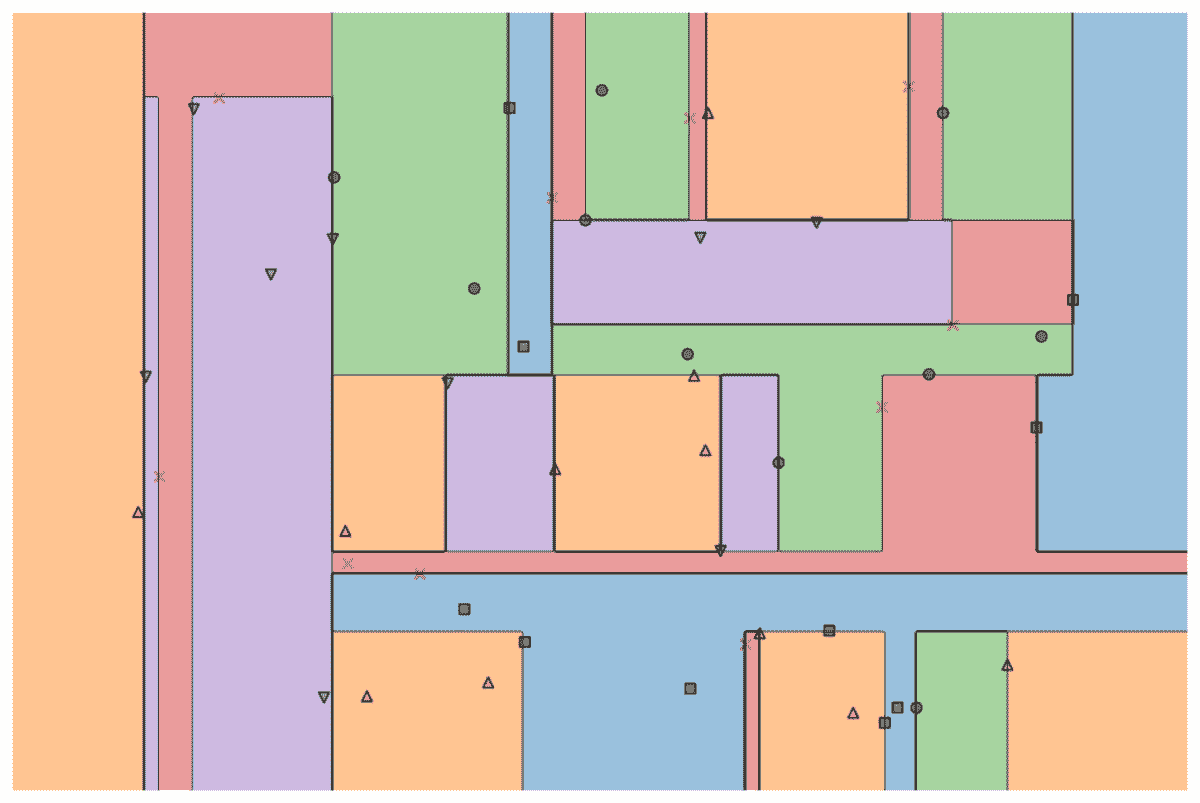

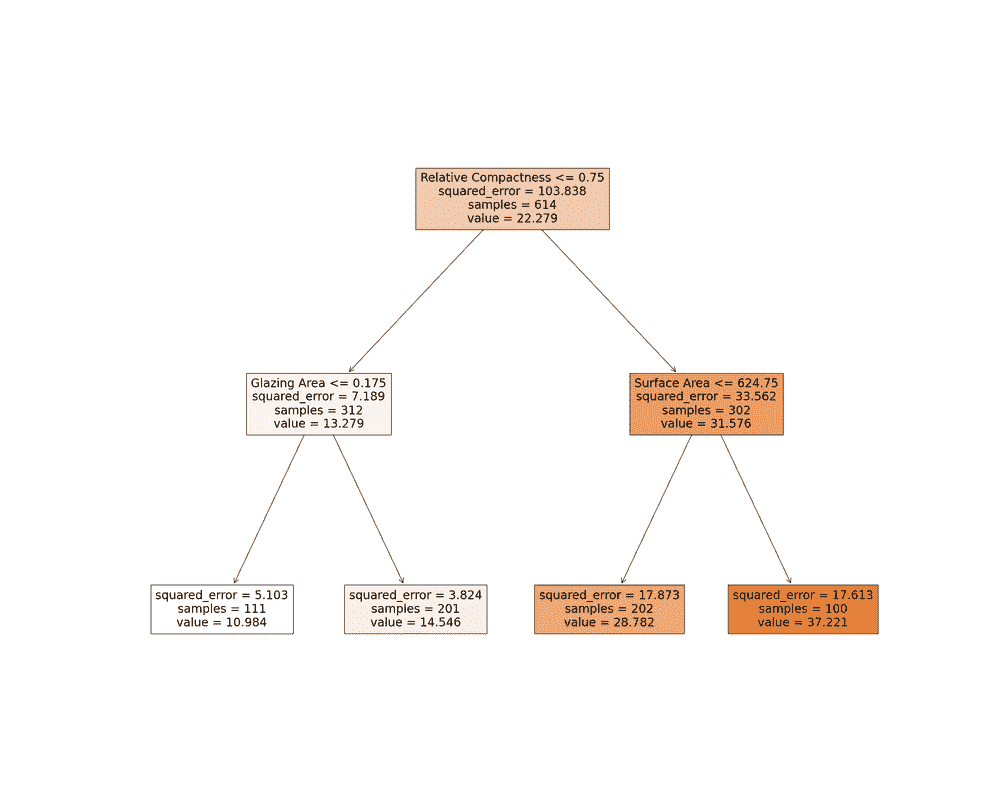

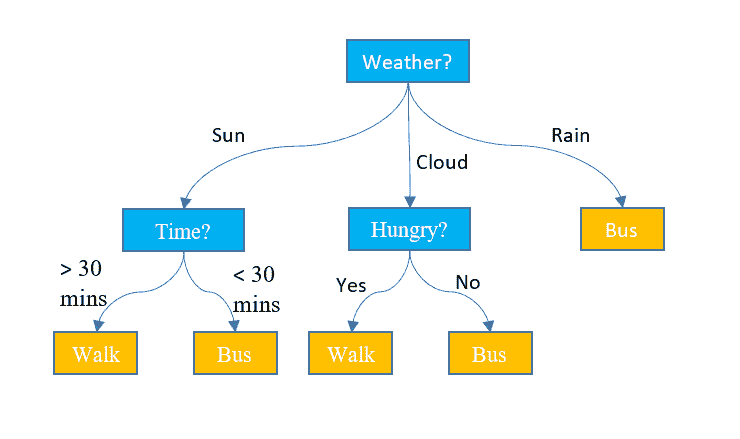

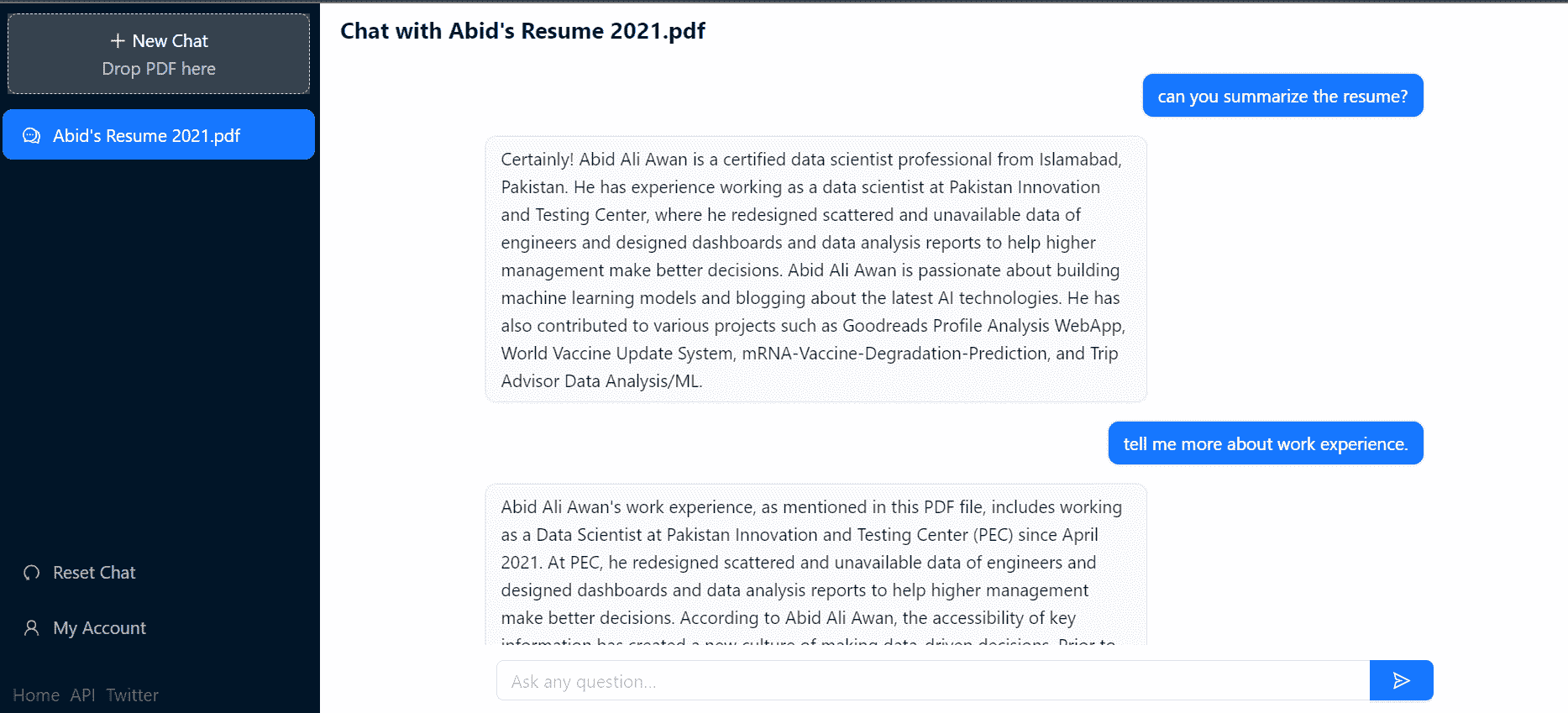

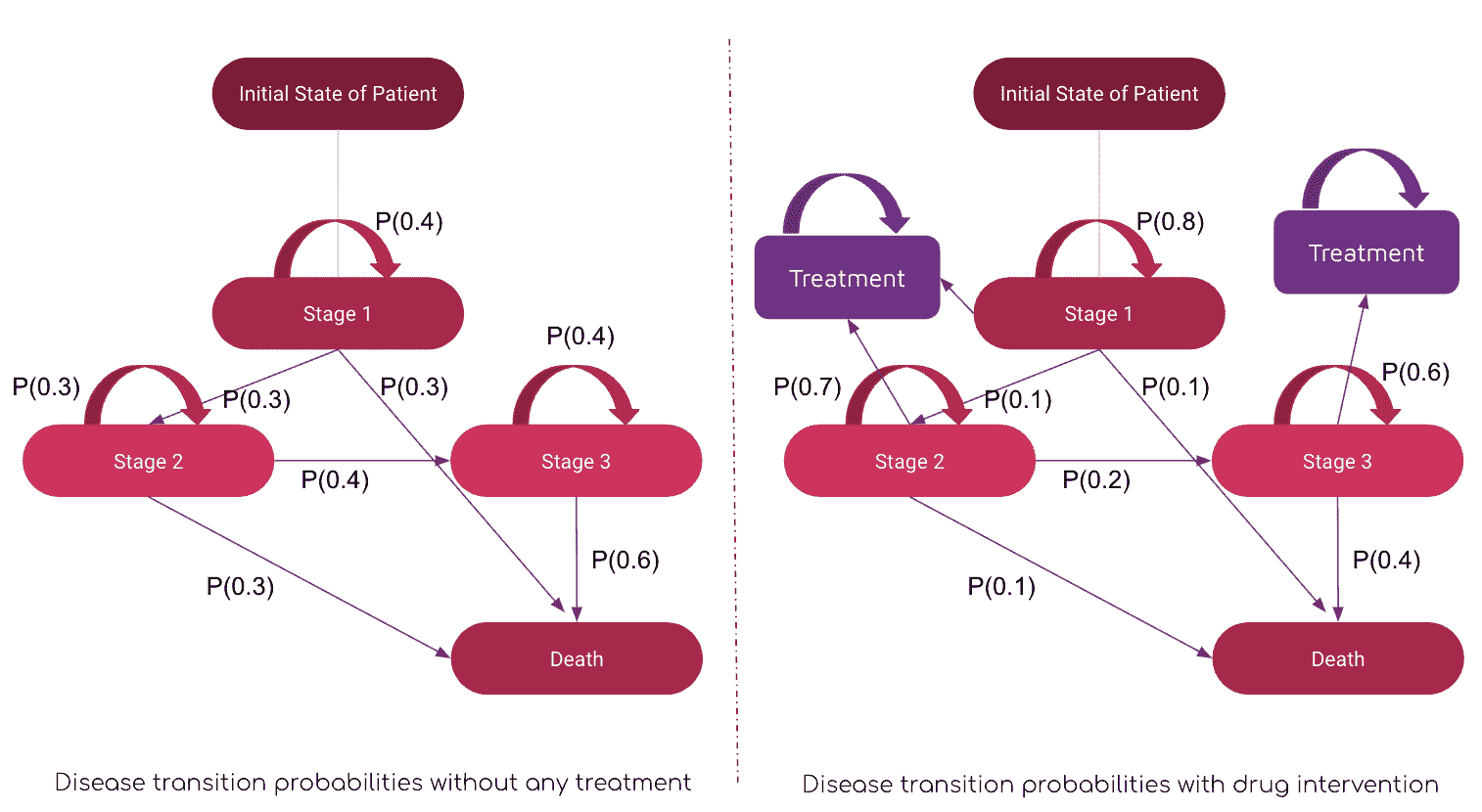

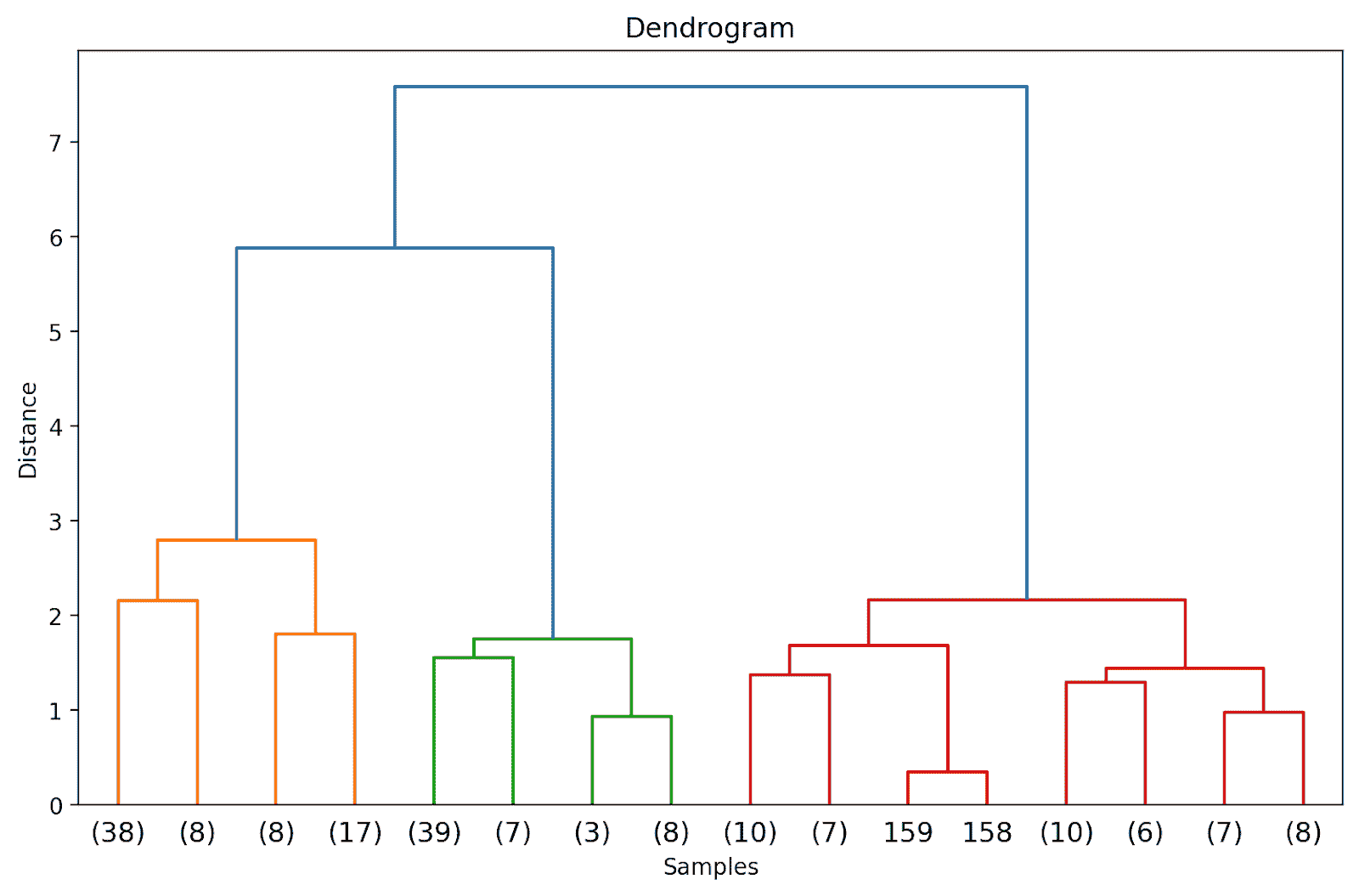

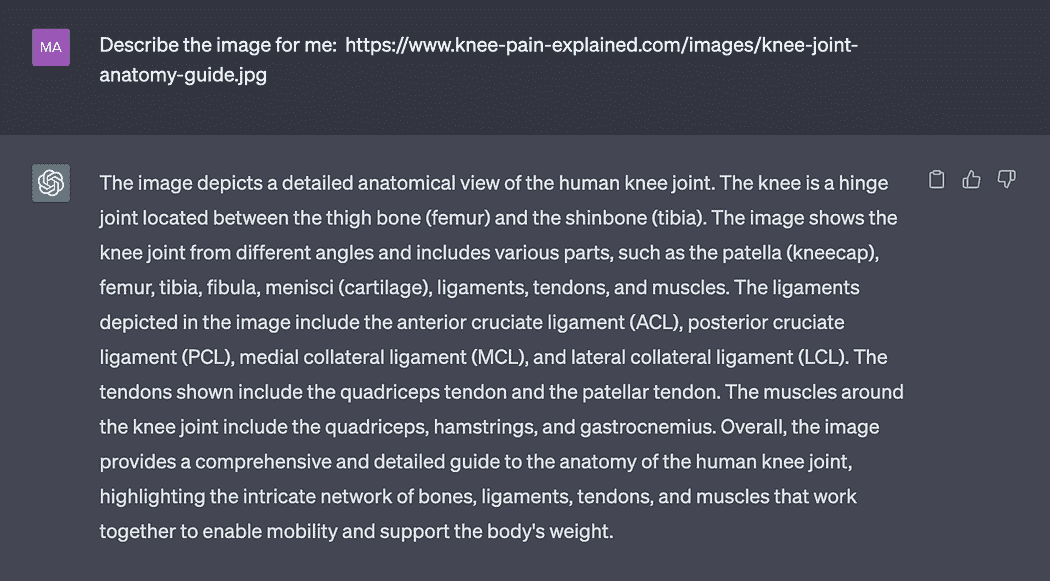

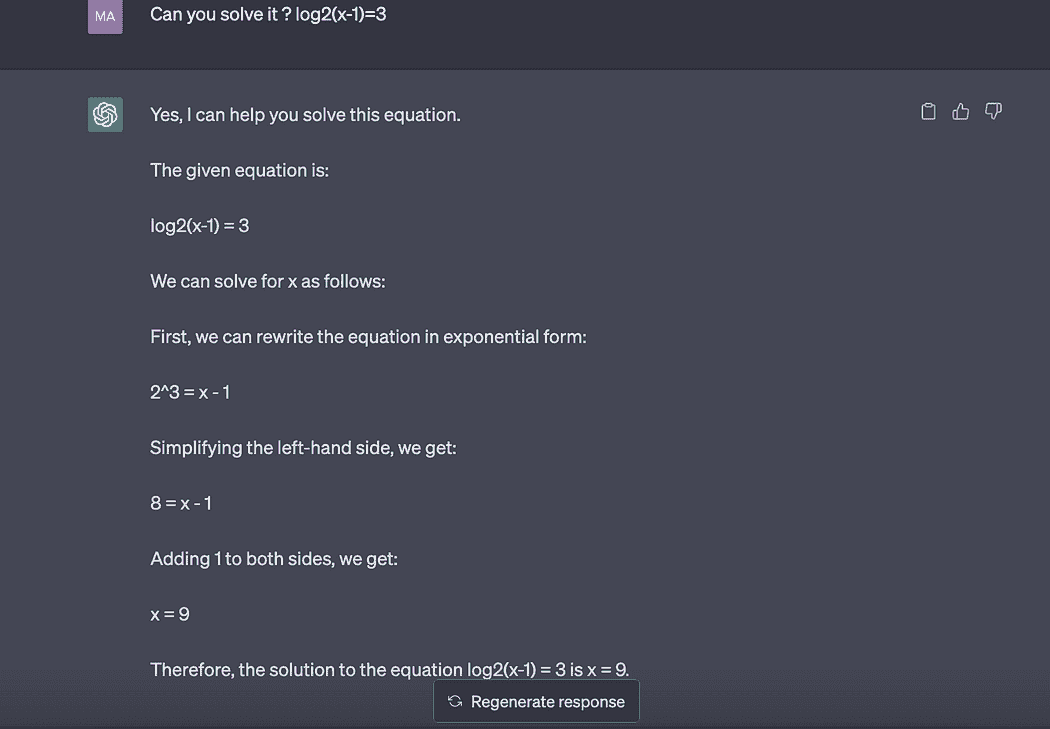

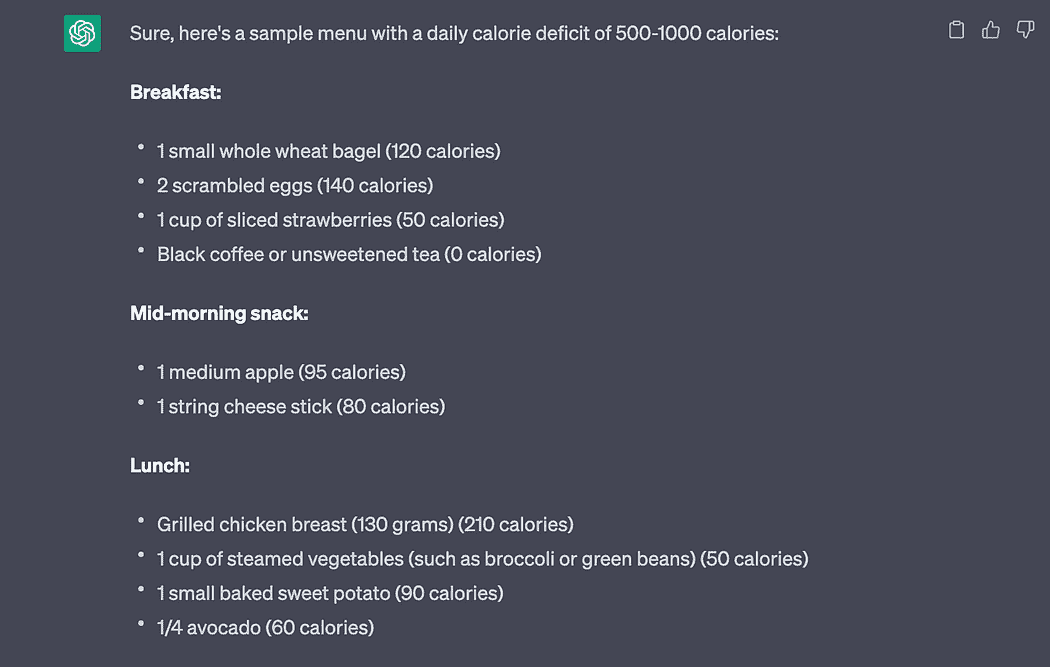

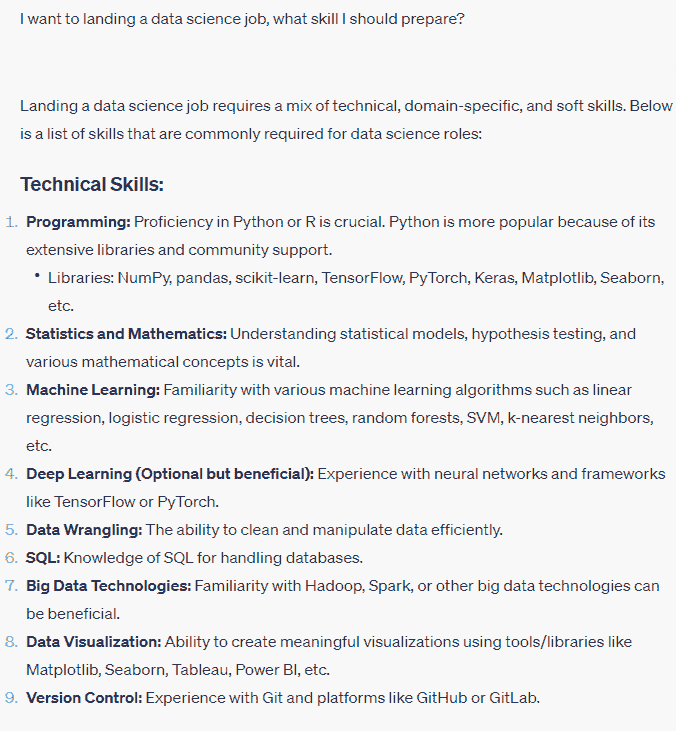

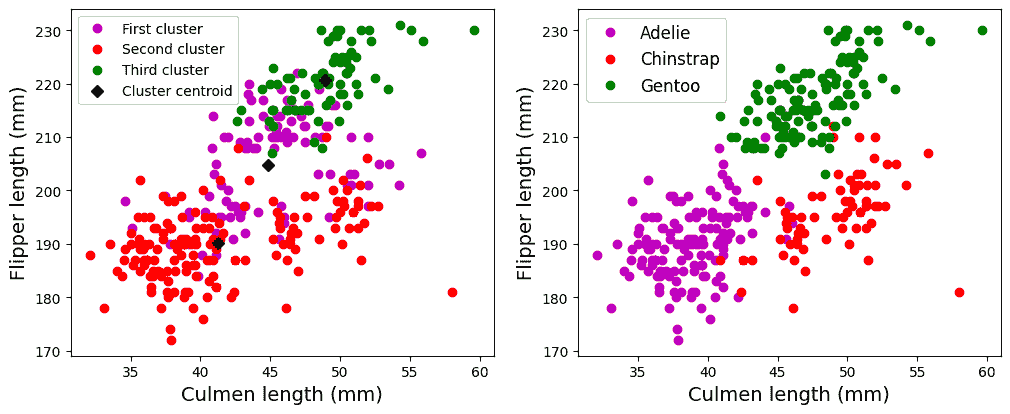

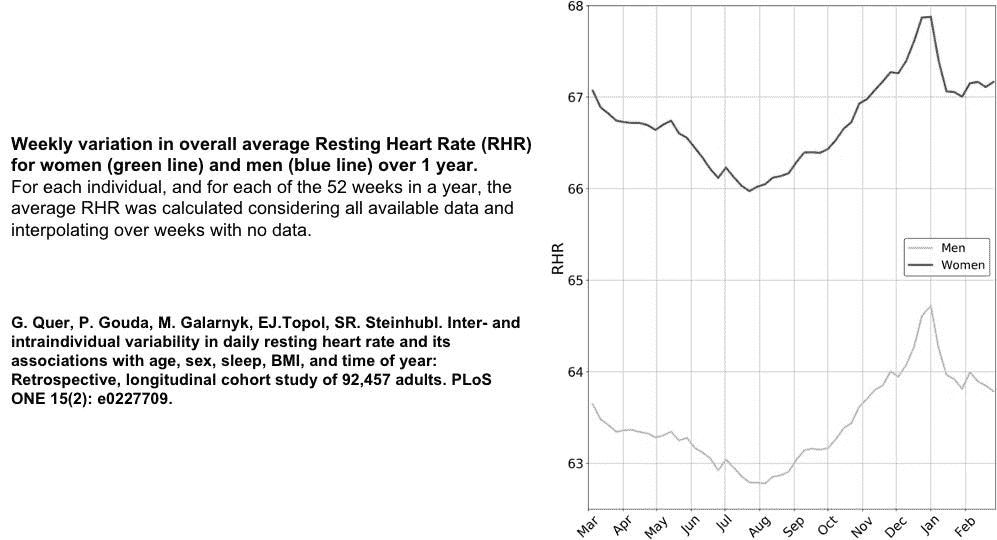

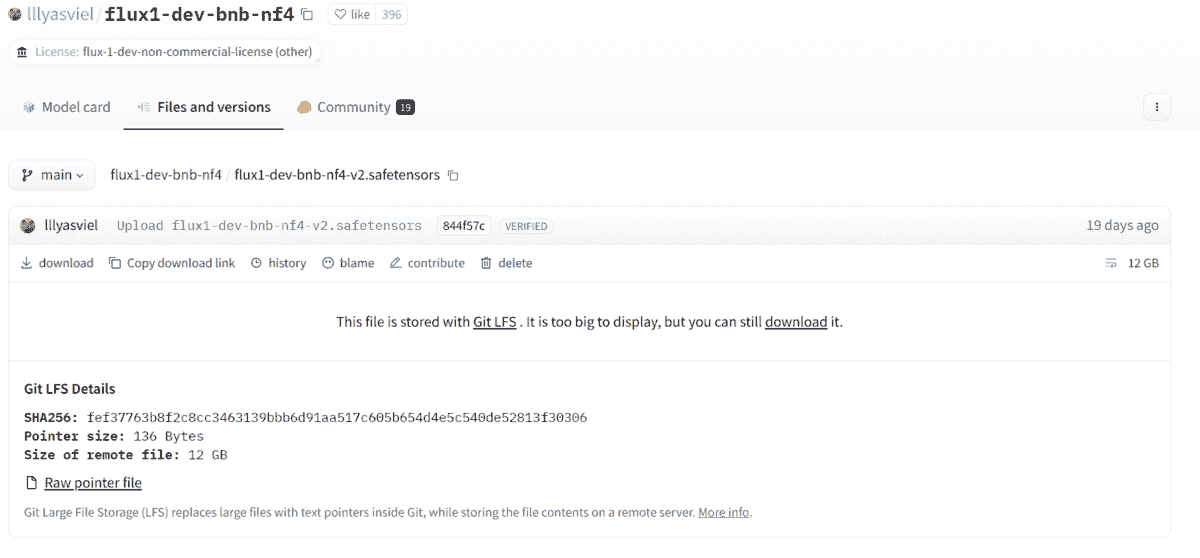

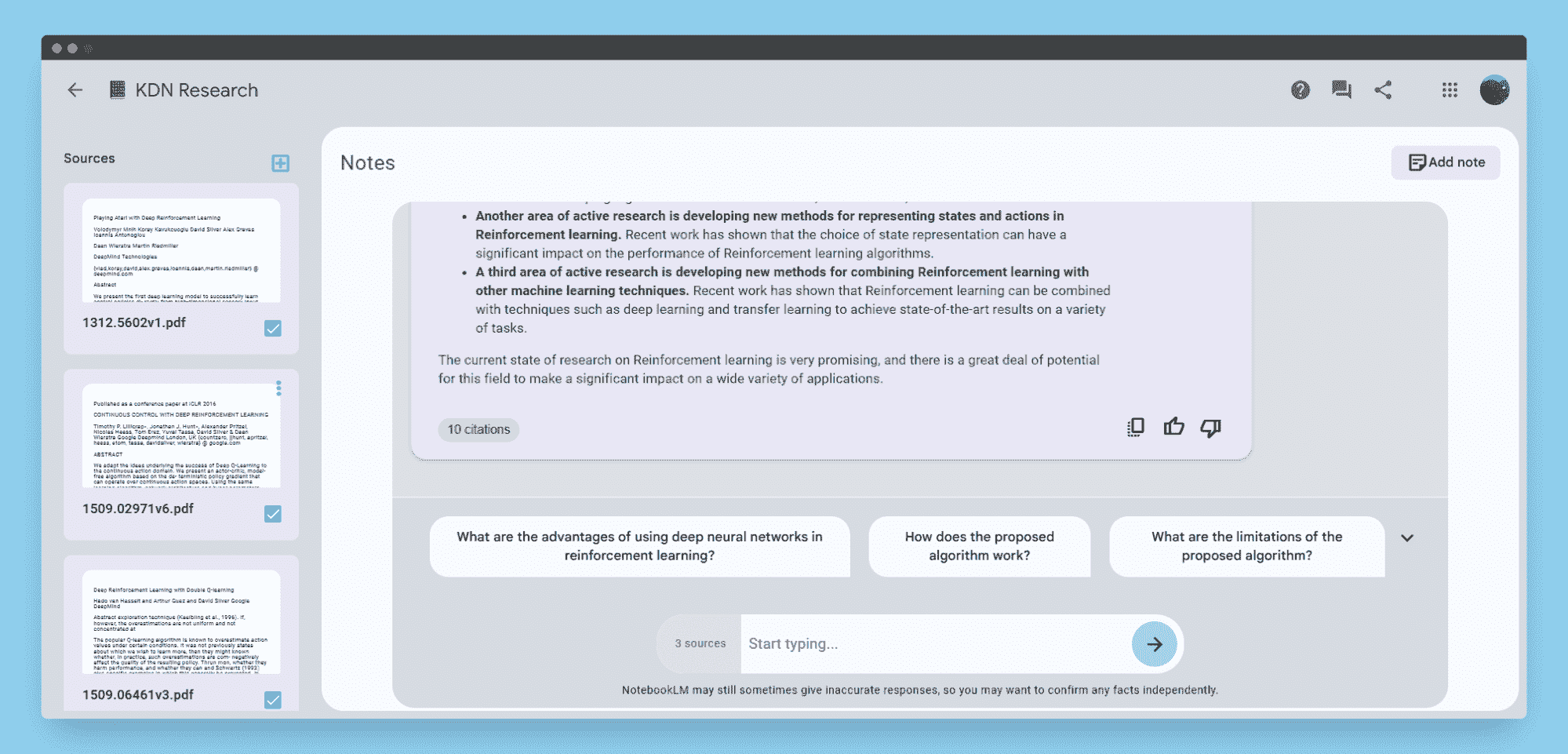

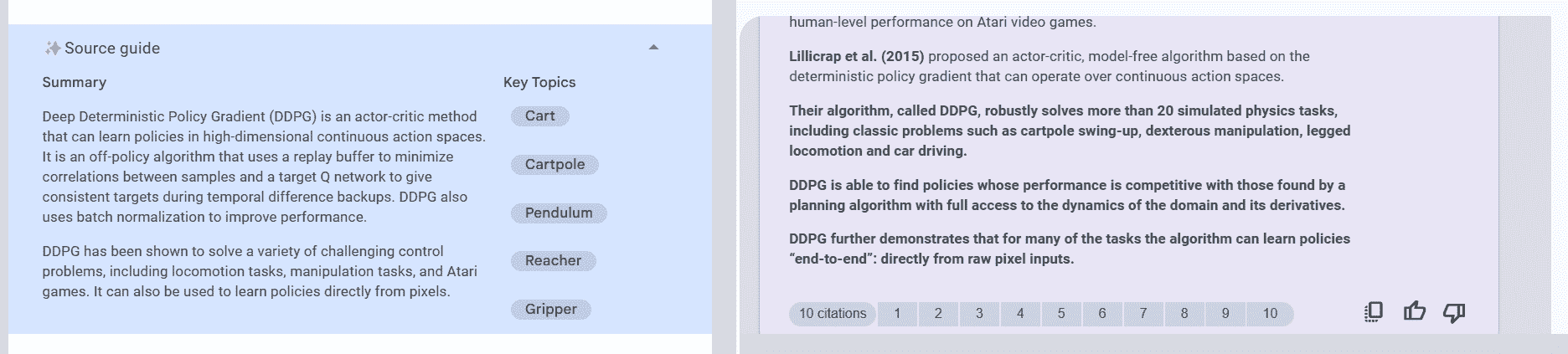

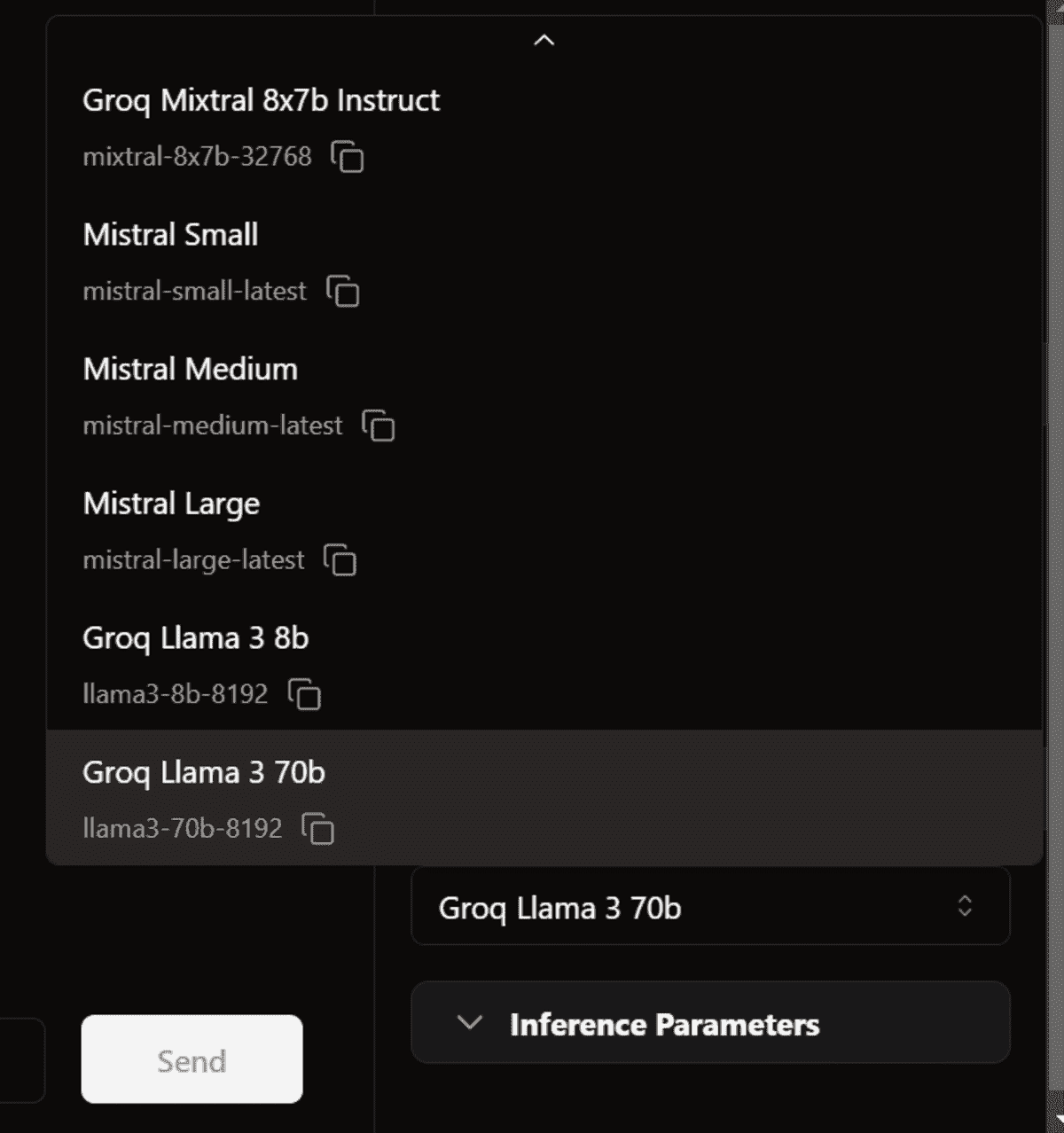

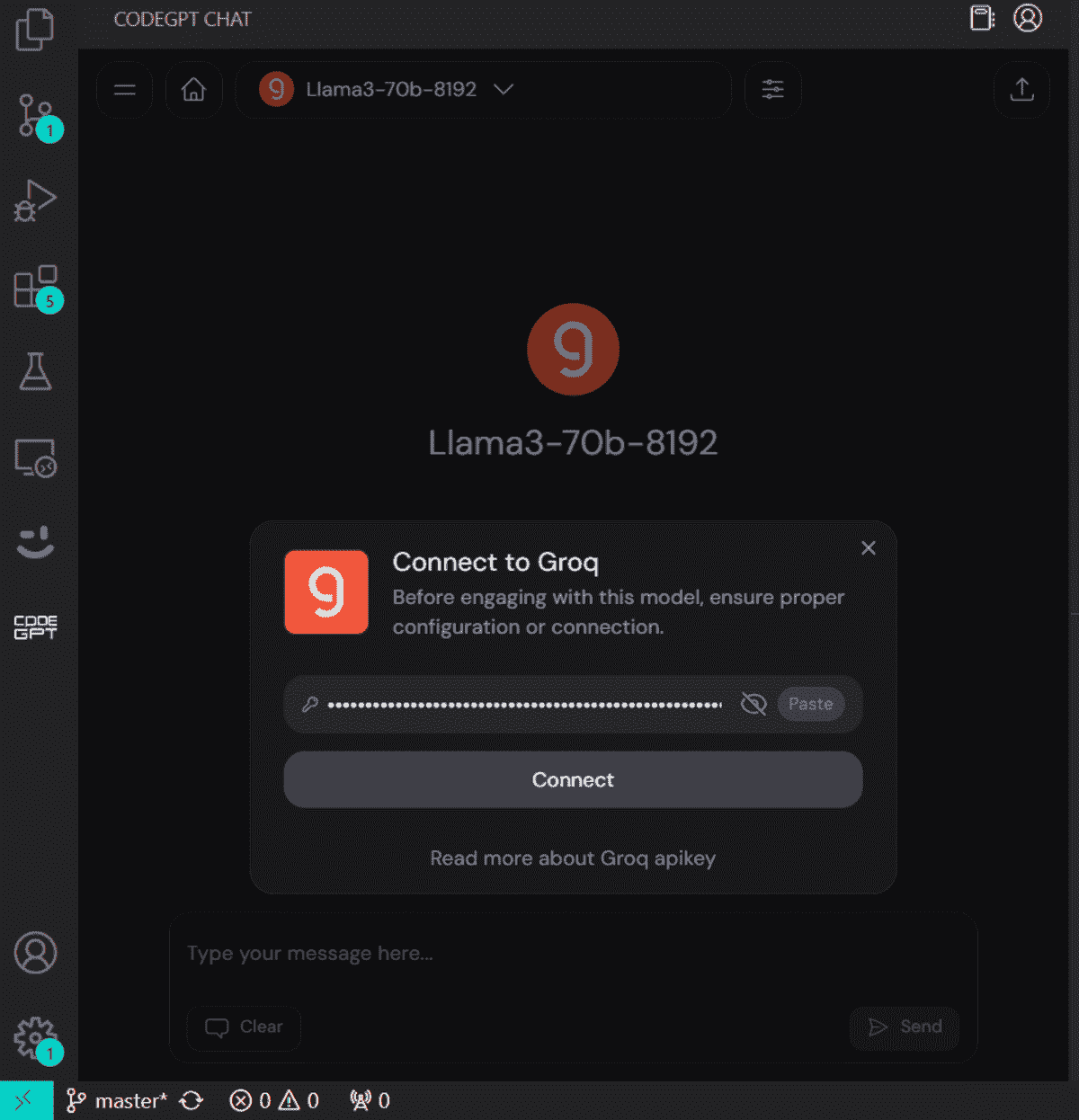

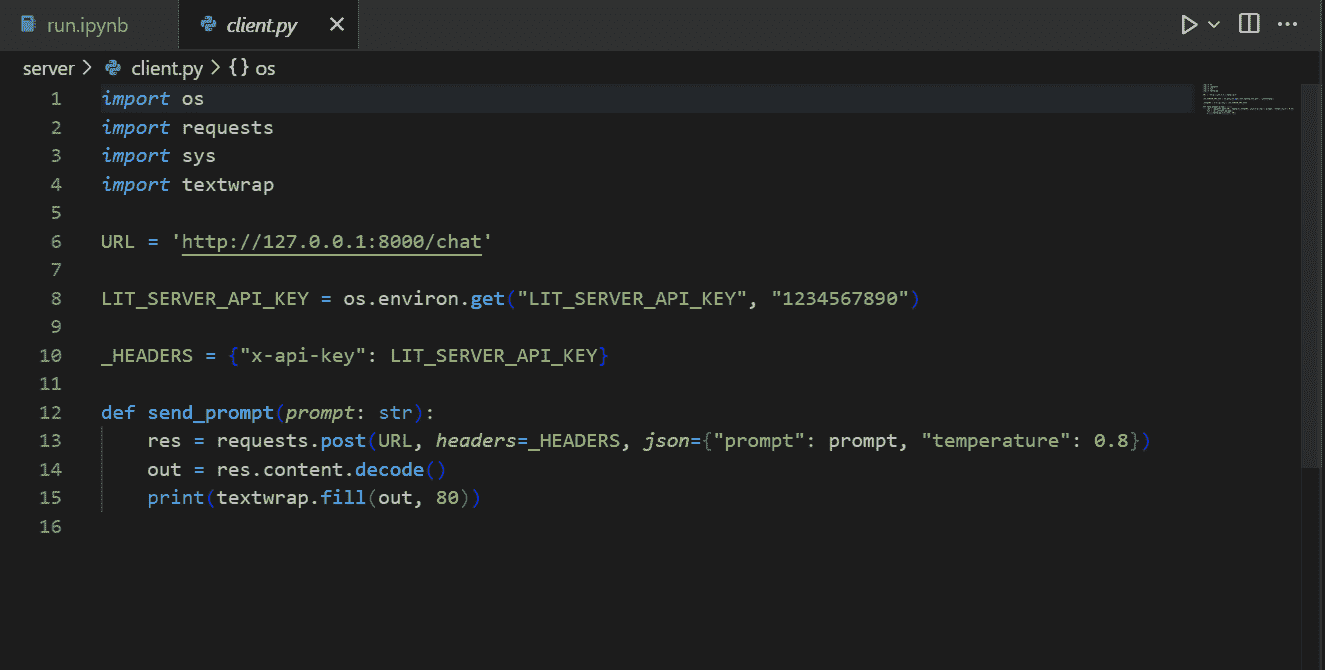

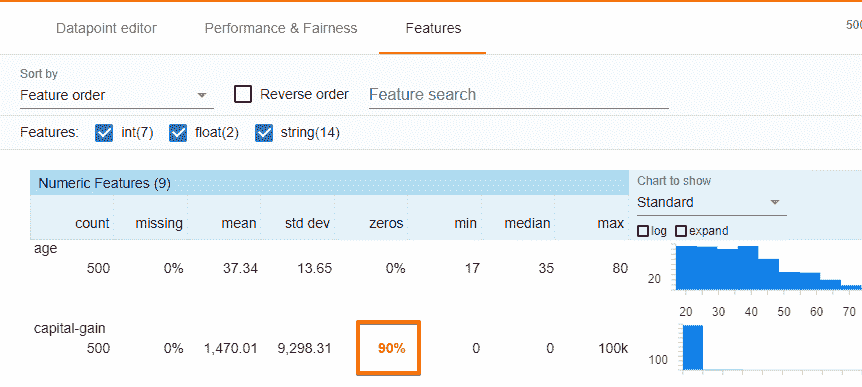

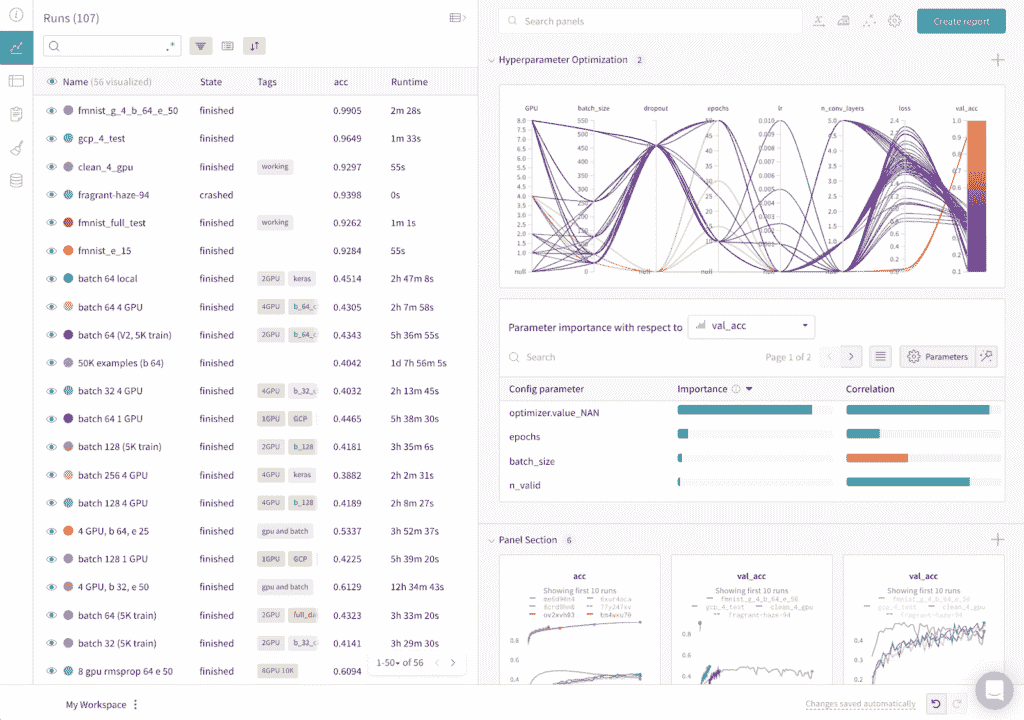

这个例子说明了一个常见的场景,其中将数据适配到内存并训练单个分类器是微不足道的,但超参数调整所需的拟合次数很快就会增加。以下是使用 sk-dist 运行如上例的网格搜索问题的幕后分析:

使用 sk-dist 的网格搜索

在 Ibotta 的传统机器学习实际应用中,我们经常发现自己处于类似的情况:小到中等规模的数据(10 万到 100 万条记录),需要多次迭代简单的分类器以进行超参数调整、集成和多类解决方案。

现有解决方案

目前有一些解决方案用于分布式传统机器学习元估计器训练。第一个是最简单的:scikit-learn 内置的使用 joblib 的元估计器并行化。这与 sk-dist 的操作非常相似,除了一个主要限制:性能受限于任何一台机器的资源。即使与理论上拥有数百个核心的单台机器相比,Spark 仍具有诸如 针对执行器的精细调优内存规范、容错 以及像使用 抢占实例 作为工作节点的成本控制选项等优势。

另一种现有解决方案是 Spark ML。这是 Spark 的原生机器学习库,支持许多与 scikit-learn 相同的分类和回归算法。它还具有像树集成和网格搜索这样的元估计器,并支持多类问题。虽然这听起来可能是一个足以分布式处理 scikit-learn 风格机器学习负载的解决方案,但它的分布式训练方式并未解决我们关心的并行性问题。

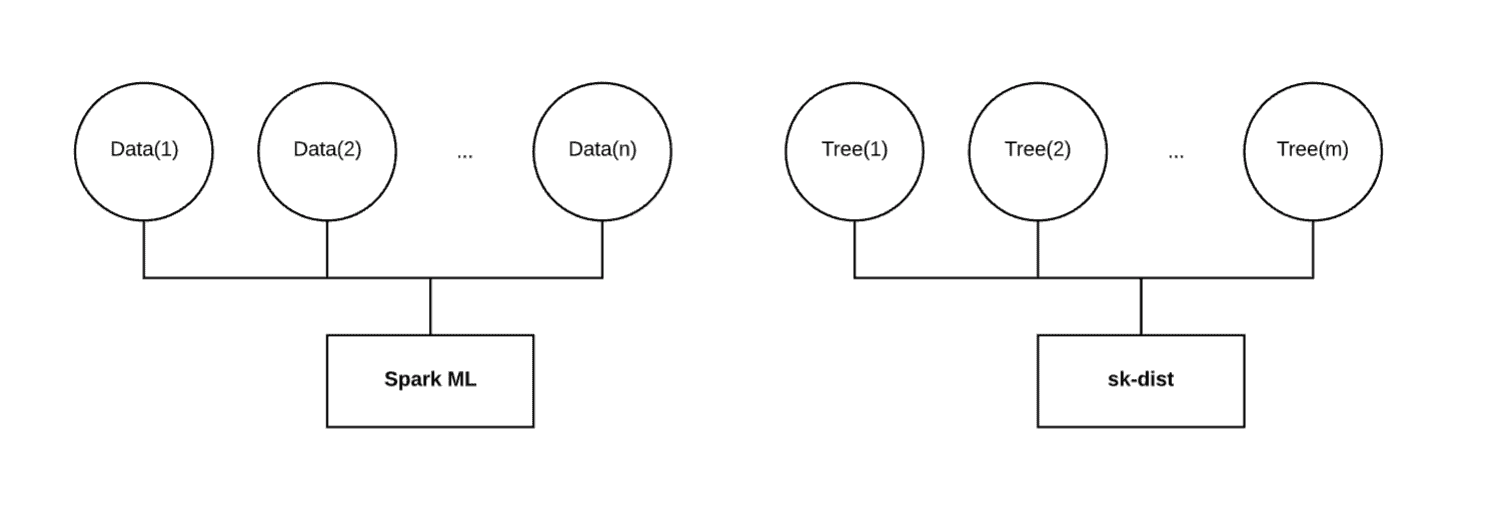

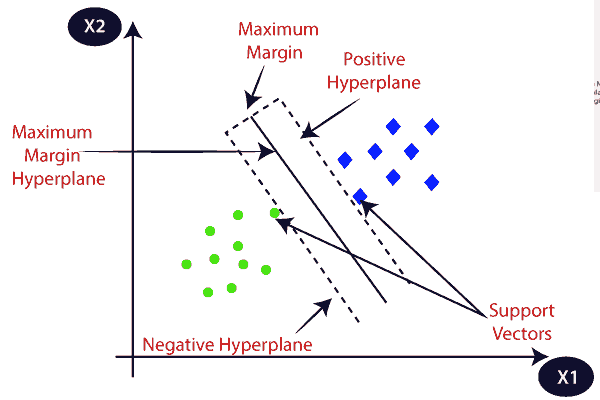

在不同维度上的分布式

如上所示,Spark ML 会在分布在多个执行器上的数据上训练一个单一模型。当数据量很大且无法适应单台机器的内存时,这种方法效果很好。然而,当数据量较小时,这可能会导致 scikit-learn 在单台机器上表现不如预期。此外,例如,在训练随机森林时,Spark ML 会按顺序训练每棵决策树。无论为此任务分配了多少资源,其壁垒时间将随着决策树数量的增加而线性增长。

对于网格搜索,Spark ML确实实现了一个并行参数,该参数可以并行训练单独模型。然而,每个单独的模型仍然是在分布在执行器上的数据上进行训练的。如果纯粹沿模型维度而非数据维度进行分布,该任务的总并行度是可以有的一个小数。

最终,我们希望在不同于 Spark ML 的维度上分布我们的训练。当使用小型或中型数据时,将数据适配到内存中并不是问题。以随机森林为例,我们希望将完整的训练数据广播到每个执行器,分别在每个执行器上拟合一个独立的决策树,然后将这些拟合的决策树带回驱动程序以组装随机森林。沿此维度分布可以比将数据分布和串行训练决策树快数量级得多。其他元估计技术,如网格搜索和多类别,也有类似的行为。

特性

鉴于这些现有解决方案在我们问题空间中的局限性,我们决定内部开发 sk-dist。底线是我们想要分布模型,而不是数据。

虽然主要关注的是元估计器的分布式训练,但 sk-dist 还包括用于与 Spark 进行 scikit-learn 模型分布式预测的模块、用于不使用 Spark 的多个前处理/后处理 scikit-learn 转换器以及一个灵活的特征编码器,可在有或没有 Spark 的情况下使用。

-

分布式训练 — 使用 Spark 分发元估计器训练。支持以下算法:超参数优化(包括网格搜索和随机搜索)、树集成(包括随机森林、额外树和随机树嵌入)以及多类别策略(包括一对多和一对一)。所有这些元估计器在拟合后都与其 scikit-learn 对应物一致。

-

分布式预测 — 使用Spark DataFrames分发拟合的 scikit-learn 估计器的预测方法。这样可以实现大规模的分布式预测,使用便携的 scikit-learn 估计器,可以选择是否使用 Spark。

-

特征编码 — 使用一个名为Encoderizer的灵活特征变换器来分发特征编码。它可以在有无 Spark 并行化的情况下运行。它会推断数据类型和形状,自动应用默认的特征变换器,以最佳猜测实现标准特征编码技术。它还可以作为一个完全可定制的特征联合编码器使用,具有 Spark 分布式变换器拟合的附加优势。

用例

这里是一些指导方针,用于决定 sk-dist 是否适合你的机器学习问题领域:

-

传统机器学习 — 像广义线性模型、随机梯度下降、最近邻、决策树和朴素贝叶斯等方法在 sk-dist 中表现良好。这些方法在 scikit-learn 中都有实现,可以直接与 sk-dist 元估计器配合使用。

-

小到中等规模数据 — 大数据与 sk-dist 不兼容。请记住,训练分布的维度沿着模型的轴,而不是数据。数据不仅需要能够适应每个执行器的内存,还需要足够小以便进行广播。根据 Spark 配置,最大广播大小可能会成为限制因素。

-

Spark 定向和访问 — sk-dist 的核心功能需要运行 Spark。这对于个人或小型数据科学团队来说并不总是可行的。此外,还需要一些 Spark 调优和配置,以成本效益的方式充分利用 sk-dist,这需要对 Spark 基础知识有一定的培训。

这里需要注意的是,尽管神经网络和深度学习技术理论上可以与 sk-dist 一起使用,但这些技术需要大量的训练数据,有时还需要专门的基础设施才能有效。深度学习并不是 sk-dist 的预期使用场景,因为它违背了上述 (1) 和 (2) 条。作为替代方案,我们在 Ibotta 使用了 Amazon SageMaker 进行这些技术,我们发现其在这些工作负载中的计算效率优于 Spark。

入门指南

要开始使用 sk-dist,请查看 安装指南。代码库还包含一个 示例 库,以展示 sk-dist 的一些使用案例。 欢迎所有人 提交问题并参与项目贡献。

如果这些项目和挑战对您感兴趣,Ibotta 正在招聘!请查看我们的 招聘页面 了解更多信息。

感谢 charley frazier、Chad Foley 和 Sam Weiss。

简介: Evan Harris 是一位经验丰富的技术专家,专注于数据科学和机器学习。他目前领导一个机器学习团队,致力于构建搜索相关性、内容推荐、定价优化和欺诈检测服务,支持一个服务于数百万用户的移动应用程序。

原文。经许可转载。

相关:

-

理解 Python 中的决策树分类

-

高级 Keras — 准确恢复训练过程

-

分布式人工智能:多智能体系统、基于代理的建模和群体智能简介

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织进行 IT 服务

3. Google IT 支持专业证书 - 支持您的组织进行 IT 服务

更多相关话题

训练一个神经网络以模仿洛夫克拉夫特的写作风格

原文:

www.kdnuggets.com/2019/07/training-neural-network-write-like-lovecraft.html

评论

评论

LSTM 神经网络近年来被广泛应用于文本和音乐生成以及时间序列预测。

今天,我将教你如何训练一个 LSTM 神经网络进行文本生成,以便它可以以 H. P. 洛夫克拉夫特的风格写作。

为了训练这个 LSTM,我们将使用 TensorFlow 的 Keras API for Python。

我从这个很棒的 LSTM 神经网络教程 学习到了这个主题。我的代码紧随这个 文本生成教程。

我将像往常一样展示我的 Python 示例和结果,但首先,让我们先做一些解释。

什么是 LSTM 神经网络?

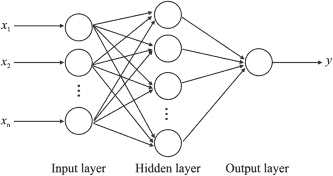

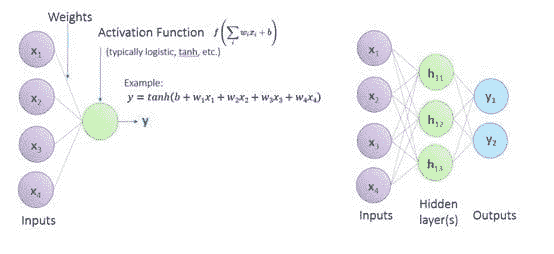

最普通的、最基本的神经网络,称为多层感知器,就是完全连接层的组合。

在这些模型中,输入是特征的向量,每一层是一个“神经元”集合。

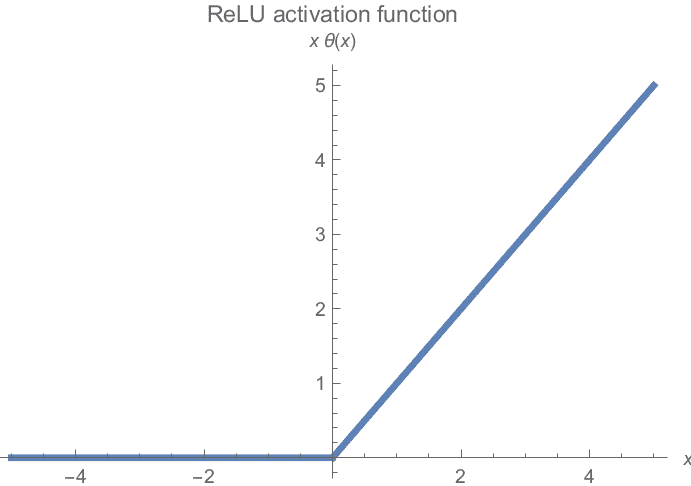

每个神经元对前一层的输出进行仿射(线性)变换,然后对结果应用某种非线性函数。

一层的神经元的输出,即一个新的向量,被传递到下一层,依此类推。

LSTM(长短期记忆)神经网络只是另一种 人工神经网络,属于递归神经网络的范畴。

LSTM 神经网络与普通神经网络不同之处在于,它们在某些层中使用 LSTM 单元作为神经元。

就像 卷积层 帮助神经网络学习图像特征一样,LSTM 单元帮助网络学习时间序列数据,这是其他机器学习模型传统上难以处理的。

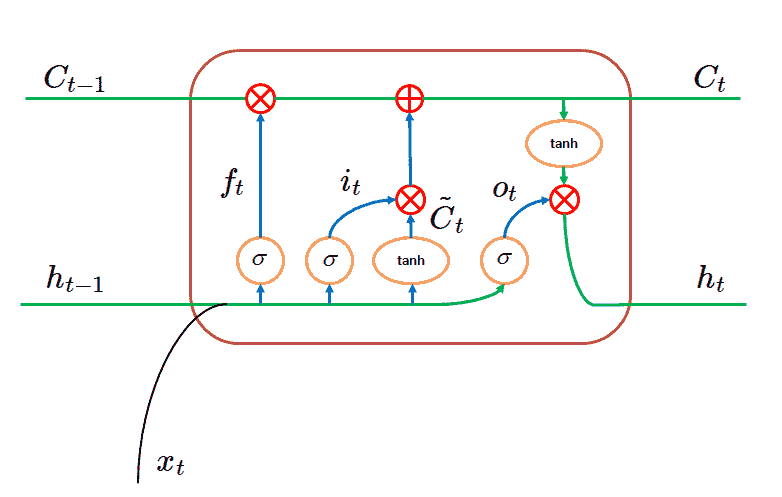

LSTM 单元是如何工作的?我现在将解释,不过我强烈建议你也看看那些教程。

LSTM 单元是如何工作的?

一个 LSTM 层将包含许多 LSTM 单元。

我们神经网络中的每个 LSTM 单元只会查看输入的单列,以及前一列的 LSTM 单元输出。

通常,我们将整个矩阵作为输入喂给 LSTM 神经网络,每列对应于“前面”某个内容的下一个列。

这样,每个 LSTM 单元将有两个不同的输入向量:前一个 LSTM 单元的输出(为其提供有关前一个输入列的一些信息)和它自己的输入列。

LSTM 单元的实际运作:一个直观的例子。

例如,如果我们训练一个 LSTM 神经网络来预测股票市场值,我们可以给它输入一个包含过去三天股票收盘价的向量。

在这种情况下,第一个 LSTM 单元将使用第一天的数据作为输入,并将一些提取的特征传递给下一个单元。

那个第二个单元会查看第二天的价格,并且还会查看前一个单元从昨天学到的内容,然后生成下一个单元的新输入。

在对每个单元做完这些操作后,最后一个单元实际上会有很多时间信息。它将接收来自前一个单元的昨日收盘价的学习结果,以及来自前两个单元的信息(通过其他单元提取的信息)。

你可以尝试不同的时间窗口,也可以改变有多少单元(神经元)查看每天的数据,但这是大致的思路。

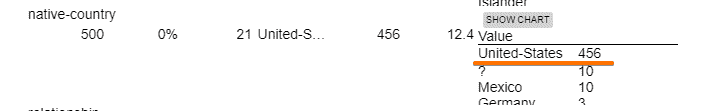

LSTM 单元如何工作:数学原理。

实际上,每个单元从前一个单元提取的内容的数学原理要复杂一些。

忘记门

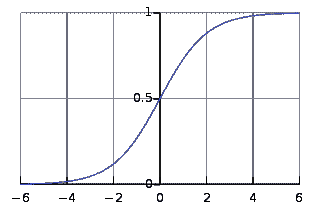

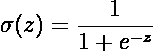

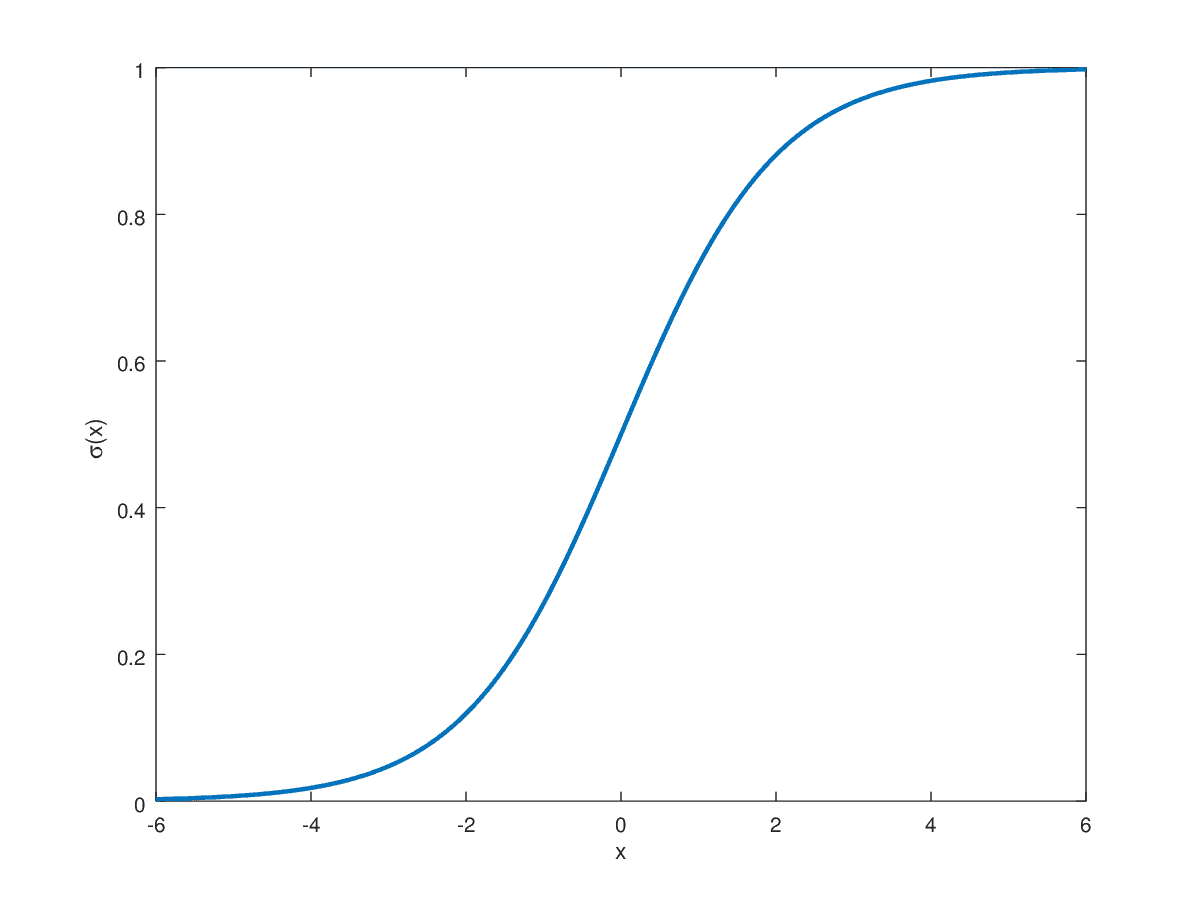

“忘记门”是一个 sigmoid 层,它调节前一个单元的输出对当前单元的影响程度。

它以前一个单元的“隐藏状态”(另一个输出向量)和来自前一层的实际输入作为输入。

由于它是一个 sigmoid 函数,它将返回一个“概率”向量:值在 0 和 1 之间。

它们将前一个单元的输出进行乘法运算,以调节它们所持有的影响力,从而创建该单元的状态。

例如,在极端情况下,sigmoid 可能返回一个零向量,整个状态将被乘以 0,从而被丢弃。

如果该层看到输入分布的变化非常大,例如,可能会发生这种情况。

输入门

与忘记门不同,输入门的输出会被添加到前一个单元的输出中(在它们被忘记门的输出乘法运算后)。

输入门是两个不同层输出的点积,尽管它们都使用与忘记门相同的输入(前一个单元的隐藏状态和前一层的输出):

-

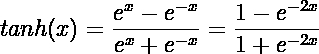

一个sigmoid 单元,调节新信息对该单元输出的影响程度。

-

一个tanh 单元,实际提取新信息。请注意,tanh 的取值范围在-1 和 1 之间。

这两个单元的乘积(可能再次是 0,也可能完全等于 tanh 的输出,或介于两者之间)被添加到该神经元的单元状态中。

LSTM 单元的输出

单元的状态是下一个 LSTM 单元将接收的输入,连同该单元的隐藏状态一起。

隐藏状态将是另一个 tanh 单元,应用于该神经元的状态,再乘以另一个sigmoid 单元,该单元接受前一层和单元的输出(就像忘记门一样)。

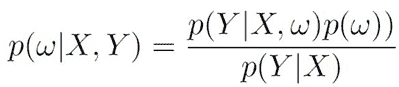

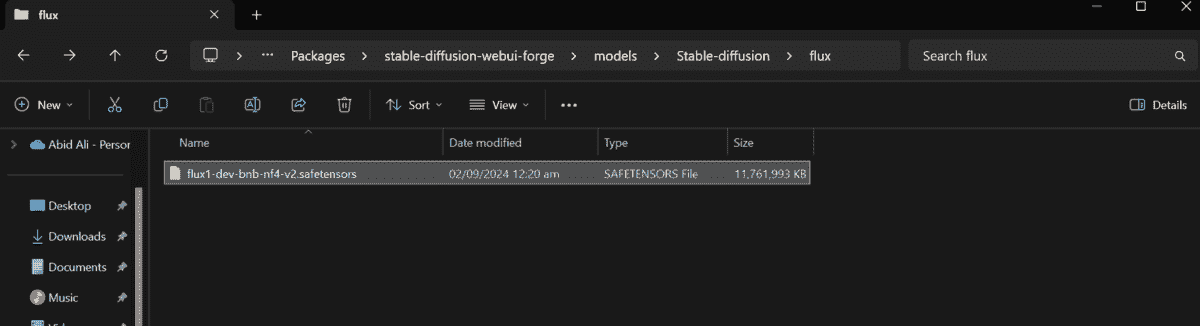

这是我刚刚链接的教程中借用的每个 LSTM 单元的可视化图像。

来源: 文本生成 LSTM

现在我们已经覆盖了理论部分,让我们转到一些实际应用吧!

像往常一样,所有代码都可以在GitHub 上找到,如果你想尝试一下,或者你可以继续跟随并查看要点。

使用 TensorFlow Keras 训练 LSTM 神经网络

对于这个任务,我使用了这个包含 60 篇洛夫克拉夫特故事的数据集。

由于他大部分作品是在 20 年代写的,他在 1937 年去世,因此现在大部分作品已进入公有领域,所以获取这些作品并不困难。

我认为训练一个神经网络来模仿他的写作风格将是一个有趣的挑战。

这是因为,一方面,他有一种非常独特的风格(充满华丽的修辞:使用奇怪的词汇和复杂的语言),但另一方面,他使用了非常复杂的词汇,网络可能难以理解。

例如,这里是数据集中的第一个故事中的一句随机句子:

夜晚,黑暗城市的细微躁动、蛀虫隔板中老鼠的阴险奔走,以及百年老屋中隐蔽木材的吱吱声,足以让他感受到刺耳的混乱。

如果我能让神经网络写出“pandemonium”,那么我会很惊讶。

预处理我们的数据

为了训练 LSTM 神经网络生成文本,我们必须首先预处理文本数据,以便网络可以处理。

在这种情况下,由于神经网络接受向量作为输入,我们需要一种将文本转换为向量的方法。

对于这些示例,我决定训练我的 LSTM 神经网络来预测字符串中的下一个 M 个字符,以之前的 N 个字符作为输入。

为了能够输入 N 个字符,我对每个字符进行了独热编码,使得网络的输入是一个 CxN 的矩阵,其中 C 是数据集中不同字符的总数。

首先,我们读取文本文件并将它们的内容连接起来。

我们将字符限制为字母数字和一些标点符号。

然后,我们可以将字符串进行独热编码,转化为矩阵,其中每个j列的元素都是 0,除了对应于语料库中的j字符的那个元素。

为了实现这一点,我们首先定义一个字典,将每个字符分配一个索引。

注意,如果我们希望对数据进行采样,我们可以将变量slices调整得更小。

我还为SEQ_LENGTH选择了 50 的值,使网络接收 50 个字符并尝试预测接下来的 50 个字符。

训练我们的 LSTM 神经网络

为了训练神经网络,我们必须首先定义它。

这段 Python 代码创建了一个具有两个 LSTM 层的 LSTM 神经网络,每层有 100 个单元。

记住,每个单元对输入序列中的每个字符都有一个单元,因此有 50 个。

这里VOCAB_SIZE只是我们将使用的字符数量,而TimeDistributed是一种将给定层应用于每个不同单元格的方式,保持时间顺序。

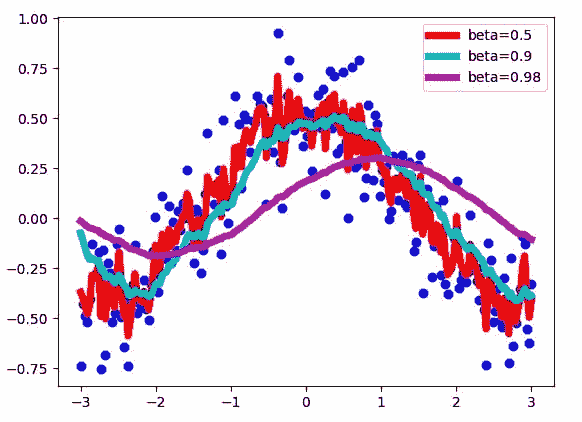

对于这个模型,我实际上尝试了许多不同的学习率来测试收敛速度与过拟合。

这是训练的代码:

你看到的是在损失最小化方面表现最好的结果。

然而,在最后一个周期(500 个周期后)中,binary_cross_entropy 为 0.0244,模型的输出如下。

Tolman hast toemtnsteaetl nh otmn tf titer aut tot tust tot ahen h l the srrers ohre trrl tf thes snneenpecg tettng s olt oait ted beally tad ened ths tan en ng y afstrte and trr t sare t teohetilman hnd tdwasd hxpeinte thicpered the reed af the satl r tnnd Tev hilman hnteut iout y techesd d ty ter thet te wnow tn tis strdend af ttece and tn aise ecn

这个输出有很多好处,也有很多坏处。

间距设置的方式,单词大多在 2 到 5 个字符之间,偶尔有较长的例外,这与语料库中的实际单词长度分布非常相似。

我还注意到字母‘T’,‘E’和‘I’非常常见,而‘y’或‘x’则较少见。

当我查看字母相对频率在样本输出与语料库中的比较时,它们相当相似。问题在于排序完全错乱。

还有一点需要指出的是,大写字母仅在空格后出现,这通常是英语中的情况。

为了生成这些输出,我只是让模型预测语料库中不同 50 个字符子集的下一个 50 个字符。如果训练数据如此糟糕,我觉得测试或随机数据也不会值得检查。

这些无意义的内容实际上让我想起了 H. P. Lovecraft 最著名的故事之一,“克苏鲁的呼唤”,其中人们开始对这个宇宙的、古怪的存在产生幻觉,他们会说:

Ph’nglui mglw’nafh Cthulhu R’lyeh wgah’nagl fhtagn.

可惜模型也没有过拟合,它明显欠拟合。

所以我试图让任务更小,模型更大:125 个单元,预测仅 30 个字符。

更大的模型,更小的问题。有什么结果吗?

在这个更小的模型下,再经过 500 个训练周期后,一些模式开始出现。

尽管损失函数(210)没有小太多,字符的频率仍然与语料库相似。

尽管如此,字符的排序改善了很多:这是它输出的一个随机样本,看看你能否发现一些单词。

the sreun troor Tvwood sas an ahet eae rin and t paared th te aoolling onout The e was thme trr t sovtle tousersation oefore tifdeng tor teiak uth tnd tone gen ao tolman aarreed y arsred tor h tndarcount tf tis feaont oieams wnd toar Tes heut oas nery tositreenic and t aeed aoet thme hing tftht to te tene Te was noewked ay tis prass s deegn aedgireean ect and tot ced the sueer anoormal -iuking torsarn oaich hnher tad beaerked toring the sars tark he e was tot tech

技术、the 和 and,was… 小词是重点!它还意识到许多单词以常见后缀如-ing,-ed 和-tion 结尾。

在 10000 个单词中,740 个是“the”,37 个以“tion”结尾(而只有 3 个是没有以此结尾的),115 个以-ing结尾。

其他常见单词包括“than”和“that”,尽管模型显然仍然无法生成英文句子。

更大的模型

这给了我希望。神经网络显然在学习某些东西,只是还不够多。

所以我做了当模型欠拟合时应该做的事情:我尝试了一个更大的神经网络。

请考虑,我是在我的笔记本电脑上运行这个。

即使配备了 16GB 的内存和 i7 处理器,这些模型仍需数小时才能完成学习。

所以我将单位数量设置为 150,再次尝试了 50 个字符。

我想也许给它更小的时间窗口会让网络更难处理。

这是模型在经过几个小时训练后的输出情况。

andeonlenl oou torl u aote targore -trnnt d tft thit tewk d tene tosenof the stown ooaued aetane ng thet thes teutd nn aostenered tn t9t aad tndeutler y aean the stun h tf trrns anpne thin te saithdotaer totre aene Tahe sasen ahet teae es y aeweeaherr aore ereus oorsedt aern totl s a dthe snlanete toase af the srrls-thet treud tn the tewdetern tarsd totl s a dthe searle of the sere t trrd eneor tes ansreat tear d af teseleedtaner nl and tad thre n tnsrnn tearltf trrn T has tn oredt d to e e te hlte tf the sndirehio aeartdtf trrns afey aoug ath e -ahe sigtereeng tnd tnenheneo l arther ardseu troa Tnethe setded toaue and tfethe sawt ontnaeteenn an the setk eeusd ao enl af treu r ue oartenng otueried tnd toottes the r arlet ahicl tend orn teer ohre teleole tf the sastr ahete ng tf toeeteyng tnteut ooseh aore of theu y aeagteng tntn rtng aoanleterrh ahrhnterted tnsastenely aisg ng tf toueea en toaue y anter aaneonht tf the sane ng tf the

完全是无意义的,除了大量的“the”和“and”。

实际上,它说“the”的频率比之前更高,但它还没有学会动名词(没有 -ing)。

有趣的是,这里许多单词以“-ed”结尾,这意味着它有点儿掌握了过去时的概念。

我让它继续训练了几百个周期(共 750 个)。

输出变化不大,仍然是大量的“the”、“a”和“an”,并且没有更大的结构。这里是另一个样本:

Tn t srtriueth ao tnsect on tias ng the sasteten c wntnerseoa onplsineon was ahe ey thet tf teerreag tispsliaer atecoeent of teok ond ttundtrom tirious arrte of the sncirthio sousangst tnr r te the seaol enle tiedleoisened ty trococtinetrongsoa Trrlricswf tnr txeenesd ng tispreeent T wad botmithoth te tnsrtusds tn t y afher worsl ahet then

但有趣的是,出现了对介词和代词的使用。

网络写了几次“I”,“you”,“she”,“we”,“of”等类似的词。总的来说,介词和代词大约占总采样单词的 10%。

这是一个改进,因为网络显然在学习低熵的单词。

然而,它仍然远未生成连贯的英语文本。

我让它再训练了 100 个周期,然后停止了。

这是它的最后输出。

thes was aooceett than engd and te trognd tarnereohs aot teiweth tncen etf thet torei The t hhod nem tait t had nornd tn t yand tesle onet te heen t960 tnd t960 wndardhe tnong toresy aarers oot tnsoglnorom thine tarhare toneeng ahet and the sontain teadlny of the ttrrteof ty tndirtanss aoane ond terk thich hhe senr aesteeeld Tthhod nem ah tf the saar hof tnhe e on thet teauons and teu the ware taiceered t rn trr trnerileon and

我知道它已经尽力而为,但它确实没有取得实质性的进展,至少不够快。

我考虑通过批量归一化来加快收敛速度。

然而,我在 StackOverflow 上读到,BatchNorm 不应该与 LSTM 神经网络一起使用。

如果你们中有人对 LSTM 网络更有经验,请在评论中告诉我这是否正确!

最后,我尝试了用 10 个字符作为输入,10 个字符作为输出来执行相同的任务。

我想模型没有获得足够的上下文来很好地预测事物:结果非常糟糕。

我考虑目前实验已经结束了。

结论

尽管从其他人的工作中可以看出,LSTM 神经网络可能学会像洛夫克拉夫特一样写作,但我认为我的电脑不够强大,无法在合理的时间内训练出足够大的模型。

或者,也许它只是需要比我拥有的更多的数据。

未来,我希望用基于词的方式重复这个实验,而不是基于字符的方式。

我检查了一下,语料库中大约 10%的单词只出现过一次。

如果我在训练之前删除了它们,有什么好的做法吗?比如用相同的名词替换所有名词,从簇中采样,或者其他方法?请告诉我!我相信你们中的许多人在 LSTM 神经网络方面比我更有经验。

你认为如果使用不同的架构会更好吗?有什么我应该以不同方式处理的地方吗?请告诉我,我想了解更多关于这方面的知识。

你在我的代码中发现了什么新手错误吗?你认为我因为没尝试 XYZ 而显得很愚蠢吗?还是你实际上觉得我的实验很有趣,或者你甚至从这篇文章中学到了什么?

如需讨论此事或相关话题,请在Twitter、LinkedIn、Medium或Dev.to与我联系。

如果你想成为数据科学家或学习新东西,查看我的机器学习阅读清单!

简介:Luciano Strika 是布宜诺斯艾利斯大学的计算机科学学生,同时也是 MercadoLibre 的数据科学家。他还在www.datastuff.tech上撰写有关机器学习和数据的文章。

原文。经许可转载。

相关:

-

自动编码器:使用 TensorFlow 的 Eager Execution 进行深度学习

-

3 本提升我作为数据科学家技能的机器学习书籍

-

理解反向传播在 LSTM 中的应用

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关话题

训练集、测试集和 10 折交叉验证

原文:

www.kdnuggets.com/2018/01/training-test-sets-cross-validation.html

评论

评论

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

编辑注释: 这是 Ron Zacharski 的免费在线书籍摘录,标题为数据挖掘程序员指南:古老的数字艺术。

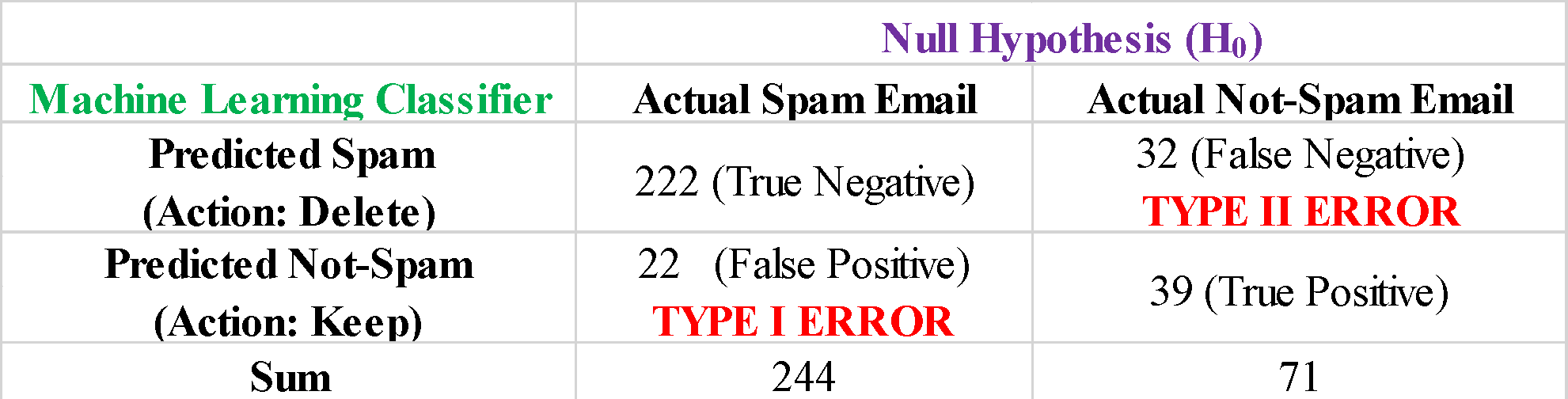

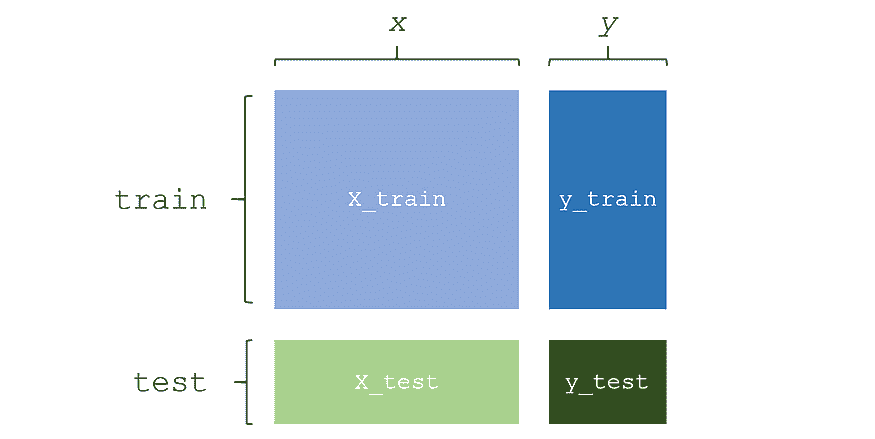

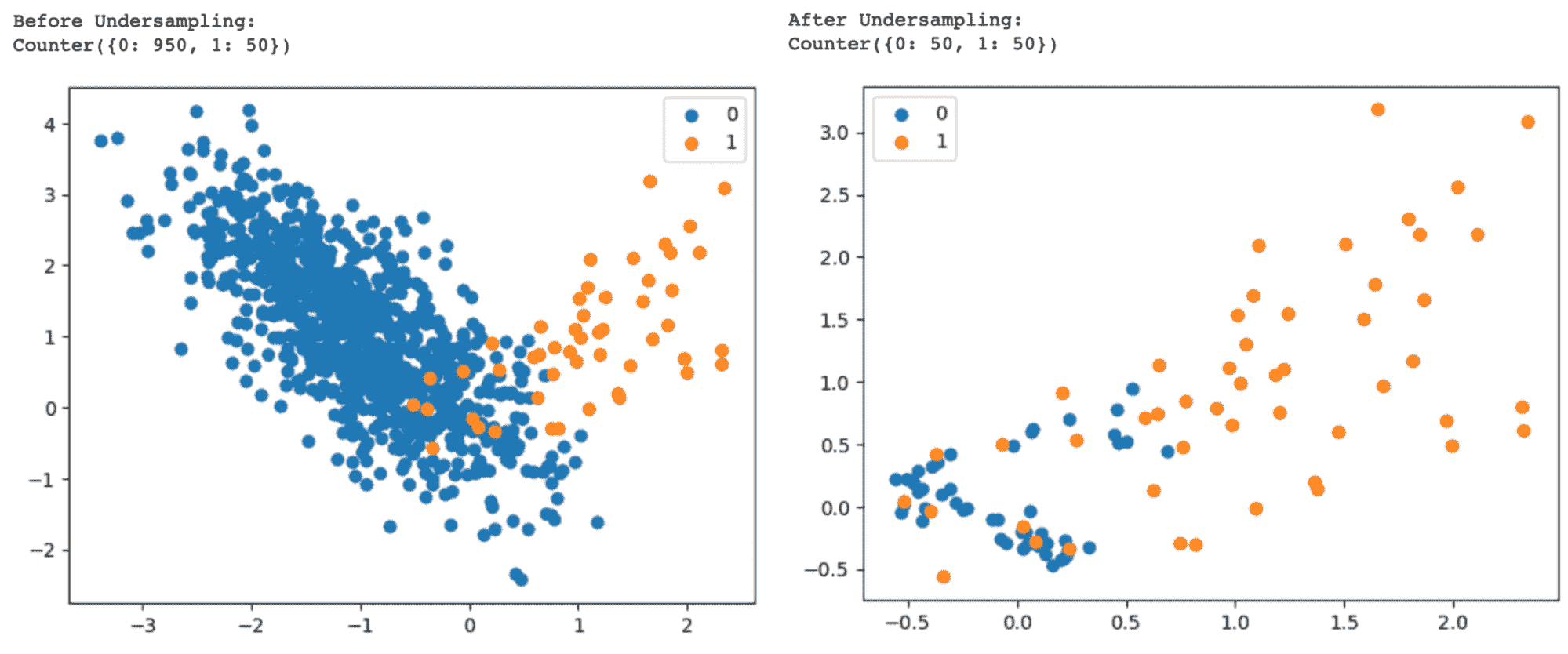

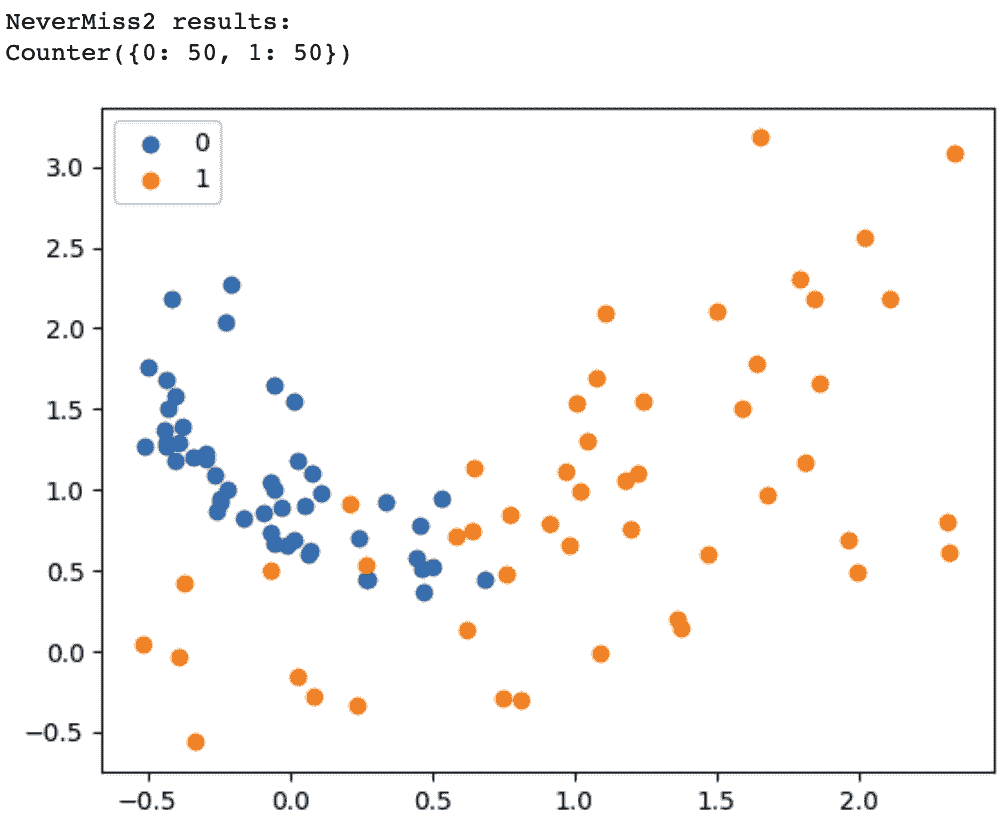

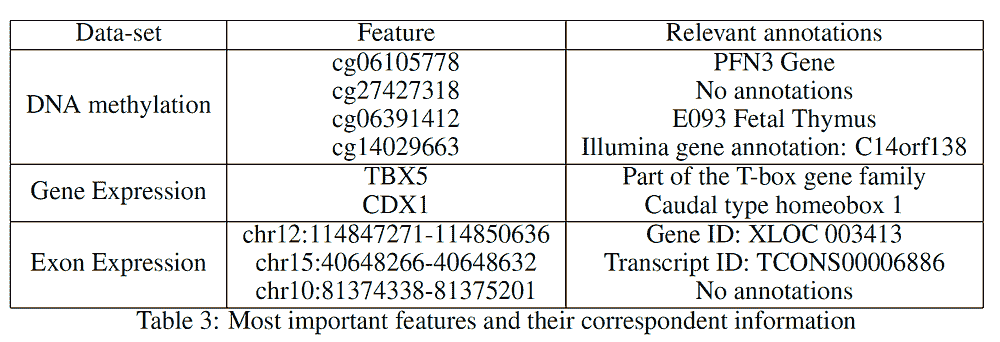

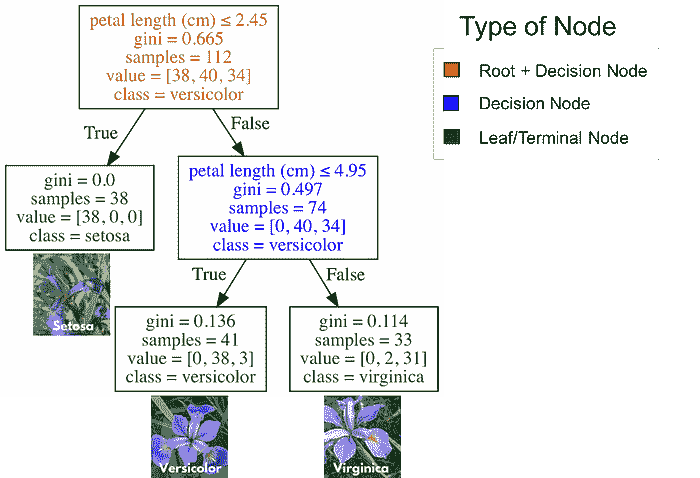

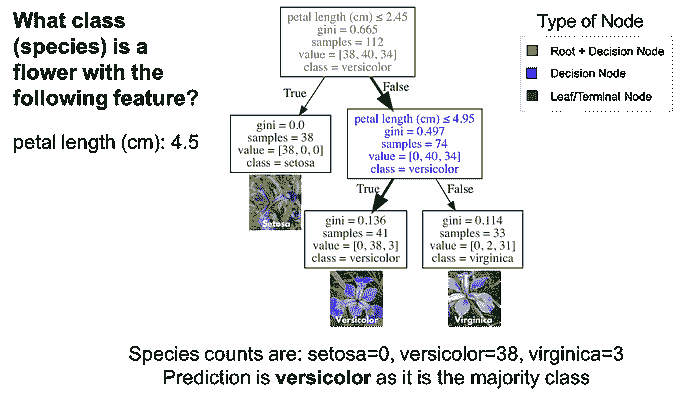

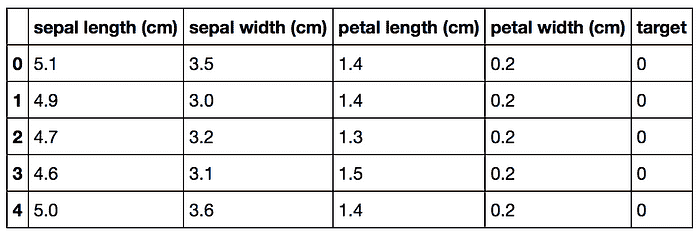

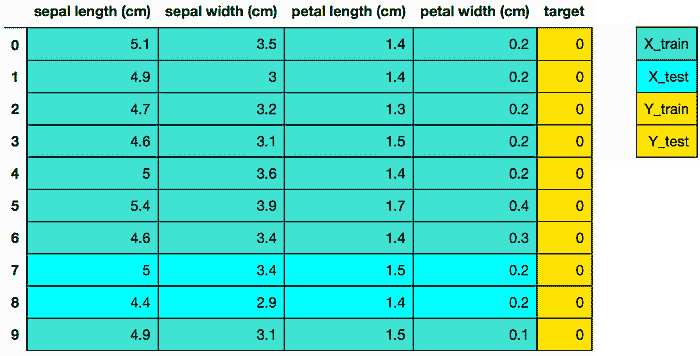

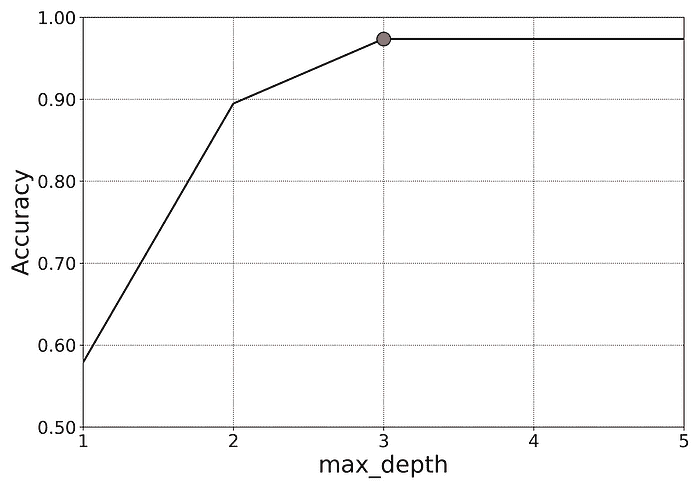

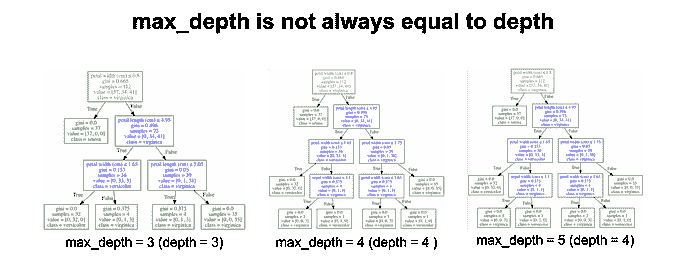

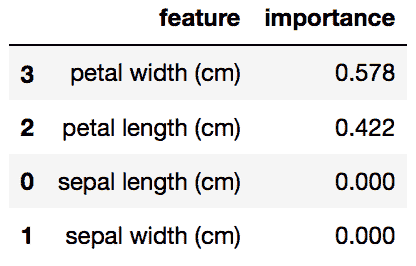

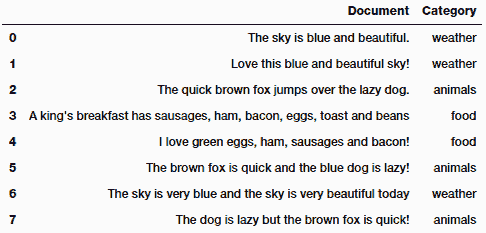

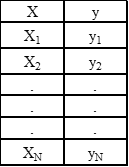

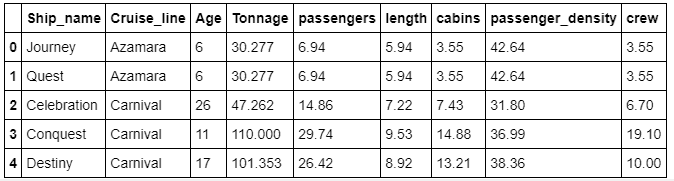

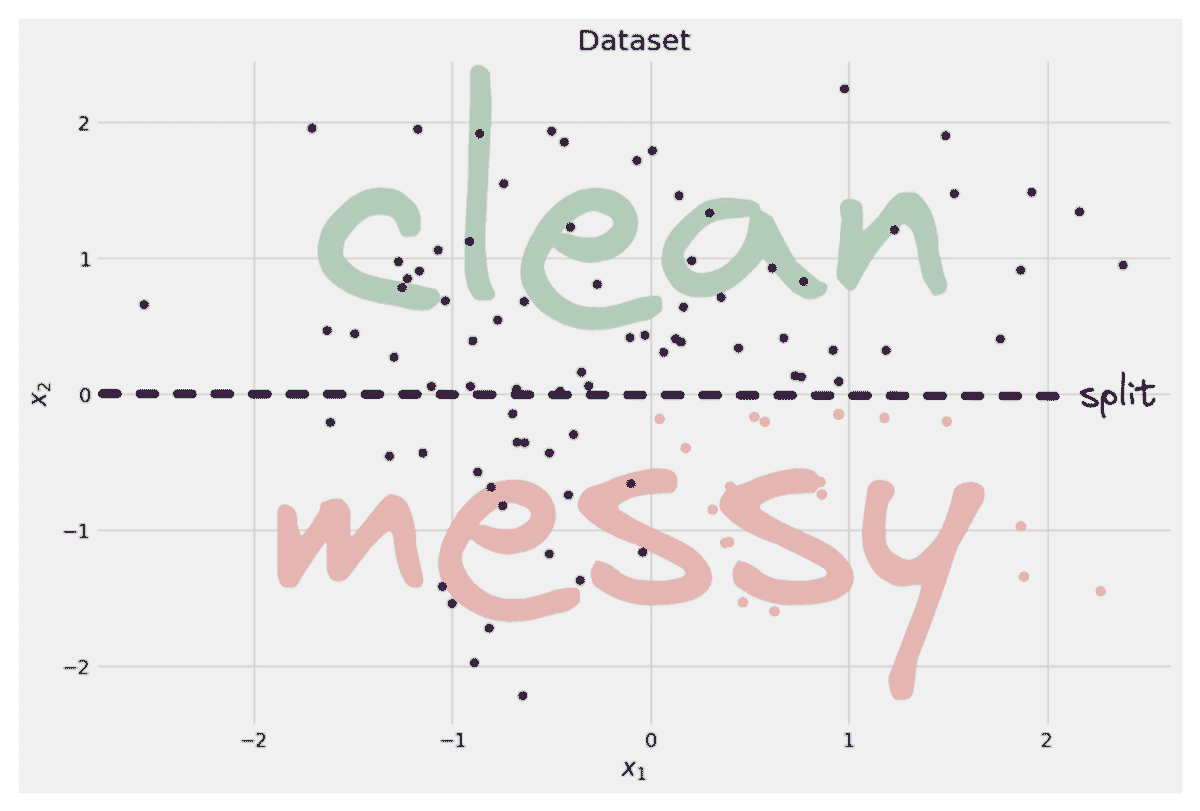

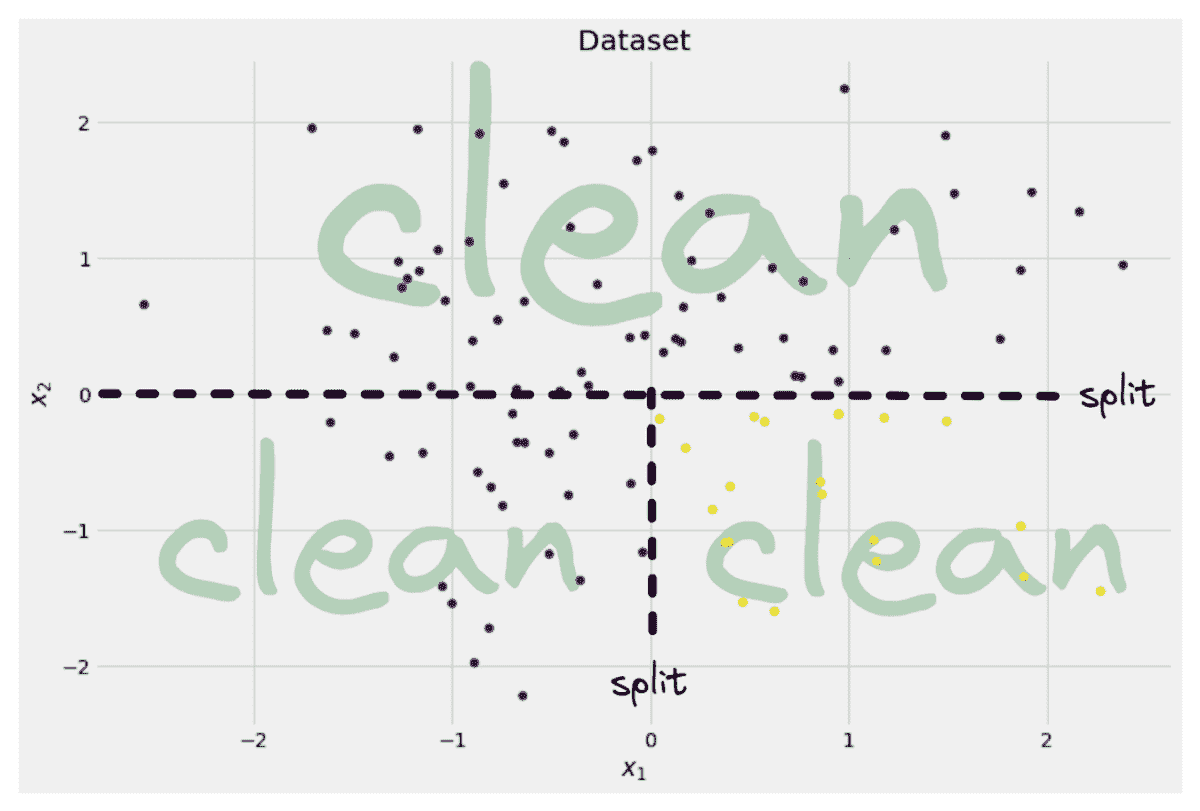

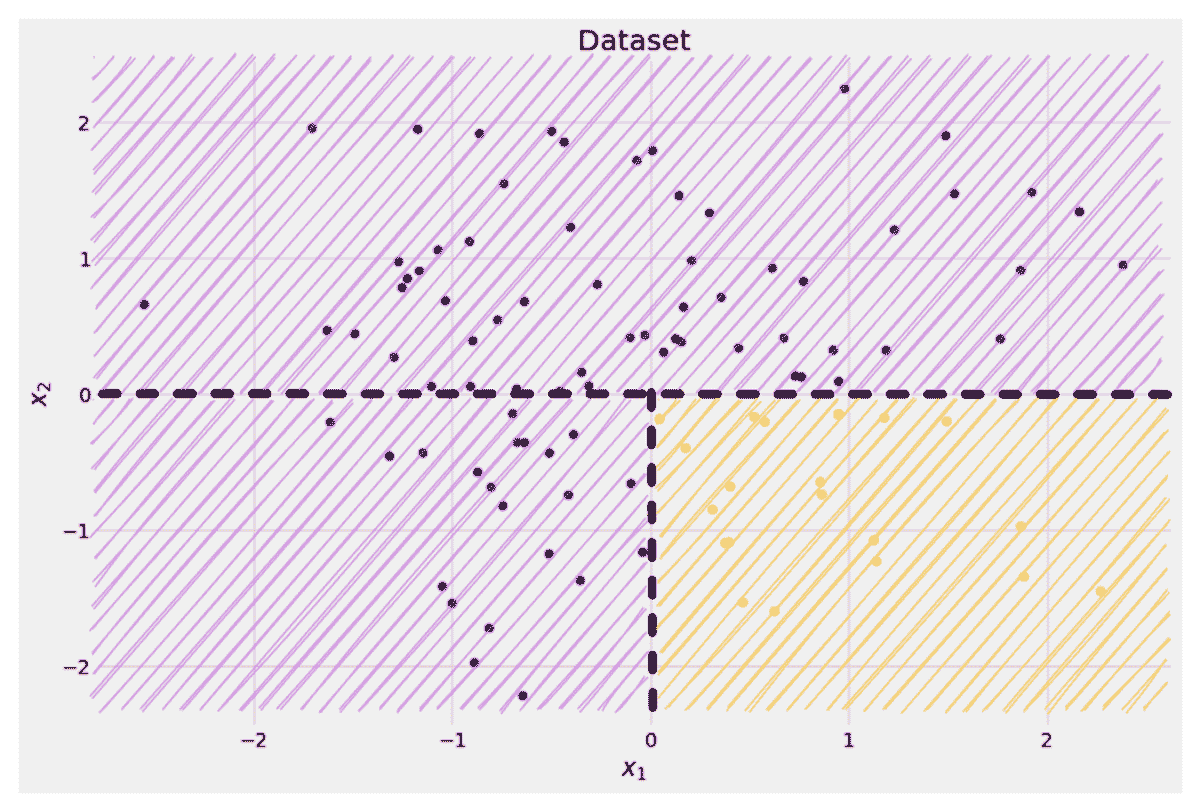

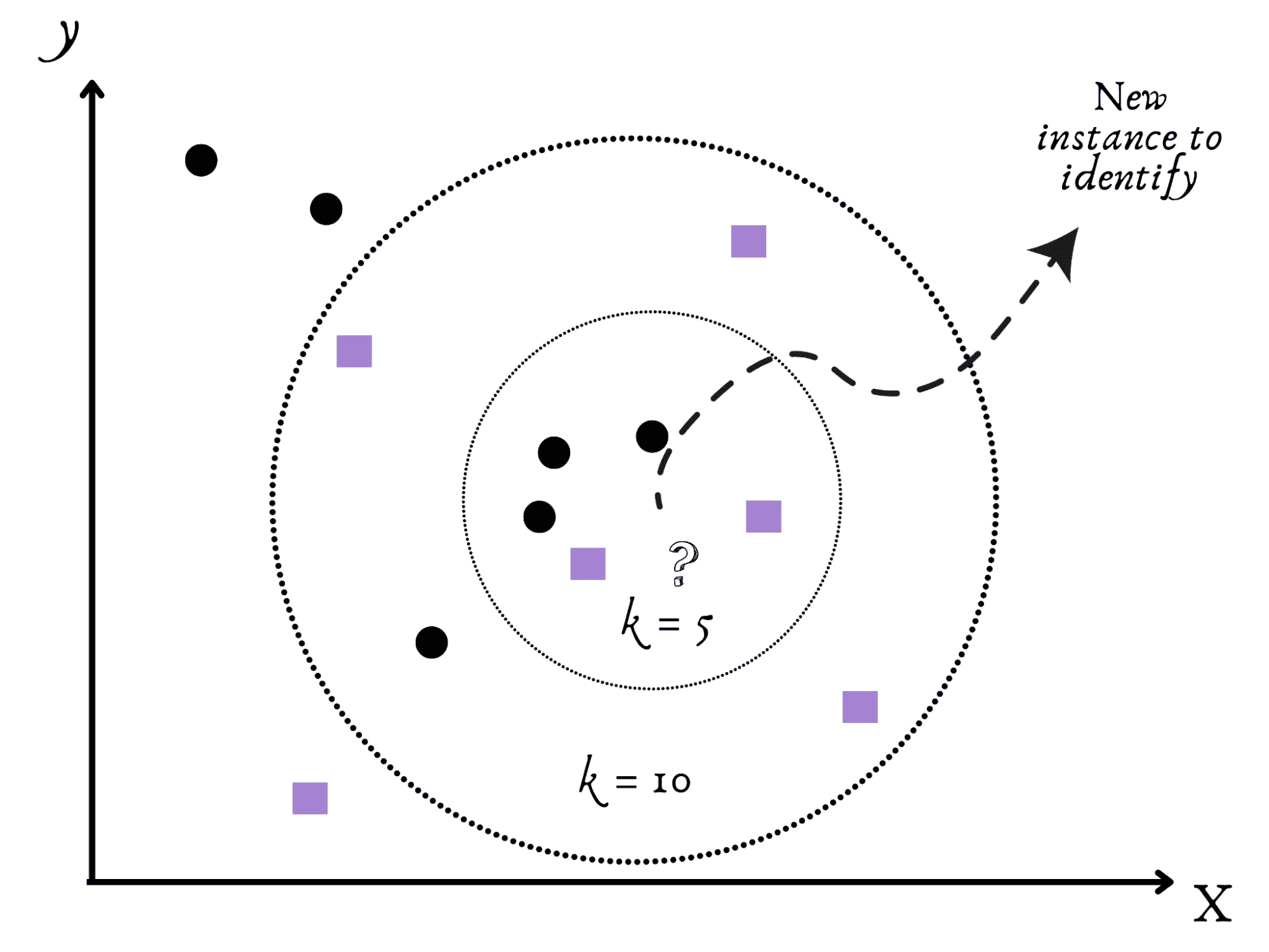

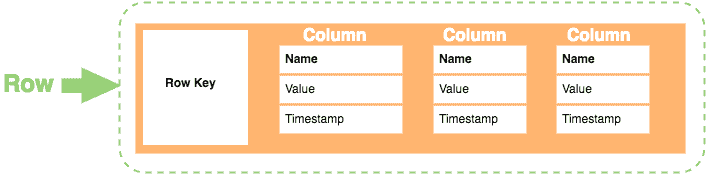

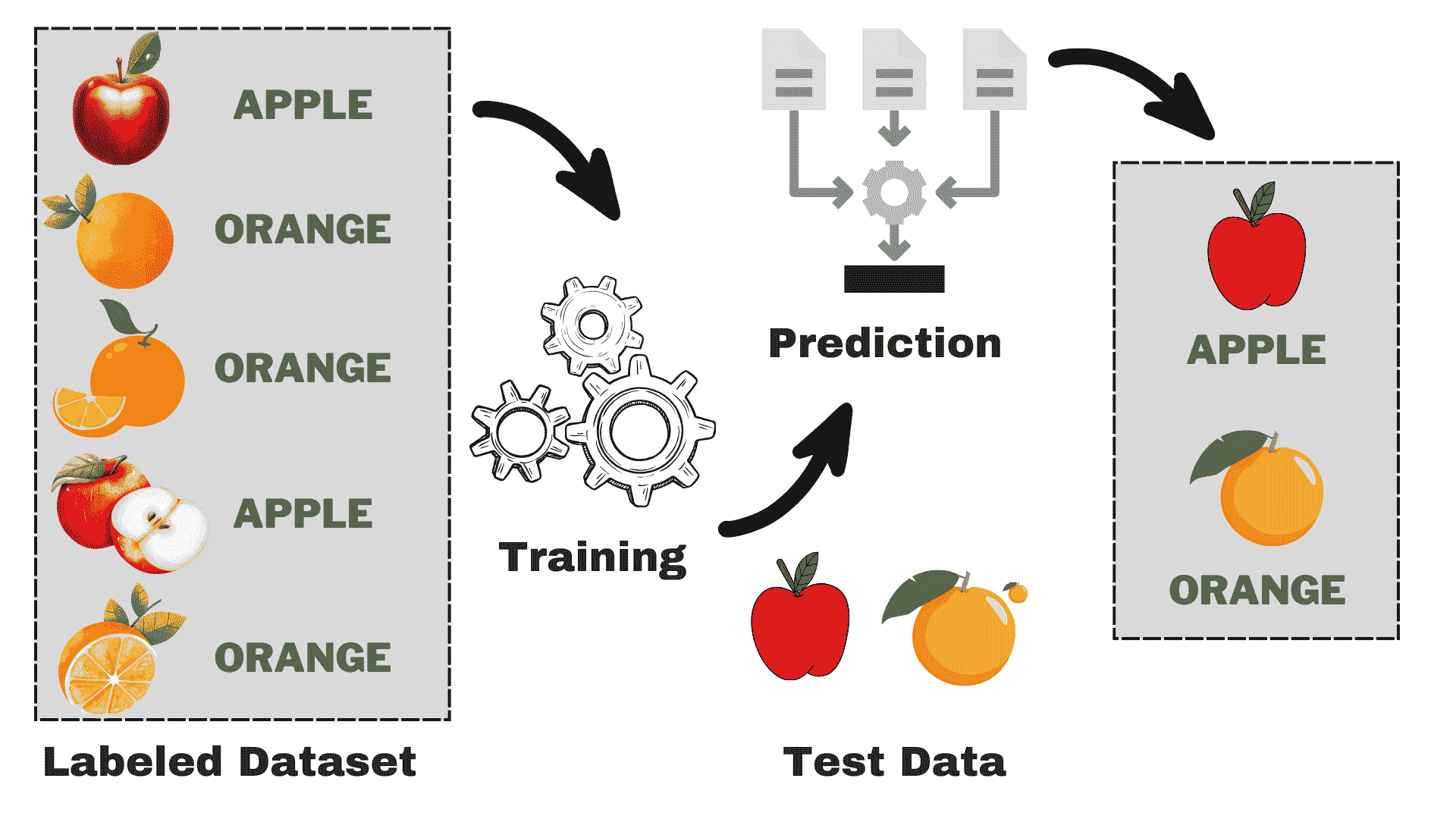

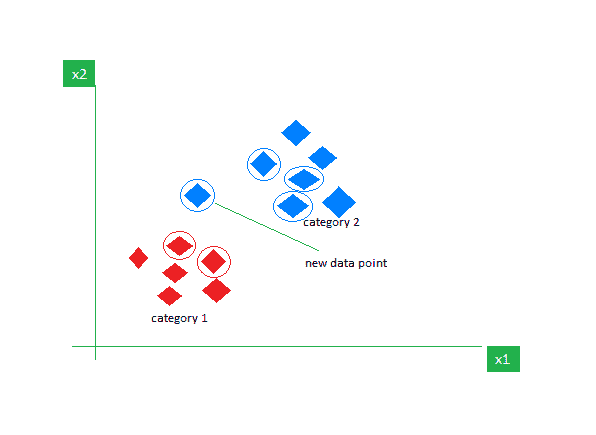

在上一章的结尾,我们处理了三个不同的数据集:女性运动员数据集、鸢尾花数据集和汽车每加仑行驶里程数据集。我们将这些数据集分别分成了两个子集。一个子集用于构建分类器,这个数据集称为训练集。另一个子集用于评估分类器,这个数据称为测试集。训练集和测试集是数据挖掘中常见的术语。

数据挖掘中的人们从不使用用于训练系统的数据进行测试。

如果我们考虑最近邻算法,就可以理解为什么我们不使用训练数据进行测试。如果上述例子中的篮球运动员 Marissa Coleman 在我们的训练数据中,她身高 6 英尺 1 寸,体重 160 磅,那么她自己将是最近的邻居。因此,在评估最近邻算法时,如果我们的测试集是训练数据的一个子集,我们的准确率将始终接近 100%。更一般地说,在评估任何数据挖掘算法时,如果我们的测试集是训练数据的子集,结果将会是乐观的,并且往往过于乐观。所以,这似乎不是一个好主意。

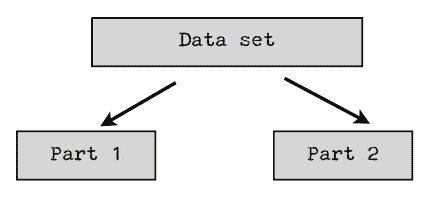

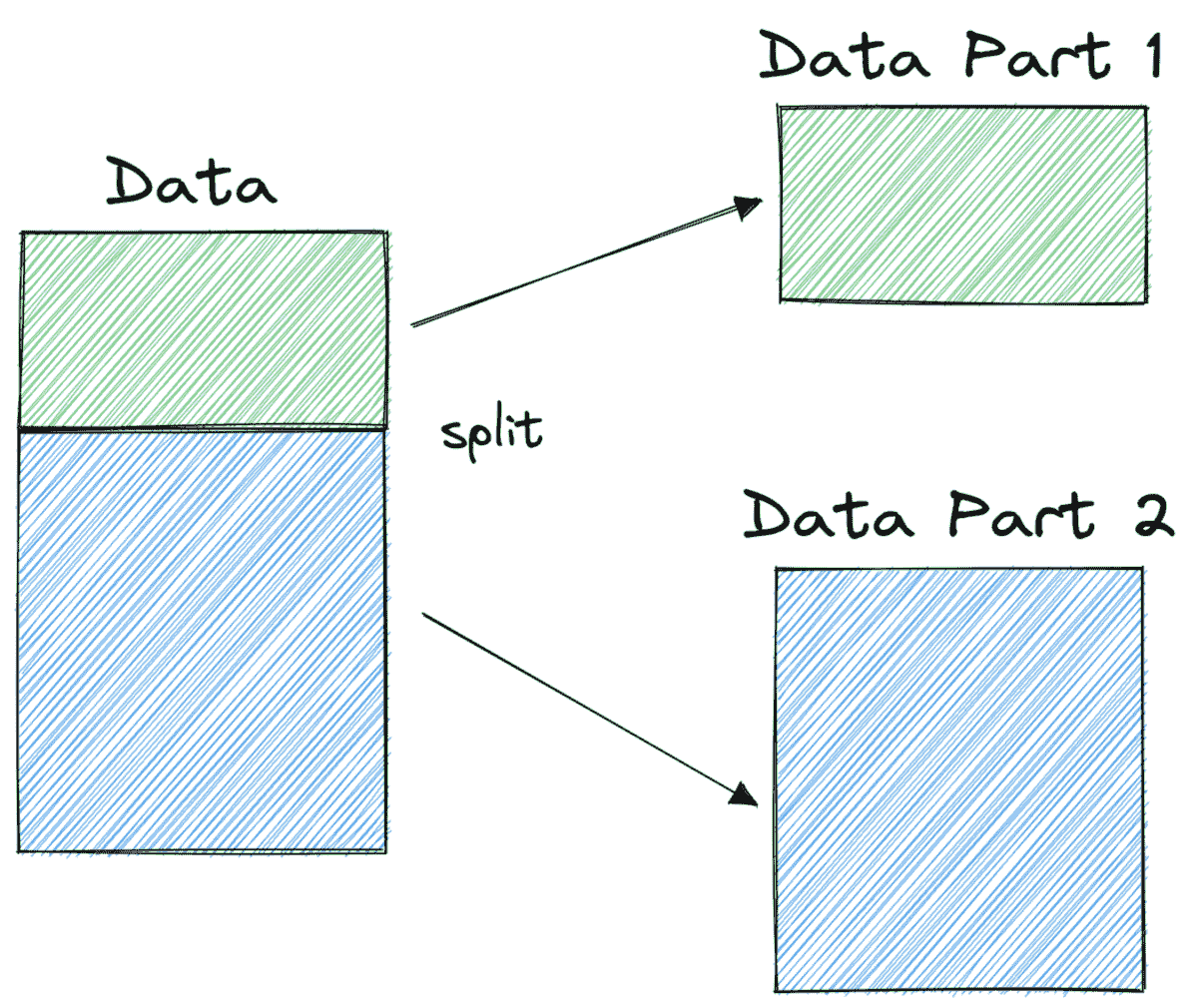

我们在上一章使用的想法怎么样?我们将数据分成两部分。较大的部分用于训练,较小的部分用于评估。事实证明,这种方法也有其问题。我们可能在数据分割时非常不幸。例如,我们的测试集中的所有篮球运动员可能都很矮(像 Debbie Black 一样,她只有 5 英尺 3 英寸高,体重 124 磅),可能会被分类为马拉松运动员。而测试集中的所有田径运动员可能也都很矮且体重较轻(像 Tatyana Petrova 一样,她只有 5 英尺 3 英寸高,体重 108 磅),可能会被分类为体操运动员。像这样的测试集会导致我们的准确率很低。另一方面,我们也可能在测试集的选择中非常幸运。测试集中的每个人都是其运动项目的典型身高和体重,我们的准确率接近 100%。无论哪种情况,基于单个测试集的准确率可能无法反映我们分类器在处理新数据时的真实准确率。

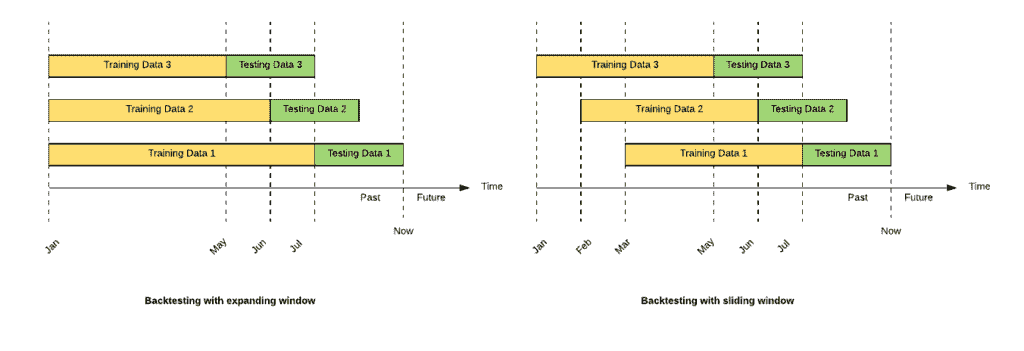

解决这个问题的一种方法可能是重复该过程若干次并取平均结果。例如,我们可以将数据分成两部分。我们称这些部分为第一部分和第二部分:

我们可以使用第一部分的数据来训练我们的分类器,而使用第二部分的数据来测试它。然后我们将重复这个过程,这次用第二部分进行训练,用第一部分进行测试。最后我们对结果取平均。然而,这样做的一个问题是我们在每次迭代中只使用了 1/2 的数据来进行训练。但我们可以通过增加部分数量来解决这个问题。例如,我们可以将数据分成三部分,每次迭代时,我们将在 2/3 的数据上进行训练,并在 1/3 的数据上进行测试。因此,它可能看起来像这样:

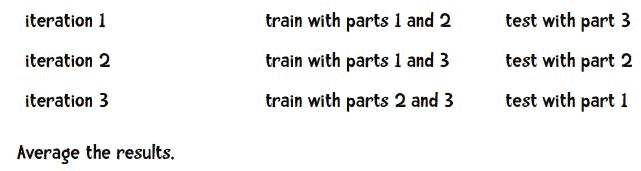

在数据挖掘中,最常见的部分数量是 10,这种方法被称为...

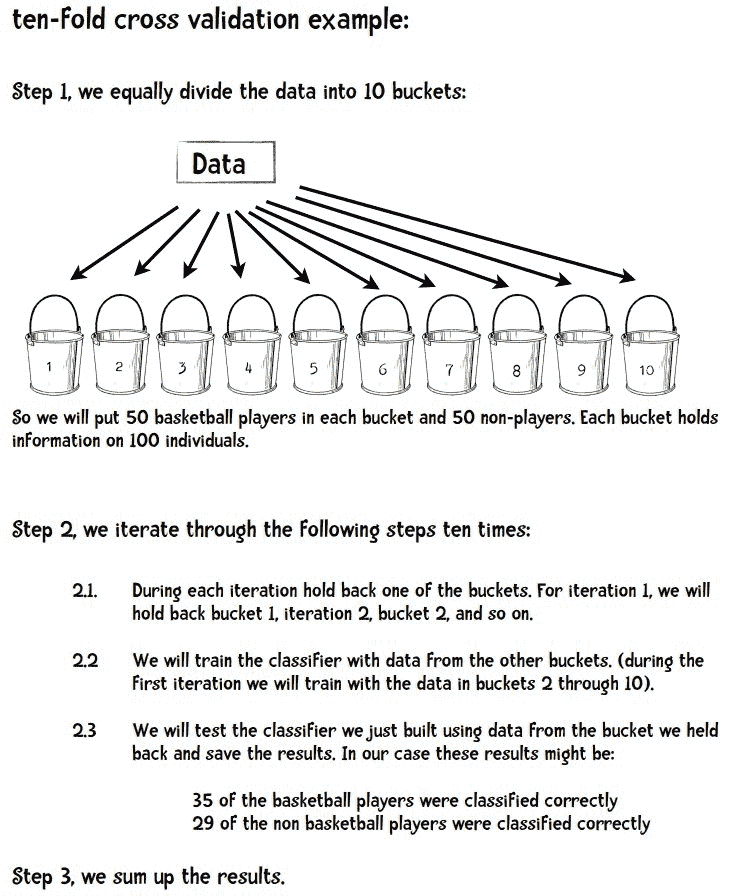

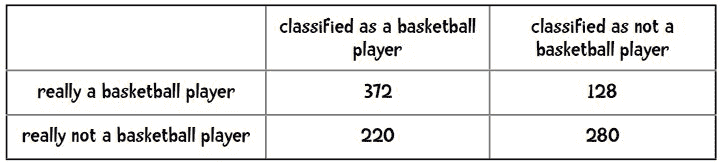

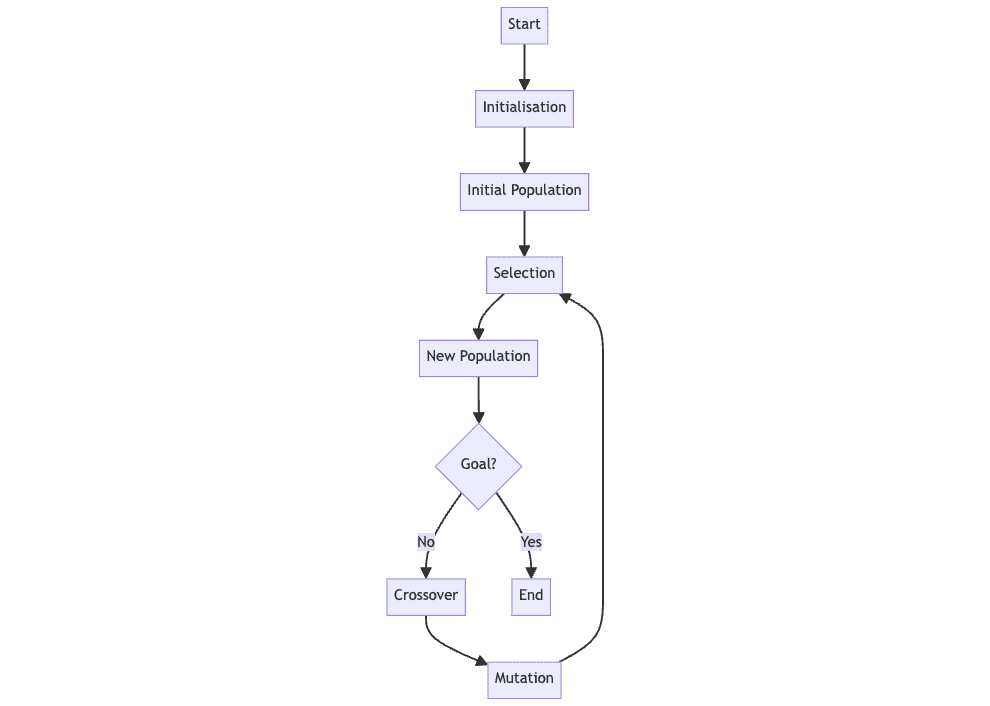

10 折交叉验证

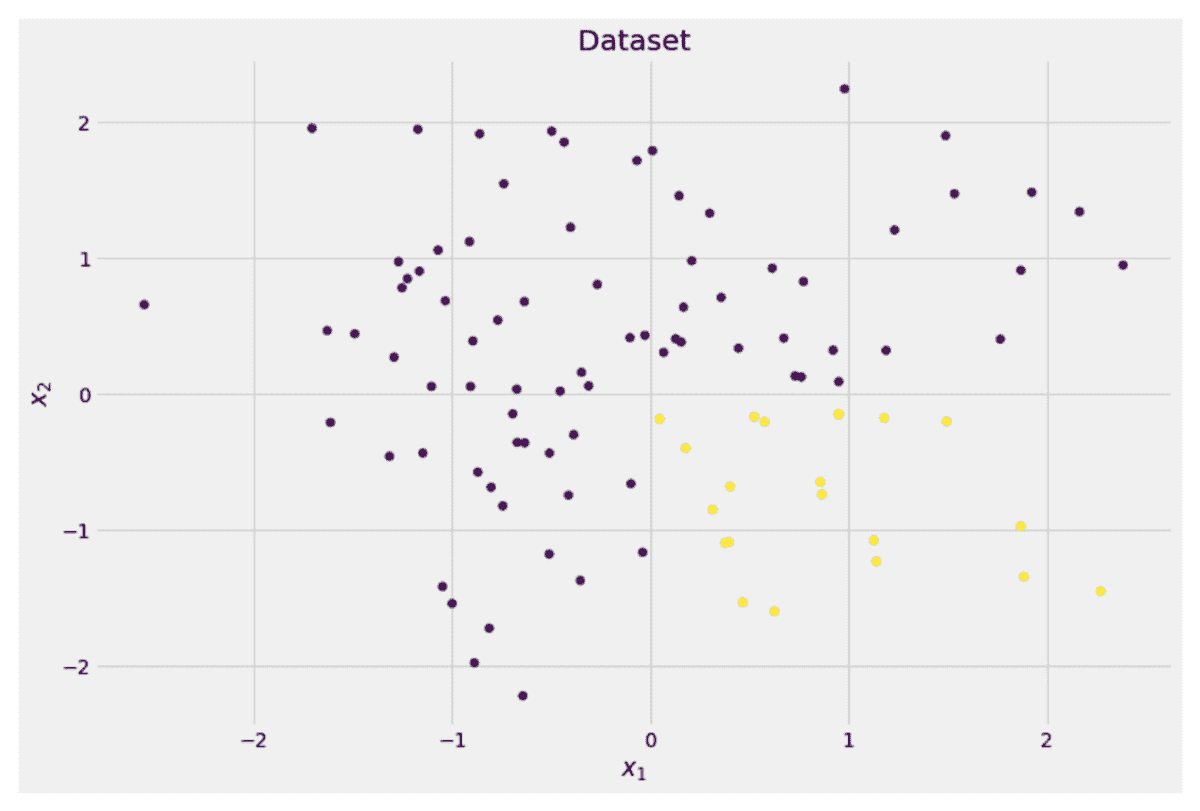

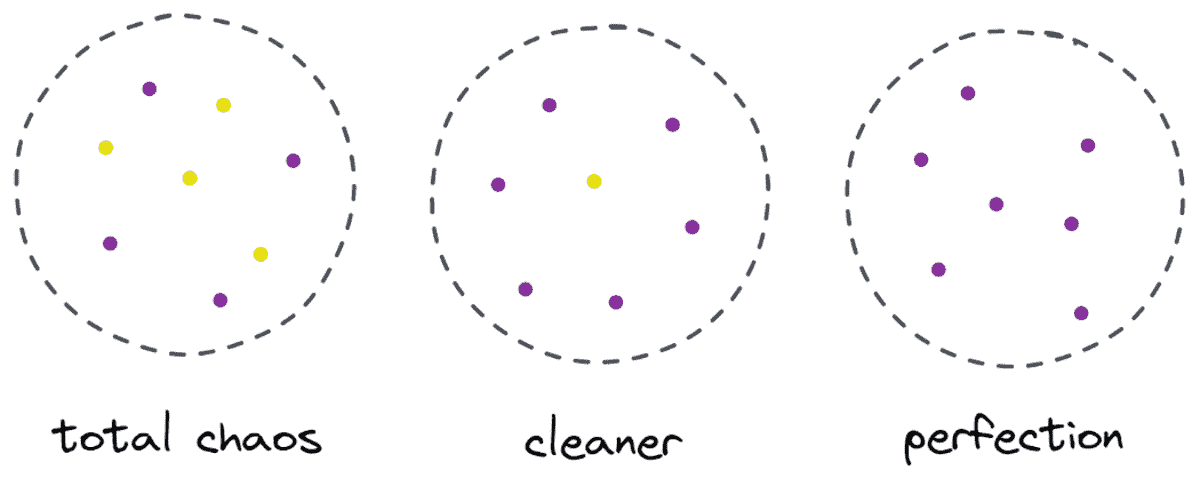

使用这种方法,我们有一个数据集,将其随机分成 10 部分。我们使用其中的 9 部分进行训练,并保留十分之一用于测试。我们重复这个过程 10 次,每次保留不同的十分之一用于测试。

我们来看一个例子。假设我想建立一个分类器来回答问题这个人是职业篮球运动员吗? 我的数据包括 500 名篮球运动员和 500 名非篮球运动员的信息。

通常,我们会将最终结果放在如下表格中:

在 500 名篮球运动员中,有 372 人被正确分类。我们可以把它们加起来,说明在 1,000 人中我们正确分类了 652 人(372 + 280)。所以我们的准确率是 65.2%。通过十折交叉验证获得的测量值相比于二折或三折交叉验证,更可能真正代表分类器的性能。这是因为每次训练分类器时,我们使用了 90%的数据,而二折交叉验证只使用了 50%。

要阅读更多关于这一讨论的内容,请参见 Ron Zacharski 的《程序员的数据挖掘指南:古老的 Numerati 艺术》第五章。

个人简介: Ron Zacharski 是一位禅宗僧侣和计算语言学家,居住在新墨西哥州拉斯克鲁塞斯,他是《程序员的数据挖掘指南:古老的 Numerati 艺术》的作者。他的 Erdõs 数是 3。他的科学生产力 h 指数为 14,g 指数为 41。

相关内容:

-

可视化交叉验证代码

-

如何(以及为什么)创建一个好的验证集

-

数据挖掘技术,免费章节:派生变量——让数据更有意义

更多相关主题

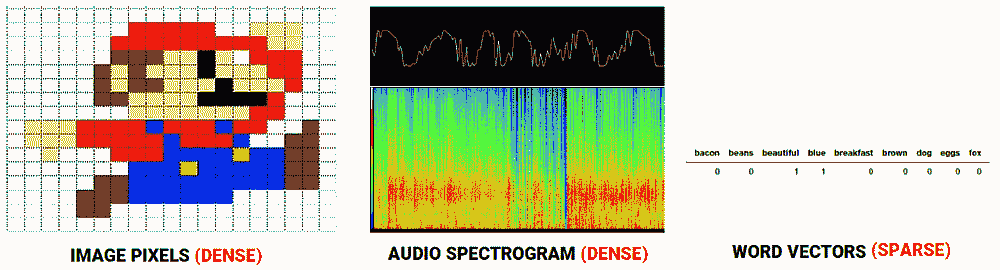

训练和可视化词向量

原文:

www.kdnuggets.com/2018/01/training-visualising-word-vectors.html

评论

评论

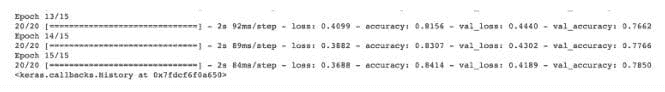

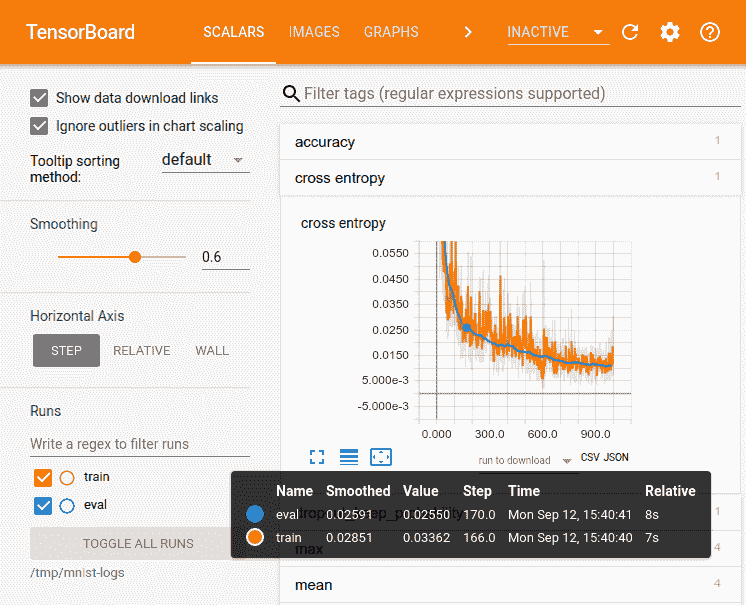

由 Priyanka Kochhar 编写,深度学习顾问

在本教程中,我想展示如何在 TensorFlow 中实现 Skip Gram 模型,以生成你正在处理的任何文本的词向量,然后使用 TensorBoard 进行可视化。我发现这个练习非常有用:一是理解 Skip Gram 模型如何工作,二是感受这些向量在你将它们用于 CNN 或 RNN 之前捕捉的文本关系。

我在 text8 数据集上训练了一个 Skip Gram 模型,该数据集是英语维基百科文章的集合。我使用 TensorBoard 可视化了这些嵌入。TensorBoard 允许你通过使用 PCA 选择三个主轴来投影数据,从而查看整个词云。非常酷!你可以输入任何单词,它会显示其邻近词。你也可以隔离离它最近的 101 个点。

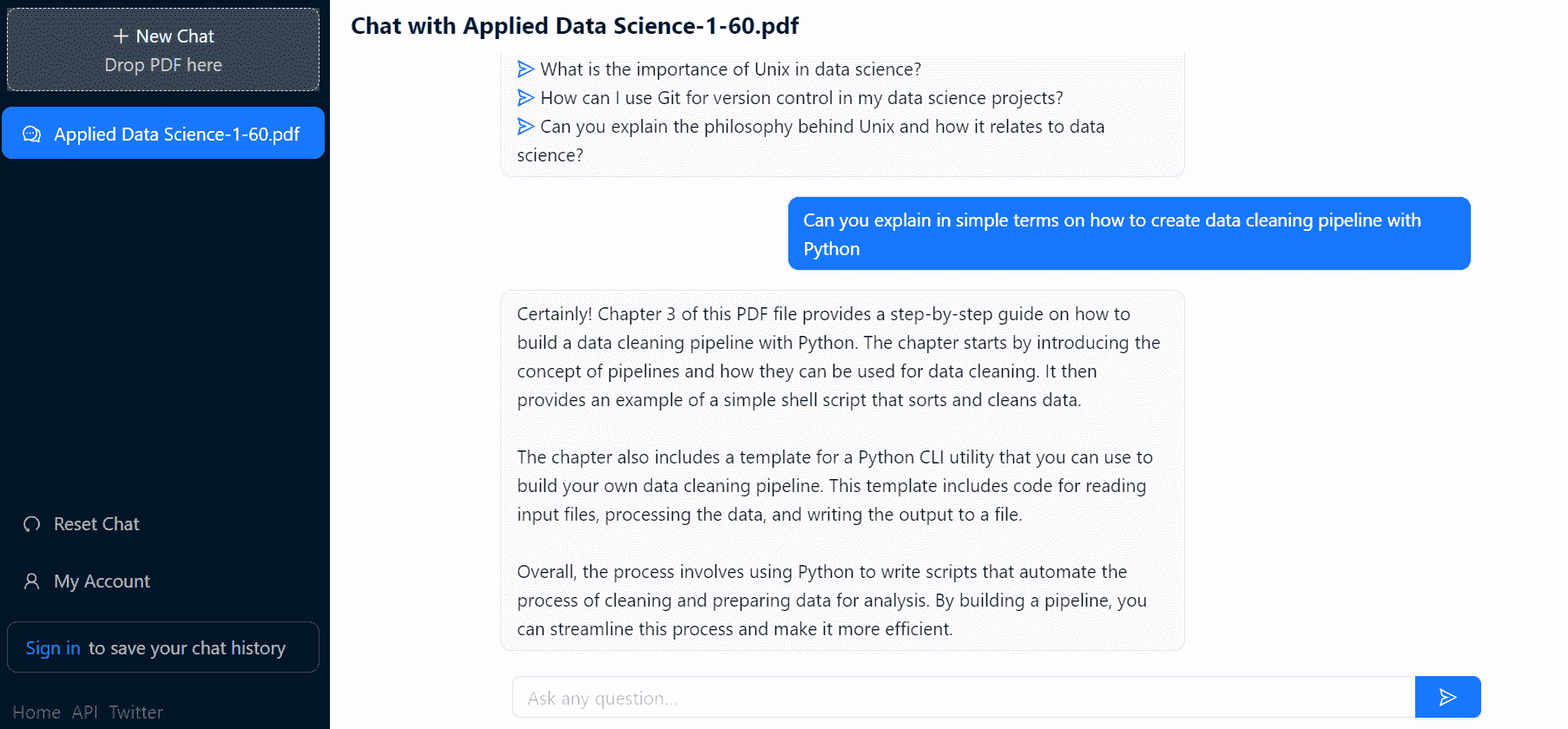

请参见下面的剪辑。

你可以在我的 Github 仓库中找到完整代码。

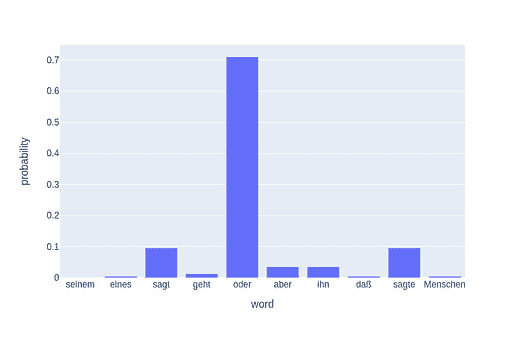

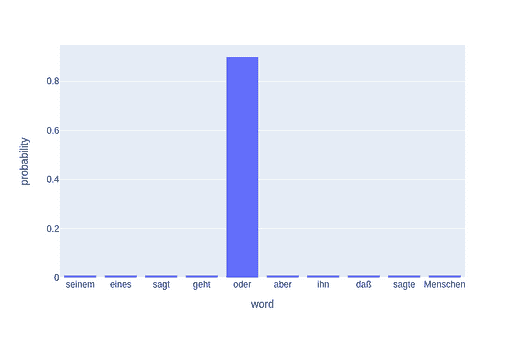

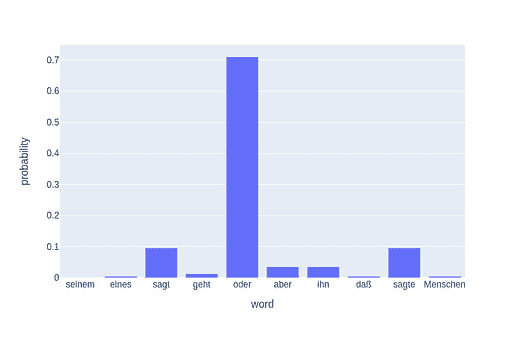

为了可视化训练,我还查看了与一组随机单词最接近的预测单词。在第一次迭代中,最接近的预测单词似乎非常随意,这很合理,因为所有词向量都是随机初始化的。

Nearest to cost: sensationalism, adversity, ldp, durians, hennepin, expound, skylark, wolfowitz,

Nearest to engine: vdash, alloys, fsb, seafaring, tundra, frot, arsenic, invalidate,

Nearest to construction: dolphins, camels, quantifier, hellenes, accents, contemporary, colm, cyprian,

Nearest to http: internally, chaffee, avoid, oilers, mystic, chappell, vascones, cruciger,

到训练结束时,模型在发现单词之间的关系方面变得更为出色。

Nearest to cost: expense, expensive, purchase, technologies, inconsistent, part, dollars, commercial,

Nearest to engine: engines, combustion, piston, stroke, exhaust, cylinder, jet, thrust,

Nearest to construction: completed, constructed, bridge, tourism, built, materials, building, designed,

Nearest to http: www, htm, com, edu, html, org, php, ac,

Word2Vec 和 Skip Gram 模型

创建词向量是将大量文本语料库中的每个单词创建一个向量的过程,使得在语料库中共享相同上下文的单词在向量空间中彼此接近。

这些词向量在捕捉单词之间的上下文关系方面表现得非常好(例如,黑色、白色和红色的向量会非常接近),我们在使用这些向量而不是原始单词进行自然语言处理任务(如文本分类或新文本生成)时,性能会更好。

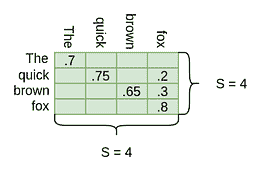

生成这些词向量主要有两种模型——连续词袋模型(CBOW)和 Skip Gram 模型。CBOW 模型试图根据上下文单词预测中心单词,而 Skip Gram 模型试图根据中心单词预测上下文单词。一个简化的例子是:

CBOW: 猫吃了 ____。填补空白,在这种情况下,是“食物”。

Skip-gram: ___ ___ ___ 食物。填补词的上下文。在这种情况下,是“猫吃了”

如果你对这两种方法的详细比较感兴趣,请参见这个 链接。

各种论文发现 Skip Gram 模型生成的词向量更好,因此我专注于实现这一点。

在 Tensorflow 中实现 Skip Gram 模型

在这里,我将列出构建模型的主要步骤。详细的实现请参见我的Github。

1. 数据预处理

我们首先清理数据。去除任何标点符号、数字,并将文本拆分为单独的词。由于程序对整数的处理比对词的处理更好,我们将每个词映射到一个整数,通过创建一个词到整数的字典。下面是代码。

counts = collections.Counter(words)

vocab = sorted(counts, key=counts.get, reverse=True)

vocab_to_int = {word: ii for ii, word in enumerate(vocab, 0)}

2. 子采样

像“the”、“of”和“for”这样的常见词对附近的词没有提供太多上下文。如果我们丢弃一些这样的词,我们可以去除数据中的一些噪声,从而获得更快的训练速度和更好的表示。这个过程被称为由Mikolov提出的子采样。对于训练集中每个词,我们将以其频率的倒数给出的概率丢弃它。

3. 创建输入和目标

Skip Gram 的输入是每个词(编码为整数),目标是该窗口周围的词。Mikolov 等人发现,如果这个窗口的大小是可变的,并且离中心词较近的词被更频繁地采样,性能会更好。

“由于距离较远的词通常与当前词的相关性不如靠近的词,因此我们通过在训练示例中减少从这些词中采样的频率来给予远离词较少的权重……如果我们选择窗口大小=5,对于每个训练词,我们将随机选择一个在 1 到窗口大小之间的数字 R,然后使用当前词的历史中 R 个词和未来中 R 个词作为正确标签。”

R = np.random.randint(1, window_size+1)

start = idx — R if (idx — R) > 0 else 0

stop = idx + R

target_words = set(words[start:idx] + words[idx+1:stop+1])

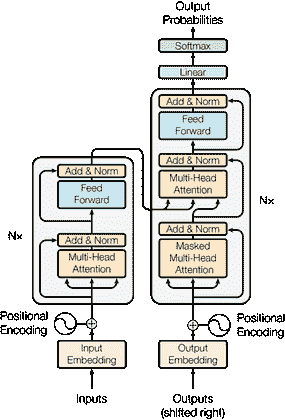

4. 构建模型

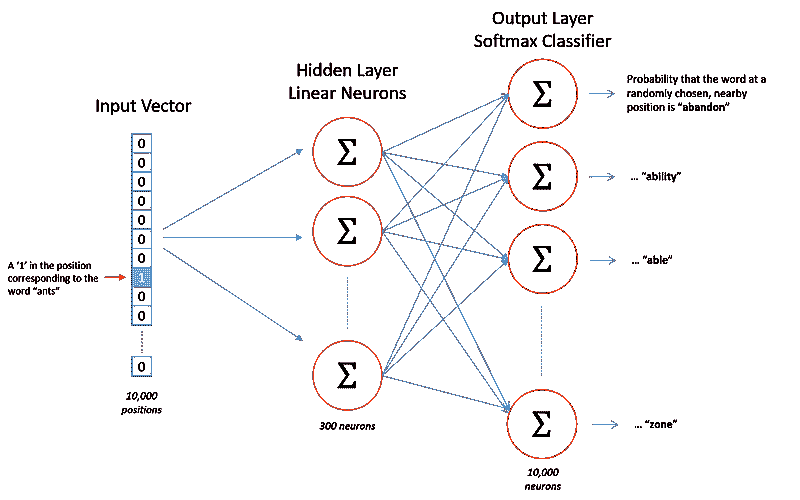

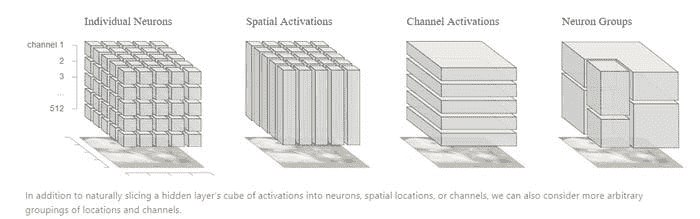

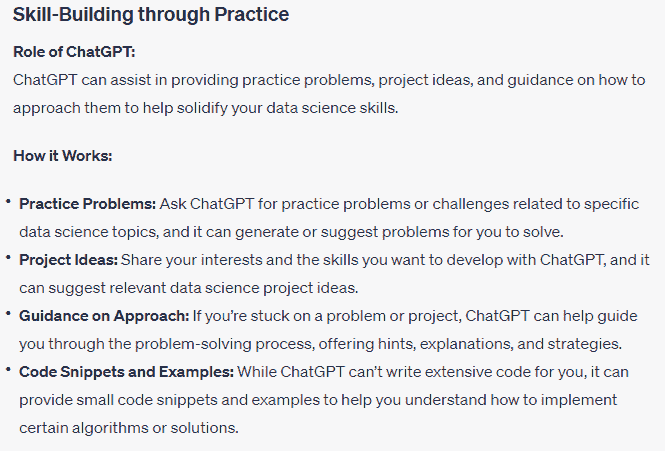

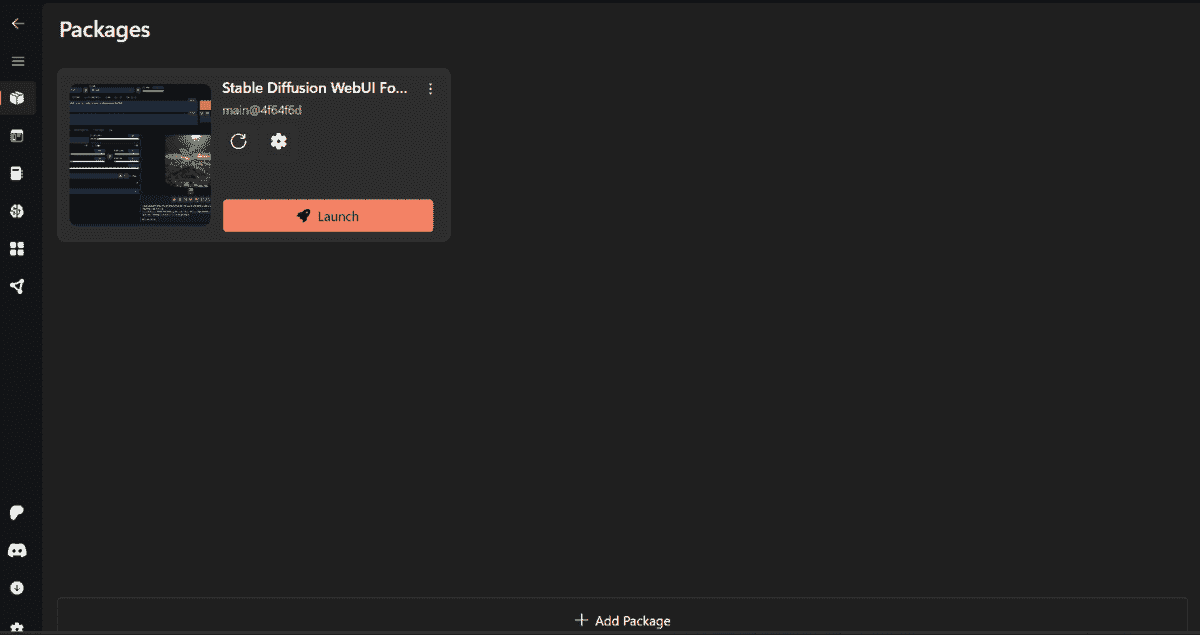

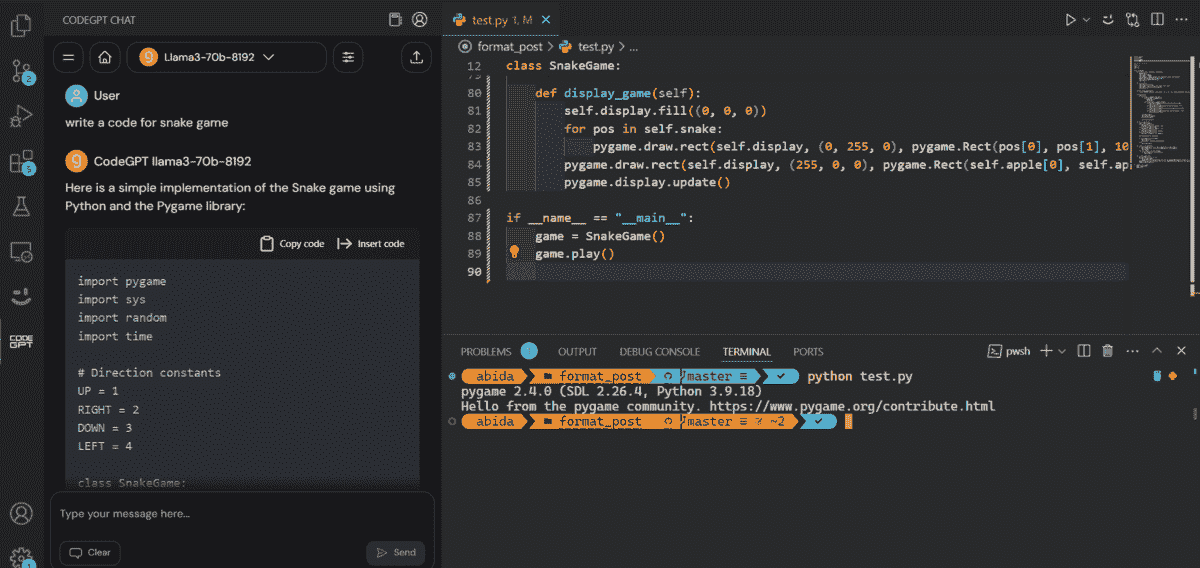

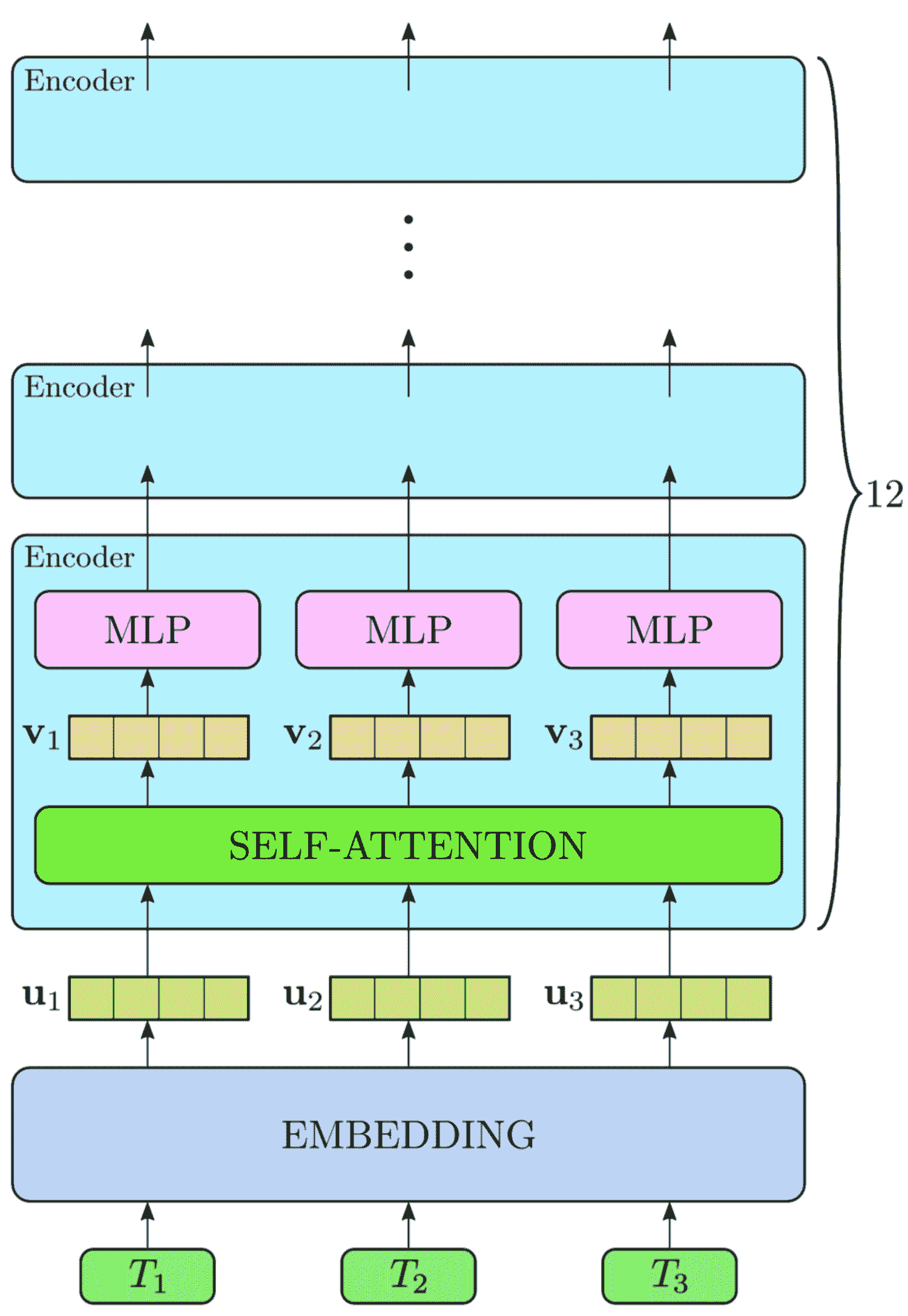

从Chris McCormick 的博客中,我们可以看到我们将要构建的网络的一般结构。

我们将把输入词“ants”表示为一个独热向量。这个向量将有 10,000 个分量(每个词汇表中的一个),我们将在对应“ants”词的位置上放置一个“1”,其他位置上放置“0”。

网络的输出是一个包含 10,000 个分量的单一向量,其中包含我们词汇表中每个词的概率,即随机选择的附近词是该词汇表词的概率。

在训练结束时,隐藏层将拥有训练好的词向量。隐藏层的大小对应于我们向量的维度数量。在上述示例中,每个词将具有长度为 300 的向量。

你可能已经注意到,skip-gram 神经网络包含大量权重……以我们 300 个特征和 10,000 个单词的词汇表为例,每个隐藏层和输出层都有 300 万权重!在大型数据集上训练将非常困难,因此 word2vec 的作者引入了一些调整以使训练成为可能。你可以在 链接 中阅读更多内容。 Github 上的代码实现了这些调整以加速训练。

5. 使用 Tensorboard 进行可视化

你可以使用 Tensorboard 中的嵌入投影器来可视化嵌入。为此,你需要做几件事:

-

在训练结束时将模型保存在检查点目录中

-

创建一个 metadata.tsv 文件,其中包含每个整数到单词的映射,以便 Tensorboard 显示单词而不是整数。将此 tsv 文件保存在相同的检查点目录中

-

运行这段代码:

from tensorflow.contrib.tensorboard.plugins import projector

summary_writer = tf.summary.FileWriter(‘checkpoints’, sess.graph)

config = projector.ProjectorConfig()

embedding_conf = config.embeddings.add()

# embedding_conf.tensor_name = ‘embedding:0’

embedding_conf.metadata_path = os.path.join(‘checkpoints’, ‘metadata.tsv’)

projector.visualize_embeddings(summary_writer, config)

- 通过将 Tensorboard 指向检查点目录来打开 Tensorboard

就这些了!

如果你喜欢这篇文章,请给我一个❤️:) 希望你能拉取代码并自己尝试。如果你对此话题有其他想法,请在这篇文章下评论或通过 priya.toronto3@gmail.com 联系我。

其他文章: https://medium.com/@priya.dwivedi/

PS:我有一家深度学习咨询公司,喜欢处理有趣的问题。如果你有一个我们可以合作的项目,请通过 priya.toronto3@gmail.com 联系我。

参考文献:

- Udacity 深度学习纳米学位

简介:Priyanka Kochhar 已从事数据科学工作超过 10 年。她现在有自己的深度学习咨询公司,喜欢处理有趣的问题。她帮助多个初创公司部署创新的 AI 解决方案。如果你有一个她可以合作的项目,请通过 priya.toronto3@gmail.com 联系她。

原文。经许可转载。

相关:

-

接近文本数据科学任务的框架

-

文本数据预处理的一般方法

-

超越 Word2Vec 仅用于词语

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

更多相关话题

迁移学习变得简单:编码一种强大的技术

评论

面向普通用户的人工智能

人工智能(A.I.)正在成为最强大且具有变革性的全球性技术,以前所未有的方式影响全球经济、医疗、金融、工业、社会文化互动等各个方面。这一点在迁移学习和机器学习能力的发展中尤为重要。

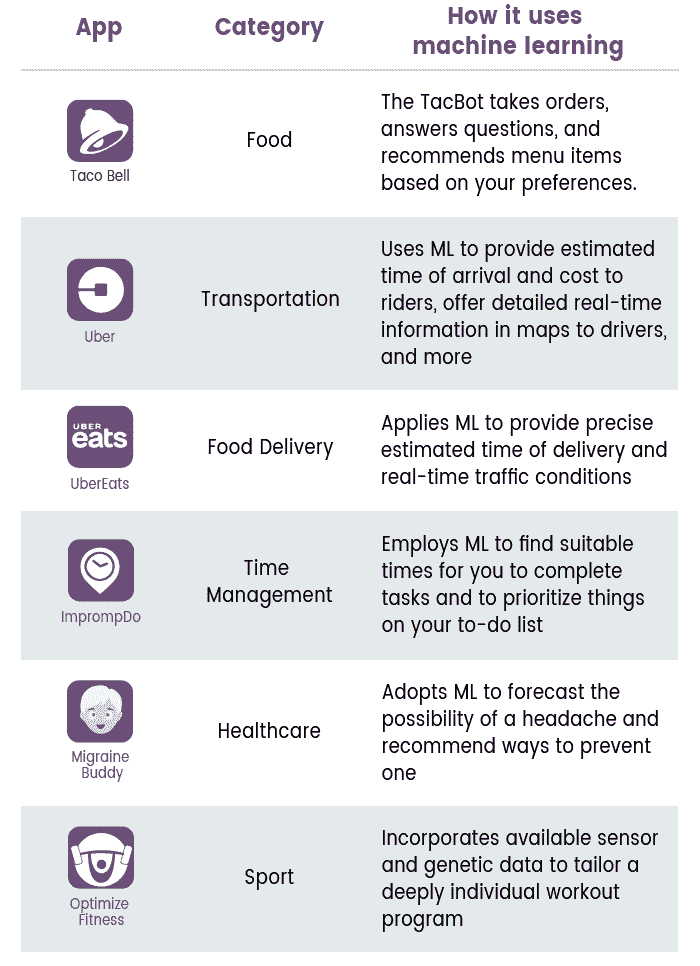

我们已经在日常生活中使用人工智能技术,无论我们是否意识到,它都在影响我们的生活和选择。从我们的 Google 搜索和导航、Netflix 电影推荐、Amazon 购买建议、日常任务的语音助手如 Siri 或 Alexa、Facebook 社区建设、医疗诊断、信用评分计算和按揭决策等,人工智能的应用只会不断增长。

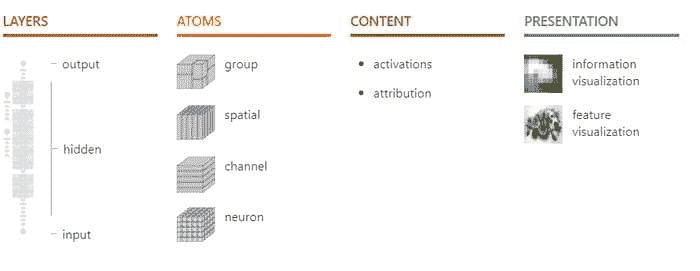

大多数现代人工智能系统目前由一类算法或技术驱动,即深度学习,它基本上训练和构建具有不同架构配置的深层神经网络。

图片来源:Fjodor van Veen – asimovinstitute.org.

经过 50 多年的起伏波动,深度学习革命已获得动力,看起来势不可挡——这得益于大数据技术、硬件创新和算法。因此,深度学习网络有望影响并从根本上改变我们人类在未来几十年的生活、工作和娱乐方式。

所以,我们终于可以看到人工智能为全球每个人带来的希望!

然而……有一个陷阱。

深度学习昂贵且专注范围狭窄

深度学习网络往往需要大量资源和计算成本。与传统的统计学习模型(如回归、决策树或支持向量机)不同,深度学习网络往往包含数百万个参数,因此需要大量的训练数据以避免过拟合。

因此,深度学习模型会使用大量的高维原始数据,如图像、非结构化文本或音频信号进行训练。此外,它们还反复进行数百万次向量化计算(例如矩阵乘法),以优化庞大的参数集以适应数据。而且,它们的构建涉及到一个大量的超参数(例如层数、每层的神经元数量、优化算法设置等),通常需要一个高水平研究团队花费数周或数月时间来创建一个最先进的模型。

所有这些都对训练和优化特定任务的鲁棒且高性能的深度学习模型所需的计算能力提出了巨大的需求。

假设我们可以在花费大量计算资源后训练出一个优秀的模型。难道我们不希望将这个模型用于尽可能多的任务,并多次收获我们投资的回报吗?

这就是问题所在。

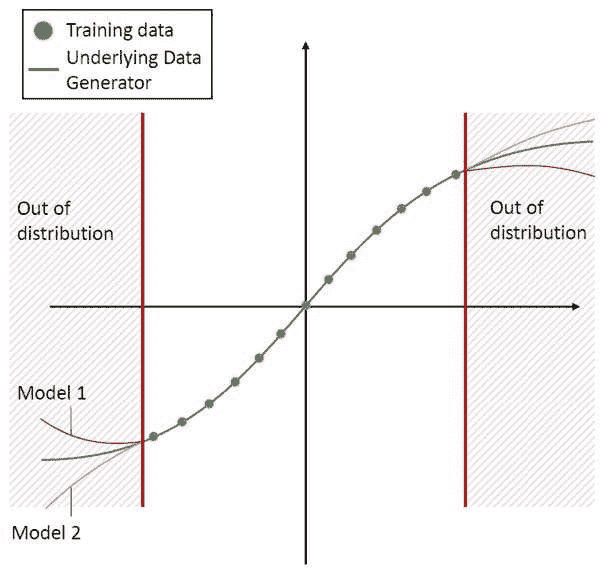

到目前为止,深度学习算法传统上被设计为孤立工作。这些算法被训练来解决特定任务。在大多数情况下,一旦特征空间分布发生变化,模型就必须从头开始重建。

但这没有意义,尤其是与我们人类目前利用有限计算速度的方式相比。

人类具有跨任务转移知识的固有能力。我们在学习一个任务时获得的知识,可以以相同的方式来解决相关任务。如果任务或领域之间的相似性很高,我们能够更好地跨任务利用我们的“已学”知识。

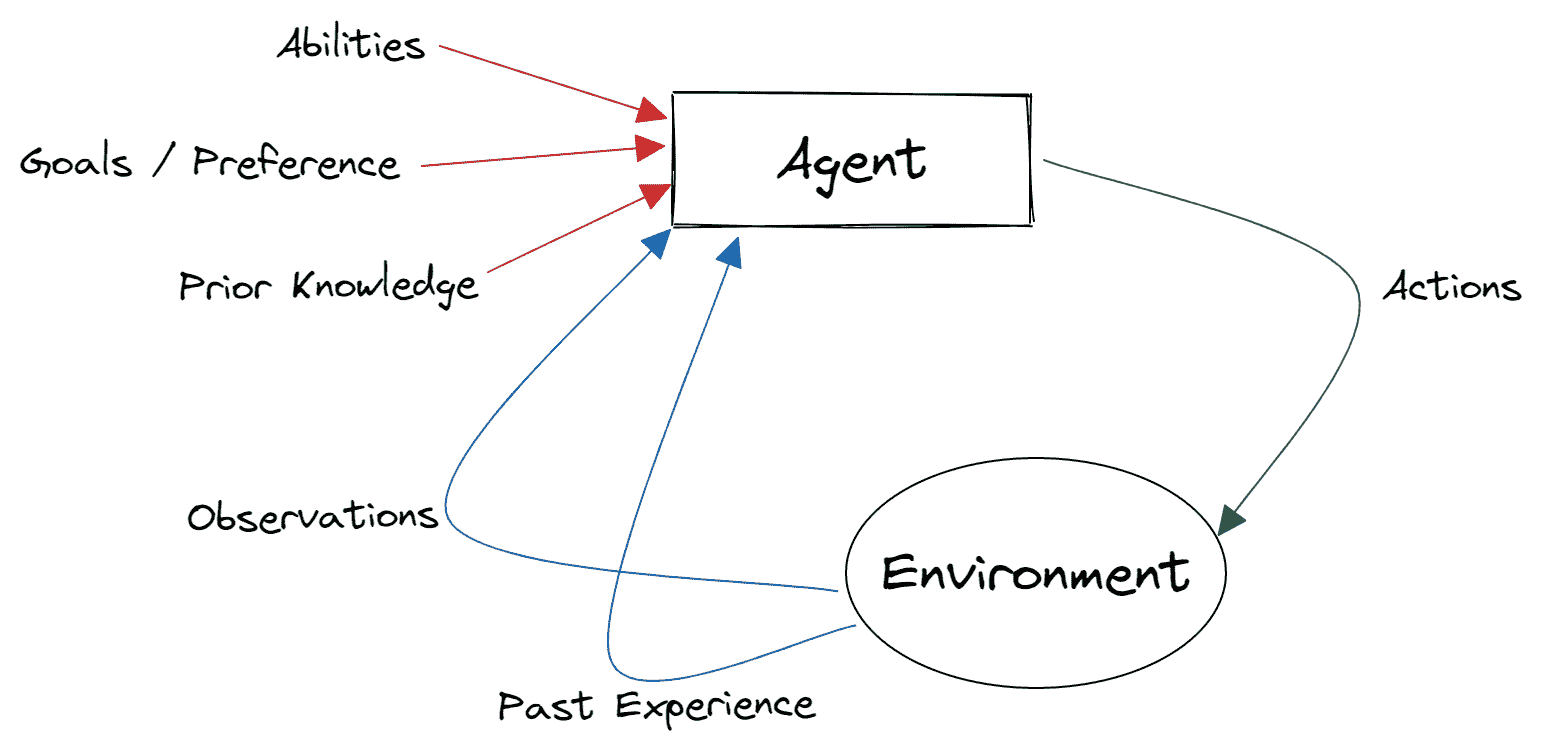

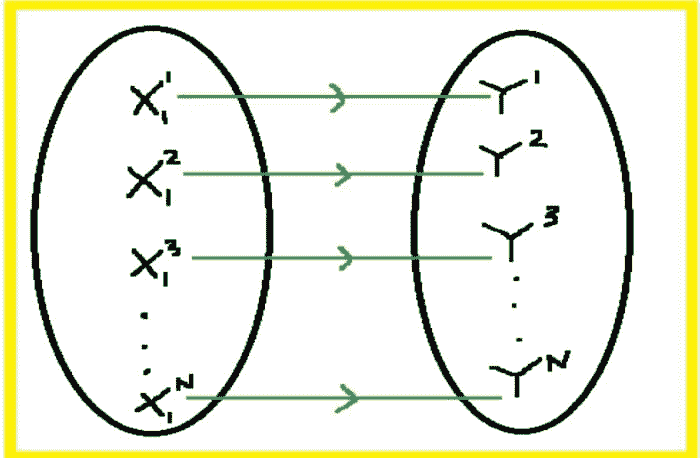

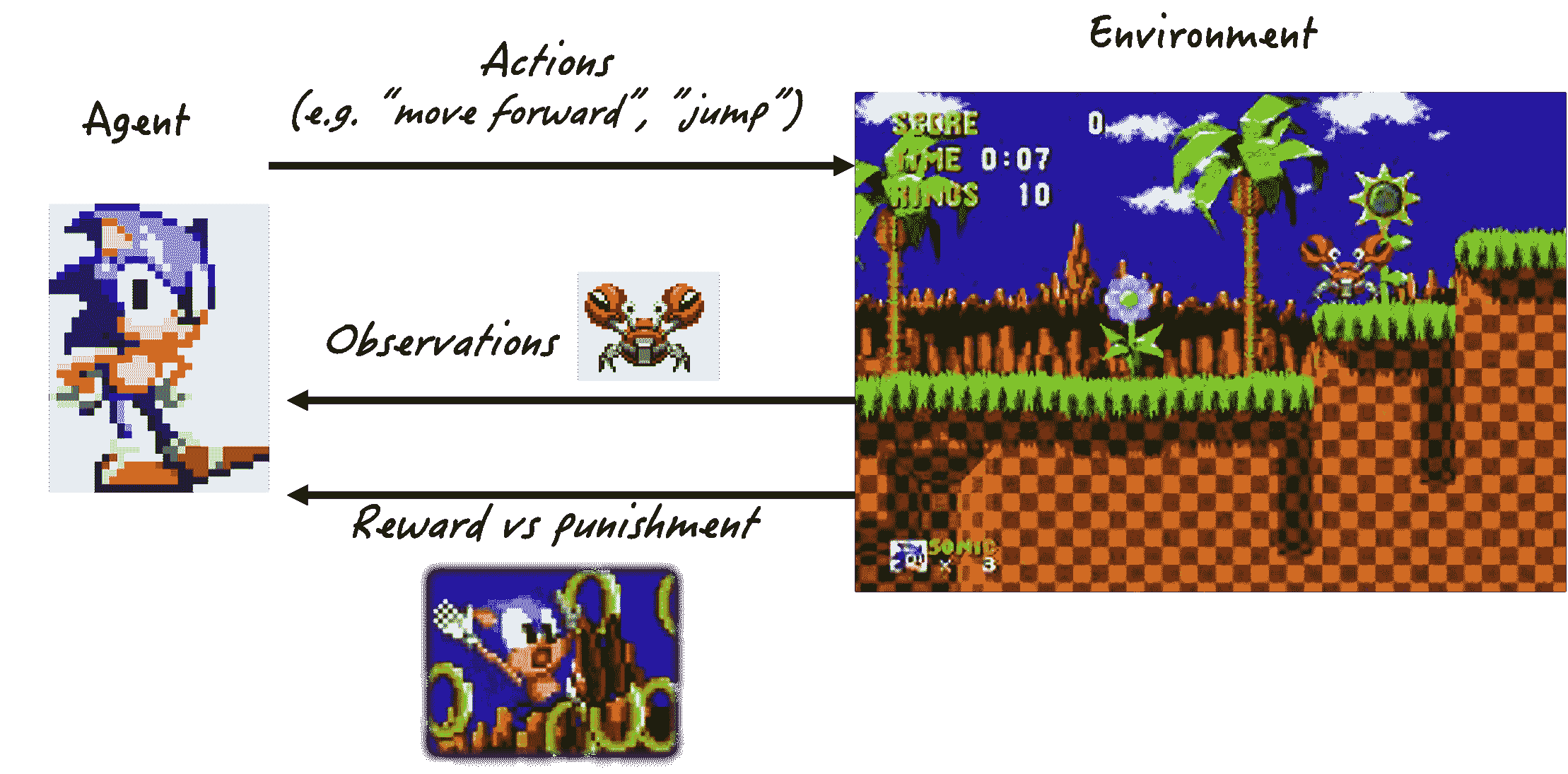

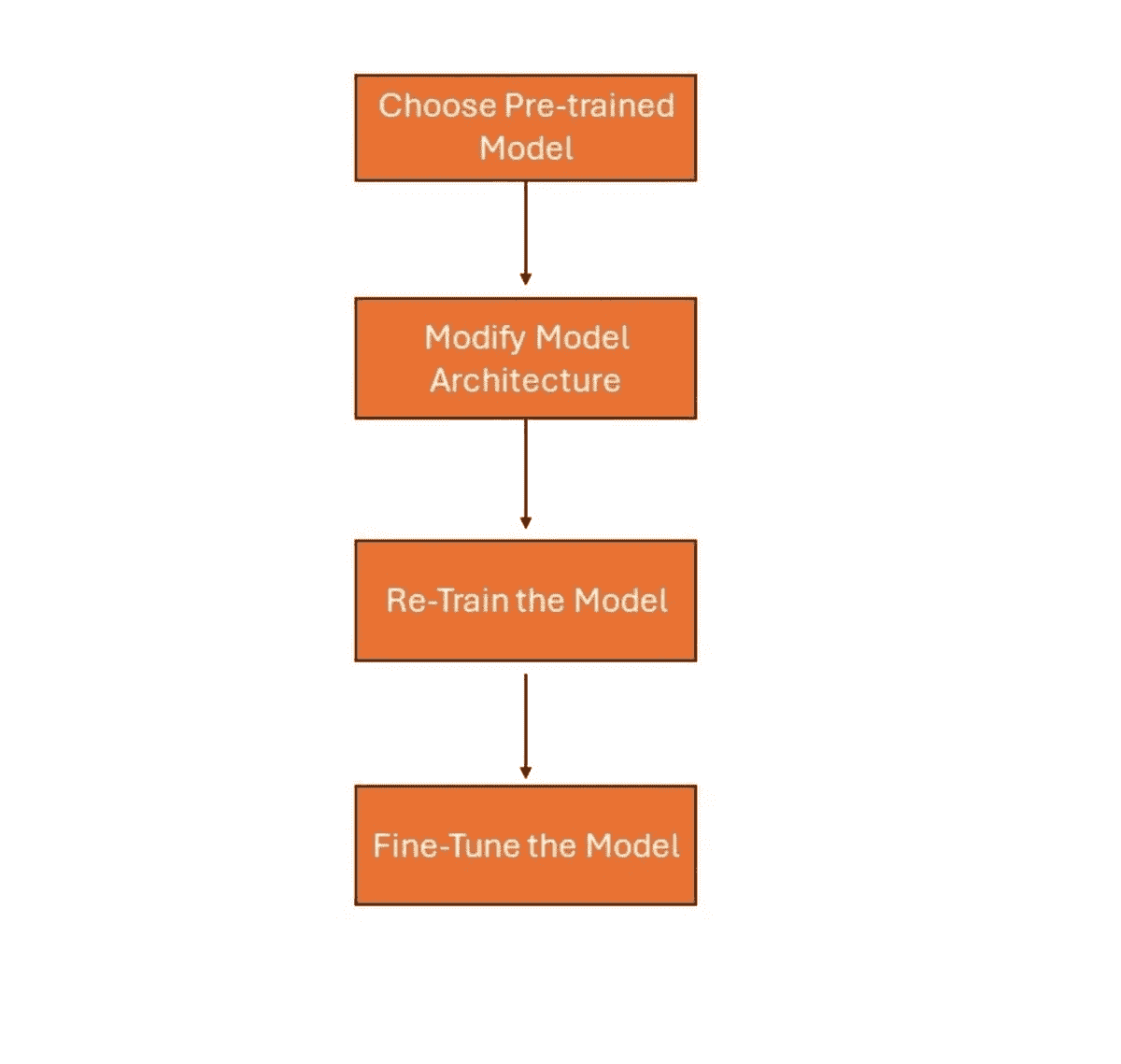

转移学习的理念是克服孤立学习范式,并利用在一个任务中获得的知识来解决相关任务,这在机器学习,特别是在深度学习领域中得到了应用。

图片来源:转移学习综合实用指南:在深度学习中的实际应用。

深度学习网络的转移学习

在深度学习环境中,转移学习过程有许多策略可供选择,还有多个重要因素需要考虑和工程决策需要做出——数据集和领域的相似性、监督或非监督设置、需要多少重新训练等。

然而,简单来说,我们可以假设对于转移学习:

-

我们需要使用一个预训练的深度学习模型

-

重新使用全部或某些部分

-

将其应用于我们新感兴趣的领域中的特定机器学习问题——分类或回归。

通过这种方式,我们可以避免训练和优化大型深度学习模型所需的大量计算工作。

最终,一个训练好的深度学习模型只是一组在特定数据结构格式下的数百万个实数,这些可以直接用于预测/推断,这是我们作为模型使用者真正感兴趣的任务。

但请记住,预训练模型可能是针对特定分类进行训练的,即其输出向量和计算图只适用于预测某一特定任务。

因此,迁移学习中广泛使用的策略是:

-

加载预训练模型的权重矩阵,但不包括离输出层最近的最后几层的权重,

-

保持这些权重固定,即不可训练

-

附加适合当前任务的新层,并使用新数据训练模型

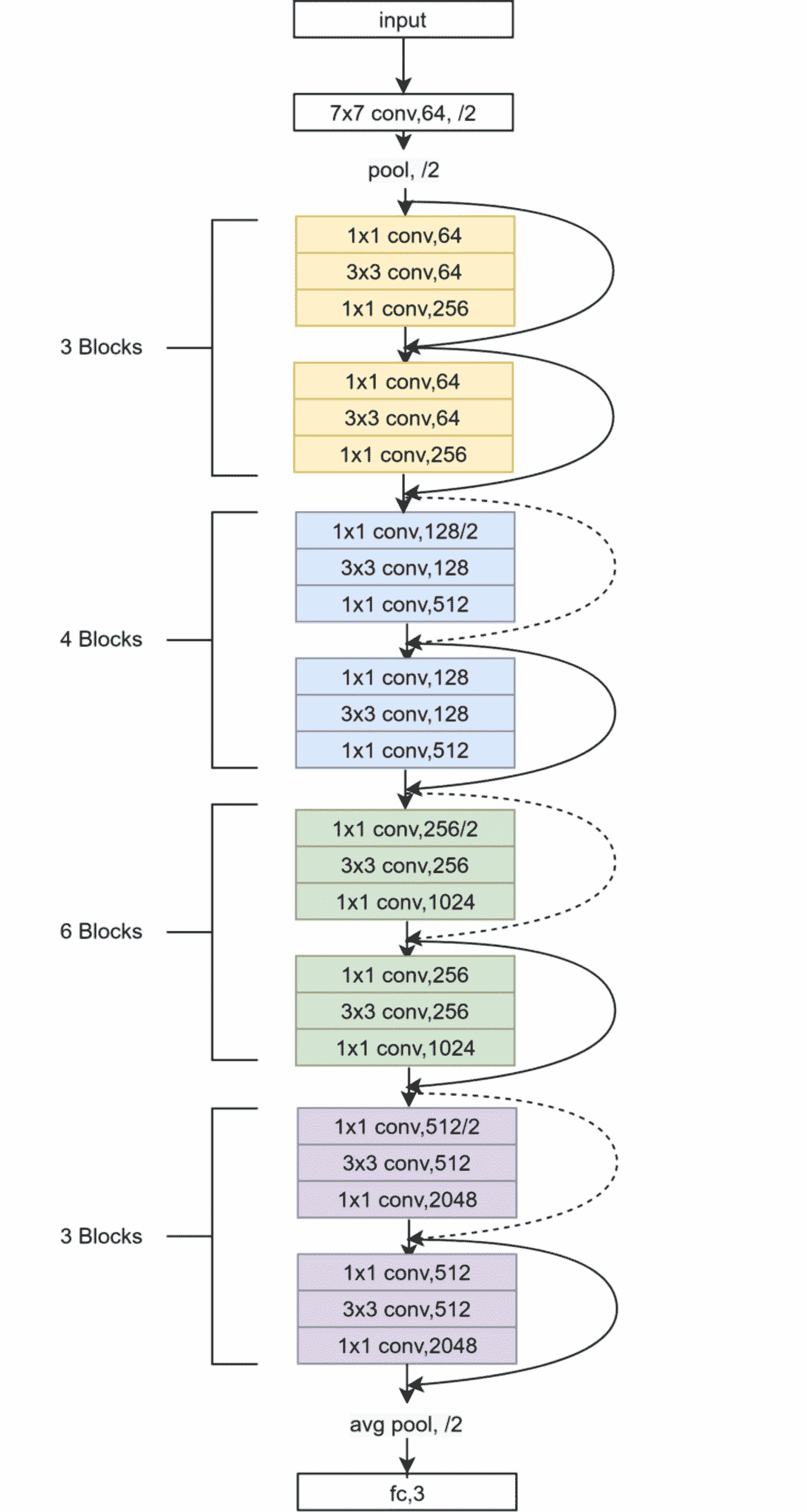

图:我们将在这里探索的深度学习网络迁移学习策略。

这样,我们无需训练整个模型,就可以将模型重新用于我们的特定机器学习任务,同时利用从预训练、优化模型中加载的固定权重中包含的数据结构和模式。

一个你可以在笔记本电脑上运行的实用示例

让我们动手构建一个简单的代码演示,展示迁移学习的力量,好吗?

为什么不遵循传统方法?

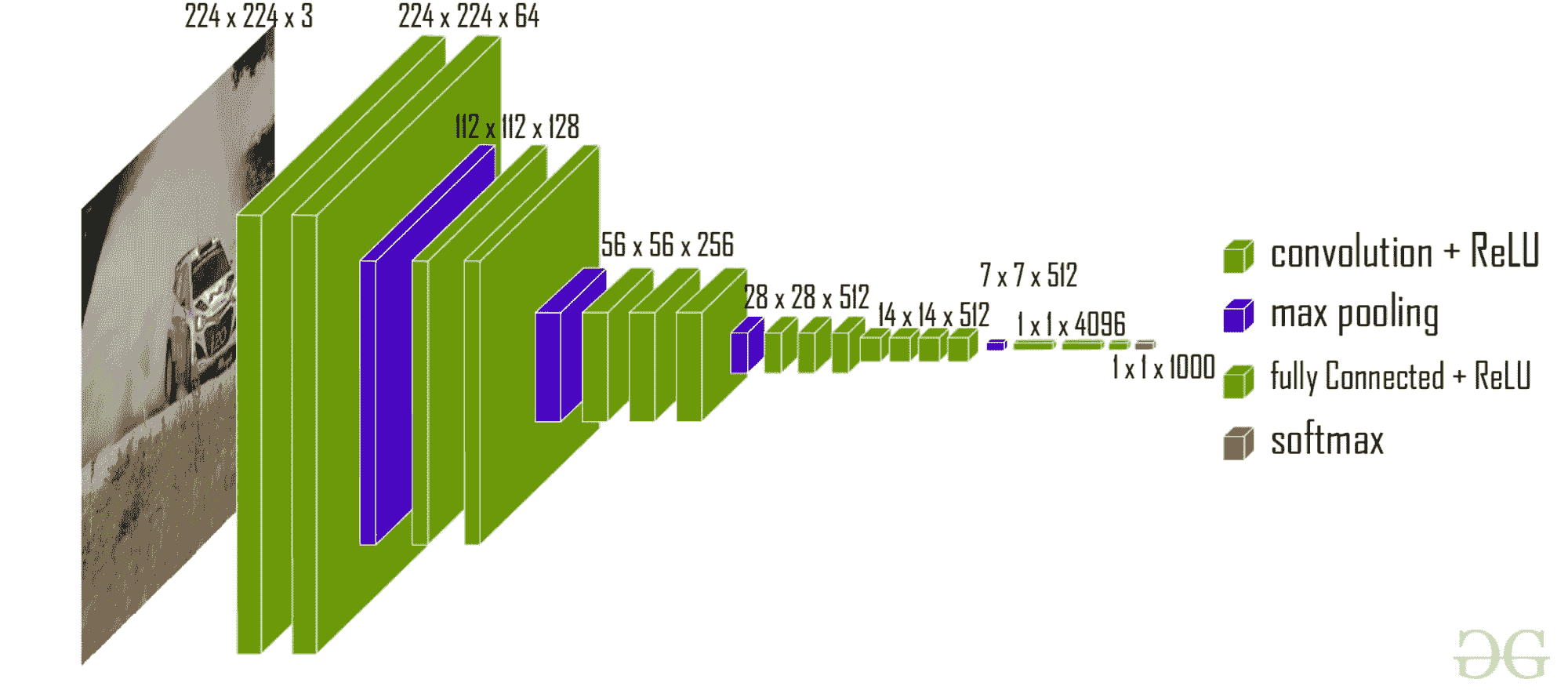

传统上,这个主题的教程集中在从著名的高性能深度学习网络中学习,例如VGGNet-16、ResNet-50 或Inception-V3/V4 等。这些网络在庞大的ImageNet 数据库上进行了训练,并在年度 ImageNet 比赛 - ILSVRC中获得了前列,从而成为图像分类任务的黄金基准模型。

然而,这些网络的问题在于它们包含大量复杂的层,当你开始学习深度学习概念时,不容易理解。

因此,如果你想从零开始编写一个迁移学习的示例,从自学和建立信心的角度来看,先尝试一个独立的示例可能会更有益。你可以先训练一个深度学习模型,将其学习转移到另一个种子网络,然后展示在标准分类任务中的性能。

我们在这个教程中要做什么?

在本文中,我们将使用 Python 和 Keras 包(TensorFlow 后端)在一个非常简单的环境中演示迁移学习概念。我们将使用著名的 CIFAR-10 数据集并进行以下操作:

-

通过在一组特征层之上堆叠一组分类层来创建一个 Keras 神经网络

-

在由前 5 类 (0…4) 的示例组成的部分 CIFAR-10 数据集上训练生成的网络。

-

冻结特征层并在其上堆叠一组新的全连接层,从而创建另一个卷积网络

-

在 CIFAR-10 的其余类别 (5..9) 的示例上训练这个新的卷积网络,只调整那些密集连接层的权重

整个代码是开源的,可以在这里找到。我们在本文中只展示了部分重要的代码。

代码示例

我们首先导入必要的库和函数:

-

from time import time

-

import keras

-

from keras.datasets import mnist,cifar10

-

from keras.models import Sequential

-

from keras.layers import Dense, Dropout, Activation, Flatten

-

from keras.layers import Conv2D, MaxPooling2D

-

from keras.optimizers import Adam

-

from keras import backend as K

-

import matplotlib.pyplot as plt

-

import random

接下来,我们决定一些深度学习模型的架构选择。我们将使用卷积神经网络 (CNN),因为它最适合图像分类任务:

-

要使用的卷积滤波器数量

-

filters = 64

-

最大池化的池化区域大小

-

pool_size = 2

-

卷积核大小

-

kernel_size = 3

接下来,我们将数据集拆分为训练集和验证集,并创建两个数据集——一个包含标签低于 5 的类别,另一个包含 5 及以上的类别。为什么要这样做?

整个 CIFAR-10 数据集有 10 类图像,尺寸非常小。我们将有两个神经网络。一个将被预训练,学习将转移到第二个网络。但是,我们不会使用所有的图像类别来训练这两个网络。第一个网络将仅使用前 5 类图像进行训练,这一学习将帮助第二个网络更快地学习最后 5 类图像。

因此,

CIFAR-10 数据集中的 10 类图像。

这里是前 5 类的一些随机图像,第一个神经网络将“看到”并进行训练。这些类别是——飞机、汽车、鸟、猫或鹿。

图:前 5 类图像,仅被第一个神经网络看到。

但我们实际上感兴趣的是为最后 5 类图像构建一个神经网络——狗、青蛙、马、羊或卡车。

图:最后 5 类图像,仅被第二个神经网络看到。

接下来,我们定义两组/类型的层:特征层(卷积)和分类层(密集)。

再次,请不要被这些代码片段的实现细节困扰。你可以从任何标准的 Keras 教程中了解细节。关键是理解概念。

特征层:

-

特征层 = [

-

Conv2D(filters, kernel_size,

-

padding='valid',

-

input_shape=input_shape),

-

Activation('relu'),

-

Conv2D(filters, kernel_size),

-

Activation('relu'),

-

MaxPooling2D(pool_size=pool_size),

-

Dropout(25),

-

Flatten(),

-

]

密集分类层:

-

分类层 = [

-

Dense(128),

-

Activation('relu'),

-

Dropout(25),

-

Dense(num_classes),

-

Activation('softmax')

-

]

接下来,我们通过将特征层和分类层堆叠在一起创建完整模型。

-

- model_1 = Sequential(特征层 + 分类层)

然后我们定义一个用于训练模型的函数(未显示),并训练模型若干轮以达到足够好的性能:

-

train_model(model_1,

-

(x_train_lt5, y_train_lt5),

-

(x_test_lt5, y_test_lt5), 类别数)

我们可以展示网络在训练轮次中的准确度演变:

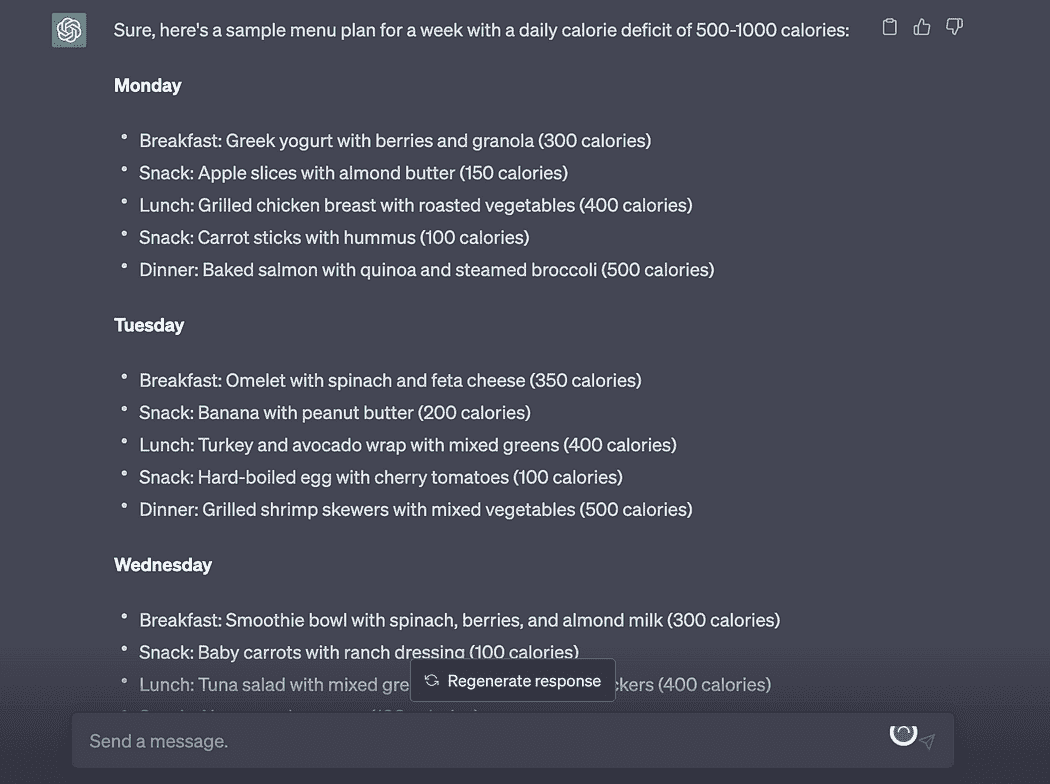

图:训练第一个网络时验证集准确度随轮次变化。

接下来,我们冻结特征层并重建模型。

冻结特征层是迁移学习的核心。这允许重新使用预训练模型进行分类任务,因为用户可以在预训练特征层上堆叠新的全连接层,从而获得良好的性能。

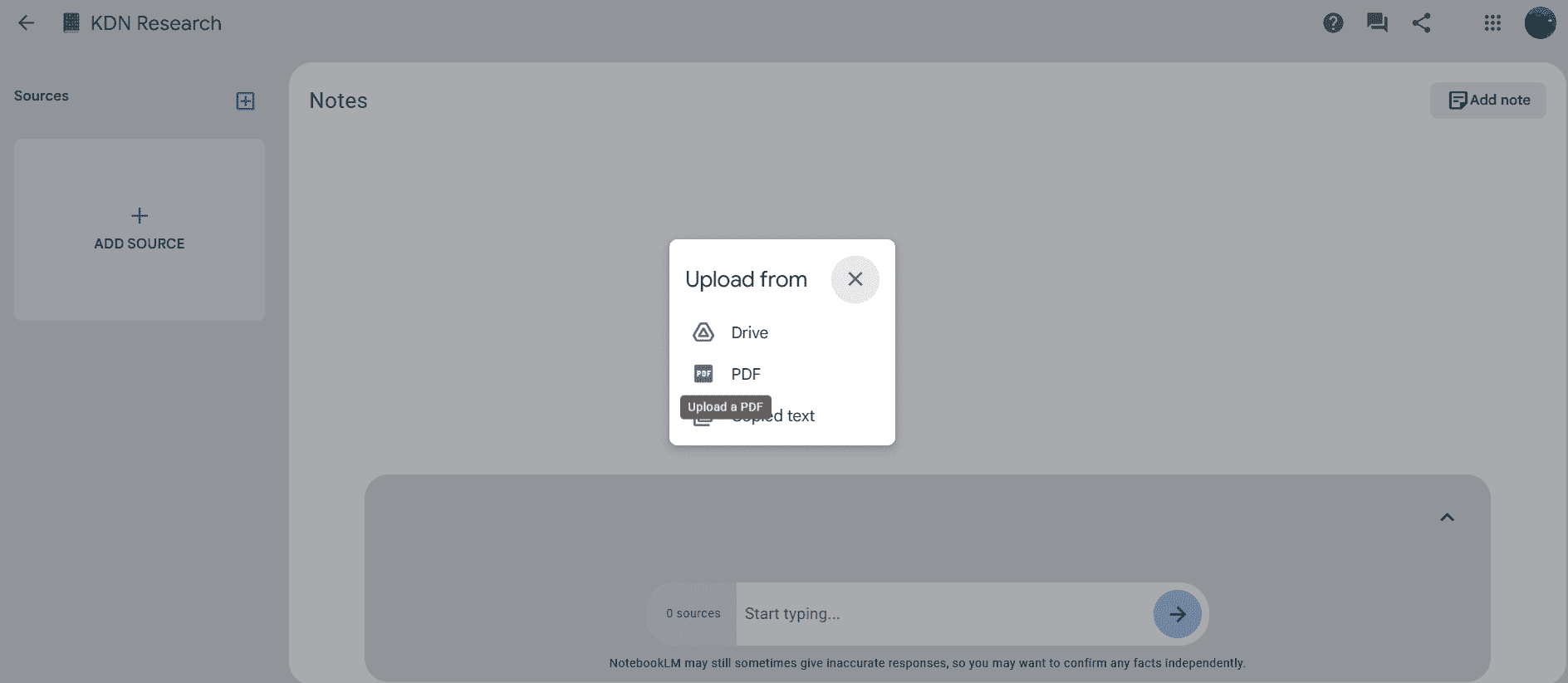

我们将创建一个名为model_2的新模型,具有不可训练的特征层和可训练的分类层。我们在下图中展示了摘要:

-

对于特征层中的每一层:

-

可训练 = False

-

model_2 = Sequential(特征层 + 分类层)

图:第二个网络的模型摘要,显示了固定和可训练的权重。固定权重直接从第一个网络转移过来。

现在我们训练第二个模型并观察它总体上所需时间更少且性能相当或更高。

-

train_model(model_2,

-

(x_train_gte5, y_train_gte5),(x_test_gte5, y_test_gte5), 类别数)

第二个模型的准确率甚至高于第一个模型,尽管这并不总是如此,且取决于模型架构和数据集。

图:训练第二个网络时验证集准确度随轮次变化。

两个模型的训练时间如下所示:

图:两个网络的训练时间。

我们达成了什么?

不仅model_2的训练速度比model_1更快,而且它还以更高的基准准确度开始,并在相同的训练轮次和相同的超参数(学习率、优化器、批量大小等)下达到了更好的最终准确度。而且,它在model_1未见过的图像上完成了训练。

这意味着虽然model_1是在airplane、automobile、bird、cat或deer的图像上训练的,但它学到的权重在转移到model_2时,帮助model_2在完全不同类别的图像分类中表现出色——dog、frog、horse、sheep或truck。

难道这不令人惊讶吗?现在,你可以用这么少的代码行来构建这种转移学习。再次强调,所有代码都是开源的,可以在这里找到。

原文。经许可转载。

相关:

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持组织的 IT 工作

3. Google IT 支持专业证书 - 支持组织的 IT 工作

更多相关话题

转移学习用于图像识别和自然语言处理

原文:

www.kdnuggets.com/2022/01/transfer-learning-image-recognition-natural-language-processing.html

如果你有机会阅读了本文的第一部分,你会记得转移学习是一种机器学习方法,其中从一个任务中获得的模型的知识应用可以作为另一个任务的基础点被重用。

如果你没有机会深入了解转移学习,读一读它将帮助你更好地理解这篇文章。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

图像识别

首先让我们了解一下什么是图像识别。图像识别是指计算机技术能够检测和分析图像或视频中的物体或特征的任务。这是深度神经网络施展魔力的主要领域,因为它们被设计用来识别模式。

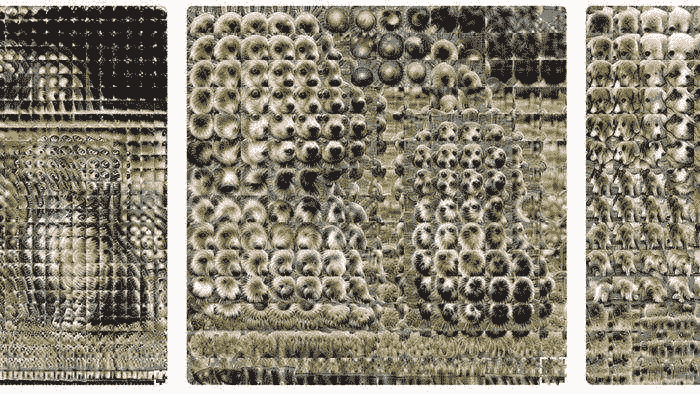

如果你想了解神经网络如何分析和掌握图像的理解,请查看这里。这将向你展示低层次的层如何集中学习低级特征,以及高层次的层如何适应学习高级特征。

我们在本文第一部分中模糊地谈到了训练网络识别猫和狗的内容,让我们更详细地讨论一下。人脑可以识别和区分物体。图像识别也旨在拥有类似于人脑的能力,能够识别和检测图像中物体之间的差异。

图像识别所使用的算法是一个图像分类器,它接收输入图像并输出图像包含的内容。这个算法必须经过训练,以学习它检测的对象之间的差异。为了让图像分类器识别猫和狗,需要用成千上万的猫和狗的图像,以及不包含猫和狗的图像来训练图像分类器。因此,从这个图像分类器获得的数据可以在其他任务中用于猫和狗的检测。

那么你可以在哪里找到预训练的图像模型呢?

目前有很多预训练模型,因此找到合适的模型来解决你的问题需要一些研究。我将为你做一点研究。我将首先讨论 Keras。Keras 提供了广泛的预训练模型,可用于迁移学习、特征提取、微调和预测。你可以在 这里 找到它们的列表。

一个 Keras 应用的例子是 Xception 架构,我在上面简要提到过。以下是如何在 ImageNet 上初始化 Xception。

tf.keras.applications.Xception(

include_top=True,

weights="imagenet",

input_tensor=None,

input_shape=None,

pooling=None,

classes=1000,

classifier_activation="softmax",

)

说到 Keras,我们也不要忘记 TensorFlow Hub。TensorFlow 是一个由 Google 开发的开源库,支持机器学习和深度学习。TensorFlow Hub 提供了多种预训练的、可部署的模型,如图像、文本、视频和音频分类。

序列模型适合用于简单的层叠堆叠,这意味着每一层都有一个输入和一个输出张量。

示例 1:

model = tf.keras.Sequential([

embed,

tf.keras.layers.Dense(16, activation="relu"),

tf.keras.layers.Dense(1, activation="sigmoid"),

])

示例 2:

m = tf.keras.Sequential([

hub.KerasLayer("https://tfhub.dev/google/imagenet/inception_v1/classification/5")

])

m.build([None, 224, 224, 3]) # Batch input shape.

在深度学习中,一些策略可以使我们最大限度地利用预训练模型。

特征提取

我将讨论的第一个策略是特征提取。你基本上是将预训练模型作为固定的特征提取器来运行,使用所需的特征来训练新的分类器。接近模型输入层的卷积层学习低级特征,如图像识别中的边缘和线条。随着层次的增加,它们开始学习更复杂的特征,最终能够解释接近输出的特定特征,即当前的分类任务。我们可以通过使用模型的不同层级作为单独的特征提取整合来分类我们的任务。

例如,如果任务与对图像中物体的分类不同(这是预训练模型所做的),那么使用预训练模型经过几层处理后的输出会更为合适。因此,所需层的新输出将作为输入提供给新模型,新模型已经获得了必要的特征,可以传递给新的分类器,并能够解决当前任务。

总的来说,这个想法是利用特征提取来利用预训练模型,以确定哪些特征对解决你的任务有用,但你不会使用网络的输出,因为它过于特定于任务。然后你将需要构建模型的最后部分,以适应你的任务。

微调

第二种策略是微调,或者我喜欢称之为网络手术。我们在上面讨论过微调,它基于对过程进行“精细”调整,以获得所需的输出,从而进一步提高性能。微调也被视为特征提取的进一步步骤。在微调中,我们冻结某些层并选择性地重新训练一些层,以提高其准确性,从而在较低的学习率下获得更高的性能,并减少训练时间。

如果你希望从基本模型中获得有效的特征表示,微调是至关重要的,这样可以更好地适应你的任务。

示例:如何在 Keras 中使用预训练的图像模型

现在让我们看一个例子。由于我们一直在讨论猫和狗,让我们对它们做一个图像识别的示例。

加载数据

所以首先让我们确保导入所需的库并加载数据。

import numpy as np

import tensorflow as tf

from tensorflow import keras

import tensorflow_datasets as tfds

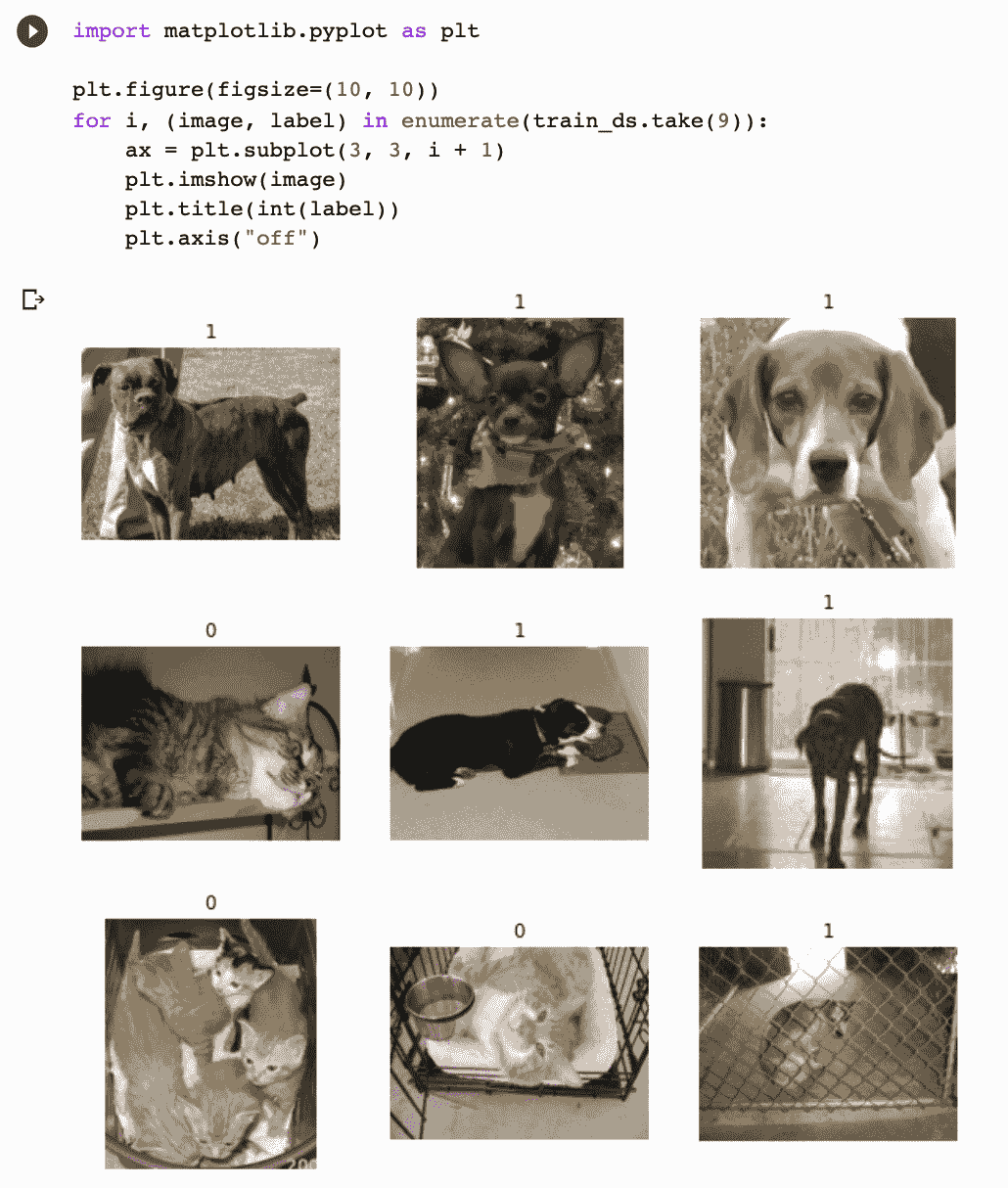

打印出训练和测试的样本量总是好的,以了解你正在处理的数据量,并查看图像,这样你可以了解你正在处理的数据。

由于图像大小各异,将图像标准化为固定大小是一种良好的方法,因为这是神经网络的一个一致输入。

数据预处理

现在让我们进入数据增强的部分。当处理较小的数据集时,应用随机变换到训练图像上是一个好的做法,例如水平翻转。翻转意味着在垂直或水平轴上旋转图像。这将帮助模型接触到训练数据的不同角度和方面,从而减少过拟合。

from tensorflow import keras

from tensorflow.keras import layers

data_augmentation = keras.Sequential(

[layers.RandomFlip("horizontal"), layers.RandomRotation(0.1),]

)

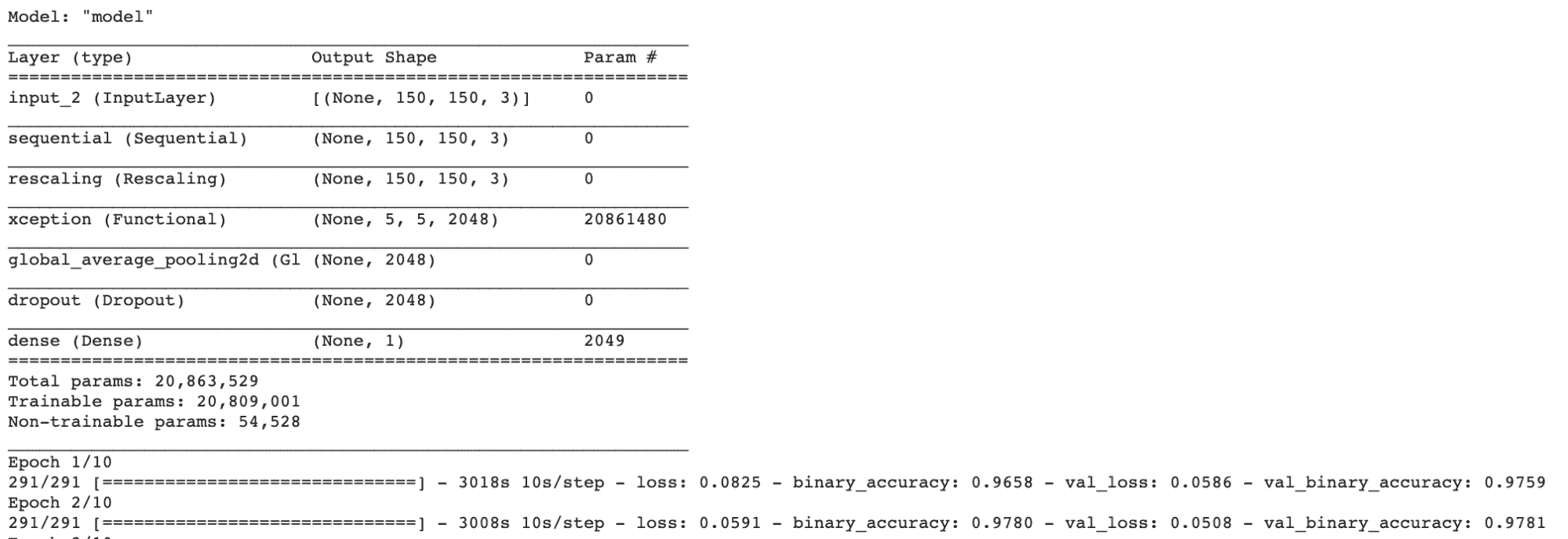

从选择的架构(Xception)创建一个基本模型

下一步是创建模型。我们首先将实例化一个基本模型,Xception,并将预训练的权重加载到其中。在这个例子中,我们使用的是 ImageNet。然后,我们冻结基本模型中的所有层。冻结有助于防止在训练过程中更新权重。

base_model = keras.applications.Xception(

weights="imagenet", # Weights pre-trained on ImageNet.

input_shape=(150, 150, 3),

include_top=False,

)

base_model.trainable = False

训练顶层

下一步是在冻结的层上创建一个新层,该层将学习旧特征的知识并利用这些知识对新数据集进行预测。正如前面迁移学习步骤中进一步解释的那样,预训练模型的当前输出与模型希望得到的输出之间的差异可能很大,因此添加新层将整体上提高模型的性能。

# Create a new model on top

inputs = keras.Input(shape=(150, 150, 3))

x = data_augmentation(inputs) # Apply random data augmentation

微调

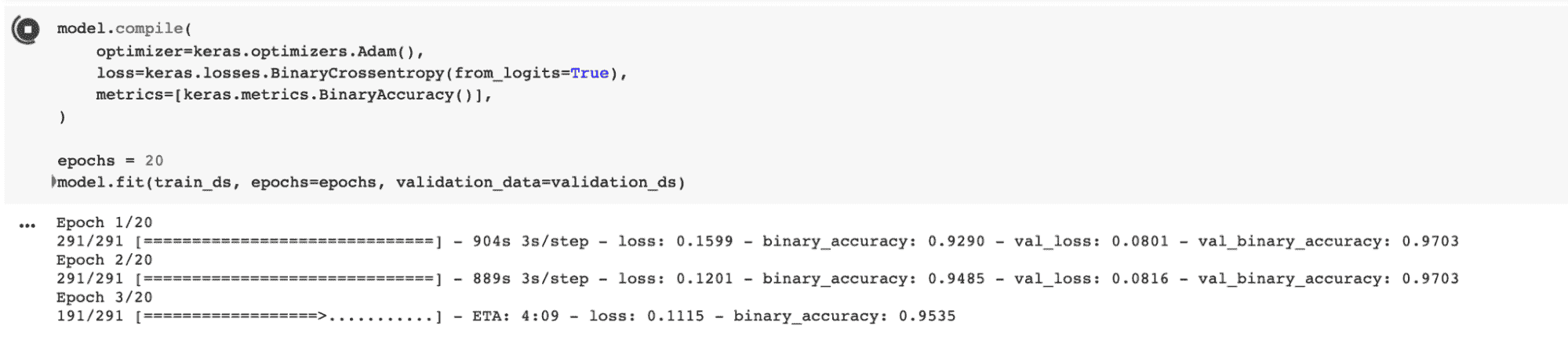

因此,在我们用冻结的层运行模型之后,我们需要用未冻结的基础模型运行模型,这样可以本质上提高模型性能,并且学习率较低。你需要减少过拟合的程度,所以让我们慢慢来,逐步解冻基础模型。

base_model.trainable = True

现在是时候再次编译模型了。

model.compile(

optimizer=keras.optimizers.Adam(1e-5), # Low learning rate

loss=keras.losses.BinaryCrossentropy(from_logits=True),

metrics=[keras.metrics.BinaryAccuracy()],

)

epochs = 10

model.fit(train_ds, epochs=epochs, validation_data=validation_ds)

如果你想进一步了解,可以点击这里查看 Colab 笔记本。

自然语言处理

我们已经讨论了很多关于图像分类的内容,现在让我们来看看自然语言处理(NLP)。那么,NLP 是什么呢?NLP 是计算机通过语音和文本检测和理解人类语言的能力,就像我们人类一样。

人类语言包含许多歧义,这使得创建能够准确检测语音和文本的软件变得困难。例如,讽刺、语法和同音词,然而,这些只是学习人类语言过程中遇到的一些小障碍。

NLP 的例子包括语音识别和情感分析。NLP 的应用场景包括垃圾邮件检测。我知道,你可能从未想到过 NLP 会被应用于垃圾邮件检测,但确实如此。NLP 的文本分类功能能够扫描电子邮件并检测出可能是垃圾邮件或钓鱼邮件的语言。它通过分析语法错误、威胁、金融术语的过度使用等来实现这一点。

那么,迁移学习在 NLP 中是如何工作的呢?其实,它与图像识别的工作方式基本相同。训练一个自然语言模型可能会非常昂贵,它需要大量的数据,并且需要在高端硬件上耗费大量的训练时间。但好消息是,和图像识别一样,你可以免费下载这些预训练模型,并对其进行微调以适应你的特定数据集。

你可能会问,在哪里可以找到这些预训练模型?

Keras 不仅提供图像识别的预训练模型,还提供 NLP 的架构。你可以在这里查看。

HuggingFace

让我们来看看HuggingFace。HuggingFace 是一个开源的自然语言处理(NLP)提供者,它在让工具易于使用方面做得非常出色。

他们的 Transformers 库是一个基于 Python 的库,提供了如 BERT 等架构,用于执行如文本分类和问答等 NLP 任务。你只需用几行代码加载他们的预训练模型,就可以开始实验。要开始使用 Transformers,你需要先安装它。

以下是使用情感分析的示例,它能够识别文本中表达的意见。

! pip install transformers

from transformers import pipeline

classifier = pipeline('sentiment-analysis')

classifier('I am finding the article about Transfer learning very useful.')

输出:

[{'label': 'POSITIVE', 'score': 0.9968850016593933}]

使用 HuggingFace 对预训练模型进行微调是一种选择,可以使用 Trainer API。Transformers 提供了一个 Trainer 类来帮助微调你的预训练模型。这一步骤在处理数据之后进行,并且需要导入 TrainingArguments。

from transformers import TrainingArguments

要了解更多关于 HuggingFace 的信息,你可以访问这个链接。

词嵌入

词嵌入是什么呢?词嵌入是一种表示方式,其中相似的词具有相似的编码。它可以在文档中检测到一个词,并将其与其他词的关系联系起来。

其中一个例子是 Word2Vec,它是一个通过向量编码处理文本的两层神经网络。

Word2Vec 使用了两种方法来学习词的表示:

-

连续词袋模型(Continuous Bag-of-Words) - 是一种模型架构,它试图基于源词(邻近词)预测目标词(中间词)。上下文中的词的顺序不一定重要,因此这个架构被称为“词袋模型”。

-

连续跳字模型(Continuous Skip-gram) - 是一种模型架构,本质上是词袋模型的对立面。它试图给定目标词(中间词)来预测源词(邻近词)。

特征提取是一种在词嵌入中使用的策略,它检测并生成对你正在处理的 NLP 任务有用的特征表示。在特征提取中,将部分(句子或词)提取到一个矩阵中,该矩阵包含每个词的表示。权重不会改变,仅使用模型的顶层。

然而,微调会调整预训练模型的权重,这可能会带来不利影响,因为该方法在调整阶段可能导致词汇的丢失,原因在于权重被更改,曾经学到的内容不再存在于记忆中。这被称为“灾难性遗忘”。

示例:如何在 Keras 中使用预训练的 NLP 模型

我们刚刚讨论了词嵌入(Word Embedding),让我们看一个例子。快速回顾一下词嵌入的定义:它是一种表示方式,其中相似的词具有相似的编码。它可以在文档中检测到一个词,并将其与其他词的关系联系起来。那么我们来看看它是如何工作的吧。

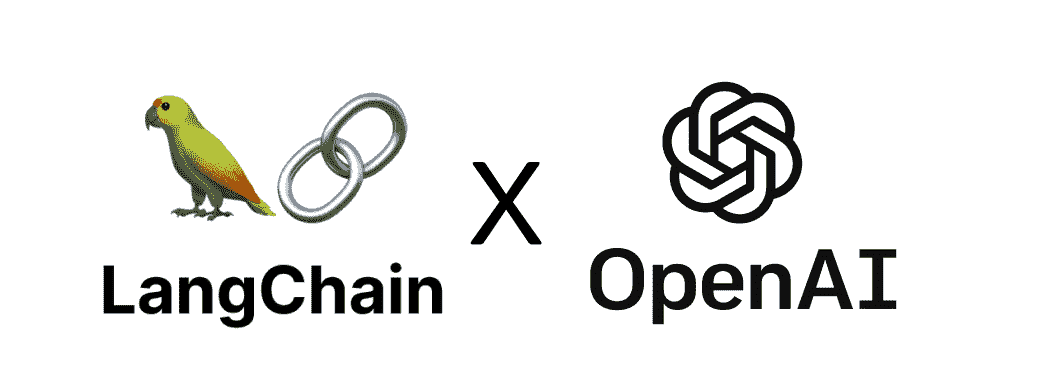

加载数据

在这个例子中,我们将查看电影评论。如果你还记得我们之前做的例子,使用情感分析得出了一个结果来确定其积极性。对于这些电影评论,我们有积极和消极的,因此这是二元分类。

url = "https://ai.stanford.edu/~amaas/data/sentiment/aclImdb_v1.tar.gz"

dataset = tf.keras.utils.get_file("aclImdb_v1.tar.gz", url,

untar=True, cache_dir='.',

cache_subdir='')

dataset_dir = os.path.join(os.path.dirname(dataset), 'aclImdb')

os.listdir(dataset_dir)

你可以在下面的图像中看到区别,0 表示负面,1 表示正面。

然后,我转向使用 Keras 的 Embedding Layer,将正整数转换为固定大小的稠密向量。嵌入的权重是随机初始化的,并在反向传播过程中进行调整。一旦知识学会了,词嵌入将编码它们所学过的词与之前学过的词之间的相似性。

# Embed a 1,000-word vocabulary into 5 dimensions.

embedding_layer = tf.keras.layers.Embedding(1000, 5)

文本预处理

在文本预处理阶段,我们将初始化一个 TextVectorization 层,以期望的参数对电影评论进行向量化。文本向量化层将帮助拆分和映射来自电影评论的字符串到整数。

# text vectorization layer to split, and map strings to integers.

vectorize_layer = TextVectorization(

standardize=custom_standardization,

max_tokens=vocab_size,

output_mode='int',

output_sequence_length=sequence_length)

创建模型

上述预处理中的 vectorize_layer 将作为模型的第一层实现,因为它已经将字符串转换为词汇索引。它将把转换后的字符串输入到 Embedding 层中。

然后,Embedding 层会接受这些词汇索引,并扫描每个词索引的向量,在模型训练时进行学习。

model = Sequential([

vectorize_layer,

Embedding(vocab_size, embedding_dim, name="embedding"),

GlobalAveragePooling1D(),

Dense(16, activation='relu'),

Dense(1)

])

在这个示例中,我们将使用TensorBoard,这是一个提供机器学习工作流可视化的工具,例如损失和准确率。

编译模型

我们将使用 Adam 优化器和 BinaryCrossentropy 损失函数来编译模型。

model.compile(optimizer='adam',

loss=tf.keras.losses.BinaryCrossentropy(from_logits=True),

metrics=['accuracy'])

我提到了 TensorBoard,它可视化模型指标,你可以在下面看到。

你已经了解了如何使用预训练的词嵌入模型训练和测试 NLP 模型。如果你想进一步查看 Colab 笔记本,你可以在这里查看。

迁移学习的最佳实践是什么?

-

预训练模型 - 利用这些预训练的开源模型,它们可以帮助你解决目标任务,因为它们涵盖了不同的领域。这可以节省你从头开始构建模型的大量时间。

-

源模型 - 找到一个与源任务和目标任务都兼容的模型是很重要的。如果源模型与你的目标差距过大,并且知识转移有限,目标模型将需要更长的时间来实现。

-

过拟合 - 如果目标任务的数据样本很小,且源任务与目标任务过于相似,这可能会导致过拟合。冻结层并调整课程模型中的学习率可以帮助你减少模型的过拟合。

我希望这篇文章让你对如何通过机器学习的不同类型实现迁移学习有了更好的理解。试试看吧!

尼莎·阿雅 是一名数据科学家和自由技术撰稿人。她特别感兴趣于提供数据科学职业建议或教程以及围绕数据科学的理论知识。她还希望探讨人工智能如何以及如何能够提升人类生命的持久性。她是一个热衷学习者,寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

相关主题

什么是迁移学习?

图片由 qimono on Pixabary 提供

迁移学习是一种机器学习方法,其中一个任务中获得的模型知识可以作为另一个任务的基础点进行重用。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道

1. Google 网络安全证书 - 快速进入网络安全职业轨道

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

机器学习算法使用历史数据作为输入来进行预测并产生新的输出值。它们通常被设计用于执行孤立的任务。源任务是指将知识转移到目标任务的任务。目标任务是指由于从源任务转移知识而发生的改进学习。

在迁移学习过程中,利用从源任务中获得的知识和快速进展来改善对新目标任务的学习和发展。知识的应用是使用源任务的属性和特征,这些属性和特征将被应用并映射到目标任务上。

然而,如果转移方法导致新目标任务性能下降,则称为负迁移。在使用迁移学习方法时,主要挑战之一是能够提供并确保相关任务之间的正迁移,同时避免与不相关任务之间的负迁移。

迁移学习的什么、何时和如何

-

迁移什么?要理解转移哪些学习到的知识,我们需要弄清楚哪些知识部分最能反映源任务和目标任务。总体而言,提高目标任务的性能和准确性。

-

何时进行迁移?了解何时进行迁移非常重要,因为我们不希望转移的知识可能使情况变得更糟,导致负迁移。我们的目标是提高目标任务的性能,而不是使其变得更差。

-

如何进行迁移?现在我们对想要迁移的内容和何时迁移有了更清楚的了解,我们可以继续研究不同的技术,以高效地转移知识。我们将在文章后面进一步讨论。

在我们深入探讨迁移学习背后的方法论之前,了解迁移学习的不同形式是很有帮助的。我们将讨论三种不同类型的迁移学习场景,这些场景是根据源任务和目标任务之间的关系来区分的。以下是不同类型的迁移学习概述:

迁移学习的不同类型

归纳迁移学习:在这种迁移学习类型中,源任务和目标任务相同,但它们之间仍然存在差异。模型将利用源任务中的归纳偏差来帮助提高目标任务的性能。源任务可能包含或不包含标记数据,这进一步导致模型使用多任务学习和自学学习。

无监督迁移学习:我假设你知道什么是无监督学习,不过,如果你不知道,无监督学习是指算法能够识别未标记或未分类的数据集中的模式。在这种情况下,源任务和目标任务是相似的,但任务是不同的,源任务和目标任务中的数据都是未标记的。降维和聚类等技术在无监督学习中是非常著名的。

转导迁移学习:在这种最后的迁移学习类型中,源任务和目标任务有相似之处,但领域是不同的。源领域包含大量的标记数据,而目标领域则缺乏标记数据,这进一步导致模型使用领域适应技术。

迁移学习与微调

微调是迁移学习中的一个可选步骤,主要用于提高模型的性能。迁移学习和微调之间的区别完全体现在名称上。

迁移学习基于从一个任务中学习到的特征,并将这些知识“转移”到新的任务上。迁移学习通常用于数据集过小,无法从头训练一个完整模型的任务。微调则是对过程进行“微小”的调整,以获得所需的输出,从而进一步提高性能。在微调过程中,经过训练的模型的参数会被精确和特定地调整,同时尝试验证模型以实现所需的输出。

为什么使用迁移学习?

使用迁移学习的原因:

无需大量数据 - 获取数据总是一个障碍,因为数据的可用性不足。使用不足量的数据可能导致性能较低。这正是迁移学习的优势所在,因为机器学习模型可以通过少量的训练数据集进行构建,因为它已经经过预训练。

节省训练时间 - 机器学习模型训练起来很困难且耗时,导致效率低下。训练一个深度神经网络从头开始处理复杂任务需要很长时间,因此使用预训练模型可以节省建立新模型的时间。

转移学习的优点

更好的基础:在转移学习中使用预训练模型为你提供了更好的基础和起点,使你能够在不进行训练的情况下完成一些任务。

更高的学习率:由于模型已经在类似任务上进行过训练,因此具有更高的学习率。

更高的准确率:凭借更好的基础和更高的学习率,模型在更高的性能下运行,产生更准确的输出。

转移学习不有效时?

当源任务的训练权重与目标任务不同的时候,应避免使用转移学习。例如,如果你之前的网络是用来分类猫和狗的,而你新的网络试图检测鞋子和袜子,那么会出现问题,因为从源任务到目标任务转移的权重无法提供最佳结果。因此,初始化一个与期望输出相似的预训练权重的网络比使用没有相关性的权重更好。

从预训练模型中移除层会对模型的架构造成问题。如果你移除前几层,模型的学习率会很低,因为它必须处理低级特征。移除层会减少可训练的参数数量,这可能导致过拟合。使用正确数量的层对于减少过拟合至关重要,但这也是一个耗时的过程。

转移学习的缺点

负迁移学习:如上所述,负迁移学习是指以前的学习方法阻碍了新任务。这仅在源任务和目标任务不够相似时发生,导致第一次训练偏差过大。算法不一定总是与我们认为的相似一致,这使得理解什么类型的训练是足够的基础和标准变得困难。

转移学习的 6 个步骤

让我们深入了解转移学习的实现方式及其步骤。转移学习一般包括 6 个步骤,我们将逐一介绍这些步骤。

-

选择源任务:第一步是选择一个拥有大量数据的预训练模型,该模型的输入和输出数据与您选择的目标任务有关系。

-

创建基础模型:实例化一个带有预训练权重的基础模型。预训练权重可以通过像 Xception 这样的架构获取。这是在开发你的源模型,使其比我们最初开始时的简单模型更好,确保学习率有所提升。

-

冻结层:为了避免再次初始化权重,冻结预训练模型的层是必要的。这将保留已经学到的知识,避免从头开始训练模型。

base_model.trainable = False

-

添加新的可训练层:在冻结层的顶部添加新的可训练层,将把旧特征转化为新数据集上的预测。

-

训练新层:预训练模型已经包含了最终的输出层。预训练模型的当前输出和你期望的模型输出之间存在较大差异的可能性很高。因此,你需要用新的输出层来训练模型。因此,添加新的密集层和最终密集层以符合你期望的模型,将提升学习率并产生你期望的输出。

-

微调:你可以通过微调来提升模型的性能,这包括解冻基础模型的全部或部分内容,然后用非常低的学习率重新训练模型。在这个阶段使用低学习率至关重要,因为你正在训练的模型比最初的第一轮大得多,并且数据集也很小。因此,如果应用较大的权重更新,你有过拟合的风险,因此你需要以增量的方式进行微调。由于你改变了模型的行为,需要重新编译模型,然后再次训练模型,监控任何过拟合的反馈。

我希望这篇文章为你提供了迁移学习的良好介绍和理解。敬请期待,我的下一篇文章将会介绍我如何实施迁移学习用于图像识别和自然语言处理。

Nisha Arya 是一名数据科学家和自由职业技术作家。她特别关注提供数据科学职业建议或教程以及数据科学相关理论知识。她还希望探索人工智能如何有助于人类寿命的不同方式。作为一个热衷学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关话题

用 LangChain 变革 AI:文本数据的游戏改变者

原文:

www.kdnuggets.com/2023/08/transforming-ai-langchain-text-data-game-changer.html

图片来源:作者

在过去几年中,大型语言模型——或者说是朋友们的 LLM——以其风靡的姿态席卷了人工智能领域。

我们的前 3 大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

随着 2020 年 OpenAI 发布 GPT-3 的突破性进展,我们见证了 LLM 的流行稳步上升,最近该领域的进步更是加剧了这一趋势。

这些强大的 AI 模型为自然语言处理应用开辟了新的可能性,使开发者能够创建更复杂、更像人类的互动。

不是吗?

然而,在处理这种 AI 技术时,很难扩展和生成可靠的算法。

在这个快速发展的环境中,LangChain 作为一个多功能框架应运而生,旨在帮助开发者充分利用 LLM 的潜力,应用于各种场景。其中最重要的用例之一就是处理大量 的文本数据。

让我们深入了解并开始利用 LLM 的力量吧!

LangChain 可以用于聊天机器人、问答系统、总结工具等。然而,LangChain 最有用且最常用的应用之一就是处理文本。

当今世界充斥着数据。而最臭名昭著的一种数据是文本数据。

所有网站和应用每天都被大量文字轰炸。没有人能处理这么多信息……

但计算机能做到吗?

LLM 技术与 LangChain 结合,是减少文本量同时保留信息核心的好方法。这就是为什么今天我们将探讨 LangChain 的两个基本但非常实用的文本处理用例。

-

总结: 表达一段文本或聊天互动中最重要的事实。它可以减少数据量,同时保留最重要的部分。

-

提取: 从一段文本或用户查询中提取结构化数据。它可以在文本中检测并提取关键词。

无论你是对 LLM 世界感到陌生还是希望将你的语言生成项目提升到一个新水平,本指南将为你提供宝贵的见解和动手示例,帮助你充分发挥 LangChain 处理文本的潜力。

⚠️ 如果你想了解一些基础知识,可以查看 ????????

LangChain 101:构建你自己的 GPT 驱动应用程序 — KDnuggets

请始终记住,要使用 OpenAI 和 GPT 模型,我们需要在本地计算机上安装 OpenAI 库,并拥有一个有效的 OpenAI 密钥。如果你不知道如何操作,可以查看这里。

1. 总结

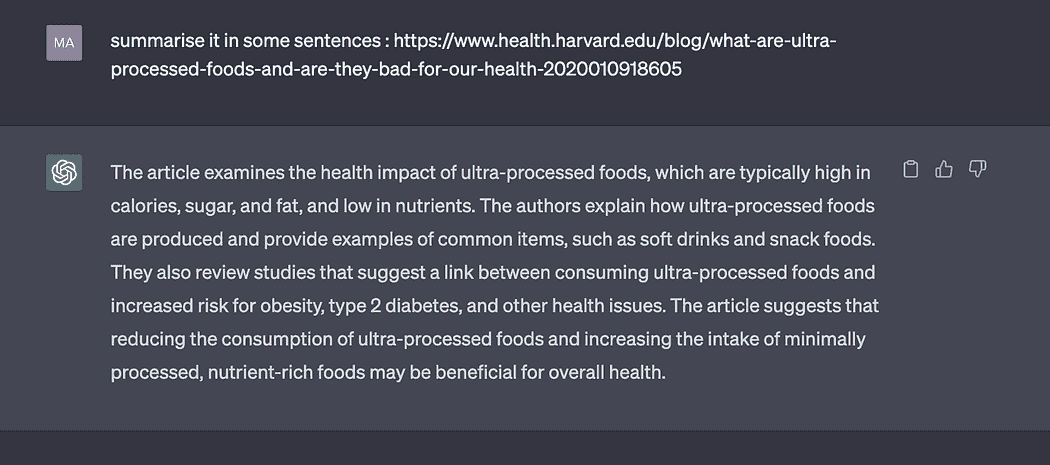

ChatGPT 结合 LangChain可以快速且非常可靠地总结信息。

LLM 总结技术是一种减少文本量同时保留消息最重要部分的好方法。这就是为什么 LLM 可以成为任何需要处理和分析大量文本数据的数字公司的最佳盟友。

执行以下示例所需的库有:

# LangChain & LLM

from langchain.llms import OpenAI

from langchain import PromptTemplate

from langchain.chains.summarize import load_summarize_chain

from langchain.text_splitter import RecursiveCharacterTextSplitter

#Wikipedia API

import wikipediaapi

1.1. 简短文本总结

对于短文本的总结,这种方法很简单,实际上,你只需要简单地进行提示并附上指令即可。

这基本上意味着生成一个带有输入变量的模板。

我知道你可能在想……什么是提示模板?

提示模板指的是一种可重复生成提示的方式。它包含一个文本字符串——模板——可以接受来自最终用户的一组参数并生成提示。

提示模板包含:

-

对语言模型的指令 - 允许我们标准化一些步骤,以便于我们的 LLM。

-

输入变量 - 允许我们将先前的指令应用于任何输入文本。

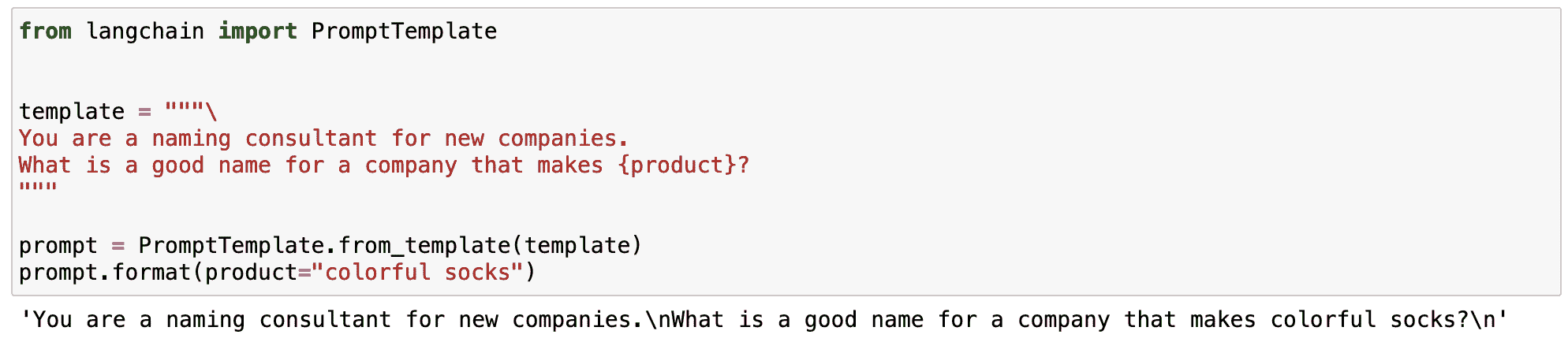

让我们在一个简单的例子中看看。我可以标准化一个生成特定产品品牌名称的提示。

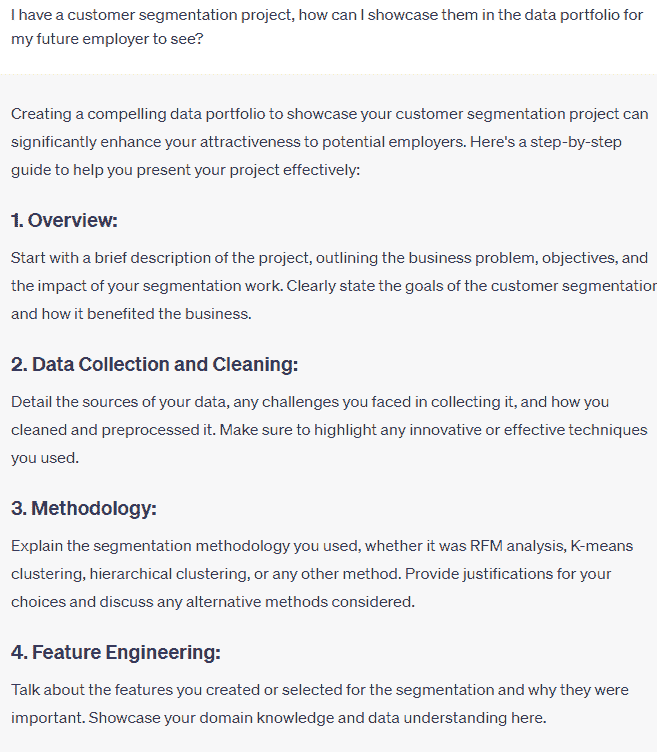

我 Jupyter Notebook 的截图。

正如你在之前的例子中看到的,LangChain 的魔力在于我们可以定义一个带有变化的输入变量的标准化提示。

-

生成品牌名称的指令始终保持不变。

-

产品变量作为一个可以改变的输入。

这使我们能够定义多功能的提示,可在不同的场景中使用。

所以现在我们知道什么是提示模板了……

让我们设想一下我们想要定义一个总结任何文本的提示,该提示使用超级易懂的词汇。我们可以定义一个包含一些具体指令和一个根据输入变量定义而变化的文本变量的提示模板。

# Create our prompt string.

template = """

%INSTRUCTIONS:

Please summarize the following text.

Always use easy-to-understand vocabulary so an elementary school student can understand.

%TEXT:

{input_text}

"""

Now we define the LLM we want to work with - OpenAI’s GPT in my case - and the prompt template.

# The default model is already 'text-davinci-003', but it can be changed.

llm = OpenAI(temperature=0, model_name='text-davinci-003', openai_api_key=openai_api_key)

# Create a LangChain prompt template that we can insert values to later

prompt = PromptTemplate(

input_variables=["input_text"],

template=template,

)

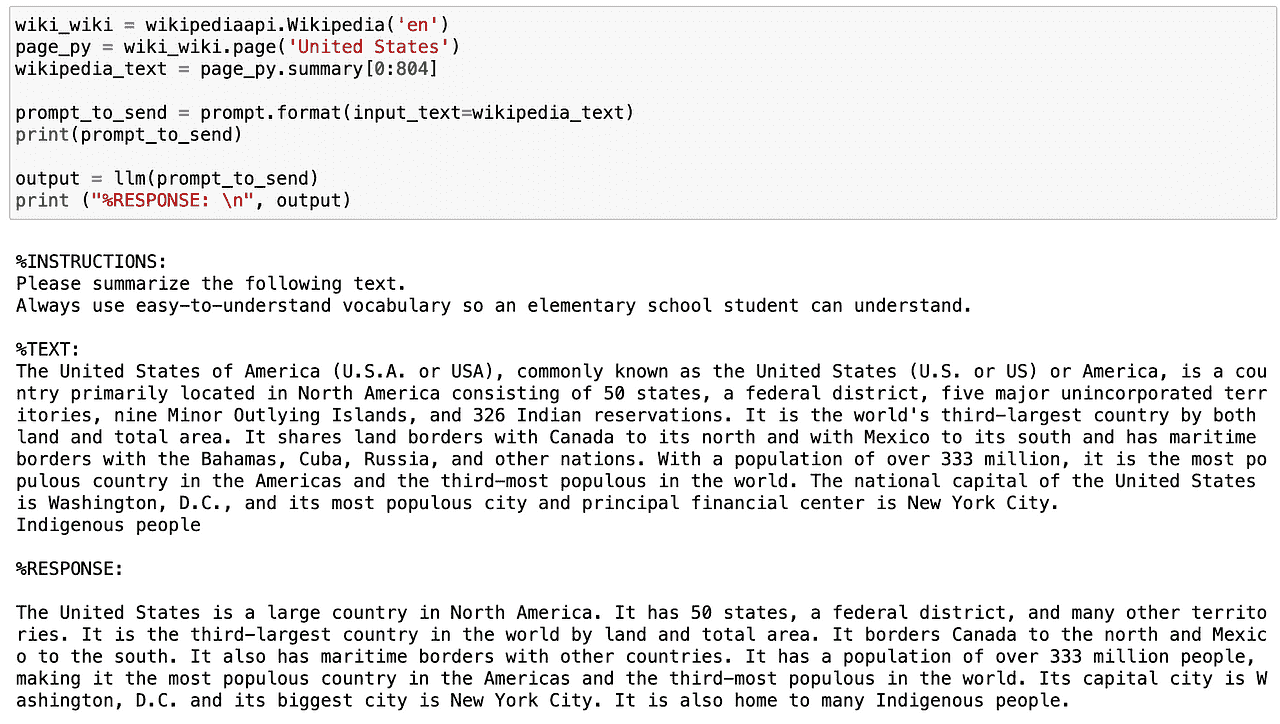

所以让我们尝试这个提示模板。使用维基百科 API,我将获取美国的摘要,并以一种非常易于理解的语气进一步总结。

我在 Jupyter Notebook 中的截图。

既然我们知道如何总结短文本……我可以稍微增加一些内容吗?

当然可以……

1.2. 长文本总结

在处理长文本时,主要的问题是我们无法通过提示直接将它们传达给我们的 AI 模型,因为它们包含了太多的 tokens。

现在你可能会想……什么是 token?

Tokens 是模型如何查看输入的方式——单个字符、单词、单词的部分或文本片段。如你所见,定义并不是很精确,这取决于每个模型。例如,OpenAI 的 GPT 中 1000 tokens 大约是 750 个单词。

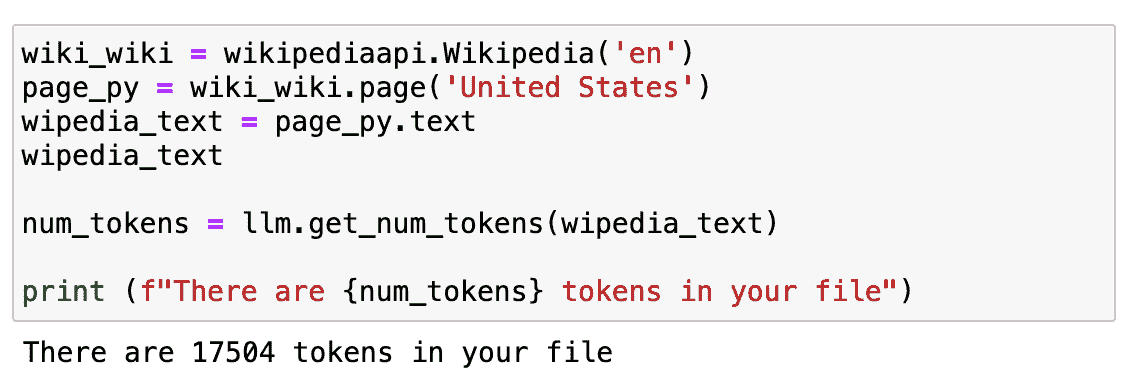

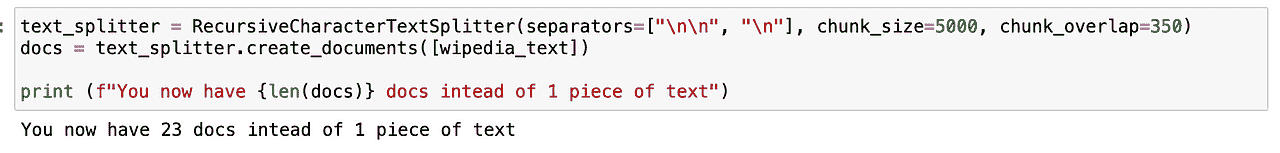

但最重要的是,我们的费用取决于 tokens 的数量,而且我们不能在单个提示中发送过多的 tokens。为了处理更长的文本,我们将重复之前的示例,但使用整个维基百科页面的文本。

我在 Jupyter Notebook 中的截图。

如果我们检查它有多长……大约是 17K tokens。

这实际上是非常多的,不能直接发送到我们的 API。

那现在怎么办?

首先,我们需要将其拆分。这一过程称为chunking或splitting你的文本为更小的片段。我通常使用RecursiveCharacterTextSplitter,因为它易于控制,但你可以尝试很多其他的工具。

使用它之后,我们不再只有一段文本,而是得到了 23 段,这有助于我们 GPT 模型的工作。

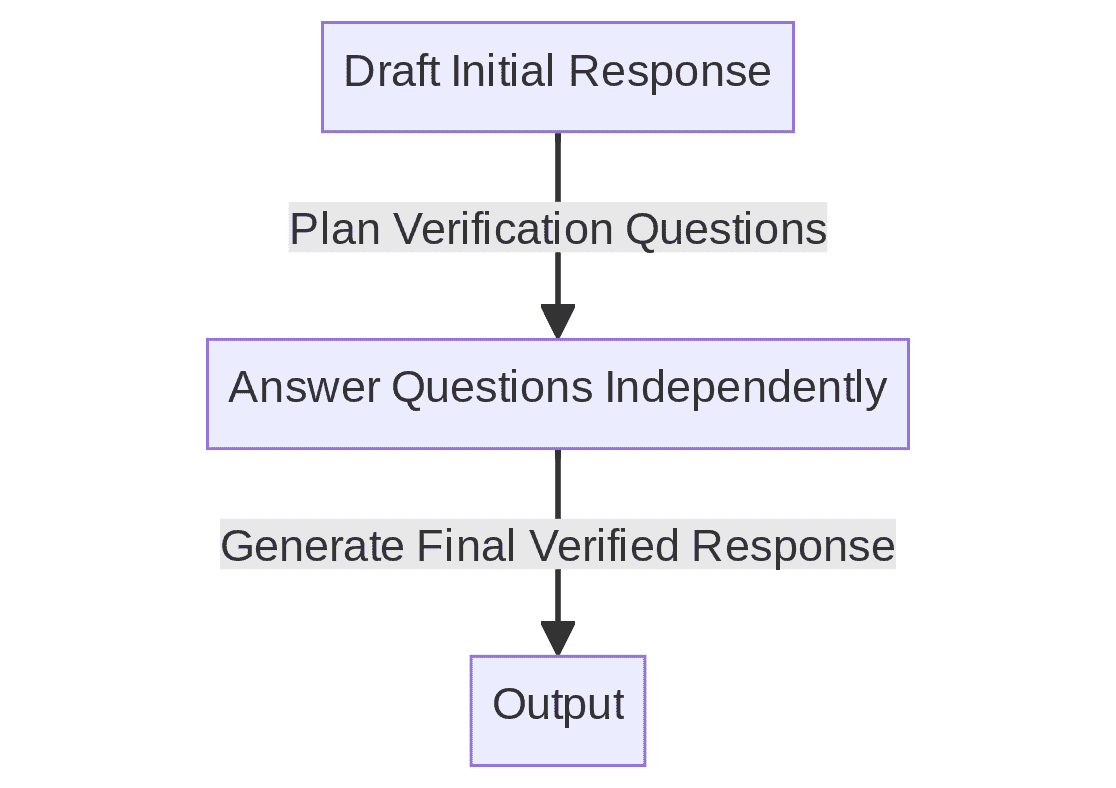

接下来我们需要加载一个链,它会为我们进行连续调用 LLM。

LangChain 为此类链式应用提供了 Chain 接口。我们非常泛泛地定义一个 Chain 为对组件的调用序列,这些组件可以包括其他链。基本接口很简单:

class Chain(BaseModel, ABC):

"""Base interface that all chains should implement."""

memory: BaseMemory

callbacks: Callbacks

def __call__(

self,

inputs: Any,

return_only_outputs: bool = False,

callbacks: Callbacks = None,

) -> Dict[str, Any]:

...

如果你想了解更多关于链的信息,可以直接查看LangChain 文档。

所以如果我们再次重复相同的程序,使用被拆分的文本——称为 docs——LLM 可以轻松生成整个页面的摘要。

我在 Jupyter Notebook 中的截图。

有用吧?

既然我们知道如何总结文本,我们可以进入第二个用例了!

2. 提取

提取是从文本片段中解析数据的过程。这通常与输出解析一起使用,以结构化我们的数据。

提取关键信息对于识别和解析文本中的关键词非常有用。 常见的用例包括从句子中提取结构化的行以插入数据库,或从长文档中提取多行以插入数据库。

假设我们正在运营一个数字电子商务公司,需要处理我们网站上所有的评论。

我可以逐一查看所有内容……这将是疯狂的。

或者我可以简单地提取我需要的信息,并分析所有数据。

听起来很简单……对吧?

让我们从一个非常简单的示例开始。首先,我们需要导入以下库:

# To help construct our Chat Messages

from langchain.schema import HumanMessage

from langchain.prompts import PromptTemplate, ChatPromptTemplate, HumanMessagePromptTemplate

# We will be using a chat model, defaults to gpt-3.5-turbo

from langchain.chat_models import ChatOpenAI

# To parse outputs and get structured data back

from langchain.output_parsers import StructuredOutputParser, ResponseSchema

chat_model = ChatOpenAI(temperature=0, model_name='gpt-3.5-turbo', openai_api_key=openai_api_key)

2.1. 提取特定词汇

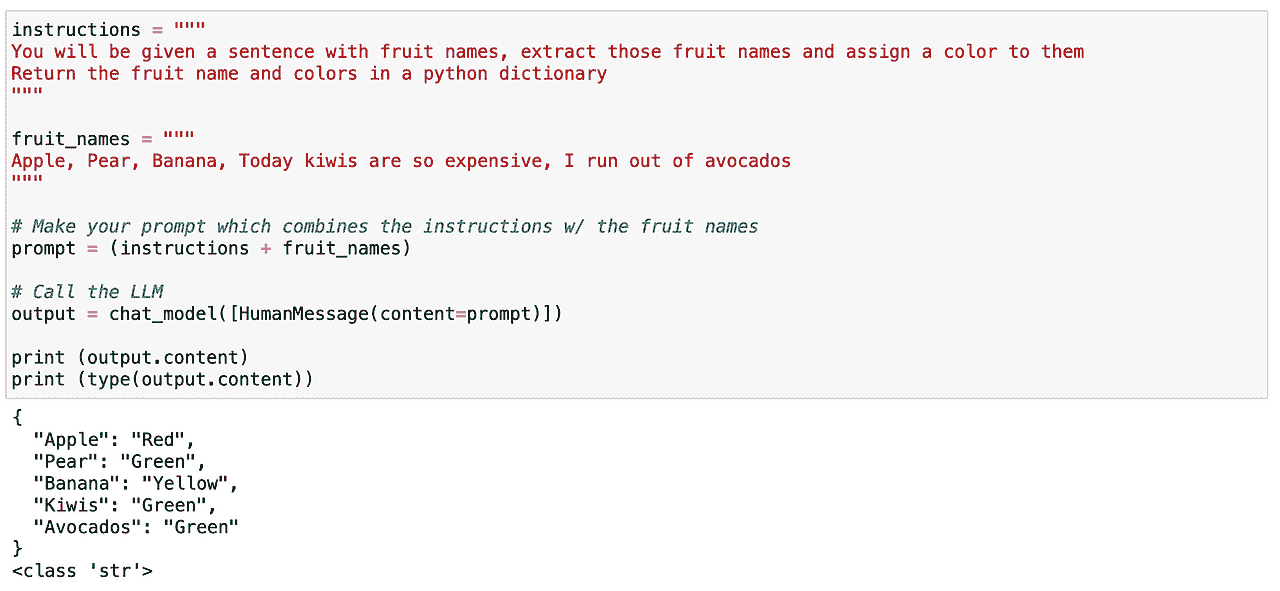

我可以尝试在文本中查找特定的词汇。在这种情况下,我想解析文本中包含的所有水果。再次,这非常直接。我们可以轻松定义一个提示,给出明确的指令,让我们的 LLM 识别文本中包含的所有水果,并返回一个包含这些水果及其对应颜色的类似 JSON 的结构。

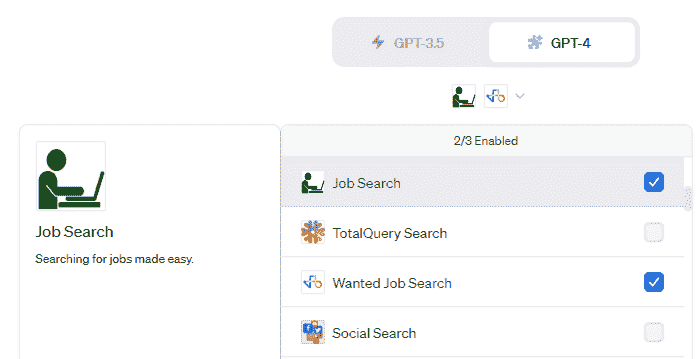

我的 Jupyter Notebook 截图。

正如我们之前所见,这效果很好!

现在……让我们再玩一下。虽然这次效果很好,但对于更高级的用例,它不是一种长期可靠的方法。这时,一个出色的 LangChain 概念就派上用场了……

2.2. 使用 LangChain 的响应模式

LangChain 的响应模式将为我们做两件主要的事情:

-

生成一个带有真实格式指令的提示。 这很好,因为我不需要担心提示工程方面的事情,我会把它留给 LangChain!

-

从 LLM 读取输出并将其转化为合适的 Python 对象。 这意味着,总是生成一个有用的结构,以便我的系统可以解析。

为了做到这一点,我只需要定义我期望从模型中获得的响应。

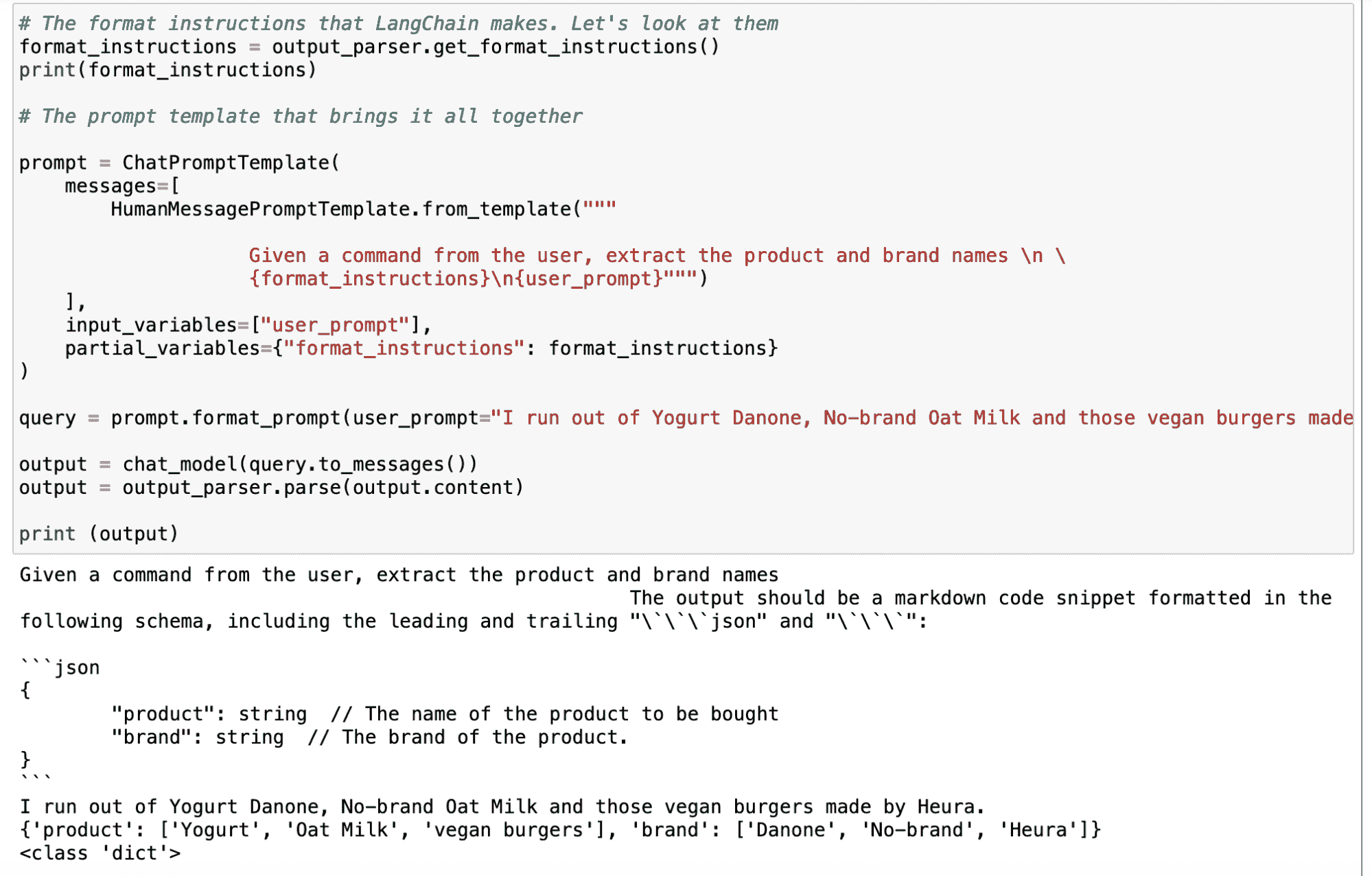

那么,假设我想确定用户评论中提到的产品和品牌。我可以像以前一样使用简单的提示 - 利用 LangChain 生成更可靠的方法。

首先,我需要定义一个 response_schema,在其中定义我想解析的每一个关键字的名称和描述。

# The schema I want out

response_schemas = [

ResponseSchema(name="product", description="The name of the product to be bought"),

ResponseSchema(name="brand", description= "The brand of the product.")

]

And then I generate an output_parser object that takes as an input my response_schema.

# The parser that will look for the LLM output in my schema and return it back to me

output_parser = StructuredOutputParser.from_response_schemas(response_schemas)

在定义我们的解析器之后,我们使用 LangChain 的 .get_format_instructions() 命令生成指令格式,并使用 ChatPromptTemplate 定义最终提示。现在,只需使用这个 output_parser 对象和我想到的任何输入查询,它就会自动生成包含我所需关键字的输出。

我的 Jupyter Notebook 截图。

如下面的示例所示,输入为“我用完了 Danone 酸奶、无品牌燕麦奶以及 Heura 制造的那些素食汉堡”,LLM 给出的输出如下:

我的 Jupyter Notebook 截图。

主要要点

LangChain 是一个多功能的 Python 库,帮助开发者充分利用 LLMs,特别是在处理大量文本数据时。它在处理文本方面表现出色。LLMs 使开发者能够在自然语言处理应用中创建更复杂和类人化的交互。

-

总结:LangChain 可以快速而可靠地总结信息,减少文本量,同时保留信息中最重要的部分。

-

提取:该库可以解析文本中的数据,允许结构化输出,并支持将数据插入数据库或根据提取的参数进行 API 调用等任务。

-

LangChain 促进了提示工程,这是一项关键技术,用于最大化像 ChatGPT 这样的 AI 模型的性能。通过提示工程,开发者可以设计可以在不同用例中重复使用的标准化提示,从而使 AI 应用更加多功能和高效。

总体而言,LangChain 作为一个强大的工具,可以增强 AI 的使用,尤其是在处理文本数据时,而提示工程是有效利用像 ChatGPT 这样的 AI 模型在各种应用中的关键技能。

Josep Ferrer 是一位来自巴塞罗那的分析工程师。他毕业于物理工程专业,目前在应用于人类流动性的 Data Science 领域工作。他是一名兼职内容创作者,专注于数据科学和技术。你可以通过LinkedIn、Twitter或Medium与他联系。

更多相关主题

如何从数据自由职业者过渡到数据创业者(几乎是一夜之间)

原文:

www.kdnuggets.com/2021/07/transition-data-freelancer-data-entrepreneur-overnight.html

评论

由Lillian Pierson, P.E.,世界级数据领导者和企业家的导师,Data-Mania 首席执行官

当我们中的许多人开始做自由职业时,往往感到非常兴奋。从任何地方工作,选择客户,只接自己喜欢的项目,这感觉真是太棒了。

但过了一段时间,你可能会感到精疲力竭。作为数据自由职业者,你能服务的客户和接的项目数量是有限的。你的收入在很大程度上依赖于你投入的小时数。

本文是一个指南,旨在帮助所有数据自由职业者突破收入上限,建立一个真正可扩展的数据业务。即使你是经验丰富的数据自由职业者,这些技巧也会帮助你找出一些阻碍你盈利最大化的缺失部分。

如果你在想,谁让我来说数据自由职业的事呢?好吧,我是莉莲·皮尔森,我在 2012 年刚刚被称为“数据科学家”时开始做数据科学自由职业者。从那时起,我创办了我的公司 Data-Mania,至今我们已经支持了超过 10%的《财富》100 强公司制定战略数据计划。

不仅如此,早在 2018 年,我开始指导其他数据专业人士启动他们的六位数数据业务,截至目前,超过10%的我的指导客户在注册后的前七个月内获得了六位数合同。

如果你有数据技能,并且已经在做自由职业或合同工作,并且准备将你的技能真正转化为一个超级盈利的数据业务,那就让我们深入探讨你需要采取的具体步骤。

首先:数据自由职业者和数据创业者之间的区别是什么?

让我们先定义数据自由职业者和数据创业者。

当我提到数据自由职业者时,我指的是以自由职业者身份提供数据服务的数据专业人士。他们在市场上出售自己的数据技能——无论是数据科学、数据分析、数据可视化,还是其他任何数据专业技能。

在某些情况下,数据自由职业者可能会与团队合作,无论这意味着他们有行政和业务支持,还是有其他数据专业人士帮助他们完成数据服务。他们进行的工作总是基于服务的工作。

相比之下,作为数据创业者,你作为 CEO 和业务的远见者出现。在工作交付方面,特别是服务方面,你通常会将所有,或至少大部分工作委派给你的团队。

如何将你的业务扩展为数据自由职业者

在从数据自由职业者过渡到数据企业家之前,你需要审视你的扩展选项。

如果你是数据服务提供商,你可以通过几种方式扩展你的业务模式。

-

你可以将其转变为一个代理机构

-

你可以将其转变为软件即服务(SAAS)公司

-

最后,你可以将你的商业模式转变为教练和顾问。

为了本文的目的,假设你是一个数据服务提供商,你希望将这一模式转变为代理机构或软件即服务。

步骤 1:记录你的流程

一旦你决定从单干的数据自由职业者转变为强大的数据团队,第一步就是记录你的流程。

记录你在业务中做的所有事情,例如:

-

销售

-

客户互动

-

客户接纳

-

服务交付

-

客户满意度

-

客户保留

为你的业务的每个方面创建明确的 SOP(标准操作程序)和指南,以便你可以进入第二步。

步骤 2:开始自动化和委派

一旦你清楚地记录了你的流程,你可以开始通过自动化和委派来优化这些流程。

这里有一些如何通过自动化节省时间和提升盈利的示例。

-

预定客户销售电话

你绝对不需要花费宝贵的时间安排潜在客户的预约。你也不需要花时间筛选他们,来回确认他们是否合适。

你可以通过潜在客户电话流程处理所有这些。

-

客户服务与互动

对于大多数客户支持和互动,你可以将这项工作委托给行政助理。你不需要回答每一封进入你收件箱的邮件!

然而,为了实现这一目标,你确实需要为你的助理制定明确的政策和程序。

-

客户接纳

你可以通过各种技术工具快速自动化你的客户接纳流程。在 Data-Mania,我们使用 Zapier、Google Forms 和 ConvertKit 来接纳新客户。

-

服务交付

是的,真的!你甚至可以委派服务的交付。一旦你围绕你提供的服务建立了流程并记录了每一步,你实际上可以找到虚拟助理或其他数据专家来按照说明执行工作!

这将使你担任 QA(质量保证)角色。最终,你要对你的业务所产生的工作负责。即使你自己不直接执行这些工作,你仍然需要对其承担责任——因此,确保它符合你的标准。

-

客户保留与满意度

创建一个自动化的流程,以跟进你的客户在接受服务期间。例如,你可以在他们服务进展到 30%时、60%时进行跟进,然后在产品或服务交付后的 15 天左右再进行一次跟进。

在交付过程中,电子邮件的处理应确保客户的期望不仅被满足,而且超出预期!找出方法使他们的客户体验尽可能愉快。

-

推荐信

创建一个简化且自动化的流程,以收集当前或甚至过去客户的反馈。在 Data-Mania,我们使用 Google Forms,因为它是免费的且易于使用!

完成所有这些后,恭喜你!是时候进入第三步了。

步骤 3:更新你的信息传达

现在你已经成功从数据自由职业者晋升为数据企业家,是时候升级你的信息传达了。

确保你的营销和业务文档清晰地反映出你的新业务结构。你希望潜在客户知道你拥有一个团队,你是一个真正的企业,并且你致力于为客户取得成果。

你需要更新你在以下地方的信息传达:

-

网站/销售页面

-

社交渠道

-

合同和协议

-

任何品牌或营销材料

尽管这一切听起来可能像是非常繁重的工作,但通过花时间记录和优化你的流程,你将能够创建一个超越仅仅是你自己的业务。你将能够提供规模更大得多的数据解决方案,因为你不再陷于业务实施的琐事中。你能自动化和委派的越多,你将有更多时间专注于成为你可以做到的最佳数据首席执行官。

想要在业务中获得更多关于自动化和工作流程的支持?下载免费数据企业家工具包——它包含了 32 个免费和低成本的工具,以帮助你发展数据业务。这些是我在 Data-Mania 日常使用的工具,帮助我们达到六位数的规模。

个人简介:莉莉安·皮尔森(Lillian Pierson, P.E.) 帮助数据专业人士转变为世界级的数据领导者和企业家。迄今为止,她已经向超过 100 万数据专业人士传授了人工智能知识。自 2008 年以来,她为美国海军、国家地理和沙特阿美等大型组织提供了战略规划。

相关:

-

数据职业不是一刀切的!揭示你在数据领域理想角色的提示

-

数据科学初学者应该避免的 10 个错误

-

麦肯锡教我的 5 个课程,能让你成为更优秀的数据科学家

相关话题

如何从不同背景转入数据科学?

原文:

www.kdnuggets.com/2023/05/transition-data-science-different-background.html

Bing 图像生成器

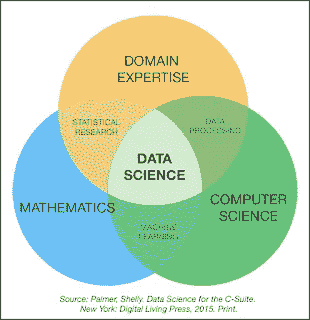

如果你来自非计算机科学背景,你知道要在数据科学领域找到一份工作需要付出多少努力。数据科学的机会吸引了很多人,但由于数据科学对世界来说还是很新的(不过十年时间!),按企业界的标准来说,真正自然符合数据科学家资格的人非常少。

这个行业充满了增长和机会,这也是为什么有人希望尽管来自完全不同的背景,仍然想要转入数据科学世界的主要原因之一。

注意: 我是少数知道数据科学可以适合非计算机科学背景人士的几个人之一,我希望这篇文章能帮助你找到提升自己旅程所需的指导。

在这篇文章中,我们将根据三个不同的部分讨论你应如何将数据科学作为职业过渡。

-

对于那些在大学里从未接触过与数据科学密切相关的任何学科的人来说。

-

对于那些来自非计算机科学背景但有几门与数据科学相关的课程且希望成为数据科学家的为什么不呢?

对于那些在某个行业工作了很长时间但现在想要转行进入数据科学这个既迷人又令人畏惧的世界的人来说。

注意: 这篇文章中的观点仅代表我个人,欢迎你对过渡过程有自己的看法或方法。我祝愿你一切顺利。

让我们直接进入正题。

第一阶段:你与数据科学关系不大,但你想进入这个领域。

好吧,在这种情况下,我会说你所付出的唯一努力是精神上的,这需要很多耐心。毫无疑问,数据科学是一个非常技术性的学科,涉及大量的数字。

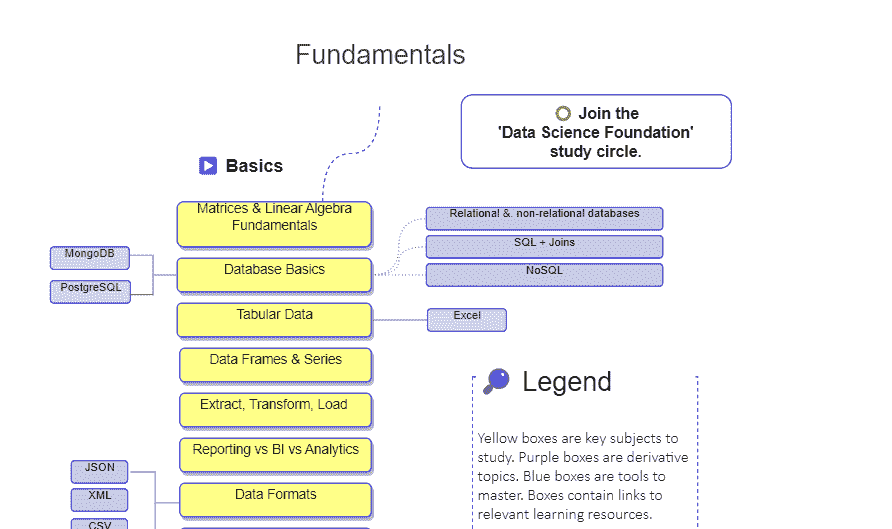

附言: 尝试首先查看一下,了解在数据科学领域取得成功的道路。然后你可以继续了解加速你的旅程所需注意的事项!

需要注意的事项:

-

数据科学就像其他任何学科一样,你总是可以在找到时间时开始学习。

-

开始永远不会太早,永远不会太晚。

-

数据科学是计算机科学、统计学、大学水平的数学、大量逻辑思维、编程语言和其他工具的结合。

-

制定你在各个领域(或特别是在你想成为专业人士的领域)的技能图谱,并进一步学习每个领域。

-

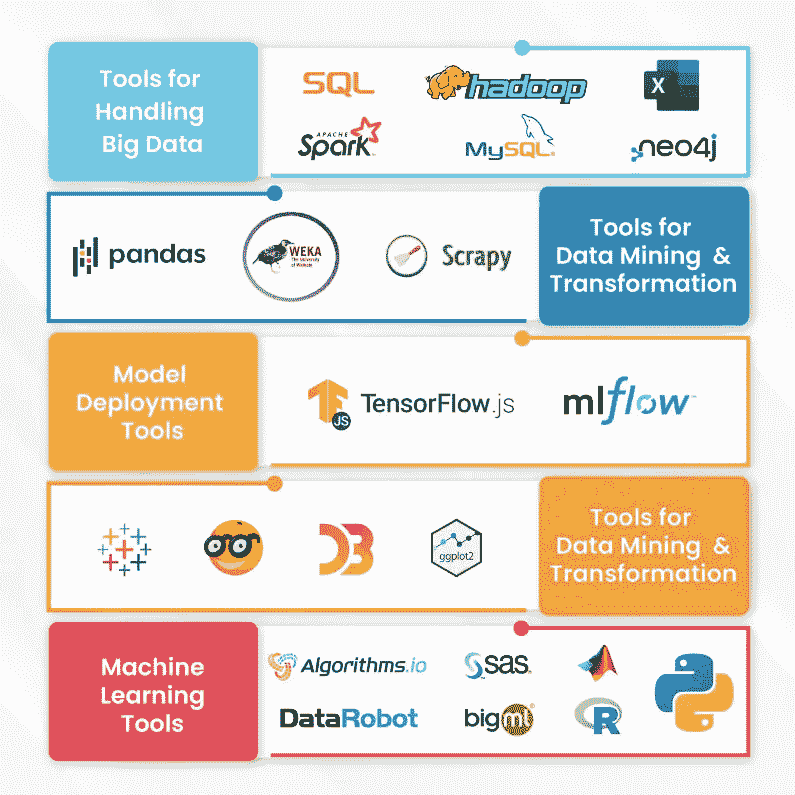

如果你想进入分析领域,提高你的统计知识和数据清洗等技能。(尽可能多地学习 Excel,它是小数据集分析的福音,也是最好的入门工具)

-

对于数据可视化,尝试学习 Tableau、PowerBI 等,但同时要理解可视化的工作原理以及如何制作更好的可视化和仪表板。

-

在学习的前两个月内,主要关注按以下顺序学习——Excel、SQL、Tableau,如果时间允许,学习 Python 基础。

有了这些,你可以进入第二阶段并继续学习。

注意:如果你是数据科学的新手,这将需要时间,所以要有耐心并相信过程。一切都会顺利的!

第二阶段:你已经涉及到一些数据科学的主题,但尚未完全投入其中。

这与我的阶段类似,我可以告诉你,学习数据科学确实需要相当大的努力。正如你最终会看到的,它依赖于许多因素,但在世界为开源学习和向任何渴望知识的人开放大门的情况下,这并不是很困难(即使他们来自非计算机科学背景)。

注意事项:

-

数据科学是一个复杂的领域,如果你试图将其整体来看,就会觉得很困难。只需将你想专注的每个组件看作是大拼图的一部分,你会顺利应对。

-

如果你想深入数据可视化方面,专注于理解仪表板和数据连接的工作原理,并学习数据故事讲述。

-

对于那些想进入机器学习领域的人,尝试理解如何使用 Python 或 R,如果选择 Python——学习 NumPy、Pandas、Scikit Learn、SciPy、Matplotlib 和 Seaborn 等库。

-

理解机器学习背后的理论概念,以便更好地理解你的算法。这可能需要时间,但理解过程比编写高等级的机器学习算法更重要。

-

如果你想推进你的分析能力——学习推断统计学,理解数据如何用于制定数据驱动的解决方案。学习如何处理非结构化数据,并尽可能多地清理数据集。

-

超越 SQL 中的常规 CRUD 命令,完美理解 JOINS 的工作原理以及如何使用 MySQL/PostgreSQL。如果你想深入 Excel,学习如何使用数据分析工具包和制作宏。

-

理解时间序列数据的工作原理,了解如何从来源中提取数据并进行时间序列预测,以推动你的学习。

你很可能会成为那些学习大量工具,并掌握所有内容到中级水平的群体之一。

我强烈建议你找到自己的专业领域并深入研究。在数据科学领域,知识量和竞争非常激烈,找到你的细分领域,确保凭借你独特的技能在竞争中脱颖而出。

第三阶段:你已经在一个行业中成为专家,但现在你想开始从事数据科学!

我认识的人中,有些人在决定要成为数据科学的一部分之前,已经在生活中拥有了令人惊叹的职位。长时间在特定行业工作后,想要改变职业是很自然的,我从那些曾经处于类似位置的人那里获得了一些有用的建议,希望能帮到你。

需要注意的事项:

-

一旦你在特定行业成为专业人士,可能是由于生活选择的改变或提升技能的需求,使你转向数据科学。

-

无论如何,数据科学领域的管理职位更愿意有在行业中有丰富企业经验的人。

-

在你现有的行业知识基础上提升数据科学技能,可能是你职业转型中最好的事情之一。数据科学虽然涉及计算机科学及其工具和技术,但在很大程度上依赖于领域知识。

-

拥有足够的领域知识,你可以通过利用数据的力量成为该领域的数据科学家,超越已有的做法。

-

行业特定的 KPI 和指标可以通过数据科学进一步开发和自动化,也可以为你打开新的大门。

-

拥有数据科学工具的额外知识,你可以在自己的领域成为培训师,并帮助新兴的数据科学家。可能性是无限的。

-

在这个阶段需要学习的工具和技能与本文前面提到的第一阶段和第二阶段相同。

无论如何,由于世界正转向数据科学,学习数据科学并坚持自己的职业领域是最好的选择。你所做的一切,都可以涉及数据,并将数据用于决策,只会让你的决策更出色。

过渡到数据科学领域并不困难,因为找工作本身并不难,而是因为有太多人在争夺这些职位。每个人都看到了这些机会,并知道-数据是未来-,数据科学也是如此。

对于那些已经具备数据科学技能的人,请继续关注,我会在这篇文章的另一部分中讨论如何从专家成长为数据科学领域的顶尖高手。

Yash Gupta 是一名数据科学爱好者与商业分析师,兼职技术作家,同时也是 Medium.com 的博主。他希望以易于理解的方式与更广泛的受众分享数据科学知识。他希望与所有像他一样喜欢数据的人分享自己的知识。他每天都尝试学习新事物,并热衷于指导初学数据科学的人。

原始内容。转载经许可。

更多相关话题

转型为数据科学:如何成为数据科学家,以及如何创建数据科学团队

原文:

www.kdnuggets.com/2017/12/transitioning-data-science-become-data-scientist-data-science-team.html

评论

评论

由 Amir Feizpour, 加拿大皇家银行

现在很难定义数据科学:每家公司都声称自己在做数据科学,每个人都声称自己是数据科学家。实践者对模糊的工作描述感到困惑,而试图成为数据科学家的人则对缺乏标准定义感到沮丧。在 2017 年多伦多机器学习峰会的讨论中,我们尝试揭示数据科学的奥秘,并澄清成为数据科学家的含义。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 工作

数据科学是应用科学方法理解数据以解决业务问题。“在我看来,一个优秀的数据科学家是一个非常重视数据科学中科学部分的人;能够通过统计、机器学习和分布式计算发现并解决问题的人。” 说的是 Thomson Reuters Labs 的研究总监 Amir Hajian。换句话说,数据科学家是能够“通过推理推断数据,用概率思考,保持科学和系统化,并利用软件工程最佳实践使数据大规模工作”的人,Aviva 的分析副总裁 Baiju Devani 说。他还补充说,重要的是要认识到,“你所解决的问题或找到的解决方案没有确定的路径,因此你必须接受模糊性,” 他说,您还需要“拥有那种实验性的思维方式,使您能够处理模糊的问题和解决方案定义。” 从某种意义上说,Lindsay Farber,MoneyKey 的高级数据科学家认为,最好的数据科学家是具有“良好的统计知识、编程和技术技能以及行业经验”的人。

微软加拿大首席数据科学家 Ozge Yeloglu 还提醒我们,在商业中需要“退后一步,了解数据科学真正是什么。它是利用数据来解决商业问题,这有时意味着没有必要使用机器学习或人工智能。” 关于数据科学的部分误解源于存在的炒作。每个企业都急于进入数据科学,而没有花时间了解为什么以及如何做。大公司在激烈竞争中争取雇佣尽可能多的数据科学家,而没有采取必要的基础步骤。“如果你有 100-200 名数据科学家(相比之下,比如 Facebook 有 500-600 名数据科学家),那么你可能在错误的行业中,” Baiju Devani 说。他补充说“虽然这些组织有很大的问题需要通过数据科学或机器学习来解决,但他们没有考虑如何将这些解决方案规模化。” 另一方面,一些初创公司过于急于通过机器学习解决所有问题,而没有考虑问题的适当规模。“如果你是一个拥有一千个客户的初创公司,你不应该进行情感分析,而是应该给每个客户打电话并与他们交谈,” Baiju Devani 说。从业者也在急于成为数据科学家,而没有真正理解这意味着什么。“每一个参加过几门在线课程的人都认为自己已经转行了,而实际上他们几乎没有投入足够的时间和精力,” Ozge Yeloglu 说。

然而,这种炒作并非完全毫无理由。确实有一些有趣的商业用例在业内引起了兴奋。“当我们的客户带着真正的数据业务问题找上我们,而我们可以利用我们的资源并结合他们的领域知识来帮助他们时,我真的感到非常高兴;这让我乐观地认为,炒作可以让我们比预期更快地实现现实,” Ozge Yeloglu 说。“组织希望找到一种新的商业方式,朝着以前不可能的方向发展,” Amir Hajian 说。他补充说,从业者想成为数据科学家,因为“他们希望找到那些不会结束的工作,并且不是每天重复同样的事情。” 他还表示“现在正是那些不是计算机科学家但希望进入这个行业并做一些有意义的事情的人的最佳时机。” 毕竟,这是一个不那么刻板的领域;“它在变化,它在找到自己的道路,并且在不断发展,所以你必须为此做好准备,你必须找到你喜欢的东西和你的细分领域,并且不断前进。”

鉴于存在的所有不确定性,有些事情可以做以增加作为数据驱动业务成功的可能性。Baiju Devani表示,其中一个最重要的步骤是:“问一下目标是什么,为什么需要数据科学,你需要不断问为什么,直到得到一个好的答案,然后其他的就自然会就位,” 下一步是建立一个高效的数据科学团队。团队的核心应该来自于业务本身,而不是任何新员工。Ozge Yeloglu说:“如果你能找到团队中已经是领域专家并理解数据的人,并且他们很可能已经在做传统的商业智能工作,如果他们想成为数据科学家,就让他们去做,并对他们进行投资,” 一旦形成了核心团队,根据优先级、时间框架和问题的复杂性,你可能会雇佣具有各种技能的人。大多数时候,最佳解决方案是让数据工程师来构建基础设施,然后在其上再加一个数据科学家,以及业务领域专家。事实上,Amir Hajian指出:“每个数据科学家都需要其他角色:数据可视化专家、开发人员和 UI/UX 设计师,”

数据团队的组成和文化确实非常重要。不同背景和思维方式的多样性提供了成功的关键因素。Baiju Devani说道:“我们谈了很多数据科学作为一种科学,但我认为它同样具有艺术性,需要大量的创造力,研究表明多样性会导致创造力,”Lindsay Farber说:“在我的公司,我必须与团队中的其他数据科学家合作,以提出更好的答案,”Amir Hajian补充道:“这是一项超越算法的艰巨工作:你必须清理数据,与客户沟通,构建整个模型,然后向利益相关者展示,并且要耐心,想出不同的方法来呈现给客户并解释给他们;这就是为什么拥有不同技术背景的人能够产生巨大影响,因为他们以不同的方式看待问题,并且具备专业知识,”Ozge Yeloglu表示:“我最近听到的一个故事是关于一个团队建立了一个检测疾病的模型,在训练中表现良好,但在实际测试中失败了;他们的训练数据完全是白人,这在拉丁裔人群、非裔美国人和亚洲人群中都失败了;这对有社会影响的公司来说是一个警示,如果你的团队看起来一样,那么他们的思维也会一样,”

创建数据科学团队时存在许多细微差别,草率处理必然会导致失败。目前,应该明确不同技术角色和专业知识以及软技能如何交织在一起,形成一个能够在数据科学领域实现伟大目标的团队。选择加入这样一个团队的个体是一个巨大的挑战,需要谨慎进行。“对我而言,团队文化是最重要的方面之一,因此我会寻找适合我团队和客户的成员。在我的团队中,数据科学家是具备非常高沟通技能的技术人员,他们能够与从数据科学家到副总裁和首席信息官的人员交谈。我在面试中通常会提出一个非常开放的案例研究,看看候选人是否能够提出正确的问题,找出正确的技术解决方案,并观察整个思考过程。” 奥兹格·耶洛格鲁说。她补充道“显然,技术技能很重要,但只要他们懂得 Python 或 R,我相信他们会继续学习和提升。这很重要,因为数据科学是一个不断发展的领域,所以你不能停滞不前。” 招聘经理在面试中还应关注候选人的头脑风暴能力和与团队合作的能力。“我会试图进行对话,看看你是否能够围绕数据科学进行讨论,而不仅仅是你技术上擅长的领域。如果我们超越这一点,我会倾向于拿起一篇论文并将其发送给候选人,要求他们来进行论文评审。我认为这样做效果很好,就像口试一样,比起在时间压力下让你写排序算法要好。” 拜祖·德瓦尼说。寻找擅长团队合作的人也至关重要。“我想强调的是,与市场营销主管、运营主管以及公司其他所有人沟通的技能真的很重要。你需要与他们交谈,以了解他们的数据需求,并向他们展示他们需要看到的内容,即使他们可能无法准确描述出来。” 林赛·法伯说。测试许多重要技能的一个好方法是要求候选人向面试官介绍他们最有趣的项目之一。“我发现通过这种方式找到最佳候选人,这从未失败过,因为这样可以立即让候选人展示他们能做什么、了解什么技术、如何思考问题以及如何沟通。你可以看到,有些人做不到这一点,而有些人则准备好并打开他们的笔记本电脑,向你展示他们所构建的东西。” 阿米尔·哈吉安说。

这些特征有些来自于个性,但经验也非常重要。这导致了一个大矛盾,因为市场上几乎没有经验丰富的数据科学家。大多数寻找数据科学职位的人都是刚刚毕业,因此没有所需的商业经验。“如果你缺乏行业经验,我认为参加 Andrew Ng 的课程、学习 Python 或者使用 Kaggle 上那些非常干净的不现实的数据集是一个方法,但为了进一步发展,你需要走出去,参加聚会和峰会,与其他数据科学家交谈,了解他们的工作,并参加面对面的课程。这将帮助你了解不同类型的数据科学家的工作内容,”Lindsay Farber 说道。她还认为,第一份工作不应设定过高的目标;“首先进入公司担任初级职位,逐步提升。当你表现出兴趣并努力工作时,你将拥有数据分析和数据科学的背景以及商业洞察力,最终为自己创造一个职位。”此外,告诉别人你与众不同的地方也很重要,超越那些每个人都能做的事情,比如参加在线课程。一种好的方法是“选择一个你感兴趣的问题,并围绕它开始构建一些东西。自学解决该问题所需的一切。这使学习过程变得有趣,你将开始学习作为数据科学家所需的所有技术和科学,”Amir Hajian 说道。无论你是来自学术界,还是已经在行业中工作并希望转行到数据科学领域,你都可以这样做。“你应该找到一个不在你工作描述中的扩展项目,但它将推动你进入数据科学领域。你可以实际使用公司的数据、现实世界的数据,通过这种方式获得经验,然后你可以展示你的潜力和愿望,”Ozge Yeloglu 说道。如果你有一个 Kaggle 竞赛的数据集,尽管大胆地发挥创意,想想你还能用它做些什么。甚至可以与许多现有的开源数据集结合,希望能从中得到一些有趣的结果。

我们之前讨论过候选人与公司文化匹配的问题,以及公司如何监控这一点。另一方面,考虑职位和公司的人应该在面试时或甚至在面试前收集关于公司的信息时提出问题。“我在寻找数据科学职位时听到的最有趣的事情是,当面试官在面试你时,你也在面试面试官。这是你了解这个角色生活将会是什么样子的机会。重要的问题包括:‘我将与谁合作?’,‘团队是什么样的’,以及‘你们正在解决哪些问题’。让他们给你讲讲他们最近做过的最令人兴奋的项目,并仔细倾听,对它提出很多问题,因为这会向你展示关于公司和团队的一切。” 说到阿米尔·哈吉安。奥兹格·耶洛格鲁指出,“在这样的对话中要记住一个重要的点是,人们是为经理工作,而不一定是为公司工作。你的经理实际上是你每天都要打交道的人,他们会决定你在公司里的成功与否。所以我认为与招聘经理沟通真的很重要。即使你没有安排那次通话,也要要求招聘人员安排。然后从那个人那里实际了解一下,看你是否能和他们建立联系。” 她还补充道,“我真的很喜欢有人问我关于成长机会的问题,因为这让我知道他们意识到这份工作并不轻松,他们必须每天不断学习。” 对于想要加入的公司和团队,提前做研究也很重要。“上 YouTube 看看是否有数据科学家最近做过演讲,观看所有这些演讲;看看他们是否发表过论文,阅读这些论文,这样你可以在面试中提到这些内容,而不是让他们告诉你,然后你可以展示你的知识。” 说到林赛·法伯。巴伊朱·德瓦尼建议,“这可能会稍微困难一点,但你也应该尝试找出是否可以与数据科学团队紧密合作的人交流,不论是业务方面还是更有可能的工程方面。弄清楚工程和数据科学团队的合作情况以及有什么样的动态。”

最后,对于从业者来说,了解作为数据科学家的生活实际情况是很重要的。“如果你来自学术背景,要记住公司并不是在寻找一个知道一切并能谈论其哲学的学者。面试你的公司有问题,他们面试你是有原因的。他们很可能希望你能帮助他们解决那个特定的问题。如果你能找出问题并说服他们你能帮助解决这个问题,你就能得到这份工作。所以要自信,找出问题,并告诉他们你打算如何解决它,” 阿米尔·哈吉安说道。林赛·法伯补充说“你需要意识到,你不能仅凭机器学习就解决所有问题。70%的工作是清理数据和预处理。你还需要意识到,仅仅做常规报告和基础统计分析也可以产生巨大影响。你可以将公司推进到 80%的进度,然后使用硬核数据科学和自定义模型将其提升到下一个层次。” 从某种意义上说,“你大多数时间只是一个被美化的 SQL 编码员或商业智能报告员。然而,你必须对数据充满热情,并记住任何周期中总会有起伏,但如果你真的对数据充满热情并感到兴奋,你将拥有一个非常有趣和令人满意的职业,” 巴伊朱·德瓦尼说道。

数据科学家之间有着巨大的互动和学习机会。找到最佳的下一份工作机会或招聘的最佳方法之一就是与志同道合的人建立网络。保持开放的心态,对每个人都要尊重,尽可能地帮助他人,他们也会在有机会的时候回过来帮助你。建立并维护良好的职业关系是非常重要的。“这对一些人来说可能显而易见,但不要断绝联系!例如,如果你正在面试,如果你意识到面试进展不如预期,不要感到沮丧或防御,而是请他们提出你可以改进的建议,” 奥兹格·耶洛格鲁说道。这是一个由知识分子组成的小社区,他们努力提升集体智慧并取得伟大成就。

点击这里查看有关讨论小组成员的详细信息。

点击这里查看讨论小组的视频。

个人简介:阿米尔·费兹普尔 是加拿大皇家银行的数据科学家,拥有物理学、分析学和数据科学的丰富研究经验。

相关内容:

-

数据科学家的一天

-

数据科学家的一天(续)

更多相关内容

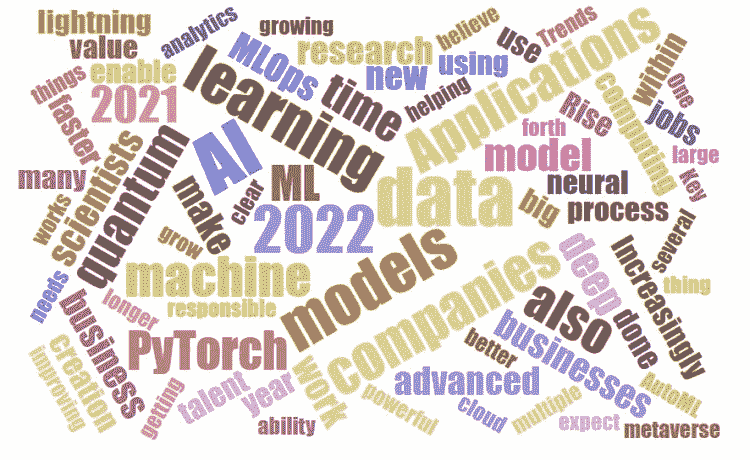

2021 年 AI、数据科学、机器学习技术的主要发展和 2022 年的关键趋势

原文:

www.kdnuggets.com/2021/12/trends-ai-data-science-ml-technology.html

评论 2021 年充满了起伏,但我希望对大多数人来说,它比 2020 年要好,生活逐渐回归正常,并且有一些愉快的传统。KDnuggets 的传统之一是我们每年的专家预测总结。

我们问专家的问题是

2021 年 AI、数据科学、机器学习的主要发展是什么?你对 2022 年有什么关键趋势的看法?

一些提到的重要话题包括 AutoML、自动化和 RPA、应用:更多更好、数据网格、数据结构和以数据为中心的方法、深度学习和 PyTorch、GPT-3 类系统、边缘设备、外部数据源、低代码和无代码 AI、MLOps、负责任的 AI、人才缺口和人员配置,以及量子计算/机器学习。

这里是我们的专家意见,包括 Marcus Borba、Kirk Borne、Tom Davenport、Carla Gentry、Doug Laney、Pierre Pinna (IPFConline)、Ganapathi Pulipaka、Kate Strachnyi 和 Mark van Rijmenam 的贡献。

同意?不同意?请在下方评论!

Marcus Borba,全球 AI、机器学习、数据科学领域的思想领袖和影响者。

目前,AI 正在被应用于大多数知识领域,并迅速发展,扩展到多个新领域,如 多模态 应用和更小的设备,使得技术发展以空前的速度增长。到 2021 年,对透明和 可信赖 的 AI 的关注促使负责任和可解释的 AI 概念变得更加重要,有助于理解 AI 如何运作。另一个看到强劲增长的领域是 超自动化,利用多种互联技术,如 AI 和机器学习、物联网、RPA 和增强分析,提升人机协作并实现更好的生产力。

对于 2022 年,我相信 量子机器学习 将是下一个大趋势。量子机器学习是量子计算和 AI 的交集,将使得创建更强大的机器学习和 AI 模型成为可能。随着大型技术公司对量子计算机上机器学习的开发和支持,资源将通过云模型可用。智能过程自动化 的不断发展和应用将为公司提供更大的灵活性,不仅仅是节省时间,还提高了操作效率并帮助简化流程。低代码 和 无代码 AI 解决方案也将越来越使公司能够开始使用 AI,从而更快且更低成本地开发 AI 模型。

Kirk D. Borne,数据科学家 @DataPrime_ai,首席科学官。全球讲者。创始人 @LeadershipData。顶尖 #BigData #DataScience #AI #IoT #ML 影响者。博士,天体物理学。

2021 年的重大趋势包括 AI/ML 在医疗应用、金融应用、面向客户的应用、物流/供应链应用以及元宇宙(游戏应用)中的快速扩展。即:应用、应用、应用,组织对其数据、AI、ML、数据科学资产和投资的生产力和价值要求越来越高。

到 2022 年,这种情况将持续,但人才缺口正带来越来越大的阻力,这可能成为这种增长势头的障碍。因此,我们可以预期组织会选择更多的低代码/无代码部署(如 AutoML),以利用和维持不断增长的 AI/ML 势头,这将进一步区分 AI 领先者与 AI 落后者,这也支持了老话“完成任务总比完美无瑕好”。

Thomas H. Davenport,Babson College 杰出教授;牛津大学 Said 商学院访问教授。

2021 年的一个重大进展是MLOps的兴起,以监控模型一旦投入生产后的表现。这在一定程度上是因为疫情的需要,在许多公司中,预测需求和供应的模型不再准确。检测模型漂移是 MLOps 的一个重要能力。但 MLOps 的兴起也是许多公司对机器学习模型依赖增加的结果,跟踪模型及其性能成为业务成功的关键。

这将在 2022 年继续,公司将使用 AutoML、MLOps 以及其他工具和流程改进来专业化 ML 开发。他们还会更明确地“谁做什么”在 AI 开发和部署中,为模型创建、模型部署、模型监控等任务创造专业角色。这些任务不能全由数据科学家负责。

Carla Gentry,Zuar 数据科学家和数据倡导者。

随着 Covid 继续影响我们的工作,公司在员工配置、远程与内部、数据在云端还是本地等方面进行了调整。一个明确的事实是,我们在数据及其影响力方面正处于十字路口。数据扩散已成为组织内部一个真实且昂贵的问题,正在损害创新。Hakkoda 调查,

“6% 的商业和 IT 领导者将他们的数据组织和流程称为垃圾堆。”

来自 (VentureBeat)

2022 年:我们将继续这种数据孤岛路径,因为每个部门总会有自己的议程和需求。能够将多个数据平台整合在一起的公司对于那些没有足够人才、时间或能力将所有数据结合起来进行决策的企业至关重要。对不良理念投入大量资金已不再被接受,投资回报率必须实现。让我们拥抱创新技术,但也要记住,数据本身是无用的,除非你对其进行处理!

道格拉斯·B·拉尼,创新研究员,数据与分析战略专家。《信息经济学》一书的作者——CIO 杂志年度必读书籍。

在 2022 年,人工智能、数据科学和机器学习的主要重点将是利用日益增长的外部数据源。由于 Covid-19 大流行和各国以及地方响应的不同、不断变化,使得许多组织的基本分析模型变得无用,甚至对业务有害。

随后,企业被迫放弃了依赖公司自身历史数据的趋势分析模型,转而采用基于驱动因素的模型,这些模型考虑了表现的领先指标。企业不再只是盯着自己的肚脐,而是被迫向组织外部寻找以诊断、预测和建议客户行为、库存水平、供应商可用性、人才需求、设备行为、竞争对手反应、合作伙伴能力等方面的信息。

这意味着数据科学家和人工智能开发者的新最佳伙伴(如果不是其他同样吸引人的人)是那些专注于研究和获取新的高价值替代数据源的个人。2022 年将是数据策展人的年代。

皮埃尔·皮纳,IFFConline CEO,数字化转型咨询。

对于 IPFConline 团队来说,2021 年标志着OpenAI GPT-3类型系统在自然语言处理领域的“战斗”,这些模型变得越来越强大且数据密集。同时,Yoshua Bengio 团队发布了一篇关于GFlowNet 基础的非凡新论文,提出了在机器学习中实现因果发现与推理的重大进展。

对于 2022 年,我们相信人工智能领域的愿景将是提升模型可解释性。因此,研究将越来越多地转向符号 AI 与实际统计深度神经网络的混合模型。这种解决方案将使得从业者对负责任系统的可信采用充满信心。

甘纳帕提·普利帕卡博士,首席人工智能高性能计算科学家,演讲者,畅销书作者。

PyTorch Lightning 使深度学习研究社区能够将更多时间用于研究,减少工程方面的时间。今年,它作为一个流行的深度学习框架取得了进展,可以在分布式硬件和高性能计算机器上读取和重现研究成果。PyTorch Lightning 在 GPU、TPU 和 CPU 上都是一个不容忽视的力量。自然语言处理在 2021 年随着 PyTorch Tabular 的推出取得了进展。PyTorch Tabular 在深度学习中处理 Pandas 数据框,因为没有像 Scikit-learn 这样的现成库用于深度学习。它运行在 PyTorch 和 PyTorch Lightning 上。

在 2022 年,我们可以期待分布式量子计算机上的量子机器学习以及量子卷积神经网络的训练。2022 年的图神经网络研究继续加速。企业在 2022 年继续采用 PyTorch、TensorFlow、Python 以及诸如 DQN 等强化学习算法,服务于各个行业。

凯特·斯特拉赫尼,DATAcated 创始人。

2021 年主要进展

-

我们看到越来越多的公司认识到数据的价值,并拥抱数据驱动的文化。

-

数据平台内的创新使企业更容易理解其数据,并缩短洞察和数据驱动决策的时间。

2022 年关键趋势

-

数据网格、数据织物、数据仓库的兴起以及向数据中心化的转变;逐渐远离应用/模型中心化。

-

对能够处理大规模合成数据集创建、处理和评估的数据科学家的需求增加;这与元宇宙中的创新有关。

马克·范·赖门南博士,未来技术战略家,主题演讲者,三次著作作者及企业家。

人工智能和机器学习将在自动化工作中发挥更大的作用。对于非编码人员或非数据科学家来说,这将导致更先进的机器人流程自动化,使办公室工作人员和经理能够在不需要编码知识的情况下进一步自动化自己的工作。因此,员工将能够完成更多的工作,因为大多数单调的工作现在可以被自动化。然而,如果没有编码专长的员工和管理层可以利用 AI 和 ML 来自动化他们的工作,那么那些拥有这些技能的人当然也可以应用相同的策略。

当然,这可以与使用 GPT-3 更快地编写代码相关联,但在 2022 年我们还将看到更先进、自动化和智能的黑客攻击。黑客们将越来越多地转向 AI 来完成更多工作、更快地渗透组织并窃取更多数据。同时,保护公司的人也将转向 AI,因此黑客和 IT 安全人员都会使用 AI,导致一场在光速下进行的战斗。

也可以查看人工智能、分析、机器学习、数据科学、深度学习研究2021 年的主要发展及 2022 年的关键趋势,本周早些时候发布。

相关:

-

人工智能、分析、机器学习、数据科学、深度学习研究2021 年的主要发展及 2022 年的关键趋势

更多相关主题

计算机视觉技术和应用的最新趋势

原文:

www.kdnuggets.com/2018/11/trends-computer-vision-technology-applications.html

评论

评论

由 Valeryia Shchutskaya、InData Labs。

计算机视觉软件正在改变各个行业,使消费者的生活不仅变得更加轻松,还变得更加有趣。作为一个领域,计算机视觉得到了大量宣传和相当数量的投资。北美市场的计算机视觉软件总投资达到了 1.2 亿美元,而中国市场则猛增至 39 亿美元。让我们深入了解一下那些最有前景和最令人兴奋的技术,它们使计算机视觉软件开发市场增长如此迅速。

深度学习的进展

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

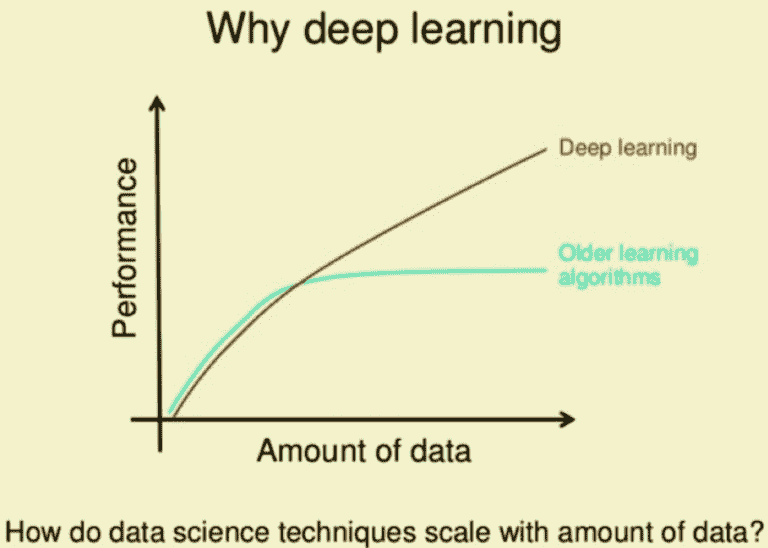

深度学习因其在提供准确结果方面的优势而获得了广泛的关注。

传统的机器学习算法,尽管它们可能很复杂,但其核心仍然非常简单。它们的训练需要大量的领域专业知识(这很昂贵),当出现错误时需要人工干预,最终它们只擅长于它们所训练的任务。

深度学习算法则通过一个神经网络来了解当前任务,将任务映射为一系列概念的层次结构。每个复杂的概念都由一系列简单的概念定义。这一切算法都可以自行完成。在计算机视觉的背景下,这意味着首先识别光暗区域,然后分类线条、形状,最后才进行完整的图像识别。

深度学习算法在数据更多时表现更好,而这在机器学习算法中并不常见。

对于计算机视觉来说,这无疑是个好消息。它不仅使得训练深度学习算法时可以使用更多的图片和视频,还减轻了与数据标注和标签相关的工作量。

零售行业在计算机视觉软件的应用上一直处于先锋地位。ASOS 在 2017 年为其应用增加了按照片搜索选项,随后许多零售商也效仿。有些甚至更进一步,利用计算机视觉软件将在线和离线体验更紧密地结合在一起。

一家名为 Lolli & Pops 的美食糖果零售商使用面部识别技术来识别进店的常客。因此,店内员工能够通过提供个性化的产品推荐和偶尔的忠诚折扣来个性化购物体验。

特殊待遇培养了品牌忠诚度,并将偶尔的顾客转变为常客,这对业务都是有益的。

边缘计算的兴起

连接到互联网和云端的机器能够从网络收集的数据中学习并进行相应调整,从而优化系统性能。然而,连接互联网和云端并不总是有保障。这就是边缘计算发挥作用的地方。

边缘计算指的是附加在物理机器上的技术,如燃气涡轮机、喷气发动机或 MRI 扫描仪。它允许数据在收集地点进行处理和分析,而不是在云端或数据中心完成。

边缘计算并不会取代云计算。它只是让机器在需要时根据新的数据洞察单独行动。换句话说,边缘设备上的机器可以根据自身经验学习和调整,独立于更大的网络。

边缘计算解决了网络可达性和延迟的问题。现在,设备可以放置在网络连接差或不存在的区域,而不会影响分析结果。此外,边缘计算还可以抵消部分数据共享云计算的使用和维护成本。

对于计算机视觉软件来说,这意味着可以更好地实时响应,并且只将相关洞察转移到云端进行进一步分析。这个功能对于自动驾驶汽车尤其有用。

为了安全操作,这些车辆需要收集和分析大量关于周围环境、方向和天气条件的数据,更不用说还要与路上的其他车辆进行实时通讯。依赖云解决方案分析数据可能是危险的,因为延迟可能导致事故。

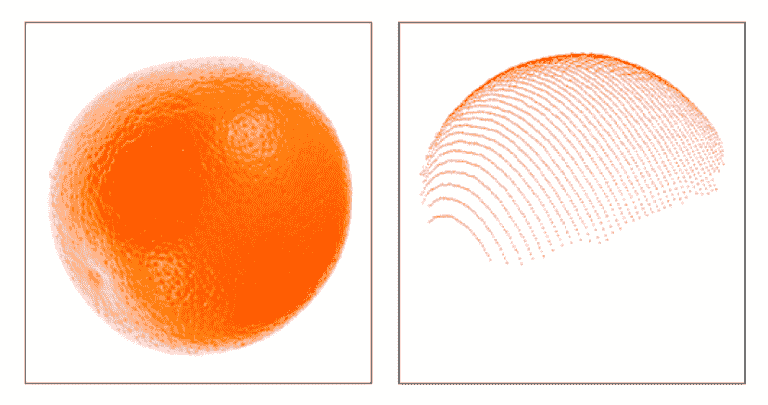

使用点云进行物体识别

最近在物体识别和跟踪中使用频率更高的技术是点云。简单来说,点云是定义在三维坐标系统中的数据点集合。

这项技术通常用于一个空间内(例如一个房间或容器),其中每个物体的位置和形状由一组坐标(X、Y 和 Z)表示。这个坐标列表被称为“点云”。

此技术提供了物体在空间中的准确表示,并且任何运动都可以被准确跟踪。

点云的应用几乎是无尽的。以下是一些行业及其从此技术中获益的例子:

-

文档:资产监控、建筑工地跟踪、破坏检测。

-

分类:城市规划、用于更简便分析的审计工具、必要的公用事业工作映射。

-

变化检测:资产管理、货物跟踪、自然灾害管理。

-

预测性维护:对资产和基础设施进行持续监控,以预测何时需要维修。

融合现实:增强的 VR 和 AR

今天,任何 VR 或 AR 系统都可以创建沉浸式 3D 环境,但与用户所在的真实环境几乎无关。大多数 AR 设备可以执行简单的环境扫描(例如,Google ARCore 可以检测平面表面和光照条件的变化),而 VR 系统可以通过头部跟踪、控制器等检测用户的动作,但它们的能力仅此而已。

计算机视觉软件正在将 VR 和 AR 推向被称为融合现实(MR)的下一个发展阶段。

借助外部摄像头和传感器来绘制环境地图,以及眼动追踪解决方案和陀螺仪来定位用户,VR 和 AR 系统能够:

-

感知环境并引导用户避开如墙壁、物品或其他用户等障碍物。

-

检测用户的眼动和身体动作,并相应地调整 VR 环境。

-

提供室内环境、公共空间、地下等的指导和方向。

硬件商店 Lowe’s 已经在他们的商店中使用了这项技术。每位购物者可以借用一个 AR 设备,在设备上制定购物清单并获取商店中每件物品的方向。该 AR 设备实时使用楼层图、库存信息和环境映射来提供准确的方向。

Sephora 更新了他们的虚拟艺术家应用程序,提供实时 3D 面部识别,让顾客可以看到不同化妆品在他们脸上以及不同光照条件下的效果。

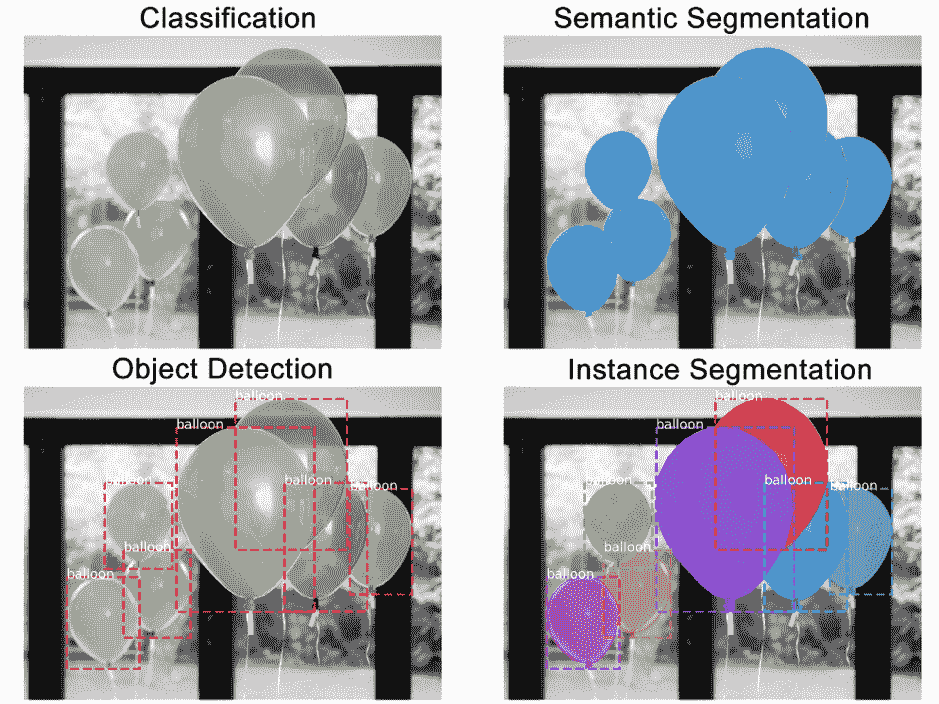

语义实例分割

要理解语义实例分割是什么,首先我们将这一概念拆分为两个部分:语义分割和实例分割。

实例分割在像素级别识别物体轮廓,而语义分割则只是将像素分组到特定的物体组。让我们用气球的图像来说明这两种技术与其他技术的比较。

-

分类:此图像中有一个气球。

-

语义分割:这些是所有的气球像素。

-

物体检测:此图像中的这些位置有 7 个气球。我们开始考虑重叠的物体。

-

实例分割:这些位置有 7 个气球,这些是属于每个气球的像素。

将语义分割和实例分割方法结合起来,成为一种强大的工具。这不仅可以检测出图像中属于物体的所有像素,还可以确定这些像素属于哪个物体以及物体在图像中的位置。

语义实例分割是用于土地覆盖分类的有用工具,具有多种应用。通过卫星图像进行土地映射可以帮助政府机构监测森林砍伐(特别是非法砍伐)、城市化、交通等。

许多建筑公司也在使用这些数据进行城市规划和建筑开发。有些公司甚至更进一步,将其与 AR 设备结合,以了解他们的设计在现实生活中的样子。

简历:Valeryia Shchutskaya 是InData Labs的市场经理——一家提供 AI 驱动的软件和技术解决方案的专业服务公司,致力于帮助公司利用数据和机器学习算法创造业务价值。

原创。经许可转载。

相关:

更多相关主题

2020 年机器学习的趋势

原文:

www.kdnuggets.com/2020/03/trends-machine-learning-2020.html

comments

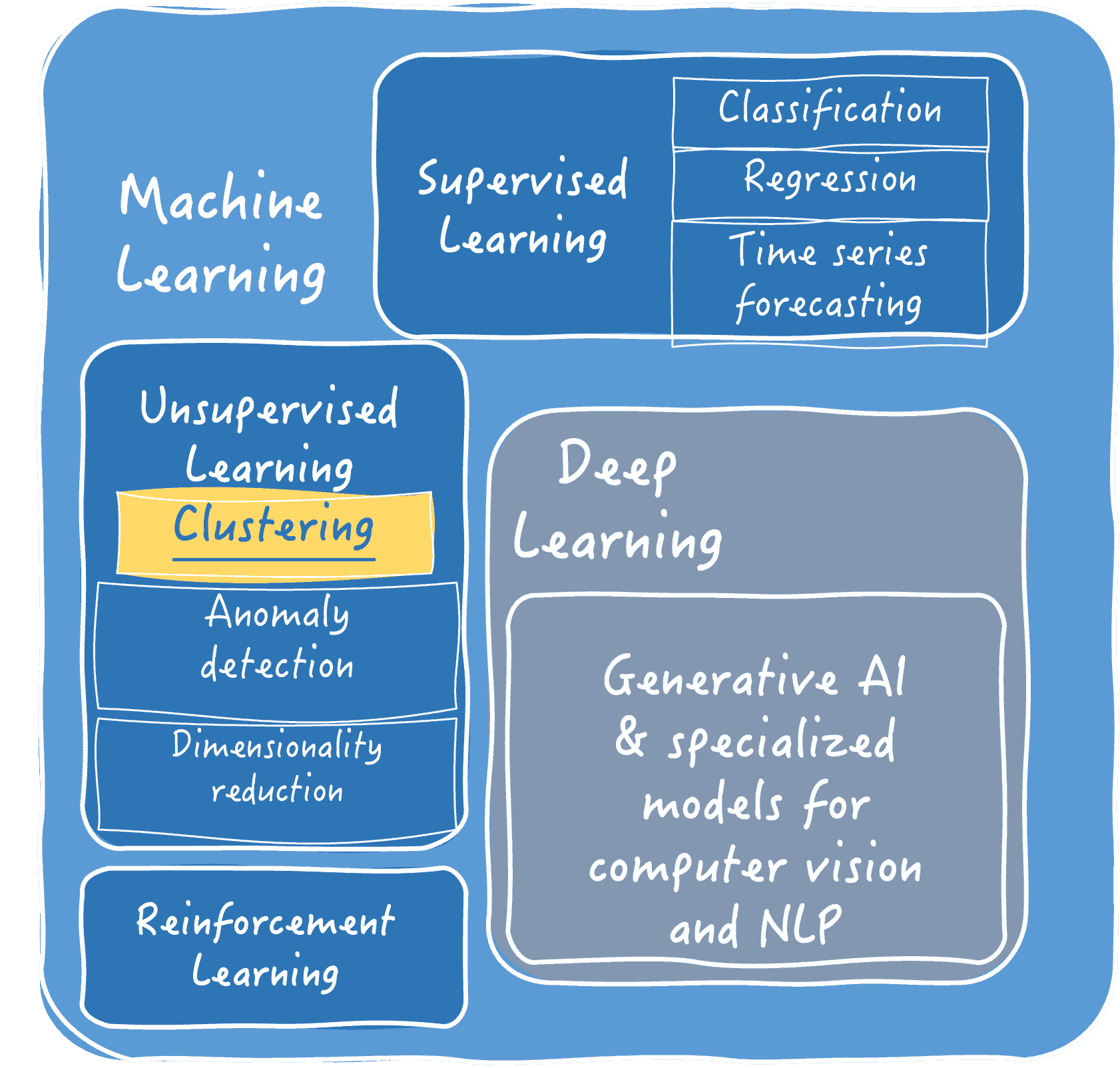

对许多人来说,机器学习可能是一个新词,但它首次由阿瑟·萨缪尔于 1952 年提出,此后,机器学习的持续evolution of Machine Learning使其成为许多行业的首选技术。从机器人过程自动化到技术专业知识,机器学习技术被广泛应用于预测和获取业务运营中的宝贵见解。它被视为人工智能(由机器展示的智能)的一个子集。

如果从书本上看,机器学习可以被定义为对统计模型和复杂算法的科学研究,这些算法主要依赖于模式和推理。这项技术独立于任何明确的指令,这就是它的强项。

机器学习的影响颇为引人入胜,因为它引起了许多公司,无论其行业类型如何的关注。说到底,机器学习确实从根本上改善了行业的基础。

机器学习的重要性可以归因于 2019 年第一季度在这项技术上分配了$28.5 billion,如 Statista 报道。

考虑到机器学习的相关性,我们预测了将在 2020 年进入市场的趋势。以下是这些备受期待的机器学习趋势,它们将改变全球各行业的基础。

1) 数字数据的管理

在今天的世界里,数据就是一切。各种技术的出现推动了数据的补充。无论是汽车行业还是制造业,数据的生成速度都达到了前所未有的水平。但问题是,“所有的数据都是相关的吗?”

为了解开这个谜团,机器学习可以被部署,因为它可以通过建立云解决方案和数据中心来处理任何数量的数据。它根据数据的重要性进行过滤,提取出功能数据,同时留下废料。这种方式节省了时间,同时也帮助组织管理开支。

在 2020 年,将会产生大量数据,行业将需要机器学习来分类相关数据,以提高效率。

2) 语音助手中的机器学习

根据2019 年 emarketer 研究,估计到 2019 年,美国将有 111.8 百万用户使用语音助手。因此,语音助手显然是各行业的重要组成部分。Siri、Cortana、Google Assistant 和 Amazon Alexa 是一些需求量大的智能个人助手例子。

机器学习结合人工智能,帮助以极高的准确性处理操作。因此,机器学习将帮助各行业轻松完成复杂和重要的任务,同时提高生产力。

预计到 2020 年,研究和投资的增长领域将主要集中在开发定制设计的机器学习语音助手上。

3) 有效营销

营销是每个企业在激烈竞争环境中生存的关键因素。它促进了企业的存在感和可见度,同时推动了预期的结果。但由于现有的多种营销平台,甚至证明企业的存在也变得具有挑战性。

然而,如果一个企业能够成功地从现有用户数据中提取模式,那么该企业很可能会制定出成功和有效的营销策略。为了分析数据,可以部署机器学习来挖掘数据并评估研究方法以获得更有利的结果。

未来,机器学习在制定有效营销策略方面的应用受到高度期待。

4) 网络安全的发展

近年来,网络空间成为了热门话题。据 Panda Security 报告,黑客每天创建约 230,000 个恶意软件样本,创建恶意软件的意图总是非常明确。而对于计算机、网络、程序和数据中心来说,检查恶意软件攻击变得更加复杂。

幸运的是,我们拥有机器学习技术,它通过自动化复杂任务和独立检测网络攻击来帮助多层保护。不仅如此,机器学习还可以扩展到对网络安全漏洞做出反应并减轻损害。它可以在不需要人工干预的情况下自动响应网络攻击。

未来,机器学习将被用于先进的网络防御程序,以控制和减少损害。

更快的计算能力

行业分析师已经开始掌握 人工神经网络的力量,这是因为我们都能预见到算法突破将是帮助问题解决系统所需的。在这里,人工智能和机器学习可以解决复杂的问题,这些问题将需要探索和调节决策能力。一旦这一切被破解,我们可以期待体验到不断增强的计算能力。

像英特尔、Hailo 和 Nvidia 这样的企业已经做好了通过定制硬件芯片和解释 AI 算法来增强现有神经网络处理的准备。

一旦企业弄清楚运行机器学习算法所需的计算能力,我们可以期待看到更多的力量中心,这些中心可以投资于为边缘数据源打造硬件。

结尾

毫无保留地说,机器学习日益壮大,到 2020 年,我们将体验到这种创新技术的更多应用。为什么不呢?借助机器学习,行业可以预测需求并在利用先进的机器学习解决方案时做出快速决策。管理复杂任务并保持准确性是业务成功的关键,而机器学习在这方面表现无瑕。

如上所述,机器学习的所有趋势都相当实际,并且在提供前所未有的客户满意度方面看起来很有前景。不断发展的行业的动态维度进一步推动了机器学习趋势的相关性。

简介: 塔尼亚·辛格 是一位知名内容营销人员,在区块链、Flutter、物联网等新兴技术领域有超过五年的经验。在这些年里,她紧跟科技行业的步伐,现在她写关于应用世界最新动态的文章。

相关:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

更多相关主题

我如何在 18 个月内通过数据科学将收入翻了三倍

原文:

www.kdnuggets.com/2021/10/tripled-my-income-data-science-18-months.html

图片由Karolina Grabowska提供

大约 18 个月前,由于 COVID-19 疫情,我失去了工作。我在大学期间兼职担任辅导员。我从辅导中获得的收入用于支付食物、汽油和汽车等费用。

在政府对整个国家实施封锁限制后,我无法继续教学。我也不能去大学,只能在家学习。

尽管一开始这似乎很糟糕,但我意识到不去上大学和工作使我腾出了很多时间。

我在这段时间开始着手扩展我的技能。经过一些研究,我发现了一个看起来很有趣的机器学习在线课程。

那是我完成的第一个在线课程。

之后,我把大部分时间花在了构建项目、学习编码和获得在线认证上。

现在——18 个月过去了,我凭借在数据科学和分析领域的知识建立了多个收入来源。

1. 全职工作

我首先以数据科学实习生的身份加入了一家公司,现在已全职工作在那里。

起初,我预期我的工作主要是模型构建。

然而,一旦我加入后,我意识到我的工作只有大约 10%是模型构建。其余时间,我和我的团队在寻找新的解决方案来解决业务问题。

经常,这些问题甚至不需要机器学习来解决。数据解决方案可能只是将业务逻辑转化为简单的 SQL 查询。

我每天的工作涉及回答这样的问题:

-

我们如何利用数据来查找关于公司 A 竞争对手的信息?

-

我们已经建立了一个客户流量预测模型。我们可以识别哪些商业用例来测试这个模型?它在生产环境中的表现是否与在测试环境中的一样?

-

我们如何持续改进客户的细分和绩效?我们是否能够从可用的数据中推断出现实场景?

这是对我日常工作的一种非常抽象的描述,但我想强调的是,创建数据科学解决方案并不仅仅是模型构建的开始和结束。

如果你是一个有志成为数据科学家的新手,我建议你获得一些你想从事的行业领域的知识。

2. 数据科学博客

我写下了我在数据科学领域的经验。

如果我在工作中构建一个项目,我会在 Kaggle 上找到类似的数据集,重复分析,并围绕它创建一个教程。

我最初开始编写和发布数据科学教程以增强我的个人作品集。

撰写关于我工作的文章是我与其他有志于数据科学的人联系的一种方式。它也是展示我编码和构建机器学习模型能力的一种方式。

起初,我从未期望通过我的写作获得报酬。我只是认为这是一个很好的方式来提升我的数据科学作品集。

然而,在过去的一年里,最初作为爱好的事情开始带来了收入。

现在,我通过简单地创建与数据相关的教程、项目以及撰写我的经验来赚取被动收入。

3. 自由职业

当我开始在数据科学社区内建立在线存在时,我开始接到多个自由职业的邀请。我为客户建立了机器学习模型,创建了竞争对手分析报告,并撰写了数据科学文章。

当我最初想到自由职业时,我想象着需要在一个在线平台上竞争和竞标项目。

然而,我所有的自由职业客户都是在阅读我的文章或查看我的作品集项目后联系我的。

几个月前,我建立了一个聚类算法,并在线发布了一个教程。第二天,有人联系我,询问我是否有兴趣为他们的客户构建一个聚类模型。

自由职业让我掌握了很多在我通常工作领域之外的技能。

在我的公司中,我处理的数据通常以某种预处理格式出现,我使用 SQL 和 Python 来查询数据并加以利用。

然而,在自由职业过程中,客户的数据格式非常不同。大部分数据未经过处理或结构化,我花了很多时间来搞清楚数据集之间的关系并理解它们。

我还需要收集外部数据来进行分析,这通常涉及到抓取第三方网站并使用开源工具。

我觉得自由职业让我接触到在日常工作中没有的知识,并且我能够在每个项目中学到新东西。

我是如何来到这里的?

我在上面提到过我参加了一个数据科学在线课程,事情从那时开始发生了变化。你可能会想知道怎么回事。

说实话,在参加我的第一个数据科学在线课程后,我感到迷茫。我花了大约一个月的时间学习不同的算法并使用 Scikit-Learn 训练模型。

我完全不知道接下来该怎么做。

我开始阅读关于那些没有硕士学位或任何专业资格却成功获得数据科学工作的人的文章。我意识到领域知识的重要性以及利用现有数据解决问题的必要性。

我并不需要建立最准确的模型或理解模型背后的算法。

我意识到,对我来说最重要的技能是利用数据解决问题的能力。这意味着我必须超越机器学习算法。

我参加了商业分析和机器学习工程的课程。我花了更多的时间学习编码,而不是理论。我花时间学习 SQL 和数据处理。

然后,我通过网络抓取从在线网站收集了自己的数据。我利用这些数据解决了一个问题,并用它构建了一个简单的机器学习网页应用。

通过这种方式,我逐渐获得了成为全栈数据科学家所需的技能。

即使在我工作的数据分析团队中,如果有任何超出我们日常工作范围的项目(需要外部数据收集或新算法的项目),我通常是被分配到这些项目的人。

结论

作为一个有抱负的数据科学家,在线有很多资源可供使用。实际上,太多了,以至于你不知道选择什么。

然而,大多数强调都集中在模型构建上。

虽然了解模型构建和训练的基本原理很重要,但大多数可用的工作要求你超越这一点。

实际需求是能够利用现有数据解决问题的人。

Natassha Selvaraj 是一位自学成才的数据科学家,热衷于写作。你可以通过 LinkedIn 与她联系。

更多相关话题

如何排查 Python 中的内存问题

原文:

www.kdnuggets.com/2021/06/troubleshoot-memory-problems-python.html

评论

由 Freddy Boulton,Alteryx 的软件工程师

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 维护

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 维护

发现应用程序内存不足是开发人员可能遇到的最糟糕的情况之一。内存问题通常很难诊断和修复,但我认为在 Python 中更是如此。Python 的自动垃圾回收机制使得语言易于上手,但它非常隐蔽,当它未按预期工作时,开发人员可能会不知道如何识别和解决问题。

在这篇博客文章中,我将展示我们是如何诊断和修复 EvalML 中的内存问题的,这是一款由 Alteryx 创新实验室开发的开源 AutoML 库。解决内存问题没有魔法公式,但我希望开发人员,特别是 Python 开发人员,可以了解在将来遇到此类问题时可以利用的工具和最佳实践。

阅读完这篇博客后,你应该能获得以下知识:

-

为什么发现和修复程序中的内存问题如此重要,

-

什么是循环引用,为什么它们可能在 Python 中引起内存泄漏,以及

-

了解 Python 的内存分析工具以及一些可以采取的步骤,以确定内存问题的原因。

设定背景

EvalML 团队在发布我们包的新版本之前,会进行一系列性能测试,以捕捉任何性能回退。这些性能测试包括在各种数据集上运行我们的 AutoML 算法,测量算法的得分以及运行时间,并将这些指标与我们之前发布的版本进行比较。

一天,我在运行测试时,应用程序突然崩溃了。发生了什么事?

第 0 步 - 什么是内存,什么是泄漏?

任何编程语言最重要的功能之一是其在计算机内存中存储信息的能力。每次你的程序创建一个新变量时,它都会分配一些内存来存储该变量的内容。

内核定义了一个接口,供程序访问计算机的 CPU、内存、磁盘存储等。每种编程语言都提供了请求内核为运行中的程序分配和释放内存块的方法。

内存泄漏发生在程序请求内核分配一块内存用于使用,但由于错误或崩溃,程序没有告诉内核它何时完成使用那块内存。在这种情况下,内核会继续认为被遗忘的内存块仍在被运行中的程序使用,其他程序将无法访问这些内存块。

如果在运行程序时相同的泄漏反复发生,遗忘的内存总量可能会增长到占用计算机内存的大部分!在这种情况下,如果程序尝试请求更多内存,内核将引发“内存不足”错误,程序将停止运行,换句话说,就是“崩溃”。

因此,找到并修复你编写的程序中的内存泄漏非常重要,因为如果不修复,你的程序最终可能会耗尽内存而崩溃,或者可能会导致其他程序崩溃。

步骤 1:确认这是一个内存问题

应用程序崩溃可能有多种原因——也许是运行代码的服务器崩溃了,也许是代码本身存在逻辑错误——因此确定当前问题是内存问题非常重要。

EvalML 性能测试以一种异常安静的方式崩溃了。突然间,服务器停止记录进度,任务安静地完成了。服务器日志会显示由代码错误引起的任何堆栈跟踪,因此我猜测这种无声的崩溃是由于任务使用了所有可用内存。

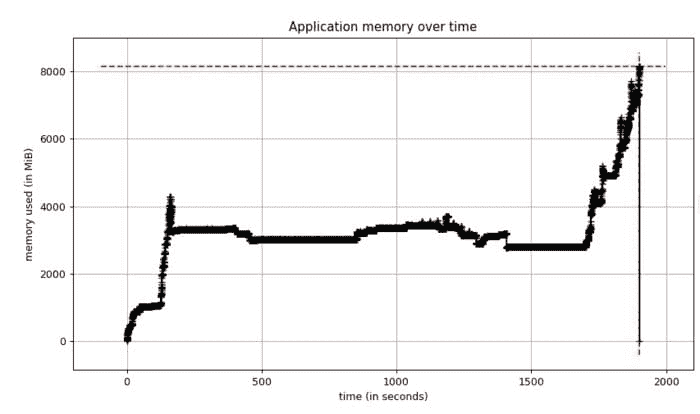

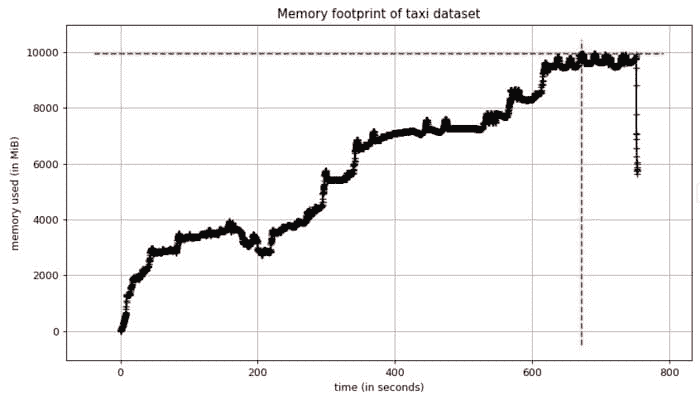

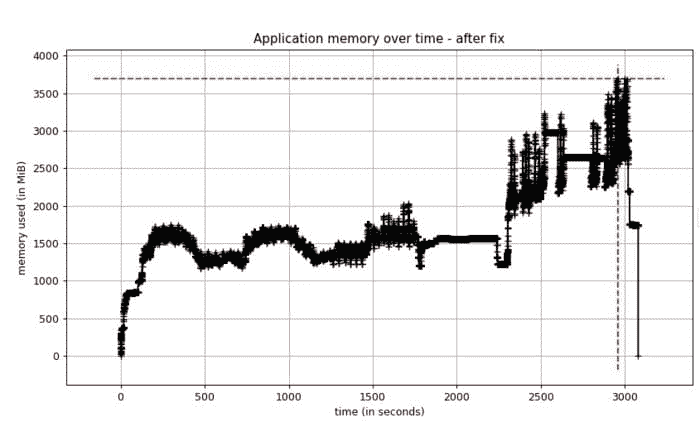

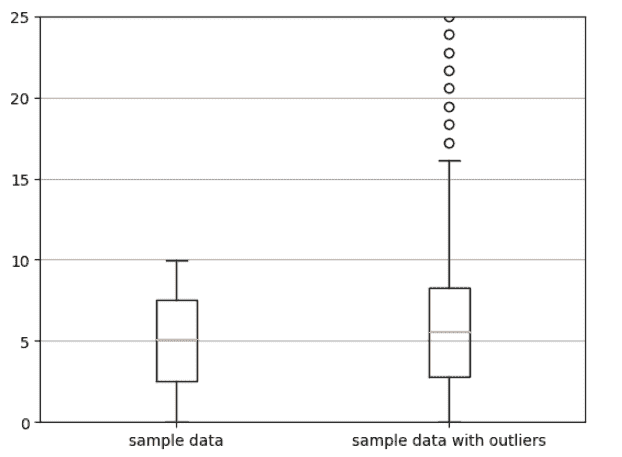

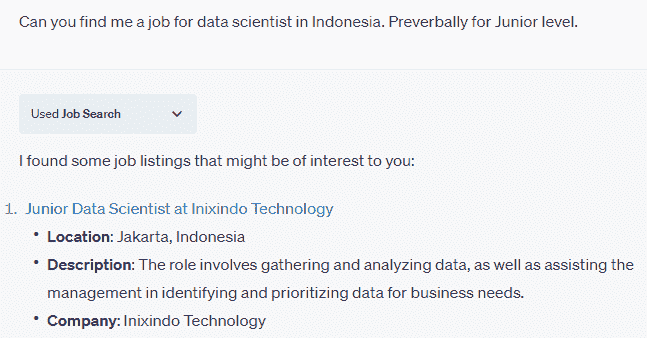

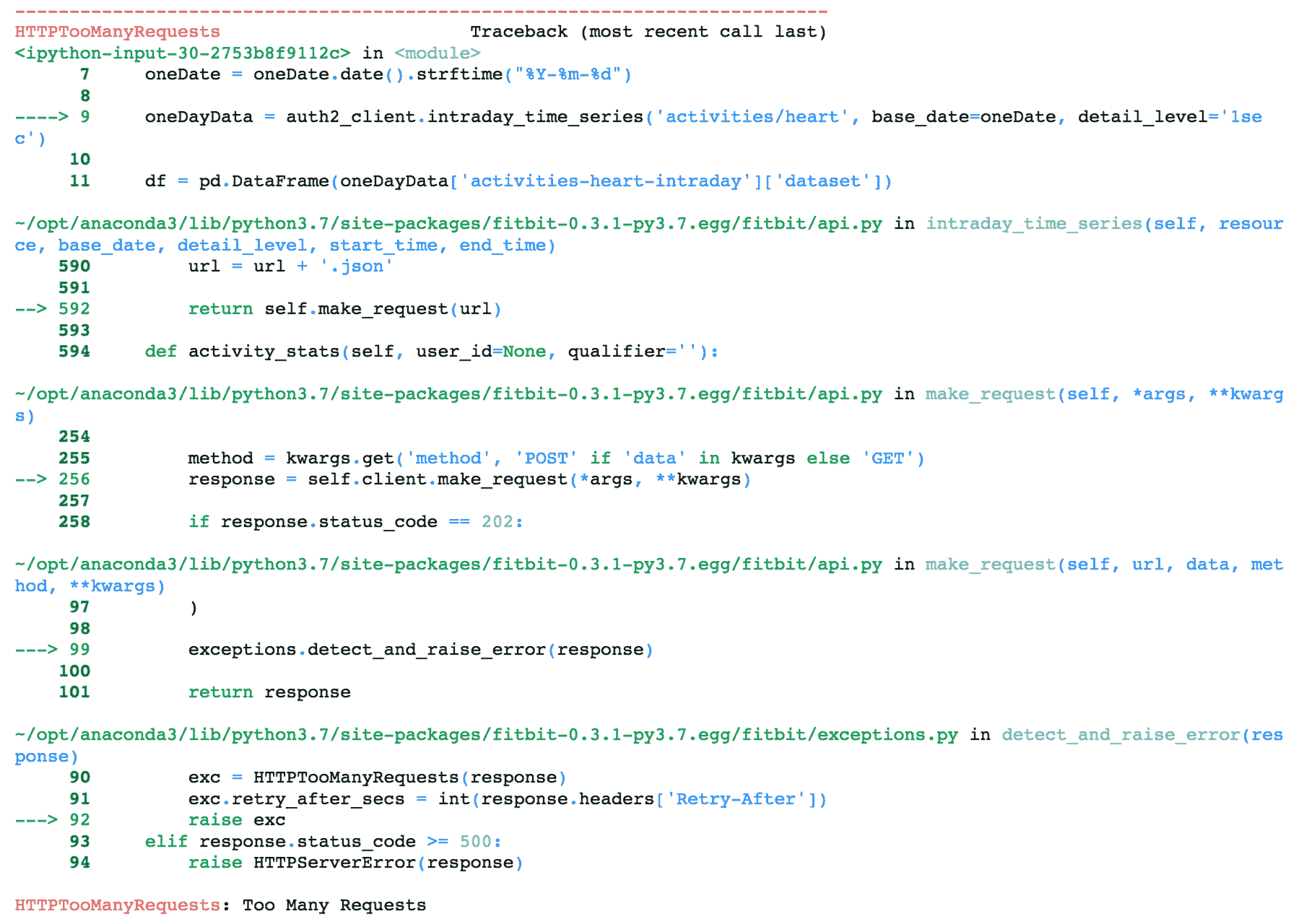

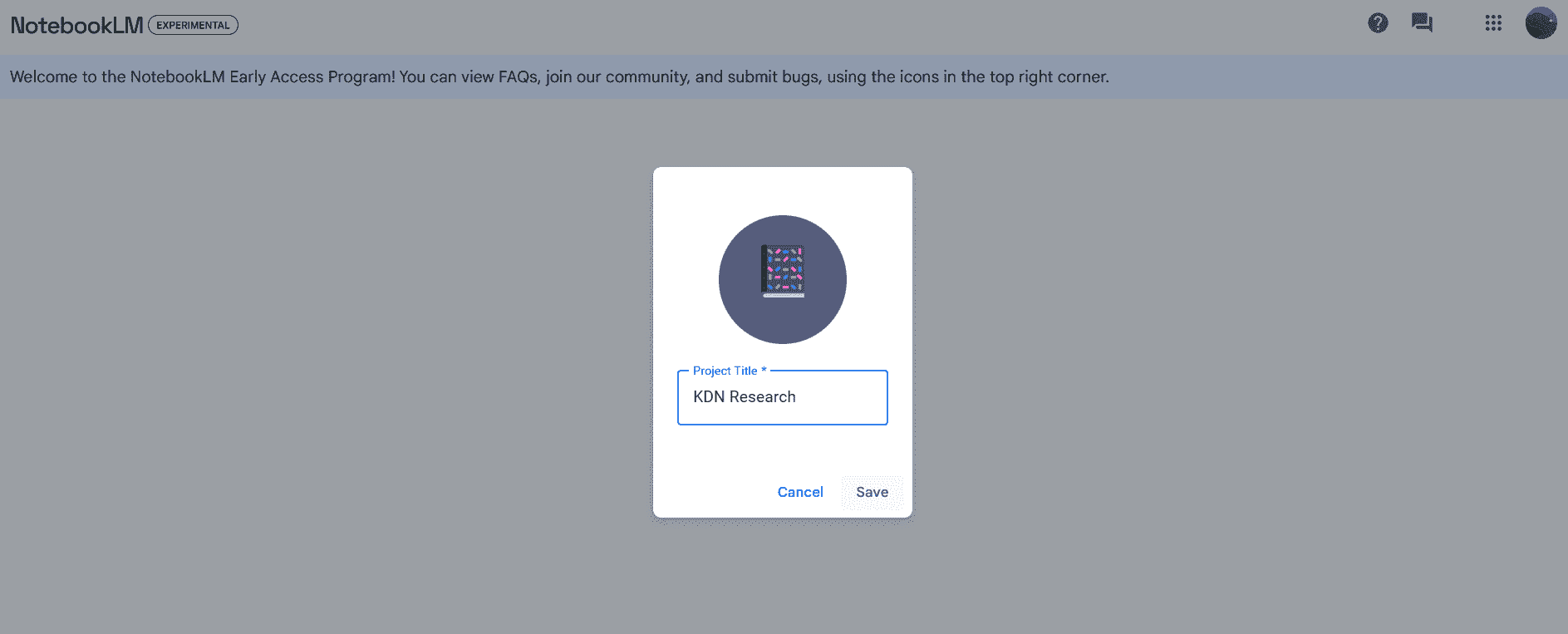

我重新运行了性能测试,这次启用了 Python 的memory-profiler以获取内存使用情况的时间图。测试再次崩溃,当我查看内存图时,我看到了这个:

我们的内存使用保持稳定,但随后达到 8 吉字节!我知道我们的应用程序服务器有 8 吉字节的 RAM,所以这个分析确认了我们内存不足。此外,当内存稳定时,我们使用了大约 4 GB 的内存,而我们之前的 EvalML 版本使用了大约 2 GB 的内存。因此,出于某种原因,这个当前版本的内存使用量大约是正常情况的两倍。

现在我需要找出原因。

步骤 2:使用最小示例在本地重现内存问题

精确找出内存问题的原因涉及大量实验和迭代,因为答案通常不明显。如果明显,你可能不会把它写到代码中!因此,我认为重要的是用尽可能少的代码行来重现问题。这个最小示例使你能够在修改代码时快速运行它以查看是否取得进展。

在我的案例中,我从经验中知道,我们的应用程序处理一个包含 150 万行数据的出租车数据集,这大约是在我看到大幅波动的时候。我将我们的应用程序简化到仅运行这个数据集的部分。我看到一个类似于我上面描述的波动,但这次内存使用达到了 10GB!

看到这个之后,我知道我有一个足够好的最小示例来深入探讨。

在出租车数据集上本地重现的内存占用

在出租车数据集上本地重现的内存占用

步骤 3:找出分配最多内存的代码行

一旦我们将问题隔离到尽可能小的代码块中,就可以查看程序在哪里分配了最多的内存。这可以是你需要的关键证据,以便能够重构代码并解决问题。

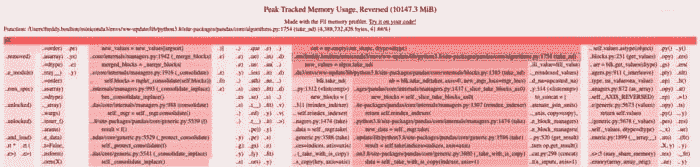

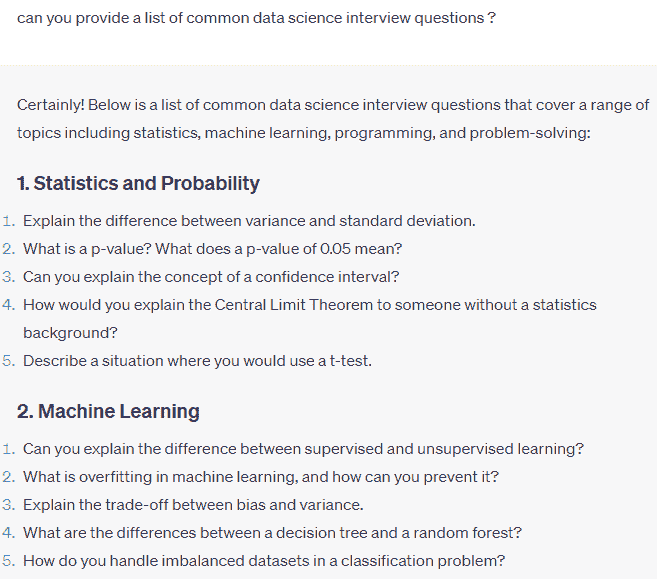

我认为filprofiler是一个很棒的 Python 工具来做到这一点。它显示了应用程序中每行代码在内存使用高峰时的内存分配。这是我本地示例的输出:

fil-profile 的输出

fil-profile 的输出

filprofiler 根据内存分配对你应用程序中的代码行(以及依赖代码)进行排名。行越长,颜色越红,分配的内存越多。

分配最多内存的代码行正在创建 pandas 数据框(pandas/core/algorithms.py 和 pandas/core/internal/managers.py),总计达 4GB 的数据!我在这里截断了 filprofiler 的输出,但它能够跟踪创建 pandas 数据框的 EvalML 中的代码。

看到这个情况有点令人困惑。是的,EvalML 创建 pandas 数据框,但这些数据框在 AutoML 算法中是短暂存在的,并应在不再使用时立即被释放。由于情况并非如此,这些数据框在 EvalML 完成它们时仍然在内存中停留了足够长的时间,我认为最新版本可能引入了一个内存泄漏。

步骤 4:识别泄漏对象