KDNuggets-博客中文翻译-三十二-

KDNuggets 博客中文翻译(三十二)

原文:KDNuggets

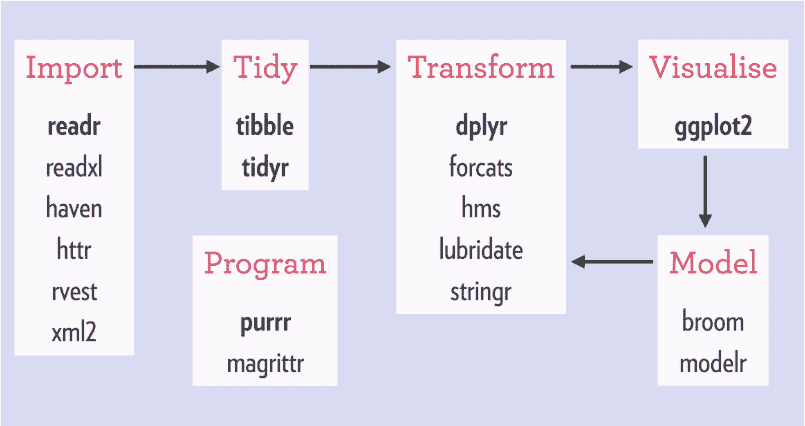

TensorFlow 计算机视觉 – 迁移学习变得简单

原文:

www.kdnuggets.com/2022/01/tensorflow-computer-vision-transfer-learning-made-easy.html

90+% 准确率?通过迁移学习变得可能。

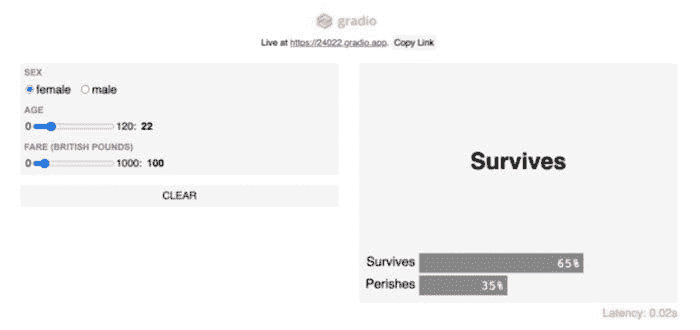

上周,你已经看到数据增强如何使你的 TensorFlow 模型的准确率提高几个百分点。相比于你今天将看到的,我们仅仅触及了表面。我们将最终用一种相当简单的方法在验证集上超过 90% 的准确率。

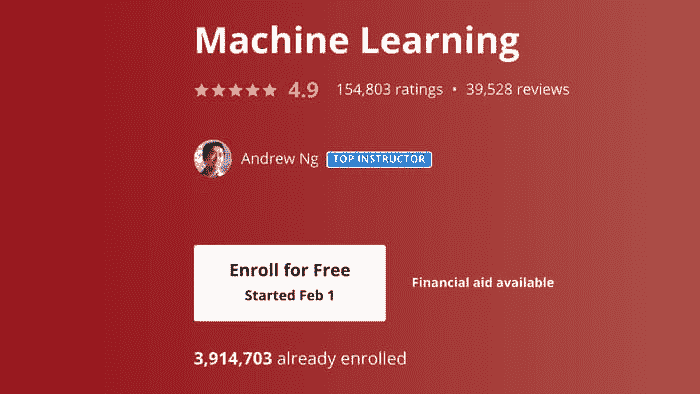

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

你还会看到如果我们将训练数据量缩小 20 倍,验证准确率会发生什么。剧透 - 它将保持不变。

不想阅读?请观看我的视频:

你可以在 GitHub 上下载源代码。

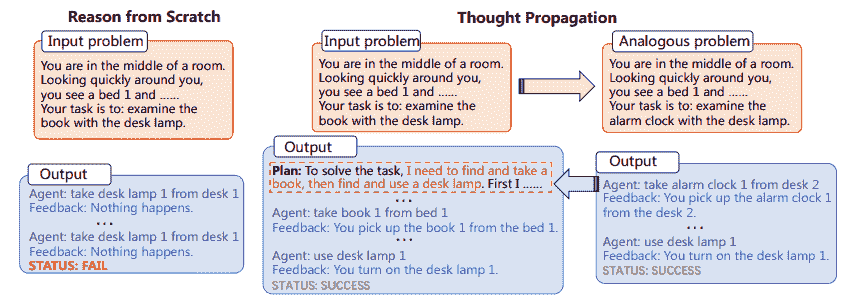

TensorFlow 中的迁移学习是什么?

从头开始编写神经网络模型架构涉及大量的猜测工作。多少层?每层多少节点?使用什么激活函数?正则化?你不会很快用完问题。

迁移学习采用不同的方法。不是从头开始,而是利用一个已经由非常聪明的人在庞大的数据集上,用比你家里拥有的更高级的硬件训练过的现有神经网络模型。这些网络可能有数百层,这与我们几周前实现的 2 层 CNN 大相径庭。

简而言之 - 你深入网络的层数越多,你提取的特征就越复杂。

整个迁移学习过程归结为 3 个步骤:

-

使用预训练的网络 - 例如,使用一个已经在数百万张图像上训练过的 VGG、ResNet 或 EfficientNet 架构,用于检测 1000 个类别。

-

剪掉模型的头部 - 排除预训练模型的最后几层,并用你自己的层替换它们。例如,我们的 狗与猫数据集 有两个类别,最终的分类层需要与之相符。

-

微调最终层 - 在你的数据集上训练网络以调整分类器。预训练模型的权重被冻结,这意味着它们在你训练模型时不会更新。

归根结底,迁移学习使你可以用更少的数据获得显著更好的结果。我们的自定义 2 块架构在验证集上的准确率仅为 76%。迁移学习将把它提高到 90%以上。

入门 - 库和数据集导入

我们将使用来自 Kaggle 的狗与猫数据集。它的许可证是创作共用许可证,这意味着你可以免费使用它:

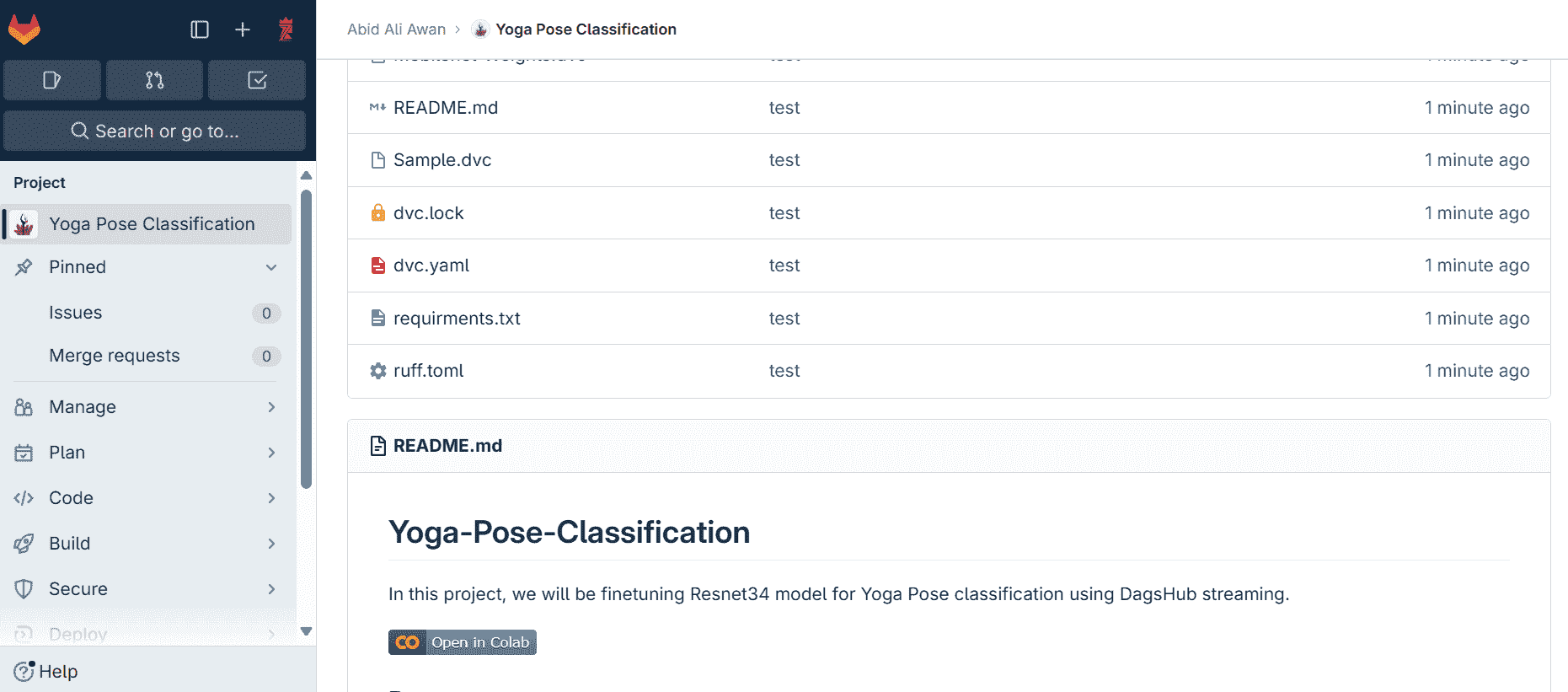

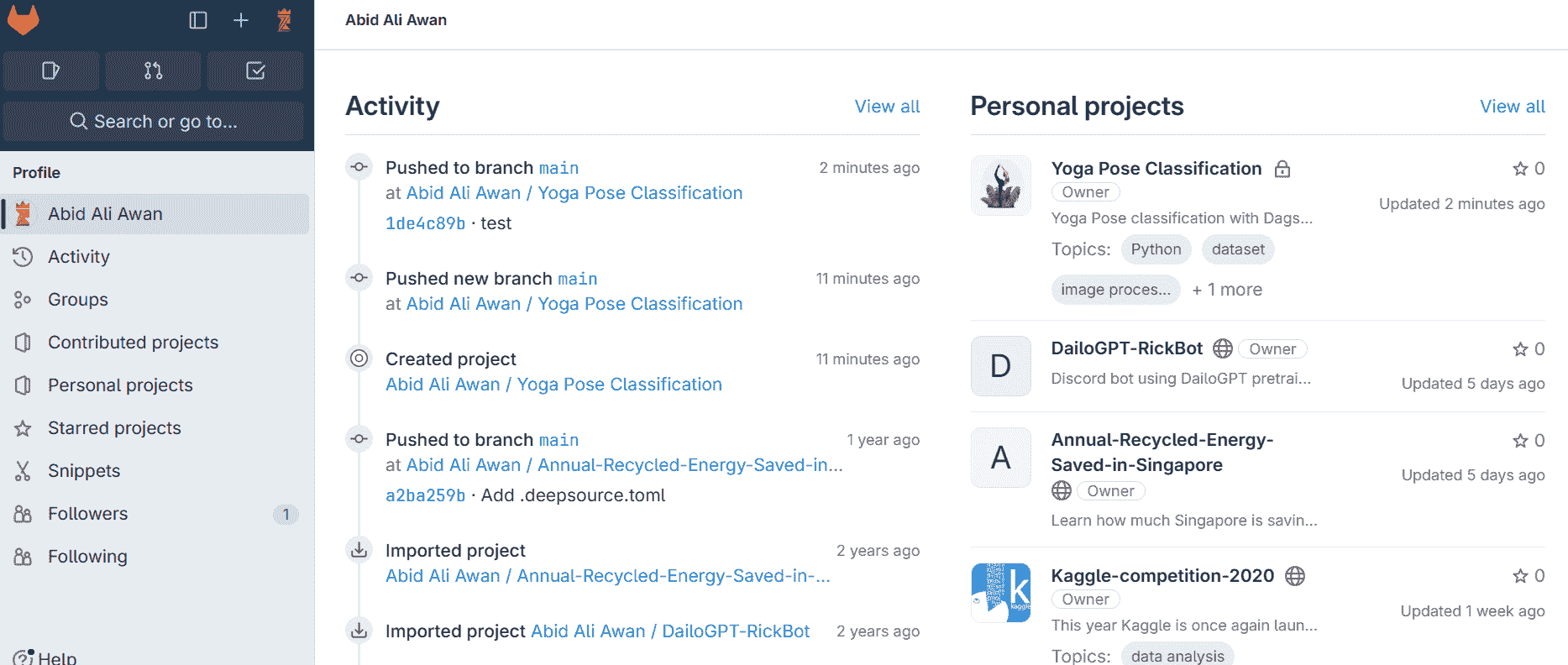

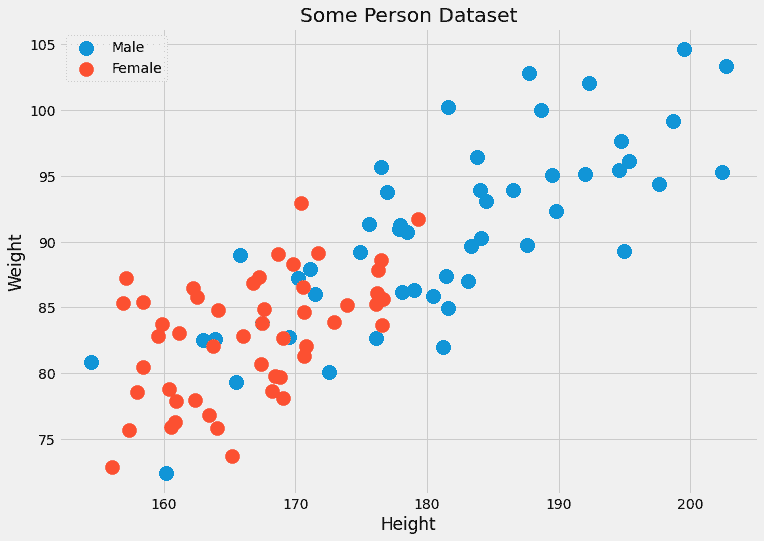

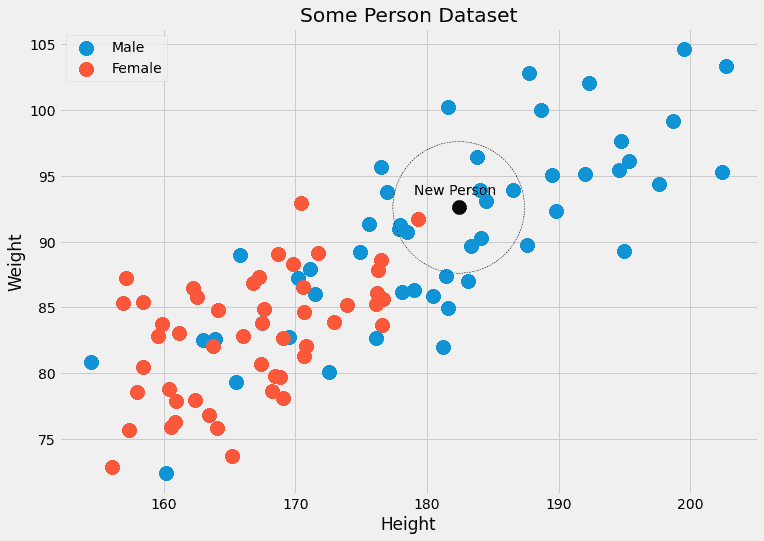

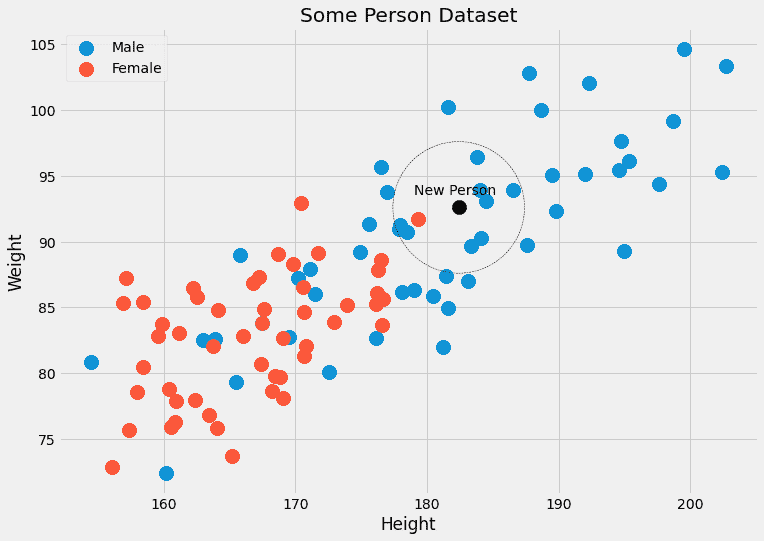

图像 1——狗与猫数据集(图像来源:作者)

图像 1——狗与猫数据集(图像来源:作者)

数据集相当大——有 25,000 张图像,按类别均匀分布(12,500 张狗图像和 12,500 张猫图像)。它应该足够大以训练一个不错的图像分类器。唯一的问题是——它的结构并不适合深度学习。你可以参考我之前的文章创建一个适当的目录结构,并将其拆分为训练集、测试集和验证集:

TensorFlow 用于图像分类——深度学习项目的三个主要前提 | 更好的数据科学

你想用 TensorFlow 训练一个神经网络进行图像分类吗?确保首先完成这三步。

你还应该删除train/cat/666.jpg和train/dog/11702.jpg图像,因为它们已损坏,模型将无法使用它们进行训练。

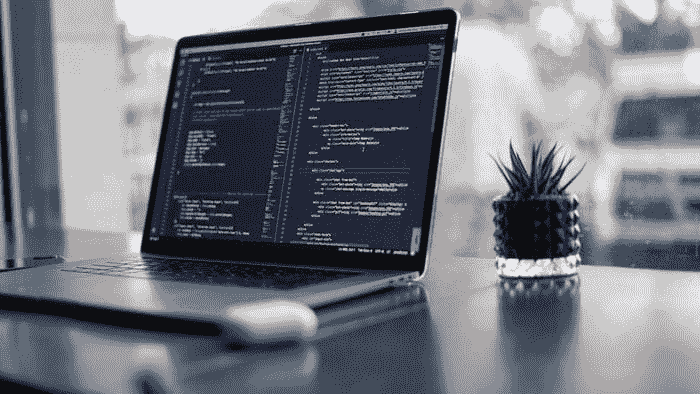

完成后,你可以继续进行库的导入。我们今天只需要 Numpy 和 TensorFlow。其他导入是为了消除不必要的警告信息:

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '3'

import warnings

warnings.filterwarnings('ignore')

import numpy as np

import tensorflow as tf

在整篇文章中,我们将不得不从不同的目录加载训练和验证数据。最佳实践是声明一个用于加载图像和数据增强的函数:

def init_data(train_dir: str, valid_dir: str) -> tuple:

train_datagen = tf.keras.preprocessing.image.ImageDataGenerator(

rescale=1/255.0,

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest'

)

valid_datagen = tf.keras.preprocessing.image.ImageDataGenerator(

rescale=1/255.0

)

train_data = train_datagen.flow_from_directory(

directory=train_dir,

target_size=(224, 224),

class_mode='categorical',

batch_size=64,

seed=42

)

valid_data = valid_datagen.flow_from_directory(

directory=valid_dir,

target_size=(224, 224),

class_mode='categorical',

batch_size=64,

seed=42

)

return train_data, valid_data

现在让我们加载我们的狗和猫数据集:

train_data, valid_data = init_data(

train_dir='data/train/',

valid_dir='data/validation/'

)

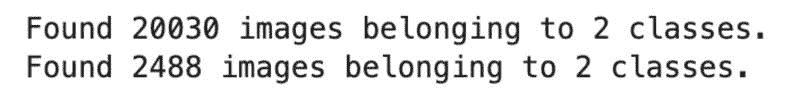

这是你应该看到的输出:

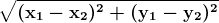

图像 2 - 训练和验证图像的数量(图像来源:作者)

图像 2 - 训练和验证图像的数量(图像来源:作者)

20K 训练图像对于迁移学习来说是否过多?可能是,但让我们看看能获得多准确的模型。

TensorFlow 中的迁移学习实践

通过迁移学习,我们基本上是加载一个巨大的预训练模型,但没有顶部的分类层。这样,我们可以冻结已学习的权重,只添加输出层以匹配我们的数据集。

例如,大多数预训练模型是基于ImageNet数据集进行训练的,该数据集有 1000 个类别。我们只有两个(猫和狗),所以我们需要指定这点。

这就是 build_transfer_learning_model() 函数的作用所在。它有一个参数 - base_model - 表示预训练的架构。首先,我们将冻结该模型中的所有层,然后通过添加几个自定义层来构建一个 Sequential 模型。最后,我们将使用常用的方法来编译模型:

def build_transfer_learning_model(base_model):

# `base_model` stands for the pretrained model

# We want to use the learned weights, and to do so we must freeze them

for layer in base_model.layers:

layer.trainable = False

# Declare a sequential model that combines the base model with custom layers

model = tf.keras.Sequential([

base_model,

tf.keras.layers.GlobalAveragePooling2D(),

tf.keras.layers.BatchNormalization(),

tf.keras.layers.Dropout(rate=0.2),

tf.keras.layers.Dense(units=2, activation='softmax')

])

# Compile the model

model.compile(

loss='categorical_crossentropy',

optimizer=tf.keras.optimizers.Adam(),

metrics=['accuracy']

)

return model

现在有趣的部分开始了。从 TensorFlow 导入 VGG16 架构,并将其指定为我们 build_transfer_learning_model() 函数的基础模型。include_top=False 参数意味着我们不需要顶层分类层,因为我们已经声明了自己的分类层。此外,注意 input_shape 如何设置以类似于我们的图像形状:

# Let's use a simple and well-known architecture - VGG16

from tensorflow.keras.applications.vgg16 import VGG16

# We'll specify it as a base model

# `include_top=False` means we don't want the top classification layer

# Specify the `input_shape` to match our image size

# Specify the `weights` accordingly

vgg_model = build_transfer_learning_model(

base_model=VGG16(include_top=False, input_shape=(224, 224, 3), weights='imagenet')

)

# Train the model for 10 epochs

vgg_hist = vgg_model.fit(

train_data,

validation_data=valid_data,

epochs=10

)

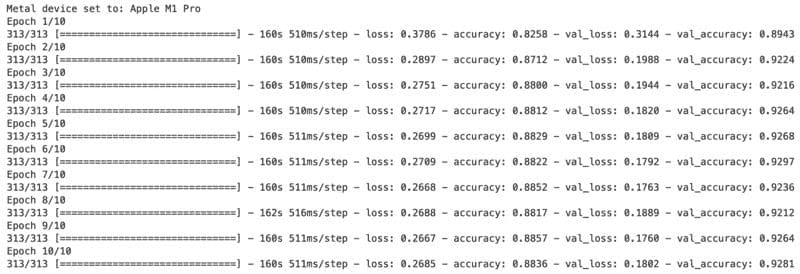

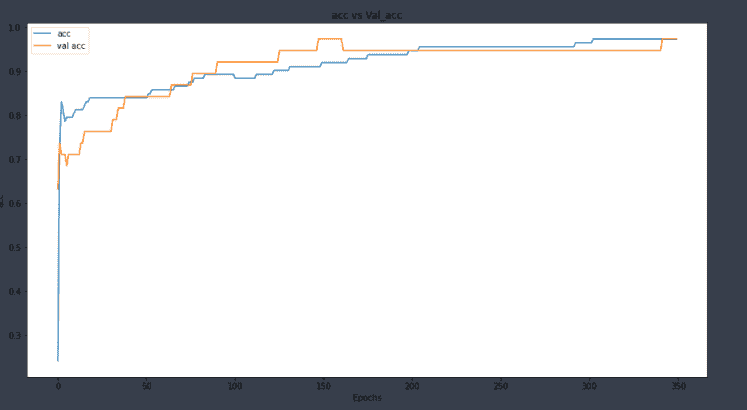

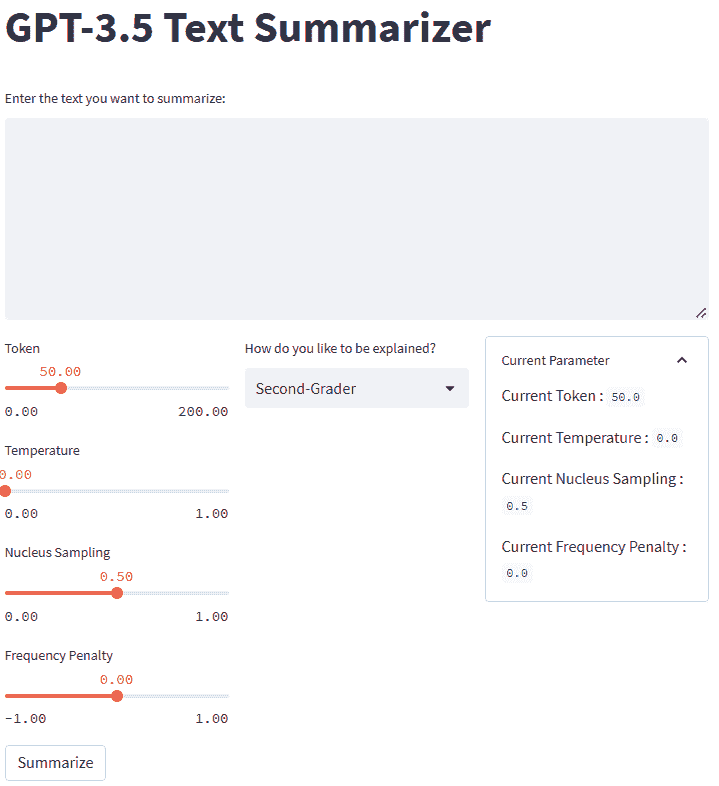

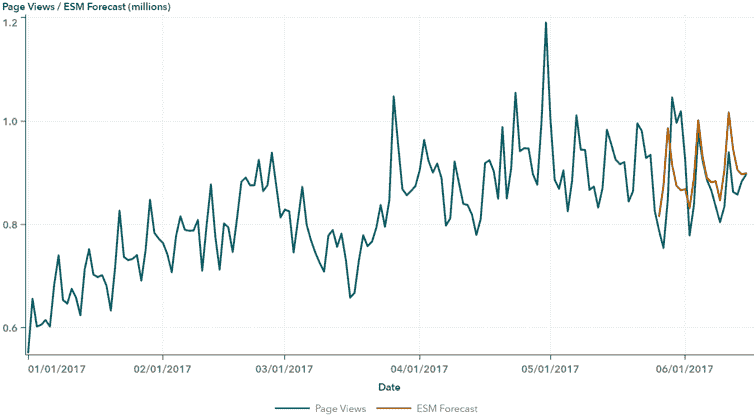

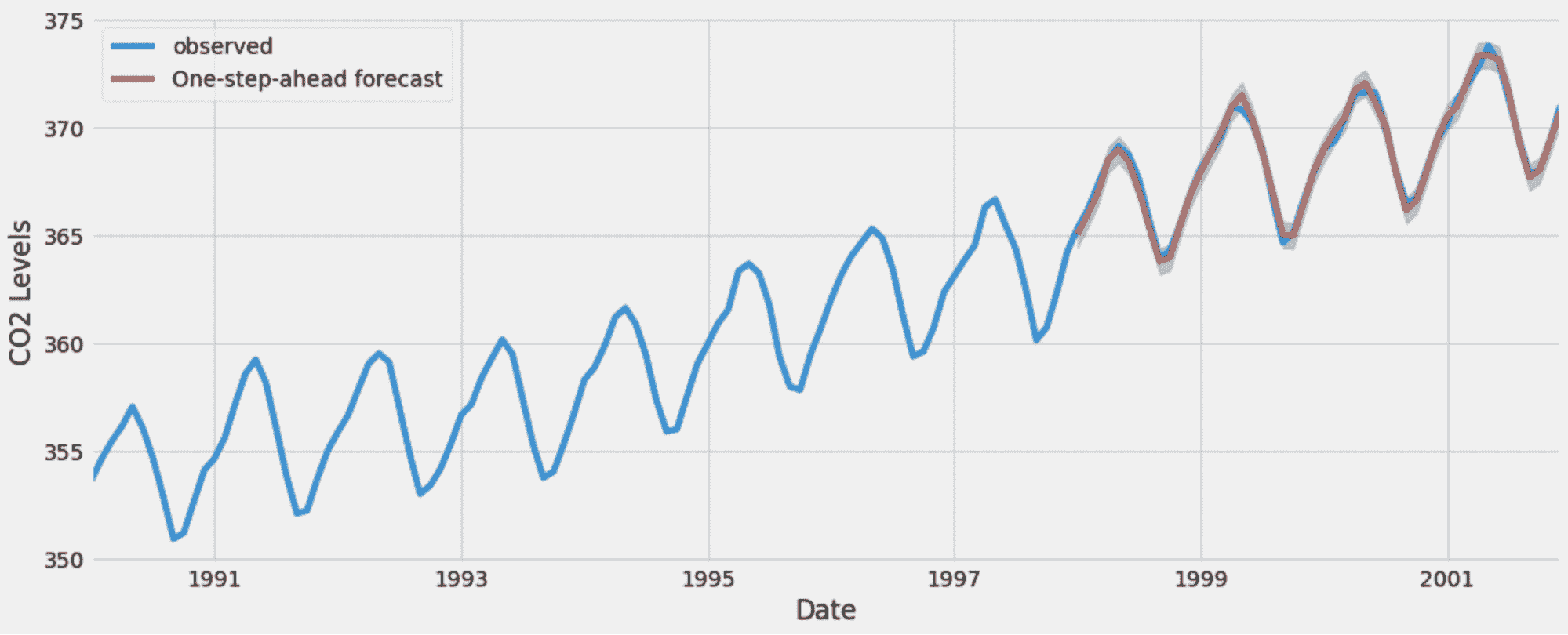

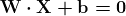

这是训练模型 10 个周期后的输出:

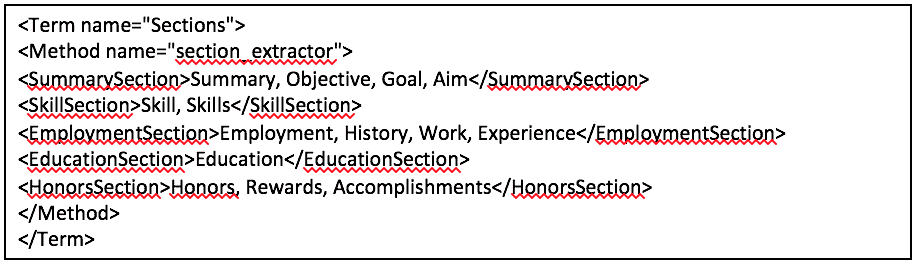

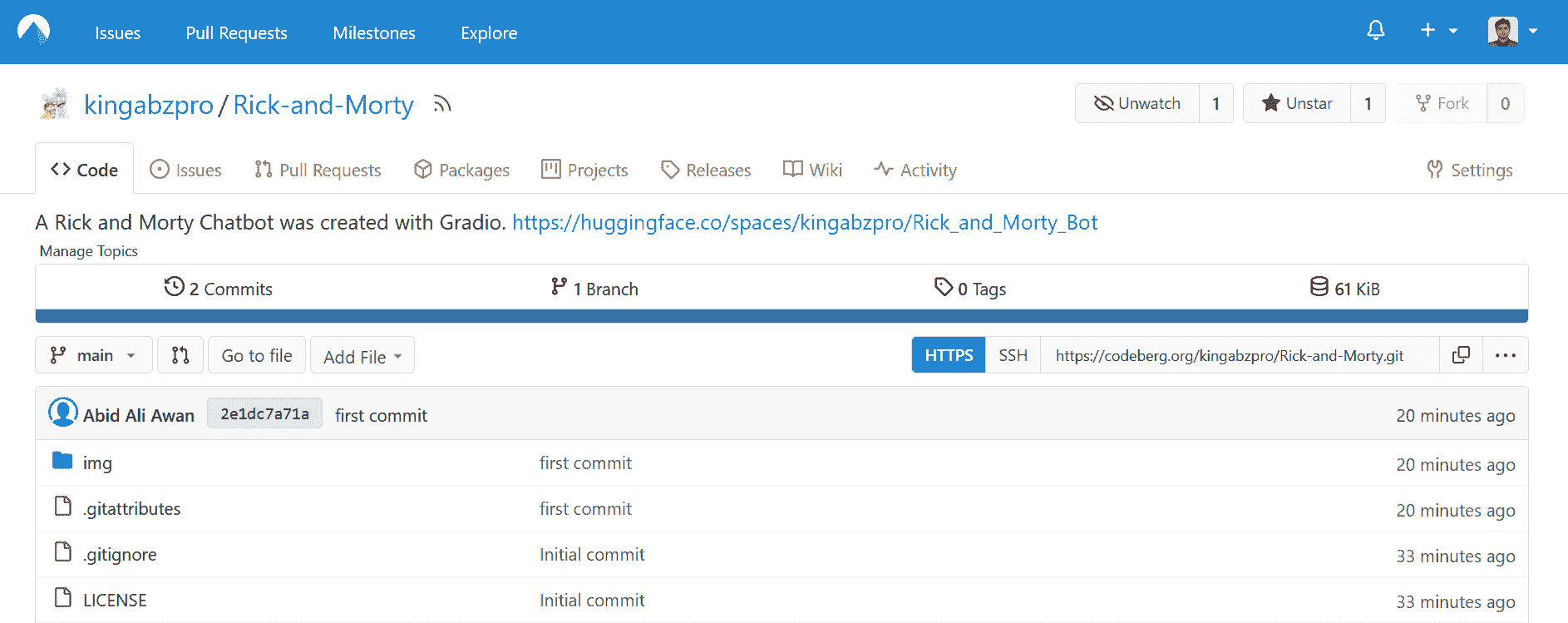

图像 3 - 在 20K 训练图像上经过 10 个周期的 VGG16 模型(图片由作者提供)

图像 3 - 在 20K 训练图像上经过 10 个周期的 VGG16 模型(图片由作者提供)

这真是值得一提 - 93% 的验证准确率,甚至不用考虑模型架构。迁移学习的真正优势在于训练准确模型所需的数据量,这比自定义架构所需的数据量要少得多。

减少了多少? 让我们将数据集缩小 20 倍,看看会发生什么。

在一个缩小了 20 倍的子集上进行迁移学习

我们希望看看减少数据集大小是否会对预测能力产生负面影响。为训练和验证图像创建新的目录结构。图像将存储在 data_small 文件夹中,但可以随意将其重命名为其他名称:

import random

import pathlib

import shutil

random.seed(42)

dir_data = pathlib.Path.cwd().joinpath('data_small')

dir_train = dir_data.joinpath('train')

dir_valid = dir_data.joinpath('validation')

if not dir_data.exists(): dir_data.mkdir()

if not dir_train.exists(): dir_train.mkdir()

if not dir_valid.exists(): dir_valid.mkdir()

for cls in ['cat', 'dog']:

if not dir_train.joinpath(cls).exists(): dir_train.joinpath(cls).mkdir()

if not dir_valid.joinpath(cls).exists(): dir_valid.joinpath(cls).mkdir()

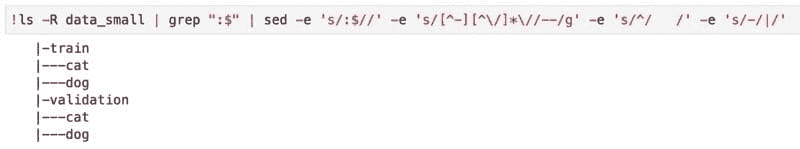

这是你可以用来打印目录结构的命令:

!ls -R data_small | grep ":$" | sed -e 's/:$//' -e 's/[^-][^\/]*\//--/g' -e 's/^/ /' -e 's/-/|/'

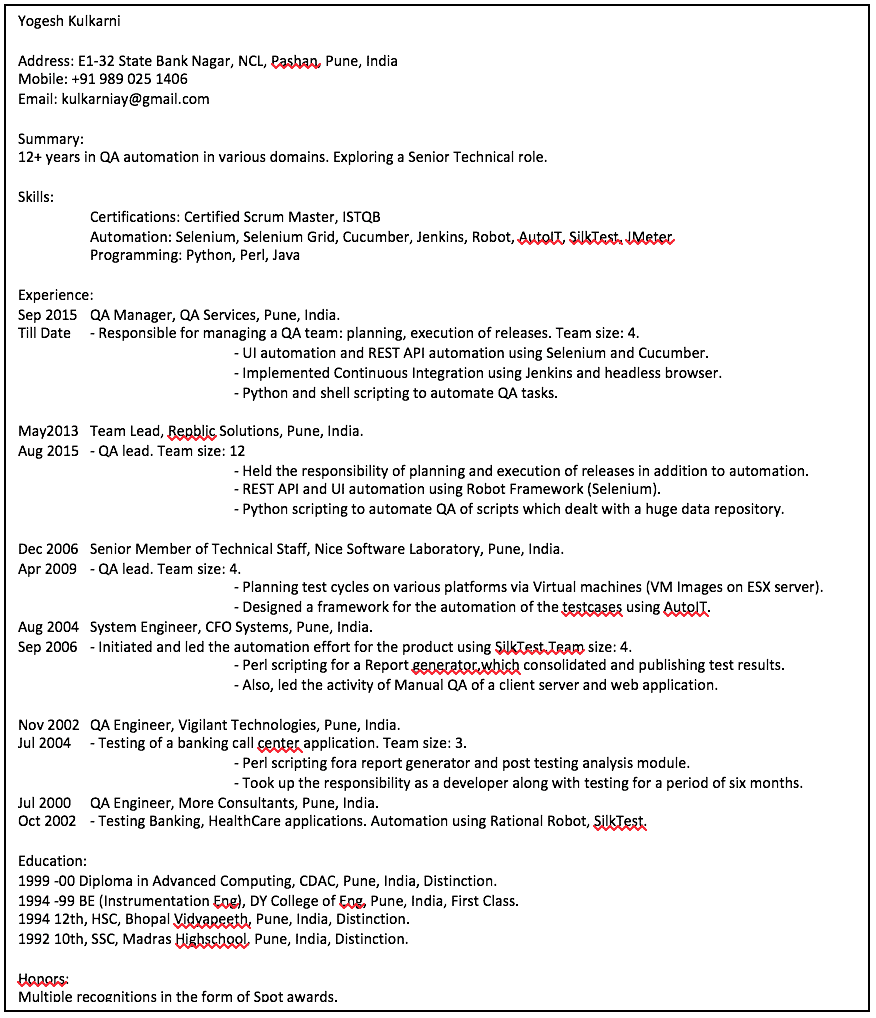

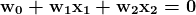

图像 4 - 目录结构(图片由作者提供)

图像 4 - 目录结构(图片由作者提供)

将一部分图像复制到新文件夹中。copy_sample() 函数从 src_folder 中提取 n 张图像并将它们复制到 tgt_folder。默认情况下,我们将 n 设置为 500:

def copy_sample(src_folder: pathlib.PosixPath, tgt_folder: pathlib.PosixPath, n: int = 500):

imgs = random.sample(list(src_folder.iterdir()), n)

for img in imgs:

img_name = str(img).split('/')[-1]

shutil.copy(

src=img,

dst=f'{tgt_folder}/{img_name}'

)

现在让我们复制训练和验证图像。对于验证集,我们将每类仅复制 100 张图像:

# Train - cat

copy_sample(

src_folder=pathlib.Path.cwd().joinpath('data/train/cat/'),

tgt_folder=pathlib.Path.cwd().joinpath('data_small/train/cat/'),

)

# Train - dog

copy_sample(

src_folder=pathlib.Path.cwd().joinpath('data/train/dog/'),

tgt_folder=pathlib.Path.cwd().joinpath('data_small/train/dog/'),

)

# Valid - cat

copy_sample(

src_folder=pathlib.Path.cwd().joinpath('data/validation/cat/'),

tgt_folder=pathlib.Path.cwd().joinpath('data_small/validation/cat/'),

n=100

)

# Valid - dog

copy_sample(

src_folder=pathlib.Path.cwd().joinpath('data/validation/dog/'),

tgt_folder=pathlib.Path.cwd().joinpath('data_small/validation/dog/'),

n=100

)

使用以下命令打印每个文件夹中的图像数量:

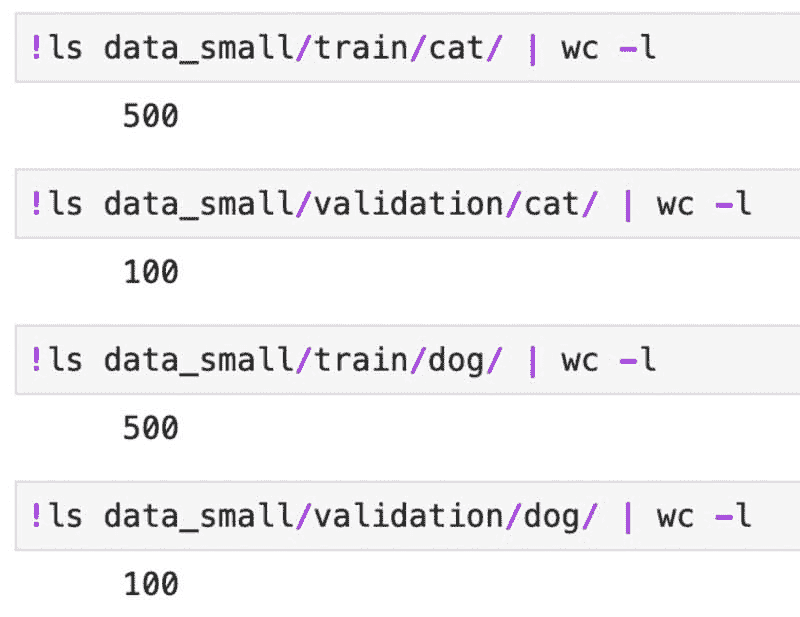

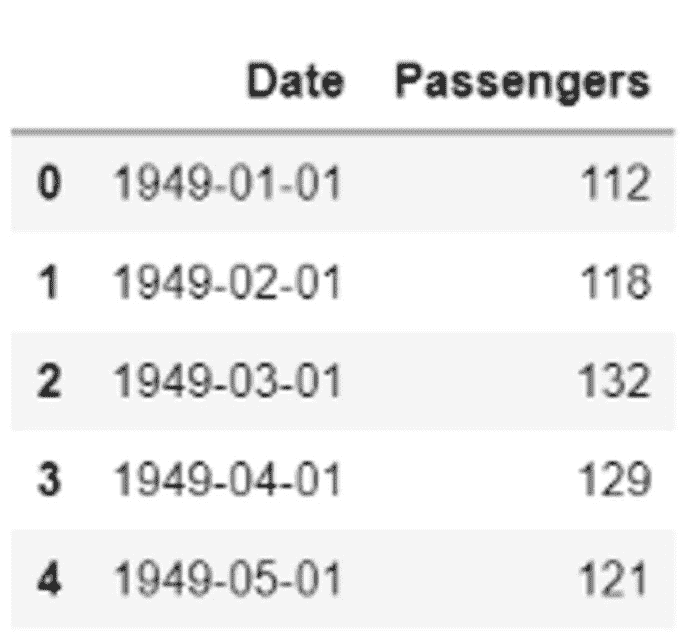

图像 5 - 每类训练和验证图像的数量(图片由作者提供)

图像 5 - 每类训练和验证图像的数量(图片由作者提供)

最后,调用 init_data() 函数从新源加载图像:

train_data, valid_data = init_data(

train_dir='data_small/train/',

valid_dir='data_small/validation/'

)

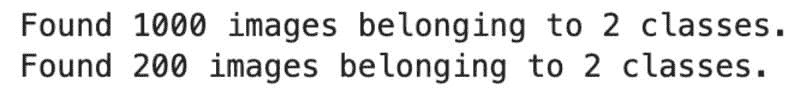

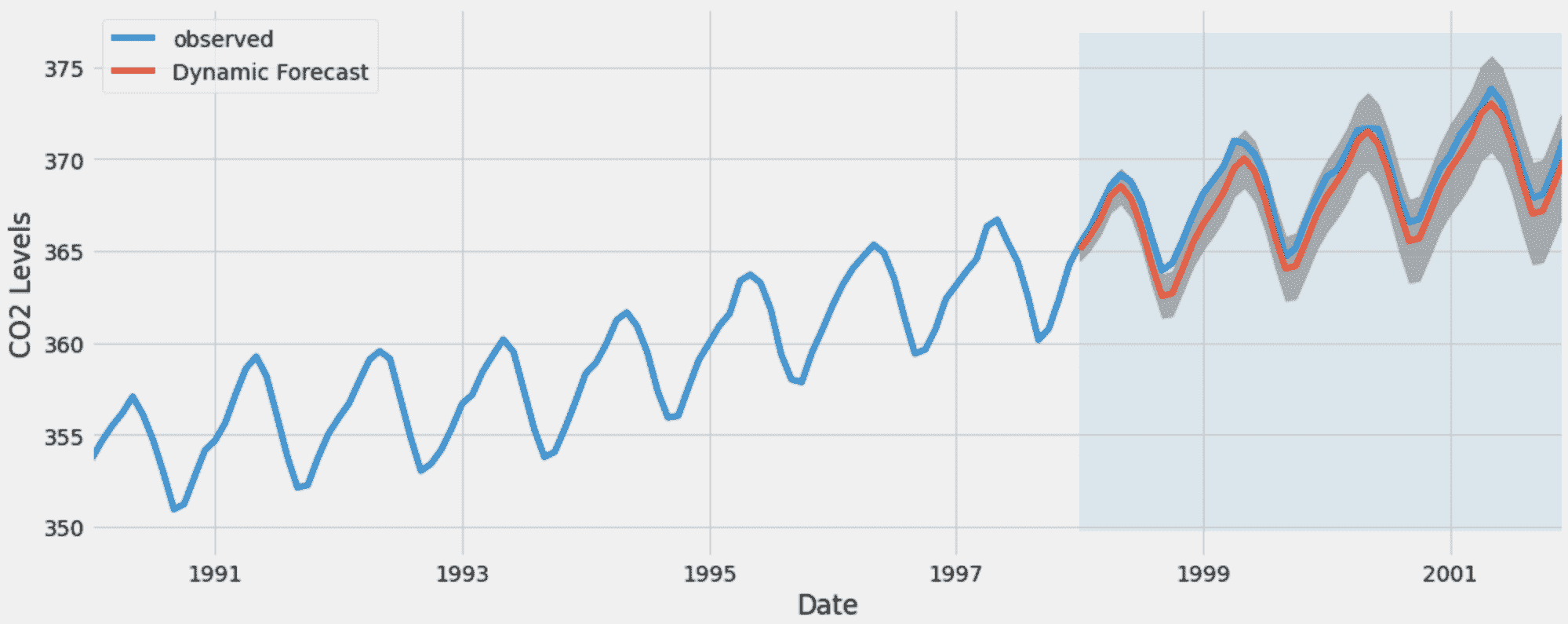

图像 6 - 缩小子集中的训练和验证图像数量(图片由作者提供)

图像 6 - 缩小子集中的训练和验证图像数量(图片由作者提供)

总共有 1000 张训练图像。看看我们能否从如此小的数据集中获得一个不错的模型会很有趣。我们将保持模型架构不变,但由于数据集较小,将训练更多周期。此外,由于每个周期的训练时间减少,我们可以进行更长时间的训练:

vgg_model = build_transfer_learning_model(

base_model=VGG16(include_top=False, input_shape=(224, 224, 3), weights='imagenet')

)

vgg_hist = vgg_model.fit(

train_data,

validation_data=valid_data,

epochs=20

)

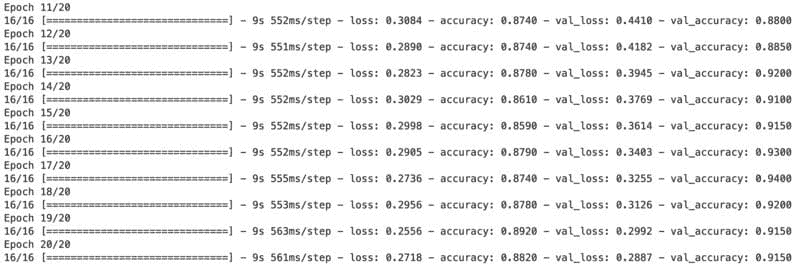

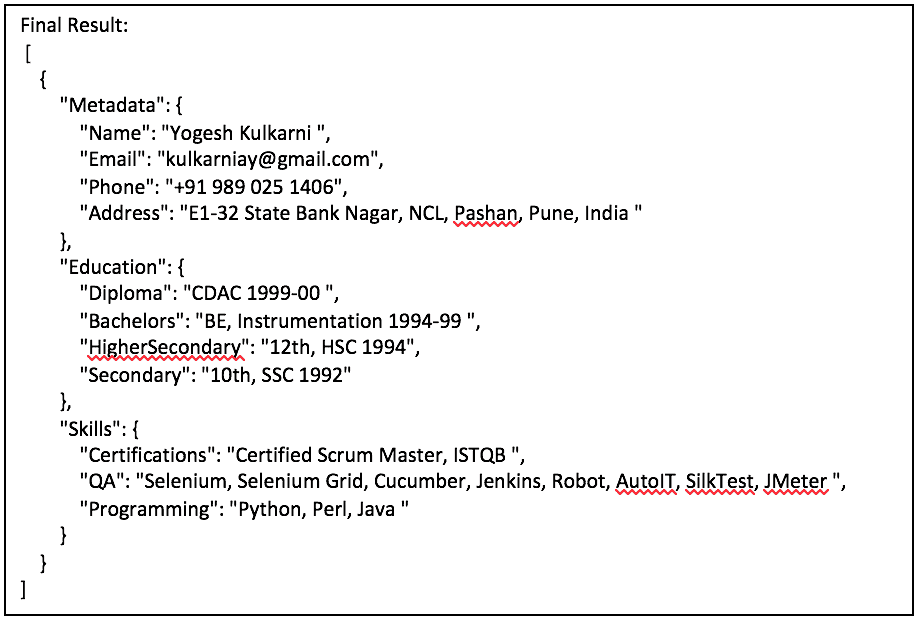

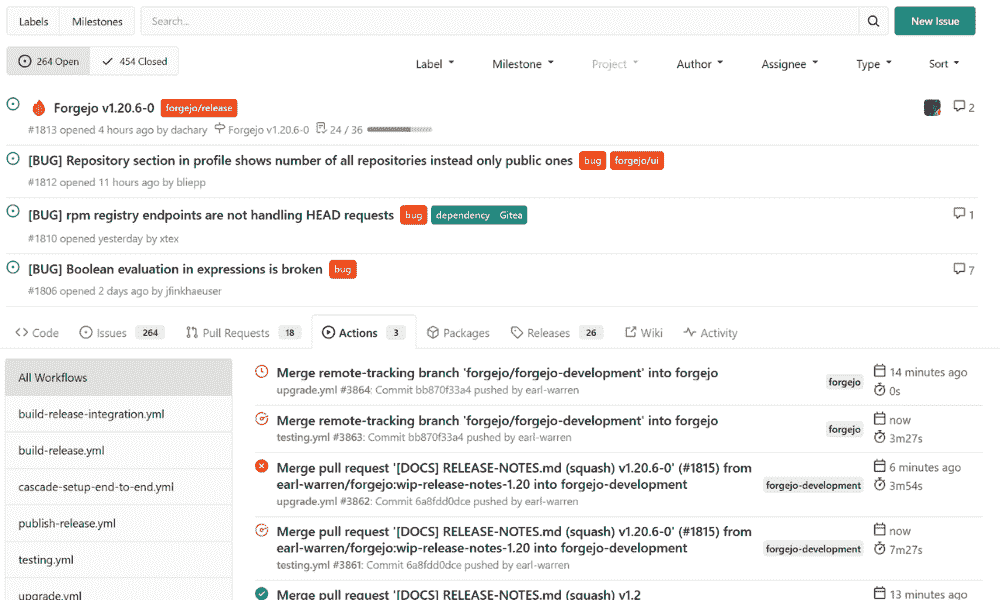

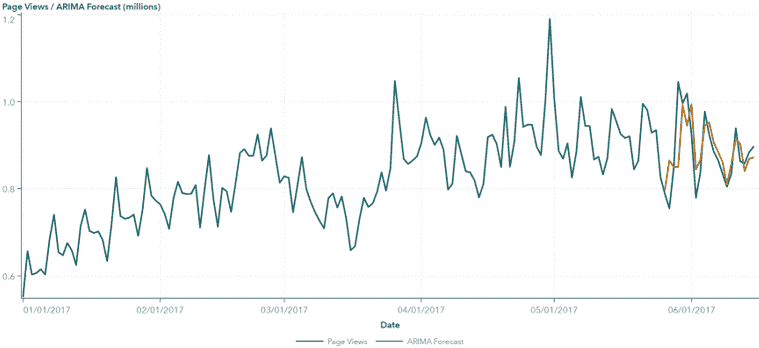

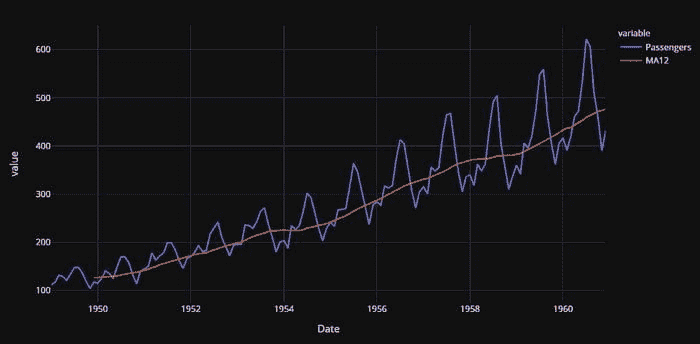

图片 7 - 最后 10 个周期的训练结果(图片由作者提供)

图片 7 - 最后 10 个周期的训练结果(图片由作者提供)

而且看看这个 - 我们获得了与在 2 万张图片上训练的模型大致相同的验证准确率,真是太棒了。

这就是迁移学习的真正力量所在。你不总是可以获得庞大的数据集,因此看到我们能在如此有限的数据下建立如此精确的模型,真是令人惊叹。

结论

总结一下,当构建图像分类模型时,迁移学习应成为你的首选方法。你无需考虑架构,因为有人已经为你做了这个工作。你无需拥有庞大的数据集,因为有人已经在数百万张图片上训练了通用模型。最后,大多数情况下,你也不需要担心性能差,除非你的数据集非常专业。

你需要做的唯一事情是选择一个预训练的架构。我们今天选择了 VGG16,但我鼓励你尝试 ResNet、MobileNet、EfficientNet 等。

这是另一个作业 - 使用今天训练的两个模型来预测整个测试集。准确率如何比较?请告知我。

保持联系

Dario Radečić 是 Deep Data Digital 的首席执行官和创始人,同时也是数据科学家和技术作家。

原文。转载经许可。

相关主题

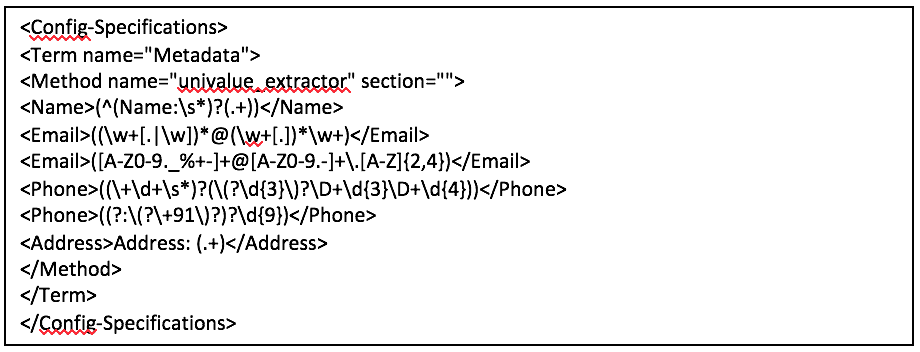

使用 TensorFlow 和 Keras 进行分词和文本数据准备

原文:

www.kdnuggets.com/2020/03/tensorflow-keras-tokenization-text-data-prep.html

评论

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

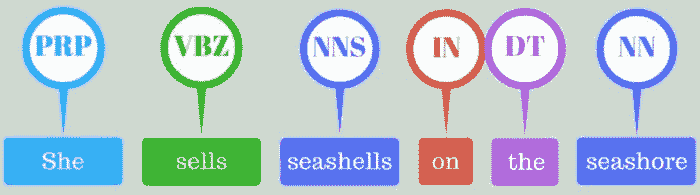

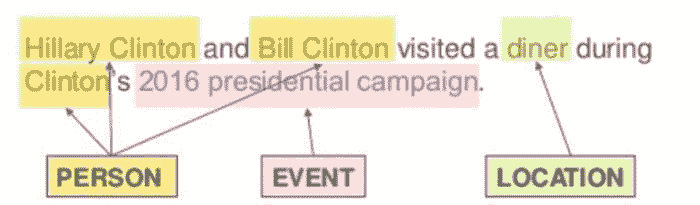

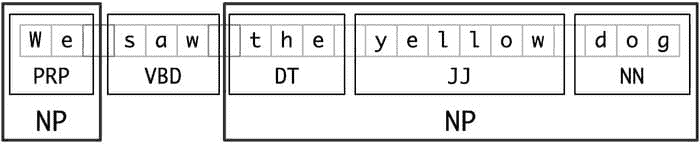

之前我们查看了一个通用文本数据预处理方法,重点关注了分词、标准化和噪声去除。然后我们概述了使用 Python 进行文本数据预处理的内容,这本质上是前一篇文章中框架的实际应用,涵盖了主要的手动文本数据预处理方法。我们还探讨了如何使用 Python 构建基础文本数据词汇。

不过,自动化许多这种预处理和文本数据准备的工具是存在的。这些工具在这些文章发表之前就已存在,但其普及程度自那时以来激增。由于许多 NLP 工作现在通过神经网络完成,使用神经网络实现库如 TensorFlow——以及同时使用 Keras——来实现这些准备任务是很自然的。

本文将探讨如何使用 TensorFlow 和 Keras 预处理工具对文本数据进行分词和进一步准备,以便输入神经网络。虽然前几篇文章没有涉及为神经网络创建和填充编码数据序列的附加概念,但本文将予以补充。相反,虽然噪声去除在之前的文章中有所涵盖,但本文不再涉及。文本数据中的噪声是什么可能是任务特定的,前文对这一主题的处理依然具有参考价值。

为了实现今天的目标,我们将使用两个 Keras 预处理工具: Tokenizer 类和 pad_sequences 模块。

我们使用一些示例句子代替真实数据集或来自现实世界的数据,来完成编码工作。下次我们可以扩展代码,使用真实数据集并执行一些有趣的任务,例如分类或类似任务。一旦理解了这个过程,扩展到更大的数据集将很简单。

让我们开始进行必要的导入和一些“数据”演示。

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

train_data = [

"I enjoy coffee.",

"I enjoy tea.",

"I dislike milk.",

"I am going to the supermarket later this morning for some coffee."

]

test_data = [

"Enjoy coffee this morning.",

"I enjoy going to the supermarket.",

"Want some milk for your coffee?"

]

接下来,一些执行分词和准备标准化数据表示的超参数,下面有解释。

num_words = 1000

oov_token = '<UNK>'

pad_type = 'post'

trunc_type = 'post'

-

num_words = 1000这将是从结果分词数据词汇表中使用的最多词数,在我们的例子中是截断到前 1000 个最常见的词。虽然在我们的小数据集中这不会成为问题,但为了演示目的,这里展示了。

-

oov_token = <UNK>这是用于处理在测试数据序列分词和编码过程中遇到的词汇表外的词汇的标记,使用在训练数据分词过程中构建的词索引创建的。

-

pad_type = 'post'当我们对文本数据进行数字序列编码时,我们的句子(或任意文本块)的长度将不一致,因此我们需要选择一个最大长度,并用填充字符填补较短句子的未使用位置。在我们的例子中,最大句子长度将通过搜索最长的句子来确定,填充字符将是'0'。

-

trunc_type = 'post'与上面一样,当我们对文本数据进行数字序列编码时,我们的句子(或任意文本块)的长度将不一致,因此我们需要选择一个最大长度,并用填充字符填补较短句子的未使用位置。我们选择在句子的末尾进行填充('post'),意味着我们的句子序列数字表示中的词索引条目将出现在结果句子向量的最左侧位置,而填充字符('0')将出现在实际数据之后,位于结果句子向量的最右侧位置。

来源: Manning

现在我们来进行分词、序列编码和序列填充。我们将逐块讲解这段代码。

# Tokenize our training data

tokenizer = Tokenizer(num_words=num_words, oov_token=oov_token)

tokenizer.fit_on_texts(train_data)

# Get our training data word index

word_index = tokenizer.word_index

# Encode training data sentences into sequences

train_sequences = tokenizer.texts_to_sequences(train_data)

# Get max training sequence length

maxlen = max([len(x) for x in train_sequences])

# Pad the training sequences

train_padded = pad_sequences(train_sequences, padding=pad_type, truncating=trunc_type, maxlen=maxlen)

# Output the results of our work

print("Word index:\n", word_index)

print("\nTraining sequences:\n", train_sequences)

print("\nPadded training sequences:\n", train_padded)

print("\nPadded training shape:", train_padded.shape)

print("Training sequences data type:", type(train_sequences))

print("Padded Training sequences data type:", type(train_padded))

下面是逐块发生的情况:

-

# Tokenize our training data这很简单;我们使用 TensorFlow(Keras)的

Tokenizer类来自动化我们的训练数据的标记化。首先,我们创建Tokenizer对象,提供最大保留的词汇数量,以及一个用于编码测试数据中未见过的词汇的超出词汇表的标记,否则这些之前未见过的词汇将被简单地从我们的词汇表中删除,且神秘地未被计算在内。要了解更多有关 TensorFlow 标记化器的其他参数,请查看 文档。创建Tokenizer后,我们将其拟合在训练数据上(我们稍后也会用它来拟合测试数据)。 -

# 获取我们的训练数据单词索引标记化过程的副产品是创建了一个单词索引,将词汇表中的单词映射到其数字表示,这一映射对于编码我们的序列至关重要。由于我们稍后会引用这个映射以进行打印,因此我们在这里为其分配一个变量以简化操作。

-

# 将训练数据句子编码为序列现在我们已经将数据标记化,并且有了词汇表的单词到数字表示的映射,让我们利用这个映射来编码序列。在这里,我们将文本句子从类似“我的名字是马修”的形式转换为类似“6 8 2 19”的形式,其中每个数字在索引中与相应的单词匹配。由于神经网络通过对数字进行计算来工作,直接传入一堆单词是不行的。因此,我们使用序列。并且记住,这仅仅是我们目前处理的训练数据;测试数据在之后会被标记化和编码。

-

# 获取最大训练序列长度记得我们之前提到过需要为编码的句子设置一个最大序列长度吗?我们可以自己设置这个限制,但在我们的案例中,我们将找到最长的编码序列,并以此作为最大序列长度。在实际操作中,确实有不想这样做的原因,但也有时这样做是合适的。接下来,在实际训练序列填充中,将使用

maxlen变量。 -

# 填充训练序列如上所述,我们需要确保编码序列的长度一致。我们刚刚找出了最长序列的长度,并将使用该长度对所有其他序列进行填充,填充额外的‘0’在末尾(‘post’),并且也会从末尾(‘post’)截断任何超出最大长度的序列。这里我们使用 TensorFlow(Keras)的

pad_sequences模块来完成这一任务。你可以查看文档以获取其他填充选项。 -

# 输出我们工作的结果现在让我们看看我们所做的工作。我们期望注意到最长的序列以及填充较短序列的情况。还要注意,当进行填充时,我们的序列会从 Python 列表转换为 Numpy 数组,这很有帮助,因为这就是我们最终会送入神经网络的内容。我们的训练序列矩阵的形状是训练集中句子(序列)的数量(4)与最长序列的长度(

maxlen,或 12)。

Word index:

{'<UNK>': 1, 'i': 2, 'enjoy': 3, 'coffee': 4, 'tea': 5, 'dislike': 6, 'milk': 7, 'am': 8, 'going': 9, 'to': 10, 'the': 11, 'supermarket': 12, 'later': 13, 'this': 14, 'morning': 15, 'for': 16, 'some': 17}

Training sequences:

[[2, 3, 4], [2, 3, 5], [2, 6, 7], [2, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 4]]

Padded training sequences:

[[ 2 3 4 0 0 0 0 0 0 0 0 0]

[ 2 3 5 0 0 0 0 0 0 0 0 0]

[ 2 6 7 0 0 0 0 0 0 0 0 0]

[ 2 8 9 10 11 12 13 14 15 16 17 4]]

Padded training shape: (4, 12)

Training sequences data type: <class 'list'>

Padded Training sequences data type: <class 'numpy.ndarray'>

现在让我们使用我们的分词器对测试数据进行分词,然后类似地编码我们的序列。这些操作与上述内容非常相似。请注意,我们使用的是为训练创建的相同分词器,以便在两个数据集之间实现一致,使用相同的词汇表。我们还按照与训练序列相同的长度和规格进行填充。

test_sequences = tokenizer.texts_to_sequences(test_data)

test_padded = pad_sequences(test_sequences, padding=pad_type, truncating=trunc_type, maxlen=maxlen)

print("Testing sequences:\n", test_sequences)

print("\nPadded testing sequences:\n", test_padded)

print("\nPadded testing shape:",test_padded.shape)

Testing sequences:

[[3, 4, 14, 15], [2, 3, 9, 10, 11, 12], [1, 17, 7, 16, 1, 4]]

Padded testing sequences:

[[ 3 4 14 15 0 0 0 0 0 0 0 0]

[ 2 3 9 10 11 12 0 0 0 0 0 0]

[ 1 17 7 16 1 4 0 0 0 0 0 0]]

Padded testing shape: (3, 12)

例如,你能看到训练集和测试集之间的填充序列长度不同会造成什么问题吗?

最后,让我们检查编码后的测试数据。

for x, y in zip(test_data, test_padded):

print('{} -> {}'.format(x, y))

print("\nWord index (for reference):", word_index)

Enjoy coffee this morning. -> [ 3 4 14 15 0 0 0 0 0 0 0 0]

I enjoy going to the supermarket. -> [ 2 3 9 10 11 12 0 0 0 0 0 0]

Want some milk for your coffee? -> [ 1 17 7 16 1 4 0 0 0 0 0 0]

Word index (for reference): {'<UNK>': 1, 'i': 2, 'enjoy': 3, 'coffee': 4, 'tea': 5, 'dislike': 6, 'milk': 7, 'am': 8, 'going': 9, 'to': 10, 'the': 11, 'supermarket': 12, 'later': 13, 'this': 14, 'morning': 15, 'for': 16, 'some': 17}

请注意,由于我们在测试数据中编码了一些在训练数据中未见过的单词,我们现在有一些词汇外的标记,这些标记被编码为

现在我们有了填充序列,更重要的是知道如何使用不同的数据再次获取它们,我们可以开始做一些事情了。下一次,我们将用实际数据替代这次使用的玩具数据,并且只需对代码做很小的更改(除非我们需要为训练和测试数据添加分类标签),我们将继续进行某种 NLP 任务,最有可能是分类。

相关:

-

10 个 Python 字符串处理技巧与窍门

-

自动文本摘要入门

-

如何在 Python 中为 NLP 任务创建词汇表

更多相关主题

提升 TensorFlow 模型的 4 种方法——你需要了解的关键正则化技术

原文:

www.kdnuggets.com/2020/08/tensorflow-model-regularization-techniques.html

评论

照片由 Jungwoo Hong 提供,发布于 Unsplash。

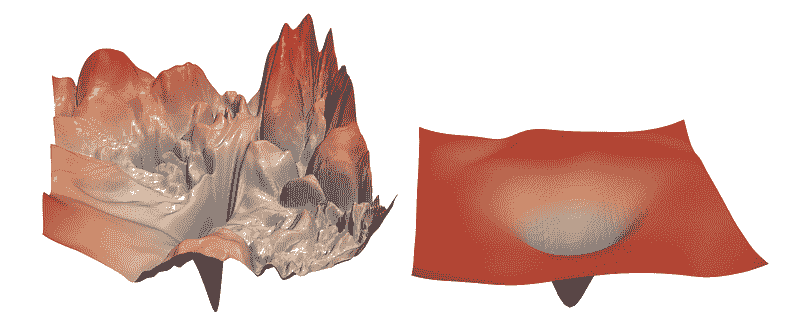

正则化

根据维基百科,

在数学、统计学和计算机科学,特别是机器学习和逆问题中,正则化是为了在解决一个不适定问题或防止过拟合时添加额外信息的过程。

这意味着我们添加一些额外的信息以解决问题并防止过拟合。

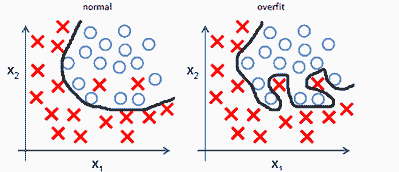

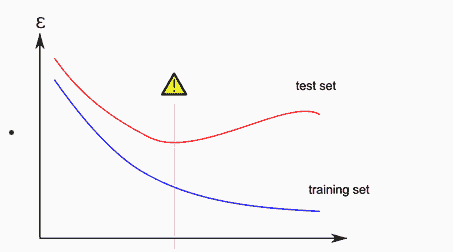

过拟合意味着我们的机器学习模型在某些数据上训练良好,在这些数据上表现极佳,但在新的未见过的样本上则会失败。

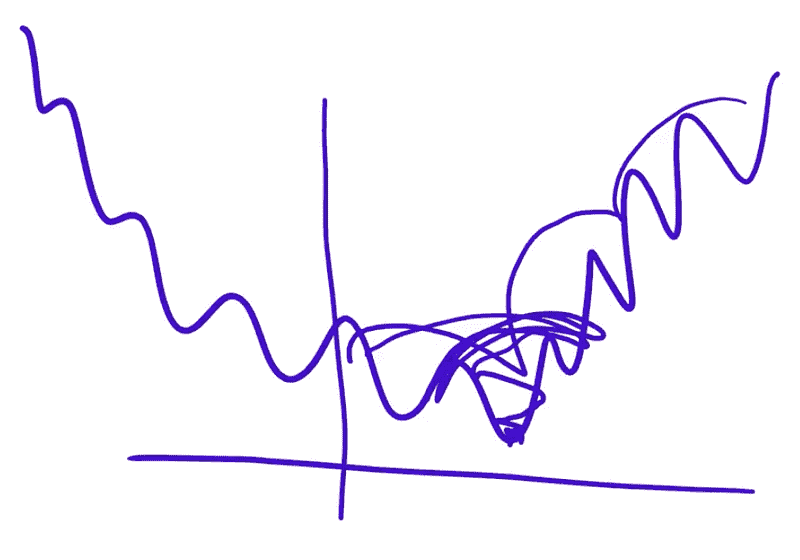

我们可以在这个简单的例子中看到过拟合现象

mlwiki.org/index.php/Overfitting

当我们的数据严格附着于训练样本时,这会导致测试/开发集上的性能较差,而训练集上的性能良好。

mlwiki.org/index.php/Overfitting

因此,为了提高模型性能,我们使用不同的正则化技术。虽然有几种技术,但我们将讨论 4 种主要技术。

-

L1 正则化

-

L2 正则化

-

丢弃法

-

批量归一化

我将简要解释这些技术是如何工作的,以及如何在 Tensorflow 2 中实现它们。

为了更好地理解这些技术如何及其工作原理,我推荐你观看 Andrew NG 教授的讲座,这些讲座在 Youtube 上很容易找到。

首先,我将编写一个没有正则化的模型,然后展示如何通过添加不同的正则化技术来改进它。我们将使用 IRIS 数据集来展示正则化如何显著改善模型。

无正则化的模型

代码:

-

基本预处理

-

模型构建

model1.summary()

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

dense_6 (Dense) (None, 512) 2560

_________________________________________________________________

dense_7 (Dense) (None, 256) 131328

_________________________________________________________________

dense_8 (Dense) (None, 128) 32896

_________________________________________________________________

dense_9 (Dense) (None, 64) 8256

_________________________________________________________________

dense_10 (Dense) (None, 32) 2080

_________________________________________________________________

dense_11 (Dense) (None, 3) 99

=================================================================

Total params: 177,219

Trainable params: 177,219

Non-trainable params: 0

_________________________________________________________________

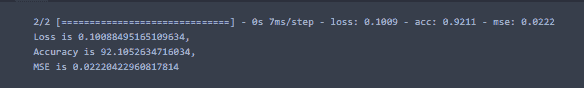

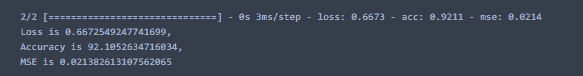

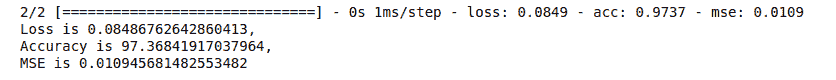

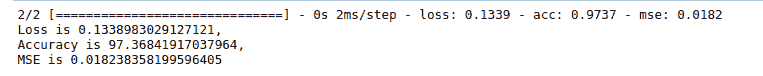

训练模型后,如果我们使用以下代码在 Tensorflow 中评估模型,我们可以找到测试集上的准确率、损失和mse。

loss1, acc1, mse1 = model1.evaluate(X_test, y_test)

print(f"Loss is {loss1},\nAccuracy is {acc1*100},\nMSE is {mse1}")

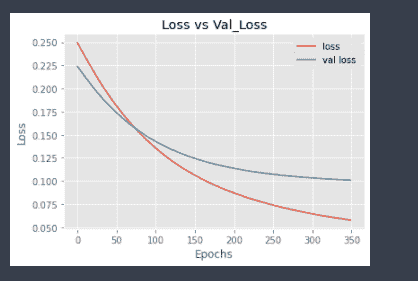

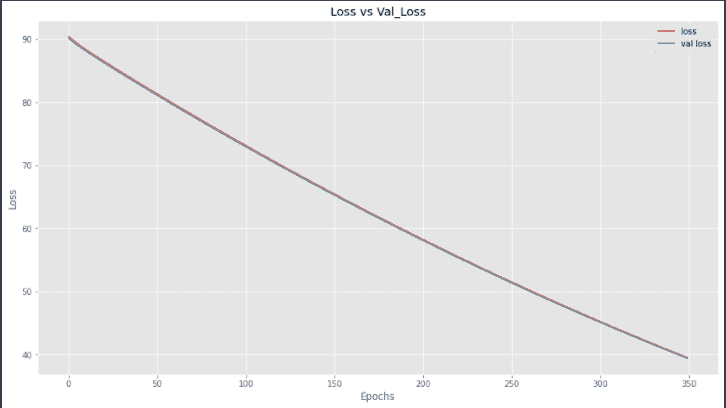

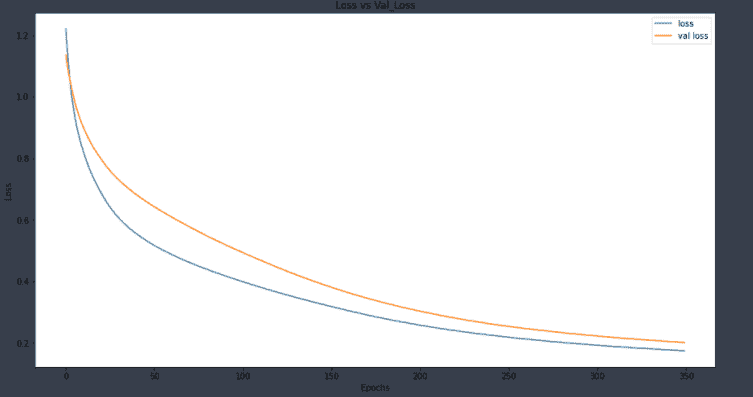

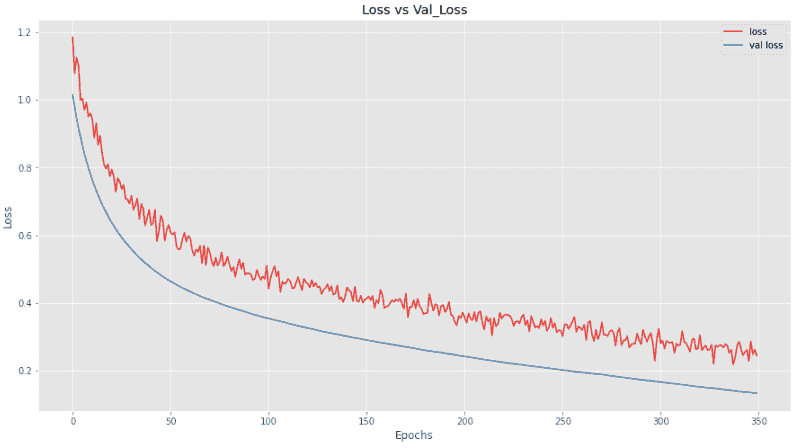

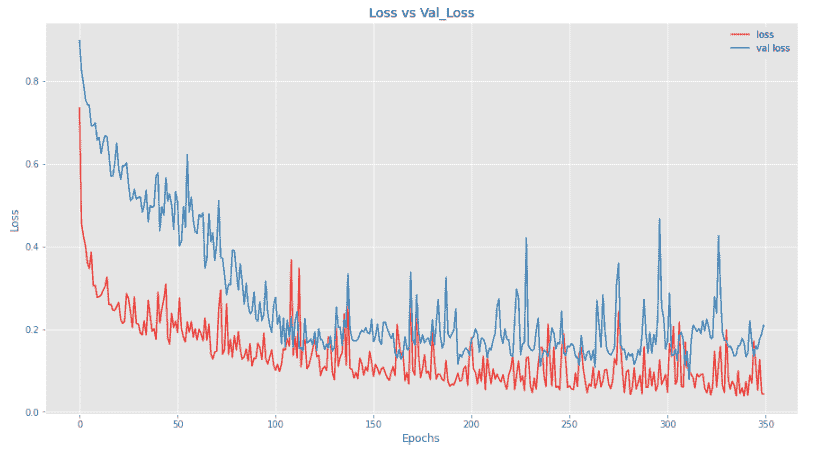

让我们检查验证损失和训练损失的图表。

import matplotlib.pyplot as plt

plt.style.use('ggplot')

plt.plot(hist.history['loss'], label = 'loss')

plt.plot(hist.history['val_loss'], label='val loss')

plt.title("Loss vs Val_Loss")

plt.xlabel("Epochs")

plt.ylabel("Loss")

plt.legend()

plt.show()

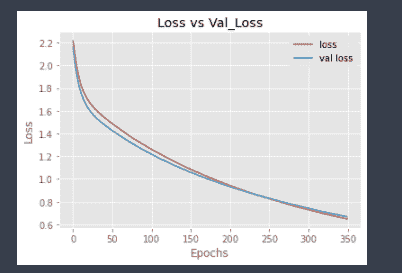

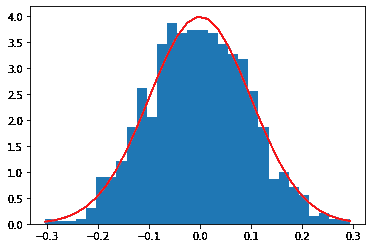

在这里,我们可以看到验证损失在≈ 60个周期后逐渐增加,而训练损失保持稳定。这表明我们的模型发生了过拟合。

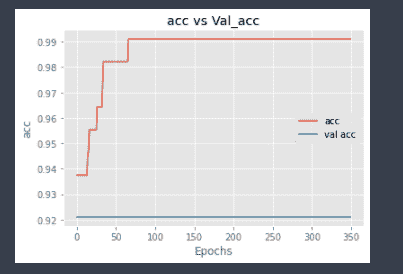

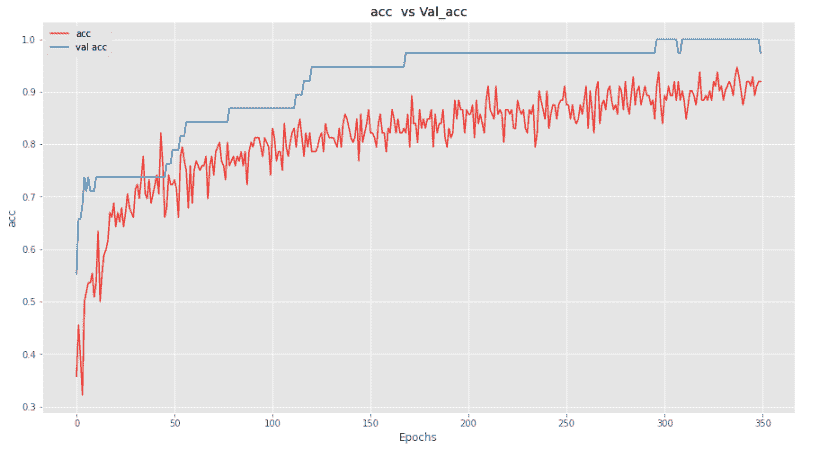

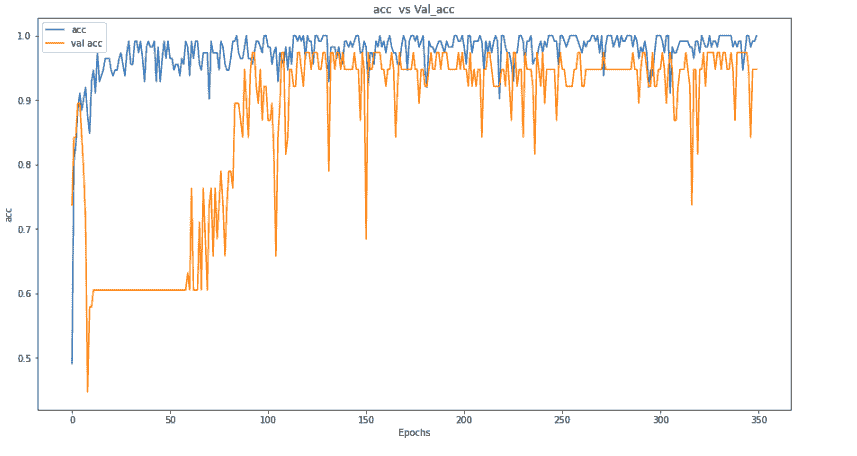

同样地,对于模型准确率图,

plt.plot(hist.history['acc'], label = 'acc')

plt.plot(hist.history['val_acc'], label='val acc')

plt.title("acc vs Val_acc")

plt.xlabel("Epochs")

plt.ylabel("acc")

plt.legend()

plt.show()

这再次表明,与训练准确率相比,验证准确率较低,这再次显示出过拟合的迹象。

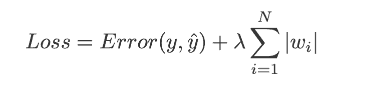

L1 正则化:

一种常用的正则化技术是 L1 正则化,也称为 Lasso 正则化。

L1 正则化的主要概念是我们必须通过将权重的绝对值添加到损失函数中,乘以正则化参数 lambda λ,其中λ是手动调节为大于 0 的。

L1 的方程是

图片来源: 数据科学前沿。

Tensorflow 代码:

这里,我们添加了一个额外的参数kernel_regularizer,我们将其设置为‘l1’,用于 L1 正则化。

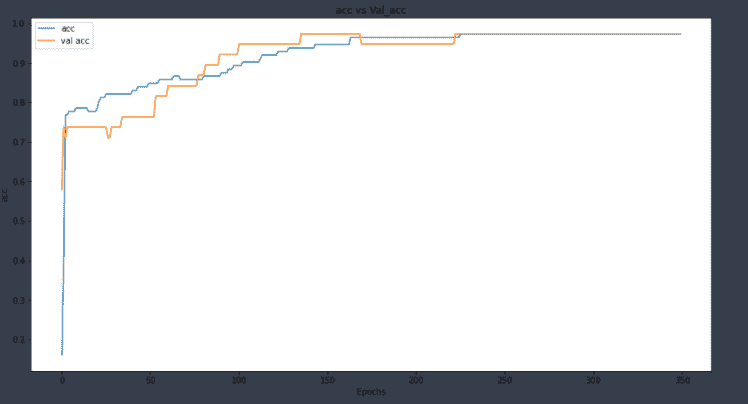

现在我们来评估并绘制模型。

loss2, acc2, mse2 = model2.evaluate(X_test, y_test)

print(f"Loss is {loss2},\nAccuracy is {acc2 * 100},\nMSE is {mse2}")

嗯,准确率差不多一样,我们来看一下图表以获得更好的直观感觉。

plt.plot(hist2.history[‘loss’], label = ‘loss’)

plt.plot(hist2.history[‘val_loss’], label=’val loss’)

plt.title(“Loss vs Val_Loss”)

plt.xlabel(“Epochs”)

plt.ylabel(“Loss”)

plt.legend()

plt.show()

对于准确率,

plt.figure(figsize=(15,8))

plt.plot(hist2.history['acc'], label = 'acc')

plt.plot(hist2.history['val_acc'], label='val acc')

plt.title("acc vs Val_acc")

plt.xlabel("Epochs")

plt.ylabel("acc")

plt.legend()

plt.show()

好吧,相当大的改进,我想,因为过拟合的验证损失没有像之前那样增加,但验证准确率提升不大。让我们在更多层中添加 l1 以检查是否能改善模型。

model3 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape, kernel_regularizer='l1'),

Dense(512//2, activation='tanh', kernel_regularizer='l1'),

Dense(512//4, activation='tanh', kernel_regularizer='l1'),

Dense(512//8, activation='tanh', kernel_regularizer='l1'),

Dense(32, activation='relu', kernel_regularizer='l1'),

Dense(3, activation='softmax')

])

model3.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist3 = model3.fit(X_train, y_train, epochs=350, batch_size=128, validation_data=(X_test,y_test), verbose=2)

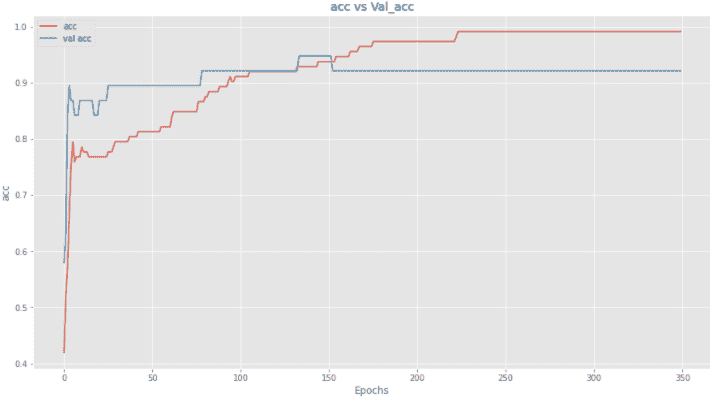

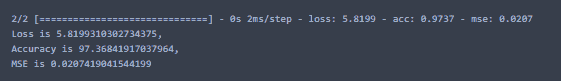

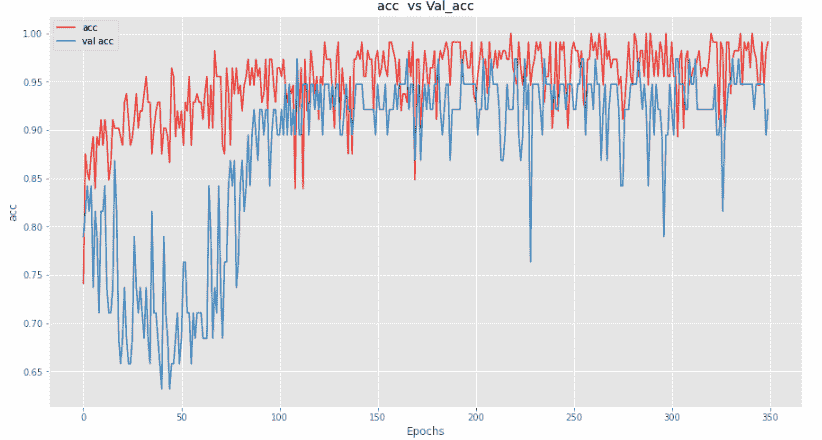

训练后,我们来评估模型。

loss3, acc3, mse3 = model3.evaluate(X_test, y_test)

print(f"Loss is {loss3},\nAccuracy is {acc3 * 100},\nMSE is {mse3}")

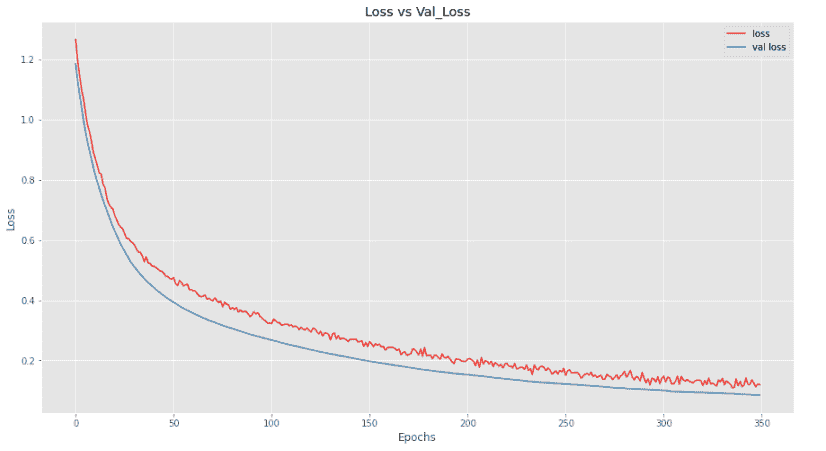

好了,准确率现在有了相当大的提高,从 92 跳升到了 94。我们来看看图表。

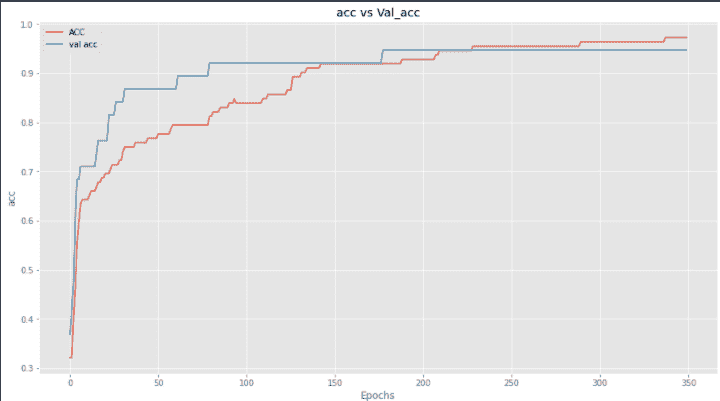

损失

plt.figure(figsize=(15,8))

plt.plot(hist3.history['loss'], label = 'loss')

plt.plot(hist3.history['val_loss'], label='val loss')

plt.title("Loss vs Val_Loss")

plt.xlabel("Epochs")

plt.ylabel("Loss")

plt.legend()

plt.show()

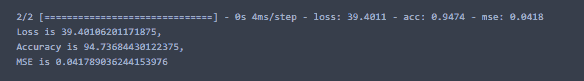

现在,两条线大致重叠,这意味着我们的模型在测试集上的表现与在训练集上的表现相同。

准确率

plt.figure(figsize=(15,8))

plt.plot(hist3.history['acc'], label = 'ACC')

plt.plot(hist3.history['val_acc'], label='val acc')

plt.title("acc vs Val_acc")

plt.xlabel("Epochs")

plt.ylabel("acc")

plt.legend()

plt.show()

我们可以看到,与训练损失相比,模型的验证损失没有增加,验证准确率也在上升。

L2 正则化

L2 正则化是另一种正则化技术,也称为岭回归。在 L2 正则化中,我们将权重的平方大小添加到损失函数中以惩罚我们的损失。

图片来源: 数据科学前沿。

Tensorflow 代码:

model5 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape, kernel_regularizer='l2'),

Dense(512//2, activation='tanh'),

Dense(512//4, activation='tanh'),

Dense(512//8, activation='tanh'),

Dense(32, activation='relu'),

Dense(3, activation='softmax')

])

model5.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist5 = model5.fit(X_train, y_train, epochs=350, batch_size=128, validation_data=(X_test,y_test), verbose=2)

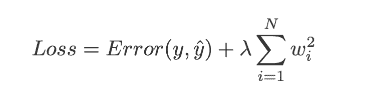

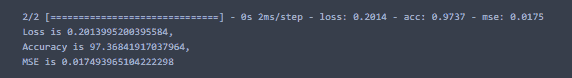

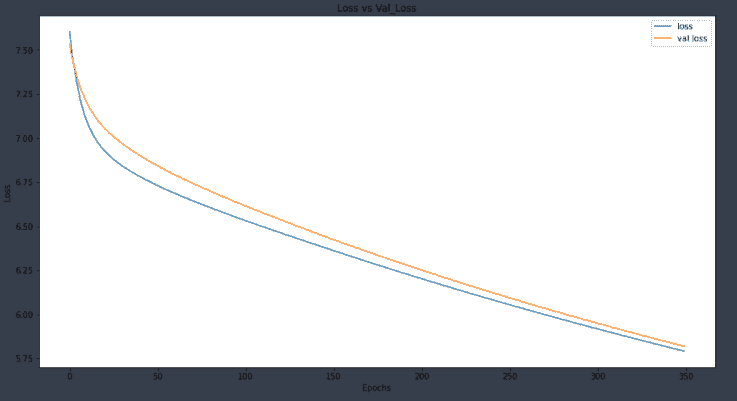

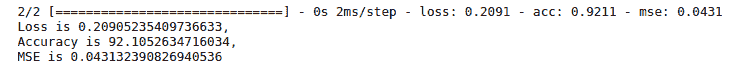

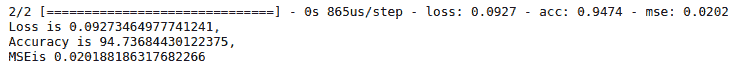

训练后,我们来评估模型。

loss5, acc5, mse5 = model5.evaluate(X_test, y_test)

print(f"Loss is {loss5},\nAccuracy is {acc5 * 100},\nMSE is {mse5}")

输出结果是

在这里我们可以看到验证准确率为 97%,这是相当不错的。我们来绘制更多图表以获得更直观的感觉。

在这里我们可以看到,我们没有过拟合数据。让我们绘制准确率。

在仅一层中添加“L2”正则化大大改善了我们的模型。

现在让我们在所有其他层中添加L2。

model6 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape, kernel_regularizer='l2'),

Dense(512//2, activation='tanh', kernel_regularizer='l2'),

Dense(512//4, activation='tanh', kernel_regularizer='l2'),

Dense(512//8, activation='tanh', kernel_regularizer='l2'),

Dense(32, activation='relu', kernel_regularizer='l2'),

Dense(3, activation='softmax')

])

model6.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist6 = model6.fit(X_train, y_train, epochs=350, batch_size=128, validation_data=(X_test,y_test), verbose=2)

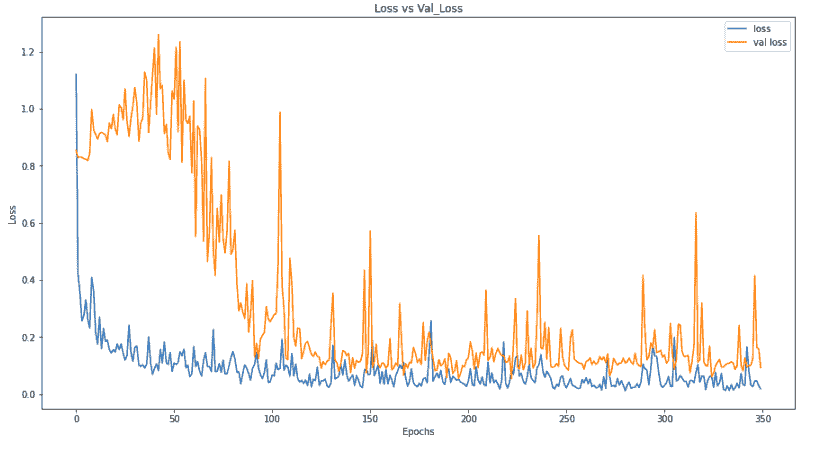

现在我们在所有层中添加了 L2。训练后,我们来评估一下。

loss6, acc6, mse6 = model6.evaluate(X_test, y_test)

print(f"Loss is {loss6},\nAccuracy is {acc6 * 100},\nMSE is {mse6}")

让我们绘图以获得更多直观感受。

plt.figure(figsize=(15,8))

plt.plot(hist6.history['loss'], label = 'loss')

plt.plot(hist6.history['val_loss'], label='val loss')

plt.title("Loss vs Val_Loss")

plt.xlabel("Epochs")

plt.ylabel("Loss")

plt.legend()

plt.show()

对于准确率

我们可以看到这个模型也表现良好,并没有过拟合数据集。

丢弃法

另一种常见的正则化方法是使用丢弃法。使用丢弃法的主要思想是根据一定的概率随机关闭我们层中的一些神经元。你可以通过教授 NG 的视频了解更多关于它的工作原理,这里。

让我们在 TensorFlow 中编写代码。

之前的导入都是一样的,我们这里只是添加了一个额外的导入。

为了实现丢弃法,我们只需从tf.keras.layers中添加一个Dropout层并设置丢弃率。

import tensorflow as tf

model7 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape),

tf.keras.layers.Dropout(0.5), #dropout with 50% rate

Dense(512//2, activation='tanh'),

Dense(512//4, activation='tanh'),

Dense(512//8, activation='tanh'),

Dense(32, activation='relu'),

Dense(3, activation='softmax')

])

model7.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist7 = model7.fit(X_train, y_train, epochs=350, batch_size=128, validation_data=(X_test,y_test), verbose=2)

训练之后,让我们在测试集上进行评估。

loss7, acc7, mse7 = model7.evaluate(X_test, y_test)

print(f"Loss is {loss7},\nAccuracy is {acc7 * 100},\nMSE is {mse7}")

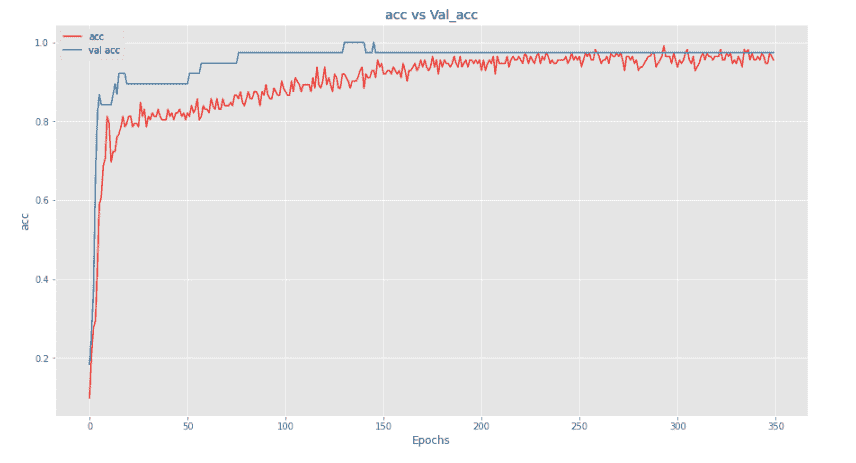

哇,我们的结果非常有希望,我们在测试集上的表现达到了 97%。让我们绘制损失和准确率图,以获得更好的直观感受。

plt.figure(figsize=(15,8))

plt.plot(hist7.history['loss'], label = 'loss')

plt.plot(hist7.history['val_loss'], label='val loss')

plt.title("Loss vs Val_Loss")

plt.xlabel("Epochs")

plt.ylabel("Loss")

plt.legend()

plt.show()

在这里,我们可以看到我们的模型在验证数据上的表现优于训练数据,这真是好消息。

现在让我们绘制准确率图。

我们可以看到,我们的模型在验证数据集上的表现优于训练集。

让我们添加更多丢弃层来查看我们的模型表现如何。

model8 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape),

tf.keras.layers.Dropout(0.5),

Dense(512//2, activation='tanh'),

tf.keras.layers.Dropout(0.5),

Dense(512//4, activation='tanh'),

tf.keras.layers.Dropout(0.5),

Dense(512//8, activation='tanh'),

tf.keras.layers.Dropout(0.3),

Dense(32, activation='relu'),

Dense(3, activation='softmax')

])

model8.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist8 = model8.fit(X_train, y_train, epochs=350, batch_size=128, validation_data=(X_test,y_test), verbose=2)

让我们评估一下。

loss8, acc8, mse8 = model8.evaluate(X_test, y_test)

print(f"Loss is {loss8},\nAccuracy is {acc8 * 100},\nMSE is {mse8}")

这个模型也非常好,因为它在测试集上的表现达到了 98%。让我们绘图以获得更好的直观感受。

plt.figure(figsize=(15,8))

plt.plot(hist8.history['loss'], label = 'loss')

plt.plot(hist8.history['val_loss'], label='val loss')

plt.title("Loss vs Val_Loss")

plt.xlabel("Epochs")

plt.ylabel("Loss")

plt.legend()

plt.show()

我们可以看到,添加更多丢弃层会使模型在训练时表现稍逊,但在验证集上,它表现得非常好。

现在让我们绘制准确率图。

我们在这里看到相同的模式,即我们的模型在训练时表现不佳,但在评估时表现非常好。

批量归一化

批量归一化的主要思想是我们通过使用几种技术(在我们的案例中是sklearn.preprocessing.StandardScaler)对输入层进行归一化,从而提高模型性能。如果输入层通过归一化受益,那为何不对隐藏层进行归一化,以进一步提高和加快学习呢?

要学习数学并获得更多直观感受,我会再次引导你到教授 NG 的讲座,这里和这里。

要在你的 TensorFlow 模型中添加它,只需在你的层后面添加tf.keras.layers.BatchNormalization()。

让我们看看代码。

model9 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape),

Dense(512//2, activation='tanh'),

tf.keras.layers.BatchNormalization(),

Dense(512//4, activation='tanh'),

Dense(512//8, activation='tanh'),

Dense(32, activation='relu'),

Dense(3, activation='softmax')

])

model9.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist9 = model9.fit(X_train, y_train, epochs=350, validation_data=(X_test,y_test), verbose=2)

在这里,如果你注意到我已经去掉了batch_size选项。这是因为在仅使用tf.keras.BatchNormalization()作为正则化时,添加batch_size参数会导致模型性能非常差。我尝试在网上寻找原因,但未能找到。如果你真的想在训练时使用batch_size,也可以将优化器从sgd更改为rmsprop或adam。

训练后,让我们评估模型。

loss9, acc9, mse9 = model9.evaluate(X_test, y_test)

print(f"Loss is {loss9},\nAccuracy is {acc9 * 100},\nMSE is {mse9}")

对于一个批量归一化的准确性,其验证准确性不如其他技术。让我们绘制损失和准确性图,以获得更好的直观感受。

在这里,我们可以看到我们的模型在验证集上的表现不如在测试集上的表现。让我们将归一化添加到所有层中以查看结果。

model11 = Sequential([

Dense(512, activation='tanh', input_shape = X_train[0].shape),

tf.keras.layers.BatchNormalization(),

Dense(512//2, activation='tanh'),

tf.keras.layers.BatchNormalization(),

Dense(512//4, activation='tanh'),

tf.keras.layers.BatchNormalization(),

Dense(512//8, activation='tanh'),

tf.keras.layers.BatchNormalization(),

Dense(32, activation='relu'),

tf.keras.layers.BatchNormalization(),

Dense(3, activation='softmax')

])

model11.compile(optimizer='sgd',loss='categorical_crossentropy', metrics=['acc', 'mse'])

hist11 = model11.fit(X_train, y_train, epochs=350, validation_data=(X_test,y_test), verbose=2)

让我们来评估一下。

loss11, acc11, mse11 = model11.evaluate(X_test, y_test)

print(f"Loss is {loss11},\nAccuracy is {acc11 * 100},\nMSEis {mse11}")

通过在每一层中添加批量归一化,我们实现了良好的准确性。让我们绘制损失和准确性图。

通过绘制准确性和损失,我们可以看到我们的模型在训练集上的表现仍优于验证集,但仍在提升性能。

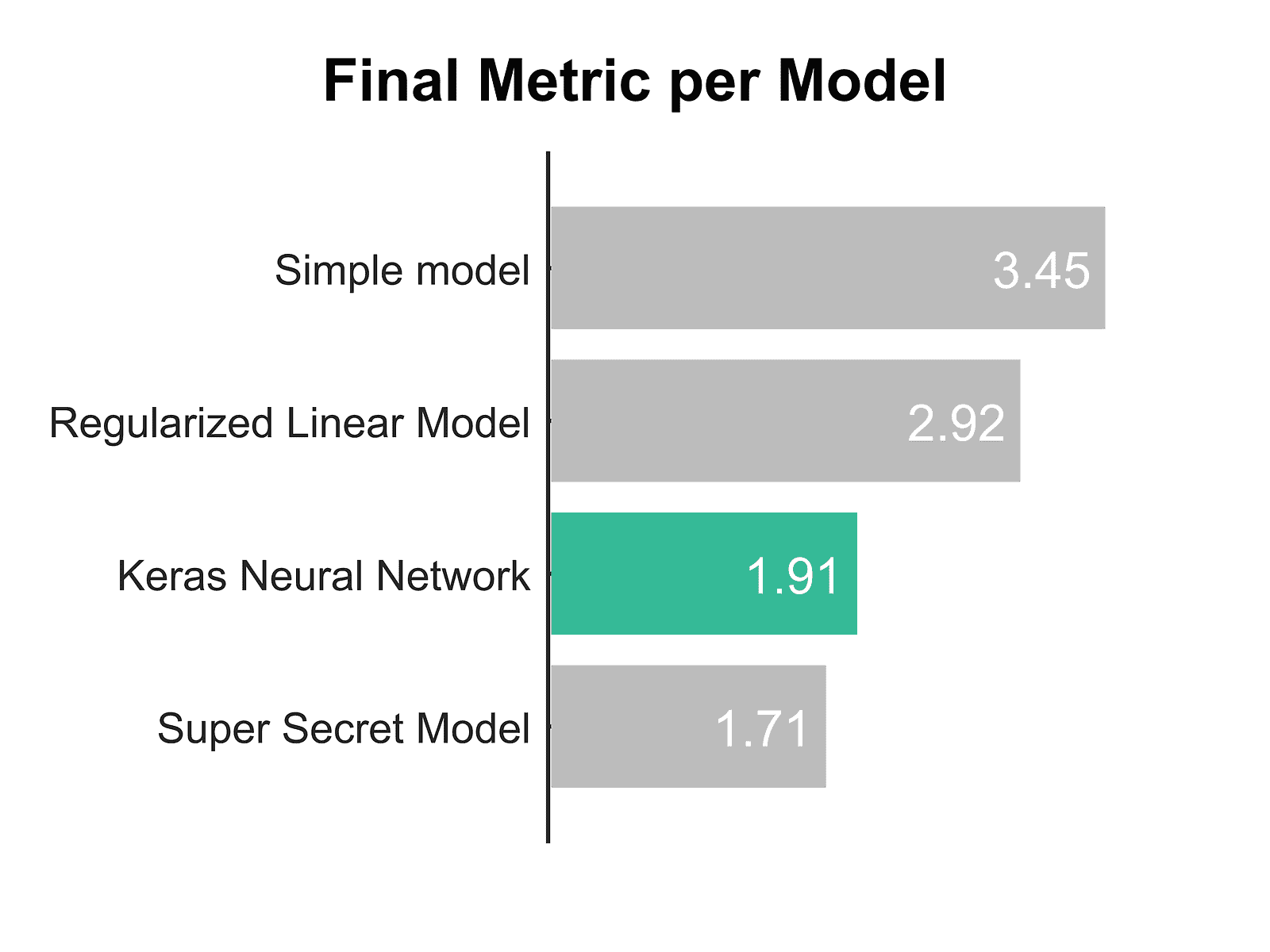

结果:

这篇文章简要介绍了如何在 TensorFlow 中使用不同的技术。如果你对理论不够了解,我建议你学习 Coursera 深度学习专项课程中的第 2 和第 3 课程,以了解更多关于正则化的内容。

你还需要学习何时使用哪些技术,以及如何将不同技术结合起来,以产生真正有成效的结果。

希望现在你对如何在 TensorFlow 2 中实现不同的正则化技术有了一个概念。

相关:

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关话题

使用 Tensorflow Object Detection 进行逐像素分类

原文:

www.kdnuggets.com/2018/03/tensorflow-object-detection-pixel-wise-classification.html

评论

评论

由 Priyanka Kochhar,深度学习顾问

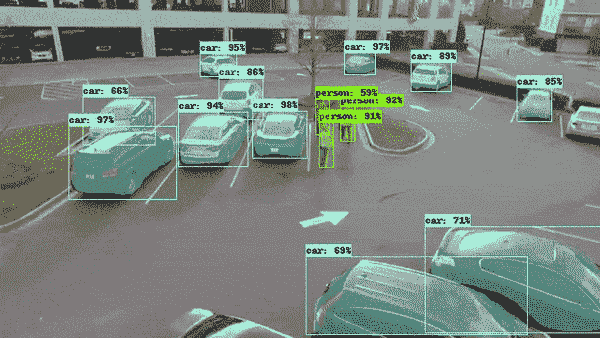

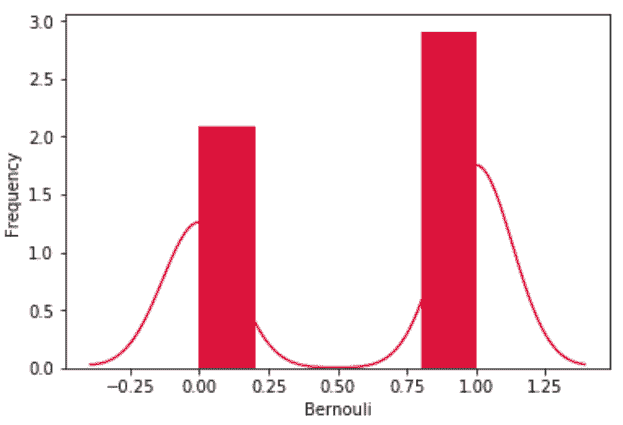

过去我使用 Tensorflow Object Detection API 实现对象检测,输出为图像中不同感兴趣对象的边界框。更多内容请参阅我的 文章。Tensorflow 最近添加了新功能,现在我们可以扩展 API 来确定感兴趣对象的逐像素位置。请见下面的示例:

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

Tensorflow Object Detection Mask RCNN

代码在我的 Github 上。

实例分割

实例分割是对象检测的扩展,其中每个边界框都关联一个二进制掩码(即对象与背景)。这提供了有关框内对象范围的更精细的信息。

那么我们何时需要这种额外的细粒度呢?一些想到的示例包括:

i) 自动驾驶汽车——可能需要知道道路上另一辆车的确切位置或人行道上人类的位置

ii) 机器人系统——能够将两个部分连接在一起的机器人,如果知道两个部分的确切位置,将表现得更好

实现实例分割的算法有很多,但 Tensorflow Object Detection API 使用的是 Mask RCNN。

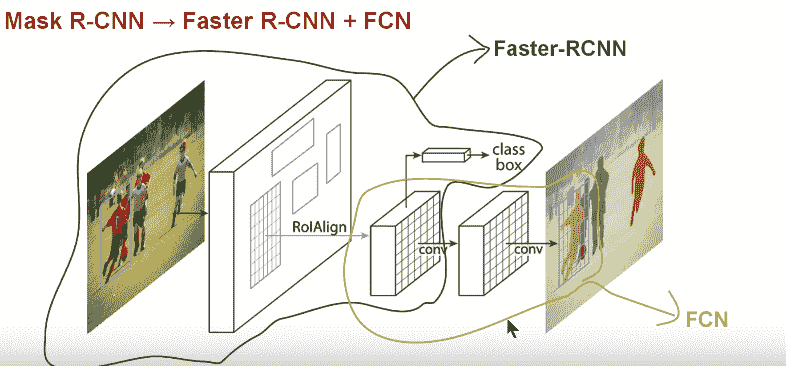

Mask RCNN

让我们从对 Mask RCNN 的温和介绍开始。

Mask RCNN 架构

Faster RCNN 是一种非常优秀的对象检测算法。Faster R-CNN 由两个阶段组成。第一个阶段称为区域提议网络(RPN),它提出候选对象边界框。第二个阶段,本质上是 Fast R-CNN,使用 RoIPool 从每个候选框中提取特征,并进行分类和边界框回归。两个阶段使用的特征可以共享,以加快推断速度。

Mask R-CNN 从概念上讲是简单的:Faster R-CNN 为每个候选对象提供两个输出,一个是类别标签,一个是边界框偏移量;在此基础上,我们增加了第三个分支,该分支输出对象掩码 — 这是一个二值掩码,指示对象在边界框中的像素。但额外的掩码输出与类别和框的输出不同,需要提取对象的更精细的空间布局。为此,Mask RCNN 使用了Fully Convolution NetworkMask RCNN 论文(FCN)所描述的网络。

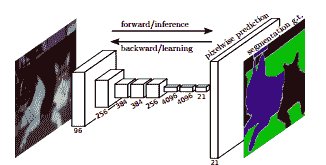

完全卷积网络架构

FCN 是一种用于语义分割的流行算法。该模型使用各种卷积块和最大池化层,首先将图像解压到其原始大小的 1/32。然后,它在这个粒度水平上进行类别预测。最后,它使用上采样和反卷积层将图像调整到其原始尺寸。

简而言之,我们可以说 Mask RCNN 将两个网络 — Faster RCNN 和 FCN 结合成一个超级架构。模型的损失函数是分类、生成边界框和生成掩码的总损失。

Mask RCNN 有一些额外的改进,使其比 FCN 更准确。你可以在他们的论文中阅读更多细节。

实现

在图像上的测试

要在图像上测试这个模型,你可以利用在 tensorflow 网站上共享的代码。我测试了他们最轻量级的模型 — mask_rcnn_inception_v2_coco。只需下载模型并升级到 tensorflow 1.5(这一点很重要!)。请参见下面的示例结果:

Mask RCNN 在风筝图像上的应用

在视频上的测试

对我来说,更有趣的实验是运行模型来处理来自 YouTube 的样本视频。我使用 keepvid 从 YouTube 下载了几个视频。我喜欢使用库 moviepy 来处理视频文件。

主要步骤是:

-

使用 VideoFileClip 函数从视频中提取每一帧

-

fl_image 函数是一个很棒的函数,可以接收图像并用修改后的图像替换它。我用它来对从视频中提取的每一张图像进行对象检测

-

最终,所有修改后的剪辑图像都被合并成一个新视频。

你可以在我的 Github 上找到完整的代码。

下一步

一些进一步探索此 API 的额外想法:

-

尝试那些更准确但开销较大的模型,看看它们能带来多大的差异。

-

使用 API 在自定义数据集上训练 Mask RCNN。这是我接下来的任务。

如果你喜欢这篇文章,请给我一个❤️:) 希望你能拉取代码并亲自尝试。

其他写作: https://medium.com/@priya.dwivedi/

PS: 我有自己的深度学习咨询公司,喜欢构建有趣的深度学习模型。我帮助了多家初创公司部署创新的 AI 解决方案。如果你有一个可以合作的项目,请通过 priya.toronto3@gmail.com 联系我。

参考文献:

-

对 Mask RCNN 的非常好的 解释

简介: Priyanka Kochhar 拥有超过 10 年的数据科学经验。她现在拥有自己的深度学习咨询公司,喜欢解决有趣的问题。她帮助了多家初创公司部署创新的 AI 解决方案。如果你有一个可以合作的项目,请通过 priya.toronto3@gmail.com 联系她。

原文。经许可转载。

相关:

-

Google Tensorflow Object Detection API 是实现图像识别的最简单方式吗?

-

使用 Tensorflow Object Detection API 构建一个玩具检测器

-

训练和可视化词向量

更多相关主题

TensorFlow 2.0 教程:优化训练时间性能

原文:

www.kdnuggets.com/2020/03/tensorflow-optimizing-training-time-performance.html

评论

由Raphael Meudec,数据科学家 @ Sicara

本教程探讨了如何提升你的 TensorFlow 2.0 模型的训练时间性能:

-

tf.data

-

混合精度训练

-

多 GPU 训练策略

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 为你的组织提供 IT 支持

3. 谷歌 IT 支持专业证书 - 为你的组织提供 IT 支持

我将所有这些技巧应用到一个自定义的图像去模糊项目中,结果令人惊讶。根据你当前的流程,你可以获得 2 到 10 倍的训练时间加速。

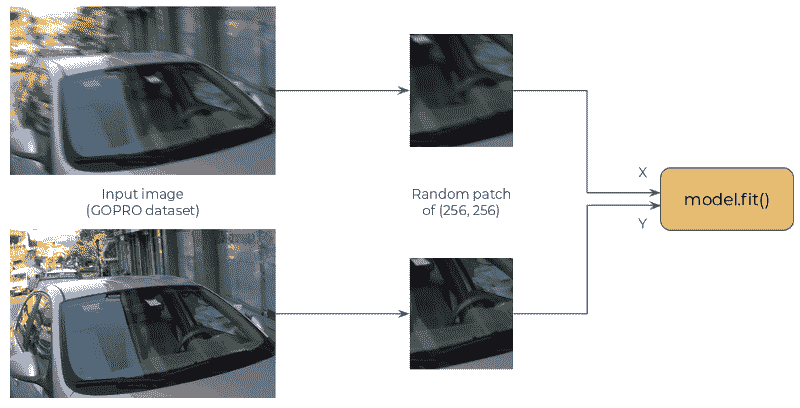

使用案例:提高图像去模糊 CNN 的 TensorFlow 训练时间

2 年前,我在使用 GANs 在 Keras 中去模糊图像上发表了一篇博客文章。我觉得将 TF2.0 的代码库传递过来理解变化和对代码的影响是一个不错的过渡。在这篇文章中,我将训练一个更简单版本的模型(仅 CNN 部分)。

模型是一个卷积网络,它接受(256, 256, 3)的模糊补丁,并预测(256, 256, 3)的对应清晰补丁。它基于 ResNet 架构,并且是完全卷积的。

步骤 1:识别瓶颈

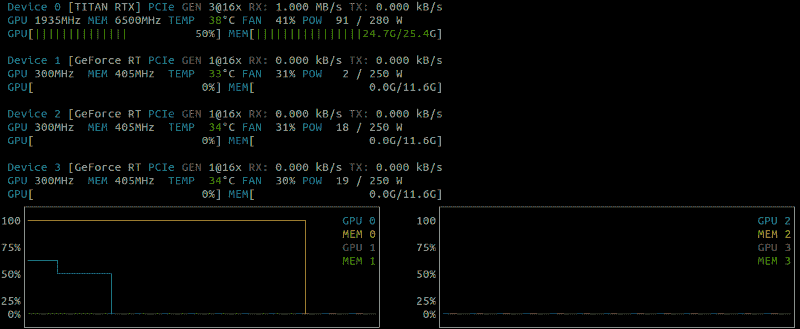

为了优化训练速度,你希望你的 GPU 以 100%的速度运行。nvidia-smi很适合确保你的进程在 GPU 上运行,但当涉及 GPU 监控时,还有更智能的工具。因此,本 TensorFlow 教程的第一步是探索这些更好的选项。

nvtop

如果你使用的是 Nvidia 显卡,监控 GPU 利用率的最简单解决方案可能就是nvtop。可视化比nvidia-smi更友好,你可以随时间跟踪指标。

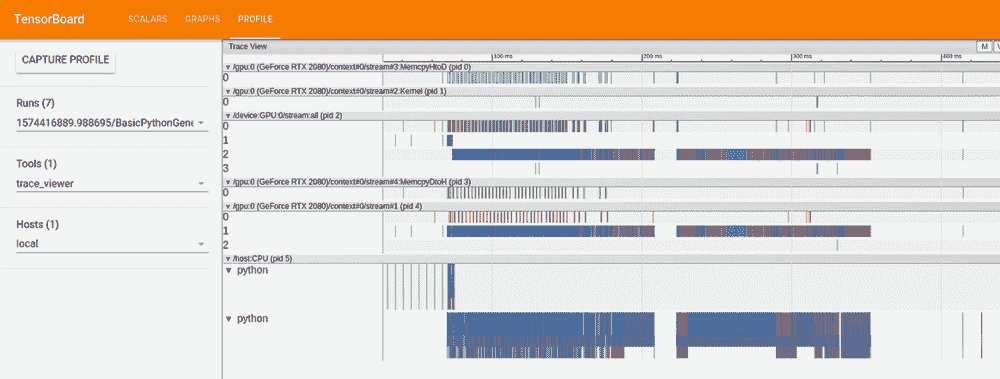

TensorBoard Profiler

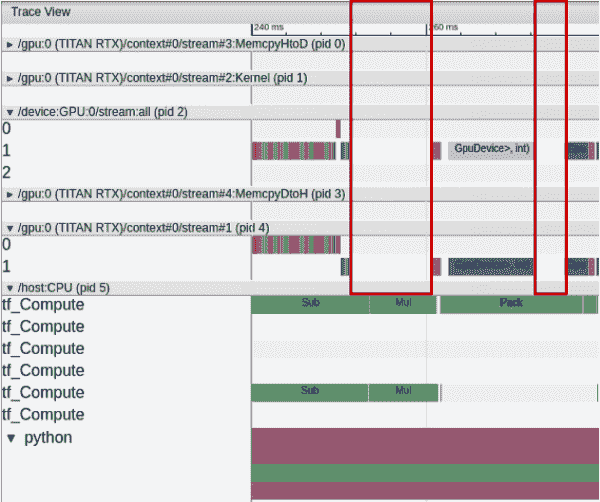

只需在 TensorBoard 回调中设置profile_batch={BATCH_INDEX_TO_MONITOR},TF 会添加一个关于 CPU 或 GPU 在给定批次上执行的操作的完整报告。这有助于识别你的 GPU 是否因为数据不足而在某些点停滞。

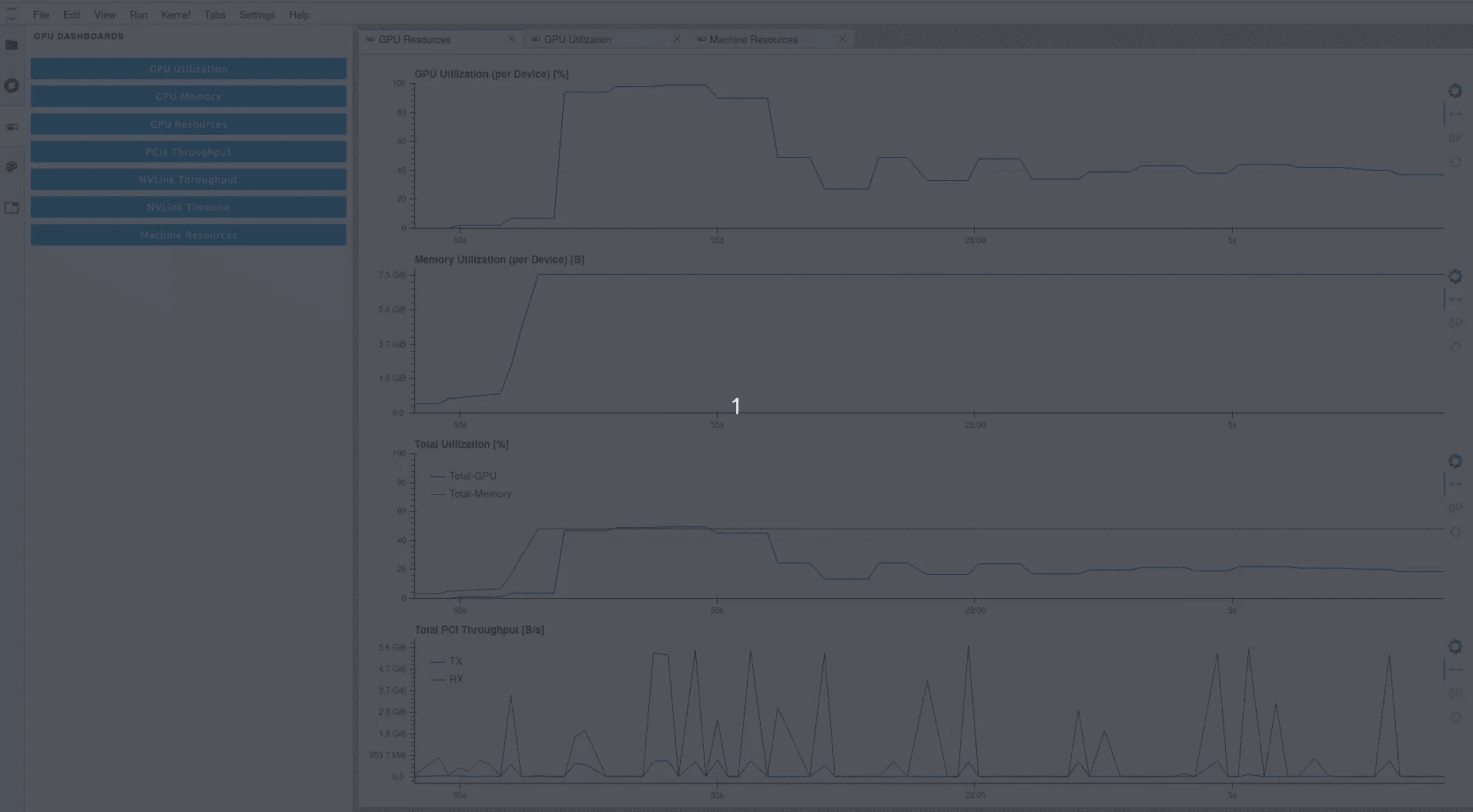

这是一个 Jupyterlab 扩展,可以访问各种指标。除了 GPU,你还可以监控来自主板的元素(CPU、磁盘等)。优势在于你不必监控特定的批次,而是查看整个训练过程的性能。

在这里,我们可以很容易地发现 GPU 大部分时间运行在 40% 的速度。我只激活了计算机上的 1 个 GPU,因此总利用率约为 20%。

步骤 2:优化你的 tf.data 管道

首要目标是让 GPU 始终 100% 繁忙。为此,我们希望减少数据加载瓶颈。如果你使用的是 Python 生成器或 Keras Sequence,你的数据加载可能并不理想。即使使用 tf.data,数据加载仍然可能是一个问题。在我的文章中,我最初使用 Keras Sequences 加载图像。

你可以使用 TensorBoard 的性能分析功能轻松发现这一现象。GPU 在 CPU 执行多个与数据加载相关的操作时通常会有空闲时间。

从原始 Keras 序列切换到 tf.data 相对容易。数据加载的大部分操作都得到了很好的支持,唯一棘手的部分是要在模糊图像和真实图像上获取相同的补丁。

从 Keras Sequence 切换到 tf.data 可以提高训练时间。从这里,我们添加了一些小技巧,你也可以在 TensorFlow 文档 中找到这些技巧:

-

并行化:通过添加

num_parallel_calls=tf.data.experimental.AUTOTUNE参数,使所有.map()调用并行化。 -

缓存:通过在补丁选择之前缓存数据集,将加载的图像保留在内存中。

-

预取:在前一个批次结束之前开始获取元素。

数据集创建现在看起来是这样的:

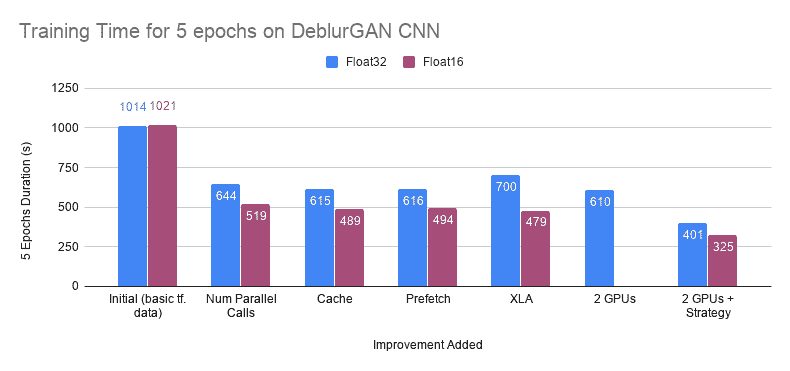

这些小变化使得 5 个周期的训练时间从 1000 秒(在 RTX2080 上)下降到 616 秒(完整图表见下)。

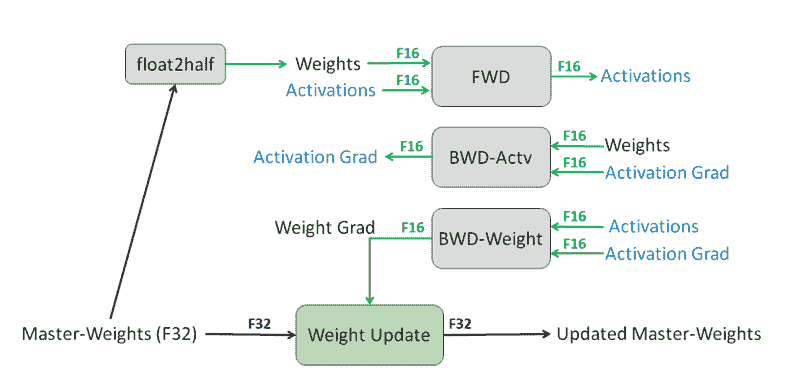

步骤 3:混合精度训练

默认情况下,我们神经网络训练中使用的所有变量都存储在 float32 中。这意味着每个元素都必须编码为 32 位。混合精度训练 的核心概念是:我们不需要始终保持如此高的精度,可以在某些情况下使用 16 位。

在混合精度训练过程中,你保留了权重的 float32 版本,但在 float16 版本的权重上执行前向和后向传递。所有获取梯度的昂贵操作都是使用 float16 元素执行的。最后,你使用 float16 梯度来更新 float32 权重。训练过程中使用了损失缩放以保持训练稳定性。

通过保持 float32 权重,这个过程不会降低你模型的准确性。相反,他们声称在各种任务上有一些性能改进。

从版本 2.1.0 开始,TensorFlow 使得实现变得简单,通过添加不同的 Policy. 混合精度训练可以通过在模型实例化之前使用这两行代码来激活。

使用这种方法,我们可以将 5 个 epoch 的训练时间缩短到 480 秒。

第四步:多 GPU 策略

最后一部分讨论如何使用 TF2.0 进行多 GPU 训练。如果你不调整你的代码以适应多 GPU,你不会减少 TensorFlow 的训练时间,因为它们不会被有效利用。

执行多 GPU 训练的最简单方法是使用 MirroredStrategy。它会在每个 GPU 上实例化你的模型。在每一步,不同的批量数据被发送到 GPUs,这些 GPU 执行反向传播。然后,梯度被聚合以进行权重更新,更新后的值被传播到每个实例化的模型。

分布策略在 TensorFlow 2.0 中仍然相当简单。你只需要考虑将通常的批量大小乘以可用 GPU 的数量。

如果你使用 TPU,可能需要更深入地查看官方的 Tensorflow 文档教程 关于训练分布。

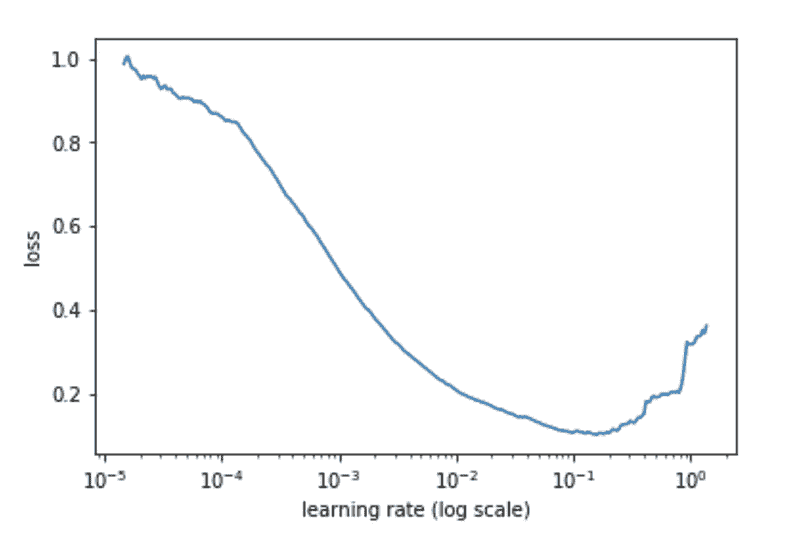

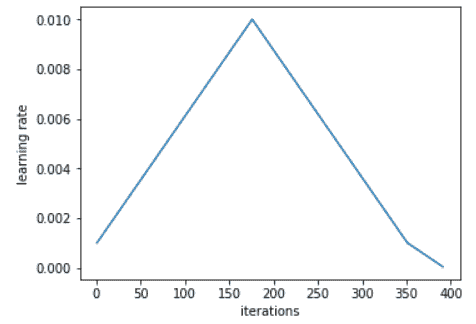

关于提升 TensorFlow 训练时间的技巧总结

所有这些步骤都导致了你模型训练时间的巨大减少。此图跟踪了每次训练管道改进后的 5 个 epoch 训练时间。希望你喜欢这个关于 TensorFlow 训练时间性能的教程。如果你有任何反馈,可以在 Twitter 上@我(@raphaelmeudec)!

tf.data、MPT 和 GPU 策略对训练时间的影响

个人简介: Raphael Meudec (@raphaelmeudec)是 Sicara 的数据科学家。

原文。已获许可转载。

相关内容:

-

使用 Keras Tuner 进行超参数调整

-

使用 TensorFlow 简单图像数据集增强

-

转移学习简化:编码强大的技术

更多相关内容

TensorFlow:优化哪些参数?

原文:

www.kdnuggets.com/2017/11/tensorflow-parameters-optimize.html

本文针对的是对 TensorFlow Core API 有基本了解的读者。

学习 TensorFlow Core API,即 TensorFlow 中的最低级 API,是开始学习 TensorFlow 的一个很好的步骤,因为它可以让你理解库的核心。以下是一个非常简单的 TensorFlow Core API 示例,其中我们创建并训练一个线性回归模型。

步骤如下:

-

读取模型的可训练参数(在此示例中只有一个权重和一个偏置)。

-

将训练数据读取到占位符中。

-

创建线性回归模型函数。

-

创建一个损失函数来评估模型的预测误差。

-

创建一个 TensorFlow 会话。

-

初始化可训练参数。

-

运行会话以训练回归模型。

1. import tensorflow

2.

3. #Trainable Parameters

4. W = tensorflow.Variable([.6], dtype=tensorflow.float32)

5. b = tensorflow.Variable([.2], dtype=tensorflow.float32)

6.

7. #Training Data (inputs/outputs)

8. x = tensorflow.placeholder(dtype=tensorflow.float32)

9. y = tensorflow.placeholder(dtype=tensorflow.float32)

10\.

11\. #Linear Model

12\. linear_model = W * x + b

13\.

14\. #Linear Regression Loss Function - sum of the squares

15\. squared_deltas = tensorflow.square(linear_model - y)

16\. loss = tensorflow.reduce_sum(squared_deltas)

17\.

18\. #Creating a session

19\. sess = tensorflow.Session()

20\.

21\. #Initializing variables

22\. init = tensorflow.global_variables_initializer()

23\. sess.run(init)

24\.

25\. #Print the loss

26\. print(sess.run(loss, feed_dict={ x: [1, 2, 3, 4], y: [0, 1, 2, 3]}))

27\.

28\. sess.close()

返回的损失为 53.76。存在误差,特别是对于较大的误差,意味着必须更新所用的参数。这些参数预计会自动更新,但我们可以开始手动更新,直到误差为零。

-

对于 W=0.8 和 b=0.4,损失为 3.44。

-

对于 W=1.0 和 b=0.8,损失为 12.96。

-

对于 W=1.0 和 b=-0.5,损失为 1.0。

-

对于 W=1.0 和 b=-1.0,损失为 0.0。

因此,当 W=1.0 和 b=-1.0 时,期望结果与预测结果一致,因此我们不能进一步提高模型性能。我们已达到参数的最佳值,但不是使用最佳方式。计算参数的最佳方式是自动的。

TensorFlow 中已经存在多种优化器,用于简化操作。这些优化器存在于 TensorFlow 的 API 中,例如:

-

tensorflow.train

-

tensorflow.estimator

以下是如何使用 tensorflow.train 自动更新参数的方法。

tensorflow.train API

TensorFlow 提供了多种优化器,这些优化器能够自动完成之前手动计算模型参数最佳值的工作。

最简单的优化器是梯度下降法,它通过缓慢改变每个参数的值,直到达到最小化损失的值。梯度下降法根据损失对变量的导数的大小来调整每个变量。

由于计算导数的操作复杂且容易出错,TensorFlow 可以自动计算梯度。在计算梯度后,你需要自行优化参数。

但 TensorFlow 通过提供优化器,使得事情变得越来越简单,这些优化器除了优化参数外,还会计算导数。

tensorflow.train API 包含一个名为 GradientDescentOptimizer 的类,它既可以计算导数,又可以优化参数。例如,以下代码展示了如何使用 GradientDescentOptimizer 最小化损失:

1. import tensorflow

2.

3. #Trainable Parameters

4. W = tensorflow.Variable([0.3], dtype=tensorflow.float32)

5. b = tensorflow.Variable([-0.2], dtype=tensorflow.float32)

6.

7. #Training Data (inputs/outputs)

8. x = tensorflow.placeholder(dtype=tensorflow.float32)

9. y = tensorflow.placeholder(dtype=tensorflow.float32)

10\.

11\. x_train = [1, 2, 3, 4]

12\. y_train = [0, 1, 2, 3]

13\.

14\. #Linear Model

15\. linear_model = W * x + b

16\.

17\. #Linear Regression Loss Function - sum of the squares

18\. squared_deltas = tensorflow.square(linear_model - y_train)

19\. loss = tensorflow.reduce_sum(squared_deltas)

20\.

21\. #Gradient descent optimizer

22\. optimizer = tensorflow.train.GradientDescentOptimizer(learning_rate=0.01)

23\. train = optimizer.minimize(loss=loss)

24\.

25\. #Creating a session

26\. sess = tensorflow.Session()

27\.

28\. writer = tensorflow.summary.FileWriter("/tmp/log/", sess.graph)

29\.

30\. #Initializing variables

31\. init = tensorflow.global_variables_initializer()

32\. sess.run(init)

33\.

34\. #Optimizing the parameters

35\. for i in range(1000):

36\. sess.run(train, feed_dict={x: x_train, y: y_train})

37\.

38\. #Print the parameters and loss

39\. curr_W, curr_b, curr_loss = sess.run([W, b, loss], {x: x_train, y: y_train})

40\. print("W : ", curr_W, ", b : ", curr_b, ", loss : ", curr_loss)

41\.

42\. writer.close()

43\.

44\. sess.close()

这是优化器返回的结果。它似乎自动推导出了正确的参数值,以获得最小损失。

W : [ 0.99999809] , b : [-0.9999944] , loss : 2.05063e-11

使用这样的内置优化器有一些优势,而不是手动构建它。这是因为使用 TensorFlow Core API 创建这样简单的线性回归模型的代码并不复杂。但当处理更复杂的模型时情况并非如此。因此,建议使用 TensorFlow 中的高级 API 来完成经常使用的任务。

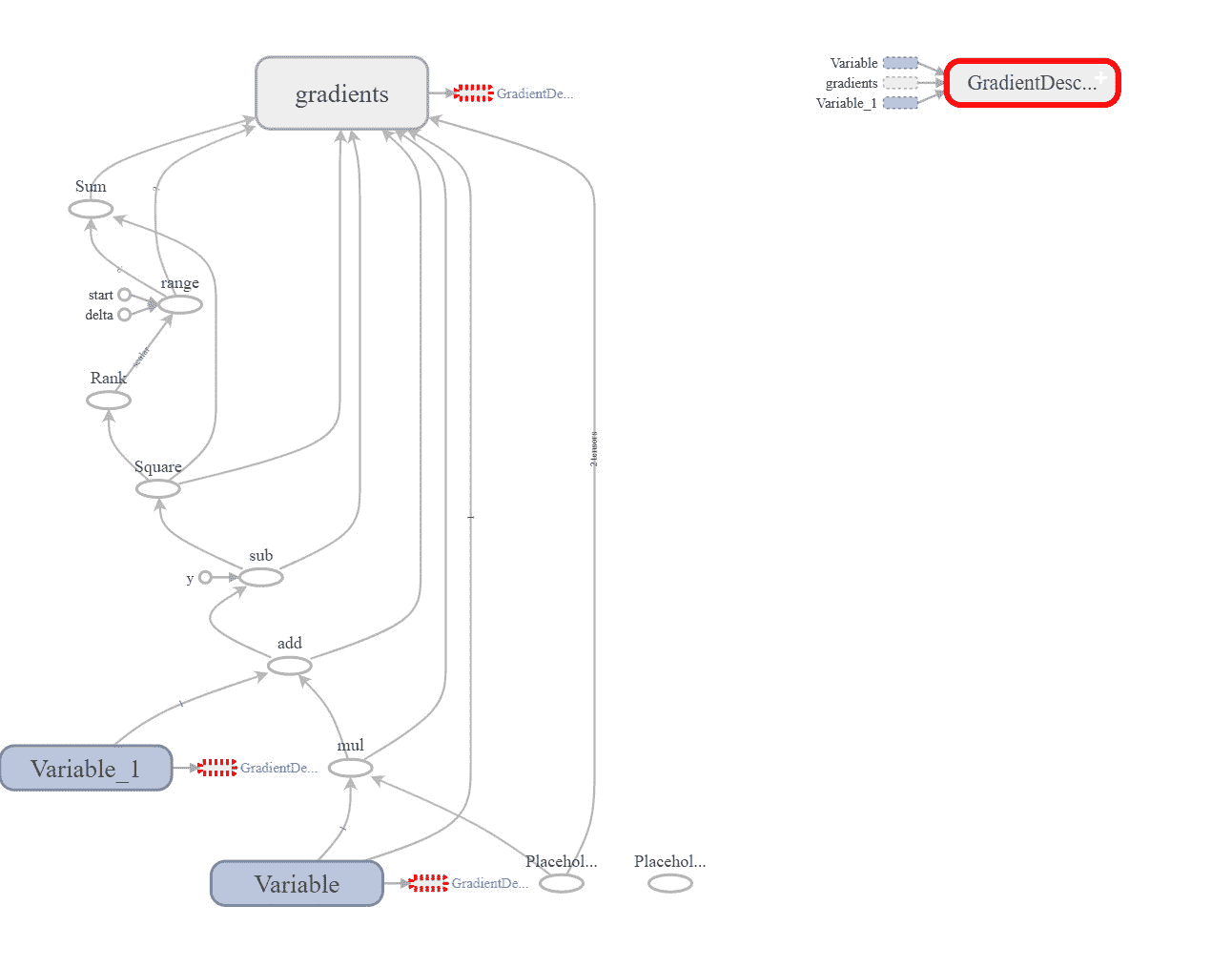

这是使用 TensorBoard (TB)可视化的前一个程序的数据流图。

但有一个非常重要的问题。优化器是如何推导出应当改变哪些参数的?它是如何推导出我们需要优化权重(W)和偏置(b)的?我们没有明确告诉优化器这些是它将改变的参数以减少损失,但它自己推导了出来。那它是如何做到的?

在第 35 行,我们运行会话并要求评估训练 Tensor。TensorFlow 会按照图节点链评估该 Tensor。在第 23 行,TensorFlow 发现要评估训练 Tensor,它需要评估 optimizer.minimize 操作。该操作将尽可能地最小化其输入参数。

追溯回来,为了评估最小化操作,它将接受一个 Tensor,即损失。因此,现在的目标是最小化损失 Tensor。但如何最小化损失?它仍然会沿着图回溯,并发现它是通过 tensorflow.reduce_sum()操作进行评估的。因此,我们现在的目标是最小化 tensorflow.reduce_sum()操作的结果。

追溯回来,这个操作是使用一个 Tensor 作为输入进行评估的,即 squared_deltas。因此,我们现在的目标是最小化 squared_deltas Tensor,而不是最小化 tensorflow.reduce_sum()操作。

沿着链回溯,我们发现 squared_deltas Tensor 依赖于 tensorflow.square()操作。因此,我们应该最小化 tensorflow.square()操作。最小化该操作将要求我们最小化其输入 Tensors,即 linear_model 和 y_train。查看这两个 Tensor,哪个可以被修改?可以修改的 Tensor 是 Variables 类型的。由于 y_train 不是 Variable 而是 placeholder,因此我们不能修改它,因此我们可以修改 linear_model 来最小化结果。

在第 15 行,linear_model Tensor 是基于三个输入计算的,即 W、x 和 b。查看这些 Tensors,只有 W 和 x 可以被改变,因为它们是变量。因此,我们的目标是最小化这两个 Tensors W 和 x。

这就是 TensorFlow 推导出要最小化损失应当最小化权重和偏置参数的方法。

简历:Ahmed Gad 于 2015 年 7 月获得埃及门努菲亚大学计算机与信息学院信息技术学士学位,并以优异成绩获得荣誉。由于在学院排名第一,他被推荐于 2015 年在埃及的一所学院担任助教,随后在 2016 年继续在学院担任助教及研究员。他当前的研究兴趣包括深度学习、机器学习、人工智能、数字信号处理和计算机视觉。

原文。经许可转载。

相关内容:

-

TensorFlow:逐步构建前馈神经网络

-

5 个免费资源,帮助你深入理解深度学习

-

7 种用于自然语言处理的人工神经网络类型

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速迈向网络安全职业生涯。

1. 谷歌网络安全证书 - 快速迈向网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

更多相关话题

探索 TensorFlow Quantum:Google 用于创建量子机器学习模型的新框架

原文:

www.kdnuggets.com/2020/03/tensorflow-quantum-framework-quantum-machine-learning-models.html

评论

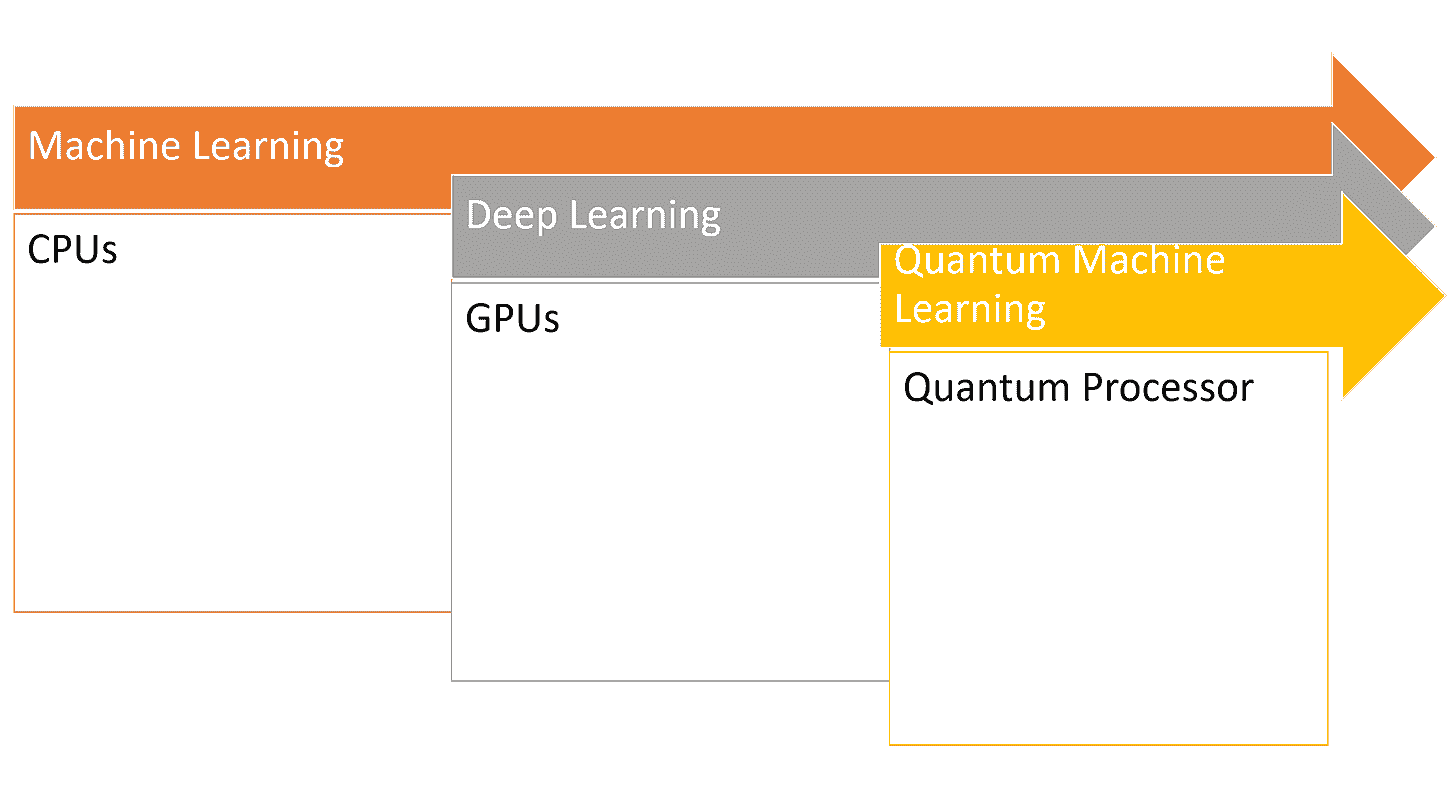

量子计算与人工智能(AI)的交汇点有望成为整个技术历史中最令人着迷的进展之一。量子计算的出现可能迫使我们重新构想几乎所有现有的计算范式,而 AI 也不例外。然而,量子计算机的计算能力也有可能加速许多目前尚不实用的 AI 领域。AI 和量子计算共同工作的第一步是重新构想机器学习模型以适应量子架构。最近,Google 开源了 TensorFlow Quantum,这是一个用于构建量子机器学习模型的框架。

TensorFlow Quantum 的核心理念是将量子算法和机器学习程序交错在 TensorFlow 编程模型中。Google 将这种方法称为量子机器学习,并通过利用一些最新的量子计算框架,如 Google Cirq,来实现这一点。

量子机器学习

当涉及量子计算和 AI 时,我们需要回答的第一个问题是后者如何从量子架构的出现中受益。量子机器学习(QML)是一个广泛的术语,用来指代能够利用量子特性的机器学习模型。最初的 QML 应用集中在重构传统的机器学习模型,以便它们能够在随着量子比特数量呈指数增长的状态空间上快速执行线性代数。然而,量子硬件的进化拓展了 QML 的视野,使其发展到启发式方法,这些方法由于量子硬件的计算能力增加而可以通过实证研究。这一过程类似于 GPU 的创建如何使机器学习发展到深度学习范式。

在 TensorFlow Quantum 的背景下,QML 可以定义为两个主要组成部分:

-

量子数据集

-

混合量子模型

量子数据集

量子数据是发生在自然或人工量子系统中的任何数据源。这可以是来自量子力学实验的经典数据,或是由量子设备直接生成并作为输入喂入算法的数据。有证据表明,在“量子数据”上的混合量子-经典机器学习应用可能提供量子优势,超越仅使用经典机器学习的原因如下面所述。量子数据展示了叠加和纠缠,导致联合概率分布,这可能需要指数级的经典计算资源来表示或存储。

混合量子模型

就像机器学习可以从训练数据集中推广模型一样,量子机器学习(QML)也能够从量子数据集中推广量子模型。然而,由于量子处理器仍然相对较小且噪声较多,量子模型不能仅凭量子处理器来推广量子数据。混合量子模型提出了一种方案,在这种方案中,量子计算机作为硬件加速器最为有用,与传统计算机协同工作。这种模型非常适合 TensorFlow,因为它已经支持跨 CPU、GPU 和 TPU 的异构计算。

Cirq

构建混合量子模型的第一步是能够利用量子操作。为此,TensorFlow Quantum 依赖于 Cirq,一个用于在近期设备上调用量子电路的开源框架。Cirq 包含了指定量子计算所需的基本结构,如量子比特、门、电路和测量算子。Cirq 的理念是提供一个简单的编程模型,抽象出量子应用的基本构建块。目前的版本包括以下关键构建块:

-

电路: 在 Cirq 中,电路表示量子电路的最基本形式。一个 Cirq 电路被表示为一系列包含操作的时刻,这些操作可以在某个抽象的时间滑动中在量子比特上执行。

-

计划和设备: 计划是另一种形式的量子电路,其中包含有关门的定时和持续时间的更多详细信息。从概念上讲,计划由一组计划操作以及描述计划将要运行的设备的内容组成。

-

门: 在 Cirq 中,门抽象了对量子比特集合的操作。

-

模拟器: Cirq 包括一个 Python 模拟器,可用于运行电路和计划。模拟器架构可以跨多个线程和 CPU 扩展,这使得它能够运行相当复杂的电路。

TensorFlow Quantum

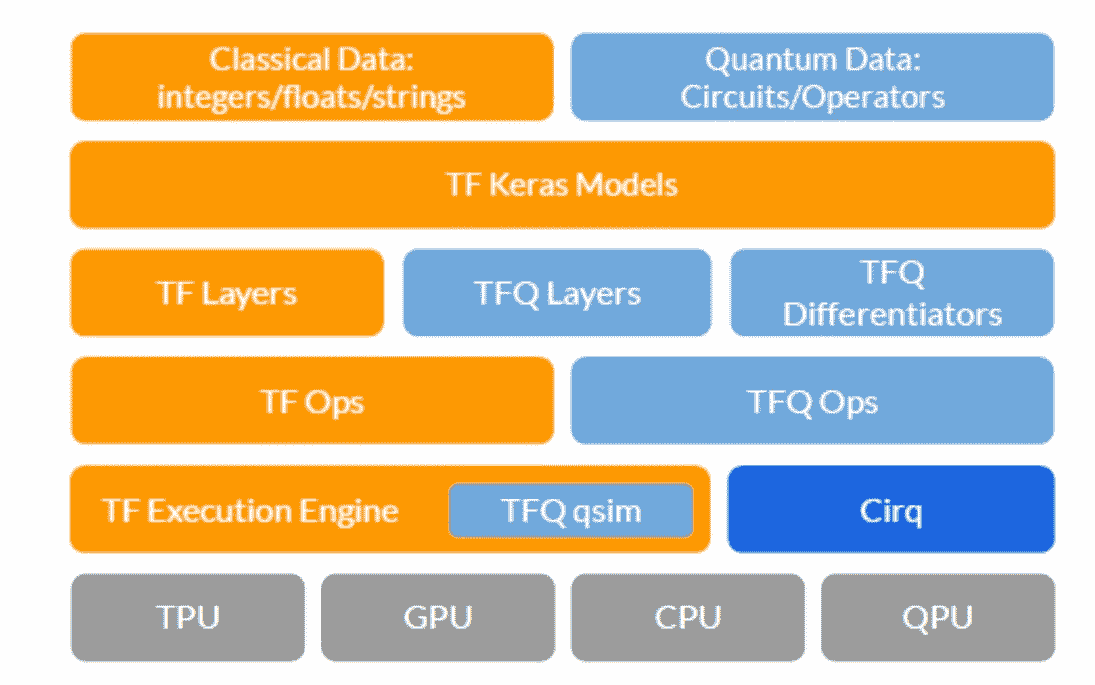

TensorFlow Quantum(TFQ) 是一个用于构建 QML 应用程序的框架。TFQ 允许机器学习研究人员在单个计算图中构建量子数据集、量子模型和经典控制参数。

从架构的角度来看,TFQ 提供了一个抽象与 TensorFlow、Cirq 和计算硬件交互的模型。栈顶是待处理的数据。经典数据由 TensorFlow 原生处理;TFQ 增加了处理量子数据的能力,包括量子电路和量子算符。栈的下一级是 TensorFlow 中的 Keras API。由于 TFQ 的核心原则是与核心 TensorFlow(特别是 Keras 模型和优化器)的原生集成,因此这一层跨越了整个栈。Keras 模型抽象下方是我们的量子层和区分器,它们在与经典 TensorFlow 层连接时实现了混合量子-经典自动微分。在层和区分器下方,TFQ 依赖于 TensorFlow 操作,这些操作实例化数据流图。

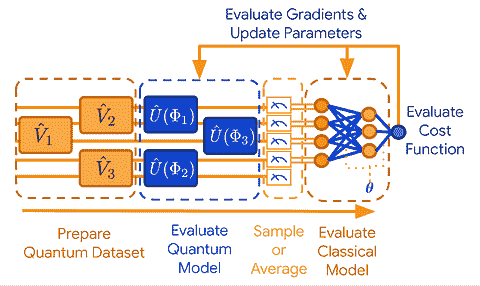

从执行的角度来看,TFQ 按照以下步骤来训练和构建 QML 模型。

-

准备量子数据集:量子数据作为张量加载,指定为用 Cirq 编写的量子电路。TensorFlow 在量子计算机上执行张量以生成量子数据集。

-

评估量子神经网络模型:在此步骤中,研究人员可以使用 Cirq 原型化一个量子神经网络,然后将其嵌入到 TensorFlow 计算图中。

-

采样或平均:此步骤利用了对几个运行的平均方法,涉及步骤(1)和(2)。

-

评估经典神经网络模型:此步骤使用经典深度神经网络来提炼在前面步骤中提取的度量之间的相关性。

-

评估成本函数:与传统机器学习模型类似,TFQ 使用此步骤来评估成本函数。这可以基于模型在分类任务中的准确性(如果量子数据已标记),或根据其他标准(如果任务是无监督的)。

-

评估梯度与更新参数 — 在评估成本函数后,应将管道中的自由参数更新为预期能减少成本的方向。

TensorFlow 和 Cirq 的结合使 TFQ 具备了一套丰富的功能,包括更简单且熟悉的编程模型以及同时训练和执行多个量子电路的能力。

量子计算与机器学习之间的桥接工作仍处于非常初步的阶段。显然,TFQ 代表了这一领域最重要的里程碑之一,并利用了量子和机器学习领域的一些最佳知识产权。有关 TFQ 的更多详细信息,请访问 该项目的网站。

原文。经许可转载。

相关:

-

关于谷歌自称的量子霸权及其对人工智能的影响

-

2020 年十大科技趋势

-

谷歌开源 TFCO 以帮助构建公平的机器学习模型

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

更多相关话题

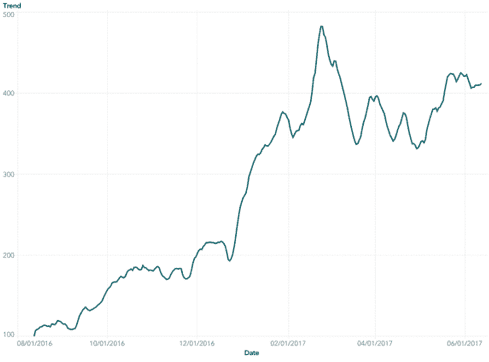

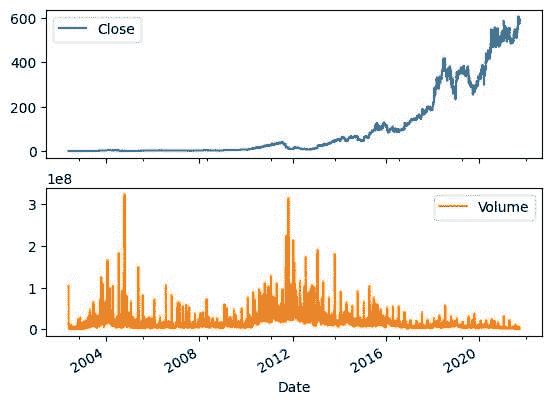

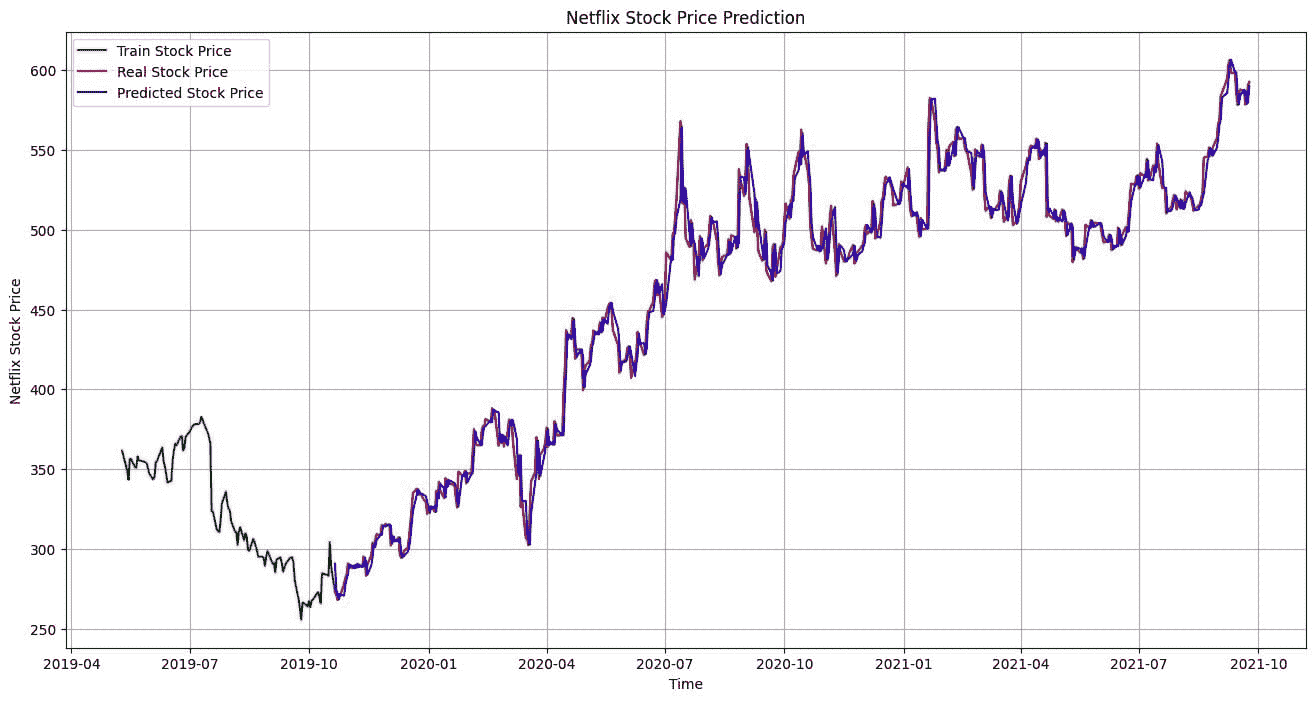

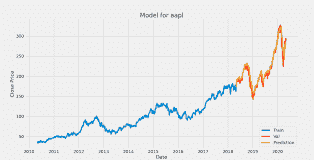

短期股票预测的 TensorFlow

原文:

www.kdnuggets.com/2017/12/tensorflow-short-term-stocks-prediction.html

评论

评论

由 Mattia Brusamento 提供

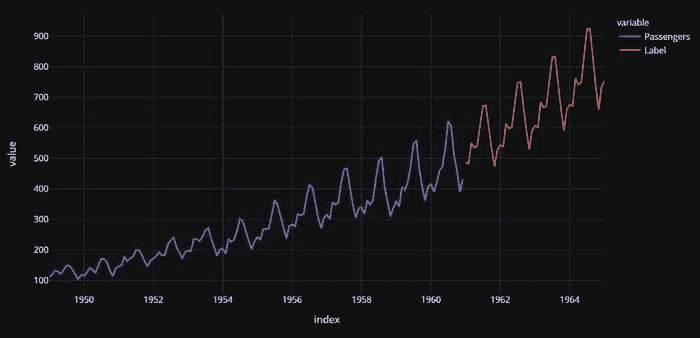

总结

在机器学习中,卷积神经网络(CNN 或 ConvNet)是一类成功应用于图像识别和分析的神经网络。在这个项目中,我尝试将这一类模型应用于股票市场预测,将股票价格与情感分析结合起来。网络的实现是使用 TensorFlow,从在线教程开始。在这篇文章中,我将描述以下步骤:数据集创建、CNN 训练和模型评估。

数据集

本节简要描述了构建数据集的过程、数据来源和进行的情感分析。

股票代码

为了构建数据集,我首先选择了一个行业和一个时间段来关注。我决定选择医疗保健行业,以及 2016 年 1 月 4 日到 2017 年 9 月 30 日的时间范围,并进一步将其拆分为训练集和评估集。具体来说,从 nasdaq.com 下载了股票列表,只保留了市值为 Mega、Large 或 Mid 的公司。从这个股票列表开始,分别使用 Google Finance 和 Intrinio API 检索了股票和新闻数据。

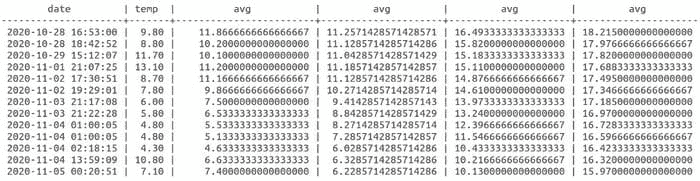

股票数据

如前所述,股票数据是通过 Google Finance 历史 API("https://finance.google.com/finance/historical?q={tick}&startdate={startdate}&output=csv",针对列表中的每个股票代码)检索的。

时间单位为天,我保留的值是收盘价。为了训练目的,使用线性插值填补了缺失的天数(pandas.DataFrame.interpolate):

新闻数据和情感分析

为了检索新闻数据,我使用了来自 intrinio 的 API。对于每个股票代码,我从" https://api.intrinio.com/news.csv?ticker={tick}"下载了相关的新闻。数据为 csv 格式,包含以下列:

TICKER,FIGI_TICKER,FIGI,TITLE,PUBLICATION_DATE,URL,SUMMARY,以下是一个示例:

"AAAP,AAAP:UW,BBG007K5CV53,"周四值得关注的 3 只股票:Advanced Accelerator Application SA(ADR) (AAAP)、Jabil Inc (JBL) 和 Medtronic Plc. (MDT)",2017-09-28 15:45:56 +0000,https://articlefeeds.nasdaq.com/r/nasdaq/symbols/3/ywZ6I5j5mIE/3-stocks-to-watch-on-thursday-advanced-accelerator-application-saadr-aaap-jabil-inc-jbl-and-medtronic-plc-mdt-cm852684,InvestorPlace 股市新闻、股票建议与交易技巧,大多数主要美国指数在周三上涨,金融股领涨,上涨 1.3%。标准普尔 500 指数上涨 0.4%,道琼斯工业平均指数上涨 0.3%。

新闻基于标题进行了去重。最后保留了 TICKER、PUBLICATION_DATE 和 SUMMARY 列。

对 SUMMARY 列进行了情感分析,使用了 Loughran 和 McDonald 金融情感词典进行金融情感分析,实施在pysentiment Python 库中。

这个库提供了一个分词器,能够进行词干提取和停用词去除,以及一个评分方法来评估分词文本。选择 get_score 方法中的值作为情感的代理是极性,计算方式如下:

(#Positives - #Negatives)/(#Positives + #Negatives)

import pysentiment as ps

lm = ps.LM()

df_news['SUMMARY_SCORES'] = df_news.SUMMARY.map(lambda x: lm.get_score(lm.tokenize(str(x))))

df_news['POLARITY'] = df_news['SUMMARY_SCORES'].map(lambda x: x['Polarity'])

没有新闻的日期用 0 填充极性。

最后,数据按股票和日期分组,计算极性得分,对有多个新闻的日期进行求和。

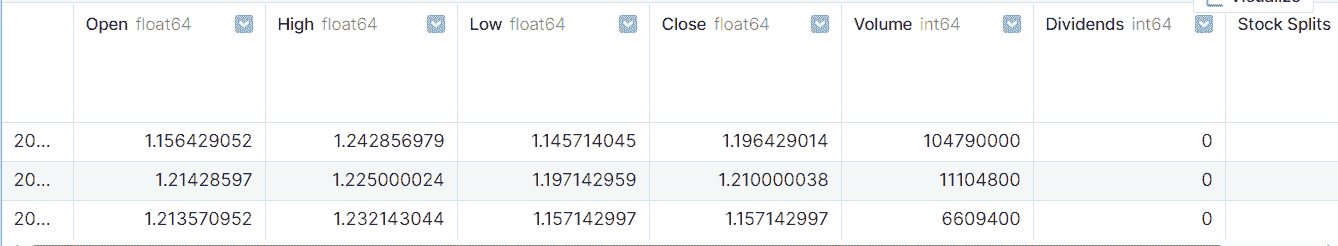

完整数据集

通过合并股票和新闻数据,我们得到一个数据集,包含 2016-01-04 到 2017-09-30 的所有 154 个数据点,包含股票的收盘值和相应的极性值:

| 日期 | 股票 | 收盘 | 极性 |

|---|---|---|---|

| 2017-09-26 | ALXN | 139.700000 | 2.333332 |

| 2017-09-27 | ALXN | 139.450000 | 3.599997 |

| 2017-09-28 | ALXN | 138.340000 | 1.000000 |

| 2017-09-29 | ALXN | 140.290000 | -0.999999 |

使用 TensorFlow 的 CNN

为了开始使用 Tensorflow 中的卷积神经网络,我参考了官方教程。它展示了如何使用层来构建一个卷积神经网络模型,以识别 MNIST 数据集中的手写数字。为了使其适用于我们的目的,我们需要调整输入数据和网络。

数据模型

输入数据的模型化方式是单个特征元素为 154x100x2 的张量:

-

154 个数据点

-

100 连续天

-

2 个通道,一个用于股票价格,一个用于极性值

标签则被建模为长度为 154 的向量,其中每个元素为 1,如果相应的股票在次日上涨,否则为 0。

这样,有一个 100 天的滑动时间窗口,因此前 100 天不能用作标签。训练集包含 435 条记录,而评估集包含 100 条记录。

卷积神经网络

CNN 的构建从 TensorFlow 的教程示例开始,然后适应了这个使用案例。前两个卷积和池化层的高度都等于 1,因此它们对单个股票进行卷积和池化,最后一层的高度等于 154,以学习股票之间的相关性。最后是全连接层,最后一层的长度为 154,每个股票一个。

网络的规模已经调整到可以在一台笔记本电脑上使用这个数据集训练几个小时。部分代码如下:

def cnn_model_fn(features, labels, mode):

"""Model function for CNN."""

# Input Layer

input_layer = tf.reshape(tf.cast(features["x"], tf.float32), [-1, 154, 100, 2])

# Convolutional Layer #1

conv1 = tf.layers.conv2d(

inputs=input_layer,

filters=32,

kernel_size=[1, 5],

padding="same",

activation=tf.nn.relu)

# Pooling Layer #1

pool1 = tf.layers.max_pooling2d(inputs=conv1, pool_size=[1, 2], strides=[1,2])

# Convolutional Layer #2

conv2 = tf.layers.conv2d(

inputs=pool1,

filters=8,

kernel_size=[1, 5],

padding="same",

activation=tf.nn.relu)

# Pooling Layer #2

pool2 = tf.layers.max_pooling2d(inputs=conv2, pool_size=[1, 5], strides=[1,5])

# Convolutional Layer #3

conv3 = tf.layers.conv2d(

inputs=pool2,

filters=2,

kernel_size=[154, 5],

padding="same",

activation=tf.nn.relu)

# Pooling Layer #3

pool3 = tf.layers.max_pooling2d(inputs=conv3, pool_size=[1, 2], strides=[1, 2])

# Dense Layer

pool3_flat = tf.reshape(pool3, [-1, 154 * 5 * 2])

dense = tf.layers.dense(inputs=pool3_flat, units=512, activation=tf.nn.relu)

dropout = tf.layers.dropout(

inputs=dense, rate=0.4, training=mode == tf.estimator.ModeKeys.TRAIN)

# Logits Layer

logits = tf.layers.dense(inputs=dropout, units=154)

predictions = {

# Generate predictions (for PREDICT and EVAL mode)

"classes": tf.argmax(input=logits, axis=1),

"probabilities": tf.nn.softmax(logits, name="softmax_tensor")

}

if mode == tf.estimator.ModeKeys.PREDICT:

return tf.estimator.EstimatorSpec(mode=mode, predictions=predictions)

# Calculate Loss (for both TRAIN and EVAL modes)

multiclass_labels = tf.reshape(tf.cast(labels, tf.int32), [-1, 154])

loss = tf.losses.sigmoid_cross_entropy(

multi_class_labels=multiclass_labels, logits=logits)

# Configure the Training Op (for TRAIN mode)

if mode == tf.estimator.ModeKeys.TRAIN:

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.001)

train_op = optimizer.minimize(

loss=loss,

global_step=tf.train.get_global_step())

return tf.estimator.EstimatorSpec(mode=mode, loss=loss, train_op=train_op)

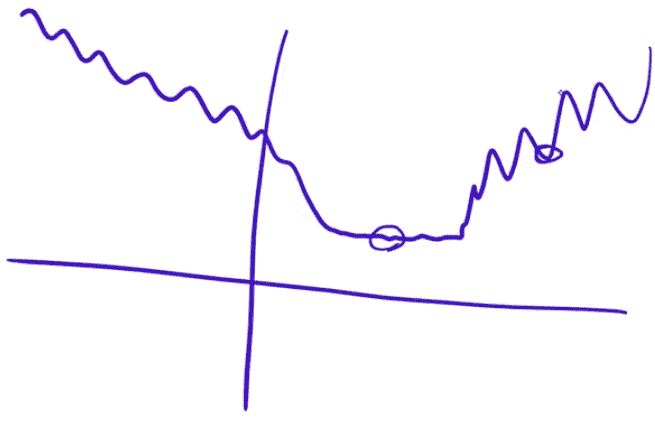

评估

为了评估模型的性能,没有使用标准指标,而是构建了一个更接近实际使用的模型的模拟。

假设以初始资本 (C) 为 1,对于评估集中的每一天,我们将资本分为 N 个相等的部分,其中 N 从 1 到 154。

我们在模型预测概率最高的前 N 只股票上放置 C/N,其余的股票上放置 0。

此时,我们有一个向量 A 表示我们的每日分配,我们可以计算每日的收益/损失,方法是将 A 乘以每只股票当天的百分比变化。

我们得到一个新的资本 C = C + delta,可以在第二天重新投资。

最终,我们会得到一个大于或小于 1 的资本,取决于我们选择的好坏。

模型的一个良好基准已确定为 N=154:这代表了所有股票的通用性能,并模拟了将资本平均分配到所有股票上的情景。这产生了大约 4.27% 的收益。

为了评估目的,数据已被纠正,移除了市场关闭的天数。

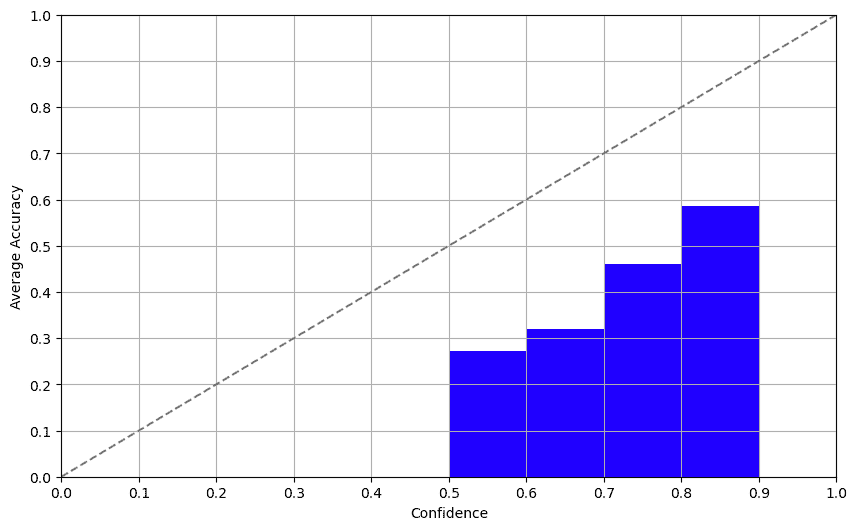

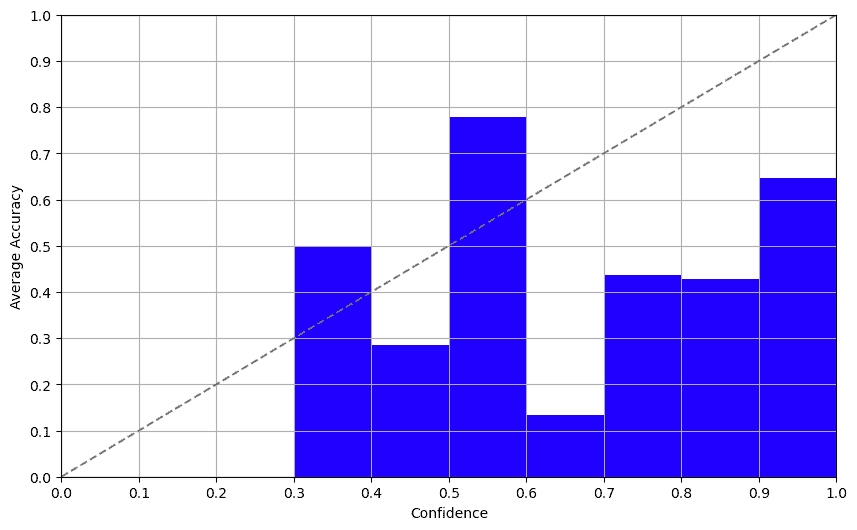

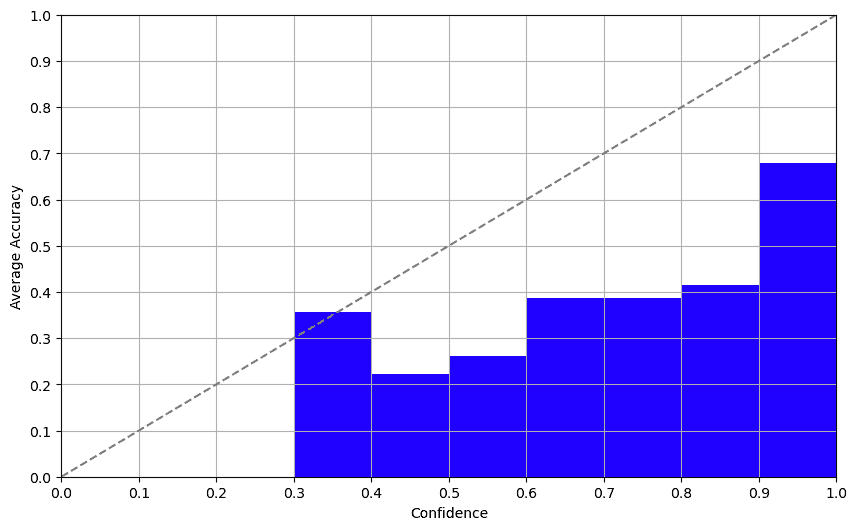

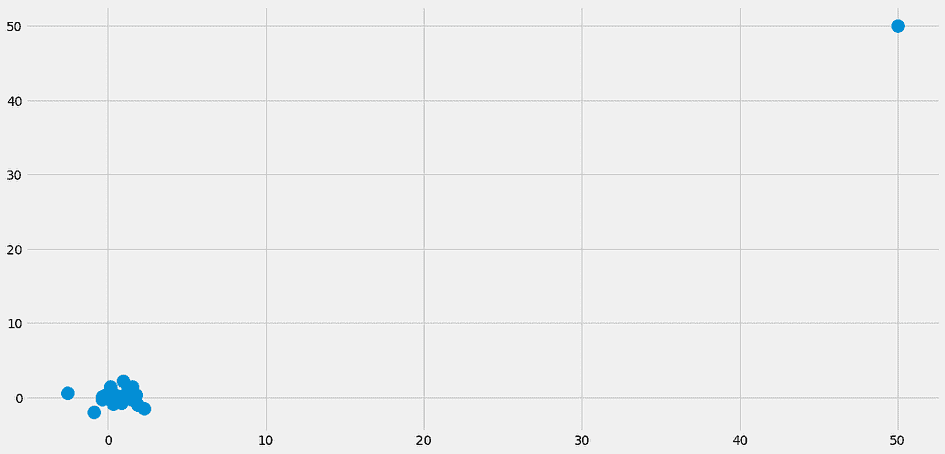

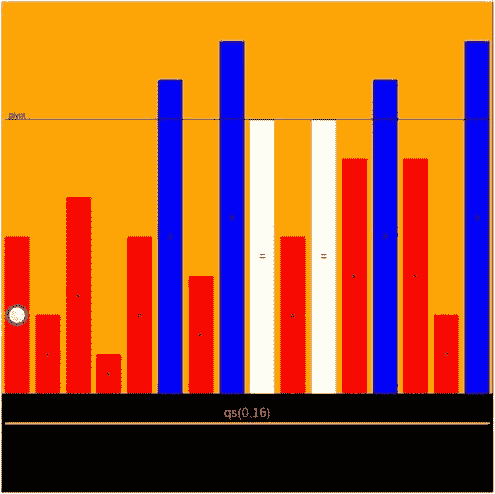

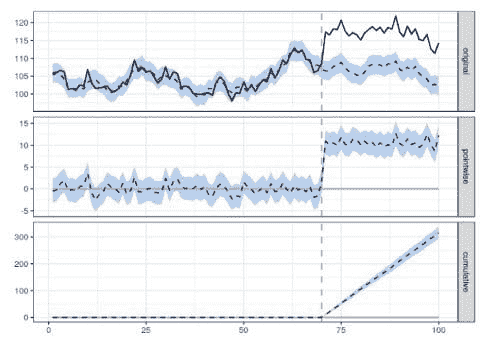

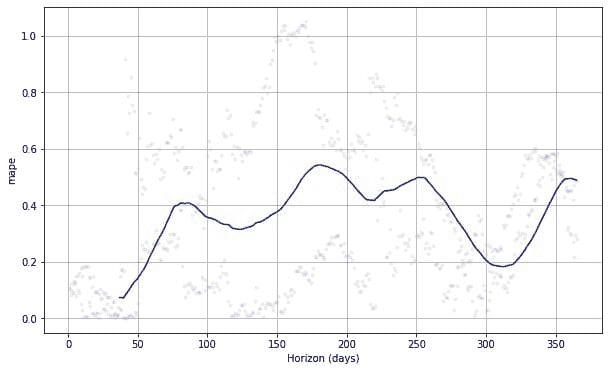

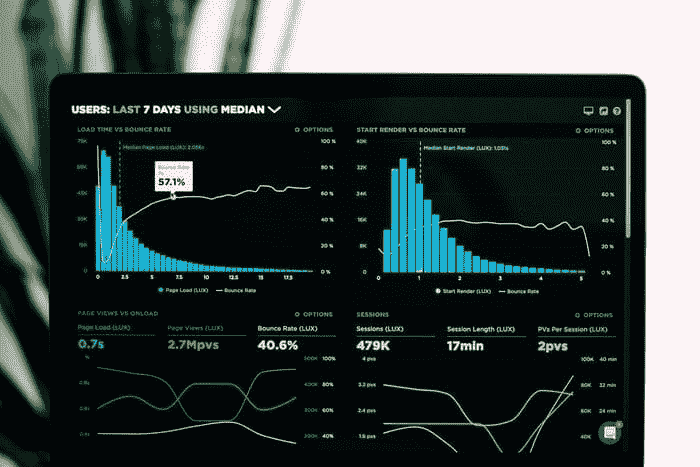

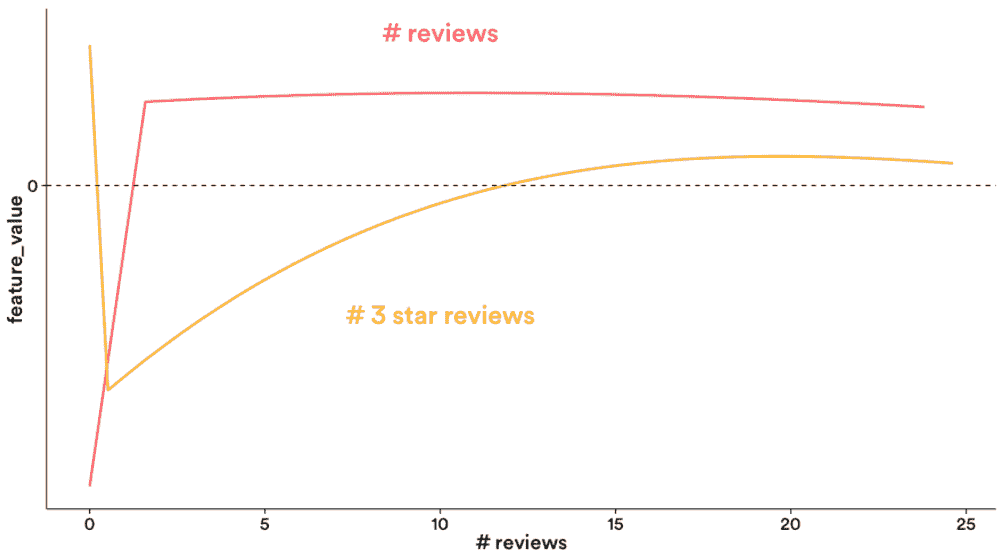

不同 N 值下模型的性能在下面的图片中报告。

红色虚线是 0 基准线,而橙色线是基准线,N=154。

最佳性能是在 N=12 下获得的,*收益约为 8.41%,几乎是市场基准的两倍。

对于几乎所有大于 10 的 N 值,我们都有不错的表现,优于基准线,而 N 值过小则会降低性能。

结论

第一次尝试 Tensorflow 和 CNN 并将其应用于金融数据非常有趣。

这是一个玩具示例,使用了相当小的数据集和网络,但它展示了这些模型的潜力。

请随时提供反馈和建议,或者直接通过 LinkedIn 与我联系。

简介: Mattia 在米兰理工大学获得了计算机工程硕士学位(荣誉),在 TU Delft 期间研究了推荐系统的论文。Mattia 目前在一家意大利公司担任网络安全领域的数据科学家。

相关

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业领域。

1. Google 网络安全证书 - 快速进入网络安全职业领域。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

更多相关话题

TensorFlow 教程,第二部分 – 开始使用

原文:

www.kdnuggets.com/2017/09/tensorflow-tutorial-part-2.html

作者:Vivek Kalyanarangan,专业网络联盟。

在这个多部分系列中,我们将探索如何开始使用 TensorFlow。本 TensorFlow 教程将为这个人人谈论的热门工具奠定坚实的基础。第二部分是一个关于开始使用、安装和构建小型用例的 TensorFlow 教程。

本系列摘录自我作为专业网络联盟的一部分所进行的网络研讨会教程系列。我会时不时提及在演讲中使用的一些幻灯片,以便让内容更加清晰。

请不要错过我谈论所有我写的内容的在线研讨会。请注册我们的即将举行的网络研讨会,以了解我们将讨论的主题。

本文是关于完整 TensorFlow 教程的多部分系列的第一部分 –

-

第二部分:开始使用

-

第三部分:构建第一个模型

TensorFlow 教程:目标

-

安装 TensorFlow

-

验证 TensorFlow 安装

-

在构建第一个 TensorFlow 模型之前

安装 TensorFlow

如果你已经安装了 TensorFlow,可以直接跳到下一部分。

1. 操作系统

不同操作系统有不同的安装 TensorFlow 的方法。你可以查阅文档获取更多详细信息。我将只讨论开始使用所必需的内容。

- 点击安装选项卡

以下指南解释了如何安装一个版本的 TensorFlow,使你能够用 Python 编写应用程序。

尽量遵循文档中已提到的最佳实践的基本结构。

2. GPU

使用 GPU 安装 TensorFlow 需要你有 NVIDIA GPU。AMD 显卡不受 TensorFlow 支持。NVIDIA 使用称为 CUDA 的低级 GPU 计算系统。这是 NVIDIA 专有的软件。

可以使用 OpenCL 与 AMD 配合,但目前它不支持 TensorFlow。

另外,并非所有 NVIDIA 设备都受支持。以下是NVIDIA 文档中列出的受支持的 GPU 列表。

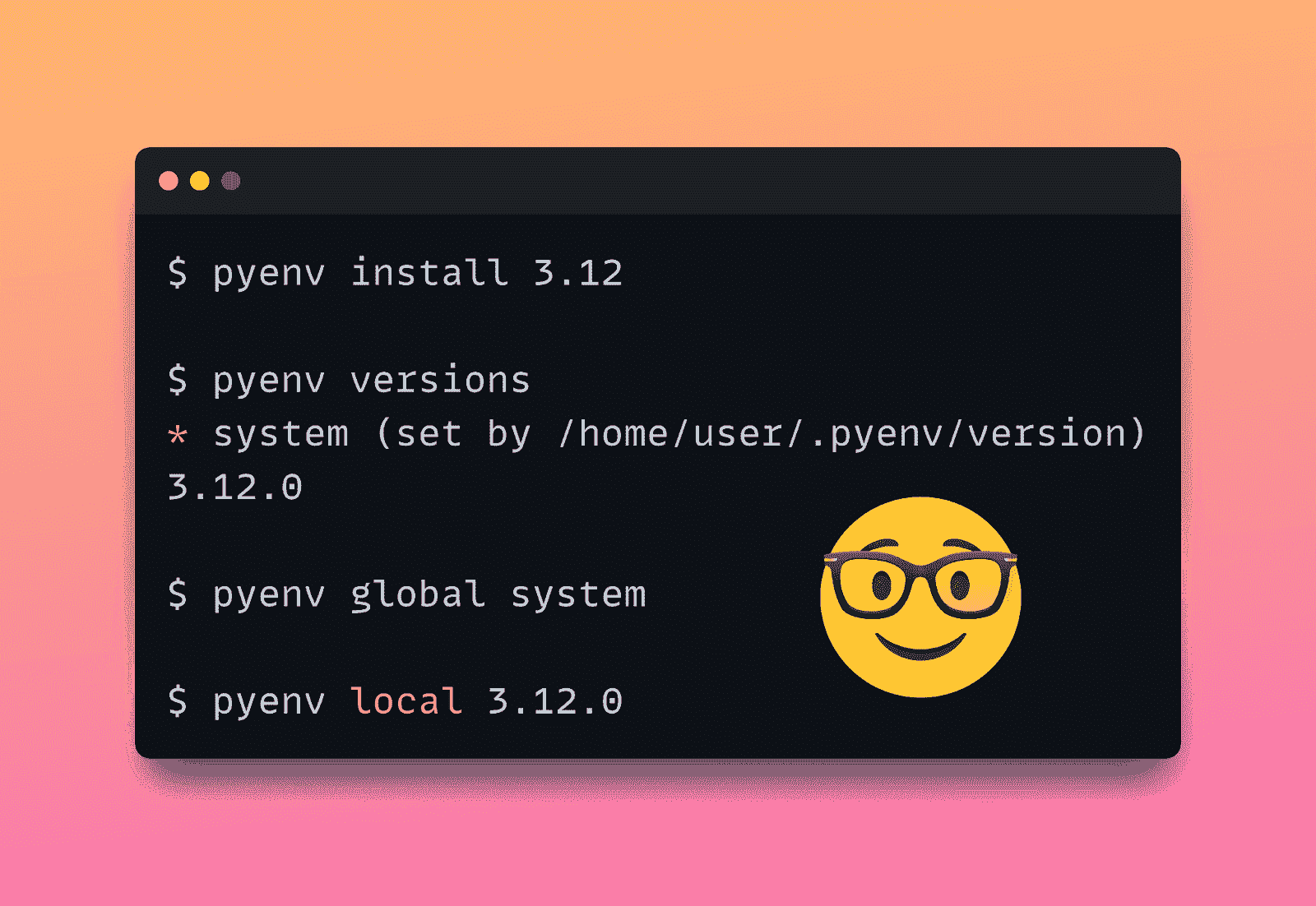

3. 环境

有三种环境可以用来设置 tensorflow –

-

直接安装 – 这只是安装任何软件库的典型方式。它直接与已安装的操作系统交互,并像其他库一样安装 tensorflow。

pip是直接安装的首选方式。 -

虚拟环境 – 对于那些不知道 python 虚拟环境优势的人,

virtualenv就像是一个与系统中已经安装的默认 python 平行的 python 安装。 在虚拟环境中安装库可以将库分开,你将不会与直接安装的其他库发生兼容性冲突。如果出现问题,你可以启动一个新的虚拟环境,重新开始。 -

Docker 容器 – 这是一种安装 tensorflow 的方式。可以将典型的 VMware 镜像想象成是一个超级强大的 docker 容器。Docker 可以用来启动具有不同操作系统环境的容器,从而允许你拥有一个与主机系统完全分开的环境。所有细节在 tensorflow 文档中都明确标出。

4. Python 版本

支持 Python 2 的 2.7 版本和 Python 3 的 3.3 或更高版本。所有操作系统均适用。

目前,Windows 仅支持 3.5 版本。Python 2 与 Windows 的组合是不受支持的。

验证安装

一旦 tensorflow 安装完成,无论操作系统、环境或 python 版本如何,你都应该运行以下脚本来验证 tensorflow 是否正常运行。

# import TensorFlow

import tensorflow as tf

sess = tf.Session()

# Verify we can print a string

hello = tf.constant("Hello UNP from TensorFlow")

print(sess.run(hello))

# Perform some simple math

a = tf.constant(20)

b = tf.constant(22)

print('a + b = {0}'.format(sess.run(a + b)))

一旦这段代码成功运行并打印输出,恭喜你!你已经成功安装了 tensorflow。接下来我们进入下一部分,构建我们的第一个应用程序。

在构建第一个 tensorflow 模型之前

张量

下面是我们在开始之前需要学习的三种张量类型。

| 类型 | 描述 |

|---|---|

| 常量 | 常量值 |

| 变量 | 在图中调整的值 |

| 占位符 | 用于在图中传递数据 |

在动手操作之前,我只想介绍几个 tensorflow 术语及其含义。

-

排名 – 张量的维度

-

形状 – 张量的形状。与排名相关

上图应有助于理解。下面是 Tensorflow 支持的不同数据类型。

注意:量化值[qint8、qint16 和 quint8]是 TensorFlow 的特殊值,有助于减少数据大小。事实上,Google 已经引入了 TensorFlow 处理单元(TPUs)来通过利用量化值加快计算速度*

准备数据

我们将快速生成一些数据以便开始。在这个例子中,我们将生成房屋大小数据以预测房价。这里的目标不是建立一个复杂的房价预测器,而是以最简单的方式在 TensorFlow 中启动。

我们将使用下面的 Python 代码生成一些数据–

import tensorflow as tf

import numpy as np

import math

import matplotlib.pyplot as plt

# generation some house sizes between 1000 and 3500 (typical sq ft of house)

num_house = 160

np.random.seed(42)

house_size = np.random.randint(low=1000, high=3500, size=num_house )

# Generate house prices from house size with a random noise added.

np.random.seed(42)

house_price = house_size * 100.0 +

np.random.randint(low=20000, high=70000, size=num_house)

# Plot generated house and size

plt.plot(house_size, house_price, "bx") # bx = blue x

plt.ylabel("Price")

plt.xlabel("Size")

plt.show()

这将生成如下输出[这是生成的数据的图示]

接下来,我们将对数据进行归一化。这有助于将数据调整到相同的尺度,从而可能导致更快的收敛。

我们还将其拆分为训练数据和测试数据,作为数据科学最佳实践的一部分。我们将用训练数据训练我们的模型,并用测试数据测试模型,以查看我们的预测有多准确。

# you need to normalize values to prevent under/overflows.

def normalize(array):

return (array - array.mean()) / array.std()

# define number of training samples, 0.7 = 70%. We can take the first 70%

# since the values are randomized

num_train_samples = math.floor(num_house * 0.7)

# define training data

train_house_size = np.asarray(house_size[:num_train_samples])

train_price = np.asanyarray(house_price[:num_train_samples:])

train_house_size_norm = normalize(train_house_size)

train_price_norm = normalize(train_price)

# define test data

test_house_size = np.array(house_size[num_train_samples:])

test_house_price = np.array(house_price[num_train_samples:])

test_house_size_norm = normalize(test_house_size)

test_house_price_norm = normalize(test_house_price)

结论

我希望这能设定对接下来内容的期望。在下一篇文章中,我们将构建我们的第一个 TensorFlow 模型。

请不要错过直播研讨会,在那里我会讨论我写的所有内容。注册我们的即将到来的研讨会以了解我们将讨论的主题。快乐编码!

在下一部分,我们终于准备好用房价数据训练我们的第一个 TensorFlow 模型。这将给我们提供第一次使用 TensorFlow 的亲身体验!

我在下面嵌入了原始演示文稿–

原始。经许可转载。

简介: Vivek Kalyanarangan 是一名数据科学家、博主、吉他手,对新技术充满热情。

相关:

-

TensorFlow 教程:第一部分 – 介绍

-

寻找最快的 Keras 深度学习后端

-

PyTorch 还是 TensorFlow?

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你组织的 IT

3. Google IT 支持专业证书 - 支持你组织的 IT

更多相关主题

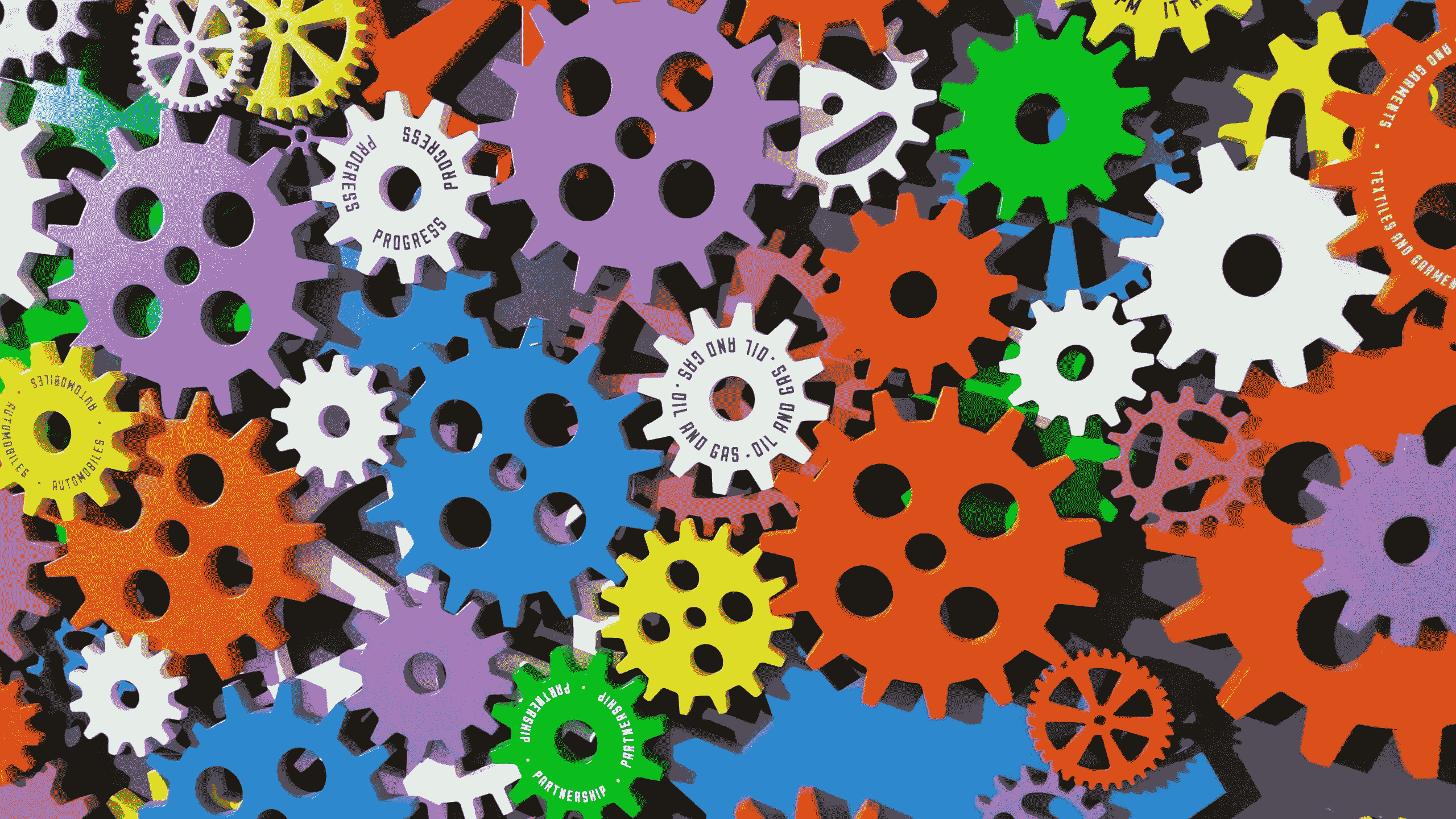

测试你的机器学习管道

原文:

www.kdnuggets.com/2019/11/testing-machine-learning-pipelines.html

评论

由 Kristina Young,高级数据科学家

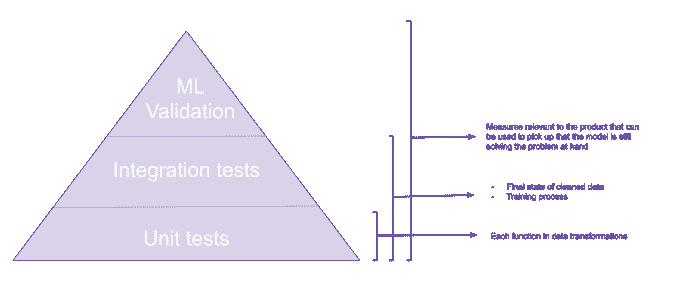

说到数据产品,很多时候存在一种误解,即这些产品无法通过自动化测试。虽然由于其实验性和随机性,管道中的某些部分无法通过传统测试方法,但大部分管道是可以的。此外,更多不可预测的算法可以通过专门的验证过程来测试。

让我们看看传统的测试方法以及如何将这些方法应用于我们的数据/机器学习管道。

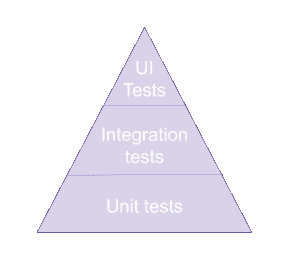

测试金字塔

你的标准简化测试金字塔如下所示:

这个金字塔表示了你为应用程序编写的测试类型。我们从大量的单元测试开始,测试单一功能是否与其他功能隔离。然后我们编写集成测试,检查将隔离的组件结合在一起是否按预期工作。最后,我们编写 UI 或验收测试,检查应用程序从用户的角度是否按预期工作。

在数据产品方面,金字塔并没有太大区别。我们有大致相同的层级。

请注意,UI 测试仍然会在产品中进行,但这篇博客文章关注的是与数据管道最相关的测试。

让我们更详细地了解每个部分在机器学习中的含义,并借助一些科幻作者的帮助。

单元测试

“这是一个将你的想法与宇宙进行对比的系统,看看它们是否匹配” —— 艾萨克·阿西莫夫。

数据管道中的大部分代码由数据清理过程组成。用于数据清理的每个函数都有一个明确的目标。例如,假设我们为模型选择的一个特征是前一天和当前一天之间值的变化。我们的代码可能如下所示:

def add_difference(asimov_dataset):

asimov_dataset['total_naughty_robots_previous_day'] =

asimov_dataset['total_naughty_robots'].shift(1)

asimov_dataset['change_in_naughty_robots'] =

abs(asimov_dataset['total_naughty_robots_previous_day'] -

asimov_dataset['total_naughty_robots'])

return asimov_dataset[['total_naughty_robots', 'change_in_naughty_robots',

'robot_takeover_type']]

在这里,我们知道对于给定的输入,我们期望得到特定的输出,因此我们可以用以下代码来测试:

import pandas as pd

from pandas.testing import assert_frame_equal

import numpy as np

from unittest import TestCase

def test_change():

asimov_dataset_input = pd.DataFrame({

'total_naughty_robots': [1, 4, 5, 3],

'robot_takeover_type': ['A', 'B', np.nan, 'A']

})

expected = pd.DataFrame({

'total_naughty_robots': [1, 4, 5, 3],

'change_in_naughty_robots': [np.nan, 3, 1, 2],

'robot_takeover_type': ['A', 'B', np.nan, 'A']

})

result = add_difference(asimov_dataset_input)

assert_frame_equal(expected, result)

对于每个独立的功能,你应该编写一个单元测试,确保数据转换过程中的每个部分对数据产生了预期的效果。对于每个功能,你还应该考虑不同的场景(是否有条件语句?如果有,则应测试所有条件)。这些测试将作为你持续集成(CI)管道的一部分在每次提交时运行。

除了检查代码是否按预期工作外,单元测试还在调试问题时给予我们帮助。通过添加一个能够重现新发现的错误的测试,我们可以确保在我们认为错误已经修复时,该错误已经被修复,并且我们可以确保该错误不会再次发生。

最后,这些测试不仅检查代码是否按预期工作,还帮助我们记录创建功能时的期望。

集成测试

因为 “无云的眼睛更好,不管它看到什么。” Frank Herbert

这些测试旨在确定单独开发的模块在结合在一起时是否按预期工作。就数据管道而言,这些测试可以检查:

-

数据清理过程产生了适合模型的数据集

-

模型训练能够处理提供给它的数据并输出结果(确保代码在未来可以重构)

所以,如果我们拿上面的单元测试函数,并添加以下两个函数:

def remove_nan_size(asimov_dataset):

return asimov_dataset.dropna(subset=['robot_takeover_type'])

def clean_data(asimov_dataset):

asimov_dataset_with_difference = add_difference(asimov_dataset)

asimov_dataset_without_na = remove_nan_size(asimov_dataset_with_difference)

return asimov_dataset_without_na

然后我们可以测试将clean_data内部的函数组合起来是否会产生预期的结果,代码如下:

def test_cleanup():

asimov_dataset_input = pd.DataFrame({

'total_naughty_robots': [1, 4, 5, 3],

'robot_takeover_type': ['A', 'B', np.nan, 'A']

})

expected = pd.DataFrame({

'total_naughty_robots': [1, 4, 3],

'change_in_naughty_robots': [np.nan, 3, 2],

'robot_takeover_type': ['A', 'B', 'A']

}).reset_index(drop=True)

result = clean_data(asimov_dataset_input).reset_index(drop=True)

assert_frame_equal(expected, result)

现在假设我们要做的下一步是将上述数据输入到逻辑回归模型中。

from sklearn.linear_model import LogisticRegression

def get_reression_training_score(asimov_dataset, seed=9787):

clean_set = clean_data(asimov_dataset).dropna()

input_features = clean_set[['total_naughty_robots',

'change_in_naughty_robots']]

labels = clean_set['robot_takeover_type']

model = LogisticRegression(random_state=seed).fit(input_features, labels)

return model.score(input_features, labels) * 100

虽然我们不知道期望值,但我们可以确保总是得到相同的值。测试这种集成对我们很有用,以确保:

-

数据可以被模型使用(每个输入都有标签,数据类型被选择的模型接受等)

-

我们能够在未来重构我们的代码,而不会破坏端到端的功能。

通过为随机生成器提供相同的种子,我们可以确保结果始终相同。所有主要的库都允许你设置种子(Tensorflow 有点特殊,因为它要求你通过 numpy 设置种子,请记住这一点)。测试可以如下所示:

from numpy.testing import assert_equal

def test_regression_score():

asimov_dataset_input = pd.DataFrame({

'total_naughty_robots': [1, 4, 5, 3, 6, 5],

'robot_takeover_type': ['A', 'B', np.nan, 'A', 'D', 'D']

})

result = get_reression_training_score(asimov_dataset_input, seed=1234)

expected = 40.0

assert_equal(result, 50.0)

这类测试不会像单元测试那样多,但它们仍会成为你 CI 管道的一部分。你会使用这些测试来检查组件的端到端功能,因此会测试更主要的场景。

机器学习验证

为什么?“展现了知道错误问题答案的完美无用性。” Ursula K. Le Guin.

现在我们已经测试了我们的代码,我们还需要测试机器学习组件是否解决了我们要解决的问题。当我们谈论产品开发时,机器学习模型的原始结果(无论基于统计方法的准确度如何)几乎从来不是期望的最终输出。这些结果通常会与其他业务规则结合,然后才会被用户或其他应用程序使用。因此,我们需要验证模型是否解决了用户的问题,而不仅仅是准确度/F1 分数/其他统计指标是否足够高。

这对我们有什么帮助?

-

它确保模型实际帮助产品解决当前的问题

- 例如,一个将蛇咬伤分类为致命或非致命的模型,如果 20%的错误导致患者未能得到所需治疗,那么这个模型并不好。

-

确保模型产生的值在行业中是合理的

- 例如,一个以 70%准确率预测价格变化的模型,如果最终显示给用户的价格值在该行业/市场中过低或过高,则不是一个好的模型。

-

它提供了决策记录的额外文档层次,帮助后来加入团队的工程师。

-

它以一种客户、产品经理和工程师都能理解的共同语言提供了产品中机器学习组件的可见性。

这种验证应定期进行(通过 CI 管道或 cron 作业),其结果应向组织公开。这确保数据科学组件的进展对组织可见,并确保由于更改或陈旧数据引起的问题能尽早被发现。

结论

毕竟,“魔法只是我们尚未理解的科学”——阿瑟·克拉克。

机器学习组件可以通过各种方式进行测试,带来以下优势:

-

采用数据驱动的方法,以确保代码的行为符合预期

-

确保我们能够重构和清理代码,而不破坏产品的功能

-

记录功能、决策和以前的错误

-

提供产品中机器学习组件的进展和状态的可见性

所以不要害怕,如果你有编写代码的技能,你也具备编写测试的技能,并获得上述所有优势????。

再见,谢谢你的所有测试!

个人简介:Kristina Young 是 BCG Digital Ventures 的高级数据科学家。她曾在 SoundCloud 担任推荐团队的后端和数据工程师。她的以往经验包括顾问和研究员。她在过去曾担任过后端、网页和移动开发人员,涉及各种技术。

原文。经许可转载。

相关:

-

5 步指南:使用 d6tflow 构建可扩展的深度学习管道

-

我如何在机器学习中变得更好

-

数据管道、Luigi、Airflow:你需要知道的一切

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

更多相关话题

文本分析:入门指南

评论

评论

编辑注: 以下是对伊利诺伊大学教授及文本分析专家彭刘的采访,由市场科学家凯文·格雷进行,彭刘简明扼要地概述了该领域的现状。

凯文·格雷: 我看到“文本分析”和“文本挖掘”在市场研究人员中被多种方式使用,并且通常可以互换使用。这些术语对你来说是什么意思?

彭刘: 我的理解是这两个术语意思相同。学术界的人更倾向于使用文本挖掘这个术语,尤其是数据挖掘研究者,而文本分析则主要在行业中使用。我很少看到学者使用文本分析这个术语。还有一个相关的术语,叫做自然语言处理(NLP)。文本挖掘和文本分析通常指将数据挖掘和机器学习算法应用于文本数据。NLP 涵盖了这些内容,并且还有其他更传统的自然语言任务,如机器翻译、句法分析、语义分析等。但这些术语之间并没有明确的划分。

彭刘 (来源)。

KG: 能简要介绍一下文本分析/挖掘的历史以及它是如何随着时间发展的吗?

BL: 它源于三个研究领域:信息检索、数据挖掘和自然语言处理(NLP)。信息检索始于 1970 年代,主要处理文本检索。也就是说,给定一个查询,可以是几个关键词或一个完整的文档,我们希望从文本集合或语料库中找到相关的文档。网络搜索引擎是巨大的信息检索系统。

传统的数据挖掘使用结构化数据,如数据库表格。在 1990 年代末,研究人员开始将文本作为数据,这催生了文本挖掘。早期的文本挖掘基本上是在文本数据上应用数据挖掘和机器学习算法,而没有使用诸如解析、词性标注、摘要等自然语言处理技术。

NLP 有更长的历史。它始于 1950 年代,目标是让计算机理解人类语言。随着文本挖掘研究在过去 10 年左右扩展其范围,它开始使用自然语言处理技术,如解析、词性标注、指代消解等。从自然语言处理会议涵盖的主题来看,文本挖掘现在已成为自然语言处理的一部分。我的研究最初是从传统的数据挖掘开始的。随后我研究了情感分析或意见挖掘,这使我转向了自然语言处理。

KG: 它在市场研究和其他领域是如何使用的?

BL: 文本分析在营销和许多其他领域得到了广泛应用。我最熟悉的是情感分析的应用。在营销中,营销人员通常希望了解消费者对公司产品以及竞争对手产品的看法。这些意见可以通过分析在线评论或其他形式的社交媒体帖子来获得。基于这些意见,营销人员可以制定适合不同市场细分的营销信息。公众意见在许多其他应用领域也非常有用,例如股市预测、消费者情感预测、政治选举预测等。

KG: 文本分析面临的主要技术挑战是什么?

BL: 这完全取决于你感兴趣的任务是什么。一些任务完成得相当好,例如命名实体识别。但许多其他任务在准确性上仍需大量改进。最终的挑战是自然语言理解。尽管研究人员对此进行了长期研究,但进展并不大。目前的文本分析技术仍主要基于传统的语言学规则和统计机器学习及数据挖掘算法。这些方法仍无法实现真正的理解。由于这个问题,大多数文本分析任务的准确性仍然相对较低。

KG: 人工智能在文本分析中扮演什么角色?

BL: 高级文本分析是人工智能(AI)的一部分。机器学习和数据挖掘等其他 AI 领域的进展对文本分析产生了重大影响。我会说,过去二十年文本分析的主要进展来自于更好的机器学习技术。

KG: 是否有许多人对文本分析存在误解或错误认识?

BL: 在学术界,我没有发现关于文本分析的重大误解或误解。我对行业情况不太确定。我所知道的唯一一点是,人们对文本分析可能有非常高的期望,但如果你想做得好且准确,这是一个非常具有挑战性的问题。

KG: 最后,展望十年后,你认为文本分析将能做到现在无法做到的哪些事情?是否有一些事情在可预见的未来对于文本分析来说是不可能实现的?

BL: 让我们讨论自然语言处理,而不是文本分析,因为高级文本分析需要自然语言处理。随着深度学习等机器学习技术的发展,我们肯定会看到更好的文本分析算法,准确性远超我们今天能实现的水平。但在可预见的未来,像我们人类那样理解自然语言是非常不可能的,因为自然语言具有高度的抽象性。我们写的每一句话背后都有大量的常识知识,我们假设读者是知道这些知识的。显然,计算机程序并不知道这些知识。学习、表示和推理常识知识是一个主要的挑战。

KG: 谢谢你,Bing!

这篇文章最初发表于 GreenBook 2017 年 1 月 24 日。

Kevin Gray 是 Cannon Gray 的总裁,Cannon Gray 是一家市场科学与分析咨询公司。

Bing Liu 是伊利诺伊大学芝加哥分校(UIC)的计算机科学终身教授。他在爱丁堡大学获得人工智能博士学位,并且是情感分析和意见挖掘、机器学习及相关主题的多本书籍和文章的作者。

相关内容:

-

自然语言处理关键术语解释

-

文本挖掘亚马逊手机评论:有趣的见解

-

贝叶斯基础解释

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

该主题的更多信息

文本分类与嵌入可视化,使用 LSTMs、CNNs 和预训练词向量

原文:

www.kdnuggets.com/2018/07/text-classification-lstm-cnn-pre-trained-word-vectors.html

评论

评论

由Sabber Ahamed,计算地球物理学家和机器学习爱好者

编辑注释: 本文总结了该系列中目前已发布的 3 篇文章,而第四篇最终篇章即将发布。

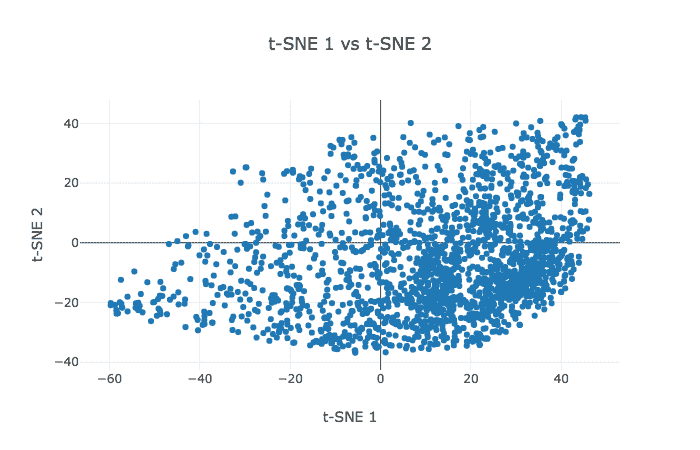

在本教程中,我对Yelp round-10 评论数据集进行了分类。这些评论包含大量可以挖掘的元数据,用于推断意义、业务属性和情感。为了简单起见,我将评论分为两类:正面或负面。星级高于三的评论被认为是正面的,而星级小于或等于 3 的评论则为负面。因此,这个问题是一个监督学习问题。为了构建和训练模型,我首先清理文本并将其转换为序列。每条评论的字数限制为 50 个单词。结果是,少于 50 个单词的短文本会用零填充,而较长的文本则会被截断。在处理完评论后,我用三种不同的方法训练了三个模型,并获得了三种词嵌入。

在这一部分,我构建了一个神经网络,使用 LSTM 和词嵌入在分类问题上进行训练。

网络从一个嵌入层开始。这个层允许系统将每个标记扩展为更大的向量,使得网络能够以有意义的方式表示一个词。该层的第一个参数是 20000,即我们的词汇表大小,第二个参数是 100,即嵌入的维度。第三个参数是 50,即每个评论序列的长度。

第二部分:使用 CNN、LSTM 进行文本分类并可视化词嵌入

在这一部分,我在 LSTM 层上添加了一个额外的 1D 卷积层,以减少训练时间。

LSTM 模型表现良好。然而,训练三个 epoch 的时间非常长。加快训练速度的一种方法是通过增加“卷积”层来改进网络。卷积神经网络(CNN)起源于图像处理。它们在数据上应用“滤波器”并计算更高层次的表示。尽管 CNN 没有 LSTM 的序列处理能力,但它们在文本处理上表现出意外的好效果。

第三部分:使用 CNN、LSTM 和预训练 Glove 词嵌入进行文本分类

在第三部分中,我使用与第二部分相同的网络架构,但使用预训练的 100 维 Glove 词嵌入作为初始输入。

在这一小节中,我想使用预训练的 Glove 词嵌入。它是在一个包含十亿个标记(单词)和 40 万个单词词汇的数据集上训练的。Glove 提供了包括 50、100、200 和 300 维的嵌入向量。我选择了 100 维的版本。我还希望看到模型的表现,假设学习到的单词权重没有更新。因此,我将模型的可训练属性设置为 False。

第四部分:(尚未发布)

在第四部分中,我使用 word2vec 学习词嵌入。

简介:Sabber Ahamed 是 xoolooloo.com 的创始人。计算地球物理学家和机器学习爱好者。

相关:

-

自然语言处理精华:NLP 入门

-

关于神经网络和词嵌入在自然语言处理中的贡献

-

使用深度卷积神经网络检测讽刺

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持

更多相关内容

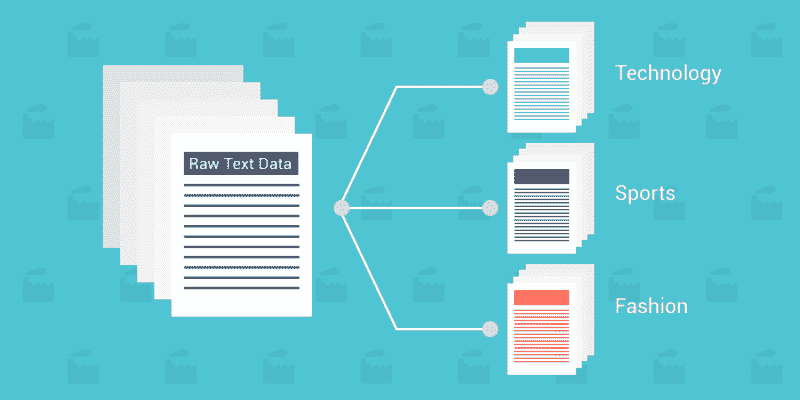

什么是文本分类?

什么是文本分类?

文本分类是将文本分类到一个或多个不同类别中的过程,以组织、结构化和过滤任何参数。例如,文本分类用于法律文件、医学研究和文件,甚至是简单的产品评论。数据比以往任何时候都重要;公司在努力提取尽可能多的洞察力上花费了巨额资金。

由于文本/文档数据比其他数据类型更加丰富,因此利用它们的新方法是必需的。由于数据本质上是非结构化和极其丰富的,将数据组织成易于理解的方式可以极大地提高其价值。使用机器学习进行文本分类可以以更快、更经济的方式自动结构化相关文本。

我们将定义文本分类、其工作原理、一些最知名的算法,并提供可能帮助你开始文本分类之旅的数据集。

为什么使用机器学习文本分类?

-

规模:手动数据录入、分析和组织繁琐且缓慢。机器学习允许进行自动分析,无论数据集大小如何,都能适用。

-

一致性:由于疲劳和对数据集材料的麻木,人为错误会发生。机器学习通过算法的无偏见性和一致性提高了可扩展性,并显著提高了准确性。

-

速度:数据有时需要快速访问和组织。机器学习算法可以解析数据,以便以易于消化的方式提供信息。

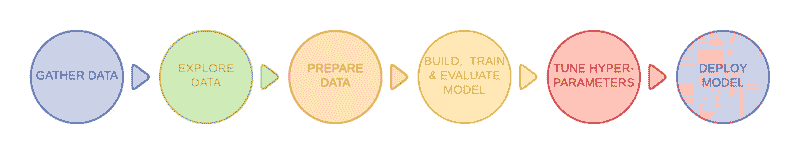

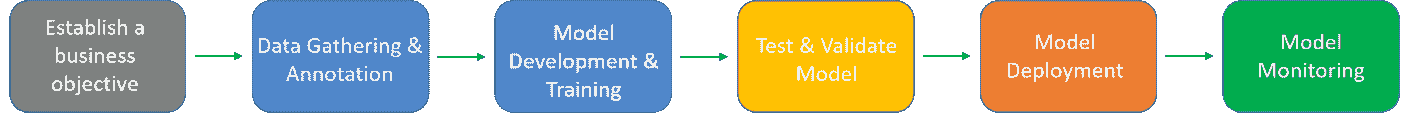

开始使用 6 个通用步骤

一些基本方法可以在一定程度上对不同的文本文档进行分类,但最常用的方法涉及机器学习。文本分类模型在部署之前会经历六个基本步骤。

1. 提供高质量的数据集

数据集是用于为我们的模型提供数据源的原始数据块。在文本分类的情况下,使用的是监督式机器学习算法,从而为我们的机器学习模型提供标记数据。标记数据是为我们的算法预定义的,并附有信息标签的数据。

2. 过滤和处理数据

由于机器学习模型只能理解数值,因此将提供的文本进行分词和词嵌入是模型正确识别数据所必需的。

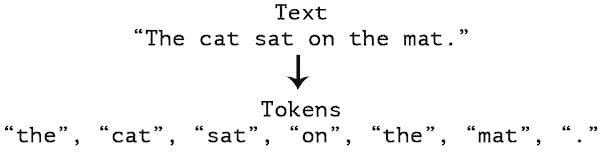

分词是将文本文档拆分为称为令牌的更小片段的过程。令牌可以表示为整个单词、子单词或单个字符。例如,对“work smarter”进行分词可以这样做:

-

令牌词:Smarter

-

令牌子词:Smart-er

-

令牌字符:S-m-a-r-t-e-r

词元化很重要,因为文本分类模型只能处理基于词元的数据,无法理解和处理完整的句子。进一步处理给定的原始数据集将有助于我们的模型轻松消化给定的数据。移除不必要的特征,过滤掉空值和无限值等。对整个数据集进行洗牌有助于在训练阶段防止任何偏差。

3. 将数据集拆分为训练集和测试集

我们希望在数据集的 80%上训练我们的数据,同时保留 20%的数据集以测试算法的准确性。

4. 训练算法

通过使用训练数据集运行我们的模型,算法可以通过识别隐藏的模式和洞察,将提供的文本分类到不同的类别中。

5. 测试和检查模型的性能

接下来,使用步骤 3 中提到的测试数据集测试模型的完整性。测试数据集将是未标记的,用于测试模型的准确性与实际结果的对比。为了准确测试模型,测试数据集必须包含新的测试案例(与之前的训练数据集不同的数据),以避免过拟合我们的模型。

6. 调整模型

通过调整模型的不同超参数来调整机器学习模型,避免过拟合或产生高方差。超参数是控制模型学习过程的参数。你现在准备好进行部署了!

文本分类是如何工作的?

词嵌入

在前面提到的过滤过程中,机器学习和深度学习算法只能理解数值,这迫使我们对数据集进行一些词嵌入技术。词嵌入是将词表示为实值向量的过程,这些向量可以编码给定词的含义。

-

Word2Vec:一种由 Google 开发的无监督词嵌入方法。它利用神经网络从大型文本数据集中学习。顾名思义,Word2Vec 方法将每个词转换为一个给定的向量。

-

GloVe:也称为全局向量,是一种无监督的机器学习模型,用于获取词的向量表示。类似于 Word2Vec 方法,GloVe 算法将词映射到有意义的空间中,其中词与词之间的距离与语义相似性相关。

-

TF-IDF:是词频-逆文档频率的缩写,TF-IDF 是一种词嵌入算法,用于评估词在给定文档中的重要性。TF-IDF 为每个词分配一个得分,以表示它在一组文档中的重要性。

文本分类算法

这里是三种最著名和有效的文本分类算法。请记住,每种方法中都包含了进一步定义的算法。

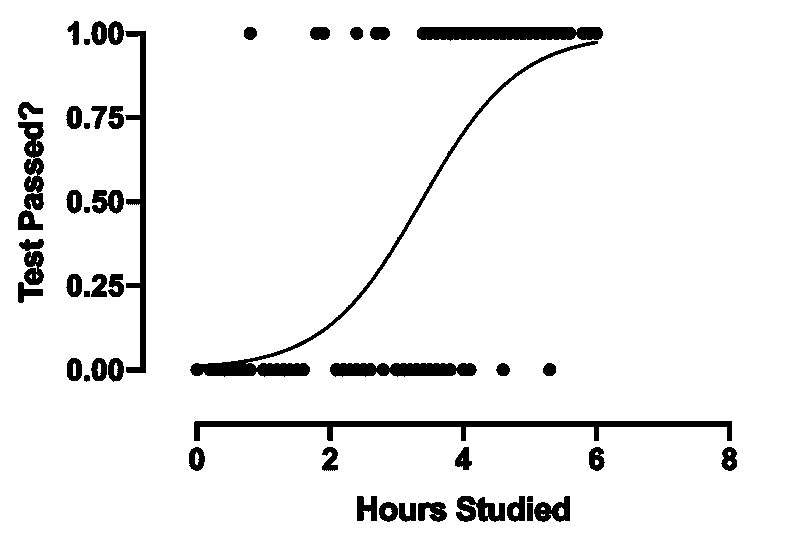

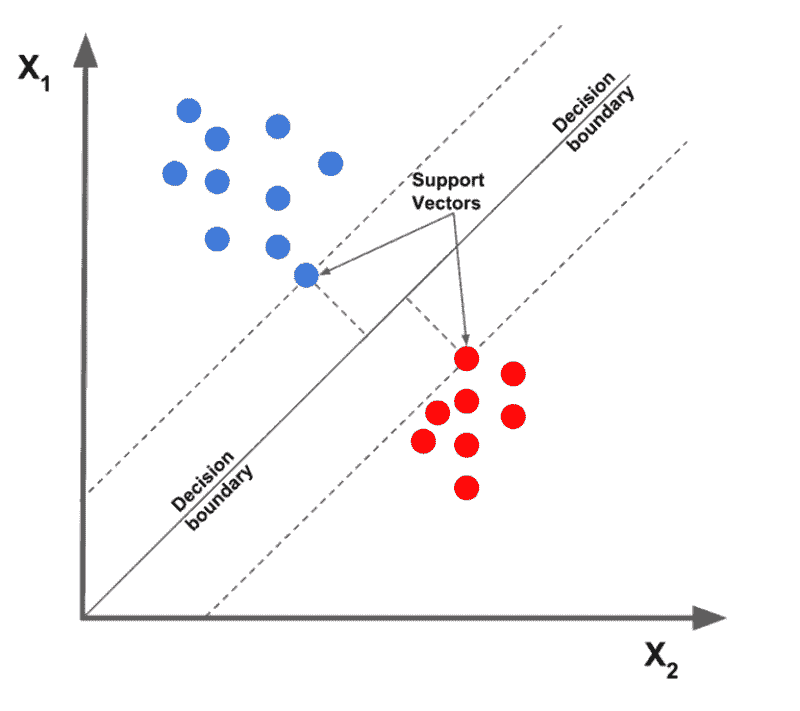

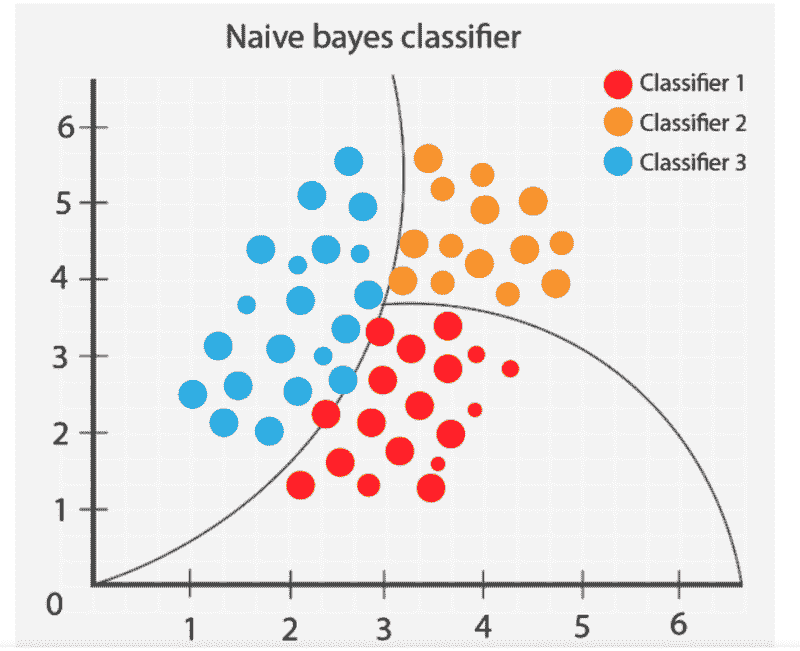

1. 线性支持向量机

被认为是最好的文本分类算法之一,线性支持向量机算法将给定数据点根据其提供的特征进行绘制,然后绘制最佳拟合线,将数据分割并分类到不同的类别中。

2. 逻辑回归

逻辑回归是回归的一个子类,主要关注分类问题。它使用决策边界、回归和距离来评估和分类数据集。

3. 朴素贝叶斯

朴素贝叶斯算法根据提供的特征对不同的对象进行分类。然后它绘制组边界,以推断这些组分类,以解决和进一步分类。

设置文本分类时需要避免的事项

数据过度拥挤

向算法提供低质量的数据会导致未来的预测不佳。然而,机器学习从业者常见的一个问题是将过于详细的数据集喂入训练模型,其中包括不必要的特征。用无关数据填充数据可能会导致模型性能下降。在选择和组织数据集时,少即是多。

错误的训练与测试数据比例会严重影响模型的性能,并影响数据的混洗和过滤。拥有不受其他不必要因素影响的精确数据点,可以使训练模型更高效地执行。

在训练模型时选择符合模型要求的数据集,过滤掉不必要的值,混洗数据集,并测试最终模型的准确性。更简单的算法消耗的计算时间和资源更少;最佳模型是那些能够解决复杂问题的最简单模型。

过拟合与欠拟合

模型的准确率在训练达到峰值后,会随着训练的继续而逐渐下降。这被称为过拟合;模型开始学习意图之外的模式,因为训练时间过长。在训练集上达到高准确率时要小心,因为主要目标是开发其准确率基于测试集(模型未见过的数据)的模型。

另一方面,欠拟合是指训练模型仍有改进空间,尚未达到其最大潜力。训练不充分的模型可能是由于训练时间过短或对数据集过度正则化。这说明了拥有简洁而精确数据的重要性。

在训练模型时找到最佳点至关重要。将数据集分割为 80/20 是一个好的开始,但调整参数可能是你的具体模型所需的,以达到最佳性能。

错误的文本格式

虽然在本文中没有过多提及,但为文本分类问题使用正确的文本格式将带来更好的结果。一些表示文本数据的方法包括GloVe、Word2Vec和嵌入模型。

使用正确的文本格式将改善模型读取和解释数据集的方式,从而帮助其理解模式。

文本分类应用

-

过滤垃圾邮件: 通过搜索特定的关键词,可以将电子邮件分类为有用或垃圾邮件。

-

文本分类: 通过使用文本分类,应用程序可以将不同的项目(文章、书籍等)分类到不同的类别中,方法是对相关文本(如项目名称、描述等)进行分类。使用这种技术可以改善用户体验,因为它使用户在数据库中浏览变得更加容易。

-

识别仇恨言论: 某些社交媒体公司使用文本分类来检测和禁用带有冒犯性言辞的评论或帖子,例如禁止在多人儿童游戏中输入任何形式的脏话。

-

市场营销与广告: 通过了解用户对特定产品的反应,公司可以进行具体的调整以满足客户需求。它还可以根据用户对类似产品的评论推荐某些产品。文本分类算法可以与推荐系统结合使用,推荐系统是许多在线网站用来获取回头客的深度学习算法之一。

流行的文本分类数据集

由于有大量标记好且可直接使用的数据集,你总能找到与模型要求匹配的完美数据集。

虽然在选择使用哪个数据集时可能会遇到一些问题,但在接下来的部分中,我们将推荐一些最著名的公共数据集。

像 Kaggle 这样的网站提供了各种涵盖所有主题的数据集。试着在上述提到的数据集上运行你的模型以进行实践!

机器学习中的文本分类

随着机器学习在过去十年里产生了巨大的影响,各家公司都在尝试各种方法利用机器学习来自动化流程。评论、评论、帖子、文章、期刊和文档都在文本中具有无价的价值。利用文本分类以多种创造性方式提取用户洞察和模式,公司可以做出有数据支持的决策;专业人员可以比以往更快地获得和学习有价值的信息。

Kevin Vu 管理 Exxact Corp 博客,并与许多撰写有关深度学习不同方面的才华横溢的作者合作。

原文。已获许可转载。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关话题

文本聚类:从非结构化数据中快速获得洞察,第二部分

原文:

www.kdnuggets.com/2017/07/text-clustering-unstructured-data-part2.html

评论

评论

由 Vivek Kalyanarangan 提供。

在这两部分系列中,我们将探讨文本聚类以及如何从非结构化数据中获得洞察。它将非常强大且具备工业级别的力量。第一部分将关注动机,第二部分将讨论实施。

本文是关于如何使用文本聚类从非结构化数据中获得洞察的两部分系列的第二部分。我们将以非常模块化的方式构建它,以便可以应用于任何数据集。此外,我们还将专注于将功能暴露为 API,以便它可以作为即插即用的模型,而不会对现有系统造成干扰。

-

文本聚类:如何从非结构化数据中快速获得洞察——第一部分:动机

-

文本聚类:如何从非结构化数据中快速获得洞察——第二部分:实施

如果你很急,你可以在我的 Github 页面 找到完整的项目代码

这只是最终输出效果的预览——

安装

-

Anaconda Python 2.7 发行版——从这里下载

-

flask API python 包——安装 anaconda 后,打开命令提示符并输入

pip install flask -

flasgger python 包——安装 anaconda 和 flask 后,打开命令提示符并输入

pip install flasgger

现在你已经准备好工具了。点击这里下载代码以开始设置。

运行中

解压缩内容,打开命令提示符并输入

python CLAAS_public.py

服务器将启动,你现在可以在此位置访问工具——localhost:8180/apidocs/index.html

工作流程

无指导聚类

这就是实际进行 KMeans 聚类的地方。

-

它需要一个 CSV 文件作为输入。此外,你还需要输入包含非结构化文本的列名和集群数量

-

一旦你点击“尝试一下”按钮,输入将由 API 使用

-

API 进行文本清理、Tfidf 向量化和聚类

-

一旦完成,它会提供一个下载链接,附加一个包含集群编号的额外列

有指导的聚类

就这项技术而言,它要简单一些。

-

它需要两个文件作为输入,一个是要聚类的数据文件,另一个是预定义的关键词

-

此外,它需要与无指导聚类等效的列名称

-

输出会为每个给定的关键词添加额外的列

-

如果文档包含该词,则为 TRUE,否则为 FALSE

这可以感知文档中关键字的存在/缺失,指示哪些文档包含关键字信号,哪些文档不包含。

结论

这就是关于文本聚类的多系列内容的全部。这样就足够开始了,对吧?撰写这一系列内容是一次很棒的体验。下一部分见。玩得开心!

原文。经许可转载。

简介: Vivek Kalyanarangan 是一名数据科学家,关注医疗领域的问题。

相关:

-

文本聚类:从非结构化数据中快速获得见解

-

K-means 聚类与 Tableau – 呼叫详细记录示例

-

从零开始的 Python 机器学习工作流程 第二部分:k-means 聚类

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织进行 IT

3. Google IT 支持专业证书 - 支持你的组织进行 IT

更多相关主题

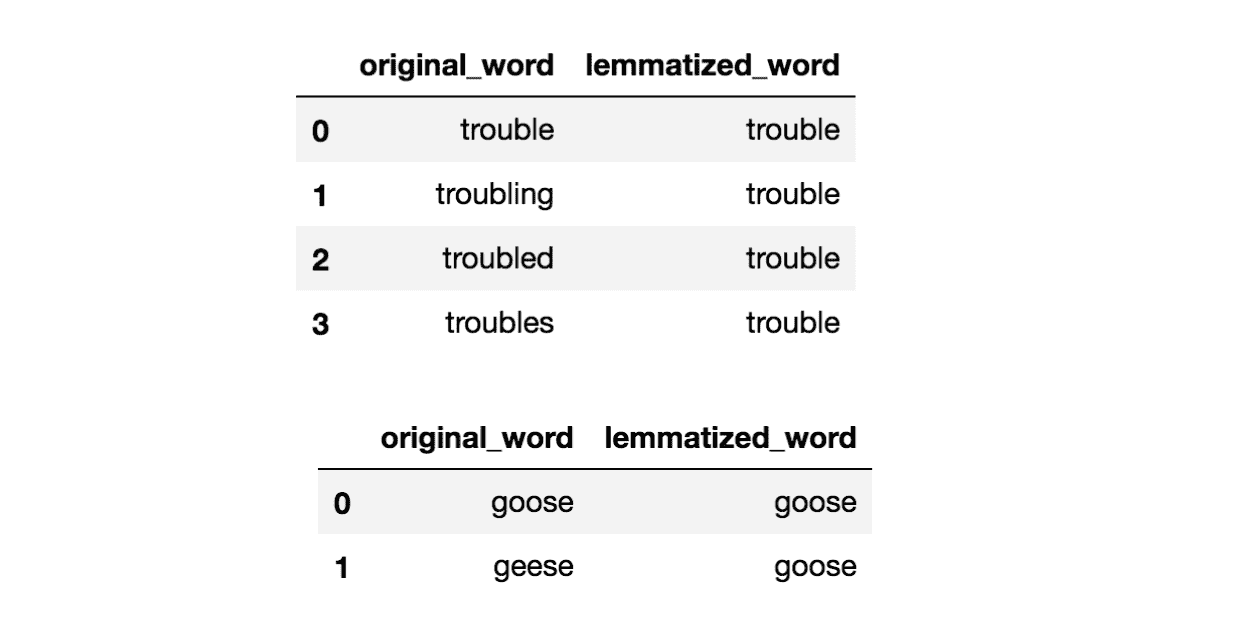

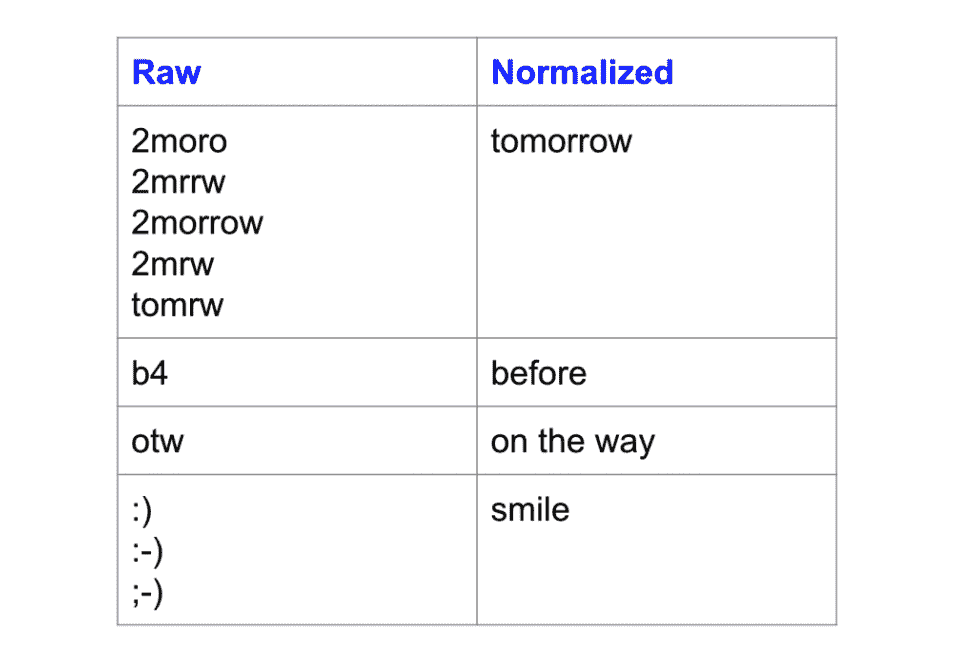

文本数据预处理:Python 实战指南

原文:

www.kdnuggets.com/2018/03/text-data-preprocessing-walkthrough-python.html

评论

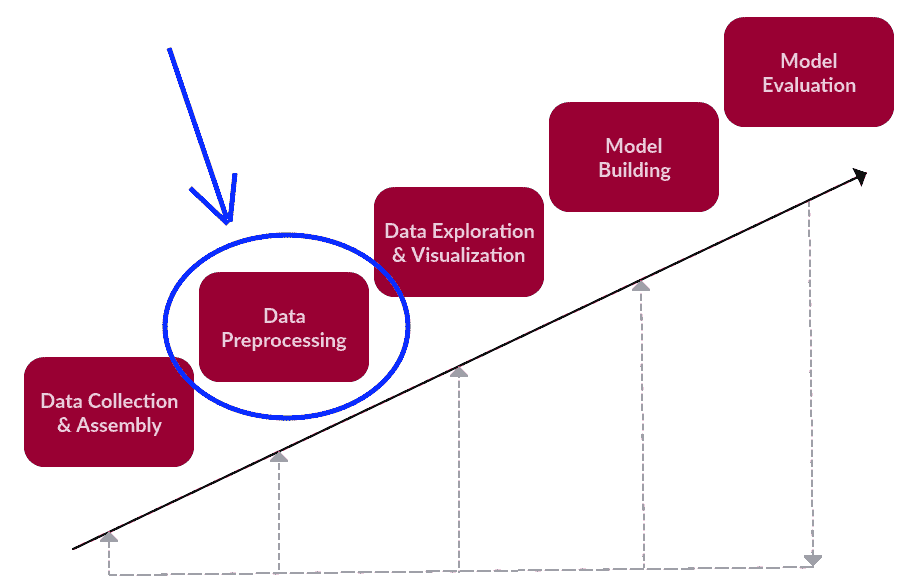

在之前的一对帖子中,我们首先讨论了一个 处理文本数据科学任务的框架,接着讨论了 文本数据预处理的一般方法。这篇文章将作为使用一些常见 Python 工具进行文本数据预处理任务的实用指南。

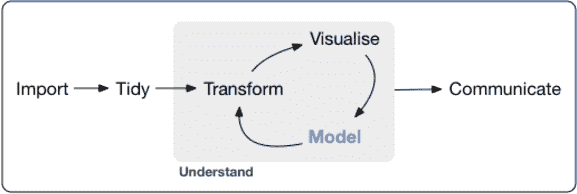

在文本数据科学框架的背景下进行预处理。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 部门

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 部门

我们的目标是从我们将描述的文本块(不要与文本块化混淆),一个冗长的未处理单一字符串,开始,最后得到一个(或几个)清理后的标记列表,这些标记将对进一步的文本挖掘和/或自然语言处理任务有用。

首先我们从导入开始。

除了标准的 Python 库,我们还使用以下库:

-

NLTK - 自然语言工具包是 Python 生态系统中最知名和最常用的 NLP 库之一,适用于从标记化、词干提取到词性标注等各种任务

-

BeautifulSoup - BeautifulSoup 是一个用于从 HTML 和 XML 文档中提取数据的有用库

-

Inflect - 这是一个简单的库,用于完成生成复数、单数名词、序数词和不定冠词等自然语言相关任务,以及(最吸引我们的是)将数字转换为单词

-

Contractions - 另一个简单的库,仅用于扩展缩写词

如果你已安装 NLTK,但需要下载其任何额外的数据,请查看这里。

我们需要一些示例文本。我们将从非常小且人为的数据开始,以便能够一步步清楚地看到我们所做的结果。

确实是一个玩具数据集,但不要误解;我们在这里进行的数据预处理步骤是完全可迁移的。

文本数据预处理框架。

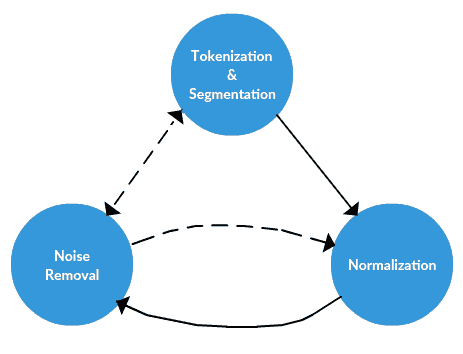

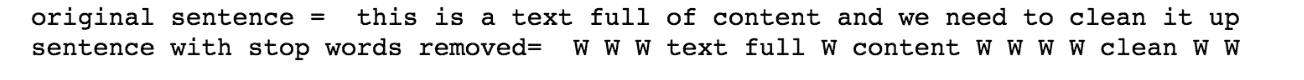

噪声移除

我们可以将噪声移除大致定义为经常在分词前进行的文本特定标准化任务。我认为,尽管预处理框架的其他两个主要步骤(分词和标准化)基本上与任务无关,但噪声移除则更具任务特定性。

样本噪声移除任务可能包括:

-

移除文本文件头部和尾部

-

移除 HTML、XML 等标记和元数据

-

从其他格式(如 JSON)中提取有价值的数据

如你所想,噪声移除与数据收集和组装之间的界限一方面是模糊的,而噪声移除与标准化之间的界限另一方面也较为模糊。考虑到与特定文本及其收集和组装的紧密关系,许多去噪任务,如解析 JSON 结构,显然需要在分词之前实现。

在我们的数据预处理管道中,我们将利用 BeautifulSoup 库去除 HTML 标记,并使用正则表达式去除开放和关闭的双括号及其之间的内容(我们根据样本文本假设这是必要的)。

虽然在此阶段进行分词前并不是强制性操作(你会发现这一点是相对灵活的文本数据预处理任务顺序的常态),但在此时将缩写词替换为其扩展形式可能是有益的,因为我们的分词器将把像“didn't”这样的单词拆分为“did”和“n't”。虽然在后续阶段解决这一分词问题并非不可能,但提前处理会使其更简单直接。

这是我们样本文本去噪的结果。

Title Goes Here

Bolded Text

Italicized Text

But this will still be here!

I run. He ran. She is running. Will they stop running?

I talked. She was talking. They talked to them about running. Who ran to the talking runner?

¡Sebastián, Nicolás, Alejandro and Jéronimo are going to the store tomorrow morning!

something... is! wrong() with.,; this :: sentence.

I cannot do this anymore. I did not know them. Why could not you have dinner at the restaurant?

My favorite movie franchises, in order: Indiana Jones; Marvel Cinematic Universe; Star Wars; Back to the Future; Harry Potter.

do not do it.... Just do not. Billy! I know what you are doing. This is a great little house you have got here.

John: "Well, well, well."

James: "There, there. There, there."

There are a lot of reasons not to do this. There are 101 reasons not to do it. 1000000 reasons, actually.

I have to go get 2 tutus from 2 different stores, too.

22 45 1067 445

{{Here is some stuff inside of double curly braces.}}

{Here is more stuff in single curly braces.}

分词

分词是将较长的文本字符串拆分为更小的片段或词元的步骤。较大的文本块可以分词为句子,句子可以分词为单词等。通常在文本被适当地分词后会进行进一步处理。分词也称为文本分割或词汇分析。有时分割用来指代将大块文本拆分为比单词更大的片段(例如段落或句子),而分词则专指仅拆分为单词的过程。

对于我们的任务,我们将把样本文本分词为单词列表。这是通过 NLTK 的 word_tokenize() 函数完成的。

这是我们的单词词元:

['Title', 'Goes', 'Here', 'Bolded', 'Text', 'Italicized', 'Text', 'But', 'this', 'will', 'still',

'be', 'here', '!', 'I', 'run', '.', 'He', 'ran', '.', 'She', 'is', 'running', '.', 'Will', 'they',

'stop', 'running', '?', 'I', 'talked', '.', 'She', 'was', 'talking', '.', 'They', 'talked', 'to', 'them',

'about', 'running', '.', 'Who', 'ran', 'to', 'the', 'talking', 'runner', '?', '¡Sebastián', ',',

'Nicolás', ',', 'Alejandro', 'and', 'Jéronimo', 'are', 'going', 'tot', 'he', 'store', 'tomorrow',

'morning', '!', 'something', '...', 'is', '!', 'wrong', '(', ')', 'with.', ',', ';', 'this', ':', ':',

'sentence', '.', 'I', 'can', 'not', 'do', 'this', 'anymore', '.', 'I', 'did', 'not', 'know', 'them', '.',

'Why', 'could', 'not', 'you', 'have', 'dinner', 'at', 'the', 'restaurant', '?', 'My', 'favorite',

'movie', 'franchises', ',', 'in', 'order', ':', 'Indiana', 'Jones', ';', 'Star', 'Wars', ';', 'Marvel',

'Cinematic', 'Universe', ';', 'Back', 'to', 'the', 'Future', ';', 'Harry', 'Potter', '.', 'do', 'not',

'do', 'it', '...', '.', 'Just', 'do', 'not', '.', 'Billy', '!', 'I', 'know', 'what', 'you', 'are',

'doing', '.', 'This', 'is', 'a', 'great', 'little', 'house', 'you', 'have', 'got', 'here', '.', 'John',

':', '``', 'Well', ',', 'well', ',', 'well', '.', "''", 'James', ':', '``', 'There', ',', 'there', '.',

'There', ',', 'there', '.', "''", 'There', 'are', 'a', 'lot', 'of', 'reasons', 'not', 'to', 'do', 'this',

'.', 'There', 'are', '101', 'reasons', 'not', 'to', 'do', 'it', '.', '1000000', 'reasons', ',',

'actually', '.', 'I', 'have', 'to', 'go', 'get', '2', 'tutus', 'from', '2', 'different', 'stores', ',',

'too', '.', '22', '45', '1067', '445', '{', '{', 'Here', 'is', 'some', 'stuff', 'inside', 'of', 'double',

'curly', 'braces', '.', '}', '}', '{', 'Here', 'is', 'more', 'stuff', 'in', 'single', 'curly', 'braces',

'.', '}']

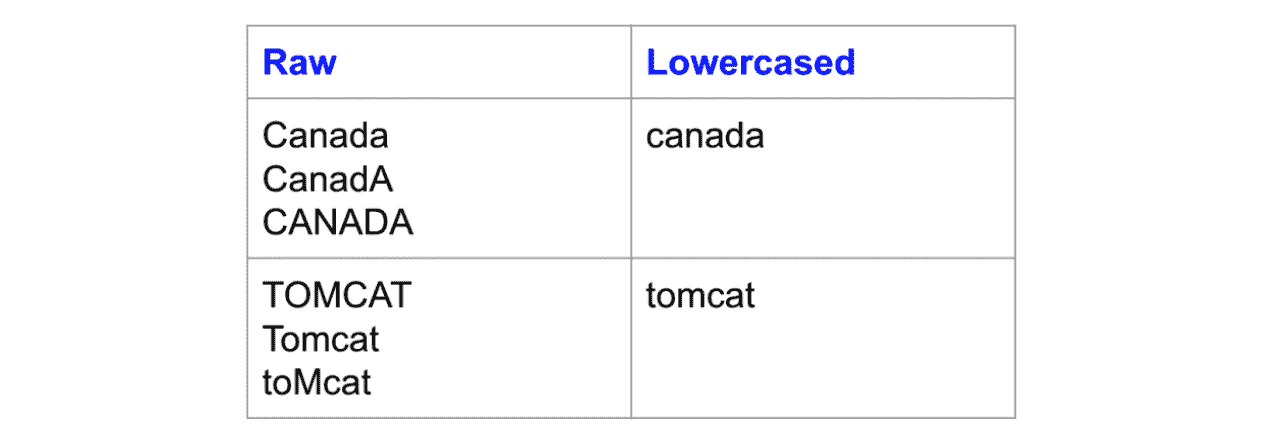

标准化

标准化通常指一系列相关任务,旨在使所有文本处于同一水平:将所有文本转换为相同的大小写(大写或小写),去除标点符号,将数字转换为其单词等价形式,等等。标准化使所有单词处于平等地位,并允许处理以统一的方式进行。

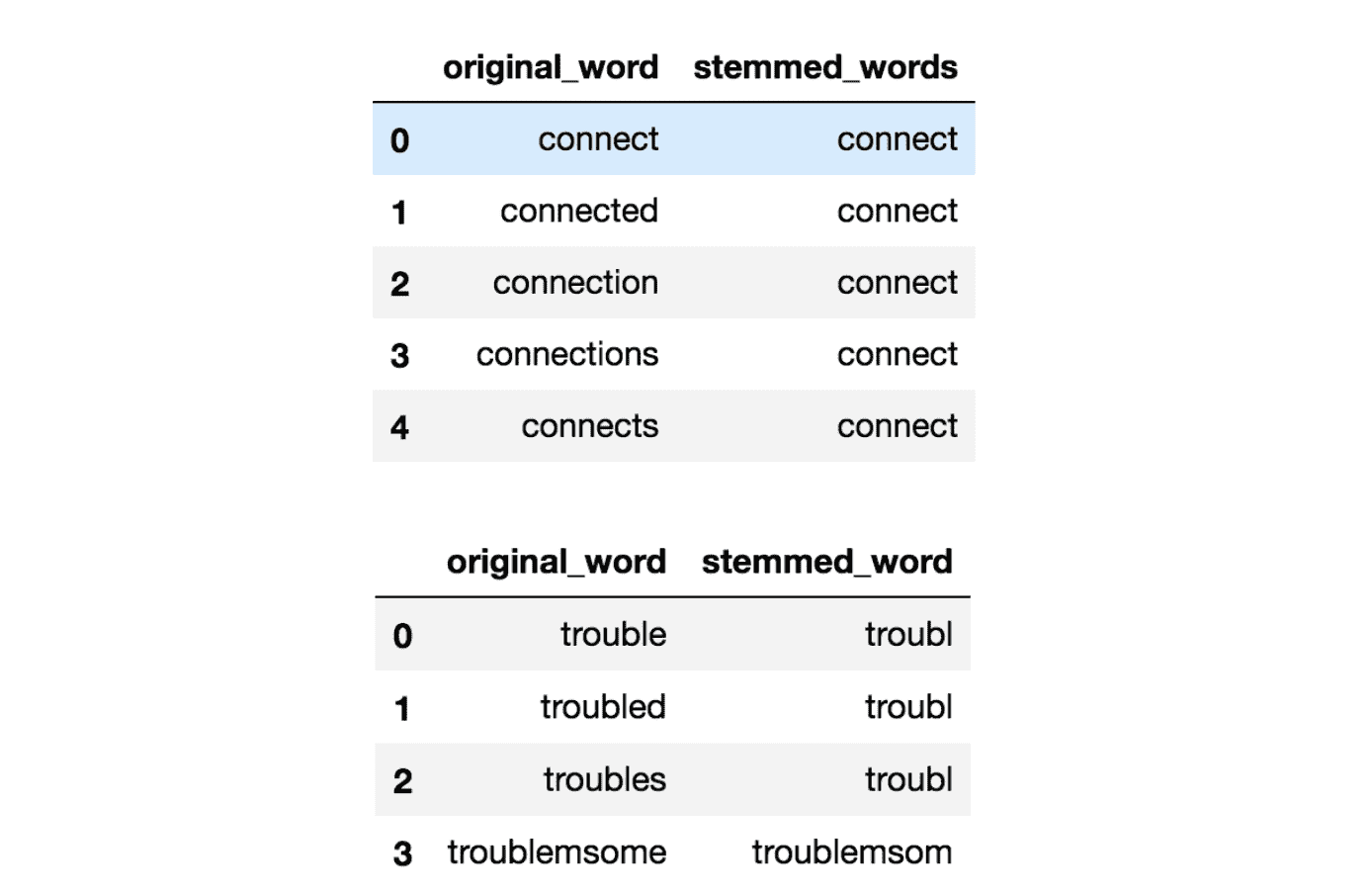

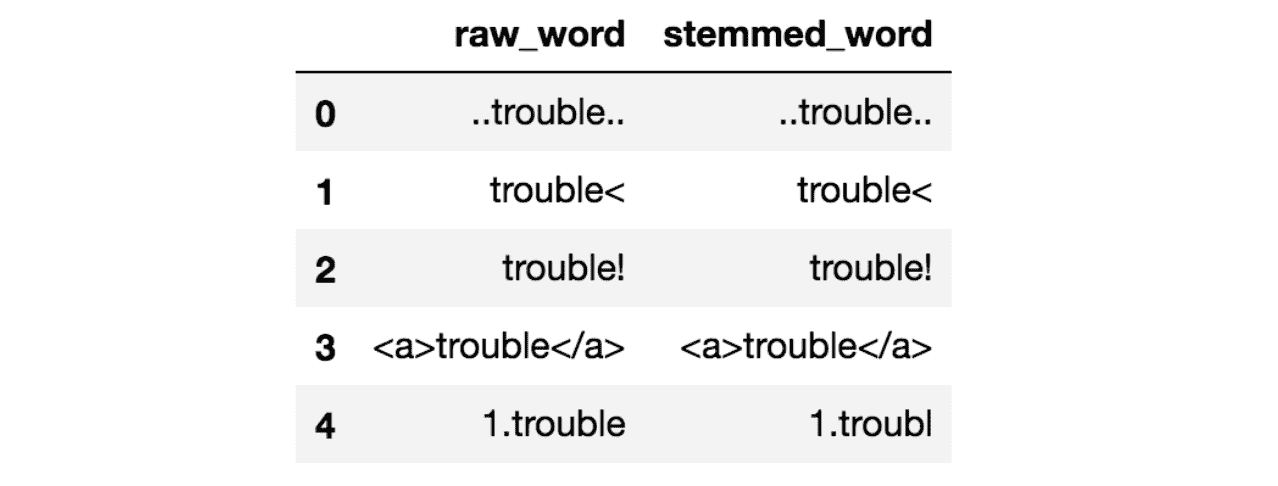

文本归一化可以包含多个任务,但对于我们的框架,我们将归一化分为三个不同的步骤:(1) 词干化,(2) 词形还原,以及 (3) 其他所有操作。有关这些不同步骤的具体信息,请参阅这篇文章。

请记住,在标记化之后,我们不再处理文本级别的数据,而是转向词级别。我们下面展示的归一化函数反映了这一点。函数名称和注释应提供每个函数的必要信息。

调用归一化函数后:

['title', 'goes', 'bolded', 'text', 'italicized', 'text', 'still', 'run', 'ran', 'running', 'stop',

'running', 'talked', 'talking', 'talked', 'running', 'ran', 'talking', 'runner', 'sebastian', 'nicolas',

'alejandro', 'jeronimo', 'going', 'store', 'tomorrow', 'morning', 'something', 'wrong', 'sentence',

'anymore', 'know', 'could', 'dinner', 'restaurant', 'favorite', 'movie', 'franchises', 'order',

'indiana', 'jones', 'marvel', 'cinematic', 'universe', 'star', 'wars', 'back', 'future', 'harry',

'potter', 'billy', 'know', 'great', 'little', 'house', 'got', 'john', 'well', 'well', 'well', 'james',

'lot', 'reasons', 'one hundred and one', 'reasons', 'one million', 'reasons', 'actually', 'go', 'get',

'two', 'tutus', 'two', 'different', 'stores', 'twenty-two', 'forty-five', 'one thousand and sixty-seven',

'four hundred and forty-five', 'stuff', 'inside', 'double', 'curly', 'braces', 'stuff', 'single',

'curly', 'braces']

调用词干化和词形还原函数如下所示:

这会产生两个新的列表:一个是词干化的标记,另一个是与动词相关的词形还原标记。根据你即将进行的 NLP 任务或偏好,这其中一个可能比另一个更合适。有关词形还原与词干化的讨论,请参见此处。

Stemmed:

['titl', 'goe', 'bold', 'text', 'it', 'text', 'stil', 'run', 'ran', 'run', 'stop', 'run', 'talk',

'talk', 'talk', 'run', 'ran', 'talk', 'run', 'sebast', 'nicola', 'alejandro', 'jeronimo', 'going',

'stor', 'tomorrow', 'morn', 'someth', 'wrong', 'sent', 'anym', 'know', 'could', 'din', 'resta',

'favorit', 'movy', 'franch', 'ord', 'indian', 'jon', 'marvel', 'cinem', 'univers', 'star', 'war', 'back',

'fut', 'harry', 'pot', 'bil', 'know', 'gre', 'littl', 'hous', 'got', 'john', 'wel', 'wel', 'wel', 'jam',

'lot', 'reason', 'one hundred and on', 'reason', 'one million', 'reason', 'act', 'go', 'get', 'two',

'tut', 'two', 'diff', 'stor', 'twenty-two', 'forty-five', 'one thousand and sixty-seven', 'four hundred

and forty-five', 'stuff', 'insid', 'doubl', 'cur', 'brac', 'stuff', 'singl', 'cur', 'brac']

Lemmatized:

['title', 'go', 'bolded', 'text', 'italicize', 'text', 'still', 'run', 'run', 'run', 'stop', 'run',

'talk', 'talk', 'talk', 'run', 'run', 'talk', 'runner', 'sebastian', 'nicolas', 'alejandro', 'jeronimo',

'go', 'store', 'tomorrow', 'morning', 'something', 'wrong', 'sentence', 'anymore', 'know', 'could',

'dinner', 'restaurant', 'favorite', 'movie', 'franchise', 'order', 'indiana', 'jones', 'marvel',

'cinematic', 'universe', 'star', 'war', 'back', 'future', 'harry', 'potter', 'billy', 'know', 'great',

'little', 'house', 'get', 'john', 'well', 'well', 'well', 'jam', 'lot', 'reason', 'one hundred and one',

'reason', 'one million', 'reason', 'actually', 'go', 'get', 'two', 'tutus', 'two', 'different', 'store',

'twenty-two', 'forty-five', 'one thousand and sixty-seven', 'four hundred and forty-five', 'stuff',

'inside', 'double', 'curly', 'brace', 'stuff', 'single', 'curly', 'brace']

这就是使用 Python 对一段文本进行简单数据预处理的过程。我建议你对一些额外的文本执行这些任务以验证结果。我们将使用相同的过程来清理下一任务的文本数据,在此任务中,我们将进行实际的 NLP 任务,而不是花时间准备数据以进行这样的实际任务。

相关:

-

文本数据预处理的通用方法

-

处理文本数据科学任务的框架

-

自然语言处理关键术语解释

更多相关内容