KDNuggets-博客中文翻译-三十-

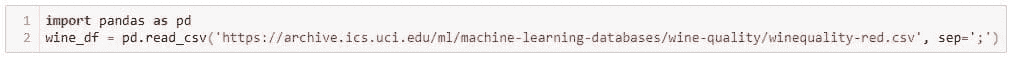

KDNuggets 博客中文翻译(三十)

原文:KDNuggets

将你的数据科学职业生涯提升到新水平

原文:

www.kdnuggets.com/2021/12/sas-advance-data-science-career-next-level.html

赞助广告。

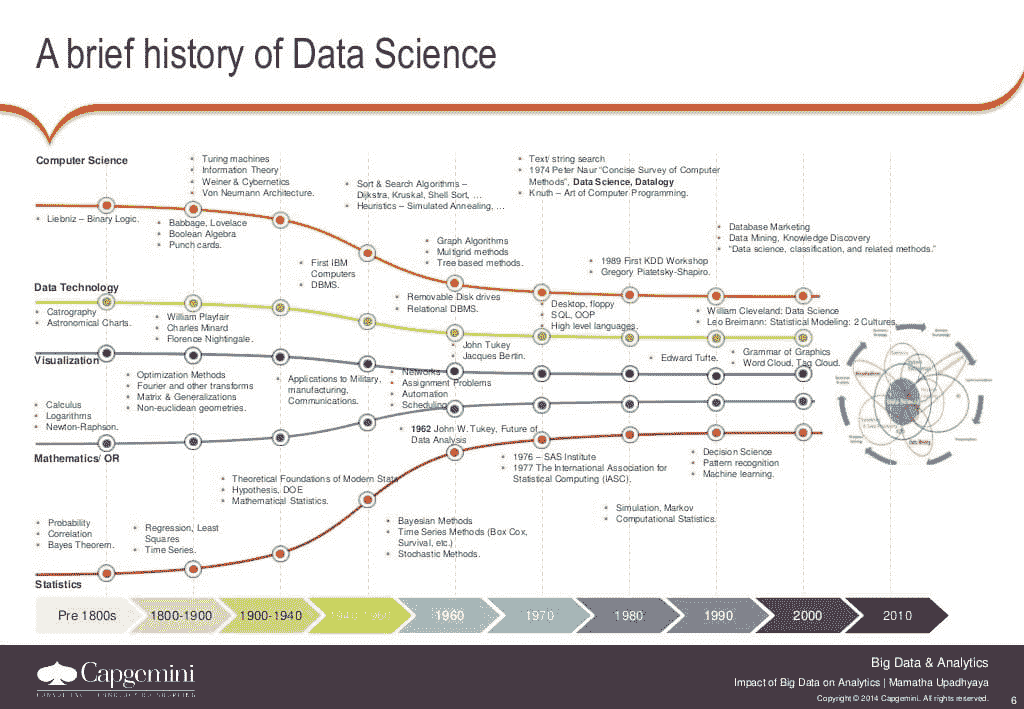

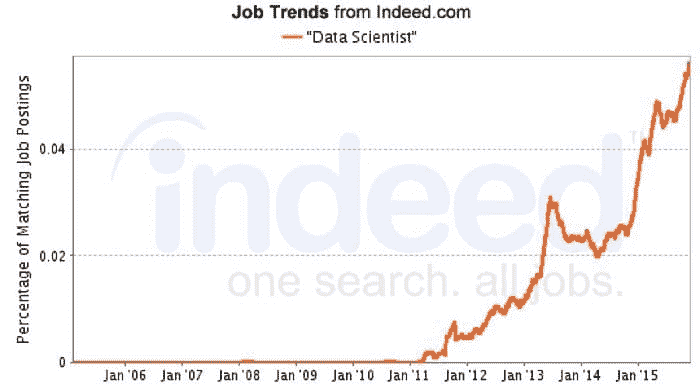

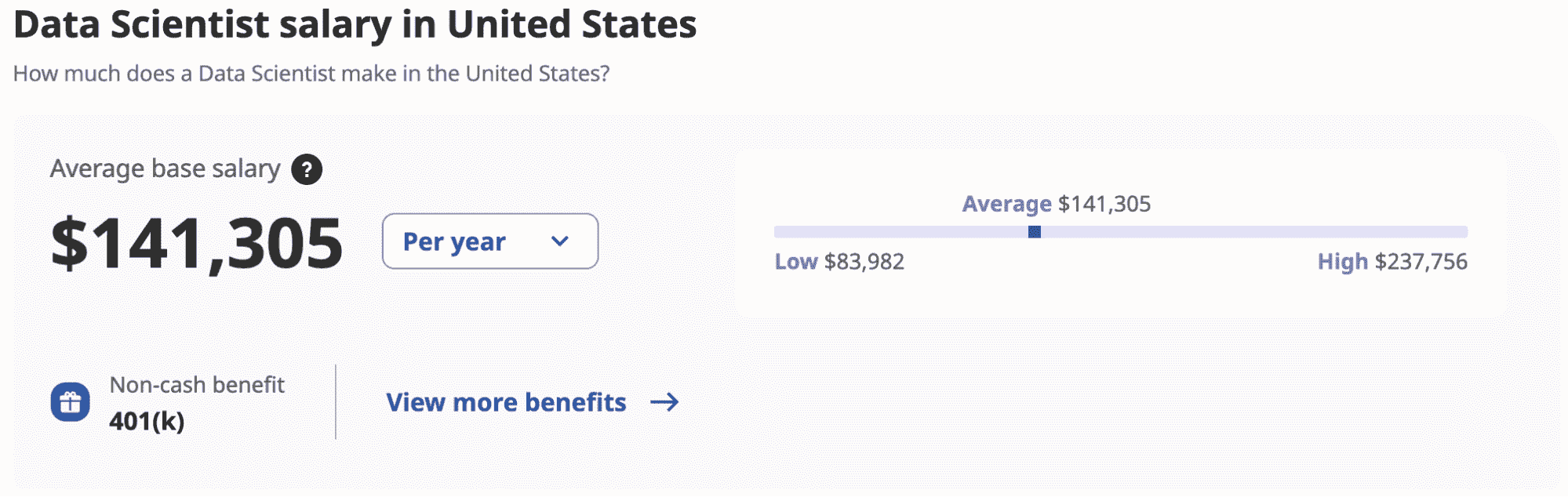

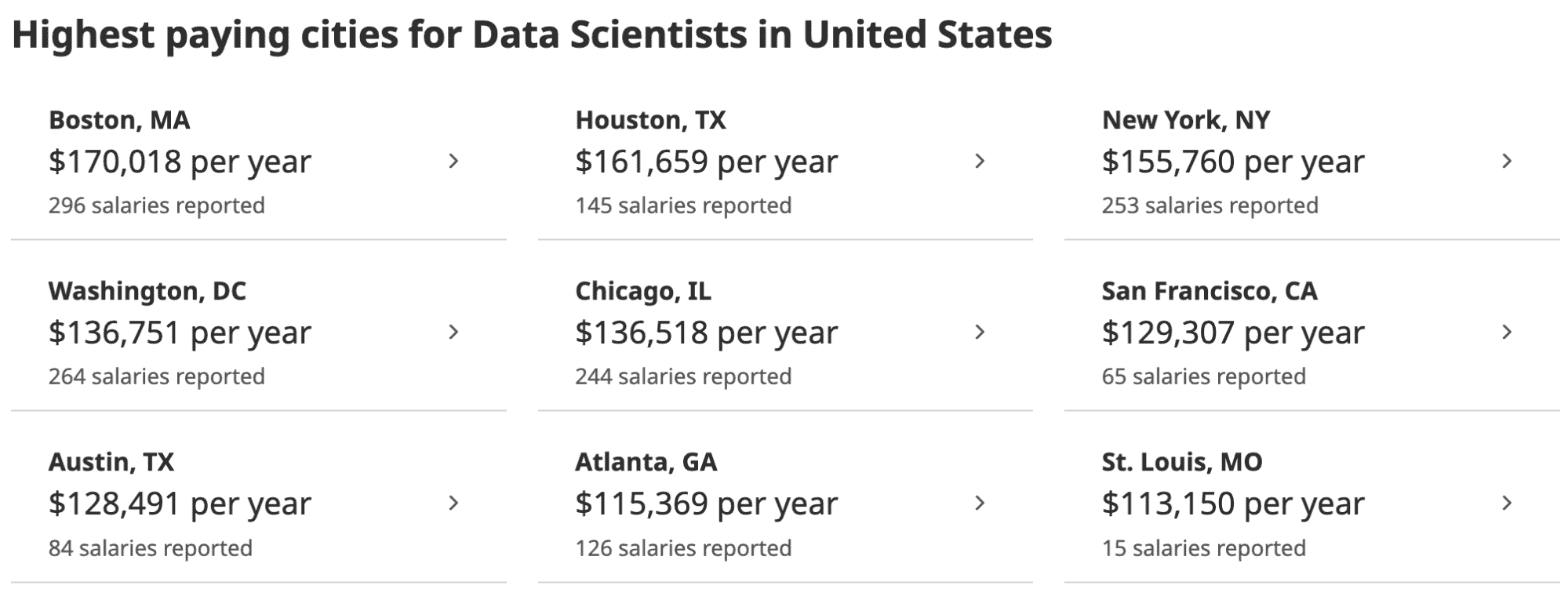

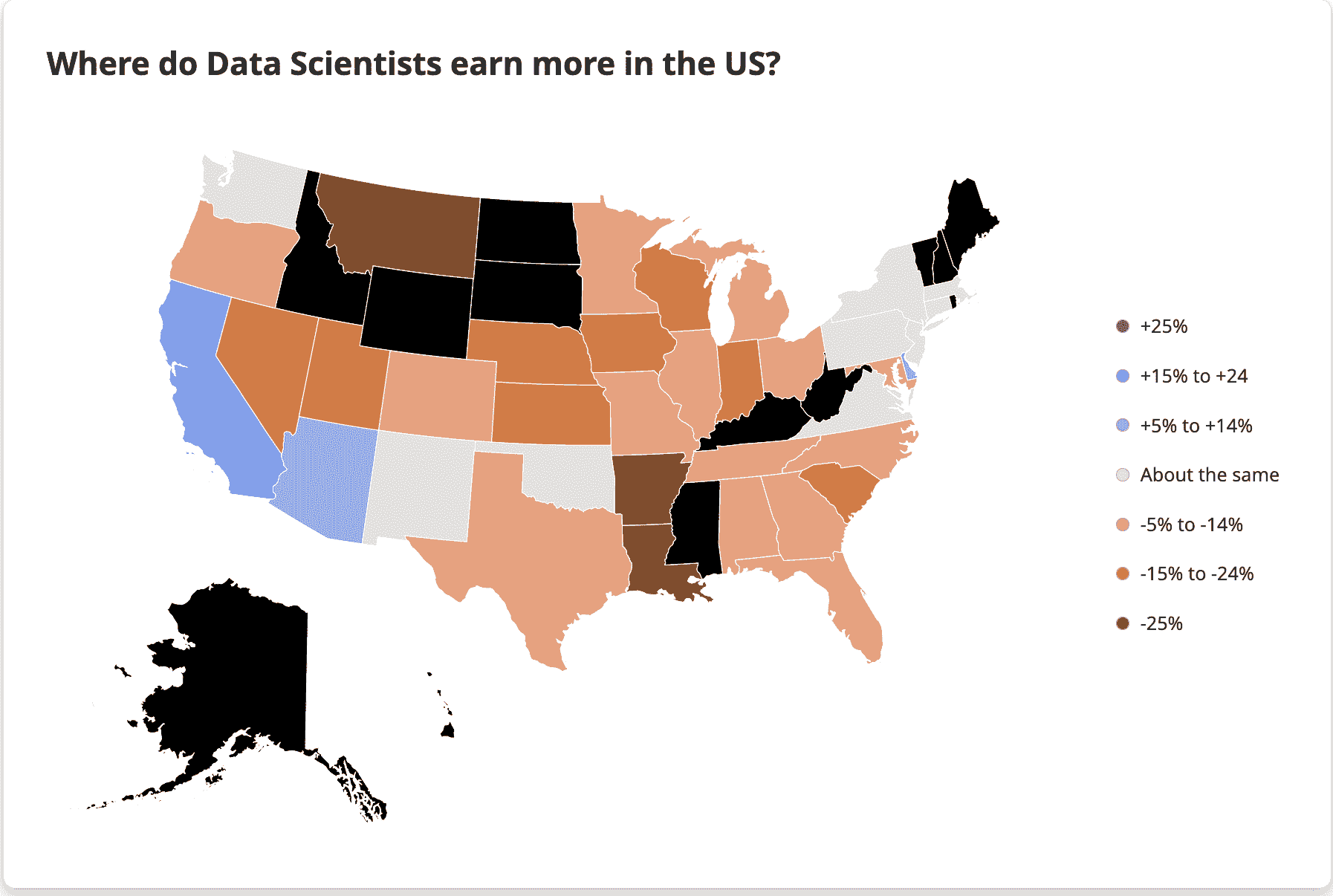

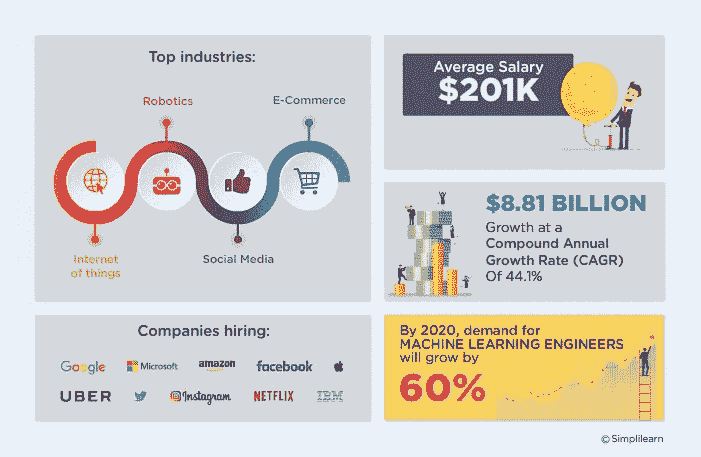

数据科学职业路径的增长速度和吸引力空前强劲。事实上,自 2012 年以来,数据科学职位增长了 650%。此外,美国劳工统计局预测到 2026 年职位数量将增加约 28%,这相当于约1150 万个新职位。你很难找到一个不将数据科学融入关键业务功能的行业。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

无论你是刚刚起步还是经验丰富的专业人士,SAS 提供了广泛的实操课程,帮助数据科学专业人士在职业生涯中取得进步并保持领先:

-

SAS^(®)数据科学学院 通过 SAS 的深入培训和专业认证掌握成为数据科学家的必要技能。利用 免费 30 天试用。

-

专为数据科学家设计,该项目涵盖数据策展技术的 SAS 主题,包括使用 Hadoop 进行大数据准备。

-

通过学习预测建模、文本分析、实验和优化技术来扩展你的分析技能。

-

AI 和机器学习专业 学习如何将 AI 和机器学习应用于业务问题,并理解分析生命周期的每一步。

-

使用 SAS^(®)** Viya^(®**) 通过深入的教学和免费的 SAS 软件互动练习来建立机器学习技能。

-

我们全面的培训工具帮助您学习 SAS,扩展员工知识,衡量价值并培训新员工。拥有超过 100 门电子学习课程,适合每个人!

为了支持您的数据科学职业之旅,SAS 还提供了免费资源——从白皮书和文章到播客和视频教程,选择丰富。通过访问 数据科学资源中心 开始,或在 数据科学家学习之旅 系列中注册免费网络研讨会。

更多相关话题

SAS®视觉数据科学决策,由 SAS® Viya®驱动:免费试用

原文:

www.kdnuggets.com/2021/06/sas-viya-visual-data-science-free-trial.html

赞助帖子。

由 Lindsay Marshall撰写

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

能够解读和分析数据的组织在数字经济中具备了获胜的条件。在 COVID-19 之后,Gartner 表示 69%的董事会已经加快了他们的数字业务计划。分析是整个企业的重要投资,组织需要对所选择的供应商充满信心。为何不免费发现 SAS®如何帮助你准备、探索、分析和可视化你的数据?

使用 SAS 视觉数据科学决策(VDSD)试用版,你可以获得终极的分析体验,免费访问所有 SAS Viya 分析功能,时间为 14 天。 SAS 视觉数据科学决策提供涵盖整个分析生命周期的终极体验——从数据管理、模型开发,到模型部署和决策。

SAS 视觉数据科学决策由 SAS® Viya®驱动,我们的 AI、分析和数据管理平台,运行在现代、可扩展的架构上,使得每时每刻的决策都充满信心。

这个免费试用版为你提供对 SAS Viya 功能的访问,包括:

-

数据访问、数据准备、数据质量与信息目录

-

高级流程步骤与信息治理

-

可视化与报告

-

统计学

-

矩阵编程

-

机器学习与深度学习

-

模型部署与管理

-

预测

-

文本分析

-

优化

-

计量经济学

-

数字决策

-

事件流分析

尝试一个,或全部尝试。所有这些都包含在您的免费试用中。

每个用户可以上传 1GB 的非个人识别信息(PII)数据。支持以下常用数据源:Microsoft Excel 电子表格、CSV 文件和 SAS 数据集。

您还可以从您的组织中添加最多四个用户(包括您自己,总共五个用户)到此试用体验中。每个用户只需一个 SAS 账户即可开始使用。改进的注册和试用体验确保您将比以往更快地学习新的分析和 AI 能力,并且如果需要,您还可以选择延长使用时间。我们已为 VDSD 中包含的许多数据管理、分析和 AI 功能预加载数据集和预构建管道,并且如果您有问题,可以从用户社区、支持页面和教程中获得快速支持。

为什么等待?今天就开始您的免费 SAS 试用吧!

相关主题

用数据科学拯救莎拉·康纳

原文:

www.kdnuggets.com/2021/10/save-sarah-connor-data-science.html

评论

作者:彼得·科兹洛夫,数据分析硕士,拥有超过 30 年的不同行业经验。

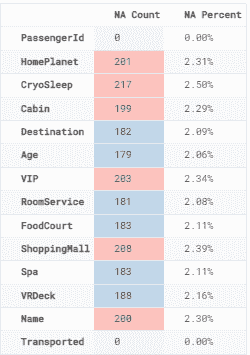

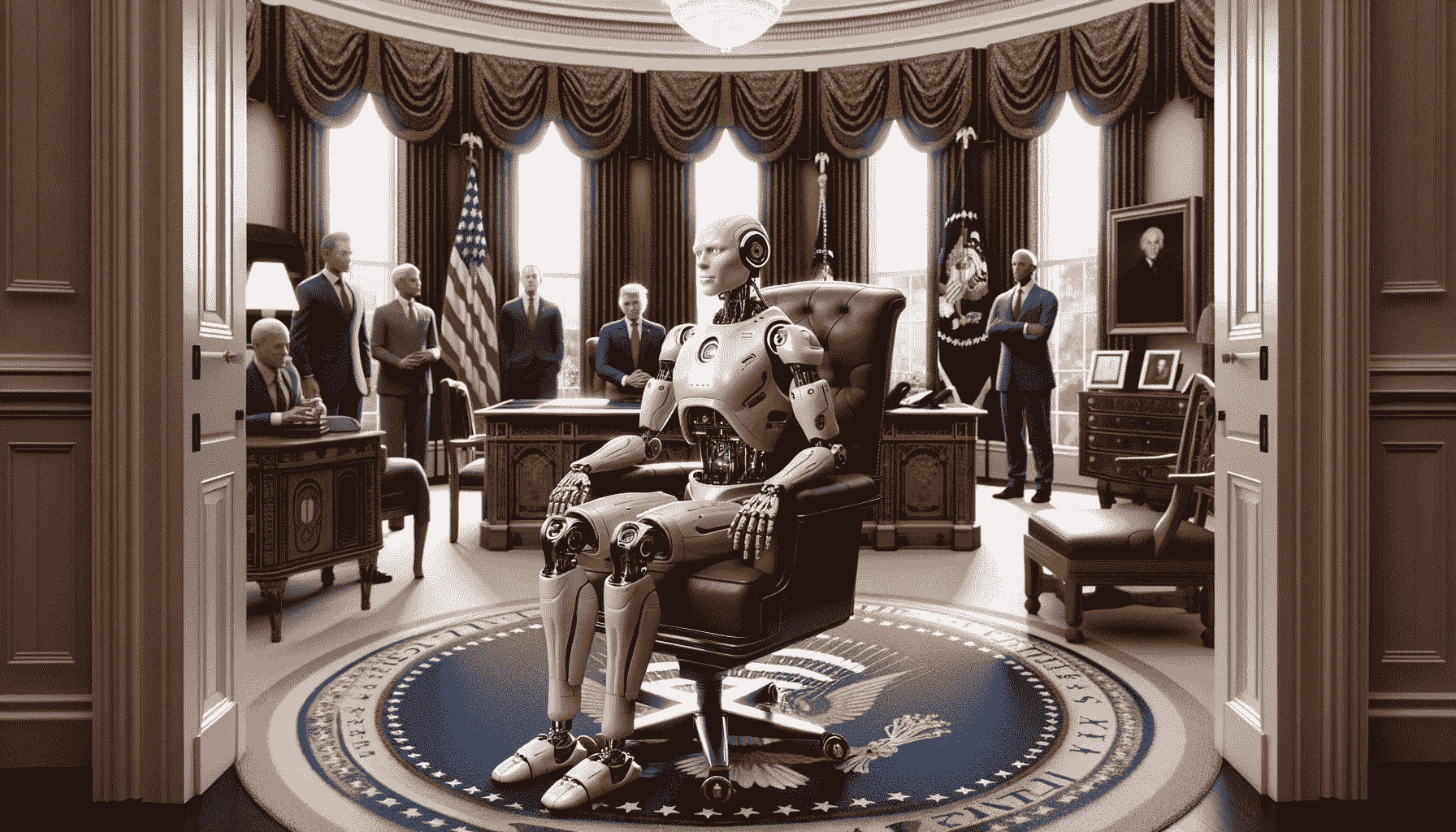

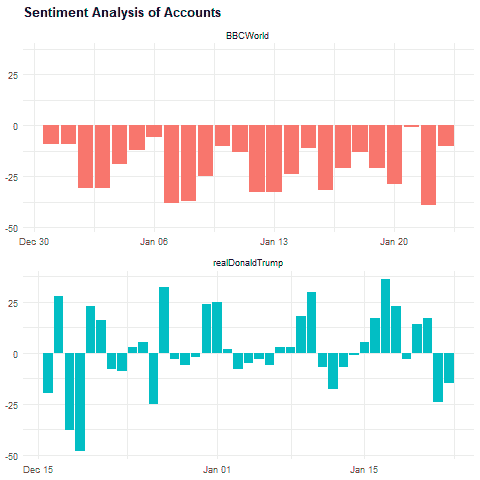

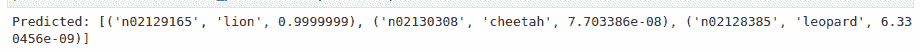

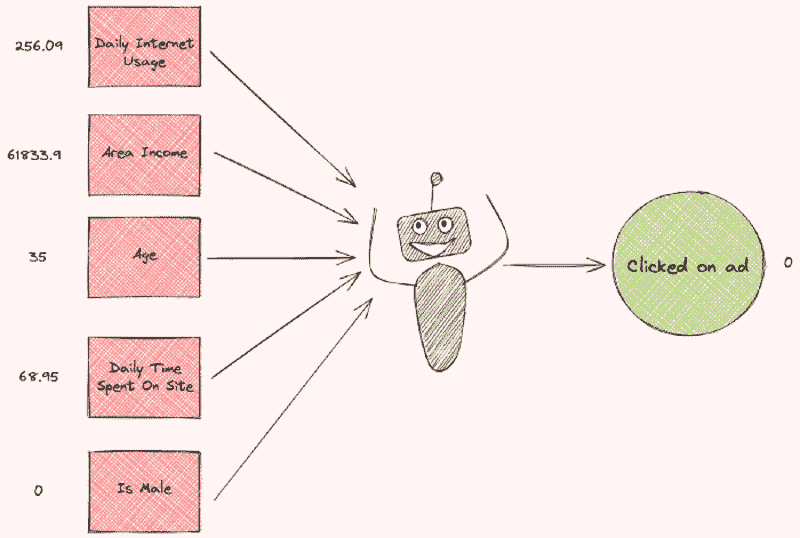

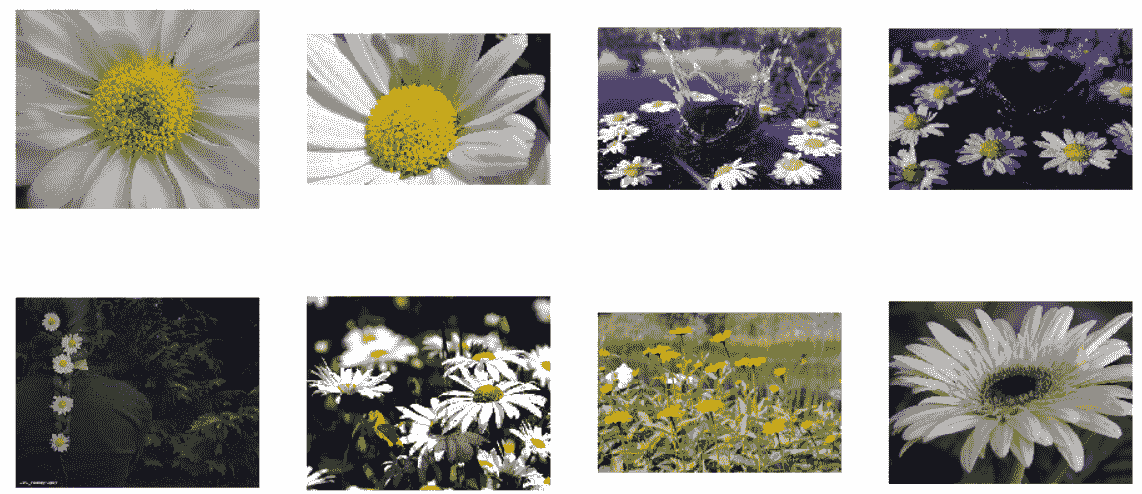

下面的图片发生了什么?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 服务。

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 服务。

我们在这里看到数据窃贼了吗?

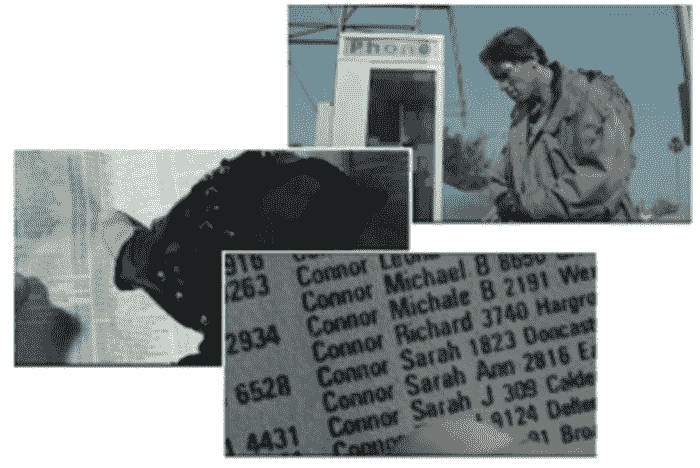

图片 1. 来自 1984 年上映的《终结者》电影的镜头。

这是 1984 年的加州。我们可能会认出未来的加州州长阿诺德·施瓦辛格,他在电影《终结者》中扮演了直接针对加州人的角色。他正在使用在电话亭里找到的电话簿。

终结者是数据窃贼吗?实际上,他并不是,因为在 1984 年,这类个人数据是公开可用的。

近年来个人信息处理的认知发生了显著变化,并且有一些迹象:

-

(欧洲) 一般数据保护条例 (GDPR) 于 2018 年 5 月 25 日实施。

-

(澳大利亚) 消费者数据权利 (CDR) 从 2019 年 9 月 1 日起生效。

-

(美国) 健康保险流通与问责法案 (HIPAA) 预计在 2021 年会有变更。

今天,加州人对数据隐私非常重视,根据 2019 年 10 月 11 日签署的加州消费者隐私法案 (CCPA)。加州人走在前面,为每一条不合规的客户记录附上了价格标签。价格范围在每条记录 100 到 750 美元之间。

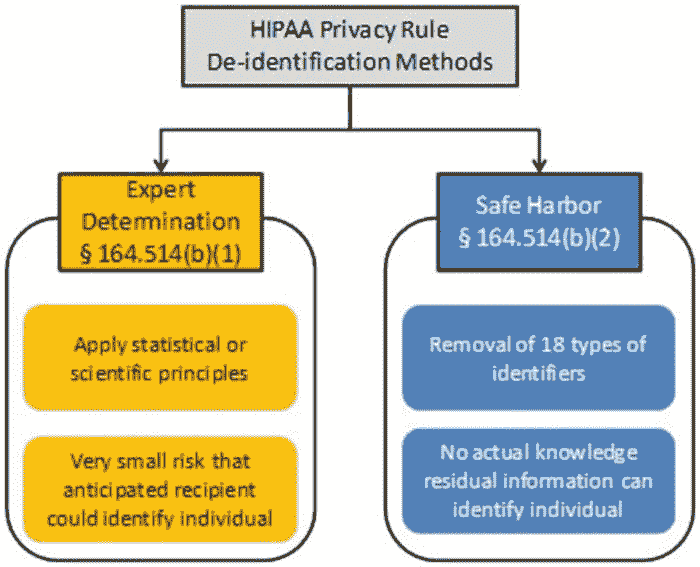

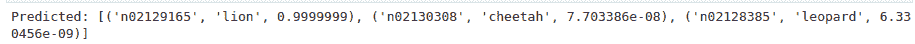

数据隐私的最佳实践是什么?美国监管机构 HIPAA 一直是健康行业以及其他行业的数据隐私模范。它传播知识,并为隐私数据处理方法提供明确的定义。HIPAA 区分了安全港和专家判定方法。我们将比较这些数据模糊化的方法。

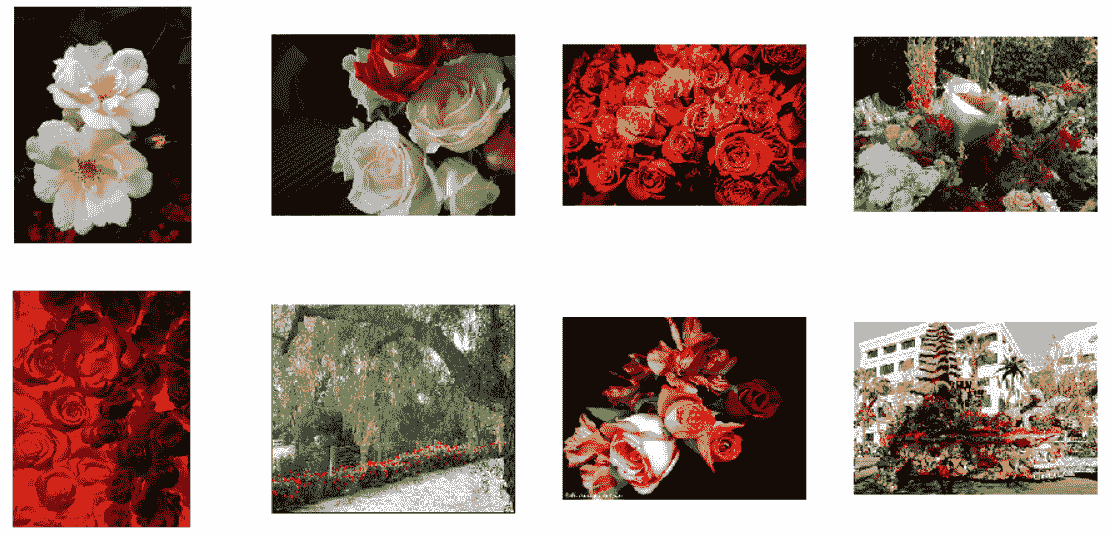

图片 2. HIPAA 推荐的去标识化方法。来自美国卫生与公共服务部的插图。

专家鉴定由合格的统计学家/数据科学家提供作为客观风险评估。相比之下,Safe Harbour 是一个让企业自己完成这项工作的配方。

“Safe Harbour”是一个非常引人注目的概念,因为它基于一套简单的规则来移除明确的标识符。例如,前两个标识符是个人的姓名和小于州的地理细分。完整的标识符列表可以在这里找到。除了移除密钥外,我们还需要确保没有留下识别个人的信息。这可能是由于微密钥(如非常罕见的疾病或独特的治疗参数)而成为一个挑战。Safe Harbour 是基于规则的,因此在考虑数据的实际内容和微密钥时过于僵化。技术科学期刊中的文章A Re-identification of Patients in Maine and Vermont Statewide Hospital Data演示了 3.2%的 Safe Harbour 数据通过地方出版物重新识别为个人。

专家鉴定方法可以考虑数据研究的目的,并在研究背景中容忍各种混淆方法:

-

扰乱

-

加密

-

目录替换

-

屏蔽

-

标记化

-

数据模糊

-

噪声添加

-

聚合

专家鉴定使我们能够在产生的信息丧失与个人信息泄露的概率之间取得平衡,并确保信息处理的意义得以保留。

让我们讨论一个例子。

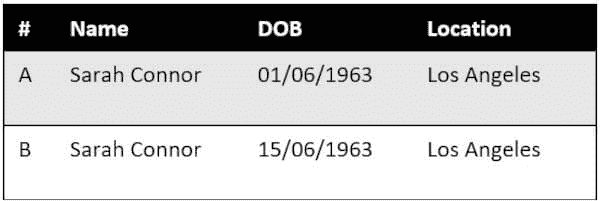

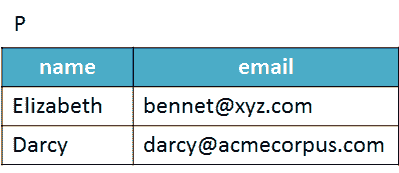

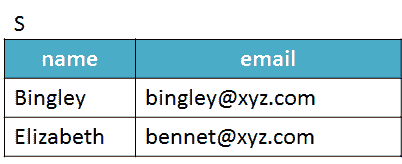

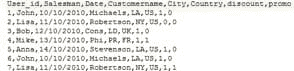

我们的任务是进行客户研究并减少数据风险。我们想要将城市与农村客户通过 Safe Harbour 和专家鉴定进行比较。我们将使用两个记录和四个字段的数据示例。我们假设为研究记录收集的顺序在内部数据集中是随机的,并且收集的“有价值客户数据”不会逐行公开。我们还假设以下数据集在一个诊所中可用,作为本练习的外部数据源:

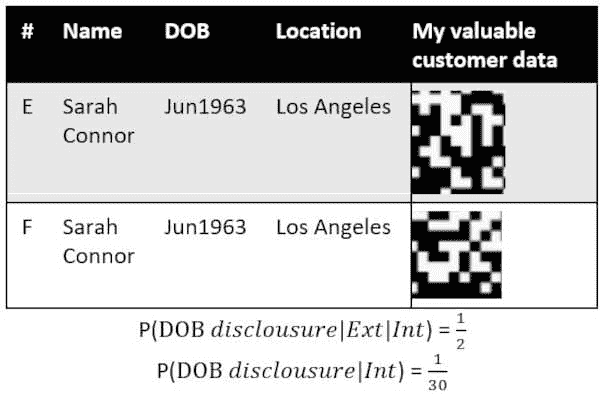

表 1. 外部数据源的数据示例。

我们的 Safe Harbour 混淆要求我们从出生日期(DOB)中移除姓名、日期和月份,并将位置仅替换为州:

表 2. Safe Harbour 数据混淆的示例。

对于数据泄漏,我们有两个关注点:

-

泄露的数据与外部源结合以利用出生日期。

-

从我们的内部数据集中可能推测出出生日期。

P(DOB 公开|Ext|Int) 是当内部和外部数据泄露时出生日期公开的概率。由于我们在内部数据集中有两个具有相同出生年份(YOB)和地点的记录,因此有一半的机会可以将“1963,加利福尼亚”匹配到外部来源的出生日期。

P(DOB 公开|Int) 是当攻击者尝试从我们的内部数据集中恢复出生日期时的出生日期公开概率。1963 年有 365 天,内部数据集中没有其他信息来猜测这样一个大日期范围中的具体日期。

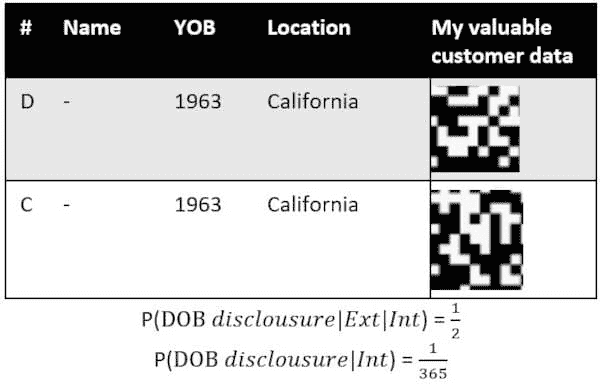

专家判断方法分为两个步骤。首先,我们尽量保留最大的信息,其次,我们通过调整保留的数据来审查这种“数据储存”,以符合研究目的。

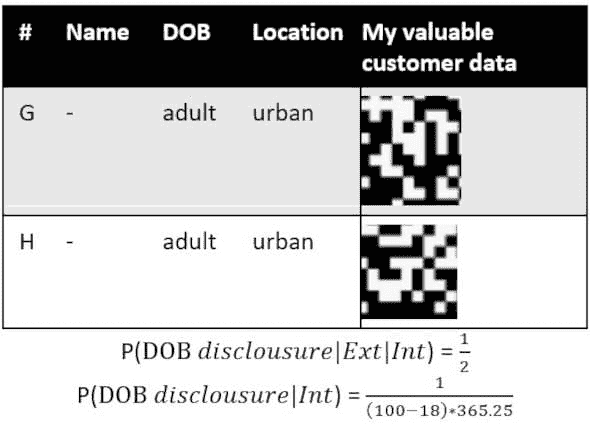

表 3. 数据示例的专家判断数据混淆的第一次尝试。

P(DOB 公开|Ext|Int) 与 Safe Harbor 数据集中的值相同。

P(DOB 公开|Int) 是 30 分之一的几率,比之前的情况更高。根据我们的任意决策,这个 P 值可以被接受为低风险或中等风险。

在第一次专家判断混淆尝试中,我们设法保留了姓名、地点和出生日期到月份级别。问题在于这些混淆结果是否与研究目的对齐。更仔细地对齐城乡客户研究,可以排除姓名,仅标记客户年龄组为成人和儿童。

表 4. 数据示例的专家判断数据混淆的第二次尝试。

P(DOB 公开|Ext|Int) 的值没有变化。

P(DOB 公开|Int) 是基于最大成人年龄 100(你也可以使用更保守的数字,例如平均寿命)的估算值。其他两个参数是最小成人年龄 18 和每年的平均天数 365.25。第二次专家判断混淆的 P(DOB 公开|Int) 明显低于 Safe Harbor 实施的结果。

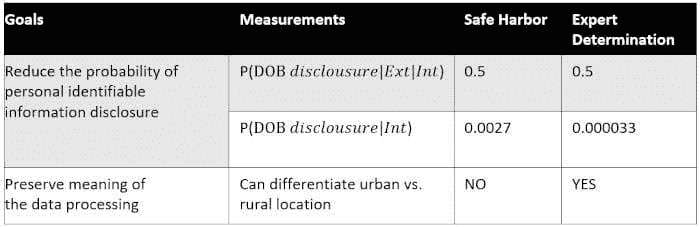

对这两种 HIPAA 混淆方法的数据示例的最终比较:

表 5. 比较 HIPAA 方法对数据示例和研究目的的影响。

所选的数据示例和研究目的旨在展示专家判断方法相较于 Safe Harbour 的灵活性。专家判断的主要优势在于,该方法不仅处理了披露的概率,同时还允许我们控制相关的信息丢失。使用专家判断数据示例混淆的数据样本允许我们进行城乡对比研究,而 Safe Harbour 则不允许。

或许这个例子会证明,问题的最简单解决方案并不总是合适的,应用最佳而非最快的解决方案可以拯救莎拉·康纳免于被终结者发现。

相关:

更多主题

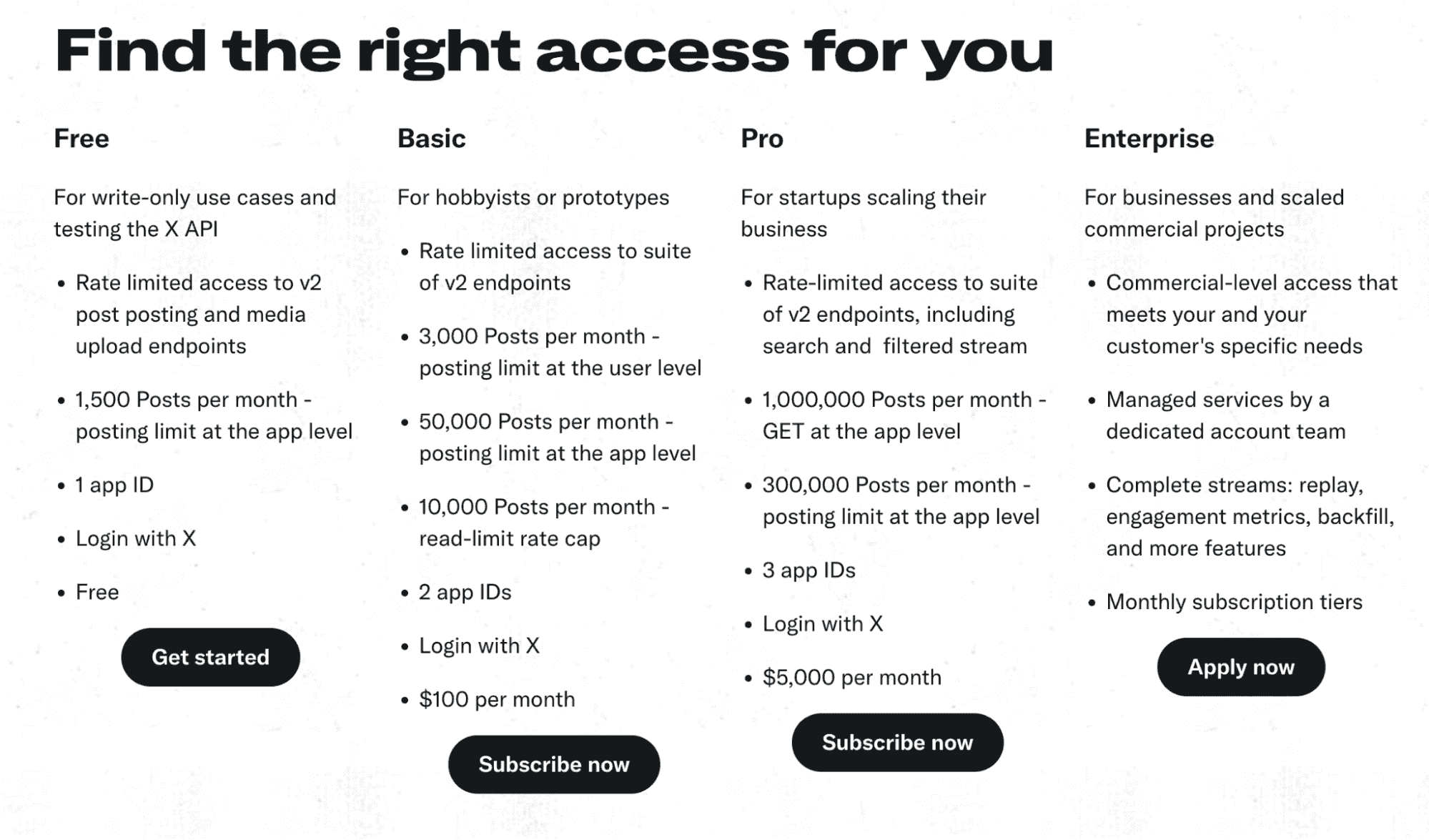

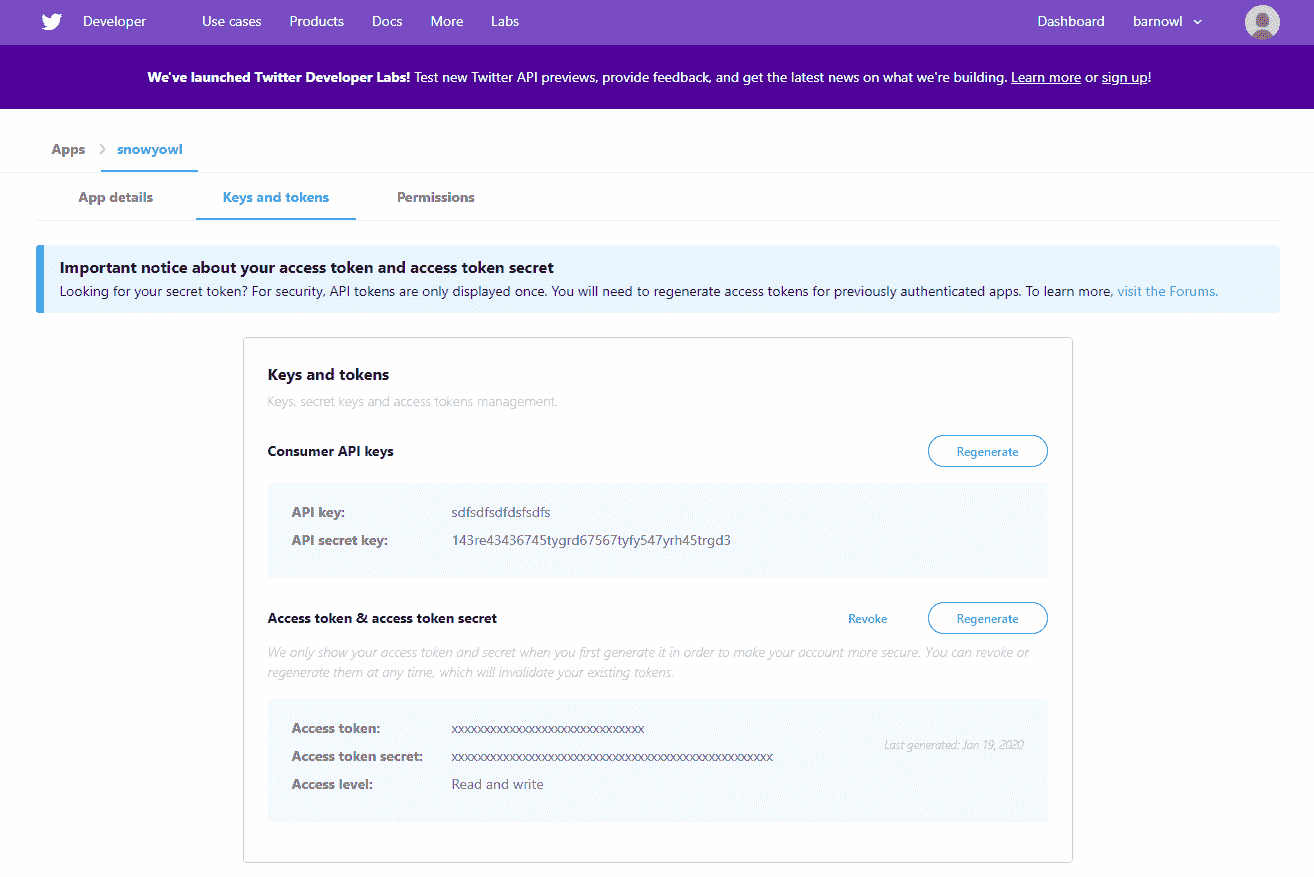

在 TensorFlow 中保存和加载模型——为什么这很重要以及如何做到

原文:

www.kdnuggets.com/2021/02/saving-loading-models-tensorflow.html

评论

照片由 Nana Smirnova 提供,来自 Unsplash。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

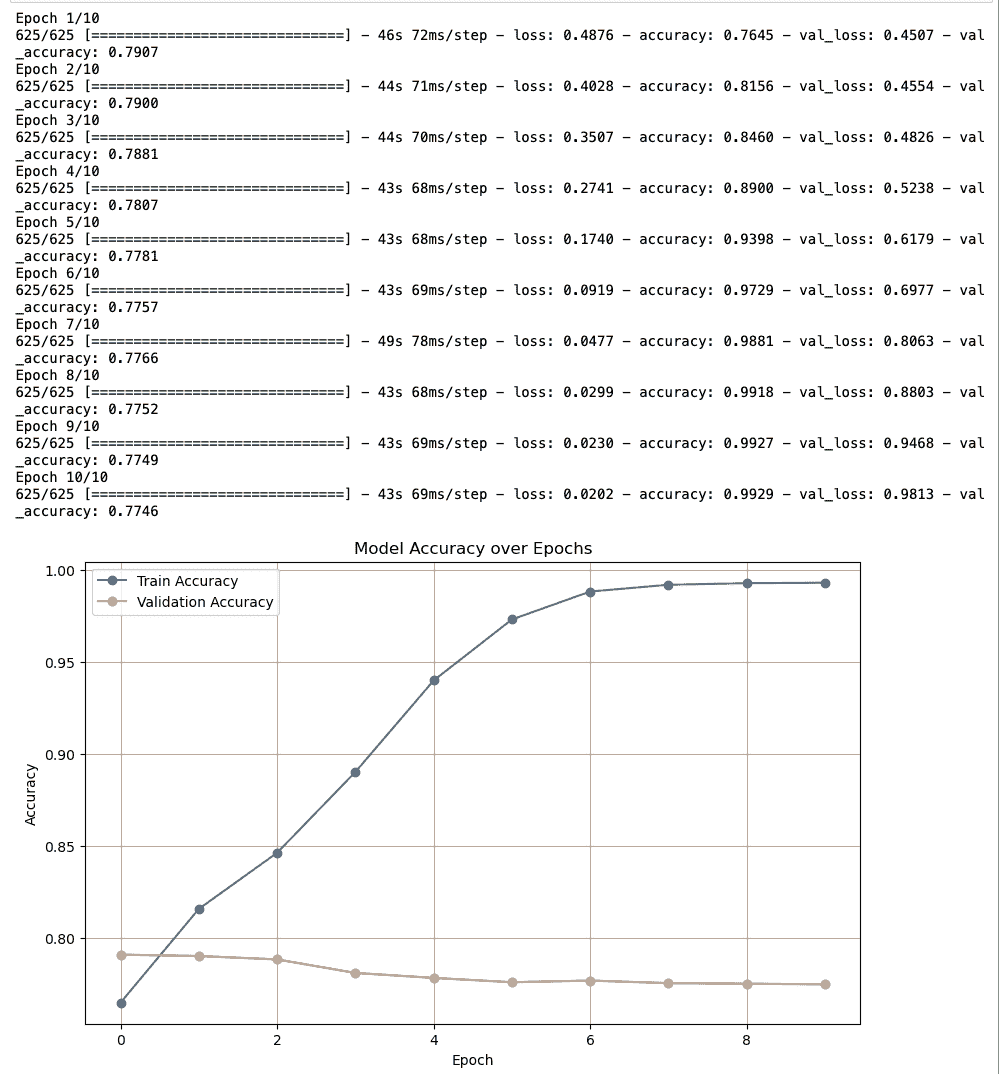

在本文中,我们将讨论以下主题

-

保存深度学习模型的重要性(一般而言,不限于 TensorFlow)。

-

如何在 TensorFlow 2 中保存深度学习模型,以及不同类型、类别和保存模型的技术。

-

在 TensorFlow 2 中加载保存的模型。

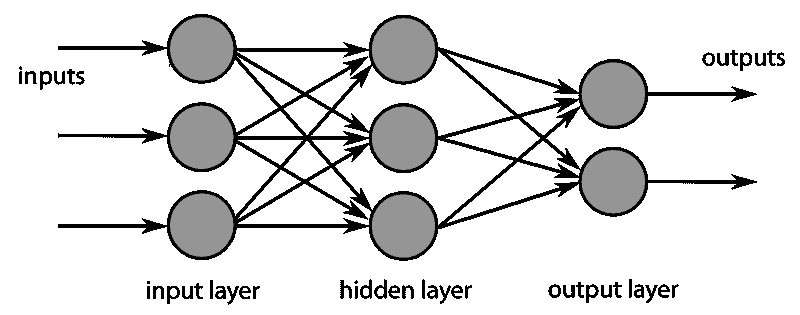

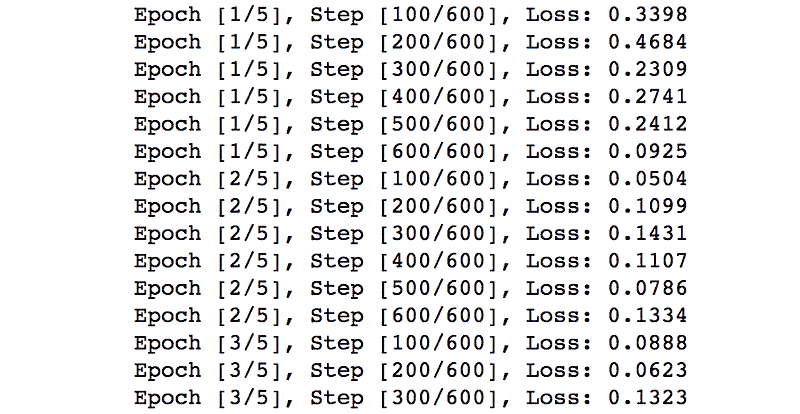

保存深度学习模型的重要性

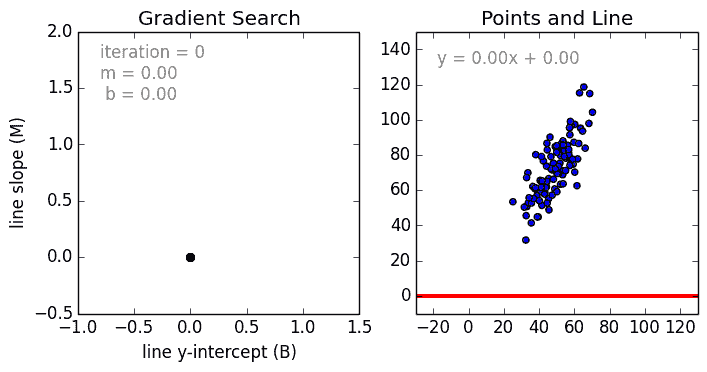

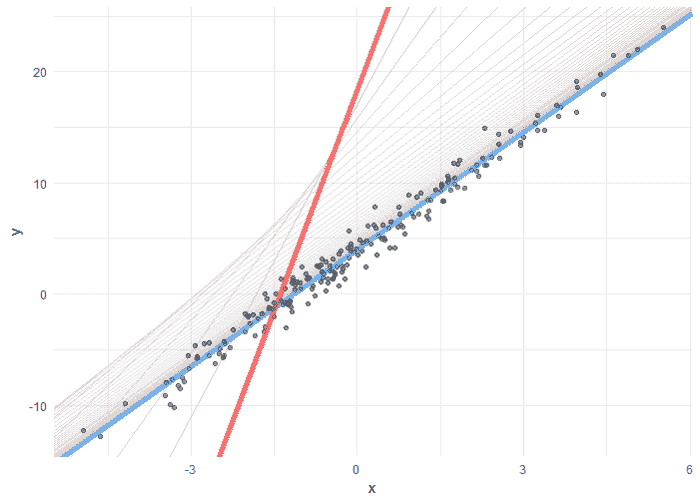

记住,在梯度下降中,我们根据误差或损失函数更新权重和偏差。

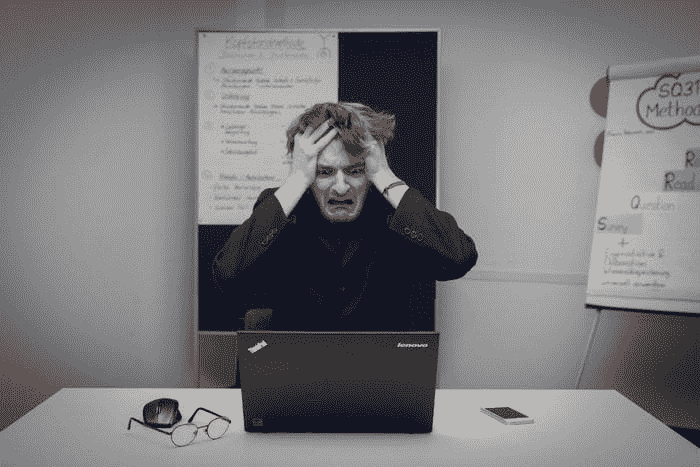

现在想象一下,你训练了一个模型数千个周期,可能是几天、几周甚至几小时,并且得到了相当好的权重,这意味着你的模型表现非常好,然后当你关闭程序/Jupyter notebook 时丢失了所有权重。

当你想在另一个应用程序中重用该模型而没有保存进度时,这将变成一个更繁琐的问题。你必须从头开始训练,这可能浪费你几个小时或几天。

实际上,你可以想象这样一个场景:你已经编码了一个准确率超过 99%、精确度极高的面部识别模型应用,且训练该模型在大数据集上花费了大约 30 小时。现在,如果你没有保存模型,而你希望在任何应用程序中使用它,你将不得不重新训练整个模型 30 小时。

这就是为什么保存模型是一个非常重要的步骤,只需额外的几行代码就能节省大量时间和资源。

在 TensorFlow 2 中保存模型

在 TensorFlow 中保存模型权重有 2 种不同的格式。第一种是TensorFlow 原生格式,第二种是hdf5 格式,也称为h5 或HDF 格式。

另外,还有 2 种不同的保存模型的方法。

-

简单且不复杂的方法,但不提供自由度。

-

使用回调来保存模型,允许你进行很多自由操作,例如每个 epoch 保存,保存每隔 n 个示例后等。

我们将详细讨论这两种方法。

让我们首先加载重要的 Python 库和数据集。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Flatten, Conv2D, MaxPooling2D

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.cifar10.load_data() #cifar10 dataset

x_train = x_train / 255.0 #normalizing images

x_test = x_test / 255.0

简单方法

在 TensorFlow 中保存模型的简单方法是使用 Tensorflow.Keras.models 的内置函数“模型保存与序列化 API”,即 save_weights 方法。

假设我们有一个 TensorFlow 中的顺序模型。

model = Sequential([

Conv2D(filters=16, input_shape=(32, 32, 3), kernel_size=(3, 3), activation='relu', name='conv_1'),

MaxPooling2D(pool_size=(4, 4), name='pool_1'),

tf.keras.layers.BatchNormalization(),

Flatten(name='flatten'),

Dense(units=32, activation='relu', name='dense_1'),

tf.keras.layers.Dropout(0.5),

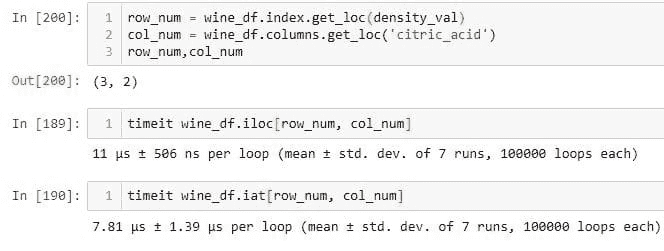

Dense(units=10, activation='softmax', name='dense_2')

])

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

现在我们使用 model.fit 函数在 TensorFlow 中拟合模型。

hist = model.fit(x_train,y_train,epochs=5, batch_size=512)

我们可以通过以下方式评估模型的性能,

loss, acc = model.evaluate(x_test, y_test, verbose=0)

print(f"test accuracy {acc*100}")

现在,我们只需调用 model.save 函数并传入 filepath 作为参数,就可以保存模型。

-

模型架构

-

模型权重

-

模型优化器状态(以便你可以从中断处继续训练)

model.save('myModel.h5')

现在添加扩展名很重要。如果你添加 .h5 作为扩展名,它会将模型保存为 hdf5 格式,如果没有提供扩展名,模型将以 TensorFlow 原生格式保存。

现在,当模型保存在当前目录中的 myModel.h5 文件时,你可以通过以下方式在新程序中或同一程序中作为不同模型加载它,

new_model = tf.keras.models.load_model('my_model.h5') #same file path

我们可以通过以下方式检查新加载模型的准确率,

loss, acc = new_model.evaluate(x_test, y_test, verbose=0)

print(f"test accuracy {acc*100}")

我们可以看到我们得到的准确率与旧模型完全相同。

我们可以通过检查模型摘要进一步确认。

newmodel.summary()

新的摘要与我们原始模型的摘要完全相同。

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

conv_1 (Conv2D) (None, 30, 30, 16) 448

_________________________________________________________________

pool_1 (MaxPooling2D) (None, 7, 7, 16) 0

_________________________________________________________________

batch_normalization (BatchNo (None, 7, 7, 16) 64

_________________________________________________________________

flatten (Flatten) (None, 784) 0

_________________________________________________________________

dense_1 (Dense) (None, 32) 25120

_________________________________________________________________

dropout (Dropout) (None, 32) 0

_________________________________________________________________

dense_2 (Dense) (None, 10) 330

=================================================================

Total params: 25,962

Trainable params: 25,930

Non-trainable params: 32

_________________________________________________________________

同样,我们可以通过以下方式以 TensorFlow 原生格式保存权重,

new_model.save('newmodel')

看看我们在名称后没有添加任何文件格式。这会将我们的模型以 TensorFlow 原生格式保存在 newmodel 文件夹中。如果我们查看该文件夹,我们可以检查文件的

!dir newmodel

这个命令只会在 jupyter notebook 中运行,因此你也可以打开文件夹查看文件。

你将始终有 1 个文件和 2 个文件夹,它们是:

-

assets (文件夹)

-

pb

-

variables (文件夹)

我们稍后会查看这些文件夹和文件是什么。但要简单地加载模型,我们只需提供用于保存模型的路径名,例如

other_model = tf.keras.models.load_model('newmodel')

你可以通过检查其 summary 或评估结果来确认它是相同的模型。

现在以简单的方法仅保存 权重,你只需在模型上调用内置函数 save_weights。

让我们使用同一个旧模型,

model = Sequential([

Conv2D(filters=16, input_shape=(32, 32, 3), kernel_size=(3, 3), activation='relu', name='conv_1'),

MaxPooling2D(pool_size=(4, 4), name='pool_1'),

tf.keras.layers.BatchNormalization(),

Flatten(name='flatten'),

Dense(units=32, activation='relu', name='dense_1'),

tf.keras.layers.Dropout(0.5),

Dense(units=10, activation='softmax', name='dense_2')

])

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

并训练几个 epoch。

model.fit(x_train,y_train,epochs=5, batch_size=512)

现在你可以简单地通过以下方式保存权重,

path = 'weights_folder/my_weights'

model.save_weights(path)

这将创建一个名为 weights_folder 的文件夹,并将权重以 TensorFlow 原生格式保存,文件名为 my_weights。它将包含 3 个文件。

-

checkpoint

-

data-00000-of-00001

-

index

让我们看看这些文件。

- ****my_weights.index

这个文件告诉 TensorFlow 权重存储的位置。当在分布式系统上运行模型时,可能会有不同的 分片,这意味着整个模型可能需要从多个来源重新组合。在上一个笔记本中,你在一台机器上创建了一个单一模型,所以只有一个 分片,所有权重都存储在同一个地方。

- my_weights.data-00000-of-00001

该文件包含模型的实际权重。它是这三个文件中最大的。回想一下,你训练的模型有大约 14000 个参数,这意味着这个文件的大小大约是每个保存的权重 12 字节。

- 检查点

这个文件是迄今为止最小的。实际上小到我们可以直接查看。它是一个人类可读的文件,包含以下文本,

model_checkpoint_path: "my_weights"

all_model_checkpoint_paths: "my_weights"

现在,当你保存了权重后,你可以通过简单地调用来加载它们,

model.load_weights(path)

这将会在特定路径加载该模型的权重。

或者,你可以仅通过 hdf5 格式保存权重,方法是,

model.save_weights('my_weights.h5')

这将会在你的工作目录中创建一个 my_weights.h5 文件,你可以通过 model.load_weights('my_weights.h5') 轻松加载它们。

重要提示

当你为模型加载权重时,你需要有该模型的正确架构。

例如:

你不能将我们刚创建的 模型 的权重加载到具有 1 个 Dense 层的顺序模型中,因为两者不兼容。所以你可能会想,保存权重的用途是什么?

好吧,答案是,如果你在看一些大型的 SOTA 应用,比如 YOLO,或者类似的东西,它们会给你源代码。但是,在你的机器上训练它们是一项漫长的任务,所以它们也会给你在不同 epochs 上的预训练权重,例如,如果你想查看这个模型在 50 epochs 时的表现,那么你可以加载保存的 50 epochs 权重,以此类推。这样,你可以根据模型在 X 次训练 epochs 上的表现检查模型的性能,而无需明确训练它。

TensorFlow 原生格式与 hdf5,什么时候使用哪一个?

你已经看到,使用 .h5 格式简单而干净,因为它只创建一个单一的文件,而使用 TensorFlow 原生格式会创建多个文件夹和文件,这样不易阅读。所以,你可能会想,为什么我们还要使用 TensorFlow 原生格式?答案是,在 TensorFlow 原生格式中,一切都是结构化的,并且组织得井井有条。例如,.pb 文件包含结构数据,可以被多种语言加载。TF 原生格式的一些优点列在下面。

TensorFlow 原生格式的优点

-

TensorFlow’s Serving 在你想将模型投入生产时使用它。

-

语言无关 — 二进制格式可以被多种语言读取(如 Java、Python、Objective-C 和 C++ 等)。

-

自 0 版以来建议使用,你可以查看 TensorFlow 的官方序列化指南,它推荐使用 TensorFlow 原生格式。

-

保存模型的各种元数据,如优化器信息、损失、学习率等,这些信息以后可能会有帮助。

缺点

-

SavedModel 在概念上比单个文件更难理解

-

创建一个单独的文件夹来存储权重。

h5 的优势

-

用于保存可能不是表格数据的大型数据。

-

常见的文件保存格式。

-

所有内容保存在一个文件中(权重、损失、使用的优化器)

缺点

- 不能与 TensorFlow Serving 一起使用,但你可以通过 experimental.export_saved_model(model, 'path_to_saved_model') 将其简单转换为 .pb 格式

应该使用什么

如果你在服务或部署模型时不打算使用 TensorFlow,为了简便起见,你可以使用 .hdf5 格式,但如果你打算使用 TensorFlow 服务,那么你应该使用 tensorflow 原生格式。

学习成果

在这篇文章中,你学到了

-

为什么你应该保存你的机器学习模型。

-

如何仅使用简单的方法保存模型权重。

-

如何使用简单的方法保存完整模型。

-

在 TensorFlow 原生格式或 HDF5 格式中保存。

-

TensorFlow 原生格式和 HDF5 格式的区别以及该使用什么。

欲了解更多详情,请查看:

相关:

更多相关主题

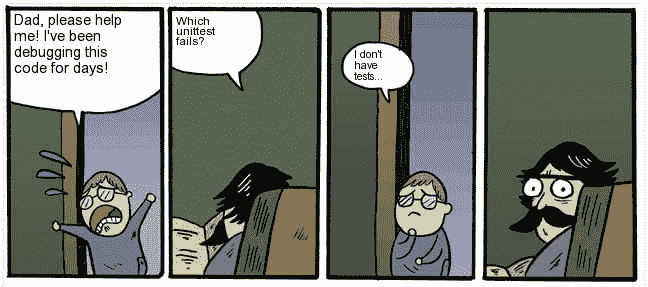

告别Print():使用日志模块进行有效调试

原文:

www.kdnuggets.com/say-goodbye-to-print-use-logging-module-for-effective-debugging

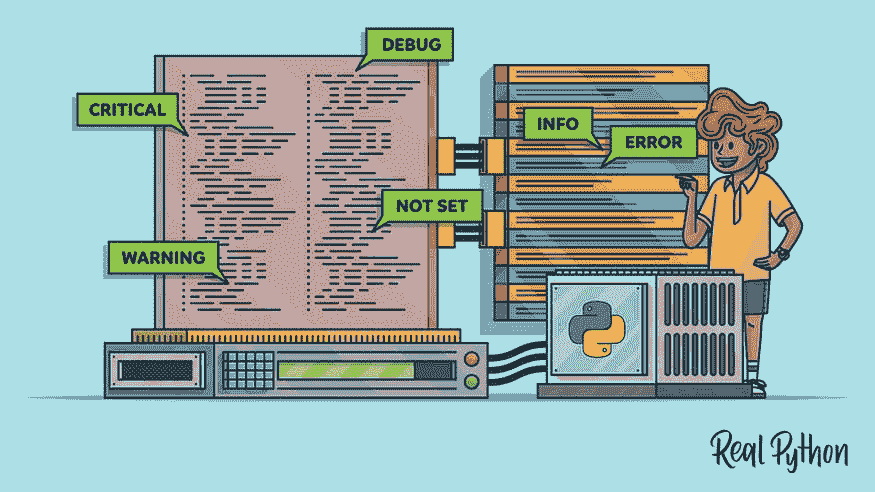

作者提供的图片 | DALLE-3 & Canva

许多人开始编程时会通过 YouTube 视频学习,为了简单起见,他们通常使用print()语句来跟踪错误。这是可以理解的,但随着初学者养成这个习惯,它可能会变得问题重重。虽然这些语句对于简单的脚本可能有效,但随着代码库的扩展,这种方法变得非常低效。因此,在这篇文章中,我将向你介绍 Python 内置的日志模块,它解决了这个问题。我们将看到什么是日志记录,它与print()语句的区别,以及一个实用的例子来全面了解其功能。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

为什么使用日志模块而不是Print()?

当我们谈论调试时,Python 的日志模块提供了比简单的print()语句更详细的信息。这包括时间戳、模块名称、日志级别以及错误发生的行号等。这些额外的细节帮助我们更有效地理解代码的行为。我们想要记录的信息取决于应用程序的需求和开发者的偏好。因此,在进一步探讨之前,我们先讨论一下日志级别及其设置方法。

日志级别

你可以通过这些日志级别控制你想看到的信息量。每个日志级别都有一个数值,表示其严重性,数值越高表示事件越严重。例如,如果你将日志级别设置为WARNING,你是在告诉日志模块只显示WARNING级别或更高级别的消息。这意味着你将看不到DEBUG、INFO或其他较低严重性的消息。这样,你可以集中关注重要事件,忽略噪音。

这是一个展示每个日志级别所代表的详细信息的表格:

| 日志级别 | 数值 | 目的 |

|---|---|---|

| DEBUG | 10 | 提供详细的信息以诊断与代码相关的问题,例如打印变量值和函数调用跟踪。 |

| INFO | 20 | 用于确认程序按预期工作,比如显示启动消息和进度指示器。 |

| WARNING | 30 | 表示一个潜在的问题,这可能不会中断程序的执行,但可能会在以后引发问题。 |

| ERROR | 40 | 表示代码的意外行为,这影响了其功能,如异常、语法错误或内存不足错误。 |

| CRITICAL | 50 | 表示严重错误,可能导致程序终止,如系统崩溃或致命错误。 |

设置日志模块

要使用日志模块,你需要按照一些配置步骤。这包括创建日志记录器、设置日志级别、创建格式化程序以及定义一个或多个处理器。处理器基本上决定将日志消息发送到哪里,比如控制台或文件。让我们从一个简单的例子开始。我们将设置日志模块做两件事:首先,它将在控制台上显示消息,为我们提供有用的信息(在 INFO 级别)。其次,它将把更详细的消息保存到文件中(在 DEBUG 级别)。希望你能跟上!

1. 设置日志级别

日志记录器的默认级别设置为 WARNING。在我们的例子中,我们的两个处理器被设置为 DEBUG 和 INFO 级别。因此,为了确保所有消息都得到适当处理,我们必须将日志记录器的级别设置为所有处理器中的最低级别,在这种情况下是 DEBUG。

import logging

# Create a logger

logger = logging.getLogger(__name__)

# Set logger level to DEBUG

logger.setLevel(logging.DEBUG)

2. 创建一个格式化程序

你可以使用格式化程序个性化你的日志信息。这些格式化程序决定日志信息的显示方式。在这里,我们将设置格式化程序以包含时间戳、日志级别和消息内容,使用以下命令:

formatter = logging.Formatter('%(asctime)s - %(levelname)s - %(message)s')

3. 创建处理器

正如之前讨论的,处理器管理日志信息的发送位置。我们将创建两个处理器:一个控制台处理器,用于将消息记录到控制台,一个文件处理器,用于将日志消息写入名为 'app.log' 的文件。

console_handler = logging.StreamHandler()

console_handler.setLevel(logging.INFO)

console_handler.setFormatter(formatter)

file_handler = logging.FileHandler('app.log')

file_handler.setLevel(logging.DEBUG)

file_handler.setFormatter(formatter)

然后使用 addHandler() 方法将两个处理器添加到日志记录器中。

logger.addHandler(console_handler)

logger.addHandler(file_handler)

4. 测试日志设置

现在我们的设置完成了,在转到实际示例之前,让我们测试一下它是否正常工作。我们可以如下记录一些消息:

logger.debug('This is a debug message')

logger.info('This is an info message')

logger.warning('This is a warning message')

logger.error('This is an error message')

logger.critical('This is a critical message')

当你运行这段代码时,你应该会看到日志信息被打印到控制台并写入名为 'app.log' 的文件中,格式如下:

控制台

2024-05-18 11:51:44,187 - INFO - This is an info message

2024-05-18 11:51:44,187 - WARNING - This is a warning message

2024-05-18 11:51:44,187 - ERROR - This is an error message

2024-05-18 11:51:44,187 - CRITICAL - This is a critical message

app.log

2024-05-18 11:51:44,187 - DEBUG - This is a debug message

2024-05-18 11:51:44,187 - INFO - This is an info message

2024-05-18 11:51:44,187 - WARNING - This is a warning message

2024-05-18 11:51:44,187 - ERROR - This is an error message

2024-05-18 11:51:44,187 - CRITICAL - This is a critical message

在 Web 应用程序中记录用户活动

在这个简单的示例中,我们将创建一个基本的网络应用程序,使用 Python 的 logging 模块记录用户活动。这个应用程序将有两个端点:一个用于记录成功的登录尝试,另一个用于记录失败的登录尝试(INFO 表示成功,WARNING 表示失败)。

1. 设置你的环境

在开始之前,设置你的虚拟环境并安装 Flask:

python -m venv myenv

# For Mac

source myenv/bin/activate

#Install flask

pip install flask

2. 创建一个简单的 Flask 应用程序

当你向/login端点发送一个包含用户名和密码参数的 POST 请求时,服务器将检查凭据是否有效。如果有效,记录器会使用 logger.info() 记录事件,以表示登录尝试成功。然而,如果凭据无效,记录器会使用 logger.error() 记录事件,标记为登录尝试失败。

#Making Imports

from flask import Flask, request

import logging

import os

# Initialize the Flask app

app = Flask(__name__)

# Configure logging

if not os.path.exists('logs'):

os.makedirs('logs')

log_file = 'logs/app.log'

logging.basicConfig(filename=log_file, level=logging.DEBUG, format='%(asctime)s - %(levelname)s - %(message)s')

log = logging.getLogger(__name__)

# Define route and handler

@app.route('/login', methods=['POST'])

def login():

log.info('Received login request')

username = request.form['username']

password = request.form['password']

if username == 'admin' and password == 'password':

log.info('Login successful')

return 'Welcome, admin!'

else:

log.error('Invalid credentials')

return 'Invalid username or password', 401

if __name__ == '__main__':

app.run(debug=True)

3. 测试应用程序

要测试应用程序,请运行 Python 脚本,并使用 Web 浏览器或类似 curl 的工具访问/login端点。例如:

测试用例 01

curl -X POST -d "username=admin&password=password" http://localhost:5000/login

输出

Welcome, admin!

测试用例 02

curl -X POST -d "username=admin&password=wrongpassword" http://localhost:5000/login

输出

Invalid username or password

app.log

2024-05-18 12:36:56,845 - INFO - Received login request

2024-05-18 12:36:56,846 - INFO - Login successful

2024-05-18 12:36:56,847 - INFO - 127.0.0.1 - - [18/May/2024 12:36:56] "POST /login HTTP/1.1" 200 -

2024-05-18 12:37:00,960 - INFO - Received login request

2024-05-18 12:37:00,960 - ERROR - Invalid credentials

2024-05-18 12:37:00,960 - INFO - 127.0.0.1 - - [18/May/2024 12:37:00] "POST /login HTTP/1.1" 200 -

总结

这篇文章到此为止。我强烈建议将日志记录作为你的编码常规的一部分。这是保持代码清洁和简化调试的好方法。如果你想深入了解,可以查看 Python 日志记录文档 以获取更多功能和高级技术。如果你希望进一步提升你的 Python 技能,欢迎查阅我其他的一些文章:

Kanwal Mehreen**** Kanwal 是一名机器学习工程师和技术作家,对数据科学及其与医学的交汇点充满热情。她共同撰写了电子书《利用 ChatGPT 最大化生产力》。作为 2022 年 APAC 的 Google Generation Scholar,她倡导多样性和学术卓越。她还被认可为 Teradata 多样性技术学者、Mitacs Globalink 研究学者以及哈佛 WeCode 学者。Kanwal 是变革的坚定倡导者,创立了 FEMCodes 以赋能 STEM 领域的女性。

更多相关话题

数据科学中的可扩展性挑战与策略

原文:

www.kdnuggets.com/scalability-challenges-strategies-in-data-science

图片由编辑 | Midjourney

每天生成的数据量庞大,在数据科学领域带来了许多挑战和机遇。由于数据量巨大,可扩展性成为了首要关注点,因为传统的数据处理方法在面对这些庞大的数据量时显得力不从心。通过学习如何解决可扩展性问题,数据科学家可以在各个行业和领域中开启创新、决策和问题解决的新可能性。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

本文探讨了数据科学家和组织面临的多方面可扩展性挑战,分析了管理、处理和从海量数据集中提取洞察的复杂性。它还概述了为克服这些障碍而设计的策略和技术,以便充分发挥大数据的潜力。

可扩展性挑战

首先我们来看一些可扩展性面临的最大挑战。

数据量

存储大规模数据集非常困难,因为涉及的数据量巨大。传统的存储解决方案通常难以扩展。分布式存储系统通过将数据分散到多个服务器上来帮助解决这个问题。然而,管理这些系统非常复杂。确保数据的完整性和冗余性至关重要。如果没有优化的系统,数据检索可能会很慢。像索引和缓存这样的技术可以提高检索速度。

模型训练

使用大数据训练机器学习模型需要大量的资源和时间。复杂的算法需要强大的计算机来处理大规模的数据集。高性能硬件如 GPU 和 TPU 可以加速训练。高效的数据处理管道对于快速训练至关重要。分布式计算框架有助于分担工作负载。适当的资源分配可以减少训练时间并提高准确性。

资源管理

良好的资源管理对可扩展性至关重要。管理不善会增加成本并减慢处理速度。根据需求分配资源是必要的。监控使用情况有助于发现问题并提升性能。自动扩展根据需要调整资源。这保持计算能力、内存和存储的高效使用。平衡资源可以提升性能并降低成本。

实时数据处理

实时数据需要快速处理。延迟可能会影响像金融交易和实时监控这样的应用。这些系统依赖最新信息做出准确决策。低延迟的数据管道对快速处理至关重要。流处理框架处理高吞吐量的数据。实时处理基础设施必须强大且可扩展。确保可靠性和容错能力对于防止停机至关重要。结合高速存储和高效算法是处理实时数据需求的关键。

| 挑战 | 描述 | 关键考虑因素 |

|---|---|---|

| 数据量 | 高效存储和管理大型数据集 |

-

传统存储解决方案通常不够充分

-

对分布式存储系统的需求

-

数据完整性和冗余的重要性

-

优化数据检索速度

|

| 模型训练 | 处理大型数据集以进行机器学习模型训练 |

|---|

-

对计算资源的高需求

-

高性能硬件(GPU、TPU)的需求

-

高效数据处理管道的重要性

-

分布式计算框架的利用

|

| 资源管理 | 高效分配和利用计算资源 |

|---|

-

对处理速度和成本的影响

-

动态资源分配的重要性

-

需要持续监控资源使用情况

-

自动扩展系统的好处

|

| 实时数据处理 | 实时处理和分析数据以获得即时洞察 |

|---|

-

在金融交易等应用中的关键性

-

对低延迟数据管道的需求

-

流处理框架的重要性

-

平衡可靠性和容错能力

|

应对可扩展性挑战的策略

识别挑战后,我们现在转向一些应对策略。

并行计算

并行计算将任务分割成较小的子任务,这些子任务在多个处理器或机器上同时运行。这通过利用多个资源的计算能力组合来提升处理速度和效率。这对于科学模拟、数据分析和机器学习训练中的大规模计算至关重要。将工作负载分布到并行单元有助于系统有效扩展,提升整体性能和响应能力,以满足不断增长的需求。

数据分区

数据分区将大型数据集拆分为分布在多个存储位置或节点的小部分。每个部分可以独立处理,帮助系统高效地管理大量数据。这种方法减少了对单个资源的压力,并支持并行处理,加快了数据检索速度并提高了整体系统性能。数据分区对于高效处理大数据至关重要。

数据存储解决方案

实施可扩展的数据存储解决方案涉及部署设计用来高效且经济地处理大量数据的系统。这些解决方案包括分布式文件系统、基于云的存储服务以及能够水平扩展以适应增长的可扩展数据库。可扩展存储解决方案提供快速的数据访问和高效的管理。它们对于管理现代应用程序中数据的快速增长、保持性能以及有效满足可扩展性要求至关重要。

可扩展数据科学的工具和技术

存在许多工具和技术用于实现应对可扩展性的各种策略。这些是一些突出的工具。

Apache Hadoop

Apache Hadoop 是一个用于处理大量数据的开源工具。它将数据分布到多台计算机上,并进行并行处理。Hadoop 包含 HDFS 用于存储和 MapReduce 用于处理。这种设置高效地处理大数据。

Apache Spark

Apache Spark 是一个快速的大数据处理工具。它支持 Java、Python 和 R 语言。Spark 使用内存计算来加快数据处理速度。它处理大型数据集和复杂的分析,支持分布式集群。

Google BigQuery

Google BigQuery 是一个自动处理所有操作的数据仓库。它允许使用 SQL 查询快速分析大型数据集。BigQuery 以高性能和低延迟处理大量数据,非常适合数据分析和商业洞察。

MongoDB

MongoDB 是一个用于非结构化数据的 NoSQL 数据库。它使用灵活的模式将各种数据类型存储在一个数据库中。MongoDB 设计用于跨多个服务器进行水平扩展,使其非常适合可扩展和灵活的应用程序。

Amazon S3(简单存储服务)

Amazon S3 是 AWS 提供的基于云的存储服务。它为任何大小的数据提供可扩展的存储。S3 提供安全可靠的数据存储,适用于大型数据集,并确保高可用性和耐用性。

Kubernetes

Kubernetes 是一个用于管理容器应用的开源工具。它自动化了容器的设置、扩展和管理。Kubernetes 确保在不同环境下的平稳运行,非常适合高效处理大规模应用程序。

可扩展数据科学的最佳实践

最后,让我们看看一些数据科学可扩展性的最佳实践。

模型优化

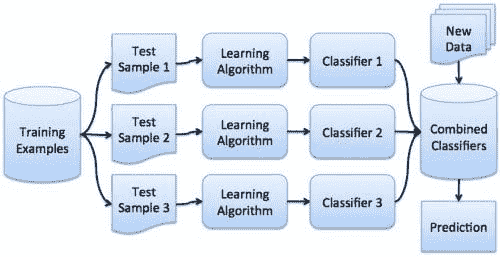

优化机器学习模型涉及调整参数、选择正确的算法以及使用集成学习或深度学习等技术。这些方法有助于提高模型的准确性和效率。优化后的模型能够更好地处理大数据集和复杂任务,提升数据科学工作流中的性能和可扩展性。

持续监控与自动扩展

对数据管道、模型性能和资源利用率的持续监控对于可扩展性是必要的。它可以识别系统中的瓶颈和低效之处。云环境中的自动扩展机制根据工作负载需求调整资源,从而确保最佳性能和成本效益。

云计算

云计算平台,如 AWS、Google Cloud Platform(GCP)和 Microsoft Azure,提供可扩展的数据存储、处理和分析基础设施。这些平台提供灵活性。它们允许组织根据需要扩展或缩减资源。云服务比本地解决方案便宜,提供了高效管理数据的工具。

数据安全

在处理大规模数据集时,维护数据安全和遵守法规(例如,GDPR、HIPAA)至关重要。加密可以在传输和存储过程中保护数据安全。访问控制限制只有授权人员才能进入。数据匿名化技术有助于保护个人信息,确保符合法规要求,并增强数据安全。

总结

总之,解决数据科学中的可扩展性挑战涉及使用诸如并行计算、数据分区和可扩展存储等策略。这些方法提高了处理大数据集和复杂任务的效率。最佳实践,如模型优化和云计算,有助于满足数据需求。

Jayita Gulati 是一位机器学习爱好者和技术作者,她对构建机器学习模型充满热情。她拥有利物浦大学的计算机科学硕士学位。

更多相关话题

可扩展的图机器学习:我们能攀登的高峰?

原文:

www.kdnuggets.com/2019/12/scalable-graph-machine-learning.html

评论

由Kevin Jung,CSIRO Data61 的软件工程师。

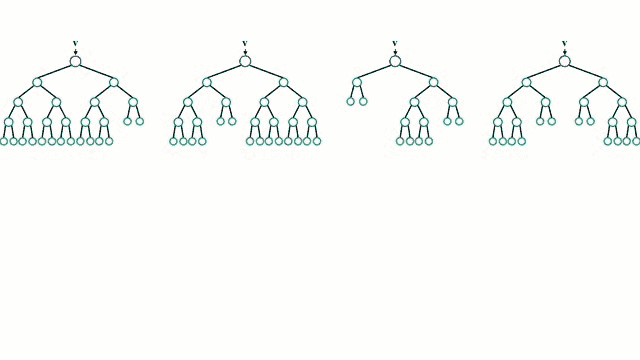

图机器学习仍然是一个相对较新且正在发展的研究领域,带来了大量的复杂性和挑战。其中一个既让我们着迷又让我们感到愤怒的挑战就是——扩展性。

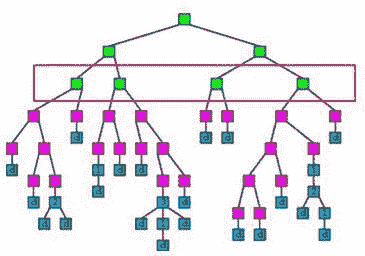

两种方法早期被确立为利用网络信息的标准方法:图卷积网络 [1](用于图形的强大神经网络架构)和 Node2Vec [2](用于图形的表示学习的算法框架)。这两种方法对于从高度连接的数据集中提取洞见非常有用。

但我亲身体验到,当尝试应用图机器学习技术来识别比特币区块链数据中的欺诈行为时,扩展性是最大的障碍。我们使用的比特币区块链图包含数百万个钱包(节点)和数十亿个交易(边),这使得大多数图机器学习方法不可行。

在这篇文章中,我们将更详细地探讨图机器学习方法的扩展性:它是什么,它为什么困难,以及一种试图直接应对这一挑战的方法示例。

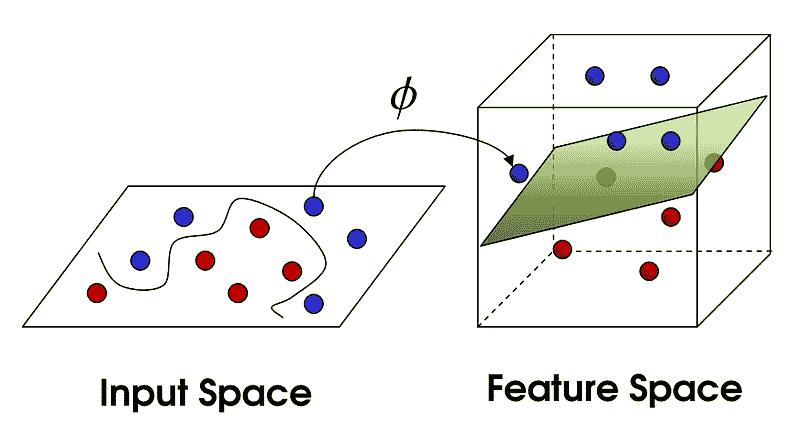

什么是图机器学习?

首先,让我们确保我们对图机器学习的定义达成共识。

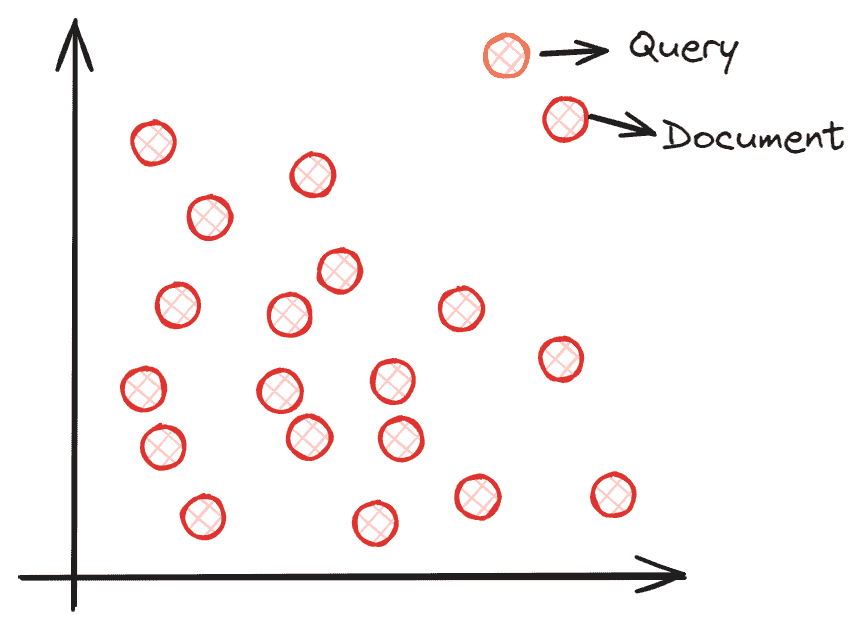

当我们说‘图’时,我们指的是一种将数据表示为具有连接的实体的方式。从数学的角度来看,我们称实体为节点或顶点,连接为边。一组顶点V和一组边E组成一个图G = (V, E)。

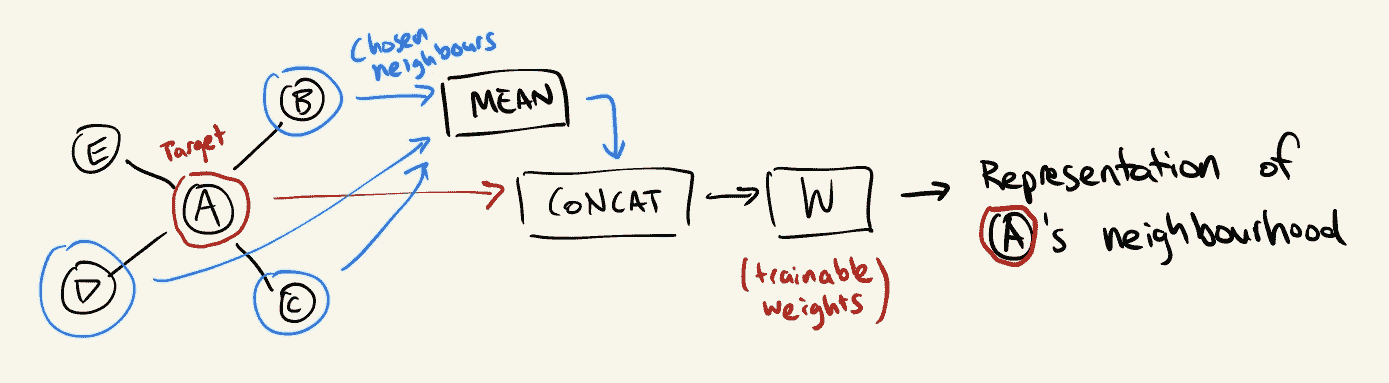

图机器学习是一种可以自然地从图结构数据中学习并进行预测的机器学习技术。我们可以将机器学习视为学习某种转换函数;y = f(x),其中x是数据的一部分,而y是我们想要预测的东西。

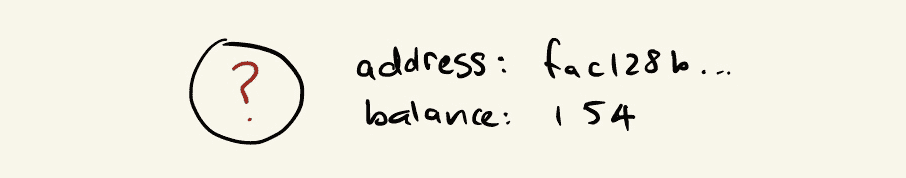

比如我们以检测欺诈比特币地址为例,我们知道区块链上所有地址的账户余额。一个非常简单的模型可能会学到,如果一个地址的账户余额为零,则它不太可能是欺诈性的。换句话说,当x为零时,我们的函数f(x)表示一个接近零的值(即非欺诈性):

我们可以同意,仅仅查看一个地址的账户余额并不足以解决这样的问题。因此,此时我们可以考虑如何工程化额外特征,以便为我们的模型提供更多关于每个地址行为的信息。

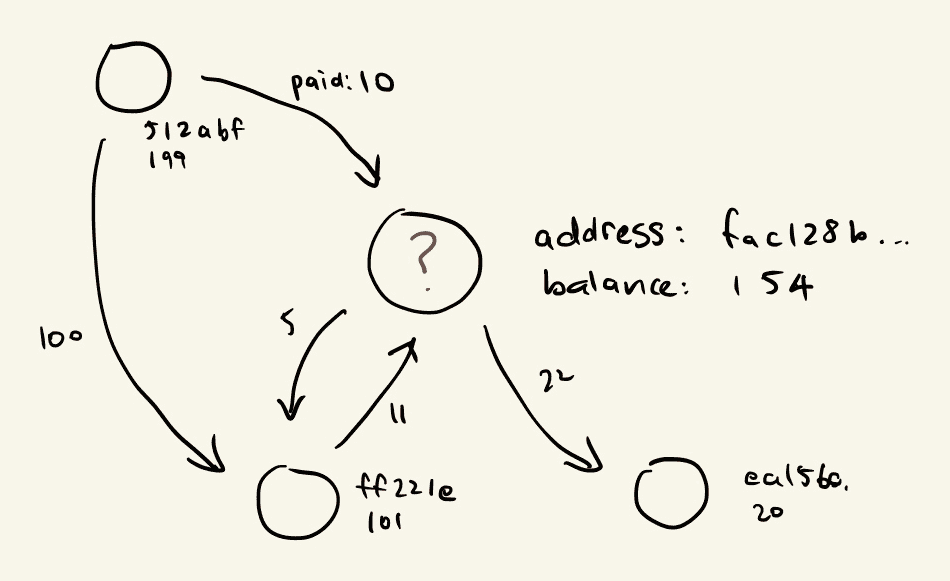

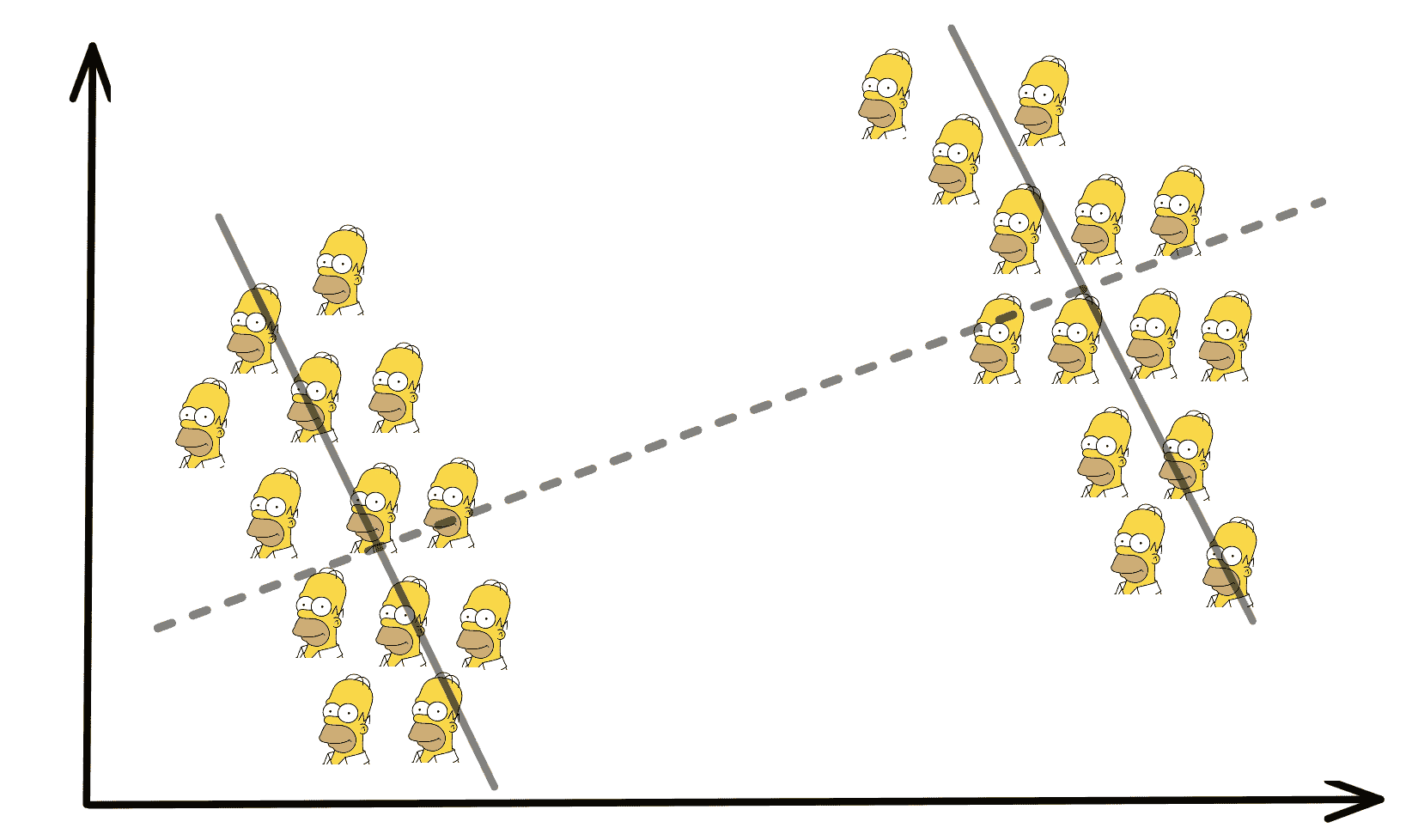

我们已经拥有了来自比特币付款人和收款人之间交易的丰富网络结构。通过设计一个利用这些信息的模型,我们将对结果更有信心:

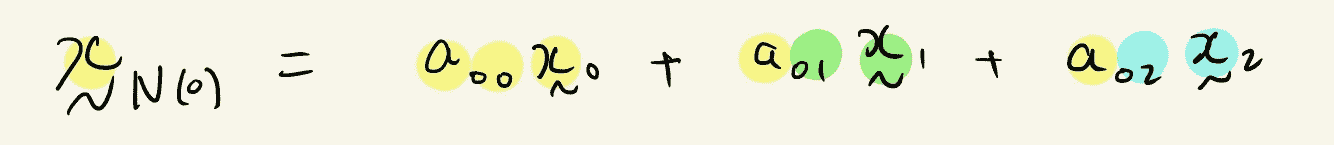

我们希望对地址进行预测,不仅基于其账户余额,还基于与其他地址进行的交易。我们可以尝试将f公式化为f(x, x’₀, x’₁, …),其中x’ᵢ是由我们的图结构定义的x的局部邻域中的其他数据点。

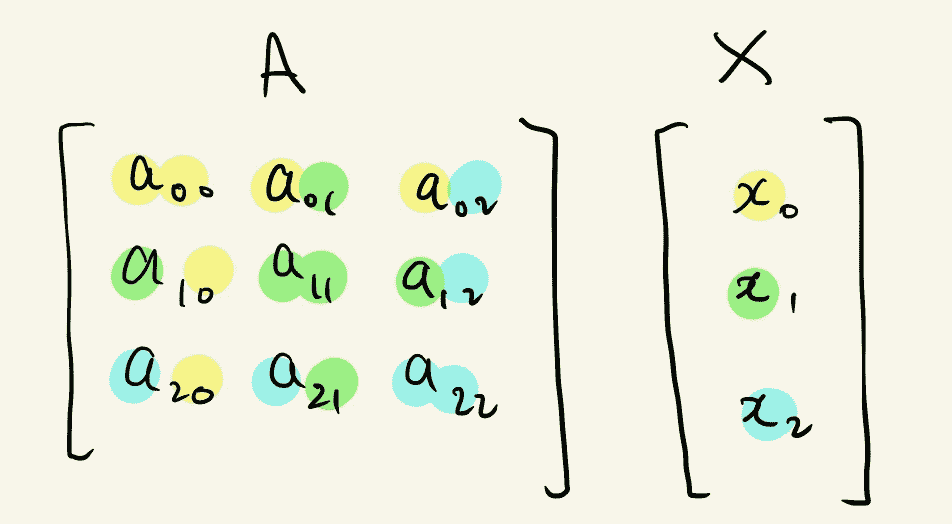

实现这一点的一种方法是利用邻接矩阵形式的图结构。将输入数据与邻接矩阵(或其某种规范化形式)相乘的效果是将数据点与其相邻点线性组合。

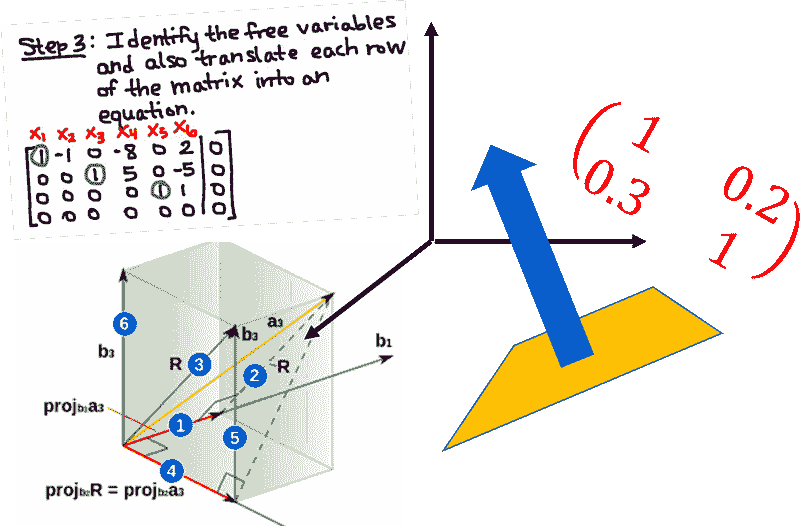

以下是一个有三个节点的图的邻接矩阵表示以及一组特征:

节点 0 的邻域可以被聚合为:

这是诸如图卷积网络等算法遵循的基本高层原理。一般而言,局部邻域信息的聚合是递归应用的,以增加汇集在一起进行节点预测的局部网络的规模。(阅读 StellarGraph 的文章了解你的邻居:图上的机器学习以获得更彻底的概念介绍)。

什么是可扩展的?

一个可扩展的山是一个人们可以攀登的山。一个可扩展的系统是一个能够处理不断增长的需求的系统。一个可扩展的图机器学习方法应该是一个能够处理不断增长的数据规模的方法……这也恰好是一座巨大的山。

在这里,我将争论简单地在节点邻域之间聚合的基本原理是不可扩展的,并描述算法必须解决的问题,以便被认为是可扩展的。

第一个问题源于一个节点可以任意连接到图中的许多其他节点——甚至是整个图。

在更传统的深度学习管道中,如果我们想要预测关于x的某些内容,我们只需x本身的信息。但考虑到图结构,为了预测关于x的某些内容,我们可能需要从整个数据集中聚合信息。随着数据集的不断增大,我们突然需要聚合 TB 级的数据才能对单个数据点进行预测。这听起来并不那么可扩展。

第二个问题的解释涉及理解传导算法和归纳算法之间的区别。

归纳算法尝试发现世界的一般规则。模型以数据为基础,对未见过的数据进行预测。

传导算法试图通过不泛化一个通用模型来为数据集中的未标记数据做出更好的预测。

当我们试图解决现实世界中的问题时,我们面临着数据不是静态的挑战。每天可能会出现数以千计的新数据,这就是为什么可扩展性如此重要的原因。但许多图机器学习方法由于从整个数据集中聚合信息的方式,天生具有传导性,而不是仅仅查看单一的数据实例。

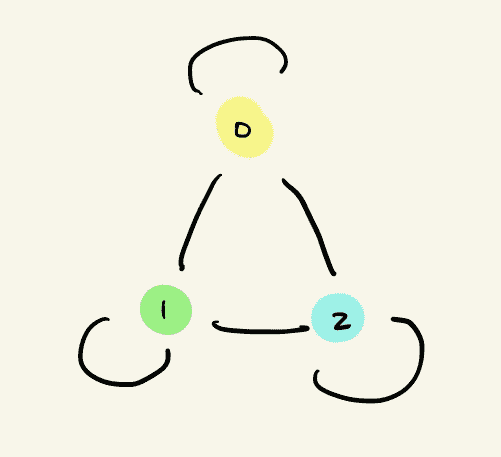

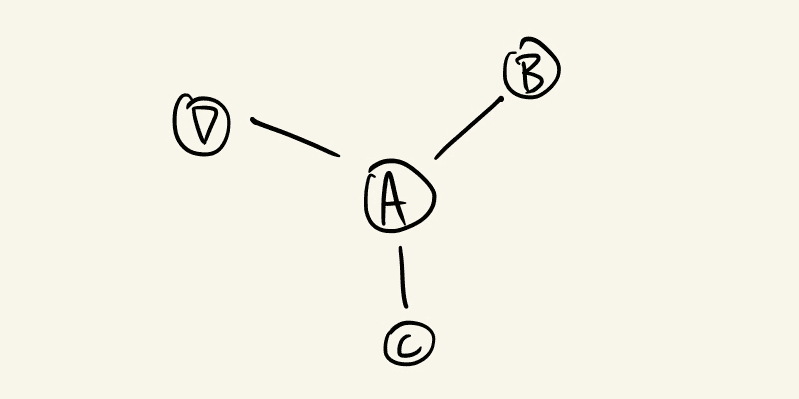

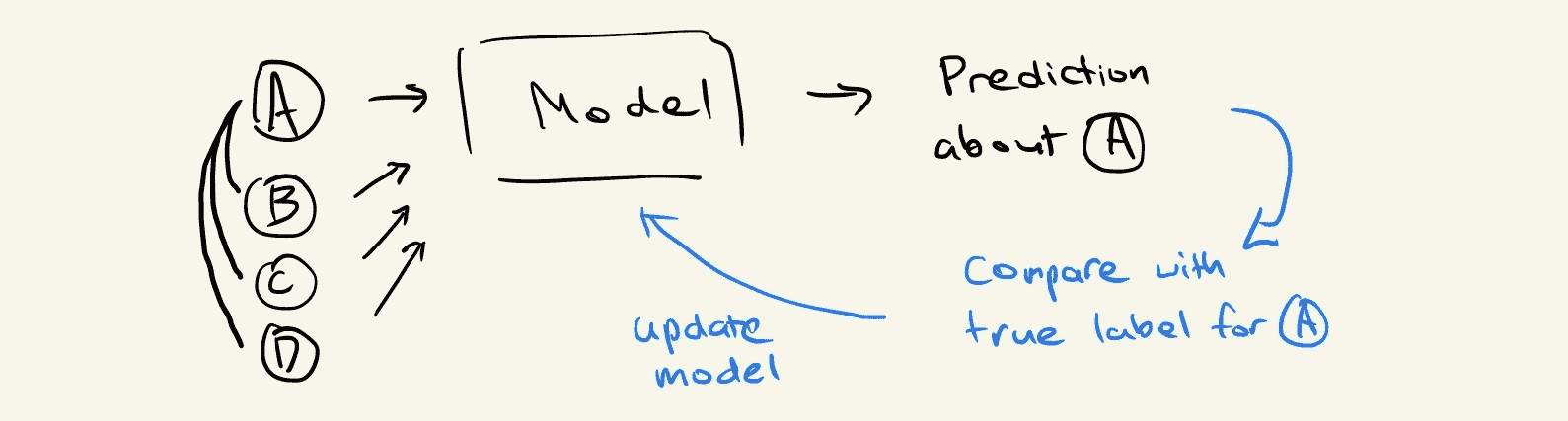

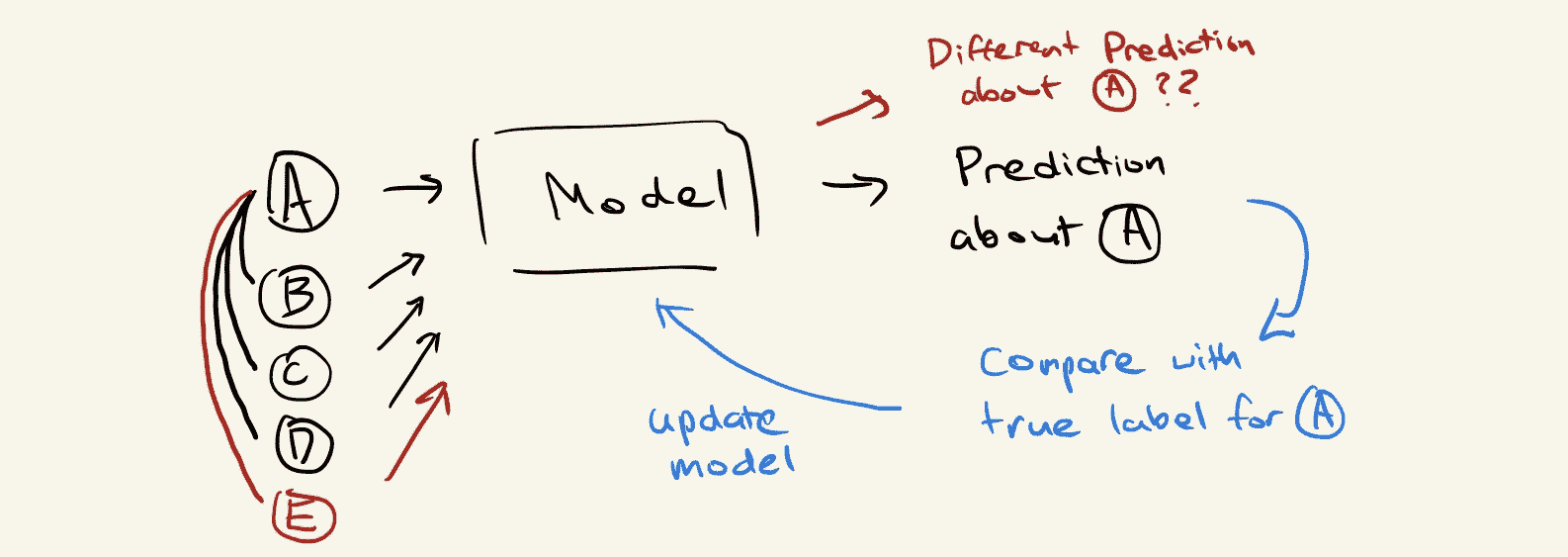

让我们看一个更具体的示例来演示这个问题。考虑一个在图中与三个其他节点 B、C 和 D 相连的节点 A:

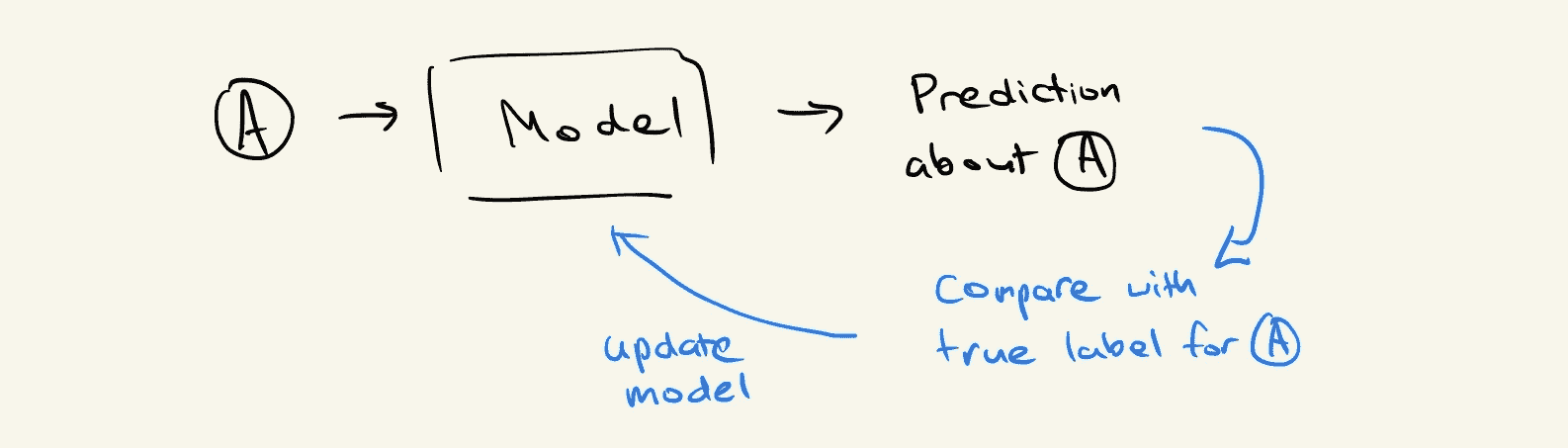

如果我们没有应用任何复杂的图方法,我们将简单地学习一个从 A 的特征到更有用的指标的映射;例如,我们想对节点做出的预测:

然而,由于我们希望利用图结构,我们最终将 B、C 和 D 的特征作为我们学习的函数的输入:

想象一下,当我们训练完模型后,未来某个时刻到达了一个新的数据点,它恰好与我们原始节点 A 相连。我们最终学习了一个没有考虑到这一连接的函数,因此我们陷入了一个不确定我们训练的模型是否对新数据集有效的情况。

节点 E 和边 AE 被引入,导致模型在聚合邻域信息以对 A 进行新的预测时也带入了 E 的特征。

到目前为止,我们对图算法的理解表明,它们通常不太具备良好的可扩展性,尤其是当算法具有传导性质时。接下来,我们将探讨一种试图解决这些挑战的算法。

引入 GraphSAGE

许多算法试图通过引入某种形式的采样来解决图机器学习中的可扩展性问题。在本节中我们将讨论的一种特定方法是邻居采样方法,它是由 GraphSAGE [3] 算法引入的。

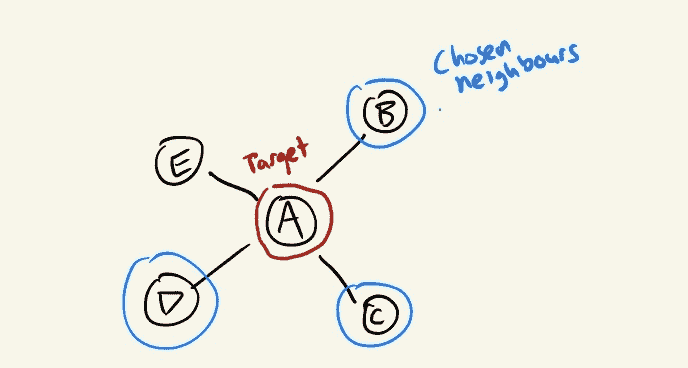

GraphSAGE 中的 SAGE 代表采样和聚合,简单来说就是:“对于每个节点,从其局部邻域中取样节点,并聚合它们的特征。”

“取样其邻居”和“聚合特征”这两个概念听起来比较模糊,因此我们来探讨一下它们实际意味着什么。

GraphSAGE 规定我们对任何给定节点的局部邻域进行固定大小的采样。这立即解决了我们需要从整个数据集中汇总信息的第一个问题。但这样做我们牺牲了什么呢?

-

首先最明显的一点是,进行采样意味着我们正在对邻域的实际情况进行近似。根据我们选择的样本大小,它可能对我们的目的足够好,但仍然是一种近似。

-

我们放弃了模型从节点的连接程度中学习的机会。对于 GraphSAGE,拥有五个邻居的节点与拥有 50 个邻居的节点看起来完全相同,因为我们总是对每个节点采样相同数量的邻居。

-

最终,我们可能会进入一个世界,在这个世界中,我们可以根据当时采样到的邻居做出不同的节点预测。

根据我们希望解决的问题和对数据的了解,我们可以尝试猜测这些问题可能如何影响我们的结果,并决定 GraphSAGE 是否适合特定的用例。

聚合特征可以通过多种不同的方式完成,但每种方式都可以描述为一个函数,该函数从采样的邻域中获取特征列表并输出一个“聚合”的特征向量。

例如,均值聚合器简单地对特征进行逐元素均值计算:

GraphSAGE 平均聚合器。

然后我们可以应用第二个聚合步骤,将节点自身及其聚合邻居的特征结合起来。上述演示的简单方法是将两个特征向量连接起来,并用一组可训练的权重进行乘法运算。

GraphSAGE 的局部采样特性为我们提供了归纳算法和扩展机制。我们还可以选择聚合方法,为模型提供一些灵活性。尽管这些好处有代价,我们需要牺牲模型性能来换取可扩展性。然而,就我们的目的而言,GraphSAGE 算法为在比特币数据集上扩展图机器学习提供了一个良好的方法。

成功,但不是没有挑战

GraphSAGE 提出了邻域采样的方法来克服一些扩展性挑战。具体而言,它:

-

为我们提供了一个良好的近似,同时限制了进行预测时的输入大小;并且

-

允许使用归纳算法。

这是一个实质性的突破,但并未完全解决问题。

1. 高效采样仍然困难

为了在不引入偏差的情况下对节点的邻居进行采样,你仍然需要遍历所有邻居。这意味着虽然 GraphSAGE 确实限制了神经网络的输入大小,但填充输入所需的步骤涉及浏览整个图,这可能是非常昂贵的。

2. 即使在采样的情况下,邻域聚合仍然聚合了大量数据

即使在固定的邻域大小下,递归地应用这种方案意味着邻域大小会指数级增长。例如,如果我们每次选择 10 个随机邻居,但在三个递归步骤上应用聚合,这最终会导致邻域大小为 10³。

3. 分布式数据为基于图的方法引入了更多挑战

大数据生态系统的很多部分围绕着分发数据以启用并行化的工作负载,并根据需求提供水平扩展的能力。然而,天真地分发图数据会引入一个重大问题,因为没有保证邻域聚合可以在没有网络通信的情况下完成。这使得基于图的方法处于一个需要付出在网络中传输数据成本或错过利用大数据技术来启用管道的价值的位置。

仍然有许多困难需要克服,以及更多探索需要进行,以使可扩展的图机器学习变得更加实用。我个人将密切关注这个领域的新进展。

如果你想了解更多关于图机器学习的信息,欢迎下载开源的StellarGraph Python 库或通过stellargraph.io联系我们。

这项工作得到了 CSIRO 的 Data61 支持,这是澳大利亚领先的数字研究网络。

参考文献

-

图卷积网络(GCN):具有图卷积网络的半监督分类。Thomas N. Kipf, Max Welling。国际学习表征会议(ICLR),2017 年

-

Node2Vec:网络的可扩展特征学习。A. Grover, J. Leskovec。ACM SIGKDD 国际知识发现与数据挖掘会议(KDD),2016 年。

-

大规模图的归纳表示学习。W.L. Hamilton, R. Ying, 和 J. Leskovec。神经信息处理系统(NIPS),2017 年。

原文。经许可转载。

简介: Kevin Jung 是 CSIRO Data61 团队中的一名软件工程师,该团队是澳大利亚领先的数字研究网络StellarGraph。

相关:

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

更多相关主题

使用 Pandas UDFs 的可扩展 Python 代码:数据科学应用

原文:

www.kdnuggets.com/2019/06/scalable-python-code-pandas-udfs.html

评论

评论

作者 Ben Weber,Zynga 的数据科学家及 Mischief 顾问

来源:

来源:pxhere.com/en/photo/1417846

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 管理

PySpark 是一个非常强大的工具,因为它能够让 Python 代码从单台机器扩展到大型集群。虽然像 MLlib 这样的库提供了对数据科学家在这种环境中可能想要执行的标准任务的良好支持,但 Python 库提供了在分布式环境中未配置的广泛功能。虽然像 Koalas 这样的库应该可以更容易地将 Python 库移植到 PySpark 中,但在可扩展运行时所需的库集合与支持分布式执行的库之间仍然存在差距。这篇文章讨论了如何使用 Spark 2.3+中的 Pandas UDFs 功能来弥合这一差距。

我遇到了 Pandas UDFs,因为我需要一种方法来扩展我在 Zynga 开发的项目的自动特征工程。我们有几十款游戏,事件分类各异,需要一种自动化方法来为不同模型生成特征。计划是使用 Featuretools 库来完成这一任务,但面临的挑战是它仅支持在单台机器上的 Pandas。我们的用例需要扩展到大型集群,并且我们需要以并行和分布式模式运行 Python 库。我在 2019 年 Spark 峰会上展示了我们实现这一规模的方法。

我们采取的方法是首先在 Spark 集群中的驱动节点上使用数据样本执行任务,然后使用 Pandas UDFs 扩展到完整的数据集,以处理数十亿条记录。我们在建模管道的特征生成步骤中使用了这种方法。这种方法也可以应用于数据科学工作流中的不同步骤,并且可以用于数据科学之外的领域。我们在以下 Medium 文章中对我们的方法进行了深入探讨:

[Zynga 的 Portfolio-Scale 机器学习

自动化处理数十款游戏的预测建模medium.com](https://medium.com/zynga-engineering/portfolio-scale-machine-learning-at-zynga-bda8e29ee561)

这篇文章通过一个例子展示了如何使用 Pandas UDFs 扩展批量预测管道的模型应用步骤,但 UDFs 的使用案例远比博客中涵盖的要广泛。

数据科学应用

Pandas UDFs 可以用于数据科学中的各种应用,从特征生成到统计测试再到分布式模型应用。然而,这种扩展 Python 的方法并不限于数据科学,只要你可以将数据编码为数据框并将任务分解为子问题,它可以应用于各种领域。为了展示 Pandas UDFs 如何用于扩展 Python 代码,我们将通过一个示例演示,其中批处理过程用于创建购买可能性模型,首先使用单台机器,然后使用集群扩展到可能的数十亿条记录。此帖子的完整源代码可在github上获取,我们将使用的库已预安装在 Databricks 社区版中。

我们笔记本中的第一步是加载我们将用于执行分布式模型应用的库。我们需要 Pandas 来加载数据集和实现用户定义的函数,需要 sklearn 来构建分类模型,以及用于定义 UDF 的 pyspark 库。

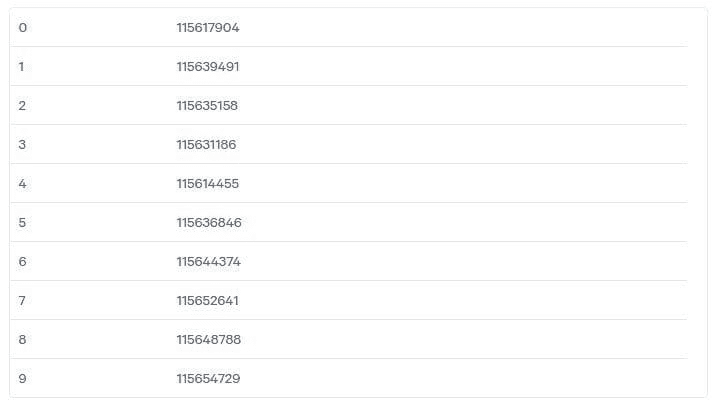

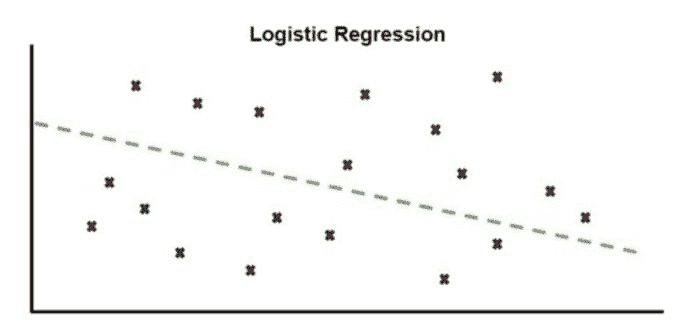

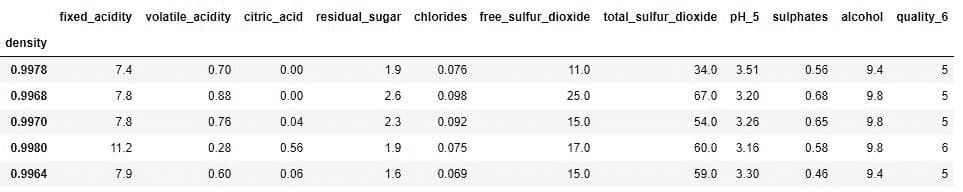

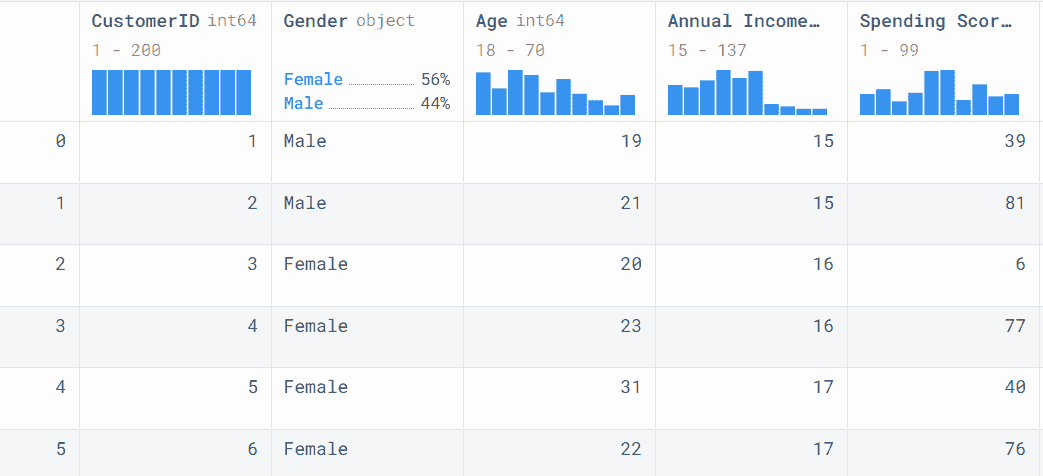

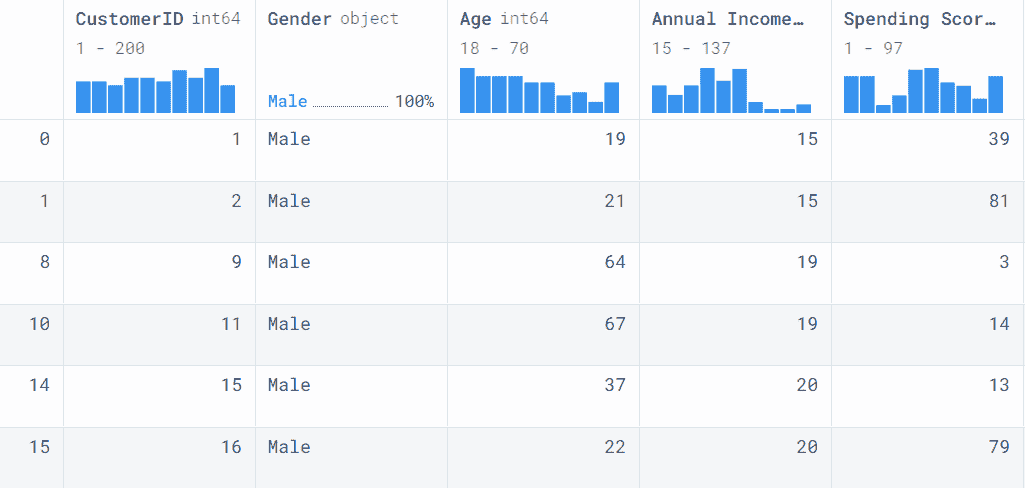

接下来,我们将加载一个数据集以构建分类模型。在这个代码片段中,一个 CSV 文件被急切地加载到内存中,使用 Pandas 的read_csv函数,然后转换为 Spark 数据框。代码还为每条记录附加了一个唯一 ID 和一个用于分发数据框的分区 ID。

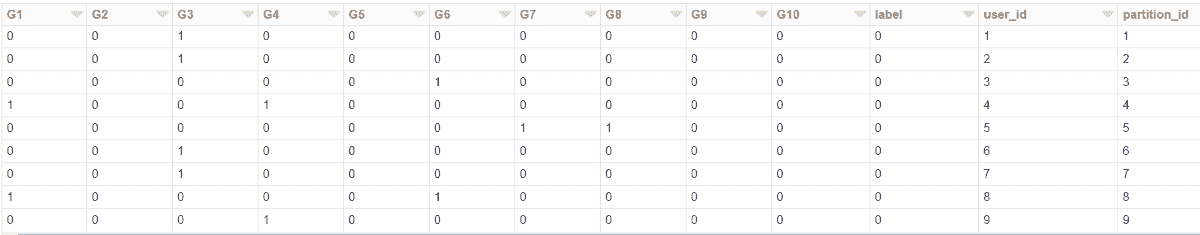

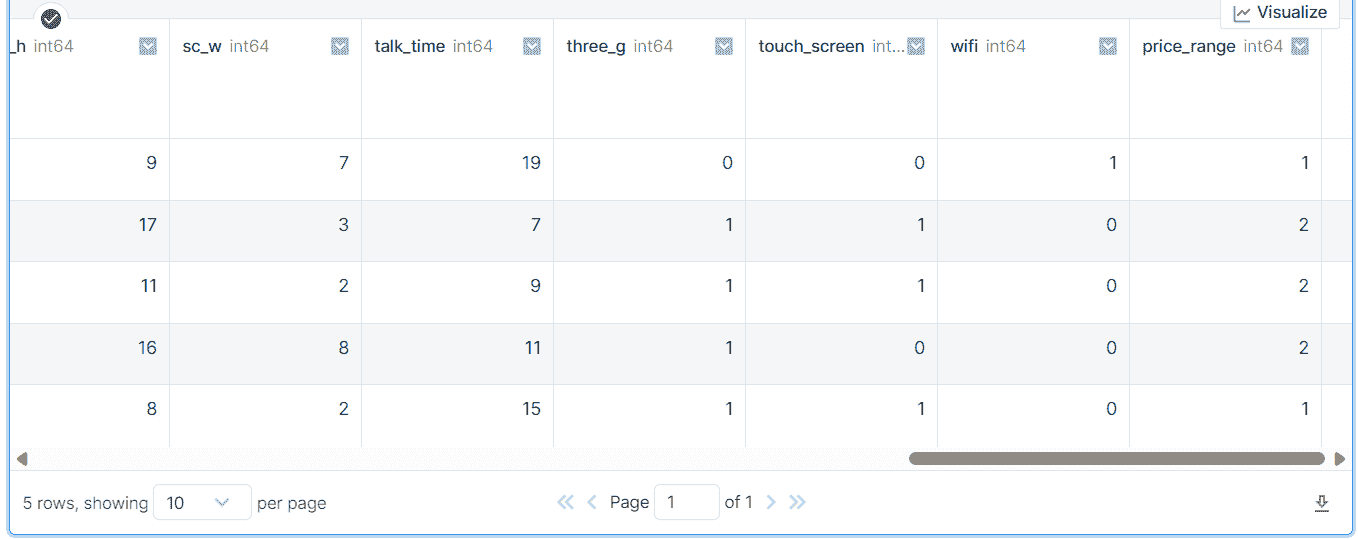

该步骤的输出见下表。Spark 数据框是记录的集合,每条记录指定用户是否以前购买过目录中的一组游戏,标签指定用户是否购买了新游戏发行,user_id 和 partition_id 字段是使用上面代码片段中的 Spark SQL 语句生成的。

现在我们有一个 Spark 数据框,可以用来执行建模任务。然而,对于这个例子,我们将专注于当将数据集的样本拉取到驱动节点时可以执行的任务。运行 toPandas() 命令时,整个数据框会被急切地提取到驱动节点的内存中。由于我们处理的是一个小数据集,这种做法没问题。但在使用 toPandas 函数之前,最好先对数据集进行采样。一旦将数据框拉取到驱动节点后,我们可以使用 sklearn 来构建逻辑回归模型。

只要你的完整数据集能够适应内存,你可以使用下面展示的单机方法将 sklearn 模型应用于新的数据框。然而,如果需要对数百万或数十亿条记录进行评分,这种单机方法可能会失败。

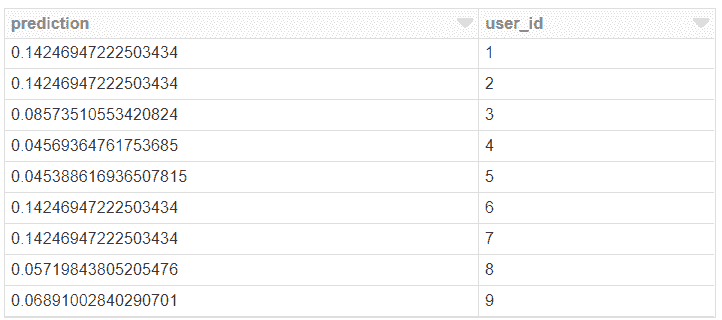

这一阶段的结果是一个包含用户 ID 和模型预测的数据框。

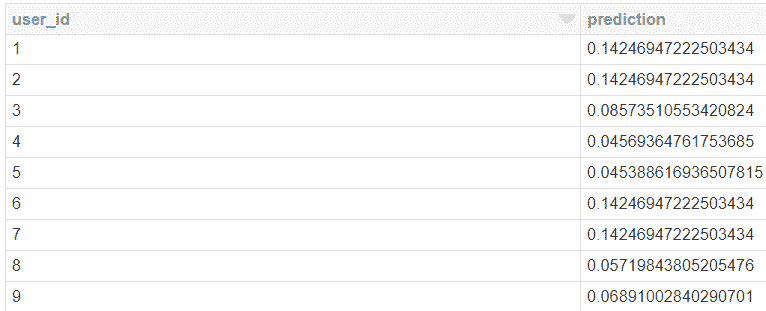

在笔记本的最后一步,我们将使用 Pandas UDF 来扩展模型应用过程。我们可以使用 Pandas UDF 将数据集分布到 Spark 集群中,而不是将整个数据集拉取到驱动节点的内存中,并使用 pyarrow 在 Spark 和 Pandas 数据框表示之间进行转换。结果与上面的代码片段相同,但在这种情况下,数据框分布在集群的工作节点上,任务在集群上并行执行。

结果与之前相同,但计算现在已从驱动节点转移到工作节点集群。这个过程的输入和输出是一个 Spark 数据框,即使我们使用 Pandas 在 UDF 内执行任务。

有关设置 Pandas UDF 的更多详细信息,请查看我之前关于如何开始使用 PySpark 的帖子。

PySpark 是一种用于大规模执行探索性数据分析、构建机器学习管道的优秀语言,等等 towardsdatascience.com

这是一个介绍,展示了如何将 sklearn 处理从 Spark 集群的驱动节点移动到工作节点。我还使用了这个功能,将 Featuretools 库扩展到处理数十亿条记录并创建数百个预测模型。

结论

Pandas UDFs 是一种功能,允许 Python 代码在分布式环境中运行,即使该库最初是为单节点执行开发的。数据科学家在构建可扩展的数据管道时可以受益于这一功能,但许多不同领域也可以从这一新功能中获益。我提供了一个批处理模型应用的示例,并链接到一个使用 Pandas UDFs 进行自动化特征生成的项目。UDFs 的许多应用尚未被探索,现在为 Python 开发者提供了新的计算规模。

简介:Ben Weber 是 Zynga 的杰出数据科学家以及 Mischief 的顾问。

原文。已获得许可转载。

相关:

-

Optimus v2:简化的数据科学工作流

-

Swiftapply – 自动化高效的 pandas apply 操作

-

使用 Apache Spark 进行深度学习:第一部分

更多相关主题

SQL 中的可扩展随机行选择

原文:

www.kdnuggets.com/2018/04/scalable-select-random-rows-sql.html

评论

评论

作者:Pavel Tiunov,Statsbot

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您组织的 IT 部门

3. Google IT 支持专业证书 - 支持您组织的 IT 部门

如果您刚刚进入大数据领域,并且还从 Google Analytics 或 Mixpanel 等工具迁移过来进行网络分析,您可能注意到了性能差异。Google Analytics 可以在几秒钟内显示预定义的报告,而在您的数据仓库中对相同数据的相同查询可能需要几分钟甚至更长时间。这样的性能提升是通过选择随机行或sampling technique实现的。让我们学习如何在 SQL 中选择随机行。

样本与总体

在我们开始进行抽样实现之前,值得提及一些抽样基础知识。抽样是基于从某些总体中选择个体的子集来描述该总体的属性。因此,如果您有一些事件数据,您可以选择一个唯一用户及其事件的子集来计算描述所有用户行为的指标。另一方面,如果您选择一个事件子集,它不会准确描述总体的行为。

鉴于这一事实,我们假设所有应用了抽样的数据集都有唯一的用户标识符。此外,如果您同时拥有匿名用户标识符和授权用户标识符,我们建议使用后者,因为它提供更准确的结果。

在 SQL 中选择随机行

有很多不同的方法可以用来选择用户子集,您可以查看这些方法中的多种选择。我们只考虑其中最明显和最简单实现的两种方法:简单随机抽样和系统抽样。

简单随机采样可以实现为给每个用户一个唯一的编号,范围从 0 到 N-1,然后从 0 到 N-1 中选择 X 个随机数。N 表示用户的总数,X 是样本大小。尽管这种方法易于理解,但在 SQL 环境中实现起来有点棘手,主要是因为随机数生成器输出在样本大小达到数十亿时不太稳定。此外,也不清楚如何在时间上获得均匀分布的样本。

考虑到这一点,我们将使用系统采样,它可以从 SQL 实现的角度克服这些障碍。简单的系统采样可以实现为在指定间隔内从每 M 个用户中选择一个用户。在这种情况下,样本大小将等于 N / M。选择 M 个用户中的一个,同时保持样本桶间的均匀分布,是这种方法的主要挑战。让我们看看如何在 SQL 中实现这一点。

序列生成的用户标识符

如果你的用户 ID 是生成的严格序列的整数且没有间隙(如由 AUTO_INCREMENT 主键字段生成的那样),你就很幸运。在这种情况下,你可以将系统采样实现得非常简单:

select * from events where ABS(MOD(user_id, 10)) = 7

这个 SQL 查询和下面的所有 SQL 查询都采用标准 BigQuery SQL。在这个示例中,我们从 10 个用户中选择一个,这是一个 10% 的样本。7 是采样桶的随机数,它可以是 0 到 9 之间的任何数字。我们使用 MOD 操作来创建代表在这种情况下除以 10 余数的采样桶。很容易证明,如果 user_id 是严格的整数序列,则当用户数量足够高时,用户计数在所有采样桶中是均匀分布的。

要估计事件数量,例如,你可以写如下内容:

select count(*) * 10 as events_count from events where ABS(MOD(user_id, 10)) = 7

请注意这个查询中的乘以 10。考虑到我们使用了 10% 的样本,所有估计的加性度量应按 1/10% 进行缩放,以匹配实际值。

我们可以质疑这种采样方法对特定数据集的准确性。你可以通过检查采样桶内分布的均匀性来估计。为此,你可以查询如下内容:

select ABS(MOD(user_id, 10)), count(distinct user_id) from events GROUP BY 1

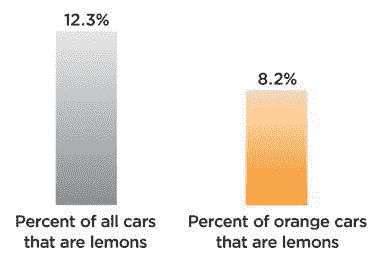

让我们考虑这个查询的一些示例结果:

我们可以计算这些采样桶大小的 alpha 系数为 0.01 的均值和置信区间。该 置信区间 将等于采样桶平均大小的 0.01%。这意味着有 99% 的概率,采样桶大小的差异不超过 0.01%。不同的度量值与这些采样桶计算的统计数据相关联但并不继承它。因此,为了计算事件计数估计的精度,你可以计算每个样本的事件计数如下:

select ABS(MOD(user_id, 10)), count(*) * 10 from events GROUP BY 1

然后计算这些事件计数的绝对和相对置信区间,如用户计数的情况,以获得事件计数估计的精度。

字符串标识符和其他用户标识符

如果您有字符串用户标识符或整数,但不是严格的整数序列标识符,您需要一种均匀地将所有用户 ID 分配到不同采样桶中的方法。 这 可以通过哈希函数完成。并非所有哈希函数在不同情况下都能实现均匀分布。您可以检查 smhasher 测试套件的结果,以检查特定哈希函数的效果。

例如,在 BigQuery 中,您可以使用 FARM_FINGERPRINT 哈希函数来准备选择样本:

select * from events where ABS(MOD(FARM_FINGERPRINT(string_user_id), 10)) = 7

FARM_FINGERPRINT 可以替换为任何合适的哈希函数,例如 Presto 中的 xxhash64,或者甚至是 Redshift 中的 md5 和 strtol 的组合。

如同序列生成的用户标识符一样,您可以检查均匀性统计数据:

select ABS(MOD(FARM_FINGERPRINT(string_user_id), 10)), count(distinct string_user_id) from events GROUP BY 1

常见陷阱

通常,采样可以将您的 SQL 查询执行时间减少 5-10 倍而不会对精度造成危害,但仍然存在需要谨慎的情况。这主要是由于样本大小引起的采样偏差问题。当您感兴趣的指标在样本之间的离散度过高时,即使样本量足够大,也可能发生这种情况。

例如,您可能对某些稀有事件计数感兴趣,比如一个 B2C 网站上的企业演示请求,尽管该网站有大量流量。如果企业演示请求的数量约为每月 100 个事件,而您的月活跃用户约为 1M,那么采样可能会导致企业演示请求数量的估计误差显著。一般而言,在这种情况下应避免在 SQL 中随机采样行,或使用 更复杂的方法。

和往常一样,请随时留下您的评论或 联系我们的团队 以获取帮助。

原文。经许可转载。

相关:

-

计算客户终生价值:SQL 示例

-

业务分析的 SQL 窗口函数教程

-

SQL 客户保留分析指南

更多相关主题

使用 Dataflow 扩展计算机视觉模型

原文:

www.kdnuggets.com/2020/07/scaling-computer-vision-models-dataflow.html

评论

作者 Pablo Soto,Pento 的创始合伙人

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

我们将简要介绍 Google Cloud 服务 Dataflow,以及它如何以无服务器的方式运行数百万张图像的预测。无需创建集群,无需维护,您只需为您使用的部分付费。我们将首先提供一个背景,说明我们为什么认为这很重要,简要介绍几个概念,然后直接进入一个用例。

扩展机器学习模型是困难且昂贵的。主要有两个原因:基础设施成本高,以及您的实验管道缓慢,导致机器学习团队不断等待结果。

很容易低估拥有一个等待结果的机器学习团队的费用。这不仅仅是因为浪费的时间,还因为人们会感到沮丧并最终失去动力。

优化您的机器学习实验过程的一种方法是建立和管理自己的基础设施。这在大公司中很常见,但对于小公司来说,这往往代价高昂。

传统的软件开发几年前面临类似的挑战,企业需要扩展,这主要是由业务需求驱动的(服务/API/网站缓慢不适合扩展)。云服务提供商看到了提供服务的机会,这些服务允许公司在没有前期成本的情况下扩展。他们主要通过两种方式来解决这个问题:易于管理的服务和无服务器服务。后者对没有大规模 DevOps 团队或资金不足以支付自己基础设施的小公司尤其具有吸引力。

机器学习中也出现了类似的趋势。这次是由机器学习人才的稀缺和高成本驱动的。像软件一样,小公司无法投入大量资金创建定制的优化基础设施,这需要一支专家团队来构建和维护。

云服务提供商看到了通过提供无服务器解决方案来增加价值的机会。特别是 GCP 已经这样做了一段时间。GCP AI Platform 提供了 ML 项目每个阶段的不同服务。但他们也依靠其他服务来帮助解决 ML 挑战。

Dataflow 是什么?

Dataflow 是一个完全托管的处理服务,它使用 Apache Beam 作为其编程模型来定义和执行管道。Dataflow 是 Beam 支持的 许多运行器 之一。

Apache Beam 提供了一个可移植的 API 层,用于构建复杂的数据并行处理管道,这些管道可以在多种执行引擎或运行器上执行。

Dataflow 特别有一些有趣的特性:

-

完全托管

-

自动缩放

-

简单实现

什么是 Apache Beam?

如上所述,Beam 是一个用于定义和执行处理管道的编程模型。它提供了一个接口来创建可以在多种环境(如 Spark、Hadoop、Dataflow)中执行的处理管道。

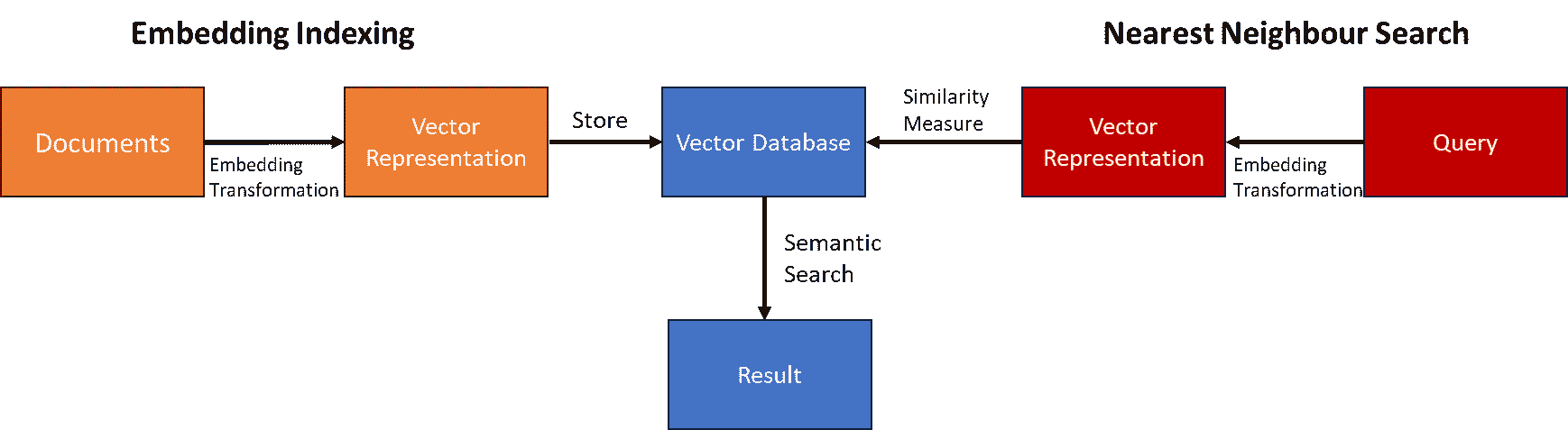

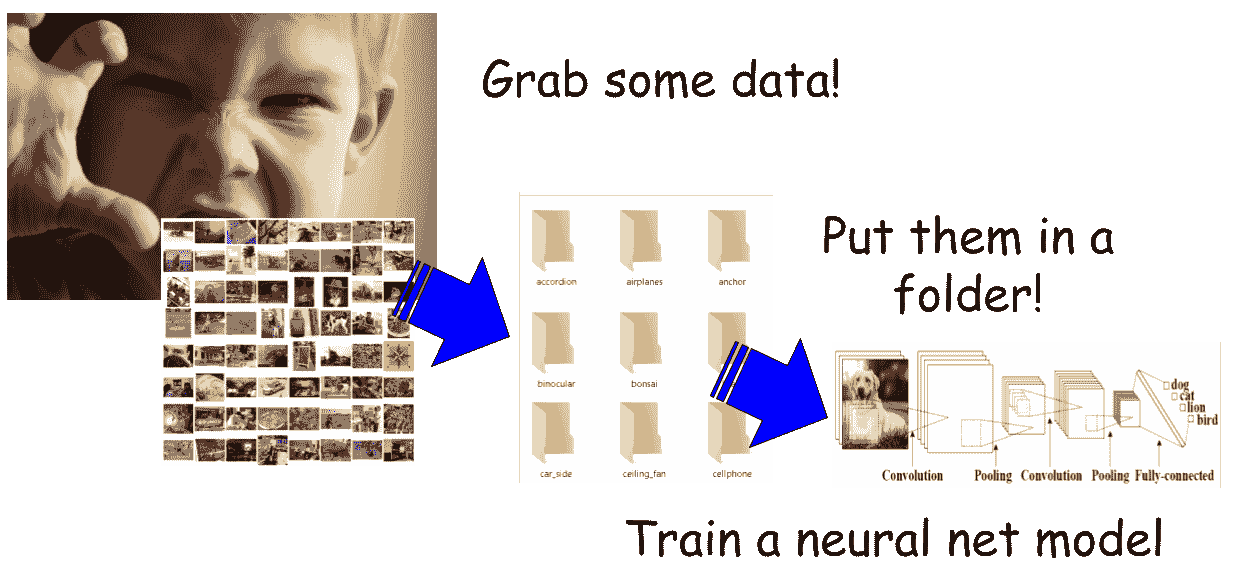

用例:使用预训练的 ResNet50 提取图像特征

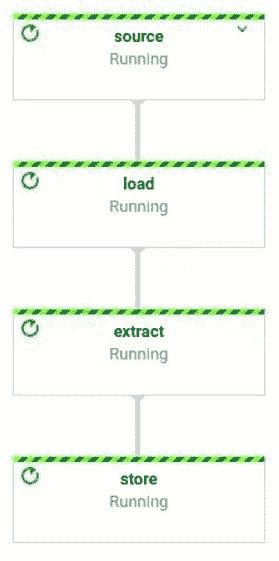

作为计算机视觉工程师,我们经常需要使用 CNN 模型提取嵌入特征。在这里,我们将介绍如何构建一个数据流管道,该管道使用预训练的 ResNet50 生成图像特征嵌入。我们的管道将包括 3 个简单步骤:

-

加载图像

-

提取特征

-

存储特征

为了实现我们的管道,我们将使用 Apache Beam Python SDK、Keras、Pillow 和 Click。由于我们将使用非 Python 依赖项,我们必须按照 这里 所述的方式来构建我们的代码。

我们需要做的第一件事是创建一个管道配置:

if local:

# Execute pipeline in your local machine.

runner_options = {

"runner": "DirectRunner",

}

else:

runner_options = {

"runner": "DataflowRunner",

"temp_location": "...",

"staging_location.": "...",

"max_num_workers": max_num_workers,

}

options = PipelineOptions(

project=project_id,

job_name=job_name,

region=region,

**runner_options

)

options.view_as(SetupOptions).save_main_session = True

options.view_as(SetupOptions).setup_file = os.path.join(

pathlib.Path(__file__).parent.absolute(), "..", "setup.py")

如你所见,根据我们是在本地执行管道还是在 Dataflow 上执行,选项会有所不同。

然后我们需要创建一个 管道:

with beam.Pipeline(options=options) as p:

...

p 是我们的管道,向管道中添加新步骤时使用操作符 | ,如下所示:

p = p | Task();

如果你想明确命名步骤,你可以使用操作符 >>:

p = p | ("task_name" >> Task());

现在我们需要指定管道的步骤。有多种实现方式:

-

内置实现:BigQuery 连接器、ReadFile 等

-

自定义实现:Map、Filter、ParDo

(p

| "source" >> ReadFromText(input_path)

| "load" >> beam.Map(load)

| "extract" >> beam.Map(extract)

| "store" >> beam.ParDo(store, output_path))

在这里你可以看到我们已经添加了上述三个步骤。我们从 Google Cloud 的 CSV 文件中加载图像路径,然后加载图像,提取它们的嵌入,并将它们存储在 Google Cloud Storage 中。

在我们管道中的所有步骤中,我们期望接收一个输入并返回一个输出。为了应用这些类型的步骤,我们必须使用方法 beam.Map。另外,如果你处理的是可能接收/返回零个或多个输入/输出的步骤,你可以使用 beam.ParDo。

现在管道已经定义,我们来看一下实现细节。

加载图像

在这一步中,我们需要从 GCS 下载图像,将其加载为 Pillow 图像,调整大小,并将其转换为 numpy 数组对象。之所以在一个步骤中下载和调整大小,是为了减少管道步骤之间的数据传输,从而降低成本。

def load(path):

"""

Receives an image path and returns a dictionary containing

the image path and a resized version of the image as a np.array.

"""

buf = GcsIO().open(path, mime_type="image/jpeg")

img = Image.open(io.BytesIO(buf.read()))

img = img.resize((IMAGE_HEIGHT, IMAGE_WIDTH), Image.ANTIALIAS)

return {"path": path, "image": np.array(img)}

Beam 提供了一组 内置连接器 来处理 I/O。

提取特征

在这一步中,我们需要加载 ResNet 模型并运行预测。为了避免在同一工作节点上多次加载模型,FeatureExtractor 类中添加了一个单例包装器。一旦提取了嵌入,我们将其添加到项目字典中,由于不再需要将完整图像加载到内存中,我们将其从字典中删除。

def singleton(cls):

instances = {}

def get_instance(*args, **kwargs):

if cls not in instances:

instances[cls] = cls(*args, **kwargs)

return instances[cls]

return get_instance

@singleton

class Extractor:

"""

Extract image embeddings using a pre-trained ResNet50 model.

"""

def __init__(self):

self.model = ResNet50(

input_shape=(IMAGE_WIDTH, IMAGE_HEIGHT, 3),

include_top=False,

weights="imagenet",

pooling=None,

)

def extract(self, image):

return self.model.predict(np.expand_dims(image, axis=0))[0]

def extract(item):

"""

Extracts the feature embedding from item["image"].

"""

extractor = Extractor()

item["embedding"] = extractor.extract(item["image"])

# We do not longer need the image, remove it from the dictonary to free memory.

del item["image"]

return item

存储特征

现在我们有了嵌入,只需将其存储在 GCS 中即可。

def store(item, output_path):

"""

Store the image embeddings item["embedding"] in GCS.

"""

name = item["path"].split("/")[-1].split(".")[0]

path = os.path.join(output_path, f"{name}.npy")

fin = io.BytesIO()

np.save(fin, item["embedding"])

fout = beam.io.gcp.gcsio.GcsIO().open(path, mode="w")

fin.seek(0)

fout.write(fin.read())

Dataflow 允许你指定机器类型、工作节点数量、目标等,提供了大量的灵活性来找到适合当前任务的配置。你可以在 这里查看所有选项。

一旦你运行 Dataflow 管道,你将会在你的机器上看到关于执行状态的日志。另一种选择是使用 Dataflow Web UI。你可以在 文档 中了解更多信息。

你可以在 这里查看完整代码。

Apache Beam 还支持将管道分支。例如,如果你想创建嵌入的 2D 可视化,可以通过以下方式分支你的管道:

p = (

p

| "source" >> ReadFromText(input_path)

| "load" >> beam.Map(load)

| "extract" >> beam.Map(extract)))

(p | "store" >> beam.ParDo(store, output_path))

(p | "reduce_dim" >> beam.ParDo(reduce_dim))

这允许 Beam 独立执行 store 和 reduce_dim,提供更多优化管道的灵活性,从而提高性能。

扩展

Dataflow 提供了 多种配置,允许你以非常简单的方式自定义你希望的扩展方式。默认情况下,它会选择提升性能的值。在执行过程中,Dataflow 会更改配置以优化性能,例如调整工作节点的数量、机器类型等。

你可以让 Dataflow 每次运行管道时找到最佳配置。但如果你已经知道你的作业需要的资源,如内存量、是否 CPU 密集型、外部服务(即你的数据库或 API 容量)支持的最大吞吐量,最好直接指定这些信息。这将帮助 Dataflow 更快地收敛到正确的配置,加快执行速度并降低成本。

Dataflow 应足以满足大多数小型/中型公司扩展的需求。作为参考,Dataflow 能以每秒 5k 张图像的速度执行上述用例,最多使用 1k 名工人。这里是Dataflow 配额的列表,主要限制为 1k 名工人。

摘要

Apache Beam 是一种简单的编程模型,允许你以结构化的方式执行 ML 步骤,并在不同环境中运行。其中之一是 Dataflow,Beam 执行引擎,它是完全托管的,支持自动扩展,并允许我们针对不同目标进行优化。

Dataflow 是一个优秀的工具,可以在大规模运行你的 ML 模型,而无需过多的前期投资或维护。它提供了一个简单的 API,并拥有一个活跃的开源社区。本文展示了如何使用 Apache Beam 构建图像嵌入提取器,并扩展到数百万张图像。这样,你可以在不担心基础设施的情况下节省数百美元,同时加速实验过程。

资源

Python 示例:

简历: 帕布罗·索托 是Pento 的创始合伙人,专注于机器学习。

原文. 经许可转载。

相关:

-

使用 Tensorflow.js 实现计算机视觉应用的 6 个简单步骤

-

使用机器学习和计算机视觉进行作物疾病检测

-

使用深度学习自动旋转图像

更多相关内容

通过 Apache Gobblin 扩展数据管理

原文:

www.kdnuggets.com/2023/01/scaling-data-management-apache-gobblin.html

大数据管理的挑战

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的 IT 组织

3. 谷歌 IT 支持专业证书 - 支持你的 IT 组织

在现代世界,大多数企业依赖大数据和分析的力量来推动其增长、战略投资和客户参与。大数据是目标广告、个性化营销、产品推荐、洞察生成、价格优化、情感分析、预测分析等的基础。

数据通常从多个来源收集,经过转换、存储,并在本地或云端的数据湖中处理。虽然数据的初步摄取相对简单,可以通过内部开发的自定义脚本或传统的 ETL(提取、转换、加载)工具实现,但问题很快会变得复杂且昂贵,公司必须:

-

管理整个数据生命周期 - 以满足清理和合规要求

-

优化存储 - 以减少相关成本

-

简化架构 - 通过重用计算基础设施

-

增量处理数据 - 通过强大的状态管理

-

在批量和流数据上应用相同的政策 - 避免重复劳动

-

在本地和云端之间迁移 - 以最小的努力

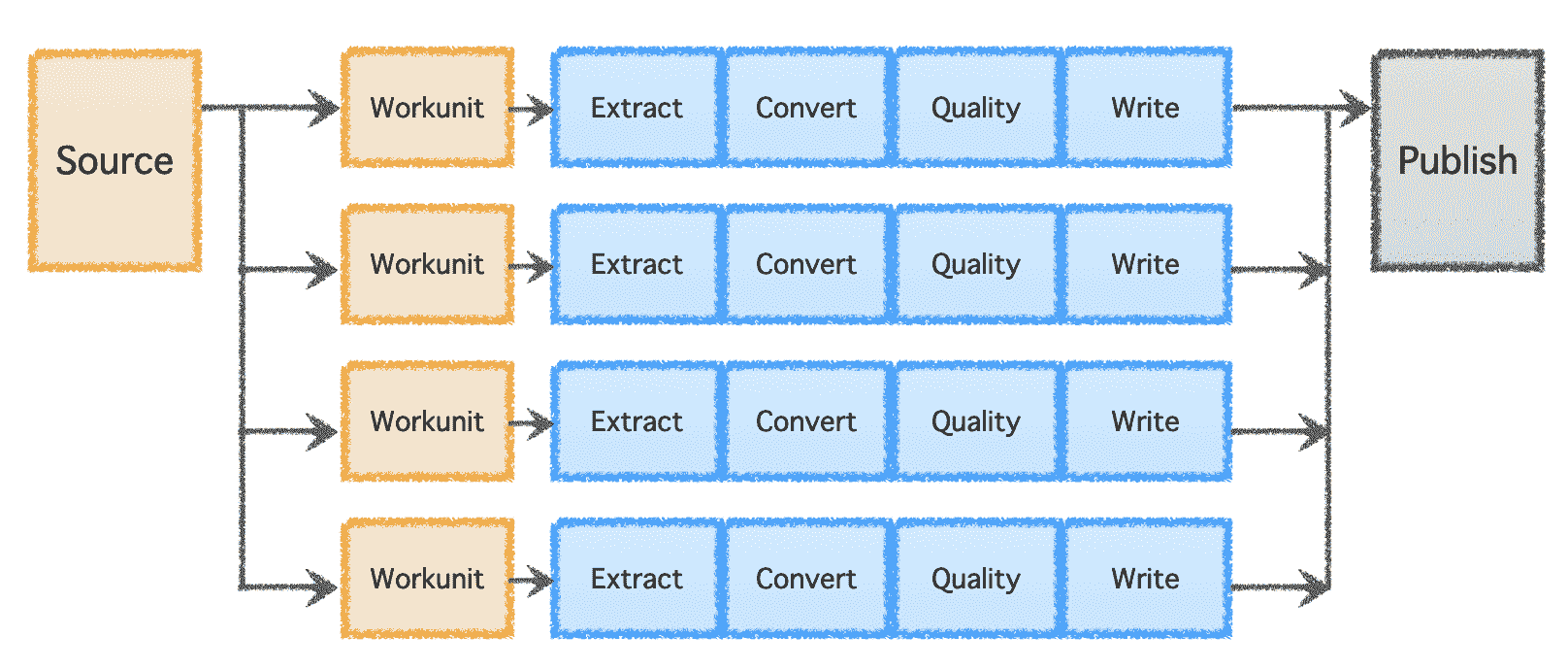

这就是Apache Gobblin,一个开源的数据管理和集成系统的用武之地。Apache Gobblin 提供了无与伦比的功能,可以根据业务需求选择整体或部分使用。

使用 Gobblin 简化大数据管理

在本节中,我们将深入探讨 Apache Gobblin 的各种功能,帮助解决之前概述的挑战。

管理整个数据生命周期

Apache Gobblin 提供了一系列功能来构建数据管道,支持对数据集的所有生命周期操作。

-

数据摄取 - 从多个来源到各种目的地,包括数据库、Rest API、FTP/SFTP 服务器、文件存储、如 Salesforce 和 Dynamics 等 CRM 系统,等等。

-

复制数据 - 在多个数据湖之间,通过 Distcp-NG 为 Hadoop 分布式文件系统提供专门的功能。

-

清理数据 - 使用基于时间的、新近 K、版本化或组合政策等保留政策。

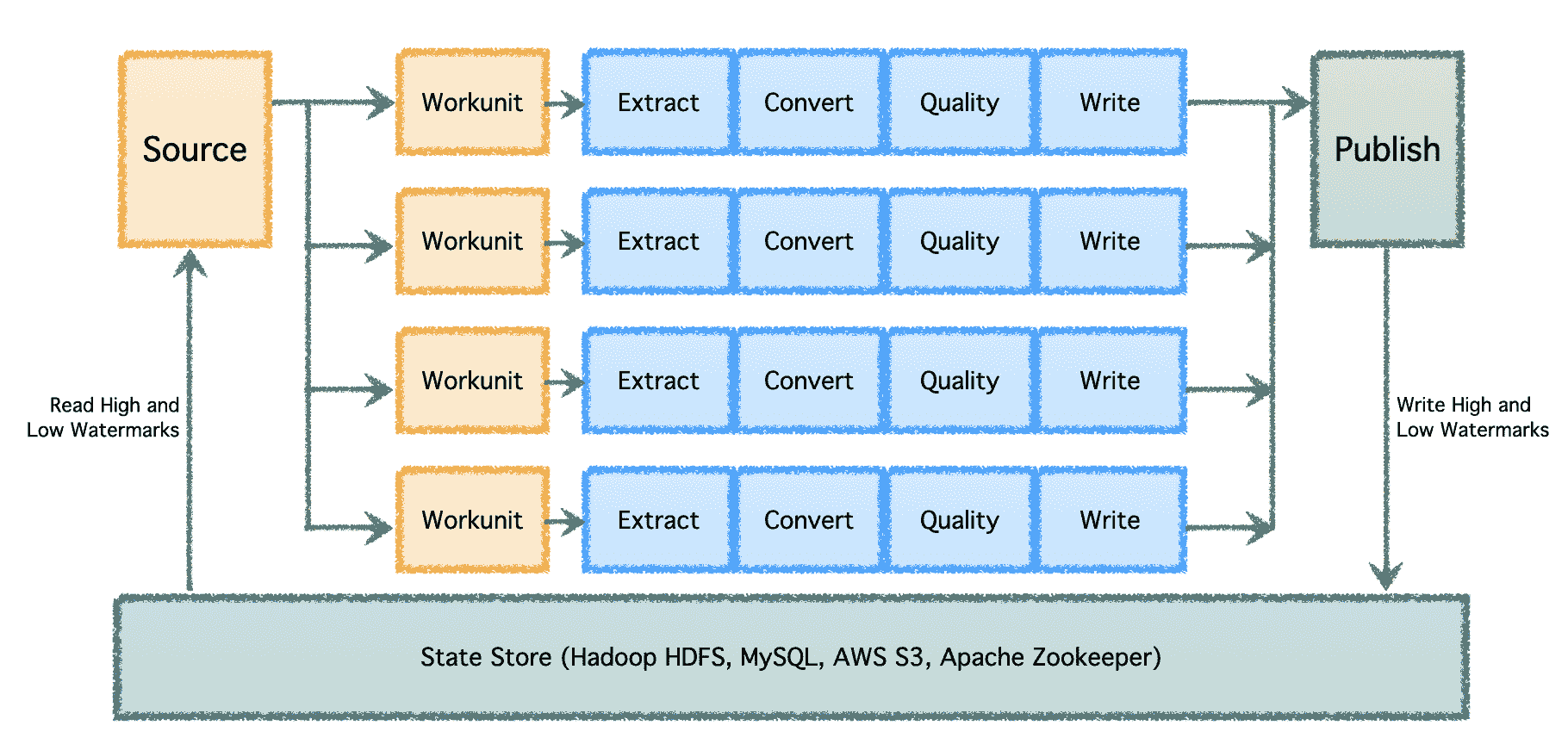

Gobblin 的逻辑管道包括一个确定工作分配并创建“工作单元”('Workunits')的“源”('Source')。这些“工作单元”随后被提取执行为“任务”('Tasks'),任务包括数据提取、转换、质量检查和写入目标。最后一步,“数据发布”('Data Publish'),验证管道的成功执行,并在目标支持的情况下原子性地提交输出数据。

图片由作者提供

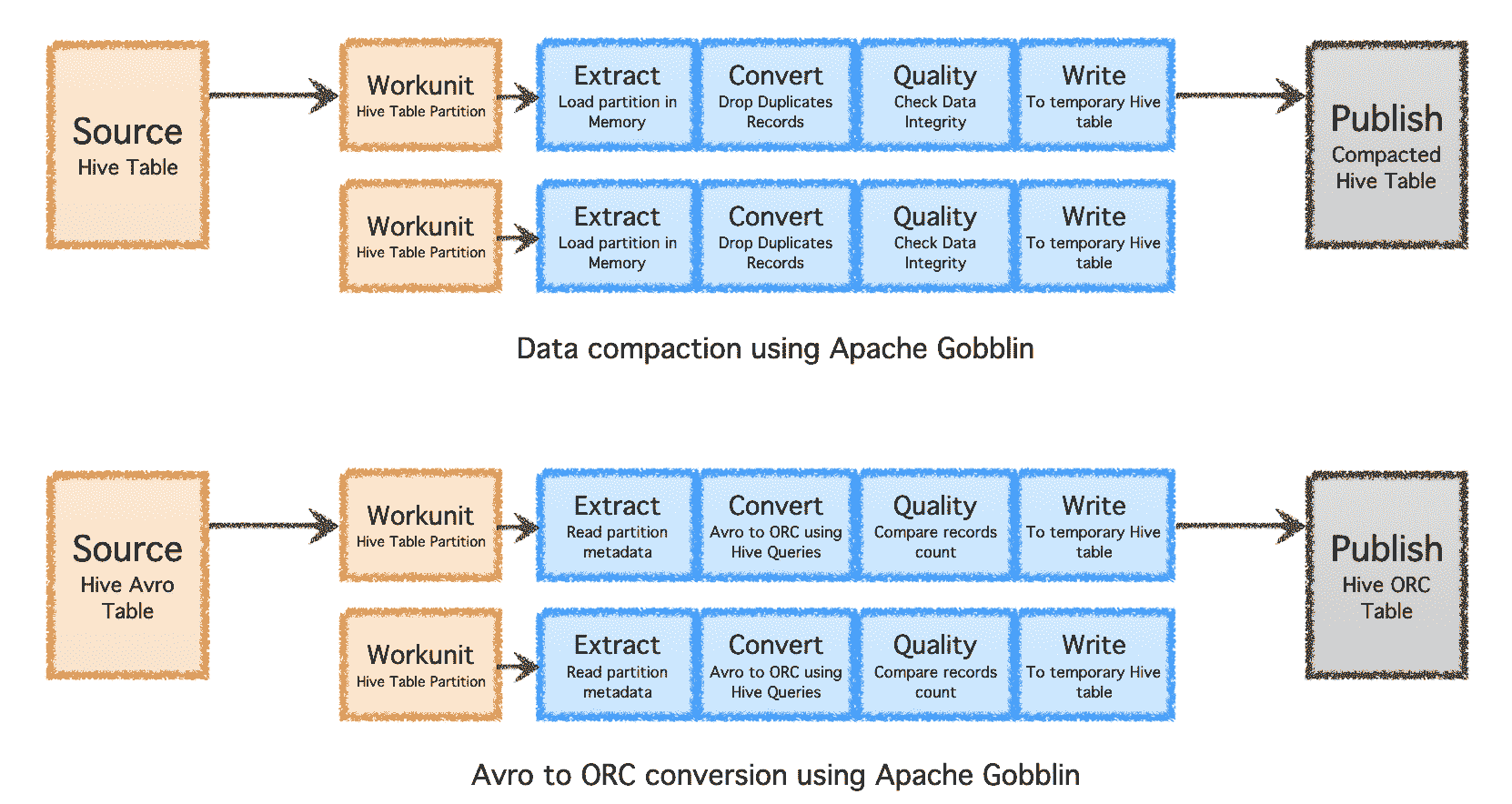

优化存储

Apache Gobblin 可以通过在数据摄取或复制后进行后处理(例如压缩或格式转换),帮助减少所需的存储量。

-

压缩 - 对数据进行后处理,以基于所有字段或关键字段去重,修剪数据以保留具有最新时间戳的唯一记录。

-

Avro 到 ORC - 作为一种专用格式转换机制,将流行的行基 Avro 格式转换为超优化的列基 ORC 格式。

图片由作者提供

简化架构

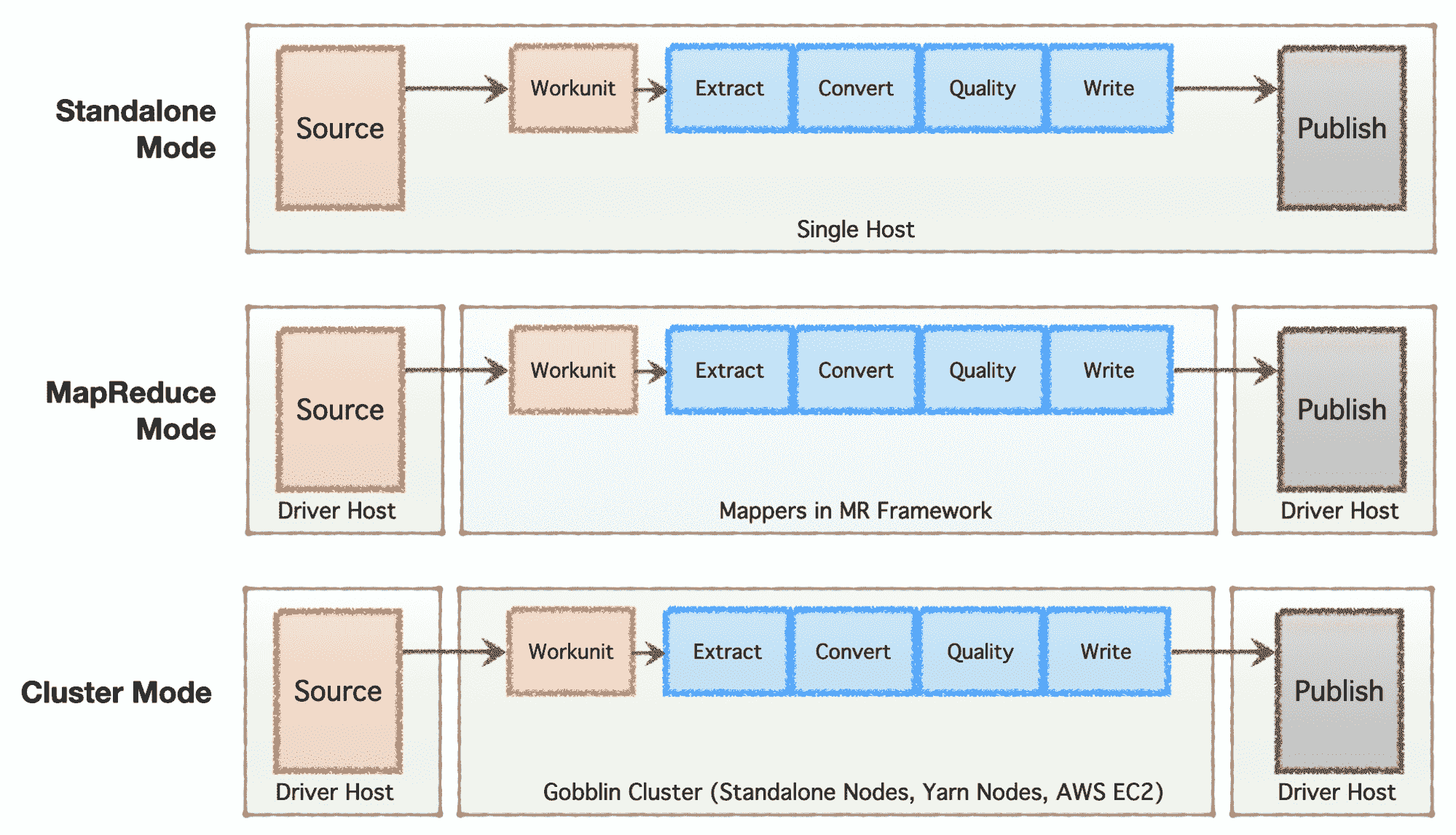

根据公司的阶段(从初创公司到企业)、规模需求及其各自的架构,公司倾向于建立或发展他们的数据基础设施。Apache Gobblin 非常灵活,支持多种执行模型。

-

独立模式 - 作为单独进程在裸金属主机上运行,即单个主机,适用于简单用例和低需求情况。

-

MapReduce 模式 - 作为一个 MapReduce 作业在 Hadoop 基础设施上运行,用于处理范围为 PB 规模的大数据集。

-

集群模式:独立 - 作为一个集群运行,由 Apache Helix 和 Apache Zookeeper 支持,部署在一组裸金属机器或主机上,以处理大规模独立于 Hadoop MR 框架的工作负载。

-

集群模式:Yarn - 作为一个集群在原生 Yarn 上运行,无需 Hadoop MR 框架。

-

集群模式:AWS - 作为一个集群在亚马逊公共云服务(即 AWS)上运行,用于托管在 AWS 上的基础设施。

图片由作者提供

增量处理数据

在具有多个数据管道和高数据量的大规模环境下,数据需要批量处理并随时间处理。因此,需要进行检查点,以便数据管道能够从上次中断的地方恢复并继续进行。Apache Gobblin 支持低水位和高水位,并通过 HDFS、AWS S3、MySQL 等提供强大的状态管理语义。

图片由作者提供

批处理和流数据的相同策略

目前大多数数据管道需要编写两次,一次用于批量数据,一次用于近线或流数据。这会加倍工作量,并在应用于不同类型管道的策略和算法中引入不一致。Apache Gobblin 通过允许用户编写一次管道并在批量和流数据上运行来解决这个问题,如果在 Gobblin 集群模式、AWS 模式或 Yarn 模式中使用 Gobblin。

在本地和云之间迁移

由于其多功能模式可以在单台机器、节点集群或云上运行,Apache Gobblin 可以在本地和云上部署和使用。因此,用户可以根据具体需求,仅需编写一次数据管道,并与 Gobblin 部署一起轻松迁移本地和云之间。

由于其高度灵活的架构、强大的功能以及支持和处理极大数据量的能力,Apache Gobblin 被主要技术公司 用于生产基础设施,并且是今天任何大数据基础设施部署的必备工具。

有关 Apache Gobblin 及其使用方式的更多细节可以在 gobblin.apache.org 找到。

Abhishek Tiwari 是 LinkedIn 的高级经理,负责领导公司的大数据管道组织。他还是 Apache 软件基金会的 Apache Gobblin 副总裁以及英国计算机学会的会员。

更多相关话题

扩展您的数据战略

评论

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道

1. Google 网络安全证书 - 快速进入网络安全职业的快车道

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

适用于数据相关增长痛点的企业指南

快速增长的公司同时享有两个独特的优势。它们能够利用小而强大的团队,拥有积极的态度,并迅速将产品特性推向市场。同时,为了维持快速扩展,它们有实际的动机同样重视建立可持续增长的基本实践。这意味着要管理数字化转型,以利用新技术的好处,并管理越来越多的同时进行且相互关联的项目。更不用说在这些项目和流程交汇处,通常会有大量的数据在流动!随着数据呈指数增长,这一独特的位置可以被用来制定一个强大且长期的数据战略。

在 SSENSE,我们尝试通过数据驱动的解决方案来解决大规模问题。在这种背景下,商业关系可能迅速变得复杂,识别数据中的模式和行为可能变得越来越具有挑战性。如果您定期启动与组织中现有功能和流程紧密交织的新项目,那么您将无法再建立孤立的、一锤子买卖的解决方案。您的运营已经增长到值得制定企业数据战略的程度。在本文中,我将基于我之前的专业经验,展示我对一致性数据战略的愿景。尽管本文的目的是不是详细描述我们在 SSENSE 的具体数据战略,但许多主要原则都从中汲取了灵感。

数据战略

无论你在数据驱动的旅程中处于何种阶段,拥有一个数据策略都能帮助解锁数据的潜力,使组织能够将数据视为关键资产。数据策略是一个旨在改善组织内数据使用方法、实践和流程的计划,并确保数据的使用是可持续和可复制的。由于数据由不同业务部门生成和使用,这些部门有着不同的实践和责任,因此,拥有一个委员会来监督组织内的数据策略对业务成功至关重要。根据你在旅程中的位置,可能没有数据策略也是可以的,但这会导致不同部门自行解决数据问题,进而浪费资源,部门孤立运作,组织的凝聚力日益下降。我已经将这种严峻的可能性浓缩成一句话,因此从现在开始,让我们专注于积极和建设性的想法。

良好数据策略的组成部分

一个稳健的数据策略通常应涵盖以下核心主题:

语义 — 识别数据并定义其含义

这涉及到理解组织数据的所有核心实体,如:客户、位置、产品、交易及其关系。在操作的早期阶段,将这些关系表示在关系数据库模式中是可以的,但随着各种数据类型、流程和存储格式的发展,拥有一个管理的数据目录,包含定义、含义和关系,将不同系统连接起来是非常重要的。

通过如数据湖这样的单一接口结合数据的新方法,有助于避免管理和使用组织数据时遇到的许多问题和复杂性。即便如此,将术语、元数据和关系整合到一个目录下使访问和使用数据变得更加简单。对于每个数据字段,这样的目录可能包括定义、来源、位置、领域、用例、利益相关者等。

治理 — 建立并沟通适当的数据使用政策和机制

数据治理的概念通常似乎仅限于用户和分析环境,但实际上,我们在每个操作中都在使用和生成数据。一旦数据从创建它的应用程序中解耦,组织应该定义数据的规则和细节,以便所有利益相关者都能理解如何使用数据。

一个强有力的治理模型概述了安全细节、访问权限、高层次的转换逻辑、命名约定和数据使用规则。在一个数据驱动的组织中,强有力的治理模型不应被视为用户的一个压倒性的障碍,也不应作为限制数据访问的手段。相反,它应该使组织中的所有成员能够负责任和有效地使用数据。

存储和供应 — 以一种可访问且直观的结构持久化数据

企业不断处于数字化转型的状态。我们应该将其视为常态,以利用新技术的好处,并且不能忽视我们在组织内部生成越来越多的数据。数据存储是技术栈的基本能力之一。确定一个应用程序或业务流程的正确数据存储对于确保存储技术的正确使用至关重要。

借助上述提到的适当数据目录,组织能够确保存在实际的方式来存储业务应用程序的数据,同时使其对所有相关方易于访问和共享。

数据存储类型的具体选择,无论是 SQL、图数据库、数据仓库等,都应根据具体情况来决定,以最好地满足所存储数据及其利益相关者的需求。

一个好的数据存储策略确保所有数据都被高效地存储,以适应其使用场景,同时为中心化的数据共享过程奠定基础。

过程 — 在不同的系统中移动和合并数据,以提供统一且一致的访问点

对于数据和业务分析师而言,来自应用程序的原始数据是知识的宝贵财富。如果今天无法识别其业务影响,那么将数据存储和转化以便未来使用是明智的。处理数据是数据策略的一个重要组成部分,它将原始数据转化为成品。因此,它将来自业务应用程序的数据转化为可用于数据驱动决策的资产。

如果每个新项目都需要工程师和分析师从多个来源处理原始数据,这将是巨大的时间和精力浪费!同样重要的是,如果一个组织期望其开发人员花费大量时间在临时基础上构建逻辑以匹配和链接来自多个数据源的实体,这将浪费宝贵的人力资源。

如果你没有提前准备,快速增长的公司将会遇到这个严峻的现实,其绩效将开始停滞。当然,你可以通过增强技术人才来掩盖这种行为,但这并不能消除问题。

实施一个统一且集中的数据处理、清洗、合并和转化策略,使组织能够正确利用数据并保持灵活性。实际上,这部分的数据策略可能是最关键的,因为它使最终用户能够更快地使用数据。

数据委员会的框架

为了成功有效地使用数据,重要的是要聚集合适的利益相关者,以便组织能够在推动数据战略时产生最大的价值。根据你当前的能力和背景,这个委员会应该由以下团队的成员组成:

-

技术方向:监督更广泛的架构影响和技术创新的变化。

-

软件工程:实施并评估新产品和/或功能的可行性。

-

产品:管理软件产品的范围和复杂性,并在短期和长期收益之间进行权衡。确定如何利用数据来实现他们的业务目标。

-

数据运营:对组织的数据有深入理解的数据管理者,负责报告、分析和数据标准。

-

数据科学:定义如何使用数据来开发模型和生成洞察。

-

数据工程:构建从所有数据生成源提取、收集和简化数据的管道,将数据转化为业务可以使用的数据。

-

法律:监督数据使用的隐私、伦理问题和法律影响。

-

高层:定义数据如何帮助公司实现业务目标的高层战略。

如果你之前没有数据委员会,这些问题可能是由较小的软件或数据领导者单位处理的。这对于较小和简单的操作可能有效,但它不适合规模化。根据你的成长阶段,你的委员会可以更小或更大。然而,它应当代表或涵盖上述团队及其职责的关切。

结论

像实施新的业务战略或技术应用一样,实施数据战略是一个不断发展的过程。理解数据战略的必要性以及一个监督其实施的委员会是一个好的开始。组织的成员开始将数据视为一个战略资产,它能够更好地理解他们的业务,以及如何利用数据来创造价值。

对你想要达到的清晰愿景使得数据委员会的成员能够利用他们独特的技能和经验来设计一个适合组织的路线图。

确定所有数据实体、数据源、定义和关系的过程应该是第一步。下一步是定义数据使用的治理标准,以及将所有数据源链接在一起的系统。数据战略中的每个过程都应该有关键的利益相关者来推动该部分过程。例如,来自数据报告和运营团队的成员最有可能适合推动数据治理标准。利用你的数据委员会的专业知识可以确保你能够快速有效地交付和实施数据战略。

参考文献

编辑评论 Deanna Chow、Liela Touré 和 Prateek Sanyal。

想和我们一起工作吗?点击 这里 查看 SSENSE 的所有职位空缺!

简介: Javier Bosch 是 SSENSE 的高级数据科学家。

原文。经授权转载。

相关内容:

-

怀念严格类型化模式

-

推荐系统指标:比较苹果、橙子和香蕉

-

数据湖中的模式演变

更多相关主题

数据科学家与数据工程师之间的墙

原文:

www.kdnuggets.com/2020/02/scaling-wall-data-scientist-data-engineer.html

评论

由 Byron Allen,Servian 的 ML 工程师

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

来源: Chris Gonzalez。

对我来说,今天机器学习(ML)中最令人兴奋的事情,并不在于深度学习或强化学习的前沿,而是如何管理模型以及数据科学家和数据工程师如何有效地作为团队合作。掌握这些,将引导组织实现更有效和可持续的机器学习应用。

遗憾的是,“科学家”和“工程师”之间存在一堵墙。Databricks 的联合创始人兼产品副总裁 Andy Konwinski 和其他人,在最近的一篇关于 MLFlow 的博客文章中指出了一些关键的障碍。Databricks 表示:“构建生产级机器学习应用程序具有挑战性,因为目前没有标准化的方法来记录实验、确保可重复的运行以及管理和部署模型。”

许多今天应用机器学习的主要挑战——无论是技术、商业还是社会方面——的起因在于数据随时间的失衡以及机器学习工件的管理和利用。一个模型可能表现得非常好,但如果底层数据发生漂移且工件未被用来评估性能,那么你的模型将无法很好地泛化或适当地更新。这个问题处于一个模糊地带,既涉及数据科学家,也涉及工程师。

来源: burak kostak。

换句话说,问题的关键在于机器学习中缺少 CI/CD 的原则。如果你的环境发生变化,比如输入数据,而模型没有在其构建目标的背景下进行定期评估,导致其随时间失去相关性和价值,那么即使你可以创建一个非常好的“黑箱”模型也没有意义。这是一个难以解决的问题,因为提供数据的工程师和设计模型的科学家之间的关系并不和谐。

这个挑战有实际的例子。想想那些预测希拉里·克林顿会赢的预测,以及其他几种机器学习的失误。从自动驾驶汽车撞死无辜行人到有偏见的人工智能,已经出现了一些大的失误,我认为这些问题通常起源于数据科学和工程之间的灰色地带。

来源: Kayla Velasquez。

也就是说,机器学习对我们的社会产生了负面和积极的影响。更积极、商业性较少的例子包括electricityMap,它使用机器学习来映射全球电力的环境影响;机器学习在癌症研究中目前帮助我们更早、更准确地检测几种癌症类型;由人工智能驱动的传感器推动Agriculture朝着满足全球日益增长的食品需求迈进。

墙

因此,正确处理生产机器学习(ML),尤其是模型管理,是至关重要的。然而,回到一点,数据科学家和数据工程师并不总是使用相同的语言。

数据科学家往往缺乏对其模型如何在一个不断摄取新数据、整合新代码、被最终用户调用并且偶尔出现多种失败情况的环境中运行的理解(即生产环境)。另一方面,许多数据工程师对机器学习了解不足,不理解他们投入生产的东西以及对组织的影响。

这两个角色往往在没有足够考虑彼此的情况下运作,尽管它们占据了相同的空间。“那不是我的工作”不是正确的态度。为了生产出可靠、可持续和适应性强的产品,这两个角色必须更加有效地协作。

爬墙

交流的第一步是建立共同的词汇——对语义进行某种程度的标准化,从而讨论挑战或相关挑战。自然,这充满了挑战——只要问几个不同的人数据湖是什么,你很可能会得到至少两个不同的答案,甚至更多。

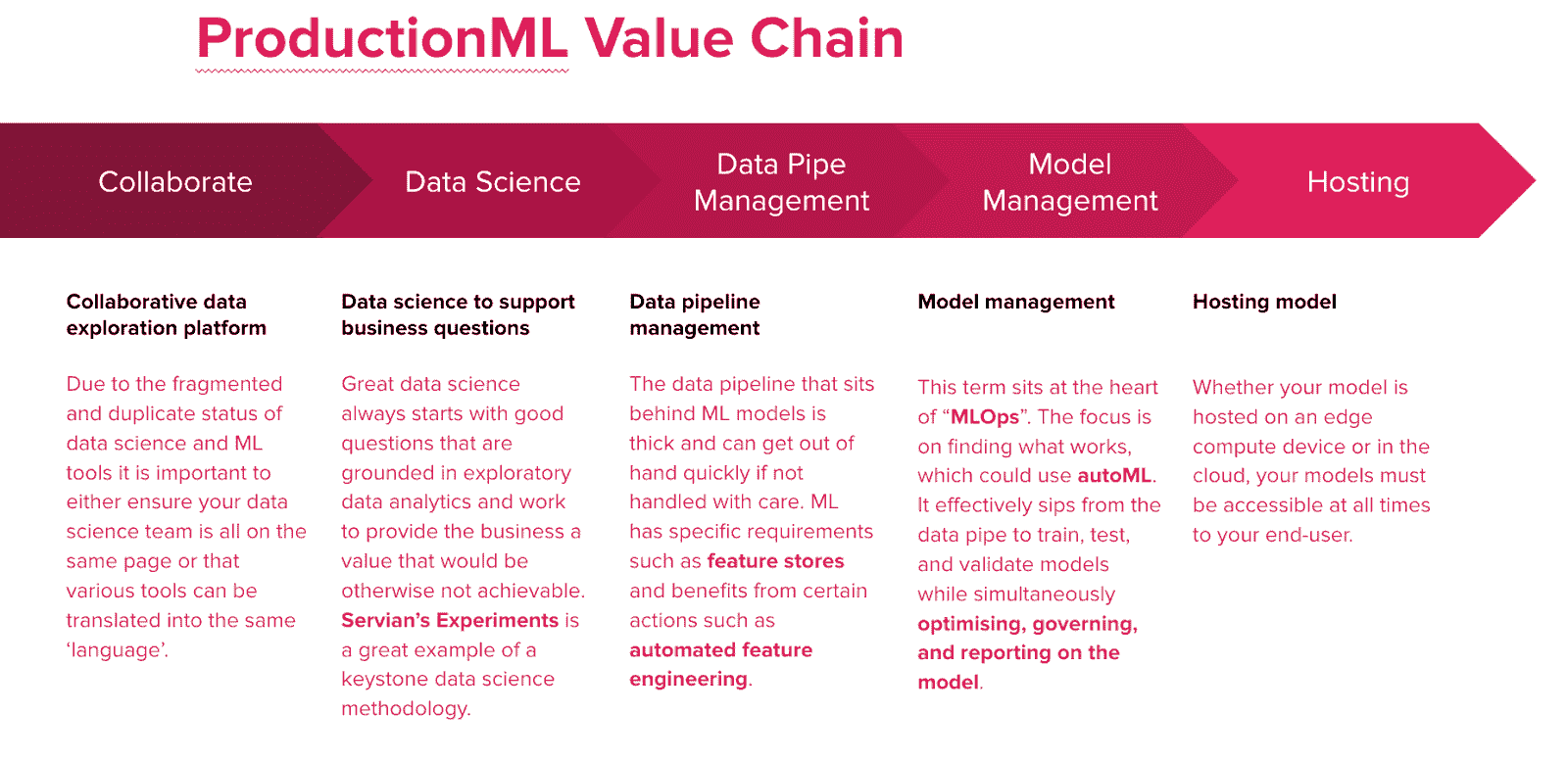

我开发了被称为 ProductionML 价值链和 ProductionML 框架的通用参考点。

我们将生产化 ML 的过程分解为五个重叠的概念,这些概念通常被分开考虑。虽然引入这样一个整体框架可能会增加复杂性和相互依赖性——但实际上,这些复杂性和相互依赖性已经存在——忽视它们只是将问题推迟到未来。

通过在设计你的生产 ML 管道时考虑邻近概念——你开始引入那种难以捉摸的可靠性、可持续性和适应性。

ProductionML 框架

ProductionML 价值链是对运营数据科学和工程团队以便将模型部署到最终用户所需内容的高层描述。自然还有更技术和详细的理解——我称之为 ProductionML 框架(有些人可能称之为持续智能)。

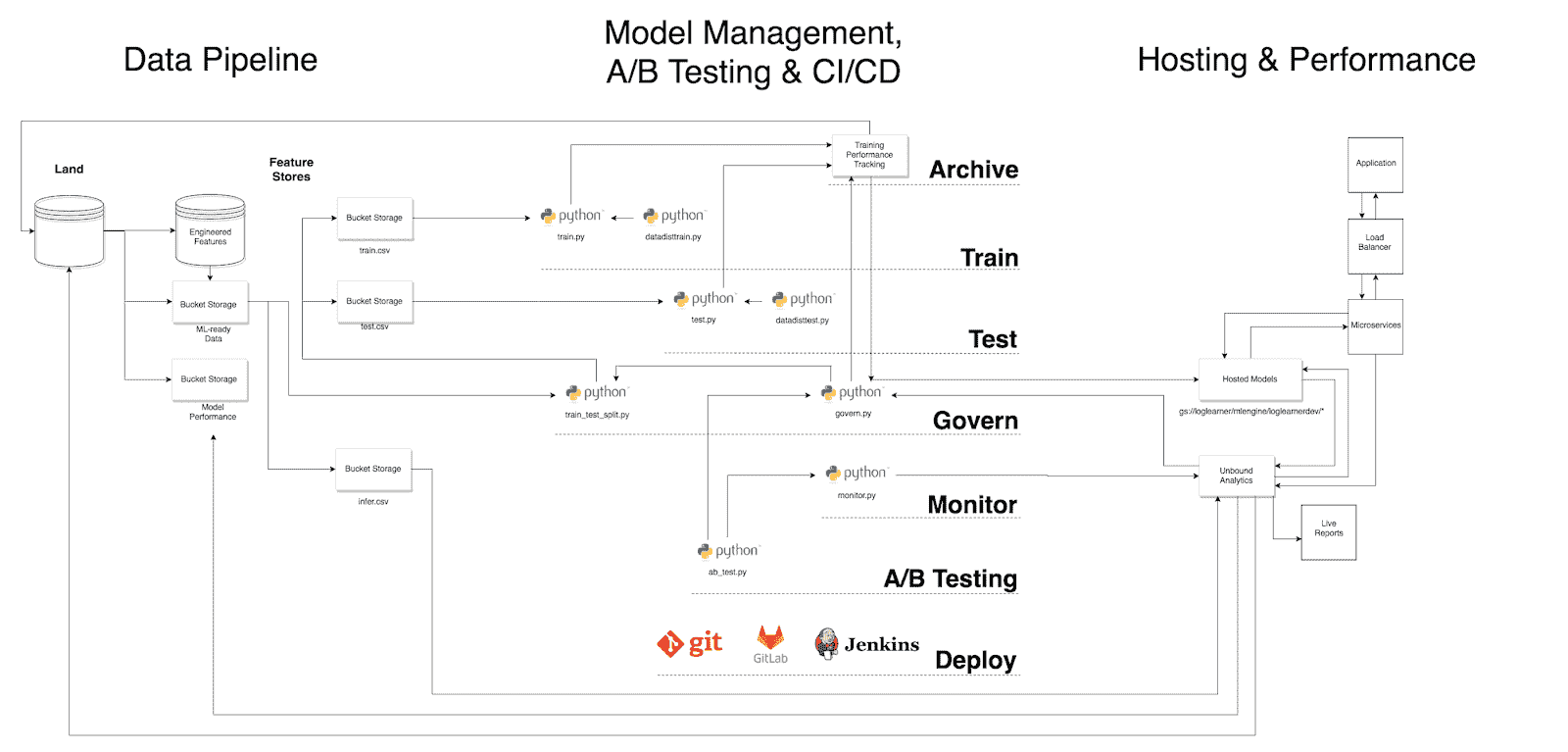

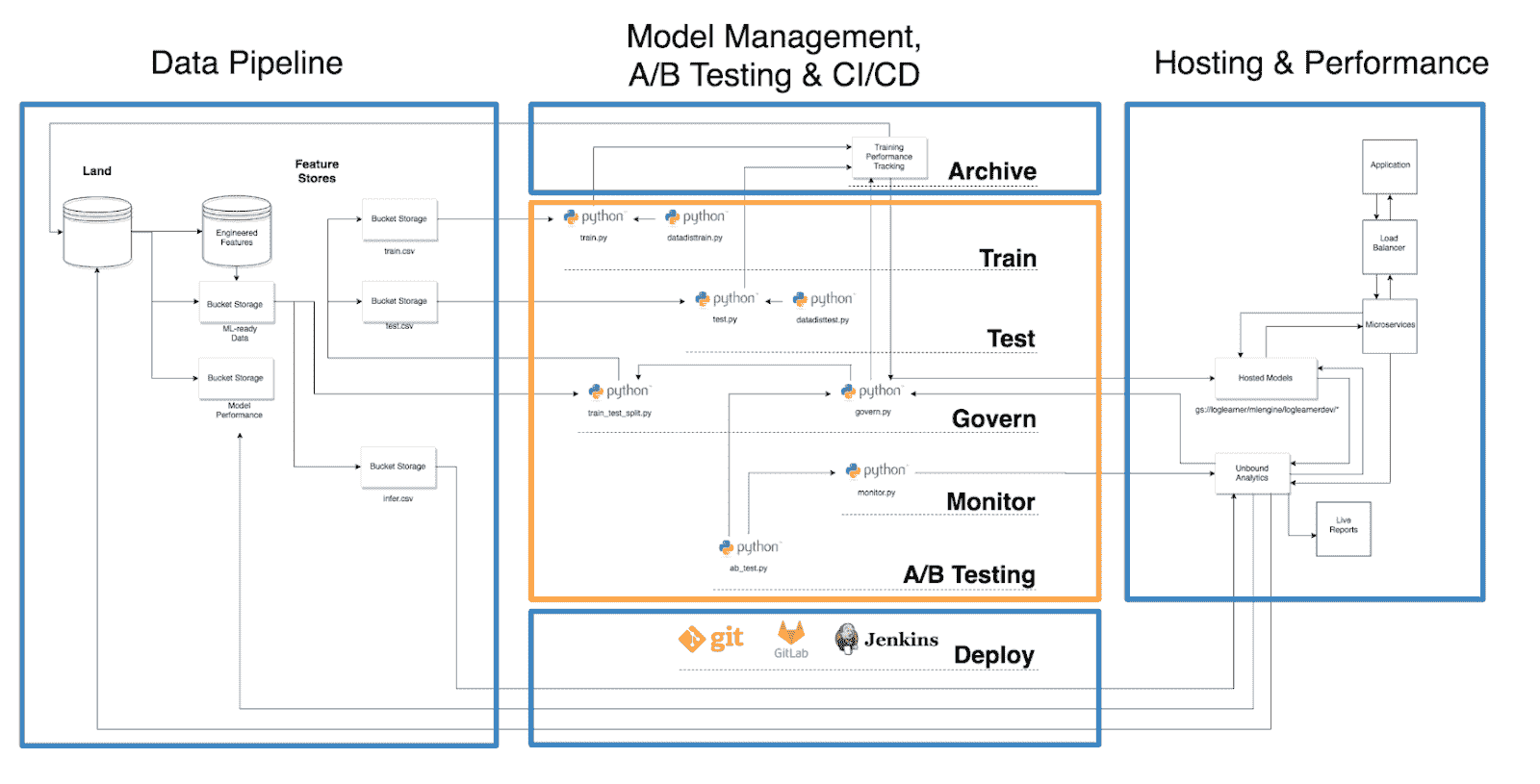

ProductionML 框架。

这个框架是在经过几轮对商业 MLOps 工具、开源选项和内部 PoC 的实验之后开发的。它旨在指导 ProductionML 项目的未来发展,特别是那些需要数据科学家和工程师共同参与的生产 ML 方面。

橙色的数据科学和蓝色的数据工程/DevOps。

如果你对这些方面不太熟悉,请参见橙色的“数据科学”和蓝色的“数据工程/DevOps”。

如你所见,“训练性能跟踪”机制(例如,MLFlow)和 Govern 机制在这个架构中处于核心位置。这是因为每个工件,包括指标、参数和图形,都必须在训练和测试阶段进行归档。此外,被称为模型管理的东西与模型如何被管理是根本相关的,这利用了那些模型工件。

Govern 机制将工件和业务规则结合起来,以推动适当的模型,或更具体地说,是估算器的生产,同时根据特定于用例的规则对其他模型进行标记。这也被称为模型版本控制,但使用“govern”一词是为了避免与版本控制混淆,并强调该机制在监督模型管理中的核心作用。

黄金枪?

我们都在这段旅程中。我们都在尝试攀登这面墙。市场上有许多优秀的工具,但迄今为止,没有人拥有一把金色的枪……

来源:mrgarethm — 黄金枪 — 国际间谍博物馆。

从我的角度来看,MLFlow 取得了巨大进展,它解答了关于模型管理和工件归档的某些问题。其他产品也类似地解决了相对具体的问题——尽管它们的优势可能体现在生产 ML 价值链的其他部分。这在 Google Cloud ML Engine 和 AWS Sagemaker 中可以看到。最近,GCP 发布了 AutoML Tables 的测试版,但即便如此,也无法完全满足所有需求,尽管接近了。

牢记这一持续存在的差异,科学家和工程师之间拥有共同的词汇和框架作为基础至关重要。

墙太高了吗?根据我的经验,答案是否定的,但这并不意味着生产 ML 不复杂。

必须的詹姆斯·邦德名言

M:所以如果我听得没错的话,斯卡拉曼加逃脱了——坐在一辆长出翅膀的车里!

问:哦,这完全可行,先生。事实上,我们现在正在研发一款。

或许这就是你应该如何越过那面墙……

原文。经许可转载。

相关:

更多相关话题

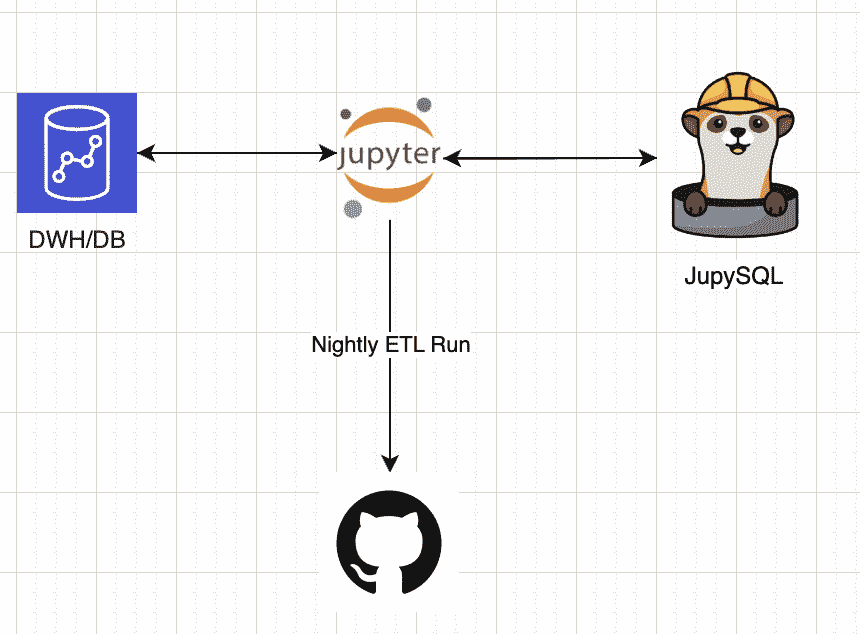

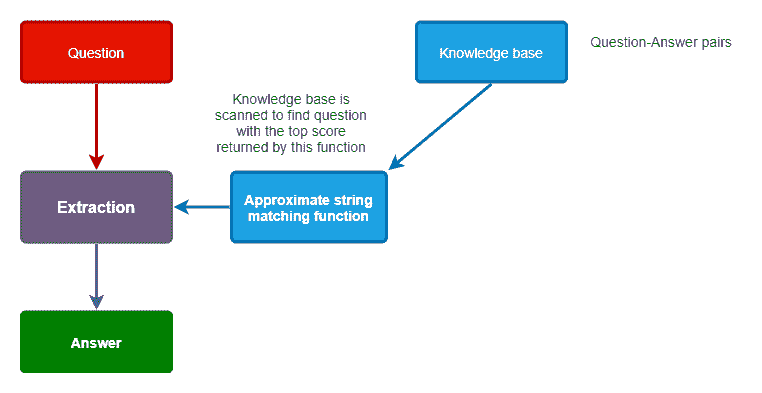

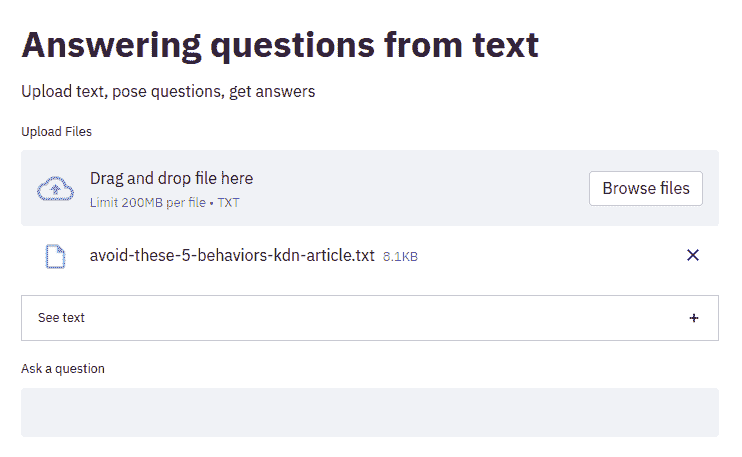

使用 Jupysql 和 GitHub Actions 安排和运行 ETL

原文:

www.kdnuggets.com/2023/05/schedule-run-etls-jupysql-github-actions.html

作者提供的图片

在本博客中你将实现:

-

了解 ETL 和 JupySQL 的基本概念

-

使用公共企鹅数据集并执行 ETL。

-

在 GitHub Actions 上安排我们构建的 ETL。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

介绍

在这份简短而信息丰富的指南中,我们旨在为你提供对 ETL(提取、转换、加载)和 JupySQL 这一灵活且多功能工具的基本概念的全面理解,该工具允许从 Jupyter 中无缝地进行基于 SQL 的 ETL 操作。

我们的主要关注点将是演示如何通过 JupySQL 这一流行且强大的 Python 库有效地执行 ETL 操作,同时强调通过 GitHub Actions 安排完整的 ETL 笔记本的自动化 ETL 过程的好处。

但首先,什么是 ETL?

现在,让我们深入了解细节。ETL(提取、转换、加载)是数据管理中至关重要的过程,它涉及从各种来源提取数据,将提取的数据转换为可用格式,并将转换后的数据加载到目标数据库或数据仓库中。它是数据分析、数据科学、数据集成和数据迁移等多个目的的关键过程。另一方面,JupySQL 是一个广泛使用的 Python 库,它通过 SQL 查询的强大功能简化了与数据库的交互。通过使用 JupySQL,数据科学家和分析师可以轻松执行 SQL 查询,操作数据框,并在 Jupyter 笔记本中与数据库交互。

为什么 ETL 很重要?

ETL 在数据分析和商业智能中扮演着重要角色。它们帮助企业从各种来源收集数据,包括社交媒体、网页、传感器以及其他内部和外部系统。通过这样做,企业可以获得其运营、客户和市场趋势的整体视图。

提取数据后,ETL 将其转换为结构化格式,例如关系数据库,这使企业能够轻松分析和操作数据。通过转换数据,ETL 可以清理、验证和标准化数据,使其更易于理解和分析。

最终,ETL 将数据加载到数据库或数据仓库中,企业可以轻松访问这些数据。通过这样做,ETL 使企业能够访问准确和最新的信息,从而做出明智的决策。

什么是 JupySQL?

JupySQL 是 Jupyter 笔记本的一个扩展,允许您使用 SQL 查询与数据库进行交互。它提供了一种方便的方式,直接从 Jupyter 笔记本访问数据库和数据仓库,使您能够执行复杂的数据操作和分析。

JupySQL 支持多种数据库管理系统,包括 SQLite、MySQL、PostgreSQL、DuckDB、Oracle、Snowflake 等(查看左侧的集成部分了解更多信息)。您可以使用标准连接字符串或通过环境变量连接到数据库。

为什么选择 JupySQL?

JupySQL 是一个强大的工具,便于在 Jupyter 笔记本中直接使用 SQL 查询与数据库进行交互。为了高效和准确地执行数据提取和转换过程,在通过 JupySQL 执行 ETL 时有几个关键因素需要考虑。JupySQL 为用户提供了与数据源交互并轻松进行数据转换的必要工具。为了节省宝贵的时间和精力,同时确保一致性和可靠性,通过 GitHub Actions 调度完整的 ETL 笔记本来自动化 ETL 过程可能是一个改变游戏规则的选择。通过利用 JupySQL,用户可以实现数据交互性(Jupyter)和易用性及 SQL 连接性(JupySQL)的最佳结合,从而简化数据管理过程,使数据科学家和分析师能够专注于他们的核心能力——生成有价值的见解和报告。

开始使用 JupySQL

要使用 JupySQL,您需要使用 pip 安装它。您可以运行以下命令:

!pip install jupysql --quiet

安装后,您可以使用以下命令在 Jupyter 笔记本中加载扩展:

%load_ext sql

加载扩展后,您可以使用以下命令连接到数据库:

%sql dialect://username:password@host:port/database

例如,要连接到本地 DuckDB 数据库,您可以使用以下命令:

%sql duckdb://

使用 JupySQL 执行 ETL

使用 JupySQL 执行 ETL 时,我们将遵循标准 ETL 流程,其中包括以下步骤:

-

提取数据

-

转换数据

-

加载数据

-

提取数据

提取数据

要使用 JupySQL 提取数据,我们需要连接到源数据库并执行查询以检索数据。例如,要从 MySQL 数据库中提取数据,我们可以使用以下命令:

%sql mysql://username:password@host:port/database

data = %sql SELECT * FROM mytable

该命令使用指定的连接字符串连接到 MySQL 数据库,并从“mytable”表中检索所有数据。数据存储在名为“data”的变量中,作为 Pandas DataFrame。

注意:我们还可以使用 %%sql df << 将数据保存到 df 变量中

由于我们将通过 DuckDB 在本地运行,我们可以直接提取一个公共数据集并立即开始工作。我们将获取我们的样本数据集(我们将通过 csv 文件处理企鹅数据集):

from urllib.request import urlretrieve

_ = urlretrieve(

"https://raw.githubusercontent.com/mwaskom/seaborn-data/master/penguins.csv",

"penguins.csv",

)

我们可以获取数据的样本,以检查我们是否已连接并且可以查询数据:

SELECT *

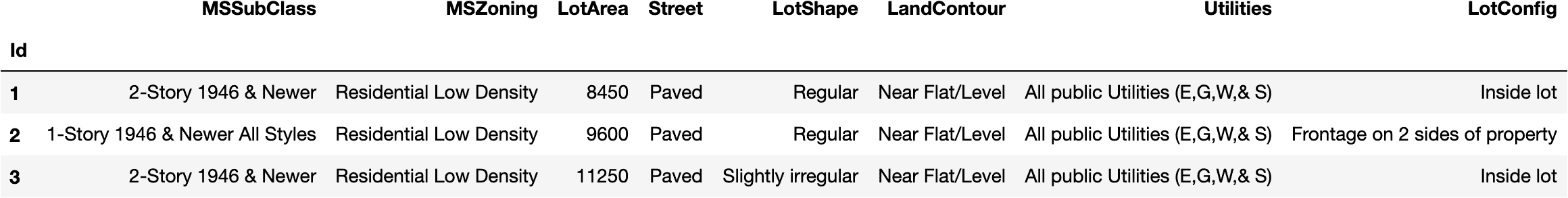

FROM penguins.csv

LIMIT 3

转换数据

提取数据后,通常需要将其转换为更适合分析的格式。此步骤可能包括数据清理、数据过滤、数据聚合和合并来自多个来源的数据。以下是一些常见的数据转换技术:

-

清理数据:数据清理涉及删除或修复数据中的错误、不一致性或缺失值。例如,你可能会删除缺失值的行,将缺失值替换为均值或中位数,或修正错别字或格式错误。

-

过滤数据:数据过滤涉及选择符合特定标准的数据子集。例如,你可以过滤数据,仅包含特定日期范围的记录,或符合某一阈值的记录。

-

聚合数据:数据聚合涉及通过计算统计数据(如某个变量的总和、均值、中位数或计数)来总结数据。例如,你可以按月或按产品类别聚合销售数据。

-

合并数据:数据合并涉及将来自多个来源的数据合并为一个数据集。例如,你可以合并关系数据库中不同表的数据,或合并不同文件中的数据。

在 JupySQL 中,你可以使用 Pandas DataFrame 方法进行数据转换,也可以使用原生 SQL。例如,你可以使用 rename 方法重命名列,使用 dropna 方法删除缺失值,使用 astype 方法转换数据类型。我将演示如何使用 pandas 或 SQL 来完成这些操作。

- 注意:你可以使用

%sql或%%sql,了解它们之间的区别,请查看 这里

这是一个如何使用 Pandas 和 JupySQL 替代方案进行数据转换的示例:

# Rename columns

df = data.rename(columns={'old_column_name': 'new_column_name'}) # Pandas

%%sql df <<

SELECT *, old_column_name

AS new_column_name

FROM data; # JupySQL

# Remove missing values

data = data.dropna() # Pandas

%%sql df <<

SELECT *

FROM data

WHERE column_name IS NOT NULL; # JupySQL single column, can add conditions to all columns as needed.

# Convert data types

data['date_column'] = data['date_column'].astype('datetime64[ns]') # Pandas

%sql df <<

SELECT *,

CAST(date_column AS timestamp) AS date_column

FROM data # Jupysql

# Filter data

filtered_data = data[data['sales'] > 1000] # Pandas

%%sql df <<

SELECT * FROM data

WHERE sales > 1000; # JupySQL

# Aggregate data

monthly_sales = data.groupby(['year', 'month'])['sales'].sum() # Pandas

%%sql df <<

SELECT year, month,

SUM(sales) as monthly_sales

FROM data

GROUP BY year, month # JupySQL

# Combine data

merged_data = pd.merge(data1, data2, on='key_column') # Pandas

%%sql df <<

SELECT * FROM data1

JOIN data2

ON data1.key_column = data2.key_column; # JupySQL

在我们的示例中,我们将使用简单的转换方式,类似于上述代码。我们将清理数据中的 NA,并将一列(species)拆分成 3 列(分别命名为每种物种):

# Combine data

merged_data = pd.merge(data1, data2, on='key_column') # Pandas

%%sql df <<

SELECT * FROM data1

JOIN data2

ON data1.key_column = data2.key_column; # JupySQL

SELECT *

FROM penguins.csv

WHERE species IS NOT NULL AND island IS NOT NULL AND bill_length_mm IS NOT NULL AND bill_depth_mm IS NOT NULL

AND flipper_length_mm IS NOT NULL AND body_mass_g IS NOT NULL AND sex IS NOT NULL;

# Map the species column into classifiers

transformed_df = transformed_df.DataFrame().dropna()

transformed_df["mapped_species"] = transformed_df.species.map(

{"Adelie": 0, "Chinstrap": 1, "Gentoo": 2}

)

transformed_df.drop("species", inplace=True, axis=1)

# Checking our transformed data

transformed_df.head()

加载数据

转换数据后,我们需要将数据加载到目标数据库或数据仓库中。我们可以使用 ipython-sql 连接到目标数据库并执行 SQL 查询以加载数据。例如,要将数据加载到 PostgreSQL 数据库中,我们可以使用以下命令:

%sql postgresql://username:password@host:port/database

%sql DROP TABLE IF EXISTS mytable;

%sql CREATE TABLE mytable (column1 datatype1, column2 datatype2, ...);

%sql COPY mytable FROM '/path/to/datafile.csv' DELIMITER ',' CSV HEADER;

此命令使用指定的连接字符串连接到 PostgreSQL 数据库,删除“mytable”表(如果存在),创建一个具有指定列和数据类型的新表,并从 CSV 文件中加载数据。

由于我们的用例是本地使用 DuckDB,我们可以简单地将新创建的 transformed_df 保存为 CSV 文件,但我们也可以使用上面的代码片段根据我们的用例将其保存到数据库或数据仓库中。

运行以下步骤以将新数据保存为 CSV 文件:

transformed_df.to_csv("transformed_data.csv")

我们可以看到一个名为 transformed_data.csv 的新文件被创建了。在下一步中,我们将看到如何自动化这个过程并通过 GitHub 消耗最终文件。

GitHub actions 上的调度

我们流程中的最后一步是通过 GitHub actions 执行完整的 notebook。为此,我们可以使用 ploomber-engine,它允许你调度 notebooks,以及其他 notebook 功能,如分析、调试等。如果需要,我们可以向 notebook 传递外部参数,并将其制作成通用模板。

- 注意:我们的 notebook 文件正在加载一个公共数据集,并在本地 ETL 后保存,我们可以轻松地更改为使用任何数据集,并将其加载到 S3,作为仪表盘可视化数据等。

对于我们的示例,我们可以使用这个示例 ci.yml 文件(这是设置 GitHub 工作流的文件),并将其放入我们的代码库中,最终文件应位于 .github/workflows/ci.yml 下。

ci.yml 文件的内容:

name: CI

on:

push:

pull_request:

schedule:

- cron: '0 0 4 * *'

# These permissions are needed to interact with GitHub's OIDC Token endpoint.

permissions:

id-token: write

contents: read

jobs:

report:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python ${{ matrix.python-version }}

uses: conda-incubator/setup-miniconda@v2

with:

python-version: '3.10'

miniconda-version: latest

activate-environment: conda-env

channels: conda-forge, defaults

- name: Run notebook

env:

PLOOMBER_STATS_ENABLED: false

PYTHON_VERSION: '3.10'

shell: bash -l {0}

run: |

eval "$(conda shell.bash hook)"

# pip install -r requirements.txt

pip install jupysql pandas ploomber-engine --quiet

ploomber-engine --log-output posthog.ipynb report.ipynb

- uses: actions/upload-artifact@v3

if: always()

with:

name: Transformed_data

path: transformed_data.csv

在这个 CI 示例中,我还添加了一个计划触发器,这个任务将每晚凌晨 4 点运行。

结论

ETL 是数据分析和商业智能的重要过程。它们帮助企业从各种来源收集、转换和加载数据,使分析和做出明智决策变得更加容易。JupySQL 是一个强大的工具,允许你直接在 Jupyter notebooks 中使用 SQL 查询与数据库交互。结合 GitHub actions,我们可以创建强大的工作流,这些工作流可以被调度并帮助我们将数据处理到最终阶段。

使用 JupySQL,你可以轻松高效地执行 ETL,允许你以结构化格式提取、转换和加载数据,同时 GitHub actions 分配计算资源并设置环境。

Ido Michael 共同创办了 Ploomber,旨在帮助数据科学家更快地构建。他曾在 AWS 领导数据工程/科学团队。在这些客户互动中,他和团队一起单独构建了数百个数据管道。来自以色列的他来到纽约攻读哥伦比亚大学的硕士学位。他专注于构建 Ploomber,因为他发现项目通常将大约 30% 的时间用于将开发工作(原型)重构为生产管道。

更多相关主题

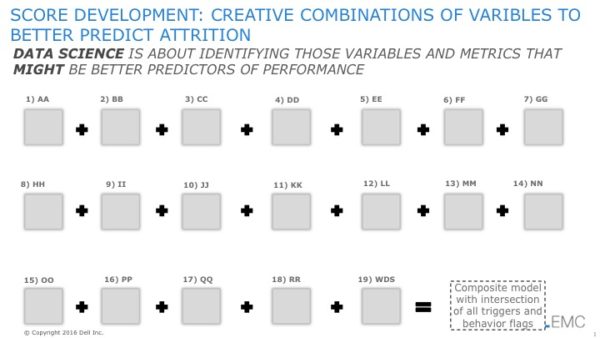

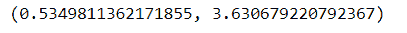

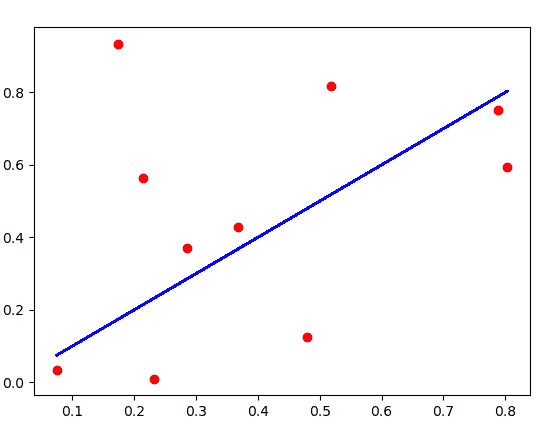

识别可能更好预测的变量

原文:

www.kdnuggets.com/2017/02/schmarzo-variables-better-predictors.html

我喜欢书籍《点球成金》中所传授的数据科学概念的简洁性。每个人都想直接跳入那些内容丰富、高度技术性的数据库书籍。但我建议我的学生先从《点球成金》开始。这本书很好地展现了数据科学的力量(而且电影不算,因为我妻子看了后只记得“布拉德·皮特真帅!”... 哎)。我最喜欢的课程之一就是对数据科学的定义:

数据科学就是识别那些 可能 是更好表现预测指标的变量和指标

我们的前三个课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

3. Google IT Support Professional Certificate - 支持你的组织进行 IT 方面的工作

3. Google IT Support Professional Certificate - 支持你的组织进行 IT 方面的工作

这个直接的定义为定义业务利益相关者和数据科学团队的角色和责任奠定了基础:

-

业务利益相关者负责识别(头脑风暴)那些 可能 是更好表现预测指标的变量和指标,并且

-

数据科学团队负责量化哪些变量和指标实际上 是 更好的表现预测指标

这种方法利用了业务利益相关者最了解的内容——即业务。同时,这种方法也利用了数据科学团队最了解的内容——即数据转换、数据丰富、数据探索和分析建模。完美的数据科学团队!

注意:词汇“might” 可能是数据科学定义中最重要的词汇。业务利益相关者必须感到舒适,能够头脑风暴不同的变量和指标,这些变量和指标 可能 更好地预测表现,而不必担心他们的想法会被评判。我们的一些最佳想法来自那些声音通常不会被听到的人。我们的大数据愿景研讨会过程将所有想法视为值得考虑的。如果你不接受这一概念,你可能会限制业务利益相关者的创造性思维,或者更糟的是,错过可能有价值的数据洞察。

这篇博客旨在扩展数据科学团队用来识别(和量化)哪些变量和指标 是 更好预测表现的方式。让我通过一个例子来说明。

我们最近与一家金融服务机构合作,他们要求我们预测客户流失者,即识别哪些客户有可能结束与组织的关系。正如我们在大数据愿景研讨会中通常做的那样,我们与业务利益相关者举行了促进性头脑风暴会议,以识别可能是更好预测绩效的变量和指标(见图 1)。

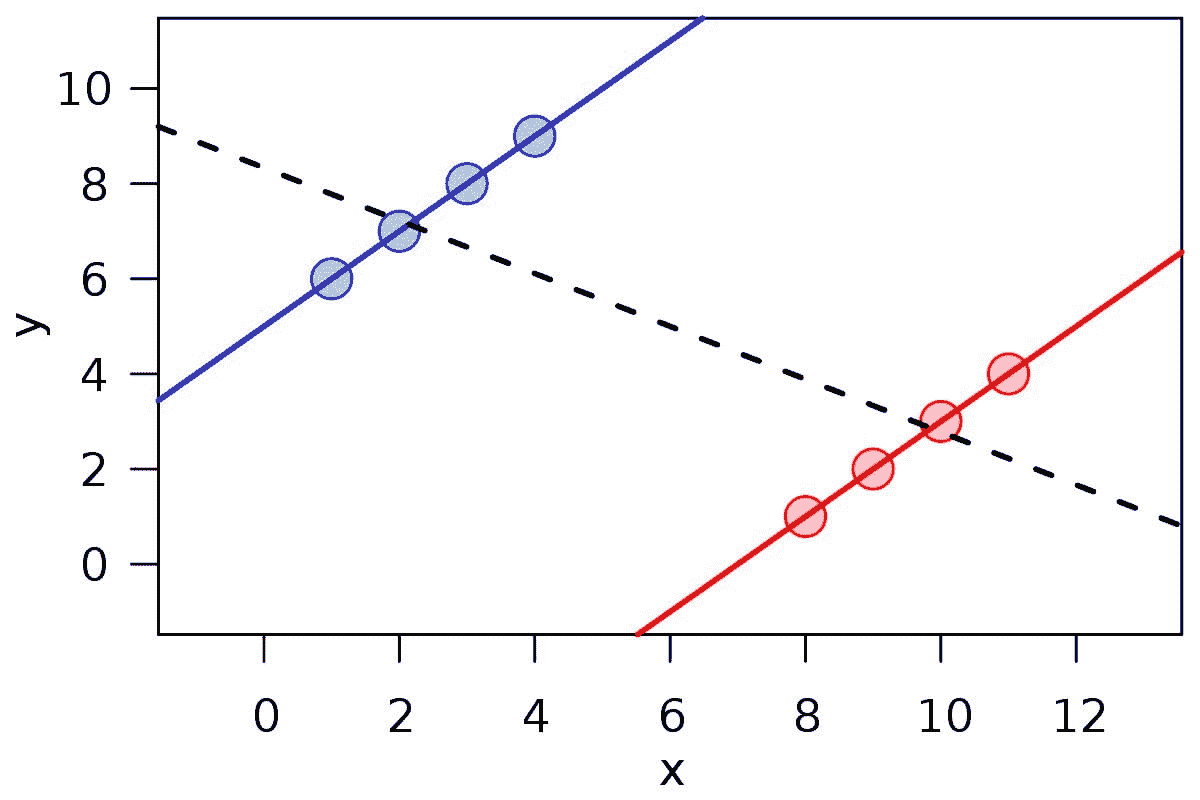

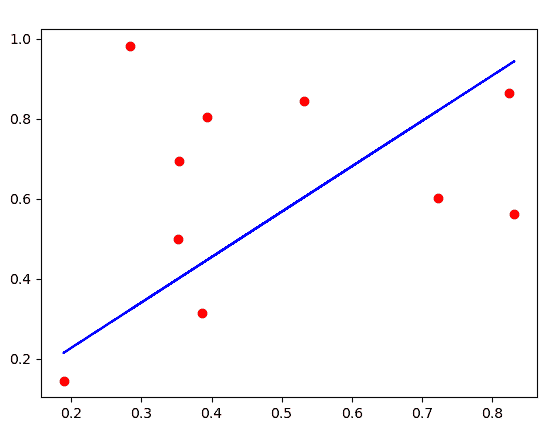

图 1: 头脑风暴可能是更好预测变量和指标

注意:由于客户的竞争优势原因,我不得不模糊处理我们识别出的确切指标。是的,我喜欢这样!

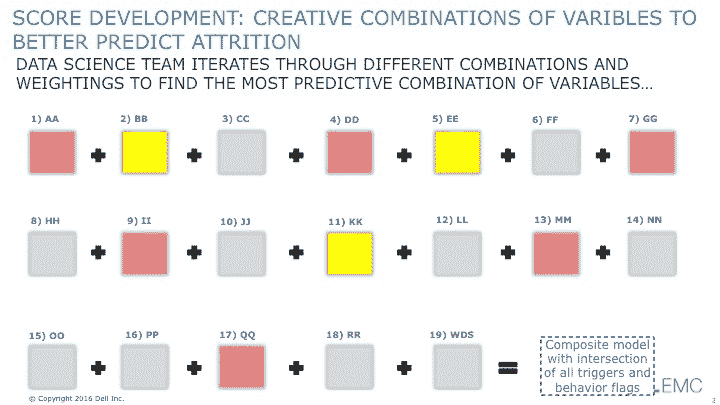

从这些变量和指标的列表中,数据科学团队寻求创建一个“流失评分”,用于识别(或评分)有风险的客户。数据科学团队采纳了迭代的“快速失败/更快学习”过程,测试不同的变量和指标组合。数据科学团队测试了不同的数据增强和转化技术以及不同的分析算法,并尝试了不同变量和指标的组合,以查看哪些变量组合产生了最佳结果(见图 2)。

图 2: 探索不同的变量和指标组合

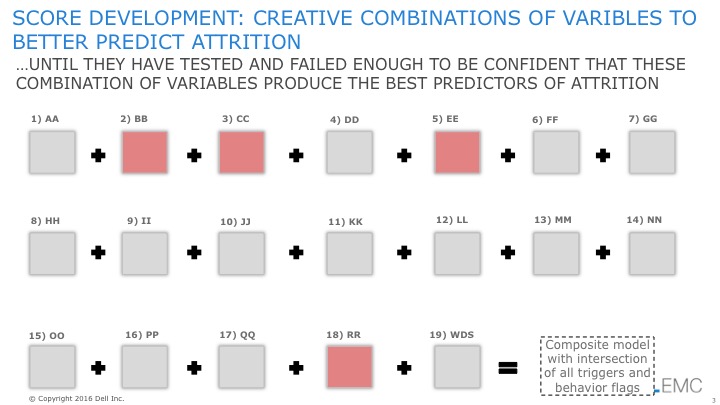

数据科学团队面临的挑战是不能满足于第一个“有效”的模型。数据科学团队需要不断突破极限,因此,需要在测试不同的变量组合时经历足够多的失败,才能对最终模型的结果充满信心。

经过大量的测试和失败——以及测试和失败——再测试和失败,数据科学团队提出了一个“流失评分”模型,该模型经过足够的失败,使他们对结果充满信心(见图 3)。

图 3: 识别出更好的预测变量和指标

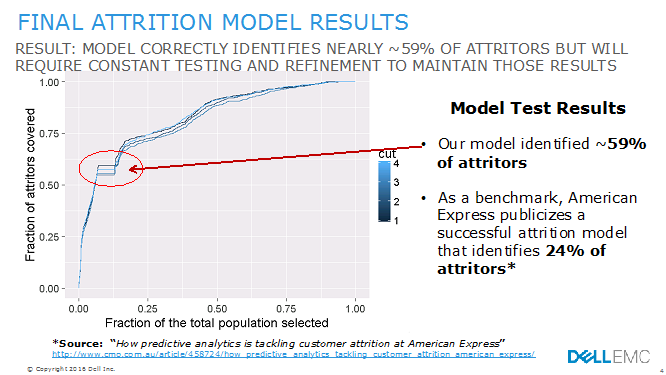

我们需要一种方法,能够充分发挥项目中每个人的作用——业务利益相关者进行变量和指标的头脑风暴,以及数据科学团队创造性地测试不同的组合。此次参与的最终结果相当令人印象深刻(见图 4):

-

Dell EMC 过程生成了一个模型,识别出了约 59% 的流失者

-

作为基准,American Express 宣布了一种成功的流失模型,识别出 24%的流失客户(来源:“预测分析如何应对 American Express 的客户流失”)。

图 4: 最终流失模型结果

将不同变量和指标结合起来的创造性数据科学过程高度依赖于业务利益相关者头脑风暴练习的成功。如果业务利益相关者没有在这一过程中早期参与,并被允许创造性地思考哪些变量和指标可能是更好的绩效预测因素,那么数据科学团队将寻求测试的变量和指标的集合将受到限制。换句话说,数据科学过程的成功和可操作评分的创建高度依赖于业务利益相关者在过程开始时的创造性参与。

这就是我们大数据愿景研讨会过程的力量。

如果你有兴趣了解更多关于戴尔 EMC 大数据愿景研讨会的信息,请查看下面的博客:

原文。已获许可转载。

相关:

-

公民数据科学家、巨型虾和其他无意义的描述

-

物联网(IoT)挑战:呼救的传感器

-

确定数据的经济价值

更多相关主题

让数据科学回归“科学”

评论

评论

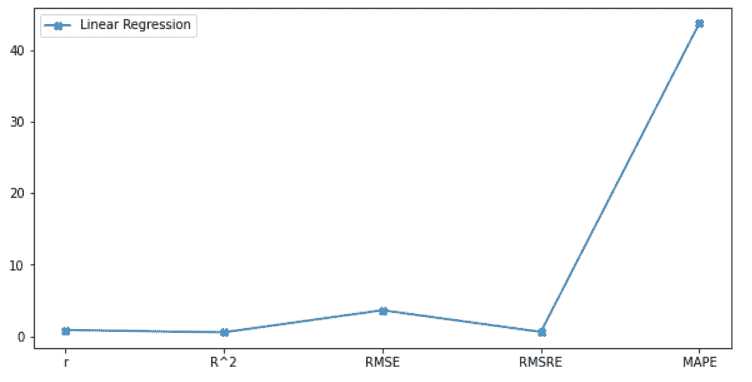

作者:Rubens Zimbres,数据科学家及机器学习研究员。

最近,我看到很多关于数据科学领域的炒作,以及很多新手加入这个领域。但在我看来,数据科学中的“科学”究竟是什么?科学方法来解决问题,是应对问题并提供最佳解决方案的最好方式。如果你开始数据分析时只是简单地陈述假设并应用机器学习算法,那么这就是错误的方法。

我们的三大课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业生涯

1. Google 网络安全证书 - 快速入门网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 工作

3. Google IT 支持专业证书 - 支持你的组织 IT 工作

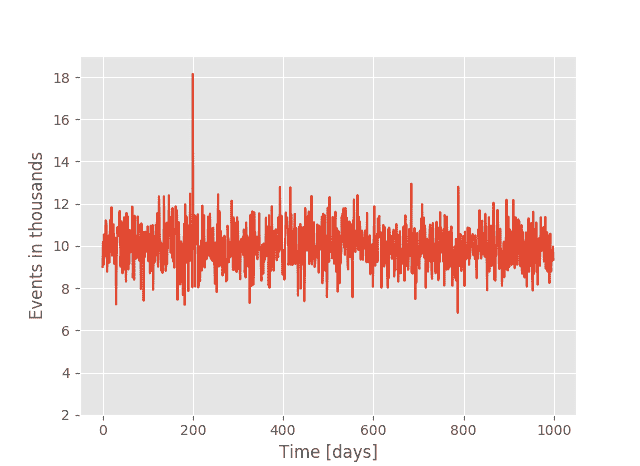

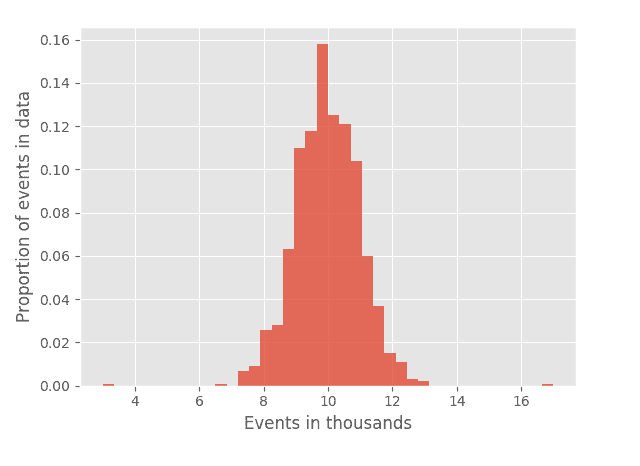

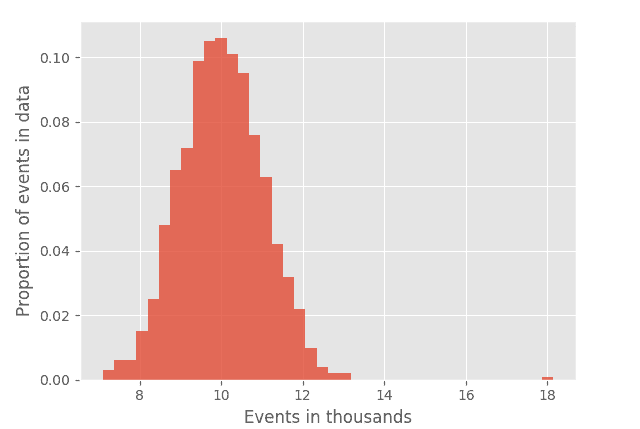

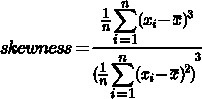

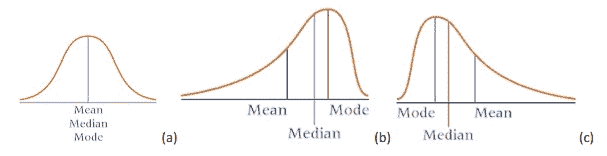

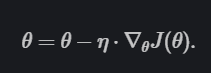

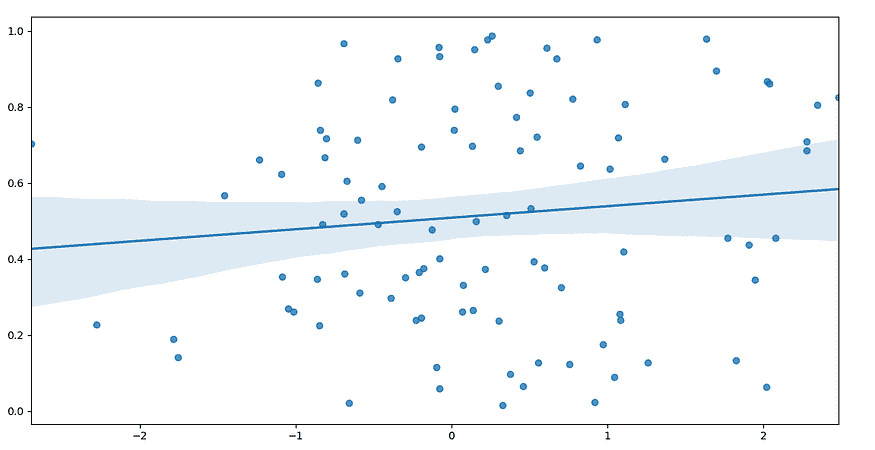

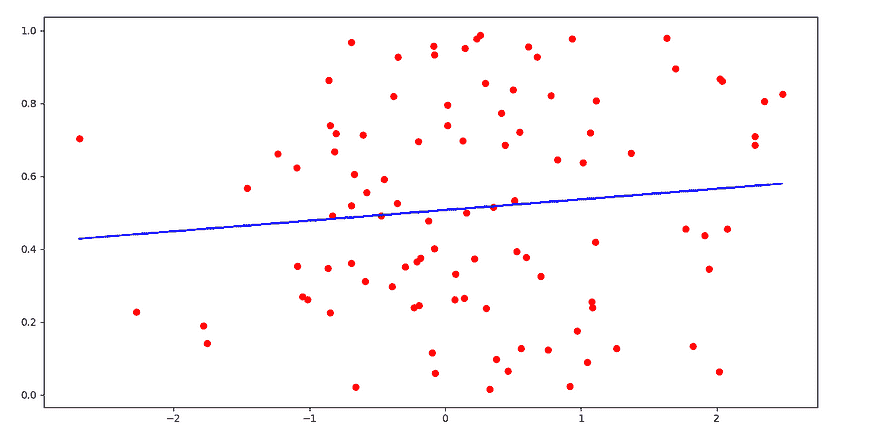

下面的图片展示了科学研究所需的步骤,包括相应的数据分析和模拟。实际上,这是我在博士论文中做的草图。简而言之,我研究了过去 27 年的商业管理文献,并试图开发一种知识上颠覆性的方式来衡量和预测服务质量,将商业管理与电气工程概念相结合。在 4 年的过程中,我进行了定性-定量纵向研究,并使用基于代理的建模开发了一个模拟,试图找到一种可以模拟人类行为的 5 状态细胞自动机规则。我探讨了复杂性概念、自组织系统、秩序的涌现和社会网络。

一篇论文发表在 Elsevier 的《电子计算机科学理论笔记》(Electronic Notes in Theoretical Computer Science)(2009),标题为《社交网络中质量感知的动态:一种基于细胞自动机的美学服务模型》。

我从科学方法中学到的一件事是,在解决问题时要摆脱先验和后验偏见。先验偏见发生在你以预先设定的想法开始分析时。在这种情况下,你的发现只会确认你最初陈述的内容,因为整个研究过程都存在偏见。后验偏见发生在你开始分析某事时,但实际上你已经知道结果是什么,这样整个过程也会有偏见。

一旦你摆脱了对问题的先入为主的想法,你会找到解决问题的新方法。在数据科学过程中,这一点至关重要,因为创造力能让你对整个环境有一个清晰的认识。

首先,什么是业务问题?你想实现什么目标?你是想利用利润、投资回报吗?你是否清楚你的业务如何为客户增加价值?什么是价值?客户到底是谁?客户的需求和认知是什么?你打算如何获取这些数据?是否有市场研究可以与业务数据一起使用?

要开始构建科学的解决问题的方法,首先定义问题、文献中的空白(如果你是硕士或博士生)或业务需求:发生了什么,想要实现什么,策略和数据分析的受益者(利益相关者)是谁,何时开始和结束,使用什么资源和算法,如何实现目标以及为什么?

在评估所有这些变量并制作思维导图后,问问自己:问题中涉及了什么类型的知识?假设你正在处理客户流失问题。是什么让人们离开你的业务?当然,任何人都可以对原因有直觉,但请记住,科学文章是比随机猜测更有价值的知识来源。

假设客户离开是因为他们没有看到业务中的价值。价值是一些独特的东西,通常由人力资源提供,无法被复制,也没有竞争对手能提供。这带来了竞争优势、更多利润、忠诚度、口碑宣传和回购。

注意到到目前为止我们甚至没有考虑假设和算法。只有在准确知道问题中涉及哪些变量之后,我们才会制定假设。假设你认为利润受到对产品质量的正面客户认知和关于你公司的高口碑广告的影响。这就是名义网络,你在其中绘制相关性和因果关系。在数据科学中,你需要了解客户的认知,并且是否存在口碑广告。然后你会发现你在处理不同的数据集,一个是市场研究数据,另一个是社交媒体推荐。你还有另一个包含公司财务数据的数据集(包含利润数据)。

现在是时候选择了:你是选择定量方法,使用市场研究数据集和财务数据中的结构化数据吗?但社交媒体是非结构化的,因此你必须使用自然语言处理进行定性分析。更糟糕的是,你想进行纵向分析,将数据转换为时间序列并用 ARIMA 进行分析。啊,利润可以通过深度神经网络来预测,使用市场研究数据、财务数据和社交媒体中的词嵌入作为特征!

现在我们进入了数据科学家的乐趣:算法、分类、回归、深度学习、无监督学习、准确性、过拟合、偏差-方差权衡、超参数调优。乐趣开始了!

是的,乐趣已经开始,但请注意,在这个具体案例中,我们在到达算法之前经历了一段漫长的旅程。在研究问题的规划方面有整个过程。不能仅仅“应用算法”并检查拟合和过拟合的度量。另一个大问题是,当你对发生的事情有一个完整的认识时,你通常会发现需要的数据并不存在。

然后是你算法的验证过程。关于模型的外部有效性(泛化能力)有很多讨论:你的模型在训练集和测试集上的表现良好,几乎没有过拟合,但这些发现是否适用于新情况?你的测试集分布是否能复制现实世界场景?是的,但我们不能忘记其他类型的验证,例如:

-

实证验证: 与现实的比较成功

-

概念验证: 你的机器学习模型成功地将自然系统转化为数学语言

-

内部验证: 你的代码没有错误

-

你的模型是否展现了遍历性(在人工智能和复杂行为不存在时的稳定性)和同方差性

在验证你的数据分析结果后,你将确认或拒绝假设,并向高层管理人员建议战略举措。请注意,数据科学家需要商业管理人员的全面参与才能成功。数据分析和建模的发现必须为战略决策、市场定位、产品发布、品牌形象等多个领域提供洞察。

所以,数据科学中的科学不仅仅涉及机器学习、深度学习、自然语言处理、人工智能算法和公式。这不仅仅是 STEM。它涉及我们从学术界借鉴的一种跨学科且严谨的方法,旨在为企业带来超出平均水平的利润,常常涉及心理学、博弈论、商业管理、复杂性、非线性效应和复杂因果关系。

简介:鲁本斯·辛布雷斯 是一名数据科学家,拥有电气工程方向的工商管理硕士和博士学位。他的研究重点是机器学习、深度学习和自然语言处理。

相关:

-

应用于大数据的机器学习,解释

-

特征选择的实际重要性

-

教学数据科学过程

更多相关内容

科学债务——对数据科学意味着什么?

评论

评论

由David Robinson,Datacamp 提供

在软件工程中,一个非常有用的概念是技术债务。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

技术债务发生在工程师选择了一个快速但不理想的解决方案,或者没有花时间建立可持续的基础设施。也许他们正在使用一种在团队和代码库扩展时不够灵活的方法(例如硬编码“魔法数字”),或出于便利而非适当性使用工具(“我们将用 PHP 编写 DevOps 基础设施,因为这是我们团队已经掌握的”)。无论如何,这是一种看起来最初有效,但在长期中会带来真正挑战的情况,比如推迟功能发布和难以修复的漏洞。

在我担任DataCamp 首席数据科学家的新工作中,我一直在思考数据科学在企业中的角色,并与该领域的其他专业人士讨论。在今年早些时候的一个讨论小组上,我意识到数据科学家有一个大致相当于这一概念的东西:“科学债务。”

科学债务是指团队在数据分析、实验实践和监控中采取的捷径,这些捷径可能会带来长期的负面影响。 当你听到这样的陈述时:

-

“我们没有足够的时间进行随机测试,让我们直接上线吧”

-

“初步估计,这个效应可能是线性的”

-

“这可能是一个混淆因素,但我们稍后会研究这个问题”

-

“至少在方向上是准确的”

你听到的是一些“借用”的科学债务。

示例:WidgetCorp

大多数工程师对公司在面对技术债务时的感觉有所了解。一个面临科学债务的公司会是什么样子?

想象一个小型初创公司 WidgetCorp 正在开发一款 B2B 产品,并决定他们的销售策略。某一年,他们决定开始将销售重点放在较大的企业客户上。他们注意到,随着这种新策略的实施,他们的月收入有所增加。他们因此受到鼓舞,并在接下来几年中聘请了半打有大型客户经验的销售人员,投入营销和设计工作,将其作为品牌的一部分。

几年后,这种策略似乎没有带来预期的效果:他们的收入陷入困境,早期的成功没有重现。他们聘请了一位分析师,查看了他们的销售数据,并发现实际上他们从未在向大公司销售时获得更高的投资回报率。在早期那一年,他们的收入上升是因为季节性效应(秋冬季节对小部件的需求增加),这与一些随机噪声和轶事(例如“SmallCompany.com 是浪费时间,但我们刚刚与 Megabiz 签署了一份大单!”)叠加在一起。

WidgetCorp 承担了过多的科学债务。

这可能发生的几种方式:

他们基于有缺陷的分析做出了不可逆转的决定。 对于指标,快速查看并欣慰地发现它们朝着正确的方向发展是合理的。但一旦公司在产品、销售和市场营销上做出了改变,就很难再进行调整。在做出重大业务变动之前,值得确保数据能够支持这些决策:即确保他们已经考虑了季节性影响,并应用了适当的统计测试。

缺乏监控。在早期,可能没有足够的数据来判断大型客户是否是更好的投资。但是随着更多数据的收集,值得不断测试这个假设,形式可以是仪表板或季度报告。如果没有进行跟踪,即使他们获得了数据,也没有人会注意到这个假设被证伪了。

数据基础设施的缺乏:也许在公司早期,潜在客户被锁定在销售 CRM 系统中,而会计数据则存储在通过电子邮件传送的 Excel 电子表格中。即便公司内有专门的分析师,他们也可能无法轻易获取相关数据(例如,将销售成功与公司规模联系起来)。即使理论上可以通过一些努力将数据集结合起来,懒惰盲点 也可能让每个人都完全避免进行分析。这是一个技术债务和科学债务常常一起出现的领域,因为解决科学问题需要工程方面的努力。

传播不准确的传说。假设 WidgetCorp 的 CEO 进行了一系列公司范围的演讲和公开博客文章,传达的信息是“WidgetCorp 的未来是服务大公司!”产品团队开始习惯性地优先考虑这个方向的功能,每次失败都归咎于“我想我们没有足够专注于大客户”。这种“文化惯性”可能非常难以扭转,即使高管团队愿意公开承认他们的错误(这并不是保证的!)。

几乎每个经验丰富的数据科学家都有至少一些这样的故事,即使是来自其他成功的公司。这些故事对科学债务的意义就像Daily WTF对技术债务的意义一样。

科学债务总是坏的吗?

完全不是!

我在自己的分析中经常走捷径。对一个功能发布进行随机实验有时成本过高,尤其是当用户数量相对较少或变化相当无争议时(例如,你不会对拼写错误修正进行 A/B 测试)。尽管相关性不意味着因果关系,但在做出商业决策时,它通常比什么都没有要好。

将其与技术债务相比是有用的:一个小型工程团队的首要目标通常是快速构建一个最小可行产品,而不是过度工程一个他们认为在遥远的未来会非常稳健的系统。(科学债务中的等价物通常被称为过度思考,例如:“是的,我认为我们可以在检查销售交易成功与否时控制天气,但我很确定你在过度思考这个问题。”)与财务债务的比较也是有意义的:公司在成长过程中通常会承担债务(或类似地,放弃股份)。就像你不能在不借钱的情况下建立一家公司一样,你不能在确定每个决策都得到充分数据支持的情况下建立公司。

技术债务和科学债务中重要的是要记住长期成本。

如果你没有...

利用它先获得一些有价值的东西

定期支付利息

将其视为一种可能最终需要全额偿还的负债

不符合这些标准的代码不是债务,它只是低质量的工作。

— 实践开发者 (@practicingdev) 2018 年 2 月 26 日

错误的决策代价高昂,不关注数据是一种风险。我们可以对这种风险是否值得进行成本效益分析,但不应将其视为“数据科学家总是找借口”的表现。

为什么还要称之为“债务”?

对于数据科学家或分析师来说,这篇文章可能听起来相当明显。当然,忽视统计严谨性是有缺陷的,那么为什么还要给它一个“流行术语”的名字呢?因为它将这个概念放在了高管和经理们易于理解的术语中。

再次回到技术债务。个人工程师可能有很多原因想要编写“干净的代码”:他们欣赏代码的优雅,他们想给同行留下深刻印象,或者他们是完美主义者,拖延其他工作。这些原因对非技术员工通常并不重要,他们关心的是产品特性和可靠性。技术债务的框架帮助强调公司因不投资架构而失去的东西:即使产品看起来在正常工作,缺陷在实际的金钱和时间上也会有长期的成本。

工程师: 我很烦恼不同的内部项目使用不同的命名规范。

首席技术官: 对不起让你烦恼了,但代码就是代码,我不明白你为什么要在这上面浪费时间。

工程师: 我们不一致的命名规范就是技术债务:它使新开发者更难学习系统。

首席技术官: 我一直在寻找减少我们入职时间的方法!好主意,告诉我你需要什么来解决它。

同样,科学家,尤其是来自学术背景的科学家,通常对揭示现实中的真相有特别的兴趣。因此,“我想分析 X 是否是这里的一个混杂因素”的想法可能听起来像是一种奢侈,而不是一个迫切的商业需求。统计学家尤其喜欢发现数学方法中的缺陷。因此,当数据科学家说“我们不能使用那个方法,Jones 等人在 2012 年证明了它在渐近上是不一致的”时,非技术同事可能会认为他们在过度思考,甚至是炫耀。将其框架化为我们实际上冒的风险有助于传达为何花时间去做是值得的。

我们如何有效地管理科学债务?

-

让数据科学家“支付利息”。正如不是每个工程项目都会带来新特性一样,不是每次分析都会带来令人兴奋的发现或新颖的算法。有些时间需要花费在确认或证伪现有假设上。乔纳森·诺利斯关于数据科学工作的优先级排序有一篇很好的文章,他在文章中将这一象限描述为“提供证明”。

-

构建数据工程流程: 正如之前所描述的,公司可能会陷入科学债务的一个原因是分析师可能无法轻松访问他们需要的数据。这些数据可能被锁在尚未被摄取的平台中,或存储在需要手动编辑的 Google 表格中。将相关数据摄取到数据仓库或数据湖中,可以使数据科学家更有可能进行相关发现。

-

重新审视旧的分析:早期阶段公司进入科学债务的一个常见原因是数据不足以得出可靠的结论。即使你还没有足够的数据,也不意味着你应该忘记这个问题。有时,我会在日历上安排时间以便在预期有足够数据时进行分析,即使这可能要几个月。这样也可以帮助确认一个重要的分析是否仍然相关:就像你会随着时间跟踪 KPI 一样,你也要跟踪结论是否仍然正确。

-

让数据专业知识在公司内部传播。就像一个不能编程的人可能不会认识到技术债务一样,一个没有分析和理解数据经验的人可能不会认识到科学债务。这是另一个在公司内部实现数据科学民主化的理由,正如我们在 DataCamp 所做的。

简介:David Robinson,是 DataCamp 的首席数据科学家,使用 R 和 Python 进行工作。

原文。经许可转载。

相关:

更多相关主题

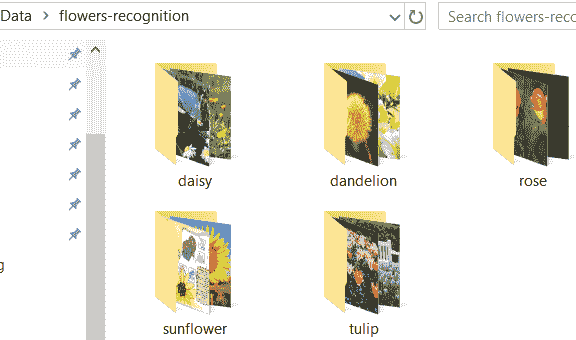

scikit-feature: 开源特征选择库(Python)

原文:

www.kdnuggets.com/2016/03/scikit-feature-open-source-feature-selection-python.html

作者:Jundong Li,ASU。

scikit-feature 是一个在亚利桑那州立大学开发的开源特征选择库,基于 Python。它建立在广泛使用的机器学习包 scikit-learn 以及两个科学计算包 Numpy 和 Scipy 之上。scikit-feature 包含约 40 种流行的特征选择算法,包括传统特征选择算法以及一些结构化和流式特征选择算法。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

它作为一个平台,促进特征选择的应用、研究和比较研究。它旨在共享在特征选择研究中开发的广泛使用的特征选择算法,并为研究人员和实践者提供便利,以进行新的特征选择算法的实证评估。

目前,scikit-feature 包含以下类别的监督和无监督特征选择算法:

-

基于相似性的特征选择

-

基于信息论的特征选择

-

稀疏学习基础的特征选择

-

基于统计的特征选择

-

基于包装器的特征选择

-

结构特征选择

-

流式特征选择

此外,scikit-feature 还提供了许多基准特征选择数据集,并提供了如何通过分类或聚类任务评估特征选择算法的示例。

要下载 scikit-feature,请访问其附加信息网站:featureselection.asu.edu/

如果你需要更多信息,请联系亚利桑那州立大学的 Jundong Li(firstname.lastname@asu.edu)。

简介:Jundong Li 是亚利桑那州立大学计算机科学与工程博士生。他的研究兴趣包括数据挖掘、机器学习及其在社交媒体中的应用。

相关:

-

数据科学机器,或‘如何进行特征工程’

-

构建机器学习系统的 20 条经验

-

数据维度减少的七种技术

更多相关话题

Scikit Flow: 使用 TensorFlow 和 Scikit-learn 轻松进行深度学习

原文:

www.kdnuggets.com/2016/02/scikit-flow-easy-deep-learning-tensorflow-scikit-learn.html

评论

评论

Google 的 TensorFlow 自 2015 年 11 月起公开发布,毫无疑问,在短短几个月内,它对机器学习以及深度学习产生了影响。通过博客文章、学术论文和各种网络教程,有广泛的接受证据。

当然,估计真正的采纳率是困难的,但 TensorFlow 的 Github 仓库有 几乎是两倍的星标数量 比下一个最多星标的机器学习项目 Scikit-learn 和最接近的深度学习项目 Berkeley Vision and Learning Center 的 Caffe。虽然这不能具体指示 TensorFlow 已经成为该领域的领导者,但可以相当容易地推测,鉴于其相对较新的发布,Google 的深度学习库引起了相当大的兴趣和使用。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业

1. Google 网络安全证书 - 快速进入网络安全职业

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

大多数情况下,TensorFlow 相对简单易用,没有使用该库经验的神经网络爱好者可以查看给定网络的代码并直观地理解其内容。语法可能会更加直接和简洁,而不使用任何包装器,但显然有原因不这样做。从技术上讲,TensorFlow 是“一个用于数据流图的数值计算的开源软件库”,虽然它(主要)用于机器学习和深度学习研究(及生产),但该系统足够通用,可以应用于广泛的其他领域。如果 TensorFlow 更加深度学习友好,这种特性可能会削弱其在其他潜在领域的适用性。

# A simple Hello World! using TensorFlow

import tensorflow as tf

hello = tf.constant('Hello, TensorFlow!')

sess = tf.Session()

sess.run(hello)

# -> Hello, TensorFlow!

然而,许多机器学习研究人员和从业者使用 Python 的原因之一,是因为其快速原型设计能力。TensorFlow 本身并不一定禁止这种快速周转,但确实存在某种学习曲线,特别是如果你对其他类似的库,如 Theano,不熟悉的话。

但如果你可以快速上手 TensorFlow 并几乎立即开始训练神经网络,而不需要学习额外的语法或配置怎么办?这正是 Scikit Flow 的作用。然而,我会稍微偏离一下话题。

Scikit-learn + TensorFlow = Scikit Flow

Scikit-learn 作为 事实 上的官方 Python 通用机器学习框架,拥有丰富的历史。虽然我相信这句话会(并且可以)引起争议,也许它有点强烈,但不可否认的是,Scikit-learn 在 Python 机器学习生态系统中占据了重要地位,并且在机器学习领域也如此。

其易用性和标准化接口与此有关。例如,Scikit-learn 利用简单的 fit/predict 工作流模型 来实现其分类算法。这使得构建、训练和测试模型变得非常简单。一个典型逻辑回归模型的测试/训练相关代码可能看起来像这样:

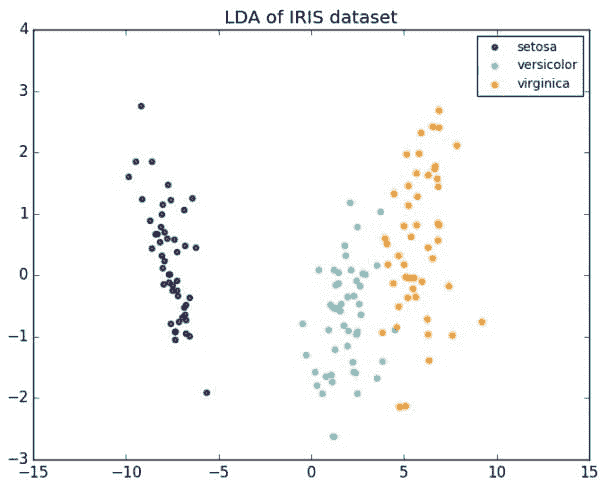

from sklearn.linear_model import LogisticRegression

from sklearn import datasets, metrics

iris = datasets.load_iris()

classifier = LogisticRegression()

classifier.fit(iris.data, iris.target)

score = metrics.accuracy_score(iris.target, classifier.predict(iris.data))

print("Accuracy: %f" % score)

想尝试一个朴素贝叶斯分类器?这不需要太多更改:

from sklearn.naive_bayes import GaussianNB

from sklearn import datasets, metrics

iris = datasets.load_iris()

classifier = GaussianNB()

classifier.fit(iris.data, iris.target)

score = metrics.accuracy_score(iris.target, classifier.predict(iris.data))

print("Accuracy: %f" % score)

唯一的变化是在第一行的导入语句和分类器实例化语句。鉴于此,我们可以轻松看到 Scikit 模型接口的一致性和简洁性。即使在阅读之前你对此一无所知,你也已经明白了,因为它很简单。尽管当然,机器学习管道的内容远不止于上述的 7 行代码,但这 7 行涵盖了一个重要且广泛的方面,并且无论分类器如何都一样。

现在回到 Scikit Flow (skflow):既然(几乎)每个 Python 机器学习生态系统中的人都对 Scikit-learn 有一定了解,那么如果你能立即利用 TensorFlow 的建模能力,同时保留 Scikit-learn 的语法简洁性呢?Scikit Flow(名字本身就暗示了这种利用和引导)官方的介绍如下:

这是 TensorFlow 的简化接口,用于让人们开始进行预测分析和数据挖掘。

实际上,更明确地说,Scikit Flow 是 TensorFlow 深度学习库的高级封装器,它允许使用简洁、熟悉的 Scikit-learn 方法来训练和拟合神经网络。

为了回答“为什么选择 Scikit Flow?”的问题,它的仓库 README 解释了:

为了使从 Scikit Learn 的单行机器学习世界过渡到更开放的构建不同形状的 ML 模型的世界变得更加顺畅,你可以从使用 fit/predict 开始,随着你逐渐适应,再逐步过渡到 TensorFlow APIs。

重要的是,Scikit Flow 是 Google 推出的官方 TensorFlow 项目;这不是一个被破解的第三方解决方案……并不是说这样做有什么问题。完全没有。但 Google 开发、发布并支持这个项目的事实,应该能给你足够的信心,它确实会使这两个库按承诺协同工作。它也很受欢迎;在写这篇文章时,Scikit Flow 的仓库拥有近 1700 个星标。

讨论

现在我们将查看几个示例。如果你想在家尝试,请确保你已安装以下内容:

-

Python: 2.7, 3.4+

-

Scikit learn: 0.16, 0.17, 0.18+

-

Tensorflow: 0.6+

Scikit Flow 可以使用 pip 通过以下一行代码轻松安装:

>>> pip install git+git://github.com/tensorflow/skflow.git

首先,我们将查看在 Scikit Flow 中实现通用线性分类器的方法。

import skflow

from sklearn import datasets, metrics

iris = datasets.load_iris()

classifier = skflow.TensorFlowLinearClassifier(n_classes=3)

classifier.fit(iris.data, iris.target)

score = metrics.accuracy_score(iris.target, classifier.predict(iris.data))

print("Accuracy: %f" % score)

如上所示,上述示例遵循了 Scikit-learn 的类似 fit/predict 模型。如果你查看早期的 Scikit-learn 模型,你会发现它们与上述示例的相似性。

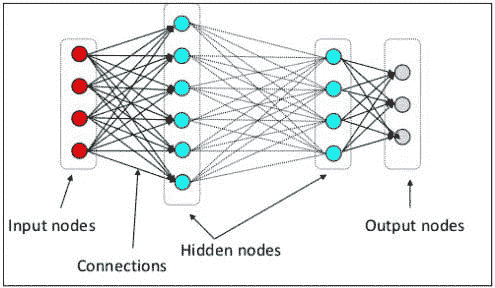

但这只是一个线性分类器,并不是真正的深度学习。真正展现 Scikit Flow 强大功能的是深度神经网络。一个通用的三层神经网络,具有 10、20 和 10 个隐藏节点,可以通过如下代码轻松实现:

import skflow

from sklearn import datasets, metrics

iris = datasets.load_iris()

classifier = skflow.TensorFlowDNNClassifier(hidden_units=[10, 20, 10], n_classes=3)

classifier.fit(iris.data, iris.target)

score = metrics.accuracy_score(iris.target, classifier.predict(iris.data))

print("Accuracy: %f" % score)

再次强调,变化非常小。我们没有使用前一个示例中的 TensorFlowLinearClassifier,而是使用了 TensorFlowDNNClassifier,这使我们能够在 7 行(大量辅助)代码中构建、训练和测试一个深度神经分类器。我们仅明确指定了节点数和隐藏层数。Scikit Flow 还提供了一个标准的递归神经网络,一些额外的分类器,作为一个早期的工作和官方 TensorFlow 项目之一,可以认为将很快增加其他标准架构和分类器。

若要进行几乎完全相同的比较,请查看 Scikit Flow 和“原始” TensorFlow 对 MNIST 图像分类器的实现。Github 仓库中还有 更多示例(包括一个有趣的示例,它与 Dask 并行处理引擎接口,用于核心外数据分类)。

Scikit Flow 也允许在低级 TensorFlow 之间进行混合交互。对于那些有兴趣在较低级别创建架构,然后通过高级接口进行训练和测试的人来说,Scikit Flow 可能是一个不错的选择。它也可能有助于深度架构的分布性;当共享在较低级别创建的架构时,为其他人提供熟悉的 Scikit-learn 接口进行训练和测试可能不是一个坏主意,当然,这取决于具体情况。

结论

虽然 skflow 可能没有“原始” TensorFlow 的灵活性,但高级抽象允许快速原型设计神经网络。它还使深度学习和 TensorFlow 的新手几乎可以立即变得高效。考虑到 TensorFlow 代码仍然可以与之并行编写,在需要时有机会混合代码并提供更大的灵活性。

Scikit Flow 可能会在其他情况下找到市场,比如模型共享或管理较低级别网络的训练和测试,看来谷歌确实推出了一个设计良好的 TensorFlow 附加组件,这个附加组件肯定不会阻碍其进一步的采用。

更新:来自 Scikit Flow 开发者的 新 Reddit 帖子 正在征求添加功能的意见。有什么想法吗?可以在那儿留言。

简介:Matthew Mayo 是一名计算机科学研究生,目前正在撰写关于并行化机器学习算法的论文。他还是数据挖掘的学生、数据爱好者和有志于成为机器学习科学家的人。

相关:

-

TensorFlow 令人失望 – 谷歌深度学习表现平平

-

微软深度学习带来创新功能 – CNTK 显示出潜力

-

7 步理解深度学习

更多相关话题

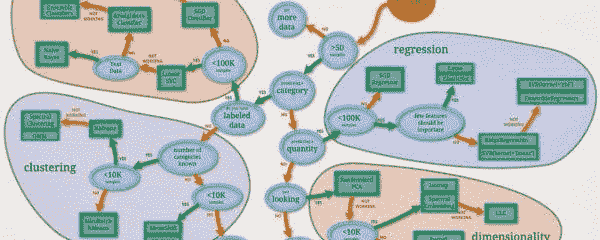

Scikit-learn 机器学习备忘单

原文:

www.kdnuggets.com/2022/12/scikit-learn-machine-learning-cheatsheet.html

你的工具包中的机器学习工具

你想开始学习机器学习。你对机器学习概念有基础了解。你会 Python。你该怎么办?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 管理

3. Google IT 支持专业证书 - 支持你的组织进行 IT 管理

最明显的答案是开始使用Scikit-learn。Scikit-learn 是一个开源的 Python 库,用于各种预测数据分析任务。你可以执行分类、回归、聚类、降维、模型调优和数据预处理等任务。

Scikit-learn 的统一 API 接口使得学习如何实现各种算法和任务变得比其他方法更容易。一旦你掌握了如何调用 Scikit-learn 的方法,你就能顺利开展。除此之外,你所需要的就是一个实用的参考资料,再加上你的想象力和决心。

KDnuggets 整理了你所需的一切。这个备忘单涵盖了学习如何使用 Scikit-learn 进行机器学习所需的基础知识,并为你推进机器学习项目提供了参考。备忘单中包含了你将反复使用的最常见功能。请看下面以确认。

你可以在这里下载备忘单。

在备忘单中,你会找到以下常见 Scikit-learn 任务的实用参考:

-

数据加载

-

将数据集拆分为训练集和测试集

-

数据预处理

-

执行监督机器学习任务

-

执行无监督机器学习任务

-

模型拟合

-

预测

-

评估

-

交叉验证

-

模型调优

不需要再等一分钟来掌握机器学习从业者工具箱中最常用的工具之一。一旦你安装了Scikit-learn,只需按照备忘单中的相关代码片段进行操作即可开始使用。只要记得在进展过程中随时准备好它。

立即查看,并随时回来获取更多信息。

更多相关话题

Scikit-Learn 与 MLR 在机器学习中的对比

原文:

www.kdnuggets.com/2019/09/scikit-learn-mlr-machine-learning.html

评论

Scikit-Learn 以其易于理解的 Python 用户 API 而闻名,而 MLR 成为了流行的 Caret 包的替代品,提供了更多的算法库和简单的超参数调整方式。这两个包因许多人在分析工作中倾向于使用 Python 进行机器学习而 R 用于统计分析而处于竞争状态。

使用 Python 的一个原因可能是当前用于机器学习的 R 包通过其他包含算法的包提供。这些包通过 MLR 调用,但仍需额外安装。甚至外部特征选择库也需要,且它们还有其他外部依赖需要满足。

Scikit-Learn 被称为一个统一的 API,提供多个机器学习算法,无需用户调用更多库。

这绝不会贬低 R。 R 在数据科学领域仍然是一个主要组成部分,不论在线调查如何说。任何有统计学或数学背景的人都会知道为什么你应该使用 R(即使他们自己不使用,它们也认识到它的吸引力)。

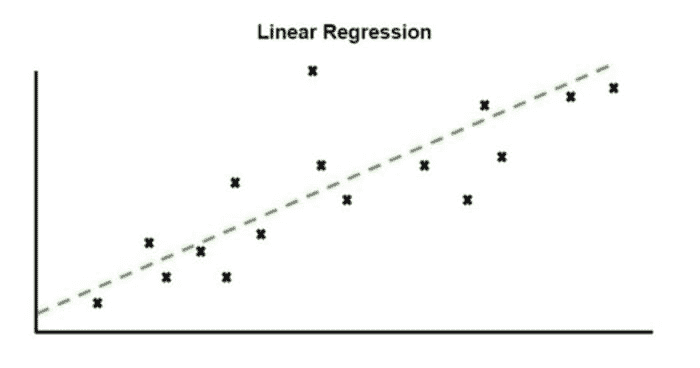

现在我们将查看用户如何通过典型的机器学习工作流。我们将使用 Scikit-Learn 中的 Logistic Regression 和 MLR 中的决策树。

创建你的训练和测试数据

-

Scikit-Learn

-

x_train, x_test, y_train, y_test = train_test_split(x,y,test_size)这是在 Scikit-Learn 中分割数据集的最简单方法。test_size 用于确定数据的百分比进入测试集。train_test_split 将自动在一行代码中创建训练集和测试集。x 是特征集,y 是目标变量。

-

-

MLR

-

train <- sample(1:nrow(data), 0.8 * nrow(data)) -

test <- setdiff(1:nrow(train), train) -

MLR 没有内置的函数来子集数据集,因此用户需要依赖其他 R 函数。这是创建 80/20 训练测试集的一个例子。

-

选择算法

-

Scikit-Learn

-

LogisticRegression()分类器可以通过调用一个明显命名的函数来选择和初始化,这样便于识别。

-

-

MLR

-

makeLearner('classif.rpart')算法被称为学习器,这个函数被调用以初始化它。 -

makeClassifTask(data=, target=)如果我们进行分类,我们需要调用此函数来初始化分类任务。此函数将接受两个参数:训练数据和目标变量的名称。

-

超参数调整

在任何一个软件包中,调整超参数都有一个流程。你首先需要指定要改变哪些参数以及这些参数的范围。然后进行网格搜索或随机搜索,以找到最佳的参数组合,从而获得最佳结果(即,最小化错误或最大化准确度)。

-

Scikit-Learn

-

penalty = ['l2'] -

C = np.logspace(0, 4, 10) -

dual= [False] -

max_iter= [100,110,120,130,140] -

hyperparameters = dict(C=C, penalty=penalty, dual=dual, max_iter=max_iter) -

GridSearchCV(logreg, hyperparameters, cv=5, verbose=0) -

clf.fit(x_train, y_train)

-

-

MLR

-