KDNuggets-博客中文翻译-三-

KDNuggets 博客中文翻译(三)

原文:KDNuggets

3 种将行附加到 Pandas 数据框的方法

原文:

www.kdnuggets.com/2022/08/3-ways-append-rows-pandas-dataframes.html

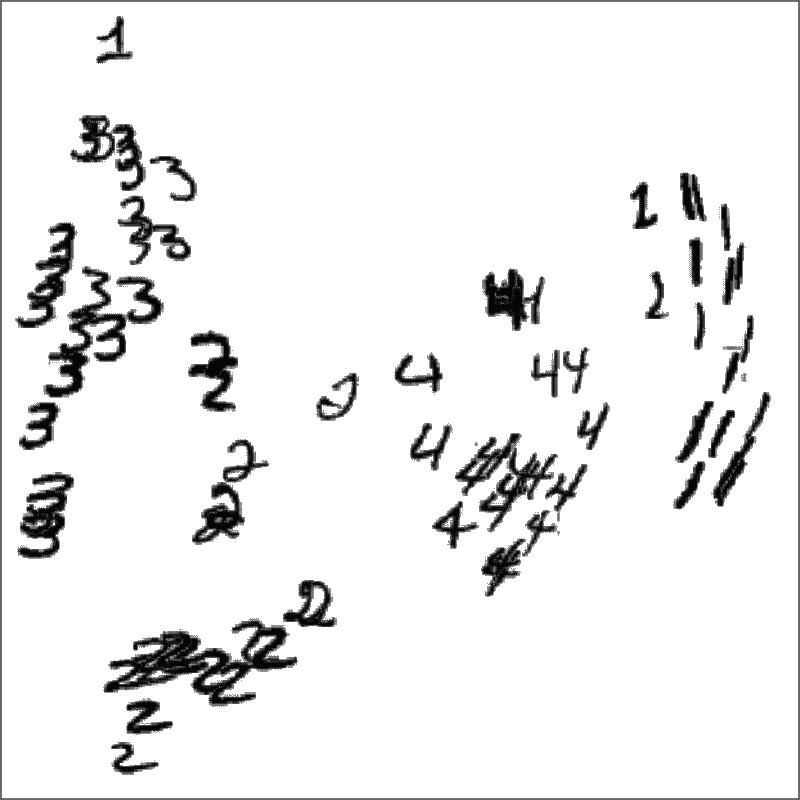

图片来源:作者

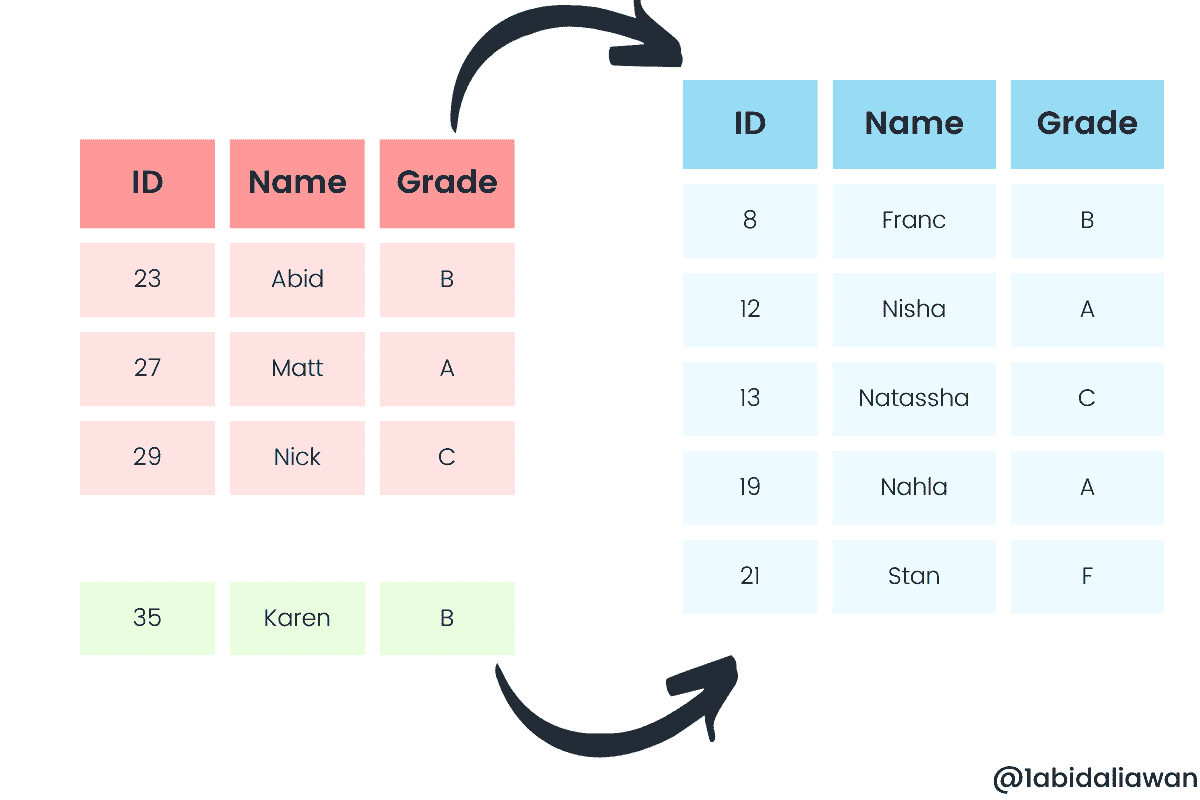

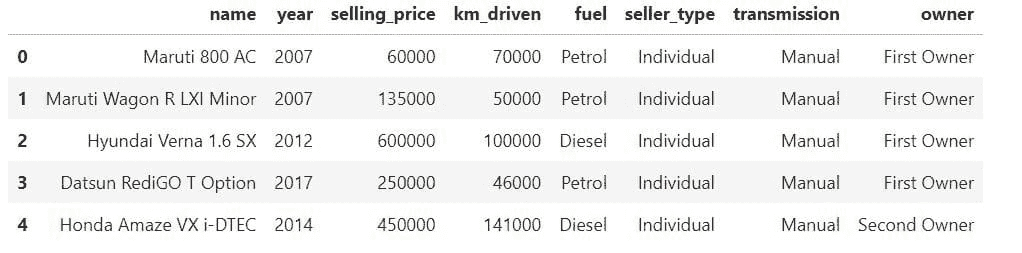

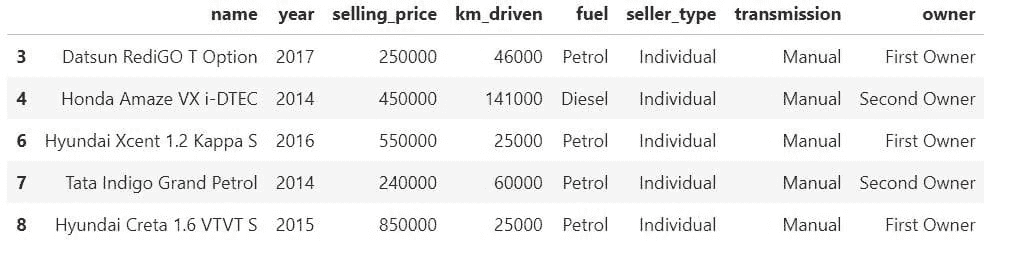

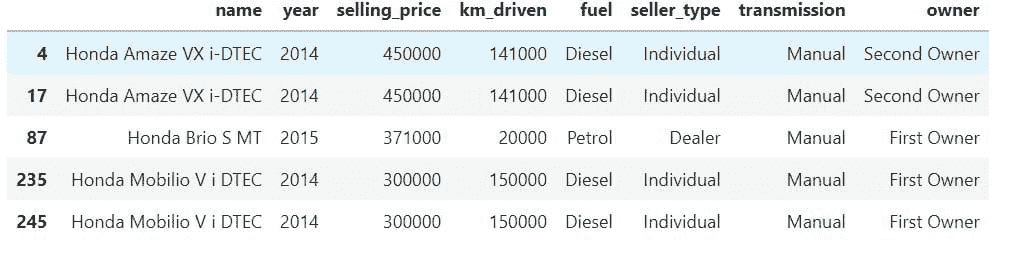

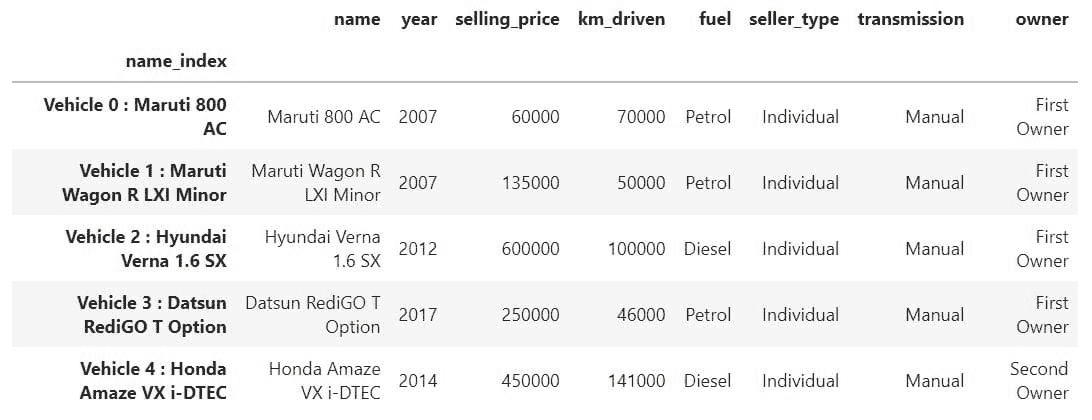

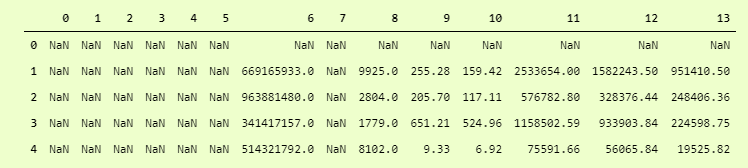

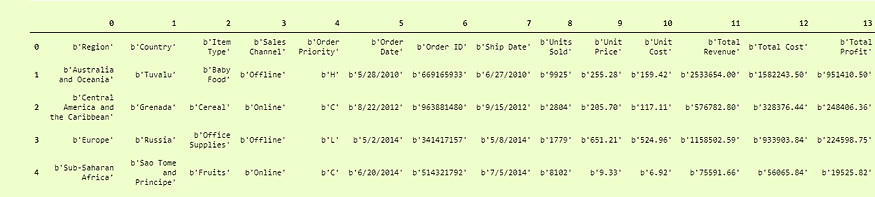

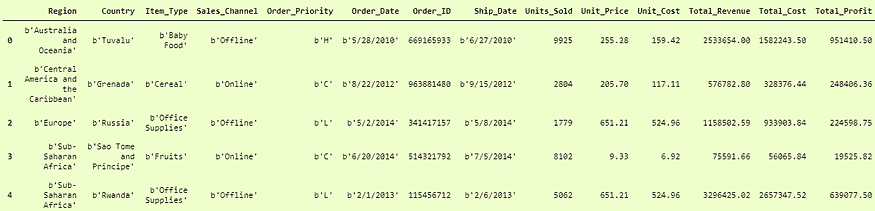

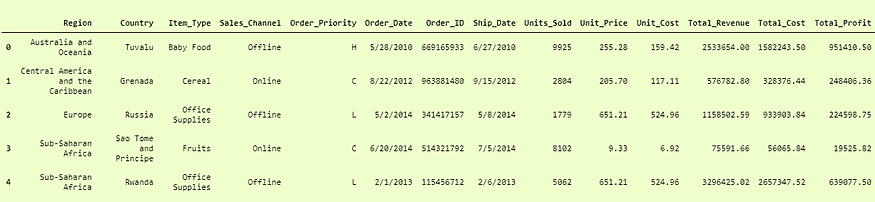

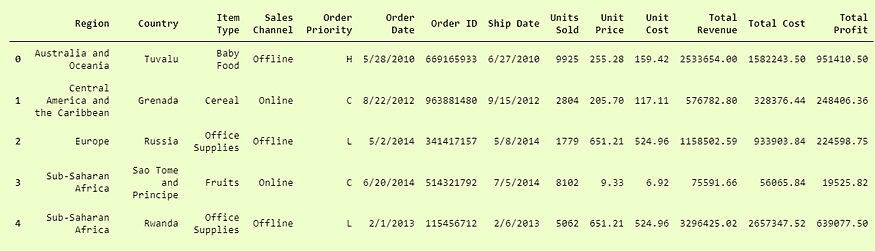

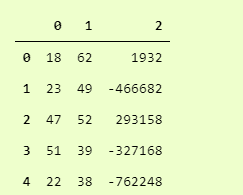

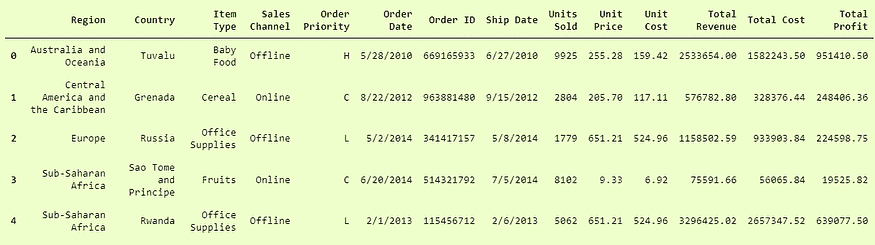

在这个迷你教程中,我们将学习三种将行附加到 pandas 数据框中的方法。我们还将学习添加多行的最有效和简单的方法。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全领域的职业生涯。

1. Google 网络安全证书 - 快速进入网络安全领域的职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

方法 1

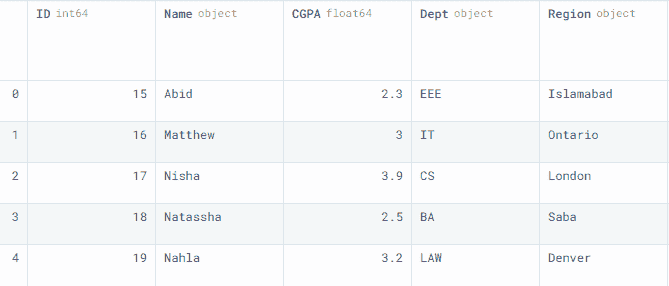

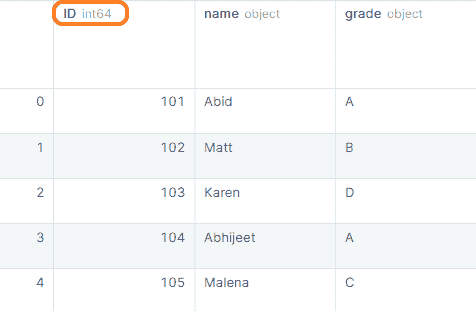

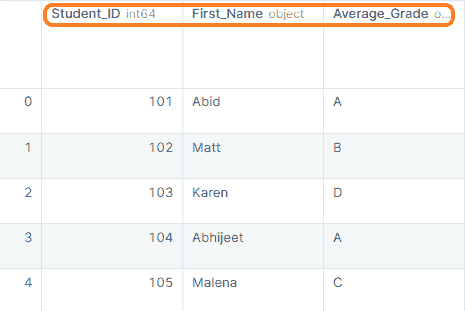

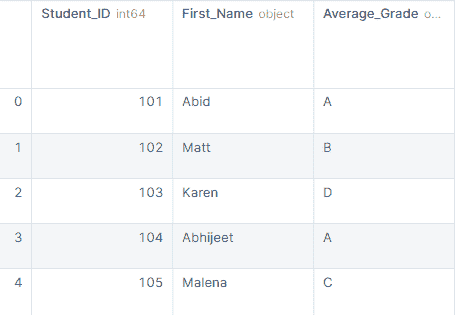

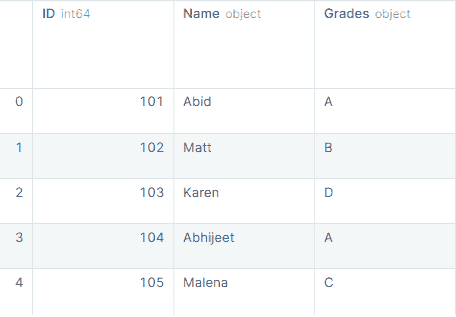

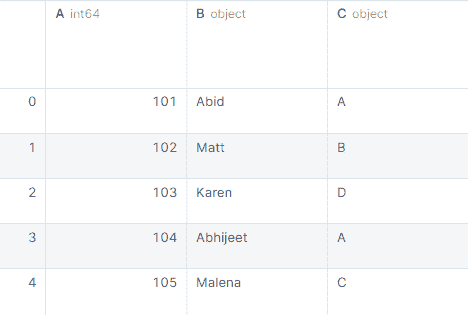

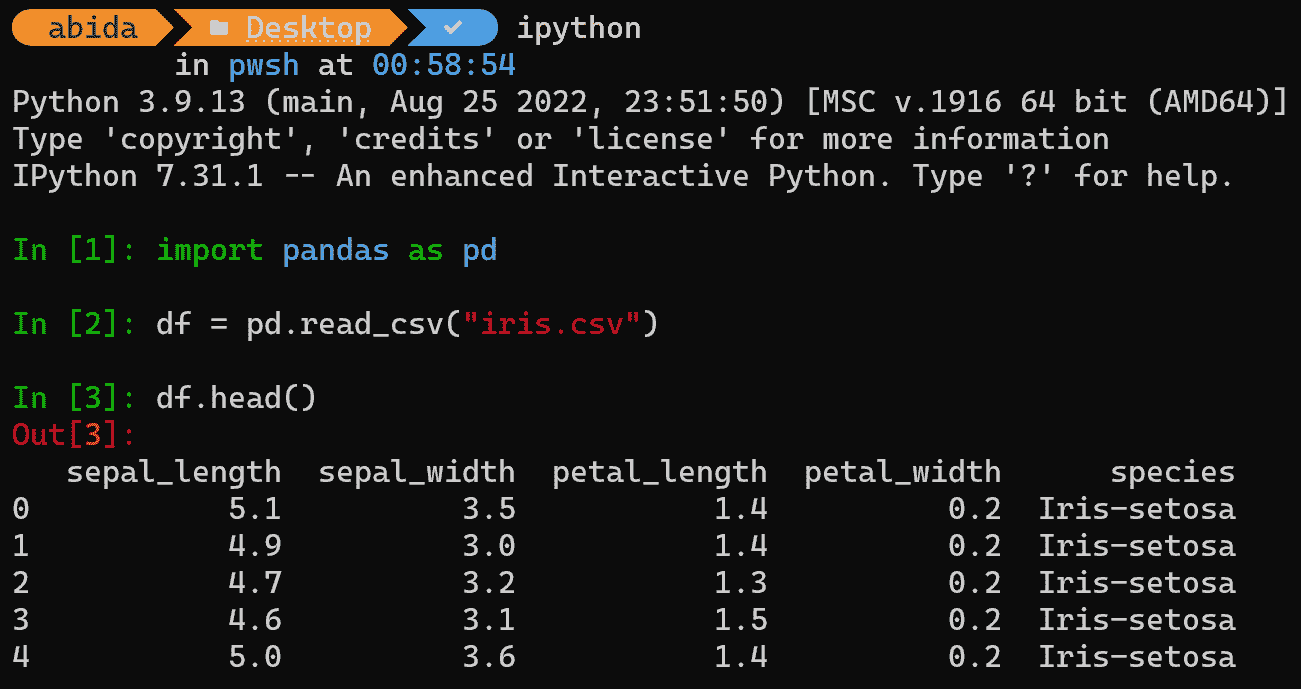

我们将使用 pandas DataFrame() 并以字典形式输入数据来创建一个示例数据框,以供在线硕士学位的学生使用。

import pandas as pd

data1 = pd.DataFrame(

{

"ID": [15, 16, 17, 18, 19],

"Name": ["Abid", "Matthew", "Nisha", "Natassha", "Nahla"],

"CGPA": [2.3, 3.0, 3.9, 2.5, 3.2],

"Dept": ["EEE", "IT", "CS", "BA", "LAW"],

"Region": ["Islamabad", "Ontario", "London", "Saba", "Denver"],

}

)

data1

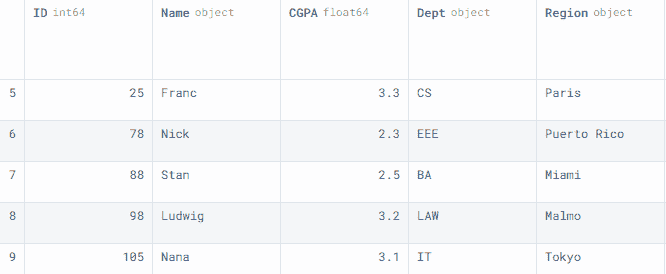

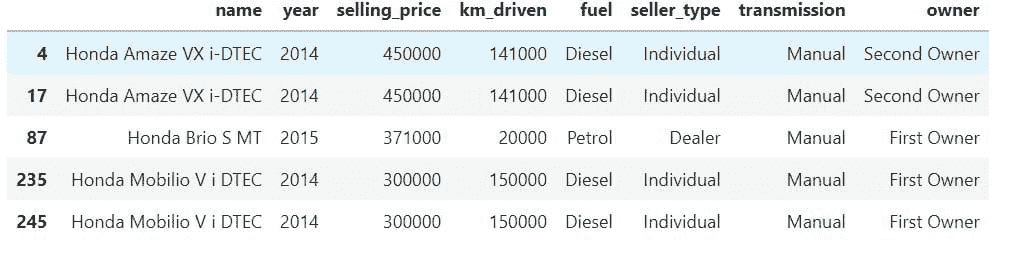

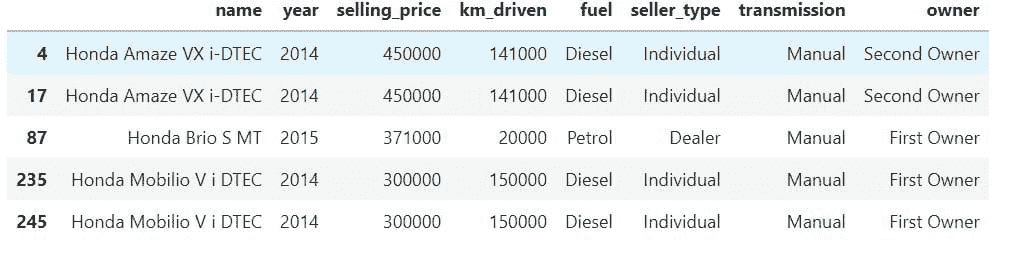

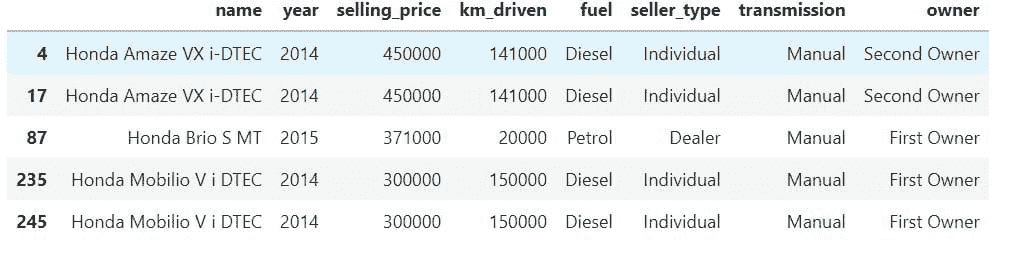

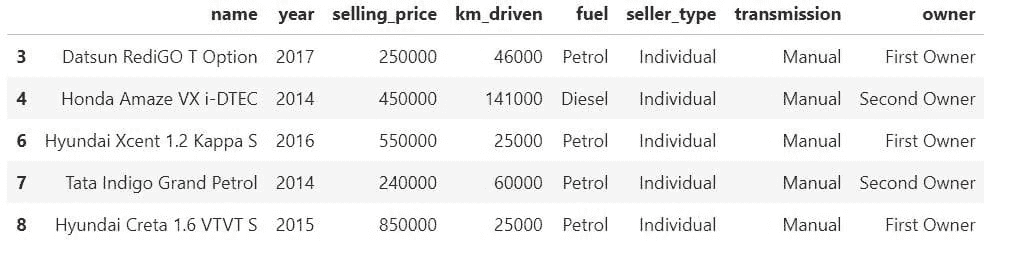

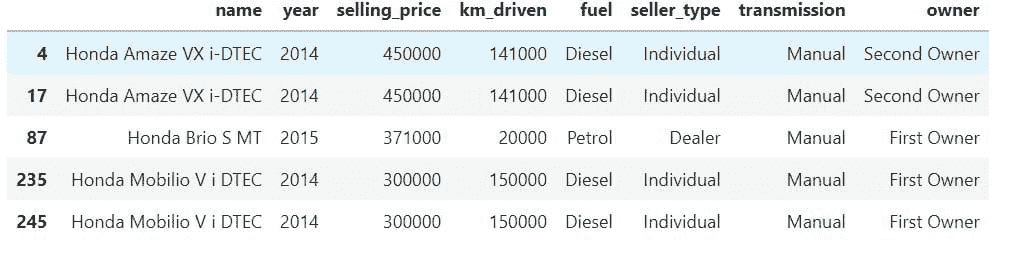

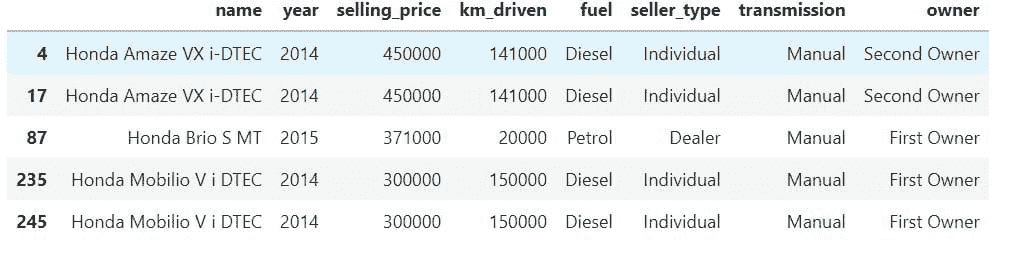

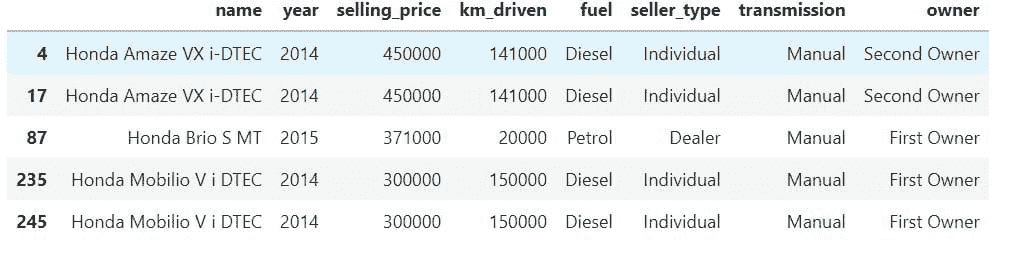

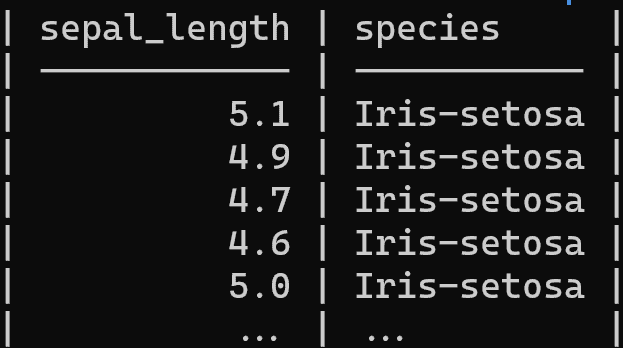

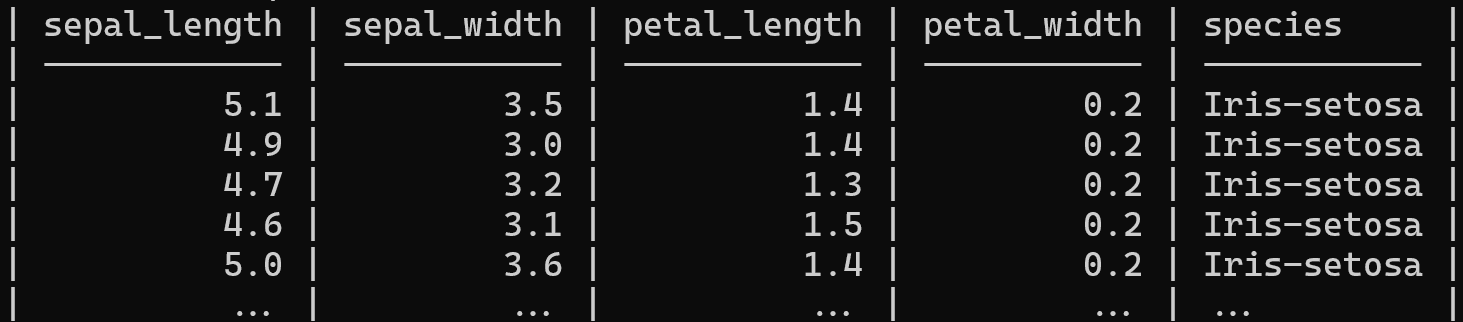

我们有五列和五行不同的行。这将是基础数据框。

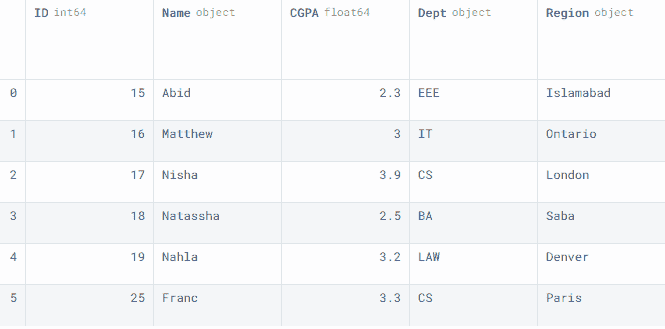

我们可以以 pandas Series 的形式附加行。

要将一个 Series 添加到数据框中,我们将在数据框对象后使用append()函数,并在括号中添加 Series 对象。ignore_index 设置为True,以便结果索引将被标记为 0,1,....,n-1。

row1 = pd.Series([25, 'Franc', 3.3, 'CS', 'Paris'], index=data1.columns)

data1 = data1.append(row1,ignore_index=True)

data1

正如我们可以观察到的,我们已经成功地将一名学生的信息添加到数据框中。

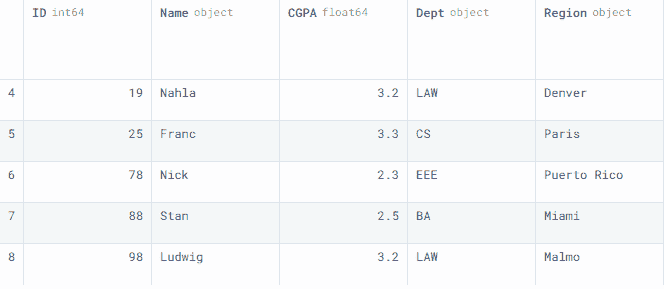

类似地,我们也可以附加一个数据框。在我们的案例中,我们创建了一个data2数据框,并使用.append()函数将多行添加到data1中。

data2 = pd.DataFrame(

{

"ID": [78, 88, 98],

"Name": ["Nick", "Stan", "Ludwig"],

"CGPA": [2.3, 2.5, 3.2],

"Dept": ["EEE", "BA", "LAW"],

"Region": ["Puerto Rico", "Miami", "Malmo"],

}

)

要查看最后五行,我们使用了.tail()。

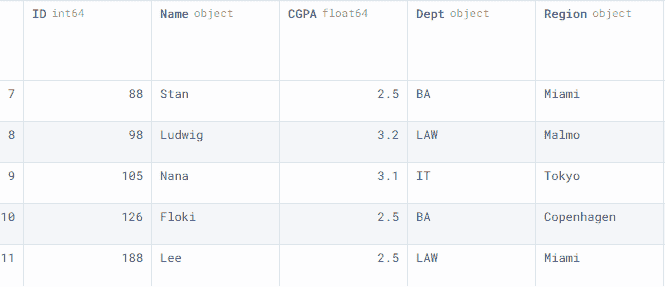

方法 2

第二种方法相当简单。我们可以创建并附加一个字典到数据框中,使用 append。确保字典遵循下面的格式。每条记录应包含一个列名和相应的值。

row2 = {

"ID": 105,

"Name": "Nana",

"CGPA": 3.1,

"Dept": "IT",

"Region": "Tokyo",

}

data1 = data1.append(row2, ignore_index=True)

data1.tail()

方法 3

第三种方法是将行附加到数据框中的一种有效方式。

注意: DataFrame.append() 或 Series.append() 从 1.4.0 版本开始已被弃用。因此,如果您想使用最新版本,您需要使用这种方法。

要连接两个数据框或 Series,我们将使用 pandas concat() 函数。它提供了高级功能,例如使用内连接或外连接追加列。

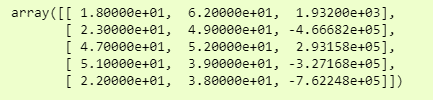

在我们的例子中,我们使用数组创建了一个第三个数据框data3。我们也可以将一个 Numpy 数组追加到数据框中,但需要先将其转换为数据框。

我们正在沿着 0 轴连接data1和data3。这意味着我们在追加行,而不是列。

data3 = pd.DataFrame(

[[126, "Floki",2.5,"BA","Copenhagen" ],

[188, "Lee",2.5,"LAW", "Miami"]],

columns= data1.columns

)

正如我们所见,我们已经成功地使用concat函数添加了行。

结论

你也可以使用 .loc[<index_number>] 将行添加到数据框的末尾。

例如:

data1.loc[12] = [200, "Bala",2.4,"DS","Delhi"]

这是一种简单的方法,但并不充分,因为你需要跟踪索引编号。

在本教程中,我们学习了多种将行添加到 pandas 数据框的方法。学习如何添加数据、管理数据以及为分析任务处理数据是成为专业数据科学家的第一步。

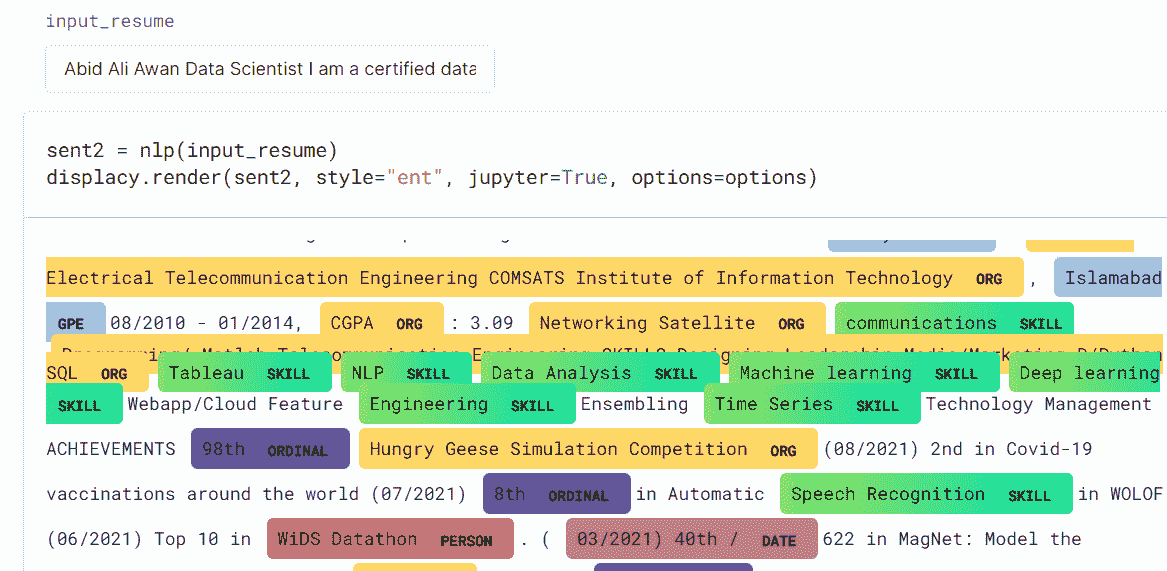

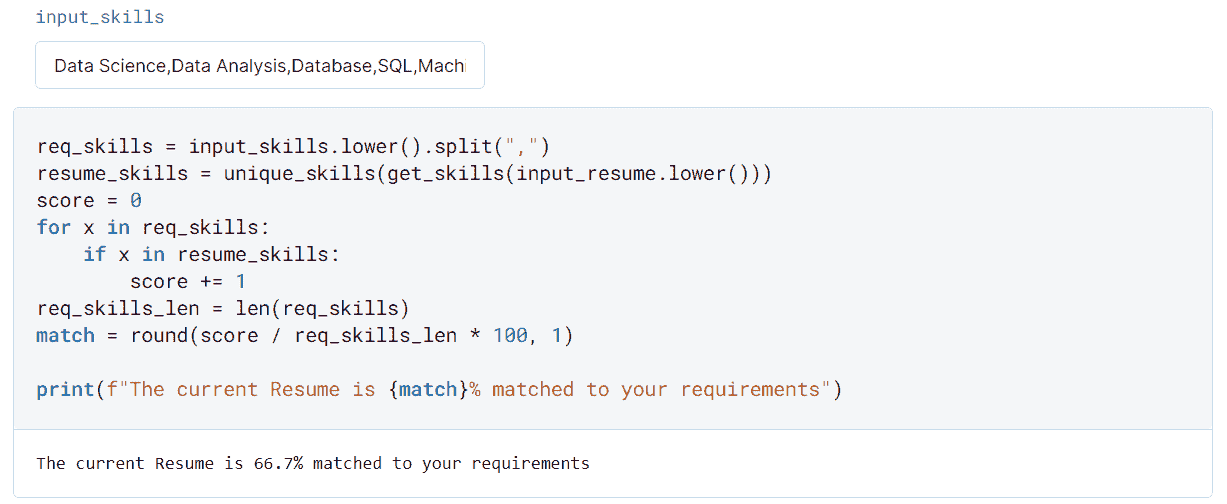

Abid Ali Awan (@1abidaliawan) 是一位认证数据科学专业人士,喜欢构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为那些遭受心理疾病困扰的学生构建一个人工智能产品。

主题扩展

3 种合并 Pandas 数据框的方法

原文:

www.kdnuggets.com/2023/03/3-ways-merge-pandas-dataframes.html

编辑器提供的图像

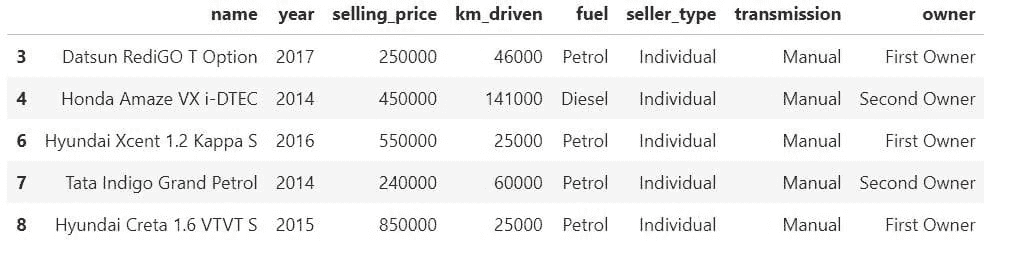

现实世界中的数据是分散的,需要在一些共同的基础上将不同的来源结合在一起。为了提高效率并降低组织存储所有数据在单一表中的成本,保持数据在多个表中,并在需要时将它们连接在一起,是获取效率和有价值见解的最佳方式。

“Pandas” 提供了数据框合并功能,这在数据分析中非常有用,因为它允许你将来自多个来源的数据合并到一个数据框中。例如,假设你有一个包含客户订单信息的销售数据集和另一个包含客户人口统计信息的数据集。通过在客户 ID 上连接这两个数据框,你可以创建一个包含所有信息的新数据框,使得分析和理解客户人口统计与销售之间的关系变得更加容易。

合并这些数据框可以让你为数据添加额外的列,例如计算字段或汇总统计,这些列可以驱动复杂的机器学习系统。合并也有助于数据准备任务,如清理、标准化和预处理。

在本文中,你将学习三种合并 Pandas 数据框的方法以及输出之间的区别。你还将能够理解如何通过合并、连接和串联操作来促进不同的数据分析用例。

合并

merge() 操作是一种方法,用于根据一个或多个共同的列(也称为键)合并两个数据框。结果数据框仅包含两个数据框中具有匹配键的行。merge() 函数类似于 SQL 的 JOIN 操作。

使用 merge() 的基本语法是:

merged_df = pd.merge(df1, df2, on='key')

这里,df1 和 df2 是你想要合并的两个数据框,而 “on” 参数定义了用于合并的列。

默认情况下,pandas 会执行内连接,这意味着仅包含两个数据框中具有匹配键的行。然而,你可以使用 how 参数指定其他类型的连接,例如左连接、右连接或外连接。

让我们通过下面的示例来理解这一点。

请注意,你可以使用 Jupyter Notebook(或你选择的 IDE)运行以下代码。

import pandas as pd

# Define two dataframes

df1 = pd.dataframe({"key": ["A", "B", "C", "D"], "value1": [1, 2, 3, 4]})

df2 = pd.dataframe({"key": ["B", "D", "E", "F"], "value2": [5, 6, 7, 8]})

# Perform the merge

merged_df = pd.merge(df1, df2, on="key", how="inner")

# Show the resulting

print(merged_df)

这将产生以下输出:

key value1 value2

0 B 2 5

1 D 4 6

从结果中可以明显看出,新的数据框 merged_df 仅包含 'key' 列中值匹配的行,即 B 和 D。

连接

另一方面,join() 操作基于索引而不是特定列来合并两个数据框。结果数据框仅包含两个数据框中具有匹配索引的行。

使用 join() 的基本语法是:

joined_df = df1.join(df2)

其中 df1 和 df2 是要合并的两个数据框。

默认情况下,join() 执行左连接,这意味着第一个数据框(df1)中的所有行都会包含在结果数据框中,而第二个数据框(df2)中具有匹配索引值的任何行也会被添加。如果第二个数据框中有非匹配的行,它们将具有 NaN 值。通过使用 how 参数,你可以指定其他类型的连接,如右连接、内连接或外连接。

让我们通过一个示例来理解,如下所示。

import pandas as pd

# Define two dataframes

df1 = pd.dataframe({"value1": [1, 2, 3, 4]}, index=["A", "B", "C", "D"])

df2 = pd.dataframe({"value2": [5, 6, 7, 8]}, index=["B", "D", "E", "F"])

# Perform the join

joined_df = df1.join(df2, how="inner")

# Show the resulting

print(joined_df)

上述代码将产生以下输出:

value1 value2

B 2 5

D 4 6

在这里,新数据框 joined_df 仅包含索引匹配的行,即 B 和 D。

合并

concat() 用于沿特定轴(行或列)连接多个 pandas 对象(数据框或 Series)。默认情况下,轴为 0,意味着数据沿行(垂直方向)拼接。它的第一个参数是一个 pandas 对象的列表,按列表中指定的顺序拼接。

concatenated_df = pd.concat([df1, df2])

该函数可以通过各种参数进行自定义,如 axis、join、ignore_index 等。

使用 Pandas 的 concat 函数来合并两个数据框的示例如下所示:

import pandas as pd

df1 = pd.dataframe(

{

"A": ["A0", "A1", "A2", "A3"],

"B": ["B0", "B1", "B2", "B3"],

"C": ["C0", "C1", "C2", "C3"],

"D": ["D0", "D1", "D2", "D3"],

},

index=[0, 1, 2, 3],

)

df2 = pd.dataframe(

{

"A": ["A4", "A5", "A6", "A7"],

"B": ["B4", "B5", "B6", "B7"],

"C": ["C4", "C5", "C6", "C7"],

"D": ["D4", "D5", "D6", "D7"],

},

index=[0, 1, 2, 3],

)

concatenated_df = pd.concat([df1, df2])

print(concatenated_df)

这将产生以下输出:

A B C D

0 A0 B0 C0 D0

1 A1 B1 C1 D1

2 A2 B2 C2 D2

3 A3 B3 C3 D3

0 A4 B4 C4 D4

1 A5 B5 C5 D5

2 A6 B6 C6 D6

3 A7 B7 C7 D7

为了避免如上所示的索引重复(在拼接数据框中索引从 0 到 3 出现两次),请使用 ignore_index=True,如下所示。

concatenated_df = pd.concat([df1, df2], ignore_index=True)

print(concatenated_df)

结果将如下所示。

A B C D

0 A0 B0 C0 D0

1 A1 B1 C1 D1

2 A2 B2 C2 D2

3 A3 B3 C3 D3

4 A4 B4 C4 D4

5 A5 B5 C5 D5

6 A6 B6 C6 D6

7 A7 B7 C7 D7

概要

在这篇文章中,你学会了三种合并 Pandas 数据框的方法,并了解它们在任何 BI 项目中处理数据时如何解决不同的目的。该文章通过 Python 代码演示了合并、连接和拼接操作的示例。

Vidhi Chugh 是一位 AI 策略师和数字化转型领导者,在产品、科学和工程交汇处工作,致力于构建可扩展的机器学习系统。她是获奖的创新领导者、作者和国际演讲者。她的使命是使机器学习大众化,并打破术语,让每个人都能参与到这一转型中。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

更多相关内容

使用 GPT-4o 构建 Python 项目的 3 种方法

原文:

www.kdnuggets.com/3-ways-of-building-python-projects-using-gpt-4o

图片来源:作者

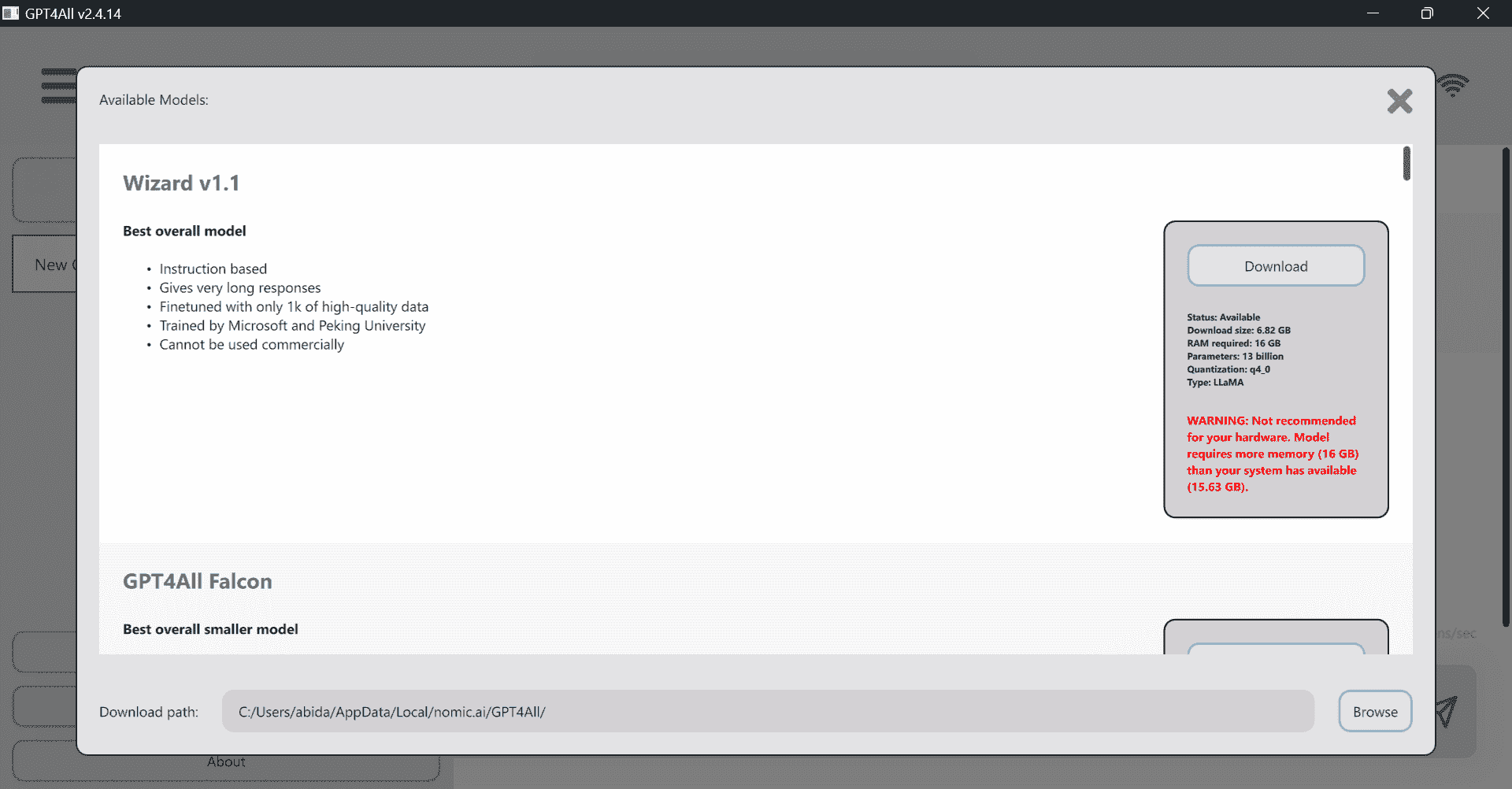

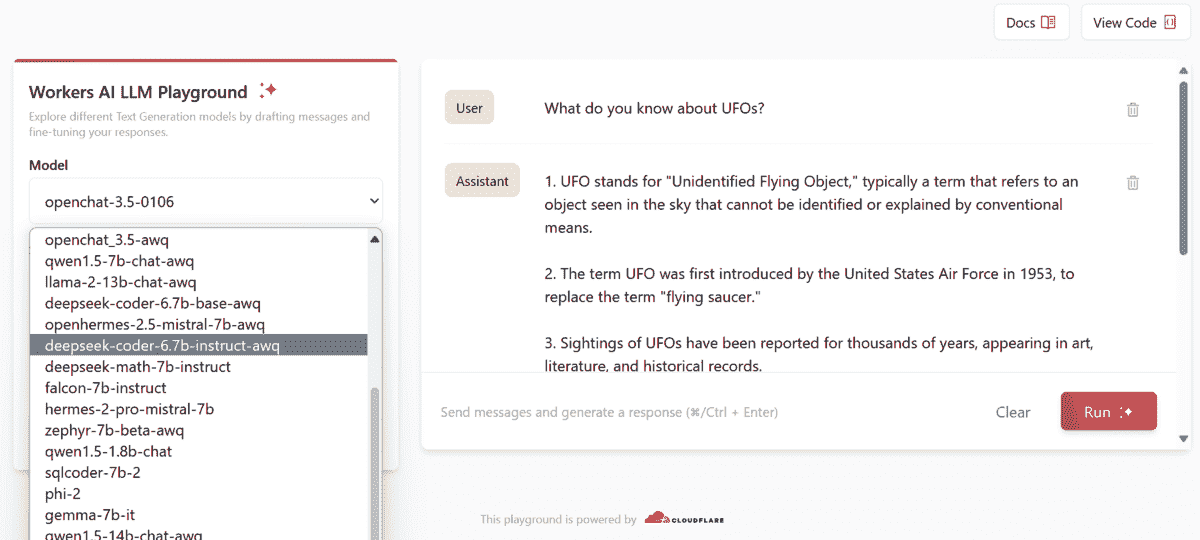

如果你希望提高工作流程,加快开发速度,并最小化错误,GPT-4o 模型是你首选的 AI 工具。通过将这种先进的 AI 集成到你的 Python 项目中,你可以简化流程,更快地解决问题,专注于真正重要的事情。即使你是编程新手,也可以使用像 ChatGPT、配备 GPTCode 扩展的 VSCode 和 Cursor IDE 等工具创建 Python 项目。这些工具对于在开发环境中实现 GPT-4o 模型的全部潜力至关重要。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

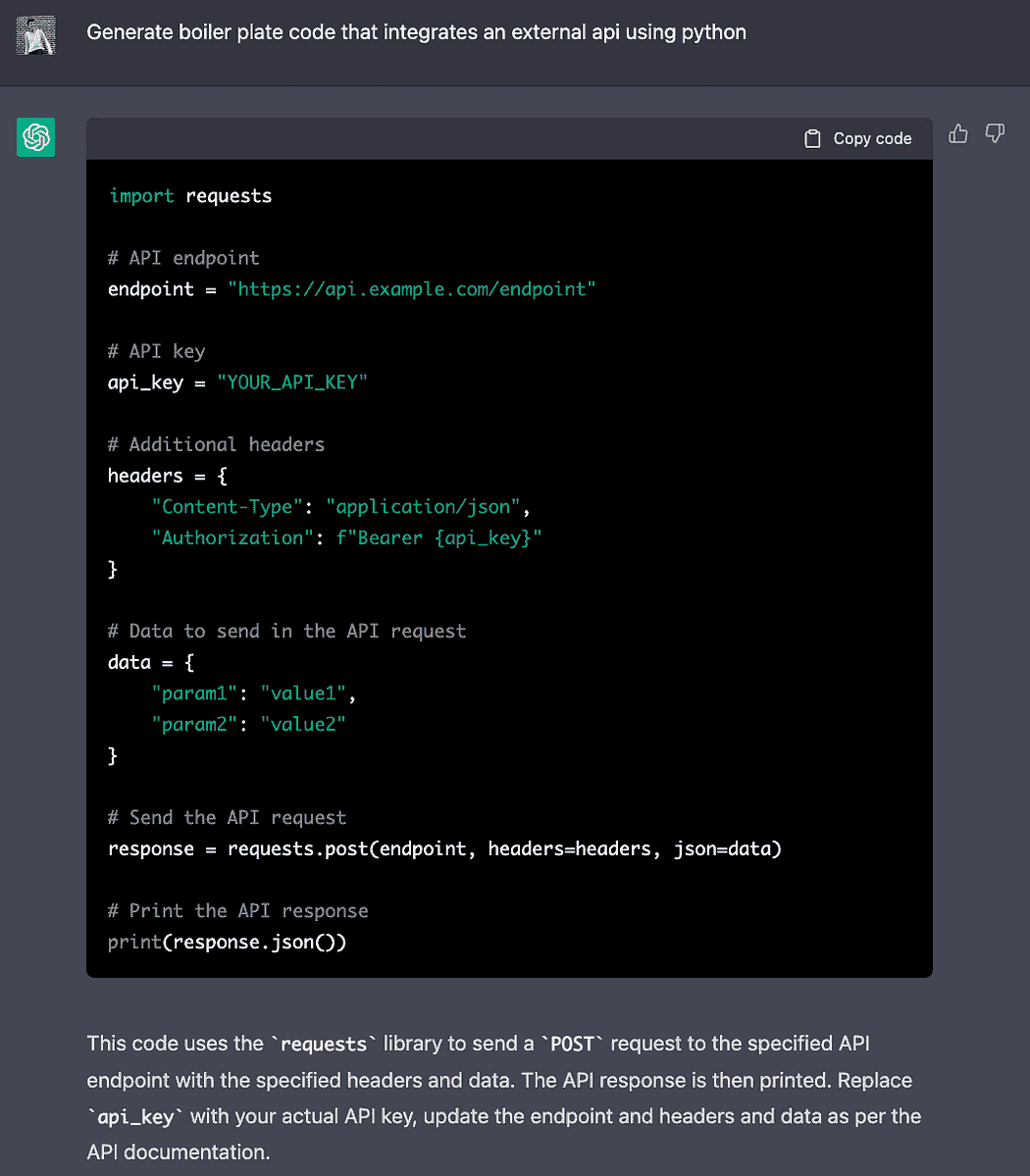

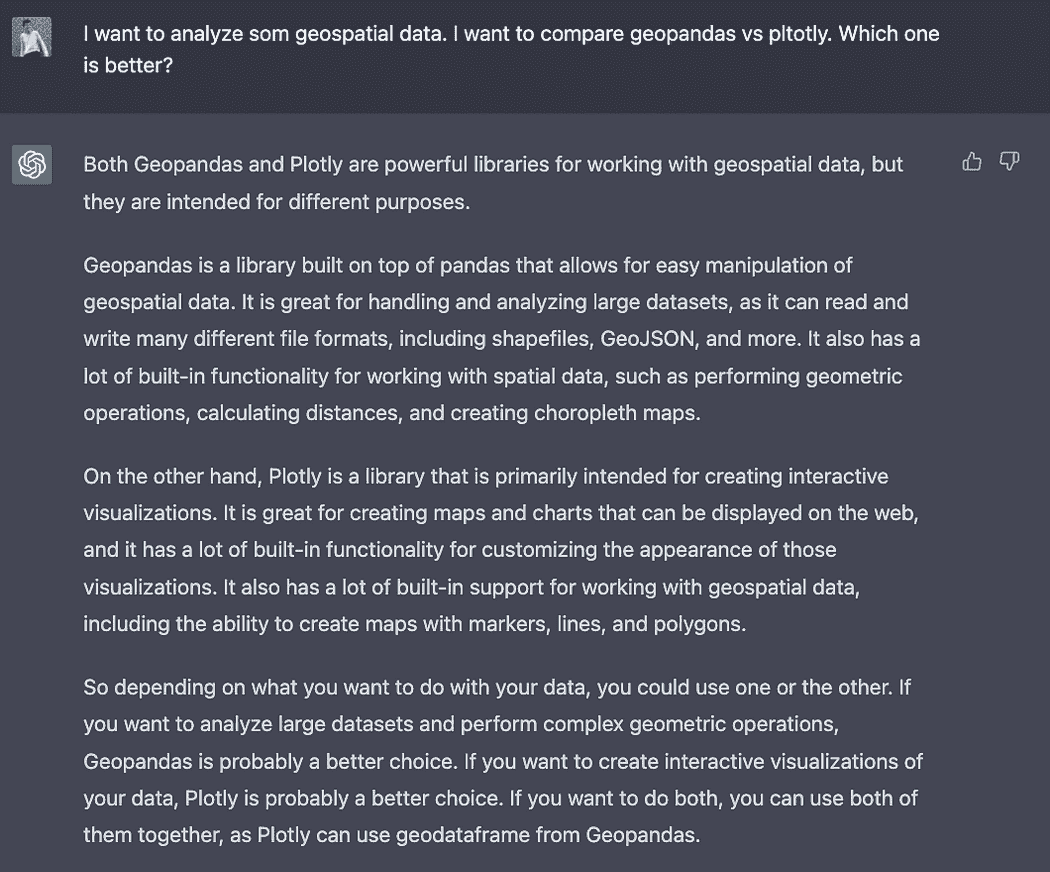

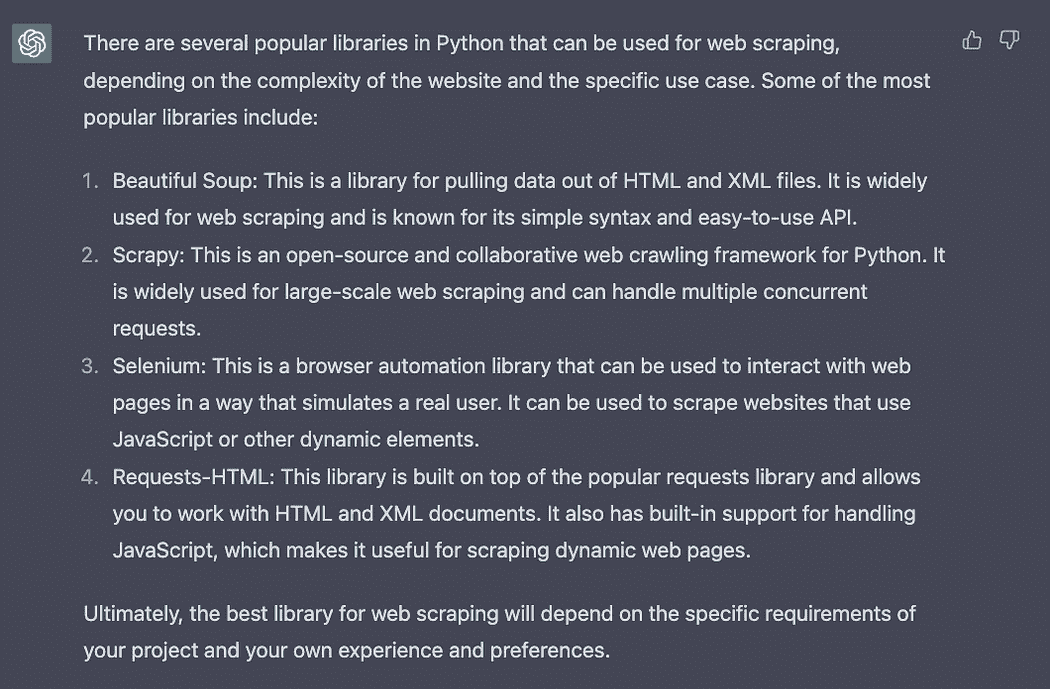

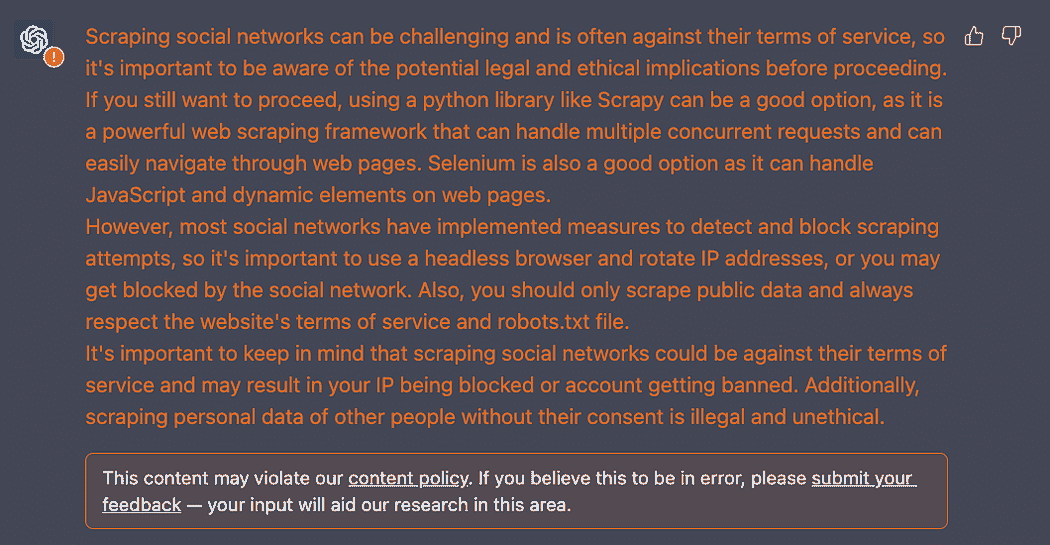

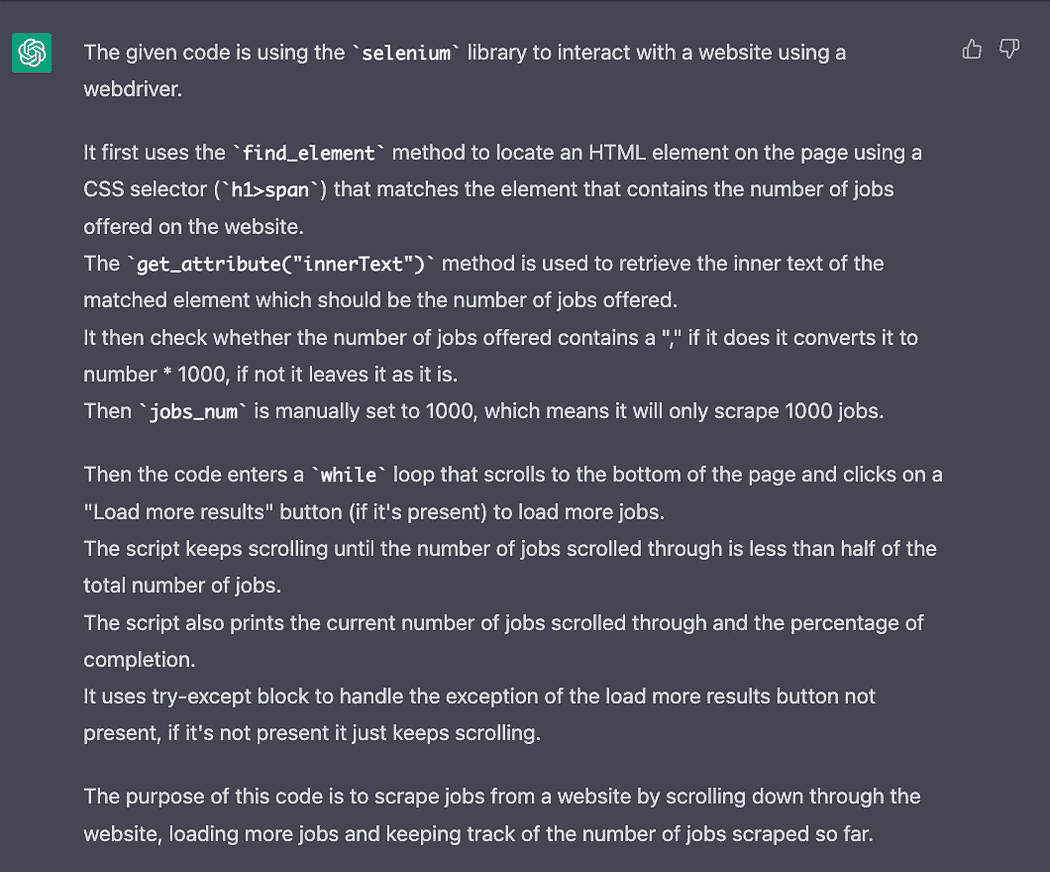

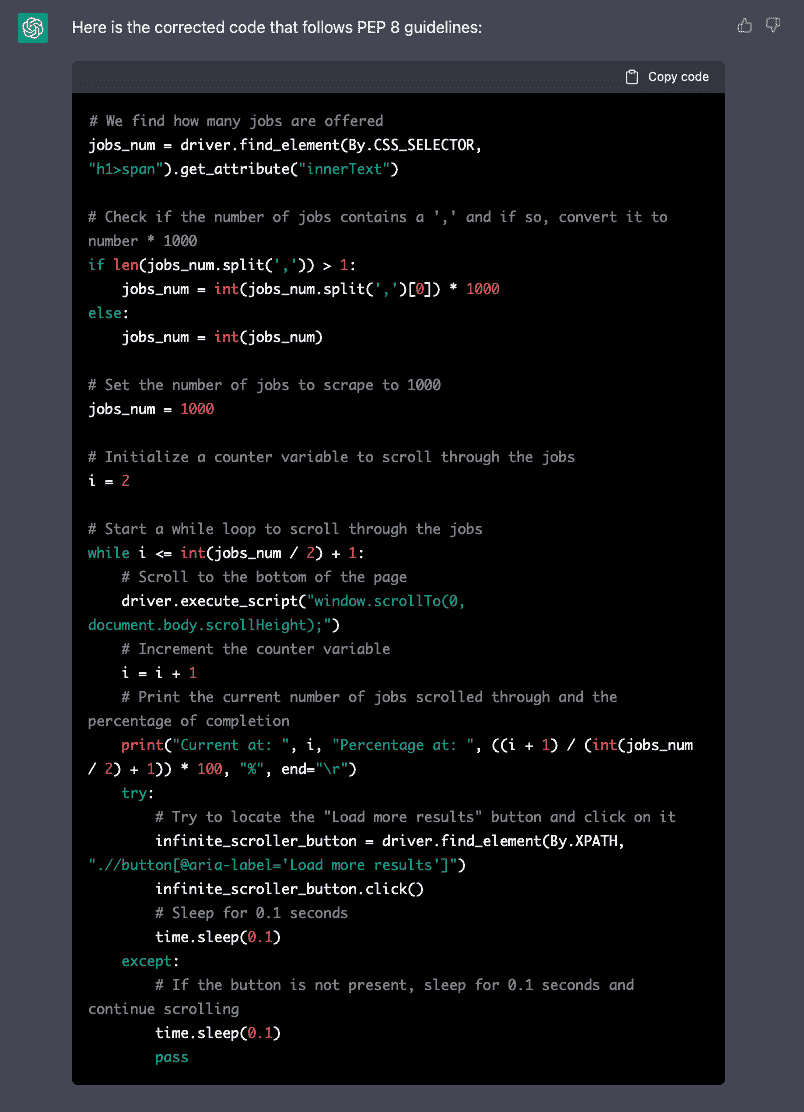

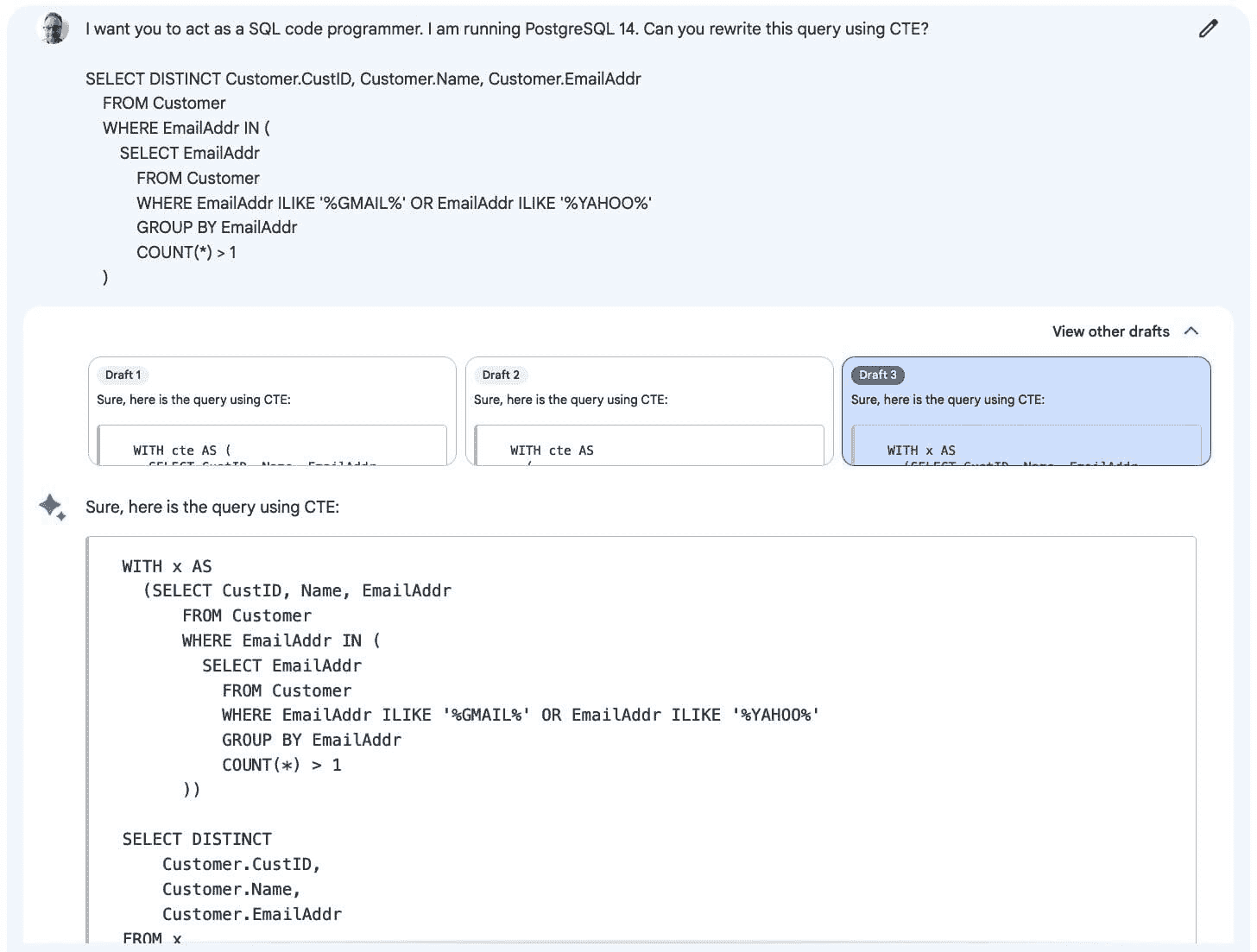

1. ChatGPT

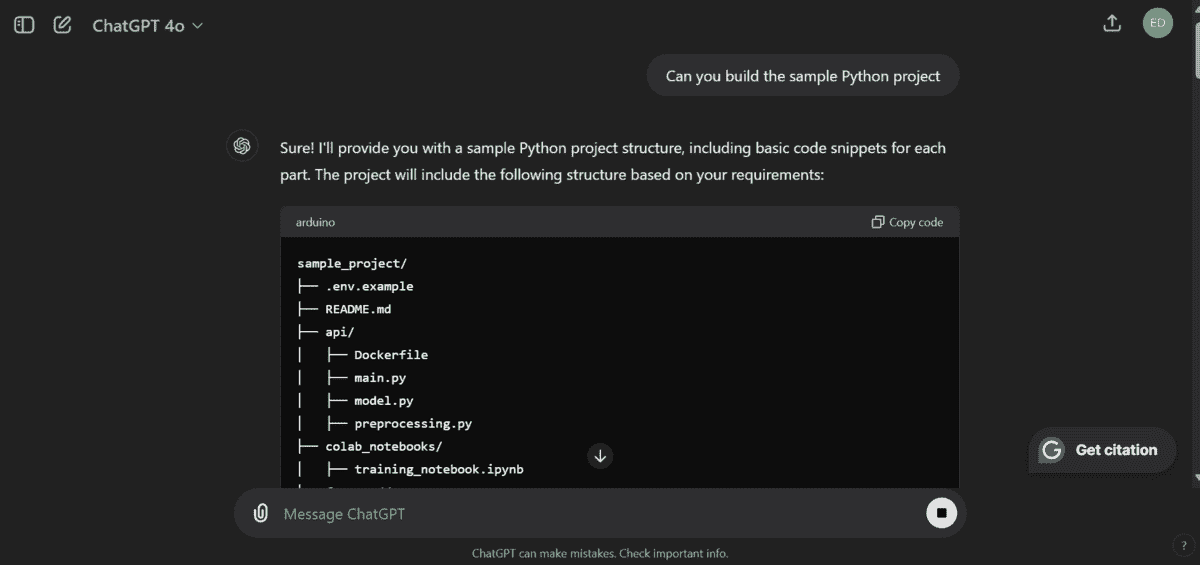

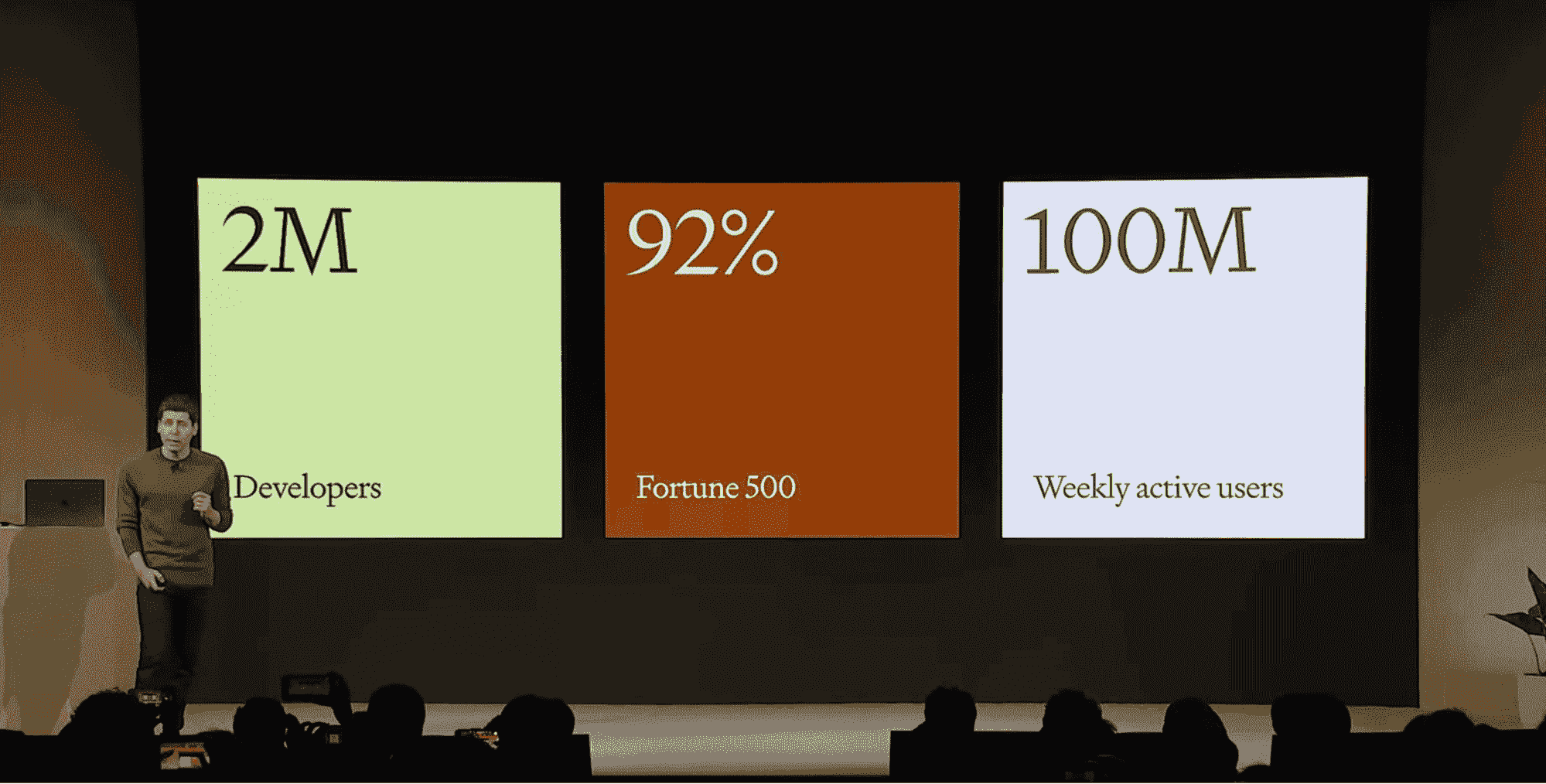

我们都熟悉 ChatGPT 及其生成 Python 代码的能力。在 OpenAI 的最新更新中,新的 GPT-4o 模型已免费提供给所有人使用。我使用 ChatGPT 来生成代码、解决问题和头脑风暴。它真正理解我们在应用程序中想要实现的目标。

例如,我让它构建一个示例 Python 项目。它提供了构建所需的所有代码和指令,包括项目结构中的文件和文件夹。你可以提出后续问题来修改项目,甚至请求它运行脚本以测试是否有效。

截图来自 ChatGPT

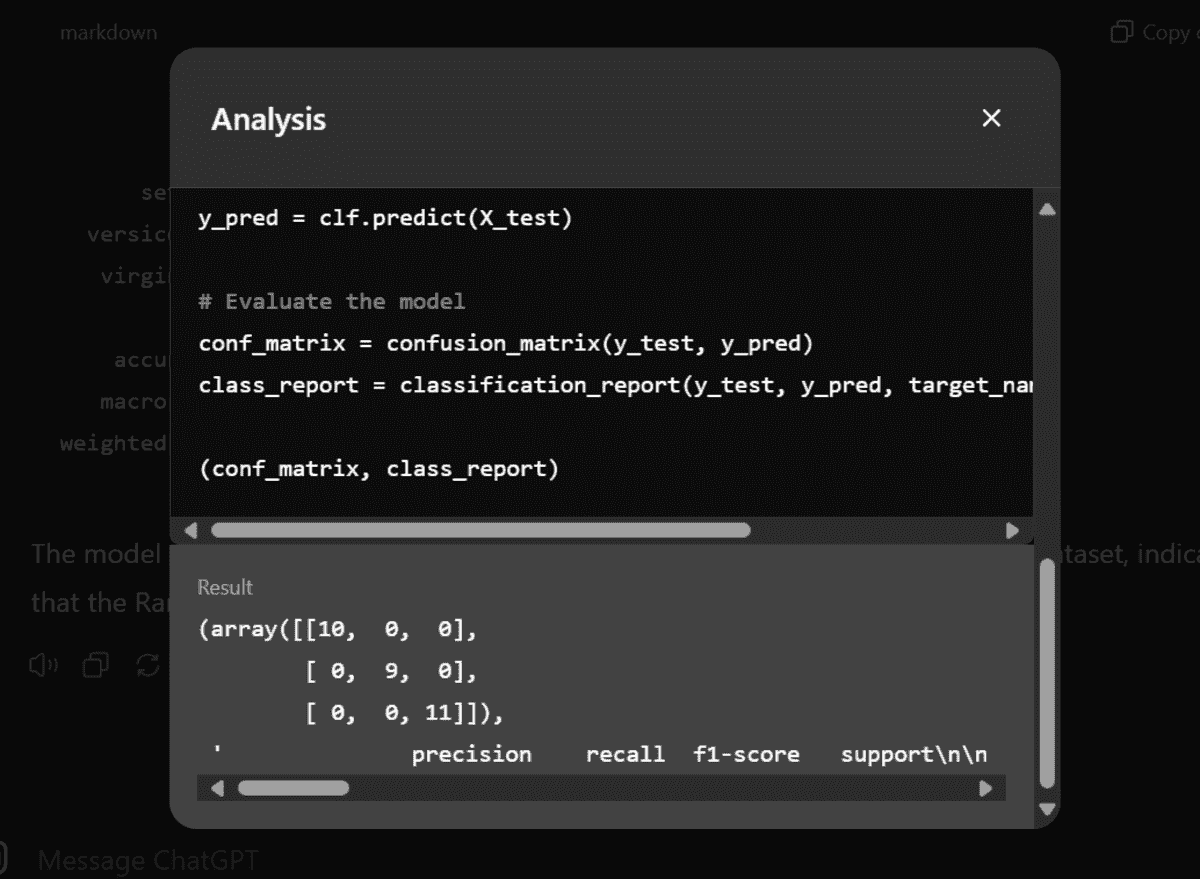

ChatGPT 配备了一个 Python 环境,这意味着它可以为你生成和运行代码,并显示结果。

截图来自 ChatGPT

简而言之,如果你是初学者,ChatGPT 是你唯一需要的编码助手。但如果你是开发人员或软件工程师,你需要一个与工作空间集成的工具。那就是 CodeGPT 的作用。

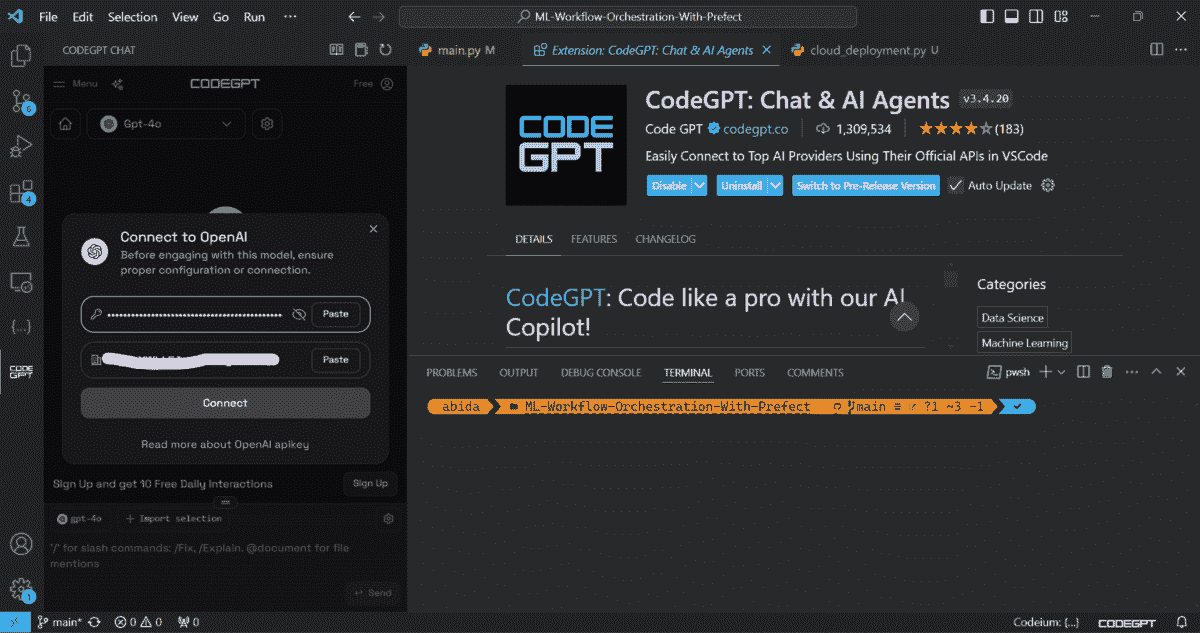

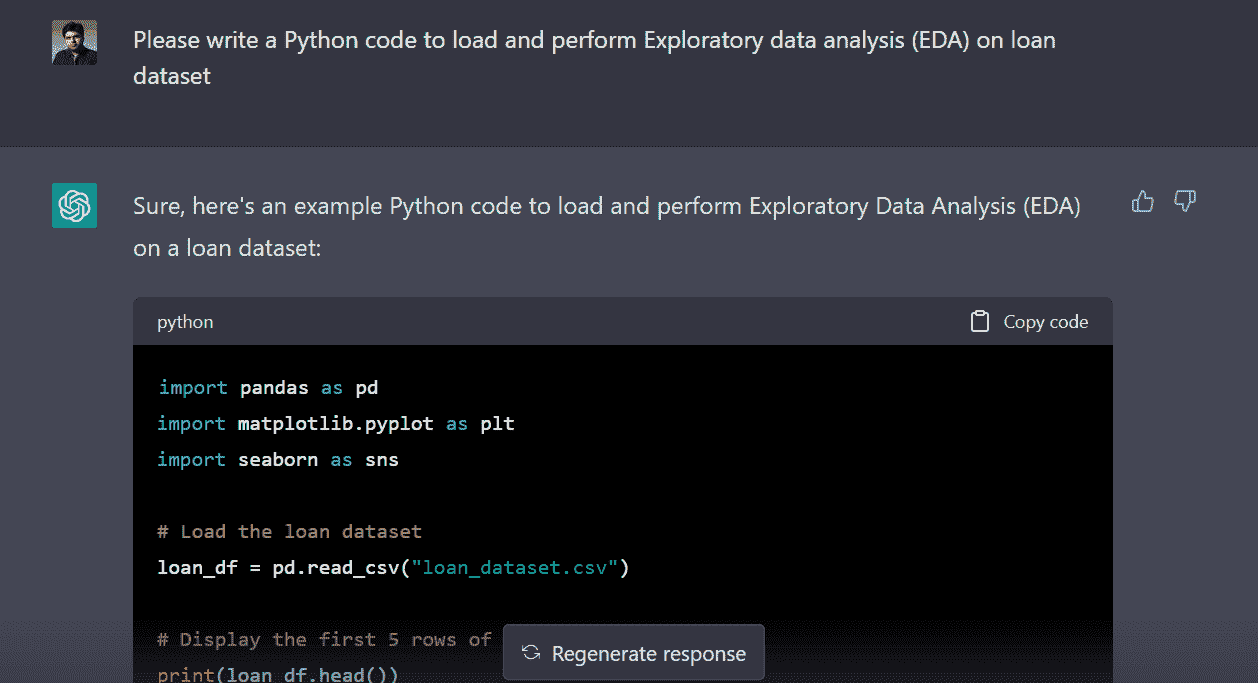

2. CodeGPT

CodeGPT VSCode AI 编码助手扩展,让你更高效地编写代码。它提供 AI 聊天帮助、自动完成、代码解释、重构、文档编写、单元测试等功能。

CodeGPT 扩展还允许你尝试来自不同提供者的各种 AI 模型。你甚至可以使用 Ollama 在本地运行自己的 AI 模型,并将其与 CodeGPT 扩展一起使用。这是一个集成的解决方案,用于软件开发。

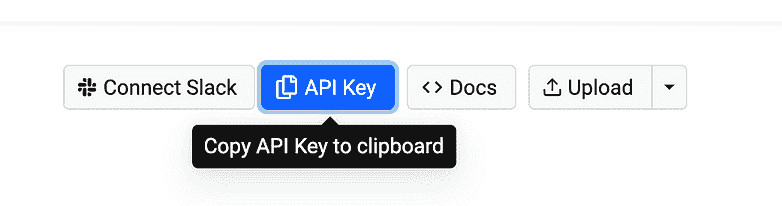

在这篇博客中,我们将学习如何设置以便与 GPT-4o 一起使用。首先,你需要通过访问 OpenAI API 来生成一个 OpenAI API 密钥。然后,在 VSCode 扩展市场中搜索并安装 CodeGPT 扩展。接下来,点击 CodeGPT 标签,选择 OpenAI 作为提供者,选择 GPT-4o 作为模型。系统会要求你粘贴 OpenAI API 密钥以访问该模型。

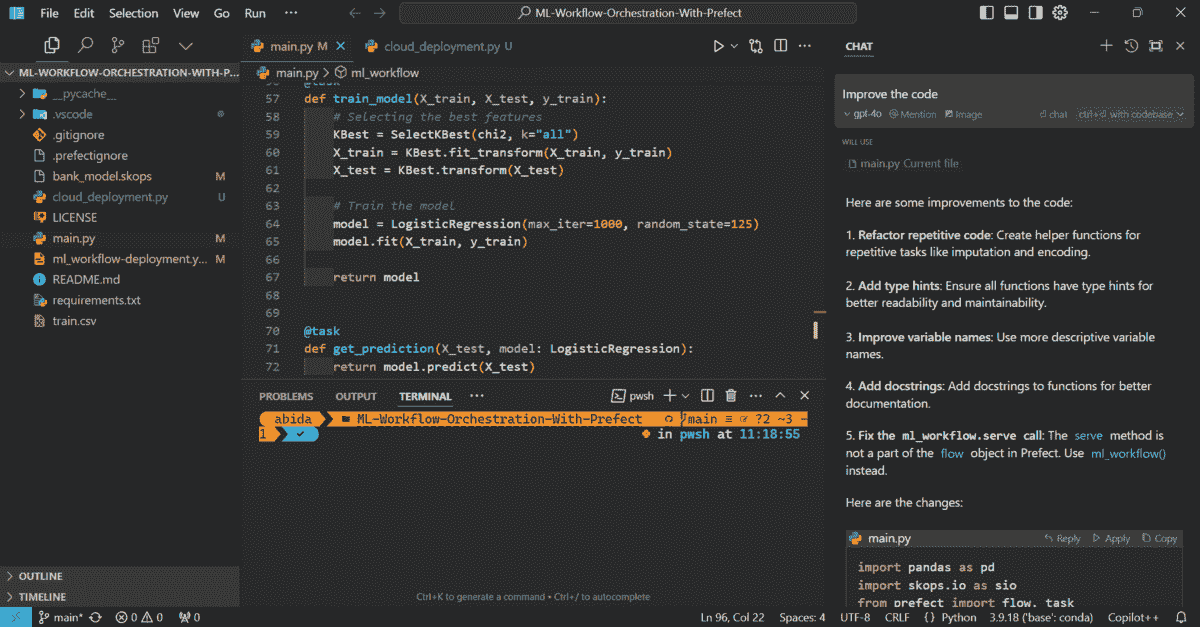

来自 VSCode 的截图

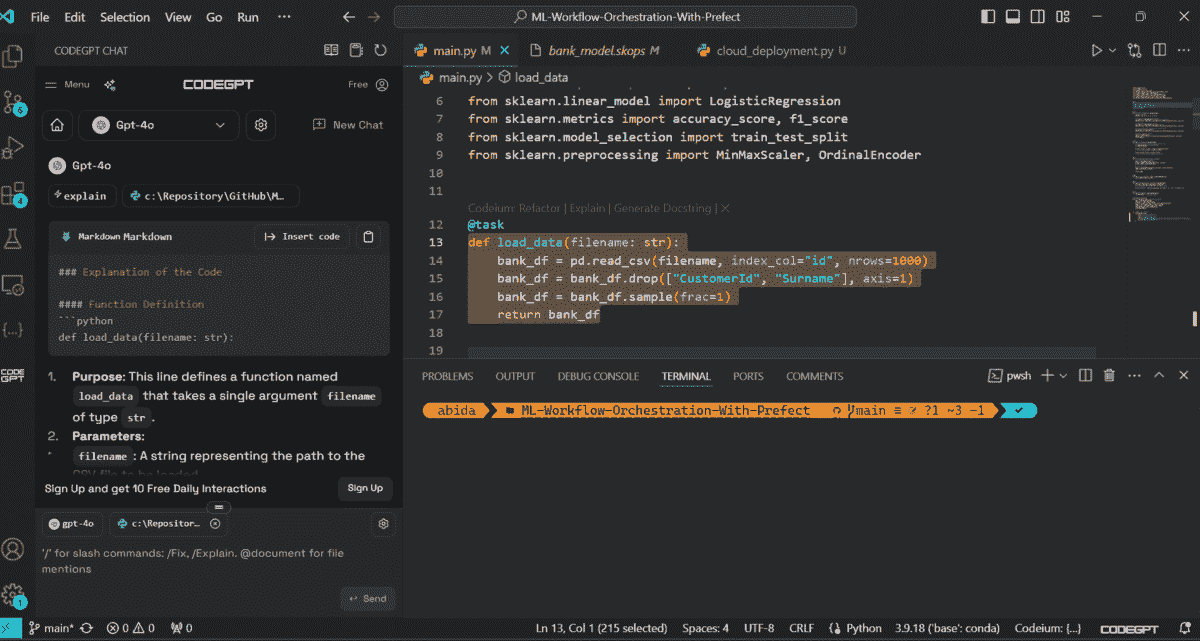

当一切设置完成后,你可以开始使用 GPT-4o 来生成代码、调试、记录和改进你的代码源。

来自 VSCode 的截图

CodeGPT 有许多限制,在自动完成方面速度较慢。你可以购买订阅以访问更好的自动完成模型和 AI 代理,但在将 AI 工具集成到软件开发环境中时,它仍然不够充分。它仍然是一个依赖于代码编辑器的扩展。

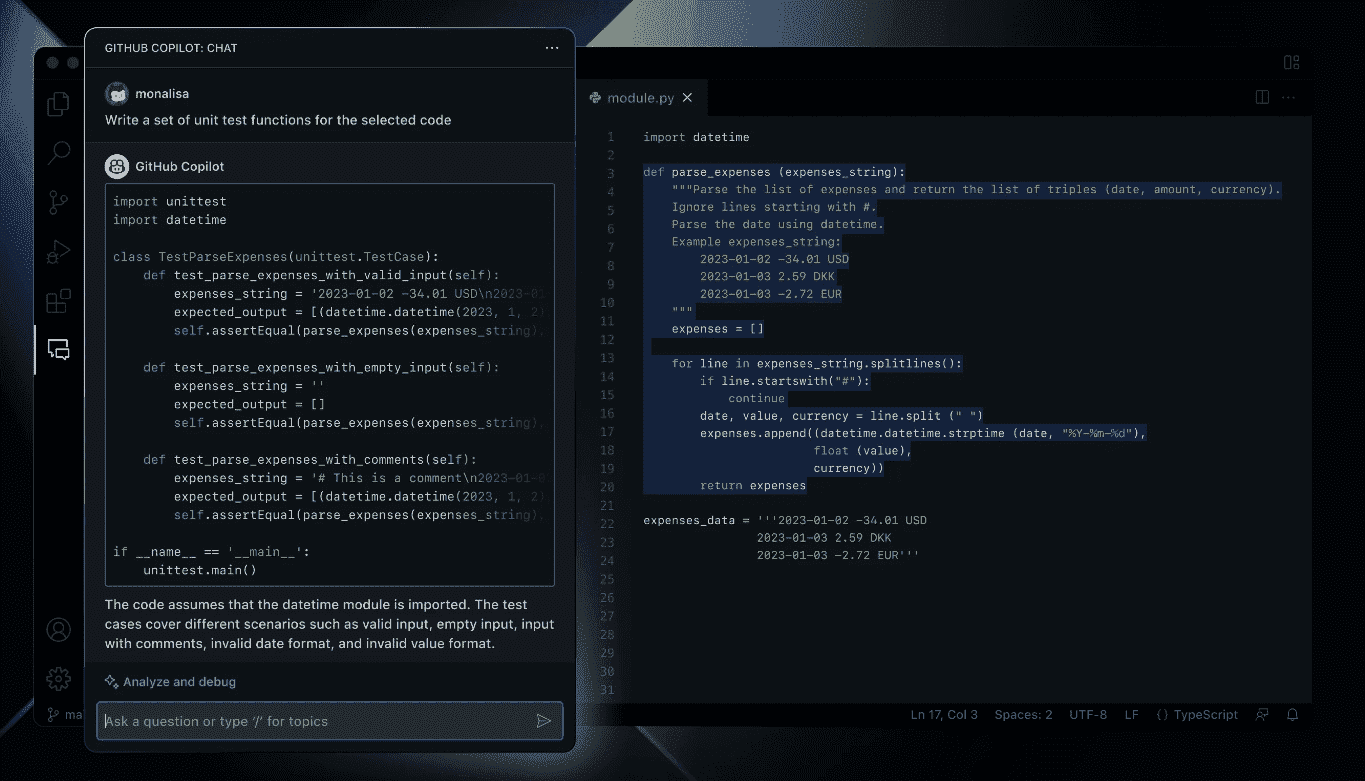

3. Cursor IDE

Cursor AI IDE 是硬核程序员、高级软件工程师和数据专业人士的完美工具。它是为 AI 辅助软件开发设计的 VSCode 的一个分支。这意味着它不仅仅是一个扩展,而是一个内置功能的生态系统,帮助你编写更好的代码。

Cursor 理解你的代码源,以提供更好的代码建议,甚至帮助你从零开始编写整个 Python 项目。我已经完全将工作流程从 VSCode 切换到 Cursor,因为它易于使用,响应速度比 VSCode 扩展更快。我没有错过任何功能——它基本上就像使用 VSCode。我仍然可以安装我喜欢的 VSCode 扩展,并使用相同的环境。没有变化。

在下面的示例中,我让 GPT-4o 改进我的代码,它做得非常好。

来自 Cursor 的截图

它还配备了内联聊天、理解图像和文档的能力、选择代码进行编辑或改进的能力以及保存之前聊天记录的能力,就像 ChatGPT 一样。

来自 Cursor 的截图

我强烈推荐数据专业人士切换到 Cursor 并享受两周的免费试用,以体验其惊人的功能。无论是编写代码还是向 GPT-4o 提问,感觉都很自然。

结论

我认识的所有数据专业人士都在他们的工作流程中使用 AI 以提高生产力和准确性。在使用 AI 助手工具之前,他们通常需要花费数小时来构建和测试 Python 应用程序,但现在他们可以在几分钟内完成相同的任务。他们所要做的就是审查并运行代码。

在这篇博客中,我们了解了 ChatGPT 用于构建和运行 Python 代码的新功能。我们还了解了 VSCode AI 助手扩展 CodeGPT,它允许你使用各种 AI 模型生成和改进你的 Python 代码。最后,我们了解了 Cursor IDE,这是一款为 AI 辅助软件开发而构建的 VSCode 分支。这些是我在数据分析、机器学习甚至网页开发中的日常工作中使用的工具。我希望你也能从中受益。

Abid Ali Awan (@1abidaliawan) 是一名认证的数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为面临心理问题的学生开发 AI 产品。

更多相关话题

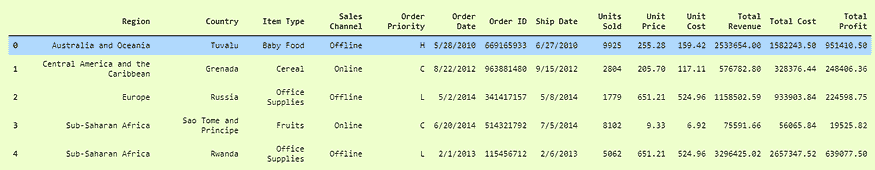

处理 CSV 文件的 3 种方法

原文:

www.kdnuggets.com/2022/10/3-ways-process-csv-files-python.html

来源:flaticon

对于那些刚开始学习 Python 编程语言、启动数据科学职业生涯,或只是需要快速回顾的人来说,本文介绍了 3 种在 Python 中处理 CSV 文件的方法。

我们的 3 大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

让我们快速了解什么是 CSV 文件。

什么是 CSV?

CSV 代表逗号分隔值,是一种包含数据的纯文本文件。它被认为是最简单的数据存储格式之一,数据科学家和其他工程师广泛使用。

这是一个示例结构:

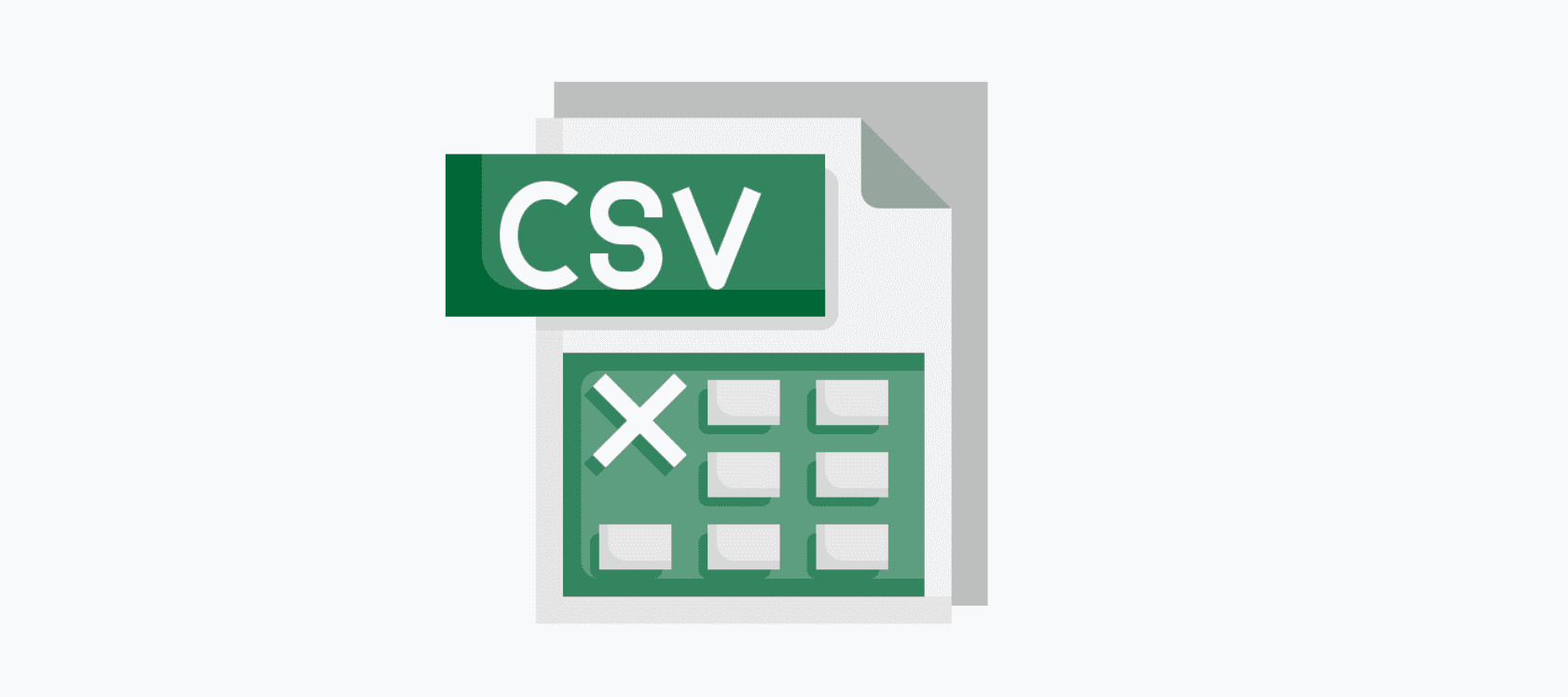

我从 Kaggle 获取了这个数据集,你可以在这里找到它:电动汽车价格

现在让我们深入了解如何在 Python 中处理 CSV 文件。

处理 CSV 文件

出于本文的目的,我将使用电动汽车价格数据集作为示例。

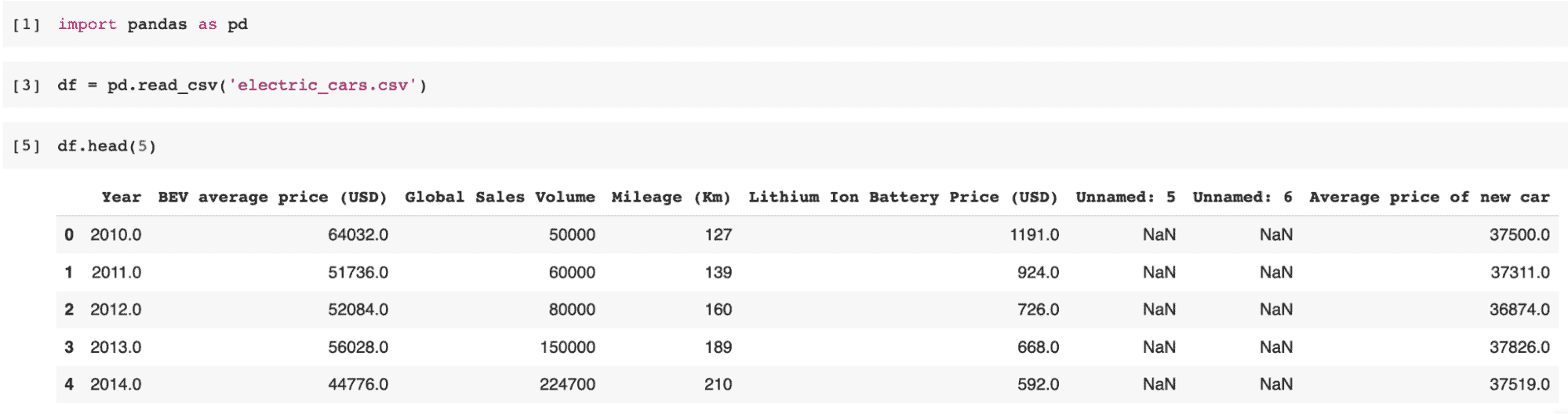

使用 pandas

Pandas 是一个开源 Python 包,建立在 Numpy 之上。步骤如下:

导入库:

import pandas as pd

使用 read_csv() 读取文件

read_csv() 就是它的名字,它将你的 CSV 文件读取到 DataFrame 中,如下所示:

df = pd.read_csv("electric_cars.csv")

df.head(5)

示例:

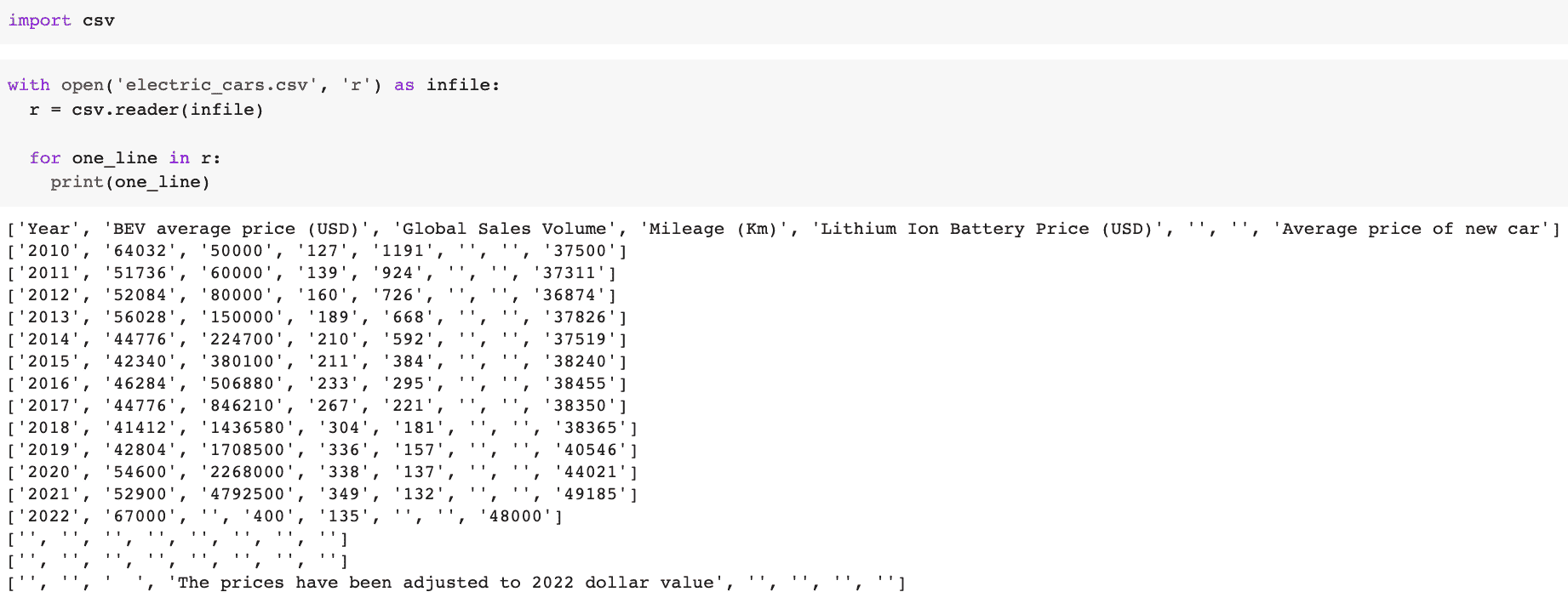

使用 csv.reader

Python 有一个内置模块叫做 csv,可以用来读取文件。以下是一些快速简单的步骤:

导入库:

import csv

打开你的 CSV 文件:

with open('electric_cars.csv', 'r') as infile:

r = csv.reader(infile)

for one_line in r:

print(one_line)

示例:

分割方法

我们可以通过 .split 方法轻松加载 CSV 文件。字符串上的 .split 方法返回一个字符串列表。

for one_line in open('electric_cars.csv'):

print(one_line.split(','))

然而,查看下面的示例图像,如果你想用制表符作为分隔符而不是逗号,可以这样做:

with open('format1.csv', 'w') as outfile:

for one_line in open('electric_cars.csv'):

outfile.write(('\t'.join(one_line.strip().split(',')) + '\n'))

示例:

总结

处理 CSV 文件到 Python 有多种方法。你可能有些方法未曾听说过,也可能已经知道。了解解决数据科学问题的多种方法总是有益的,你应该始终保持学习这些不同方法的开放态度!

Nisha Arya 是一名数据科学家和自由职业技术作家。她特别感兴趣于提供数据科学职业建议或教程以及数据科学的理论知识。她还希望探索人工智能如何/能够促进人类寿命的延续。作为一个热衷学习的人,她希望拓宽自己的技术知识和写作技能,同时帮助引导他人。

更多相关话题

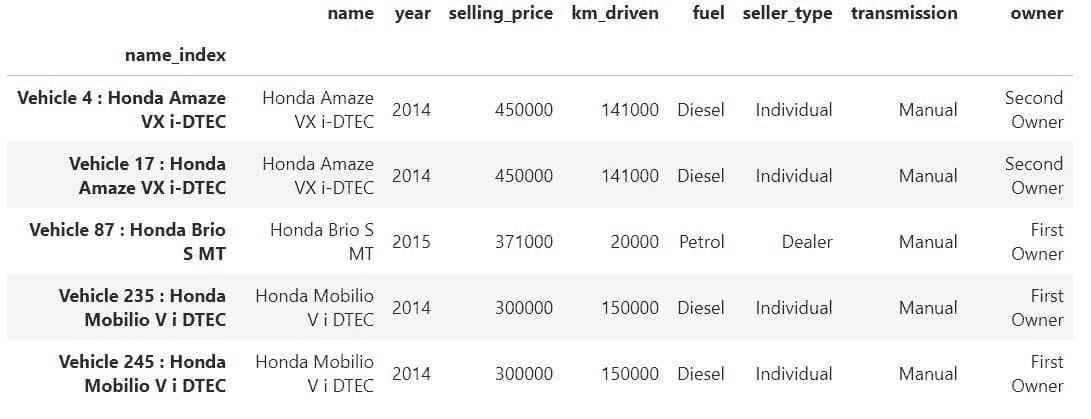

使用稳定扩散生成超现实面孔的三种方法

原文:

www.kdnuggets.com/3-ways-to-generate-hyper-realistic-faces-using-stable-diffusion

作者提供的图片

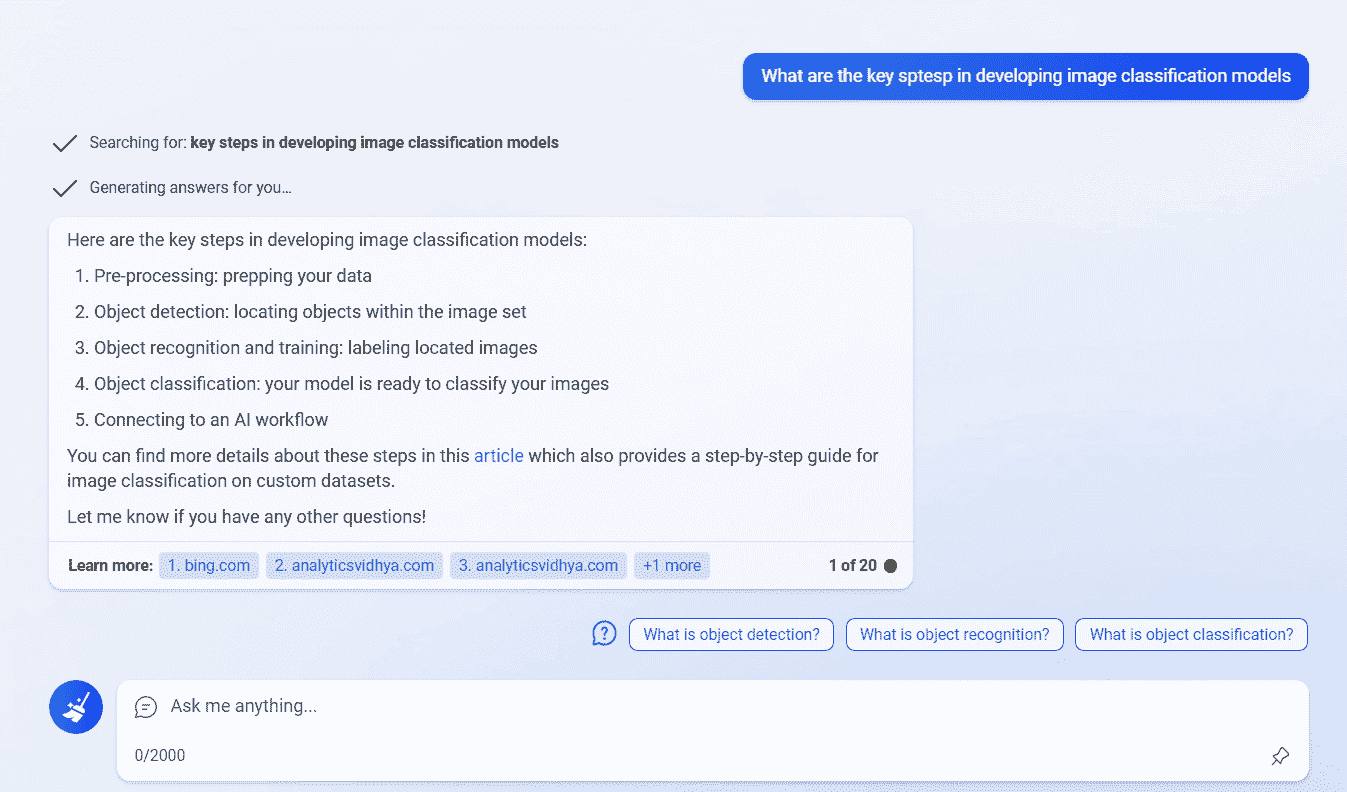

你是否曾经想知道人们是如何使用 AI 图像生成技术生成如此超现实的面孔,而你的尝试却总是充满了缺陷和伪影,看起来明显是假的?你已经尝试调整提示和设置,但仍然无法匹配你看到的其他人生产的质量。你究竟做错了什么?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在这篇博客文章中,我将带你了解三种关键技巧,以开始使用稳定扩散生成超现实的人脸。首先,我们将涵盖提示工程的基础,以帮助你使用基本模型生成图像。接下来,我们将探索如何通过升级到稳定扩散 XL 模型,通过更多的参数和训练显著提高图像质量。最后,我将向你介绍一个专门为生成高质量肖像而微调的自定义模型。

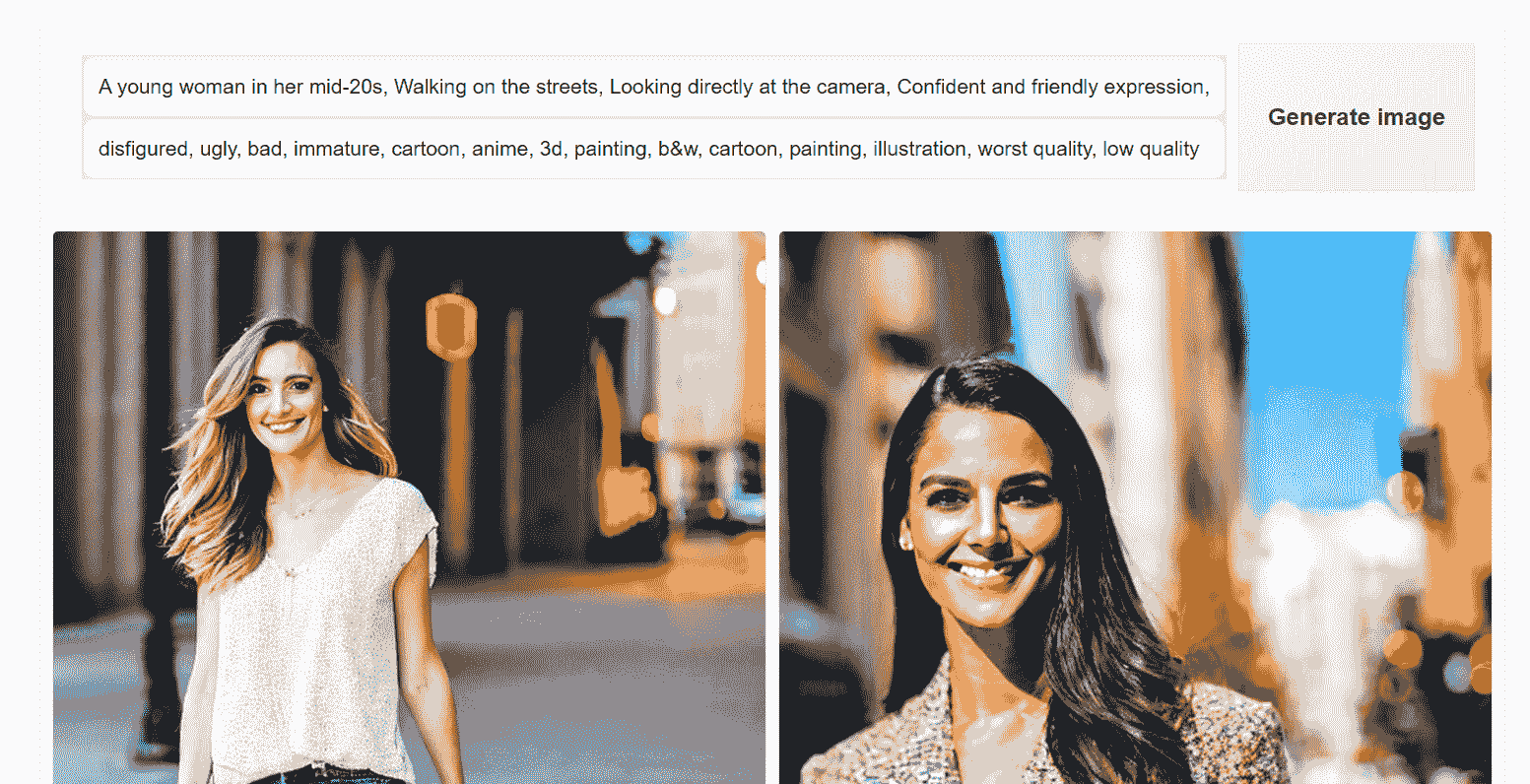

1. 提示工程

首先,我们将学习如何编写正面和负面提示以生成逼真的面孔。我们将使用 Hugging Face Spaces 上可用的稳定扩散 2.1 版本演示。它是免费的,你可以在不设置任何东西的情况下开始。

链接: hf.co/spaces/stabilityai/stable-diffusion

创建正面提示时,请确保包含所有必要的细节和图像风格。在这种情况下,我们希望生成一张年轻女性在街上走路的图像。我们将使用一个通用的负面提示,但你可以添加额外的关键词以避免图像中的重复错误。

正面提示: “一个二十多岁的年轻女性,走在街上,直视镜头,自信友好的表情,随意穿着现代时尚的服饰,城市街景背景,明亮的阳光照射,鲜艳的色彩”

负面提示: “变形的,丑陋的,糟糕的,不成熟的,卡通的,动漫的,3d 的,画作的,黑白的,卡通的,画作的,插图的,最差质量,低质量”

我们取得了一个良好的开端。图像准确,但质量还可以更好。你可以尝试不同的提示,但这是基础模型能提供的最佳效果。

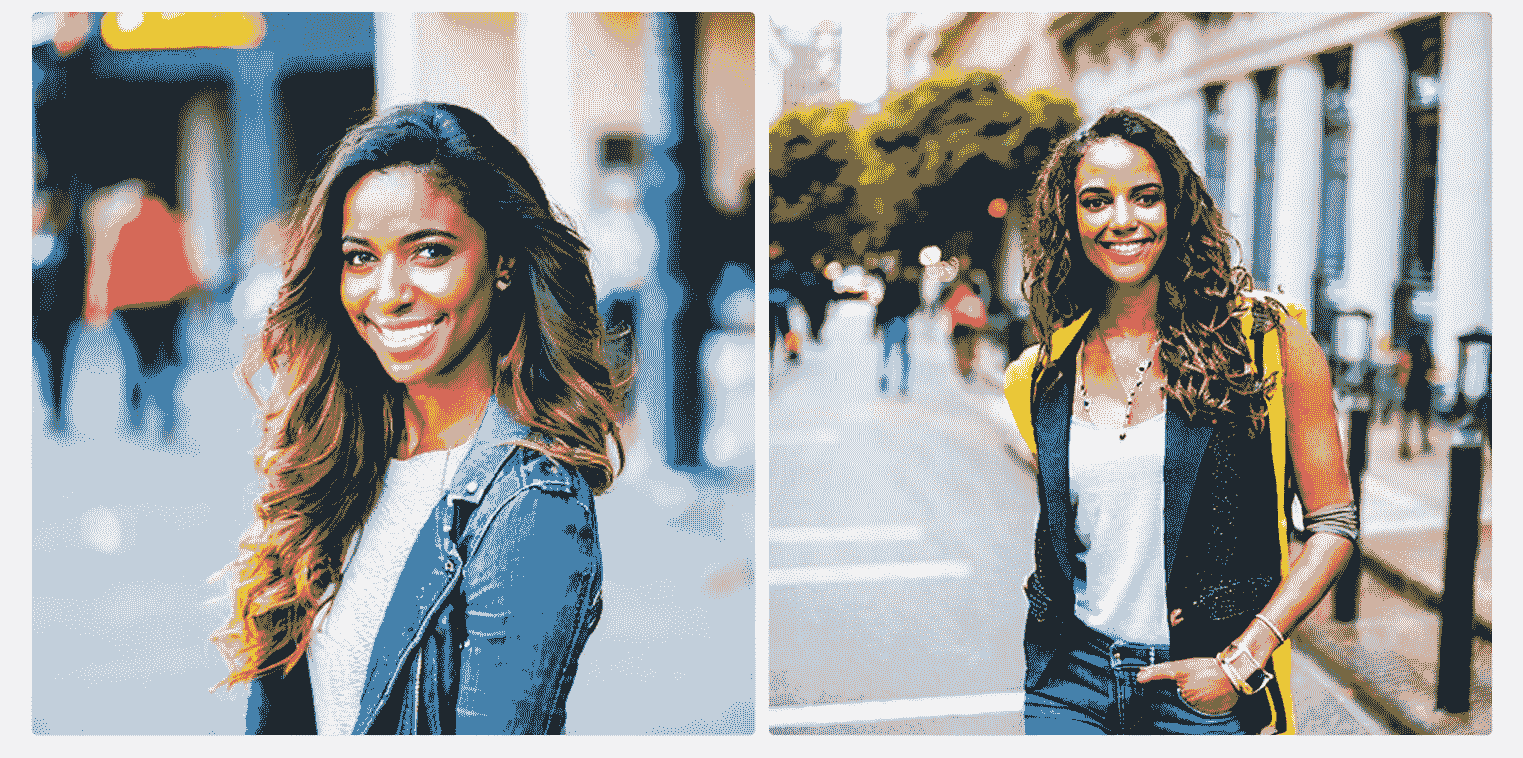

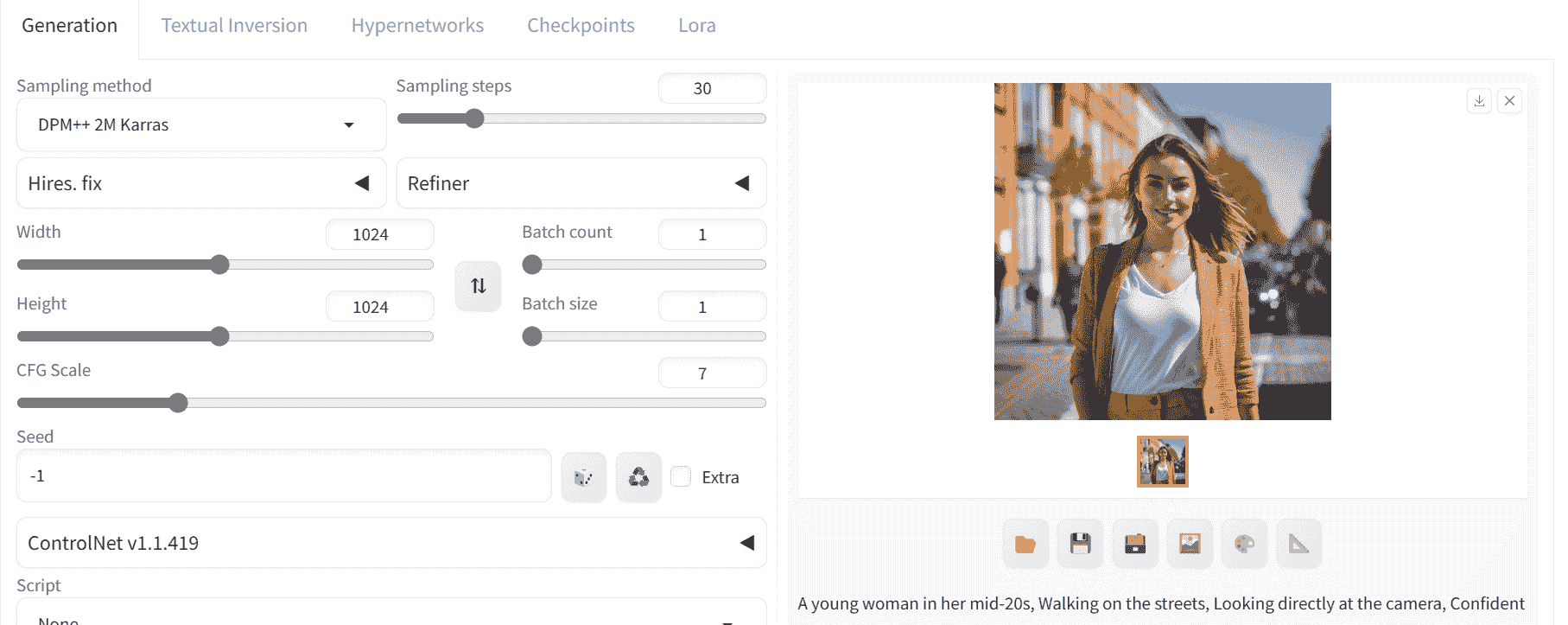

2. Stable Diffusion XL

我们将使用 Stable Diffusion XL(SDXL)模型生成高质量的图像。它通过使用基础模式生成潜在图像,然后通过精化器处理,以生成详细且准确的图像。

链接: hf.co/spaces/hysts/SD-XL

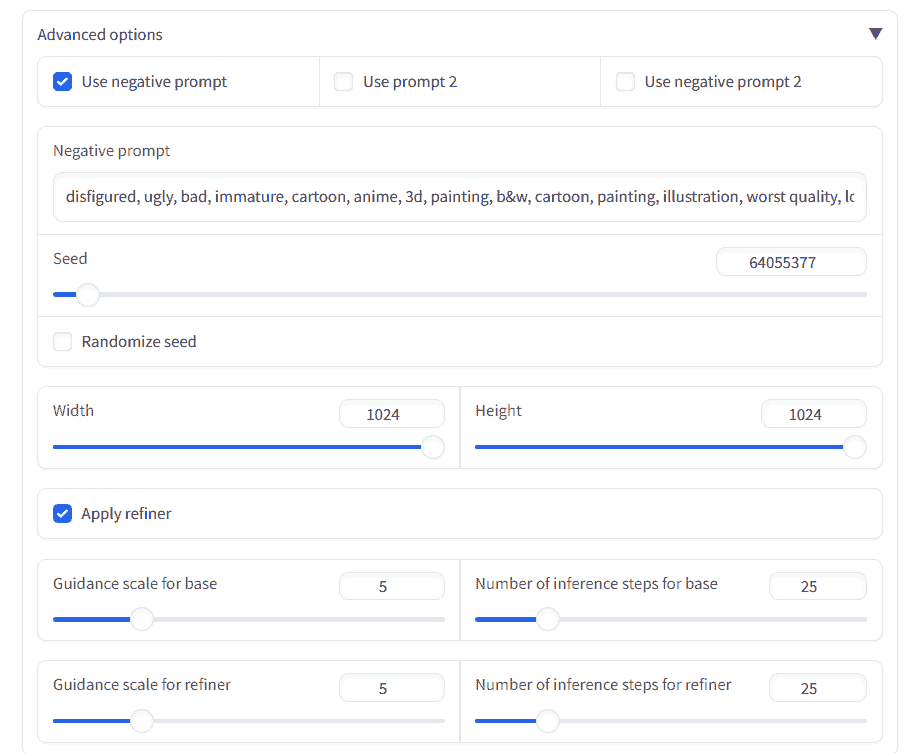

在生成图像之前,我们将向下滚动并打开“高级选项”。我们将添加负面提示,设置种子,并应用精化器以获得最佳图像质量。

然后,我们将编写与之前相同的提示,并做出小的更改。我们将生成一位年轻印度女性的图像,而不是普通的年轻女性。

这是一个显著改进的结果。面部特征完美。让我们尝试生成其他种族的图像,以检查偏差并比较结果。

我们得到了逼真的面孔,但所有图像都有 Instagram 滤镜。通常,真实生活中的皮肤不会这么光滑,常常有痤疮、标记、雀斑和皱纹。

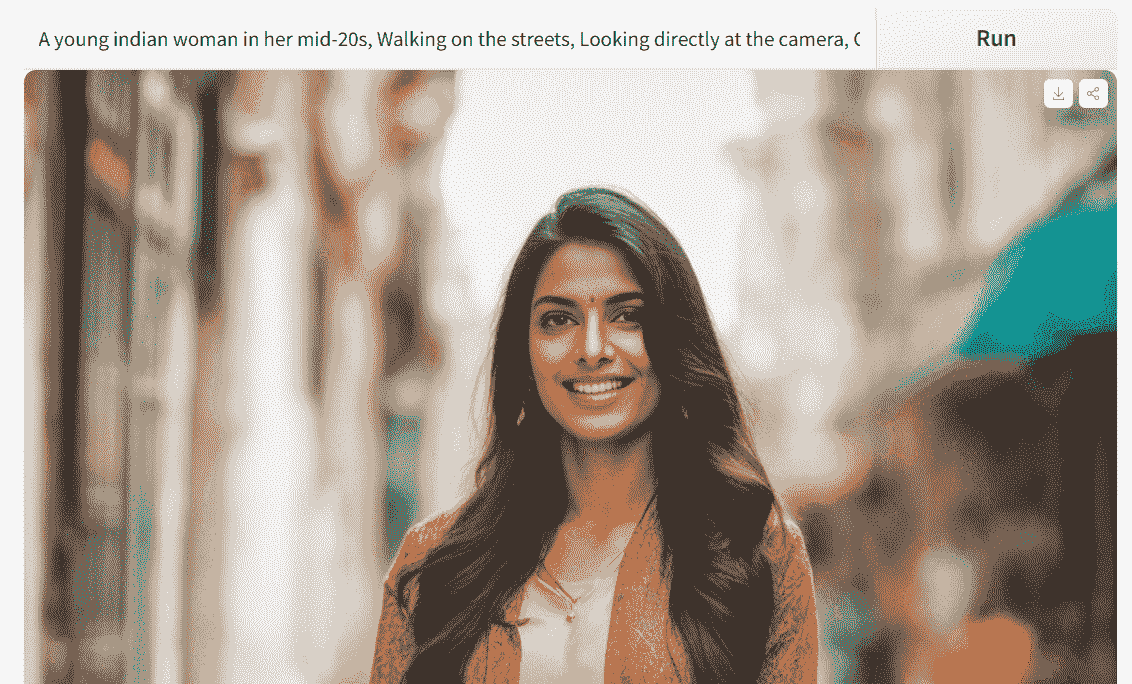

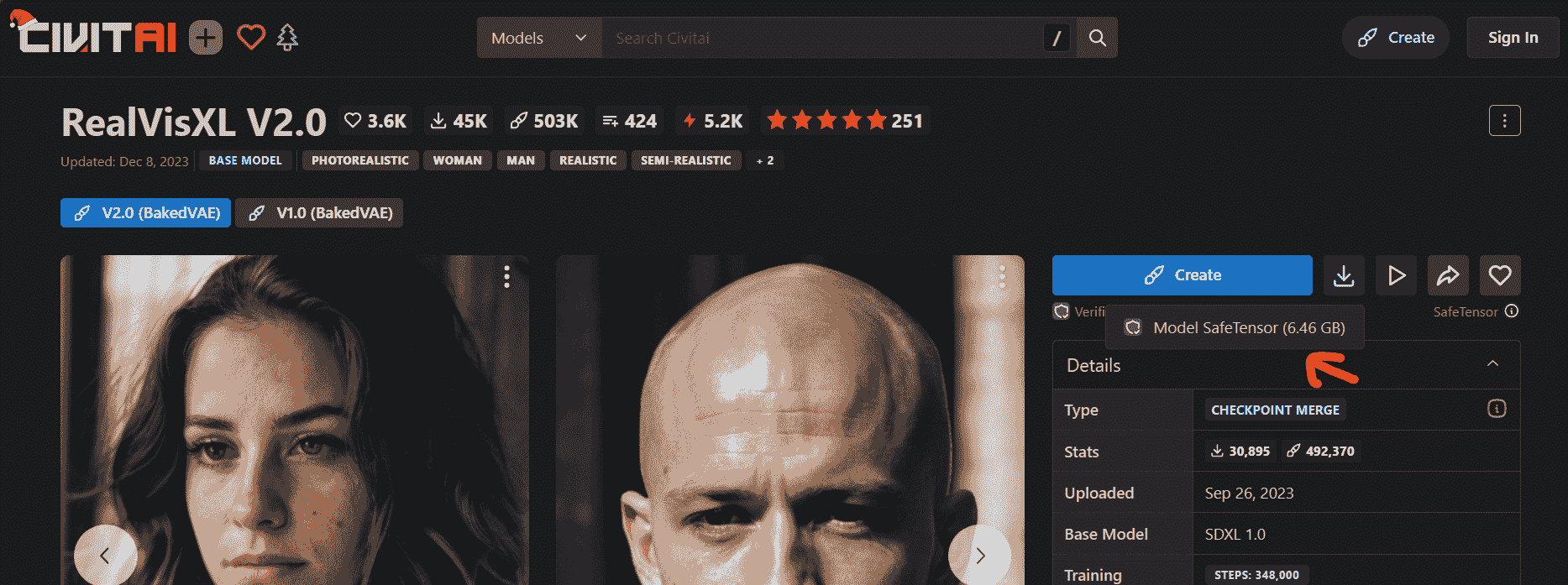

3. CivitAI: RealVisXL V2.0

在这一部分,我们将生成具有标记和逼真皮肤的详细面孔。为此,我们将使用来自 CivitAI 的定制模型(RealVisXL V2.0),该模型经过微调以获得高质量的肖像。

链接: civitai.com/models/139562/realvisxl-v20

你可以点击“创建”按钮在线使用模型,或者下载以便在本地通过 Stable Diffusion WebUI 使用。

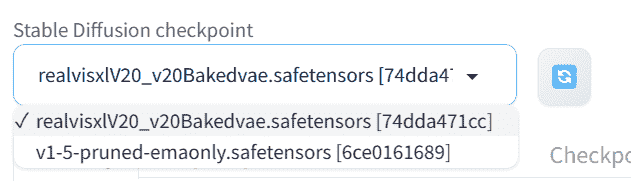

首先,下载模型并将文件移动到 Stable Diffusion WebUI 模型目录:C:\WebUI\webui\models\Stable-diffusion。

要在 WebUI 上显示模型,你需要按下刷新按钮,然后选择“realvisxl20…”模型检查点。

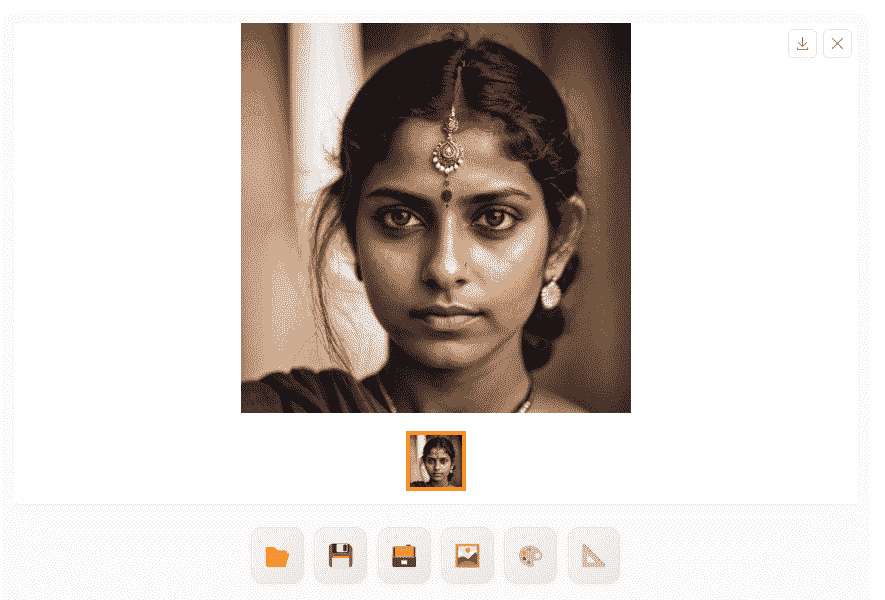

我们将开始编写相同的正面和负面提示,并生成高质量的 1024X1024 图像。

图像看起来很完美。为了充分利用定制模型,我们需要更改我们的提示。

新的积极和消极提示可以通过滚动模型页面并点击你喜欢的逼真图像来获得。CivitAI 上的图像附带了积极和消极提示以及高级引导。

积极提示: “一个专注、果断、超现实的印度年轻女性的图像,动态姿势,超高分辨率,清晰纹理,高细节 RAW 照片,详细的面部,浅景深,锐利的眼睛,(逼真的皮肤纹理:1.2),浅色皮肤,单反,相机颗粒”

消极提示: “(最差质量,低质量,插图,3d,2d,画画,漫画,素描),张嘴”

我们有一张详细的印度女性的图像,皮肤逼真。与基础的 SDXL 模型相比,这是一个改进版本。

我们生成了三张更多的图像以比较不同的民族。这些结果非常出色,包含了皮肤标记、多孔皮肤和准确的特征。

结论

生成艺术的进步将很快达到一个我们难以区分真实和合成图像的水平。这预示着一个可持续的未来,在这个未来中,任何人都可以利用基于多样化真实世界数据训练的自定义模型,从简单的文本提示生成高度逼真的媒体。快速的发展暗示着激动人心的潜力——也许有一天,生成一个逼真的视频来复制你自己的相貌和语言模式将像键入描述性提示一样简单。

在这篇文章中,我们学习了提示工程、高级稳定设计模型以及用于生成高精度和逼真面孔的定制微调模型。如果你想要更好的结果,我建议你探索 civitai.com 上各种高质量的模型。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,热爱构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为面临心理健康困扰的学生构建一个 AI 产品。

更多相关内容

利用 ChatGPT 和 AI 赚钱的 3 种方式

原文:

www.kdnuggets.com/3-ways-to-make-money-with-chatgpt-and-ai

编辑提供的图片

作为一个白天有全职工作、晚上从事多个副业(包括创建书面内容、在线课程,以及最近的科技YouTube 频道)的人,我总是在寻找新的被动收入来源。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

所以,当 ChatGPT 发布时,我是第一个在网上寻找如何利用这个工具赚取更多收入的人。

不出所料,我在网上找到的大部分推荐从模糊和不可操作到完全不道德。

显然,成千上万的人开始向亚马逊涌入AI 生成的书籍,导致平台对自出版施加了限制,并大量删除了怀疑为 AI 生成的内容。

然而,在筛选了大量网络上的糟糕建议后,我确实发现了一些相当有用的方法,人们利用 ChatGPT 和生成型 AI 工具来实现货币化。

我甚至开始将这些建议融入到我自己的工作流程中(并成功地在过去一个月里几乎翻倍了我的在线收入)。

在本文中,我将分享我的经验,并提供 3 种实际的方法,帮助你利用 ChatGPT 开始赚取收入。

1. 创建无面孔的社交媒体内容

创作者经济正在爆炸式增长。

通过建立个人品牌并生成他人认为有价值的内容,赚取收入的机会巨大。

然而,内容创作需要花费大量的时间(和金钱)。

一个 YouTube 视频需要构思主题、编写脚本、花费数小时对着摄像头讲话,并在后期制作中进行编辑。

确定理想的视频背景、灯光和音频也需要大量的试错过程。对很多人来说,坐下来对着摄像头讲话可能显得令人生畏和不自然。

生成性 AI 在内容创作领域是一个改变游戏规则的工具。你可以使用 ChatGPT 进行主题研究,为你的 YouTube 视频生成一个吸引人的“引子”,甚至优化你的内容以便在 Google 上获得良好的排名。

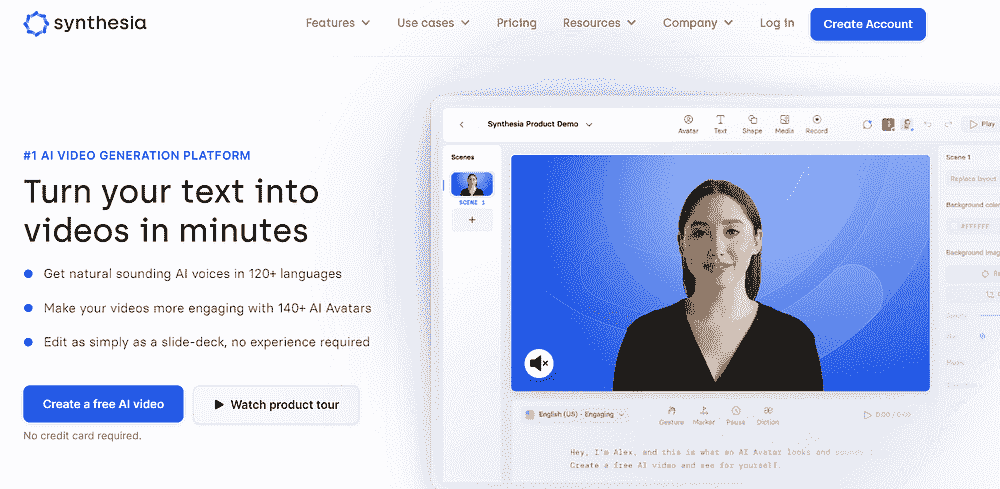

然后,你可以使用像Synthesia这样的工具为你的影片创建 AI 头像和配音,这样你就不需要亲自出现在视频中:

图片由作者提供

最后,为了在各种平台上推广你的内容,只需使用像Opus AI这样的工具,将你的 YouTube 视频中的部分内容转换为短视频,这些短视频可以在 TikTok 和 Instagram 等网站上重复使用。

当然,你要让自己与泛滥在互联网上的 AI 生成内容区分开来,这意味着要在视频制作中投入相当的研究,并选择一个细分领域。

ChatGPT 和生成性 AI 应该加快内容创作的过程,而不是取代你的创造力和独特声音。

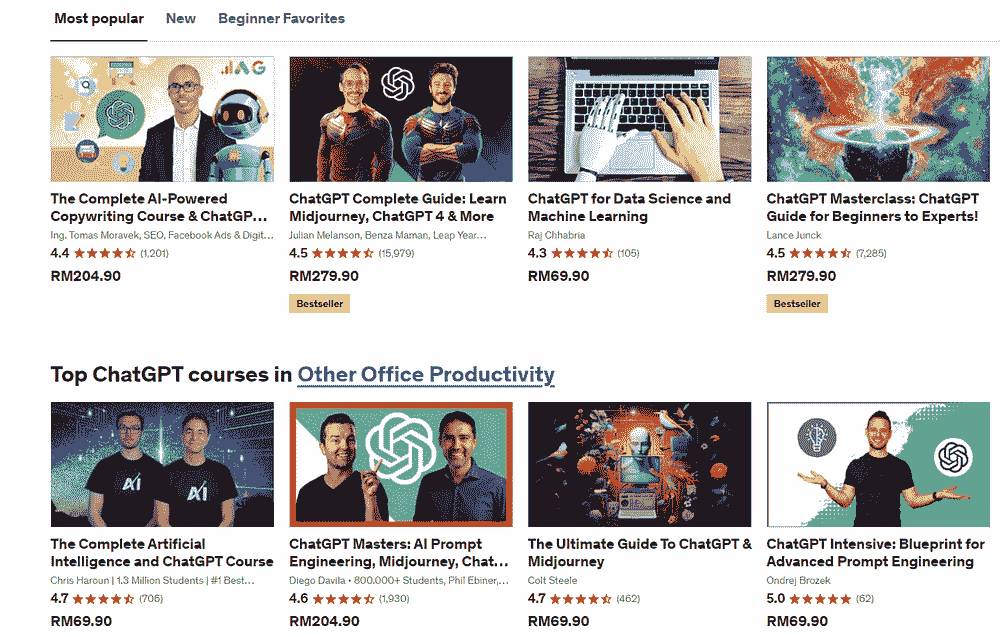

2. 在线课程

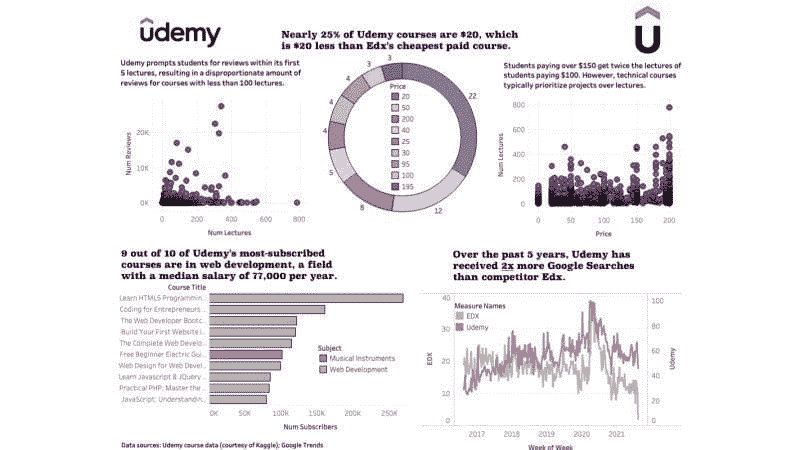

关于生成性 AI 工具如 ChatGPT、Midjourney 和 DALLE 的在线课程正在迅速流行。

注意: 顶级 Udemy 讲师在平台上的收入超过**\(1 百万**](https://www.nichepursuits.com/how-much-do-udemy-instructors-make/),而普通创作者的年收入大约为[**\),而普通创作者的年收入大约为$3,306。

这里是一些在 Udemy 上受欢迎且适合初学者的生成性 AI 课程:

图片由作者提供

看看上述在线课程的学生人数吧!

这应该告诉你,个人和组织愿意大力投资于学习更多关于 AI 的知识。

当然,这并不意味着任何人都可以凭借重复内容来创建一个入门级的 ChatGPT 课程。

你应该这样做:

找到一个细分领域

如果你在市场营销领域工作,例如,你已经拥有了将你与普通人区分开来的专业知识。

现在,开始学习将 ChatGPT 融入到你的日常工作流程中。你的工作中是否有生成性 AI 可以自动化的方面?

例如,AI 在生成符合 SEO 要求的内容方面已经变得非常出色,以至于谷歌也无法可靠地区分这些内容和人类撰写的文章。

利用这些知识,你能否教会小企业主有效地营销他们的产品,而不必雇佣内容创作者或 SEO 专家?

这是一个许多人愿意支付费用学习的技能,因为它教会他们如何节省开支并在长期内提升商业成果。

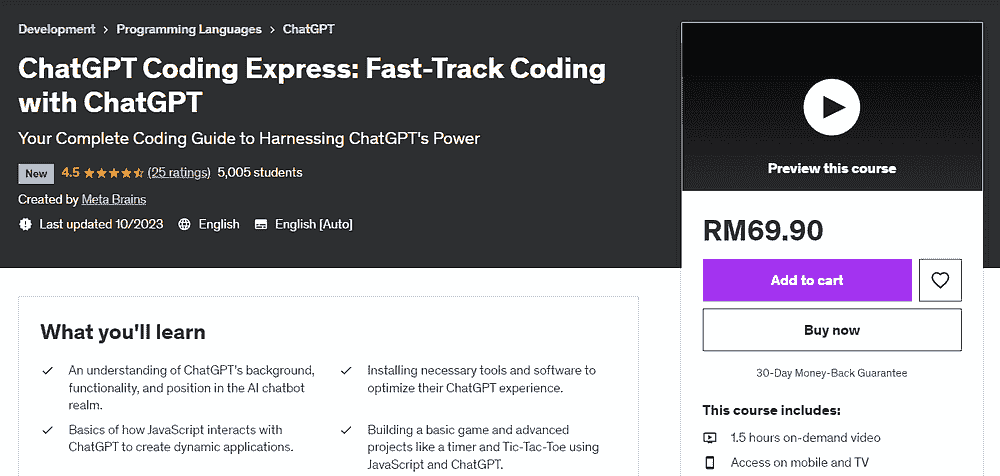

比如说,这个 Udemy 课程仅用不到 2 小时的视频内容,就已经有了 5000 名学生,因为它教会了人们如何通过 ChatGPT 学习编程:

作者提供的图片

如果你已经拥有一项可销售的技能,你可以通过教别人如何利用 ChatGPT 来磨练这项技能,从而赚到很多钱。

在今天的创作者经济中,开始变得前所未有的简单!

你只需注册一个平台,如Udemy或Teachable,并开始创建课程。

3. 提示工程与人工智能咨询

如果你最近关注了人工智能领域的公告,你可能听说过市场上新兴的热门工作——“提示工程师”。

根据《商业内幕》的报道,这些职位的年薪高达 375,000 美元,甚至不需要技术学位。

那么……这是否意味着任何人只需在 ChatGPT 中输入提示就能赚到这类的钱?有什么陷阱吗?

尽管这是一个相对较新的领域,未来几年将持续发展,但提示工程师的主要角色是利用生成性人工智能来改善商业成果并最大化效率。

大多数提示工程职位需要专业领域的知识。你必须能够应用提示技术来解决特定行业的问题。

例如,如果你从事市场营销工作,你可能会被聘用来让 ChatGPT 创建与业务相关且准确的 SEO 友好内容。

人工智能研究公司 Anthropic 正在积极招聘提示工程师,并没有固定的申请要求。

职位招聘信息指出,他们将考虑那些能够为自己提出有力论据的申请者,并表示:

“如果你还没有做过多少提示工程的工作,你可以通过花一些时间实验 Claude 或 GPT3,并展示你通过一系列精心设计的提示获得了复杂行为,从而最好地展示你的提示工程技能。”

公司的代表进一步提到,逻辑和推理能力是提示工程师最重要的特质,拥有编程知识或机器学习背景在申请这个职位时是一个额外的优势。

尽管许多这些要求看起来非常模糊,但提示工程确实似乎是一项有利可图的技能,各个领域的人们都将受益。

即使你最终没有找到提示工程师的工作,这仍然是一项企业愿意支付来学习的技能,因为员工在人工智能的应用方面仍然面临困难。

你可以在特定领域,如市场营销或金融,提供围绕生成性人工智能和提示工程的咨询服务。

作为曾经向组织提供数据和机器学习咨询服务的人,我成功地通过建立在线存在和创建网站来获得客户,我在另一篇文章中讨论了这一点。

此外,如果从零开始建立品牌看起来很艰巨,这里有一个AI 工具列表,可以帮助你自动化这个过程。

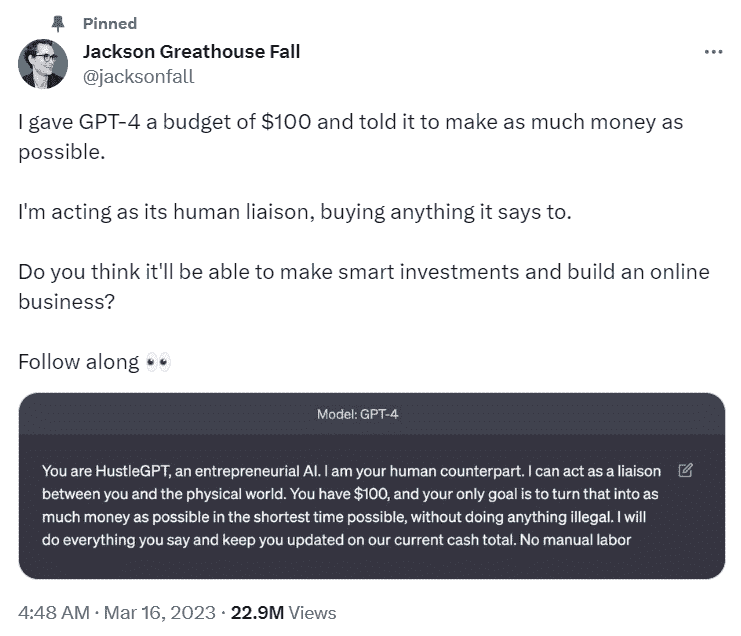

这个人用 ChatGPT 一天之内把 100 美元变成了一个生意

我想通过推荐Jackson Greathouse Fall的故事来结束这篇文章,他用生成式 AI 在一天之内启动了他的业务,要求 ChatGPT 将 100 美元变成“尽可能多的钱”。

他按照聊天机器人的指示操作,成功在一天之内为公司筹集了 1378 美元。截至三月中旬,公司估值为 25000 美元。

你可以在Business Insider上阅读整个故事。

Natassha Selvaraj 是一位自学成才的数据科学家,热爱写作。Natassha 涉猎所有与数据科学相关的内容,是数据主题的真正大师。你可以通过LinkedIn与她联系,或查看她的YouTube 频道。

更多相关内容

了解贝叶斯定理的 3 种方式将提升你的数据科学水平

原文:

www.kdnuggets.com/2022/06/3-ways-understanding-bayes-theorem-improve-data-science.html

图片由 Ella Olsson 提供,来自 Pexels

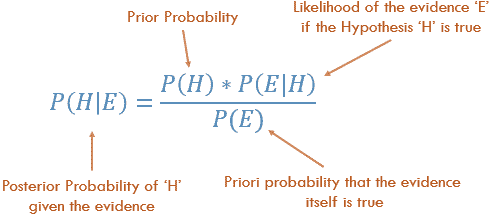

贝叶斯定理为我们提供了一种在考虑先前信念的强度的情况下,根据新证据更新信念的方法。应用贝叶斯定理时,你会寻求回答这样一个问题:在新证据面前,我的假设的可能性有多大?

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全领域。

1. 谷歌网络安全证书 - 快速进入网络安全领域。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

在这篇文章中,我们将探讨贝叶斯定理如何提高你在数据科学中的实践:

-

更新

-

沟通

-

分类

到最后,你将对这一基础概念有深刻的理解。

#1 — 更新

贝叶斯定理提供了一种测试假设的结构,考虑到先前假设的强度和新证据。这个过程被称为贝叶斯更新。

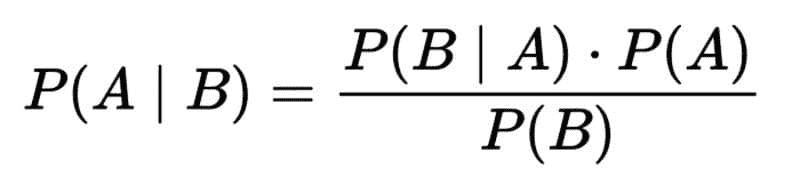

贝叶斯定理,其中 A 代表假设,B 代表与假设相关的新证据。

用语言表达,这个公式是“在 B 给定的情况下 A 的可能性 等于 (左括号) A 给定 B 的可能性 乘以 A 的可能性 (右括号) ***除以 *** B 的可能性。”

让我们再次回顾公式,这次附上变量的定义:

“在新证据面前假设的似然 等于 在假设也为真的情况下新证据为真的似然 乘以 假设在观察到新证据之前的似然,全部除以 新证据的似然。”

这可以进一步简化:

“后验概率 等于 似然 乘以 先验概率 除以 边际似然。”

无论贝叶斯定理现在是否听起来直观,我保证你一直在使用它。

现实世界的例子

比如说,你的朋友打电话告诉你,她非常抱歉,但今晚不能来参加晚餐。她最近领养了一只宠物考拉,这只考拉得了感冒。她真的需要待在家里监控情况。

你的假设是你的朋友不会无缘无故地抛弃你。(毕竟,你做的 ph 很棒,你的朋友会疯狂地错过。)考虑到她新宠物的最近证据,你的假设为真的可能性有多大?

照片由Valeriia Miller提供,来自Pexels

为了评估后验概率,即我们朋友因为照顾考拉而没有来参加晚餐的情况,我们需要考虑你朋友在假设她是一个不抛弃晚餐计划的正直人物的情况下,照顾考拉的可能性。你可能会得出结论,一个通常负责任的好朋友会待在家里照看宠物的可能性很高。

接下来,我们将可能性与先验****概率相乘。在你朋友打电话之前,你对她晚餐计划的承诺的信念有多强?如果你相信你的朋友很坚定,通常不愿在最后一刻改变计划,那么你的先验概率就很强,你不太可能改变这一观点,无论新证据如何。另一方面,如果你的朋友很不靠谱,你已经在想她是否会打电话取消,你的先验概率就会很弱,这也可能会质疑她关于与考拉待在家的说法。

最后,我们将上述计算结果除以考拉拥有的边际可能性??

贝叶斯推断建立在这种灵活的常识性方法上,根据先验的强度和新证据的可能性来更新我们对世界的模型。实际上,贝叶斯定理最初的应用是为了评估上帝的存在。

当涉及到生活和数据科学中的关键问题时,没有什么比贝叶斯定理更直观的方法来评估信念如何随时间变化。

#2 — 沟通

正如贝叶斯定理可以帮助你理解并阐述在面对新证据时如何更新你的理论,贝叶斯定理也可以使你成为一个更强的数据科学沟通者。

数据科学的核心在于应用数据来改善决策制定。

只有两件事决定了你的人生结果:运气和你的决策质量。你只能控制这两件事中的一件。— Annie Duke,扑克冠军和作家

提高决策质量通常意味着说服决策者。像每个人一样,你组织中的决策者也会进入谈话。

现实世界示例

我曾经是一个热气球制造商的顾问。我的任务是帮助建立一个数据库,以改善客户对其供应链、制造过程和销售的end-to-end understanding。

当工厂经理在第一天带我们参观车间时,他自豪地描述了一个关于更轻、更便宜的原材料的新供应商合同。

但有一个问题。随着我的团队将来自不同数据源的表格连接起来,我们发现了新供应商的材料与废品增加 2.5%之间的关系。

由Darren Lee拍摄,来自Unsplash

工厂经理对新供应商有一个非常强烈的先验知识,认为它对他的业务是一个净正面影响。我们有一些相反的证据。我们也有贝叶斯定理。我们理解这一事实:

先验知识越强,改变它所需的证据就越多。

在向工厂经理展示我们的发现之前,我们需要收集额外的证据,以排除其他因素(例如:磨损的机器、新员工、环境条件等)对废品水平差异的影响。

最终,我们向经理提供了更多证据,并帮助他重新谈判了供应商合同。

#3 — 分类

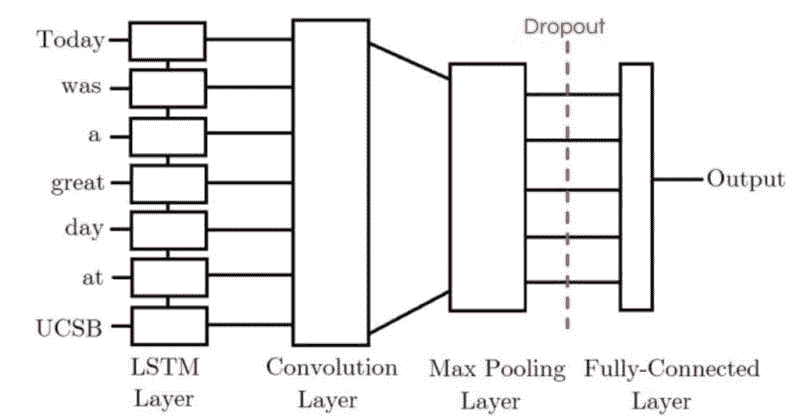

贝叶斯定理可以应用于文本分析的用例,这是一种称为朴素贝叶斯的技术,因为它天真地假设数据集中的每个输入变量(在这种情况下是每个单词)彼此独立。

现实世界示例

假设你发现了一堆你祖父母写的信件。它们中包含了足够的戏剧性,以证明动荡的恋情并不仅限于年轻人在现实电视中。

由RODNAE Productions拍摄,来自Pexels

你想构建一个情感分类器来确定内容的大多数是正面还是负面。一种方法是利用朴素贝叶斯。

一个生成模型(如朴素贝叶斯)将建立一个模型,描述一个类别(在这种情况下是正面或负面)如何生成一些输入数据。给定一个观测值(我们信件测试语料库中的新句子),它返回最可能生成该观测值的类别。这与学习输入特征预测能力的判别模型(如逻辑回归)相对。

朴素贝叶斯基于词袋模型技术——基本上是将文档转换为直方图,统计每个词出现的次数。

你可以使用我们在第 #1 部分学习的贝叶斯推断公式的略微修改版本来计算每个观测值的最可能类别。这种略微的修改就是朴素贝叶斯中的朴素部分:假设在给定类别的条件下,每个词的概率是独立的,因此你可以将它们相乘以生成句子属于该类别的概率。

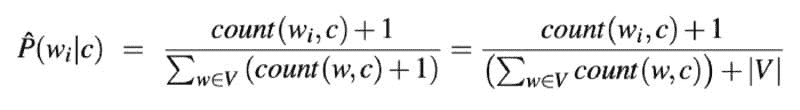

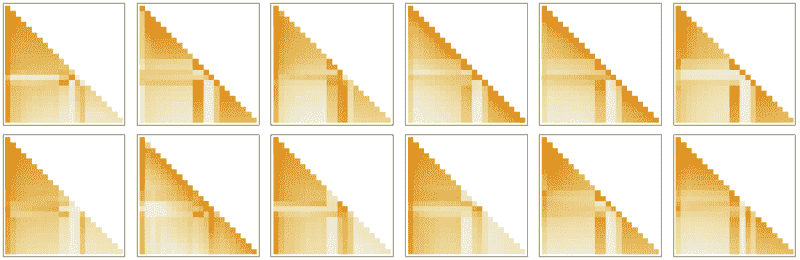

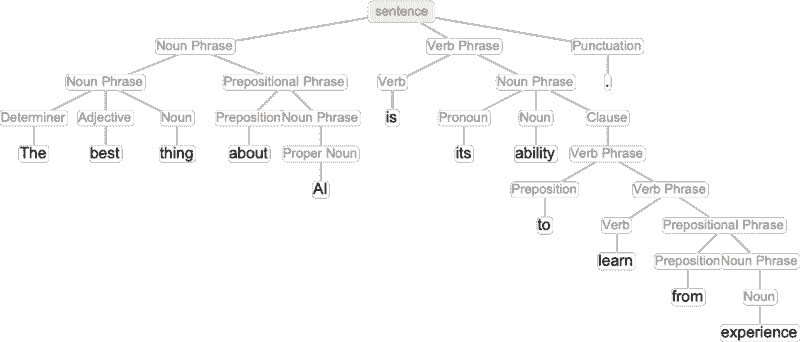

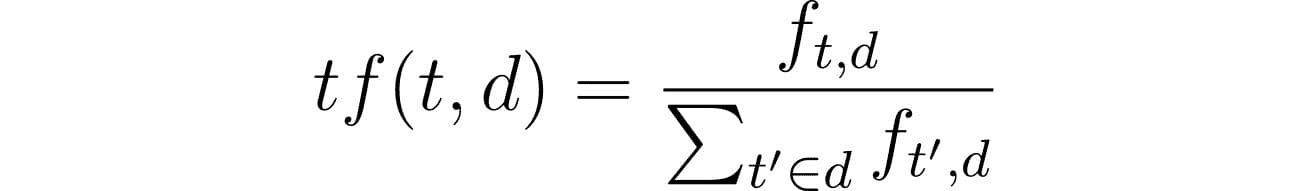

通过 语音与语言处理 由 丹尼尔·朱拉夫斯基 和 詹姆斯·H·马丁

在上述公式中,w? 代表文档 c 中词的计数。公式的分母是词落入给定类别的条件概率之和。

公式中的 +1 防止在类别内没有观测到词的情况下乘以零。这种加一的技术称为拉普拉斯平滑。

最后,|V| 由所有类别中的所有词的并集组成。

贝叶斯定理词汇

-

后验概率:在新证据出现后,假设成立的可能性

-

似然:在假设为真的情况下,证据为真的可能性

-

先验概率:在新证据出现之前你对假设成立的信念强度

-

边际似然:证据

-

朴素贝叶斯:一种假设数据集中特征之间独立的分类器算法

-

生成模型:模拟特定类别如何生成输入数据

-

词袋模型:一种简化文本的表示方法,将文档转换为直方图

-

拉普拉斯平滑:一种简单的加法平滑技术,避免乘以零

总结

我对贝叶斯定理对数据科学家有用持有强烈的先验信念,但我会根据你在评论中留下的反馈更新后验概率。我期待了解你如何在生活和工作中使用贝叶斯定理。

原文。已获许可转载。

更多相关话题

30 个免费资源用于机器学习、深度学习、自然语言处理和人工智能

原文:

www.kdnuggets.com/2018/06/30-free-resources-machine-learning-deep-learning-nlp-ai.html

评论

评论

这是一个免费资源的集合,超出了常分享的书籍、MOOCs 和课程,主要来自过去一年。它们从零开始,并按顺序进展,适合那些希望掌握一些基本概念的个人,希望能够进一步拓展(参见下面列出的最后 2 个资源以了解更多信息)。

这些资源没有特定的顺序,所以可以随意选择那些对你最具吸引力的。所有的荣誉归于各自材料的作者,如果没有他们的辛勤工作,我们将无法从如此伟大的内容中受益。

有兴趣开始机器学习吗?

由于许多良好的理由,许多高质量的机器学习教育资源往往非常注重理论,特别是在开始时。然而,似乎有一种越来越明显的趋势,即从一开始就进入实际应用,并在资源进展过程中混合实践和理论。本文介绍了 5 个这样的资源。

涵盖从基础的机器学习到从零开始编写算法,以及使用特定的深度学习框架,这些资源覆盖了相当广泛的内容。它们都是免费的,所以赶快阅读、观看和编码吧。

想进一步了解神经网络和深度学习,超越那些基本的入门教程和视频吗?本文包括 5 个具体的视频选项,总共提供了很多小时的见解。如果你已经具备一些基本的神经网络知识,可能是时候深入研究一些更高级的概念了。

你对一些实用的自然语言处理资源感兴趣吗?

在线有如此多的自然语言处理资源,尤其是那些依赖于深度学习方法的,筛选出优质的资源可能是一项任务。有一些著名的、顶尖的主要理论性资源,特别是斯坦福大学和牛津大学的深度学习课程:

-

使用深度学习进行自然语言处理(斯坦福)

-

自然语言处理的深度学习(牛津)

但如果你已经完成了这些内容,已经在 NLP 领域有了基础,并且想转向一些实际资源,或者对其他方法感兴趣,这些方法可能不一定依赖于神经网络,这篇文章(希望)会对你有所帮助。

对将深度学习应用于自然语言处理(NLP)感兴趣?不知道从哪里或如何开始学习?

这是一个针对新手的 5 个资源集合,应该能让你了解可能性和自然语言处理与深度学习交汇处的现状。它也应该为你提供下一步的方向。希望这个集合对你有所帮助。

寻找一个由在线免费材料提供的入门级研究生 AI 课程?随着越来越多的高等教育机构决定允许通过网络向非学生开放课程材料,几乎任何人、任何地方都可以体验到伪大学课程。请查看以下免费的课程材料,所有这些材料都适合初级 AI 理解水平,其中一些还涵盖了特定应用概念和材料。

以下一些教授及其分享的材料在塑造世界顶级 AI 研究人员和从业者的思想方面发挥了重要作用。没有理由你不能从这些材料和指导中获益。

对自动驾驶车辆感兴趣?不知道从哪里或如何开始学习?

这个话题的正规教育资源稀缺,因此那些有兴趣学习的人必须以黑客思维来学习。我整理了一个简短的 5 个资源列表,以帮助新手找到方向,所有这些资源都是免费的。希望对一些人有用。

相关:

-

自然语言处理秘籍:入门 NLP

-

你不应忽视的 5 个机器学习项目,2018 年 6 月

-

DIY 深度学习项目

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关话题

30 个最常被问到的机器学习问题回答

原文:

www.kdnuggets.com/2021/08/30-machine-learning-questions-answered.html

评论

由 Abhay Parashar, Python 开发者 | 数据科学学习者。

图像由作者提供。

机器学习是通向更好和更先进未来的途径。机器学习开发者是 2021 年最热门的工作之一,预计在未来 3-5 年内将增长 20-30%。机器学习本质上是所有统计学和编程概念的结合。机器学习开发者最常用的编程语言是 Python,因为它的简单性。在本博客中,你会找到一些最常被问到的机器学习问题,每个机器学习爱好者都有一天必须回答这些问题。让我们开始吧。

0. 什么是机器学习?

答案:机器学习是让计算机在实时情况下自主行动的科学,而无需明确编程。这是一种人工智能应用,使系统能够自动从先前的经验中学习和改进。它使计算机能够在没有任何人工干预的情况下学习和适应新数据。

1. 解释监督学习、无监督学习和半监督学习之间的基本区别?

答案:

监督学习:模型在标记的数据上进行训练,然后根据之前标记的数据做出预测。它需要一个监督者(标签)来训练数据。例如:文本分类。

无监督学习:模型在未标记的数据上进行训练。模型尝试发现数据中的模式和关系,并根据这些模式进行分类。我们没有任何标记的数据。

半监督学习:这是一种机器学习类型,它使用一些标记的数据和大量未标记的数据来训练模型。其目标是借助标记数据对一些未标记的数据进行分类。

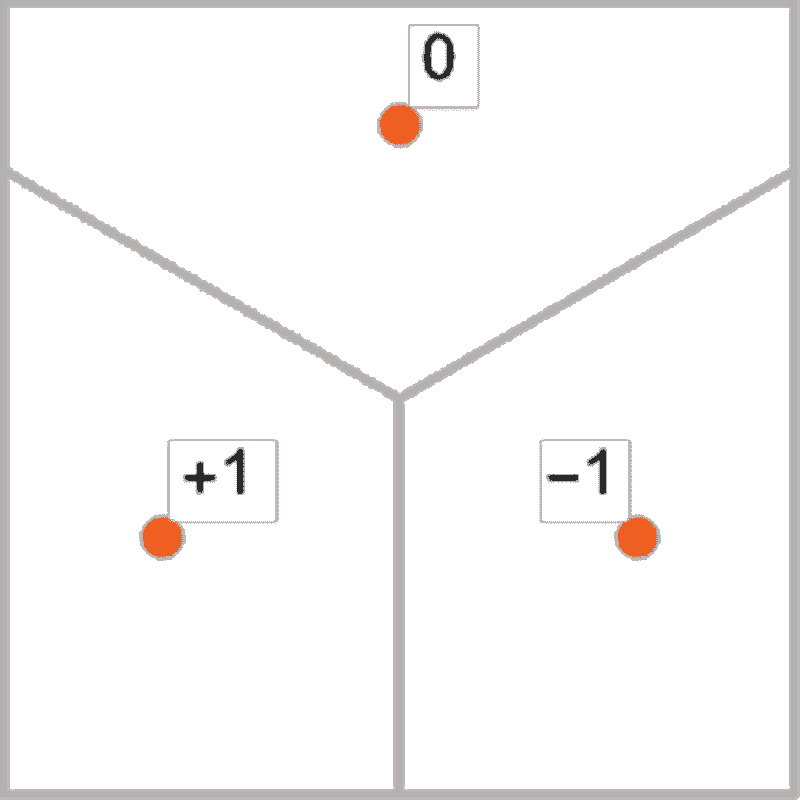

2. 你所说的强化学习是什么意思?

答案:强化学习是机器学习的一个领域,其中模型根据其在环境中的先前行为所获得的奖励进行训练。有一个代理负责给出奖励,并最大化奖励。如果模型正确执行任务,则获得+1 奖励;如果模型任务执行错误,则获得-1 奖励。

应用:自动驾驶汽车、自动停车、难题求解器等。

3. 机器学习中使用的不同类型的数据有哪些?

答案:有两种类型的数据。结构化数据和非结构化数据。

1. 结构化数据:这类数据在存储之前是预定义的、标记的和格式化好的。例如:学生记录表。

2. 非结构化数据:这种类型的数据是原始格式的,直到使用时才会被处理。例如:文本、音频、视频、电子邮件等。

4. 特征与标签?

答:特征是输入信息。另一方面,标签是模式的输出信息。

特征用于预测某些内容,而标签是我们预测的内容。此外,特征被称为独立变量,标签被称为依赖变量。

5. 解释回归和分类之间的区别?

答:

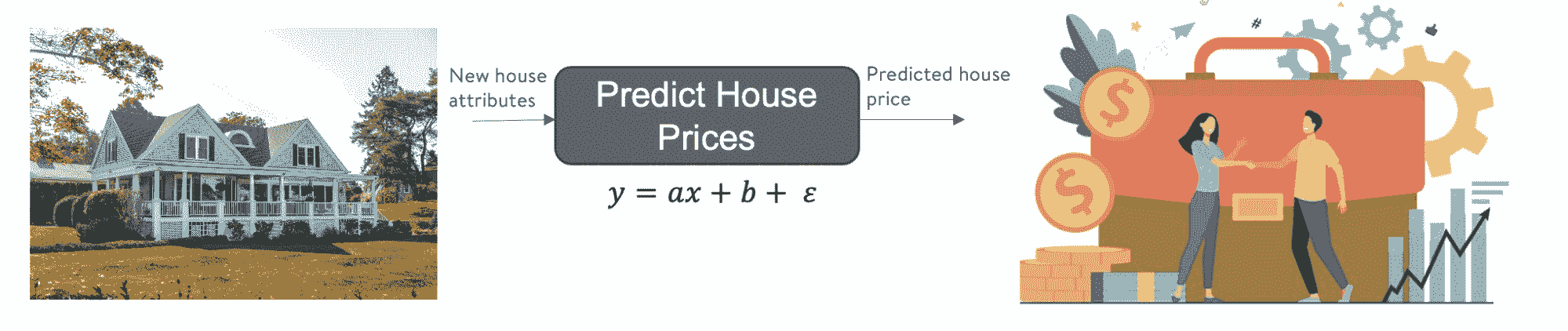

回归:回归是寻找依赖变量和独立变量之间相关性的过程。它有助于预测连续变量,例如股票市场预测、房价预测等。在回归中,我们的任务是找到最适合的线,以准确预测输出。

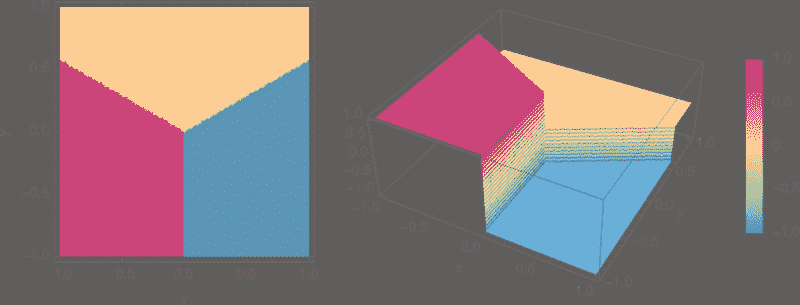

分类:分类是找到一个函数,帮助将数据分成不同类别的过程。这些主要用于离散数据。在分类中,我们的目标是找到一个决策边界,将数据集划分为不同的类别。

图片由作者提供。

6. Scikit-learn 用于什么?

答:Scikit-learn 是一个强大的 Python 库,用于机器学习任务。Scikit-learn 库包含许多高效的机器学习和统计建模工具和类,包括分类、回归、聚类、特征选择、参数调整等。它是进行预测分析的高效工具。它以类和函数的形式提供所有主要算法。在 Python 中,它被称为sklearn。

7. 什么是机器学习中的训练集和测试集,它们为什么重要?

答:训练集是提供给模型进行训练、分析和学习的数据集。测试集是用于在实际应用之前对模型进行本地测试的数据集。训练集是标记数据,而测试集没有标签。

将数据集划分为训练集和测试集非常重要,这样模型才能避免过拟合或欠拟合。此外,这是评估模型并理解数据特征的一个有效方法。在大多数情况下,划分比例为 70/30,即 70%的数据用于训练,30%的数据用于测试。

8. 解释构建机器学习模型的阶段?

答:

数据收集:这是任何机器学习模型的第一阶段。在这个阶段,决定合适的数据,然后通过某些算法或手动收集这些数据。

数据处理:在这个阶段,我们对第一阶段收集的数据进行预处理,处理所有的空值、分类数据等。此外,在同一阶段,如果数据特征的范围不一致,还会将它们调整到相同的范围。

模型构建:在这个阶段,我们首先选择适当的算法来创建模型,然后借助如 sklearn 等工具构建模型。

模型评估:在模型创建后,使用一些统计技术对其进行评估,例如准确度分数、z 分数、准确性矩阵等。

模型保存与测试:在模型成功评估后,它会被保存以备将来使用,并进行实时测试。

9. 过拟合与欠拟合?

答:

过拟合:当模型在训练数据上的表现很好,但在测试数据上的表现差时,就会出现过拟合。例如:模型在训练集上的准确率为 94%,在测试集上的准确率为 56%。这是一种建模错误,发生在函数过于紧密地拟合有限的数据点集时。为避免过拟合,我们可以收集更多数据,使用集成方法或选择最适合数据的算法。

欠拟合:模型在训练数据和测试数据上的表现都很差。换句话说,这种模型未能对新数据点进行有效泛化。

“机器智能是人类将来不再需要制造的最后发明。” ~ 尼克·博斯特罗姆

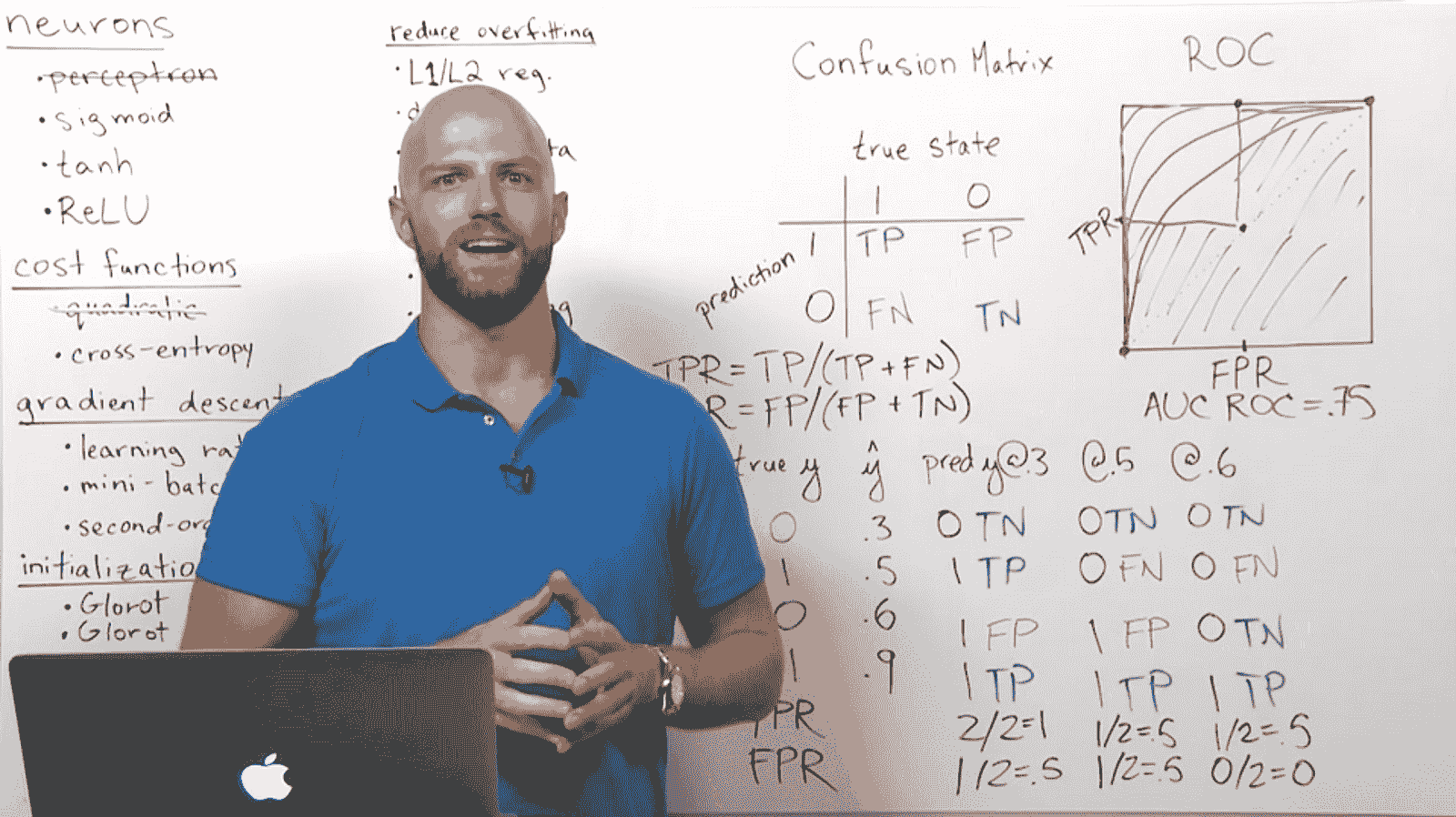

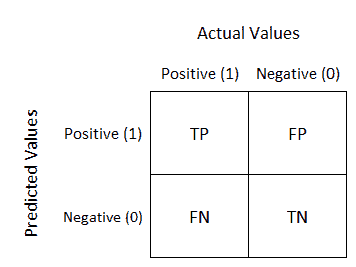

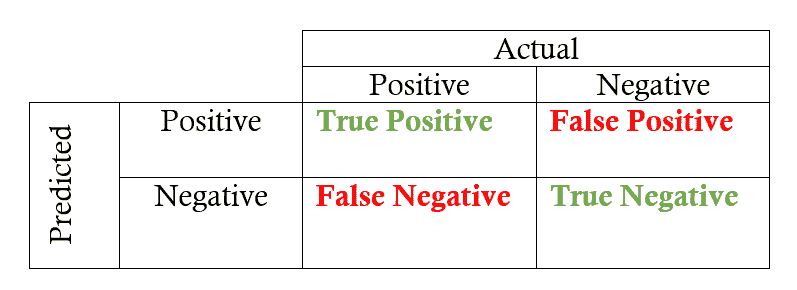

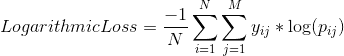

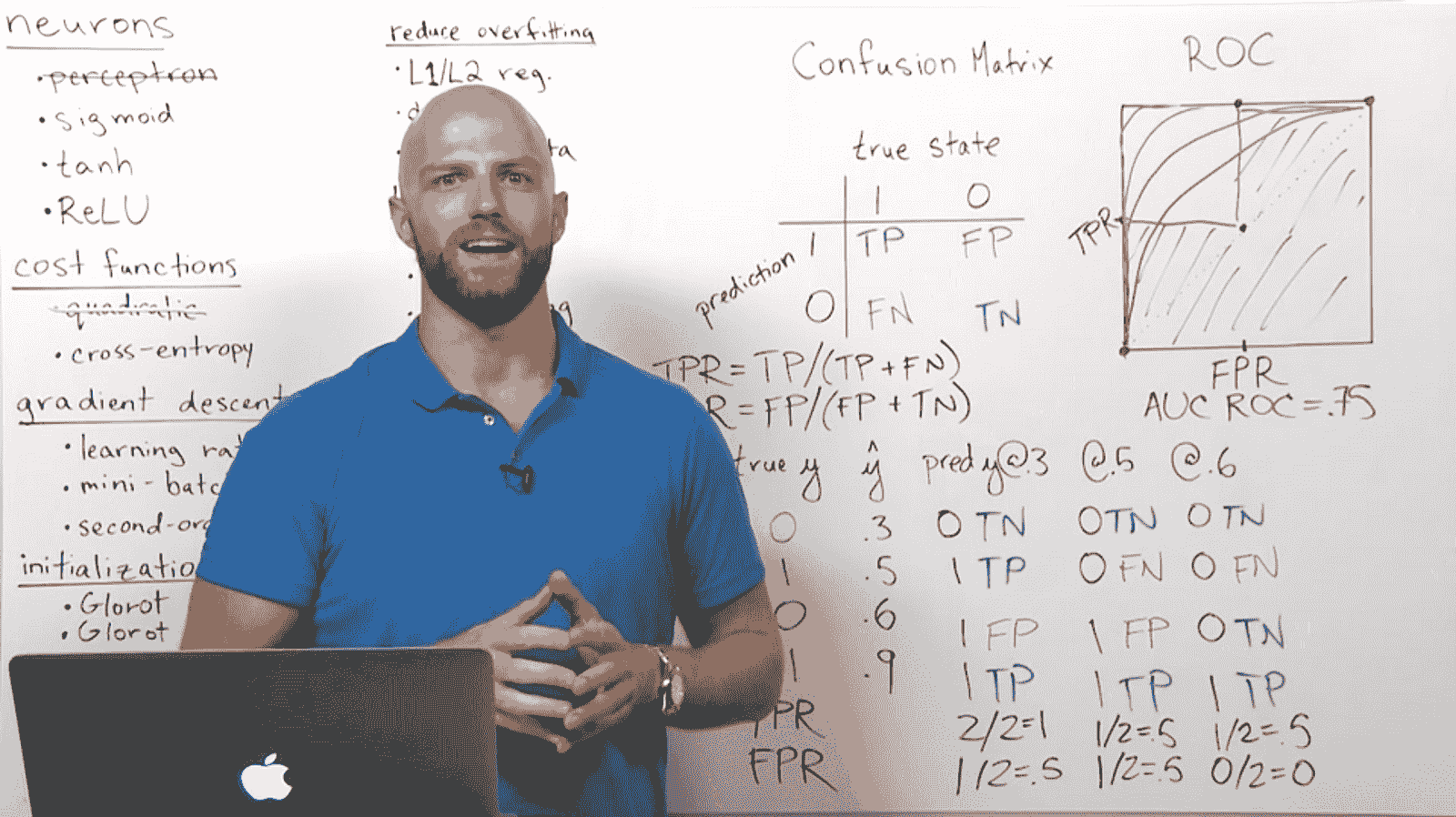

10. 解释混淆矩阵在模型评估中的作用?

答:混淆矩阵是用来衡量机器学习算法性能的测量表。它是一个不同预测值和实际值组合的表。它用于衡量召回率、精确度、AUC-ROC 曲线和准确性。矩阵的对角线包含所有正确的数据。矩阵的大小取决于因变量中的类别数。矩阵的大小等于 N*N,其中 N 是因变量输出中的类别数量。

-

真阳性:实际值 = 预测值 当输出为 1 时

-

真阴性:实际值 != 预测值 当输出为 0 时

-

假阳性:第一类错误

-

假阴性:第二类错误

11. 第一类错误和第二类错误有什么区别?

答:

第一类错误(假阳性错误):当零假设为真时却被拒绝,意味着声称某事发生了,但实际上并未发生。

第二类错误(假阴性错误):当零假设被接受时它实际上不是真的,意味着声称什么都没有发生,但实际上发生了。

例子:以零假设为一个无辜的人为例。将无辜的人定罪是第一类错误。另一方面,让一个有罪的人逍遥法外是第二类错误。

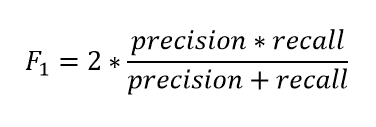

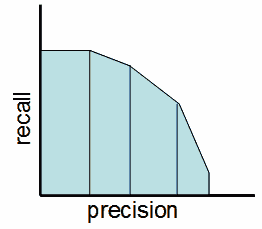

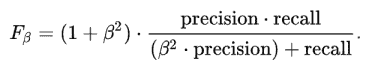

12. 区分精确度、召回率、准确性和 F1 分数?

答:

精确度是正确预测的正观察值与总预测正观察值的比率。它显示了我们的模型有多精确。

- 精确度 = TP/TP+FP

召回率是正确预测的正观察值与该类别总观察值的比率。

- 召回率 = TP/TP+FN

F1-分数是召回率和精确度的加权平均值。

- F1-分数 = 2*(召回率 * 精确度) / (召回率 + 精确度)

准确率是正确预测的正观察值与总正观察值的比率。

- 准确率 = TP+TN/TP+TN+FP+FN

13. P 值是什么意思?

答案:P 值是在假设零假设为真的情况下对结果的确定。如果 p 值非常小(<0.05),则我们假设零假设是正确的可能性很小。因此我们拒绝零假设。

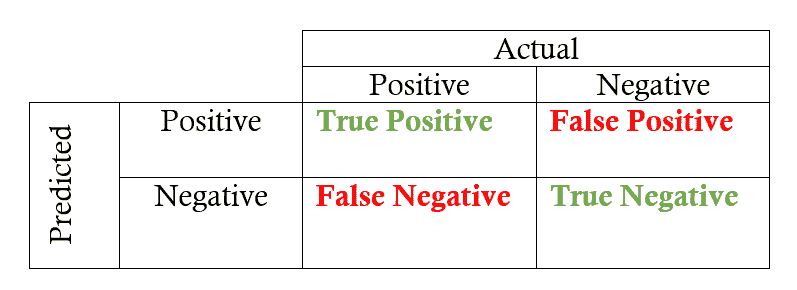

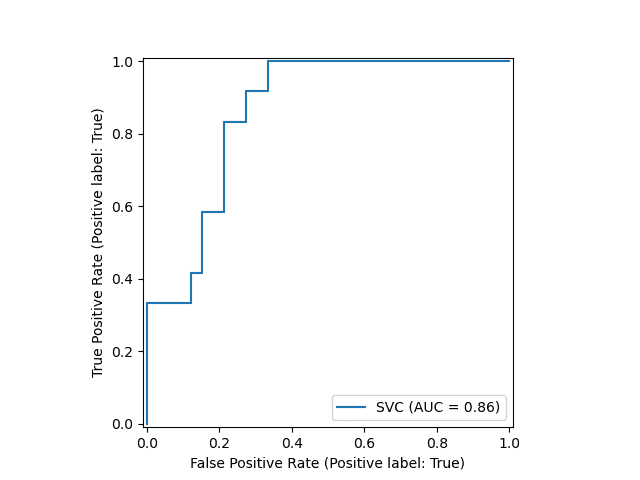

14. 解释一下 ROC 曲线是如何工作的?

答案:ROC 曲线是一个显示分类模型在不同阈值下性能的图表。它使用两个曲线绘制参数,即真正率(灵敏度)和假正率(特异性)。

-

曲线越接近左边界然后是上边界,测试的准确度就越高。

-

曲线越接近 ROC 空间的 45 度对角线,测试的准确度就越低。

15. KNN 和 K-means 聚类有什么不同?

答案:KNN 是一种监督式机器学习技术,用于分类或回归问题。在 KNN 中,K 代表用于预测因变量的最近邻居的数量。

K-means 聚类是一种无监督的机器学习算法,用于根据 K(聚类数目)和质心将数据划分为不同的簇。

16. 朴素贝叶斯定理中的“朴素”是什么意思?

答案:朴素贝叶斯分类器假设所有输入变量彼此独立,即它们之间没有任何关系,这实际上对于真实数据来说是不现实的假设。

假设有一个包含水果信息的数据集,用来检测水果是否是苹果。一个样本包含一个红色的、圆形的直径约为 4 英寸的水果。即使这些特征彼此依赖或依赖于其他特征的存在,朴素贝叶斯分类器仍会将它们视为独立的因素来预测水果。

17. 集成学习是如何工作的?

答案:集成学习是一种将多个模型的预测结果或结果组合以实现更好性能的技术。比如说,如果你买一辆车,你通常会在网上查找不同车型的评论和特点。最终,在汇总所有评论后,你会创建自己对这辆车的评论,并决定是否购买它。你创建的评论是所有评论的更好版本,因为它包含了所有评论的信息。

集成学习的工作原理相同:使用来自多个算法的预测来创建更好的模型。

集成学习可以通过两种方式进行。一种是将不同算法的预测结果结合生成新的高精度预测。另一种是多次使用单一算法,最后使用每个模型的预测结果生成一个更好的模型,具有良好的准确性。

“不要让昨天占据今天太多的时间。” ~ 威尔·罗杰斯

18. 机器学习中的袋装和提升是什么?

答案:

袋装是一种结合相同类型预测的方法,即来自相同算法的预测。例如:随机森林。在这种方法中,每个模型独立构建,给予它们相等的权重。它减少了过拟合问题,也降低了方差。

提升是一种结合不同算法预测的方法。例如:梯度提升。新模型受到之前构建的模型表现的高度影响。它减少了偏差。

19. 偏差-方差权衡是什么?

答案:偏差是模型平均预测值与正确值之间的差异。另一方面,方差是数据点的变异性,显示数据的分布情况。

如果我们的模型参数较少,那么它可能具有高偏差和低方差。因此,它将是稳定的但平均不准确。具有大量参数的模型可能具有低偏差和高方差,这些模型在平均上大多准确,但在性质上不一致。一个好的模型总是具有低偏差和低方差。

20. 解释 L1 和 L2 正则化?

答案:使用 L1 正则化的回归模型称为Lasso 回归,而使用 L2 正则化的模型称为Ridge 回归。

-

L1 正则化通过在成本函数中添加权重 (Wj) 的绝对值来增加惩罚项,而 L2 正则化则通过在成本函数中添加权重 (Wj) 的平方值来增加惩罚项。

-

两者之间的另一种区别是,L1 正则化尝试估计数据的中位数,而 L2 正则化尝试估计数据的均值。

-

L1 正则化有助于去除不重要的特征。

21. 处理机器学习中缺失值的不同方法是什么?

答案:

1. 用均值、中位数或众数替换缺失值。

2. 用随机值替换缺失值。

3. 将所有 NaN 值作为新特征使用。

4. 用第三个偏差值替换 NaN 值。

5. 用最小值或最后的异常值替换 NaN

6. 用最频繁的类别替换 NaN (分类值)**7. 将缺失值视为新类别

8. 应用分类器预测 NaN 值

9. 丢弃值

了解更多:处理机器学习中缺失值的 9 种方法

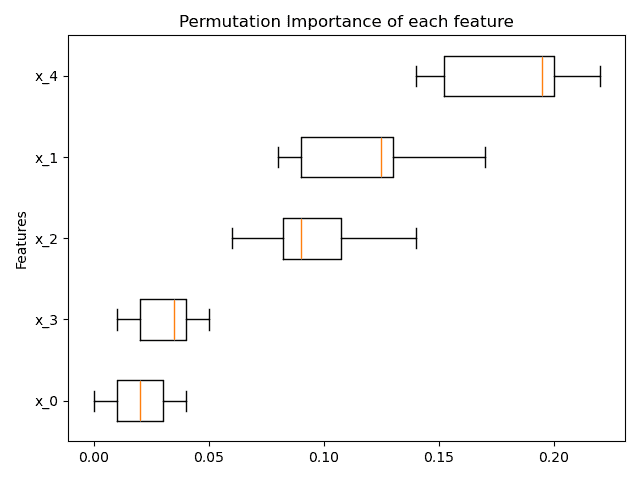

22. 你可以使用哪些不同的技术来选择特征。

答案:

-

单变量选择: 在这种方法中,我们使用 SelectKBest 算法根据依赖列找到特征分数。

-

额外树分类器:该技术为数据的每个特征提供一个分数。分数越高,该特征的重要性和相关性越强。你可以从 sklearn.ensemble 中导入这个类。

-

相关矩阵:一个显示所有特征之间相关性的表格。表格中的每个单元格显示两个变量之间的相关性。我们可以使用阈值来选择数据集中相关性较低的变量。

-

互信息:这是一种分类器,生成每个特征与依赖特征的互信息。信息量越高,相关性越强。

“折磨数据,它会承认一切。” ~ 罗纳德·科斯

23. 如何处理数据集中的分类值?

答案:处理分类值,我们可以进行编码,将分类数据基本上转换为数值数据。

-

名义编码: 当数据没有固有的顺序时。

1 一热编码

1.2 具有许多特征的一热编码

1.3 平均编码

-

序数编码: 当数据具有固有顺序时。

2 标签编码

2.2 目标引导编码

-

计数编码

了解更多:处理分类值的不同方法

24. 什么是异常值,我们如何在机器学习中处理它们?

答案:异常值是与数据集中其他数据点或样本有显著不同的一些不寻常的数据点。它们可能对模型性能产生重大影响。处理异常值,我们可以做三件事。

-

移除所有异常值

-

用合适的值(如第三个偏差)替换异常值

-

使用对异常值不敏感的不同算法。

25. 什么是特征缩放和转换,它们为何必要?

答案:特征转换是一种将特征从一种表示转换为另一种表示的技术。另一方面,特征缩放是将特征的所有值转换到相同范围的技术。

有时候在我们的数据集中,我们有一些具有不同单位的列——比如一个列可以是年龄,而另一个列可以是人的工资。在这种情况下,年龄列的范围是 0 到 100,而工资列的范围是 0 到 10000。这些列的值差异如此之大,因此值较大的列将更大程度地影响输出。这将导致模型性能差。因此,我们需要进行特征缩放和转换。

26. 如何处理不平衡的数据集?

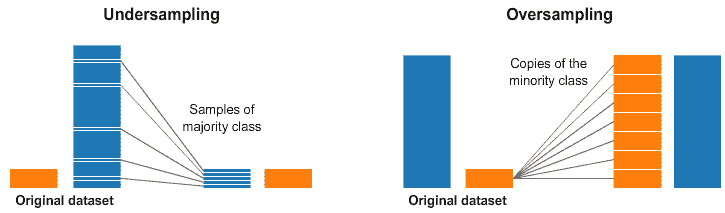

答案:在不平衡数据中,各个类别之间的样本差异很大。例如,一个类别可能有 1000 个样本,而另一个类别可能只有 200–300 个样本。在这种情况下,在做任何事情之前,我们首先需要处理数据的不平衡。有许多技术可以遵循。

-

收集更多数据。

-

当我们有大量数据时应用过采样

-

应用欠采样

-

尝试其他算法

27. 什么是 A/B 测试?

答案:A/B 测试是一种用于随机化两个变量实验的统计假设检验方法。它通常用于比较使用不同预测变量的两个模型,以检查哪个模型更适合数据。

在实际场景中,假设你创建了两个为用户推荐产品的模型。A/B 测试可以用于比较这两个模型,以检查哪个模型给出的推荐最好。

28. 什么是机器学习中的交叉验证?

答案:这是一种通过向模型提供来自数据集的多个样本数据来提高模型性能的技术。采样过程是通过将数据分成具有相同数量行的小部分来完成的。在所有部分中,随机选择一个用于测试集,另一个用于训练集。它包含以下技术:

-

k 折交叉验证

-

保留法

-

分层 k 折交叉验证

-

留出 p 折交叉验证

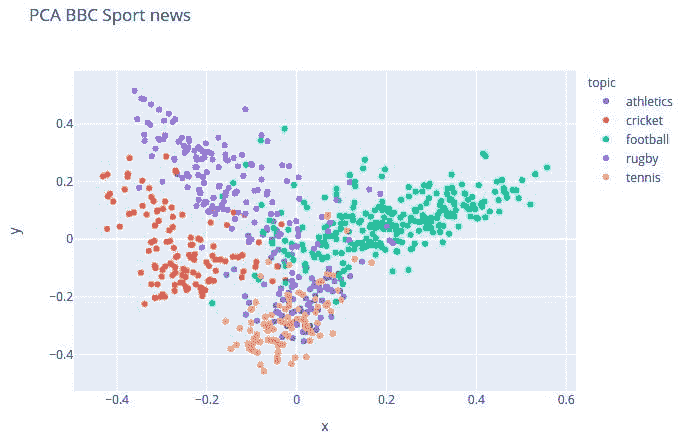

29. PCA 是什么,它有什么用?

答案:PCA(主成分分析)是一种用于减少大型数据集维度的降维方法。

在现实生活中,我们通常会遇到具有大维度的数据集,因此,视觉化和分析这些数据集变得困难。PCA 可以通过移除数据集中不必要的维度来帮助减少数据集的维度。

“你学得越多,你赚得越多。” ~ 沃伦·巴菲特

30. 在机器学习中,管道是如何使用的?

答案:管道用于自动化机器学习工作流程。一个管道由几个步骤组成,用于训练一个模型。这些管道是迭代的,所以每一步都重复多次以提高模型的准确性。

这个管道主要用于自然语言处理。管道的一部分负责清理和向量化,另一部分则负责模型训练和验证。

原文。经授权转载。

相关内容:

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

更多相关内容

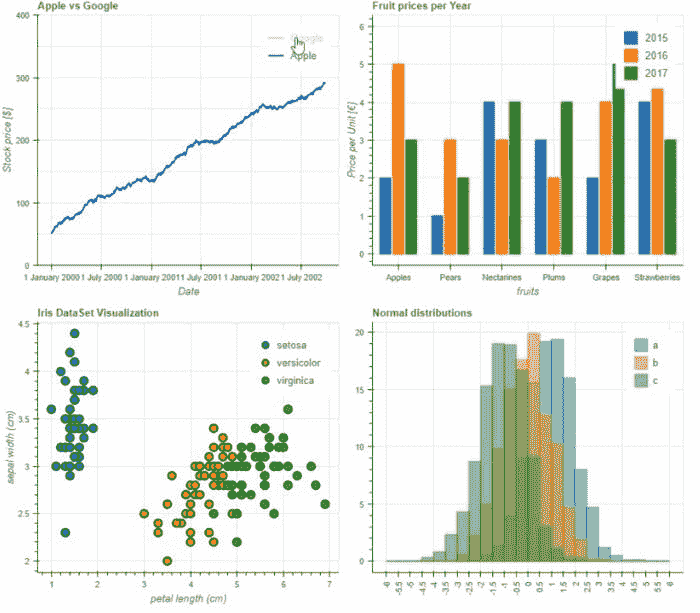

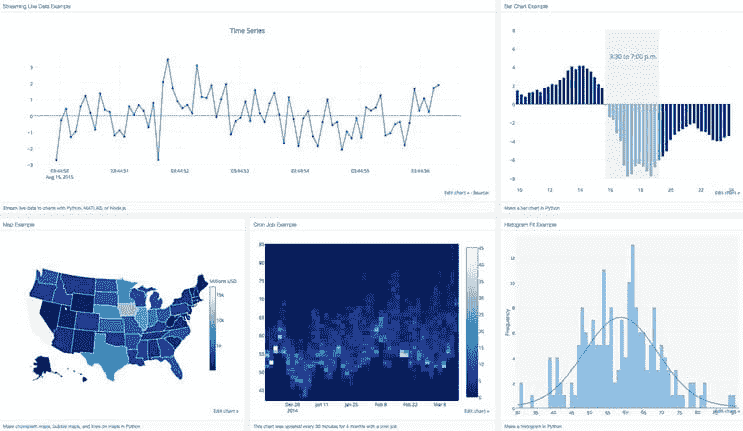

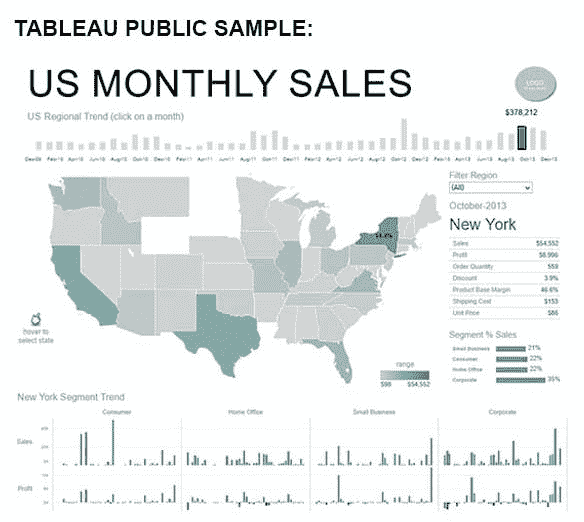

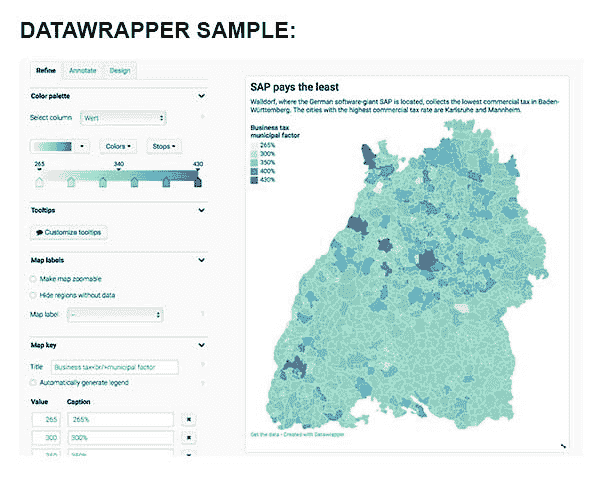

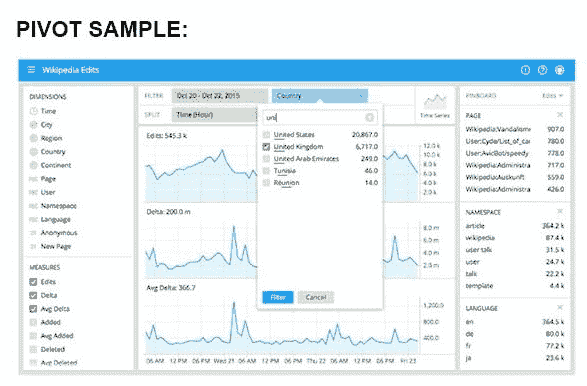

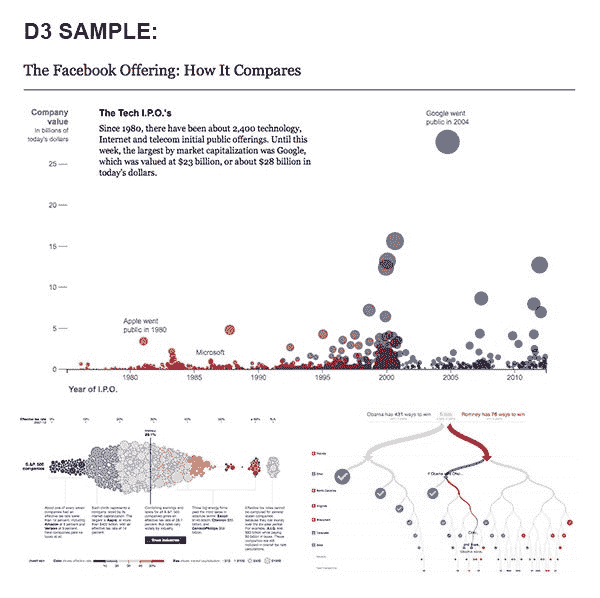

30 个掌握数据可视化的资源

原文:

www.kdnuggets.com/2022/11/30-resources-mastering-data-visualization.html

我们都有过这样的经历。在你看到某些数据中有一个非常酷的模式时,你兴奋地想要分享它。例如,或许你注意到,当你在寒冷天气下跑步时,每英里比在温暖天气下跑步时快一分钟。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

你想与对你重要的人分享这些令人兴奋的发现。也许是你的老板。也许,在跑步的例子中,是你的伴侣或跑步小组。

你向他们展示了你那令人惊叹的表格和超级有趣的数字——他们却呆呆地看着你。因为你兴奋地展示你的发现,忘记了人类的一个基本真理:没有人喜欢看表格。但每个人都喜欢看美观且信息丰富的图表。这就是数据可视化的重要性。

研究 表明 我们处理图像的速度比处理文字快 60,000 倍。你可以自己测试一下——看一个充满数字的表格,然后再看一个表示相同内容的图表。哪一个让你获取更多信息更快?哪一个更让你喜欢?

数据可视化既是一门艺术,也是一门科学。它是一门科学,因为数据部分来自数字和事实。但它是一门艺术,因为你需要考虑受众的心理。你需要考虑数字的格式。你需要考虑你试图传达的内容和方式。你还需要知道如何让它变得漂亮。这就是可视化的部分。

在我看来,如果每个人都知道如何有效地使用数据可视化(LinkedIn Business 的 Paul Petrone 也同意),每个人都会更好。我们几乎所有人,都会在生活中的某个时刻被要求分享一些数字。越来越多地,做生意就意味着处理数据。这是无止境的。

想要掌握数据可视化?这份包含 30 个资源和工具的列表将帮助你开始掌握数据可视化的旅程。

你需要什么来掌握数据可视化?

学习数据可视化只需三件事。

一个是数据。非常自明。

其次是某种界面,用于进行可视化——它可以是像 Python 或 R 这样的语言,也可以是像 Google Sheets 这样的工具。

第三,你需要有分享知识的愿望。如果你只是为了完成某个清单而学习数据可视化,你会遇到困难。但如果你有强烈的愿望去制作一些酷炫的图表以展示某个有趣的发现,那么这将会容易得多。

例子包括:

-

为了你的工作或学位

-

一个热情的项目,比如我之前提到的跑步例子

-

你面临的问题,比如如何做更便宜的饭菜。

有了这三种要素,你可以掌握数据可视化。

从哪里获取数据?

如果你没有来自工作、学校或个人生活的数据,你将需要一些开源数据的来源。以下是一些免费的选项:

-

Tidy Tuesdays。这个 GitHub 每周更新一次,提供免费、有趣的数据,任何人都可以使用。它旨在帮助新手学习使用 R 和

tidyverse包,但任何人都可以使用这些数据。 -

The Pudding。这是一个非常有趣的网站,供任何人探索数据可视化。他们使用来自 音乐、历史、政治、社会公正、和 填字游戏(以及其他大量主题)的数据编写文章。浏览一下,你会发现一些有趣的内容。

-

Kaggle。Kaggle 是一个数据科学家社区,提供大量竞赛和比赛。当你参加比赛时,你可以下载该比赛的数据。

-

FiveThirtyEight。这是一个新闻和体育网站,提供大量非常有趣的数据报道。

-

NASA。可能不需要介绍。如果你喜欢空间或地球科学,你会在这里找到一些很棒的数据集。

学习数据可视化的免费资源

互联网充满了免费的知识。它存在于博客文章、YouTube 视频、免费课程甚至短视频 TikTok 中。困难的部分是导航找到真正有价值的内容。

这里是其中最好的几个。我根据界面对它们进行了分类,因为在我看来,这是学习数据可视化的决定性方式。

Python 中的数据可视化

Python 在数据可视化方面非常出色,得益于其用户友好的库,如 matplotlinb 和 Plotly。Python 本身也是开源和免费的。为了掌握使用 Python 的数据科学,以下是一些我推荐的免费资源:

-

Data Visualization with Python Coursera 课程。Coursera 课程是可审计的,所以你可以免费学习这些技能——只不过你不会得到证书。

-

EdX提供了一个类似的免费课程,不过课程材料的访问权限在你开始后大约一个月后会过期。快速学习吧!

-

SimpliLearn YouTube 频道充满了免费和绝妙的资源。这里仅提供他们 Python 数据可视化教程的一个例子。

-

这篇Towards Data Science 文章介绍了一些你需要的 Python 库以便开始。

-

(免费)《Python 数据分析》一书的第九章是一颗瑰宝,可以在这里找到。(如果你对 Python 感兴趣,整本书值得完整阅读。)

R 中的数据可视化

和 Python 一样,R 是开源的、免费的,并且由热心慷慨的编码社区维护。其ggplot2包和tidyverse使得数据可视化成为梦想。以下是你需要的免费资源:

-

这是关于 R 数据可视化的可审计 Coursera 课程。

-

EdX 的对应课程在这里。

-

Simplilearn 有一个R 数据可视化视频和播放列表。

-

我喜欢这篇关于“为不使用 R 的研究人员进行数据可视化的文章” 。正如标题所示,它适合那些想制作漂亮图表但从未使用过 R 的人。我发现它是一个全面且有趣的教程。

-

这是关于数据科学的R 宝典/教科书。第三章和第三十八章是关键章节,但整本书都很有趣且富有信息量。

Google Sheets 中的数据可视化

Google Sheets 不是开源的。然而,我仍然包括它,因为对于那些不熟悉 R 和 Python(或其他编程语言)的人来说,它更容易获得。此外,由于该产品由一家非常富有的公司拥有,且希望你采用他们的产品,因此有大量旨在让你迷上 Google Sheets 的免费信息。

这是掌握 Google Sheets 数据可视化的免费资源:

-

从他们的介绍博客文章开始。这篇文章给你一个很好的概述,了解可能性。

-

接下来,查看 他们的教程,该教程指导你创建一些关于最高票房电影的可视化。

-

这是一个 很棒(且简短)的 YouTube 视频,由 Pailsware 产品学院制作,讲解如何使用 Google Sheets 可视化预算。

-

这本 免费教科书 帮助你全面掌握 Google Sheets 数据可视化的所有细节。内容全面且深入。

数据可视化的灵感来源

回到我最初关于如何掌握数据可视化的观点,其中一个关键要素是热情。你必须真正关心你正在做的事情。数据可视化必须令人兴奋才能掌握。

那种动力可以是内在的,但如果你缺乏灵感,还有很多地方可以获得外部的激励。

数据可视化影响者

这是我推荐关注的一些优秀数据可视化影响者。这些数据可视化专家将会:

-

展示顶级技术和风格

-

让你了解最新的工具或语言

-

提供额外的数据来源

-

分享他们对数据可视化的热情和激情

这是我推荐关注的对象:

-

Nadieh Bremer。她是一位数据可视化艺术家和毕业天文学家。这里是我喜欢的 她的数据可视化之一,关于婴儿出生的时间。

-

Cole Knaflic。她是《Storytelling With You》的首席执行官和作者,她的网站 storytellingwithdata.com 有一个很棒的社区部分,提供挑战和数据可视化。

-

David McCandless 是一位作家、设计师和作者,运营着 @infobeautiful Twitter 账户。我最喜欢的数据可视化之一 记录 了最无聊的 Wikipedia 编辑战。

-

定期浏览 #dataviz 或 #datavisualization 标签,将有机会创建你自己策划的数据可视化影响者列表。

网上有大量的人在享受并创建精彩的数据可视化。选择你喜欢的,然后从那里开始。

数据可视化社区

灵感不一定只来自于顶层。另一个获得数据可视化动机和激励的好方法是加入社区。以下是一些值得参与的优秀社区:

-

TidyTuesday。我知道我已经分享过这个,但我再分享一次!这是一个定期挑战、汇集了了不起的人和免费资源的好地方,帮助你掌握数据可视化。

-

Kaggle。另一个重复,但值得记住。竞赛方面是一个很好的方式来投入到数据可视化的掌握中。

-

数据可视化协会提供一个免费会员层级(还有几个付费层级)。免费层级让你可以访问一个 Slack 频道,与其他志同道合的数据可视化爱好者聊天。

-

Python 有一个Discord 服务器,他们经常聊数据科学和数据可视化。

如何掌握数据可视化

数据可视化是任何人都应该练习的好技能,无论你的工作或情况如何。无论你是数据科学家还是咖啡师,了解如何有效地展示数据总是有用的。而且,知道如何以让人关注的方式分享信息,竟然出乎意料地有趣和令人满意。

如果你想知道作为数据科学家还需要具备什么其他技能,可以查看我们的帖子“数据科学家技能”。

像其他任何技能一样,掌握数据可视化归结为兴趣和实践。如果你有数据、一个接口工具,以及坚持下去的意愿,你很快就会在路上。这份包含 30 个资源的列表应该能帮助你在掌握数据可视化的旅程中——同时享受过程。

Nate Rosidi 是一名数据科学家和产品战略专家。他还是一名兼职教授,教授分析课程,并且是StrataScratch的创始人,这个平台帮助数据科学家准备与顶级公司面试的真实问题。可以在Twitter: StrataScratch或LinkedIn上与他联系。

相关话题

30 年数据科学:数据科学从业者的回顾

原文:

www.kdnuggets.com/30-years-of-data-science-a-review-from-a-data-science-practitioner

编辑提供的图片

30 年的 KDnuggets 和 30 年的数据科学。差不多是我职业生涯的 30 年。长期从事同一领域工作所带来的特权之一——即经验——就是有机会作为直接目击者撰写其演变过程。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

算法

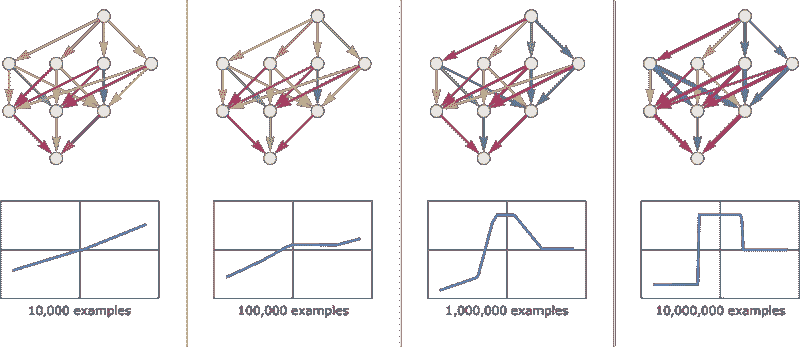

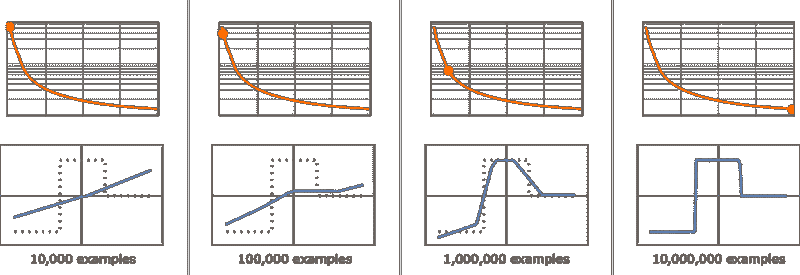

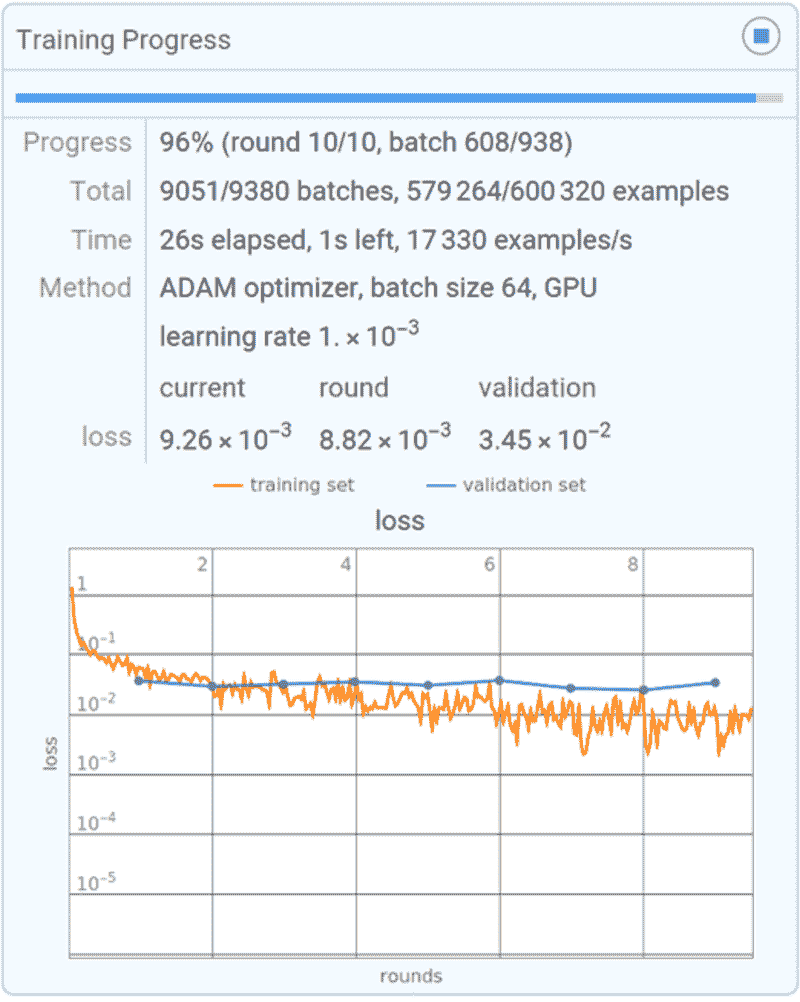

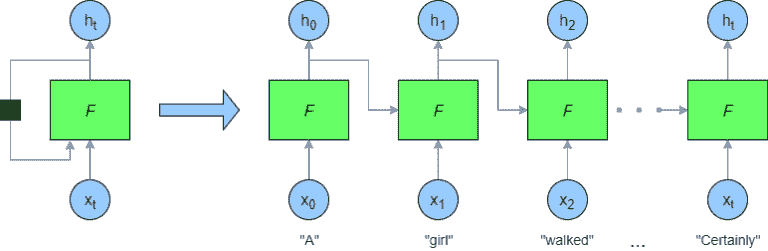

我在 90 年代初开始从事当时称为人工智能的工作,指的是一种自我学习的新范式,模仿神经细胞的组织,并且不需要验证任何统计假设:没错,就是神经网络!几年前刚刚发布了有效使用回传算法的研究成果[1],解决了多层神经网络隐藏层训练的问题,使得一大批热情的学生能够探索多种老用例的新解决方案。没有什么能阻止我们……只有机器性能。

训练一个多层神经网络需要相当大的计算能力,特别是当网络参数数量多且数据集庞大时。计算能力是当时机器所缺乏的。理论框架已经发展出来,如 1988 年的时间序列回传算法(BPTT)[2]或 1997 年的长短期记忆网络(LSTM)[3]用于选择性记忆学习。然而,计算能力仍然是个问题,大多数数据分析从业者将神经网络搁置,等待更好的时机。

与此同时,出现了更精简且通常表现相当的算法。决策树形式的 C4.5 [4] 在 1993 年变得流行,尽管以 CART [5] 形式的决策树早在 1984 年就已存在。决策树训练起来更轻便,更易于理解,并且在当时的数据集上表现良好。很快,我们还学会了将多个决策树组合成一个森林 [6],在随机森林算法中,或组合成一个级联 [7] [8],在梯度提升树算法中。尽管这些模型相当庞大,即有大量的参数需要训练,但在合理的时间内仍然可管理。尤其是梯度提升树,利用级联的树按序列训练,将所需的计算能力分散到时间上,使其成为数据科学中非常实惠且成功的算法。

直到 90 年代末,所有数据集都是经典的、合理大小的数据集:客户数据、患者数据、交易数据、化学数据等等。基本上,都是经典的业务操作数据。随着社交媒体、电子商务和流媒体平台的扩展,数据开始以更快的速度增长,带来了全新的挑战。首先是存储和快速访问如此大量结构化和非结构化数据的挑战。其次是对更快算法的需求来进行分析。大数据平台负责存储和快速访问。传统的关系型数据库承载结构化数据,逐渐让位于新的数据湖,这些数据湖承载各种类型的数据。此外,电子商务业务的扩展推动了推荐引擎的普及。无论是用于市场篮子分析还是视频流推荐,这两种算法变得常用:apriori 算法 [9] 和协同过滤算法 [10]。

与此同时,计算机硬件的性能得到了提升,达到了难以想象的速度……我们又回到了神经网络。GPU 开始被用作神经网络训练中特定操作的加速器,使得越来越复杂的神经算法和神经架构得以创建、训练和部署。这一神经网络的第二次青春被称为深度学习 [11] [12]。人工智能(AI)这一术语开始重新浮现。

深度学习的一个分支,生成式 AI [13],专注于生成新数据:数字、文本、图像,甚至音乐。模型和数据集的规模和复杂性不断增长,以实现更现实的图像、文本和人机互动的生成。

新模型和新数据在一个持续循环中迅速被新的模型和数据所替代。它越来越成为一个工程问题,而不是数据科学问题。最近,由于数据和机器学习工程方面的卓越努力,已经开发出了用于持续数据收集、模型训练、测试、人机交互动作,以及最终部署大型机器学习模型的自动化框架。所有这些工程基础设施是当前大型语言模型(LLMs)的基础,这些模型经过训练,旨在提供各种问题的答案,同时模拟人际互动。

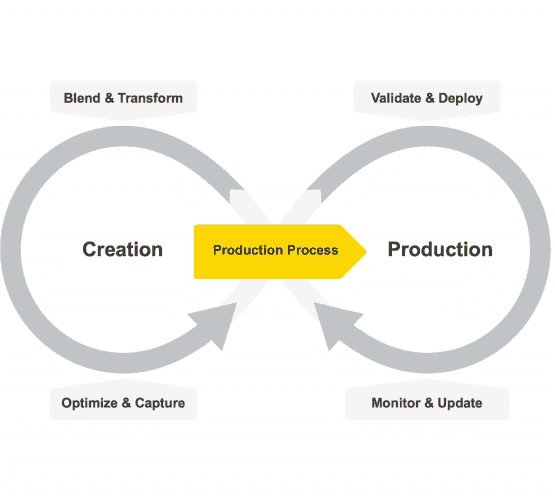

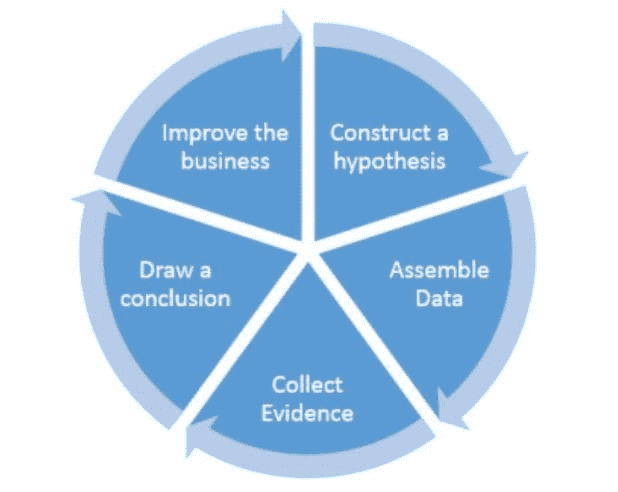

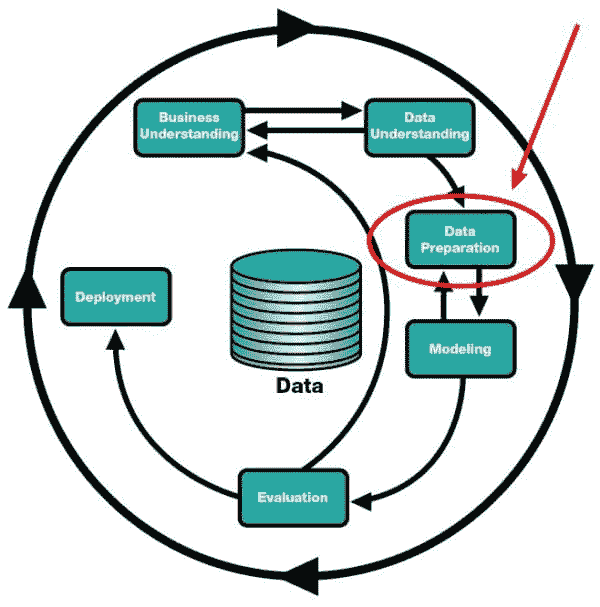

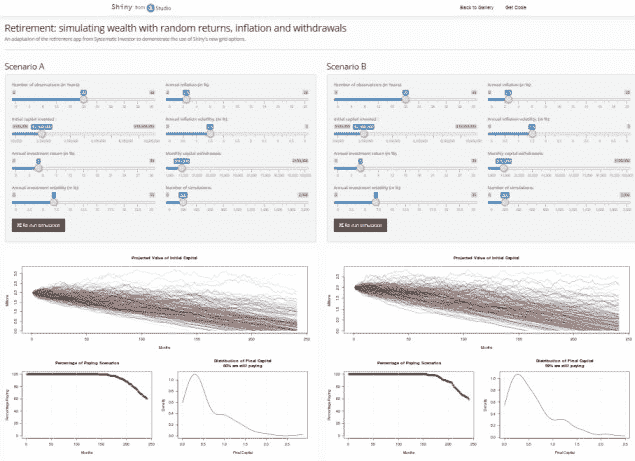

生命周期

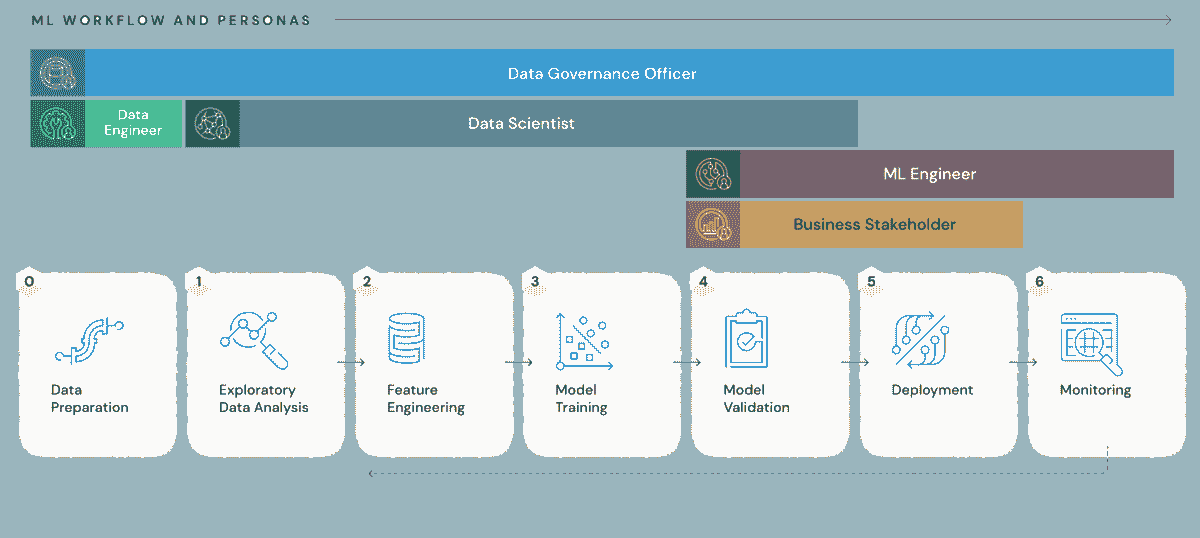

在我看来,过去几年数据科学最大的变化不在于算法,而在于基础设施的变革:从频繁的数据获取到模型的持续平滑再训练和重新部署。也就是说,数据科学已经从一个研究学科转变为一个工程努力。

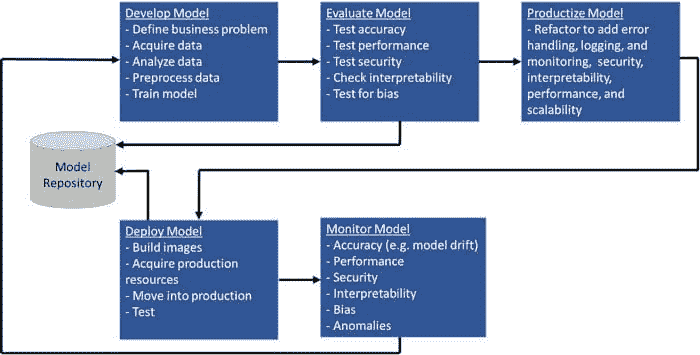

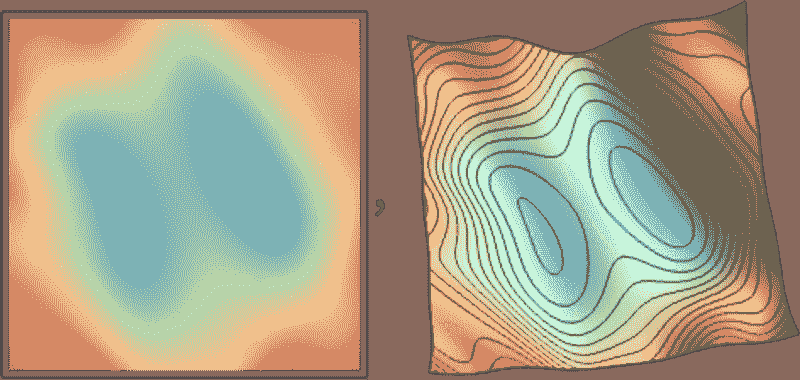

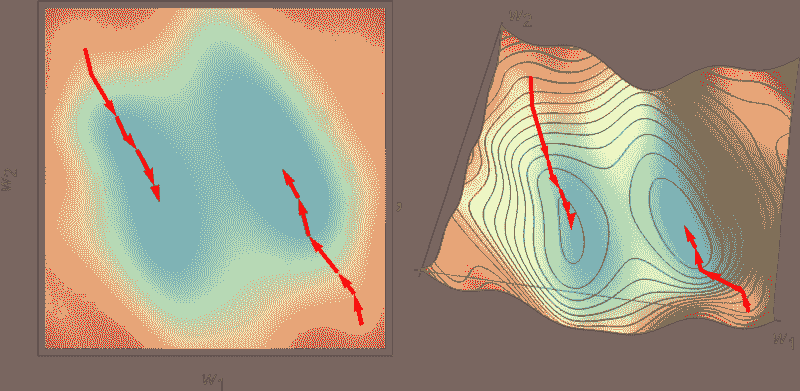

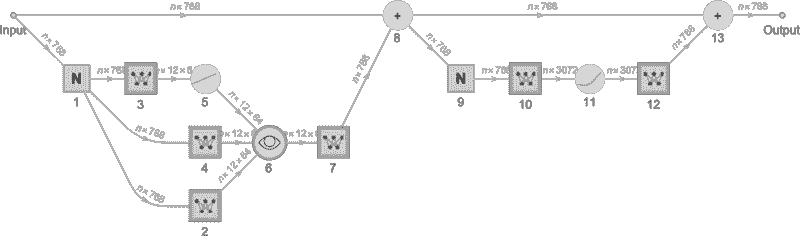

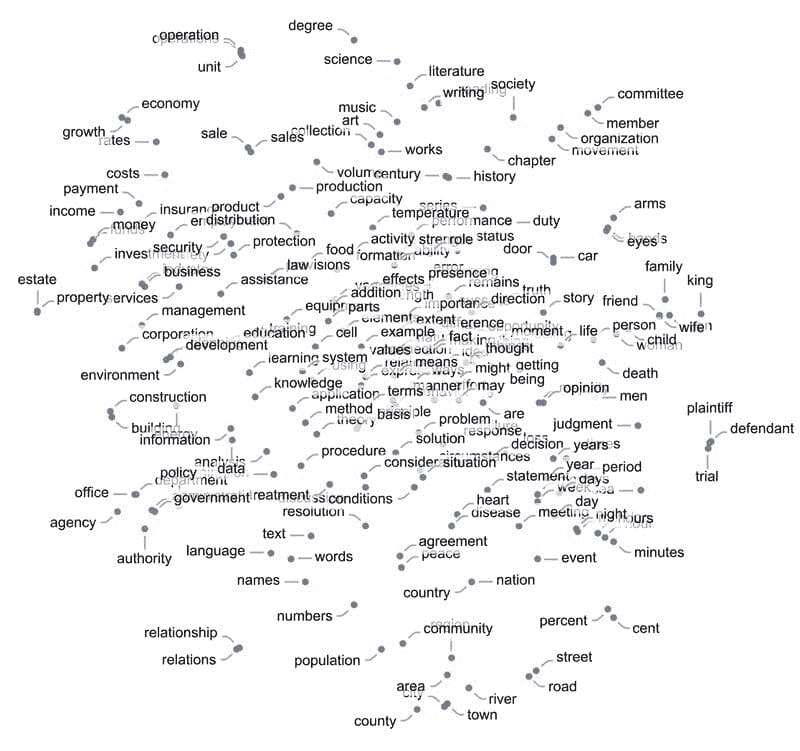

机器学习模型的生命周期已经从类似 CRISP-DM [14]的纯创建、训练、测试和部署的单一周期,变成了一个双周期,其中一边是创建,而另一边是生产化——部署、验证、消费和维护 [15]。

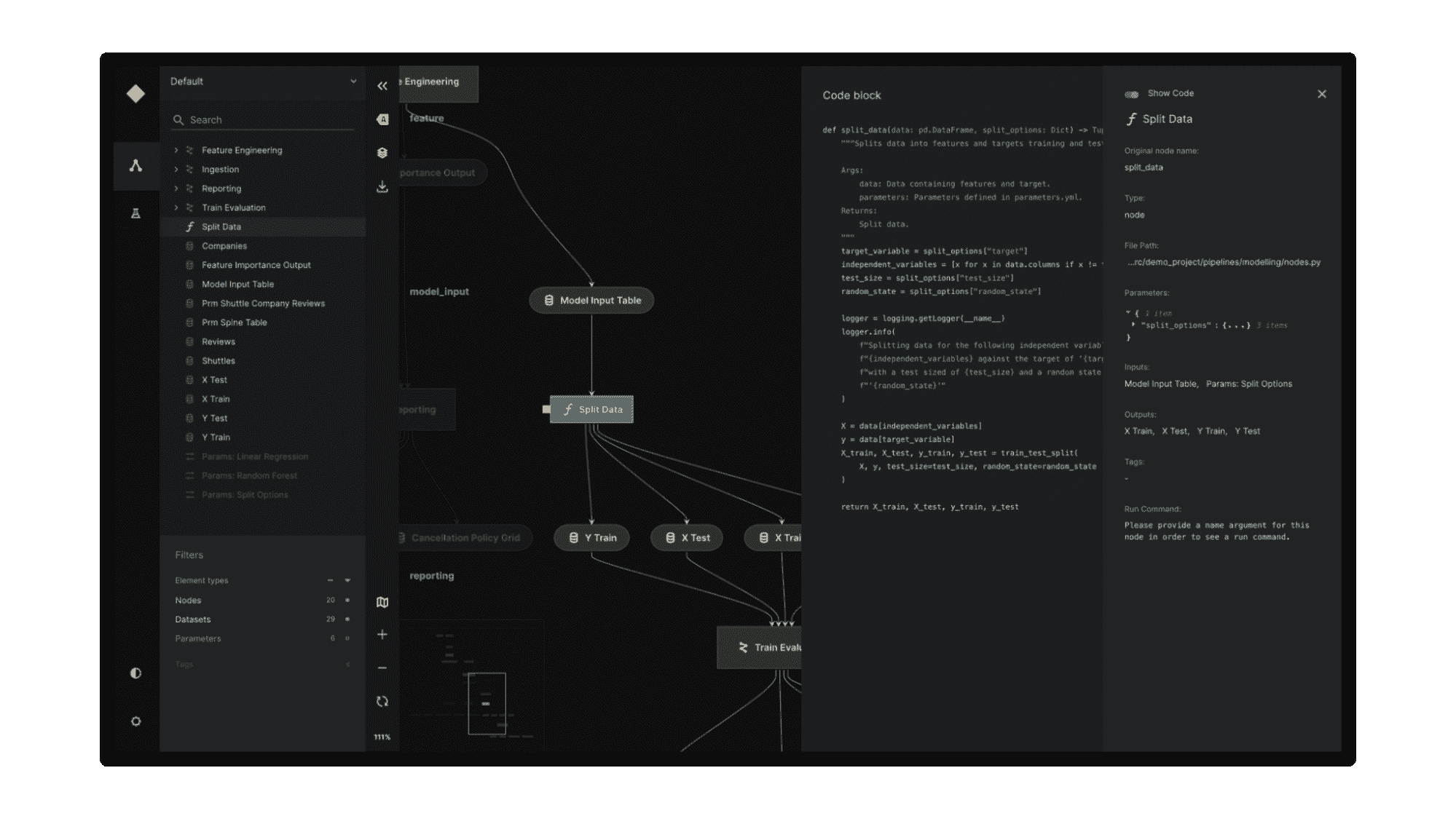

图 1 机器学习模型的生命周期

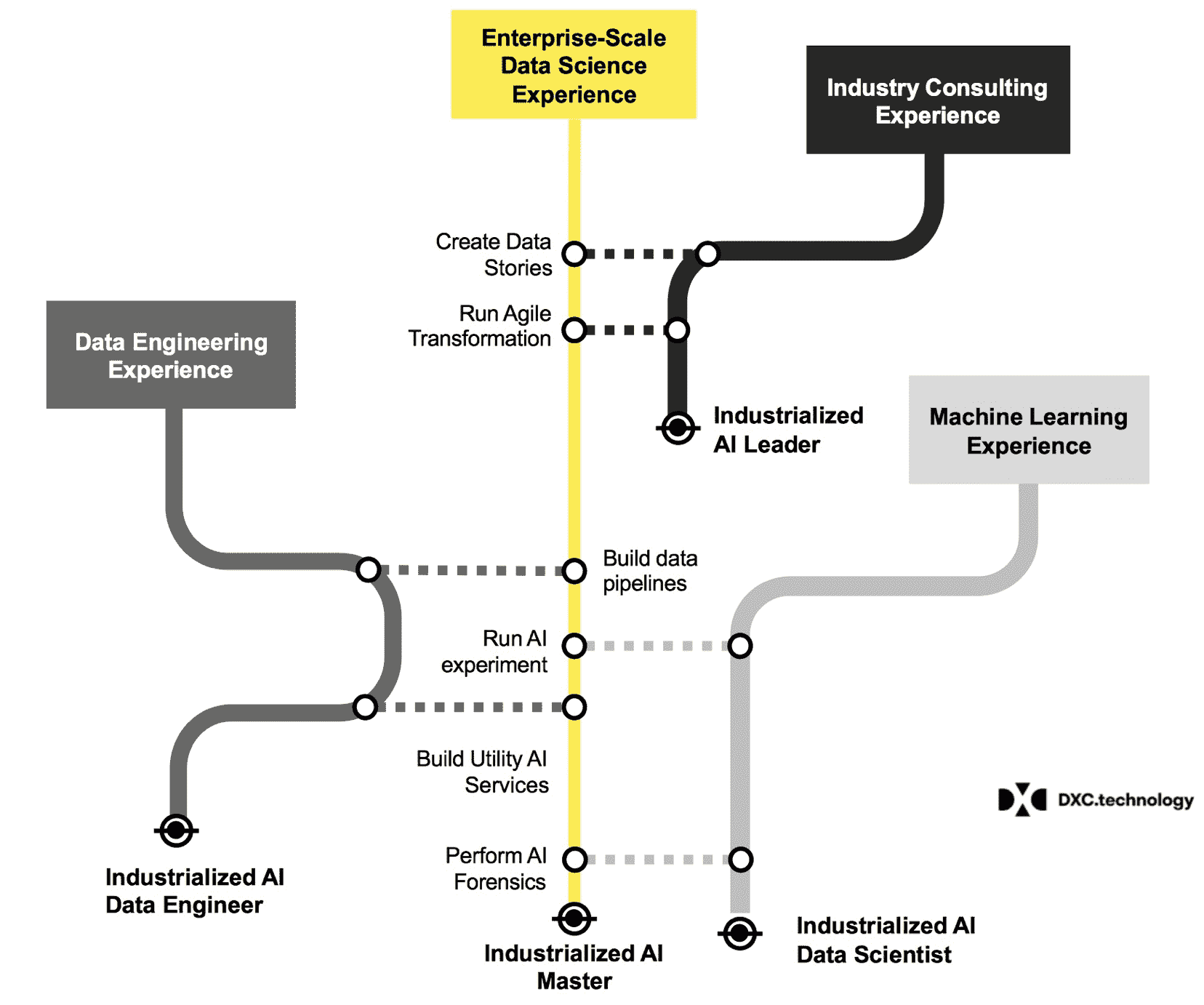

工具

因此,数据科学工具不得不适应变化。它们不仅要支持创建阶段,还要支持机器学习模型的生产化阶段。必须有两个产品或一个产品的两个独立部分:一个支持用户创建和训练数据科学模型,另一个则使最终结果的生产化过程顺畅且无误。虽然创建部分仍然是智力的练习,但生产化部分则是结构化的重复任务。

显然,在创建阶段,数据科学家需要一个涵盖广泛机器学习算法的平台,从基本算法到最先进、最复杂的算法应有尽有。你永远不知道你需要哪个算法来解决哪个问题。当然,最强大的模型成功的机会更高,但代价是更高的过拟合风险和较慢的执行速度。数据科学家最终就像工匠一样,需要一个装满各种工具的工具箱,以应对他们工作中的各种挑战。

低代码平台也获得了人气,因为低代码使程序员甚至非程序员能够创建和快速更新各种数据科学应用程序。

作为智力的练习,机器学习模型的创建应该对每个人都可及。这就是为什么,尽管不是绝对必要的,但一个开源的数据科学平台将是理想的。开源允许所有有志于数据科学的人员自由访问数据操作和机器学习算法,同时允许社区调查和贡献源代码。

在生命周期的另一端,生产化需要一个提供可靠 IT 框架的平台,用于部署、执行和监控准备好的数据科学应用程序。

结论

在不到 2000 字的篇幅中总结 30 年的数据科学发展当然是不可能的。此外,我引用了当时最受欢迎的出版物,尽管它们可能不是该主题上的绝对首篇。我对那些在这一过程中扮演了重要角色但未在这里提及的许多算法表示歉意。尽管如此,我希望这段简短的总结能让你对数据科学在 30 年后的现状有更深入的理解!

参考文献

[1] Rumelhart, D.E.; Hinton, G.E.; Williams, R.J. (1986). “通过误差反向传播学习表示”。自然,323,页码 533-536。

[2] Werbos, P.J. (1988). "反向传播的泛化及其在递归气体市场模型中的应用"。神经网络。1 (4): 339–356。 doi:10.1016/0893-6080(88)90007

[3] Hochreiter, S.; Schmidhuber, J. (1997). "长短期记忆". 神经计算。9 (8): 1735–1780。

[4] Quinlan, J. R. (1993). “C4.5:机器学习程序” 摩根·考夫曼出版社。

[5] Breiman, L.; Friedman, J.; Stone, C.J.; Olshen, R.A. (1984) “分类与回归树”,Routledge。 doi.org/10.1201/9781315139470

[6] Ho, T.K. (1995). 随机决策森林. 第三届国际文档分析与识别会议论文集,蒙特利尔,QC,1995 年 8 月 14-16 日,页码 278-282。

[7] Friedman, J. H. (1999). "贪婪函数近似:一种梯度提升机器,Reitz 讲座

[8] Mason, L.; Baxter, J.; Bartlett, P. L.; Frean, Marcus (1999). "将提升算法视为梯度下降"。见 S.A. Solla 和 T.K. Leen 和 K. Müller (编辑)。神经信息处理系统进展 12。MIT 出版社。页码 512-518

[9] Agrawal, R.; Srikant, R (1994) “挖掘关联规则的快速算法”。 第 20 届国际大型数据库会议论文集,VLDB,第 487-499 页,智利圣地亚哥,1994 年 9 月。

[10] Breese, J.S.; Heckerman, D.; Kadie C. (1998) “协同过滤预测算法的实证分析”, 第十四届人工智能不确定性会议论文集 (UAI1998)

[11] Ciresan, D.; Meier, U.; Schmidhuber, J. (2012). “用于图像分类的多列深度神经网络”。2012 IEEE 计算机视觉与模式识别会议,第 3642–3649 页。 arXiv:1202.2745。 doi:10.1109/cvpr.2012.6248110。 ISBN 978-1-4673-1228-8。 S2CID 2161592。

[12] Krizhevsky, A.; Sutskever, I.; Hinton, G. (2012). “使用深度卷积神经网络进行 ImageNet 分类”。 NIPS 2012: 神经信息处理系统,内华达州湖塔霍。

[13] Hinton, G.E.; Osindero, S.; Teh, Y.W. (2006) “一种快速的深度信念网络学习算法”。 Neural Comput 2006; 18 (7): 1527–1554. doi: doi.org/10.1162/neco.2006.18.7.1527

[14] Wirth, R.; Jochen, H. (2000) “CRISP-DM: 面向数据挖掘的标准过程模型。” 第四届国际知识发现与数据挖掘应用会议论文集 (4),第 29–39 页。

[15] Berthold, R.M. (2021) “如何将数据科学转移到生产环境”,KNIME 博客

Rosaria Silipo 不仅是数据挖掘、机器学习、报告和数据仓库的专家,她还成为了 KNIME 数据挖掘引擎的公认专家,关于这个领域她已经出版了三本书:《KNIME 初学者的好运》、《KNIME 食谱》和《KNIME SAS 用户手册》。此前,Rosaria 曾在欧洲多家公司担任自由数据分析师。她还曾领导 Viseca(苏黎世)的 SAS 开发小组,在 Spoken Translation(加州伯克利)用 C#实现了语音转文本和文本转语音接口,并在 Nuance Communications(加州门洛帕克)开发了多个不同语言的语音识别引擎。Rosaria 于 1996 年在意大利佛罗伦萨大学获得生物医学工程博士学位。

更多相关话题

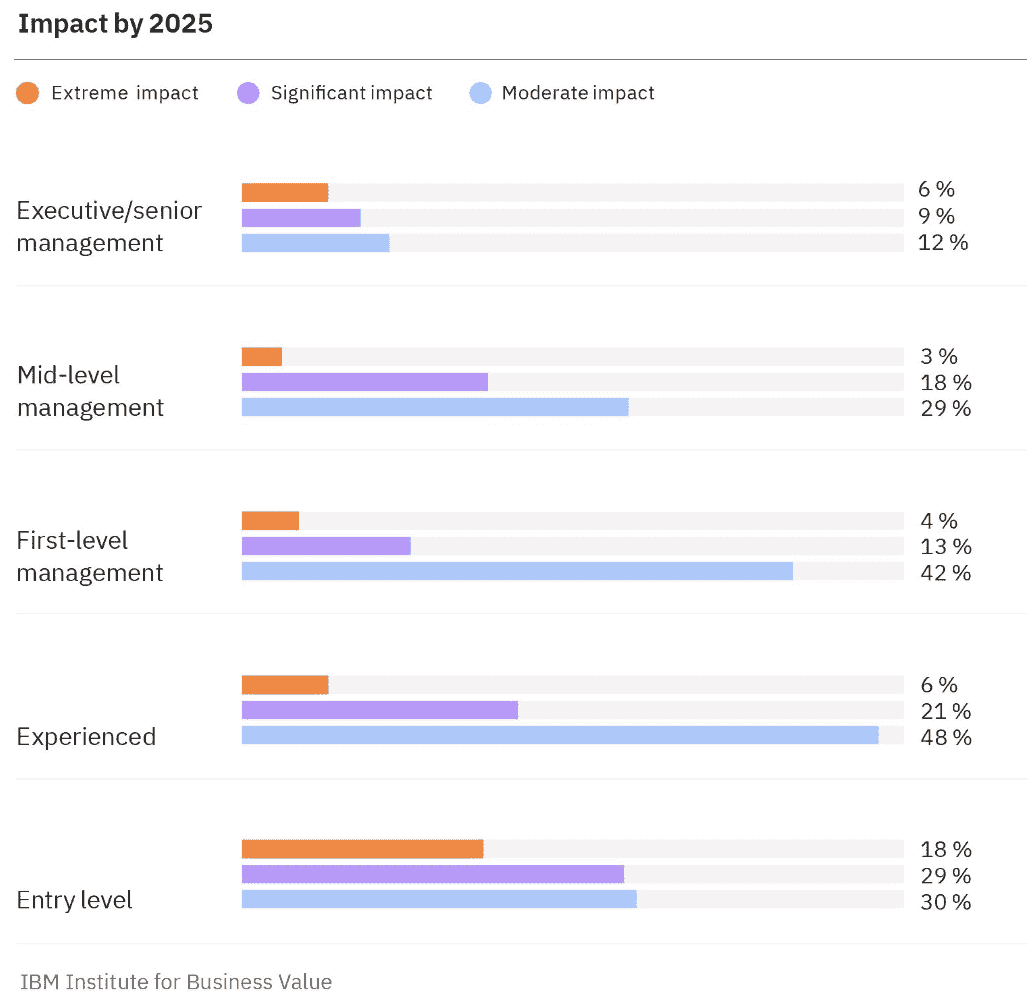

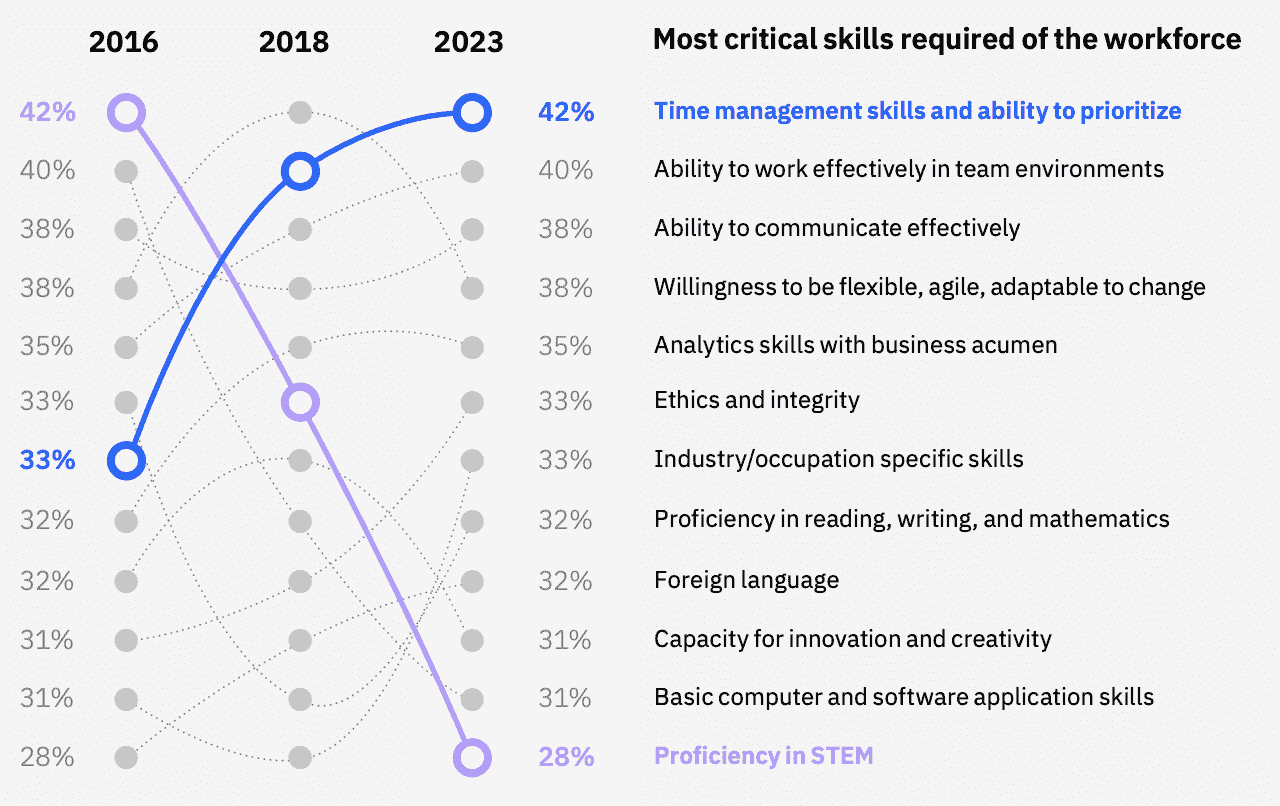

300 百万个工作岗位真的会被 AI 替代或丧失吗?

原文:

www.kdnuggets.com/2023/07/300-million-jobs-really-exposed-lost-ai-replacement.html

图片来源:Pavel Danilyuk

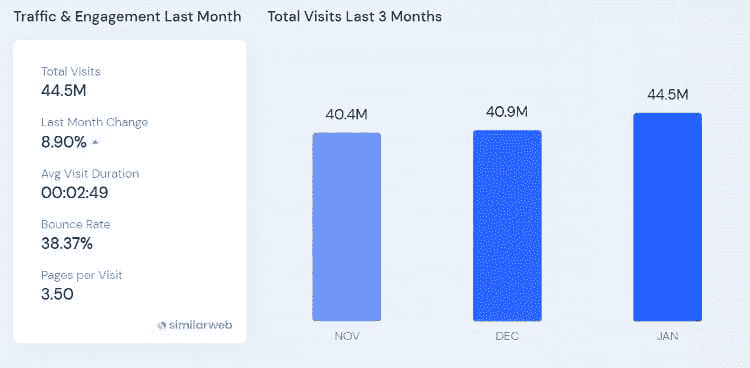

AI 技术在过去六个月里迅速进入主流,得益于 Midjourney 和 ChatGPT 等工具的广泛流行。自然地,随着这些工具的快速普及以及关于AI 能治愈癌症、通过律师资格考试、在 AP 考试中得高分、编写游戏、和取代记者的惊人文章,人们感觉他们的生计受到了威胁。

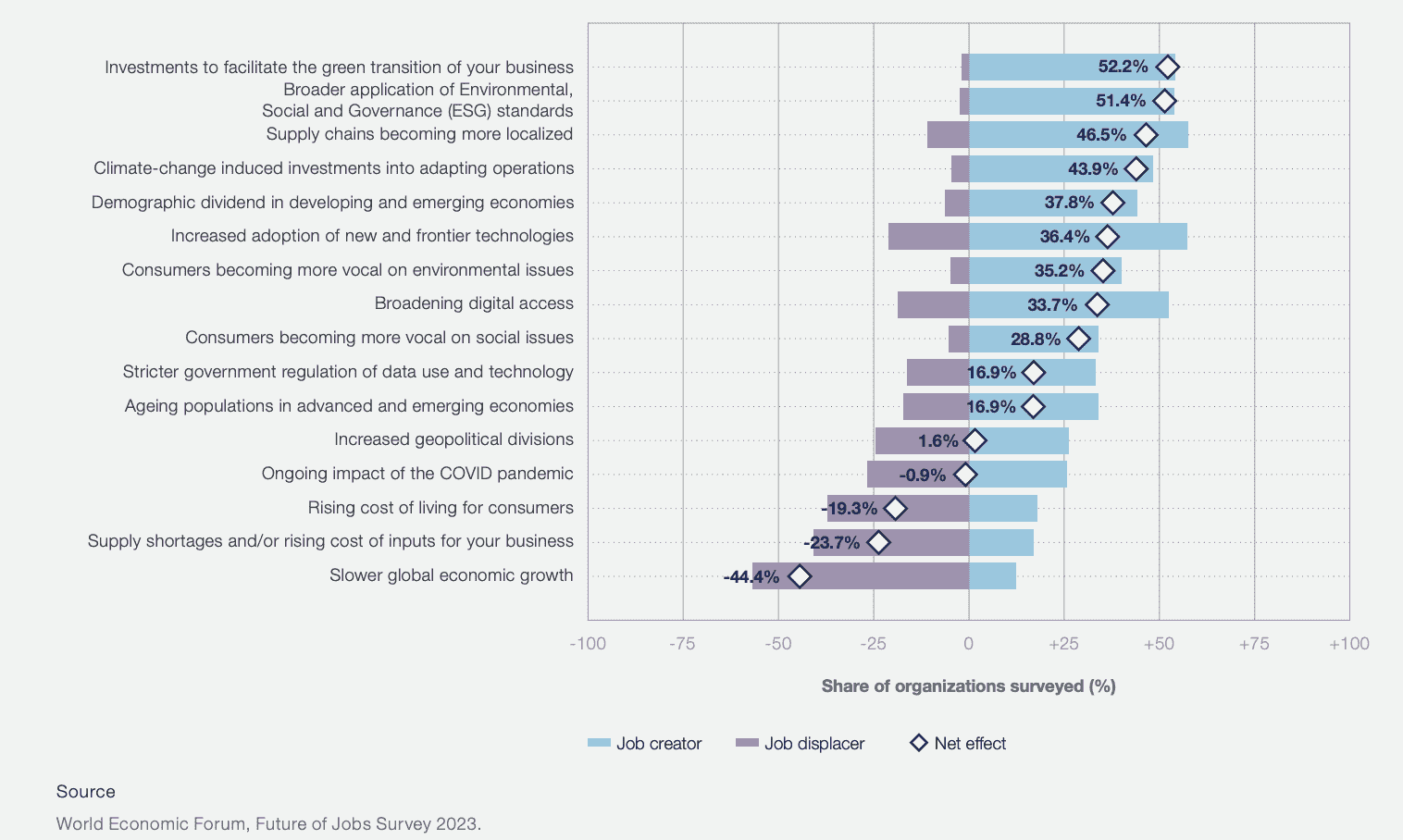

然后高盛发布了一份报告,指出 AI 可能导致美国和欧洲市场的 3 亿个工作岗位被降级或丧失。引发了恐慌的头条新闻。

我认为值得深入探讨一下报告的真正含义,我们可以预期哪些类型的工作会丧失,涉及哪些领域,以及那些面临最大风险的人可以采取哪些措施来抵消这些危险。

报告概述

报告基本上有三点内容:

-

几乎每个行业都有任务被 AI 取代的风险。他们指出法律和行政行业最有可能被 AI 取代,而制造业和建筑业则风险最小。

-

作者预测,美国当前最多有 7%的就业岗位会被 AI 完全取代。大约 63%将会得到补充。约 30%将不会受到影响。

-

其累积效应将是生产力的提高,从而导致全球年 GDP 最终增长 7%

尽管有悲观的标题,作者最后却给出了一个充满希望的结论。“显著的劳动成本节省、新职位的创造以及非被取代工人的更高生产力提升了生产力大爆发的可能性,从而大幅提高经济增长。”

如何理解高盛报告

我建议你阅读报告,而不仅仅依赖头条新闻。高盛的报告要谨慎得多。整份报告名为《人工智能对经济增长的潜在巨大影响》,其中包含了很多细微的差别。

例如,虽然 Forbes 作者 Jack Kelly 说 报告暗示 AI 将“减少”职位,但原报告的作者明确表示,他们期望 AI 补充这些工作,而不是减少它们。作者还明确表示,他们期望只有少数员工会被 AI 完全替代。

想象一下报告所提到的行政行业的员工,这是最容易受到 AI 影响的职业之一,46% 的任务可以被 AI 替代。即使你可以替代一个员工 90%的工作,也极不可能让 AI 做到那个员工所做的所有事情。

行政工作人员不仅仅做基本任务;他们还与员工沟通,协作安排会议,并处理意外问题——这些都是只有人类才能做的。如果自动化可以替代行政助理,Calendly 早就会做到这一点了。

这基本上就是报告所说的内容。工作可能面临风险,但大多数(93%)不会。大多数工作只是受到影响,这意味着一些日常任务可能会被 AI 替代,但这将提高生产力。

报告的作者还强调了 AI 将创造新工作的观点。 “[W]自动化带来的工人失业历史上通常被新工作的创造所抵消,技术创新后的新职业出现占长期就业增长的绝大多数,”他们写道。

许多报道还声称 AI 已经替代了许多职业,但我知道这不可能。例如,Kelly 继续写道:“与其让一个真人解决问题,你可以与在线聊天机器人互动。AI 可以帮助诊断癌症和健康问题。”许多医疗专业人士已经公开表明,他们的工作是 AI 无法替代的。

急诊医生 Josh Tamayo-Sarver 测试 了 ChatGPT 诊断病人的能力,并发现其严重不足。

“他写道,当我给 ChatGPT 提供了完美的信息,且病人有典型的症状时,ChatGPT 作为诊断工具表现得相当好,”他详细描述了 ChatGPT 如何误诊了一些病人,同时未能提出人类医生会问的明显问题。“医疗接触中的绝大多数工作是确定正确的病人叙述。”而这一点是无法替代的。

图片来源于Youtube

而任何与聊天机器人互动过的人都知道,能够在电话的另一端联系到真实的人是多么重要和必要。

人工智能如何夺走工作

当然,仍然有工作面临风险。虽然人工智能的净效应可能是创造更多的工作岗位,但这对目前因人工智能失业的人没有任何好处。有两条路径会使你的工作面临风险:直接替代和间接竞争。

直接替代

许多作家、程序员和图形设计师直接受到那些想要削减成本而使用平庸内容生成的无良首席执行官的威胁。至少现在,生成性人工智能还不能完成程序员所做的所有工作,比如调试、同行评审和深思熟虑的问题解决。

但注重成本的老板可能在为时已晚之前不会在意这一点。

间接竞争

在任何一个快速生成优于质量的领域,人工智能都会导致工作岗位流失。例如,我的一位同行最近告诉我,她丢掉了主编的职位——这不是因为她的老板将工作外包给了人工智能,而是因为整个网站由于被人工智能生成的内容在那些关键词上的竞争所致,导致利润减少了 90%。

她的老板遗憾地裁掉了她以节省成本,并希望将来能重新雇用她。从长远来看,我预计内容会受到更多的处罚,但这对她现在来说没有安慰。

哪些工作将会丧失?

根据你阅读的不同研究,不同的工作面临不同程度的风险。例如,高盛的研究指出,行政、法律和信息处理行业面临的风险最大。另一项研究指出写作和编程面临裁员风险;而科学和批判性思维则不在此列。

我认为值得强调的是,这两者有时并不是互斥的。哪个程序员没有使用过批判性思维?这使我相信,造成工作流失的并不是人工智能本身,而是那些试图节省成本的负责人。我相信他们会在长远中感到后悔。

针对人工智能造成的就业流失,目前采取了哪些措施?

目前有几条途径正在被追求以保护员工免受人工智能导致的就业流失。在个人层面,许多人正在学习如何在日常工作中使用人工智能,以提高效率和效果。许多公司和国家正在彻底禁止生成性人工智能以防范安全风险。某些行业正在对抗人工智能。

学习使用人工智能

防止与人工智能相关的工作流失的最简单最快的方法是学习将人工智能融入你的工作流程。作为一家公司的创始人,我几乎不可能在短期内解雇自己,但我已经学会了使用人工智能来草拟电子邮件、记录重要通话的转录、总结长文章以节省时间、获取项目的技术帮助,甚至帮助我编写代码。

其他从业者已将人工智能加入他们的职位名称,例如人工智能提示专家或人工智能驱动的 SEO 专家。雇主也在这样做,在房地产经纪、市场营销领军人物以及技术知识工作者等各个领域雇佣人工智能辅助的工作人员。

如果你是数据科学家或有志于成为数据科学家,这是 ChatGPT 如何帮助你成为更好的数据科学家。

行业罢工和要求

我想到两个例子。首先,一封公开信获得了超过 27,000 名个人的签署,包括像埃隆·马斯克这样的领导者,要求暂停人工智能的发展。签署者引用了其他已经暂停的技术,直到进行研究以使其更安全,比如克隆、人类胚系修改、功能获得研究和优生学。

其次,好莱坞编剧罢工,要求其中包括确保写作室里不会有人工智能,无论是完全自动化还是部分自动化。他们的罢工尚未成功,但它确立了一个先例。

最后,许多在线出版物对人工智能生成的内容(无论是代码、写作还是艺术作品)有限制或完全禁止。以下是一些例子:

使用lexica生成图像

安全禁令

最后,一些国家和公司因安全问题禁止使用 ChatGPT。包括俄罗斯和意大利在内的七个国家禁止使用 ChatGPT,理由包括儿童安全和国际安全。三星要求员工不要使用 ChatGPT 以防安全风险,而美国银行、花旗集团、德意志银行、高盛和富国银行出于相同的原因禁止使用 ChatGPT。

所以说,人工智能的发展并非毫无挑战,许多方面正在仔细考虑如何以对每个人都安全的方式实施它。

人工智能的潜在好处

我喜欢高盛报告总结他们对人工智能可能如何影响经济的立场:“有时替代,常常补充。”

如前所述,预计人工智能技术将在未来几年内使 GDP 增长 7%,与此同时,我知道它至少帮助我提高了整体工作生产力和乐趣。正如我想象今天的程序员很庆幸不再需要通过一系列打孔纸来编程一样,我怀疑明天的程序员将以一种让生活更轻松的方式整合人工智能生成技术,而不是让生活变得更困难或财务状况更不稳定。

计算机科学家玛格丽特·汉密尔顿与她和团队在麻省理工学院开发的阿波罗导航软件合影。来源:麻省理工学院博物馆提供。

关于人工智能对就业的真实风险的最终思考

没有办法预测人工智能可能做的任何事情,原始文章的作者也强调了这一点。毕竟,这被称为“潜在的”大影响。任何声称知道答案的人要么是在撒谎,要么是被误导了。

从我的角度来看,有理由既保持谨慎,又充满希望。一方面,总会有人希望通过牺牲他人来快速赚取利益。另一方面,人工智能代表了一种我们自个人电脑普及以来未曾见过的潜在未来转变。

我不会假装知道结果如何,但我知道,对于任何希望理解人工智能对工作丧失的真实风险的人来说,阅读原始研究、关注思想领袖,并且不要被任何积极或消极的炒作所左右是值得的。这是一个复杂的问题,我很期待看到它的发展。

内特·罗西迪 是一名数据科学家,专注于产品战略。他还是一名兼职教授,教授分析学,并且是 StrataScratch 的创始人,该平台帮助数据科学家通过顶级公司真实面试问题准备面试。可以通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

相关话题

如何在 Python 中创建一个简单的神经网络

译文:

www.kdnuggets.com/2018/10/simple-neural-network-python.html

评论

神经网络(NN),也称为人工神经网络(ANN),是机器学习领域内的一类学习算法,松散地基于生物神经网络的概念。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

安德烈·布列祖克,一位拥有五年以上经验的德国机器学习专家表示:“神经网络正在彻底改变机器学习,因为它们能够高效地建模跨多个学科和行业的复杂抽象。”

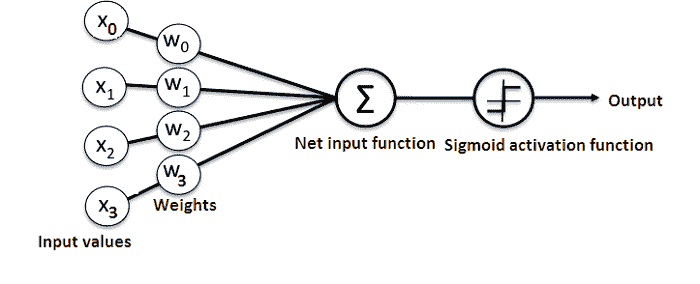

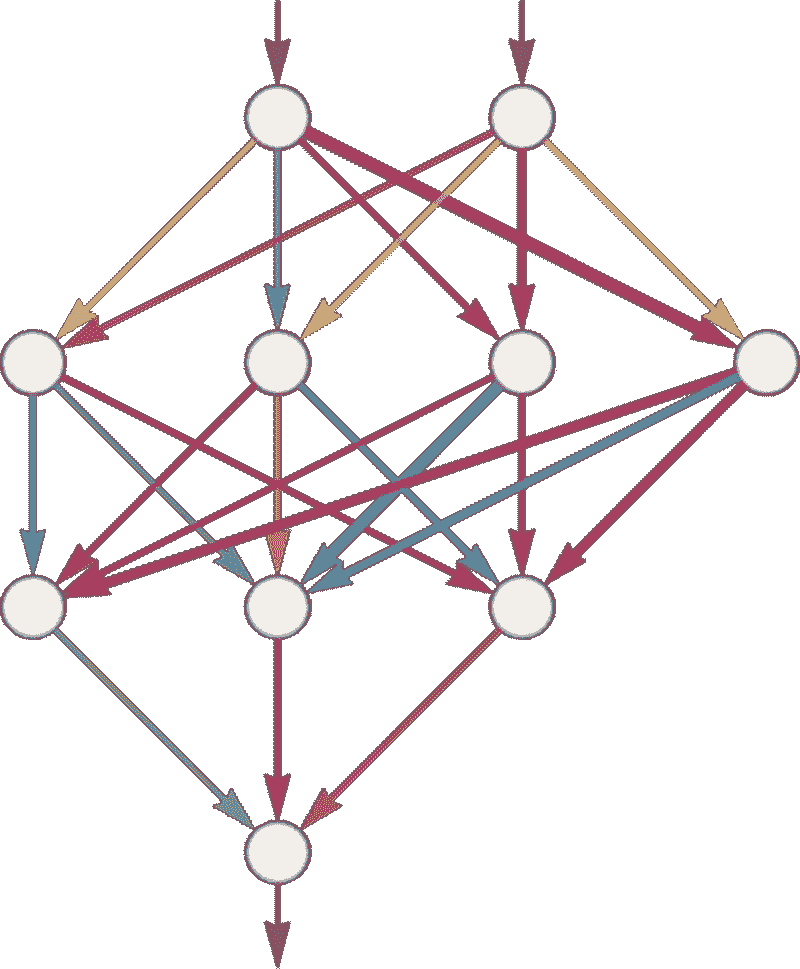

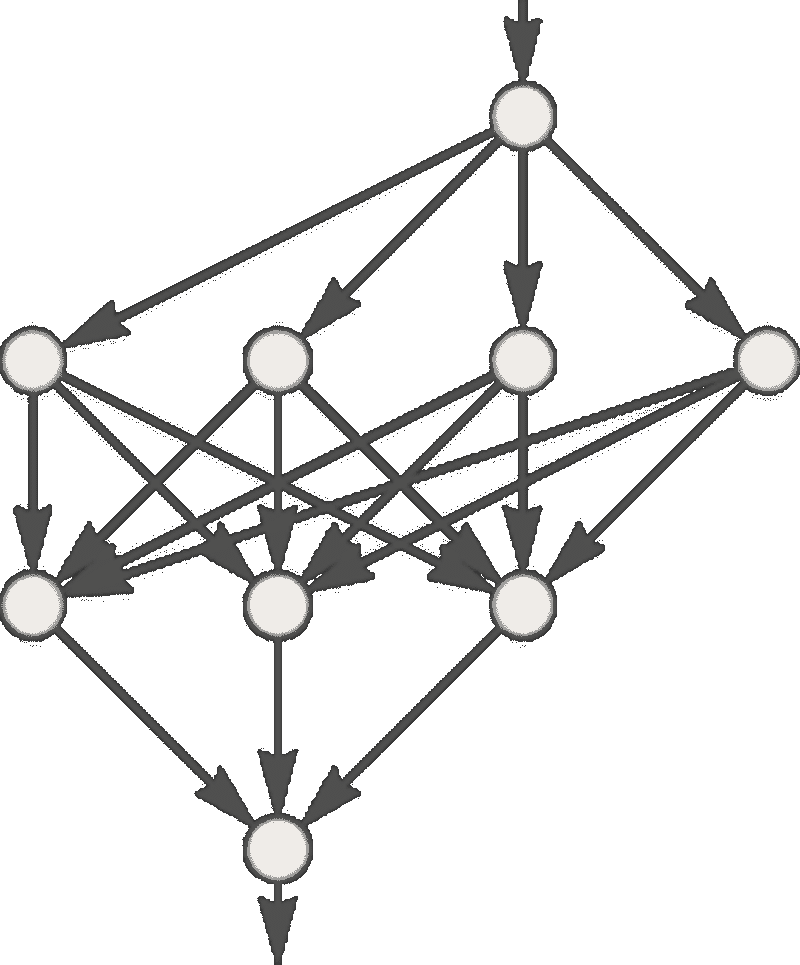

基本上,一个 ANN 包括以下组件:

-

一个接收数据并传递数据的输入层

-

一个隐藏层

-

一个输出层

-

层间权重

-

每个隐藏层的激活函数。在这个简单的神经网络 Python 教程中,我们将使用 Sigmoid 激活函数。

有多种类型的神经网络。在这个项目中,我们将创建前馈或感知神经网络。这种类型的 ANN 直接从前到后传递数据。

训练前馈神经元通常需要反向传播,这为网络提供了相应的输入和输出数据。当输入数据传输到神经元中时,会被处理并生成输出。

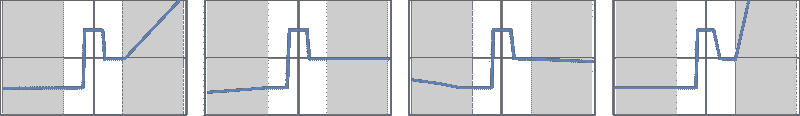

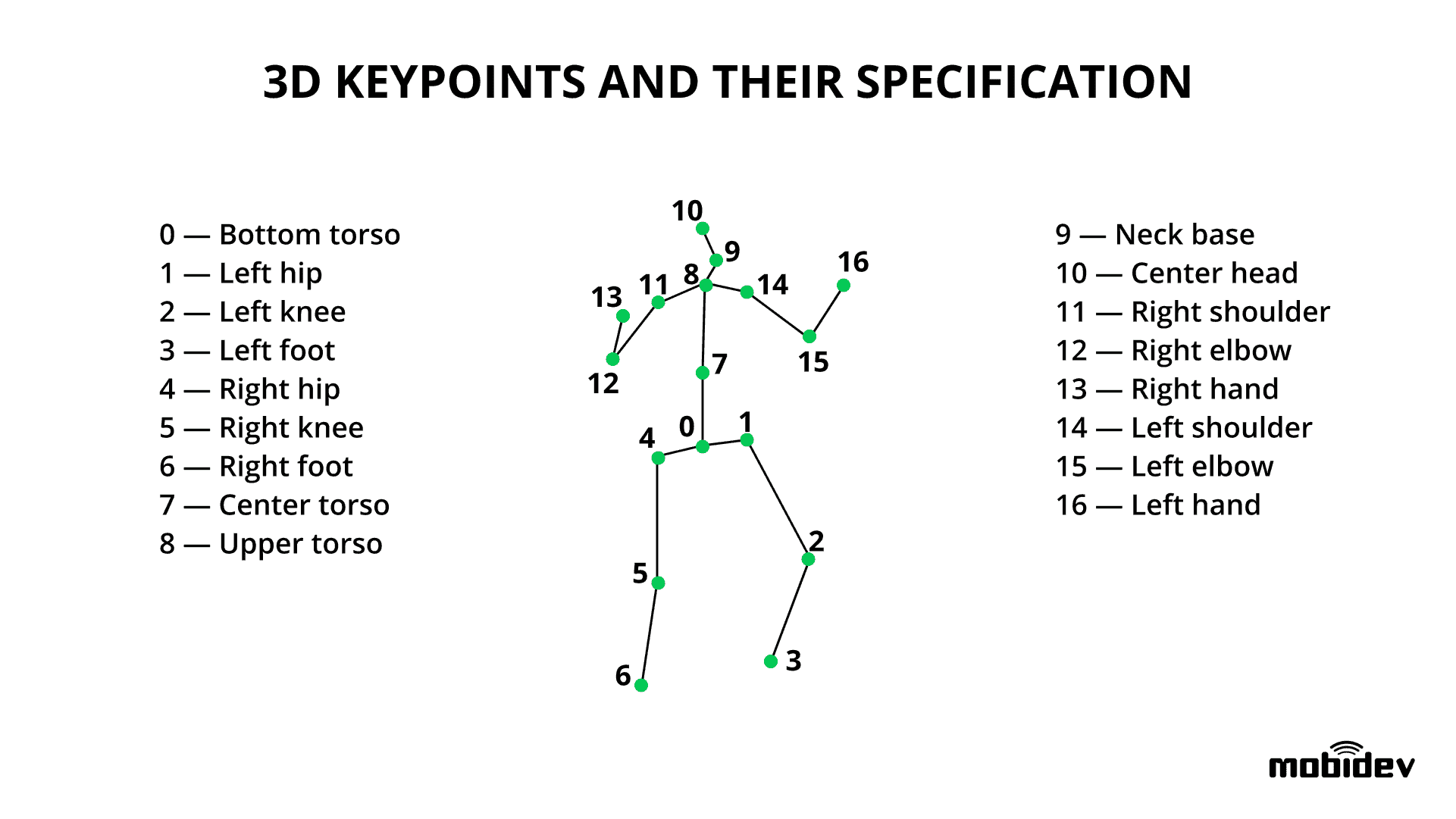

这里是一个展示简单神经网络结构的图示:

了解神经网络工作原理的最佳方法是学习如何从头开始构建一个(不使用任何库)。

在本文中,我们将演示如何使用 Python 编程语言创建一个简单的神经网络。

问题

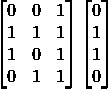

这里是一个展示问题的表格。

| 输入 | 输出 | ||

|---|---|---|---|

| 训练数据 1 | 0 | 0 | 1 |

| 训练数据 2 | 1 | 1 | 1 |

| 训练数据 3 | 1 | 0 | 1 |

| 训练数据 4 | 0 | 1 | 1 |

| 新情况 | 1 | 0 | 0 |

我们将训练神经网络,使其在提供新数据集时能够预测正确的输出值。

如你在表中所见,输出的值始终等于输入部分的第一个值。因此,我们期望输出的值(?)为 1。

让我们看看是否可以使用一些 Python 代码得到相同的结果(在继续阅读之前,你可以在本文末尾查看这个项目的代码)。

创建一个 NeuralNetwork 类

我们将在 Python 中创建一个NeuralNetwork类来训练神经元以提供准确的预测。这个类还将包含其他辅助函数。

尽管我们不会在这个简单的神经网络示例中使用神经网络库,我们将导入numpy库来协助计算。

这个库提供了以下四个重要的方法:

-

exp——用于生成自然指数

-

array——用于生成矩阵

-

dot——用于矩阵相乘

-

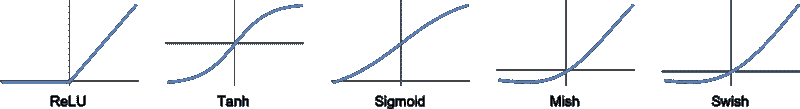

random——用于生成随机数。注意,我们将对随机数进行初始化,以确保其有效分布。

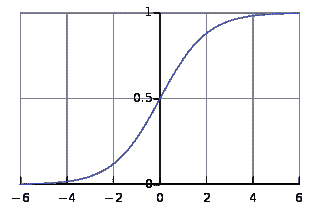

- 应用 Sigmoid 函数

我们将使用Sigmoid 函数,它绘制了一个特征性的“S”形曲线,作为神经网络的激活函数。

这个函数可以将任何值映射到 0 到 1 之间的值。它将帮助我们对输入的加权和进行归一化。

然后,我们将创建 Sigmoid 函数的导数,以帮助计算对权重的必要调整。

Sigmoid 函数的输出可以用来生成其导数。例如,如果输出变量是“x”,则其导数将是 x * (1-x)。

- 训练模型

这是我们将教神经网络做出准确预测的阶段。每个输入都有一个权重——可以是正的也可以是负的。

这意味着具有大量正权重或大量负权重的输入将对结果输出产生更大的影响。

记住,我们最初是通过将每个权重分配给一个随机数来开始的。

这是我们在这个神经网络示例问题中使用的训练过程:

-

我们从训练数据集中获取输入,根据其权重进行一些调整,并通过一种计算 ANN 输出的方法来处理它们。

-

我们计算了反向传播的误差率。在这种情况下,它是神经元预测输出与训练数据集期望输出之间的差异。

-

根据获得的误差程度,我们使用误差加权导数公式进行了些许权重调整。

-

我们将这个过程迭代了任意次数的 15,000 次。在每次迭代中,整个训练集同时处理。

我们使用了“.T”函数将矩阵从横向位置转置为纵向位置。因此,数字将以这种方式存储:

最终,神经元的权重将根据提供的训练数据进行优化。因此,如果神经元被要求思考一个新的情况,与之前的情况相同,它可以做出准确的预测。这就是反向传播的过程。

总结

最后,我们初始化了 NeuralNetwork 类并运行了代码。

这是用于在 Python 项目中创建神经网络的完整代码:

import numpy as np

class NeuralNetwork():

def __init__(self):

# seeding for random number generation

np.random.seed(1)

#converting weights to a 3 by 1 matrix with values from -1 to 1 and mean of 0

self.synaptic_weights = 2 * np.random.random((3, 1)) - 1

def sigmoid(self, x):

#applying the sigmoid function

return 1 / (1 + np.exp(-x))

def sigmoid_derivative(self, x):

#computing derivative to the Sigmoid function

return x * (1 - x)

def train(self, training_inputs, training_outputs, training_iterations):

#training the model to make accurate predictions while adjusting weights continually

for iteration in range(training_iterations):

#siphon the training data via the neuron

output = self.think(training_inputs)

#computing error rate for back-propagation

error = training_outputs - output

#performing weight adjustments

adjustments = np.dot(training_inputs.T, error * self.sigmoid_derivative(output))

self.synaptic_weights += adjustments

def think(self, inputs):

#passing the inputs via the neuron to get output

#converting values to floats

inputs = inputs.astype(float)

output = self.sigmoid(np.dot(inputs, self.synaptic_weights))

return output

if __name__ == "__main__":

#initializing the neuron class

neural_network = NeuralNetwork()

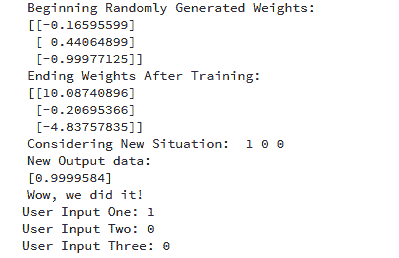

print("Beginning Randomly Generated Weights: ")

print(neural_network.synaptic_weights)

#training data consisting of 4 examples--3 input values and 1 output

training_inputs = np.array([[0,0,1],

[1,1,1],

[1,0,1],

[0,1,1]])

training_outputs = np.array([[0,1,1,0]]).T

#training taking place

neural_network.train(training_inputs, training_outputs, 15000)

print("Ending Weights After Training: ")

print(neural_network.synaptic_weights)

user_input_one = str(input("User Input One: "))

user_input_two = str(input("User Input Two: "))

user_input_three = str(input("User Input Three: "))

print("Considering New Situation: ", user_input_one, user_input_two, user_input_three)

print("New Output data: ")

print(neural_network.think(np.array([user_input_one, user_input_two, user_input_three])))

print("Wow, we did it!")

这是运行代码后的输出:

我们成功地创建了一个简单的神经网络。

神经元开始时分配了一些随机权重。之后,它使用训练样本进行了训练。

因此,如果面对一个新的情况 [1,0,0],它给出的值是 0.9999584。

你记得我们想要的正确答案是 1 吗?

那么,这非常接近——考虑到 Sigmoid 函数输出的值介于 0 和 1 之间。

当然,我们只使用了一个神经元网络来完成这个简单的任务。如果我们将几千个这样的人工神经网络连接在一起呢?我们能否可能 100% 模拟人脑的工作方式?

你有任何问题或评论吗?

请在下方提供。

个人简介: Dr. Michael J. Garbade 是洛杉矶区块链教育公司 LiveEdu 的创始人兼 CEO。这是全球领先的平台,为人们提供在未来技术领域创建完整产品的实用技能,包括机器学习。

相关:

更多相关内容

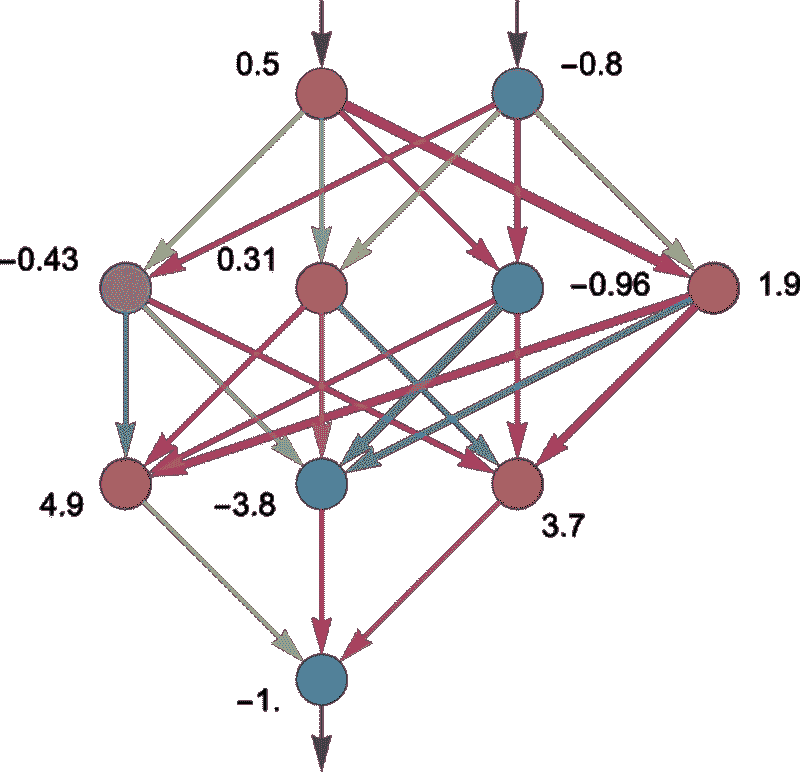

成为数据科学家应该了解的十种机器学习算法

www.kdnuggets.com/2018/04/10-machine-learning-algorithms-data-scientist.html

评论

评论

作者:Muktabh Mayank,ParallelDots

机器学习从业者有不同的个性。有些人是“我是 X 领域的专家,X 算法可以处理任何类型的数据”,其中 X=某个算法;而有些人则是“适合的工具用于合适的工作”。许多人还遵循“全才,专才”策略,即他们在一个领域有深厚的专业知识,同时对机器学习的不同领域有略微的了解。尽管如此,作为实践中的数据科学家,我们必须了解一些常见的机器学习算法的基础知识,这将帮助我们应对遇到的新领域问题。这是对常见机器学习算法的快速浏览及其相关资源,这些资源可以帮助你入门。

1. 主成分分析(PCA)/奇异值分解(SVD)

PCA 是一种无监督方法,用于理解由向量组成的数据集的全局属性。这里分析数据点的协方差矩阵,以了解哪些维度(通常是)/数据点(有时)更重要(即,在它们之间具有高方差,但与其他数据点的协方差低)。一种理解矩阵顶级主成分的方法是考虑其具有最高特征值的特征向量。SVD 本质上也是一种计算有序组件的方法,但你无需获取点的协方差矩阵就能得到它。

该算法通过获取维度减少的数据点来帮助克服维度诅咒。

库:

docs.scipy.org/doc/scipy/reference/generated/scipy.linalg.svd.html

scikit-learn.org/stable/modules/generated/sklearn.decomposition.PCA.html

入门教程:

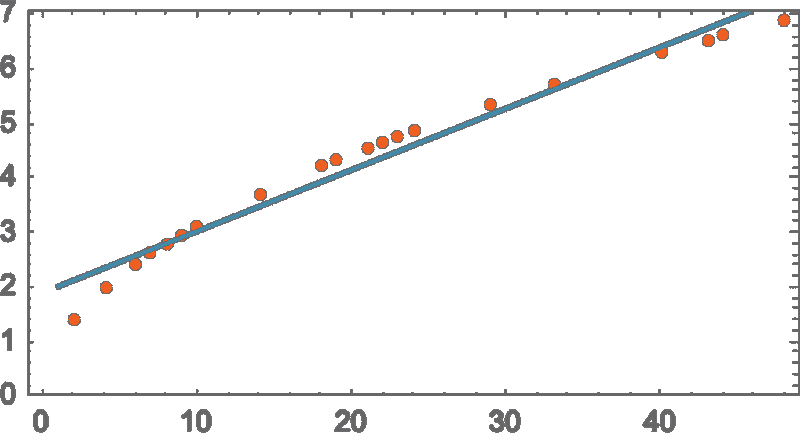

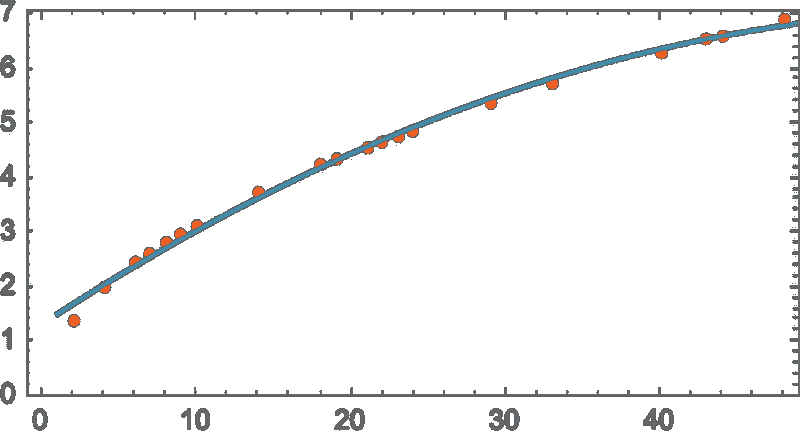

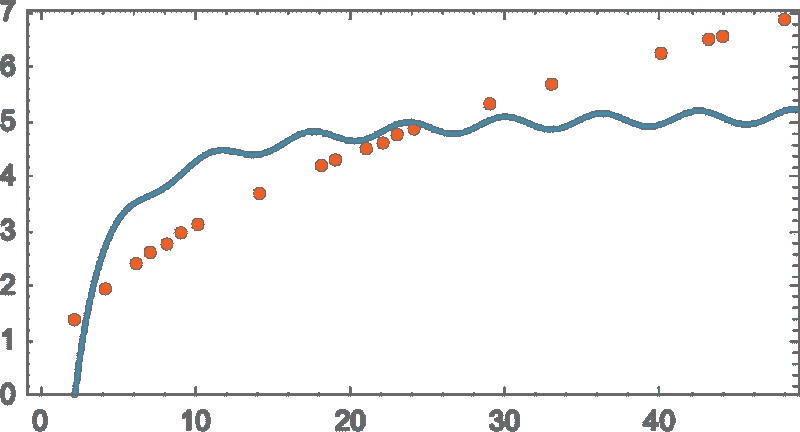

2a. 最小二乘法和多项式拟合

记得你在大学时的数值分析代码吗?你用来拟合点上的直线和曲线以得到一个方程。你可以在机器学习中使用这些方法来拟合非常小的数据集中的曲线(对于大数据或高维数据集,你可能会严重过拟合,因此不要使用)。OLS 有一个闭式解,因此你不需要使用复杂的优化技术。

显而易见,使用此算法来拟合简单曲线/回归

库:

docs.scipy.org/doc/numpy/reference/generated/numpy.linalg.lstsq.htmldocs.scipy.org/doc/numpy-1.10.0/reference/generated/numpy.polyfit.html

入门教程:

lagunita.stanford.edu/c4x/HumanitiesScience/StatLearning/asset/linear_regression.pdf

2b. 约束线性回归

最小二乘法可能会受到异常值、虚假字段和数据噪声的干扰。因此,我们需要约束条件来减少拟合数据集的线的方差。正确的方法是拟合一个线性回归模型,以确保权重不会出现异常。模型可以具有 L1 范数(LASSO)或 L2 范数(岭回归)或两者都有(弹性回归)。均方损失被优化。

使用这些算法来拟合带约束的回归线,避免过拟合,并掩盖模型中的噪声维度。

库:

scikit-learn.org/stable/modules/linear_model.html

入门教程:

www.youtube.com/watch?v=5asL5Eq2x0A

www.youtube.com/watch?v=jbwSCwoT51M

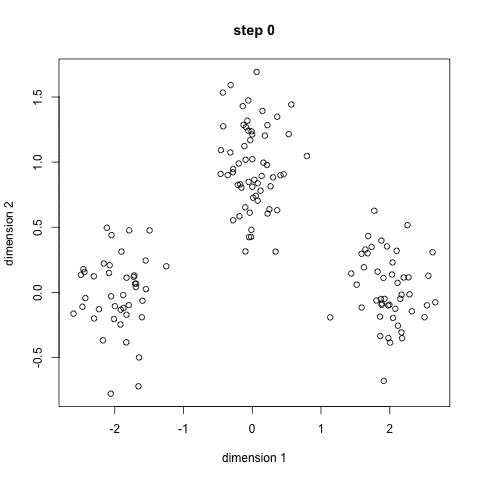

3. K 均值聚类

每个人最喜欢的无监督聚类算法。给定一组以向量形式存在的数据点,我们可以根据它们之间的距离来创建点的聚类。这是一种期望最大化算法,它通过迭代移动聚类的中心,然后将点与每个聚类中心组合在一起。算法所需的输入是要生成的聚类数和尝试收敛聚类的迭代次数。

从名称中显而易见,你可以使用这个算法在数据集中创建 K 个簇

库:

scikit-learn.org/stable/modules/generated/sklearn.cluster.KMeans.html

入门教程:

www.youtube.com/watch?v=hDmNF9JG3lo

www.datascience.com/blog/k-means-clustering

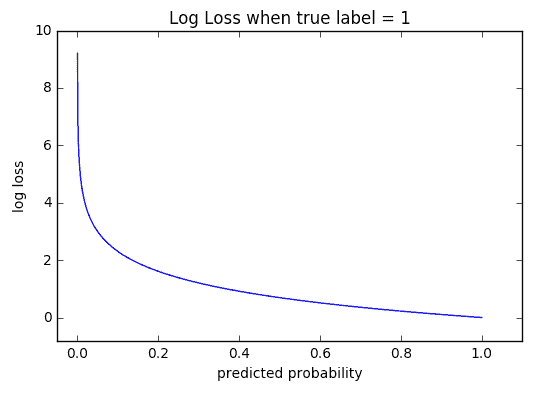

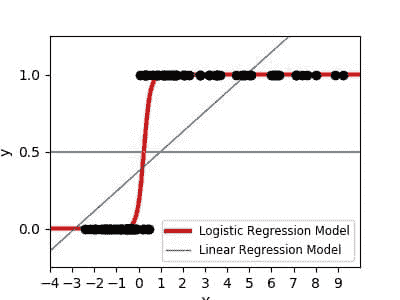

4. 逻辑回归

逻辑回归是受限的线性回归,在应用非线性(通常使用 sigmoid 函数或 tanh 函数)后,限制输出接近于+/-类别(在 sigmoid 的情况下为 1 和 0)。交叉熵损失函数使用梯度下降法进行优化。给初学者的提示:逻辑回归用于分类,而不是回归。你也可以把逻辑回归看作是一个单层的神经网络。逻辑回归使用梯度下降法或 L-BFGS 等优化方法进行训练。NLP 领域的人们经常用最大熵分类器的名称来表示它。

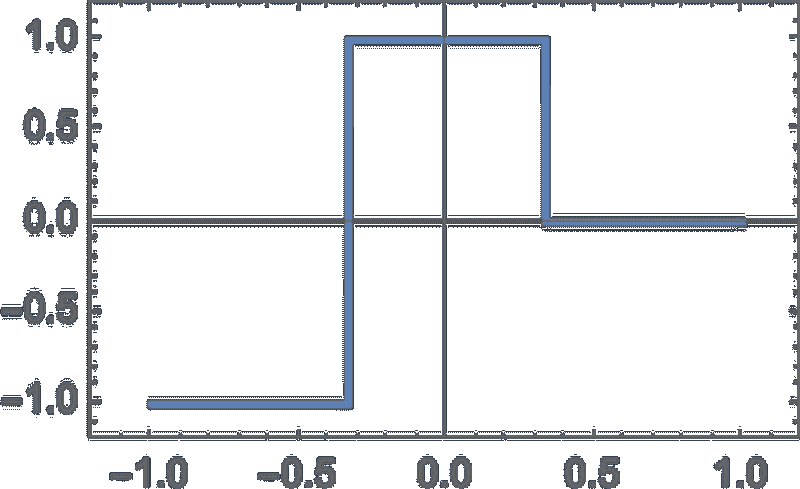

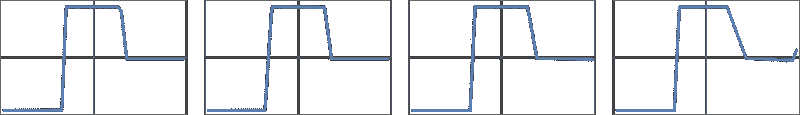

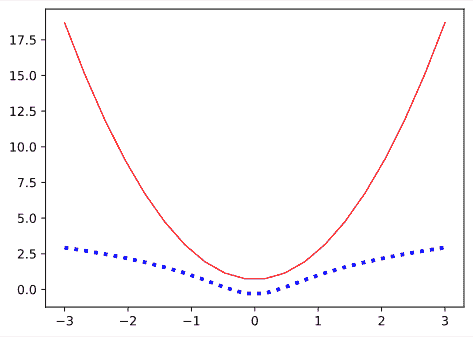

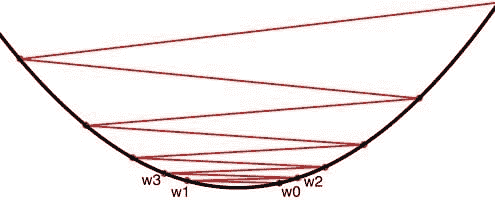

这就是 Sigmoid 的样子:

使用 LR 来训练简单但非常强大的分类器。

库:

scikit-learn.org/stable/modules/generated/sklearn.linear_model.LogisticRegression.html

入门教程:

www.youtube.com/watch?v=-la3q9d7AKQ

5. SVM(支持向量机)

SVM 是类似于线性/逻辑回归的线性模型,不同之处在于它们具有不同的基于边界的损失函数(支持向量的推导是我见过的最美丽的数学结果之一,与特征值计算一起)。你可以使用优化方法,如 L-BFGS 或甚至 SGD 来优化损失函数。

SVM 的另一个创新是使用核函数对数据进行特征工程。如果你对领域有深入的了解,你可以用更聪明的核函数替代传统的 RBF 核,并从中获利。

SVM 的一个独特之处是它可以学习单类分类器。

SVM 可用于训练分类器(甚至回归器)

库:

scikit-learn.org/stable/modules/generated/sklearn.svm.SVC.html

入门教程:

www.youtube.com/watch?v=eHsErlPJWUU

注意: 逻辑回归和 SVM 的 SGD 基于训练可以在 SKLearn 的 scikit-learn.org/stable/modules/generated/sklearn.linear_model.SGDClassifier.html中找到,我常用它,因为它让我可以通过一个通用接口检查 LR 和 SVM。你还可以在大于 RAM 大小的数据集上使用迷你批量进行训练。

我们的前三大课程推荐

1. Google Cybersecurity Certificate - 快速通道进入网络安全领域的职业生涯。

1. Google Cybersecurity Certificate - 快速通道进入网络安全领域的职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

更多相关话题

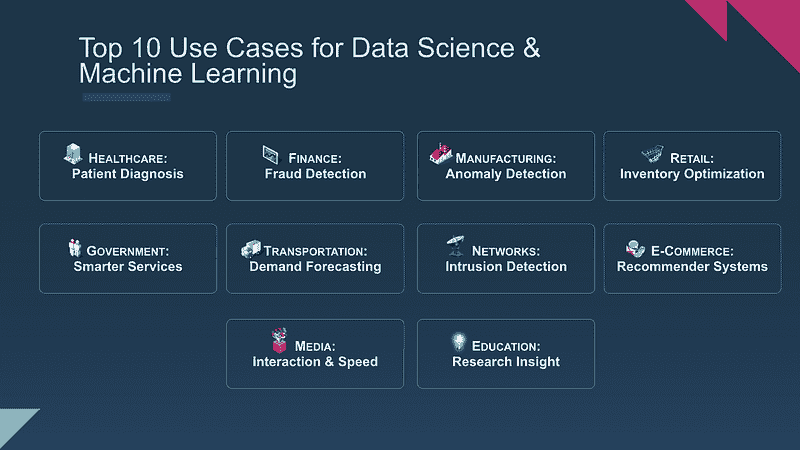

前 10 大机器学习应用场景:第二部分

译文:

www.kdnuggets.com/2017/09/ibm-top-10-machine-learning-use-cases-part2.html

作者:Steve Moore,IBM 故事策略师。赞助帖子。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

上个月,我们发布了 第一部分 ,这是一个系列帖子,旨在突出 IBM 机器学习中心 的前 10 大应用场景。我们特别希望分享那些能扩展我们对机器学习理解的场景——得益于我们与客户数据科学家的合作。

如果你有兴趣尝试 IBM 的新 Watson 机器学习服务 - 点击这里

本系列的目标是超越考虑特定领域时常见的机器学习应用场景。例如,第一部分专注于政府,但不仅仅探讨了机器学习在判刑和假释中的作用,还探索了推动区域和市政机构重要改进的应用场景。在第二部分,我们将超越机器学习在肿瘤学和放射学中的作用,探讨其对心理健康、整体健康和减少再入院率的影响。

1. 利用机器学习帮助减少再入院率

医院和诊所通过多种方式评估自身的有效性——从平均住院时间到急诊等待时间,再到直接的服务调查。再入院率是指标中很重要的一项,它定义为患者出院后在指定时间内返回医院或诊所的比例。再入院可能会给提供者、保险公司和患者带来巨大的成本和麻烦。

但现在,美国的一家医疗保健系统正在利用机器学习来帮助创建一个透视影响再入院因素的视角。从最初的预判再入院率的努力开始,预测建模和认知评估模型汇总了许多因素:医生笔记、医疗注释员、社会因素、患者人口统计等。这些模型不仅将预测准确率提高了 47%,还帮助隔离出有助于降低再入院率的因素,保持患者健康,并节省了开支。

2. 终身的机器学习与健康

一家总部位于华沙的国际医疗公司通过广泛的附属机构网络在其自有健康中心提供医院和临床护理。多年来,他们协调了初级和专科护理、诊断测试、医院服务和后续护理。

由于他们在患者的整个生命周期内提供端到端的护理,他们所捕获的数据赋予了他们个性化医疗计划的巨大能力,以更好地服务患者,平滑不同护理中心之间的过渡,建立信任,并降低成本。做到这一点意味着对患者数据、风险因素和主动解决方案的组合进行深入分析。

3. 将机器学习引入心理健康项目

对心理健康和成瘾问题的研究,无论如何都是一项复杂的工作——但对于那些渴望将实验室和诊所的见解应用于现实世界项目以帮助困境中的个人改善生活的研究人员来说,更是如此。这是美国东北部一家研究机构的任务,该机构与 IBM 合作,组织、维护并挖掘他们的研究数据,以发现数据中的趋势,从而指导他们所采取的干预措施。在 IBM 的帮助下,他们建立了一个系统,该系统跟踪研究环境、患者和时间跨度上的结果。

因为找到足够的资源来支付项目可能是一个挑战,所以能够证实其发现的严谨性——以及干预措施的结果——有助于说服资助者支持该机构的关键工作。

健康图像

随着数据不断涌入医疗保健系统,包括程序、检查、处方信息、可穿戴传感器等,提供者有望利用机器学习来根除低效,并通过改善服务和结果让患者惊艳。进展依赖于我们所有人发现和倡导机会。让我们继续宣传机器学习——并继续分享将其应用的新愿景。

如果你有兴趣尝试IBM 的 Watson 机器学习服务 - 点击这里

更多相关主题

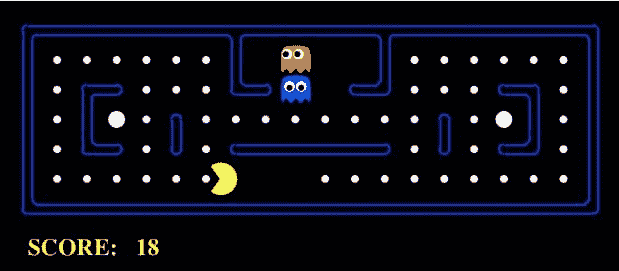

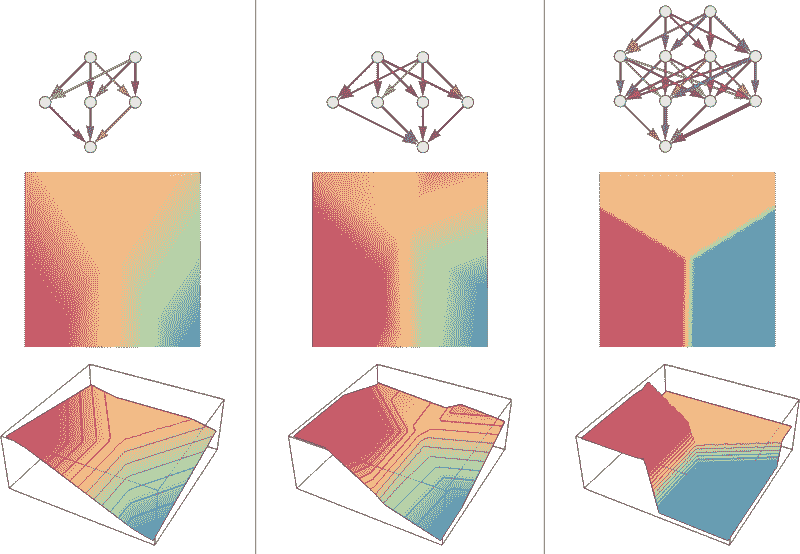

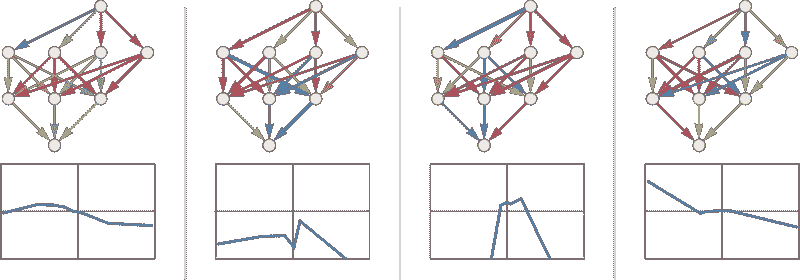

深度学习研究回顾:强化学习

www.kdnuggets.com/2016/11/deep-learning-research-review-reinforcement-learning.html

这是一个名为深度学习研究回顾的新系列的第 2 期。每隔几周,我会总结并解释特定深度学习子领域的研究论文。本周关注强化学习。

上次 是生成对抗网络 ICYMI

强化学习简介

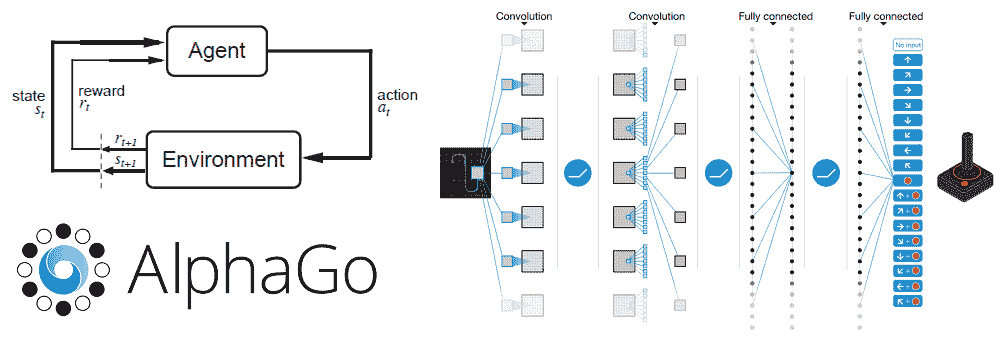

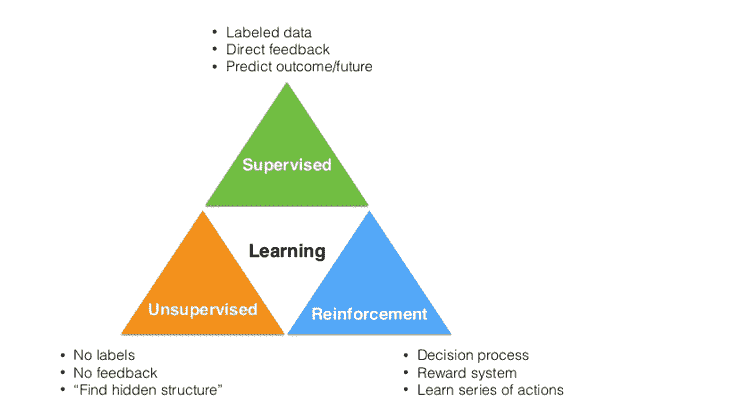

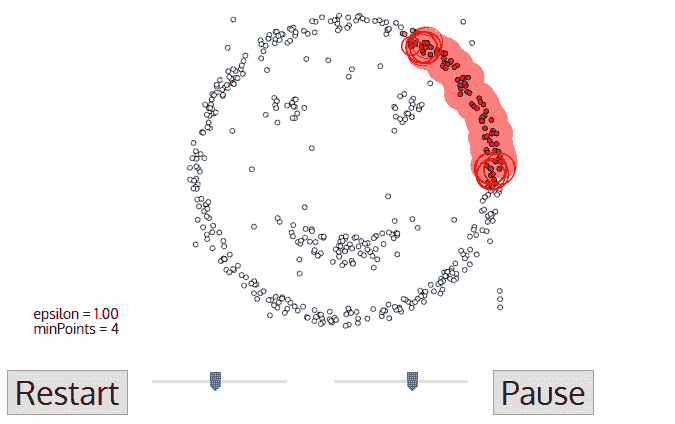

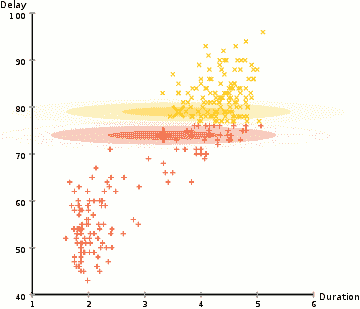

机器学习的 3 个类别

在进入论文之前,我们先来谈谈什么是强化学习。机器学习领域可以分为 3 个主要类别。

-

监督学习

-

无监督学习

-

强化学习

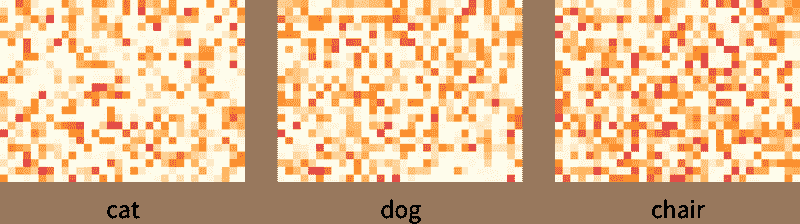

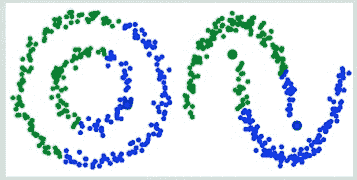

第一个类别,监督学习,是你可能最熟悉的。它依赖于基于一组训练数据(包含输入及其对应的标签)来创建一个函数或模型。卷积神经网络就是一个很好的例子,因为图像是输入,而输出是图像的分类(狗、猫等)。

无监督学习 通过聚类分析的方法在数据中寻找某种结构。最著名的机器学习聚类算法之一 K-Means 就是无监督学习的一个例子。

强化学习 是学习在给定某种情况/环境下应该采取什么行动,以最大化奖励信号的任务。监督学习和强化学习之间有趣的区别在于,奖励信号仅仅告诉你代理采取的行动(或输入)是好是坏,并不会告诉你最佳行动是什么。与此相对的是 CNN,其中每个图像输入的对应标签明确指示了每个输入的输出应该是什么。强化学习的另一个独特组成部分是代理的行动将影响其后续接收到的数据。例如,代理向左移动而不是向右移动意味着代理在下一时间步骤将接收到来自环境的不同输入。让我们从一个例子开始。

强化学习问题

所以,让我们首先考虑在强化学习问题中有什么。假设在一个小房间里有一个小机器人。我们还没有编程这个机器人去移动或走动或采取任何行动。它只是站在那里。这个机器人就是我们的代理。

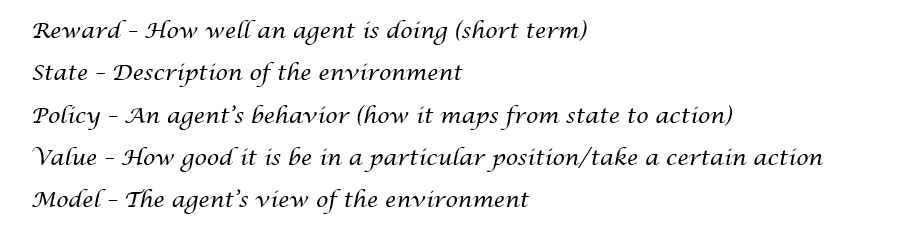

如前所述,强化学习完全是关于理解做决策/行动的最佳方式,以便我们最大化某个奖励 R。这个奖励是一个反馈信号,仅仅表示代理在给定时间步的表现如何。代理在每个时间步采取的动作 A是奖励(告知代理当前表现如何)的信号和状态 S(描述代理所处环境的情况)的函数。环境状态到动作的映射称为我们的策略 P。策略基本上定义了在特定情况下,代理在特定时间的行为方式。现在,我们还有一个价值函数 V,这是衡量每个位置好坏的标准。这与奖励不同,因为奖励信号指示即时的好处,而价值函数更多地表示在长期来看处于这个状态/位置的好处。最后,我们还有一个模型 M,它是代理对环境的表示。这是代理对环境如何表现的模型。

马尔可夫决策过程

因此,让我们回到我们的小房间中的机器人(代理)。我们的奖励函数取决于我们希望代理完成的任务。假设我们希望它移动到房间的一个角落,在那里它将获得奖励。机器人到达这个点时将获得 +25,并且每经过一个时间步就会得到 -1。我们基本上希望机器人尽快到达角落。代理可以采取的动作是向北、向南、向东或向西移动。代理的策略可以是简单的,即代理将始终移动到具有更高价值函数的位置。对吧?一个高价值函数的位置 = 在这个位置(就长期奖励而言)很好。

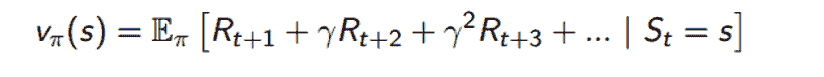

现在,这整个 RL 环境可以用马尔可夫决策过程来描述。对于那些以前没听过这个术语的人来说,MDP 是一个建模代理决策的框架。它包含一个有限的状态集(及这些状态的价值函数),一个有限的动作集,一个策略和一个奖励函数。我们的价值函数可以分为两个部分。

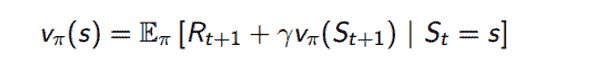

- 状态价值函数 V:在状态 S 中,遵循策略 π 的预期回报。这个回报是通过查看每个未来时间步的奖励总和来计算的(gamma 指的是一个常数折扣因子,这意味着时间步 10 的奖励的权重比时间步 1 的奖励略低)。

- 动作价值函数 Q:在状态 S 中,遵循策略 π 并采取动作 a 的预期回报(方程与上面相同,只是我们增加了一个额外条件 At = a)。

现在我们有了所有的组成部分,我们该如何处理这个 MDP 呢?当然,我们想要解决它。通过解决 MDP,你将能够找到最大化代理可以从环境中任何状态获得的奖励的最优行为(策略)。

解决 MDP

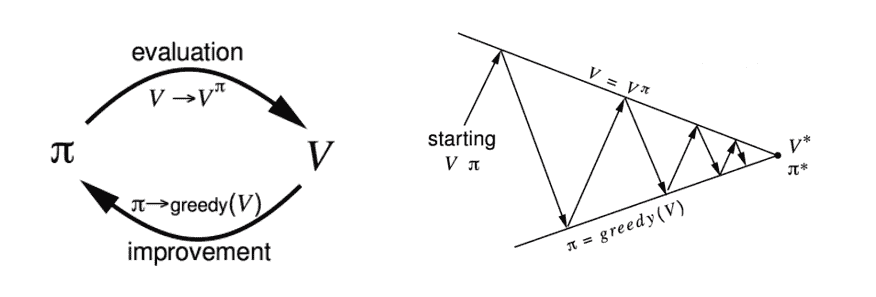

我们可以通过使用动态规划和特别是策略迭代来解决一个 MDP(还有一种叫做价值迭代的技术,但现在不讨论)。其想法是我们从一些初始策略 π1 开始,并评估该策略的状态价值函数。我们通过贝尔曼期望方程来完成这个过程。

这个方程基本上说,给定我们遵循策略 π,我们的价值函数可以被分解为即时奖励 Rt+1 和后继状态 St+1 的价值函数的期望回报和。如果仔细想想,这等同于我们在上一节中使用的价值函数定义。使用这个方程是我们的策略评估组成部分。为了得到更好的策略,我们使用策略改进步骤,在这个步骤中我们简单地相对于价值函数采取贪婪行动。换句话说,代理采取最大化价值的行动。

现在,为了获得最优策略,我们重复这两个步骤,一个接一个,直到我们收敛到最优策略 π*。

当没有给定 MDP 时

策略迭代非常棒,但它只在我们有一个给定的 MDP 时才有效。MDP 本质上告诉你环境是如何工作的,而在现实世界中这通常不会被直接给出。当没有给定 MDP 时,我们使用无模型的方法,这些方法直接从代理与环境的经验/交互中得出价值函数和策略。我们将进行相同的策略评估和策略改进步骤,只是没有 MDP 提供的信息。

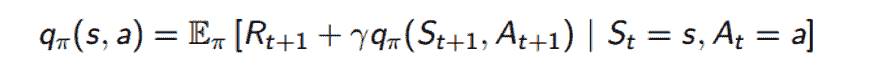

我们的做法是,不是通过优化状态价值函数来改进我们的策略,而是优化行动价值函数 Q。还记得我们是如何将状态价值函数分解为即时奖励和后继状态的价值函数之和的吗?我们可以用同样的方法处理我们的 Q 函数。

现在,我们将按照相同的过程进行策略评估和策略改进,不过我们将状态值函数 V 替换为动作值函数 Q。现在,我将略过评估/改进步骤中的详细变化。要理解 MDP 无关的评估和改进方法,如蒙特卡罗学习、时间差分学习和 SARSA 等话题需要专门的博客(如果你感兴趣的话,可以听听 David Silver 的Lecture 4和Lecture 5)。然而,现在我将跳到值函数近似以及 AlphaGo 和 Atari 论文中讨论的方法,希望这能让你了解现代强化学习技术。主要的收获是我们想要找到能够最大化我们的动作值函数 Q 的最优策略π*。

值函数近似

所以,如果你考虑到迄今为止我们学到的一切,我们以一种相对简单的方式处理了我们的问题。看看上面的 Q 方程。我们接受一个特定的状态 S 和动作 A,然后计算一个基本上告诉我们预期回报的数字。现在假设我们的代理向右移动了 1 毫米。这意味着我们有了一个全新的状态 S’,现在我们需要为此计算一个 Q 值。在现实世界的强化学习问题中,有成千上万的状态,因此我们的值函数必须理解泛化,以便我们不需要为每个可能的状态存储一个完全独立的值函数。解决方案是使用Q 值函数近似,它能够对未知状态进行泛化。

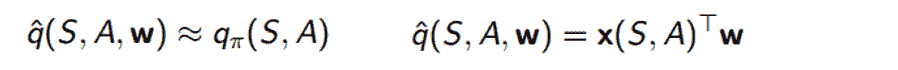

所以,我们想要的是一个函数,我们称之为 Qhat,它可以在给定某个状态 S 和某个动作 A 的情况下,提供 Q 值的粗略近似。

这个函数将接受 S、A 和一个老旧的权重向量 W(一旦你看到 W,你就知道我们引入了一些梯度下降)。它将计算 x(即表示 S 和 A 的特征向量)和 W 之间的点积。我们改进这个函数的方法是计算真实 Q 值(暂时假设它是已知的)和近似函数输出之间的损失。

在我们计算损失之后,我们使用梯度下降来找到最小值,到那时我们将获得最优的 W 向量。函数近似的这一概念将在稍后查看的论文中非常关键。

还有一件事

在进入论文之前,想要提及最后一件事。有关强化学习的一个有趣讨论是探索与利用的主题。利用是代理利用其已知的知识,并采取它知道会产生最大奖励的行动。听起来不错,对吧?代理将始终根据其当前知识做出最佳行动。然而,这句话中有一个关键短语。当前知识。如果代理没有足够探索状态空间,它无法知道自己是否真的采取了最佳可能的行动。这种以探索状态空间为主要目的的行动被称为探索。

这个想法可以很容易地联系到现实世界的例子。假设你今晚要选择去哪个餐厅用餐。你(作为代理)知道你喜欢墨西哥菜,因此从 RL 的角度来看,去墨西哥餐厅将是最大化你奖励的行动,即在这种情况下是幸福感/满足感。然而,还有一个意大利餐的选择,你以前从未尝试过。有可能它比墨西哥菜更好,或者可能更差。这种在利用代理过去知识与尝试新事物以期发现更大奖励之间的权衡是强化学习(以及我们日常生活中的一个主要挑战)。

其他学习 RL 的资源

哎呀,那真是很多信息。然而,这绝不是对该领域的全面概述。如果你想要更深入的 RL 概述,我强烈推荐这些资源。

-

David Silver(来自 Deepmind)强化学习视频讲座

- 我在 RL 课程中的个人笔记

-

Sutton 和 Barto 的强化学习教材(如果你决心学习这一子领域的所有细节,这真的是终极宝典)

-

Andrej Karpathy 的博客文章关于 RL(如果你想轻松入门 RL,并查看一个做得非常好的实际示例,可以从这个开始)

-

UC Berkeley CS 188 讲座 8-11

-

Open AI Gym: 当你对 RL 感到舒适时,尝试使用 Open AI 创建的这个强化学习工具包创建自己的代理

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

相关话题

AI 尚未触及的难题

评论

评论

谁更强,勒布朗·詹姆斯还是斯蒂芬·库里?哪个国家更强大,美国还是中国?现代 AI 相比于人类有多先进?在上述这三个荒谬的问题中,哪个显得最不明确?尽管如此,我们常常将复杂、多面的议题讨论得好像它们可以简化为单一的标量量。

在过去几年里,现代 AI 技术取得了巨大进展,实现了许多传统上与人类智能相关的成就。特别是,使用深度神经网络的机器学习系统现在可以进行人类水平的语音识别和转录。它们还能为图像添加标签,用合理的自然语言描述它们。就在几个月前,一个将强化学习与深度学习相结合的系统击败了人类在围棋比赛中,这一直被认为是最难以匹敌人类能力的棋类游戏。

在这些成功的背后,人们很容易将 AI 的进展视为一个单一的整体,认为它在所有领域都在均等发展。如果我们只关注监督学习和用于游戏的强化学习,这似乎是可信的。但在接受 AI 单一主义的魔法思维之前,我们应该稍作停顿。尽管一些流行的未来主义者提出了不同的观点,AI 的进展并不会在所有方向上均匀进行,尽管每次计算成本在下降。相反,我们在某些问题类别上取得了快速进展,而在其他问题上则停滞不前。我们的成功来自于那些目标容易且无争议地量化的问题。其他目标更模糊的问题,如个人助手、对话代理、医疗决策等,在向人类能力的进展上相对较少。

哪些问题很难?

人工智能/机器学习研究历史中的一个反复出现的主题是,我们很难确定人类智能的哪个方面是值得注意的。三十年前,许多人认为击败国际象棋大师将构成比匹敌高中生的认知能力更伟大的智能成就。然而,尽管现任冠军马格努斯·卡尔森无法抵挡运行树搜索的 Macbook Pro,但现代对话机器人却无法匹敌一个普通 10 岁孩子的对话能力。也许,我们对各种类型智能的价值观根植于经济思维中。在其他条件相同的情况下,稀缺技能似乎更有价值。国际象棋冠军可能看起来比社交名流更具智能,仅仅因为他们的数量更少。

机器学习问题可能因多种原因而复杂。大多数公开的人工智能处理的是结构良好的模式匹配问题。这些问题包括图像分类等监督学习问题,或像下棋、围棋或玩 Atari 等强化学习问题。这些问题的难度因训练数据的稀缺、行动空间或类别的多样性,或需要学习的模式尤其复杂(如原始音频或视频数据)而有所不同。在这些方面,机器学习研究已经取得了相当大的进展。

然而,机器学习问题也可能因另一个被忽视的原因而变得困难。对于许多我们可能想要引入人工智能代理的场景,这些问题并不是结构良好的。也就是说,优化的目标并不明显。

几乎所有的机器学习任务都涉及某种形式的优化。对于图像分类,我们的目标是最大化正确分类的图像比例。对于语言翻译,我们的目标是输出一个与一组真实候选翻译高度一致的字符串。对于像国际象棋或围棋这样的游戏,我们的目标就是赢。简而言之,监督学习和强化学习都假定存在一个先验的标量量,其最大化等同于成功。

但对于许多我们可能想要插入人工智能代理的现实世界场景,目前没有人能明确目标函数应该是什么。例如,医生的确切目标是什么?我们如何将医疗专业人员的成功提炼为一个随着结果显现而发放的单一奖励?我们如何准确衡量生活质量?肢体与寿命之间的权衡是什么?医生应该如何权衡收入与病人健康(如果生命的价值是无限的,那么所有患者都应该免费就诊)。有时,医生的目标函数可能因患者的偏好而有所不同。人类医生会不断地隐性评估这些权衡,但在我们学会确认目标之前,现有的人工智能可能仍然局限于更孤立的、低层次的模式识别问题。

类似地,对话中的标量量优化是什么?是否仅仅是最大化互动?如果通过恶搞来最大化互动呢?目标是友善吗?提供信息吗?建立持久关系吗?是否应该对不友好的行为施加惩罚?如果是,那么如何量化这种惩罚?

尽管我们在模式识别上取得了显著进展,在监督学习和强化学习中的困难问题上也有所突破,但我们整个学习范式仍需要预先确定的明确目标。然而,对于我们设想中的“强 AI”或类人智能的复杂环境来说,确定这些目标却是一个巨大的障碍。

此外,正是这些无争议的成功指标(测试集准确率、棋类评分等)推动了该领域的进展。与其他因主观性而受阻的领域不同,机器学习受益于这些指标所赋予的客观性。如果目标定义模糊,社区如何才能实现对更一般 AI 的同样和谐的进展?

机器学习已进入黄金时代。它在智力上令人着迷,在经济上影响深远。随着进展似乎稳定地推进,人们很容易将其视为向超智能的单向推进,这种智能在所有领域都与人类能力匹敌或超越。然而,我们可能会记住我们在识别我们智能中具体有趣、有价值或难以复制的方面的糟糕记录。也许正是我们在目标定义模糊的情况下有效操作的能力最为显著——这是机器学习尚未取得显著进展的领域。

扎克里·蔡斯·利普顿 是加州大学圣地亚哥分校计算机科学工程系的博士生。在生物医学信息学系资助下,他对机器学习的理论基础和应用均感兴趣。除了在 UCSD 的工作外,他还曾在微软研究院和亚马逊担任机器学习科学家,并在 KDnuggets 担任贡献编辑。

扎克里·蔡斯·利普顿 是加州大学圣地亚哥分校计算机科学工程系的博士生。在生物医学信息学系资助下,他对机器学习的理论基础和应用均感兴趣。除了在 UCSD 的工作外,他还曾在微软研究院和亚马逊担任机器学习科学家,并在 KDnuggets 担任贡献编辑。

相关:

-

深度学习来自魔鬼吗?

-

MetaMind 与 IBM Watson Analytics 和 Microsoft Azure Machine Learning 竞争

-

深度学习与经验主义的胜利

-

模型可解释性的神话

-

(深度学习的深层缺陷)的深层缺陷

-

数据科学中最常用、最混乱和最滥用的术语

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的捷径。

1. 谷歌网络安全证书 - 快速进入网络安全职业的捷径。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关内容

100 个活跃的分析、大数据、数据挖掘、数据科学和机器学习博客

www.kdnuggets.com/2016/03/100-active-blogs-analytics-big-data-science-machine-learning.html/2

-

奥卡姆剃刀 由阿维纳什·考什克(Avinash Kaushik)撰写,审视网页分析和数字营销。

-

OpenGardens 互联网物联网(IoT)数据科学,由阿吉特·贾奥卡尔(Ajit Jaokar)撰写。

-

O'Reilly 雷达 提供广泛的研究主题和书籍。

-

Oracle 数据挖掘博客 关于 Oracle 数据挖掘的一切——新闻、技术信息、观点、技巧与窍门,尽在一处。

-

观察性流行病学 一位大学教授和统计顾问提供他们在应用统计学、高等教育和流行病学方面的评论、观察和思考。

-

克服偏见 由罗宾·汉森(Robin Hanson)和埃利泽·尤德科夫斯基(Eliezer Yudkowsky)撰写,探讨统计分析在诚实、信号、分歧、预测和远期未来中的作用。

-

概率与统计博客 由马特·阿舍(Matt Asher)撰写,他是多伦多大学的统计学研究生。查看阿舍的统计学宣言。

-

永久谜题 由普拉提克·乔希(Prateek Joshi)撰写,他是一名计算机视觉爱好者,写有以问题形式呈现的引人入胜的机器学习故事。

-

预测分析世界 博客,由预测分析世界和文本分析世界的创始人埃里克·西格尔(Eric Siegel)撰写,同时也是预测分析时报的执行主编,使预测分析的原理和方法变得易于理解和引人入胜。

-

R-bloggers 来自 R 丰富社区的最佳博客,包含代码、示例和可视化。

-

R chart 一个关于 R 语言的博客,由一名网页应用/数据库开发者撰写。

-

R 统计学 由塔尔·加利利(Tal Galili)撰写,他是特拉维夫大学统计学博士生,同时还担任多门统计课程的助教。

-

Revolution Analytics 由 Revolution Analytics 托管和维护。

-

随机思考 由岳一松(Yisong Yue)撰写,内容涉及人工智能、机器学习和统计学。

-

Salford Systems 数据挖掘与预测分析博客 由丹·斯坦伯格(Dan Steinberg)撰写。

-

赛伯统计研究 由菲尔·伯恩鲍姆(Phil Burnbaum)撰写,涉及棒球、股票市场、运动预测和各种主题的统计学。

-

满意度 由巴黎(巴黎第六大学、CREST)的博士生和博士后共同撰写的博客。主要提供日常工作中的技巧和窍门,链接到各种有趣的页面、文章、研讨会等。

-

SAS 文本挖掘博客,SAS 专家撰写,涵盖语音挖掘和非结构化数据。

-

数据的形状,由杰西·约翰逊从几何学的角度介绍数据分析算法。

-

简单统计 由三位生物统计学教授(杰夫·李克、罗杰·彭和拉法·伊里萨里)撰写,他们对数据丰富的新纪元充满热情,并认为统计学家是科学家。

-

智能数据集,集合了许多有趣的数据科学人员的博客

-

统计建模、因果推断与社会科学 作者:安德鲁·杰尔曼

-

猫咪统计 由查理·库夫斯撰写,他从事数据分析已有三十多年,最初作为水文地质学家,自 1990 年代起作为统计学家。他的标语是:当你不能仅凭统计学解决生活中的问题时。

-

统计博客,一个专注于统计相关内容的博客聚合器,通过 RSS 订阅源发布贡献博客的帖子。

-

史蒂夫·米勒 BI 博客,信息管理领域的博客。

-

Geomblog 由苏雷什撰写

-

非官方谷歌分析博客 来自 ROI Revolution。

-

分析因素 作者:凯伦·格雷斯·马丁

-

卫报数据博客,关于新闻中的数据新闻报道。

-

坏科学 作者:本·戈尔德克雷博士,一位使用统计学揭穿坏科学的流行病学家。

-

实用量化 由 O'Reilly Media 首席数据科学家本·洛里卡撰写,内容涉及 OLAP 分析、大数据、数据应用等。

-

数字达人 由《华尔街日报》记者卡尔·比阿利克撰写,他‘审视数字的使用和滥用’

-

三趾树懒 由卡内基梅隆大学统计学教授科斯马·沙利兹撰写的博客。

-

汤姆·H·C·安德森/Odintext 博客,专注于数据和文本挖掘的市场研究。

-

文森特·格兰维尔博客。文森特是 AnalyticBridge 和 Data Science Central 的创始人,定期发布有关数据科学和数据挖掘的有趣话题。

-

什么是大数据。吉尔·普雷斯覆盖大数据领域,并在《福布斯》上撰写关于大数据和商业的专栏。

-

Walking Randomly 由迈克·克劳彻撰写

-

网页分析与联盟营销,丹尼斯·R·莫滕森关于如何通过分析提高出版商收入的博客。

-

Xi’ans Og Blog 由巴黎第九大学统计学教授撰写的博客,主要集中在计算和贝叶斯主题上。

本文更新了 2015 年的帖子 90+ 个关于分析、大数据、数据挖掘、数据科学和机器学习的活跃博客。

相关:

-

Salford Systems: 软件工程师。机器学习算法。C++

-

30 篇哈佛商业评论关于数据科学、大数据和分析的必读文章

-

主动数据挖掘,数据科学博客

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关主题

5 款最佳机器学习 API 用于数据科学

www.kdnuggets.com/2015/11/machine-learning-apis-data-science.html

作者:Khushbu Shah (DeZyre)

大数据正在通过各种数据源(如传感器、社交媒体数据、Excel 电子表格、评论、客户数据等)流入互联网上的企业。许多公司,如 Google、IBM、亚马逊和微软,正在通过构建机器学习 API 帮助企业处理大数据,以便组织可以充分利用机器学习技术。

机器学习是大数据创新的主要前沿,但对于那些非技术狂人或数据科学领域专家的人来说,它可能令人望而却步。类似于标准 API 帮助开发人员创建应用程序,机器学习 API 使得机器学习变得易于使用,适合每个人。机器学习 API 抽象了创建和部署机器学习模型所涉及的复杂性,使开发人员可以专注于数据处理、用户体验、设计、实验以及从数据中获取洞察。

在早期,机器学习算法和技术主要由科学家、技术狂人或领域专家使用。然而,许多组织现在使用机器学习 API 将这些技术提供给大众。机器学习 API 使得开发人员可以轻松地将机器学习应用于数据集,从而为他们的应用程序添加预测功能。机器学习 API 为开发人员提供了一个抽象层,以将机器学习集成到现实世界的应用程序中,而无需担心在其基础设施上扩展算法以及深入了解机器学习算法的细节。机器学习 API 要求开发人员专注于两个重要方面——

-

开发人员可以通过将机器学习 API 集成到他们的应用程序中,专注于查询预测。

-

开发人员可以跟踪他们应用程序中的事件以收集使用数据。

机器学习 API 为企业提供了整合预测分析的能力,以便他们能够更好地了解客户、理解他们的需求,并基于过去的数据趋势提供产品或服务,从而启动销售过程。实时消费者互动通过机器学习 API 的比例不断增加——使它们成为向应用开发人员展示实时预测分析的理想选择。

应用开发人员总是寻找各种方式来简化用户的生活,通过引入新颖和创新的功能,帮助用户节省时间。这就是机器学习 API 在应用开发人员中受欢迎的原因。一些标准的 API 示例包括智能标记、产品推荐、优先级过滤和垃圾邮件过滤。

使用机器学习 API 相关的挑战

使用机器学习 API 最耗时且最重要的部分是识别需要解决的业务问题并构建有意义的数据集。这意味着 –

-

机器学习从业者必须确保他们对需要预测或分类的内容非常清楚。并非所有问题都可以通过机器学习 API 解决,因此决定场景是否适合非常重要。

-

机器学习从业者应尽可能多地收集关于给定上下文的数据,而不是做出多个假设。这很重要,因为 数据科学家 或分析师经常会发现输入数据与他们试图预测或分类的列(即目标值)之间的不可预测的相关性。

机器学习从业者的顶级机器学习 API

机器学习的最新趋势将被商品化为服务,这将成为主流,就像商品化的可视化和存储一样。以下是一些提供商品化机器学习作为服务(MLaaS)给业务分析师和开发人员进行应用集成的最佳机器学习 API –

1) IBM Watson

对于那些正在使用 IBM Watson 机器智能服务的机器学习从业者来说,无需再苦苦寻找。IBM Watson API 是一种认知服务,它简化了数据准备过程,使预测分析变得更加容易。它还提供了使用视觉讲故事工具,如信息图表、地图或图形,以示例化分析结果。IBM Watson 通过 IBM 的 Bluemix 云服务平台对公众开放。

IBM 的 Watson 通过扩展的工具、机器学习技术和认知 API 听、看、说和理解,让自己更具人性。开发人员可以通过嵌入 IBM Watson 创建具有更多认知技能的产品、服务或应用程序,以了解人们如何与他们的应用程序互动和反应。IBM Watson 在短短 2 年内已经发展出 25 个以上的 API,这些 API 由大约 50 种技术驱动。IBM Watson API 提供的一些最佳服务包括 –

-

机器翻译 – 帮助翻译不同语言对中的文本。

-

信息共鸣 – 了解短语或词汇在预定受众中的受欢迎程度。

-

问答服务 – 此服务提供对由主要文档来源触发的查询的直接答案。

-

用户建模 – 从给定文本中预测某人的社会特征。

2) Microsoft Azure 机器学习 API

Azure Machine Learning API 帮助数据科学家在几分钟内发布模型,而以前开发出可行模型后需要几天时间。Azure Machine Learning 通过提供用于欺诈检测、文本分析、推荐系统和其他业务场景的 API,使数据科学家能够轻松地在 IoT 应用程序中使用预测模型。该 API 基于 Microsoft 产品(如 Bing 和 Xbox)中的机器学习能力。

Azure Machine Learning API 提供了各种功能,如 –

-

能够创建自定义的可配置 R 模块,以便数据分析师或数据科学家可以整合他们自己的 R 语言 代码来进行训练或预测任务。

-

Azure 允许数据科学家或分析师使用各种 Python 库(如 SciPy、SciKit-Learn、NumPy、Pandas 等)来包含他们自己的 Python 脚本。流行的工具,如 iPython Notebook 和其他多种 Visual Studio 的 Python 工具,也可以与 Azure Machine Learning API 一起使用。

“我们添加了 Python,这是数据科学家最喜欢的工具之一。它有一个庞大的生态系统。这个功能将对数据科学家非常有力。我们做了很多改进,添加 Python 就是其中的一部分。Azure Machine Learning 是这个平台。你可以复制一段 Python 代码,将其插入到工作室中并创建一个 API。” - 微软公司副总裁 Joseph Sirosh 说

-

分析师或数据科学家可以使用一个类 SVM 进行异常检测,或通过 PCA 或“计数学习”来训练 PB 级的数据。

-

Azure Machine Learning API 还支持 Spark 和 Hadoop 用于大数据处理,使其成为不论平台如何的理想选择。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持组织的 IT

3. Google IT 支持专业证书 - 支持组织的 IT

更多相关内容

50+ 数据科学和机器学习备忘单

评论

评论

关于 Python、R 以及 Numpy、Scipy、Pandas 的备忘单

在数据科学领域,有成千上万的包和数百个函数!一个有抱负的数据爱好者不需要了解所有内容。这里是经过头脑风暴并浓缩在几页中的最重要的备忘单。

精通数据科学涉及理解统计学、数学、编程知识,特别是在 R、Python 和 SQL 方面,然后将这些知识组合起来,通过业务理解和人类直觉来推导见解,从而驱动决策。

这里是按类别整理的备忘单:

Python 备忘单:

Python 是初学者的热门选择,同时也足够强大,能够支持一些全球最受欢迎的产品和应用。它的设计使编程体验几乎像用英语写作一样自然。Python 基础或 Python 调试器备忘单为初学者覆盖了开始时重要的语法。社区提供的库如 numpy、scipy、sci-kit 和 pandas 被广泛依赖,而 NumPy/SciPy/Pandas 备忘单提供了对这些库的快速回顾。

R 备忘单:

R 的生态系统扩展得如此之多,以至于需要大量参考。R 参考卡在几页中覆盖了大部分 R 世界。Rstudio 也发布了一系列备忘单,方便 R 社区使用。数据可视化与 ggplot2 似乎特别受欢迎,因为它有助于你在创建结果图表时。

MySQL 和 SQL 备忘单:

对于数据科学家来说,SQL 的基础知识和其他语言一样重要。PIG 和 Hive 查询语言都与 SQL(原始结构化查询语言)紧密相关。SQL 备忘单提供了一个 5 分钟的快速指南,让你学习它,然后你可以探索 Hive 和 MySQL!

Spark 备忘单:

Apache Spark 是一个用于大规模数据处理的引擎。对于某些应用场景,如迭代机器学习,Spark 的速度可以比 Hadoop(使用 MapReduce)快多达 100 倍。Apache Spark 备忘单解释了其在大数据生态系统中的位置,讲解了基本 Spark 应用的设置和创建,并解释了常用的操作和操作。

Hadoop 和 Hive 速查表:

Hadoop 作为一种非传统工具出现,它提供了一个开源软件框架,用于并行处理大量数据,解决了被认为不可解决的问题。探索 Hadoop 速查表,了解在命令行中使用 Hadoop 时的有用命令。SQL 和 Hive 函数的组合是另一个值得查看的速查表。

机器学习速查表:

我们常常花时间思考哪种算法最好?然后再翻回大部头的书籍进行参考!这些速查表给出了关于数据的性质和你正在解决的问题的想法,并建议你尝试一种算法。

-

预测分析模式

Django 速查表:

Django 是一个免费的开源 web 应用框架,用 Python 编写。如果你是 Django 新手,你可以查看这些速查表,快速了解概念,并深入学习每一个概念。

分享更多 & 学习!我们遗漏了什么吗?在评论中添加你最喜欢的备忘单吧!

相关:

-

数据科学备忘单指南

-

按人气排名前 20 的 R 包

-

大数据与 Hadoop 中最具影响力的 150 人

更多相关内容

GitHub 上的极棒公开数据集

数据挑战

经济学

能源

金融

你还可以找到以下类别的各种数据集:

GitHub 链接: github.com/caesar0301/awesome-public-datasets

是 上海交通大学 的博士生。他于 2010 年在 西电大学,中国西安,获得了光信息与科学技术学士学位。他的研究领域是移动网络流量的测量与分析,特别是网络流量的更新模型和特性,使用统计和机器学习技术在 Apache Spark 等分布式处理平台上。

那么,你今天会选择哪个数据集?你想向这个列表中添加什么吗?

在下面的评论中告诉我们你的想法。

相关:

-

KDnuggets 数据集用于数据挖掘和数据科学

-

有趣的社交媒体数据集

-

免费的城市数据 - 有什么用?

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

更多相关话题

=MLOPS=

MLOps 概述

评论

作者:Steve Shwartz,人工智能作者、投资者和连续创业者。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

照片来源:iStockPhoto / NanoStockk

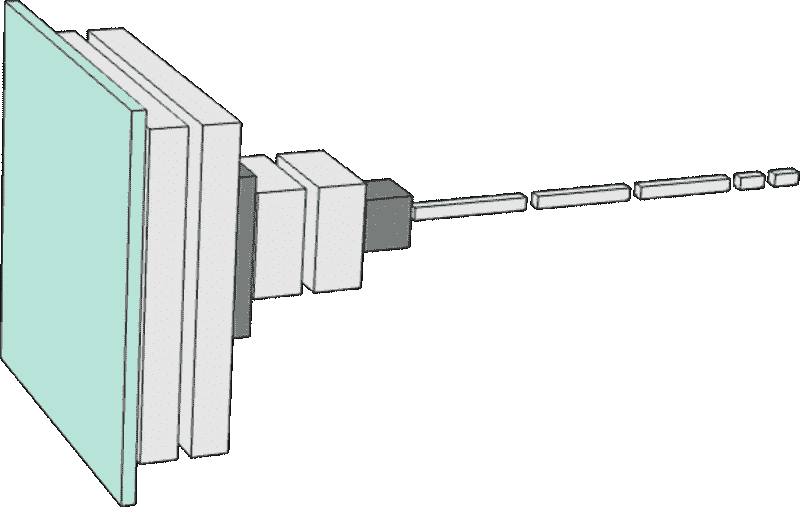

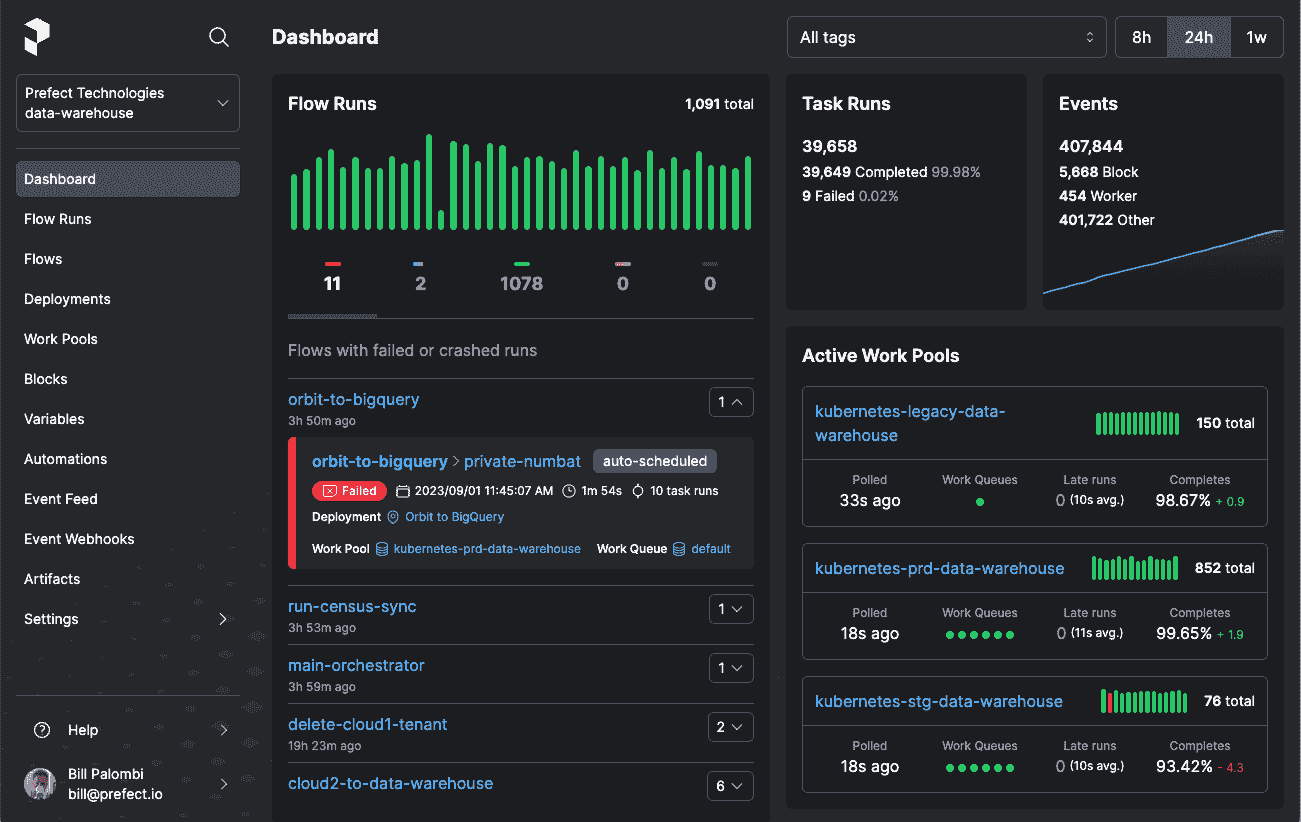

通常需要相当的数据科学专业知识来创建数据集并为特定应用构建模型。但构建一个好的模型通常是不够的。事实上,这远远不够。如下面所示,开发和测试模型只是第一步。

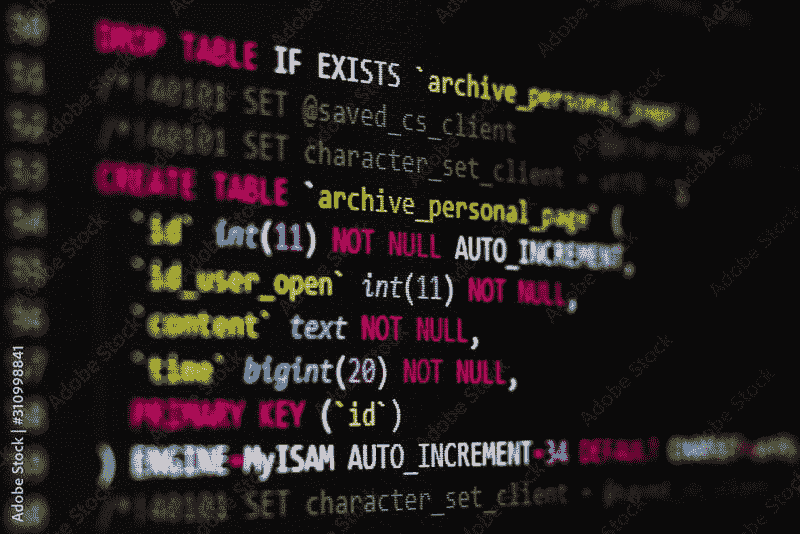

机器学习模型生命周期。

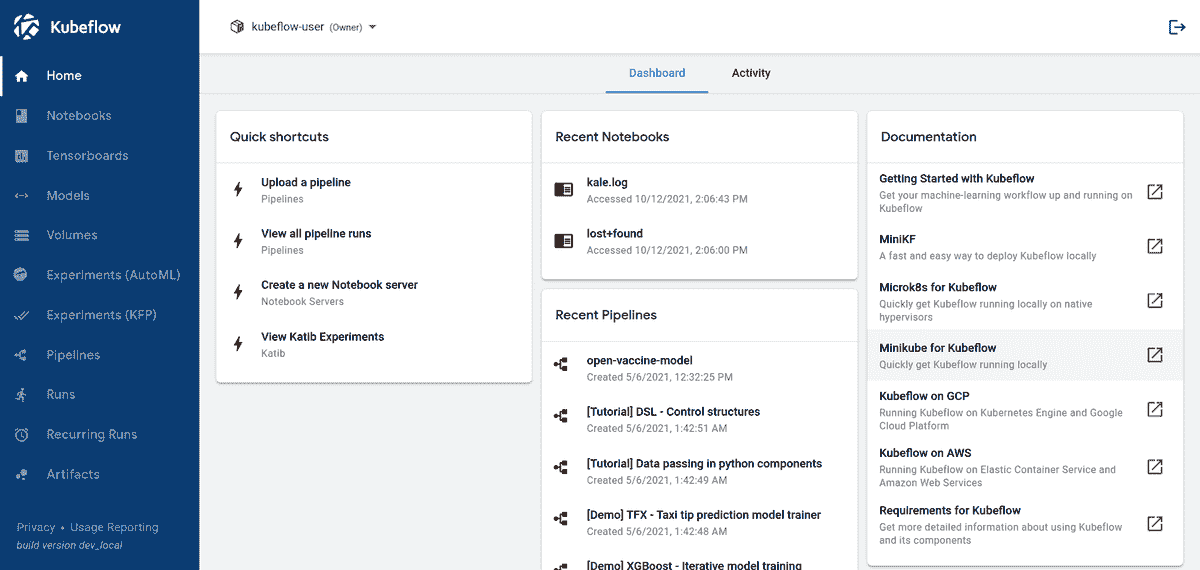

机器学习运维(MLOps)是使模型有用所需的其他一切,包括自动化开发和部署管道、监控、生命周期管理和治理等能力,如上所示。让我们详细了解每一个。

自动化管道

创建生产 ML 系统需要多个步骤:首先,数据必须经历一系列的转换。然后,训练模型。通常,这需要对不同的网络架构和超参数进行实验。经常需要回到数据中尝试不同的特征。接下来,模型必须通过单元测试和集成测试进行验证。它需要通过数据和模型偏差及可解释性的测试。最后,它被部署到公共云、本地环境或混合环境中。此外,过程中的某些步骤可能需要审批流程。

如果这些步骤每一步都手动执行,开发过程往往会很慢且不稳定。幸运的是,许多 MLOps 工具可以自动化这些从数据转换到最终部署的步骤。当需要重新训练时,这一过程是自动化、可靠且可重复的。

监控

机器学习模型在首次部署时往往表现良好,但随着时间的推移表现会下降。正如 Forrester 分析师 Dr. Kjell Carlsson 所说: “AI 模型就像隔离中的六岁小孩:它们需要持续关注……否则,某些东西会坏掉。”

部署中包括各种类型的监控至关重要,以便机器学习团队在这种情况开始发生时能够收到警报。 性能可能因基础设施问题(例如不足的 CPU 或内存)而下降。 当构成模型输入的独立变量的现实世界数据开始表现出不同于训练数据的特征时,性能也可能下降,这种现象称为数据漂移。

同样,由于现实世界条件的变化,模型可能变得不再适用,这种现象称为概念漂移。 例如,许多客户和供应商行为的预测模型在 COVID-19 大流行时陷入了困境。

一些公司还监控替代模型(例如,不同的网络架构或不同的超参数),以查看这些“挑战者”模型是否开始表现得比生产模型更好。

通常,为模型做出的决策设置保护措施是合理的。 这些保护措施是简单的规则,可以触发警报、阻止决策或将决策放入人类审批的工作流中。

生命周期管理

当模型性能由于数据或模型漂移开始下降时,需要对模型进行重新训练,并可能需要重新设计模型。 然而,数据科学团队不应从头开始。 在开发原始模型时,或许在之前的重新设计中,他们可能测试了许多架构、超参数和特征。 记录所有这些先前的实验(及其结果)至关重要,以便数据科学团队不必从头再来。这对于数据科学团队成员之间的沟通与协作也至关重要。

治理

机器学习模型被用于许多影响人们的应用场景,如银行贷款决策、医疗诊断以及招聘/解雇决策。 机器学习模型在决策中的使用受到批评有两个原因:首先,这些模型容易受到偏见的影响,尤其是当训练数据导致模型根据种族、肤色、民族、国籍、宗教、性别、性取向或其他受保护类别进行歧视时。 其次,这些模型往往是黑箱,无法解释其决策过程。

因此,使用基于机器学习的决策的组织面临压力,确保其模型不会歧视并能够解释其决策。 许多 MLOps 供应商正在整合基于学术研究的工具(例如,SHAP和Grad-CAM),帮助解释模型决策,并使用各种技术确保数据和模型不偏见。此外,他们还在监控协议中加入了偏见和可解释性测试,因为模型可能随着时间的推移而变得有偏见或失去解释能力。

组织还需要建立信任,并开始确保持续的性能、无偏见性和可解释性是可审计的。这需要模型目录,不仅记录所有数据、参数和架构决策,还要记录每个决策并提供可追溯性,以便确定每个决策使用了哪些数据、模型和参数、何时重新训练或修改模型,以及谁做出了每个更改。审计员还需要能够重复历史交易,并用假设情境测试模型决策的边界。

安全性和数据隐私也是使用机器学习的组织的关键关注点。必须确保个人信息得到保护,并且基于角色的数据访问能力至关重要,特别是在受监管的行业中。

世界各国政府也在迅速推动对影响人们的机器学习决策进行监管。欧盟通过其 GDPR 和 CRD IV 规章制度走在了前列。在美国,包括美国联邦储备银行和 FDA 在内的几个监管机构已经制定了关于机器学习决策的法规,涉及金融和医疗决策。最近提出的《2020 年数据问责与透明法案》计划在 2021 年提交国会审议。法规可能会发展到 CEO 需要签署他们的机器学习模型的可解释性和无偏见性。

MLOps 领域

随着 2021 年的推进,MLOps 市场正在迅速增长。根据分析公司 Cognilytica 的预测,到 2025 年,这将是一个$4 billion market。

MLOps 领域有大玩家和小玩家。像 Amazon、Google、Microsoft、IBM、Cloudera、Domino、DataRobot 和 H2O 这样的主要机器学习平台供应商正在将 MLOps 能力融入他们的平台中。根据 Crunchbase 数据,在 MLOps 领域,有 35 家私人公司已融资在 $1.8M 和 $1B 之间,且在 LinkedIn 上员工数量在 3 到 2800 之间:

| 融资(百万美元) | 员工数量 | 描述 | |

|---|---|---|---|

| Cloudera | 1000 | 2803 | Cloudera 提供一个适用于任何数据、任何地方的企业数据云,从边缘到人工智能。 |

| Databricks | 897 | 1757 | Databricks 是一个软件平台,帮助其客户统一业务、数据科学和数据工程中的分析。 |

| DataRobot | 750 | 1105 | DataRobot 为全球企业带来人工智能技术和投资回报启用服务。 |

| Dataiku | 246 | 556 | Dataiku 作为一个企业人工智能和机器学习平台进行操作。 |

| Alteryx | 163 | 1623 | Alteryx 通过统一分析、数据科学和自动化流程来加速数字化转型。 |

| H2O | 151 | 257 | H2O.ai 是人工智能和自动化机器学习的开源领导者,致力于使人工智能民主化。 |

| Domino | 124 | 232 | Domino 是全球领先的企业数据科学平台,为超过 20% 的财富 100 强公司提供数据科学支持。 |

| Iguazio | 72 | 83 | Iguazio 数据科学平台使你能够大规模和实时开发、部署和管理人工智能应用 |

| Explorium.ai | 50 | 96 | Explorium 提供一个由增强数据发现和特征工程驱动的数据科学平台 |

| Algorithmia | 38 | 63 | Algorithmia 是一个机器学习模型部署和管理解决方案,自动化组织的 MLOps |

| Paperspace | 23 | 37 | Paperspace 驱动基于 GPU 的下一代应用程序。 |

| Pachyderm | 21 | 32 | Pachyderm 是一个企业级数据科学平台,使可解释、可重复和可扩展的 AI/ML 成为现实。 |

| Weights and Biases | 20 | 58 | 用于实验跟踪、提高模型性能和结果协作的工具 |

| OctoML | 19 | 37 | OctoML 正在改变开发者优化和部署机器学习模型以满足人工智能需求的方式。 |

| Arthur AI | 18 | 28 | Arthur AI 是一个监控机器学习模型生产力的平台。 |

| Truera | 17 | 26 | Truera 为企业提供一个模型智能平台,用于分析机器学习。 |

| Snorkel AI | 15 | 39 | Snorkel AI 专注于通过 Snorkel Flow 实现人工智能的实用性:企业人工智能的数据优先平台 |

| Seldon.io | 14 | 48 | 机器学习部署平台 |

| Fiddler Labs | 13 | 46 | Fiddler 使用户能够创建透明、可解释和易于理解的人工智能解决方案。 |

| run.ai | 13 | 26 | Run:AI 开发了一种自动化分布式训练技术,可虚拟化和加速深度学习。 |

| ClearML (Allegro) | 11 | 29 | ML / DL 实验管理器和 ML-Ops 开源解决方案,端到端产品生命周期管理企业解决方案 |

| Verta | 10 | 15 | Verta 构建软件基础设施,帮助企业数据科学和机器学习(ML)团队开发和部署 ML 模型。 |

| cnvrg.io | 8 | 38 | cnvrg.io 是一个完整的数据科学平台,帮助团队管理模型并构建自适应机器学习管道 |

| Datatron | 8 | 19 | Datatron 提供一个单一的模型治理(管理)平台,管理你所有的 ML、AI 和数据科学模型在生产中 |

| Comet | 7 | 19 | Comet.ml 是一个机器学习平台,旨在帮助人工智能从业者和团队构建可靠的机器学习模型。 |

| ModelOp | 6 | 39 | 管理、监控和管理企业中的所有模型 |

| WhyLabs | 4 | 15 | WhyLabs 是人工智能可观察性和监控公司。 |

| Arize AI | 4 | 14 | Arize AI 提供一个平台,用于解释和排查生产中的人工智能。 |

| DarwinAI | 4 | 31 | DarwinAI 的生成合成“AI 造 AI”技术实现了优化和可解释的深度学习。 |

| Mona | 4 | 11 | Mona 是一个用于数据和 AI 驱动系统的 SaaS 监控平台。 |

| Valohai | 2 | 13 | 您的托管机器学习平台,让数据科学家能够构建、部署和跟踪机器学习模型。 |

| Modzy | 0 | 31 | 可靠的 ModelOps 平台,用于发现、部署、管理和治理大规模机器学习——更快实现价值。 |

| Algomox | 0 | 17 | 促进您的 AI 转型 |

| Monitaur | 0 | 8 | Monitaur 是一家提供审计性、透明度和治理的机器学习软件公司。 |

| Hydrosphere.io | 0 | 3 | Hydrosphere.io 是一个用于 AI/ML 操作自动化的平台 |

这些公司中的许多专注于 MLOps 的某一个环节,例如自动化管道、监控、生命周期管理或治理。有些人认为使用多个最佳实践的 MLOps 产品比单一平台更适合数据科学项目。一些公司正在为特定行业构建 MLOps 产品。例如,Monitaur将自己定位为能够与任何平台兼容的最佳治理解决方案。Monitaur 还为受监管行业(从保险开始)构建特定行业的 MLOps 治理能力。(完全披露:我是 Monitaur 的投资者。)

还有许多开源的 MLOps 项目,包括:

-

MLFlow管理 ML 生命周期,包括实验、可重复性和部署,并包括一个模型注册库。

-

DVC管理 ML 项目的版本控制,使其可共享和可重复。

-

Polyaxon具备实验、生命周期自动化、协作和部署的能力,并包括一个模型注册库。

-

Metaflow是 Netflix 之前的一个项目,用于管理自动化管道和部署。

-

Kubeflow具备在 Kubernetes 容器中进行工作流自动化和部署的能力。

2021 年对 MLOps 来说是个有趣的一年。我们可能会看到快速增长、激烈竞争,并且很可能会有一些整合。

简介: Steve Shwartz (@sshwartz) 多年前在耶鲁大学作为博士后开始了他的人工智能事业,是成功的连续创业者和投资者,也是《邪恶机器人、杀手机器和其他神话:人工智能与人类未来的真相》的作者。

相关:

更多相关话题

=自然语言处理=

你可以在线成为数据科学家吗?

原文:

www.kdnuggets.com/2021/11/365datascience-become-data-scientist-online.html

赞助文章。

技能熟练的数据科学专业人才在各行各业的企业中需求巨大。根据美国劳工统计局的数据,到 2026 年,数据科学工作的数量将增长约 28%,这大约是1150 万个领域职位空缺。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

由于合格候选人供给仍在追赶中,数据科学继续成为任何寻求回报丰厚且不断发展的领域工作的人的绝佳前景。

然而,问题仍然存在——在强大的教育基础设施存在的情况下,传统的数据科学和分析学位是否是通向这一激动人心的职业道路的唯一途径?

数据科学家来自许多不同的背景,这已不是什么秘密。这意味着,许多希望在该领域取得成功的人需要承担起自我学习技能的责任。事实上,在过去几年里,超过 40%的数据科学家在简历中加入了在线课程。考虑到传统学位通常过于昂贵、耗时或不够灵活,以满足大多数需求,这并不令人惊讶。

所以,是的——只要你自律且有足够的动力,你可以在线成为数据科学家。然而,要覆盖这一广泛的专业领域,你需要合适的培训。

365 Data Science提供了一个简单明了的解决方案。其团队由全球公认的讲师组成,创建了一个全面的在线课程,为学生提供数据科学的理论知识和实践经验,同时教授求职过程的方方面面。从基础知识到最先进的主题,他们的全能培训适合完全初学者和希望在工具箱中增加热门技能和技术的在职专业人士。通过大量实际练习、在实际编码环境中编程和真实世界项目,你可以获得实际经验。此外,一旦你通过必要的考试,你将有资格获得课程或职业发展证书——这两种都是业界认可的官方证书,展示你新获得的技能给潜在雇主。

如果你对培训感兴趣,从今天到 11 月 29 日,你可以加入全球150 万名学生,以72% 折扣获得 365 Data Science 项目的无限年度访问权限,学习成功的数据科学专业人士的技能。要了解有关培训内容和运作方式的更多信息,请访问他们的黑色星期五优惠官方页面。

更多相关主题

ChatGPT 在做什么以及它为何有效?

它只是一次添加一个词

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

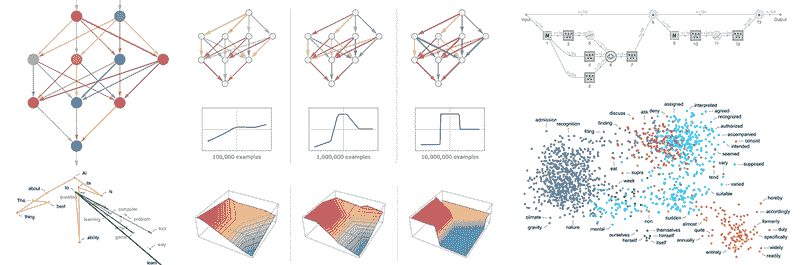

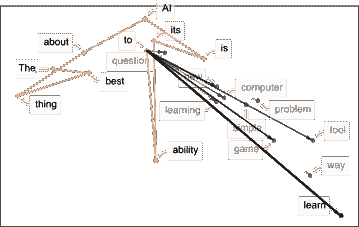

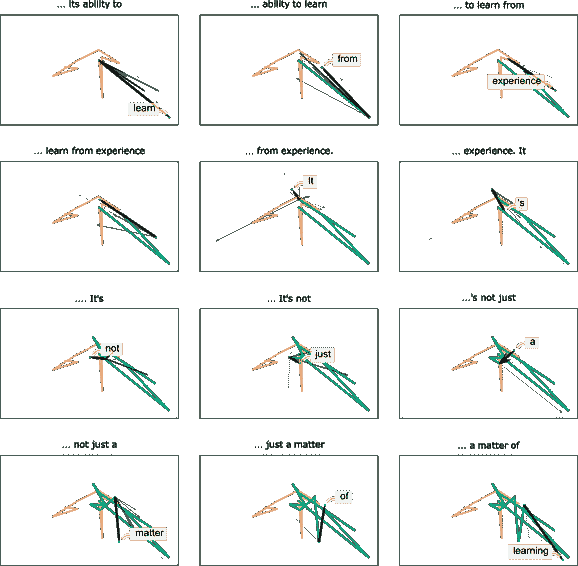

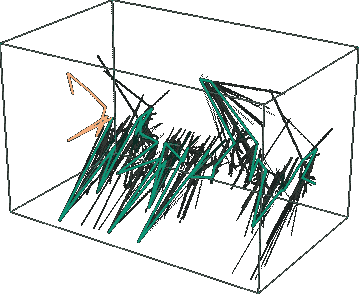

ChatGPT 能够自动生成即使在表面上也像是人类编写的文本的能力是令人惊叹的,也出乎意料。但是它是如何做到的呢?为什么它能有效地工作?我的目的在于粗略勾勒一下 ChatGPT 内部的运作机制——然后探讨它为何能如此成功地生成我们认为有意义的文本。我一开始就要说明,我将重点关注整体情况——虽然我会提到一些工程细节,但不会深入探讨。(我将要讲述的本质同样适用于其他当前的“大型语言模型” [LLMs],而不仅仅是 ChatGPT。)

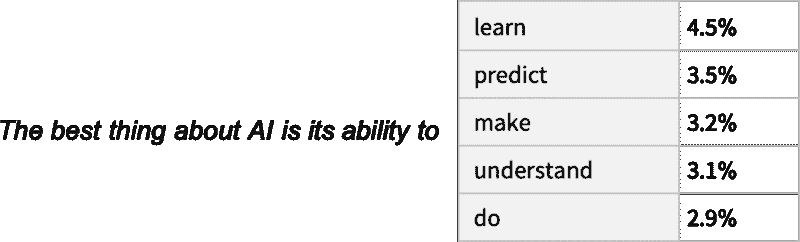

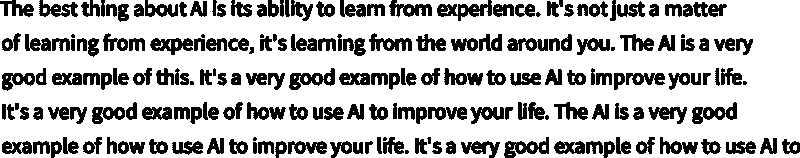

首先需要解释的是,ChatGPT 始终基本上试图做的是生成对目前文本的“合理延续”,其中“合理”的意思是“在看到人们在数十亿个网页上写的内容后,可能会期望某人写出的内容。”

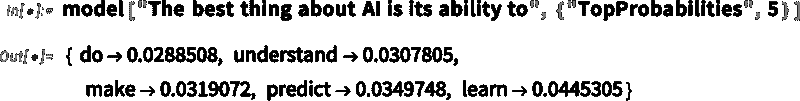

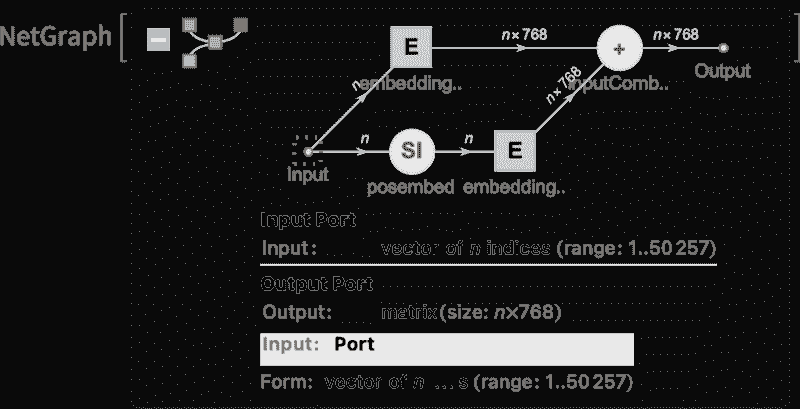

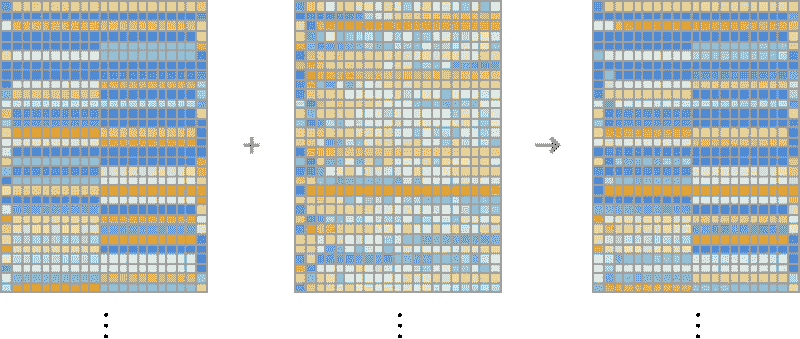

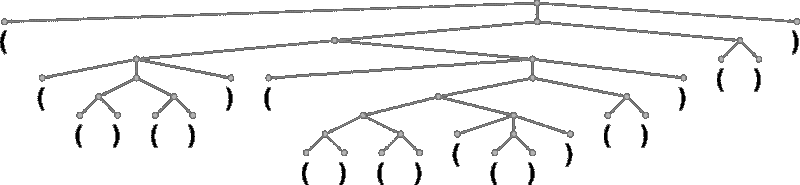

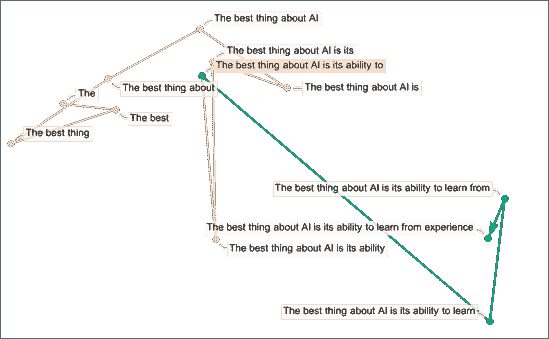

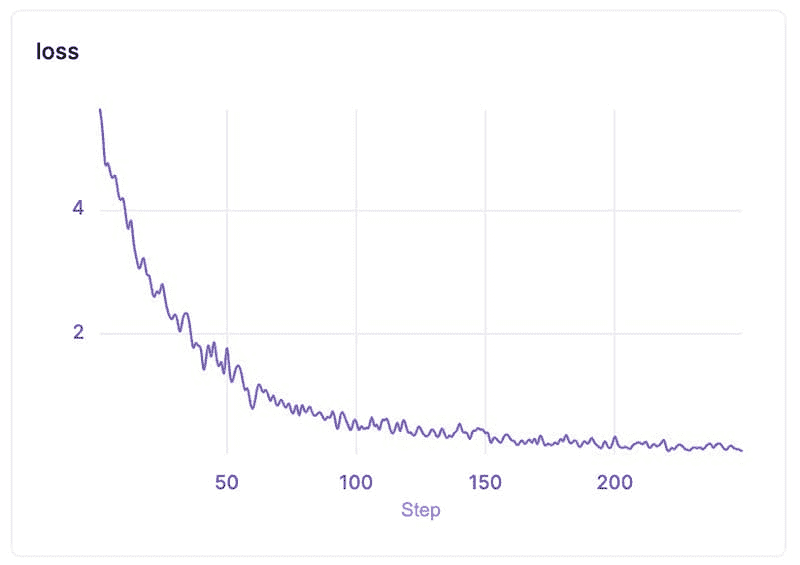

所以假设我们有一段文本“AI 最棒的地方在于它的能力”。想象一下扫描数十亿页人类编写的文本(比如在网上和数字化的书籍中),并找出所有出现该文本的实例——然后查看接下来哪个词出现的频率。ChatGPT 实际上做的就是类似的事情,只不过(正如我将要解释的那样)它并不直接查看文字;它寻找在某种意义上“意义匹配”的内容。但最终的结果是,它生成了一个可能接下来的词的排名列表,以及相应的“概率”:

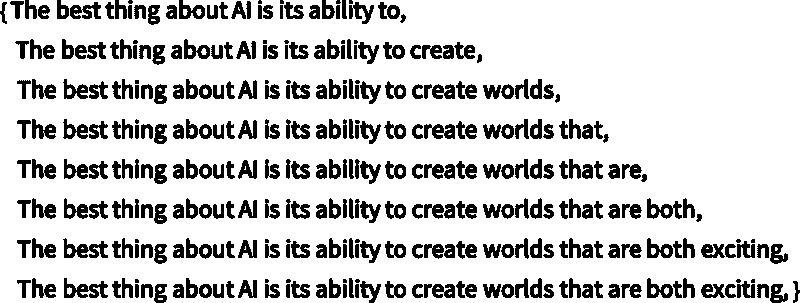

令人惊讶的是,当 ChatGPT 写作时,它本质上在做的就是一次又一次地问“鉴于目前的文本,接下来的词应该是什么?”——每次添加一个词。(更准确地说,正如我将解释的,它是添加一个“标记”,这可能只是一个词的一部分,这就是它有时能够“创造新词”的原因。)

但是,好吧,每一步它会得到一个带有概率的词汇列表。那么,它应该实际选择哪个词来添加到它正在写的文章中(或其他内容)呢?人们可能认为应该选择“排名最高”的词(即被分配了最高“概率”的词)。但这时一点巫术开始悄然出现。因为出于某种原因——也许有一天我们会有科学风格的理解——如果我们总是选择排名最高的词,通常会得到非常“平淡”的文章,似乎从未“展现出任何创造力”(有时甚至逐字重复)。但如果有时(随机地)选择较低排名的词,我们就会得到一篇“更有趣”的文章。

这里的随机性意味着如果我们多次使用相同的提示,可能会得到不同的文章。而且,按照巫术的想法,有一个所谓的“温度”参数,决定了较低排名的词汇出现的频率。在文章生成中,结果显示“温度”设置为 0.8 似乎是最好的。(值得强调的是,这里并没有使用“理论”;这只是实践中发现有效的方法。比如“温度”概念的存在是因为使用了来自统计物理学的指数分布,但并没有“物理”上的联系——至少我们现在还不知道。)

在继续之前,我应该解释一下,为了阐述的目的,我主要不会使用ChatGPT 中的完整系统,而是通常使用一个更简单的GPT-2 系统,它有一个很好的特点,就是足够小可以在标准桌面计算机上运行。因此,我展示的几乎所有内容都可以包括可以立即在你电脑上运行的明确Wolfram Language代码。(点击任何图片可以复制其背后的代码。)

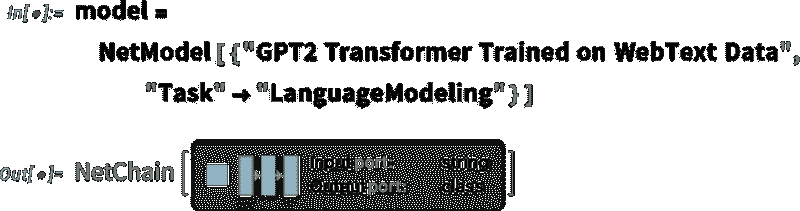

例如,下面是如何获取上述概率表的。首先,我们必须检索底层的“语言模型”神经网络:

稍后,我们将查看这个神经网络内部的工作原理。但现在我们可以将这个“网络模型”作为黑箱应用于到目前为止的文本,并请求模型所说的按概率排名前 5 的词汇:

这将结果转换为一个明确格式的“数据集”:

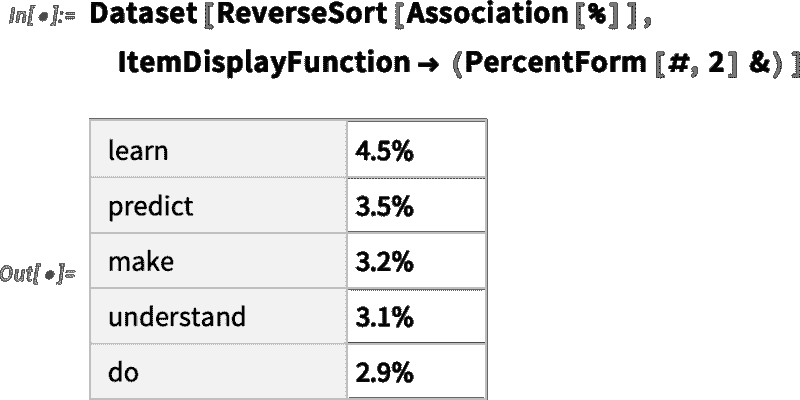

如果一个人重复“应用模型”——每一步都添加具有最高概率的单词(在此代码中指定为模型的“决策”)——会发生什么:

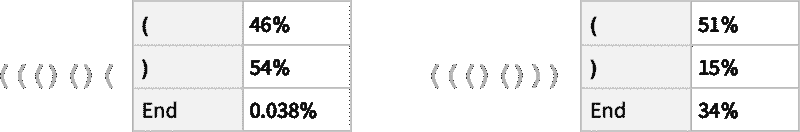

如果继续下去会发生什么?在这种(“零温度”)情况下,生成的文本很快变得相当混乱和重复:

但如果不是总是选择“最高”单词,而是有时随机选择“非最高”单词(“随机性”对应于“温度”0.8)会怎么样?同样可以生成文本:

每次这样做时,会做出不同的随机选择,文本也会不同——如下这 5 个示例:

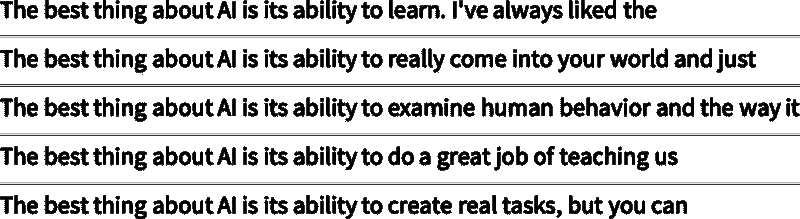

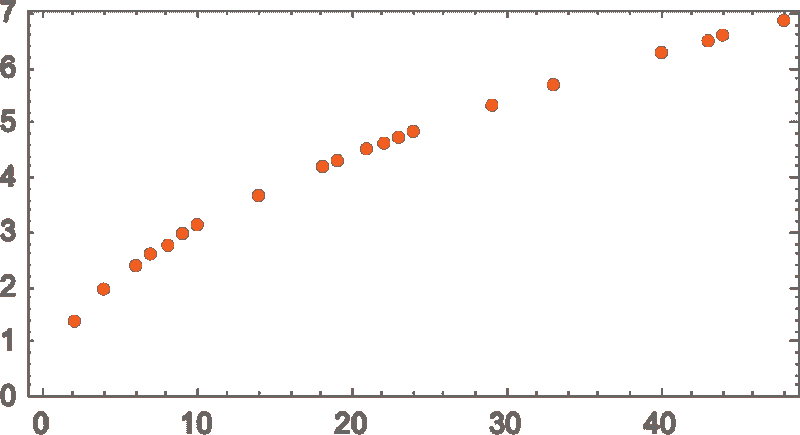

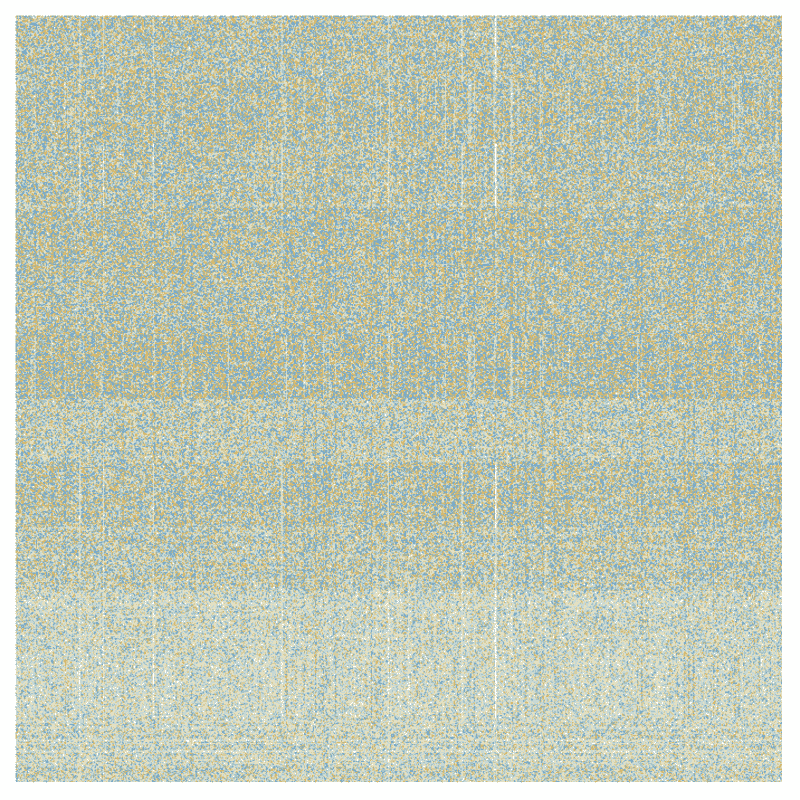

值得指出的是,即使在第一步,有很多可能的“下一个单词”可供选择(在温度 0.8 下),尽管它们的概率很快就会下降(是的,这个对数-对数图上的直线对应于一种 n^(–1) “幂律”衰减,这在语言的一般统计中非常有特点):

那么如果继续下去会发生什么?这是一个随机示例。它比最高概率(零温度)情况更好,但仍然有点怪异:

这是用 最简单的 GPT-2 模型 (来自 2019 年)完成的。使用更新的 更大的 GPT-3 模型,结果会更好。这是用相同的“提示”生成的最高概率(零温度)文本,但使用的是最大的 GPT-3 模型:

这是一个“温度 0.8”的随机示例:

概率从哪里来?

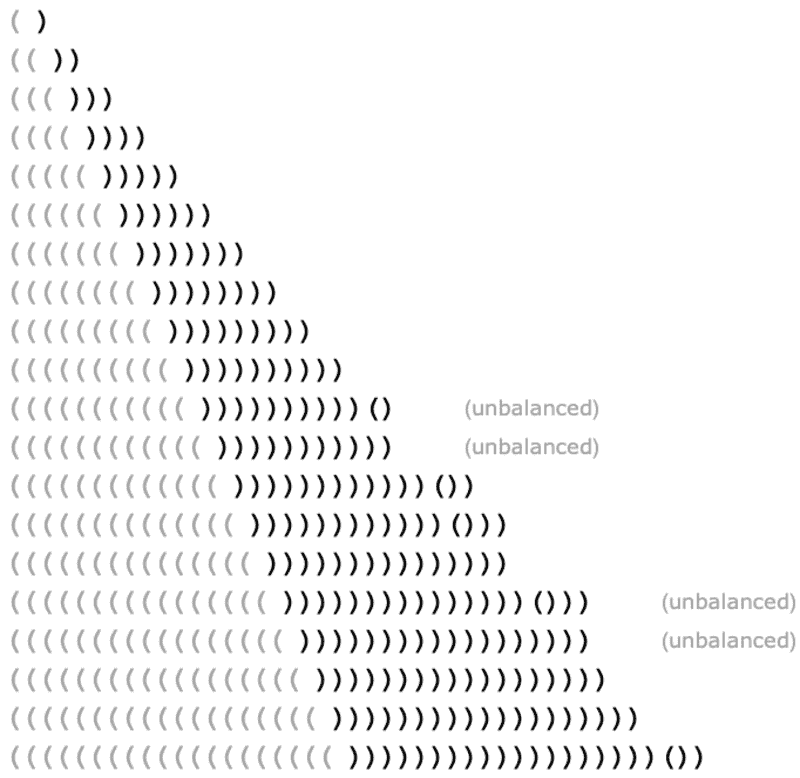

好吧,ChatGPT 总是基于概率选择下一个单词。但这些概率来自哪里?让我们从一个更简单的问题开始。我们来考虑逐字生成英语文本。我们如何计算每个字母的概率?

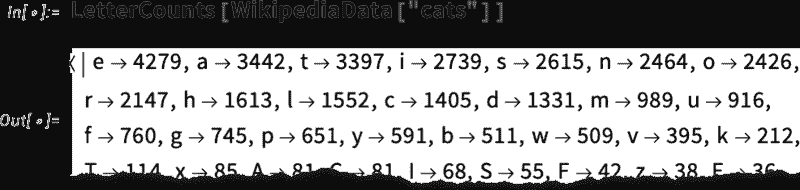

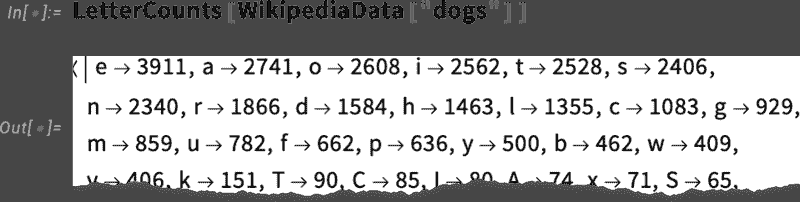

我们可以做的一个非常简单的事情是,取一段英语文本样本,计算其中不同字母的出现频率。例如,这个工具统计了维基百科文章中“cats”一词的字母:

这对“dogs”也做了相同的处理:

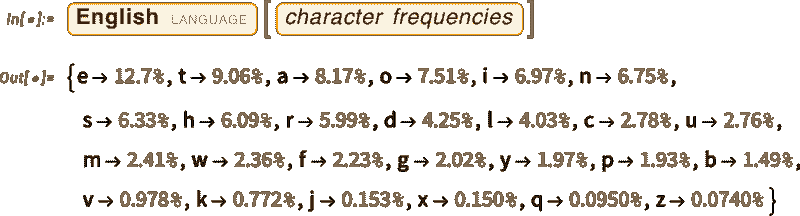

结果相似,但不完全相同(“o”在“dogs”文章中无疑更常见,因为它出现在“dog”这个单词中)。不过,如果我们取一个足够大的英语文本样本,我们可以预期最终会得到至少相当一致的结果:

这是如果我们仅仅根据这些概率生成字母序列的一个样本:

我们可以通过添加空格,将其划分成“单词”,就像这些空格是具有一定概率的字母一样:

我们可以通过强制“单词长度”的分布与英语中的实际情况相符,稍微改善一下“单词”的生成效果:

我们这里没有生成任何“实际单词”,但结果看起来稍微好一些。不过,要进一步改进,我们需要做的不仅仅是随机挑选每个字母。例如,我们知道如果有一个“q”,下一个字母基本上必须是“u”。

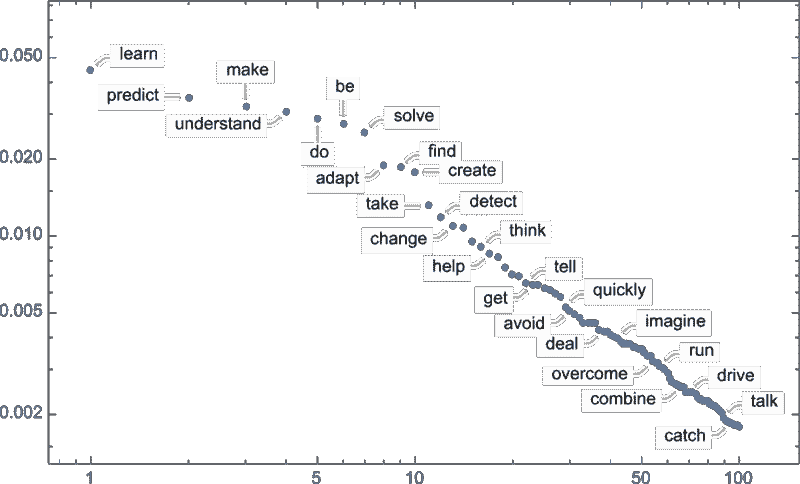

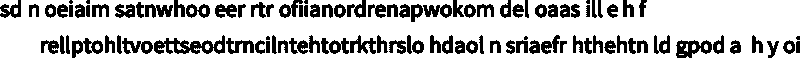

这是单个字母概率的图示:

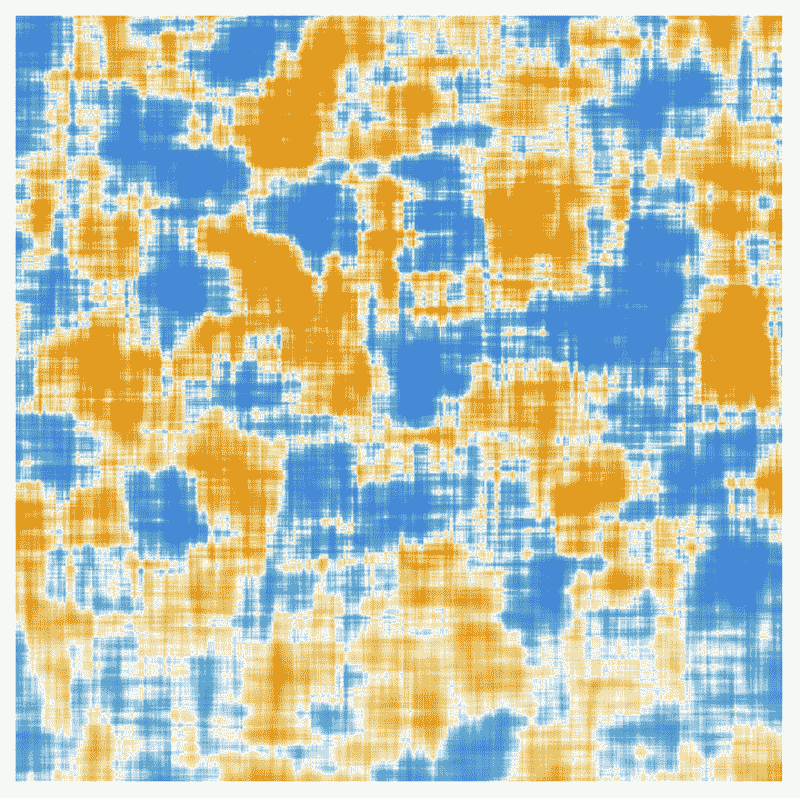

这里是一个图示,显示了典型英语文本中字母对(“2-grams”)的概率。可能的首字母显示在页面的横向,第二个字母显示在页面的纵向:

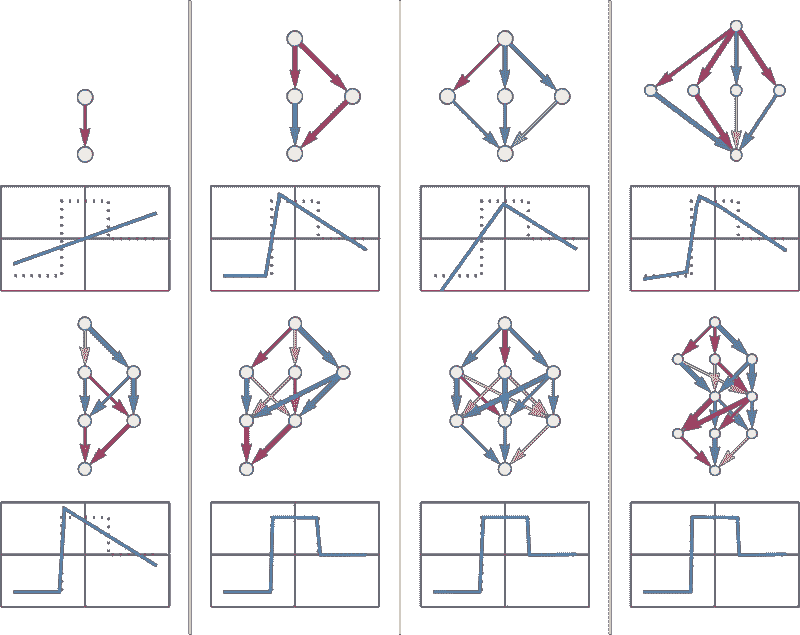

我们在这里看到,例如,“q”列是空白的(零概率),除了在“u”行。好,现在我们不再一次生成一个字母,而是一次看两个字母,利用这些“2-gram”概率生成“单词”。下面是结果的一个样本,其中包含一些“实际单词”: