KDNuggets-博客中文翻译-二十二-

KDNuggets 博客中文翻译(二十二)

原文:KDNuggets

使用 PyCaret 进行 Python 中的集群分析简介

原文:

www.kdnuggets.com/2021/12/introduction-clustering-python-pycaret.html

评论

由 Moez Ali,PyCaret 创始人及作者

图片来源:Paola Galimberti 在 Unsplash

1. 介绍

PyCaret 是一个开源低代码机器学习库,旨在自动化机器学习工作流程。它是一个端到端的机器学习和模型管理工具,可以显著加快实验周期,提高生产力。

与其他开源机器学习库相比,PyCaret 是一个低代码库,可以用几行代码替代数百行代码。这使得实验速度和效率成倍提高。PyCaret 本质上是多个机器学习库和框架(如 scikit-learn、XGBoost、LightGBM、CatBoost、spaCy、Optuna、Hyperopt、Ray 等)的 Python 封装器。

PyCaret 的设计和简洁性受到市民数据科学家新兴角色的启发,这一术语最早由 Gartner 提出。市民数据科学家是能够执行既简单又中等复杂的分析任务的高级用户,这些任务以前需要更多的技术专长。

要了解更多关于 PyCaret 的信息,可以查看官方 网站 或 GitHub。

2. 教程目标

在本教程中,我们将学习:

-

获取数据: 如何从 PyCaret 仓库导入数据。

-

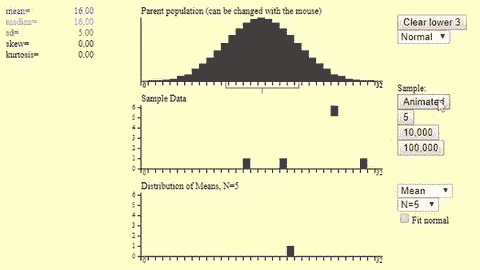

设置环境: 如何在 PyCaret 的无监督 集群模块 中设置实验。

-

创建模型: 如何训练无监督集群模型,并为训练数据集分配集群标签以便进一步分析。

-

绘图模型: 如何使用各种图表(肘部法、轮廓图、分布图等)分析模型性能。

-

预测模型: 如何根据训练好的模型为新的未见数据集分配集群标签。

-

保存/加载模型: 如何保存/加载模型以供将来使用。

3. 安装 PyCaret

安装很简单,只需几分钟。PyCaret 的默认安装通过 pip 只安装 requirements.txt 文件中列出的硬依赖。

pip install pycaret

要安装完整版:

pip install pycaret[full]

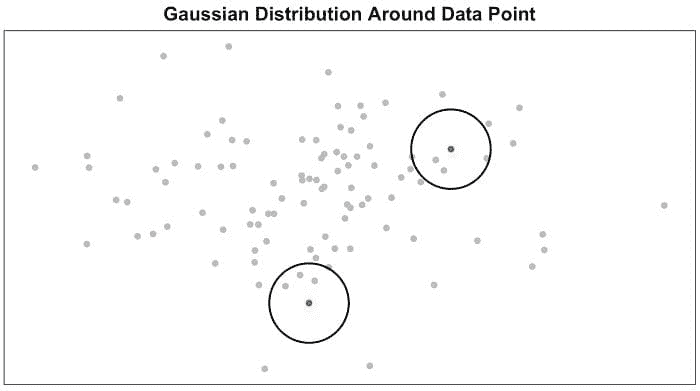

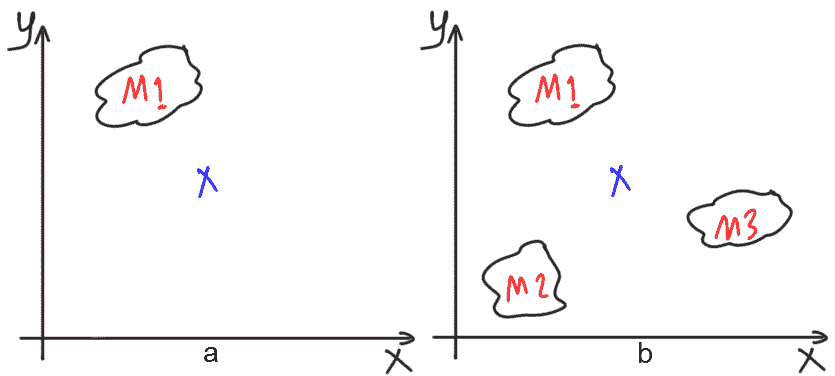

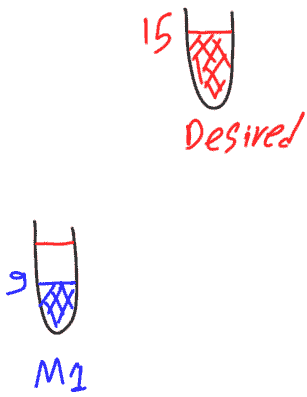

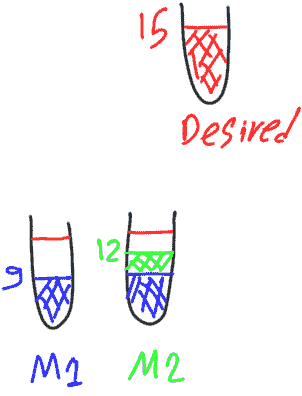

4. 什么是集群?

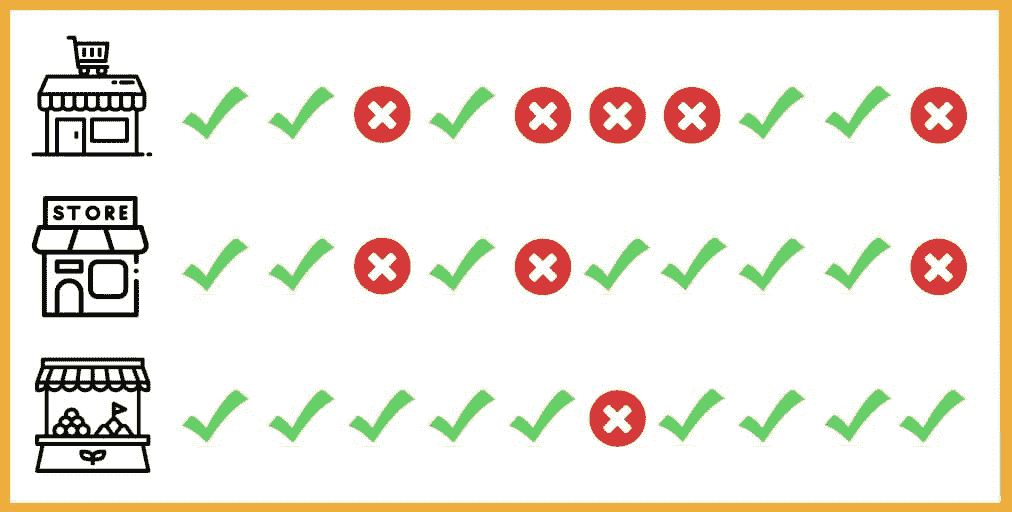

聚类是将一组对象分组的任务,使得同一组(称为簇)中的对象彼此之间比与其他组中的对象更相似。它是一种探索性数据挖掘活动,是统计数据分析中常用的技术,广泛应用于许多领域,包括机器学习、模式识别、图像分析、信息检索、生物信息学、数据压缩和计算机图形学。聚类的一些常见现实生活应用包括:

-

基于购买历史或兴趣进行客户细分,以设计有针对性的营销活动。

-

根据标签、主题和文档内容将文档分类到多个类别中。

-

在社会科学/生活科学实验中分析结果,以发现数据中的自然分组和模式。

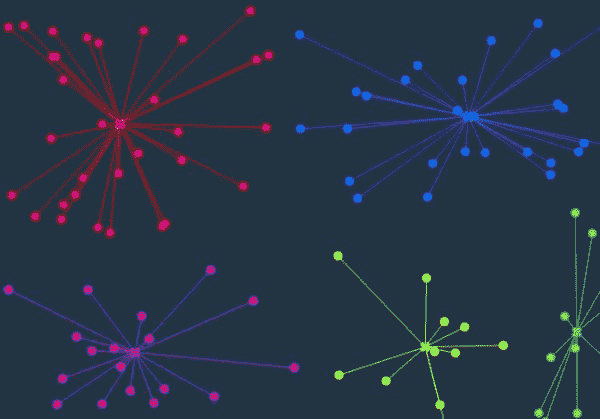

5. PyCaret 中聚类模块概述

PyCaret 的聚类模块 (pycaret.clustering) 是一个无监督机器学习模块,用于将一组对象分组,使得同一组(称为簇)中的对象彼此之间比与其他组中的对象更相似。

PyCaret 的聚类模块提供了多个预处理功能,可以在通过 setup 函数初始化设置时进行配置。它有超过 8 种算法和多种图形来分析结果。PyCaret 的聚类模块还实现了一个独特的函数 tune_model,允许你调整聚类模型的超参数,以优化监督学习目标,如分类的 AUC 或回归的 R2。

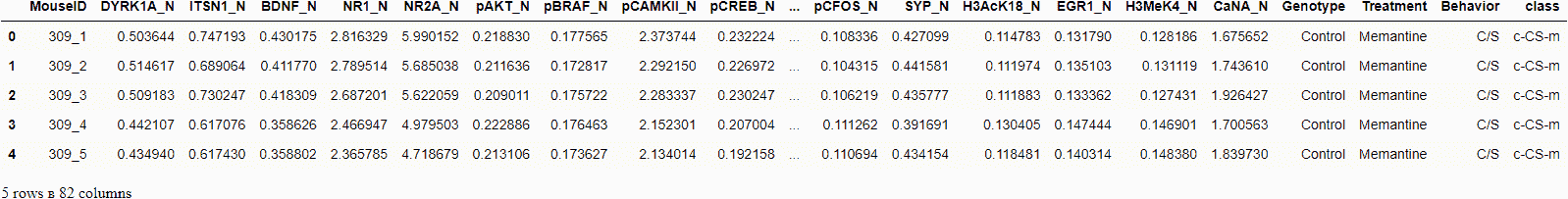

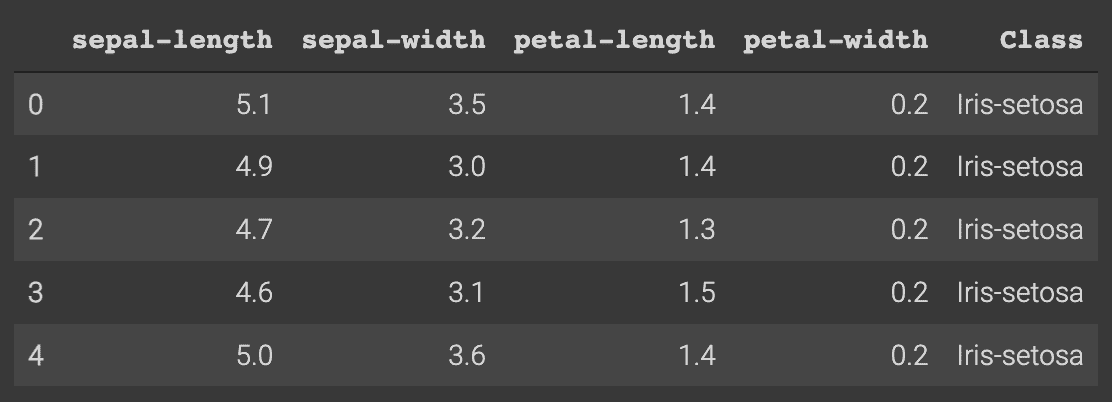

6. 教程数据集

在本教程中,我们将使用来自 UCI 的数据集,称为 Mice Protein Expression。该数据集包含 77 种蛋白质的表达水平,这些蛋白质在皮层的核分数中产生了可检测的信号。数据集每种蛋白质包含总共 1080 次测量。每次测量可以视为一个独立的样本(小鼠)。

数据集引用:

Higuera C, Gardiner KJ, Cios KJ (2015) 自组织特征图识别在小鼠唐氏综合症模型中学习关键的蛋白质。PLoS ONE 10(6): e0129126. [Web Link] journal.pone.0129126

你可以从原始来源找到这里下载数据,并使用 pandas(学习如何)加载它,或者你可以使用 PyCaret 的数据仓库,通过 get_data() 函数加载数据(这将需要互联网连接)。

from pycaret.datasets import get_data

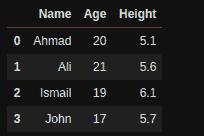

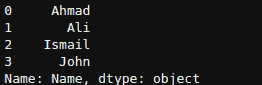

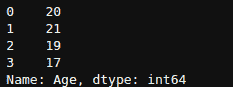

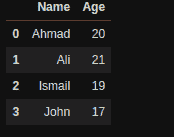

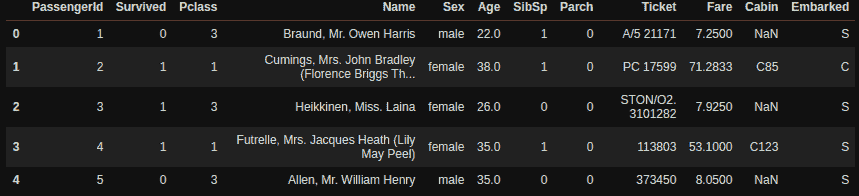

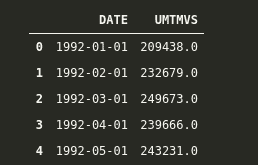

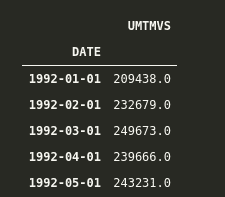

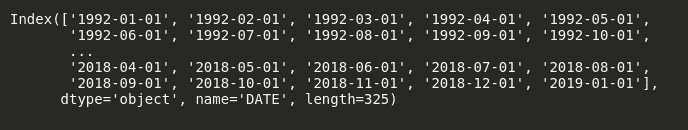

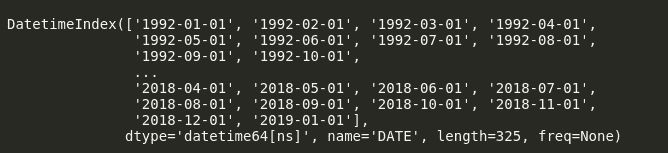

dataset = get_data('mice')

**# check the shape of data**

dataset.shape>>> (1080, 82)

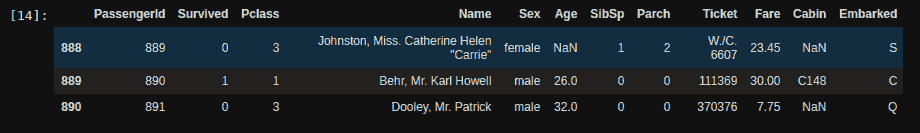

为了演示 predict_model 函数在未见数据上的使用,原始数据集中已保留了 5%(54 条记录)的样本,以便在实验结束时用于预测。

data = dataset.sample(frac=0.95, random_state=786)

data_unseen = dataset.drop(data.index)

data.reset_index(drop=True, inplace=True)

data_unseen.reset_index(drop=True, inplace=True)

print('Data for Modeling: ' + str(data.shape))

print('Unseen Data For Predictions: ' + str(data_unseen.shape))**>>> Data for Modeling: (1026, 82)

>>> Unseen Data For Predictions: (54, 82)**

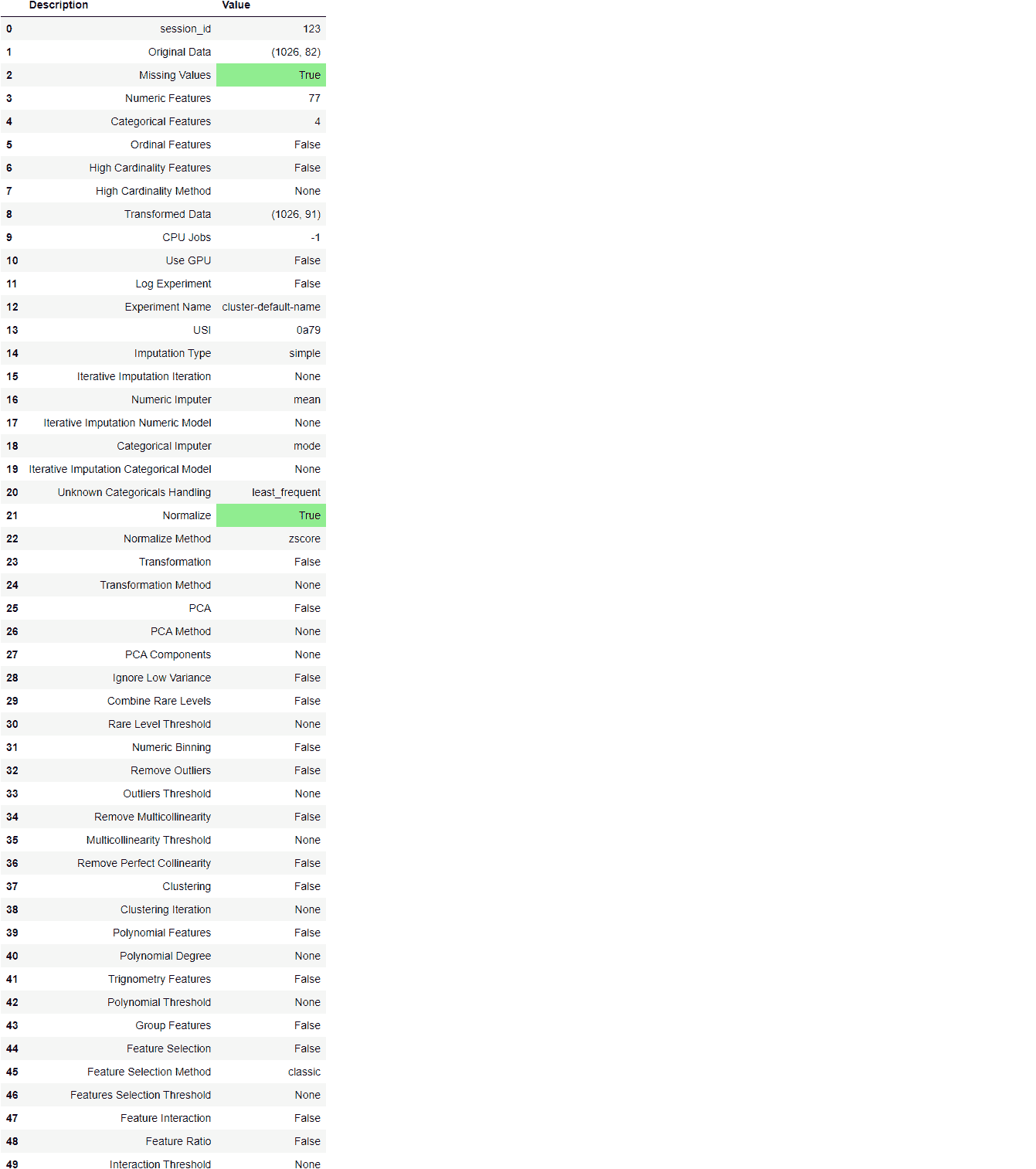

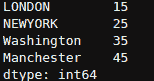

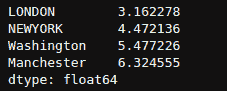

8. 在 PyCaret 中设置环境

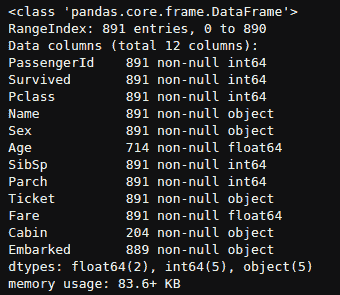

setup函数在 PyCaret 中初始化环境并创建用于建模和部署的转换管道。setup必须在执行 pycaret 中的任何其他函数之前调用。它只需要一个必需的参数:一个 pandas 数据框。所有其他参数都是可选的,可用于自定义预处理管道。

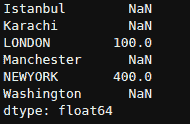

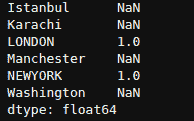

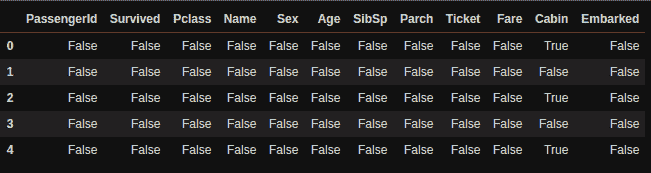

当setup执行时,PyCaret 的推断算法将基于某些属性自动推断所有特征的数据类型。数据类型应该被正确推断,但这并不总是如此。为了解决这个问题,PyCaret 在执行setup时会显示提示,要求确认数据类型。如果所有数据类型正确,可以按回车键;如果要退出设置,可以输入quit。

确保数据类型的正确性在 PyCaret 中非常重要,因为它会自动执行多个特定类型的预处理任务,这些任务对机器学习模型至关重要。

或者,你也可以使用numeric_features和categorical_features参数在setup中预先定义数据类型。

from pycaret.clustering import *

exp_clu101 = setup(data, normalize = True,

ignore_features = ['MouseID'],

session_id = 123)

一旦setup成功执行,它会显示包含有关实验的重要信息的网格。大多数信息与在setup执行时构建的预处理管道相关。虽然这些特征的大多数超出了本教程的范围,但需要注意以下几点:

-

session_id:一个伪随机数,在所有函数中作为种子分布,以便后续的可重复性。如果没有传递

session_id,则会自动生成一个随机数,并分配给所有函数。在此实验中,session_id设置为123以便后续的可重复性。 -

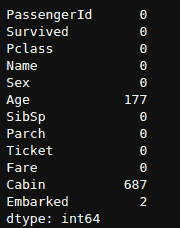

缺失值:当原始数据中存在缺失值时,这将显示为 True。请注意,信息网格中的

Missing Values显示为True,因为数据包含缺失值,这些缺失值通过mean自动填充数值特征,通过constant自动填充分类特征。填充方法可以通过numeric_imputation和categorical_imputation参数在setup函数中更改。 -

原始数据:显示数据集的原始形状。在此实验中,(1026, 82)表示 1026 个样本和 82 个特征。

-

转换后的数据:显示转换后的数据集的形状。请注意,原始数据集的形状 (1026, 82) 被转换为 (1026, 91)。特征数量增加是由于数据集中分类特征的编码。

-

数值特征:推断为数值型的特征数量。在此数据集中,82 个特征中的 77 个被推断为数值型。

-

分类特征: 推断为分类的特征数量。在此数据集中,82 个特征中有 5 个被推断为分类特征。还要注意,我们通过

ignore_feature参数忽略了一个分类特征MouseID,因为它是每个样本的唯一标识符,我们不希望在模型训练过程中考虑它。

请注意,一些对建模至关重要的任务会自动处理,例如缺失值填补、分类编码等。setup函数中的大多数参数是可选的,用于自定义预处理管道。这些参数超出了本教程的范围,但我会在以后写更多内容。

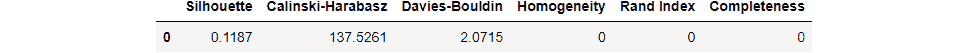

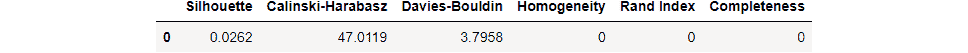

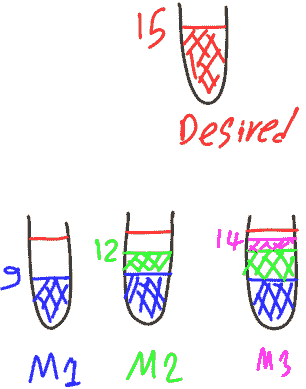

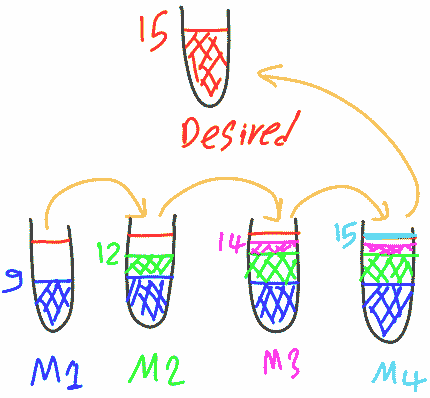

9. 创建模型

在 PyCaret 中训练聚类模型很简单,类似于在 PyCaret 的监督学习模块中创建模型的方式。使用create_model函数创建一个聚类模型。此函数返回一个训练好的模型对象和一些无监督的度量。请参见下面的示例:

kmeans = create_model('kmeans')

print(kmeans)**>>> OUTPUT** KMeans(algorithm='auto', copy_x=True, init='k-means++', max_iter=300,

n_clusters=4, n_init=10, n_jobs=-1, precompute_distances='deprecated',

random_state=123, tol=0.0001, verbose=0)

我们使用create_model训练了一个无监督的 K-Means 模型。请注意,n_clusters参数被设置为4,这是当你未向num_clusters参数传递值时的默认值。在下面的示例中,我们将创建一个具有 6 个簇的kmodes模型。

kmodes = create_model('kmodes', num_clusters = 6)

print(kmodes)**>>> OUTPUT** KModes(cat_dissim=<function matching_dissim at 0x00000168B0B403A0>, init='Cao',

max_iter=100, n_clusters=6, n_init=1, n_jobs=-1, random_state=123,

verbose=0)

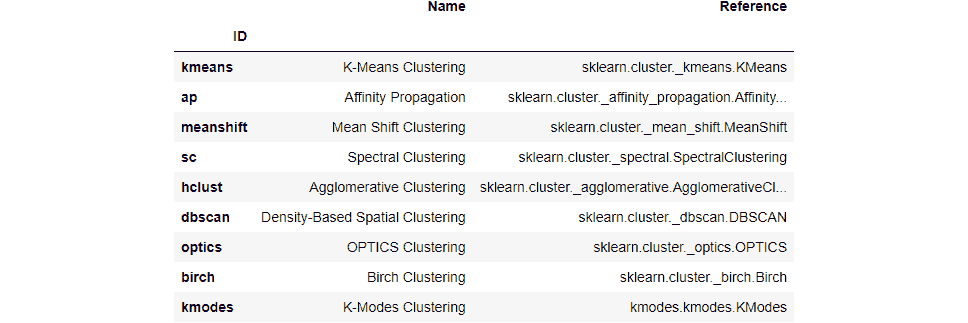

要查看模型库中可用模型的完整列表,请检查文档或使用models函数。

models()

10. 指定模型

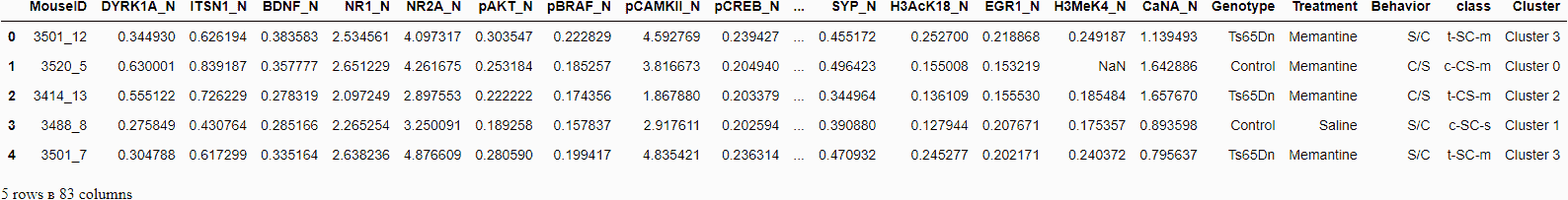

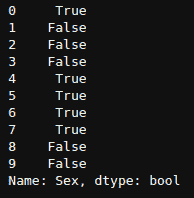

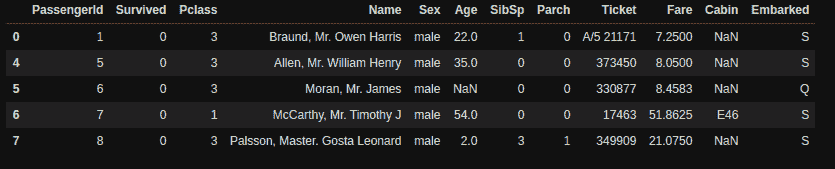

现在我们已经训练了一个模型,我们可以通过使用assign_model函数将聚类标签分配给我们的训练数据集(1026 个样本)。

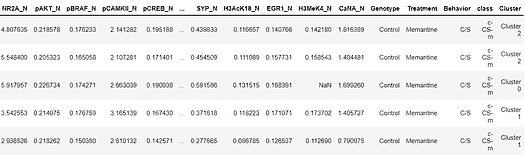

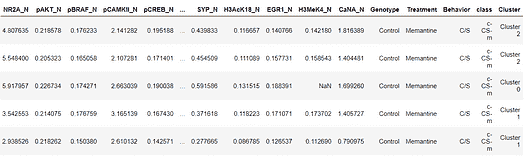

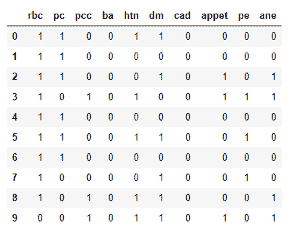

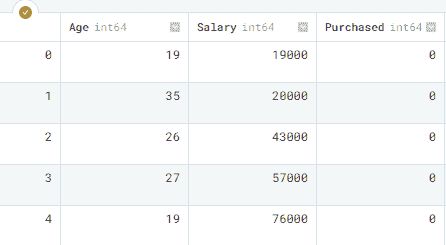

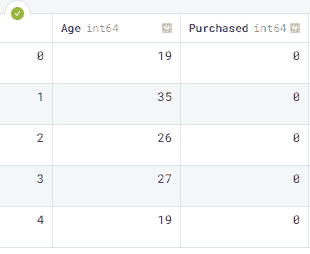

kmean_results = assign_model(kmeans)

kmean_results.head()

请注意,原始数据集中添加了一个名为Cluster的新列。

请注意,结果中还包含了我们在setup过程中实际上删除的MouseID列。无需担心,它不会用于模型训练,而只是当调用assign_model时,才会被添加到数据集中。

11. 绘制模型

plot_model函数用于分析聚类模型。此函数接受一个训练好的模型对象,并返回一个图表。

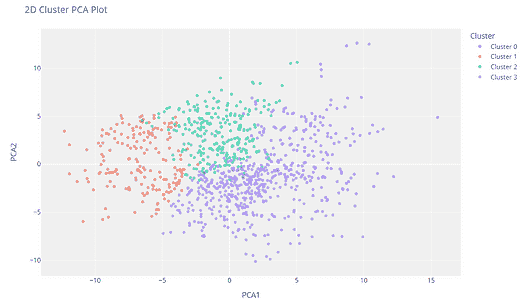

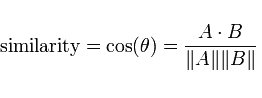

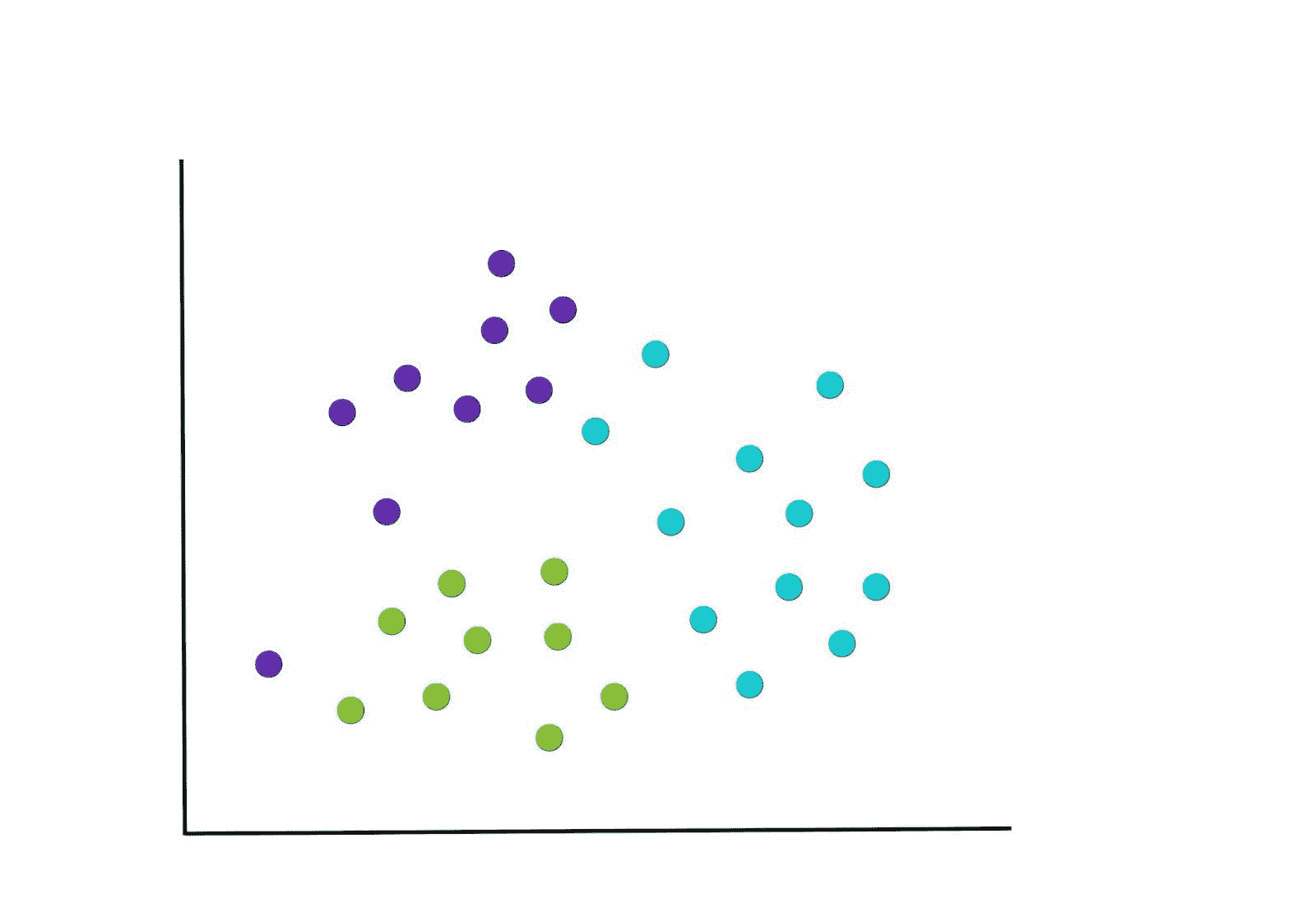

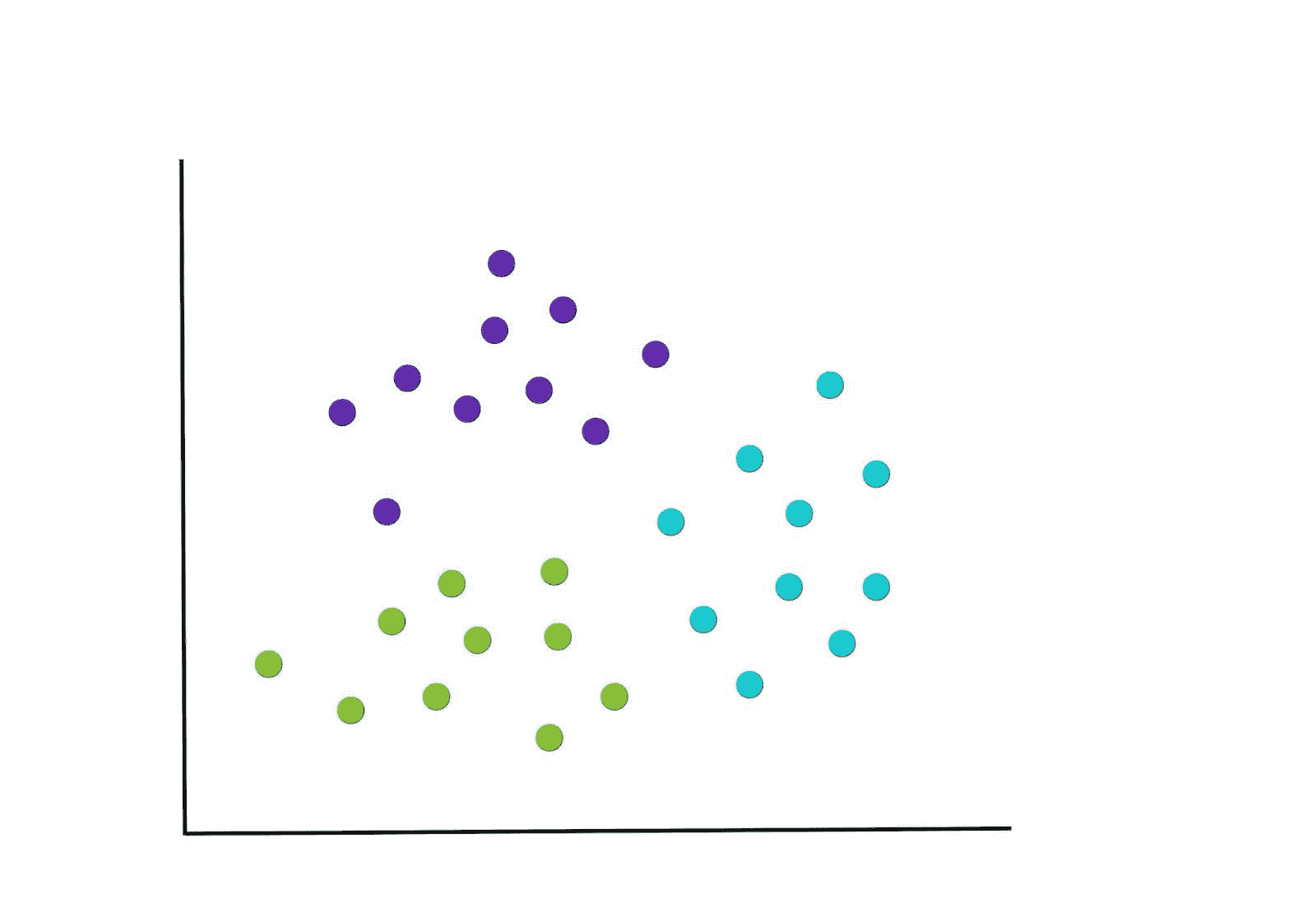

11.1 聚类 PCA 图

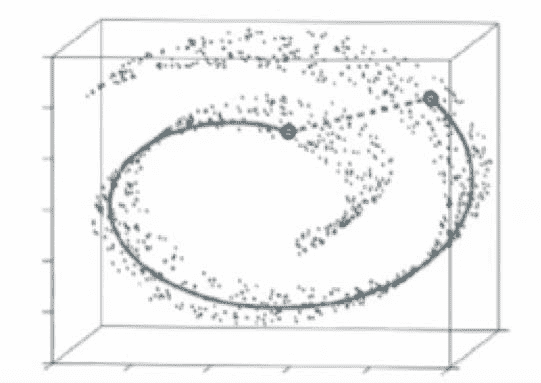

plot_model(kmeans)

聚类标签会自动着色并显示在图例中。当你将鼠标悬停在数据点上时,你会看到额外的特征,这些特征默认使用数据集的第一列(在本例中是 MouseID)。你可以通过传递feature参数来更改此设置,并且如果你希望在图上打印标签,可以将label设置为True。

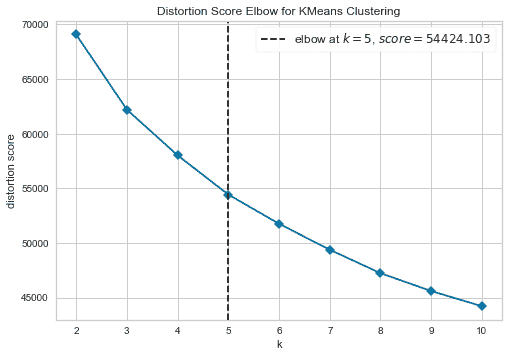

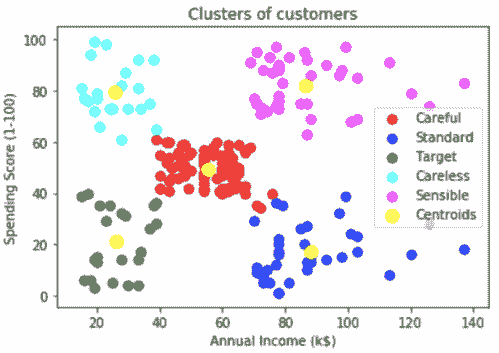

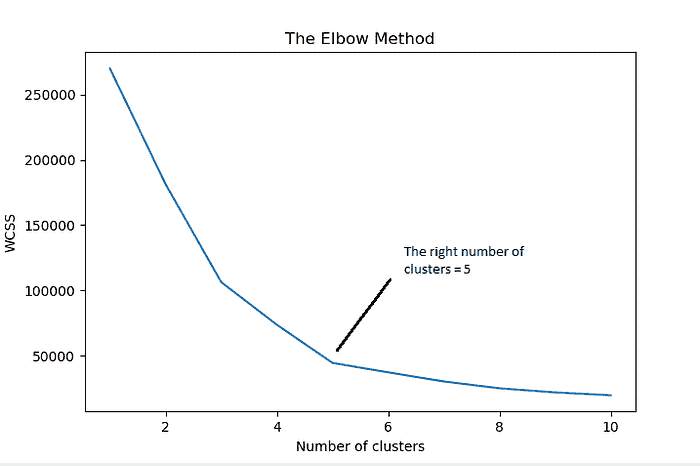

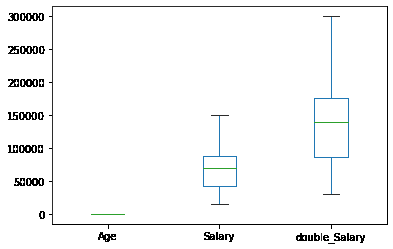

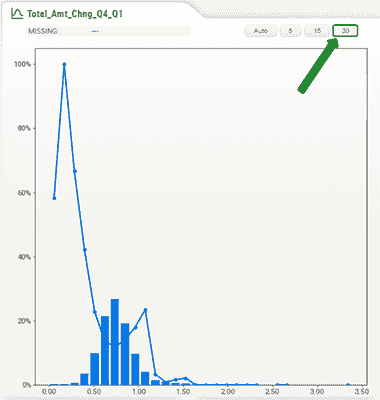

11.2 肘部图

plot_model(kmeans, plot = 'elbow')

肘部法则是一种启发式方法,用于解释和验证簇内分析的一致性,旨在帮助找到数据集中的适当簇数。在这个示例中,上面的肘部图建议 5 是最优的簇数。

11.3 轮廓图

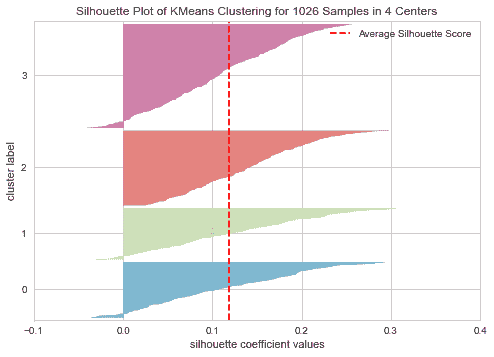

plot_model(kmeans, plot = 'silhouette')

Silhouette(轮廓系数)是一种解释和验证数据簇内部一致性的方法。该技术提供了一个简洁的图形表示,显示了每个对象被分类的效果。换句话说,轮廓值是衡量一个对象与其自身簇(凝聚度)相比,与其他簇(分离度)的相似程度。

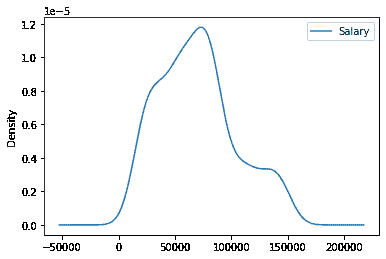

11.4 分布图

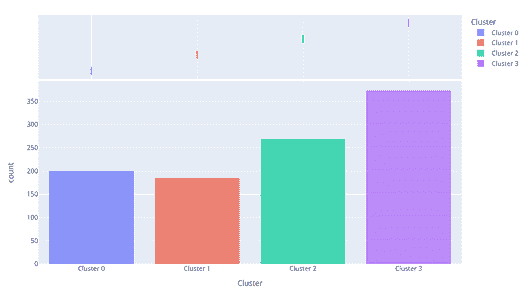

plot_model(kmeans, plot = 'distribution')

分布图显示了每个簇的大小。当将鼠标悬停在条形上时,会看到分配到每个簇的样本数量。从上面的例子中,我们可以观察到簇 3 拥有最多的样本。我们还可以使用 distribution 图来查看簇标签与任何其他数值或类别特征的分布情况。

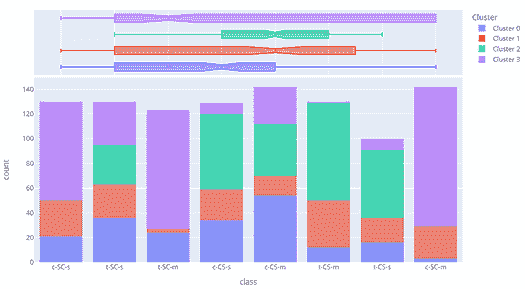

plot_model(kmeans, plot = 'distribution', feature = 'class')

在上述示例中,我们使用了 class 作为特征,因此每个条形代表一个 class,并用簇标签(右侧图例)着色。我们可以观察到 t-SC-m 和 c-SC-m 类别大多由 Cluster 3 主导。我们也可以使用相同的图来查看任何连续特征的分布。

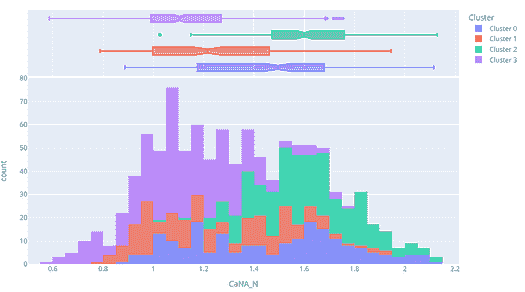

plot_model(kmeans, plot = 'distribution', feature = 'CaNA_N')

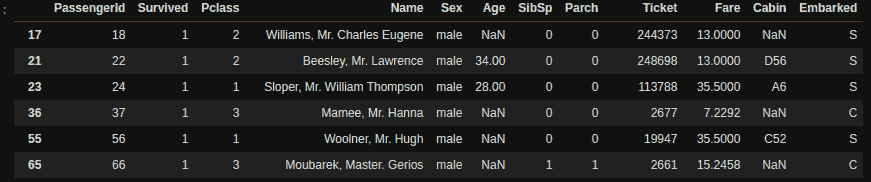

12. 在未见数据上进行预测

predict_model 函数用于为新的未见数据集分配簇标签。我们现在将使用训练好的 kmeans 模型来预测存储在 data_unseen 中的数据。这个变量在教程开始时创建,包含了原始数据集中从未暴露于 PyCaret 的 54 个样本。

unseen_predictions = predict_model(kmeans, data=data_unseen)

unseen_predictions.head()

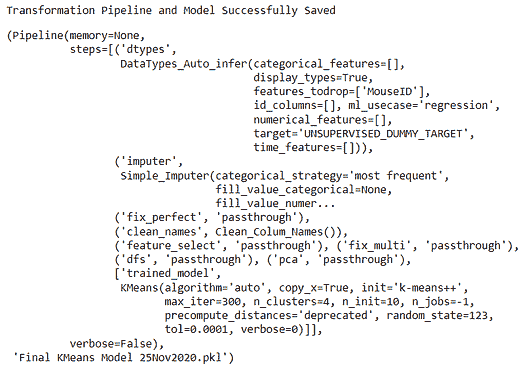

13. 保存模型

我们现在已经完成了实验,通过使用我们的 kmeans 模型在未见数据上预测标签。

这标志着我们实验的结束,但还有一个问题需要回答:当你有更多新数据需要预测时会发生什么?你需要重新进行整个实验吗?答案是否定的,PyCaret 的内置函数 save_model 允许你保存模型及整个转换管道,以便以后使用。

save_model(kmeans,’Final KMeans Model 25Nov2020')

要在未来某个日期在相同或不同环境中加载已保存的模型,我们可以使用 PyCaret 的 load_model 函数,然后轻松地将已保存的模型应用于新的未见数据进行预测。

saved_kmeans = load_model('Final KMeans Model 25Nov2020')

new_prediction = predict_model(saved_kmeans, data=data_unseen)

new_prediction.head()

14. 总结 / 下一步?

我们仅覆盖了PyCaret 的聚类模块的基础内容。在接下来的教程中,我们将深入探讨高级预处理技术,这些技术允许你完全自定义你的机器学习管道,是任何数据科学家必须了解的。

感谢阅读 ????

重要链接

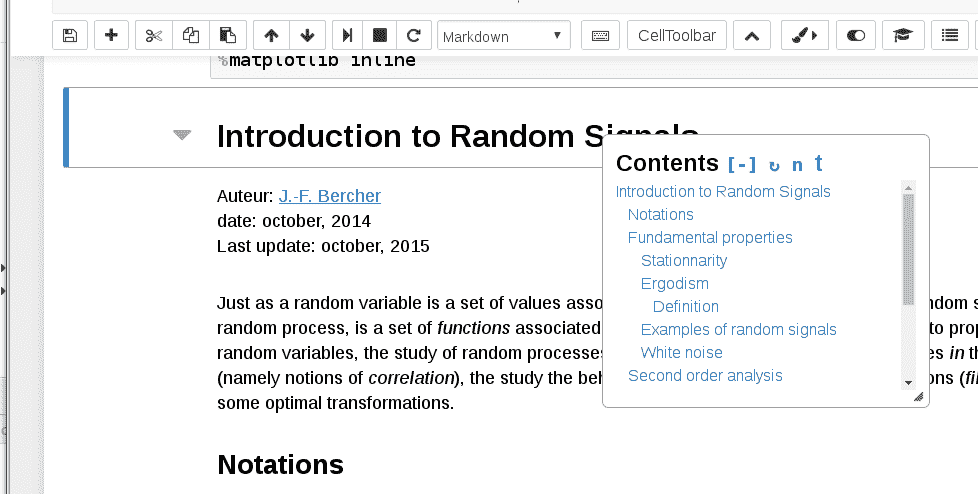

⭐ 教程 新接触 PyCaret?查看我们的官方笔记本!

???? 示例笔记本 由社区创建。

???? 博客 贡献者的教程和文章。

???? 文档 PyCaret 的详细 API 文档。

???? 视频教程 我们来自各种活动的视频教程。

???? 讨论 有问题?与社区和贡献者互动。

????️ 更新日志 更改和版本历史。

???? 路线图 PyCaret 的软件和社区发展计划。

个人简介:Moez Ali 撰写关于 PyCaret 及其实际应用的文章,如果你希望自动获取通知,可以关注 Moez 的 Medium、LinkedIn 和 Twitter。

原文。已获转载许可。

相关:

-

使用 PyCaret 的新时间序列模块

-

使用 PyCaret 进行二分类介绍

-

初学者的端到端机器学习指南

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

更多相关内容

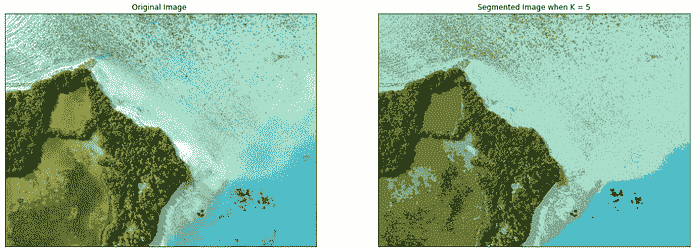

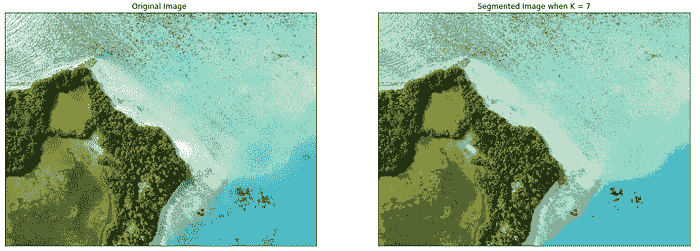

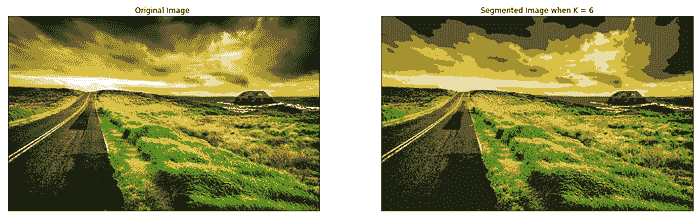

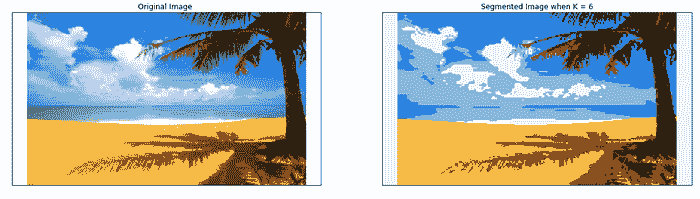

卷积神经网络简介

原文:

www.kdnuggets.com/2020/06/introduction-convolutional-neural-networks.html

评论

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道

1. Google 网络安全证书 - 快速进入网络安全职业轨道

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

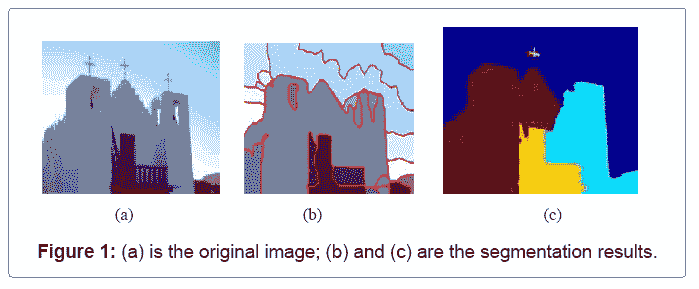

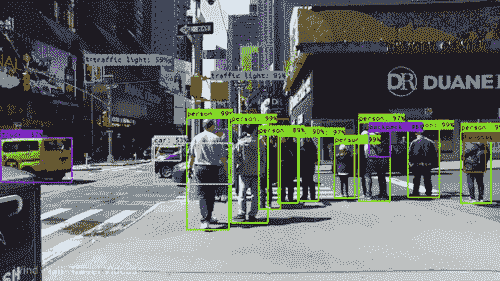

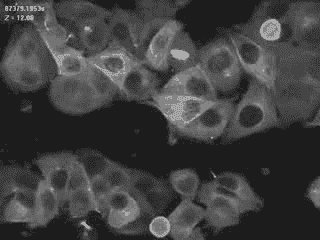

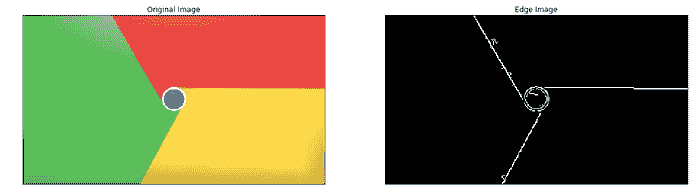

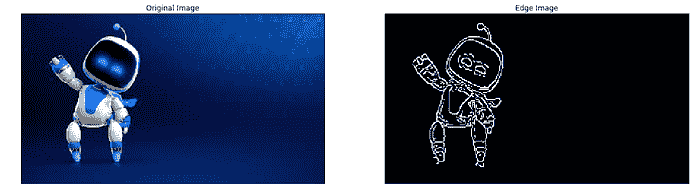

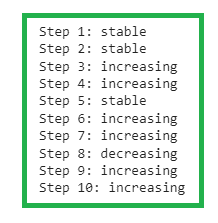

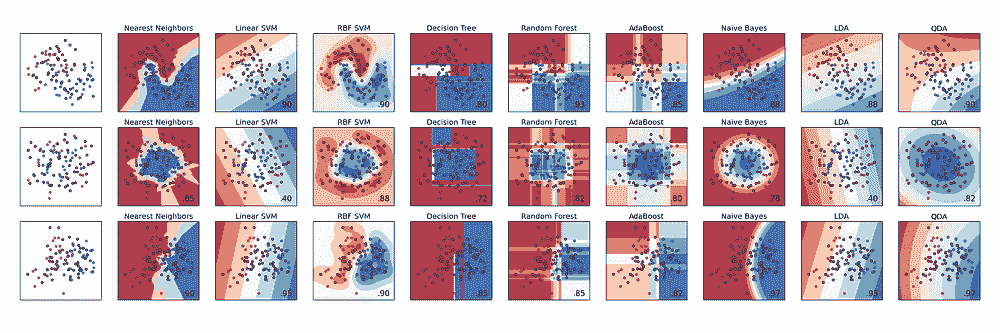

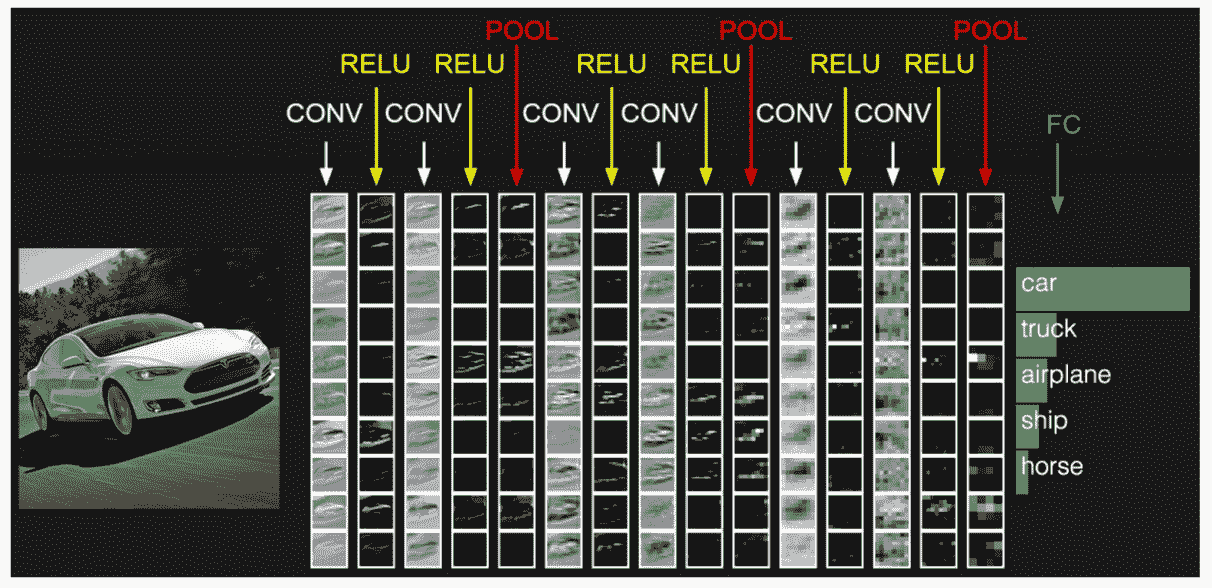

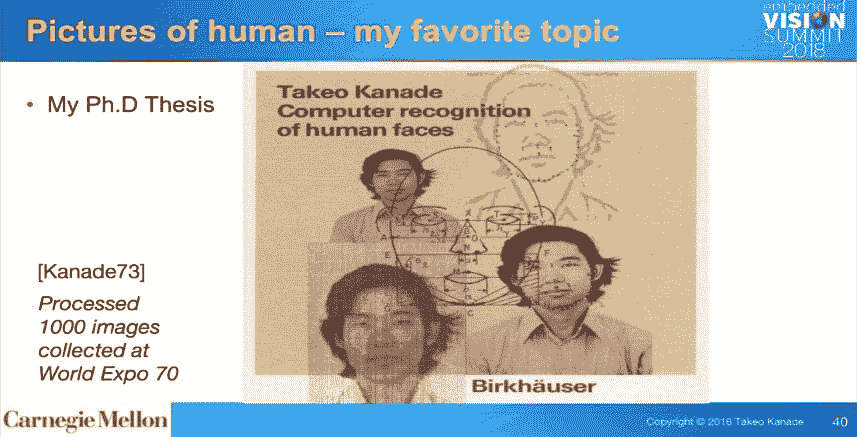

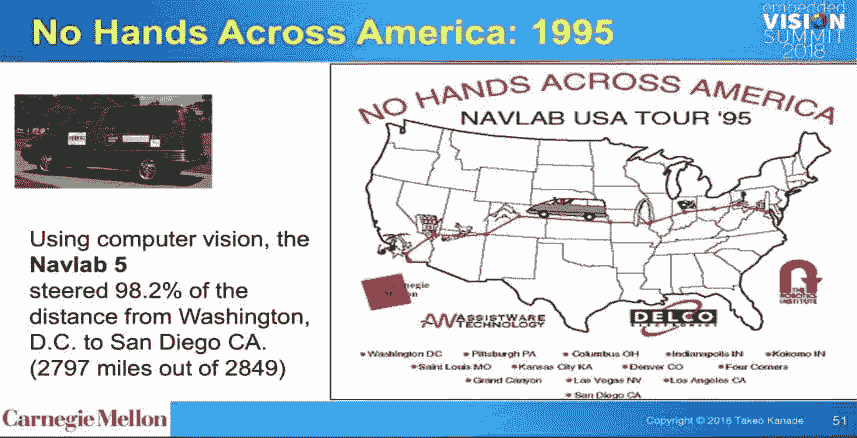

你是否想过面部识别如何在 社交媒体 上工作,或者对象检测如何在自动驾驶汽车中发挥作用,或者疾病检测如何通过视觉影像在医疗保健中完成?这一切都得益于卷积神经网络(CNN)。

介绍

就像孩子学习识别对象一样,我们需要向算法展示数百万张图片,才能使其对输入进行归纳并对从未见过的图像进行预测。

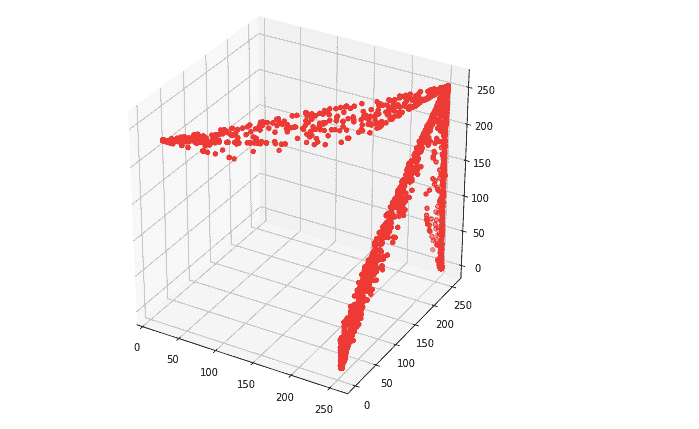

计算机的“视野”与我们不同。它们的世界仅由数字构成。每个图像可以表示为二维的数字数组,称为像素。

但它们以不同的方式感知图像,并不意味着我们不能训练它们像我们一样识别模式。我们只需要考虑图像的不同之处。

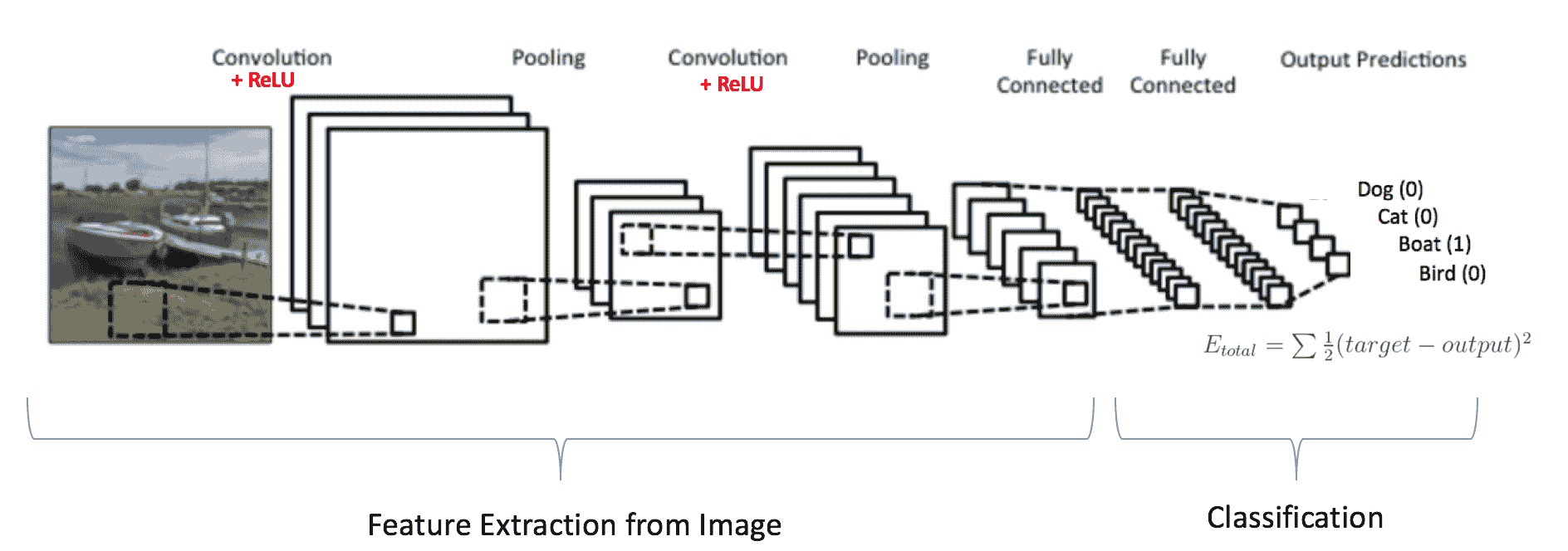

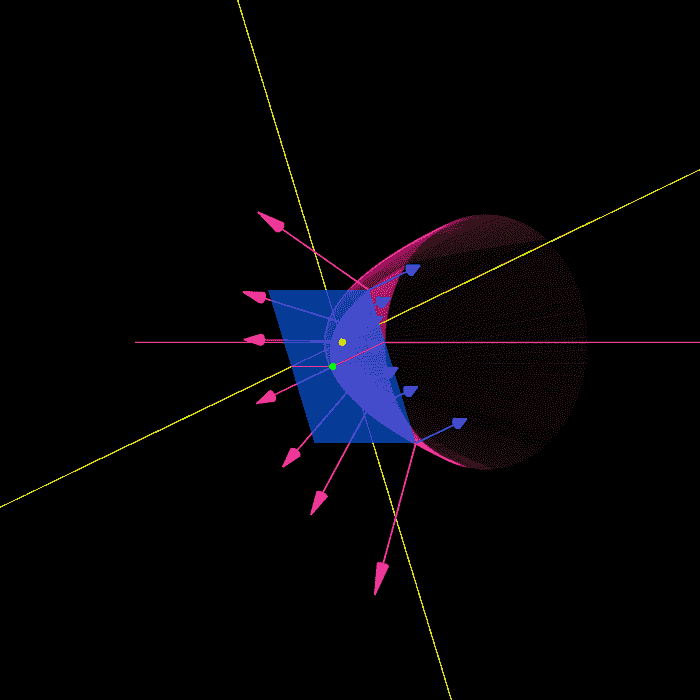

要教一个算法识别图像中的对象,我们使用一种特定类型的 人工神经网络:卷积神经网络(CNN)。它们的名称源自网络中一种重要操作叫做 卷积。

卷积神经网络

卷积神经网络(CNN 或 ConvNets) 是普通的神经网络,假设输入是图像。它们用于分析和分类图像,通过相似性对图像进行聚类,并在框架内执行对象识别。例如,卷积神经网络(ConvNets 或 CNNs)用于识别面孔、个人、路标、肿瘤、鸭嘴兽以及视觉数据的许多其他方面。

CNN 的生物学连接

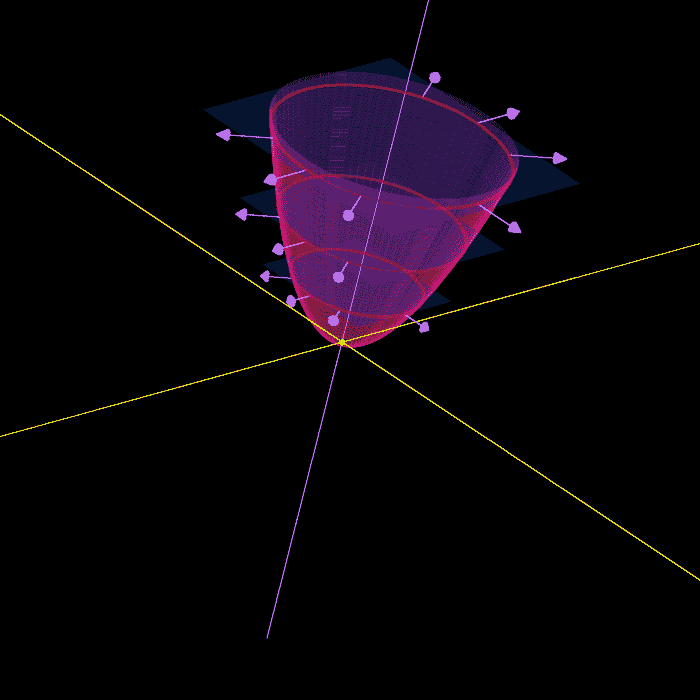

当你第一次听到卷积神经网络这个术语时,你可能会想到与神经科学或生物学有关的东西,你的想法是对的。某种程度上。CNN 确实从视觉皮层中获得了生物学上的启发。视觉皮层有小区域的细胞对视觉场的特定区域敏感。

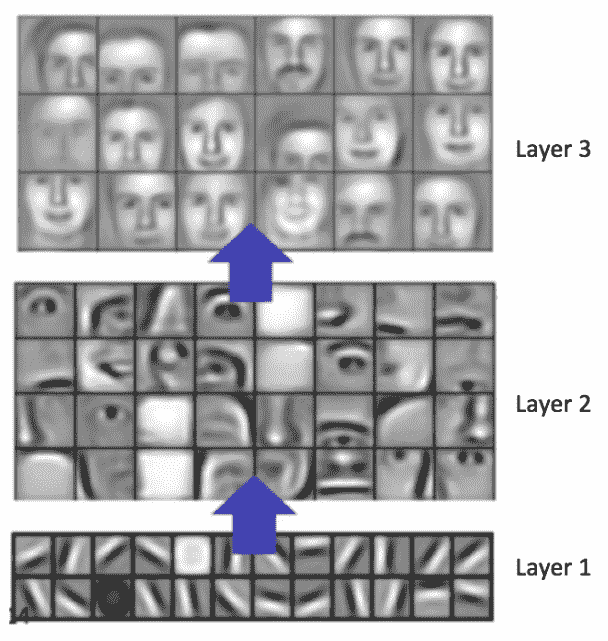

这个想法在 1962 年通过 Hubel 和 Wiesel 的一项引人入胜的实验得到了扩展(视频),他们展示了大脑中的某些单个神经元细胞仅在特定方向的边缘存在时才会响应(或发放)。例如,一些神经元在暴露于垂直边缘时会发放,而在水平或对角边缘出现时也会发放。Hubel 和 Wiesel 发现所有这些神经元都以柱状结构组织在一起,并且它们能够共同产生视觉感知。系统内专门组件具有特定任务的这种思想(视觉皮层中的神经细胞寻找特定特征)也是机器使用的基础,并且是 CNN 的基础。

在你继续之前,如果你是深度学习的初学者,我强烈建议查看下面的文章,以便对神经网络有一个基本的理解。

人工神经网络简介

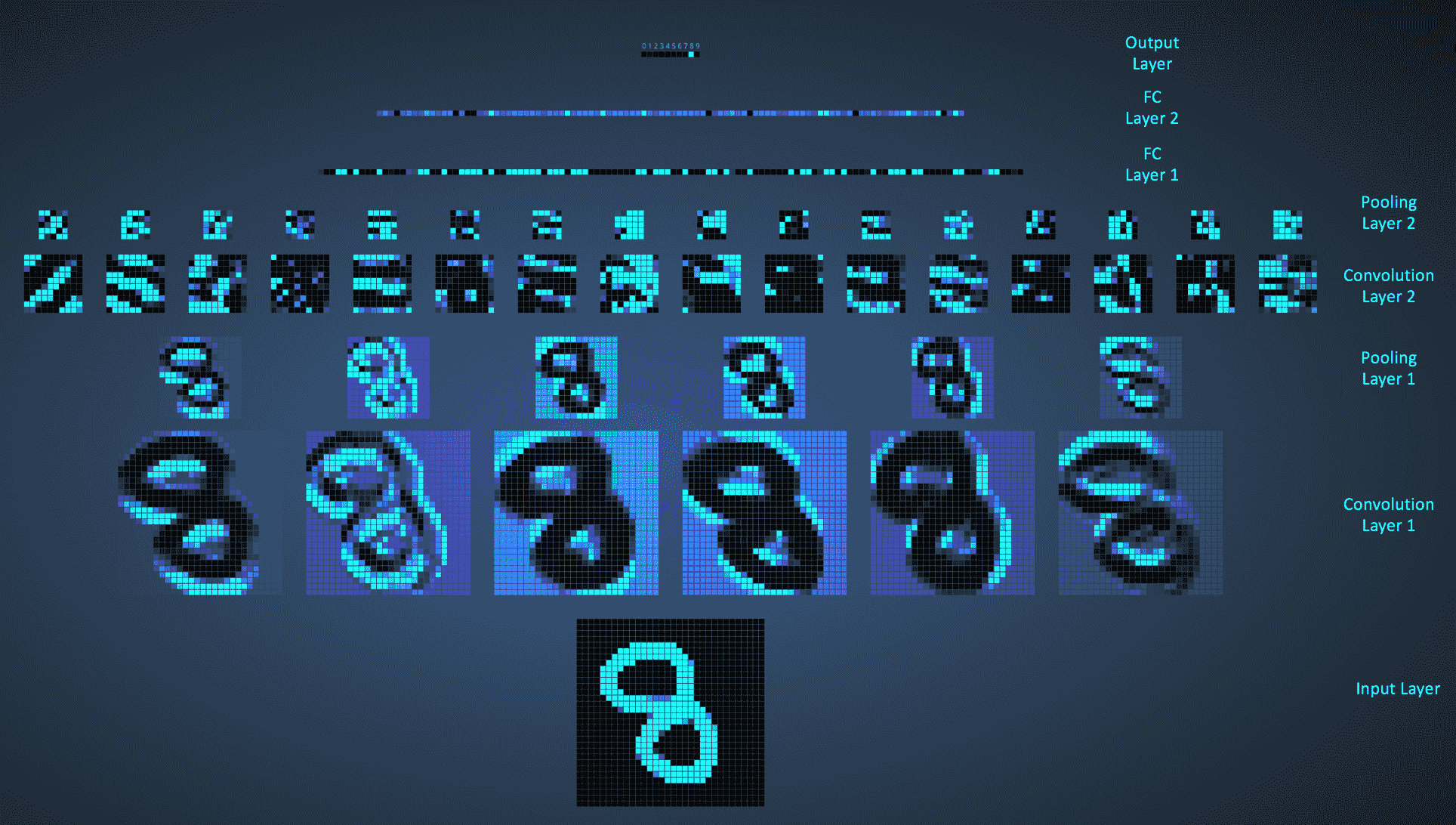

卷积神经网络如何学习?

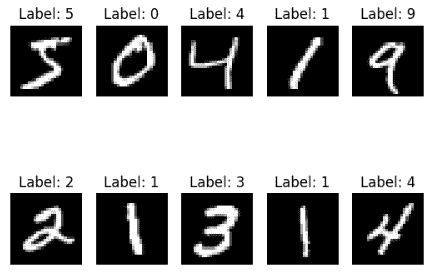

图像由像素组成。每个像素由 0 到 255 之间的一个数字表示。因此,每个图像都有一个数字表示,这就是计算机能够处理图像的方式。

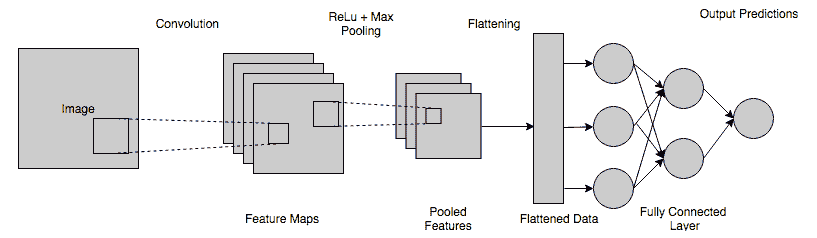

CNN 图像检测/分类中有 4 个主要操作。

-

卷积

-

激活图

-

最大池化

-

扁平化

-

全连接层

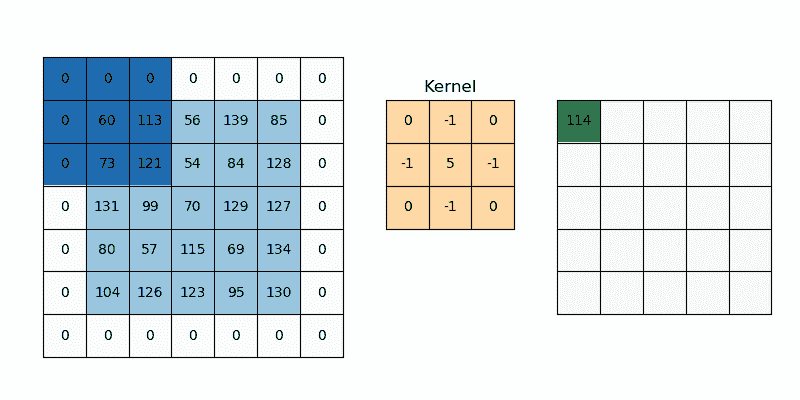

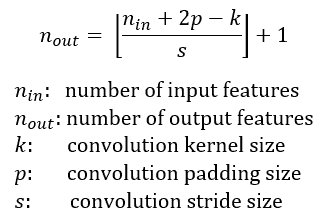

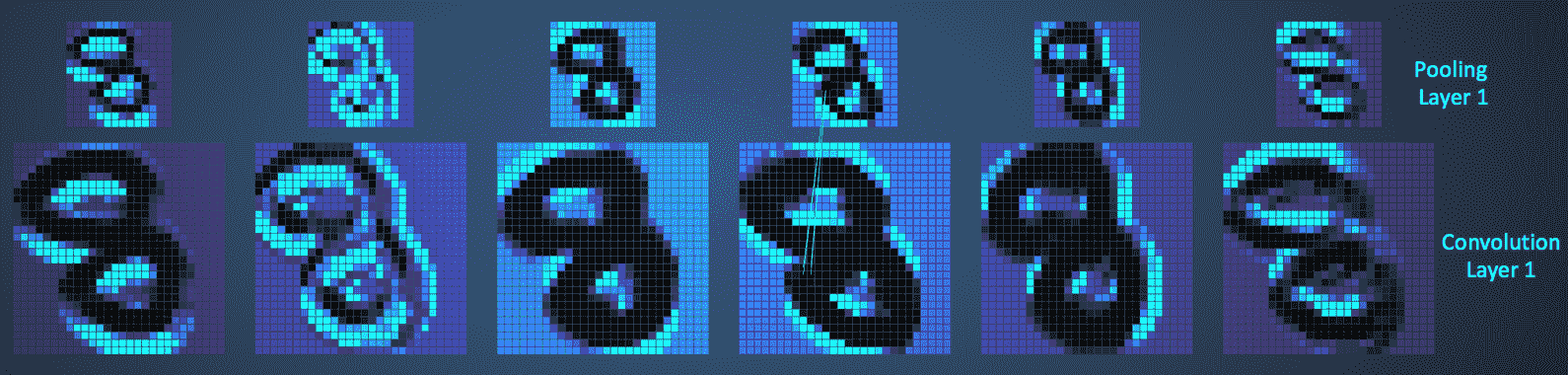

1.1 卷积

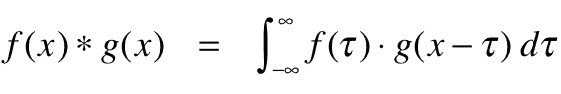

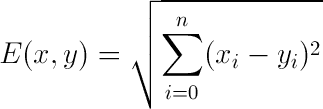

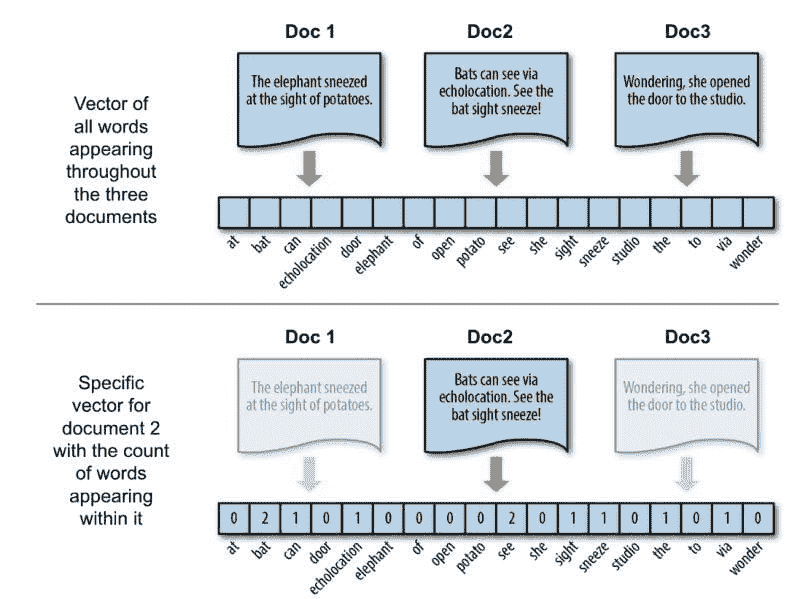

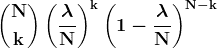

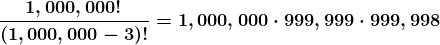

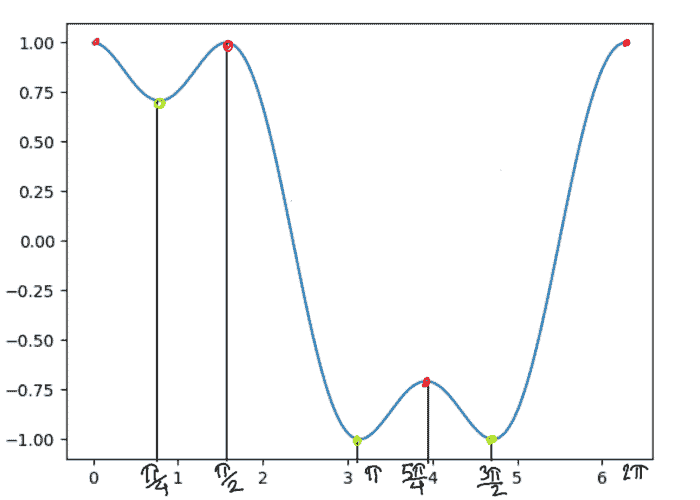

卷积操作在 1D 的两个信号和 2D 的两幅图像上进行。数学上,卷积是两个函数的综合积分,展示了一个函数如何修改另一个函数:

卷积层的主要目的是检测图像中的特征或视觉特征,例如边缘、线条、颜色斑点等。这是一个非常有趣的特性,因为一旦它在图像的特定点学会了某个特征,它就能在图像的任何部分识别它。

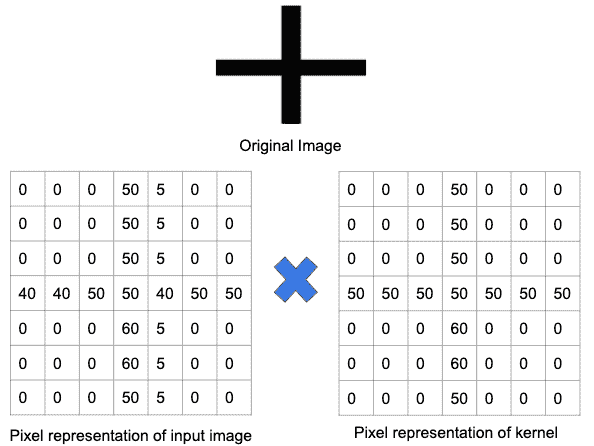

CNN 使用滤波器(也称为卷积核、特征检测器)来检测图像中是否存在诸如边缘等特征。滤波器只是一个值矩阵,称为权重,经过训练以检测特定特征。滤波器在图像的每个部分移动,以检查是否存在其预期检测的特征。为了提供一个值,表示它对特定特征存在的信心,滤波器执行卷积操作,这是一种矩阵之间逐元素的乘积和求和。

当图像的某部分存在特征时,滤波器与该部分图像之间的卷积操作结果是一个高值的实数。如果特征不存在,结果值则较低。

在下图中,训练用于检测加号的滤波器被应用于图像的一部分。由于该部分图像包含了滤波器所寻找的相同加号,卷积操作的结果是一个大数值。

卷积(逐元素乘积和求和) = (5050)+(5050)+(5050)+(5050)+(5050)+(6060)+(6060)+(4050)+(4050)+(5050)+(5050)+(4050)+(5050)+(5050) = 非常大的实数

但是当相同的滤波器/核应用于具有显著不同边缘集合的图像部分时,卷积的输出会很小,这意味着没有明显的加号存在,逐元素乘积和求和将导致零或非常小的值。

因此,我们需要 N 个特征检测器来检测图像的不同曲线/边缘。

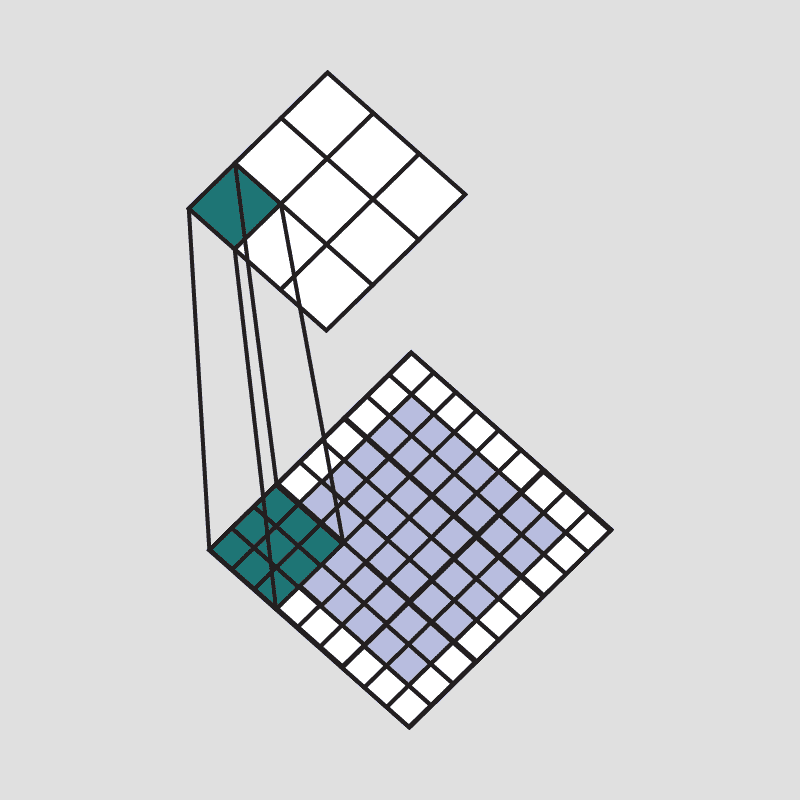

将该滤波器应用于整个图像的结果是一个称为特征图或卷积特征的输出矩阵,它存储了该滤波器在图像不同部分上的卷积结果。由于我们有多个滤波器,因此我们得到一个 3D 输出:每个滤波器一个 2D 特征图。滤波器必须具有与输入图像相同的通道数,以便进行逐元素乘法。

此外,可以通过使用步幅值,在不同的间隔上滑动滤波器到输入图像上。步幅值决定了滤波器在每一步移动的距离。

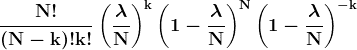

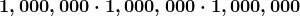

我们可以确定给定卷积块的输出层数量:

1.2 填充

应用卷积层时一个棘手的问题是我们往往会丢失图像边缘的像素。由于我们通常使用小型核,对于任何给定的卷积,我们可能只会丢失几个像素,但随着我们应用许多连续的卷积层,这种丢失会逐渐积累。

填充是指在图像被 CNN 的核处理时,添加到图像上的像素数量。

一个解决方案是通过在图像周围添加零(零填充)来帮助核处理图像,从而为核提供更多的覆盖图像的空间。对 CNN 处理的图像添加填充可以实现更准确的图像分析。

在输入图像的周围添加额外的零,以便捕获所有特征。

2.1 激活图

这些特征图必须经过非线性映射。特征图与偏置项相加,并通过非线性激活函数ReLu。激活函数的目的是将非线性引入网络中,因为图像由彼此不线性的不同对象组成,所以图像具有高度的非线性。

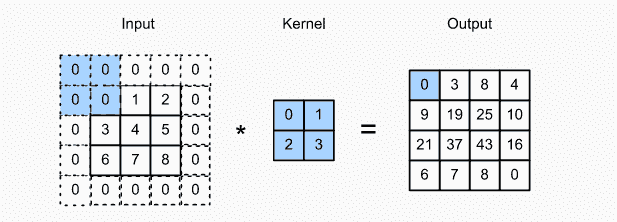

2.2 最大池化

ReLU 之后是一个池化步骤,在该步骤中,CNN 对卷积特征进行下采样(以节省处理时间),同时还减少图像的大小。这有助于减少过拟合,如果 CNN 接收到过多的信息,特别是当这些信息在分类图像时不相关时,过拟合会发生。

有不同类型的池化,例如最大池化和最小池化。在最大池化中,窗口按照设定的步幅值在图像上滑动。在每一步,窗口内的最大值会被池化到输出矩阵中,因此得名最大池化。

这些值形成一个新的矩阵,称为池化特征图。

最大池化的一个额外好处是,它迫使网络关注少数神经元,而不是所有神经元,这对网络有正则化作用,使其不易过拟合训练数据,并希望能够很好地泛化。

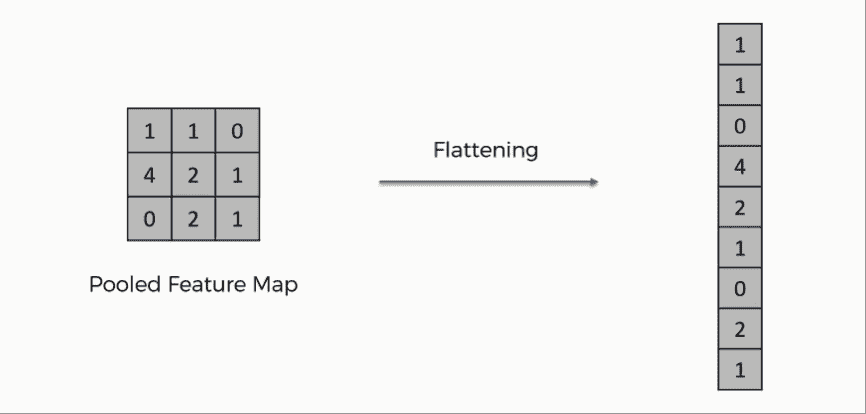

3.3 扁平化

经过多个卷积层和下采样操作后,图像的 3D 表示会转换成一个特征向量,该特征向量会传入多层感知机以输出概率。下图描述了扁平化操作:

扁平化操作

行被连接起来形成一个长特征向量。如果存在多个输入层,则这些行也会连接起来形成一个更长的特征向量。

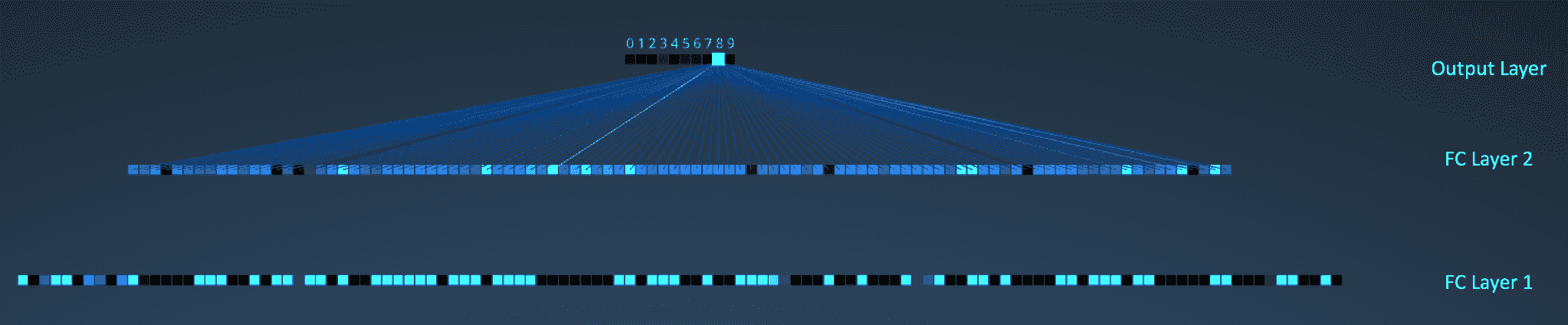

4. 全连接层

在这一步,扁平化的特征图会传递给一个神经网络。这一步包括输入层、全连接层和输出层。全连接层类似于 ANN 中的隐藏层,但在这种情况下,它是完全连接的。输出层是我们得到预测类别的地方。信息会通过网络传递,并计算预测的误差。然后,误差会通过系统进行反向传播,以改进预测。

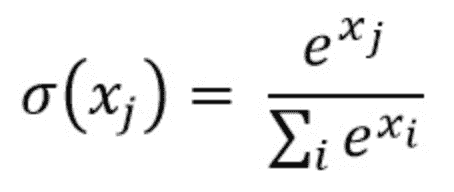

全连接层

密集层神经网络产生的最终输出通常不会加起来等于一。然而,这些输出必须被缩减到零到一之间的数值,这些数值代表每个类别的概率。这就是 Softmax 函数的作用。

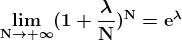

因此,这一密集层的输出会传递给Softmax 激活函数,该函数将所有最终密集层的输出映射到一个元素总和为一的向量中:

其中 x 表示最终层输出中的每个元素。

全连接层的工作方式是查看前一层的输出(我们记得应该表示高层特征的激活图),并确定哪些特征与特定类别最相关。例如,如果程序预测某图像是狗,它将在表示高层特征如爪子或四条腿等的激活图中具有高值。同样,如果程序预测某图像是鸟,它将在表示高层特征如翅膀或喙等的激活图中具有高值。全连接层查看哪些高层特征最强烈地与特定类别相关,并具有特定的权重,以便当你计算权重和前一层之间的乘积时,可以得到不同类别的正确概率。

让我们总结一下 CNN 如何识别的整个过程:

-

图像中的像素被送入执行卷积操作的卷积层。

-

它生成一个卷积映射。

-

卷积映射应用于 ReLU 函数生成一个整流特征图。

-

图像经过多次卷积和 ReLU 层处理以定位特征。

-

使用不同的池化层和各种滤波器来识别图像的特定部分。

-

池化特征图被展平并馈送到全连接层以获得最终输出。

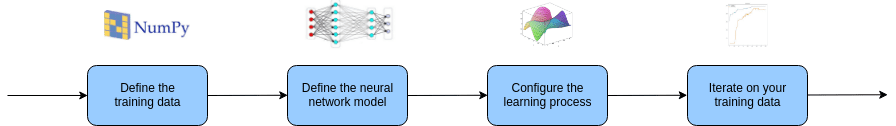

使用 Keras 实现 CNN

现在,让我们编写能够分类图像的代码。这段代码可以在大多数图像数据集上应用,只需稍作修改。因此,一旦你拥有图像数据,将它们分开到文件夹中并命名,例如训练集和测试集。

构建 CNN

在这一步,第一步是构建包含以下提到的层的卷积神经网络:

-

Sequential 用于初始化神经网络。

-

Convolution2D用于构建处理图像的卷积网络。

-

MaxPooling2D 层用于添加池化层。

-

Flatten是将池化特征图转换为传递到全连接层的单列的函数。

-

Dense添加了一个全连接层到神经网络中。

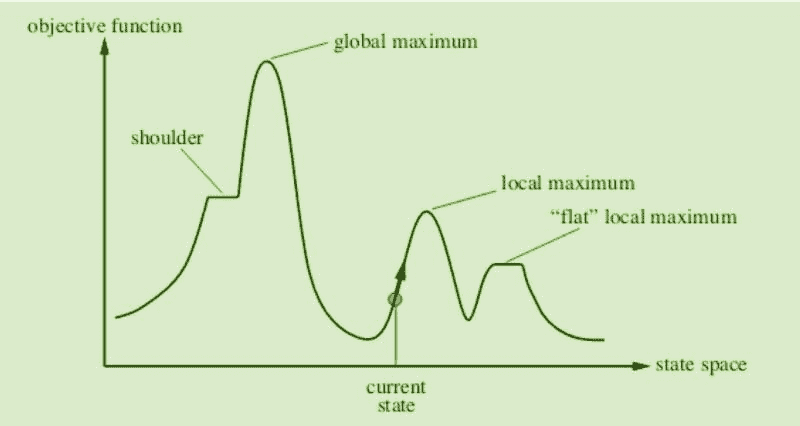

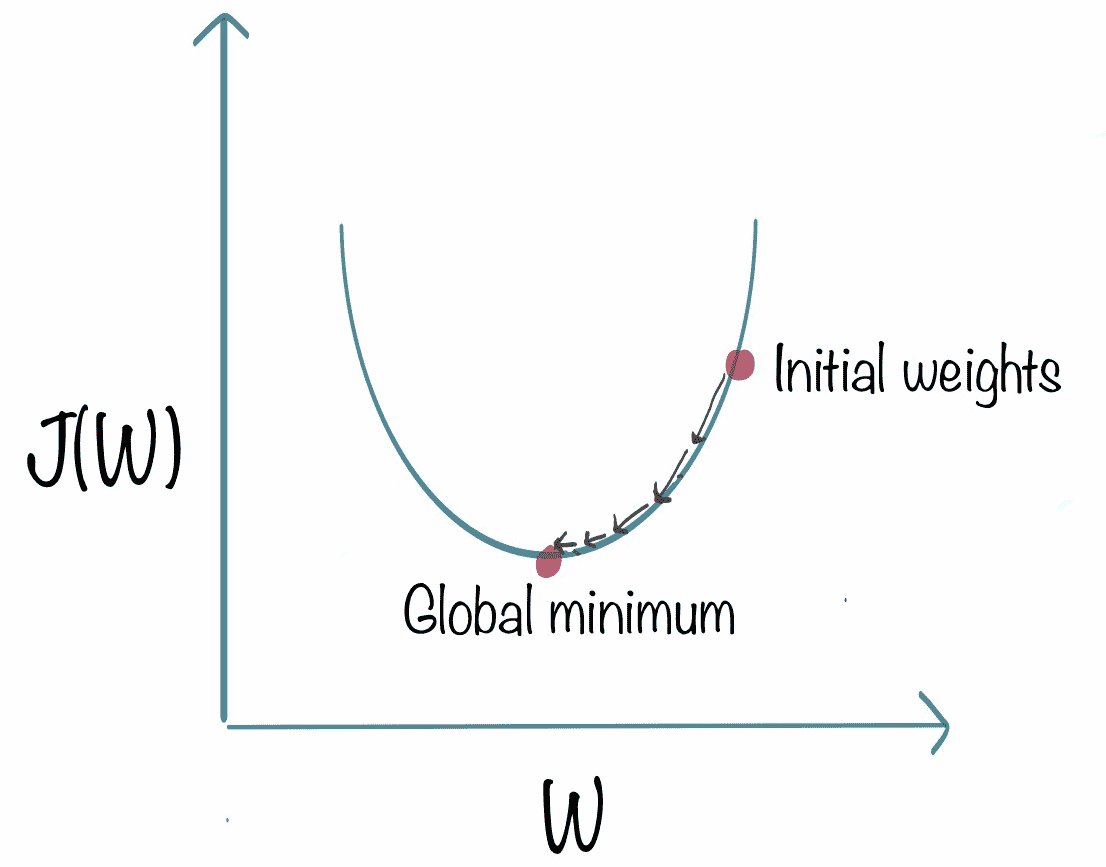

一旦网络建立完成,然后使用 随机梯度下降(SGD) 来编译/训练网络。梯度下降在我们有凸曲线时效果很好。但如果我们没有凸曲线,梯度下降会失败。因此,在随机梯度下降中,每次迭代随机选择一些样本,而不是整个数据集。

现在网络已经编译完毕,是时候用训练图像来训练 CNN 模型了。

将 CNN 适配到图像上

执行图像增强,与其用大量图像训练模型,不如用较少的图像进行训练,并通过不同角度和修改图像来训练模型。Keras 有一个ImageDataGenerator类,可以让用户以非常简单的方式动态执行图像增强。

一旦你用训练图像数据集训练了你的 CNN 网络,就该检查模型的准确性了。

结论

CNN 是最好的人工神经网络,它不仅用于图像建模,还有许多其他应用。基于 CNN 架构有很多改进版,如 AlexNet、VGG、YOLO 等。

好了,这篇文章就到这里,希望你们喜欢阅读。如果这篇文章对你们有帮助,我会很高兴。欢迎在评论区分享你们的评论/想法/反馈。

感谢阅读!!!

简历:Nagesh Singh Chauhan 是 CirrusLabs 的一个大数据开发人员。他在电信、分析、销售、数据科学等多个领域有超过 4 年的工作经验,专注于多个大数据组件。

原文。经许可转载。

相关:

-

每个数据科学家应该阅读的 5 篇 CNN 论文

-

机器学习中的模型评估指标

-

主成分分析(PCA)的降维

更多相关内容

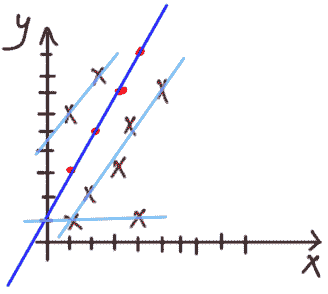

相关性介绍

编辑提供的图片

阅读完本文后,读者将学到以下内容:

-

相关性的定义

-

正相关

-

负相关

-

无相关性

-

相关性的数学定义

-

相关系数的 Python 实现

-

协方差矩阵

-

协方差矩阵的 Python 实现

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 在 IT 方面支持你的组织

3. 谷歌 IT 支持专业证书 - 在 IT 方面支持你的组织

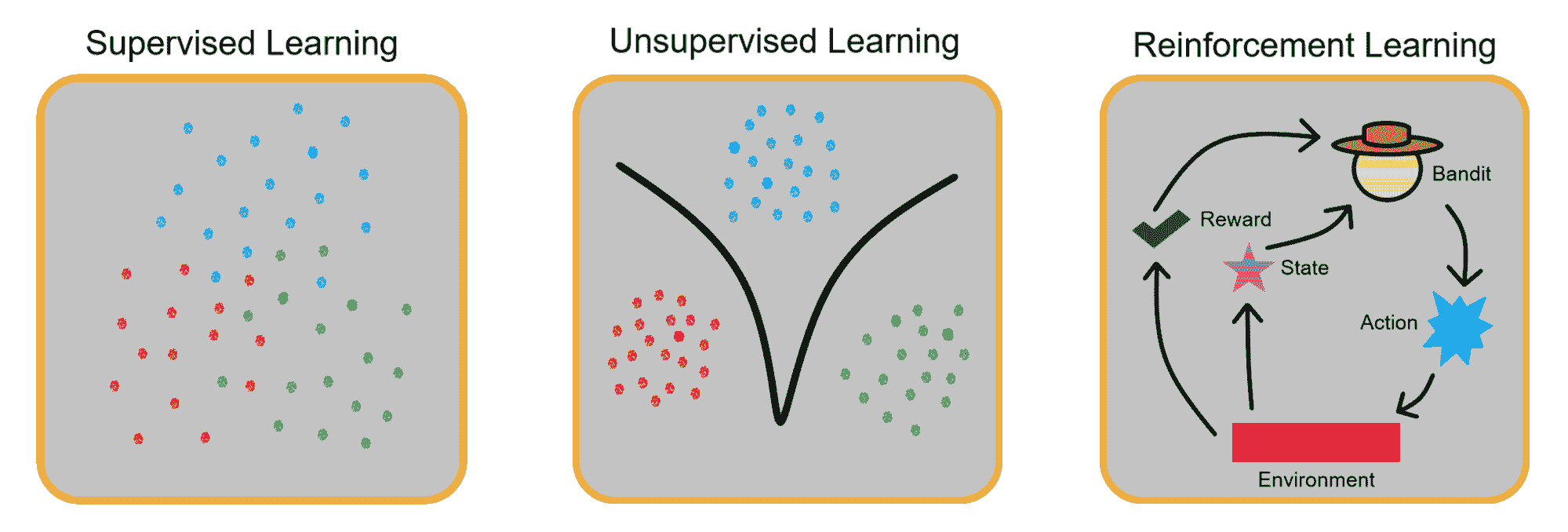

相关性

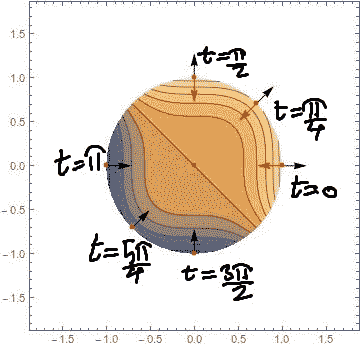

相关性衡量两个变量的共同变化程度。

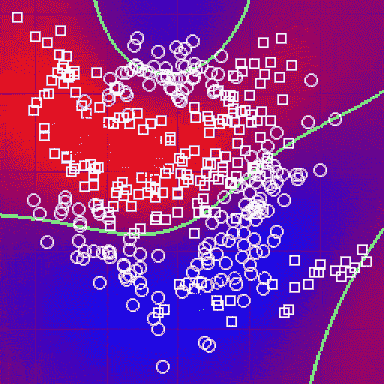

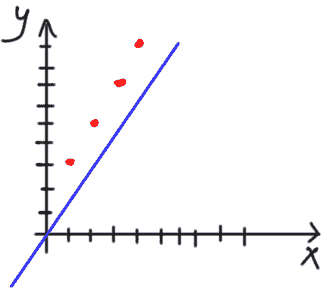

正相关

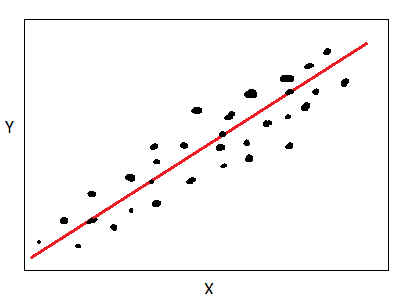

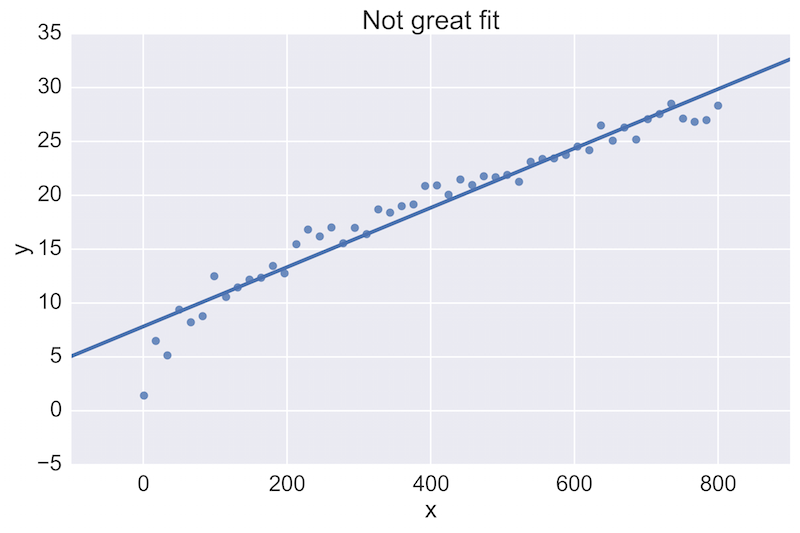

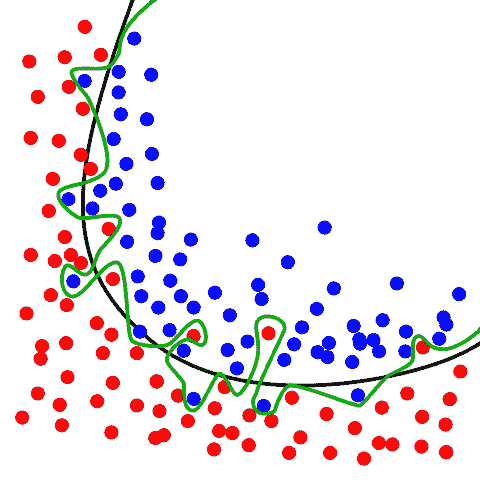

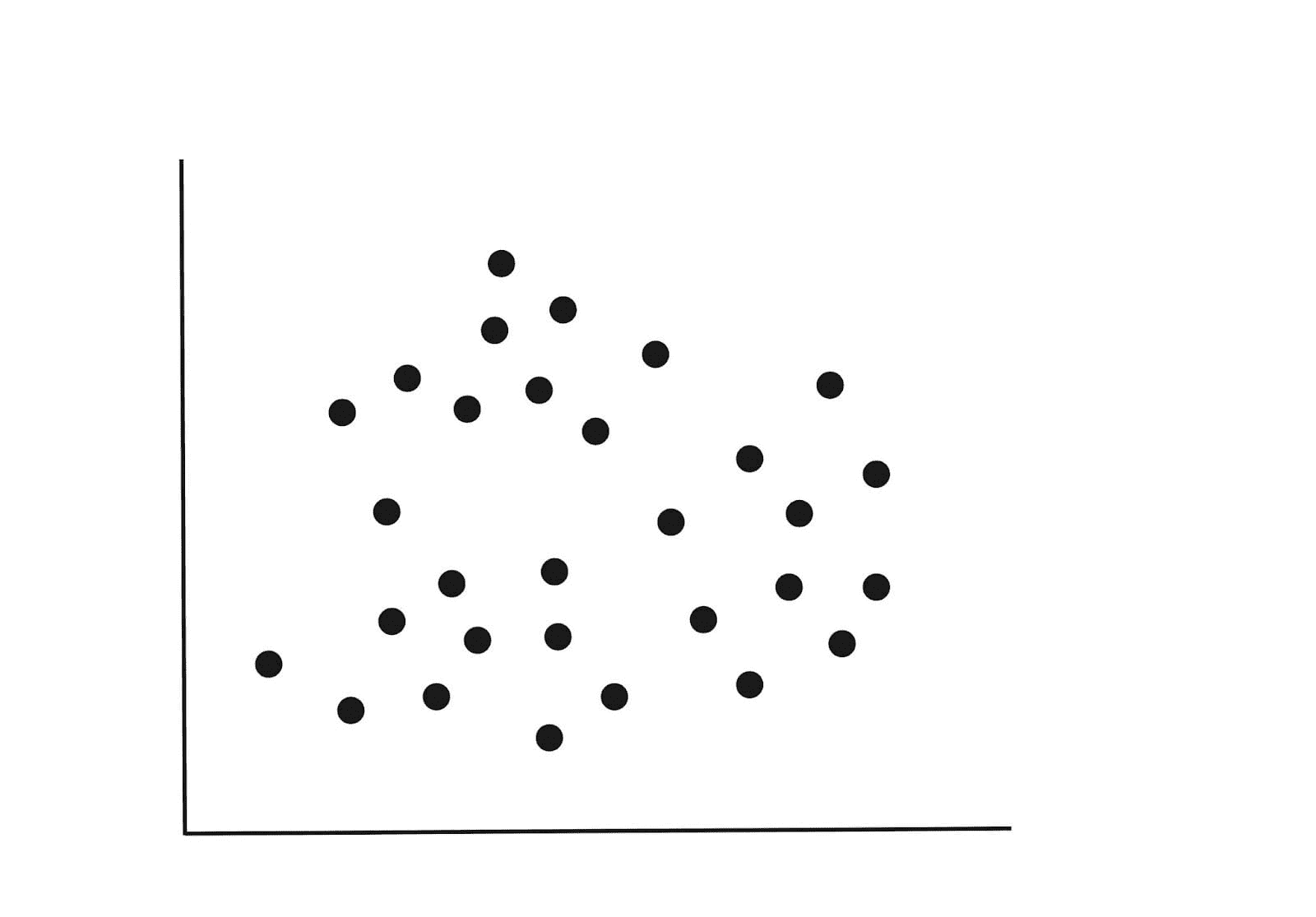

如果变量Y在变量X增加时也增加,那么X和Y是正相关的,如下所示:

X 和 Y 之间的正相关。 图片由作者提供。

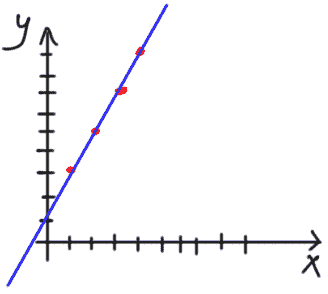

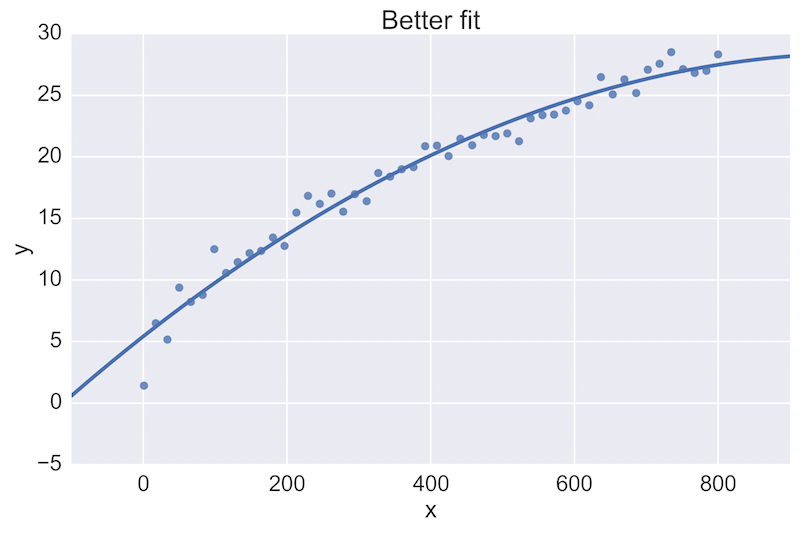

负相关

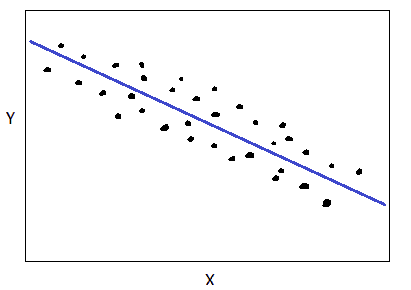

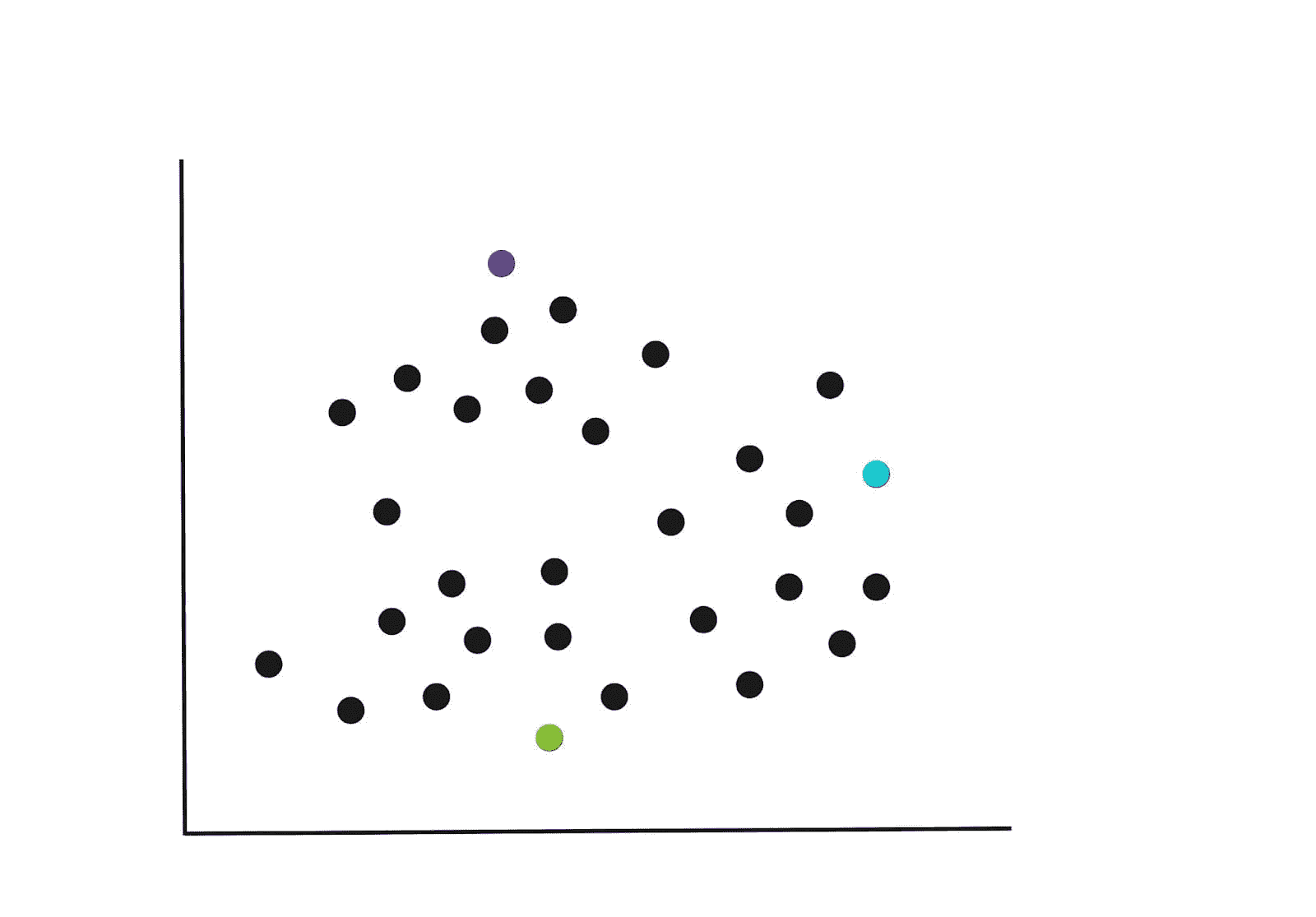

如果变量Y在变量X增加时减少,那么X和Y是负相关的,如下所示:

X 和 Y 之间的负相关。 图片由作者提供。

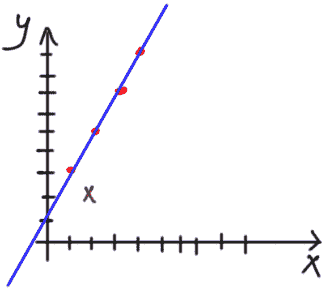

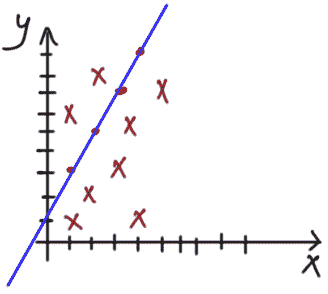

无相关性

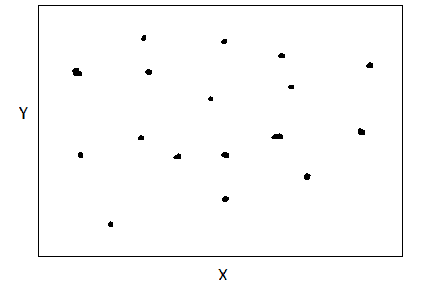

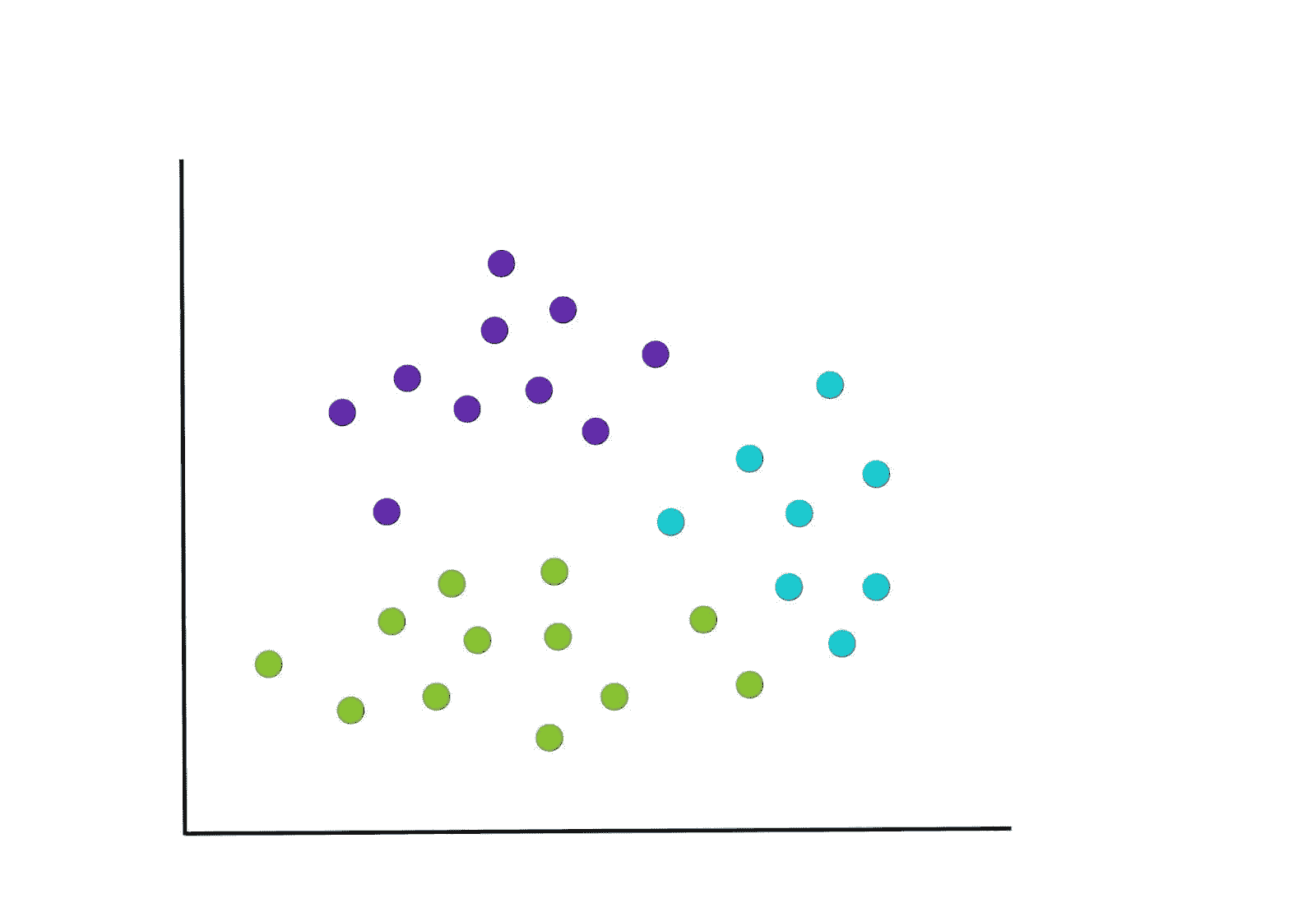

当X和Y之间没有明显关系时,我们说X和Y是无相关的,如下所示:

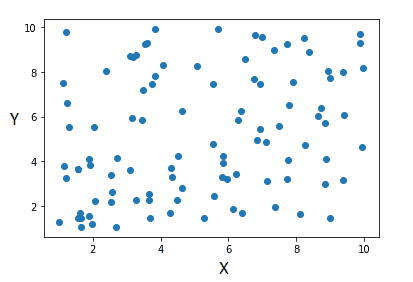

X 和 Y 是无相关的。 图片由作者提供。

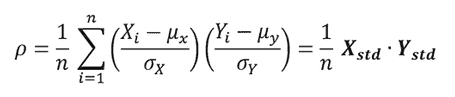

相关性的数学定义

设X和Y为两个特征

X = (X1 , X2 , . . ., Xn )

Y = (Y1 , Y2 , . . ., Yn )

X和Y之间的相关系数定义为

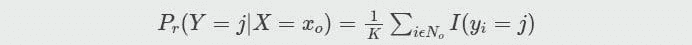

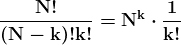

其中 mu 和 sigma 分别表示均值和标准差,Xstd 是变量 X 的标准化特征。相关系数是X和Y的标准化特征之间的向量点积(标量积)。相关系数的取值范围在-1 到 1 之间。接近 1 的值表示强正相关,接近-1 的值表示强负相关,接近零的值表示低相关性或无相关性。

相关系数的 Python 实现

import numpy as np

import matplotlib.pyplot as plt

n = 100

X = np.random.uniform(1,10,n)

Y = np.random.uniform(1,10,n)

plt.scatter(X,Y)

plt.show()

X 和 Y 之间没有相关性。图片由作者提供。

X_std = (X - np.mean(X))/np.std(X)

Y_std = (Y - np.mean(Y))/np.std(Y)

np.dot(X_std, Y_std)/n

0.2756215872210571

# Using numpy

np.corrcoef(X, Y)

array([[1\. , 0.27562159],

[0.27562159, 1\. ]])

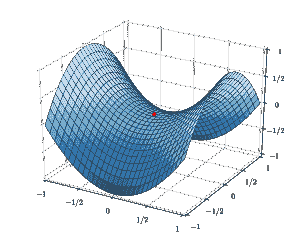

协方差矩阵

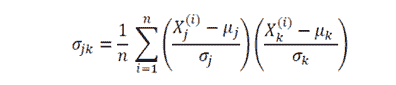

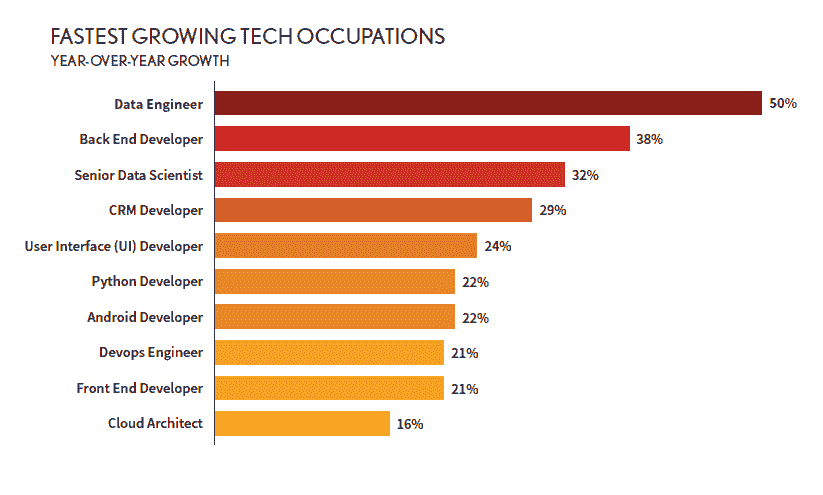

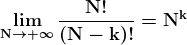

协方差矩阵 是数据科学和机器学习中非常有用的矩阵。它提供了数据集中特征之间的共同变动(相关性)信息。协方差矩阵定义如下:

其中 mu 和 sigma 代表给定特征的均值和标准差。这里的 n 是数据集中观察的数量,j 和 k 的下标取值为 1, 2, 3, . . ., m,其中 m 是数据集中的特征数量。例如,如果一个数据集有 4 个特征和 100 个观察值,则 n = 100,m = 4,因此协方差矩阵将是一个 4 x 4 的矩阵。对角线元素将全为 1,因为它们表示特征与自身之间的相关性,根据定义,相关性等于 1。

协方差矩阵的 Python 实现

假设我想计算 4 只科技股票(AAPL、TSLA、GOOGL 和 AMZN)在 1000 天内的相关程度。我们的数据集有 m = 4 个特征和 n = 1000 个观察值。协方差矩阵将是一个 4 x 4 的矩阵,如下图所示。

技术股票之间的协方差矩阵。图片由作者提供。

生成上述图形的代码可以在这里找到:数据科学和机器学习的基本线性代数。

总结

总之,我们回顾了相关性的基础知识。相关性定义了 2 个变量之间的共同变动程度。相关系数的取值范围在 -1 和 1 之间。接近零的值表示低相关性或无相关性。

本杰明·O·塔约 是物理学家、数据科学教育者和作家,同时也是 DataScienceHub 的拥有者。之前,本杰明曾在中央俄克拉荷马大学、大峡谷大学和匹兹堡州立大学教授工程学和物理学。

更多相关主题

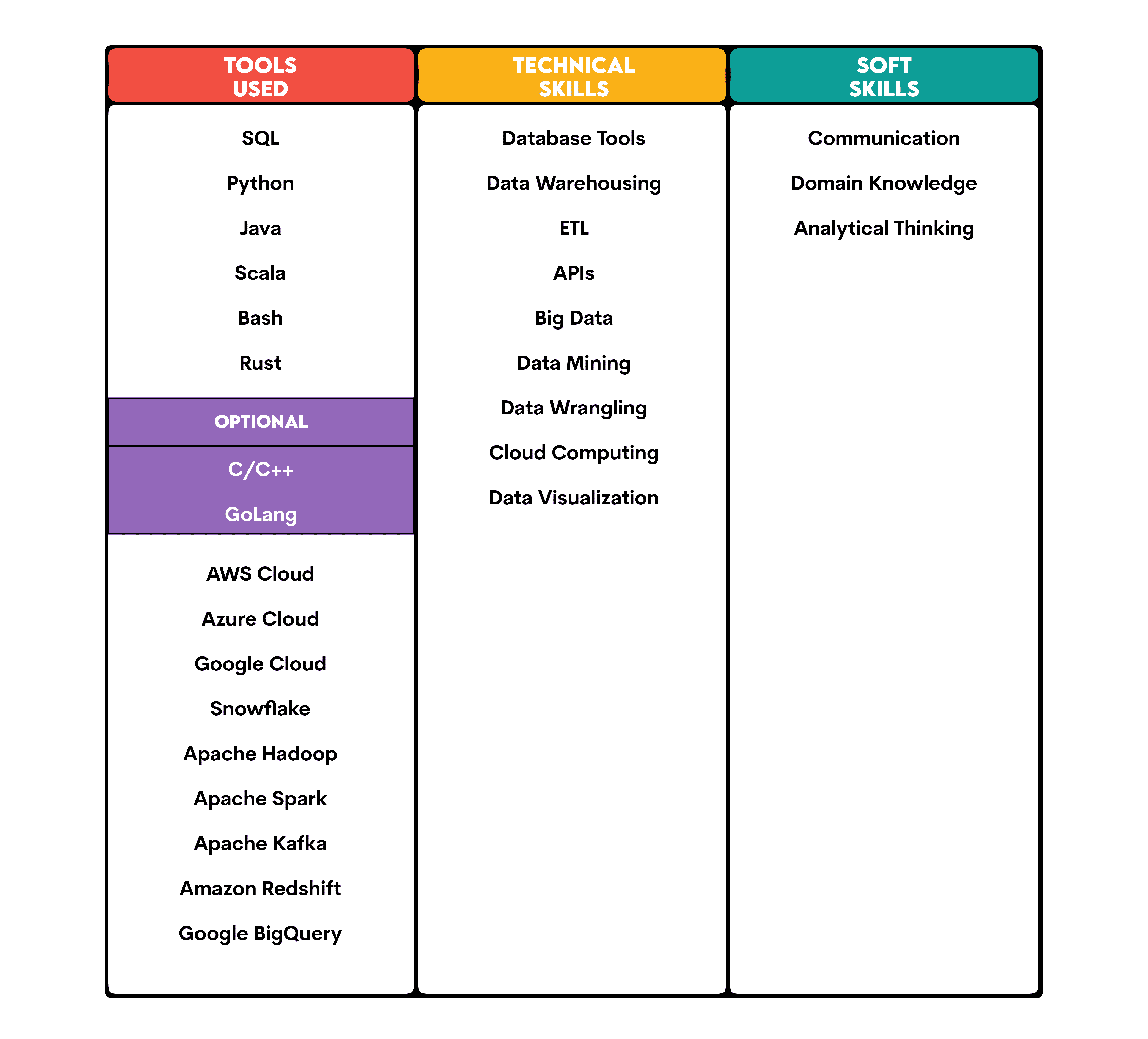

数据工程简介

原文:

www.kdnuggets.com/2020/12/introduction-data-engineering.html

评论

作者:Xinran Waibel,Netflix 的数据工程师。

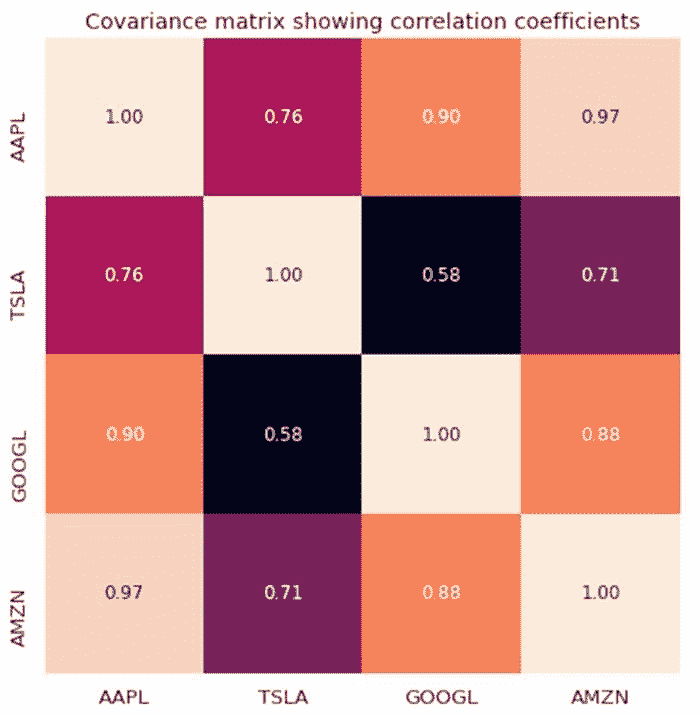

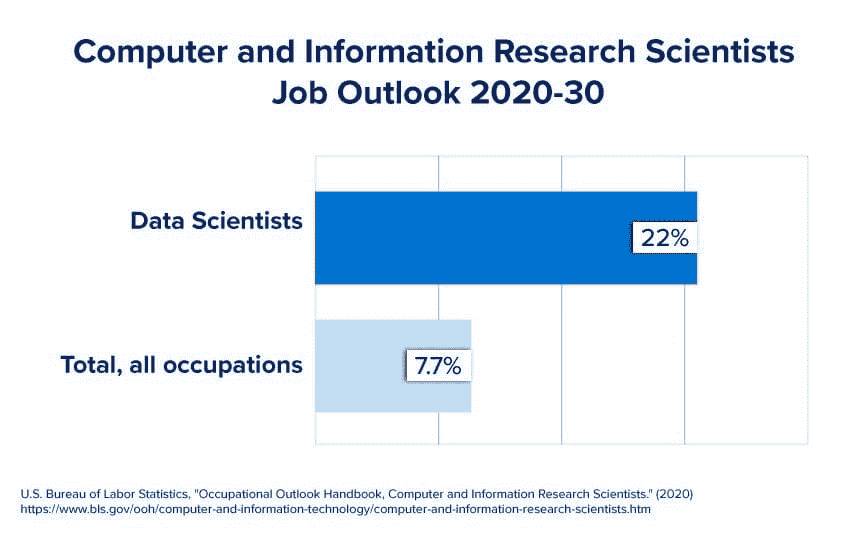

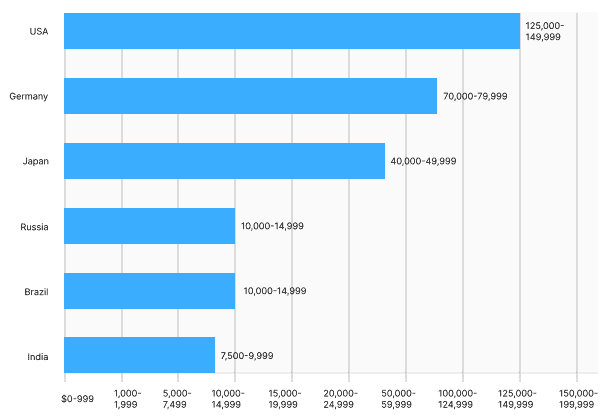

根据最近发布的Dice 2020 科技职位报告,数据工程师是 2019 年增长最快的科技职业,开放职位数量同比增长了 50%。由于数据工程是一个相对较新的职业类别,我经常收到有意从事这一职业的人的问题。在这篇博客文章中,我将分享我成为数据工程师的经历,并回答一些关于数据工程的常见问题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

1. 谷歌网络安全证书 - 快速通道进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

来源:Dice 2020 科技职位报告。

我的数据工程师之旅

几年前,在成为数据工程师之前,我主要从事数据库和应用程序开发(以及规模和性能测试)。我非常喜欢使用RDBMS和数据,因此决定从事专注于大数据的工程职业。在网上研究后,我了解到一种我从未听说过的工作,但认为可能是适合我的“白马王子”:数据工程师。当时我感到迷茫,因为不知道从何开始,也不确定这是否适合我。然而,我幸运地有一位导师,他指导我入门并帮助我获得了第一份数据工程工作。从那时起,我一直在这个领域全职工作,仍然非常热爱!

随便问我什么

图片由Camylla Battani提供,发布在Unsplash上。

问:数据工程师做什么?

简而言之,数据工程师负责设计、开发和维护数据平台,包括数据基础设施、数据应用、数据仓库和数据管道。

在大公司中,数据工程师通常被分成不同的团队,各自负责数据平台的特定部分。

-

数据仓库与管道:数据仓库工程师构建批处理和/或实时数据管道,以整合系统之间的数据并支持data warehouse。由于数据仓库旨在解决业务问题,因此数据仓库工程师通常与数据分析师、科学家或服务于特定业务职能的业务团队密切合作。

-

数据基础设施:数据基础设施工程师构建和维护数据平台的基础:所有运行其上的分布式系统。例如,在 Target,数据基础设施团队维护整个组织使用的Hadoop集群。

-

数据应用:数据应用工程师是构建内部数据工具和 API 的软件工程师。有时,一个出色的内部工具后来可能会成为公司的开源产品。例如,Lyft 的一个数据产品团队构建了一个名为Amundsen的数据发现工具,并于 2019 年开源。

问:什么是数据仓库?

数据仓库是一个数据存储系统,存储来自各种来源的数据,主要用于数据分析。公司的数据通常存储在不同的事务系统中(甚至更糟的是作为文本文件),而事务数据高度规范化,不适合分析。建立数据仓库的主要原因是将所有类型的数据以优化的格式存储在一个集中位置,以便数据科学家可以一起分析这些数据。许多数据库适合作为数据仓库,例如Apache Hive、BigQuery(GCP)和RedShift(AWS)。

问:什么是数据管道?

数据管道是一系列数据处理过程,用于在不同系统之间提取、处理和加载数据。数据管道主要有两种类型:批处理驱动和实时驱动:

-

批处理驱动:批处理数据管道仅在特定频率下处理数据,通常由数据编排工具调度,如Airflow、Oozie或Cron。它们通常一次处理大量历史数据,因此需要较长时间才能完成,并且在最终系统中引入更多数据延迟。例如,一个基于批处理的数据管道每天 12 AM 从 API 下载前一天的数据,转换数据,然后将其加载到数据仓库中。

-

实时:实时数据管道会在新数据可用时立即处理,源系统与终端系统之间几乎没有延迟。实时数据处理的架构与批处理管道非常不同,因为数据被视为事件流,而不是记录块。例如,为了将上述管道重建为实时管道,需要一个像 Kafka 这样的事件流工具:Kafka Connector 将数据从 API 流式传输到 Kafka 主题,Kafka Streams(或 Kafka Producer)处理 Kafka 主题中的原始数据,并将转换后的数据加载到另一个 Kafka 主题中。源 API 和目标 Kafka 主题之间的延迟可能在一秒内!

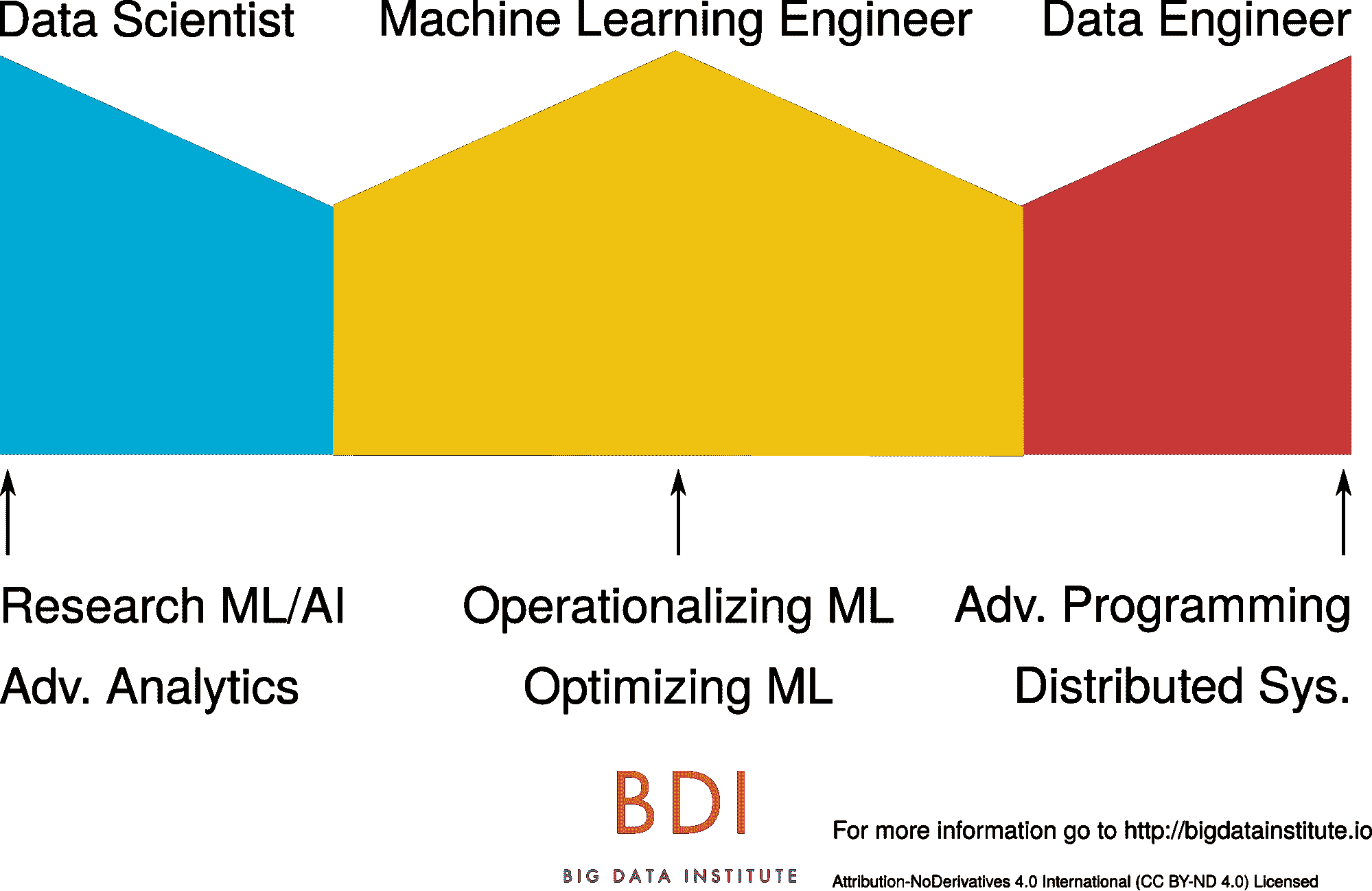

来源:数据工程师与数据科学家。

问:数据工程师与数据科学家的区别是什么?

数据工程师构建数据平台,使数据科学家能够分析数据和训练机器学习 (ML)模型。有时,数据工程师也需要进行数据分析,并帮助数据科学家将 ML 模型集成到数据管道中。在一些数据团队中,你可能会发现数据科学家从事数据工程工作。数据工程师和数据科学家之间有几个重叠的技能:编程、数据管道建设和数据分析。

有一个新兴角色叫做 ML 工程师,负责在两个领域之间搭建桥梁。ML 工程师在工程和机器学习方面拥有强大的技能,负责优化和生产化 ML 模型。

照片由 Christopher Gower 提供,来自 Unsplash。

问:要成为数据工程师,我应该学习哪些编程语言?

简短的答案是:Python、Java/Scala 和 SQL。

对于数据应用轨道,你还需要学习用于 全栈 开发的常见编程语言,例如 HTML、CSS 和 JavaScript。

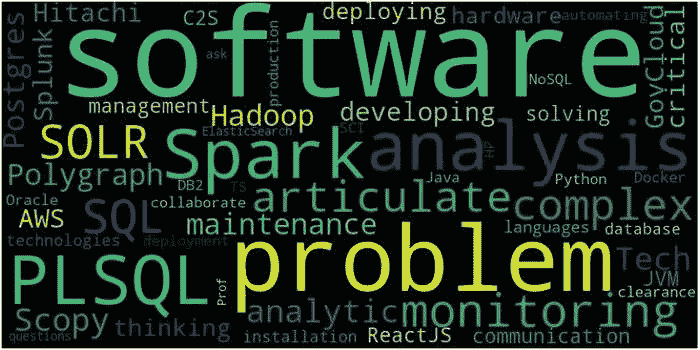

问:我应该学习哪些技能和工具?

以下是核心技能列表以及一个流行的框架:

-

分布式系统: Hadoop

-

数据库: MySQL

-

数据处理: Spark

-

实时数据生态系统: Kafka

-

数据编排:Airflow

-

数据科学和机器学习:pandas(Python 库)

-

全栈开发:React

由于大数据世界中不再存在一刀切的解决方案,每家公司都在为其数据平台利用不同的工具。因此,我建议你首先学习每个核心技能的基础知识,然后选择一个流行的工具深入学习,并理解你选择的工具与其他工具之间的权衡。要达到下一个层次,你还需要了解所有工具如何在数据架构中协同工作。

(对高效学习技术栈感兴趣?查看一下系统化学习方法。)

今天,地球上每个人每秒钟生成大约 1.7MB 的新数据,这些数据包含巨大的价值,没有数据工程无法收获。这就是为什么我如此热爱我的工作的原因。 😃

原文。转载已获许可。

简介: Xinran Waibel 是一位经验丰富的数据工程师,现居旧金山湾区,目前在 Netflix 工作。她还是《Towards Data Science》、《Google Cloud》和 Medium 上的《The Startup》的技术作家。

相关:

更多相关内容

数据科学入门:初学者指南

原文:

www.kdnuggets.com/2023/07/introduction-data-science-beginner-guide.html

作者提供的图片

你在过去的二十年里没有生活在石头下,所以你可能或多或少知道什么是数据科学。你可能希望对其进行简要概述,以了解开始学习数据科学并找到工作所需的内容。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

本文将为你提供的要点如下:

-

数据科学的核心点是:数据进入,洞察输出。数据科学家的工作是管理数据到洞察的每个阶段。

-

你需要哪些工具、技术和技能才能获得数据科学工作。

-

数据科学作为职业的整体状况。

如果这听起来像是你在寻找的内容,那就让我们深入了解吧。

什么是数据科学?

正如我之前所说,数据科学最好总结为一个数据到洞察的流程。作为数据科学家,无论你在哪家公司,你都会执行以下任务:

-

提取数据

-

清洗或处理数据

-

分析数据

-

识别模式或趋势

-

在数据上构建预测和统计模型

-

可视化和沟通数据

简而言之,你在解决问题、做出预测、优化过程和指导战略决策。

因为很少有公司能准确掌握数据科学家的工作内容,所以你可能还会有其他责任。一些雇主希望数据科学家在角色中加入信息安全或网络安全的职责。其他人可能期望数据科学家具备云计算、数据库管理、数据工程或软件开发的专长。要准备好担任多个角色。

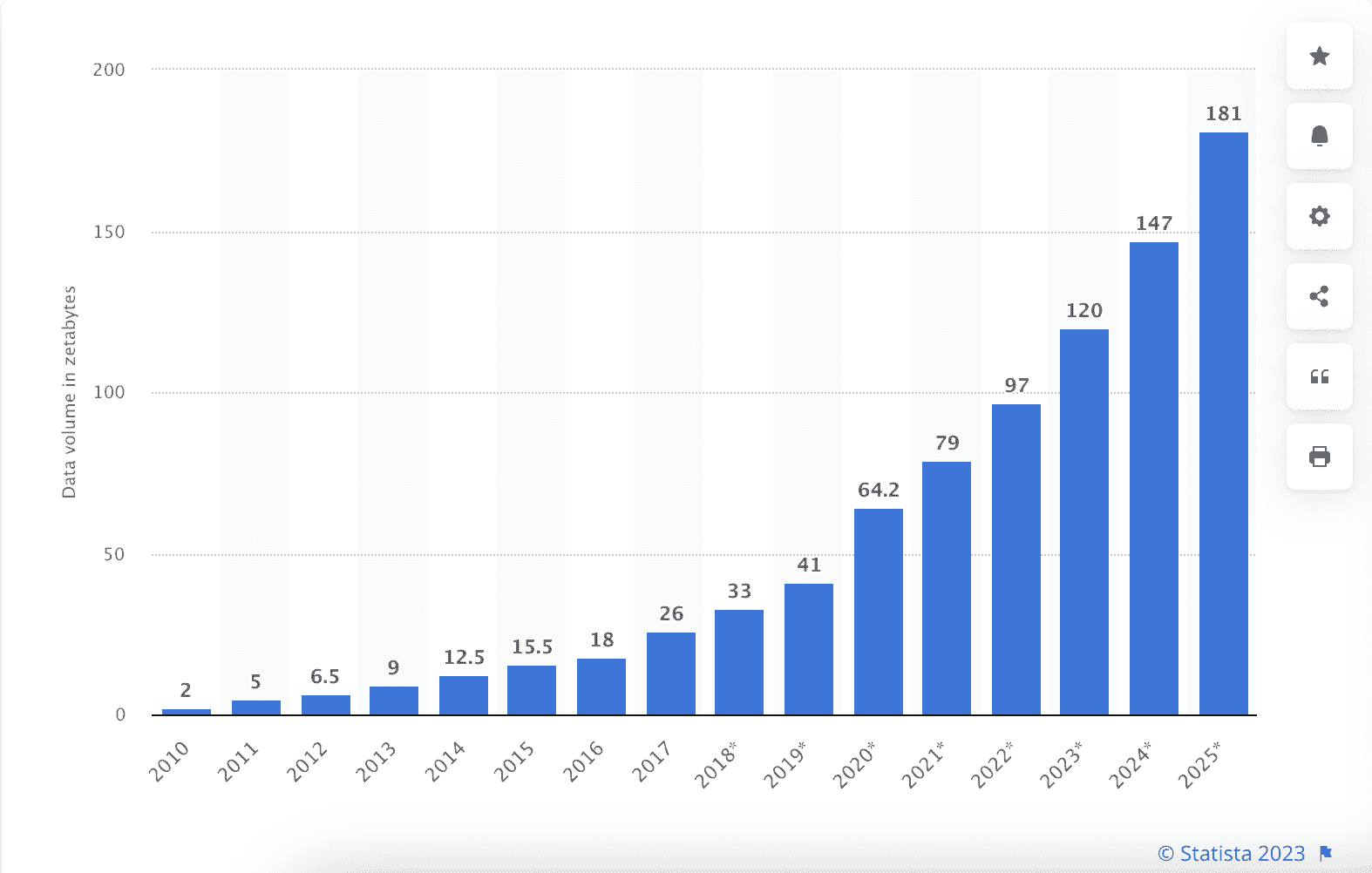

这份工作之所以重要,不是因为《哈佛商业评论》称其为 21 世纪最性感的工作,而是因为数据量在不断增加,而很少有人知道如何将数据转化为洞察。作为数据科学家,你能看清全貌。

全球从 2010 年到 2020 年创建、捕捉、复制和消费的数据/信息量,以及 2021 年至 2025 年的预测

来源:www.statista.com/statistics/871513/worldwide-data-created/

数据科学中的关键概念

现在你已经了解了大概念。让我们来看看数据科学中的一些关键概念。如果你能设想数据到见解的流程,我将确定每个关键概念的作用。

数据处理

在流程的最开始,你得到的是一堆混合质量的数据。一个著名的(而且不正确的)统计数据指出数据科学家花费 80%的时间来清理数据。虽然这可能没有那么高,但建立数据处理流程和调整数据是工作中的重要部分。

想象一下你是一个电商公司的数据科学家。在那里,数据处理可能涉及清理和转换客户交易数据,合并和调和来自不同来源的数据,如网站分析和客户关系管理(CRM)系统,以及处理缺失或不一致的数据。

你可能需要标准化格式,删除重复项或 NaN,并处理离群值或错误条目。这个过程确保数据准确、一致,并准备好进行分析。

数据探索和可视化

一旦数据被整理好,你现在可以开始查看它了。你可能认为数据科学家会立刻将统计模型应用于数据,但事实是模型种类繁多。首先,你需要了解你所拥有的数据类型。然后你可以寻找重要的见解和预测。

例如,如果你是 GitHub 的数据科学家,数据探索可能涉及分析平台上的用户活动和参与度。你可以查看提交次数、拉取请求和问题等指标,以及用户互动和合作情况。通过探索这些数据,你可以了解用户如何与平台互动,识别受欢迎的代码库,并发现软件开发实践中的趋势。

由于大多数人对图片的意义解析要优于对表格的解析,因此数据可视化也被纳入数据探索中。例如,作为 GitHub 的数据科学家,你可能会使用折线图来展示随时间变化的提交次数。柱状图可以用来比较平台上不同编程语言的流行度。网络图可以用来展示用户或代码库之间的合作关系。

来源:www.reddit.com/r/DataScienceMemes/comments/nzoogr/i_dont_like_gravy/

统计分析

在数据科学的数据到洞见流程的这一阶段,你已经完成了前两个部分的数据处理。数据已经到位,你正在对其进行探查和分析。现在是时候提取洞见了。最后,你可以对你的数据进行一些统计分析。

假设你是一家类似于 Hello Fresh 的公司的数据科学家。你可能会进行线性回归等统计分析,以了解影响客户流失的因素,使用聚类算法根据客户的偏好或行为对客户进行分组,或进行假设检验以确定营销活动的有效性。这些统计分析有助于揭示数据中的关系、模式和重要发现。

机器学习

数据科学家的酷炫之处在于他们可以预测未来。想象数据到洞见的流程。你对过去和现在的情况有了洞察。但你的老板可能会问:如果我们添加一种新产品会发生什么?如果我们在周一关门会怎么样?如果我们将一半的车队转换为电动车会怎样?

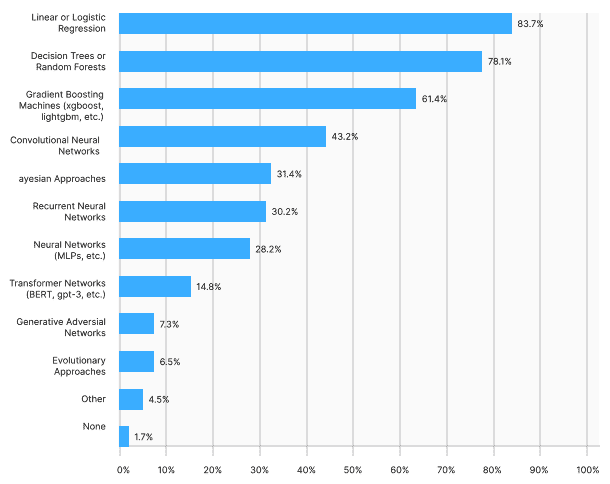

作为数据科学家,你像看水晶球一样利用机器学习创建智能预测。例如,假设你是物流公司 FedEx 的数据科学家。你可以利用历史运输数据、天气数据以及其他相关变量来开发预测模型。这些模型可以预测运输量、估计交货时间、优化路线规划或预测潜在的延误。

通过使用回归、时间序列分析或神经网络等机器学习算法,你可以预测添加一个新的配送中心对交货时间的影响,模拟不同操作变更对运输成本的影响,或预测对特定运输服务的客户需求。

沟通与商业智能

数据科学中最重要的概念不是机器学习或数据清洗,而是沟通。你需要将这些洞见呈现给公司中的决策者,他们可能对神经网络和梯度提升算法一无所知。沟通和商业敏锐度在数据科学中都是关键概念。

想象你是一家类似于 Meta 的公司的数据科学家。你刚刚发现用户参与指标与客户留存率之间有显著的相关性,但你需要将其与一位不熟悉“统计显著性”概念的营销副总裁分享。你还需要熟悉客户终生价值(CLV),以便能够解释你发现的相关性和重要性。

数据科学家的基本技能

我们已经覆盖了数据科学中的关键概念。现在让我们来看一下作为数据科学家你需要掌握的基本技能。如果你有兴趣了解更多,我在这里介绍了一些更具体的数据科学家所需技能。

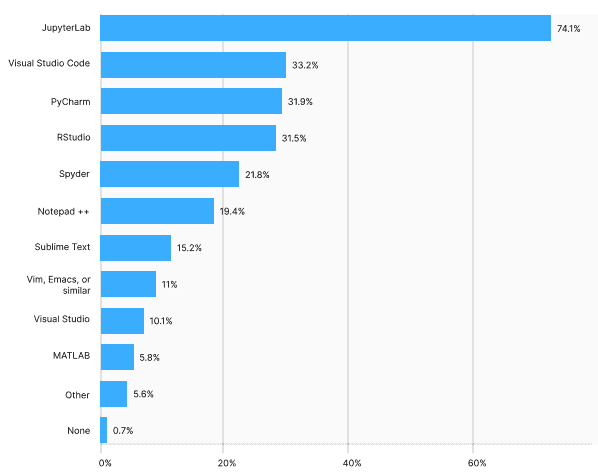

编程语言、数据查询和数据可视化

很难对技能的重要性进行排名——数据科学家需要各种技能,这些技能都同等重要。也就是说,如果有一种技能是绝对不可或缺的,那一定是编码。

编码分为几个方面——你需要编程语言,通常是 R 或 Python(或两者)。你还需要数据检索和操作的查询语言,如 SQL(结构化查询语言)用于关系数据库。最后,你可能还需要了解其他语言或程序,如 Tableau 进行数据可视化,尽管值得一提的是,现在很多数据可视化是用 Python 或 R 完成的。

数学

还记得我之前提到的统计学吗?作为数据科学家,你需要知道如何进行数学计算。数据可视化只能走到一定程度,之后你需要一些实际的统计显著性。关键的数学技能包括:

-

概率与统计:概率分布、假设检验、统计推断、回归分析和方差分析(ANOVA)。这些技能使你能够做出可靠的统计判断,并从数据中得出有意义的结论。

-

线性代数:向量和矩阵运算、线性方程组的求解、矩阵分解、特征值和特征向量,以及矩阵变换。

-

微积分:你需要熟悉导数、梯度和优化等概念,以训练模型、优化和微调模型。

-

离散数学:如组合学、图论和算法。你将使用这些知识进行网络分析、推荐系统和算法设计。对于开发处理大规模数据的算法来说,这非常重要。

模型管理

让我们谈谈模型。作为数据科学家,你需要知道如何构建、部署和维护模型。这包括确保模型与现有基础设施的无缝集成,解决可扩展性和效率问题,并持续评估模型在实际场景中的表现。

在技术方面,这意味着你需要熟悉:

-

机器学习库:这些包括 Python 中的 scikit-learn、TensorFlow、PyTorch 或 Keras 进行深度学习,以及 XGBoost 或 LightGBM 进行梯度提升。

-

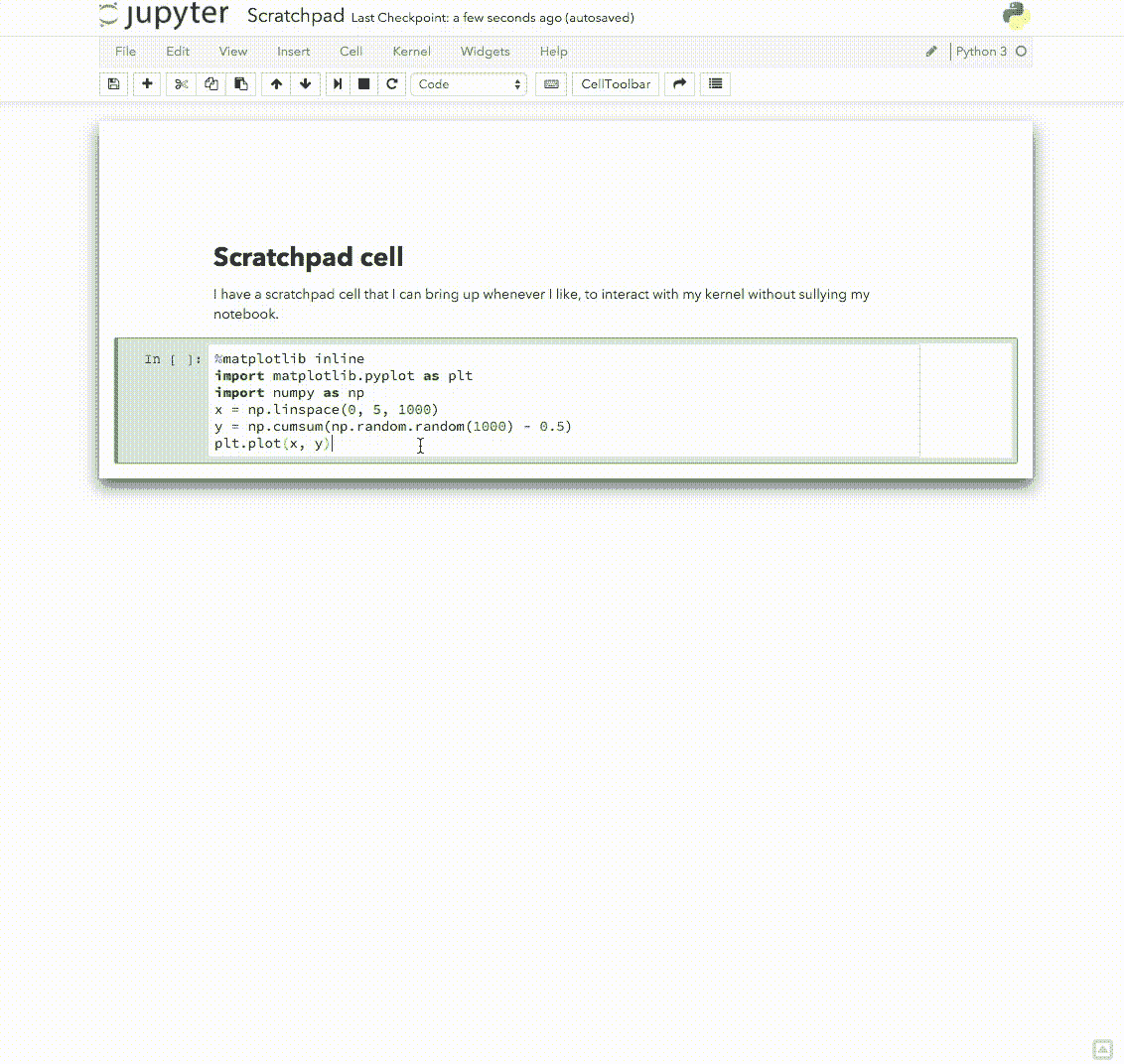

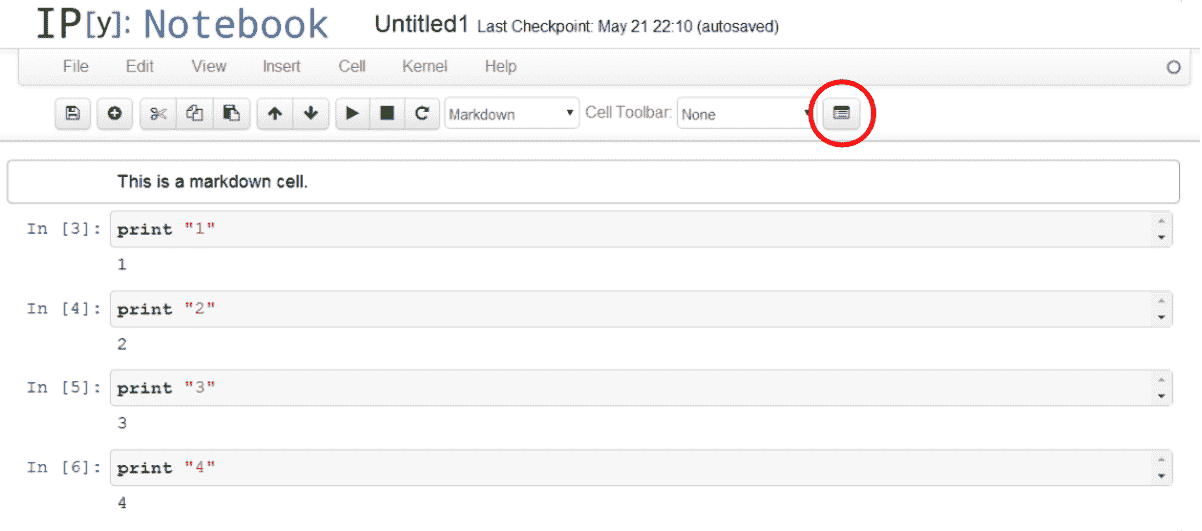

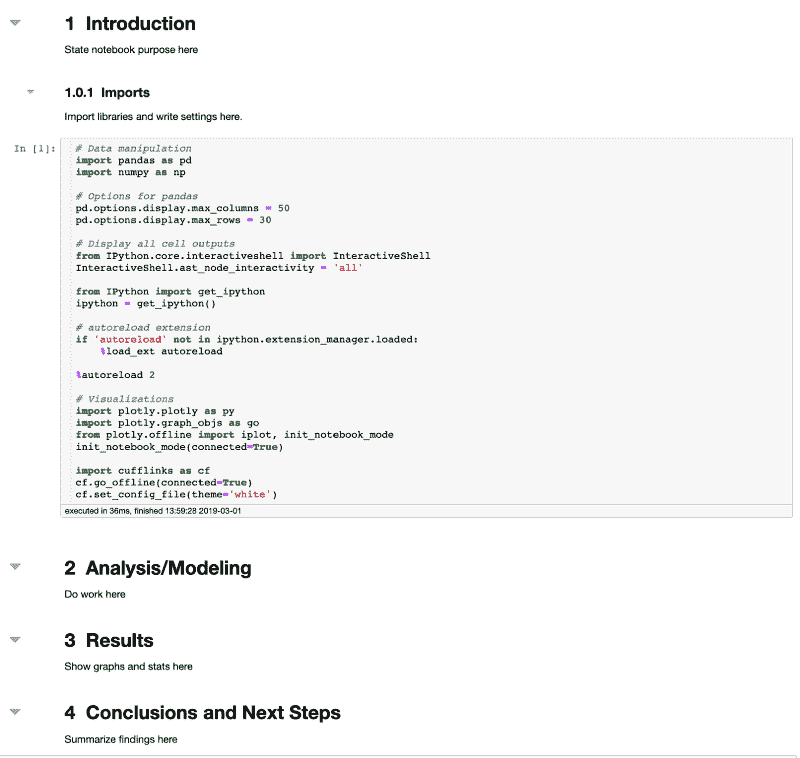

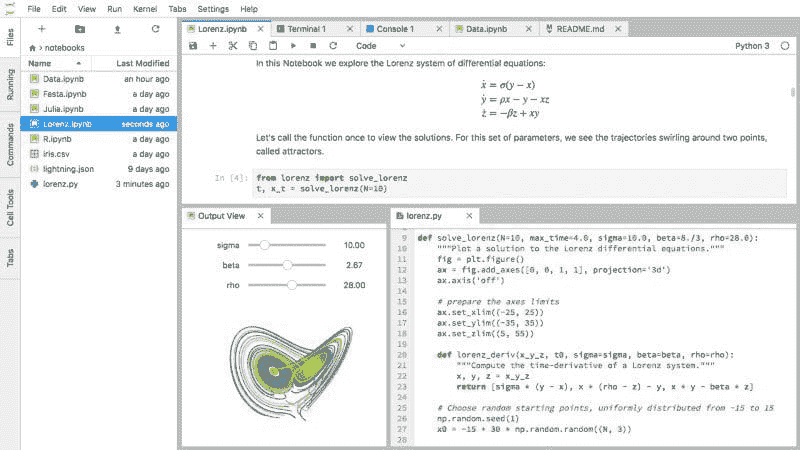

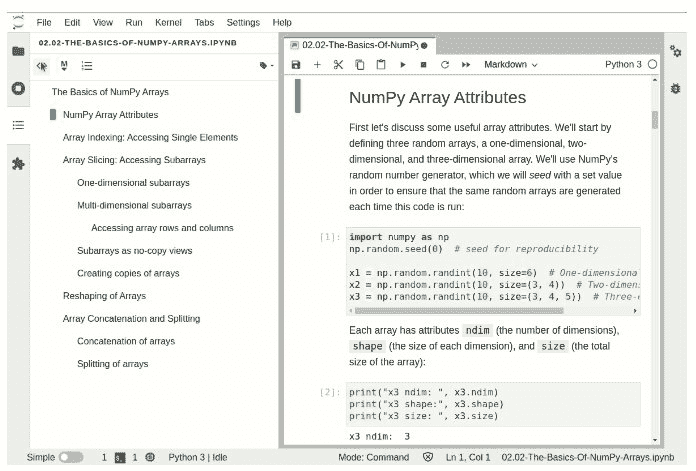

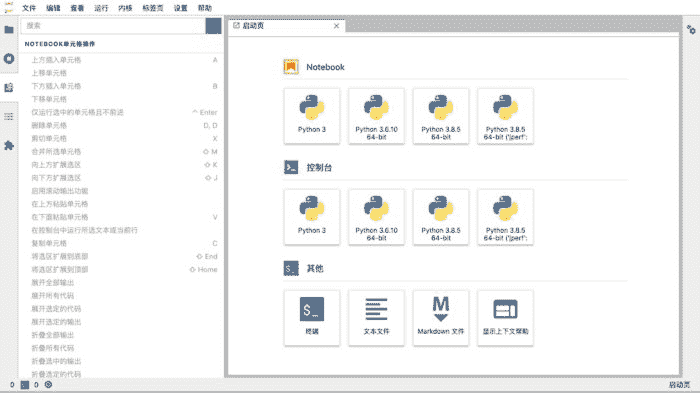

模型开发框架:如 Jupyter Notebook 或 JupyterLab,用于互动和协作的模型开发。

-

云平台:考虑使用亚马逊网络服务(AWS)、微软 Azure 或谷歌云平台(GCP)来部署和扩展机器学习模型。

-

自动化机器学习(AutoML):Google AutoML、H2O.ai 或 DataRobot 自动化构建机器学习模型的过程,无需大量手动编码。

-

模型部署与服务:Docker 和 Kubernetes 通常用于将模型打包并部署为容器。这些工具使得模型可以在不同环境中部署和扩展。此外,像 Python 中的 Flask 或 Django 工具可以让你创建 Web API 来服务模型,并将其集成到生产系统中。

-

模型监控与评估:使用 Prometheus、Grafana 或 ELK(Elasticsearch、Logstash、Kibana)堆栈进行日志聚合和分析。这些工具有助于跟踪模型指标、检测异常,并确保模型随着时间的推移继续表现良好。

沟通

到目前为止,我们已经覆盖了“硬技能”。现在,让我们思考一下你需要什么软技能。如我在“概念”部分提到的,你需要的一项重要技能是沟通。以下是作为数据科学家你需要进行的一些沟通示例:

-

数据讲述:你需要将复杂的技术概念转化为清晰、简洁且引人入胜的叙述,这些叙述能够引起你的听众共鸣,包括你的分析的重要性及其对决策的影响。

-

可视化:是的,数据可视化在沟通技能中有一个小节。除了创建图表的技术能力,你还应该知道何时、何种类型以及如何谈论你的数据可视化。

-

协作与团队合作:没有数据科学家在孤立环境中工作。你将与数据工程师、业务分析师和领域专家合作。练习你的积极倾听和建设性反馈技能。

-

客户管理:这并非所有数据科学家的情况,但有时你会直接与客户或外部利益相关者合作。你需要培养强大的客户管理技能,包括理解他们的需求、管理期望以及定期提供项目进展更新。

-

持续学习与适应能力:最后但同样重要的是,你需要随时准备学习新事物。保持对领域最新进展的了解,并开放地获取新技能和知识。

商业头脑

这归结于在你业务的背景下了解一个数字的重要性。例如,你可能会发现人们在周日购买鸡蛋与天气之间存在高度显著的关系。但这对你的业务有何意义?

在这种情况下,你可能会进一步分析,发现周日鸡蛋购买的增加与晴朗的天气相关,这表明客户在天气良好时更可能参与户外活动或举办早午餐。这一洞察可以被超市或餐厅利用,以便相应地计划库存和促销活动。

通过将数据模式与业务结果联系起来,你可以提供战略指导和可操作的建议。在这个例子中,这可能涉及到在晴朗的周末优化与鸡蛋相关的营销活动,或探索与本地早午餐场所的合作。

数据科学工作流程

数据科学家做什么?为了了解这一点,让我们看看数据科学项目中涉及的典型步骤:问题定义、数据收集、数据清理、探索性数据分析、模型构建、评估和沟通。

我将通过一个例子来说明每一步:在本节其余部分中,假设你作为一家电子商务公司的数据科学家,公司营销团队希望提高客户留存率。

1. 问题定义:

这意味着你需要了解业务目标,明确问题陈述,并定义衡量客户留存的关键指标。

你将致力于识别导致客户流失的因素,并制定减少流失率的策略。

为了衡量客户留存,你需要定义关键指标,包括客户流失率、客户生命周期价值(CLV)、重复购买率或客户满意度评分。通过定义这些指标,你建立了一种量化的方法来跟踪和评估提高客户留存的策略效果。

2. 数据收集

收集相关的数据源,如客户购买历史、人口统计信息、网站互动和客户反馈。这些数据可以从数据库、API 或第三方来源获取。

3. 数据清理

收集的数据几乎肯定会包含缺失值、异常值或不一致之处。在数据清理阶段,你需要通过处理缺失值、删除重复项、处理异常值和确保数据完整性来预处理和清理数据。

4. 探索性数据分析(EDA)

接下来,通过可视化数据、检查统计摘要、识别相关性以及发现模式或异常来深入了解数据及其特征。例如,你可能会发现经常购买的客户通常具有更高的留存率。

5. 模型构建

开发预测模型来分析不同变量与客户留存之间的关系。例如,你可以构建像逻辑回归或随机森林这样的机器学习模型,以预测客户流失的可能性,基于诸如购买频率、客户人口统计信息或网站参与指标等各种因素。

6. 评估

使用准确率、精确率、召回率或 ROC 曲线下面积等指标来评估模型的性能。你通过交叉验证或训练-测试拆分等技术来验证模型的可靠性。

7. 沟通

你已经获得了一些发现——现在与大家分享吧。按照我们的示例,你需要能够在你所在公司的业务背景以及更广泛的商业环境中,智能地讨论你的客户流失结果。让大家关注,并解释这个特定发现的重要性以及他们应该怎么做。

例如,在分析客户流失后,你可能会发现客户满意度评分和流失率之间存在显著的相关性。

当你与市场营销团队或高级主管分享时,你需要有效地传达其影响和可操作的见解。你会解释通过改进客户支持、个性化体验或有针对性的促销,关注提升客户满意度,公司可以减轻流失、保留更多客户,并最终带来更高的收入。

此外,你需要将这一发现置于更广泛的商业环境中进行分析。比较你公司与竞争对手的流失率。

所以这就是你如何从数据湖转变为实际业务输入。最终,请记住数据科学是迭代和循环的。你会重复这个过程的各个步骤以及整个过程,以寻求有趣的见解,回答商业问题,并为你的雇主解决问题。

数据科学应用

数据科学是一个广阔的领域。你可以发现数据科学家几乎在每一个行业、任何规模的公司中工作。这是一个关键角色。

这里有一些现实世界的例子,展示了数据科学在解决复杂问题中的影响:

-

医疗保健:数据科学家分析大量医疗数据以改善患者结果和医疗服务。他们开发预测模型以识别高风险患者,优化治疗计划,并检测疾病爆发中的模式。

-

财务:考虑风险评估、欺诈检测、算法交易和投资组合管理。数据科学家开发模型,以帮助做出明智的投资决策和管理金融风险。

-

运输与物流:数据科学家优化路线规划,减少燃料消耗,提高供应链效率,并预测维护需求。

-

零售和电子商务:数据科学家分析客户数据、购买历史、浏览模式和人口统计信息,开发模型以推动客户参与,增加销售,并改善客户满意度。

数据科学入门

好的,这信息量很大。到现在为止,你应该已经清楚数据科学是什么,它如何运作,你应该熟悉哪些工具和技术,以及数据科学家的工作内容。

现在我们来看一下在哪里学习和实践数据科学。这可能会成为一篇独立的文章,所以我将链接到你可以开始的资源列表。

-

最佳免费数据科学课程

-

数据科学的最佳学习资源(书籍、课程和教程)

-

数据科学可视化最佳实践

-

获取数据以进行数据科学项目的最佳网站

-

最佳平台以练习关键数据科学技能

总的来说,我建议你这样做:

-

制定你需要的技能清单,参考这篇博客文章和数据科学家的职位描述。

-

先从免费资源入门,然后寻找优质的付费平台以深入学习。

-

建立项目和库的组合。

-

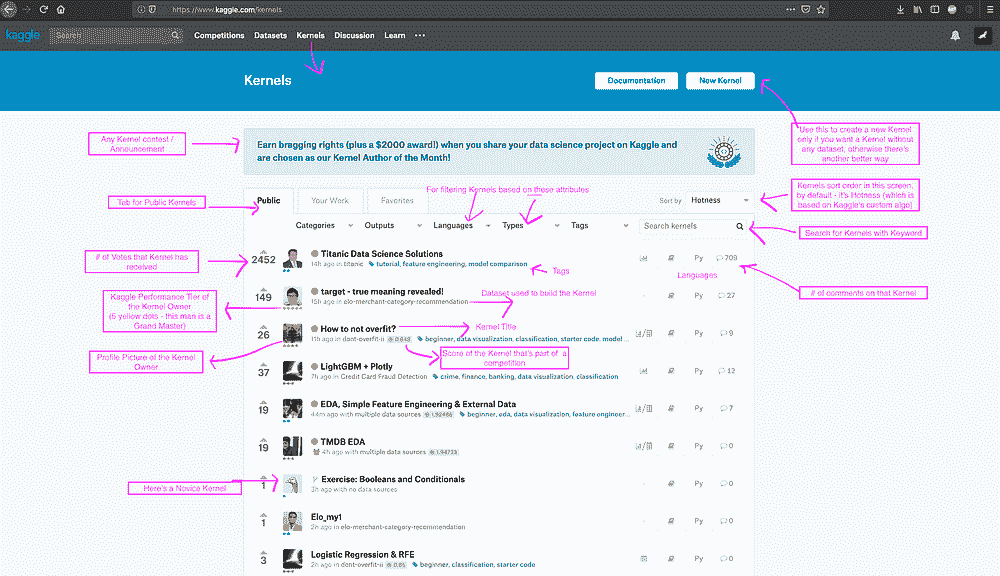

在像 Kaggle 和 StrataScratch 这样的平台上进行实践。

-

获得认证——一些平台如 LinkedIn 提供认证,以证明你具备相关技能。

-

开始申请。

-

网络建设——加入社区、Slack 群组和 LinkedIn 群组,参加活动。

最终,你可以预期这个过程会需要一些时间。但最终是值得的。

职业机会和职业路径

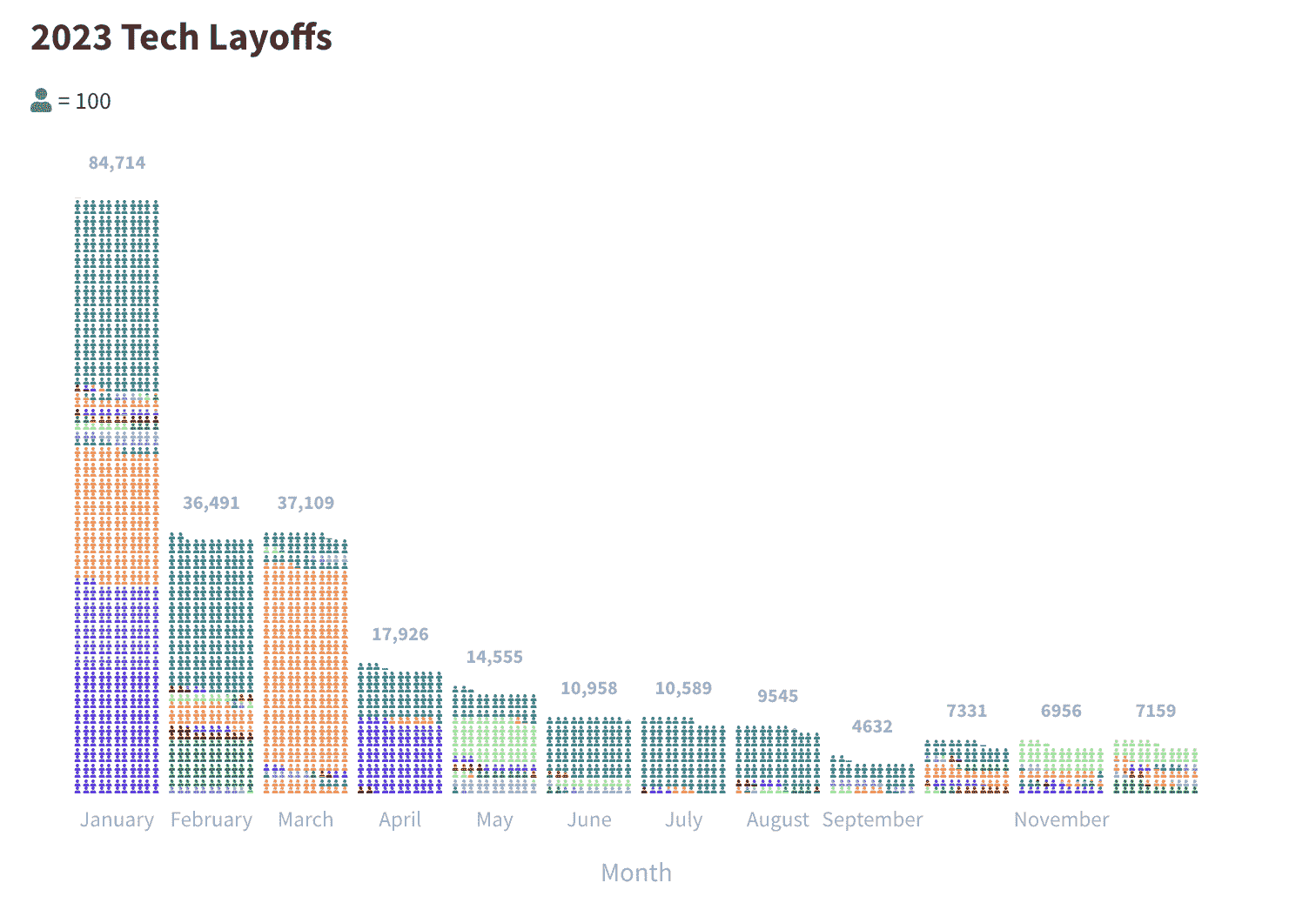

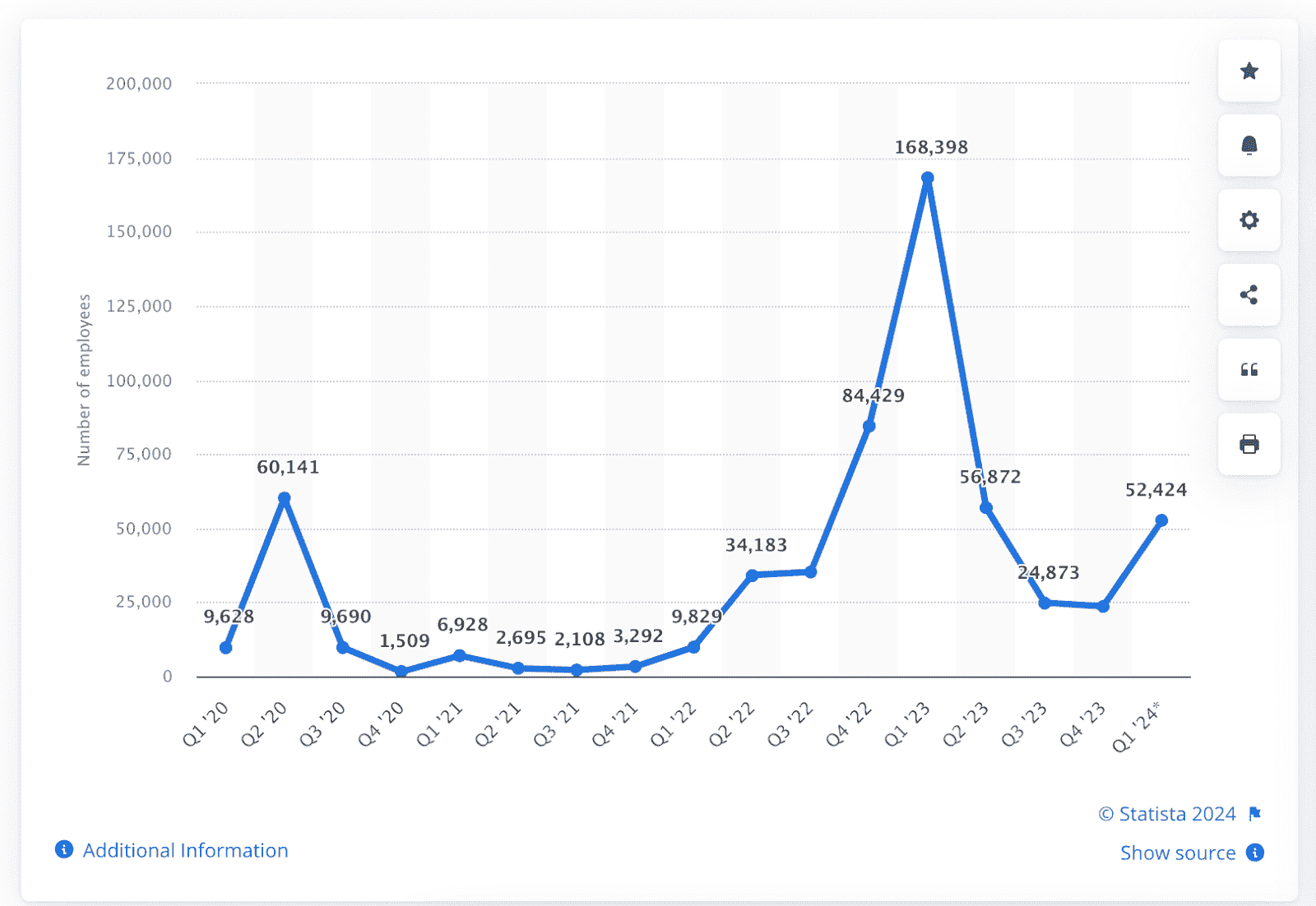

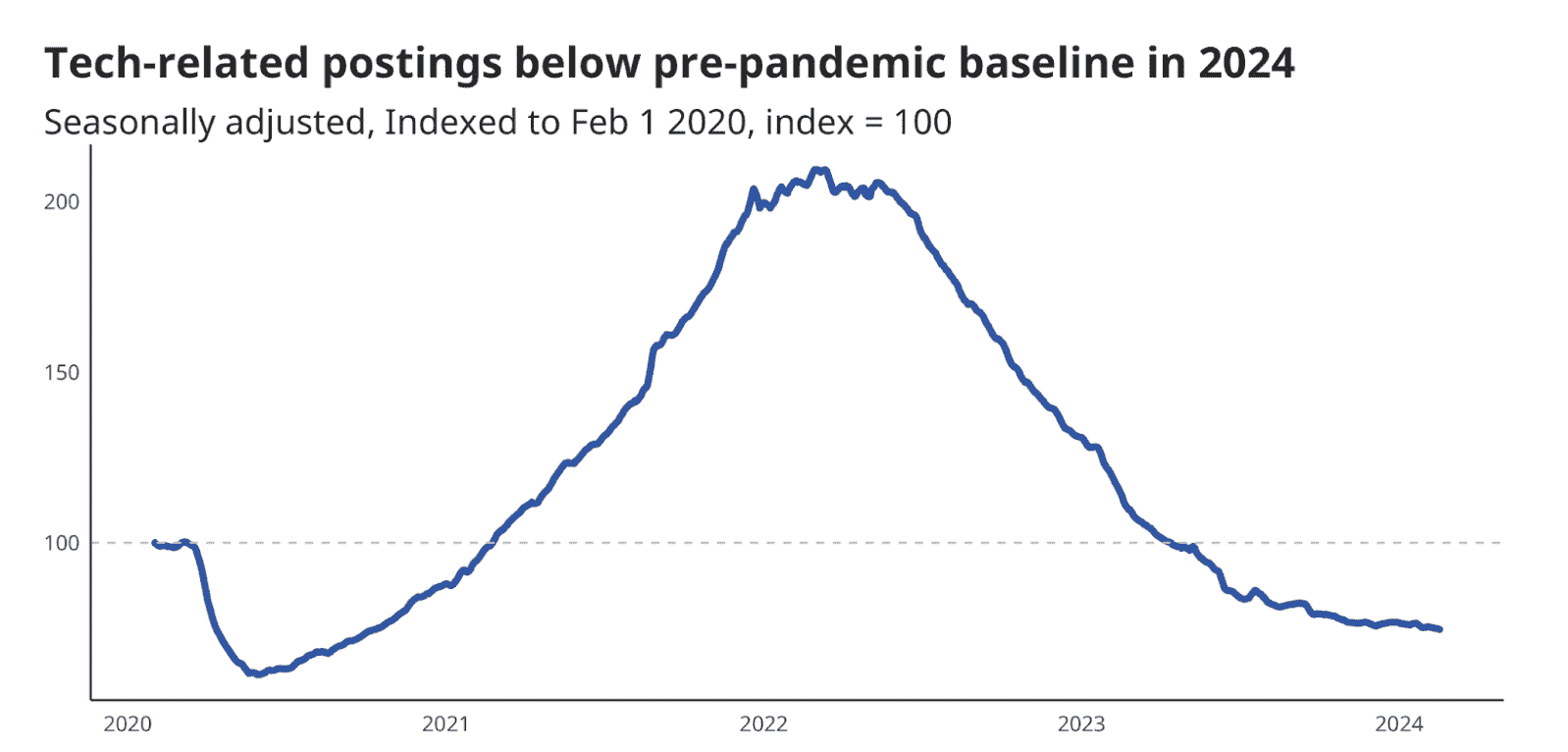

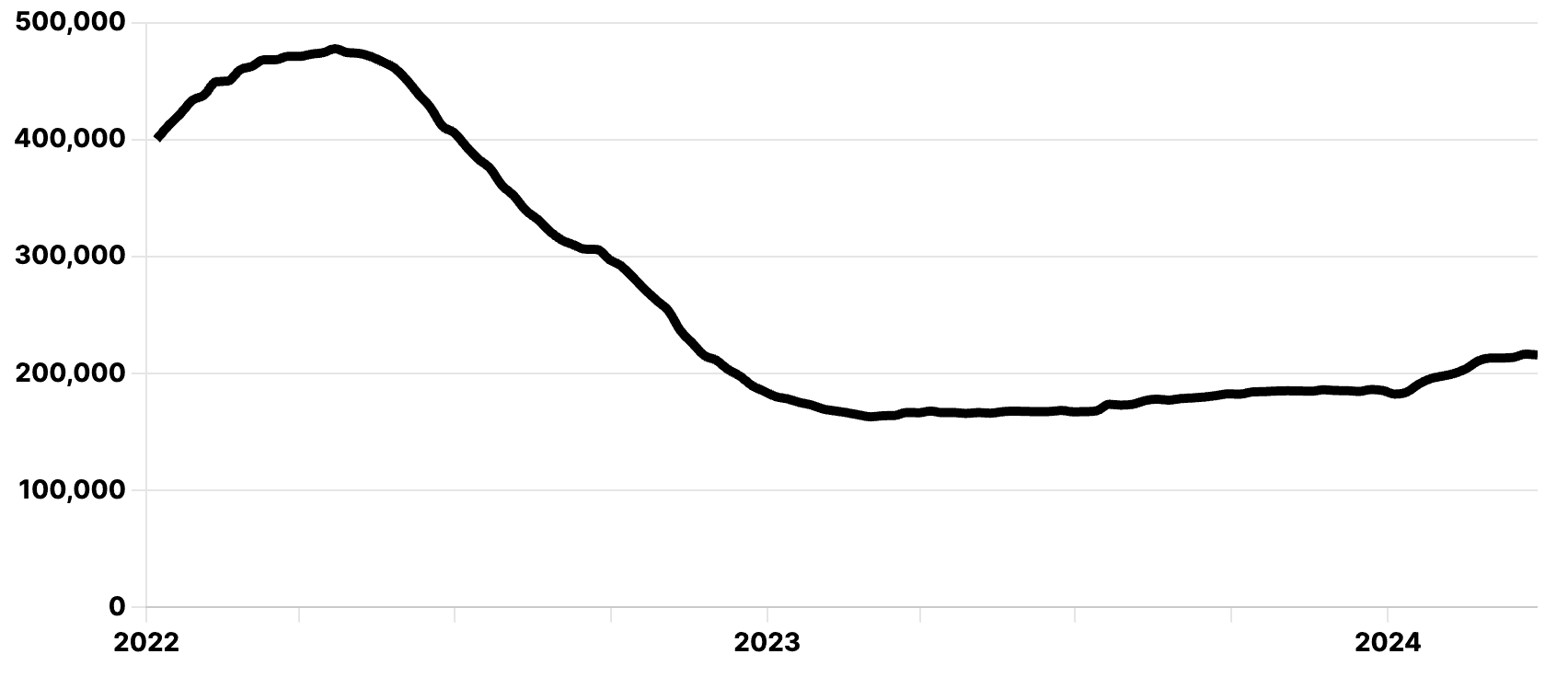

尽管FAANG 裁员的新闻不断,依据US News and World Report 2022的排名,信息安全分析师、软件开发人员、数据科学家和统计学家仍位列前十名工作。

来源: bootcamp.cvn.columbia.edu/blog/data-scientist-career-path/

求职市场依然火热。公司仍然需要数据科学家。如果你在找数据科学家的工作时遇到困难,请记住你不必从零开始。我建议你从更初级的岗位入手,随着时间的推移逐步过渡到这一角色。你可以从数据分析师、数据工程师或机器学习工程师做起。

结论

很难为数据科学写一个介绍,因为这是一个庞大的领域,正在不断发展,越来越多的技术和工具每天都在添加。如果你从这篇文章中学到几件事,那就是:

-

数据科学需要多学科的综合方法。你需要掌握来自多个领域的技能,包括统计学、机器学习、编程和领域专长。而学习是永无止境的。

-

数据科学是迭代的。它非常依赖过程,但你可以期待在继续工作过程中反复优化和更新你的过程。成功且快乐的数据科学家拥抱实验。

-

软技能至关重要。你不能仅仅成为一个 Python 高手;你需要用故事、数据和图表将发现和见解传达给非技术利益相关者。

希望这些能为你提供一个起点。数据科学是一个既有回报又具挑战性的职业道路。如果你学习这些技能并付诸实践,你将能够迅速进入这个领域。

内特·罗西迪 是一名数据科学家,专注于产品战略。他还是一名兼职教授,教授分析学,并且是 StrataScratch 的创始人,该平台帮助数据科学家通过来自顶级公司的真实面试题来准备面试。你可以通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

更多相关内容

使用 Matplotlib 进行数据可视化简介

原文:

www.kdnuggets.com/2022/12/introduction-data-visualization-matplotlib.html

图片来源于作者

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

许多组织收集大量数据以进行业务决策。数据可视化 是将这些信息以各种图表和图形的形式呈现的过程。它简化了复杂数据,使得识别模式、分析趋势和发现可操作的见解变得更加容易。Matplotlib 是一个多平台的数据可视化库,使用 Python 编写。它最初是为了模拟 MATLAB 的绘图功能而创建的,但它强大且易于使用。Matplotlib 的一些优点如下:

-

更容易自定义

-

更适合入门

-

高质量输出

-

轻松获取

-

提供对图形各个元素的良好控制

入门

安装 Matplotlib

要安装 Matplotlib,请在 Windows、Mac OS 和 Linux 的终端中运行以下命令:

pip install matplotlib

对于 Jupyter notebook:

!pip install matplotlib

对于 Anaconda 环境:

conda install matplotlib

导入库

import numpy as np

import pandas as pd #If you are reading data from CSV

import matplotlib.pyplot as plt

Matplotlib 基础

创建图形

在 matplotlib 中创建图形有两种方法:

1) 函数式方法

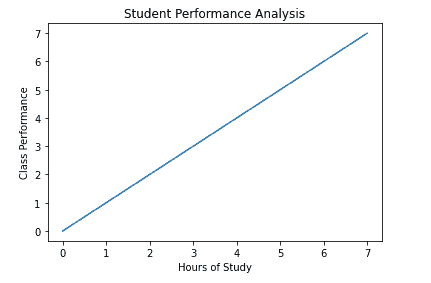

它们使用简单,但不允许非常高的控制程度。它使用 py.plot(x,y) 函数。我们在本教程的其他地方不会使用它,但你应该了解它的工作原理,所以让我们看看其中一个示例。

x = np.arange(0,8)

y = x

plt.plot(x, y)

plt.xlabel('Hours of Study')

plt.ylabel('Class Performance')

plt.title('Student Performance Analysis')

plt.show() # For non-jupyter users

2) OOP 方法

OOP 方法是创建图形的推荐方式。它通过创建图形对象,然后将坐标轴添加到其中来实现。图形对象在没有添加坐标轴之前是不可见的。

fig = plt.figure()

在我们绘制坐标轴之前,让我们理解其语法。

figureobject.add_axes([a,b,c,d])

这里的 a,b 指的是原点的位置。(0,0) 代表左下角,c,d 设置绘图的宽度和高度。两个值的范围从 0 到 1。

fig = plt.figure() # blank canvas

axes = fig.add_axes([0, 0, 0.5, 0.5])

axes.plot(x, y)

plt.show()

图形对象可以接受一些额外的参数,如 dpi 和图形大小。Dpi 指的是每英寸的点数,如果图形模糊,可以增加分辨率。图形大小则控制图形的尺寸(以英寸为单位)。

fig = plt.figure(figsize=(0.5,0.5),dpi=200) # blank canvas

axes = fig.add_axes([0, 0, 0.5, 0.5])

axes.plot(x, y)

plt.show()

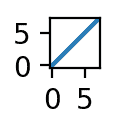

你还可以按照如下方式将多个坐标轴添加到图形对象中:

a = np.arange(0,50)

b = a**3

fig = plt.figure()

outer_axes = fig.add_axes([0,0,1,1])

inner_axes = fig.add_axes([0.25,0.5,0.25,0.25])

outer_axes.plot(a,b)

inner_axes.set_xlim(10,20) #sets the range on x-axis

inner_axes.set_ylim(0,10000) #sets the range on y-axis

inner_axes.set_title("Zoomed Version")

inner_axes.plot(a,b)

plt.show()

我们可以使用 subplots()函数来创建多个图形,而不是手动管理图形对象中的不同坐标轴。让我们查看其语法,

fig, axes = plt.subplots(nrows=1, ncols=2)

它返回一个包含图形对象以及保存所有坐标轴对象的 numpy 数组的元组。我们需要指定实际坐标轴的行数和列数。每个坐标轴对象都会单独返回,可以独立访问。

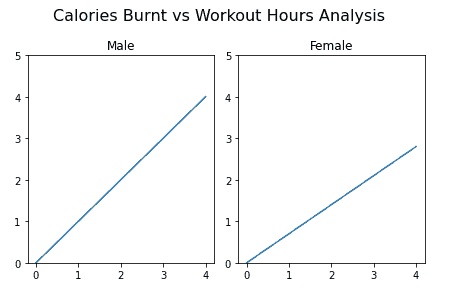

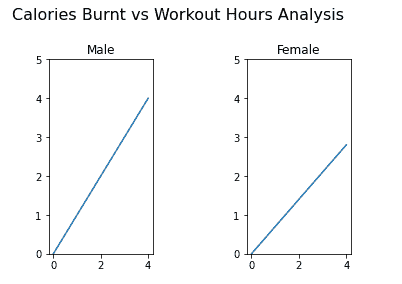

exercise_hrs = np.arange(0, 5)

male_cal = exercise_hrs

female_cal = 0.70 * exercise_hrs

fig, axes = plt.subplots(nrows=1, ncols=2)

axes[0].plot(exercise_hrs, male_cal)

axes[0].set_ylim(0, 5) # Sets range of y

axes[0].set_title("Male")

axes[1].plot(exercise_hrs, female_cal)

axes[1].set_ylim(0, 5)

axes[1].set_title("Female")

fig.suptitle(

"Calories Burnt vs Workout Hours Analysis", fontsize=16

) # Displays the main title

fig.tight_layout() # Prevents overlapping of subplots

子图间距可以通过以下方法手动调整:

fig.subplots_adjust(left=None,top=None,right=None,top=None,wspace=None, hspace=None)

-

left = 图形子图的左侧

-

right = 图形子图的右侧

-

bottom = 图形子图的底部

-

top = 图形子图的顶部

-

wspace = 保留的子图之间的宽度空间

-

hspace = 保留的子图之间的高度空间

fig.subplots_adjust(left=0.2,top=0.8,wspace=0.9, hspace=0.1)

应用到上面的图形中:

自定义图形

1) 图例

如果我们在一个图形对象中创建多个图形,可能会变得难以识别每个图形所表示的内容。因此,我们在axes.plot()函数中添加label= “text”属性,然后调用axes.legend()函数来显示图例。

axes.legend(loc=0) or axes.legend() #Default - Matplotlib decides position

axes.legend(loc=1) # upper right

axes.legend(loc=2) # upper left

axes.legend(loc=3) # lower left

axes.legend(loc=4) # lower right

axes.legend(loc=(x,y)) # At (x,y) position

axes.legend() 还有一个参数 loc,用于决定图例的位置。

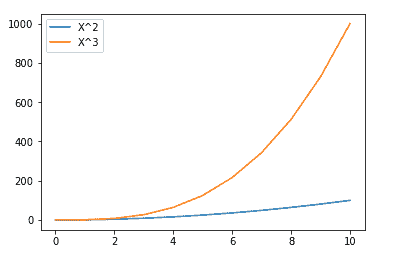

x = np.arange(0,11)

fig = plt.figure()

ax = fig.add_axes([0,0,0.75,0.75])

ax.plot(x, x**2, label="X²")

ax.plot(x, x**3, label="X³")

ax.legend(loc=0) #Let matplotlib decide

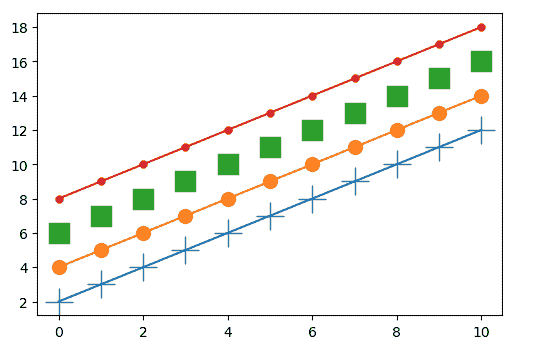

2) 线条样式

Matplotlib 提供了很多自定义选项。让我们深入分析一下更改线条颜色、宽度和样式的语法。

axes.plot(x, y, color or c = 'red',alpha= ‘0.5’, linestyle or ls = ':', linewidth or lw= 5)

颜色: 我们可以通过名称或 RGB 值来定义颜色,或者使用 Matlab 类型的语法,其中 r 表示红色等。我们还可以使用 alpha 属性设置透明度。

线型: 自定义样式也可以创建,但由于我们主要关注可视化,因此简单的样式对我们来说就足够了。它们如下所示:

linestyle = “-” or linestyle = “solid”

linestyle = “:” or linestyle = “dotted”

linestyle = “--” or linestyle = “dashed”

linestyle = “-.” or linestyle = “dashdot”

线宽: 默认值为 1,但我们可以根据需要进行更改。

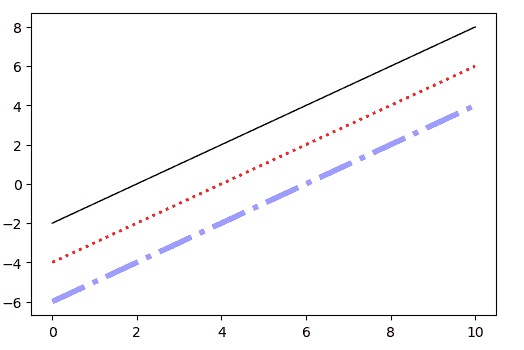

fig, ax = plt.subplots()

ax.plot(x, x-2, color="#000000", linewidth=1 , linestyle='solid')

ax.plot(x, x-4, color="red", lw=2 ,ls=":")

ax.plot(x, x-6, color="blue",alpha=0.4,lw=4 , ls="-.")

3) 标记样式

在 matplotlib 中,所有绘制的点称为标记。默认情况下,我们只看到最终的线条,但我们可以根据自己的选择设置标记类型及其大小。

axes.plot(x, y,marker =”+” , markersize or ms= 20)

标记有很多类型,详见这里,但我们只讨论主要的几种:

marker='+' # plus

marker='o' # circle

marker='s' # square

marker='.' # point

示例:

fig, ax = plt.subplots()

ax.plot(x, x+2,marker='+',markersize=20)

ax.plot(x, x+4,marker='o',ms=10)

ax.plot(x, x+6,marker='s',ms=15,lw=0)

ax.plot(x, x+8,marker='.',ms=10)

图表类型

Matplotlib 提供了各种特殊图表,因为不同类型的数据需要不同的表示方式。选择图表取决于分析的问题。例如,如果你关注部分与整体的关系,可以使用饼图;如果你想比较值或组,可以使用条形图;如果你想观察不同变量之间的对应关系,可以使用散点图等。在本教程中,我们将逐一讲解并讨论 5 种最常用的图表。让我们开始吧:

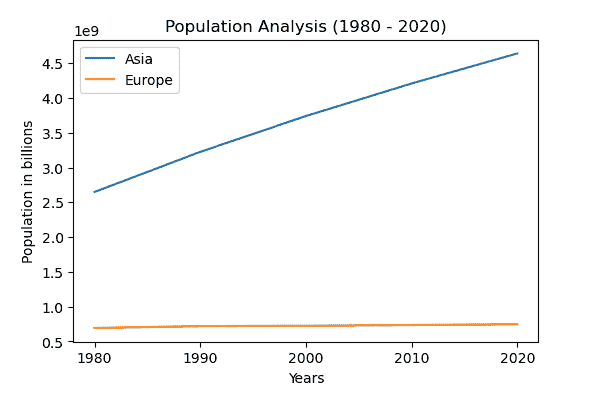

1) 折线图

这是表示数据的最简单形式。它们主要用于分析与时间相关的数据,因此也称为时间序列图。向上的趋势表示变量之间的正相关,反之亦然。它广泛应用于天气预报、股市预测以及监测日常客户或销售等。

# Data is collected from worldometer

years = ["1980", "1990", "2000", "2010", "2020"]

Asia = [2649578300, 3226098962, 3741263381, 4209593693, 4641054775]

Europe = [693566517, 720858450, 725558036, 736412989, 747636026]

fig, ax = plt.subplots()

ax.set_title("Population Analysis (1980 - 2020)")

ax.set_xlabel("Years")

ax.set_ylabel("Population in billions")

ax.plot(years, Asia, label="Asia")

ax.plot(years, Europe, label="Europe")

ax.legend()

我们可以看到,自 1980 年以来,亚洲的人口呈指数增长。

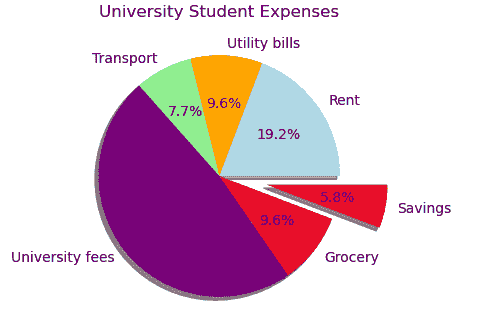

2) 饼图

饼图将圆圈分成代表部分与整体关系的比例区域。每一部分加起来总和为 100%。这些切片的面积也被称为楔形。

matplotlib.pyplot.pie(data,explode=None,labels=None,colors=None,autopct=None, shadow=False)

-

data = 你想绘制的值的数组

-

explode = 分离图表中的楔形

-

labels = 代表不同切片的字符串

-

colors = 用指定颜色填充楔形

-

autopct = 在楔形图上标注数值

-

shadow = 为楔形添加阴影

labels = [

"Rent",

"Utility bills",

"Transport",

"University fees",

"Grocery",

"Savings",

]

expenses = [200, 100, 80, 500, 100, 60]

explode = [0.0, 0.0, 0.0, 0.0, 0.0, 0.4]

colors = [

"lightblue",

"orange",

"lightgreen",

"purple",

"crimson",

"red",

]

fig, ax = plt.subplots()

ax.set_title("University Student Expenses")

ax.pie(

expenses,

labels=labels,

explode=explode,

colors=colors,

autopct="%.1f%%",

shadow=True,

)

plt.show()

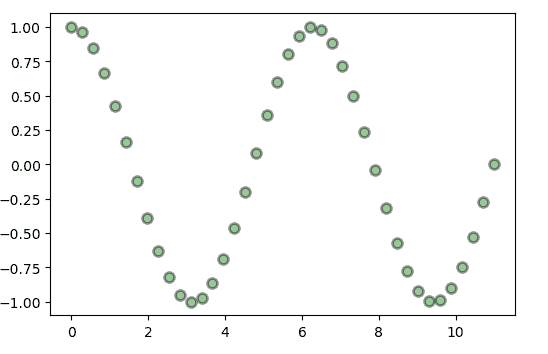

3) 散点图

散点图,也称为 XY 图,用于观察因变量和自变量之间的关系。它绘制个别数据点以进行趋势分析。使用散点图可以轻松检测异常值和相关关系。

matplotlib.pyplot.scatter(x, y, s=None, c=None, marker=None,alpha=None, linewidths=None, edgecolors=None)

-

(x,y) = 数据位置

-

s= 标记的大小

-

c= 标记颜色的序列

-

marker= 标记样式

-

alpha= 透明度

-

linewidth= 标记边缘的线宽

-

edgecolors= 标记边缘的颜色

x = np.linspace(0, 11, 40)

y = np.cos(x)

fig, ax = plt.subplots()

ax.scatter(

x,

y,

s=50,

c="green",

marker="o",

alpha=0.4,

linewidth=2,

edgecolor="black",

)

4) 条形图

条形图用于通过垂直或水平的矩形条来可视化分类数据。条形的长度或高度(取决于是柱状图还是水平条形图)表示其数值。当你想比较某些组时,条形图非常有用。

matplotlib.pyplot.bar(x, height, width, bottom, align)

-

x= 类别变量

-

height= 对应的数值

-

width= 条形图的宽度(默认值为 0.8)

-

bottom= 条形图基底的起始点(默认值为 0)

-

align= 类别名称的对齐方式(默认值为居中)

注意: 颜色、边框颜色和线宽也可以自定义。

fig,ax = plt.subplots()

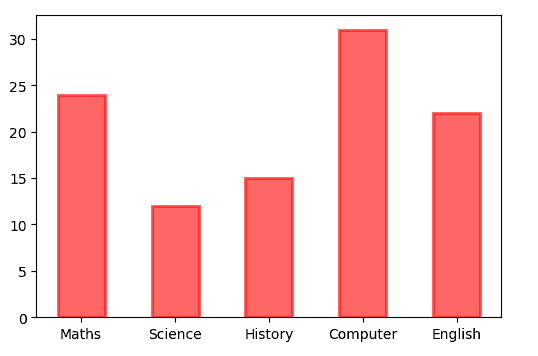

courses = ['Maths', 'Science', 'History', 'Computer', 'English']

students = [24,12,15,31,22]

ax.bar(courses,students,width=0.5,color="red",alpha=0.6,edgecolor="red",linewidth=2)

我们还可以通过调整底部属性来堆叠类别。

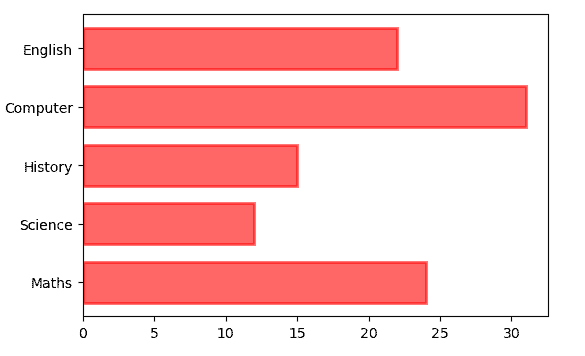

# For Horizontal Bar Chart

ax.barh(

courses,

students,

height=0.7,

color="red",

alpha=0.6,

edgecolor="red",

linewidth=2,

)

我们还可以通过调整底部属性来堆叠类别。

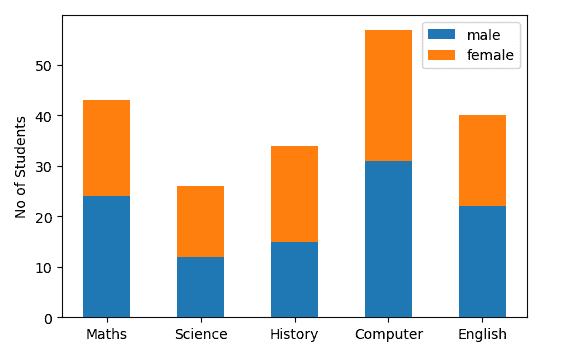

fig,ax = plt.subplots()

courses = ['Maths', 'Science', 'History', 'Computer', 'English']

students = [[24,12,15,31,22],[19,14,19,26,18]] #Male array then female array

ax.bar(courses,students[0],width=0.5,label="male")

ax.bar(courses,students[1],width=0.5,bottom=students[0],label="female")

ax.set_ylabel("No of Students")

ax.legend()

我们还可以通过调整条形的厚度和位置来绘制多个条形。

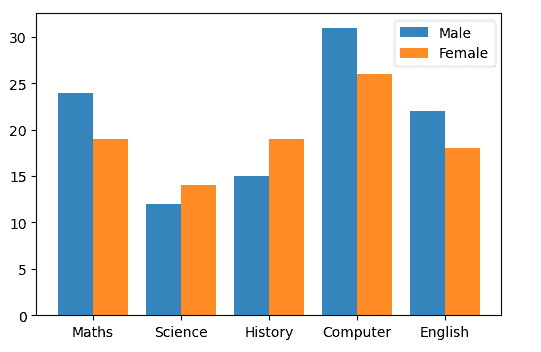

fig,ax = plt.subplots()

courses = ['Maths', 'Science', 'History', 'Computer', 'English']

males = (24,12,15,31,22)

females = (19,14,19,26,18)

index=np.arange(5)

bar_width=0.4

ax.bar(index,males,bar_width,alpha=.9,label="Male")

# We will adjust the bar_width so it is placed side to side

ax.bar(index + bar_width ,females,bar_width,alpha=.9,label="Female")

ax.set_xticks(index + 0.2,courses) # Show labels

ax.legend()

5) 直方图

由于其相似性,许多人经常将其与条形图混淆,但它在表示信息的方式上有所不同。它将数据点组织成称为“箱”的范围,绘制在 X 轴上,而 Y 轴包含有关频率的信息。与条形图不同,它仅用于表示数值数据。

matplotlib.pyplot.hist(x,bins=None,cumulative=False,range=None,bottom=None,histtype=’bar’,rwidth=None, color=None, label=None, stacked=False)

-

bins = 如果是 int,则为等宽的箱子,否则取决于序列

-

cumulative = 最后一个箱将给出总数据点(基于累积频率)

-

bottom = 箱的位置

-

range = 用于切割数据

-

histtype= bar, barstacked, step, stepfilled(默认= bar)

-

rwidth= 直方图条的相对宽度

-

stacked= 如果为 True,则多个数据将堆叠在一起

-

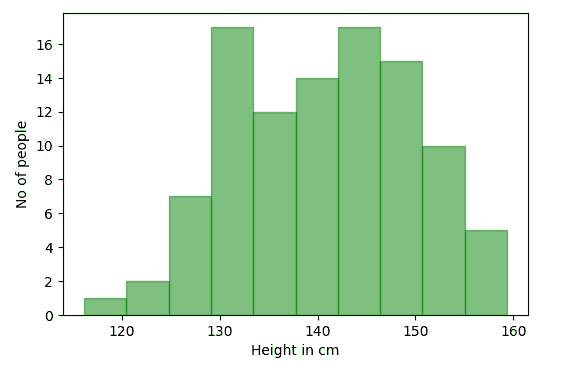

data = np.random.normal(140, 10,100) # 生成 100 人的身高数据

-

bins = 10

data = np.random.normal(140, 10,100) # Generating height of 100 people

bins = 10

fig,ax = plt.subplots()

ax.set_xlabel("Height in cm")

ax.set_ylabel("No of people")

ax.hist(data,bins=bins, color="green",alpha=0.5,edgecolor="green")

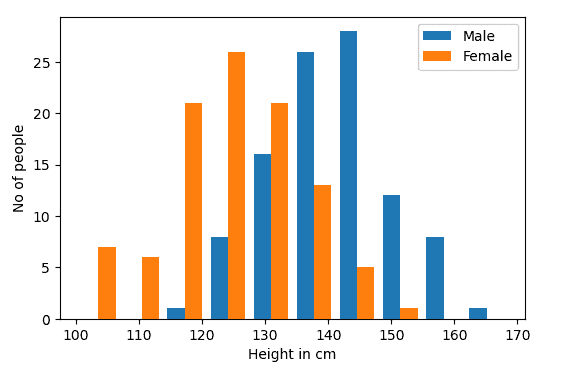

male = np.random.normal(140, 10,100) # Generating height of 100 males

female = np.random.normal(125,10,100) # Generating height of 100 females

bins = 10

fig,ax = plt.subplots()

ax.set_xlabel("Height in cm")

ax.set_ylabel("No of people")

ax.hist([male,female],bins=bins,label=["Male","Female"])

ax.legend()

结论

希望你喜欢阅读这篇文章,并且现在能够使用 Matplotlib 执行不同的可视化。如果你有任何想法或反馈,请随时在评论区分享。这里是 Matplotlib 文档的链接,如果你有兴趣深入了解。

Kanwal Mehreen 是一名有志的软件开发人员,对数据科学和 AI 在医学中的应用充满热情。Kanwal 被选为 2022 年亚太地区的 Google Generation Scholar。Kanwal 喜欢通过撰写有关趋势话题的文章来分享技术知识,并热衷于改善女性在科技行业中的代表性。

更多相关话题

使用 Keras 深度学习简介

原文:

www.kdnuggets.com/2018/10/introduction-deep-learning-keras.html/2

评论

评论

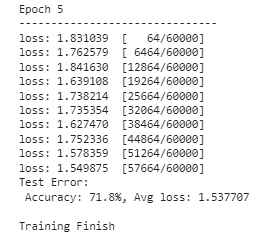

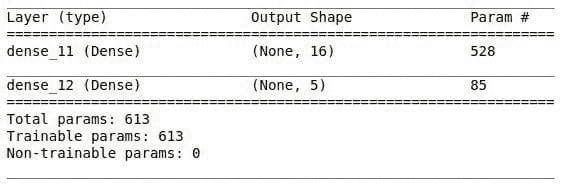

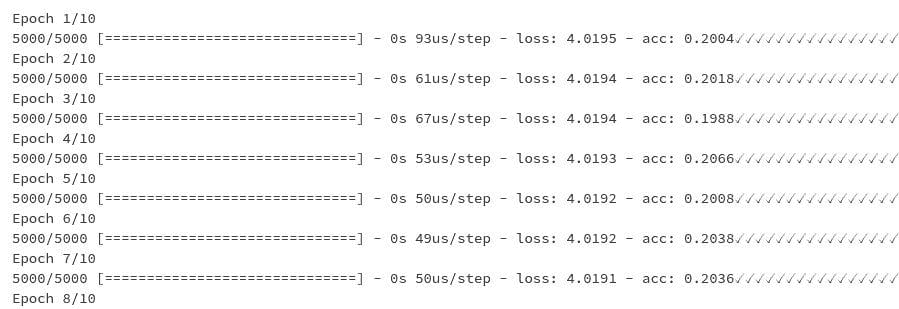

编译人工神经网络

*classifier.compile(optimizer= ‘adam’,

loss = ‘binary_crossentropy’,

metrics = [‘accuracy’])*

编译基本上是将随机梯度下降应用于整个神经网络。第一个参数是你想用来获得神经网络最佳权重集合的算法。这里使用的算法是随机梯度算法。这有很多变体,一种非常有效的是 adam。第二个参数是随机梯度算法中的损失函数。由于我们的类别是二元的,我们使用 binary_crossentropy 损失函数。否则我们会使用 categorical_crossentropy。最后一个参数是我们用来评估模型的标准。在这种情况下,我们使用准确率。

将我们的人工神经网络拟合到训练集

*classifier.fit(X_train, y_train, batch_size = 10, epochs = 100)*

X_train 代表我们用来训练人工神经网络的自变量,而 y_train 代表我们要预测的列。Epochs 代表我们将数据集通过人工神经网络的次数。Batch_size 是更新权重后的一组观察值的数量。

使用训练集进行预测

*y_pred = classifier.predict(X_test)*

这将展示索赔是欺诈性的概率。然后我们设定了一个 50% 的阈值来将索赔分类为欺诈性。这意味着任何概率为 0.5 或以上的索赔将被分类为欺诈性。

*y_pred = (y_pred > 0.5)*

这样,保险公司可以首先跟踪那些不被怀疑的索赔,然后花更多时间评估被标记为欺诈的索赔。

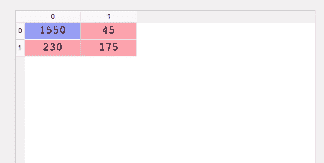

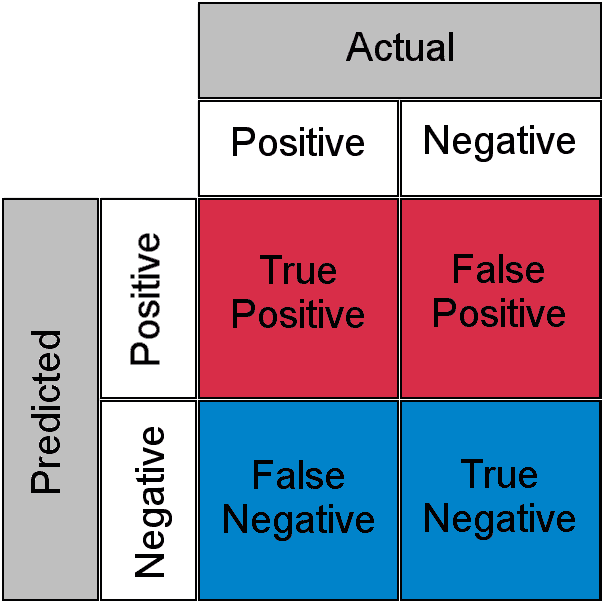

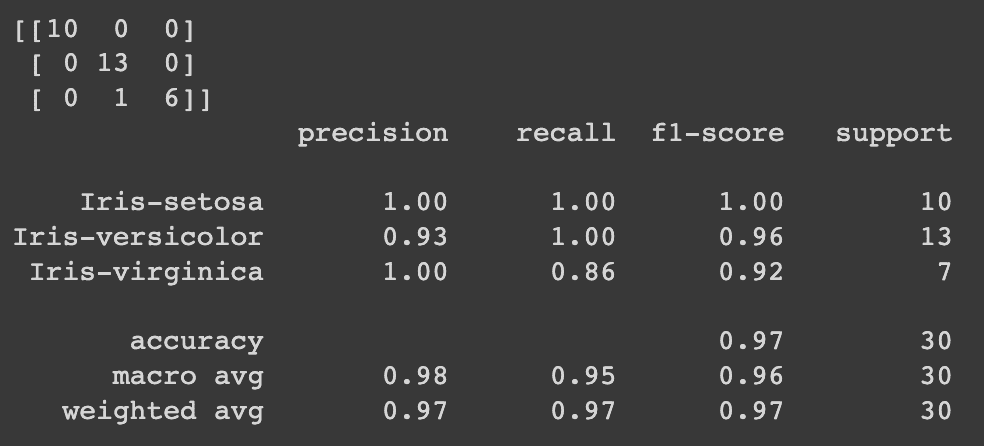

检查混淆矩阵

*from sklearn.metrics import confusion_matrix*

*cm = confusion_matrix(y_test, y_pred)*

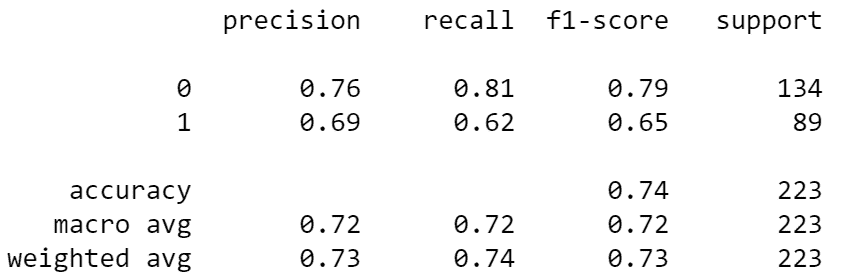

混淆矩阵可以这样解释。在 2000 个观察值中,1550 + 175 个被正确预测,而 230 + 45 个被错误预测。你可以通过将正确预测的数量除以预测的总数来计算准确率。在这种情况下是 (1550+175) / 2000,结果是 86%。

做出单一预测

假设保险公司给你一个索赔,他们希望知道这个索赔是否是欺诈性的。你会怎么做来找出答案?

*new_pred = classifier.predict(sc.transform(np.array([[a,b,c,d]])))*

其中 a、b、c、d 代表你拥有的特征。

*new_pred = (new_prediction > 0.5)*

由于我们的分类器期望的是 numpy 数组,我们必须将单个观察值转换为 numpy 数组,并使用标准缩放器进行缩放。

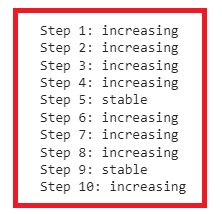

评估我们的人工神经网络

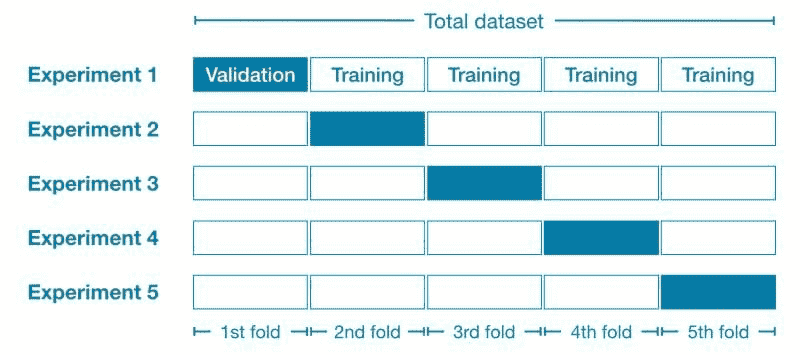

训练模型一两次后,你会注意到准确度不断变化。这使得你不太确定哪一个是正确的。这引入了偏差方差权衡。本质上,我们试图训练一个模型,使其准确且在多次训练时不会有太大的准确度方差。为了解决这个问题,我们使用 K 折交叉验证,K 等于 10。这将把训练集分成 10 折。然后我们将在 9 折上训练模型,并在剩下的折上测试。由于我们有 10 折,我们将通过 10 种组合进行迭代。每次迭代都会给我们一个准确度。然后我们计算所有准确度的均值,并将其作为我们的模型准确度。我们还计算方差,以确保其最小。

Keras 有一个 scikit learn 的封装器(KerasClassifier),使我们可以在我们的 Keras 代码中包含 K 折交叉验证。

*from keras.wrappers.scikit_learn import KerasClassifier*

接下来我们从 scikit_learn 导入 k 折交叉验证函数。

*from sklearn.model_selection import cross_val_score*

KerasClassifier 期望其参数之一是一个函数,因此我们需要构建这个函数。这个函数的目的是建立我们的 ANN 架构。

这个函数将构建分类器并返回,以便在下一步中使用。我们在这里做的唯一事情就是将我们之前的 ANN 架构封装在一个函数中并返回分类器。

然后我们创建一个新的分类器,使用 K 折交叉验证,并将参数build_fn传递为我们刚刚创建的函数。接下来,我们传递批次大小和训练轮数,就像我们在之前的分类器中做的那样。

*classiifier = KerasClassifier(build_fn = make_classifier,

batch_size=10, nb_epoch=100)*

要应用 k 折交叉验证函数,我们可以使用 scikit-learn 的cross_val_score函数。估算器是我们刚刚用make_classifier构建的分类器,n_jobs=-1 将利用所有可用的 CPU。cv 是折数,10 是一个典型的选择。cross_val_score将返回计算中使用的十个测试折的准确度。

*accuracies = cross_val_score(estimator = classifier,

X = X_train,

y = y_train,

cv = 10,

n_jobs = -1)*

为了获得相对准确度,我们需要计算准确度的均值。

*mean = accuracies.mean()*

方差可以按以下方式获得:

*variance = accuracies.var()*

目标是使准确度之间的方差尽可能小。

对抗过拟合

在机器学习中,过拟合是指模型学习了训练集中的细节和噪声,从而在测试集上表现不佳。这可以通过测试集和训练集的准确度之间存在巨大差异,或在应用 k 折交叉验证时观察到高方差来发现。在人工神经网络中,我们使用一种叫做丢弃正则化的技术来对抗这一问题。丢弃正则化通过在每次训练迭代时随机禁用一些神经元,以防止它们过于依赖彼此。

在这种情况下,我们在第一个隐藏层和第二个隐藏层之后应用 dropout。使用 0.1 的比率意味着每次迭代时 1%的神经元将被禁用。建议从 0.1 的比率开始。然而,你绝不要超过 0.4,因为这会导致欠拟合。

参数调优

一旦获得准确率,你可以调整参数以获得更高的准确率。网格搜索使我们能够测试不同的参数,以获得最佳参数。

第一步是从 sklearn 中导入 *GridSearchCV *模块。

*from sklearn.model_selection import GridSearchCV*

我们还需要按如下方式修改我们的 make_classifier 函数。我们创建一个名为 ***optimizer ***的新变量,以便在我们的 params 变量中添加多个优化器。

我们仍然使用 KerasClassifier,但不传递批量大小和迭代次数,因为这些是我们想要调优的参数。

*classifier = KerasClassifier(build_fn = make_classifier)*

下一步是创建一个包含我们想要调优的参数的字典——在这个例子中是批量大小、迭代次数和优化器函数。我们仍然使用 adam 作为优化器,并添加一个名为 rmsprop 的新优化器。Keras 文档推荐在处理递归神经网络时使用 rmsprop。然而,我们可以尝试在这个人工神经网络中使用它,看是否能得到更好的结果。

*params = {

'batch_size':[20,35],*

*'nb_epoch':[150,500],*

*'Optimizer':['adam','rmsprop'**]

}*

然后我们使用网格搜索来测试这些参数。网格搜索函数期望我们的估算器、我们刚刚定义的参数、评分指标和折叠数。

*grid_search = GridSearchCV(estimator=classifier,

param_grid=params,

scoring=’accuracy’,

cv=10)*

像以前的对象一样,我们需要对训练集进行拟合。

*grid_search = grid_search.fit(X_train,y_train)*

我们可以使用best_params从网格搜索对象中获取最佳参数选择。同样,我们使用 best_score_ 来获取最佳分数。

*best_param = grid_search.best_params_*

*best_accuracy = grid_search.best_score_*

需要注意的是,这个过程会花费一些时间,因为它会搜索最佳参数。

结论

人工神经网络只是深度神经网络的一种。还有其他网络,例如递归神经网络(RNN)、卷积神经网络(CNN)和玻尔兹曼机。RNN 可以预测股票价格未来是上涨还是下跌。CNN 用于计算机视觉——例如识别图像中的猫和狗或识别脑部图像中的癌细胞。玻尔兹曼机用于编程推荐系统。也许我们可以在未来讨论这些神经网络中的某一个。

干杯。

简介: Derrick Mwiti 是一位数据分析师、作家和导师。他致力于在每个任务中交付卓越的成果,并且是 Lapid Leaders Africa 的导师。

原文。经许可转载。

相关:

-

Keras 4 步工作流程

-

掌握 Keras 深度学习的 7 个步骤

-

初学者数据可视化与探索使用 Pandas

我们的前三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

更多相关内容

可解释人工智能简介,以及我们为何需要它

原文:

www.kdnuggets.com/2019/04/introduction-explainable-ai.html

评论

评论

由 Patrick Ferris 撰写。

黑箱 - 代表神经网络等函数的未知内部机制的隐喻

神经网络(及其所有子类型)越来越多地用于构建能够在各种不同环境中进行预测和分类的程序。

示例包括使用递归神经网络的机器翻译,以及使用卷积神经网络的图像分类。谷歌 DeepMind 发布的研究引发了对强化学习的兴趣。

所有这些方法都推动了许多领域的发展,并产生了可用于提高生产力和效率的模型。

然而,我们真的不知道它们是如何工作的。

我有幸参加了今年的知识发现与数据挖掘(KDD)会议。在我参加的讲座中,有两个主要的研究领域似乎引起了很多人的关注:

-

首先,寻找有意义的图结构表示以供神经网络使用。Oriol Vinyals来自 DeepMind 做了关于他们的消息传递神经网络的讲座。

-

第二个领域,以及本文的重点,是可解释的人工智能模型。随着我们为神经网络生成更新、更具创新性的应用,“它们是如何工作的?”这个问题变得越来越重要。

为何需要可解释模型?

神经网络并非万无一失。

除了我们已经开发出许多工具(如 Dropout 或增加数据量)来对抗的过拟合和欠拟合问题之外,神经网络以一种不透明的方式操作。

我们实际上不知道它们为什么做出这些选择。随着模型变得越来越复杂,生成一个可解释的模型变得更加困难。

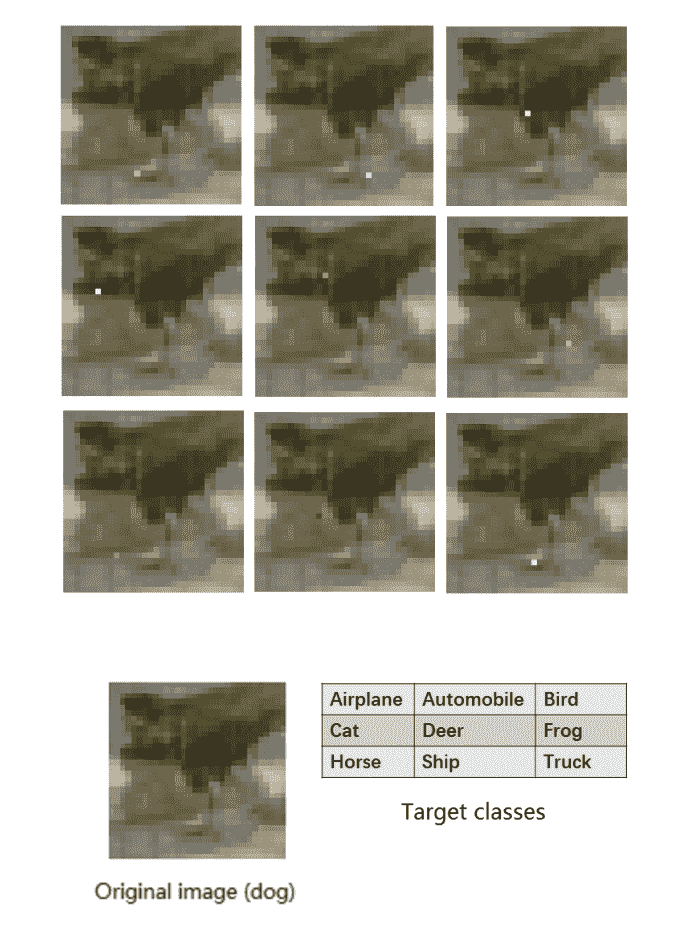

以单像素攻击为例(请查看这里的视频)。这是一种通过分析卷积神经网络(CNN)并应用差分进化(进化算法的一个成员)来实施的复杂方法。

与限制目标函数可微的其他优化策略不同,这种方法使用迭代进化算法来生成更好的解决方案。具体来说,对于这个单像素攻击,唯一需要的信息是类别标签的概率。

来自单像素攻击以欺骗深度神经网络的 Jiawei Su 等人

欺骗这些神经网络的相对容易性令人担忧。在这背后存在一个更系统性的问题:信任神经网络。

最好的例子是在医学领域。假设你正在构建一个神经网络(或任何黑箱模型)来帮助预测根据患者记录的心脏病。

当你训练和测试模型时,你会获得良好的准确性和令人信服的正预测值。你把它交给临床医生,他们同意这似乎是一个强大的模型。

但他们会犹豫使用它,因为你(或模型)不能回答一个简单的问题:“你为什么预测这个人更可能发展成心脏病?”

缺乏透明度对希望了解模型工作方式以改善服务的临床医生来说是个问题。对患者来说,他们也希望有一个具体的预测理由。

从伦理角度来看,如果你的唯一理由是“黑箱告诉我如此”,是否正确告知患者他们有更高的疾病概率?医疗保健不仅关乎科学,也关乎对患者的同情。

可解释 AI 领域近年来不断发展,这一趋势似乎将继续。

接下来是一些有趣和创新的方向,研究人员和机器学习专家正在探索这些方向,以寻找不仅表现良好,而且能够解释其决策原因的模型。

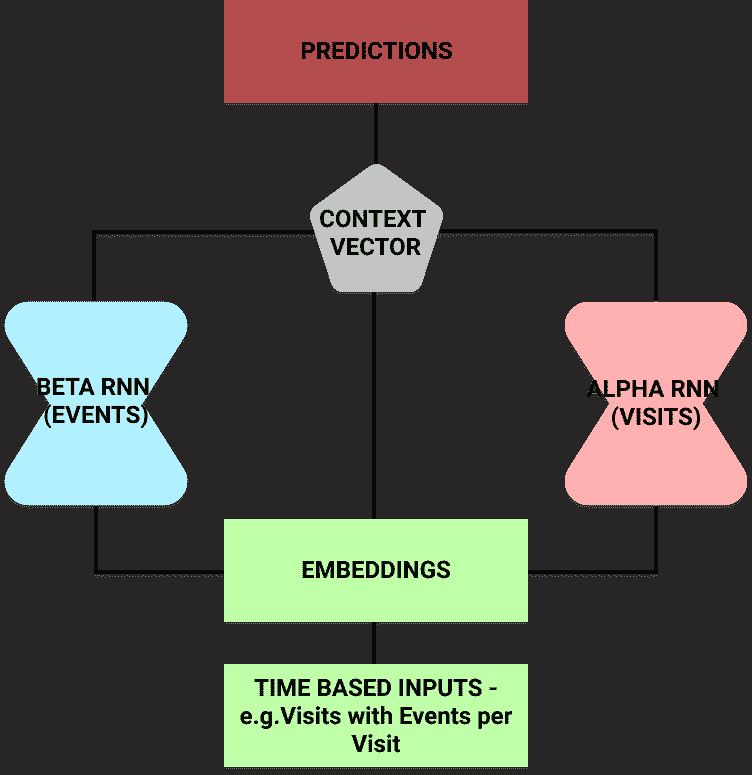

反向时间注意力模型(RETAIN)

RETAIN 模型由Edward Choi et al.在乔治亚理工学院开发。它的推出旨在帮助医生理解为什么模型预测患者有心力衰竭的风险。

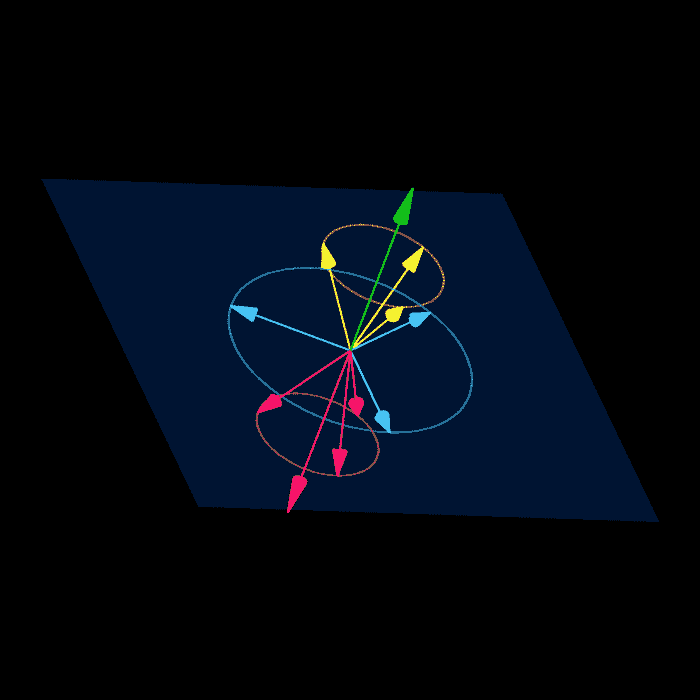

RETAIN 递归神经网络模型利用注意力机制提高可解释性

这个想法是,根据患者的住院记录以及访问事件,它们可以预测心力衰竭的风险。

研究人员将输入分成两个递归神经网络。这使他们能够对每个网络使用注意力机制以了解神经网络关注的重点。

一旦训练完成,模型可以预测患者的风险。但它也可以利用 alpha 和 beta 参数输出哪些住院记录(以及住院中的哪些事件)影响了它的选择。

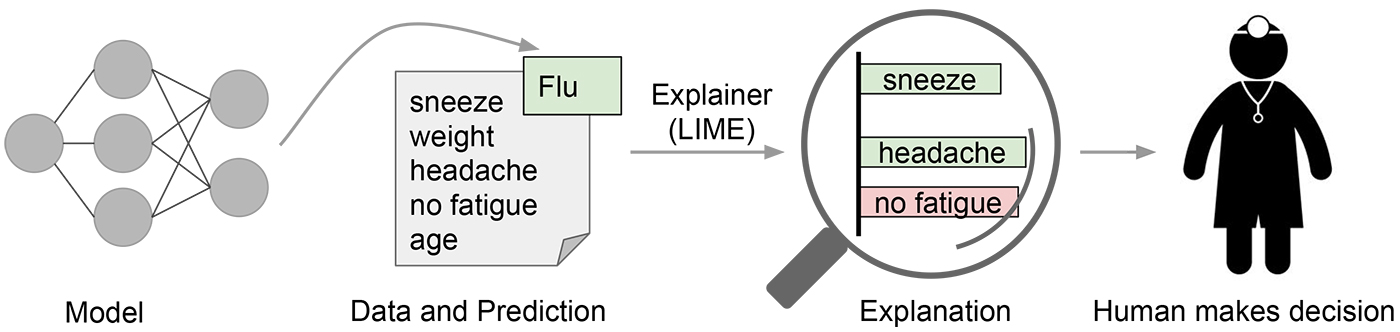

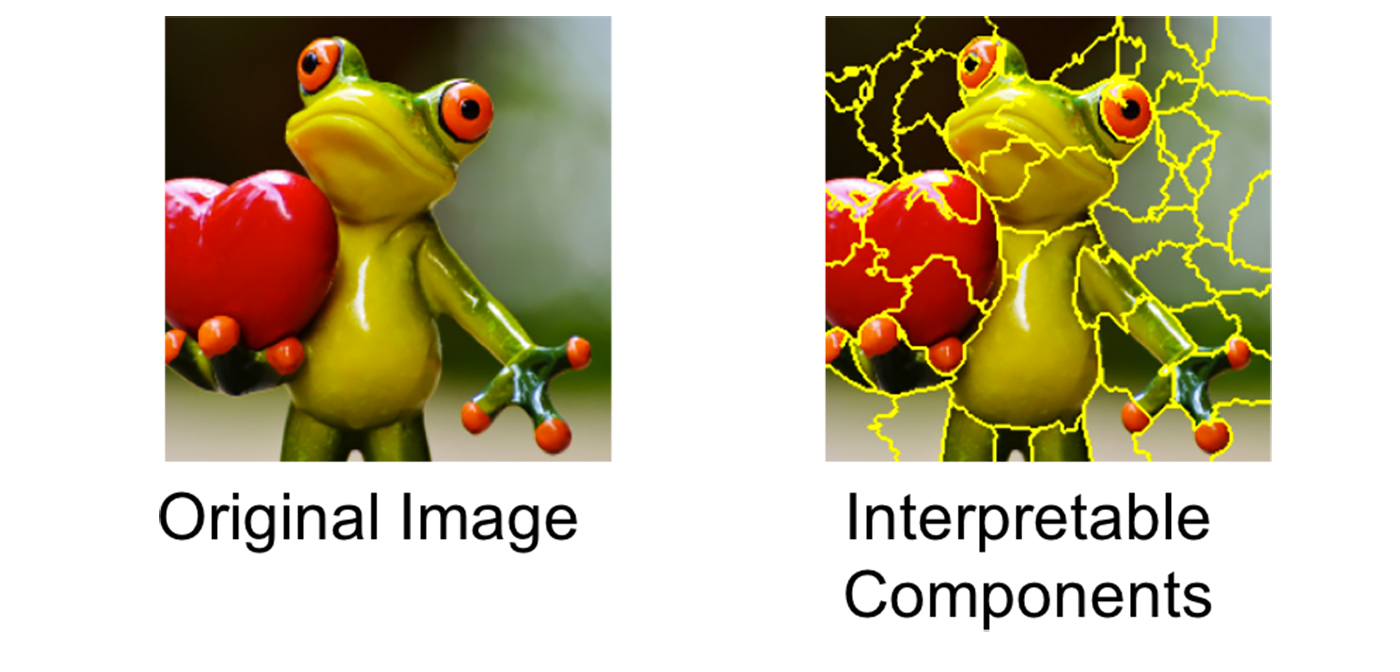

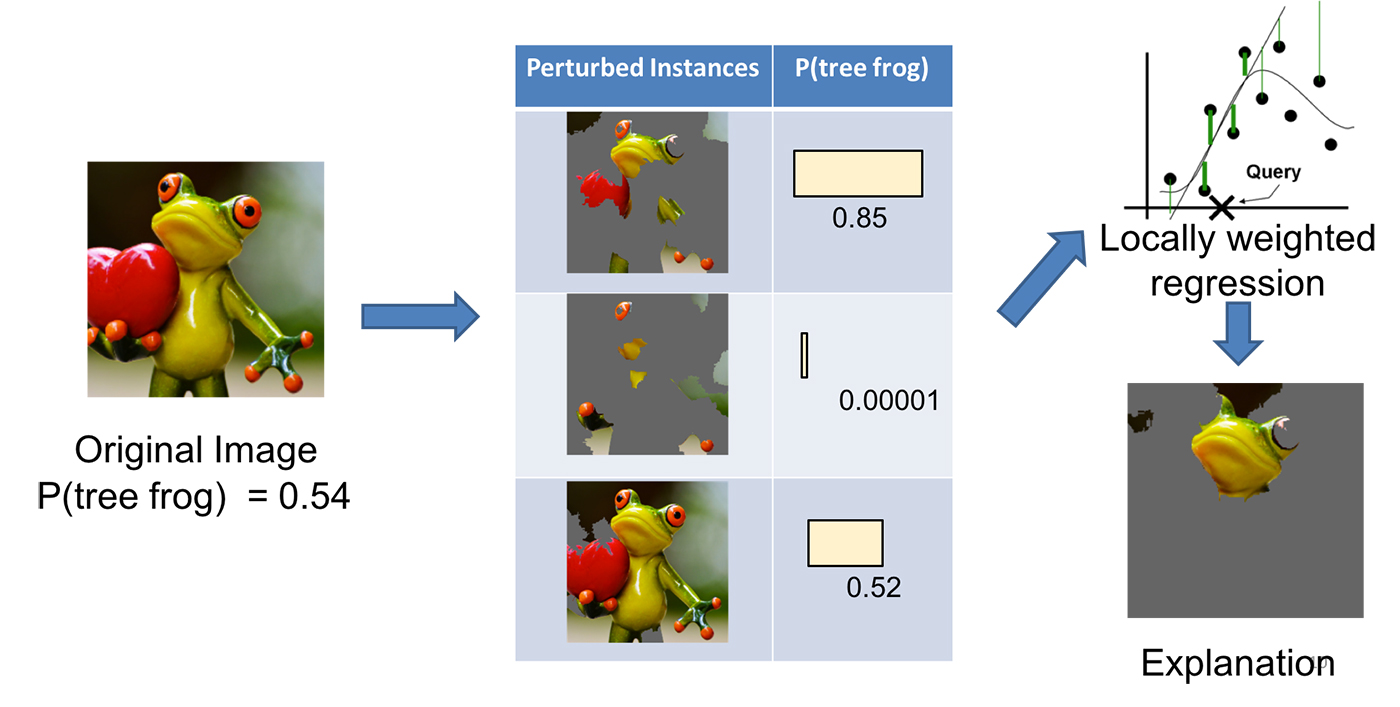

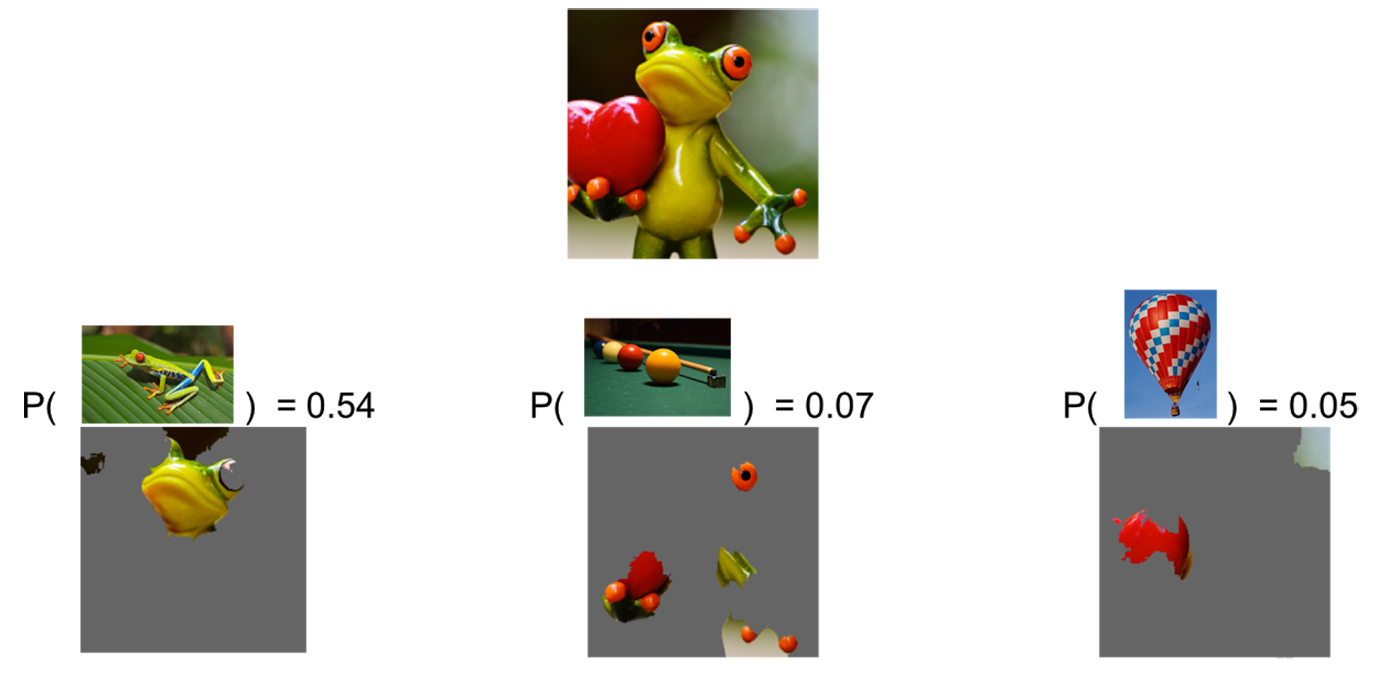

局部可解释模型无关解释(LIME)

另一种已经变得相当常用的方法是LIME。

这是一种事后模型——它在决策做出后提供解释。这意味着它不是一个从头到尾纯粹的‘玻璃箱’透明模型(如决策树)。

这种方法的主要优势之一是它对模型无关。可以应用于任何模型,以产生对其预测的解释。

这种方法的关键概念是扰动输入,并观察这样做如何影响模型的输出。这使我们能够建立起模型关注和利用哪些输入以进行预测的图像。

例如,假设一种用于图像分类的 CNN。使用 LIME 模型生成解释的主要步骤有四个:

-

从一张正常图像开始,使用黑箱模型生成类别的概率分布。

-

然后以某种方式扰动输入。对于图像来说,这可能是通过将像素遮挡成灰色来完成的。现在将这些输入通过黑箱模型运行,以观察原本预测的类别概率如何变化。

-

对这组扰动和概率数据集使用可解释的(通常是线性的)模型,如决策树,以提取解释变化的关键特征。模型是局部加权的——这意味着我们更关心那些与我们使用的原始图像最相似的扰动。

-

输出权重最大的特征(在我们的例子中是像素)作为我们的解释。

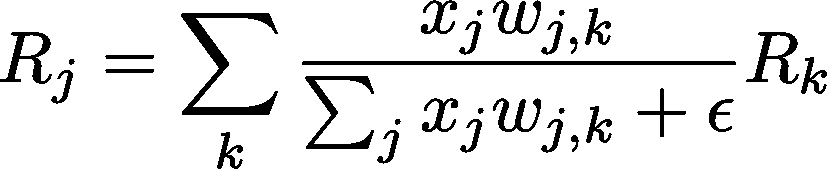

层次相关传播(LRP)

这个方法利用了相关性重新分配和保留的思想。

我们从一个输入(例如,一张图像)及其分类概率开始。然后,向后推导,将这一概率重新分配给所有的输入(在这种情况下是像素)。

从一层到另一层的重新分配过程相当简单。

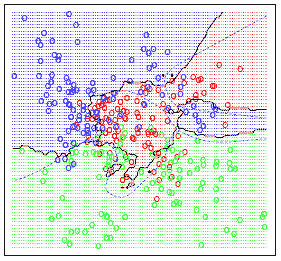

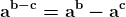

不要害怕——这个方程只是基于神经元激活和权重连接来加权相关性

在上述方程中,每一项代表以下思想:

-

x_j — 第l层中神经元j的激活值

-

w_j,k — 第l层中神经元j与第l + 1层中神经元k之间的连接权重

-

R_j — 第l层中每个神经元的相关性评分

-

R_k — 第l+1层中每个神经元的相关性评分

epsilon 只是一个小值,用于防止除以零。

正如你所看到的,我们可以向后推导以确定各个输入的相关性。此外,我们可以按相关性排序。这使我们能够提取出最有用或最强大的输入子集,以进行预测。

接下来做什么?

以上生成可解释模型的方法绝非穷尽。这些只是研究人员尝试过的一些方法的样本,用于从黑箱模型中生成可解释的预测。

希望这篇文章也能揭示为什么这是一个如此重要的研究领域。我们需要继续研究这些方法,并开发新的方法,以便机器学习能够以安全可靠的方式惠及尽可能多的领域。

如果你想阅读更多论文和领域,尝试以下一些。

-

Finale Doshi-Velez 和 Been Kim 关于该领域的论文

人工智能不应该成为我们盲目追随的强大神明。但我们也不应该忘记它及其可能带来的有益洞察。理想情况下,我们将建立灵活且可解释的模型,与专家及其领域知识合作,为每个人提供一个更光明的未来。

个人简介: Patrick Ferris 是一名十九岁的程序员、博客作者和全方位的技术爱好者,目前是剑桥黑客博客的主编。

原文。经许可转载。

资源:

相关:

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

更多相关主题

欺诈检测系统简介

原文:

www.kdnuggets.com/2018/08/introduction-fraud-detection-systems.html

评论

评论

由米格尔·冈萨雷斯-费罗,微软。

欺诈检测是银行和金融机构的首要任务之一,可以通过机器学习来解决。根据a report published by Nilson,2017 年全球因卡片欺诈案件造成的损失达到 228 亿美元。预计这一问题在未来几年将进一步恶化,到 2021 年,卡片欺诈的损失预计将达到 329.6 亿美元。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织 IT 需求

3. Google IT 支持专业证书 - 支持您的组织 IT 需求

在本教程中,我们将使用Kaggle 上的信用卡欺诈检测数据集来识别欺诈案例。我们将使用梯度提升树作为机器学习算法。最后,我们将创建一个简单的 API 来使模型投入实际使用。

我们将使用梯度提升库LightGBM,它最近已成为Kaggle 竞赛顶级参与者中最受欢迎的库之一。

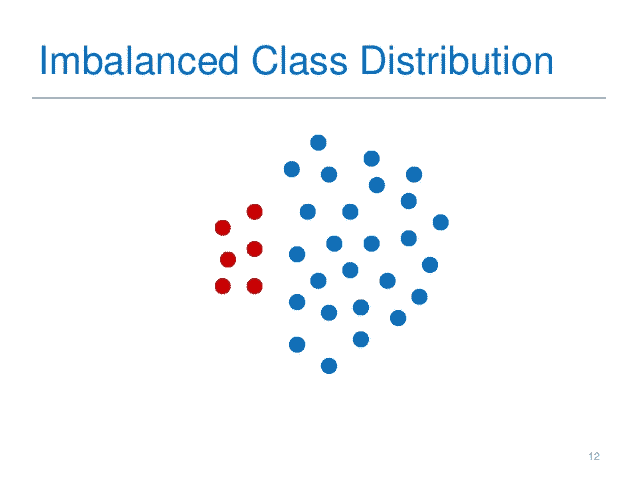

欺诈检测问题以极其不平衡而著称。Boosting 是一种通常适用于这类数据集的技术。它通过迭代创建弱分类器(决策树),加权实例以提高性能。在第一个子集中,训练和测试一个弱分类器,在所有训练数据上测试表现差的实例权重被提高,以便在下一个数据子集中出现更多。最终,所有分类器都通过加权平均其预测结果进行集成。

在 LightGBM 中,有一个参数叫做is_unbalanced,可以自动帮助你控制这个问题。

LightGBM 可以在有或没有 GPU的情况下使用。对于像我们这里使用的小数据集,使用 CPU 更快,因为 IO 开销较大。然而,我想展示 GPU 的替代方案,虽然安装更复杂,以便有兴趣的人可以尝试更大的数据集。

在 Linux 中安装依赖项:

$ sudo apt-get update

$ sudo apt-get install cmake build-essential libboost-all-dev -y

$ conda env create -n fraud -f conda.yaml

$ source activate fraud

(fraud)$ python -m ipykernel install --user --name fraud --display-name "Python (fraud)"

import numpy as np

import sys

import os

import json

import pandas as pd

from collections import Counter

import requests

from IPython.core.display import display, HTML

import lightgbm as lgb

import sklearn

import aiohttp

import asyncio

from utils import (split_train_test, classification_metrics_binary, classification_metrics_binary_prob,

binarize_prediction, plot_confusion_matrix, run_load_test, read_from_sqlite)

from utils import BASELINE_MODEL, PORT, TABLE_FRAUD, TABLE_LOCATIONS, DATABASE_FILE

print("System version: {}".format(sys.version))

print("Numpy version: {}".format(np.__version__))

print("Pandas version: {}".format(pd.__version__))

print("LightGBM version: {}".format(lgb.__version__))

print("Sklearn version: {}".format(sklearn.__version__))

%load_ext autoreload

%autoreload 2

System version: 3.6.0 |Continuum Analytics, Inc.| (default, Dec 23 2016, 13:19:00) [GCC 4.2.1 Compatible Apple LLVM 6.0 (clang-600.0.57)]

Numpy version: 1.13.3

Pandas version: 0.22.0

LightGBM version: 2.1.1

Sklearn version: 0.19.1

数据集

第一步是加载数据集并分析它。

在继续之前,你必须运行笔记本 data_prep.ipynb,这将生成 SQLite 数据库。

query = 'SELECT * FROM ' + TABLE_FRAUD

df = read_from_sqlite(DATABASE_FILE, query)

print("Shape: {}".format(df.shape))

df.head()

Shape: (284807, 31)

| 时间 | V1 | V2 | V3 | V4 | V5 | V6 | V7 | V8 | V9 | ... | V21 | V22 | V23 | V24 | V25 | V26 | V27 | V28 | 金额 | 类别 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.0 | -1.359807 | -0.072781 | 2.536347 | 1.378155 | -0.338321 | 0.462388 | 0.239599 | 0.098698 | 0.363787 | ... | -0.018307 | 0.277838 | -0.110474 | 0.066928 | 0.128539 | -0.189115 | 0.133558 | -0.021053 | 149.62 | 0 |

| 1 | 0.0 | 1.191857 | 0.266151 | 0.166480 | 0.448154 | 0.060018 | -0.082361 | -0.078803 | 0.085102 | -0.255425 | ... | -0.225775 | -0.638672 | 0.101288 | -0.339846 | 0.167170 | 0.125895 | -0.008983 | 0.014724 | 2.69 | 0 |

| 2 | 1.0 | -1.358354 | -1.340163 | 1.773209 | 0.379780 | -0.503198 | 1.800499 | 0.791461 | 0.247676 | -1.514654 | ... | 0.247998 | 0.771679 | 0.909412 | -0.689281 | -0.327642 | -0.139097 | -0.055353 | -0.059752 | 378.66 | 0 |

| 3 | 1.0 | -0.966272 | -0.185226 | 1.792993 | -0.863291 | -0.010309 | 1.247203 | 0.237609 | 0.377436 | -1.387024 | ... | -0.108300 | 0.005274 | -0.190321 | -1.175575 | 0.647376 | -0.221929 | 0.062723 | 0.061458 | 123.50 | 0 |

| 4 | 2.0 | -1.158233 | 0.877737 | 1.548718 | 0.403034 | -0.407193 | 0.095921 | 0.592941 | -0.270533 | 0.817739 | ... | -0.009431 | 0.798278 | -0.137458 | 0.141267 | -0.206010 | 0.502292 | 0.219422 | 0.215153 | 69.99 | 0 |

5 行 × 31 列

如我们所见,数据集极为不平衡。少数类别约占 0.002%的样本。

df['Class'].value_counts()

0 284315

1 492

Name: Class, dtype: int64

df['Class'].value_counts(normalize=True)

0 0.998273

1 0.001727

Name: Class, dtype: float64

下一步是将数据集拆分为训练集和测试集。

X_train, X_test, y_train, y_test = split_train_test(df.drop('Class', axis=1), df['Class'], test_size=0.2)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)

(227845, 30)

(56962, 30)

(227845,)

(56962,)

print(y_train.value_counts())

print(y_train.value_counts(normalize=True))

print(y_test.value_counts())

print(y_test.value_counts(normalize=True))

0 227451

1 394

Name: Class, dtype: int64

0 0.998271

1 0.001729

Name: Class, dtype: float64

0 56864

1 98

Name: Class, dtype: int64

0 0.99828

1 0.00172

Name: Class, dtype: float64

使用 LightGBM 进行训练 - 基准

对于这个任务,我们使用了一组简单的参数来训练模型。我们只想创建一个基准模型,因此这里没有进行交叉验证或参数调优。

LightGBM 的不同参数细节可以在 文档 中找到。此外,作者提供了 一些建议 来调整参数并防止过拟合。

lgb_train = lgb.Dataset(X_train, y_train, free_raw_data=False)

lgb_test = lgb.Dataset(X_test, y_test, reference=lgb_train, free_raw_data=False)

parameters = {'num_leaves': 2**8,

'learning_rate': 0.1,

'is_unbalance': True,

'min_split_gain': 0.1,

'min_child_weight': 1,

'reg_lambda': 1,

'subsample': 1,

'objective':'binary',

#'device': 'gpu', # comment this line if you are not using GPU

'task': 'train'

}

num_rounds = 300

%%time

clf = lgb.train(parameters, lgb_train, num_boost_round=num_rounds)

CPU times: user 45.1 s, sys: 7.68 s, total: 52.8 s

Wall time: 11.9 s

一旦我们拥有了训练好的模型,我们可以获得一些指标。

y_prob = clf.predict(X_test)

y_pred = binarize_prediction(y_prob, threshold=0.5)

metricsmetrics == classification_metrics_binaryclassifi (y_test, y_pred)

metrics2 = classification_metrics_binary_prob(y_test, y_prob)

metrics.update(metrics2)

cm = metrics['Confusion Matrix']

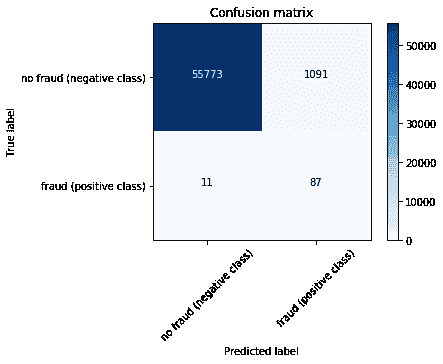

metrics.pop('Confusion Matrix', None)

array([[55773, 1091],

[ 11, 87]])

print(json.dumps(metrics, indent=4, sort_keys=True))

plot_confusion_matrix(cm, ['no fraud (negative class)', 'fraud (positive class)'])

{

"AUC": 0.9322482105532139,

"Accuracy": 0.980653769179453,

"F1": 0.13636363636363638,

"Log loss": 0.6375216445628125,

"Precision": 0.07385398981324279,

"Recall": 0.8877551020408163

}

从商业角度来看,如果系统将一个正常的交易误分类为欺诈(假阳性),银行将会进行调查,可能需要人工干预。根据2015 年 Javelin 策略报告,15%的持卡人在前一年中至少有一笔交易被错误地拒绝,总金额近 1180 亿美元。近 4 成被拒绝的持卡人表示,他们在被错误拒绝后放弃了他们的卡。

然而,如果欺诈交易未被检测到,实际上意味着分类器预测交易是正常的,而实际是欺诈性的(假阴性),那么银行就会亏损,而犯罪分子则逃脱了。

在这些预测中使用商业规则的一个常见方法是控制预测的阈值或操作点。这可以通过在binarize_prediction(y_prob, threshold=0.5)中更改阈值来控制。通常会从 0.1 到 0.9 进行循环,评估不同的商业结果。

clf.save_model(BASELINE_MODEL)

使用 Flask 和 Websockets 进行操作化

下一步是将机器学习模型投入使用。为此,我们将使用Flask来创建一个 RESTful API。API 的输入将是一个交易(由其特征定义),输出将是模型的预测。

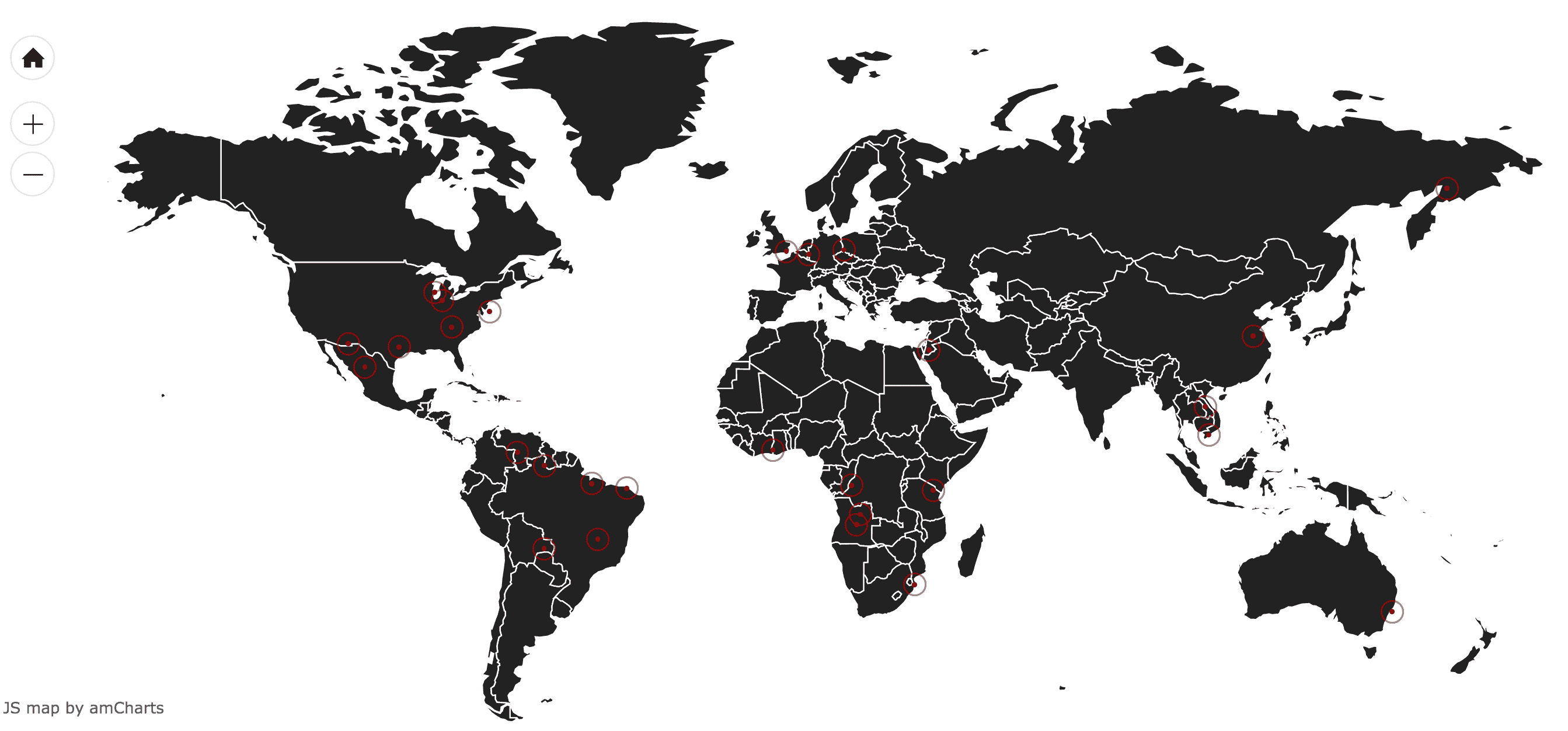

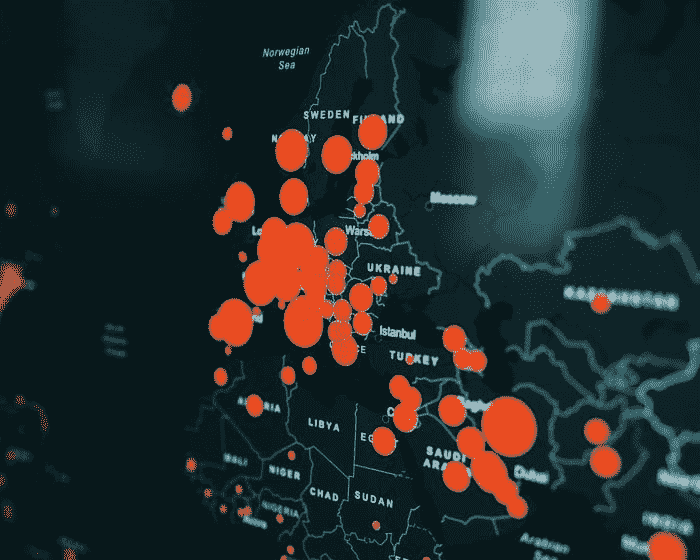

此外,我们设计了一个websocket 服务来在地图上可视化欺诈交易。系统使用库flask-socketio实时工作。

当新交易被发送到 API 时,LightGBM 模型会预测交易是正常还是欺诈。如果交易是欺诈性的,服务器会向一个 web 客户端发送信号,客户端渲染出一个世界地图,显示欺诈交易的位置。地图使用javascript和之前创建的 SQLite 数据库中的位置数据制作。

要启动 API,请在 conda 环境中执行(fraud)$ python api.py。

# You can also run the api from inside the notebook (even though I find it more difficult for debugging).

# To do it, just uncomment the next two lines:

#%%bash --bg --proc bg_proc

#python api.py

首先,我们确保 API 正在运行

#server_name = 'http://the-name-of-your-server'

server_name = 'http://localhost'

root_url = '{}:{}'.format(server_name, PORT)

res = requests.get(root_url)

display(HTML(res.text))

欺诈警察在监视你

现在,我们将选择一个值并预测输出。

vals = y_test[y_test == 1].index.values

X_target = X_test.loc[vals[0]]

dict_query = X_target.to_dict()

print(dict_query)

{'Time': 57007.0, 'V1': -1.2712441917143702, 'V2': 2.46267526851135, 'V3': -2.85139500331783, 'V4': 2.3244800653477995, 'V5': -1.37224488981369, 'V6': -0.948195686538643, 'V7': -3.06523436172054, 'V8': 1.1669269478721105, 'V9': -2.2687705884481297, 'V10': -4.88114292689057, 'V11': 2.2551474887046297, 'V12': -4.68638689759229, 'V13': 0.652374668512965, 'V14': -6.17428834800643, 'V15': 0.594379608016446, 'V16': -4.8496923870965185, 'V17': -6.53652073527011, 'V18': -3.11909388163881, 'V19': 1.71549441975915, 'V20': 0.560478075726644, 'V21': 0.652941051330455, 'V22': 0.0819309763507574, 'V23': -0.22134783119833895, 'V24': -0.5235821592333061, 'V25': 0.224228161862968, 'V26': 0.756334522703558, 'V27': 0.632800477330469, 'V28': 0.25018709275719697, 'Amount': 0.01}

headers = {'Content-type':'application/json'}

end_point = root_url + '/predict'

res = requests.post(end_point, data=json.dumps(dict_query), headers=headers)

print(res.ok)

print(json.dumps(res.json(), indent=2))

True

{

"fraud": 1.0

}

欺诈交易可视化

现在我们知道 API 的主要端点工作正常,我们将尝试/predict_map 端点。它使用 websockets 创建一个实时可视化系统来展示欺诈交易。

WebSocket 是一种旨在进行实时通信的协议,为 HTML5 规范开发。它创建了一个持久的、低延迟的连接,可以支持由客户端或服务器发起的事务。在这篇文章中,你可以找到关于 WebSocket 和其他相关技术的详细解释。

对于我们的案例,每当用户向端点

对于我们的案例,每当用户向端点/predict_map发出请求时,机器学习模型会评估交易详情并进行预测。如果预测被分类为欺诈,服务器会使用socketio.emit('map_update', location)发送信号。该信号仅包含一个名为location的字典,包含一个模拟的名称和欺诈交易发生的位置。信号在index.html中显示,该文件仅渲染一些通过id="chartdiv"引用的 JavaScript 代码。

JavaScript 代码定义在文件frauddetection.js中。WebSocket 部分如下:

var mapLocations = [];

// Location updated emitted by the server via websockets

socket.on("map_update", function (msg) {

var message = "New event in " + msg.title + " (" + msg.latitude

+ "," + msg.longitude + ")";

console.log(message);

var newLocation = new Location(msg.title, msg.latitude, msg.longitude);

mapLocations.push(newLocation);

clear the markers before redrawing

mapLocations.forEach(function (location) {

if (location.externalElement) {

location.externalElement = undefined;

}

});

map.dataProvider.images = mapLocations;

map.validateData(); //call to redraw the map with new data

});

当服务器在 Python 中发出新的信号时,JavaScript 代码会接收并处理它。它创建了一个名为newLocation的新变量,包含要保存到名为mapLocations的全局数组中的位置信息。这个变量包含了自会话开始以来出现的所有欺诈位置。接下来,进行一个清理过程,以便 amCharts 能够在地图上绘制新信息,最后将数组存储在map.dataProvider.images中,这实际上是用新点刷新地图。变量map在代码中较早定义,它是负责定义地图的 amCharts 对象。

要向可视化端点发起查询:

headers = {'Content-type':'application/json'}

end_point_map = root_url + '/predict_map'

res = requests.post(end_point_map, data=json.dumps(dict_query), headers=headers)

print(res.text)

True

{

"fraud": 1.0

}

现在你可以访问地图 URL(在本地是 http://localhost:5000/map),查看每次执行前一个单元格时地图如何更新为新的欺诈位置。你应该会看到类似下面的地图:

负载测试

一旦我们拥有了 API,我们就可以测试它的可扩展性和响应时间。

这里你可以找到一个简单的负载测试来评估你的 API 性能。请记住,在这种情况下,由于客户端和服务器位于同一台计算机上,因此没有请求开销。

10 个请求的响应时间大约为 300 毫秒,因此一个请求的响应时间为 30 毫秒。

num = 10

concurrent = 2

verbose = True

payload_list = [dict_query]*num

%%time

with aiohttp.ClientSession() as session: # We create a persistent connection

loop = asyncio.get_event_loop()

calc_routes = loop.run_until_complete(run_load_test(end_point, payload_list, session, concurrent, verbose))

ERROR:asyncio:Creating a client session outside of coroutine

client_session: aiohttp.client.ClientSession object at 0x7f16847333c8

Response status: 200

{'fraud': 7.284115783035928e-06}

Response status: 200

{'fraud': 7.284115783035928e-06}

Response status: 200

{'fraud': 7.284115783035928e-06}

Response status: 200

{'fraud': 7.284115783035928e-06}

Response status: 200

Response status: 200

{'fraud': 7.284115783035928e-06}

{'fraud': 7.284115783035928e-06}

Response status: 200

Response status: 200

{'fraud': 7.284115783035928e-06}

{'fraud': 7.284115783035928e-06}

Response status: 200

{'fraud': 7.284115783035928e-06}

Response status: 200

{'fraud': 7.284115783035928e-06}

CPU times: user 14.8 ms, sys: 15.8 ms, total: 30.6 ms

Wall time: 296 ms

*# If you run the API from the notebook, you can uncomment the following two lines to kill the process

#%%bash

#ps aux | grep 'api.py' | grep -v 'grep' | awk '{print $2}' | xargs kill*

企业级欺诈检测参考架构

在本教程中,我们已经看到如何创建一个基线欺诈检测模型。然而,对于大公司来说,这还不够。

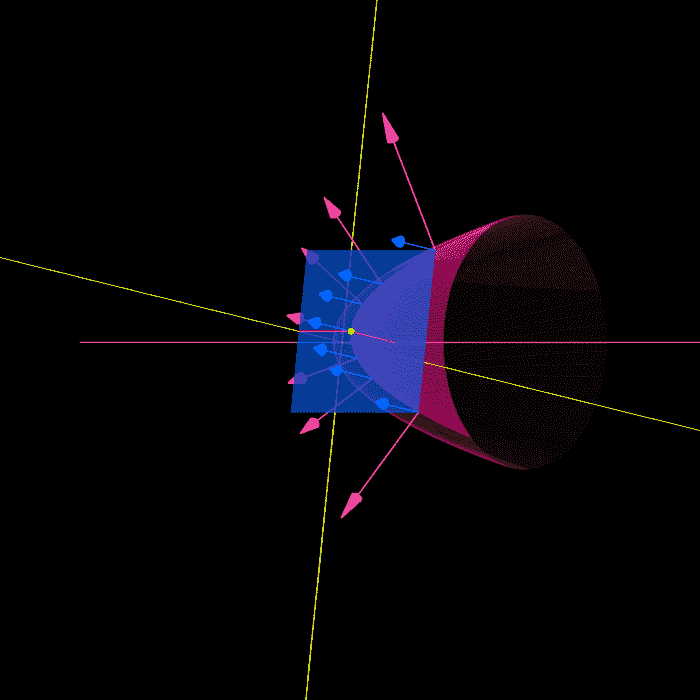

在下图中,我们可以看到一个欺诈检测的参考架构,这个架构应根据客户的具体情况进行调整。所有服务都基于 Azure。

-

客户的两个主要数据源:实时数据和静态信息。

-

用于存储数据的一般数据库部分。由于这是一个参考架构,并且没有更多数据,我将几个选项组合在一起(SQL 数据库,CosmosDB,SQL 数据仓库,等)无论是云端还是本地。

-

使用Azure ML进行模型实验,再次使用通用计算目标,如DSVM,BatchAI,Databricks或HDInsight。

-

使用新数据进行模型再训练,并从模型管理中获得模型。

-

运营层使用一个Kubernetes 集群,将最佳模型投入生产。

-

报告层以展示结果。

原文。转载经许可。

相关:

更多相关话题

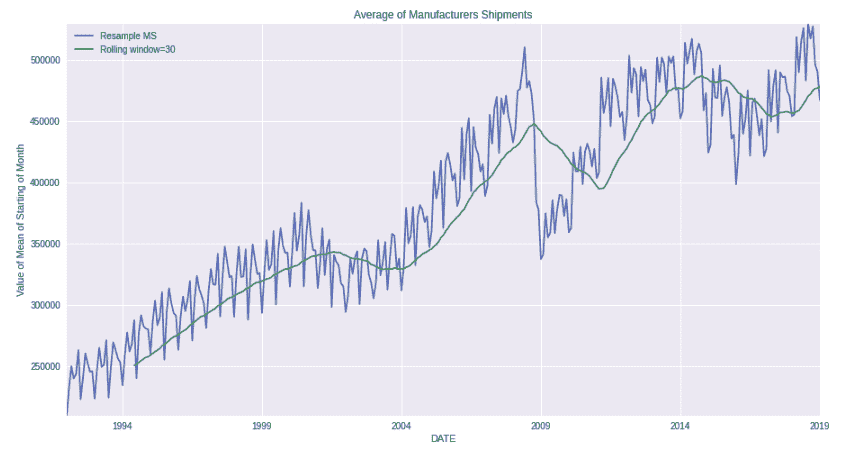

用 R、SQL 和 Tableau 进行犯罪数据的地理时间序列预测简介

原文:

www.kdnuggets.com/2020/02/introduction-geographical-time-series-crime-r-sql-tableau.html

评论

作者:Jason Wittenauer,Huron Consulting Group 首席数据科学家

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

在本教程中,你将学习如何为时间序列预测准备地理数据。

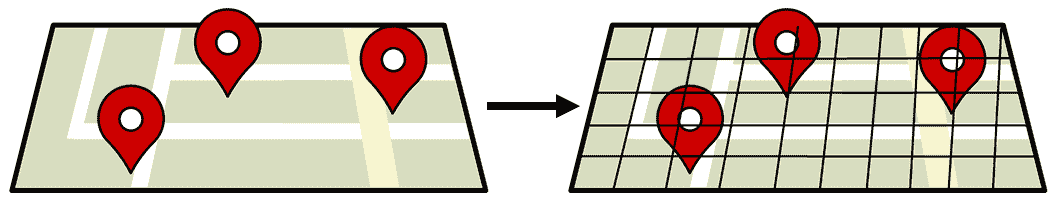

在审查地理数据时,准备数据进行分析可能会很困难。虽然可以使用特定的算法,但它们的功能可能有限。如果我们花一些时间将数据分割成网格,然后为每个网格点添加一个时间点,这将为建模算法和其他可添加的功能打开更多可能性。然而,这也会造成数据集大小的问题。

五年的犯罪数据集可能包含 250,000 条记录。一旦将其外推到整个城市的时间序列网格中,它可能轻松达到 7500 万个数据点。处理如此规模的数据时,使用数据库来清理数据在将其发送到建模脚本之前是很有帮助的。我们将遵循的步骤如下:

-

将数据导入 SQL Server 数据库。

-

清理和分组数据到地图网格中。

-

为网格数据集添加时间数据点,并填补没有发生犯罪的空白。

-

将数据导入 R

-

运行 XGBoost 模型来确定特定日期犯罪的发生地点

最后,我们将讨论如何在 Tableau 等 BI 工具中使预测结果对最终用户更具可用性。

前提条件

在开始本教程之前,你需要:

-

安装 SQL Server Express

-

使用 SQL Management Studio 或类似 IDE 来与 SQL Server 接口

-

已安装 R

-

R Studio、Jupyter notebook 或其他 IDE 来与 R 接口

-

SQL 和 R 的一般工作知识

数据流概览

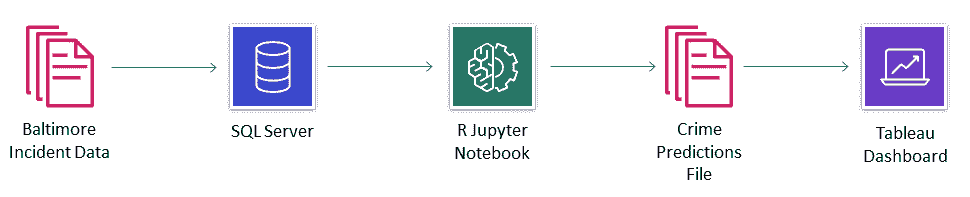

目前我们将保持数据库和数据流的简单结构。数据库本身将非常扁平,最终的数据交接将通过文本文件在 Tableau 仪表板中执行。在更具生产力的版本中,我们会将预测结果保存回数据库,并从数据库中提取数据到报告仪表板中。对于这个示例,我们并不试图完美架构一切,而是了解地理时间序列预测的基本概念。

我们的数据流如下:

设置数据库

我们的预测模型将使用 2012 年至 2017 年巴尔的摩地区的犯罪数据。这些数据位于此仓库中的“Data”文件夹中,文件名为“Baltimore Incident Data.zip”。在导入这些数据之前,您需要按照以下选项之一来设置数据库:

选项 1

- 使用位于“Database Objects\Clean Backup\”文件夹中的备份文件恢复 SQL 数据库。

选项 2

- 使用“Database Objects”文件夹中的“Tables”和“Procedures”下的脚本手动创建所有对象。

导入数据

数据库成功创建后,您现在可以导入数据。这需要您执行以下操作:

-

解压缩“Data”文件夹中的“Baltimore Incident Data.zip”文件。

-

运行“Insert_StagingCrime”过程,并确保它指向正确的导入文件和正确的格式文件(位于“Data”文件夹中的“FormatFile.fmt”)。

EXEC Insert_StagingCrime

该过程将截断 Staging_Crime 表并通过 BULK INSERT 将文件中的数据直接插入其中。临时表本身具有所有 VARCHAR(MAX) 数据类型,我们将在导入过程的下一阶段将其转换为更好的数据类型。下面是过程的代码片段。

BULK INSERT Staging_Crime

FROM 'C:\Projects\Crime Prediction\Data\Baltimore Incident Data.csv'

WITH (FIRSTROW = 2, FORMATFILE = 'C:\Projects\Crime Prediction\Data\FormatFile.fmt')

复审数据。

数据已导入到临时表中后,您可以在 SQL Management Studio 中运行以下代码查看它:

SELECT TOP 10 *

FROM [dbo].[Staging_Crime]

给你以下结果。

| CrimeDate | CrimeTime | CrimeCode | Address | Description | InsideOutside | Weapon | Post | District | Neighborhood | Location | Premise | TotalIncidents |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 02/28/2017 | 23:50:00 | 6D | 2400 KEYWORTH AVE | LARCENY FROM AUTO | O | NULL | 533 | NORTHERN | Greenspring | (39.3348700000, -76.6590200000) | STREET | 1 |

| 02/28/2017 | 23:36:00 | 4D | 200 DIENER PL | AGG. ASSAULT | I | HANDS | 843 | SOUTHWESTERN | Irvington | (39.2830300000, -76.6878200000) | APT/CONDO | 1 |

| 02/28/2017 | 23:02:00 | 4E | 1800 N MOUNT ST | COMMON ASSAULT | I | HANDS | 742 | WESTERN | Sandtown-Winchester | (39.3092400000, -76.6449800000) | ROW/TOWNHO | 1 |

| 02/28/2017 | 23:00:00 | 6D | 200 S CLINTON ST | LARCENY FROM AUTO | O | NULL | 231 | SOUTHEASTERN | Highlandtown | (39.2894600000, -76.5701900000) | STREET | 1 |

| 02/28/2017 | 22:00:00 | 6E | 1300 TOWSON ST | 偷窃 | O | NULL | 943 | SOUTHERN | Locust Point | (39.2707100000, -76.5911800000) | 街道 | 1 |

| 02/28/2017 | 21:40:00 | 6J | 1000 WILMOT CT | 偷窃 | O | NULL | 312 | EASTERN | Oldtown | (39.2993600000, -76.6034100000) | 街道 | 1 |

| 02/28/2017 | 21:40:00 | 6J | 2400 PENNSYLVANIA AVE | 偷窃 | O | NULL | 733 | WESTERN | Penn North | (39.3094200000, -76.6417700000) | 街道 | 1 |

| 02/28/2017 | 21:30:00 | 5D | 1500 STACK ST | 入室盗窃 | I | NULL | 943 | SOUTHERN | Riverside | (39.2721500000, -76.6033600000) | 其他/住宅 | 1 |

| 02/28/2017 | 21:30:00 | 6D | 2100 KOKO LN | 汽车盗窃 | O | NULL | 731 | WESTERN | Panway/Braddish Avenue | (39.3117800000, -76.6633200000) | 街道 | 1 |

| 02/28/2017 | 21:10:00 | 3CF | 800 W LEXINGTON ST | 商业抢劫 | O | 火器 | 712 | WESTERN | Poppleton | (39.2910500000, -76.6310600000) | 街道 | 1 |

注意到这些数据包括了犯罪发生的时间点、经纬度,甚至还有犯罪类别。这些类别对更高级的建模技术和分析非常有用。

清洗数据并创建地图网格

接下来,我们可以将数据转移到一个具有正确数据类型的“犯罪”表中。在此步骤中,我们还将位置字段拆分为经度和纬度字段。完成这些步骤的所有逻辑可以通过运行以下执行语句来完成:

EXEC Insert_Crime

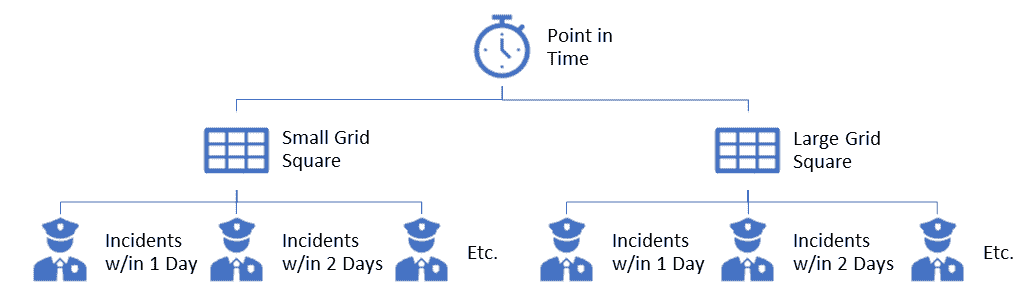

现在,我们将数据填充到“犯罪”表中。这将允许我们完成下一步,即在城市中创建一个网格并将每个犯罪分配到一个网格方块中。你会注意到我们创建了两个网格(小的和大的)。这使我们能够创建在犯罪地点及其周围区域的特征,从而基本上给出城市中的犯罪热点。

运行以下代码以创建网格并为“犯罪”表分配 SmallGridID 和 LargeGridID:

EXEC Update_CrimeCoordinates

这个过程分为三个独立的任务:

-

在 GridSmall 表中创建地图上的小网格(过程:Insert_GridSmall)。

-

在 GridLarge 表中创建地图上的大网格(过程:Insert_GridLarge)。

-

将所有犯罪记录分配到地图上的小方块和大方块中。

创建网格方块的两个过程需要变量来确定地图的角落以及我们希望在地图上有多少个方块。这默认为 200x200 的小网格和 100x100 的大网格。

你可以通过运行以下命令查看一些网格数据:

SELECT TOP 10 c.CrimeId, gs.*

FROM [dbo].[Crime] c

JOIN GridSmall gs

ON gs.GridSmallId = c.GridSmallId

| CrimeId | GridSmallId | BotLeftLatitude | TopRightLatitude | BotLeftLongitude | TopRightLongitude |

|---|---|---|---|---|---|

| 1 | 31012 | 39.3341282000001 | 39.3349965000001 | -76.6594308000001 | -76.6585152000001 |

| 2 | 19121 | 39.2828985 | 39.2837668 | -76.68873 | -76.6878144 |

| 3 | 25198 | 39.3089475000001 | 39.3098158000001 | -76.6456968000001 | -76.6447812000001 |

| 4 | 20657 | 39.2889766 | 39.2898449 | -76.5706176000001 | -76.5697020000001 |

| 5 | 16212 | 39.269874 | 39.2707423 | -76.5916764000001 | -76.5907608000001 |

| 6 | 22832 | 39.2985279000001 | 39.2993962000001 | -76.6035792000001 | -76.6026636000001 |

| 7 | 25202 | 39.3089475000001 | 39.3098158000001 | -76.6420344000001 | -76.6411188000001 |

| 8 | 16601 | 39.2716106 | 39.2724789 | -76.6035792000001 | -76.6026636000001 |

| 9 | 25781 | 39.3115524000001 | 39.3124207000001 | -76.6640088 | -76.6630932 |

| 10 | 20992 | 39.2907132 | 39.2915815 | -76.6319628000001 | -76.6310472000001 |

注意到一个方格中计算了两个点,即右上角和左下角的点。尽管在绘制经纬线时真实地图上确实有一些曲线,我们不必计算方格中的所有四个点。当比例缩小到足够小的时候,我们可以假设这些方格大多是直线的。

创建犯罪网格和滞后特征

我们需要完成的最后一步是为我们想要评估的所有时间段创建整个地图网格。在我们的案例中,这意味着每天一个网格点,以确定犯罪是否会发生。要完成这一步,需要执行以下过程:

EXEC Insert_CrimeGrid

在这一步中,每个犯罪事件将被分组到地图方格中,以便我们可以确定在数据集中每个日期发生了多少犯罪事件。我们还需要计算每个方格中没有发生犯罪的所有填充日期,以完成数据集。

这个过程运行的时间比较长。在我的笔记本电脑上,它运行了大约 1 小时,随后生成的表格(“CrimeGrid”)包含了大约 7500 万条记录。好的一点是,输出现在已保存到表格中,因此我们不必在 R 脚本中运行它,那里的大型数据操作可能无法像在数据库中那样高效运行。

在这个步骤中,我们还将创建“滞后特征”。这些将是告诉我们在过去的一天、两天、一周、一月等时间段内,网格方格中发生了多少次犯罪的列。这实际上是帮助我们进行数据的“热点”分析,这可以用来查看附近的其他网格方格,以判断犯罪是否局限于我们的单个方格或是集中在所有附近方格中,类似于地震后的余震。这些特征可能会根据你所做的建模类型而有所不同。

预测设置

随着所有数据清理和特征工程在数据库端完成,进行预测的代码相当简单。在我们的示例中,我们将使用 R 中的 XGBoost 分析五年的训练数据来预测未来的犯罪事件。

首先,我们加载我们的库。

# Load required libraries

library(RODBC)

library(xgboost)

library(ROCR)

library(caret)

Loading required package: gplots

Attaching package: 'gplots'

The following object is masked from 'package:stats':

lowess

Loading required package: lattice

Loading required package: ggplot2

Registered S3 methods overwritten by 'ggplot2':

method from

[.quosures rlang

c.quosures rlang

print.quosures rlang

然后直接从数据库中将数据导入 R。你也可以将数据导出为文本文件,并以 CSV 数据的形式读取,如果这是你喜欢的方法。提取数据的查询仅仅是用带有一些日期限制的 SQL 语句编写的。这些查询可以重新编写为从带有日期参数的报告存储过程直接提取数据,以获得更具生产力的代码版本。

# Set seed

set.seed(1001)

# Read in data

dbhandle <- odbcDriverConnect('driver={SQL Server};server=DESKTOP-VLN71V7\\SQLEXPRESS;database=crime;trusted_connection=true')

train <- sqlQuery(dbhandle, 'select IncidentOccurred as target, GridSmallId, GridLargeId, DayOfWeek, MonthOfYear, DayOfYear, Year, PriorIncident1Day, PriorIncident2Days, PriorIncident3Days, PriorIncident7Days, PriorIncident14Days, PriorIncident30Days, PriorIncident1Day_Large, PriorIncident2Days_Large, PriorIncident3Days_Large, PriorIncident7Days_Large, PriorIncident14Days_Large, PriorIncident30Days_Large from crimegrid where crimedate <= \'2/20/2017\' and crimedate >= \'6/1/2012\'')

test <- sqlQuery(dbhandle, 'select IncidentOccurred as target, GridSmallId, GridLargeId, DayOfWeek, MonthOfYear, DayOfYear, Year, PriorIncident1Day, PriorIncident2Days, PriorIncident3Days, PriorIncident7Days, PriorIncident14Days, PriorIncident30Days, PriorIncident1Day_Large, PriorIncident2Days_Large, PriorIncident3Days_Large, PriorIncident7Days_Large, PriorIncident14Days_Large, PriorIncident30Days_Large from crimegrid where crimedate >= \'2/21/2017\' and crimedate <= \'2/27/2017\'')

# Convert integers to numeric for DMatrix

train[] <- lapply(train, as.numeric)

test[] <- lapply(test, as.numeric)

head(train)

| 目标 | GridSmallId | GridLargeId | 星期几 | 年月份 | 年中的天数 | 年 | 过去 1 天事件 | 过去 2 天事件 | 过去 3 天事件 | 过去 7 天事件 | 过去 14 天事件 | 过去 30 天事件 | 过去 1 天事件 _ 大 | 过去 2 天事件 _ 大 | 过去 3 天事件 _ 大 | 过去 7 天事件 _ 大 | 过去 14 天事件 _ 大 | 过去 30 天事件 _ 大 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 3780 | 990 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 0 | 3781 | 991 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 0 | 3782 | 991 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 0 | 3783 | 992 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 0 | 3784 | 992 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 0 | 3785 | 993 | 5 | 9 | 262 | 2013 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

注意在测试数据集中,我们一次提取 7 天的数据进行测试,但仍然保持特征输入时仿佛我们知道前一天发生了什么。这只是为了便于我们一次测试 7 天的数据,并在最后的报告中查看多天预测的效果。

另一个需要注意的是,标记为“_Large”的特征是针对较大的网格的,而不是较小的网格。

创建特征集和模型参数

我们将特征定义为 SQL 查询中第一个“目标”列之后的所有列。这些特征会作为标签的一部分传递给训练和测试数据集。

# Get feature names (all but first column which is the target)

feature.names <- names(train)[2:ncol(train)]

print(feature.names)

# Make train and test matrices

dtrain <- xgb.DMatrix(data.matrix(train[,feature.names]), label=train$target)

dtest <- xgb.DMatrix(data.matrix(test[,feature.names]), label=test$target)

[1] "GridSmallId" "GridLargeId"

[3] "DayOfWeek" "MonthOfYear"

[5] "DayOfYear" "Year"

[7] "PriorIncident1Day" "PriorIncident2Days"

[9] "PriorIncident3Days" "PriorIncident7Days"

[11] "PriorIncident14Days" "PriorIncident30Days"

[13] "PriorIncident1Day_Large" "PriorIncident2Days_Large"

[15] "PriorIncident3Days_Large" "PriorIncident7Days_Large"

[17] "PriorIncident14Days_Large" "PriorIncident30Days_Large"

接下来,设置模型训练的参数。我们目前保持它们相当基础。确保评估指标是 AUC,以便我们可以尽量提高我们的真正阳性率。这将防止警察不必要地巡逻某些区域。可能还需要额外的工作来用巧妙的巡逻覆盖所有预测区域,但我们在本教程中不涉及这些内容。

# Training parameters

watchlist <- list(eval = dtest, train = dtrain)

param <- list( objective = "binary:logistic",

booster = "gbtree",

eta = 0.01,

max_depth = 10,

eval_metric = "auc"

)

运行模型

既然一切都已设置好,我们可以运行模型并查看其预测效果。请记住,这里使用的是一个相当基本的特征集,仅仅是为了演示处理地理时间序列数据的一种方法。虽然数据集可能会非常庞大,但它们易于理解,并且在使用像 AWS 这样的云服务时运行速度相当快。

这个特定的训练数据集有 7000 万行,在我的笔记本电脑上完成 67 轮评估大约花了 30 分钟。

# Run model

clf <- xgb.train( params = param,

data = dtrain,

nrounds = 100,

verbose = 2,

early_stopping_rounds = 10,

watchlist = watchlist,

maximize = TRUE)

[14:30:32] WARNING: amalgamation/../src/learner.cc:686: Tree method is automatically selected to be 'approx' for faster speed. To use old behavior (exact greedy algorithm on single machine), set tree_method to 'exact'.

[1] eval-auc:0.858208 train-auc:0.858555

Multiple eval metrics are present. Will use train_auc for early stopping.

Will train until train_auc hasn't improved in 10 rounds.

[2] eval-auc:0.858208 train-auc:0.858555

[3] eval-auc:0.858208 train-auc:0.858555

[4] eval-auc:0.858208 train-auc:0.858556

[5] eval-auc:0.858208 train-auc:0.858556

[6] eval-auc:0.858208 train-auc:0.858556

[7] eval-auc:0.858311 train-auc:0.858997

[8] eval-auc:0.858311 train-auc:0.858997

[9] eval-auc:0.858311 train-auc:0.858997

[10] eval-auc:0.858315 train-auc:0.859000

[11] eval-auc:0.858436 train-auc:0.859110

[12] eval-auc:0.858436 train-auc:0.859110

[13] eval-auc:0.858512 train-auc:0.859157

[14] eval-auc:0.858493 train-auc:0.859157

[15] eval-auc:0.858496 train-auc:0.859160

[16] eval-auc:0.858498 train-auc:0.859160

[17] eval-auc:0.858498 train-auc:0.859160

[18] eval-auc:0.858342 train-auc:0.859851

[19] eval-auc:0.858177 train-auc:0.859907

[20] eval-auc:0.858228 train-auc:0.859971

[21] eval-auc:0.858231 train-auc:0.859971

[22] eval-auc:0.858206 train-auc:0.860695

[23] eval-auc:0.858207 train-auc:0.860695

[24] eval-auc:0.858731 train-auc:0.860894

[25] eval-auc:0.858702 train-auc:0.860844

[26] eval-auc:0.858607 train-auc:0.860844

[27] eval-auc:0.858574 train-auc:0.860842

[28] eval-auc:0.858602 train-auc:0.860892

[29] eval-auc:0.858576 train-auc:0.860843

[30] eval-auc:0.858574 train-auc:0.860841

[31] eval-auc:0.858607 train-auc:0.860893

[32] eval-auc:0.858578 train-auc:0.860843

[33] eval-auc:0.858611 train-auc:0.860894

[34] eval-auc:0.858612 train-auc:0.860895

[35] eval-auc:0.858614 train-auc:0.860898

[36] eval-auc:0.858615 train-auc:0.860899

[37] eval-auc:0.858616 train-auc:0.860897

[38] eval-auc:0.858573 train-auc:0.860870

[39] eval-auc:0.858546 train-auc:0.860822

[40] eval-auc:0.858575 train-auc:0.860872

[41] eval-auc:0.858622 train-auc:0.860898

[42] eval-auc:0.858578 train-auc:0.860875

[43] eval-auc:0.858583 train-auc:0.860870

[44] eval-auc:0.859223 train-auc:0.861768

[45] eval-auc:0.859220 train-auc:0.861760

[46] eval-auc:0.859221 train-auc:0.861760

[47] eval-auc:0.859099 train-auc:0.861719

[48] eval-auc:0.859112 train-auc:0.861735

[49] eval-auc:0.859112 train-auc:0.861735

[50] eval-auc:0.859094 train-auc:0.861734

[51] eval-auc:0.859125 train-auc:0.861785

[52] eval-auc:0.859021 train-auc:0.861771

[53] eval-auc:0.859028 train-auc:0.861784

[54] eval-auc:0.859029 train-auc:0.861781

[55] eval-auc:0.859028 train-auc:0.861784

[56] eval-auc:0.859035 train-auc:0.861788

[57] eval-auc:0.859037 train-auc:0.861789

[58] eval-auc:0.859035 train-auc:0.861775

[59] eval-auc:0.859035 train-auc:0.861774

[60] eval-auc:0.859010 train-auc:0.861738

[61] eval-auc:0.859011 train-auc:0.861739

[62] eval-auc:0.859039 train-auc:0.861778

[63] eval-auc:0.859016 train-auc:0.861739

[64] eval-auc:0.859017 train-auc:0.861741

[65] eval-auc:0.859018 train-auc:0.861746

[66] eval-auc:0.859019 train-auc:0.861747

[67] eval-auc:0.859024 train-auc:0.861755

Stopping. Best iteration:

[57] eval-auc:0.859037 train-auc:0.861789

模型很快找到了模式,每轮改进不大。这可以通过更好的模型参数和更多特征来提升。

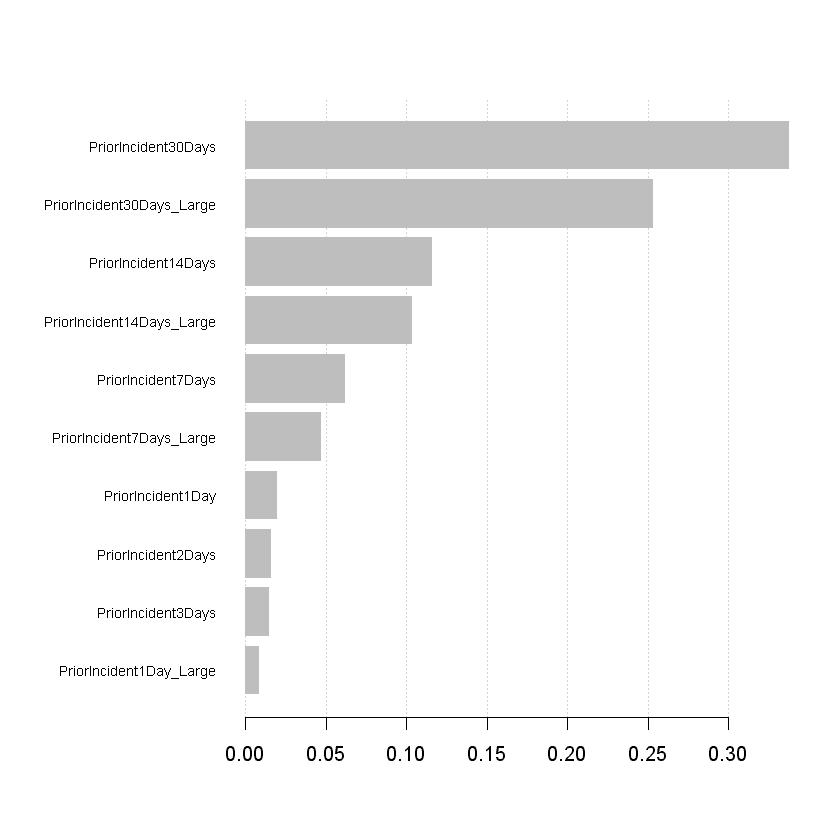

审查重要性矩阵

现在是分析我们的特征,看看哪些在模型中评分较高的时候了,通过查看重要性矩阵。这可以帮助我们确定新增的特征在大型数据集上是否真的值得(较大数据集 = 每增加一个特征的额外处理时间)。

# Compute feature importance matrix

importance_matrix <- xgb.importance(feature.names, model = clf)

# Graph important features

xgb.plot.importance(importance_matrix[1:10,])

看起来模型使用了小网格和大网格特征的组合来判断当前日是否会发生事件。有趣的是,长期特征似乎更重要,表明该区域及其周边地区存在犯罪活动历史。

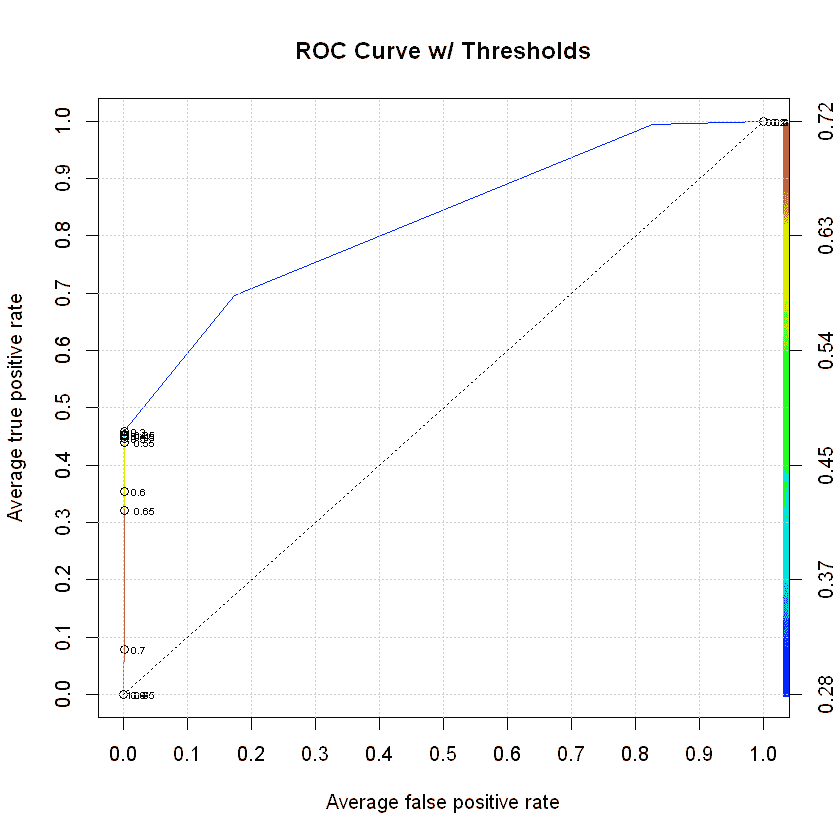

在测试集上预测并检查 ROC 曲线

最后一步是将我们的预测与测试数据集进行对比,看看效果如何。我们总是希望 ROC 曲线会快速而高地跃升,但这并非总是如此。在我们的例子中,只有基本特征包含在模型中,我们得到了一个不错的得分。这确实表明我们可以进行预测,并且应该投入更多时间来提高预测的准确性。

# Predict on test data

preds <- predict(clf, dtest)

# Graph AUC curve

xgb.pred <- prediction(preds, test$target)

xgb.perf <- performance(xgb.pred, "tpr", "fpr")

plot(xgb.perf,

avg="threshold",

colorize=TRUE,

lwd=1,

main="ROC Curve w/ Thresholds",

print.cutoffs.at=seq(0, 1, by=0.05),

text.adj=c(-0.5, 0.5),

text.cex=0.5)

grid(col="lightgray")

axis(1, at=seq(0, 1, by=0.1))

axis(2, at=seq(0, 1, by=0.1))

abline(v=c(0.1, 0.3, 0.5, 0.7, 0.9), col="lightgray", lty="dotted")

abline(h=c(0.1, 0.3, 0.5, 0.7, 0.9), col="lightgray", lty="dotted")

lines(x=c(0, 1), y=c(0, 1), col="black", lty="dotted")

审查混淆矩阵

我们知道有一个不错的 AUC 得分,但让我们看看我们预测的结果与实际发生的情况。最简单的方法是审查混淆矩阵。我们希望左上角和右下角的框(正确预测)较大,其他框(错误预测)较小。

# Set our cutoff threshold

preds.resp <- ifelse(preds >= 0.5, 1, 0)

# Create the confusion matrix

confusionMatrix(as.factor(preds.resp), as.factor(test$target), positive = "1")

Confusion Matrix and Statistics

Reference

Prediction 0 1

0 280581 454

1 62 367

Accuracy : 0.9982

95% CI : (0.998, 0.9983)

No Information Rate : 0.9971

P-Value [Acc > NIR] : < 2.2e-16

Kappa : 0.5864

Mcnemar's Test P-Value : < 2.2e-16

Sensitivity : 0.447016

Specificity : 0.999779

Pos Pred Value : 0.855478

Neg Pred Value : 0.998385

Prevalence : 0.002917

Detection Rate : 0.001304

Detection Prevalence : 0.001524

Balanced Accuracy : 0.723397

'Positive' Class : 1

在 7 天内,发生了 821 起事件,我们的模型正确预测了 367 起。另一个关键点是我们错误预测了 62 起事件,这基本上是将警察派往我们认为可能发生犯罪的地区,但实际上没有发生。从表面上看,这似乎还不算太糟,但我们需要查看这对犯罪活动响应时间的影响与当前响应时间的对比。目标是使警察在足够接近犯罪发生的区域,以便他们可以通过存在预防犯罪或快速响应尽可能减少伤害。

准备报告数据

接下来,我们可以为测试数据集添加经度和纬度坐标,并将其导出为 CSV 文件。这将使我们能够在像 Tableau 这样的 BI 工具中查看实际预测结果。

# Read in the grid coordinates

gridsmall <- sqlQuery(dbhandle, 'select * from gridsmall')

# Merge the predictions with the test data

results <- cbind(test, preds)

# Merge the grid coordinates with the test data

results <- merge(results, gridsmall, by="GridSmallId")

head(results)

# Save to file

write.csv(results,"Data\\CrimePredictions.csv", row.names = TRUE)

| GridSmallId | 目标 | GridLargeId.x | 星期几 | 月份 | 年中的天数 | 年份 | 前一天事件 | 前两天事件 | 前三天事件 | ... | 前三天事件 _ 大 | 前七天事件 _ 大 | 前十四天事件 _ 大 | 前三十天事件 _ 大 | 预测值 | 左下纬度 | 右上纬度 | 左下经度 | 右上经度 | GridLargeId.y |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 0 | 1 | 3 | 2 | 52 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

| 1 | 0 | 1 | 5 | 2 | 54 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

| 1 | 0 | 1 | 7 | 2 | 56 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

| 1 | 0 | 1 | 4 | 2 | 53 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

| 1 | 0 | 1 | 2 | 2 | 58 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

| 1 | 0 | 1 | 1 | 2 | 57 | 2017 | 0 | 0 | 0 | ... | 0 | 0 | 0 | 0 | 0.2822689 | 39.20041 | 39.20128 | -76.71162 | -76.7107 | 1 |

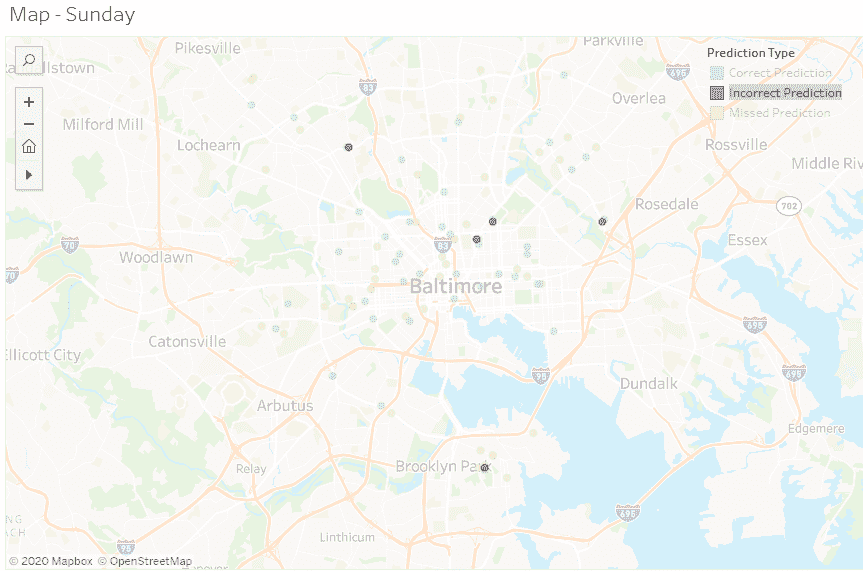

预测可视化

现在是时候查看这些预测在 7 天内实际的情况了。Tableau 仪表板可以在这里找到:

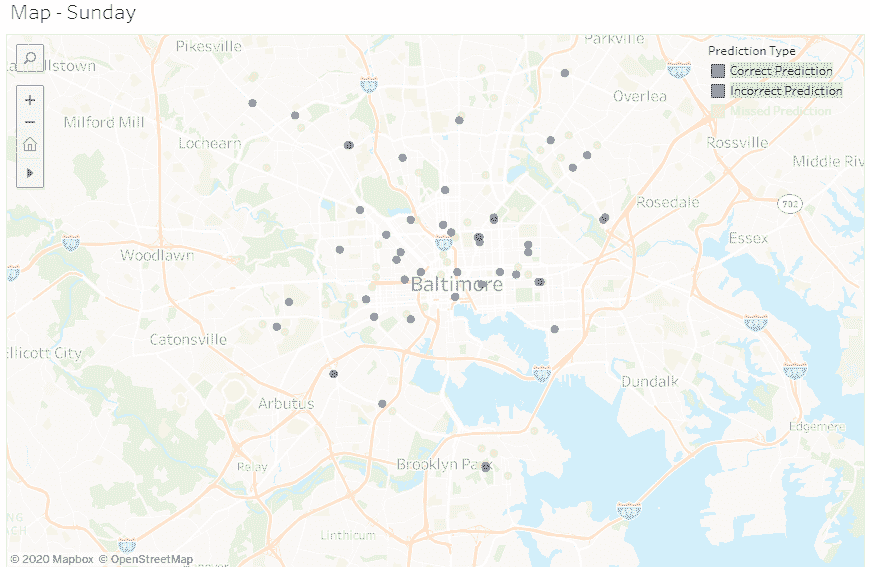

在查看错误预测(红点)时,它们看起来非常接近正确预测。这将使警察处于犯罪发生的一般附近。所以,错误预测可能对整体结果的影响不大。下面是显示正确预测(蓝色)和错误预测(红色)的示例截图。

错误预测

错误和正确预测

总体来看情况似乎还不错,但我们需要更多的特征和/或更多的数据来捕捉所有缺失的预测。此外,我们可能还可以做更多的工作,专注于发生的特定犯罪类型,并针对每种类型进行具体的预测建模。

下一步是什么?

本教程让我们开始使用犯罪数据进行地理时间序列预测。我们可以看到预测确实有效,但在创建特征方面还有更多工作要做。我们可能需要添加一些其他特征,检查更大范围的犯罪发生情况。另一个有用的步骤是将预测频率改为每小时,并按时间段绘制巡逻车路线。即使预测不完美,只要你将警察放在犯罪的附近,这比现有的巡逻方法要好,他们可以更快响应,甚至通过他们的存在防止犯罪的发生。

其他值得考虑的想法:

-

去除警察局、消防局、医院等附近的犯罪数据,因为这些数据可能对报告提交者有偏见。

-

添加与人口普查信息相关的统计特征。

-

将犯罪映射到社区,而不是方格网格,以进行预测。

希望你喜欢这个教程!

简介: Jason Wittenauer 是一位数据科学家,专注于通过 R、Python、Microsoft SQL Server、Tableau、TIBCO Spotfire 和 .NET 网页编程提升医院收入。他在医疗保健领域的关注点包括业务运营、收入改善和费用减少。

原文。经许可转载。

相关:

-

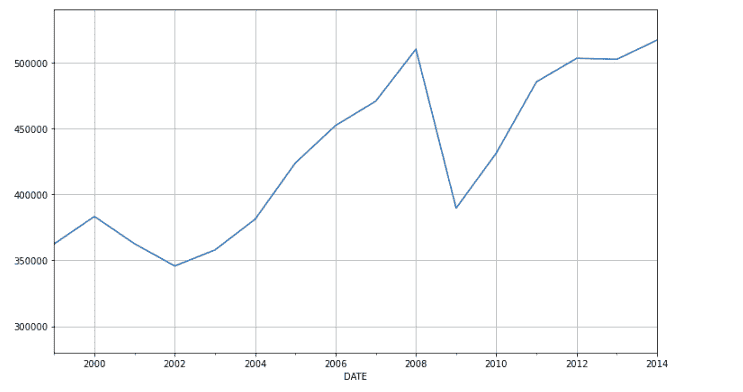

使用时间序列分析进行股票市场预测

-

你需要知道的:现代开源数据科学/机器学习生态系统

-

正义不能盲目:如何通过预测警务对抗偏见

更多相关话题

__getitem__ 介绍:Python 中的魔法方法

原文:

www.kdnuggets.com/2023/03/introduction-getitem-magic-method-python.html

作者图片

介绍

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能