KDNuggets-博客中文翻译-七-

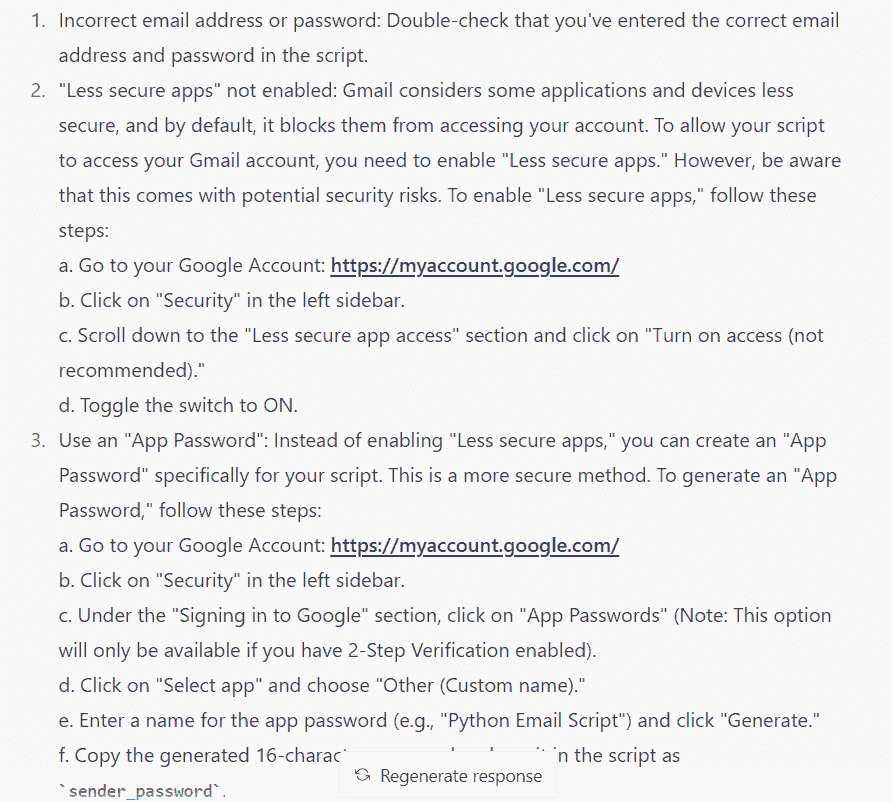

KDNuggets 博客中文翻译(七)

原文:KDNuggets

神经网络 201:自编码器全解

评论

由 Zak Jost,亚马逊网络服务研究科学家。

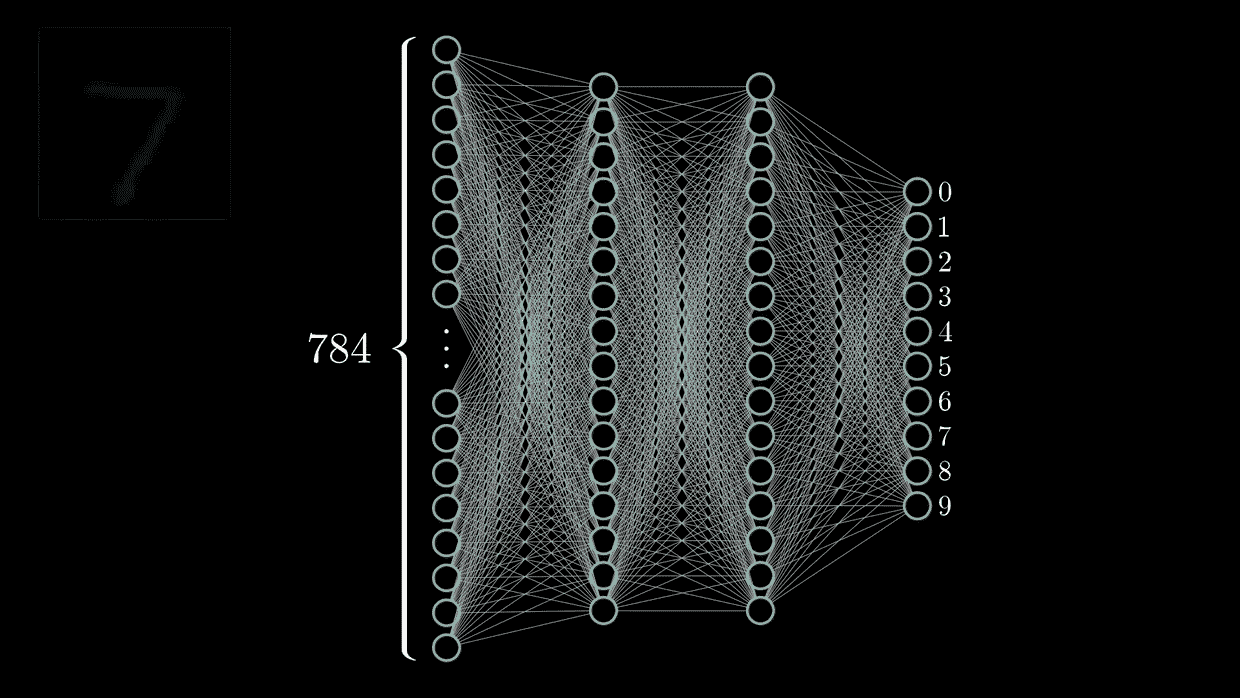

对于刚入门神经网络的人来说,自编码器可能看起来令人畏惧。 但实际上,它们是一个概念上简单而优雅的方法,将为机器学习从业者打开许多大门。 它们可以用于异常检测和缺失值填补,或帮助构建更好的分类器或聚类器。 无论如何,使它们独特的是它们为您提供了一个利用未标记数据的机制,这通常比获取标记数据要容易得多。 例如,获取一组图像要比获取一组每个图像都有标签的图像要容易得多。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

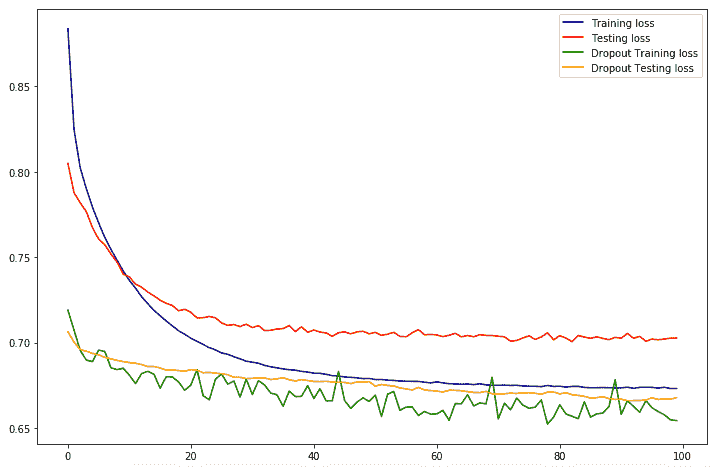

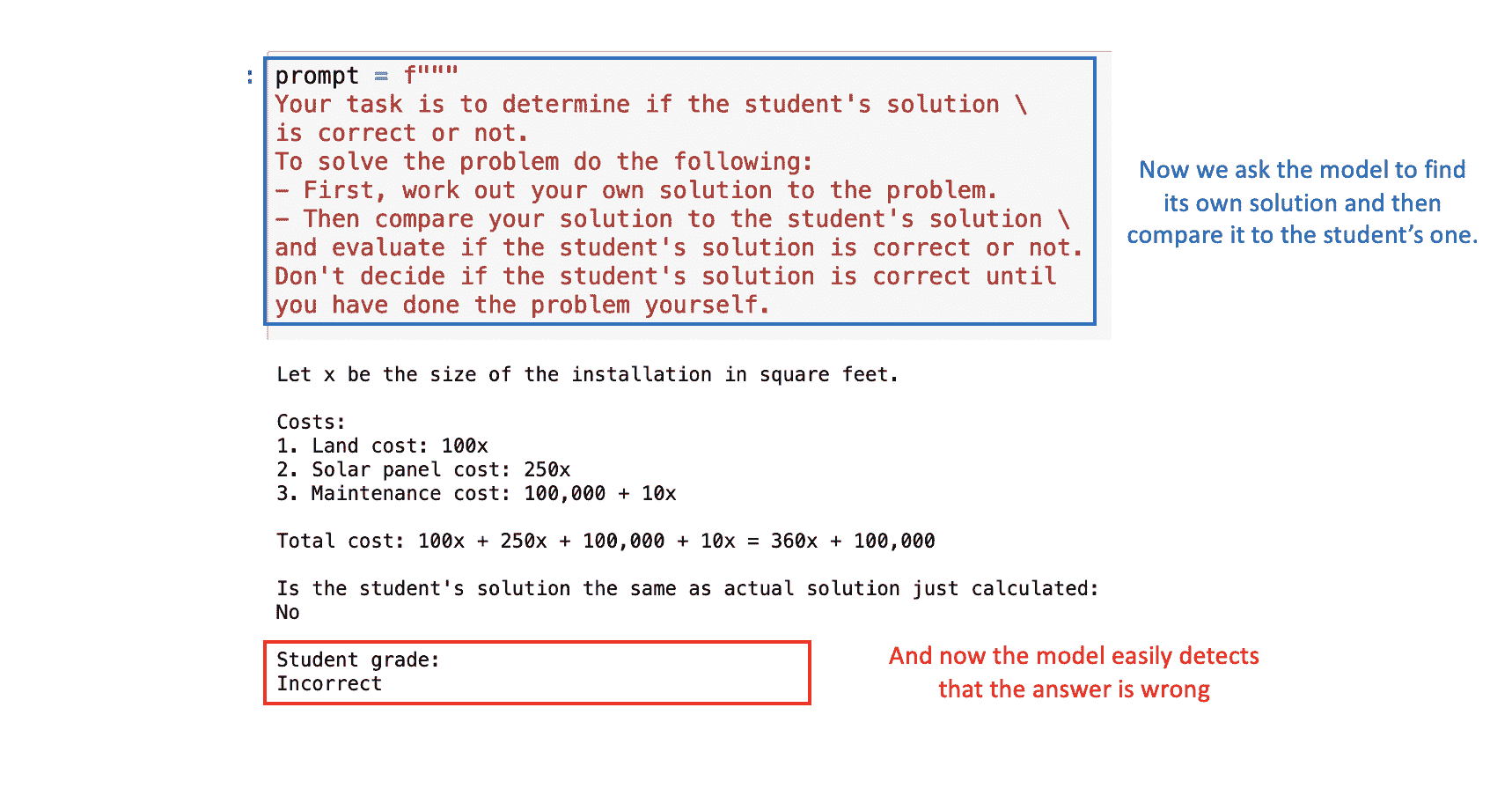

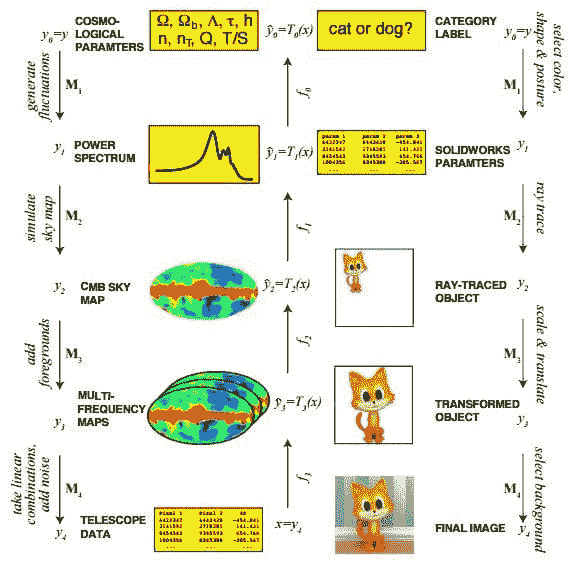

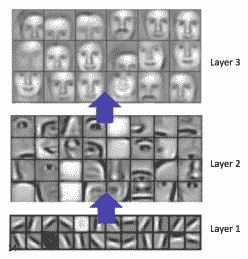

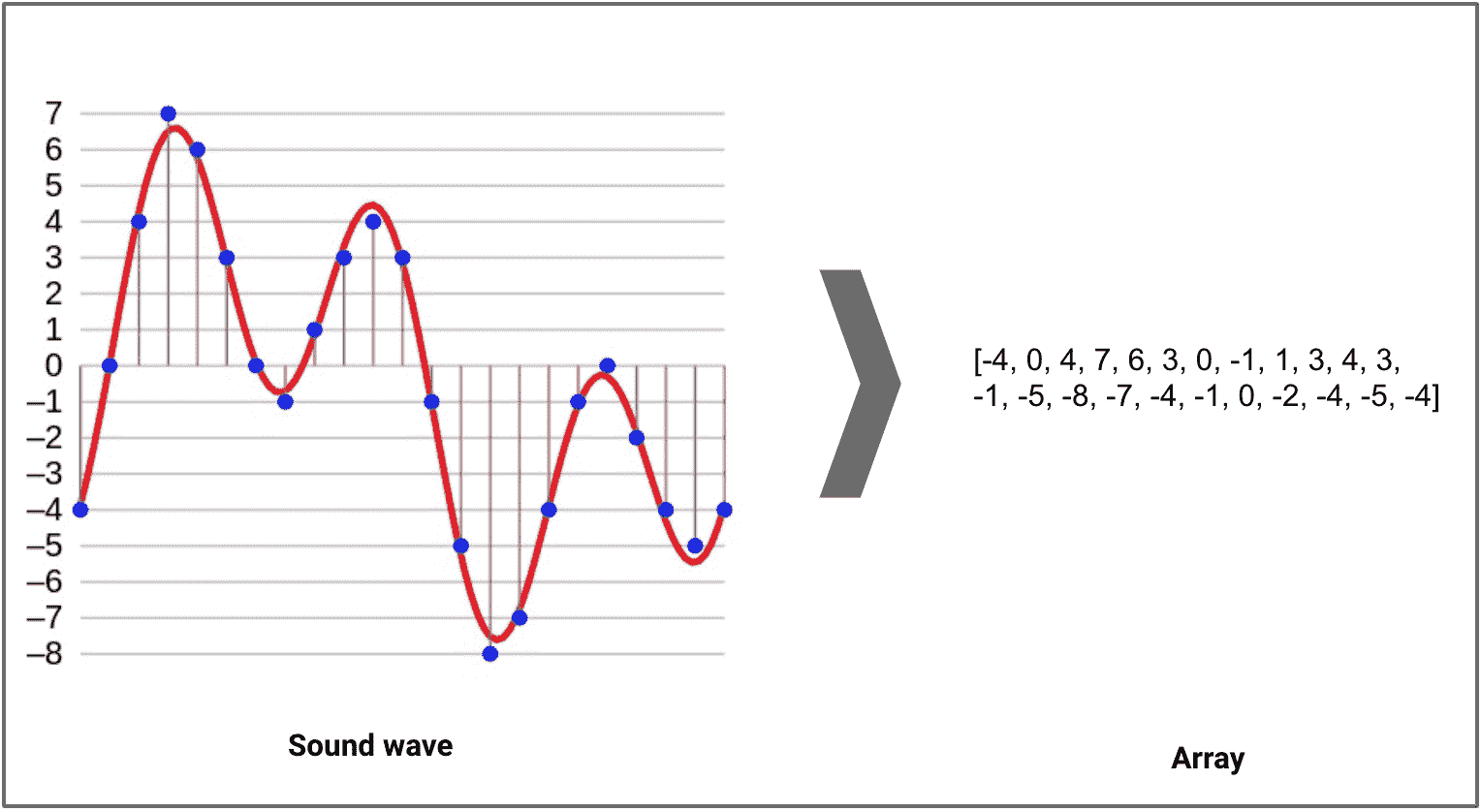

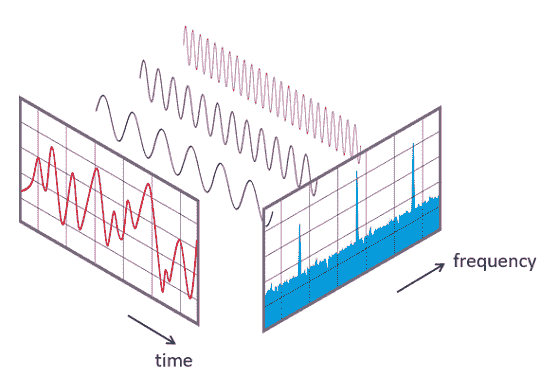

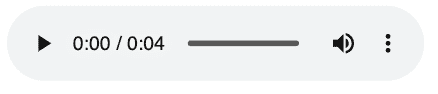

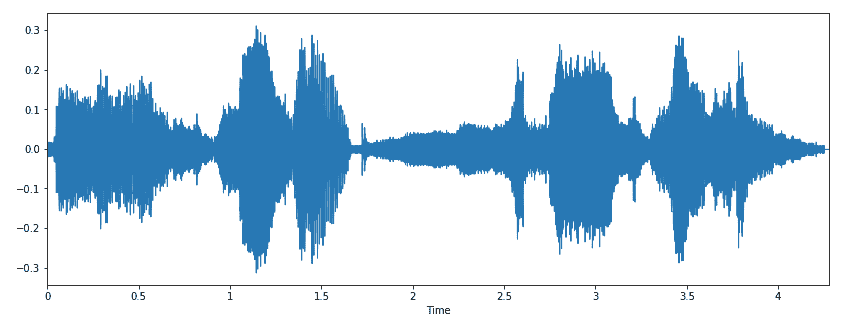

首先,自编码器通过 无监督 学习进行训练,这意味着您不需要标签。 自编码器通过使用自身的噪声版本来 预测自己的输入,这迫使其利用数据中的结构来学习紧凑的表示方式。 从高层次看,这意味着学会丢弃噪声细节,只保留重要的内容。 一旦您拥有一个能够将数据压缩到紧凑形式并丢弃细节的网络,这将打开许多新门。

为了更好地理解自编码器的工作原理以及如何使用它们,我制作了一个简短的视频,解释了关键概念。

简介: Zak Jost (@ZakJost) 是亚马逊网络服务的机器学习研究科学家,专注于欺诈应用。在此之前,Zak 曾在 Capital One 担任首席数据科学家,构建大规模建模工具以支持业务的投资组合风险评估,并在半导体行业担任材料科学家,致力于薄膜纳米材料的开发。

相关:

相关主题

关于 AI 监管环境的所有信息

图片来自 Canva

AI 正在以加速的速度发展,尽管可能性令人惊叹,但伴随而来的风险同样不容小觑,例如偏见、数据隐私、安全等。理想的方法是将伦理和负责任的指导方针嵌入到 AI 设计中。它应该被系统性地构建,以过滤风险,并仅保留技术利益。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

引用 Salesforce:

“伦理设计是将我们的伦理和人文使用指导原则有意嵌入设计和开发过程中的过程。”

但是,说起来容易做起来难。即使是开发人员也发现解读 AI 算法的复杂性,尤其是新兴能力,具有挑战性。

“根据 deepchecks 的说法,‘如果在模型开发过程中没有明确训练或期望的能力,但随着模型规模和复杂性增加而显现出来,则被认为是 LLM 的新兴能力。’”

鉴于开发人员需要帮助理解算法的内部机制以及其行为和预测背后的原因,期望在短时间内让主管部门理解并加以监管是不现实的。

此外,跟上最新发展的步伐对每个人来说都是同样具有挑战性的,更不用说及时理解这些发展以制定合适的监管措施。

欧盟 AI 法案

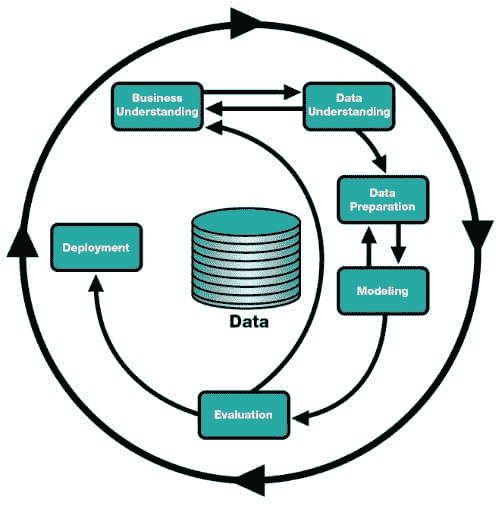

这引导我们讨论欧盟 (EU) AI 法案——这一历史性举措涵盖了一整套规则,旨在促进值得信赖的 AI。

图片来自 Canva

法律框架 旨在“确保在支持创新和改善内部市场运作的同时,保护健康、安全、基本权利、民主和法治以及环境免受 AI 系统有害影响。”

欧盟以引入《通用数据保护条例》(GDPR)而闻名,如今还通过《人工智能法案》在人工智能监管方面引领潮流。

时间线

为了论证为何制定法规需要较长时间,我们来看一下《人工智能法案》的时间线,该法案首次由欧盟委员会于 2021 年 4 月提出,随后在 2022 年 12 月被欧盟理事会采纳。三大立法机构——欧盟委员会、理事会和议会的三方会谈已于 2024 年 3 月完成,预计《法案》将于 2024 年 5 月生效。

关切谁?

关于其适用的组织,《法案》不仅适用于欧盟内的开发者,还适用于将其人工智能系统提供给欧盟用户的全球供应商。

风险等级划分

尽管所有风险并不相同,但《法案》包含了一种基于风险的方法,将应用程序分为四类——不可接受、高风险、有限和最小,根据它们对个人健康、安全或基本权利的影响。

风险等级划分意味着随着应用风险的增加,法规变得更加严格,需要更多的监管。它禁止那些带有不可接受风险的应用程序,如社会评分和生物识别监控。

不可接受的风险和高风险人工智能系统将在法规生效后六个月和三十六个月内实施。

透明度

从基本问题开始,定义什么构成人工智能系统至关重要。如果定义过于宽泛,会使大量传统软件系统也纳入监管范围,影响创新;而如果定义过于严格,则可能出现疏漏。

例如,一般用途的生成型人工智能应用程序或其基础模型必须提供必要的披露信息,如训练数据,以确保遵守《法案》。越来越强大的模型将需要额外的细节,如模型评估、评估和减轻系统性风险以及事件报告。

在人工智能生成的内容和互动中,最终用户很难理解何时看到的是人工智能生成的回应。因此,当结果不是人工生成的或包含人工图像、音频或视频时,用户必须被通知。

监管还是不监管?

像人工智能这样的技术,特别是生成型人工智能,超越了边界,可能会改变今天企业的运作方式。《人工智能法案》的时机恰到好处,与生成型人工智能时代的到来相契合,而这一时代倾向于加剧风险。

凭借集体的智慧和头脑,确保人工智能安全应成为每个组织的议程。尽管其他国家正在考虑是否引入有关人工智能风险的新规定或修订现有规定,以应对来自先进人工智能系统的新挑战,人工智能法案作为治理人工智能的黄金标准,开创了其他国家跟随和合作的道路,将人工智能用于正当用途。

监管环境面临在国家之间领导科技竞赛的挑战,常被视为获得全球主导地位的障碍。

然而,如果必须进行竞争,那最好看到的是我们在争取让人工智能对每个人都更安全,并遵循黄金伦理标准以推出全球最值得信赖的人工智能。

Vidhi Chugh是一位人工智能战略家和数字化转型领导者,她在产品、科学和工程的交汇点上工作,致力于构建可扩展的机器学习系统。她是获奖的创新领导者、作者和国际演讲者。她的使命是使机器学习普及化,并打破术语,让每个人都能参与到这一转型中。

更多相关主题

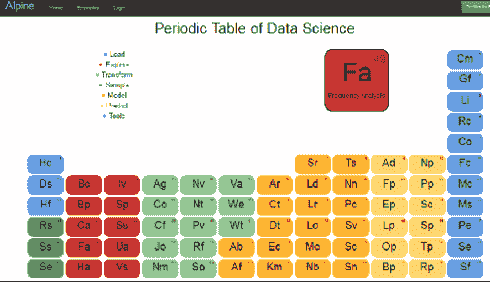

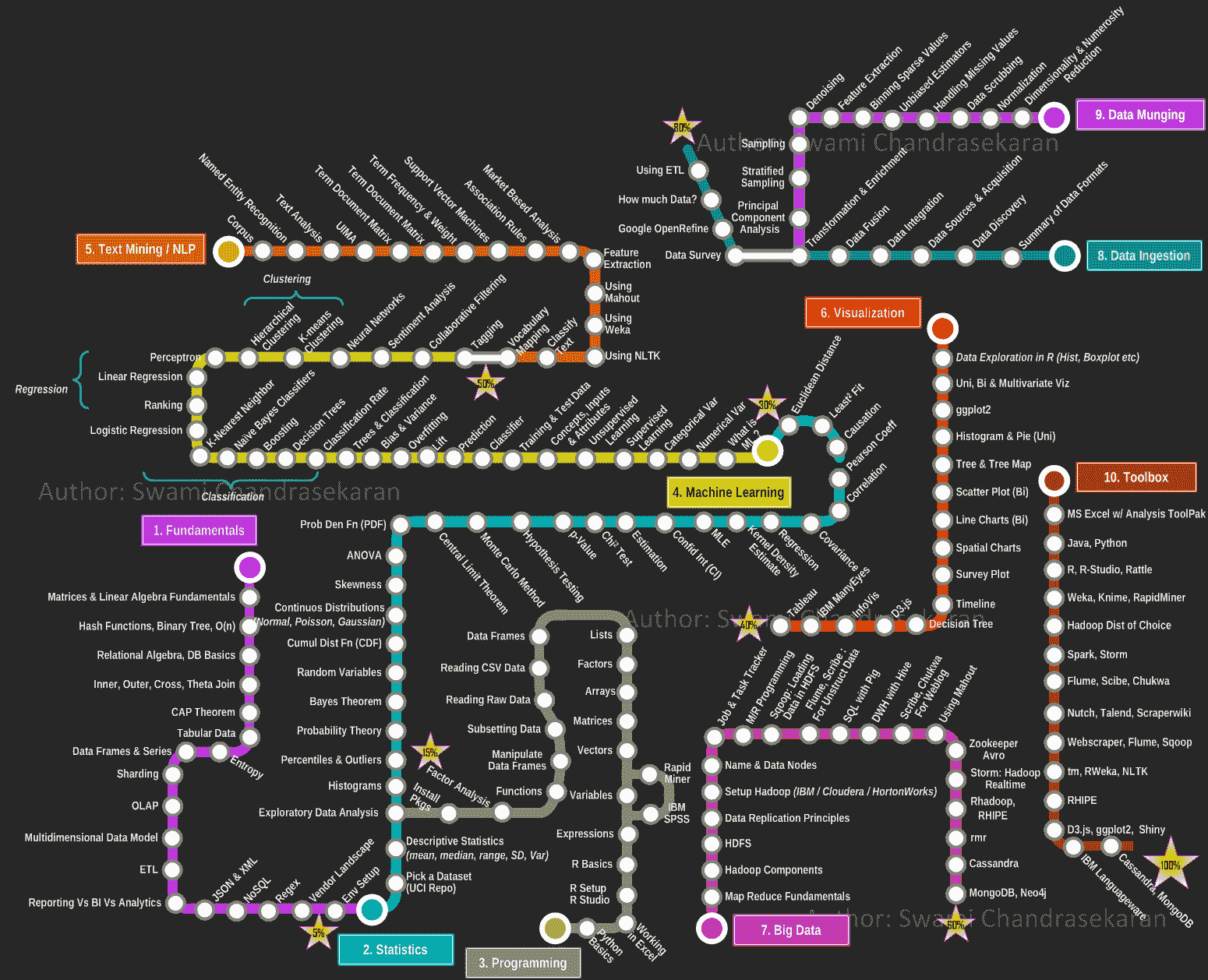

Alpine 数据科学周期表

原文:

www.kdnuggets.com/2014/02/alpine-data-science-periodic-table.html

在最近的 Strata 会议上(2014 年 2 月 11 日至 13 日在圣克拉拉),有许多创意赠品公司用来吸引潜在客户到他们的展位。

最巧妙的之一是 Alpine 的数据科学周期表

它将数据科学操作员分为 7 类:

加载:Hc - 复制到 Hadoop,Ds - 数据集 ...

探索:Bc - 条形图,Bp - 箱线图 ...

变换:Ag - 聚合,Co - 收缩 ...

样本:Rs - 随机抽样,Ss - 分层抽样 ...

模型:Ar - 关联规则,Sr - SVM 回归 ...

预测:Ad - Adaboost 预测器,Np - 神经网络预测器 ...

工具:Cm - 混淆矩阵,Gf - 拟合优度 ...

一个互动版本可以在

一个互动版本可以在 start.alpinenow.com/#/periodic-table 找到,它旨在与 Alpine Chorus 一起使用,你可以在 这里 免费获取。

更多相关话题

替代的云托管数据科学环境

原文:

www.kdnuggets.com/2019/12/alternative-cloud-data-science-environments.html

评论 来源

来源

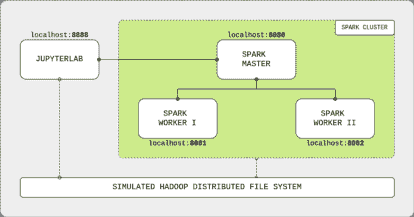

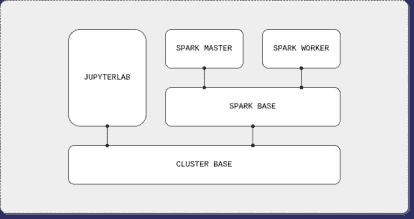

主要云服务提供商如 AWS、GCP 和 Azure 都提供使用 Jupyter 环境的数据科学环境。曾几何时,它们是需要强大计算和存储能力的数据科学家的唯一选择。多年来,新的替代提供商涌现,提供了一种独立的数据科学环境,托管在云端,供数据科学家分析、托管和分享他们的工作。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织 IT

3. Google IT 支持专业证书 - 支持您的组织 IT

以下 2 个提供商是那些想跳过整个云环境,寻找一个可以获得大存储空间和强大 CPU/GPU 性能的替代选择。

Matrix DS

MatrixDS 提供一个数据科学环境,具有社交网络类型的界面,用于分享工作和接收对工作评价。用户可以轻松地添加其他人加入他们的项目,以便与同事合作。该平台还允许您像 GitHub 一样分叉其他人的项目,并具有私有和公开模式。我们可以直接在平台上上传文件,或从 GitHub、Amazon S3、Dropbox 或 Google Cloud 拉取文件。

用户可以选择启动虚拟机,每台虚拟机都有自己的语言环境,目前 MatrixDS 支持 R、Python 和 Julia 进行分析。对于可视化和展示,它支持 Shiny、Superset、Bokeh 等。

要在 MatrixDS 中开始使用 Jupyter 环境:

-

注册一个免费账户开始使用。

-

您将被带到“项目”页面,点击右上角的绿色按钮以开始一个新项目。为其命名并添加描述,然后点击“创建”。

-

需要配置您的虚拟机,我们可以从 4GB 内存和 1 核 CPU 开始。

Saturn Cloud

Saturn Cloud 是一个相对较新的服务,由Hugo Shi于 2018 年共同创办,他也是 Anaconda 的共同创始人。Saturn Cloud 旨在成为一个平台,使我们可以成为数据科学家,而他们则可以成为数据工程师。他们的目标是为大众提供数据科学的 DevOps 服务,以便我们可以尽可能多地专注于分析阶段。

Saturn Cloud 使用 AWS 作为后端来托管他们的 Jupyter 环境,并为你和你的团队提供控制和预算成本的能力。它提供版本控制和与 Dask 的并行计算,以便与 NumPy、Pandas 和 Scikit Learn 等 Python 库兼容,而无需使用 Spark 或 Scala 等语言进行分布式计算。

开始使用 Saturn Cloud:

-

第一步是注册并创建一个账户。

-

要创建你的笔记本实例,请指定一个名称、存储、GPU 和 requirements.txt 文件以开始使用。

-

点击 CREATE,你的服务器将启动,并且你的笔记本实例将准备就绪。

Saturn Cloud 最大的吸引力之一是其并行处理能力,可以加速任何数据科学操作。Saturn Cloud 已经撰写了一篇关于进行使用 Dask 的并行处理的文章。

这些服务正被越来越多的数据科学社区采用,作为传统云提供商的替代方案。有时,对于某些项目来说,可能不需要完整的云体验,因此这两个平台可以提供仅满足我们项目需求的服务,而不会在存储或计算能力上妥协。

相关:

-

2020 年数据科学的 4 大热门趋势

-

简便的一键 Jupyter 笔记本

-

使用 DC/OS 加速企业中的数据科学

更多相关话题

机器学习中的替代特征选择方法

原文:

www.kdnuggets.com/2021/12/alternative-feature-selection-methods-machine-learning.html

图片来源于 Gerd Altmann Pixabay

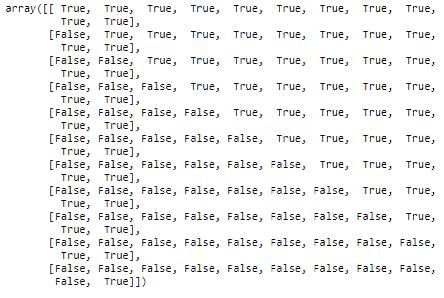

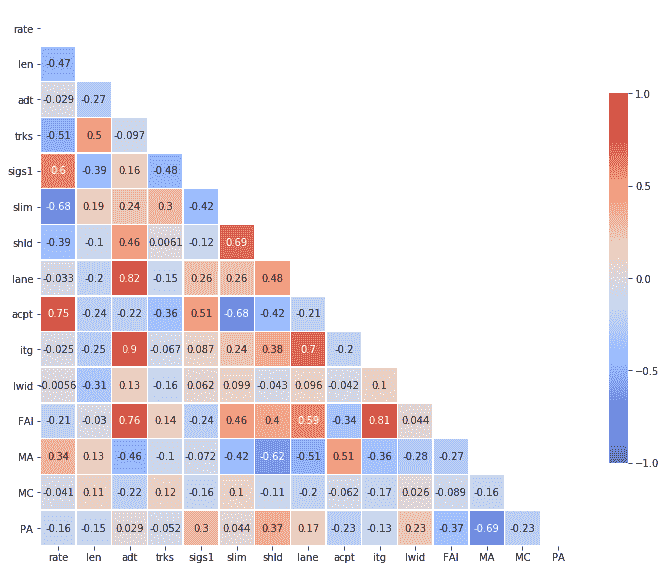

你可能已经在网上搜索过“特征选择”,也可能找到大量描述三种选择方法的文章,即“过滤方法”、“包裹方法”和“嵌入方法”。

在“过滤方法”下,我们找到基于特征分布的统计测试。这些方法计算速度非常快,但在实践中,它们未必能为我们的模型提供好的特征。此外,当我们处理大数据集时,统计测试的 p 值通常非常小,突出显示了分布中的微小差异,这些差异可能并不真正重要。

“包裹方法”类别包括贪婪算法,这些算法将基于向前、向后或穷举搜索的每种可能特征组合进行尝试。对于每种特征组合,这些方法会训练一个机器学习模型,通常使用交叉验证,并确定其性能。因此,包裹方法计算开销非常大,通常无法实现。

另一方面,“嵌入方法”会训练一个单一的机器学习模型,并基于该模型返回的特征重要性来选择特征。这些方法在实践中通常效果很好,并且计算速度较快。然而,无法从所有机器学习模型中推导出特征重要性值。例如,我们无法从最近邻算法中推导出重要性值。此外,共线性会影响线性模型返回的系数值,或决策树算法返回的重要性值,这可能掩盖其真实的重要性。最后,决策树算法在非常大的特征空间中可能表现不佳,因此重要性值可能不可靠。

过滤方法难以解释,并且在实践中不常用;包裹方法计算开销大且常常无法实施;嵌入方法并不适用于每种场景或每个机器学习模型。那么我们该怎么做呢?我们还能如何选择预测特征?

幸运的是,还有更多方法可以选择监督学习的特征。我将在这篇博客文章中详细介绍其中三种方法。有关更多特征选择方法,请查看在线课程机器学习特征选择。

替代特征选择方法

在本文中,我将描述三种基于特征对模型性能影响的算法。它们通常被称为“混合方法”,因为它们具有 Wrapper 和 Embedded 方法的特征。一些方法依赖于训练多个机器学习模型,有点像 Wrapper 方法。某些选择程序则依赖于特征重要性,如 Embedded 方法。

抛开术语不谈,这些方法在工业界或数据科学竞赛中已被成功应用,并提供了额外的方式来发现某个机器学习模型的最具预测性的特征。

在整个文章中,我将展示一些特征选择方法的逻辑和过程,并展示如何使用开源库 Feature-engine 在 Python 中实现它们。让我们开始吧。

我们将通过以下方式进行讨论:

-

特征洗牌

-

特征性能

-

目标均值性能

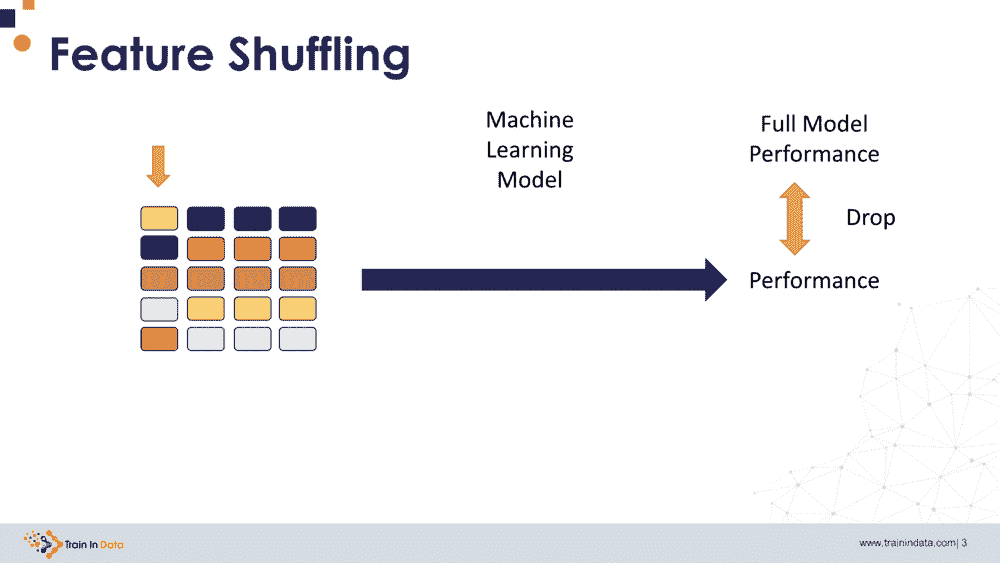

特征洗牌

特征洗牌,或称为排列特征重要性,指的是通过随机洗牌单一特征的值来评估该特征的重要性,这种方法通过观察模型性能得分的下降来进行。洗牌特征值的顺序(跨数据集的行)会改变特征与目标之间的原始关系,因此模型性能得分的下降表明模型对该特征的依赖程度。

该过程如下:

-

它训练一个机器学习模型并确定其性能。

-

它洗牌一个特征的值的顺序。

-

它用第 1 步中训练的模型进行预测,并确定其性能。

-

如果性能下降低于阈值,则保留该特征,否则将其移除。

-

它从第 2 步开始重复,直到所有特征都被检查过。

通过洗牌特征进行选择有几个优点。首先,我们只需训练一个机器学习模型。重要性随后通过洗牌特征值并用该模型进行预测来分配。其次,我们可以为我们选择的任何监督机器学习模型选择特征。第三,我们可以利用开源实施这一选择程序,接下来的段落中我们将看到如何做到这一点。

优点:

-

它只训练一个机器学习模型,因此速度较快。

-

它适用于任何监督机器学习模型。

-

它可以在 Feature-engine 中找到,这是一个 Python 开源库。

不利的一面是,如果两个特征相关,当其中一个特征被洗牌时,模型仍然可以通过其相关变量访问信息。这可能导致两个特征的重要性值较低,即使它们可能实际上是重要的。此外,为了选择特征,我们需要定义一个任意的重要性阈值,低于该阈值的特征将被移除。阈值越高,选择的特征就越少。最后,特征洗牌引入了随机性因素,因此对于重要性边界的特征,即接近阈值的特征,算法的不同运行可能会返回不同的特征子集。

考虑因素:

-

相关性可能会影响特征重要性的解释。

-

用户需要定义一个任意的阈值。

-

随机性的因素使得选择过程具有非确定性。

鉴于此,通过特征洗牌选择特征是一种良好的特征选择方法,侧重于突出直接影响模型性能的变量。我们可以使用 Scikit-learn 手动推导置换重要性,然后选择那些显示出高于某个阈值的变量。或者,我们可以使用 Feature-engine 自动化整个过程。

Python 实现

让我们看看如何使用 Feature-engine 进行特征洗牌选择。我们将使用 Scikit-learn 提供的糖尿病数据集。首先,我们加载数据:

import pandas as pd

from sklearn.datasets import load_diabetes

from sklearn.linear_model import LinearRegression

from feature_engine.selection import SelectByShuffling

# load dataset

diabetes_X, diabetes_y = load_diabetes(return_X_y=True)

X = pd.DataFrame(diabetes_X)

y = pd.DataFrame(diabetes_y)

我们设置了我们感兴趣的机器学习模型:

# initialize linear regression estimator

linear_model = LinearRegression()

我们将基于 r² 的下降使用 3 折交叉验证来选择特征:

# initialize the feature selector

tr = SelectByShuffling(estimator=linear_model, scoring="r2", cv=3)

使用 fit() 方法,转换器会找出重要变量——那些在打乱时导致 r² 下降的变量。默认情况下,如果性能下降超过所有特征引起的平均下降,则特征将被选择。

# fit transformer

tr.fit(X, y)

使用 transform() 方法,我们从数据集中删除未选择的特征:

Xt = tr.transform(X)

我们可以通过转换器的一个属性检查单个特征的重要性:

tr.performance_drifts_

{0: -0.02368121940502793,

1: 0.017909161264480666,

2: 0.18565460365508413,

3: 0.07655405817715671,

4: 0.4327180164470878,

5: 0.16394693824418372,

6: -0.012876023845921625,

7: 0.01048781540981647,

8: 0.3921465005640224,

9: -0.01427065640301245}

我们可以访问将被移除的特征名称,这些名称会在另一个属性中显示:

tr.features_to_drop_

[0, 1, 3, 6, 7, 9]

就这样,简单。我们在 Xt 中得到了一个减少的数据框。

特征性能

确定特征重要性的直接方法是仅使用该特征训练机器学习模型。在这种情况下,特征的“重要性”由模型的性能得分决定。换句话说,就是用单个特征训练的模型对目标的预测效果如何。差的性能指标表明特征较弱或无法预测。

该过程如下:

-

它为每个特征训练一个机器学习模型。

-

对于每个模型,它会进行预测并确定模型性能。

-

它选择性能指标高于阈值的特征。

在这个选择过程中,我们为每个特征训练一个机器学习模型。该模型使用一个特征来预测目标变量。然后,我们通过交叉验证来确定模型性能,并选择性能高于某个阈值的特征。

一方面,这种方法计算成本较高,因为我们需要训练与数据集中特征数量相同的模型。另一方面,基于单一特征训练的模型往往训练速度较快。

使用这种方法,我们可以为任何我们想要的模型选择特征,因为重要性由性能指标决定。缺点是,我们需要提供一个任意的阈值来进行特征选择。阈值较高时,我们选择的特征组较小。有些阈值可能比较直观。例如,如果性能指标是 roc-auc,我们可以选择性能高于 0.5 的特征。对于其他指标,如准确率,什么值算好并不那么明确。

优点:

-

它适用于任何监督式机器学习模型。

-

它逐个探索特征,从而避免了相关性问题。

-

该方法在 Feature-engine 中可用,这是一个 Python 开源项目。

考虑事项:

-

每个特征训练一个模型可能会计算成本较高。

-

用户需要定义一个任意的阈值。

-

它不会捕捉特征交互。

我们可以利用 Feature-engine 通过单特征性能来实现选择。

Python 实现

让我们从 Scikit-learn 加载糖尿病数据集:

import pandas as pd

from sklearn.datasets import load_diabetes

from sklearn.linear_model import LinearRegression

from feature_engine.selection import SelectBySingleFeaturePerformance

# load dataset

diabetes_X, diabetes_y = load_diabetes(return_X_y=True)

X = pd.DataFrame(diabetes_X)

y = pd.DataFrame(diabetes_y)

我们想要选择 r² > 0.01 的特征,利用线性回归并使用 3 折交叉验证。

# initialize the feature selector

sel = SelectBySingleFeaturePerformance(

estimator=LinearRegression(), scoring="r2", cv=3, threshold=0.01)

变换器使用 fit() 方法为每个特征拟合 1 个模型,确定性能,并选择重要特征。

# fit transformer

sel.fit(X, y)

我们可以探索将被丢弃的特征:

sel.features_to_drop_

[1]

我们还可以检查每个单独特征的性能:

sel.feature_performance_

{0: 0.029231969375784466,

1: -0.003738551760264386,

2: 0.336620809987693,

3: 0.19219056680145055,

4: 0.037115559827549806,

5: 0.017854228256932614,

6: 0.15153886177526896,

7: 0.17721609966501747,

8: 0.3149462084418813,

9: 0.13876602125792703}

使用 transform() 方法,我们可以从数据集中移除特征:

# drop variables

Xt = sel.transform(X)

就这样。现在我们有了一个减少的数据集。

目标均值性能

我现在讨论的选择过程是在 KDD 2009 数据科学竞赛中由 Miller 和同事 引入的。作者没有给这项技术命名,但由于它使用每组观察的目标均值作为预测的代理,我喜欢将这项技术称为“基于目标均值性能的选择”。

这种选择方法还为每个特征分配了一个“重要性”值。这个重要性值是从性能指标中得出的。有趣的是,该模型不训练任何机器学习模型。相反,它使用了一个简单的代理作为预测。

简而言之,该过程使用每个类别或每个区间(如果变量是连续的)的目标均值作为预测的代理。基于这个预测,它导出一个性能指标,如 r²、准确率或任何其他评估预测与实际情况的指标。

这个过程具体是如何工作的?

对于分类变量:

-

它将数据框分成训练集和测试集。

-

对于每个分类特征,它确定每个类别的平均目标值(使用训练集)。

-

它用相应的目标均值替换测试中的类别。

-

它使用编码特征和目标(在测试集上)确定一个性能指标。

-

它选择性能高于阈值的特征。

对于分类值,基于训练集确定每个类别的目标均值。然后,在测试集中用学习到的值替换这些类别,并使用这些值来确定性能指标。

对于连续变量,这个过程相当类似:

-

它将数据框分成训练集和测试集。

-

对于每个连续特征,它将值排序到离散区间中,使用训练集找出这些区间的边界。

-

它确定每个区间的平均目标值(使用训练集)。

-

它将测试集中的变量按照 2 中识别出的区间进行排序。

-

它用相应的目标均值替换区间(使用测试集)。

-

它确定编码特征和目标之间的性能指标(在测试集上)。

-

它选择性能高于阈值的特征。

对于连续变量,作者首先将观测值分到箱子中,这一过程称为离散化。他们使用了 1%的分位数。然后,他们使用训练集确定每个箱子中的目标均值,并在测试集中用目标均值替换箱子值后评估性能。

该特征选择技术非常简单;它涉及对每个水平(类别或区间)的响应进行平均,然后将这些值与目标值进行比较,以获得一个性能指标。尽管其简单,但它有许多优点。

首先,它不涉及训练机器学习模型,因此计算速度极快。其次,它能够捕捉与目标的非线性关系。第三,它适用于分类变量,这与绝大多数现有选择算法不同。它对异常值具有鲁棒性,因为这些值会被分配到一个极端的箱子中。根据作者的说法,它在分类变量和数值变量之间提供了相当的性能。而且,它是模型无关的。理论上,这个过程选择的特征适用于任何机器学习模型。

优点:

-

它计算速度快,因为没有训练机器学习模型。

-

它适用于分类变量和数值变量。

-

它对异常值具有鲁棒性。

-

它捕捉特征与目标之间的非线性关系。

-

它是模型无关的。

这种选择方法也有一些局限性。首先,对于连续变量,用户需要定义一个任意数量的区间来对值进行排序。这对于偏态变量来说是一个问题,因为大多数值可能会落在一个箱子里。其次,标签不频繁的分类变量可能导致不可靠的结果,因为这些类别的观察值很少。因此,每个类别的平均目标值将是不可靠的。在极端情况下,如果一个类别在训练集中不存在,我们将没有平均目标值作为代理来确定性能。

注意事项:

-

需要对偏态变量的区间数量进行调整。

-

稀有类别将提供不可靠的性能代理,或使该方法无法计算。

牢记这些注意事项,我们可以使用 Feature-engine 基于目标均值性能来选择变量。

Python 实现

我们将使用此方法从泰坦尼克号数据集中选择变量,该数据集混合了数值和分类变量。在加载数据时,我会进行一些预处理以方便演示,然后将其分为训练集和测试集。

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.metrics import roc_auc_score

from feature_engine.selection import SelectByTargetMeanPerformance

# load data

data = pd.read_csv('https://www.openml.org/data/get_csv/16826755/phpMYEkMl')

# extract cabin letter

data['cabin'] = data['cabin'].str[0]

# replace infrequent cabins by N

data['cabin'] = np.where(data['cabin'].isin(['T', 'G']), 'N', data['cabin'])

# cap maximum values

data['parch'] = np.where(data['parch']>3,3,data['parch'])

data['sibsp'] = np.where(data['sibsp']>3,3,data['sibsp'])

# cast variables as object to treat as categorical

data[['pclass','sibsp','parch']] = data[['pclass','sibsp','parch']].astype('O')

# separate train and test sets

X_train, X_test, y_train, y_test = train_test_split(

data.drop(['survived'], axis=1),

data['survived'],

test_size=0.3,

random_state=0)

我们将基于 roc-auc 使用 2 折交叉验证来选择特征。首先需要注意的是,Feature-engine 允许我们使用交叉验证,这是对作者原始方法的改进。

Feature-engine 还允许我们决定如何确定数值变量的区间。我们可以选择等频或等宽区间。作者使用了 1%分位数,这适用于值分布较广的连续变量,但不适用于偏态变量。在这个演示中,我们将数值变量分成等频区间。

最终,我们希望选择 roc-auc 大于 0.6 的特征。

# Feature-engine automates the selection of

# categorical and numerical variables

sel = SelectByTargetMeanPerformance(

variables=None,

scoring="roc_auc_score",

threshold=0.6,

bins=3,

strategy="equal_frequency",

cv=2,# cross validation

random_state=1, # seed for reproducibility

)

使用 fit()方法,转换器:

-

用目标均值替换类别

-

将数值变量排序为等频箱

-

用目标均值替换箱子

-

使用目标均值编码变量返回 roc-auc

-

选择 roc-auc > 0.6 的特征

# find important features

sel.fit(X_train, y_train)

我们可以探索每个特征的 ROC-AUC:

sel.feature_performance_

{'pclass': 0.6802934787230475,

'sex': 0.7491365252482871,

'age': 0.5345141148737766,

'sibsp': 0.5720480307315783,

'parch': 0.5243557188989476,

'fare': 0.6600883312700917,

'cabin': 0.6379782658154696,

'embarked': 0.5672382248783936}

我们可以找到将从数据中删除的特征:

sel.features_to_drop_

['age', 'sibsp', 'parch', 'embarked']

使用 transform()方法,我们从数据集中删除特征:

# remove features

X_train = sel.transform(X_train)

X_test = sel.transform(X_test)

简单。现在我们已经减少了训练集和测试集的版本。

总结

我们已经结束了文章。如果你看到这里,做得好,谢谢你的阅读。如果你想了解更多关于特征选择的内容,包括过滤器、包裹法、嵌入法和多种混合方法,请查看在线课程机器学习特征选择。

有关机器学习的更多课程,包括特征工程、超参数优化和模型部署,请访问我们的网站。

要在 Python 中实现过滤器、包装器、嵌入式和混合选择方法,可以查看Scikit-learn、MLXtend和Feature-engine中的选择模块。这些库附带了详尽的文档,将帮助你深入理解其背后的方法论。

简历: Soledad Galli, PhD 是Train in Data的首席数据科学家和机器学习讲师。Sole 教授中级和高级数据科学及机器学习课程。她曾在金融和保险行业工作,2018 年获得了数据科学领袖奖,并于 2019 年被选为"LinkedIn 的声音"。她还是 Python 开源库Feature-engine的创作者和维护者。Sole 对分享知识和帮助他人在数据科学领域取得成功充满热情。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关主题

持续学习:人工智能如何防止数据泄露

原文:

www.kdnuggets.com/2023/07/always-learning-ai-prevents-data-breaches.html

图片来源:Mati Mango

随着技术的进步,犯罪分子利用技术的方式也在不断演变。如今,恶意攻击和数据泄露已成为个人和组织关注的重大问题。勒索软件、钓鱼攻击以及恶意内部人员都是企业数据可能面临威胁的例子。为了减少这些威胁的影响,企业投资于基于人工智能进展的前沿技术。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 需求

问题有多严重?

要了解数据泄露问题的严重性,可以参考最新的Verizon 2023 数据泄露调查报告。报告指出,74%的报告泄露涉及人为因素,而外部经济动机的行为者负责了 83%的事件——这意味着内部人员,包括恶意和无意的人员,负责了其余的事件。

在报告的泄露事件中,24%是由于勒索软件攻击造成的,而商业电子邮件欺诈(BEC)则占了报告钓鱼攻击的一半。当数据发生泄露时,最常见的三类信息是个人数据、登录凭证以及内部企业信息,如知识产权和战略业务计划。

如果我们考察数据泄露的影响,就会发现对企业的财务负担巨大;2022 年数据泄露的平均成本为 435 万美元,相比 2020 年累计增长了 12.7%。受影响最严重的行业包括医疗保健、金融、制药、能源及其他关键业务领域。

随着犯罪分子利用人工智能(AI)工具,如生成式 AI 或大型语言模型(LLM),来制作复杂的恶意软件和诱人的钓鱼邮件,问题变得更加棘手,因为现有的安全控制措施无法检测和缓解这些威胁。

AI 如何帮助预防数据泄露?

然而,AI 既是诅咒又是福音。尽管其恶意使用可能对企业产生不利影响,但在正确的使用下,它可以成为救星。AI 技术利用算法分析数据并识别可能表示恶意活动或可疑行为的模式。凭借这些信息,可以标记潜在威胁,并提醒安全团队采取适当措施。

AI 有很多方法可以检测和预防威胁和数据泄露。

-

提高检测准确性:AI 可以通过利用检测数据中可能暗示可疑活动的模式的算法来提升恶意软件检测系统的精度。

-

监控用户活动:通过监控多个平台上的用户行为,人工智能可以识别任何可疑活动,使安全团队在发生有害攻击之前被警告。

-

更新基于签名的恶意软件防御:借助人工智能,更新基于签名的恶意软件检测系统可以变得更加高效。通过利用先进的算法,AI 可以轻松检测到现有恶意软件的新变种,防止诸如勒索软件攻击等恶意行为,并减少其影响。

-

识别可疑内容:AI 可以帮助识别可疑内容,如钓鱼链接、恶意网址或感染的附件,免去你手动检查其有效性的麻烦。通过扫描这些内容,安全团队可以采取预防措施,避免有人成为钓鱼或基于电子邮件的攻击的受害者。

-

检测零日漏洞:AI 还可以帮助识别零日漏洞。在算法的帮助下,可以分析数据趋势来预测潜在的零日攻击,并在它们成为真正的威胁之前将其隔离。

AI 在数据安全中的好处

使用 AI 来识别和预防威胁和数据泄露对组织有许多好处。首先,AI 使得安全团队能够迅速响应对公司数据的潜在风险。这些系统持续扫描网络并监控用户行为,实时警告团队任何可疑活动,从而增加在数据被泄露或窃取之前阻止攻击的可能性。

其次,AI 通过自动化诸如恶意软件扫描和识别恶意网址等枯燥的任务,提供了更高效的威胁响应方法。这使得安全团队可以专注于需要更多关注的关键领域。将手动工作从工作流程中移除,使得团队在检测和防止数据攻击方面更为有效,从而减少数据泄露的数量及其对组织的影响。

此外,人工智能可以通过减少对人工劳动力的需求来帮助降低安全成本。通过及早检测威胁,这些系统可以减少恶意攻击造成的损害,并降低数据泄露带来的损害。IBM 数据泄露成本报告强调了尽早缓解数据泄露的情况可以显著减少对受影响组织的整体成本。

最后,人工智能可以通过识别数据中的攻击模式来帮助安全团队预防未来的攻击。通过从过去的事件中学习,人工智能算法可以帮助安全团队采取适当的主动措施,增强企业和敏感数据的安全性,并防止攻击。

然而,组织也应了解人工智能系统固有的某些局限性。例如,人工智能安全工具需要大量数据才能得到充分的训练,从而提供准确的检测和警报。否则,人工智能系统可能会产生误报或遗漏特定威胁,这会给安全团队带来额外压力,并损害安全态势。此外,为了保持有效性,训练人工智能算法应当是一个持续的努力,以适应不断变化的威胁环境。

利用人工智能提升数据安全

在与网络犯罪分子的斗争中,人工智能是一个宝贵的盟友。投资于人工智能以提高数据安全性和整体业务网络安全是明智的决定,因为它可以提供更强的保护,抵御恶意活动,降低数据泄露和其他网络攻击的可能性。然而,就像生成性人工智能不能替代人类创造力一样,人工智能安全工具也不能(尚未)替代人类在网络安全中的作用。

Anastasios Arampatzis 是一位退役的希腊空军军官,拥有超过 20 年的 IT 项目管理和网络安全评估经验。在他的军旅生涯中,他曾被分配到国家、北约和欧盟总部的多个关键岗位,并因其专业知识和职业精神获得了众多高级军官的荣誉。他被提名为信息安全的认证北约评估员。目前,他在Bora Design担任网络安全内容撰写工作。

相关话题

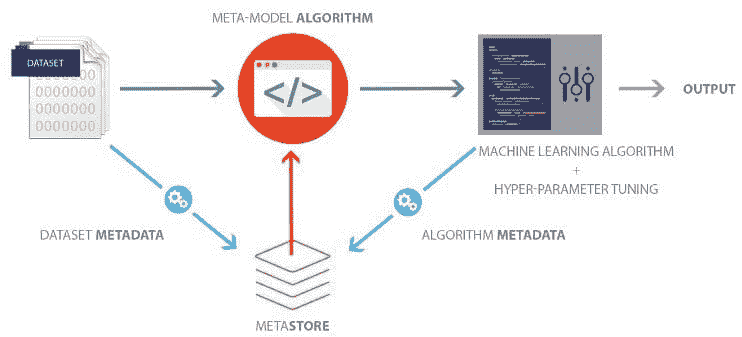

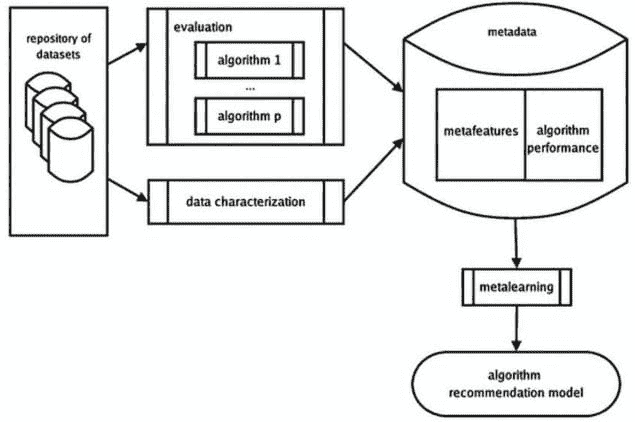

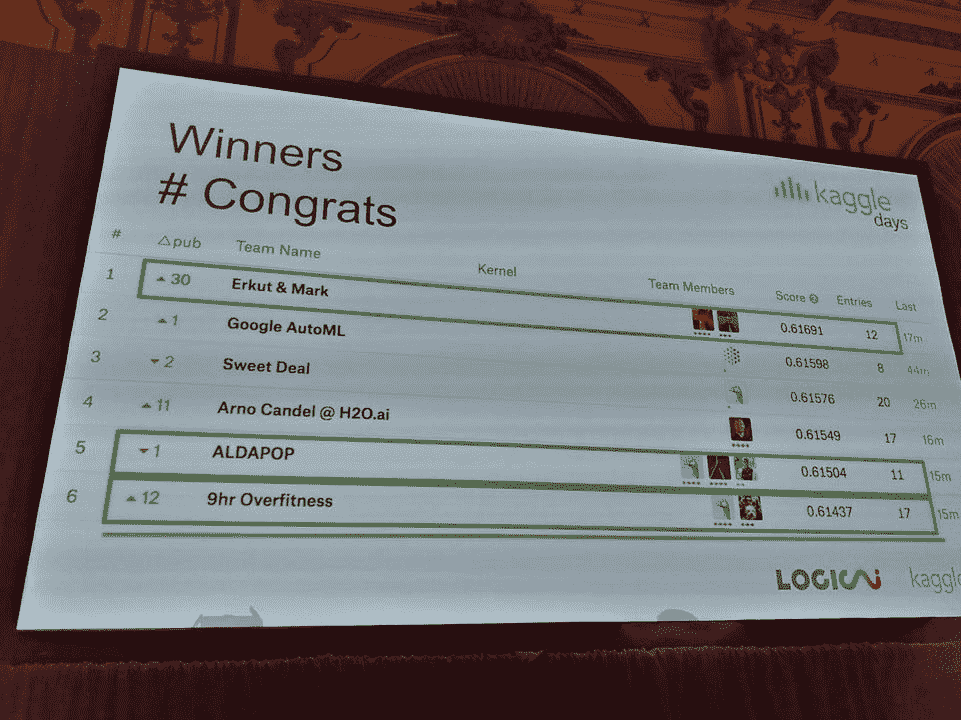

亚马逊通过 AutoGluon 进入 AutoML 竞赛:一些你应该了解的 AutoML 架构

原文:

www.kdnuggets.com/2020/01/amazon-automl-autogluon-architectures-know-about.html

评论

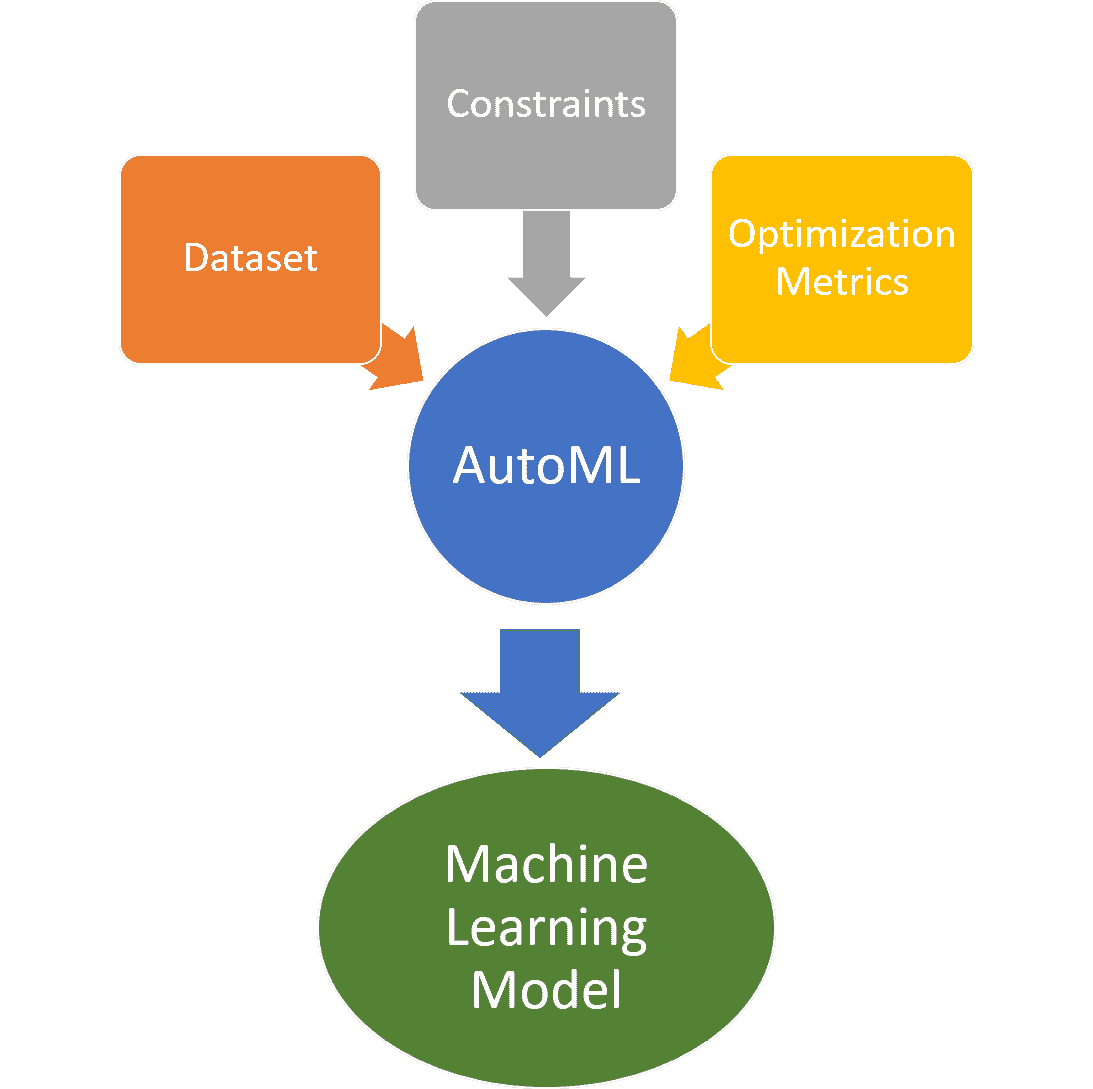

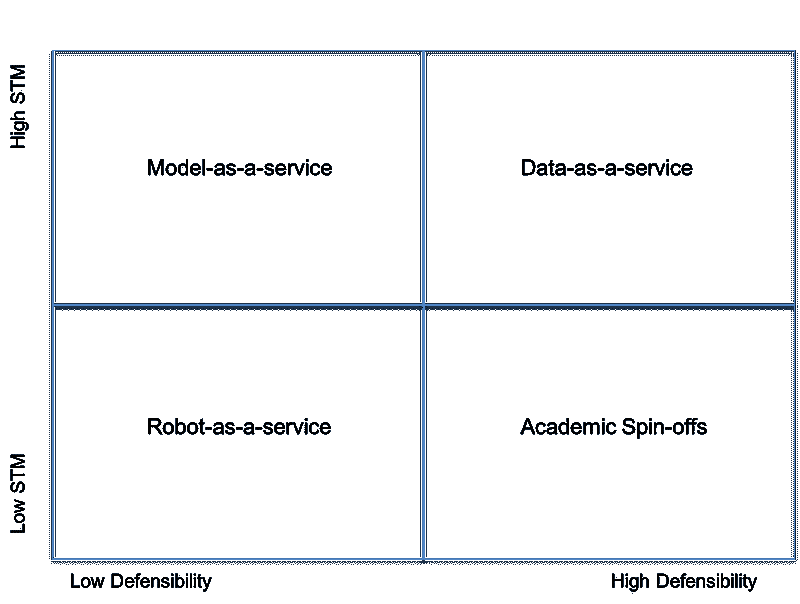

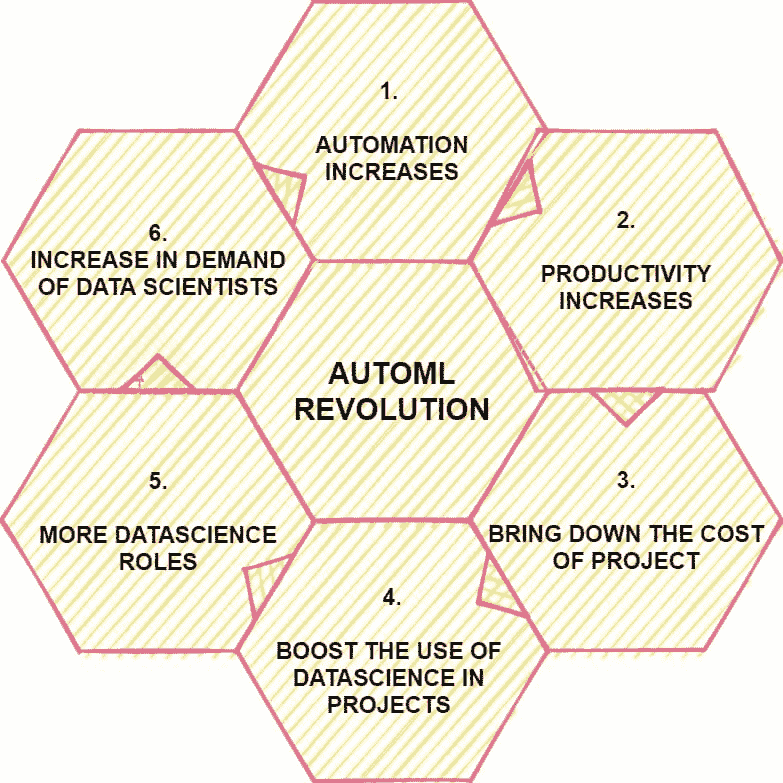

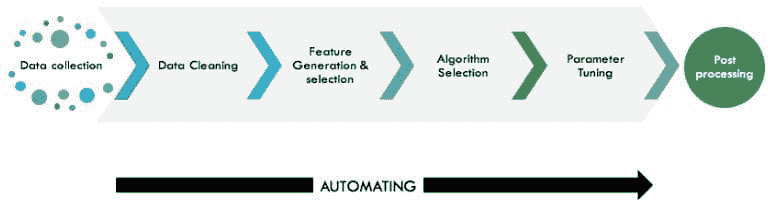

几天前,亚马逊宣布发布 AutoGloun,一个新工具包,通过仅仅几行代码简化了深度学习模型的创建。这次发布标志着亚马逊进入了竞争激烈的自动化机器学习(AutoML)领域,而这一领域正成为企业机器学习平台的热门趋势。在 AutoML 生态系统的新闻如此之多的情况下,有时很难从中分辨出真正的重要信息。今天,我想探索一些市场上最具创新性的 AutoML 堆栈,这些堆栈并未获得太多的宣传。

AutoML 正成为现代数据科学应用中最热门的话题之一。人们常常将 AutoML 视为一种无需复杂数据科学知识即可使用现成机器学习模型的机制。虽然从理论上讲,这种说法是有道理的,但现实情况却有所不同。在当前的人工智能(AI)阶段,大多数现实世界的应用需要一定程度的机器学习知识。使用如 Watson Developer Cloud 或 Microsoft Cognitive Services 这样的基础 API 可以解决的场景非常基本,只占机器学习场景广泛范围的一小部分。如果是这样的话,那么我们应该考虑 AutoML 的真正价值是什么。

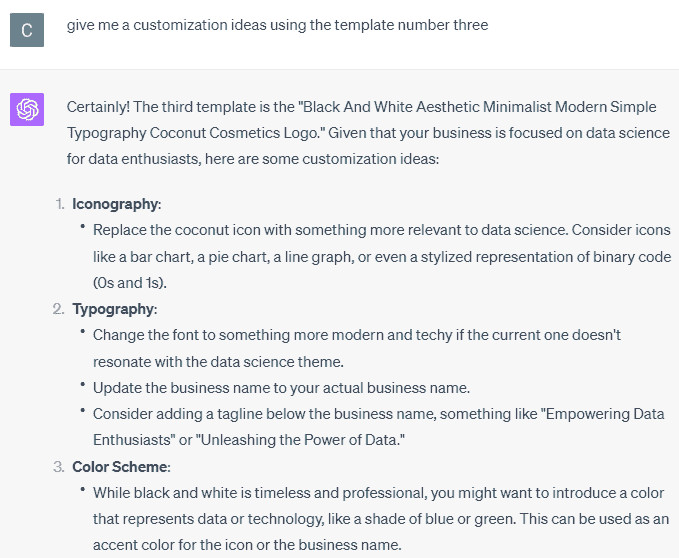

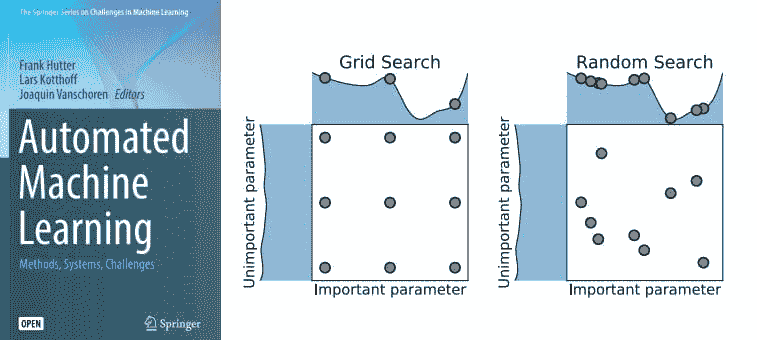

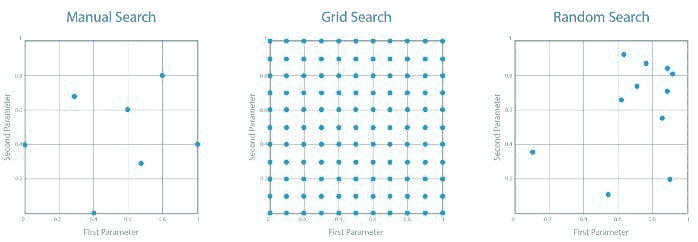

挑战

模型选择是构建机器学习解决方案中最困难的方面之一。有些讽刺的是,尽管机器学习应用中融入了大量科学和数学,模型选择仍然是一个高度主观的任务,依赖于专家的意见。在任何给定的场景中,能够解决该场景的机器学习模型数量都非常庞大,那么我们如何真正知道我们是否在使用最优模型呢?更糟糕的是,即使我们选择了正确的机器学习技术,我们如何确定我们拥有正确的神经网络架构?而一旦我们确定了具体的架构,我们又如何知道正确的超参数配置?这些问题在整个机器学习应用生命周期中困扰着数据科学家。此外,对机器学习问题所需的准确度越高,模型选择过程花费的时间就越多。

毫不奇怪,选择和构建机器学习模型的过程是一个极其耗时的工作,且从未提供过确切的答案。矛盾的是,这正是机器学习擅长的领域,那么我们能否发挥创意,将选择机器学习架构的过程建模为一个机器学习问题呢?

AutoML 来拯救

模型搜索是一个看起来非常适合 AutoML 的应用场景。给定一个数据集、一系列优化指标以及一些时间或资源的限制,AutoML 方法应该能够评估成千上万的神经网络架构并产生最佳结果。虽然有效的数据科学团队可能只能评估几个模型来解决特定问题,但 AutoML 方法可以在相对可控的时间内快速搜索成千上万的架构。

使用机器学习来构建更好的机器学习模型似乎像是铁人电影中的情节 ???? 这在现实世界中真的发生了吗?绝对发生了!以下是一些我最喜欢的 AutoML 在关键任务应用中的高调案例研究。

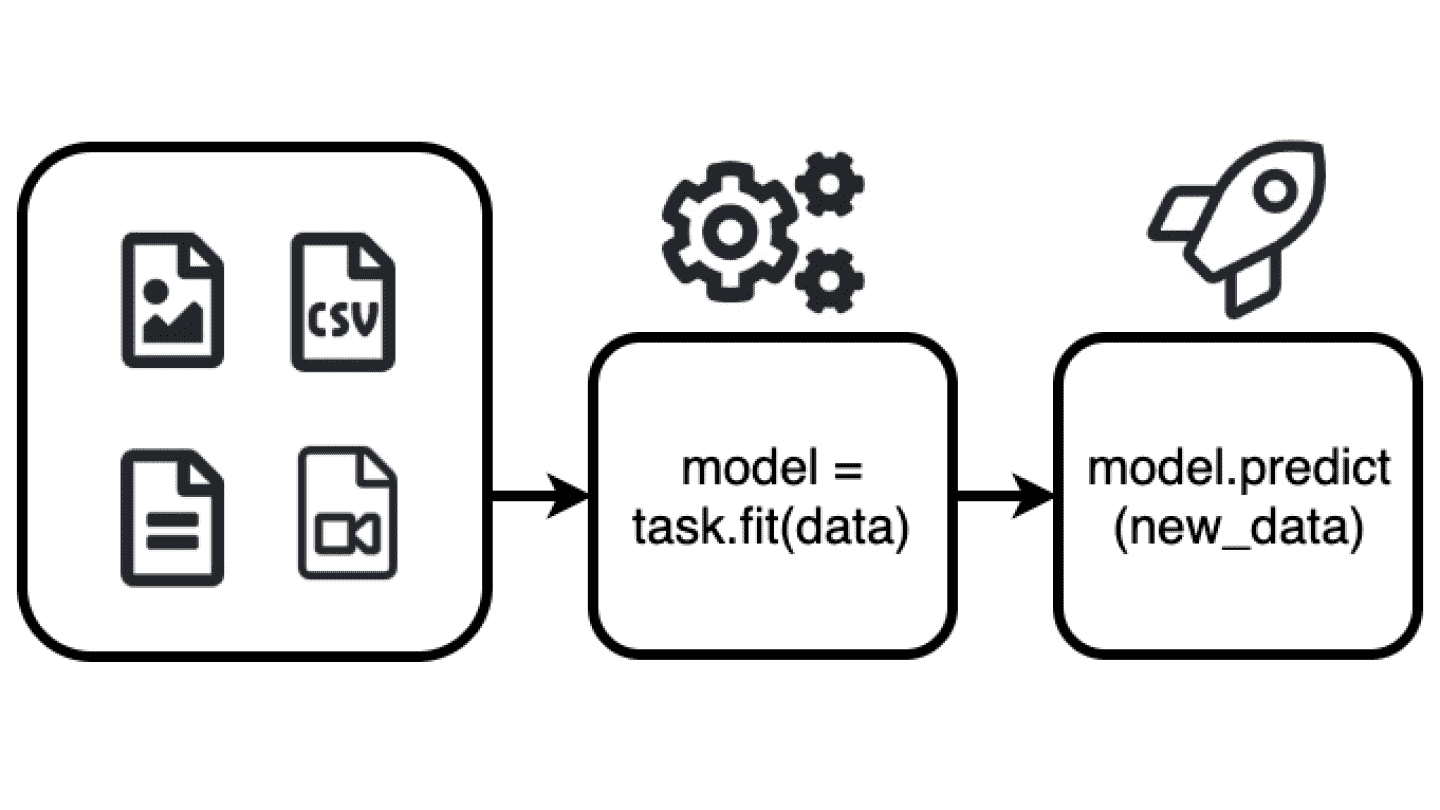

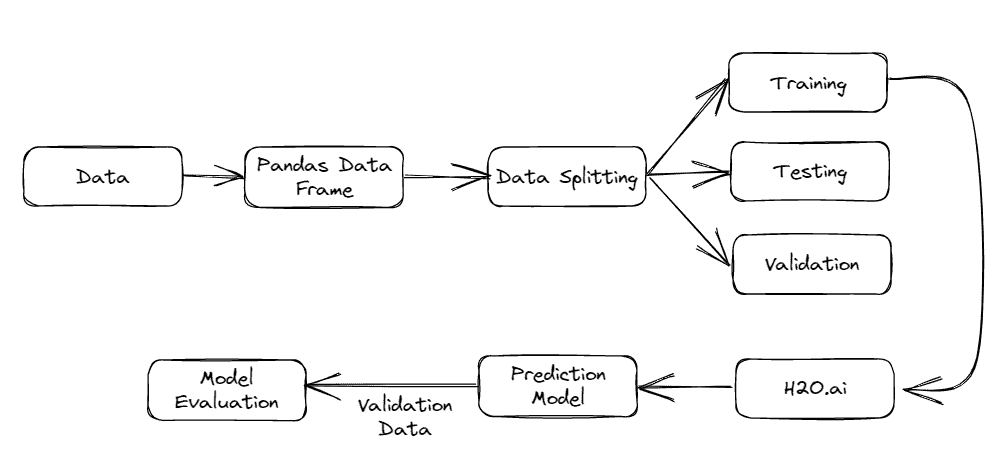

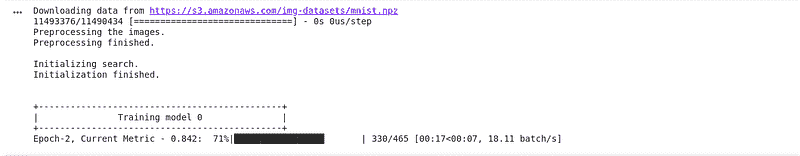

AutoGluon

让我们从最新的成员开始:亚马逊的 AutoGluon。功能上,AutoGluon 是一个开源库,供开发者在处理涉及图像、文本或表格数据集的机器学习应用时使用。AutoGluon 提供易于使用和扩展的 AutoML,专注于深度学习及涵盖图像、文本或表格数据的实际应用。该框架旨在服务于机器学习初学者和高级专家。AutoML 的第一个版本包括以下一些功能:

-

用少量代码快速原型化深度学习解决方案。

-

利用自动超参数调整、模型选择/架构搜索和数据处理。

-

自动使用最先进的深度学习技术,无需专家知识。

-

轻松改进现有的定制模型和数据管道,或根据你的使用场景定制 AutoGluon。

Salesforce TransmogrifAI:Einstein 背后的大脑

Salesforce.com 的 Einstein 是全球应用最广泛的机器学习应用之一。最终,Einstein 解决了一系列机器学习场景,如销售预测或潜在客户优先级排序,这些场景在销售和营销应用中无处不在。然而,Einstein 的独特之处在于其机器学习模型能够在完全不同的 Salesforce.com 配置下以自助服务的方式运行。每个客户可能有完全不同的销售和营销模式,但 Einstein 仍然可以完成工作。

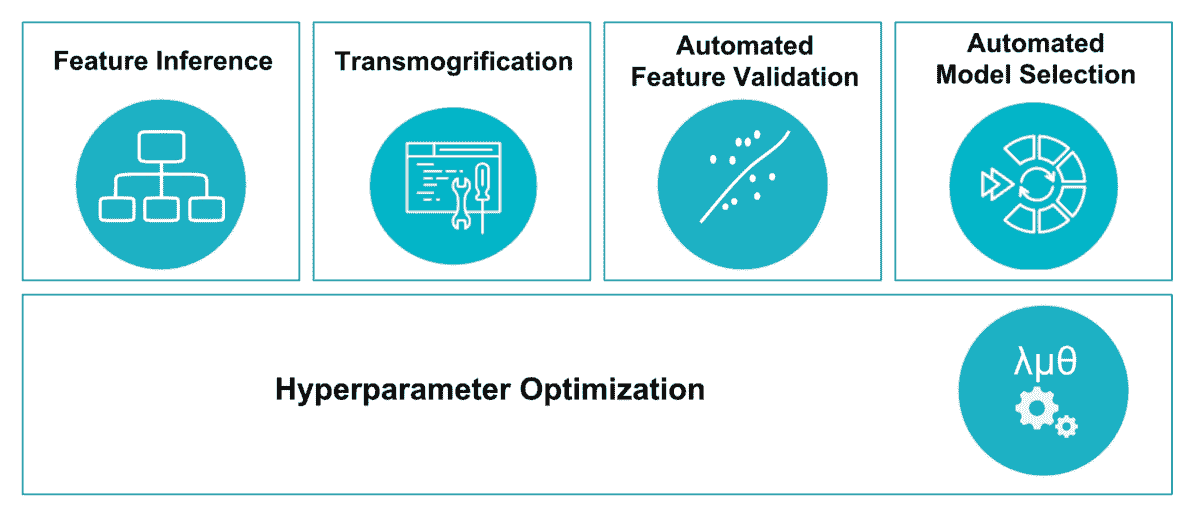

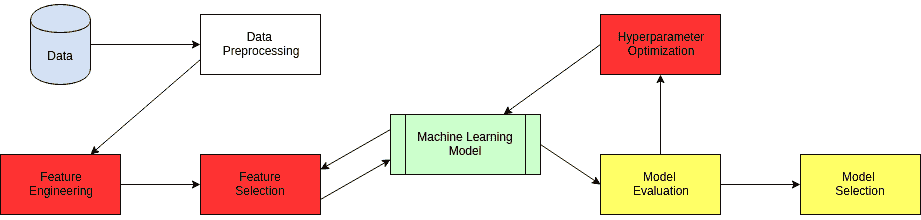

Salesforce 的 Einstein 背后的魔力由一个名为 TransmogrifAI 的开源框架提供支持。从概念上讲,TransmogrifAI 是一个基于 AutoML 的框架,用于针对结构化数据(行和列)创建机器学习模型。更具体地说,TransmogrifAI 在机器学习工作流程的五个基本领域中利用了 AutoML:

-

特征推断: 从给定数据集中提取特征。

-

变形: 将特征转换为数值。

-

特征验证: 减少维度,识别潜在偏差等。

-

模型选择: 在数千个潜在模型中进行搜索。

-

超参数优化: 调整超参数配置。

鉴于 Salesforce.com 的影响,TransmogrifAI 可能被认为是全球最大的 AutoML 应用之一。

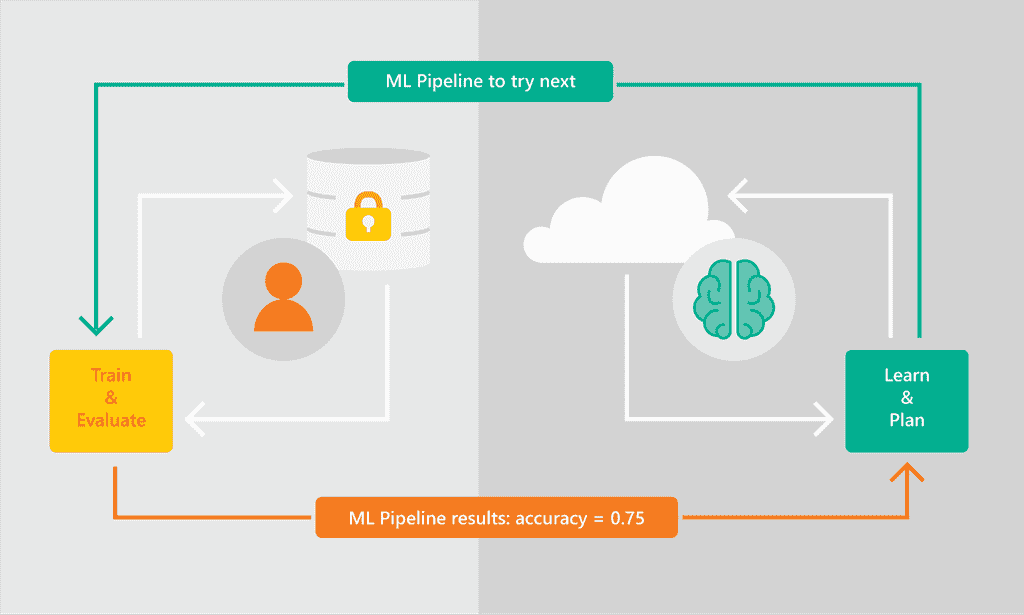

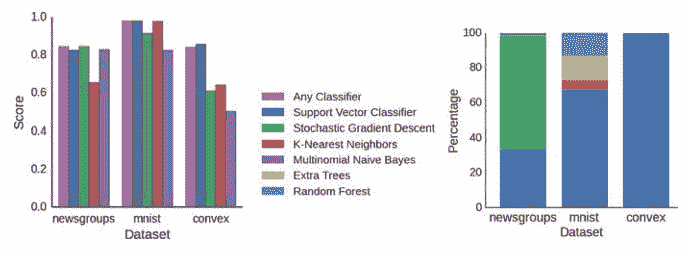

Azure ML:帮助开发者选择合适的机器学习模型

去年,微软研究院进行了一项实验,利用 AutoML 和概率编程来自动化模型选择。结果 被记录在一篇非常受欢迎的研究论文中,并在性能上代表了一项突破。在短短几个月内,微软研究团队开创的 AutoML 方法被应用于微软的旗舰机器学习产品:Azure ML。

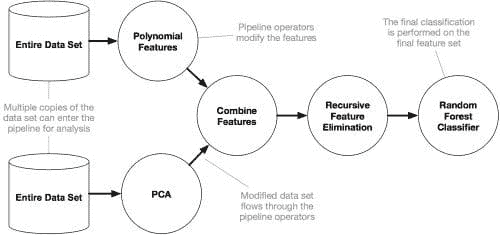

Azure ML 的最新版本利用 AutoML 简化模型选择。该平台包括一个 AutoML 服务,定期推荐新的机器学习管道以解决特定问题。管道的执行在客户的 Azure ML 实例中进行,而 AutoML 服务仅查看结果并使用这些结果做出更好的推荐。

Azure ML 堆栈中的 AutoML 实现是我见过的最完整的之一。当前版本支持对数值和文本数据进行分类和回归 ML 模型推荐,支持自动特征生成(包括缺失值填补、编码、归一化和基于启发式的方法的特征)、特征转换和选择。开发者可以通过 Python SDK 或 Jupyter Notebooks 使用 AutoML。

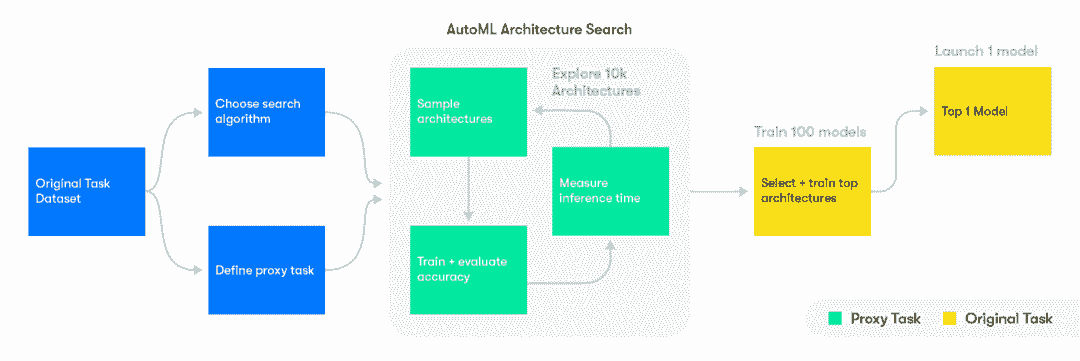

Waymo:自动化模型选择用于自动驾驶汽车

自动驾驶汽车就像是一大群安装在四个轮子上的机器学习模型 ????。机器学习使自动驾驶汽车具备所有智能功能,如帮助车辆识别周围环境、理解世界、预测他人行为并决定最佳行动方案。字母表公司的子公司 Waymo 处于自动驾驶汽车技术的最前沿,因此在机器学习领域不断创新。

最近,Waymo 工程团队 发布了详细的博客文章,介绍了他们如何利用 AutoML 自动化不同机器学习应用中的模型选择。具体而言,Waymo 团队利用了一种名为 NAS 单元 的 AutoML 技术,这在图像分析算法中已被证明非常有效。

在 Waymo,AutoML 被用于探索卷积网络架构(CNN)中的数百种不同 NAS 单元组合,训练和评估 Waymo 的 LiDAR 分割任务模型。实验已产生出具有 20%-30% 更低延迟和 8%-10% 更低错误率的 CNN 架构,相较于手工设计的模型。

从这些例子中可以看出,AutoML 正在成为高度可扩展机器学习架构中的重要元素之一。亚马逊的进入无疑是推动 AutoML 成为机器学习架构关键组件的又一推动力。AutoGluon 是另一个例子,说明用于模型搜索的 AutoML 工具和框架正在不断改进,并逐渐向主流开发者开放。虽然 AutoML 有其他很好的使用案例,但在现实世界机器学习应用中,模型选择仍然是带来最大好处的驱动力。

原文。经授权转载。

相关:

-

AutoML 调查结果:如果你尝试它,你会更喜欢它

-

自动化机器学习:团队如何在 AutoML 项目中协作?

-

AutoML 对时序关系数据:一个新前沿

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关主题

Amazon Machine Learning:实用还是过于简单?

原文:

www.kdnuggets.com/2016/02/amazon-machine-learning-nice-easy-simple.html

作者:Alex Perrier,@alexip,(最初发布于Open Data Science 博客)

机器学习即服务(MLaaS)承诺将数据科学带入公司可及的范围。在这种背景下,Amazon Machine Learning 是一种具有二分类/多分类和线性回归特性的预测分析服务。该服务提供了简单的工作流程,但缺乏模型选择功能,执行时间较慢。预测性能令人满意。

数据科学很热门且具有吸引力,但它也很复杂。构建和维护数据科学基础设施可能很昂贵。经验丰富的数据科学家稀缺,内部开发算法、构建预测分析应用程序和创建生产就绪的 API 需要特定的专业知识和资源。尽管公司可能预计数据科学服务的好处,但在进行必要投资之前,他们可能不愿意先行测试。

这就是机器学习即服务(Machine Learning-as-a-Service)介入的地方,它承诺简化和普及机器学习:在短时间内享受机器学习的好处,同时保持低成本。

一些关键参与者已经进入了这个领域:Google Predictive Analytics、Microsoft Azure Machine Learning、IBM Watson、Big ML和许多其他。有些提供简化的预测分析服务,而有些则提供更专业的界面和超越预测的数据科学服务。

相对较新的参与者是 AWS 的Amazon Machine Learning服务。该服务于 2015 年 4 月在 AWS 2015 峰会上推出,距今不足一年。Amazon Machine Learning 旨在通过关注数据工作流并将更复杂的技术细节隐藏在后台,简化预测分析。通过将技术细节的重要部分从用户视野中移除,Amazon Machine Learning 将数据科学带给更广泛的受众。它显著降低了公司尝试预测分析的门槛,使强大的机器学习工具能够在很短的时间内可用和运作。

互联网的大部分已经在运行 AWS 的许多服务。AWS 将机器学习服务添加到其中将允许工程师将预测分析能力纳入现有应用程序。

亚马逊机器学习使公司能够在不投入大量资源和投资的情况下尝试数据科学并评估其业务价值。在这方面,亚马逊机器学习是希望搭乘数据科学列车的公司的 预测分析入门。

活塞、汽化器和滤清器:引擎下的秘密是什么?

亚马逊机器学习的一个重要特征是其简化的机器学习方法。它“为我们简化了机器学习 [InfoWorld]“;它“使任何开发者都能触及机器学习 [Techcrunch].”

但预测分析是一个复杂的领域。诸如数据处理、特征工程、参数调整和模型选择等任务需要时间,并遵循一套完善的协议、方法和技术。亚马逊机器学习的简化服务是否仍能在不牺牲复杂性的情况下提供性能?你是否还能通过简化的机器学习流程获得预测分析的好处?

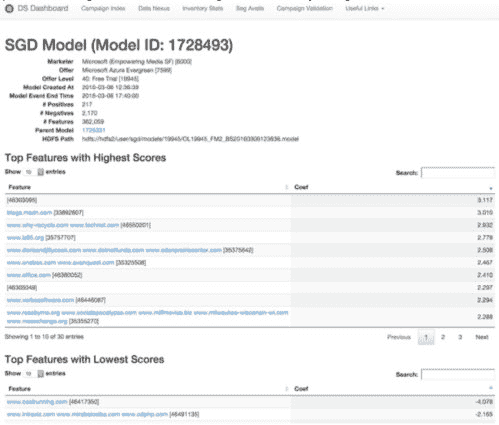

1 个模型,1 种算法,3 种任务,简单的管道设置,向导和智能默认值

根据 文档,亚马逊机器学习基于通过 随机梯度下降(简称 SGD)训练的线性模型。就是这样。没有随机森林或提升树,没有内核 SVM、贝叶斯分类器或聚类。这可能看起来是一个严峻的限制。然而,由 Leon Bottou 开发的随机梯度下降算法是一个非常稳定和鲁棒的算法。这个算法已经存在很长时间,并且多年来有许多改进版本。

这个简单的预测设置很可能足以解决大量现实世界的商业预测问题。正如我们将看到的,它也表现出不错的性能。

任务

亚马逊机器学习平台提供三种监督学习任务,每种任务都有其相关模型和损失函数。

-

二分类 使用逻辑回归(逻辑损失函数 + SGD)

-

多分类 使用多项逻辑回归(多项逻辑损失 + SGD)

-

以及 回归 使用线性回归(平方损失函数 + SGD)

对于二分类器,评分函数是F1-measure;对于多类分类器,评分是宏平均 F1-measure,它是每个类别 F1-measure 的平均值;对于回归使用 RMSE 指标。F1-measure 通常用于信息检索,是精确率和召回率的调和平均数。这是一种稳健的分类度量,对多类不平衡不太敏感。

使用 Recipes 进行特征工程

在 Amazon 机器学习管道中,可以使用Recipes来转换你的变量。通过 JSON 格式的指令可以进行多种转换:替换缺失值、笛卡尔积、将分类变量分箱为数值型变量,或为文本数据形成 n-grams。

例如,这里是一个在处理鸢尾花数据集时自动生成的将分类值转换为数值值的 Recipe。

{

"groups" : {

"NUMERIC_VARS_QB_50" : "group('sepal_width')",

"NUMERIC_VARS_QB_20" : "group('petal_width')",

"NUMERIC_VARS_QB_10" : "group('petal_length','sepal_length')"

},

"assignments" : { },

"outputs" : [ "ALL_CATEGORICAL",

"quantile_bin(NUMERIC_VARS_QB_50,50)",

"quantile_bin(NUMERIC_VARS_QB_20,20)",

"quantile_bin(NUMERIC_VARS_QB_10,10)" ]

}

训练集与验证集

默认情况下,Amazon 机器学习将你的训练数据集拆分为 70/30。Amazon 机器学习将丰富的技术简化为非常简单且有限的选择。数据拆分为训练集和验证集可以用多种方式进行,而 Amazon 机器学习将其简化为随机化样本或不随机化。你当然可以在 Amazon 机器学习之外自行拆分数据,创建一个新的数据源用于保留集,并在该保留集上评估模型的性能。

SGD 参数调整

可用于调整模型的参数数量较少:传递次数、正则化类型(无、L1、L2)和正则化参数。无法设置算法的学习率,也没有信息说明如何设置这个重要参数。

那么,你从哪里开始?

AWS 控制台主页有超过 50 种不同服务,名称如 Elastic Beanstalk、Kinesis、RedShift 或 Route 53,这可能会让人感到畏惧。然而,得益于良好的文档和一套设计良好的向导,创建你的第一个项目将是一个快速且愉快的体验。

一旦你的数据集以正确格式的 csv 文件存储在 S3 上,整个过程分为四个步骤:

-

创建一个数据源:告知 Amazon 机器学习你的数据所在位置及其遵循的模式。

-

创建一个模型:任务由目标的数据类型推断(数值型 => 回归,二分类 => 分类或分类数据用于多项分类),你可以为模型设置一些自定义参数。

-

训练和评估模型

-

执行批量预测

最佳的入门策略是遵循编写精良且详细的 Amazon Machine Learning 的教程。

这些资源也可用:

-

以及这个优秀的 YouTube 视频 你在 Amazon AWS 的第一周,由 Miles Ward 提供,用于 EC2 设置。

那实践中呢?

交叉验证

在 Amazon Machine Learning 中没有专门的交叉验证方法。建议的方式是按照 K 折交叉验证方案创建数据文件,为每个折创建数据源,并在每个数据源上训练模型。例如,为了执行四折交叉验证,你需要创建四个数据源、四个模型和四个评估。然后,你可以平均这四个评估分数,以获得模型的最终交叉验证分数。

过拟合

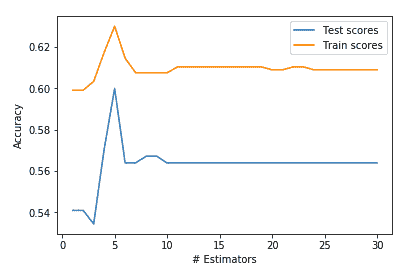

过拟合发生在你的模型过于紧密地贴合训练数据,以至于丧失预测新数据的能力。检测过拟合很重要,以确保模型具有预测能力。这可以通过 学习曲线 来完成,通过比较训练集和验证集的 误差曲线 来检测不同样本大小的表现。

Amazon Machine Learning 提供了两种经典的正则化方法(L1 Lasso 和 L2 Ridge)来减少过拟合,但没有过拟合检测方法。要检查你的模型是否对训练数据过拟合,你需要创建不同的数据集和模型,并对每个模型进行评估。

成本

特征工程和特征选择是一个反复进行的过程,需要创建和评估许多数据集。每次创建新的数据源时,Amazon Machine Learning 会对数据进行统计分析,这可能会显著增加项目的整体成本。在为本文进行研究时,95% 的成本是由于为我尝试的每个新数据源创建数据统计。而且 Amazon Machine Learning 处理大约 400,000 个样本花费了大约 15 小时。

控制台的替代方案

构建一个快速的测试/失败循环对任何数据科学项目都是至关重要的。数据文件、模型和验证之间的反复过程需要进行,以构建一个具有强大预测能力的鲁棒模型。

通过 UI 与 Amazon Machine Learning 交互会很快变得乏味,特别是如果你已经习惯了命令行的话。全新的数据-模型-评估流程涉及大约八到十页的页面、字段和点击。这些 UI 操作需要时间。此外,每个新实体可能需要几分钟才能可用。与基于脚本的流程(如命令行、R Studio、Jupyter notebooks 等)相比,这个过程非常缓慢。

使用配方、上传预定义的模式以及使用 AWS CLI 管理 S3 将有助于加快速度。

AWS 提供了多种语言的 SDK,包括用于 Amazon Machine Learning 的方法。你可以使用 Python、Java 或 Scala 来驱动你的 Amazon Machine Learning 项目。例如,可以查看这个Amazon Machine Learning 代码示例的 GitHub 仓库。

通过脚本与 Amazon Machine Learning 交互可能是与该服务交互的最有效方式。但如果你无论如何都会编写 Python 脚本,那么使用 Amazon Machine Learning 的优势就不那么明显了。你完全可以使用像 Scikit-learn 这样的专用数据科学工具包。

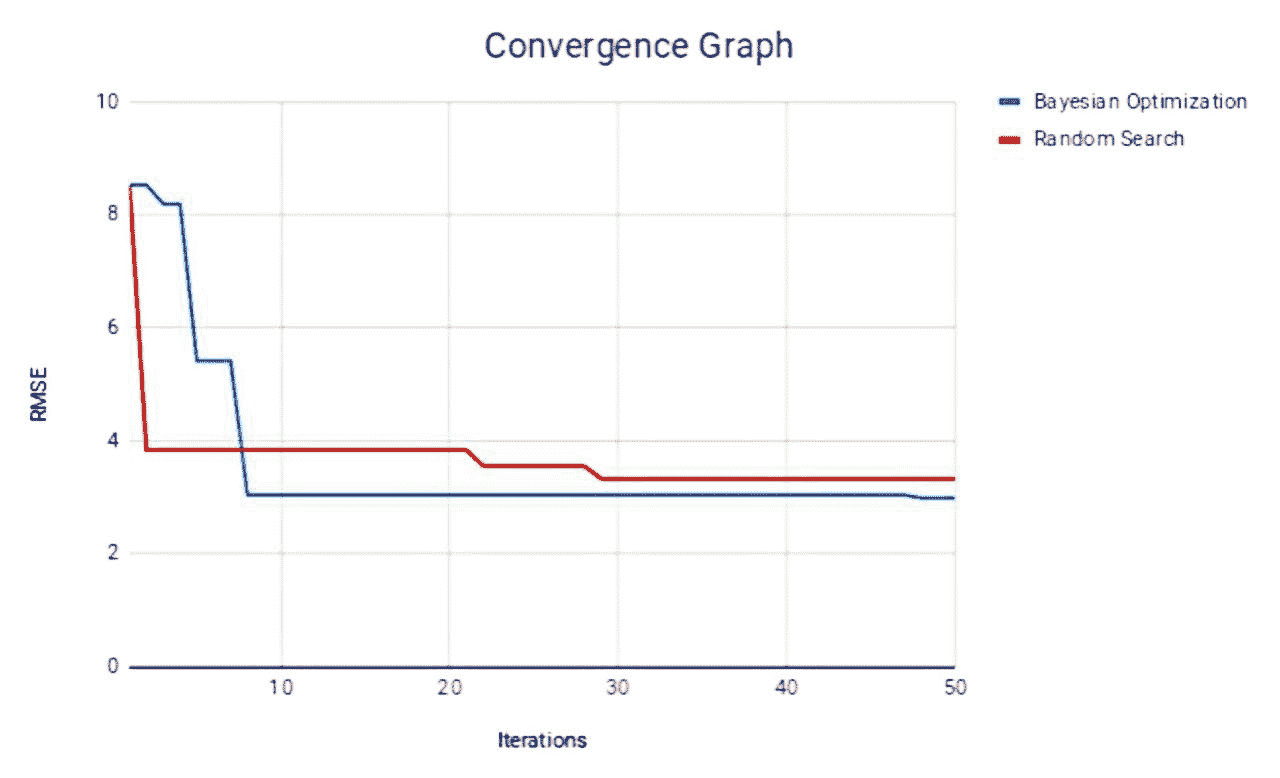

案例研究

由于限制在线性模型和随机梯度下降算法上,人们可能会对服务的性能产生疑问。在本文的其余部分,我将比较 Scikit-learn 和 Amazon Machine Learning 在二分类和多分类任务中的表现。

鸢尾花数据集

让我们从一个简单且非常容易的多分类数据集——鸢尾花数据集 开始,并比较 Scikit-learn 的 SGDClassifier 与 Amazon Machine Learning 的多分类任务的表现。

SGDClassifier 的设置与 Amazon Machine Learning 的 SGD 参数类似:

-

L2 正则化 (alpha = 10^(-6) )

-

最优学习率

-

对数损失函数

-

10 次迭代

训练集被随机选择为 70/30 以进行训练和评估。宏平均 F1 分数在 Scikit 和 Amazon Machine Learning 中都被使用。

在保留集上的最终评估分数在 Scikit-learn 和 Amazon Machine Learning 之间非常相似:

-

Scikit-learn: 0.93

-

Amazon Machine Learning: 0.94

到目前为止,一切顺利。现在来处理一个更复杂的数据集。

Kaggle Airbnb 数据

最近的 Airbnb 新用户预订 Kaggle 竞赛旨在预测 Airbnb 用户的国家目的地,给定一系列数据集(国家、年龄、性别信息、用户和会话)。

我们将简化数据集,仅考虑由性别、年龄、附属、浏览器、注册日期等特征组成的用户训练数据。数据集在竞赛页面上免费提供,只需注册 Kaggle 即可。

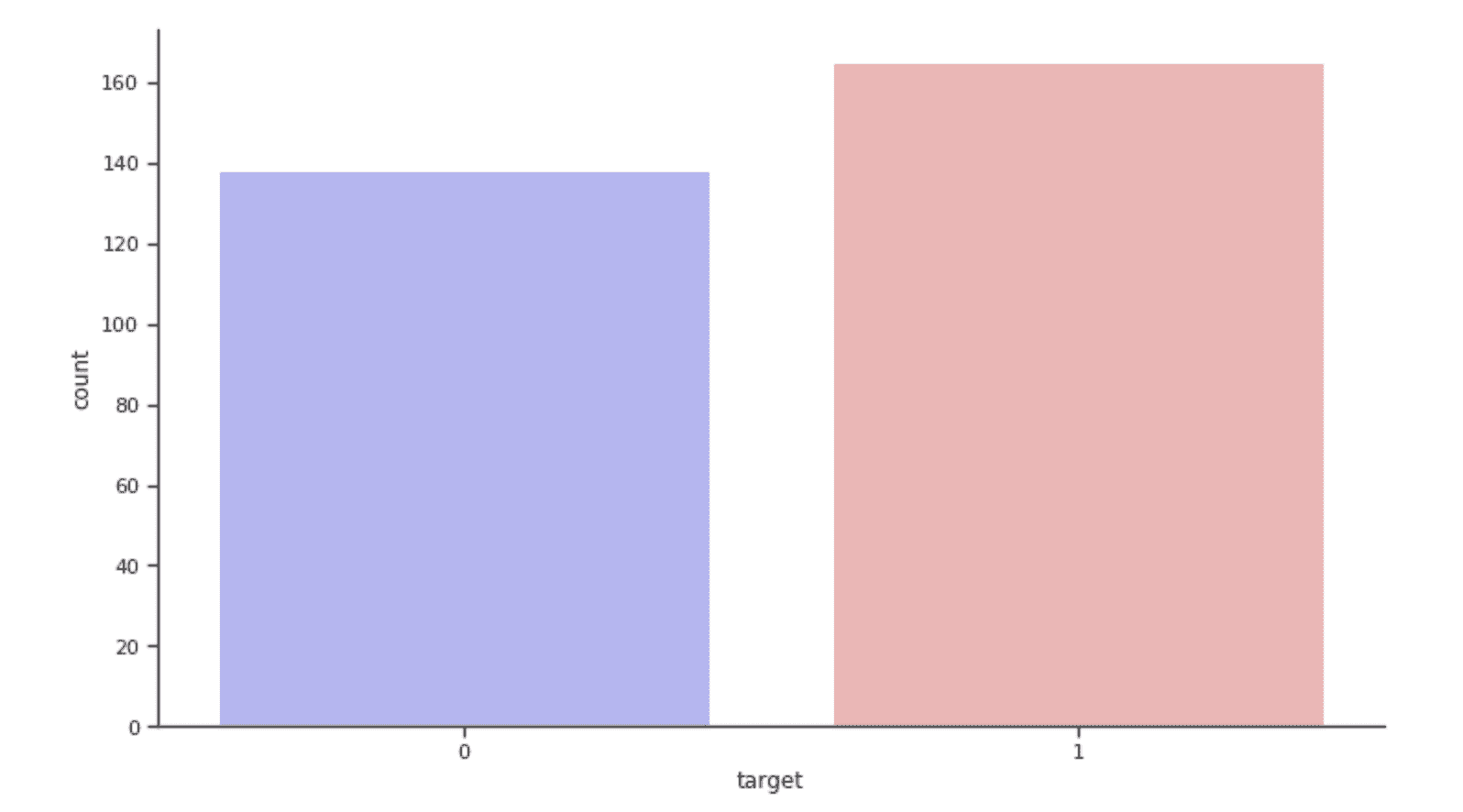

在这个数据集中,大约 40%的用户没有进行任何预订。我们将尝试预测用户是否进行了预订,而不是预测目的地国家(如果有的话),从而解决一个二分类问题。

使用 10 万行数据作为训练数据集,根据 AUC 分数,我们在训练数据集上获得了以下性能结果:

-

Amazon Machine Learning SGD : 0.71

-

scikit SGD : 0.61

-

scikit RandomForest: 0.70

-

XGboost: 0.74

注意:这绝不是一个基准测试。以上结果仅用于说明。

我们尝试了多种 SGD 设置,但未能更接近 Amazon Machine Learning 的分数。分数是基于 Amazon Machine Learning 创建的初始验证 30k 样本和另一组 50k 样本进行平均的。

XGBoost 分类器的随机森林没有使用网格搜索。我们在可能的情况下使用了默认设置。

这些结果表明,当使用 SGD 分类器时,Amazon Machine Learning 的性能达到了最佳水平。Amazon Machine Learning SGD 超越了 Scikit-learn 的 SGD。它与随机森林性能相近,但被 XGboost 超越。在这篇博客文章中也观察到了类似的表现。

结论

总之,Amazon Machine Learning 是一个让公司快速启动数据科学项目的绝佳方式。该服务性能出色且易于使用。但它缺少重要的模型选择功能,算法种类非常有限,执行时间较长。

Amazon Machine Learning 的简化方法使工程师能够快速实现预测分析服务。这反过来允许公司进行实验并评估数据科学的商业价值。

这也是一个很好的平台,可以学习和实践机器学习概念,而无需担心算法和模型。对于有志成为数据科学家的人员来说,这是体验真实(尽管简化过的)数据科学项目工作流程的好方法。

基于控制台的工作流程较慢。使用SDKs和AWS CLI很快变得必要。

通过正则化可以调整模型以解决欠拟合和过拟合问题。然而,没有简单的方法来检测过拟合或欠拟合的存在。添加经典的可视化,如学习曲线,将极大地促进模型选择。

简介:亚历克斯·佩里埃博士,是数据科学家、Berklee Online 的软件工程师以及 ODSC 的贡献者。你可以在他的机器学习博客上阅读更多内容。

原文。

相关:

-

数据科学中 5 个最佳机器学习 API

-

标准化机器学习网络服务 API 的世界

-

云机器学习战争:亚马逊 vs IBM Watson vs 微软 Azure

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

更多相关话题

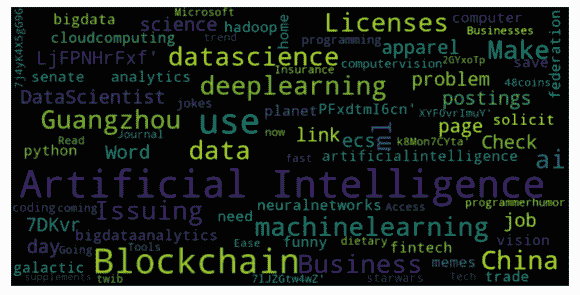

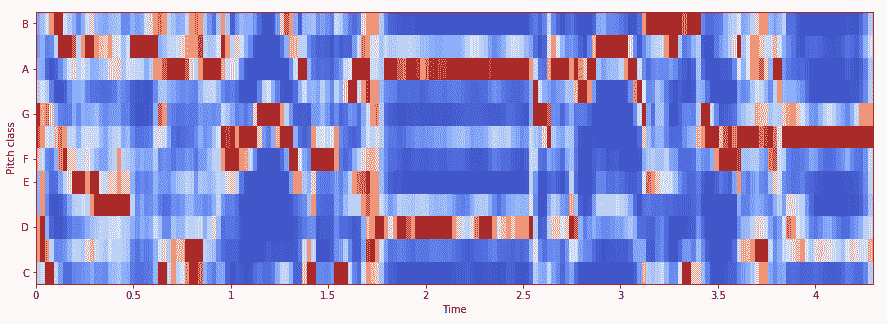

美国的下一个主题模型

由 Lev Konstantinovskiy,RaRe Technologies。

“如何选择最佳主题模型?”是我们社区邮件列表上的头号问题。在 RaRe Technologies,我管理 Python 开源主题建模包 gensim 的社区。由于很多人正在寻找答案,我们最近发布了更新的 gensim 0.13.1,包含了几个新兴功能,可以评估您的模型是否有效,帮助您选择最佳主题模型。

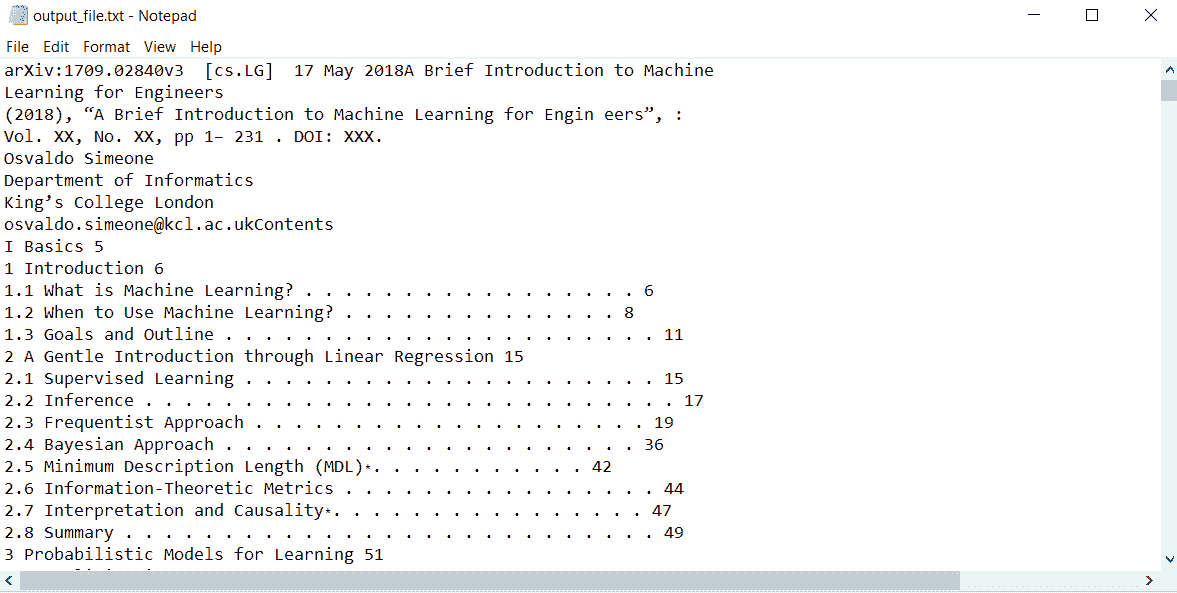

图 1。顶部:四个选定主题的 15 个最可能的词汇。底部:根据词汇所属的主题着色的文本文档。摘自 David M. Blei 的《潜在狄利克雷分配论文》

什么是主题建模?

主题建模是一种利用机器学习从非结构化文本中自动提取共同主题的技术。它是获取大量文本集合全局视图的好方法。

主题建模的快速回顾:一个主题是对词汇表的概率分布。例如,如果我们手动为《哈利·波特》系列书籍创建三个主题,我们可能会得到如下内容:

-

(麻瓜主题) 50% “麻瓜”,25% “达斯利”,10% “常春藤”,5% “血脉污秽”...

-

(伏地魔主题) 65% “伏地魔”,12% “死亡”,10% “魂器”,5% “蛇”...

-

(哈利主题) 42% “哈利·波特”,15% “伤疤”,7% “魁地奇”,7% “格兰芬多”...

同样,我们可以将单个文档表示为对主题的概率分布。例如,《哈利·波特》第一本书的第一章介绍了达斯利一家,并让邓布利多讨论哈利父母的去世。如果我们把这一章当作一个文档,它可以被分解为这样的主题:40% 麻瓜主题,30% 伏地魔主题,剩下的 30% 是哈利主题。

当然,我们不想像这样手动提取主题和文档概率。我们希望机器利用我们的无标签文本集合作为唯一输入,自动完成这一任务。由于没有文档标注或人工注释,主题建模是一种无监督的机器学习技术。

另一个更实际的例子是将您的公司内部文档分成主题,为其内容提供全局视图,方便可视化和浏览:

图 2。使用主题模型创建公司内部文档的全局视图,并可通过主题(而非仅仅关键词)深入到单个文档中。

隐狄利克雷分配 = LDA

当前最受欢迎的主题模型是隐狄利克雷分配。要了解它是如何工作的,Edwin Chen 的博客文章是一个非常好的资源。这个链接包含了 LDA 的各种解释,这可能需要一些数学背景。David Blei 的这篇论文总结了迄今为止开发的各种主题模型,是一个很好的参考。

如果你想深入了解一些 LDA 和向量空间代码,gensim 教程总是很有用的。

选择最佳主题模型:着色词汇

一旦你有了主题,下一步是确定它们是否有效。如果有效,那么你可以直接将它们插入你的集合浏览器或分类器中。如果无效,也许你应该再训练一下模型或使用不同的参数。

分析模型的一种方法是根据文档词汇所属的主题来着色。这一功能最近由我们的 2016 年 Google Summer of Code 学生 Bhargav 添加到 gensim 中。你可以查看此笔记本中的 Python 代码。上面的图 1 是 David Blei 在原始 LDA 论文中的此功能的示例。

一个有趣的例子是‘银行’这个词,它可能指‘金融机构’或‘河岸’。一个好的主题建模算法可以根据上下文区分这两种含义。着色词汇是一种快速评估模型是否理解其含义以及是否有效的方法。

例如,我们在一个包含九个文档的玩具语料库上训练了两个主题模型。

texts = [['river', 'bank', 'nature'],

['money', 'finance', 'bank', 'currency', 'up', 'down'],

['trading', 'computer', 'interface', 'system'],

['forest', 'nature', 'water', 'tree'],

['option', 'derivative', 'latency', 'bank', 'trading'],

['tree'],

['exchange', 'rate', 'option'],

['interest', 'rate', 'up'],

['field', 'forest', 'river']]

dictionary = Dictionary(texts)

corpus = [dictionary.doc2bow(text) for text in texts]

goodLdaModel = LdaModel(corpus=corpus, id2word=dictionary, iterations=50, num_topics=2)

badLdaModel = LdaModel(corpus=corpus, id2word=dictionary, iterations=1, num_topics=2)

一个 LDA 模型训练了 50 次迭代,另一个只训练了一次迭代。我们期望模型训练时间越长,效果越好。

你可能会注意到,上面的文本看起来不像我们习惯的文本,而实际上它们是 Python 列表。这是因为我们将它们转换为词袋模型表示形式。这就是 LDA 模型如何查看文本的方式。词序不重要,一些非常频繁的词会被移除。例如,'A bank of a fast river.' 在词袋模型格式中变成了['bank', 'river', 'fast']。

让我们看看这两个模型在区分‘河流银行’和‘金融银行’方面的效果。如果文档中的所有词汇都与自然相关,那么我们的多义词‘银行’应该被着色为‘蓝色’的自然主题颜色。

bow_water = ['bank','water','river', 'tree']

color_words(goodLdaModel, bow_water)

**银行 河流 水树**

color_words(badLdaModel, bow_water)

**银行 河流 水树**

好的模型成功地完成了这个任务,而差的模型认为这是一个‘金融银行’,并将其标记为红色。

选择最佳主题模型:pyLDAvis

我们还可以看出,经过更好训练的模型非常合适,因为它具有明确的自然和金融主题。下面的可视化来自 pyLDAvis,这是一个用于定性评估主题模型的出色可视化工具。你可以在这个 Jupyter notebook 中互动式地玩这个特定的可视化。Ben Mabey 在 YouTube 上的演讲 中也对 pyLDAvis 进行了很好的介绍。

图 3. pyLDAvis 中的好主题模型。右侧显示了红色突出显示的圆圈(主题)的最相关词汇。例如,‘bank’ 旁边的蓝色条表示词汇‘bank’在文档集合中出现的频率。红色部分的条表示‘bank’在选定主题中的频率。我们可以自信地将主题 #1 命名为金融主题,因为显示在其旁边的词汇正是我们在金融中期望看到的:‘bank’,‘trading’,‘option’ 和 ‘rate’。此外,‘bank’ 这个词在这个主题中出现的频率最高,因为它有一个大红条。

图 4. pyLDAvis 中的差主题模型。一个主题中的词语彼此无关。让我们将训练了 50 次(950 = 450 个文档)的好模型与只训练了 1 次(九个文档)的差模型进行比较。差模型中的一个主题包含了彼此无关的词汇。‘tree’ 和 ‘trading’ 都出现在了同一主题 #2 的列表中。我们期望它们出现在不同的主题中:‘tree’ 与自然相关,而 ‘trading’ 应该与金融相关。所以这个主题模型是没有意义的。*

选择最佳主题模型:定量方法

现在有一个新的 gensim 功能,可以在没有手动可视化 pyLDAvis 或词汇着色的情况下自动选择最佳模型。它被称为‘主题一致性’。我们 孵化器计划 中的一名学生 Devashish,基于 Michael Röder 等 的论文在 Python 中实现了这个功能。

这里有一个有趣的转折。令人惊讶的是,模型拟合的数学严格计算(数据似然性、困惑度)并不总是与对模型质量的人工评价一致,正如在标题为 "阅读茶叶:人类如何解读主题模型" 的论文中所展示的那样。但另一个公式被发现与人类判断有很好的相关性。它被称为 'C_v 主题一致性'。它衡量主题词在语料库中共同出现的频率。当然,关键在于如何定义‘共同’。Gensim 支持包括 C_v 在内的几种主题一致性度量。你可以在这个 Jupyter notebook 中探索它们。

正如我们在上面的人工检查中预期的那样,训练了 50 轮的模型具有更高的一致性。现在你可以使用这个数字自动选择最佳模型。

goodcm = CoherenceModel(model=goodLdaModel, texts=texts, dictionary=dictionary, coherence='c_v')

print goodcm.get_coherence()

0.552164532134

badcm = CoherenceModel(model=badLdaModel, texts=texts, dictionary=dictionary, coherence='c_v')

print badcm.get_coherence()

0.5269189184

结论

我们已经介绍了评估主题模型的三种方法——词汇着色、pyLDAvis 和主题一致性。你选择哪种方法取决于模型和主题的数量。如果你有少量模型和少量主题,那么可以在合理的时间内进行人工检查。特别是在你的特定领域中,词汇着色是一个重要的步骤。在其他情况下,人工检查是不切实际的。例如,如果你进行了 LDA 参数网格搜索并拥有大量模型,或者有数千个主题。在这种情况下,唯一的方法是通过自动主题一致性来找到最一致的模型,然后用词汇着色和 pyLDAvis 进行快速人工验证。

我希望你发现这些模型选择技术在你的 NLP 应用中有用!如果你对它们有任何问题,请在 gensim 邮件列表 上告诉我们。我们还在 RaRe Technologies 提供 NLP 咨询服务。

个人简介:Lev Konstantinovskiy,自然语言处理专家,是一名 Python 和 Java 开发者。Lev 拥有丰富的金融机构工作经验,并且是 RaRe 的开源社区经理,包括 gensim,一个用于理解人类语言的开源机器学习工具包。Lev 在 RaRe Technologies 担任开源布道者和研发职位。

个人简介:Lev Konstantinovskiy,自然语言处理专家,是一名 Python 和 Java 开发者。Lev 拥有丰富的金融机构工作经验,并且是 RaRe 的开源社区经理,包括 gensim,一个用于理解人类语言的开源机器学习工具包。Lev 在 RaRe Technologies 担任开源布道者和研发职位。

相关:

-

HPE Haven OnDemand 文本提取 API 开发者备忘单

-

使用 Python 矿化 Twitter 数据 第一部分:数据收集

-

文本挖掘 101:主题建模

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

更多相关话题

开源向量数据库的诚实比较

原文:

www.kdnuggets.com/an-honest-comparison-of-open-source-vector-databases

图像来源于 DALL-E 3

向量数据库提供了广泛的好处,特别是在生成式人工智能(AI)领域,更具体地说,在大规模语言模型(LLMs)中。这些好处可以从先进的索引到准确的相似性搜索,帮助实现强大的最先进项目,

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

在这篇文章中,我们将对三种开源向量数据库进行诚实的比较,这些数据库建立了令人印象深刻的声誉——Chroma、Milvus 和 Weaviate。我们将探讨它们的使用案例、主要功能、性能指标、支持的编程语言等,以提供对每个数据库的全面且公正的概述。

什么是向量数据库?

从最简单的定义来看,向量数据库将信息存储为向量(向量嵌入),这是数据对象的数值版本。

因此,向量嵌入是一种强大的方法,用于在非常大且非结构化或半结构化的数据集中进行索引和搜索。这些数据集可以包括文本、图像或传感器数据,向量数据库将这些信息整理成可管理的格式。

向量数据库通过高维向量进行工作,这些向量可以包含数百个不同的维度,每个维度与数据对象的特定属性相关联。因此,创建了无与伦比的复杂性。

不要与向量索引或向量搜索库混淆,向量数据库是一个完整的管理解决方案,用于以以下方式存储和过滤元数据:

-

完全可扩展

-

可以轻松备份

-

允许动态数据更改

-

提供高水平的安全性

使用开源向量数据库的好处

开源向量数据库相对于授权的替代方案提供了许多好处,例如:

-

他们是一个灵活的解决方案,可以很容易地修改以适应特定需求,而授权选项通常是为特定项目设计的。

-

开源向量数据库得到大量开发者社区的支持,这些社区随时准备协助解决问题或提供改进项目的建议。

-

开源解决方案具有无许可费用、订阅费用或任何意外费用的优点,在项目实施过程中非常经济实惠。

-

由于开源向量数据库的透明特性,开发者可以更有效地工作,了解每个组件以及数据库的构建方式。

-

开源产品随着技术变化不断改进和演变,因为它们得到了活跃社区的支持。

开源向量数据库比较:Chroma 与 Milvus 与 Weaviate

现在我们已经了解了什么是向量数据库以及开源解决方案的好处,让我们考虑市场上一些最受欢迎的选项。我们将重点关注 Chroma、Milvus 和 Weaviate 的优点、特性和用例,然后进行直接的对比,以确定哪个选项最适合您的需求。

1. Chroma

Chroma 旨在帮助各种规模的开发者和企业创建 LLM 应用程序,提供构建复杂项目所需的所有资源。Chroma 确保项目高度可扩展,并以最佳方式工作,以便能够快速存储、搜索和检索高维向量。

它因其作为极其灵活的解决方案而广受欢迎,提供了广泛的部署选项。此外,Chroma 可以直接在云端部署,也可以在现场运行,使其成为任何业务的可行选择,无论其 IT 基础设施如何。

用例

Chroma 还支持多种数据类型和格式,使其适用于几乎任何应用程序。然而,Chroma 的一个关键优势是其对音频数据的支持,使其成为音频搜索引擎、音乐推荐应用程序以及其他声音项目的首选。

2. Milvus

Milvus 在机器学习和数据科学领域获得了很高的声誉,在向量索引和查询方面表现出色。利用强大的算法,Milvus 提供了闪电般的处理和数据检索速度以及 GPU 支持,即使在处理非常大的数据集时也如此。Milvus 还可以与其他流行的框架如 PyTorch 和 TensorFlow 集成,使其能够加入到现有的机器学习工作流程中。

用例

Milvus 以其在相似度搜索和分析方面的能力而闻名,并且对多种编程语言有广泛的支持。这种灵活性意味着开发人员不仅限于后端操作,还可以在前端执行通常保留给服务器端语言的任务。例如,你可以用 JavaScript 生成 PDF同时利用 Milvus 的实时数据。这为应用开发开辟了新途径,尤其是针对教育内容和无障碍应用程序。

这个开源向量数据库可以在广泛的行业和大量应用中使用。另一个显著的例子涉及电子商务,在这里,Milvus 可以驱动精确的推荐系统,以根据客户的偏好和购买习惯推荐产品。

它也适用于图像/视频分析项目,协助图像相似度搜索、物体识别和基于内容的图像检索。另一个关键用例是自然语言处理(NLP),提供文档聚类和语义搜索功能,同时为问答系统提供基础。

3. Weaviate

我们的诚实比较中的第三个开源向量数据库是 Weaviate,它提供了自托管和完全托管的解决方案。由于其出色的性能、简洁性和高度可扩展性,无数企业正在使用 Weaviate 来处理和管理大型数据集。

Weaviate 能够管理多种数据类型,非常灵活,可以存储向量和数据对象,这使得它非常适合需要多种搜索技术的应用(例如:向量搜索和关键词搜索)。

用例

就其用途而言,Weaviate 非常适合用于像企业资源计划软件中的数据分类项目或涉及以下内容的应用:

-

相似度搜索

-

语义搜索

-

图像搜索

-

电子商务产品搜索

-

推荐引擎

-

网络安全威胁分析与检测

-

异常检测

-

自动化数据协调

现在我们对每个向量数据库可以提供的功能有了初步了解,让我们考虑一下区分每个开源解决方案的更细节,在我们实用的比较表中。

比较表

| Chroma | Milvus | Weaviate | |

|---|---|---|---|

| 开源状态 | 是 - Apache-2.0 许可证 | 是 - Apache-2.0 许可证 | 是 - BSD-3-Clause 许可证 |

| 发行日期 | 2023 年 2 月 | 2019 年 10 月 | 2021 年 1 月 |

| 使用案例 | 适用于广泛的应用,支持多种数据类型和格式。专注于基于音频的搜索项目和图像/视频检索。 | 适用于广泛的应用,支持大量数据类型和格式。非常适合电子商务推荐系统、自然语言处理和图像/视频分析 | 适用于广泛的应用,支持多种数据类型和格式。非常适合企业资源规划软件中的数据分类。 |

| 关键特点 | 使用非常便捷。开发、测试和生产环境都在 Jupyter Notebook 上使用相同的 API。强大的搜索、过滤和密度估计功能。 | 使用内存和持久存储相结合的方式,提供高速查询和插入性能。提供自动数据分区、负载均衡和故障容错,以处理大规模向量数据。支持多种向量相似性搜索算法。 | 提供基于 GraphQL 的 API,提供在与知识图谱互动时的灵活性和高效性。支持实时数据更新,以确保知识图谱保持最新。其模式推断功能自动化定义数据结构的过程。 |

| 支持的编程语言 | Python 或 JavaScript | Python、Java、C++ 和 Go | Python、JavaScript 和 Go |

| 社区和行业认可 | 拥有强大的社区,并提供一个 Discord 频道以回答实时问题。 | 在 GitHub、Slack、Reddit 和 Twitter 上有活跃的社区。超过 1000 个企业用户。文档详尽。 | 拥有专门的论坛和活跃的 Slack、Twitter 和 LinkedIn 社区。此外,还有定期的播客和新闻通讯。文档详尽。 |

| 性能指标 | 不适用 | 链接 | 链接 |

| GitHub Stars | 9k | 23.5k | 7.8k |

结论

我们诚实比较指南中的每个开源向量数据库都非常强大、可扩展且完全免费。这可能会使选择完美的解决方案变得有些困难,但通过了解您正在处理的确切项目和所需的支持水平,可以使这一过程变得更容易。

Chroma 是最新的解决方案,在社区支持方面不如其他两个数据库,但其易用性和灵活性使其成为一个很好的选择,尤其适合涉及音频搜索的项目。

Milvus 拥有最高的 GitHub Star 评分和强大的社区支持,有大量企业信任该向量数据库以满足他们的需求。因此,Milvus 是自然语言处理和图像/视频分析项目的不错选择。

最后,Weaviate 提供自托管和完全管理的解决方案,拥有广泛的文档和支持。一个关键的应用场景是企业资源规划软件中的数据分类,但这个解决方案适合多种项目。

娜赫拉·戴维斯是一位软件开发人员和技术写作者。在全职从事技术写作之前,她曾担任过—除了其他有趣的工作之外—一所 Inc. 5,000 体验品牌组织的首席程序员,该组织的客户包括三星、时代华纳、Netflix 和索尼。

这个话题的更多信息

可解释 AI (XAI) 简介

图片由编辑 | Midjourney

AI 系统在我们日常生活中越来越普遍,做出的决策可能难以理解。可解释 AI (XAI) 旨在使这些决策更加透明和易于理解。本文介绍了 XAI 的概念,探讨了其技术,并讨论了它在各个领域的应用。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

什么是可解释 AI (XAI)?

传统的 AI 模型就像“黑箱”。它们使用复杂的算法而不解释其工作原理。这使得理解其结果变得困难。

XAI 旨在使过程透明。它帮助人们了解和理解 AI 为什么做出特定的选择。它使用简单的模型和视觉辅助工具来解释这一过程。

可解释性的重要性

AI 系统的可解释性有许多重要原因。以下列出了一些最重要的原因。

-

信任:透明的过程有助于确保决策公平。这帮助用户信任并接受结果。

-

公平性:透明的过程可以防止不公平或歧视性的结果。它们防止可能存在偏见的结果。

-

问责:可解释性允许我们审查决策。

-

安全性:XAI 有助于识别和修复错误。这对于防止有害结果至关重要。

可解释 AI 技术

模型无关方法

这些技术适用于任何 AI 模型。

-

LIME(Local Interpretable Model-agnostic Explanations):LIME 简化复杂模型以进行个体预测。它创建一个更简单的模型,以展示输入的小变化如何影响结果。

-

SHAP(SHapley Additive exPlanations):SHAP 利用博弈论为每个特征分配重要性评分。它展示了每个特征如何影响最终预测结果。

模型特定方法

这些技术专门针对特定类型的 AI 模型。

-

决策树:决策树通过将数据分支来做出决策。每个分支代表一个基于特征的规则,而叶子节点显示结果。

-

基于规则的模型:这些模型使用简单的规则来解释其决策。每个规则概述了导致结果的条件。

特征可视化

该技术使用可视化工具显示不同特征如何影响人工智能决策。

-

显著性图:显著性图突出显示图像中影响人工智能预测的重要区域。

-

激活图:激活图展示了在决策过程中神经网络的哪些部分是活跃的。

使用 LIME 进行可解释人工智能

我们将探讨如何使用LIME来解释模型的决策。

代码使用LIME库。它解释了随机森林模型的预测。这个示例使用了鸢尾花数据集。

首先确保库已经安装:

pip install lime

然后尝试以下代码。

import lime

import lime.lime_tabular

import numpy as np

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

# Load dataset and train model

iris = load_iris()

X, y = iris.data, iris.target

model = RandomForestClassifier()

model.fit(X, y)

# Create LIME explainer

explainer = lime.lime_tabular.LimeTabularExplainer(X, feature_names=iris.feature_names, class_names=iris.target_names, discretize_continuous=True)

# Explain a prediction

i = 1

exp = explainer.explain_instance(X[i], model.predict_proba, num_features=2)

exp.show_in_notebook(show_table=True, show_all=False)

输出:

输出分为三个部分:

-

预测概率:指的是模型为给定输入实例分配给每个类别的概率。这些概率显示了模型的信心。它们反映了每个可能结果的可能性。

-

特征重要性:该组件显示了局部模型中每个特征的重要性。它表明每个特征在特定实例的预测中影响了多少。

-

局部预测解释:输出的这一部分展示了模型如何为特定实例做出预测。它分解了哪些特征是重要的以及它们如何影响结果。

XAI 的应用领域

医疗保健

人工智能系统通过分析医学影像和患者数据显著提高了诊断准确性。它们可以识别图像中的模式和异常。然而,它们的真正价值在于可解释人工智能(XAI)。XAI 澄清了人工智能系统如何做出诊断决策。这种透明性帮助医生理解人工智能为何做出某些结论。XAI 还解释了每个治疗建议背后的原因。这有助于医生设计治疗计划。

金融

在金融领域,可解释人工智能用于信用评分和欺诈检测。在信用评分方面,XAI 解释了信用评分的计算方式。它显示了哪些因素影响一个人的信用 worthiness。这有助于消费者了解他们的评分,并确保金融机构的公平性。在欺诈检测中,XAI 解释了为什么交易被标记。它显示了检测到的异常,帮助调查人员发现并确认潜在的欺诈行为。

法律

在法律领域,可解释人工智能帮助使人工智能决策变得清晰和易于理解。它解释了人工智能在预测犯罪或确定案件结果等领域如何得出结论。这种透明性帮助律师和法官了解人工智能推荐的生成过程。它还确保法律过程中使用的人工智能工具公平且无偏见。这促进了法律决策中的信任和责任感。

自主车辆

在自动驾驶中,解释性人工智能(XAI)对安全性和法规非常重要。XAI 提供实时解释,说明车辆如何做出决策。这有助于用户理解和信任系统的行动。开发者可以利用 XAI 来提高系统的性能。XAI 还通过详细说明驾驶决策的制定过程来支持监管批准,确保技术符合公共道路的安全标准。

XAI 中的挑战

-

复杂模型:一些 AI 模型非常复杂。这使得它们很难解释。

-

准确性与解释性:更准确的模型使用复杂的算法。模型的性能和解释的易用性之间往往存在权衡。

-

缺乏标准:没有一种单一的方法来解释 AI。不同的行业应用需要不同的方法。

-

计算成本:详细的解释需要额外的资源。这可能使过程变得缓慢和昂贵。

结论

解释性人工智能是一个关键领域,解决了 AI 决策过程中的透明性需求。它提供了各种技术和方法,使复杂的 AI 模型更具可解释性和理解性。随着 AI 的不断发展,XAI 的开发和实施将在建立信任、确保公平性以及推动不同领域 AI 的负责任使用中发挥重要作用。

Jayita Gulati 是一位机器学习爱好者和技术作家,致力于构建机器学习模型。她拥有利物浦大学计算机科学硕士学位。

更多相关内容

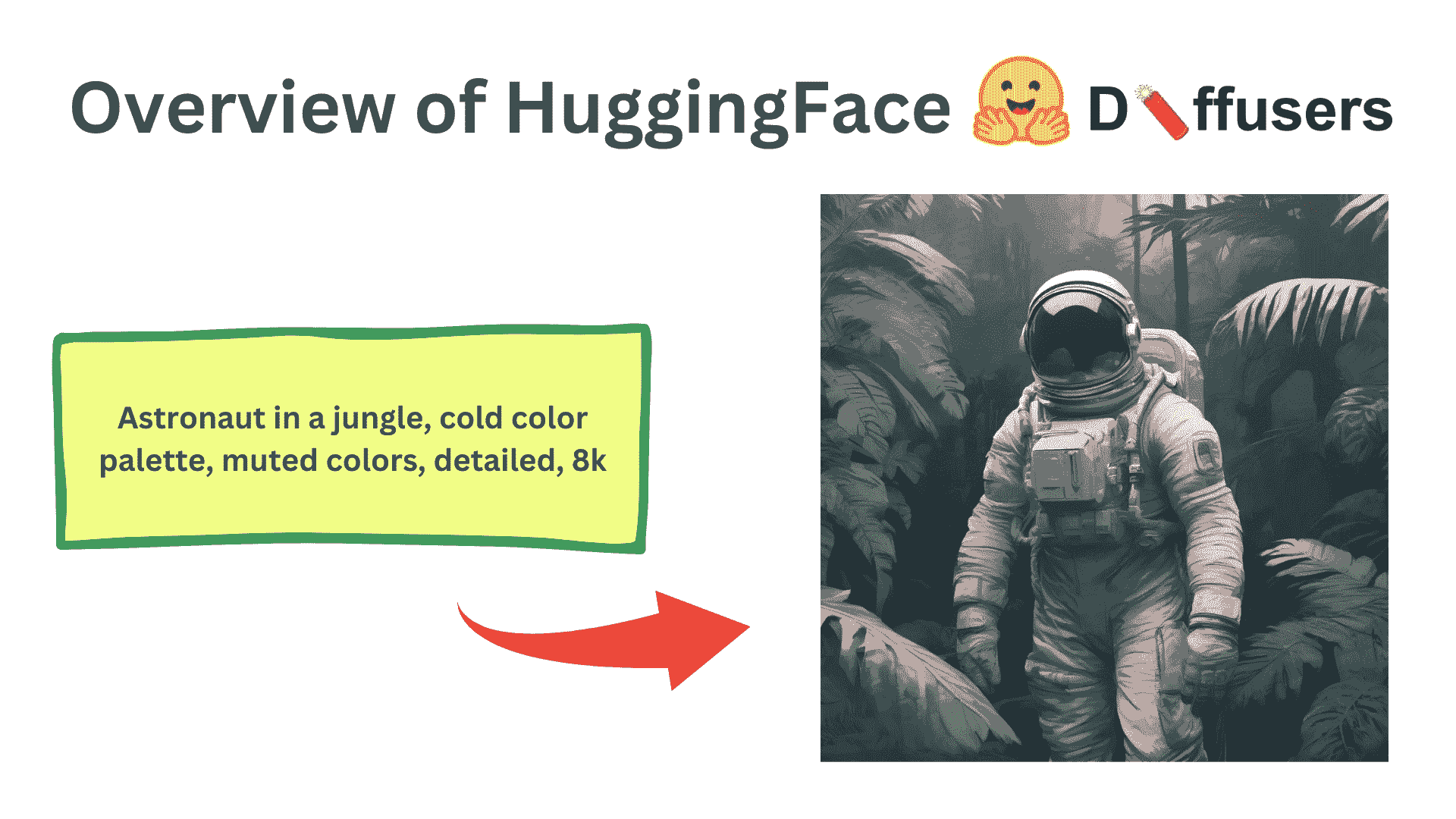

Hugging Face Diffusers 概览

图片由作者提供

我们的前三大课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业的快车道。

1. Google Cybersecurity Certificate - 快速进入网络安全职业的快车道。

2. Google Data Analytics Professional Certificate - 提升您的数据分析技能

2. Google Data Analytics Professional Certificate - 提升您的数据分析技能

3. Google IT Support Professional Certificate - 支持您的组织的 IT

3. Google IT Support Professional Certificate - 支持您的组织的 IT

Diffusers 是一个由 HuggingFace 开发和维护的 Python 库。它简化了从用户定义的提示生成图像的扩散模型的开发和推理。代码在 GitHub 上公开提供,仓库有 22.4k 星标。HuggingFace 还维护了多种 Stable Diffusion 和其他扩散模型,可以轻松地与其库一起使用。

安装和设置

从一个新的 Python 环境开始是很好的,以避免库版本和依赖之间的冲突。

要设置一个新的 Python 环境,请运行以下命令:

python3 -m venv venv

source venv/bin/activate

安装 Diffusers 库非常简单。它作为一个官方 pip 包提供,并内部使用 PyTorch 库。此外,许多扩散模型基于 Transformers 架构,因此加载模型也需要 transformers pip 包。

pip install 'diffusers[torch]' transformers

使用 Diffusers 生成 AI 图像

Diffuser 库使得通过稳定扩散模型从提示生成图像变得非常简单。这里,我们将逐行探讨一个简单的代码,了解 Diffusers 库的不同部分。

导入

import torch

from diffusers import AutoPipelineForText2Image

torch 包将用于 diffuser 管道的一般设置和配置。AutoPipelineForText2Image 是一个自动识别正在加载的模型的类,例如 StableDiffusion1-5、StableDiffusion2.1 或 SDXL,并内部加载适当的类和模块。这让我们避免了每次想加载新模型时都需要更改管道的麻烦。

加载模型

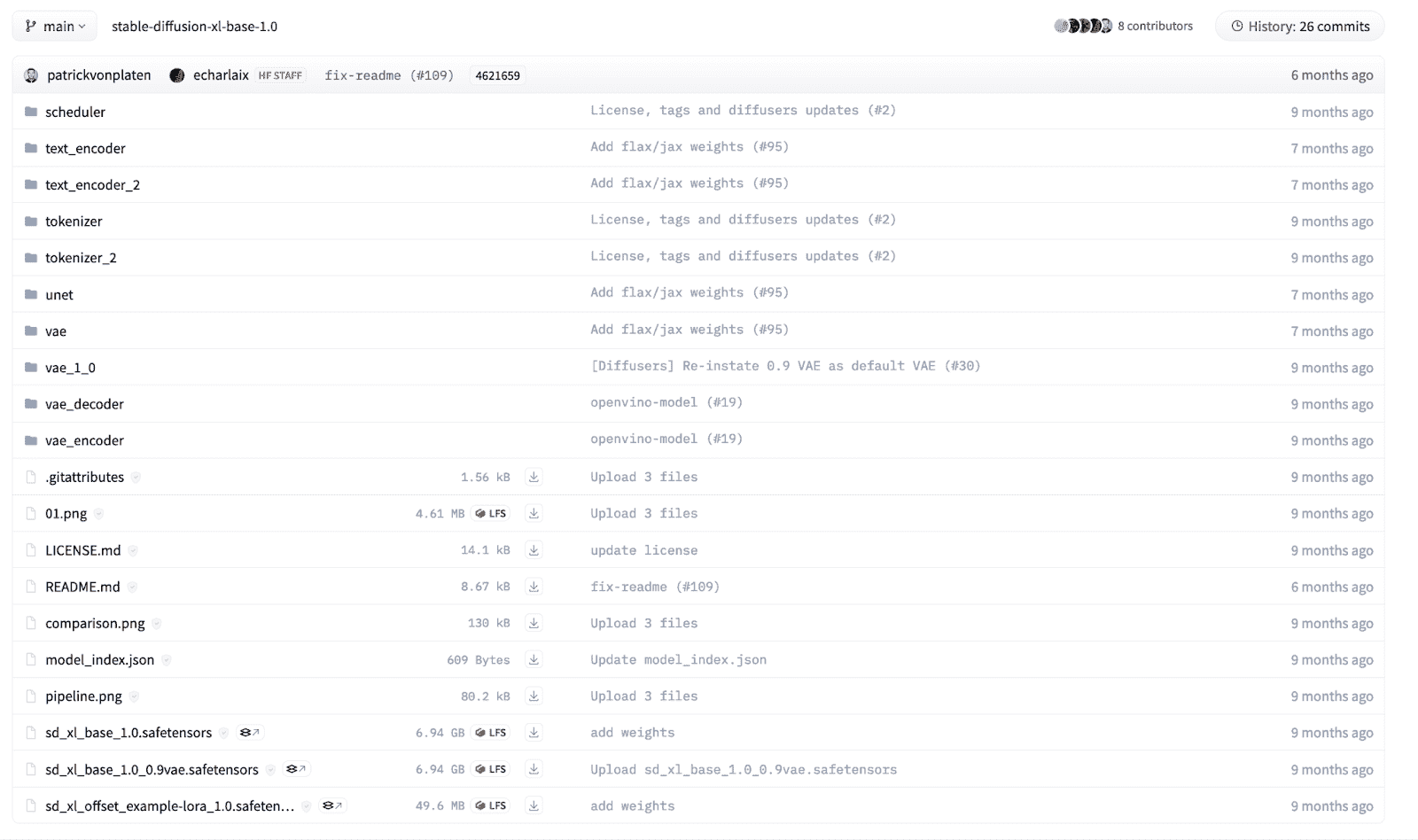

扩散模型由多个组件组成,包括但不限于文本编码器、UNet、调度器和变分自编码器。我们可以单独加载这些模块,但 diffusers 库提供了一个构建方法,可以加载给定结构化检查点目录的预训练模型。对于初学者来说,可能很难知道使用哪个管道,因此 AutoPipeline 使得为特定任务加载模型变得更容易。

在这个例子中,我们将加载一个由 Stability AI 训练的、在HuggingFace上公开提供的 SDXL 模型。目录中的文件根据其名称进行结构化,每个目录都有自己的 safetensors 文件。SDXL 模型的目录结构如下所示:

要在我们的代码中加载模型,我们使用 AutoPipelineForText2Image 类并调用 from_pretrained 函数。

pipeline = AutoPipelineForText2Image.from_pretrained(

"stability/stable-diffusion-xl-base-1.0",

torch_dtype=torch.float32 # Float32 for CPU, Float16 for GPU,

)

我们将模型路径作为第一个参数提供。它可以是上述的 HuggingFace 模型卡名称,也可以是您提前下载模型的本地目录。此外,我们将模型权重精度定义为关键字参数。当我们在 CPU 上运行模型时,通常使用 32 位浮点精度。然而,运行扩散模型计算成本高昂,且在 CPU 设备上运行推理将需要几个小时!对于 GPU,我们可以使用 16 位或 32 位数据类型,但 16 位更优,因为它利用了较低的 GPU 内存。

上述命令将从 HuggingFace 下载模型,下载时间可能会根据您的互联网连接而有所不同。模型的大小可以从 1GB 到超过 10GB 不等。

一旦模型加载完成,我们需要将模型移动到合适的硬件设备上。使用以下代码将模型移动到 CPU 或 GPU。请注意,对于 Apple Silicon 芯片,将模型移动到 MPS 设备以利用 MacOS 设备上的 GPU。

# "mps" if on M1/M2 MacOS Device

DEVICE = "cuda" if torch.cuda.is_available() else "cpu"

pipeline.to(DEVICE)

推理

现在,我们已经准备好使用加载的扩散模型从文本提示中生成图像。我们可以使用以下代码进行推理:

prompt = "Astronaut in a jungle, cold color palette, muted colors, detailed, 8k"

results = pipeline(

prompt=prompt,

height=1024,

width=1024,

num_inference_steps=20,

)

我们可以使用管道对象,并通过多个关键字参数调用它以控制生成的图像。我们将提示定义为描述我们希望生成的图像的字符串参数。此外,我们可以定义生成图像的高度和宽度,但应为 8 或 16 的倍数,因为底层的变压器架构要求如此。此外,总的推理步骤可以调整以控制最终图像的质量。更多的去噪步骤会生成更高质量的图像,但需要更长时间生成。

最终,管道返回一个生成的图像列表。我们可以从数组中访问第一个图像,并将其作为 Pillow 图像进行操作,以便保存或显示图像。

img = results.images[0]

img.save('result.png')

img # To show the image in Jupyter notebook

生成的图像

高级用法

文本到图像的示例只是一个基础教程,旨在突出 Diffusers 库的基本用法。它还提供了多种其他功能,包括图像到图像生成、修复、扩展以及控制网络。此外,它们还提供了对扩散模型中每个模块的精细控制。它们可以作为小型构建块,无缝集成以创建自定义扩散管道。此外,它们还提供了在自己的数据集和用例上训练扩散模型的额外功能。

总结

在这篇文章中,我们介绍了 Diffusers 库的基础知识以及如何使用扩散模型进行简单的推理。这是最常用的生成 AI 管道之一,每天都有功能和修改。你可以尝试很多不同的用例和功能,而 HuggingFace 文档 和 GitHub 代码 是你入门的最佳地方。

Kanwal Mehreen**** Kanwal 是一位机器学习工程师和技术作家,对数据科学以及 AI 与医学的交叉领域充满热情。她共同撰写了电子书《用 ChatGPT 最大化生产力》。作为 2022 年 APAC 地区的 Google Generation 学者,她倡导多样性和学术卓越。她还被认可为 Teradata 技术多样性学者、Mitacs Globalink 研究学者和哈佛 WeCode 学者。Kanwal 是变革的积极倡导者,创立了 FEMCodes,旨在赋能 STEM 领域的女性。

更多相关话题

Anaconda:为大数据和预测分析提供的免费企业级 Python

原文:

www.kdnuggets.com/2014/02/anaconda-free-enterprise-ready-python-big-data-predictive-analytics.html

完全免费的企业级 Python 发行版,适用于大规模数据处理、预测分析和科学计算。

-

125+ 个最受欢迎的 Python 包,适用于科学、数学、工程和数据分析

-

完全免费 - 包括商业使用和甚至再分发。

-

跨平台支持 Linux、Windows、Mac

-

安装到单一目录,不影响系统上的其他 Python 安装。不需要 root 或本地管理员权限。

-

通过轻松从我们的免费在线库更新包,保持最新。

-

使用我们的conda包管理器,轻松在 Python 2.6、2.7、3.3 之间切换,并试验多个版本的库,支持虚拟环境。

我们为什么要免费提供这些?

-

我们希望确保 Python、NumPy、SciPy、Pandas、IPython、Matplotlib、Numba、Blaze、Bokeh 及其他优秀的 Python 数据分析工具能够被广泛使用。

-

我们希望让 Python 推广者和教师更容易推广 Python 的使用。

-

我们希望回馈我们热爱参与的 Python 社区。

但所有这些都需要艰苦的工作和资源!

帮助我们 -- 查看我们的产品、注册我们的虚拟和现场课程,并联系我们进行数据科学或 SciPy/NumPy 的咨询项目!

在专业环境中使用 Anaconda?

查看Anaconda Server,以掌控防火墙和代理后 Python、R 和内部包的部署和管理。包含集成工具和安装支持。

请注意:Anaconda 默认安装包含 Python 2.7。Python 2.6 和 3.3 可以通过conda 命令获得。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

更多相关话题

驯服 Python 可视化丛林,11 月 29 日网络研讨会

原文:

www.kdnuggets.com/2017/11/anaconda-taming-python-visualization-jungle.html

![[网络研讨会] 驯服 Python 数据可视化丛林](../Images/79722ea7ae3bed19e1f86c8c521c8bb2.png) |

|---|

| Python 拥有大量的绘图库,这一点毫无疑问——但你应该使用哪些库呢?以及你应该如何选择它们?许多人最终会坚持使用他们第一次遇到的库,即使现在有更好的工具来完成这项工作。请加入 Anaconda 联合创始人兼首席技术官 Peter Wang 和高级解决方案架构师 James Bednar,于 11 月 29 日(星期三)中午 12 点 CT 参加一个直播网络研讨会,他们将为你提供一些关键的起点,并演示如何解决一系列常见问题。他们将采取以工作流为导向的方法来探索 Python 可视化库的大生态系统,并向你展示如何:

-

探索数据集,甚至多达数十亿行

-

创建报告和演示文稿

-

构建交互式仪表板,以便与团队共享和部署

|

| 随时联系Anaconda 大使以了解更多关于 Anaconda Enterprise 如何将你的组织提升到一个新水平的信息。诚挚的问候,Anaconda 团队 |

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道

1. Google 网络安全证书 - 快速进入网络安全职业的快车道

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关话题

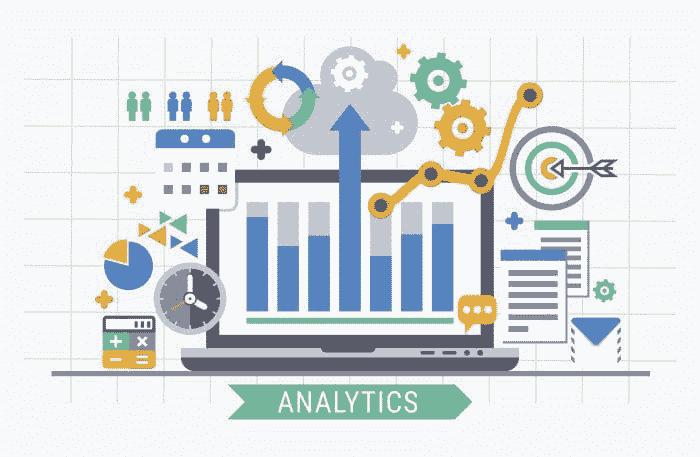

如何利用分析加速业务增长?

原文:

www.kdnuggets.com/2022/12/analytics-accelerate-business-growth.html

分析及其目标

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

分析通常与通过分析历史数据来理解特定事件发生的原因相关。这更多的是一种诊断方法,用于找出过去发生的事情的原因。随着更先进和复杂的算法的出现,分析已经发展为一种前瞻性的方法。这种预测性的方法从过去的数据中学习关联,以预测未来的趋势和行为。这种预测性前瞻使企业领导者能够校准他们的决策,并根据这些预测采取正确的行动。

图片来源于 rawpixel.com,来自 Freepik

分析可以用于多个计划——有许多项目可能会增加业务价值,但不可能一一进行。时间至关重要,因此优先考虑那些与整体战略业务目标对齐的项目。

业务需求和目标可能集中在提高运营效率、通过了解用户偏好提供更好的用户体验、引入新功能或产品等方面。

说明分析的力量

让我们通过一个例子来了解如何利用分析来学习客户行为。搜索引擎营销要求竞争者为他们的广告出价,以便在搜索结果页面上获得展示。注意不要在所有区域的所有广告上都持续出高价(接下来我们会使用一个称为“活动”的通用区域形式)。通常,企业会将某些活动识别为比其他活动更能产生投资回报,因此为不同的活动设计优化的出价策略会更具成本效益。

竞标优化算法通过增加曝光量来提高销售,更多的曝光会导致更多的潜在点击,从而产生转化。此外,这种优化工具通过识别每个广告系列的定制竞标来带来成本节省,而不是在多个广告系列中使用一个静态的统一竞标。这类分析项目有潜力对组织的底线产生显著的积极影响。

分析丰富了用户体验

从上面解释的使用案例来看,如果一个组织能够以有效且高效的方式进行竞标,那么他们就成功通过了获得曝光的第一阶段。用户点击这些曝光并进入组织生态系统的网页。从这里开始,用户参与的新旅程就此展开。你有很少的时间来了解用户在寻找什么,并以飞快的速度满足他们的需求和偏好。在快速数字化的时代,客户从一个应用程序跳槽到另一个平台是很常见的。

你必须通过回答以下问题来了解你的客户:

-

什么促使用户来到我们的平台?

-

他们在寻找什么服务和产品?

-

他们花更多时间在哪一页?

-

哪种轨迹会带来更多的转化?

-

转化发生的时间是否有规律——某个特定的小时、星期或日期?

-

客户通常在哪一页流失?

-

什么阻止他们完成结账并转化为销售?

-

他们在寻找什么具体信息而这些信息没有及时提供?

不仅仅是引入客户,更要确保在整个过程中留住他们,这一点非常重要。一个满意的客户就是一个重复的客户,反之亦然。获取一个客户需要付出大量的努力,而没有制定成功的客户留存策略将是一场噩梦。不用说,获取一个客户的成本要高于留住一个客户。企业对此非常了解,因此他们希望利用分析提供的每一个见解,以便为现有客户提供更好的体验。

利用分析工具来了解你当前的用户群体,并为他们提供更好的优惠和服务,从而建立与产品和服务的长期关系。如果你有兴趣了解更多关于客户留存与获取成本的数据驱动分析,可以查看这个链接。这表明,新客户的获取成本是留住老客户的七倍。此外,还指出,从现有客户中产生转化的概率为 60-70%,这远高于从新客户中产生转化的 5-20%的概率。

人员、流程和技术

分析项目的成功依赖于三个支柱——人员、流程和技术。让我们深入探讨哪个方面需要更多的投资以提升组织的分析能力。

组织已经拥有大量计划变现的数据。作为商业战略的一部分,领导者了解当前技术的差距,并投入资金建立运行复杂模型所需的基础设施。然而,自上而下采用新技术的方式并不像听起来那么简单。它需要一个初始的辅导阶段,在此阶段,技术专家会协助团队快速上手。

流程是下一个需要关注的大问题。领导者可能会制定多个流程,但如果没有将人员置于任何转型的前沿,这些流程会失败得很惨。

商业成功的关键在于依赖于其员工的组织文化。

你需要具备正确技能的人来支持这些流程,并成为你组织业务目标的倡导者。

人员需要与核心业务目标保持一致,并加入这场技术进步的旅程。这种以人为本的文化需要贯穿整个组织。

摘要

文章解释了利用分析成为行业领袖的力量。它专注于如何以客户为中心可以加速企业的数字化转型之旅。它还解释了成功实现战略业务目标的关键驱动因素,即人员、流程和技术。

Vidhi Chugh 是一位人工智能战略家和数字化转型领导者,致力于在产品、科学和工程的交汇处构建可扩展的机器学习系统。她是获奖的创新领袖、作者和国际演讲者。她的使命是使机器学习民主化,并打破术语,让每个人都能参与这场转型。

更多相关话题

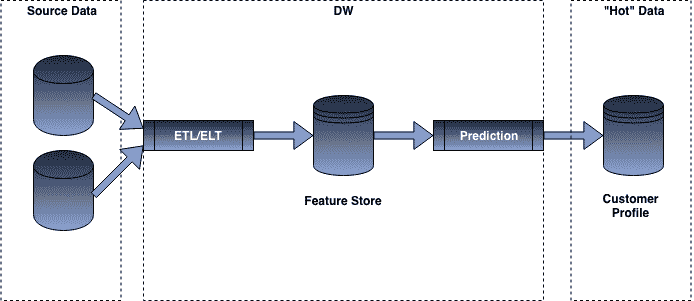

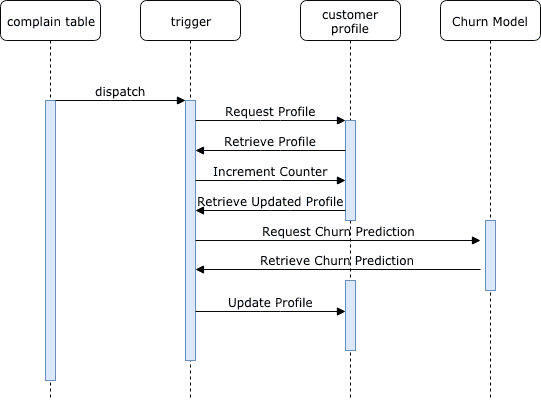

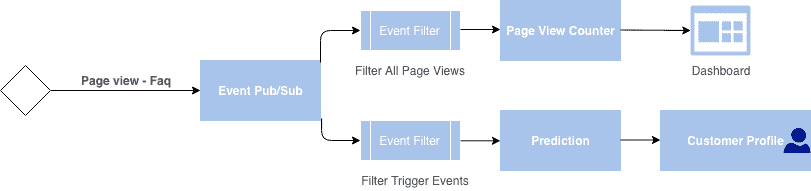

分析工程学无处不在

原文:

www.kdnuggets.com/2021/06/analytics-engineering-everywhere.html

评论

作者:Jason Ganz,数据进步特别顾问。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

分析工程学 — 介绍

数据领域正在发生一场悄然的革命。多年来,我们不断被各种关于“21 世纪最性感的职业” — 数据科学家的文章轰炸。我们被教导,数据科学家是一个几乎具有超凡智慧的角色,使用准神秘的技艺来完成数据魔法。但如今,如果你与那些最密切关注数据领域的人交谈,你会发现另一个数据角色让他们更加兴奋。

需要明确的是,数据科学有一些非常实际且很酷的应用,可以让组织利用数据彻底改变其运作方式。但对于许多组织,尤其是那些没有数百万美元投资的小型组织,数据科学项目往往因为缺乏可靠的数据基础设施而失败。

当每个人都集中关注数据科学的崛起时,另一个学科在悄然形成,这一学科并不是通过《哈佛商业评论》上的华丽文章推动的,而是由那些在数据密集型角色中工作的人推动的。他们称之为分析工程师。

分析工程师是将分析师的数据敏锐性和领域知识与软件工程工具和最佳实践相结合的人。日常工作中,这意味着使用一套被称为“现代数据栈”的工具,特别是 dbt。这些工具使分析工程师能够集中数据,然后以一种极其便宜且简单的方式进行建模分析,相比于传统商业智能团队过去的 ETL 操作方式,这种方式要便捷得多。

尽管数据科学家被一些人视为神秘的存在,分析工程师的态度却有所不同。你会听到他们把自己称为“谦逊的数据管道工”或者“一个恼火的数据分析师”等。分析工程师的工作似乎容易理解,甚至有些平淡。他们整合数据源,应用逻辑,确保生成干净且建模良好的分析材料。

事实证明,分析工程学是该死的超级能力。任何在基本上任何组织中工作过的人都知道,为了标准化那些应该是简单易得的数据点而付出了巨大的努力,而更复杂的问题却往往被搁置多年。分析工程学使你能够拥有正常运作的数据系统。

一位优秀的分析工程师对组织有着极大的影响,每位分析工程师都能够帮助建立真正的数据驱动文化,这对于使用传统工具的团队来说将是具有挑战性的。虽然过去做任何简单分析都需要大量重复的工作,但分析工程师可以利用像 dbt 这样的工具构建复杂的数据模型,并在任何时间表上构建分析准备好的数据表。过去很难让任何人就指标的标准定义达成一致,而分析工程师可以将这些定义直接融入到他们的代码库中。虽然过去人们在处理不完整和杂乱的数据时很吃力,但分析工程师……仍然在与不完整和杂乱的数据作斗争。但至少我们可以在我们的分析系统上进行一系列测试,以便知道何时出现问题!

分析工程学的崛起

你可能会认为这种发展对数据领域的人来说会感到恐慌——如果一位分析工程师的影响力远大于数据分析师,我们的工作是否会受到威胁?一个组织是否可以用一位分析工程师替代五位数据分析师而获益?

但事实上,任何数据分析师都无法完成他们认为对组织有影响的所有分析——问题往往恰恰相反。大多数数据组织都在急切地寻求增加人手。

随着分析工程师增加组织从数据中获得的洞察量,这些组织实际上更可能想要招聘更多的数据人才(包括分析工程师和分析师)。在他精彩的文章工厂的重组中,Erik Bernhardsson 提出了这样一个观点:随着软件工程师的工具集变得越来越高效,对软件工程师的需求反而增长——因为现在有越来越多的使用案例表明,构建软件而不是手动处理更有意义。这个观点不仅适用于数据,我认为它实际上对数据更为准确。

虽然每个组织都需要软件,但并不是每个组织都需要软件工程师。但每个组织都需要从数据中学习,而由于数据需要被理解的方式在每个组织中都是独特的,他们都会需要分析工程师。人们常说软件正在吞噬世界——而分析工程将在世界中嵌入。随着每个数据岗位的增值,数据洞察和学习可以应用的新领域也显著增加。即使你不打算成为分析工程师,拥有良好建模和准确的数据也会使数据分析师和数据科学家更有效。这是一种全方位的胜利。

这并不一定意味着每个分析工程师的角色都会对世界产生积极影响。拥有更强大的数据操作能力,可以让你提出问题、寻求洞察和寻找新策略。它也可能为组织提供新的监控员工、进行监视或歧视的方式。只需看看当前技术和数据科学行业中的各种公众问题,就可以看到强大技术被滥用的方式。识别潜在的危险和新机会同样重要。

如果感觉我们正处于分析工程的真正拐点,那是因为我们确实处于这一点上。曾经只有少数冒险的数据团队涉足的领域,现在正迅速成为技术组织的行业标准——而且完全有理由相信,其他类型的组织也将很快跟进。影响实在是太大了。

我们即将看到分析工程师的就业机会数量和类型的大幅扩展。分析工程师的机会即将呈现出三大粗略领域,每个领域都有不同的挑战和机会。

-

越来越多的大型企业,无论是技术还是非技术组织,都将适应现代数据架构。随着数据分析工程被引入最复杂的传统数据系统中,我们将开始看到支持大规模数据分析工程的发展模式。如果你有兴趣真正弄清楚未来的大规模数据系统是什么样的,这将是一个理想的地方。

-

几乎每个新公司都会寻找一位数据分析工程师来领导他们的数据工作。这将使他们在任何不投资核心数据的竞争对手面前占据优势。在一家快速增长的公司中成为早期数据分析工程师是非常有趣和令人兴奋的,因为你能够从零开始建立数据组织,并亲眼看到数据分析工程如何改变组织的轨迹。

-

最后,许多科技业务外的组织将开始看到数据分析工程所能带来的影响。你可能没有相同的技术预算,你可能需要学会更多地为自己辩护,但这可能是数据分析工程对世界产生最大潜力的领域。城市政府将利用数据分析工程来监控项目,确保政府资源得到有效使用。学术机构将利用数据分析工程来创建数据集,其中许多是公开的,这将有助于科学和技术的发展。可能性空间是广阔的。

数据分析工程从根本上来说是一门关于理解我们周围世界的学科。它旨在让组织中的每个人都能更深入地了解他们对组织的影响以及他们的工作与组织的连接。目前,数据分析工程仍然是一个新兴领域——很快,它将无处不在。

原文。经许可转载。

相关:

更多相关主题

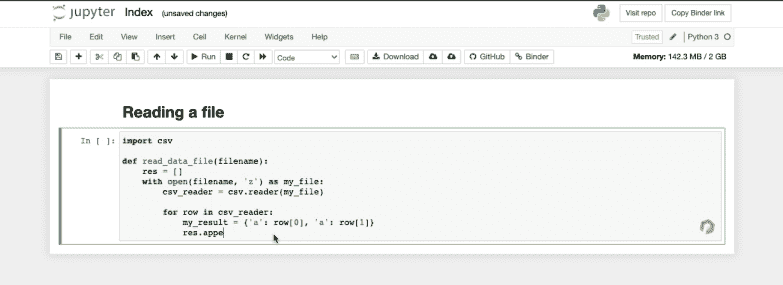

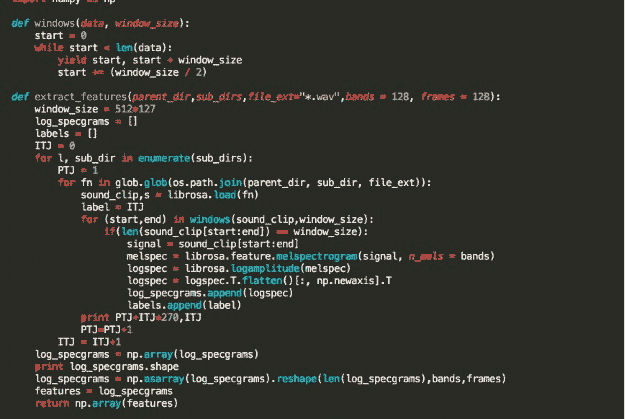

分析 Jupyter 笔记本中的 Python 代码

原文:

www.kdnuggets.com/2021/10/analyze-python-code-jupyter-notebooks.html

评论

作者 Julien Delange,Codiga 首席执行官

摘要

Jupyter 笔记本不支持传统的代码分析工具,这使得发现错误变得更加困难。我们提出了一种新工具,将现代代码分析技术与 Jupyter 笔记本集成,帮助开发者在编写代码时发现错误。

为什么验证 Python 代码?

Python 成为最受欢迎的编程语言(在 TIOBE 指数中排名第 1)。即使是这样一个受欢迎的语言也可能容易出错,特别是因为其特性(解释型语言,动态类型)由于其控制流由缩进定义。在 2018 年的研究中,Python 被发现是最容易出错的语言之一(与 C++、C 和 Objective-C 一起)。与其他编程语言一样,Python 有其自身的陷阱,开发者应该避免(并且这些问题已经在多年来得到了修复)。

因此,使用代码分析工具检查代码并检测潜在错误始终是一个良好的实践。主要目的是帮助你在将代码交付生产环境之前找到潜在错误。同时,它还帮助你遵循良好的编码规范。

现有生态系统

大多数集成开发环境(IDE)都带有一些代码分析功能,用于验证代码的语法。例如,PyCharm 提供了语法和语义问题检查的分析功能。还有多种开源工具可以从语义(例如 pylint)、安全(例如 bandit)或风格(例如 black)的角度检查 Python 代码。这些工具通常通过自定义插件和扩展集成到 IDE 中。

然而,静态分析工具未与 Jupyter 笔记本集成,开发者无法从这些工具的分析中受益。

在 Jupyter 笔记本中检查代码

作为定期使用 Jupyter 进行数据分析的 Python 开发者,我们希望将这些工具带入 Jupyter 生态系统,并帮助开发者快速捕捉错误。我们实现了一个 Chrome 插件,它可以在开发者编写代码时分析 Jupyter 笔记本中的 Python 代码,并报告所有问题。

该工具执行静态分析器,如 Pylint 和 Bandit,以检测 Python 代码中的语法、语义和安全错误,并将错误直接报告到 Jupyter 笔记本中。该插件目前兼容 Jupyter 笔记本,并将很快支持 Google Colab 或 AWS Sagemaker 等其他平台。

结论

Python 是当今最受欢迎的编程语言,但编写无瑕疵的 Python 代码非常困难。幸运的是,存在多种工具可以帮助开发人员检测次优代码。通过将这些工具与 Jupyter 笔记本接口,我们的 Chrome 扩展帮助开发人员在编写代码时检测问题,并在将代码投入生产前快速修复它们。

资源

个人简介: 朱利安·德朗日 是 Codiga(前身为 Code Inspector)的 CEO,该公司帮助开发人员更快地编写更好的代码。朱利安是一位经验丰富的软件开发人员,曾在 Twitter、Amazon Web Services 工作,并且是 MIT Press 出版的《技术债务》( Technical Debt )一书的作者。

相关:

-

计算机视觉的开源数据集

-

机器学习与深度学习大全开放书籍

-

Albumentations 概述:用于高级图像增强的开源库

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道

1. Google 网络安全证书 - 快速进入网络安全职业轨道

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关内容

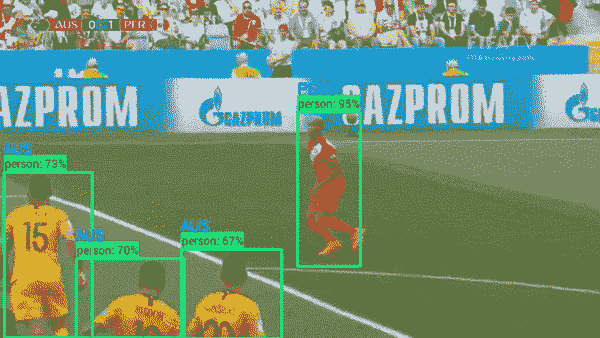

使用 Tensorflow Object Detection 和 OpenCV 分析足球(足球)比赛

原文:

www.kdnuggets.com/2018/07/analyze-soccer-game-using-tensorflow-object-detection-opencv.html

评论

评论

由 Priyanka Kochhar 提供,深度学习顾问

介绍

世界杯赛季来了,并且开始得非常有趣。谁曾想到卫冕冠军德国会在小组赛中被淘汰 😦

我们的前三大课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

3. Google IT Support Professional Certificate - 支持你的组织 IT

3. Google IT Support Professional Certificate - 支持你的组织 IT

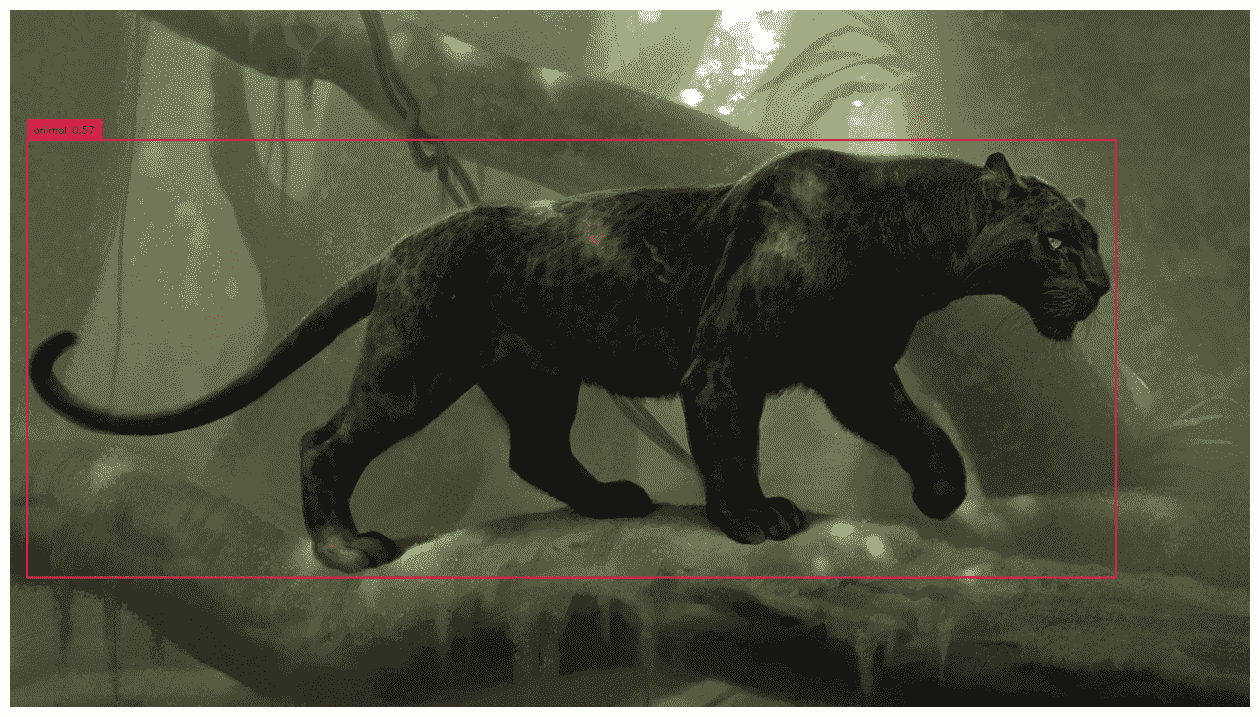

对于你内心的数据科学家来说,让我们利用这个机会对足球片段进行一些分析。通过深度学习和 OpenCV,我们可以从视频片段中提取有趣的见解。见下图澳大利亚与秘鲁比赛的示例 GIF,我们可以识别所有的球员 + 裁判,足球,并预测球员的球队基于他们球衣的颜色。所有这些都可以实时完成。

球员检测和团队预测

你可以在我的 Github 仓库 找到我使用的代码。

步骤概览

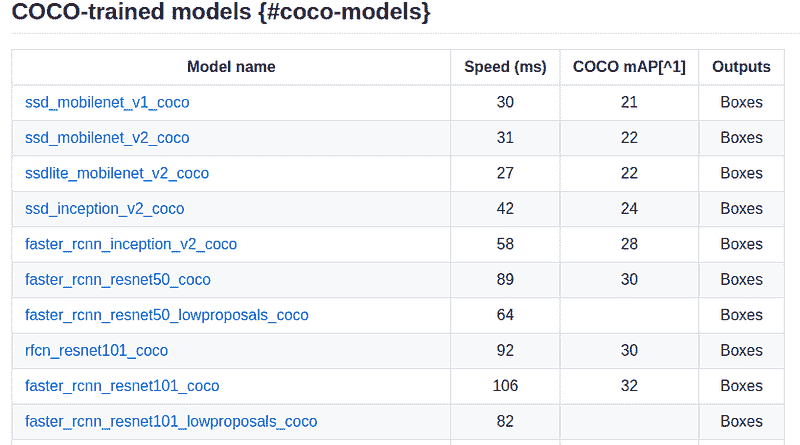

Tensorflow Object Detection API 是一个非常强大的工具,用于快速构建物体检测模型。如果你不熟悉这个 API,请查看我以下的博客,这些博客介绍了该 API 并教你如何使用它构建自定义模型。

Tensorflow Object Detection API 介绍

使用 Tensorflow Object Detection API 构建自定义模型

该 API 提供了在 COCO 数据集上训练的预训练物体检测模型。COCO 数据集是一个包含 90 种常见对象的数据集。见下图 COCO 数据集的一部分对象。

coco 对象类别

在这种情况下,我们关心的是类别——人和足球,这些都是 COCO 数据集的一部分。

该 API 还支持大量的模型。见下表作为参考。

API 支持的模型的小子集

模型在速度和准确性之间有权衡。由于我对实时分析感兴趣,我选择了 SSDLite mobilenet v2。

一旦我们使用对象检测 API 识别出球员,为了预测他们属于哪个队,我们可以使用 OpenCV,它是一个强大的图像处理库。如果你是 OpenCV 的新手,请参见下面的教程:

OpenCV 允许我们识别特定颜色的掩膜,我们可以利用这一点来识别红色球员和黄色球员。请参见下面的示例,了解 OpenCV 掩膜如何在图像中检测红色。

图像中红色区域的预测

深入了解主要步骤

现在让我们详细了解一下代码。

如果你第一次使用 Tensorflow 对象检测 API,请从这个link 下载 GitHub,并使用这些instructions 安装所有依赖项。

如果你还没有设置 OpenCV,请按照这个tutorial 从源代码构建。

我遵循的主要步骤是(请在我的Github上的 jupyter notebook 中跟随):

-

将 SSDLite mobilenet 模型加载到图形中,并加载 COCO 数据集中的类别列表

-

使用 cv2.VideoCapture(filename) 打开视频,并逐帧读取每一帧

-

对每一帧执行对象检测,使用加载的图形

-

从 SSDLite 返回的结果是每个识别的类别及其置信度分数和边界框预测。因此,现在识别所有置信度 > 0.6 的人员并裁剪他们。

-

现在你已经提取出每个球员。我们需要读取他们球衣的颜色来预测他们是澳大利亚球员还是秘鲁球员。这是通过代码块 detect team 完成的。我们首先定义红色和蓝色的颜色范围。然后使用 cv2.inRange 和 cv2.bitwise 创建该颜色的掩膜。为了检测团队,我计算了检测到的红色像素和黄色像素的数量以及这些像素与裁剪图像总像素数的百分比。

-

最终将所有代码片段组合起来,同时运行并使用 cv2.imshow 显示结果

结论和参考文献

太棒了。现在你可以看到深度学习和 OpenCV 的简单组合如何产生有趣的结果。既然你有了这些数据,有很多方法可以从中挖掘更多的见解:

-

通过将相机角度对准澳大利亚进球区域,你可以计算出在该区域内的秘鲁球员与澳大利亚球员的数量

-

你可以绘制每个团队足迹的热图——例如,哪些区域是秘鲁团队的高占用区域

-

你可以绘制出守门员的路径

对象检测 API 还提供其他更准确但更慢的模型。你也可以尝试那些。

如果你喜欢这篇文章,请给我一个 ❤️ 😃 希望你能下载代码并自己试试。

其他著作: deeplearninganalytics.org/blog

附言:我拥有自己的深度学习咨询公司,并且喜欢处理有趣的问题。我曾帮助多家初创公司部署创新的人工智能解决方案。查看我们的网站——deeplearninganalytics.org/。

如果你有一个我们可以合作的项目,请通过我的网站或 email priya.toronto3@gmail.com 联系我

参考文献

-

一个关于使用 OpenCV 检测颜色的好 教程

个人简介:Priyanka Kochhar 拥有超过 10 年的数据科学经验。她现在拥有自己的深度学习咨询公司,喜欢处理有趣的问题。她曾帮助多家初创公司部署创新的人工智能解决方案。如果你有一个她可以合作的项目,请通过 priya.toronto3@gmail.com 联系她。

原文。已获许可转载。

相关内容:

-

Google Tensorflow 对象检测 API 是否是实现图像识别的最简单方法?

-

使用 Tensorflow 对象检测 API 构建玩具探测器

-

训练和可视化词向量

更多相关内容

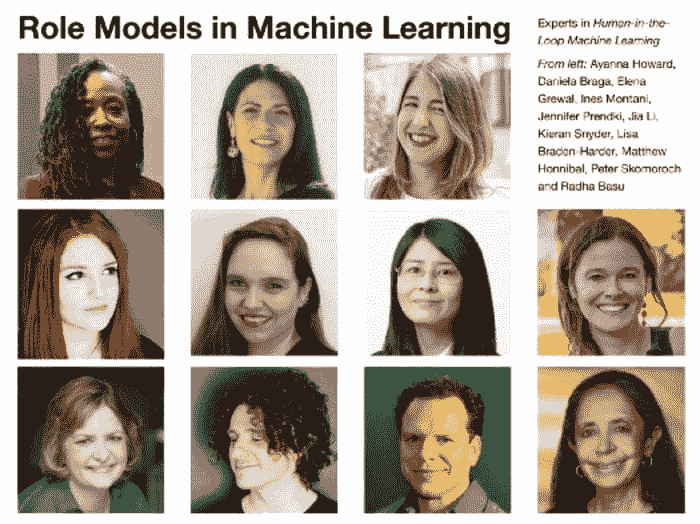

用 SQL 分析多样性与包容性

原文:

www.kdnuggets.com/2022/11/analyzing-diversity-inclusion-sql.html

图片来源:编辑

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

在过去 3-5 年中,与多样性、公平性和包容性相关的职位急剧增加已得到充分记录。DEI 分析师可能会花时间追踪、分析并回答诸如以下问题,

-

薪资在性别之间有何差异?

-

我们的部门在种族多样性方面的排名如何?

-

哪些职位和头衔最不具多样性?

虽然 DEI 分析师关注的问答类型与业务分析师不同,但他们仍然使用相同的技术技能和方法。

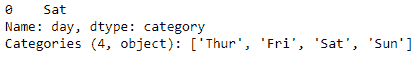

受保护的类别通常是分类的:性别、种族、民族和年龄(通常年龄被分为几个类别)

数值数据,如薪资,可以在受保护类别之间进行汇总

-

平均值

-

中位数

-

最小值

-

最大值

当你分析分类变量与数值变量的组合时,SQL 使其变得相当简单:

SELECT

ethnicity,

AVG(salary) as AVG_SALARY,

MEDIAN(salary) as MEDIAN_SALARY

FROM

HRDATA

GROUP BY

ethnicity

| 种族 | 平均薪资 | 中位薪资 |

|---|---|---|

| 白人 | $68,513 | $60,050 | |

| 非洲裔美国人 | $67,691 | $55,114 | |

| 亚洲 | $68,842 | $65,632 |

那么,分析分类变量与分类变量的结合有哪些方法呢?标准选项非常有限:

-

众数(最常见)

-

计数唯一值

SELECT

department,

COUNT(1) AS employees,

COUNT(DISTINCT ethnicity) AS DISTINCT_ETHNICITY,

MODE(ethnicity) AS MOST_COMMON_ETHNICITY

FROM

HRDATA

GROUP BY

ethnicity

| 部门 | 员工数 | 不同性别 | 最常见性别 |

|---|---|---|---|

| 销售 | 100 | 2 | 男性 |

| IT | 100 | 2 | 男性 |

初看起来,各部门似乎非常相似。但你如何区分:

-

销售部门有99名男性员工和1名女性员工

-

IT 部门有51名男性员工和49名女性员工。

我们肯定会认为后者更加多样化,但如何使用 SQL 快速得知这一点呢?

我在这里教你一种被低估的聚合函数,叫做熵,它将帮助我们准确量化每个部门的多样性。

| 部门 | 员工数 | 不同性别 | 最常见性别 | 熵 |

|---|---|---|---|---|

| 销售 | 100 | 2 | 男性 | 0.08 |

| IT | 100 | 2 | 男性 | 0.99 |

不幸的是,这不是简单地执行 SELECT Department, ENTROPY(ethnicity) 这么简单,但我会教你 SQL 逻辑,并将其添加到开源的 SQL Generator 5000 中,以便你随时生成所需的 SQL。

一些示例 HR 数据

Rich Huebner 博士 在 Kaggle.com 提供了一些示例 HR 数据,我们可以用来探索分析多样性的一些方法。

让我们开始查询数据,将职位与种族进行比较。我们将从基础开始:计数、唯一计数和众数。

SELECT

POSITION,

COUNT(1) AS employees,

COUNT(DISTINCT RACEDESC) AS DISTINCT_RACE,

MODE(RACEDESC) AS MOST_COMMON_RACE

FROM HR_DATA

WHERE DATEOFTERMINATION IS NULL /*active employees*/

GROUP BY

POSITION

ORDER BY 2 DESC

看结果,三个最受欢迎的职位在多样性方面似乎非常相似:

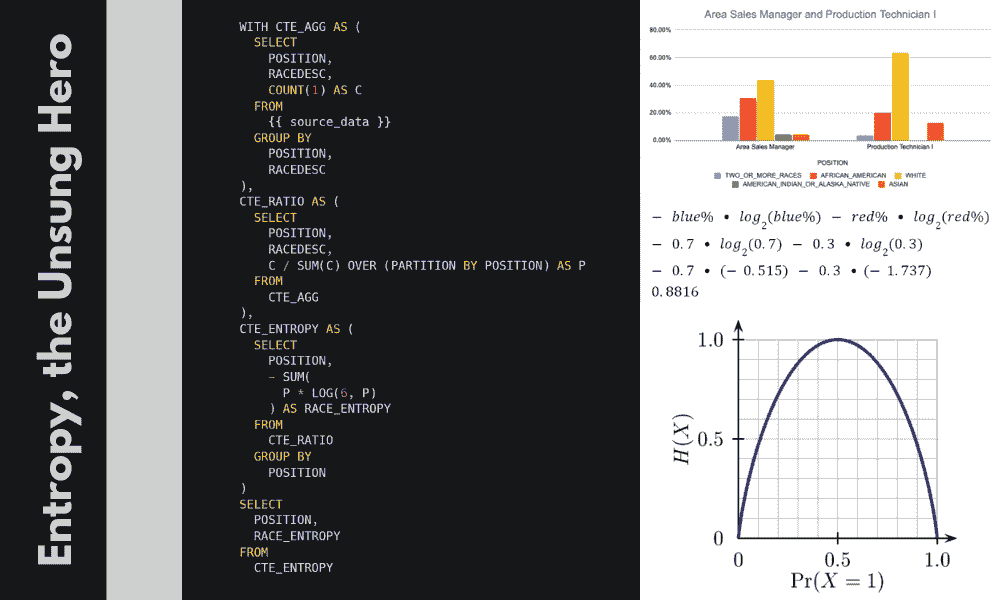

Entropy 来拯救我们

那么,我们如何按多样性对这三个部门进行排名呢?这就是 Entropy 的作用。

什么是 Entropy?

在继续之前,让我们花一分钟时间了解 Entropy 是什么,以及我们如何解释它。Entropy 的概念根植于信息理论的深层研究,并在机器学习、热力学和密码学等多个领域有广泛应用。因此,如果你查阅定义,它可能会令人困惑。

然而,Entropy 最简单的定义是类似于:Entropy 是一个用来描述事物多样性的数值度量。

想象一个只有两种颜色的弹珠袋:红色和蓝色。

现在,想象我们统计了袋子中的弹珠,发现有 99 个蓝色弹珠和仅 1 个红色弹珠。这种情况的多样性不高,因此袋子的 Entropy 很低。

接下来,想象一个包含 50 个蓝色和 50 个红色弹珠的袋子。这个袋子非常多样化,实际上已经不能再多样化了。一个包含 51 个蓝色和 49 个红色弹珠的袋子则稍微 少 一些多样性。因此,这个袋子的 Entropy 很高。

因此,

-

一个包含 100 个蓝色弹珠和 0 个蓝色弹珠的袋子是最不具多样性的: Entropy = 0

-

一个包含 50 个蓝色弹珠和 50 个红色弹珠的袋子是最具多样性的: Entropy = 1

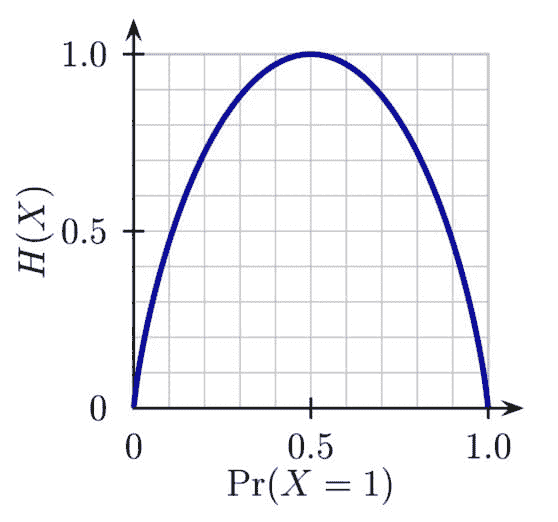

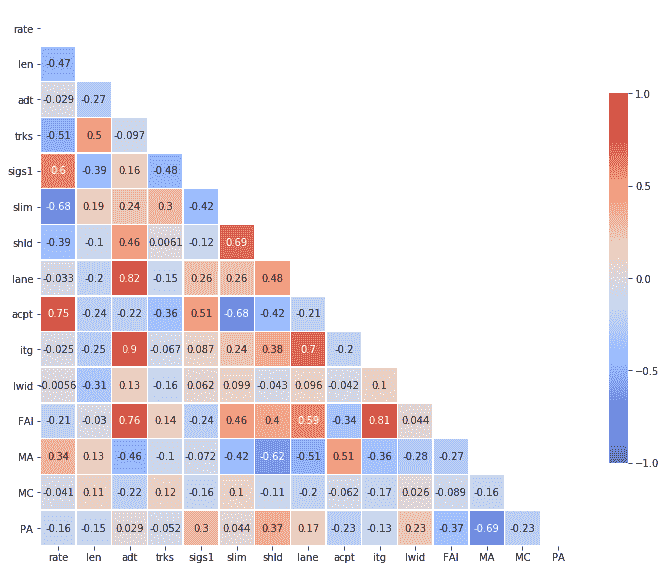

因此,Entropy 在 50/50 时达到最大值 1。以下是 Entropy 随着弹珠蓝色百分比变化的常见图示:

版权: commons.wikimedia.org/wiki/File:Binary_entropy_plot.png

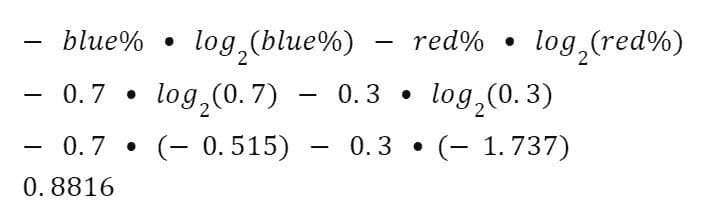

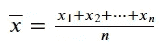

要计算 Entropy,我们需要计算每种颜色的百分比,并记住公式:

然后,对于一个 70% 是蓝色弹珠的袋子,我们构造公式如下:

当你将其扩展到超过 2 种选择时,你只需将对数的底数更改为匹配可能性数量即可。

使用 SQL

这是一个 SQL 处理起来相当简单而高效的操作。

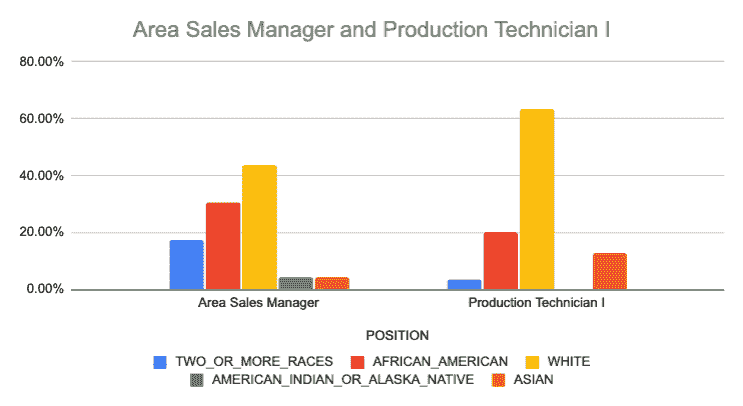

最终结果向我们展示了,尽管两个职位都不完全多样化,但区域销售经理的多样化程度高于生产技术员。

我们可以通过将其绘制在图表上来直观地确认这一点。

结论

熵是一种描述多样性的有用方法。它允许你通过将这些类别与受保护的类别(如种族或性别)结合,来对部门、职位或公司进行排序或排名。尽管这种函数在大多数 RDMBS 中并不存在,我们可以轻松构建 SQL 来计算它。我认为,对于从事多样性、公平性和包容性工作的人来说,在审视其组织的劳动力时,使用这些计算是很重要的。此外,作为在数据领域工作了大部分职业生涯的人,看到 SQL 的力量在所有数据驱动的团队中都有效,从传统的数据分析师到 DEI 分析师,真的很棒。

Josh Berry (@Twitter) 负责 Rasgo 的面向客户的数据科学工作,自 2008 年起从事数据和分析行业。Josh 在 Comcast 工作了 10 年,期间建立了数据科学团队,并且是内部开发的 Comcast 特性库的关键负责人之一——这是市场上首批特性库之一。在离开 Comcast 后,Josh 在 DataRobot 领导了面向客户的数据科学团队。在闲暇时间,Josh 会对一些有趣的主题进行复杂分析,比如棒球、F1 赛车、住房市场预测等。

更多相关内容

使用 Intelligence Node 的属性演变模型分析未来成功概率

快时尚的时代和不断演变的消费者购买趋势使品牌在预测未来购买行为和寻找可能需求的产品方面变得更加具有挑战性和复杂性。Intelligence Node 对庞大的在线和竞争对手数据的访问以及专有的人工智能分析使其在基于多个因素理解趋势和分析数据方面具有优势,从而基于历史数据和产品属性 预测未来成功的概率。

在这篇文章中,我们将阐明由 Intelligence Node 分析团队建立的未来成功概率模型。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 加速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 加速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

未来成功概率模型最初被开发为反应模型,后来演变为有限记忆模型。考虑到模型的应用以及‘心智理论’系统的未来发展,我们可以进行转变,使预测‘意识到实际影响情感和行为的变量’。我们可以开始将零售市场(可以进一步细分为不同的群体)视为具有自身情感和情绪的个体……这让人想起了本杰明·格雷厄姆创造的‘市场先生’寓言。

深入探讨未来成功概率模型

Intelligence Node 的未来成功概率模型包含 4 个关键步骤。每个步骤对生成可以用来推测某一产品在未来 6 到 12 个月内成功概率的历史行为数据都至关重要。

方法论

第 1 步:分析历史数据

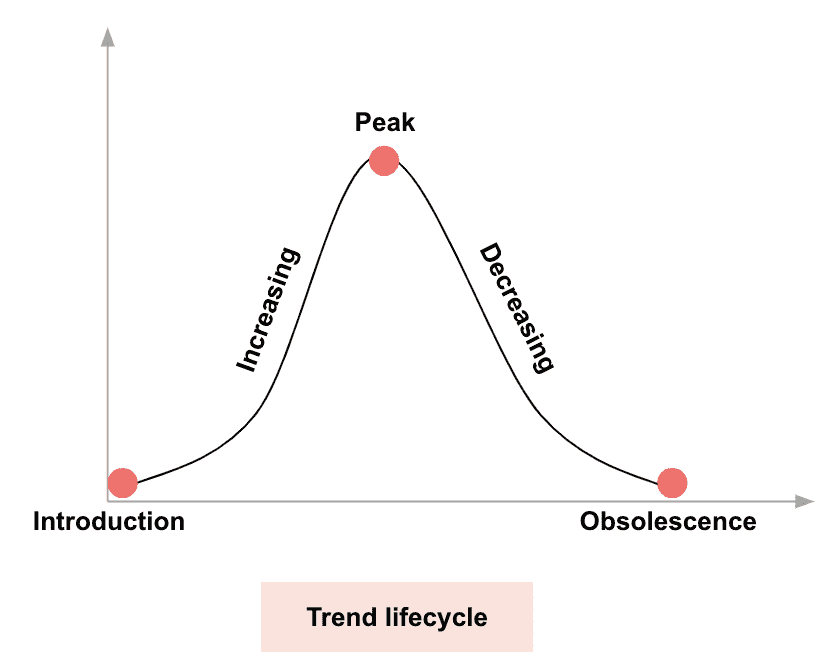

- 趋势/属性的演变可能有多种可能的结果。通过分析历史数据,我们可以估计未来成功的概率。

第 2 步:跟踪既定和新兴的产品属性

- 属性可以是库驱动的(已建立)或机器驱动的(新兴)。跟踪属性在一段时间内的表现可以帮助我们理解它们未来进展的概率

第 3 步:评估关键指标的表现

- 对于每个趋势/属性,我们评估货架份额、时间排名和权力排名(子组件包括评论速度、销售速度、产品可见性、产品生命周期动态等)

第 4 步:分析未来成功的概率

- 基于对历史回顾以及当前市场动态的信号 KPI 的叠加分析,我们可以识别出未来成功概率较高的趋势/属性

第 1 步:分析历史数据

历史数据是确定未来趋势和产品成功概率的关键因素。通过了解产品过去的表现、其在产品生命周期中的位置以及观众的接受程度,可以对其未来的成功(以及类似趋势的未来成功)获得见解,前提是结合其他关键决定因素。趋势/属性的演变可能有多种可能的结果,分析历史数据可以帮助估计各种情况的未来成功概率。

第 2 步:跟踪已建立和新兴的产品属性

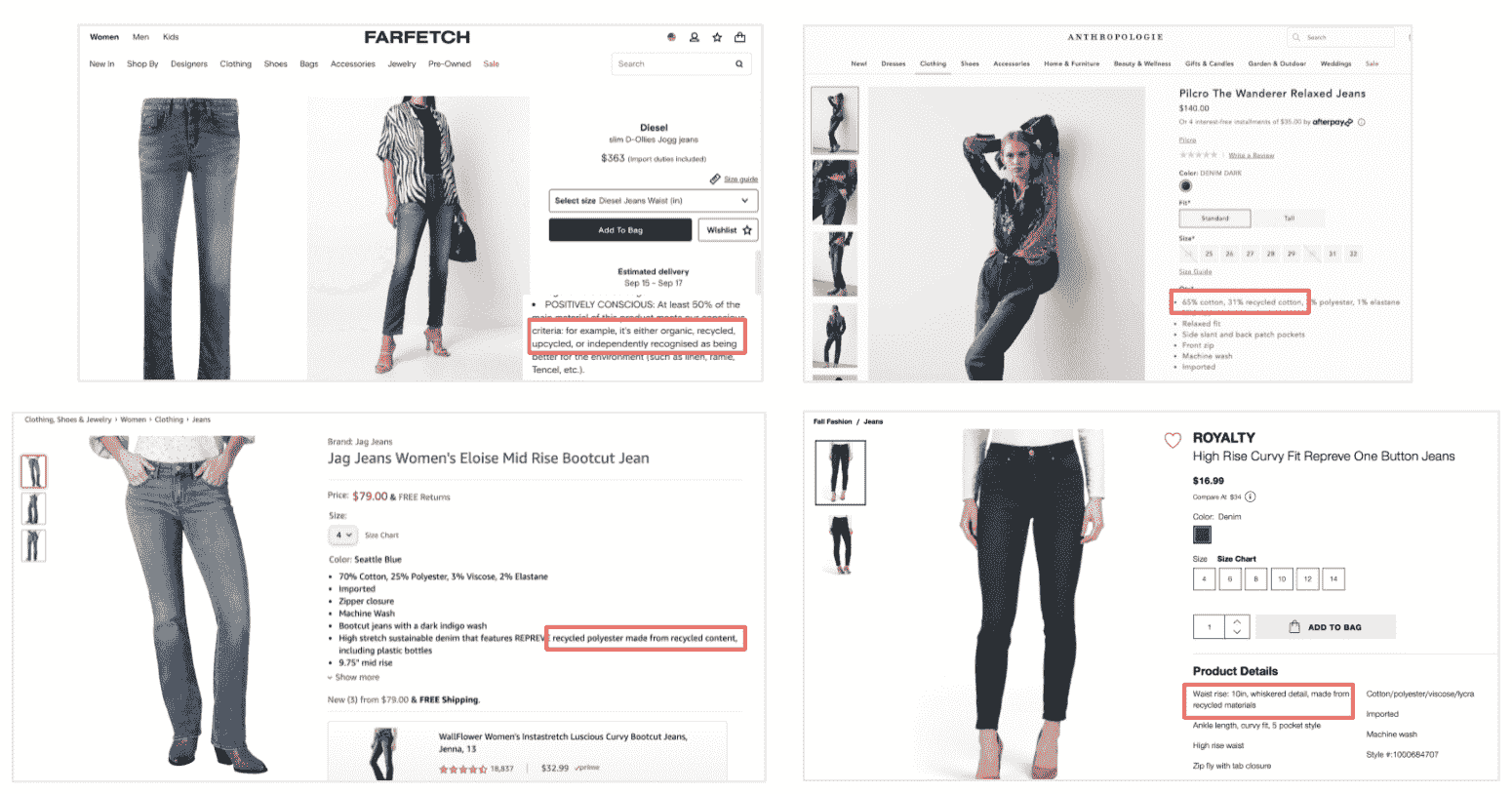

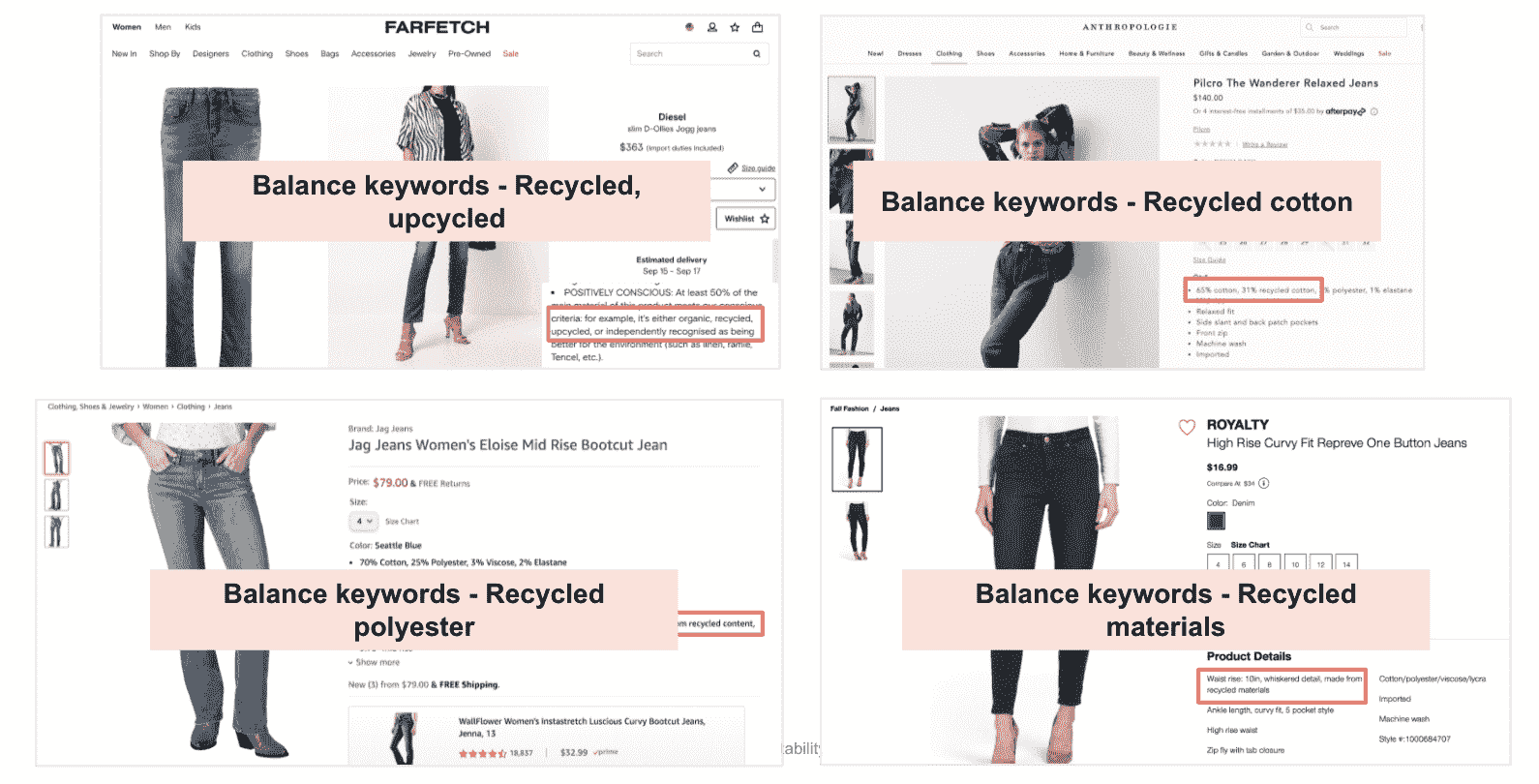

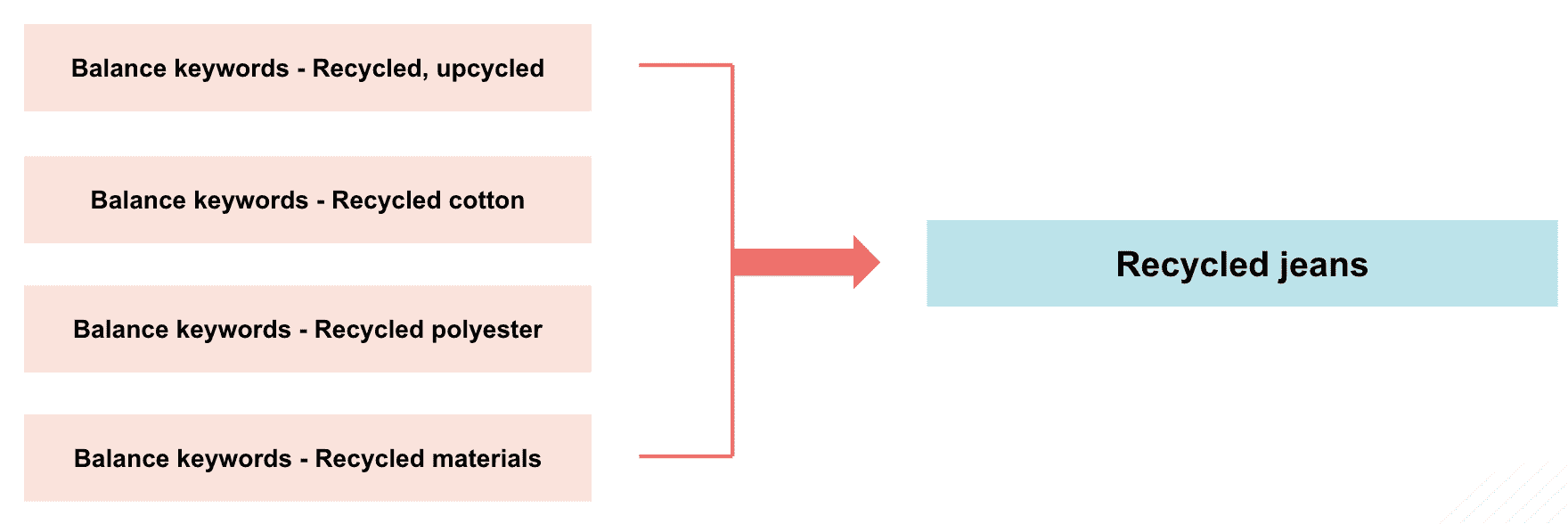

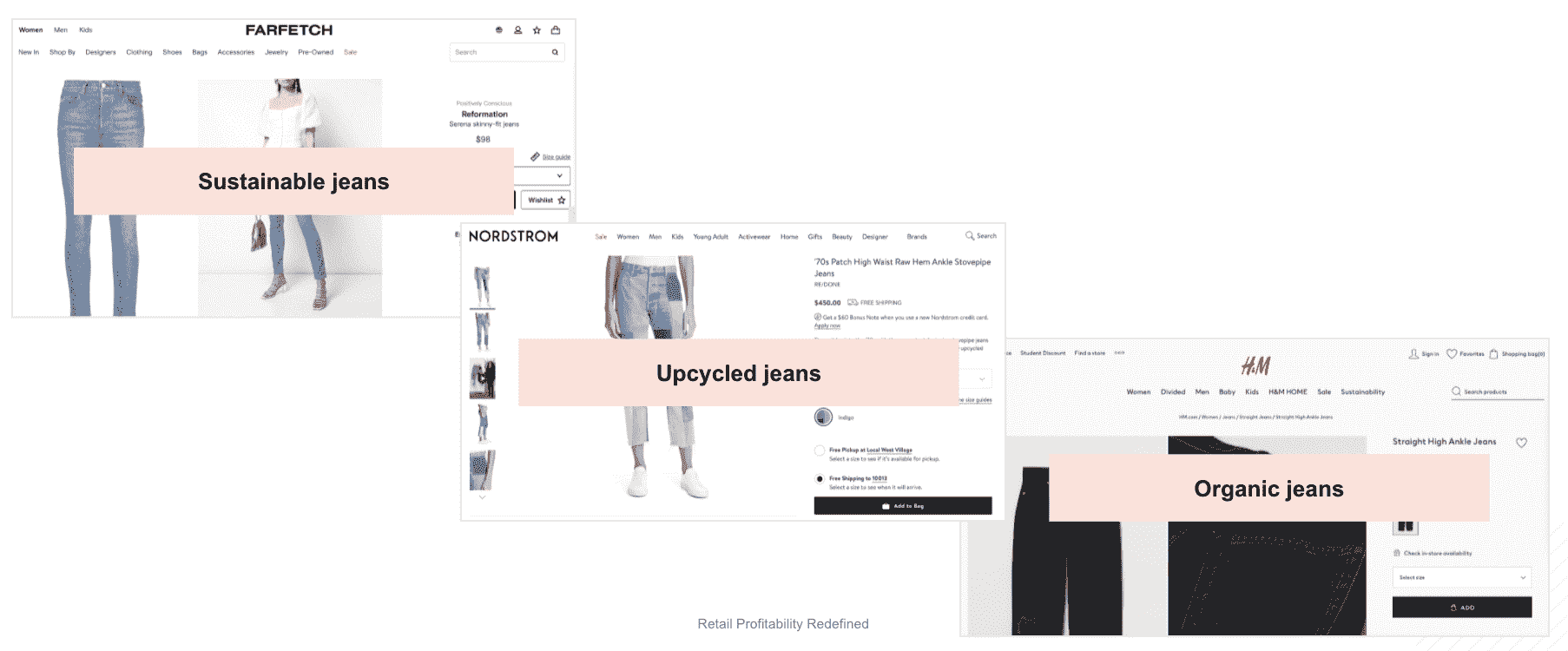

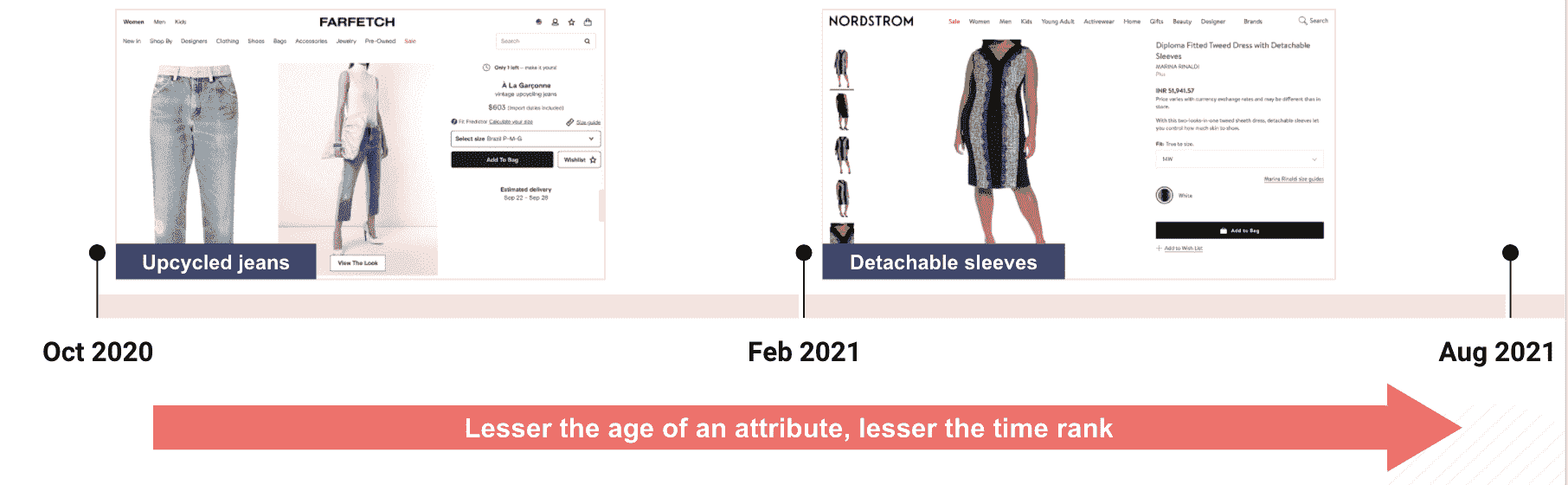

通过分析机器驱动的属性(及相似的关键词),我们可以识别市场趋势。以下是‘回收牛仔裤’关键词的例子,我们将了解如何使用机器驱动的方法来识别相似的关键词/属性:

第 1 步:挖掘产品副本中的关键词

我们利用全面的属性库从所有竞争对手的产品名称/描述中捕获重复的关键词(计算机视觉也被部署以确保最大覆盖率)。

第 2 步:过滤属性值

我们从属性库中过滤出现有的属性值,并分析平衡关键词(Transformer 模型被部署 + BERT 的自定义实现提取句子向量并使用它们来训练一个全连接前馈神经网络)。

第 3 步:对平衡关键词进行零样本聚类

我们运行一个定制的零样本聚类模型(该模型被编程以识别和调整其内部偏差)以创建“逻辑”聚类。

第 4 步:识别相似的关键词/属性

此外,该模型(定制开发的 NN 测量上下文相似度)寻找可能围绕初始主题(例如环境意识)展开的相似关键词。

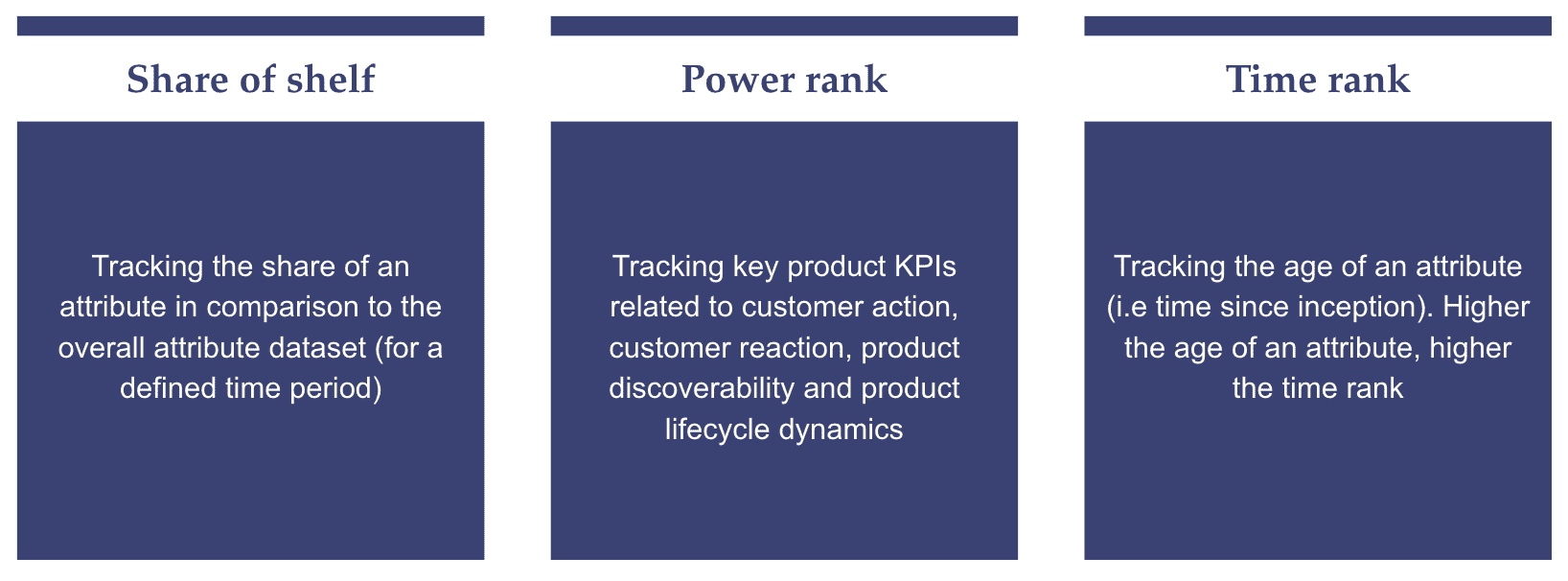

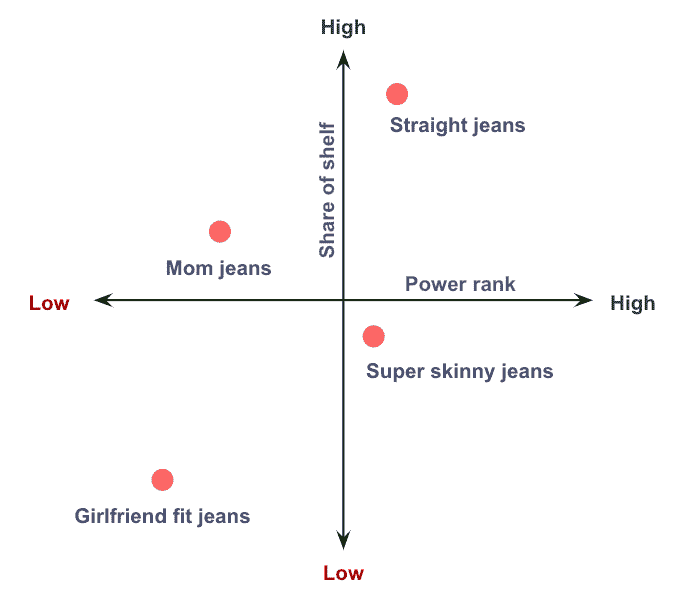

第三步:评估关键指标的表现

评估关键指标是未来成功概率模型中最重要的步骤之一。在此步骤中,我们分析如货架份额、时间排名和权重排名等指标,以全面评估产品表现并推断其未来成功的概率:

货架份额:跟踪某一属性与整体数据的比较份额

“数字货架份额”是指产品在关键词/属性查询中获得的可见性百分比。

示例:

权重排名: 一个重要标准,综合信号 KPI 如下:

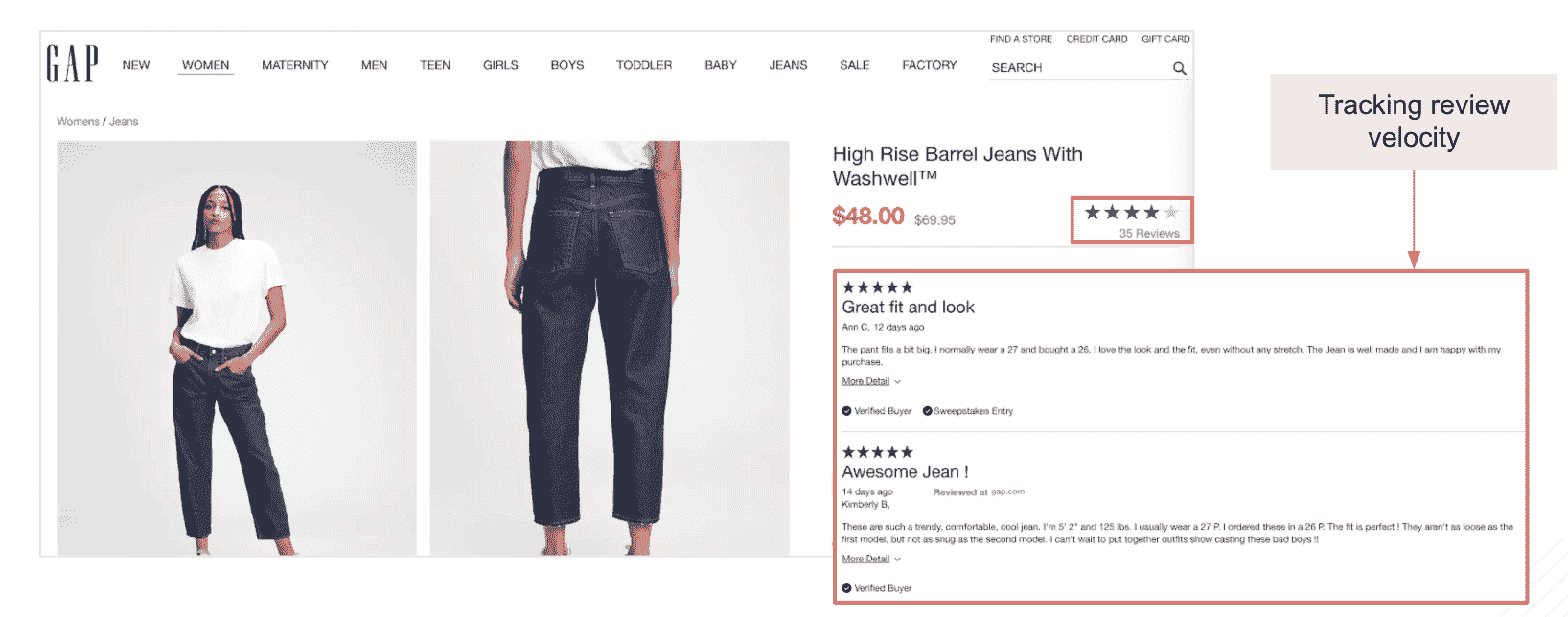

a. 客户反应(产品评价和评分的数量及速度)

我们通过计算网站上客户评价的总数以及这些评价的速度(这些评价发布的时间距离现在有多近)来跟踪这一 KPI,以分析属性级别的客户情感。

示例:

在上述示例中,我们跟踪了 GAP 高腰桶形牛仔裤的评论数量和评论速度。

b. 客户行动(跟踪销售速度和产品在不同领域的可见性)

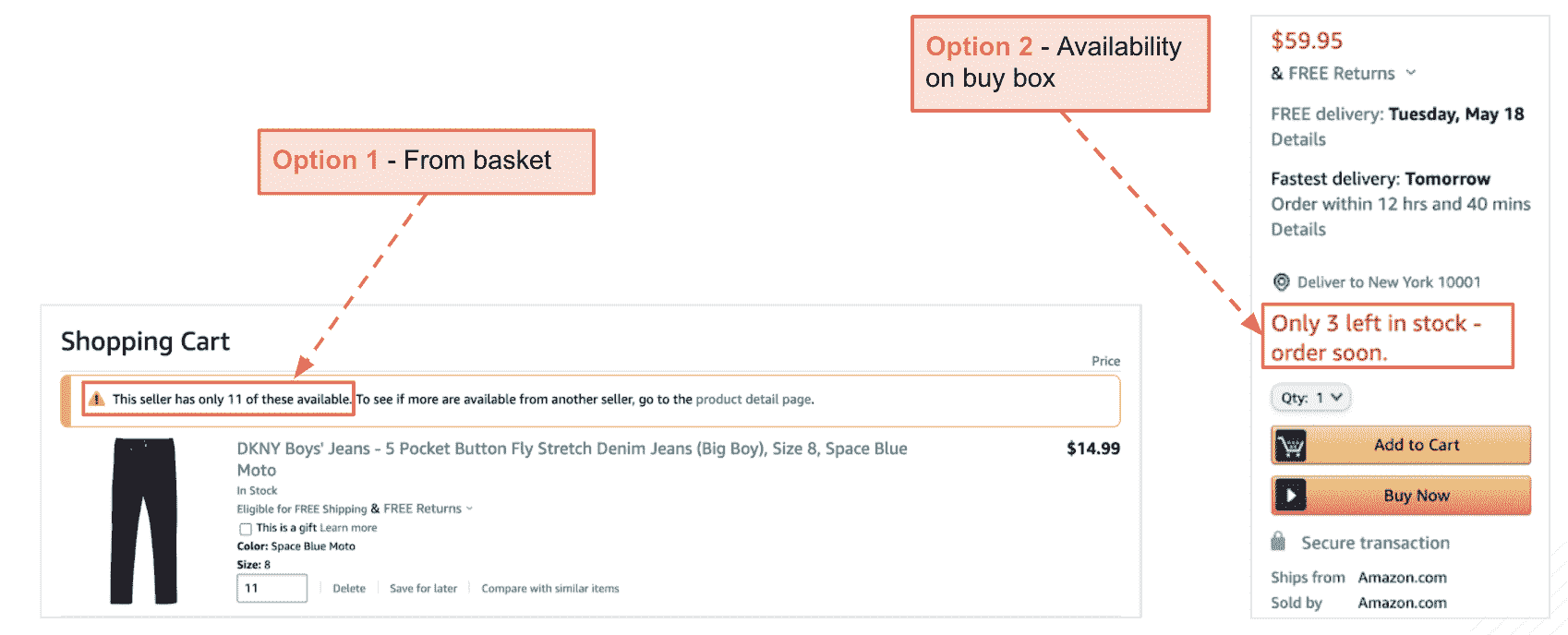

我们的“智能配方抓取”算法可以通过从多个来源抓取库存数量来跟踪销售速度,包括产品页面、购物车、Amazon 购买框等,并分析库存水平在某一时间段内的消耗频率。

示例:

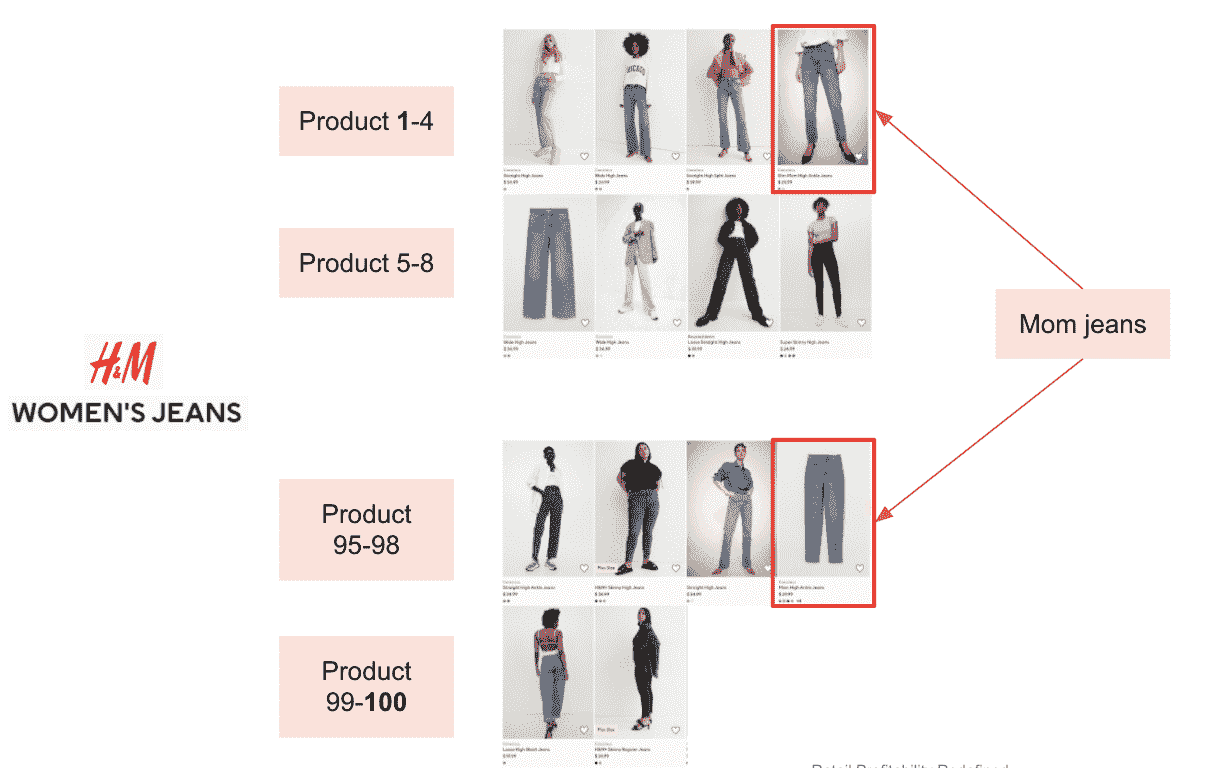

c. 客户发现性(使用目标竞争对手领域的搜索算法跟踪产品的可搜索性和受欢迎程度)

从可搜索性角度来看,我们跟踪竞争对手领域的前 100 款产品并分析每个属性的份额。

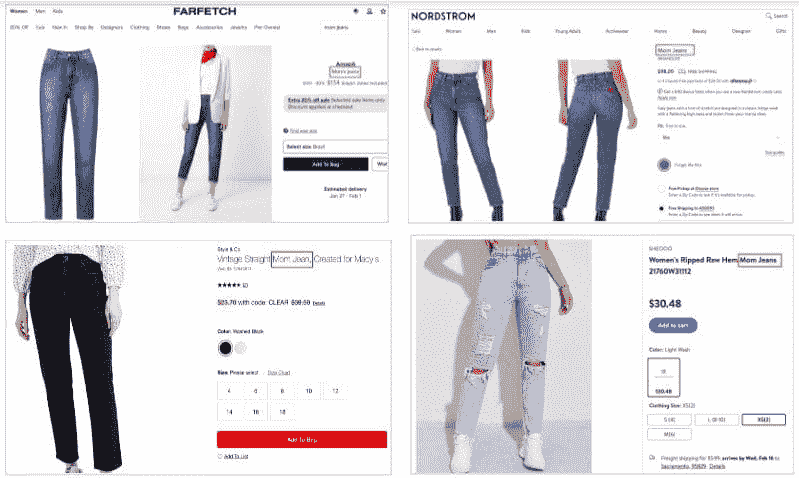

示例:

例如,“妈妈牛仔裤”占 H&M 前 100 款产品中的 26%。

我们还跟踪 Google 趋势上每周/每月的属性受欢迎程度。这些数据是“实际搜索兴趣”的直接反映,覆盖定义的区域。

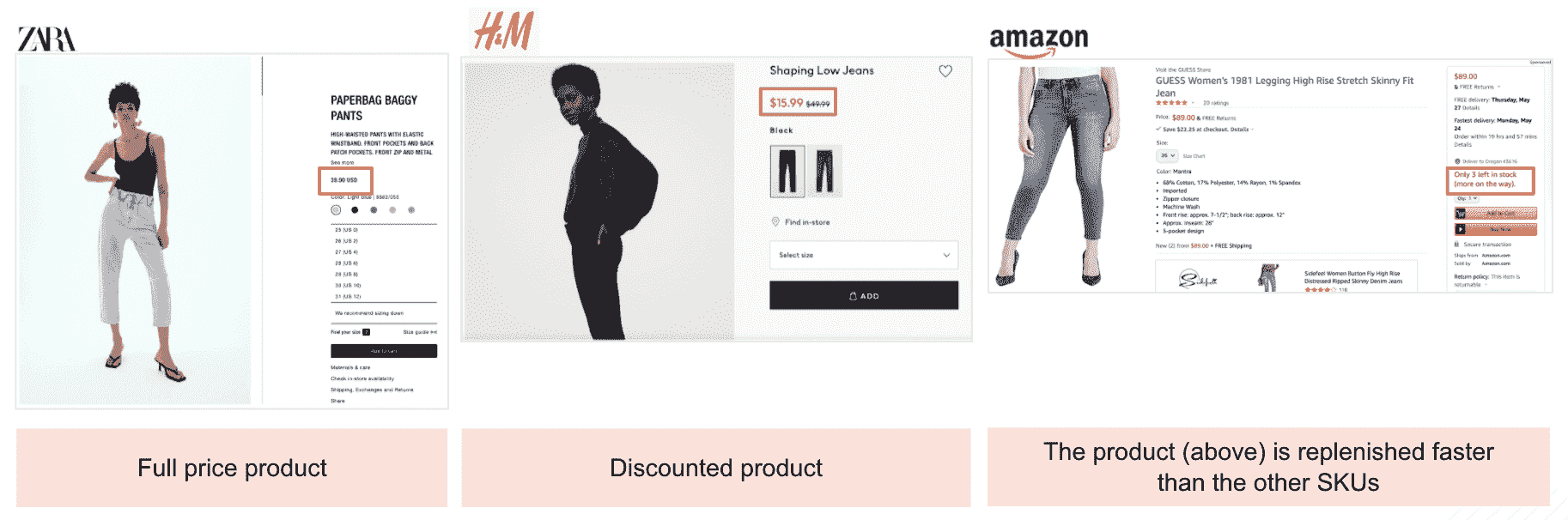

d. 产品生命周期

我们可以通过跟踪属性层面的关键产品活动来分析产品生命周期动态,例如产品促销、折扣比率、产品亲和力、产品可用性、补货率、产品缺货的平均时间等。

示例:

3. 时间排名:跟踪属性的年龄

我们可以跟踪每个属性的年龄(自创立以来的时间)。这可以帮助早期识别新趋势,并揭示市场中的衰退趋势。

示例

第 4 步:分析未来成功的概率

基于第 3 步中涵盖的所有指标的历史表现,我们可以识别出在未来具有高成功概率或可能脱离趋势的趋势/属性。通过这项分析,制造商和品牌可以提前 6-12 个月计划生产或订购哪些产品,哪些 SKU 需要备货或投资,以及哪些产品可以停产,以优化库存储存和仓储,节省成本和开销,并以计划性和数据驱动的方式满足消费者需求。

在上述示例中,我们分析了‘直筒牛仔裤’在过去 24 个月的关键指标表现。通过应用我们的分析方法,我们可以预测直筒牛仔裤在未来几个月的成功概率。

数据分析为零售企业解答的问题

如本文所述的未来成功概率模型,是一种基于一系列预设指标和属性的市场驱动方法,用于识别特定产品属性的未来趋势和成功概率。它基于可靠的实时和历史数据、深入的数据分析、直观的智能以及市场和消费者趋势,回答了许多涉及关键业务领域的主要问题。让我们看看未来成功概率模型能够回答的一些问题:

-

我应该关注哪些新趋势?

-

我应该如何调整既定趋势以最大化成功的机会?

-

既定趋势是否在增强?

-

既定趋势是否在减弱?

最后总结:面向未来的零售数据驱动分析

当前零售和消费者偏好的变化速度使得零售企业必须利用先进的零售技术和 AI 分析的力量。零售企业的成功将主要取决于它们在将数据作为战略决策工具的有效性。利用高级分析将帮助零售商获得洞察,以识别未来趋势和消费者偏好,为零售业务的未来做准备,并做出数据驱动的决策,从而对未来结果产生积极影响。这正是 Intelligence Node 最新的未来成功概率模型旨在为零售生态系统提供的。它是一种解决方案,将通过分析和提取大量数据、参数和属性的洞察,赋能品牌、零售商和制造商,提供可操作的对未来可能性的洞察 - 使他们能够精准地做出制造、采购、定价和产品组合决策。

Yasen Dimitrov 是 Intelligence Node 的联合创始人兼首席分析官,该平台通过专利 AI 提供 99% 的数据准确性。

更多相关主题

使用微调的 SciBERT NER 模型和 Neo4j 分析科学文章

原文:

www.kdnuggets.com/2021/12/analyzing-scientific-articles-finetuned-scibert-ner-model-neo4j.html

评论

由 Khaled Adrani,UBIAI

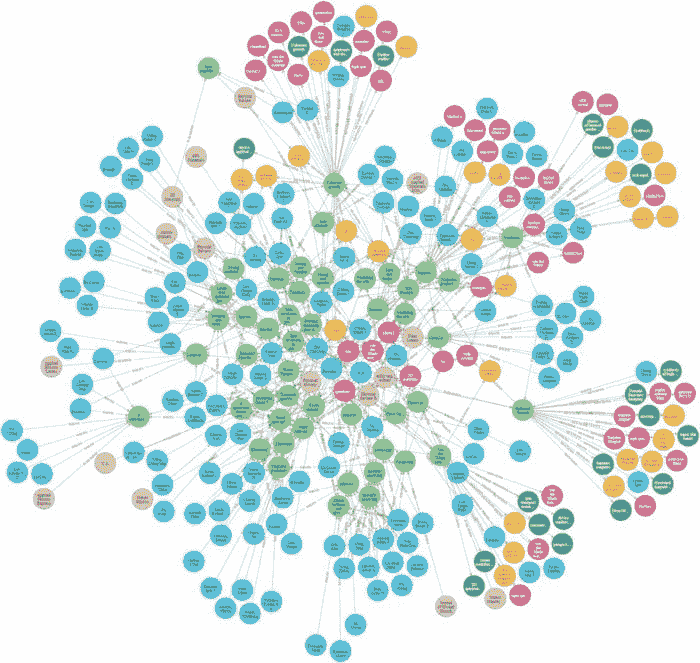

作者提供的图片:科学文章的知识图谱

据估计,每年发表约 180 万篇文章,分布在大约 28,000 个期刊中。出版物的产出在过去十年中每年增长了 4%,从 2008 年到 2018 年从 180 万增长到 260 万。但实际上谁在阅读这些论文呢?根据 2007 年的一项研究,阅读这些论文的人并不多:一半的学术论文仅由作者和期刊编辑阅读。手动分析文章是繁琐且耗时的。因此,为研究人员提供一个能够快速提取和分析文章信息的工具,将对加速新发现产生巨大的影响。

知识图谱 KG 是快速和高效分析信息的理想解决方案。它们表示现实世界实体(如对象和概念)之间的网络,并提供它们之间的关系。这些信息通常存储在图形数据库中,并以图形结构可视化。然而,手动构建知识图谱是一项耗时的任务。幸运的是,随着机器学习和自然语言处理的最新进展,命名实体识别(NER)得到了救援。

在本文中,我们将使用 Neo4j 图形数据库和微调的 SciBERT 模型分析科学摘要数据集。之后,我们将查询数据以回答一些问题,作为我们对该语料库的分析。本文假设你具有 NLP 和 Neo4j 的基本知识。

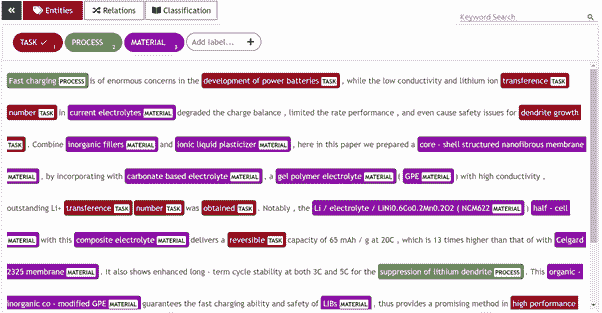

模型训练

我们将使用的 NER 模型基于 SciBERT,并通过对材料、过程和任务的注释进行了微调:

-

材料:表示摘要中提到的任何材料

-

过程:表示实验中使用的过程或方法

-

任务:表示要进行的研究任务

对于注释部分,我们使用了UBIAI 文本注释工具,并将注释导出为 IOB 格式,如下所示:

作者提供的图片:UBIAI 文本注释工具

有关如何使用 UBIAI 生成训练数据和微调 NER 模型的更多信息,请查看以下文章:

设置

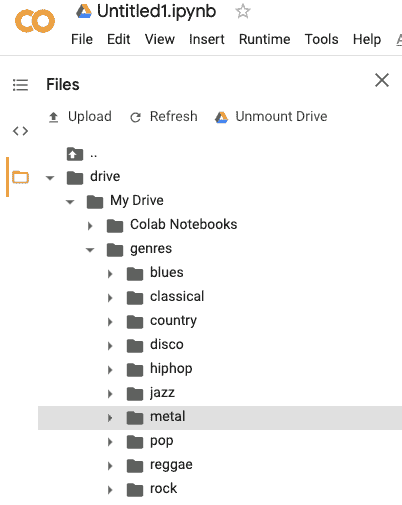

我们将在 Google Collaboratory 上工作。显然,我们将使用 Python。我们挂载了包含数据集和模型的 Google 云端硬盘。我们还需要安装各种依赖项。

#Mount google drive

from google.colab import drive

drive.mount(‘/content/drive’)

!pip install neo4j

!pip install -U spacy

!pip install -U pip setuptools wheel

!python -m spacy download en_core_web_trf

!wget https://developer.nvidia.com/compute/cuda/9.2/Prod/local_installers/cuda-repo-ubuntu1604-9-2-local_9.2.88-1_amd64 -O cuda-repo-ubuntu1604-9-2-local_9.2.88-1_amd64.deb

!dpkg -i cuda-repo-ubuntu1604-9-2-local_9.2.88-1_amd64.deb

!apt-key add /var/cuda-repo-9-2-local/7fa2af80.pub

!apt-get update

!apt-get install cuda-9.2

!pip install torch==1.7.1+cu92 torchvision==0.8.2+cu92 torchaudio==0.7.2 -f https://download.pytorch.org/whl/torch_stable.html

!pip install -U spacy[cuda92,transformers]

让我们加载我们的 NER 模型:

import spacy

nlp = spacy.load("/content/drive/MyDrive/Public/model_science/model-best")

数据准备

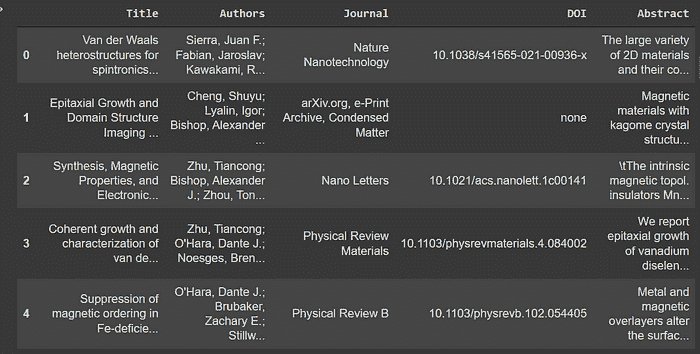

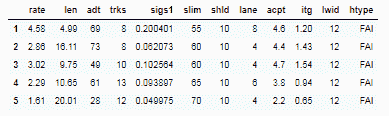

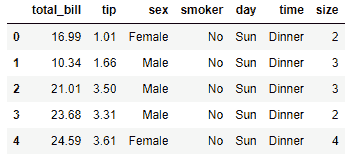

数据集包含了主要作者撰写并发表在各种科学期刊上的科学文章的摘要。我们还对这些文章中提到的实体感兴趣。因此,你可以清楚地看到我们的图谱将如何结构化。让我们加载数据并查看一些示例:

import pandas as pd

path = "/content/drive/MyDrive/Public/Database_ABI_updated.csv"

df = pd.read_csv(path)[["Title","Authors","Journal","DOI","Abstract"]]

df.head()

我们数据集的一个样本

为了构建我们的知识图谱,我们将添加作者、期刊和具有其属性的文章,然后添加它们之间的现有关系。

我们从提取作者列表开始。需要进行一些预处理。每篇文章通常有多个作者,因此我们将包含作者姓名的字符串转换为列表。我们还需要通过对实体进行哈希来生成 ids。

import hashlib

ls = list(df.Authors)

ls_authors = []

for e in ls:

sep = ";"

if ";" in e:

sep = ";"

else:

sep = ","

ls_authors.extend(e.split(sep))

print(len(ls_authors))

ls_authors = list(set(ls_authors))

print(len(ls_authors))

def hash_text(text):

return hashlib.sha256(str(text).encode('utf-8')).hexdigest()

authors = []

for e in ls_authors:

authors.append({"name":e,"id":hash_text(e)})

下面是获取所有期刊列表的代码:

journals = []

for j in list(df.Journal.unique()):

journals.append({"name":j,"id":hash_text(j)})

journals[0]

对于这些文章,我们将把数据框转换为字典列表。每篇文章将把其字典的属性作为图谱中的属性(例如名称、作者列表等)。

import copy

records = df.to_dict("records")

def extract_authors(text):

ls_authors = []

sep = ";"

if ";" in text:

sep = ";"

else:

sep = ","

ls_authors.extend(text.split(sep))

return ls_authors

articles = copy.deepcopy(records)

for r in articles:

r["Authors"] = extract_authors(r['Authors'])

为了从每篇文章中提取实体,我们将其标题和摘要结合起来作为待分析的文本。同时,我们通过将其文本内容进行哈希来添加其自身的 id:

for article in articles:

article["text"]= article["Title"]+" "+article["Abstract"]

article["id"] = hash_text(article["text"])

article

现在,这个函数作为一个可重用的代码来处理文档列表对我很有帮助。我们的实体标签是:

-

过程

-

材料

-

任务

def extract_ents(articles,nlp):

texts = []

for article in articles:

texts.append(article["text"])

docs = list()

for doc in nlp.pipe(texts, disable=["tagger", "parser"]):

dictionary=dict.fromkeys(["text", "annotations"])

dictionary["text"]= str(doc)

dictionary['id'] = hash_text(dictionary["text"])

annotations=[]

for e in doc.ents:

ent_id = hash_text(e.text)

ent = {"start":e.start_char,"end":e.end_char, "label":e.label_.upper(),"text":e.text,"id":ent_id}

annotations.append(ent)

dictionary["annotations"] = annotations

docs.append(dictionary)

return docs

docs = extract_ents(articles,nlp)

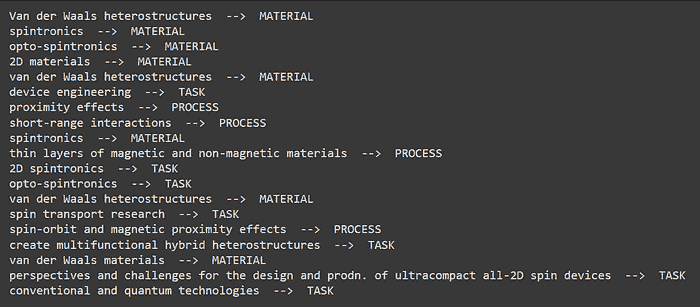

让我们看看从第一篇文章中提取的实体是什么:

for e in docs[0]['annotations']:

print(e['text'],' --> ',e['label'])

文章中存在的实体示例

最后,我们将每个字典添加到文章列表中其适当的文章字典中:

for i in range(len(docs)):

articles[i]['annotations'] = copy.deepcopy(docs[i]['annotations'])

创建知识图谱

数据准备已经完成。现在是时候使用 Neo4j 插入和操作这些数据了!

我们定义了一个函数,用于与我们的Neo4j Aura 数据库进行通信。

from neo4j import GraphDatabase

import pandas as pd

uri ="your uri here"

user="your username here"

password='your password here'

driver = GraphDatabase.driver(uri,auth=(user, password))

def neo4j_query(query, params=None):

with driver.session() as session:

result = session.run(query, params)

return pd.DataFrame([r.values() for r in result], columns=result.keys())

这些是我们用来填充数据库的查询,它们非常直接。

#create journals

neo4j_query("""

UNWIND $data as journal

MERGE (j:JOURNAL {id:journal.id})

SET j.name = journal.name

RETURN count(j)

""",{"data":journals})

#create authors

neo4j_query("""

UNWIND $data as author

MERGE (a:AUTHOR {id:author.id})

SET a.name = author.name

RETURN count(a)

""",{"data":authors})

#create articles

neo4j_query("""

UNWIND $data as row

MERGE (a:ARTICLE{id:row.id})

ON CREATE SET a.title = row.Title, a.DOI = row.DOI, a.abstract = row.Abstract,

a.authors = row.Authors, a.journal=row.Journal

RETURN count(*)

""", {'data': articles})

# Match articles with their authors

neo4j_query("""

MATCH (a:ARTICLE)

WITH a

UNWIND a.authors as name

MATCH (author:AUTHOR) where author.name = name

MERGE (author)-[:WROTE]->(a)

""")

# Match articles with their journals

neo4j_query("""

MATCH (a:ARTICLE)

WITH a

MATCH (j:JOURNAL) where j.name = a.journal

MERGE (j)-[:PUBLISHED]->(a)

""")

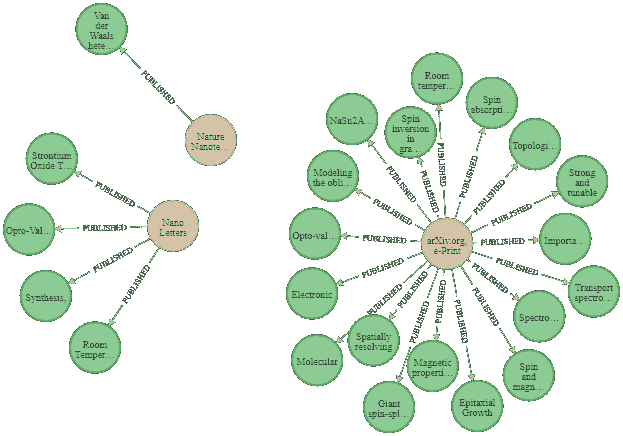

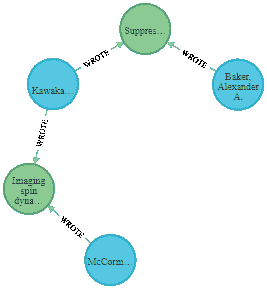

作者提供的图像:三本期刊及其发表的文章

添加实体有点棘手。这个查询由三部分组成:

-

首先,我们将数据库中的每个文章节点与我们文章列表中的字典进行匹配。UNWIND 帮助我们遍历列表,每次获取一篇文章。

-

其次,对于每个实体,我们如果它不存在则创建它,或者使用 MERGE 来匹配它。之后,实体将与当前文章连接。

-

最后,我们为每个实体添加标签 PROCESS、MATERIAL 或 TASK,标签的值已经包含在一个同名属性中。然后我们继续删除该属性。

# Add entities (Material, Process, Task) and match them with any article that mentions them.

neo4j_query("""

UNWIND $data as row

MATCH (a:ARTICLE) where row.id = a.id

WITH a, row.annotations as entities

UNWIND entities as entity

MERGE (e:ENTITY {id:entity.id})

ON CREATE SET

e.name = entity.text,

e.label = entity.label

MERGE (a)-[m:MENTIONS]->(e)

ON CREATE SET m.count = 1

ON MATCH SET m.count = m.count + 1

WITH e as e

CALL apoc.create.addLabels( id(e), [ e.label ] )

YIELD node

REMOVE node.label

RETURN node

""", {'data': articles})

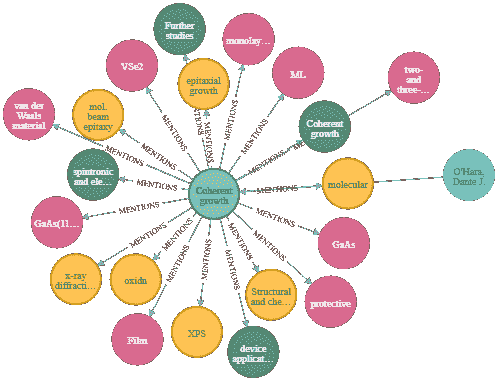

作者提供的图片:一篇文章及其连接的节点

摘要分析

最终,我们来到了最有趣的部分!

假设你是一名自然语言处理(NLP)专家,与一位物理学专家合作。他希望你分析他认为非常有趣的几篇科学论文的摘要。他给你四个问题:

-

最受欢迎的材料和过程

-

最受欢迎的作者

-

材料和过程之间的最高共现

-

两个给定作者之间的最短路径

让我们使用 Neo4j 来回答这些问题!

要找出在整个语料库中最受欢迎的材料和过程,我们需要计算一个实体与期刊的关系数,以查看它们出现了多少次:

neo4j_query("""

MATCH (e) where e:PROCESS OR e:MATERIAL

MATCH (e)-[]-(a:ARTICLE)-[]-(j:JOURNAL)

RETURN e.name as entity, labels(e) as label, count(*) as freq ORDER by freq DESC LIMIT 10

""")

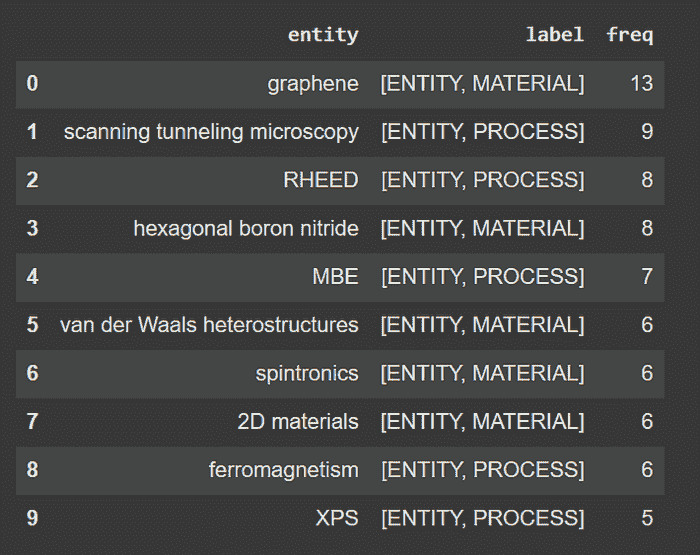

我们语料库中的十大热门材料和过程

最受欢迎的作者可以使用相同的推理来获得,以下是查询语句:

neo4j_query("""

MATCH (a:AUTHOR)-[]-(ar:ARTICLE)-[]-(j:JOURNAL)

RETURN a.name as author, count(*) as freq

ORDER BY freq DESC

LIMIT 10

""")

现在,共现分析是计算文档中一对实体的出现次数。例如,我们想知道某个过程和某种材料在同一篇文章中一共提到了多少次。

neo4j_query("""

MATCH (m:MATERIAL)<-[:MENTIONS]-(a:ARTICLE)-[:MENTIONS]->(p:PROCESS)

WHERE id(m) < id(p)

RETURN m.name as MATERIAL, p.name as PROCESS, count(*) as cooccurrence

ORDER BY cooccurrence

DESC LIMIT 5

""")

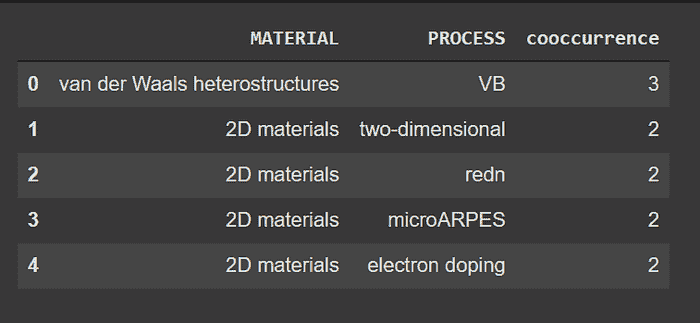

共现分析输出

我们可以看到,材料范德华异质结构和术语 VB 在整个语料库中一共提到了三次。VB 是价带(Valence Band)的缩写,表示电子可以跃迁到导带的最高能量,它在范德华结构中扮演着重要角色。通过我们的知识图谱,我们在没有任何先验知识的情况下语义上发现了这种相关性!这样的分析可以帮助我们发现科学概念之间的新连接和未曾发现的关联。

最后,我们希望找到两个给定作者之间的最短路径,为此,我们将每个作者与他们各自的 ID 匹配,使用预定义的函数 shortestPath 作为输入,然后得到结果。我们直接在 Neo4j 浏览器上运行了这个查询,以便获得图形图片。

MATCH (a1:AUTHOR ),

(a2:AUTHOR ),

p = shortestPath((a1)-[*]-(a2))

where a1.id = '6a2552ac2861474da7da6ace1240b92509f56a6ec894d3e166b3475af81e65ae' AND a2.id='3b7d8b78fc7b097e2fd29c2f12df0abc90537971e2ac5c774d677bcdf384a3b7'

RETURN p

作者提供的图片:两个给定作者之间的最短路径

有趣的是,我们可以预测这两位作者可能需要一个共同的文章来进行研究,或者他们实际上可以以某种形式合作。可视化有意义的关系在做出明智决策时至关重要。

结论

这展示了将命名实体识别与知识图谱结合在文本挖掘中的力量。我们没有深入细节,因为我们想更多地展示处理文本语义分析的工作流程。希望你已经学到了一些东西,未来我们将深入探讨更多内容!

如果你有任何问题或想为你的具体情况创建自定义模型,请在下方留言或通过电子邮件联系 admin@ubiai.tools。

在 Twitter 上关注我们 @UBIAI5

简介:Khaled Adrani 是一名计算机科学工程师及 UBIAI 实习生。

原文。经许可转载。

相关:

-

使用 AWS 云上的 ML 构建无服务器新闻数据管道

-

关键短语提取的元学习

-

NLP 中不同词嵌入技术的终极指南

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 相关工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 相关工作

更多相关话题

使用 Spark、Optimus 和 Twint 进行几分钟内的推文分析

原文:

www.kdnuggets.com/2019/05/analyzing-tweets-nlp-spark-optimus-twint.html/2

comments

comments

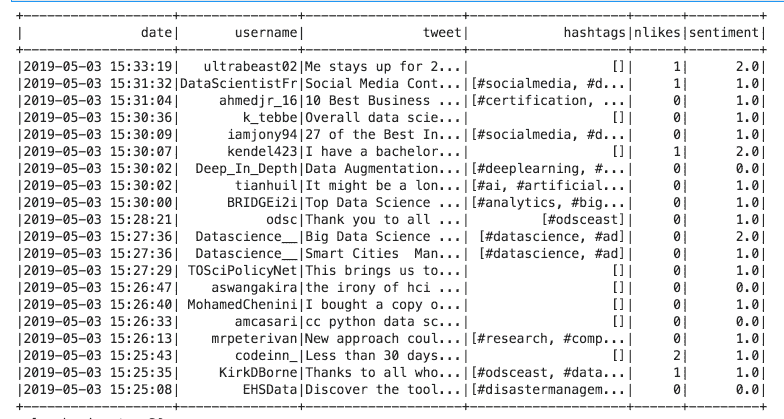

直接将情感添加到 Spark 数据框中

将这段代码转换为 Spark 代码很简单。这段代码可以帮助你转换其他代码。所以让我们开始导入 Spark 的用户定义函数模块:

from pyspark.sql.functions import udf

然后我们将把上面的代码转换为一个函数:

def apply_blob(sentence):

temp = TextBlob(sentence).sentiment[0]

if temp == 0.0:

return 0.0 # Neutral

elif temp >= 0.0:

return 1.0 # Positive

else:

return 2.0 # Negative

之后我们将把函数注册为 Spark UDF:

sentiment = udf(apply_blob)

那么,要将函数应用于整个数据框,我们需要写:

clean_tweets.withColumn("sentiment", sentiment(clean_tweets['tweet'])).show()

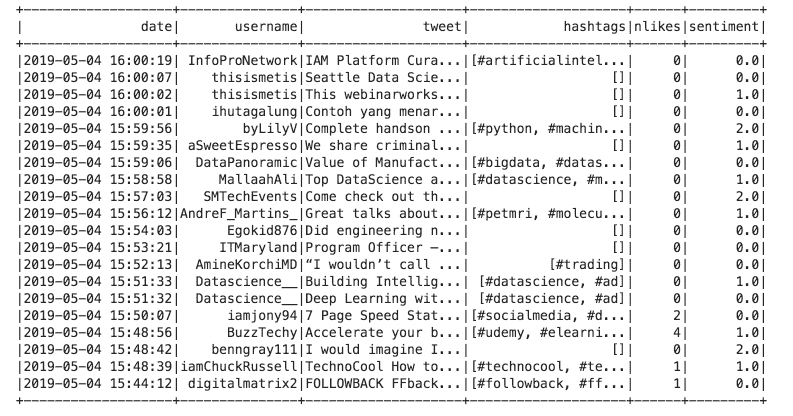

我们将看到:

情感分析,好的程序员方式(使代码模块化)

这实际上不是优质代码。让我们将其转换为函数,以便反复使用。

第一部分是设置一切:

%load_ext autoreload

%autoreload 2

# Import twint

import sys

sys.path.append("twint/")

# Set up TWINT config

import twint

c = twint.Config()

# Other imports

import seaborn as sns

import os

from optimus import Optimus

op = Optimus()

# Solve compatibility issues with notebooks and RunTime errors.

import nest_asyncio

nest_asyncio.apply()

# Disable annoying printing

class HiddenPrints:

def __enter__(self):

self._original_stdout = sys.stdout

sys.stdout = open(os.devnull, 'w')

def __exit__(self, exc_type, exc_val, exc_tb):

sys.stdout.close()

sys.stdout = self._original_stdout

最后一部分是一个类,它将移除 Twint 的自动打印,因此我们只看到数据框。

上述所有内容可以总结为这些函数:

from textblob import TextBlob

from pyspark.sql.functions import udf

from pyspark.sql.types import DoubleType

# Function to get sentiment

def apply_blob(sentence):

temp = TextBlob(sentence).sentiment[0]

if temp == 0.0:

return 0.0 # Neutral

elif temp >= 0.0:

return 1.0 # Positive

else:

return 2.0 # Negative

# UDF to write sentiment on DF

sentiment = udf(apply_blob, DoubleType())

# Transform result to pandas

def twint_to_pandas(columns):

return twint.output.panda.Tweets_df[columns]

def tweets_sentiment(search, limit=1):

c.Search = search

# Custom output format

c.Format = "Username: {username} | Tweet: {tweet}"

c.Limit = limit

c.Pandas = True

with HiddenPrints():

print(twint.run.Search(c))

# Transform tweets to pandas DF

df_pd = twint_to_pandas(["date", "username", "tweet", "hashtags", "nlikes"])

# Transform Pandas DF to Optimus/Spark DF

df = op.create.data_frame(pdf= df_pd)

# Clean tweets

clean_tweets = df.cols.remove_accents("tweet") \

.cols.remove_special_chars("tweet")

# Add sentiment to final DF

return clean_tweets.withColumn("sentiment", sentiment(clean_tweets['tweet']))

所以要获取推文并添加情感,我们使用:

df_result = tweets_sentiment("data science", limit=1)

df_result.show()

就这样 😃

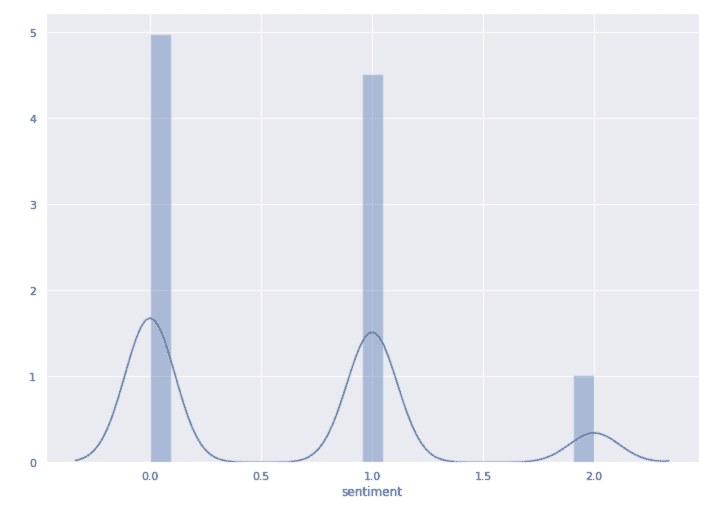

让我们看看情感的分布:

df_res_pandas = df_result.toPandas()

sns.distplot(df_res_pandas['sentiment'])

sns.set(rc={'figure.figsize':(11.7,8.27)})

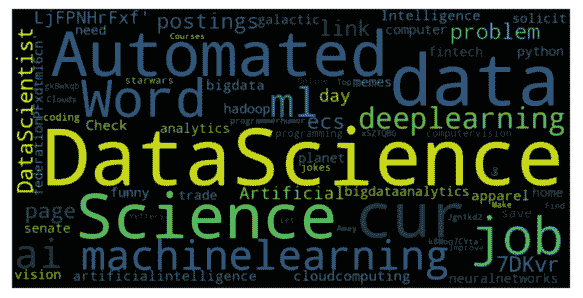

使用 Twint 做更多事情

要查看如何做,请访问:

要查看如何做,请访问:amueller.github.io/word_cloud/auto_examples/masked.html

我们可以做更多的事情,这里我将展示如何创建一个简单的函数来获取推文,以及如何从中构建词云。

所以要从简单的搜索中获取推文:

def get_tweets(search, limit=100):

c = twint.Config()

c.Search = search

c.Limit = limit

c.Pandas = True

c.Pandas_clean = True

with HiddenPrints():